Prac przedk adam do oceny

Data:

Podpis autora pracy:

Praca jest gotowa do oceny przez recenzenta

Data:

Podpis kieruj cego prac :

Streszczenie

W ramach niniejszej pracy zaprojektowano i zaimplementowano nowy modu do

obs ugi klastra dla serwera WWW Jakarta-Tomcat. W cz ci pisemnej pracy

przedstawiono definicj klastra, podstawowe funkcje, które musi on spe nia w

kontek cie serwerów WWW oraz problemy, które trzeba rozwi za w czasie jego

implementacji. Na cz

praktyczn sk ada si realizacja przedstawionego projektu

oraz wykonanie testów wydajno ci stworzonego modu u, ukazuj cych jego wady i

zalety w praktycznych zastosowaniach.

S owa kluczowe

Klaster, Java, komunikacja sieciowa, aplikacja internetowa, serwer WWW, HTTP,

HTTPS

Klasyfikacja tematyczna

C. Computer Systems Organization

C.2 COMPUTER-COMMUNICATION NETWORKS

C.2.4 Distributed Systems

Spis tre ci

Spis tre ci .......................................................................................................................5

1

Wst p .....................................................................................................................7

2

Klastry....................................................................................................................8

2.1

Definicja.........................................................................................................8

2.1.1

Klaster o wysokiej wydajno ci ..............................................................8

2.1.2

Klaster równowa cy obci enie...........................................................8

2.1.3

Klaster odporny na awarie .....................................................................9

2.2

Rozwój systemów klastrowych......................................................................9

2.3

Klastry w serwerach WWW ........................................................................10

2.3.1

Wyst puj ce problemy.........................................................................10

2.3.2

Stosowane rozwi zania........................................................................10

3

Jakarta-Tomcat 5.0...............................................................................................13

3.1

Rozwój serwera Jakarta-Tomcat..................................................................13

3.2

G ówne za o enia koncepcyjne....................................................................13

3.3

Opis implementacji ......................................................................................14

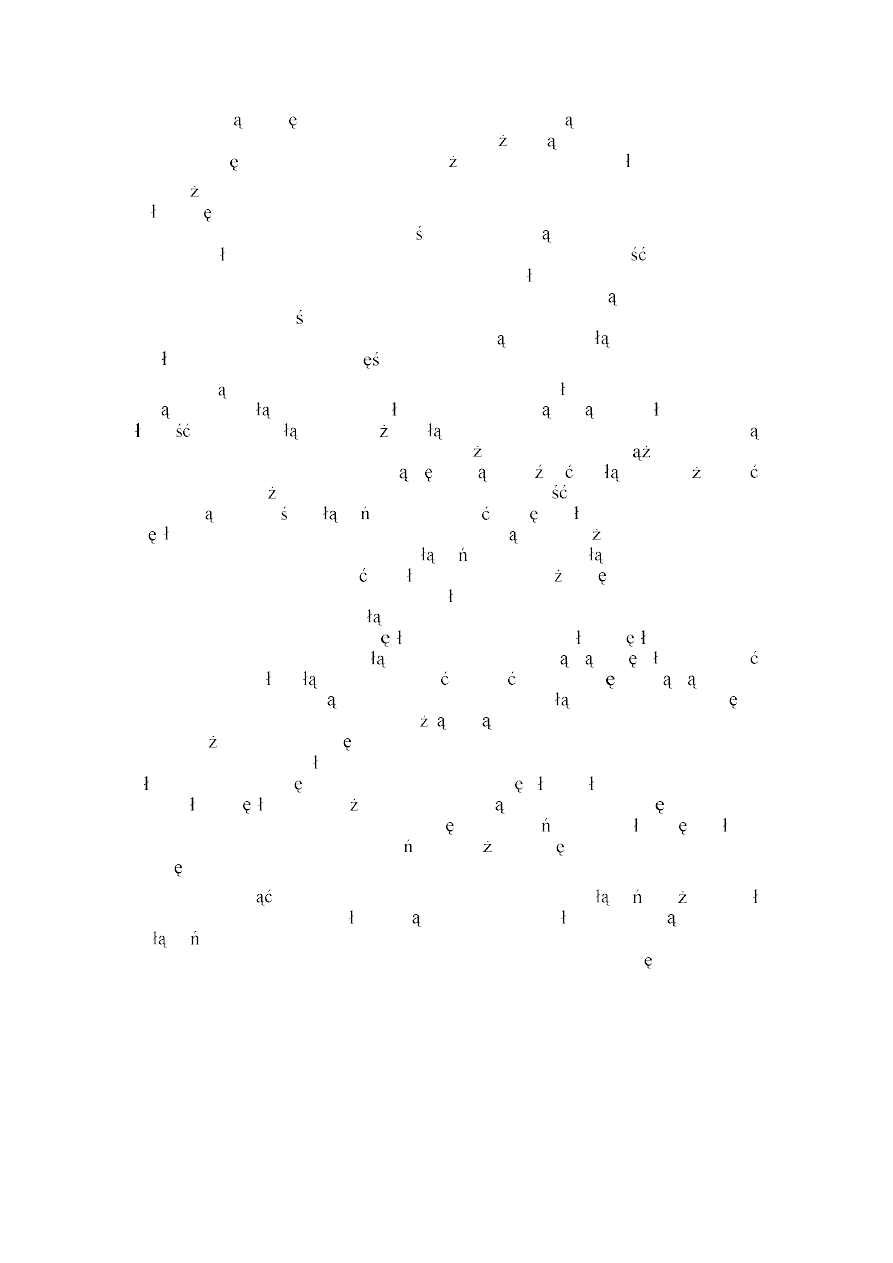

3.3.1

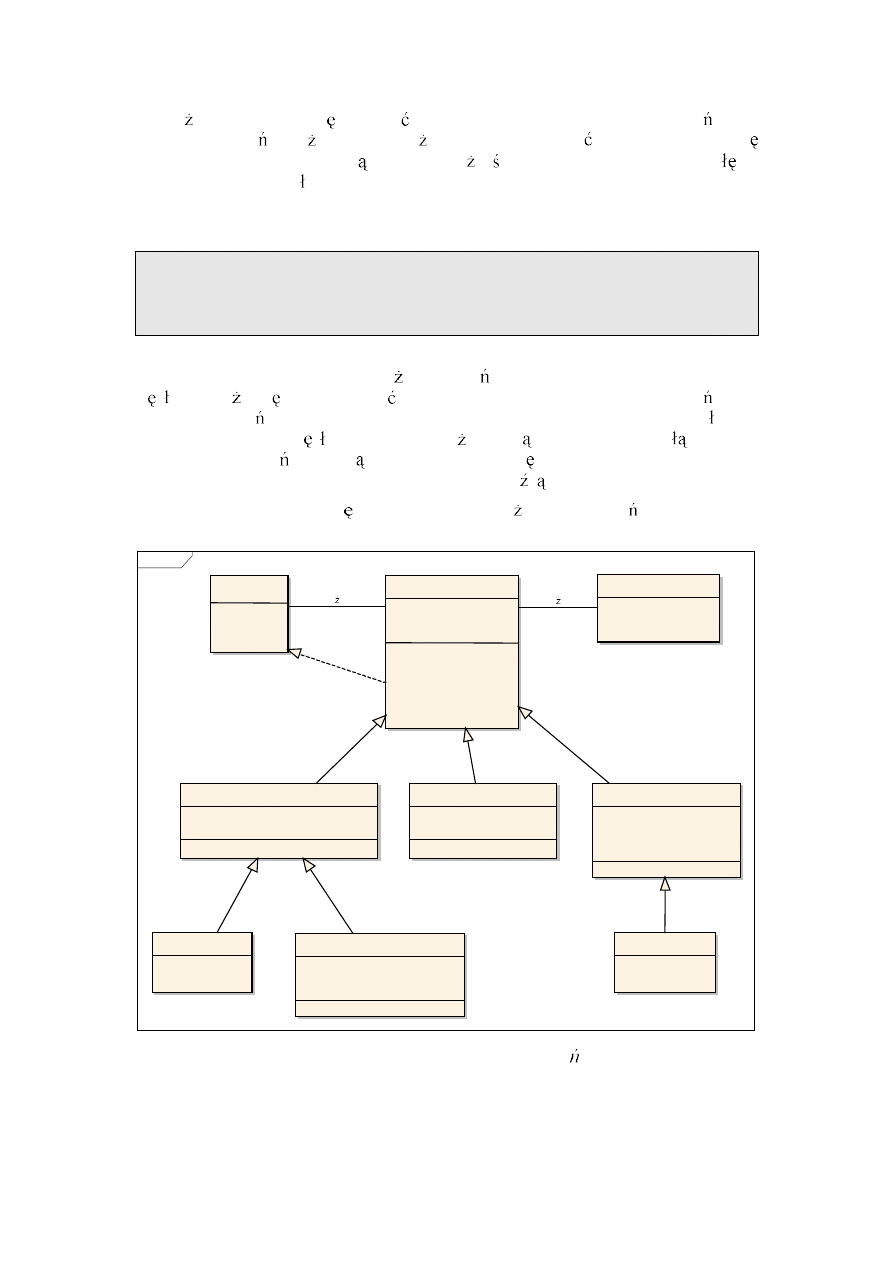

Hierarchia obiektów.............................................................................14

3.3.2

Strumie przetwarzania da .............................................................16

3.3.3

Wyzwalacze .........................................................................................16

3.4

Implementacja klastra w serwerze Tomcat 5.0............................................17

3.4.1

Klaster dla wersji 4.0 ...........................................................................17

3.4.2

Architektura klastra w wersji 5.0 .........................................................17

3.4.3

Implementacja klastra w wersji 5.0 .....................................................18

3.4.4

Konfiguracja klastra w wersji 5.0 ........................................................21

3.4.5

Zalety rozwi zania ...............................................................................22

3.4.6

Wady rozwi zania................................................................................23

4

Nowy klaster dla serwera Jakarta-Tomcat ...........................................................25

4.1

Architektura i za o enia koncepcyjne..........................................................25

4.1.1

Koncepcja centralnego sterowania ......................................................25

4.1.2

Podzia na warstwy ..............................................................................26

4.1.3

Wersjonowanie sesji ............................................................................27

4.1.4

Zintegrowany mechanizm równowa enia obci enia .........................27

4.1.5

Bezpiecze stwo....................................................................................28

4.2

Dzia anie systemu ........................................................................................28

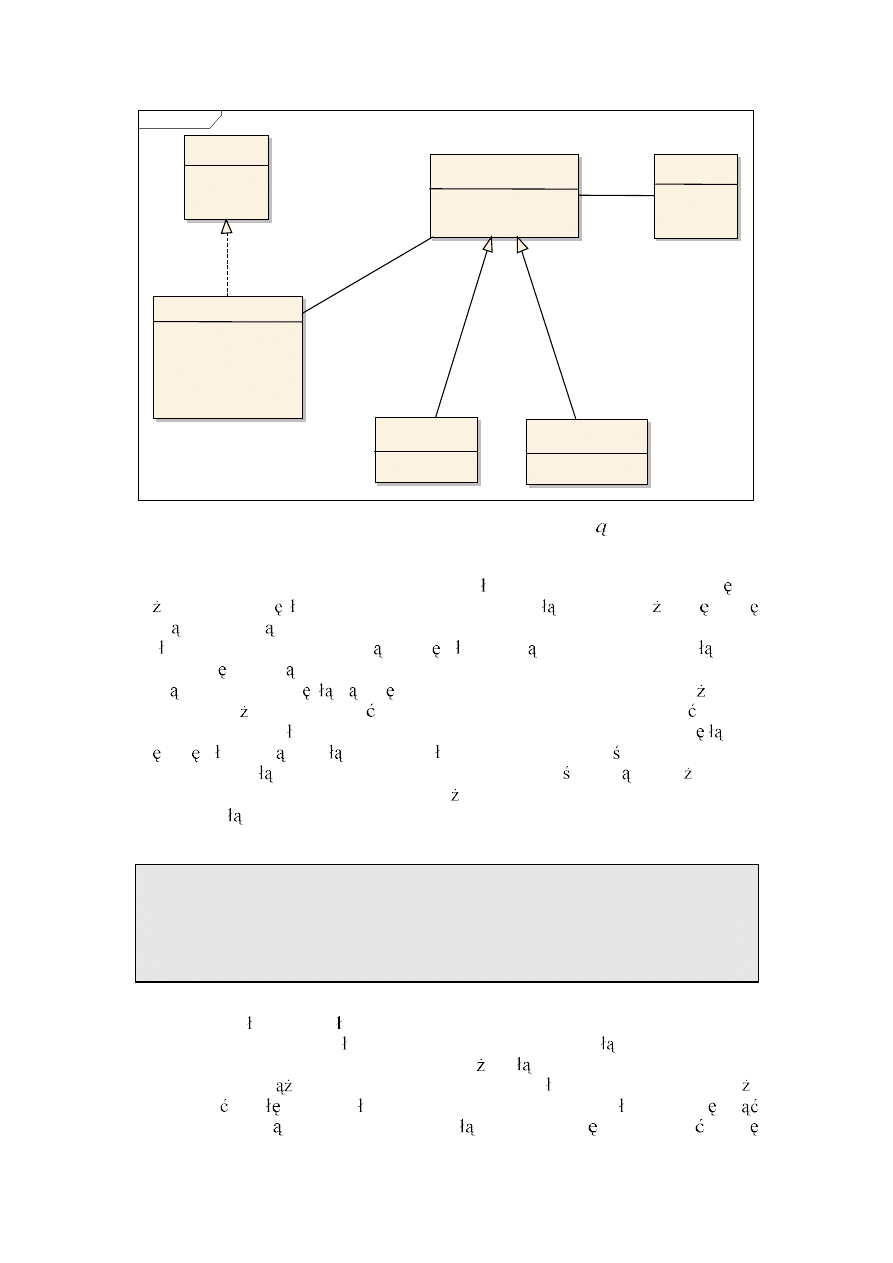

4.2.1

Do czanie nowego w z a....................................................................29

4.2.2

Awaria po czenia................................................................................31

4.2.3

Awaria w z a .......................................................................................32

4.2.4

Awaria serwera zarz dcy .....................................................................33

4.3

Implementacja..............................................................................................34

4.3.1

Warstwa transportuj ca........................................................................35

4.3.2

Komunikacja w klastrze.......................................................................39

4.3.3

Mechanizm kolejki zada zale nych ...................................................41

4.3.4

Buforowanie.........................................................................................45

4.3.5

Algorytm przetwarzania dania .........................................................47

4.3.6

Serwer zarz dca ...................................................................................51

4.3.7

Serwer ruchu ........................................................................................53

4.4

Konfiguracja klastra.....................................................................................54

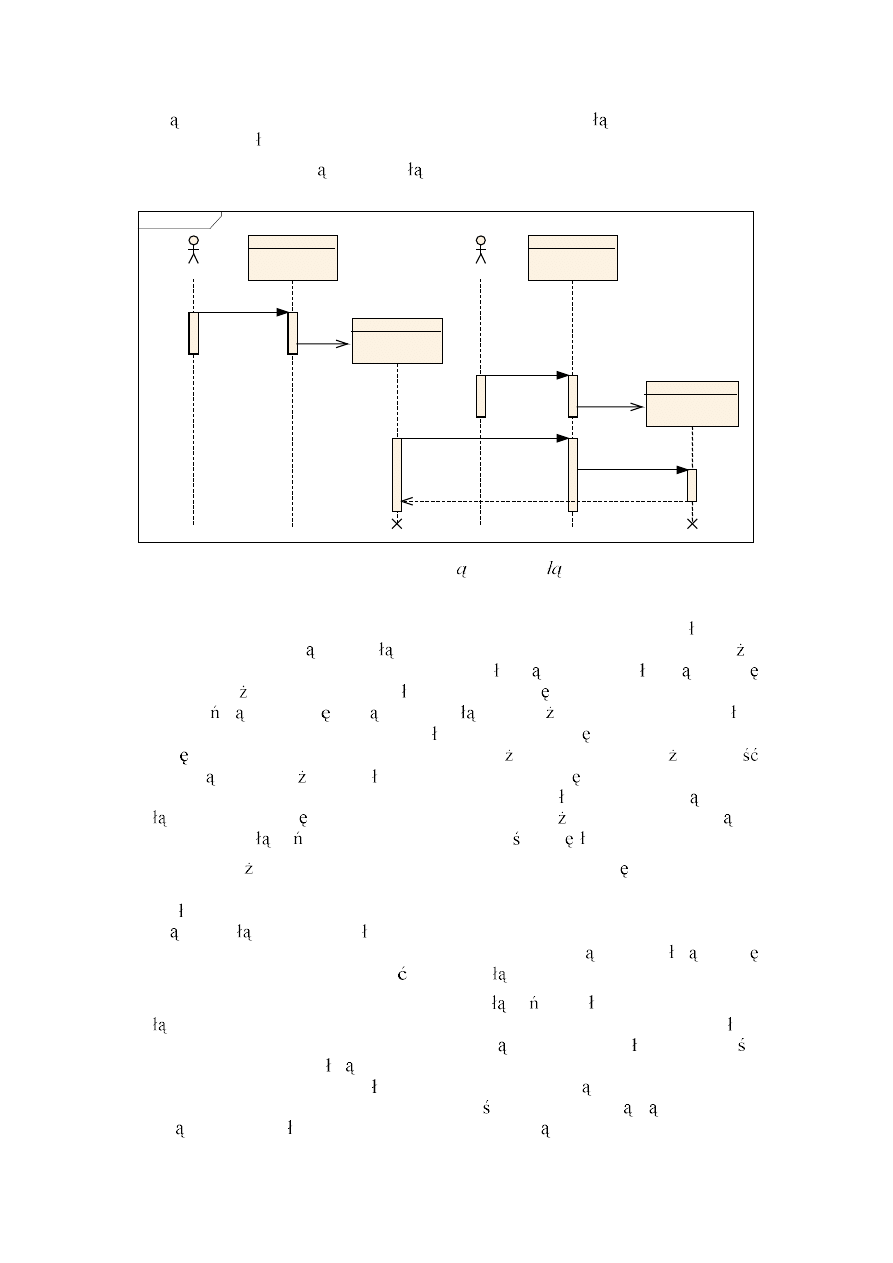

4.4.1

Koncepcja dwóch sieci ........................................................................56

5

4.4.2

Mo liwe konfiguracje przy wykorzystaniu HTTPS ............................56

5

Testy wydajno ci .................................................................................................58

5.1

Test poprawno ci .........................................................................................59

5.2

Test wydajno ci ...........................................................................................61

5.3

Test HTTPS .................................................................................................62

6

Mo liwe rozszerzenia ..........................................................................................64

6.1

Algorytm elekcji ..........................................................................................64

6.2

Podzia klastra na podgrupy.........................................................................64

6.3

Zmniejszanie ilo ci przesy anych informacji...............................................65

6.4

Implementacja interfejsu u ytkownika do zarz dzania klastrem ................65

6.5

Rozbudowa serwera ruchu ...........................................................................66

7

Podsumowanie .....................................................................................................67

Dodatek A Opis za czników.......................................................................................68

Bibliografia ..................................................................................................................69

6

1 Wst p

W dzisiejszych czasach us ugi informatyczne zdominowa y zarówno wiat

biznesu, jak i prywatne ycie zwyk ych ludzi. Internet spopularyzowa systemy

komputerowe do tego stopnia, e zaczynaj one wypiera tradycyjne metody

przetwarzania informacji ze wszystkich dziedzin ycia. W wiecie WWW mo na

skorzysta ze s ownika, obejrze mapy, szybko i komfortowo wyszuka dowolne

interesuj ce nas dane.

Jak atwo si domy le wraz z popularno ci systemów informatycznych wzros a

liczba ich potencjalnych u ytkowników, co bezpo rednio wi e si z potrzeb

zwi kszenia mocy obliczeniowej. Firmy prze cigaj si w ofertach du ych,

wieloprocesorowych maszyn, które umo liwi yby obs ug tysi cy czy nawet

milionów u ytkowników na sekund . Niestety koszt takiej maszyny bardzo cz sto

przekracza bud et ma ych czy rednich firm, które maj dobre pomys y, ale brakuje

im odpowiednich funduszy, aby je zrealizowa . W takiej sytuacji idealnym

rozwi zaniem mo e okaza si po czenie wielu zwyk ych, niedrogich komputerów,

które wspólnie umo liwi obs ug du ej liczby klientów. Aby taka architektura mog a

rozwi za problem zwi kszonego zapotrzebowania na moc obliczeniow w sposób

niewidoczny

dla

ko cowego

u ytkownika,

niezb dne

jest

odpowiednie

oprogramowanie.

W swojej pracy przedstawi pomys stworzenia modu u wspieraj cego

rozproszone przetwarzanie danych (klaster) dla bardzo popularnego serwera WWW

Jakarta-Tomcat. W pierwszej cz ci zostanie przedstawiona koncepcja klastra (por.

rozdz. 2) oraz opisany sposób dzia ania Tomcata (por. rozdz. 3). W drugiej cz ci

pracy przedstawi zrealizowany przeze mnie modu klastra (por. rozdz. 4) wraz z

testami jego wydajno ci (por. rozdz. 5). Mo liwe rozszerzenia opisuj w rozdz. 6.

W pracy prezentuj pozytywne strony wykorzystania modelu replikowania

ka dy do ka dego. Wykazuj , e dobrze zaimplementowany modu mo e okaza

si bezpieczniejszy i wydajniejszy od modelu serwer macierzysty, serwer kopii.

Oczywi cie implementacja jest znacznie bardziej skomplikowana (pojawia si

problem synchronizowania dost pu do sesji) niemniej jednak zysk jaki mo na

osi gn stosuj c ten model w przypadku protoko u HTTPS rekompensuje trudy

implementacji modu u.

7

2 Klastry

2.1 Definicja

W literaturze fachowej pojawia si nast puj ca definicja klastra:

Klaster to zbiór niezale nych komputerów (w z ów), po czonych

sieci komunikacyjn , które z punktu widzenia u ytkownika

sprawiaj wra enie pojedynczego systemu (komputera) [2].

G ównym zadaniem jakie stawia si klastrom jest zwi kszenie szybko ci,

niezawodno ci i dost pno ci systemów informatycznych. Rozdzielaj c obci enie

jednej maszyny na ca farm maszyn otrzymuje si zrównoleglenie oblicze ,

niewidoczne dla ko cowego u ytkownika. W systemach, które obs uguj tysi ce lub

nawet miliony u ytkowników na sekund rozdzielenie obci enia na wiele fizycznych

maszyn mo e okaza si jedynym mo liwym rozwi zaniem problemu wydajno ci i

zapewnienia ci g ej pracy systemu.

Bardzo wa n cech , która cz sto powoduje,

e administratorzy du ych

systemów decyduj si na instalacj klastra jest jego odporno na awarie pojedynczej

maszyny. Je eli klaster zapewnia mechanizm niewidocznej dla u ytkownika obs ugi

awarii w z a (ang. fail-over), to zastosowanie architektury korzystaj cej z wielu

maszyn fizycznych mo e by jedynym sposobem uzyskania niezawodno ci systemu

informatycznego. W przypadku awarii w z a klaster zapewnia przeniesienie

kontekstu wykonania na inny serwer, a ko cowy u ytkownik mo e si nie

zorientowa , e nast pi a awaria, gdy zachowa swoje dane. Ponadto nie mniej wa n

zalet jest skalowalno rozwi za wykorzystuj cych klaster. W momencie, gdy

administrator zaczyna zauwa a spadek mocy obliczeniowej systemu mo e pod czy

kolejn maszyn , zwi kszaj c przepustowo klastra. Z drugiej strony je eli oka e

si , e system nie wykorzystuje w pe ni zasobów sprz towych, to cz

maszyn

mo na od czy od klastra, wykorzystuj c je w innych systemach, na dan chwil

bardziej wymagaj cych.

W szczególno ci wyró nia si trzy rodzaje klastrów:

1. Klaster o wysokiej wydajno ci (ang. high performance cluster),

2. Klaster równowa cy obci enie (ang. load balancing cluster),

3. Klaster odporny na awarie (ang. fail over cluster).

W ka dym z trzech rodzajów klastrów k adzie si nacisk na inne aspekty

zwi zane z systemami informatycznymi lub sprz tem. W kolejnych podrozdzia ach

umieszczono krótk charakterystyk ka dego z wymienionych rodzajów.

2.1.1 Klaster o wysokiej wydajno ci

Zadaniem klastra o wysokiej wydajno ci jest maksymalizowanie mocy

obliczeniowej, któr mo na uzyska tworz c farm maszyn. Przy implementacji

g ówny nacisk k adzie si na wydajno systemu (co cz sto wi e si równie z

drugim rodzajem klastra czyli klastrem równowa cym obci enie).

2.1.2 Klaster równowa

cy obci

enie

Klaster równowa cy obci enie jest instalowany w celu zapewnienia równego

podzia u zada na wszystkie maszyny w klastrze. Tego typu klaster instaluje si w

systemach, w których bardzo istotny jest czas reakcji na

danie klienta. Klaster

8

minimalizuje wariancj czasu oczekiwania na odpowied od systemu. Jest

odpowiedzialny za wykorzystywanie wszystkich swoich zasobów sprz towych w

równym stopniu, eliminuj c sytuacje, gdzie jedno

danie od klienta trafia do

ca kowicie niewykorzystywanego w z a i jego obs uga trwa kilka sekund, a inne

trafia do mocno obci onego w z a i obs uga trwa kilkadziesi t sekund. Najbardziej

wyspecjalizowane systemy podczas wyboru w z a do obs ugi

dania bior pod

uwag statystyki obci enia maszyny (zu ycie procesora, dysków, pami ci) z

ostatnich kilku sekund i na tej podstawie okre laj jego potencjaln moc przerobow .

Niemniej jednak mniej wyrafinowane algorytmy w przypadku wielu systemów s

wystarczaj co skuteczne. Przyk adem jest najcz ciej stosowany algorytm

karuzelowy (ang. Round Robin), który ka de kolejne

danie wysy a do nast pnego

w z a, w pewnym z góry ustalonym cyklu.

2.1.3 Klaster odporny na awarie

Zadaniem klastra odpornego na awarie jest zapewnienie niezawodno ci systemu,

nawet w przypadku fizycznych b d programowych awarii. Klaster w zale no ci od

stopnia zaawansowania mo e obs ugiwa odpowiednio du y procent awarii w z ów

bez utraty danych oczywi cie dania przetwarzane w momencie awarii mog cz

danych utraci . Odporno na awarie w z ów uzyskuje si w dwojaki sposób: na

poziomie sprz tu oraz programowo.

Ka d niezb dn z punktu widzenia funkcjonowania systemu maszyn duplikuje

si i w przypadku awarii duplikat przejmuje rol podstawowej maszyny. Niemniej

jednak takie rozwi zanie nie gwarantuje nam, e dane u ytkowników trzymane w

pami ci operacyjnej maszyny nie zostan utracone podczas awarii. Dlatego w

systemach przechowuj cych dane zwi zane z sesj u ytkownika stosuje si

programowe wsparcie dla mechanizmów automatycznego wykrywania i obs ugi

awarii. Najcz ciej spotykane rozwi zania to zapis danych na no niku fizycznym (na

przyk ad w bazie danych) lub replikacja danych w obr bie w z ów klastra. Oba

rozwi zania maj swoje wady i zalety. Zapis danych w bazie umo liwia ich

odzyskanie nawet po awarii ca ego klastra, ale powoduje du y narzut przy obs udze

da klientów. Replikacja uniemo liwia odzyskanie danych przy awarii ca ego

klastra, ale daje du e mo liwo ci równowa enia obci enia kontekst danego

u ytkownika nie musi by na sta e powi zany z w z em, na którym zacz si

wykonywa jego program.

2.2 Rozwój systemów klastrowych

Pierwsze udane próby stworzenia klastra si gaj 1968 roku. Grupa naukowców

na Uniwersytecie Illinois w ramach projektu ILLIAC IV [2] stworzy a klaster

umo liwiaj cy po czenie setek, a nawet tysi cy w z ów w jeden superkomputer. W

czasie realizacji projektu pojawi o si wiele problemów, jednak mimo to idea

przetrwa a. W pó niejszych latach programi ci odeszli od koncepcji równoleg ego

przetwarzania, co wi za o si z przekonaniem, e skoro w ci gu dziewi ciu miesi cy

szybko mikroprocesora podwaja si , to nie ma potrzeby pisania skomplikowanego

oprogramowania wspieraj cego klastry, w celu zwi kszenia mocy obliczeniowej.

Pr dzej czy pó niej technologia dogoni wymagania programów.

Koncepcja klastrów obroni a si jednak przed p dz cym rozwojem technologii.

W ci gu ostatnich kilkunastu lat firmy zacz y bardzo ywo interesowa si

tworzeniem oprogramowania (szczególnie du ych serwisów i baz danych) w

rodowisku rozproszonym, z o onym z wielu fizycznie niezale nych maszyn.

9

Okazuje si , e w dzisiejszych czasach wa niejsza staje si gwarancja niezawodno ci

oraz dost pno ci (ang. high availability) systemu od jego wydajno ci. Wydajno

mo na uzyska kupuj c wieloprocesorow maszyn , jednak nikt nie zagwarantuje, e

taka maszyna b dzie dzia a a non-stop przez wiele lat. Instaluj c klaster firma ma

pewno , e nawet w przypadku awarii jednego z w z ów system wci b dzie

dost pny.

Innym aspektem powoduj cym wzmo one zainteresowanie klastrami jest ich

skalowalno . Cz sto liczba u ytkowników ko cowych systemu jest niemo liwa do

oszacowania (szczególnie, je eli system jest dost pny w Internecie jako serwer

WWW). Bez tej wiedzy projektanci systemu nie s w stanie z góry okre li niezb dn

moc obliczeniow , która pozwoli u ytkownikom systemu na wygodn prac .

Skalowalno i niezawodno klastrów powoduje, e staj si one bardzo atrakcyjne

dla twórców takich systemów.

2.3 Klastry w serwerach WWW

Wi kszo du ych systemów informatycznych tworzonych w dzisiejszych

czasach w jakim stopniu korzysta z serwerów WWW. Wynika to z ogromnej rzeszy

potencjalnych u ytkowników systemu znajduj cej si w Internecie, a tak e z jasno

wyznaczonych standardów, które takie serwery spe niaj . Pisz c interfejs

u ytkownika jako strony HTML mamy pewno , e klient b dzie w stanie korzysta z

serwisu na dowolnej platformie, bez potrzeby doinstalowywania lokalnie

dodatkowych komponentów.

Popularno protoko u HTTP spowodowa a masowe wykorzystywanie go nawet

w przypadku aplikacji nie bazuj cych na j zyku HTML. Standardy takie jak serwisy

sieciowe (ang. web-services) czy XML bardzo cz sto id w parze ze stosunkowo

prostym schematem programowania w serwerach WWW.

Wraz ze wzrostem popularno ci serwerów WWW pojawi a si potrzeba

zapewnienia ich niezawodno ci, co wi e si z koncepcj klastrów. W kolejnym

punkcie zostan na wietlone g ówne problemy, które mog pojawi si przy

implementowaniu klastra na potrzeby serwerów WWW.

2.3.1 Wyst puj ce problemy

Ze wzgl du na specyfik serwerów WWW nale y przeanalizowa cele jakie

musi realizowa klaster. W przypadku serwera (lub aplikacji) bezstanowej jedynym

zadaniem klastra b dzie równowa enie obci enia i detekcja wadliwych w z ów, w

celu zapobiegni cia przes aniu zadania do niesprawnej maszyny.

Je eli serwer, b d zainstalowana na nim aplikacja, przechowuj informacj o

swoim stanie (sesja u ytkownika), to klaster musi zapewnia mechanizm

odzyskiwania danych w przypadku awarii.

Spotyka si bardzo ró ne rozwi zania tych problemów w serwerach

komercyjnych. Aby uzyska niezawodno , w niektórych rozwi zaniach stosuje si

zapis danych na no nikach fizycznych, a w innych wykorzystuje si mechanizm

replikacji danych pomi dzy w z ami klastra.

2.3.2 Stosowane rozwi zania

W dzisiejszych czasach w zasadzie ka dy komercyjny serwer WWW mo e

pracowa jako klaster, co zosta o wymuszone przez rynek. Dla osoby zajmuj cej si

10

projektem informatycznym od strony biznesowej s owa takie jak skalowalno czy

odporno na awarie sta y si wyznacznikiem jako ci rozwi za informatycznych.

Ka da licz ca si na rynku firma stara si przekona swoich klientów,

e

implementacja ich klastra jest najlepsza i zapewnia najwi ksz niezawodno . W

pracy zostan omówione dwa przyk adowe rozwi zania zastosowane w komercyjnych

serwerach wspieraj cych standard J2EE (Java 2 Enterprise Edition). Uwaga zostanie

skupiona na mechanizmach zabezpiecze zapobiegaj cych utracie danych sesji

u ytkownika. Celowo zostanie pomini ta cz

zwi zana z EJB (Entity Java Beans)

oraz JMS (Java Messaging Service), jako nie zwi zana z prac .

2.3.2.1 BEA Weblogic Server 8.0

Serwer Weblogic firmy Bea jest uznawany za najlepiej przystosowany do

dzia ania w klastrze serwer J2EE [1]. Autorzy klastra zaproponowali architektur

z o on z maszyny równowa cej obci enie (programowo lub sprz towo) oraz

po czonych sieci w z ów klastra z zainstalowanym serwerem Weblogic [10].

Architektura jest w pe ni zdecentralizowana, to znaczy nie ma serwera, który

nadzorowa by prac ca ego klastra. W ze do cza do klastra wysy aj c w trybie

rozg oszeniowym komunikat w sieci powiadamiaj cy pozosta e komputery o swoim

istnieniu. Je eli która z maszyn przestanie wysy a regularne komunikaty w trybie

rozg oszeniowym (tzw. heartbeats), to pozosta e uznaj , e nast pi a w niej awaria i

przejm jej zadania.

Ka da sesja u ytkownika posiada swój serwer macierzysty oraz serwer

zast pczy. Identyfikatory obu w z ów klastra s zaszyte w nazwie ciasteczka (ang.

cookie) okre laj cego numer sesji u ytkownika.

Domy lnie ka de

danie od klienta jest przekierowywane do macierzystego

w z a sesji (czyli w z a, na którym sesja zosta a utworzona). Wybór miejsca

przekierowania nast puje w serwerze rozdzielaj cym

dania. W przypadku awarii

w z a macierzystego serwer równowa cy przekierowuje

danie do w z a

zast pczego, który zawiera pe n kopi danych z sesji. W ze zast pczy przejmuje

rol macierzystego i wybiera inny w ze jako zast pczy. Jednocze nie zmienia

identyfikator sesji, aby kolejne dania by y kierowane do niego.

Niestety w przypadku awarii dwóch w z ów w sieci dane replikowane mi dzy

nimi zostaj bezpowrotnie utracone.

Drug znacz c wad tego rozwi zania jest s abe równowa enie obci enia w

klastrze. Ka dy u ytkownik jest na sta e przypisany do konkretnego serwera i dopiero

w momencie awarii zostaje przekierowany do innego. Czyli w ogólno ci nowo

dodany w ze w sieci nie przejmie obci enia od pozosta ych maszyn, a jedynie

zacznie obs ugiwa nowych u ytkowników. W razie awarii w z a wszystkie jego

sesje zostan przej te przez pozosta e maszyny, a po ponownym uruchomieniu nie

b dzie on w stanie z powrotem przej obci enia. W praktyce mo e to doprowadzi

do efektu domina: kolejny serwer przestaje odpowiada z powodu coraz wi kszej

liczby obs ugiwanych u ytkowników zwi kszanej wraz z ka d kolejn awari .

Przy takim podej ciu administrator systemu ma du o mniej czasu na w czenie

kolejnej maszyny do klastra, je eli zobaczy, e obci enie zaczyna przerasta

mo liwo ci klastra. Je eli si spó ni, to u ytkownicy, którzy zalogowali si przed

do czeniem nowego w z a nie b d w stanie komfortowo pracowa .

11

2.3.2.2 Sybase Enterprise Application Server

Projektanci klastra z firmy Sybase [9] oferuj dwa rozwi zania problemu

przechowywania stanu sesji. Jedno z nich korzysta z bazy danych, a drugie, podobnie

jak w serwerze Bea Weblogic, replikuje stan sesji pomi dzy dwoma wybranymi

w z ami.

W pierwszym rozwi zaniu autorzy stworzyli system scentralizowany, w którym

w rodku klastra znajduje si w ze z baz danych zapisuj cy stan wszystkich sesji. W

przypadku awarii jakiego w z a stan obs ugiwanych przez niego sesji zosta

wcze niej zapisany na fizycznym no niku i mo e by odzyskany przez inne maszyny.

Niestety baza danych jest w skim gard em tego rozwi zania. Zapisanie

informacji na fizycznym no niku jest bardzo kosztowne (trwa d u ej ni przes anie

danych przez sie ). Zapis trzeba wykonywa po obs udze ka dego

dania co mo e

doprowadzi do zatkania serwera kopii zapasowej i w rezultacie braku mechanizmu

odzyskiwania danych po awarii.

Dodatkowo dochodzi tu problem wydajno ci silnika bazy danych je eli

zostanie stworzony klaster sk adaj cy si z wielu maszyn i ka da z nich b dzie

zapisywa a stan swoich sesji w bazie, to mo e si okaza , e wydajno ca o ci zale y

nie od liczby w z ów w sieci, ale od mo liwo ci serwera z baz danych.

Niew tpliw zalet rozwi zania jest mo liwo odzyskania stanu sesji nawet po

awarii ca ego klastra (wszystkich w z ów, w cznie z baz danych). Informacje s

zapisane na fizycznym no niku, wi c zawsze mo na je odzyska .

Drugie rozwi zanie jest bardzo podobne do rozwi zania firmy Bea.

12

3 Jakarta-Tomcat 5.0

Serwer Jakarta-Tomcat [8] jest darmowym serwerem WWW z ogólnodost pnym

kodem ród owym. Umo liwia on tworzenie dynamicznych stron w oparciu o

standardy Java (serwlety i strony JSP). Pomimo bardzo pr nego rozwoju serwera

wci brakuje w nim w pe ni funkcjonalnego i dzia aj cego klastra. Twórcy Tomcata

dostrzegli ju jak du y wp yw na decyzj o wyborze kontenera aplikacji ma jego

skalowalno i odporno na awarie. W wersji 5.0 wprowadzili standard klastra w

kodach ród owych serwera oraz pod czyli bardzo prosty modu replikuj cy stan

sesji mi dzy w z ami klastra. Przyk adowa implementacja modu u nie rozwi zuje

jednak wielu problemów, które mog spowodowa wadliwe dzia anie klastra. St d

zrodzi a si idea stworzenia nowego klastra dla serwera Jakarta-Tomcat.

W kolejnych punktach zostanie opisany serwer Jakarta-Tomcat oraz

przedstawiona implementacja pierwszego modu u klastra napisana przez Filipa

Hanika (por. p. 3.4).

3.1 Rozwój serwera Jakarta-Tomcat

Pierwszym pomys odawc i twórc Tomcata by James Duncan Davidson

(projektant i programista z firmy Sun). Pod koniec lat dziewi dziesi tych rozpocz

on prace nad wzorcow implementacj kontenera dla serwletów i stron JSP. Po

napisaniu sporej cz ci systemu przekaza kody ród owe organizacji Apache

Software Foundation, aby dalszy rozwój serwera odbywa si pod jej patronatem.

Organizacja ochrzci a projekt nazw Jakarta-Tomcat i w 1999 roku opublikowa a

wersj 3.0, jako wtyczk do serwera WWW Apache. Kolejna wersja (4.0) by a ju

w pe ni niezale nym serwerem. Pojawi a si obs uga takich standardów jak JDBC,

SSL czy Realms.

Serwer Jakarta-Tomcat sta si bardzo popularnym kontenerem serwletów oraz

stron JSP, g ównie za spraw ogólnodost pnego kodu ród owego oraz jego dobrej

wydajno ci. Prosta implementacja ograniczonego podzbioru standardów J2EE [3]

umo liwi a stworzenie bardzo szybkiego i lekkiego serwera, który móg by bardzo

dobr alternatyw dla serwerów ze stronami pisanymi w j zyku PHP. W wielu

projektach nie ma potrzeby wykorzystywania skomplikowanych mechanizmów EJB

czy JMS, a do pe nej realizacji zada wystarcz serwlety z mo liwo ci dost pu do

bazy danych. Do tego typu projektów idealnie nadawa si serwer Jakarta-Tomcat.

Wiele projektów i firm korzysta z Tomcata jako jednego z komponentów, jak cho by

Jonas [7] czy Hyperion Analyzer [5].

3.2 G ówne za o enia koncepcyjne

Serwer Jakarta-Tomcat jest przede wszystkim kontenerem serwletów (wersja

2.4) i stron JSP (wersja 2.0). Intencj twórców projektu nie by o stworzenie pe nej

implementacji standardu J2EE [3], ale szybkiego i stabilnego kontenera serwuj cego

strony dynamiczne napisane w j zyku Java. Poniewa ca y serwer zosta napisany w

j zyku Java, wi c mo e dzia a w zasadzie na dowolnej platformie, posiadaj cej

implementacj maszyny wirtualnej.

W kolejnych wersjach dosz o sporo ró nego rodzaju dodatków, u atwiaj cych

prac programistom i administratorom systemu.

13

Autoryzacja

Dosz o wsparcie dla obiektów autoryzacji (czyli tzw. realms). Administrator

mo e stworzy w asne implementacje mechanizmu uwierzytelniania lub skorzysta z

trzech gotowych komponentów (w szczególno ci dost pny jest mechanizm

korzystaj cy z bazy danych). Ponadto obs ug

da mo na tunelowa w protokole

HTTPS.

Drzewa JNDI, JDBC, JavaMail

Tomcat udost pnia proste mechanizmy rejestrowania obiektów w drzewie nazw

(JNDI). Programista mo e pobiera w kodzie obiekty, wyszukuj c je po nazwie.

Najcz ciej stosuje si ten mechanizm przy korzystaniu z po cze do bazy danych

(obiekty typu

javax.sql.DataSource

) administrator mo e modyfikowa

parametry po czenia bez potrzeby zagl dania czy modyfikowania kodu aplikacji.

Analogicznie mo na korzysta z obiektów umo liwiaj cych wysy anie listów

poczt elektroniczn [4].

Mened er bezpiecze stwa

Tomcat w wersji 5.0 posiada wsparcie dla mened era bezpiecze stwa (ang.

security manager). Administrator mo e definiowa poziom izolacji przy

wykonywaniu kodu napisanego przez programistów. W ten sposób mo na obroni si

przed wykonaniem niebezpiecznego z punktu widzenia serwera kodu w aplikacjach,

np.

System.exit(0);

co powodowa oby koniec pracy ca ego systemu.

3.3 Opis implementacji

Jakarta-Tomcat jest w ca o ci napisany w j zyku Java.

ród a systemu s podzielone na trzy grupy:

1. jakarta-tomcat-catalina cz

, w której znajduje si faktyczna implementacja

kontenera serwletów,

2. jakarta-tomcat-connectors implementacja podstawowych typów po cze

stosowanych w systemie (mi dzy klientem a serwerem),

3. jakarta-tomcat-jasper implementacja kompilatora do stron JSP.

Z punktu widzenia klastrów najciekawsza jest pierwsza cz

, poniewa tu

znajduje si implementacja j dra systemu, a tak e modu do tworzenia klastra.

Tomcat zosta zaimplementowany w postaci hierarchicznego drzewa obiektów,

w którym ka dy w ze mo e zosta przedefiniowany przez odpowiednie wpisy w

plikach konfiguracyjnych. Takie podej cie u atwia modyfikacj systemu, co mia o

du y wp yw na spopularyzowanie serwera.

3.3.1 Hierarchia obiektów

Serwer Jakarta-Tomcat zazwyczaj sk ada si z nast puj cej hierarchii

komponentów:

-

Korzeniem drzewa jest maszyna (obiekt implementuj cy interfejs

org.apache.catalina.Engine

). Reprezentuje ona niezale ny serwer.

14

-

Maszyna

posiada

w z y

(obiekty

implementuj ce

interfejs

org.apache.catalina.Host

), które reprezentuj wirtualne w z y.

-

W ze

posiada

konteksty

(obiekty

implementuj ce

interfejs

org.apache.catalina.Context

), które reprezentuj aplikacje internetowe

(ang. web applications). Aplikacj mo e by plik z rozszerzeniem .war lub

podkatalog w katalogu webapps.

-

Kontekst sk ada si z serwletów zadeklarowanych przez programist w pliku

opisuj cym aplikacj (plik web.xml) oraz mened era sesji.

-

Mened er sesji (obiekt implementuj cy interfejs

org.apache.catalina.

Manager

) zarz dza sesjami u ytkowników.

Taka hierarchia nie jest obligatoryjna dla przyk adu w sytuacji, gdy instalujemy

Tomcat jako wtyczk w serwerze Apache, drzewo degraduje si do ostatniego

poziomu, czyli samych obiektów aplikacji. Wszystkie pozosta e staj si zb dne, gdy

obs ug dania na wy szym poziomie zajmuje si macierzysty serwer.

Konfiguracja hierarchii obiektów znajduje si w pliku server.xml. Ka dy poziom

jest definiowany przez odpowiedni znacznik w j zyku XML. W szczególno ci,

standardowa dystrybucja Tomcata dostarcza trzy ró ne rodzaje mened erów sesji,

które w zale no ci od zapotrzebowania mo na ustawia w pliku konfiguracyjnym. Ze

wzgl du na rol jak odgrywa mened er sesji w klastrze (przechowuje stan sesji), w

p. 3.3.1.1 zostan zaprezentowane dost pne implementacje tego obiektu.

3.3.1.1 Implementacje mened era sesji

W standardowej dystrybucji serwera Tomcat dost pne s trzy rodzaje mened era

sesji:

1. standardowy (ang. StandardManager),

2. plikowy (ang. PersistentManager),

3. bazodanowy (ang. JDBCManager).

Pierwszy z nich udost pnia podstawow funkcjonalno mened era sesji czyli

po prostu przechowuje dane w pami ci operacyjnej jednej maszyny.

Drugi pozwala na periodyczne zapisywanie stanu sesji do pliku i odzyskanie tych

danych po restarcie maszyny. Jest równie przydatny w sytuacji, gdy nie wszystkie

sesje mieszcz si w pami ci operacyjnej maszyny. Wtedy mened er zapewnia nam

dodatkowy mechanizm wymiany.

Trzecie rozwi zanie dzia a analogicznie do drugiego z t ró nic , e zapis

odbywa si w bazie danych, w odpowiednio zdefiniowanym schemacie.

3.3.1.2 Klaster w serwerze Tomcat

W wersji 5.0 zosta a dodana obs uga klastra. Administrator mo e zdefiniowa

klas implementuj c klaster (interfejs

org.apache.catalina.Cluster

) w

znaczniku

Cluster

, w pliku konfiguracyjnym serwera. Klaster jest definiowany na

poziomie w z a, dzi ki czemu mo na atwo rozdzieli aplikacje, które maj dzia a w

trybie rozproszonym od tych dzia aj cych na pojedynczym serwerze. Klaster jest

odpowiedzialny za obs ug wszystkich aplikacji (kontekstów) zainstalowanych w

obr bie w z a. Implementacja musi zapewni mechanizmy replikacji i synchronizacji

w obr bie grupy po czonych maszyn oraz mo e udost pnia metody instalowania i

odinstalowywania aplikacji w ca ym klastrze (metody

installContext(String

15

contextPath, URL war)

,

start(String contextPath)

oraz

stop(String

contextPath)

).

Dodatkowo rozszerzono specyfikacj pliku opisuj cego aplikacj (web.xml [3])

o znacznik

<distributable/>

, okre laj cy czy aplikacja ma by obs ugiwana przez

klaster. Je eli znacznik zostanie wstawiony, to system pod czy do kontekstu

mened er sesji utworzony przez implementacj klastra. W przeciwnym przypadku do

kontekstu zostanie pod czony standardowy mened er.

Ka dy obiekt tworzony w drzewie hierarchii Tomcata b dzie mia skopiowane

warto ci parametrów z pliku konfiguracyjnego, poprzez wywo anie metod

setXXX(String value)

(gdzie XXX jest nazw parametru oraz jednocze nie nazw

atrybutu w pliku XML). Dodatkowo w specjalny sposób traktowane s obiekty

implementuj ce interfejs klasy

org.apache.catalina.Lifecycle

.

3.3.1.3 Obiekty klasy Lifecycle

Je eli tworzone na poziomie serwera obiekty implementuj interfejs

org.apache.catalina.Lifecycle

, to w momencie startu systemu wywo ywana jest

dla nich metoda

start()

. Obiekty tego interfejsu zostan powiadomione o

zamkni ciu systemu poprzez wywo anie dla nich metody

stop()

. Dla przyk adu

obiekt implementuj cy interfejs

Cluster

w module klastrowania jednocze nie

implementuje interfejs

Lifecycle

, aby w metodach

start

i

stop

wykona czynno ci

przygotowuj ce do pracy oraz czynno ci ko cz ce prac klastra.

Ka de

danie obs ugiwane przez serwer Tomcat przechodzi przez odpowiedni

strumie wywo a procedur. Jest to najbardziej newralgiczne miejsce systemu, ze

wzgl du na cz sto wywo ywania jego kodu.

3.3.2 Strumie przetwarzania

da

Strumie przetwarzania

da w serwerze Tomcat sk ada si z nast puj cych

wywo a :

1. Strumie jest inicjowany przez konektor, dostarczaj cy

danie klienta.

2. Lokalizowany jest odpowiedni w ze , a w nim kontekst, do którego odwo uje

si danie.

3. Wykonywany jest ci g wyzwalaczy (tzw. valve), które obudowuj wywo anie

serwletu (szerzej o wyzwalaczach b dzie mowa w p. 3.3.3).

4. Uruchamiany jest serwlet.

5. Wyzwalacze ko cz dzia anie.

6. Konektor przekazuje odpowied do klienta.

3.3.3 Wyzwalacze

Serwer Tomcat umo liwia podpi cie wyzwalaczy obudowuj cych wykonanie

dania przez serwlet. Zasada dzia ania jest podobna do serwletów filtruj cych [3], z

tym e wyzwalacze definiuje si na poziomie w z a. Wyzwalacz musi by obiektem

klasy implementuj cej interfejs

org.apache.catalina.Valve

.

W metodzie

invoke(Request, Response, Context)

programista mo e

zdefiniowa akcje, które b d wykonywane podczas obs ugi ka dego

dania.

Programista decyduje czy

danie ma by przetwarzane dalej, czy ma zosta

przerwane, wywo uj c lub nie metody

invokeNext(Request,

Response)

.

16

Przyk adowo implementacja kontenera autoryzuj cego opiera si na wyzwalaczach.

Przed wywo aniem odpowiedniej strony obs ugi

dania sprawdzane jest czy klient

posiada wystarczaj ce uprawnienia.

Wyzwalacze umo liwiaj tworzenie dzienników serwera lub stosowanie

globalnych dla ca ego serwera filtrów przychodz cych da .

W szczególno ci mechanizm ten jest równie wykorzystywany przy

implementacji klastra (patrz p. 3.4).

3.4 Implementacja klastra w serwerze Tomcat 5.0

W wersji 5.0 klaster dla serwera Tomcat zosta ustandaryzowany. Do czono

odpowiedni mechanizm pod czania i konfiguracji odr bnych implementacji

mechanizmu rozpraszania oblicze . Osob odpowiedzialn za rozwój standardu, jak

równie do czenie pierwszego w pe ni dzia aj cego modu u klastra w oficjalnej

dystrybucji serwera, jest Filip Hanik cz onek zespo u programistów Tomcata.

Wybór Filipa Hanika jako osoby odpowiedzialnej za klaster nie by

przypadkowy. Ju wcze niej zaimplementowa on dzia aj c wtyczk do Tomcata

wersji 4.0 umo liwiaj c stworzenie klastra.

3.4.1 Klaster dla wersji 4.0

Hanik zaimplementowa w pe ni funkcjonalny modu dla Tomcata w wersji 4.0,

który po podpi ciu do serwera umo liwia stworzenie klastra. Jego pomys polega na

podmianie klasy mened era sesji, w której doda mechanizm replikowania zmian

zachodz cych w sesjach u ytkowników. Jako warstwy transportuj cej u y biblioteki

JavaGroups [6] dostarczaj cej mechanizmów u atwiaj cych programowanie w

rodowisku rozproszonym. Konfiguracja JavaGroups dopuszcza komunikacj w

trybie rozg oszeniowym (ang. multicast), minimalizuj c liczb przesy anych

pakietów (niestety implementacja nie posiada mechanizmów zapewniaj cych

niezawodno transmisji, jaka jest w protokole TPC/IP).

Rozwi zanie Filipa Hanika by o tylko zewn trzn nadbudówk do serwera, który

sam w sobie nie posiada jeszcze wtedy adnego wbudowanego wsparcia dla

klastrów. Wymusza o to tworzenie odr bnych klastrów dla ka dej aplikacji, co

oczywi cie powodowa o zb dny narzut.

W wersji 5.0 modu Filipa Hanika zosta przepisany i do czony do oficjalnej

dystrybucji.

3.4.2 Architektura klastra w wersji 5.0

Klaster jest ca kowicie zdecentralizowany, ka dy kolejny w ze do cza si

rozsy aj c odpowiedni komunikat w trybie rozg oszeniowym, w lokalnej sieci. Sesje

replikowane s do wszystkich w z ów w szczególno ci zak ada si , e w z y

posiadaj identyczny stan ka dej sesji. Klaster nie zak ada istnienia zintegrowanego

mechanizmu równowa cego obci enie ka de kolejne

danie mo e trafi do

dowolnego serwera w klastrze i b dzie obs u one tak, jakby ca a interakcja odbywa a

si na jednej fizycznej maszynie. Takie podej cie pozwala na zastosowanie

dynamicznego równowa enia obci enia, z czym wi e si minimalizacja wariancji

czasu obs ugi dania.

Klaster jest zaimplementowany jako modu (plik z rozszerzeniem .jar), który

mo na opcjonalnie do czy do serwera Tomcat.

17

3.4.3 Implementacja klastra w wersji 5.0

Kody ród owe modu u mo na podzieli na trzy cz ci:

1. warstwa transportuj ca (por. p. 3.4.3.1),

2. warstwa zwi zana z serwerem Tomcat: mened er sesji, obiekt sesji (por. p.

3.4.3.2),

3. klasy pomocnicze (por. p. 3.4.3.3).

3.4.3.1 Warstwa transportuj ca

Hanik zrezygnowa z korzystania z biblioteki JavaGroups jak sam twierdzi z

powodu

braku

gwarancji

poprawno ci

przesy anych

informacji

[11].

Zaimplementowa warstw opart na protokole TCP/IP, s u c do wymiany danych

mi dzy w z ami klastra. Ka dy w ze trzyma otwarte po czenia do wszystkich

pozosta ych w z ów. Lista pozosta ych w z ów uaktualniana jest na podstawie

periodycznie

wysy anych

komunikatów

o

istnieniu

w z a

(w

trybie

rozg oszeniowym). Je eli który w ze przestanie wysy a komunikat, to pozosta e

komputery uznaj , e nast pi a w nim awaria i wyrzuc go z listy cz onków klastra.

Niestety pojawia si tu problem rozspójnienia klastra mo e zdarzy si , e cz

w z ów uzna, e dany komputer przesta dzia a (np. z powodu nadmiernego

obci enia sieci, b d procesora), a cz

pozostawi go na li cie aktywnych w z ów.

Wtedy podczas replikacji uaktualniona wersja sesji nie dotrze do wszystkich

komputerów. Przy za o eniu, e ca y klaster posiada spójn wersj sesji, mo e okaza

si to du ym zagro eniem utraty danych. Wystarczy, e kolejne

danie zostanie

przekierowane do w z a nie posiadaj cego najnowszej wersji sesji.

Ka dy w ze przy starcie otwiera jeden port, na którym b dzie oczekiwa na

po czenia od pozosta ych w z ów. Po czenie nawi zywane jest tylko raz, a przy

wysy aniu danych korzysta si z wcze niej otwartego po czenia. Niestety mi dzy

ka dymi dwoma w z ami otwierane s dwa osobne po czenia, co negatywnie

wp ywa na wydajno sieci.

Ka dy w ze otwiera jeden port w trybie rozg oszeniowym, w celu

periodycznego wysy ania komunikatu o swoim istnieniu. W komunikacie znajduje si

informacja o w le oraz o porcie, na którym nas uchuje. Je eli odbiorca komunikatu

nie posiada otwartego po czenia do og aszaj cego si w z a, to inicjowane jest nowe

po czenie.

Wad wysy ania komunikatów w trybie rozg oszeniowym jest uniemo liwienie

pracy dwóch serwerów Tomcat na jednej fizycznej maszynie, tak aby oba nale a y do

tego samego klastra. Tylko jeden z serwerów b dzie w stanie otworzy konkretny

port rozg oszeniowy.

Wszelkie informacje wymieniane mi dzy w z ami klastra przesy ane s za

pomoc wiadomo ci. Komunikacja jest ca kowicie bezstanowa to znaczy po

wys aniu komunikatu nadawca nie oczekuje na odpowied , minimalizuj c ryzyko

potencjalnych zakleszcze (ang. deadlock). Format rozsy anych wiadomo ci jest

nast puj cy:

-

7 bajtów preambu a,

-

1 bajt d ugo wiadomo ci,

-

dane wiadomo ci,

-

7 bajtów zako czenie wiadomo ci.

18

Na dane sk ada si zserializowana posta klasy

SessionMessage

. Klasa zawiera

typ wiadomo ci, identyfikator sesji, dane sesji, identyfikator kontekstu oraz adres

w z a wysy aj cego wiadomo .

Wyst puj nast puj ce typy wiadomo ci:

1.

EVT_SESSION_CREATED

zosta a utworzona nowa sesja lub istniej ca sesja

zosta a zmieniona;

2.

EVT_SESSION_EXPIRED_WONOTIFY

wygas a sesja, ale nie nale y

powiadamia o tym s uchaczy (ang. listner);

3.

EVT_SESSION_EXPIRED_WNOTIFY

wygas a sesja i nale y powiadomi

s uchaczy;

4.

EVT_SESSION_ACCESSED

u ytkownik odwo a si do sesji, ale jej nie

zmienia ;

5.

EVT_GET_ALL_SESSIONS

nowy w ze pobiera wszystkie do tej pory

stworzone sesje;

6.

EVT_ALL_SESSION_DATA

przesy ane s dane sesji.

W aktualnej wersji rozwi zania zdarzenia

EVT_SESSION_EXPIRED_WONOTIFY

oraz

EVT_SESSION_EXPIRED_WNOTIFY

s obs ugiwane jednakowo, z powiadamianiem

s uchaczy.

Zapisywanie i odtwarzanie danych sesji

Dane sesji s serializowane za pomoc wywo ania standardowej metody

writeObjectData(ObjectOutputStream stream)

z klasy

StandardSession

, a

deserializowane

za

pomoc

metody

readObjectData(ObjectInputStream

stream)

. Przy odtwarzaniu danych sesji z tablicy bajtów, tworzony jest strumie

wej ciowy

ReplicationStream

, który czyta obiekty korzystaj c z mechanizmu

adowania klas dostarczanego przez kontekst aplikacji, do której nale y sesja. W ten

sposób przesy a si obiekty klas stworzonych w ramach danej aplikacji.

3.4.3.2 Warstwa zwi zana z serwerem Tomcat

Modu Hanika pod czany jest za pomoc klasy

SimpleTcpCluster

, któr

definiuje si w znaczniku

<Cluster>

, w pliku konfiguracyjnym serwera. Klasa

implementuje standardowy interfejs

org.apache.catalina.Cluster

, dostarczaj c

niezb dnych metod do pracy systemu. W aktualnej wersji implementacja nie wspiera

metod instalacji oraz deinstalacji aplikacji w ca ym klastrze.

Klasa

SimpleTcpCluster

implementuje interfejs

org.apache.catalina.

Lifecycle

, wykorzystuj c metody

start()

oraz

stop()

do inicjowania swoich

struktur danych.

Przy starcie systemu w metodzie

start()

obiekt tworzy warstw transportuj c ,

przekazuj c do niej parametry pobrane z pliku konfiguracyjnego server.xml

(dok adniej o parametrach klastra b dzie mowa w p. 3.4.4).

W metodzie

createManager(String name)

, odpowiadaj cej za tworzenie

mened era

sesji,

przekazywany

jest

obiekt

instancji

klasy

SimpleTcpReplicationManager

, b d cej nadklas klasy

StandardManager

. Klasa

przeimplementowuje metod

createSession()

, w której tworzy i przekazuje obiekt

19

typu

ReplicatedSession

zamiast

StandardSession

. Obiekty replikowanych sesji

przechwytuj wywo ania metod

-

setAttribute(String name, Object value)

,

-

removeAttribute(String name)

,

-

expire(boolean notify)

z poziomu aplikacji w celu ustawienia bitu informuj cego o przeprowadzonych

zmianach w sesji. Po zako czeniu przetwarzania dania system podejmuje decyzj o

replikacji na podstawie warto ci tego bitu.

Inicjowanie procesu replikacji zachodzi w odpowiednim wyzwalaczu (obiekt

klasy

ReplicationValve

), podpi tym pod wywo ania

da . Po wykonaniu

dania

przez aplikacj obs uguj c dany kontekst, wyzwalacz wywo uje metod

requestCompleted(String sessionId)

w obiekcie zarz dcy sesji. Metoda

przekazuje wiadomo , zawieraj c zserializowane dane sesji, która zostaje rozes ana

do wszystkich w z ów w klastrze.

Rozsy anie wiadomo ci do w z ów mo e by wykonywane w dwóch trybach:

synchronicznym oraz asynchronicznym. Przy pierwszym trybie w tek obs uguj cy

danie jest równocze nie odpowiedzialny za rozes anie pakietów w obr bie klastra.

Powoduje to oczywi cie wyd u enie czasu obs ugi

dania, co mo e negatywnie

wp ywa na wydajno systemu.

W trybie asynchronicznym tworzone jest zadanie replikacji sesji, które zostanie

wykonane przez jeden ze specjalnych w tków zazwyczaj ju po zako czeniu

obs ugi

dania. Przy takim podej ciu klient nie musi niepotrzebnie czeka na

zako czenie zadania replikacji sesji; proces ten wykonywany jest w tle, w czasie

przesy ania odpowiedzi do klienta. Niestety implementacja tego mechanizmu ma du

wad nie jest w aden sposób sprawdzane czy w ze zd y rozes a now wersj

sesji przy kolejnym odwo aniu. Czyli mo e zdarzy si nast puj ca sytuacja:

1. Klient wysy a danie do klastra i zostaje przekierowany do maszyny A.

2. Podczas obs ugi dania sesja zostaje zmodyfikowana (na maszynie A).

3. Klient otrzymuje odpowied i natychmiastowo wysy a kolejne danie.

4. Serwer równowa cy obci enie przekierowuje danie do maszyny B.

5. Kod obs uguj cy

danie odwo uje si do sesji, której maszyna A nie zd y a

jeszcze wys a do maszyny B.

Taka sytuacja mo e z atwo ci zaj przy nadmiernym obci eniu danego

w z a. Z powodu braku mocy obliczeniowej (lub przeci enia sieci) wysy anie

wiadomo ci ze zmienionym stanem sesji zaczyna si opó nia , co mo e doprowadzi

do rozspójnienia klastra i w konsekwencji utraty danych. W praktycznych

zastosowaniach tryb asynchroniczny jest rozwi zaniem niedopuszczalnym, w a nie z

powodu ryzyka utraty danych.

Kolejnym powa nym problemem implementacji jest brak synchronizacji dost pu

do sesji w obr bie klastra. Klaster nie posiada adnego mechanizmu kontroluj cego

równoczesny dost p do tej samej sesji. Je eli klient wy le równolegle dwa

dania,

modyfikuj ce te same zasoby, to doprowadzi to do utraty danych. Co gorsze, mo e

okaza si , e cz

w z ów b dzie posiada a sesj zmienion przez jedno

danie, a

cz

przez drugie je eli wiadomo ci z replikami b d dociera y w ró nej

kolejno ci.

20

Taka sytuacja mo e mie miejsce w przypadku stron HTML posiadaj cych

ramki. Po od wie eniu strony przegl darka wysy a równolegle wiele

da do tych

samych zasobów, automatycznie generuj c równoleg e odwo ania do tej samej sesji.

3.4.3.3 Klasy pomocnicze

Buforowanie

Zosta zaimplementowany prosty mechanizm buforowania przesy anych w sieci

informacji. W przypadku pracy w trybie asynchronicznym po przetworzeniu

dania

kolejkowane jest zadanie replikacji sesji. Je eli zadanie dotycz ce tej samej sesji

znajdowa o si ju w kolejce, to zostanie ono nadpisane przez nowsz wersj . W ten

sposób eliminuje si niepotrzebny ruch w sieci. Niemniej jednak taka sytuacja ma

miejsce tylko przy du ym obci eniu sieci, kiedy w ze nie jest w stanie

wystarczaj co szybko wys a wiadomo ci do pozosta ych w z ów. Niestety zysk z

wykorzystania

tego

mechanizmu

jest

iluzoryczny,

poniewa

jest

ma o

prawdopodobne, e kolejne danie trafi do tego samego w z a. Skoro zak ada si , e

mog wyst powa tak du e opó nienia w rozsy aniu replik zmienionej sesji, to klaster

bardzo szybko stanie si niespójny i zacznie traci dane.

Pula w tków

W celu minimalizowania narzutu zwi zanego z tworzeniem w tków zosta a

zaimplementowana pula w tków, obs uguj ca przychodz ce wiadomo ci. Je eli

w tek nas uchuj cy na otwartych po czeniach z pozosta ymi w z ami odbierze dane,

to budzi jeden z w tków z puli i przydziela mu gniazdo (ang. socket), z którego

nale y wczyta dane. W tek wczytuje kolejne wiadomo ci przetwarzaj c je

synchronicznie. Po zako czeniu zwraca gniazdo i przechodzi w stan oczekiwania.

3.4.4 Konfiguracja klastra w wersji 5.0

Klaster w cza si poprzez odkomentowanie sekcji klastra w pliku server.xml:

<Cluster

className=org.apache.catalina.cluster.tcp.SimpleTcpCluster

name=FilipsCluster

debug=10

serviceclass=org.apache.catalina.cluster.mcast.McastService

mcastAddr=228.0.0.4

mcastPort=45564

mcastFrequency=500

mcastDropTime=3000

tcpThreadCount=2

tcpListenAddress=auto

tcpListenPort=4001

tcpSelectorTimeout=100

printToScreen=false

expireSessionsOnShutdown=false

useDirtyFlag=true

replicationMode=synchronous

/>

21

oraz sekcji wyzwalacza wykorzystywanego przez klaster:

<Valve

className=org.apache.catalina.cluster.tcp.ReplicationValve

filter=.*\.gif;.*\.js;.*\.jpg;.*\.htm;.*\.html;.*\.txt;

/>

Znaczenie odpowiednich atrybutów w sekcji klastra:

1.

name

nazwa klastra (warto w zasadzie nie wykorzystywana),

2.

debug

poziom szczegó owo ci generowanych przez implementacj zapisów

systemowych,

3.

serviceclass

klasa s u ca do dostarczania informacji o dost pnych

w z ach

w

klastrze

(musi

implementowa

interfejs

org.apache.catalina.cluster.MembershipService

),

4.

mcastAddr

adres rozg oszeniowy, na którym w z y b d powiadamia y si

nawzajem o swoim istnieniu,

5.

mcastPort

port u ywany przy rozg aszaniu,

6.

mcastFrequency

cz stotliwo rozsy ania informacji o istnieniu w z a (w

milisekundach),

7.

mcastDropTime

czas po jakim w ze zostaje uznany za niesprawny od

momentu otrzymania ostatniego pakietu o jego istnieniu,

8.

tcpThreadCount

liczba w tków obs uguj cych przychodz ce wiadomo ci

w klastrze,

9.

tcpListenAddress

adres, na którym w ze spodziewa si po cze od

pozosta ych w z ów (je eli ustawiona jest warto auto, to zostanie u yty

domy lny adres komputera). Wykorzystuje si go, je eli komputer posiada

wi cej ni jedn kart sieciow ,

10.

tcpListenPort

port, na którym nas uchuje w ze ,

11.

tcpSelectorTimeout

czas w milisekundach po jakim w tek nas uchuj cy

na otwartych po czeniach ma sprawdzi czy serwer nie jest zamykany,

12.

printToScreen

czy strumie diagnostyczny ma by przekierowany do

standardowego wyj cia,

13.

expireSessionsOnShutdown

czy podczas zamykania serwera sesje maj

zosta zdezaktualizowane,

14.

useDirtyFlag

czy sesja ma by replikowana tylko po wywo aniu metod

setAttribute(..)

,

removeAttribute(..)

,

expire()

,

invalidate()

,

setPrincipal(..)

,

setMaxInactiveInterval(..)

,

15.

replicationMode

przyjmuje warto

synchronous

lub

asynchronous

i

oznacza tryb w jakim sesje b d replikowane.

Wyzwalacz przyjmuje atrybuty:

1.

filter

zawiera wyra enia regularne oddzielone znakiem

rednika,

definiuj ce adresy, podczas przetwarzania których na pewno sesja nie b dzie

zmieniana. Przy obs udze tych

da mechanizm replikacji nie b dzie

wywo ywany, nawet gdy flaga

useDirty

b dzie ustawiona na fa sz.

3.4.5 Zalety rozwi zania

Zalet przedstawionego rozwi zania jest jego ca kowite zdecentralizowanie.

Klaster nie posiada wyró nionego w z a, co zwi ksza stabilno i odporno na

22

awarie konkretnej maszyny. Do czanie kolejnego w z a wi e si jedynie z

w czeniem go do sieci.

Kolejn cech wyró niaj c klaster w serwerze Tomcat jest ca kowita

niezale no od algorytmu równowa enia obci enia. Rozwi zanie nie wymaga

specjalnego

oprogramowania

interpretuj cego

identyfikatory

sesji

czy

zapami tuj cego przypisania w ze -sesja. Administrator mo e wykorzysta dowolny

mechanizm przekierowywania (programowy czy sprz towy).

Pe na replikacja (tzn. ka dy w ze replikuje swoje sesje do wszystkich

pozosta ych w z ów) zapewnia du odporno klastra na awarie. Wystarczy, e

chocia jeden z serwerów pozostanie sprawny, aby nie utraci adnych informacji.

Poza tym umo liwia zastosowanie wyrafinowanych algorytmów równowa enia

obci enia, które nie b d ograniczane sta ymi przypisaniami sesji do w z ów. W

szczególno ci po dodaniu kolejnego w z a do klastra bardzo szybko mo emy

przerzuci na niego obci enie z pozosta ych komputerów, a nie tylko

przekierowywa nowo przyby ych u ytkowników.

Niestety rozwi zanie oprócz zalet ma równie wady. Niektóre z nich s na tyle

powa ne, e uniemo liwiaj wykorzystanie serwera w komercyjnych zastosowaniach.

Rozwi zanie nie gwarantuje poprawnego dzia ania systemu.

3.4.6 Wady rozwi zania

G ówn wad rozwi zania jest brak synchronizacji przy dost pie do sesji oraz

brak kontroli nad spójno ci klastra. Za o enie o pe nej replikacji poci ga za sob

konieczno zapewnienia mechanizmu synchronizacji przy wprowadzaniu zmian czy

chocia by odczycie sesji. Je eli ka dy komputer mo e uchodzi za serwer

macierzysty dowolnej sesji (czyli mo e obs ugiwa wszelkie

dania, jakie docieraj

do klastra), to nale y uniemo liwi wprowadzanie równoczesnych zmian na ró nych

maszynach. Niestety rozwi zanie Filipa Hanika ignoruje zagro enie równoleg ych

zmian, tak samo jak ignoruje mo liwo opó nie w replikacji sesji. Je eli komputer

z powodu nadmiernego obci enia opó ni rozes anie nowej wersji sesji, to przy

kolejnym

daniu klienta, przekierowanym do innego w z a, aplikacja b dzie

korzysta a z nieaktualnej wersji danych, nadpisuj c tym samym poprzednie zmiany.

Co gorsze w takiej sytuacji nie ma pewno ci, która wersja sesji trafi do pozosta ych

w z ów, poniewa b dzie to zale a o tylko od kolejno ci w jakiej odbior one repliki

z dwóch ró nych róde .

Nie mniej wa ne jest niebezpiecze stwo rozspójnienia klastra. Zak ada si , e

wszystkie w z y w klastrze posiadaj identyczn wersj dowolnej sesji, ale co si

stanie je eli w ze chwilowo uzna inny komputer za niesprawny i nie prze le mu

repliki zmienionej sesji? Taka sytuacja mo e zaistnie przy du ym obci eniu sieci

lub maszyny wystarczy, e na czas nie dotrze do którego w z a pakiet

rozg oszeniowy informuj cy o istnieniu innego w z a. Ten odrzuci go, s dz c, e

w ze przesta dzia a i nie b dzie wysy a do niego wiadomo ci. Za chwile pakiet o

istnieniu znowu dotrze i w ze ponownie zostanie w czony do listy aktywnych

cz onków, ale sesja nie zostanie ju zaktualizowana.

Korzystanie z trybu rozg oszeniowego w sieci uniemo liwia zainstalowanie

dwóch w z ów klastra na jednej fizycznej maszynie tylko jeden serwer otworzy port

rozg oszeniowy i b dzie móg z niego korzysta . To mo e okaza si spor

niedogodno ci w niektórych topologiach klastrów. Czasami administrator mo e

chcie zainstalowa wi cej ni jeden serwer na fizycznej maszynie zapewniaj c

23

wi ksz odporno klastra na awarie oprogramowania. Niestety przedstawione

rozwi zanie wyklucza taki model.

Architektura rozwi zania powoduje generowanie du ego ruchu w sieci ka dy

w ze rozsy a repliki sesji do wszystkich pozosta ych. Przy du ym obci eniu sie

mo e okaza si w skim gard em ca ego klastra. Powoduje to spore ograniczenia na

liczb w z ów jednocze nie dzia aj cych w klastrze. Liczba przesy anych

komunikatów jest kwadratowo zale na od liczby pod czonych w z ów.

Reasumuj c mo na stwierdzi , e Hanik przygotowa bardzo stabilne podstawy

do implementacji modu u klastra dla serwera Jakarta-Tomcat. Wy oni si standard

jaki musz spe nia modu y, aby mog y poprawnie dzia a przy ka dej kolejnej

dystrybucji Tomcata oraz zosta naszkicowany schemat pod czenia modu u do

serwera. Wzorcowa implementacja dostarcza wiele wskazówek, które mog u atwi

prac twórcom kolejnych rozwi za . Niestety nie spe nia ona wymaga stawianych

przez komercyjne zastosowania i mo e s u y jedynie jako przyk ad.

Celem tej pracy jest stworzenie modu u, bazuj cego na koncepcji Hanika,

wykorzystuj cego zalety rozwi zania, ale przede wszystkim eliminuj cego jego wady

i zagro enia. G ówn zalet , która zosta a zidentyfikowana w bazowym rozwi zaniu,

jest mo liwo dynamicznego sterowania obci eniem poszczególnych jednostek

klastra. G ówn wad jest brak synchronizacji podczas odwo ywania si do sesji oraz

brak kontroli nad spójno ci klastra. Drugim bardzo wa nym celem jest

optymalizacja rozwi zania, aby jego wydajno nie sta a si powodem rezygnacji ze

stosowania klastra w serwerze Jakarta-Tomcat. W rozdziale 4 przedstawi now ,

autorsk implementacj klastra, a w rozdziale 5 opisz wyniki testów

wydajno ciowych zaproponowanego rozwi zania.

24

4 Nowy klaster dla serwera Jakarta-Tomcat

W tym rozdziale przedstawiam w pe ni funkcjonalny i sprawnie dzia aj cy

klaster dla serwera Jakarta-Tomcat. Nowy projekt bazuje na koncepcji replikacji

ka dy

do ka dego,

ale

dodatkowo

rozwi zuje

wi kszo problemów

zidentyfikowanych w implementacji Hanika. W szczególno ci rozwi zuje problem

synchronizacji przy dost pie do sesji oraz uniemo liwia przypadkowe rozspójnienie

klastra. Nowa implementacja dostarcza pewniejszy mechanizm automatycznej

detekcji i obs ugi awarii.

W rozdziale zostanie przedstawiony projekt i za o enia koncepcyjne nowego

klastra. Zostanie równie na wietlona implementacja wa niejszych cz ci systemu,

wraz z zastosowanymi algorytmami.

4.1 Architektura i za o enia koncepcyjne

Architektura zbli ona jest do tej wyst puj cej w klastrze z Tomcat wersji 5.0

ka dy w ze posiada po czenia do wszystkich pozosta ych i zak ada si , e stan

ka dej sesji na ka dym serwerze jest identyczny. Brak tutaj przypisania sesji do

konkretnego serwera.

Aby zapewni efektywne synchronizowanie dost pu do sesji konieczne sta o si

scentralizowanie klastra.

4.1.1 Koncepcja centralnego sterowania

Wybrany w ze w sieci pe ni rol semafora przy dost pie do zasobów.

Przechowuje on informacje o wszystkich dost pnych obiektach oraz w z ach, które

oczekuj na zwolnienie obiektów. Granulacja dost pu jest na poziomie w ze -sesja, to

znaczy ca y obiekt sesji jest udost pniany w danej chwili tylko jednemu w z owi.

Je eli serwer obs uguje wiele

da równocze nie odwo uj cych si do tej samej

sesji, to aplikacja internetowa musi zapewni synchronizacj w obr bie pojedynczej

maszyny wirtualnej serwera (np. poprzez wykorzystanie s owa kluczowego

synchronized

w j zyku Java). Je eli

dania zostan rozrzucone po ró nych

maszynach, to zostan wykonane synchronicznie w nieokre lonej kolejno ci, ale

ka de

danie b dzie wykonywane z aktualn wersj sesji. Przy takim rozwi zaniu

aplikacje, w których wymagana jest równoczesna obs uga wielu

da dotycz cych

tej samej sesji (np. z powodu synchronizowania w tków

da ), b d musia y

wykonywa si w rodowisku ze zintegrowanym mechanizmem równowa cym

obci enie (patrz p. 4.1.4). Mechanizm ten zapewni przekierowywanie zg osze

odwo uj cych si do tego samego zasobu na maszyn , która w danym momencie go

zajmuje.

Stworzenie w z a wyró nionego (serwer zarz dca) umo liwi o implementacj

centralnego nadzorowania spójno ci klastra. Maszyna zajmuj ca si synchronizacj

dost pu do sesji równocze nie jest odpowiedzialna za przechowywanie informacji o

w z ach klastra i rozpropagowywanie tych informacji do ka dego w z a. W ten

sposób w ze zostanie uznany za niesprawny dopiero wtedy, gdy serwer zarz dca

uzna go za niesprawny i tak e dopiero wtedy zostanie on odrzucony przez wszystkie

pozosta e w z y. Takie podej cie eliminuje niebezpiecze stwo zaistnienia sytuacji,

gdzie jeden z w z ów z powodu utraty czno ci odrzuca chwilowo inny w ze , nie

przesy aj c mu uaktualnionej wersji sesji. Dopóki w ze nie dostanie komunikatu od

centralnego serwera o odrzuceniu danej maszyny, dopóty b dzie próbowa nawi za

25

po czenie w celu uko czenia procesu replikacji, nie zwalniaj c replikowanych sesji.

Taki mechanizm gwarantuje, e ka de

danie, które trafi do klastra b dzie

obs ugiwane z najnowsz wersj sesji. W najgorszym przypadku mog nast powa

opó nienia spowodowane nie zwalnianiem sesji przez w z y, ale to mo na

wyeliminowa , je eli rol zarz dcy przejmie serwer równowa cy obci enie. Wtedy

ka de kolejne

danie b dzie przekierowywane do serwera aktualnie zajmuj cego

sesj , do której nast pi o odwo anie.

Implementacja przewiduje sta konfiguracj , gdzie serwerem centralnym b dzie

z góry ustalony komputer. Niemniej jednak istnieje mo liwo rozszerzenia klastra

tak, aby serwer zarz dca by wybierany drog elekcji, w ród aktualnie pod czonych

w z ów (patrz p. 6). Wtedy w momencie awarii g ównej maszyny inny w ze móg by

przej jego rol i zachowa ci g o pracy systemu. W aktualnej wersji

zaimplementowanego klastra, aby zapewni ci g o pracy w przypadku awarii

serwera zarz dcy niezb dne by oby zastosowanie mechanizmu dublowania serwera

(ang. mirroring). W sytuacji, gdy serwer synchronizacyjny przesta by odpowiada

nast pi oby automatyczne od czenie komputera od sieci i wstawienie na jego miejsce

identycznie skonfigurowanej maszyny (z tym samym adresem IP oraz serwerem

synchronizacyjnym s uchaj cym na tym samym porcie). Wtedy pozosta e w z y

ponownie nawi za yby po czenia z serwerem zarz dc i rozpocz aby si procedura

przy czania kolejnych w z ów klastra (dok adniej jest to opisane w p. 4.2.4). W

wyniku tych dzia a system zosta by samoistnie odbudowany.

4.1.2 Podzia na warstwy

Implementacja modu u klastra sk ada si z dwóch podstawowych warstw:

1. warstwa transportuj ca,

2. warstwa synchronizacyjna.

Pierwsza z warstw jest odpowiedzialna za komunikacj w obr bie klastra tzn.

nawi zuje po czenia z ustalonymi komputerami i umo liwia przesy anie danych w

sieci. Dodatkowo implementacja tej warstwy musi by odporna na tymczasowe

awarie w sieci. Je eli zostanie zlecone wys anie pakietu do danego komputera to,

warstwa ma dot d próbowa wys a dane, a w ca o ci dotr one do odbiorcy lub do

momentu, gdy komputer ten nie zostanie explicite wyrzucony z listy aktywnych

adresów.

Warstwa synchronizacyjna jest ci le zwi zana z serwerem Tomcat, zapewniaj c

mechanizmy wy cznego dost pu do sesji. W sytuacji, gdy serwer pokrywa si z

serwerem zarz dc , warstwa dzia a lokalnie. Je eli serwer synchronizuj cy jest na

innej maszynie, to warstwa w sposób przezroczysty komunikuje si z zarz dc

poprzez warstw transportuj c . System wykorzystuje warstw w celu za o enia

blokady na zasoby zwi zane z przetwarzanym

daniem. Po zako czeniu

przetwarzania blokada jest zwalniana. Warstwa przechowuje informacje o wszystkich

dost pnych w z ach w klastrze i jest odpowiedzialna za replikacj sesji.

W przypadku serwera zarz dcy implementacja warstwy synchronizacyjnej jest

dodatkowo rozbudowana. Przechowuje szczegó owe informacje o wszystkich

dost pnych zasobach i kolejkuje

dania dost pu do tych zasobów. W momencie

zwolnienia zasobu warstwa przydziela obiekt kolejnemu czekaj cemu w z owi,

wysy aj c do niego odpowiedni komunikat.

26

4.1.3 Wersjonowanie sesji

W systemie ka da sesja posiada swój numer wersji. Numer pocz tkowo jest

ustawiany na zero i jest zwi kszany po przetworzeniu ka dego kolejnego

dania

odwo uj cego si do danej sesji. Numer wersji jest u ywany podczas odzyskiwania

danych po awarii w z a. Je eli dany w ze przetworzy

danie zmieniaj ce sesj i

przed zwolnieniem blokady tej sesji nast pi a awaria, to system wykorzysta numer

wersji w celu wyszukania najnowszych danych w ród pozosta ych w z ów. Istnieje

szansa, e w ze zd y przes a uaktualnion replik sesji do chocia jednego z

pozosta ych serwerów i na tej podstawie uda si odzyska wprowadzone zmiany. Po

awarii w z a serwer zarz dca dla ka dej sesji, której w ze nie zd y zwolni , wysy a

zapytanie o numer wersji do pozosta ych komputerów. Ten który przeka e najwy szy

numer wersji rozpropaguje swoje dane do pozosta ych. Oczywi cie mechanizm nie

zadzia a w przypadku sesji, których obs uga nie zosta a w pe ni uko czona, jednak

ka da awaria poci ga za sob pewne niebezpiecze stwo utraty danych, a zadaniem

oprogramowania jest minimalizowanie tego ryzyka. Mechanizm odzyskiwania

danych po awarii w z a zosta dok adniej opisany w p. 4.2.

4.1.4 Zintegrowany mechanizm równowa enia obci

enia

Ka dy klaster musi posiada serwer przekierowuj cy

dania do ko cowych

w z ów czyli tzw. punkt dost powy (serwer ruchu). Aplikacje klienckie zg aszaj ce

si do systemu negocjuj po czenie z punktem dost powym, nie widz c architektury

samego klastra. Serwer ten zazwyczaj pe ni jednocze nie rol jednostki równowa cej

obci enie, równomiernie dziel c

dania na wszystkie maszyny. Posiada on swój

sta y adres IP, na który s t umaczone adresy WWW w serwerach nazw

1

. Poniewa

serwer ruchu musi posiada informacje o dost pnych w z ach w klastrze, aby móc

przesy a do nich dania od klientów, naturalne wydaje si po czenie serwera ruchu

z serwerem zarz dc . Przy takim rozwi zaniu administrator nie musi dodatkowo

konfigurowa serwera ruchu, ustawiaj c mu list dost pnych w z ów. Dodatkowym

atutem wykorzystania zintegrowanego mechanizmu równowa enia obci enia jest

mo liwo zwi kszenia wydajno ci systemu, poprzez skrócenie czasu reakcji na

danie klienta. Serwer steruj cy ruchem ma dost p do informacji, który w ze

aktualnie zajmuje dan sesj . Posiadaj c takie dane jest w stanie kierowa ruch tak,

aby

minimalizowa

liczb

stosunkowo

drogich

wywo a

blokowania

i

odblokowywania sesji. Przy obs udze zg oszenia klient nie b dzie musia oczekiwa

na zako czenie procesu replikacji sesji i zwolnienie blokady przez poprzednio

obs uguj cy go w ze , tylko od razu zostanie przekierowany do w z a aktualnie

posiadaj cego najnowsze dane.

Zastosowanie takiego rozwi zania daje ogromne mo liwo ci usprawnienia

samego procesu replikacji. Maj c pewno , e nikt nie b dzie oczekiwa na

zwolnienie blokady, ka dy z serwerów mo e opó nia moment oddania sesji, a co

wi cej mo e opó nia moment replikacji. Dla zapewnienia niezawodno ci w

przypadku awarii, ka dy z serwerów replikuje zmienion sesj , zaraz po zako czeniu

obs ugi

dania, do jednego, losowo wybranego w z a klastra. Zadania rozes ania

danych do pozosta ych w z ów zostaj opó nione. Je eli w mi dzyczasie, przed

rozes aniem zmian w sesji, nadejdzie kolejne

danie zmieniaj ce t sam sesj , to

1

Istnieje mo liwo równowa enia obci enia na poziomie serwerów nazw, poprzez przekazywanie

ró nych adresów IP dla tego samego adresu WWW, ale takie rozwi zanie nie zapewnia mechanizmu

automatycznej naprawy awarii i jest du o bardziej statyczne w kontek cie równomiernej dystrybucji

ruchu.

27

system w momencie wykonywania zada replikacji roze le wersj uwzgl dniaj c

najnowsze zmiany. Zmniejsza to ruch w sieci, eliminuj c konieczno rozes ania

wcze niejszych zmian. Bardzo wa ne jest tutaj dobranie odpowiednich czasów

buforowania, aby nie doprowadzi do sytuacji, gdzie adna sesja nie zmienia

kontekstu wykonania (analogicznie do architektury serwer macierzysty-zast pczy) i

zanika g ówna zaleta architektury ka dy do ka dego, czyli równomierne

równowa enia obci enia.

4.1.5 Bezpiecze stwo

System nie zapewnia

adnych mechanizmów bezpiecze stwa podczas

replikowania sesji czy autoryzacji do czanego w z a. Zak ada si , e klaster

komunikuje si w prywatnej sieci, za cian ogniow (ang. firewall) i wszystkie

odebrane komunikaty pochodz od w a ciwych adresatów. Wszelkie przypadkowe

lub z o liwe komunikaty w sieci mog doprowadzi do wadliwego dzia ania klastra, a

nawet do jego ca kowitego zablokowania. W gestii administratora systemu jest

odpowiednie zabezpieczenie sieci, w której komunikuj si w z y.

4.2 Dzia anie systemu

W tym podrozdziale zostanie opisany sposób reakcji systemu na podstawowe

rodzaje zdarze , które mog si pojawi podczas dzia ania. Zostanie omówiony

mechanizm do czania nowego w z a czy reakcja na zerwanie po czenia i ca kowit

awari jednego z komputerów. Przy ka dym zdarzeniu g ówny nacisk k adziony jest

na zapewnienie niezawodno ci i minimalizowanie prawdopodobie stwa utraty

danych przechowywanych w sesji.

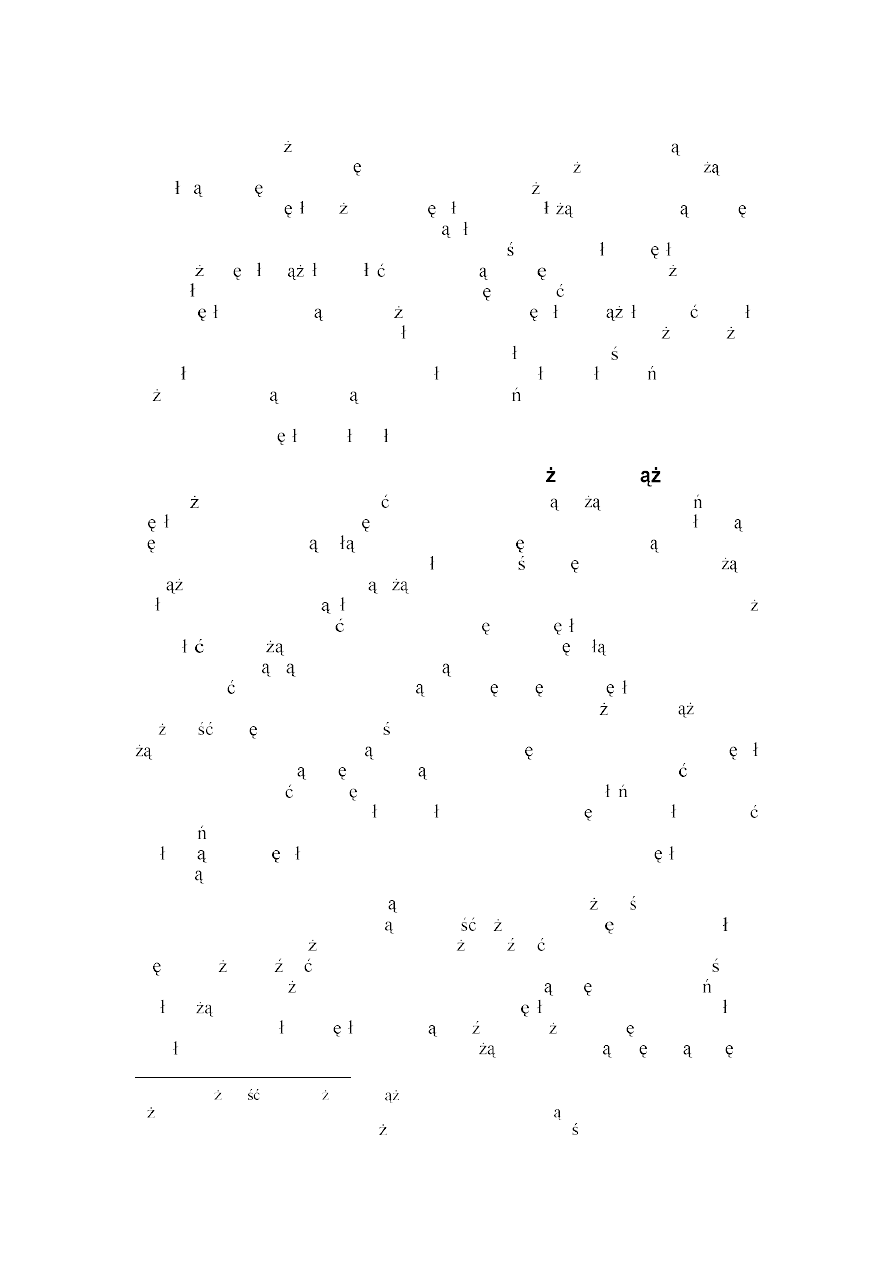

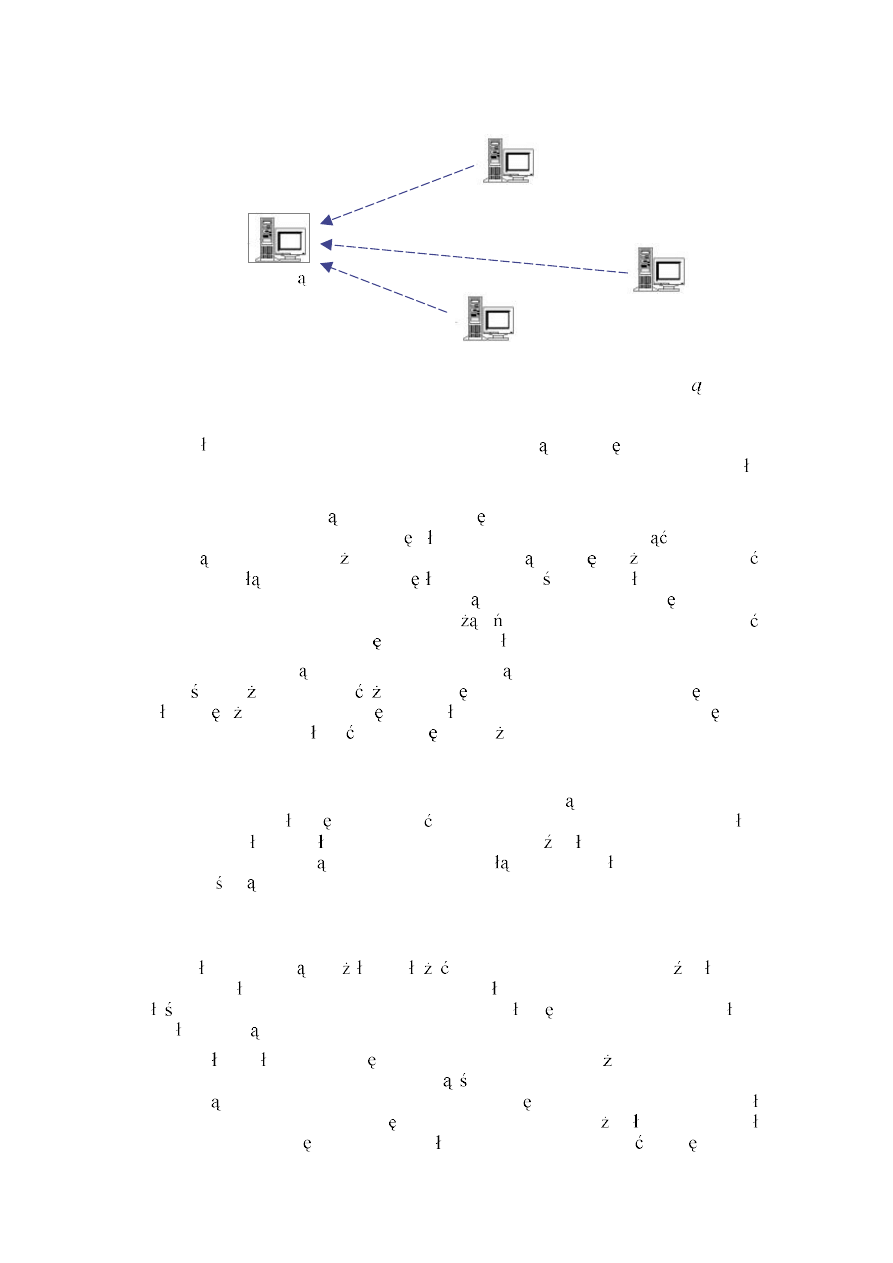

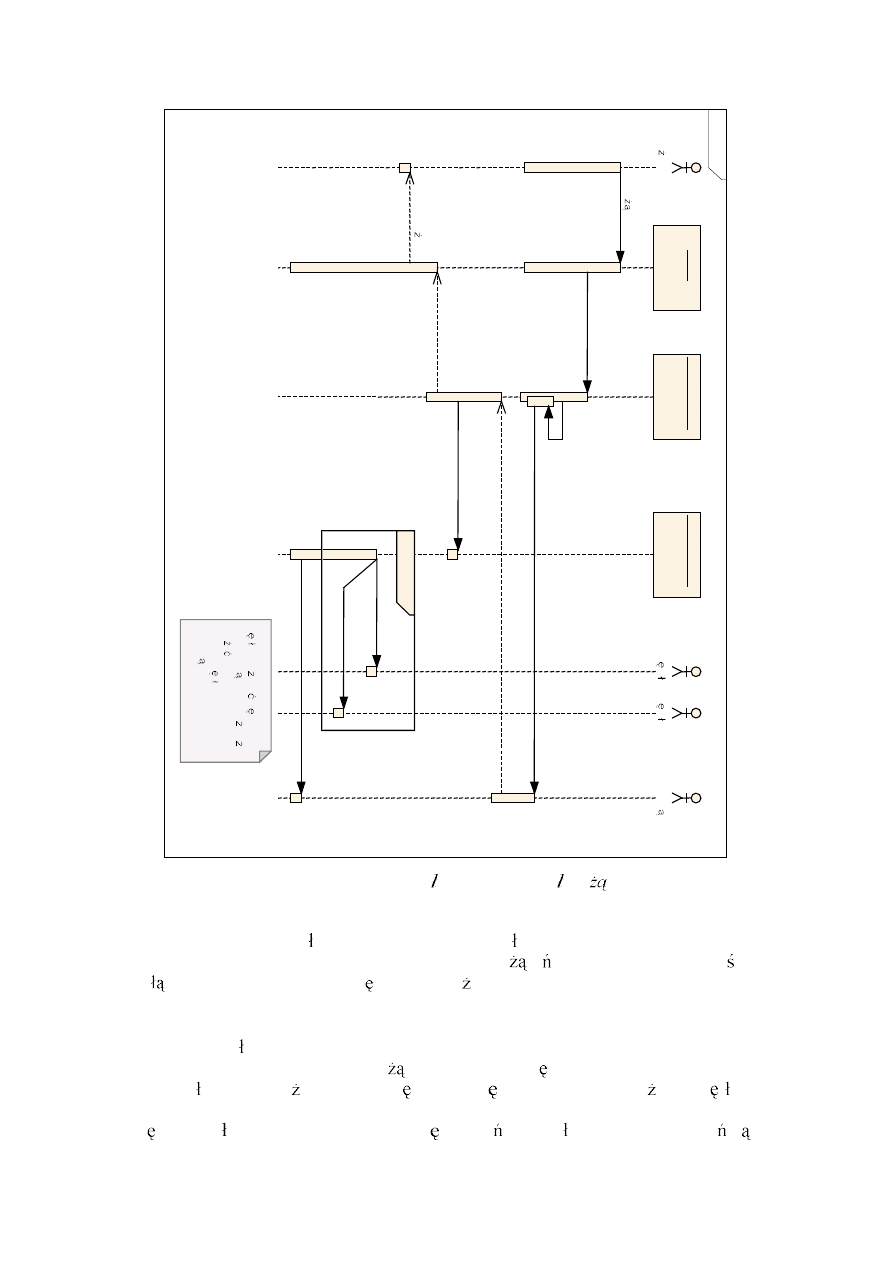

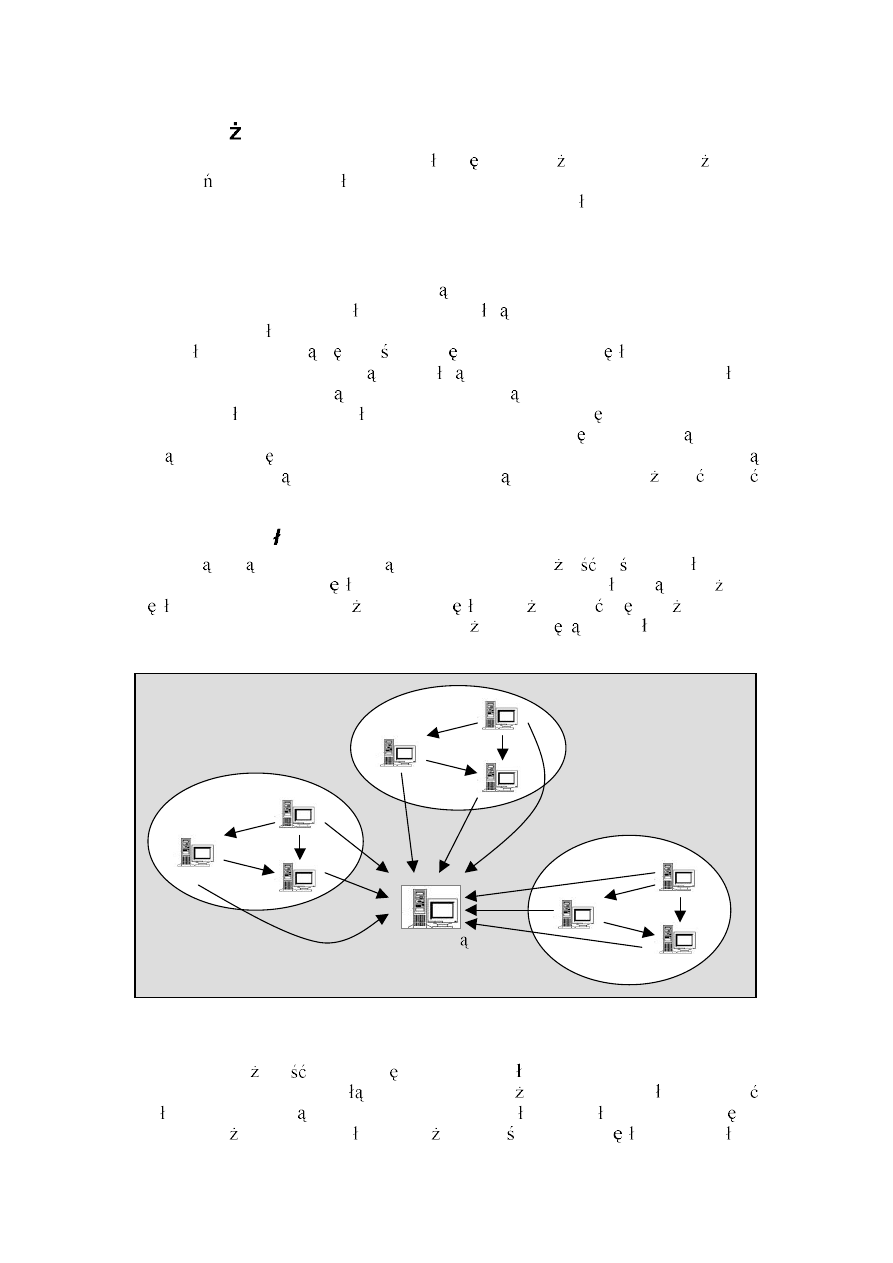

Legenda diagramów:

Pojedynczy w ze klastra. Fizyczna maszyna mo e posiada

wiele odr bnych w z ów. Ka dy w ze to serwer Tomcat z

nowym modu em wspieraj cym klastry.

Serwer zarz dca mo e to by albo jeden z w z ów klastra,

albo serwer ruchu.

W ze , w którym nast pi a awaria.

Po czenie TCP/IP mi dzy dwoma w z ami. Poniewa

mi dzy ka dymi dwoma w z ami jest nawi zywane tylko

jedno fizyczne po czenie, wi c kierunek strza ki oznacza

stron aktywn nawi zywanego po czenia.

Nowo

nawi zane

po czenie

TCP/IP.

W

przypadku

diagramów ukazuj cych awari w z a przerywana linia b dzie

oznacza a logiczne po czenie.

Zerwane fizyczne po czenie (np. z powodu zerwania kabla

lub awarii karty sieciowej).

KOMUNIKAT

Du ymi literami oznaczane s przesy ane komunikaty.

Strza ka nad komunikatem informuje o kierunku przesy ania.

28

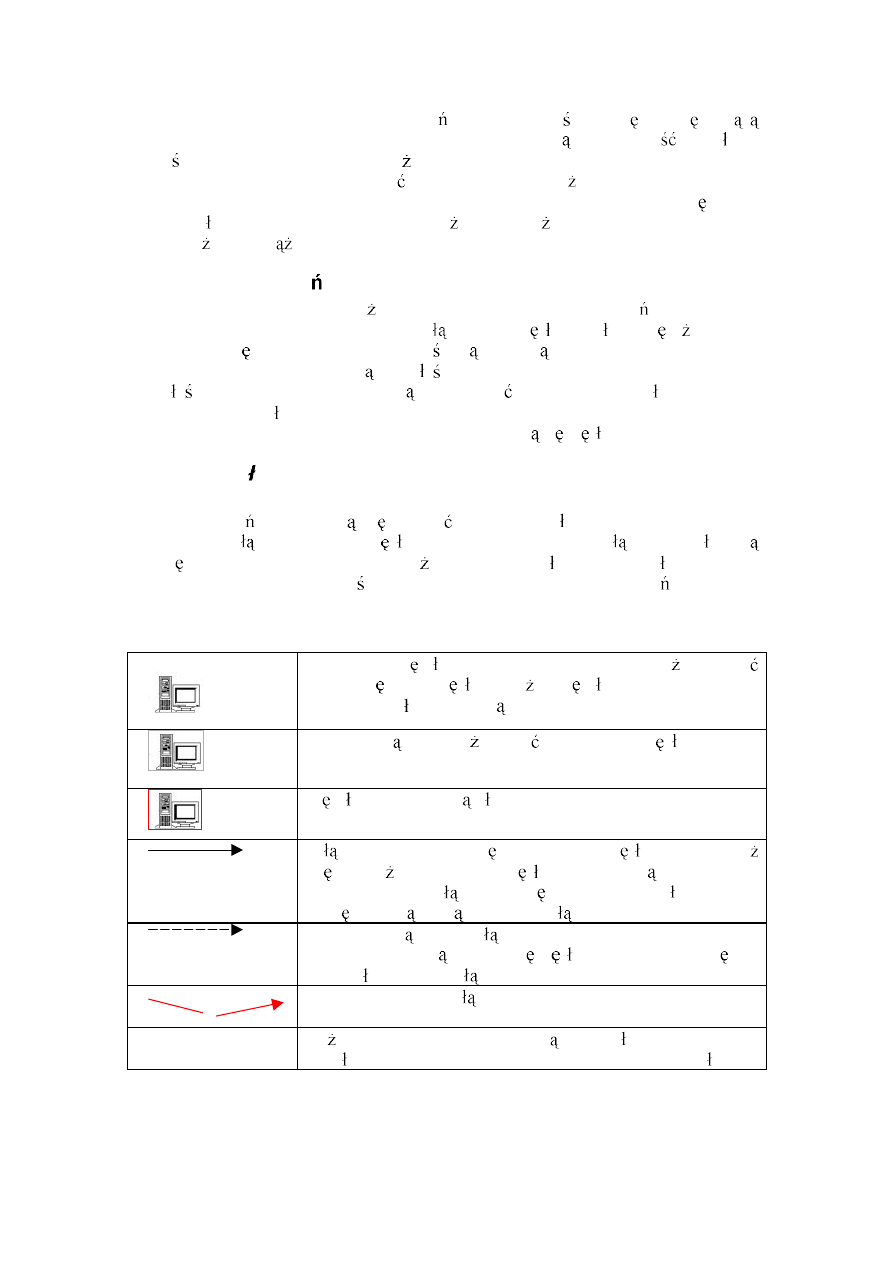

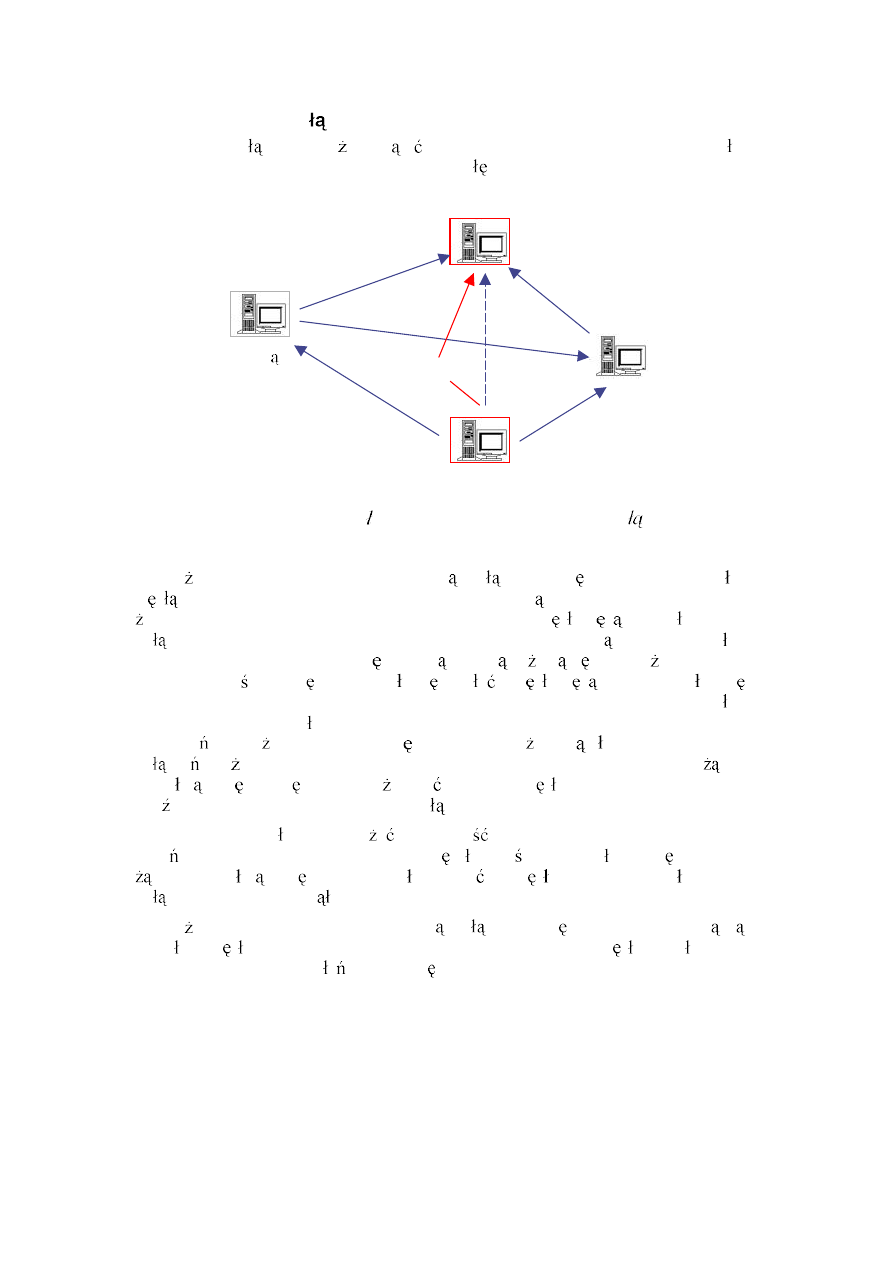

4.2.1 Do czanie nowego w z a

Jest to standardowa sytuacja, która ma miejsce przy ka dym restarcie

któregokolwiek z w z ów klastra lub te podczas rozbudowy superkomputera.

Zg aszaj cy si w ze

Serwer zarz dca

ADDMEMBER

ADDMEMBER

NEWMEMBER

[sesja, wersja]

ADDMEMBER

Rys. 4.1. Schemat zg aszania si nowego w z a w klastrze

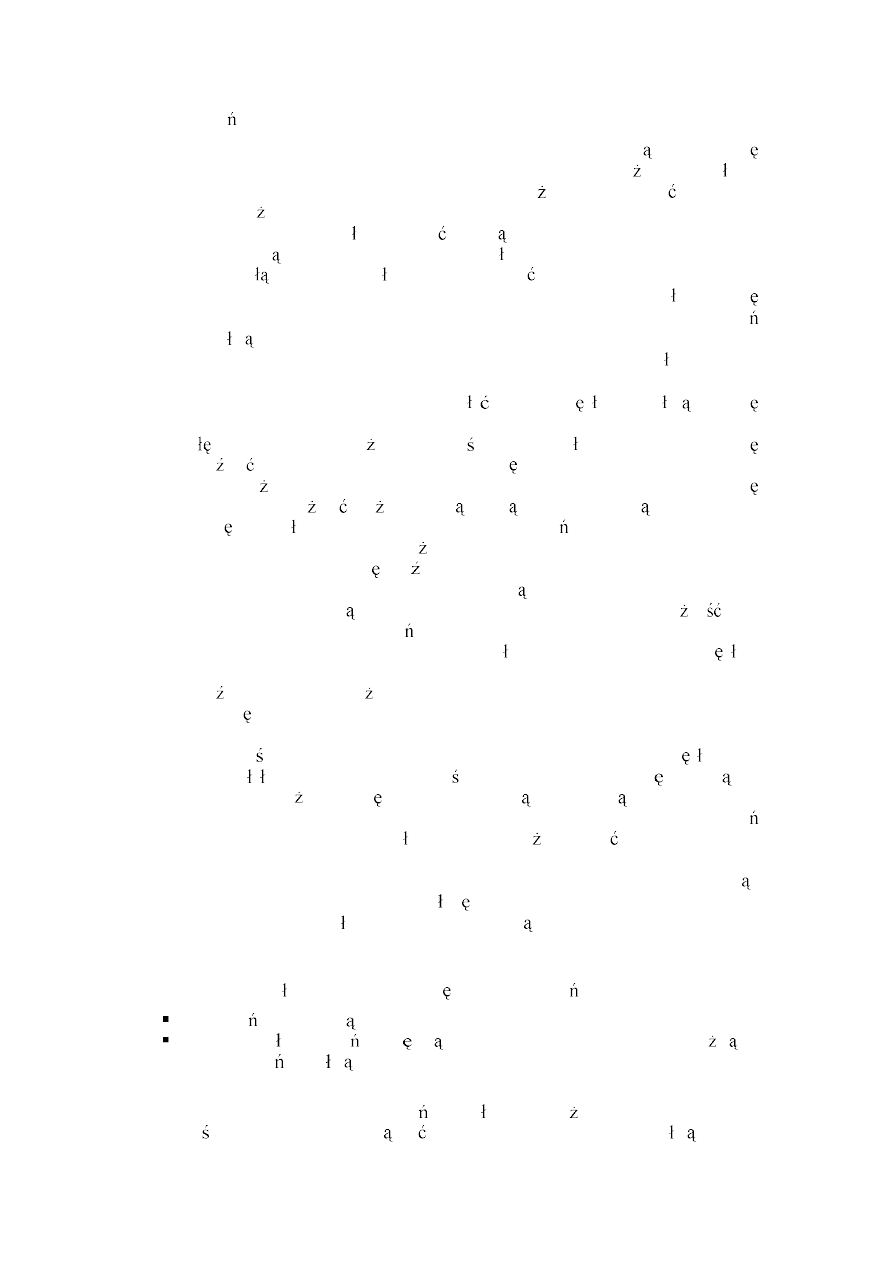

Zg aszaj cy si w ze nawi zuje po czenie z serwerem zarz dc (por. rys. 4.1);

zak adamy, e w ze zna adres IP oraz port serwera zarz dcy (ustawione na sztywno

w pliku konfiguracyjnym lub pobrane z sieci poprzez protokó rozg oszeniowy).

Wysy a komunikat

NEWMEMBER

, wraz z identyfikatorami wszystkich posiadanych sesji

oraz numerami wersji. Serwer zarz dca, po odebraniu komunikatu wysy a komend

ADDMEMBER

do wszystkich pozosta ych w z ów, informuj c o konieczno ci

przy czenia nowego w z a (komunikat zawiera adres nowego w z a). Do

zg aszaj cego si w z a wysy a komunikat

ADDMEMBER

z adresami przy czonych do

tej pory w z ów. Czyli w pierwszej fazie serwer zarz dca uspójnia klaster,

wymuszaj c tworzenie nowych par po cze . Bez komunikatu

ADDMEMBER

od serwera

zarz dcy aden z w z ów nie mo e przyj nowych po cze .

29

B

Serwer zarz dca

FORCESYNC

FORCESYNC

FORCESYNC

Zg aszaj cy si w ze

A

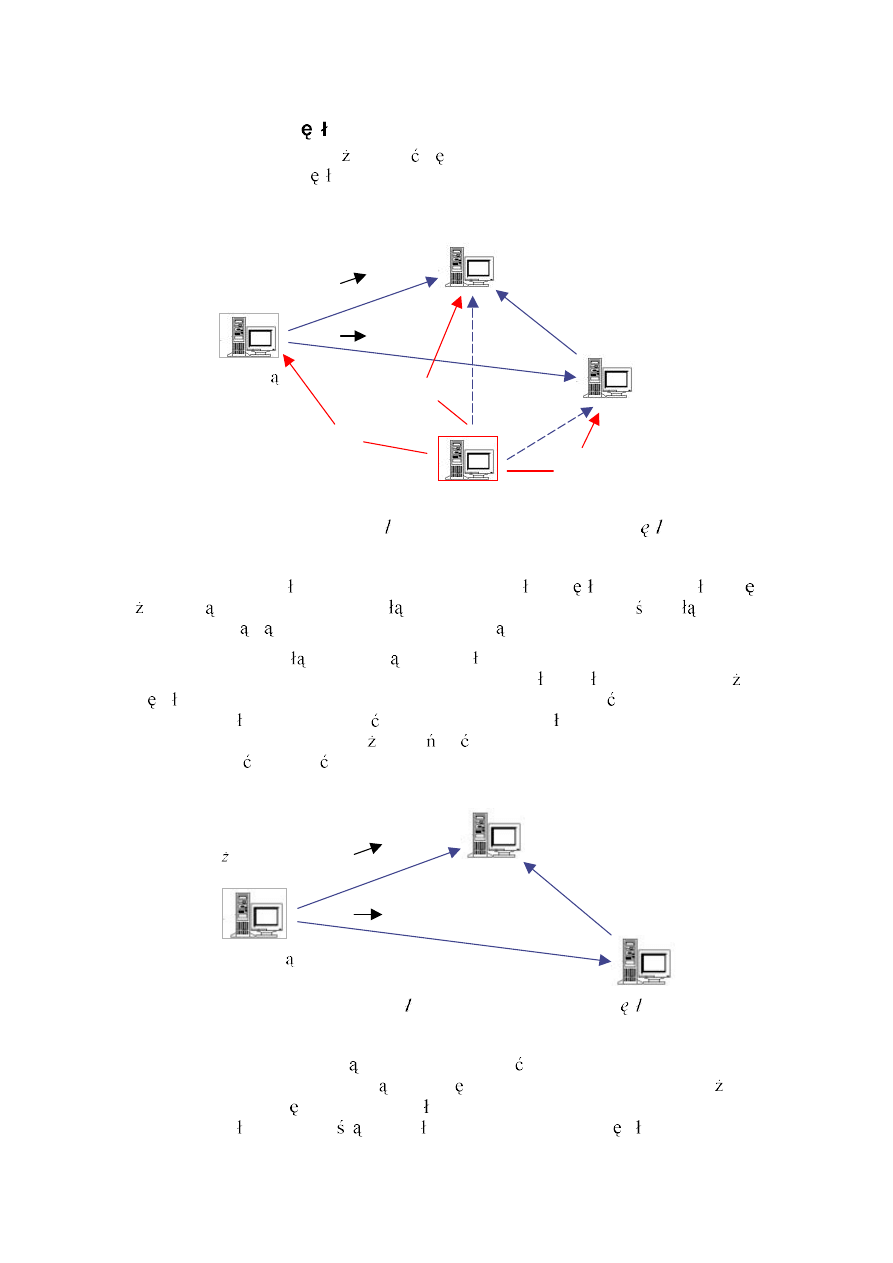

Rys. 4.2. Schemat wykonywanych operacji po przy czeniu w z a

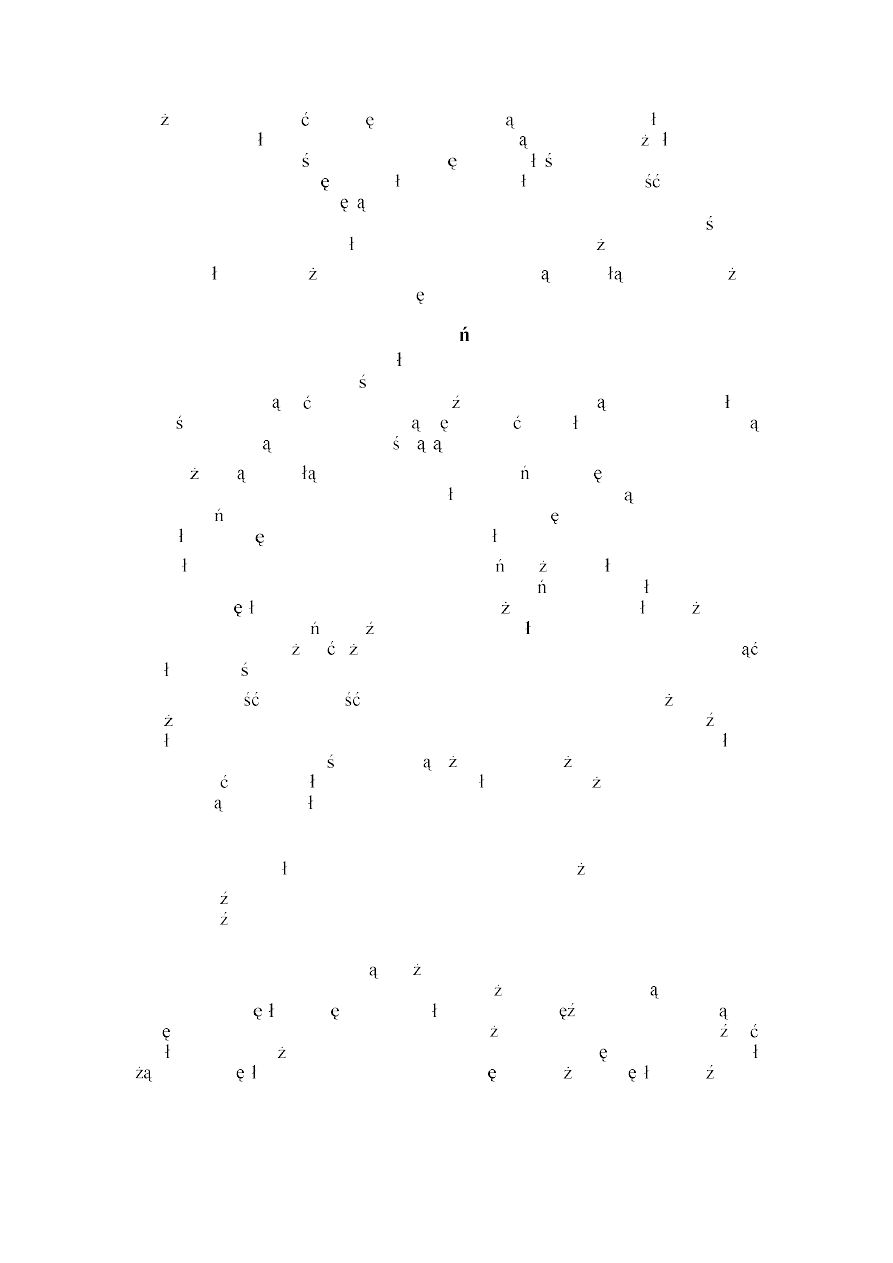

W drugiej fazie nast puje synchronizacja zasobów (por. rys. 4.2). Dla ka dego

identyfikatora sesji, wys anego przez nowy w ze , serwer zarz dca sprawdza numer

wersji z numerem zapisanym u siebie w strukturach danych. S mo liwe trzy

sytuacje:

1. Numery wersji s identyczne nie s podejmowane adne dzia ania.

2. Numer wersji trzymany przez zarz dc jest mniejszy od numeru

dostarczonego przez nowy w ze serwer wysy a do nowego w z a

komunikat

FORCESYNC

z identyfikatorem tej sesji.

3. Numer wersji trzymany przez zarz dc jest wi kszy od numeru dostarczonego

przez nowy w ze serwer wysy a komunikat

FORCESYNC

do jednego z

wcze niejszych cz onków klastra. Komunikat zawiera identyfikator sesji oraz

adres nowego w z a.

Komunikat

FORCESYNC

powoduje wymuszenie replikacji sesji dla danego

identyfikatora. Opcjonalnie mo na wys a adres w z a, do którego nale y wys a

replik . Je eli adres nie zostanie podany, to replika b dzie rozes ana do wszystkich

cz onków klastra. Dodatkowo serwer zarz dca przed wys aniem komunikatu ustawia

adresata jako aktualnie zajmuj cego sesj . Jest to konieczne, poniewa serwer

zarz dca zak ada,

e wszystkie pod czone w z y posiadaj identyczny stan

wszystkich sesji. Je eli nie zosta aby za o ona blokada, to

danie odwo uj ce si do

niezsynchronizowanej sesji mog oby zosta przekierowane do w z a A, który

jeszcze nie otrzyma nowej repliki. Wtedy w ze za o y by blokad w serwerze

synchronizacyjnym i zacz przetwarzanie

dania. Niestety

danie mia oby dost p

do nieaktualnej wersji sesji. Mechanizm obroni si przed tak sytuacj ,

uniemo liwiaj c w z owi A za o enie blokady dopóty, dopóki nie zwolni jej w ze

replikuj cy. Ten z kolei zwolni sesj dopiero po zako czeniu procesu replikacji, czyli

przes aniu najnowszej wersji danych do w z a A.

W sytuacji, gdy pod czany w ze jest ca kowicie nowym serwerem Tomcat,

przesy ana tablica identyfikatorów sesji b dzie pusta. Niemniej jednak przy

ponownym pod czaniu tego samego w z a (na przyk ad z powodu chwilowego

zerwania po czenia) tablica mo e zawiera dane.

30

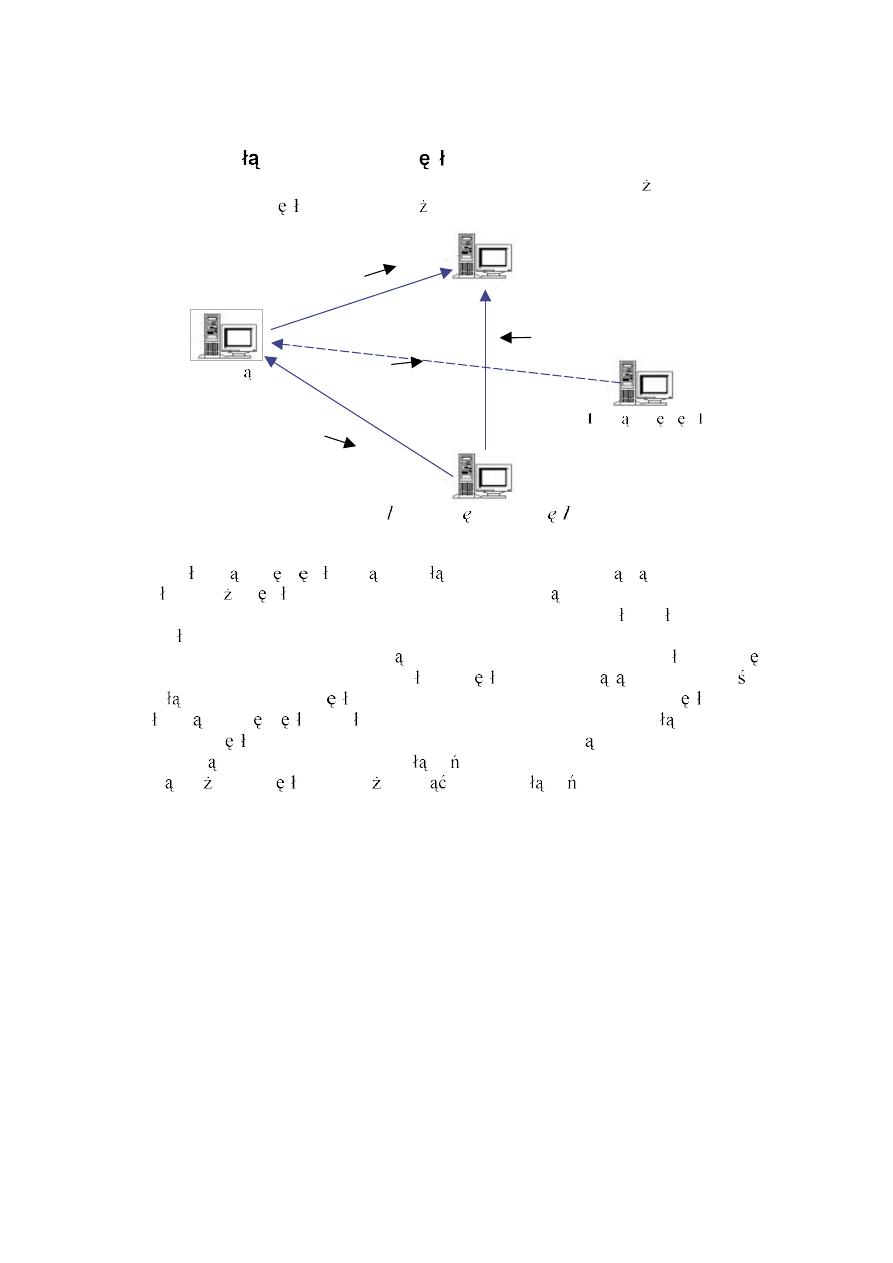

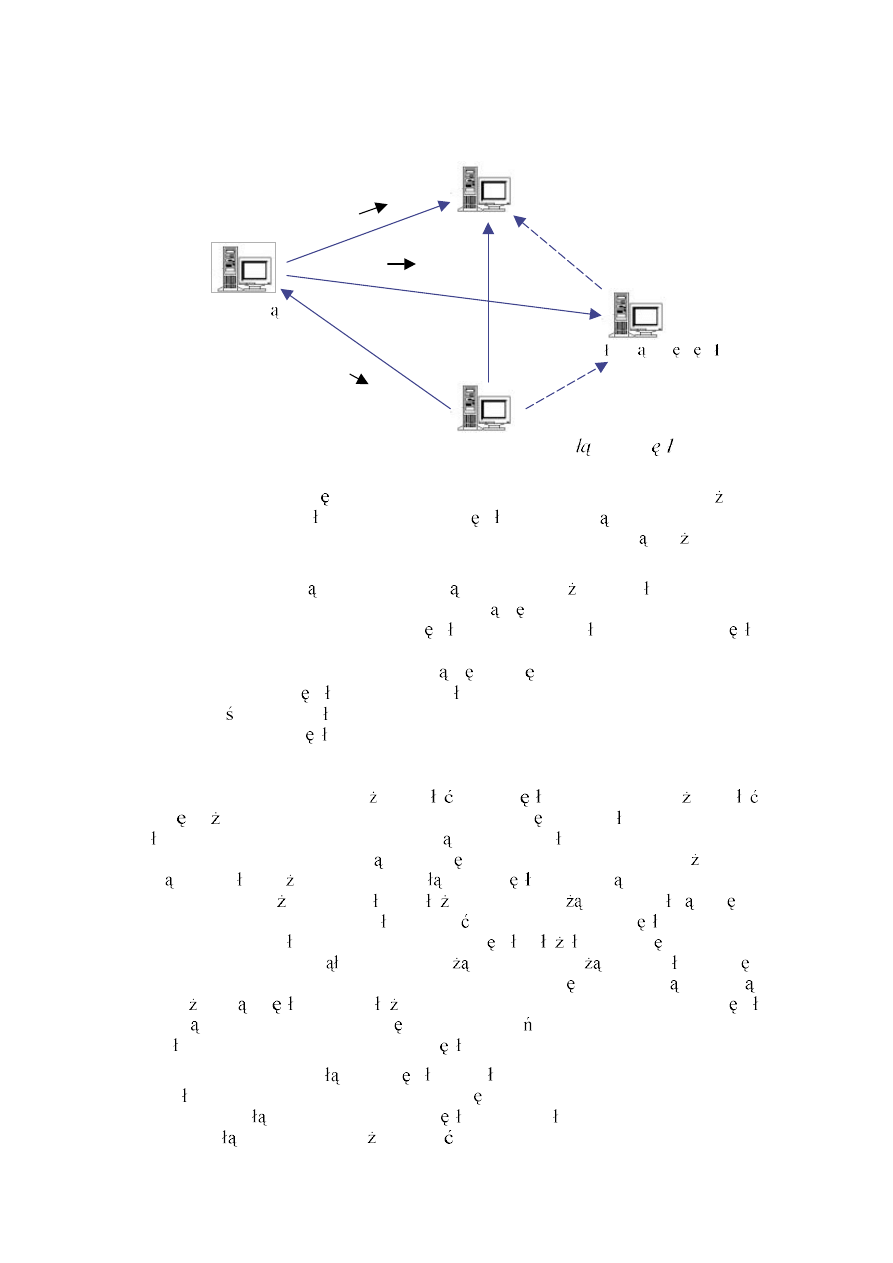

4.2.2 Awaria po czenia

Awaria po czenia mo e nast pi z winy karty sieciowej (przepalenie uk adu

scalonego), z powodu przerwania kabla lub b du w konfiguracji sieciowej systemu

operacyjnego.

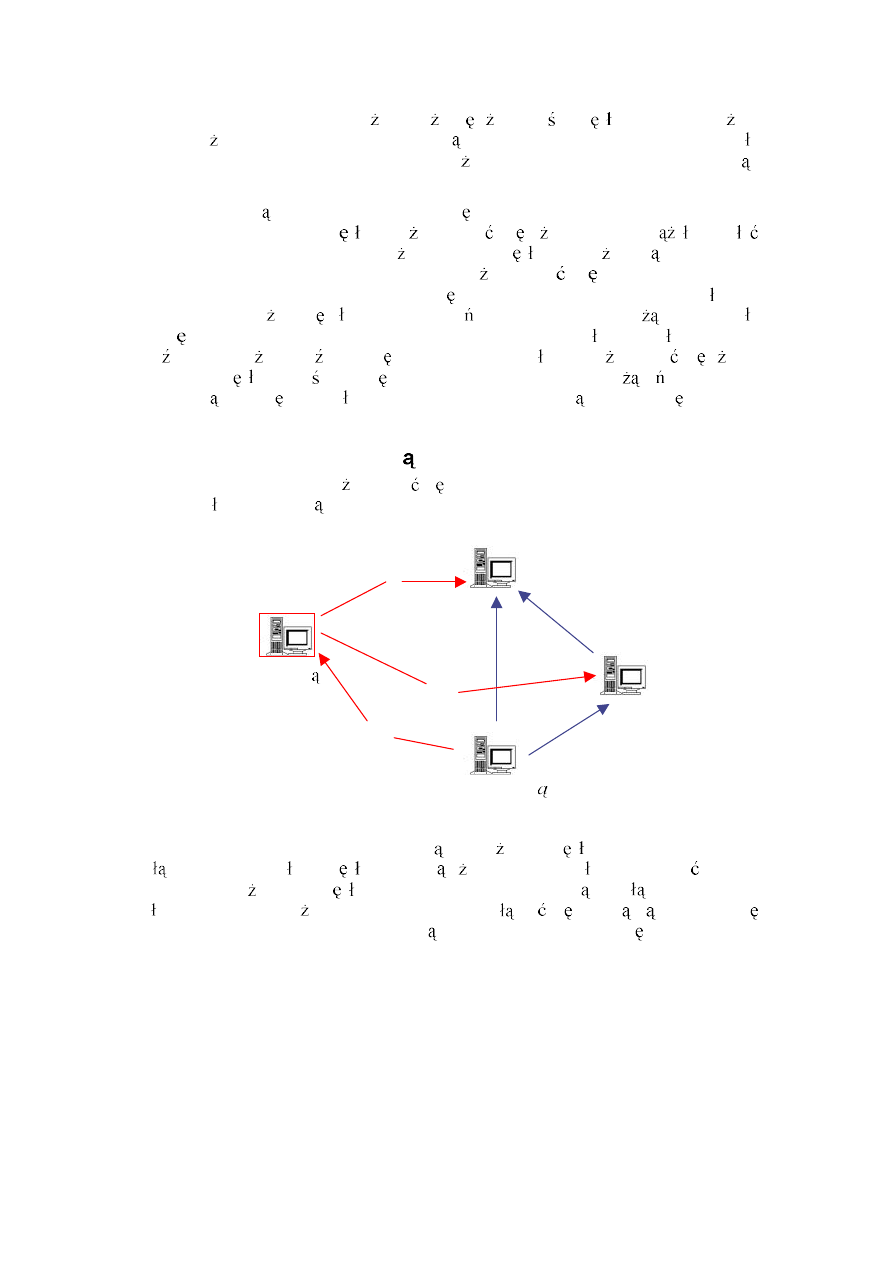

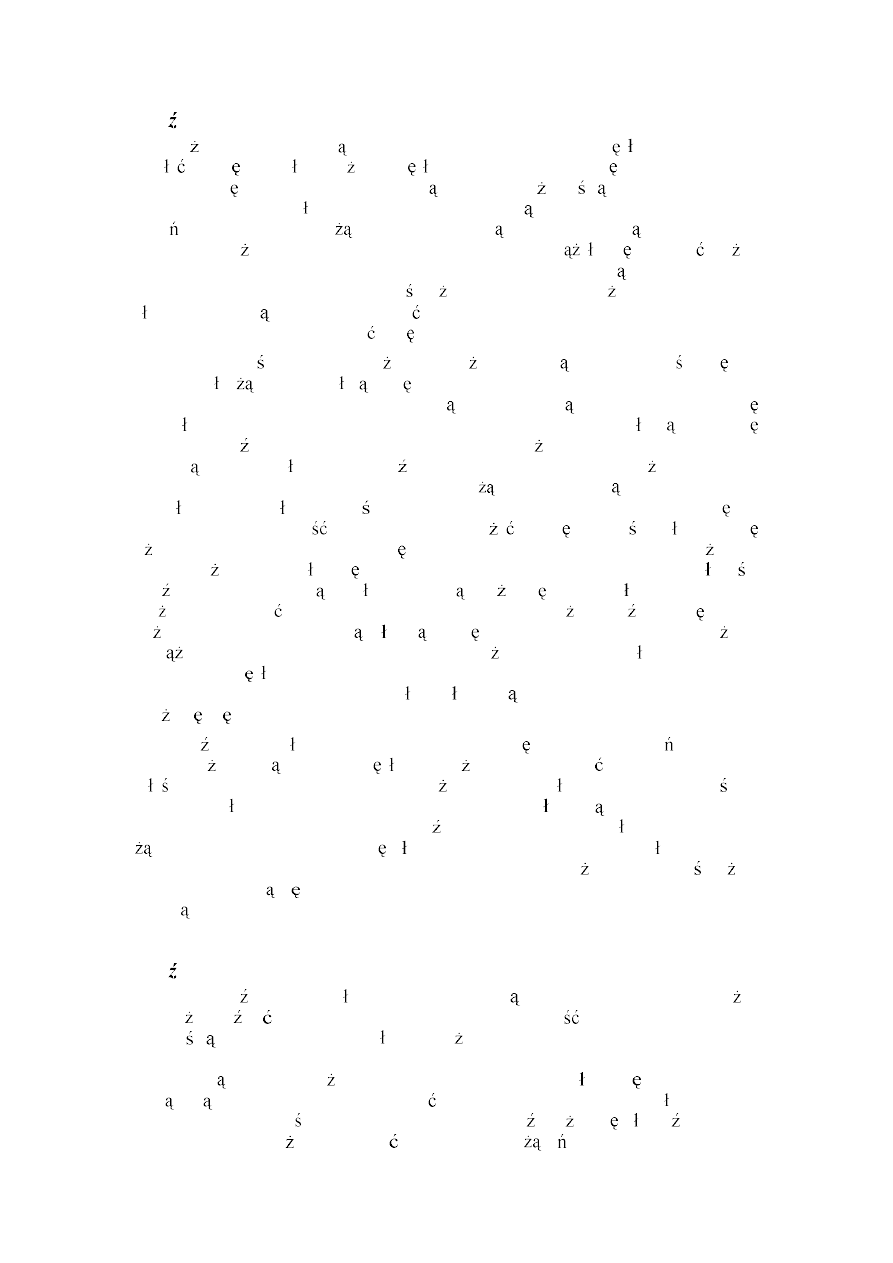

Wstrzymanie sesji

Serwer zarz dca

Wstrzymanie sesji

Rys. 4.3. Schemat dzia ania klastra w przypadku awarii po czenia

Je eli mamy do czynienia z awari po czenia mi dzy dwoma zwyk ymi

w z mi klastra (tzn. nie dotyczy ona serwera zarz dcy), to nie spowoduje ona

adnych zmian w architekturze klastra (por. rys. 4.3). W z y b d trzyma y logiczne

po czenie w swoich strukturach danych, nie zaprzestaj c prób wysy ania

komunikatów replikacyjnych mi dzy sob . Jedyn ró nic b dzie to, e komunikatu

w rzeczywisto ci nie b dzie udawa o si wys a i w z y b d wstrzymywa y zaj te

przez siebie sesje (sesja jest zwalniana tylko w momencie poprawnego rozes ania

replik do wszystkich cz onków klastra). Przy wykorzystaniu zintegrowanego serwera

ruchu ko cowy u ytkownik nawet si nie zorientuje, e nast pi a jakakolwiek awaria

po cze . Je eli nie wykorzystamy zintegrowanego serwera ruchu, to

danie

odwo uj ce si do zaj tej sesji mo e trafi do innego w z a i jego wykonanie zostanie

opó nione o czas naprawy zerwanego po czenia.

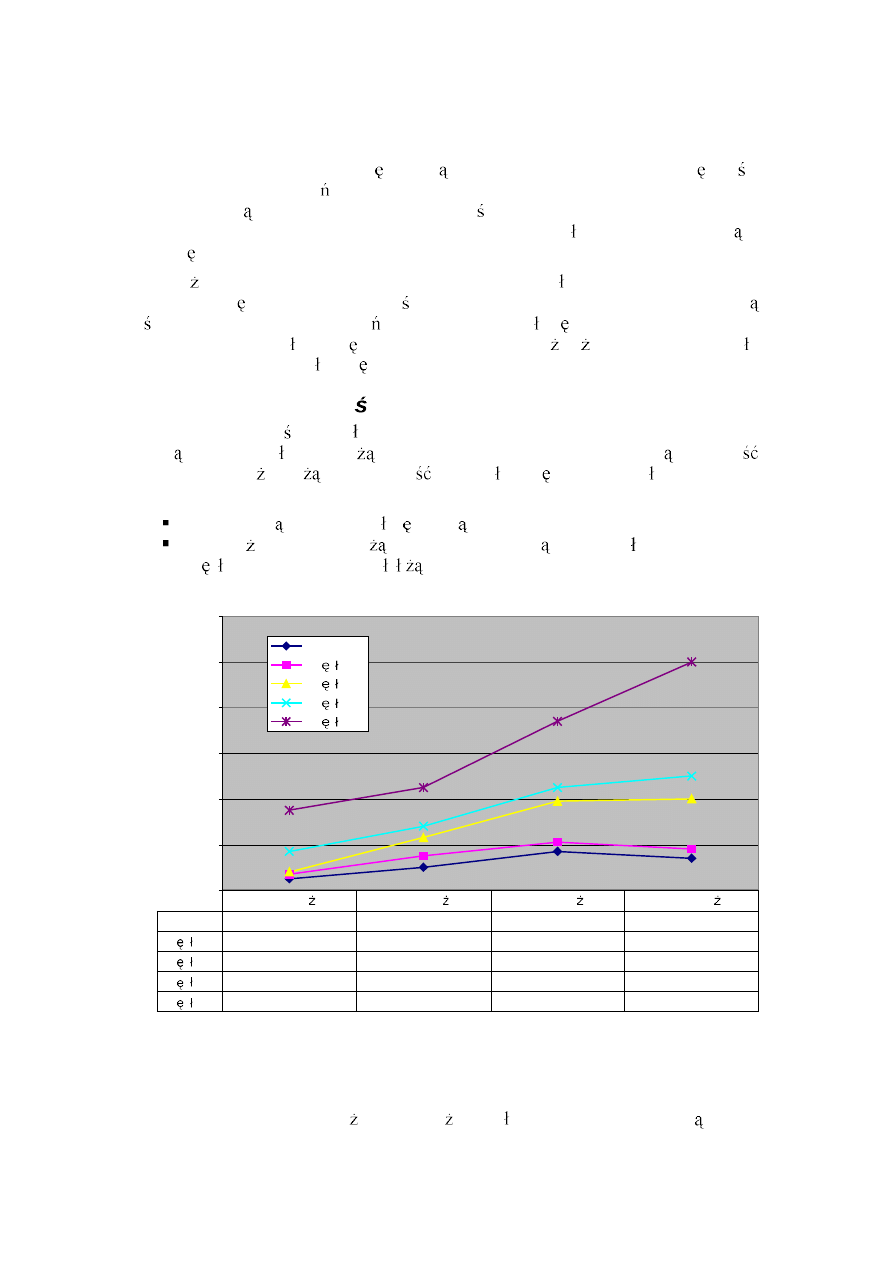

Przy tej okazji atwo zauwa y konieczno trzymania blokady sesji do momentu