Praca magisterska

INTERAKTYWNY SYSTEM REGUŁOWEJ

ANALIZY DANYCH MARKETINGOWYCH

DOTYCZĄCYCH SATYSFAKCJI KLIENTA

SPIS TREŚCI

SPIS TREŚCI ............................................................................................................................................. 4

1

WSTĘP.............................................................................................................................................. 5

2

CEL I ZAKRES PRACY................................................................................................................. 8

3

PRZEGLĄD WYBRANYCH ZAGADNIEŃ ANALIZY SATYSFAKCJI KLIENTA (ASK) 10

3.1

S

POSOBY ANALIZY SATYSFAKCJI KLIENTA

.............................................................................. 10

3.1.1

Badanie poziomu zadowolenia klienta............................................................................... 10

3.1.2

Indeks satysfakcji klienta ................................................................................................... 12

3.1.3

Zarządzanie relacjami z klientem....................................................................................... 13

3.2

ASK

PRZY WYKORZYSTANIU REGUŁ DECYZYJNYCH

............................................................... 14

3.2.1

Elementy teorii zbiorów przybliżonych i indukcji reguł decyzyjnych................................. 14

3.2.2

Wprowadzenie do metodologii ASK w oparciu o reguły decyzyjne ................................... 22

3.2.3

Formalne przedstawienie metodologii............................................................................... 22

3.3

T

ECHNOLOGIA ANALIZY WIELOWYMIAROWYCH DANYCH

OLAP............................................ 25

3.3.1

Terminologia i przykłady ................................................................................................... 25

3.3.2

Zastosowanie ..................................................................................................................... 27

4

PROPOZYCJE ROZSZERZEŃ METODOLOGII ASK W OPARCIU O REGUŁY

DECYZYJNE........................................................................................................................................... 28

4.1

P

RZYKŁAD DANYCH WEJŚCIOWYCH DO ANALIZY SATYSFAKCJI KLIENTA

................................ 28

4.2

T

ESTOWANIE STRATEGII INTERWENCJI

.................................................................................... 29

4.2.1

Przykład analizy danych metodą testowania strategii interwencji .................................... 29

4.2.2

Algorytm testowania strategii interwencji ......................................................................... 31

4.2.3

Możliwe zastosowania i kierunki rozwoju.......................................................................... 31

4.3

S

ZUKANIE STRATEGII INTERWENCJI

......................................................................................... 32

4.3.1

Przykład analizy danych metodą szukania strategii interwencji........................................ 32

4.3.2

Algorytm szukania strategii interwencji............................................................................. 33

4.3.3

Możliwe zastosowania i kierunki rozwoju.......................................................................... 34

4.4

P

OŁĄCZENIE

OLAP

I

DRSA

DO ANALIZY SATYSFAKCJI KLIENTA

........................................... 34

5

PROJEKT SYSTEMU I IMPLEMENTACJA............................................................................ 38

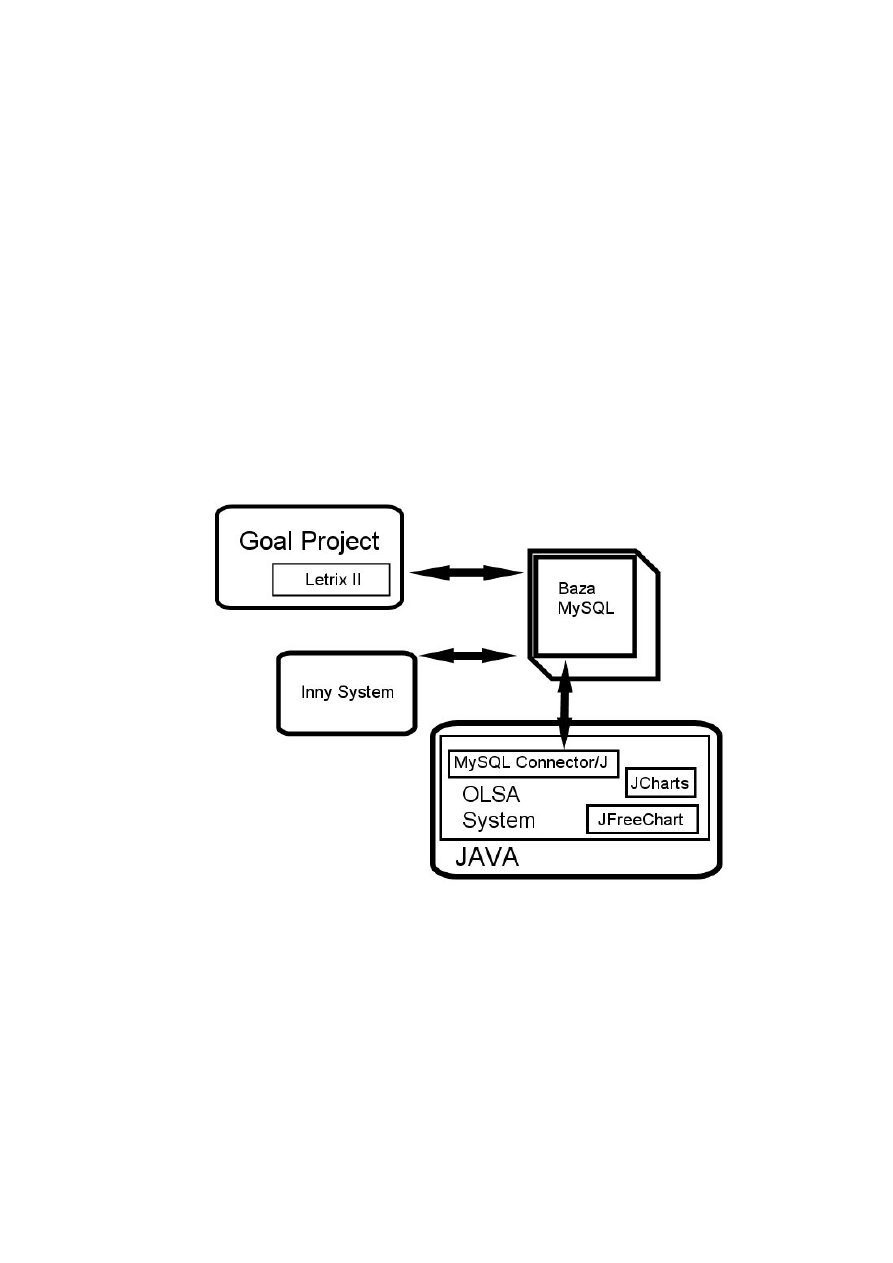

5.1

A

RCHITEKTURA SYSTEMU I WYKORZYSTANE TECHNOLOGIE

................................................... 38

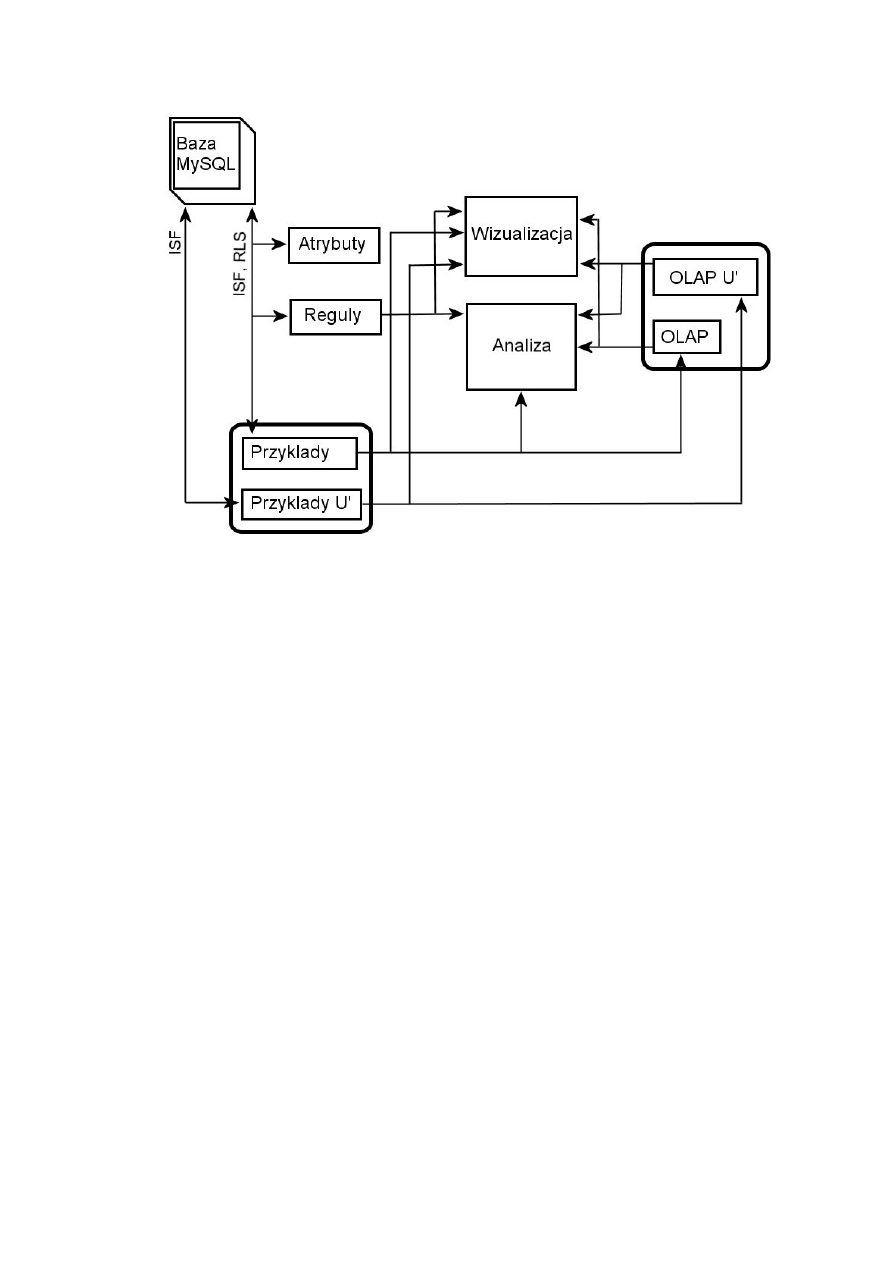

5.2

E

LEMENTY SYSTEMU I POWIĄZANIA MIĘDZY NIMI

................................................................... 39

5.2.1

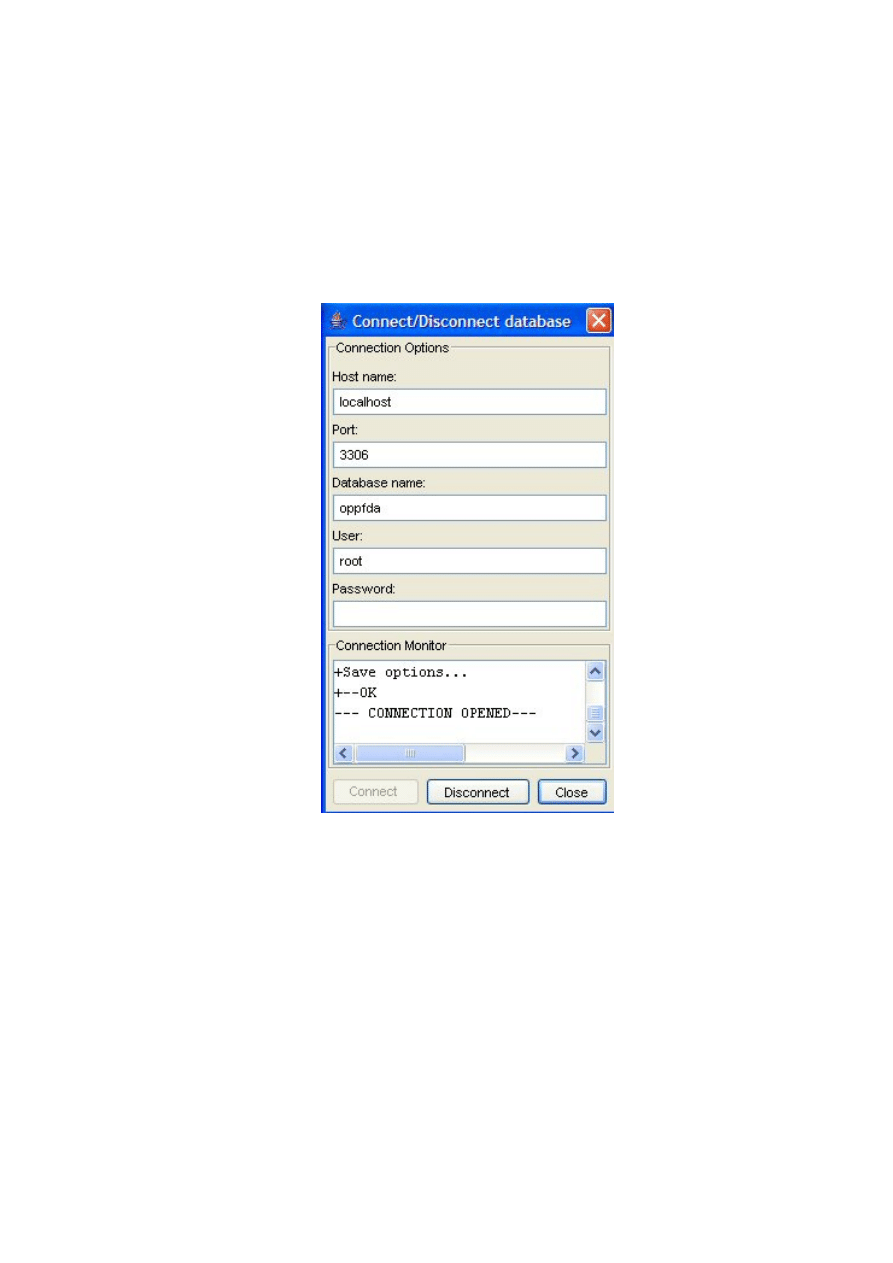

Moduł komunikacji z bazą danych ..................................................................................... 40

5.2.2

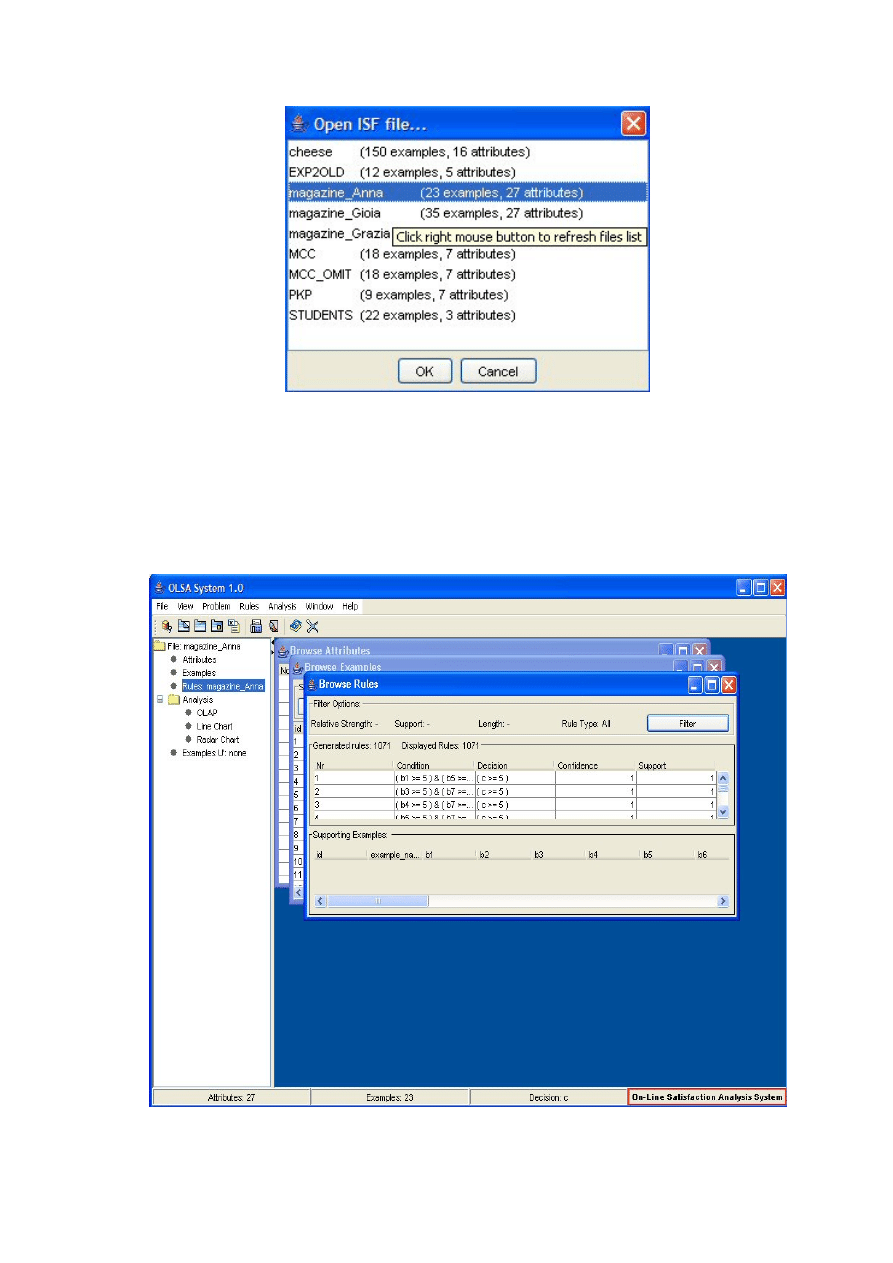

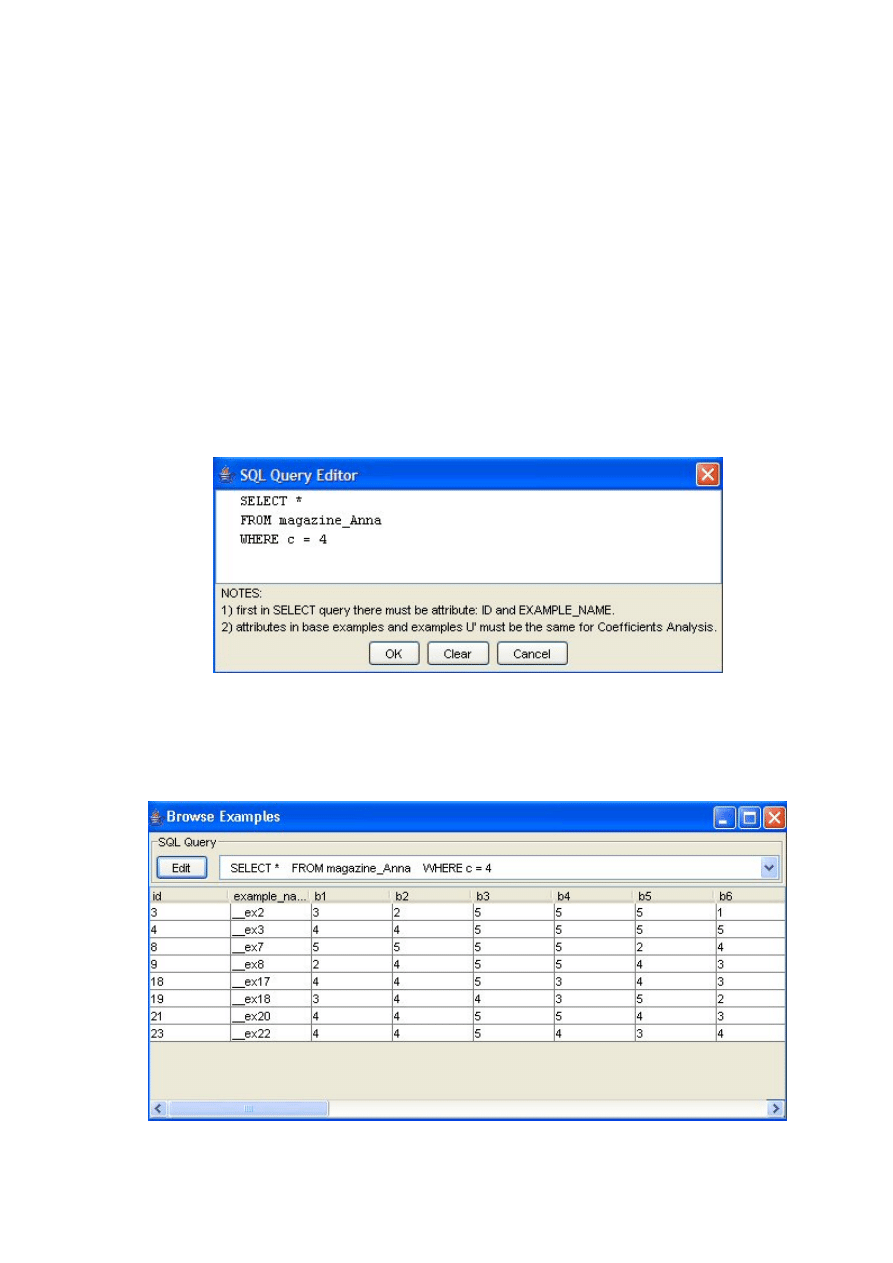

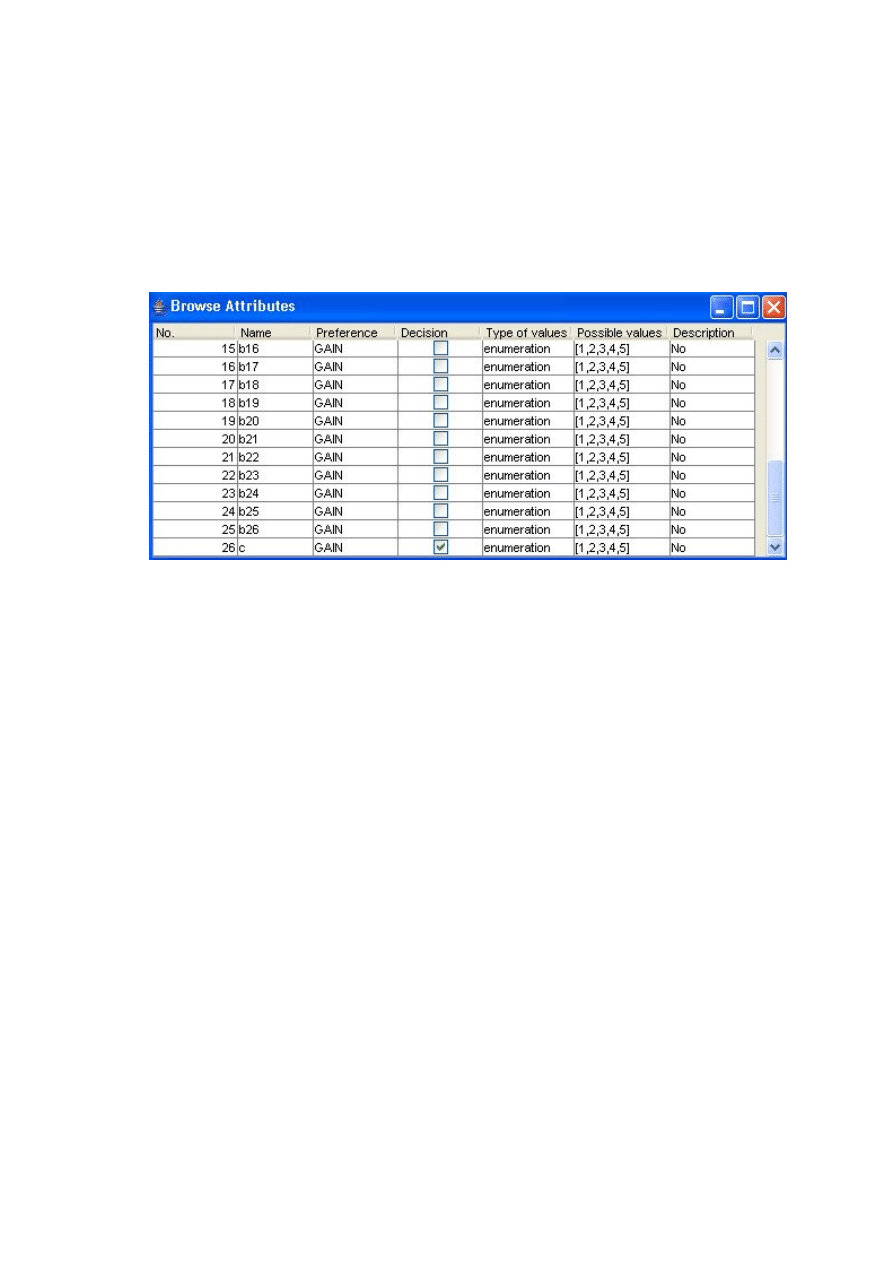

Moduły do prezentacji atrybutów i przykładów ................................................................. 41

5.2.3

Moduł do prezentacji reguł ................................................................................................ 42

5.2.4

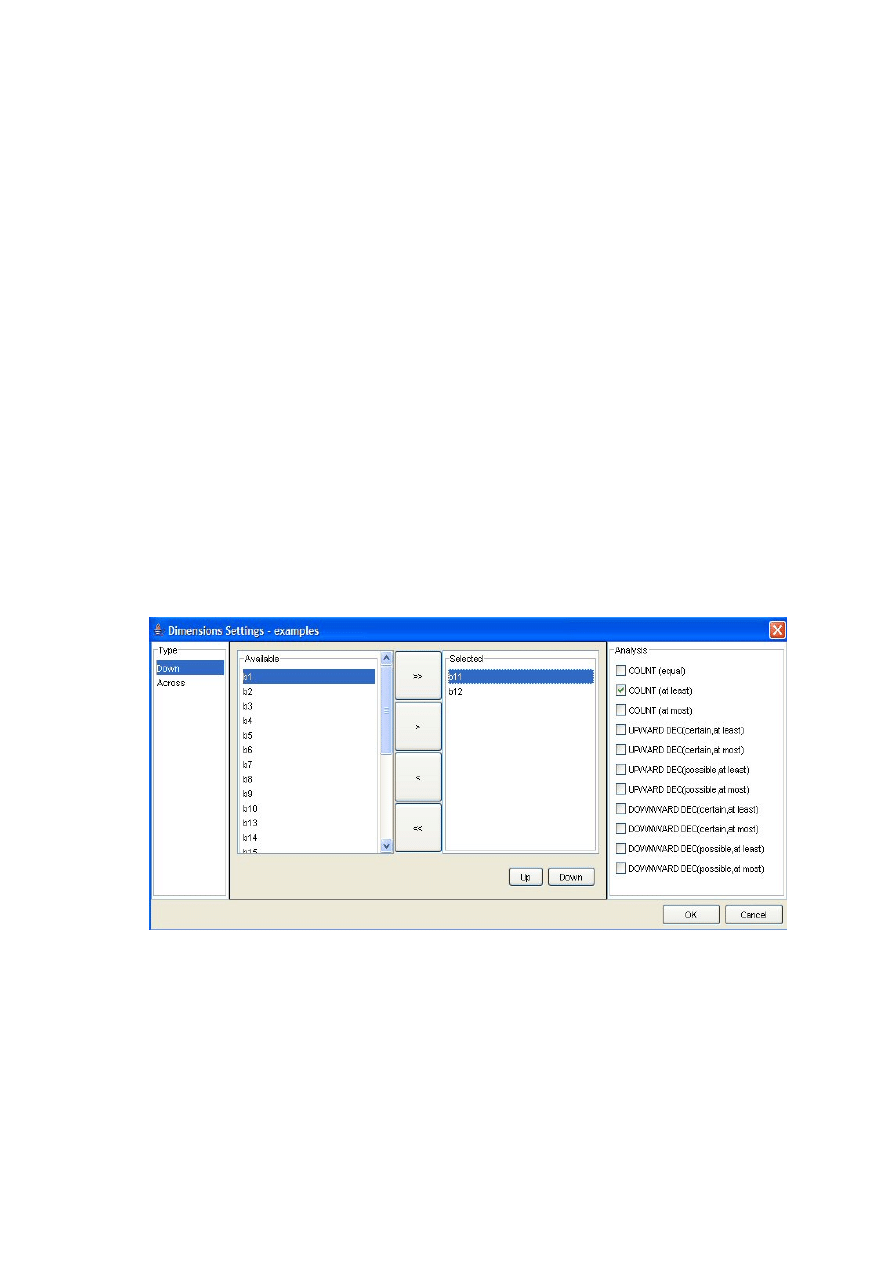

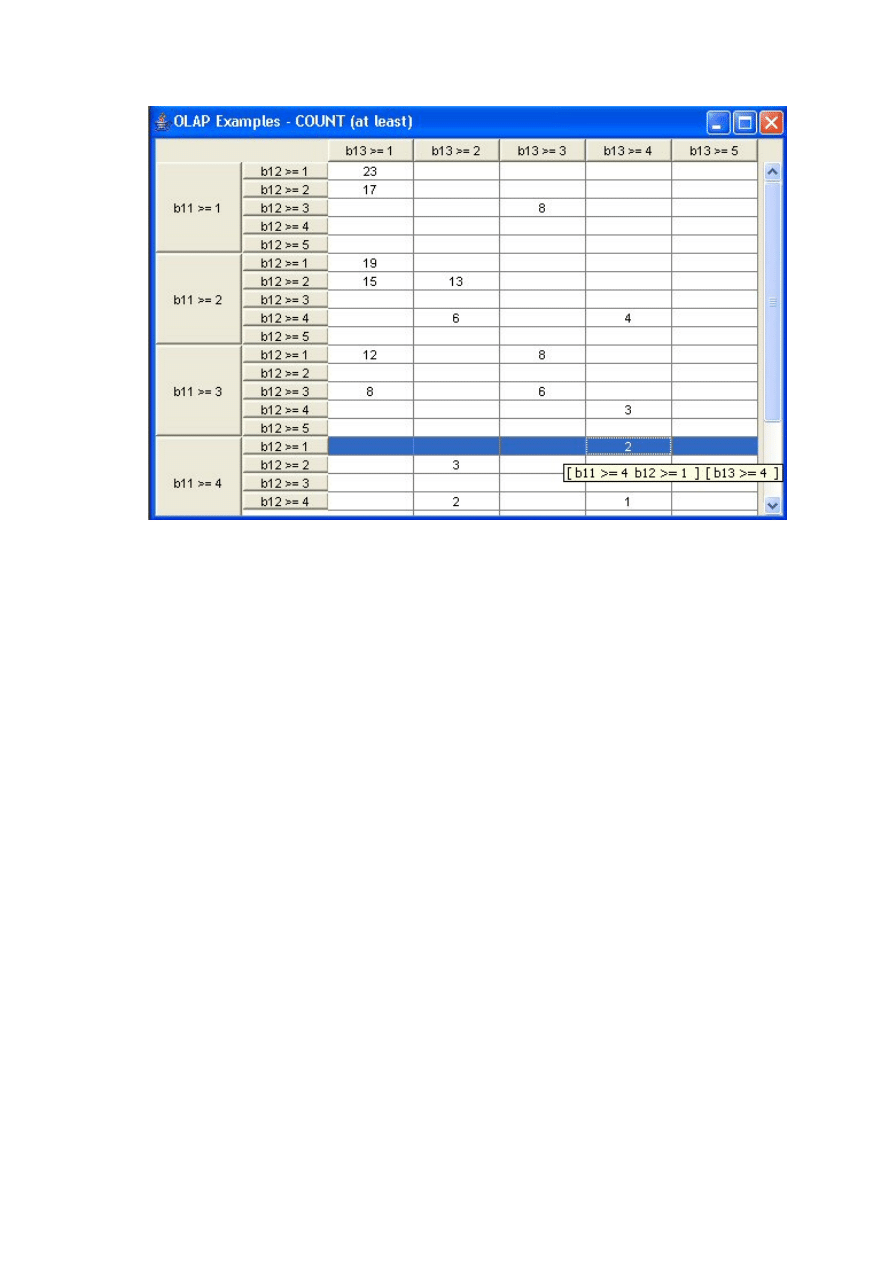

Moduły prezentacji danych OLAP ..................................................................................... 43

5.2.5

Moduły do analizy satysfakcji klienta ................................................................................ 43

6

STUDIUM PRZYPADKÓW – EKSPERYMENT I WYNIKI................................................... 45

6.1

D

ANE WEJŚCIOWE PRZEZNACZONE DO ANALIZY SATYSFAKCJI KLIENTA

................................. 45

6.2

P

RZEBIEG EKSPERYMENTU

...................................................................................................... 46

6.2.1

Etap 1 – prezentacja danych marketingowych do analizy ................................................. 48

6.2.2

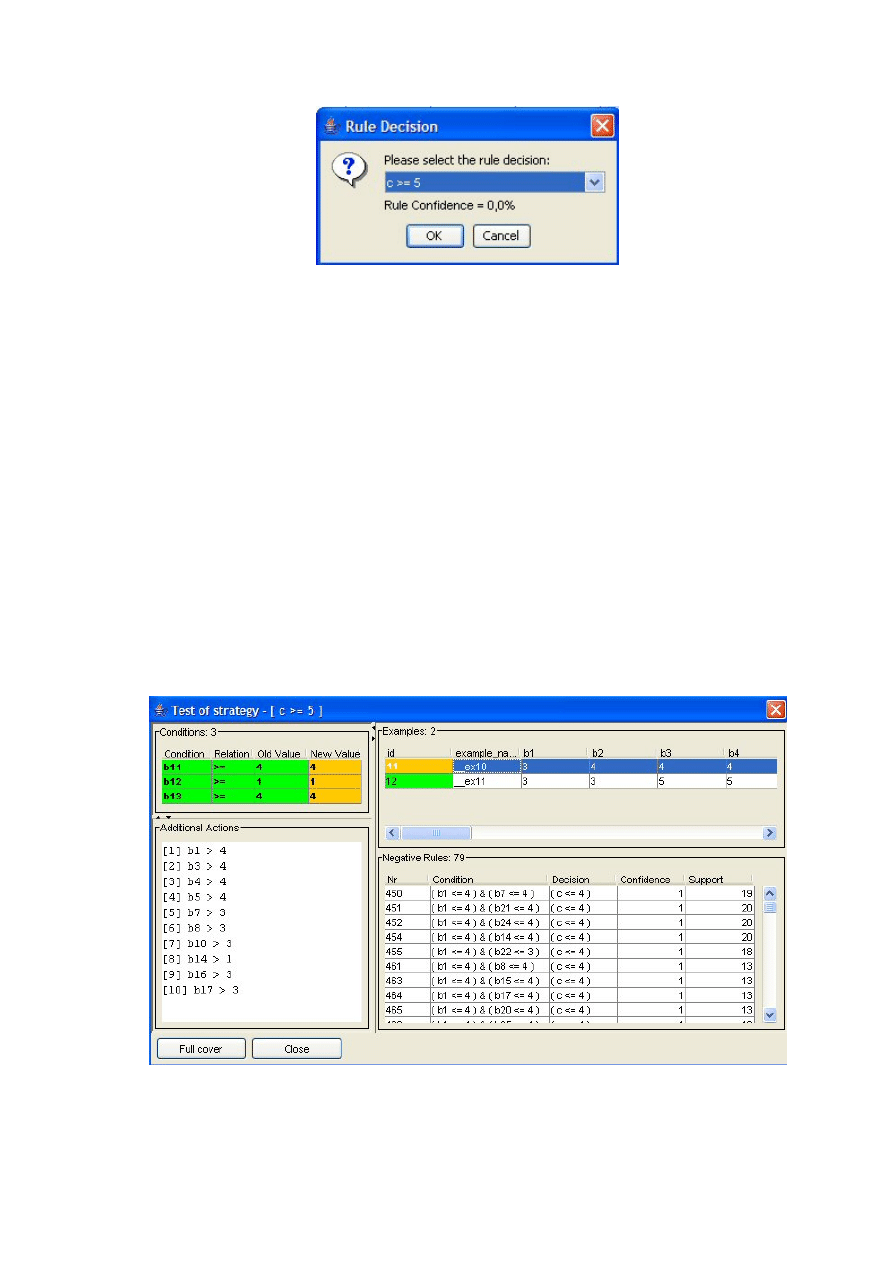

Etap 2 – analiza metodą szukania strategii interwencji..................................................... 51

6.2.3

Etap 3 – analiza metodą testowania strategii interwencji ................................................. 54

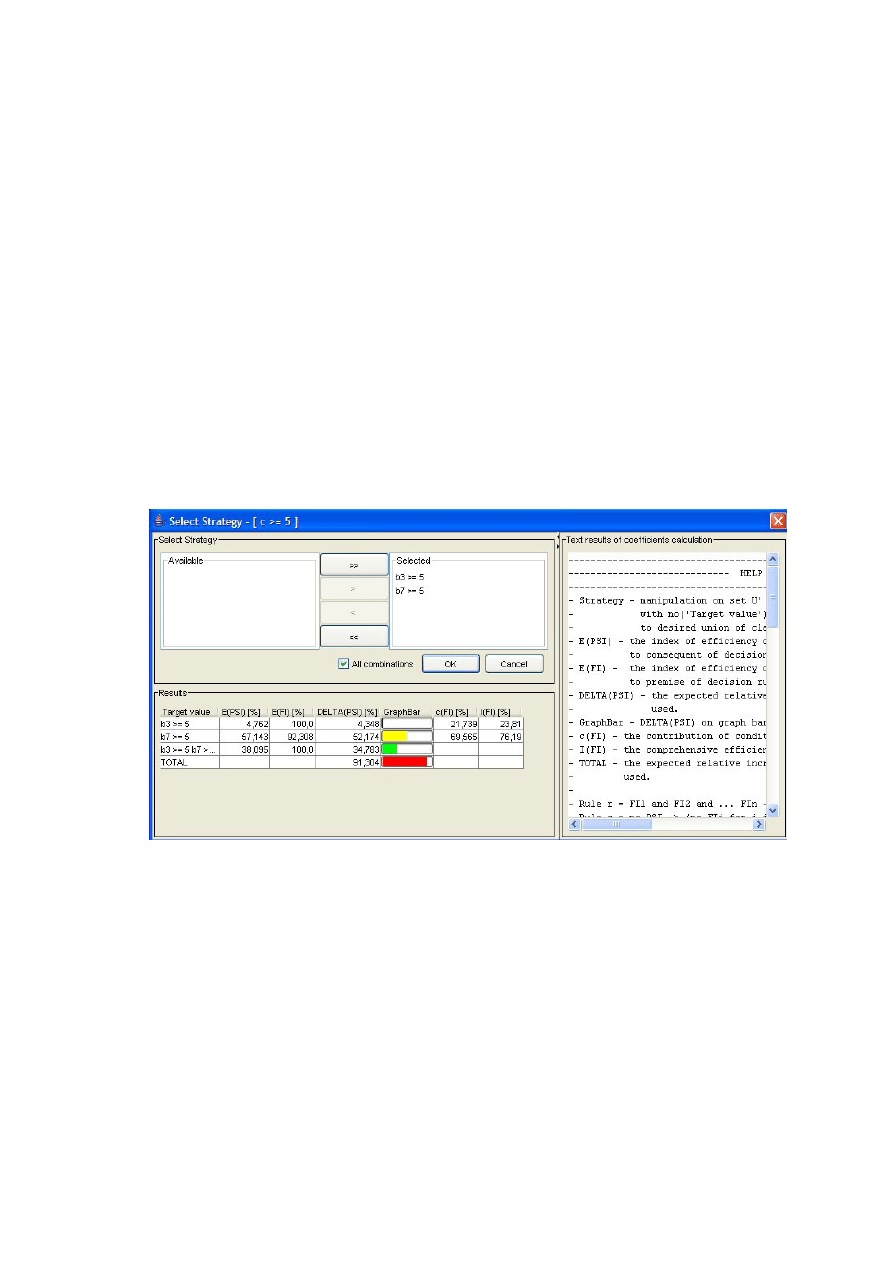

6.2.4

Etap 4 – badanie oczekiwanej efektywności strategii interwencji ..................................... 57

6.3

K

OŃCOWE WNIOSKI

................................................................................................................. 61

7

PODSUMOWANIE I WNIOSKI.................................................................................................. 62

BIBLIOGRAFIA ..................................................................................................................................... 65

DODATEK A – WYKAZ TABEL I RYSUNKÓW .............................................................................. 67

DODATEK B – PRZEWODNIK INSTALACYJNY UŻYTKOWNIKA........................................... 68

DODATEK C – PRZEWODNIK INSTALACYJNY PROGRAMISTY ............................................ 70

DODATEK D – SPIS CD ........................................................................................................................ 71

5

1 Wstęp

Strategia każdej firmy, działającej na rynku konkurencyjnym opiera się na

utrzymywaniu i pozyskiwaniu nabywców swojego produktu lub usługi. Ze

strategicznego punktu widzenia wynika więc, że najważniejsi dla firmy są klienci,

ponieważ to oni decydują tak naprawdę o sukcesie firmy. W warunkach nasilającej się

konkurencji najważniejszym czynnikiem wpływającym na zdobycie klienta i

zatrzymanie go, a co za tym idzie – sukces przedsiębiorstwa, staje się zadowolenie

klienta.

Co tak naprawdę kryje się pod pojęciem „satysfakcja klienta” (ang. Customer

Satisfaction)? Klienci od dawna już nie płacą za produkt w sensie fizycznym, ale za to,

co w produkcie czy usłudze cenią i czego od niego/niej oczekują. W wyniku zakupu i

korzystania z produktu/usługi klient zaspokaja lub nie swoje oczekiwania. W

końcowym efekcie może on być niezadowolony (jego oczekiwania były większe),

zadowolony (oczekiwania spełniają się) lub bardzo zadowolony (oczekiwania były

mniejsze) [26]. Usatysfakcjonowani klienci są bardziej lojalni i dzielą się swoimi

korzystnymi opiniami o produkcie/usłudze z innymi, natomiast obniżenie poziomu ich

satysfakcji zmniejsza prawdopodobieństwo ponownego zakupu, a szansa na to, że nie

odejdą redukuje się do kilkunastu procent [15]. Stopień satysfakcji staje się jednym z

najlepszych wskaźników przyszłych zysków firmy oraz dużą pomocą w ustalaniu

strategii przedsiębiorstwa oraz zwiększaniu wpływów i udziału w rynku. Wszystko to

wskazuje na celowość badań ukierunkowanych na poznanie stopnia satysfakcji

klientów.

Pojawia się problem sprawnego i wiarygodnego badania tej satysfakcji ze

względu na wpływ różnorodnych czynników, czy zależność od dziedziny życia. Firmy

posiadają szereg własnych informacji bądź mają możliwość ich zgromadzenia,

najczęściej przez indywidualne wywiady grupowe, wywiady telefoniczne oraz ankiety

pocztowe. Aby dokonać najlepszej i najbardziej obiektywnej analizy satysfakcji klienta

(ASK) stosuje się wiele metod badawczych zarówno ilościowych jak i jakościowych,

m.in.: analizę poziomu sprzedaży, analizę utraty klientów, analizę reklamacji lub

kontrolowany zakup [6]. Podejmowane są próby ujednolicenia sposobów określających

stopień satysfakcji klienta, czego przykładem może być amerykański indeks satysfakcji

6

klienta (ang. American Customer Satisfaction Index) [26] oraz jego odpowiednik

szwedzki (ang. Swedish Customer Satisfaction Barometr). Wymienione indeksy oparte

są na modelu opracowanym przez C. Fornella [14], którego podstawą jest analizowanie

satysfakcji klienta w oparciu o trzy grupy czynników, tj. postrzeganą jakość,

oczekiwaną jakość i postrzeganą wartość oraz powiązania i zależności między nimi.

Otrzymywane informacje można skutecznie wykorzystać do analizy zadowolenia

odbiorców, ale są one bezwartościowe, jeśli nie są systematycznie analizowane, nie

wyciąga się z nich wniosków i nie wprowadza w życie.

Najczęstszą i najpopularniejszą formą zbierania potrzebnych informacji przez

firmy jest opracowywanie kwestionariuszy i przeprowadzanie ankiet. Pozwalają one na

wyróżnienie czynników satysfakcjonujących i

niesatysfakcjonujących klienta,

tkwiących w samym produkcie/usłudze, oraz na ocenę różnorodnych cech

produktu/usługi. Otrzymane rezultaty (dane marketingowe) można łatwo przedstawić

w postaci tabeli zwanej tablicą decyzyjną; wiersze tej tablicy zawierają uzyskane

ankiety, a kolumny kryteria oceny. Na przecięciu wiersza i kolumny znajduje się ocena

produktu/usługi ze względu na dane kryterium. Opisany powyżej model danych stanowi

typowe dane wejściowe dla metody eksploracji danych i odkrywania wiedzy opartej na

teorii zbiorów przybliżonych (ang. Rough Set Theory) zaproponowanej przez Z.

Pawlaka [20]. Podstawą filozofii zbiorów przybliżonych jest wyrażenie wiedzy o

klasyfikacji obiektów ze względu na zmienną niezależną (zwaną decyzją) za pomocą

wiedzy o klasyfikacji obiektów ze względu na zbiór zmiennych zależnych (kryteria

ocen). To wyrażenie jednej wiedzy w kategoriach innej nosi nazwę przybliżenia (ang.

approximation). Teoria ta podaje również definicje jakości przybliżenia klasyfikacji

oraz zależności występujących w danych [8][20][21]. Wynikiem analizy danych za

pomocą teorii zbiorów przybliżonych jest zbiór reguł decyzyjnych, które stanowią

zwartą reprezentację wiedzy zawartej w danych.

W zakresie poszukiwania metod i sposobów skutecznego pomiaru stopnia

satysfakcji klientów wiele jest jeszcze możliwości ich doskonalenia. Dostępne na rynku

narzędzia są najczęściej bardzo kosztowne, a same metody analizy nie są wolne od wad.

Konieczne jest więc ciągłe poszukiwanie takich sposobów pomiaru, które pozwalałyby

na osiągnięcie możliwie najwyższej skuteczności i wiarygodności przy możliwie

największej prostocie wykonania i ograniczonych kosztach. Wydaje się, że

przeprowadzanie ankiet spełnia dwa ostatnie warunki. Niniejsza praca podejmuje

7

powyższe wyzwanie z zamiarem wykorzystania podejścia zbiorów przybliżonych do

analizy wyników ankiet. Celem pracy jest sprawdzenie, czy reguły decyzyjne mogą być

pomocne w analizie satysfakcji klienta i czy możliwa jest ocena skuteczności strategii

interwencji opracowanej na podstawie uzyskanych reguł.

8

2 Cel i zakres pracy

Podstawowym celem mojej pracy było stworzenie interaktywnego systemu

wykorzystującego metodę analizy danych marketingowych dotyczących satysfakcji

klienta (kwestionariuszy, ankiet) w oparciu o teorię zbiorów przybliżonych z relacją

dominacji. W systemie należało dodatkowo zaimplementować metodologię badania

wpływu strategii interwencji wywiedzionej z reguł decyzyjnych [7], prezentację

otrzymanych wyników, a także sam algorytm indukcji satysfakcjonującego zbioru

reguł.

W ramach pracy inżynierskiej wykonanej w 2003r. na Politechnice Poznańskiej,

powstał system GoalProject [1][19] wspierający szeroko pojętą eksplorację danych.

Zawiera on m.in. moduł dostępu do danych pozwalający na odczyt/zapis plików z

tablicą decyzyjną (ISF) i ze zbiorem reguł decyzyjnych (RLS) do pamięci i do bazy

danych (MySQL) oraz moduł obliczeniowy generujący redukty i reguły decyzyjne. Aby

uniknąć powtórnego pisania powtarzalnych części systemu ustalono, że tworzony

program będzie komunikował się z GoalProject-em poprzez bazę danych MySQL i

wyciągał z niej potrzebne dane - wykorzysta się tym samym zaimplementowane już

parsery plików oraz algorytmy generowania reguł.

Ważnym elementem pracy jest odpowiedni wybór technologii programistycznej.

Ponieważ moim celem było stworzenie aplikacji wieloplatformowej, łatwo dostępnej i

darmowej, mój wybór padł na Javę. Takie założenie dodatkowo przyczyni się do

łatwiejszego rozbudowywania i dostępności systemu w przyszłości, bez ponoszenia

dodatkowych kosztów.

Główne cele projektu przedstawiają się następująco:

• stworzenie systemu regułowej analizy danych marketingowych dotyczących

satysfakcji klienta, obejmujące:

o

implementację zaproponowanej w pracy [7] metodologii badania

wpływu strategii interwencji wywiedzionej z reguł decyzyjnych,

o

opracowanie i implementację własnych propozycji i pomysłów

wykorzystania reguł decyzyjnych do analizy satysfakcji klienta,

9

• wykorzystanie systemu GoalProject

o

wczytywanie plików z danymi wejściowymi (ISF/RLS),

o

algorytmy generowania reguł,

• implementację modułu prezentacji otrzymywanych wyników analizy,

• dobre udokumentowanie pracy.

Główne założenia projektu:

• „otwartość” oprogramowania – umożliwienie łatwej rozbudowy systemu w

przyszłości,

• „przenośność” oprogramowania – możliwość uruchamiana na różnych

platformach systemowych,

• „ergonomiczność” oprogramowania – umożliwienie łatwego i możliwie

najprostszego korzystania z systemu,

• niezawodność oprogramowania,

• spójność i uniwersalność modułów.

Powyższym celom i założeniom podporządkowana jest struktura pracy złożonej

z 7 rozdziałów. W rozdziale 3 dokonano przeglądu istniejących sposobów analizy

satysfakcji klienta i nowego podejścia wykorzystującego reguły decyzyjne, a także

zaprezentowano technologię OLAP. Rozdział 4 zawiera propozycje rozszerzeń

metodologii ASK w oparciu o reguły decyzyjne. Dokładny opis powstałej aplikacji

można znaleźć w rozdziale 5. Natomiast przykład jej zastosowania w postaci

przeprowadzonego eksperymentu znajduje się w rozdziale 6. Pracę kończą 4 dodatki,

wśród których są przewodnik instalacyjny użytkownika i programisty.

10

3 Przegląd wybranych zagadnień Analizy Satysfakcji

Klienta (ASK)

Rozdział ten zawiera opis wybranych zagadnień z problematyki pracy i

dotychczasowy stan wiedzy w danym zakresie. Omówione zostały najpopularniejsze

metody badania satysfakcji klienta stosowane w praktyce, a także nowa metodologia

wykorzystująca do tego celu reguły decyzyjne. W rozdziale przedstawiono również

elementy wykorzystane w stworzonym w ramach pracy magisterskiej systemie: bardzo

efektywną i przejrzystą formę wielowymiarowej prezentacji danych, a także

zastosowanie języka SQL oraz systemu zarządzania bazą danych MySQL.

3.1 Sposoby analizy satysfakcji klienta

Uzyskanie przez przedsiębiorstwo przewagi konkurencyjnej w silnie zmiennym

otoczeniu wymaga ciągłego analizowania sytuacji rynkowej i wyprzedzania

konkurentów. W tych działaniach podstawową kategorią jest zaspokajanie potrzeb

klienta i jego (możliwie jak największe) zadowolenie. Przedstawione w tym rozdziale

metody pomiaru stopnia zadowolenia klienta, zarówno ilościowe, jakościowe i

wielowariantowe, dostarczają przedsiębiorstwu informacji do oceny satysfakcji klienta.

Ze względu na przedstawione ograniczenia tych metod konieczne jest jednak

doskonalenie ich i propagowanie w środowisku decydentów podejmujących

strategiczne decyzje rynkowe.

3.1.1 Badanie poziomu zadowolenia klienta

• Analiza poziomu sprzedaży

Ogólna analiza sprzedaży pozwala na wyznaczenie wzrostu lub spadku

sprzedaży w określonych okresach. Na poziomie pojedynczego klienta poziom

sprzedaży to analiza liczby transakcji zawartych z danym klientem w określonym

czasie oraz ich wartość pieniężna. Niestety metoda ta nie pozwala w pełni określić

poziomu zadowolenia klienta – daje jedynie ogólny pogląd na liczbę klientów

dokonujących zakupu.

Trzeba sobie zadać pytania: Czy wysoka sprzedaż oznacza zadowolenie

klientów? Czy klient dokonujący stałych zakupów jest zadowolony i pozostanie

11

lojalny wobec firmy w przyszłości? W tym przypadku nie można odpowiedzieć na

nie jednoznacznie. Wysoka sprzedaż może oznaczać zadowolenie klientów, ale

również może być wynikiem obniżek cen i promocji w danym okresie czasu.

Natomiast stałe zakupy dokonywane przez klientów mogą być spowodowane

przyzwyczajeniem lub brakiem czasu na zakupy w innej konkurencyjnej firmie.

• Analiza utraty klientów

Analiza utraty klientów jest metodą badania niezadowolenia klientów. Jeżeli

zmniejsza się liczba klientów firmy to można zakładać, że są oni niezadowoleni z jej

usług, produktów lub obsługi. Należy wtedy na bieżąco analizować ich utratę i

próbować odpowiedzieć na pytanie, dlaczego tak się dzieje, a następnie

przeciwdziałać takim sytuacjom w przyszłości.

• Analiza reklamacji

Reklamacje to cenna informacja dla firmy. W rzeczywistości reklamacje

składane przez klientów nie są dobrze odbierane przez firmy i traktowane jako

krytyka ich działań. Firma musi jednak wyciągać wnioski ze składanych skarg i

zażaleń. Z analiz wynika bowiem, że jeżeli klient zgłasza swoje niezadowolenie to

oznacza, że zależy mu na współpracy z firmą i jest do niej przywiązany. Natomiast

klient niezadowolony nie traci czasu na składanie reklamacji i woli przejść do

konkurencyjnej firmy.

• Analiza kontrolowanego zakupu

Kontrolowany zakup może być badany przez wprowadzenie klienta – aktora

(osoby zatrudnionej z zewnątrz) do udziału w zakupie. Taki klient przechodzi przez

wszystkie etapy sprzedaży i obsługi posprzedażowej, notując na bieżąco swoje

odczucia, potrzeby i uwagi. Analiza informacji zebranych w ten sposób pozwala

stwierdzić, co spodoba się potencjalnemu klientowi, a co może spowodować spadek

jego zadowolenia.

Drugą metodą analizy kontrolowanego zakupu jest zakup przez klienta –

pracownika firmy. Metoda sprowadza się do tego, że pracownik ma do wyboru

zakup produktu w sklepie firmowym z określoną zniżką lub takiego samego

produktu w konkurencyjnej firmie. Po dokonanym zakupie analizuje się, co wybrał

pracownik i jakimi kryteriami kierował się przy zakupie.

12

3.1.2 Indeks satysfakcji klienta

Indeks satysfakcji klienta [26] (ang. Customer Satisfaction Index – CSI) pozwala

na analizę poziomu zadowolenia klienta pod względem każdej cechy istotnej z punktu

widzenia satysfakcji klienta jak i całości produktu/usługi. Jest również doskonałym

narzędziem do podejmowania decyzji związanych ze strategią marketingową firmy,

ponieważ pozwala analizować zmiany preferencji i oceniać poziom satysfakcji z

produktów konkurencyjnych. Dokładniej CSI daje odpowiedź na pytania: jakie są

oczekiwania klienta co do produktu/usługi, które z tych oczekiwań mają największą

wartość dla klienta, w jakim stopniu nasz produkt lub konkurencyjny spełnia te

oczekiwania, oraz w które elementy należy inwestować i rozwijać, a które są

przeinwestowane.

W analizie można wyróżnić trzy etapy:

• Etap I – wtórna eksploracja

Celem tego etapu jest zdefiniowanie cech, które mają być oceniane i

wyeliminowanie niepotrzebnych elementów badania. W praktyce wiele informacji

posiada sama firma, dlatego też w tym etapie przeprowadza się analizę informacji

dostępnych wewnątrz firmy prowadząc rozmowy z pracownikami poszczególnych

działów (sprzedaży, marketingu, produkcji). W wyniku definiowane są czynniki

generujące zadowolenie lub niezadowolenie klienta oraz kryteria, którymi kierują

się nabywcy.

• Etap II – budowa kwestionariusza

Budowa kwestionariusza polega na umieszczaniu w nim odpowiednich pytań

dotyczących czynników satysfakcji klienta, zdefiniowanych w pierwszym etapie,

dających się zwymiarować za pomocą skali Likerta (od 1 do 5). Respondenci

dodatkowo nadają powyższym czynnikom wagi, co w rezultacie powoduje, że

otrzymana ocena konkretnego czynnika jest miara ważoną. Ponieważ stworzenie

dobrego kwestionariusza nie jest rzeczą trywialną, więc istnieją różne podejścia

tworzenia takich kwestionariuszy, przykładem może być amerykański lub szwedzki

indeks satysfakcji klienta [10].

• Etap III – prezentacja i analiza wyników

Ogólny ważony CSI jest miarą średnią z ważonych ocen wszystkich czynników.

Procedura wyliczania ważonych ocen każdego czynnika jest dokonywana dla

13

każdego respondenta, natomiast miara CSI wykonywana jest dla danej firmy jak

również dla każdej firmy konkurencyjnej, co umożliwia dokonywanie

pozycjonowania firm pod względem ich atrakcyjności dla klientów.

Skonstruowany indeks zadowolenia klienta przedstawiany jest również w

powiązaniu z przychodami firmy. Przychody wynikające z zadowolenia klienta

opisuje się w postaci funkcji zależnej od kształtowania się tego indeksu. Funkcja

jest z założenia rosnąca, co oznacza, że im wyższy jest indeks tym przedsiębiorstwo

osiąga wyższe przychody.

Na sam koniec należy zaznaczyć, że omawiana w tym punkcie metoda badania

satysfakcji klienta nie jest bez wad i ma swoje ograniczenia. Jej stosowanie wymaga

systematycznego prowadzenia badań rynkowych. Poza tym wyższy indeks zadowolenia

klienta może, lecz nie musi, oznaczać wyższych przychodów ze sprzedaży i-tego

produktu. Ograniczeniem jest to, że przyjmuje się teoretyczne założenia dotyczące

tworzenia indeksu – wielowariantową ocenę produktu przez klienta przy użyciu n

różnych parametrów oraz uwzględnienie znaczenia każdego z parametrów przez

przyporządkowanie mu odpowiedniego współczynnika znaczenia (wagi). Dodatkowo

należy zapewnić porównywalność parametrów i ich wag.

3.1.3 Zarządzanie relacjami z klientem

Zarządzanie relacjami klienta [4] (ang. Customer Relationship

Management – CRM) to koncepcja określana mianem strategii, której głównym celem

jest budowanie długotrwałych i pozytywnych relacji z klientami. Program ten obejmuje

zarówno same przedsiębiorstwo, jak i jego partnerów rynkowych (dostawców,

uczestników kanałów dystrybucji, klientów) tworząc w ten sposób tzw. sieć wartości.

Na strategie składają się cztery etapy: zdefiniowanie wartości dla klienta, kreowanie

wartości dla klienta, komunikowanie wartości dostarczonej klientom (dotarcie do

wybranych klientów, umiejętność kształtowania ich oczekiwań i wsłuchiwania się w ich

potrzeby), dostarczanie klientom oczekiwanej wartości.

Takie rozwiązanie pozwala firmom na podnoszenie zadowolenia klientów, na lepsze

utrzymanie ich najbardziej wartościowych klientów i zdobywanie nowych w tym

samym czasie. Ponieważ bardzo trudnym staje się rozpoznanie potrzeb i preferencji

klientów, to około 55% wdrożonych programów nie przyniosło oczekiwanych korzyści.

14

3.2 ASK przy wykorzystaniu reguł decyzyjnych

Reguły decyzyjne są wynikiem eksploracji danych i stanowią pewien rodzaj

odkrytej wiedzy. Zawierają one informacje o regularnościach w danych z przeszłości,

ale mogą być również bardzo użyteczne w podejmowaniu decyzji w przyszłości.

Przykładowo w odniesieniu do medycyny reguła z jednej strony ukazuje zależności

między objawami a chorobą, ale może także pomagać w diagnozowaniu nowych

pacjentów. Dodatkowo taka reguła może nam podpowiedzieć określoną strategię

interwencji, która umożliwi osiągnięcie wyznaczonego celu – dla opisywanego

przypadku medycznego z reguły możemy się dowiedzieć, co zrobić, aby zwiększyć

wyleczalność z danej choroby.

W punkcie tym zostały przedstawione elementy teorii zbiorów przybliżonych

oraz indukcji reguł decyzyjnych, a także elementy metodologii badania oczekiwanej

efektywności strategii interwencji, której dokładny opis można znaleźć w artykule [7].

3.2.1 Elementy teorii zbiorów przybliżonych i indukcji reguł decyzyjnych

a. Wprowadzenie

Teoria zbiorów przybliżonych [8][20][23][24][25] jest jednym z podejść

rozumienia pojęcia zbioru, natomiast z praktycznego punktu widzenia teoria ta jest

nową metodą analizy danych. W klasycznej teorii mnogości, zbiór jest definiowany

poprzez swoje elementy, przy czym nie jest tu potrzebna żadna dodatkowa wiedza o

elementach uniwersum, z których tworzymy zbiory. W teorii zbiorów przybliżonych

przeciwnie, zakłada się, iż istnieją pewne dane o elementach uniwersum i dane te są

wykorzystywane w tworzeniu zbiorów. Elementy, o których mamy identyczną

informację są nierozróżnialne i tworzą tzw. zbiory elementarne. Stanowią one podstawę

rozumowań w teorii zbiorów przybliżonych. Suma dowolnych zbiorów elementarnych

jest nazywana zbiorem definiowalnym. Zbiory, które nie są zbiorami definiowalnymi

nazywane są zbiorami przybliżonymi.

Oczywiście, zbiory definiowalne można jednoznacznie scharakteryzować

poprzez własności ich elementów, natomiast zbiorów przybliżonych nie można

scharakteryzować w ten sposób. Np. zbiór „liczb parzystych” jest pojęciem

definiowalnym (ostrym), gdyż każdą liczbę naturalną możemy jednoznacznie

zaklasyfikować jako parzystą lub nieparzystą. Natomiast zbiór „zdolnych studentów”

15

jest pojęciem przybliżonym (nieostrym), gdyż nie o każdym studencie możemy

jednoznacznie twierdzić, iż jest on zdolny czy też nie. Dlatego w teorii zbiorów

przybliżonych wprowadza się pojęcia dolnego i górnego przybliżenia zbioru, które

pozwalają każdy zbiór niedefiniowalny (przybliżony) scharakteryzować za pomocą dwu

zbiorów definiowalnych

− jego dolnego i górnego przybliżenia.

b. Zbiory przybliżone – pojęcia podstawowe

System informacyjny, jest parą

)

,

,

,

(

f

V

A

U

, gdzie U jest niepustym i

skończonym zbiorem obiektów zwanym uniwersum, A jest niepustym i skończonym

zbiorem atrybutów.

U

A

a

a

V

V

∈

=

,

a

V jest dziedziną atrybutu a

∈

A, oraz

V

A

U

f

→

×

:

jest funkcją informacyjną, taką, że

∀

a

∈

A, x

∈

U, f(a,x)

∈

a

V

. Jeżeli w systemie

informacyjnym wyróżniamy rozłączne zbiory atrybutów warunkowych C i atrybutów

decyzyjnych D (gdzie A=C

∪

D), to system taki nazywany jest tablicą decyzyjną.

Z każdym podzbiorem atrybutów P

⊆

A związana jest binarna relacja I(P),

nazywana relacją nierozróżnialności, zdefiniowana jako:

I(P) = {(x,y)

∈U×U : f(a,x)=f(a,y), ∀a∈P}

Jeśli (x,y)

∈

I(P) to obiekty x i y są nierozróżnialne ze względu na podzbiór atrybutów P

(relacja nierozróżnialności jest relacją równoważności). P(x) oznacza klasę abstrakcji

relacji I(P) zawierającą obiekt x i nazywane są zbiorami P-elementarnymi.

Niech

)

,

,

,

(

f

V

A

U

S

=

będzie systemem informacyjnym, X niepustym

podzbiorem U oraz P

⊆

A. Celem jest opisanie zbioru X w kategoriach wartości

atrybutów z P. Prowadzi to zdefiniowania dwóch zbiorów

( )

X

P

i

( )

X

P

, nazywanych

odpowiednio P-dolnym przybliżeniem i P-górnym przybliżeniem X, zdefiniowanych

jako:

( )

}

)

(

:

{

X

x

P

U

x

X

P

⊆

∈

=

( )

( )

{

}

∅

≠

∩

∈

=

X

x

P

U

x

X

P

:

Zbiór (różnica między górnym a dolnym przybliżeniem) BN

P

(X) =

( )

X

P

–

( )

X

P

jest

nazywany P-brzegiem zbioru X. Dolne przybliżenie

( )

X

P

zbioru X jest zbiorem

obiektów, które można z pewnością zaliczyć do X na podstawie zbioru atrybutów P (w

świetle posiadanej wiedzy mogą być zaklasyfikowane jednoznacznie do rozważanego

zbioru), podczas gdy obiekty z

( )

X

P

mogą być tylko uznane za możliwie należące do

16

X, na podstawie atrybutów P (nie można ich wykluczyć, w świetle posiadanej wiedzy, z

danego zbioru). P-brzeg BN

P

(X) zawiera obiekty, których nie można jednoznacznie

przydzielić do X z uwagi na sprzeczny opis w terminach atrybutów P. Natomiast

obiekty z U\

( )

X

P

z pewnością nie należą do X. O zbiorze X mówimy, że jest

P-przybliżony, jeśli BN

P

(X)

≠

∅

(gdy jego obszar brzegowy jest niepusty) w

przeciwnym razie jest on P-definiowalny (dokładny). Zauważmy też, że konstrukcja

przybliżeń ma charakter obliczeń granularnych, gdyż operuje na blokach obiektów

nierozróżnialnych przez atrybuty P, czyli na zbiorach P-elementarnych.

Wiersze tablicy decyzyjnej określają reguły decyzyjne, które można wyrazić w

postaci wyrażeń „jeżeli…,to…”:

Ψ

→

Φ

, gdzie

m

Φ

∧

∧

Φ

∧

Φ

=

Φ

...

2

1

jest częścią

warunkową reguły, a

Ψ jej częścią decyzyjną. Każda reguła decyzyjna wyznacza

decyzje, które musza być podjęte, jeśli warunki podane w tablicy są spełnione. Reguły

decyzyjne są ściśle związane z przybliżeniami. Dolne przybliżenia klas decyzyjnych

wyznaczają deterministyczne reguły decyzyjne, to jest takie reguły, które jednoznacznie

wyznaczają decyzje na podstawie warunków; zaś górne przybliżenia klas decyzyjnych

wyznaczają niedeterministyczne reguły decyzyjne, to jest reguły nie wyznaczające

jednoznacznie decyzji na podstawie warunków.

Atrybuty z dziedziną uporządkowaną według preferencji nazywane są

kryteriami, ponieważ dotyczą oceny w określonej skali preferencji. Przykład natomiast

to wiersz tablicy decyzyjnej, czyli obiekt z opisem i przydziałem do klasy.

c. Podejście zbiorów przybliżonych oparte na relacji dominacji

Ogólnie semantyczna korelacja między kryteriami warunkowymi a decyzyjnymi

wymaga, by obiekt x dominujący obiekt y na wszystkich kryteriach warunkowych (tzn.

x mający oceny co najmniej tak dobre jak y na wszystkich kryteriach warunkowych)

powinien również dominować y na wszystkich kryteriach decyzyjnych (tzn. x powinien

być oceniony co najmniej tak dobrze jak y na wszystkich kryteriach decyzyjnych).

Zasada ta zwana jest zasadą dominacji (lub zasadą Pareto) i jest to jedyna obiektywna

zasada wielokryterialnego porównywania obiektów, której racjonalności nikt nie

podważa.

Każda reguła decyzyjna określona jest przez profil warunkowy i profil

decyzyjny, które są wektorami wartości progowych na wybranych atrybutach i

17

kryteriach, odpowiednio, po stronie warunkowej i decyzyjnej. Mówimy, że jeden profil

dominuje drugi, jeśli oba profile mają takie same wartości na zwykłych atrybutach, a

wartości kryteriów pierwszego profilu są nie gorsze od wartości kryteriów drugiego

profilu.

Zachowując oznaczenia, przyjmiemy ponadto, że X

C

=

∏

=

C

q

q

V

1

i X

D

=

∏

=

D

q

q

V

1

oznaczają odpowiednio, przestrzenie atrybutów warunkowych i decyzyjnych. Punkty

przestrzeni X

C

i X

D

są wektorami możliwych ocen obiektów, odpowiednio, za pomocą

atrybutów warunkowych C={1,…,|C|} i decyzyjnych D={1,…,|D|}. Ocena obiektu x na

atrybucie q

∈

A jest oznaczona przez x

q

. Relacja nierozróżnialności na U ze względu na

zbiór atrybutów decyzyjnych D dokonuje podziału U na skończoną liczbę klas

decyzyjnych Cl={Cl

t

, t=1,...,n}. Każdy obiekt x

∈

U należy do jednej i tylko jednej klasy

Cl

t

∈

Cl. Załóżmy bez utraty ogólności, że wszystkie atrybuty warunkowe w C i

decyzyjne w D są kryteriami, oraz że C i D są skorelowane semantycznie.

Niech

q

f

będzie relacją słabej preferencji na U (zwaną też relacją

przewyższania) reprezentującą preferencję na zbiorze obiektów ze względu na

kryterium q

∈

{C

∪

D}; x

q

q

f

y

q

oznacza, że “x

q

jest co najmniej tak dobry jak y

q

ze

względu na kryterium q”. Z drugiej strony mówimy, że x dominuje y ze względu na

P

⊆

C (x P-dominuje y) w przestrzeni atrybutów warunkowych X

P

(oznaczenie: xD

P

y)

jeśli x

q

q

f

y

q

dla wszystkich kryteriów q

∈

P. Zakładając, bez utraty ogólności, że

dziedziny wszystkich kryteriów są liczbowe, tzn. X

q

⊆

R dla każdego q

∈

C, oraz, że są

uporządkowane w ten sposób, że preferencja rośnie z wartością, można powiedzieć, że

xD

P

y jest równoważne: x

q

≥

y

q

dla wszystkich q

∈

P, P

⊆

C. Zauważmy, że dla każdego

x

∈

X

P

, xD

P

x, tzn. P-dominacja jest zwrotna. Analogiczną definicję dominacji można

sformułować dla przestrzeni atrybutów decyzyjnych X

R

(oznaczenie: xD

R

y), R

⊆

D.

Relacje dominacji xD

P

y i xD

R

y (P

⊆

C i R

⊆

D) są stwierdzeniami

ukierunkowanymi, w których x jest podmiotem a y jest obiektem odniesienia. Jeśli

x

∈

X

P

jest obiektem odniesienia, P

⊆

C, to można zdefiniować zbiór obiektów y

∈

X

P

P-

dominujących x, zwany zbiorem P-dominującym:

D

P

+

(x)={y

∈U: yD

P

x}. Jeśli x

∈

X

P

jest

podmiotem, P

⊆

C, to można zdefiniować zbiór obiektów y

∈

X

P

P-zdominowanych przez

x, zwany zbiorem P-zdominowanym:

D

P

−

(x)={y

∈U: xD

P

y}.

18

Jeśli chodzi o przestrzeń atrybutów decyzyjnych X

R

, R

⊆D, to relacja

R-dominacji pozwala na zdefiniowanie zbiorów: Cl

x

R

≥

={y

∈U: yD

R

x},

Cl

x

R

≤

={y

∈U: xD

R

y}.

q

t

Cl

={x

∈

X

D

: x

q

=t

q

} jest klasą decyzyjną ze względu na pojedyncze kryterium

decyzyjne q

∈

D. Cl

x

R

≥

nazywamy złożeniem klas „w górę”, a Cl

x

R

≤

, złożeniem klas „w

dół”. Jeśli x

∈

Cl

x

R

≥

, to x należy do klasy

q

t

Cl

, x

q

=t

q

, lub lepszej, na każdym kryterium

decyzyjnym q

∈

R. Jeśli z kolei x

∈

Cl

x

R

≤

, to x należy do klasy

q

t

Cl

, x

q

=t

q

, lub gorszej, na

każdym kryterium decyzyjnym q

∈

R. Złożenia klas w górę i w dół odpowiadają

pozytywnym i negatywnym stożkom dominacji w X

R

, z początkiem w punkcie x o

współrzędnych [

q

t

Cl

, x

q

=t

q

, q

∈

R].

d. Podejście zbiorów przybliżonych oparte na dominacji – DRSA

W sytuacjach praktycznych zbiór D atrybutów decyzyjnych jest zazwyczaj

jednoelementowy, D={d}. Przyjmijmy to założenie, aczkolwiek nie jest ono konieczne

dla DRSA. Atrybut decyzyjny d dokonuje, tak samo jak poprzednio zbiór D, podziału U

na skończona liczbę klas decyzyjnych Cl={Cl

t

, t=1,...,n}. Także tutaj, im wyższy numer

klasy, tym lepsza klasa. Złożenia klas decyzyjnych w górę i w dół sprowadzają się,

odpowiednio, do:

U

t

s

s

t

Cl

Cl

≥

≥

=

,

U

t

s

s

t

Cl

Cl

≤

≤

=

, t=1,...,n,

co odpowiada określeniom: „klasa co najmniej Cl

t

” i „klasa co najwyżej Cl

t

”.

Zauważmy, że

U

Cl =

≥

1

,

U

Cl

n

=

≤

, oraz dla t=2,...,n mamy Cl

t

≥

=U– Cl

t

≤

−1

, tzn. wszystkie

obiekty nie należące do klasy Cl

t

lub lepszej, należą do klasy Cl

t-1

lub gorszej.

Wyjaśnijmy jak pojęcie zbioru przybliżonego zostało uogólnione w podejściu

DRSA w celu umożliwienia obliczeń granularnych na stożkach dominacji. Dla danego

zbioru kryteriów P

⊆C, zaliczenie obiektu x∈U do złożenia klas w górę Cl

t

≥

, t=2,…,n,

jest niespójne z zasadą dominacji, gdy zachodzi jedna z poniższych sytuacji:

• obiekt x należy do klasy Cl

t

lub lepszej, lecz jest P-zdominowany przez obiekt y

należący do klasy gorszej od Cl

t

, tzn. x

∈Cl

t

≥

lecz

)

(

x

D

P

+

∩

≤

−1

t

Cl

≠∅,

19

• obiekt x należy do klasy gorszej od Cl

t

lecz

P-dominuje obiekt y należący do

klasy

Cl

t

lub lepszej, tzn.

x

∉Cl

t

≥

lecz

)

(

x

D

P

−

∩Cl

t

≥

≠∅.

Jeśli dla danego zbioru kryteriów

P

⊆C, zaliczenie x∈U do Cl

t

≥

,

t=2,…,n, jest niespójne

z zasadą dominacji, to mówimy, że

x należy do Cl

t

≥

z pewną wątpliwością. Zatem, x

należy do Cl

t

≥

bez wątpliwości

, biorąc pod uwagę P

⊆C, jeśli x∈Cl

t

≥

i nie ma

niespójności z zasadą dominacji. To oznacza, że wszystkie obiekty

P-dominujące x

należą do Cl

t

≥

, tzn.

)

(

x

D

P

+

⊆Cl

t

≥

. Ponadto, x być może należy do Cl

t

≥

, biorąc pod

uwagę

P

⊆C, gdy zachodzi jedna z poniższych sytuacji:

• zgodnie z decyzją d, x należy do Cl

t

≥

,

• zgodnie z decyzją d, x nie należy do Cl

t

≥

, lecz obiekt ten jest niespójny w sensie

zasady dominacji z obiektem

y należącym do Cl

t

≥

.

Używając pojęcia wątpliwości,

x być może należy do Cl

t

≥

, biorąc pod uwagę

P

⊆C, jeśli x należy do Cl

t

≥

z wątpliwością lub bez. Ze względu na zwrotność relacji

dominacji

D

P

, powyższe sytuacje mogą być podsumowane następująco: biorąc pod

uwagę

P

⊆C, x być może należy do klasy Cl

t

lub lepszej, jeśli wśród obiektów

P-zdominowanych przez x istnieje obiekt y należący do klasy Cl

t

lub lepszej, tzn.

)

(

x

D

P

−

∩Cl

t

≥

≠∅.

Dla

P

⊆C, zbiór wszystkich obiektów należących bez wątpliwości do Cl

t

≥

tworzy

P-dolne przybliżenie złożenia klas Cl

t

≥

, oznaczone przez

)

(Cl

P

t

≥

; natomiast

zbiór wszystkich obiektów należących być może do Cl

t

≥

tworzy

P-górne przybliżenie

złożenia klas Cl

t

≥

, oznaczone przez

)

(Cl

P

t

≥

:

)

(Cl

P

t

≥

={

x

∈U:

)

(

x

D

P

+

⊆ Cl

t

≥

},

)

(Cl

P

t

≥

={

x

∈

U:

)

(

x

D

P

−

∩Cl

t

≥

≠∅

},

t=2,…,n

Analogicznie można zdefiniować

P-dolne przybliżenie i P-górne przybliżenie złożenia

klas Cl

t

≤

:

)

(Cl

P

t

≤

={

x

∈U:

)

(

x

D

P

−

⊆ Cl

t

≤

},

)

(Cl

P

t

≤

={

x

∈U:

)

(

x

D

P

+

∩Cl

t

≤

≠∅

},

t=1,...,n-1

20

e. Indukcja reguł decyzyjnych

Zdefiniowane w poprzednim punkcie przybliżenia złożeń klas decyzyjnych „w

górę” i „w dół” są punktem wyjścia dla indukcyjnego generowania reguł decyzyjnych

opartych na dominacji. Dla danego złożenia klas Cl

t

≥

, reguły decyzyjne indukowane

przy założeniu, że obiekty należące do dolnego przybliżenia

)

(Cl

P

t

≥

są pozytywne, a

wszystkie inne negatywne, zalecają przydział do „klasy

Cl

t

lub lepszej”. Analogicznie,

dla danego złożenia klas

≤

s

Cl , reguły decyzyjne indukowane przy założeniu, że obiekty

należące do dolnego przybliżenia

)

(

≤

s

Cl

P

są pozytywne, a wszystkie inne negatywne,

zalecają przydział do „klasy Cl

s

lub gorszej”. Z drugiej strony, reguły decyzyjne

indukowane przy założeniu, że obiekty należące do przekroju

)

(

)

(

≥

≤

∩

t

s

Cl

P

Cl

P

są

pozytywne, a wszystkie inne negatywne, zalecają przydział do ciągu dwóch lub więcej

klas od

Cl

s

do

Cl

t

(

s<t).

W celu uwzględnienia porządku preferencyjnego, zaproponowano reguły

decyzyjne o składni opartej na dominacji. W zależności od źródła obiektów

pozytywnych w procedurze indukcji reguł, rozpatruje się następujące typy reguł:

1) D≥-reguły pewne, dla których obiektami pozytywnymi są obiekty należące do

)

(Cl

P

t

≥

:

Jeżeli x

q1

f

q1

r

q1

oraz x

q2

f

q2

r

q2

oraz … x

qp

f

qp

r

qp

,

to x należy do Cl

t

≥

,

gdzie dla każdego

w

q

,z

q

∈X

q

, “

w

q

f

q

z

q

” oznacza, że “

w

q

jest co najmniej tak dobry

jak

z

q

”,

2) D≥-reguły możliwe, dla których obiektami pozytywnymi są obiekty należące do

)

(Cl

P

t

≥

:

Jeżeli x

q1

f

q1

r

q1

oraz x

q2

f

q2

r

q2

oraz … x

qp

f

qp

r

qp

,

to x być może należy do

Cl

t

≥

,

3) D≤-reguły pewne, dla których obiektami pozytywnymi są obiekty należące do

)

(Cl

P

t

≤

:

Jeżeli x

q1

p

q1

r

q1

oraz x

q2

p

q2

r

q2

oraz … x

qp

p

qp

r

qp

,

to x należy do Cl

t

≤

,

gdzie dla każdego

w

q

,z

q

∈X

q

, “

w

q

p

q

z

q

” oznacza, że “

w

q

jest co najwyżej tak

dobry jak

z

q

”,

4) D≤-reguły możliwe, dla których obiektami pozytywnymi są obiekty należące do

)

(Cl

P

t

≤

:

Jeżeli x

q1

p

q1

r

q1

oraz x

q2

p

q2

r

q2

oraz … x

qp

p

qp

r

qp

,

to x być może należy do

Cl

t

≤

,

21

5) D≥≤-reguły przybliżone, dla których obiektami pozytywnymi są obiekty

należące do

)

(

)

(

≥

≤

∩

t

s

Cl

P

Cl

P

(

s<t): Jeżeli x

q1

f

q1

r

q1

oraz... x

qk

f

qk

r

qk

oraz

x

qk+1

p

qk+1

r

qk+1

oraz ... x

qp

p

qp

r

qp

,

to x należy do Cl

s

∪Cl

s+1

∪…∪Cl

t

.

W części warunkowej D≥≤-reguł przybliżonych możemy mieć warunki “x

q

f

q

r

q

” i

“

x

q

p

q

r'

q

”, gdzie

r

q

≤r'

q

, dla tego samego kryterium

q

∈C. Ponadto, jeśli r

q

=

r'

q

, to te dwa

warunki sprowadzają się do “

x

q

∼

q

r

q

”, gdzie dla każdego

w

q

,z

q

∈X

q

, “

w

q

∼

q

z

q

” oznacza, że

“

w

q

jest nierozróżnialny z

z

q

”.

Reguły decyzyjne typu 1) i 3) reprezentują wiedzę pewną wyindukowaną z

tablicy decyzyjnej, podczas gdy reguły typu 2) i 4) reprezentują wiedzę możliwą (być

może wątpliwą), a reguły typu 5) reprezentują wiedzę wątpliwą. Ponadto, reguły typu 1)

i 3) są dokładne, jeśli nie pokrywają obiektów spoza klas wskazanych w części

decyzyjnej; w przeciwnym razie są one probabilistyczne. Reguła probabilistyczna jest

scharakteryzowana przez współczynnik wiarygodności, określający

prawdopodobieństwo, że obiekt spełniający część warunkową reguły spełnia również

jej część decyzyjną. Aby go czytelnie zapisać wprowadźmy na początek pewne

oznaczenia:

)

(

Φ

m

będzie oznaczać zbiór obiektów spełniających wyrażenie

warunkowe

Φ ,

)

(

Ψ

m

zbiór obiektów należących do klasy decyzyjnej Ψ ,

)

(

Φ

m

to

liczba obiektów spełniających część warunkową reguły, a

)

(

)

(

Ψ

∩

Φ

m

m

to liczba

obiektów spełniających zarówno część warunkową jak i decyzyjną reguły. Drugą

natomiast zaufanie reguły lub inaczej jej pewność:

)

(

)

(

)

(

)

,

(

Φ

Ψ

∩

Φ

=

m

m

m

U

r

conf

Zakres tej miary zawiera się w przedziale <0, 1> i jeśli otrzymaną wartość pomnożymy

razy 100% to można ją interpretować jako prawdopodobieństwo przynależności

obiektów do danej klasy

Ψ przy spełnionych warunkach Φ .

Inną miarą jest siła reguły definiowana przez liczbę obiektów pokrywanych

przez część warunkową reguły i należących do zalecanej klasy (spełniających jej część

decyzyjną):

)

(

)

(

)

,

(

Ψ

∩

Φ

=

m

m

U

r

strength

22

3.2.2 Wprowadzenie do metodologii ASK w oparciu o reguły decyzyjne

Załóżmy, że mam przykładowy zbiór danych

U

w postaci tablicy decyzyjnej.

Indukujemy z niego zbiór reguł decyzyjnych informujący nas o występujących

regularnościach w danych. Dodatkowo posiadamy inny zbiór danych

'

U

, w

szczególnym przypadku może się on pokrywać z

U

, na którym chcemy sprawdzić

wywiedzioną z reguł strategię interwencji. W wyniku jej zastosowania na zbiorze

'

U

otrzymujemy nowy zbiór

''

U

. Jeśli odnieść to do rzeczywistości to przykładowo w

medycynie mamy zbiór pacjentów i strategię w postaci leczenia objawów powiązanych

z chorobą w celu wyleczenia pacjenta. Innym przykładem może być dziedzina

marketingu i zbioru danych w postaci klientów oraz strategii polegającej na zmianach

ocen produktów/usług przez klientów w celu zwiększenia liczby zadowolonych.

W szczególności przypuśćmy, że mamy regułę decyzyjną wyidukowaną ze

zbioru

U

postaci: „jeśli pewien składnik

α jest obecny we krwi pacjenta, to pacjent

jest zdrowy” z zaufaniem

)

,

( U

r

conf

. Zależy nam oczywiście na jak największej liczbie

zdrowych pacjentów. Strategia wywiedziona z takiej reguły nakazuje nam „wstrzyknąć

składnik

α do krwi tym pacjentom, którzy go nie mają i są chorzy”. W tym momencie

nasuwa się pytanie o oczekiwany procentowy wzrost zdrowych pacjentów po

zastosowaniu takiego rodzaju leczenia (co nam da zastosowanie takiej właśnie strategii

interwencji). Formalny zapis powyższej metodologii został zaproponowany w [7] i jest

przedstawiony w kolejnym podpunkcie. Należy zaznaczyć, że całość propozycji opiera

się na hipotezie homogeniczności (jednorodności) zbiorów

U

i

'

U

.

3.2.3 Formalne przedstawienie metodologii

Niech dana będzie reguła

r , dla której liczona będzie miara skuteczności

wywiedzionej strategii interwencji:

Ψ

→

Φ

∧

∧

Φ

∧

Φ

≡

n

r

...

2

1

W odniesieniu do medycyny powyższą regułę można zapisać w postaci „jeżeli składniki

A

1

i

A

2

… i

A

n

są obecne we krwi pacjenta, to pacjent jest zdrowy” z

prawdopodobieństwem

)

,

( U

r

conf

.

Załóżmy, że strategią dla tej reguły będzie leczenie

T - „wprowadź składnik A

1

i

A

2

… i

A

n

do krwi pacjentom, którzy nie mają tych składników i są chorzy”. Leczenie

T może

być w takim przypadku dodatkowo rozbite na pewne bardziej szczegółowe leczenia

23

T

P

– „wprowadź tylko składniki

A

i

(

N

P

i

⊆

∈

) do krwi pacjentom, którzy nie mają

żadnego ze składników

A

i

(

P

i

∈

), ale mają składniki

A

j

(

P

j

∉ ) i są chorzy”. W takim

przypadku dla każdego

N

P

⊆ można zadać pytanie, jaki będzie oczekiwany wzrost

liczby zdrowych pacjentów po zastosowaniu leczenia

T

P

?

W oparciu o powyższe rozważania i wprowadzone wcześniej oznaczenia

oczekiwany wzrost liczby zdrowych pacjentów można wyliczyć następująco:

'

)

(

'

)

(

'

)

(

'

)

,

(

)

(

U

m

m

m

U

r

conf

i

P

i

i

P

i

P

Ψ

¬

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

¬

×

=

Ψ

∉

∈

I

I

δ

Ten sam wzór można zapisać inaczej:

'

)

(

'

)

(

'

)

(

'

)

(

'

)

(

'

)

(

)

(

)

(

)

(

U

m

m

m

m

m

m

m

m

i

P

i

i

P

i

i

N

i

i

N

i

P

Ψ

¬

×

Ψ

¬

Ψ

¬

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

¬

×

⎥⎦

⎤

⎢⎣

⎡

Φ

Ψ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

=

Ψ

∉

∈

∈

∈

I

I

I

I

δ

'

)

(

'

)

'

,

(

)

,

(

)

(

U

m

U

s

conf

U

r

conf

P

P

Ψ

¬

×

×

=

Ψ

δ

, gdzie

(

)

( )

i

P

i

i

P

i

P

s

Φ

∧

∧

Φ

¬

∧

→

Ψ

¬

≡

∉

∈

Na podstawie powyższej formuły można zdefiniować wskaźnik efektywności

stworzonej strategii pod względem konsekwencji reguły decyzyjnej r , wyidukowanej

ze zbioru

U

i zastosowanej na

i

P

i

Φ

∧

∈

w zbiorze

'

U

:

)

'

,

(

)

,

(

)

'

,

,

(

U

s

conf

U

r

conf

U

U

r

E

P

P

×

=

Ψ

Oczekiwany wzrost liczy zdrowych pacjentów można wyrazić także formułą:

'

)

(

'

)

(

'

)

(

'

)

(

'

)

(

'

)

(

'

)

(

'

)

(

)

(

)

(

)

(

U

m

m

m

m

m

m

m

m

m

m

i

P

i

i

P

i

i

P

i

i

P

i

i

P

i

i

P

i

i

N

i

i

N

i

P

⎥⎦

⎤

⎢⎣

⎡

Φ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

¬

×

×

⎥⎦

⎤

⎢⎣

⎡

Φ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

¬

Ψ

¬

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

¬

×

⎥⎦

⎤

⎢⎣

⎡

Φ

Ψ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

=

Ψ

∉

∈

∉

∈

∉

∈

∈

∈

I

I

I

I

I

I

I

I

δ

'

)

(

'

)

(

'

)

'

,

(

)

,

(

)

(

U

m

m

U

t

conf

U

r

conf

i

P

i

i

P

i

P

P

⎥⎦

⎤

⎢⎣

⎡

Φ

∩

⎥⎦

⎤

⎢⎣

⎡

Φ

¬

×

×

=

Ψ

∉

∈

I

I

δ

, gdzie

(

)

( )

Ψ

¬

→

Φ

∧

∧

Φ

¬

∧

≡

∉

∈

i

P

i

i

P

i

P

t

24

Na bazie powyższych wyliczeń można zdefiniować inny indeks – efektywności

wywiedzionej strategii pod względem przesłanki reguły decyzyjnej r , wyidukowanej

ze zbioru

U

i zastosowanej na

i

P

i

Φ

∧

∈

w zbiorze

'

U

:

)

'

,

(

)

,

(

)

'

,

,

(

U

t

conf

U

r

conf

U

U

r

E

P

P

×

=

Φ

Podsumowując, oczekiwany wzrost liczby zdrowych pacjentów po zastosowaniu

leczenia

T będzie równy:

∑

⊆

Ψ

=

Ψ

N

P

P

)

(

)

(

δ

δ

Opisywana metodologia wprowadza jeszcze dwa współczynniki pomocne w

mierzeniu oczekiwanej efektywności strategii interwencji opartej na regułach

decyzyjnych. Pierwszy z nich określa udział (wkład) warunku

N

i

i

∈

Φ ,

użytego w

strategii bazującej na regule

r i jest ilorazem sumy oczekiwanych wzrostów

)

(

Ψ

P

δ

na

skutek leczeń

T

P

i liczności zbioru

P, dla wszystkich P zawierających i:

∑

∈

⊆

Ψ

=

Φ

P

i

N

P

P

i

P

c

:

)

(

)

(

δ

Drugi natomiast definiuje kompletną skuteczność warunku

N

i

i

∈

Φ ,

użytego w tej

strategii:

∑

∈

⊆

Ψ

=

Φ

P

i

N

P

P

i

P

U

U

r

E

I

:

)

'

,

,

(

)

(

Opisana tutaj metodologia jest jednym ze sposobów wykorzystania odkrytej

wiedzy. Pokazuje jak tworzyć strategie bazujące na regułach decyzyjnych

wyidukowanych z danych, a także jak mierzyć oczekiwaną efektywność ich stosowania.

Całe działanie sprowadza się do 3 kroków:

1) Indukcja reguł decyzyjnych w zbiorze

U

,

2) Interwencja (modyfikacja) w zbiorze

'

U

tak, aby w rezultacie otrzymać

pożądane wyniki,

3) Przejście ze zbioru

'

U

do zbioru

''

U

na skutek interwencji dokonanej w

kroku 2.

25

3.3 Technologia analizy wielowymiarowych danych OLAP

Technologia OLAP (ang. On-line Analytic Processing) jest bardzo dynamicznie

rozwijającym się narzędziem do interakcyjnego tworzenia, zarządzania i analizy danych

postrzeganych jako struktury wielowymiarowe [5]. Podstawowymi korzyściami

wynikającymi ze struktur wielowymiarowych do przechowywania informacji to

przejrzysta reprezentacja wiedzy i znaczenie efektywnościowe. Interakcyjna eksploracja

i zgłębianie danych to najpopularniejsze wykorzystanie techniki OLAP. Należy

zauważyć, że pomimo swej nazwy (on-line) analizy nie muszą być przeprowadzane na

bieżąco (w czasie rzeczywistym).

Systemy wykorzystujące tę technikę możemy traktować nie tylko jako sposób na

dokonywanie wszechstronnych analiz danych, ale jako sposób na odkrywanie wiedzy.

Mogą one operować na dowolnym typie nieprzetworzonej informacji, nawet informacji

nie ujętej w określone struktury, oraz mogą być stosowane do przeglądania i

zestawiania danych generowanych za pomocą OLAP w celu dostarczenia bardziej

dogłębnej, a często również bardziej wieloaspektowej wiedzy.

Rezultaty osiągane technikami OLAP mogą mieć bardzo prostą postać (np. tablice

liczebności, statystyki opisowe, proste tabele krzyżowe) lub nieco bardziej złożoną (np.

mogą uwzględniać pewnie korekty, usuwanie odstających obserwacji lub inne metody

filtracji danych).

3.3.1 Terminologia i przykłady

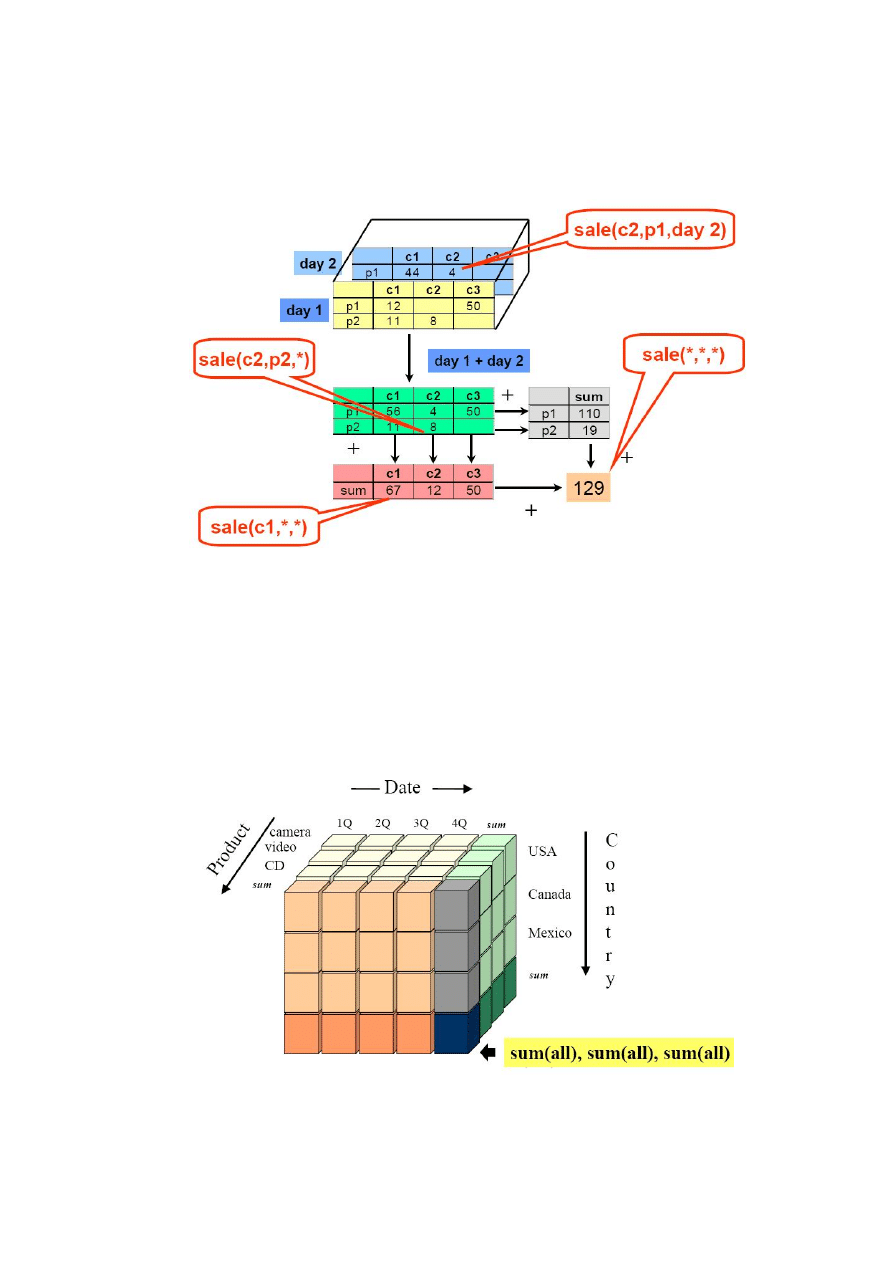

Dana wielowymiarowa (ang. cube, multi-dimensional array) jest zbiorem

komórek danej (ang. cell) zlokalizowanych w przestrzeni wielowymiarowej, określonej

przez wymiary (ang. dimension) danej.

Pojedyncza komórka wyznaczona przez zbiór wartości wymiarów reprezentuje miarę

danej w określonym punkcie przestrzeni – np. ilość towarów lub obrót ze sprzedaży, są

nazwane miarą.

Wymiary danych są strukturalnymi i w ogólności złożonymi atrybutami grupującymi

elementy (ang. member) tego samego typu, np. wymiar czasu jest zbiorem elementów:

dekada, rok, kwartał, miesiąc, tydzień, dzień, godzina. W typowych zastosowaniach

rolę wymiarów pełnią czas, lokalizacja i typ produktu. Operacja grupowanie dla

wskazanych wymiarów tworzy i wylicza tzw. agregaty.

26

Wymiary mogą być wewnętrznie złożone i opisane za pomocą wielu atrybutów, a

atrybuty mogą pozostawać w pewnych zależnościach, tworząc hierarchię atrybutów, np.

dla miejsca sprzedaży hierarchia może przyjąć postać klient-miasto-województwo.

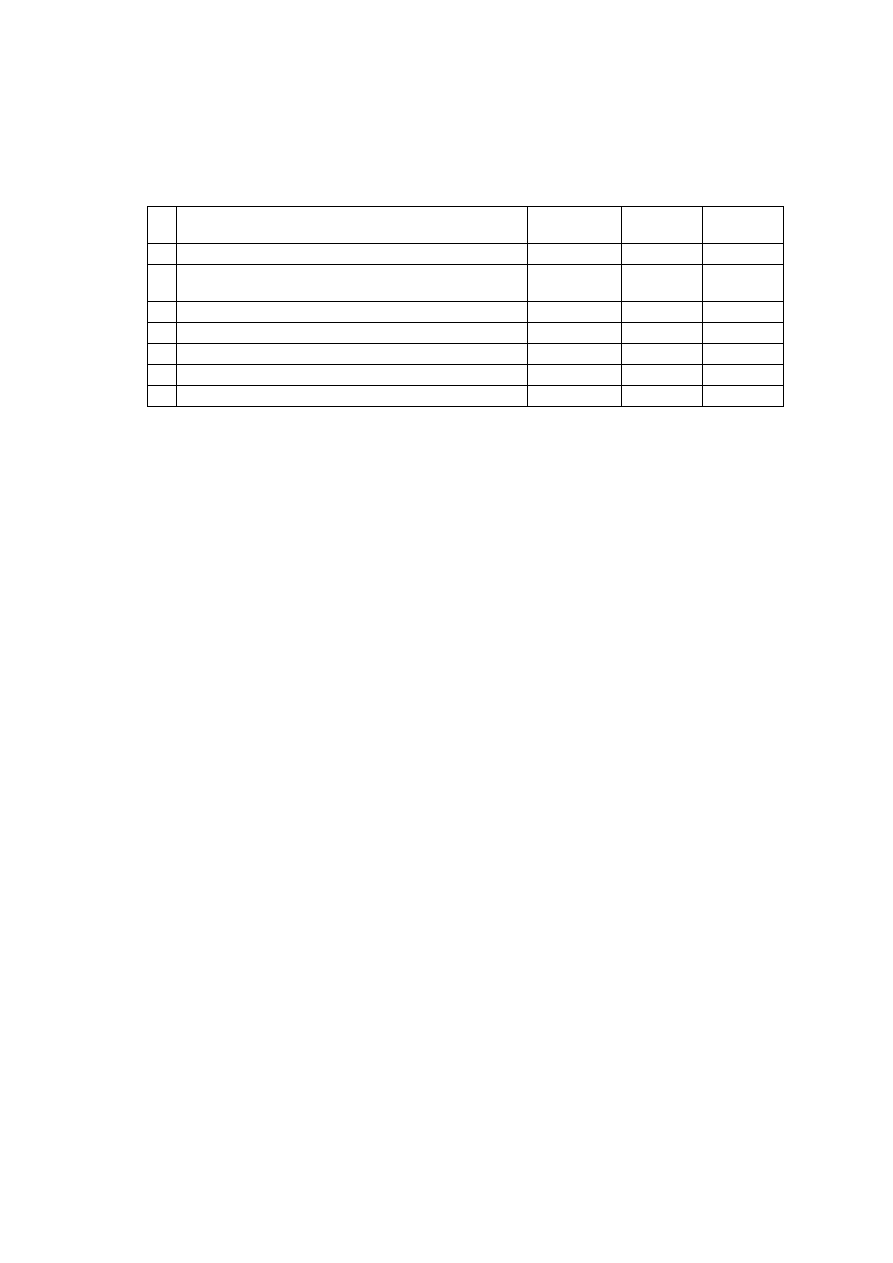

Rys. 1 Struktura danych wielowymiarowych z wykorzystaniem agregacji

(źródło: T.Morzy)

Formą prezentacji jest kostka danych (Rys. 1 i 2). Pozwala to na swobodne

manipulowanie perspektywami analizy, przechodzenie od danych ogólnych do coraz

bardziej szczegółowych, wybieranie do analizy dowolnego fragmentu danych,

filtrowanie wymiarów według dowolnych kryteriów.

Rys. 2 Przykładowa kostka danych OLAP

(źródło: T.Morzy)

27

Najpopularniejsze metody analizy:

• wyznaczanie punktu centralnego (ang. pivoting) – polega na wskazaniu miary i

wybraniu wymiarów, w których ma ona być zaprezentowana, np. country=USA,

• eksploracja danych w górę lub w dół (rozwijanie (ang. drill-down), zwijanie

(ang. roll-up lub drill-up)) wzdłuż hierarchii wymiarów. Powoduje to

zwiększenie lub zmniejszenie stopnia szczegółowości analizy, np. rozwijanie lub

zwijanie hierarchii czasu,

• obracanie (ang. rotating) – pozwala na analizę miary w kolejnych wymiarach

danej, np. obrót kostki o

°

90

w lewo,

• projekcja (ang. slice and dice) – polega na wycinaniu wybranych fragmentów

danej wielowymiarowej. W rezultacie następuje zmniejszenie liczby wymiarów

i agregacja danych,

• ranking (ang. ranking) – np. wg wzrostu miary lub jej agregatu.

3.3.2 Zastosowanie

OLAP jest jedną z popularnych metod do aktywnego wykorzystywania

informacji gromadzonych w firmach. Istnieje wiele danych w przedsiębiorstwie, które

opisane są przez kilka wymiarów jednocześnie, np. czas, produkt, region, klient,

dostawca. Wartościowe informacje biznesowe powstają najczęściej dopiero po

połączeniu pojedynczych danych w wielowymiarowej strukturze. Możliwość dokładnej

analizy takich informacji pozwala na poprawę jakości procesu podejmowania decyzji,

co w konsekwencji może wpłynąć na zwiększenie stopnia satysfakcji klientów.

Narzędzia OLAP mogą być również integrowane z systemami baz danych

(korporacyjnymi) tworząc magazyny danych [29] i umożliwiając analitykom i

menedżerom śledzenie wydajności przedsiębiorstwa (np. różnych aspektów procesu

produkcyjnego lub ilości i rodzajów transakcji przeprowadzanych w różnych

oddziałach) lub rynku. Wynikiem analizy może być dotarcie do tak niezbędnych

informacji jak trendy, relacje czy wartości charakterystyczne. W ten sposób otrzymuje

się natychmiastowe odpowiedzi na najistotniejsze pytania biznesowe oraz wsparcie w

podejmowaniu decyzji krótko i długookresowych.

28

4 Propozycje rozszerzeń metodologii ASK w oparciu o

reguły decyzyjne

W rozdziale tym można się zaznajomić z propozycjami rozszerzeń podejścia do

analizy satysfakcji klienta, które wykorzystuje mechanizm reguł decyzyjnych. Próbują

one odpowiedzieć na pytanie, co należy zrobić, aby jak największa liczba obiektów

zmieniła swój obecny przydział do klasy na klasę przynajmniej o jeden lepszą. W opisie

wykorzystano przykładowe dane ankietowe przedstawione na samym wstępie rozdziału.

Opisaną wcześniej technologię OLAP można powiązać z teorią zbiorów przybliżonych,

co daje w rezultacie bogate narzędzie do prezentacji i analizy danych opisane poniżej.

4.1 Przykład danych wejściowych do analizy satysfakcji klienta

Przedstawiony w tym punkcie prosty problem będzie kanwą wykorzystaną do

opisu proponowanego narzędzia. Przypuśćmy, że dysponujemy danymi ankietowymi

uzyskanymi od kilku osób na temat oceny Polskiej Kolei Państwowej (PKP). W

ankiecie respondenci dokonywali oceny PKP według sześciu kryteriów a następnie

wyrażali ogólną satysfakcję z usług PKP dokonując przydziału do odpowiedniej klasy.

Definicja problemu wygląda następująco:

• Kryteria: rozkład jazdy, punktualność, wygoda, czystość, obsługa, cena

• Skala ocen kryteriów: bardzo źle (1), źle (2), dostatecznie (3), dobrze (4), bardzo

dobrze(5)

• Klasa: przeciętna (1), standard (2), komfort (3)

Wyniki ankiety (posortowane rosnąco wg przydziału do klas):

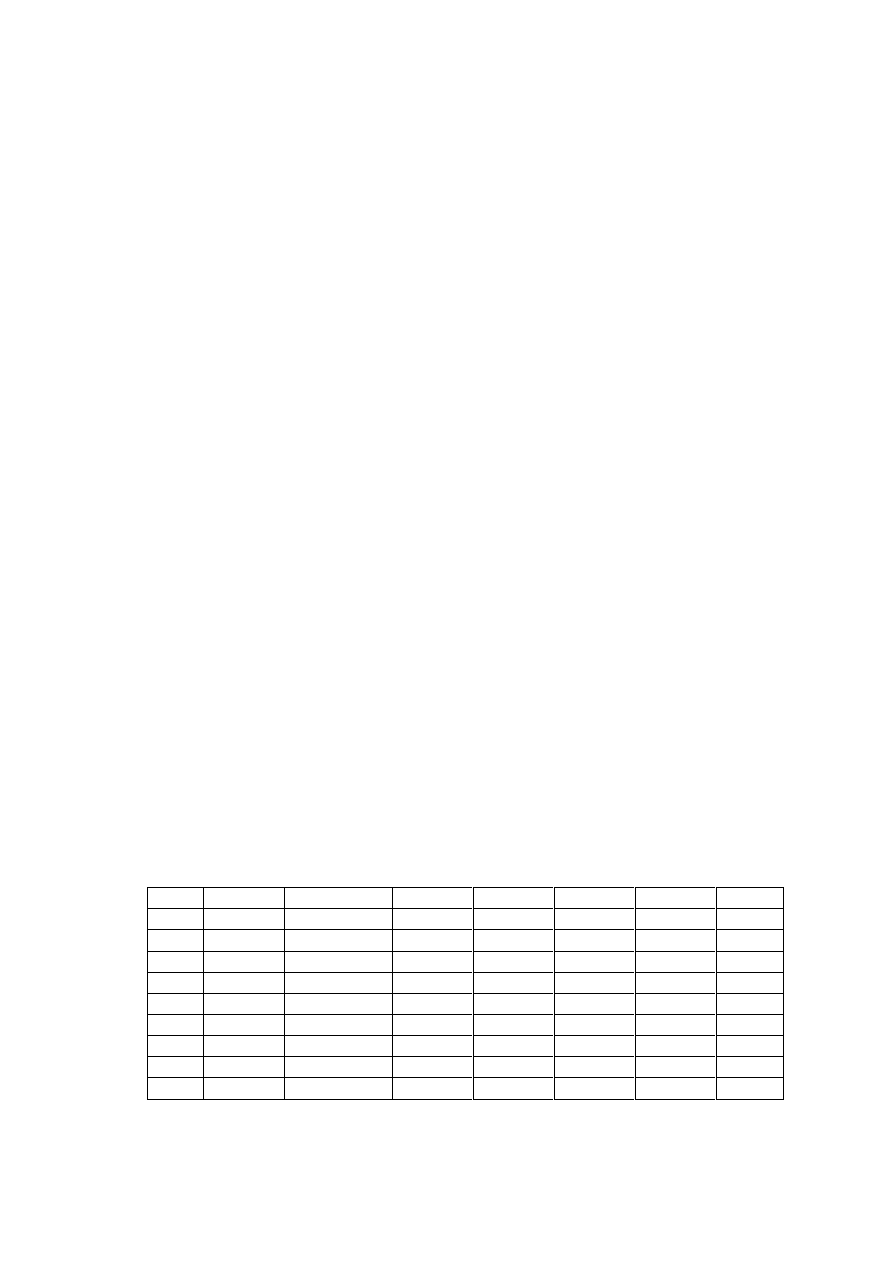

Tabela 1 Wyniki ankiety PKP

Odp. Rozkład jazdy Punktualność Wygoda Czystość Obsługa Cena Klasa

1

4 4 3 3 3 2 1

2

3 3 1 1 2 1 1

3

4 3 3 2 4 3 1

4

4 3 3 2 3 3 1

5

1 4 3 2 3 3 2

6

3 2 2 3 4 3 2

7

3 2 2 2 5 3 2

8

4 3 5 5 5 4 3

9

4 4 4 4 5 4 3

29

Dla przedstawionego problemu, przy pomocy programu 4eMka2, wygenerowano reguły

decyzyjne (opcja Minimal Cover Algorithm - DomLEM), które znajdują się poniżej:

Tabela 2 Reguły decyzyjne dla ankiety PKP

Nr Reguła

Liczba przykł.

wspierających

Relatywna

siła [%]

Przykłady

pokrywane

1 (Cena <= 2) => (Klasa <= 1)

2

50

1,2

2

(Obsługa <= 4) & (Czystość <=2) & (Punktualność<=2)

=> (Klasa <= 1)

3 75

2,3,4

3 (Cena <= 3) => (Klasa <= 2)

7

100

1,2,3,4,5,6,7

4 (Czystość >= 4) => (Klasa >= 3)

2

100

8,9

5 (Obsługa >= 5) => (Klasa => 2)

3

60

7,8,9

6 (Cena => 2) & (Czystość => 3) => (Klasa => 2)

3

60

6,8,9

7 (Punktualność => 4) & (Cena => 3) => (Klasa => 2)

2

40

5,9

4.2 Testowanie strategii interwencji

Dla przypomnienia reguła mówi o minimalnych warunkach, których spełnienie

powoduje, że spełniona jest również jej część decyzyjna. Z regułą związane jest również

wsparcie wyrażone przez liczbę przykładów, które ona pokrywa (spełniona jest część

warunkowa i część decyzyjna). Analiza w tej metodzie polega na hipotetycznej zmianie

warunku(ów) elementarnych w danej regule i sprawdzeniu jak ta zmiana wpłynęła na

liczbę przykładów pokrywanych przez regułę, czy ich liczba się zwiększyła czy

zmniejszyła i w jakim stopniu. Innymi słowy przy pomocy reguły definiujemy pewną

strategię interwencji i testujemy jej wpływ. Można sobie zadać pytania – co nam to

daje? Jak interpretować otrzymany w rezultacie wynik? Odpowiedź na te pytania

znajduje się w poniższym przykładzie analizy danych proponowaną metodą.

4.2.1 Przykład analizy danych metodą testowania strategii interwencji

Ponieważ najlepiej coś tłumaczyć na przykładzie, dlatego poniżej znajduje się

przykładowa analiza danych metodą testowania strategii interwencji (ang. Strategy of

Intervention Test), bazująca na wynikach ankiety PKP (Tabela 1) i przeprowadzona dla

reguły nr 5 (Tabela 2):

• Reguła nr 5 mówi, że jeżeli Obsługa PKP jest oceniana na co najmniej 5 to

następuje przydział PKP do Klasy co najmniej 2. Przykłady z tablicy decyzyjnej,

które ją wspierają to 7,8 i 9.

30

• Zmieniając hipotetycznie warunek elementarny reguły (w tym przypadku tylko

jeden) np. na Obsługa>=3 (ocena Obsługi PKP na co najmniej 3) można

zauważyć, że taka reguła, a dokładniej jej część warunkowa (na tym etapie

analizy pomija się część decyzyjną reguły), pokrywa oprócz wcześniejszych

przykładów również przykłady nr 1, 3, 4, 5 i 6. Jak interpretować ten przyrost?

Otrzymany wynik wskazuje ilu klientów PKP, którzy aktualnie oceniają

Obsługę na co najmniej 3 po jej zmianie na co najmniej 5 (jeśli spowoduje się u

nich taką zmianę oceny przez zastosowanie testowanej strategii interwencji)

może zmienić przydział do Klasy na co najmniej 2.

• Z ankiety PKP wynika, że klienci nr 5 i 6 przydzielają już teraz PKP do Klasy 2,

więc zmiana oceny Obsługi u nich nic nie zmieni, dlatego pomija się ich w

dalszej analizie. Odwrotnie jest w przypadku klientów nr 1, 3 i 4, którzy obecnie

przydzielają PKP do Klasy 1 – oznacza to, że po zmianie oceny Obsługi z 3 na

co najmniej 5 zgodnie z regułą nr 6 zmienią przydział z Klasy 1 na co najmniej

2.

• Ponieważ analizowana reguła nie jest jedyną w zbiorze reguł, dlatego trzeba też

mieć wzgląd na możliwe niezgodności występujące w zbiorze. Dla danej reguły

za takie niezgodności uznaje się wszystkie takie reguły, których część decyzyjna

jest negacją decyzji wybranej reguły – dla relacji „co najmniej” oznaczać będzie

to relację „co najwyżej” klasa o jeden niższa (np. dla Klasa>=2 zaprzeczeniem

będzie Klasa<=1) i odwrotnie, dla „co najwyżej” będzie to „co najmniej” klasa

o jeden wyższa. Ponadto reguły niezgodne to takie, które będą nadal pokrywać

wybrane przykłady po hipotetycznej zmianie ich oceny na danych kryteriach.

• Dla analizowanej reguły możliwie niezgodne są wszystkie reguły, których część

decyzyjna ma postać: co najwyżej 1 (Klasa<=1) – w analizowanym zbiorze

mogą to być reguły nr 1 i 2. Rozpatruje się każdy przykład osobno. Przykłady nr

3 i 4 nie są pokrywane przez regułę 1, ponieważ ich ocena Ceny wynosi 3, ani

przez regułę nr 2 po hipotetycznej zmianie oceny Obsługi na co najmniej 5.

Sytuacja jest inna dla klienta nr 1, gdyż pokrywa go reguła nr 1 (ocenia Cenę na

2). Należy pozbyć się niezgodności przez dodanie dodatkowego wymogu, że dla

tego konkretnego przykładu ocena Ceny musi być co najmniej 3. W tym

momencie nastąpiły dwie hipotetyczne zmiany, dalej postępuje się podobnie i

sprawdza czy po tych zmianach nadal są reguły, które są niezgodne.

31

• Podsumowując powyższą analizę okazuje się, że ze wszystkich ankietowanych,

którzy oceniają aktualnie Obsługę PKP na co najmniej 3, po zastosowaniu

strategii i zmianie ich ocen na tym kryterium na co najmniej 5, trzech zmieni

swój przydział z Klasy 1 na co najmniej 2, przy dodatkowym wymogu dla

klienta nr 1, że należy spowodować dodatkowo zmianę oceny Ceny z 2 na co

najmniej 3.

4.2.2 Algorytm testowania strategii interwencji

Dokładny algorytm postępowania w tej metodzie wygląda następująco:

• Określ interesującą Cię strategię interwencji przez wskazanie reguły do analizy,

• Zmodyfikuj według uznania warunek/warunki wybranej reguły,

• Wyszukaj wszystkie przykłady, które pokrywa zmieniona część warunkowa

reguły decyzyjnej,

• Dokonaj hipotetycznej zmiany wartości w znalezionych przykładach na tych

kryteriach, dla których zostały zmienione warunki reguły,

• Dla wybranej reguły znajdź reguły, które mogą być niezgodne,

• Dla każdego przykładu z osobna przeglądaj zbiór tych reguł i sprawdzaj, czy nie

jest pokrywany przez którąś z nich,

• Jeśli tak jest (reguła niezgodna) to dodaj dodatkowy wymóg, jaki musi być

spełniony dla tego przykładu taki, żeby reguła go nie pokrywała (np. negacja

pierwszego warunku w regule),

• Dokonaj kolejnej hipotetycznej zmiany w przykładzie będącej wynikiem

nałożenia dodatkowego wymogu i kontynuuj przeglądanie zbioru możliwych

niezgodnych reguł.

4.2.3 Możliwe zastosowania i kierunki rozwoju

Opisane tutaj podejście pozwala w łatwy sposób zdefiniować konkretną strategię

interwencji, która jest interesująca z punktu widzenia przedsiębiorstwa i wskazać, co

należy zrobić (jakich zmian dokonać w ocenach satysfakcji klientów), aby dała ona

zamierzone rezultaty. Dla przykładu firma może być zainteresowana zwiększeniem

liczby klientów, którzy przydzielaliby ją do klasy najwyższej. W metodzie testowania

32

strategii interwencji wystarczy wskazać regułę odpowiadającą zamierzonej strategii i

zmianami na warunkach tej reguły sterować liczbą i rodzajem klientów, którzy zostaną

jej poddani.

Należy zauważyć, że w zbiorze wszystkich reguł będzie się znajdować

przynajmniej kilka reguł, które będą odpowiadać określonej przez nas strategii. W

rezultacie możemy otrzymać kila różnych rozwiązań. Dodatkowo, w rzeczywistości, z

każdą zmianą oceny satysfakcji klienta związany jest pewien koszt zależny od

kryterium, na którym ta zmiana jest dokonywana. Wskazane by więc było określenie

dla każdego kryterium kosztów zmian na jego wartościach, co umożliwiłoby

wprowadzenie elementu optymalizacji i wyboru najlepszej strategii – jak największy

wzrost liczby klientów przy jak najmniejszym koszcie koniecznych zmian.

4.3 Szukanie strategii interwencji

W metodzie szukania strategii interwencji zaczynamy analizę nie od zbioru

reguł, ale od zbioru przykładów. Wybieramy konkretny przykład i wskazujemy

konkretną decyzję. Celem tego podejścia jest wskazanie zmian, jakich należy dokonać,

aby dany przykład miał określoną decyzję – poszukanie możliwej strategii interwencji,

która pozwoli osiągnąć zamierzony cel. Dokonuje się tego na podstawie zbioru reguł

decyzyjnych.

4.3.1 Przykład analizy danych metodą szukania strategii interwencji

W celu wyjaśnienia metody dokonano przykładowej analizy danych metodą

szukania strategii interwencji (ang. Strategy of Intervention Search) w oparciu o ankietę

PKP (Tabela 1) i zbiór reguł decyzyjnych (Tabela 2):

• Do analizy ze zbioru danych wejściowych wybrany został przykład (klient) nr 2.

• Interesuje nas strategia interwencji mająca na celu zmianę przydziału PKP tego

klienta do Klasy co najmniej 2. Chcemy wiedzieć, co musimy zrobić, aby tak się

stało.

• Należy w tym celu przeanalizować zbiór reguł i wybrać takie, których decyzja

odpowiada określonej strategii; w tym przypadku będą to wszystkie reguły z

decyzją Klasa>=2 (nr 5, 6 i 7). Każda z takich reguł jest jednym z możliwych

rozwiązań.

33

• Tak jak w metodzie testowania strategii interwencji również i tutaj mogą

występować niezgodności w zbiorze reguł decyzyjnych. W naszym przykładzie

mogą ją ewentualnie wprowadzać reguły o decyzji Klasa<=1 (nr 1 i 2).

• Reguła nr 5 wskazuje, że jeżeli Obsługa PKP jest oceniona na co najmniej 5 to

PKP zostaje przydzielone do Klasy co najmniej 2. Wybrany klient ocenia to

kryterium na 2, a więc zmieniając ocenę na co najmniej 5 według tej reguły,

spowoduje się, że zmieni on przydział z Klasy 1 na co najmniej 2.

• Należy zauważyć, że po zmianie oceny Obsługi analizowany klient nr 2 spełnia

część warunkową już tylko reguły nr 1 (niezgodność). Reguła nr 1 pokazuje, że

Cena musi być co najmniej 3, żeby nie pokrywała przykładu.

• Analizując regułę nr 6 tak samo jak nr 5 okazuje się, że trzeba zmienić ocenę

Ceny i Czystości z 1 na co najmniej 3. Po tych hipotetycznych zmianach klient

nie będzie już pokrywany przez żadną ze niezgodnych reguł.

• Dla reguły nr 7 postępując analogicznie jak w dwóch powyższych przypadkach

otrzymujemy, że należy zmienić ocenę Punktualności z 3 na co najmniej 4 i

Ceny z 1 na co najmniej 3. Po takich zmianach nie zachodzi już żadna

niezgodność.

• Podsumowując, w końcowym rezultacie otrzymujemy trzy różne rozwiązania –

strategie interwencji (z 3 reguł). Klient nr 2 zmieni przydział z Klasy 1 na co

najmniej 2 jeśli: spowodujemy u niego zmianę oceny Obsługi na co najmniej 5 i

Ceny na co najmniej 3 lub Czystości i Ceny na co najmniej 3 lub Punktualności

na co najmniej 4 i Ceny na co najmniej 3.

4.3.2 Algorytm szukania strategii interwencji

Dokładny algorytm tej metody przedstawia się następująco:

• Wybierz interesujący Cię przykład w danych wejściowych,

• Określ interesującą Cię strategię interwencji przez wskazanie decyzji,

• Znajdź w zbiorze reguł decyzyjnych takie, które odpowiadają pożądanej decyzji,

tzn. ich część decyzyjna pokrywa się ze wskazaną decyzją. Każda ze

znalezionych reguł stanowi jedno z możliwych rozwiązań strategicznych,

34

• Znajdź w zbiorze reguł decyzyjnych reguły mogące stanowić niezgodność dla

reguł znalezionych w poprzednim kroku – negacja wskazanej decyzji,

• Dla każdego znalezionego rozwiązania dokonaj hipotetycznej zmiany wartości

w wybranym przykładzie na tych kryteriach, które wskazują zmienione warunki

reguły,

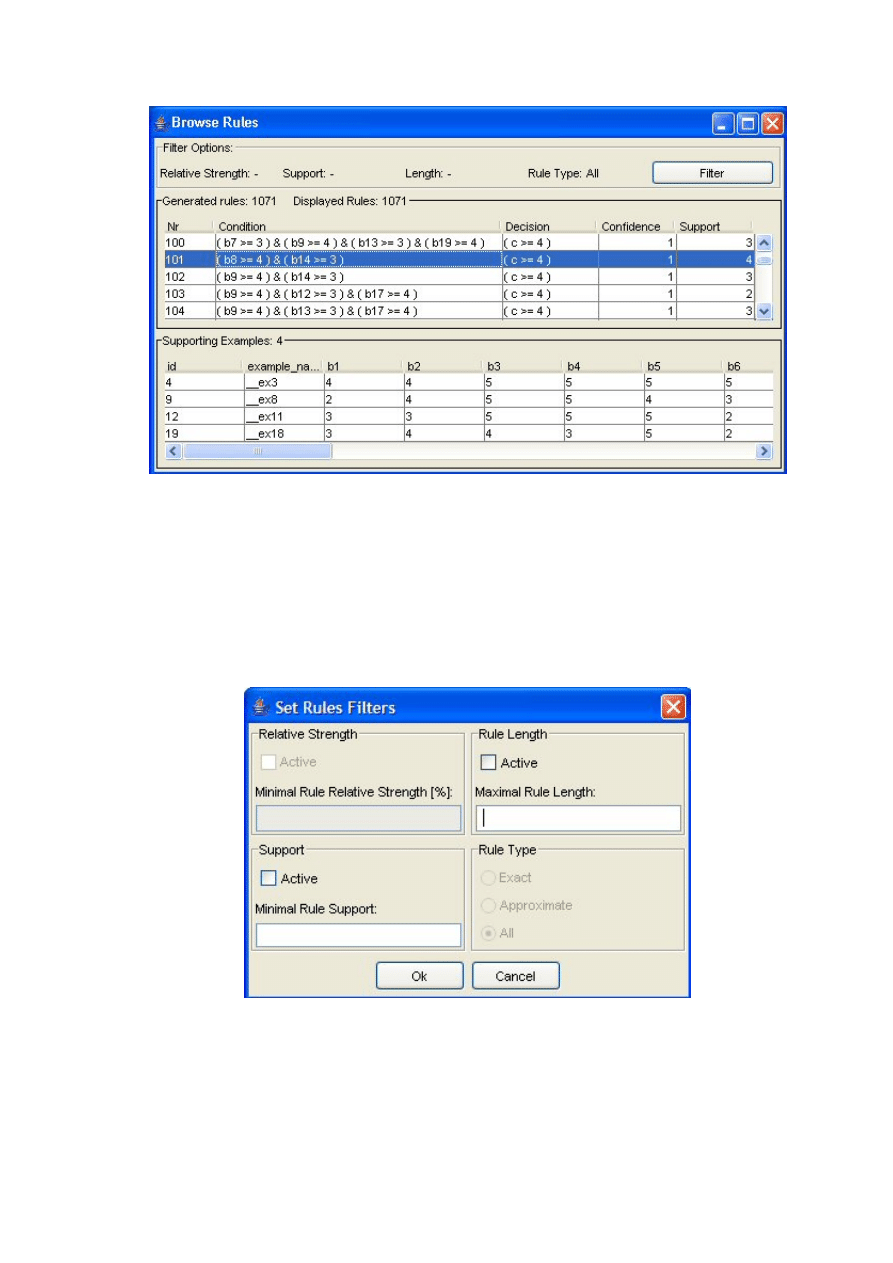

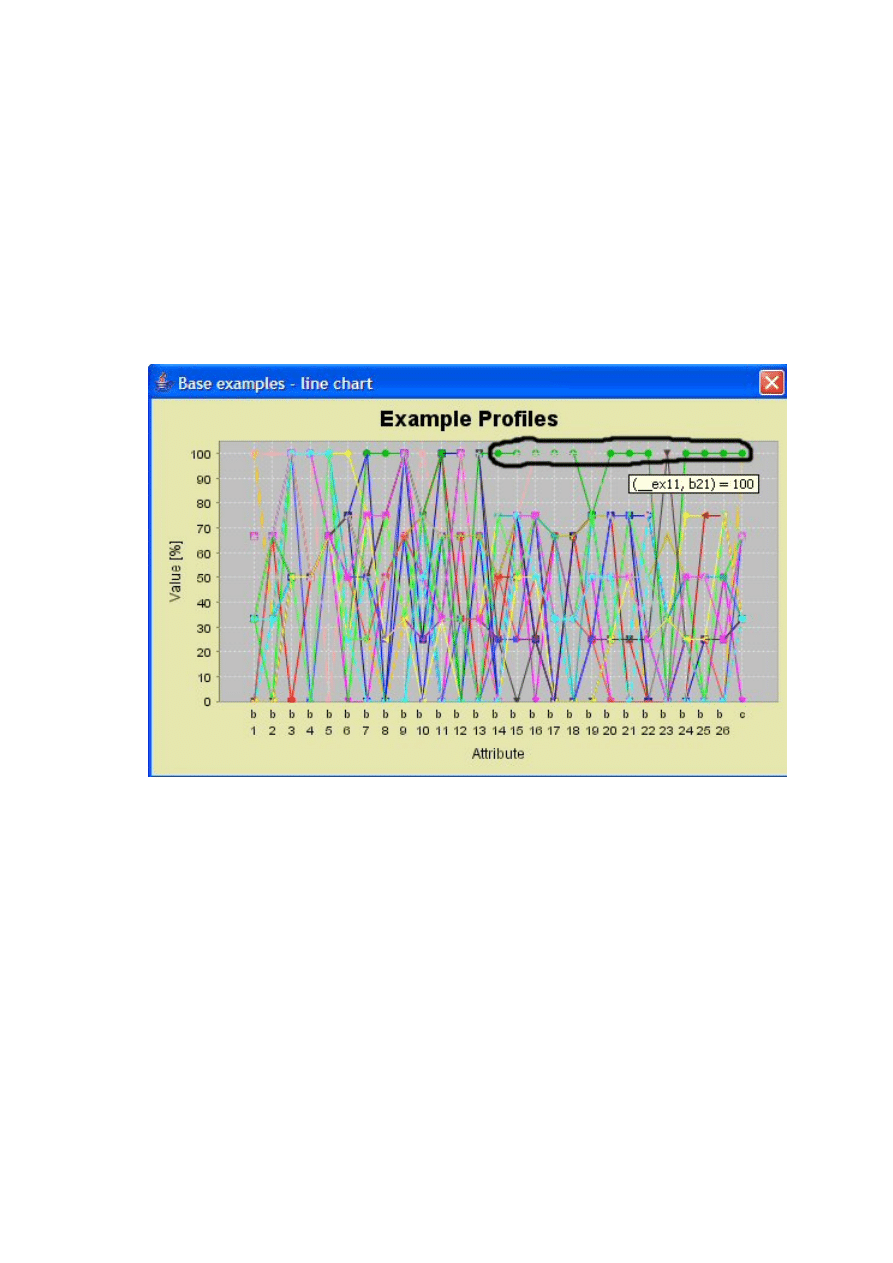

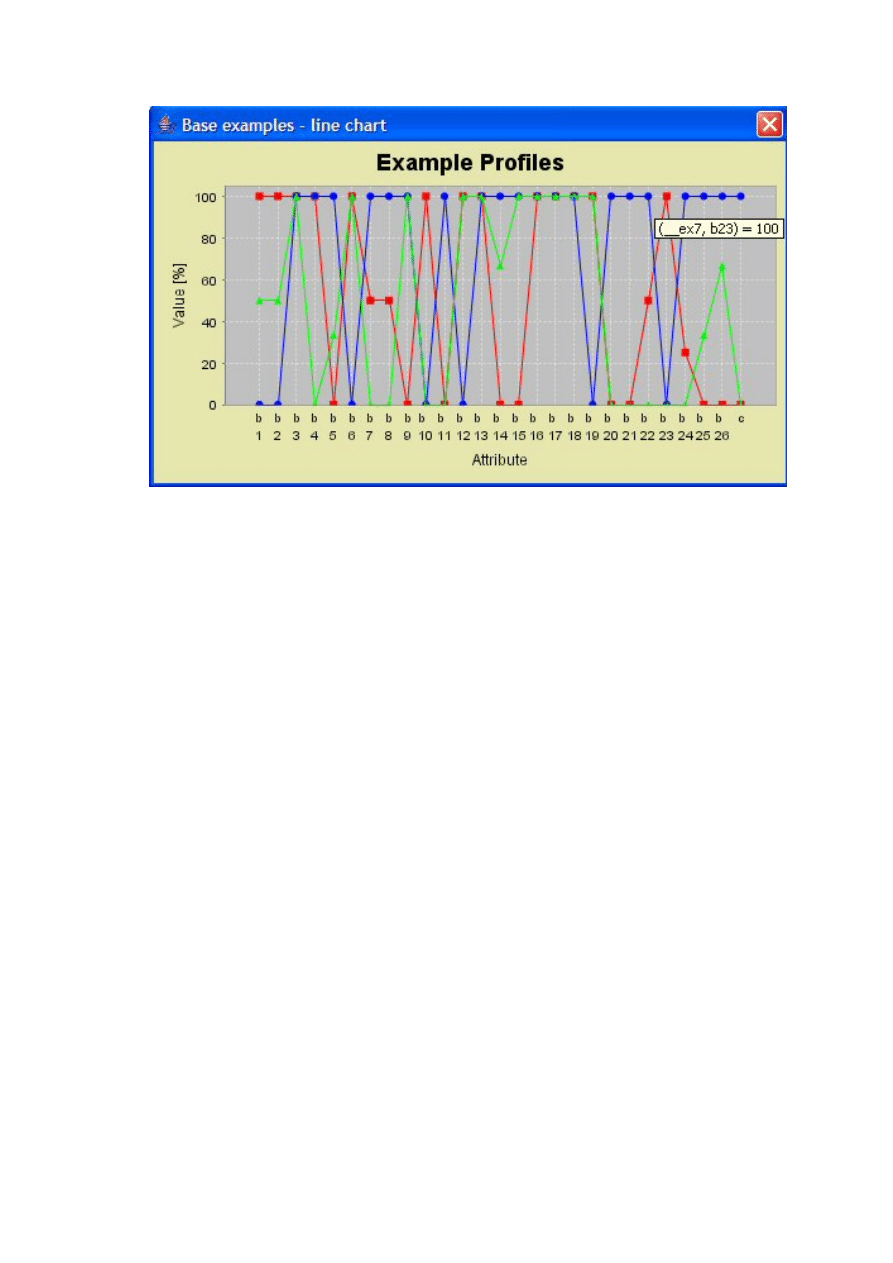

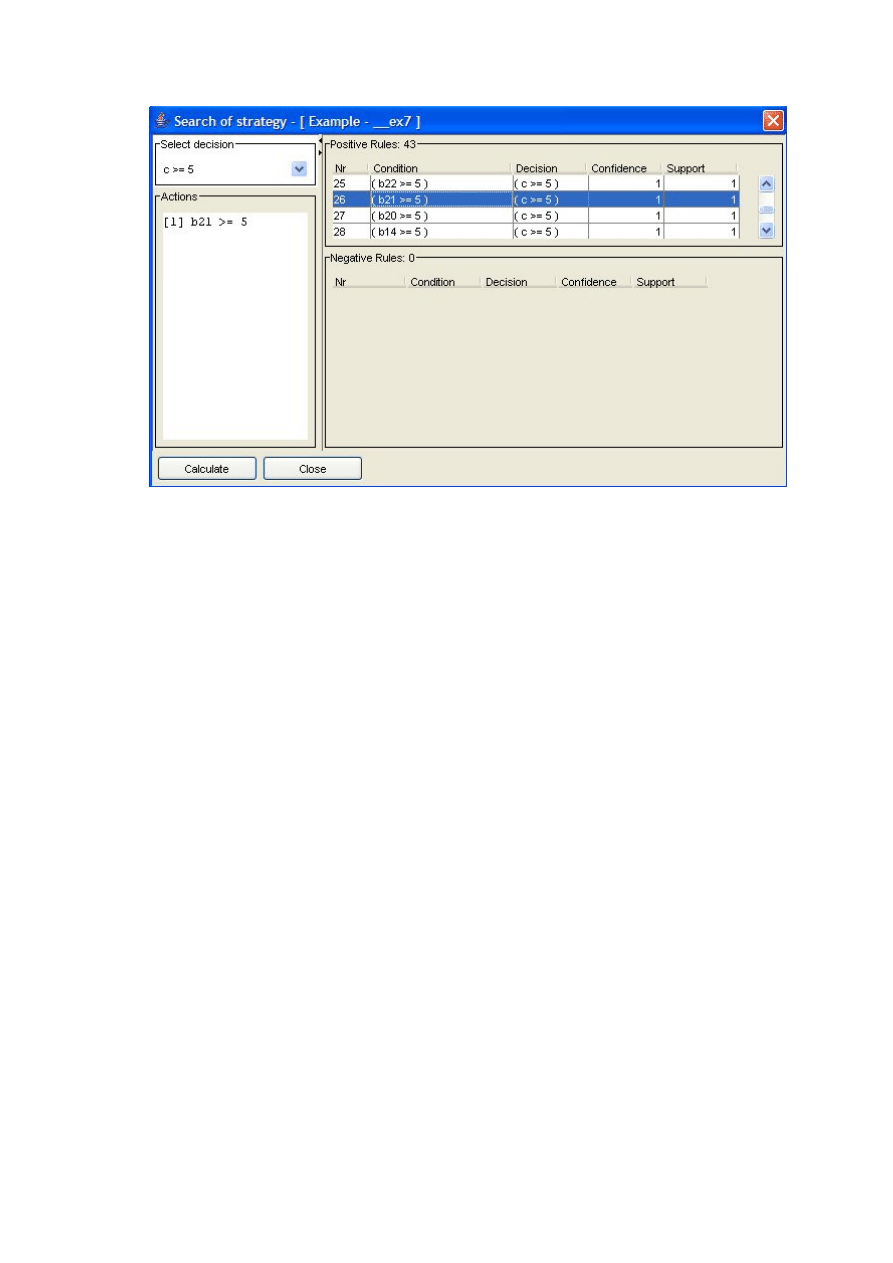

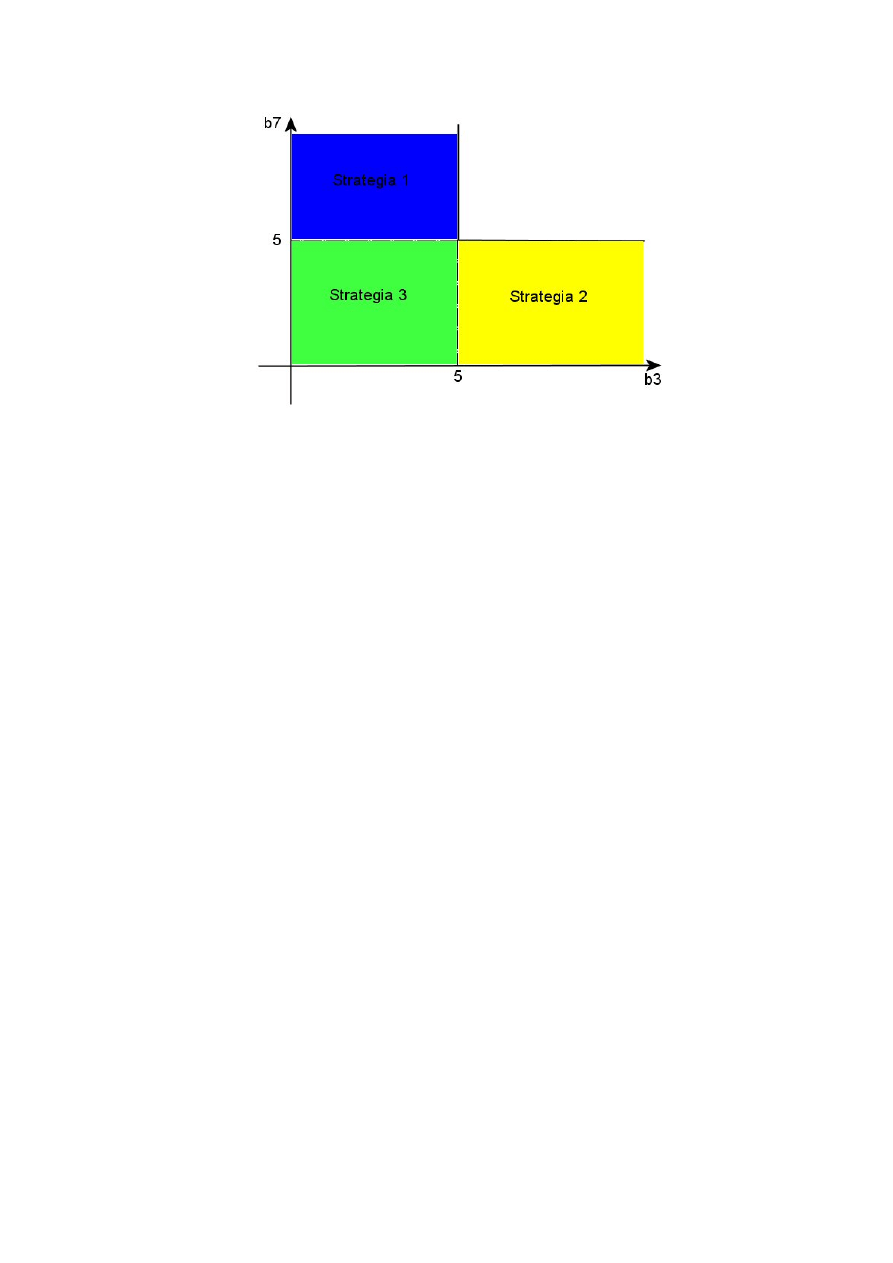

• Przejrzyj zbiór reguł, które mogą wprowadzać niezgodność dla