Budowa aparatu cyfrowego - MATRYCA

Karol Żebruń, styczeń 2007

Wstęp

Gdy trzymamy w ręce aparat cyfrowy, zwykle nie zdajemy sobie sprawy, że w jego

sercu znajduje się niepozorny układ elektroniczny, którego wynalezienie

zrewolucjonizowało cały nasz świat. Cyfrowa rewolucja wydaje się nam czymś

oczywistym, zwłaszcza dla młodszego pokolenia, które nie wyobraża sobie świata bez

komputera czy odtwarzacza DVD. Słowo "cyfrowy" jest dla nas synonimem

stwierdzenia "wysoka jakość" w przeciwieństwie do słowa "analogowy", jakim często

określa się tradycyjne aparaty na klisze. Najważniejsze dla wielu osób w cyfrówce jest

to, aby "miała jak najwięcej megapikseli". To słowo ma magiczne znaczenie. W

rzeczywistości nie jest to jednak najistotniejszy wyznacznik jakości cyfrowych zdjęć.

Aby docenić rewolucję, jaka dokonała się w świecie fotografii, musimy poznać sekrety detektorów cyfrowych,

zwanych popularnie matrycami światłoczułymi. Przy omawianiu budowy aparatu cyfrowego nie sposób o nich

zapomnieć. Nie będziemy się oczywiście zagłębiać dokładnie w fizyczne szczegóły ich działania. Choć jest to

fascynujący kawałek nauki, to jednak bardziej interesowałby miłośnika fizyki, a nie fotografii. Skupimy się na

tych aspektach konstrukcji i działania detektorów cyfrowych, które mają znaczenie dla fotografa. Dowiemy się

również, na jakie korzyści możemy liczyć biorąc do ręki cyfrówkę, ale także z jakimi niedociągnięciami

musimy się liczyć - gdyż fotografia cyfrowa ma swoje wady i ograniczenia, które choć powoli eliminowane

dzięki postępowi nauki, to nadal istnieją.

Matryca CCD stosowana w aparacie Nikon D70. Wygląda "prawie" jak zwykły układ scalony.

Być może ten artykuł pomoże przełamać niechęć do technologii cyfrowej tym, którzy uważają, że "cyfrowość"

zabija ducha fotografii.

1. Dlaczego detektor cyfrowy

Odpowiedź wydaje na pozór się prosta. Klisza ma tę przewagę nad ludzkim okiem, że potrafi integrować

padające światło. Innymi słowy im dłużej "patrzy" się na źródło światła, tym jaśniejsze się ono wydaje.

Ludzkie oko potrafi się na przykład, przyzwyczaić do ciemności, ale to nadal będzie ciemność. Z kolei

naświetlając odpowiednio długo zdjęcie otoczenie na nim stanie się tak jasne, jak za dnia.

Matryca w cyfrówce ma z kolei tę przewagę nad kliszą fotograficzną, że tworzy obraz, który jest od razu w

postaci cyfrowej, można zapisać go jako plik graficzny na karcie pamięci. Kliszę niestety trzeba dopiero

skanować za pomocą skanera. Aby uzyskać odpowiedni rezultat powinno się stosować dobre, a co za tym idzie,

drogie urządzenia.

Wiele osób myśli, że cyfrowe zdjęcie to już nie to, co zdjęcie na kliszy. Choć nie da się zaprzeczyć, że

fotografia analogowa ma swoją "duszę", to nie oznacza to, że cyfrowe zdjęcie będzie gorsze. W większości

przypadków nawet nie zdajemy sobie sprawy, że i w świat analogowej fotografii wkradła się technika cyfrowa.

Fotografowie korzystający z analogowych lustrzanek zwykle skanują swoje zdjęcia, aby "dopracować" ich

wygląd na komputerze, lub dokonać niezbędnego retuszu. A i nasze amatorskie zdjęcia na kliszach podlegają

skanowaniu w "cyfrowych labach", zanim zostaną naświetlone na papierze fotograficznym.

O wyjątkowości elementu, zwanego detektorem cyfrowym, świadczy jeszcze to, że jest on wykorzystywany nie

tylko w cyfrówkach, a również w każdej dziedzinie, w której obraz ma najważniejsze znaczenie, czyli nauce,

medycynie czy w wojsku.

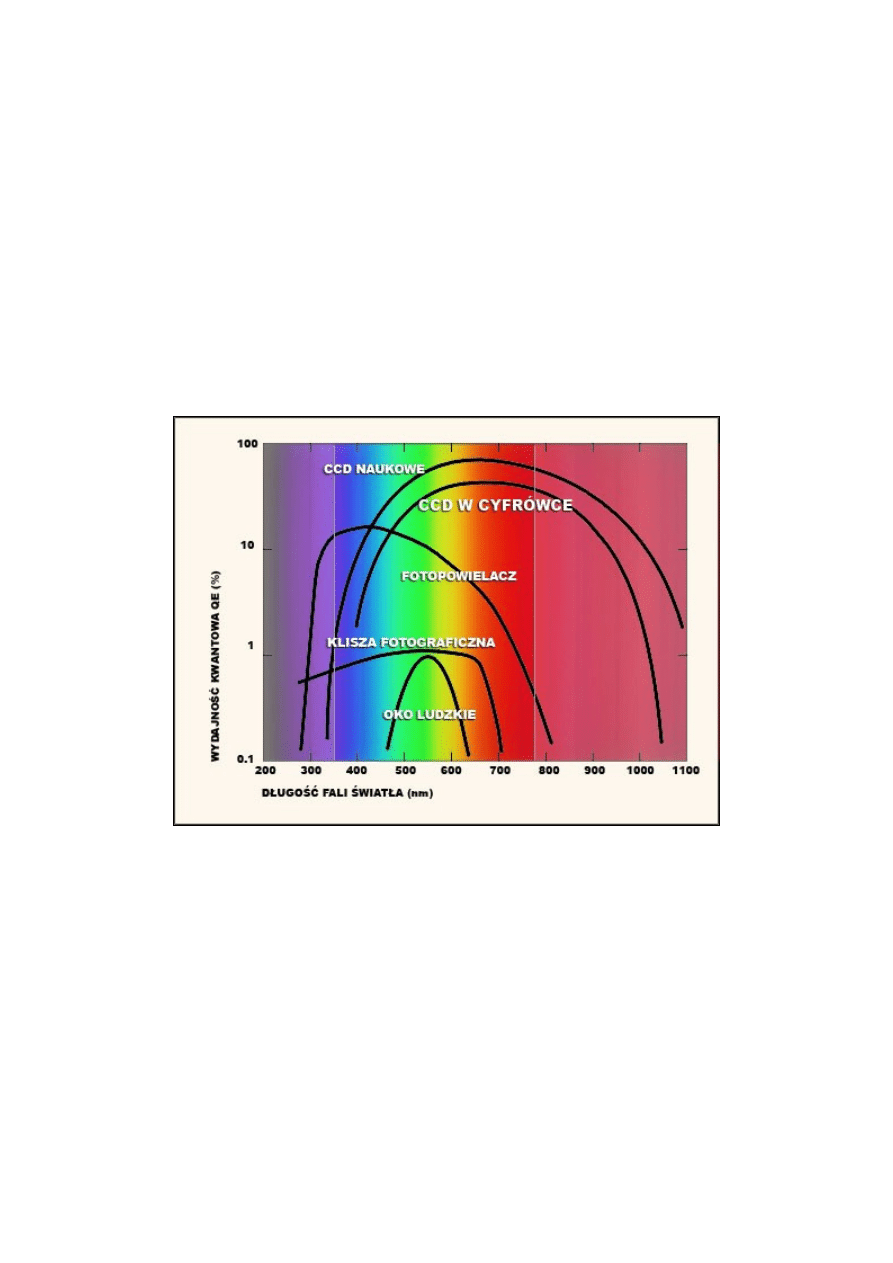

Spójrzmy się na obrazek poniżej. Przedstawia on wydajność kwantową (QE) dla danej długości fali świetlnej

oraz różnych detektorów światła. Widzimy, że oko ludzkie nie wypada tutaj najlepiej. Mimo ogromnej

rozdzielczości i zdolności do adaptowania się do różnych warunków oświetleniowych, reaguje dość słabo na

padające światło. Dlatego możemy spoglądać na zachodzące słońce (oczywiście z umiarem) bez obawy o

prześwietlenie obrazu. Przez oko postrzegamy również świat w ograniczonej liczbie kolorów, ale to chyba nie

jest zbytnim ograniczeniem J. Jak widać klisza fotograficzna prezentuje się sporo lepiej niż oko ludzkie, a

profesjonalne klisze o wysokiej czułości mogą mieć jeszcze lepsze parametry. Jeszcze wydajniejszy jest

fotopowielacz, urządzenie stosowane, do wzmacniania padającego światła. Spójrzmy się jednak na linie

wykresu dla detektorów CCD (jeden z rodzajów matryc światłoczułych). Ich wydajność jest ogromna, w

większości zakresu przekracza 20%, a sięga nawet 90% (zastosowania naukowe). Co to oznacza? Tyle, że aż

90% sygnału świetlnego docierającego do nas od źródła światła może być zamienione w sygnał elektryczny, co

oznacza, że są to urządzenia bardzo czułe.

QE - ang. Quantum Eficiency (wydajność kwantowa) mówi nam o zdolności danego detektora światła do

reagowania na padające światło. 100% oznaczałoby, że nie ma prawie żadnych strat przy rejestracji sygnału,

gdyż zawsze istnieją zakłócenia wprowadzane samorzutnie podczas rejestracji sygnału

DŁUGOŚĆ FALI - to długość fali padającego światła. Po lewej stronie znajdują się kolory z zakresu

ultrafioletu, a po prawej dalekiej podczerwieni, oko ludzkie najlepiej reaguje na długość fali około 500-550 nm

odpowiadającą barwie zielonej (co ma odzwierciedlenie w konstrukcji matryc).

Na wykresie zauważymy także, że CCD reaguje doskonale nie tylko na światło widzialne (oznaczone

pionowymi liniami), ale również na promieniowanie z zakresu podczerwieni. Zdolność rejestracji światła

podczerwonego jest ogromną zaletą detektorów cyfrowych, ale niesie to ze sobą niestety problem. Choć

możemy nie zdawać sobie z tego sprawy, jest on bardzo istotny w fotografii cyfrowej, o czym napisano dalej.

UWAGA: Matryce wykorzystywane w fotografii nie posiadają, aż takiej wydajności QE, jak te

stosowane w nauce. W tym przypadku jest ona rzędu 25-50%. Dodatkowym problemem są szumy, które

niestety obniżają znacznie czułość stosowanych w fotografii detektorów.

Podsumowując można powiedzieć, że matryca światłoczuła to wymarzony detektor światła dla fotografa.

Mamy od razu cyfrowy obraz, doskonałą wydajność. Możemy wykonywać setki zdjęć bez obawy o

nadszarpnięcie naszego budżetu, a potem łatwo przegrać je do komputera i wydrukować tylko te najlepsze.

Nauka fotografii nigdy nie była tak prosta i wygodna, a więc czego chcieć więcej. Dla większości

użytkowników to wystarczający powód, aby wyrzucić stary aparat i kupić cyfrówkę.

Jednak w pewnym momencie mogą się nam w głowie zrodzić różne pytania dotyczące pstrykniętych fotek.

Zechcemy wiedzieć na przykład dlaczego akurat "to" ujęcie nie wyszło tak, jak to było planowane, albo

dlaczego tak dziwnie widać deseń na swetrze. No i skąd te paskudne kolory?

To wszystko stanie się oczywiste, gdy poznamy sekrety działania matryc światłoczułych w aparatach.

2. Trochę historii

Jak to zwykle bywa w historii różnych urządzeń i tutaj narodzinom cyfrowego detektora przyświecał zupełnie

inny cel, niż by się mogło wydawać.

Od początku, czyli od połowy XIX wieku, do wytworzenia obrazu na materiale światłoczułym

wykorzystywano procesy chemiczne. Początkowo były to szklane płyty fotograficzne powlekane substancją

światłoczułą, a potem produkowane do dziś klisze fotograficzne.

W drugiej połowie XX wieku na scenie pojawiły się układy cyfrowe. Powstały jednak nie w wyniku badań

prowadzących do stworzenia doskonalszego detektora światła. W roku 1969 pracownicy laboratorium Bella

(zadziwiające ile powszechnych dziś wynalazków powstało w tym miejscu) Willard Boyle i George Smith

poszukując technologii pozwalającej na przechowywanie dużej ilości danych, czyli w pewnym sensie pamięci,

wynaleźli coś, co nazwano CCD.

Szybko zorientowano się w potencjale tkwiącym w tych urządzeniach (jak zwykle najszybsze były media) i już

w 1974 pierwsze detektory CCD trafiły do kamer telewizyjnych. Od lat 80 stosuje się je powszechnie w nauce.

W tym samym okresie powstawała także bliźniacza technologia CMOS, która stała się podstawą dzisiejszej

mikroelektroniki, a do świata fotografii wkroczyła niejako kuchennymi drzwiami. Mimo wielu różnic

pomiędzy tymi technologiami, a zarazem problemów ,jakie sprawiają użytkownikom, podstawa działania obu

rodzajów urządzeń jest taka sama.

PODSTAWOWA ZASADA:

Na początku XX wieku Einstein opisał istotę zjawiska fotoelektrycznego wewnętrznego. Polega ono na

przekazaniu energii fotonów padającego światła elektronom metalu (w matrycach stosuje się krzemowe

półprzewodniki), które zostają uwolnione (odseparowane od atomu, nazywa się je fotoelektronami). Jest to

podstawa działania każdej matrycy cyfrowej w aparacie.

Nazwy obu technologii to skróty:

CCD - układ o sprzężeniu ładunkowym (ang. charge coupled device)

CMOS - komplementarny półprzewodnik tlenkowy (ang. complementary metal-oxide

semiconductor),

W dalszej części artykułu, jeśli nie będzie to jednoznacznie określone, terminy "matryca światłoczuła",

"detektor" będą odnosiły się zarówno do układów wykonanych w technologii CCD jak i CMOS.

Wśród niektórych użytkowników aparatów cyfrowych popularne są spory na temat "który detektor jest lepszy".

Przypomina to często "wojny systemowe", gdzie zwolennicy jednej marki aparatu udowadniają jej wyższość

nad inną. Nie jest to jednak dobre podejście. Obie technologie są intensywnie rozwijane, miewają także okresy

zastoju, i choć każda ma swoje zalety i wady, to obie doskonale sprawdzają się w fotografii cyfrowej.

Historia rozwoju aparatów cyfrowych to wiele wydarzeń i związanych z nimi dat. Niektóre z nich były

przełomowe, niektóre nie doprowadziły do żadnych osiągnięć. Ciężko podać jednoznacznie, kto stworzył

pierwszą cyfrówkę lub który model można traktować jako pierwszy powszechnie dostępny.

Jak zwykle dużą rolę odegrała tutaj m.in. firma Kodak. W 1986 roku stworzono w ich laboratoriach pierwszy

układ o 1 milionie pikseli (1MPix, o megapikselach mowa będzie dalej). Początek lat 90-tych możemy

potraktować jako początek ery cyfrówek. Wtedy to pojawiły się na rynku pierwsze aparaty cyfrowe, m.in.

Kodak DCS-100 SLR z matrycą 1.3Mpix. Nowa technologia słono kosztowała - 30000$. Musiało jednak

upłynąć jeszcze kilka lat zanim cyfrówki zaczęły podbijać nasze serca i "kieszenie". W połowie lat 90-tych

zaczęły się pojawiać cyfrowe kompakty o swojsko dziś brzmiących nazwach Canon Powershot, Sony

Cybershot, Casio QV, Nikon Coolpix, które mogliśmy już podłączyć do komputera.

Jedna z pierwszych cyfrówek - Canon Powershot 600 i najnowszy model Canon Powershot G7.

Jak widać wyglądać zewnętrzny nie uległ znaczącej zmianie.

Matryce stosowane w pierwszych szeroko dostępnych aparatach miały niewielką rozdzielczość. Była ona rzędu

640x480pix (0.3Mpix).Dziś taką rozdzielczością może pochwalić się prawie każdy telefon komórkowy, a

raczej wbudowany weń aparat. Szybko nastąpiły zmiany i już w 1997 roku aparaty mogły się poszczycić

przetwornikami 1Mpix. Na przełomie stuleci aparaty miały już zwykle montowane matryce 2Mpix. W roku

2003 większość nowych cyfrówek miała detektory 3 lub 4Mpix, a na horyzoncie widać było już modele z

matrycą 5Mpix. Każdy kolejny rok przynosił nam zwiększanie ilości Mpix w aparatach. Dzisiaj jesteśmy w

stanie wykonać zdjęcie mające 10Mpix za pomocą niezbyt drogiego (oczywiście w porównaniu z dawnymi

konstrukcjami) kompaktu. Lustrzanki mają matryce 6,10,12 aż do kilkudziesięciu (w profesjonalnych

modelach) Mpix.

MATRYCE CYFROWE W NAUCE: Jednym z bardzo ważnych pól zastosowań CCD, a ostatnio także i CMOS

jest nauka. Zastosowanie CCD w połowie lat 70-tych do obserwacji astronomicznych stanowiło ogromny

przełom w rozwoju tej dziedziny nauki. Od tej pory astronom nie jest skazany na żmudne i długotrwałe

naświetlanie szklanych płyt fotograficznych (w profesjonalnej astronomii nie stosuje się klisz), a może uzyskać

znacznie szybciej bardziej dokładny obraz za pomocą detektora cyfrowego. Co ciekawe, nie analizuje już

danych za pomocą własnego wzroku (a tak dawniej bywało), ale może pozwolić wykonać to zadanie szybciej i

precyzyjniej komputerom. I w ten oto sposób dzisiejszy astronom to często także zdolny programista, znający

się doskonale na cyfrowej obróbce obrazu. To dzięki tym urządzeniom otrzymujemy obecnie wspaniałe obrazy

nieba i planet z sond kosmicznych. Astronomowie uwolnili się od ograniczeń jakie niosły ze sobą klisze -

głównie konieczności wywołania, a także ograniczenia w ilości wykonanych obrazów.

Układy stosowane w nauce w pełni wykorzystują potencjał, jaki niesie ze sobą czułość matryc, okupione jest to

jednak koniecznością bardzo precyzyjnej kalibracji urządzeń, a często także utrzymywania w temperaturze

poniżej -90'C. Wymaga to chłodzenia za pomocą ciekłego azotu, a nawet helu, co jest nie do pomyślenia w

przypadku aparatu cyfrowego.

Kolejne Mpix w aparatach pozwoliły nam wykonywać coraz lepsze powiększenia i przyczyniły się do

zwycięstwa techniki cyfrowej nad analogową. Czy jednak można tak w nieskończoność? Czy za parę lat

pójdziemy do sklepu po Canona G10 z 20Mpix matrycą? Możliwe, choć nie takie pewne. Aby stało się to

rzeczywistością producenci będą musieli pokonać kolejną barierę - jakości obrazu. Dlaczego? O tym

przekonamy się z dalszej lektury tego artykułu.

3. Wewnątrz cyfrówki - czyli jak to wygląda?

Wiemy już, że matryca światłoczuła to doskonały kompan każdego fotografa. Poznaliśmy też kilka szczegółów

z historii. Zobaczmy teraz jak wygląda budowa matrycy stosowanej w aparacie cyfrowym.

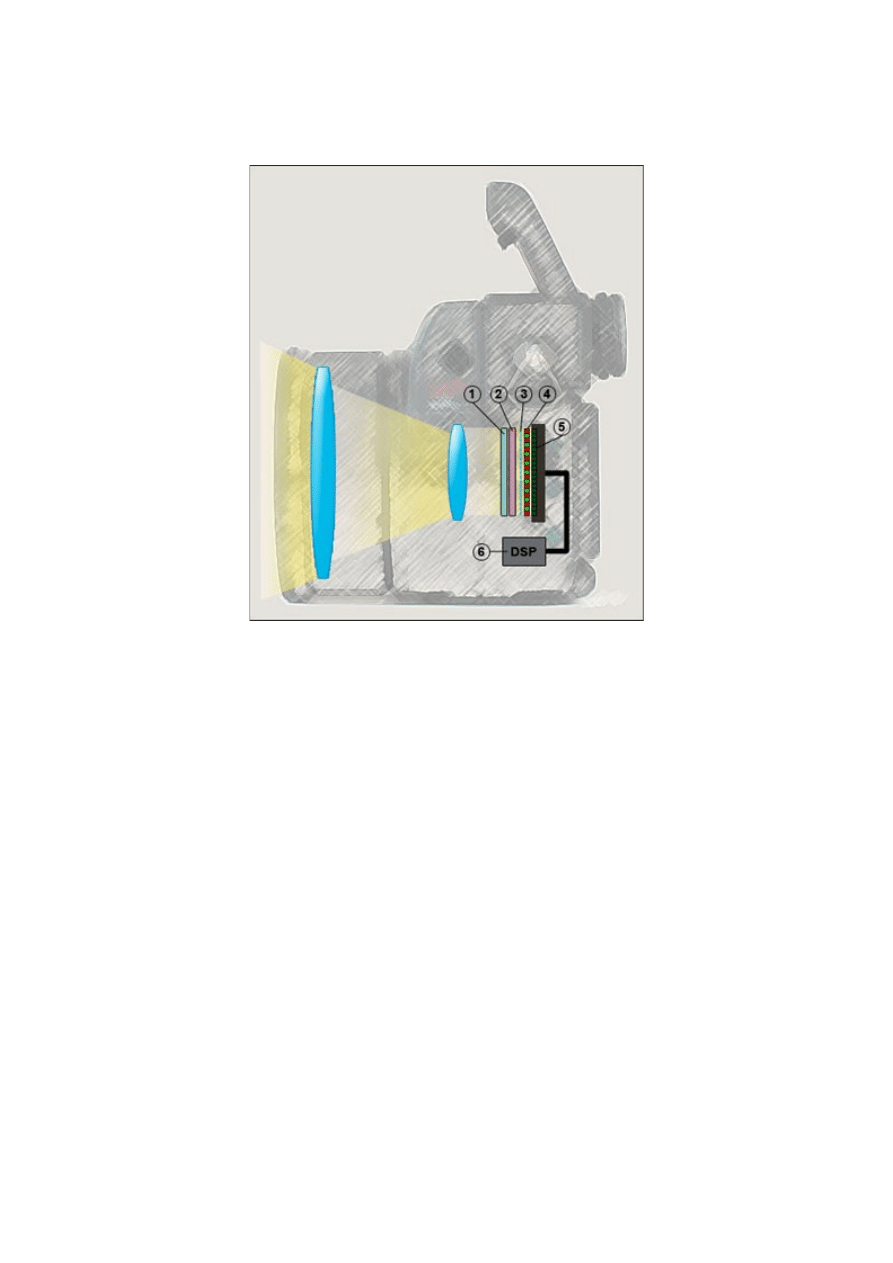

Światło zogniskowane przez obiektyw pada ma matrycę. Na rysunku widzimy jednak, że matryca światłoczuła

stosowana w aparacie cyfrowym to nie tylko detektor światła CCD/CMOS (5). Przed pikselami umieszczone są

na stałe filtry barwne (4) i mikrosoczewki (3) i zestaw filtrów. Dodatkowo przed matrycą umieszczony jest

także filtr IR (1) oraz AA (2), które nie są zainstalowane na stałe (można je usunąć). Zanim zdjęcie zostanie

zapisane na karcie pamięci przetwarzane jest przez układ DSP (6, ang. Digital Signal Processor, cyfrowy

procesor sygnału).

LCD TO NIE MATRYCA:

Prawie każdy aparat cyfrowy ma na tylnej ściance wyświetlacz LCD. Służy on do wyświetlania podglądu już

zrobionego zdjęcia i pozwala na nawigację po zakamarkach często bardzo rozbudowanego menu. Jednak nie

należy mylić go z matrycą. Ta jest umieszczona całkowicie wewnątrz aparatu, zwykle tuż przed wyświetlaczem

LCD, w jego tylnej części. Czasem aparaty mają umieszczony specjalny znaczek określający płaszczyznę

matrycy czyli miejsce, gdzie powstaje nasze zdjęcie.

Możemy więc zaryzykować stwierdzenie, że mianem matrycy w aparacie możemy określać te wszystkie

podzespoły razem. Teraz zapoznamy się bardziej szczegółowo z wymienionymi elementami. Zaczniemy od

detektora światła.

4. Od światła do bitów - czyli jak to działa

Jak już wspomnieliśmy, najpopularniejsze technologie wytwarzania matryc stosowanych w fotografii cyfrowej

to CCD i CMOS. Zarówno sensory CCD jak i CMOS składają się z pikseli. Światło padające na pojedynczy

piksel powoduje wygenerowanie w nim ładunku, w postaci elektronów wybitych z półprzewodnika tworzącego

piksel (zjawisko fotoelektryczne wewnętrzne). Ładunek odpowiada intensywności padającego światła.

Następnie zablokowany zostaje dostęp światła, mechanicznie za pomocą migawki (zwykle tak jest w

lustrzankach cyfrowych) lub elektronicznie (technika powszechna w kompaktach), i sygnał zawarty w

pikselach zostaje odczytany. Czasem stosowana jest migawka hybrydowa (mechaniczno-elektroniczna).

Po lewej stronie układ CMOS (na dole widać zintegrowaną w chipie elektronikę), po prawej układ CCD.

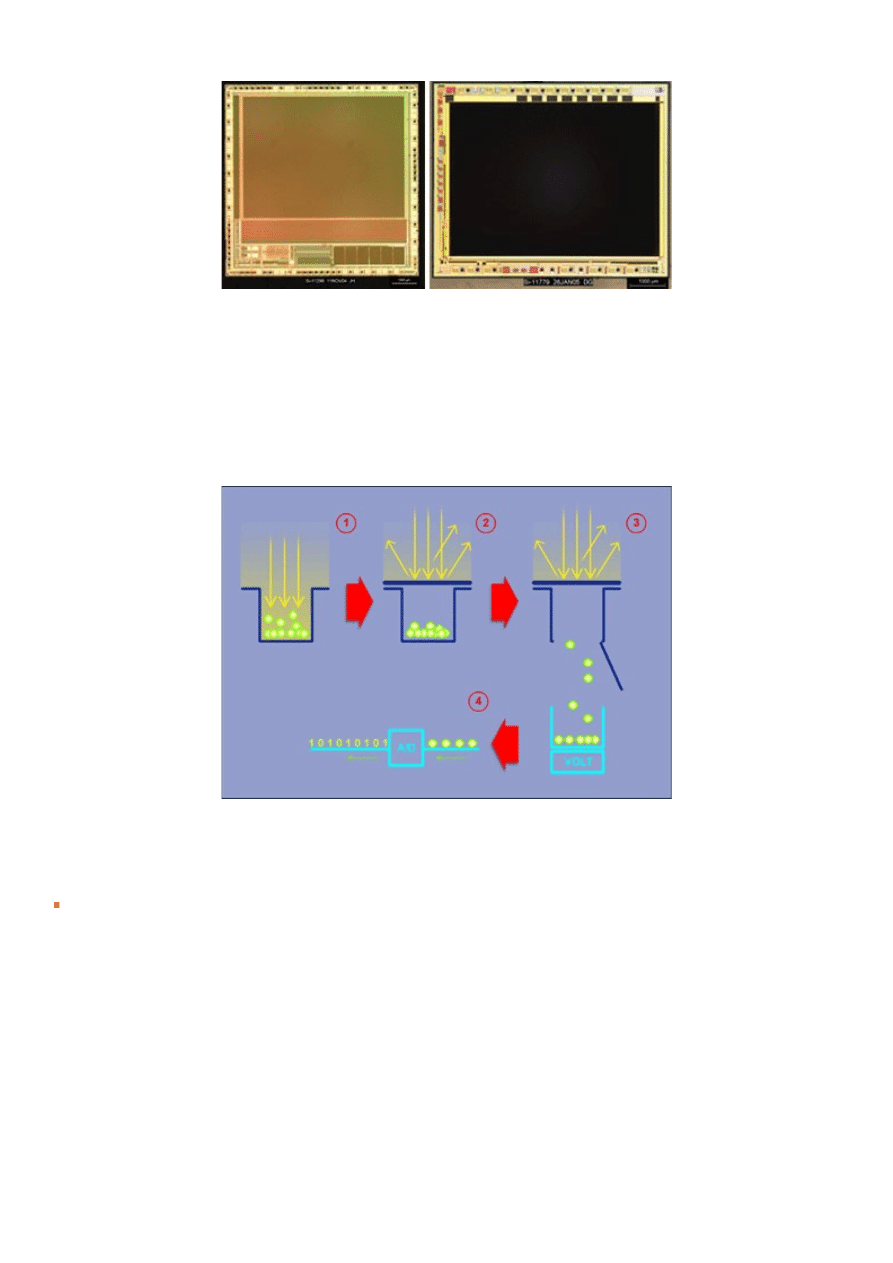

Często stosowaną analogią jest porównanie pikseli do kubełków na wodę. Działanie detektora, zarówno w

przypadku CCD jak i CMOS, można opisać w następujących krokach:

1. Wytworzenie i integracja ładunku w pikselach pod wpływem padających fotonów - napełniamy kubełek

wodą.

2. Zablokowanie dostępu światła - czyli zakrywamy wierzch kubełka pokrywką.

3. Pomiar i przeskalowanie zgromadzonego ładunku na napięcie - opróżniamy kubełek z wody.

4. Zamiana napięcia na odpowiadający mu sygnał cyfrowy - sprawdzamy, ile zebraliśmy wody w każdym

kubełku.

Mimo podobieństw w procesie rejestracji/odczytu danych istnieje kilka istotnych różnic pomiędzy matrycami

CCD a CMOS.

Budowa Piksela

W układach cyfrowych elementem światłoczułym mogą być fotodiody bądź fotobramki.

1. Fotobramki (z ang. photogates) - wykorzystują kondensatory MOS do wytworzenia studni potencjału

(ładunkowej) gdzie fotoelektrony są zbierane. Fotobramki mają bardzo duży fillfactor, co pozwala

maksymalnie wykorzystać powierzchnię piksela. Wadą jest zmniejszona czułość w paśmie niebieskim.

2. Fotodiody (z ang. photodiodes) - składają się z warstwy jonów (półprzewodnik n), umieszczonych na

podstawie krzemowej (półprzewodnik p) - generacja sygnału tworzy pary p-n w obszarze stycznym obu

warstw. Fotodiody mają mniejszy niż fotobramki fillfactor i zdolność integrowania ładunku (mniejszą

studnię potencjału), ale są lepsze w paśmie niebieskim.

W fotografii cyfrowej układy CCD (z wyjątkami) i CMOS jako elementy konstrukcyjne wykorzystują

fotodiody. Zwykle piksele są kwadratowe, choć istnieją konstrukcje o innym kształcie piksela, np. prostokąt czy

ośmiokąt.

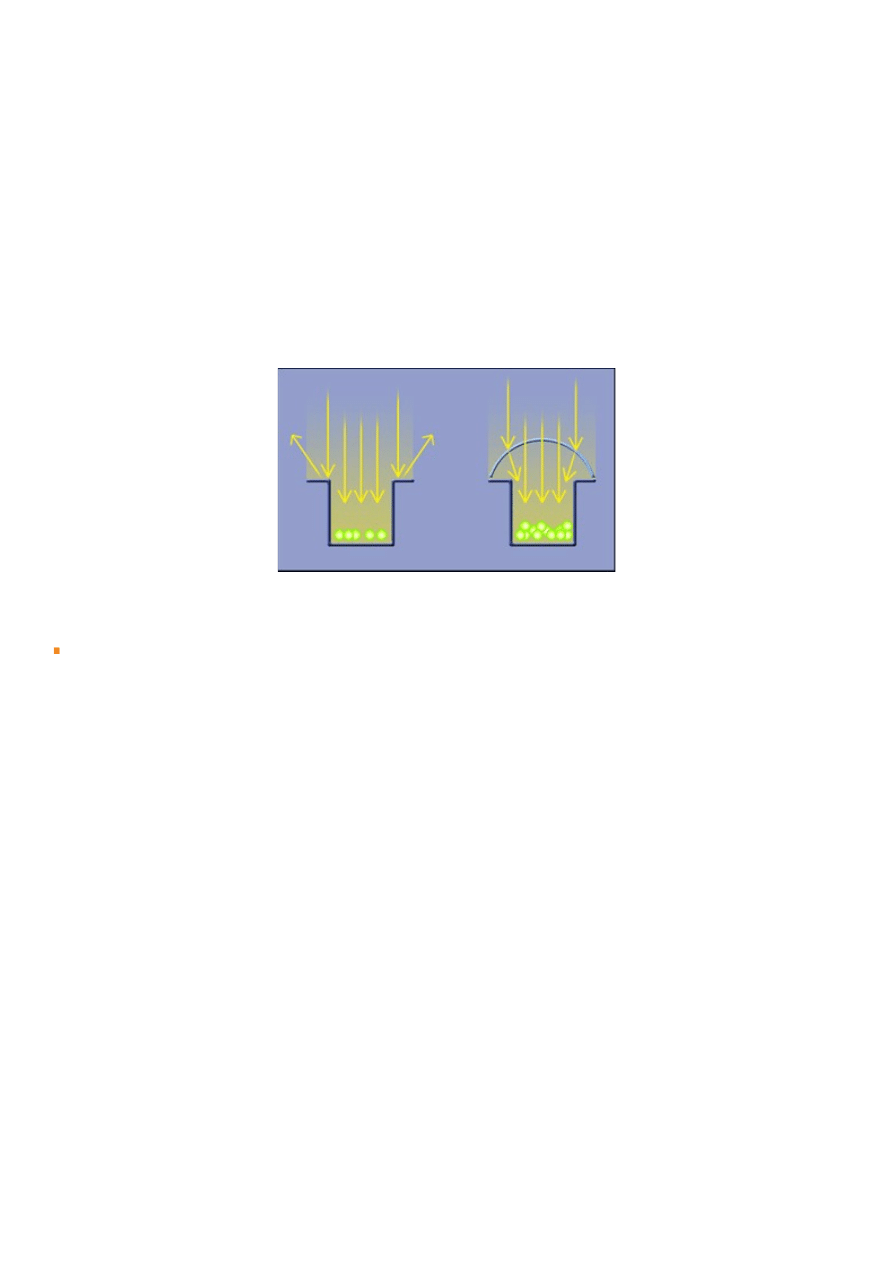

Tajemniczy czynnik 'Fill Factor'

W CCD większość powierzchni piksela jest aktywna fotoelektrycznie - czyli mówiąc inaczej, reaguje na

padające światło. Natomiast w CMOS sporą część powierzchni piksela zajmują układy elektroniczne

(konieczne do ich działania), a część światłoczuła jest znacznie mniejsza niż w CCD przy tym samym

rozmiarze piksela. Procent światłoczułej powierzchni piksela określa się mianem FILL-FACTOR. Teoretycznie

dla CCD sięga nawet od 50% do 100% (zależnie od typu układu), a dla układów CMOS tylko 25%-50%. W

fotografii cyfrowej należy brać pod uwagę dolne wartości. Z tego powodu w matryce stosowane w aparatach

cyfrowych niezależnie od technologii wytwarzania wyposażone są w mikrosoczewki (miniaturowe soczewki),

umieszczone przed każdym z pikseli. Ich zadaniem jest ogniskowanie padającego na powierzchnię piksela

światła tak, aby zminimalizować jego straty.

Rysunek pokazuje, że gdyby nie stosowano mikrosoczewek, to spora część światła byłaby utracona. Dzięki

soczewkom prawie całe padające światło trafia na powierzchnię światłoczułą.

Mikrosoczewki, choć tak pomocne, czasem są również źródłem niepożądanych efektów. Napisaliśmy o tym w

rozdziale 9.

Sposób odczytu sygnału

Po zarejestrowaniu światła, czyli po upływie czasu ekspozycji, następuje odczyt sygnału. I tutaj pojawia się

kolejna, bodajże jedna z najistotniejszych różnic pomiędzy CCD i CMOS.

CCD - tutaj ładunek jest najpierw przesuwany kolumnami (lub wierszami) do równoległego rejestru, który

następnie jest odczytywany piksel za pikselem. Odczytany dla każdego piksela ładunek, który może być

odpowiednio wzmocniony przez wzmacniacz sygnału (regulacja czułości układu, patrz rozdział 7), jest

przekształcony w napięcie. Następnie sygnał ten trafia do przetwornika analogowo-cyfrowego (A/D) i jest

przekształcany na sygnał cyfrowy, który po obróbce w układzie DSP można zapisać na karcie pamięci. Tak

więc odczyt wartości jakiegokolwiek piksela wymaga odczytania zawartości całej matrycy lub przynajmniej jej

części.

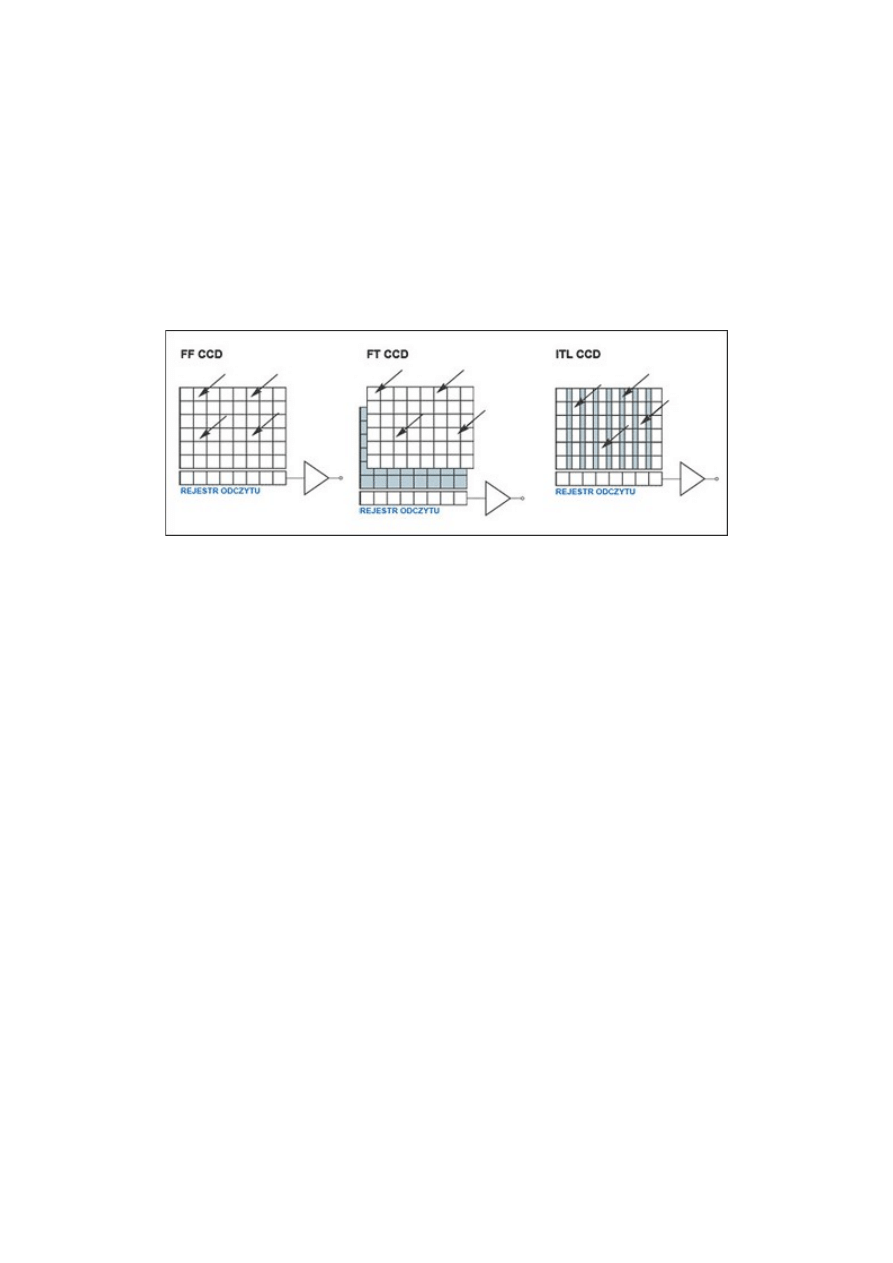

W konstrukcji detektora CCD istotny jest sposób w jaki zarejestrowany sygnał jest izolowany od czynników

zewnętrznych na czas odczytu. Z tego powodu wyróżniamy trzy typy architektury CCD:

Full Frame CCD (FF CCD) - (nie mylić z rozmiarem detektora określanym jako full frame, patrz

rozdział 6.1). Sygnał odczytywany jest kolumna po kolumnie (lub wiersz po wierszu), co limituje

szybkość takiego układu, ale daje możliwość uzyskania bardzo niskich szumów i wysokiej czułości,

jak również dynamiki rejestrowanego obrazu. Te układy wymagają mechanicznej migawki, gdyż w

trakcie odczytu matryca jest ciągle wystawiona na światło, a procesu generacji sygnału nie można

zatrzymać. Nie wykorzystują mikrosoczewek Stosowane głównie w zastosowaniach naukowych.

Frame Transfer CCD (FT CCD) - jest to modyfikacja FF CCD. Zastosowano tu odseparowany

obszar, do którego w momencie odczytu ładunek jest szybko przemieszczany, a następnie podobnie

jak w FF CCD następuje odczyt sygnału. Układy te mają też większe straty energii niż FF CCD, co

daje większy szum, nadal jednak tak jak FF CCD mają bardzo duży fill factor i dynamikę oraz

jednorodną czułość całego układu. Układy FT CCD mają znacznie większą szybkość odczytu niż

FF CCD. Wadą jest dużo wyższy koszt produkcji. Stosowane są w niektórych aparatach cyfrowych.

InterLine Transfer CCD (ILT CCD) - wykorzystują fotodiody podobnie jak CMOS. Ich zaletą jest

możliwość elektronicznej regulacji czasu ekspozycji - migawka elektroniczna - sygnał jest

przesuwany do tak zwanego shift register (jest ekranowany świetlnie), a dopiero potem

odczytywany. Zmniejszony fill factor, tylko 50% a czasem mniej, wymusza stosowanie

mikrosoczewek. Pozwala to podnieść jego wartość do ponad 70%. Niestety, mimo to dynamika

układów ILT CCD jest znacznie mniejsza niż FF CCD. Ten typ CCD stosowany jest najczęściej w

aparatach fotograficznych.

Trzy rodzaje architektury CCD. We wszystkich przypadkach ładunek jest przesuwany pionowo w dół do

rejestru odczytu, a następnie zamieniany w napięcie. Kolor szary w przypadku FT CCD to odseparowany

obszar, a w przypadku ITL CCD to "shift register".

CMOS - tu zawartość każdego piksela jest odczytywana niezależnie (zaletą jest dowolność w sposobie odczytu

poszczególnych partii obrazu, co pozwala łatwiej odczytywać wybrane partie obrazu). Mówiąc inaczej, dzięki

możliwości bezpośredniego adresowania pikseli za pomocą współrzędnych XY na matrycy, możemy odczytać

zarejestrowany sygnał z jednego z nich nie odczytując sygnału w pozostałych, a zintegrowana elektronika

pozwala na konwersję do napięcia na poziomie pikseli. Dodatkowo przetwornik analogowo cyfrowy jest

zintegrowany w układzie CMOS. Można więc powiedzieć, że sygnał po odczytaniu z piksela jest w pełni

cyfrowy w przeciwieństwie do sygnału z CCD, który ma postać napięcia.

Układy wykonane w technologii CMOS dzielimy na typy w zależności od ilości wykorzystanych dodatkowo

tranzystorów. I tak mamy:

1T - pierwsze produkowane CMOS-y, pasywne układy, dające słabej jakości obraz;

3T - układy aktywne, tranzystory służą do wzmacniania sygnału, niestety mają bardzo duże szumy i

niewielką dynamikę;

4T,5T i więcej - najbardziej zaawansowane konstrukcje, mimo mniejszego FILL-FACTOR niż typ

3T, dzięki dodatkowym tranzystorom oferują wysoką jakość obrazu oraz możliwość precyzyjnego

usuwania zakłóceń obrazu (m.in. szumu).

Tego typu układy wykorzystują dzisiaj cyfrówki.

Jak widać układ CMOS różni się od CCD tym, że zamiana sygnału na napięcie następuje w pikselu

i nie wymaga odczytywania zawartości wszystkich pozostałych pikseli.

Cechy obu technologii

Wydajność odczytu - identyczna w obu technologiach CCD i CMOS, choć tak naprawdę jest ona o wiele

bardziej efektywna w przypadku CCD (większy fillfactor), pomimo bezpośredniego adresowania pikseli w

CMOS. Obecnie znacznie zmniejszyła się przewaga CCD.

Zapotrzebowanie na energię - sensory CMOS potrzebują mniejszych napięć do sterowania układami niż

CCD. Choć postęp technologiczny doprowadził do znacznego obniżenia energochłoności układów CCD, to

nadal przewaga jest po stronie CMOS.

Stopień integracji układu - układy CMOS są silnie zintegrowane (elektronika w każdym pikselu), ale

wynikiem tego jest wzrost zakłóceń obrazu. Aby zminimalizować ten efekt najlepsze układy CMOS mają

odseparowaną dodatkową elektronikę i układ przetwarzający sygnał cyfrowy (DSP) od sekcji reagującej na

światło. W CCD, ze względu na większe zapotrzebowanie na energię, zawsze stosuje się kilka układów

elektronicznych - sekcja detektora i całej elektroniki zawsze są odseparowane. Przy obecnym zaawansowaniu

technologicznym nie wpływa to znacząco na rozmiary całego układu, choć pozwala na lepszą optymalizację

procesu odczytu.

Zakres dynamiczny - częściowo ma związek z rozmiarem części światłoczułej (tak zwana głębokość studni

potencjału). Tutaj CCD oferuje większą rozpiętość rejestrowanych poziomów jasności na wynikowym obrazie,

niż konstrukcje wykorzystujące CMOS.

Jednorodność - układ CMOS w przeciwieństwie do CCD wykorzystuje wzmacniacze sygnału w każdym

pikselu, a nie tylko na ostatnim etapie odczytu sygnału. Dlatego ważne staje się to, jak podobnie (jednorodnie)

one działają. Różnice w ich działaniu to źródło dodatkowego szumu (patrz rozdział 7). Układy CCD dysponują

pojedynczą sekcją wzmacniacza, co pozwala osiągnąć wysoką jednorodność wynikowego obrazu.

Szybkośc - choć dla fotografa amatora różnica jest nieistotna, to w rzeczywistości detektory CMOS, dzięki

bezpośredniemu adresowaniu pikseli, są o wiele szybsze przy odczycie sygnału niż CCD

Migawka - w CCD stosowanie migawki elektronicznej nie wpływa na fill-factor. W CMOS wymaga to

zastosowania kolejnego tranzystora, co obniża wartość fill-factor.

Antiblooming - Ekranowanie zarejestrowanego sygnału pomiędzy pikselami to naturalna zdolność CMOS.

CCD wypada pod tym względem gorzej - ale jest to poprawiane w każdej nowej generacji układów.

Jakość obrazu - Przewaga jest po stronie CCD. Technologia CMOS nadrabia straty przez możliwość

zastosowania dodatkowej elektroniki.

Koszt produkcji - ceny aparatów cyfrowych spadają bardzo szybko, ale i tak obie technologie są kosztowne.

Mimo iż technologia CMOS jest wykorzystywana powszechnie w elektronice (procesory, pamięci) to, aby

uzyskać odpowiednio wysokie parametry, trzeba stosować zaawansowane procesy produkcyjne. Jedynie układy

CMOS wykorzystywane w segmencie low-end są bardzo tanie w produkcji.

Inne technologie

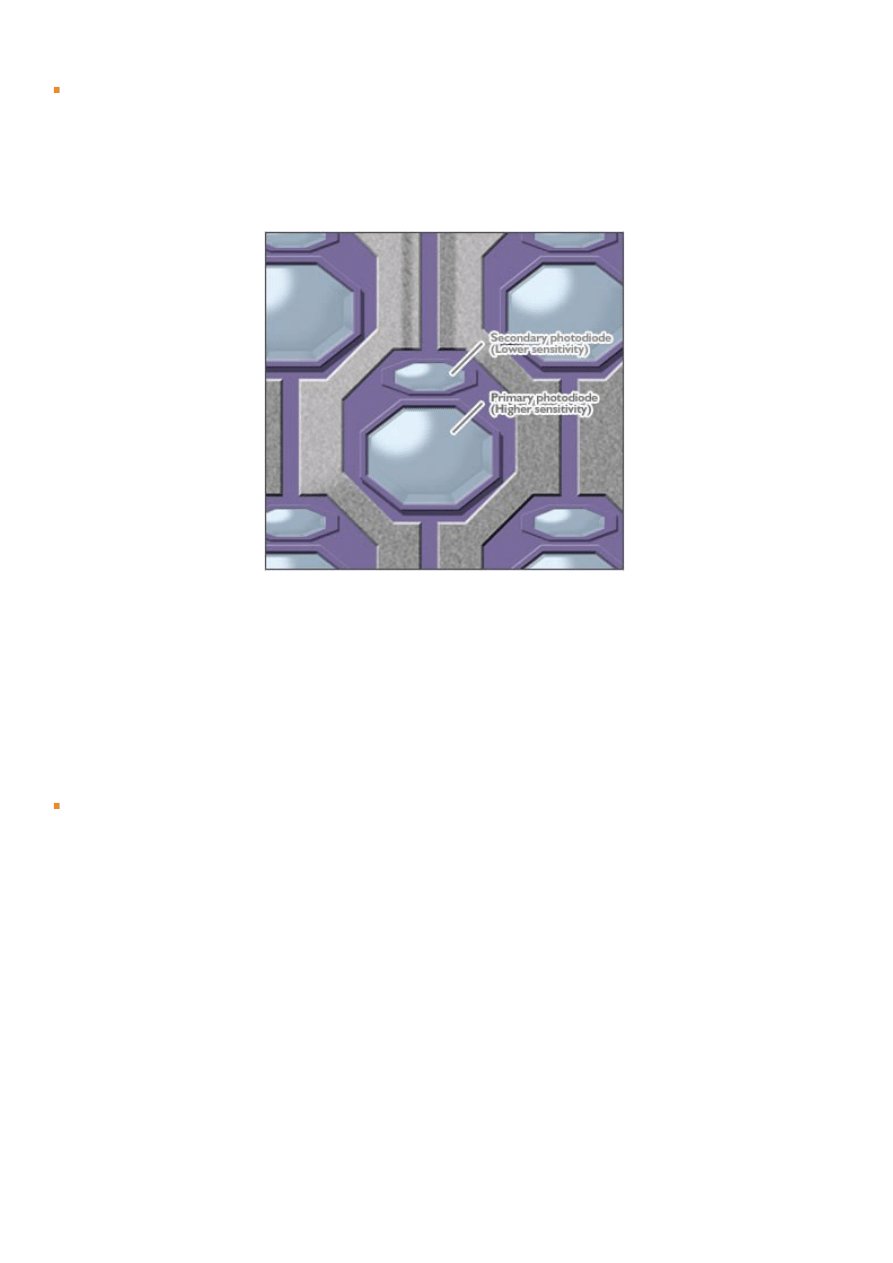

Super CCD (1 generacja 1999 rok, 4 generacja 2003 rok, obecnie mamy 6 generację) - układy posiadają inny

kształt pikseli (ośmiokątne piksele składają się z dwóch sub-pikseli reagujących odpowiednio dobrze na silne i

słabe światło, co pozwala na osiągnięcie lepszej dynamiki obrazu) lub inne ich rozmieszczenie (piksele

rozmieszczone pod kątem 45o, obraz z sąsiednich pikseli jest interpolowany co zwiększa ilość Mpix na

zdjęciu). Technologia rozwijana przez koncern Fuji i wykorzystywana w aparatach tej marki.

LBCAST (Lateral Buried Charge Accumulator and Sensing Transistor array) - układ zastosowany w lustrzance

Nikon D2H. Układ podobny do CMOS, ale oferujący znacznie szybszy odczyt (efektywniejsze adresowanie

pikseli), mniejsze zapotrzebowanie na energię i większą funkcjonalność przy tej samej ilości zintegrowanych

tranzystorów w pikselu. Układ skonstruowany w laboratoriach Nikona.

FOVEON X3 - zmodyfikowane układy CMOS. W tym przypadku każdy z pikseli składa się z trzech warstw,

które reagują na różne barwy światła (patrz rozdział 5.3). Przy podawaniu rozmiaru układu w pikselach podaje

się liczbę pikseli tworzących obraz pomnożoną przez 3. Wykorzystywane w aparatach marki SIGMA.

Kto wygra?

Obecnie trwa silna rywalizacja obu technologii na rynku fotografii cyfrowej, w większości przypadków z

korzyścią dla naszej kieszeni. Dlatego werdykt, który z tych układów ostatecznie zdobędzie rynek, jest trudny

do przewidzenia. To, co dzisiaj świadczy o wadzie danego układu, może zostać wkrótce wyeliminowane - na

przykład dzisiejsze układy CCD są o wiele bardziej energooszczędne, niż wiele lat temu. Układy CMOS

początkowo charakteryzowały się sporym poziomem szumów - teraz jest wręcz przeciwnie. Dlatego spory na

temat przewagi jednej technologii nad drugą są raczej bezsensowne, gdyż i tak wiele zależy od naszych

fotograficznych umiejętności.

Najnowszy raport dotyczący rynku sensorów światłoczułych wskazuje na wzrastającą przewagę układów

CMOS. Przewaga ta bierze się z faktu, iż większość obecnie sprzedawanych aparatów cyfrowych jest

montowana w komórkach - a tam liczy się energooszczędność. Z kolei rynek kompaktów cyfrowych

zdominowany jest obecnie przez detektory CCD (do 10Mpix), z pominięciem najtańszych konstrukcji -

zabawek.

Na rynku lustrzanek cyfrowych daje się zauważyć dwie tendencje, Canon stosuje wyłącznie układy CMOS (do

ponad 16Mpix) w przeciwieństwie do konkurencji, która głównie bazuje na wciąż usprawnianych

konstrukcjach CCD (do 10Mpix).

Ostatnio firma Sharp ogłosiła wprowadzenie na rynek nowego układu CCD o rozmiarze 12Mpix, który ma

znaleźć zastosowanie w kompaktach cyfrowych.

Zastosowania profesjonalne, a także cyfrowa fotografia średnioformatowa, to nadal domena układów CCD

(stosuje się tu matryce nawet 39 Mpix).

Oprócz zastosowanej technologii jest jeszcze jeden istotny element, który decyduje o jakości tworzonego

obrazu, często bardziej niż typ zastosowanego detektora. Jest to rozmiar piksela matrycy. Ale zanim o tym

opowiemy, musimy poznać pozostałe elementy tworzące matrycę światłoczułą w naszej cyfrówce.

5. Niezbędne dodatki... czy na pewno?

Poznaliśmy działanie matrycy światłoczułej. Jednak stosowana w aparacie cyfrowym matryca to nie tylko

płytka półprzewodnikowa z naniesionymi na nią pikselami. Aby poprawnie rejestrowała obraz konieczne jest

zapewnienie jej odpowiedniego źródła światła. Oprócz wspomnianych mikrosoczewek, znajdujących się przed

każdym pikselem, umieszcza się tu dodatkowo specjalne filtry (niezależnie od typu detektora). Pełnią one różną

rolę - zabezpieczają przed uszkodzeniami, poprawiają jakość obrazu, a także eliminują wspomnianą wcześniej

nadmierną czułość na światło podczerwone.

To wszystko razem stanowi jedną całość.

Zobaczmy teraz do czego dokładnie przydaje się każdy z filtrów w aparacie.

Filtr anty-aliasingowy

Termin ANTYALIASING znany jest pewnie każdemu miłośnikowi gier komputerowych. Efekt ten występuje

w momencie, gdy szczegółowość sceny jest większa niż liczba pikseli. Taki obraz wydaje się nam zbyt ostry i

poszatkowany - dobrym przykładem jest na przykład fotografia korony drzewa z milionami liści. Może

zaistnieć sytuacja, że jeden liść reprezentowany jest przez niewiele pikseli, a nawet tylko 1 (określa się to

mianem undersamplingu), co uniemożliwia poprawne określenie wyglądu jego krawędzi (kształt) czy koloru

powierzchni.

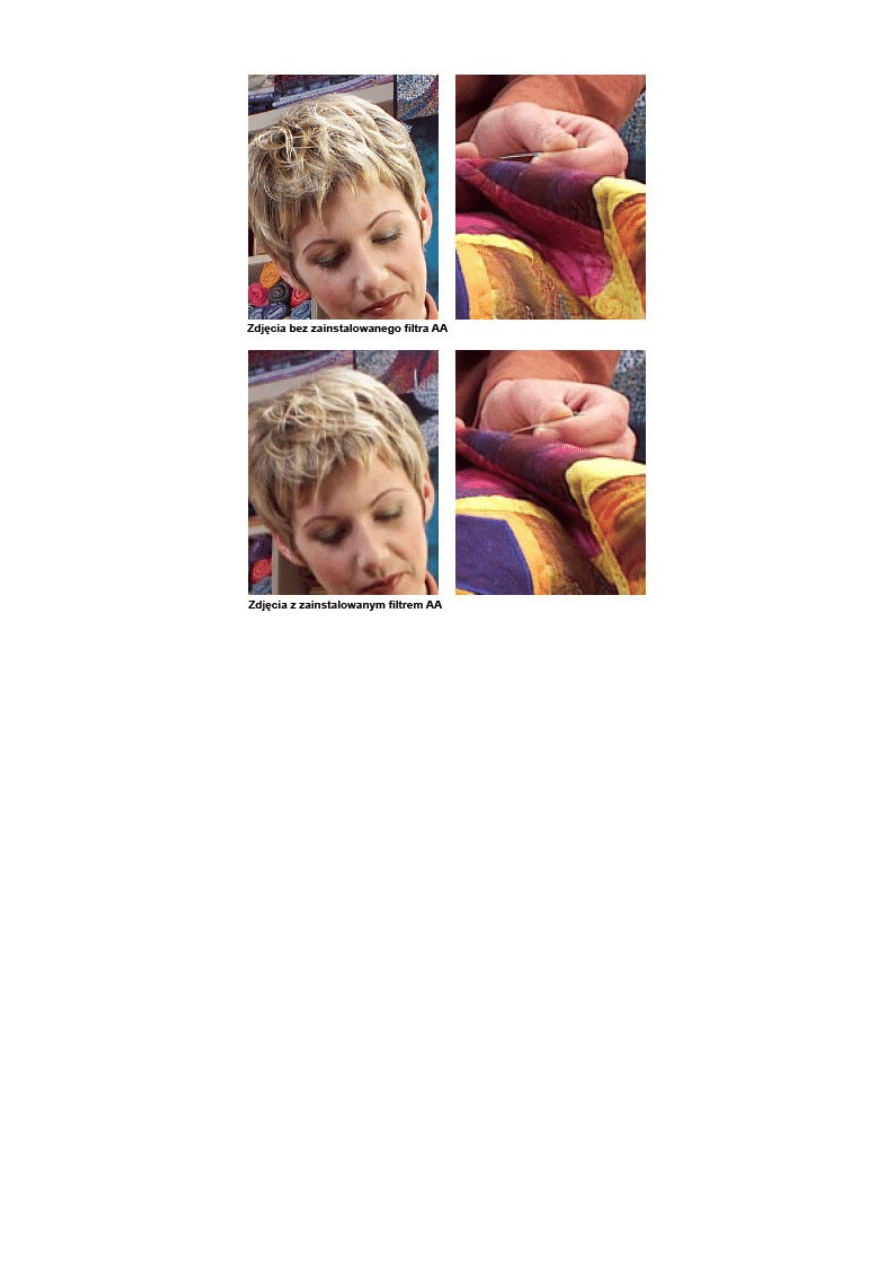

Stosowany w cyfrówkach filtr AA (czyli mówiąc inaczej dolnoprzepustowy), umieszczany przed detektorem

CCD/CMOS, ma za zadanie zminimalizować ten efekt (rozmywając nieco obraz), poprzez obniżenie zbyt

wysokich kontrastów i umożliwienie aparatowi dokładnego próbkowania danych i ich interpretacji. Filtr AA

działa podobnie jak funkcja "Clear Type" w systemie Windows, która wygładza krawędzie czcionek.

Stosowanie tego filtra może obniżyć wynikową ostrość obrazu, ale nie na tyle, aby nie była ona do odzyskania

za pomocą choćby filtra unsharp mask (USM) w programach graficznych, takich jak Photoshop. Często filtr

AA jest jednocześnie filtrem IR, o którym mowa poniżej, a także dodatkowo ochroną delikatnej elektroniki

matrycy.

Materiały KODAK

Ponieważ filtr AA nie zawsze działa idealnie, na zdjęciach zauważymy wiele negatywnych efektów

niedostatecznej rozdzielczości matrycy. Opisane są one w rozdziale 9.

Filtr IR - podczerwieni mówimy NIE

Każdy cyfrowy detektor światła stosowany w cyfrówce jest bardzo czuły w świetle podczerwonym. Gdyby

zarejestrować to światło wraz z zakresem widzialnym, otrzymalibyśmy zdjęcia o bardzo dziwnych

(poczerwienionych) barwach. Nasze oko jednak jest przyzwyczajone do postrzegania wyłącznie w świetle

widzialnym, czyli dla fal EM o zakresie 350-780nm. Wszystko, co jest poza tym zakresem, jest dla nas

niewidzialne. Niestety, wszystkie fotografowane obiekty świecą w podczerwieni (co jest częściowo związane z

temperaturą ciał) i stad te dziwne barwy.

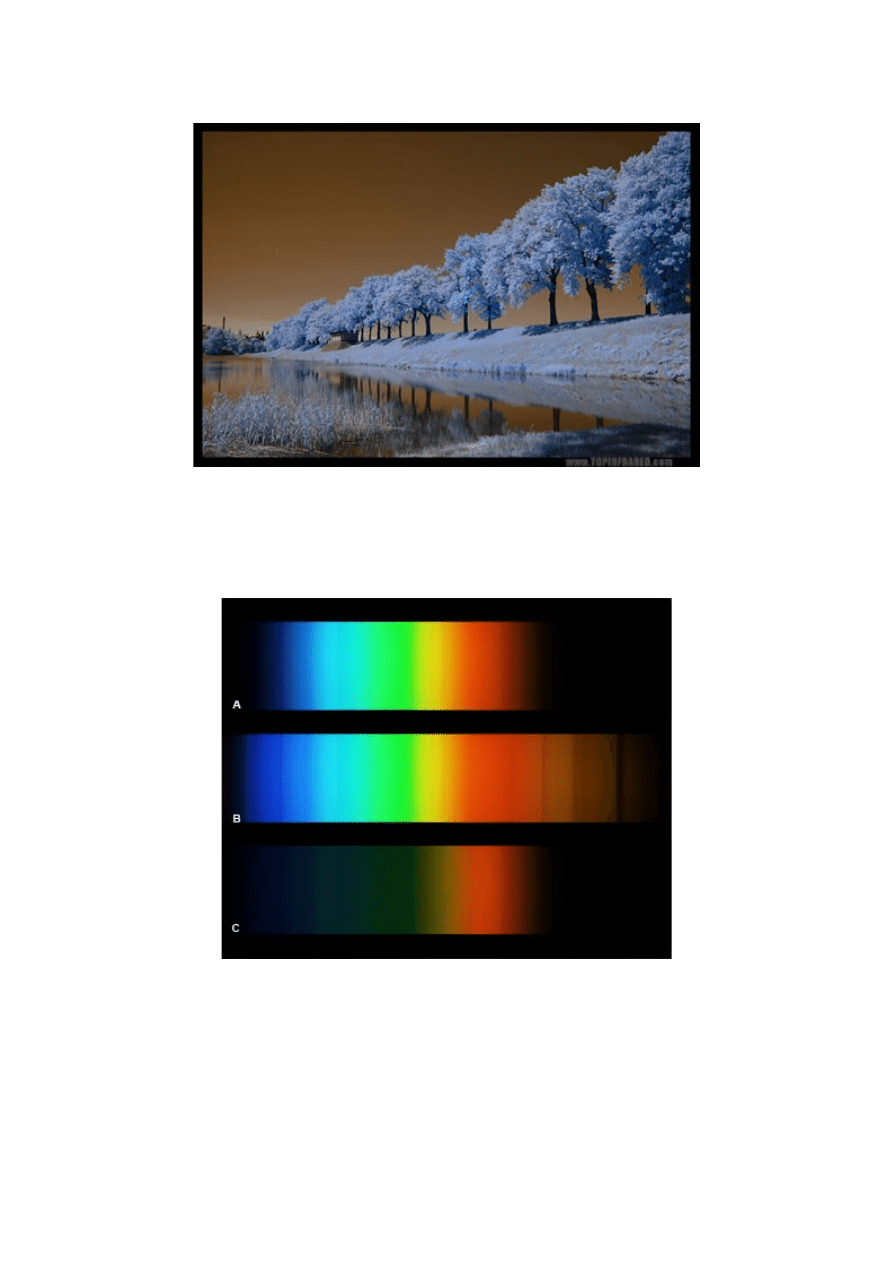

fot. Daniel Gaworski www.topinfrared.com

PODPIS: Gdyby przed matrycą nie umieszczono filtra IR, otrzymalibyśmy takie oto kolory na zdjęciu

(symulacja)

Aby aparat rejestrował wyłącznie światło widzialne, stosuje się filtr IR, który odcina większość światła o

długości fali większej niż 0.7um, a także nadmiar światła UV. Docierające do detektora światło ma dzięki temu

taki zakres barw, jak ten rejestrowany przez oko ludzkie.

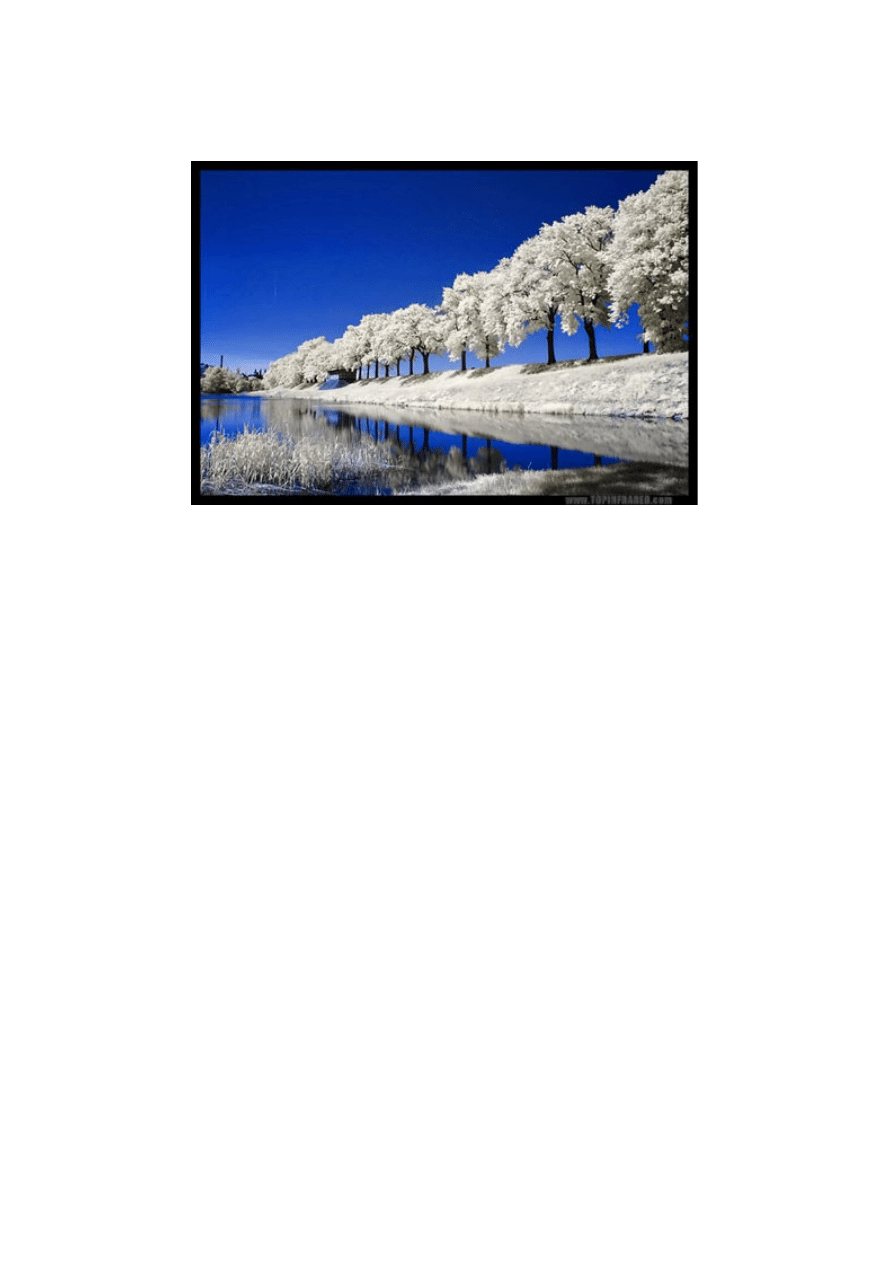

fot. Daniel Gaworski www.topinfrared.com

PODPIS: Dzięki filtrowi IR zamontowanemu wewnątrz aparatu możemy cieszyć się naturalnymi kolorami

zdjęcia.

USUWANIE FILTRA IR SPRZED MATRYCY CZY KUPNO FOTOGRAFICZNEGO FITRA IR?:

Filtr IR, choć tak potrzebny, nie przez każdego jest pożądany. Najbardziej zmartwieni jego zastosowaniem są

miłośnicy fotografii w podczerwieni czy amatorzy fotografii nieba, które jak wiemy w podczerwieni prezentuje

się dużo ciekawiej. Można oczywiście usunąć filtr IR na stałe (lub zakupić specjalną wersję aparatu Canon

20Da pozbawioną tego filtru) - w Internecie można znaleźć porady jak to zrobić. Niestety wtedy pozbawimy się

możliwości wykonywania normalnych fotografii w świetle dziennym. Jeśli jednak aparat ma służyć wyłącznie

celom astronomicznym lub fotografii w IR, skórka jest warta wyprawki. Zwykle jednak nie w smak będzie nam

ryzyko związane z usuwaniem filtra - istnieje możliwość uszkodzenia matrycy. Dlatego możemy ograniczyć się

do zastosowania filtrów do fotografii w podczerwieni. W przeciwieństwie do tego stosowanego w aparacie,

fotograficzny filtr IR blokuje większość światła widzialnego, a przepuszcza podczerwień. Ponieważ matryca,

nawet z zainstalowanym filtrem IR, reaguje na podczerwień (choć w znacznie mniejszym zakresie) to możliwe

będzie wykonanie zdjęcia w świetle podczerwonym. Trzeba tylko pamiętać o stosowaniu znacznie większego

czasu naświetlania, gdyż po założeniu fotograficznego filtra IR ilość docierającego do matrycy światła będzie

bardzo niewielka.

fot. Daniel Gaworski www.topinfrared.com

PODPIS: Jeśli pozostawimy filtr IR przed matrycą, a na obiektyw nakręcimy filtr przepuszczający tylko

podczerwień, otrzymamy zdjęcie o barwach zbliżonych do zdjęcia ze zdjętym wewnętrznym filtrem IR.

O takich a nie innych barwach na zdjęciu decydują dwa czynniki. Przede wszystkim w każdej z pokazanych

sytuacji na matrycę pada światło o innym zakresie widmowym co daje inny zakres barw, Dodatkowo proces

interpolacji koloru (patrz kolejny rozdział) również wprowadza pewne zakłócenia co owocuje tak zmienionymi

barwami.

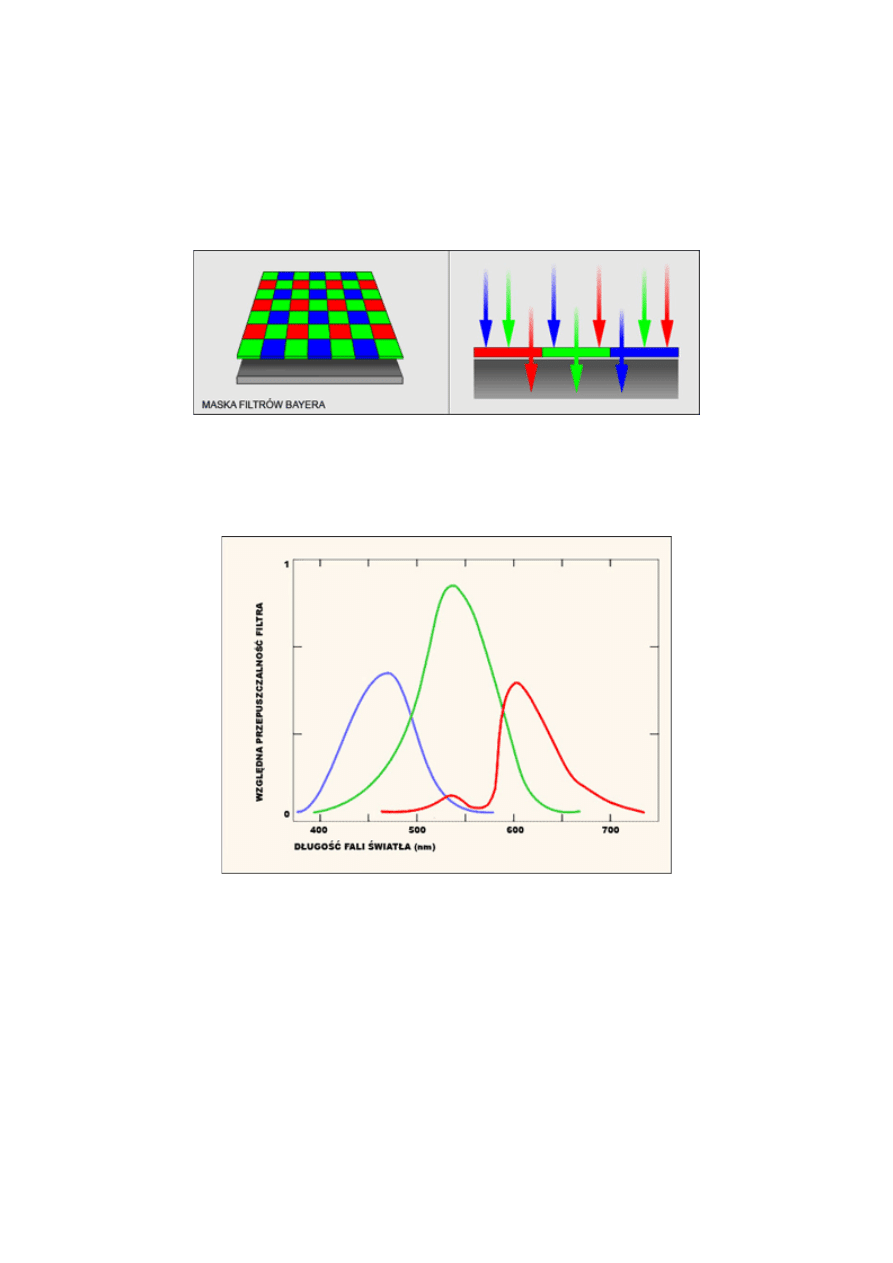

Rysunek pokazuje zakres barw widzianych przez matryce aparatu w trzech sytuacjach.

A - aparat ma zainstalowany filtr IR przed matrycą, na obiektywie nie ma żadnego filtra

B - po usunięciu filtra IR sprzed matrycy, na obiektywie nie ma żadnego filtra

C - aparat ma zainstalowany filtr IR, na obiektyw nakręcony filtr do fotografii w IR

DETEKTORY CYFROWE W NAUCE:

Stosowane w naukowym obrazowaniu detektory CCD lub CMOS zwykle mają inną budowę, niż te znane w

fotografii. Często pozbawione są większości filtrów, które choć poprawiają obraz, to zacierają też część

sygnału, która w nauce jest istotna. I tak we wspominanej już astronomii nie stosuje się stale filtra IR, bo jest to

zbędne. Zamiast tego umieszcza się na drodze światła filtry przepuszczające światło o pożądanej długości fali.

Zdjęcia nieba uzyskane przez astronomów są monochromatyczne. Kolorowe obrazy, jakie oglądamy w

Internecie, to wynik złożenia kilku obrazów, wykonanych przez różne filtry - a i w tym przypadku pamiętajmy,

że kolory nie muszą być naturalne.

Fotografia w podczerwieni pozwala osiągnąć niesamowite rezultaty kolorystyczne, zwłaszcza jeśli pomożemy

naturze i poprawimy kolory w programie graficznym. Efekt może być taki jak na zdjęciu poniżej.

fot. Daniel Gaworski www.topinfrared.com

Filtr barwny, czyli skąd się bierze kolor na zdjęciach

Umieściliśmy przed pikselami matrycy już dwa filtry AA i IR. Nasze zdjęcie powinno mieć teraz poprawne

barwy i być odpowiednio ostre. Niestety tak wykonane zdjęcie będzie czarno-białe, a dokładniej mówiąc, w

odcieniach szarości. Przyczyną tego jest fakt, iż piksele matrycy reagują wyłącznie na intensywność padającego

światła, a nie jego barwę - a więc kolejny problem. Co zrobić, aby uzyskać kolorowy obraz? Można to osiągnąć

na kilka sposobów.

•

możemy rozdzielić sygnał świetlny na trzy wiązki RGB i wykorzystać 3 detektory do jednoczesnej

rejestracji światła. Ta metoda, znana jako 3CCD, jest często stosowana w kamerach cyfrowych.

Niestety, wymaga stosowania dodatkowego układu pryzmatycznego, co podraża produkcję i zmniejsza

kompaktowość konstrukcji,

•

możliwe jest też wykonanie 3 zdjęć zmieniając filtry, zakładając kolejno filtr R, G i B. Można

zautomatyzować ten proces umieszczając ruchome koło filtrów przed matrycą (najczęściej stosowane w

astronomii). Lecz tradycyjna fotografia wymaga rejestracji obrazów, które zmieniają się często bardzo

szybko i ponowne uchwycenie takiego samego obrazu byłoby niemożliwe,

•

stosując technikę z fotografii analogowej, gdzie klisza zbudowana jest z kilku warstw, reagujących na

różne barwy światła, kolejno niebieską, zieloną i czerwoną (związane jest to z różną głębokością

penetracji warstwy światłoczułej, zależnie od barwy światła). Matryce, wykorzystujące ten pomysł

(opatentowany już w latach 70 przez Kodaka), już istnieją. Są to wspomniane układy FOVEON X3.

Niestety obecnie są bardzo drogie w produkcji, a także nie oferują zbyt wielkiej rozdzielczości w

pikselach. Technologia jest jednak rozwijana,

•

ostatnia metoda bazuje na podobnych założeniach, jak funkcjonowanie ludzkiego oka, czyli na

interpolacji barwnej. Mówiąc w skrócie, proces interpolacji pozwala na stworzenie dodatkowej

informacji, wykorzystując już istniejącą

CIEKAWOSTKA - proces interpolacji barwnej nie jest nam tak obcy, jak by się wydawało. Oko ludzkie też

posiada receptory (tzw. czopki), które są czułe na różne długości światła odpowiadające mniej więcej RGB.

Mózg ludzki dokonuje tej interpolacji samoistnie i widzimy kolorowy obraz. Błędy w tym procesie mogą się

objawić takimi schorzeniami jak np. daltonizm.

Pierwsze dwie metody rejestracji koloru są w fotografii cyfrowej nieopłacalne. Trzecia metoda to być może

przyszłość matryc światłoczułych. Obecnie jednak powszechny jest sposób czwarty, czyli metoda interpolacji

barwnej.

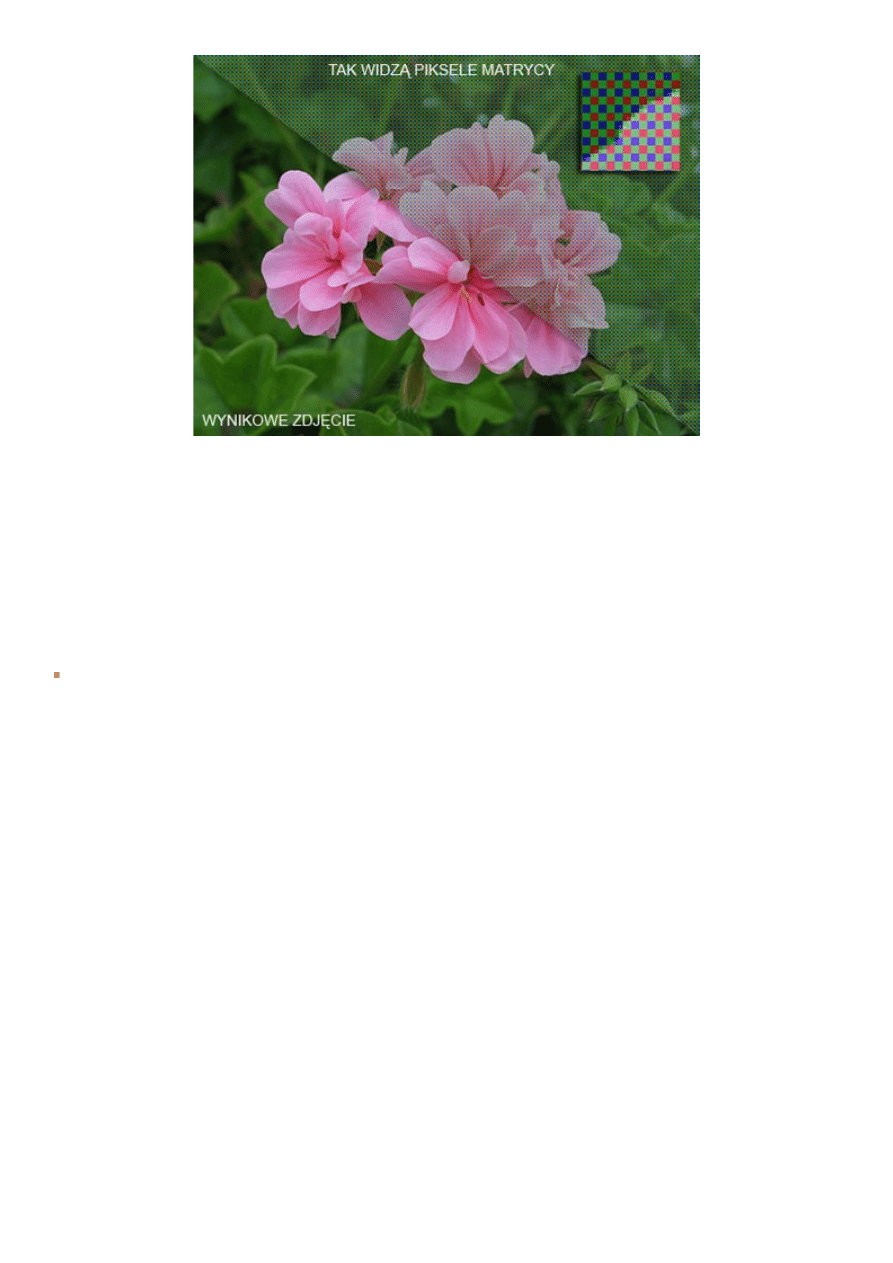

W fotografii cyfrowej działa to w następujący sposób. Przez każdym pikselem znajduje się filtr, który

przepuszcza jedną z barw R, G lub B, a pozostałe dwie blokuje. Zwykle filtry są ułożone w postaci

szachownicy, a układ jej sprawia, że na co drugi piksel pada światło zielone, a na co czwarty czerwone bądź

niebieskie. Taki układ filtrów (RGBG) znany jest pod nazwą maski Bayera (od nazwiska wynalazcy). Takie

proporcje wybrano dlatego, gdyż 50% pikseli G i po 25% R i B odpowiada dość dobrze czułości oka ludzkiego.

Jest to najpopularniejszy stosowany układ filtrów.

Ale nie jest to jedyny stosowany układ - firma Sony zastosowała w 2003 roku w aparacie DSC-F828 układ

RGBE z dodatkowym filtrem szmaragdowym (E - emerald).

Inny stosowany układ wykorzystuje dopełniające kolory do RGB czyli CMY + G (green) - ten układ pozwala

na większa transmisyjność światła i zmniejszenie szumu w sygnale niż zwykłe RGB. Rzadko spotykany (Nikon

Coolpix 4500).

PODPIS: Przykładowa czułość każdego z filtrów w przypadku maski barwnej RGB (wykres dla aparatu Nikon

D70). Widzimy, że zakresy czułości zachodzą na siebie co wpływa na dokładność odzwierciedlenia barw.

Przebieg zakresu czułości dla innych modeli cyfrówek może być nieco inny co wpływa na ogólną kolorystykę

zdjęcia.

Tak więc stosując maskę barwnych filtrów możemy rejestrować różne barwy. Ponieważ jednak dla danego

piksela mamy informacje tylko o jednej ze składowych koloru, np. R w przypadku maski RGB, to aby określić

jego prawdziwy kolor trzeba uwzględnić informacje z sąsiednich pikseli, a ponieważ mają one inne barwy, jest

to możliwe. Proces ten jest realizowany przez procesor aparatu, a jego dokładność zależy od zastosowanych

algorytmów (jest to tzw. interpolacja barwna).

Istnieje możliwość pominięcia interpolacji i zapis w postaci pliku RAW. Jest to plik z informacją o tym, co

widzi matryca CCD bez żadnej obróbki. Zapis danych w tym formacie daje nam duże możliwości, gdyż

dopiero po zrobieniu zdjęcia możemy nadać mu odpowiedni balans bieli skorygować barwy lub naświetlenie, i

nie musimy się o to za bardzo martwić w momencie wykonywania zdjęcia. Tryb RAW nie uwalnia nas jednak

od odpowiedniego ustawienia czasu i przysłony, gdyż te parametry nie zależą od własności matrycy.

Tryb RAW stosowany jest w każdej lustrzance i niektórych kompaktach. Dla większości fotografujących

wystarczająco satysfakcjonujący będzie zapis do formatu JPEG, którego jakość została znacznie poprawiona w

ostatnich latach.

6. O parametrach matrycy

Rozmiar matrycy - Fizyczny i pikselowy

Piksel - to najmniejsza część obrazu niosąca informację.

Choć piksele w matrycy odpowiadają pikselom obrazka, to tylko ich część reaguje na padające światło (patrz

FILL-FACTOR). Dlatego mówiąc o pikselach w matrycy, mamy na myśli ich część światłoczułą.

Piksele te nie reagują na kolor czy kierunek docierającego światła (wyjątek FOVEON X3), a więc widzą

wyłącznie w odcieniach szarości. Wykorzystując sygnał zawarty w pojedynczym pikselu nie można zbyt wiele

powiedzieć o jego cechach. Jednak wokół każdego piksela występują piksele sąsiednie. Dzięki informacjom z

sąsiednich pikseli układ DSP może określić jaką barwę powinien mieć nasz piksel, a także dokonać poprawy

jakości obrazu (wyostrzanie, redukcja artefaktów, odszumianie).

W tworzeniu obrazu nie są wykorzystywane wszystkie piksele matrycy. Część z nich bierze udział tylko w

procesie interpolacji barwnej (tak, aby dobrze określić kolor pikseli na krawędzi obrazka) lub jest

wykorzystywana do kalibracji wykonanego zdjęcia, czyli na przykład usuwania szumów. Dlatego też dla

fotografa istotna jest ilość PIKSELI EFEKTYWNYCH na matrycy, a więc tworzących nasz obraz.

Przykładowo zaawansowany kompakt Panasonic DMC-FZ50 posiada 10.4Mpix ale zdjęcia w maksymalnej

rozdzielczości mają tylko 10Mpix. Z kolei lustrzanka Sony A100 mimo że tworzy również obrazy 10Mpix to

posiada matrycę 10.8Mpix.

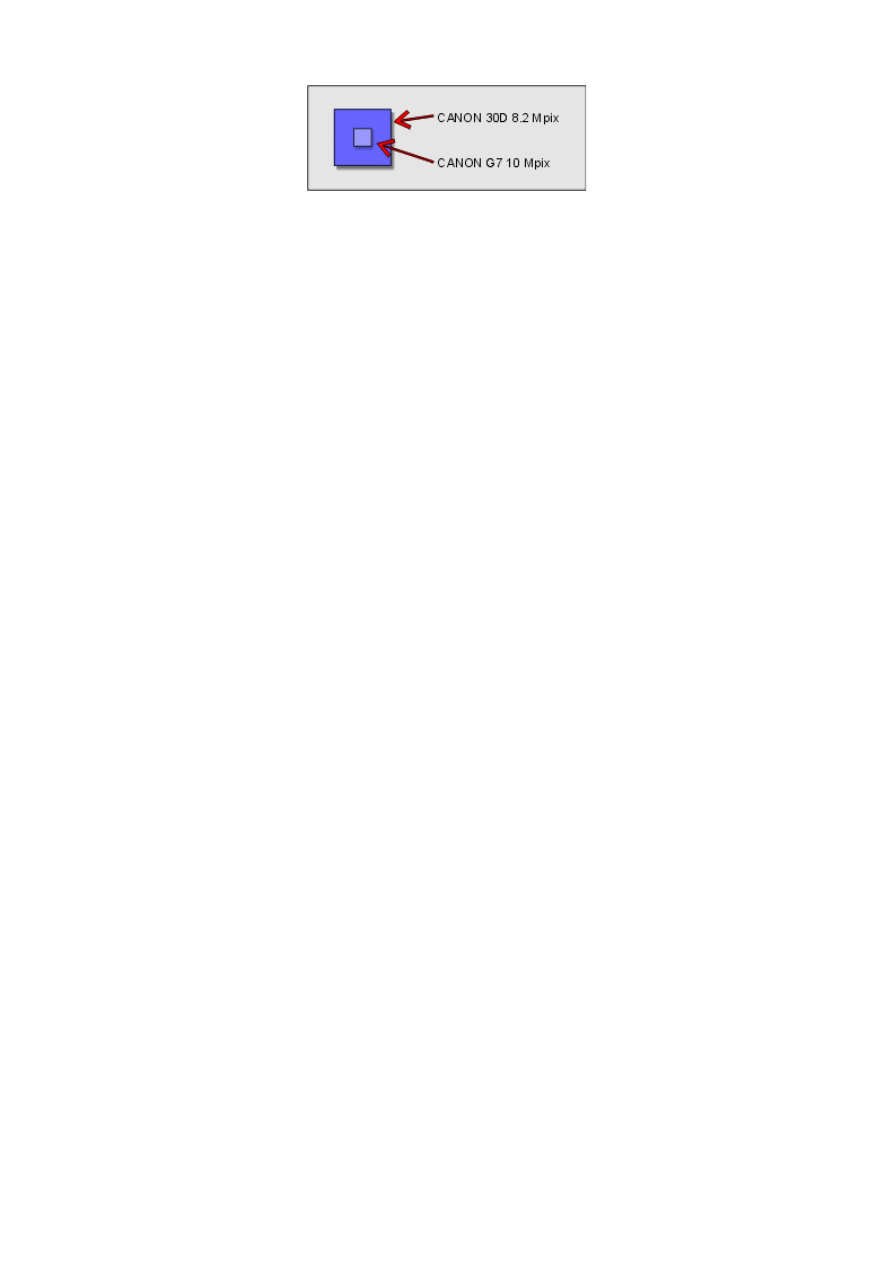

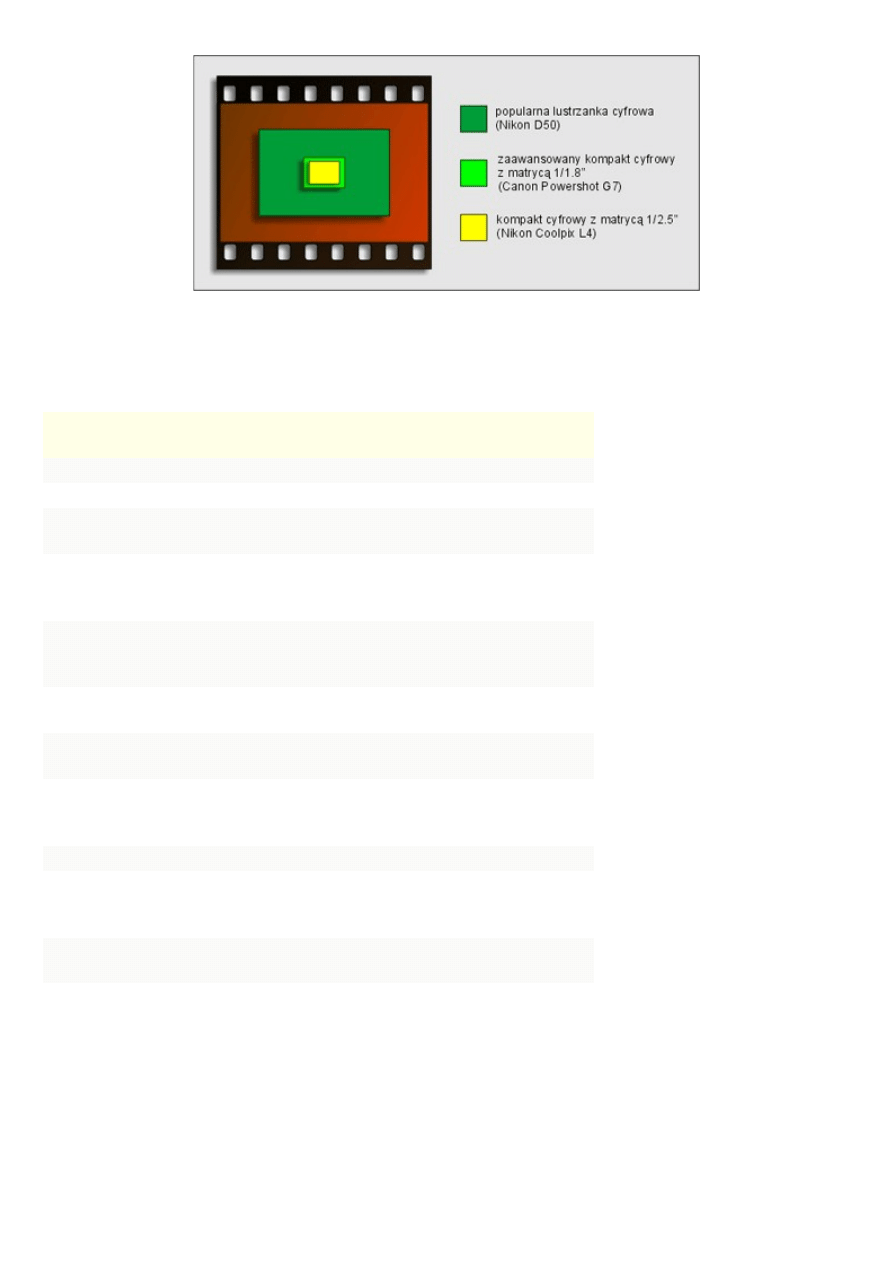

Jednym z najbardziej błędnych przekonań wśród początkujących fotografów jest powiązanie rozmiaru matrycy

w pikselach (popularnie zwanego rozdzielczością) z rozmiarem matrycy fizycznym (zmierzonym linijką).

Przykładowo matryca w kompakcie Canon G7 ma aż 10Mpix, a lustrzanka Canon 10D ma 8Mpix. Nie oznacza

to wcale, że matryca G7 jest większa niż 30D. Wręcz przeciwnie - lustrzanki mają matryce o rozmiarze na

przykład 23.6 x 15.8 mm (określany jako APS-C, lub DX format). Wśród kompaktów najpopularniejsze

matryce mają rozmiary kilka razy mniejsze, na przykład 5.76 x 4.29 mm (typ 1/2.5"), a więc piksele Canona

30D są znacznie większe niż piksele Canon G7.

Konsekwencje tego faktu są bardzo znaczące, gdyż:

•

większy piksel pozwala na zarejestrowanie większej ilości sygnału, co skutkuje osiągnięciem lepszej

dynamiki zdjęcia (ilości rejestrowanych odcieni),

•

większe piksele pozwalają na znaczne zmniejszenie generowanych szumów (patrz rozdział 7), dlatego

lustrzanki cyfrowe tworzą obraz o wiele lepszej jakości niż kompakty i pozwalają na stosowanie

wyższych czułości,

•

większa powierzchnia piksela pozwala na zmniejszenie efektu wykorzystania części jego powierzchni

do umieszczenia elektroniki (zwłaszcza dla CMOS),

•

duży piksel, a zarazem duża matryca, lepiej wykorzystują własności zastosowanego układu optycznego

(a im większe szkło, tym lepsze parametry), między innymi efekt głębi ostrości znany z fotografii

analogowej, znacznie lepiej jest osiągnąć za pomocą lustrzanki niż kompaktu,

•

z kolei mniejszy piksel to konieczność wykorzystania większych napięć do odczytu sygnału, a co za

tym idzie - większa energożerność całego układu,

•

mniejsze piksele rejestrują mniej światła, a więc musi być ono wzmacniane (co daje szumy), dlatego

kompakty wykorzystują głównie CCD, gdzie fill-factor jest większy.

Z tych właśnie powodów nie można spodziewać się zdjęć takiej samej jakości, jeśli wykonamy je za pomocą

kompaktu i lustrzanki, które mają różny rozmiar fizyczny matrycy, nawet, jeśli ilość megapikseli jest ta sama.

Dodatkowo również i wśród kompaktów istnieje podział na lepsze i gorsze konstrukcje (ma to związek z ceną).

Trzeba ten fakt uwzględnić przy zakupie aparatu. Producenci dostrzegli, że duża liczba osób nie jest jednak

skłonna zainwestować w lustrzankę. Potrzebują łatwego w użytkowaniu aparatu pozwalającego kadrować na

LCD, lecz o maksymalnie wysokiej jakości obrazu. Odpowiedzią na to jest pojawienie się w sprzedaży takich

konstrukcji jak Sony R1. Aparat ten posiada matrycę o rozmiarze APS-C, czyli taką jak stosowana w

lustrzankach, a jednocześnie zapewnia częściowo funkcjonalność kompaktu.

WNIOSEK: Matryca najpierw powinna być duża, a dopiero potem mieć wiele megapikseli.

Przy produkcji aparatu cyfrowego nie opłaca się stosować w każdym modelu innego sensora światłoczułego.

Zwykle wiele modeli wykorzystuje ten sam układ CCD czy CMOS. Różnice mogą dotyczyć zastosowanej

elektroniki czy optyki. A to wpływa na jakość uzyskiwanych zdjęć.

Najlepszym rozwiązaniem wydaje się stosowanie matrycy o rozmiarze pełnej klatki (FULL FRAME), czyli o

rozmiarze klatki tradycyjnego filmu małoobrazkowego. Pociąga to jednak za sobą konieczność stosowania

znacznie droższej optyki. Przykładowo aparat Canon 5D pełnię swoich możliwości ukazuje dopiero po

zastosowaniu profesjonalnych (kosztujących małą fortunę) obiektywów.

ZASZŁOŚĆ: Rozmiary matryc w lustrzankach podaje się zwykle w mm i są to rzeczywiste rozmiary matryc.

Czasem stosuje się również inne określenia: FULL FRAME, APS-C czy 4/3". W przypadku kompaktów

rozmiary podawane są także w mm, ale częściej podawany jest tylko typ (przekątna) matrycy, np. 1/1.8" lub

1/2.5". W tym przypadku nie jest to wymiar rzeczywisty i informuje tylko o klasie układu. W tabelce podane są

właściwe wymiary.

Typ matrycy Szerokość Wysokość

CROP

FACTOR

PRZYKŁADOWY

APARAT

1/3.6"

4.00

3.00

8.7

1/3.2"

4.54

3.42

7.6

1/3"

4.80

3.60

7.2

Nikon Coolpix 100

Canon PowerShot 350

1/2.7"

5.37

4.03

6.4

Sony Mavica FD-200

Konica Minolta

DiMAGE Xg

1/2.5"

5.76

4.29

6

Canon Powershot A700

Panasonic Lumix DMC-

FX50

1/2"

6.40

4.80

5.4

Olympus C-21

Canon PowerShot S10

1/1.8"

7.18

5.32

4.8

Canon Powershot G7

Sony DSC-W100

2/3"

8.80

6.60

3.9

Sony DSC-828

Olympus C-8080 Wide

Zoom

1"

12.80

9.60

2.7

KAMERY WIDEO

4/3"

18.00

13.50

2

Olympus E-400

Panasonic Lumix DMC-

L1

APS-C (DX

format)

23.6

15.8

1.5

Nikon D70

Sony DSLR-A100

Full frame

(jak klatka

filmu 35 mm)

36.00

24.00

1

Canon EOS 5D

Kodak DCS 14n

Tabelka: Tabelka pokazuje nam wymiary matrycy dla danego typy oraz wartość współczynnika CROP

FACTOR (patrz rozdział 6.2). Najpopularniejsze rozmiary matryc stosowane w kompaktach 1/1.8" i 1/2.5"

mają przekątną odpowiednio 4.8 i 6 razy mniejszą niż klatka filmu 35mm.

Crop Factor - przyczyna nieporozumień

Rozmiar matrycy jest ściśle związany z zastosowanymi w cyfrówkach (zwłaszcza kompaktowych)

ogniskowymi oraz tzw. współczynnikiem CROP FACTOR czyli stosunkiem przekątnej klatki filmu

małoobrazkowego do przekątnej matrycy w danym aparacie.

Mały rozmiar matrycy wymusił na producentach zastosowanie dużo krótszych ogniskowych, aby obszar (kąt

widzenia) zarejestrowany przez detektor światłoczuły obejmował podobny obszar, jak klatka kliszy. I tak np.

aby kompakt cyfrowy o matrycy typu 1/1.8" uwiecznił obszar taki, jak aparat tradycyjny z zastosowaną

ogniskową 35mm, musi mieć obiektyw o ogniskowej około 7,2 mm (czyli mniej więcej 4.8 raza mniejszą -

liczba ta oznacza właśnie CROP FACTOR). Z tego powodu często mówi się, że CROP FACTOR oznacza, o ile

matryca zmienia ogniskową obiektywu. To błędne rozumowanie - nie ma żadnej zmiany ogniskowej. Podanie

liczby crop factor lub przeliczonych wartości ogniskowych pozwala nam lepiej zorientować się w parametrach

obiektywu.

Inny rozmiar matrycy wpływa jednak na inne parametry tworzonego obrazu - między innymi głębię ostrości, o

czym

pisaliśmy tutaj już jakiś czas temu

Nie powinniśmy się jednak tak bardzo martwić. Nie musimy koniecznie kupować drogiej lustrzanki, choć

obecnie ich ceny spadają i warto się nad takim zakupem zastanowić. Jakość obrazu, jaką jest w stanie

zaoferować nam mniejsza matryca (stosowana w kompaktach) jest wystarczająca, aby pozwolić sobie na piękne

odbitki nawet w formacie A4. W tabelce poniżej mamy podane rozmiary możliwych do otrzymania odbitek z

różnych aparatów:

Rozmiar zdjęcia w pikselach / rozdzielczość matrycy*

Format

odbitki

[cm]

1600x1200

(2 Mpix)

2048x1536

(3 Mpix)

2272x1704

(4 Mpix)

2593x1944

(5 Mpix)

3072x2048

(6 Mpix)

9x13

bd jakość

bd jakość

bd jakość

bd jakość

bd jakość

10x15

dobra jakość

bd jakość

bd jakość

bd jakość

bd jakość

13x18

akceptowalna

jakość

dobra jakość

bd jakość

bd jakość

bd jakość

15x21

zła jakość

akceptowalna

jakość

dobra jakość

bd jakość

bd jakość

18x24

zła jakość

zła jakość

akceptowalna

jakość

dobra jakość

bd jakość

20x30

zła jakość

zła jakość

zła jakość

akceptowalna

jakość

dobra jakość

Tabelka --- rozmiary odbitek. Kolor zielony oznacza bardzo dobrą jakość, rozmiar zdjęcia w pikselach pozwala

na rozdzielczość odbitki lub wydruku ponad 300dpi. Kolor pomarańczowy oznacza wystarczającą jakość,

natomiast czerwony ostrzega, że musimy się liczyć z pogorszeniem jakości.

Wszystko zależy jednak od naszych oczekiwań i warunków, w jakich będziemy oglądać zdjęcia. W przypadku

tradycyjnych odbitek 10x15cm czy oglądania na ekranie komputera (a tutaj prawie zawsze oglądamy obraz

pomniejszony, co w naturalny sposób poprawia jego jakość i ostrość) nawet matryca 1/2.5" o rozdzielczości 5

Mpix zastosowana w miniaturowym kompakcie zapewni bardzo dobry obraz.

UWAGA: O JAKOŚCI OBRAZU DECYDUJE W DUŻYM STOPNIU TAKŻE OPTYKA (A TA W

TANIUTKICH KOMPAKTACH JEST NIENAJLEPSZA) ORAZ UMIEJĘTNOŚCI

FOTOGRAFUJĄCEGO.

Dlaczego coraz więcej MegaPikseli?

Początkowo było to uzasadnione koniecznością umożliwienia posiadaczom cyfrówek wykonywania odbitek

czy wydruków w dobrej jakości w rozmiarach, do których przyzwyczailiśmy się z czasów fotografii

analogowej. Obecnie rozdzielczość matrycy nie jest problemem, gdyż nawet najtańsze konstrukcje oferują

"nadmiar pikseli" (patrz tabelka wyżej). Dlatego można stwierdzić, że dziś jest to raczej chwyt marketingowy

niż rzeczywista konieczność. Widać to szczególnie w segmencie kompaktów cyfrowych. Tutaj rozmiary

fizyczne matryc się nie zmieniają, a rośnie ilość pikseli, których rozmiary są coraz mniejsze. Dalszy wzrost

ilości megapikseli może oznaczać to tylko jedno - degradację obrazu.

Świat lustrzanek cyfrowych to inna bajka. Tutaj rozmiary pikseli są znacznie większe, a i często

zapotrzebowanie na duże odbitki częstsze. Dlatego w tym segmencie wzrost ilości megapikseli nie wpływa

jeszcze tak negatywnie na obraz i nadal jest pożądany.

Obecne sensory 8 czy 10Mpix w aparatach cyfrowych oferują rozdzielczość wystarczającą do większości

zastosowań w amatorskiej fotografii (oczywiście profesjonaliści mogą być innego zdania). Na dodatek trzeba

popracować nad jakością optyki, aby ta "dorastała" do możliwości nowych matryc, a to w przypadku malutkich

obiektywów w kompaktach może być bardzo trudne do osiągnięcia.

Czy w takim razie wyścig na megapiksele zbliża się do końca? To raczej wątpliwe. Nauka zawsze znajdzie

sposób na przezwyciężenie ograniczeń i dlatego dziś największe matryce oferują lepszy obraz, niż

przypuszczano kilka lat temu.

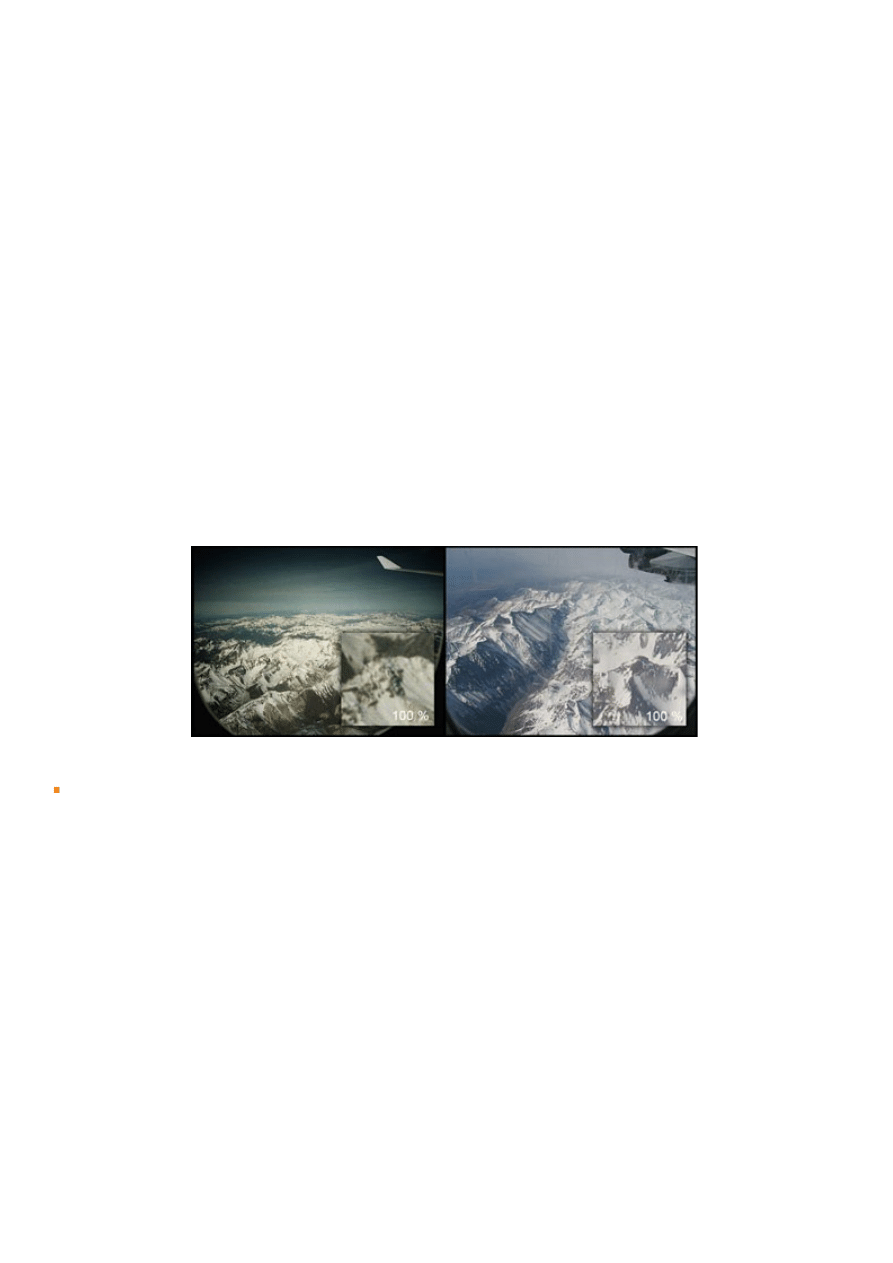

Często słyszymy, że tradycyjna klisza oferuje rozdzielczość nawet ponad 20Mpix. Tak jest w rzeczywistości,

ale tylko w przypadku drogich profesjonalnych produktów. Na dodatek konieczne jest użycie dobrego

obiektywu, a i proces wywoływania także musi być profesjonalny. Prawda jest taka, że najtańsza klisza leżąca

na wygrzanej półeczce w kiosku nie zapewni nam lepszej jakości obrazu, niż obecnie dostępne cyfrówki (patrz

zdjęcie).

Porównanie jakości zdjęcia oferowanej przez bardzo tanią kliszę oraz przez aparat z matrycą 4Mpix (Canon

G3). Jak widać stosując kliszę przeciętnej jakości nie osiągniemy tak satysfakcjonujących rezultatów, jakie

zaoferuje nam cyfrówka.

Proporcje boków matrycy

Oprócz rozmiaru i rozdzielczości matrycy istotne są również proporcje jej boków. Prawie wszystkie popularne

lustrzanki cyfrowe mają matryce o proporcjach boków 3:2 (podobnie jak klatka kliszy), natomiast w

kompaktach najczęściej wykorzystywane są układy o proporcjach 4:3. Nie jest to wprawdzie czynnik

wpływający na jakość zdjęć, lecz staje się istotny podczas robienia odbitek. Najpopularniejszy format papieru

fotograficznego (czyli 10 x 15) ma proporcje zbliżone do 3:2, a albumy fotograficzne przygotowane są właśnie

do odbitek o takich proporcjach. Proporcje boków dla innych formatów papieru też nie są idealnie 4:3 czy 3:2.

Jeśli zatem nie chcemy mieć mocno wykadrowanego zdjęcia, dzięki zamówieniu odbitek z białymi paskami

(zdjęcie) na bokach nie stracimy części cennej zawartości fotografii. Można też skorzystać z dostępnej w menu

niektórych aparatów opcji przełączenia proporcji wykonywanego zdjęcia na 3:2 - oczywiście kosztem drobnego

zmniejszenia rozdzielczości zdjęcia.

7. SZUMY - ich związek z ISO i CZUŁOŚCIĄ:

Fraza "szumy matrycy" wielu fotografów przyprawia o dreszcze. Czy rzeczywiście stanowią one taki problem

w fotografii cyfrowej? Okazuje się, że tak. Najpierw zobaczmy co to jest "szum".

Rodzaje szumu (zakłóceń)

Istnieją trzy główne źródła szumu w matrycy.

PHOTON NOISE (szum fotonowy)

Rejestracja jakiegokolwiek sygnału (w naszym przypadku światła) jest obarczona błędem. Nigdy nie będziemy

doskonale pewni dokładnej wartości sygnału, a tylko jego wartości uśrednionej. Ale im więcej sygnału jesteśmy

w stanie zarejestrować, tym mniejsza jest niepewność co do prawidłowej wartości. Dlatego też ROZMIAR

PIKSELA jest tak ważny w fotografii cyfrowej. Na większy piksel pada więcej światła i generuje on więcej

elektronów, a to prowadzi do lepszego określenia prawidłowej wartości sygnału. Często stosowane jest przy tej

okazji określenie SNR - stosunek sygnału do szumu (signal to noise ratio). Jeśli SNR ma dużą wartość,

fotografowany obiekt będzie łatwy do zauważenia na tle. Przy niskim SNR trudno będzie dokładnie określić

kształt, kolor i inne cechy fotografowanego obiektu.

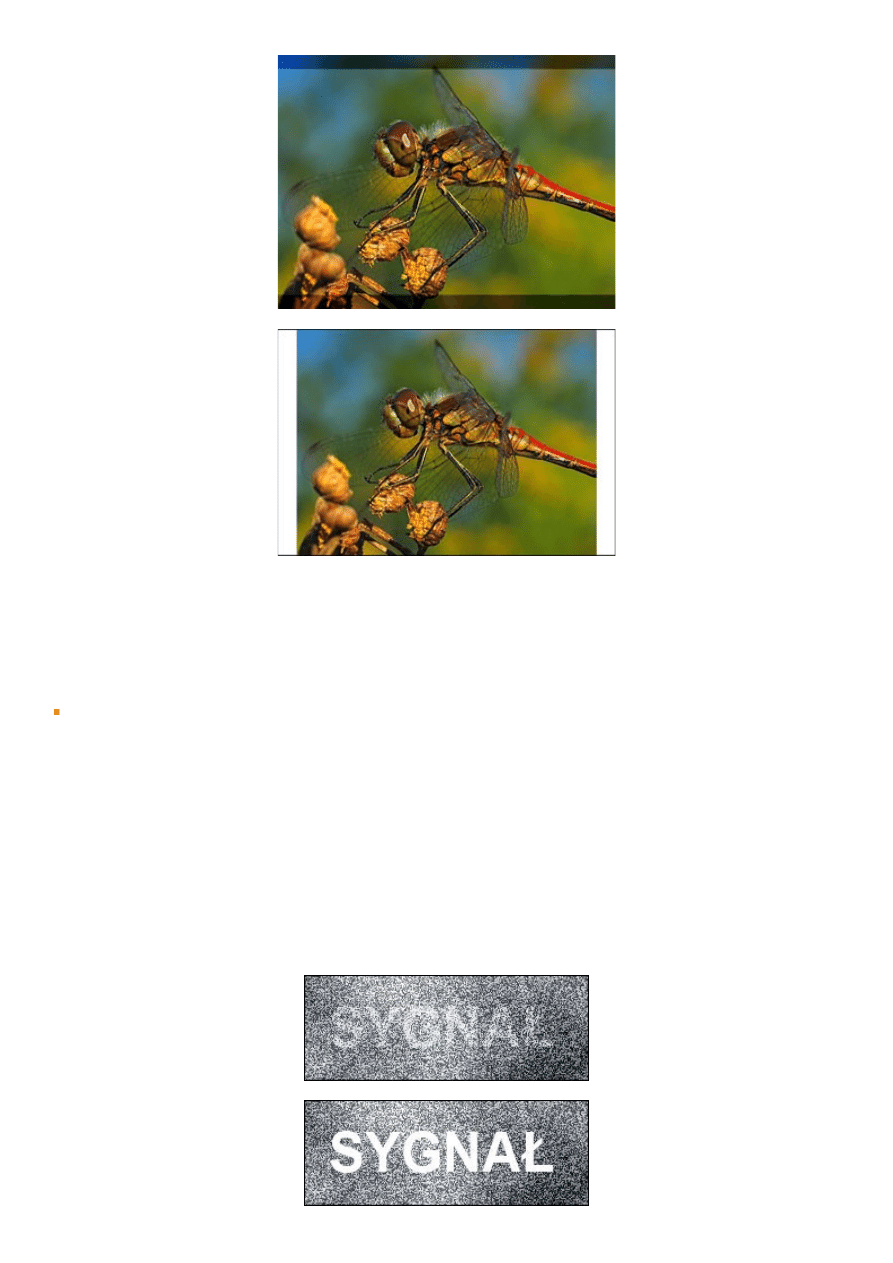

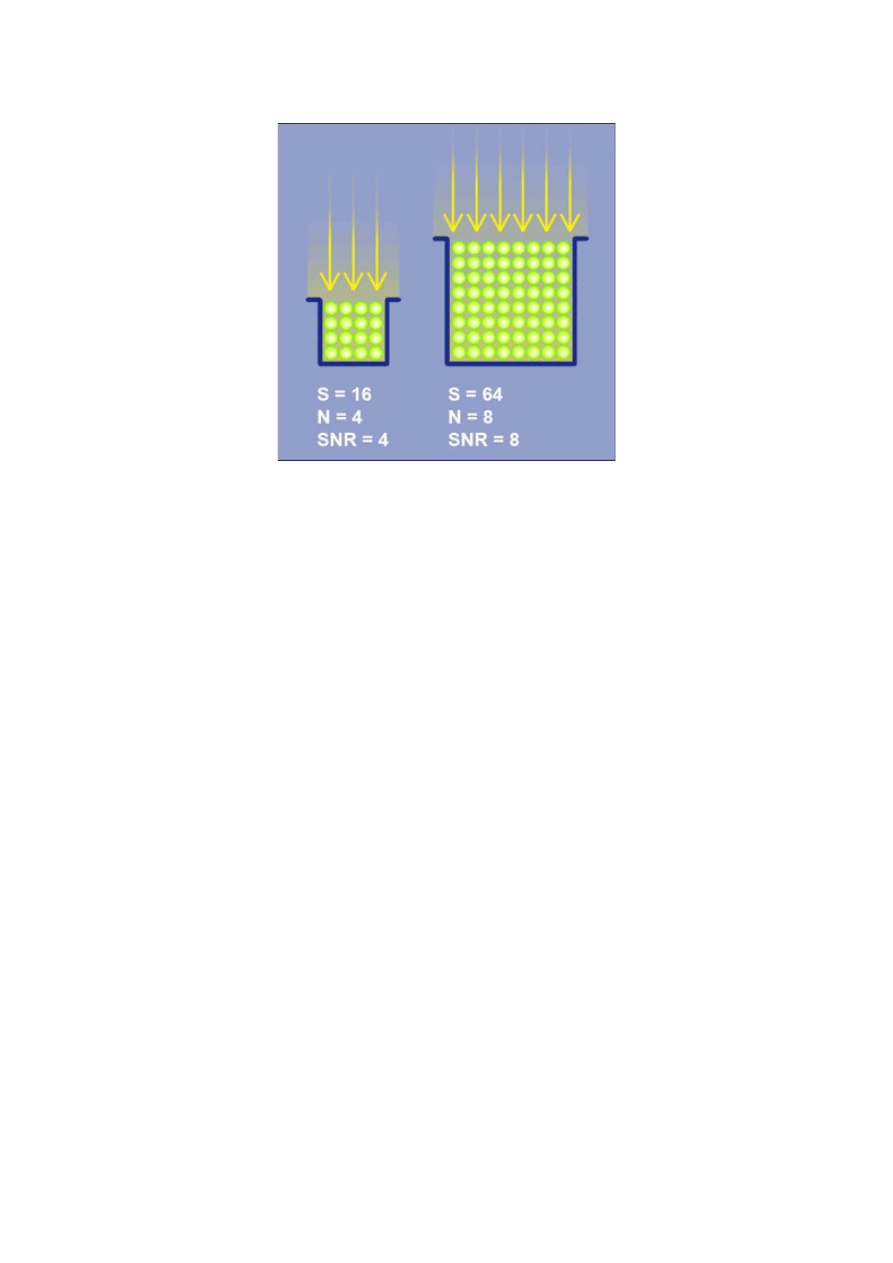

W tym przykładzie mały piksel ma 4 razy mniejszą pojemność (S) niż duży. Szum fotonowy (N) wzrasta w tej

sytuacji dwukrotnie. Tak więc zwiększenie wielkości piksela pozwala na zwiększenie SNR i otrzymanie mniej

zaszumionego obrazu.

Tak więc gdyby matryca nie posiadała żadnych własnych źródeł szumu, to i tak obraz będzie zawierał szum.

Jest to tak zwany szum fotonowy. Mimo, że wzrasta on wraz ze wzrostem natężenia padającego światła, to

wzrasta on wolniej niż wartość sygnału (szum fotonowy jest proporcjonalny do pierwiastka z sygnału) dzięki

czemu wzrasta wartość SNR i obraz staje się bardziej wyraźny. Wartość SNR może być różna na tym samym

zdjęciu. Na cyfrowym zdjęciu ciemniejsze partie obrazu będą silniej zaszumione niż jasne. Zwiększając jasność

zdjęcia w komputerze trzeba pamiętać, że wtedy szum z ciemnych obszarów stanie się bardziej widoczny.

DARK CURRENT (prąd ciemny/szum elektroniki)

Oprócz szumu fotonowego w sygnale pojawia się także tzw. prąd ciemny (dark noise). Ten szum nie pochodzi

od źródła światła. Jest to dodatkowy sygnał generowany w pikselu - tym większy, im dłuższy jest czas

naświetlania, a także temperatura matrycy.

READOUT NOISE (szum odczytu)

Ten rodzaj szumu to suma wszystkich zakłóceń wprowadzanych przez elektronikę matrycy i aparatu przy

odczycie sygnału. W układach CCD jest on jednorodny, gdyż sygnał każdego piksela jest przetwarzany przez

ten sam układ. Natomiast w matrycach CMOS jego wartość może zależeć od miejsca na matrycy. Wartość

szumu odczytu w nowoczesnych konstrukcjach nie stanowi już zazwyczaj problemu, ale pierwsze cyfrówki

miały z tym problem.

Często na zdjęciach zakłócenia przyjmują określoną strukturę tzw. fixed pattern noise (FPN). Ten nieprzyjemny

dla oka rodzaj szumu związany jest z wadami matrycy i zakłóceniami w jej działaniu (niejednorodność czułości

poszczególnych fragmentów matrycy). Staje się bardziej widoczny, im dłuższy czas naświetlania lub silniejszy

sygnał. Rozkład tego szumu jest niezmienny i stąd jego nazwa. Zaliczamy do niego m.in. występujące na

matrycy hot piksele. Przy standardowych ekspozycjach (niezbyt długich) ze względu na powtarzalność jego

usunięcie nie stanowi problemu.

Szum fotonowy jest rozłożony przypadkowo na zdjęciu . Z kolei prąd ciemny może być silniejszy po tej stronie

układu, gdzie znajduje się elektronika, która grzejąc się (przy długiej ekspozycji, 1s i dłużej) wprowadza

zakłócenia, istotny jest tylko przy bardzo słabym sygnale. Przy standardowej ekspozycji najistotniejszy staje się

szum fotonowy. Natomiast, gdy zdjęcie jest mocno naświetlone lub prześwietlone, najistotniejszy jest FPN.

BANDING NOISE

Na zdjęciach wykonanych przy wysokim ISO lub, gdy na zdjęciu pojawił się duży kontrast pomiędzy cieniami

i silnie prześwietlonymi partiami obrazu, może pojawić się tzw. banding noise. Jego występowanie jest

związane często z danym modelem aparatu. Objawia się on jako naprzemienne jaśniejsze i ciemniejsze pasy na

zdjęciu.

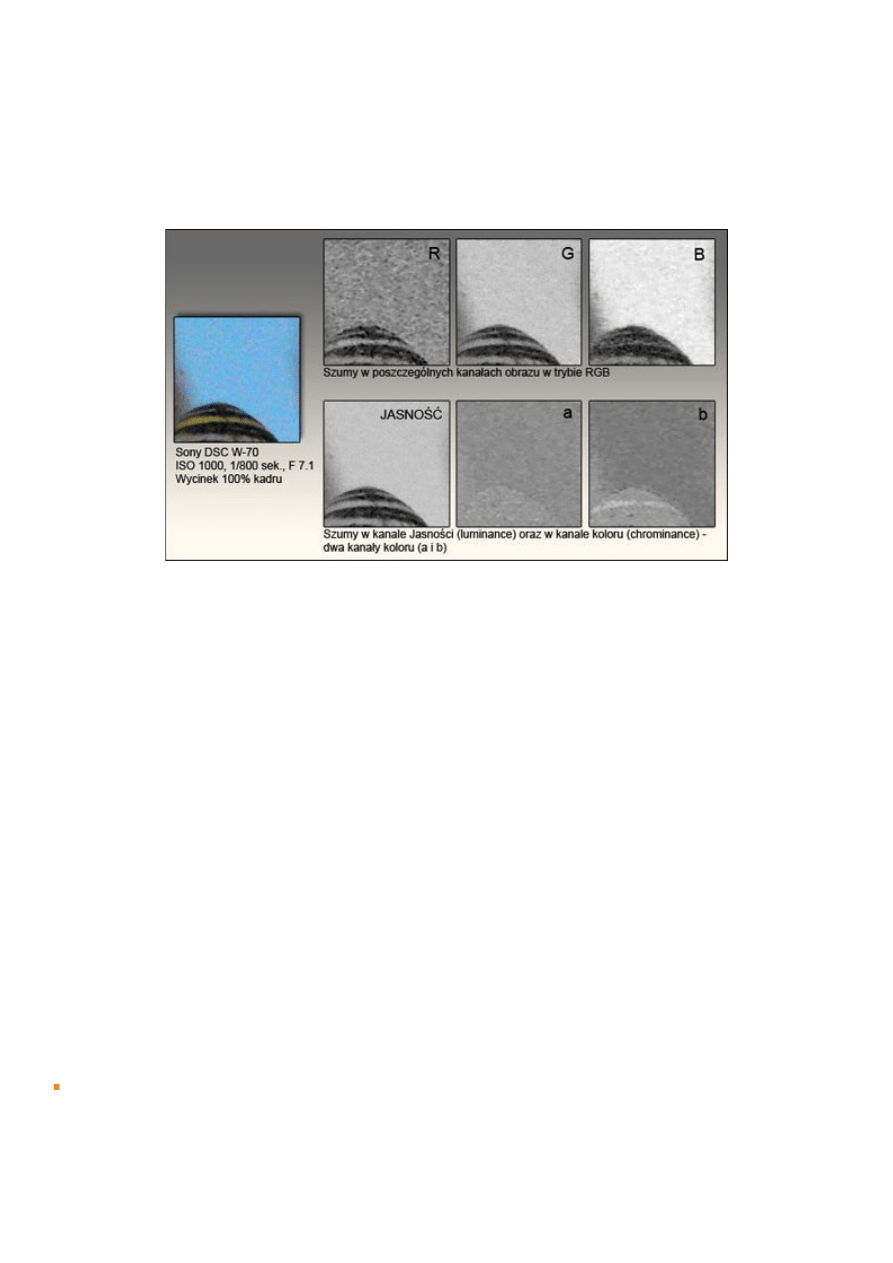

INNY PODZIAŁ

Wszystkie szumy, jakie występują na zdjęciu, można podzielić jeszcze w inny sposób. Mianowicie na szumy w

jasności (luminance noise), przypominające ziarno na kliszy, a także szumy w kolorze (chroma noise). Ten

pierwszy związany jest z informacjami o detalach i próba jego usunięcia może źle wpłynąć na ostrość zdjęcia.

Szum w kolorze ma związek wyłącznie z barwą piksela. Na zdjęciu widać go jako kolorowe plamki. To czy

szum w kolorze jest mocno widoczny czy nie zależy w dużym stopniu od danego modelu aparatu.

Widzimy więc, że źródeł zakłóceń w tworzonym obrazie jest wiele. Jak już wspomnieliśmy, im większy piksel,

tym mniejsze szumy, powstające na etapie tworzenia obrazu. Ale również proces jego odczytu i przetwarzania

wprowadza dodatkowe źródła szumu. Ważne jest więc nie tylko, aby piksele matrycy był jak największe (duża

wartość SNR). Towarzysząca im elektronika powinna generować jak najmniejsze szumy, a ich zmniejszenie

umożliwia ciągły postęp technologiczny.

Czułość matrycy

Zmiana czułości w aparacie polega nie na zmianie własności poszczególnych pikseli, lecz na zmianie

wzmocnienia (ang. gain) rejestrowanego przez piksele sygnału. A ponieważ ze wzrostem ISO wzmacniamy

cały sygnał, więc także szum ulega wzmocnieniu. Dlatego tak ważne jest, aby matryca generowała jak

najmniejszy szum - wtedy nie będzie on zbyt istotnie zakłócał obrazu nawet po wzmocnieniu. Dziś matryce

pozwalają na korzystanie z wyższych wartości ISO przy takiej samej jakości obrazu, jak stare konstrukcje przy

niższym ISO.

Możliwe jest umieszczenie w menu nawet taniego kompaktu opcji zawierającej 1600 ISO i więcej. Ale w

przypadku malutkich matryc jest to mało przydatne, gdyż wytworzony obraz będzie bardzo kiepskiej jakości.

W aparatach cyfrowych stosuje się tzw. ekwiwalent ISO. Kompaktowe aparaty pozwalają na uzyskanie czułości

od 50-800 ISO (ostatnio pojawiły się modele z 1600 ISO). Większość kompaktów przy wyższych wartościach

ISO produkuje bardzo duże szumy, dlatego zwykle maksymalny użyteczny zakres nie przekracza 400 ISO. W

cyfrowych lustrzankach szumy są znacznie mniejsze i przydatne są także ustawienia 800,1600,3200 a nawet

6400 ISO (modele profesjonalne), jednak przy maksymalnych wartościach szum staje się zauważalny i zaczyna

wpływać na estetykę fotografii.

Zakres dynamiczny

Jest to wartość określająca zakres jasności fotografowanego obiektu, który matryca jest w stanie uchwycić na

pojedynczej ekspozycji. Przekłada się to pośrednio na ilość różnych odcieni szarości, ponieważ jasność jest

reprezentowana na zdjęciu przez te odcienie. Niestety, teoretyczne wartości są ograniczone przez kilka

czynników, m.in. szumy w matrycy (zwłaszcza przy dużych wartościach ISO) oraz stosowane przetworniki

analogowo-cyfrowe, które zamieniają sygnał z postaci napięcia na sygnał cyfrowy w formie bitów. Dziś

montuje się w aparatach układy 10,12 czy 14bit, które dają teoretycznie 1024,4096 czy 16384 odcieni dla

każdej z barw. Ale nawet jeśli parametry matrycy pozwolą na osiągnięcie tak dużej ilości barw, to jesteśmy

zwykle ograniczeni konsekwencjami zapisu do JPEG, najpopularniejszego formatu zapisu fotografii. JPEG

posiada tylko 8bitów (256 odcieni) na każdy kolor.

Aby w pełni wykorzystać możliwości oferowane przez matryce, lustrzanki cyfrowe i nieliczne kompakty

pozwalają na zapis w formacie RAW. Mówiąc w skrócie, ten format zapisu pozwala na uniknięcie obniżenia

jakości zdjęcia poprzez obróbkę w aparacie i zapis do JPEG.

Nie musimy się jednak przejmować, jeśli nasz aparat oferuje tylko format JPEG. Jakość zapisu w tym formacie

zadowoli nas w większości sytuacji.

UWAGA: Trzeba pamiętać że liczba barw rejestrowanych na zdjęciu nie oznacza automatycznie zakresu

dynamicznego matrycy. Natomiast im większa liczba kolorów tym lepiej można ten zakres dynamiczny

oddać.

8. Na co pozwala nam matryca - czyli o tym czego klisza nie potrafi

1. Podgląd zdjęcia na od razu po zrobieniu oraz kadrowanie na żywo za pomocą LCD (nie dotyczy

większości lustrzanek cyfrowych), co znacznie ułatwia wykonywanie zdjęć takich, jak chcemy.

2. Możliwość skasowania niepotrzebnych zdjęć, na przykład w przypadku, gdy braknie miejsca na karcie

pamięci.

3. Zmienne ISO - każdy aparat cyfrowy oferuje kilka wartości czułości ISO, które można przełączyć

przyciskiem, zamiast zmieniać kliszę na tę o innej czułości.

4. Balans bieli - ponieważ zdjęcie ma postać cyfrową, łatwo jest dopasować kolory tak, aby dokładnie

odzwierciedlały to, co w rzeczywistości.

5. Zastosowanie różnych efektów - emulacja fotografii czarno-białej, filtrów kolorowych dla tych osób,

które nie chcą do tego celu wykorzystywać komputera.

6. Potencjalnie dużo szybsza niż klisza - sekwencje seryjne dostępne nawet w prostych kompaktach.

9. Niepożądane cechy cyfrowych detektorów

Zwykle skan kliszy fotograficznej nie wygląda na pierwszy rzut oka zachęcająco. Natomiast na zdjęciu z

cyfrówki rzuca się w oczy czystość obrazu cyfrowego, nawet jeśli zdjęcie nie jest ostre czy dobrze naświetlone.

Jednak po dokładniejszym przyjrzeniu się zdjęciu zauważymy, że i cyfrowy obraz nie jest taki doskonały. Na

naszych zdjęciach mogą się ujawnić pewne cechy cyfrowych detektorów, z którymi musimy się pogodzić, lub

starać się ich unikać wiedząc, jak powstają.

Wady pikseli

Teoretycznie nowo wyprodukowana matryca nie powinna mieć żadnych defektów - każdy piksel powinien

prawidłowo reagować na światło. Zdarza się jednak, że pojedyncze piksele działają wadliwie. W zależności od

wady nazywamy je:

Bad pixel (zły piksel) - to piksel, który zwykle stale jest prześwietlony, czyli widoczny na wynikowym obrazku

jako biały punkt, nawet jeśli zdjęcie zostało wykonane przy bardzo krótkim czasie naświetlania. Czasem

widoczny jest, gdy motyw jest ciemny, a znika przy mocniejszym oświetleniu - wtedy może być także

czerwony, zielony lub niebieski. Często stosuje się zamiennie nazwę hot pixel.

Hot pixel (gorący piksel) - to piksel silniej reagujący na padające światło, niż reszta pikseli na matrycy. Ulega

prześwietleniu przy znacznie mniejszym natężeniu padającego światła niż pozostała część matrycy. Na

wynikowym obrazku pojawia się jako kolorowy punkt czerwony, zielony lub niebieski lub całkowicie biały (ze

względu na proces interpolacji koloru, barwa sąsiednich pikseli także ulega zakłóceniu). Nie zawsze musi być

widoczny, może się pojawić przy długim czasie naświetlania, np. powyżej kilku sekund. Hot piksele mogą

także zacząć występować po dłuższym czasie ciągłej eksploatacji aparatu lub nawet dopiero po kilku latach od

zakupu.

Cool pixel (zimny piksel) - w przeciwieństwie do hot pixela te piksele reagują znacznie słabiej na padające

światło i na wynikowym obrazie są widoczne jako punkty dużo ciemniejsze niż otoczenie.

Dead pixel (martwy piksel) - jest to piksel, który w ogóle nie reaguje na światło, na wynikowym obrazku

pojawia się zawsze jako czarny punkt.

Przykłady hot pikseli na zdjęciach (100% i 1600% powiększenia kadru). Oba pojawiły się dopiero w trakcie

użytkowania aparatu. Ten po lewej jest bardziej dokuczliwy i widać go na każdym zdjęciu. Drugi z kolei

niełatwo zauważyć na zdjęciu.

Te wady to prawdziwa zmora, nie tylko fotografów cyfrowych. Oczywiście, o ile martwe piksele, zwłaszcza w

dużej ilości, dyskwalifikują przydatność matrycy do fotograficznych zastosowań, to inne rodzaje

szwankujących pikseli są bardzo powszechne w sprzedawanych dziś aparatach.

Dlatego nie zawsze powinniśmy się martwić widząc piksele o dziwnym kolorze. Jeśli na kolejnym zdjęciu

znikły lub zmieniły miejsce, to mogą one być wynikiem zbyt długiej ekspozycji (co jest całkiem normalne),

wysokiego ISO (tu bardzo często pojawiają się hot piksele), przegrzania się elektroniki aparatu czy błędami

obróbki obrazu przez DSP. Na tylnej ściance aparatu na wyświetlaczu LCD również mogą się pojawić

szwankujące piksele, ale nie ma to żadnego wpływu na nasze zdjęcia.

DARK FRAME: Obecnie aparaty przy wykonywaniu naświetleń powyżej 1-2 sekund stosują mechanizm

redukcji szumów i ewentualnych hot pikseli. W tym procesie wykonywane jest dodatkowe zdjęcie z takim

samym czasem naświetlania, ale przy zamkniętej migawce - dark frame. Czasem ta funkcja wymaga

aktywowania w menu, o czym przeczytamy w instrukcji aparatu.

ODSZUMIANIE BEZ NASZEJ WIEDZY: Producenci dążąc do podniesienia maksymalnie jakości

wynikowego zdjęcia wzbogacają proces przetwarzania obrazu o procedury odszumiające, na które nie mamy

wpływu. Zwykle dzieje się to z korzyścią dla nas, ale jest przyczyną różnej charakterystyki obrazu

uzyskiwanego przez aparaty poszczególnych producentów.

Przy dużej ilości błędnie działających pikseli jest szansa na ich "naprawienie". Czasem dokonuje się tego przez

ich mapowanie (zwykle w serwisie), czyli poinformowanie oprogramowania aparatu przetwarzającego obraz,

które piksele są złe. Wtedy w miejsce takiego piksela wpisuje się uśrednioną informację z sąsiednich pikseli.

Wynik jest niezauważalny na ostatecznym zdjęciu. Druga możliwość to wymiana matrycy w aparacie, jeśli tak

stwierdzi serwis (zwykle dzieje się to po przekroczeniu dopuszczalnych norm jakości matrycy). Warto jednak

upewnić się, czy istnieje taka możliwość, gdyż koszt matrycy to znaczący element ceny całego aparatu.

Czasem niepoprawnie może działać cała matryca w aparacie. W wyniku tego obraz może mieć całkowicie

abstrakcyjny wygląd, na przykład tęczowy. Zwykle taka wada dotyczy większej partii aparatów, które

oczywiście podlegają wymianie na koszt producenta.

Wady obrazu

Mimo postępu technologicznego często zdarza się, że nasza matryca posiada zbyt mało pikseli, aby wiernie

oddać fotografowaną scenę. W danym układzie piksele mają określony stały rozmiar i są rozłożone bardzo

równomiernie, w przeciwieństwie do ziarna kliszy. Nie rejestrują także pełnej informacji o kolorze. Proces

tworzenia się obrazu związany jest z generacją ładunku, nad którym czasem trudno zapanować (na poziomie

poszczególnych pikseli).

Z tych to właśnie przyczyn obraz cyfrowy nie zawsze będzie doskonały. Zwykle wady ujawniają się w

skrajnych sytuacjach, gdy oświetlenie jest bardzo silne lub fotografowane obiekty bardzo szczegółowe, ale

mogą także dać się we znaki przy zwykłych codziennych fotkach.

Poniżej opisujemy kilka najczęściej spotykanych wad występujących na zdjęciach otrzymanych za pomocą

aparatu cyfrowego.

ARTEFAKTY OBRAZU - mimo stosowania przed matrycą filtrów AA mających wyeliminować błędy

związane z niedostateczną rozdzielczością matrycy, przy fotografowaniu bardzo złożonych scen, jak na

przykład korona drzewa, mogą pojawić się różnorodne artefakty. Są to szczegóły nie występujące w

rzeczywistości, które pojawiają się na zdjęciu w wyniku błędnej interpretacji przez układ przetwarzający obraz.

Zapisywanie zdjęć w formacie JPEG może w skrajnych sytuacjach doprowadzić do spotęgowania tego efektu.

ABBERACJE - te związane z matrycą (nie obiektywem aparatu) są wprowadzane są przez umieszczone przed

pikselami mikrosoczewki, zwykle mają kolor fioletowy (purple fringing) i występują na całej powierzchni

zdjęcia. Najbardziej to jest widoczne gdy występuje silny kontrast jasności (zdjęcia pod światło oraz przy

szeroko otwartej przysłonie w aparacie lub szerokokątnym obiektywie w lustrzance). W tym przypadku skrajne

promienie są źle ogniskowane przez mikrosoczewki i zachodzi zjawisko pixel-crosstalk, czyli przeskoku

sygnału do sąsiednich pikseli.

BLOOMING - to wada głównie detektorów CCD. Gdy są wystawione na zbyt silne światło, piksele ulegają

saturacji i ładunki rozlewają się na sąsiednie piksele, tworząc nieregularną białą plamę. W detektorach CMOS

ten efekt jest znacznie słabszy, ponieważ piksele są ekranowane oraz odczytywane niezależnie, a nie

kolumnami, i nie pozwalają na przepływ ładunku do sąsiadujących pikseli. Dlatego zachodzące słońce inaczej

wygląda na zdjęciu wykonanym matrycą CMOS niż CCD. Efekt bloomingu zwiększa także

prawdopodobieństwo wystąpienia abberacji.

SMEAR - rozmazanie się ładunku w trakcie jego odczytywania w układzie CCD. Pojawia się jako jasny pas na

obrazie, zwłaszcza, gdy odczytujemy bardzo prześwietlony piksel. Kierunek tego paska pokazuje, w jakim

kierunku odczytywane są dane. Czasem odczytywanie hot piksela wywołuje podobny efekt.

AMPLIFIER GLOW (świecenie wzmacniacza) - ten nieprzyjemny efekt dokuczy nam tylko wówczas, gdy

pokusimy się na długie, nawet kilkuminutowe, ekspozycje np. przy fotografii nocnego nieba. Będzie on

widoczny na zdjęciu jako jasna poświata, np. fioletowa na czarnym tle, silniejsza od strony, gdzie znajduje się

elektronika aparatu. Dlatego tryb BULB dla migawki w aparacie nie jest efektywny przy bardzo długich

czasach naświetlania.

COLOR ALIASING - jeśli fotografowany szczegół nie pokrywa wystarczającej liczby pikseli, aby możliwe

było prawidłowe odtworzenie jego prawidłowego koloru, na zdjęciu pojawią się przekłamania barwy (nie

należy tego mylić z błędnym balansem bieli). Często można je zauważyć na włosach fotografowanych osób. To

wynik stosowania barwnej maski Bayera.

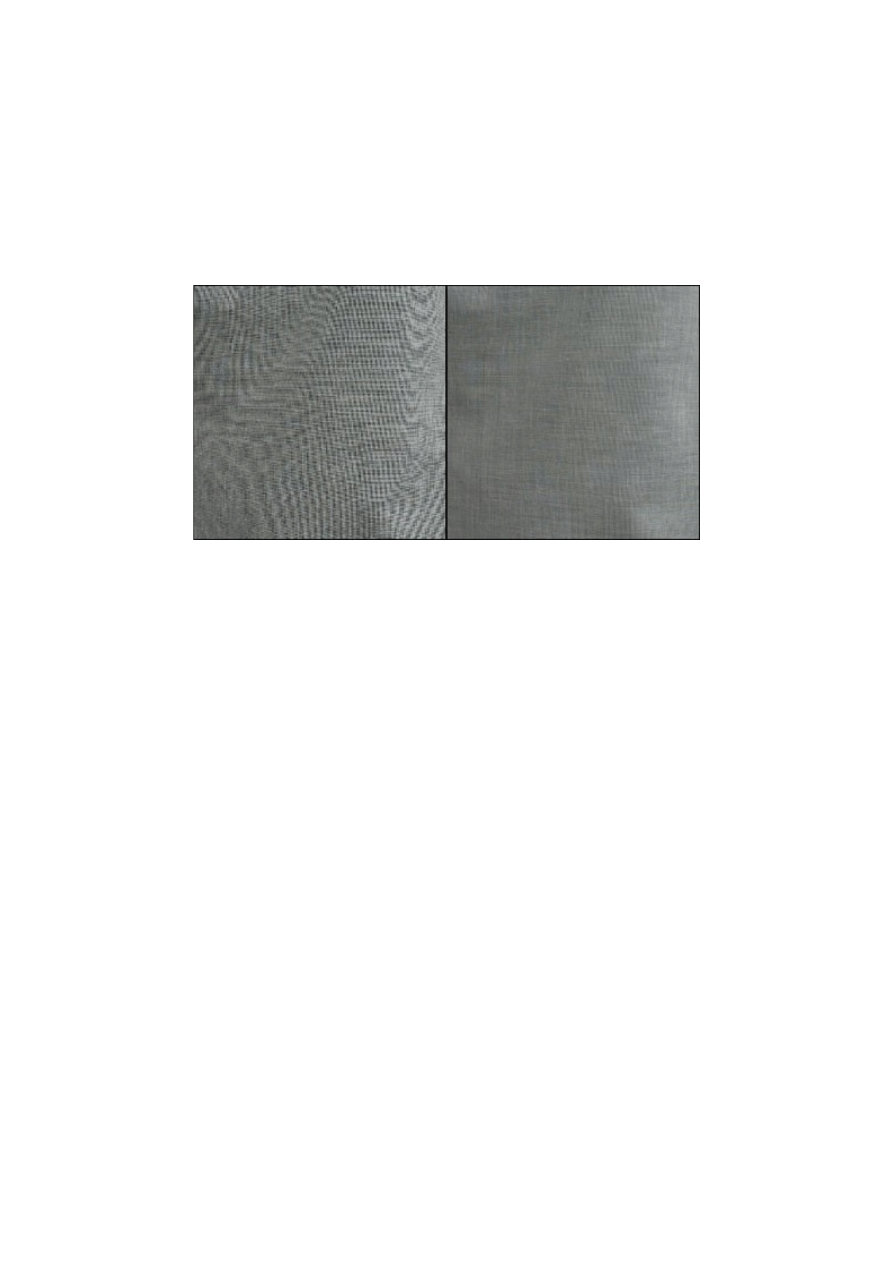

MORA - to także jeden z artefaktów związanych z niedostateczną rozdzielczością matrycy. Pojawia się, gdy

fotografujemy często powtarzające się wzory na odzieży, na przykład fakturę kurtki. Ponieważ matryca nie jest

w stanie odtworzyć pierwotnego wzoru, na zdjęciu pojawiają się naprzemiennie leżące jaśniejsze i ciemniejsze

pasy. Mogą one mieć także zmienne barwy.

Przykład mory powstałej na fotografii okiennej zasłony.

Po prawej efekt mory w znacznym stopniu wyeliminowano zmniejszając nieco zdjęcie za pomocą funkcji

resample w Photoshopie.

Jak uniknąć powyższych efektów? Często nie jest możliwe fotografowanie "inaczej", a efektów prześwietlenia

nie da się skompensować. W innych przypadkach z pomocą mogą przyjść nam programy komputerowe lub

fotografowanie w trybie RAW (ale nie zawsze jest to możliwe).

Najprostszą metodą jest robienie zdjęć w maksymalnej dostępnej rozdzielczości aparatu, a następnie

zmniejszanie zdjęcia w komputerze wykorzystując algorytm uśredniający informacje w pikselach - resample.

Przykładowo zmniejszenie zdjęcia z 10Mpix do 6 czy 8Mpix może usunąć wiele nieprzyjemnych efektów, a

nadal pozwoli na "duże" odbitki.

Także oprogramowanie i elektronika aparatu przychodzi nam z pomocą. Nowe matryce w aparatach to nie tylko

w dodatkowe megapiksele, ale i nowa elektronika, która coraz lepiej radzi nam sobie z usuwaniem

niepożądanych efektów.

Ostatnie z istotnych źródeł zakłóceń na zdjęciu to zanieczyszczenia samej matrycy i, choć trudno nazwać je

szumem, to czasem znacząco wpływają na ostateczne zdjęcie. Dlatego na koniec dowiemy się dlaczego warto

dbać o czystość matrycy.

10. Higiena - jak dbać o matrycę

Wydawałoby się, że matryca w aparacie cyfrowym jest doskonale zabezpieczona i nie grożą jej żadne

niebezpieczeństwa. Warto jednak pamiętać o kilku zasadach, aby cieszyć się pięknymi zdjęciami.

Nie dopuszczajmy do przegrzania się matrycy i elektroniki aparatu. Jak już wspomnieliśmy, może się to

zdarzyć w sytuacji, gdy detektor pracuje bez przerw przez długi okres czasu. Nie ma wtedy czasu na

odpoczynek i na zdjęciach mogą się pojawić różnokolorowe plamki. Taka sytuacja jest najbardziej

prawdopodobna, gdy wykonujemy wiele ujęć na długim (czyli znacznie więcej niż 1 sekunda) czasie. Przy

normalnym fotografowaniu na krótkich czasach matryca ma czas na ostygnięcie pomiędzy zdjęciami. Warto

jednak sprawdzać czy tylna ścianka aparatu nie nagrzewa się zbyt mocno.

Niebezpieczne dla matrycy mogą być także ekstremalnie niskie temperatury. Silny mróz może źle wpłynąć na

mikrosoczewki i filtry doprowadzić do ich uszkodzenia. Na szczęście raczej niewielu z nas wybierze się z

cyfrówką na biegun polarny.

Zarówno CCD jak i CMOS są odporne na długotrwałe naświetlanie silnym światłem, na przykład słonecznym

czy żarówki, i nie wywołuje to negatywnego efektu. Spokojnie możemy wykonywać takie zdjęcia. Jednak

należy pamiętać, aby robić to z umiarem, gdyż zawsze zwiększa to ryzyko pojawienia się defektów.

I najważniejsza sprawa - czystość matrycy. Tym na ogół nie musza się przejmować użytkownicy markowych

kompaktów czy hybryd, a więc aparatów, w których nie ma bezpośredniego dostępu do matrycy i nie istnieje

możliwość jej zakurzenia. Problem dotyczy głównie użytkowników lustrzanek.

Możliwość wymiany obiektywów sprawia, że kurz i inne zanieczyszczenia mają dostęp do matrycy, nawet jeśli

mamy założony na stałe jeden obiektyw. Jeśli osiądą na filtrze przed matrycą (nie mylić z lustrem czy

matówką, które mogą być zakurzone bez wpływu na jakość zdjęcia), to będą widoczne jako ciemniejsze plamki

lub paski.

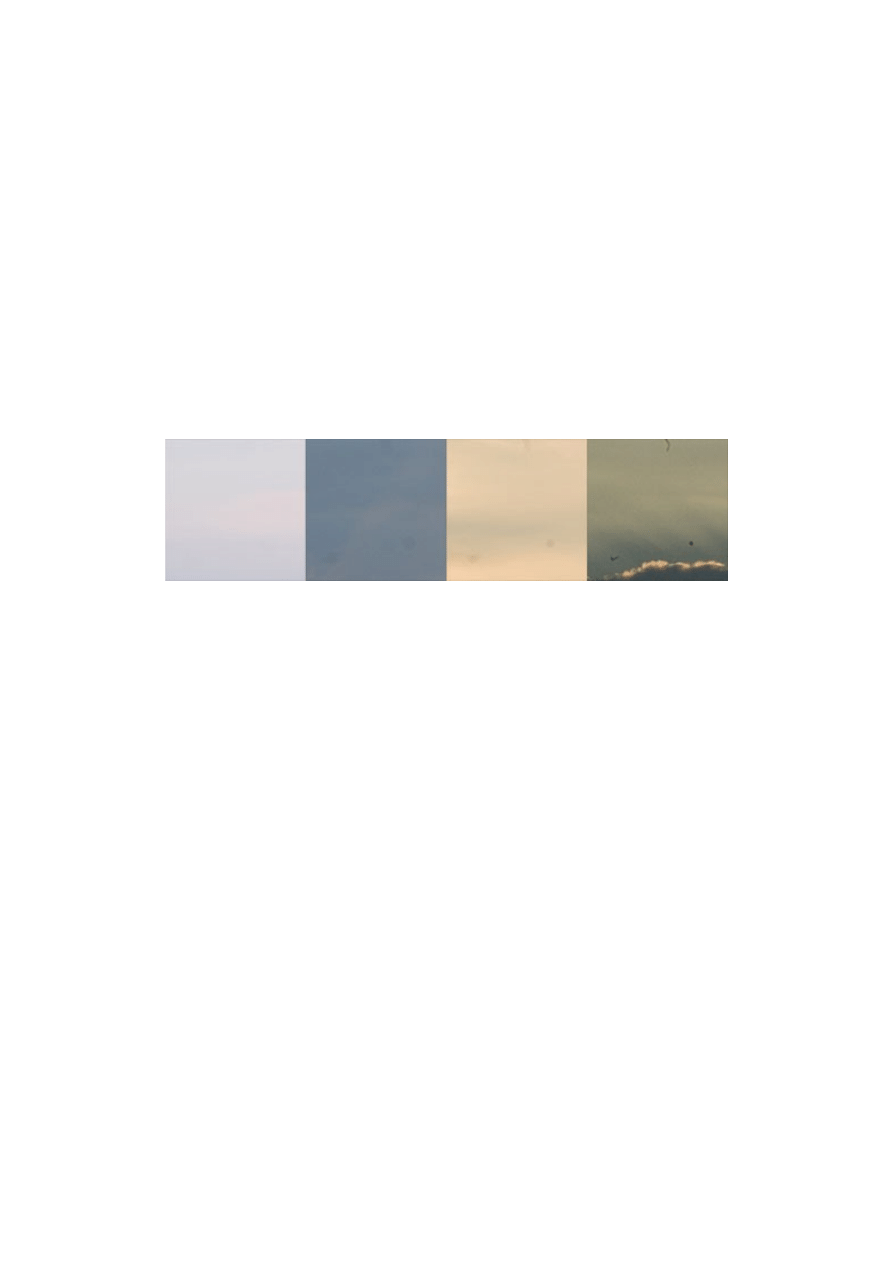

BŁOGA NIEWIEDZA

Czasem, gdy wykonujemy zdjęcia przy większym otworze przysłony, większym niż F4, na przykład portrety,

możemy nie zauważyć zanieczyszczeń matrycy. Jeśli chcemy sprawdzić czystość naszego detektora,

wykonajmy zdjęcie przy dużej przysłonie, np. F16 i więcej. Wtedy paprochy na matrycy staną się widoczne.

Zdjęcie pokazuje ten sam wycinek kadru na zdjęciach wykonanych przy różnych wartościach przysłony

(kolejno F5, F8, F13, F32). Widzimy, że dla przysłony mniejszej niż F8 paprochy znajdujące się przed matrycą

są niezauważalne. Jednak w miarę zwiększania jej wartości są coraz wyraźniejsze. Przy F13 jako rozmyta

plamka, ale przy F32 już jako denerwująca kropka.

To czy powinniśmy wyczyścić matrycę zależy od nas. Jeśli fotografujemy z mocno otwartą przysłoną nie

powinniśmy się tym przejmować. Ale jeśli decydujemy się na mocne przymkniecie przysłony - warto pomyśleć

o usunięciu "intruza".

Na koniec jeszcze jedna porada. Nie sugerujmy się zbytnio przy wyborze aparatu peanami na temat przewagi

CMOS nad CCD czy odwrotnie. Jeśli zdecydujemy się na konkretny model aparatu, warto wziąć w rękę ten

egzemplarz, który właśnie zamierzamy nabyć, i zrobić kilka fotek. Zobaczmy czy jakość zdjęć nas