Technologie informacyjne. Zakres materiału do kolokwium,

1. Budowa komputera

Płyta główna

•

Sterowanie (chipset), zegar

•

BIOS

•

Magistrala danych

•

Procesor

Jednostka arytmetyczno logiczna + koprocesor(y) + rejestry

Pamięć notatnikowa (cache), poziom L1-L2

Sterowanie, magistrala danych

Jeden/dwa rdzenie, jeden/dwa/wiele procesorów

Typ gniazda (socket)

•

Pamięć RAM, banki pamięci (socket)

•

Gniazda rozszerzeń AGP, PCI, PCI Expres, ISA

•

Kontrolery zewnętrznych napędów ATA, SATA, SCSI

•

Opcjonalne kontrolery zintegrowane

•

Interfejsy zewnętrzne (PS2, USB 1.0/2.0, LPT, FireWire, RS232,…)

•

Karta graficzna (procesor graficzny, pamięć, biblioteka OpenGL)

•

Karta sieciowa (NIC), modem, adaptery

•

Karta dźwiękowa, kanały

•

Pamięć trwała HDD, SDD; 100Gb = 100,000 tomów encyklopedii PWN

•

Napędy optyczne CD, DVD, BlueRay, inne; napędy zewnętrzne FDD,

streamer (taśma mag.)

•

Monitor

•

Klawiatura, mysz

•

Drukarka (igłowa, atramentowa, laserowa,…)

•

Skaner

•

Tablet, ploter

•

Kamera, głośniki

2. Technologie przesyłowe w sieci; typy łączy

•

łącza rozgłoszeniowe (rozsyłanie rozgłoszeniowe, broadcast)

•

łącza wieloadresowe (rozsyłanie grupowe, multicast)

•

łącza jednoadresowe dwupunktowe (point-to-point, unicast)

3. Klasyfikacja sieci wg skali odległości połączonych procesorów

•

1 m (sieć osobista, Private Area Network, PAN)

•

10 m - 1km (sieć lokalna, Local Area Network, LAN)

•

10 km (sieć miejska, Metropolitan Area Network, MAN)

•

100 km – 1 000 km (sieć rozległa, Wide Area Network, WAN)

•

10 000 km (Internet)

4. Architektury sieci

•

Magistrala

Można ją traktować jak "autostradę" służącą transmisji danych i łączącą stacje sieci.

Dane, nim dotrą do stacji przeznaczenia, przechodzą po drodze przez wszystkie

pozostałe stacje. W rozwiązaniu tym do wspólnego kabla transmisyjnego zostają

podłączone komputery o dzielonym dostępie do medium transmisyjnego. Każdy

komputer jest przyłączony do kanału, nadawane sygnały docierają do wszystkich

stacji, ale pakiety odbierane są tylko przez stację, do której są adresowane, ponieważ

każda stacja sprawdza, czy dane są skierowane do niej. Topologia magistrali jest jedną

z najbardziej popularnych konfiguracji sieci komputerowych.

Zalety magistrali:

małe zużycie kabla

prosta instalacja

niska cena instalacji

bardzo prosta rozbudowa sieci

łatwe łączenie segmentów sieci w jeden system (bez zmian oprogramowania

komunikacyjnego)

każdy komputer jest podłączony tylko do jednego kabla

pojedyncze uszkodzenie (przerwa w kablu lub awaria komputera) nie powoduje

unieruchomienia całej sieci

Wady magistrali:

konkurencja o dostęp - wszystkie komputery muszą dzielić się kablem

utrudniona diagnostyka błędów z powodu braku

centralnego systemu zarządzającego siecią

rozproszenie zadań zarządzających siecią, co w

określonych przypadkach niekorzystnie wpływa na

szybkość realizacji zadań informatycznych

zwykle dla uniknięcia zakłóceń sygnałów należy

zachować pewną odległość między punktami

przyłączenia poszczególnych stacji

•

Pierścień

Topologia pierścieniowa ma wiele zalet. Funkcjonowanie sieci nie zostaje przerwane

nawet w razie awarii głównego komputera, gdyż jego zadanie może przejąć inna

stacja. Dzięki układom obejściowym (ang. by-pass) można wyłączyć z sieci dowolną

stację i tym sposobem uniknąć awarii sieci. Każdy węzeł sieci bierze bezpośredni

udział w procesie transmisji informacji i jest połączony z dwoma innymi "sąsiadami".

Węzły połączone w pierścień przekazują komunikaty sterujące (tokeny) do

następnego; węzeł aktualnie mający token może wysyłać komunikat; termin "token

ring" często odnosi się do standardu Institute of Electrical and Electronics Engineers

(IEEE) 802.5 sieci token ring, który jest najbardziej powszechnym typem sieci token

ring; pierwszy standard przewidywał przesyłanie z szybkością 4 Mb/s, natomiast w

obecnych sieciach osiągana prędkość to 16 Mb/s. Informacja wędruje w jednym

kierunku i po przejściu wszystkich węzłów wraca do miejsca nadania. Interfejs

sieciowy każdego komputera musi odbierać dane od jednego sąsiada i przesyłać je do

następnego. Podczas przechodzenia przez kolejne węzły sygnał w każdym z nich jest

wzmacniany.

Zalety :

małe zużycie kabla

możliwość zastosowania łącz optoelektronicznych, które wymagają bezpośredniego

nadawania i odbierania transmitowanych sygnałów

możliwe wysokie osiągi, ponieważ każdy kabel łączy dwa konkretne komputery

Wady :

awaria pojedynczego kabla lub komputera

powoduje przerwanie pracy całej sieci jeśli nie

jest zainstalowany dodatkowy sprzęt

złożona diagnostyka sieci (możliwe usprawnienie

przez wyposażenie każdego węzła

w procedury samotestowania)

trudna lokalizacja uszkodzenia

trudna rekonfiguracja sieci

•

•

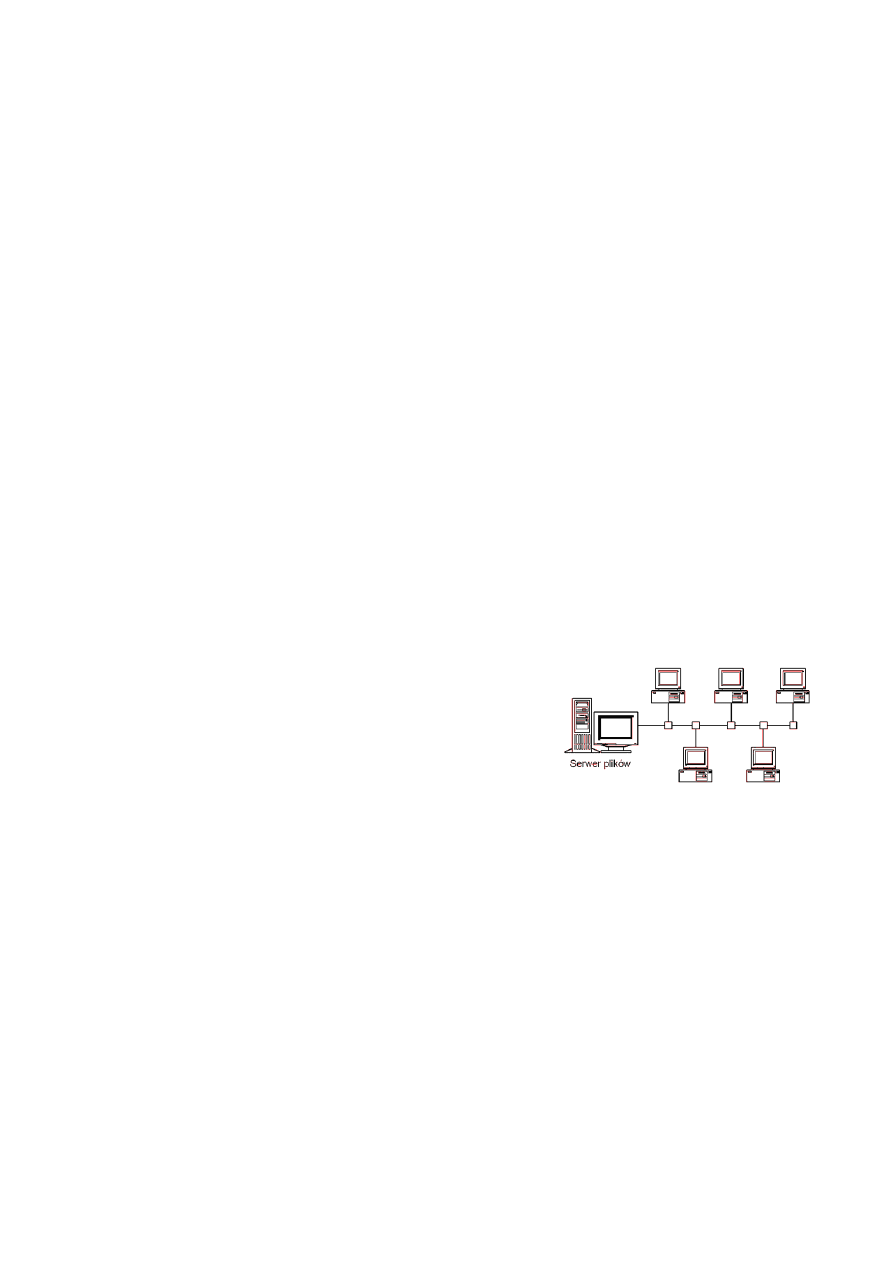

Gwiazda

Jest to sieć zawierająca jeden centralny węzeł (serwer), do którego zostają przyłączone

pozostałe elementy składowe sieci za pomocą huba. Chroni to sieć przed awariami,

gdyż awaria jednego łącza nie powoduje unieruchomienia całej sieci. Stosowana jest

do łączenia komputerów w jednej instytucji, budynku. większość zasobów sieci

znajduje się w komputerze centralnym przetwarzającym i zarządzającym siecią.

Pozostałe komputery zwane terminalami są stacjami przygotowania danych lub mają

niewielkie możliwości obliczeniowe. Wszystkie informacje są przekazywane przez

centralny komputer. Topologia ta może być określona jako drzewo z jednym

poziomem połączeń. Okablowanie: popularna skrętka (UTP, światłowód).

Zalety gwiazdy:

łatwa konserwacja i lokalizacja uszkodzeń

prosta rekonfiguracja

proste i szybkie oprogramowanie użytkowe sieci

centralne sterowanie i centralna programowa diagnostyka sieci

możliwe wysokie szybkości transmisji (warunek -

szybki komputer centralny)

Wady gwiazdy:

duża liczba kabli

wszystkie maszyny wymagają podłączenia wprost do

głównego komputera

ograniczona możliwość rozbudowy sieci

zależność działania sieci od sprawności komputera

centralnego

ograniczenie odległości komputera od huba

w przypadku awarii huba przestaje działać cała sieć.

•

hierarchiczna

•

mieszana

5. Sprzęt sieciowy

•

Karta sieciowa (Network Interface Controler, NIC), modem

•

Repeater,

N

azywany jest również wzmacniakiem lub regeneratorem.

I

nformacja przesyłana kablem ulega zniekształceniom proporcjonalnie do jego

długości. Jednym z urządzeń, które wzmacnia i regeneruje sygnały przesyłane kablem

jest repeater. Repeater służy więc do fizycznego zwiększania rozmiarów sieci .

Zwykle zawierają one z kilka wzmacniaków.

•

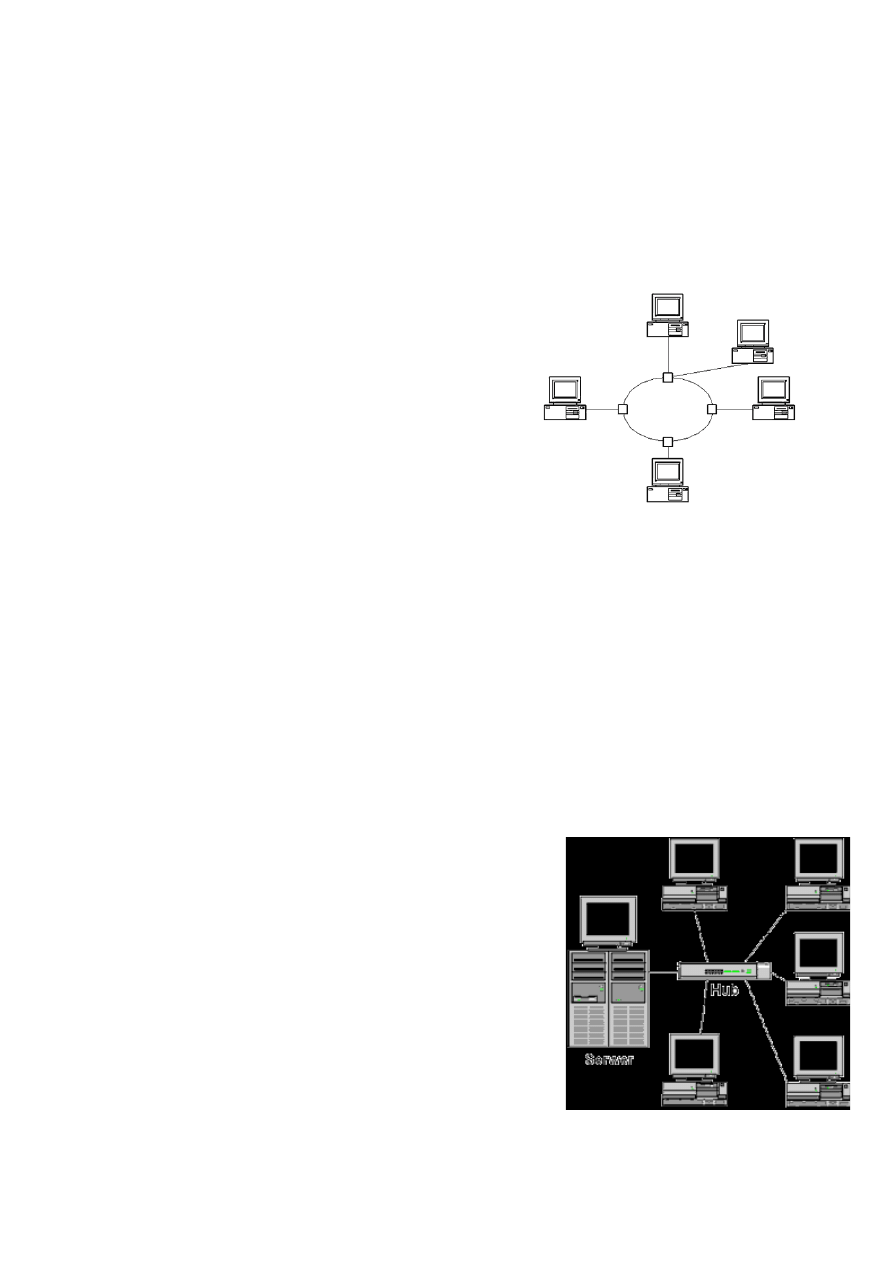

Hub (koncentrator)

Koncentrator pracuje w warstwie pierwszej modelu ISO/OSI (warstwie fizycznej),

przesyłając sygnał z jednego portu na wszystkie pozostałe. Nie analizuje ramki pod

kątem adresu MAC oraz IP.

Koncentrator najczęściej podłączany jest do routera jako rozgałęziacz, do niego zaś

dopiero podłączane są pozostałe urządzenia sieciowe: komputery pełniące rolę stacji

roboczych, serwerów, drukarki sieciowe i inne.

•

Most (bridge)

to urządzenie warstwy łącza danych (ang. Data Link Layer – DLL) modelu OSI/ISO

decydujące o przesyłaniu ramek danych (czyli pakietów danych warstwy 2) na

podstawie stworzonej przez siebie tablicy forwardingu (ang. Forwarding DataBase –

FDB lub MAC DataBase), zawierającej numery portów (interfejs E0/0, E0/1, itd...), do

których przyłączone są urządzenia (każdy port to inny segment sieci), oraz adresy

sprzętowe MAC urządzeń w segmencie sieci.

•

Switch (przełącznik)

urządzenie łączące segmenty sieci komputerowej pracujące w drugiej warstwie

modelu ISO/OSI (łącza danych), jego zadaniem jest przekazywanie ramek między

segmentami. Przełącznik określa się też jako wieloportowy most lub inteligentny

koncentrator, gdyż:

przekazuje ramki wyłącznie do docelowego segmentu sieci (podobnie do mostu, w

przeciwieństwie do koncentratora),

umożliwia połączenie wielu segmentów sieci w gwiazdę (podobnie do huba, w

przeciwieństwie do mostu ograniczonego do dwóch segmentów),

działa w trybie dupleks (w przeciwieństwie do koncentratora).

•

Ruter (router)

urządzenie sieciowe pracujące w trzeciej warstwie modelu OSI, pełniące rolę węzła

komunikacyjnego, służącego do rozdzielenia sygnału i rozgałęzienia połączeń

sieciowych. Proces kierowania ruchem nosi nazwę trasowania, routingu lub

rutowania.

•

Serwer

jest to program świadczący usługi na rzecz innych programów, zazwyczaj

korzystających z innych komputerów połączonych w sieć. Serwerem nazywa się

często komputer świadczący takie usługi, sprowadzające się zazwyczaj do

udostępniania pewnych zasobów innym komputerom lub pośredniczący w

przekazywaniu danych między komputerami. Serwerem nazywa się też systemy

oprogramowania biorące udział w udostępnianiu zasobów. Przykładami

udostępnianych zasobów są pliki, bazy danych, łącza internetowe, a także urządzeń

peryferyjnych jak drukarki i skanery.

•

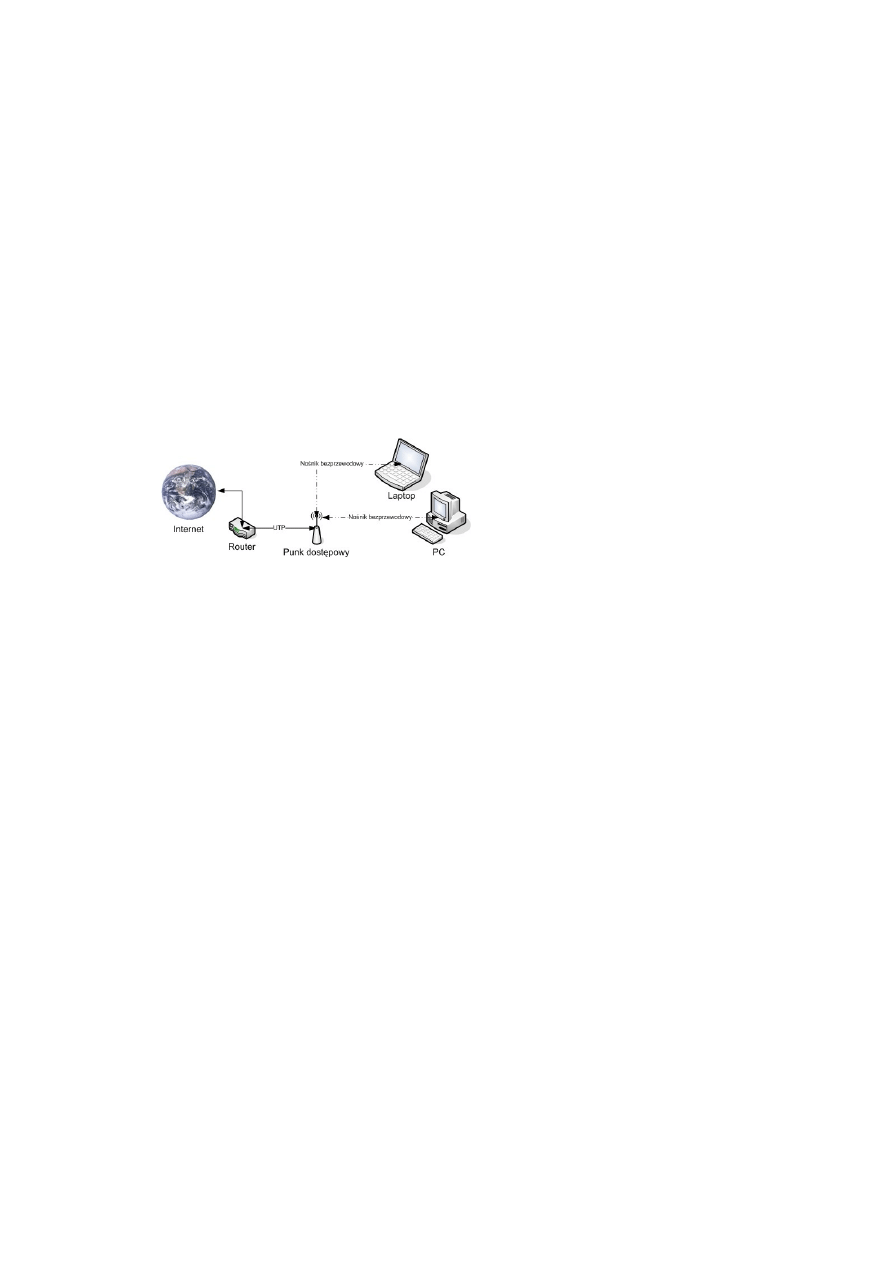

Punkt dostępowy do sieci bezprzewodowej (access point, AP)

urządzenie zapewniające stacjom bezprzewodowym dostęp do zasobów sieci za

pomocą bezprzewodowego medium transmisyjnego (częstotliwości radiowe).

Access point jest także mostem łączącym sieć bezprzewodową z siecią przewodową

(najczęściej Ethernet). W związku z tym każdy access point ma minimum dwa

interfejsy: interfejs bezprzewodowy komunikujący się z sieciami standardu 802.11

oraz drugi służący połączeniu AP z siecią przewodową. Stacjami łączonymi w sieć

bezprzewodową za pomocą punktów dostępowych są komputery wyposażone w

bezprzewodowe karty sieciowe. Zazwyczaj są to laptopy lub palmtopy, choć niekiedy

stacjami bywają także komputery stacjonarne a sieć bezprzewodowa stosowana jest w

celu uniknięcia zbytniego okablowania.

6. Rodzaje okablowania

•

Skrętka

(ang. twisted-pair wire) to rodzaj kabla sygnałowego służącego do przesyłania

informacji, który zbudowany jest z jednej lub więcej par skręconych z sobą

przewodów miedzianych, przy czym każda z par posiada inną długość

skręcenia w celu obniżenia zakłóceń wzajemnych, zwanych przesłuchami.

Niestety skręcenie przewodów powoduje równocześnie zawężenie pasma

transmisyjnego.

Wyróżnia się skrętkę nieekranowaną, ekranowaną (posiadającą dodatkowe

płaszcze z folii) oraz skrętkę z folią (FTP (nie mylić z protokołem FTP)).

Zastosowanie skrętki to łącza telekomunikacyjne oraz sieci komputerowe,

obecnie najczęściej wykorzystywana jest w telefonii analogowej oraz w

sieciach Ethernet. Skrętka ma zastosowanie zarówno do przesyłania danych w

postaci analogowej jak i cyfrowej.

•

Kabel koncentryczny

(ang. coaxial cable) – przewód miedziany otoczony izolacją, wspólnym

ekranem oraz zewnętrzną koszulką ochronną, wykorzystywany np. jako

medium transmisyjne w sieciach Ethernet (np. 10BASE5) z szybkością do 10

Mb/s, w instalacjach antenowych do radia i telewizora, jak również w

aparaturze pomiarowej. Typowy kabel koncentryczny ma impedancję 50 Ω,

choć w instalacjach antenowych powszechna jest wartość 75Ω. Kabel

koncentryczny jest najczęściej określany przez wojskowy numer

specyfikacyjny rozpoczynający się od liter RG: np. RG-58A/U, RG-62/U, itd.

Kable o różnych numerach RG mają różne charakterystyki fizyczne i

elektryczne.

•

Światłowód

przezroczyste włókno (szklane lub wykonane z tworzyw sztucznych), w

którym odbywa się propagacja światła. Aby wyeliminować (lub, przynajmniej,

znacząco ograniczyć), wypromieniowanie światła przez boczne powierzchnie

światłowodu, stosuje się odpowiednio dobrany poprzeczny gradient

współczynnika załamania światła.

7. Warstwy sieci w modelu OSI (Open System Interconnections):

•

warstwa fizyczna - definiuje połączenia elektryczno-mechaniczne z

okablowaniem sieciowym oraz zajmuje się transmisją bitów danych pomiędzy

urządzeniami w sieci. W tej warstwie zdefiniowane są rodzaje okablowania:

10BASE-5 (gruby ETHERNET - ok. 450m)

10BASE-2 (cienki ETHERNET - ok.180m)

10BASE-T (skrętka - ok. 90m)

10BASE-F (światłowód - do 2,5km).

•

warstwa łącza danych - definiuje sposoby kontroli dostępu do okablowania

(m.in. wykrywanie kolizji). Definiuje sposoby tworzenia pakietów i sposoby

ich wysyłania oraz odbierania. Przy przesyłaniu danych w sieci dane

przepływają z jednej karty sieciowej do drugiej. Ma zapewnić bezbłędną

komunikację w sieci. W tej warstwie są zdefiniowane specyfikacje sieci

(802.2, 802.5).

Standard Ethernet zawiera zestaw protokołów warstwy sieciowej,

ukrywających fizyczny obraz sieci przed warstwą sieciową. W wyniku

istnienia warstwy łącza danych rodzaj używanej technologii sieciowej

(Ethernet, Token Ring) nie ma wpływu na protokoły warstwy sieciowej.

Jednak rodzaj karty sieciowej zależy od stosowanej technologii. Do połączenia

komputera z siecią Ethernet należy użyć innej karty sieciowej, a do połączenia

go z siecią Token Ring - innej.

•

warstwa sieciowa - definiuje sposób kierowania danych z jednego urządzenia

do innego. W tej warstwie działają protokóły sieciowe, takie jak IPX czy IP.

Warstwa sieciowa zajmuje się ruchem w sieci, przeciążeniami sieci oraz

szybkościami transmisji. Do zarządzania przepływem danych w sieci warstwa

sieciowa wykorzystuje mosty i routery.

•

warstwa transportowa - definiuje kontrolowanie różnych procesów sieciowych.

Między innymi obsługuje sytuacje błędne, jak zgubione czy powtórzone

pakiety. Np. w tej warstwie działa SPX. Aby zapewnić niezawodną transmisję

danych, warstwa transportowa dzieli dane odbierane z warstwy sesji na

mniejsze fragmenty wymagane przez warstwę sieciową. Po stronie odbiorcy

warstwa transportowa musi z powrotem połączyć podzielone dane. Wynika z

tego, że struktura warstwy transportowej ma duży wpływ na wielkość

pakietów przesyłanych przez sieć.

•

warstwa sesji - zarządza współdziałaniem funkcji i programów użytkowych

wykonywanych na różnych urządzeniach sieciowych. Przed skorzystaniem z

usługi sieciowej należy się zalogować (wprowadzić nazwę użytkownika i

hasło). Każda taka operacja rozpoczyna tzw. sesję sieciową. Przy każdym

logowaniu się warstwa sesji negocjuje i ustala warunki połączenia między

procesami bądź aplikacjami, a różnymi węzłami.

•

warstwa prezentacji - definiuje sposoby konwersji kodu i reformatowania

danych. W tej warstwie są tłumaczone nazwy i format plików przy

przenoszeniu np. z serwera Unixa do komputera użytkownika, na którym

działa np. DOS. Warstwa prezentacji udostępnia funkcje używane wielokrotnie

przez sieć podczas komunikacji w sieci. Do funkcji tych należy współpraca z

drukarkami, monitorami oraz formatami plików. Często warstwy znajdujące

się pod warstwą prezentacji wykonują funkcje mające zagwarantować

poprawne wykonywanie operacji sieciowych. Warstwa prezentacji może także

wykonywać takie operacje, jak szyfrowanie i kompresja danych.

•

warstwa aplikacji - pozwala na działanie aplikacji usługi sieciowych, takich jak

poczta, transfer plików, drukowanie w sieci, uruchamianie programów.

Większość zestawów oprogramowania opartych na protokole TCP/IP zawiera

standardowe aplikacje sieciowe, jak na przykład FTP czy Telnet. FTP pozwala

na połączenie z innymi komputerami sieci w celu przesyłania plików.

Analogicznie program Telnet pozwala na zalogowanie się na odległym

komputerze. Innym przykładem aplikacji sieciowej jest poczta elektroniczna.

Przeglądarki WWW są także programami warstwy sieciowej.

8. Rodzaje dostępu do sieci

•

Publiczna sieć komutowana (analogowa) - modem

•

Publiczna sieć komutowana (cyfrowa) – xDSL (ADSL)

•

Dedykowane łącza cyfrowe

•

Sieci bezprzewodowe

•

Telefonia mobilna

•

Telewizja kablowa

•

Telewizja satelitarna

9. Protokoły dostępu do sieci

•

TCP/IP

Transmission Control Protocol / Internet Protocol) jest pakietem najbardziej

rozpowszechnionych protokołów komunikacyjnych współczesnych sieci

komputerowych. Następca protokołu NCP. Najczęściej obecnie

wykorzystywany standard sieciowy, stanowiący podstawę współczesnego

Internetu. Nazwa pochodzi od dwóch najważniejszych jego protokołów: TCP

oraz IP.

TCP/IP jest standardem komunikacji otwartej. Otwartość oznacza tu

możliwości komunikacji między dowolnymi typami urządzeń, bez względu na

ich fizyczną różnorodność. TCP/IP zwany jest także stosem protokołów ze

względu na strukturę warstwową, w której ramka protokołu wyższej warstwy

jest zawarta jako dane w protokole warstwy niższej.

•

IPX/SPX

(ang. Internet Packet EXchange/Sequential Packet EXchange) - zestaw

protokołów sieciowych firmy Novell (protokół warstwy sieciowej IPX i

warstwy transportowej SPX). Użytkowany w różnych sieciach lokalnych (od

PC LAN do sieci branżowych). Rozwiązanie to jako implementacja

protokołów XNS (ang. Xerox Network Service) warstwy transportu i sieciowej

dostępne jest w systemach: NetWare, MS-DOS, MS Windows i OS/2. Obecnie

protokoły te są wycofywane i zastępowane zestawem protokołów TCP/IP.

•

NETBEUI

Interfejs NetBEUI został opracowany przez IBM i wprowadzony na rynek w

1985 roku. Jest stosunkowo małym, ale wydajnym protokołem

komunikacyjnym LAN. NetBEUI jest wyłącznie protokołem transportu sieci

LAN dla systemów operacyjnych Microsoft. Nie jest trasowany. Dlatego jego

implementacje ograniczają się do warstwy 2 modelu OSI, w których działają

wyłącznie komputery wykorzystujące systemy operacyjne firmy Microsoft.

10. Kategorie oprogramowania

•

Firmware (sterowniki)

•

Oprogramowanie komercyjne

•

Shareware (demonstracyjne)

•

Freeware (darmowe)

•

Open source

11. Typy licencji

•

Komercyjna

•

Akademicka

•

Free, GNU GPL (General Public Licence), BSD (Berkeley Software

Distribution),

12. Wersjonowanie, łaty, piractwo, hacking, cracking, prawa autorskie

System kontroli wersji(Wersjonowanie) (ang. version/revision control system) służy

do śledzenia zmian głównie w kodzie źródłowym oraz pomocy programistom w

łączeniu i modyfikacji zmian dokonanych przez wiele osób w różnych momentach.

Systemy kontroli wersji można podzielić na scentralizowane, oparte na architekturze

klient-serwer (np. CVS, Subversion) i rozproszone, oparte na architekturze P2P (np.

BitKeeper, Code Co-op, svk, Git).

Łata, łatka (ang. patch) – jest to poprawka lub uaktualnienie do programu bądź gry

(rzadziej danych), przeznaczona do usunięcia pewnych problemów, błędów,

rozszerzenia funkcjonalności programu albo zwiększenia wydajności (ang.

performance) wcześniejszej wersji programu.

Piractwo – potoczne określenie działalności polegającej na nielegalnym kopiowaniu i

posługiwaniu się własnością intelektualną (programami komputerowymi, muzyką,

filmami itp.) bez zgody autora lub producenta i bez uiszczenia odpowiednich opłat.

Termin ten jest lansowany przez Business Software Alliance. Wcześniejszy przykład

użycia słowa w podobnym kontekście to pirackie stacje radiowe.

Cracking - dziedzina informatyki zajmująca się łamaniem zabezpieczeń. Cracking

dokonywany jest niemal zawsze z naruszeniem praw autorskich, a tym samym

nielegalnie. Zasadniczo wyróżnia się dwa typy crackingu:

•

cracking sieciowy czyli łamanie zabezpieczeń komputerów w sieciach

komputerowych

•

cracking oprogramowania czyli łamanie zabezpieczeń przed niedozwolonym

użytkowaniem programów

Prawo autorskie (ang. copyright, symbol: © ) – pojęcie prawnicze oznaczające (1)

ogół praw przysługujących autorowi utworu albo (2) przepisy upoważniające autora

do decydowania o użytkowaniu dzieła i czerpaniu z niego korzyści.

Ustawa z dnia 4 lutego 1994 r. o prawie autorskim i prawach pokrewnych (Dz. U. z

2006 r. Nr 90, poz. 631 z późn. zm.) wyróżnia:

•

autorskie prawa osobiste

•

autorskie prawa majątkowe

13. Zastosowania sieci komputerowych

•

w biznesie (klient-serwer)

•

domowe (każdy z każdym)

•

użytkownicy mobilni

•

problemy społeczne

14. Formy handlu elektronicznego

•

B2C business-to-consumer (sklep internetowy, bank)

•

B2B business-to-business (współpraca firm i hurtowni)

•

G2C government-to-consumer (usługi administracyjno-finansowe)

•

C2C consumer-to-consumer (aukcje internetowe)

•

P2P peer-to-peer (wolne udostępnianie plików)

15.

Problemy zakupu i eksploatacji sprzętu komputerowego (outsourcing,

pielęgnacja oprogramowania, niezawodność, bezpieczeństwo,…)

•

Outsourcing i netsourcing (def. Wikipedii): Outsourcing (z ang. out-source

- zewnętrzne źródło) to praktyka polegająca na przeniesieniu części zadań

wykonywanych przez firmę lub organizację z własnych pracowników na

zewnętrznych kontrahentów. Najczęstszą przyczyną wprowadzania praktyk

outsourcingowych jest chęć obniżenia kosztów i uniknięcia sytuacji

korupcjogennych. Netsourcing - odmiana outsourcingu, polegająca na

korzystaniu z aplikacji internetowych umieszczonych na zewnętrznym,

wynajętym serwerze WWW, a nie na własnym, w ramach sieci firmowej.

16. Pojęcia i elementy wpływające na niezawodność sprzętu komputerowego

•

Niezawodność elementów składowych (reliability, dependability)

•

Architektura systemu i sieci

•

Obciążalność jest to wielkość charakteryzująca elementy przewodzące torów

prądowych takie, jak przewody, zestyki, rezystory, cewki, kondensatory,

diody/tyrystory oraz inne. Wielkość ta informuje nas o tym, jaki prąd

możemy maksymalnie przepuścić przez dany element nie powodując jego

uszkodzenia.

•

Redundancja sprzętowa (łac. redundantia – powódź, nadmiar, zbytek),

inaczej nadmiarowość w stosunku do tego, co konieczne lub zwykłe.

Określenie może odnosić się zarówno do nadmiaru zbędnego lub

szkodliwego, niecelowo zużywającego zasoby, jak i do pożądanego

zabezpieczenia na wypadek uszkodzenia części systemu. W celu

zmniejszenia prawdopodobieństwa załamania pracy systemu stosuje się

duplikację krytycznych elementów systemu. W systemach, w których w

przypadku awarii zagrożone jest życie ludzi, niektóre części występują

potrójnie. W konstrukcjach takich jak samoloty używające całkowicie

skomputeryzowanego systemu sterowania – fly-by-wire – element generujący

błędną decyzję zostaje przegłosowany przez dwa pozostałe. Inna możliwość

to równoległa praca trzech komponentów, ponieważ oczekuje się, że jeśli

awarie podsystemów będą rzadkie i niezależne w każdym, to

prawdopodobieństwo jednoczesnej awarii trzech jest znikomo małe.

W programowaniu często można się spotkać z pojęciem nadmiarowego

kodu (ang. redundant code). Jest to:

•

Kod¤, który jest wykonywany, ale nie ma absolutnie żadnego wpływu

na wynik końcowy;

•

tak zwany kod zombie, który znajduje się w programie, ale nigdy nie

jest wykonywany;

•

tak zwany kod zdublowany - zawarty dwu lub wielokrotnie taki sam

fragment kodu, pełniący tą samą funkcję (lub bardzo zbliżony), a dający się

zredukować przez zastąpienie go funkcją lub procedurą.

•

Routing w sieci

•

Zasilanie awaryjne, UPS

•

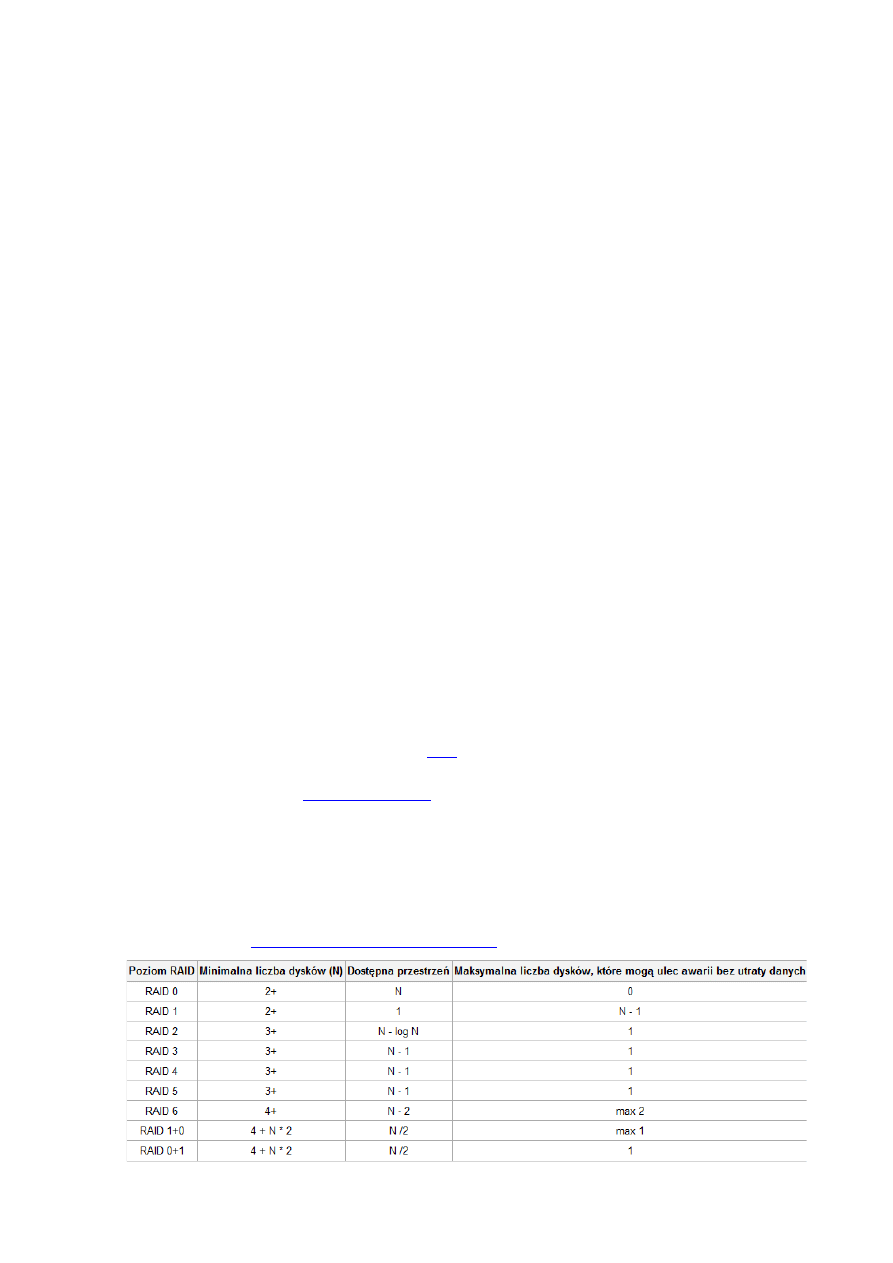

Macierze dyskowe RAID (

Redundant Array of Independent Disks,

Nadmiarowa macierz niezależnych dysków) - polega na współpracy dwóch

lub więcej

w taki sposób, aby zapewnić dodatkowe

możliwości, nieosiągalne przy użyciu jednego dysku. RAID używa się w

następujących celach:

•

zwiększenie niezawodności (odporność na awarie),

•

przyspieszenie transmisji danych,

•

powiększenie przestrzeni dostępnej jako jedna całość.

•

Składowanie danych

•

Mirroring, Mirror (ang. lustro) to dokładna kopia strony internetowej lub

innych zasobów (np. bazy danych lub plików udostępnianych przez FTP).

Tworzona jest najczęściej po to, aby umożliwić szerszy dostęp do pewnej

informacji. Mirror może też służyć jako kopia bezpieczeństwa. Innym

zastosowaniem mirrorów jest odciążenie serwerów. Jeśli na jakimś serwerze

pojawi się duży plik, który wiele osób będzie chciało ściągnąć, umieszczenie

tego pliku na kilku mirrorach sprawi, że transfer rozłoży się równomiernie na

wszystkie serwery i żaden z nich nie zostanie nadmiernie obciążony. Mirrory

mogą też być narzędziem w walce z cenzurą. Kiedy w 2002 roku chińskie

władze zablokowały dostęp do wyszukiwarki Google, powstał jej mirror o

nazwie elgooG. Mirrory są też czasami wykorzystywane aby podnieść

pozycje strony w wyszukiwarkach.

•

Kody korekcyjne i detekcyjne\

Kod korekcyjny lub kod korygujący (ang. Error Correction Code) - system

cyfrowego kodowania nadmiarowego używany w celach ochrony danych

przenoszonych z pomocą sygnałów cyfrowych, umożliwiający wykrycie, jak

również korekcję błędów.

•

Redundancja programowa usług

•

Przeżywalność systemu (survivability)

•

Tolerowanie uszkodzeń (fault tolerance)

•

Uszkodzenia bizantyjskie

•

Rekonfigurowalność systemu sieciowego

•

Systemy wysokiej dostępności (HA)

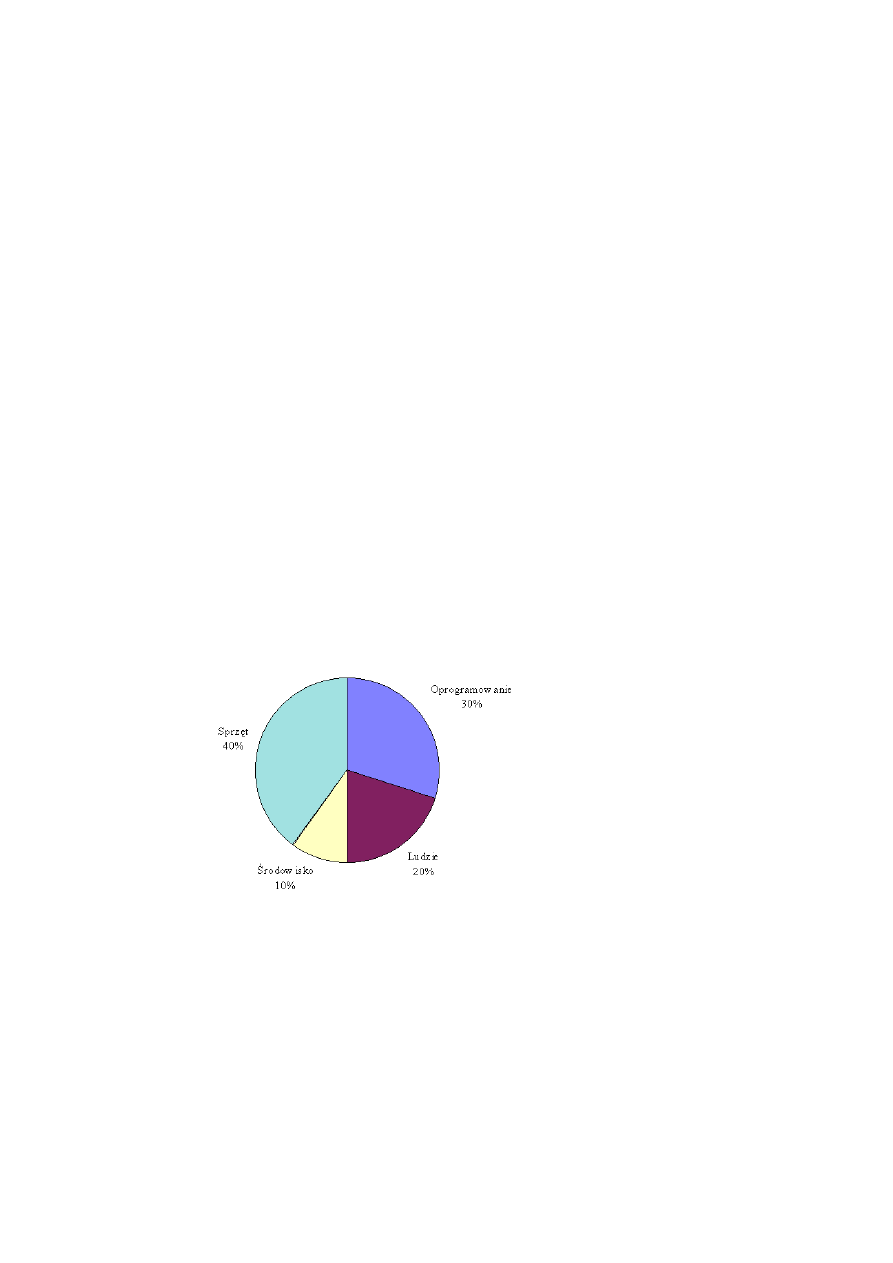

17. Przyczyny awarii systemów komputerowych

18. Sprzętowe i programowe metody poprawy niezawodności systemów

RAID

Detekcja/korekcja

Redundancja najbardziej zawodnych elementów sprzętowych: zasilacze, karty

sieciowe, interfejsy, dyski

Redundancja w sieciach, cała idea Internetu

UPS

Układy FTC

HARDWARE

Architektura systemów HA

…

Rezerwowe serwery usług (tryb pracy active/active, active/passive)

Replikacja/migracja

Mirroring zasobów, np www

SOFTWARE

Wielokrotne wpisy w dns: rezerwowe serwery lub load-balancing

Zabezpieczenia przed atakami

19. Systemy wysokiej dostępności

High availability is a system design protocol and associated implementation that

ensures a certain absolute degree of operational continuity during a given

measurement period.

Availability refers to the ability of the user community to access the system, whether

to submit new work, update or alter existing work, or collect the results of previous

work. If a user cannot access the system, it is said to be unavailable. Generally, the

term downtime is used to refer to periods when a system is unavailable.

Najprościej rzecz ujmując chodzi o to, że systemy wysokiej dostępności są

„serwerami” na których pracują ludzie lub instytucje (na przykład sieć w firmie gdzie

pracownicy mogą pracować zdalnie z domu). Systemy musza spełniać pewne normy

związane z brakiem dostępu do serwisu.

20.

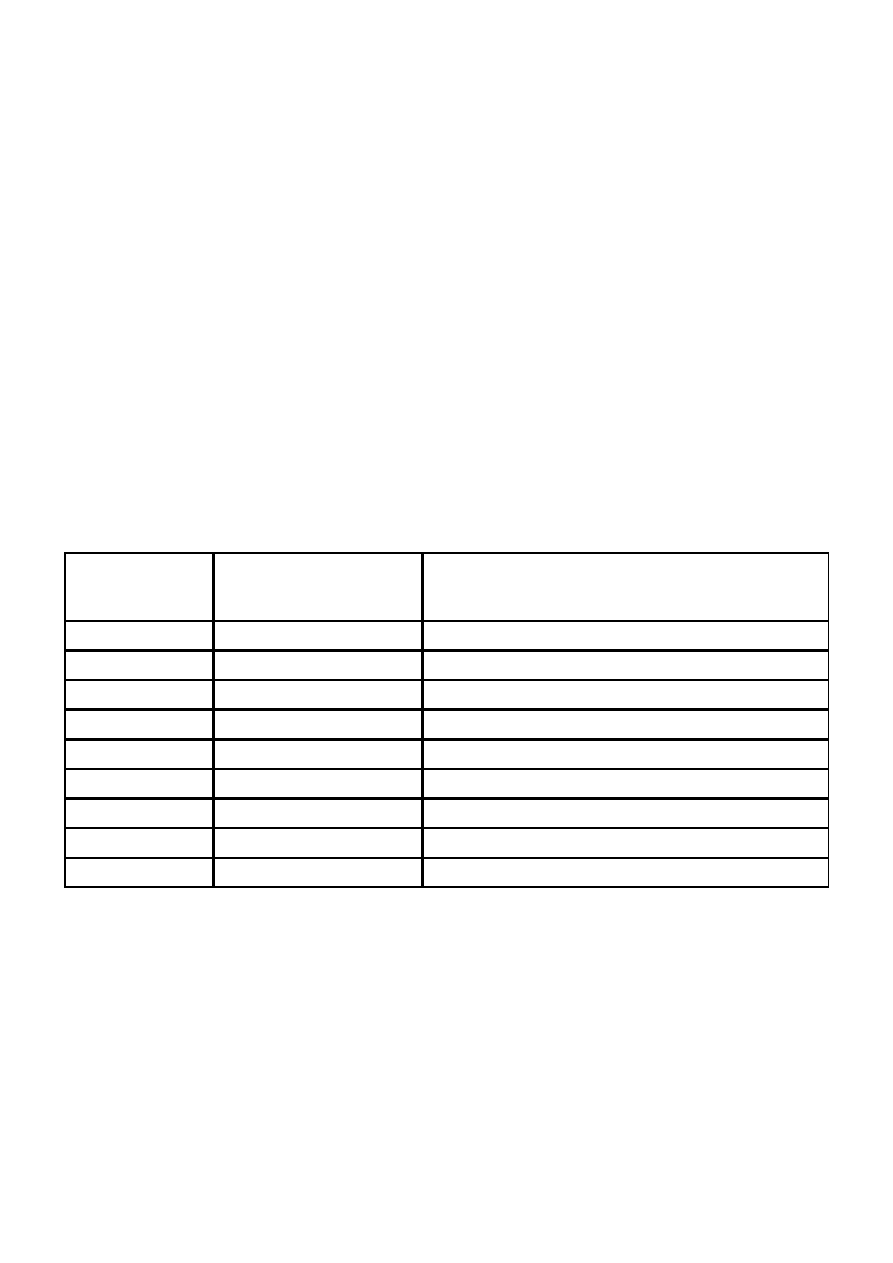

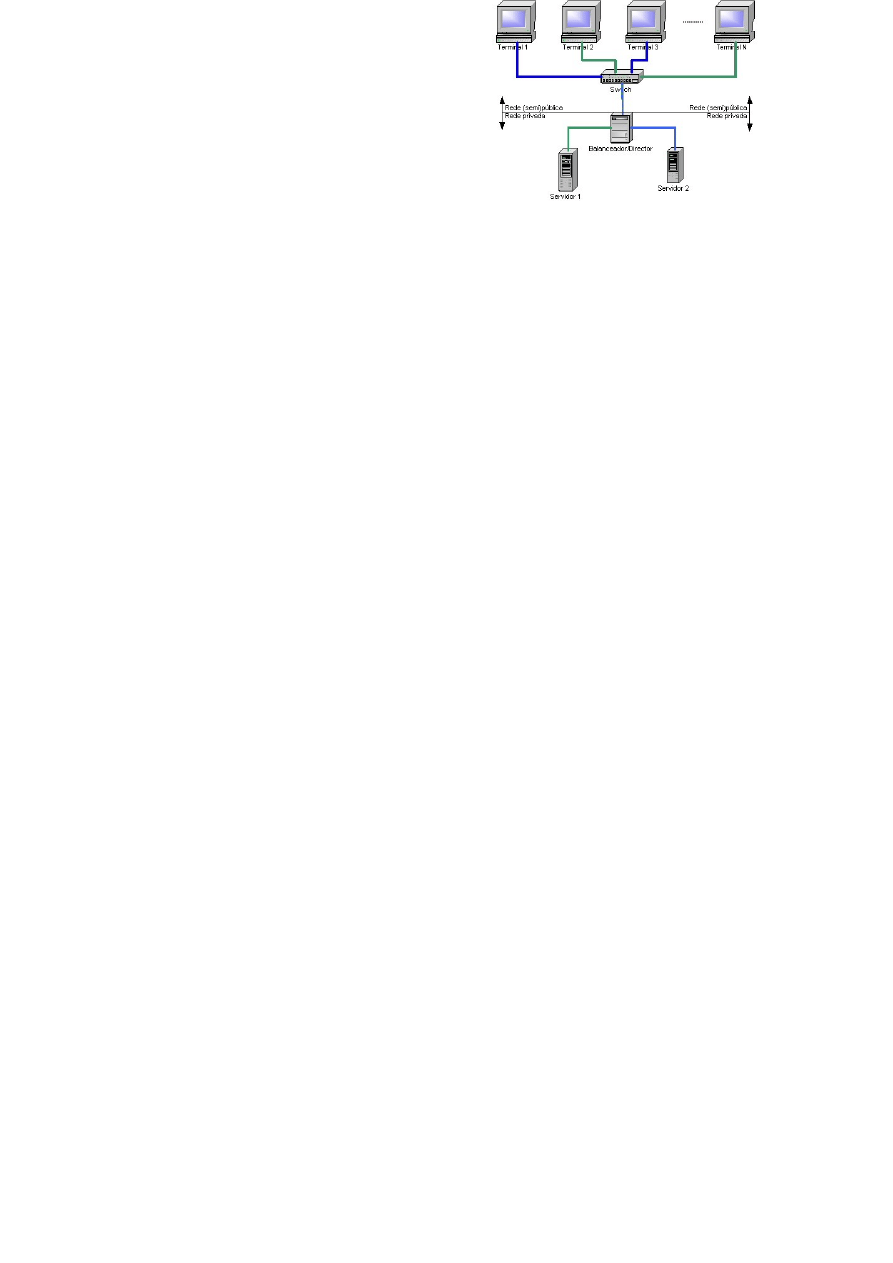

Równoważenie obciążeń (ang. load balancing) to technika rozpraszania

obciążenia pomiędzy wiele procesorów, komputerów, dysków, połączeń sieciowych

lub innych zasobów.Przykładowy system load balancing mógłby zapewniać

bezawaryjną i optymalną pracę na N-aplikacjach znajdujących się na bliźniaczych M-

serwerach (zawierających równoważne aplikacje). Podczas gdy wielu użytkowników

wysyła wiele żądań, trafiają one najpierw do SLB, który analizuje obciążenie na

poszczególnych M-serwerach. Następnie dokonuje optymalnego wyboru - odsyłając

użytkownika do jednego z serwerów do konkretnej aplikacji - według żądania.

Optymalny wybór zazwyczaj ma prowadzić do równomiernego obciążenia wszystkich

bliźniaczych serwerów. SLB zapewnia że awaria jednego z serwerów nie jest

odczuwalna przez użytkowników aplikacji.

Dostępność

Dopuszczalny przestój

w ciągu roku

Dopuszczalny przestój

w ciągu miesiąca

95%

18 dni 6:00:00

1 dni 12:00:00

96%

14 dni 14:24:00

1 dni 4:48:00

97%

10 dni 22:48:00

0 dni 21:36:00

98%

7 dni 7:12:00

0 dni 14:24:00

99%

3 dni 15:36:00

0 dni 7:12:00

99.9%

0 dni 8:45:35.99

0 dni 0:43:11.99

99.99%

0 dni 0:52:33.60

0 dni 0:04:19.20

99.999%

0 dni 0:05:15.36

0 dni 0:00:25.92

99.9999%

0 dni 0:00:31.53

0 dni 0:00:02.59

21. Migracja i replikacja

Mobilnosc uzytkowników powoduje ciagla

zmiane topologii sieci. Wymaga to od systemu ciaglego dostosowywania sie do

zmiennej sytuacji, do takiego zarzadzania zasobami, by zapewnic optymalny dostep

przez uzytkownika. Wiadomo jest bowiem, ze serwer lokalny bedzie mógl najlepiej

swiadczyc uslugi dla mobilnego klienta. Jest to zgodne z zasada, ze dostep do danych

polozonych blizej jest bardziej efektywny. Potrzeba zapewnienia efektywnego dostepu

powoduje ciagla replikacje danych. W polaczeniu z ruchem uzytkownika mobilnego

nastepuje niespotykane w systemie klasycznym zjawisko migracji danych. Dane po

prostu "wedruja„ za uzytkownikiem, a mówiac scislej sa replikowane miedzy

serwerami na trasie ruchu uzytkownika.

22. Arkusz kalkulacyjny: tworzenie formuł, użycie solvera,

23. Baza danych: pole danych, rekord, relacja, kwerenda, formularz, klucz

24. Kryptografia, szyfrowanie, kodowanie, klucz, klucz jednokrotny, krypto analiza

•

Kryptologia (z gr. κρυπτός – kryptos – "ukryty" i λόγος – logos – "słowo") – nauka o

przekazywaniu informacji w sposób zabezpieczony przed niepowołanym dostępem.

Kryptologię dzieli się na:

kryptografię (z gr. κρυπτός oraz γράφω gráfo "pisać"), czyli naukę o układaniu

systemów kryptograficznych, i

kryptoanalizę (gr. kryptós oraz analýein – rozluźnić), czyli naukę o ich łamaniu.

Współcześnie kryptologia jest uznawana za gałąź zarówno matematyki, jak i

informatyki; ponadto jest blisko związana z teorią informacji, inżynierią oraz

bezpieczeństwem komputerowym. Kryptologia ma szerokie zastosowanie w

społeczeństwach rozwiniętych technicznie; wykorzystuje się ją np. w rozwiązaniach

zapewniających bezpieczeństwo kart bankomatowych, haseł komputerowych i handlu

elektronicznego.

•

Szyfrowanie jest procedurą przekształcania wiadomości nie zaszyfrowanej w

zaszyfrowaną.Wiadomość przed zaszyfrowaniem nazywa się tekstem jawnym

(plaintext), a wiadomość zaszyfrowaną – szyfrogramem (ciphertext). Jako

ciekawostkę można podać, że Marian Rejewski używał w swoich pracach określeń

kler na tekst jawny i krypt na tekst tajny, zapewne w nawiązaniu do niem. klar

lub ang. clear (czysty) oraz ang. crypt (szyfrowany).

•

W kryptografii kodowanie jest metodą przeobrażenia jawnej formy wiadomości w

formę ukrytą w celu uniemożliwienia dostępu do przekazywanych informacji osobom

niepowołanym. Zwykle do tego celu używana jest książka kodowa zawierająca listę

powszechnych słów i/lub wyrażeń wraz z odpowiadającymi im słowami kodowymi.

Zakodowaną wiadomość określa się czasami mianem tekstu kodowego, podczas gdy

pierwotną wiadomość nazywa się zazwyczaj tekstem jawnym.

•

Terminem kodowanie określa się często wszelkie formy szyfrowania. Jednak w

technicznych zastosowaniach między określeniami kod i szyfr jest istotna różnica –

dotyczy ona stopnia zastosowanego przekształcenia tekstu; kody operują na poziomie

znaczeń słów i zwrotów, przekształcając te ostatnie w inną ich postać. Szyfrowanie

odbywa się na poziomie pojedynczych liter lub ich małych grup, w nowoczesnych

szyfrach, nawet na poziomie poszczególnych bitów.

•

Klucz – w kryptografii informacja umożliwiająca wykonywanie pewnej czynności

kryptograficznej – szyfrowania, deszyfrowania, podpisywania, weryfikacji podpisu

itp.

•

Szyfr z kluczem jednorazowym (one-time pad) został zaproponowany w 1917 roku

przez majora Josepha Mauborgne’a. Szyfr z kluczem jednorazowym jest dużym

zbiorem o niepowtarzalnych i przypadkowych sekwencjach znaków. W swojej

oryginalnej postaci była to jednorazowa taśma perforowana do dalekopisu. Nadawca

używa każdej litery z tego zbioru do zaszyfrowania jednego znaku tekstu jawnego.

Szyfrowanie to dodanie modulo 26 jednego znaku tekstu jawnego i znaku

jednorazowego klucza. Każdy klucz używany jest tylko raz, do zaszyfrowania tylko

jednej wiadomości. Klucz tworzony jest w sposób losowy, przeciwnik nie ma

informacji, która może ułatwić złamanie szyfru

•

Kryptoanaliza to dział kryptologii zajmujący się łamaniem systemów

kryptograficznych.Badane są możliwości naruszenia wszystkich zakładanych cech

bezpieczeństwa – ataki na protokoły, łamanie szyfrów, fałszowanie podpisów,

naruszanie integralności wiadomości itd.Kryptoanaliza jest bardzo szybko rozwijającą

się nauką i z zasady długość życia systemu kryptograficznego jest o wiele krótsza niż

oczekiwali tego jego autorzy.

25. Szyfrowanie z kluczem symetrycznym, z kluczem jawnym

•

Kryptografia symetryczna to taki rodzaj szyfrowania, w którym tekst jawny ulega

przekształceniu na tekst zaszyfrowany za pomocą pewnego klucza, a do

odszyfrowania jest niezbędna znajomość tego samego klucza.

Bezpieczeństwo takiego szyfrowania zależy od:

ilości możliwych kluczy, czyli długości klucza

odporności na ataki inne niż brute force

Wszystkie tradycyjne szyfry miały charakter symetryczny.

Szyfry symetryczne dzielą się na szyfry blokowe i szyfry strumieniowe.

Popularne szyfry symetryczne to m.in.:

AES

Blowfish

DES i jego odmiany 3DES, DESX

IDEA

3DES używa takich samych rozmiarów bloków oraz trybów jak zwykły DES. 3DES z

trzema różnymi kluczami (3TDES) ma siłę 168 bitów: trzykrotne szyfrowanie DES

kluczem 56-bitowym (wliczając bit parzystości siła 3DES wynosi 192 bity), jednak ze

względu na atak typu meet in the middle siła 3DES-a wynosi 2

112

.

AES (ang. Advanced Encryption Standard, nazywany również Rijndael) to

symetryczny szyfr blokowy przyjęty przez NIST w wyniku konkursu ogłoszonego w

roku 1997. Bezpośrednią przyczyną rozpisania konkursu była niewystarczająca siła

algorytmu DES. W roku 1997 organizacja EFF była w stanie złamać wiadomość

zakodowaną DES-em w ciągu 3 dni sprzętem o wartości 250 tysięcy dolarów; obecnie

można złamać DES-a jeszcze szybciej i taniej.

Do finału konkursu zakwalifikowało się pięć algorytmów szyfrujących (Rijndael,

RC6, Mars, Serpent oraz Twofish), ze szczególnym wskazaniem na algorytm Rijndael.

Możliwe jest w nim użycie kluczy o długościach 128, 192 i 256 bitów i operuje on na

blokach danych o długości 128 bitów (oryginalna specyfikacja Rijndael dopuszczała

również bloki 192- i 256-bitowe).

26. Podpis cyfrowy (podpis elektroniczny) to dodatkowa informacja dołączona do

wiadomości służąca do weryfikacji jej źródła.

Podpis elektroniczny służy zapewnieniu między innymi następujących funkcji:

•

autentyczności, czyli pewności co do autorstwa dokumentu,

•

niezaprzeczalności nadania informacji, nadawca wiadomości nie może

wyprzeć się wysłania wiadomości, gdyż podpis cyfrowy stanowi dowód jej wysłania

(istnieją także inne rodzaje niezaprzeczalności),

•

integralności, czyli pewności, że wiadomość nie została zmodyfikowana po

złożeniu podpisu przez autora.

Do zapewnienia wszystkich wymienionych funkcji potrzebne jest zastosowanie trzech

środków:

•

instrumentów technicznych - algorytmów, protokołów i formatów, które dzięki

zastosowaniu technik kryptograficznych zapewniają integralność oraz wiążą klucz

prywatny autora z dokumentem, zapewniając autentyczność i niezaprzeczalność

•

instrumentów prawnych, czyli dyrektyw, ustaw i rozporządzeń, które osadzają

wymienione instrumenty techniczne w obowiązującym prawie,

•

instrumentów organizacyjnych, takich jak centra certyfikacji, które występując

jako zaufana trzecia strona poświadczają związek klucza prywatnego z konkretną

osobą.

27. Zarządzanie kluczami

Certyfikaty

X.509 (standard)

Infrastruktura kluczy publicznych: łańcuch zaufania, ścieżka ceryfikacji,

kotwice zaufania, anulowanie ceryfikatów,

Sieć zaufania (web of trust) to zdecentralizowana metoda uwierzytelniania osób, w

której nie ma hierarchicznej struktury organizacji uwierzytelniających, a zaufanie do

poszczególnych certyfikatów jest sumą podpisów złożonych przez innych

uczestników sieci.

X.509 to standard opisujący sposób użycia asymetrycznych algorytmów

kryptograficznych w celu składania podpisu elektronicznego oraz jego weryfikacji.

Jego istota polega na istnieniu organizacji cieszącej się powszechnym zaufaniem,

której zadaniem jest potwierdzanie tożsamości właścicieli konkretnych par kluczy

poprzez podpisywanie za pomocą własnej pary kluczy certyfikatów subskrybentów

systemu.

Koncepcja certyfikatów, ich ważności oraz odwoływania została przedstawiona po raz

pierwszy w 1978 roku przez Lorena Kohnfeldra

. Pierwsza wersja standardu X.509

została opublikowana w 1988 roku.

Na certyfikat składają się pola zawierające dane właściciela, dane podmiotu

wystawiającego certyfikat, okres ważności, klucz publiczny, oraz certyfikaty

głównego i pośrednich urzędów certyfikacji - jest to tzw. ścieżka certyfikacji. Jest to

najpowszechniej obsługiwany przez klientów poczty elektronicznej oraz przeglądarki

internetowe system podpisu elektronicznego. W Polsce standard ten jest

wykorzystywany w systemie elektronicznych podpisów kwalifikowanych (prawnie

niezaprzeczalnych). Bezpieczny (kwalifikowany) podpis elektroniczny, na mocy

Ustawy o podpisie elektronicznym jest w świetle prawa równy podpisowi

odręcznemu.

28. Metody zapewnienia bezpieczeństwa komunikacji

IPsec: tryb transportowy, tryb tunelowy, analiza ruchu

IPsec to zbiór protokołów służących implementacji bezpiecznych połączeń oraz

wymiany kluczy kodowych pomiędzy komputerami. Protokoły tej grupy mogą być

wykorzystywane do tworzenia Wirtualnej Sieci Prywatnej (ang. VPN).

VPN oparta na IPsec składa się z dwóch kanałów komunikacyjnych pomiędzy

połączonymi komputerami: kanał wymiany kluczy za pośrednictwem którego

przekazywane są dane związane z uwierzytelnianiem oraz kodowaniem (klucze) oraz

kanału (jednego lub więcej), który niesie pakiety transmitowane poprzez sieć

prywatną. Kanał wymiany kluczy jest standardowym protokołem UDP (port 500).

Kanały przesyłu danych oparte są na protokole ESP (protokół numer 50) opisanym w

dokumencie RFC 2406.

Zapory sieciowe, filtr pakietów, brama aplikacyjna, atak DoS, DDoS

Zapora sieciowa (ang. firewall – "ściana ogniowa") – jeden ze sposobów

zabezpieczania sieci i systemów przed intruzami.

Termin ten może odnosić się zarówno do dedykowanego sprzętu komputerowego

wraz ze specjalnym oprogramowaniem, jak i do samego oprogramowania blokującego

niepowołany dostęp do komputera, na którego straży stoi. Pełni rolę połączenia

ochrony sprzętowej i programowej sieci wewnętrznej LAN przed dostępem z zewnątrz

tzn. sieci publicznych, Internetu, chroni też przed nieuprawnionym wypływem danych

z sieci lokalnej na zewnątrz.

DoS (ang. Denial of Service - odmowa usługi) - atak na system komputerowy lub

usługę sieciową w celu uniemożliwienia działania poprzez zajęcie wszystkich

wolnych zasobów.

Atak polega zwykle na przeciążeniu aplikacji serwującej określone dane czy

obsługującej danych klientów (np. wyczerpanie limitu wolnych gniazd dla serwerów

FTP czy WWW), zapełnienie całego systemu plików tak, by dogrywanie kolejnych

informacji nie było możliwe (w szczególności serwery FTP), czy po prostu

wykorzystanie błędu powodującego załamanie się pracy aplikacji.

DDoS (ang. Distributed Denial of Service) - atak na system komputerowy lub usługę

sieciową w celu uniemożliwienia działania poprzez zajęcie wszystkich wolnych

zasobów, przeprowadzany równocześnie z wielu komputerów (np. zombie).

Atak DDoS jest odmianą ataku DoS polegającą na jednoczesnym atakowaniu ofiary z

wielu miejsc. Służą do tego najczęściej komputery, nad którymi przejęto kontrolę przy

użyciu specjalnego oprogramowania (różnego rodzaju tzw. boty i trojany).

VPN (ang. Virtual Private Network, Wirtualna Sieć Prywatna), można opisać jako

"tunel", przez który płynie ruch w ramach sieci prywatnej pomiędzy klientami

końcowymi za pośrednictwem publicznej sieci (takiej, jak Internet) w taki sposób, że

węzły tej sieci są przezroczyste dla przesyłanych w ten sposób pakietów. Taki kanał

może opcjonalnie kompresować lub szyfrować w celu zapewnienia lepszej jakości lub

większego poziomu bezpieczeństwa przesyłanych danych.

Określenie "Wirtualna" oznacza, że sieć ta istnieje jedynie jako struktura logiczna

działająca w rzeczywistości w ramach sieci publicznej, w odróżnieniu od sieci

prywatnej, która powstaje na bazie specjalnie dzierżawionych w tym celu łącz.

WEP (ang. Wired Equivalent Privacy) to standard szyfrowania stosowany w sieciach

bezprzewodowych standardu IEEE 802.11.

Standard specyfikuje klucze 40- i 104-bitowe, do których w procesie wysyłania

ramki dołączany jest wektor inicjujący (IV) o długości 24 bitów. Stąd popularnie

mówi się o 64- i 128-bitowych kluczach WEP, ale nie jest to stwierdzenie poprawne

technicznie. W rozszerzeniach firmowych tego standardu znaleźć można również

klucze o długości 232 bitów (z IV daje to 256 bitów), które jednak z uwagi na znane

słabości w doborze IV nie zwiększają w istotny sposób siły kryptograficznej całości

rozwiązania.

Wyszukiwarka

Podobne podstrony:

kolowkium opiola id 242363 Nieznany

Abolicja podatkowa id 50334 Nieznany (2)

4 LIDER MENEDZER id 37733 Nieznany (2)

katechezy MB id 233498 Nieznany

metro sciaga id 296943 Nieznany

perf id 354744 Nieznany

interbase id 92028 Nieznany

Mbaku id 289860 Nieznany

Probiotyki antybiotyki id 66316 Nieznany

miedziowanie cz 2 id 113259 Nieznany

LTC1729 id 273494 Nieznany

D11B7AOver0400 id 130434 Nieznany

analiza ryzyka bio id 61320 Nieznany

pedagogika ogolna id 353595 Nieznany

Misc3 id 302777 Nieznany

cw med 5 id 122239 Nieznany

więcej podobnych podstron