Seria artykułów: ABC Fotografii cyfrowej

cz. 1

ABC fotografii cyfrowej cz. 1 - balans bieli Dzisiaj rozpoczynamy nowy cykl poradnikowy na

stronach Fotopolis.pl. Seria artykułów ABC Fotografii cyfrowej przeznaczona będzie dla

początkujących użytkowników aparatów cyfrowych, którzy chcą poznać i efektywnie

użytkować ich najważniejsze funkcje. W pierwszej części cyklu wyjaśnimy czym jest i jak

działa funkcja balansu bieli w aparatach cyfrowych.

Balans bieli, to jedno z najtrudniejszych pojęć w fotografii cyfrowej. Człowiek, a raczej oko

ludzkie, widzi dowolny kolor, np. żółty jako żółty, niezależnie od tego czy ogląda go w świetle

słabej żarówki czy w słoneczny dzień. Aparat fotograficzny nie ma takiej zdolności adaptacji do

rodzaju oświetlenia i rejestruje kolory zależnie od natężenia i koloru światła padającego na

fotografowane obiekty. Konstruktorom aparatów zależy na tym, by odtwarzane kolory były jak

najbardziej zbliżone do tego, co widzi człowiek - by wyglądały na zdjęciu naturalnie. I tu wkracza

funkcja

Balans bieli

(zwany także równoważeniem bieli).

Aparat fotograficzny, a raczej jego oprogramowanie, musi zostać "poinformowane" o tym, jaki jest

kolor i jasność światła padającego na fotografowaną scenę. Od tego bowiem zależą kolory i

jasności uzyskane na zdjęciu. Tymczasem aparat fotograficzny cyfrowy (analogowy także) mierzy i

analizuje jedynie światło odbite od fotografowanych przedmiotów, które wpada do niego przez

obiektyw. Analiza tego światła wpadającego do aparatu musi dać informacje o tym jakie jest

natężenie światła padającego na obiekty fotografowane.

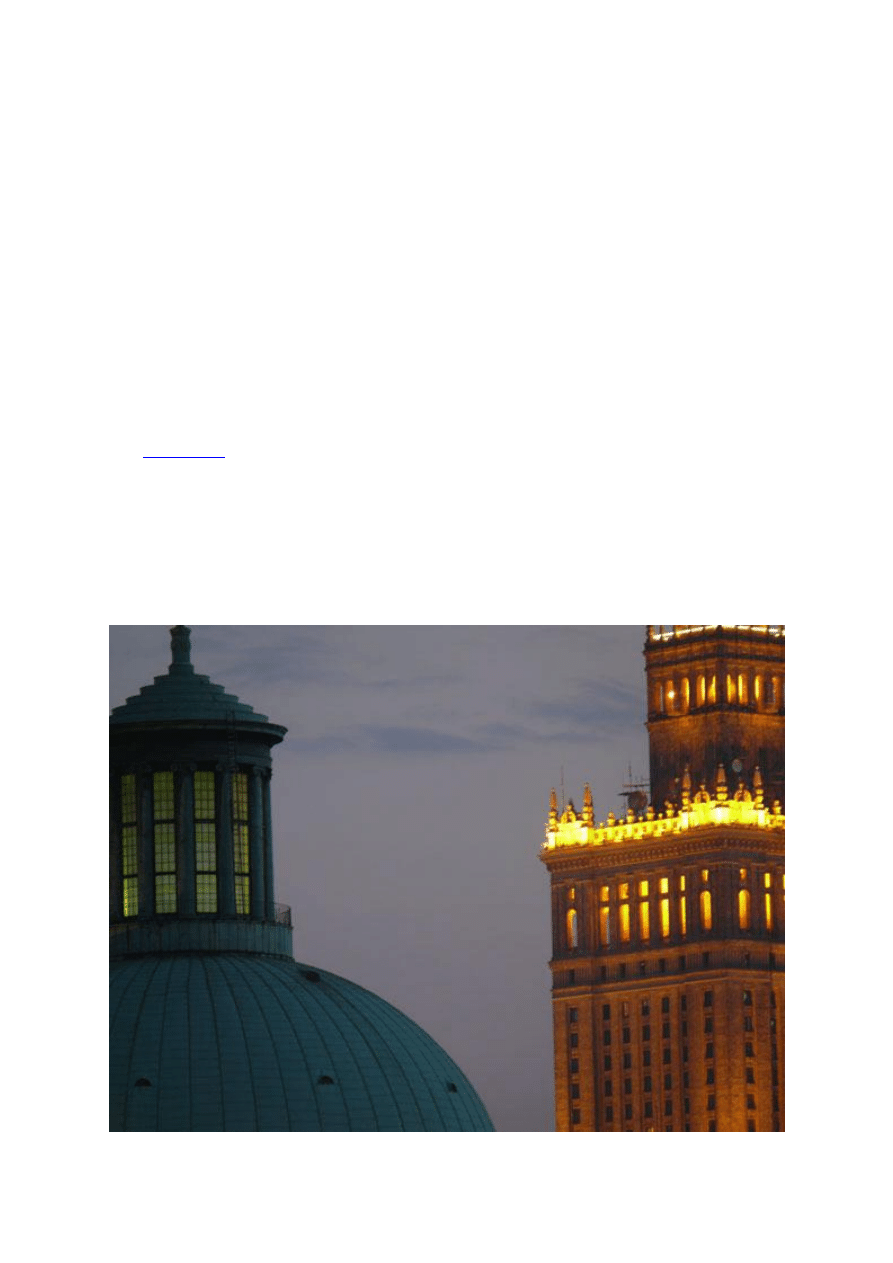

różne źródła światła dają na zdjęciu różne kolory

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

1

a

u

d

i o

k

s

i

a

z

k i

.o

rg

Każdy aparat cyfrowy, od najprostszego po najbardziej zaawansowany ma opcję AWB, co jest

skrótem od Auto White Balans, czyli automatyczne ustawianie balansu bieli. Ustawienie balansu

bieli na AWB (auto) pozwala na robienie zdjęć w szybko zmieniających się warunkach oświetlenia.

Dla początkującego fotoamatora to powinno wystarczyć, ale jeżeli chcemy robić zdjęcia lepsze niż

przeciętne, to trzeba dobrze postudiować zagadnienie balansu bieli.

Automatyczny balans bieli

Włączamy aparat, kierujemy go w stronę obiektów, które chcemy fotografować i naciskamy spust

migawki. Każdy użytkownik aparatów cyfrowych wie, że moment wykonania zdjęcia jest

opóźniony w stosunku do momentu naciśnięcia spustu migawki. Coraz nowsze i lepsze aparaty

mają to opóźnienie coraz mniejsze. Dlatego, że posiadają coraz szybciej działające procesory

obliczające i ustawiające parametry dla wykonania zdjęcia. Jednak opóźnienie występuje i jest nie

do uniknięcia. To opóźnienie to czas potrzebny procesorowi na ustawienie, między innymi,

właściwego balansu bieli, czyli na określenie rodzaju i jasności światła oświetlającego scenę

widzianą przez aparat.

Procedura tego ustawiania balansu bieli w typowych aparatach kompaktowych jest następująca. Na

matrycy rejestrowany jest obraz, który ma być za chwilę zapisany jako zdjęcie. Odpowiedni

program (analogiczny do komputerowego) zapisany w pamięci procesora aparatu analizuje ten

obraz. Wyszukuje najjaśniejszy obszar i uznaje, że jest to odwzorowanie obiektu białego. Na tej

podstawie program wylicza kolor i intensywność światła padającego na fotografowaną scenę. Ta

informacja zostanie potem wykorzystana do odtworzenia kolorów wszystkich obiektów, które

zostaną zarejestrowane na matrycy aparatu. Niestety, w niektórych sytuacjach, ustawienie

automatycznego balansu bieli może zawieść. Dlatego producenci przewidzieli możliwość ręcznego

ustawienia balansu bieli przez fotografa.

W lustrzankach cyfrowych ustawianie automatycznego balansu bieli odbywa się na podobnej

zasadzie, jednak znacznie szybciej niż w aparatach kompaktowych - cały proces praktycznie nie

opóźnia wykonania zdjęcia. Dzieje się tak dlatego, że konstrukcja aparatu lustrzankowego pozwala

na pomiar balansu bieli za pomocą dodatkowego układu światłoczułego, innego niż zasadnicza

matryca aparatu służąca do rejestracji zdjęć.

Ustawienia własne balansu bieli

Każdy, nawet najprostszy, aparat cyfrowy daje użytkownikowi możliwość "informowania" aparatu

o kolorze i jasności światła padającego na fotografowane obiekty. W tanich kompaktach mamy do

wyboru kilka podstawowych rodzajów oświetlenia. Zależnie od producenta aparatu mogą się one

różnie nazywać ale zazwyczaj są to:

•

światło słoneczne,

•

dzień pochmurny,

•

żarówka,

•

lampa jarzeniowa,

•

lampa błyskowa.

Ustawienie w aparacie którejś z tych opcji oznacza wprowadzenie do oprogramowania aparatu

informacji, jaki rodzaj światła pada na fotografowaną scenę. Informacja ta jest wykorzystana przez

procesor aparatu w trakcie przetwarzania obrazu zarejestrowanego na matrycy w kolorowy obraz

przeznaczony do oglądania na monitorze i do zapisania na karcie pamięci.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

2

a

u

d

i o

k

s

i

a

z

k i

.o

rg

przycisk WB (white balance) na korpusie cyfrowej lustrzanki Nikon D200 umożliwia szybki wybór

trybu balansu bieli, jednak większość aparatów kompaktowych wymaga skorzystania w tym celu z

menu

Najważniejszym elementem tego przetwarzania jest odtwarzanie kolorów, zwane

demozaikowaniem. Dla realizacji tego etapu konieczna jest informacja o rodzaju oświetlenia w

którym wykonano zdjęcie. Złe ustawienie opcji Balans bieli/White Balance może dać w efekcie

zdjęcie o całkowicie nienaturalnych kolorach - innych niż rejestrowana scena miała w

rzeczywistości widziana ludzkim okiem.

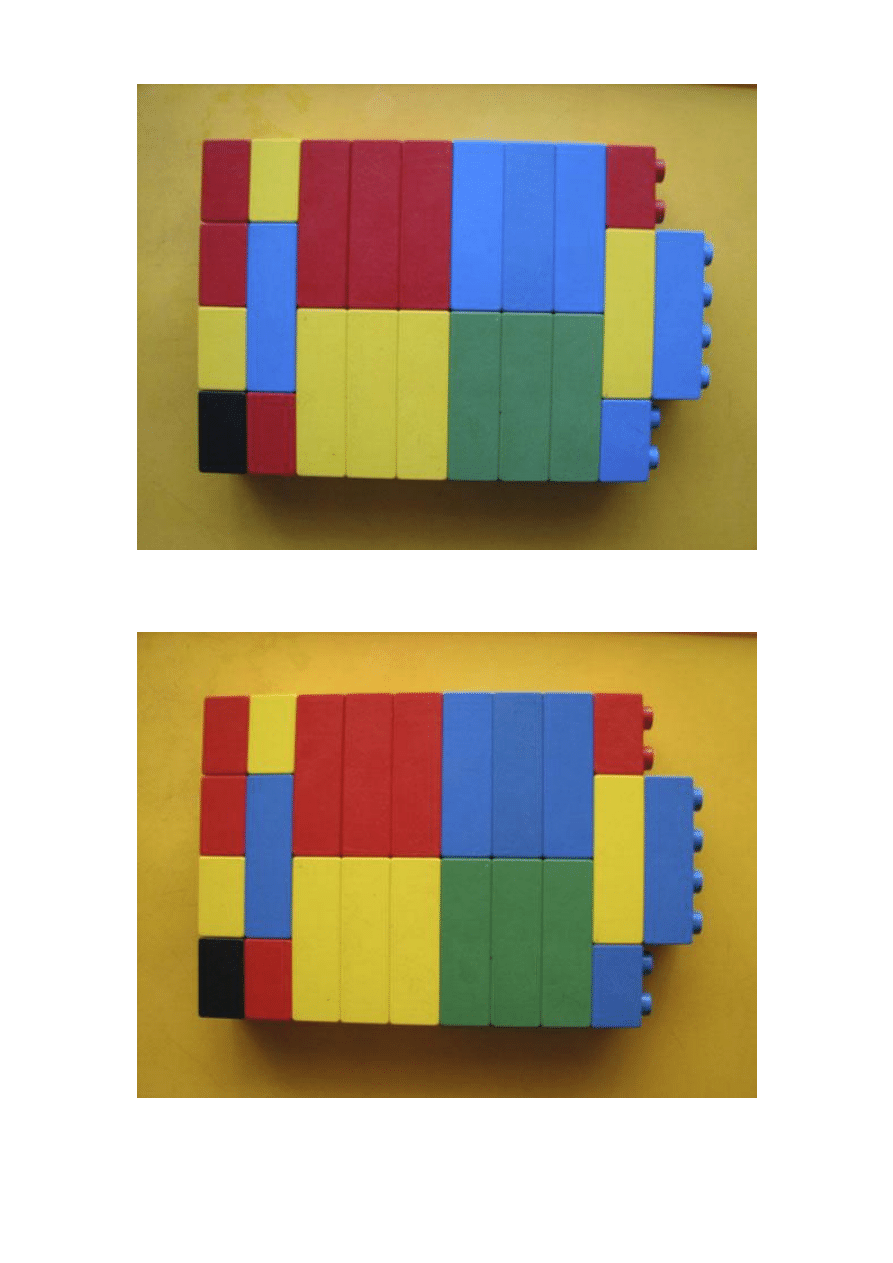

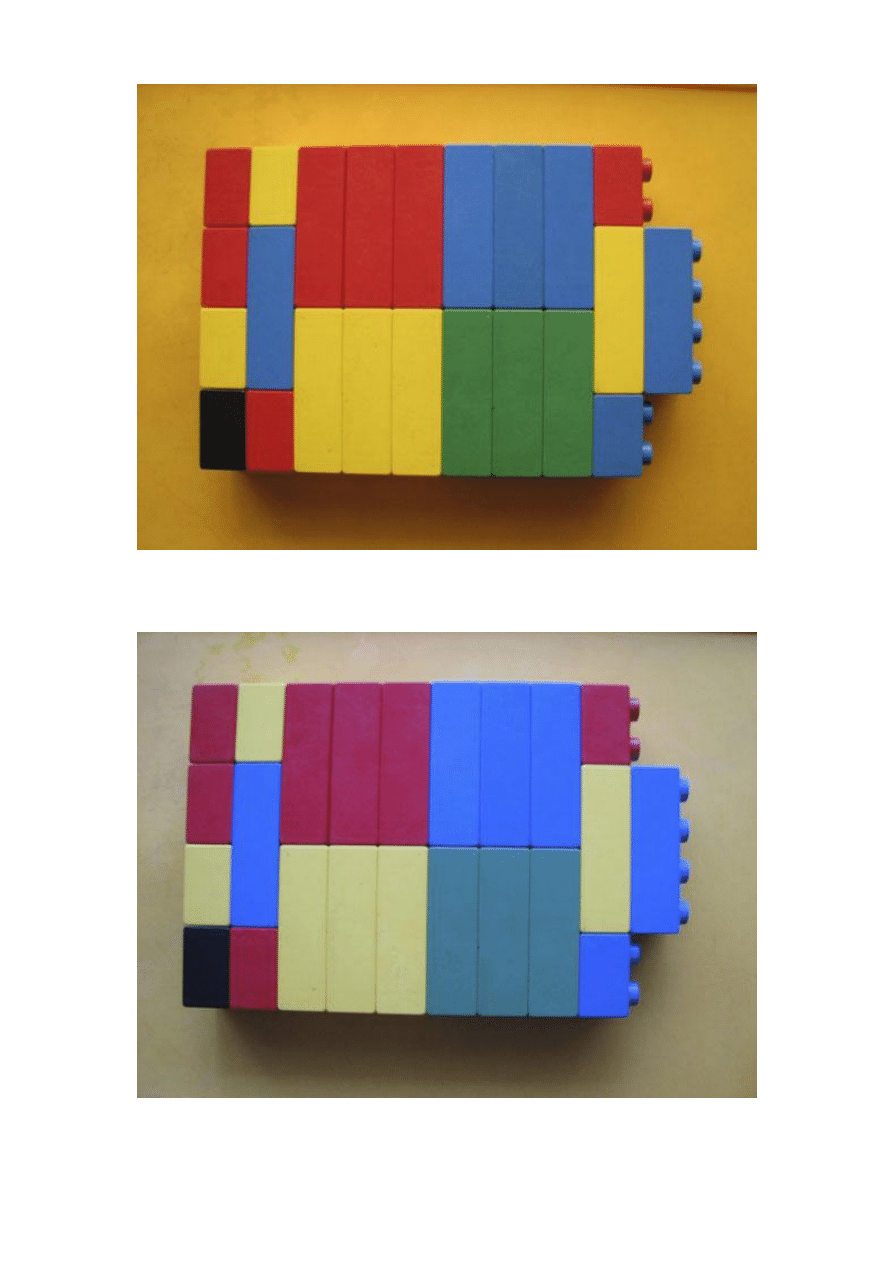

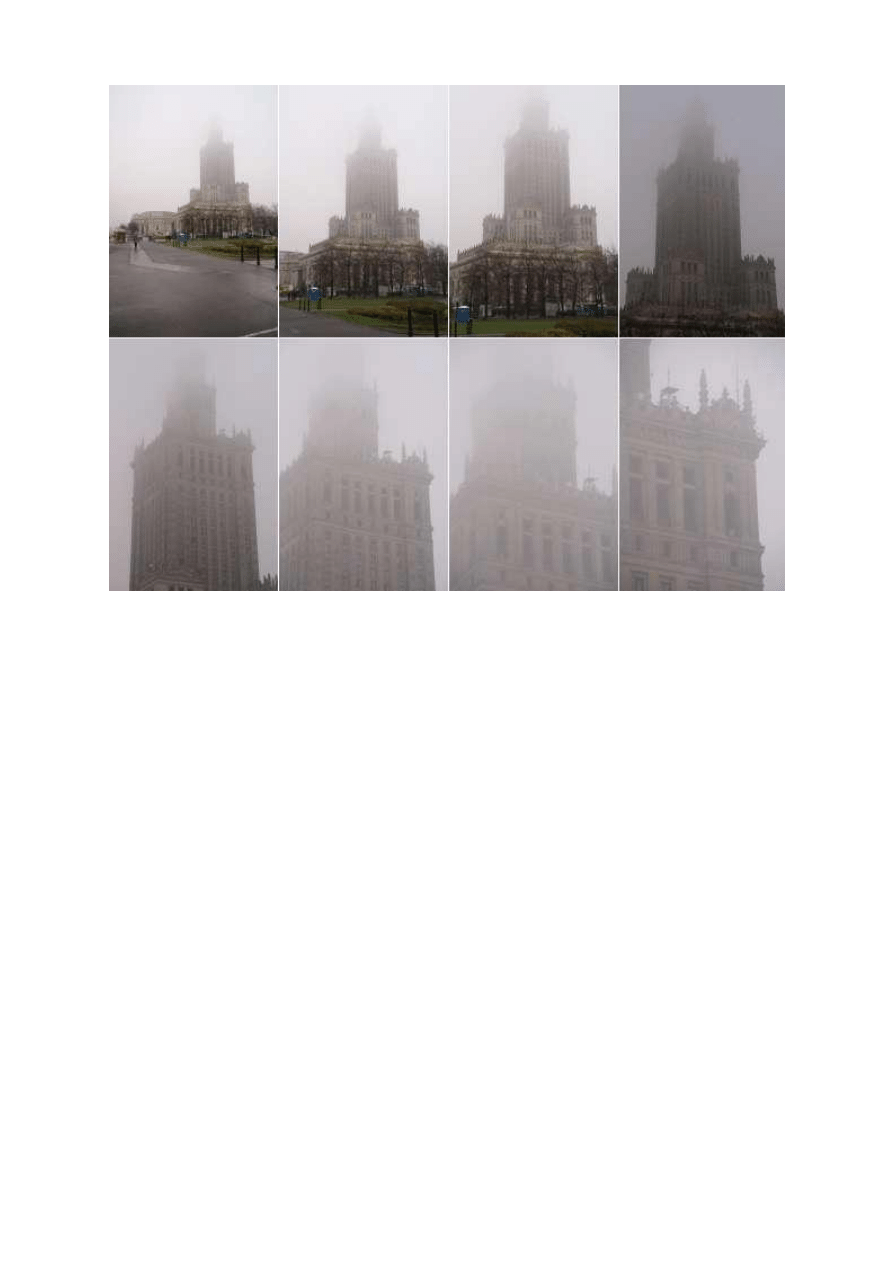

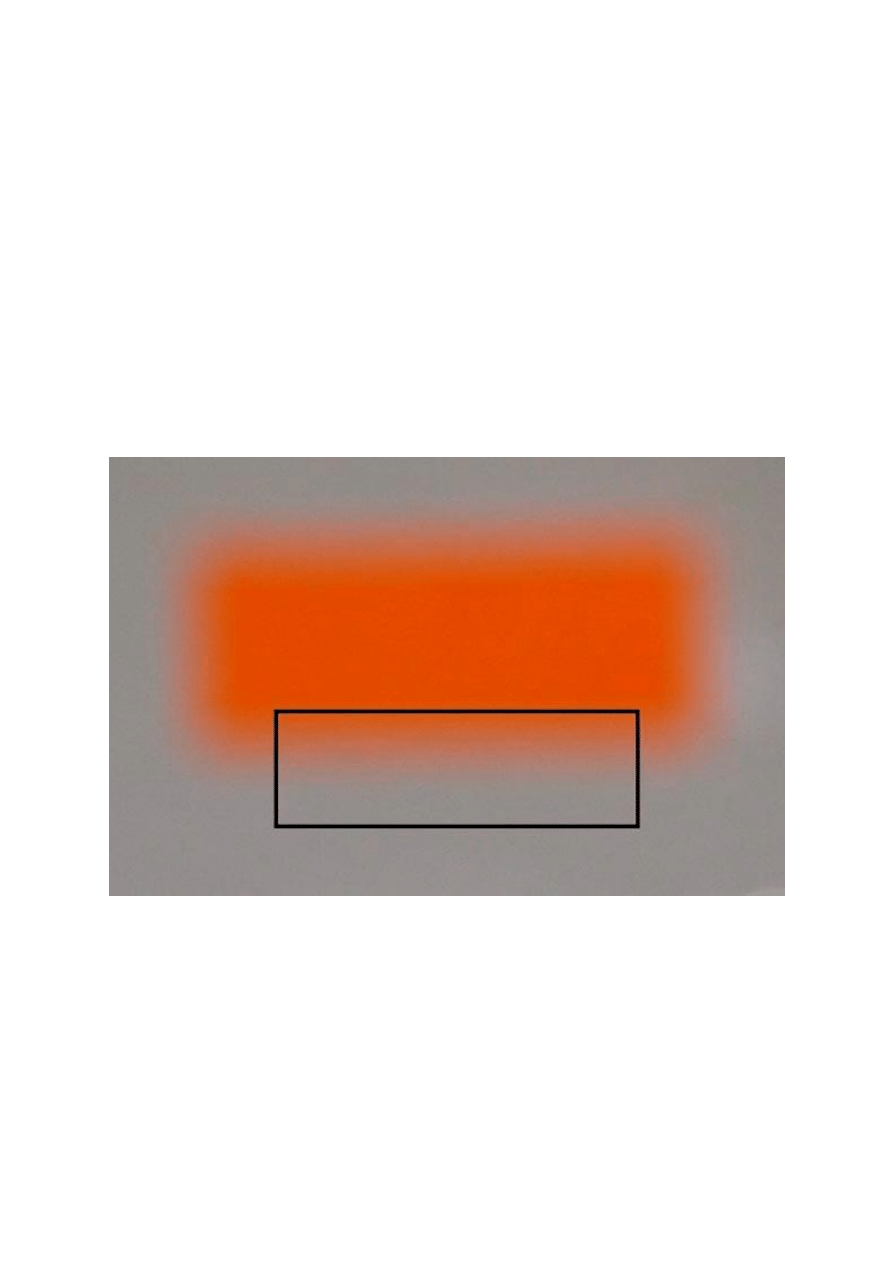

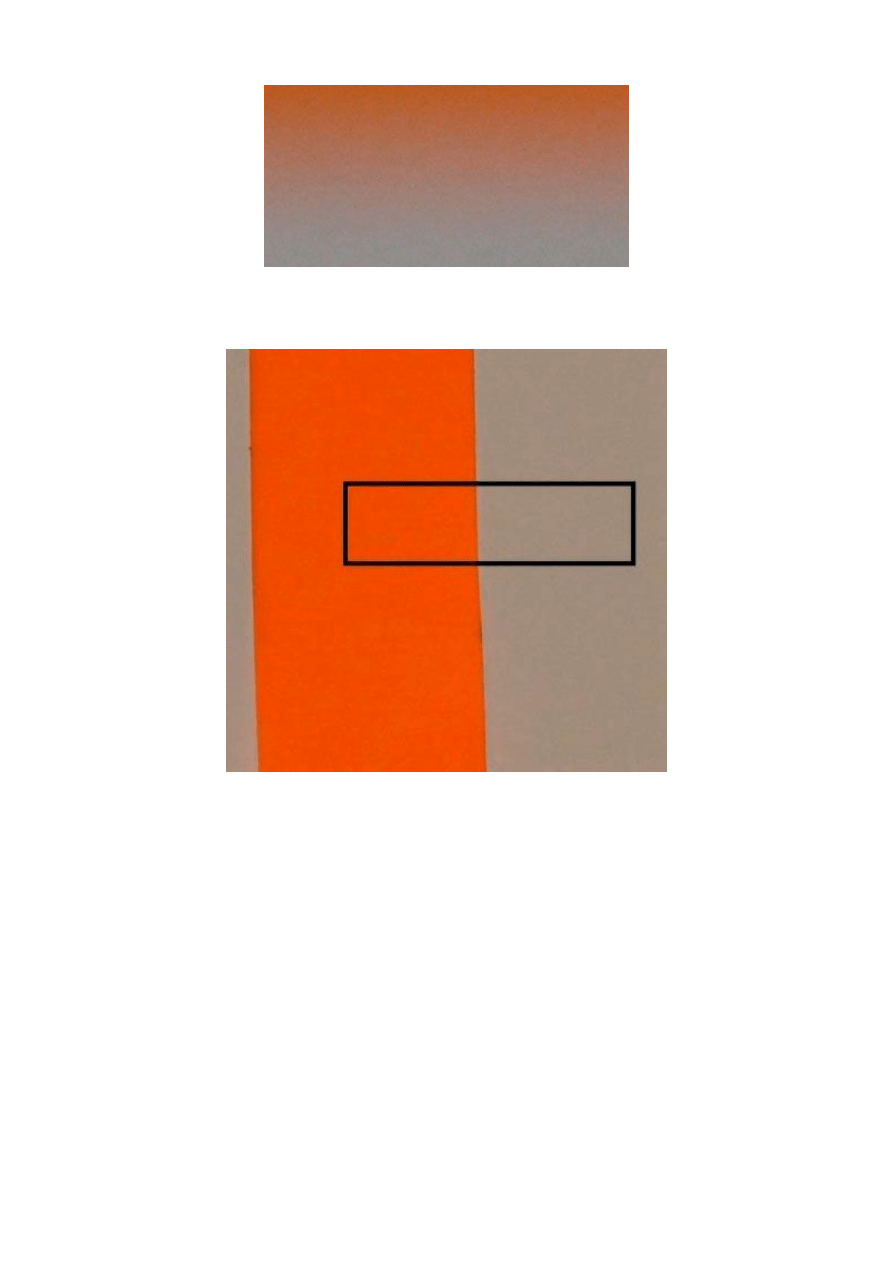

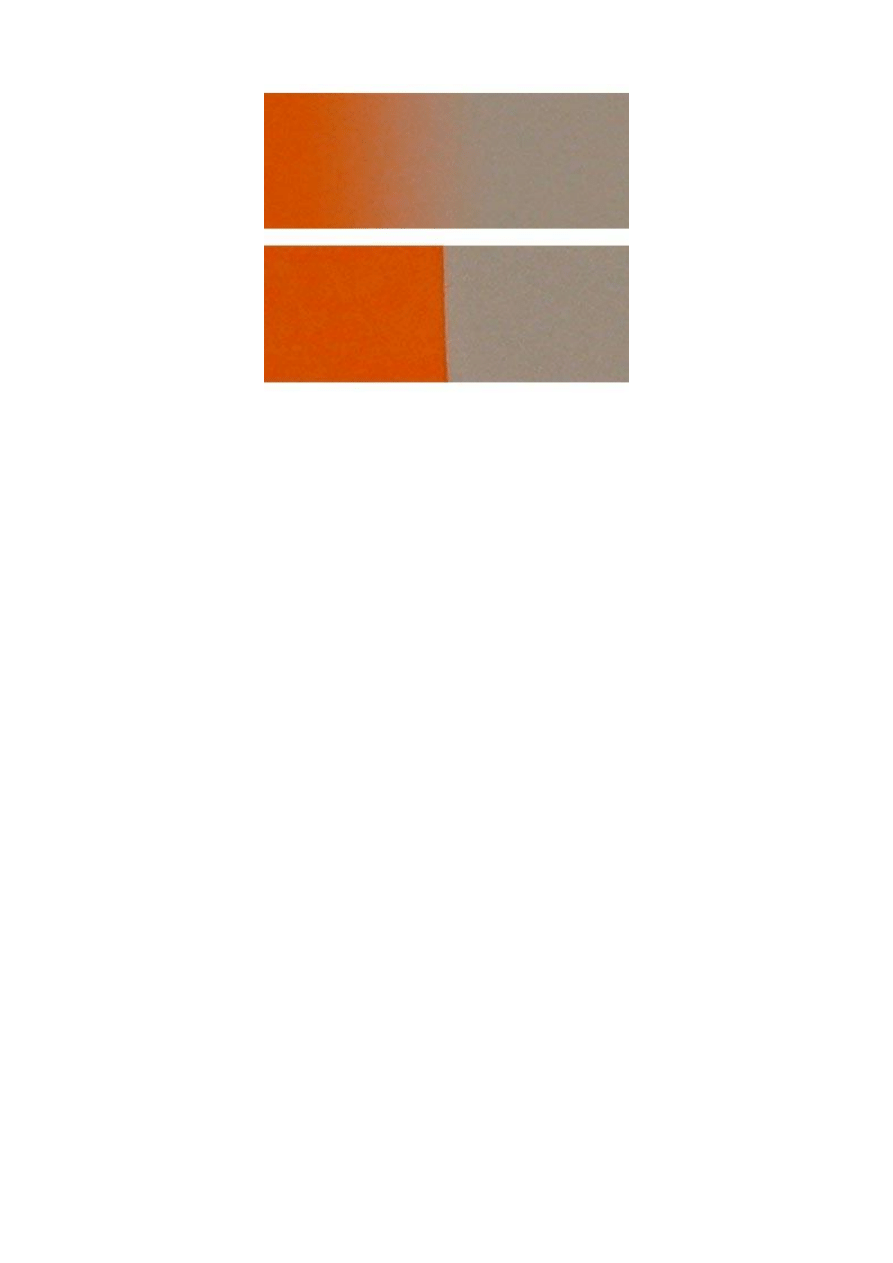

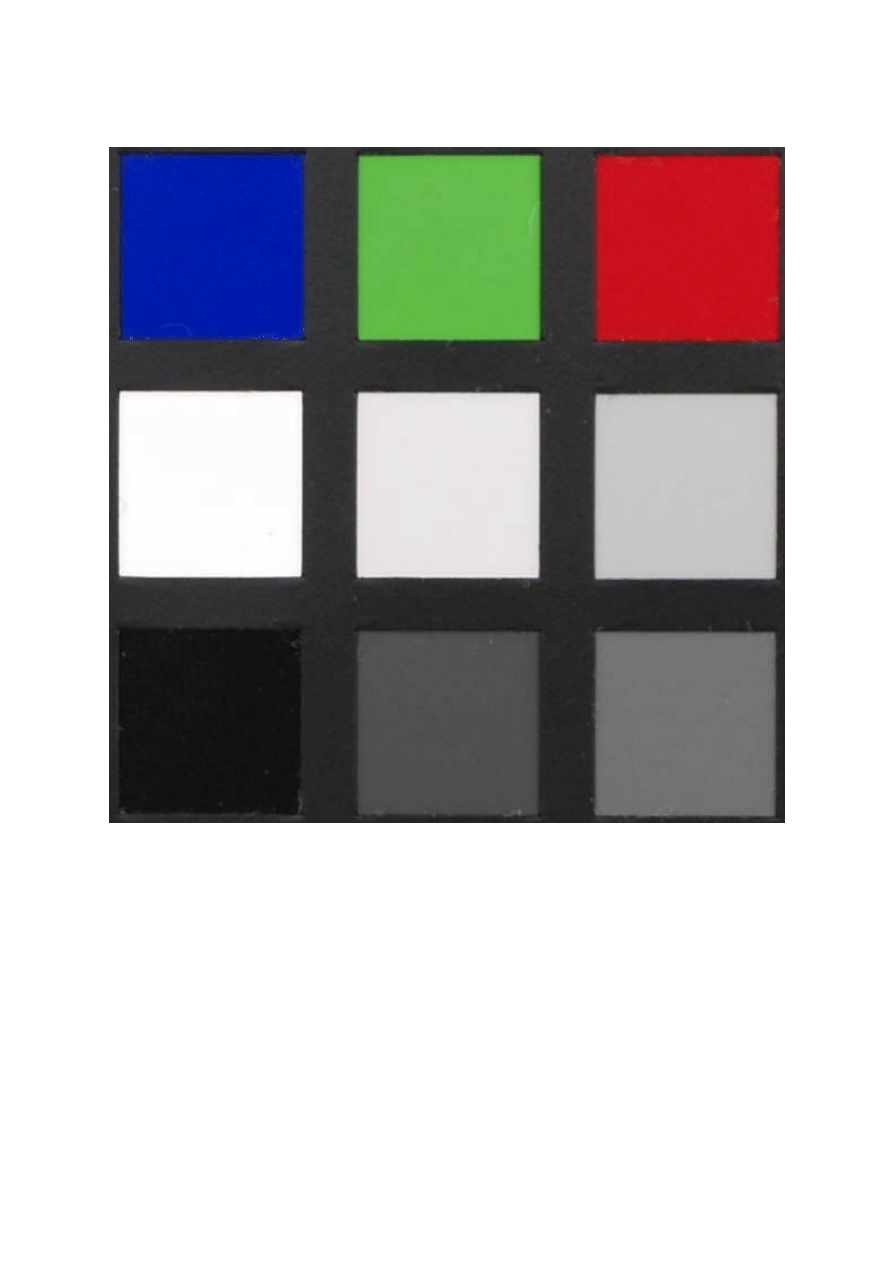

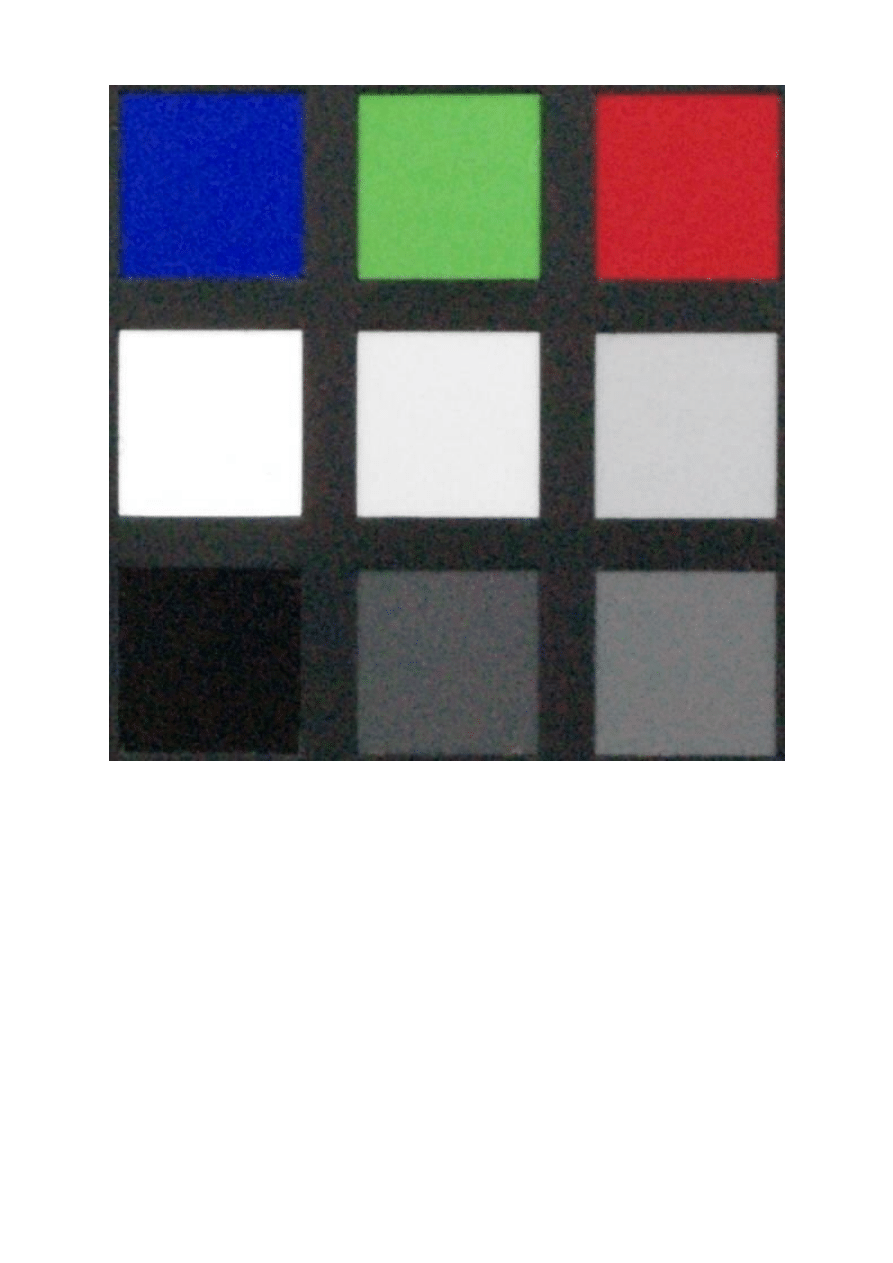

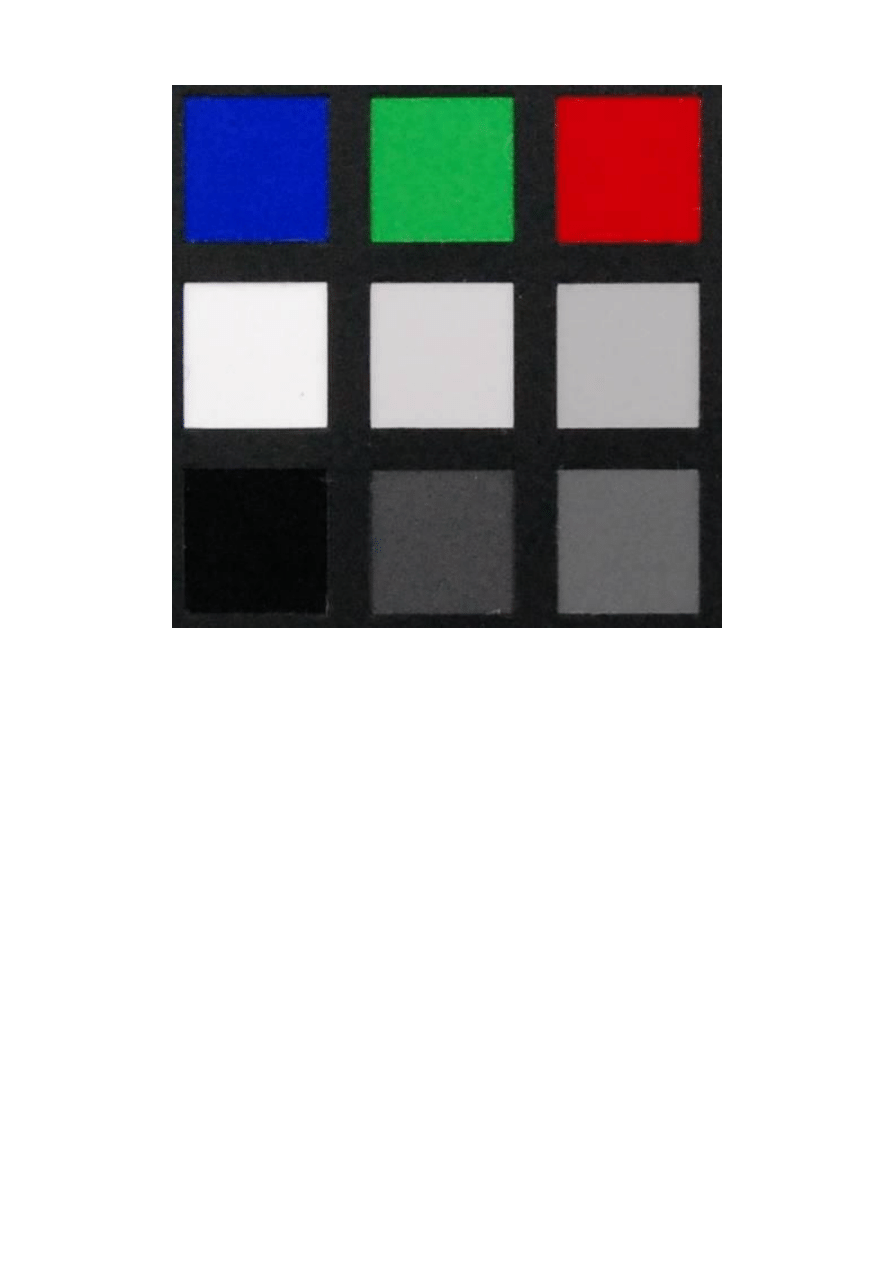

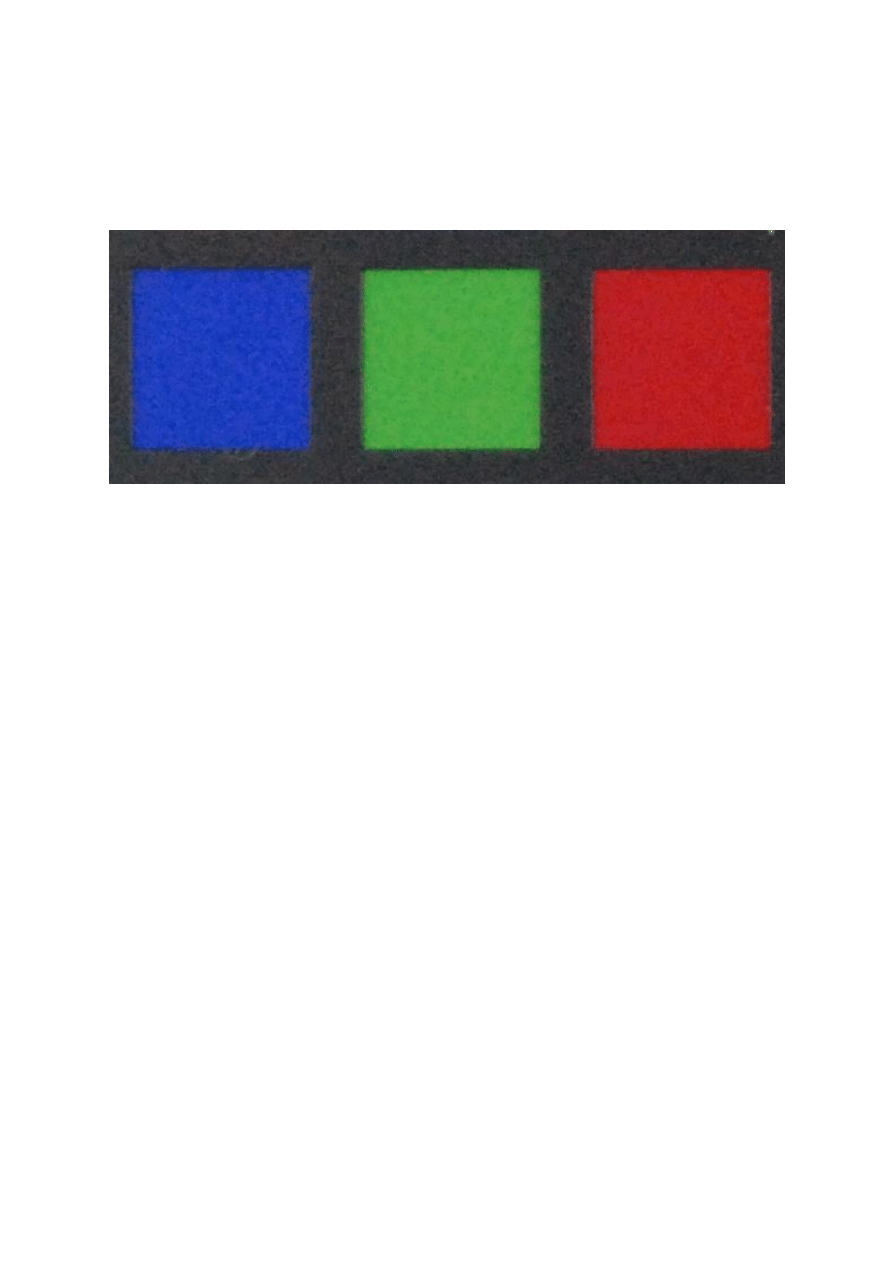

Dla ilustracji wpływu ustawienia balansu bieli na odtwarzane kolory prezentujemy 4 zdjęcia

klocków DUPLO. Wszystkie zrobione w lekko pochmurny, listopadowy dzień, około godziny 15.

Pod każdym z nich podane jest zastosowane ustawienie balansu bieli. Na zdjęciu nie ma żadnego

obszaru białego lub szarego, stąd ustawienie auto nie zdołało zapewnić poprawnego odwzorowania

kolorów. Najpoprawniej, wg oceny autora, kolory zostały odwzorowane przy ustawieniu dzień

pochmurny, czyli zgodnie z faktycznym oświetleniem.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

3

a

u

d

i o

k

s

i

a

z

k i

.o

rg

auto

światło słoneczne

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

4

a

u

d

i o

k

s

i

a

z

k i

.o

rg

dzień pochmurny

żarówka

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

5

a

u

d

i o

k

s

i

a

z

k i

.o

rg

Nieco bardziej zaawansowane ustawianie balansu bieli to ustawianie według wzorca.

Balans bieli według wzorca

Kompaktowe aparaty cyfrowe średniej klasy mają opcję ustawiania balansu bieli zwaną według

wzorca. W warunkach, w których ma zostać wykonane zdjęcie, podstawiamy przed obiektyw

przedmiot, którego kolor uznajemy za biały (lub neutralnie szary) i naciskamy odpowiedni przycisk

aparatu (albo przechodzimy procedurę opisaną w instrukcji obsługi aparatu.) Kolor podstawionego

przedmiotu zostanie zarejestrowany przez aparat jako biały (lub neutralny) a wszystkie inne kolory

pojawiające się przed obiektywem w trakcie fotografowania będą oceniane w stosunku do tego

uznanego, z woli fotografa, wzorca. Ta opcja balansu bieli pozwala także na uzyskiwanie różnych

efektów kolorystycznych. Możemy bowiem jako wzorzec koloru białego podsunąć kartkę

dowolnego koloru, co może dać na zdjęciu kolory zupełnie różne od rzeczywistych kolorów

fotografowanych przedmiotów. W ten sposób można uzyskiwać ciekawe efekty kolorystyczne na

zdjęciach.

Fotograficzny aparat cyfrowy ma tę zaletę, że robienie nim dziesiątek, czy setek zdjęć

doświadczalnych nic nas nie kosztuje, poza czasem i ewentualnym miejscem na dysku komputera.

Możemy więc do woli eksperymentować z wszystkimi jego parametrami.

Różnorodność oświetlenia, z jakim możemy spotkać się na co dzień, jest jednak tak duża, że

opisane dotychczas metody "cechowania" kolorów mogą nie wystarczyć zaawansowanemu

fotografowi. Dlatego cyfrowe aparaty fotograficzne wysokiej klasy mają opcję ustawiania

temperatury źródła światła, które oświetla fotografowaną scenę.

Temperatura źródła światła

Każdy może wykonać w domu bardzo proste ale pouczające doświadczenie ilustrujące pojęcie

temperatury źródła światła. Wieczorem, przy zgaszonym świetle, nad palnikiem gazowym

przytrzymujemy odpowiednio długi (aby się nie oparzyć) i dość gruby drut żelazny. Co jakiś czas

wyjmujemy go znad płomienia i oceniamy jego kolor.

Początkowo jest ciemno czerwony, po trochę dłuższym ogrzewaniu jest już jasno czerwony, a

jeżeli potrzymamy jeszcze dłużej zaczyna świecić białym kolorem. Wiemy, że im dłużej grzejemy,

tym wyższą temperaturę ma nasz drut. Oczywiście do pewnej granicy, czyli do temperatury

płomienia, w którym go ogrzewamy.

Wniosek z tego doświadczenia jest prosty. Temperatura źródła światła określa kolor emitowanego

światła. Temperaturę w tym przypadku mierzymy w skali Kelvina. Skala Kelvina to skala

temperatur, w której zero na skali Celsjusza (zamarzanie wody) odpowiada 273,15 K. Jednostką

jest kelvin (nie mówimy stopień Kelvina, tylko kelvin) i jest on równy stopniowi Celsjusza. Mamy

więc jedynie przesunięcie wszystkich wartości o te 273,15 jednostek, co nie ma specjalnego

znaczenia dla naszych rozważań.

Pomijając teoretyczne uzasadnienia, nieistotne dla fotografa, poszczególnym źródłom światła

występującym w przyrodzie przypisane są następujące temperatury.

Źródło oświetlenia

Temperatura

Świeca

1000 K do 1500 K

Światło o wschodzie/zachodzie słońca

2000 K do 3000 K

Żarówka (100 W do 200 W)

2500 K do 2900 K

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

6

a

u

d

i o

k

s

i

a

z

k i

.o

rg

Światło w słoneczny dzień

5000 K do 6000 K

Światło słoneczne w bezchmurny dzień

6000 K do 7500 K

Światło słoneczne w bezchmurny dzień, w górach 10000 K do 12000 K

Błyskawica

15000 K do 22000 K

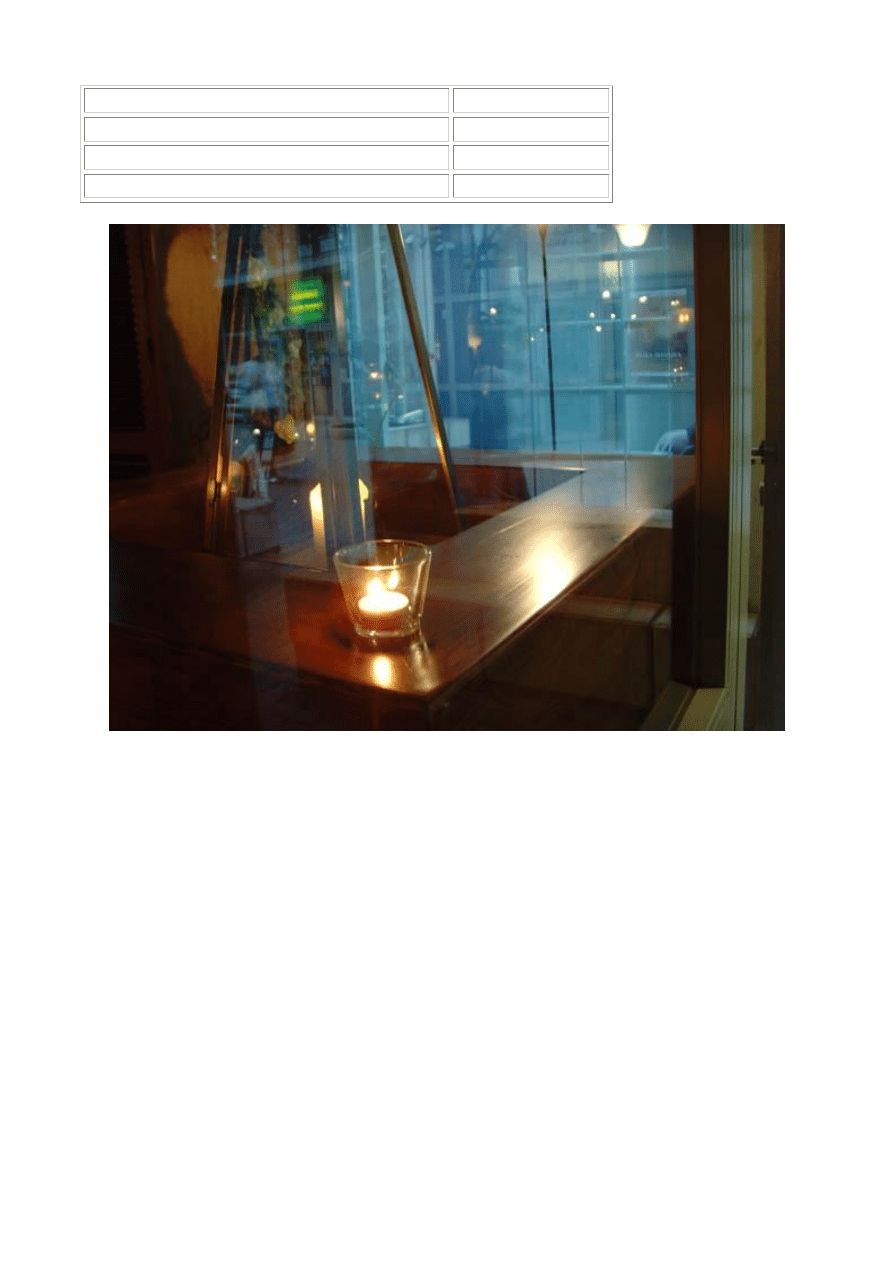

przykład różnych barw światła - czerwonawe zabarwienie światła świecy i niebieskie światło

dzienne w głębi

Liczby podane w tabeli są przybliżonymi wartościami. W praktyce fotograficznej ustawiamy kolor

źródła światła taki, by obraz oglądany na monitorze wyglądał jak najbardziej naturalnie, co

oczywiście jest pojęciem subiektywnym. Możliwość ustawienia temperatury koloru światła

padającego na fotografowane obiekty stwarza zaawansowanemu fotoamatorowi ogromne pole do

popisu, jeżeli chodzi o kompozycję kolorów zdjęcia.

Balans bieli dla plików RAW

Warto podkreślić, że korekta zdjęcia zależna od ustawienia balansu bieli dokonywana jest na etapie

obróbki danych zarejestrowanych bezpośrednio z matrycy. Czyli surowe pliki RAW nie mają

zapisanego balansu bieli. Niestety, większość aparatów kompaktowych nie ma możliwości zapisu

pliku RAW, a zapisuje jedynie plik po wszelkich korektach dokonanych przez oprogramowanie

aparatu w formacie JPEG. Do pliku zapisanego jako JPEG lub TIFF nie można już wprowadzić

innego balansu bieli, niż był ustawiony w aparacie.

Jeżeli jednak aparat pozwala na zapisywanie plików RAW, to umożliwia to wielokrotne

powtarzanie odtwarzania kolorów - już poza aparatem z różnymi ustawieniami balansu bieli. To tak

jak byśmy mieli możliwość wielokrotnego wywoływania filmu (z aparatu analogowego) za każdym

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

7

a

u

d

i o

k

s

i

a

z

k i

.o

rg

razem w innych warunkach czy innym wywoływaczem.

W przyszłym tygodniu, w drugiej części naszego cyklu opiszemy systemy stabilizacji drgań w

aparatach cyfrowych.

Autor jest profesorem na Wydziale Fizyki Uniwersytetu im. A. Mickiewicza. autor:

Roman Goc

źródło:

cz. 2

ABC fotografii cyfrowej cz. 2 - stabilizacja drgań aparatu Stabilizacja drgań to coraz

popularniejsza funkcja w aparatach cyfrowych. Dzięki niej można wykonywać nieporuszone

zdjęcia nawet w słabych warunkach oświetleniowych. W kolejnym odcinku cyklu ABC

fotografii cyfrowej opisujemy jak działają różne rodzaje stabilizacji drgań aparatu.

Rodzaje stabilizacji drgań aparatu

Terminy stabilizacja i kompensacja drgań używane są naprzemiennie, choć tak naprawdę

stabilizacja to mechanizm nie dopuszczający do drgań a kompensacja to minimalizowanie efektu

drgań, które występują. W literaturze dotyczącej amatorskich aparatów cyfrowych powszechnie

stosowany jest termin stabilizacja drgań i dla unikania zamętu będziemy też go używać.

Wszelkiego rodzaju drgania aparatu fotograficznego podczas wykonywania zdjęcia mogą

powodować pogorszenie ostrości zarejestrowanego obrazu. Najczęściej za te drgania

odpowiedzialni jesteśmy my sami trzymając aparat w rękach. Producenci aparatów fotograficznych

i kamer filmowych od lat opracowują i stosują różne metody stabilizacji drgań. Niektóre z takich

urządzeń są większe i cięższe od samego aparatu, czy kamery filmowej. Takie "monstra" są

głównie stosowane w samolotach dla wykonywania zdjęć z powietrza, czy w specjalnych

samochodach z których filmuje się dzikie zwierzęta w parkach narodowych.

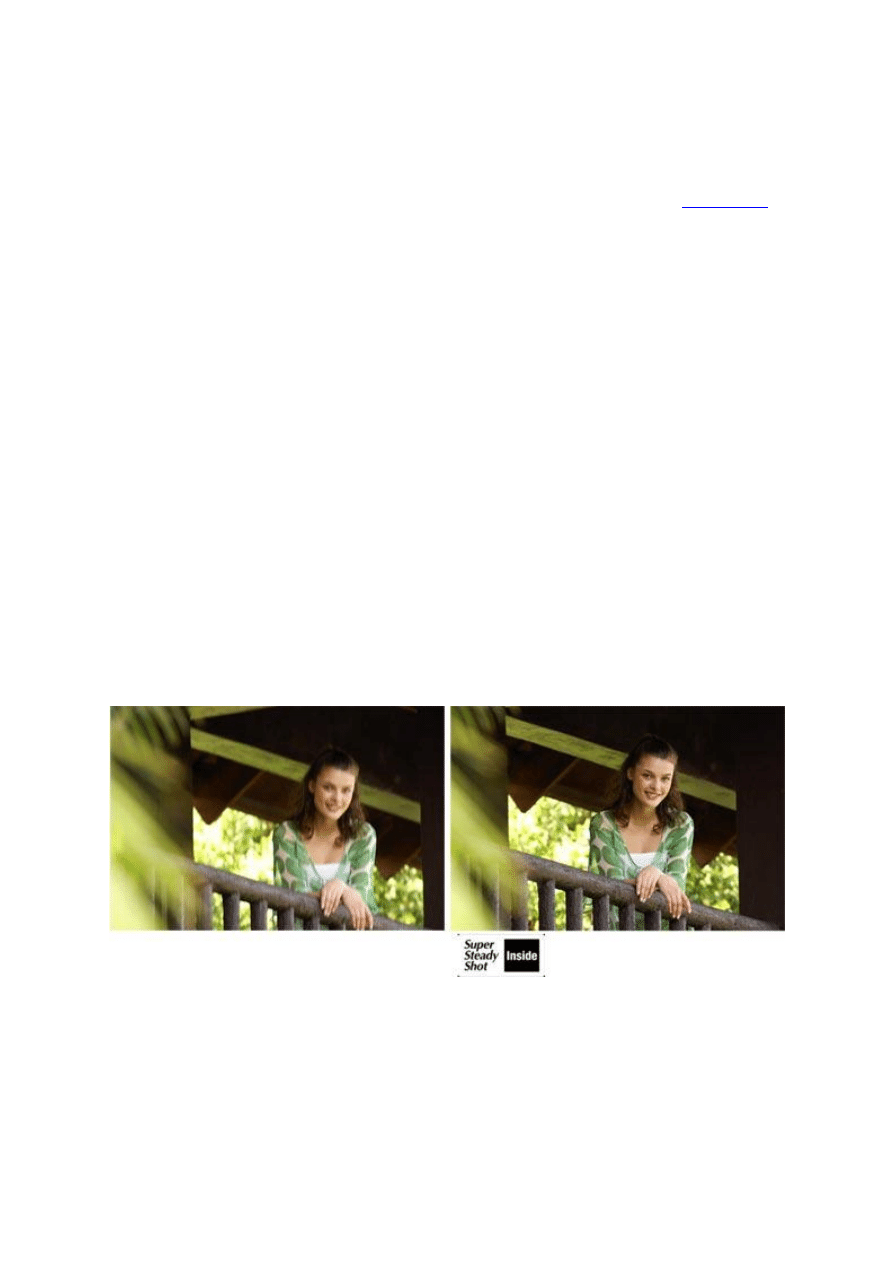

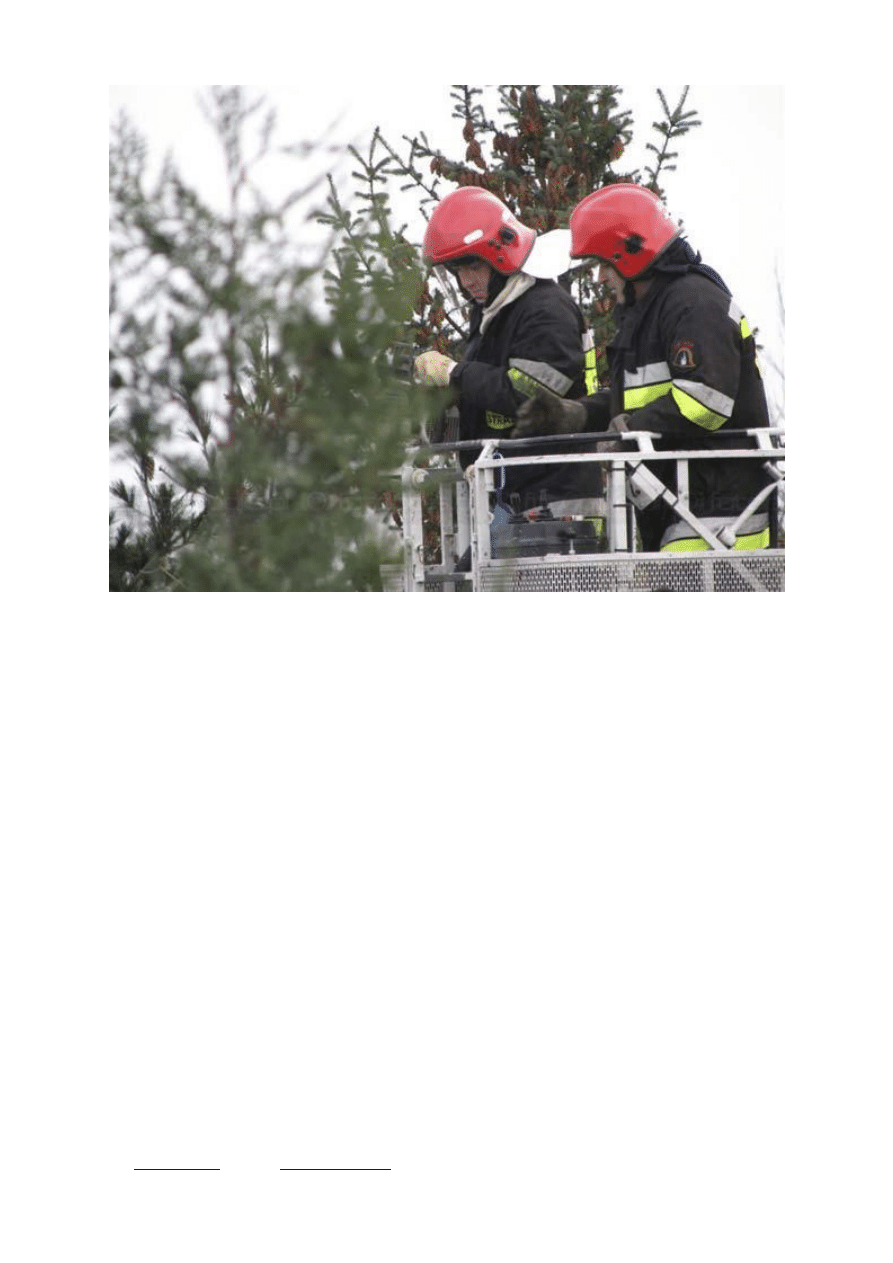

przykład działania stabilizacji obrazu - różnica w jakości obrazu jest oczywista (źródło: Sony)

Jednak w tym artykule opiszemy zasady działania systemów stabilizacji drgań stosowanych w

cyfrowych aparatach fotograficznych, przeznaczonych dla powszechnego użytku. W aparatach tej

klasy stosuje się cztery metody stabilizacji drgań. Podstawowym elementem trzech z nich jest

urządzenie, które wykrywa i rejestruje drgania aparatu. Nie wnikając w szczegóły konstrukcyjne,

takie czujniki ruchu potrafią rejestrować drgania aparatu o częstotliwościach do 20 a nawet 40

tysięcy drgań na sekundę.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

8

a

u

d

i o

k

s

i

a

z

k i

.o

rg

1. Stabilizacja położenia matrycy

W aparacie zamontowany jest czujnik drgań, który wykrywa i przekazuje do procesora wielkości i

kierunki wychylania się aparatu. Matryca aparatu jest tak zamontowana, że odpowiedni mechanizm

elektromagnetyczny może ją przesuwać w pionie i w poziomie. Idea działania tego systemu jest

następująca.

Jeżeli na skutek drgnięcia ręki aparat zmienił położenie, to czujnik ruchu zarejestrował tę zmianę i

przekazał informację o niej do procesora. Program zapisany w pamięci aparatu analizuje to

przesunięcie (jego kierunek i wielkość) i przekazuje odpowiedni sygnał elektryczny do

mechanizmu poruszającego matrycę. Sygnał ten jest tak dobrany, by przesunął matrycę o taką

odległość o jaką przesunął się aparat, tylko w przeciwnym kierunku. Innymi słowy, aparat

przesuwa się w jednym kierunku a matryca w przeciwnym, tak, by obraz padający na nią przez

obiektyw był zawsze w tym samym miejscu.

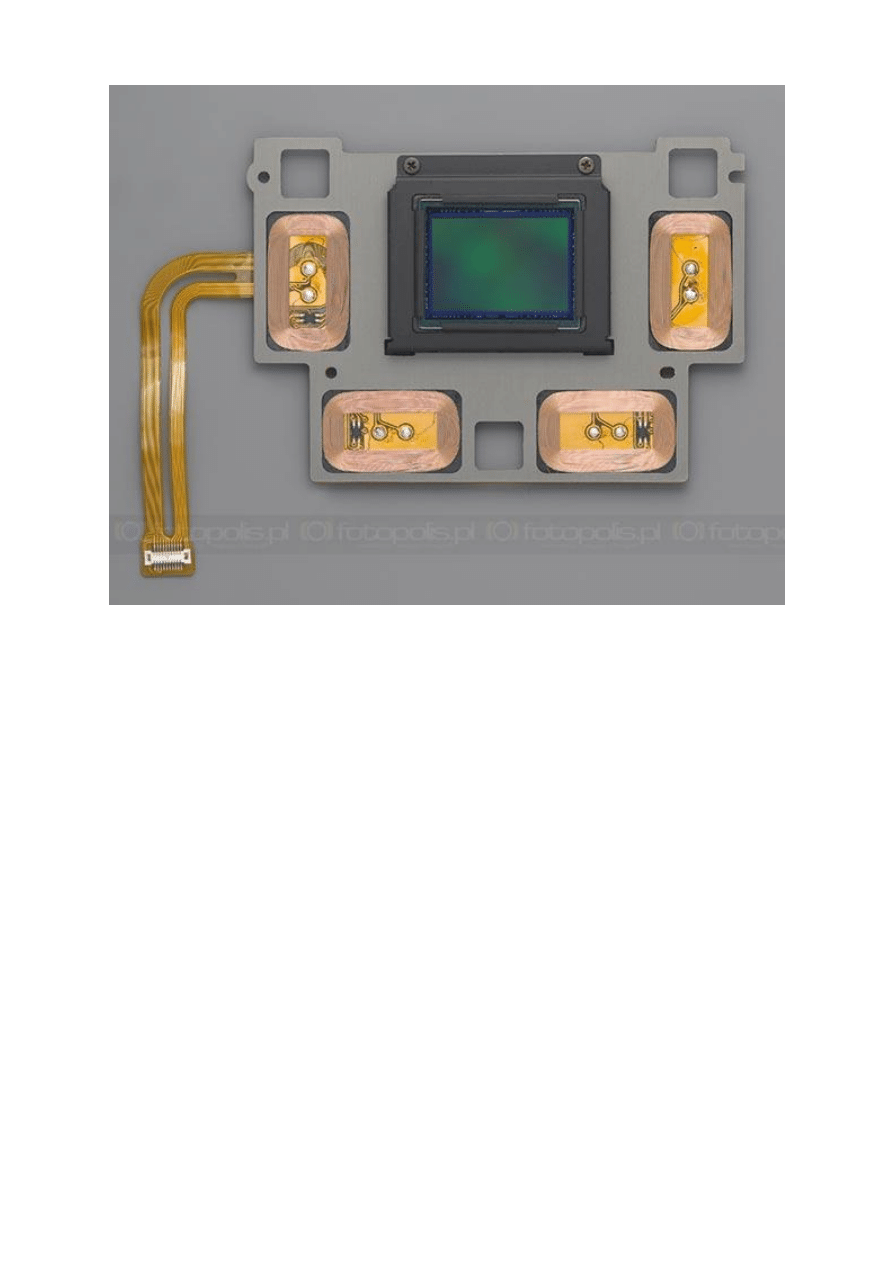

schemat aparatu Pentax K100D - matryca zamontowana jest na specjalnym układzie

umożliwiającym jej ruch, a tym samym kompensację drgań aparatu

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

9

a

u

d

i o

k

s

i

a

z

k i

.o

rg

konstrukcja mocowania matrycy w modelu Pentax K10D

Ten typ stabilizacji drgań jest stosowany głównie w lustrzankach z wymiennymi obiektywami i

uważany jest za najdoskonalszy w klasie aparatów amatorskich. Po raz pierwszy na masową skalę

system ten zastosowała w swoich aparatach (kompaktowych i lustrzankach) firma Minolta, która

następnie została przejęta przez koncern Sony i obecnie system stabilizacji matrycy znajdziemy w

lustrzance Sony α A100. Stabilizację matrycy stosuje również firma Pentax w wybranych modelach

swoich lustrzanek cyfrowych (K100D i K10D).

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

10

a

u

d

i o

k

s

i

a

z

k i

.o

rg

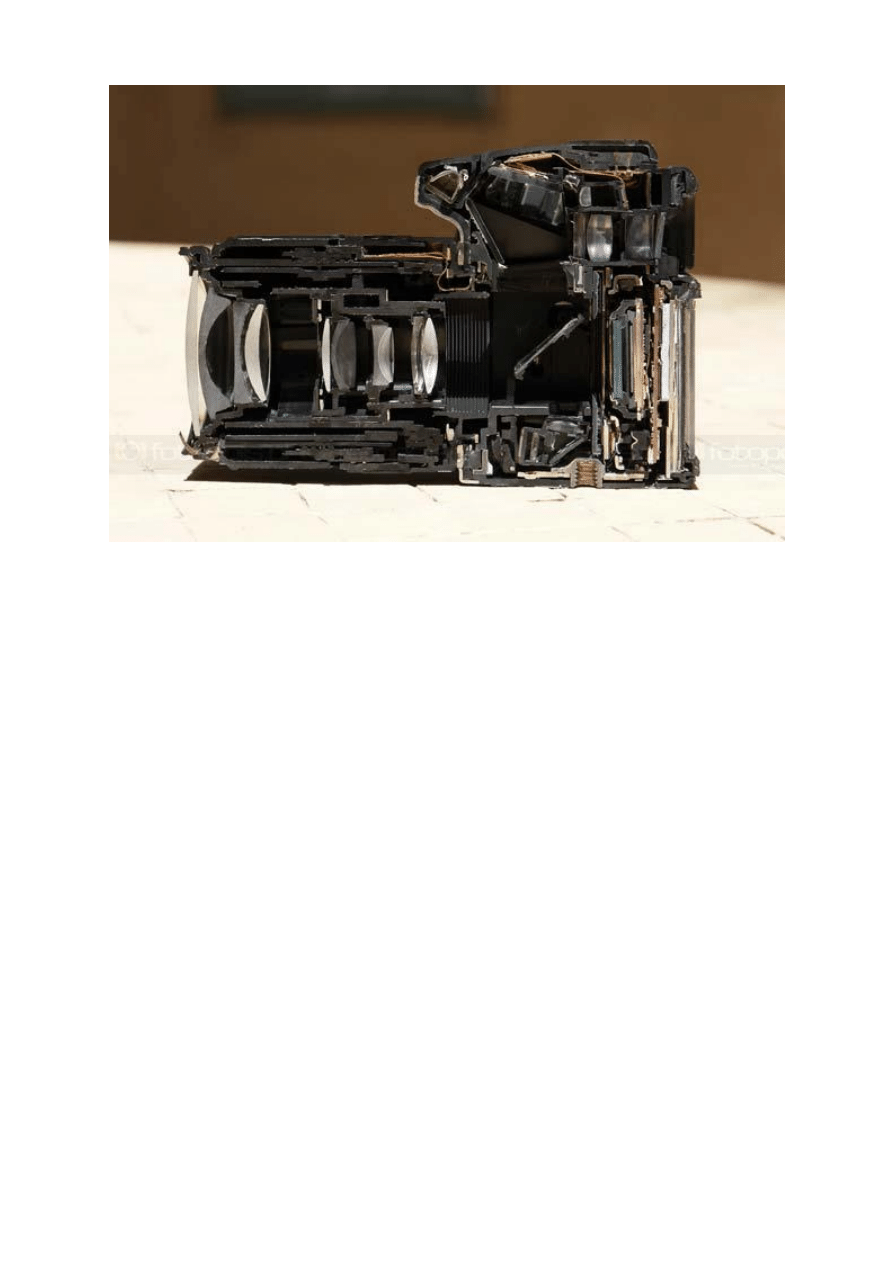

przekrój modelu Sony A100 - w tylnej części widać skomplikowany układ przesuwający matrycę

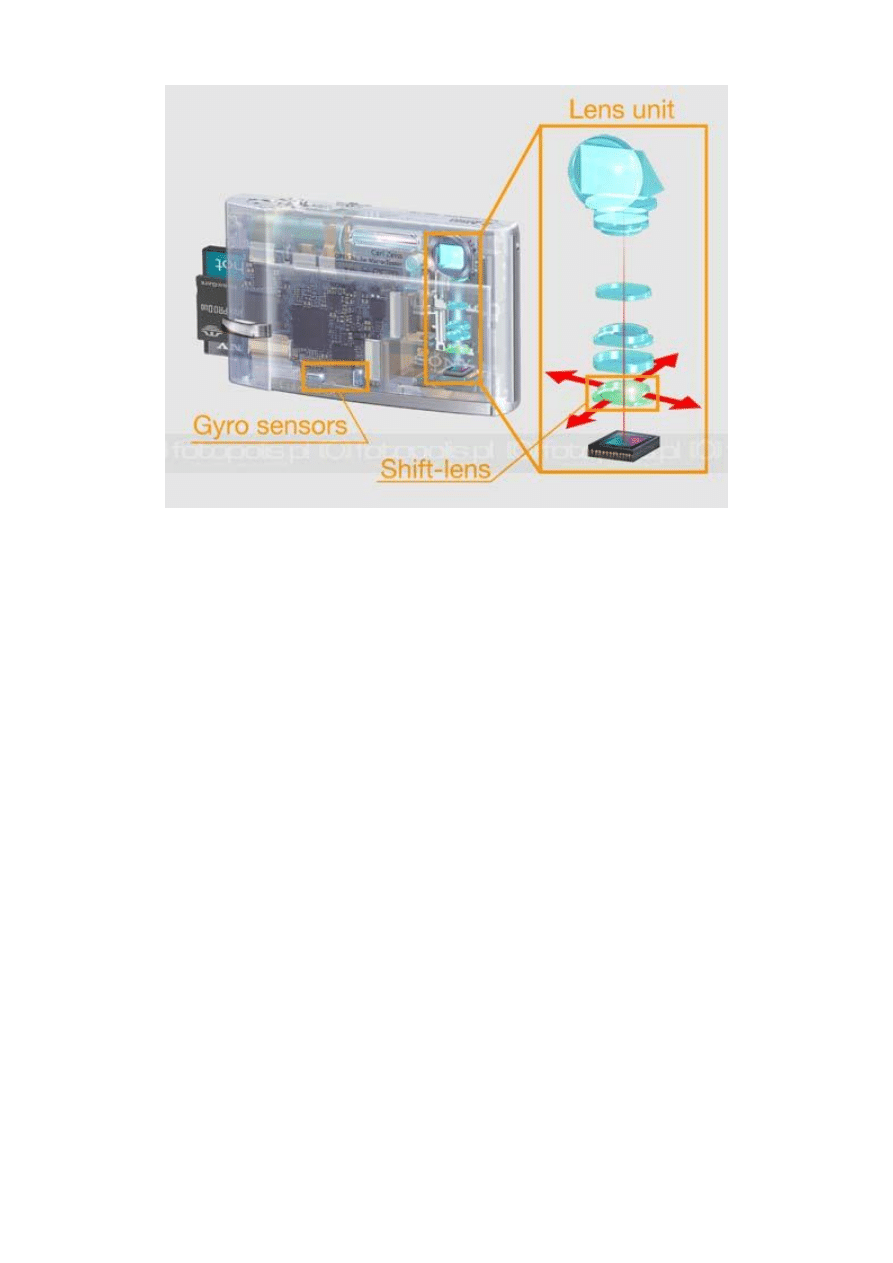

2. Stabilizacja optyczna

Czujnik drgań wykrywa drgania aparatu. Elementem kompensującym te drgania jest dodatkowa

soczewka (lub układ soczewek) wbudowana w obiektyw. Położenie tej soczewki, sterowane

sygnałami z procesora, zmienia się zależnie od kierunku i wielkości drgań aparatu. Zmiana tego

położenia jest tak dobierana przez układ stabilizacji, że promień wpadający przez obiektyw trafia w

ten sam punkt matrycy, niezależnie od drgań aparatu. Do pewnej granicy wielkości drgań daje to

nieruchomy względem matrycy obraz, a więc zapobiega nieostrości wywoływanej małymi ruchami

aparatu. System ten jest nieco gorszy od systemu stabilizacji matrycy, gdyż ruchome soczewki w

obiektywie pogarszają nieco jakość obrazu. W przypadku lustrzanek, działa tylko w obiektywach

skonstruowanych specjalnie dla tego typu stabilizacji drgań. Spośród dużych producentów optyki

obiektywy z wbudowaną stabilizacją drgań oferuje Nikon (obiektywy oznaczone VR) i Canon

(obiektywy IS).

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

11

a

u

d

i o

k

s

i

a

z

k i

.o

rg

schemat stabilizacji optycznej o obiektywie modelu Sony Cyber-shot T30 (źródło: Sony

3. Stabilizacja elektroniczna I

Czujnik drgań wykrywa przesunięcia aparatu. Wielkości i kierunki drgań zapisywane są w pamięci

procesora. Po wykonaniu zdjęcia, odpowiedni program oparty na bardzo skomplikowanym

algorytmie (czyli przepisie obliczeń) dokonuje korekcji zarejestrowanego na matrycy zdjęcia.

Korekcja odbywa się w oparciu o informacje jakie ruchy wykonał aparat w trakcie naświetlania

zdjęcia. Pozwala to zmniejszyć rozmycie obrazu będące wynikiem drgań aparatu. System ten jest

znacznie tańszy od poprzednich ale też mniej doskonały.

Aby zwiększyć jego skuteczność, często do zapisu obrazu używana jest mniejsza, środkowa

powierzchnia matrycy światłoczułej. Pozostała część wykorzystywana jest do zapisu tej części

zdjęcia, która na skutek drgań aparatu normalnie znalazłaby się poza kadrem. Jednak

wykorzystanie tylko części matrycy wiąże się ze zmniejszeniem rozdzielczości zdjęcia, czyli

spadkiem jego jakości. Dlatego też, producenci matryc pracują nad specjalnymi matrycami od razu

wyposażonymi w dodatkowy obszar wykorzystywany przy kompensacji przesunięć aparatu na

skutek drgań. Więcej na temat tego systemu piszemy w rozdziale Stabilizacja drgań w trakcie

filmowania, który znajduje się dalej w tym artykule.

4. Stabilizacja elektroniczna II

Jest to system korekcji nieostrości bez zastosowania czujnika drgań. Zarejestrowany na matrycy

obraz jest analizowany bardzo skomplikowanym programem, który potrafi identyfikować rozmycia

obrazu wywołane drganiami aparatu a kolejne funkcje tego programu potrafią te rozmycia

"wyostrzać". Z punktu widzenia konstrukcji jest to system najtańszy ale i najbardziej zawodny.

Wszystko zależy od jakości zastosowanych programów a siłą rzeczy, w aparacie nie można mieć

potężnych programów zajmujących setki megabajtów. A gdyby nawet je umieścić, to korekcja

nieostrości trwała by kilka do kilkunastu sekund. Ponieważ i tak nie dało by to kompensacji drgań

tak dobrej, jak w metodach poprzednio opisanych, tę metodę stabilizacji drgań stosuje się w tanich

kompaktach. Jest to w końcu lepsze niż zupełny brak stabilizacji.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

12

a

u

d

i o

k

s

i

a

z

k i

.o

rg

Również w tym wypadku konstruktorzy pracują nad poprawieniem systemów elektronicznych.

Jedną metod jest natychmiastowe wykonanie drugiego zdjęcia. Dzięki temu programy analizując

przesunięcie obrazu na dwóch ujęciach mają większą możliwość ustalenia właściwego wyglądu

zdjęcia. Taki system używany jest na przykład w niektórych modelach kompaktów cyfrowych

firmy Samsung.

Samsung NV10 wyposażony w nowatorski system elektronicznej redukcji drgań Advanced Shake

Reduction (ASR)

Systemy elektronicznych stabilizacji drgań określane są angielskim skrótem EIS - Elelctronic

Image Stabilization.

Stabilizacja drgań w trakcie filmowania

Drgania aparatu w trakcie filmowania nie są tak groźne dla jakości filmu, gdyż co około 1/30

sekundy powstaje nowe zdjęcie. Ale problemem może być widoczne "skakanie" obrazu. Jeżeli w

trakcie filmowania aparat drga w kierunku pionowym, to choć kolejne klatki mogą być ostre, to np.

tocząca się po boisku piłka będzie rejestrowana w coraz to innym miejscu (w kierunku pionowym)

matrycy. W trakcie wyświetlania będzie ona widoczna jako tocząca się po boisku "podskakującym"

w górę co jakiś czas.

Eliminacja takich efektów drgań realizowana jest w inny sposób, niż dla zdjęć statycznych.

Podstawą sytemu są:

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

13

a

u

d

i o

k

s

i

a

z

k i

.o

rg

•

czujnik drgań,

•

matryca światłoczuła o rozmiarach nieco większych niż rozmiary rejestrowanej klatki,

•

i odpowiedni program zapisany w aparacie.

W trakcie filmowania aparatem cyfrowym wykorzystuje się rozdzielczość matrycy wielokrotnie

mniejszą, niż do zdjęć statycznych, a więc automatycznie mamy "zapas" powierzchni na jej

brzegach.

W przypadku drgania aparatu podczas filmowania, każda klatka jest zapisywana w nieco innym

miejscu matrycy a równocześnie czujnik drgań przesyła do procesora informacje o tym jakie było

przesunięcie aparatu w momencie rejestrowania każdej klatki. Procesor, w oparciu o odpowiedni

program, zapisuje kolejne klatki filmu do pamięci po zrobieniu korekcji na ich położenie względem

jakiegoś ustalonego punktu, np. środka matrycy. System daje więc film "płynny", bez

nieprzyjemnych dla widza skoków obrazu po ekranie.

Zasady stosowania stabilizacji drgań

Aparat cyfrowy zaopatrzony w opcję stabilizacji obrazu ma zazwyczaj 3 tryby jej pracy:

•

I - wyłączona,

•

II - włączona na stałe,

•

III - włączana na czas otwarcia migawki, czyli robienia zdjęcia.

Najlepszą praktyką jest ustawienie stabilizacji w trybie III. Tryb II powoduje, że aparat zużywa

więcej energii elektrycznej - stabilizacja pracuje cały czas, gdy aparat jest włączony. W trybie II

następuje też szybsze zużycie elementów mechanicznych, o ile takie są, układu stabilizacji. Tryb I

stwarza zagrożenie, że któreś z robionych zdjęć będzie rozmyte w wyniku drgnięcia ręki w

momencie jego robienia.

Jeżeli ktoś chce fotografować w trybie I, to musi wiedzieć, że czas otwarcia migawki około 1/60 s

jest w zasadzie najdłuższym możliwym do stosowania przy robieniu zdjęć bez statywu. Ten czas

dotyczy obiektywu o ogniskowej normalnej, czyli około 50 mm, w przeliczeniu na format 35 mm.

Jeżeli robimy zdjęcia z teleobiektywem, to ogólnie akceptowana reguła dla zdjęć bez stabilizacji

drgań jest następująca: czas otwarcia migawki nie może być dłuższy niż odwrotność długości

ogniskowej, przeliczonej dla formatu 35 mm.

A więc dla ogniskowej F=200 mm czas otwarcia migawki może być co najwyżej 1/200 s, by

drgania nie powodowały nieostrości. Większość prostych kompaktowych aparatów cyfrowych ma

obiektywy o zmiennej ogniskowej od około 35 mm do około 100 mm. Czyli bezpieczny czas

otwarcia migawki powinien być krótszy od 1/100 s.

Stabilizacja drgań może jednak dawać efekty niepożądane np. przy robieniu zdjęć, na których

chcemy stworzyć wrażenie ruchu. Dlatego, też profesjonalne obiektywy wyposażone w stabilizację

drgań oferują od dwóch do kilku trybów działania tego systemu, które najlepiej sprawdzają się w

różnych sytuacjach zdjęciowych. Doświadczony fotografujący powinien więc korzystać ze

stabilizatora drgań w sposób przemyślany.

Stabilizacja drgań dobra na wszystko?

Stabilizacja drgań aparatu nie jest lekarstwem na wszystkie problemy z rozmazanym obrazem, o

czym często zapominają kupujący nowy aparat cyfrowy i, co gorsza, sprzedawcy tych aparatów.

Przede wszystkim nawet najbardziej zaawansowane systemy nie są w stanie zapobiec rozmazaniu

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

14

a

u

d

i o

k

s

i

a

z

k i

.o

rg

szybko poruszających się obiektów. Po prostu działają one tylko na ruch aparatu, a nie na ruch

innych obiektów w kadrze. Jedynym lekarstwem w tym wypadku jest skrócenie czasu otwarcia

migawki (czasu naświetlenia) poprzez wybranie większej czułości ISO, zastosowanie lampy

błyskowej lub wykonywanie zdjęć przy lepszym świetle.

Wiedząc o tym problemie niektórzy producenci (np. Sony, Panasonic) oferują tak zwany

"podwójny system stabilizacji drgań". W praktyce sprowadza się on do połączenia optycznego

(mechanicznego) układu stabilizacji z funkcją podwyższającą ekwiwalent czułości ISO w aparacie.

Należy jednak pamiętać, że samo podwyższenie czułości ISO nie jest stablizacją obrazu w sensie ?

mimo, że zapobiega rozmazaniu obrazu również na skutek drgań aparatu. To po prostu zabieg

pozwalający na skrócenie czasu otwarcia migawki. Każdy świadomy użytkownik aparatu może

osiągnąć podobny efekt samemu podwyższając ekwiwalent czułości ISO w menu aparatu. Należy

jednak pamiętać, że podwyższenie ISO wiąże się z pogorszeniem jakości oddania szczegółów na

zdjęciu poprzez zwiększenie szumów. Jest to więc rozwiązanie połowiczne i jak do tej pory tylko

"prawdziwa" stabilizacja obrazu oferuje kompensancję niepożądanych ruchów aparatu bez

pogorszenia jakości obrazu, a z wymienionych w tym artykule rodzajów jak na razie najlepiej

sprawdzają się systemy mechaniczne - stabilizacja optyczna i stabilizacja matrycy.

W przyszłym tygodniu, w trzeciej części naszego cyklu opiszemy pojęcie ekwiwalentu ogniskowej w

aparatach cyfrowych.

Autor jest profesorem na Wydziale Fizyki Uniwersytetu im. A. Mickiewicza. autor:

Roman Goc

źródło:

cz. 3

ABC fotografii cyfrowej cz. 3 - ekwiwalent i przelicznik ogniskowej obiektywu W trzeciej części

naszego cyklu poradnikowego dla początkujących właścicieli aparatów cyfrowych zajęliśmy

się problemem kąta widzenia obiektywu w aparatach cyfrowych. W większość aparatów

cyfrowych powierzchnia matrycy jest mniejsza niż klasycznej klatki filmu małoobrazkowego.

Wynikają z tego określone konsekwencje dla optyki, szczególnie w aparatach z wymiennymi

obiektywami.

Kąt widzenia obiektywu a rozmiar matrycy

W okresie królowania aparatów analogowych formatu 24 x 36mm (zwanego formatem 135 lub w

skrócie 35 mm)

Ogniskowa obiektywu

F jednoznacznie określała kąt widzenia tego obiektywu.

Obecnie, w erze aparatów cyfrowych o różnych rozmiarach matrycy, która zastępuje film, należy

mówić o kącie widzenia obiektywu w aparacie o podanym formacie matrycy. Kąt widzenia

obiektywu zależy bowiem od długości ogniskowej i od wielkości matrycy. Zaczniemy od definicji i

objaśnienia kąta widzenia obiektywu.

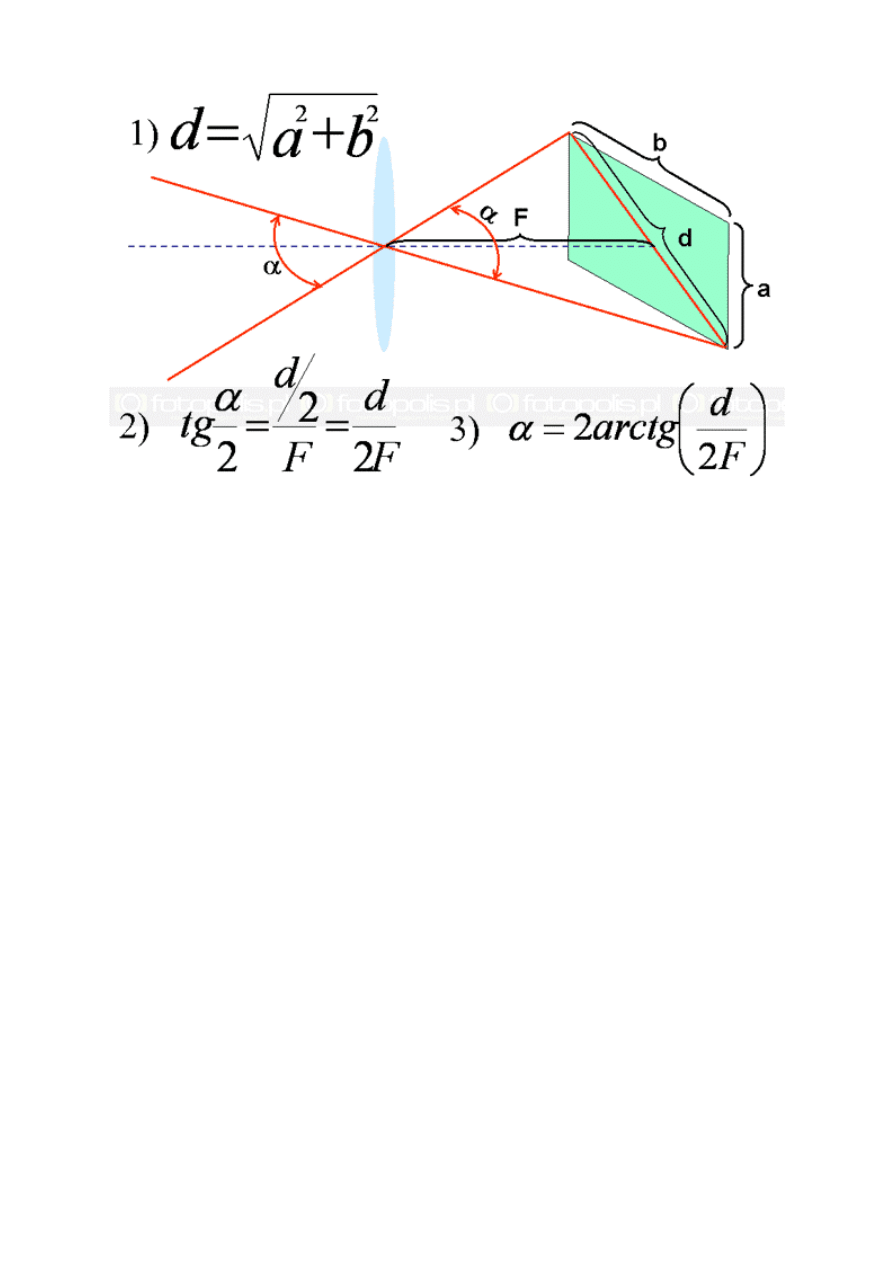

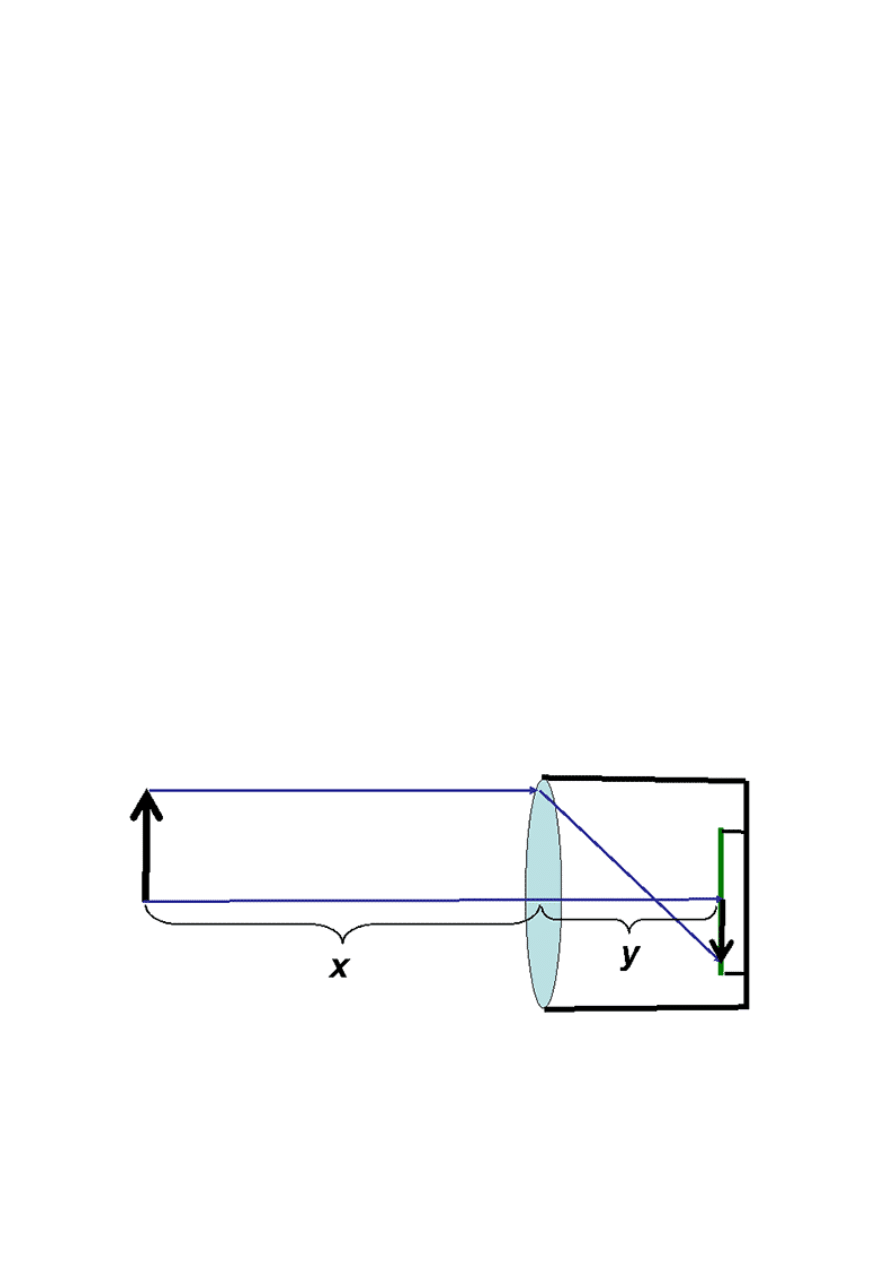

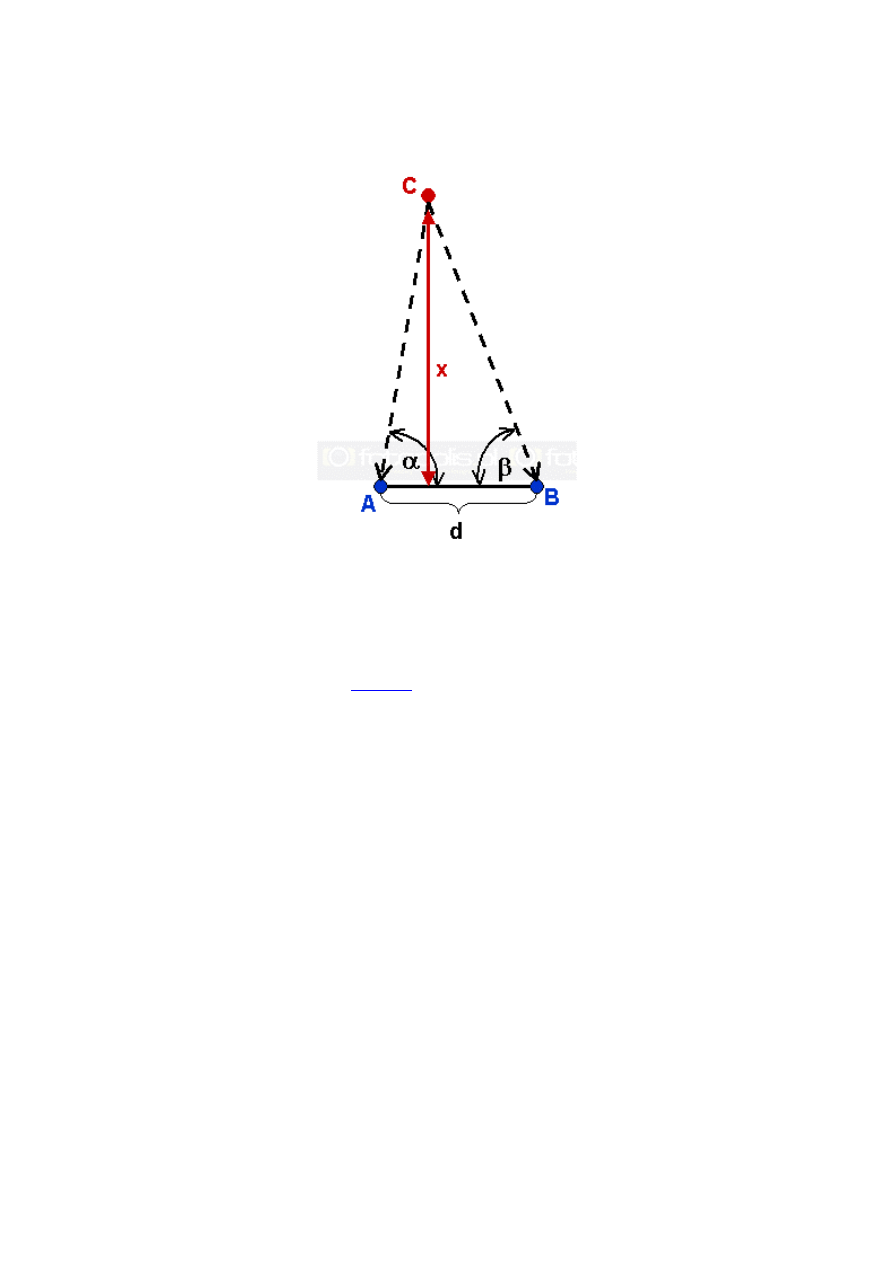

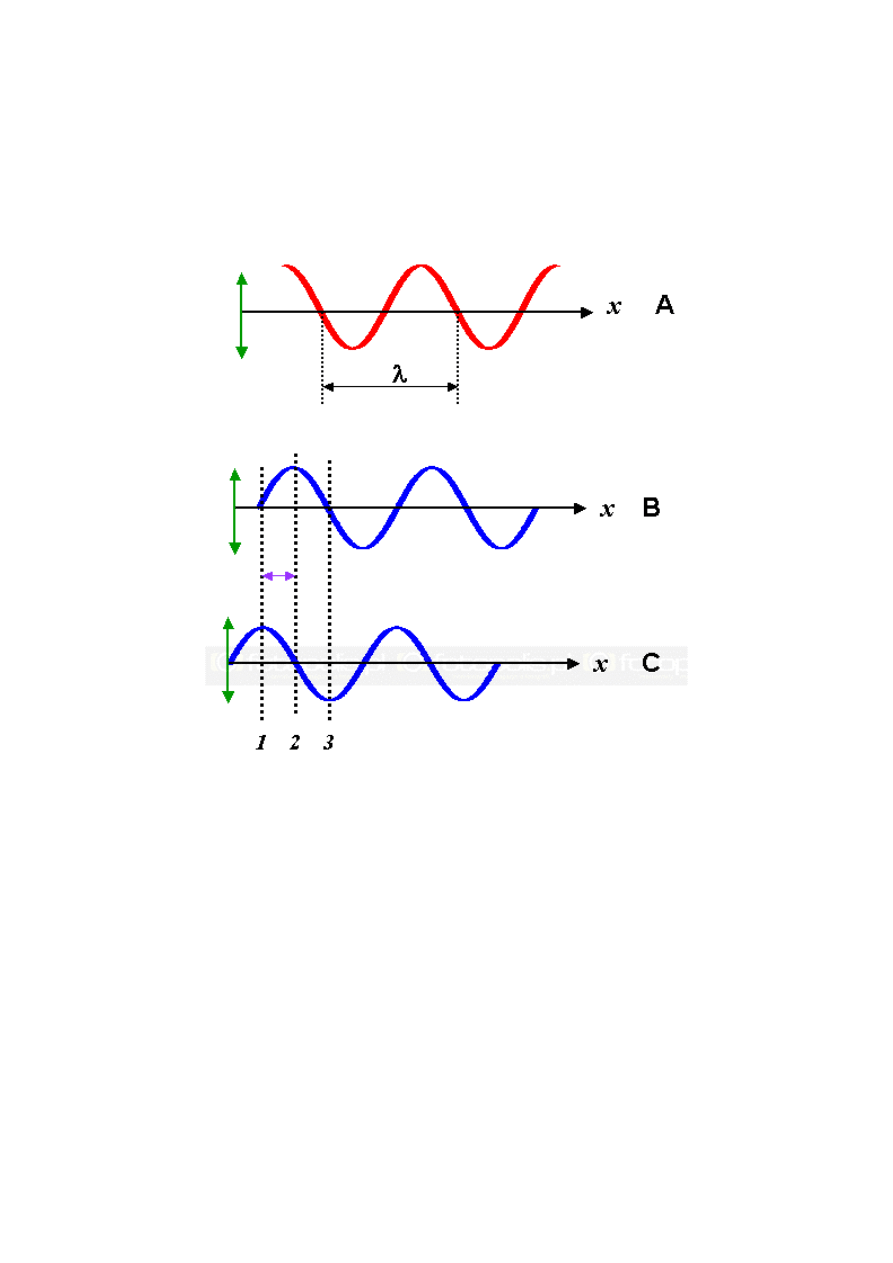

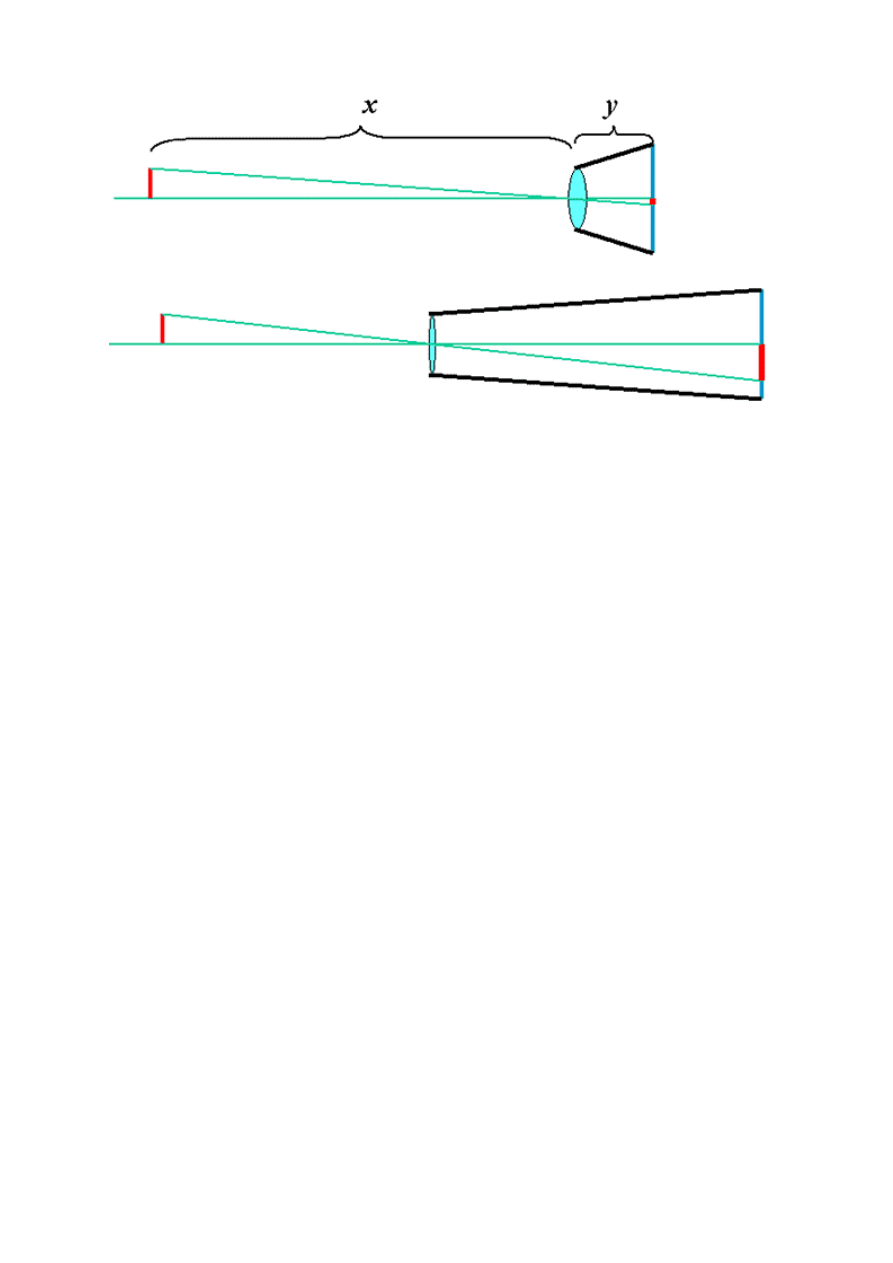

Kąt widzenia obiektywu to kąt pomiędzy najbardziej zewnętrznymi promieniami światła

wpadającymi do aparatu, które jeszcze "trafiają" w matrycę lub film rejestrujący obraz. Na rys.1

jest on oznaczony grecką literą α (alfa). Obiektywem, dla jasności rysunku, jest pojedyncza

soczewka. Aby otrzymywać ostre zdjęcia matryca w aparacie fotograficznym musi się znajdować

w odległości od obiektywu równej długości ogniskowej F i taka jest sytuacja na rys.1.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

15

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys. 1: kąt widzenia obiektywu o ogniskowej F w aparacie o rozmiarach matrycy a x b mm. Wzory

na rysunku pozwalają obliczyć wartość kąta widzenia obiektywu w tym aparacie

Czytelnik nie znający trygonometrii niech się nie przejmuje wzorami. Wystarczy uwierzyć, że ze

wzoru 3) wynika iż kąt widzenia maleje:

1. przy stałych rozmiarach matrycy - wraz ze wzrostem ogniskowej F

2. przy stałej ogniskowej - wraz ze zmniejszaniem rozmiarów matrycy.

Przypadek 1. to sytuacja znana w lustrzankach. Mamy w aparacie matrycę o stałych rozmiarach i

możemy zakładać do niego obiektywy o różnej długości ogniskowej. Analogiczna sytuacja jest w

kompaktach cyfrowych z obiektywem typu zoom.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

16

a

u

d

i o

k

s

i

a

z

k i

.o

rg

przykład kadrów możliwych do uzyskania w przypadku obiektywu zoom o nominalnym zakresie

ogniskowych 18-200 (11-krotny zoom)

Sytuacja 2. pojawiła się dopiero wraz z aparatami cyfrowymi o różnych rozmiarach matryc i jest

tematem tego artykułu. Dla dalszych objaśnień zdefiniujemy pojęcie ogniskowej normalnej i

oznaczymy ją Fn. Jest to ogniskowa o długości równej przekątnej matrycy, czy klatki filmu.

Obiektyw o ogniskowej normalnej ma kąt widzenia taki, jak oko ludzkie. Obiektyw taki

odwzorowuje fotografowaną scenę tak, jak widzi ją człowiek.

Dla formatu 24 x 36 mm Fn = 43,3 mm a kąt widzenia tego obiektywu wynosi 53°. Przyjęło się

jednak używać dla tego formatu obiektywu o ogniskowej F=50,0 mm, jako obiektywu

"normalnego", czyli standardowego. Kąt widzenia tego obiektywu wynosi około 47°. Do

przeliczania długości ogniskowych obiektywów dla formatu 35 mm, czyli do wyliczania tzw.

ogniskowej równoważnej używa się jednak Fn=43,3mm.

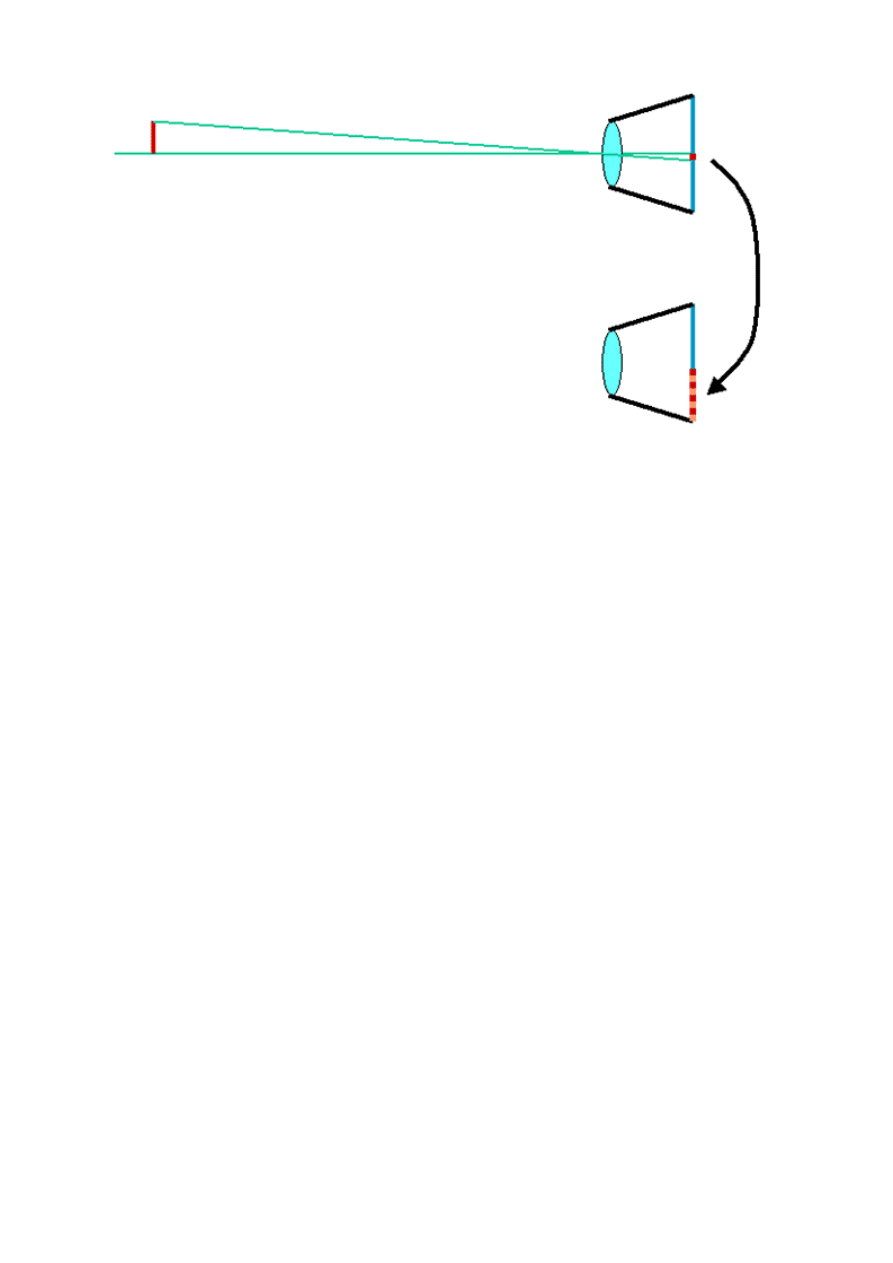

Należy mocno podkreślić, że parametrem decydującym o odwzorowaniu obrazu na matrycy jest kąt

widzenia obiektywu dla danej matrycy a nie ogniskowa obiektywu. Ten sam obiektyw

zamontowany aparatach o różnych rozmiarach matrycy będzie miał inny kąt widzenia w każdym z

nich.

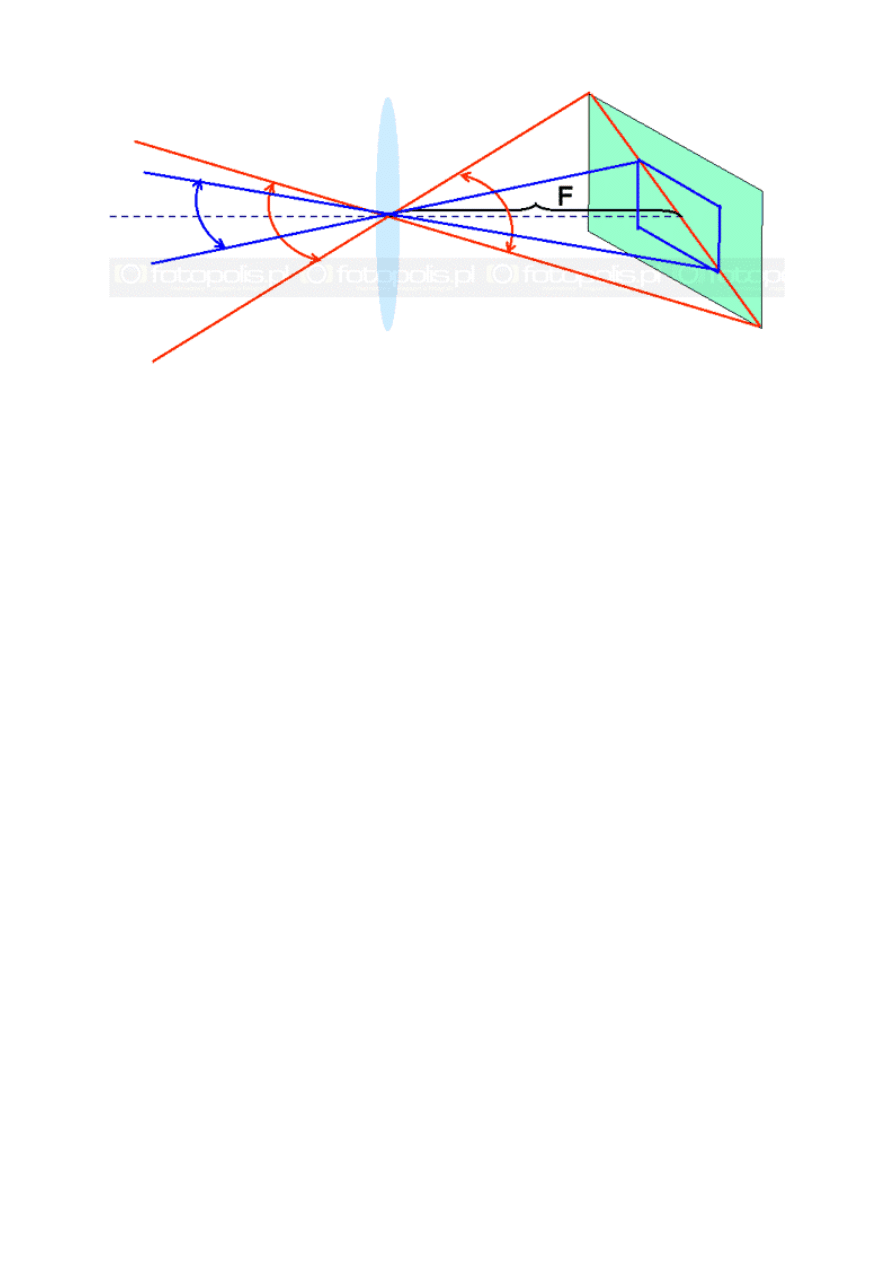

Sytuacja taka dotyczy lustrzanek z wymiennymi obiektywami, kiedy ten sam obiektyw możemy

używać z aparatami o różnej wielkości matrycy. Schematycznie ilustruje to rys. 2. Obiektyw o tej

samej długości ogniskowej ma różne kąty widzenia, zależne od wielkości matrycy, na którą rzutuje

obraz.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

17

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys.2: kąty widzenia obiektywu o ogniskowej F dla dwóch różnych rozmiarów matryc. Dla matrycy

zaznaczonej kolorem niebieskim ten sam obiektyw ma mniejszy kąt widzenia

W kompaktach mamy stałą wielkość matrycy a możemy zmieniać długość ogniskowej. Na

obiektywie aparatu kompaktowego mamy podany przedział w którym możemy zmieniać długość

ogniskowej, np. 6 mm do 72 mm. To są wartości ogniskowej rzeczywistej ale ze względów na

wieloletnie przyzwyczajenie do aparatów formatu 35 mm, producent podaje wartości ogniskowych

równoważnych zwanych inaczej ekwiwalentem ogniskowych.

ekwiwalent ogniskowej, to ogniskowa, jaką powinien mieć obiektyw aparatu formatu 35 mm, aby

miał taki sam kąt widzenia jak obiektyw naszego aparatu cyfrowego. Inaczej, to ogniskowa w

aparacie 35 mm odpowiadająca takiemu obrazowi, jaki widzimy w aparacie cyfrowym.

Obliczymy dla przykładu ogniskową równoważną obiektywu o F = 6,0 mm w aparacie o matrycy

oznaczonej 1/2.5". Matryca taka ma przekątną o długości 7,2 mm, co można znaleźć w różnych

tablicach podających rozmiary matryc. Klatka filmu 35 mm ma przekątną 43,3 mm. A więc

przekątna formatu 35 mm jest 6 razy dłuższa (43,3/7,2=6) od przekątnej matrycy oznaczonej

symbolem 1/2.5". Ogniskowa równoważna dla naszego aparatu będzie:

6 x 6,0 mm = 36 mm

W ogólnym przypadku ogniskowa równoważna dla danej matrycy jest tyle razy dłuższa od

ogniskowej rzeczywistej, ile razy przekątna danej matrycy jest mniejsza od przekątnej matrycy

formatu 35 mm. Dla kompaktowych aparatów cyfrowych producenci podają ogniskowe

rzeczywiste i równoważne, więc nie ma potrzeby niczego przeliczać.

Natomiast w przypadku lustrzanek cyfrowych o różnych rozmiarach matryc, do których można

zakładać obiektywy o różnych długościach rzeczywistej ogniskowej, producenci podają tzw.

krotność ogniskowej czyli przelicznik ogniskowej. Jest to liczba, przez którą należy pomnożyć

nominalną (rzeczywistą) długość ogniskowej napisaną na obiektywie, aby otrzymać długość

ogniskowej równoważnej (ekwiwalent ogniskowej). Dla większości typów lustrzanek ta krotność

wynosi 1,5 lub 1,6, a lustrzanki Systemu 4/3 mają przelicznik 2,0. Wartości te można znaleźć w

publikowanych przez Fotopolis.pl specyfikacjach konkretnych modeli aparatów.

W praktyce oznacza to, że jeżeli do takiego aparatu dołączamy obiektyw o ogniskowej 50,0 mm, to

będzie on dawał kąt widzenia taki, jak obiektyw o ogniskowej 80,0 mm w aparacie o formacie 35

mm.

Z rozważań przytoczonych w tym artykule wynika, że krotność zależy od rozmiarów matrycy

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

18

a

u

d

i o

k

s

i

a

z

k i

.o

rg

wbudowanej do aparatu. Im ta matryca jest mniejsza, tym większy będzie przelicznik ogniskowej.

Z długością ekwiwalentu ogniskowej i normalnej wiążą się pojęcia obiektywów szerokokątnych i

teleobiektywów. To zagadnienie będzie jednak omówione osobno.

Zapraszamy za tydzień do czwartej części naszego poradnika.

Autor jest profesorem na Wydziale Fizyki Uniwersytetu im. A. Mickiewicza.

cz. 4

ABC fotografii cyfrowej cz. 4 - metody pomiaru ekspozycji Czwartą część poradnika

poświęciliśmy metodom pomiaru ekspozycji - jednej z najważniejszej czynności podczas

wykonywania zdjęcia aparatem. W tej części dowiemy się czym jest poprawna ekspozycja i

jak aparat ją oblicza. Poznamy takie pojęcia jak exposure value oraz metody pomiaru

ewaluacyjnego, centralnie ważonego i punktowego.

Pomiar ekspozycji - metody

Dla otrzymania poprawnego technicznie zdjęcia muszą być spełnione dwa warunki. Obraz musi

być ostry i poprawnie naświetlony. Ustawianiem ostrości zajmiemy się w innym artykule, ten

poświęcony jest metodom pomiaru ekspozycji.

Ekspozycja

, inaczej naświetlenie, określa ilość

światła, która pada na matrycę lub film w aparacie analogowym w trakcie robienia zdjęcia.

Ekspozycja zależy od ustawienia przysłony i od czasu otwarcia migawki. Im większy otwór

przysłony, czyli im mniejsza liczba ją określająca, tym więcej światła wpada przez obiektyw. Z

kolei, im dłuższy czas otwarcia migawki, tym dłużej światło działa na matrycę lub film, a więc

silniej je naświetli.

Ekspozycję podaje się w jednostkach zwanych EV - od angielskiego terminu exposure value, co

znaczy wartość ekspozycji. Istnieje wzór z którego można wyliczać EV dla różnych wartości

przysłon i czasów otwarcia migawki, ale on by tylko zagmatwał objaśnienia, dlatego podamy

gotową tablicę z obliczonymi już wielkościami EV.

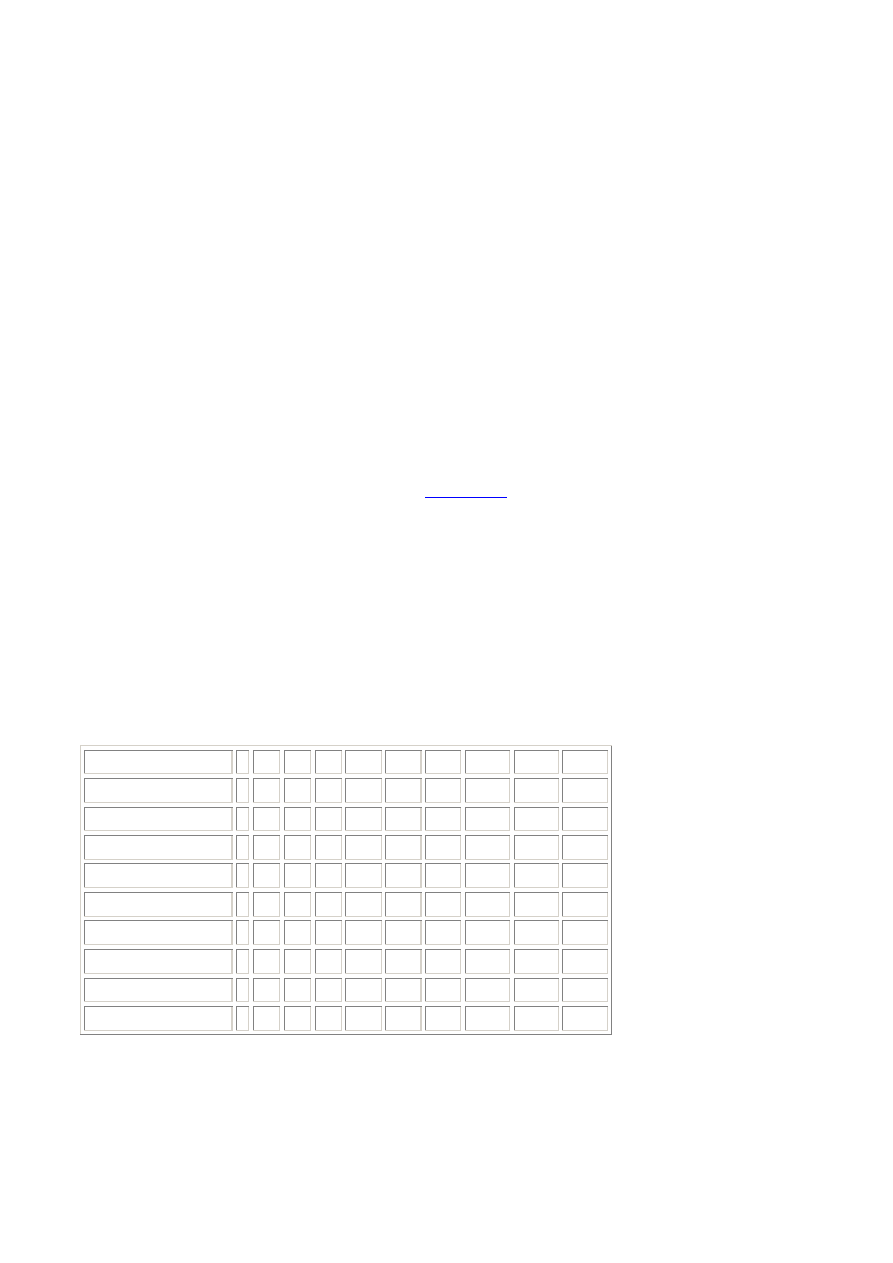

Przysłona/Migawka 1 1/2 1/4 1/8 1/15 1/30 1/60 1/125 1/250 1/500

1

0 1

2

3

4

5

6

7

8

9

1.4

1 2

3

4

5

6

7

8

9

10

2.0

2 3

4

5

6

7

8

9

10

11

2.8

3 4

5

6

7

8

9

10

11

12

4.0

4 5

6

7

8

9

10

11

12

13

5.6

5 6

7

8

9

10

11

12

13

14

8.0

6 7

8

9

10

11

12

13

14

15

11

7 8

9

10 11

12

13

14

15

16

16

8 9

10 11 12

13

14

15

16

17

tabela 1: Wartości EV dla różnych przysłon i czasów otwarcia migawki, dla ISO 100.

Zmiana wartości EV o 1 zmienia DWUKROTNIE ilość światła wpadającego do aparatu. Wynika

to z liczb podanych w tabeli. Na przykład dwukrotne skrócenie czasu naświetlania oznacza, że

zmierzona wartość EV stała się większa od poprzedniej o 1 działkę. Analogiczny efekt daje zmiana

przysłony. Zwiększenie wartości ISO o jeden "skok", np. ze 100 na 200 zmniejszy wartości EV o 1.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

19

a

u

d

i o

k

s

i

a

z

k i

.o

rg

Można też na tę tabelę patrzeć od drugiej strony - im więcej światła pada na obiekt tym większą

trzeba ustawić wartość EV aby zdjęcie nie zostało prześwietlone. Dla uzyskania prawidłowo

naświetlonego zdjęcia należy zmierzyć ilość światła wpadającą przez obiektyw lub padającą na

obiekt i w zależności od wyniku tego pomiaru ustawić przysłonę i czas migawki.

Aby nie komplikować opisu pomiaru ekspozycji, ograniczmy się do aparatów cyfrowych i do

pomiaru typu TTL. TTL to pierwsze litery słów through the lens - poprzez obiektyw, czyli metoda

TTL to pomiar światła wpadającego przez obiektyw do aparatu.

W aparatach fotograficznych wykorzystujących film, zasady pomiaru ekspozycji są analogiczne jak

w cyfrowych, tylko musi w nich być dodatkowy element światłoczuły który służy do pomiaru

natężenia światła. Natomiast w większości aparatów cyfrowych matryca, na której rejestrujemy

zdjęcie, jest równocześnie elementem pomiarowym natężenia wpadającego światła. Wyjątkiem są

tu lustrzanki cyfrowe, w których pomiar dokonywany jest przez dodatkowy czujnik - jak w

aparatach na film.

W cyfrowych aparatach kompaktowych, z których korzysta większość fotografujących matryca jest

wykorzystywana najpierw do pomiaru ekspozycji, a w następnym momencie do utrwalenia

fotografowanych obiektów. Przypomnijmy, że aparat mierzy światło odbite od fotografowanych

obiektów, na które jest skierowany. I tu pojawia się problem. Jak zmierzyć ekspozycję, jeżeli

fotografowane obiekty, czy krajobraz, zawierają elementy o bardzo różnej jasności. Aby temu

zaradzić, opracowano wiele metod pomiaru ekspozycji, które w założeniu powinny wyznaczyć taką

wartość EV, która da możliwie najbardziej prawidłowo naświetlone zdjęcie. Co znaczy

"naświetlone prawidłowo" zdjęcie?

Najłatwiej wyjaśnić to na przykładzie zdjęcia czarno-białego. Prawidłowo naświetlone zdjęcie

powinno pozwalać na rozróżnienie możliwie największej liczby odcieni szarości, od białego do

czarnego. W przypadku kolorów sprawa się komplikuje, ale idea jest ta sama. Zdjęcie ma

odtwarzać maksymalną liczbę kolorów i ich odcieni.

Podstawowe metody pomiaru ekspozycji TTL to:

•

A. matrycowa (ewaluacyjna),

•

B. centralnie ważona.

•

C. punktowa.

We wszystkich metodach elementem pomiarowym jest matryca światłoczuła. W aparatach

kompaktowych, jest to ta sama matryca, na której rejestrowane jest zdjęcie. W lustrzankach

natomiast najczęściej montowany jest osobny element światłoczuły do pomiaru ekspozycji. Zasady

pomiaru są tam takie same, ale odciążenie głównej matrycy od tych zadań pomocniczych pozwala

w lustrzance na skrócenie czasu oczekiwania na gotowość aparatu do wykonania kolejnego zdjęcia.

Nie mówiąc już o tym, że z technicznego punktu widzenia taki pomiar byłby niemożliwy (matryca

jest zasłonięta lustrem i migawką). Dla prostoty opisu zajmiemy się jedynie aparatem

kompaktowym.

W metodach A i B matryca "podzielona" jest na kilka prostokątów, od 3 w tanich, do 256 w

drogich aparatach. Procesor odczytuje natężenie światła padające na poszczególne fragmenty

matrycy. Innymi słowy - wyznacza ekspozycję dla każdego elementu i zapisuje wszystkie wartości

EV w pamięci.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

20

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys.1: Schemat matrycy światłoczułej dla pomiaru ekspozycji metodą A lub B Podział na 9

elementów jest wirtualny. Matryca tworzy jedną całość a jedynie program odczytuje osobno

wartości ekspozycji dla każdego zaznaczonego elementu. Liczby w kolejnych segmentach matrycy

to przykładowe wartości EV, które mogły zostać zmierzone dla nich.

Metoda ewaluacyjna.

Na podstawie wartości EV w poszczególnych segmentach, odpowiedni program oblicza wartość

EV, jaką należy zastosować przy robieniu zdjęcia, aby wszystkie elementy matrycy wykorzystane

do pomiaru światła zostały naświetlone w sposób najbliższy optymalnego. Niestety, jedyne co

możemy powiedzieć o tych obliczeniach, to to, że wypadkowa wartość EV nie jest prostą średnią z

wartości zmierzonych dla poszczególnych elementów matrycy, gdyż algorytmy, czyli przepisy

obliczania tej wartości wypadkowej, opracowane przez różnych producentów, są ściśle strzeżoną

tajemnicą.

W droższych modelach aparatów cyfrowych stosowane są metody matrycowe (ewaluacyjne) zwane

inteligentnymi. Canon stosuje metodę, którą nazwał Intelligent Scene Analysis based on

Photographic Space - iSAPS. Metoda polega na analizowaniu przez procesor elementów

fotografowanej sceny, porównywanie ich z informacjami zapisanymi w pamięci procesora a

pochodzącymi od setek, czy nawet tysięcy wykonanych zdjęć testowych i wybraniu z bazy danych

najlepszych, dla danej sceny, parametrów określających ekspozycję. Szczegółów metody nikt, poza

jej twórcami, nie zna. Podobny system porównywania z bazą danych stosuje Nikon obliczając

ekspozycję w swoim systemie 3D Color Matrix II.

Metoda centralnie ważona.

Program zapisany w pamięci procesora aparatu mierzy ekspozycję dla każdego z wydzielonych

elementów matrycy i oblicza tzw. średnią ważoną centralnie. Obliczana jest średnia ze

zmierzonych wartości, ale liczby bliżej środka matrycy mają większe znaczenie (nadawana jest im

większa waga). Mówiąc prościej, im bliżej środka matrycy (kadru), tym "ważniejsza" jest

zmierzona dla niej liczba EV i ona będzie dominująca w obliczonej średniej. Gdyby np. dla

matrycy "podzielonej" na 3 kawałki zmierzone ekspozycje, od lewej do prawej strony, wynosiły

14, 7 i 15, to zwykła średnia arytmetyczna byłaby :

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

21

a

u

d

i o

k

s

i

a

z

k i

.o

rg

(1/3)*14 + (1/3)*7 + (1/3)*15 = 12

natomiast średnia centralnie ważona mogłaby być obliczona jako:

(1/5)*14 + (3/5)*7 + (1/5)*15 = 10

Ułamki w nawiasach, to owe "wagi" dla obliczenia średniej wartości. W tym drugim obliczeniu

wartość ekspozycji dla środkowego elementu brana jest z wagą trzykrotnie większą, niż wartości

brzegowe. W przypadku większej liczby elementów dla których zmierzono ekspozycję, obliczenia

będą bardziej skomplikowane i, podobnie jak w poprzedniej metodzie, dokładny algorytm, czyli

przepis obliczania średniej, jest tajemnicą ściśle strzeżoną przez producenta.

Metoda punktowa.

W tej metodzie z matrycy wydzielony jest mały obszar, prostokąt lub koło o powierzchni 1,5% do

6% całej matrycy i pomiar dokonywany jest tylko dla obiektów odwzorowywanych w tym

obszarze. Punkt, czy raczej obszar pomiarowy, może być usytuowany na stałe na środku matrycy a

w bardziej zaawansowanych aparatach może on być ustawiony w dowolnym rejonie matrycy lub

sprzężony z punktem ustawiania ostrości.

W jakich warunkach i w jakim celu stosować którąś z opisanych tu metod pomiaru ekspozycji to

zupełnie inne, bardzo obszerne zagadnienie. Warto jedynie zauważyć, że dowolną wartość

ekspozycji można uzyskać z kilku, a nawet kilkunastu kombinacji przysłony, czasu otwarcia

migawki i ustawionej czułości ISO. Jak więc program aparatu cyfrowego decyduje, czy zdjęcie

zrobić z nastawami ISO 100, f=2.8 i 1/125 s, czy ISO 200, f=8.0 i 1/30 s. To bardzo obszerne

zagadnienie, warte omówienia w oddzielnym artykule.

Korekcja ekspozycji.

Każdy aparat cyfrowy ma możliwość korekcji ekspozycji. Typowy zakres takiej korekcji to od -2.0

EV do +2.0 EV, ze skokiem 1/3 EV. Co to znaczy i w jakim celu jest ta możliwość? Robimy np.

zdjęcia w słoneczny dzień na stoku pokrytym czystym, białym śniegiem. W tych warunkach układ

pomiarowy ekspozycji może nie być w stanie zmierzyć jej poprawnie albo ustali takie warunki

ekspozycji, że śnieg będzie na zdjęciu szary. W takiej sytuacji możemy sami ustawić korekcję

ekspozycji na pozycję np. +1/3 EV, czy +1.0 EV, co zapewni zwiększenie naświetlenia matrycy (i

w tym wypadku - rozjaśnienie śniegu). W sytuacji bardzo słabego oświetlenia może zaistnieć

konieczność korekcji "w dół", np. -1.0 EV, żeby czerń była czarna, a nie szara. Korekcja ekspozycji

może też służyć uzyskiwaniu ciekawych efektów artystycznych, ale to już zupełnie inne

zagadnienie.

Przykład zdjęć.

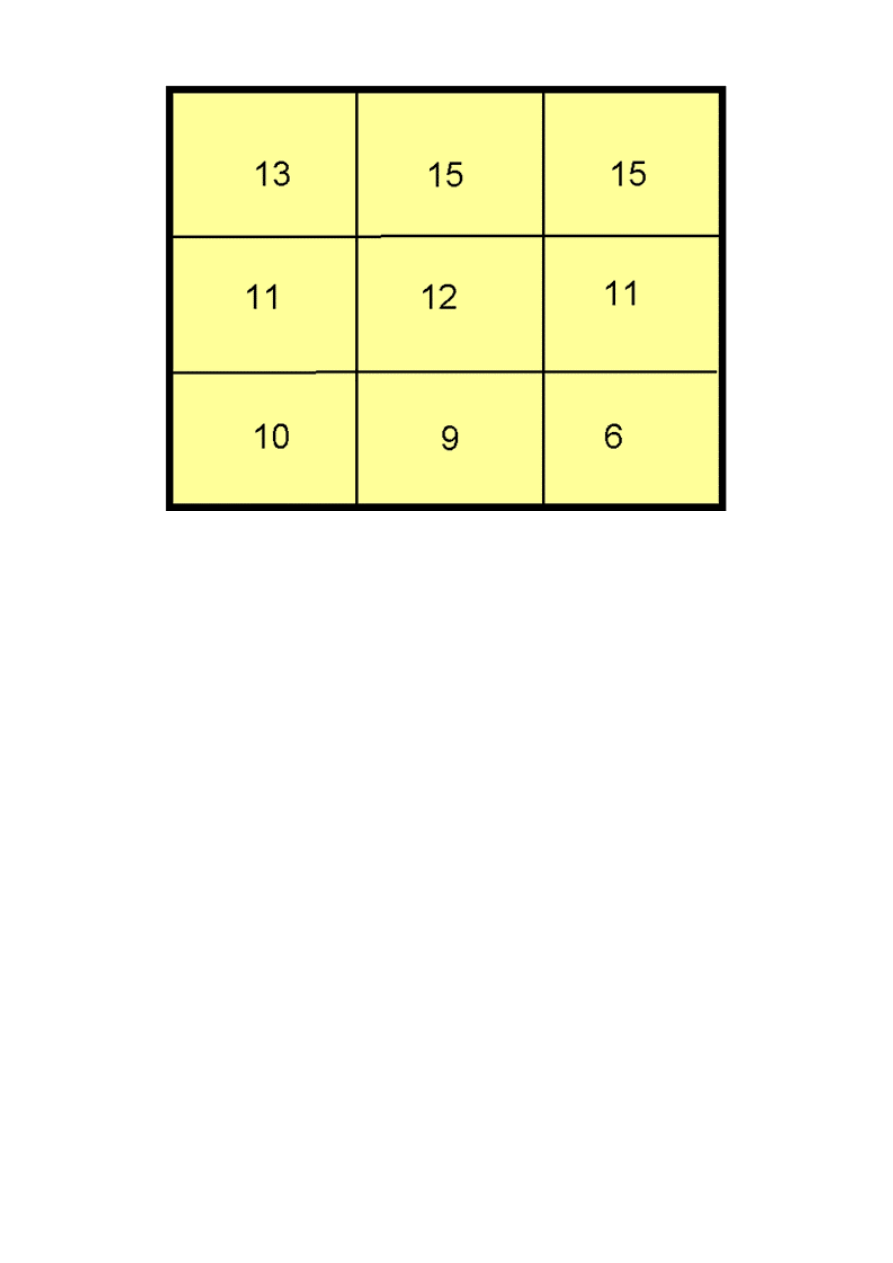

Pokazujemy 2 zdjęcia księżyca. Zdjęcie A zostało wykonane z ewaluacyjnym pomiarem

ekspozycji. Procesor wyznaczył jakieś średnie natężenie światła dla całego kadru, którego znaczna

część jest bardzo ciemna. Migawka została ustawiona na 1/8 s, a przysłona na F3.5. Sam księżyc

jest biały bez żadnych szczegółów na powierzchni.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

22

a

u

d

i o

k

s

i

a

z

k i

.o

rg

zdjęcie A

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

23

a

u

d

i o

k

s

i

a

z

k i

.o

rg

zdjęcie B

Zdjęcie B wykonano z pomiarem punktowym ekspozycji. Punkt, czy raczej obszar pomiarowy,

ustawiono na księżyc. Tu parametry wyznaczone to: migawka 1/160 s a przysłona F4. Te

ustawienia dają na zdjęciu szczegóły powierzchni księżyca, a reszta jest dokładnie czarna.

Warto zauważyć, że oryginalne pliki typu JPEG tych zdjęć zapisane na karcie pamięci mają

wielkość 203 kB dla A i 1441 kB dla B. Dlaczego taka różnica przy tej samej rozdzielczości -

będzie to omówione przy innej okazji.

Zapraszamy za tydzień do czwartej części naszego poradnika.

Autor jest profesorem na Wydziale Fizyki Uniwersytetu im. A. Mickiewicza.

cz. 5

ABC fotografii cyfrowej cz. 5 - Matryce światłoczułe - budowa i działanie W piątej części

naszego cyklu opiszemy rodzaje i zasady działań matryc światłoczułych wykorzystywanych w

cyfrowych aparatach fotograficznych i kamerach wideo. Matryce CMOS i CCD różnią się

szczegółami jednak podstawowe zasady ich działania są podobne.

Wstęp

W cyfrowych aparatach fotograficznych stosowane są dwa rodzaje matryc światłoczułych o

nazwach - CCD i CMOS. Nazwy te to pierwsze litery anglojęzycznych terminów.

CCD - Charge-Coupled Device, co można przetłumaczyć na język polski zwrotem "urządzenie o

sprzężeniu za pomocą ładunku", w domyśle - elektrycznego. Nazwa pochodzi od sposobu

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

24

a

u

d

i o

k

s

i

a

z

k i

.o

rg

przekazywania informacji (sprzężenia) pomiędzy elementami urządzenia tego typu. Odbywa się

ono poprzez przekazywanie ładunku elektrycznego i nie chodzi tu o przepływ prądu, który jest też

ruchem ładunków, tylko o przekazywanie ładunków, tak jak przekazuje się np. worki z piaskiem w

czasie ustawiania zapory przeciwpowodziowej. Jak zobaczymy dalej, to porównanie jest dość

trafne.

CMOS - Complementary Metal Oxide Semiconductor. CMOS to pewna klasa elementów

półprzewodnikowych, diod, tranzystorów i bramek logicznych o specyficznej budowie, innej niż

tranzystorów typu pnp i npn. Elementy wykonane w technologii CMOS charakteryzują się małym

poborem mocy i dużą odpornością na zakłócenia zewnętrzne. Technologia ich produkcji

opanowana została do perfekcji, dzięki masowemu stosowaniu elementów CMOS w urządzeniach

komputerowych.

Różnice w działaniu matryc światłoczułych typu CCD i CMOS polegają głównie na sposobie

przekazywania ładunków elektrycznych zgromadzonych w nich pod wpływem padającego światła

do dalszej obróbki przez procesor aparatu. Oczywiście istnieją też wspomniane już różnice

technologiczne. Jednak sam proces gromadzenia ładunku proporcjonalnego do ilości padającego

światła jest w obu typach matryc taki sam z punktu widzenia fizyki tego zjawiska.

Jako pierwszą omówimy matrycę typu CCD, dotychczas najczęściej stosowaną w aparatach

fotograficznych. Matryca CCD (ale także typu CMOS) to układ kilku do kilkunastu milionów

identycznych elementów zdolnych do rejestrowania ilości padającego na nią światła. Przez ilość

rozumiemy tu natężenie światła pomnożone przez czas jego działania. W terminologii

fotograficznej ilość światła, padająca na całą matrycę, nazywana jest wartością ekspozycji - EV.

Konwersja światła na ładunek elektryczny

Proces ten jest faktycznie jednakowy dla obu typów matryc a więc opis zamieszczony w tym

paragrafie jest niezależny od tego czy mamy matrycę CCD, czy CMOS.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

25

a

u

d

i o

k

s

i

a

z

k i

.o

rg

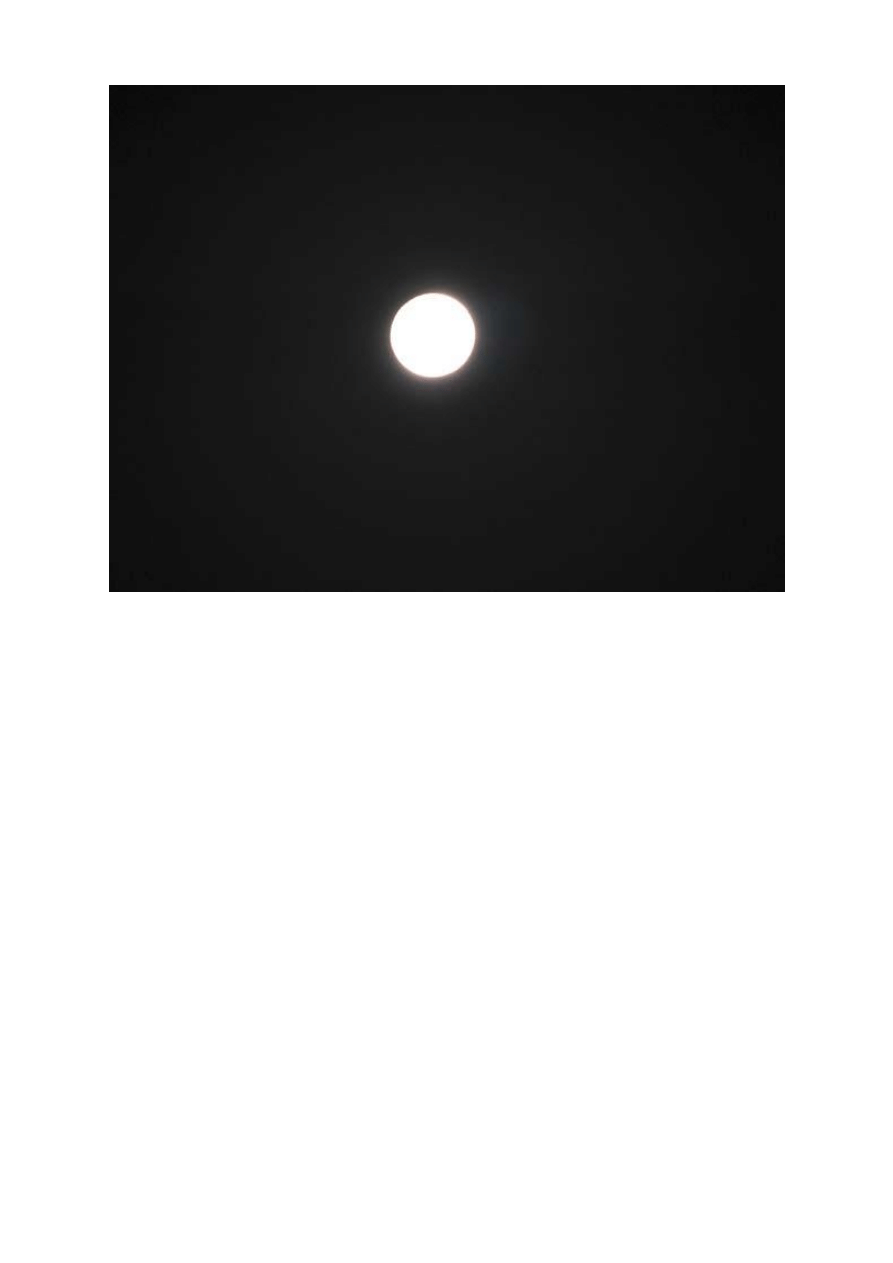

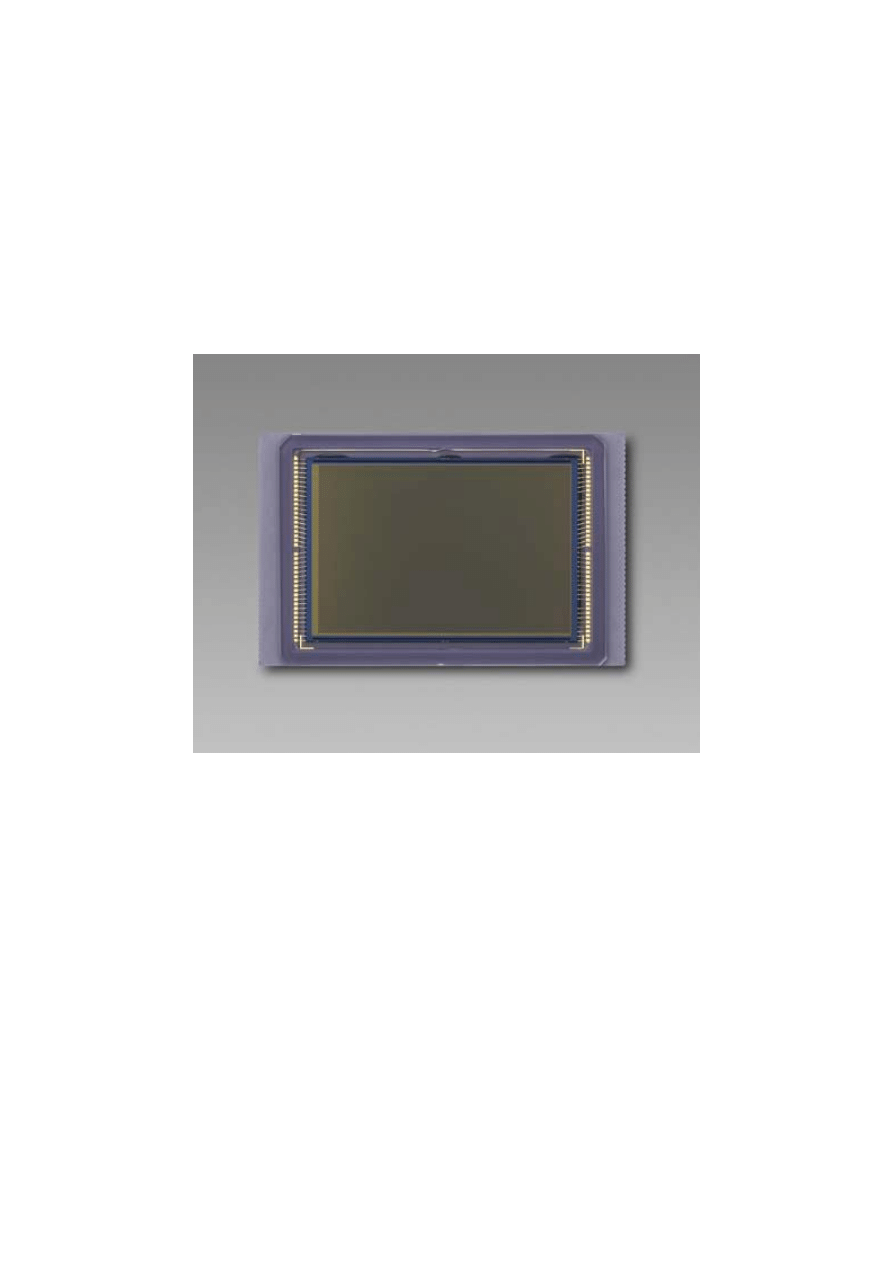

matryca typu CCD aparatu Nikon D80 (źródło: Nikon)

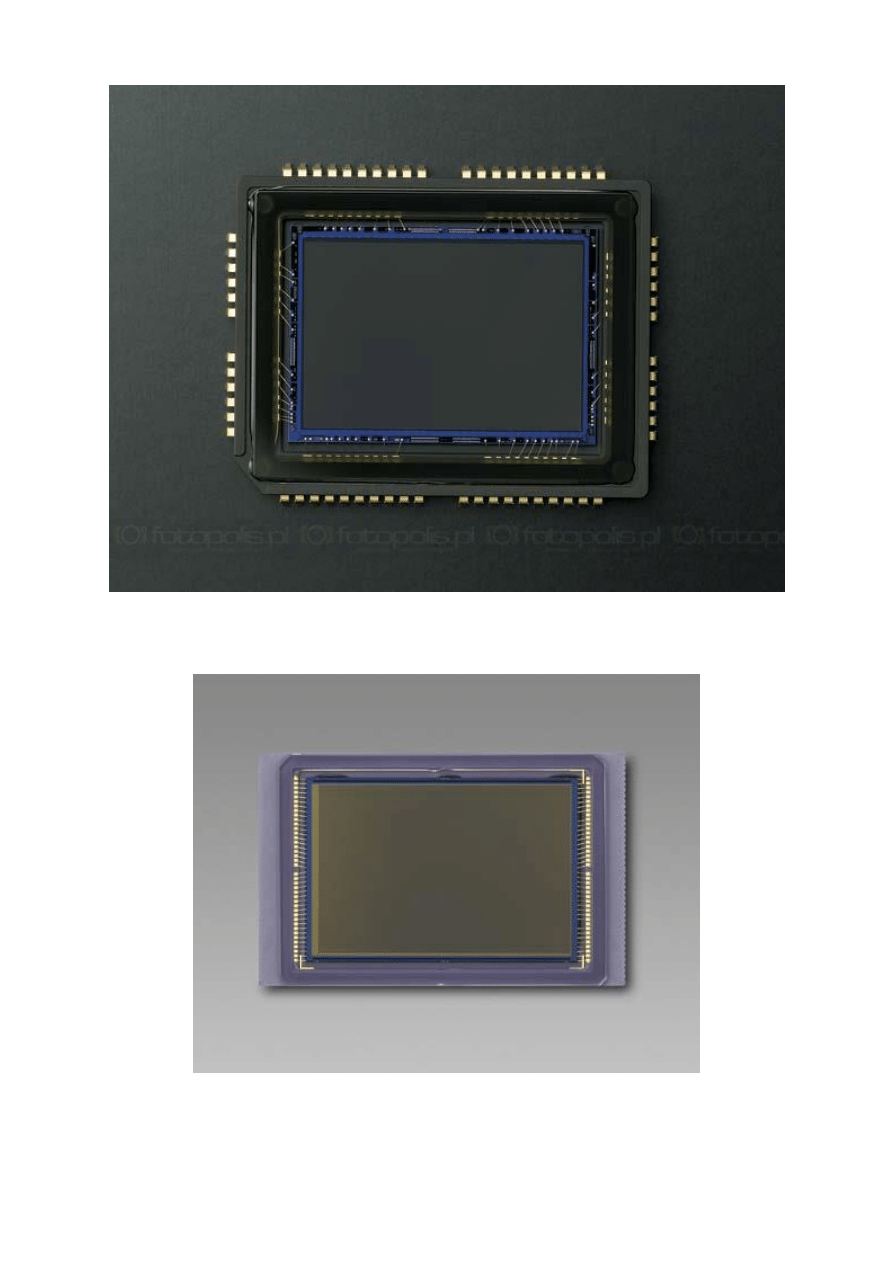

matryca typu CMOS aparatu Canon EOS 5D (źródło: Canon)

Zaczniemy od objaśnienia budowy i zasady działania pojedynczego elementu matrycy zwanego

pikselem. Piksel to spolszczona wersja angielskiego terminu pixel, który powstał z połączenia słów

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

26

a

u

d

i o

k

s

i

a

z

k i

.o

rg

"picture" i "element", które znaczą "element obrazu". W dalszej części artykułu opiszemy, jak

odbywa się zbieranie informacji zgromadzonych w pikselach i przetwarzanie ich na zbiór liczb

reprezentujących ilość światła zarejestrowaną przez każdy z nich. Utworzenie pliku z tymi danymi

i zapisanie go w pamięci procesora cyfrowego aparatu fotograficznego to pierwszy etap tworzenia

zdjęcia. W użyciu jest kilka rodzajów matryc CCD, opiszemy tu piksel matrycy jednego z nich -

najbardziej popularnego.

Pojedynczy piksel to wydzielony na powierzchni matrycy kwadrat o boku około 2,2 mikrometra.

Przedrostek mikro oznacza 1/1 000 000 część jednostki, w tym przypadku metra. Jeden mikrometr

to jedna milionowa część metra czyli 1/1000 część milimetra. Piksel pokryty jest warstwą

substancji nieprzepuszczającej światła (jest to przeważnie aluminium), w której zrobione jest małe

okienko. Powierzchnia tego okienka, to powierzchnia czynna piksela, przez którą światło dociera w

głąb półprzewodnikowej płytki, która jest elementem wyjściowym do produkcji matrycy.

W zasłoniętej przed padającym światłem części piksela znajdują się elementy elektroniki

umożliwiające jego działanie oraz izolujące go elektrycznie od sąsiednich pikseli. Stosunek

powierzchni tego okienka, czyli czynnej części piksela, do powierzchni całego piksela nazywa się

współczynnikiem wypełnienia (po angielsku fill factor). Łatwo się domyślić, że coraz to nowsze

technologie zmierzają do zwiększenia tego współczynnika wypełnienia.

Dokładny opis zasady działania piksela oparty jest na teorii fizyki ciała stałego i jego prezentacja

przekracza możliwości tego artykułu a do tego jest on potrzebny wyłącznie konstruktorom matryc.

W naszym opisie budowy i działania piksela posłużymy się jego uproszczonym modelem

oddającym jednak dobrze wszystkie zalety i wady mające wpływ na jakość robionych zdjęć.

Znajomość budowy i działania piksela oraz całej matrycy pozwoli lepiej wykorzystać możliwości

posiadanego aparatu cyfrowego i może być wskazówką przy wyborze modelu aparatu właściwego

dla naszych celów.

Dla dalszego opisu musimy przypomnieć trochę fizyki. Atomy dowolnego pierwiastka zbudowane

są z jąder o ładunku elektrycznym dodatnim i elektronów o ładunku ujemnym. Atom jako całość

jest neutralny, gdyż ładunki jądra i elektronów wzajemnie się kompensują. Jeżeli od atomu

oderwiemy w jakiś sposób elektron to powstają dwa osobne ładunki: dodatni, czyli atom

pozbawiony jednego elektronu (nazywa się on jonem) i ujemny, czyli ów oderwany elektron, który

jest około 1000 razy mniejszy od najmniejszego jądra atomowego i dlatego ma dużą swobodę

przemieszczania się pomiędzy atomami tworzącymi (w naszym przypadku) strukturę matrycy.

Ważnym pojęciem stosowanym w fizyce, które pomoże nam objaśnić działanie piksela, jest foton.

Foton to elementarna porcja światła, traktowana jak cząstka o zerowej masie, nie posiadająca

ładunku elektrycznego i poruszająca się z prędkością światła. Duża liczba fotonów poruszających

się w tym samym kierunku tworzy wiązkę światła.

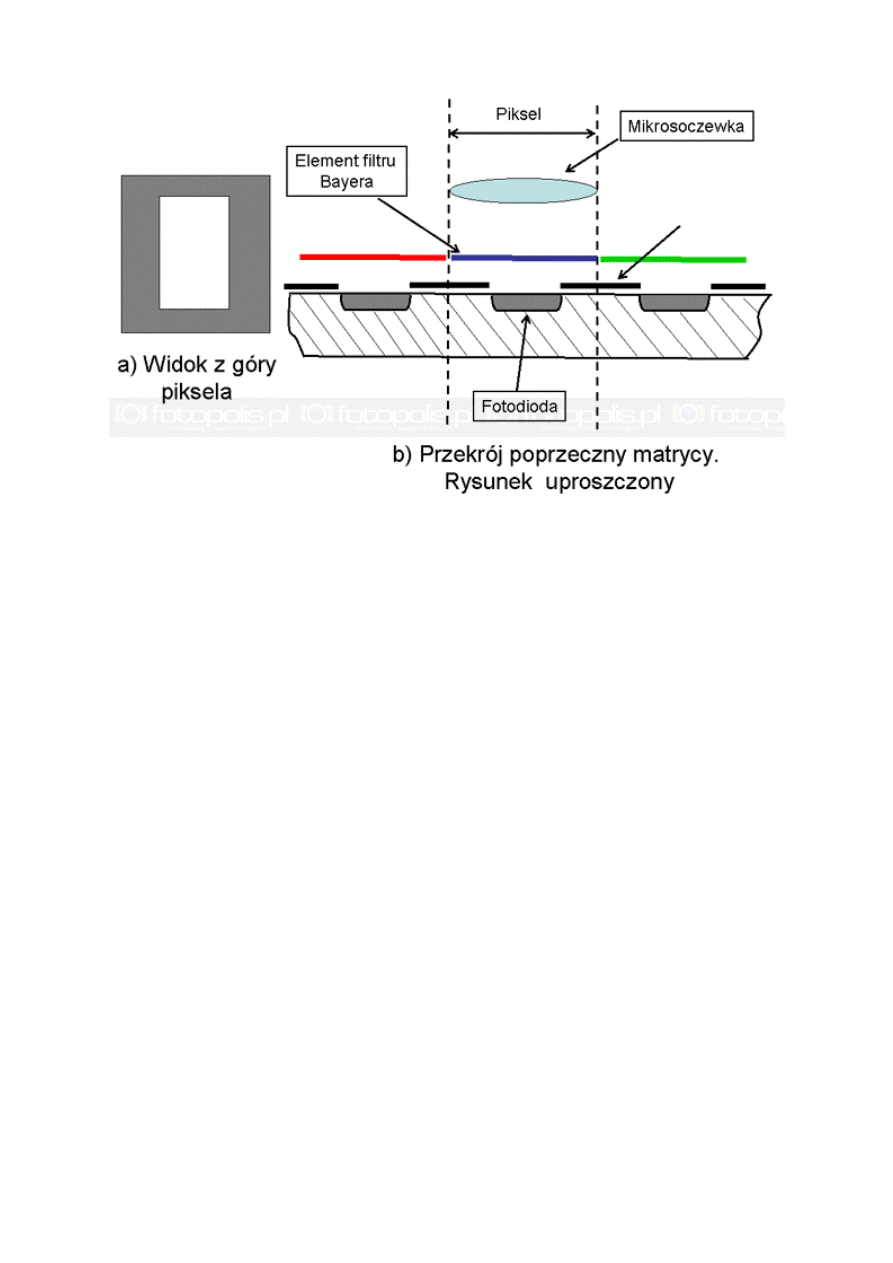

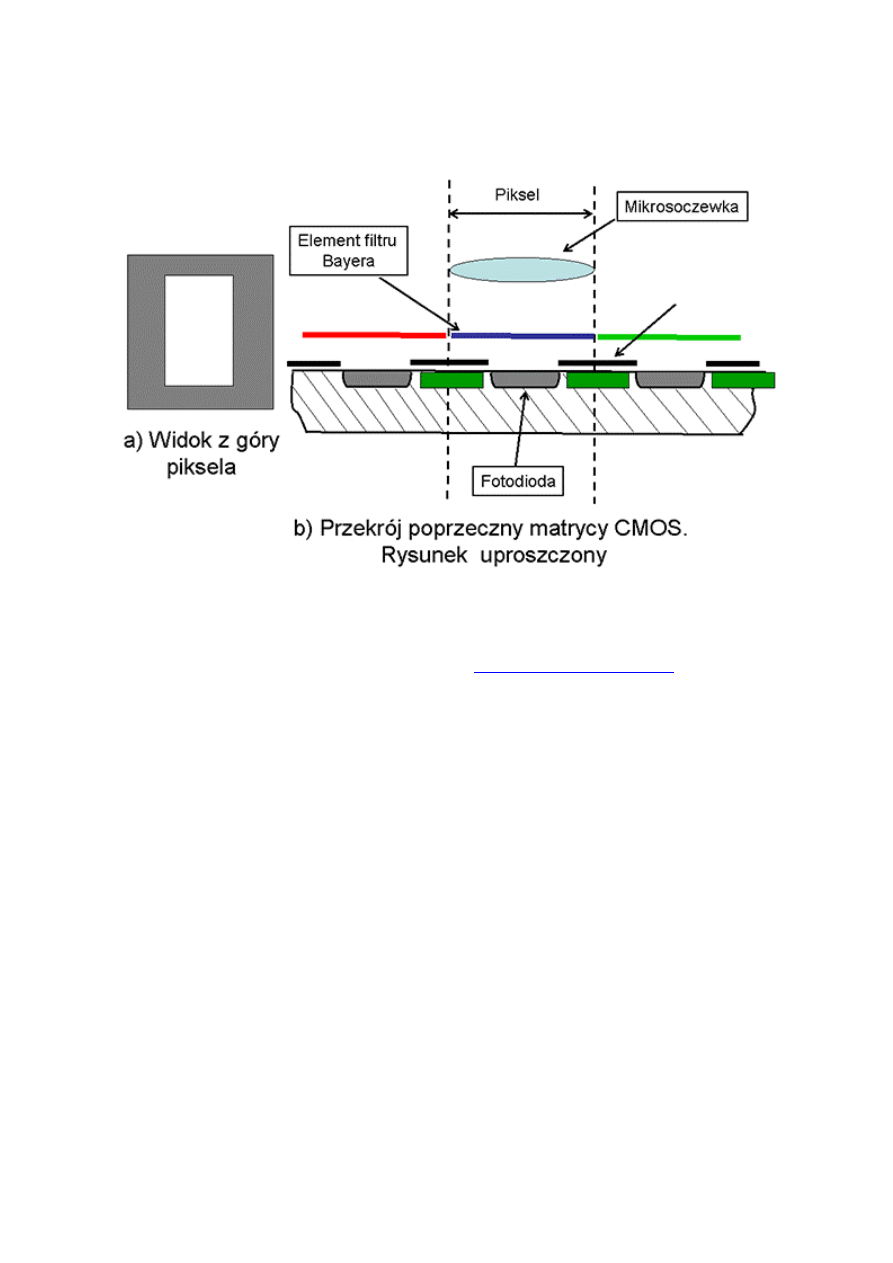

Zaczniemy od objaśnienia sposobu zamiany światła na ładunki elektryczne. Ten etap działania

piksela jest faktycznie jednakowy dla matryc typów CCD i CMOS. Rys. 1 przedstawia widok z

góry pojedynczego piksela i uproszczony schemat przekroju matrycy. W schemacie uwzględniono

tylko elementy odpowiedzialne za konwersję światła na ładunki elektryczne (pominięto na przykład

filtr dolnoprzepustowy). Zaznaczone na rys. 1 mikrosoczewka i filtr Bayera będą omówione nieco

dalej.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

27

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys. 1: schemat matrycy światłoczułej w części wspólnej dla typów CCD i CMOS

Głównym elementem piksela jest fotodioda, czyli element półprzewodnikowy, w którym następuje

wydzielanie się ładunków elektrycznych pod wpływem padającego światła. Szczegółowy model

tego procesu jest następujący. Strumień fotonów tworzący wiązkę światła pada na fotodiodę.

Bardzo mała część z nich jest pochłaniana przez krzem, z którego zbudowana jest matryca,

zamieniając swoją energię na ciepło. Znacznie większa część fotonów trafia w elektron atomów

fotodiody i odrywa go od tego atomu. Nazywa się to efektem fotoelektrycznym wewnętrznym.

Stosunek liczby wybitych elektronów do liczby padających fotonów określa tzw. wydajność

kwantową piksela. Dla matryc światłoczułych jest ona około 90%. Warto przytoczyć tu wydajność

kwantową filmów światłoczułych. Jest ona nieco inaczej zdefiniowana i wynosi około 2%. Nie

dziwi więc, że astronomowie jako pierwsi zaczęli stosować matryce CCD do fotografowania słabo

świecących obiektów na niebie.

Obok wydajności kwantowej piksel charakteryzowany jest czułością optyczną. Czułość optyczna

piksela to stosunek energii fotonów padających na piksel do energii elektrycznej wytworzonej

przez piksel pod wpływem tych fotonów. Ten parametr piksela nie jest równoznaczny z czułością

aparatu podawaną w jednostkach ISO, choć jest jednym ze składników tej czułości.

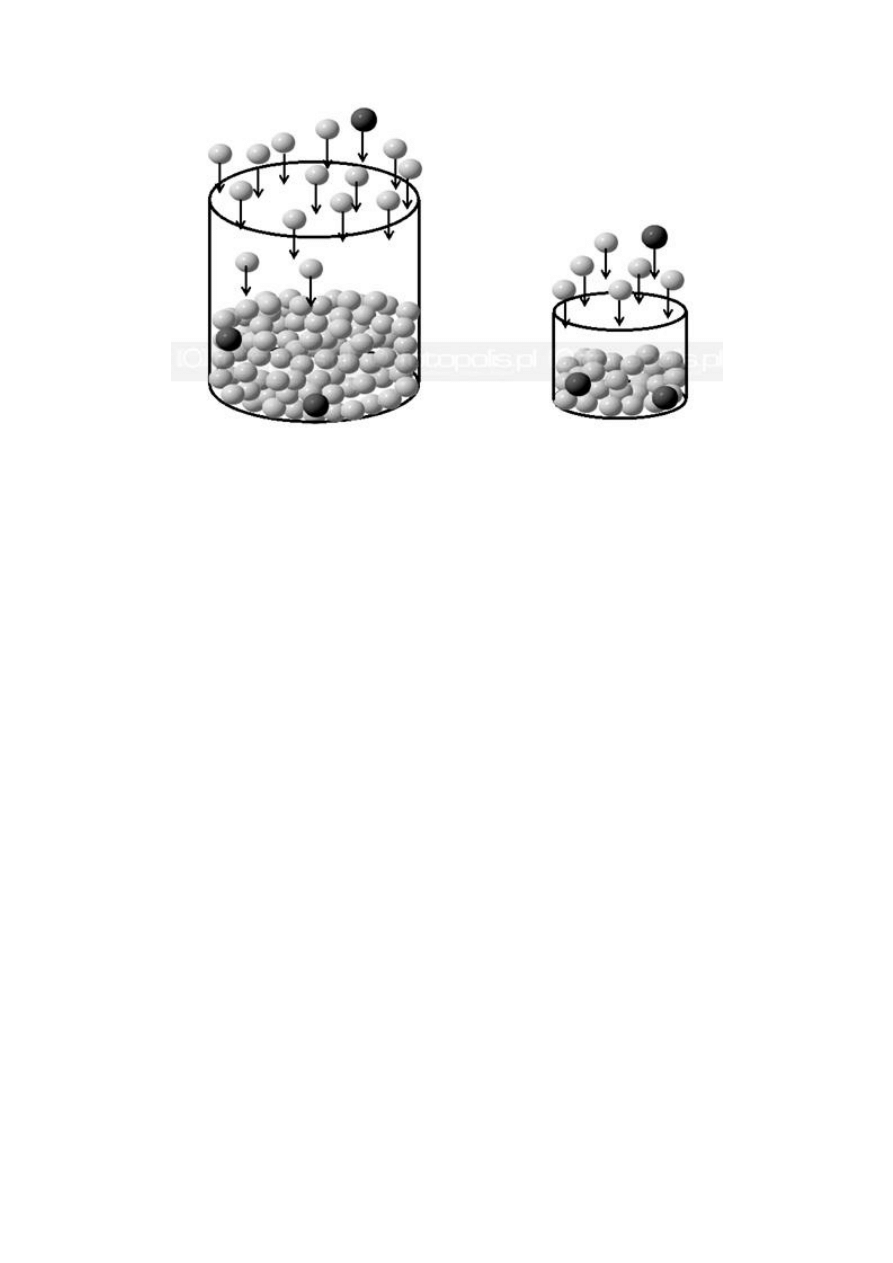

Oderwany od atomu elektron musi zostać gdzieś zmagazynowany. Wytwarza się więc obszar z

dodatnim potencjałem przyciągającym ujemne elektrony. Jako model takiego obszaru może

posłużyć mały pojemnik, do którego wpadają elektrony wybijane z atomów krzemu fotonami

padającymi na fotodiodę. Model ten dobrze oddaje takie własności piksela jak czułość, liniowość,

czy efekt zwany bloomingiem.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

28

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys. 2: modelowe przedstawienie czułości matrycy w zależności od wielkości pojedynczego piksela

Na rys. 2 pokazane są dwa takie zbiorniki elektronów o różnej wielkości, co ma odzwierciedlać

fakt, że w różnych matrycach mogą być piksele o różnej wielkości powierzchni czynnej. Szare

kulki symbolizują elektrony wybite z atomów fotonami, których liczba jest proporcjonalna do

ilości światła padającego na dany piksel. Kulki czarne to elektrony, które powstały w wyniku

innych procesów zachodzących w fotodiodzie, np. grzania się matrycy. Elektronika aparatu

cyfrowego nie rozróżnia tych dwóch rodzajów elektronów gromadzonych w pikselu i dlatego te

oznaczone czarnym kolorem zakłócają obraz rejestrowany przez matrycę. Piksel po prostu

gromadzi więcej elektronów, co dalsze elementy aparatu interpretują jako większą jasność obrazu

w tym miejscu a wiemy, że to nie większa jasność, tylko zakłócenie pracy fotodiody. Zjawisko to

nazywamy szumem. Szumy w aparacie cyfrowym to bardzo szerokie zagadnienie i będzie

omówione oddzielnie. Rys. 2 oddaje znany fakt, że im większa powierzchnia piksela, tym większa

czułość całej matrycy, gdyż więcej elektronów jest wytwarzanych przez światło padające na jeden

piksel.

Model części matrycy wystawionej na działanie światła z rys.1 i model procesu gromadzenia

ładunku elektrycznego z rys. 2 są w zasadzie identyczne dla typów CCD i CMOS. Opis

generowania elektronów fotonami padającymi na piksel, jak i opis gromadzenia tych elektronów są

również takie same dla obu typów matryc. Za tydzień w następnej części tego artykułu opiszemy te

elementy budowy i działania matryc CCD i CMOS, które są różne dla obu typów.

Autor jest profesorem na Wydziale Fizyki Uniwersytetu im. A. Mickiewicza.

cz. 6

ABC fotografii cyfrowej cz. 6 - Matryce światłoczułe CCD W szóstej części naszego cyklu

opisujemy szczegółowo zasadę działania kilku rodzajów matryc CCD charakteryzujących się

architekturą odczytu typu "frame transfer", "full frame transfer" oraz "interline transfer".

Zapraszamy!

Matryce CCD

Z punktu widzenia technologii wykonania i zasad działania istnieje jeden rodzaj matryc CCD, w

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

29

a

u

d

i o

k

s

i

a

z

k i

.o

rg

których ładunek wytworzony padającym światłem i zgromadzony w oddzielnym miejscu dla

każdego piksela jest następnie przemieszczany do układów elektronicznych zamieniających go na

napięcie, a dalej na liczbę proporcjonalną do wytworzonego ładunku. Oświetleniu każdego piksela

odpowiada jedna liczba. Liczby te tworzą plik, który przetwarzany jest w procesorze aparatu na

obraz. Proces konwersji oświetlenia matrycy w plik liczb to etap realizowany przez matrycę i

urządzenia bezpośrednio z nią współpracujące. Istnieje wiele rozwiązań konstrukcyjnych

realizujących przemieszczanie ładunków elektrycznych zgromadzonych w pikselach do układów

elektronicznych. Należy jednak pamiętać, że te, które omówimy w dzisiejszym odcinku, dotyczą

wyłącznie matryc typu CCD.

Warto tu przytoczyć analogię do rodzajów silników benzynowych. Są silniki z gaźnikiem, z

wtryskiem jedno- lub wielopunktowym, z turbodoładowaniem. Każdy z nich może mieć kilka

odmian. Wszystkie działają w oparciu o spalanie benzyny, stąd ich nazwa - benzynowe. Drugi typ

silników spalinowych to silniki wytwarzające energię mechaniczną w wyniku spalania oleju

napędowego. Ten typ silników również ma wiele odmian i modyfikacji, ale wszystkie stanowią

jeden typ - są silnikami Diesla.

Analogicznie wygląda sprawa matryc światłoczułych w aparatach fotograficznych. Stosowane są

dwa typy - CCD i CMOS. Różnią się technologią wykonania i szczegółami przetwarzania

zgromadzonego ładunku na liczby. Oba typy matryc realizują jednak to samo zadanie - rejestrują

padający na nie obraz fotografowanych obiektów. Piszemy o tej analogi tak obszernie, ale naszym

zdaniem to bardzo istotne, gdyż ogromna większość pytań czytelników dotyczących matryc brzmi:

"Które matryce są lepsze - CCD, czy CMOS?". Jest to pytanie, na które nie można dać

jednoznacznej odpowiedzi, tak jak na pytanie: "Który silnik jest lepszy - benzynowy, czy Diesel?".

Przesyłanie ładunków z pikseli do układów elektronicznych

Jedną z cech identyfikujących różne odmiany matryc typu CCD jest wspólny dla wszystkich pikseli

układ przetwarzania ładunków na napięcia i tych napięć na liczby. Proces ten nazywany jest

odczytem matrycy. W praktyce najczęściej stosowane są trzy systemy odczytu ładunku z matryc

CCD. Wiele terminów anglojęzycznych fotografii cyfrowej nie doczekało się jeszcze oficjalnie

zatwierdzonych nazw polskich. Będziemy w takich przypadkach posługiwać się nazwami

anglojęzycznymi, aby nie wprowadzać zamętu poprzez tworzenie polskiej terminologii ad hoc.

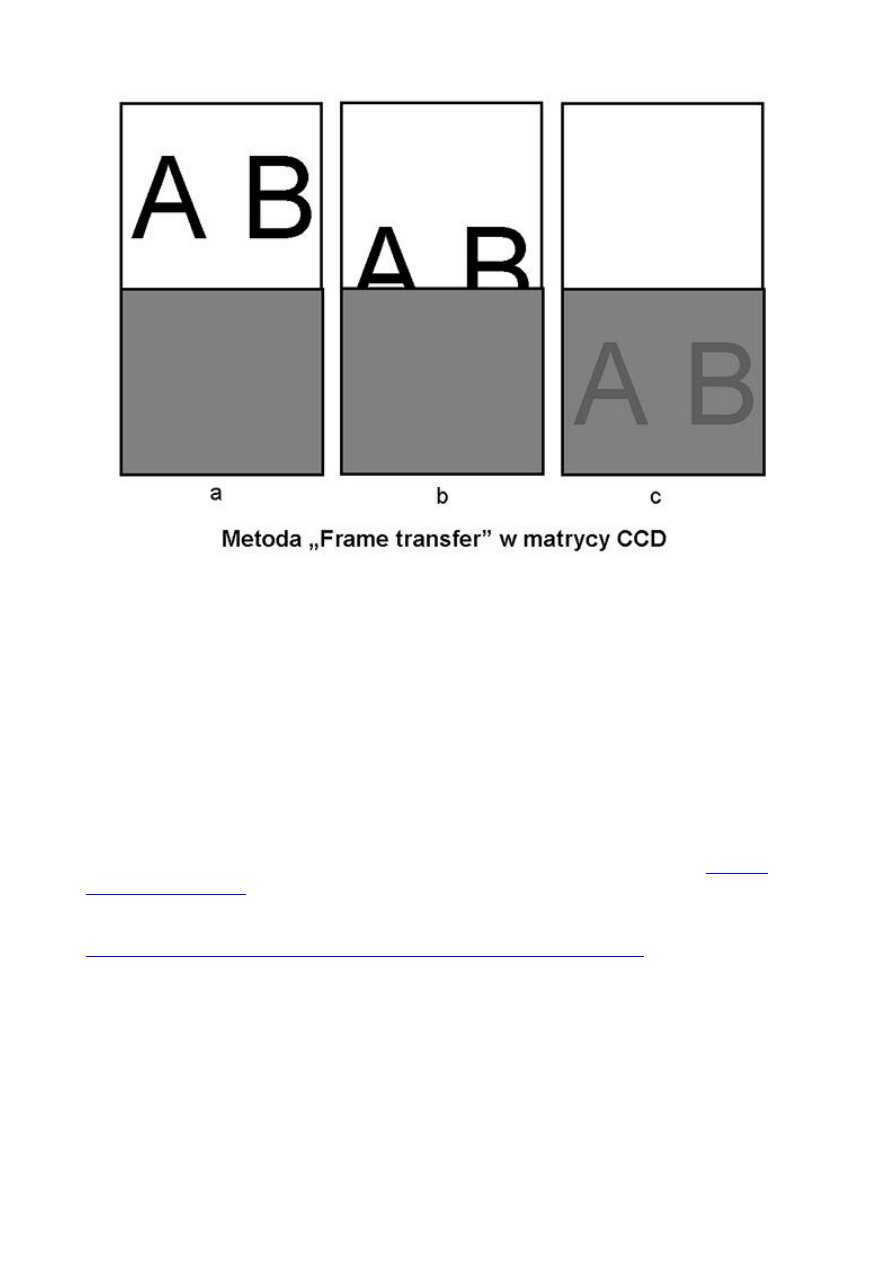

Frame transfer, czyli przenoszenie całego zarejestrowanego obrazu. Matryca składa się z dwóch

części, każda o tej samej liczbie pikseli. Po zarejestrowaniu obrazu ładunek ze wszystkich pikseli,

czyli odwzorowanie fotografowanego obiektu, zostaje przesunięty do pikseli magazynujących,

zasłoniętych przed światłem. Schematycznie przedstawia to rys. 1.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

30

a

u

d

i o

k

s

i

a

z

k i

.o

rg

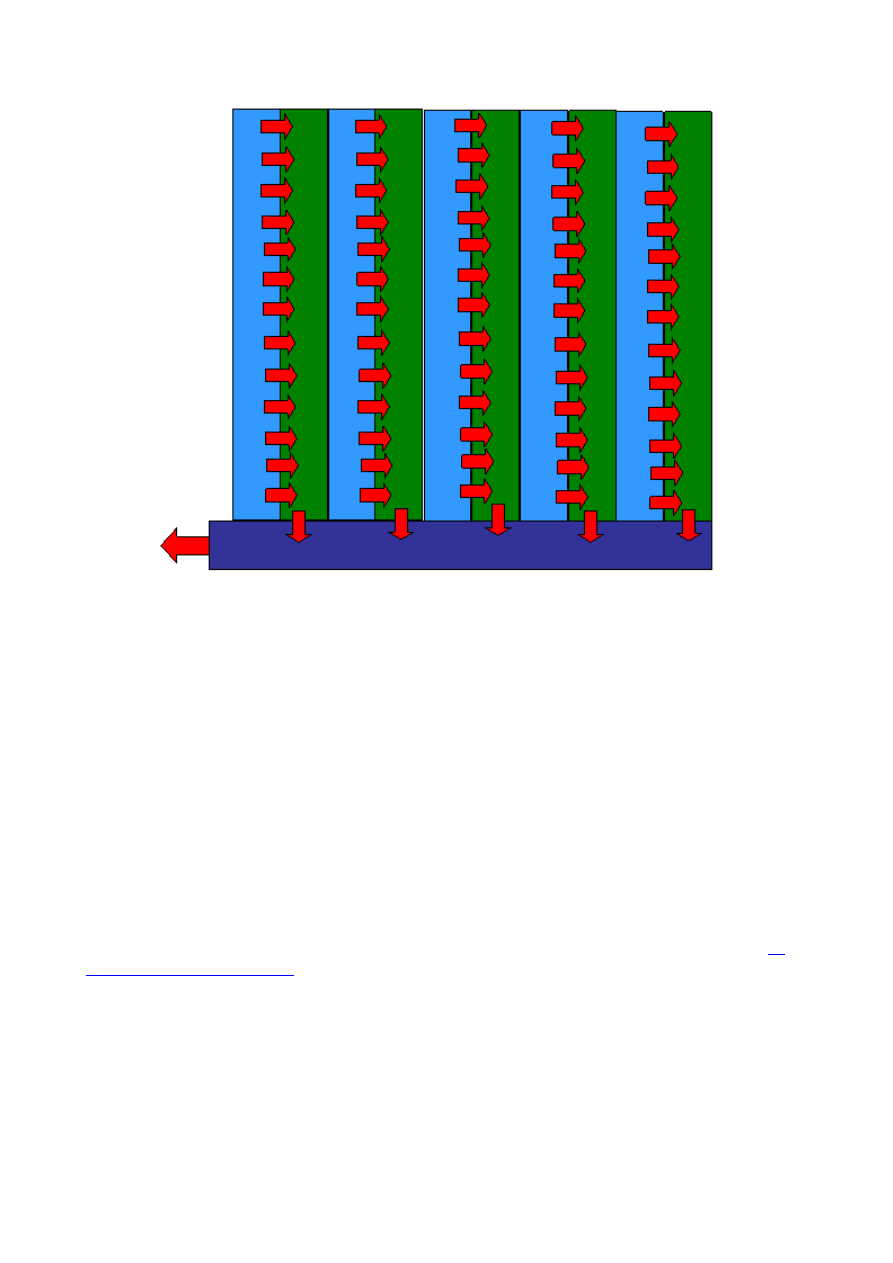

rys. 1: schemat matrycy CCD typu "frame transfer"

Część górna, biała, to piksele wystawione na działanie światła, rejestrujące obraz. Część dolna to

piksele zasłonięte przed wpadającym do aparatu światłem, magazynujące przesunięte do nich

ładunki elektryczne. Przesunięcie wszystkich ładunków trwa około 0,5 ms, czyli 1/2000 część

sekundy. Niestety w tym czasie matryca jest wystawiona na działanie światła i następuje lekkie

rozmycie obrazu. Zanim ładunek przemieści się przez kolejne piksele aż do "schowania" się w

dolnej części, światło wpadające przez obiektyw wygeneruje trochę dodatkowych elektronów.

Przesuwanie ładunków realizują specjalne rejestry zintegrowane z matrycą.

Czas transferu ładunków jest jednak na tyle krótki, że dla większości zastosowań powstałe

zniekształcenia obrazu można uznać za nieistotne. Można też zastosować migawkę mechaniczną,

która po naświetleniu matrycy zasłoni ją na czas przesuwania ładunku do części dolnej. Taka

konstrukcja matrycy daje prawie 100 % współczynnik wypełnienia, o którym mowa w

5. części

naszego przewodnika.

Bardzo ładną animację odczytu typu "Frame transfer" można obejrzeć na stronach laboratorium

Optical Microscopy Division of the National High Magnetic Field Laboratory.

Full frame transfer, to rodzaj matryc CCD, w których ładunki elektryczne zgromadzone w

pikselach pod wpływem światła są przenoszone do elementów przetwarzających je na obraz bez

etapu składowania ich w obszarze zasłoniętym przed światłem. Schematycznie obrazuje to rys. 2.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

31

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys. 2: schemat działania matrycy CCD typu "full frame transfer"

Po naświetleniu matrycy ładunki z kolejnych wierszy pikseli są przesuwane w dół do rejestru

zaznaczonego kolorem niebieskim. To przesuwanie realizuje rejestr zaznaczony kolorem zielonym.

Nazwy tych rejestrów to: rejestr przesuwu pionowego - zielony, i przesuwu poziomego - niebieski.

Rejestr przesuwu poziomego przenosi ładunki do dalszych elementów aparatu cyfrowego, które nie

stanowią integralnej części matrycy CCD i będą omówione osobno.

W tym systemie odczytanie ładunków powstałych w trakcie robienia zdjęcia trwa znacznie dłużej,

niż w opisanym powyżej systemie "frame transfer". Dlatego w aparatach o takiej konstrukcji

matrycy konieczne jest zastosowanie migawki mechanicznej, która zasłoni matrycę na czas

odczytu. Matryca ma prawie 100 % współczynnik wypełnienia, podobnie jak w systemie "frame

transfer". Zapewnia to dużą czułość, gdyż prawie cała powierzchnia matrycy jest wykorzystana do

rejestracji natężenia padającego światła.

Animację tego systemu odczytu można obejrzeć na wspomnianych już stronach laboratorium

Optical Microscopy Division of the National High Magnetic Field Laboratory.

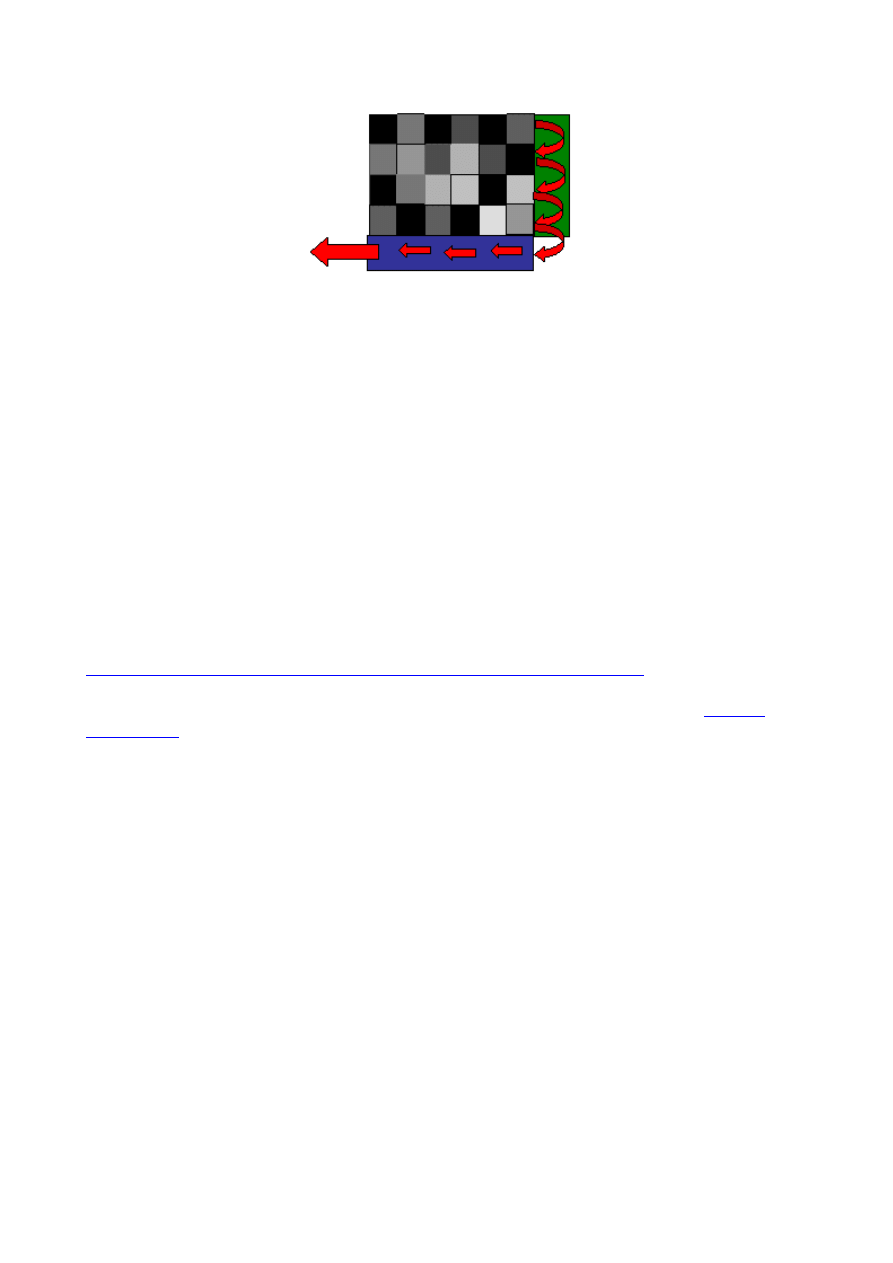

Interlinie transfer, co można przetłumaczyć jako przesuw międzyliniowy. Na rys.1 z

5. części

przewodnika

pokazano puste miejsce obok czynnej części piksela. To właśnie miejsce jest

wykorzystane do "zmagazynowania" ładunku zaraz po jego zgromadzeniu w trakcie ekspozycji.

Patrząc z góry na schemat takiej matrycy zobaczymy, że obok każdej kolumny pikseli

rejestrujących światło znajduje się kolumna do przechowywania ładunku elektrycznego, który

następnie jest odczytywany i przekazywany w celu przetworzenia go w zdjęcie.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

32

a

u

d

i o

k

s

i

a

z

k i

.o

rg

rys. 3: schemat matrycy CCD o architekturze odczytu zwanej "interline transfer"

Kolumny niebieskie oznaczają piksele odsłonięte dla padającego światła. Kolumny zielone -

piksele zasłonięte przed światłem i wykorzystywane dla przechowania ładunku na czas jego

transferu do elementów aparatu przetwarzających ładunki na obraz. Na rys. 3 zaznaczono kierunki

przemieszczania ładunków. Przeniesienie ładunków z pikseli rejestrujących do pikseli

magazynujących zajmuje około 1000 razy mniej czasu, niż w matrycach o architekturze "full frame

transfer", bo wymaga ich przesunięcia tylko o szerokość jednego piksela, podczas gdy w trybie

"full frame transfer" ładunki muszą zostać przeniesione na odległość równą liczbie wierszy

matrycy pomnożonej przez wysokość pojedynczego piksela. Przy tej metodzie odczytu nie jest w

ogóle potrzebna migawka mechaniczna. Czas przesuwania ładunków to rząd 1μs i nie ma obawy,

by w tak krótkim czasie nastąpiło znaczące zaburzenie liczby zgromadzonych na pikselu ładunków.

Parametry techniczne matryc

Czytelnicy zainteresowani szczegółowymi parametrami różnych typów matryc mogą je znaleźć

na

stronie internetowej Kodaka.

Dla wygody czytelnika wyjaśniamy znaczenie poszczególnych nazw z tabelek.

Full frame CCD - wiemy już, co to znaczy.

Pixel count - to liczba pikseli w kierunku poziomym (H) i pionowym (V).

Pixel size - wymiary piksela.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

33

a

u

d

i o

k

s

i

a

z

k i

.o

rg

Optical Fill Factor - współczynnik wypełnienia; wiemy już, co to jest.

Saturation signal - to liczba elektronów, która "zapełnia" piksel. Dalsze naświetlanie nie przekłada

się już na przyrost tej liczby, a może jedynie dawać efekty zniekształcające zdjęcie. Nowoczesne

konstrukcje matryc są zabezpieczone przed takim "przepełnieniem" piksela elektronami.

"Nadwyżka" jest odprowadzana i neutralizowana w obudowie matrycy.

Output Sensitivity - czyli czułość wyjściowa, to wielkość napięcia jaką uzyskuje się z

wygenerowanego w pikselu 1 elektronu. Ma ona wartość rzędu 10 μV/elektron. Łatwo przeliczyć,

że przy zgromadzenie w pikselu około 50 tys. elektronów (typowa maksymalna liczba elektronów

mieszcząca się w pikselu) napięcie uzyskane z tego piksela bez wzmacniania wyniesie około 0,5 V,

czyli wartość łatwą do mierzenia czy przetwarzania przez inne układy elektroniczne.

Dark Current (25 C, Accumulation Mode) - prąd wytwarzany w fotodiodzie przy braku

oświetlenia, w trybie rejestracji obrazu. Polska nazwa - prąd ciemny. 25° C oznacza temperaturę, w

której wyznaczono ten parametr. Prąd ten ma wartość rzędu kilku p/A cm

2

(przedrostek piko

oznacza 10

-12

, czyli jeden podzielone przez tysiąc miliardów!). To jest prąd, jaki generowałby

samoistnie piksel o powierzchni 1 cm

2

. Powierzchnia czynna jednego piksela to mniej niż 10

-6

cm

2

,

czyli prąd ciemny jednego piksela jest przynajmniej milion razy słabszy. Z punktu widzenia życia

codziennego to bardzo mała wartość natężenia prądu. Stuwatowa żarówka pobiera około 0,4 A,

czyli około 10

18

razy więcej. Prąd ciemny decyduje o szumach widocznych na zdjęciu.

Dark Current Doubling Rate - przyrost temperatury, który wywołuje podwojenie się prądu

ciemnego. Mieści się zakresie od 5° C do 10° C. Ten parametr wyjaśnia, dlaczego w aparatach dla

celów specjalnych, np. w astronomii, chłodzi się matryce do temperatur ciekłego azotu (-196° C).

Pozwala to na stosowanie bardzo długich czasów naświetlania bez obawy zaszumienia zdjęcia

prądem ciemnym matrycy.

Dynamic Range (Sat Sig/Dark Noise) - dynamika piksela, czyli stosunek liczby elektronów przy

nasyceniu do liczby elektronów wyzwalanych samorzutnie przez nieoświetloną fotodiodę. Ten

parametr informuje nas, jaka będzie maksymalna rozpiętość odcieni jasności, którą rozróżnimy na

zdjęciu wykonanym aparatem z taką matrycą. Dynamika podawana jest w decybelach i dla matryc

CCD wynosi około 80 dB. Nie wnikając w definicję decybeli, 80 dB oznacza, że stosunek jasności

rejestrowanych przez piksel wynosi 1:10000.

Quantum Efficiency (450, 550, 650 nm) - wydajność kwantowa dla długości fal świetlnych

podanych w nawiasach. Odpowiada to kolorom - niebieskiemu, zielonemu i czerwonemu. To

bardzo wyszukany parametr, który ma znaczenie dla zastosowań matryc w przyrządach

naukowych. Nie będziemy więc tu za dużo o nim pisać. Wydajność podawana jest w procentach.

Pojęcie to zostało objaśnione w

5. części naszego przewodnika.

Istnieje wiele modyfikacji konstrukcyjnych matryc CCD, charakteryzujących się różnym kształtem

pikseli i ich rozmieszczeniem w matrycy. Zasada ich działania i odczytu jest jednak zawsze taka

sama. W następnym rozdziale tego artykułu opiszemy matryce typu CMOS, a następnie zrobimy

ich porównanie.

Szersze omówienie przedstawionych problemów można znaleźć w monografii Image Sensors and

Signal Processing for Digital Still Camera pod redakcją Junichiego Nakamury wydanej przez

wydawnictwo Taylor & Francis (Londyn 2006).

Autor jest profesorem na Wydziale Fizyki Uniwersytetu im. A. Mickiewicza.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

34

a

u

d

i o

k

s

i

a

z

k i

.o

rg

cz. 7

ABC fotografii cyfrowej cz. 7 - Matryce światłoczułe CMOS W siódmej części naszego cyklu

opisujemy szczegółowo zasadę działania matryc CMOS. Omawiamy podstawowe różnice

między przetwornikami typu CMOS i CCD oraz zastanawiamy się, które rozwiązanie

zasługuje na miano lepszego. Zapraszamy!

1. Matryce CMOS

CMOS to pierwsze litery nazwy Complementary Metal Oxide Semiconductor, która oznacza pewną

technologię wykonania elementów półprzewodnikowych, charakteryzującą się niższym napięciem

zasilania, mniejszym poborem mocy i większą odpornością na zakłócenia (w porównaniu z

elementami matryc CCD). Najistotniejszą cechą matryc CMOS, odróżniającą je od sensorów CCD,

jest jednak ich architektura, a dopiero potem technologia wytwarzania zastosowanych elementów

półprzewodnikowych.

W matrycach CMOS każdy piksel jest zintegrowany z przetwornikiem ładunku elektrycznego na

napięcie i wzmacniaczem tego napięcia. Taka architektura eliminuje szumy wnoszone w matrycy

CCD w trakcie przemieszczania ładunków do wspólnego dla wszystkich pikseli układu

przetwarzania ich na napięcie.

Każdy piksel ma swój adres (x, y), określający jego położenie w matrycy CMOS. Pozwala to nie

tylko na odczytywanie pikseli w dowolnej kolejności, ale też dowolnej ich liczby. Daje to

możliwość łatwego odczytu fragmentu obrazu (ang. windowing, co można przetłumaczyć jako

"okienkowanie"). Z matrycą CMOS jest na ogół zintegrowany dodatkowy wzmacniacz napięcia i

przetwornik analogowo-cyfrowy, więc faktycznie odczytujemy z przetwornika od razu liczby

reprezentujące jasność poszczególnych pikseli. Te elementy dają matrycom CMOS przewagę nad

sensorami CCD jeżeli chodzi o szybkość działania i elastyczność odczytu. CMOS to jednak nie

same zalety.

Fotodiody wykonane w technologii CMOS mają mniejszą czułość (w przeliczeniu na jednostkę

powierzchni) i większy prąd ciemny, który przejawia się jako szum na zdjęciach z długimi czasami

ekspozycji. Mniejszą czułość fotodiod rekompensuje się stosowaniem w matrycach CMOS pikseli

o większej powierzchni, co jednak wymaga większych rozmiarów całego sensora. Dlatego CMOS-

y są stosowane głównie w lustrzankach o dużych wymiarach przetwornika. Dużych, czyli formatu

zbliżonego do małego obrazka lub wręcz pełnoklatkowych (24x36 mm).

Jeżeli większość aparatów kompaktowych ma matryce CCD o symbolu 1/1,8", co odpowiada

wymiarom około 5,3x7,2 mm, to matryce CMOS stosowane w popularnych lustrzankach mają

symbol APS, któremu odpowiadają rozmiary od około 14x21 mm do 16x24 mm. Powierzchnia

matrycy formatu APS jest więc około 8 razy większa od powierzchni matrycy 1/1,8". Niestety

część tej powierzchni zajmują układy elektroniczne zintegrowane z każdym pikselem. Dlatego też

współczynnik wypełnienia piksela jest mniejszy niż w matrycach CCD. Na wszelki wypadek

przypomnijmy - współczynnik wypełnienia to stosunek powierzchni całego piksela do powierzchni

wystawionej na działanie światła.

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

35

a

u

d

i o

k

s

i

a

z

k i

.o

rg

schematyczne przedstawienie przekroju poprzecznego matrycy typu CMOS

Porównując powyższy rysunek z pierwszą ilustracją z

5. części naszego poradnika

widzimy

dodatkowe zielone prostokąty, które symbolizują układ elektroniczny konwersji ładunku na

napięcie i wzmacniacz tego napięcia. Zintegrowanie z fotodiodą przetwornika ładunku na napięcie i

odczytywanie tego napięcia w systemie adresowym (x, y) jest najistotniejszym wyróżnikiem

matryc CMOS w odniesieniu do sensorów CCD. Taka architektura znacząco skraca czas odczytu

całej matrycy, gdyż przetwarzanie ładunków na napięcie odbywa się równocześnie dla wszystkich

pikseli, podczas gdy w matrycy CCD ładunki z każdego piksela doprowadzane są po kolei do

jednego układu przetwarzającego.

Konstrukcja matryc CMOS ma jednak pewną wadę. Z technologicznego punktu widzenia nie da się

wytworzyć kilku czy kilkunastu milionów idealnie jednakowych układów zamieniających ładunek

na napięcie. Tak więc przy równym naświetleniu całej matrycy CMOS z każdego piksela

odczytamy nieco inne napięcie, co objawi się na zdjęciu jako szum. Ten mankament można jednak

łatwo usunąć odpowiednią funkcją programu zapisanego w aparacie. Bezpośrednio po wykonaniu

zdjęcia aparat wykonuje drugie, przy zamkniętej migawce mechanicznej. Od napięć

reprezentujących zdjęcie obiektu program w aparacie fotograficznym odejmuje napięcia

reprezentujące "zdjęcie" z zamkniętą migawką. W ten sposób eliminuje się zarówno szumy

pochodzące od nierównomiernego wzmacniania sygnału przy poszczególnych pikselach, jak i

szumy pochodzące od prądu ciemnego.

2. Migawka elektroniczna w matrycy CMOS

Możliwość sterowania resetowaniem pikseli, czyli zerowaniem zebranego na nich ładunku, oraz

procesem zbierania ładunku pod wpływem światła pozwala na stosowanie "elektronicznej

migawki". Nie wnikając w szczegóły wygląda to tak:

| fotopolis.pl © | sharing >> a u d i o k s i a z k i.org |

36

a

u

d

i o

k

s

i

a

z

k i

.o

rg

•

odpowiednimi impulsami elektrycznymi resetujemy ładunek zgromadzony w pikselach,

•

odczekujemy ustalony programem czas, np. 1/125 s,

•

dokonujemy odczytu ładunków zgromadzonych na matrycy.

Otrzymujemy w ten sposób zdjęcie z czasem ekspozycji 1/125 s. Oczywiście dla jasności przekazu

pominęliśmy w tym opisie proces ustawiania innych parametrów wymaganych dla otrzymania

zdjęcia poprawnego technicznie.