Pytanie 32:

Sieci neuronowe – rodzaje,

zastosowania

opracował Grzegorz Golaś 127386

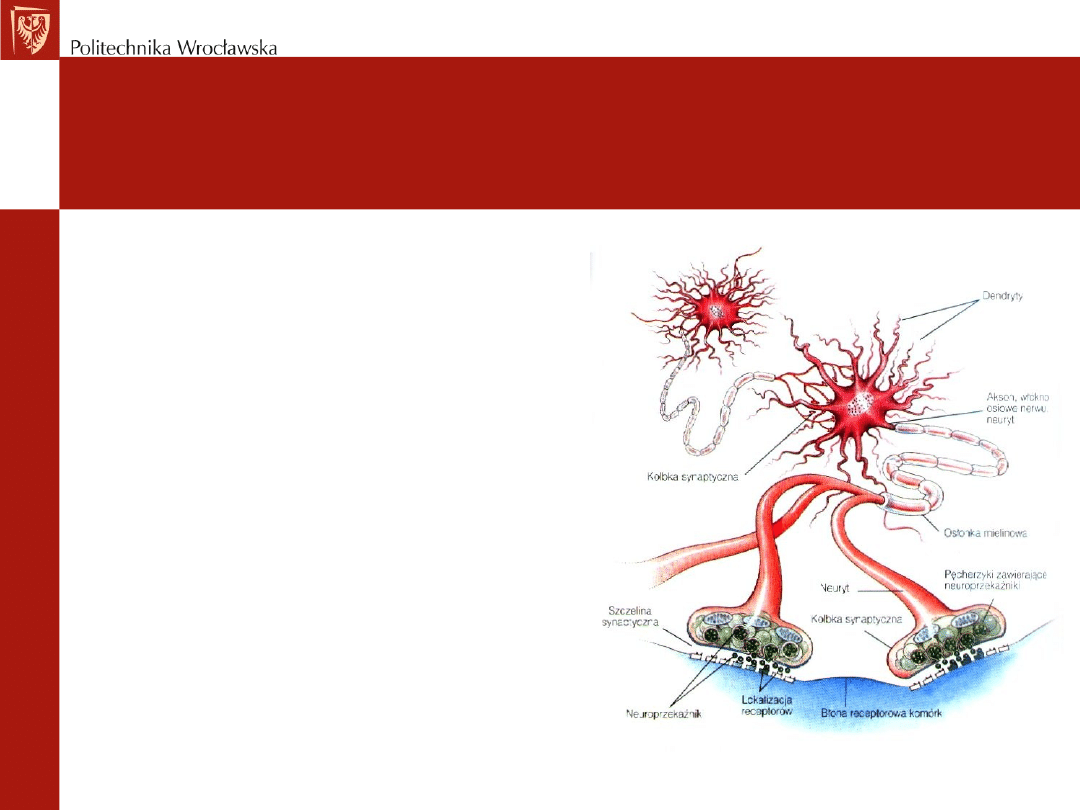

Budowa komórki nerwowej

Układ nerwowy składa się z milionów

wzajemnie połączonych komórek

nazywanych komórkami

neuralnymi lub neuronami. Każda

z nich jest złożonym układem

zajmującym się przetwarzaniem

sygnałów. Niektóre otrzymuja

informacje od narządów zmysłow,

inne przekazują informacje z

mózgu czy rdzenia kręgowego do

mięśni i gruczołów. Większość

łączy się z innymi neuronami

tworząc splątane struktury

nazywane siecią neuronową.

Rys historyczny

• 1943 McCulloch i Pitts przedstawiają pierwszy matematyczny opis

komórki nerwowej

• 1949 Donald Hebb odkrywa, że informacja może być przechowywana

w strukturze połączeń pomiędzy neuronami i zaproponował metodę

uczenia siecipoprzez zmianę wag

• 1968 Rosenblatt stworzył pierwszą sieć neuropodobną (perceptron) do

rozpoznawania znaków. Był to układ częściowo elektromechaniczny,

częściowo elektroniczny. Została zbudowana w 1957 roku w Cornell

Aeronautical Laboratory. Po próbach okazało się, że nie rozpoznawała

bardziej złożonych znaków i wykazywała wrażliwość na zmianę skali

obiektów, ich położenie w polu widzenia oraz zmiany kształtu. Zaletą

była zdolność do zachowania poprawnego działania nawet po

uszkodzeniu pewnej części elementów. Po ogłoszeniu wyników

nastąpił gwałtowny rozwój tego typu sieci neuronowych na całym

świecie.

Rys historyczny (2)

•

1960 Bernard Widrow z Uniwersytetu Standforda sieć elektrochemicznych uczących się

elementów Adaline (ang. Adaptive linear element), połączone w układ Madaline (ang.

Many Adaline). Pierwszy neurokomputer oferowany komercyjnie. Zajmował się

przetwarzaniem sygnałów w radarach, sonarach, modemach i liniach telefonicznych

•

Początek lat 70' zahamowanie rozwoju – Minsky i Papert dowodzą, że sieci

jednowarstwowe mają bardzo ograniczony zakres zastosowań.

•

Mimo to w latach 70-tych Stephen Grossberg z Uniwers. w Bostonie stworzył sieć

Avalanche do rozpoznawania mowy oraz sterowania ramieniem robota. W MIT powstał

Cerebellatron, także do sterowania robota. James Anderson tworzy Brain State in the

Box - pamięci asocjacyjna z dwustronnym dostępem.

•

1974 Werbos podaje nowe zasady uczenia sieci warstwowej. Badania nad pamięcią

asocjacyjną - Kohonen (1977, 1984, 1987) i Anderson (1977). Kohonen w 1982 roku

opracował sieci uczące się bez nauczyciela.

•

1982 sieci ze sprzężeniem zwrotnym oraz John Hopfield z AT&T Bell Labs tworzy sieć do

odtwarzania obrazów z ich fragmentów i do rozwiązywania zadań optymalizacyjnych

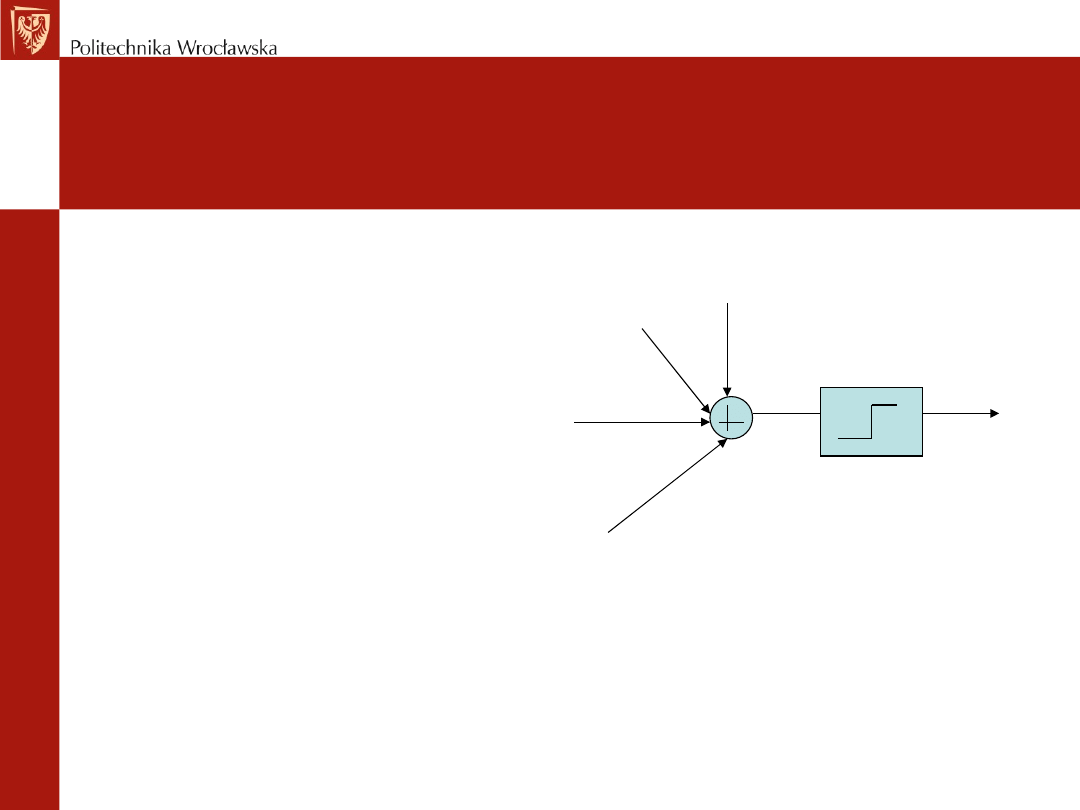

Sygnały wejściowe x

j

(j=1,2,…,N) z

odpowiednimi wagami W

jj

oraz

tak zwanym biasem (opcjonalny)

b

i,

sumowane są w Sumatorze.

Sygnał taki wyraża się

zależnością:

W której funkcja f(u) jest tzw.

funkcją aktywacji:

Model neuronu McCullocha-Pittsa

)

)

(

(

1

i

j

N

j

ij

i

b

t

x

W

f

y

+

=

∑

=

x

1

x

2

x

n

W

i1

W

i2

W

iN

1

b

i

y

i

≤

>

=

0

u

0

0

u

1

)

(u

f

Rodzaje sieci neuronowych

(budowa)

• Jednowarstwowe

• Wielowarstwowe

• Rekurencyjne

• Komórkowe

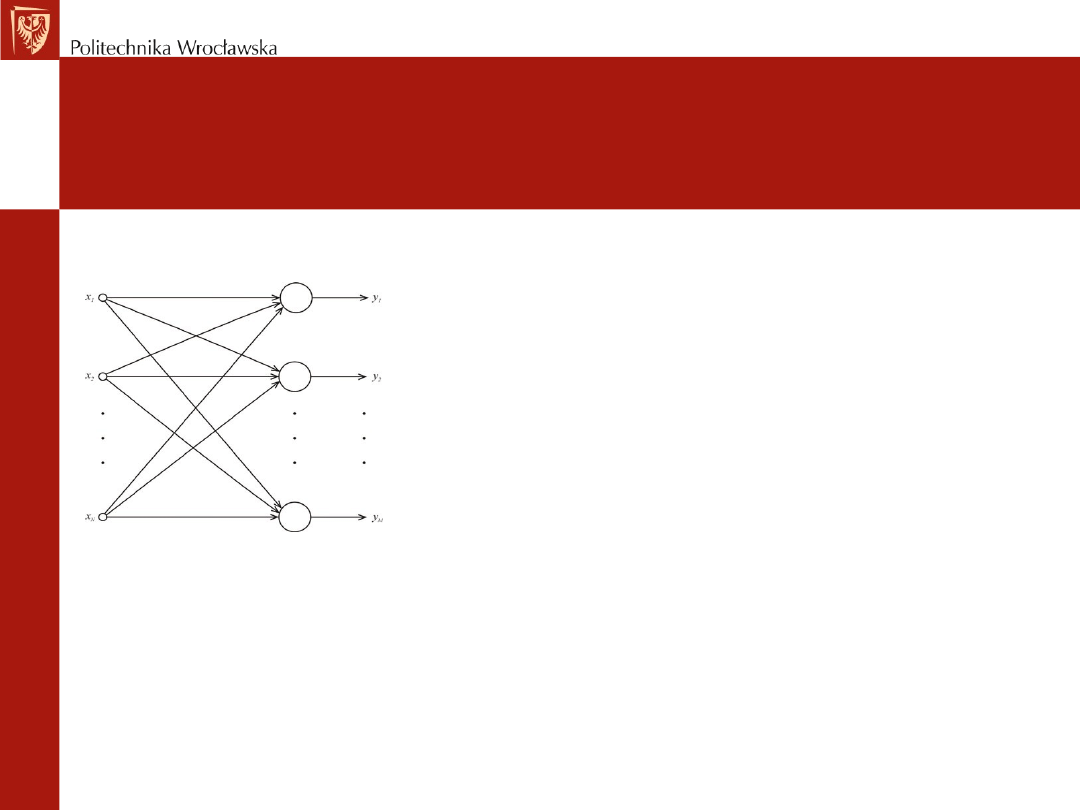

Sieć jednowarstwowa

• W sieci jednokierunkowej jednowarstwowej (rys.)

neurony są ułożone w jednej warstwie, zasilanej z

węzłów wejściowych. Połączenie węzłów

wejściowych z wyjściową jest zwykle typu każdy z

każdym. Przepływ sygnałów występuje w jednym

kierunku, od wejścia do wyjścia.

• Węzły wejściowe nie tworzą warstwy neuronów,

gdyż nie zachodzi w nich żaden proces

obliczeniowy. Sposób doboru wag i wybór metody

uczenia decyduje tutaj o nazwie sieci. Metody

uczenia są łatwe i proste w implementacji

praktycznej. Sieć tego rodzaju może stanowić

zarówno sieć Kohenena, jak i perceptron

jednowarstwowy. Będą z tym także związane

rodzaje funkcji aktywacji oraz metody uczenia.

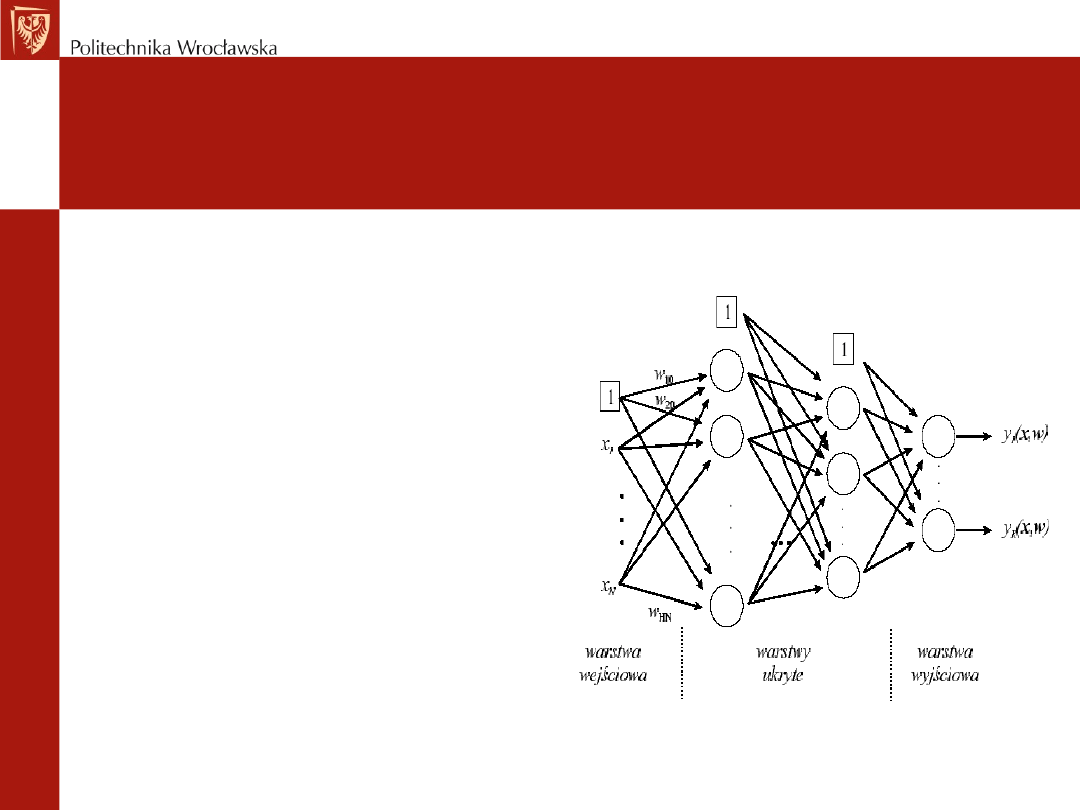

Sieć wielowarstwowa

•Cechą

sieci

jednokierunkowych

wielowarstwowych jest występowanie, co

najmniej jednej warstwy ukrytej, pośredniącej

w przekazywaniu sygnałów

•Sygnały wejściowe są podawane na

pierwszą warstwę ukrytą neuronów, a te z

kolei stanowią sygnały źródłowe dla kolejnej

warstwy. W sieci tej występują połączenia

pełne między warstwami. W szczególności w

niektórych zastosowaniach pewne połączenia

międzyneuronowe mogą nie wystąpić i mówi

się wówczas o połączeniu częściowym.

Uczenie

perceptronu

wielowarstwowego

odbywa się zwykle z nauczycielem.

•Sieci

jednokierunkowe

wielowarstwowe

często

wykorzystują

nieliniową

funkcję

aktywacji typu sigmoidalnego i stanowią

naturalne

uogólnienie

perceptronu

Rosenblatta.

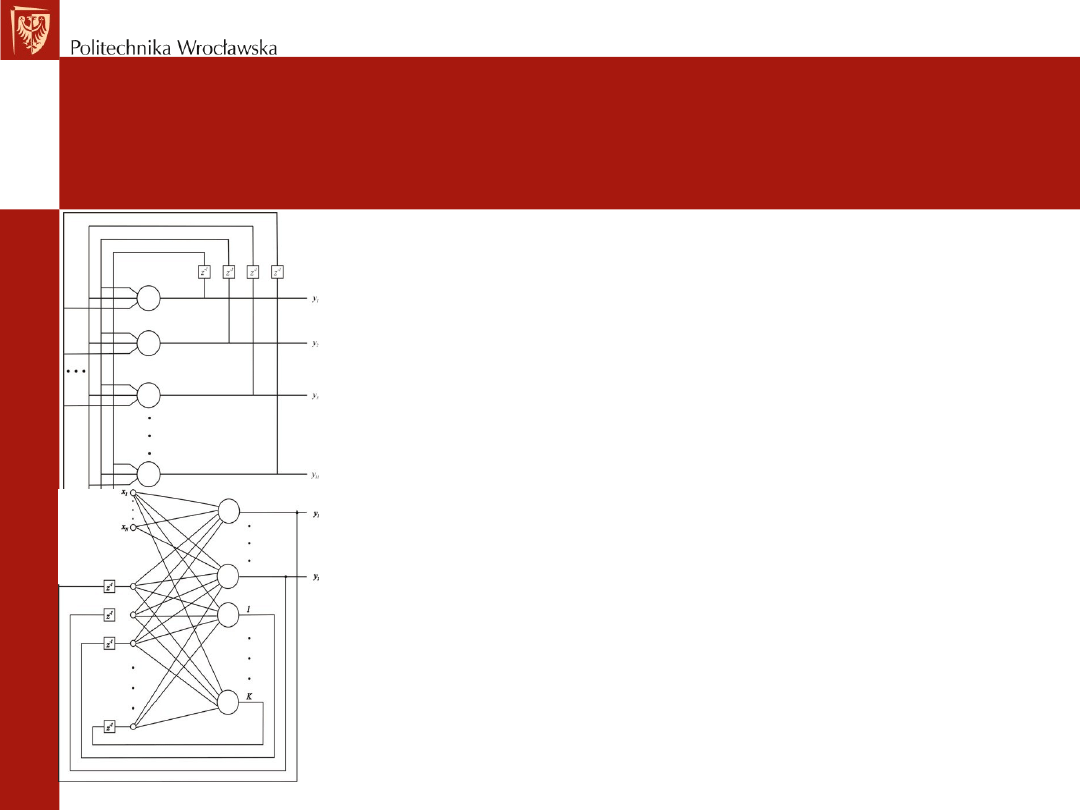

Sieć rekurencyjna

• Sieci rekurencyjne różnią się od sieci

jednokierunkowych występowaniem sprzężenia

zwrotnego między warstwami wyjściowymi i

wejściowymi. Można tu wyróżnić sieci

jednowarstwowe (rys. u góry) mające jedynie jedną

warstwę neuronów wyjściowych oraz sieci mające

dodatkową warstwę ukrytą - sieci wielowarstwowe

rekurencyjne (rys. u dołu).

• Proces ustalania się sygnałów wyjściowych sieci

rekurencyjnych jest procesem dynamicznym ze

względu na występowanie jednostkowych operatorów

opóźnienia. Biorąc pod uwagę nieliniowość funkcji

aktywacji neuronów jest to dynamika nieliniowa,

stanowiąca istotną cechę tego rodzaju sieci.

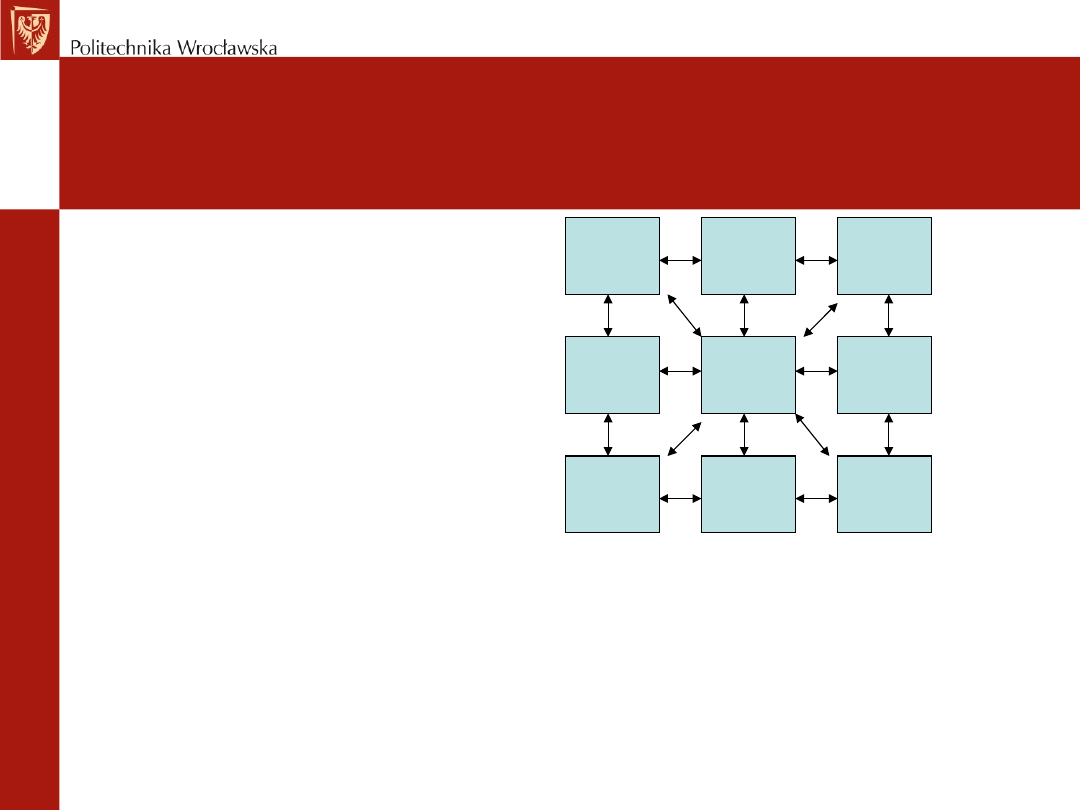

Sieć komórkowa

Sieć komórkowa –

neurony powiązane

są jedynie z lokalnymi

sąsiadami, przy czym

powiązanie jest

Wzajemne

(dwukierunkowe)

i dotyczy neuronów

należących do tzw.

sąsiedztwa.

C(1,1)

C(2,3)

C(2,2)

C(2,1)

C(1,3)

C(1,2)

C(3,3)

C(3,2)

C(3,1)

Metody uczenia sieci

neuronowych

Uczenie z nauczycielem

Uczenie z krytykiem

Uczenie bez nauczyciela

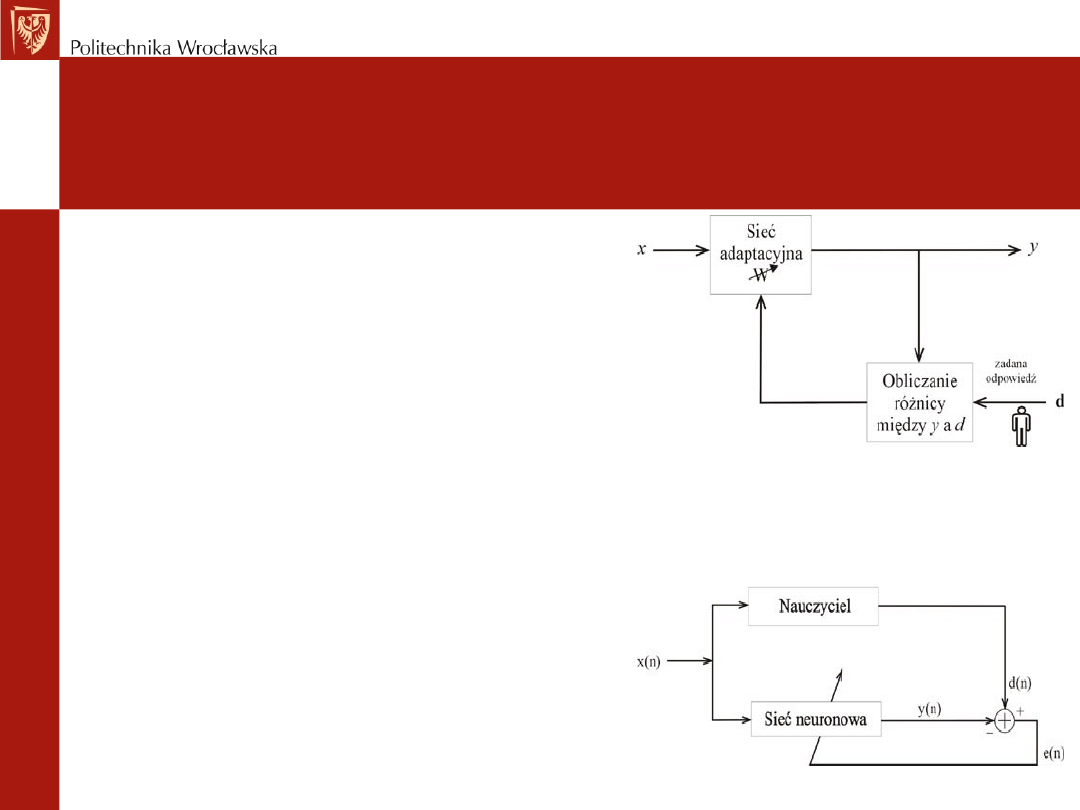

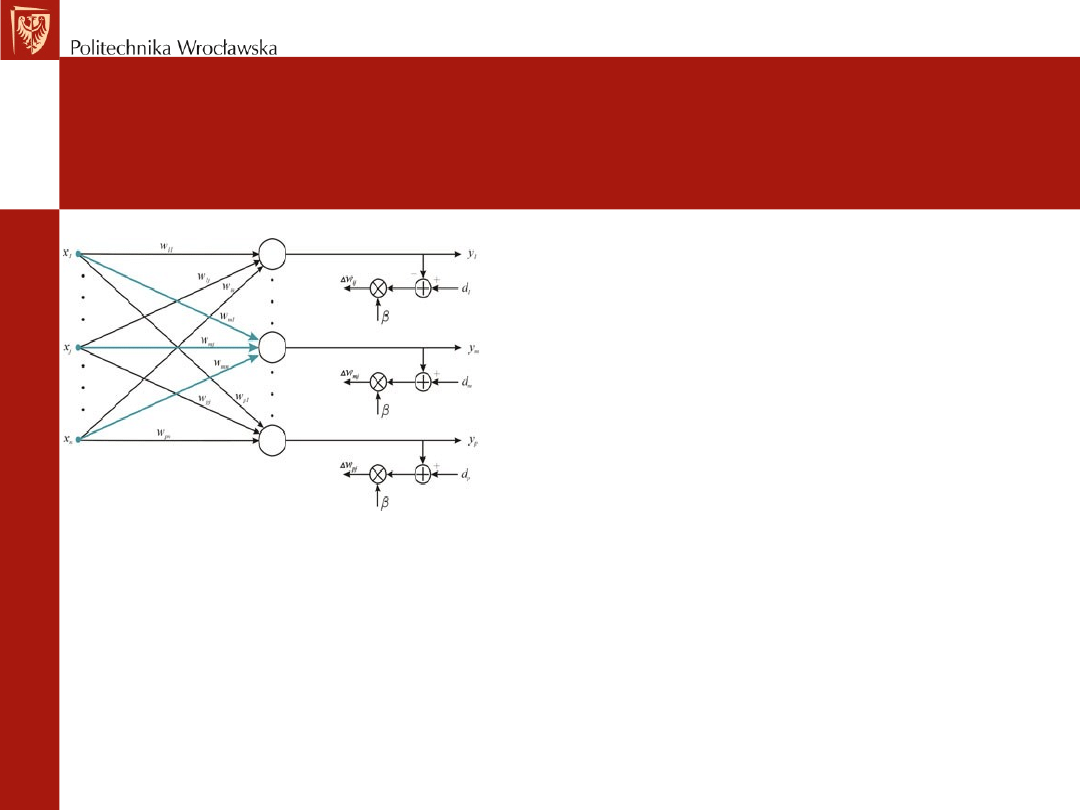

Uczenie z nauczycielem

•

Przy uczeniu z nauczycielem (uczeniu pod

nadzorem) oprócz danych wejściowych

posiadamy również sygnały wyjściowe, jakie

chcemy uzyskać. Dobór wag jest prowadzony

w taki sposób, aby aktualny sygnał wyjściowy

y był najbliższy wartości zadanej d.

•

Celem uczenia pod nadzorem jest

minimalizacja zdefiniowanej funkcji celu, tak

aby dopasować odpowiedzi neuronów

wyjściowych do wartości żądanych.

•

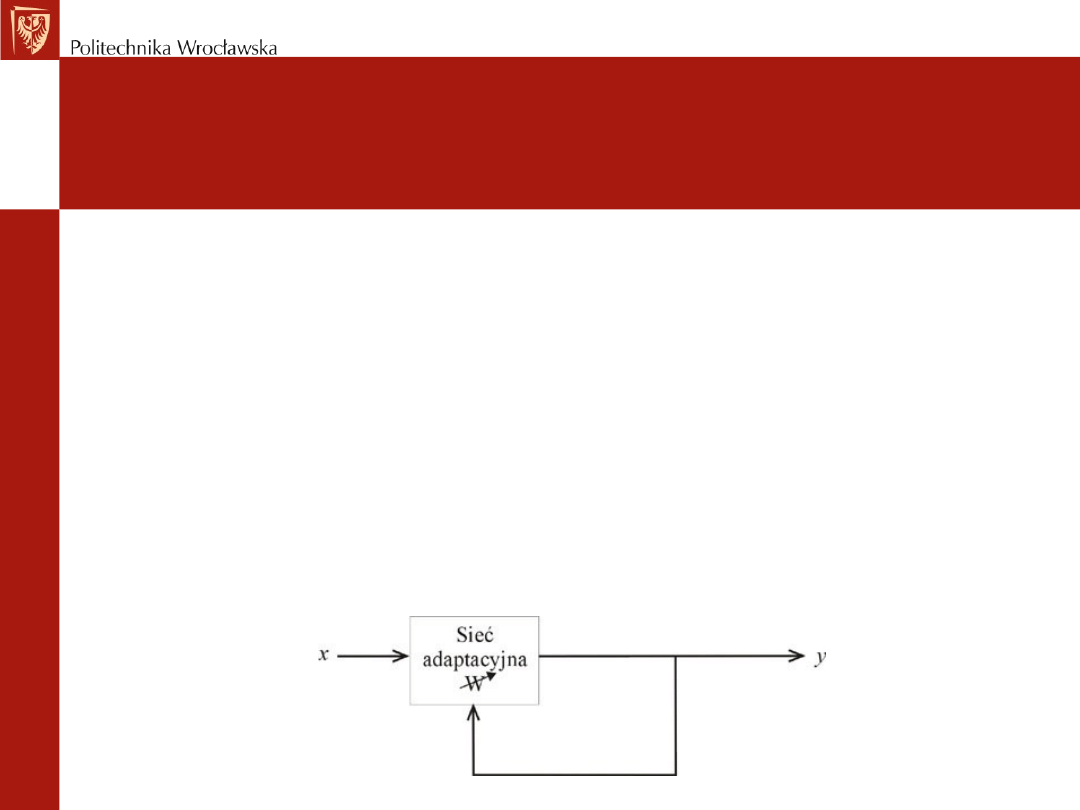

Schemat uczenia pod nadzorem zarówno typu

gradientowego jak i bezgradientowego może

być przedstawiony w postaci systemu

adaptacyjnego (rys. U dołu), gdzie adaptacja

wag odbywa się pod wpływem błędu e(n),

określonego dla każdej pary uczącej. Cechą

tego procesu jest istnienie sprzężenia

zwrotnego.

Uczenie z nauczycielem (2)

• Reguła delta

• Najpopularniejszą i najczęściej

stosowaną metodą uczenia z

nauczycielem jest metoda

największego spadku. Uaktualnianie

wag następuje każdorazowo po

prezentacji jednej pary uczącej.

Gdy uaktualnianie zachodzi po

prezentacji wszystkich par mamy do

czynienia ze skumulowaną regułą

delta.

• Reguła delta przeznaczona jest dla

neuronów z ciągłymi funkcjami

aktywacji.

•

Reguła perceptronu

•

Przy skokowych funkcji aktywacji metody

gradientowe są nieskuteczne bo funkcja celu

nie spełnia warunku ciągłości. Stosuje się

wtedy metody bezgradientowe,takie jak

reguła perceptronowa.

•

Dobór wag odbywa się w cyklu:

•

Przy zadanych wstępnie wartościach wag

prezentuje się na wejściu wektor uczący i

oblicza wartość sygnału wyjściowego. W

wyniku porównania aktualnej wartości i

wartości zadanej dokonuje się aktualizacji

wag

•

Proces powtarzany jest na wszystkich

próbkach uczących wielokrotnie, aż do

minimalizacji funkcji celu.

•

Wykorzystuje się w uczeniu jedynie

informacje o aktualnej wartości sygnału

wyjściowego i wartości żądanej.

Uczenie z nauczycielem (3)

•

Reguła gwiazdy wyjść

•

Kolejnym wariantem metody uczenia z

nauczycielem jest reguła gwiazdy wyjść

zilustrowana na rys. Używa się ją do uczenia

powtarzających się, charakterystycznych

właściwości relacji wejście-wyjście. Od sieci,

mimo iż uczenie odbywa się z nauczycielem,

oczekuje się dodatkowo zdolności wydobywania

statystycznych własności sygnałów wejściowych

i wyjściowych.

•

Uczenie metodą gwiazdy wyjść prowadzi

zwykle do wytworzenia wymaganej reakcji na

określony obraz wejściowy nawet wtedy, gdy

korzysta się z rzeczywistego, a nie z

pożądanego sygnału wyjściowego.

•

W odróżnieniu od pozostałych metod uczenia

wagi dostrajane są w połączeniach

"rozbiegających się" z wyjściem neuronu

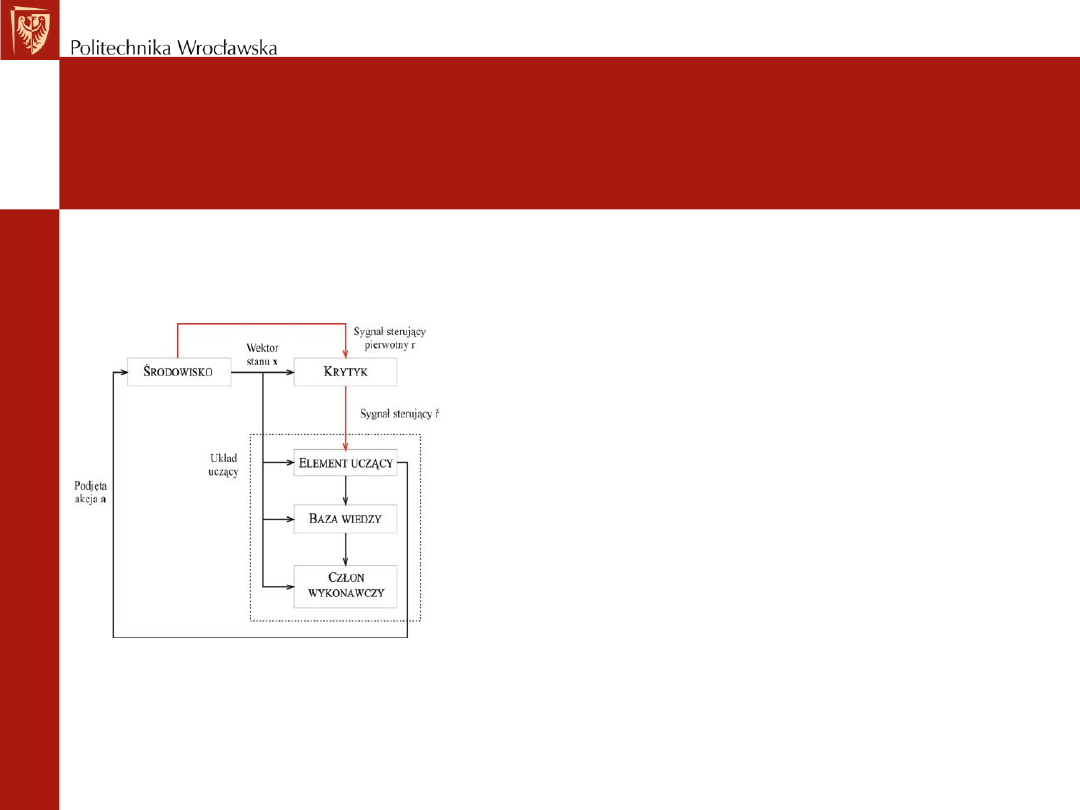

Uczenie z krytykiem

•

Uczenie z krytykiem jest odmianą uczenia pod

nadzorem, w którym nie występuje informacja o

wartościach pożądanych na wyjściu systemu, a jedynie

informacja czy podjęta akcja (zmiana wag) daje wyniki

pozytywne czy negatywne.

•

Jeśli działania podjęte przez układ uczący dają wyniki

pozytywny, to następuje wzmocnienie tej tendencji, w

przeciwnym wypadku osłabienie.

•

Układ uczący współpracuje ze środowiskiem za

pośrednictwem krytyka, który na podstawie aktualnego

stanu środowiska i predykcji co do jego przyszłych zmian

przekazuje sygnał sterujący umożliwiający podjęcie

akcji a, wpływającej na stan środowiska x. Podjęta

przez układ uczący akcja wpływa na środowisko

zmieniając jego stan.(Osowski 1996)

•

Uczenie z krytykiem jest znacznie bardziej uniwersalne

w zastosowaniu, gdyż nie wymaga obecności sygnałów

żądanych na wyjściu systemu. Jednocześnie jego

realizacja praktyczna jest bardziej skomplikowana.

Uczenie bez nauczyciela

• Podczas uczenia bez nauczyciela pożądana odpowiedz

nie jest znana. Ze względu na brak informacji o

poprawności, czy niepoprawności odpowiedzi sieć

musi się uczyć poprzez analizę reakcji na pobudzenia,

o których naturze wie mało lub nic. W trakcie analizy

parametry sieci podlegają zmianom, co nazywamy

samoorganizacją.

Uczenie bez nauczyciela (2)

•

Uczenie typu Hebba

•

W modelu Hebba wykorzystuje się obserwacje neurobiologiczne: "jeżeli akson komórki A

bierze systematycznie udział w pobudzeniu komórki B powodującym jej aktywację, to

wywołuje to zmianę metaboliczną w jednej lub obu komórkach, prowadzącą do wzrostu

skuteczności pobudzania B przez A" (Hebb 1949).

•

Zgodnie z tym waga powiązań między dwoma neuronami wzrasta przy jednoczesnym stanie

pobudzenia obu neuronów, w przeciwnym wypadku maleje.

•

Reguła Hebba przyjmuje, że sygnałem uczącym jest sygnał wyjściowy neuronu yi.

•

Reguła Hebba może być stosowana do różnego typu struktur sieci neuronowych i różnych

funkcji aktywacji neuronu.

•

Przy wielokrotnej prezentacji takiego samego wymuszenia xj obserwuje się wykładniczy

wzrost wag, czego efektem jest nasycenie neuronu. Aby uniknąć takiej niepożądanej sytuacji

modyfikuje się tą regułę przez wprowadzenie współczynnika zapomnienia.

•

Algorytm uczący Hebba można zaliczyć do uczenia typu korelacyjnego, w którym siła

połączenia międzyneuronowego wzrasta przy istnieniu korelacji między sygnałami

presynaptycznym i postsynaptycznym neuronu.

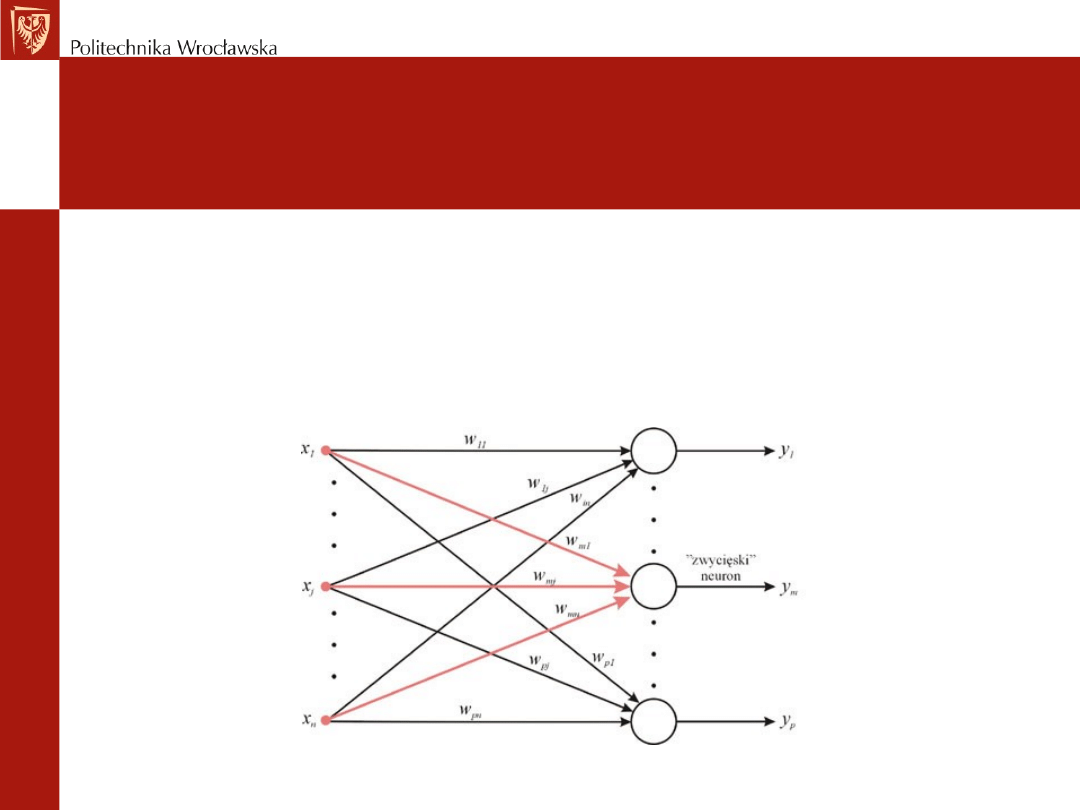

Uczenie bez nauczyciela (3)

•

Uczenie typu konkurencyjnego

•

W uczeniu typu konkurencyjnego neurony współzawodniczą ze sobą, aby stać się aktywnymi

(pobudzonymi). W odróżnieniu od uczenia Hebba, gdzie dowolna liczba neuronów mogła być

aktywna, w uczeniu konkurencyjnym tylko jeden neuron może być aktywny, a reszta pozostaje w

stanie spoczynku.

•

Reguła WTA (Winner Takes All) - zwycięzca bierze wszystko

Uczenie bez nauczyciela (4)

• W metodzie WTA grupa neuronów otrzymuje te same sygnały wejściowe.

Sygnały wyjściowe neuronów różnią się między sobą. W wyniku porównania

tych sygnałów zwycięża neuron o największej wartości. Zwycięzca przyjmuje

wartość 1, a pozostałe - przegrywające 0.

• Neuron zwycięzca dostaje możliwość aktualizacji wag. Pozostałe neurony

mają na wyjściu przypisane 0 i zablokowany proces aktualizacji wag.

• Przy wektorach zbliżonych do siebie będzie zwyciężał ten sam neuron.

• W efekcie następuje samoorganizacja uczenia. W trybie odtworzeniowym,

(przy ustalonych wagach podaje się sygnały testujące), neurony rozpoznają

swoje kategorie (specjalizacja).

• Problemem WTA jest występowanie martwych neuronów, które nigdy nie

zwyciężyły. Występowanie ich zmniejsza liczbę jednostek biorących udział w

uczeniu, a zatem zwiększa się globalny błąd odwzorowania. Aby taka sytuacja

nie miała miejsca do uczenia wprowadza się próg zwycięstw, który

uwzględnia liczbę zwycięstw, po przekroczeniu której neuron zostaje

przymusowo pauzowany, dając szanse innym neuronom na zwycięstwo.

Uczenie bez nauczyciela (5)

• Reguła WTM (Winner Takes Most)

• Jest to odmiana uczenia konkurencyjnego, w którym neuron

wygrywający konkurencję uaktywnia się maksymalnie przyjmując

wartość 1 i umożliwia częściowe uaktualnianie innych neuronów z

sąsiedztwa. Stopień uaktywniania neuronów zależy od odległości ich

wektorów wagowych od wag neuronu wygrywającego.

• Jeżeli obowiązuje zasada WTM, to zmianie ulegają nie tylko wagi

neuronu zwycięzcy, ale również jego sąsiadów w zależności od stopnia

sąsiedztwa. Sąsiedztwo neuronu określa się zbiorem, który jest

wyznaczony na podstawie przyjętej (a tym samym znanej) funkcji

sąsiedztwa. Funkcja sąsiedztwa może wyrażać również stopień tego

sąsiedztwa, czyli sąsiedztwo może być bliższe i dalsze. Im bliżej

neuronu zwycięskiego neurony leżą tym w większym stopniu są

aktualizowane.

Zastosowanie sieci neuronowych

•

W technice:

•

zagadnienia rozpoznawania, a zwłaszcza rozpoznawania kontekstowego

•

klasyfikacja, analiza i przetwarzanie obrazów (kompresja, segmentacja, odtwarzanie,

rozumienie)

•

przetwarzanie sygnałów (konwersje, filtracje, aproksymacje, transformacje)

•

robotyka i automatyka (teoria sterowania, optymalizacja, percepcja ruchu i jego planowanie,

identyfikacja i sterowanie procesami dynamicznymi, modelowanie nieliniowe procesów,

opracowywanie sygnałów sterujących, układy śledzące i nadążne, adaptacja, klasyfikacja)

•

pamięci asocjacyjne (dwukierunkowe, skojarzeniowe, pamięci heteroasocjacyjne

-odtwarzanie, odszumianie)

•

W ekonomii:

•

przewidywanie (prognozy ekonomiczne)

•

klasyfikacja (kondycja przedsiębiorstw, opłacalne branże)

•

adaptacja (wnioskowanie na podstawie zgromadzonych danych)

•

Analiza danych (ustalenie np. przyczyn niepowodzeń określonych przedsięwzięć)

•

Optymalizacja (poszukiwanie rozwiązań np. problem komiwojażera)

Wyszukiwarka

Podobne podstrony:

32 Sieci neuronowe

MSI-program-stacjonarne-15h-2011, logistyka, semestr IV, sieci neuronowe w log (metody sztucznej int

Ontogeniczne sieci neuronowe skrypt(1)

04 Wyklad4 predykcja sieci neuronoweid 523 (2)

Pytania egz AGiSN, SiMR - st. mgr, Alg. i Sieci Neuronowe

MSI-ściaga, SiMR - st. mgr, Alg. i Sieci Neuronowe

Identyfikacja Procesów Technologicznych, Identyfikacja charakterystyki statycznej obiektu dynamiczne

sieci neuronowe, Sieci NeuronoweKolos

sztuczne sieci neuronowe sciaga

Identyfikacja Procesów Technologicznych, Identyfikacja charakterystyk statycznych obiektu dynamiczne

Projekt I Sztuczna Inteligencja, Sprawozdanie, Techniczne zastosowanie sieci neuronowych

badania operacyjne, badania operacyjne - skrypt z PUTINF, Sieci neuronowe

Prognozowanie z zastosowaniem metod regresji krokowej, sieci neuronowych i modeli ARIMA

Sztuczne sieci neuronowe podstawy zagadnienia

więcej podobnych podstron