Wielu użytkowników ma problemy z rozróżnieniem 16-bitowych i 32-bitowych połączeń magistrali oraz 16-bitowych i 32-bitowych przyłączy dysku. Magistrala PCI pozwala na 32-bitowe (a prawdopodobnie w przyszłości 64-bitowe) połączenie pomiędzy adapterem hosta interfejsu ATA, który zwykle znajduje się w układzie mostka południowego płyty głównej lub układzie koncentratora kontrolera l/O (ICH). Jednak interfejs ATA pomiędzy złączem adaptera hosta na płycie głównej a dyskiem jest interfejsem 16-bitowym. Dlatego dyski korzystające z równoległego interfejsu ATA korzystają z 16-bitowego transferu pomiędzy dyskiem a płytą główną. Mimo to szybkość zegara interfejsu ATA jest na tyle duża, że nawet dwa dyski nie są w stanie dostarczać takiej ilości danych danych, aby nasycić ten 16-bitowy kanał. To samo dotyczy interfejsu Serial ATA, który choć przesyła dane po jednym bicie, wykonuje to z ekstremalnie dużą szybkością.

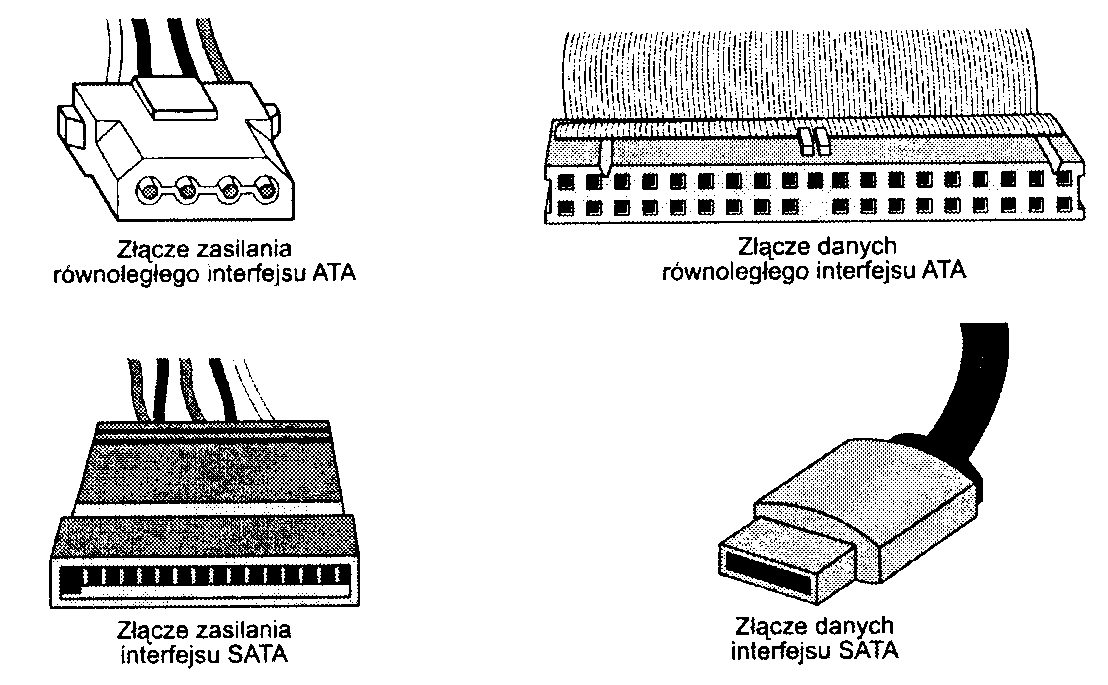

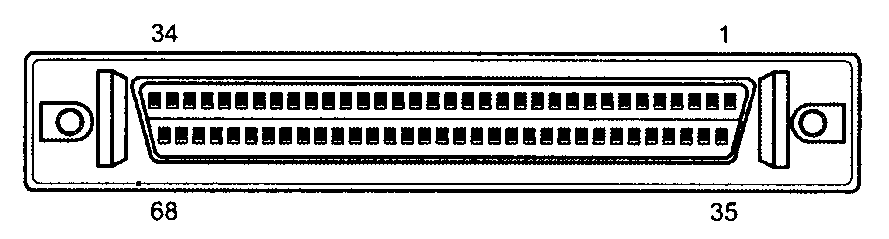

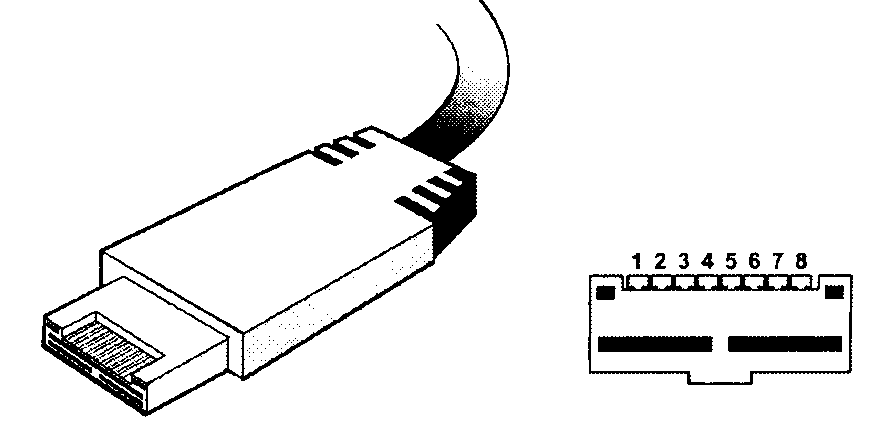

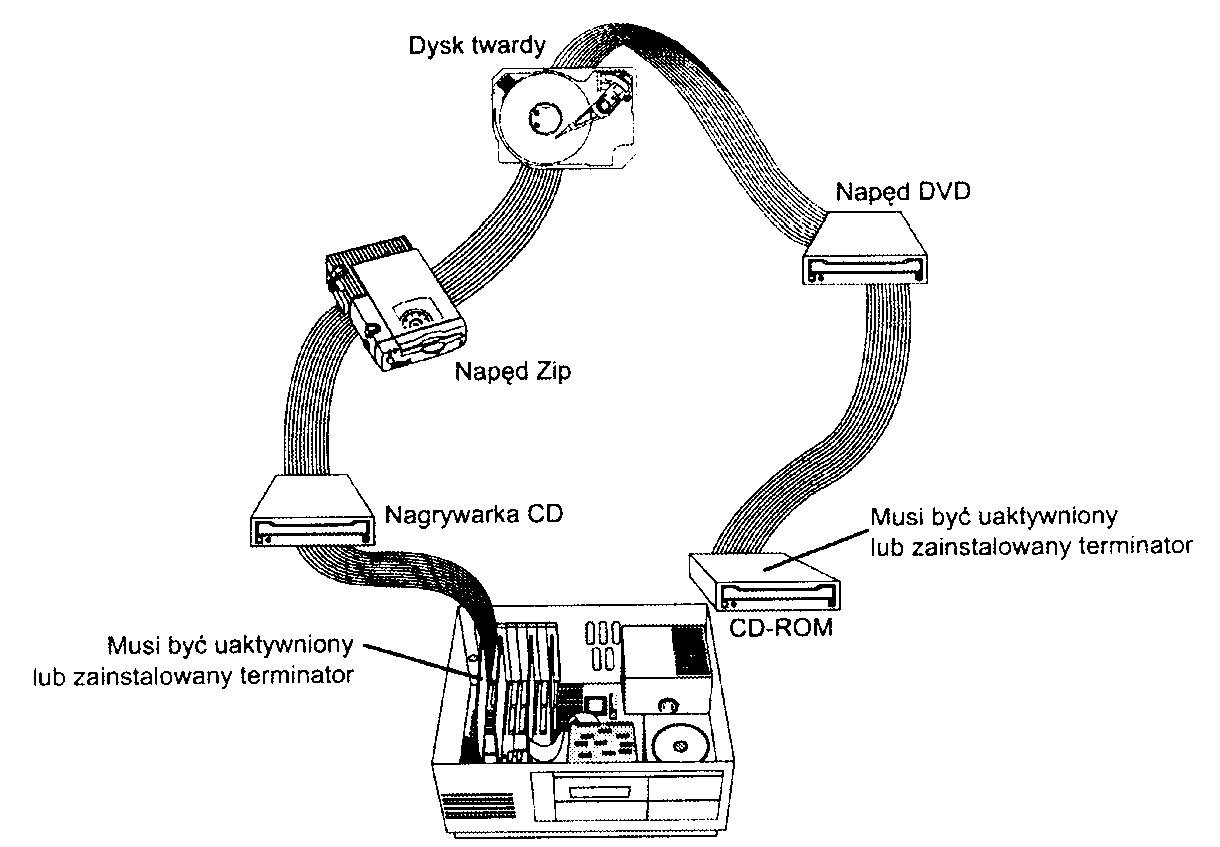

Równoległy interfejs ATA jest 16-bitowy. co oznacza, że jednocześnie kablem przesyłanych jest 16 bitów. Interfejs szeregowy, nazwany Serial ATA, oficjalnie zaprezentowany został pod koniec 2000 r., a w komputerach zaczął pojawiać się od 2003 r. W interfejsie tym w danej chwili kablem przesyłany jest 1 bit, dzięki czemu możliwe jest zastosowanie cieńszych i mniejszych kabli, a także — ze względu na szybsze cykle — osiągnięcie wyższej wydajności. Interfejs SATA posiada zupełnie nową i uaktualnioną fizyczną konstrukcję. Jednocześnie na poziomie oprogramowania pozostaje zgodny z interfejsem ATA. W książce termin ATA dotyczy zarówno szeregowej, jak i równoległej wersji interfejsu, natomiast określenia PATA (Parallel ATA) i SATA (Serial ATA) odnoszą się do określonej wersji. Na rysunku 7.1 porównano wielkość złączy danych i zasilania stosowanych w przypadku szeregowego interfejsu SATA i równoległego ATA.

Rysunek 7.1.

Złącze danych Serial A TA (na dole po prawej) jest znacznie mniejsze od stosowanego w przypadku interfejsu równoległego A TA (u góry po prawej). Z kolei złącza zasilania obu interfejsów są podobnej wielkości (po lewej)

Podstawową przewagą dysków ATA nad starszymi interfejsami opartymi na oddzielnych kontrolerach oraz nowszymi interfejsami magistral hosta, takimi jak USB, SCSI i IEEE 1394 (i.Link lub FireWire), jest koszt. Ponieważ wyeliminowano oddzielny kontroler lub adapter hosta i uproszczono połączenia kablowe, dyski ATA są znacznie tańsze od tradycyjnego kontrolera i kombinacji napędów.

► Zajrzyj do podrozdziału „Smali Computer System Interface", znajdującego się na stronie 655.

^ ^ Zajrzyj do podrozdziału „USB i IEEE 1394 (i.Link/FireWire)", znajdującego się na stronie 1043.

W kategoriach wydajności dyski ATA często zaliczają się do tych. które oferują najwyższą możliwą do uzyskania efektywność. Jednak mogą znaleźć się też w grupie dysków o najniższej wydajności. Tak wyraźna sprzeczność jest wynikiem tego różnic między poszczególnymi napędami ATA. Nie można jednoznacznie wypowiedzieć się na temat wydajności dysków ATA, ponieważ każdy z nich jest niepowtarzalny. Droższe modele oferują jednak wydajność równą wydajności dostępnych na rynku dysków innego typu stosowanych w komputerach z systemem operacyjnym obsługiwanym przez jednego użytkownika wykonującego pojedyncze zadania lub nawet lepszą.

Standardy ATA

W chwili obecnej interfejs ATA jest kontrolowany przez niezależną grupę reprezentantów dużych producentów systemów PC, dysków i komponentów. Grupa ta nosi nazwę Technical Committee T13 (http://www.tl3.org) i jest odpowiedzialna za wszystkie standardy dotyczące równoległego i szeregowego interfejsu AT Attachment. Grupa T13 stanowi część komitetu National Committee on Information Technology Standards (NCTIS), który pracuje według zasad zatwierdzonych przez American National Standards Institute (ANSI), z ramienia rządu ustanawiającego zasady określające standardy w przemyśle komputerowym oraz innych działach techniki. Powstała również druga grupa, o nazwie Serial ATA Workgroup (http://www.serialata.org), która opracowuje standardy dla szeregowego interfejsu ATA. Standardy są następnie przekazywane grupie Technical Comittee Tl3 w celu dopracowania i opublikowania w ramach organizacji ANSI. Standard ATA-7 uwzględnia zarówno interfejs szeregowy, jak i równoległy ATA oraz wyznacza kres tego drugiego, ponieważ standard ATA-8 i jego następcy opierają się już wyłącznie na interfejsie szeregowym.

Zasady działania tych komitetów gwarantują, że dobrowolne standardy są tworzone na zasadzie porozumienia ludzi i organizacji działających w branży, której będzie dotyczył standard. NCITS tworzy standardy dla systemów przetwarzania informacji, natomiast ANSI aprobuje proces ich tworzenia i publikuje je. Ponieważ grupa Tl3 jest organizacją całkowicie publiczną, wszystkie robocze dokumenty, dyskusje i spotkania grupy są otwarte dla każdego.

Kopię każdego opublikowanego standardu można nabyć od organizacji ANSI lub firmy Global Engineering Documents. Robocze wersje standardów można pobrać z witryny WWW grupy Technical Committee Tl 3 lub Serial ATA Working Group.

Równoległy interfejs ATA rozwijał się poprzez kilka kolejnych wersji standardu. Kolejno były to:

ATA-1,

ATA-2 (nazywany również Fast-ATA, Fast-ATA-2 lub EIDE),

ATA-3,

ATA-4 (Ultra-ATA/33),

ATA-5 (Ultra-ATA/66),

ATA-6(Ultra-ATA/100),

ATA-7 (Ultra-ATA/133 lub Serial ATA),

SATA-8 (Serial ATA II).

Od czasów pojawienia się standardu AT A-l nowsze wersje interfejsu ATA i uzupełniający je BIOS obsługują pojemniejsze i szybsze dyski twarde, a także innego typu urządzenia. W przypadku standardu ATA-2 i jego następców oryginalna wersja interfejsu ATA rozszerzona została w pięciu podstawowych obszarach. Oto one:

dodatkowy kanał obsługujący dwa urządzenia.

zwiększona maksymalna obsługiwana pojemność dysków,

większe transfery danych.

ATAPI (ATA Packet Interface),

SATA (Serial ATA).

Każda wersja interfejsu ATA jest zgodna z poprzednimi wersjami. Inaczej mówiąc, stare urządzenia ATA-1 lub ATA-2 działają świetnie z interfejsami ATA-6 lub ATA-7. ATA-7 uwzględnia zarówno równoległy, jak i szeregowy interfejs ATA, natomiast ATA-8 tylko szeregowy. Nowsze wersje interfejsu ATA są tworzone na podstawie starszej wersji i z kilkoma wyjątkami mogą być traktowane jako rozszerzenia poprzedniej wersji. Oznacza to, że interfejs ATA-7 może być postrzegany jako ATA-6 z dodatkowymi możliwościami.

W tabeli 7.2 przedstawiamy różne standardy ATA. W kolejnych akapitach opiszemy bardziej szczegółowo wszystkie wersje tego interfejsu.

ATA-1

ATA-l definiuje oryginalny interfejs AT Attachment, który jest zintegrowanym interfejsem magistrali pomiędzy napędem dysku a systemem korzystającym z magistrali ISA (AT). Podstawowymi funkcjami wprowadzonymi i udokumentowanymi w specyfikacji ATA-1 były:

okablowanie i złącza 40- i 44-pinowe,

opcje konfiguracji Master/Slave oraz Cable Select,

taktowanie sygnału dla trybów programowalnego I/O (PIO) i bezpośredniego dostępu do pamięci (DMA),

translacja parametrów dysku: cylinder, głowica, sektor (CHS) i adres bloku logicznego (LBA), pozwalająca na obsługę dysków o pojemnościach do 228 - 220 (267 386 880) sektorów lub 136,9 GB.

Choć specyfikacja ATA-1 była w użyciu od 1986 r., prace mające na celu ustanowienie jej oficjalnym standardem rozpoczęły się w 1988 r. pod nadzorem organizacji CAM (Common Access Method). Standard ATA-1 został ukończony i oficjalnie opublikowany w 1994 r. jako ANSI X3.221-1994, AT Attachment Interface for Disk Drives. Specyfikacja ATA-1 została oficjalnie wycofana 6 sierpnia 1999 roku.

Choć ATA-1 obsługiwała teoretycznie dyski o pojemności do 136,9 GB (228 - 220 = 267 386 880 sektorów), BIOS ograniczał tę pojemność do 528 MB (1024 x 16 x 63 = 1 032 192 sektory). Ograniczenia BIOS były rozwiązane w kolejnych wersjach interfejsu ATA, ponieważ w tym czasie nie były dostępne dyski o pojemności większej niż 528 MB.

ATA-2

Standard ATA-2, który po raz pierwszy pojawił się w roku 1993, został znacznie ulepszony w stosunku do pierwszego standardu ATA. Prawdopodobnie największą zmianą była zmiana funkcji interfejsu. Standard ATA-2 nie jest ograniczony jedynie do dysków twardych, definiuje on interfejs pomiędzy systemem a dowolnym urządzeniem służącym do przechowywania danych. W porównaniu do oryginalnego standardu ATA, w ATA-2 zostały dodane między innymi następujące funkcje:

szybsze tryby transmisji PIO i DMA,

obsługa zarządzania energią,

obsługa nośników wymiennych,

obsługa urządzeń PCIMCA (obecnie PC card),

polecenie Identify Drive zwracające więcej informacji o urządzeniu,

zdefiniowane metody translacji CHS/LBA dla napędów o pojemności do 8,4 GB.

Najważniejszymi udoskonaleniami standardu ATA-2 były obsługa szybszych trybów PIO i DMA, jak również umożliwienie obsługi przez BIOS dysków o pojemności do 8,4 GB. Wspomaganie BIOS-u było niezbędne, ponieważ pozwalał on na obsługę dysków o maksymalnej pojemności 528 MB, mimo że sam standard ATA pozwalał na konstruowanie dysków o maksymalnej pojemności 136,9 GB. Dodanie funkcji translacji parametrów umożliwiło obsługę przez BIOS dysków o pojemnościach do 8,4 GB. Funkcja ta zostanie dokładniej omówiona w dalszej części rozdziału.

W standardzie ATA-2 znalazły się również rozszerzenia polecenia Identify Drive, co pozwala na odczytywanie przez oprogramowanie dokładnej charakterystyki dysku. Usprawnienie to jest kluczowe dla działania technologii Pług and Play (PnP) oraz zgodności z kolejnymi wersjami standardu.

Tabela 7.2. Standardy ATA

Standard |

Zaproponowany |

Opublikowany |

Wycofany |

Tryby PIO |

Tryby DMA |

Tryby UDMA |

Szybkość interfejsu równoległego (MB/s) |

Szybkość interfejsu równoległego (MB/s) |

ATA-1 |

1988 |

1994 |

1999 |

0-2 |

0 |

— |

8,33 |

— |

ATA-2 |

1993 |

1996 |

2001 |

0-4 |

0-2 |

— |

16,67 |

— |

ATA-3 |

1995 |

1997 |

2002 |

0-4 |

0-2 |

— |

16,67 |

— |

ATA-4 |

1996 |

1998 |

— |

0-4 |

0-2 |

0-2 |

33,33 |

— |

ATA-5 |

1998 |

2000 |

— |

0-4 |

0-2 |

0-4 |

66,67 |

— |

ATA-6 |

2000 |

2002 |

— |

0-4 |

0-2 |

0-5 |

100 |

— |

ATA-7 |

2001 |

2004 |

— |

0-4 |

0-2 |

0-6 |

133 |

150 |

SATA-8 |

2004 |

— |

— |

— |

|

— |

— |

300 |

SMART = Self-Monitoring, Analysis and Reporting Techology — technologia samoczynnego monitorowania,

analizy i raportowania uszkodzeń.

A TAPI = AT Attachment Packet Interface.

MB = Megabajt; milion bajtów.

GB = Gigabajt; miliard bajtów.

PB = Pelabajl; kwadrylion bajtów.

CHS - Cylinder, Head, Sector — cylinder, głowica, sektor. LBA = Logical błock address — adres bloku logicznego. PIO = Programmed l/O—programowalne wejście-wyjście. DMA = Direct Memory Access — bezpośredni dostąp do pamięci. UDMA = Ultra DMA.

Standard ATA-2 byl również znany pod nieoficjalną nazwą Fast-ATA lub Fast-ATA-2 (Seagate i Quantum) oraz EIDE (Enchanced IDE — Western Digital).

Choć prace nad standardem ATA-2 rozpoczęły się w 1993 r., oficjalnie został on opublikowany dopiero w 1996 r. jako ANSI X3.279-1996 AT Attachment Interface with Extensions. Standard oficjalnie wycofano w 2001 r.

ATA-3

Standard ten po raz pierwszy pojawił się w roku 1995 i był stosunkowo niewielkim rozszerzeniem standardu ATA-2. Zawierał on kilka zmian oraz wyjaśnień mających na celu uporządkowanie specyfikacji. Największymi zmianami były:

usunięcie protokołu komunikacji DMA korzystającego z jednego słowa (8 bitów),

dodanie technologii SMART (Self-Monitoring, Analysis and Reporting Techology) służącej do przewidywania awarii urządzenia,

obowiązkowe użycie trybu LBA (początkowo było to opcjonalne),

dodanie trybu bezpiecznego, który pozwalał na stosowanie hasła chroniącego przed dostępem do urządzenia,

zalecenie stosowania terminatorów magistrali źródła i odbiornika, co pozwoliło na rozwiązanie problemów z zakłóceniami przy szybszych trybach transmisji danych.

Standard ten, oparty na ATA-2, pozwolił na zwiększenie niezawodności, szczególnie dla szybkiego trybu transmisji PIO 4, choć standard ten nie definiował nowego, szybszego trybu transmisji. ATA-3 pozwalał na stosowanie prostego schematu bezpieczeństwa korzystającego z hasła, bardziej zaawansowanego systemu zarządzania energią oraz technologii SMART Pozwala ona na wykrywanie problemów mogących spowodować awarię urządzenia. Technologia ta została opracowana w firmie IBM.

Prace nad standardem ATA-3 zaczęły się w 1995 r., a ukończono je w roku 1997, w którym oficjalnie opublikowano go jako ANSI X3.298-1997 AT Attachment 3 Interface. Standard oficjalnie wycofano w 2002 r.

Standard |

Możliwości |

ATA-1 |

Maksymalna pojemność dysku 136,9 GB; brak obsługi BIOS-u |

ATA-2 |

Szybsze tryby PIO; translacja BIOS CHS/LBA zdefiniowana do 8,4 GB; PC-Card |

ATA-3 |

SMART; ulepszona integralność sygnału; obowiązkowa obsługa LBA; usunięte tryby DMA na jednym słowie |

ATA-4 |

Tryby Ultra-DMA; ATAPI Packet Interface; obsługa BIOS-u do 136,9 GB |

ATA-5 |

Szybsze tryby UDMA; 80-pinowe kable z autodetekcją |

ATA-6 |

Tryb UDMA 100 MB/s; pojemność dysku i obsługa BIOS-u do 144 PB |

ATA-7 |

Tryb UDMA 133 MB/s; Serial ATA |

SATA-8 |

Serial ATA II |

ATA/ATAPI-4

Standard ATA-4 po raz pierwszy pojawił się w roku 1996 i zawierał kilka ważnych ulepszeń standardu ATA. Zawiera on polecenie Packet Command, które pozwala na skorzystanie z funkcji o nazwie AT Attachment Packet Interface (ATAPI). Funkcja ta pozwala na przyłączenie urządzeń takich jak: napędy CD-ROM i CD-RW, napędy dyskietek LS-120 SuperDisk, napędy Zip, napędy taśm i inne tego typu urządzenia. Do czasu opublikowania ATA-4, ATAPI było osobno publikowanym standardem. W standardzie ATA-4 dodano również tryb przesyłu z prędkością 33 MB/s, znany pod nazwą Ultra-DMA lub Ultra-ATA. Standard ATA-4 jest zgodny z ATA-3 i wcześniejszymi definicjami ATAPI.

Prace nad standardem ATA-4 zaczęły się w 1996 r., a ukończono je w roku 1998, w którym oficjalnie opublikowano go jako ANSINCITS 317-1998 ATAttachment-4 with Packet Interface Extension.

Głównymi rozszerzeniami ATA-4 były:

Tryb przesyłu Ultra-DMA (UDMA) 2, który zapewniał przepustowość 33 MB/s (zwany również UDMA/33 lub Ultra-AT A/33).

Wbudowana obsługa ATAPI.

Zaawansowane zarządzanie energią.

Opcjonalna 80-żyłowa taśma dla 40-pinowego gniazda, która zapewniała lepszą odporność na zakłócenia.

Obsługa przestrzeni HPA (Host Protected Area).

Obsługa czytnika kart Compact Flash (CFA).

Wprowadzenie rozszerzonej obsługi BIOS-u dla dysków o pojemnościach do 9,4 ZB (zetabajtów lub biliona gigabajtów), choć standard ATA nadal ograniczał pojemność dysków do 136,9 GB.

Wydajność i poziom obsługi standardu ATA w komputerach w większości zależny jest od układów płyty głównej. Większość z nich wykorzystuje komponent płyty głównej nazywany mostkiem południowym (ang. South Bridge) lub koncentratorem kontrolera wejścia-wyjścia (ang. I/O Controller Hub), który, oprócz innych funkcji, zawiera również interfejs ATA. Specyfikacja płyty głównej lub układów płyty głównej określa obsługiwane tryby: ATA/33, ATA/66, ATA/100 lub ATA/133. Innym sposobem na sprawdzenie dostępnych trybów jest uruchomienie trybu BIOS Setup i na ekranie ręcznego ustawiania parametrów dysku odczytanie dostępnych trybów Ultra-DMA. Większość płyt głównych z roku 1998 obsługuje ATA/33; w 2000 roku dostępny był tryb ATA/66, a już na końcu 2000 większość płyt zapewniała obsługę ATA/100. Obsługa ATA/133 stała się powszechna w połowie 2002 r.

► ► Zajrzyj do punktu „Chipsety'' znajdującego się na stronie 292.

Do standardu ATA-4 została dołączona specyfikacja ATAPI. Dzięki temu stał się on interfejsem dla różnych typów urządzeń. Do standardu ATA-4 dodano również nowe tryby Ultra-DMA (nazywane również Ultra-ATA) zapewniające wyższe prędkości przesyłu danych. Tryb o najwyższej przepustowości, nazwany UDMA/33. zapewniał transfer 33 MB/s — dwukrotnie więcej niż najszybszy tryb PIO lub najszybszy poprzednio obsługiwany tryb DMA. Oprócz wysokiej prędkości przesyłu osiągnięto dalsze zwiększenie wydajności systemu, ponieważ tryb UDMA powoduje mniejsze obciążenie procesora.

Dla potrzeb transferu w trybie UDMA/33 zaprojektowano opcjonalny 80-żyłowy kabel (wraz z funkcją cable select). Choć w oryginale kabel ten był elementem opcjonalnym, później okazało się, że jest on niezbędny dla szybszych trybów przesyłu: ATA/66, ATA/100 i ATA/133, wprowadzonych w specyfikacji ATA-5 i późniejszych. Wiele dysków twardych zakupionych w sklepie jest wyposażonych w 80-żyłowy kabel, natomiast innego typu urządzenia, takie jak napędy optyczne, dysponują jedynie kablem 40-żyłowym.

Za pomocą opcjonalnego polecenia SET MAX ADDRESS wprowadzono obsługę zarezerwowanego obszaru dysku, nazywanego przestrzenią HPA. Dzięki temu poleceniu część dysku przeznaczana jest na potrzeby oprogramowania odzyskującego dane.

Dodano również obsługę poleceń kolejkowania, podobnych do zastosowanych w interfejsie SCSI-2. Pozwala to na lepszą obsługę wielozadaniowości w sytuacjach, gdy liczne programy wymagają komunikacji z dyskiem ATA.

► ► Zajrzyj do punktu „SCSI kontra ATA" znajdującego się na stronie 657.

Kolejnym standardem zatwierdzonym w 1998 r. przez organizację Technical Committee T13 był ANSI NCITS 316-1998 1394 to ATAttachment — Tailgate. Jest to standard protokołu mostka łączącego magistralę IEEE 1394 (i.Link/FireWire) z interfejsem ATA. Protokół umożliwia przystosowanie napędów ATA do interfejsu FireWire. Tailgate jest adapterem (niewielka płytka obwodów drukowanych) zamieniającym interfejs IEEE 1394 (i.Link/FireWire) na interfejs ATA, dzięki czemu możliwe jest przede wszystkim podłączenie napędów ATA do magistrali FireWire. Rozwiązanie to umożliwiło producentom, takim jak Maxtor, Western Digital i inne firmy, w krótkim czasie stworzyć zewnętrzne napędy IEEE 1394 (FireWire) przeznaczone do archiwizacji i przechowywania danych na nośnikach wymiennych o dużej pojemności. Wewnątrz prawie każdego zewnętrznego napędu FireWire znajduje się urządzenie Tailgate i standardowy dysk ATA.

► ^ Zajrzyj do punktu „IEEE 1394" znajdującego się na stronie 1053.

ATA/ATAPI-5

Standard ATA-5 po raz pierwszy pojawił się w 1998 r. i oparty był na poprzednim standardzie interfejsu ATA-4. ATA-5 uwzględnia tryb Ultra-ATA/66 (inaczej Ultra-DMA lub UDMA/66), podwajający szybkość przesyłania danych, co jest osiągane przez zmniejszenie czasu przygotowania i zwiększenie częstotliwości zegara. Wyższa częstotliwość zwiększa zakłócenia wywołujące problemy ze zwykłym 40-żyłowym kablem stosowanym w przypadku interfejsów ATA i Ultra-ATA. W celu wyeliminowania szumów i zakłóceń obecnie w przypadku dysków zgodnych z trybem UDMA/66 lub jego szybszymi wersjami wymagane jest stosowanie nowszych 80-żytowych kabli ze złączem 40-pinowym. Po raz pierwszy kabel został zaprezentowany przy okazji standardu ATA-4. Obecnie użycie kabla jest wymagane w przypadku interfejsu ATA-5, obsługującego tryb Ultra-ATA/66. Kabel posiada 40 dodatkowych żył uziemienia, z których każda umieszczona jest pomiędzy pierwotnymi 40 żyłami uziemienia i danych. Pomaga to w odizolowaniu sygnałów od zakłóceń. Warto zauważyć, że za pomocą kabla można podłączyć starsze urządzenia niezgodne z Ultra-ATA, ponieważ nadal posiada on identyczne złącza 40-pinowe.

Prace nad standardem ATA-5 zaczęły się w 1998 r.. a ukończono je w roku 2000, w którym oficjalnie opublikowano go jako ANSI NCITS 340-2000 AT Attachment-5 with Packet Interface.

Głównymi zmianami w stosunku do poprzedniego standardu są:

Tryb Ultra-DMA (UDMA) 4, który zapewnia przepustowość 66 MB/s (nazywany również UDMA/66 lub Ultra-ATA/66).

80-żyłowy kabel jest niezbędny dla pracy w trybie UDMA/66.

Dodana funkcja automatycznego wykrywania rodzaju kabla — 40 lub 80-żyłowego.

Tryby UDMA powyżej UDMA/33 są dostępne jedynie po wykryciu 80-żyłowego kabla.

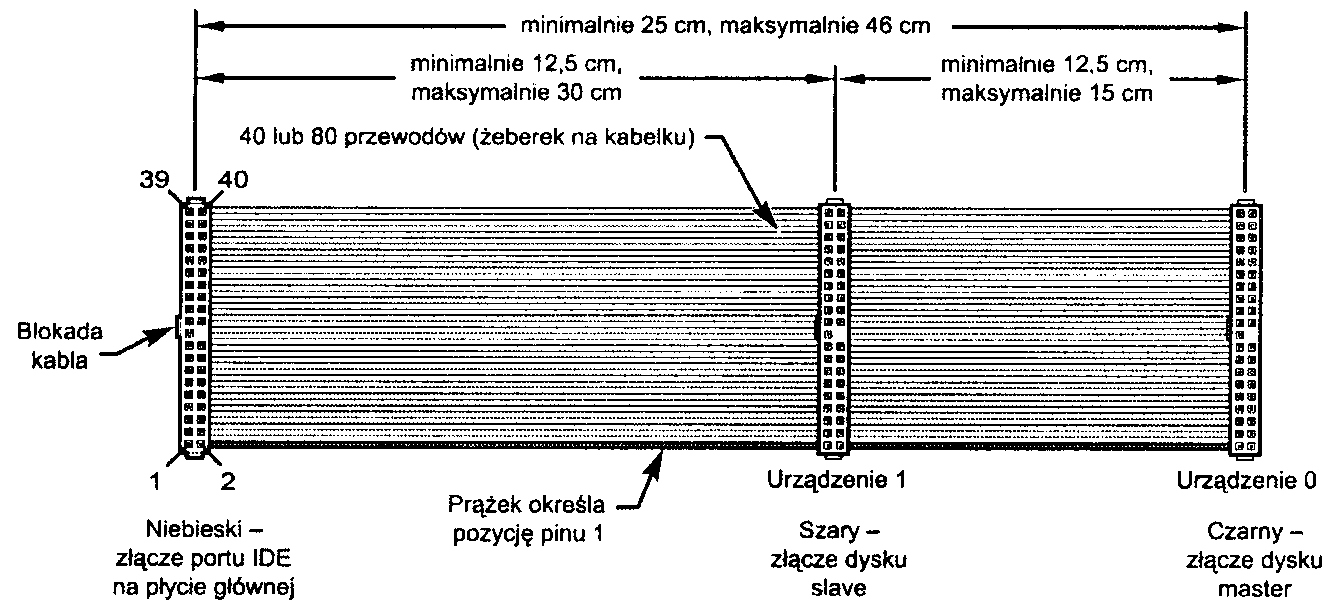

Nowy, 40-pinowy i 80-żyłowy kabel obsługuje również funkcję cable select, a kolory złączy oznaczają ich funkcję. Niebieskie złącze powinno być włączone do gniazda interfejsu ATA (zwykle na płycie głównej). Złącze czarne (na drugim końcu kabla)jest przeznaczone dla urządzeń master i wpina sieje do podstawowego urządzenia. Złącze szare (pomiędzy powyżej wymienionymi) służy do podłączenia urządzenia slave.

Aby skorzystać z trybu UDMA/66 niezbędne jest posiadanie odpowiedniego interfejsu ATA, napędu, BIOS-u i kabla. Również system operacyjny musi obsługiwać transfer DMA. Windows 95 OSR2 i późniejsze, Windows 98/ME i Windows 2000/XP obsługują przesył DMA, ale starsze wersje Windows 95 i NT (bez Service Pack 3) dla pełnego wykorzystania szybszych trybów przesyłu wymagają zastosowania dodatkowych lub poprawionych sterowników. W celu uzyskania najnowszych sterowników należy skontaktować się z producentem płyty głównej lub komputera.

W celu poprawienia niezawodności w trybie Ultra-DMA zastosowano mechanizm wykrywania błędów zwany cyklicznym kodem nadmiarowym (CRC). CRC jest algorytmem obliczającym sumę kontrolną wykorzystywaną do wykrywania błędów w przesyłanym strumieniu danych. Suma kontrolna dla każdego przesyłu Ultra-DMA jest wyliczana zarówno w kontrolerze, jak i dysku. Po przesłaniu danych obie sumy kontrolne są porównywane i w przypadku wykrycia różnic kontroler może wybrać wolniejszy tryb przesyłu i powtórzyć żądanie przesłania danych.

ATA/ATAPI-6

Rozpoczęcie prac nad standardem ATA-6 nastąpiło w roku 2000. Standard zawiera tryb Ultra-ATA/100 (nazywany również Ultra-DMA lub UDMA/100), w którym osiągnięto większą szybkość przesyłu dzięki skróceniu czasów ustalania sygnału i zwiększeniu częstotliwości zegara. Podobnie jak w przypadku ATA-5. szybszy tryb przesyłu wymaga zastosowania kabla 80-żyłowego. Aby skorzystać z trybu ATA/100. należy mieć płytę główną i dysk obsługujący ten tryb.

Prace nad standardem ATA-6 zaczęły się w 2000 r., a ukończono je w roku 2002, w którym oficjalnie opublikowano go jako ANSI NCITS 361-2002 AT Attachment-6 with Packet Interface.

Głównymi zmianami i uzupełnieniami są:

Dodany tryb Ultra-DMA 5, pozwalający na osiągnięcie przepustowości 100 MB/s (nazywany również UDMA/100, Ultra-ATA/100 lub ATA/100).

Rozmiar pola maksymalnej liczby sektorów na polecenie została zwiększona z 8 bitów (256 sektorów lub 131 kB) do 16 bitów (65 536 sektorów lub 33.5 MB), co pozwala na efektywniejsze przesyłanie dużych plików.

Adresowanie LBA zostało rozszerzone z 238 do 248 (281 474 976 710 565) sektorów, co pozwala na obsługę dysków do 144,12 PB (petabajtów = kwadryliona bajtów). Funkcja często nazywana jest 48-bitowym LBA lub obsługą pojemności przekraczających 137 GB. Firma Maxtor określa funkcję terminem Big Drive.

Adresowanie CHS wyszło z użycia; dyski mogą korzystać jedynie z 28-bitowego lub 48-bitowego adresowania LBA.

Oprócz udostępnienia trybu UDMA 5, w standardzie ATA-6 znacznie powiększono rozmiar dysku. ATA-5 i wcześniejsze pozwalały na budowanie dysków o pojemności do 137 GB. Było to kłopotliwe ograniczenie, ponieważ dostępne były już dyski o większej pojemności. Dyski 3,5-calowe przekraczające 137 GB można było kupić już w roku 2001, ale na początku były oferowane jedynie w wersji SCSI, ponieważ interfejs SCSI nie posiada tych samych ograniczeń, co interfejs ATA. W standardzie ATA-6 limit adresowania został zwiększony z 228 do 248 sektorów. Oznacza to, że poprzednio adresowanie LBA korzystało z liczb 28-bitowych, a w przypadku ATA-6, jeżeli jest to konieczne, można korzystać z liczb 48-bitowych. W przypadku zastosowania 512 bajtów na sektor podnosi to maksymalną pojemność dysku do 144,12 PB. Jest to ponad 144 kwadry-liony bajtów! Adresowanie 48-bitowe jest opcjonalne i niezbędne jedynie w przypadku dysków o pojemności większej nić 137 GB. W przypadku mniejszych dysków można stosować zarówno adresowanie 28-bitowe, jak i 48-bitowe.

ATA/ATAPI-7

Prace nad standardem ATA-7 rozpoczęły się pod koniec roku 2001 i trwają nadal. Podobnie jak wszystkie inne standardy, ATA-7 powstał w oparciu o poprzedni standard, do którego wprowadzono kilka ulepszeń.

Podstawowym ulepszeniem w ATA-7 jest kolejny tryb przesyłu noszący nazwę UDMA 6, który pozwala na osiągnięcie przepustowości 133 MB/s. Podobnie jak w przypadku UDMA 5 (100 MB/s) i UDMA 4 (66 MB/s), niezbędne jest zastosowanie 80-żyłowego kabla transmisyjnego. Wolniejsze tryby nie wymagają zastosowania tego kabla, ale jego stosowanie zawsze jest zalecane.

Kolejną znaczącą zmianą wprowadzoną w standardzie ATA-7 było uwzględnienie w nim specyfikacji Serial ATA 1.0. Dzięki temu standard SATA stanowi oficjalną część standardu ATA. Prace nad standardem ATA-7 zaczęto w 2001 r., a ukończono je w roku 2004, w którym oficjalnie go opublikowano.

Należy zauważyć, że choć dzięki trybom UDMA zwiększyła się przepustowość pomiędzy kontrolerem napędu (na dysku) a płytą główną, w przypadku większości dysków ATA — nawet tych, które obsługują tryb UDMA 6 (133 MB/s) pomiędzy dyskiem a płytą główną— nadal maksymalny ciągły transfer odczytywanych danych utrzymuje się poniżej 60 MB/s. Oznacza to, że chociaż najnowsze dyski ATA potrafią transmitować dane pomiędzy elektroniką dysku a płytą główną z prędkością 133 MB/s, dane z talerzy dysku do jego elektroniki są przesyłane o ponad połowę wolniej. Z tego powodu przyłączenie dysku UDMA 6 (133 MB/s) do płyty głównej, która obsługuje jedynie tryb UDMA 5 (100 MB/s), nie spowoduje zbytniego spowolnienia systemu. Podobnie wymiana adaptera ATA 100 MB/s na taki, który obsługuje 133 MB/s, nie zwiększy szybkości działania systemu, ponieważ zastosowany dysk potrafi odczytywać dane ze swoich talerzy z prędkością o połowę mniejszą. Należy pamiętać, że ważniejsza od szybkości przesyłu przez interfejs jest szybkość odczytu danych z nośnika, ponieważ właśnie ona ogranicza maksymalną wydajność systemu.

Standard ATA-7 jest ostatnią wersją wiekowego równoległego standardu ATA. Standard ATA rozwija się pod postacią standardu Serial ATA, który uwzględniono w specyfikacji ATA-7 i szczegółowo omówiono w dalszej części rozdziału.

SATA/ATAPI-8

W 2004 r. rozpoczęły się prace nad standardem SATA-8, będącym nową wersją standardu ATA, opartą na poprzedniku — ATA-7. W nowym standardzie zostanie dodatkowo udoskonalony interfejs Serial ATA, usunięty natomiast zostanie całkowicie równoległy interfejs ATA.

Główne zmiany dokonane w standardzie SATA-8 to:

Usunięcie ze standardu równoległego interfejsu ATA.

Zastąpienie długich funkcji odczytu i zapisu.

Udoskonalenie zarządzania przestrzenią HPA.

Najbardziej radykalną zmianą jest wyeliminowanie ze standardu SATA-8 równoległego interfejsu ATA. Celem tego nie jest jednak wycofanie z użycia tego typu interfejsu. Przy pracach nad standardem SATA-8 dąży się do udostępnienia w zgodnych z nim dyskach SATA nowych możliwości i funkcji, a jednocześnie także do umożliwienia dalszej produkcji dysków z interfejsem równoległym ATA, zgodnych ze standardem ATA-7. Innymi słowy, dyski z interfejsem równoległym nadal będą zgodne ze standardem ATA-7 i jego poprzednikami, natomiast dyski SATA — ze standardem ATA-7 i jego następcami. Uproszczenie w ten sposób standardu ATA pozwala wyeliminować przestarzałe funkcje równoległego interfejsu ATA. Dokonano tego z myślą o przyszłych standardach, w których będzie można uzyskać bardziej przejrzysty i zwięzły opis interfejsu Serial ATA. Można oczekiwać, że prace nad standardem SATA-8 zakończą się w 2006 r. i wtedy zostanie on opublikowany.

Interfejs równoległy ATA

W porównaniu z interfejsem Serial ATA równoległy interfejs ATA posiada unikalne specyfikacje i wymagania dotyczące fizycznego interfejsu, kabli i złącz. W kolejnych punktach szczegółowo zostaną omówione funkcje równoległego interfejsu ATA.

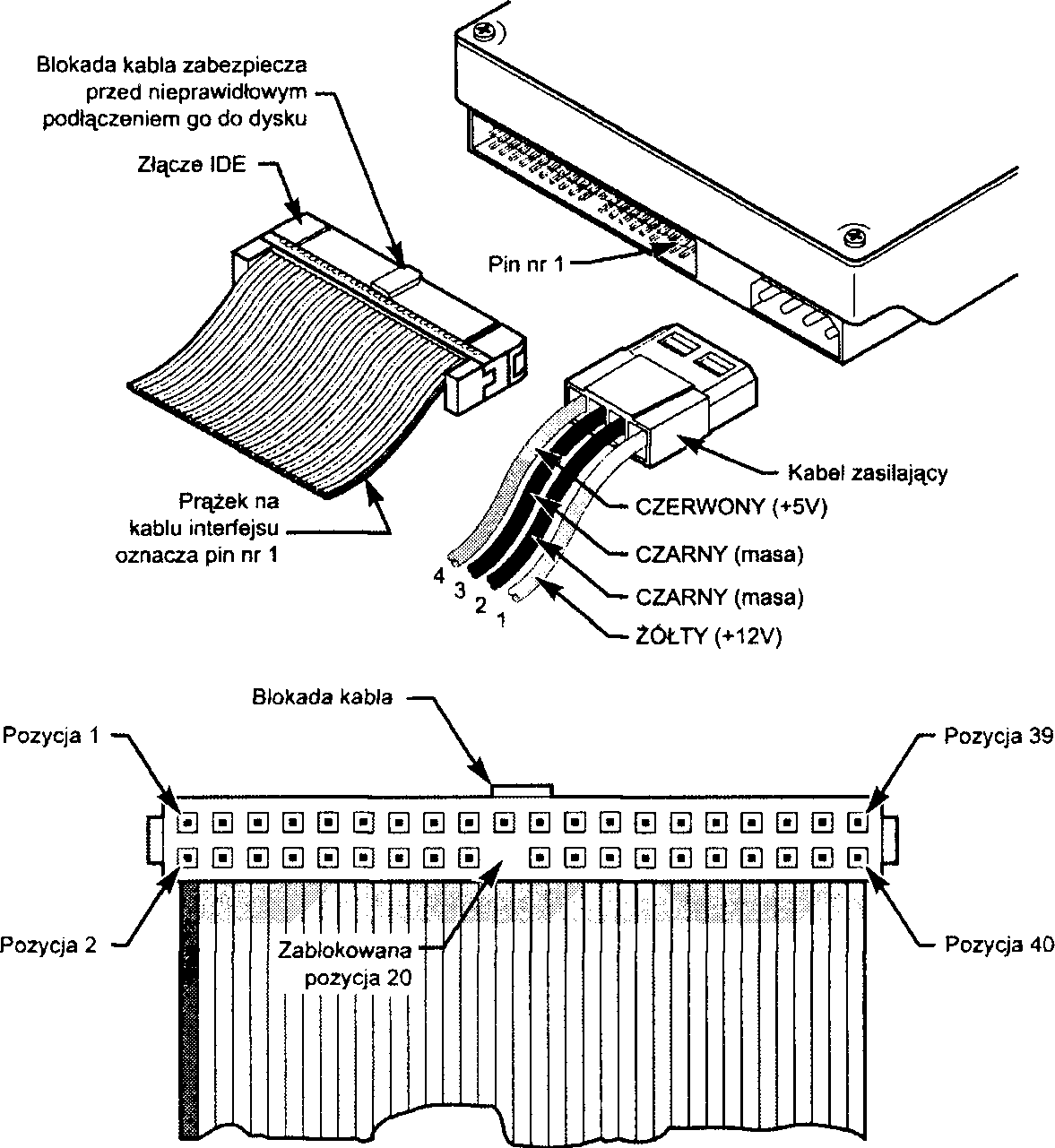

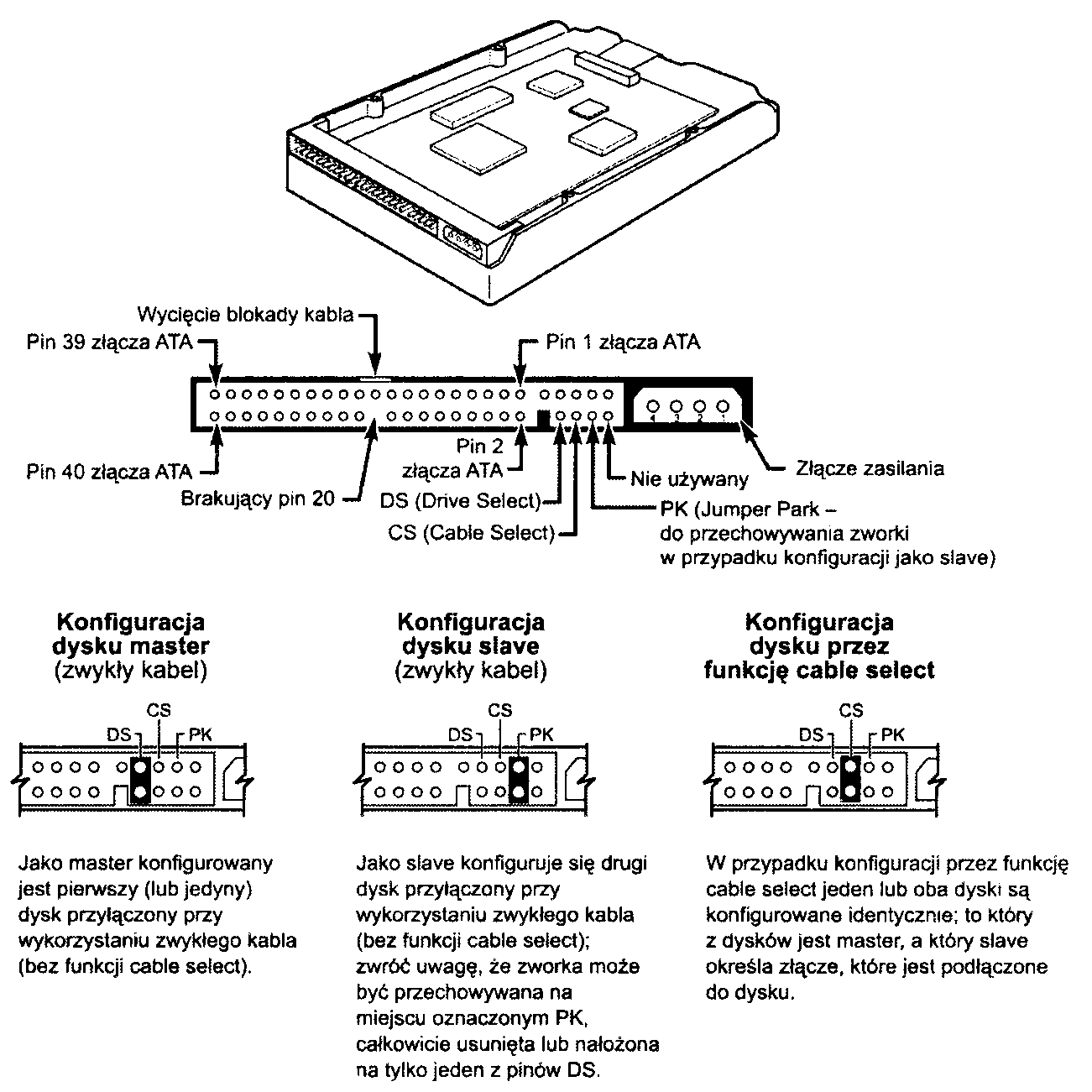

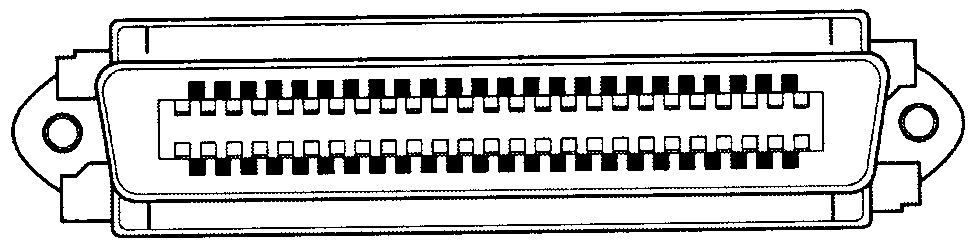

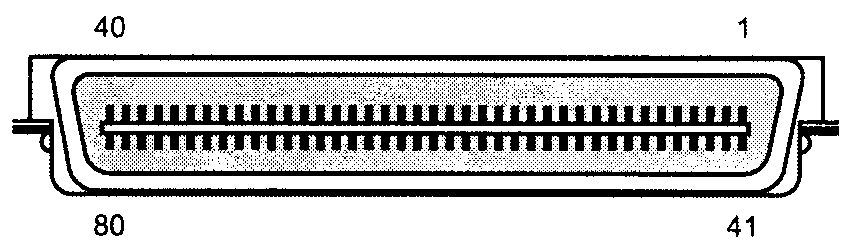

Złącze równoległe ATA

Złącze równoległego interfejsu ATA jest 40-pinowym złączem szufladowym z pinami rozmieszczonymi co 0,1 cala (2,54 mm) i najczęściej ma zabezpieczenie przed włożeniem go odwrotną stroną (patrz rysunki 7.2 i 7.3.). W celu utworzenia takiej blokady, producenci najczęściej usuwają pin 20 z gniazda męskiego i blokują pin 20 w żeńskim złączu kabla. Zabezpiecza to przez odwrotnym zainstalowaniem kabla danych. Niektóre kable posiadają również występ na górze złącza żeńskiego, który trafia w wycięcie obudowie współpracującego z nim złącza męskiego w urządzeniu. Zalecane jest stosowanie blokowanych złączy i kabli. Odwrotne włączenie kabla ATA nie powoduje zwykle żadnych uszkodzeń, ale może sprawić, że systemu nie da się uruchomić.

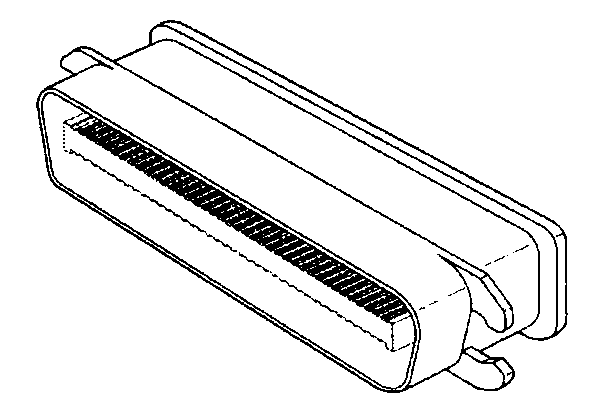

Rysunek 7.2.

Typowe złącza dysku twardego ATA (IDE)

Rysunek 7.3.

Szczegóły budowy 40-pinowego złącza interfejsu A TA (IDE)

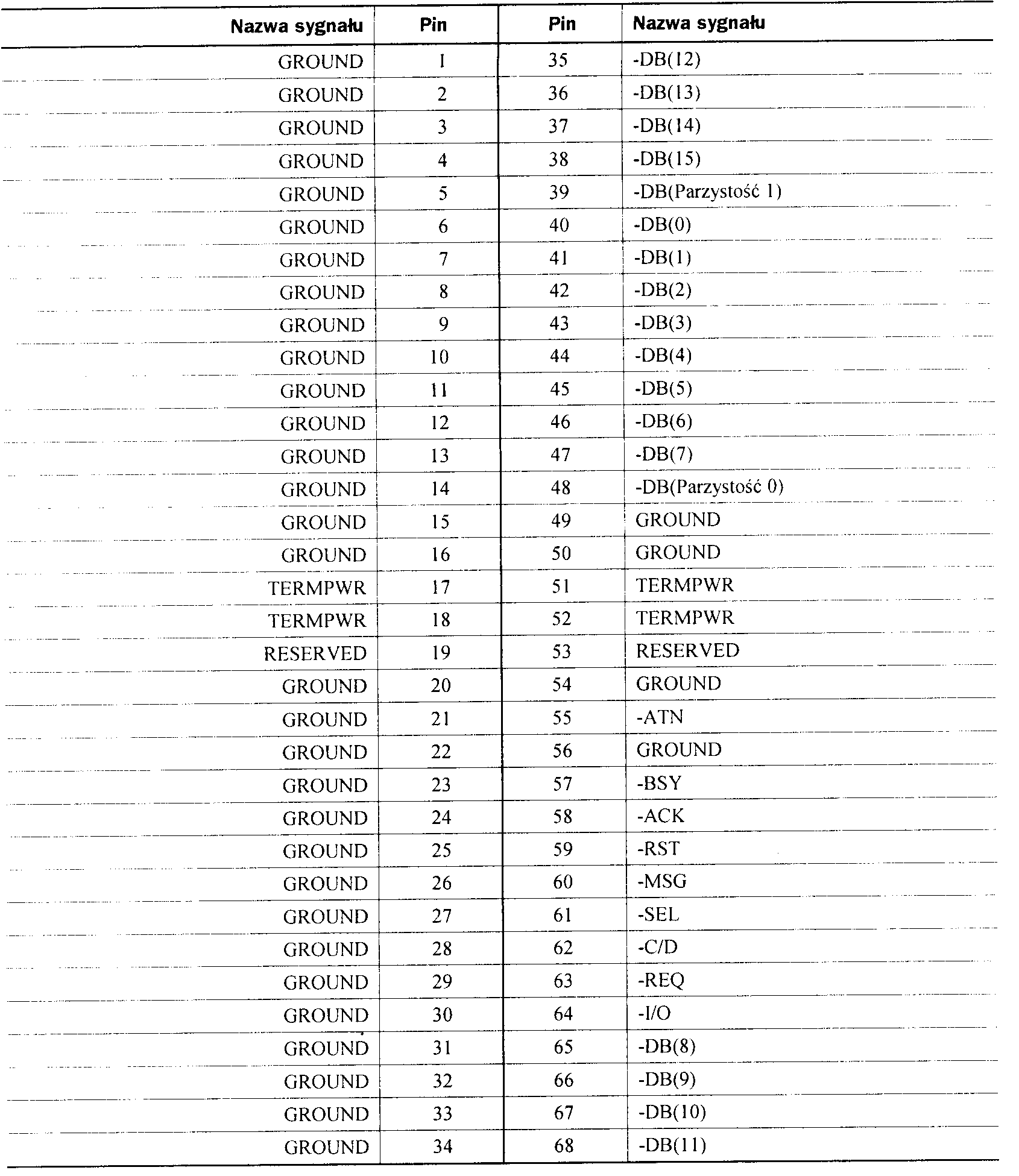

W tabeli 7.3 pokazane zostały funkcje poszczególnych pinów złącza równoległe interfejsu ATA (IDE).

Tabela 7.3. 40-pinowe złącze równoległe ATA

Nazwa sygnału |

Pin |

Pin |

Nazwa sygnału |

-RESET 1 |

2 |

GROUND |

|

7 bit danych |

3 |

4 |

8 bit danych |

6 bit danych |

5 |

6 |

9 bit danych |

5 bit danych |

7 |

8 10 bit danych |

|

4 bit danych |

9 |

10 |

11 bit danych |

3 bit danych |

11 |

12 |

12 bit danych |

2 bit danych |

13 |

14 |

13 bit danych |

1 bit danych |

15 |

16 |

14 bit danych |

0 bit danych |

17 |

18 15 bit danych |

|

GROUND |

19 |

20 |

Blokada (brakujący pin) |

DRQ 3 |

21 |

22 |

GROUND |

-IOW |

23 |

24 |

GROUND |

-IOR |

25 |

26 |

GROUND |

l/O CH RDY |

27 |

28 |

CSELiSPSYNC1 |

-DACK |

29 |

30 |

GROUND |

IRQ 14 |

31 |

32 |

Zarezerwowane2 |

1 bit adresu |

33 |

34 |

-PDIAG |

0 bit adresu |

35 |

36 |

2 bit adresu |

-CS1FX |

37 |

38 |

-CS3FX |

-DA/SP |

39 |

40 |

GROUND |

+5V (elektronika) |

41 |

42 |

+5V (silnik) |

GROUND |

43 |

44 |

Zarezerwowane |

Pin 28 jest zwykle używany przez funkcję cable select, ale niektóre starsze dyski wykorzystują go do synchronizacji obrotów pomiędzy dyskami.

2Pin 32 był w standardzie A TA-2 zdefiniowany jako -IOCSl 6. ale nie jest już używany.

Znak „ - " poprzedzający nazwę sygnału (na przykład -RESET) wskazuje, że sygnał jest aktywny w stanie niskim.

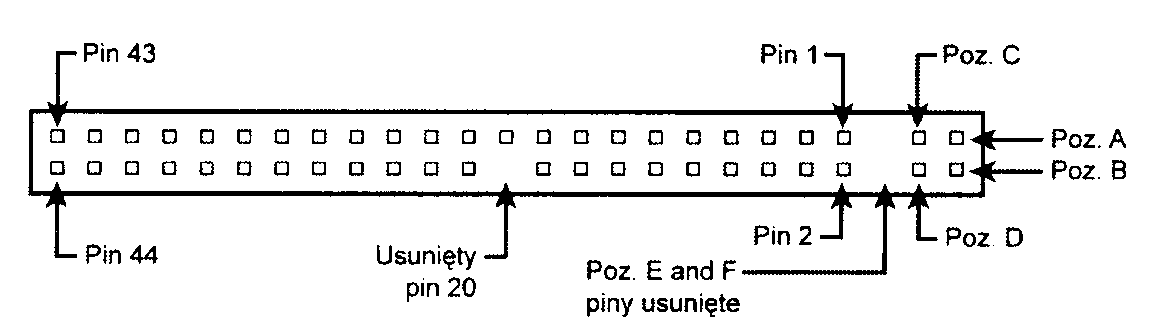

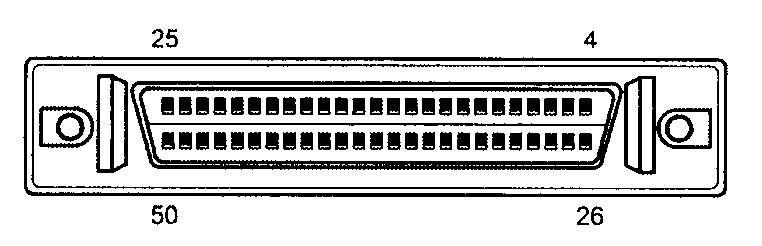

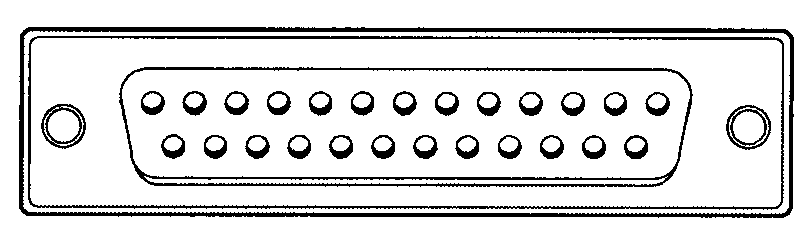

Napędy 2,5 cala, stosowane w laptopach i notebookach, korzystają zwykle z mniejszego zintegrowanego gniazda 50-pinowego, którego piny są od siebie oddalone jedynie o 2 mm (0,079 cala). Główna 40-pinowa część złącza jest identyczna jak standardowe złącze ATA (poza rozstawem pinów), ale dodane są do tego złącza piny zasilające i służące do montowania zworek. Normalnie podłączany kabel ma 44 przewody i oprócz standardowych sygnałów ATA służy również do zasilania dysku. Na piny oznaczone na rysunku literami A-D zwykle nałożona jest zworka, której położenie określa ustawienia master, slave i cable select). Na rysunku 7.4 pokazane zostało zintegrowane 50-pinowe złącze używane do podłączania dysków 2,5 cala stosowanych w laptopach i notebookach.

Rysunek 7.4.

Budowa 50-pinowego zintegrowanego złącza równoległego interfejsu ATA (wykorzystywanego w 2,5-calowych napędach dysków A TA dla notebooków i laptopów, używających 44-pinowego kabla)

Należy zwrócić uwagę na zworkę na pinach A-D oraz usunięte piny E i F. Zworka umieszczona na pinach B i D najczęściej ustawia dysk w tryb cable select. W przypadku tego złącza pin 41 dostarcza napięcia +5V wykorzystywanego do zasilania układów elektronicznych dysku, a pin 42 dostarcza napięcia +5V wykorzystywanego do zasilania silnika (w dyskach 2,5 cala stosowane są silniki 5 V w przeciwieństwie do większych napędów, gdzie stosuje się zwykle silniki 12 V), natomiast na pinie 43 doprowadzona jest masa. Ostatni pin (44) jest zarezerwowany i nie jest wykorzystywany.

W tabeli 7.4 przedstawiono budowę 50-pinowego zintegrowanego złącza równoległego interfejsu ATA wykorzystywanego w większości 2,5-calowych napędów dysków ATA (dla notebooków i laptopów).

Tabela 7.4. 50-pinowe zintegrowane złącze równoległego interfejsu ATA 2,5 cala (napędy dla notebooków i laptopów)

Nazwa sygnału |

Pin |

Pin |

Nazwa sygnału |

Zworka |

A |

|

Zworka |

Zworka |

C |

D |

Zworka |

Blokada (brakujący pin) |

E |

F |

Blokada (brakujący pin) |

-RESET |

1 |

2 |

GROUND |

7 bit danych |

3 |

4 |

8 bit danych |

6 bit danych |

5 |

6 |

9 bit danych |

5 bit danych |

7 |

8 10 bit danych |

|

4 bit danych |

9 |

10 |

11 bit danych |

3 bit danych |

11 |

12 |

12 bit danych |

2 bit danych |

13 |

14 |

13 bit danych |

1 bit danych |

15 |

16 |

14 bit danych |

0 bit danych |

17 |

18 15 bit danych |

|

GROUND |

19 |

20 |

Blokada (brakujący pin) |

DRQ 3 |

21 |

22 |

GROUND |

-IOW |

23 |

24 |

GROUND |

-IOR |

25 |

26 |

GROUND |

I/O CH RDY |

27 |

28 |

CSEL |

-DACK |

29 |

30 |

GROUND |

1RQ 14 |

31 |

32 |

Zarezerwowane |

1 bit adresu |

33 |

34 |

-PDIAG |

0 bit adresu |

35 |

36 |

2 bit adresu |

-CS1FX |

37 |

38 |

-CS3FX |

-DA/SP |

39 |

40 |

GROUND |

+5V (elektronika) |

41 |

42 |

+5V (silnik) |

GROUND |

43 |

44 |

Zarezerwowane |

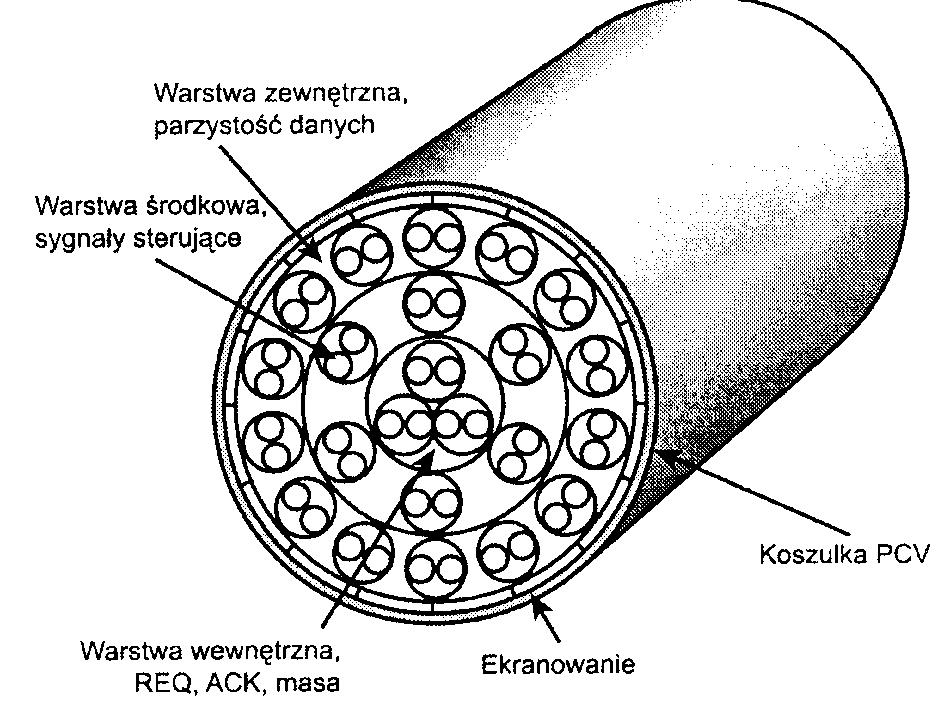

Kabel danych równoległego interfejsu ATA

Do przesyłania sygnałów pomiędzy układami adaptera magistrali i dyskiem (kontrolerem) stosowany jest 40-żyłowy kabel w postaci taśmy. W celu maksymalnego zwiększenia integralności sygnału i wyeliminowania potencjalnych problemów z zakłóceniami i opóźnieniami, kabel ten nie może być dłuższy niż 18 cali (46 cm). Testy pokazują, że z powodzeniem można korzystać z 80-żyłowego kabla o maksymalnej długości 69 cm.

Nie wszystkie kable i złącza są blokowane

Wielu producentów tanich płyt głównych i kabli nie stosuje tego mechanizmu. Tańsze płyty główne nie posiadają również usuniętego 20. pinu ze złącza ATA i konsekwentnie wykorzystują kabel bez zablokowanego otworu dla 20. pinu. Jeżeli nie zostanie zastosowane obudowane gniazdo z wycięciem i odpowiadającym mu występem na złączu kabla, nie istnieje żadne blokowanie i możliwe jest odwrotne przyłączenie kabli. Na szczęście jedyną konsekwencją nieprawidłowego połączenia jest to, że urządzenie nie działa do chwili prawidłowego przyłączenia kabla.

Warto zauważyć, że w przypadku niektórych komputerów na ekranie nie jest nic wyświetlane do momentu zareagowania napędów ATA na uruchamiające je polecenie. Polecenie nie może jednak zostać do nich przekazane, gdy kabel zostanie podłączony odwrotnie. A zatem, jeśli po zainstalowaniu napędu ATA pozbawionego blokad w złączu i włączeniu komputera ma się wrażenie, że komputer się „zawiesił" (nic nie pojawia się na ekranie), należy sprawdzić kabel ATA (na rysunku 7.6 pokazano przykłady kabli ATA posiadających w złączach blokady i kabli ich pozbawionych).

W rzadkich sytuacjach, gdy dopasowujemy różne elementy, może się zdarzyć, że kabel ma zablokowany 20. pin (tak jak powinno być), natomiast na płycie głównej istnieje pin 20. W tym przypadku można wyłamać tenże pin z płyty głównej lub usunąć blokadę z kabla. Niektóre kable posiadają tę blokadę zainstalowaną na stałe, jako część obudowy złącza, i w takim przypadku trzeba wyłamać pin 20. z płyty głównej lub skorzystać z innego kabla.

Należy pamiętać o prostej zasadzie, że pin 1. powinien być umieszczony obok gniazda zasilającego urządzenie i zwykle jest on oznaczony prążkiem na kablu.

Należy pamiętać, że napędy ATA obsługujące tryby transmisji o dużej szybkości przesyłu, na przykład PIO 4 i wszystkie tryby Ultra-DMA (UDMA), w przypadku gdy kable są zbyt długie, są szczególnie narażone na zakłócenia integralności sygnału. Jeżeli kabel jest zbyt długi, dane mogą zostać uszkodzone lub będą występowały inne dokuczliwe problemy. Będą się one objawiać błędami odczytu i zapisu na dysku. Dodatkowo, wszystkie dyski korzystające z trybu UDMA 5 (66 MB/s), UDMA 6 (100 MB/s) lub UDMA 7 (133 MB/s) muszą korzystać ze specjalnego 80-żyłowego kabla o lepszej jakości (kable takie są dodatkowo uziemione w celu zmniejszenia szumów). Polecam również stosowanie takich kabli w przypadku dysków pracujących w trybie UDMA 2 (33 MB/s) lub wolniejszych, ponieważ w żadnym przypadku to nie zaszkodzi, a może jedynie pomóc. Zawsze mam zapasowy kabel 80-żyłowy wysokiej jakości i stosuję go do testowania poprawności pracy dysków w przypadku, gdy podejrzewam problemy związane z długością lub jakością kabla. Na rysunku 7.5 pokazany jest typowy układ kabla ATA i jego wymiary.

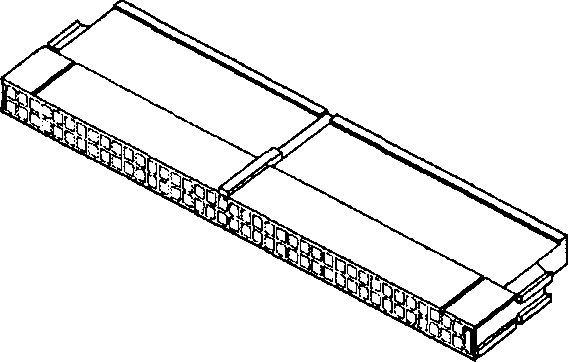

Rysunek 7.5.

Kabel

równoległego interfejsu ATA (IDE) z 40-pinowymi złączami i 40 lub 80-żyłowym kablem (w wersji 80-żyłowej dodatkowe przewody są uziemione)

W przypadku większości kabli 40-żyłowych nie jest stosowane kodowanie kolorami, natomiast w przypadku kabli 80-żyłowych takie kodowanie stosowane jest zawsze.

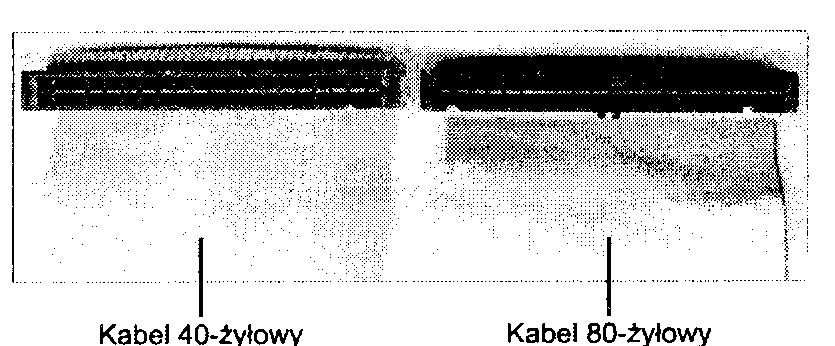

W chwili obecnej stosowane są dwa rodzaje kabli równoległego interfejsu ATA: 40-żyłowy i 80-żyłowy (rysunek 7.6). Oba korzystają ze złączy 40-pinowych — dodatkowe przewody w kablu 80-żyłowym są po prostu uziemieniem. Dzięki tym dodatkowym przewodom zmniejszają się zakłócenia i interferencje. Kabel taki jest

Rysunek 7.6.

40-żylowy

(po lewej)

i 80-żyłowy

(po prawej)

kabel równoległego

interfejsu A TA

wymagany, jeżeli interfejs ma pracować z prędkością 66 MB/s (ATA/66) lub większą. Dysk oraz host adapter są zaprojektowane w taki sposób, aby wyłączać tryby ATA/66, ATA/100 lub ATA/133 w przypadku, gdy nie zostanie wykryty 80-żyłowy kabel. Jeśli w takim przypadku napęd ATA/66 lub szybszy zostanie podłączony do 40-żyłowego kabla, podczas uruchamiania komputera może pojawić się komunikat ostrzegawczy. Kabel ten może być również stosowany w przypadku wolniejszych trybów; nie jest to wymagane, ale polepsza się wtedy jakość sygnału. Dlatego zaleca się stosowanie kabli 80-żyłowych do podłączania wszystkich rodzajów dysków.

Kiedyś student zapytał mnie, jak odróżnić kabel 80-żyłowy od 40-żyłowego. Pomyślałem przez chwilę: „Czy to pytanie nie jest podchwytliwe?"'. Może student ów nie wiedział, że każda żyła kabla taśmowego jest identyfikowana przez wypukłość kabla. Prostą odpowiedzią jest policzenie żył znajdujących się w kablu. Jeśli będzie ich 40, musi to być kabel 40-żyłowy. Jeśli natomiast okaże się, że żył jest 80, odpowiedzi można się samemu domyślić. Jeśli oba typy kabli położy się obok siebie, różnica między nimi stanie się oczywista. W porównaniu z wersją 40-żyłową kabel 80-żyłowy ma oczywiście większą liczbę wypukłości.

Należy zwrócić uwagę na blokady na złączach 80-żyłowego kabla, które mają za zadanie zapobiec jego odwrotnemu podpięciu. Warto też zauważyć, że kiepskiej jakości 40-żyłowy kabel pokazany na powyższym rysunku jest pozbawiony blokad. Większość dobrze wykonanych kabli 40-żyłowych posiada takie blokady, jednak — ze względu na to, że ich używanie nie jest konieczne — wiele tanich kabli nie jest w nie wyposażonych. W przypadku kabli 80-żyłowych jest inaczej — tu stosowanie blokad jest nakazane w standardzie.

Kable dłuższe i „zaokrąglone"

Oficjalny standard równoległego interfejsu ATA ogranicza długość kabli do 46 cm. Jednak sprzedawanych jest wiele kabli o długości osiągającej 91 cm, a nawet więcej. Wielu Czytelników zadało mi pytanie: „Dlaczego sprzedawane są kable dłuższe niż 46 cm, jeśli standard na to nie zezwala?". Jeżeli coś znalazło się w sprzedaży, nie oznacza to, że zgodne jest ze standardem i poprawnie działa! Cały czas spotykam się z produktami nieprawidłowo zaprojektowanymi, kiepskiej jakości i niezgodnymi z normami. Nadal wiele osób korzysta ze zbyt długich kabli i pomimo to ich komputery świetnie działają, ale miałem też do czynienia z kilkoma przypadkami, w których zbyt długie kable stały się przyczyną problemów. W związku z tym postanowiłem dokładniej przyjrzeć się tej kwestii.

Stwierdziłem, że bez obaw można korzystać z 80-żyłowego kabla o długości przekraczającej standardową i wynoszącej maksymalnie 69 cm. Jednak w przypadku kabla 40-żyłowego długość zgodnie ze standardem powinna wynosić 46 cm.

Tak naprawdę podjęto próbę dokonania zmian w standardzie równoległego interfejsu ATA, umożliwiających zastosowanie kabli o długości 69 cm. W dokumencie e00151r0.pdf dostępnym pod adresem http://www.tl3.org/ technical, można przeczytać o nieznacznych różnicach w integralności sygnałów trybu Ultra DMA 5 występujących pomiędzy 80-żyłowym kablem o długości 69 cm i 46 cm. Choć propozycja wprowadzenie kabla o zwiększonej długości pojawiła się już w październiku 2000 r„ nigdy nie została uwzględniona w standardzie. Nawet pomimo braku oficjalnej aprobaty informację zawartą w powyższym dokumencie traktuje się niczym empiryczny dowód możliwości bezproblemowego stosowania 80-żyłowego kabla o maksymalnej długości 69 cm.

Do powyższych informacji dodam kolejne zalecenie, odradzające w większości przypadków stosowanie „zaokrąglonych" kabli ATA. Użycie tego typu kabli nie zostało zaaprobowane w standardzie ATA. Co więcej, są dowody na to, że mogą one być przyczyną występowania przesłuchu i szumów. W przypadku 80-żyłowego kabla każda żyła danych kabla taśmowego przeplatana jest żyłą uziemienia. ..Zaokrąglanie" kabla powoduje tymczasem, że część żył danych w losowy sposób do siebie przylega. W efekcie pojawia się przesłuch i szumy, powodujące występowanie błędów w sygnale.

Szukając informacji na ten temat, zapoznałem się z wywiadem udzielonym w marcu 2004 r. przez Rahula Sooda dla czasopisma CPU (http://www.computerpoweruser.com). Sood jest szefem działu technologicznego popularnego producenta zaawansowanych systemów, Voodoo PC (http://www.voodoopc.com). W wywiadzie Sood powiedział: „Nie popieram stosowania »zaokrąglonych« kabli. Kable SATA są oczywiście znakomite, natomiast kable »zaokrąglone« to już inna historia, ponieważ są potencjalnym źródłem szumów. Wszystkie testy wykonane przy użyciu tego typu kabli pokazały, że z czasem generują one błędy lub są wolniejsze od dobrej jakości płaskich kabli IDE".

Oczywiście wiele osób z powodzeniem korzysta z kabli „zaokrąglonych", ale moja wiedza na temat elektroniki, a także standardu ATA, zawsze sprawiała, że używając ich, czułem się nieswojo. Choć nie dysponuję żadnymi wynikami testów przeprowadzonych przez Sooda, które potwierdzają jego wnioski, w przypadku własnych komputerów wolę pozostać przy 80-żyłowych kablach taśmowych o długości 69 cm lub mniejszej.

Sygnały równoległego interfejsu ATA

Opiszemy teraz najważniejsze sygnały interfejsu ATA, które mają wpływ na instalację i konfigurację dysku. Informacje te pomogą zrozumieć sposób działania funkcji cable select.

Pin 20. jest wykorzystywany jako klucz ustalający orientację kabla i nie jest on podłączony do interfejsu. Powinien być on usunięty ze złączy ATA, natomiast od strony kabla nie powinno być otworu na ten pin, dzięki czemu nie można będzie odwrotnie włożyć kabla w złącze.

Przez pin 39. przesyłany jest sygnał aktywności dysku i wykrycia dysku slave (DASP); jest to sygnał o podwójnym znaczeniu, multipleksowany w czasie. W czasie inicjalizacji po uruchomieniu sygnał ten wskazuje, czy do interfejsu podłączony jest dysk slave. Po fazie inicjalizacji każdy z dysków wykorzystuje ten sygnał do wskazania, że trwa transmisja danych z dysku. Pierwsze dyski mogły nie posiadać funkcji multipleksowa-nia tego sygnału i wymagały zainstalowania specjalnej zworki wskazującej na pracę z drugim dyskiem. Standaryzacja tej funkcji zapewniającej prawidłową pracę systemu z dwoma dyskami jest jednym z elementów standardu ATA. Jest to powód, dla którego niektóre dyski posiadają zworkę slave present (SP) oznaczającą pracę z dyskiem slave, natomiast niektóre jej nie mają.

Pin 28. udostępnia sygnał cable select (CSEL). W niektórych starszych dyskach może być to również sygnał synchronizacji obrotów (SPSYNC), ale nie występuje on zwykle w nowych dyskach. Sygnał CSEL jest przeznaczony do kontroli wyboru dysku master (dysk 0) i slave (dysk 1) bez konieczności ustawiania zworek na dysku. Jeżeli dysk wykryje na linii CSEL logiczne 0, ustawiany jest jako master, a jeżeli logiczną jedynkę, pracuje jako slave.

Można zainstalować specjalne okablowanie do selektywnego uziemiania sygnału CSEL. Najczęściej jest to realizowanie poprzez kabel typu Y, gdzie złącze magistrali znajduje się pośrodku, natomiast dyski na obu odgałęzieniach. Jedno z odgałęzień Y posiada uziemioną linię CSEL, co wskazuje, że dysk pracuje jako master, natomiast drugie odgałęzienie ma niepodłączoną linię CSEL (przerwany lub usunięty kabel), co sprawia, że dysk pracuje jako slave.

Konfiguracja z dwoma dyskami ATA

Instalacja dwóch dysków ATA może sprawiać kłopoty, ponieważ każdy z dysków posiada własny kontroler i oba te kontrolery muszą poprawnie pracować mimo to, że są podłączone do tej samej magistrali. Nie można zapewnić, że na polecenie odpowie tylko jeden z kontrolerów.

Standard ATA posiada opcje pracy dwóch dysków połączonych w łańcuch. Dysk podstawowy (dysk 0) nosi nazwę master, natomiast dysk dodatkowy (dysk 1) nazywany jest slave. Można ustawić funkcję dysków master i slave przez ustawienie zworek na dysku lub przez wykorzystanie linii CS w interfejsie oraz ustawiając na dysku zworkę CS.

Gdy zainstalowany jest tylko jeden dysk, jego kontroler odpowiada na wszystkie polecenia z systemu. W przypadku zastosowania dwóch dysków (i jednocześnie dwóch kontrolerów) oba kontrolery odbierają polecenia z systemu. Każdy kontroler musi być tak skonfigurowany, aby reagował jedynie na polecenia kierowane do niego. W takiej sytuacji jeden z kontrolerów jest ustawiany jako master, natomiast drugi jako slave. Gdy system wysyła polecenie do określonego dysku, kontroler na drugim dysku musi poczekać do czasu zakończenia pracy przez wybrany dysk i kontroler. Ustawienie zworki master lub slave uaktywnia rozróżnianie kontrolerów przy wykorzystaniu specjalnego bitu (bitu DRV) w rejestrze Drive/Head bloku polecenia.

Konfigurowanie dysków ATA może być tak samo proste jak w przypadku instalacji z jednym dyskiem lub kłopotliwe — szczególnie gdy do jednego kabla trzeba przyłączyć dwa stare dyski różnych producentów.

Większość dysków ATA można skonfigurować do pracy w jednym z czterech trybów:

master (jeden dysk),

master (dwa dyski),

stave (dwa dyski),

cable select.

Wiele z dysków posiada uproszczoną konfigurację składającą się z trzech ustawień: master, slave i cable select. Ponieważ każdy z dysków ATA posiada własny kontroler, należy określić, który z nich będzie pracował jako master, a który jako s!ave. Nie ma żadnej funkcjonalnej różnicy pomiędzy tymi dyskami poza tym, że dysk slave uaktywnia po uruchomieniu systemu sygnał DASP, informujący dysk master o jego obecności. Po wykryciu tego sygnału dysk master monitoruje linię aktywności dysku, która w przypadku niewykrycia dysku slave jest ignorowana. Ustawienie dysku jako slave często powoduje, że opóźnia on na kilka sekund rozpoczęcie procesu rozpędzania talerzy, zmniejszając w ten sposób obciążenie zasilacza komputera.

Do czasu opublikowania specyfikacji ATA nie wykorzystywano zbyt często konfiguracji z dwoma dyskami. Niektórzy producenci używali różnych metod synchronizacji dysków master i slave w różnych modelach swoich urządzeń. Z powodu tych niezgodności niektóre z dysków mogą działać ze sobą jedynie w określonej kolejności master-slave. Problem ten dotyczy wyłącznie urządzeń wyprodukowanych przed opublikowaniem specyfikacji ATA.

Większość dysków, które w pełni implementują specyfikację ATA, wymaga w czasie konfiguracji ustawienia tylko jednej zworki (master-slave). W niewielu niezbędna jest również zworka oznaczająca podłączenie dysku slave. W tabeli 7.5 pokazane są ustawienia zworek wymaganych przez większość dysków ATA.

Tabela 7.5. Ustawienia zworek dla większości dysków zgodnych ze standardem ATA w przypadku zastosowania zwykłego kabla (bez funkcji cable select

Nazwa zworki |

Jeden dysk |

Dwa dyski — master |

Dwa dyski — slave |

Master (M/S) |

Wł. |

Wł. |

Wyl. |

Slave Present (SP) |

Wył. |

Wł. |

Wyl. |

Cable Select (CS) |

Wył. |

Wył. |

Wyl. |

Jeżeli zastosowany jest kabel z funkcją cable select, zworka CS powinna być włączona, a pozostałe wyłączone. Funkcje dysków są wtedy określane przez poszczególne złącza kabla.

Na rysunku 7.7 pokazane są zworki typowego dysku ATA.

Zworka master określa, czy dysk pracuje jako master czy jako slave. Niektóre dyski wymagają zastosowania zworki Slave Present w przypadku pracy w konfiguracji dwudyskowej. Zworka ta informuje urządzenie, że podłączony jest s/ave. W przypadku wielu dysków ATA zworka master jest opcjonalna i może być usunięta. Zainstalowanie w takich przypadkach zworki pomaga jednak wyeliminować pomyłki; zalecam instalowanie zworek w sposób pokazany na rysunku.

Niektóre dyski mają zworki umieszczone na płycie z elektroniką i mogą nie być one widoczne od tyłu.

Aby wyeliminować pomyłki przy ustawianiu trybu pracy dysków, większość nowych systemów wykorzystuje funkcję cable select. Aby skorzystać z tej funkcji, należy zastosować specjalny kabel ATA, który posiada wszystkie przewody oprócz 28. biegnącego od płyty głównej do obu dysków. Pin 28. jest wykorzystywany przez funkcję cable select i jest on podłączony do jednego złącza (nazwanego master), a nie jest on podłączony do drugiego (nazwanego slave). Oba dyski muszą być odpowiednio skonfigurowane przez zastosowanie zworki CS na obu dyskach.

W przypadku zastosowania funkcji cable select, dysk, który otrzyma sygnał na pin 28. automatycznie jest konfigurowany jako master, natomiast drugi jako slave. W większości kabli funkcja ta jest realizowana przez usunięcie metalowej złączki otworu pinu 28. (co jest trudne do zauważenia) lub widoczne przecięcie kabla pinu 28. gdzieś na długości tasiemki. Ponieważ są to niewielkie modyfikacje kabla i mogą zostać one niezauważone, kable z funkcją cable select zwykle posiadają na wtyczkach napisy master, slave i system. Wszystkie 80-żyłowe kable UltraATA pozwalają na zastosowanie funkcji cable select.

W przypadku zastosowania funkcji cable select wystarczy umieścić zworkę CS na wszystkich dyskach, a następnie włożyć do dysku, który ma być dyskiem master wtyczkę opisaną master, a do dysku mającego być dyskiem slave wtyczkę opisanąslave.

Jedyną wadą, jaką można zauważyć, jest ograniczenie swobody rozmieszczania kabli w obudowie lub wyboru miejsca, gdzie montowane są dyski, ponieważ muszą być one podłączone do określonych złączy kabla.

Tryby przesyłu danych PIO równoległego interfejsu ATA

Standardy ATA-2 i ATA-3 definiowały pierwsze tryby dużej przepustowości przesyłające dane do i z dysku za pośrednictwem równoległego interfejsu ATA. Te szybsze tryby transmisji były częścią nowej specyfikacji i przyczyniły się do opublikowania nowych wersji standardu. Omówimy teraz kolejno te tryby transmisji.

Tryby PIO (programowalne wejście-wyjście) określają szybkość transmisji danych z dysku i do niego korzystając z PIO. W najwolniejszym trybie PIO — PIO 0 — cykl transmisji danych nie może przekraczać 600 na-nosekund (ns). W jednym cyklu przesyłane jest 16 bitów, co daje teoretyczną prędkość trybu transmisji PIO 0 (czas cyklu 600 ns) 3,3 MB/s, natomiast w trybie PIO 4 (czas cyklu 120 ns) osiąga 16,6 MB/s.

W tabeli 7.6 zestawione są tryby PIO wraz z ich wydajnością.

Tabela 7.6. Tryby PIO i ich wydajności

Tryb PIO |

Szerokość magistrali (bity) |

Czas cyklu (ns) |

Częstotliwość magistrali (MHz) |

Cykle na takt zegara |

Przepustowość (MB/s) |

Specyfikacja ATA |

|

0 |

16 |

600 |

1,67 |

1 |

3,33 |

ATA-1 |

|

1 |

16 |

383 |

2.61 |

1 |

5,22 |

ATA-1 |

|

2 |

16 |

240 |

4,17 |

1 |

8,33 |

ATA-1 |

|

3 |

16 |

180 |

5,56 |

1 |

11,11 |

ATA-2 |

|

4 |

16 |

120 |

8,33 |

|

16,67 |

ATA-2 |

|

ATA-2 nazywany jest również El DE (Enhanced IDE) lub Fast-AT A.

ns = nanosekundy (miliardowa część sekundy). MB = milion bajtów.

Większość płyt głównych z ATA-2 i nowszych posiada dwa gniazda kanałów IDE. Większość układów płyt głównych w mostku południowym ma interfejs ATA, który to komponent w większości systemów jest przyłączony do magistrali PCI.

Starsze płyty główne 486 i niektóre pierwsze Pentium posiadająjedynie podstawowy kanał przyłączony przez systemową magistralę PCI. Dodatkowy kanał przyłączony jest najczęściej do magistrali i przez to ograniczony do pracy jedynie w trybie PIO 2.

Dysk odpowiadający na polecenie Identify Drive zwraca między innymi dane na temat obsługiwanych przez niego trybów PIO i DMA. Większość zaawansowanych BIOS-ów automatycznie ustawia prawidłowy tryb dopasowany do możliwości dysku. Jeżeli zostanie ustawiony tryb szybszy niż obsługiwany przez dysk. może się przytrafić utrata danych.

Interfejs ATA-2 i nowsze obsługują również blokowy tryb PIO, co oznacza, że wykorzystywane jest polecenie Read/Write Multiple, które znacznie zmniejsza ilość przerwań wysyłanych do procesora komputera. Obniża to obciążenie systemu i powoduje zwiększenie szybkości transmisji.

Tryby DMA równoległego interfejsu ATA

Dyski ATA obsługują również transfer DMA (bezpośredni dostęp do pamięci). Oznacza to, że dane są przesyłane bezpośrednio pomiędzy dyskiem a pamięcią bez potrzeby użycia procesora jako pośrednika, jak dzieje się to w trybie PIO. Odciąża to procesor od obsługi transmisji danych, co daje możliwość wykonywania w tym czasie innych zadań.

Istnieją dwa różne typu bezpośredniego dostępu do pamięci: z jednym słowem (8-bitowy) i z wieloma słowami (16-bitowy). Tryb DMA z jednym słowem został usunięty w specyfikacji ATA-3, ponieważ jest przestarzały. Tryby DMA są czasami określane jako ATA busmaster, ponieważ korzystają z adaptera hosta obsługującego tryb busmaster. Zwykły tryb DMA korzysta ze starego kontrolera DMA znajdującego się na płycie głównej, który wykonuje operacje arbitrażu, zawłaszczenia magistrali systemowej i transmisji danych. W przypadku DMA z busmasteringiem wszystkie te operacje są realizowane przez układ o wysokiej wydajności znajdujący się w interfejsie adaptera hosta (który również znajduje się na płycie głównej).

Systemy korzystające z układów Intel PIIX (PCI IDE ISA eXcelerator) i układów mostka południowego (lub spełniających ich funkcje) posiadają funkcję busmasteringu ATA. Tryby busmaster ATA z jednym słowem i dwoma słowami wraz z osiąganymi prędkościami transmisji są zestawione w tabelach 7.7 i 7.8.

Tabela 7.7. Tryby transmisji DMA z jednym słowem i ich prędkości transmisji

8-bitowy tryb DMA |

Szerokość magistrali (bity) |

Czas cyklu (ns) |

Częstotliwość magistrali (MHz) |

Cykle na takt zegara |

Przepustowość (MB/s) |

Specyfikacja ATA |

0 |

16 |

960 |

1,04 |

1 ! 2,08 |

ATA-1* |

|

1 ! 16 |

480 |

2,08 |

1 |

4,17 |

ATA-1* |

|

2| 16 |

240 |

4,17 |

1 |

8,33 |

ATA-1* |

|

*Tryb DMA z jednym słowem (8-bitowy) został usunięty ze specyfikacji ATA-3 i późniejszych. Tabela 7.8. Tryby transmisji DMA z dwoma słowami i ich prędkości transmisji |

||||||

16-bitowy tryb DMA |

Szerokość magistrali (bity) |

Czas cyklu Częstotliwość (ns) magistrali (MHz) |

Cykle na takt zegara |

Przepustowość (MB/s) |

Specyfikacja ATA |

|

0 |

16 |

480 |

2,08 |

1 |

4,17 |

ATA-1 |

1 |

16 |

150 |

6,67 |

1 |

13,33 |

ATA-2* |

2 |

16 |

120 |

8,33 |

1 |

16.67 |

ATA-2* |

* ATA-2 jest również nazywane EIDE (Enhanced IDE) łub Fast-ATA.

Należy zwrócić uwagę, że tryby DMA z podwójnym słowem są również przez niektórych producentów nazywane trybami busmaster DMA. Niestety, nawet najszybszy tryb DMA — tryb 2 z podwójnym słowem — osiąga taką samą prędkość przesyłu, 16,67 MB/s, co PIO 4. Jednak, mimo że prędkość transferu jest taka sama jak w przypadku PIO, DMA w mniejszym stopniu obciąża procesor, dzięki czemu całkowita wydajność systemu może być większa. Pomimo to tryby DMA z wieloma słowami nie stały się zbyt popularne i zostały zastąpione nowymi trybami, Ultra-DMA, obsługiwanymi w napędach zgodnych ze specyfikacją ATA-4 do ATA-7.

W tabeli 7.9 zestawione są tryby Ultra-DMA obsługiwane w specyfikacjach ATA-4 do ATA-7. Warto zauważyć, że aby było możliwe użycie trybu Ultra-DMA, konieczne jest zainstalowanie sterowników odpowiednich dla kontrolera i posiadanej wersji systemu Windows.

Tabela 7.9. Obsługa Ultra-DMA w ATA-4 do ATA-7

16-bitowy tryb DMA |

Szerokość magistrali (bity) |

Czas cyklu (ns) |

Częstotliwość magistrali (MHz) |

Cykle na takt zegara |

Przepustowość (MB/s) |

Specyfikacja ATA |

0 |

16 |

240 |

4,17 |

2 |

16,67 |

ATA-4 |

1 |

16 |

160 |

6,25 |

2 |

25,00 |

ATA-4 |

2 |

16 |

120 |

8,33 |

2 |

33,33 |

ATA-4 |

3 |

16 |

90 |

11,11 |

2 |

44,44 |

ATA-5 |

4 |

16 |

60 |

16,67 |

2 |

66,67 |

ATA-5 |

5 |

16 |

40 |

25,00 |

2 |

100,00 |

ATA-6 |

6 |

16 |

30 |

33,00 |

2 |

133,00 |

ATA-7 |

Tryb A TA-4 UDMA 2 jest czasami nazywany Ultra-A TA/33 lub A TA-33.

Tryb ATA-5 UDMA 4 jest czasami nazywany Ultra-ATA/66 lub ATA-66.

Tryb A TA-6 UDMA 5 jest czasami nazywany Ultra-A TA/100 lub A TA-100.

Tryb ATA-7 UDMA 6 jest czasami nazywany Ultra-ATA/133 lub ATA-133.

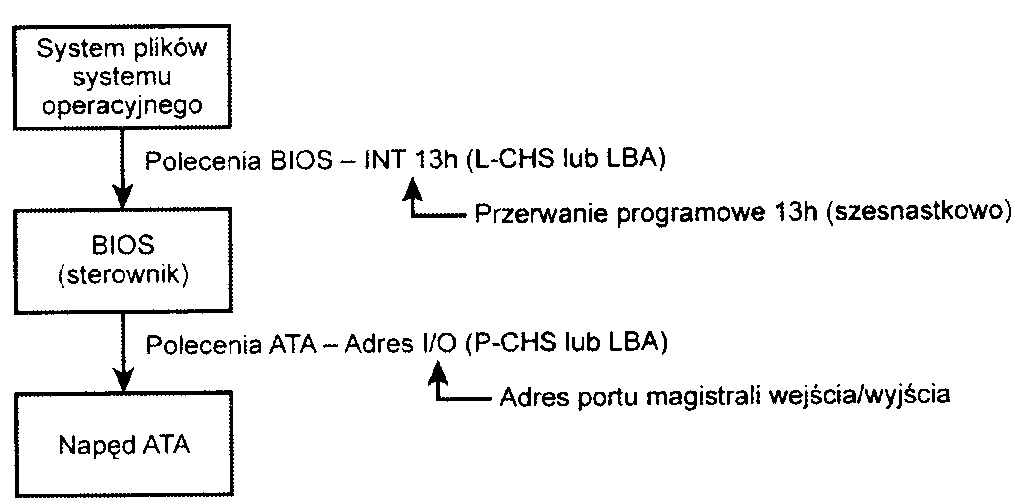

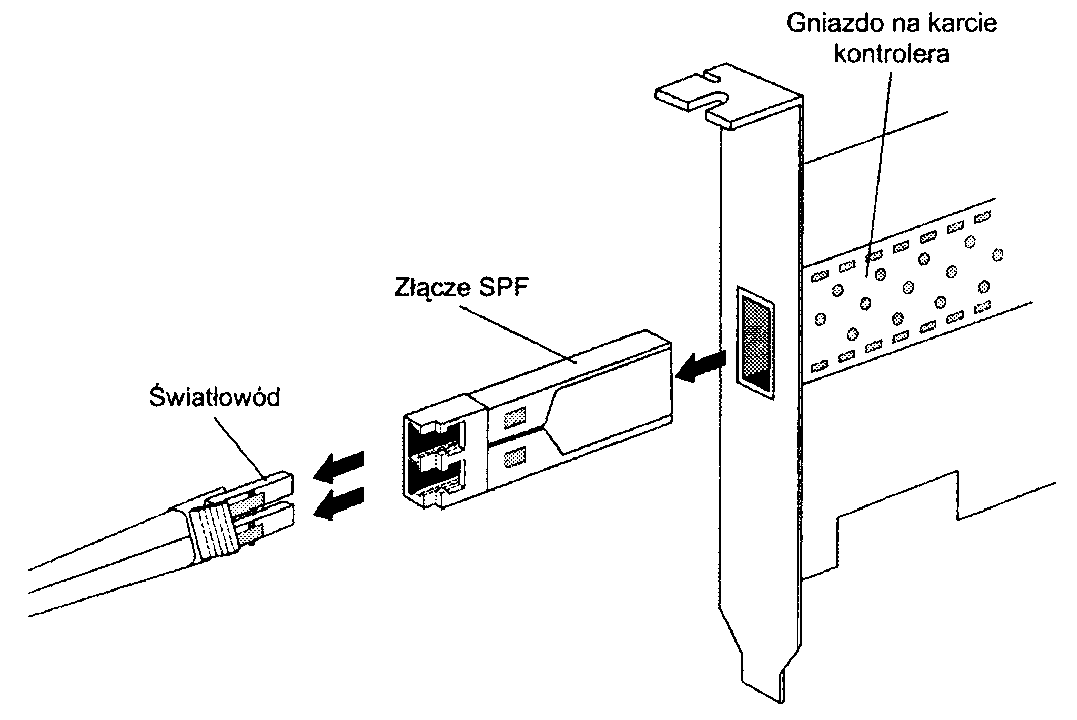

Interfejs Serial ATA

Wraz z wprowadzeniem standardu ATA-7 stało się jasne, że historia równoległego interfejsu ATA, który był wykorzystywany przez ponad 10 lat, dobiegła końca. Przesyłanie danych z prędkością większą od 133 MB/s przez równoległy kabel w formie taśmy jest narażone na różne problemy spowodowane opóźnieniami sygnału, interferencjami elektromagnetycznymi i innymi zakłóceniami integralności sygnału. Rozwiązaniem tych problemów stał się szeregowy interfejs ATA, który jest rewolucyjnym, zgodnym wstecz następcą równoległego interfejsu ATA. Standard Serial ATA jest zgodny na poziomie oprogramowania z interfejsem równoległym ATA, co oznacza, że w pełni emuluje wszystkie polecenia, rejestry i sterowanie. Dzięki temu istniejące oprogramowanie może być uruchamiane na nowym sprzęcie bez żadnych modyfikacji. Inaczej mówiąc, istniejący BIOS, system operacyjny i programy narzędziowe działające z równoległym interfejsem ATA działają również z interfejsem szeregowym.

Urządzenia te oczywiście różnią się budową — nie można podłączyć równoległego napędu ATA do szeregowego adaptera ATA i odwrotnie (jest to możliwe po zastosowaniu konwerterów sygnałów). Zmiany w warstwie fizycznej poszły w dobrym kierunku, ponieważ szeregowy interfejs ATA korzysta z cienkich siedmio-żylowych kabli, które są łatwiejsze do ułożenia wewnątrz obudowy komputera oraz są łatwiejsze do montażu dzięki nowym, przeprojektowanym złączom. Projekt układu sterującego również został zmieniony i układ ten ma teraz mniej nóżek oraz potrzebuje niższego napięcia zasilania. Ulepszenia te zostały wprowadzone w celu wyeliminowania problemów na stałe związanych z równoległym interfejsem ATA.

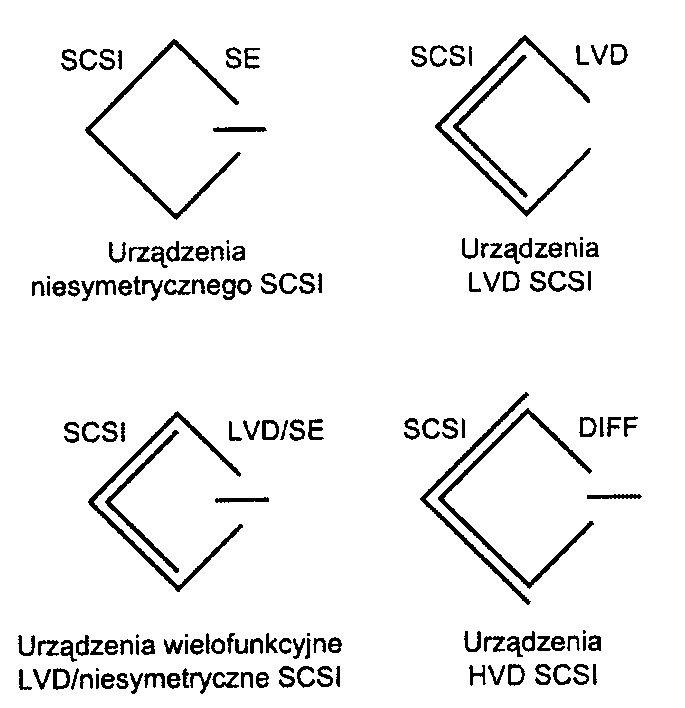

Na rysunku 7.8 pokazano oficjalne logo organizacji Serial ATA Working Group, zajmującej się standardem Serial ATA. Logo służy do identyfikacji większości urządzeń SATA.

Rysunek 7.8.

Oficjalne logo identyfikujące

Choć interfejs SATA nie zastąpi od razu równoległego interfejsu ATA, większość nowych komputerów obsługuje oba standardy. W końcu interfejs Serial ATA (SATA) zastąpi równoległy interfejs ATA jako standardowy interfejs dla urządzeń pamięci masowej w komputerach PC. Jak pokazują rozwiązania stosowane obecnie w płytach głównych, przechodzenie z ATA do SATA jest stopniowe i w czasie trwania tego procesu możliwości równoległego interfejsu ATA nadal będą dostępne. Można się spodziewać, ze w związku z ponad 10-letnią historią urządzenia ATA będą dostępne nawet wtedy, gdy w większości komputerów PC będzie stosowany tylko standard SATA.

Prace nad standardem Serial ATA rozpoczęły się od ogłoszenia na konferencji Intel Developer Forum w styczniu 2000 roku faktu powstania grupy Serial ATA Working Group. Pierwszymi członkami tej grupy były firmy APT Technologies, Dell, IBM, Intel, Maxtor, Quantum i Seagate. Pierwsza specyfikacja Serial ATA 1.0 została ukończona w listopadzie 2000 r„ a jej ostateczna wersja pojawiła się w sierpniu 2001 r. W październiku 2002 r. zaprezentowano specyfikację Serial ATA II. rozszerzającą specyfikację Serial ATA 1.0, dzięki której interfejs SATA mógt zostać użyty w przypadku sieciowych magazynów danych. Obie specyfikacje można pobrać z witryny organizacji Serial ATA Working Group, znajdującej się pod adresem http://www.serialata.org. Od czasu zawiązania grupy dołączyło do niej ponad 150 firm z różnych branż. Pierwsze komputery wykorzystujące interfejs SATA zostały udostępnione pod koniec roku 2002. Zastosowano w nich układy i karty z interfejsem PCI. W końcu w kwietniu 2003 r. interfejs SATA został zintegrowany z chipsetem płyty głównej. Nastąpiło to wraz ze wprowadzeniem układu ICH5 (I/O Controller Hub 5), wchodzącego w skład chipsetu. Od tego czasu większość nowych chipsetów płyt głównych zawiera interfejs Serial ATA.

Choć wydajność interfejsu SATA jest imponująca, dostępne obecnie dyski twarde nie są w stanie wykorzystać w pełni oferowanej przez niego przepustowości. Istnieją trzy warianty standardu korzystające z takiego samego okablowania, a różniące się jedynie szybkością transmisji. Obecnie oferowane są tylko pierwsze dwie szybkości. Większe szybkości mają być dostępne w przyszłości. W tabeli 7.10 zawarto specyfikacje obecnych i proponowanych wersji interfejsu SATA. Wersja następnej generacji o szybkości 300 MB/s nie pojawi się wcześniej niż w 2005 r. Z kolei wersja o szybkości 600 MB/s ma być dostępna w 2007 r.

Tabela 7.10. Specyfikacja standardów SATA

Typ interfejsu SATA |

Szybkość sygnalizacji (Gb/s) |

Szerokość magistrali (bity) |

Szybkość magistrali (MHz) |

Cykle danych na cykl zegara |

Przepustowość (MB/s) |

SATA-150 |

1,5 |

1 |

1500 |

1 |

150 |

SATA-300 |

3,0 |

1 |

3000 |

1 |

300 |

SATA-600 |

6,0 |

1 |

6000 |

1 |

600 |

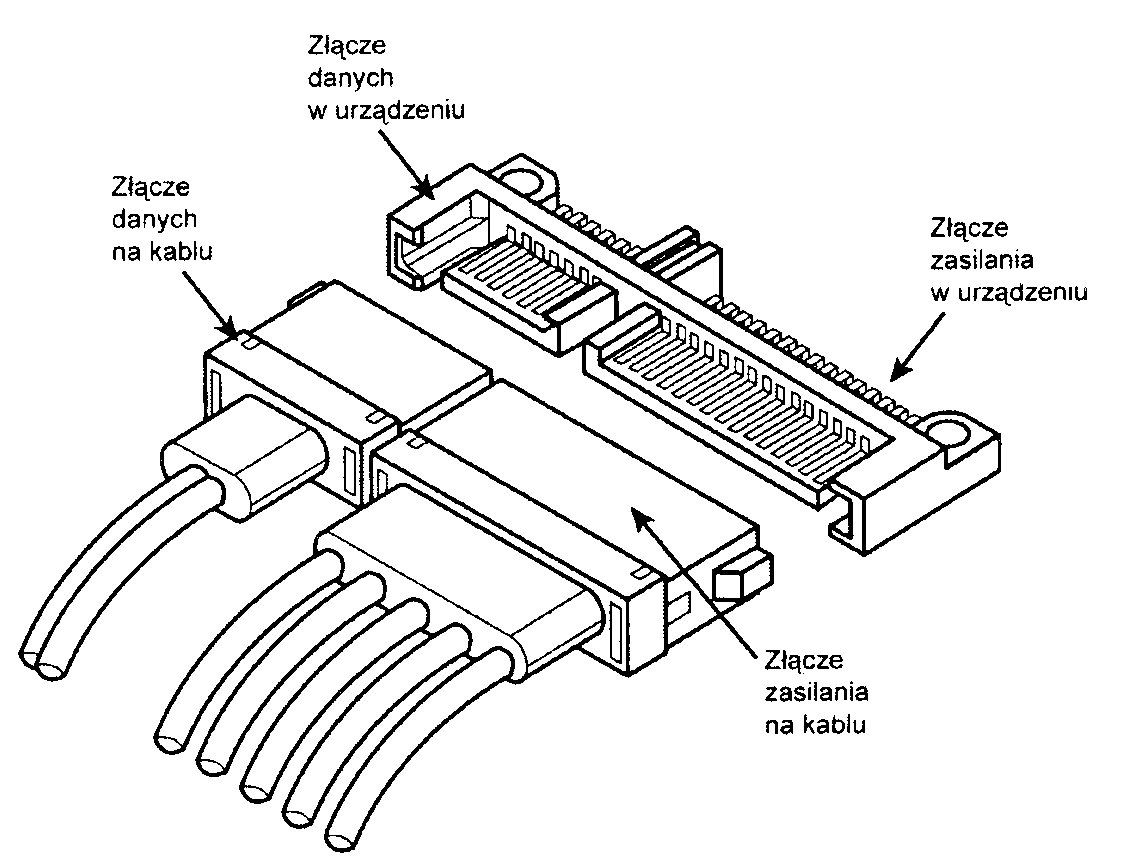

Z tabeli 7.10 wynika, że szeregowy interfejs ATA wysyła dane po jednym bicie. Wykorzystane kable mają tylko siedem przewodów (cztery sygnałowe i trzy uziemiające), są bardzo cienkie i zakończone złączami o szerokości tylko 14 mm. Eliminuje to problem obiegu powietrza wokół szerokich taśm interfejsu ATA. Każdy z kabli ma złącza na obu końcach i każdy kabel służy do bezpośredniego podłączenia urządzenia do adaptera hosta (zwykle na płycie głównej). Nie ma potrzeby ustawiania trybu master i slave, ponieważ każdy kabel służy do podłączenia tylko jednego urządzenia. Orientacja przewodów jest dowolna, wtyczka podłączana do płyty głównej jest identyczna jak wtyczka podłączana do urządzenia, więc oba końce kabla są identyczne. Maksymalna długość kabla SATA wynosi 1 metr (39,37 cali) co jest znacznie lepszym wynikiem niż 45 centymetrów (18 cali) kabla ATA. Wykorzystując te cieńsze, dłuższe i tańsze kable prędkość przesyłu danych wynosi 150 MB/s (niemal 13% więcej niż równoległy ATA/133). Interfejs Serial ATA II pozwala osiągnąć prędkość 300 MB/s, a nawet 600 MB/s.

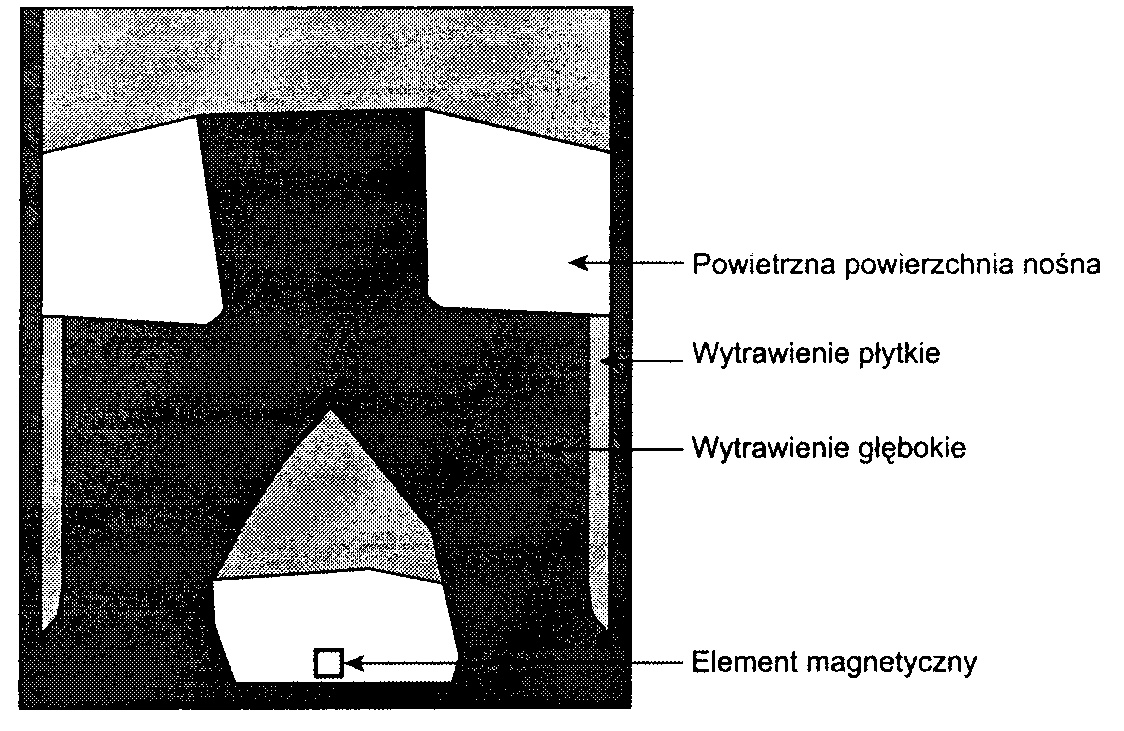

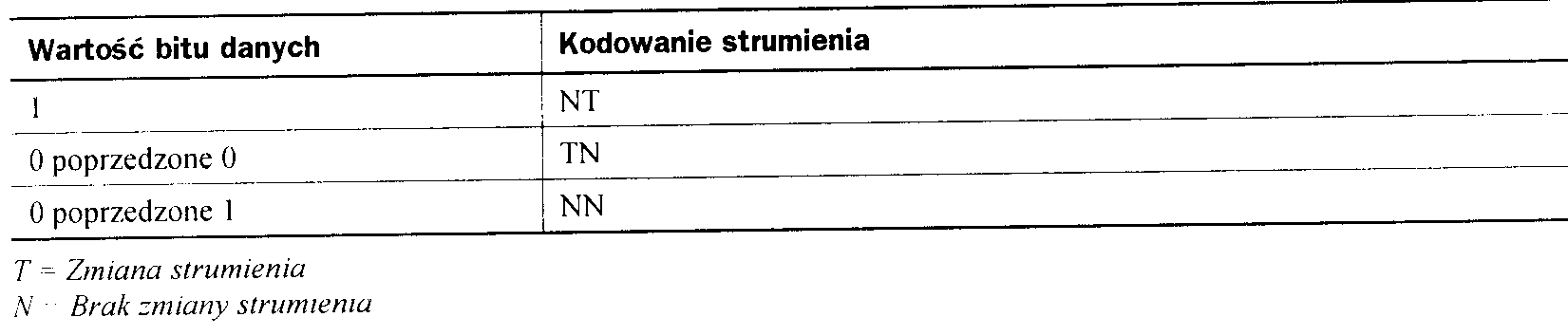

Interfejs Serial ATA wykorzystuje do kodowania przesyłanych danych specjalny schemat kodowania zwany 8B/10B. Kod transmisji 8B/10B został wymyślony (i opatentowany) w firmie IBM na początku lat 80. Ten schemat kodowania jest w chwili obecnej wykorzystywany w wielu standardach transmisji o wysokiej prędkości, w tym GigabitEthernet, Fibrę Channel, FireWire i inne. Podstawowym zadaniem kodowania 8B/10B jest zagwarantowanie, że nigdy nie zostaną wysłane kolejno więcej niż cztery zera lub cztery jedynki. Jest to odmiana kodowania Run Length Limited (RLL) o nazwie RLL 0,4, gdzie 0 oznacza minimalną, a 4 maksymalną ilość kolejnych zer w każdym zakodowanym znaku.

Kodowanie 8B/10B zapewnia również, że nigdy nie wystąpi więcej niż sześć lub mniej niż cztery zera (lub jedynki) w każdym zakodowanym 10-bitowym znaku). Ponieważ zera i jedynki są przesyłane w postaci zmian napięcia, zapewnia to, że odstępy pomiędzy tymi zmianami będą odpowiednio zbalansowane i otrzymamy regularny i ustalony strumień impulsów. Daje to w efekcie bardziej równomierne obciążenie układów, dzięki czemu zwiększa się ich niezawodność. Konwersja z danych 8-bitowych na 10-bitowe wykorzystywane w transmisji powoduje powstanie nieużywanych wzorców 10-bitowych. Wiele z tych wzorców jest wykorzystanych do kontroli przepływu, oznaczania pakietów danych, zapewniania kontroli błędów itp.

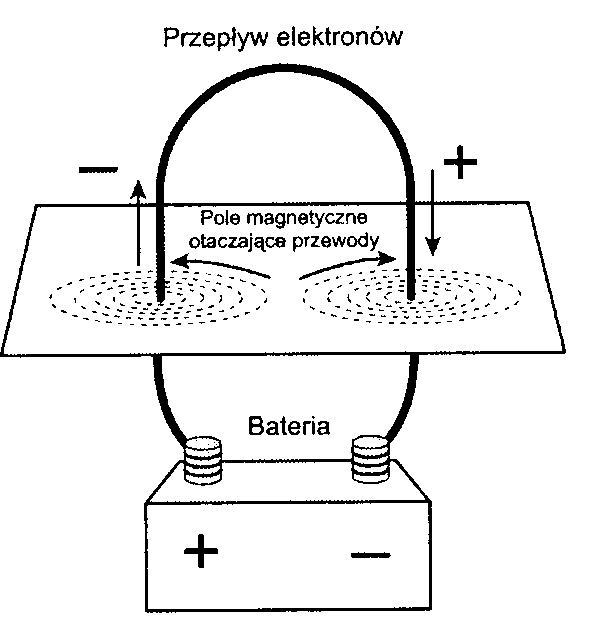

Złącza i kable Serial ATA

Fizyczny model transmisji interfejsu SATA korzysta z różnicowej metody NRZ (ang. Non-Return to Zero). Wykorzystana jest para przewodów, w których wysyłany jest sygnał plus lub minus 0,25 V. Sygnały są wysyłane w taki sposób, że jeżeli w jednym przewodzie występuje napięcie +0,25 V, to w drugim -0,25 V — różnica napięć pomiędzy tymi przewodami wynosi 0,5 V. Oznacza to, że dla podanego przebiegu napięcia, przebieg przeciwnego napięcia jest przesyłany sąsiednim przewodem. Transmisja różnicowa minimalizuje promieniowanie elektromagnetyczne i ułatwia odczytanie sygnału na przeciwnym końcu przewodu.

W interfejsie SATA występuje opcjonalny 15-żyłowy kabel zasilania doprowadzający napięcie 3,3 V, oprócz 5 V i 12 V występujących w standardowym 4-pinowym gnieździe zasilającym. Choć posiada 15 pinów, nowe złącze zasilania ma tylko 24 mm szerokości. Dla każdego z napięć, 3,3 V, 5 V i 12 V przeznaczone są trzy piny, co pozwala na przesłanie prądu o natężeniu 4,5 ampera dla każdego z napięć. Jest to wystarczająco dużo nawet dla energochłonnych urządzeń. Aby zachować zgodność z istniejącymi zasilaczami, napędy SATA posiadają standardowe 4-pinowe gniazdo zasilania, nowe 15-pinowe gniazdo lub oba. Jeżeli napęd nie posiada potrzebnego gniazda zasilania, można zastosować odpowiednie konwertery.

Na rysunku 7.9 pokazano wygląd nowych gniazd sygnałowych i zasilania.

Rysunek 7.9.

Złącza danych i zasilania interfejsu SATA (SerialATA) przeznaczone dla typowego dysku twardego SA TA

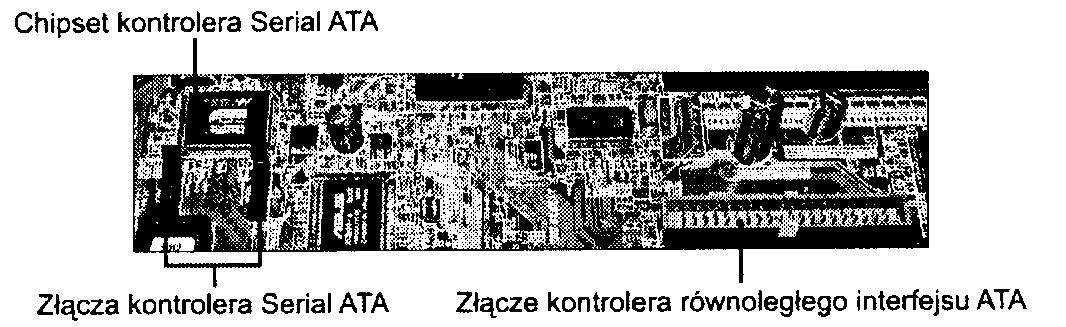

Na rysunku 7.10 przedstawiono kontrolery interfejsów SATA i równoległego ATA, umieszczone na typowej płycie głównej.

Rysunek 7.10.

Płyta główna z kontrolerami interfejsów SA TA i równoległego A TA

Funkcje pinów gniazda danych i zasilania są przedstawione w tabelach 7.11 i 7.12.

Tabela 7.11. Funkcje pinów złącza danych Serial ATA

Pin danych |

Sygnał |

Opis |

SI |

GND |

Dłuższy pin |

S2 |

A+ |

Nadawanie + |

S3 |

A- |

Nadawanie - |

S4 |

GND |

Dłuższy pin |

S5 |

B- |

Odbiór- |

S6 |

B+ |

Odbiór + |

S7 |

GND |

Dłuższy pin |

Wszystkie piny w jednym rzędzie są od siebie oddalone o 1,27 mm.

Wszystkie piny masy są dłuższe, więc wchodzą w gniazdo jako pierwsze, przed pinami sygnałowymi lub zasilania. Umożliwia to przyłączanie w czasie pracy systemu.

Konfiguracja urządzeń Serial ATA

Konfiguracja urządzeń Serial ATA jest o wiele prostsza, ponieważ w ich przypadku nie jest już wymagane określanie za pomocą zworek ustawień master/slave lub cable select, co było niezbędne przy równoległym interfejsie ATA.

Tabela 7.12. Funkcje pinów opcjonalnego gniazda zasilania interfejsu Serial ATA

Pin zasilania |

Sygnał |

Opis |

PI |

+3,3V |

Zasilanie +3,3V |

P2 |

+3,3V |

Zasilanie +3,3V |

P3 |

+3,3V |

Zasilanie +3,3V |

P4 |

GND |

Dłuższy pm |

P5 |

GND |

Dłuższy pin |

P6 |

GND |

Dłuższy pin |

P7 |

+5V |

Zasilanie +5V |

P8 |

+5V |

Zasilanie +5V |

P9 |

+5V |

Zasilanie +5V |

PIO |

GND |

Dłuższy pin |

PI 1 |

GND |

Dłuższy pin |

P12 |

GND |

Dłuższy pin |

P13 |

+ 12V |

Zasilanie +12V |

P14 |

+ 12V |

Zasilanie +12V |

P15 |

+12V |

Zasilanie +12V |

Wszystkie piny w jednym rzędzie są od siebie oddalone o 1,27 mm.

Wszystkie piny masy są dłuższe, więc wchodzą w gniazdo jako pierwsze, przed pinami sygnałowymi lub zasilania. Umożliwia to przyłączanie w czasie pracy systemu.

Aby zapewnić przesyłanie maksymalnego prądu 4,5 amperów, zastosowano po trzy piny na każde napięcie zasilające.

Dość prosta jest też konfiguracja ustawień BIOS związanych z napędami Serial ATA. Ponieważ interfejs SATA bazuje na interfejsie ATA, w komputerach wyposażonych w złącza SATA automatyczna detekcja ustawień napędów wygląda identycznie, jak w przypadku systemów ze złączami ATA. W zależności od komputera interfejsy Serial ATA mogą być aktywne domyślnie lub może być wymagane włączenie ich przy użyciu programu BIOS Setup (więcej informacji zawarto w rozdziale 5„ ..BIOS").

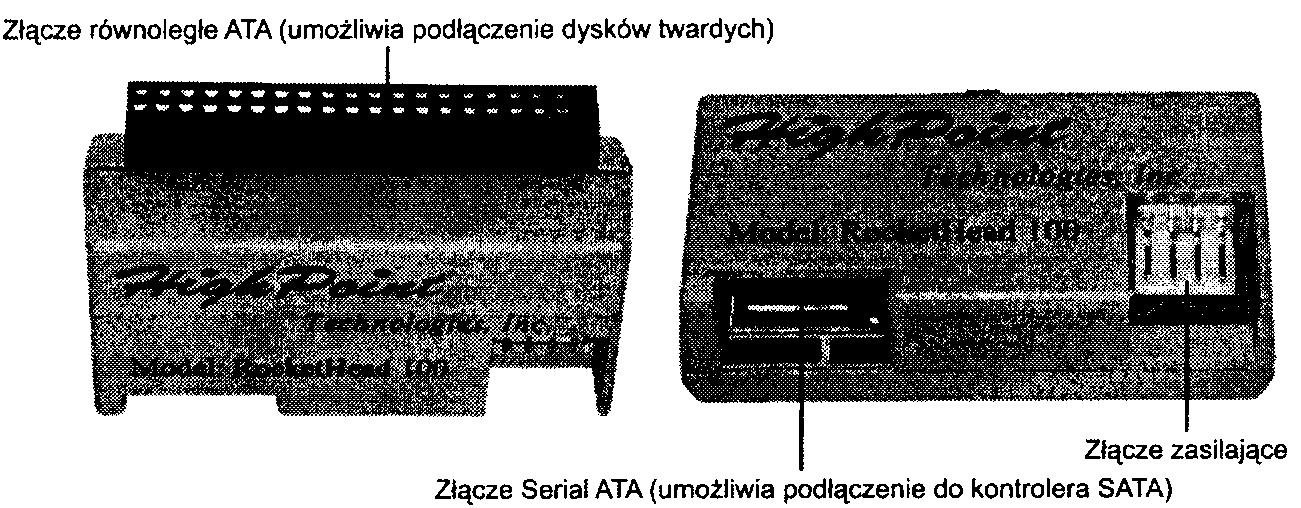

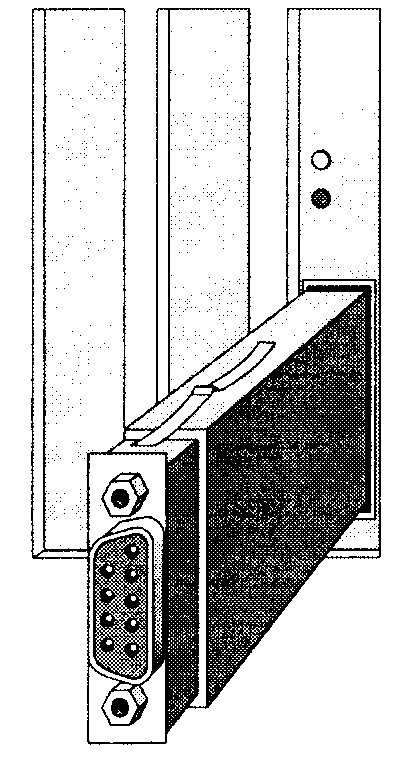

Ze względu na to, że interfejs SATA oparty jest na równoległym interfejsie ATA, można — korzystając z konwertera, takiego jak HighPoint RocketHead 100 (rysunek 7.11) — podłączyć do kontrolera Serial ATA dyski twarde ATA-100 i ATA-133. Konwerter jest dołączany do kontrolerów HighPoint Serial ATA RAID i podobnych urządzeń, które można nabyć od mniejszych producentów.

Rysunek 7.11.

Konwerter HighPoint RocketHead 100 przedstawiony w dwóch widokach

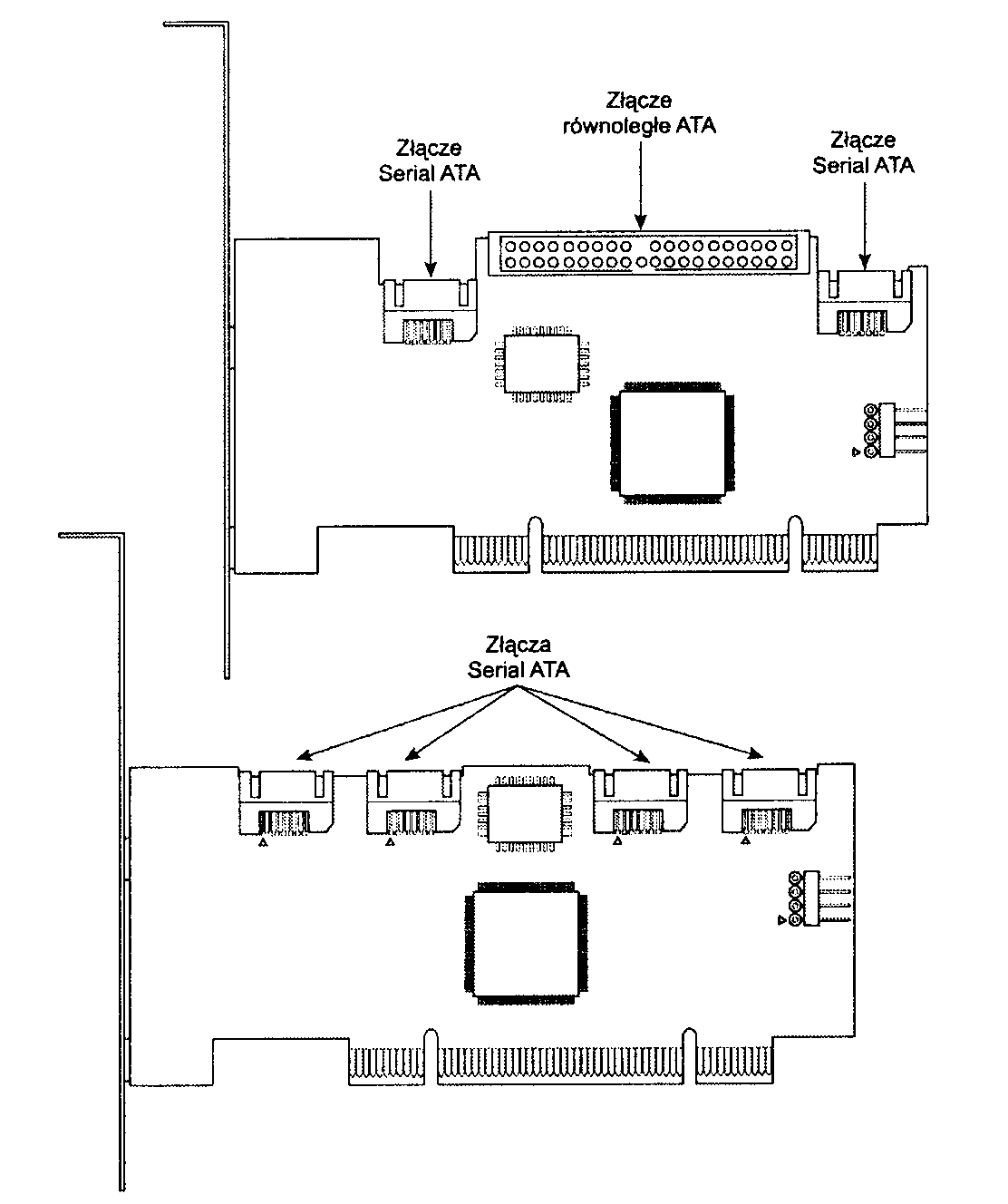

Jeśli zależy Ci na zastosowaniu napędów Serial ATA, ale bez konieczności zakupu nowej płyty głównej wyposażonej w kontroler SATA, można go w postaci oddzielnej karty umieścić w gnieździe PCI (rysunek 7.12). Większość tego typu kontrolerów oferuje funkcje ATA RAID.

Rysunek 7.12.

Typowe 2- (u góry) i 4-kanalowe (na dole) kontrolery Serial ATA RAID. Kontroler 2-kanalowy jest też wyposażony w funkcje kontrolera równoległego interfejsu A TA

Niektóre z pierwszych modeli kontrolerów Serial ATA wyprodukowane przez takie firmy, jak HighPoint i 3Ware, korzystają z mostka ATA-Serial ATA, który zużywa aż połowę dostępnej przepustowości. W kontrolerach innych firm, takich jak Promise Technology, używane są osobne układy kontrolera SATA, co teoretycznie jest lepszym rozwiązaniem, ponieważ pozwala przeznaczyć całą przepustowość na potrzeby dysków. Jednak obecnie dostępne napędy Serial ATA — podobnie do swoich „rówieśników" z równoległym interfejsem ATA — nie są w stanie przesyłać danych z oferowaną przez kontroler szybkością zbliżoną do 150 MB/s. Średni transfer danych napędów Serial ATA o prędkości obrotowej 7200 obr./min zawiera się zwykle w przedziale od 40 do 50 MB/s.

Serial ATA II

Podobnie jak równoległy interfejs ATA, interfejs Serial ATA miał z założenia odgrywać rolę podstawowego interfejsu urządzeń pamięci masowej stosowanych w komputerach PC. Początkowo nie planowano stosowania go jako interfejsu zewnętrznego. Jednak wraz z pojawieniem się interfejsu Serial ATA II (SATA-8; obecnie trwają prace projektowe nad nim) Serial ATA swoim zakresem obejmie zewnętrzne połączenia, magazyny danych zawierające wiele dysków i rozgałęźniki portów umożliwiające podłączenie do jednego portu SATA maksymalnie 15 napędów tego rodzaju. Zewnętrzne połączenie obsługuje cztery tory. Na każdy z nich przypada przepustowość 300 MB/s, co w sumie daje 1200 MB/s. Stanowi to konkurencję dla zewnętrznych połączeń SCSI przeznaczonych dla macierzy RAID, ale najprawdopodobniej nie dla bardzo szybkich interfejsów ogólnego zastosowania obsługujących zewnętrzne urządzenia, takich jak USB 2.0 i IEEE 1394 (i.Link/FireWire). Ze względu na niższy koszt i zajmujące mniej miejsca wewnętrzne kable bardzo prawdopodobne jest, że w ciągu kilku kolejnych lat interfejs Serial ATA zastąpi równoległy interfejs ATA zarówno w komputerach stacjonarnych, jak i przenośnych.

Advanced Host Controller Interface

Interfejs Serial ATA został stworzony nie tylko z zamiarem zastąpienia równoległego interfejsu ATA, ale też w celu udostępnienia rozwiązania oferującego w porównaniu ze swoim poprzednikiem znacznie więcej możliwości i funkcji. Początkowo zgodność z interfejsem ATA była jedną z najważniejszych funkcji interfejsu SATA, ponieważ dzięki temu możliwe było łagodne i proste przejście z jednej technologii do drugiej. Zakres zgodności został rozszerzony do poziomu sterowników, w wyniku czego napędy Serial ATA korzystają z takich samych sterowników BIOS i oprogramowania, co starsze napędy ATA.

Choć zamierzeniem twórców interfejsu Serial ATA było umożliwienie łatwego przejścia z technologii równoległego interfejsu ATA, został on też zaprojektowany tak, aby możliwy był dalszy jego rozwój i zwiększanie możliwości. W tym celu opracowano najpierw rozszerzony interfejs programowy AHCI {Advanced Host Controller Interface). Interfejs stworzyła organizacja AHCI Contributor Group, kierowana przez firmę Intel i początkowo złożona z takich korporacji, jak AMD. Dell, Marvell, Maxtor. Microsoft. Red Hat. Seagate i StorageGear. W maju 2003 r. organizacja zaprezentowała wstępną wersję 0.95 specyfikacji AHCI. natomiast w 2004 r. udostępniła jej ostateczną postać.

Specyfikacja AHCI definiuje standard interfejsu o dużej wydajności, komunikującego się ze sterownikami i aplikacjami systemu operacyjnego w celu identyfikacji i zastosowania zaawansowanych funkcji SATA, takich jak kolejkowanie poleceń, podłączanie urządzeń w trakcie pracy systemu i zarządzanie energią. Interfejs AHCI został zintegrowany z chipsetami obsługującymi interfejs Serial ATA, które pojawiły się na rynku w 2004 r. Dodatkowo interfejs AHCI obsługiwany jest przez odpowiednie sterowniki systemu Windows.

Transfery danych interfejsu Serial ATA

W porównaniu z równoległym interfejsem ATA interfejs Serial ATA przesyła dane w całkiem inny sposób. Jak już wcześniej wspomniano, oferowane szybkości przesyłania danych to 150, 300 i 600 MB/s. Większość dostępnych obecnie napędów obsługuje szybkość 150 MB/s. Ze względu na zgodność wstecz interfejsu SATA z interfejsem ATA mogą pojawić się niejasności, ponieważ napędy SATA potrafią emulować tryby ATA. Oznacza to, że w celu zachowania zgodności wstecz z istniejącym oprogramowaniem napęd zwyczajnie „oszukuje".

Przykładowo wiele płyt głównych wykrywa napęd Serial ATA i informuje, że jest on zgodny z trybem Ultra DMA Mode 5 (ATA/100), będącym trybem równoległego interfejsu ATA o szybkości 100 MB/s. Oczywiście nie jest to prawdą, ponieważ nawet najwolniejszy tryb interfejsu Serial ATA (SATA-150) oferuje szybkość 150 MB/s, a tryby Ultra DMA po prostu nie dotyczą napędów SATA.

Choć interfejsy równoległy ATA i Serial ATA zupełnie różnią się pod względem specyfikacji elektrycznej i fizycznej, drugi z nich emuluje pierwszy w sposób całkowicie „przezroczysty" dla oprogramowania. Tak naprawdę emulacja równoległego interfejsu ATA wykonywana przez interfejs Serial ATA jest zgodna ze specy-fikacjąATA-5.

Jest to szczególnie widoczne w przypadku polecenia IDENTIFY DEVICE, używanego przy wczytywaniu parametrów napędu przez funkcje BIOS odpowiedzialne za automatyczną detekcję. W specyfikacji Serial ATA zaznaczono, że wiele pozycji (uwzględniających tryby i ustawienia Ultra DMA) zwróconych przez to polecenie ma być ustawionych tak, jak w przypadku specyfikacji ATA/ATAPI-5.

W specyfikacji SATA 1 stwierdzono też, że emulacja zachowania urządzenia równoległego interfejsu ATA z perspektywy BIOS lub sterownika jest realizowana wspólnie przez urządzenia i kontroler Serial ATA. Emulowane jest zachowanie rejestrów Command and Control Błock, a także operacje przesyłania danych w trybach PIO i DMA, resetowanie i przerwania. Kontroler zawiera zestaw rejestrów Shadow Register Błock. powielających zawartość tradycyjnych rejestrów urządzeń. Wszystkie urządzenia SATA zachowują się jak urządzenia Device 0. Urządzenia powinny ignorować bit DEV pola Device/Head otrzymanych poleceń Register FIS. Korzystający z wartości bitu DEV kontroler odpowiedzialny jest za obsługę transmisji poleceń Register FIS do urządzeń.

Oznacza to, że rejestry Shadow Register Błock są „fałszywymi" rejestrami równoległego interfejsu ATA, umożliwiającymi emulowanie wszystkich poleceń i trybów ATA, Interfejs Serial ATA został zaprojektowany tak, aby na poziomie oprogramowania był w pełni zgodny ze specyfikacją ATA/ATAPI-5. Właśnie z tego powodu napęd SATA w pewien sposób może przekazywać informacje, tak jakby był zgodny z interfejsem ATA lub korzystał z jednego z jego trybów, nawet jeśli tak faktycznie nie jest.

Funkcje interfejsu ATA

Wersje standardu ATA pokonały długą drogę, zanim wyeliminowano niezgodności i problemy ze współpracą napędów IDE z magistralami PCI i ISA komputerów. Specyfikacje ATA definiują sygnały 40-pinowego złącza, funkcje tych sygnałów i ich taktowanie, parametry kabli itp. W tym podrozdziale omówiono niektóre elementy i funkcje zdefiniowane w specyfikacjach interfejsu ATA.

Polecenia ATA

Jedną z największych zalet interfejsu ATA jest szeroki zakres dostępnych poleceń. Interfejs ATA powstał na bazie kontrolera WD 1003 zastosowanego w oryginalnym systemie IBM AT. Wszystkie dyski ATA muszą bez żadnych wyjątków obsługiwać wszystkie polecenia kontrolera WD (osiem poleceń), dzięki czemu bardzo łatwo można je instalować we współczesnych systemach. Wszystkie systemy zgodne z komputerami IBM PC posiadają wbudowaną w ROM BIOS obsługę WD1003. a więc i obsługę ATA.