1. Logika rozmyta

Podaj przykładowe funkcję przynależności - trójkątna

Podaj przykładowe t - normy

podaj przykładowe s - normy

schemat ogólny systemu wnioskowania rozmytego

2. Sieci neuronowe

Reguła delta

siec z propagacja wsteczną

sieci hopfielda

sieci kohonena

sieci nadzorowane i nienadzorowane

Co to jest perceptron

schemat sieci adaline

zastosowanie sieci neuronowych - SSN

Budowa modelu neuronu

przejścia w neuronie

3. Genetyczne

Krzyżowanie rodzaje krzyżowań

Wpływ mutacji na zachowanie algorytmu,

schemat ogólny alg genetycznego

zastosowanie w minimalizacji funkcji dowolnej

4. Podstawowe

omówic pojecie reguły i wniosku i faktu

podstawowe mechanizmy wnioskowania

omówić mech wnioskowania wprzód

omówić mech wnioskowania wstecz

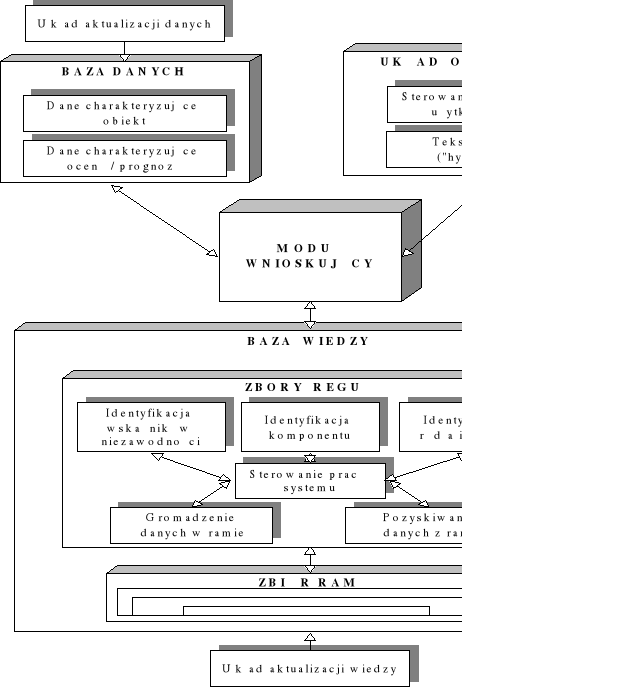

schemat ogólny systemu ekspertowego

system decyzyjny / baza wiedzy

5. Dodatkowe

1. Sieć jednokierunkowa i ze sprzężeniem zwrotnym

2. Sieć kategoryczna i ilościowa

3. Metody redukcji

4. Metody optymalizacji dyskretnej

5. Schemat działania neuronu:

6. podaj przynajmniej 4 systemy ekspertowe i dziedziny w jakich znalazły zastosowanie

1.1 trójkątna funkcja przynależności

Rys. 4.1 Trójkątna funkcja przynależności z podziałem na α-przekroje

Trójkątną symetryczną funkcję przynależności μ(x) obliczaną według

wzoru:

a - współrzędne wierzchołków podstawy trójkąta,

e - współrzędna środka podstawy trójkąta,

x - zmienna,

w - wartość logiczna.

1.2. Podaj przykładowe t - normy

1.3. podaj przykładowe s - normy

1. 4. schemat ogólny systemu wnioskowania rozmytego

2. 1. Reguła delta

Reguła Delta jest najpopularniejszą i najczęściej stosowaną metodą uczenia z nauczycielem.

Reguła ta polega na tym, że każdy neuron po otrzymaniu na swoich wejściach określonych sygnałów (z wejść sieci albo od innych neuronów, stanowiących wcześniejsze warstwy sieci) wyznacza swój sygnał wyjściowy wykorzystując posiadaną wiedzę w postaci wcześniej ustalonych wartości wag, wartości wejść oraz (ewentualnie) progu. Wartość sygnału wyjściowego, wyznaczonego przez neuron w danym kroku procesu uczenia porównywana jest z odpowiedzią wzorcową podaną przez nauczyciela w ciągu uczącym. Jeśli występuje rozbieżność - neuron wyznacza różnicę pomiędzy swoim sygnałem wyjściowym a tą wartością sygnału, która była by - według nauczyciela prawidłowa. Ta różnica oznaczana jest zwykle symbolem greckiej litery δ (delta) i stąd nazwa opisywanej metody. Reguła Delta przeznaczona jest dla neuronów z ciągłymi funkcjami aktywacji i stanowi odpowiednik reguły perceptronowej.

2. 2. Sieć backpropagation (z wsteczną propagacją błędów)

Podstawą większości bieżących prac na temat uczenia sieci neuronowych jest algorytm propagacji wstecznej. Był on odkryty niezależnie, kilka razy przez Bronsona i Ho (1969), Werbosa (1974), Parkera (1985) i Rumelharta, Hintona i Williamsa (1986).

Algorytm polega na zmianie wag W w dowolnej sieci jednokierunkowej, mającej się nauczyć zbioru treningowego par wejścia - wyjścia . Podstawą działania tej sieci jest spadek gradientu. Teraz należy rozpatrzyć sieć dwuwymiarową.

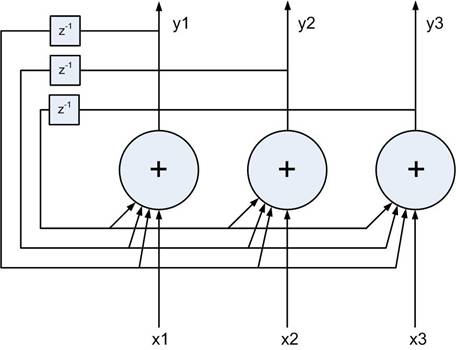

Rys.17. Dwuwymiarowa sieć jednokierunkowa.

gdzie

Yk - jednostki wyjściowe,

Vj - jednostki ukryte,

Xn - jednostki wejściowe,

wjn - połączenie od wejść do jednostek ukrytych,

Wkj - połączenie od jednostek ukrytych do wyjściowych.

Indeksy: n, k, j dotyczą odpowiednio jednostek wejściowych, ukrytych oraz wyjściowych.

Różne wzorce oznaczone indeksem q, a więc wejście n - te jest równe , gdy jest prezentowany q - ty wzorzec. Dla danego q - tego wzorca j - ta jednostka ukryta otrzymuje sygnał pobudzenia sieciowego,

i wytwarza sygnał wyjściowy

Jednostka wyjściowa i - ta otrzymuje zatem sygnał

i ostatecznie wytwarza wyjściowy

Zwykła miara błędu, czyli funkcja kosztu ma postać:

gdzie

- zadana wartość wyjściowa.

2. 3. Sieć Hopfielda

jest przykładem sieci ze sprzężeniem zwrotnym (tzw. sieć rekurencyjna), gdzie wyjścia poszczególnych neuronów są podawane z odpowiednimi wagami na wejścia każdego z neuronów. Oczywiście do każdego neuronu podpięte jest wejście, którym doprowadzana jest odpowiednia składowa wektora testowego.

W przypadku, gdy sieć pracuje jako pamięć autoasocjacyjna (nasz przykład) wagi połączenia wyjścia neuronu z własnym wejściem są zerowane. Wymagane jest także, aby macierz wag W była symetryczna.

2. 4. Sieć Kohonena

Pochodząca jeszcze od Arystotelesa, a rozwinięta później przez Locke'a koncepcja "tabula rasa", czyli umysłu rodzącego się jako niezapisana karta, zapełniana w trakcie zdobywania doświadczeń, może być zrealizowana przez sieci samoorganizujące. Ważną rolę odgrywają wśród nich sieci działające na zasadzie współzawodnictwa między neuronami. Taki model uczenia został zaproponowany po raz pierwszy przez Kohonena w roku 1981. Celem tych sieci jest grupowanie bądź klasyfikowanie danych wejściowych. Podobne sygnały wejściowe powinny być klasyfikowane jako należące do tej samej kategorii; kategorie te natomiast wyznaczane są przez samą sieć na podstawie korelacji danych wejściowych.

Samoorganizująca sieć Kohonena znalazła liczne praktyczne zastosowania, wynikające z jej zdolności do kompresji danych - duże grupy danych wejściowych tworzących klaster reprezentowane są przez jeden wektor wag neuronu zwycięzcy. Typowymi przykładami zastosowania sieci Kohonena są kompresja obrazów, wykrywanie uszkodzeń oraz przetwarzanie mowy.

System, który miałby realizować funkcjonowanie sieci samoorganizującej powinien składać się z kilku podstawowych elementów. Pierwszym z nich jest macierz neuronów pobudzanych przez sygnały wejściowe. Sygnały te powinny opisywać pewne charakterystyczne cechy zjawisk zachodzących w otoczeniu, tak, aby na ich podstawie sieć była w stanie je pogrupować. Informacja o zdarzeniach jest przekładana na bodźce pobudzające neurony. Zbiór sygnałów przekazywanych do każdego neuronu nie musi być identyczny, nawet ich ilość może być różna. Muszą one jednak spełniać pewien warunek, a mianowicie jednoznacznie określać dane zdarzenia.

Kolejną częścią składową sieci jest mechanizm, który dla każdego neuronu określa stopień podobieństwa jego wag do danego sygnału wejściowego oraz wyznacza jednostkę z największym dopasowaniem - zwycięzcę. Obliczenia zaczynamy dla wag równych małym liczbom losowym, przy czym ważne jest, aby nie zachodziła żadna symetria. W trakcie uczenia wagi te są modyfikowane w taki sposób, aby najlepiej odzwierciedlać wewnętrzną strukturę danych wejściowych. Istnieje jednak niebezpieczeństwo, że zwiążą się one z pewnymi wartościami zanim jeszcze grupy zostaną prawidłowo rozpoznane i wtedy trzeba ponawiać uczenie z innymi wagami.

Wreszcie konieczne do przeprowadzenia samoorganizacji jest, aby sieć była wyposażona w zdolność do adaptacji wartości wag neuronu zwycięzcy i jego sąsiadów w zależności od siły, z jaką odpowiedział on na dane wejście. Topologię sieci można w łatwy sposób określić poprzez zdefiniowanie sąsiadów dla każdego neuronu. Załóżmy, że jednostkę, której odpowiedź na dane pobudzenie jest maksymalna, będziemy nazywali "obrazem" tego pobudzenia. Wtedy możemy przyjąć, że sieć jest uporządkowana, jeśli topologiczne relacje między sygnałami wejściowymi i ich obrazami są takie same.

2. 5. sieci nadzorowane i nienadzorowane

Istnieją dwa najczęściej stosowane algorytmy nauczania sztucznych sieci neuronowych:

- nadzorowane nauczanie, właściwy rezultat jest znany (prawidłowe dane wyjściowe) i podany sieci, która zmieniając poszczególne wagi połączeń stara się otrzymać wynik jak najbardziej podobny do podanego. Po treningu sieć poddawana jest testom, podczas których sieć nie zna prawidłowych rozwiązań a podane przez nią rozwiązanie jest porównywane z prawidłowym.

- nienadzorowane nauczanie, podczas treningu sieci nie jest podawane prawidłowe rozwiązanie. Nienadzorowana sieć neuronowa najczęściej stosuje różne metody kompresji danych, jak wymiarowa redukcja. Różnice pomiędzy nadzorowanym i nienadzorowanym nauczaniem nie są często jasne. Uczenie nadzorowane posiada dwie podkategorie: auto-związek i hetero-związek. W auto-związku wartości wyjściowe są takie same jak wejściowe. W heter-związku są one odmienne. Wiele metod nienadzorowanego nauczania jest równoważna z auto-związkowymi metodami nadzorowanymi.

2. 6. Perceptron - sieć neuronowa najprostszego typu. Pojęcie to stosowane jest zamiennie do określenia sieci składającej się z:

pojedynczego neuronu McCullocha-Pittsa

pewnej liczby neuronów wejściowych, których wyjścia połączone są z wejściami pewnej liczby neuronów wyjściowych; mimo iż ten typ perceptronów bywa nazywany perceptronem dwuwarstwowym, zwykle określa się go mianem perceptronu jednowarstwowego, ponieważ właściwą warstwą dokonującą sumowania i obliczania wyjścia według wartości funkcji aktywacji jest tylko warstwa druga

wielu warstw neuronów, gdzie wyjścia poprzedniej warstwy łączą się z wejściami kolejnej; są to tak zwane perceptrony wielowarstwowe.

Działanie perceptronu polega na klasyfikowaniu danych pojawiających się na wejściu i ustawianiu stosownie do tego wartości wyjścia. Przed używaniem perceptron należy wytrenować podając mu przykładowe dane na wejście i modyfikując w odpowiedni sposób wagi wejść i połączeń między warstwami neuronów, tak aby wartość na wyjściu przybierała pożądane wartości.

Perceptrony mogą klasyfikować dane na zbiory, które są liniowo separowalne. Własność ta uniemożliwia na przykład wytrenowanie złożonego z jednego neuronu perceptronu, który wykonywałby logiczną operację XOR na wartościach wejść.

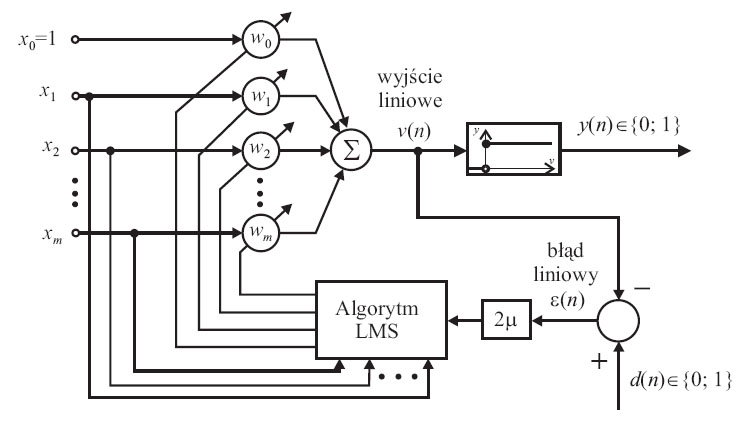

2. 7. Sieć adaline:

2. 8. zastosowanie sieci neuronowych - SSN

Współcześnie nie ma wątpliwości, że sztuczne sieci neuronowe nie stanowią dobrego modelu mózgu, choć różne ich postaci wykazują cechy charakterystyczne dla biologicznych układów neuronowych: zdolność do uogólniania wiedzy, uaktualniania kosztem wcześniej poznanych wzorców, dawanie mylnych odpowiedzi po przepełnieniu. Mimo uproszczonej budowy, sztuczne sieci neuronowe stosuje się czasem do modelowania schorzeń mózgu.

Sztuczne sieci neuronowe znajdują zastosowanie w rozpoznawaniu i klasyfikacji wzorców (przydzielaniu wzorcom kategorii), predykcji szeregów czasowych, analizie danych statystycznych, odszumianiu i kompresji obrazu i dźwięku oraz w zagadnieniach sterowania i automatyzacji.

Magazyn BYTE wymienia między innymi następujące zastosowania tych sieci:

diagnostyka układów elektronicznych

badania psychiatryczne

prognozy giełdowe

prognozowanie sprzedaży

poszukiwania ropy naftowej

interpretacja badań biologicznych

prognozy cen

analiza badań medycznych

planowanie remontów maszyn

planowanie postępów w nauce

analiza problemów produkcyjnych

optymalizacja działalności handlowej

analiza spektralna

optymalizacja utylizacji odpadów

dobór surowców

selekcja celów śledztwa w kryminalistyce

dobór pracowników

sterowanie procesów przemysłowych.

Najpopularniejsze obecnie zastosowanie sieci neuronowych:

w programach do rozpoznawania pisma (OCR)

na lotniskach do sprawdzania, czy prześwietlony bagaż zawiera niebezpieczne ładunki

do syntezy mowy

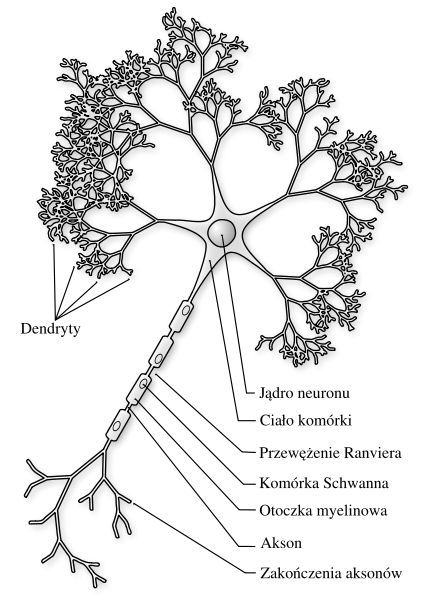

2. 9. Budowa modelu neuronu

2. 10. Przejścia w neuronach

Neuron o jednym wejściu aktywnym pokazano na rys.2. Wartość wejścia skalarnego p jest mnożona przez skalarną wagę w i wysyłana do sumatora. Dodatkowe wejście o wartości wagi ustalonej na 1 służy do wprowadzenia stałego przesunięcia o wartość b zwaną bias. Wyjście z sumatora n, często określane jako sygnał wejściowy do sieci net input , jest przetwarzane przez funkcję przejścia f . W wyniku przetworzenia przez funkcje przejścia otrzymamy skalarną wartość wyjściową a. Odnosząc się do opisanego wyżej modelu biologicznego trzeba stwierdzić, że wagi w stanowią odpowiednik większej lub mniejszej energii określonej synapsy. Komórka nerwowa jest reprezentowana przez sumator i funkcję przejścia a wyjście z neuronu a jest odpowiednikiem sygnału niesionego przez akson.

Rys. 2. Model sztucznego neuronu

Wartość wyjścia a zależy od postaci funkcji f. Postać ta jest dobierana przez konstruktora sieci. Wartości wag w są określane w procesie uczenia sieci zgodnie z założonym algorytmem uczenia.

Funkcja przejścia może być funkcją liniową lub nieliniową. Szczegółowo funkcja ta jest dobierana w zależności od charakteru problemu jaki ma rozwiązywać projektowana sieć.

Jedną z takich funkcji, szczególnie przydatnych, gdy rozwiązywany problem ma charakter dwustanowy jest pokazana na rys.3. funkcja skokowa ograniczająca wartość wyjścia do dwu wartości 0 i 1.

Rys. 3. Funkcja przejścia w postaci funkcji skokowej ograniczającej wartości wyjścia do 0 lub 1.

3. 1. Krzyżowanie, rodzaje krzyżowań

Krzyżowanie - kojarzenie zwierząt gospodarskich genetycznie odmiennych, różnych ras, odmian lub linii. Ponadto termin ten odnosi się również do kojarzenie osobników odmiennych gatunków.

Rodzaje krzyżowań:

krzyżowanie twórcze - ma na celu wytworzenie nowej rasy. U bydła trwa 30-40 lat.

krzyżowanie uszlachetniające - ma na celu poprawienie genotypu rasy, poprzez krzyżowanie rasy szlachetnej z rasą miejscową.

krzyżowanie wypierające - polega na zastąpieniu genów danej rasy genami innej o pożądanych cechach i uzyskanie mieszańców aż do prawie całkowitej zmiany genotypu rasy rodzimej w rasę wypierającą. Takie krzyżowanie jest prowadzone, aby wprowadzić nową rasę zachowując jednocześnie zdolności adaptacyjne rasy rodzimej i zmienić produkcyjność mniejszym kosztem i przy mniejszych nakładach pracy, niż w przypadku zakupu stada czystej rasy i jej przystosowywania do nowych warunków przez kilka pokoleń.

krzyżowanie przemienne - prowadzenie w celu uzyskania heterozji, krzyżowanie 2 ras szlachetnych.

krzyżowanie towarowe - prowadzone w celu uzyskanie heterozji mieszańców pod względem cech użytkowych.

krzyżowanie międzygatunkowe - dwóch pokrewnych gatunków.

3. 2. Mutacje

Mutacja wprowadza do genotypu losowe zmiany. Jej zadaniem jest wprowadzanie różnorodności w populacji, czyli zapobieganie (przynajmniej częściowe) przedwczesnej zbieżności algorytmu. Mutacja zachodzi z pewnym przyjętym prawdopodobieństwem - zazwyczaj rzędu 1%. Jest ono niskie, ponieważ zbyt silna mutacja przynosi efekt odwrotny do zamierzonego: zamiast subtelnie różnicować dobre rozwiązania - niszczy je. Stąd w procesie ewolucji mutacja ma znaczenie drugorzędne, szczególnie w przypadku długich chromosomów.

W przypadku chromosomów kodowanych binarnie losuje się zazwyczaj dwa geny i zamienia się je miejscami bądź np. neguje pewien wylosowany gen.

W przypadku genotypów zakodowanych liczbami całkowitymi stosuje się permutacje.

W przypadku genotypów zakodowanych liczbami rzeczywistymi wprowadza się do przypadkowych genów losowe zmiany o danym rozkładzie - najczęściej normalnym.

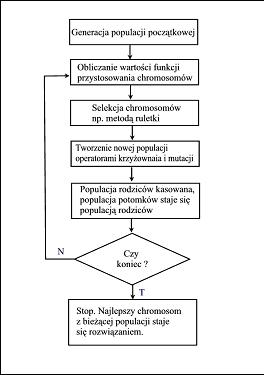

3. 3. schemat ogólny alg genetycznego

Algorytmy genetyczne są szczególnie interesującą formą rozwiązywania problemów optymalizacyjnych. Podobnie jak sieci neuronowe, metodyka ta powstała na podstawie obserwacji procesów zachodzących w świecie organizmów żywych.

Implementacje algorytmów genetycznych pozwoliły stwierdzić, że jest to metoda skuteczna i łatwa do zastosowania w wielu problemach optymalizacji. Podobnie jak sieć neuronowa, algorytm genetyczny nie wymaga od użytkownika znajomości szczegółów procesu optymalizacji danego zadania. Wymagane jest jedynie określenie pewnej funkcji, zwanej funkcją przystosowania, której wartość będzie maksymalizowana w kolejnych przebiegach algorytmu.

Zasada działania klasycznego algorytmu genetycznego

Algorytm genetyczny operuje na chromosomach. Rolę tę pełni wektor o stałej długości, najczęściej składający się z wartości binarnych. Każdy z bitów wektora pełni rolę genu. Zbiór chromosomów o określonej liczności tworzy populację. Algorytm genetyczny potrzebuje zdefiniowania następujących operacji:

- generacji populacji początkowej,

- określenia jakości poszczególnych osobników,

- reprodukcji,

- mutacji,

- krzyżowania.

Schemat algorytmu genetycznego przedstawiono na rys:

Schemat klasycznego algorytmu genetycznego.

3. 4. zastosowanie w minimalizacji funkcji dowolnej

Algorytmy genetyczne mają zastosowanie w minimalizacji funkcji dowolnych. Do ich dziedziny należeć mogą tzw problemy NP, których sposób rozwiązania nie mieści się w czasie wielomianowym natomiast sprawdzenie skuteczności rozwiązania określa się wielomianem. (?) Przykład - problem komiwojażera.

Algorytm genetyczny umożliwia znalezienie takiego rozwiązania.

funkcje przetwarzania

np. signum, skok jedn., perceptronowa, BAM i wiele innych

określają one stan wyjścia neuronu y w zależności od < stanu sumy stanów wejść przemnożonych przez wagi > e

4. 1. omówic pojecie reguły i wniosku i faktu

Reguła - jest to pewna zasada określająca sposób postępowania.

Fakt w rozumieniu potocznym jest to wydarzenie, które miało miejsce w określonym miejscu i czasie. W tym sensie faktem nie może być zdarzenie, które nie miało jeszcze miejsca, można jednak mówić o przewidywaniu przyszłych faktów - czyli zdarzeń które najprawdopodobniej się wydarzą. Zdarzenia te jednak stają się faktami dopiero wtedy, gdy się już wydarzą. W sensie filozoficznym fakt jest to zaistniały stan rzeczy.

Wniosek - wynik, rezultat wnioskowania. Twierdzenie wywiedzione ze zdań zwanych przesłankami, które wcześniej uznano za prawdziwe.

4. 2. Wymień podstawowe mechanizmy wnioskowania

Sposoby wnioskowania

Dedukcja (sound) - wnioski muszą wypływać z przesłanek; metoda wnioskowania w logice

Indukcja (unsound) - wyciąganie ogólnych wniosków na podstawie jednostkowych przypadków

Abdukcja (unsound) - od prawdziwych wniosków dochodzimy do przesłanek które mogły je spowodować

Rezolucja (sound) - ...

Metoda prób i błędów (unsound) - wygeneruj przypuszczalne rozwiązanie i sprawdź je

Wnioskowanie z wartościami domyślnymi (unsound) - wartości domyślne (wiedza ogólna) są zakładane gdy brak szczególowej wiedzy

Analogia (unsound) - wniosek na podstawie podobieństwa do poprzednich sytuacji

Heurystyki (unsound) - reguły oparte na doświadczeniu

Wnioskowanie niemonotoniczne (unsound) - nowe fakty mogą uczynić poprzednie nieprawdziwymi

4. 3. Wnioskowanie „wprzód

Mechanizmy wnioskowania (Inference Engine) stanowią część systemu kierującą rozwiązaniem problemu. Są odpowiedzialne za poprawne zastosowanie wiedzy zgromadzonej w bazie wiedzy.

Wnioskowanie „wprzód" (forward chaining), rozpoczyna od faktów i posuwa się w kierunku diagnozy. System na podstawie podanych faktów oraz faktów i reguł zawartych w bazie wiedzy stara się wygenerować nowe fakty. Nowe fakty dołącza się do bazy wiedzy i powtarza się próbę znalezienia kolejnych, nowych faktów. Wnioskowanie kończy się, kiedy nie da się wygenerować żadnych nowych faktów lub kiedy znaleziono szukaną diagnozę.

4. 4. Wnioskowanie wstecz przebiega w odwrotną stronę niż wnioskowanie w przód. Ogólnie polega ono na wykazaniu prawdziwości hipotezy głównej na postawie prawdziwości przesłanek. Jeśli nie wiemy, czy jakaś przesłanka jest prawdziwa, to traktujemy tę przesłankę jako nową hipotezę i próbujemy ją wykazać. Jeżeli w wyniku takiego postępowania zostanie wreszcie znaleziona reguła, której wszystkie przesłanki są prawdziwe, to konkluzja tej reguły jest prawdziwa. Na podstawie tej konkluzji dowodzi się następną regułę, której przesłanka nie była poprzednio znana itd. Postawiona hipoteza jest prawdziwa, jeśli wszystkie rozważane przesłanki dadzą się wykazać.

We wnioskowaniu dedukcyjnym przesłanka czy koniunkcja przesłanek racją, a wniosek — następstwem logicznie wynikającym z tej racji: wnioskowa przebiega tu zgodnie z kierunkiem wynikania. Prawo logiczne, według którego przebiega wnioskowanie, gwarantuje niezawodność wnioskowania dedukcyjne jeśli tylko w danym przypadku wnioskowania dedukcyjnego prawdziwe są przesłanki, to musi być prawdziwy i wniosek. Wnioskowanie dedukcyjne należy więc wnioskowań niezawodnych.

Zalety wnioskowania wstecz:

występuje mniejsza liczba generowanych faktów niż przy wnioskowaniu wprzód, co oszczędza pamięć komputera

czas oczekiwania na udowodnienie prawdziwości lub fałszywości hipotezy głównej jest przeważnie o wiele krótszy niż w przypadku wnioskowania indukcyjnego

wnioskowanie wstecz jest niezawodne

4. 5. schemat ogólny systemu ekspertowego

4. 6. system decyzyjny / baza wiedzy

WIEDZA + WNIOSKOWANIE = SYSTEM EKSPERTOWY

Wiedza zgromadzona w systemie może być obarczona wieloma błędami, nie do końca wyczerpująca lub wątpliwa. Aby temu zapobiec stosuje się różne techniki jej przetwarzania: symbole, zbiory rozmyte, metody heurystyczne.

Obok wiedzy bazy wiedzy systemy nie są pozbawione klasycznej bazy danych zawierającej fakty z dziedziny wiedzy opisanej w bazie wiedzy. Dla udowodnienia zadanych celów lub wysunięcia propozycji określonych decyzji używa się mechanizmu wnioskowania. Mechanizm ten operuje na bazach wiedzy oraz na bazie danych.

Aby użytkownik systemu mógł redagować bazę w języku przybliżonym do naturalnego potrzebny jest mechanizm pozyskiwania wiedzy. Pośredniczy on między użytkownikiem a bazą wiedzy i odpowiada za translację wiedzy w postaci przystępnej dla użytkownika do postaci niezbędnej dla mechanizmu wnioskowania.

Efektywne pozyskiwanie wiedzy jeszcze szczególnie ważne dla dużych baz wiedzy gdzie szczególny nacisk kładzie się na weryfikację wiedzy pod względem jej:

niesprzeczności

zupełności

nie nadmiarowości informacji

DODATKOWE:

1.

Sieć jednokierunkowa i ze sprzężeniem zwrotnym

Dwa główne kierunki jeżeli chodzi o topologię sieci neuronowych to:

- sieci jednokierunkowe, połączenia pomiędzy poszczególnymi częściami nie tworzą pętli. Sieci takie najczęściej bardzo szybko reagują na impulsy wejściowe. Trenowanie takich sieci odbywa się najczęściej przez sprawdzone już i poznane algorytmy.

- sieci ze sprzężeniem zwrotnym, sieci rekurencyjne, posiadają pętle w połączeniach. W rekurencyjnych sieciach neuronowy kiedy podawany jest sygnał na wejście, sieć musi powtarzać go stosukowo długo zanim uzyska dane wyjściowe. Sieci takie są trudniejsze do wytrenowania niż jednokierunkowe.

2.

Sieć kategoryczna i ilościowa

Sieci neuronowe różnią się też pod względem rodzaju danych, który przetwarzają:

- kategoryczne - sieci, które przeważają tylko kilka stanów (np. 0 i 1; mężczyzna i kobieta; biały, zielony, czarny), wartości jakie przyjmują wejścia i wyjścia są symboliczne i muszą zostać zamienione na liczby, zanim zostaną podane sieci. Wartości takie należą do pewnej kategorii. Zarówno nadzorowane uczenie z kategorycznymi wartościami, jak i nienadzorowane uczenie z kategorycznymi wartościami nazywane jest "klasyfikacją".

- ilościowe - wartości przedstawiają pewne atrybuty, jak długość w metrach. Uczenie nadzorowane z wartościami ilościowymi nazywane jest "regresją".

3. Metody redukcji

Algorytmy metody redukcji są równie często stosowane jak metody wzrostu. Opierają się one na założeniu, że kolejne iteracje mają zmniejszać ilość neuronów ukrytych. Wyróżnia się tu następujące metody:

- metody wrażliwości,

- metody analizy kowariancji.

W początkowym stadium sieć neuronowa charakteryzuje się dużą złożonością strukturalną. Zostaje ona redukowana aż do osiągnięcia optymalnej struktury.

W metodzie wrażliwości usuwa się połączenia synaptyczne, których wagi mają najmniejszy wpływ na wynik sieci.

Metoda analizy kowariancji jest zbliżona do wcześniej wymienionej metody. Analizie poddawana jest macierz kowariancji sygnałów generowanych przez neurony warstwy ukrytej. Liczba znacząco dużych wartości własnych macierzy określa liczbę neuronów, które powinny znajdować się w warstwie ukrytej.

4. Metody optymalizacji dyskretnej

Algorytmy optymalizacji dyskretnej opierają się na założeniu, że proces nauki sieci i wyboru architektury zachodzą równocześnie. Czynnikiem, który zostaje poddany ocenie jest określona funkcja, reprezentująca jakość danej sieci. W kolejnych krokach sieci dobierane są tak, by dążyć do maksymalizacji funkcji jakości.

Jednym z najciekawszych algorytmów optymalizacji jest algorytm genetyczny.

5. Schemat działania neuronu:

Neuron

Jego schemat został opracowany przez McCullocha i Pittsa w 1943 roku i oparty został na budowie komórki nerwowej.

Jego działanie jest następujące:

Do wejść doprowadzane są sygnały dochodzące z neuronów warstwy poprzedniej. Każdy sygnał mnożony jest przez odpowiadającą mu wartość liczbową zwaną wagą. Wpływa ona na percepcję danego sygnału wejściowego i jego udział w tworzeniu sygnału wyjściowego przez neuron. Waga może być pobudzająca - dodatnia lub opóźniająca - ujemna; jeżeli nie ma połączenia między neuronami to waga jest równa zero. Zsumowane iloczyny sygnałów i wag stanowią argument funkcji aktywacji neuronu.

6.

podaj przynajmniej 4 systemy ekspertowe i dziedziny w jakich znalazły zastosowanie:

DENDRAL chemia

MACSYMA matematyka

HEARSEAY rozpoznawanie mowy

MYCIN medycyna

μ(x)

x

1

α1

α2

Aα1

Aα2

Wyszukiwarka