Tytuł oryginału: Web Security Testing Cookbook

Tłumaczenie: Radosław Meryk

ISBN: 978-83-246-5863-3

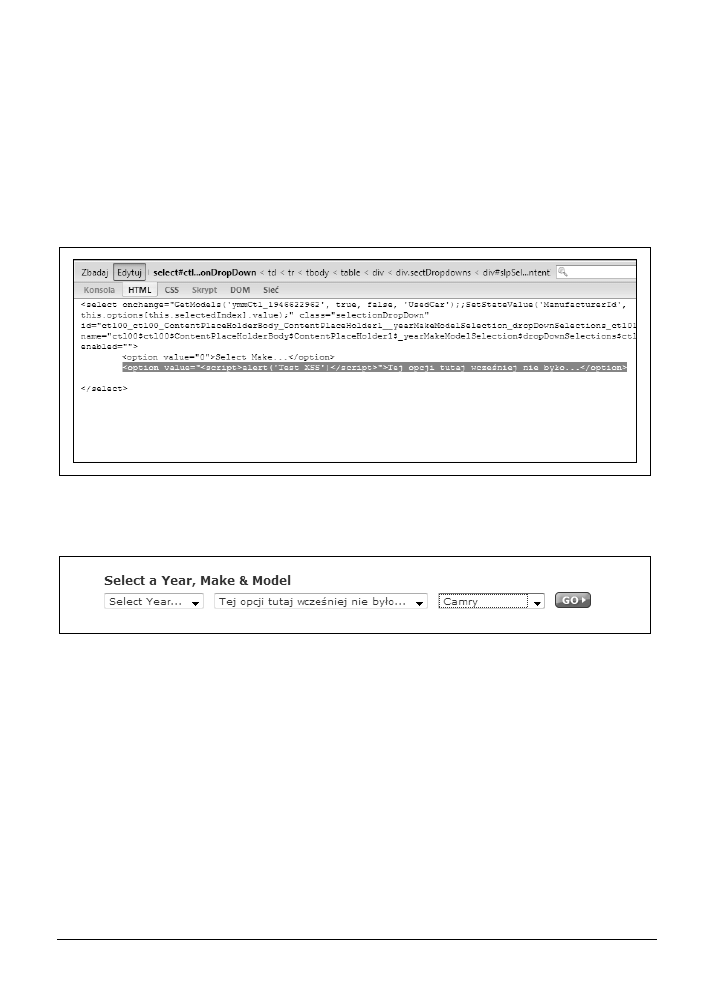

© Helion S.A. 2010

Authorized translation of the English edition of Web Security Testing Cookbook,

ISBN 9780596514839 © 2009, Brian Hope and Ben Walther.

This translation is published and sold by permission of O’Reilly Media, Inc.,

the owner of all rights to publish and sell the same.

All rights reserved. No part of this book may be reproduced or transmitted in any form or by

any means, electronic or mechanical, including photocopying, recording or by any information

storage retrieval system, without permission from the Publisher.

Wszelkie prawa zastrzeżone. Nieautoryzowane rozpowszechnianie całości lub fragmentu

niniejszej publikacji w jakiejkolwiek postaci jest zabronione. Wykonywanie kopii metodą

kserograficzną, fotograficzną, a także kopiowanie książki na nośniku filmowym, magnetycznym

lub innym powoduje naruszenie praw autorskich niniejszej publikacji.

Wszystkie znaki występujące w tekście są zastrzeżonymi znakami firmowymi bądź towarowymi

ich właścicieli.

Autor oraz Wydawnictwo HELION dołożyli wszelkich starań, by zawarte w tej książce

informacje były kompletne i rzetelne. Nie biorą jednak żadnej odpowiedzialności ani za ich

wykorzystanie, ani za związane z tym ewentualne naruszenie praw patentowych lub autorskich.

Autor oraz Wydawnictwo HELION nie ponoszą również żadnej odpowiedzialności

za ewentualne szkody wynikłe z wykorzystania informacji zawartych w książce.

Wydawnictwo HELION

ul. Kościuszki 1c, 44-100 GLIWICE

tel. 32 231 22 19, 32 230 98 63

e-mail: helion@helion.pl

WWW: http://helion.pl (księgarnia internetowa, katalog książek)

Drogi Czytelniku!

Jeżeli chcesz ocenić tę książkę, zajrzyj pod adres

http://helion.pl/user/opinie?tebeap_ebook

Możesz tam wpisać swoje uwagi, spostrzeżenia, recenzję.

Pliki z przykładami omawianymi w książce można znaleźć pod adresem:

ftp://ftp.helion.pl/przyklady/tebeap.zip

Printed in Poland.

•

•

•

•

•

Ebookpoint.pl KOPIA DLA: Michal Matuszak fristajler2008@gmail.com

Opinie o książce „Testowanie bezpieczeństwa aplikacji

internetowych. Receptury”

„Paco i Ben rozumieją i dokładnie objaśniają zagadnienia związane z narzędziem cURL oraz

pojęciami dotyczącymi HTTP. Robią to w przystępny, a jednocześnie techniczny i precyzyjny

sposób. Stworzyli książkę, która jest doskonałym przewodnikiem dla każdego, kto chce zrozu-

mieć »cegiełki«, z jakich składa się aplikacja internetowa, oraz sposób, w jaki można je prze-

testować pod kątem zabezpieczeń”.

— Daniel Stenberg, twórca narzędzia cURL

„Uwielbiam dobre jedzenie, choć nie jestem dobrym kucharzem. Dlatego właśnie polegam na

recepturach. Dzięki recepturom kucharze tacy jak ja mogą szybko uzyskać dobre rezultaty.

Dzięki nim zdobywa się również podstawy do eksperymentowania, nauki i usprawniania.

Książka Testowanie bezpieczeństwa aplikacji internetowych. Receptury spełniła dla mnie — nowi-

cjusza w dziedzinie testowania zabezpieczeń — tę samą funkcję.

Opis darmowych narzędzi takich jak przeglądarka Firefox, jej rozszerzenie do testowania za-

bezpieczeń — WebScarab — oraz wielu innych pozwolił mi szybko osiągnąć efekty. Jestem

pod wrażeniem listy opisanych narzędzi, ale może jeszcze bardziej ostrzeżeń o skutkach ubocz-

nych stosowania narzędzi w nieodpowiedni sposób.

Dzięki opisowi zagadnień kodowania mogłem zrozumieć sens tych zabawnych znaczków,

które można zobaczyć w adresach URL i treści plików cookie.

Jako tester wiem, że można zadławić aplikacje plikami o dużej objętości, ale złośliwy kod

XML czy pliki ZIP to następne pokolenie. Atak »billion laughs« wkrótce stanie się klasykiem.

Ponieważ technologia AJAX jest coraz powszechniej obecna w aplikacjach internetowych, w obli-

czu coraz większej liczby luk bezpieczeństwa w aplikacjach zaprezentowane receptury testowania

będą miały kluczowe znaczenie dla wszystkich testerów.

Doskonałe przykłady z życia sprawiają, że teoria ożywa, a opis ataków jest bardzo interesujący”.

— Lee Copeland, szef komitetu programowego konferencji testerów StarEast i StarWest

oraz autor książki A Practitioner's Guide to Software Test Design

„Testowanie zabezpieczeń aplikacji internetowych jest czasochłonnym, żmudnym i nazbyt

często niezautomatyzowanym procesem. Nie musi tak być, a niniejsza książka dostarcza klu-

czy do prostych, skutecznych i powtarzalnych technik, dzięki którym można znaleźć pro-

blemy w aplikacjach, zanim zrobią to hakerzy”.

— Mike Andrews, autor książki How to Break Web Software

„Nareszcie sensowny, napisany prostym językiem podręcznik dla testerów, uczący mechani-

zmów testowania zabezpieczeń. Dzięki zaprezentowaniu tematów w formie receptur niniejsza

książka uzbraja testera w narzędzia pozwalające na znajdowanie słabych punktów, których

często nie można znaleźć, posługując się najbardziej znanymi narzędziami testowania zabez-

pieczeń”.

— Matt Fisher, założyciel i dyrektor zarządzający firmy Piscis LLC

„Jeśli zastanawiasz się, czy w Twojej instytucji występuje problem z zabezpieczeniami apli-

kacji, nie ma bardziej przekonującego dowodu od kilku nieudanych testów zabezpieczeń.

Książka Paco i Bena pomoże czytelnikom w posługiwaniu się najlepszymi darmowymi na-

rzędziami testowania zabezpieczeń aplikacji internetowych — wiele z nich należy do projektu

OWASP — a proste receptury, które zostały w niej zaprezentowane, doskonale nadają się dla

wszystkich programistów i testerów”.

— Jeff Williams, dyrektor zarządzający firmy Aspect Security i szef projektu OWASP

„Niezależnie od tego, jak dobrzy są programiści, rygorystyczne testy zawsze będą należeć do

procesu produkcji bezpiecznego oprogramowania. Hope i Walther wykradli techniki testowania

zabezpieczeń grupie L33T hax0rs i przekazali tę wiedzę zdyscyplinowanym profesjonalistom”.

—

Brian Chess, założyciel i główny naukowiec firmy Fortify Software

5

Spis treści

Słowo wstępne .............................................................................................................11

Przedmowa .................................................................................................................. 13

1. Wprowadzenie

............................................................................................................23

1.1. Co to jest testowanie zabezpieczeń? 23

1.2. Czym są aplikacje internetowe?

27

1.3. Podstawowe pojęcia dotyczące aplikacji internetowych

31

1.4. Testowanie zabezpieczeń aplikacji internetowej

36

1.5. Zasadnicze pytanie brzmi: „Jak”

37

2. Instalacja darmowych narzędzi .................................................................................. 41

2.1. Instalacja przeglądarki Firefox

42

2.2. Instalacja rozszerzeń przeglądarki Firefox

42

2.3. Instalacja rozszerzenia Firebug

43

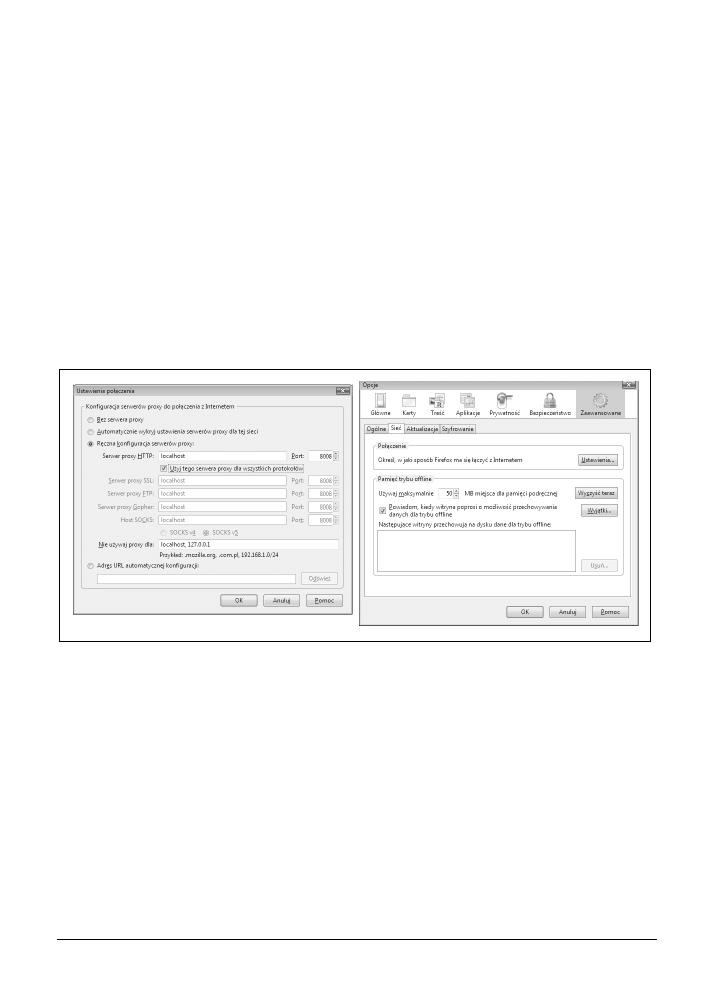

2.4. Instalacja programu WebScarab grupy OWASP

44

2.5. Instalowanie Perla i pakietów w systemie Windows

45

2.6. Instalacja Perla i korzystanie z repozytorium CPAN w systemie Linux

46

2.7. Instalacja narzędzia CAL9000

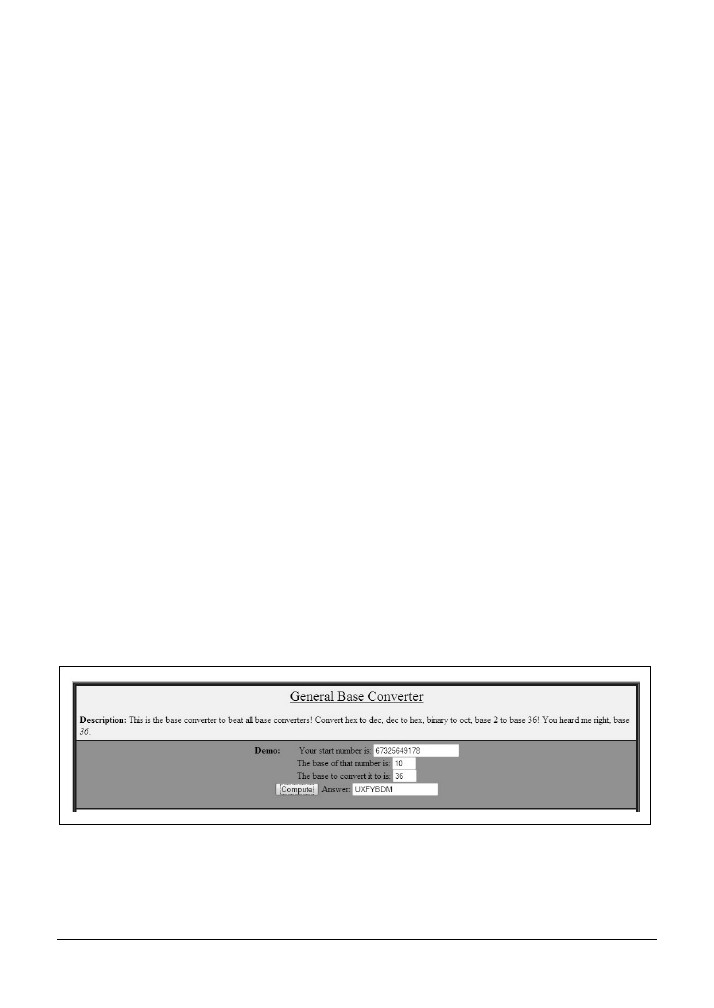

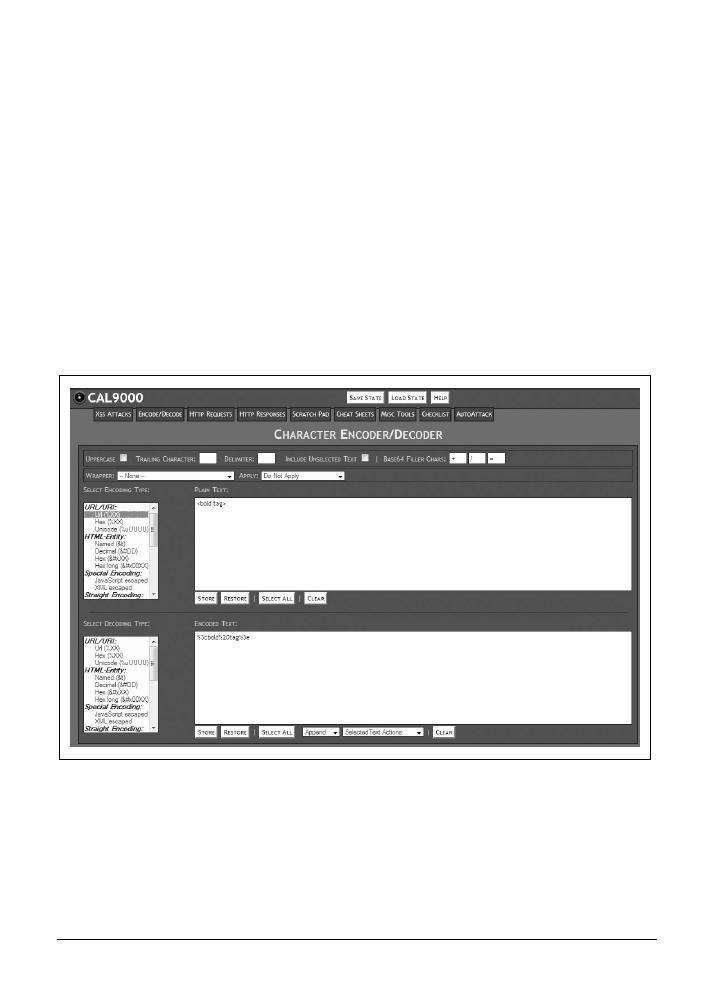

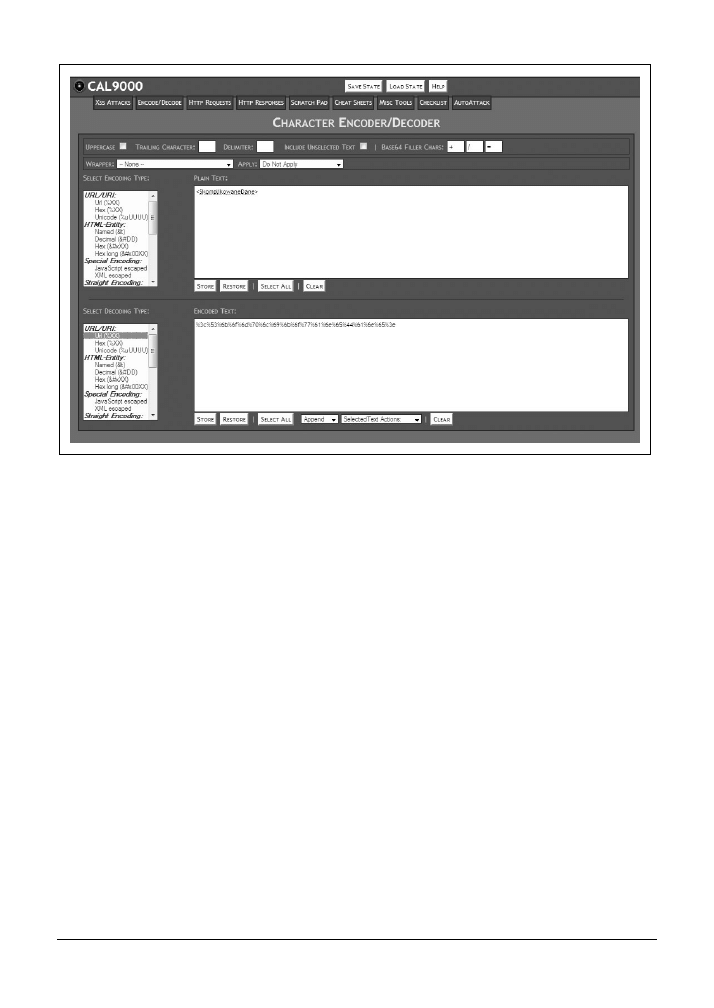

47

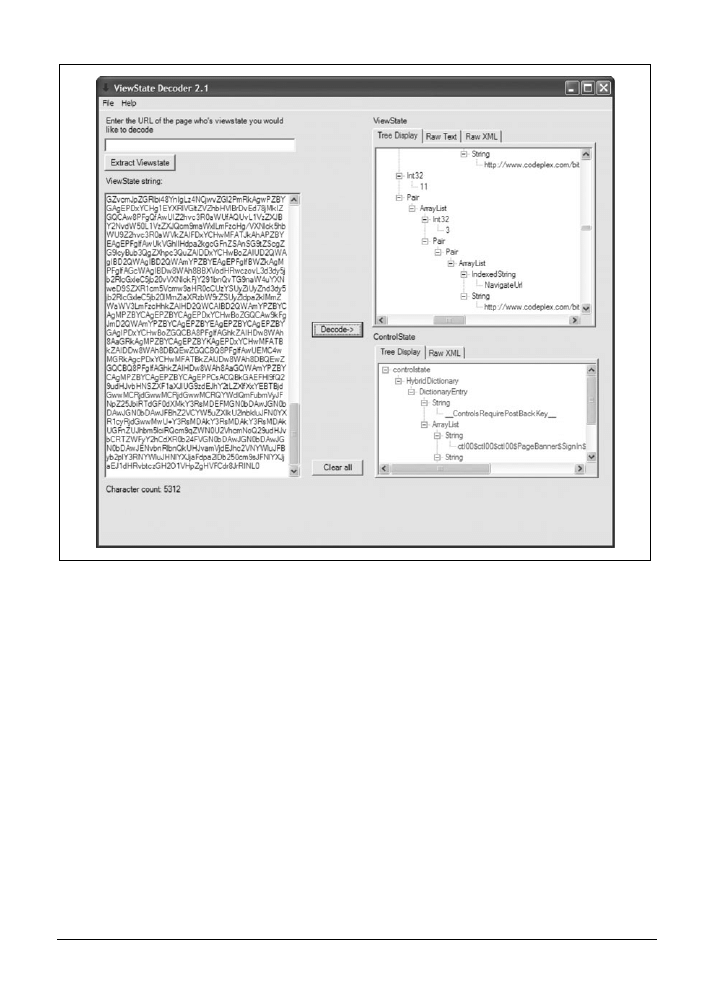

2.8. Instalacja narzędzia ViewState Decoder

47

2.9. Instalacja cURL

48

2.10. Instalacja narzędzia Pornzilla

49

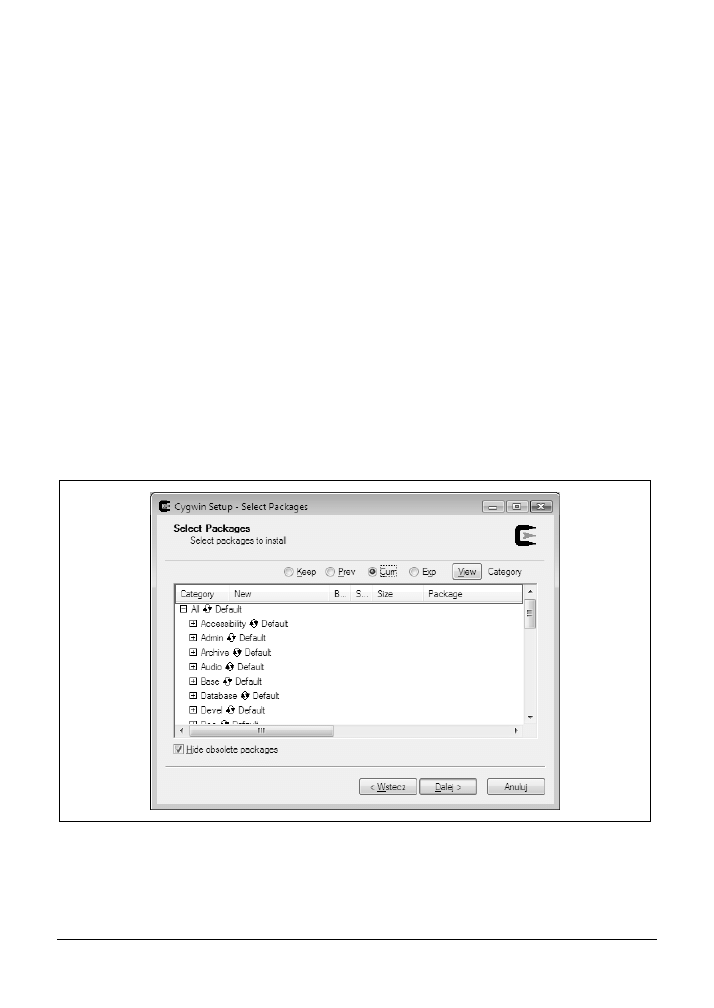

2.11. Instalacja środowiska Cygwin

49

2.12. Instalacja narzędzia Nikto 2

51

2.13. Instalacja zestawu narzędzi Burp Suite

52

2.14. Instalacja serwera HTTP Apache

53

6

| Spis treści

3. Prosta

obserwacja .......................................................................................................55

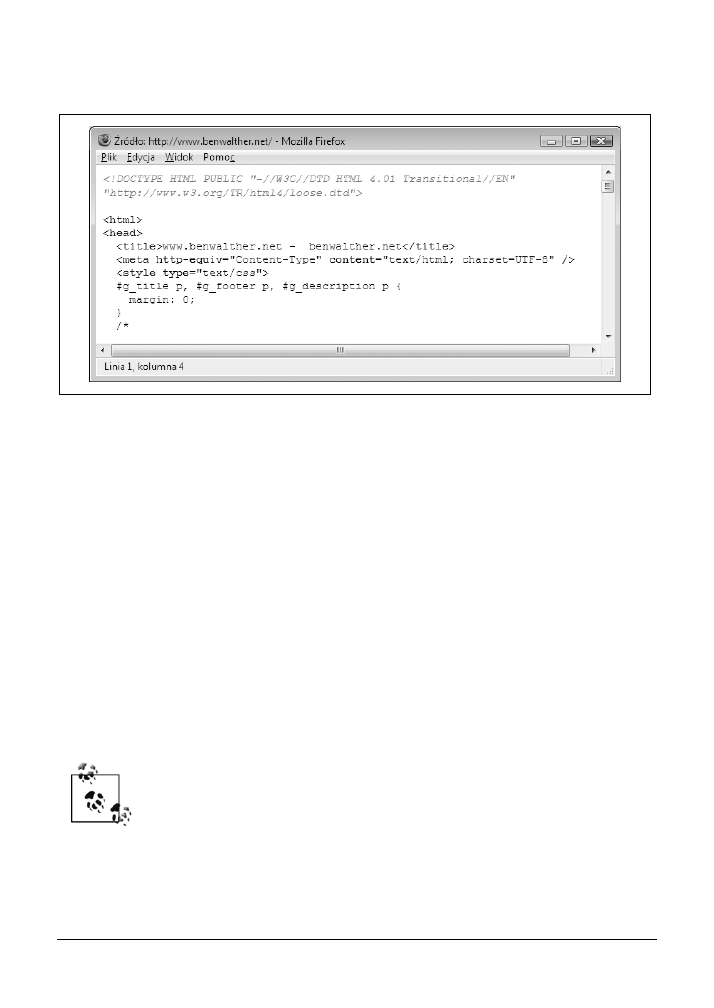

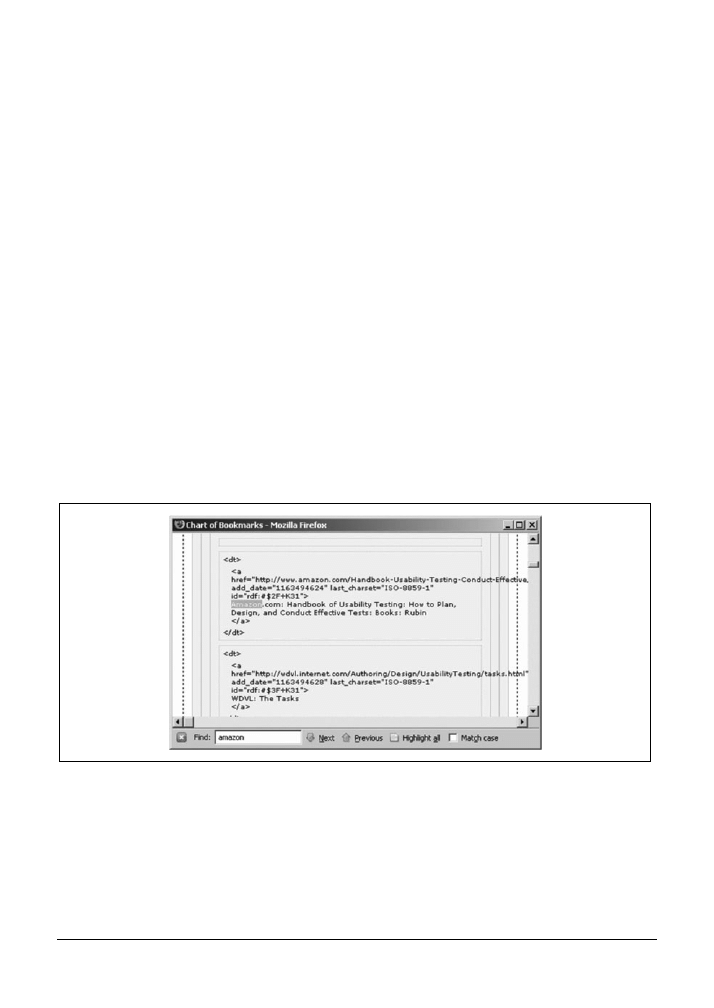

3.1. Przeglądanie źródła HTML strony

56

3.2. Zaawansowane przeglądanie kodu źródłowego 58

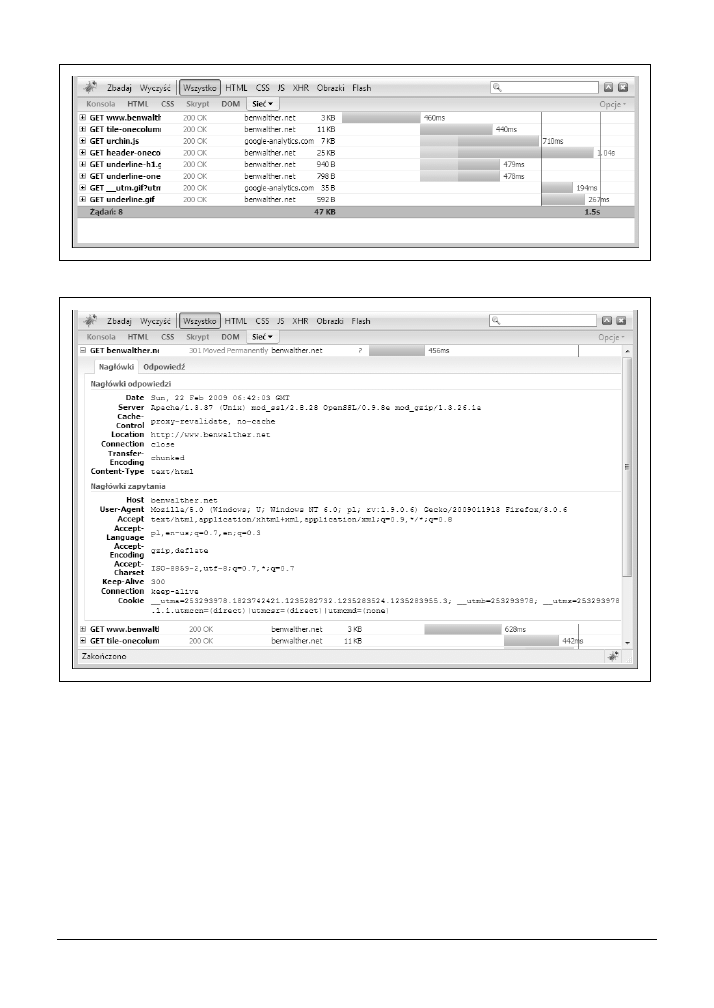

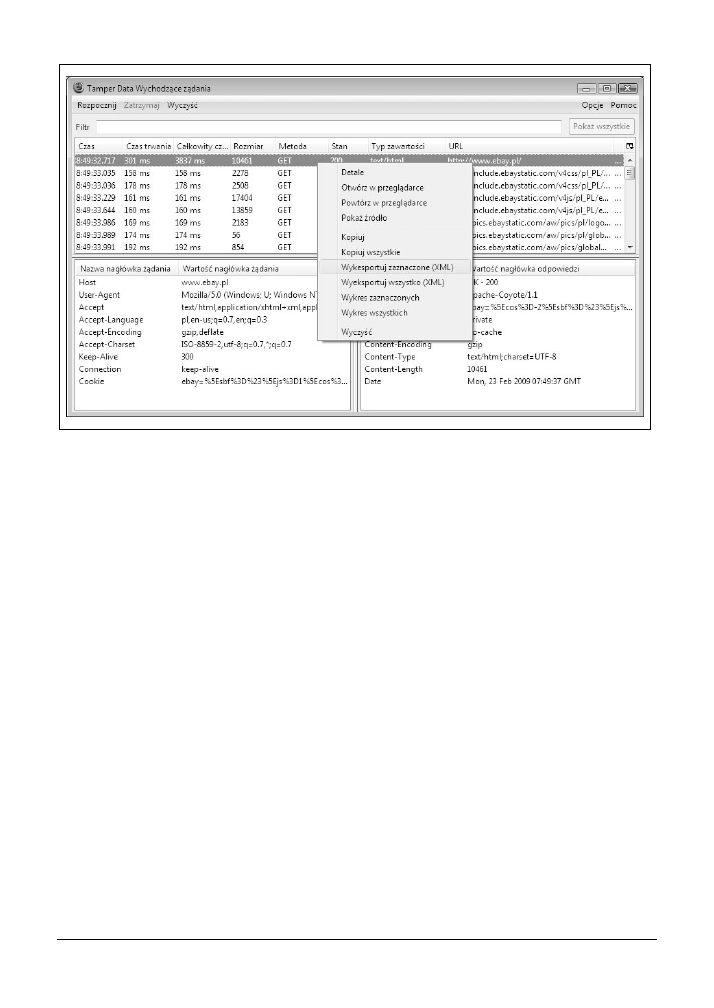

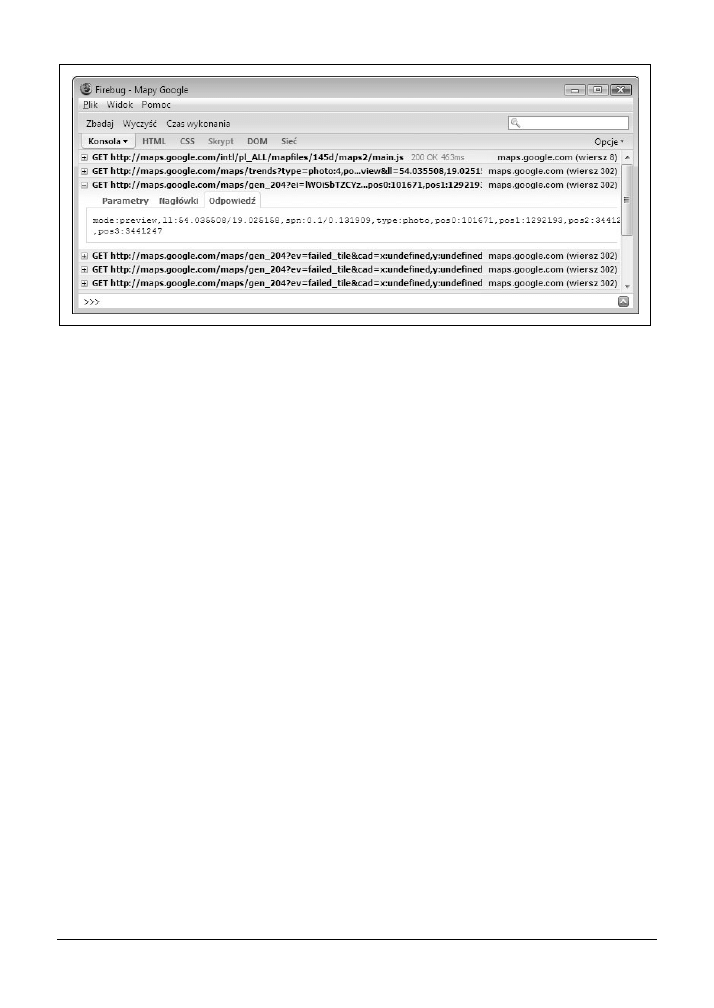

3.3. Obserwacja nagłówków żądań „na żywo” za pomocą dodatku Firebug

60

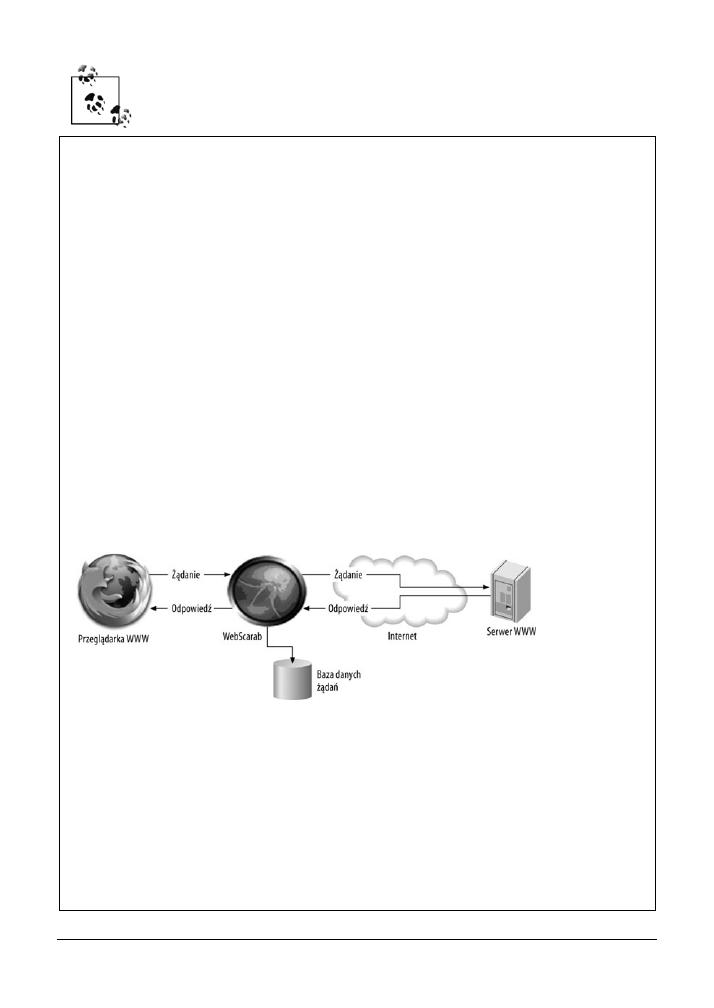

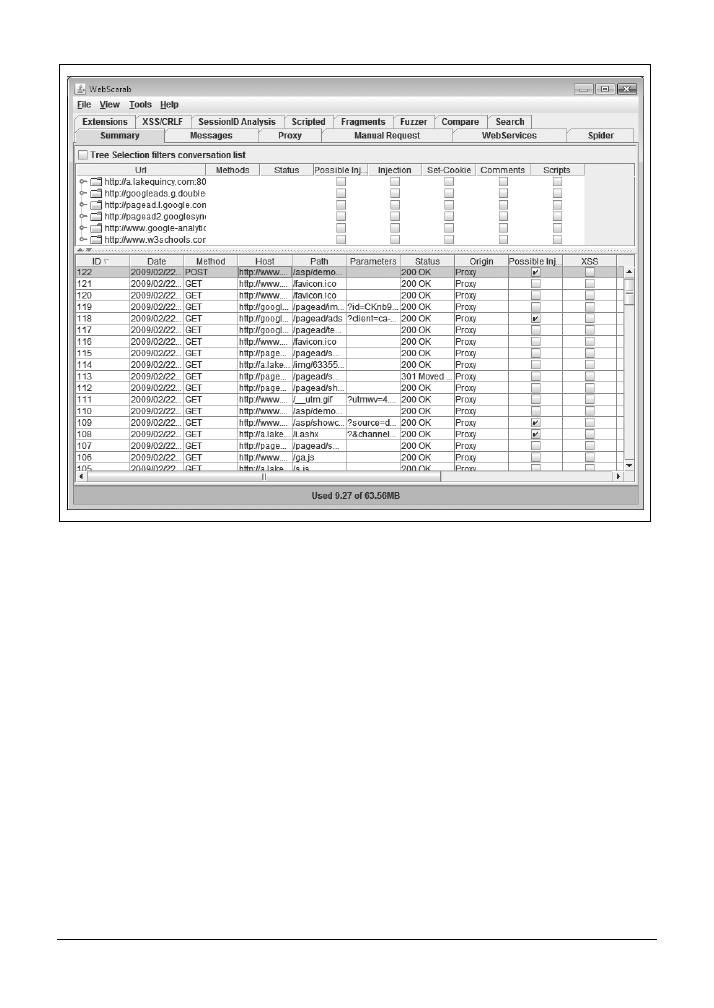

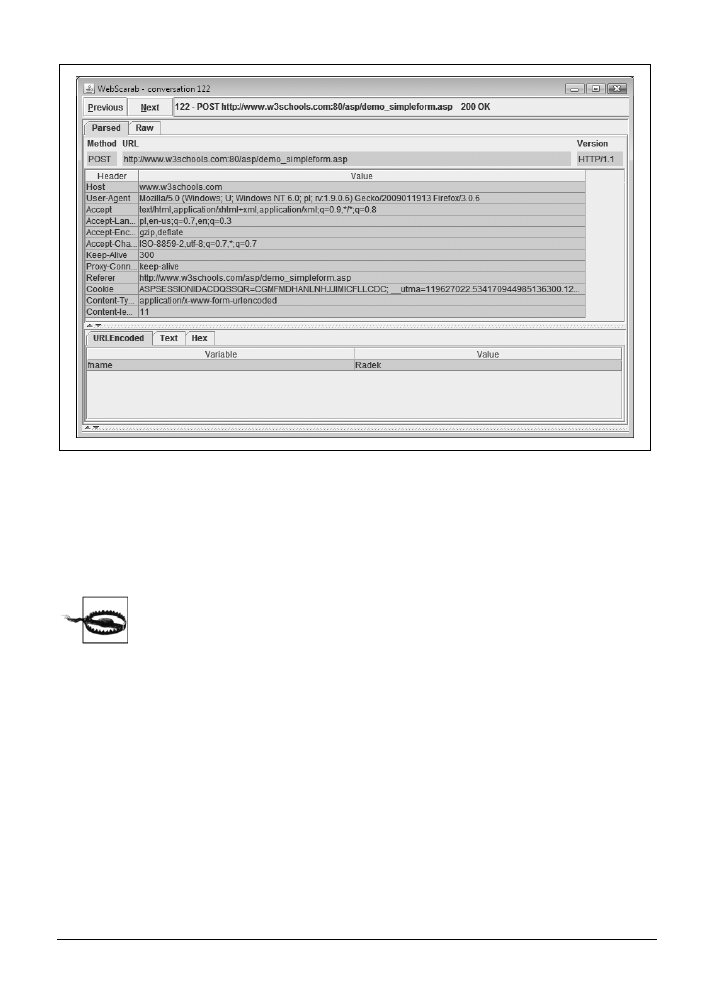

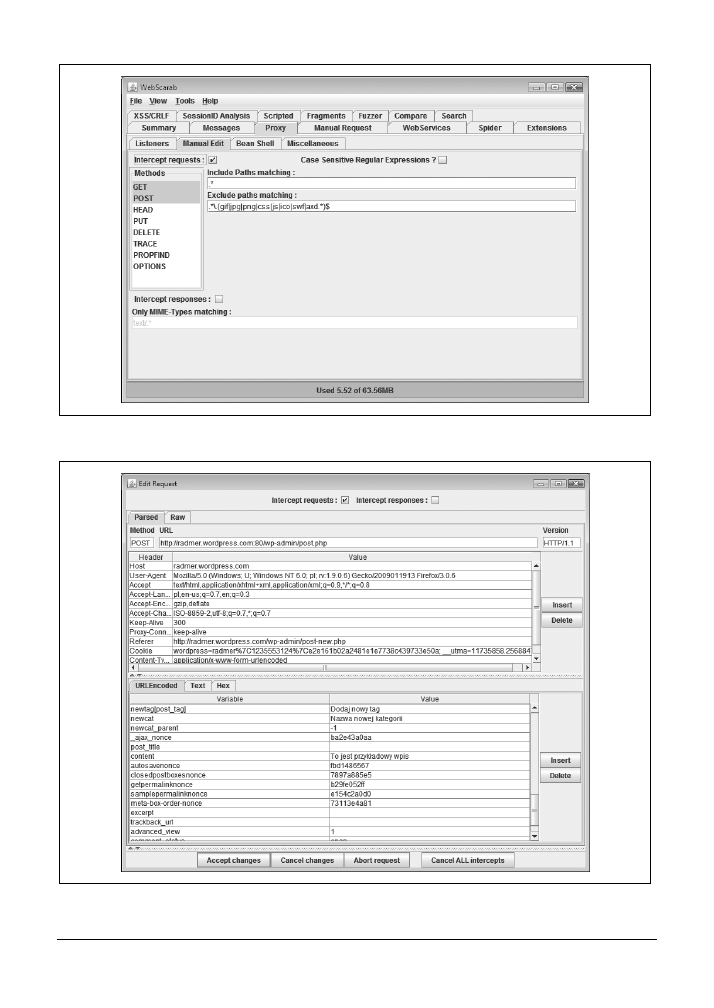

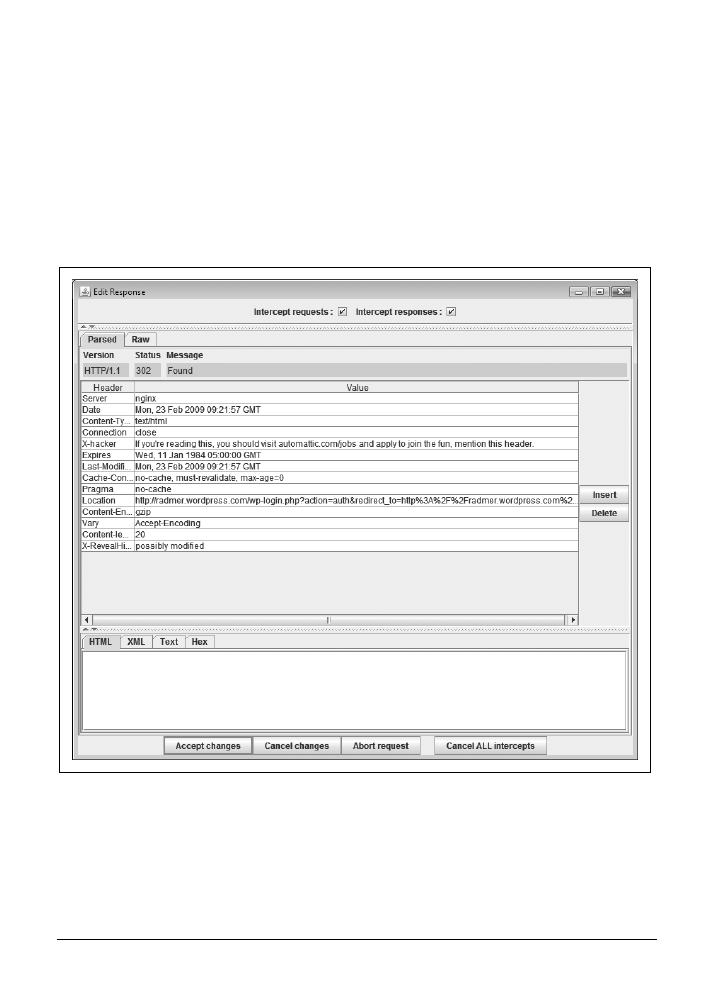

3.4. Obserwacja danych POST „na żywo” za pomocą narzędzia WebScarab

64

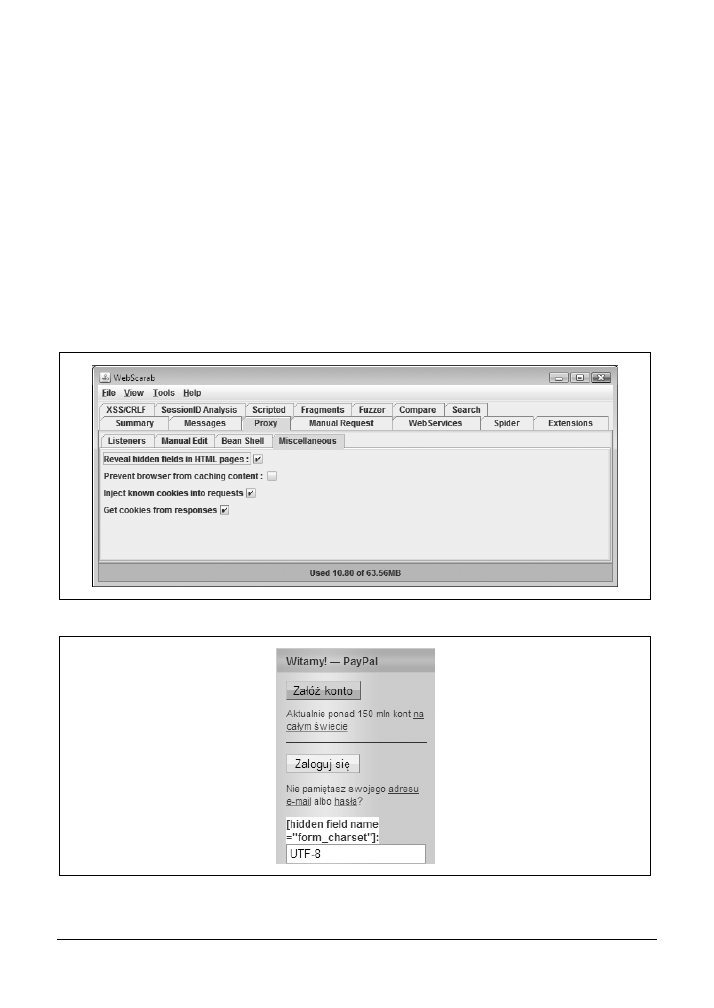

3.5. Oglądanie ukrytych pól formularza

68

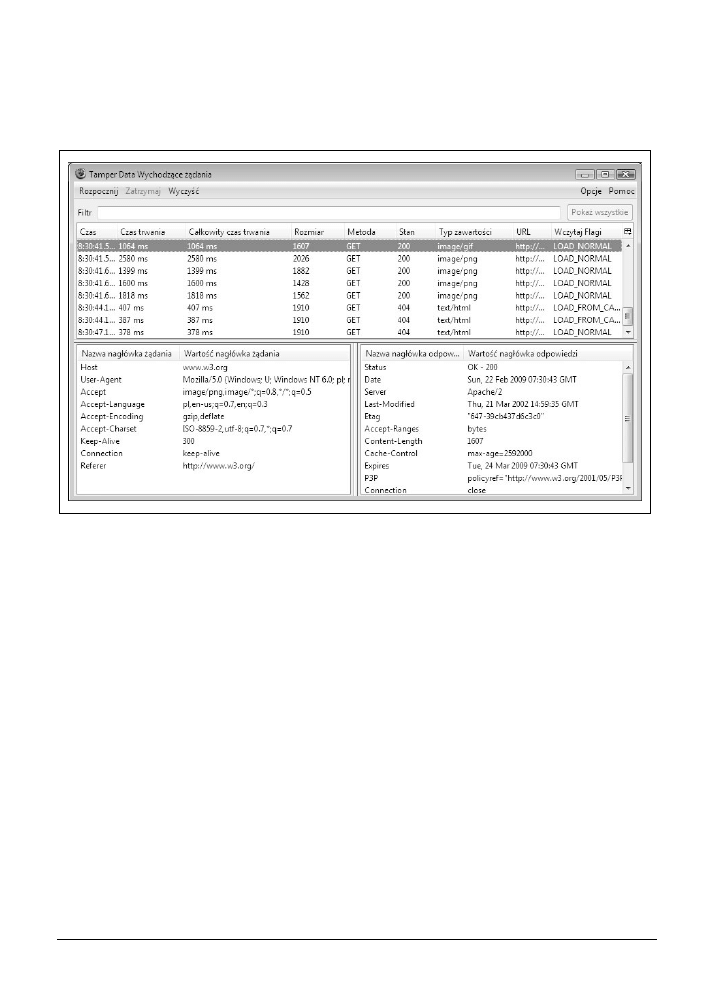

3.6. Obserwacja nagłówków odpowiedzi „na żywo”

za pomocą dodatku TamperData

69

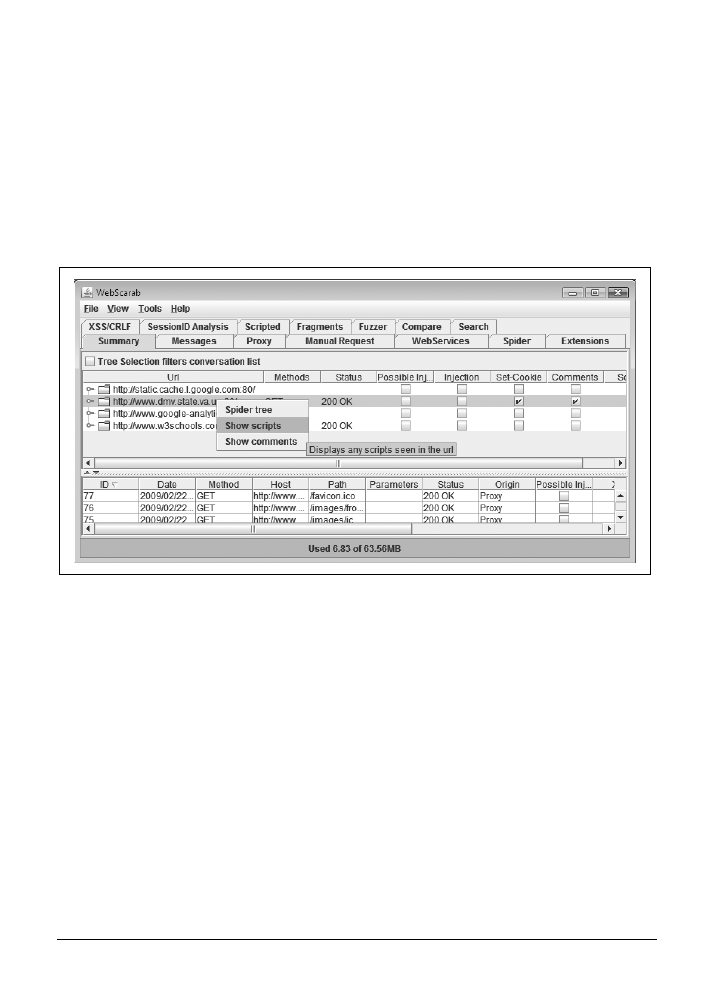

3.7. Podświetlanie kodu JavaScript i komentarzy

71

3.8. Wykrywanie zdarzeń JavaScript

73

3.9. Modyfikowanie specyficznych atrybutów elementów

74

3.10. Dynamiczne śledzenie atrybutów elementów

76

3.11. Wnioski

78

4. Kodowanie

danych w internecie ................................................................................79

4.1. Rozpoznawanie binarnych reprezentacji danych

80

4.2. Korzystanie z danych Base64

82

4.3. Konwersja liczb zakodowanych w Base36 na stronie WWW

84

4.4. Korzystanie z danych Base36 w Perlu

85

4.5. Wykorzystanie danych kodowanych w URL

85

4.6. Wykorzystywanie danych w formacie encji HTML

88

4.7. Wyliczanie skrótów

89

4.8. Rozpoznawanie formatów czasowych

91

4.9. Programowe kodowanie wartości oznaczających czas

93

4.10. Dekodowanie wartości ViewState języka ASP.NET

94

4.11. Dekodowanie danych zakodowanych wielokrotnie

96

5. Manipulowanie danymi wejściowymi ........................................................................99

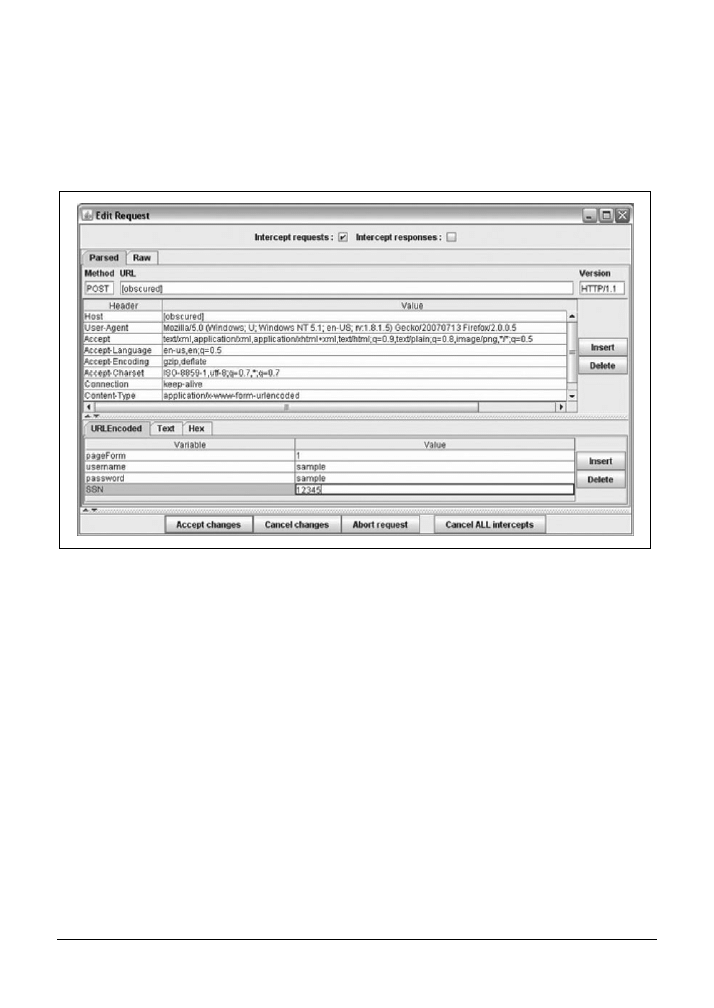

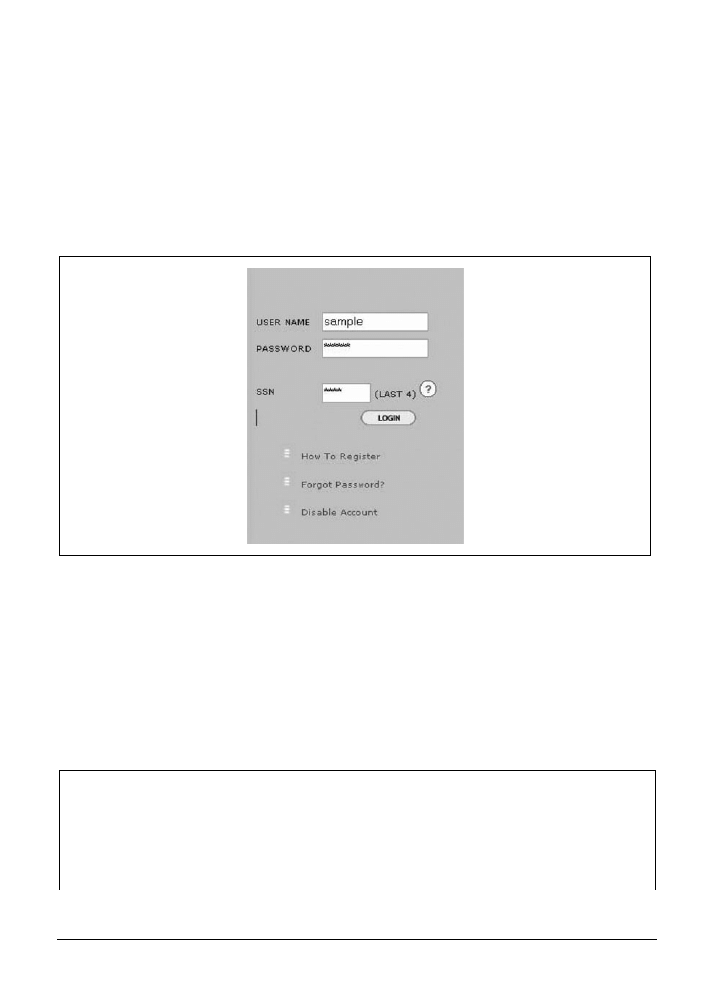

5.1. Przechwytywanie i modyfikowanie żądań POST

100

5.2. Obejścia ograniczeń pól wejściowych 103

5.3. Modyfikowanie adresu URL

104

5.4. Automatyzacja modyfikowania adresów URL

107

5.5. Testowanie obsługi długich adresów URL

108

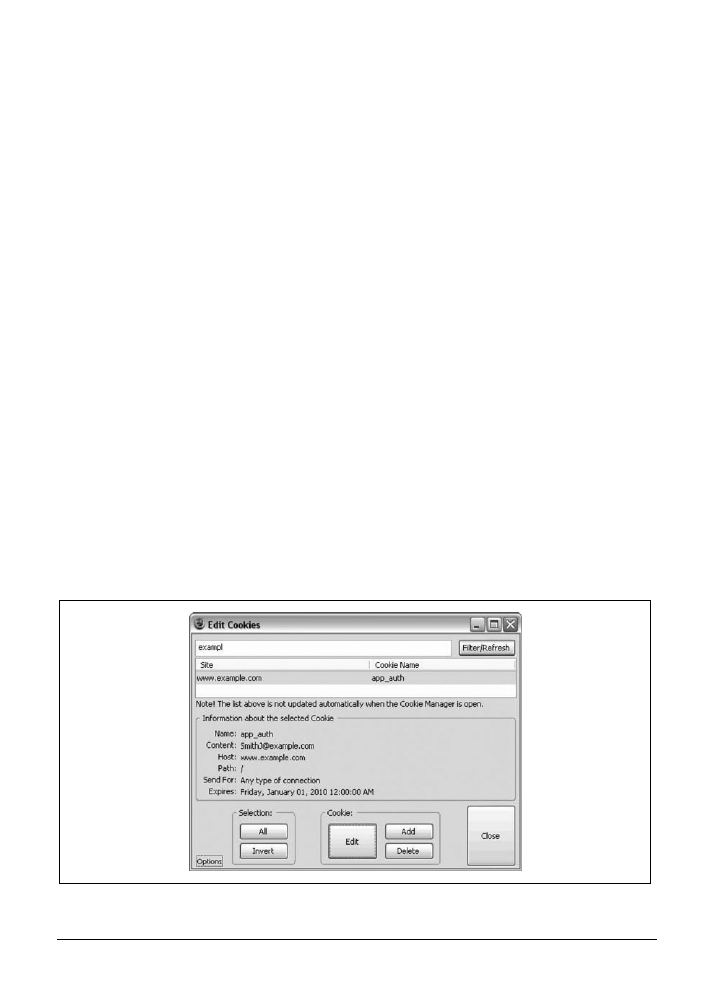

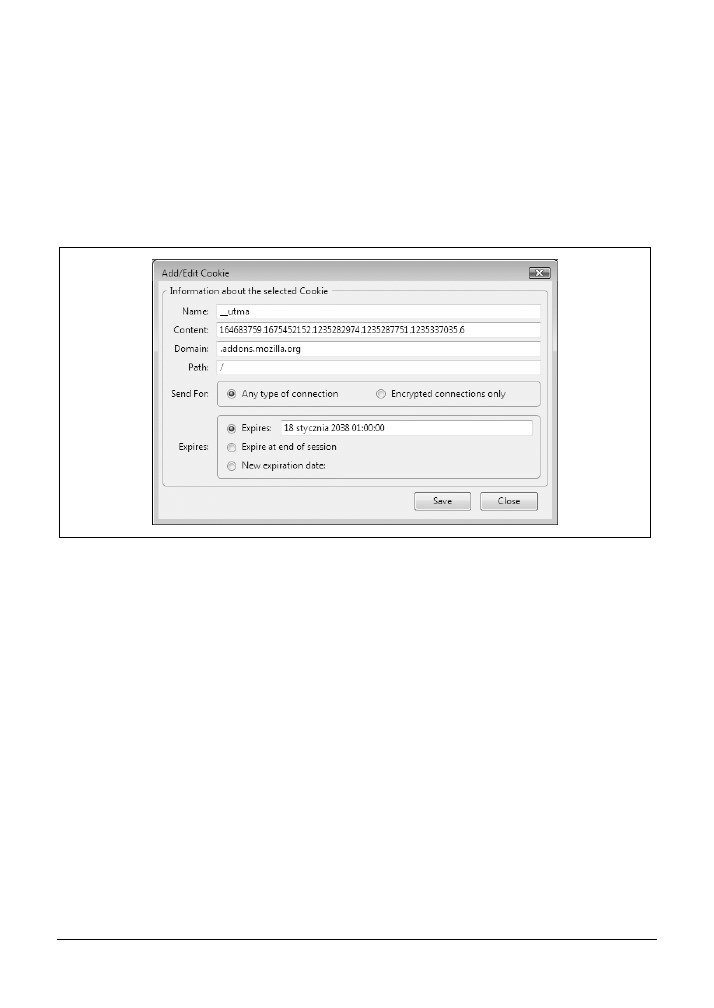

5.6. Edycja plików cookie

110

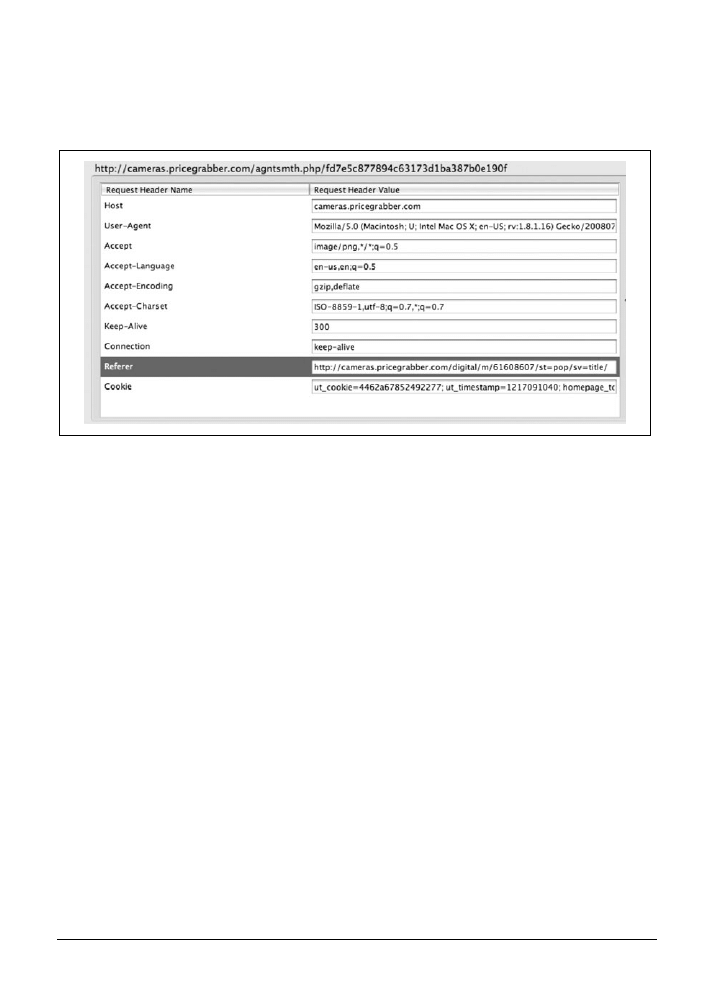

5.7. Fałszowanie informacji przesyłanych przez przeglądarki w nagłówkach 112

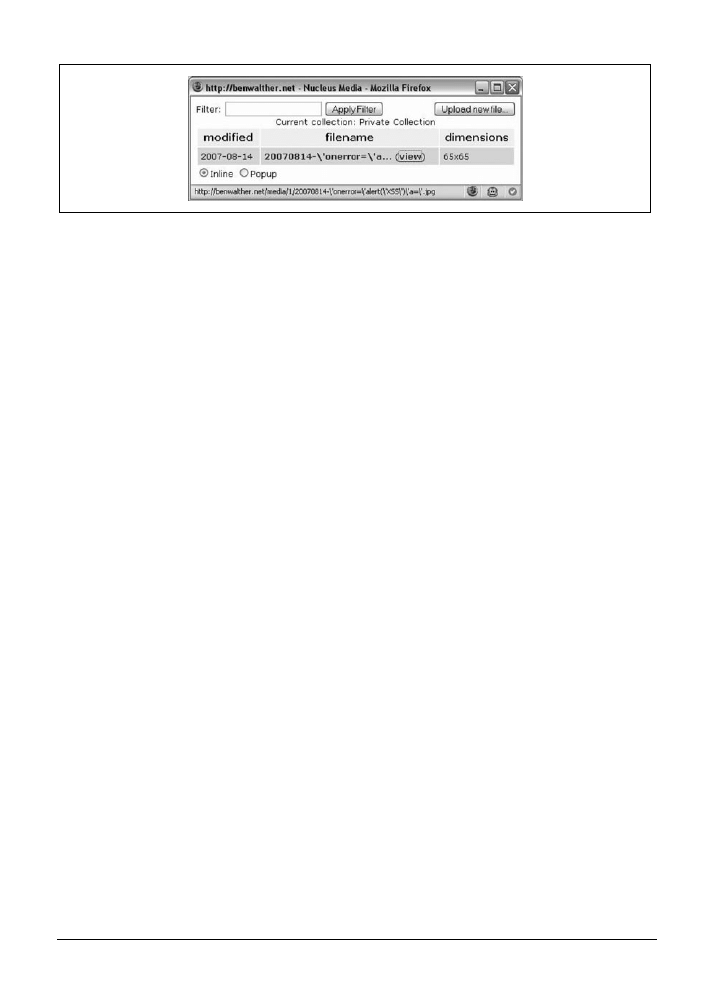

5.8. Przesyłanie na serwer plików o złośliwych nazwach

115

5.9. Przesyłanie na serwer plików o dużej objętości 117

5.10. Przesyłanie plików XML o złośliwej zawartości 118

5.11. Przesyłanie plików XML o złośliwej strukturze

120

5.12. Przesyłanie złośliwych plików ZIP

122

5.13. Przesyłanie na serwer przykładowych plików wirusów

123

5.14. Obchodzenie ograniczeń interfejsu użytkownika 124

Spis treści

|

7

6. Automatyzacja

masowego skanowania ...................................................................127

6.1. Przeglądanie serwisu WWW za pomocą programu WebScarab

128

6.2. Przekształcanie wyników działania programów typu pająk

do postaci listy inwentaryzacyjnej

130

6.3. Redukowanie listy adresów URL do testowania

133

6.4. Wykorzystanie arkusza kalkulacyjnego do redukcji listy

134

6.5. Tworzenie kopii lustrzanej serwisu WWW za pomocą programu LWP

134

6.6. Tworzenie kopii lustrzanej serwisu WWW za pomocą polecenia wget

136

6.7. Tworzenie kopii lustrzanej specyficznych elementów

za pomocą polecenia wget

138

6.8. Skanowanie serwisu WWW za pomocą programu Nikto

138

6.9. Interpretacja wyników programu Nikto

140

6.10. Skanowanie serwisów HTTPS za pomocą programu Nikto

142

6.11. Używanie programu Nikto z uwierzytelnianiem

143

6.12. Uruchamianie Nikto w określonym punkcie startowym

144

6.13. Wykorzystywanie specyficznego pliku cookie sesji z programem Nikto

145

6.14. Testowanie usług sieciowych za pomocą programu WSFuzzer

146

6.15. Interpretacja wyników programu WSFuzzer

148

7. Automatyzacja wybranych zadań z wykorzystaniem cURL .....................................151

7.1. Pobieranie strony za pomocą cURL

152

7.2. Pobieranie wielu odmian strony spod adresu URL

153

7.3. Automatyczne śledzenie przekierowań 154

7.4. Wykorzystanie cURL do testowania podatności

na ataki za pomocą skryptów krzyżowych 155

7.5. Wykorzystanie cURL do testowania podatności

na ataki typu „przechodzenie przez katalog”

158

7.6. Naśladowanie specyficznego typu przeglądarki lub urządzenia 161

7.7. Interaktywne naśladowanie innego urządzenia 162

7.8. Imitowanie wyszukiwarki za pomocą cURL

165

7.9. Pozorowanie przepływu poprzez fałszowanie nagłówków referer

166

7.10. Pobieranie samych nagłówków HTTP

167

7.11. Symulacja żądań POST za pomocą cURL

168

7.12. Utrzymywanie stanu sesji

169

7.13. Modyfikowanie plików cookie

171

7.14. Przesyłanie pliku na serwer za pomocą cURL

171

7.15. Tworzenie wieloetapowego przypadku testowego

172

7.16. Wnioski

177

8

| Spis treści

8. Automatyzacja

zadań z wykorzystaniem biblioteki LibWWWPerl ........................ 179

8.1. Napisanie prostego skryptu Perla do pobierania strony

180

8.2. Programowe modyfikowanie parametrów

181

8.3. Symulacja wprowadzania danych za pośrednictwem formularzy

z wykorzystaniem żądań POST

183

8.4. Przechwytywanie i zapisywanie plików cookie

184

8.5. Sprawdzanie ważności sesji

185

8.6. Testowanie podatności na wymuszenia sesji

188

8.7. Wysyłanie złośliwych wartości w plikach cookie

190

8.8. Przesyłanie na serwer złośliwej zawartości plików

192

8.9. Przesyłanie na serwer plików o złośliwych nazwach

193

8.10. Przesyłanie wirusów do aplikacji

195

8.11. Parsowanie odpowiedzi za pomocą skryptu Perla w celu sprawdzenia

odczytanych wartości 197

8.12. Programowa edycja strony

198

8.13. Wykorzystanie wątków do poprawy wydajności 200

9. Wyszukiwanie

wad projektu ....................................................................................203

9.1. Pomijanie obowiązkowych elementów nawigacji

204

9.2. Próby wykonywania uprzywilejowanych operacji

206

9.3. Nadużywanie mechanizmu odzyskiwania haseł 207

9.4. Nadużywanie łatwych do odgadnięcia identyfikatorów

209

9.5. Odgadywanie danych do uwierzytelniania

211

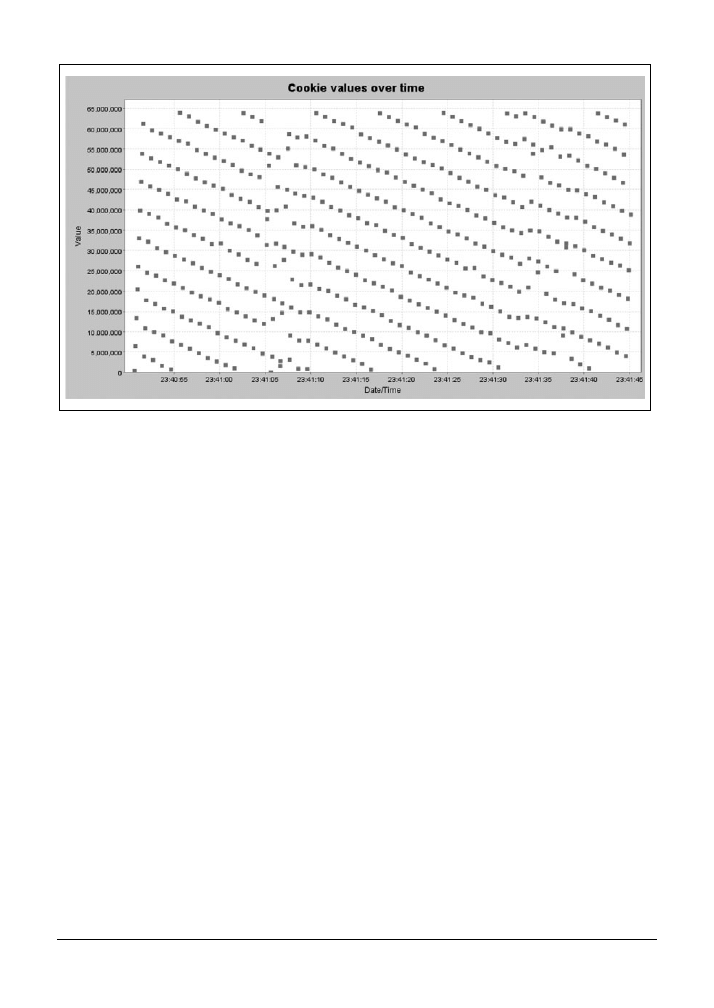

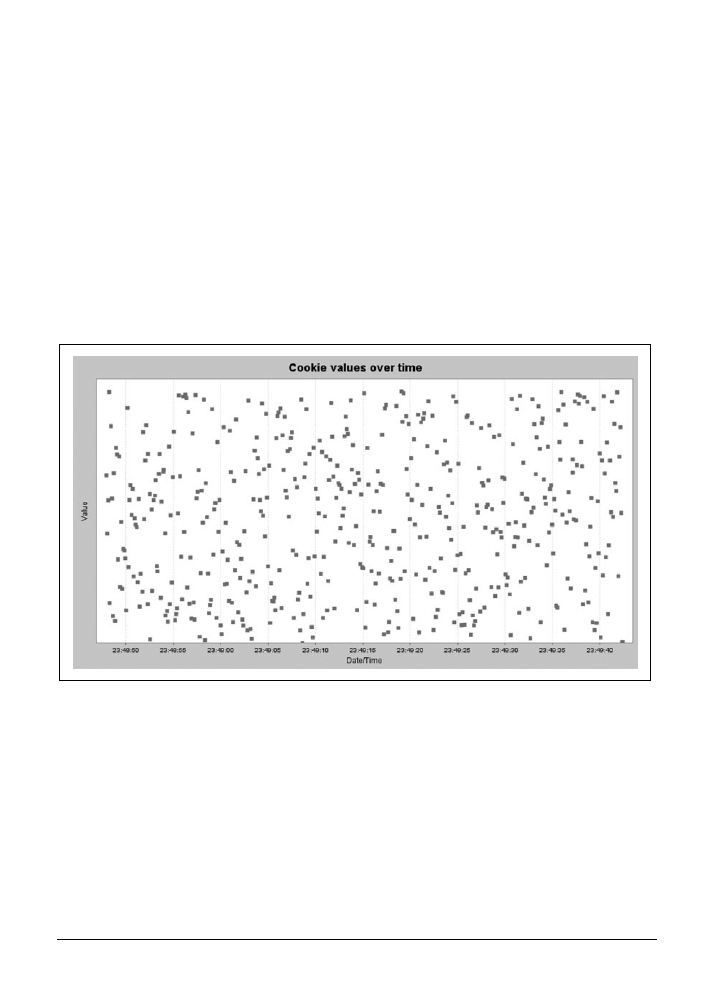

9.6. Wyszukiwanie liczb losowych w aplikacji

213

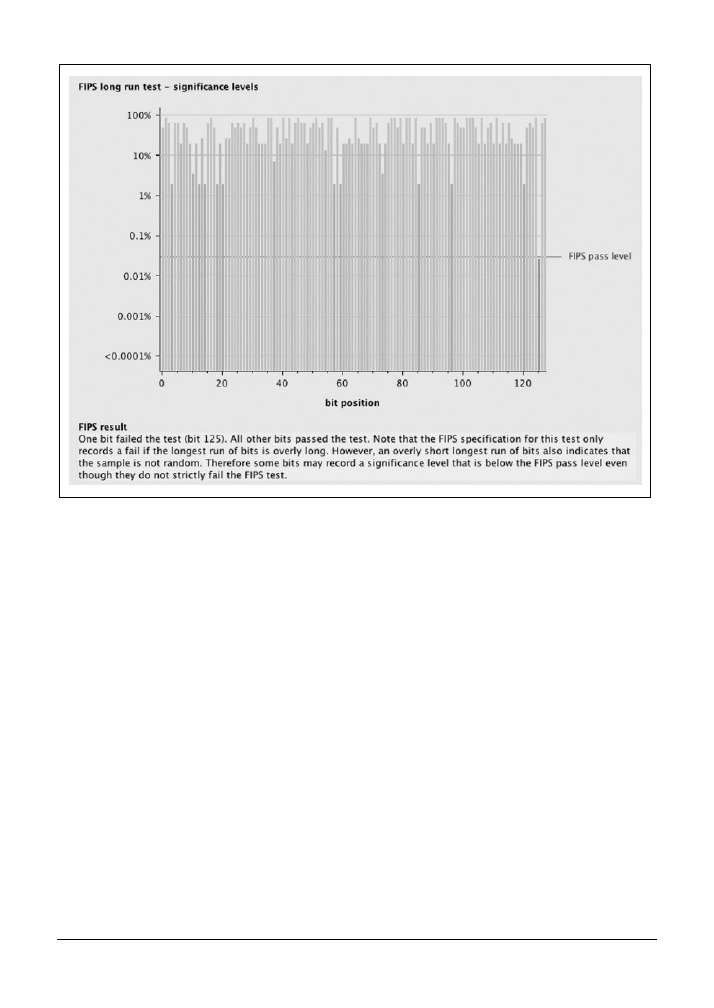

9.7. Testowanie liczb losowych

215

9.8. Nadużywanie powtarzalności 217

9.9. Nadużywanie operacji powodujących duże obciążenia 219

9.10. Nadużywanie funkcji ograniczających dostęp do aplikacji

221

9.11. Nadużywanie sytuacji wyścigu 222

10. Ataki przeciwko aplikacjom AJAX ............................................................................225

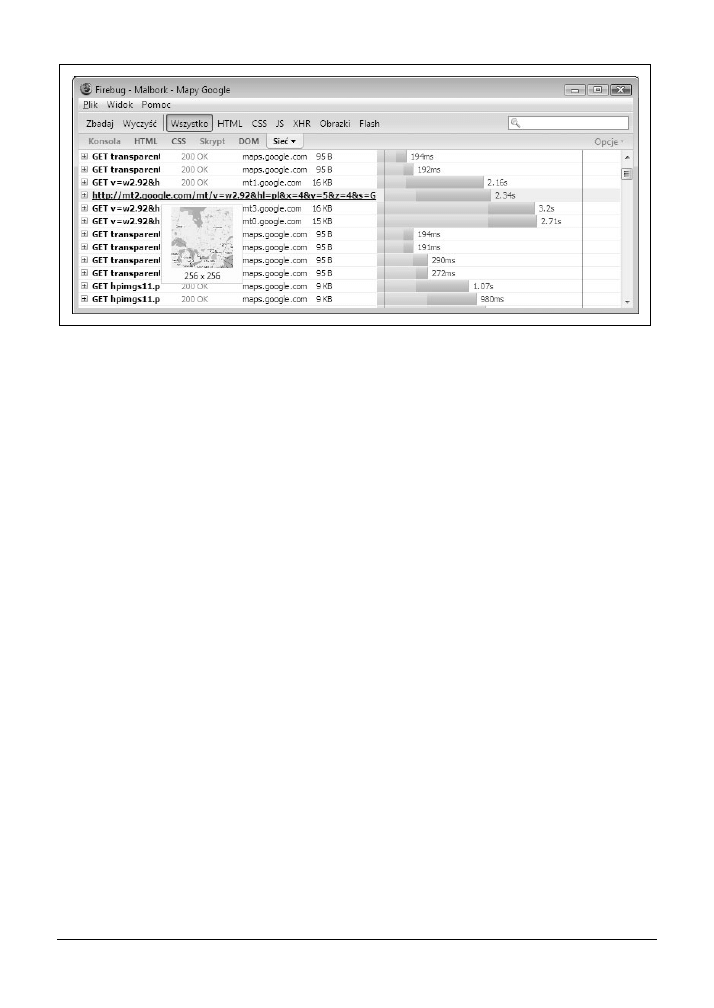

10.1. Obserwacja żądań AJAX „na żywo” 227

10.2. Identyfikacja kodu JavaScript w aplikacjach

228

10.3. Śledzenie operacji AJAX do poziomu kodu źródłowego 229

10.4. Przechwytywanie i modyfikowanie żądań AJAX

230

10.5. Przechwytywanie i modyfikowanie odpowiedzi serwera

232

10.6. Wstrzykiwanie danych do aplikacji AJAX

234

10.7. Wstrzykiwanie danych w formacie XML do aplikacji AJAX

236

10.8. Wstrzykiwanie danych w formacie JSON do aplikacji AJAX

237

10.9. Modyfikowanie stanu klienta

239

10.10. Sprawdzenie możliwości dostępu z innych domen

240

10.11. Odczytywanie prywatnych danych dzięki przechwytywaniu danych JSON 241

Spis treści

|

9

11. Manipulowanie sesjami ...........................................................................................245

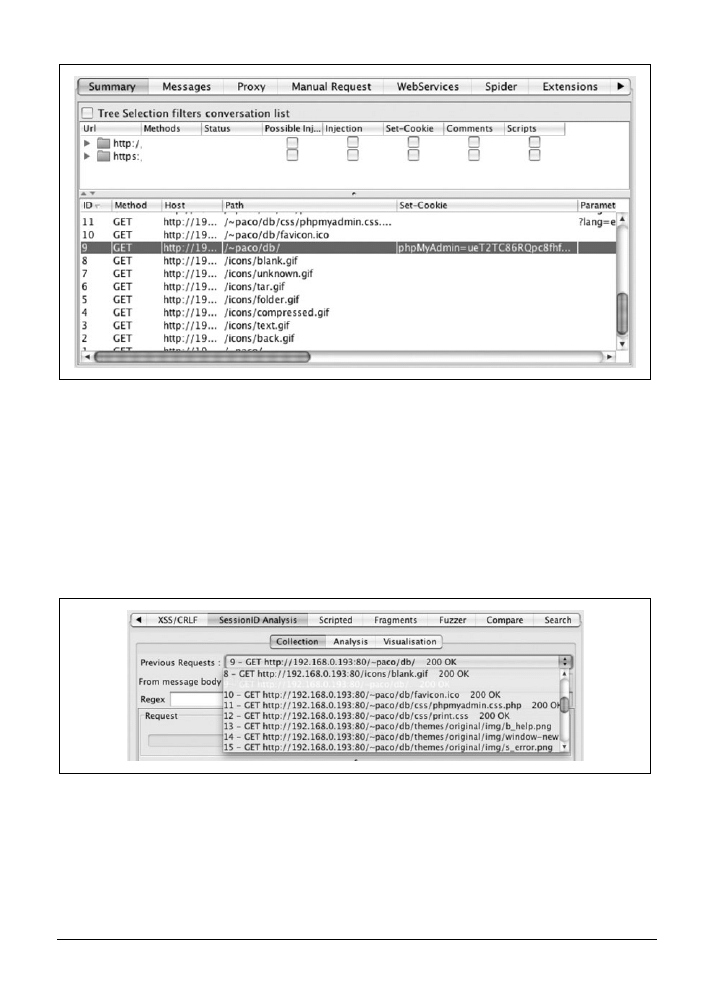

11.1. Wyszukiwanie identyfikatorów sesji w plikach cookie

246

11.2. Wyszukiwanie identyfikatorów sesji w żądaniach 248

11.3. Wyszukiwanie nagłówków autoryzacji

249

11.4. Analiza terminu ważności sesji

252

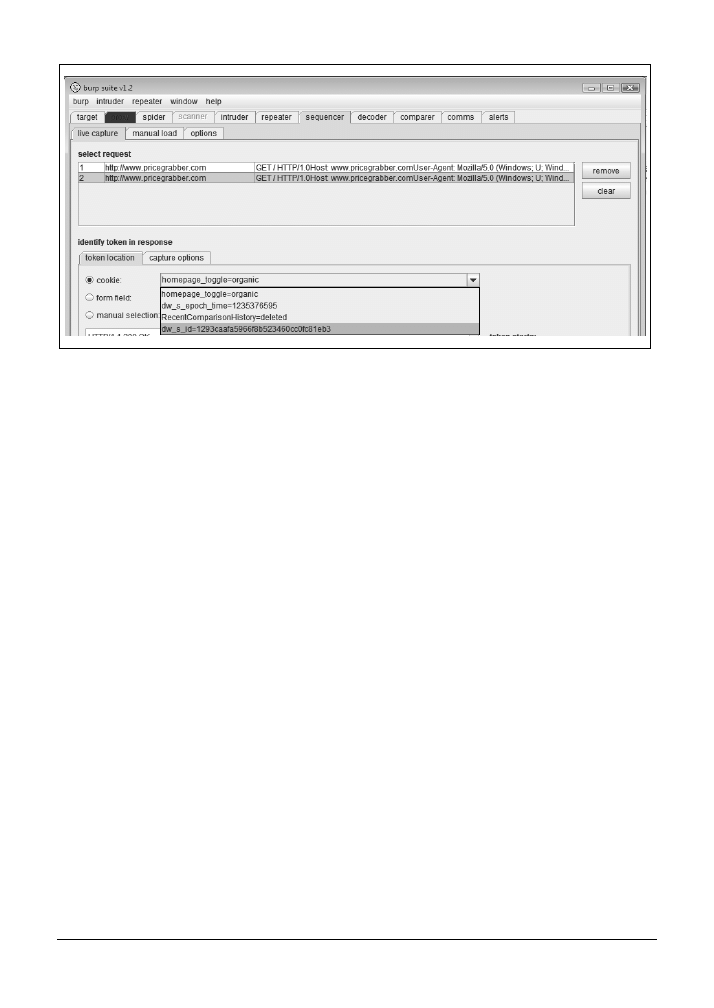

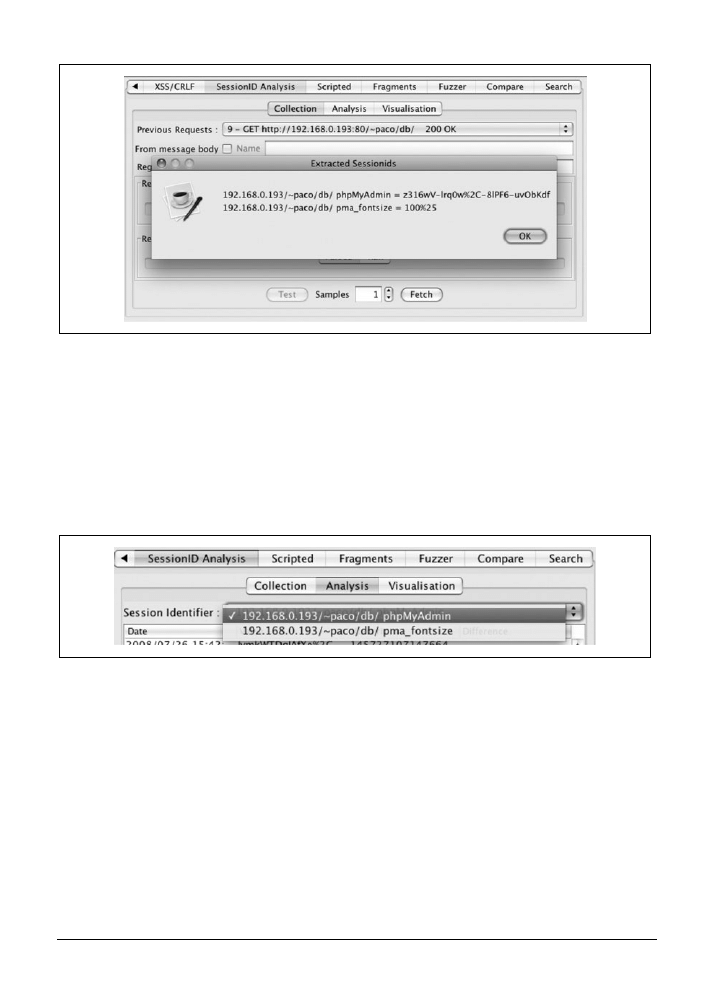

11.5. Analiza identyfikatorów sesji za pomocą programu Burp

256

11.6. Analiza losowości sesji za pomocą programu WebScarab

258

11.7. Zmiany sesji w celu uniknięcia ograniczeń 262

11.8. Podszywanie się pod innego użytkownika 264

11.9. Preparowanie sesji

265

11.10. Testowanie pod kątem podatności na ataki CSRF

266

12. Testy wielostronne ....................................................................................................269

12.1. Wykradanie plików cookie za pomocą ataków XSS

269

12.2. Tworzenie nakładek za pomocą ataków XSS

271

12.3. Tworzenie żądań HTTP za pomocą ataków XSS

273

12.4. Interaktywne wykonywanie ataków XSS bazujących na modelu DOM

274

12.5. Pomijanie ograniczeń długości pola (XSS)

276

12.6. Interaktywne przeprowadzanie ataków XST

277

12.7. Modyfikowanie nagłówka Host

279

12.8. Odgadywanie nazw użytkowników i haseł metodą siłową 281

12.9. Interaktywne przeprowadzanie ataków wstrzykiwania kodu

w instrukcji włączania skryptów PHP

283

12.10. Tworzenie bomb dekompresji

285

12.11. Interaktywne przeprowadzanie ataków wstrzykiwania

poleceń systemu operacyjnego

286

12.12. Systemowe przeprowadzanie ataków wstrzykiwania

poleceń systemu operacyjnego

288

12.13. Interaktywne przeprowadzanie ataków wstrzykiwania instrukcji XPath

291

12.14. Interaktywne przeprowadzanie ataków wstrzykiwania SSI

293

12.15. Systemowe przeprowadzanie ataków wstrzykiwania SSI

294

12.16. Interaktywne przeprowadzanie ataków wstrzykiwania LDAP

296

12.17. Interaktywne przeprowadzanie ataków

wstrzykiwania zapisów w dziennikach

298

Skorowidz ................................................................................................................. 301

10

| Spis treści

11

Słowo wstępne

Aplikacje internetowe bardziej niż aplikacje innego typu są narażone na ataki. Dlaczego tak

się dzieje? Witryny internetowe i aplikacje, które w nich występują, są w pewnym sensie

wirtualnymi drzwiami frontowymi do wszystkich korporacji oraz instytucji. Rozwój, jaki na-

stąpił od 1993 roku, jest zdumiewający. Szybkość rozpowszechniania się internetu jest większa

nawet od szybkości rozpowszechniania się telewizji i elektryczności.

Aplikacje internetowe odgrywają coraz większą rolę w produkcji oprogramowania. Obecnie

wchodzimy już w erę aplikacji Web 3.0 (patrz: http://www.informit.com/articles/article.

aspx?p=1217101

). Problem polega na tym, że zabezpieczenia nie wytrzymują tak wysokiego

tempa. Obecnie mamy tak wiele problemów z zabezpieczaniem aplikacji Web 1.0, że nie za-

częliśmy nawet zastanawiać się nad aplikacjami Web 2.0, nie mówiąc już o Web 3.0.

Zanim przejdę dalej, muszę o czymś powiedzieć. Aplikacje internetowe to ważny, rozwijający

się typ oprogramowania, ale niejedyny rodzaj oprogramowania, jaki istnieje. Biorąc pod

uwagę liczbę tradycyjnych aplikacji, systemów wbudowanych oraz innych kodów używanych

na świecie, zaryzykowałbym nawet stwierdzenie, że aplikacje internetowe stanowią zaledwie

nikły procent całości oprogramowania. Zatem kiedy cała uwaga wszystkich specjalistów

w dziedzinie zabezpieczeń na świecie koncentruje się na aplikacjach internetowych, zaczynam się

obawiać. Istnieje całe mnóstwo innego typu aplikacji, które nie mają nic wspólnego z internetem.

Dlatego właśnie uważam siebie za specjalistę w dziedzinie bezpieczeństwa oprogramowania,

a nie aplikacji internetowych.

Tak czy owak, bezpieczeństwo aplikacji internetowych i innego rodzaju oprogramowania łą-

czy wiele problemów i pułapek (czemu nie należy się dziwić, ponieważ jedna grupa jest

podzbiorem drugiej). Jednym ze wspólnych problemów jest traktowanie bezpieczeństwa jako

funkcji oprogramowania, jako swego rodzaju „wyposażenia”. Bezpieczeństwo nie jest „wy-

posażeniem”. Bezpieczeństwo jest właściwością systemu. Oznacza to, że żadna technologia

uwierzytelniania, wyszukane mechanizmy kryptograficzne lub interfejsy API ws-* architektury

zorientowanej na usługi (Service-oriented Architecture — SOA) nie rozwiążą w magiczny spo-

sób problemów z bezpieczeństwem. Bezpieczeństwo ma znacznie więcej wspólnego z testo-

waniem i zabezpieczeniami niż z czymkolwiek innym.

Otwórzmy tę książkę! Potrzebne są nam odpowiednie miary do testowania zabezpieczeń

aplikacji internetowych! Jak się okazuje, wiele „testów” opracowanych przez ekspertów od

zabezpieczeń jest wykonywanych bez żadnych reguł. Zapomina się o tym, że testowanie jest

dyscypliną naukową, której poświęcono wiele prac. Informacje przedstawione przez Paco i Bena

w tej książce to gruntowna wiedza na temat testowania. W literaturze to rzadkość.

12

|

Słowo wstępne

Kluczowym wymaganiem dla testów, o którym powinny pamiętać wszystkie osoby zajmują-

ce się tą dziedziną, to warunek, aby wyniki testów stanowiły podstawę do działania. W kiep-

skich wynikach testów można spotkać mgliste uwagi w rodzaju: „Problem ataku XSS w pliku

bigjavaglob.java

file”. W jaki sposób programista ma naprawić ten problem? W tym przypad-

ku ewidentnie brakuje sensownego objaśnienia, co to jest XSS (oczywiście chodzi o skrypty

krzyżowe), gdzie w pliku zawierającym tysiące wierszy wystąpił problem oraz co należy

zrobić, aby go rozwiązać. W tej książce zamieszczono wystarczająco dużo technicznych in-

formacji, aby testerzy nauczyli się tworzyć raporty pozwalające na opracowywanie planów

działania przez programistów.

Mam nadzieję, że lekcje zamieszczone w niniejszej książce będą stosowane nie tylko przez

specjalistów od zabezpieczeń, ale także przez testerów aplikacji internetowych. Osobom zaj-

mującym się zapewnianiem jakości oprogramowania powinien spodobać się fakt, że niniejsza

książka jest skierowana wprost do testerów — omówiono w niej pojęcia testów regresji, te-

stów pokrycia i wbudowanych testów jednostkowych. Z mojego doświadczenia wynika, że

osoby zajmujące się testowaniem są znacznie lepsze w testowaniu niż eksperci od zabezpie-

czeń. Jeśli ta książka będzie wykorzystywana prawidłowo, może uczynić ekspertów od za-

bezpieczeń lepszymi testerami, a testerów lepszymi specjalistami od zabezpieczeń.

Inną kluczową własnością tej książki jest skoncentrowanie się na narzędziach i automatyzacji.

Nowocześni testerzy używają narzędzi, podobnie jak nowocześni specjaliści od zabezpieczeń.

W niniejszej książce zamieszczono mnóstwo praktycznych przykładów, z których wiele

można pobrać za darmo z internetu. W rzeczywistości ta książka służy jako przewodnik wła-

ściwego posługiwania się narzędziami, ponieważ wiele narzędzi typu open source opisanych

w tej książce jest pozbawionych wbudowanych podręczników lub przewodników. Jestem fanem

materiałów podręcznych — ta książka doskonale nadaje się do tej roli.

Zbyt optymistyczne podejście do projektowania oprogramowania z pewnością doprowadziło

do chaosu, ale równocześnie umożliwiło nam spojrzenie na oprogramowanie z perspektywy

bezpieczeństwa. Mówiąc prosto, nie myśleliśmy dotąd o tym, co mogłoby się zdarzyć z na-

szym oprogramowaniem, gdyby zostało ono celowo i złośliwie zaatakowane. Napastnicy

pukają do drzwi. Każdego dnia próbują dostać się do naszych aplikacji internetowych.

Bezpieczeństwo oprogramowania to praktyka tworzenia programów bezpiecznych, które

będą działały prawidłowo również w warunkach złośliwych ataków. Niniejsza książka doty-

czy jednej z najważniejszych praktyk związanych z bezpieczeństwem oprogramowania — te-

stowaniem zabezpieczeń.

13

Przedmowa

Aplikacje internetowe są wszędzie — można je spotkać w każdej branży. Od sprzedawców

detalicznych po bankowców, od pracowników działów kadr po hazardzistów — w każdym

zakątku internetu. Od trywialnych blogów osobistych po kluczowe aplikacje finansowe —

wszystko dziś bazuje na jakiejś aplikacji internetowej. Aby skutecznie przenosić aplikacje do

internetu i tworzyć nowe w internecie, musimy umieć je skutecznie testować. Dawno minęły

jednak czasy, kiedy wystarczało testowanie funkcjonalne. Współczesne aplikacje internetowe

podlegają wszechobecnym i coraz poważniejszym zagrożeniom bezpieczeństwa — ze strony

hakerów, pracowników wewnętrznych, przestępców i innych.

Niniejsza książka opowiada o testowaniu aplikacji internetowych ze szczególnym uwzględ-

nieniem zagadnień bezpieczeństwa. Aplikacje internetowe testują programiści, testerzy, ar-

chitekci, menedżerowie jakości i konsultanci. Niezależnie od stosowanych metodologii doty-

czących jakości lub projektowania uwzględnienie bezpieczeństwa w planie testowania wymaga

nowego do niego podejścia. Potrzebne są również specjalistyczne narzędzia umożliwiające testo-

wanie zabezpieczeń. W recepturach zamieszczonych w tej książce będziemy wykorzystywać ho-

mogeniczną naturę aplikacji internetowych. Jeśli tylko będzie to możliwe, będziemy wykorzy-

stywać własności aplikacji internetowych, które są zawsze prawdziwe lub często prawdziwe.

Dzięki temu receptury zamieszczone w niniejszej książce są uniwersalne i sprawdzają się

niemal w każdym przypadku. Co więcej, oznacza to, że będziemy tworzyć uniwersalne na-

rzędzia do testowania, które najprawdopodobniej będą pozwalały na testowanie więcej niż

jednej aplikacji.

Dla kogo jest ta książka?

Niniejsza książka jest przeznaczona dla programistów i testerów, a nie dla specjalistów w dzie-

dzinie zabezpieczeń. W tej książce powinny znaleźć cenne informacje wszystkie osoby zaan-

gażowane w projektowanie aplikacji internetowych. Programiści odpowiedzialni za pisanie

testów jednostkowych tworzonych przez siebie komponentów docenią fakt, iż opisywane na-

rzędzia można precyzyjnie skupić na pojedynczej stronie, własności lub formularzu. Inżynie-

rowie jakości zobowiązani do testowania całych apliacji internetowych szczególnie zaintere-

sują się automatyzacją i opracowaniem przypadków testowych, które z łatwością mogą stać się

częścią zestawów testów regresji. W recepturach zamieszczonych w tej książce w znakomitej

większości wykorzystano narzędzia darmowe, dzięki czemu można je z łatwością zastosować bez

konieczności składania zapotrzebowania zakupu lub inwestowania znacznych sum pieniężnych.

14

|

Przedmowa

Narzędzia, które wybraliśmy do zaprezentowania w tej książce, oraz zadania, które wyznaczyli-

śmy sobie jako receptury do wykonania, są niezależne od platformy. Wynikają stąd dwie

bardzo istotne rzeczy: będą one działały w komputerach czytelników niezależnie od wyko-

rzystywanego środowiska (Windows, Mac OS, Linux itp.) oraz będą działały z dowolną apli-

kacją internetową, niezależnie od technologii, w jakiej ją wykonano. W równym stopniu dotyczy

to ASP, PHP, CGI, Java oraz dowolnych innych technologii internetowych. W niektórych

przypadkach będziemy wykonywać zadania specyficzne dla określonego środowiska, ale

ogólnie rzecz biorąc, będą to dodatki do receptury, a nie główna jej treść. Tak więc czytelni-

kiem tej książki może być każdy programista lub tester posługujący się dowolną platformą

tworzenia aplikacji internetowych. Do studiowania materiału zamieszczonego w tej książce

nie są potrzebne ani specjalne narzędzia (poza darmowymi, które zostały omówione w tej

książce), ani specjalne środowisko.

Darmowe narzędzia

Istnieje wiele darmowych narzędzi, które programista lub tester może wykorzystać do testo-

wania zabezpieczeń podstawowych własności aplikacji. Narzędzia te nie tylko są darmowe,

ale także bardzo elastyczne — można je z łatwością przystosować do indywidualnych wa-

runków. W dziedzinie bezpieczeństwa w większym stopniu niż w większości specjalistycznych

dziedzin zapewniania jakości najlepsze narzędzia zwykle są darmowe. Nawet w dziedzinie

zabezpieczeń sieciowych, gdzie narzędzia komercyjne są dojrzałe i rozbudowane, musiało

upłynąć dużo czasu, zanim narzędzia komercyjne mogły skutecznie konkurować z dostępnymi

od ręki narzędziami darmowymi. Nawet dziś żaden inżynier sieci nie wykonuje swojej pracy

wyłącznie za pomocą narzędzi komercyjnych. Narzędzia darmowe w dalszym ciągu odgrywają

ważną rolę.

Jednak w wielu przypadkach darmowe narzędzia są pozbawione dokumentacji. Jest to jedna

z luk, którą stara się wypełnić niniejsza książka: pokazuje ona, jak skorzystać z narzędzi, o któ-

rych być może słyszeliśmy, a które nie mają dobrej dokumentacji opisującej, w jaki sposób

można je wykorzystać i dlaczego. Wielu programistów i testerów nie korzysta z darmowych

i ogólnie dostępnych narzędzi tylko dlatego, że nie wiedzą, jak można z nich korzystać.

Inną barierą skutecznego testowania aplikacji internetowych za pomocą darmowych narzędzi

jest ogólny brak wiedzy na temat tego, jak można je zastosować w celu przeprowadzenia dobrych

testów zabezpieczeń. Inną rzeczą jest wiedza, że za pomocą programu TamperData można

pominąć testy wykonywane po stronie klienta, a zupełnie inną opracowanie dobrego testu

skryptów krzyżowych, posługując się tym narzędziem. Mamy zamiar nauczyć czytelników

czegoś więcej niż tworzenia dobrych testów aplikacji internetowych — opracowywania przypad-

ków testów bezpieczeństwa oraz wyciągania sensownych wniosków na ich podstawie.

Ważnym powodem skoncentrowania się na darmowych narzędziach są ograniczone środki

budżetowe na narzędzia i szkolenia w wielu firmach zajmujących się projektowaniem aplikacji

internetowych i zapewnianiem jakości. Zamiast kupować drogie licencje wersji demonstracyjnych

narzędzi komercyjnych, mogą one wypróbować receptury zamieszczone w tej książce.

Organizacja

|

15

O okładce

Ptak zaprezentowany na okładce niniejszej książki to orzechówka (Nucifraga columbiana). Jest

on doskonałą maskotką dla procesu testowania zabezpieczeń aplikacji internetowych. Orze-

chówki próbują podważać szyszki sosnowe w celu wydobycia nasion. Ich dzioby są przysto-

sowane do penetrowania wąskich szpar w celu wydobywania z nich pożywienia. Testerzy

zabezpieczeń próbują wykorzystywać specjalistyczne narzędzia w celu wyważania aplikacji

i pobierania z nich prywatnych danych, uzyskiwania dostępu do uprzywilejowanych funkcji

oraz wykonywania działań niepożądanych przez właścicieli. Jednym z celów niniejszej książki

jest zaprezentowanie czytelnikom wielu specjalistycznych narzędzi. Innym jest pokazanie zaka-

marków, w których można znaleźć błędy.

Orzechówki są również znane ze swojej zdolności do zapamiętywania i powracania do różnych

miejsc, w których ukryły pożywienie. Zebrane ziarna przechowują w bardzo wielu kryjów-

kach, do których później powracają, by zaspokoić głód. Nasze operacje testowania aplikacji

pod tym względem także można porównać do działań orzechówek — tworzymy przecież

zestawy testów regresji i rejestrujemy miejsca, w których wcześniej znaleźliśmy słabe punkty

w aplikacjach. Korzystając z narzędzi i technik opisanych w tej książce, będziemy powracać

do problemów znalezionych wcześniej i upewniać się, czy te problemy nie występują także

w tym przypadku.

Więcej informacji na temat gatunku Nucifraga columbiana można znaleźć w serwisie The Birds of

North America Online prowadzonym przez Uniwersytet Cornell pod adresem http://bna.birds.

cornell.edu/bna/

. Więcej informacji na temat testowania zabezpieczeń aplikacji internetowych

można znaleźć w dalszej części niniejszej książki.

Organizacja

Materiał zamieszczony w niniejszej książce podzielono na trzy części. W pierwszej opisano

konfigurację narzędzi oraz zaprezentowano podstawowe pojęcia potrzebne do opracowywa-

nia testów. Druga część koncentruje się na różnych sposobach pomijania mechanizmów

sprawdzania poprawności danych działających po stronie klienta. Robi się to w różnych celach

(ataki SQL Injection, skrypty krzyżowe, manipulowanie ukrytymi polami formularzy itp.).

Ostatnia część opisuje zagadnienia dotyczące sesji — wyszukiwania identyfikatorów sesji,

analizowania możliwości ich przewidywania oraz wykonywania z nimi operacji za pomocą

różnych narzędzi.

Każda receptura ma podobny format — przedstawienie problemu do rozwiązania, wymaga-

ne narzędzia i techniki, procedura testowa i przykłady. Wszystkie receptury mają wspólny,

ogólny cel — powinny być przydatne podczas testowania. Oznacza to, że receptury będą nas

interesować dlatego, że ułatwiają testowanie określonego aspektu zabezpieczeń aplikacji in-

ternetowej.

Ogólnie rzecz biorąc, książkę zorganizowano w taki sposób, aby przechodzić od zadań pod-

stawowych do bardziej złożonych. Każda główna część rozpoczyna się od stosunkowo pro-

stych zadań, a następnie na ich podstawie są opisywane zadania bardziej złożone. Pierwsze

receptury pełnią rolę przykładów naświetlających określony problem — pokazują, co się

16

|

Przedmowa

dzieje w aplikacjach internetowych „za kulisami”. Ostatnie receptury w poszczególnych częściach

łączą wiele bloków budulcowych w złożone zadania, które mogą tworzyć podstawę głów-

nych testów zabezpieczeń aplikacji internetowych.

Część pierwsza: podstawy

Rozpoczniemy od skonfigurowania środowiska testowego. Ta część ma za zadanie zapoznać

czytelników z podstawowymi wiadomościami, które będą wykorzystane w dalszej części

książki. Najpierw trzeba się nauczyć, w jaki sposób należy zainstalować, skonfigurować i przy-

gotować do działania potrzebne narzędzia. Następnie należy zapoznać się z podstawowymi

własnościami aplikacji internetowych, które będziemy wykorzystywać po to, by opisywane

testy można było stosować w jak najszerszym zakresie.

W rozdziale 1., „Wprowadzenie”, zaprezentowaliśmy Czytelnikowi naszą wizję testowania

zabezpieczeń aplikacji oraz przedstawiliśmy, w jakim sensie dotyczy to aplikacji interneto-

wych. W rozdziale tym zaprezentowaliśmy nieco terminologii oraz kilka istotnych pojęć

związanych z testowaniem, do których będziemy odwoływać się w dalszej części książki.

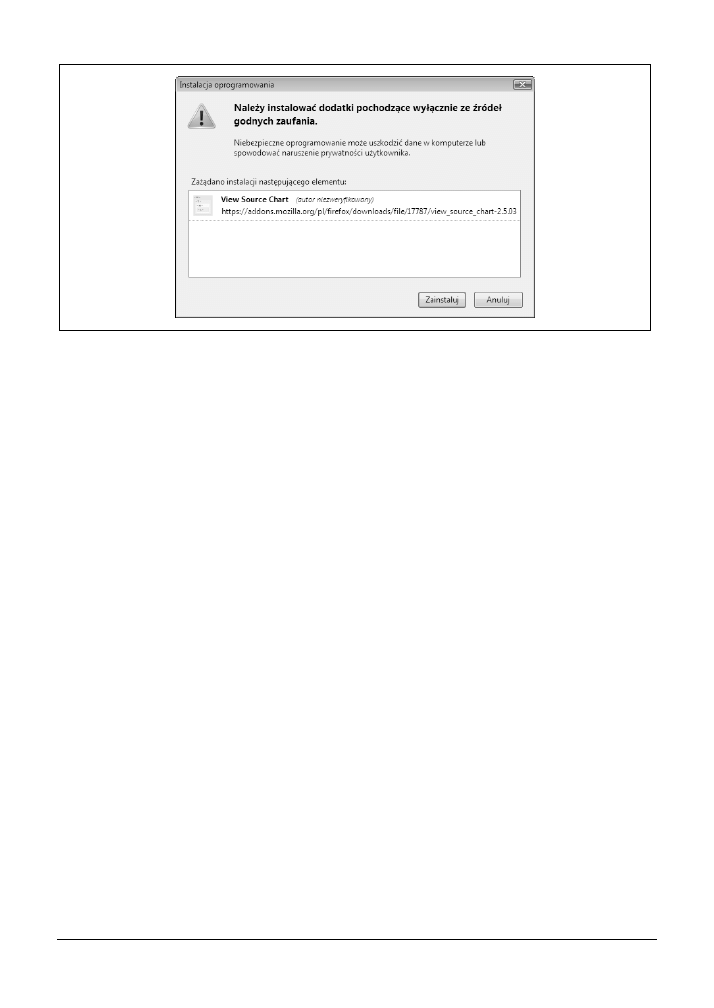

Rozdział 2., „Instalacja darmowych narzędzi”, obejmuje zestaw różnych darmowych narzę-

dzi, które można pobrać z internetu i zainstalować. W opisie każdego z nich zamieszczono

kilka podstawowych instrukcji na temat tego, gdzie je można znaleźć oraz jak się je instaluje

i uruchamia. Narzędzia te wykorzystamy w recepturach zamieszczonych w dalszej części

książki do właściwego przeprowadzania testów zabezpieczeń.

Rozdział 3., „Prosta obserwacja”, uczy podstaw obserwacji aplikacji internetowych oraz te-

stowania własności funkcjonalnych systemu. Te podstawowe pojęcia będą potrzebne do stu-

diowania bardziej zaawansowanych receptur w dalszej części książki.

W rozdziale 4., „Kodowanie danych w internecie”, zaprezentowano sposoby kodowania da-

nych. Trzeba znać różne metody kodowania i dekodowania danych wykorzystywane w aplika-

cjach internetowych. Oprócz kodowania i dekodowania potrzebna jest umiejętność wywnio-

skowania sposobu kodowania danych na podstawie ich fragmentu. W niektórych testach

trzeba dane zdekodować, przetworzyć i ponownie zakodować.

Część druga: techniki testowania

W środkowej części książki zamieszczono opis podstawowych technik testowania. Zapre-

zentujemy tu zarówno ręczne, jak i automatyczne metody skanowania. W rozdziałach za-

mieszczonych w tej części omówiono zarówno narzędzia ogólnego przeznaczenia, jak i na-

rzędzia specjalistyczne służące do realizacji różnych zadań. Poprzez wykorzystanie kilku

narzędzi można przeprowadzać bardziej złożone testy.

W rozdziale 5., „Manipulowanie danymi wejściowymi”, omówiono najważniejszą technikę

podstawową: złośliwe modyfikowanie danych wejściowych. W jaki sposób można przekazać

tego typu dane do aplikacji? Jak można zobaczyć, co się dzieje w przeglądarce i jakie dane są

wysyłane do aplikacji internetowej?

W rozdziale 6., „Automatyzacja masowego skanowania”, zaprezentowano kilka technik i na-

rzędzi skanowania w trybie masowym. Pokażemy w nim, w jaki sposób przeszukuje się aplikację

w celu znalezienia punktów i stron wejściowych, a także zaprezentujemy sposoby przepro-

wadzania testów w trybie wsadowym niektórych specjalistycznych aplikacji.

Organizacja

|

17

W rozdziale 7., „Automatyzacja wybranych zadań z wykorzystaniem cURL”, pokazano

doskonałe narzędzie do tworzenia zautomatyzowanych testów: cURL. Zaprezentujemy w nim

kilka prostych sposobów zlecania grup testów, stopniowego przechodzenia do trudniejszych

zadań takich jak zachowywanie stanu podczas rejestrowania i wykonywania operacji ze znacz-

nikami cookie. Na koniec przejdziemy do złożonego zadania: logowania do serwisu eBay.

Rozdział 8., „Automatyzacja zadań z wykorzystaniem biblioteki LibWWWPerl”, koncentruje

się na języku Perl i bibliotece LibWWWPerl (LWP). Niniejsza książka nie jest o tym, jak pro-

gramuje się w Perlu. W tym rozdziale opisano zbiór specyficznych technik, które można wy-

korzystać wraz z językiem Perl i biblioteką LWP do przeprowadzania interesujących testów

bezpieczeństwa. Należą do nich: przesyłanie wirusów do aplikacji, próby wykorzystania nie-

zwykle długich nazw plików oraz parsowanie odpowiedzi aplikacji. Tę część zakończono

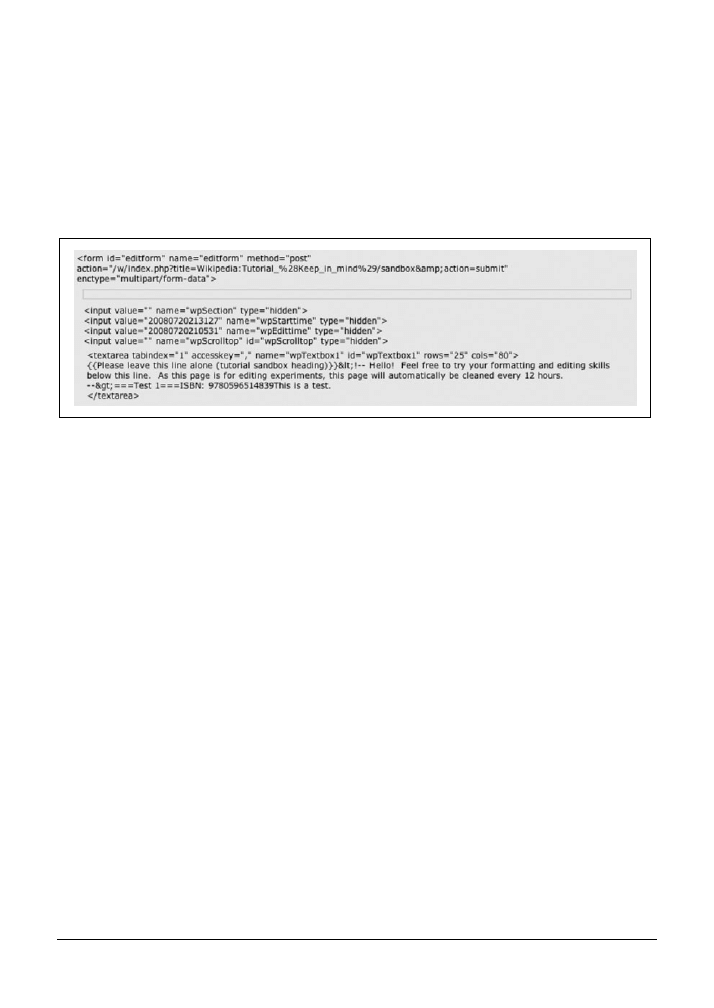

skryptem, który modyfikuje stronę WWW Wikipedii.

Część trzecia: techniki zaawansowane

Techniki zaawansowane zaprezentowane w ostatnich rozdziałach wykorzystują receptu-

ry z wcześniejszej części książki. Połączyliśmy je w taki sposób, aby przeprowadzić dodatkowe

testy lub przetestować te aspekty bezpieczeństwa, które nie były prezentowane we wcze-

śniejszych recepturach.

W rozdziale 9., „Wyszukiwanie wad projektu”, opisano nieumyślne interakcje z aplikacją in-

ternetową oraz sposoby ich wyszukiwania za pomocą dobrych testów zabezpieczeń. Recep-

tury zamieszczone w tym rozdziale koncentrują się na sposobach wykonywania testów za

pomocą programów testujących, których bez użycia specjalistycznych narzędzi nie dałoby się

przeprowadzić. W tej części omówiono takie wady projektu jak przewidywalne identyfikato-

ry, słabą losowość oraz powtarzalne transakcje.

Rozdział 10., „

Ataki przeciwko aplikacjom AJAX”, prezentuje mnóstwo informacji na temat

wyrafinowanych ataków w internecie. Pokazano, jak można je przeprowadzić w uporząd-

kowany sposób w celach testowych, korzystając z technik, z którymi zapoznaliśmy się wcze-

śniej. W rozdziale 10. opisano między innymi takie ataki jak SSI (Server-Side Includes), nad-

używanie instrukcji LDAP oraz tzw. wstrzykiwanie SQL (ang. SQL Injection).

W rozdziale 11., „Manipulowanie sesjami”, skoncentrowaliśmy się na AJAX — technologii,

która zdominowała tzw. aplikacje Web 2.0. Pokazaliśmy, w jaki sposób przyjrzeć się działa-

niu aplikacji AJAX „od kuchni” oraz jak ją można przetestować zarówno ręcznie, jak i „ma-

gicznie”. W recepturach zamieszczonych w tym rozdziale przechwytujemy żądania przeka-

zywane ze strony klienta do testowania logiki po stronie serwera oraz odwrotnie —

testowania kodu działającego po stronie klienta poprzez manipulowanie odpowiedziami

serwera.

Rozdział 12. „Testy wielostronne”, koncentruje się na sesjach, zarządzaniu sesjami oraz spo-

sobach atakowania sesji za pomocą testów bezpieczeństwa. W rozdziale zaprezentowano kilka

receptur, które pokazują sposoby wyszukiwania, analizy i na koniec testowania siły mecha-

nizmów zarządzania sesjami.

18

|

Przedmowa

Konwencje stosowane w książce

Podczas odwoływania się do skryptów lub poleceń w stylu Unix wykorzystano konwencje

typograficzne oraz typowe zasady stosowane w dokumentacji systemu Unix. Podczas od-

woływania się do skryptów lub poleceń w stylu systemu Windows wykorzystano konwencje

typograficzne oraz typowe zasady stosowane w systemie Windows.

Konwencje typograficzne

Zwykły tekst

Zwykłym tekstem zapisano tytuły menu, opcje menu, przyciski menu oraz skróty kla-

wiaturowe (na przykład Alt i Ctrl).

Kursywa

Oznaczono nią nowe terminy lub pojęcia techniczne, wywołania systemowe, adresy URL,

nazwy hostów i adresy e-mail.

Czcionka o stałej szerokości

Wykorzystywana do oznaczania poleceń, opcji, przełączników, zmiennych, atrybutów,

kluczy, funkcji, typów, obiektów, znaczników HTML, makr, zawartości plików, wyniku

poleceń, nazw plików, rozszerzeń plików, nazw ścieżek i katalogów.

Czcionka o stałej szerokości — pogrubiona

Wykorzystywana do oznaczania poleceń lub innego tekstu, który użytkownik powinien

wprowadzić literalnie.

Czcionka o stałej szerokości — kursywa

Wykorzystywana do oznaczania tekstu, który należy zastąpić wartościami wprowadza-

nymi przez użytkownika.

Ta ikona oznacza wskazówkę, sugestię lub ogólną uwagę.

Ta ikona oznacza ostrzeżenie bądź uwagę dotyczącą określonego zagrożenia.

W niektórych miejscach należy zwrócić baczną uwagę na typografię, ponieważ za jej pomocą

rozróżnione są dwa podobne, a jednak różne pojęcia. Na przykład w rozwiązaniach często

podajemy adresy URL. W większości przypadków są one fikcyjne lub mają formę oficjalnego

przykładowego adresu URL w internecie:

. Należy zwrócić uwagę na

różnicę między krojem pisma takiego adresu URL (czcionka o stałej szerokości) a http://ha.

ckers.org/xss.html

— adresu witryny zawierającej wiele przykładów skryptów krzyżowych.

Pierwszy adres URL nie oznacza rzeczywistego serwisu, który można odwiedzić (nie ma ta-

kiej strony). Drugi to przydatny zasób, który powinniśmy zapamiętać.

Wykorzystywanie przykładowego kodu

|

19

Konwencje stosowane w przykładach

W przykładach uruchamiania poleceń można zauważyć dwa różne symbole zachęty. W książce

wykorzystaliśmy tradycyjną konwencję systemu Unix, zgodnie z którą symbol

%

reprezentuje

powłokę zwykłego użytkownika, natomiast

#

reprezentuje powłokę użytkownika root. Pole-

cenia występujące za symbolem zachęty

%

mogą (i prawdopodobnie powinny) być urucha-

miane przez nieuprzywilejowanego użytkownika. Polecenia występujące za symbolem za-

chęty

#

muszą być uruchamiane przez użytkownika z uprawnieniami root. W listingu P2.1

zamieszczono cztery różne polecenia ilustrujące te zasady.

Listing P2.1. Polecenia z różnymi symbolami zachęty

% ls -lo /var/log

% sudo ifconfig lo0 127.0.0.2 netmask 255.255.255.255

# shutdown -r now

C:\> ipconfig /renew /all

Polecenie

ls

zostało uruchomione z uprawnieniami zwykłego użytkownika. Polecenie

ifconfig

uruchomiono z uprawnieniami użytkownika root, ale tylko dlatego, że zwykły

użytkownik skorzystał z polecenia

sudo

w celu czasowego wypromowania swoich upraw-

nień. W ostatnim poleceniu występuje symbol zachęty

#

przy założeniu, że użytkownik na-

był uprawnienia root przed uruchomieniem polecenia

shutdown

.

Zakładamy, że w systemie Windows można w miarę potrzeb uruchomić wiersz poleceń

CMD.EXE

i wykonać polecenia. Polecenie

ipconfig

w listingu P2.1 prezentuje wygląd typowego

polecenia systemu Windows z naszych przykładów.

Wykorzystywanie przykładowego kodu

Celem tej książki jest ułatwienie czytelnikom wykonywania ich pracy. Ogólnie rzecz biorąc,

kod zamieszczony w tej książce można wykorzystywać w programach i dokumentacji. Nie

trzeba prosić o zgodę, chyba że mamy zamiar wykorzystać znaczną część przykładów. Na

przykład napisanie programu, w którym wykorzystano kilka fragmentów kodu z tej książki,

nie wymaga zezwolenia. Z kolei sprzedaż lub dystrybucja płyty CD-ROM z przykładami z książ-

ki wymaga uzyskania zgody. Udzielanie odpowiedzi na pytania poprzez cytowanie tej książki

i przytaczanie przykładowego kodu nie wymaga zezwolenia, natomiast włączanie znaczącej

liczby przykładów kodu z tej książki do dokumentacji własnych produktów wymaga zgody.

Mile widziana, choć nieobowiązkowa, jest wzmianka o źródle wykorzystywanych materiałów.

Powinna ona zawierać tytuł, autora, wydawcę i numer ISBN, na przykład: Paco Hope i Ben

Walther Testowanie bezpieczeństwa aplikacji internetowych. Receptury Copyright 2009 Brian Hope

i Ben Walther, 978-0-596-51483-9.

Aby uzyskać zgodę na wykorzystywanie przykładów kodu w sposób wykraczający poza

ramy określone powyżej, można wysłać e-mail pod adres permissions@oreilly.com.

Przykładowe kody omawiane w książce można pobrać z serwera FTP wydawnictwa Helion,

pod adresem: ftp://ftp.helion.pl/przyklady/tebeap.zip.

20

|

Przedmowa

Podziękowania

Podczas pisania tej książki wiele osób udzieliło nam pomocy. Niektóre z nich włożyły w tę

pomoc wiele wysiłku, natomiast inne udzieliły pomocy, która na pozór jest niewidoczna, choć

miała kluczowe znaczenie. Chcielibyśmy im za to podziękować.

Paco Hope

Żaden człowiek nie żyje w izolacji, a już na pewno nie ja. Ta książka nigdy by nie powstała,

gdyby nie pomoc i inspiracja wielu osób. Przede wszystkim chciałbym podziękować mojej

żonie Rebece, która zarządzała wszystkim, co nie działa pod kontrolą systemu Mac OS (jak

nasze dzieci, dom i zwierzęta). Jest mistrzynią we wprowadzaniu nieprawidłowych danych

wejściowych, obsłudze nieoczekiwanego wyjścia i przepełnień bufora.

Dziękuję zarówno moim kolegom, jak i klientom w firmie Cigital Inc. za wprowadzenie mnie

w zagadnienia bezpieczeństwa oprogramowania, jakości i testowania na bazie oceny ryzyka.

Wielu pracowników firmy Cigital miało znaczący wpływ na sposób mojego podejścia do

bezpieczeństwa i testowania oprogramowania. Oto kilku z nich wymienionych w odwróco-

nym porządku alfabetycznym (ponieważ John zawsze był wymieniany na ostatnim miejscu):

John Steven, Amit Sethi, Penny Parkinson, Jeff Payne, Scott Matsumoto, Gary McGraw i Will

Kruse. Dziękuję Alison Wade i wspaniałym pracownikom firmy Software Quality Engineer-

ing (SQE) za możliwość przemawiania na organizowanych przez nich konferencjach poświę-

conych jakości oprogramowania oraz za sposobność spotkania niezwykłych profesjonalistów

szczerze oddanych swojemu zawodowi. Podziękowanie kieruję również do Bruce’a Pottera,

który pomógł mi zacząć pisać.

Ben Walther

Paco Hope miał wizję, smykałkę, kontakty i był siłą napędową niniejszej książki. Rozdziały,

które czyta się jak powieść? To on je napisał. Dziękuję Ci, Paco, za marchewki i kije — pomoc

w pisaniu i porady techniczne.

Dziękuję moim kolegom z firmy Cigital za wskazówki, naukę i dobry humor — szczególnie

dziękuję za te wszystkie biurowe psoty.

Wreszcie dziękuję wszystkim, którzy czytają tę książkę. Ciągłe czytanie jest jedną z najważ-

niejszych idei w moim życiu. Fakt, że poświęciliście czas na to, by poszerzyć swoją wiedzę,

mówi bardzo wiele o Waszych zasadach osobistych i zawodowych. Zapraszam do rozmowy

i komentowania wszystkiego, co znalazło się w tej książce (zwłaszcza jeśli chcielibyście coś

dodać od siebie). Można wysłać do mnie e-mail na adres root@benwalther.net lub zostawić

komentarz na blogu pod adresem http://blog.benwalther.net.

Nasi korektorzy

Doceniamy wszystkie komentarze otrzymane od korektorów merytorycznych zajmujących

się tą książką. Dzięki ich fachowym poradom i opiniom z całą pewnością ta książka stała się

lepsza. Podziękowania kierujemy do Mike’a Andrewsa, Jeremy’ego Epsteina, Matta Fishera

i Karen N. Johnson.

Podziękowania

|

21

O'Reilly

Na koniec dziękujemy personelowi wydawnictwa O’Reilly — zwłaszcza Mike’owi Loukide-

sowi, Adamowi Witwerowi, Keithowi Fahlgrenowi oraz wielu utalentowanym osobom, które

pomogły w tym, aby ta książka stała się rzeczywistością, Bez wskazówek Adama na temat

sposobu pisania książki technicznej oraz heroizmu Keitha ta książka byłaby zaledwie nic

niewartym zlepkiem jedynek i zer.

22

|

Przedmowa

23

ROZDZIAŁ 1.

Wprowadzenie

Zazwyczaj obecność wprowadzenia świadczy o tym, że jest

coś ważnego do przedstawienia.

— Arthur Machen

Wielu z nas testuje aplikacje internetowe codziennie lub przynajmniej regularnie. Czasami

wykonujemy skrypt interakcji („kliknij tutaj; wpisz XYZ; kliknij Zatwierdź; sprawdź, czy na-

deszła odpowiedź OK…”). Innym razem piszemy szkielet, który wywołuje zestaw testów dla

aplikacji internetowej. Większość z nas jest gdzieś pośrodku. Niezależnie od tego, jak testu-

jemy, musimy zastosować testy zabezpieczeń wykonywanych działań. Testowanie współcze-

snych aplikacji internetowych musi uwzględniać odpowiedzi aplikacji na przypadki aktywnego

używania jej niezgodnie z przeznaczeniem.

W niniejszym rozdziale ustawimy scenę dla przyszłych działań — pokażemy sposób konfiguro-

wania narzędzi i technik, którymi będziemy się posługiwać. Zanim zaczniemy mówić o testowa-

niu zabezpieczeń aplikacji internetowych, zdefiniujemy kilka pojęć: jakie aplikacje mamy na

myśli, kiedy mówimy „aplikacje internetowe”; jakie cechy je wyróżniają i dlaczego piszemy

książki takie jak ta; co mamy na myśli, kiedy mówimy „bezpieczeństwo”; i w ogóle, czym

różnią się testy zabezpieczeń od testów standardowych.

1.1. Co to jest testowanie zabezpieczeń?

Testowanie funkcji aplikacji jest często dosyć proste — należy podążać ścieżkami, którymi

powinni poruszać się zwykli użytkownicy. Kiedy nie jesteśmy pewni, jakie jest oczekiwane

działanie, zwykle możemy to wywnioskować — zapytać kogoś, przeczytać wymagania, skorzy-

stać z intuicji. Testowanie negatywne w naturalny sposób i bezpośrednio wywodzi się z testowa-

nia pozytywnego. Wiemy, że depozyt bankowy nie powinien mieć wartości ujemnej, hasło

nie powinno być plikiem graficznym JPEG o rozmiarze jednego bajta, a numery telefonów

nie powinny zawierać liter. Kiedy testujemy aplikację i budujemy pozytywne testy funkcjo-

nalne, powinniśmy wykonać następny logiczny krok — utworzyć testy negatywne. Co jed-

nak z bezpieczeństwem?

Testowanie zabezpieczeń polega na dostarczeniu dowodu, że aplikacja w wystarczający sposób

wypełnia stawiane przed nią wymagania w obliczu wrogich i złośliwych danych wejściowych.

24

|

Rozdział 1. Wprowadzenie

Dostarczanie dowodu

Podczas testowania zabezpieczeń bierzemy pod uwagę cały zestaw niedopuszczalnych da-

nych wejściowych (jest ich nieskończenie wiele) i koncentrujemy się na takim podzbiorze

tych danych wejściowych, dla którego istnieje prawdopodobieństwo powstania znaczącego

naruszenia wymagań bezpieczeństwa naszej aplikacji — w dalszym ciągu jest to bardzo ob-

szerny zbiór. Musimy określić, jakie są wymagania bezpieczeństwa, i zdecydować, jakiego

rodzaju testy dostarczą dowodów, że te wymagania zostały spełnione. Nie jest to łatwe, ale

przy zachowaniu logiki i odpowiedniej dokładności możemy dostarczyć przydatnych dowo-

dów właścicielowi produktu.

Dowodów spełnienia wymagań bezpieczeństwa dostarczymy w taki sam sposób, w jaki do-

starczamy dowodów spełnienia wymagań funkcjonalnych. Ustalimy dane wejściowe, okre-

ślimy spodziewane wyniki, a następnie stworzymy i uruchomimy testy mające na celu

sprawdzenie systemu. Z naszych doświadczeń wynika, że dla testerów nieznających zagad-

nień testowania zabezpieczeń, pierwszy i ostatni krok jest najtrudniejszy. Wymyślanie da-

nych wejściowych zagrażających bezpieczeństwu oraz testowanie oprogramowania są naj-

trudniejsze. W większości przypadków ustalanie spodziewanych wyników jest dość proste.

Jeśli zapytam menedżera produktu: „Czy niezalogowany użytkownik powinien mieć możliwość

pobierania poufnych danych”, zazwyczaj natychmiast usłyszę odpowiedź: „Nie”. Trudnym

elementem podczas dostarczania dowodów jest określenie danych wejściowych, które mogą

spowodować niepożądaną sytuację, a następnie sprawdzenie, czy wprowadzenie tych danych

spowodowało taką sytuację.

Spełnianie wymagań

Zgodnie ze standardem ANSI/IEEE numer 729 inżynierii oprogramowania wymaganie to waru-

nek lub zdolność potrzebna użytkownikowi do rozwiązania problemu lub osiągnięcia celu lub jako

warunek bądź zdolność, która musi być spełniona lub osiągnięta przez system… w celu wypełnienia kon-

traktu, standardu, specyfikacji lub innego dokumentu formalnego

. Wszyscy testerzy testują zgodność

z wymaganiami, jeśli mają dostępne wymagania. Nawet jeśli wymagania nie są dostępne w for-

mie dokumentu pełnego zdań „oprogramowanie powinno…”, testerzy oprogramowania zwykle

ustalają konsensus dotyczący prawidłowego zachowania, a następnie kodyfikują go w testach

w postaci oczekiwanych wyników.

Testowanie zabezpieczeń przypomina testowanie własności funkcjonalnych, ponieważ w taki

sam sposób zależy od właściwego zrozumienie tego, „o jakie zachowanie oprogramowania

nam chodzi”. Dyskusyjny pogląd o tym, że testowanie zabezpieczeń bardziej zależy od wy-

magań w porównaniu z testowaniem własności funkcjonalnych wynika stąd, że w przypad-

ku testowania zabezpieczeń trzeba zbadać większy zbiór potencjalnych danych wejściowych

i wyników. Zachowania aplikacji związane z bezpieczeństwem wydają się być gorzej zdefi-

niowane w umysłach osób tworzących wymagania, ponieważ większa część oprogramowa-

nia to nie są programy bezpieczne. Program ma inny podstawowy cel. Bezpieczeństwo nie

jest wymogiem funkcjonalnym, który musi być spełniony. W związku ze słabszą koncentracją

na zagadnieniach bezpieczeństwa często brakuje wymagań dotyczących zabezpieczeń lub są

one niepełne.

Co z postulatem wystarczającego spełnienia wymagań? Ponieważ bezpieczeństwo podlega

przeobrażeniom i zazwyczaj nie jest to podstawowa funkcja aplikacji, nie zawsze decyduje-

my się na jakieś rozwiązanie właśnie dlatego, że jest ono bardziej bezpieczne. Rzeczywiste

1.1. Co to jest testowanie zabezpieczeń?

|

25

bezpieczeństwo aplikacji jest związane z zarządzaniem ryzykiem. Powinniśmy zapewnić wy-

starczające bezpieczeństwo oprogramowania zgodne z wymogami danego przedsięwzięcia.

Czasami puryści w dziedzinie zabezpieczeń mogą sugerować, że oprogramowanie nie jest

wystarczająco bezpieczne. Jeśli tylko jego poziom bezpieczeństwa satysfakcjonuje właściciela

firmy — w przypadku, gdy zdaje on sobie sprawę z zagrożeń i jest w pełni świadom tego, na

co się decyduje — to oprogramowanie jest wystarczająco bezpieczne. Testowanie zabezpie-

czeń dostarcza dowodów i wiedzy potrzebnej do tego, aby można było podjąć świadomą decyzję

co do tego, jakie ryzyko jest do zaakceptowania.

Testowanie zabezpieczeń to więcej niż testowanie

Bezpieczeństwo jest podróżą, a nie celem. Nigdy nie osiągniemy punktu, w którym będziemy

mogli zadeklarować, że oprogramowanie jest bezpieczne, a nasza misja zakończona. Kiedy

przeprowadzamy testy własności funkcjonalnych, zazwyczaj dysponujemy oczekiwanymi, ak-

ceptowalnymi danymi wejściowymi, które powodują wygenerowanie znanych, oczekiwa-

nych wyników. W przypadku bezpieczeństwa nie mamy takiej pewności co do oczekiwań.

Wyobraźmy sobie, że testujemy wymaganie następującej postaci: „funkcja

convertIntTo

´

Roman(int)

zwraca ciąg prawidłowej liczby rzymskiej dla wszystkich dodatnich liczb cał-

kowitych do wartości

MAXINT

”. Gdybyśmy przeprowadzali wyłącznie testy funkcjonalne,

wystarczyłoby przekazać do funkcji wartość „

5

” i sprawdzić, czy w odpowiedzi funkcja

zwróciła „

V

”. W przypadku testowania wartości granicznych sprawdzilibyśmy takie ele-

menty jak maksymalne wartości dla liczb całkowitych

0

,

–1

itp. Sprawdzilibyśmy, czy aplika-

cja w prawidłowy sposób obsługuje wyjątki — na przykład czy w odpowiedzi na argument

„

–5

” nie zwraca „

–V

”, tylko odpowiednio sformatowany komunikat o błędzie. Na koniec

podczas testowania wyjątków skorzystalibyśmy z relacji równoważności, aby upewnić się,

czy w odpowiedzi na nieprawidłowy argument — na przykład 3,42 — funkcja nie zwraca

„

III.IVII

”. Oprócz tego należałoby sprawdzić, czy w odpowiedzi na dowolny ciąg znaków

— na przykład „widelec” — jest zwracany właściwy komunikat o błędzie.

Testowanie zabezpieczeń wykracza jednak poza te ramy. Wymaga zrozumienia dziedziny

problemu i utworzenia nieprawidłowych danych wejściowych. Na przykład trudnym argu-

mentem wejściowym dla funkcji zwracającej liczbę w postaci rzymskiej jest liczba złożona

z wielu dziewiątek i czwórek (na przykład 9494949494). Ponieważ funkcja wymaga użycia reku-

rencji lub odwołań do poprzedniej liczby rzymskiej, może doprowadzić do powstania głębo-

kiego stosu w programie lub znacznego zużycia pamięci. To więcej niż warunek graniczny.

Kiedy przeprowadzamy testy zabezpieczeń na bazie testów funkcjonalnych, powinniśmy

dodać wiele przypadków testowych. Oznacza to, że musimy wykonać dwie rzeczy, aby te-

stowanie było możliwe do wykonania: skupić uwagę i zautomatyzować działania.

Każdy, kto zna tematykę systemowego testowania oprogramowania, rozumie pojęcia warto-

ści granicznych oraz podziału klas równoważności. Nie wchodząc zbyt głęboko w standardową

literaturę dotyczącą testowania, spróbujmy przybliżyć te dwa pojęcia. Są one bardzo ważne,

ponieważ w dużej części testowanie zabezpieczeń aplikacji internetowych jest przeprowa-

dzane zgodnie z modelem właściwym dla testowania funkcjonalnego. Po zapoznaniu się z pod-

stawowymi procesami testowania na ich bazie z łatwością zorganizujemy nasze testy za-

bezpieczeń.

26

|

Rozdział 1. Wprowadzenie

Wartości graniczne

W testach wartości granicznych bierze się pod uwagę określony argument wejściowy i bardzo

dokładnie testuje jego dopuszczalne wartości graniczne. Na przykład jeśli argument wejściowy

ma być liczbą całkowitą reprezentującą procent — od 0 do 100 — to można wyznaczyć na-

stępujące wartości graniczne: –1, 0, 1, 37, 99, 100, 101. W celu stworzenia przypadków gra-

nicznych skoncentrujemy się na dwóch wartościach z początku i końca przedziału (0 i 100).

Dla każdej z wartości granicznych wykorzystamy tę wartość oraz wartość o jeden mniejszą

i o jeden większą. W celu stworzenia właściwego punktu odniesienia wybierzemy wartość ze

środka przedziału, która powinna zachowywać się prawidłowo. Jest to przypadek bazowy.

Klasy równoważności

Próbując wyznaczyć negatywne wartości do testów, powinniśmy pamiętać, że zbiór niedopusz-

czalnych danych wejściowych jest nieskończony. Zamiast testowania obszernego zbioru danych

wejściowych tworzymy ich strategiczną próbkę. Dzielimy nieskończony zbiór na grupy o pew-

nych wspólnych cechach — klasy równoważności — a następnie wybieramy po kilka próbek

z każdej takiej grupy.

W przykładzie z punktu „Wartości graniczne” należałoby wybrać kilka klas nieprawidło-

wych danych wejściowych i je wypróbować. Można wyznaczyć takie klasy jak liczby ujemne,

bardzo duże liczby dodatnie, ciągi znaków złożone z liter, liczby zmiennoprzecinkowe oraz

kilka wartości specjalnych, na przykład

MAXINT

. Zazwyczaj wybiera się niewielką liczbę

wartości — na przykład po dwie — z każdej klasy i dodaje się je do zbioru danych wejścio-

wych.

Klasy bezpieczeństwa

Siedem wartości granicznych wyznaczonych w punkcie „Wartości graniczne” oraz po dwie

wartości z dziewięciu klas równoważności z punktu „Klasy równoważności” ograniczają

zbiór przypadków testowych dla negatywnych danych z nieskończoności do 25. To dobry

punkt wyjścia. Teraz możemy rozpocząć dodawanie przypadków testowania bezpieczeństwa

na podstawie znanych ataków i słabych punktów. W ten sposób testy zabezpieczeń mogą

stać się wspólną częścią codziennego testowania własności funkcjonalnych. Wybraliśmy spe-

cjalne wartości graniczne mające znaczenie dla bezpieczeństwa oraz specjalne klasy równo-

ważności i włączyliśmy je do planowania testów oraz procesu strategii testowych.

Istnieje kilka powszechnie rozpoznawanych klas danych wejściowych powiązanych z bezpie-

czeństwem: ciągi ataków SQL Injection, skryptów krzyżowych oraz zakodowane wersje in-

nych klas (omówiono je odpowiednio w recepturach 5.8 i 12.1 oraz w rozdziale 4.). Na przy-

kład możemy zakodować niektóre ciągi ataków za pomocą kodowania Base64 lub URL-encode

po to, by przejść przez procedury sprawdzania poprawności danych niektórych aplikacji. Teraz,

w odróżnieniu od wartości granicznych oraz innych klas równoważności, te klasy zabezpie-

czeń są właściwie nieskończone. A zatem ponownie wybieramy strategiczne próbki tak, by

stworzyły one zbiór umożliwiający zarządzanie. W przypadku kodowania możemy wybrać

trzy bądź cztery ciągi. Powoduje to zwiększenie liczności zbioru danych testowych trzy lub

nawet czterokrotnie — 25 wartości testowych zamienia się na 75 lub 100. Istnieją sposoby

obejścia tego problemu, ponieważ zastosowanie kodowania w systemie kończy się porażką

lub powodzeniem. Jeśli system ulega awarii, gdy zastosujemy kodowanie URL-encode dla

wartości

–1

, prawdopodobnie awaria nastąpi również wtedy, kiedy zastosujemy kodowanie

1.2. Czym są aplikacje internetowe?

|

27

URL-encode dla wartości

101

. Tak więc dla niektórych wartości możemy zastosować kodo-

wanie Base64, dla innych URL-encode, dla jeszcze innych HTML-encode lub ultiply-encode.

Dzięki temu uzyskujemy pokrycie dla przypadków testowych bez czterokrotnego powięk-

szania rozmiarów zbioru danych testowych. W tej sytuacji zbiór co najwyżej się podwoi (będzie

zawierał pięćdziesiąt przypadków testowych).

Należy teraz dobrać ciągi ataków typu SQL Injection oraz skryptów krzyżowych (Cross Site

Scripting

). Trzeba zachować ostrożność i wybrać rozsądny podzbiór danych — taki, który

uda się opracować w czasie, jaki mamy do dyspozycji. Jeśli pracujemy nad fragmentem sys-

temu łatwym do automatyzacji, możemy wykonać dziesiątki przypadków testowych w każ-

dej klasie. Jeżeli wykonujemy testy ręcznie, powinniśmy raczej utworzyć długą listę ciągów

ataków i próbować różnych ciągów przy kolejnych testach. W ten sposób, chociaż nie przete-

stujemy wszystkich ciągów w każdym uruchomieniu testu, w efekcie prześledzimy wiele

różnych przypadków.

1.2. Czym są aplikacje internetowe?

Aplikacje internetowe występują w wielu różnych kształtach i rozmiarach. Są pisane we wszyst-

kich typach języków, działają we wszystkich systemach operacyjnych i zachowują się w każdy

możliwy do wyobrażenia sposób. Zasadniczą cechą wszystkich aplikacji internetowych jest fakt,

że wszystkie ich funkcje są obsługiwane za pośrednictwem protokołu HTTP, a wyniki za-

zwyczaj są formatowane w języku HTML. Dane wejściowe są przekazywane za pomocą

metod

GET

,

POST

oraz podobnych sposobów. Spróbujmy przyjrzeć się szczegółowo wszyst-

kim tym elementom.

SSL i HTTPS

Ponieważ mówimy o bezpieczeństwie, musimy powiedzieć kilka słów o kryptografii. Nie-

którzy czytelnicy pewnie zastanawiają się, jaki wpływ na testowanie ma szyfrowanie SSL

(Secure Sockets Layer), TLS (Transport Layer Security) lub innego rodzaju szyfrowanie podob-

nego typu. Krótka odpowiedź brzmi: niewielkie. Szyfrowanie zabezpiecza jedynie kanał,

przez który odbywa się konwersacja. Zabezpiecza komunikację przed podsłuchaniem i może

pomóc w sformułowaniu pewnych twierdzeń na temat komputerów, które komunikują się

ze sobą. My zajmujemy się testowaniem oprogramowania, które działa na jednym z końców

tego zaszyfrowanego kanału komunikacyjnego. Jedyna różnica pomiędzy HTTP i HTTPS

polega na tym, że zainicjowanie połączenia HTTPS wiąże się z dodatkową konfiguracją.

Najpierw negocjowany jest bezpieczny kanał, a następnie przez ten kanał jest przesyłany

zwykły ruch HTTP. Jak się przekonamy, jedyną rzeczą, którą robi się inaczej podczas testo-

wania aplikacji HTTPS, jest wprowadzenie dodatkowego argumentu wiersza polecenia lub

opcji konfiguracyjnej programu testującego. Samo testowanie nie zmienia się tak bardzo.

Według naszej definicji aplikacja internetowa to dowolne oprogramowanie, które komuni-

kuje się z użytkownikami za pośrednictwem protokołu HTTP. Brzmi to jak bardzo ogólna

definicja i rzeczywiście tak jest. Techniki prezentowane w tej książce dotyczą dowolnej tech-

nologii bazującej na HTTP. Zwróćmy uwagę, że serwer WWW, który dostarcza statycznych

stron WWW, nie pasuje do naszej definicji. W tym przypadku nie ma oprogramowania. Jeśli

użytkownik przechodzi do takiego samego adresu URL, otrzymuje dokładnie ten sam wynik.

28

|

Rozdział 1. Wprowadzenie

W wyniku przesłania żądania nie jest wykonywany żaden program. Aby można było mówić

o aplikacji internetowej, musi zadziałać jakiś rodzaj kodu obsługi reguł biznesu (skrypt, pro-

gram, makra — cokolwiek). Musi również występować jakiś rodzaj potencjalnej zmienności

wyniku. Muszą być podejmowane jakieś decyzje. W innym przypadku nie może być mowy o te-

stowaniu oprogramowania.

Istnieje kilka innych klas programów pasujących do definicji „aplikacji internetowych”, które

tylko pobieżnie omówimy w tej książce. Są to usługi sieciowe oraz obszerne platformy pro-

gramowe korzystające z tych usług — tzn. aplikacje w architekturze SOA. To ważna grupa,

ale jest to szeroka klasa aplikacji, które zasługują na osobną książkę. Istnieją również specjali-

styczne standardy B2B (Business to Business) lub EDI (Electronic Data Interchange) bazujące na

HTTP. Tej dziedziny również nie będziemy omawiać. Wystarczy powiedzieć, że techniki opi-

sane w tej książce mogą stanowić podstawę także do testowania tych aplikacji, ale testy za-

bezpieczeń ukierunkowane na problemy technologii B2B, SOA, EDI są bardziej właściwe od

ogólnych testów zabezpieczeń aplikacji internetowych.

Terminologia

Abyśmy mogli precyzyjnie odnieść się do omawianej tematyki, przedstawimy definicje kilku

pojęć, którymi będziemy się posługiwać. Podczas ich omawiania postaramy się zachować

normy obowiązujące w branży.

Serwer

System komputerowy, który nasłuchuje połączeń HTTP. W systemie serwera zwykle

działa oprogramowanie (na przykład Apache lub Microsoft IIS), które obsługuje te połą-

czenia.

Klient

Komputer lub program, który nawiązuje połączenie z serwerem i żąda od niego danych.

Oprogramowaniem klienckim zwykle jest przeglądarka, choć istnieje wiele innych pro-

gramów kierujących żądania do serwera. Na przykład żądania HTTP może wysyłać

odtwarzacz animacji Flash firmy Adobe, a także aplikacje Javy, program Acrobat Reader

oraz większość innego oprogramowania. Jeżeli po uruchomieniu programu zobaczymy

komunikat: „Istnieje nowa wersja tego programu”, zwykle oznacza to, że program wysłał

do serwera żądanie HTTP w celu sprawdzenia, czy jest dostępna nowa wersja. Podczas

testowania warto pamiętać, że przeglądarki WWW to tylko jeden z wielu typów progra-

mów, które wysyłają żądania HTTP.

Żądanie

Żądanie opisuje informacje interesujące klienta. Żądania składają się z kilku elementów,

których definicje zamieścimy poniżej: adresu URL, parametrów oraz metadanych wystę-

pujących w postaci nagłówków.

URL

Adres URL (Universal Resource Locator) — dosłownie: uniwersalny wskaźnik zasobu —

jest specjalnym typem identyfikatora URI (Universal Resource Identifier) — uniwersalnego

identyfikatora zasobu. URL wskazuje na lokalizację obiektu, który próbujemy przetwa-

rzać za pośrednictwem protokołu HTTP. Adresy URL zawierają protokół (dla naszych

celów będziemy wykorzystywali tylko http i https). Za protokołem występuje standardo-

wy ciąg (://), który oddziela nazwę protokołu od pozostałej części lokalizacji. Dalej jest

1.2. Czym są aplikacje internetowe?

|

29

opcjonalny identyfikator użytkownika, opcjonalny dwukropek i opcjonalne hasło. Za ni-

mi występuje nazwa serwera, z którym nawiązujemy łączność. Za nazwą serwera jest

ścieżka do zasobu na tym serwerze. Adres URL może zawierać opcjonalne parametry.

Na koniec można wykorzystać symbol krzyżyka (#) w celu odwołania do wewnętrznego

fragmentu lub kotwicy wewnątrz treści strony. Przykład pełnego adresu URL zawierają-

cego wszystkie elementy opcjonalne zamieszczono w listingu 1.1.

Listing 1.1. Przykładowy adres URL zawierający wszystkie elementy opcjonalne

http://fred:wilma@www.example.com/private.asp?dok=3&czesc=4#stopka

W adresie URL pokazanym w listingu 1.1 występuje użytkownik o identyfikatorze

fred

,

posługujący się hasłem

wilma

. Dane te są przekazywane na serwer

serwera kierowane jest żądanie o dostarczenie zasobu

/private.asp

i przekazywany jest

parametr o nazwie

dok

i wartości

3

oraz parametr

czesc

o wartości

4

. Adres zawiera

odwołanie do wewnętrznej kotwicy (fragmentu) o nazwie

stopka

.

Parametr

Parametr to para klucz – wartość zawierająca znak równości (

=

) pomiędzy kluczem a warto-

ścią. Adres URL może zawierać wiele takich par. Poszczególne parametry są oddzielone

od siebie znakiem ampersand (

&

). Parametry można przekazywać za pomocą adresu

URL (tak jak pokazano w listingu 1.1) lub w treści żądania (tak jak pokażemy później).

Metoda

Każde żądanie do serwera wykorzystuje jedną z kilku typów metod. Dwie najbardziej

popularne to

GET

i

POST

. Jeśli użytkownik wpisuje adres URL w przeglądarce WWW i naci-

ska Enter lub jeśli klika na łącze, to w rzeczywistości wydaje żądanie

GET

. W większości

przypadków, kiedy klikamy na przycisk w formularzu lub wykonujemy stosunkowo

złożoną operację jak na przykład wgrywanie grafiki na serwer, wykonujemy żądanie

POST

. Istnieją również inne metody (na przykład

PROPFIND

,

OPTIONS

,

PUT

,

DELETE

), które

są wykorzystywane głównie w protokole DAV (Distributed Authoring and Versioning). W tej

książce nie będziemy się zbytnio zajmować tymi metodami.

Rozróżnianie wielkich i małych liter w adresach URL

Choć jest to dość zaskakujące, w niektórych elementach adresu URL wielkość liter ma zna-

czenie (tzn. litery wielkie znaczą coś innego niż małe), natomiast w innych nie. O tej własno-

ści należy pamiętać podczas testowania. W przykładzie zamieszczonym w listingu 1.1 można

zauważyć wiele miejsc, w których wielkość liter ma znaczenie, wiele innych, w których nie

ma żadnego znaczenia, oraz takie, w których nie można tego stwierdzić.

W identyfikatorze protokołu (w naszym przykładzie

http

) wielkość liter nie ma znaczenia.

Można tu wpisać

HTTP

,

http

,

hTtP

lub cokolwiek innego. Niezależnie od sposobu zapisu,

adres URL zadziała. To samo dotyczy protokołu HTTPS. Obowiązują identyczne zasady.

W identyfikatorze użytkownika i haśle (w naszym przykładzie

fred

i

wilma

) wielkość liter

prawdopodobnie ma znaczenie. Zależy to od oprogramowania serwera, który może rozróż-

niać wielkość liter albo nie. Może to również zależeć od samej aplikacji. Trudno to stwierdzić

na pierwszy rzut oka. Można jednak mieć pewność, że przeglądarka lub inny klient prześle

je dokładnie w taki sposób, w jaki zostaną wpisane.

30

|

Rozdział 1. Wprowadzenie

W nazwie serwera (w naszym przykładzie

) wielkość liter nigdy nie ma

znaczenia. Dlaczego? Jest to nazwa serwera w systemie DNS (Domain Name System), w któ-

rym wielkość liter jest nieważna. Równie dobrze można wpisać

wWw.eXamplE.coM

lub wy-

korzystać dowolną inną kombinację wielkich i małych liter. Powinno działać niezależnie od

pisowni.

W sekcji definiującej zasób wielkość liter nie zawsze ma znaczenie. My zażądaliśmy pliku

/private.asp

. Ponieważ ASP jest rozszerzeniem systemu Windows, sugeruje to, że przesyłamy

żądanie do systemu Windows. Z reguły w serwerach Windowsa wielkość liter nie ma znaczenia,

zatem zapis

/PRIvate.aSP

także powinien zadziałać. W systemach uniksowych z serwerem

Apache wielkość liter prawie zawsze ma znaczenie. Nie ma jednak ściśle obowiązujących

reguł, zatem każdy przypadek należy indywidualnie sprawdzać.

W parametrach również może być różnie. Parametry są przekazywane do aplikacji, a w aplika-

cjach wielkość liter może, choć nie musi, mieć znaczenie. Aby się tego dowiedzieć, należy

przeprowadzić odpowiednie testy.

Podstawowe informacje o HTTP

Istnieje wiele zasobów, które definiują i opisują protokół HTTP. Elementarne wiadomości

można znaleźć w artykule Wikipedii (http://en.wikipedia.org/wiki/HTTP). Oficjalna definicja

protokołu znajduje się w dokumencie RFC 2616 (http://tools.ietf.org/html/rfc2616). Dla naszych

celów opiszemy kilka kluczowych pojęć, które mają istotne znaczenie dla wykorzystywanych

metod testowania.

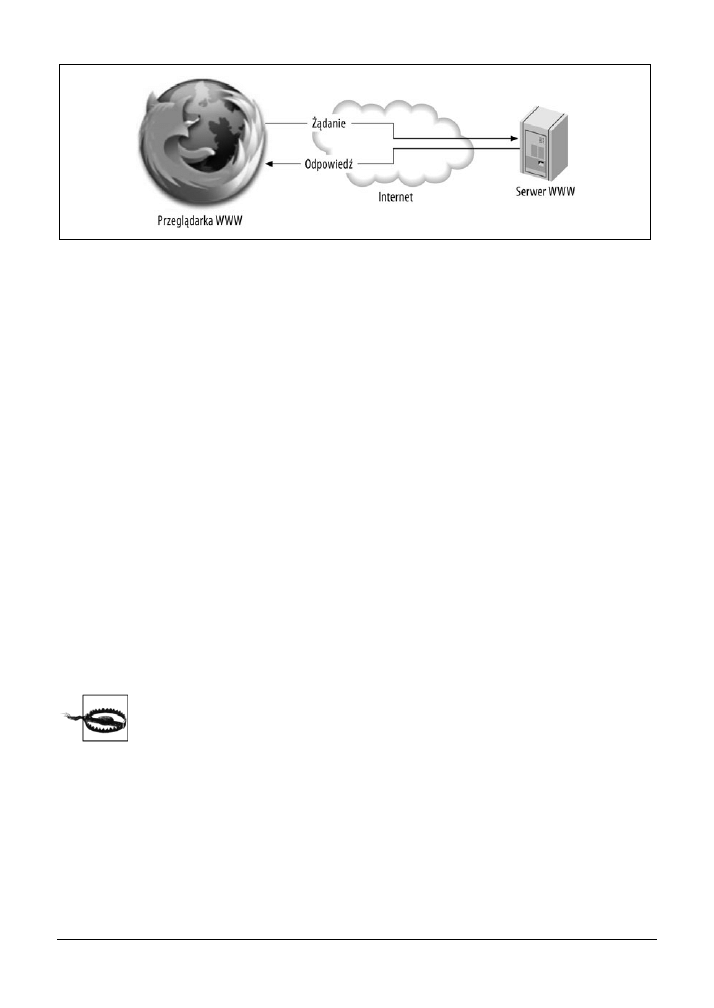

HTTP jest protokołem klient-serwer

Jak jasno stwierdziliśmy w punkcie dotyczącym terminologii, klienty przesyłają żądania, a serwe-

ry na nie odpowiadają. Nie może być inaczej. Serwer nie ma możliwości stwierdzenia, że

„taki a taki komputer potrzebuje danych; połączę się z nim i mu je prześlę”. Jeśli kiedykol-

wiek zaobserwujemy działanie, w którym serwer nagle wyświetla jakieś informacje (jeśli nic

nie klikaliśmy i nie żądaliśmy jawnie żadnych informacji), jest to zazwyczaj sygnał obecności

nieznanych własności stworzonych przez programistę aplikacji. Takie klienty jak przeglądarki

WWW oraz aplety Flash można zaprogramować w taki sposób, aby odpytywały serwer co okre-

ślony przedział czasu lub o wyznaczonych porach. Dla testera oznacza to, że możemy skupić

się na testowaniu klienckiej strony aplikacji — emulować działania klienta i oceniać odpo-

wiedzi serwera.

HTTP jest protokołem bezstanowym

W samym protokole HTTP nie istnieje pojęcie stanu. Oznacza to, że wybrane połączenie nie

ma związku z żadnym innym połączeniem. Jeśli teraz klikniemy na łącze, a następnie na inne

łącze za dziesięć minut (lub nawet za sekundę), serwer nie będzie miał żadnej informacji o tym,

że te dwa żądania zostały przesłane przez tę samą osobę. W aplikacjach przeprowadzany jest

szereg operacji w celu ustalenia, kto wykonuje jakie działania. Należy zdać sobie sprawę z tego,

że to aplikacja zarządza sesją i określa, czy dane połączenie jest powiązane z innym. Protokół

HTTP sam w sobie nie jest w stanie jawnie określić takiej relacji.

1.3. Podstawowe pojęcia dotyczące aplikacji internetowych

|

31

A co z adresem IP? Czyż nie identyfikuje on połączenia w sposób unikatowy i czy dzięki

niemu serwer nie może stwierdzić, że wszystkie połączenia z jednego adresu IP są ze sobą

powiązane? Odpowiedź brzmi: „Nie”. Pomyślmy tylko o wielu domownikach posiadających

własne komputery, ale jedno łącze z internetem (na przykład szerokopasmowe połączenie

kablowe lub połączenie DSL). To łącze ma tylko jeden adres IP, a urządzenia w sieci (routery)

wykorzystują sztuczkę, która nazywa się NAT (ang. Network Address Translation — translacja

adresów sieciowych) w celu ukrycia informacji o tym, ile komputerów korzysta z tego samego

adresu IP.

Co z plikami cookie? Czy za ich pomocą można śledzić sesje i stany? Tak, w większości przy-

padków są one wykorzystywane w tym celu. Ponieważ pliki cookie są tak często wykorzy-

stywane do śledzenia informacji o sesjach i stanach, stają się one centralnym punktem testo-

wania. Jak przekonamy się w rozdziale 11., niepowodzenia w prawidłowym śledzeniu sesji

i stanów są główną przyczyną wielu problemów bezpieczeństwa.

HTTP jest protokołem tekstowym

Możemy zajrzeć do komunikatów przesyłanych w łączu i zobaczyć, co się z nimi dzieje.

Przechwytywanie komunikacji HTTP jest bardzo łatwe. Jest ona bardzo łatwa do zinterpre-

towania przez ludzi. Co ważniejsze, ponieważ jest ona tak prosta, bardzo łatwo zasymulo-

wać żądania HTTP. Bez trudu można zasymulować żądania każdego klienta. Niezależnie od

tego, czy jest to przeglądarka WWW, odtwarzacz animacji Flash, czytnik PDF lub dowolny

inny klient. W rzeczywistości cała niniejsza książka sprowadza się do wykorzystywania nie-

standardowych klientów (narzędzi testowania) bądź też standardowych klientów (przeglądarki

WWW) w niestandardowy sposób (z wykorzystaniem wtyczek do testowania).

1.3. Podstawowe pojęcia dotyczące

aplikacji internetowych

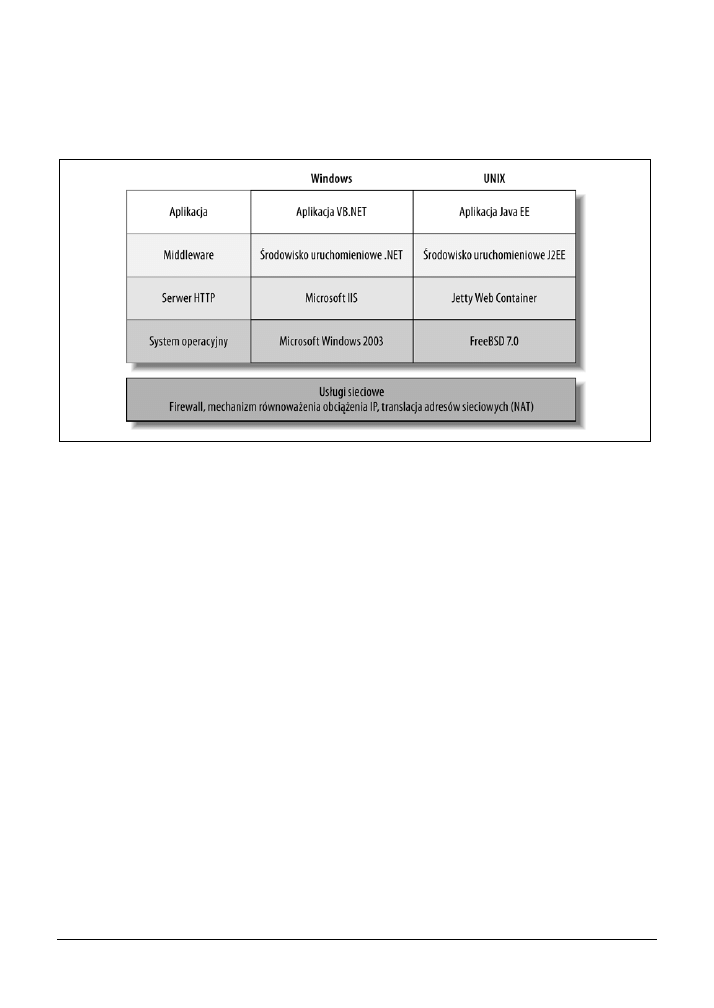

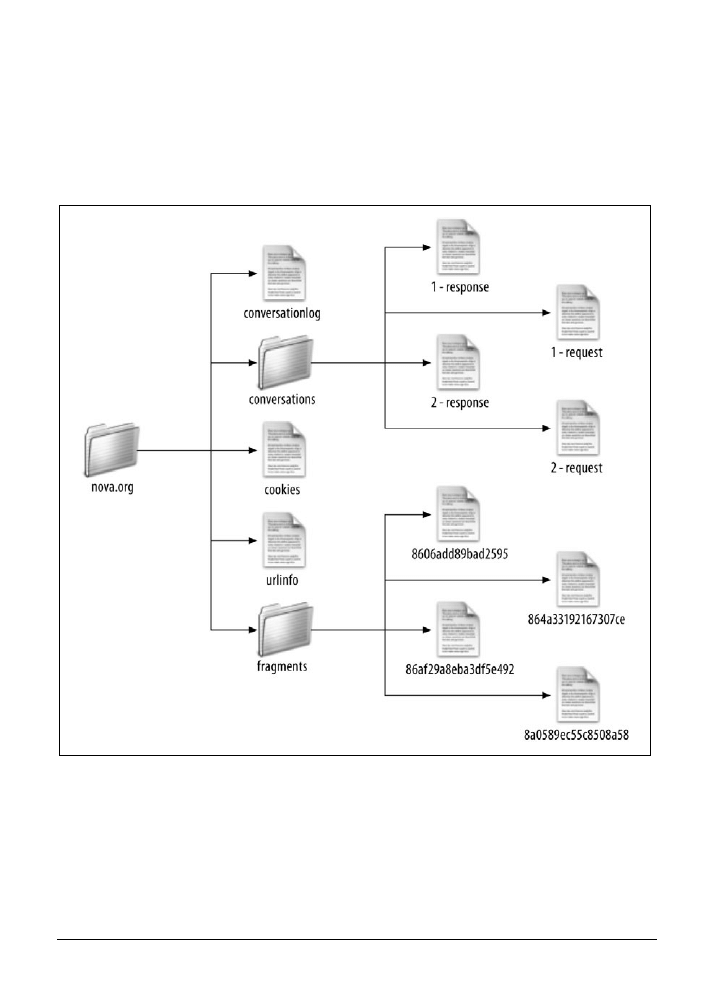

Bloki budulcowe

Aplikacje internetowe (czyli zgodnie z naszą definicją „programy korzystające z protokołu

HTTP”) występują w wielu różnych kształtach i rozmiarach. Może to być pojedynczy serwer