PRZESYŁANIE DANYCH NA ODLEGŁOŚĆ

HISTORIA

Telegraf, czyli pierwsze elektryczne urządzenie do przesyłania informacji na odległość, wykorzystywał technikę cyfrową. Wynaleziony później telefon przesyłał dźwięki w postaci sygnałów analogowych.

Do stworzenia prostego, elektrycznego systemu sygnałowego potrzeba zaledwie paru elementów. Aby przesłać sygnał po kablu należy dysponować baterią oraz wyłącznikiem. Do odebrania sygnału wystarczą elektromagnes i igła magnetyczna. Prąd elektryczny, przepływając przez elektromagnes, indukuje pole magnetyczne, które odpycha igłę kompasu. Problem może stanowić jednak opracowanie całego systemu, dzięki któremu informacje mogłyby być łatwo kodowane przez nadawcę, przesyłane i szybko interpretowane przez odbiorcę.

Telegraf Wheatstone'a

Pierwszy telegraficzny system przesyłania informacji stworzyli w 1837 roku dwaj Anglicy, Charles Wheatstone i William Cooke. Odbiornik telegraficzny ich pomysłu składał się z pięciu igieł magnetycznych, umieszczonych na planszy z wypisanymi literami alfabetu. Nadawany sygnał dwie z igieł, które wskazywały na jedną z liter. Dwa lata później Wheatstone opracował system dwuigłowy, w którym numer odchylanej igły oraz kierunek wychylenia jednoznacznie wskazywał nadawaną literę. Do nadawania i interpretacji sygnałów potrzeba było wykwalifikowanych i zręcznych operatorów, lecz ten system był wprowadzony do użytku, jako że wymagał niewielkiej ilości drutu. W 1840 roku wynalazca zbudował tak zwany telegraf „ABC”, w którym elektromagnes uruchamiał mechanizm zegarowy obracający tarczą z literami. Operator czekał, aż w okienku pojawi się żądana litera i wtedy nadawał sygnał, który był odbierany, gdy na urządzeni pojawiała się ta sama litera.

Telegraf Morse'a

W czasie, gdy Wheatstone i Cooke budowali telegraf w Anglii, w Stanach Zjednoczonych eksperymentował z podobnym urządzeniem malarz Samuel Morse. Jego pomysł polegał na tym, by każdą literę zaszyfrować w postaci kombinacji krótkich i długich sygnałów. Sygnały przesyłane po drucie, naciskając w odpowiedni sposób przełącznik, zwany kluczem. Odbiornik rejestrował sygnały na papierowej taśmie pod postacią kresek i kropek, które następnie należało odczytać. Szyfr ten zyskał sobie wkrótce nazwę alfabetu Morse'a.

Z początku operatorów szkolono w odczytywaniu szyfru taśm papierowych, lecz w praktyce operatorzy byli w stanie łatwo odczytać treść przekazu, wsłuchując się w trzaski wydawane przez odbiornik przy zapisywaniu taśmy. Zmieniono, więc formę odbiornika, wprowadzając proste urządzenie zwane stukawaką, które wydawało wyraźnie różne dźwięki, gdy żelazna sztabka była przyciągana i puszczana przez elektromagnes. W ten sposób ułatwiono identyfikację początku i końca każdego sygnału, co czyniło rozszyfrowanie wiadomości jeszcze prostszym.

Gdy telegraf rozpowszechnił się, problemem stały się opóźnienia, wynikające z konieczności oczekiwania, aż zwolni się linia. Mimo wzrastającej szybko ilości linii telegraficznych, należało znaleźć sposób na szybkie, efektywne przesyłanie informacji. Rozwiązanie znalazł znany już nam Anglik Charles Wheatstone.

Jego pomysł był bardzo prosty. Operator kodował wiadomość w alfabecie Morse'a na maszynie, która perforowała w odpowiedni sposób taśmę papierową. Następnie taśm była przepuszczana z dużą prędkością przez specjalny nadajnik, który przypisywał otworom w taśmie sygnały elektryczne. Po drugiej stronie linii inny aparat odczytywał nadawane sygnały i zapisywał je w postaci kropek i kresek na papierowej taśmie. Zautomatyzowanie nadawanie i odbioru sygnałów pozwoliło na przesyłanie paruset słów w ciągu minuty, podczas gdy sprawny i dobrze wyszkolony operator był w stanie nadać w tym czasie do 30 słów. Efekt był taki, że w tym samym czasie można było nadać tym samym kablem znacznie więcej wiadomości.

Z początku operatorzy musieli znać alfabet Morse'a, lecz już wkrótce wiadomości były kodowane automatycznie. Wystukiwano wiadomość na klawiaturze przypominającej maszynę do pisania, która sama zmieniała ją na układ kropek i kresek. Z drugiej strony maszyna odbiorcza także dokonywała konwersji z alfabetu Morse'a na normalne litery i wypisywała wiadomość na papierowej taśmie w postaci ciągu liter. Teraz należało tylko odpowiednio ją pociąć na pojedyncze wyrazy, nakleić na formularz i dostarczyć do adresata. Z tego typu aparatów wyewoluowały dalekopisy, te jednak, zamiast alfabetu Morse'a, używają specjalnego, zoptymalizowanego systemu kodowania.

Telefon

W 1876 roku Aleksander Grahama Bell jako pierwszy opatentował urządzenie, za pomocą, którego można przesyłać na odległość mowę. W mikrofonie jego telefonu fale dźwiękowe padały na giętką membranę, do której przymocowano magnes stały. Membrana z magnesem wibrowały, co dzięki zjawisku indukcji elektromagnetycznej, powodowało wytworzenie w znajdującej się tuż obok cewce zmiennego prądu, którego natężenie odpowiadało zmianom ciśnienia fali akustycznej. Ten prąd przesyłano kablem do odbiornika, czyli słuchawki, gdzie przechodził przez uzwojenie elektromagnesu. Zmiany prądu powodowały zmienne pole magnetyczne, w którym wibrowała ferromagnetyczna membrana, odtwarzając oryginalny dźwięk. Bellowski nadajnik wytwarzał jedynie słaby sygnał i nie było wówczas metody jego wzmocnienia. Znacznie lepszy efekt uzyskał amerykański wynalazca, Thomas Alva Edison. W 1878 roku ulepszył urządzenie Bella, wprowadzając mikrofon węglowy, w którym drgania membrany pobudzonej falą akustyczną powodowały zmianę ciśnienia działającego na pojemnik wypełniony granulatem węglowym. Zmiany ciśnienia były przyczyną zmian oporu elektrycznego pojemnika, który był włączony w obwód zasilany z baterii. Dzięki temu natężenie prądu płynącego w obwodzie było modulowane zgodnie ze zmianami ciśnienia powietrza, wytwarzanymi przez falę akustyczną. Odbiornik-słuchawka był prawie identyczny jak ten w oryginalnym rozwiązaniu Bella.

Aż do niedawna większość aparatów telefonicznych była wyposażona w mikrofony węglowe. Od niedawna większość telefonów ma mikrofony pojemnościowe, których mikrofon zawiera pewien stały ładunek elektryczny. Pozwalają one uzyskać znacznie lepszy stosunek sygnału do szumu, a przez to lepszą jakość odtwarzanego dźwięku.

Telefon bezprzewodowy

Niemiecki wynalazca Heinrich Rudolf Hertz, odkrył fale, które po emisji mogły by wychwycone przez ustawiony w pewnej odległości odbiornik. Kilka lat później, Guglielmo Marconi przesłał te fale na odległość kilkunastu kilometrów i nazwał je radiem. Szybko zaczęły pojawiać się pierwsze propozycje wykorzystania właściwości odkrytych fal radiowych. Jedną z rozważanych możliwości, już w roku 1891, było uruchomienie telefonii bezprzewodowej (ATS1). Pierwsze opracowane aplikacje używane były do celów komunikacji morskiej. Na początku wszystkie tego typu nowości były przyjmowane bardzo niechętnie, jednak po katastrofie Titanica zainteresowanie komunikacją zarówno między statkami na morzu, jak między statkiem i portem wzrosło bardzo gwałtownie. Wkrótce doceniono również możliwość komunikacji między pojazdami poruszającymi się po lądzie. Pierwsze eksperymenty

w tej dziedzinie przeprowadzono w roku 1921 w departamencie policji w Detroit. Polegały one na rozsyłaniu komunikatów radiowych, które odbierane były przez urządzenia znajdujące się w samochodach policji. Była to komunikacja jednokierunkowa, przypominająca trochę dzisiejsze systemy przywoławcze. Pierwszy, sprawnie działający, jednokierunkowy, ruchomy system radiowy oficjalnie uruchomiono 7 kwietnia 1928 roku. Dwa lata później wprowadzono system umożliwiający komunikację w dwóch kierunkach. Od tego czasu następuje gwałtowny rozwój podobnych systemów w wielu miastach Stanów Zjednoczonych. W roku 1934 istniały już 134 policyjne systemy radiowe. Kolejny ważny krok w pracach nad rozwojem komunikacji radiowej uczyniony został w roku 1935, kiedy to Edwin H. Armstrong zastosował do transmisji fal radiowych modulację częstotliwości (FM - ang. frequency modulation). W porównaniu ze stosowaną wcześniej modulacją amplitudy (AM - ang. amplitude modulation), FM wymagała znacznie mniej mocy,

a także była bardziej odporna na pojawiające się poprzednio problemy związane

z propagacją. Te i inne zalety przyczyniły się do tego, że bardzo szybko większość istniejących systemów zmieniono na systemy FM. Wraz z wybuchem drugiej wojny pojawiło się zapotrzebowanie na systemy, które umożliwiałyby komunikację między jednostkami biorącymi udział w walkach. Bardzo szybko skonstruowano wiele odbiorników i nadajników służących komunikacji ruchomej, robiąc jednocześnie olbrzymie postępy w pracach nad ich funkcjonowaniem i budową. Pod koniec wojny większość statków, samolotów, a nawet czołgów wyposażona była w swoje własne systemy komunikacyjne. Radiowe urządzenia komunikacyjne zaczęły być produkowane na szeroką skalę. Tym samym otwarta została droga dla rozwoju prawdziwego rynku komunikacji ruchomej. Tuż po wojnie, w Stanach Zjednoczonych zaczęto z powodzeniem wprowadzać systemy ruchome do takich sektorów, jak: policja, straż pożarna, energetyka, sieci wodociągowe i gazowe oraz transport. W 1946 roku, w St. Louis, nastąpiło połączenie sieci telefonii ruchomej ze stałą siecią telefoniczną. Nowe usługi zaczęto udostępniać coraz większej liczbie abonentów. Połączenia między stacją ruchomą i siecią stałą były w pierwszych systemach zestawiane ręcznie. Sytuacja taka utrzymywała się przez kilka lat, mimo opracowania systemu całkowicie zautomatyzowanego. W pierwszych systemach stosowany był jeden nadajnik o dużej mocy, który swym zasięgiem obejmował obszar o promieniu 40-50 mil. Szybko zorientowano się, że rozwiązanie korzystające z jednego nadajnika bardzo ogranicza pojemność systemu. Na potrzeby komunikacji ruchomej całego miasta można było wykorzystać zaledwie kilka kanałów. Zapotrzebowanie było znacznie większe, dlatego naukowcy bardzo szybko podjęli prace nad doskonalszymi rozwiązaniami. W końcu lat czterdziestych w laboratorium Bella pojawiła się koncepcja telefonii komórkowej.

Rozwój telefonii komórkowej

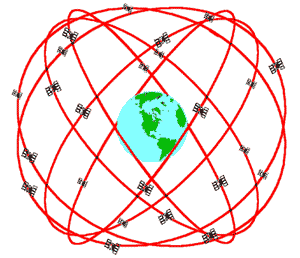

Nowe rozwiązanie pozwalało na zwiększenie pojemności systemu poprzez podział całości obszaru na mniejsze części zwane komórkami, które obsługiwane były przez nadajniki małej mocy. Na obszarze podzielonym w ten sposób możliwe stało się wielokrotne wykorzystanie tej samej częstotliwości w różnych komórkach, a tym samym zwiększenie liczby obsługiwanych stacji. Niemożliwe było użycie tych samych częstotliwości w komórkach sąsiadujących ze sobą, gdyż prowadziło to do tzw. interferencji współkanałowych, które wywoływały zakłócenia i uniemożliwiały osiągnięcie wymaganej jakości usługi. Okazało się, że występowanie interferencji jest uzależnione nie od odległości między komórkami wykorzystującymi tą samą częstotliwość, a od stosunku odległości do promienia komórek. Ponieważ promień komórki zależy od mocy użytego nadajnika, stosunek odległości do promienia mógł być regulowany przez inżynierów systemu. Inżynierowie pracujący nad rozwojem sieci komórkowej, wiedząc, że zmniejszanie rozmiarów komórek prowadzi do zwiększania pojemności systemu, zakładali teoretycznie możliwość budowy sieci składającej się z kilku tysięcy komórek, która mogłaby obsługiwać nawet milion użytkowników.

Budowa takiej sieci od samego początku byłaby niezmiernie kosztowna, dlatego zdecydowano się na konstrukcję systemu, dzieląc obszar na kilka dużych komórek, które z czasem miały być dzielone na coraz to mniejsze. Technika ta oferowała wiele korzyści, pozwalając na rozwój systemu w czasie i zwiększanie liczby użytkowników wraz ze wzrostem zainteresowania. W czasie prac nad nowym systemem pojawił się jeszcze jeden problem związany z przemieszczaniem się użytkowników z obszaru jednej komórki na obszar drugiej. Przy niewielkich rozmiarach komórek zmiany takie dokonywały się bardzo szybko, zwłaszcza w przypadku użytkowników korzystających z samochodów. Aby przejście z jednej komórki do drugiej nie miało wpływu na ciągłość transmisji, opracowano technikę przełączania kanałów (ang. hand-off). System komórkowy miał być wyposażony w centralne urządzenie kontrolujące stan połączeń w sieci, a także w systemie komutacji przełączający połączenia na obszar działania innego nadajnika. Wymagało to opracowania jeszcze kilku technik kontrolujących aktualne położenie stacji ruchomej. Nie było z tym zbyt wiele problemów i w roku 1947 prace nad pierwszą propozycją systemu telefonii komórkowej zostały zakończone. Mimo że pierwsza propozycja telefonii komórkowej pojawiła się już w końcu lat czterdziestych, na uruchomienie pierwszych systemów musiano poczekać jeszcze około 3 lata. Utworzenie sprawnie działającej sieci komórkowej wymagało przydziału nowych częstotliwości, którą to decyzję podjęto

w Stanach Zjednoczonych dopiero w latach sześćdziesiątych. Następne lata to okres standaryzacji oraz wielu regulacji prawnych związanych z wprowadzeniem nowych systemów, które na szerszą skalę zaczęły się pojawiać w latach osiemdziesiątych.

W Stanach Zjednoczonych był to system AMPS (ang. Advanced Mobile Phone Service), a w Europie: skandynawski system NMT (ang. Nordic Mobile Telephone System), europejska wersja AMPS nazwana TACS (ang. Total Access Communications System) oraz dwie mniej znane architektury: francuska R2000

i niemiecka C-450. Systemy te były systemami analogowymi i określa się je dzisiaj mianem systemów pierwszej generacji. Od chwili wprowadzenia, tempo, w jakim wzrastała ich popularność, było zaskoczeniem dla wielu ekspertów. W krótkim czasie z 2 usług w samej tylko Europie korzystały setki tysięcy abonentów. Rosnąca bardzo szybko liczba użytkowników sprawiła, że pojemność systemów analogowych zaczęła się wyczerpywać już w latach osiemdziesiątych. Pojawiła się również potrzeba opracowania ogólnoeuropejskiego systemu komórkowego. Istniejące systemy pierwszej generacji działały zupełnie niezależnie od siebie, co uniemożliwiało komunikację między abonentami dwóch różnych systemów. Problem ograniczonej pojemności sieci analogowych, a także potrzeba istnienia systemu działającego na terenie całej Europy dały początek opracowaniom nowego systemu.

Cyfrowy system telefonii komórkowej - GSM

W 1982 roku CEPT (Conference Europeenne des Administrations des Postes et des Telecommunications) widząc potrzebę ogólnoeuropejskiego standardu dla usług komunikacyjnych, zlecił opracowanie rekomendacji nowego systemu. Opracowaniem tym zajęła się grupa "Group Special Mobile, która wkrótce zarezerwowała dla przyszłego systemu dwa przedziały częstotliwości w paśmie 900 MHz. Główne założenia poczynione zostały do roku 1986. Widząc wielkie możliwości, jakie niesie ze sobą technika cyfrowa, zadecydowano, że nowy standard będzie całkowicie cyfrowy. Dawało to możliwość lepszego wykorzystania pasma radiowego, a tak że uzyskania zdecydowanie wyższej jakości transmisji. System cyfrowy umożliwia również realizację usług nieznanych w systemach analogowych oraz gwarantuje swoim użytkownikom większe bezpieczeństwo. Podjęto także decyzję, że nowy system będzie kompatybilny z siecią ISDN5. Założono, że do konstrukcji stacji ruchomych, w tym terminali kieszonkowych, zastosowane będą układy scalone VLSI6. Dzięki temu nowe terminale mogły być mniejsze i tańsze niż stacje stosowane do tej pory. We wrześniu 1987 roku powołano porozumienie przyszłych operatorów systemu, którego zadaniem miał być nadzór nad standaryzacją, opracowanie zasad taryfikacji oraz planowanie wprowadzenia usług. Ustalono wówczas termin uruchomienia systemu na lipiec 1991 roku. Mimo że podstawowa wersja systemu - nazwanego GSM (ang. Global System for Mobile communications) była gotowa już

w roku 1989, planowane wcześniej uruchomienie systemu opóźniło się. Przyczyną był brak opracowanych na czas testów homologacyjnych, służących do testowania elementów sieci GSM. Pierwszy system GSM został zaprezentowany na targach TELECOM w Genewie w październiku 1991 roku, a pierwsze komercyjne systemy uruchomiono w roku 1992. Od tej chwili popularność systemu rośnie

w oszałamiającym tempie. W 1993 roku istniało 36 sieci GSM w 22 krajach. W chwili obecnej jest już ponad 120 operatorów GSM w 70 krajach. Pomyślany jako system ogólnoeuropejski, GSM staje się praktycznie systemem ogólnoświatowym. 25 krajów spoza Europy kupiło lub nosi się z zamiarem jego kupna (m.in. Australia, USA, RPA, Rosja). Szacuje się, że do końca bieżącego roku z usług nowego systemu korzystać będzie co najmniej 10 milionów abonentów. W roku 1996 dwóch operatorów otrzymało licencje na uruchomienie sieci GSM w Polsce. Niezależnie od GSM na świecie istnieją jeszcze dwa cyfrowe systemy telefonii komórkowej: w USA system IS-95 i w Japonii system JDC (ang. Japanese Digital Cellular).

Telefonia komórkowa w Polsce

W naszym kraju pierwszy telefon komórkowy zaczął funkcjonować w roku 1992. Rok wcześniej, w lutym, rozstrzygnięto przetarg na budować polskiej sieci komórkowej. Wygrały go dwie znane firmy: Ameritech i France Telecom. Wspólnie z polskim partnerem, TP S.A., utworzyły one w październiku 1991 roku spółkę PTK Centertel Sp. z o.o., która została operatorem systemu telefonii komórkowej w Polsce. Dnia 28 grudnia 1991 otrzymała ona zezwolenie telekomunikacyjne upoważniające do zakładania i używania urządzeń sieci radiokomunikacji ruchomej oraz do świadczenia za ich pomocą usług. Systemem stosowanym w Polsce jest wspomniany wcześniej skandynawski system NMT, a dokładniej jego ulepszona wersja NMT 450i. Oficjalne uruchomienie tego systemu nastąpiło w Warszawie w czerwcu 1992, a w grudniu tego samego roku na terenie innych większych miast, między innymi Krakowa, Łodzi, Poznania, Szczecina i innych. Bardzo szybko łączność komórkowa pokryła 65 proc. powierzchni kraju, w tym wszystkie duże miasta i tereny wokół dróg i pomiędzy nimi. W maju 1995 roku liczba abonentów przekroczyła 50 tysięcy, a w chwili obecnej wynosi już ona przeszło 250 tysięcy użytkowników. Procentowy przyrost liczby abonentów od listopada 1994 r. do maja 1995 r. wyniósł w naszym kraju 112 % i był jednym z najwyższych w krajach Europy Środkowej i Wschodniej.

Rozwój radiokomunikacji ruchomej jest związany z łącznością typu komórkowego, przeznaczoną do obsługi abonentów ruchomych i stacjonarnych zarówno w systemach analogowych - opartych na emisji analogowych sygnałów radiowych, jak i bardziej nowoczesnych systemach cyfrowych (cyfrowy przekaz głosu i danych).

Wprowadzenie znormalizowanych systemów cyfrowych drugiej generacji (GSM/DCS) o zasięgu globalnym usuwa tę podstawową niedogodność dla abonenta, zmniejszając równocześnie zakres zajmowanego pasma częstotliwości. Systemy cyfrowe klasy GSM są oznaczone i normalizowane regionalnie: w Europie jako GSM 900 w paśmie 900 MHz oraz DCS 1800 w paśmie 1800 MHz, w Ameryce Północnej D-AMPS (Digital AMPS) oraz nowszy PCS 1900 (Personal Communication System), w Japonii PDC (Personal Digital Communication).

PRZEWODOWE PRZESYŁANIE DANYCH

SIEĆ TELEFONICZNA

Abonenci połączeni są ze sobą dzięki sieci telefonicznej, której głównym elementem są centrale. Pierwsza centralę telefoniczna uruchomiono, w 1878 roku, w stanie Connecticut w USA. Z początku połączenia byłe realizowane ręcznie przez operatorów. Pierwsza centrala automatyczna powstała w 1892 roku w stanie Indiana. Sygnały elektryczne wysyłane przez specjalny mechanizm wybierający dołączany do telefonu, uruchamiały przełączniki magnetyczne, które wybierały odpowiednie połączenie.

W nowoczesnym telefonie numer wybierany jest naciskając przyciski. Naciśnięcie przycisku powoduje wysłanie do centrali serii tonów, które ta rozpoznaje. Po podaniu całego numeru, połączenie jest realizowane. Dzisiaj telefony są zaledwie cząstką ogromnie rozbudowanej sieci telekomunikacyjnej. Połączenie wykonuje się nie tylko za pomocą tradycyjnych kabli, ale również światłowodami, poprzez fale radiowe, albo za pośrednictwem satelity, za pomocą wiązki mikrofalowej. Z sieci tej korzystają także komputery. Siecią telefoniczną, używając również zamiast normalnego telefonu telefaksu, faksu i poczty elektronicznej (e-mail), można przesłać dowolną informację w dowolnej formie do dowolnego miejsca na Ziemi, pod warunkiem że będzie tam ktoś dysponujący odpowiednim aparatem odbiorczym podłączonym do sieci.

Modem

Ogólna zasada działania tego urządzenia jest trochę podobna do transmisji radiowej. Zarówno przy transmisji modemowej, jak i w radiu, występuje pewien ciągły sygnał (tzw. nośna), który jest odpowiednio zmieniany (modulowany) w rytm przesyłania danych. Jak wiadomo, parametrami fali są: amplituda, częstotliwość i faza (przesunięcie fazowe). Za pomocą zmian, czyli modulacji każdego z tych parametrów nośnej, można zakodować informację. W radiu na falach ultrakrótkich stosuję się modulację częstotliwości, w skrócie FM (ang. Frequency Modulation), a w pozostałych pasmach - modulację amplitudy, w skrócie AM (ang. Amplitude Modulation). Często w przypadku przesyłania danych cyfrowych, a więc gdy występują tylko dwa dozwolone poziomy, słowo "modulacja" zamienia się słowem "kluczowanie" (ang. Shift Keying). W modemach (tych starszych) wykorzystywane były zarówno kluczowanie częstotliwości (FSK - ang. Frequency Shift Keying) jak i fazy (PSK - ang. Phase Shift Keying), a w nowszych rozwiązaniach stosuje się jednoczesną modulację fazy i amplitudy , zwaną modulacją kwadraturowo-amplitudową, w skrócie QAM (ang. Quadrature Amplitude Modulation). Do prawidłowego przesyłania informacji nie. wystarczy sama modulacja, ważne jest także samo przygotowanie danych do transmisji. Polega ono na zastąpieniu pewnych ciągów bitów innymi, łatwiejszymi do rozróżnienia, a operację tą realizuje układ zwany skramblerem, zaś powrotną zamianę po odbiorze - deskrambler. Począwszy od modemów V.32 zaczęto stosować kodowanie nadmiarowe za pomocą kodów TCM (ang. Trellis Coded Modulation. Kodowanie nadmiarowe polega na zastąpieniu pewnych ciągów bitów ciągami dłuższymi , ale łatwiejszymi do odróżnienia od pozostałych.

Modemy można podzielić na dwa zasadnicze rodzaje:

zewnętrzne - podłączane do portu COM komputera, umożliwiają odbieranie wiadomości przy wyłączonym komputerze;

wewnętrzne - mogą funkcjonować tylko przy włączonym komputerze, ale są znacznie tańsze niż zewnętrzne

Ciekawostka

Problem przesyłania danych pomiędzy komputerami próbowano rozwiązać na wiele sposobów. Gdy nie są one mocno oddalone od siebie, można próbować połączyć je kablem przez porty szeregowe lub za pomocą sieci lokalnej. Problem zaczyna się wtedy, gdy komputery te znajdują się w innych miastach, państwach czy na innych kontynentach. Warto zauważyć, że większość ludzi mieszkających w cywilizowanych krajach jest ze sobą już połączona przez sieć telefoniczną i byłoby wspaniale móc ją wykorzystać do transmisji danych komputerowych. Modem - co to takiego? Aby przesłać dane komputerowe (informacja cyfrowa) przez ogólnodostępną sieć telefoniczną (analogowa), nadawca musi je przekształcić na postać analogową dla potrzeb transmisji, a odbiorca z powrotem zamienić formę analogową na bity i bajty, zrozumiałe dla swojego komputera. Operację taką wykonuje urządzenie zwane modemem od ang. MOdulator DEModulator). Ponieważ sieć telefoniczna nie była projektowana pod kątem przesyłania nią danych komputerowych, więc istnieją w niej ograniczenia poważnie utrudniające taką transmisję. Najważniejszym z nich jest ograniczenie pasma przenoszenia do 3,5 kHz (co w zupełności wystarcza dla mowy ludzkiej), nie można też przesyłać nią składowej stałej sygnału. Modem może służyć do połączenia dowolnych dwóch urządzeń niekoniecznie komputerów), które potrafi nadawać i odbierać dane przez port szeregowy RS-232. Całą resztę, czyli skomplikowaną operację transmisji, potrafi przejąć na siebie odpowiednio skonfigurowany modem . Wydawałoby się to wszystko bardzo proste i piękne - tak niestety nie jest. Najważniejszą wadą modemów jest stosunkowo mała prędkość transmisji: najszybsze modemy obecnie stosowane (V.34) potrafią przesłać maksymalnie (w sprzyjających warunkach) ok. 3 kB danych na sekundę. Prędkość transmisji danych przez modemy (i nie tylko) podaje się w bitach na sekundę, w skrócie bps (lub w kilobitach na sekundę: kbps). Czasami użytkownik może spotkać się z jednostką "baud", która określa częstotliwość modulacji i z prędkością transmisji ma niewiele wspólnego. Jak działa modem? Ogólna zasada działania tego urządzenia jest trochę podobna do transmisji radiowej. Zarówno przy transmisji modemowej, jak i w radiu, występuje pewien ciągły sygnał (tzw. nośna), który jest odpowiednio zmieniany (modulowany) w rytm przesyłania danych. Jak wiadomo, parametrami fali są: amplituda, częstotliwość i faza (przesunięcie fazowe). Za pomocą zmian, czyli modulacji każdego z tych parametrów nośnej, można zakodować informację. W radiu na falach ultrakrótkich stosuję się modulację częstotliwości, w skrócie FM (ang. Frequency Modulation), a w pozostałych pasmach - modulację amplitudy, w skrócie AM (ang. Amplitude Modulation). Często w przypadku przesyłania danych cyfrowych, a więc gdy występują tylko dwa dozwolone poziomy, słowo "modulacja" zamienia się słowem "kluczowanie" (ang. Shift keying). W modemach (tych starszych) wykorzystywane były zarówno kluczowanie częstotliwości (FSK - ang. Frequency Shift Keying) jak i fazy (PSK - ang. Phase Shift Keying), a w nowszych rozwiązaniach stosuje się jednoczesną modulację fazy i amplitudy , zwaną modulacją kwadraturowo - amplitudową, w skrocie QAM (ang. Quadrature Amplitude Modulation). Do prawidłowego przesyłania informacji nie. wystarczy sama modulacja, ważne jest także samo przygotowanie danych do transmisji. Polega ono na zastąpieniu pewnych ciągów bitów innymi, łatwiejszymi do rozróżnienia, a operację tą realizuje układ zwany skramblerem, zaś powrotną zamianę po odbiorze - deskrambler. Począwszy od modemów V.32 zaczęto stosować kodowanie nadmiarowe za pomocą kodów TCM (ang. Trellis Coded Modulation. Kodowanie nadmiarowe polega na zastąpieniu pewnych ciągów bitów ciągami dłuższymi , ale łatwiejszymi do odróżnienia od pozostałych. Innym przykładem kodowania nadmiarowego jest kod ETF w odtwarzaczach CD-ROM (patrz rozdział o nośnikach danych).Teraz wyjaśnimy zasadę działania modemów i podstawowe pojęcia dotyczące transmisji: Slmplex : transmisja jednokierunkowa, dane są transmitowane tylko w jedną, ściśle określoną stronę (przykład: rozgłośnia radiowa - radioodbiornik). Half - duplex : (niepełny duplex, półduplex): w skrócie HDX, transmisja dwustronna , w której w tym samym czasie dane są transmitowane tylko w jedną stronę , a później następuje zamiana rolami nadajnika i odbiornika (przykład: CB- radio). W praktyce pod tą nazwą rozumie się także sytuację, w której dane w jedną stronę są transmitowane, normalnym, szerokim pasmem, podczas gdy istnieje w tym samym czasie kanał zwrotny, o przepustowości zbyt malej do normalnej transmisji danych. Full - duplex : (pełny duplex): w skrócie FDX: pełne dane są przesiane w tym samym czasie w obie strony (oczywiście po tej samej linii, przykład: telefon).Sposoby transmisji danych : W powyższym tekście pojawiły się też tajemnicze oznaczenia, składające się z literki V i cyfry. Są to oznaczenia norm ITU-TSS (ang. International Telţcomrnuni- cations Union - Telecommunications Standardization Section: Sekcja Standaryzacji Międzynarodowej Unii Telekomunikacyjnej, dawniej CCITT), definiując sposoby transmisji danych przez modem. * V.21: historycznie najstarsza, umożliwiająca transmisję z prędkością do 300 b/s poprzez kluczowanie częstotliwości (FSK). Każda ze stacji dysponuje własnym kanałem, będącym parą częstotliwosc1, z których jedna określa logiczne 0, a druga l. * V.22: umożliwia transmisję z prędkością 600 albo 1200 bps poprzez kluczowanie fazy (PSK). Każda stacja pracuje na własnej częstotliwości nośnej, jednocześnie są kodowane dwa bity. * V.22bis: umożliwia transmisję z prędkością 2400 bps poprzez modulację kwadraturowo - amplitudową (QAM). Każda stacja pracuje na własnej częstotliwości nośnej, jednoczesn1e są kodowane cztery bity. * V.32: definiuje sposób transmisji z prędkością 4800 lub 9600 b/s kodowanie dwóch lub czterech bitów danych (PSK lub QAM).0bie stacje nadają na tej samej nośnej, sygnał drugiej stacji otrzymują poprzez eliminację sygnału własnego. Norma ta zakłada stosowanie korekcji błędów. 0pcjonalnie można stosować kodowanie TCM oraz zmniejszanie prędkości transmisji w przypadku zakłóceń na linii. * V.32bis: transmisja z prędkością 4800,7200,9600 i 14400 bps. Modulacja QAM, kodowanie od dwóch do pięciu bitów (stosowanie TCM). Przewidziano w tym standardzie możliwość dynamicznego zmieniania prędkości transmisji w dół i w górę (ang. retraining) oraz całkowitej renegocjacji parametrów połączenia. * V.34: najnowsza norma, umożliwiająca transmisję z prędkością od 2400 do 28800 bps. Kodowanie do dwunastu bitów danych za pomocą QAM + TCM na kilku różnych częstotliwościach nośnych (od 1,8 do 2 kHz). Możliwość dynamicznego zmieniania prędkości transmisji i renegocjacji parametrów połączenia. * V.FAST (lub V.FC): nie jest to norma ITU-TSS, ale pewien standard przyjęty przez producentów modemów w oczekiwaniu na normęV.34 (nie jest z nim zgodny, chociaż zakłada tą samą prędkość 28,8 kbps).Prawie wszystkie normy zakładają transmisję w trybie full duplex, z wyjątkiem protokołu HST firmy USRobotics, który był stosowany w pierwszych, tańszych modemach V.32 produkowanych przez tą firmę. Rozwinięciem standardu V.32 była norma V.32bis, zwiększająca prędkość transmisji do 14,4 kbps. Bardzo ważnym unowocześnieniem w stosunku do V.32 było także wprowadzenie możliwości obniżenia prędkości transmisji w przypadku pogorszenia się jakości połączenia, a gdy jakość się poprawi, nastąpi powrót do najwyższej możliwej prędkości (ang. retraining). Pomiędzy V.32bis a V.34 znajdują się prywatne rozwiązania bardziej znanych producentów modemów, jak np. ZyXEL (16,8 i 19,2 kbps) oraz USRobotics, a także trochę wyprzedzający normę V.34 standard transmisji z prędkością 28,8 kbps, który nazwano V.FAST lub V.FC (Fast Class). Standard ten spotkał się z raczej umiarkowanym zainteresowaniem użytkowników i sprawa rozwiązała się dopiero w roku 1994, kiedy organizacja ITU-TSS opracowała normę V.34. Jest to norma najbardziej uniwersalna ze wszystkich dotychczasowych i modem zgodny z nią potrafi porozumieć się praktycznie ze wszystkimi innymi (z wyjątkiem V.FAST na prędkości 28,8 kbps). Trzeba tu zaznaczyć, że norma V.34 korzysta z całej, teoretycznie dostępnej szerokosci pasma, a więc 300-3500 Hz, co powoduje, że przy połączeniach przez starsze centrale, które obcinają górną część pasma, efektywna prędkość transmisji nigdy nie wyniesie pełnych 28,8 kbps. Korekcja i kompresja : Wraz ze wzrostem prędkości transmisji malała odporność przesyłanych danych na wszelkie przekłamania spowodowane zakłóceniami na linii, wprowadzono więc sprzętową korekcję błędów, realizowaną przez same modemy, niezależnie od stosowanego oprogramowania. Generalna zasada działania wszelkich protokołów korekcji błędów sprowadza się do sprawdzania poprawności przesyłanych danych (zwykle w pakietach po kilkaset bitów), i w wypadku błędu następuje powtórzenie. Pierwszym powszechnie zaakceptowanym protokołem korekcji był MNP4, opracowany przez firmę Microcom. Rozwinięciem tego protokołu był MNPS, umożliwiający dodatkowo kompresję przesyłanych danych. Kompresja realizowana przez ten protokół była niezbyt wysoka (maksymalnie 2:1 ), a dodatkowo MNPS nie rozróżniał typów zbiorów i usiłował kompresować wszystkie przesyłane dane, co w efekcie prowadziło nawet do wydłużenia tych przesyłanych zbiorów, które były już wstępnie skompresowane (np. ZIP). Dużą zaletą tego protokołu jest łatwość jego realizacji na drodze programowej kiedy, nie dysponujemy modemem wyposażonym w sprzętowy MNP, można wtedy łączyć się z innym modemem używającym MNP przy wykorzystaniu wszystkich jego zalet. Drugim, znacznie lepszym standardem korekcji błędów jest LAPM (ang. Link Access Protocol for Modems), zdefiniowany w normie V.42 ustanowionej przez ITU- TSS. Opracowano też normę V.42bis, określającej powiązaną z LAPM metodę kompresji danych (odpowiednik MNPS). V.42bis jest znacznie lepszy od MNP, ponieważ oprócz dwukrotnego zwiększenia maksymalnego stopnia kompresji (4:1 ), stosowana jest "inteligentna" metoda, nie próbująca już kompresować wszystkiego "jak leci". Tak więc, w odróżnieniu od MNP, stosując V.42/V.42bis w najgorszym przypadku można spodziewać się takiej samej efektywności transmisji jak bez kompresji, nigdy zaś gorszej. Handshaking Korzystając z pakietyzacji danych w procesie korekcji błędów oraz z kompresji można znacznie przyspieszyć samą operację przesyłania przez modem tak, że komputer ter, utrzymujący na łączu z modemem taką samą prędkość nominalną, jak modemy ze sobą (np. 4800 bps), nie będzie nadążał z przesyłaniem bitów do wysłania i modem będzie musiał czekać, wydłużając tym samym połączenie. Stosuje się więc rozwiązanie polegające na wyposażeniu modemu w bufor pamięci i kilkakrotnym zwiększeniu prędkości na linii komputer-modem niż prędkość samego połączenia, wraz z zastosowaniem tzw. kontroli przepływu (ang. flow control). Kontrola przepływu to nic innego , jak powiadamianie komputera przez modem, kiedy ma przesyłać do niego dane, a kiedy czekać. Termin "handshaking" oznacza dokładnie to samo co flow control a sama operacja może być realizowana na drodze sprzętowej (ang. hardware handshaking) lub programowej (ang. software handshaking). Metoda programowa była stosowana w telekomunikacji od dawna: kiedy bufor w modemie się przepełni, informuje on komputer o tym wysyłając specjalny znak, nazwany XOFF. Komputer odbierając go wstrzymuje transmisję do momentu odebrania znaku XON, informującego o możliwości wznowienia transmisji, dlatego metoda ta jest też nazywana XON/XOFF. Jak łatwo się domyśleć, stosowanie tego sposobu kontroli uniemożliwia przesyłanie znaków o kodach takich samych jak XON czy XOFF, i chociaż można ominąć tą przeszkodę , to i tak odchodzi się od metody programowej na rzecz znacznie wygodniejszej kontroli sprzętowej. Wykorzystuje ona dwie oddzielne linie sygnałowe w złączu RS- 232, zwane RTS (ang. Request To Send) i CTS (ang. Clear To Send). Pierwszy sygnał informuje komputer, że modem chce do niego przesłać odebrane z linii dane, drugi o gotowości modemu do przyjęcia danych z komputera. Ważne jest, aby tak samo skonfigurować program komunikacyjny i modem, tzn. aby oba używały tego samego rodzaju kontroli przepływu.

Isdn

Rozwój sieci telekomunikacyjnych wymaga nie tylko poprawienia i ulepszenia właściwości poszczególnych rodzajów sieci przenoszących informacje, ale przede wszystkim przejścia na nowy poziom jakości, polegający na uniwersalnym podejściu do wszelkiego rodzaju usług oferowanych przez operatorów. ISDN określany jest mianem cyfrowej sieci łączącej wszelkie usługi telekomunikacyjne w jedną płaszczyznę. ISDN jest skrótem pełnej nazwy Integrated Services Digital Network.

ISDN znajduje zastosowanie niemalże w każdej dziedzinie ludzkiej działalności, pozwalając na przesyłanie informacji ze znacznie lepszą jakością i szybkością niż w tradycyjnej telefonii, oszczędzając cenny czas, energię i pieniądze. Usługi ISDN zaspokajają potrzebę posiadania niezawodnego a zarazem elastycznego medium do transmisji danych i służą do przesyłania plików i łączenia sieci LAN. Transmisja plików przez sieć ISDN charakteryzuje się większą szybkością i niezawodnością w porównaniu z transmisją przy użyciu modemu i może być korzystniejsza w porównaniu z łączami dzierżawionymi pod względem kosztów.

ISDN stosuje się powszechnie w sieciach komputerowych, gdzie znajduje zastosowania jako łącze awaryjne, dodatkowe pasmo na żądanie lub jako łącze na żądanie.

Łącze awaryjne jest potrzebne w przypadku uszkodzenia linii dzierżawionej, łączącej odległe oddziały firm. Wówczas router zestawia połączenie, wykorzystując sieć ISDN. Połączenie zastępcze może zostać zestawione automatycznie, użytkownicy nawet nie odczują uszkodzenia łącza dzierżawionego.

Dodatkowe pasmo na żądanie jest konieczne w okresach, kiedy zapotrzebowanie na pasmo transmisyjne przekracza możliwości stałego łącza dzierżawionego, a użytkownicy nie mogą pozwolić sobie na zmniejszenie wydajności sieci. W takiej sytuacji rozwiązaniem może być zestawienie dodatkowego połączenia ISDN. Gdy ruch na łączu stałym zmniejszy się, to połączenie ISDN zostanie zakończone. Połączenie dodatkowe może zostać zestawione automatycznie a użytkownicy nie odczują utrudnień związanych z maksymalnym wykorzystaniem łącza dzierżawionego.

ISDN znajduje zastosowanie jako łącze na żądanie, jeżeli ilość wymienianych informacji pomiędzy odległymi sieciami jest niewielka. Wtedy bardziej opłacalne od zestawienia łącza stałego może być wykorzystanie ISDN do połączenia sieci. Połączenie będzie zestawiane tylko na czas transmisji danych, a użytkownik będzie pracował tak, jakby korzystał z łącza stałego.

Wyróżniamy dwa rodzaje dostępu przez ISDN:

dostęp podstawowy BRA (Basic Rate Access),

dostęp pierwotny PRA (Primary Rate Access).

Strukturę dostępu BRA tworzą dwa kanały B (każdy o przepływności 64 kbit/s) oraz kanał D o przepustowości 16 kbit/s.

Kanały B pracują w trybie komutacji łączy i są przeznaczone do zestawiania połączeń między parą lub większą grupą komunikujących się abonentów oraz do zdalnego korzystania z wszelkiego rodzaju automatycznych systemów informacyjnych, takich, jak np. publiczne lub prywatne bazy danych. Zaletą kanałów B jest izochroniczny charakter zestawianych za ich pośrednictwem połączeń. Oznacza to, że wartość opóźnienia transmisji dla przesyłanych nimi danych jest stała i na ogół niewielka. Cecha ta umożliwia wymienianie danych między połączonymi terminalami w czasie rzeczywistym. Sytuacja taka znacznie ułatwia realizację usług wymagających dużej regularności w dostarczaniu do odbiornika kolejnych próbek zakodowanego przebiegu. Strumienie danych przenoszonych kanałami B mogą mieć nie tylko strukturę ciągów słów kodowych, ale także odpowiadać wszelkim wymaganiom transmisji w trybie komutacji pakietów. Pakietowy tryb pracy kanału B jest stosowany w przypadku korzystania przez abonenta np. z dostępu do systemów pracujących zgodnie z protokołem X.25 lub innych usług podobnego typu.

Kanał D umożliwia transmisję danych wyłącznie w trybie komutacji pakietów. Podstawowym jego przeznaczeniem było przesyłanie wiadomości sygnalizacyjnych między terminalami abonenckimi a odpowiednim wyposażeniem centrali sieci publicznej. Z biegiem czasu zdefiniowano jednak wiele usług (takich jak np. teleakcja), które korzystają z przesyłania danych właśnie za pośrednictwem kanału D. Urządzenia i systemy pracujące w czasie rzeczywistym zazwyczaj nie mogą stosować transmisji w trybie pakietowym. Najważniejszą niedogodnością związaną z używaniem tego trybu jest występowanie dużego i zmiennego w czasie opóźnienia przekazywanych odbiorcy kolejnych porcji informacji. W ostatnim czasie powstało jednak wiele aplikacji nie wymagających wysokiej rytmiczności dostępu do medium transmisyjnego (np. usługi z grupy teleakcji), które mogą przesyłać swoje dane za pośrednictwem kanału sygnalizacyjnego. Możliwość korzystania z kanału D ma dla abonenta tę cenną zaletę, że unika on zajmowania kanałów B połączeniami zastawianymi np. w celu przesłania długich plików danych komputerowych. Rozwiązanie takie jest szczególnie interesujące dla tych użytkowników, którzy korzystają z dostępu podstawowego do sieci ISDN. Należy jednocześnie wyjaśnić, że zaimplementowany system priorytetów dostępu do kanału D umożliwia zagwarantowanie wiadomościom sygnalizacyjnym pierwszeństwa w procesie rywalizacji o wspólne pasmo oraz, że przesyłanie tych wiadomości nie wymaga przerywania trwających aktualnie połączeń, zestawionych np. na żądanie użytkownika.

Abonent sieci ISDN może zestawić połączenia w każdym z wymienionych kanałów całkowicie niezależnie od sposobu aktualnego wykorzystywania pozostałej części przysługującego mu pasma transmisyjnego. Dozwolone jest również multipleksowanie w pojedynczym kanale kilku połączeń lub postępowanie odwrotne, polegające na zestawieniu połączenia dysponującego sumarycznym pasmem obu kanałów B. Rozwiązanie takie jest stosowane najczęściej w celu zagwarantowania szybkiej wymiany danych między terminalami abonenckimi i oddalonymi sieciami komputerowymi lub przeprowadzania transmisji wideofonicznej.

Całkowita przepustowość kanałów dostępu podstawowego do sieci ISDN wynosi 144kbit/s (2x64kbit/s + 16kbit/s). Jej wartość została ograniczona do podanych rozmiarów w celu umożliwienia wykorzystania istniejących łączy abonenckich (nieekranowana skrętka przewodów) do przenoszenia informacji w postaci cyfrowej. W ten sposób znacznie obniżono koszty instalacji nowego systemu, unikając konieczności wymiany okablowania pętli abonenckiej.

Format transmisji danych w łączu abonenckim dostępu pierwotnego odpowiada strukturze ramki podstawowej systemu PCM 30/32. Jego główną część tworzy 30 kanałów B o właściwościach identycznych jak analogiczne kanały dostępu podstawowego. Szczelina nr 16 jest zajmowana natomiast przez sygnalizacyjny kanał pakietowy D. Tym razem jego przepustowość została poszerzona do 64kbit/s, co jest w pełni uzasadnione faktem, iż obsługuje on tutaj znacznie większą liczbę połączeń niż ma to miejsce w przypadku dostępu podstawowego. Szczelina nr 0 jest wykorzystywana do synchronizacji ramki i pozostaje dla abonenta niedostępna.

Dostęp pierwotny oferuje abonentowi znacznie szersze pasmo transmisyjne i większą liczbę zestawianych jednocześnie połączeń. Jego stosowanie jest w pełni uzasadnione w przypadku podłączania do publicznej sieci ISDN różnego rodzaju małych central abonenckich, czy też lokalnych sieci komputerowych. Niestety, transmisja strumienia danych z szybkością 2,048 Mbit/s na odległość rzędu kilku kilometrów wymaga już stosowania kabla koncentrycznego lub światłowodu. Stąd też instalacja i eksploatacja dostępu pierwotnego znacznie przekracza koszty ponoszone przez abonenta dysponującego jedynie dostępem podstawowym. Użytkownik może wykorzystywać poszczególne kanały B całkowicie niezależnie lub też łączyć je w struktury o większej przepustowości. Proces łączenia kanałów w grupy nie może być przeprowadzony w sposób dowolny lecz podlega ścisłym regułom. Określają one zasady tworzenia kanałów pochodnych, zawierających kilka, kilkanaście lub pełną liczbę 20 kanałów podstawowych B.

Opisana powyżej struktura dostępu pierwotnego jest stosowana powszechnie w krajach europejskich i oznaczona została skrótem CEPT. Jej amerykańska odmiana (T1) została dostosowana do współpracy z systemem PCM 24 i zawiera taką właśnie sumaryczną liczbę kanałów. Ich podstawowe parametry i przeznaczenie są identyczne jak w opisanym wcześniej systemie europejskim.

Usługi oferowane abonentowi przez sieć ISDN należy rozgraniczyć na odmienne grupy:

usługi przenoszenia, nazywane również bazowymi,

teleusługi,

usługi dodatkowe.

Usługi bazowe są odpowiedzialne wyłącznie za przenoszenie strumieni danych między poszczególnymi punktami dostępu do sieci ISDN. W celu właściwej realizacji poszczególnych żądań użytkownika jest bowiem niezbędne zestawienie kanałów transmisyjnych o parametrach odpowiadających wymaganiom przesyłanych nimi sygnałów.

Do zadań realizowanych przez usługi przenoszenia nie należy natomiast sterowanie terminalami abonenckimi, programowanie ich parametrów lub nadzorowanie przebiegu wymiany danych. Usługi bazowe trybu komutacji łączy podzielono na trzy podstawowe rodzaje, z których każdy nieco inaczej definiuje parametry zestawienia kanału podkładowego. Poszczególnym z nich nadano następujące nazwy:

mowa,

3.1 kHz akustyczne,

64 kbit/s, nieograniczone.

Mowa - jest przeznaczona do przenoszenia cyfrowego sygnału fonicznego, zakodowanego zgodnie z normą G.711. Tworzony tor transmisji może w tym przypadku zawierać: konwertery A/m, tłumiki echa, a także układy i odcinki analogowe. Sygnał foniczny może być przekazywany zarówno innemu użytkownikowi, jak i odpowiednim systemom rozpoznawania mowy, np. w celu automatycznej realizacji żądań abonenta i sterowania usługami świadczonymi przez sieć za pomocą głosu. Omawiana usługa bazowa nie jest przeznaczona dla transmisji danych cyfrowych przekształconych na postać analogową, jak to ma miejsce w przypadku stosowania modemów lub teleksów grupy 1, 2 i 3. Zapewnia ona natomiast poprawną komunikację między abonentami dysponującymi zarówno cyfrowymi jak i analogowymi aparatami telefonicznymi, czyli współpracę sieci ISDN i PTSN.

3.1 kHz, akustycznie - kanał definiowany przez usługę 3.1 kHz, akustycznie, akceptuje szerszy zakres typów transmitowanych informacji. Umożliwia om bowiem przesyłanie dowolnego sygnału akustycznego, zakodowanego zgodnie ze standardem G.711. Usługa ta jest więc przeznaczona do wymiany strumieni informacji za pośrednictwem modemów, telefaksów grupy 1,2 i 3 oraz tworzenia typowych połączeń telefonicznych. Dopuszczalne jest również stosowanie w torze transmisyjnym konwerterów A/m, tłumików echa, a także układów i odcinków analogowych. Jedyne odstępstwo od tej zasady stanowi przypadek transmisji sygnałów niefonicznych, wymagający odpowiedniej modyfikacji struktury zestawionego połączenia tak, aby został wyeliminowany wpływ tłumików echa. Omawiana usługa gwarantuje również współpracę systemów cyfrowych z analogową siecią PTSN.

64 kbit, akustycznie - usługa ta tworzy w pełni przeźroczysty kanał cyfrowy PCM. Strumień transmitowanych nimi danych nie daje żadnych modyfikacji w czasie przenoszenia go miedzy punktami: źródłowym i docelowym. Usługa ta umożliwia przekazywanie zarówno sygnałów fonicznych, akustycznych dowolnego typu, jak i informacji cyfrowej, pochodzącej np. z terminali komputerowych, telefaksów grupy 4 lub innych urządzeń tego typu.

Do zadań realizowanych przez teleusługi należą: telefonia, telefax 4 oraz telefax 2/3, tryb mieszany, poczta elektroniczna, transmisja danych, wideofonia, telewizja, telealarm, telealert, telekomenda, telemetria.

Telefonia - przenoszenie zakodowanego cyfrowo sygnału akustycznego w sposób charakterystyczny dla typowej usługi telefonicznej. Sieć ISND zapewnia dodatkowo możliwość: poszerzenia pasma fonicznego do 7kHz, transmisji sygnału stereofonicznego oraz uzyskania połączenia konferencyjnego

Telefax 4 oraz Telefax 2/3- umożliwia abonentom wymienianie korespondencji w formie dokumentów zawierających informacje typu facsimile, automatycznie poprzez sieć ISDN. Usługa Telefax 4 może być realizowana w oparciu o usługi bazowe trybu łączowego lub pakietowego. Pożądana jest możliwość współpracy terminali Telefax 4 (dołączonymi do sieci ISDN) z terminalami Telefax 3 (dołączonymi do sieci telefonicznej lub do ISDN).

Tryb mieszany - umożliwia kombinowaną komunikację tekstową (Teleteks) i facsimile (Telefax 4) do przesyłania dokumentów zawierających przemieszane informacje tekstowe i nieruchome obrazy.

Videotex - podobnie jak teleteks jest przeznaczony do transmisji tekstu wzbogaconego ewentualnie o znaki semigraficzne. Podstawową jego cechą jest prezentacja odbieranego obrazu za pomocą monitora ekranowego. Videotex wprowadzono głównie w celu umożliwienia abonentowi zdalnego korzystania z baz danych (publicznych i prywatnych), bibliotek oraz innych systemów informacyjnych. Użytkownik ma w tym przypadku przywołać na ekran swego monitora (w obu poprzednich usługach treść odbieranych wiadomości zależała wyłącznie od ich nadawcy). Abonent może również modyfikować zawartość baz danych i zarządzać nimi. Konieczne jest oczywiście stosowanie odpowiedniego systemu różnicowania uprawnień dostępu do określonych rodzajów informacji, uzależnionego np. od stopnia ich tajności lub dopuszczalnego zakresu modyfikowania. Stopniowa ewolucja videotexu doprowadziła do przekazywana za jego pośrednictwem obrazów o wysokiej rozdzielczości (np. ilustracji z bibliotek encyklopedycznych), a następnie obrazów ruchomych. Docelowo (w sieci B-ISDN), omawiana teleusługa ma zapewnić również zdalny dostęp do bibliotek filmów wideo.

Poczta elektroniczna - pozwala nadawcy informacji na umieszczenie jej treści w specjalnie przeznaczonym do tego celu systemie sieciowym. Pozostawiona wiadomość może mieć formę pisma, mowy, lub ilustracji (zależną od rodzaju dostępnej "skrzynki elektronicznej") i zostać odebrana przez adresata w dowolnym momencie. Na uwagę zasługuje fakt ulokowania owej skrzynki nie w terminalu abonenckim, lecz w specjalnie przeznaczonych do tego celu urządzeniach sieciowych (pozostawiona wiadomość jest zwykle przechowywana w centrali sieci publicznej, która znajduje się najbliżej jej odbiorcy). Przesyłanie odpowiedniej informacji może więc nastąpić niezależnie od tego, czy abonent docelowy pozostawił włączony odpowiedni terminal, czy też nie. Jak wynika z przedstawionego opisu, omawiany system funkcjonuje na zupełnie innych zasadach niż te, które były charakterystyczne dla podobnych urządzeń analogowych takich, jak np. automatyczna sekretarka.

Transmisja danych- jest przeznaczona do realizacji połączeń między komputerami dwóch abonentów lub zdalnego dostępu do wybranej sieci komputerowej. Usługa ta może być realizowana zarówno w trybie komutacji pakietów, jak i komutacji kanałów. W przypadku wyposażenia komputera w odpowiednie urządzenia peryferyjne (skaner, drukarka, itp.) może on realizować funkcje praktyczne wszystkich pozostałych rodzajów terminali ISDN. Osiągana przez użytkowników szybkość transmisji jest determinowana liczbą wykorzystywanych jednocześnie kanałów oraz sposobem formatowania przesyłanego strumienia informacji. W przypadku realizacji zdalnego dostępu do lokalnych sieci komputerowych można uzyskać bardzo dobre efekty stosując odpowiednie urządzenia typu gateway. Zapewniają one zwykle automatyczną kompresję transmitowanego strumienia danych. Osiągana dzięki niej efektywna szybkość transmisji waha się od 1 do 2 Mbit/s, przy założeniu wykorzystywania obu kanałów B dostępu podstawowego. W przypadku używania aplikacji nie wymagających dużej przepustowości zestawionego połączenia, jest wskazane raczej wykorzystywanie kanału D. Unika się w ten sposób zajmowania kanałów B, umożliwiając tym samym realizację za ich pośrednictwem innych usług.

Wideofonia- początkowo zakładano, że w pierwszej fazie budowy sieci ISDN usługa ta ma zapewnić jednoczesną transmisję fonii i "wolnych obrazów". Bardzo szybki postęp w technice kompresji obrazów ruchomych pozwala jednak sądzić, iż w niedługim czasie możliwa będzie transmisja sygnału wizji o stosunkowo dobrej jakości, z szybkością nie przekraczającą przepustowości kanału 2B. Już obecnie wiele firm oferuje abonentom sieci ISDN terminale wideofoniczne, posiadające formę samodzielnych urządzeń lub kart do komputerów PC. Jednak ciągle można mieć wiele zastrzeżeń do jakości odtwarzanego przez nie obrazu. Pełne możliwości tej usługi będą dostępne dla użytkowników sieci szerokopasmowej. Głównym zadaniem połączenia wideofonicznego jest umożliwienie przeprowadzenia wideo konferencji między grupą osób znajdujących się w różnych częściach świata. Obraz towarzyszący sygnałowi fonicznemu pozwoli na dyskusję nad rysunkami, schematami, fotografiami oraz dokumentami wszelkiego innego rodzaju.

Telewizja - usługa ta stanie się dostępna dopiero w sieci B ISDN. Dzięki zastosowaniu cyfrowego kodowania obrazu możliwa będzie znaczna poprawa jego jakości (eliminacja zakłóceń, szumów i zniekształceń powstających w czasie transmisji).

Telealarm - przekazywanie komunikatu o alarmie z czujników zainstalowanych u abonenta (np. przeciwpożarowych, przeciw włamaniowych, itp.) do odpowiednich centrów dyżurnych sieci. Transmisja odpowiedniej informacji jest inicjowana całkowicie automatycznie i nie wymaga żadnej formy nadzoru ze strony użytkownika. Usługa ta może zostać wzbogacona w przyszłości o wiele nowych możliwości, związanych np. z sygnalizacją ulatniania się gazu lub zdalnym nadzorem instalacji podobnego typu.

Telealert - przekazywanie podobnych jak poprzednio komunikatów, ale w przeciwnym kierunku, tzn. z centrów nadzorujących bezpieczeństwo mieszkańców danego obszaru do wszystkich dostępnych terminali abonenckich. Treść wiadomości przesyłanych w obrębie tej usługi może dotyczyć np. podnoszenia się poziomu wód, stężenia zanieczyszczeń atmosferycznych lub danych pochodzących z centrów sejsmograficznych.

Telekomenda - oferuje możliwość zdalnego sterowania wybranymi urządzeniami zainstalowanymi u abonenta. Najważniejszymi przykładami praktycznego zastosowania omawianej teleusługi są np. centrale nadzorowania systemu ogrzewania pomieszczeń, nawadnianie trawników, oświetlenia ulic, itp. Stosowanie tego typu rozwiązań może przyczynić się w znacznej mierze do obniżenia kosztów eksploatacji niektórych urządzeń. Włączanie ich w czasie obowiązywania niższej taryfy opłat za energię elektryczną lub efektywne dostosowanie ich pracy np. do zmieniających się warunków atmosferycznych, jest korzystne zarówno z punktu widzenia użytkownika, jak i producenta energii.

Telemetria - pozwala na zdalne odczytywanie stanu różnego rodzaju liczników i mierników zainstalowanych u abonenta (gazomierzy, liczników zużycia energii elektrycznej, wodomierzy, itp.). Uzyskiwane w ten sposób dane są przekazywane natychmiast wskazanym centrom rozliczeniowym, które na ich podstawie określają należności, jakie powinni uiścić poszczególni abonenci. Dokonanie owych rozliczeń finansowych może zresztą również odbywać się w sposób całkowicie automatyczny poprzez przeprowadzenie operacji przelewów między odpowiednimi kontami bankowymi.

Usługi dodatkowe: prezentacja numeru abonenta wywołującego (CLIP), blokada prezentacji numeru abonenta wywołującego (CLIR), prezentacja numeru abonenta wywołanego (COLP), blokada prezentacji numeru abonenta wywołanego (COLR), wielokrotny numer abonenta (MSN), przenośność terminala (TP), sygnalizacja abonent-abonent (UUS), połączenie oczekujące (CW), połączenie zawieszone (CH) , poadresowanie (Subaddressing), informacja o opłacie (AOC), blokada połączeń wychodzących (OCB).

Prezentacja numeru abonenta wywołującego (CLIP) - usługa oferowana jest stronie wywoływanej w celu uzyskania informacji o numerze abonenta wywołującego. Abonent wywoływany otrzymuje w chwili zestawienia połączenia pełny numer katalogowy abonenta, wystarczający do nawiązania połączenia w drugą stronę. Numer abonenta wywołującego nie jest przekazywany abonentowi wywoływanemu, gdy abonent wywołujący korzysta z usługi CLIR.

Blokada prezentacji numeru abonenta wywołującego (CLIR) - usługa pozwalająca abonentowi na zabronienie podawania jego pełnego numeru katalogowego stronie, z którą nawiązuje on połączenie. Usługa może być aktywna dla wszystkich nawiązywanych połączeń (usługa uaktywniana w centrali), lub wywoływana z terminala zgodnie z żądaniem abonenta.

Prezentacja numeru abonenta wywołanego (COLP) - usługa oferowana jest stronie nawiązującej połączenie dla uzyskania informacji o numerze abonenta, z którym zostało zrealizowane połączenie. Numer osiągnięty nie jest przekazywany gdy abonent, z którym zostało nawiązane połączenie korzysta z usługi COLR.

Blokada prezentacji numeru abonenta wywołanego (COLR) - usługa pozwalająca abonentowi na zabronienie podawania jego pełnego numeru katalogowego stronie, która nawiązuje z nim połączenie.

Wielokrotny numer abonenta (MSN) - usługa pozwalająca na zastosowanie więcej niż jednego numeru na tym samym łączu fizycznym. Usługę tą stosuje się w celu rozróżniania terminali dołączonych do jednego zakończenia sieciowego (NT1). Dzięki tej usłudze istnieje możliwość zdefiniowania oddzielnych zestawów usług dla poszczególnych terminali.

Przenośność terminala (TP) - usługa umożliwiająca chwilowe zawieszenie aktualnego połączenia w celu: przeniesienia terminala do innego gniazdka w ramach tego samego dostępu podstawowego, a następnie przywrócenie połączenia z tego samego terminala,

zmienienia jednego terminala na inny terminal dołączony do innego gniazdka w ramach tego samego dostępu podstawowego, a następnie przywrócenie z niego połączenia,

zastąpienia terminala przez inny, dołączony do tego samego gniazdka i przywrócenie z niego połączenia, zastąpienia terminala przez inny, dołączony do tego samego gniazdka i przywrócenie z niego połączenia, przywrócenia połączenia w terminie późniejszym z tego samego terminala.

Sygnalizacja abonent-abonent (UUS) - usługa pozwalająca dwóm abonentom ISDN na wzajemną wymianę krótkich informacji (w postaci ciągu znaków) podczas zestawiania lub rozłączania połączenia. Odebranie informacji nie wymaga podejmowania żadnych akcji ze strony abonenta wywoływanego, gdyż informacja jest zapamiętywana przez terminal. Maksymalna długość przesyłanych informacji wynosi 128 bajtów.

Połączenie oczekujące (CW) - dzięki usłudze CW abonent prowadzący rozmowę telefoniczną, do którego kierowane jest kolejne wywołanie, może otrzymać informację o nowym wywołaniu. Wówczas abonent ten może wybrać jedną z następujących opcji:

zignorować wywołanie oczekujące (abonent wywołujący otrzyma sygnał oczekiwania), odrzucić wywołanie oczekujące (abonent wywołujący otrzyma sygnał zajętości), przyjąć wywołanie oczekujące i zakończyć połączenie dotychczasowe, przyjąć wywołanie oczekujące i zawiesić połączenie dotychczasowe.

Połączenie zawieszone (CH) - usługa pozwalająca na zawieszanie dotychczasowego połączenia i ponowne jego uaktywnianie. Abonent może równocześnie zawiesić kilka połączeń i to niezależnie od tego czy jest stroną wywołującą czy wywoływaną.

Poadresowanie (Subaddressing) - usługa umożliwiająca odróżnienie terminali podłączonych do jednego zakończenia sieciowego poprzez subadress dołączony do numeru abonenta. Subadress może być również wykorzystywany do przesyłania podczas zestawiania połączenia dodatkowych informacji, których długość nie przekracza 20 bajtów.

Informacja o opłacie (AOC) - usługa pozwalająca abonentowi na kontrolę należności za aktualnie zestawione połączenie, zarówno w trakcie jego trwania, jak i po jego zakończeniu.

Blokada połączeń wychodzących (OCB) - usługa umożliwiająca zablokowanie realizacji niektórych połączeń wychodzących z danego aparatu, np. połączeń międzymiastowych lub połączeń międzynarodowych.

Cyfrowa sieć zintegrowana usługowo ISDN (Integrated Services Digital Network) stanowi kolejny etap rozwoju systemów telekomunikacyjnych. W odróżnieniu od wcześniejszych rozwiązań, oferuje ona zdolność jednoczesnego świadczenia szerokiego wachlarzu usług, które do tej pory były realizowane przez wydzielone, wyspecjalizowane sieci. Integracja usług oznacza więc wykorzystanie wspólnego medium oraz urządzeń teletransmisyjnych do przenoszenia wielu rodzajów informacji. Realizacja wspomnianego założenia staje się możliwa, jeżeli transmitowanym strumieniom danych zostanie nadana identyczna forma, pozwalająca na ujednolicenie sposobu ich przenoszenia miedzy kolejnymi centralami sieci. Warunek ten może być łatwo spełniony, jeśli zastosuje się wyłącznie cyfrową reprezentację transmitowanych sygnałów. W tym przypadku niezbędne staje się jednak wyeliminowanie ze struktury systemu teletransmisyjnego odcinków analogowych, co z kolei narzuca konieczność przeprowadzenia procesu cyfryzacji pętli abonenckiej. Wprowadzenie w łączu abonenckim wyłącznie cyfrowej transmisji sygnałów wyróżnia sieć ISDN od istniejących wcześniej systemów. Przekazywanie informacji cyfrowej miedzy terminalami komunikujących się użytkowników umożliwia rozszerzenie zakresu rodzajów przesyłanych informacji. Różnorodność ich typów stanowi podstawę integracji usług.

Logiczna struktura tzw. dostępu abonenckiego do sieci ISDN niesie ze sobą jeszcze jedną zaletę nowego systemu. Jest nią wydzielenie specjalnego kanału sygnalizacyjnego (kanał D), czyli zastosowanie tzw. sygnalizacji poza pasmowej (a raczej poza kanałowej). Wspomniane rozwiązanie pozwala użytkownikowi komunikować się z obsługująca go centralą niezależnie od faktu, czy aktualnie jego kanały \"rozmowne\" są zajęte realizacją innego połączenia. Możliwy staje się ciągły dostęp do oferowanych przez sieć usług (również w czasie trwania połączenia), na co nie pozwalały rozwiązania wcześniejsze.

Aby zostać abonentem sieci cyfrowej ISDN musimy znajdować się w obszarze działania centrali cyfrowej oferującej usługi typu ISDN oraz odpowiednie służby techniczne operatora muszą przeprowadzić pomiary łącza abonenckiego na podstawie których można wydać warunki techniczne określające możliwość włączenia stacji abonenckiej do sieci ISDN.

Do komunikacji z urządzeniami ISDN używane się następujące interfejsy:

"U" - przenoszący sygnały od użytkownika do centrali telefonicznej po jednej parze przewodów na odległość do 6 km.

"S/T" - przenoszący sygnały od gniazdka telefonicznego do urządzenia ISDN po dwóch parach przewodów.

Jeśli sprzęt zainstalowany u użytkownika wymaga S/T należy zastosować konwerter NT (Network Termination), który posiada najczęściej jeden interfejs U i dwa interfejsy S/T.

Łącze abonenckie (2B+D) jest zrealizowane na parze telefonicznej (styk U). Oznacza to, że jeśli abonent posiada już linię telefoniczną, to nie ma potrzeby instalacji nowego łącza. Abonent otrzymuje urządzenie zwane NT (Network Terminal), które jest zasilane z sieci ~220 V.

Od strony abonenta do NT dochodzi znormalizowany styk S. Są to 4 (opcjonalnie 8) przewody o długości do 500 m. Wszystkie urządzenia są dołączone równolegle przewodami do 10 m. W przypadku długiej linii (styku S) może być konieczne zakończenie jej opornikami 100 Om. Dla pełnego wykorzystania sieci ISDN specjalnie opracowano cyfrowe terminale zgodne z ogólnymi międzynarodowymi standardami np. karty PC ISDN, aparaty ISDN, modemy itp. Jednak nie znaczy to, że nie można korzystać nadal ze starych, sprawnych urządzeń. Podłączenie analogowych urządzeń odbywa się poprzez specjalne adaptery, które mogą być w zależności od wersji wbudowane w zakończenie sieciowe (NT) znajdujące się u abonenta.

SIEĆ KOMPUTEROWA

Sieć - system komunikacyjny, który pozwala komputerom wymieniać między sobą informacje. Sieci działają wedle określonego zestawu reguł, gwarantującego bezpieczeństwo i niezawodność przesyłania informacji. Sieci zwiększają wydajność pracy, pomagają unormować sposoby działania, obowiązujące procedury i stosowanie praktyki wśród swoich użytkowników, ułatwiają prezentowanie różnorodnych pomysłów na ogólnym forum, wspomagają rozprzestrzenianie się informacji

Sieć komputerowa to połączenie wielu komputerów za pomocą medium transmisyjnego w celu osiągnięcia następujących efektów: wymiana informacji pomiędzy połączonymi komputerami, udostępnianie użytkownikom zasobów sieci i podniesienie stopnia niezawodności systemu.

Sieci stały się popularne ponieważ umożliwiają współdzielenie zasobów komputerowych, urządzeń peryferyjnych takich jak drukarki czy pamięci masowe, aplikacji, oraz co najważniejsze, informacji, które są potrzebne przez ludzi do ich pracy. Przed erą sieci lokalnych, pojedyncze komputery były izolowane od siebie oraz ograniczone tylko do swoich indywidualnych możliwości. Przez połączenie tych komputerów w sieć, ich przydatność oraz efektywność wzrosły ogromnie. Można wyróżnić następujące rodzaje sieci:

- równorzędne (peer-to-peer),

- lokalne (LAN),

- miejskie (MAN),

- rozległe (WAN),

- globalne (np. Internet)

W sieciach typu peer-to-peer nie jest potrzebny serwer. Wszystkie komputery w tej sieci działają na tych samych prawach. Programy znajdują się na każdej z podłączonych maszyn, natomiast za pośrednictwem sieci przesyłane są jedynie potrzebne dane.

Sieć LAN

(Local Area Network - sieć lokalna) - z poziomu technologii eksperymentalnych stała się wiodącym narzędziem biznesu na całym świecie. Sieci LAN są bardzo szybkim systemem zaprojektowanym w celu łączenia komputerów oraz innych urządzeń przetwarzania danych w całość na niewielkim terenie, takim jak na przykład pojedyncze pomieszczenie, biuro, pojedyncze piętro czy nawet cały budynek. Sieci LAN mogą również być łączone ze sobą, aby zwiększyć ich zasięg.

Dzisiejsze sieci lokalne (LAN) oraz sieci intranetowe są potężnym narzędziem, aczkolwiek łatwym w użyciu dla użytkownika końcowego. Taka sieć zawiera jednak wiele skomplikowanych technologii, które muszą ze sobą współpracować. Żeby sieć naprawdę była w pełni wykorzystana, musi być zaprojektowana aby sprostać wszelkim cechom oraz wymaganiom użytkowników, niezależnie czy indywidualnych, czy też pracownikom firmy. Budowanie sieci jest wybieraniem odpowiednich komponentów oraz łączenia ich razem.

Sieć MAN

(Metropolitan Area Network - sieć miejska) - sieci tego rodzaju budowane są w dużych miastach; charakteryzują się wysoką przepustowością i są używane przede wszystkim przez urządzenia badawcze i w zastosowaniach komercyjnych o nasilonym przepływie danych. Składają się z sieci lokalnych łączonych w różny, zróżnicowany w zależności od potrzeb sposób.

Sieć WAN

(Wide Arena Network - sieć rozległa) - jest to sieć rozległa bazująca na połączeniach telefonicznych, złożona z komputerów znajdujących się w dużych odległościach od siebie, np. łącząca ze sobą użytkowników poczty elektronicznej na terenie całego kraju; wymagane jest zaangażowanie publicznej sieci telekomunikacyjnej; sieć rozległa łączy sieci lokalne LAN i miejskie MAN. Rozległe sieci WAN integrują płaszczyznę telefoniczną i informatyczną. Zastosowane muszą być rozwiązania zapewniające szybkość transmisji danych, niezawodność łączy cyfrowych oraz bezpieczeństwo przesyłu danych. W systemie stosuje się urządzenia najnowszej generacji. Sieć przewiduje implementację aplikacji telekomunikacyjnych takich, jak transfer danych komputerowych, wideo konferencje dzielenie plików, przenoszenie połączeń do komputerów znajdującego się poza LAN, do domu, firmy, samochodu i wielu innych miejsc. Do realizacji połączeń dla sieci WAN zastosuje się routery, których zadaniem jest realizowanie pomostu pomiędzy oddalonymi sieciami oraz realizowanie dostępu do Internetu. Bezpieczeństwo routera od strony sieci komputerowej jest nadzorowane przez procedurę autoryzacyjną kontrolującą logowanie użytkowników do urządzenia. Łączność - publiczne sieci telekomunikacyjne PSTN, lub pakietowa PSDN. Łącza: kablowe, światłowodowe, mikrofalowe, satelitarne.

Sieci globalne - najpopularniejszą globalną siecią komputerową jest sieć Internet. Składa się ona z setek tysięcy sieci lokalnych używających protokołu komunikacyjnego TCP/IP (Transport Control Protocol / Internet Protocol).

Podział sieci ze względu na obszar i topologię

Wyróżnia się cztery najczęściej stosowane topologie:

- szynowa (magistralowa),

- pierścieniowa,

- gwieździsta,

- drzewiasta.

Wymienione topologie są strukturami logicznymi technicznie nie muszą być w taki sposób zorganizowane.

Topologia szynowa (magistralowa) to konfiguracja, w której wszystkie komputery podłączone są do wspólnego medium transmisyjnego rozprowadzającego w sposób bierny sygnał. Dołączenie lub odłączenie komputera nie wpływa na pracę pozostałych urządzeń w sieci. Maksymalną długość łącza oraz ilość podłączonych stacji definiują normy w zależności od typu łącza. Przy intensywnej transmisji danych może dochodzić do konfliktów. Topologia ta charakteryzuje się niskim poziomem bezpieczeństwa, gdyż wszystkie dane transmitowane są jednym łączem, a więc ich przechwycenie przez nieuprawnionego użytkownika jest wysoce prawdopodobne. Przerwanie medium transmisyjnego (magistrali) powoduje zaprzestanie działania całej sieci, dodatkowo należy nadmienić, że lokalizacja uszkodzeń i błędów transmisji jest stosunkowo trudna.

Topologia pierścieniowa jest strukturą, w której stacje sieciowe są podłączone do okablowania tworzącego pierścień. Dane w układzie krążą w koło, ale tylko w jedną stronę, poszukując adresu przeznaczenia. W porównaniu do sieci szynowej, wzrasta wydajność sieci. Stosowana jest w sieciach Token Ring oraz FDD (Fiber Distributed Data Interface - to cyfrowa sieć o topologii podwójnych przeciwbieżnych pierścieni).

W topologii gwieździstej kable sieciowe są połączone w jednym wspólnym punkcie w którym znajduje się hub lub przełącznik. Topologia ta jest w odróżnieniu od topologii szynowej odporna na uszkodzenia pojedynczych jednostek, lub połączeń z nią. Jej zaletą jest bezpieczeństwo i wydajność. Stosowana w Token Ring.

Topologia drzewiasta jest strukturą podobną do topologii szynowe, z tą różnicą, że są tu możliwe gałęzie z wieloma węzłami.

Internet

Jest rozwinięciem niewielkiej sieci stworzonej na zamówienie Pentagonu w połowie lat 70. Internet jest "siecią sieci komputerowych". Składa się on z wielu lokalnych sieci należących do przedsiębiorstw, agencji rządowych i ośrodków akademickich. Sieć lokalna to grupa komputerów połączonych ze sobą lub z komputerem głównym (zwanym serwerem), które znajdują się blisko siebie. Większość firm na całym świecie korzysta z takich sieci. Wszyscy użytkownicy sieci lokalnej używają komputerów biurowych lub przenośnych wyposażonych w karty sieciowe. Karta taka może się znajdować wewnątrz komputera lub być z nim połączona przez jeden z zewnętrznych portów. Karty (a tym samym i komputery w nie wyposażone) są przyłączone za pomocą przewodów i sprzętu elektronicznego do jednego lub większej liczby serwerów sieciowych, na których znajdują się dane i programy.

Z Internetu korzystają użytkownicy tysięcy sieci przyłączonych do niego, a także miliony osób, które uzyskują do niego dostęp za pomocą linii telefonicznych i kont oferowanych przez wiele firm. Wszystkie te firmy (są one nazywane dostawcami usług internetowych) korzystając z jednego lub większej liczby serwerów sieciowych przyłączonych do Internetu. Wszystkie te serwery są wyposażone w wiele modemów. Dzięki temu użytkownicy mogą za pośrednictwem linii telefonicznej połączyć się z dostawcą usług internetowych. Lokalny komputer staje się wtedy komputerem-klientem, który współpracuje z serwerem i używa jego cyfrowych linii transmisyjnych do uzyskania połączenia z Internetem.

Każdy serwer przyłączony do Internetu staje się jego częścią. Innymi słowy, Internet łączy wszystkie do siebie przyłączone serwery obsługujące sieci lokalne, rozległa i używane przez dostawców usług internetowych.

Usługi internetowe można podzielić na trzy grupy:

a) usługa pozwala na komunikowanie się dwóch lub więcej osób (poczta elektroniczna, NEWS i IRC).

Poczta elektroniczna

(e -mail) - najbardziej znana usługa. Umożliwia wysyłanie poczty elektronicznej innym użytkownikom sieci, oczywiście aby z kimś korespondować należy znać jego adres. Adres w poczcie elektronicznej składa się z nazwy komputera w sieci (@korporacja.com) oraz indyfikatora użytkownika na tym komputerze (Jan Kowalski). Poprzez e-mail mamy dostęp do specjalnych skrzynek kontaktowych (tzw. list dyskusyjnych) dla ludzi zainteresowanych jakimś konkretny tematem. Listy wysyłane pod adresem takiej skrzynki są następnie rozsyłane do wszystkich jej uczestników. Listy dyskusyjne nie są przy tym zorganizowane raz na zawsze, przy braku zainteresowania ulegają likwidacji a w ich miejsce powstają nowe, poświęcone nowym tematom. Warunkiem jest tylko zgłoszenie się odpowiedniej liczby osób.

News

Wiadomości udostępnia inną możliwość wymiany informacji, działającej na odwrotnej zasadzie do listy dyskusyjnej. O ile listy dyskusyjne rozsyłają listy do swoich członków, o tyle grupy newsowe są miejscami gdzie korespondenci zostawiają swoje wiadomości.

Irc

(Internet Realy Chat) - jest to system umożliwiający prowadzenie zbiorowych dyskusji w jednym z około dwóch i pół tysiąca istniejących obecnie kanałów poprzez wysłania wiadomości do wszystkich osób włączonych w dany kanał lub wiadomości prywatne do wybranego uczestnika dyskusji. Programy obsługujące IRC pozwalają na dyskusję na kilku kanałach jednocześnie. Każdy z uczestników dyskusji IRC przed przystąpieniem do rozmowy musi wybrać sobie identyfikator, unikalny w skali danego kanału. Każda wypowiedź pojawiająca się na ekranach wszystkich osób na danym kanale, jest poprzedzona tym identyfikatorem. Oprogramowanie IRC daje możliwość zwracania się bezpośrednio do wybranego rozmówcy. Protokół IRC pozwala również uzyskać informacje o osobach używających identyfikatorów. Przykładowymi komendami mogą być /amsg, /whois, /chanel, itp. itd. Są niezwykle przydatne gdy chcemy się czegoś dowiedzieć bez wiedzy rozmówcy ( np. poznać jego adres e - mail ). Nazwy kanałów IRC rozpoczynają się od znaku # poprzedzającego nazwę, a na liście podany jest również preferowany na kanale temat rozmów. Istnieją również kanały prywatne różniące się od publicznych tym że aby się tam dostać, włączyć do rozmowy trzeba znać hasło lub posiadać specjalne zaproszenie. Rozmowy mogą być wzbogacone efektami dźwiękowymi lub graficznymi, a nawet odpowiednie oprogramowanie IRC ( Microsoft Comic Chat for Windows 95 ) proponuje możliwość rozmowy w formie komiksu.

b) usługi pozwalające na przesyłanie plików (danych) (FTP, WWW)

Ftp

To efektywna transmisja plików. Od czasu gdy komputery zostały ze sobą połączone w sieć zaczęły także przesyłać między sobą informacje. Obecnie, w czasach gdy Internet jest siecią globalną, różnego rodzaju pliki krążą po całym świecie. Do ich transmisji utworzono specjalny protokół nazwany FTP (File Transfer Protocol). Umożliwia on przeciętnemu użytkownikowi manipulowanie plikami na zdalnych komputerach oraz ściąganie udostępnionych w tysiącach obecnych archiwów plików.

Korzystanie z FTP przynosi wiele korzyści. Po pierwsze istnieje na świecie wiele archiwów na całym świecie, które oferują setki gigabajtów informacji w postaci tekstów, grafiki, dźwięku. Szukając w tych archiwach konkretnego pliku, możemy być prawie pewni, że go odnajdziemy.

Po drugie prędkość przesyłania danych za pomocą usługi FTP jest o wiele bardziej efektywna niż ściąganie plików np. z witryn WWW. Wpływ na to ma prędkość transmisji danych poprzez FTP. Ma to duże znaczenie dla przeciętnego użytkownika korzystającego z zasobów sieci przez łącza telefoniczne.

Usługa FTP umożliwia nam przesyłanie plików dwoma sposobami. Pierwszym sposobem przesyłamy plik nie dokonując w nim żadnych zmian, za pomocą drugiego natomiast niektóre bity są kodowane innym systemem. Nie należy więc przesyłać plików typowo binarnych (archiwów ZIP, plików wykonywalnych EXE) przy pomocy trybu ASCII, gdyż zmiany jakie zostaną wprowadzone spowodują niemożność odczytania takiego pliku.

Dane przy pomocy FTP są przesyłane w dwóch trybach: zwykłym i anonimowym. Zwykły tryb, to tryb, w którym korzystamy z zasobów konta chronionego. Aby użyć tego trybu należy mieć odpowiednie uprawnienia(tzn. własne konto i hasło). Tryb anonimowy służy do korzystania z informacji na serwerach ogólnodostępnych.

www

(WORLD WIDE WEB- światowa pajęczyna lub w skrócie WEB) - najpopularniejsza z dostępnych usług w sieci Internet. Zbiór dokumentów stworzonych najczęściej, choć niekoniecznie, przy pomocy języka HTML i odnoszących się do siebie nawzajem dzięki tzw. odnośnikom. Pomimo, że dokumenty te są umieszczone na różnych komputerach w odległych od siebie geograficznie miejscach, wspólny system nazw oparty na tzw. URL umożliwia stworzenie w ramach danego dokumentu odnośnika do niemal każdego innego, dostępnego w sieci Internet.

Wielką popularność WWW zawdzięcza niezwykłej łatwości obsługi, tworzenia i utrzymywania odpowiednich dokumentów, a także atrakcyjnej stronie graficznej.

Jest najpopularniejszą częścią Internetu. Web oparty jest o metodę prezentacji danych zwaną hypertext'em, pozwalającą mieszać tekst z grafiką i dźwiękiem. Na stronach WWW możemy przeczytać najświeższe informacje, zwiedzić galerie sztuki, muzea, a także obejrzeć katalog samochodów lub przeszukać bazę danych o firmach, jednym słowem mówiąc możemy dowiedzieć się wszystkiego o wszystkim.

Najpopularniejsze wyszukiwarki internetowe:

www.onet.pl, www.wp.pl, www.interia.pl, www.altawista.com, www.hotbot.com, www.chip.pl, www.google.pl

c)usługi umożliwiające zdalną pracę na innym komputerze (telnet)

Telnet

W praktyce usługa już nie używana. Umożliwiała podłączenie się do innego komputera i pracę na nim.

Aby połączyć się z Internetem wystarczy dowolny komputer klasy PC, oprogramowanie, modem z homologacją i aparat telefoniczny. Już teraz można powiedzieć, że popularność Internetu nie zawęzi się do grona komputerowych zapaleńców, to wciąż młoda dziedzina i trudno powiedzieć czym zaskoczy nas w przyszłości. Telekomunikacja Polska szacuje, że w roku 2000 z Internetu będzie korzystało od 2 do 3 milionów Polaków, a na przełomie wieku w skali światowej około miliarda.

KABLE

W systemach telekomunikacyjnych kable stanowią odpowiednik systemu nerwowego i są konieczne dla opłacalnej transmisji nieustannie rosnącej ilości informacji na coraz większe odległości.

Kable Miedziane

W celu przesłania jakichkolwiek informacji potrzebne jest medium transmisyjne, które może to zrobić. Najczęściej wykorzystywanym medium przesyłu danych są kable miedziane. Pierwsze kable telekomunikacyjne miały papierowo-powietrzną izolację żył miedzianych a powłokę zewnętrzną wykonaną z ołowiu. Obecnie nie produkowane, chociaż jeszcze często używane. Współczesnym środkiem izolacji żył przewodzących w kablu jest polichlorek winylu (PCW) lub polietylen. Tradycyjnym medium transmisyjnym jest w telekomunikacji kabel z parami przewodów miedzianych. W dzisiejszych sieciach dostępu używane są kable zawierające ponad 2000 par przewodów skręcanych. Oprócz tego podstawowego zastosowania kable miedziane sprawdziły się w szeregu innych m.in. jako kable instalacyjne, kable do transmisji danych, do systemów komutacyjnych, kable antenowe. W kablach miedzianych wyróżnia się łącza niesymetryczne (co najmniej 1 biegun połączony z ziemią) i symetryczne, w których prąd w obu przewodach powinien być taki sam, lecz płynący w przeciwnych kierunkach (symetrycznie). Tak skręcona para symetryczna daje dużą odporność na zakłócenia zewnętrzne. Każda para przewodów jest skręcona i stąd pochodzi nazwa - kabel typu skrętka parowa. Dotychczas używane kable koncentryczne są wypierane przez bardziej nowoczesne, składające się z 4 par przewodów miedzianych - skręcane w układzie pęczkowym - czwórki kablowe - dla których podstawową wiązką są cztery skręcone przewody.. Kabel taki umożliwia pięciokrotnie, a nawet dwudziestoparokrotnie szybszą transmisję danych. Podstawowa skrętka pozwala na przesłanie w ciągu jednej sekundy 100 mln bitów danych, zaś przy zaawansowanych i skomplikowanych technikach kodowania sygnału może to być nawet 10 razy więcej. Jest to równoważne przesłaniu w ciągu 1 sekundy 7 tys. stron maszynopisu! Mimo że to liczba niemal astronomiczna, coraz częściej ta prędkość przestaje już wystarczać. e Miedziane

Rodzaje kabli miedzianych

Skrętka nieekranowana UTP - (Unshielded Twisted Pair) Kabel wykonany ze skręconych, nieekranowanych przewodów tworzących linę symetryczną zrównoważoną . Skręcanie przewodów ze splotem 1 zwój na 16-10 cm chroni transmisję przed oddziaływaniem (interferencją) otoczenia. Skrętkę powszechnie stosuje się w sieciach telefonicznych i komputerowych. Przy przesyłaniu sygnałów cyfrowych za pomocą skrętki UTP uzyskuje się przepływności do 100 Mb/s (kategoria 5), a takie1000 Mb/s w najnowszej technologii Gigabit Ethernet.