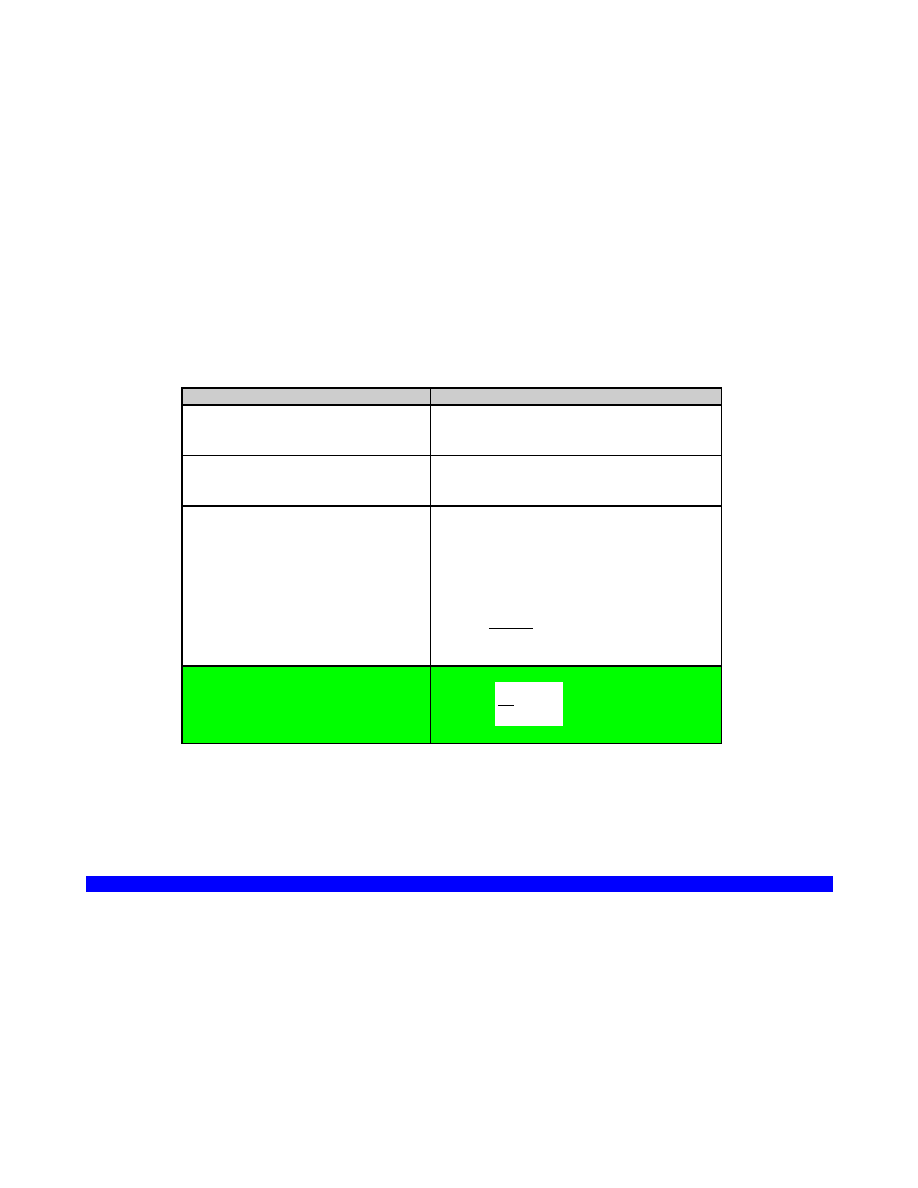

CZĘŚĆ 1. POZNANIE NAUKOWE JAK PRZEDMIOT ANALIZY

PODZIAŁ NAUK

Ze względu na metodę:

•

DEDUKCYJNE - posługują się metodami dedukcyjnymi, czyli niezawodnymi (matematyka i logika)

•

INDUKCYJNE - posługują się (obok metod dedukcyjnych) również metodami indukcyjnymi, czyli nie-niezawodnymi

Ze względu na zależność od doświadczenia:

•

APRIORYCZNE = niezależne od doświadczenia. Np. "każda liczba podzielna przez 4 jest podzielna przez 2"

•

APOSTERIORYCZNE = zależne od doświadczenia. Np. "Odległość między Warszawą i Paryżem wynosi 1500km"

Ze względu na przedmiot poznania:

•

REALNE (o rzeczywistości, np. fizyka, historia)

•

FORMALNE (o wytworach umysłu: matematyka, logika)

Nauki formalne są jednocześnie dedukcyjne i aprioryczne.

Nauki realne są jednocześnie indukcyjne i aposterioryczne.

Ze względu na stawiane zadania:

•

TEORETYCZNE (zajmujące się poznaniem)

•

PRAKTYCZNE (zajmujące się działaniem)

- prakseologiczne - teorie skutecznego działania (jak działać aby osiągnąć cel?);

- aksjologiczne - uzasadniające działania (dlaczego należy postępować w taki właśnie sposób?).

NAUKI EMPIRYCZNE

Są to nauki realne, indukcyjne, aposterioryczne, czyli nauki, które formułują twierdzenia dotyczące świata realnego i sprawdzają

(testują) je w oparciu o doświadczenie lecz ich twierdzenia nigdy nie są pewne (choć mogą być bardzo mocno potwierdzone przez

fakty). Przeciwieństwem są nauki nieempiryczne, takie jak matematyka i logika. Jako wzorzec metodologiczny dla nauk empirycznych

wskazuje się zwykle fizykę ale nie wszystkie nauki mogą być uprawiane tak jak fizyka. Dziś wskazuje się często, że innym wzorcem stają

się nauki biologiczne.

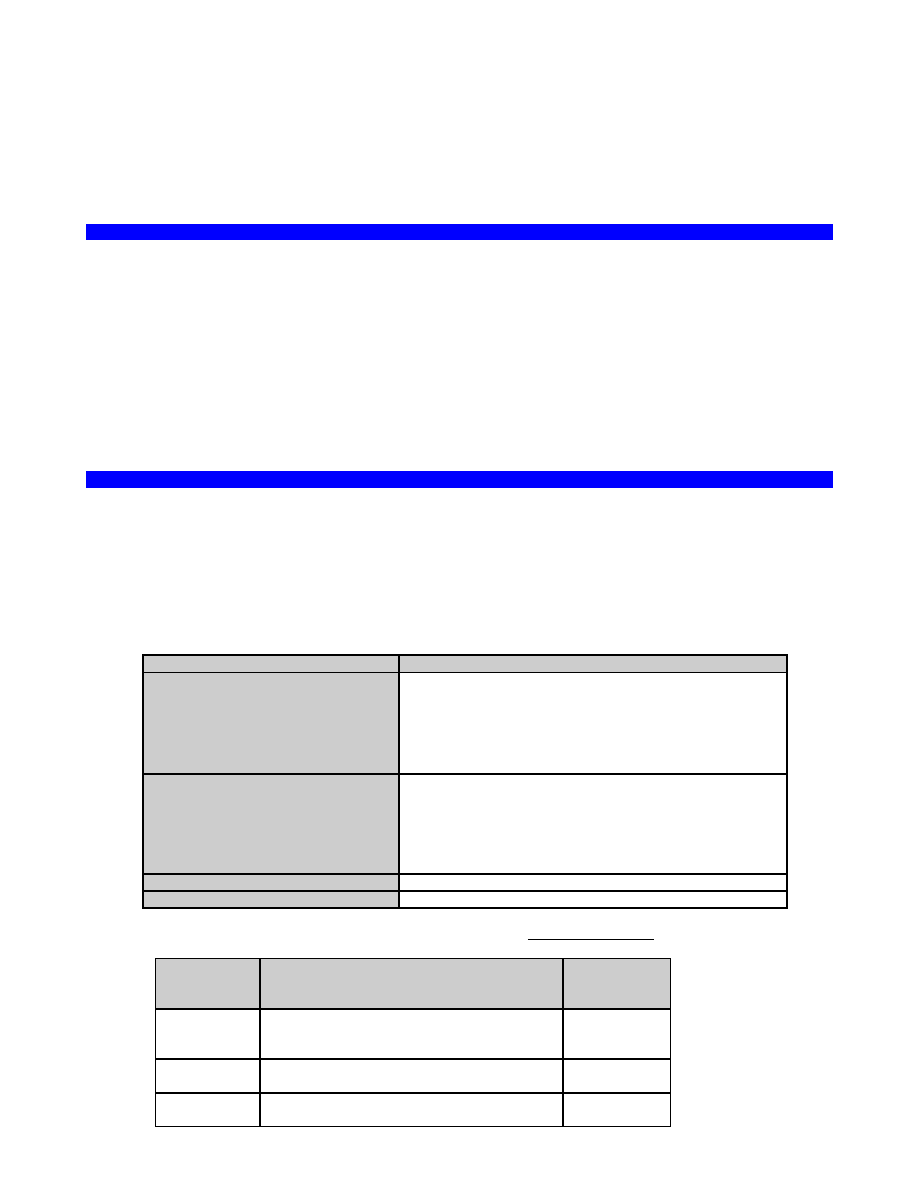

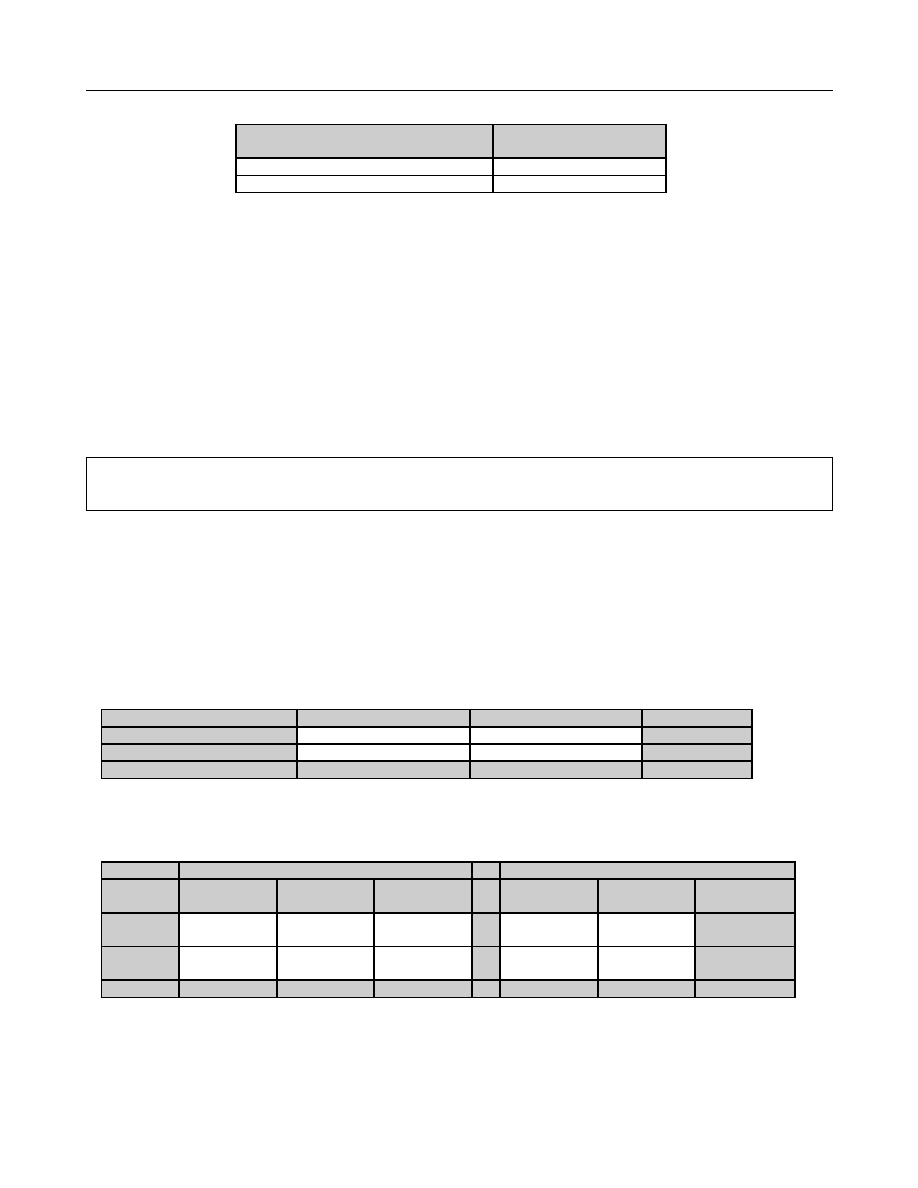

PODZIAŁ NAUK EMPIRYCZNYCH

Ze względu na charakter formułowanych twierdzeń

•

NOMOTETYCZNE - formułujące prawa mówiące o istnieniu ogólnych zależności ( np. prawa fizyki).

•

IDIOGRAFICZNO-TOPOLOGICZNE

- idiograficzne (opisowe) – zajmujące się opisem zjawisk - np. historia wojen napoleońskich

- typologiczne – ustalające typy (wzory) zjawisk – np. kultura renesansu

Ze względu na rodzaj podejmowanych problemów

•

PODSTAWOWE – np. badanie problemów ogólnych, np. badanie mechanizmu modyfikowania aktywności mięśni

szkieletowych za pomocą biofeedbacku.

•

STOSOWANE – np. stosowanie wiedzy ogólnej do rozwiązywania problemów szczegółowych): np. zastosowanie EMG-

biofeedbacku do leczenia napięciowego bólu głowy.

Ze względu na przedmiot

•

PRZYRODNICZE: o przyrodzie nieożywionej i ożywionej. Istnieją duże różnice metodologiczne między naukami o

przyrodzie nieożywionej i ożywionej, na przykład – między takimi naukami jak fizyka i biologia. Świadomość tych różnic

istniała od dawna. Przykładowo, w XVII wieku, w okresie narodzin współczesnej nauki, stosowano podział nauk

przyrodniczych (o naturze) na filozofię naturalną (np. fizyka, astronomia) i historię naturalną (np. botanika, zoologia).

•

HUMANISTYCZNE: o człowieku i społeczeństwie, wytworach kultury oraz dziejach człowieka i jego wytworów

W literaturze anglosaskiej termin "SCIENCE" oznaczał początkowo tylko nauki przyrodnicze. Dziś używa się go w szerszym

znaczeniu i określa nim wszystkie NAUKI EMPIRYCZNE a czasem nawet wszystkie nauki empiryczne i nieempiryczne (formalne).

Nadal jednak podkreśla się opozycję: filozofia – nauka. PSYCHOLOGIA jest dyscypliną empiryczną z pogranicza nauk

humanistycznych i przyrodniczych (biologicznych).

NAUKI O NAUCE

EMPIRYCZNE - badające naukę jako wytwór kultury

•

psychologia nauki - psychologiczne uwarunkowania twórczości naukowej

•

socjologia nauki - Społeczne uwarunkowania rozwoju nauki

•

historia nauki - dzieje nauki, dzieje instytucji naukowych, itp.

•

polityka naukowa - jak kierować instytucjami naukowymi

FILOZOFICZNE

•

Metodologia nauki - zajmuje się analizą metod naukowych i wytworów działalności naukowej

•

Filozofia nauki - bada najbardziej podstawowe problemy poznania naukowego (np. przedmiot poznania naukowego,

wartość poznania naukowego, podstawowe założenia poznania naukowego)

METODOLOGIA NAUK

•

APRAGMATYCZNA - o wytworach działalności naukowej (teoria systemów dedukcyjnych, analiza teorii w naukach

empirycznych)

•

PRAGMATYCZNA - o czynnościach naukowych: jak się uprawia lub jak powinno się uprawiać naukę (np. jak dobierać próbę do

badań) – podział wg Ajdukiewicza

- OGÓLNA - zajmuje się metodami stosowanymi we wszystkich naukach (np. zasady wnioskowania indukcyjnego)

- SZCZEGÓŁOWA - zajmuje się metodami specyficznymi dla poszczególnych nauk (np. zasady konstrukcji testów

psychologicznych)

- OPISOWA - jak (faktycznie) uprawia się naukę

- NORMATYWNA - jak powinno się uprawiać naukę

CZYM JEST A CZYM NIE JEST NAUKA?

Dąży do poznania prawdy (stworzenia możliwe dokładnej reprezentacji rzeczywistości)

Dąży do wyjaśniania zjawisk i tworzenia spójnych systemów wyjaśniających (teorii)

Poddaje swoje twierdzenia systematycznej kontroli empirycznej

Nauka (empiryczna) udziela odpowiedzi na pytania:

•

jak jest (opis)

•

dlaczego tak jest (wyjaśnianie)

•

czego można oczekiwać w przyszłości (przewidywanie)

•

co należy zrobić aby osiągnąć dany cel (funkcja praktyczna)

Nauka nie jest jednak w stanie udzielać odpowiedzi na pytania wartościujące, np.: co jest dobre? jak należy postępować? do jakiego

celu należy dążyć? (może natomiast wskazywać metody prowadzące do osiągnięcia jakiegoś celu jeśli cel ten został wcześniej

wskazany ). Nauka pozostawia te problemy innym dziedzinom refleksji (np. filozofii, teologii)

Wiedza naukowa nie jest też:

•

mądrością (jak osiągnąć szczęście? odnaleźć sens życia?)

•

światopoglądem (tzw. „światopogląd naukowy” zawiera zawsze obok elementów naukowych elementy pozanaukowe)

CZĘŚĆ 2. POJĘCIA I ICH DEFINIOWANIE

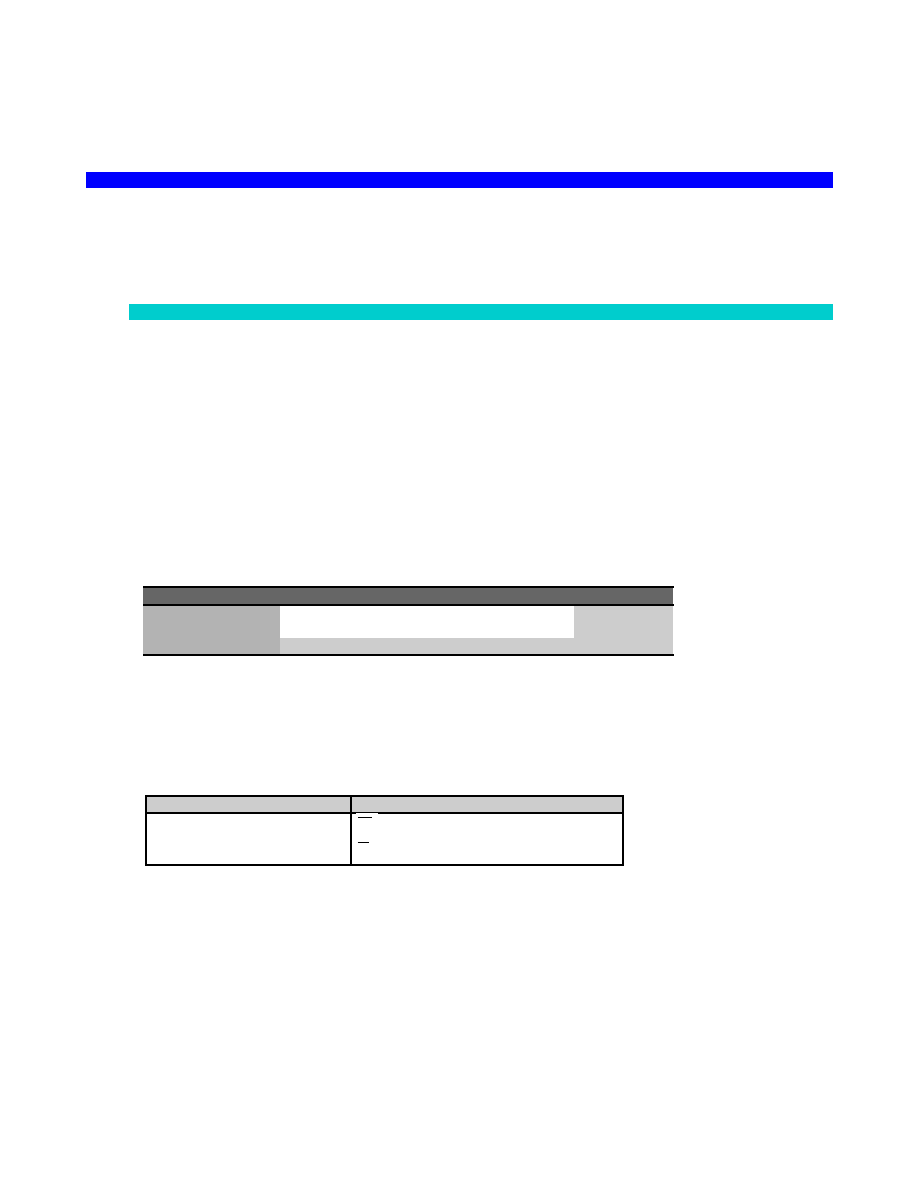

NIEKTÓRE POJĘCIA LOGICZNE UŻYWANE W WYKŁADZIE

~ lub ¬

negacja ( ~p ; nieprawda że p)

koniunkcja ( p q ; p

i q, zarówno p jak q)

alternatywa ( p q ; p

lub q, co najmniej jedno z dwóch p lub

q)

lub ,

implikacja ( p q ;

jeśli p to q; jeśli p to wykluczone że nie q)

tożsamość (p q; p

zawsze wtedy i tylko wtedy gdy q)

P(x)

(P od x) ; x ma własność P (np. „x jest studentem”)

~P(x)

nieprawda że x ma własność P

xRx lub R(x,y)

relacja R zachodzi między przedmiotami x i y (np.: x jest

większy od y)

lub

kwantyfikator duży (ogólny)

x P(x) –

dla każdego x, P od x; (inaczej: każdy przedmiot x z

rozważanej dziedziny ma własność P; np. każdy człowiek jest

rozumny)

lub

kwantyfikator mały (szczegółowy)

x P(x) –

istnieje takie x, że x ma własność P

x y P(x,y) –

dla każdego x istnieje takie y, że x pozostaje w

relacji P do y

Np. Dla każdej liczby naturalnej x istnieje liczba naturalna y taka,

że x jest mniejsze od y.

ZAGADNIENIA WSTĘPNE

Teoria znaków (w tym – językowych) nazywa się semiotyką. Podstawowe działy semiotyki:

•

SYNTAKTYKA zajmuje się relacjami zachodzącymi między wyrażeniami (przykład: sprzeczność między dwoma zdaniami)

•

SEMANTYKA zajmuje się relacjami między wyrażeniami a rzeczywistością do której się one odnoszą (przykład: oznaczanie,

prawda)

•

PRAGMATYKA zajmuje się relacjami między wyrażeniami a ich użytkownikami, tj. nadawcami i odbiorcami wyrażeń (przykład:

rozumienie wyrażeń).

KATEGORIE SYNTAKTYCZNE WYRAŻEŃ I ICH CHARAKTERYSTYKA

1.

ZDANIA

2.

NAZWY

3.

FUNKTORY

1. ZDANIE

W sensie logicznym to wyrażenie, któremu przysługuje wartość logiczna (w logice dwuwartościowej: prawda lub fałsz). Inaczej –

wyrażenie, które coś stwierdza (zdanie kategoryczne). Jeśli jest tak jak stwierdza zdanie p, zdanie p jest prawdziwe. Jeśli tak nie

jest - zdanie p jest fałszywe. Nie wszystkie zdania w sensie gramatycznym są zdaniami

w sensie logicznym. Nie są nimi:

•

pytania (zdania pytajne), np. Czy dzisiaj jest wtorek?

•

oceny, np. Zdrowie jest rzeczą dobrą.

•

dyrektywy, np. Należy myć zęby.

Ze względu na sposób rozstrzygania prawdziwości zdań można je podzielić na:

•

Zdania a priori (przed doświadczeniem) - zdania których prawdziwość jest niezależna od doświadczenia (na

przykład, twierdzenia logiki i matematyki).

•

Zdania a posteriori (po doświadczeniu) – zdania których prawdziwość ustalana jest w oparciu o doświadczenie

(przykład: zdania obserwacyjne, prawa indukcyjne).

−

zdania analityczne - są prawdziwe na mocy znaczenia jakie posiadają w danym języku. Zdaniu

takiemu nie można zaprzeczyć bez popadnięcia w wewnętrzną sprzeczność. Przykład: „centymetr

jest setną częścią metra”. Zdaniami analitycznymi są, w szczególności, wszystkie prawa logiki.

Zdania analityczne nie stwierdzają nic o rzeczywistości ani też nie można z nich takiej wiedzy

wydedukować.

−

zdania syntetyczne - stwierdzają coś, co wykracza poza samo znaczenie zawartych w nim

terminów. Ich zaprzeczenie nie prowadzi do wewnętrznej sprzeczności. Przykład: „Sevilla leży nad

rzeką Guadalquivir”.

Stary problem filozoficzny: czy istnieją zdania syntetyczne a priori? Dominuje pogląd, że wszystkie zdania analityczne są a priori

(tzn. ich prawdziwość nie zależy od doświadczenia, nie posiadają bowiem treści empirycznej), a wszystkie zdania syntetyczne są

a posteriori (ich prawdziwość zależy od zgodności z doświadczeniem). Kant uważał że istnieją zdania syntetyczne a priori,

stanowiące fundament nauki (np. „wszystko ma swoją przyczynę”). Ich podstawą są transcendentalne, aprioryczne kategorie

umysłu, które nie wywodzą się z doświadczenia zmysłowego ale warunkują to doświadczenie.

Kategorie Kanta (za Heller, 2005)

kategorie ilości: jedność wielość, całość

kategorie jakości: rzeczywistość, negacja, ograniczenie

kategorie stosunku: substancja i przypadłość, przyczyna i skutek, akcja i reakcja

kategorie modalności: możliwość i niemożliwość, istnienie i nieistnienie, konieczność i względność

Stanowisko Kanta znalazło nową interpretację na gruncie ewolucyjnej teorii poznania. Selekcja ewolucyjna „faworyzowała”

organizmy, które potrafiły najlepiej wykorzystać informację o środowisku. Sposób odbioru i oceny informacji jest częściowo

ukształtowany filogenetycznie (filogenetyczne a posteriori) i determinuje aktywność poznawczą osobnika (ontogenetyczne a

priori wiedza wrodzona)

2. NAZWA

Wyrażenie, które może pełnić w zdaniu funkcję podmiotu lub orzecznika (np. WARSZAWA jest STOLICĄ POLSKI). To także

wyrażenie które pełni funkcję oznaczania swoich desygnatów (desygnat – przedmiot o którym można nazwę zgodnie z prawdą

orzec (np. „to jest stół” - nazwę stół orzekamy o tym oto przedmiocie).

RODZAJE NAZW

INDYWIDUALNE (INDYWIDUOWE) - przysługują konkretnym, indywidualnym obiektom. Przykłady: Jan Kowalski,

Warszawa

GENERALNE (UNIWERSALNE) - przysługują pewnej klasie obiektów ze względu na jakąś ich cechę (w szczególnym

przypadku klasa ta może być jednoelementowa lub pusta). Przykłady: stół, najwyższa góra świata, krasnoludek.

Ten sam obiekt może być desygnatem nazwy indywiduowej i generalnej, np.:

- ostatni król Polski (nazwa generalna)

- Stanisław August Poniatowski (nazwa indywidualna)

Podział nazw ze względu na liczbę desygnatów

OGÓLNE – wiele desygnatów

JEDNOSTKOWE – jeden desygnat

Podział ze względu na istnienie desygnatów

NIEPUSTE (istnieją desygnaty), np. człowiek.

PUSTE (nie istnieją desygnaty), np. krasnoludek.

2.2 ELEMENTY TEORII NAZW

•

DESYGNATY NAZWY – przedmioty o których orzekamy nazwę

•

ZAKRES NAZWY (denotacja) – zbiór wszystkich jej desygnatów

Nazwa jest ostra (lub zakres nazwy jest ostry) jeśli o każdym przedmiocie można powiedzieć czy jest czy nie jest

desygnatem nazwy. Nazwa ostra dzieli uniwersum na dwie klasy: przedmioty należące i nie należące do zakresu nazwy.

Przykład nazwy nieostrej: młodzieniec.

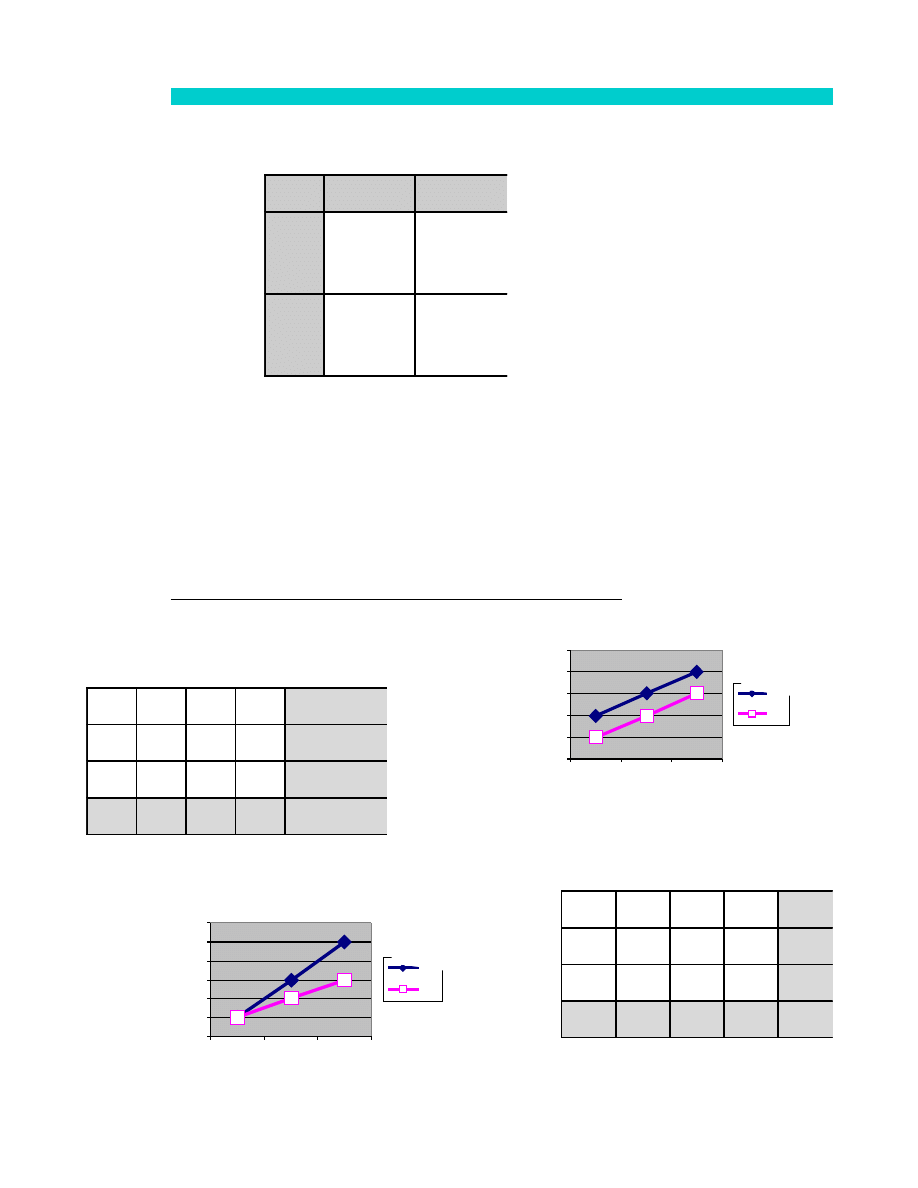

Stosunki zachodzące między zakresami dwóch nazw:

•

równoważność (równość) zakresów,

•

podrzędność / nadrzędność,

•

krzyżowanie się,

•

wykluczanie się

TREŚĆ NAZWY - zbiór cech przysługujących desygnatom nazwy.

Znaczenie nazwy (sposób rozumienia nazwy) nazywamy POJĘCIEM. Znaczenie nazw jest problemem ogromnie

złożonym. Istnieje wiele koncepcji znaczenia nazwy. ZNACZENIE nazwy jako KONOTACJA – zespół cech

charakterystycznych dla zakresu nazwy, za pomocą których myślimy o jej desygnatach. Ta sama nazwa może być

rozumiana w różny sposób (nazwy wieloznaczne) i – zależnie od tego – może oznaczać różne przedmioty (mieć różny

zakres). Przykład: zamek jako budowla i zamek jako urządzenie do zamykania drzwi. Należy więc mówić o zakresie nazwy

przy określonym jej znaczeniu.

3. FUNKTORY

Wyrażenia które razem z innymi wyrażeniami (tzw. argumentami) tworzą wyrażenia bardziej złożone. Przykłady:

•

"i" -- funktor zdaniotwórczy od dwóch argumentów zdaniowych, np. "Jan jest przystojny i Jan jest studentem"

•

"idzie" -- funktor zdaniotwórczy od jednego argumentu nazwowego, np. "Jan idzie"

•

"ładny" -- funktor nazwotwórczy od jednego argumentu nazwowego, np. "ładny dzień"

DEFINICJE

Ścisłe definiowanie pojęć umożliwia precyzyjne formułowanie sądów o rzeczywistości. Precyzyjne sądy są łatwiejsze do weryfikacji /

falsyfikacji. Ścisłe definiowanie pojęć pozwala unikać sporów pozornych (sporów werbalnych o pozorach sporów rzeczowych, czyli

sporów w których różnica stanowisk wynika z różnego rozumienia tych samych słów). Definicja (najogólniej) to krótkie określenie

czegoś.

Trzy zasadnicze funkcje definicji (wg H. Mortimerowej):

podawać charakterystykę przedmiotu (d. realna);

umożliwiać przekład jednego wyrażenia na inne;

być postulatem znaczeniowym (wprowadzać nowe wyrażenia do języka w oparciu o konwencje językowe).

DEFINICJE NOMINALNE

Definicja NOMINALNA - definicje słów - wprowadza do danego języka wyrażenie za pomocą innych wyrażeń znajdujących się już

w tym języku. Podział definicji nominalnych:

•

Definicja SPRAWOZDAWCZA – zdaje sprawę z zastanego sposobu rozumienia słowa w danym języku. Definicja taka

jest zdaniem rzeczowym (zdaniem w sensie logicznym).

•

Definicje PROJEKTUJĄCE – oparte na konwencji terminologicznej, ustanawiającej sposób rozumienia nowego

wyrażenia. Konwencja terminologiczna nie jest zdaniem w sensie logicznym ale wyraża pewien akt woli, w rodzaju:

„słowo A będę rozumiał w taki to a taki sposób”. Definicja oparta o konwencję terminologiczną nazywa się też

POSTULATEM ZNACZENIOWYM JĘZYKA. Definicje projektujące są zdaniami analitycznymi – nie można im zaprzeczyć

nie popadając w wewnętrzną sprzeczność. Nie są też zależne od doświadczenia (są zdaniami a priori). Wymaga się

natomiast podania „dowodu istnienia” tj. wykazania, że istnieje przedmiot, który tę definicję spełnia.

Wprowadzanie do języka nazw pustych może rodzić problemy logiczne (np. problem wartości logicznej zdań

zawierających nazwy puste).

•

Definicja KONSTRUKCYJNA – definicja podająca nowe znaczenie słowa. Przykład: „Manipulacja eksperymentalna to

przyporządkowanie różnych (co najmniej dwóch) wartości zmiennej niezależnej grupom zrandomizowanym”.

•

Definicja REGULUJĄCA – definicja modyfikująca znaczenie słowa już istniejącego w danym języku (wyostrzająca jego

zakres lub eliminująca wieloznaczność). Przykłady: „Dziecko (w rozumieniu PKP) to osobnik do lat 3”, „Rak, w

rozumieniu niniejszej ustawy, jest rybą”.

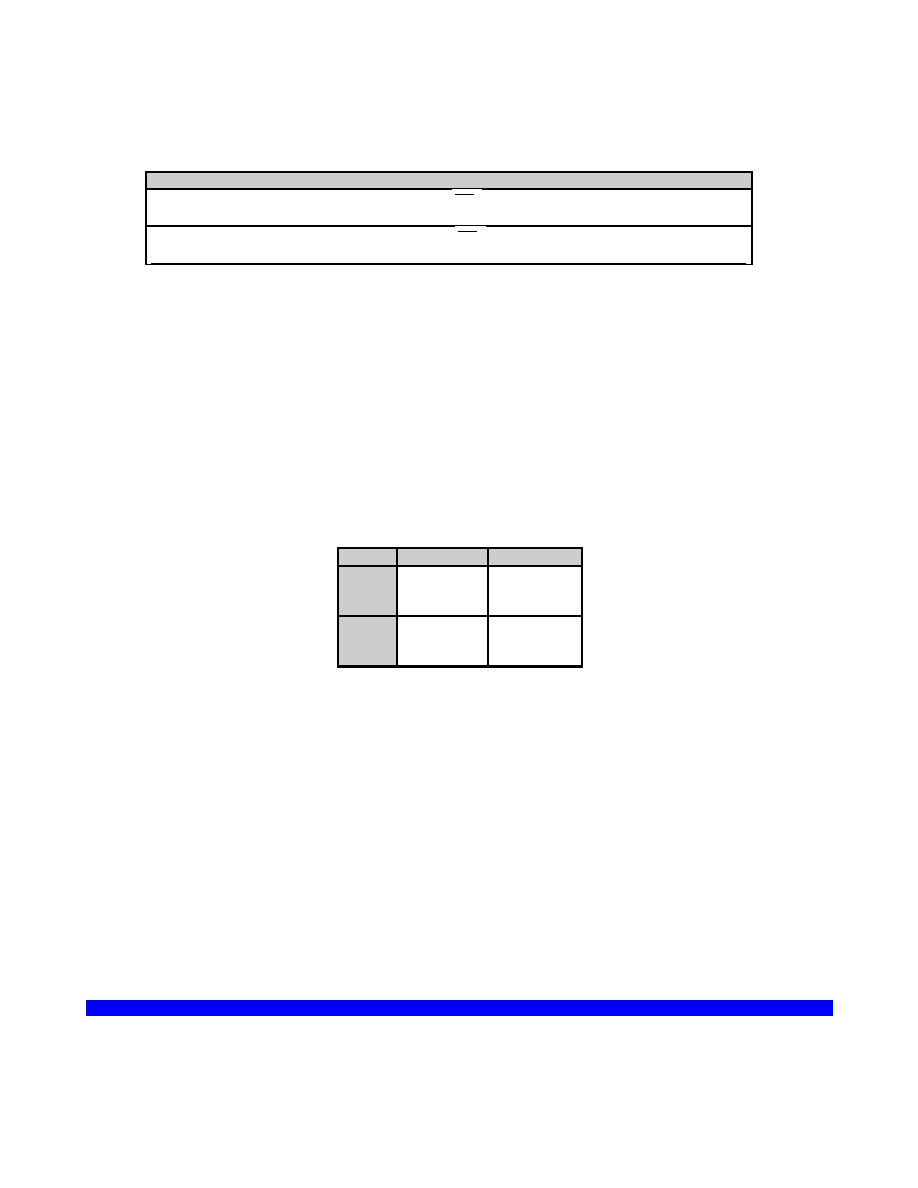

NAJWAŻNIEJSZE RODZAJE DEFINICJI NOMINALNYCH

1.

NORMALNE

Definicja NORMALNA jest definicją nominalną, która pozwala wyeliminować w dowolnym zdaniu nowo wprowadzone

wyrażenie przez inne wyrażenia, już istniejące w danym języku. Może mieć postać równości lub równoważności.Definicja

równościowa:

A =

B

Lewy człon (definiowany) nazywa się definiendum. Prawy człon (definiujący) nazywa się defiens. Znak

=

nazywa się

równością definicyjną. Przykład: „kwadrat to prostokąt równoboczny”. Definicja normalna której definiendum składa

się tylko z wyrażenia definiowanego nazywa się definicją WYRAŹNĄ. Jeśli definiendum zawiera inne wyrażenia obok

wyrażenia definiowanego mówimy o definicji KONTREKSTOWEJ (lewy człon definicji nazywa się wtedy definitum), np:

kwadrat liczby = a

iloczyn liczby a pomnożonej przez nią samą

Każdą definicję RÓWNOŚCIOWĄ można przekształcić w definicję ROWNOWAŻNOŚCIOWĄ. Definicja równoważnościowa

ma postać równoważności dwóch zdań (gdzie Q jest terminem definiowanym), np:

Qx Px

Figura jest kwadratem zawsze wtedy i tylko wtedy gdy jest prostokątem równobocznym.

WARUNKI POPRAWNOŚCI DEFINICJI NORMALNYCH (w naukach formalnych):

warunek eliminowalności (zastępowalności) - każdą formułę (wyrażenie), zawierającą zdefiniowane wyrażenie,

można zastąpić przez równoważną formułę nie zawierającą tego wyrażenia

warunek nietwórczości - definicja nie powinna być aksjomatem - czegokolwiek można dowieść w teorii T z

dodaną do niej definicją, można też dowieść bez tej definicji.

warunek niesprzeczności - definicja dołączona do systemu (niesprzecznego) nie powinna prowadzić do

sprzeczności.

Definicje w naukach formalnych są ekstensjonalne: znaczenie wyrażenia jest funkcją jego zakresu (jeśli dwa wyrażenia

mają ten sam zakres to mają też to samo znaczenie). Język potoczny nie jest ekstensjonalny (jest intensjonalny).

Przykład: „Jan wie że, ...”

•

Warszawa to Stolica Polski.

•

Warszawa to miasto liczące ponad 1 milion mieszkańców, położone na 21 długości geograficznej wschodniej

i 52 25’ szerokości geograficznej północnej”.

Zakres definiensa jest w obu definicjach (a i b) identyczny. Ale zdanie „Jan wie że Warszawa to A” może okazać się

prawdziwe, gdy A zastąpimy definiensem pierwszej definicji nazwy Warszawa a fałszywe, gdy zastąpimy je definiensem

drugiej definicji.

2.

PRZEZ ABSTRAKCJE

Każdy stosunek równości (równoważności) wyznacza pewien rodzaj (rodzinę) cech. Dwa przedmioty są równe pod

względem pewnej cechy P (mają tę samą cechę P) gdy zachodzi między nimi odpowiedni stosunek równościowy R.

Przykłady:

•

Dwa odcinki mają tę samą (konkretną) długość P gdy są ze sobą przystające (pozostają względem siebie w

relacji przystawania R). Długość (jako taką) można z kolei zdefiniować jako rodzinę (wszystkich) długości

•

Liczbę (określoną) możemy zdefiniować jako cechę przysługującą wszystkim zbiorom równolicznym z danym

zbiorem. Np. liczba pięć jest cechą wszystkich zbiorów równolicznych z liczbą palców jednej ręki. Liczba jako

taka (liczba kardynalna) to rodzina wszystkich (konkretnych) liczb. Tak definiowane cechy nazywa się

RODZINAMI CECH ABSTRAKCJI do stosunku równości (równoważności).

3.

AKSJOMATYCZNE

Definicje aksjomatyczne (inaczej: definicje przez postulaty) służą do definiowania terminów pierwotnych w rachunkach

formalnych. Dzięki takim definicjom unika się sytuacji, kiedy terminy pierwotne pozostają niezdefiniowane (jest to

jednak możliwe tylko w naukach formalnych, np. w logice). Definicja aksjomatyczna polega na odpowiednim użyciu

terminów pierwotnych w aksjomatach (zdaniach pierwotnych systemu). Zdania są dobrane tak, aby (przy założeniu ich

prawdziwości) ograniczały możliwe interpretacje użytych w nich terminów. Definicje aksjomatyczne zalicza się do

definicji

Przykład:

1) x R x

2) x R y y R x

3) (x R y y R z) x R z

Jeśli zdania 1, 2 i 3 są prawdziwe, to termin R musi oznaczać jakiś rodzaj równości.

Od definicji aksjomatycznej wymaga się aby:

•

układ postulatów określał jednoznacznie rozumienie terminu definiowanego.

•

układ postulatów był niesprzeczny

W języku naturalnym i literaturze naukowej mamy często do czynienia z sytuacją, gdy jakiś termin nie jest zdefiniowany

wprost, natomiast możemy domyślić się jego znaczenia z kontekstu. Z kontekstu uczymy się też najczęściej znaczenia

wyrażeń języka ojczystego.

4. CZĄSTKOWE

Definicje cząstkowe są wyrażeniami w postaci okresu warunkowego (ogólnie: Ax Bx), podającymi tylko

NIEKTÓRE

kryteria stosowalności terminu definiowanego.

Okres warunkowy (zdanie warunkowe) podaje:

•

albo warunek wystarczający (wystąpienie P jest warunkiem wystarczającym dla wystąpienia Q)

Px Qx

„Jeśli x ukończył uniwersytet (P), x ma wyższe wykształcenie (Q)”.

•

albo warunek konieczny (wystąpienie P jest warunkiem koniecznym dla wystąpienia Q, czyli jeśli nie wystąpi P to

nie wystąpi Q):

(~Px ~Qx) (Qx Px)

„Warunkiem (koniecznym) zaliczenia roku (Q) jest zdobycie 60 punktów ECTS (P)”.

Definicje cząstkowe pozwalają orzec definiowany termin tylko o CZĘŚCI przedmiotów – o tych mianowicie, które

spełniają warunek podany w poprzedniku definicji. O pozostałych przedmiotach nie można natomiast orzec czy

posiadają definiowaną cechę. Definicji cząstkowych używamy wtedy, gdy nie jest możliwe podanie definicji

równościowej (równoważnościowej).

Forma definicji cząstkowych:

•

Definicje CZĄSTKOWE w postaci prostego zdania warunkowego

Jeśli żarówka świeci, to żarówka jest dobra”

(ogólnie: Px Qx, gdzie Q jest terminem definiowanym).

Jeśli jednak nie świeci to nie wiadomo czy jest dobra czy nie (mógł się przepalić bezpiecznik, uszkodzić

przewód itp.)

„Jeśli figura nie ma kątów równych to figura nie jest kwadratem” (~Px ~Qx)

Ale jeśli ma kąty równe to nie wiadomo czy jest kwadratem (może być prostokątem).

•

Definicje REDUKCYJNE (zdania redukcyjne) – szczególna postać definicji cząstkowych, wprowadzona

przez Carnapa,. Służą do definiowania terminów teoretycznych za pomocą terminów empirycznych

(„redukują terminy teoretyczne do terminów obserwacyjnych”).

– jednostronne zdanie redukcyjne (Q – termin definiowany):

x (Sx (Px Qx)

– obustronne zdanie redukcyjne:

x (Sx (Px Rx)

•

Definicja operacyjna - rodzaj definicji redukcyjnej wskazującej operacje (czynności) jakie

należy wykonać aby stwierdzić, czy przedmiot ma definiowaną cechę. W szczególności,

definicja operacyjna może wskazywać metodę pomiaru („rozumieć co znaczy dana cecha

to wiedzieć jak ją zmierzyć”). Przykład definicji (w postaci zdania redukcyjnego) w oparciu

o operację pomiarową

„Jeśli osoba dorosła poddana zostanie badaniu testem Ravena to osoba ta ma wysoką

inteligencję zawsze wtedy i tylko wtedy gdy rozwiąże poprawnie co najmniej n zadań

testowych”.

Ogólnie: Jeśli wykonana zostanie na x operacja O, to x ma cechę C zawsze wtedy i tylko

wtedy gdy x uzyska wynik W.

x (Ox (Cx Wx)

Definicja operacyjna nie odwołująca się do pomiaru:

„Jeśli umieścimy x w pobliżu opiłków metalu to x jest magnesem zawsze wtedy i tylko

wtedy gdy x przyciąga opiłki”.

Operacjonizm – stanowisko zgodnie z którym pojęcia naukowe powinny być definiowane

za pomocą definicji operacyjnych (Bridgman).

INNE RODZAJE DEFINICJI

1. Definicja REALNA

Jest pojęciem niejasnym i różnie definiowanym. Zgodnie z jednym z ujęć, definicja realna podaje jednoznaczną

charakterystykę jakiegoś przedmiotu. (zakłada się przy tym, że zbiór przedmiotów, o których mowa w definiendum, jest

dobrze określony, tzn. wiadomo jakie przedmioty należą do tego zbioru a jakie nie należą; np. wiadomo co jest

człowiekiem a co nim nie jest nim). Według Marciszewskiego, definicja realna podaje cechy istotne definiowanego

przedmiotu (tzw. definicja istotnościowa). Przykład: „człowiek to istota rozumna”. Powstaje jednak pytanie jak rozumieć

„cechę istotną”. Szczególną postacią definicji realnej jest definicja KLASYCZNA – tzn. definicja przez rodzaj i różnicę

gatunkową (per genus et differentia specifica).

Przykład: „kwadrat to prostokąt równoboczny”.

Niektórzy autorzy nie godzą się na traktowanie definicji jako twierdzeń rzeczowych (czyli twierdzeń o rzeczywistości) i

akceptują tylko definicje nominalne, tj. określające zakres i znaczenie słów. Wg Poppera definicje takie powinny być

czytane „od prawej do lewej”.

Przykład: „szczeniak to młody pies”.

Definicja ta nie udziela odpowiedzi na pytanie „co to jest szczeniak”, ale odpowiada na pytanie „jak nazywamy młodego

psa”.

Pojecie definicji istotnościowej i istoty zjawiska wywodzi się z tradycji sokratejsko-platońsko-arystotelesowskiej (por.

Heller, 2005). Sokrates zastanawiał się nad istotą cnót moralnych (co to jest sprawiedliwość?) a Platon i Arystoteles nad

tym, jak to się dzieje, że rzeczy się zmieniają a jednocześnie zachowują swą tożsamość. Uznali, że zmieniają się

przygodne (niekonieczne) cechy przedmiotów (bytów) a ich istota pozostaje niezmienna. Ta niezmienna istota rzeczy

była określana mianem idei (Platon) substancji i formy (Arystoteles). Celem nauki miało być dociekanie istoty zjawisk

(Arystoteles: „poznanie każdej rzeczy sprowadza się do poznania jej istoty”), czyli szukanie odpowiedzi na pytania w

rodzaju: co to jest czas?, co to jest człowiek?, etc. Odpowiedzi na takie pytania ujmowane były w formę definicji

istotnościowych. Opisane wyżej podejście nazywa się esencjalizmem.

Zdaniem Poppera, nauka nie bada istoty przedmiotów czy zjawisk ale ich zachowanie, bądź zachodzące między nimi

relacje. Nie dociekamy tego jaka jest istota czasu, ale jak go mierzyć, bądź w jakich relacjach pozostaje on do innych

zjawisk bądź procesów. Tworzenie precyzyjnych definicji jest ważne dla zwięzłości języka (dłuższe określenia

zastępujemy krótszymi) i sprawnego komunikowania się, ale nie poszerza wiedzy o świecie. Definicje nie zawierają w

sobie żadnej wiedzy o świecie. Wiedza o świecie zawarta jest w sądach (teoriach naukowych). Pełne zdefiniowanie

wszystkich terminów naukowych jest zresztą niemożliwe (regressus ad infinitum) a ich znaczenie zmienia się z postępem

nauki.

2. Definicje OSTENSYWNE - (inaczej: „dejktyczne”, „przez pokazywanie”).

Służą do definiowania terminów obserwacyjnych, np:

„To (pokazujemy dany przedmiot) jest KOŃ”

NIEKTÓRE BŁĘDY DEFINIOWANIA

1.

Nieostrość

Definicja (równościowa lub równoważnościowa) jest NIEOSTRA jeśli o niektórych przedmiotach nie można orzec czy są czy też nie są

desygnatami definiowanego wyrażenia.

Np.: „Dziecko to osobnik młody”

Jeśli zakresy definiendum i definiensa pokrywają się definicję nazywamy adekwatną. Jeśli zakres definiensa obejmuje przedmioty nie

należące do definiendum – definicja ZA SZEROKA (np. kwadrat to figura prostokątna). Jeśli zakres definiensa nie obejmuje wszystkich

przedmiotów należących do definiendum definicja jest ZA WĄSKA (np. student to osoba ucząca się na uniwersytecie). Może się zdarzyć,

że człony definicji krzyżują się (definicja taka jest jednocześnie za wąska i za szeroka)

2.

Idem per idem (to samo przez to samo) lub błędne koło w definiowaniu (circulus in definiendo)

Błąd polegający na użyciu w definiensie wyrażenia definiowanego.

Przykład: „Definicja to zdanie podające definicję wyrażenia”

Zwykle mamy do czynienia z błędnym kołem pośrednim: termin a definiujemy za pomocą terminu b, b za pomocą c, c za pomocą ... a.

Ponieważ jednak nie można iść w definiowaniu pojęć w nieskończoność (regressus ad infinitum) pewne pojęcia muszą pozostać

niezdefiniowane.

3.

Błąd ignotum per ignotum (nieznane przez nieznane)

Definiowanie słowa nieznanego odbiorcy za pomocą innych wyrażeń również mu nieznanych. Jest to błąd ze względu na odbiorcę

definicji - ta sama definicja może być zrozumiała dla jednego odbiorcy a niezrozumiała dla innego.

„Wariancja to kwadrat odchylenia standardowego”

„Wariancja to miara zróżnicowania jakiegoś zbioru wyników”

TERMINY TEORETYCZNE A TERMINY OBSERWACYJNE

Terminy OBSERWACYJNE - odnoszą się do własności obserwowalnych (np. „X jest wysoki”).

Terminy TEORETYCZNE - odnoszą się do tego co nieobserwowalne (np. „X ma silne ego”).

Terminy obserwacyjne służą do przedstawiania wyników badań. Budowanie teorii wymaga terminów teoretycznych. Dziś uważa się

jednak, że terminy obserwacyjne są obciążone teorią (język obserwacyjny jest „uteoretyzowany”). Znaczenie pojęć obserwacyjnych

zależy od znajomość teorii. Na przykład, znaczenie wyniku pomiaru dokonanego testem psychologicznym zależy od znajomości teorii

testów i teorii mierzonej cechy. Podział pojęć naukowych na terminy teoretyczne i obserwacyjne, choć pożyteczny, jest więc nieostry.

Mamy tu raczej do czynienia z różnym stopniem nasycenia terminów obserwacyjnych teorią.

Terminy teoretyczne mogą mieć różną formę.

Terminy dyspozycyjne – mają bardzo ubogą treść. „x ma cechę dyspozycyjną (ukrytą) D” jeśli w określonych warunkach x

ujawnia pewną cechę obserwowalną O.

Przykład: rozpuszczalny, cecha lęku w koncepcji lęku Charlesa D. Spielbergera (State-Trait Anxiety Inventory).

Konstrukty teoretyczne -- pojęcia teoretyczne których treść wykracza poza zaobserwowane fakty. Mówi się, że konstrukt

teoretyczny ma tzw. nadwyżkę znaczenia

(surplus meaning)

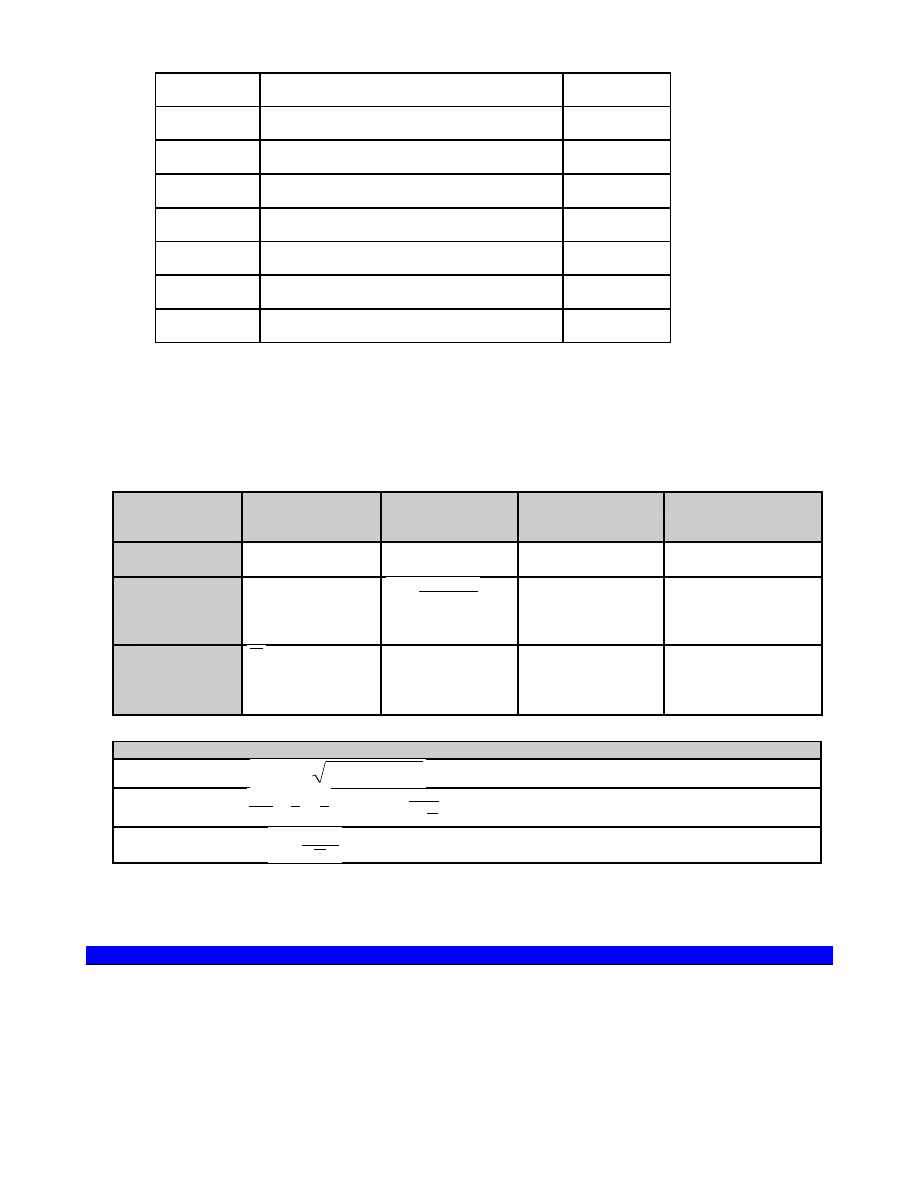

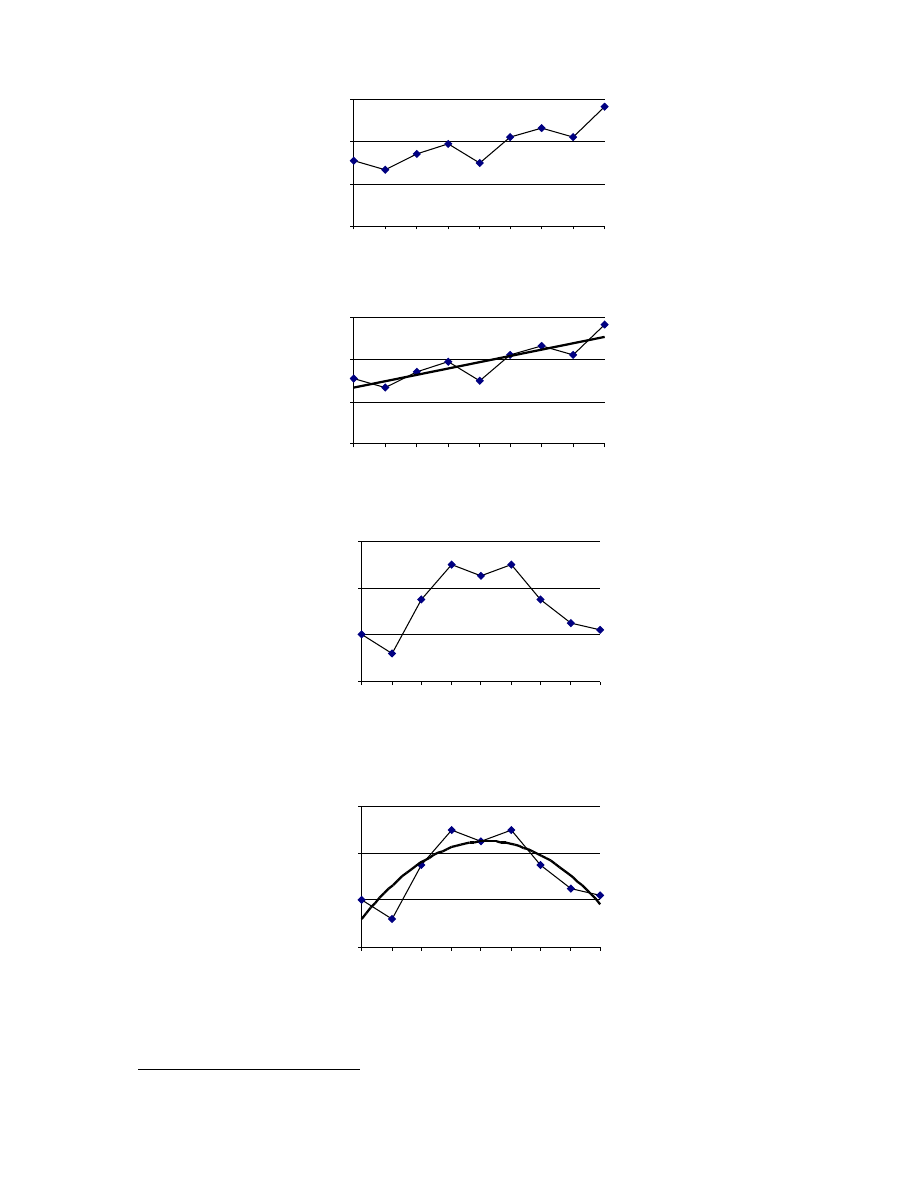

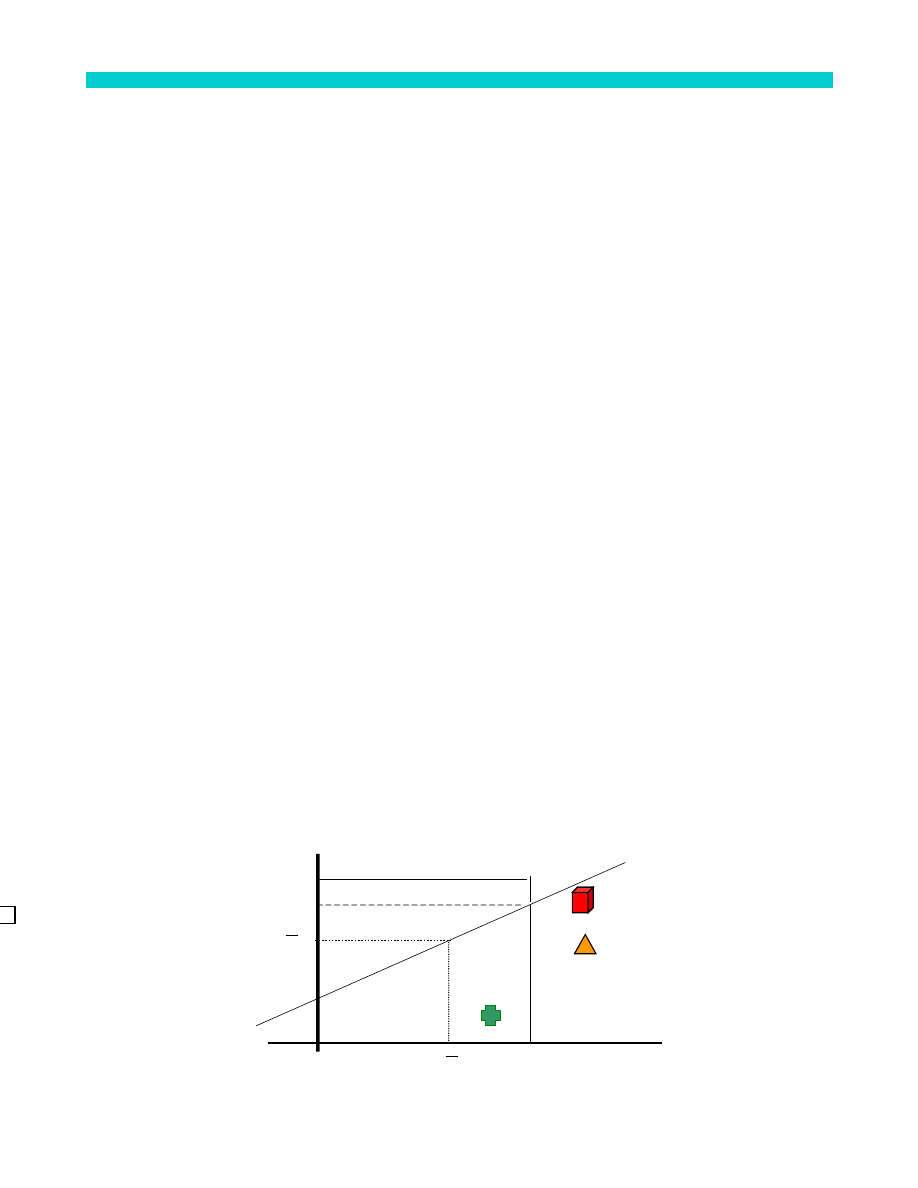

JAK POWSTAJĄ KONSTRUKTY TEORETYCZNE? Przykład (fikcyjny i bardzo uproszczony)

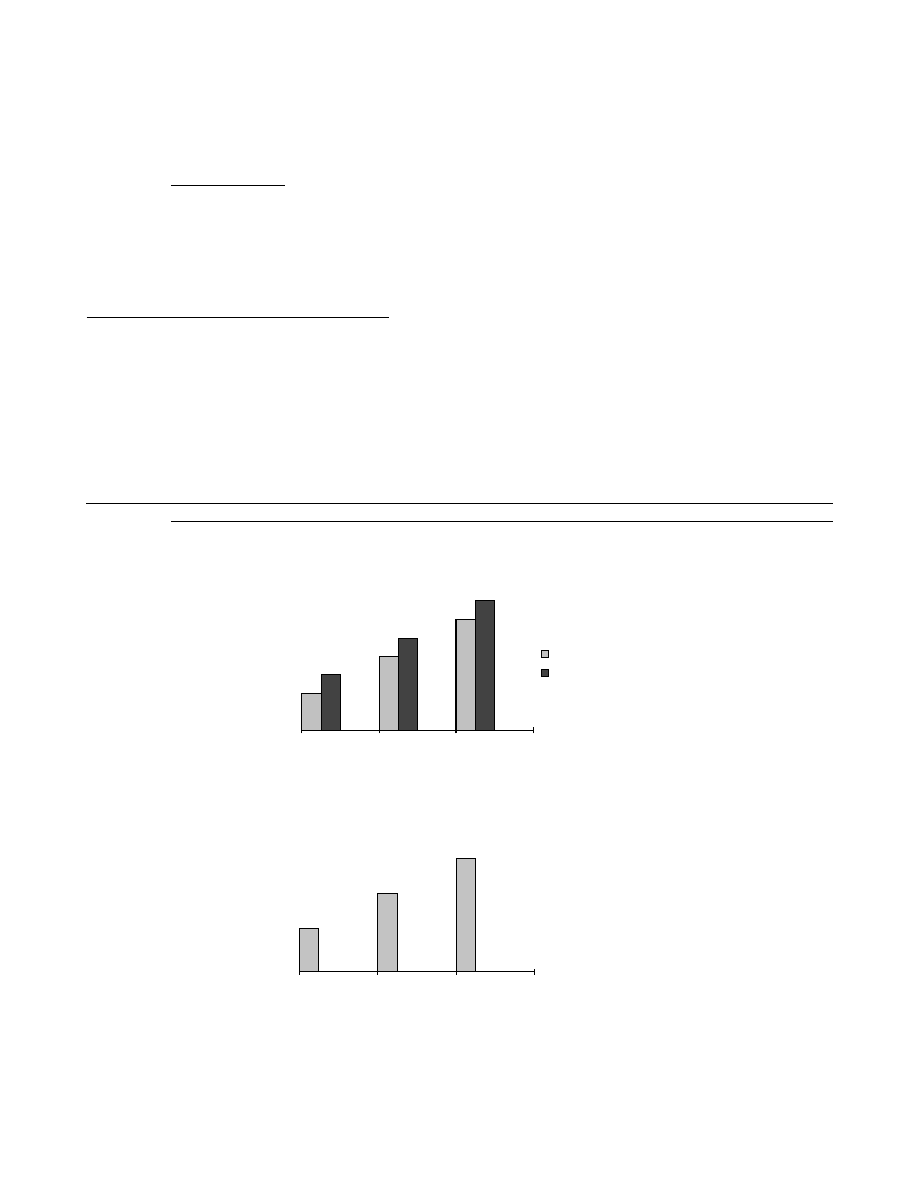

Zaobserwowano, że osoby które lepiej wykonują zadanie (1) wykonują też lepiej zadania (2), (3) i (4).

(1) 12 + 27 =

(2) 1, 4, 7, 10, ...

(3) , , , , , .....

b)

a)

c)

(4) Co to jest sztaluga? ..............

Konstrukt: inteligencja.

Definicja (teoretyczna) inteligencji: „zdolność adaptacji do nowych warunków i do wykonywania nowych zadań” (Stern). Z tak

zdefiniowanej inteligencji można wydedukować wiele nowych cech, zarówno obserwowalnych jak i (wcześniej)

nieobserwowalnych, np. osoby o wyższej inteligencji:

•

mają większe sukcesy zawodowe

•

szybciej się uczą

•

łatwiej rozwiązują problemy

Postulowane przez teorię własności osób inteligentnych, które nie zostały jeszcze zweryfikowane empirycznie (a niektóre z nich,

być może, nigdy nie zostaną zweryfikowane), stanowią NADWYŻKĘ ZNACZENIA (surplus meaning) pojęcia „inteligencja”.

DEFINIOWANIE TERMINÓW TEORETYCZNYCH ZA POMOCĄ TERMINÓW OBSERWACYJNYCH

Terminy obserwacyjne są zasadniczo przyjmowane bez definicji (jako zrozumiałe same przez się). Mogą być też definiowane

ostensywnie.

Terminy teoretyczne mogą być definiowane za pomocą innych terminów teoretycznych (lub słów z języka potocznego). Uważa

się natomiast, że terminy teoretyczne nie dają się zdefiniować w sposób zupełny za pomocą terminów obserwacyjnych, lecz

jedynie w sposób cząstkowy.

KRYTERIA STOSOWALNOŚCI TERMINÓW TEORETYCZNYCH

Na jakiej podstawie mogę orzec że x posiada jakąś nieobserwowalną (teoretyczną) własność W?

Ponieważ chodzi o powiązanie terminów teoretycznych z obserwacyjnymi, jest to pytanie o SENS EMPIRYCZNY terminów teoretycznych.

W fizyce mówi się o REGUŁACH KORESPONDENCJI, czyli o procedurach pozwalających powiązać terminy teoretyczne z obserwacyjnymi

(mogą to być np. procedury pomiarowe) Procedury takie są zwykle czymś dużo bardziej złożonym niż definicje operacyjne. Hempel

mówi o „zasadach łączących” terminy teoretyczne i obserwacyjne.

W psychologii mówi się o OPERACJONALIZACJI zmiennych teoretycznych (nie należy mylić operacjonalizacji z operacjonizmem jako

stanowiskiem metodologicznym).

Operacjonalizacja pojęć teoretycznych należy do najbardziej złożonych problemów w naukach empirycznych. Jest bardzo wiele, nieraz

trudnych do zaklasyfikowania, sposobów wiązania pojęć teoretycznych z pojęciami obserwacyjnymi.

1. DEFINICJE CZĄSTKOWE

Definicje cząstkowe (np. w postaci zdań redukcyjnych) służą (częściowemu) przekładaniu pojęć teoretycznych na pojęcia

empiryczne. Sens redukcyjnego definiowania terminów teoretycznych można (za Przełęckim) przedstawić następująco: choć

terminy teoretyczne są nieobserwowalne, to jednak w pewnych, ściśle określonych warunkach „ujawniają się” w zjawiskach

obserwowalnych.

PROBLEMY z operacyjnym definiowaniem pojęć:

Reguły korespondencji mogą przyporządkowywać temu samemu pojęciu teoretycznemu WIELE pojęć

obserwacyjnych. Przykładowo, fizyka zna wiele metod pomiaru długości a w psychologii istnieje wiele testów

inteligencji, wiele procedur manipulacji poziomem motywacji, itp. Przyjęcie sztywnego, wąsko rozumianego

stanowiska operacjonalistycznego prowadzi do konkluzji: „ile operacji tyle pojęć” (zwłaszcza gdy wyniki różnych

operacji nie są zgodne ze sobą).

Pojęcia definiowane operacyjnie mają sens tylko w tych warunkach w których operacje są wykonalne. Pojęcie „1 metr”

definiowane jako cecha przedmiotów przystających do wzorca (sztaby) metra, jest pozbawione znaczenia w

przypadku wielkich odległości kosmicznych. Iloraz inteligencji II = 100, zdefiniowany za pomocą pomiaru skalą

Wechslera, nie ma sensu tam, gdzie test Wechslera nie jest znany.

Wiele terminów teoretycznych to konstrukty o bardzo bogatej treści, nie dające się satysfakcjonująco zdefiniować za

pomocą definicji operacyjnych. Dziś uważa się, pełne zdefiniowanie pojęć teoretycznych w terminach pojęć

obserwowalnych jest nieosiągalne. Z drugiej strony, może istnieć bardzo wiele kryteriów stosowania terminów

teoretycznych, wyznaczających równie wiele implikacji testowych tych pojęć (Hempel).

W psychologii unika się definicji operacyjnych. Terminy teoretyczne operacjonalizuje się zwykle za pomocą różnych, mniej lub

bardziej złożonych procedur (przykład: operacjonalizacja pojęcia huśtawki emocjonalnej w eksperymentach Dolińskiego).

Ważną rolę wśród tych procedur odgrywają tzw. wskaźniki.

2. WSKAŹNIKI

W jest wskaźnikiem zjawiska wskazywanego I (indicatum) jeśli na podstawie zaobserwowania W możemy wnioskować o

zjawiska I, tzn.:

•

z faktu wystąpienia W możemy wnioskować

o wystąpieniu I (zjawiska jakościowe), lub

•

z natężenia W możemy wnioskować o natężeniu I (zjawiska ilościowe).

Podstawą wnioskowania o I na podstawie W jest zachodzenie związku między W i I. Zdanie stwierdzające zachodzenie takiego

związku nazywa się ZDANIEM WPROWADZAJĄCYM WSKAŹNIK.

Związek między W i I może być związkiem (podział S. Nowaka):

•

definicyjnym: wskaźnik DEFINICYJNY

•

rzeczowym: wskaźnik RZECZOWY.

Wskaźniki rzeczowe dzielimy na:

•

wskaźniki EMPIRYCZNE (W i I są obserwowalne)

•

wskaźniki INFERENCYJNE (I jest nieobserwowalne)

Zdanie wprowadzające wskaźnik definicyjny nie różni się od definicji operacyjnej. Jest ono postulatem terminologicznym

(zdaniem analitycznym) opartym na pewnej konwencji (umowie) terminologicznej: będę traktował W jako wskaźnik I (np. będę

traktował rodzinę z jednym lub dwojgiem dzieci jako rodzinę małą).

Zdanie wprowadzające wskaźnik rzeczowy jest zdaniem syntetycznym, które stwierdza zachodzenie zależności między dwoma

zjawiskami. Zdanie to może być prawdziwe (jeśli między W i I rzeczywiście zachodzi odpowiedni związek) lub fałszywe (jeśli

związek nie zachodzi). Zakłada się przy tym, że pojęcie wskazywane zostało już wcześniej zdefiniowane (wskaźnik rzeczowy nie

pełni funkcji definicji).

Przykład: Jeśli przyjmiemy, że test wynik testu T jest wskaźnikiem rzeczowym inteligencji a okaże się że osoby z wysoką

inteligencją (określoną w jakiś inny sposób) osiągają w teście T niskie wyniki, to będzie to znaczyło, że test T nie jest dobrym

wskaźnikiem inteligencji (a zdanie mówiące o istnieniu związku między W i I jest zdaniem fałszywym).

2.2 WSKAŹNIKI EMPIRYCZNE I INFERENCYJNE

Wskaźniki empiryczne stosuje się zazwyczaj wtedy, gdy W i I są obserwowalne ale zaobserwowanie zjawiska W jest

łatwiejsze,

prostsze,

wygodniejsze

niż

zaobserwowanie

zjawiska I. Na przykład, badacz może przyjąć że posiadanie mieszkania własnościowego w dobrej dzielnicy będzie

wskaźnikiem zamożności (rozumianym jako posiadanie określonych dochodów rocznych). Posiadanie mieszkania jest

łatwiejsze do zaobserwowania niż wysokość dochodów. Większość cech psychologicznych (np. siła ego, poziom

inteligencji) to konstrukty teoretyczne, musimy więc stosować wskaźniki inferencyjne. Powstaje problem jak wykazać że

zachodzi związek miedzy W i I, jeśli I jest nieobserwowalne?

Ustalanie związku między zjawiskiem nieobserwowalnym a jego wskaźnikiem INFERENCYJNYM przypomina testowanie

teorii.

•

Z teorii cechy C (konstruktu teoretycznego) dedukujemy pewne obserwowalne konsekwencje (jakie

obserwowalne zachowania powinien przejawiać ktoś, kto ma cechę C).

•

Następnie możemy sprawdzić do jakiego stopnia przewidywania zgadzają się z teorią (tzn. potwierdzają ją lub jej

przeczą)

W przypadku wskaźnika inferencyjnego, z teorii cechy wskazywanej (indicatum) dedukujemy jakie związki powinny

zachodzić między danymi obserwacyjnymi a następnie obserwujemy czy faktycznie tak jest. Na przykład, z teorii

inteligencji możemy wydedukować hipotezy, że osoby o wysokiej inteligencji powinny osiągać lepsze wyniki na studiach,

mieć większe sukcesy zawodowe, itp. Jeśli nie stwierdzimy takich faktów u osób z wysokimi wynikami w teście T to

możemy wyciągnąć wniosek, że test T nie jest dobrym wskaźnikiem inteligencji (ewentualnie, że niedobra jest teoria na

której oparty jest test T).

3. WSKAŹNIK A DEFINICJA OPERACYJNA

Definicja operacyjna określa sposób rozumienia wyrażenia. Jest to zdanie analityczne (postulat terminologiczny), któremu nie

można zaprzeczyć bez popadania w wewnętrzną sprzeczność. Zdanie wprowadzające wskaźnik rzeczowy jest zdaniem

rzeczowym, które stwierdza, że między dwoma zjawiskami (W i I) zachodzi zależność. Fakty mogą potwierdzić lub obalić takie

zdanie. Zdanie wprowadzające wskaźnik rzeczowy nie definiuje natomiast terminu I (termin I musi być zdefiniowany oddzielnie).

Inne są konsekwencje nie potwierdzenia przewidywań wydedukowanych z przyjętych wskaźników lub definicji operacyjnych.

Jeśli mamy dwa WSKAŹNIKI rzeczowe (W1 i W2) cechy Q (np. dwa testy inteligencji) i wskaźniki te nie korelują ze sobą (osoby

uzyskujące wysokie wyniki w jednym teście uzyskują niskie wyniki w drugim teście), to znaczy to, że:

•

co najmniej jeden wskaźnik jest nietrafny, a tym samym:

•

co najmniej jedno zdanie wprowadzające wskaźnik jest fałszywe.

Jeśli natomiast mamy dwie niezgodne ze sobą definicje operacyjne (tzn. definiujemy cechę Q za pomocą własności W1 i W2,

które nie korelują ze sobą) to musimy przyjąć, że definicje te definiują dwie rożne cechy (jakieś: Q1 i Q2).

Psychologowie unikają zazwyczaj operacyjnego definiowania cech psychologicznych explicite. Ślady takiego definiowania można

jednak dostrzec w sformułowaniach typu: „inteligencja mierzona testem T ...”. Sugerują one, że test T definiuje jakiś szczególny

rodzaj inteligencji, inny niż inteligencja mierzona innym testem.

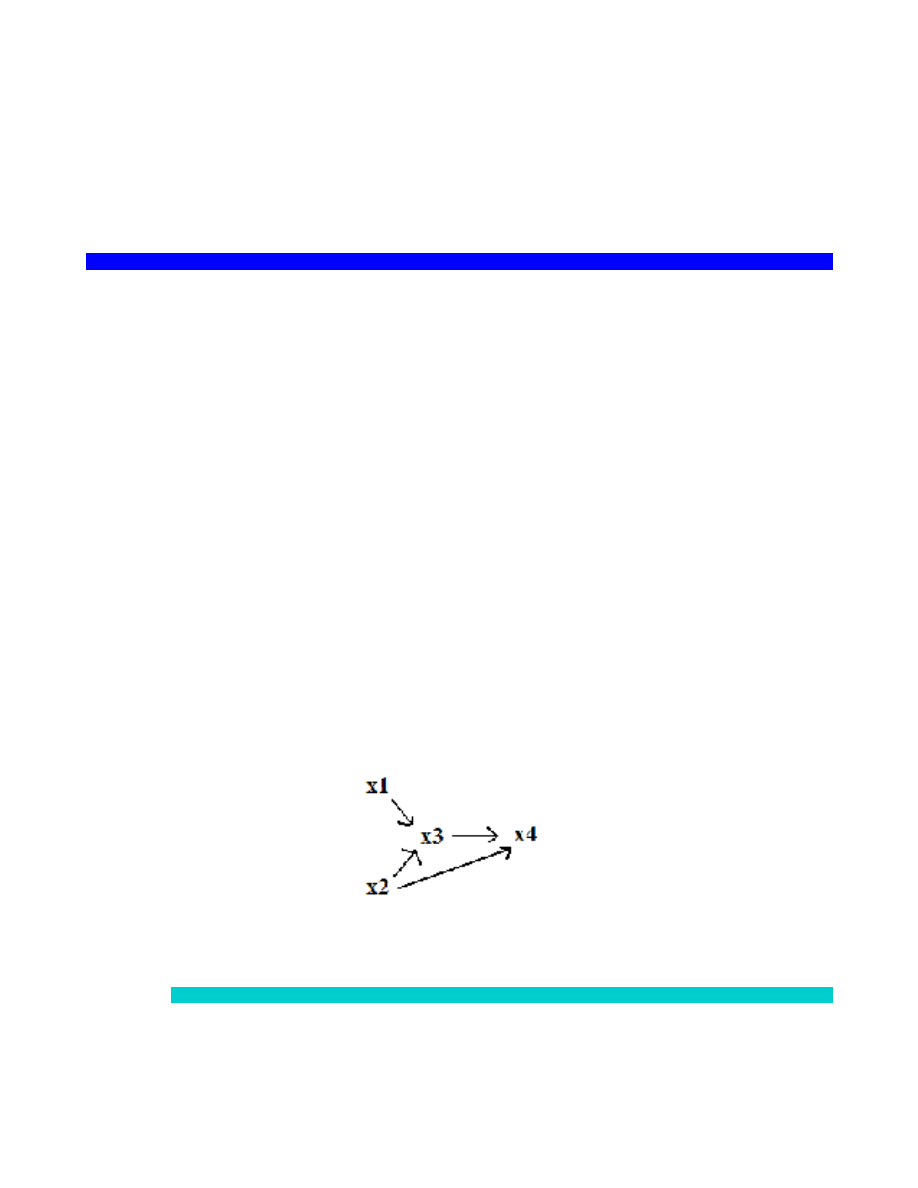

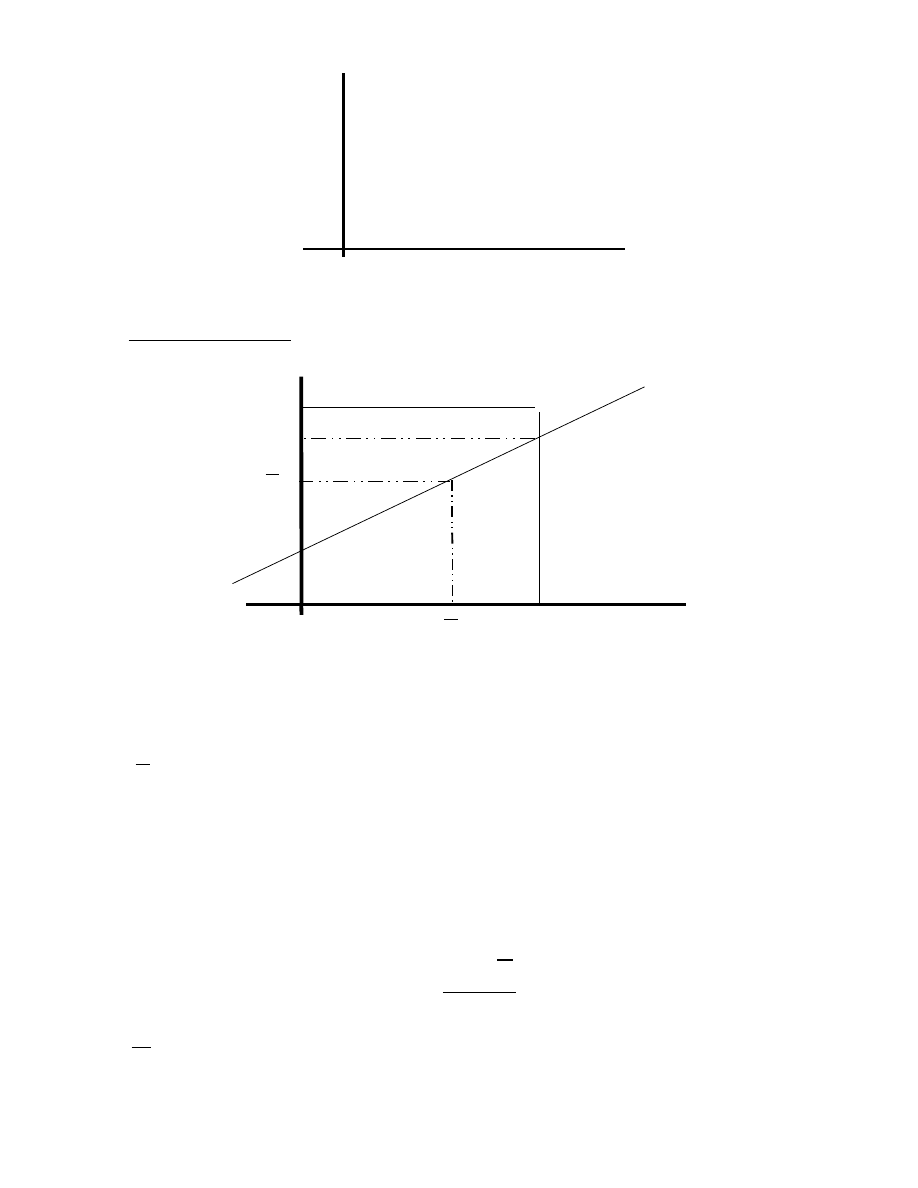

3.3 OPERACJONALIZACJA ZMIENNYCH MANIPULOWALNYCH

Operacjonalizacja może dotyczyć zmiennych mierzalnych i zmiennych manipulowalnych.

Operacjonalizacja zmiennych manipulowalnych

Chcemy np. wykazać eksperymentalnie, że lęk obniża poziom wykonania zadań złożonych. Musimy WYTWORZYĆ za

pomocą odpowiedniego oddziaływania (O) co najmniej dwa różne poziomy lęku (zmiennej manipulowalnej - X). W

jaki sposób wykazać, że oddziaływanie spowodowało rzeczywiście zmianę tej zmiennej X o którą nam chodzi?

•

Niekiedy, można użyć niezależnych wskaźników zmiennej X (np. testów mierzących stan leku)

•

Analiza wpływu oddziaływania (O) na zmienną zależną (Z);

O X Y

Jeśli manipulacja O powoduje oczekiwaną zmianę Y nie przesądza to jeszcze o trafności manipulacji zmienna X.

Zaufanie do hipotezy „O X” wzrasta, gdy zaobserwujemy, że inne efekty stosowanej manipulacji są zgodne z

teorią.

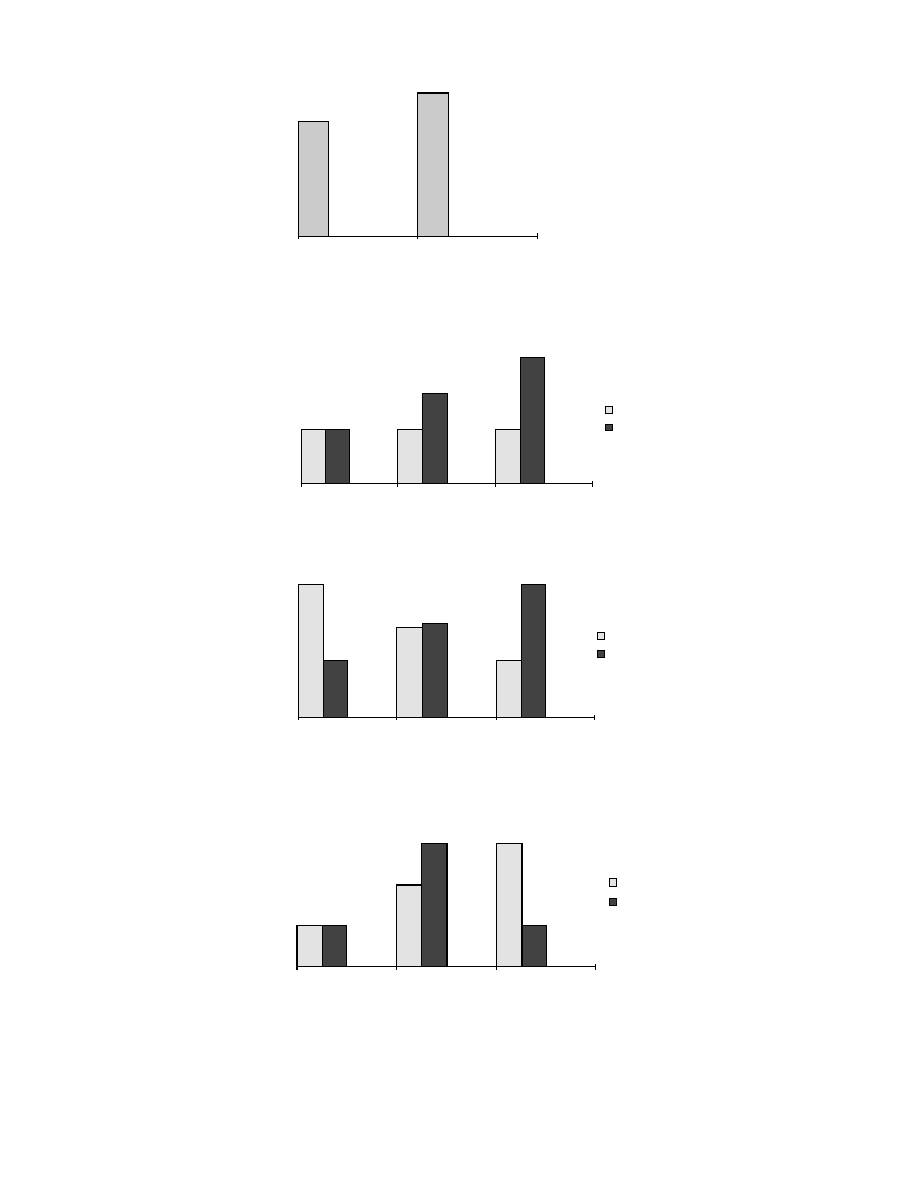

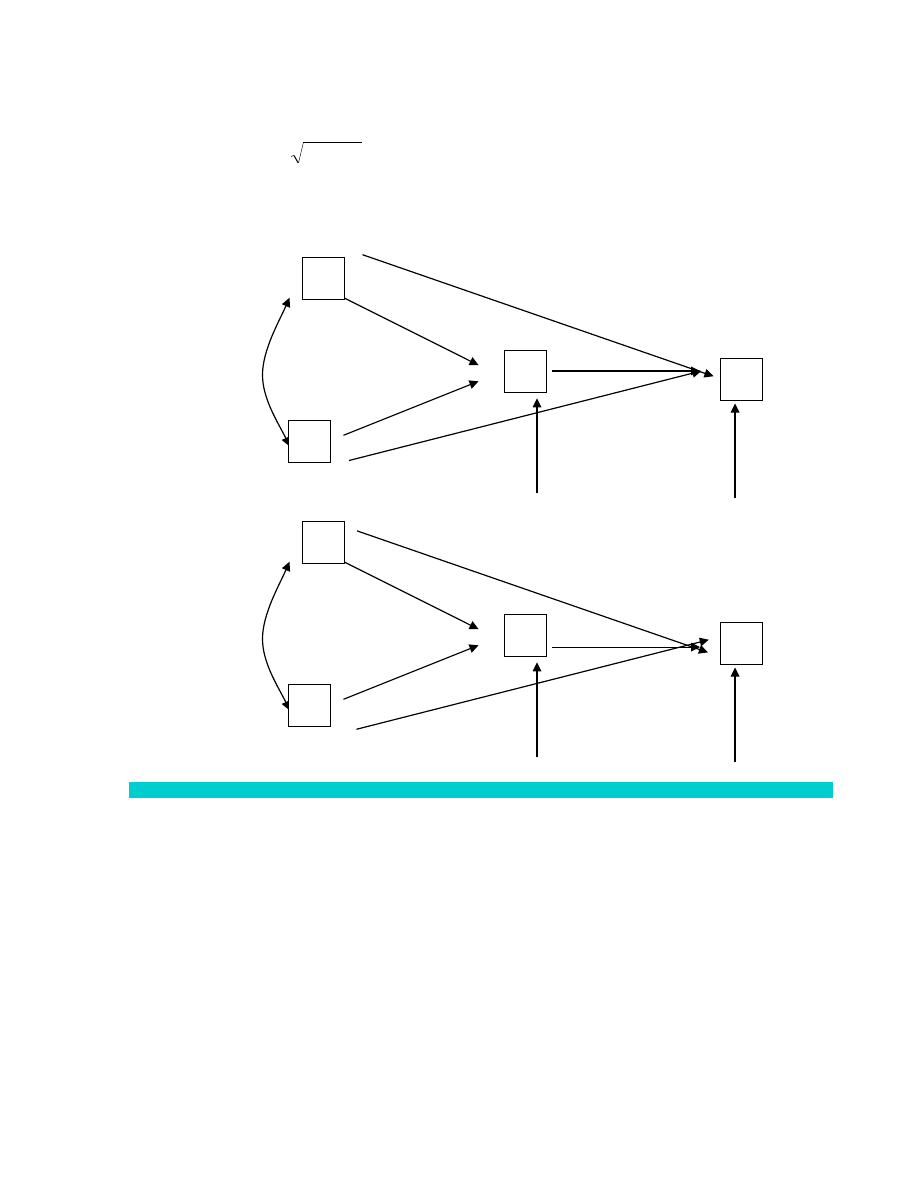

Zmienne pośredniczące w badaniach eksperymentalnych

Jeśli efekt oddziaływania może być wyjaśniony za pomocą różnych zmiennych teoretycznych (X i X’), wybiera się nieraz

zmienną (konstrukt) o większej mocy wyjaśniającej.

O X

1

Y

O X

2

Y

Zdarza się, że alternatywne teorie, wyjaśniające tę samą zależność empiryczną O Z, są niewspółmierne (twierdzeń

jednej teorii nie da się przełożyć na twierdzenia drugiej). Np. gorsze zapamiętywanie „brzydkich słów” może być

tłumaczone jako hamowanie reakcji dla uniknięcia kary (teoria uczenia) albo jako stłumienie („zepchnięcie do

podświadomości”) niepożądanych zachowań (psychoanaliza).

Eksperyment krzyżowy (experimentum crucis) – ma rozstrzygać między konkurującymi ze sobą teoriami, tzn.

definitywnie potwierdzić jedną i obalić drugą. Możliwość takich eksperymentów kwestionuje się jednak, m.in. ze

względu na niewspółmierność teorii.

Definicje projektujące, służące do definiowania pojęć teoretycznych (typu: „osobowość jest to ...”), nie są zdaniami w

sensie logicznym (nie są ani prawdziwe ani fałszywe) i nie zawierają żadnej wiedzy o świecie. Są zdaniami analitycznymi,

opartymi na pewnej konwencji terminologicznej. Na pytanie „co to jest osobowość?” nie ma więc odpowiedzi, chyba

żeby rozumieć je następująco: „co naukowiec X lub społeczność naukowa Y rozumie przez pojęcie osobowość?” Nie

znaczy to jednak, że dowolnie (ale formalnie poprawnie) zdefiniowane pojęcie teoretyczne jest z poznawczego punktu

widzenia równie dobre jak każde inne. Może się bowiem okazać, że jakaś (w określony sposób zdefiniowana) zmienna

pozostaje w nadzwyczaj interesujących relacjach do innych ważnych zmiennych.

Wybór pojęć za pomocą których formłujemy jakiś problem nazywa się KONCEPTUALZACJĄ problemu. Niekiedy nowa

konceptualizacja pozwala rozwiązać problem, który wcześniej wydawał się niemożliwy do rozwiązania.

CZĘŚĆ 3. TWIERDZENIA I ICH UZASADNIANIE

SYSTEMY AKSJOMATYCZNE W NAUKACH FORMALNYCH

TERMINY i ich definiowanie:

Pojęcia PIERWOTNE (niezdefiniowane, lub zdefiniowane za pomocą definicji aksjomatycznych) i WTÓRNE (zdefiniowane za

pomocą pojęć pierwotnych lub innych pojęć zdefiniowanych przy ich pomocy)

Pojęcia pierwotne są dokładnie wymienione

Dąży się do tego, aby pojęć pierwotnych było jak najmniej

ZDANIA i ich uzasadnianie:

Zdania (tezy) systemu dzieli się na zdania PIERWSZE (AKSJOMATY), przyjęte bez dowodu, i zdania WTÓRNE – wydedukowane

ze zdań pierwszych za pomocą niezawodnych (dedukcyjnych) reguł wnioskowania.

Aksjomaty są zazwyczaj wyraźnie wymienione.

Dąży się aby liczba aksjomatów była jak najmniejsza.

Zbór aksjomatów powinien być niezależny.

Zbiór aksjomatów jest niezależny, gdy żadnego aksjomatu nie da się wydedukować z pozostałych.

REGUŁY wnioskowania:

Reguły wnioskowania, które wychodząc od prawdziwych przesłanek prowadzą zawsze do prawdziwych wniosków, nazywamy

niezawodnymi lub dedukcyjnymi.

NIEKTÓRE FORMALNE WŁASNOŚCI TEORII

NIESPRZECZNOŚĆ

System jest NIESPRZECZNY gdy wśród jego tez nie ma pary zdań sprzecznych: p i ~p. Zwykle system nie zawiera zdań sprzecznych

wśród swych aksjomatów, może się jednak zdarzyć, że takie zdania dadzą się wydedukować z aksjomatów. Sprzeczność teorii jest

bardzo poważną wadą, ponieważ z pary zdań sprzecznych wynika dowolne zdanie:

(p

∧

~p)

⊃

q

ROZSTRZYGALNOŚĆ

System jest ROZSTRZYGALNY gdy istnieje metoda, która pozwala o każdym zdaniu z danej dziedziny rozstrzygnąć w skończonej liczbie

kroków czy jest prawdziwe ono czy nie. Przykład zdania nierozstrzygalnego:

"Liczba gwiazd we wszechświecie jest parzysta"

ZUPEŁNOŚĆ

System jest ZUPEŁNY gdy z jego aksjomatów dadzą się wydedukować wszystkie zdania prawdziwe w danej dziedzinie (każde zdanie

prawdziwe jest tezą systemu).

Jeśli jakieś zdanie prawdziwe nie da się wydedukować, można usunąć ten mankament przyjmując dodatkowe aksjomaty. Wtedy jednak

pojawiają się zwykle nowe zdania, które nie dadzą się wydedukować z aksjomatów. Kurt Gödel udowodnił, że wszystkie bogatsze teorie

w naukach formalnych (tzn. teorie zawierające w sobie arytmetykę liczb naturalnych) są niezupełne. Wynik Gödla (nad)interpretuje się

często jako dowód na istnienie granic ludzkiego poznania: nie da się zbudować takiej teorii która wyjaśniałaby wszystko.

TEORIE W NAUKACH EMPIRYCZNYCH

Przez teorię rozumie się pojedyncze zdanie teoretyczne albo system powiązanych ze sobą zdań teoretycznych. Zdanie teoretyczne to

zdanie zawierające terminy teoretyczne, których desygnaty nie są bezpośrednio obserwowalne (w przeciwieństwie do zdania

obserwacyjnego, opisującego wyniki obserwacji).

FUNKCJE TEORII NAUKOWYCH

•

FUNKCJA DESKRYPTYWNA (OPIS) – teoria dostarcza terminów do opisu rzeczywistości.

Np. lekarz może powiedzieć, że u badanego "występują objawy paranoidalne i niepokój ruchowy, badany nie potrafi

nawiązać kontaktu emocjonalnego z otoczeniem i jest stale napięty”.

Dziś podkreśla się, że język obserwacyjny jest uteoretyzowany a interpretacja wyników obserwacji zależy od teorii. Tym

samym, podział pojęć na obserwacyjne i teoretyczne przestaje być ostry.

•

FUNKCJA PRAKTYCZNA (WSKAZYWANIE REGUŁ DZIAŁANIA) - teoria mówi jak postępować aby osiągnąć jakiś cel

(spowodować zmianę rzeczywistości). Funkcja praktyczna to zastosowanie teorii.

Dyrektywy praktyczne można też formułować bez teorii, na podstawie doświadczenia. Dyrektywy takie mają jednak

ograniczony zakres zastosowania.

•

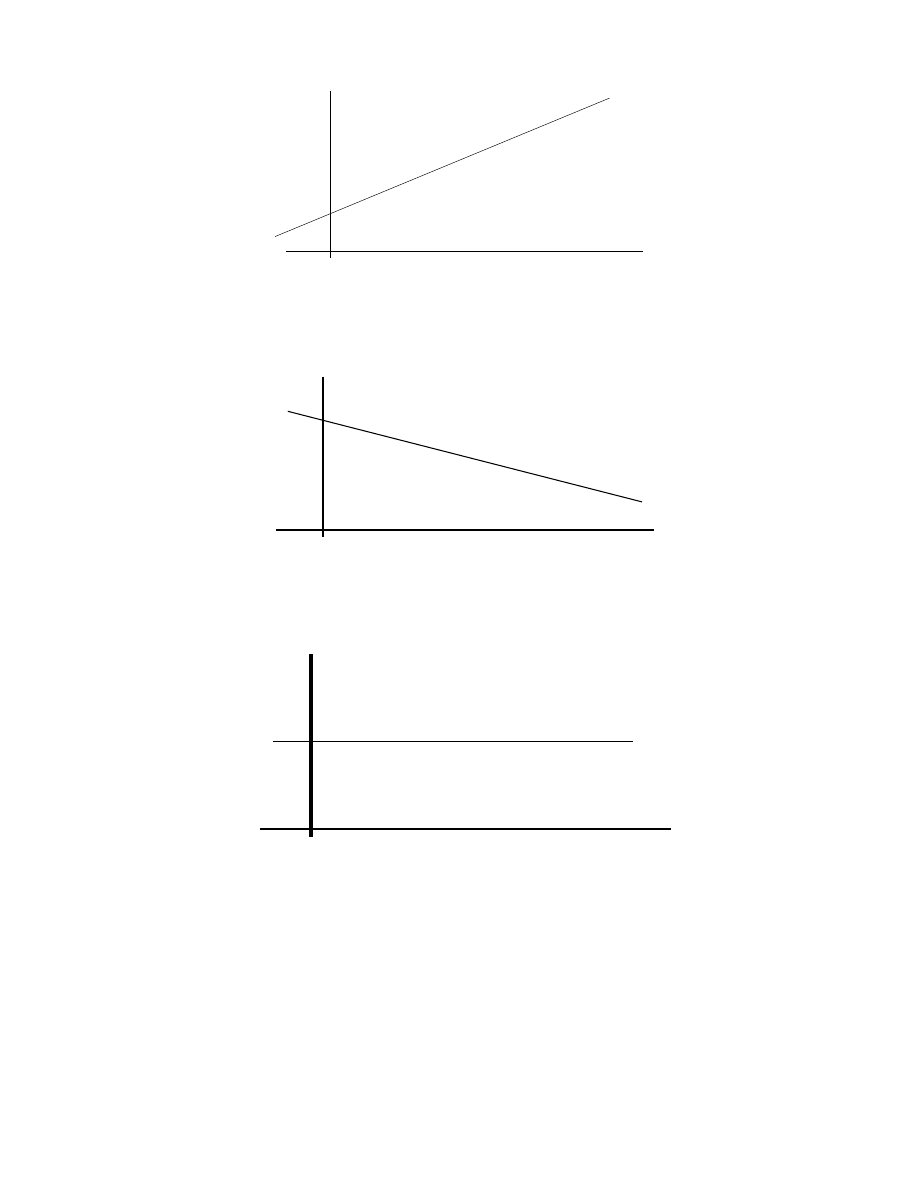

FUNKCJA EKSPLANACYJNA (WYJAŚNIANIE) i FUNKCJA PREDYKTYWNA (PRZEWIDYWANIE)

Wyjaśnianie, sprawdzanie (hipotez) i przewidywanie to, w sensie logicznym, wnioskowania odwołujące się do stosunku

wynikania, w najprostszej formie – do relacji: p

→

q

•

Przewidywanie to szukanie następnika dla uznanego poprzednika (szukanie zdania q, które wynika z uznanego

zdania p); w szczególności jest to dedukowanie zdań obserwacyjnych z uznanego prawa (praw) i pewnych

przesłanek szczegółowych.

„Jeśli zaszło X to (przewidujemy, że) zajdzie Y”

•

Wyjaśnianie to szukanie poprzednika dla uznanego następnika (szukanie zdania p, z którego można

wydedukować uznane zdanie q); w szczególności: szukanie prawa (praw) z których można wydedukować inne

prawo lub zdanie obserwacyjne.

EXPLANANS - człon wyjaśniający

EXPLANANDUM - człon wyjaśniany

"Dlatego zaszło Y (explanandum) że zaszło X (explanans)"

Potwierdzenie empiryczne przewidywań wynikających z teorii traktuje się jako argument przemawiający za tym, że

teoria dobrze wyjaśnia zjawiska w danej dziedzinie, natomiast niezgodność faktów z przewidywaniami może świadczyć o

tym, że wyjaśnienie proponowane przez teorię jest błędne. Na przykład to, że potrafimy bardzo dokładnie przewidzieć

ruchy ciał niebieskich, jest argumentem przemawiającym za tym, że współczesna teorie astronomiczne dobrze

wyjaśniają ruchy tych ciał. Przewidywanie nie jest jednak tym samym co wyjaśnianie. Na przykład:

•

Znając wysokość słońca (kąt pod jakim padają promienie słoneczne) i wysokość masztu można wydedukować

długość cienia a znając wysokość słońca i długość cienia można wydedukować wysokość masztu. Ale, o ile

długość masztu wyjaśnia długość cienia to nie uważamy, aby długość cienia wyjaśniła długość masztu.

•

Jeśli ekstrawersja i lęk są ze sobą skorelowane, to możemy przewidywać ekstrawersję na podstawie

znajomości lęku i lęk na podstawie znajomości ekstrawersji. Nie jest jednak pewne czy którekolwiek z tych

wnioskowań jest wyjaśnianiem (poziom obu tych zmiennych może być spowodowany jakimś trzecim

czynnikiem).

RODZAJE WYJAŚNIEŃ

Wyjaśnianie jako logiczne wywnioskowywanie (niekiedy – dedukowanie) faktów z teorii lub teorii mniej ogólnych z teorii bardziej

ogólnych. Do tego rodzaju wyjaśnień zaliczamy:

1. NOMOLOGICZNO-DEDUKCYJNE

2. INDUKCYJNO-STATYSTYCZNE

2.1 FUNKCJONALNE

– jaką rolę (funkcję) pełni element X w systemie S?

2.2 GENETYCZNE

– jak doszło do powstania zjawiska x?

2.3 INTENCJONALNE

– jaka była intencja lub cel działania podmiotu?

1.

WYJAŚNIANIE NOMOLOGICZNO-DEDUKCYJNE (Hempel i Oppenheimer, 1948)

•

Wyjaśnianie faktów: z dwojakiego rodzaju przesłanek: praw ogólnych (nomos) i warunków początkowych (Initial

Conditions), czyli zdań szczegółowych stwierdzających fakty, dedukujemy wystąpienie jakiegoś faktu (ewentualnie –

prawa empirycznego)

PRAWA OGÓLNE

WARUNKI POCZĄTKOWE

---- (dedukcja) -------------

KONKLUZJA (EXPLANANDUM)

(P): Dla każdego x, jeśli x ma cechę P to x ma cechę Q

(WP): Ten oto (konkretny) x

o

ma cechę P

Konkluzja: x

o

ma cechę Q

Przykład:

Dla każdego x (Jeśli x jest miedzią to x przewodzi prąd)

Ten oto kawałek drutu x

i

jest wykonany z miedzi

x

i

przewodzi prąd

Aby można było wyjaśniać fakty na podstawie praw (teorii) potrzebne są zasady wiążące terminy teoretyczne z

terminami obserwacyjnymi (podające zasady interpretacji terminów teoretycznych, wyposażające terminy

teoretyczne w treść empiryczną) – por. operacjonalizacja pojęć teoretycznych

•

Wyjaśnianie praw: wyjaśniane mogą być zarówno jednostkowe fakty jak i prawa. W szczególności, często

poszukujemy teoretycznego wyjaśnienia praw empirycznych. Dzięki takim wyjaśnieniom powstaje spójny system

powiązanych ze sobą praw (teorii). Nomologiczno-dedukcyjne wyjaśnianie praw polega na ich dedukowaniu z praw

bardziej ogólnych lub z teorii.

Przykłady:

Każde ciało lżejsze od wody pływa

Lód jest ciałem lżejszym od wody

Lód pływa

PROBLEMY ZWIĄZANE Z WYJAŚNIANIEM NOMOLOGICZNO-DEDUKCYJNYM

Nie każde wnioskowanie, formalnie zgodne z modelem nomologiczno-dedukcyjnym, stanowi rzeczywiste wyjaśnienie

faktów. Aby wyeliminować problemy związane z tym modelem nakłada się na wyjaśnianie N-D dodatkowe warunki:

Warunek ASYMETRII WYJAŚNIANIA: wyjaśnianie nie może zachodzić w obie strony.

Przykład:

Widząc że wskazówka barometru spada można wywnioskować że nadejdzie burza. Ale to nadejście

burzy wyjaśnia ruch wskazówki a nie na odwrót.

Znając kąt padania promieni światła i długość cienia można wywnioskować jaka jest wysokość

masztu. Uważamy jednak, że to wysokość masztu wyjaśnia długość cienia a nie na odwrót.

Prawa (przesłanki wnioskowania) nie mogą być PRZYPADKOWYMI UOGÓLNIENIAMI

Przesłanki powinny być PRZYCZYNOWO ISTOTNE dla wniosku (relevance)

Przykład:

Jeśli ktoś bierze pigułki antykoncepcyjne to nie zachodzi w ciążę

Jan Kowalski brał pigułki antykoncepcyjne

-------------------------------------------------------

Jan Kowalski nie zaszedł w ciążę

Pojawia się jednak problem jak rozumieć y określenie „przyczynowo istotne”. Pojęcie przyczyny, choć

powszechnie używane, nie jest jasne. Bywa też krytykowane ze względu na swój potencjalnie

„metafizyczny” charakter (por. teorię przyczyn Arystotelesa). Zdaniem Lazarsfelda (za: Babbie, 2007)

aby można było uznać A za przyczynę B muszą być spełnione co najmniej dwa warunki:

−

A poprzedza w czasie B

−

między A i B zachodzi zależność empiryczna

−

Skutek nie może dać się wyjaśnić za pomocą jakiejś trzeciej zmiennej (inaczej: zależność

między A i B nie może być zależnością pozorną)

Warunki te można uznać za operacyjną definicję przyczyny.

Wyjaśnianie naukowe nie może być WYJAŚNIANIEM „AD HOC” (wyjaśnianiem za pomocą „hipotez ad

hoc”)

Hipotezą „ad hoc” („do tego”) jest taka hipoteza, z której nie da się wydedukować żadnych

sprawdzalnych faktów poza tym jednym, dla którego wyjaśnienia hipoteza została sformułowana.

Hipoteza H stworzona dla wyjaśnienia faktu Z powinna pozwalać na predykcje innych faktów. Predykcje

takie stanowią „niezależne testy hipotezy H”. Jeśli predykcje takie nie są możliwe, hipotezę należy

traktować jako nieweryfikowalną (nienaukową).

Doskonały przykład wyjaśniania ad hoc (wyjaśniania dlaczego księżyc ma kształt doskonale kulisty

pomimo tego, że na jego powierzchni można zobaczyć góry i doliny) podaje Chalmers (1993, ss. 78-79).

2. WYJAŚNIANIE INDUKCYJNO-STATYSTYCZNE (PROBABILISTYCZNE)

Podobne do nomologiczno-dedukcyjnego z tą jednak różnicą, że przesłankami są nie prawa deterministyczne ale prawa

probabilistyczne. W takim przypadku explanandum nie wynika z przesłanek dedukcyjnie. Można mówić jedynie o (odpowiednio

wysokim) prawdopodobieństwie z jakim zajdzie zdarzenie o którym mowa w explanandum.

Przykłady:

Jest wysoce prawdopodobne, że jeśli x jest ekstrawertykiem to x jest osobą towarzyską

Jan jest ekstrawertykiem

Jest wysoce prawdopodobne, że Jan jest osobą towarzyską

Polon ma połowiczny czas rozpadu równy 3,05 minuty

W próbce jest 1 mg Polonu

Po upływie 3,05 minuty w próbce pozostanie 0,5 mg Polonu

W tym ostatnim przypadku, prawdopodobieństwo zajścia przewidywanego wyniku jest tak duże, że wniosek można

traktować jako „praktycznie pewny”.

Pierwotnie Hempel uważał, że stosowanie wyjaśniania indukcyjno-statystycznego jest wynikiem niedoskonałości naszej wiedzy.

W miarę pogłębiana się tej wiedzy, wyjaśnienie indukcyjno-statystyczne powinno się zbliżać do nomologiczno–dedukcyjnego.

Potem jednak zmienił pogląd uznając, że:

„wiele ważnych praw i teoretycznych zasad nauk przyrodniczych ma charakter probabilistyczny...”

W szczególności, prawa psychologiczne (tzn. prawa będące wynikiem badań psychologicznych) mają charakter probabilistyczny.

2.1 WYJAŚNIANIE FUNKCJONALNE

Odpowiada na pytanie jaką rolę (funkcję) pełni zjawisko X w określonym systemie S?

Wyjaśnianie funkcjonalne koncentruje się na relacjach zachodzących między systemem a jego elementami. Na przykład:

"Jaka funkcję pełni układ sercowo-naczyniowy w organizmie zwierzęcym?"

"Jaką funkcję pełni tabu kazirodztwa w regulacji zachowania społecznego?"

Funkcję można rozumieć jako własność lub proces ważne (czasem konieczne) dla funkcjonowania jakiegoś systemu.

W naukach inżynierskich funkcję definiuje się jako własność urządzenia, która jest niezbędna do realizacji jego

celu

, tzn.

do tego, do czego zostało ono skonstruowane lub do czego jest używane. Gadomski: „funkcja to własność procesu lub

systemu konieczna do realizacji jego celu”. Przykładowe: „reflektory samochodowe służą do oświetlania drogi”.

Wyjaśnienie funkcjonalne zjawisk naturalnych (przyrodniczych) nie zakłada celowości. W biologii przyjmuje się

natomiast (nieraz milcząco) założenie, że zachowanie lub cechy strukturalne organizmów żywych są zasadniczo

adaptacyjne. Jeśli np. odkryjemy jakąś nową strukturę w mózgu to nie pytamy czy jest ona potrzebna ale do czego jest

potrzebna (jaką pełni funkcję). Założenie to zapożyczone jest z teorii ewolucji zgodnie z którą, jeśli jakiś gatunek przeżył

to znaczy, że okazał się „przystosowany” – to co istnieje ma wartość adaptacyjną (ma znaczenie dla przeżywalności

organizmów) a przynajmniej nie jest nieadaptacyjne. Założenie takie pełni również funkcję heurystyczną – skłania do

poszukiwania adaptacyjnej funkcji struktur, właściwości lub procesów.

Zdaniem Nagela (1961, ss. 346, i.n.) wyjaśnianie funkcjonalne można zasadniczo zastąpić wyjaśnianiem N-D, tzn.

wyjaśnianiem odwołującym się do praw stwierdzających warunki konieczne lub wystarczające dla przebiegu danego

procesu lub zaistnienia jakiegoś zjawiska. Przykładowo zdanie „Funkcją chlorofilu znajdującego się w roślinach zielonych

jest umożliwienie im fotosyntezy” można zastąpić zdaniem „Fotosynteza zachodzi w roślinach tylko wtedy, gdy

zawierają chlorofil” lub zdaniem „Niezbędnym warunkiem zachodzenia fotosyntezy w roślinach jest obecność w nich

chlorofilu”.

Każde z tych sformułowań kładzie nacisk na inny aspekt relacji między systemem a jego częściami składowymi.

Sformułowanie pierwszego rodzaju wskazują na następstwa (skutki) jakie ma dla systemu zachodzenia pewnego

procesu lub posiadania pewnego elementu strukturalnego, sformułowanie drugiego rodzaju natomiast wskazują

warunki konieczne lub wystarczające i konieczne (przyczyny) w jakich system zachowuje swe charakterystyczne

czynności i organizację. Powstaje jednak wątpliwość czy wyjaśnianie N-D nie zaciera tego, co jest specyficzną cechą

wyjaśniania funkcjonalnego, tj. badania roli jaką w funkcjonowaniu systemu pełnią jego elementy składowe.

2. 2 WYJAŚNIANIE GENETYCZNE

Jest pytaniem o genezę jakiegoś zjawiska Z, pytaniem o to, w jaki sposób doszło do zaistnienia zjawiska Z, jaki był

przebieg (trajektoria) procesów, które doprowadziły do zaistnienia zjawiska Z. Na przykład:

"W jaki sposób doszło do powstania płuc u zwierząt lądowych?"

"W jaki sposób doszło do powstania objawów nerwicowych u Jasia?"

Wyjaśnianie genetyczne stosuje się do zjawisk, których przebieg jest wyjątkowy i niepowtarzalny, takich jak np.

powstawanie gatunków biologicznych, historia procesów społecznych, przebieg życia danej jednostki, itp. a więc takich,

których nie da się wyjaśnić satysfakcjonująco za pomocą praw ogólnych.

Prawa ogólne stosują się do zjawisk powtarzalnych - stwierdzają one, że zawsze kiedy zachodzi zjawisko A zachodzi też

zjawisko B. Przedmiotem wyjaśnień genetycznych są natomiast procesy niepowtarzalne. Na każdym etapie takiego

procesu mogą działać różne czynniki przyczynowe ale żaden z nich nie wyznacza w sposób jednoznaczny następnego

etapu procesu. Proces ten można jedynie opisać (zrekonstruować jego przebieg ex post) jak ma to np. miejsce w

wypadku ewolucji gatunków biologicznych. Opis taki nazywany jest narracją historyczną. Narracje historyczne różnią się

więc zasadniczo od wyjaśniania zjawisk za pomocą praw. Opisywane przez nie procesy nie dadzą się wydedukować w

sposób pewny z praw (nawet jeśli wyjaśnianie powołuje się jakieś prawa). Narracje nie pozwalają też na przewidywanie

przebiegu opisywanych procesów (chyba że na zasadzie ekstrapolacji aktualnych trendów). Narracje historyczne można

by więc określić jako opis ex post procesów, których przebieg nie da się ująć w prawa i który jest nieprzewidywalny.

2.3 WYJAŚNIANIE INTENCJONALNE

Przez wskazanie intencji (zamiaru) lub celu działania. Na przykład:

„Dlaczego Jaś się uczy? Bo chce dobrze zdać egzamin”

Powszechnie uznaje się, że człowiek jest zdolny do działań celowych. Niektóre zachowania zwierząt przypominają

zachowania celowe człowieka (np. używanie narzędzi przez szympansy). Interpretacja takich zachowań bywa sprawą

dyskusyjną. W sposób przenośny zachowaniem celowym (goal-oriented behavior) określa się reakcje instrumentalne

(np. szczur naciska na dźwignie „bo chce dostać pokarm”). Istnieje problem (filozoficzny, światopoglądowy) czy można

mówić np. o celowości w odniesieniu do świata pozaludzkiego (np. o celowości świata jako takiego). Wyjasnienie

odwolujące się do tego rodzaju celowości nazywa się teleologicznym. Zachowaniem celowym w znaczeniu ścisłym

nazywamy zachowanie, które jest świadomie ukierunkowane na cel. „Celowe” zachowanie zwierząt (goal-oriented

behavior) można natomiast uznać za realizację pewnego programu, który został wyselekcjonowany przez ewolucję.

Ewolucja nie zakłada jednak

żadnego

celu.

W psychologii rozróżnia się tradycyjnie:

•

Zachowania reaktywne, typu: bodziec

→

reakcja (S-R). Na przykład:

"x cofnął palec gdy dotknął do gorącego pieca"

Wyjaśnianie zachowań reaktywnych zakłada zwykle determinizm zjawisk.

•

Zachowania celowe (zwane „czynnosciami” przez prof. Tomaszewskiego), tj. zachowania podejmowane po to,

aby osiągnąć jakiś cel. Na przykład:

„Jan uczy się bo chce zostać psychologiem”

Czy można mówić o celu nieświadomym (np. dziecko płacze, bo chce zwrócić na siebie uwagę)? Wskazywanie na „cel”

działania, którego podmiot sobie nie uświadamia, jest podobne do wyjaśniania funkcjonalnego (pytamy raczej: jaką

funkcję pełni płacz dziecka?). W humanistyce pojawia się jeszcze inne rozumienie wyjaśniania:

•

Wyjaśnianie jako INTERPRETACJA (odkrywanie znaczenia)

Zgodnie z poglądem reprezentowanym przez niektóre kierunki współczesnej filozofii (hermeneutyka,

postmodernizm) wyjaśnienie zjawisk społecznych polega na odkrywaniu znaczenia jakie ludzie nadają lub

przypisują różnym zjawiskom, w szczególności – zjawiskom społecznym lub wytworom ludzkim. Zjawiska te

można, wg tego ujęcia, traktować jak TEKST posiadający określone znaczenie. Żeby zrozumieć tekst trzeba umieć

odczytać jego ZNACZENIE (SENS). Hermeneutyka poszukuje raczej uniwersalnych reguł interpretacji

doświadczenia ludzkiego natomiast postmodernim podkreśla pluralizm i relatywizm zasad interpretacyjnych (w

związku z załamaniem się narracji uniwersalistycznych, czyli tzw. „metanarracji”). Psychologia jako nauka

empiryczna nie zajmuje się sensem doświadczenia ludzkiego jako takim. Ponieważ jednak ludzie przypisują różne

subiektywne znaczenie zdarzeniom które ich spotykają (różnie interpretują te zdarzenia) i ma to wpływ na ich

zachowanie, relacja między spostrzeganym znaczeniem zdarzeń a zachowaniem może być przedmiotem badań

psychologicznych.

PRAWA NAUKOWE

Barrow: prawo naukowe (teorię) można traktować jako „kompresję informacji”. Prawo przedstawia w sposób skrócony informację

zawartą w bardzo długich szeregach danych obserwacyjnych. W takim ujęciu zaciera się różnica między opisem i wyjaśnianiem

(wyjaśnianie jest syntetycznym opisem faktów). Ale prawa zawierają terminy nieobserwacyjne („masa”, „entropia”, „motywacja”, „siła

ego”). Prawa zawierające takie terminy są czymś więcej niż samym opisem faktów (wykraczają poza zaobserwowane fakty).

Prawa naukowe są zasadniczo zdaniami warunkowymi (choć samo sformułowanie prawa może niekiedy maskować jego

warunkowy/charakter). Przykład:

Zdanie „wszystkie kruki są czarne” znaczy faktycznie:

„dla każdego x (jeśli x jest krukiem to x jest czarny)”

∧

x (Px

⊃

Qx)

Słowo „prawo” ma utrwalone tradycją miejsce w języku nauki ale czasem rodzi niepożądanie skojarzenia z prawem (nakazem, normą)

moralnym czy politycznym. Lepiej byłoby więc mówić nie o prawach ale o regularnościach zachodzących w przyrodzie.

PRAWA OGÓLNE W NAUKACH PRZYRODNICZYCH I WARUNKI JAKIE SIĘ TRADYCYJNIE NA NIE NAKŁADA

Powinny być zdaniami ogólnymi (tzn. dotyczyć WSZYSTKICH przedmiotów danej klasy);

∧

x (Px

⊃

Qx)

Nie mogą zawierać nazw indywiduowych. Przykład (negatywny):

„Wszystkie żony Kowalskiego były rude”

Powinny być zdaniami uniwersalnymi, nie zawierającymi ograniczeń czasowo-przestrzennych. Zdania zawierające takie

ograniczenia nazywają się generalizacjami historycznymi, np.:

„Wszyscy królowie, panujący w Polsce w latach 1386-1572, pochodzili z dynastii Jagiellonów”.

„Poziom dochodów w Polsce jest (obecnie) wyższy w mieście niż na wsi”.

Mówi się, że zdanie takie jak „Miedź przewodzi prąd” jest prawdziwe zawsze i wszędzie. Natomiast zdanie "Poziom

dochodów ..." odnosi się do zdarzeń w danym miejscu i czasie.

Popper: nie istnieją w ogóle „prawa rozwoju historycznego” a bieg historii ludzkości jest nieprzewidywalny, m.in. dlatego,

że nieprzewidywalny jest rozwój wiedzy (co nie wyklucza możliwości krótkoterminowego prognozowania zjawisk

społecznych). Pogląd głoszący możliwość formułowania praw historycznych (głoszony np. przez Hegla i Marksa) nazywał

Popper „historycyzmem”. Warunek 3, wysuwany pod adresem praw fizyki, jest za mocny dla teorii w naukach

biologicznych, a tym bardziej – dla teorii w naukach społecznych.

Prawo naukowe nie może być „przypadkowym ogólnieniem”(accidental generalization).

Czasem mówi się, że prawa powinny wyrażać prawdy konieczne ale jest to wymóg niejasny, bo nie wiadomo co ma

znaczyć określenie „konieczne”. Stawia się natomiast warunek, że prawo naukowe powinno nadawać się na

uzasadnienie tzw. hipotetycznego (nierzeczywistego, kontrfaktycznego) okresu warunkowego.

Przykład (negatywny) Hempla: "Każdy przedmiot ze szczerego złota ma masę mniejszą niż 100 ton". Zdaniu temu

odpowiada okres warunkowy: „Dla każdego x, gdyby x był ze złota, to x musiałby ważyć mniej niż 100 ton".

Przykład pozytywny: „Miedź przewodzi prąd” („Dla każdego x, gdyby x był z miedzi to x przewodziłby prąd”).

Uznamy drugi okres warunkowy ale nie uznamy pierwszego, bo nie ma takiego prawa z którego wynikałoby, że nie może

istnieć przedmiot ze złota o wadze równej/większej niż 100 ton.

KLASYFIKACJA PRAW NAUKOWYCH

1.

JAKOŚCIOWE – ILOŚCIOWE

•

JAKOŚCIOWE– mówią o występowaniu pewnych zdarzeń

•

ILOŚCIOWE – wyrażają wielkość pewnej zmiennej jako funkcję wielkości innej zmiennej.

2.

TEORETYCZNE – EMPIRYCZNE (EKSPERYMENTALNE)

•

TEORETYCZNE - zawierają terminy teoretyczne, np.

„Entropia układu zamkniętego nie może maleć”

„Ludzie dążą do redukcji dysonansu poznawczego”

•

EMPIRYCZNE - formułowane wyłącznie przy pomocy terminów obserwacyjnych (często stanowią proste uogólnienie

zdań obserwacyjnych – tzw. „generalizacje empiryczne”), np.:

„wszystkie kruki są czarne”

„miedź topi się w temperaturze 1083

°

C”

Prawo Ohma: U = R I

3.

PRAWA NASTĘPSTWA I PRAWA WSPÓŁISTNIENIA

•

PRAWA NASTĘPSTWA mówią o następowaniu jednych zdarzeń po innych (skutków po przyczynach), np.:

„frustracja prowadzi do agresji”

•

PRAWA WSPÓŁISTNIENIA mówią o współwystępowaniu pewnych zjawisk lub własności, np.: prawo Boyla-Mariotta o

zależności miedzy objętością i ciśnieniem gazu: PV = const.

4. DETERMINISTYCZNE I STATYSTYCZNE (PROBABILISTYCZNE)

•

DETERMINISTYCZNE – stwierdzają jednoznaczną (bezwyjątkową) zależność między zdarzeniami (przyczyną i

skutkiem) typu: ilekroć zachodzi A, tylekroć zachodzi B.

Zdanie „miedź topi się w temperaturze 1083

°

C” znaczy: „każdy kawałek miedzi, ilekroć zostanie podgrzany do

temperatury 1083

°

C, tylekroć przejdzie w stan płynny”.

Klasyczne sformułowanie zasady determinizmu podał Laplace (1820), który uważał, że gdyby jakaś potężna

inteligencja znała wszystkie prawa przyrody i aktualny stan świata, to mogłaby przewidzieć bezbłędnie jego stan

przyszły.

„Powinniśmy patrzeć na obecny stan świata jako na wynik jego stanu poprzedniego i przyczynę stanu

późniejszego. Inteligencja, która by znała wszystkie siły działające w przyrodzie w danym momencie i chwilowe

położenie wszystkich przedmiotów we wszechświecie byłaby w stanie ująć w jedną formułę ruchy zarówno

największych ciał w świecie, jak i najlżejszych atomów, pod warunkiem, że byłaby to inteligencja zdolna poddać

wszystkie te dane analizie; nic nie byłoby dla niej niepewne, widziałaby przeszłość i przyszłość. Doskonałość jaką

umysł ludzi zdołał nadać astronomii jest słabym odbiciem takiej inteligencji. Odkrycia w zakresie mechaniki i

geometrii wraz z odkryciami w zakresie powszechnego ciążenia zbliżyły nasz umysł do możliwości ujęcia w jednej

formule analitycznej przeszłości i przyszłości naszego świata. Wszystkie wysiłki ludzkiego umysłu, ażeby poznać

prawdę, zbliżają go do inteligencji, jaką sobie przed chwilą wyobraziliśmy, jakkolwiek zawsze będziemy

nieskończenie od niej dalecy”. (Laplace, Théorie de analitique des probabilités, Paris, 1820; za: Nagel, 1961, ss.

248-249)

•

STATYSTYCZNE – mówią o prawdopodobieństwie jakiegoś zdarzenia. Mówią jak zachowa się pewna zbiorowość,

ale nie pozwalają przewidzieć jak się zachowa konkretny przedmiot.

Dziś uznaje się, że prawa probabilistyczne odgrywają doniosłą rolę w nauce. Wiele praw naukowych ma

charakter explicite probabilistyczny, np. prawo połowicznego rozpadu pierwiastków, prawa termodynamiki

statystycznej (temperatura gazu to średnia energia kinetyczna cząsteczek, a ciśnienie gazu to średni pęd

cząsteczek gazu). Praktycznie wszystkie prawa psychologiczne (tzn. te które są wynikiem badań

psychologicznych) mają charakter probabilistyczny. Twierdzenie: „frustracja prowadzi do agresji” nie znaczy, że

każdy człowiek poddany frustracji zareaguje agresją ale że agresja pojawia się częściej u osób poddanych

frustracji niż nie poddanych frustracji. Probabilistyczny charakter praw może być wyrażony explicite (np. prawo

połowicznego rozpadu pierwiastków) bądź implicite (podane wyżej twierdzenie o wpływie frustracji na agresję).

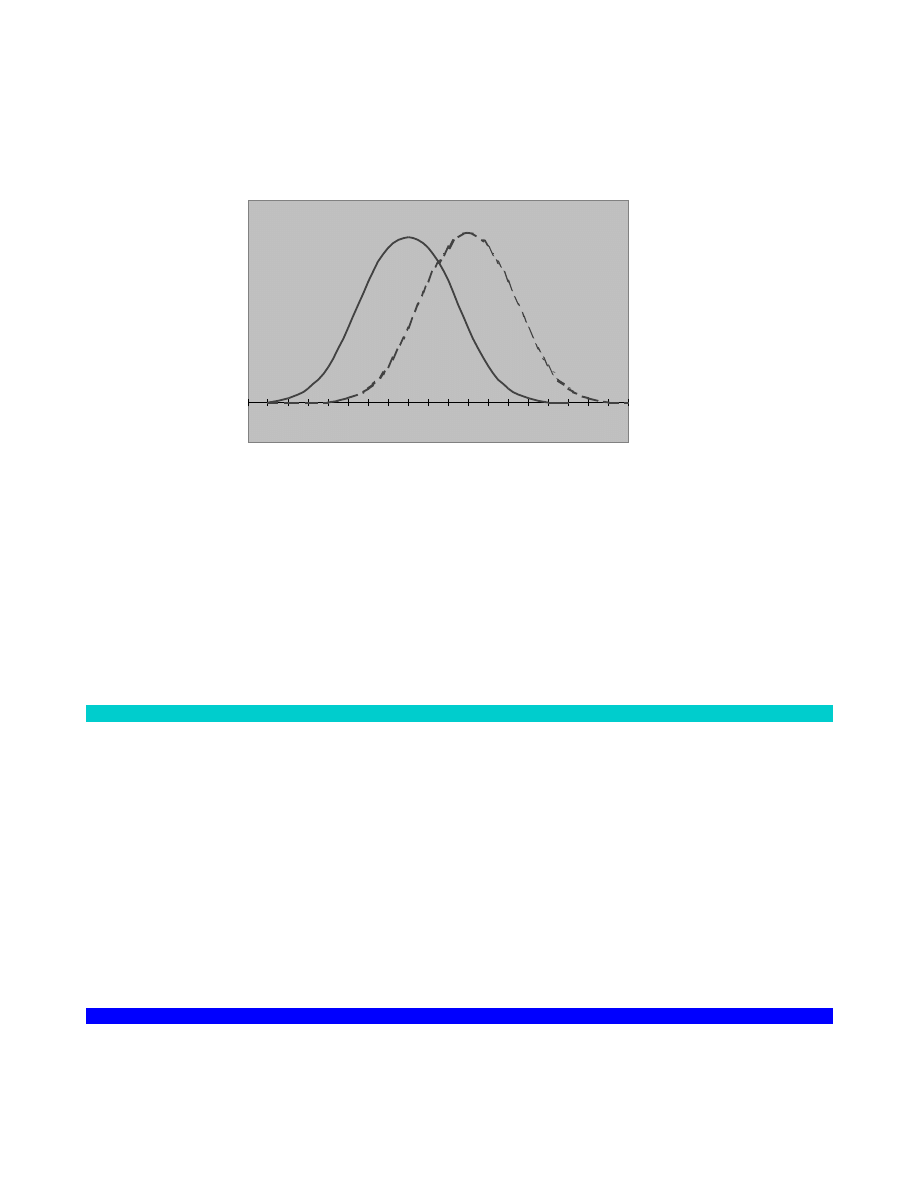

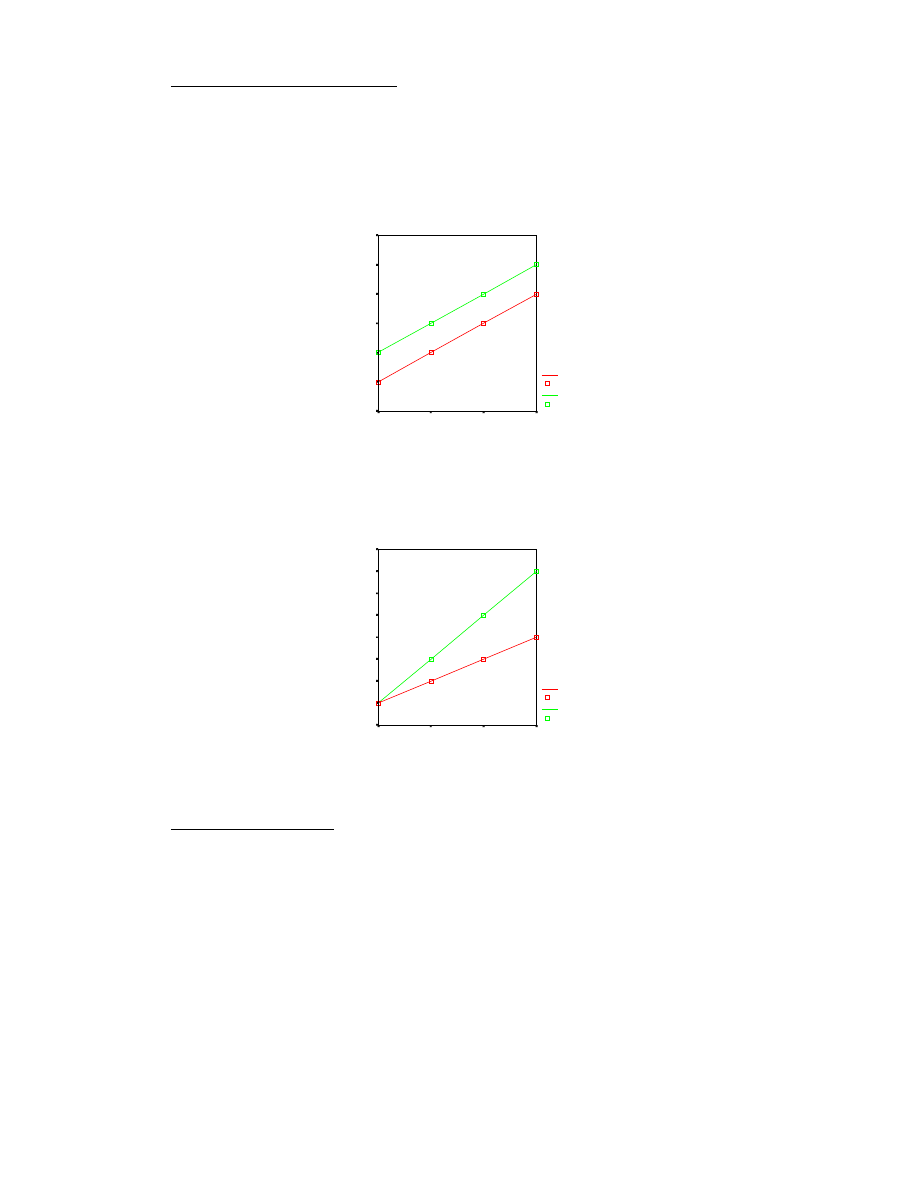

Dwa poglądy na naturę praw probabilistycznych:

•

są „przybliżeniem” praw deterministycznych (Hempel

w swych wczesnych pismach);

•

odzwierciedlają probabilistyczną naturę zjawisk.

Ernst

Mayr

podkreśla

np.,

że

przedmiotem

badań

biologicznych

są zróżnicowane populacje osobników. Jeśli zróżnicowana populacja poddana zostanie jakiemuś oddziaływaniu

to efekty tego oddziaływania będą zazwyczaj również zróżnicowane. Efekty takie dadzą się przedstawić tylko w

kategoriach statystycznych a nie deterministycznych. Zdaniem Stanisława Lema prawa statystyczne pojawiły się

w nauce bardzo późno, gdyż z różnych powodów (psychologicznych, filozoficznych) ludzie z trudem akceptują

probabilistyczny porządek rzeczy (Einstein: „Pan Bóg nie gra w kości”).

5. FAKTUALNE I IDEALIZACYJNE

•

FAKTUALNE – dotyczą obiektów rzeczywistych (np. miedź przewodzi prąd).

•

IDEALIZACYJNE dotyczą obiektów idealnych bądź warunków idealnych, spełniających pewne upraszczające

założenia, np. „każde ciało, na które nie działa żadna siła, ....”. Zastosowanie praw idealizacyjnych do obiektów

rzeczywistych wymaga konkretyzacji prawa, czyli uchylenia założeń upraszczających.

Twierdzenia psychologiczne mają często charakter idealizacyjny, np. „idealny ekstrawertyk to ...”; „gdyby nie działały

inne zmienne, to ...”.

UZASADNIANIE ZDAŃ W NAUKACH EMPIRYCZNYCH

Dwie metody uzasadniania zdań:

•

UZASADNIANIE BEZPOŚREDNIE – przez odwołanie się wprost do subiektywnych doświadczeń (boli mnie głowa) lub

obserwacji (jest ciemno).

•

UZASADNIANIE POŚREDNIE - na podstawie innych zdań

Istnieje (uproszczony) pogląd, że zdania obserwacyjne są uzasadniane wyłącznie w oparciu o obserwację (bezpośrednio) a zdania

teoretyczne są uznawane pośrednio, na podstawie zdań obserwacyjnych i innych zdań teoretycznych.

UZASADNIANIE ZADAŃ OBSERWACYJNYCH

Co powinny stwierdzać zdania obserwacyjne?

Koncepcja zdań protokolarnych (sprawozdawczych) opisujących proste fakty, dostępne bezpośredniej obserwacji (Kolo

Wiedeńskie). Faktami takimi mogą być:

•

doznania podmiotu (interpretacja subiektywna psychologiczna), np. „widzę stół”.

•

obiektywny stan rzeczy (interpretacja przedmiotowa, antypsychologiczna), np. „tu oto stoi stół”.

Podkreśla się, że zdania obserwacyjne powinny być intersubiektywnie sensowne i intersubiektywnie

sprawdzalne.

•

fizykalizm - zdania obserwacyjne powinny być formułowane w obiektywnym języku fizyki. W

psychologii zbliżone stanowisko głosili skrajni behawioryści – kwestionowali oni prawomocność

danych introspekcyjnych.

•

Czy istnieją czyste zdania obserwacyjne?

W obserwacji zawarta jest zwykle teoria. Przykładowo, interpretacja wyników pomiaru zależy od teorii na której oparta

jest budowa instrumentu. Interpretacja wyniku testu psychologicznego nie jest możliwa bez znajomości teorii testów i

teorii mierzonej cechy. Uważa się więc, że podział zdań na zdania obserwacyjne i zdania teoretyczne jest nieostry.

Można co najwyżej mówić, że pewne zdania są bardziej a inne mniej nasycone teorią (bardziej lub mniej

„uteoretyzowane”).

Kryteria uznawania zdań obserwacyjnych?

Czy sama obserwacja gwarantuje prawdziwość zdań obserwacyjnych? Przeciw takiej tezie przemawiają m.in.:

•

błędy, pomyłki, złudzenia percepcyjne

•

przypadki, kiedy kwestionujemy wyniki obserwacji na podstawie teorii.

Na przykład, nie uznamy za prawdziwe zdania mówiącego że temperatura ciała pacjenta wynosiła 80

°

C,

bo jest to niezgodne z wiedzą (teorią) fizjologiczną.

Choć obserwując zachodzące słońce widzimy, że nad samym horyzontem obniża się szybciej niż

wcześniej, przyjmujemy że jest to złudzenie a ruch słońca jest jednostajny.

•

niezgodne wyniki badań empirycznych.

Według Poppera: zdania BAZOWE (zdania o faktach mające stanowić empiryczną bazę nauki) nie są uzasadniane w

oparciu o bezpośrednie doświadczenie. Są uznawane na mocy decyzji przez społeczność naukowców, w oparciu o

dotychczasowe wyniki badań i ich konfrontację z teorią.

UZASADNIANIE ZDAŃ TEORETYCZNYCH

1. Podejście INDUKCYJNE

Teoria to wynik uogólniania obserwacji. Obserwacje te stanowią jednocześnie uzasadnienie teorii. Indukcja

enumeracyjna (przez wyliczenie):

przedmiot x

1

ma własność A

przedmiot x

2

ma własność A

przedmiot x

n

ma własność A

nie zaobserwowano żadnego przedmiotu

x który nie ma własności A

------------------------------------------

każdy x ma własność A

Argumenty przeciwko prawomocności indukcji:

Wnioskowanie indukcyjne nie jest niezawodne: żadna liczba obserwacji nie gwarantuje prawdziwości wniosku.

Wyjątkiem jest tzw. indukcja zupełna (tj. uzupełniona o przesłankę, że zaobserwowane X-y, to wszystkie X-y jakie

istnieją”) ale indukcja taka nie ma praktycznie zastosowania przy uzasadnianiu teorii naukowych.

Przykład: „Długo sądzono że ryby trzonopłetwe wyginęły ok. 70 mln lat temu. Tymczasem 22 grudnia 1938

wyłowiono w Oceanie Indyjskim egzemplarz takiej ryby (nazwanej Latimeria Chalumnae) a potem dalsze

egzemplarze. Fakty te podważyły wcześniejszą teorię mimo, że była ona oparta na bardzo licznych danych

obserwacyjnych.”

Podejście indukcyjne kłóci się z praktyką badawczą. Nie można dokonywać obserwacji bez teorii. Teoria

ukierunkowuje badania, mówi jakie fakty są ważne, co należy obserwować (nie można obserwować

wszystkiego). Fakt jest kwalifikowany jako ważny nie ze względu na problem ale ze względu na hipotezę. Fakt jest

ważny ze względu na hipotezę H jeśli z hipotezy tej wynika, że (w określonych warunkach) fakt taki powinien

wystąpić lub nie powinien wystąpić. Pewne fakty mogą zostać w ogóle nie zaobserwowane dopóki nie pojawi się

hipoteza dla której są one ważne.

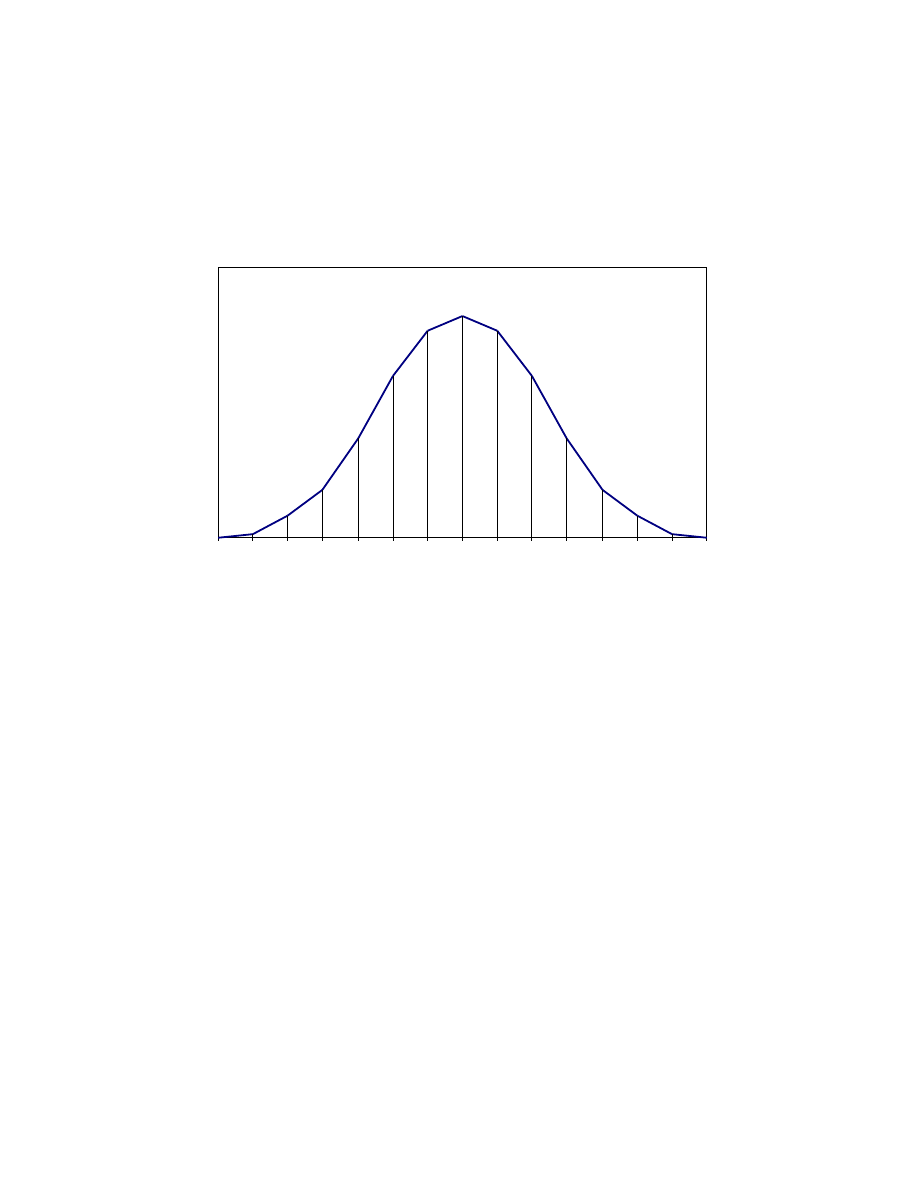

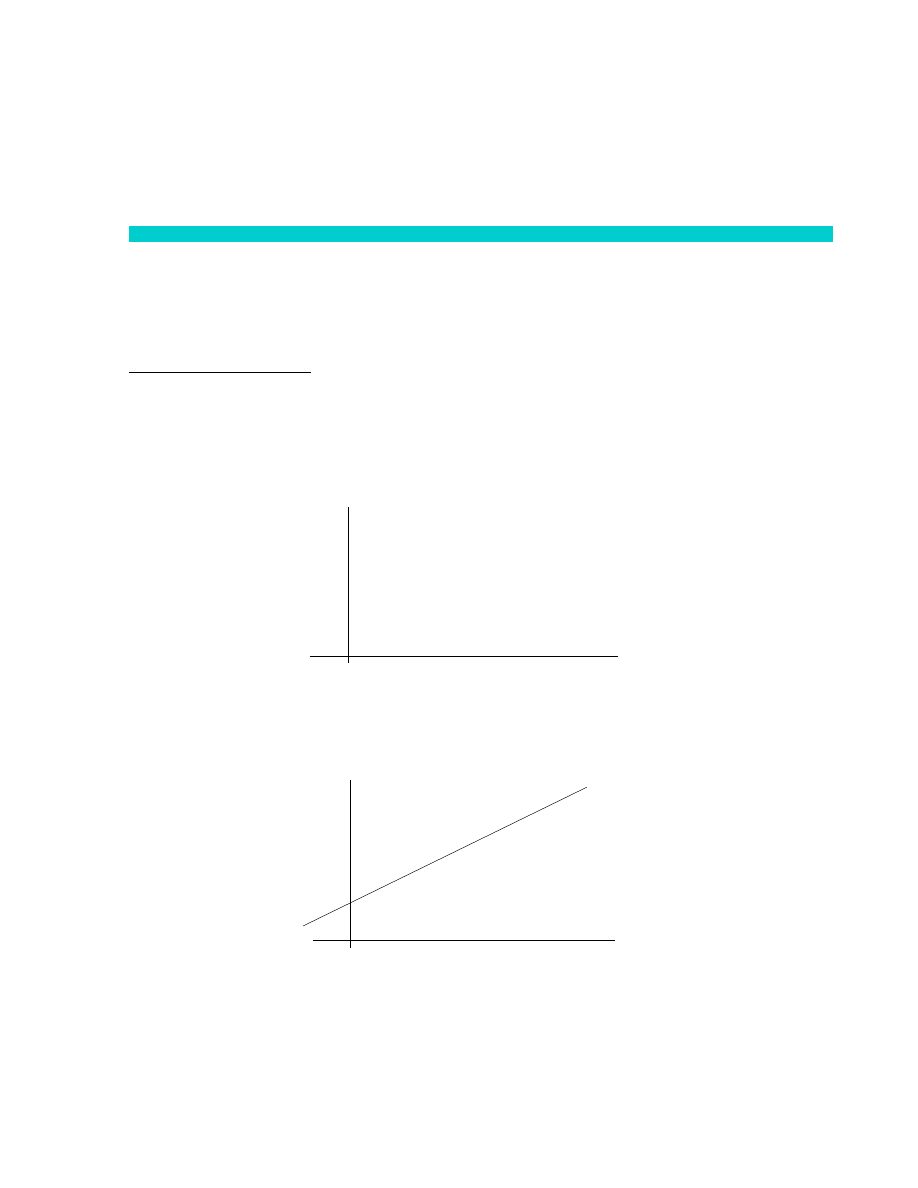

2. Podejście HIPOTETYCZNO-DEDUKCYJNE (hypothetico-deductive model)

Naukowcy wymyślają HIPOTEZY (generują pomysły) a potem poddają je sprawdzeniu (testowi) empirycznemu (schemat:

„pomysł i test”). Testowanie teorii polega na DEDUKOWANIU z niej przewidywań (obserwowalnych faktów lub praw

empirycznych) i konfrontowaniu ich z rzeczywistością: „Jeśli rzeczywiście jest tak, jak mówi teoria T, to powinniśmy

zaobserwować fakt Z. Sprawdźmy więc (przeprowadźmy badanie), czy rzeczywiście zdarzy się Z”. Testowanie hipotez

teoretycznych wymaga powiązania terminów teoretycznych z obserwacyjnymi (operacjonalizacji zmiennych

teoretycznych).

Kontekst odkrycia i kontekst uzasadnienia (koncepcja Reichenbacha)

•

Kontekst odkrycia – odnosi się generowania teorii.

•

Kontekst uzasadnienia – odnosi się do testowania teorii.

Generowanie hipotez (teorii) jest procesem twórczym i stanowi przedmiot zainteresowania raczej nauk

empirycznych (np. psychologii) niż metodologii nauk. Jeśli jednak teoria zostanie już sformułowana można ją

poddać racjonalnej rekonstrukcji i ocenić obiektywnie (zgodnie z zasadami metodologii) jej wartość, tzn. jej

poprawność formalną, wartość wyjaśniającą oraz zgodność z faktami.

Dwie logiczne reguły wnioskowania oparte na stosunku wynikania :

modus ponendo ponens

modus tollendo tollens

p

⊃

q

p

⊃

q

q

~q

----------

-------------

p

~ p

Tylko druga reguła (modus tollendo tolens) jest niezawodna (dedukcyjna), tzn. gwarantuje, że wychodząc od

prawdziwych przesłanek dojdziemy ZAWSZE do prawdziwych wniosków.

W zastosowaniu do testowania teorii oznacza to, że za pomocą faktów (F) można wykazać fałszywość teorii (T),

nie można natomiast wykazać jej prawdziwości. Inaczej mówiąc: teorie są falsyfikowalne empirycznie ale nie są

weryfikowalne empirycznie. Teza ta stanowi postawę koncepcji falsyfikacjonizmu Poppera.

T

⊃

Fi

T

⊃

Fi

Fi

~Fi

----------

-------------

T

~T

Faktycznie sytuacja jest bardziej złożona, ponieważ nigdy nie dedukujemy faktów z jednej przesłanki, lecz z wielu