Wprowadzenie

Zanim przejdziemy do omawiania systemu Windows NT

chcielibyśmy zwrócić uwagę na niektóre z

istotnych założeń

związanych z

siecią. Dla użytkowników z

pewnym bagażem

„sieciowych doświadczeń” materiał tutaj przedstawiony wydawać się

będzie zbyt ogólny i powierzchowny. Niemniej jednak wyszliśmy

z założenia, iż uporządkowanie pojęć podstawowych może być

bardzo pomocne i - tego możemy być pewni - jeszcze nikomu nie

zaszkodziło. A więc zaczynamy:

Sieć - próba definicji

Jak dotąd nie ma jednej ogólnej definicji terminu „sieć”. Najłatwiej

będzie wyobrazić sobie pod tym hasłem zbiór pojedynczych kompute-

rów połączonych ze sobą wysoko wydajnymi łączami.

Mówiąc o sieci napotykamy na takie pojęcia, jak węzły i połączenia.

Najprostszym przykładem sieci, z jaką spotykamy się na co dzień, jest

sieć telefoniczna. Pojedyncze aparaty telefoniczne tworzą węzły,

które połączone są ze sobą za pomocą linii telefonicznych.

W sieci komputerowej mamy również do czynienia z węzłami i po-

łączeniami. Połączenia to nic innego jak kable, którymi przesyłane są

informacje, natomiast węzły to poszczególne komputery składające

się na sieć. Zatem sieć to połączenie wielu komputerów za pomocą

łącz, po których mogą być przesyłane informacje. Ponieważ

w kablach elektrycznych płynie normalny prąd, przyjmujący

podobnie jak wewnątrz komputera wartości 0 i

1, informacje

przesyłane między pecetami muszą być podane w postaci cyfrowej.

24

Windows NT 4 Server

Połączenie ze sobą kilku komputerów przy pomocy odpowiedniego

kabla umożliwia np. wymianę tekstów i

grafiki, czy wspólne

korzystanie z urządzeń końcowych. W większości sieci wyróżnia się

różne typy komputerów wykonujących odmienne zadania.

Serwer

W sieciach komputerowych wyróżnia się zazwyczaj komputery-

serwery i komputery pełniące rolę klientów. Komputery te mogą być

tego samego typu i niekoniecznie muszą różnić się od siebie swoją

konfiguracją sprzętową. Maszyny te przejmują jedynie odmienne

zadania i z tego powodu korzystają z różnego oprogramowania.

Serwer to swoisty „zakład usługowy”, który oferuje następujące

usługi:

!

Dostęp do dysku twardego i zarządzanie plikami (file-services)

!

Usługi drukowania (print-services)

!

Usługi banku danych

!

Backup (zabezpieczanie danych)

!

Udostępnianie faksów (Fax-gateways)

!

Udostępnianie modemów

!

Udostępnianie napędów CD-ROM

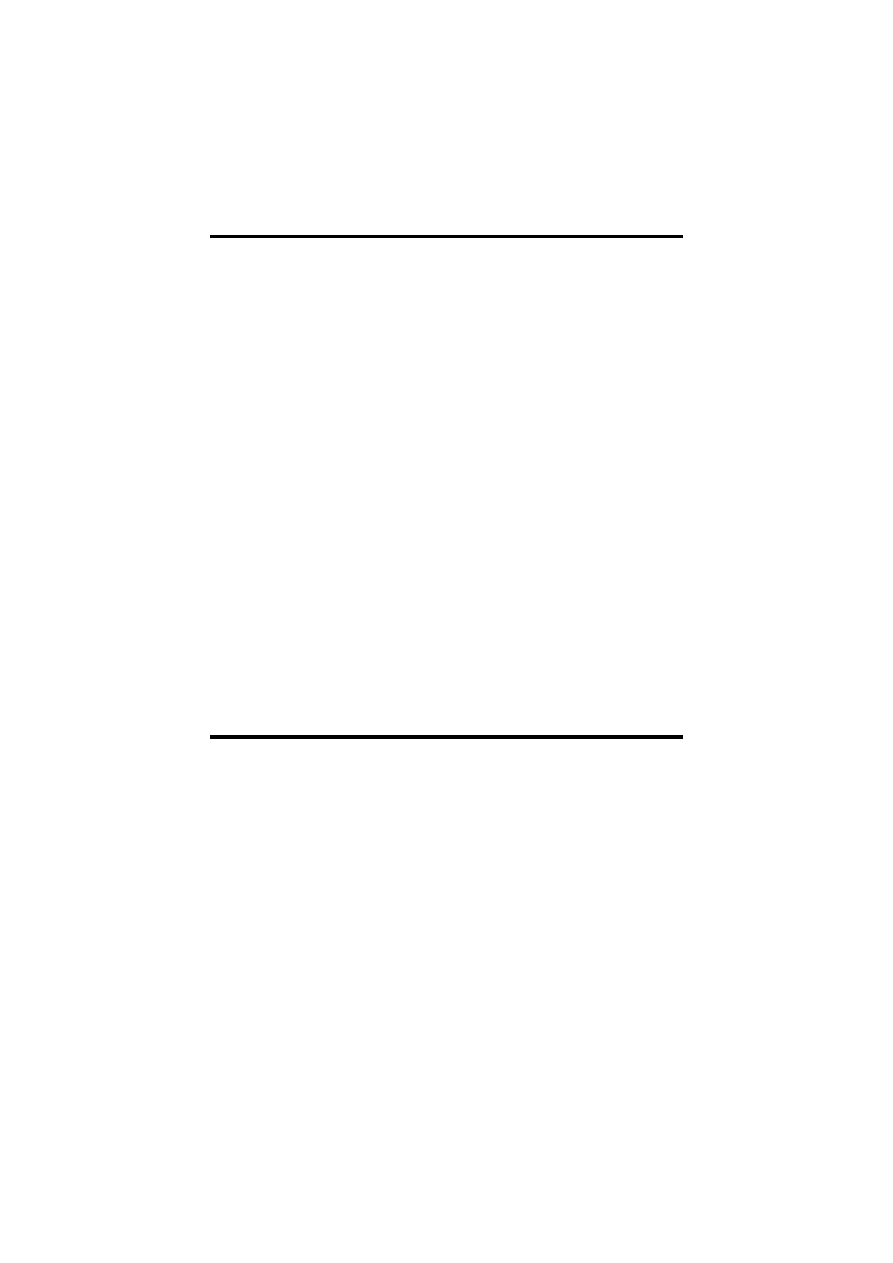

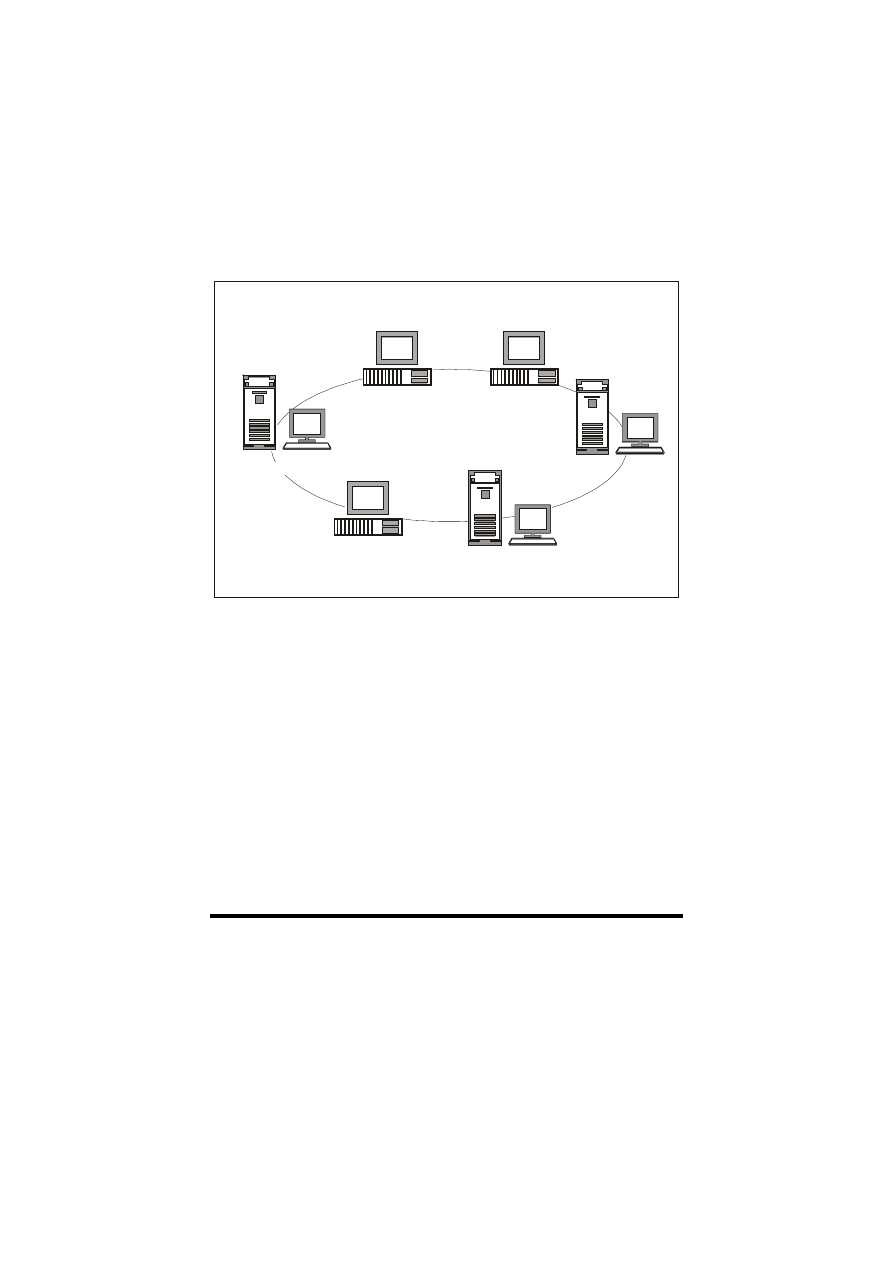

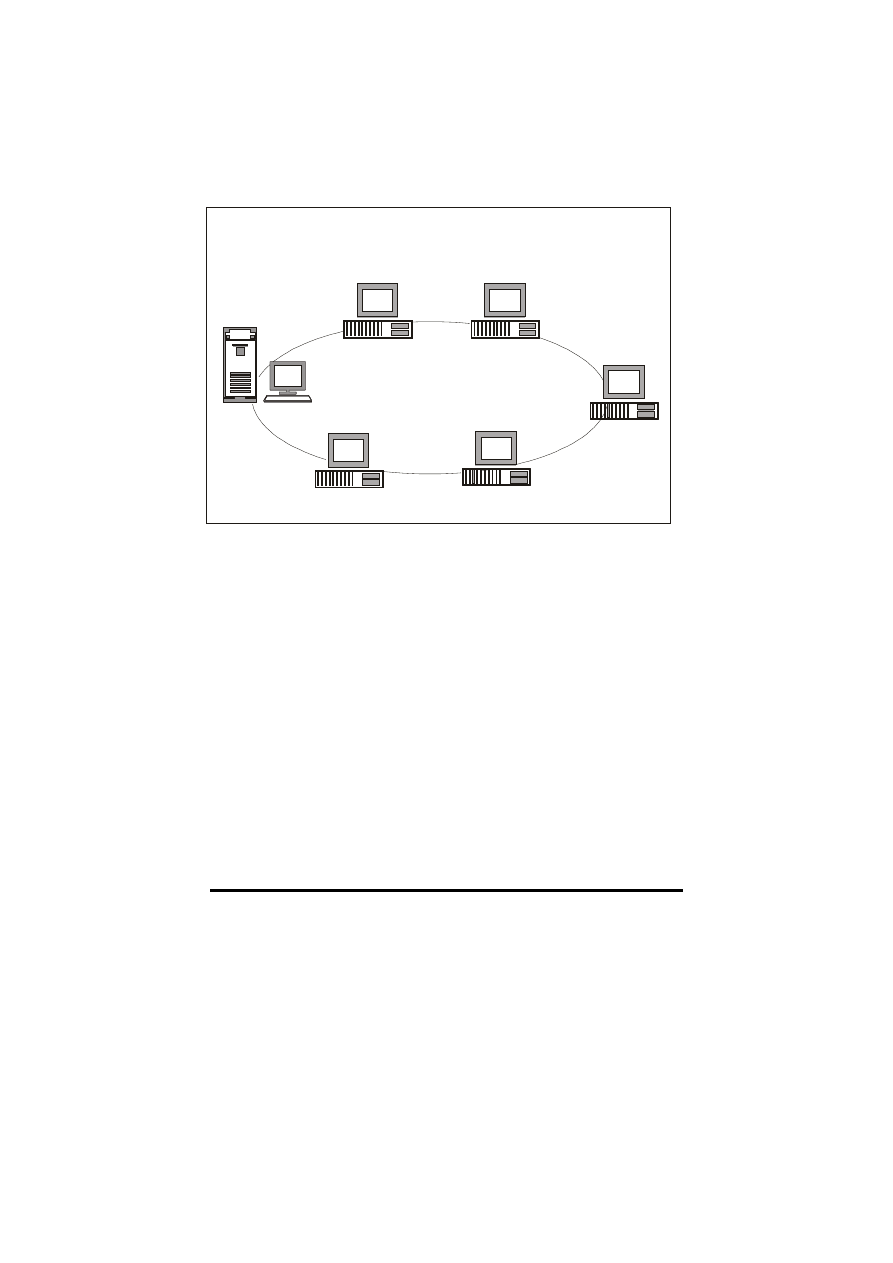

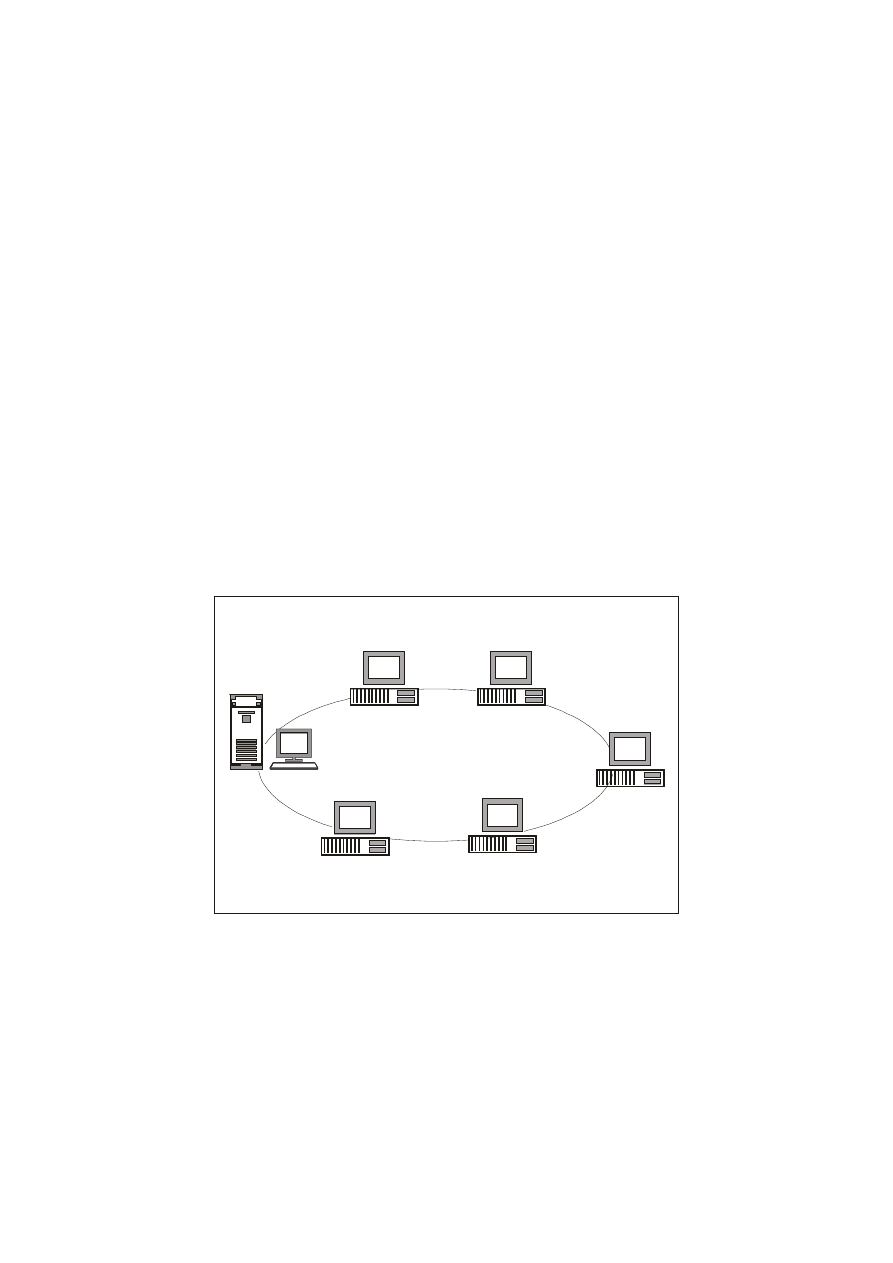

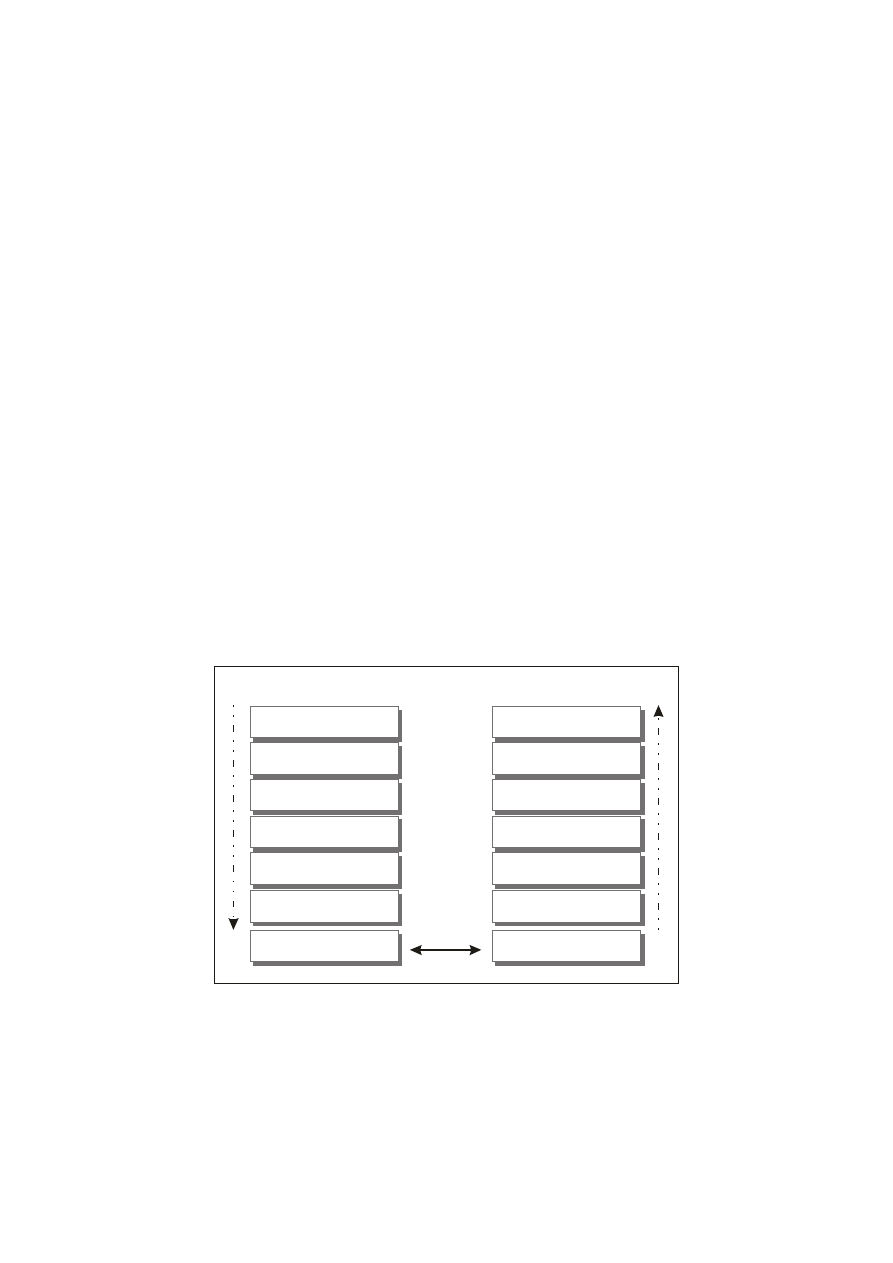

SIEĆ KOMPUTERÓW PC

Rys. 0.1. Sieć

pecetów

Wprowadzenie

25

Jeden i ten sam serwer w praktyce może oferować kilka usług. Jednak

ze względów bezpieczeństwa i

stabilności przyjęło się

wykorzystywać pojedyncze serwery tylko do określonych zadań. Np.

bank danych, udostępniający informacje na temat jakiegoś

przedsiębiorstwa, będzie z

pewnością dostępny na serwerze

pomyślanym jako bank danych. Na takiej maszynie stosowany jest

wyłącznie system zarządzania bazą danych (DBMS). Serwerom

specjalizującym się w określonej usłudze nadaje się zazwyczaj nazwy

wskazujące na rodzaj oferowanego serwisu (np. fax-server, backup-

server itd.).

Aby komputer-serwer mógł wypełniać swoje zadania, potrzebne mu

jest specjalne oprogramowanie - tj. sieciowy system operacyjny.

Dzięki takiemu oprogramowaniu serwer może oferować w sieci

usługi i udostępniać swoje zasoby.

Bardzo wysokie wymagania względem wydajności wyznaczają

rozbudowaną konfigurację (sprzętową), często znacznie obszerniejszą

niż komputer klienta.

Client

Komputer-client w sieci to odbiorca usług oferowanych przez serwer

lub serwery. Przy pomocy komputera tego typu użytkownik może

korzystać z usług serwera, tzn. może np. składować pliki na dysku

twardym, zachowywać dane, korzystać z napędu CD ROM itd.

Aby zwyczajny komputer PC mógł zostać klientem sieci, musi

najpierw stać się posiadaczem tzw. oprogramowania requester, który

umożliwi mu komunikowanie się z innymi maszynami w sieci.

Sieciowy system operacyjny

Sieciowy system operacyjny (SSO) stanowi serce sieci. Stosowany

jest on na serwerach sieciowych i jego zadaniem jest kierowanie

czynnościami serwera, jak również jego połączeniami w

sieci.

Podobnie jak system operacyjny typu desktop (np. OS/2, Windows

NT czy Windows 95), zarządzający usługami pojedynczych

komputerów i tworzący interfejsy dla użytkownika, tak i SSO kieruje

pracą serwera i

uzyskaniem dostępu przez klientów, a

także

umożliwia korzystanie z oferowanych usług.

Z perspektywy użytkownika końcowego można by powiedzieć, iż

SSO jest dostawcą sieciowych usług serwera. W każdym razie

użytkownik w ogóle nie powinien mieć kontaktu z takim SSO,

26

Windows NT 4 Server

ponieważ dla niego powinno być właściwie obojętne, w jaki sposób

i przez kogo udostępniane są mu usługi. Gdyby ktoś zechciał

zachować np. coś w katalogu wspólnym dla całego oddziału, powinno

to tak samo funkcjonować, jak gdyby składował on dane na swoim

lokalnym dysku twardym. Dawniej nie zawsze można było pozwolić

sobie na taki komfort. Nowoczesne sieciowe systemy operacyjne, jak

Windows NT Server 4.0, oferują w tym względzie zupełnie nowe

możliwości.

Sieciowy system operacyjny oferuje nie tylko interfejsy dla

użytkowników końcowych, lecz także dla administratorów

zarządzających serwerem. SSO dostarcza osobny interfejs do

kierowania siecią, przy pomocy którego sprawowany jest nadzór nad

użytkownikami, dostępem do zasobów, komponentami sprzętowymi,

modułami oprogramowania (np. DBMS) itp. Właśnie w większych

i bardziej złożonych sieciach interfejs do zarządzania siecią jest

niezwykle przydatny, ponieważ wpływa on znacznie na obniżenie

kosztów utrzymania takiego systemu.

Protokoły

Aby informacje pomiędzy poszczególnymi serwerami i klientami

sieci mogły być wymieniane, należy zatroszczyć się nie tylko

o wyposażenie komputera w techniczne elementy (np. w adapter).

Należy także zastanowić się nad metodą komunikowania się ze sobą

pojedynczych komputerów. Komputery muszą posługiwać się tym

samym językiem. Samo okablowanie do tego nie wystarczy. Dlatego

należy ustalić, w jaki sposób ma się odbywać elektroniczny przepływ

danych, przyjmujący tylko wartości 0 i 1. W tym celu konieczne staje

się stworzenie jednego języka obowiązującego w całej sieci, którym

posługiwaliby się wszyscy uczestnicy.

Taki język sieciowy nazywany jest właśnie protokołem. Obecnie

istnieje wiele rodzajów protokołów (więcej szczegółowych informacji

na ten temat nieco później).

Spojrzenie wstecz

Spróbujemy teraz poddać charakterystyce postęp technologiczny, jaki

dokonał się w ostatnich latach w technologii sieciowej, jednak bez

zagłębiania się w

szczegóły. Chcemy jedynie uświadomić

czytelnikowi aspekt zmian zachodzących w architekturze sieci wraz

z ich filozofią.

Wprowadzenie

27

Świat dużych komputerów

W latach 60-tych elektroniczne przetwarzanie danych wkroczyło do

świata biznesu. W użytku były tzw. duże komputery, dysponujące

ogromnym potencjałem sprzętowym (pamięć główna, dyski itd). Przy

pomocy komputerów centralnych przetwarzano przede wszystkim

dane masowe (np. w systemach rozrachunkowych). Aby użytkownik

końcowy mógł dotrzeć do zasobów dużego komputera musiał

najpierw zalogować się przy pomocy terminala na tymże komputerze

centralnym. Używane terminale nie dysponowały wówczas własną

mocą obliczeniową i służyły jedynie jako interfejsy do komputera

głównego (host), tzn. jako odległe stanowiska z

klawiaturą

i monitorem. W tamtych czasach zwykło się mówić o „głupich”

terminalach, ponieważ nie dysponowały one, w przeciwieństwie do

dzisiejszych komputerów osobistych, własną „inteligencją”, będącą

w posiadaniu komputera centralnego.

Później terminale zostały włączone do sieci, w której centralną część

stanowił komputer główny. Było to wydarzenie przełomowe,

ponieważ przedsiębiorstwa korzystające z sieci mogły teraz docierać

do jego zasobów z dowolnego miejsca w sieci.

Praca sieci uzależniona była od kondycji komputera-gospodarza,

ponieważ z chwilą jego awarii cała sieć przestawała funkcjonować.

Inną wadą takiego systemu była centralizacja władzy, gdyż kto dyspo-

nował komputerem głównym ten zazwyczaj miał decydujące słowo.

W każdym razie o elastycznym korzystaniu z komputera nie mogło

być w tym czasie mowy.

Pojawienie się na rynku w

latach siedemdziesiątych

mikrokomputerów wpłynęło niewątpliwie na zmianę takiego stanu

rzeczy, gdyż komputery o dużej wydajności i naprawdę niskich

cenach stały się ogólnie dostępne, a ponadto mogły być używane

„niecentralnie”. Pojawiły się nowe możliwości zastosowania

komputerów, czego wynikiem był dalszy rozrost sieci. Obok

„głupich” terminali, które w dalszym ciągu były potrzebne, do sieci

włączano także minikomputery.

W oparciu o duże komputery i mikrokomputery w wielu przedsiębior-

stwach powstawały liczne programy użytkowe, które także dzisiaj

spełniają doskonale swe zadanie.

28

Windows NT 4 Server

Komputer PC na każdym stanowisku pracy

Pod koniec lat siedemdziesiątych na rynku pojawiły się pierwsze

komputery osobiste firmy Microsoft. Tuż potem, na początku lat

osiemdziesiątych, grono komputerów osobistych poszerzyło się

o

maszyny firmy IBM. Wprowadzenie na rynek komputerów

osobistych przyczyniło się do całkowitej decentralizacji

przetwarzania danych, ponieważ oto po raz pierwszy, bezpośrednio na

stanowisku pracy, można było dysponować „inteligentnym”

komputerem.

Komputer główny okazał się mało elastyczny i ociężały dla wielu

indywidualnych potrzeb, jak np. przetwarzanie tekstu, tworzenie

grafiki, arkusze kalkulacyjne itp. Należało umożliwić korzystanie

z technologii komputerowej na miejscu, tj. na stanowisku pracy.

Możliwości pierwszych komputerów osobistych mogą wywoływać

dzisiaj u nas mały uśmieszek, jednak w tamtych czasach wzbudzały

one nie lada sensację, gdyż z „inteligencji” komputera można było

korzystać teraz bezpośrednio na miejscu. Zamiast „ustawiać” naszą

pracę w kolejce i czekać do następnego dnia na wyniki dostarczane

pocztą z

centrum komputerowego, wystarczyło teraz usiąść

bezpośrednio przy komputerze w miejscu pracy i zabrać się do dzieła.

Komputerowa technologia wkroczyła w zupełnie nową erę. W bardzo

krótkim czasie komputery osobiste stały się znane na całym świecie

i opanowały wszystkie biura.

Osieciowanie komputerów osobistych

Z chwilą pojawienia się na rynku komputerów osobistych zaczęto

dostrzegać - obok ich niewątpliwych zalet - także ich wady.

Informacje przechowywane i przetwarzane na jednym komputerze

osobistym nie były niestety dostępne dla innych użytkowników.

Wspólne korzystanie z danych czy z urządzeń peryferyjnych było nie

do pomyślenia. Aby temu zaradzić konieczne było osieciowanie

komputerów. W ten sposób wzięły swój początek technologie sieci

lokalnych LAN (Local Area Network), jak np. Token-ring czy

Ethernet. W tym samym czasie zaczęły powstawać pierwsze sieciowe

systemy operacyjne (SSO) i oprogramowania typu requester.

Dostęp do SSO spowodował zasadniczą zmianę w

strategii

stosowania komputerów. Tzw. stand-alone-PC oferował początkowo

indywidualnemu użytkownikowi szeroką gamę funkcji. Kiedy jednak

pojawiła się możliwość przyłączenia go do sieci, zaczęto skupiać

pojedyncze komputery przy pomocy Token-ring i Ethernetu - w jedną

Wprowadzenie

29

komputerową sieć lokalną LAN. Oto niektóre z zalet korzystania

z sieci komputerów osobistych:

!

Wspólne użytkowanie urządzeń peryferyjnych

!

Wysoka efektywność (wzrost wydajności, spadek cen)

!

Wymiana danych

!

Zniesienie ograniczeń dla miejsca w pamięci, banki danych/

programy użytkowe dostępne dla wszystkich

!

Korzystanie z programów sieciowych

!

Większe bezpieczeństwo i niezawodność

!

Poszerzenie funkcjonalności komputerów-klientów (korzystanie

z usług serwera)

!

Połączenie dwóch odmiennych światów - hardware’owego

i software’owego

!

Udostępnienie platformy komunikacyjnej dla elektronicznej

poczty e-mail

!

Ulepszona i bardziej skuteczna administracja, częściowo możliwe

zarządzanie centralne

Obecnie 30% wszystkich komputerów osobistych na całym świecie

jest osieciowanych (73% w USA według źródeł IDC).

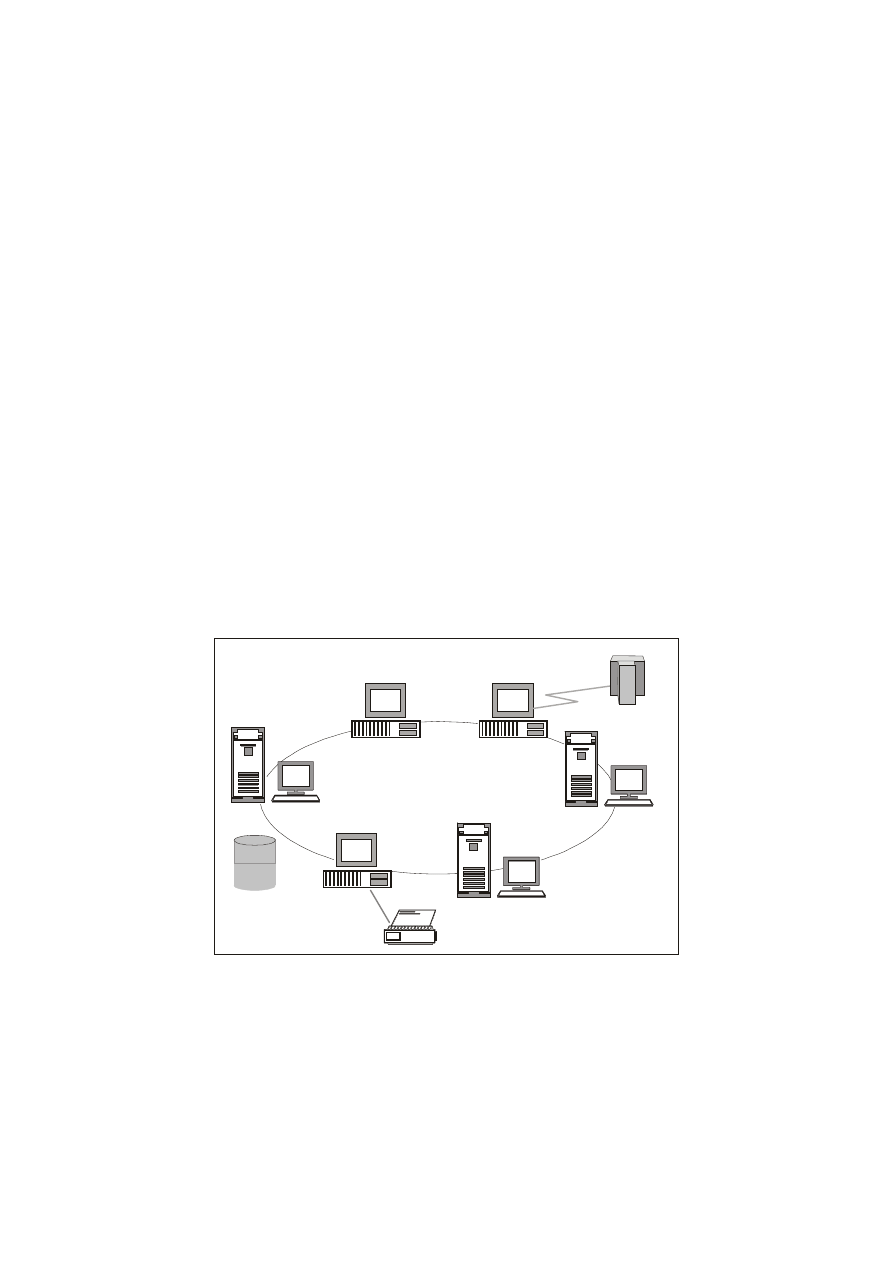

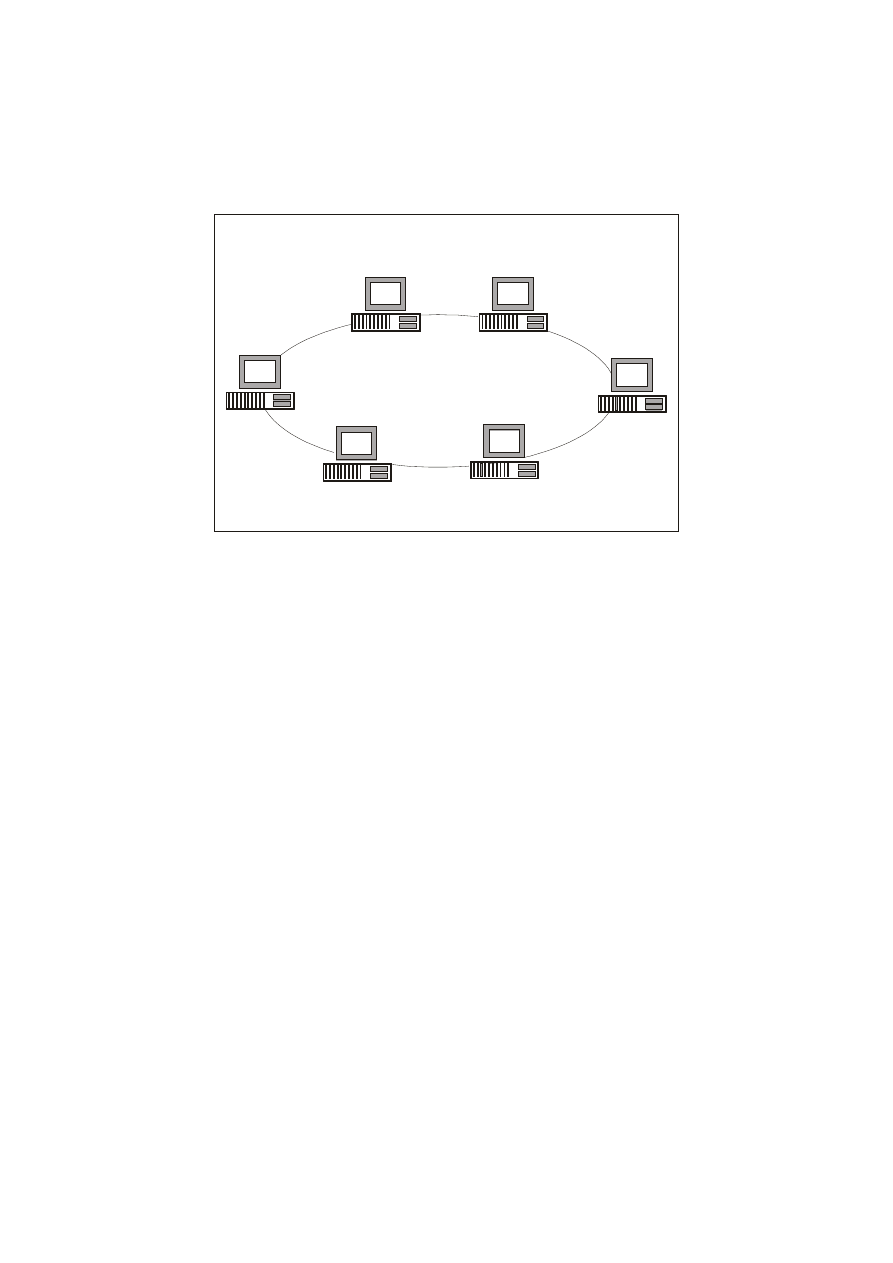

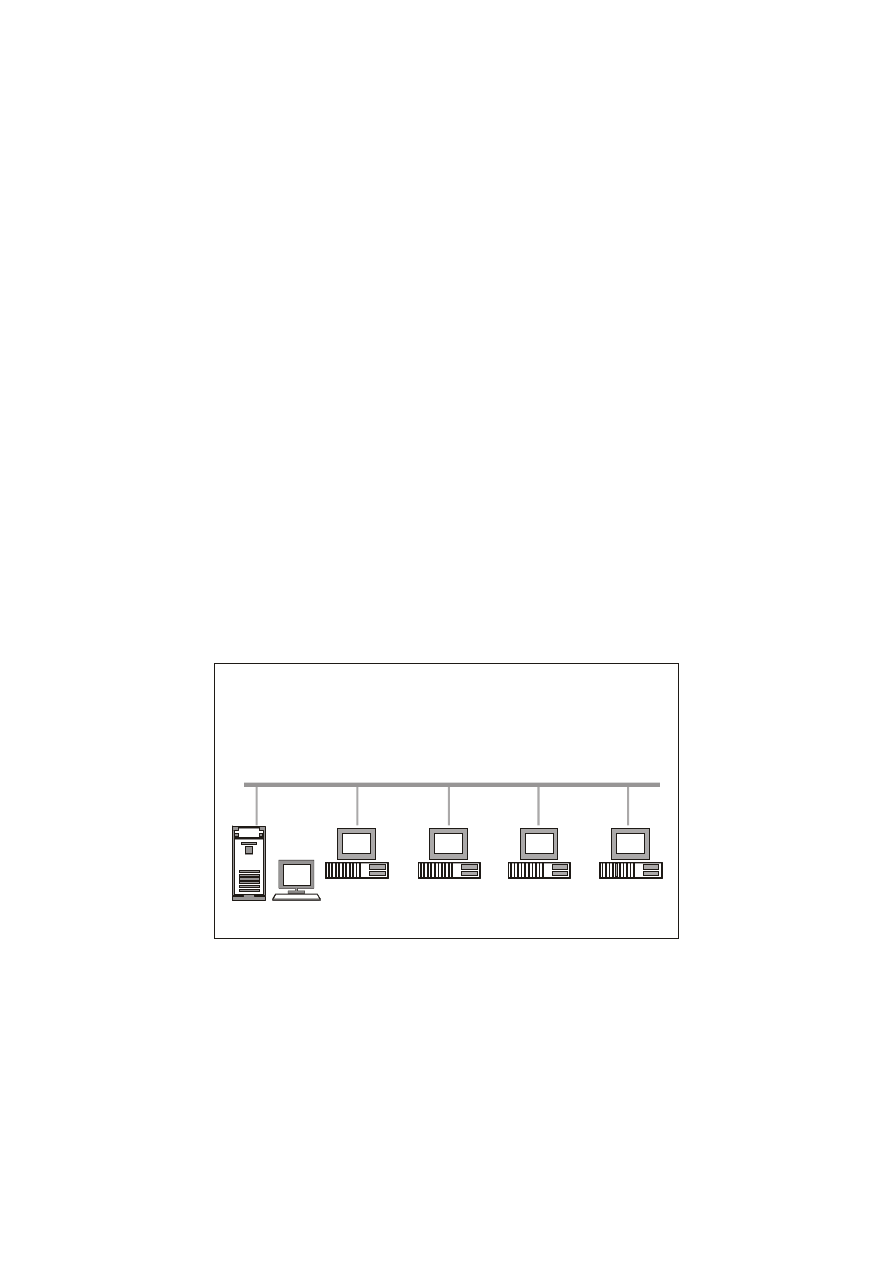

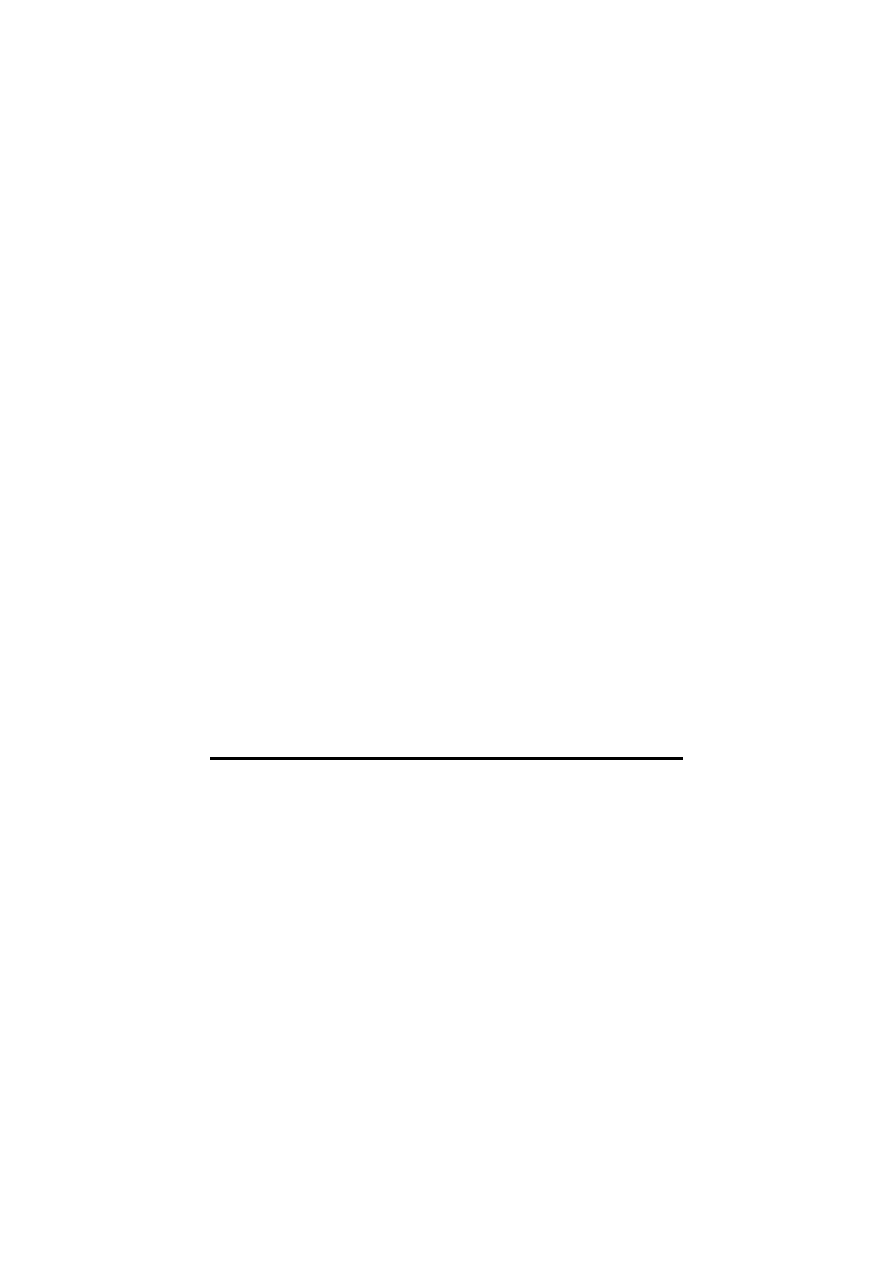

KOMPUTERY PC W SIECI

Host Connectivity

File Services

Print Services

Rys. 0.2. Komputer

osobisty w sieci

30

Windows NT 4 Server

Sieci komputerów osobistych wpływają także na rozwój technologii

client-server, która w

ostatnich latach zdobywa coraz większe

uznanie.

Od małej sieci lokalnej LAN do Corporate Network

W ostatnich latach można zauważyć nieustanny rozrost struktur

sieciowych, przede wszystkim w sektorze komunikacji biurowej.

Nadal trwa proces włączania do sieci pojedynczych komputerów

osobistych.

Gdy na początku lat osiemdziesiątych komputery osobiste pojawiły

się na rynku, korzystano prawie wyłącznie ze stand-alone-PC, które

mniej lub bardziej wychodziły na przeciw ówczesnym wymaganiom.

Stand-alone-PC, czyli komputer „działający w pojedynkę”, dawał

możliwość korzystania z niego bezpośrednio w miejscu pracy i był

niewątpliwie ogromną podporą przy wykonywaniu codziennych obo-

wiązków. Jednak bardzo szybko stało się jasne, że efektywność pracy

znacznie poprawiłaby się, gdyby połączyć pojedyncze komputery ze

sobą. Tak więc w połowie lat osiemdziesiątych rozpoczęło się wielkie

łączenie komputerów osobistych, znajdujących się na pojedynczych

stanowiskach pracy w

jednej instytucji, tworząc w

ten sposób

sieciowe enklawy. W taki oto sposób wzięły swój początek niezwykle

popularne dzisiaj i szeroko rozpowszechnione Local Area Networks

(LANs), czyli lokalne sieci komputerowe. Powstawały one zazwyczaj

z myślą o

określonych jednostkach organizacyjnych w

danym

przedsiębiorstwie, w wyniku własnej inicjatywy. Efektem takiego

działania było powstanie w większych firmach ogromnej liczby

małych indywidualnych sieci LAN, które - „rozmnażając” się

w zawrotnym - tempie zaczęły wymykać się spod jakiejkolwiek

kontroli. Obok zalet sieci, jakimi było wspólne korzystanie z danych,

sprzętu itp., dostrzegano także rażące wady (wysokie nakłady oraz

trudności z zachowaniem porządku w sieci).

Mając na uwadze te niedoskonałości rozpoczęto badania nad

ogólnymi sieciami, obejmującymi swym zasięgiem mniejsze sieci.

Zdawano sobie bowiem sprawę, że połączenie pojedynczych wysepek

w jedną większą sieć poprawiłoby znacznie efektywność pracy. W ten

sposób powstały tzw. Metropolitan Area Networks (MANs), czyli

miejskie sieci komputerowe i Wide Area Networks (WANs) - rozległe

sieci komputerowe. Różnica między nimi polega na tym, że w LAN

komputery połączone są ze sobą w obrębie jednej instytucji (lub w jej

oddziale), natomiast w

sieci MAN i

WAN rozmieszczone są

w odległości wielu kilometrów od siebie. Przy pomocy takich technik

Wprowadzenie

31

sieciowych pojedyncze sieci lokalne LAN można łączyć w logiczne

i fizyczne globalne sieci. W każdym razie wszystkie przedsiębiorstwa

mogą korzystać z jednej sieci : Corporate Network.

W dzisiejszych czasach sieci przekraczają już granice jednego

przedsiębiorstwa. Coraz więcej firm pragnie posiadać wygodne,

skuteczne i

bezpośrednie połączenia ze swoimi klientami.

W większości przypadków brakuje do tego niestety odpowiedniej

infrastruktury. Istniejące publiczne linie telefoniczne i łącza nie są

w stanie sprostać stawianym im wysokim wymaganiom.

Sukces Internetu i ciągle wzrastająca liczba użytkowników są niewąt-

pliwie widocznym dowodem na to, że sieci globalne, ogarniające

swym zasięgiem cały świat, nie są tylko utopią. Mając dostęp do

Internetu można dzisiaj bez problemu sprowadzić do swojego

komputera dane, które znajdują się gdzieś na drugim zakątku świata,

setki kilometrów od nas.

Cele osieciowania

Zanim jednak zajmiemy się dokładnie technologią sieciową,

powinniśmy najpierw zwrócić uwagę na cele i sens osieciowania.

Wybór odpowiedniej strategii dotyczącej osieciowania zależy

w dużym stopniu od tego, co chcemy osiągnąć tworząc sieć - a w tym

względzie istnieje wiele różnych możliwości.

New York

Madryd

Tokio

Kapstadt

Sieć korporacyjna

Buenos Aires

San Fransisco

Rys. 0.3. Sieć

przedsiębiorstw -

Corporate Network

32

Windows NT 4 Server

Za cel osieciowania możemy uznać:

!

Wspólne korzystanie z zasobów danych

!

Wspólne korzystanie z zasobów sprzętowych i peryferii

!

Komunikowanie się

!

Rozproszenie/zdecentralizowanie przetwarzania danych

!

Zwiększone bezpieczeństwo

!

Platforma dla workgroup-computing (pracy grupowej).

Nie wszystkie z wymienionych wyżej celów muszą mieć równe

znaczenie dla poszczególnych przypadków. Zdarzają się sytuacje, że

tylko jeden z tych aspektów decyduje o założeniu sieci. Jednak

z biegiem czasu na znaczeniu zyskują także i pozostałe czynniki, co

jest dowodem na to, że zmianie ulegają także nasze wymagania

względem sieci.

Może to prowadzić do wielu problemów. Musimy zdawać sobie

sprawę z tego, że gdy zapragniemy nagle wykonywać przy pomocy

sieci czynności inne niż dotychczas, oznaczać to będzie, że

wymagamy od sieci zupełnie nowych możliwości. Nie każda struktura

sieci, a w szczególności nie każdy sieciowy system operacyjny nadaje

się, aby znaleźć konkretne rozwiązanie dla stale rosnących wymogów

użytkownika.

Z tego powodu ważne jest, aby na samym początku zastanowić się, co

właściwie przyniesie nam korzystanie z usług sieci - i to także wtedy,

gdy nie planujemy zbyt wiele. Będąc świadomym swoich potrzeb

w przyszłości, można od razu tak zaprojektować strukturę sieci, aby

mogła w przyszłości spełnić nasze oczekiwania.

Poniżej omówimy różne aspekty, jakie niesie ze sobą osieciowanie.

Oczywiście może pojawić się jeszcze cały szereg innych kryteriów,

jednak można je z

pewnością przyporządkować tym podanym

powyżej. Np. celem połączenia odmiennych struktur komputerów jest

przecież ostatecznie chęć wspólnego korzystania z zasobów danych

i komunikowanie się użytkowników różnych komputerów.

Dane

Znaczącym argumentem przemawiającym za osieciowaniem

komputerów jest możliwość dostępu do pojedynczych zbiorów

danych z każdego osieciowanego komputera.

Wprowadzenie

33

Alternatywy dla korzystania z sieci

Znaczenie tego argumentu docenimy w pełni, gdy przyjrzymy się

bliżej alternatywom dla korzystania z danych bez stosowania sieci.

Jedna z nich polega na wymianie danych za pomocą nośnika danych.

Należy tutaj zaliczyć przede wszystkim kopiowanie informacji na

dyskietki i transport „na piechotę” do odbiorcy. Inną możliwością jest

wymiana danych za pomocą łącz szeregowych i równoległych. Jest to

prosta forma osieciowania, ograniczająca się jednak zawsze do

połączeń między dwoma urządzeniami i - w przypadku ciągłego,

wspólnego korzystania z tych samych zbiorów danych - nie zdaje

egzaminu. Trzecią możliwość należałoby określić mianem

„alternatywy zerowej”. Polega ona na gromadzeniu zasobów

informacji na własnym komputerze. Jeśli przyjrzymy się bliżej każdej

opcji, dojdziemy z

pewnością do wniosku, że każde

z przedstawionych tutaj rozwiązań nie jest wolne od problemów.

Odległość nie jest już problemem

Współczesne techniki sieciowe sprawiają, że odległość dzieląca

połączone komputery przestała być już problemem. Fakt ten jest

niezwykle istotny w przypadku korzystania ze wspólnych zbiorów

danych. Można co prawda przenieść szybko dyskietkę na sąsiednie

biurko, do sąsiedniego pokoju czy na inne piętro. Można także

położyć kabel między dwoma sąsiednimi komputerami. Ale co zrobić,

jeśli informacje mają być przesłane na większe odległości - do innego

budynku czy do zupełnie innego miasta?

Technologie sieciowe wymagają oczywiście rozsądnego planu

okablowania. Dopiero po położeniu kabla można mówić o mocnych

strukturach wewnątrz budynku, które stanowią podstawy do

jakiejkolwiek pracy. Także dzięki łączom satelitarnym i liniom

telefonicznym możliwe jest przesyłanie danych pomiędzy oddalonymi

komputerami.

Obecnie istnieje wiele sieci globalnych, o ogólnoświatowym zasięgu.

Wszystkie większe przedsiębiorstwa, liczące się na arenie

międzynarodowej, dysponują takimi właśnie sieciami. Np. firma

Microsoft posiada sieć umożliwiającą bezpośrednie połączenie się

centrali w Monachium z Redmont w USA (siedzibą główną firmy

w stanie Washington), czy z Paryżem - europejską kwaterą tej firmy.

Prędkość

Ogromną rolę przy dostępie do danych odgrywa prędkość. Jeśli ktoś

potrzebuje jakichś informacji, oznacza to zazwyczaj, że są mu one

34

Windows NT 4 Server

potrzebne natychmiast, w danym momencie i zbyt długie oczekiwanie

nie wchodzi w rachubę.

Korzystając z sieci można uzyskać dostęp do danych, które potrzebne

są w danym momencie wielu użytkownikom. Z reguły prędkość trans-

misji danych w sieci jest satysfakcjonująca.

Rozmiar danych

Innym ważnym czynnikiem jest rozmiar zbiorów danych, z których

mamy wspólnie korzystać. Pojemność dyskietki jest ograniczona

i kiedyś z pewnością się wyczerpie; można wtedy użyć programów

kompresujących, ale na dłuższą metę nie zdaje to egzaminu.

Natomiast pracując z

siecią nie trzeba zawracać sobie głowy

objętością plików, do których chcemy uzyskać dostęp. Wprost

przeciwnie - mając do czynienia z dużymi bazami danych możemy

tak kształtować przetwarzanie, w

którym specjalny komputer

zgromadzi i opracuje za nas duże zbiory danych a my otrzymamy

tylko te informacje, których naprawdę potrzebujemy.

Redundancja i niekonsystencja

Przyjrzymy się teraz zjawisku redundacji i niekonsystencji. Z redun-

dancją mamy do czynienia np. wtedy, gdy na dysku twardym

przechowywanych jest wiele egzemplarzy tego samego zbioru

danych, powodując jego „zaśmiecanie”.

Moglibyśmy spokojnie przymknąć na to oko, zważywszy na

dzisiejsze ceny dysków twardych, jednak przetrzymywanie zbędnych

informacji prowadzić może do poważnych kłopotów.

Skoro wielu użytkowników składuje na swoich komputerach takie

same dane, to wcześniej czy później dane te zostaną przez nich

zmienione - ale tylko na ich własnych komputerach.

To z

kolei doprowadza do zdezaktualizowania wielu plików.

W efekcie na dysku zapisanych jest wiele odmiennych wersji tego

samego zbioru danych. W

takim przypadku mówi się

o niekonsystencji.

Można tego uniknąć, gdy wszyscy użytkownicy korzystają tylko

z jednego egzemplarza tego samego zbioru danych. Nie będzie wtedy

mowy ani o redundancji ani o różnych aktualnych wersjach tego sa-

mego zbioru danych. Warunek ten może być spełniony jedynie

w sieci.

Wprowadzenie

35

Istnieje jeszcze inny aspekt tej sprawy. Gdy wiele osób potrzebuje

tych samych danych do wykonania swoich zadań, nie łatwo można

ustalić, czy i u kogo są one zapisane.

Zazwyczaj użytkownik próbuje w takiej sytuacji utworzyć zbiór

danych, który w innym miejscu już istnieje - a więc jeszcze raz

zaczyna tworzyć wykonane już przez innych rysunki, kreślić

ponownie takie same tabele itp. W ten oto sposób dochodzi do

redundancji, nie tylko poprzez przetrzymywanie podobnych danych

ale również poprzez ich ponowne wprowadzenie i zmianę. Kto już

kiedyś wprowadzał do komputera większe ilości danych czy

wykonywał rysunki, wie, ile pracy i wysiłku to kosztuje.

Problemów tych można uniknąć stosując oczywiście sieć. Z zasobów

danych możemy korzystać wtedy centralnie - za pośrednictwem łączy

i z góry wiadomo, które zbiory danych są ogólnie dostępne.

Połączenia miedzy różnymi platformami

Kolejna sprawa dotyczy połączeń nawiązywanych między różnymi

platformami sprzętowymi. Bardziej skomplikowane połączenia mogą

być realizowane wyłącznie za pośrednictwem sieci.

Jeśli istnieje zapotrzebowanie na tego typu połączenia, powinniśmy

rozważyć możliwość osieciowania komputerów w naszej firmie. Za

pośrednictwem nowoczesnych sieciowych systemów operacyjnych

dostępne są platformy integrujące, łączące najprzeróżniejsze

platformy sprzętowe.

Koszty i korzyści

Przy podejmowaniu decyzji o

planowaniu każdej inwestycji

zasadniczą rolę odgrywają koszty i

oczywiście korzyści, jakie

inwestycja ta przyniesie. Jeśli rozważymy kilka różnych argumentów

to okaże się, że wspólne korzystanie z zasobów danych pomoże nam

ominąć niektóre z

kosztów. Przede wszystkim unikniemy

wielokrotnego wykonywania takich prac, jak wprowadzanie danych,

tworzenie rysunków itp. - oczywiście pod warunkiem, że dane te

udostępnione zostaną do użytku publicznego a użytkownicy wiedzą,

gdzie ich szukać.

W sytuacji, gdy wielu użytkowników ma korzystać wspólnie

z większej ilości danych, duże dyski twarde na lokalnych stacjach

roboczych przestają być potrzebne, ponieważ mogą one być

gromadzone centralnie na jednym dużym dysku.

36

Windows NT 4 Server

Rozwiązaniem jest właśnie sieć. Zakładając sieć należy liczyć się

z kosztami przeznaczonymi na sieciowe oprogramowanie i sprzęt, na

administrację i szkolenie użytkowników w obsłudze sieci.

Zasoby sieci

Wprowadzenie sieci w naszej instytucji udostępni nam jej zasoby:

!

drukarki

!

karty faksowe

!

modemy

!

duże dyski twarde

W latach osiemdziesiątych sprzęt biurowy, a szczególnie drukarki

laserowe, był niezwykle drogi, dlatego opłacalne było wspólne korzy-

stanie np. z jednej drukarki przez wiele komputerów usytuowanych na

oddzielnych stanowiskach pracy.

W dalszym ciągu istnieje jednak cały szereg urządzeń, których

wspólne użytkowanie jest opłacalne (np. wysokiej klasy drukarki

kolorowe).

Gdy z jednej drukarki korzysta cały dział, jej transportowanie ani

instalowanie monstrualnych przełączników nigdy nie jest dobrym

rozwiązaniem. To samo dotyczy innych urządzeń peryferyjnych

przeznaczonych do wspólnego użytku. Wyjściem jest oczywiście ....

sieć.

Komunikacja

Trzecią dziedziną przemawiającą za wprowadzeniem sieci jest

komunikacja. Łączami mogą być przesyłane nie tylko dane ale także

informacje. W tym celu stosuje się tzw. systemy e-mail. Jest to

akronim od „electronic mail”, czyli poczty elektronicznej. Chodzi

tutaj o programy, dzięki którym użytkownicy w sieci mogą przesyłać

sobie krótkie wiadomości (czy nawet załączone pliki).

Komunikacja jest niezbędna do tworzenia efektywnych systemów.

Sieć i zintegrowane z nią systemy e-mail należy traktować jako

niezwykle ciekawe i ważne uzupełnienie tradycyjnych (słownych

i pisemnych) struktur komunikacyjnych.

Wprowadzenie

37

Niezależność

Ogromną zaletą systemów e-mail jest możliwość wysłania poczty do

odbiorcy także podczas jego nieobecności. Siadając ponownie przy

swoim komputerze może on przejrzeć pocztę, która w międzyczasie

nadeszła. I na tym polega przewaga tej formy komunikowania się nad

tradycyjną (telefoniczną).

Rozproszone przetwarzanie danych

To jeszcze nie koniec długiej listy zalet stosowania sieci. Istnieje

jeszcze cały szereg innych czynników, które odgrywają ogromną rolę

przede wszystkim w większych strukturach organizacyjnych.

Kolejnym ważnym atutem jest możliwość rozproszenia przetwarzania

danych. Dotyczy to w szczególność dwóch obszarów: Menedżera baz

danych (DBMS) i komunikacji.

Menedżer baz danych (DBMS)

Sercem całej sieci jest centralna baza danych, z której może korzystać

każdy (uprawniony) użytkownik.

Zgromadzone są tutaj m.in. adresy, informacje o klientach, dane

z zakresu rachunkowości czy księgowości, stany magazynów itp. Aby

tego typu informacje mogły być dostępne dla wszystkich

użytkowników sieci potrzebny jest Menedżer baz danych (DBMS).

Istnieją dwa różne rodzaje tego typu oprogramowania: pierwszy -

zwyczajny DBMS, przeznaczony dla komputera osobistego (np.

produkty należące do rodziny xBase), stanowi aplikację stosowaną

początkowo na maszynach lokalnych. Drugi wariant to DBMS,

przeznaczony do pracy w sieci i funkcjonujący w strukturze klient-

serwer. Różnica pomiędzy nimi polega na podziale zadań.

W

przypadku sieci opartej na serwerze dane muszą być

przechowywane właśnie na serwerze, aby mogły być

wykorzystywane przez ogół użytkowników. Dane magazynowane są

w banku danych w formie tablic oraz relacji i - aby ułatwić do nich

szybszy dostęp - zakładane są często indeksy.

W przypadku zwyczajnego zarządcy bazy danych oprogramowanie

DBMS działa tylko na stacji roboczej. Jeśli zachodzi potrzeba

dotarcia do danych, żądamy od serwera udostępnienia indeksu lub

tablicy, po czym opracowujemy je na lokalnej stacji. Oznacza to, że

każda lokalna stacja robocza musi być w

stanie przetworzyć

wszystkie zbiory danych, jakie otrzyma z serwera. Jeśli musimy np.

przeszukać 15.000 klientów, aby odnaleźć mieszkających w obszarze

38

Windows NT 4 Server

PLZ 7*, z którymi nasze obroty w ciągu ostatniego roku wyniosły

ponad 100.000 PLN, musimy opracować właśnie 15.000 rekordów

i sprowadzić je z serwera na nasz komputer. I to także wtedy, gdy

istnieje tylko 20 klientów spełniających te warunki. W takich

okolicznościach obciążenie łącz jest niezwykle duże - przy przeciętnej

długości rekordu wynoszącej 300 bajtów byłoby to 4,5 Mbajta danych

wędrujących przez sieć. Każda stacja robocza musi być w stanie

opracować tak dużą ilość danych, a ponadto pracować z lokalnymi

DBMS.

Już na pierwszy rzut oka widać, że nie jest to rozwiązanie optymalne.

W

strukturze klient-serwer mamy do czynienia z

podwójnym

podziałem zadań. Na serwerze - działa Menedżer baz danych - np.

serwer SQL Microsoft’u. Na pojedynczych stacjach roboczych

natomiast - dowolne oprogramowanie, np. Excel lub Word for

Windows z

Q+E, a

nie zarządca bazy danych DBMS (pod

warunkiem, że istnieje interfejs dla DBMS).

Gdy potrzebne są dane (np. do wydruku korespondencji seryjnej),

uzyskanie dostępu do DBMS następuje właśnie z takiego lokalnego

programu użytkowego.

Wyświetlany zostaje wtedy formularz, który należy wypełnić - w celu

poinstruowania Menedżera bazy danych, jakie informacje ma wyszu-

kać. Formularz zostaje następnie przesłany siecią do serwera. Ten

z kolei, po jego otrzymaniu, przystępuje do opracowywania danych.

Wyniki - w naszym przypadku wybranych dwudziestu klientów -

odsyłane zostają z

powrotem do komputera-klienta, gdzie są

przekształcane w tabele, listy, grafiki itp.

Zadaniem serwera jest zatem opracowywanie i zarządzanie bazą

danych, podczas gdy rolą komputera-klienta jest formatowanie

i prezentowanie danych otrzymywanych od serwera.

Tak ustalony podział zadań ma wiele zalet, mianowicie:

!

Przez sieć przepływają tylko dane netto.

!

Opracowywanie dużych zbiorów danych „spada” tylko na jeden

komputer - serwer.

!

Na komputerze-kliencie działa program, z którym użytkownik pra-

cuje na co dzień. Jego zadaniem jest przygotowanie

i formatowanie danych.

!

Dzięki zastosowaniu serwera centralnego możliwe stało się

centralne zarządzanie bazą danych przy wzroście bezpieczeństwa

zgromadzonych zasobów.

Wprowadzenie

39

Efektem takiego trybu pracy jest większa elastyczność przy

mniejszym obciążeniu sieci i zwiększonej szybkości.

Komunikacja

Trudność polega na tym, że określone interfejsy i

protokoły

komunikacyjne, z reguły nie stanowią problemu dla komputera-

centralnego (hosta), ponieważ dysponuje on wystarczającą ilością

zasobów. Gdy zamierzamy jednak uzyskać dostęp do niego

z komputera osobistego, jego obciążenie wzrasta istotnie.

Rozwiązaniem w takiej sytuacji jest komunikowanie się komputera

osobistego z serwerem komunikacyjnym, znajdującym się wewnątrz

lokalnej sieci. Serwer komunikacyjny otrzymuje od użytkownika

komputera osobistego zlecenie nawiązania połączenia z komputerem

centralnym, które należy przeprowadzić w

określonej formie.

Połączenie zostaje nawiązywane zatem za pośrednictwem specjalnego

serwera, podczas gdy komputer lokalny w dalszym ciągu pracuje

swoim normalnym, sieciowym trybem.

Wyrównanie i rozłożenie obciążenia

Inną kwestią jest rozłożenie pracy na kilka komputerów. Wyobraźmy

sobie dwa serwery, z których raz jeden a raz drugi wykonuje

określone zadania - w zależności od ich aktualnego obciążenia. Samo

komunikowanie odbywa się nawet dość sprawnie, znacznie trudniej

jest jednak z uzyskiwaniem dostępu do danych.

Jeśli chodzi o wykorzystanie mocy procesora, obecne rozwiązania

umożliwiają realizację na serwerze zadań z innego komputera,

odciążając tym samym procesor lokalny. W najbliższych latach

należy oczekiwać pojawienia się na rynku systemów operacyjnych,

które będą w

stanie pracować z

procesorami wielu różnych

komputerów rozproszonych po sieci - co w dodatku nie będzie

zauważalne dla zwykłego użytkownika.

Bezpieczeństwo

Termin „bezpieczeństwo” należy rozumieć jako:

!

Ochronę przed nieuprawnionym dostępem

!

Zabezpieczenie przed utratą danych

40

Windows NT 4 Server

Ochrona przed nieuprawnionym dostępem

Zasadniczą rolą sieciowych systemów operacyjnych jest

umożliwienie dostępu do danych tym wszystkim użytkownikom,

którzy posiadają odpowiednie uprawnienia. W zależności od rodzaju

systemu istnieje wiele możliwości zabezpieczenia danych

i zdefiniowania różnych poziomów dostępu.

Każdy z systemów pomaga jednak dokładnie określić, kto i do

jakiego typu plików i katalogów oraz w jaki sposób może uzyskać

dostęp. Na lokalnym komputerze nie ma mowy o takiej ochronie.

Wprawdzie istnieje odpowiednie oprogramowanie, ma ono jednak tę

wadę, że zainstalowanie nowej wersji, prowadzi często do poważnych

konfliktów z

oprogramowaniem zabezpieczającym. W

dodatku

zastosowanie takiej metody jest dość kosztowne.

Także użycie specjalnego typu zabezpieczeń sprzętowych nie wydaje

się być szczególnie interesujące ani pod kątem zgodności z oprogra-

mowaniem, ani ze względu na poniesione koszty. O wiele prościej

jest zabezpieczyć dane, gdy te znajdują się na jednym komputerze

centralnym. Większość systemów operacyjnych, stosowanych na

serwerach, dysponuje możliwością zabezpieczenia dostępu do danych

przed osobami nieupoważnionymi.

Zabezpieczenie przed utratą danych

Tak naprawdę tylko niewielu użytkowników przeprowadza regularną

archiwizację danych (lub zabezpiecza je w jakikolwiek inny sposób).

Musimy być świadomi, że postępując w ten sposób narażamy się na

poważne ryzyko. Centralne przechowywanie danych i

w

tym

względzie okazuje się być najlepszym rozwiązaniem.

Jeśli na naszym komputerze znajdują się ważne dane, które chcemy

trzymać z daleka od intruzów, możemy zabezpieczyć je centralnie (w

dobrze zorganizowanym przedsiębiorstwie zadanie to leży w gestii

administratora).

Ponadto sieciowe systemy operacyjne dysponują w tym względzie

cennymi funkcjami (jak np. aktualizowanie kopii dysku twardego on-

line - tzw. mirroring), czego nie można powiedzieć o zwykłych

(lokalnych) systemach.

W przypadku uszkodzenia serwera sieć może nadal funkcjonować -

dzięki tzw. serwerom lustrzanym. Wszystkie dane przechowywane są

Wprowadzenie

41

na dwóch komputerach-bliźniakach. Gdy jeden z nich ulegnie awarii

można kontynuować pracę, korzystając z usług drugiego.

Platforma dla pracy grupowej

Gdy dysponujemy siecią lokalną otwierają się przed nami także inne

możliwości, jak chociażby praca w

grupach roboczych (workgroup

computing).

Na rynek trafia coraz więcej nowych aplikacji przeznaczonych do

tego typu kooperacji. Mamy tutaj na myśli np. aplikacje

wykorzystywane do śledzenia postępów w pracy i w sprawach

dotyczących interesów firmy. Możliwe jest to dzięki systemom

zarządzania typu workflow. Podstawą dla wszystkich aplikacji

groupware’owych jest infrakstruktura sieciowa. Tak naprawdę to

dopiero dzięki grupom roboczym możemy w pełni docenić walory

„otoczenia sieciowego”.

Rodzaje sieci

Gdy przyjrzymy się bliżej lokalnym sieciom komputerowym możemy

zauważyć, że istnieją dwie różne struktury sieci. Jedną grupę stanowią

sieci bazujące na serwerze (typu klient-serwer), drugą natomiast -

sieci określane mianem peer-to-peer, o strukturze partnerskiej.

Obydwie kategorie różnią się od siebie zakresem stosowania i formą

użytkowania. Sieci typu peer-to-peer to zazwyczaj sieci mniejsze,

natomiast te, bazujące na serwerze, są sieciami większymi. Poza tym

wiele aplikacji może być wykorzystywanych jedynie w sieciach

posiadających serwery.

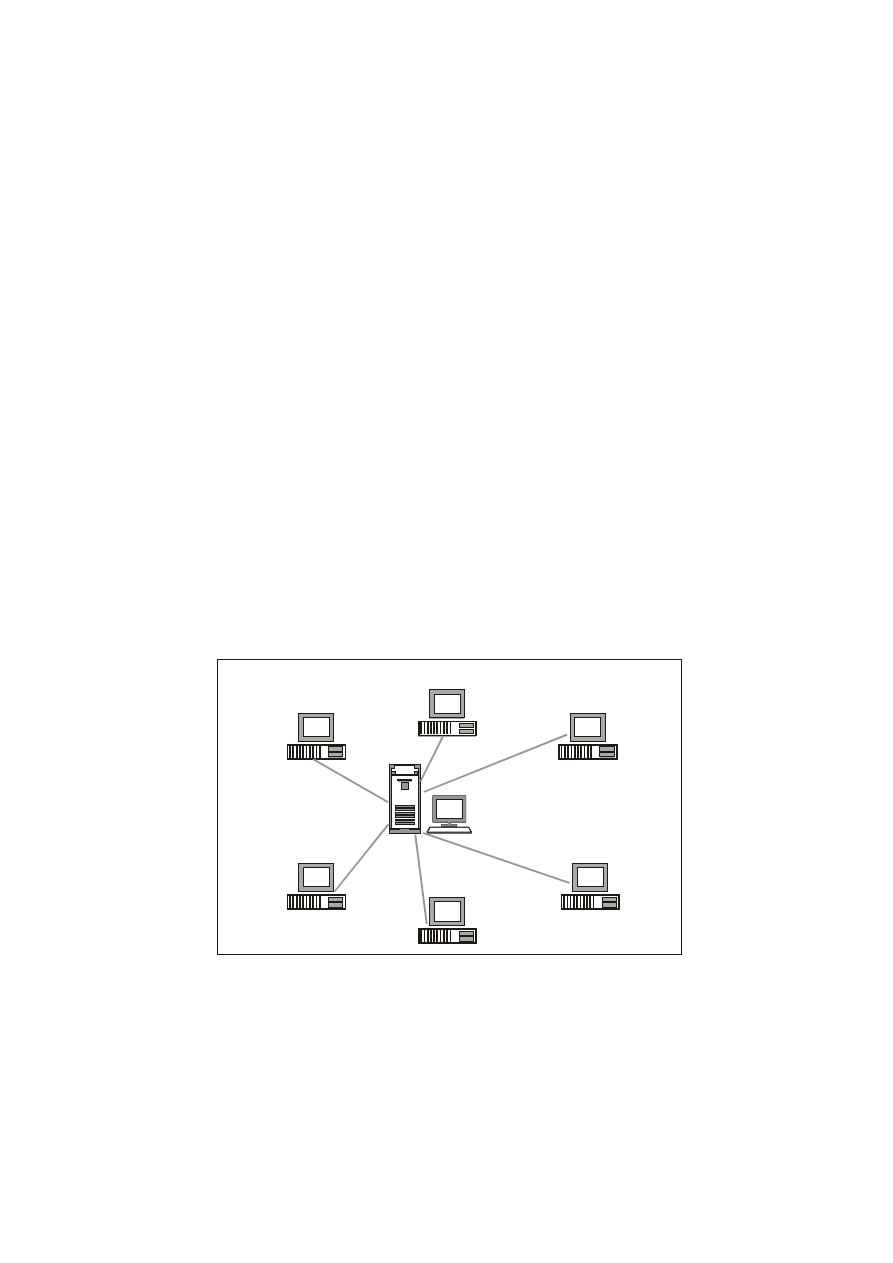

Sieci bazujące na serwerze

Sieci bazujące na serwerze organizowane są centralnie. Logicznym

centrum systemu jest tutaj serwer - tzn. komputer, z którego zasobów

i usług korzystają inne komputery (stacje robocze). W większych

sieciach może działać nawet kilka serwerów.

42

Windows NT 4 Server

Serwer jest jedynym typem komputera, który oferuje w sieci usługi

innym komputerom-klientom. Na serwerach znajdują się zasoby

danych, przeznaczonych do wspólnego wykorzystania.

Bezpieczeństwo ma więc tutaj znaczenie fundamentalne i wiąże się

z dużym nakładem pracy (ochrona przed awarią zasilania, lustrzane

dyski twarde itp.).

Sieci tego typu mają wiele zalet - np. administrowanie ogranicza się

tutaj w praktyce do jednego (centralnego) komputera. Wszystkie dane

magazynowane są na serwerze, także tam instalowane są aplikacje.

Kolejnym plusem systemów klient-serwer są produkty dodatkowe.

Instalowane są one na serwerze, celem uzyskania dostępu do kompu-

tera centralnego lub pracy z bardziej wymagającym Menedżerem bazy

danych. Windows NT Server 4 jest najnowszym, bazującym na

serwerze sieciowym, systemem operacyjnym firmy Microsoft.

Sieci typu peer-to-peer

Alternatywą dla sieci typu klient-serwer jest sieć o strukturze

partnerskiej, tzw. peer-to-peer network, jak np. Windows for

Workgroups, Windows 95, Windows NT Workstation 4 firmy

Microsoft czy Personal NetWare firmy Novell. W systemach tych

komputery połączone są każdy z każdym, a użytkownicy dzielą się

swoimi zasobami, którymi mogą być np. drukarki czy katalogi na

dysku twardym.

Workstation

Sieć bazująca na serwerze

Server

Rys. 0.4. Sieć

bazująca na

serwerze

Wprowadzenie

43

Każdy komputer w sieci zajmuje taką samą pozycję. Obsługa takiej

struktury jest prosta. To samo można powiedzieć o jej zarządzaniu -

zwłaszcza w porównaniu do modelu klient-serwer.

Sieć peer-to-peer posiada - obok niewątpliwych zalet - także wady.

Przede wszystkim w zakresie bezpieczeństwa - większość systemów

operacyjnych nie gwarantuje dostatecznej ochrony przed

nieupoważnionymi użytkownikami, czy nadużywaniem dostępu do

danych. Archiwizowanie danych wiąże się z ogromnym nakładem

pracy, gdyż trzeba wykonywać kopie zapasowe z pojedynczych stacji

roboczych. Także ze względu na stabilność zwyczajne stacje robocze

nie mogą konkurować z serwerem. Mimo, iż systemy operacyjne,

takie jak Windows NT Workstation czy Windows 95, są -

w odniesieniu do swoich starszych wersji - bardziej nowoczesne,

serwer sieciowy daje znacznie lepsze możliwości zabezpieczenia

systemu.

Kolejny mankament wynika z faktu, iż w sieciach równorzędnych nie

ma możliwości korzystania z dużych baz danych. Wszystkie większe

założenia sieciowe pracują dziś w oparciu o architekturę klient-

serwer.

Trzecim problemem w sieci partnerskiej jest nadmierne obciążenie

poszczególnych stacji roboczych, wynikające z równoczesnej - ze

świadczeniem usług innym użytkownikom - realizacji lokalnych

programów użytkowych.

Workstation

Workstation

SIEĆ PEER TO PEER

Rys. 0.5. Sieć peer-

to-peer

44

Windows NT 4 Server

Sieci peer-to-peer mają swoją ograniczoną pojemność. Np. górna

granica dla liczby użytkowników sieci bazującej na Windows for

Workgroups wynosi 25.

Technologie LAN

Przejdziemy teraz do spraw związanych z technologią i architekturą

sieci komputerowych.

Dalsze rozważania wymagają wyjaśnienia niektórych pojęć - np.

modelu warstwowego. Mamy tutaj do czynienia z

modelem

standardowym, określanym mianem modelu OSI, któremu więcej

uwagi poświęcimy jednak nieco później. Najpierw przyjrzymy się

bliżej poszczególnym komponentom sieciowym. Istotne elementy

technologii i architektury sieciowej wyznaczane są przez:

!

Topologię sieci

!

Rodzaj stosowanego kabla

!

metodę przesyłania danych

!

Stosowane protokoły

!

Sieciowy system operacyjny

!

Programy użytkowe

Topologia

Topologia jest nauką o

układzie struktur geometrycznych

w przestrzeni - chodzi więc tutaj o układ połączeń komputerów.

Topologia sieciowa tworzy fizyczny fundament sieci, na który

nakłada się wiele innych płaszczyzn. Ustala ona, według jakiego

wzoru pojedyncze komputery mogą być ze sobą połączone, a także

w jaki sposób mogą się one ze sobą porozumiewać.

Można wyróżnić trzy zasadnicze rodzaje topologii:

!

Topologia pierścieniowa

!

Topologia magistralowa

!

Topologia gwiaździsta

Każda z wyżej wymienionych posiada zarówno swoje wady jak

i zalety. Dotyczą one przede wszystkim zakresu struktury i zabezpie-

czeń na wypadek awarii. Różnice wynikające ze stosowania

odmiennych kabli omówione zostaną w osobnym akapicie.

Wprowadzenie

45

Topologia pierścieniowa

W przypadku topologii pierścieniowej mamy do czynienia z taką

architekturą sieci komputerowej, w której kabel łączący pojedyncze

stacje robocze tworzy pętlę. Poszczególne komputery łączone są ze

sobą w ten sposób, by jeden kabel wędrował zawsze od jednego

komputera do drugiego, a

ostatni komputer połączony był

z pierwszym. Powstaje w ten sposób zamknięte koło, czyli właśnie

pierścień.

Topologie pierścieniowe realizuje się obecnie przy pomocy medium -

tzw. access unit (MAU). Komputery połączone są z

nim za

pośrednictwem kabli zawierających dwa łącza - jedno od MAU do

komputera, a drugie od komputera do MAU. W ten sposób powstaje

fizycznie struktura gwiazdy, ponieważ wszystkie komputery

dołączone są tylko do jednego MAU. Logicznie jest to jednak

pierścień.

W strukturze pierścieniowej wiadomości przekazywane są od stacji

do stacji. Każdy komputer włączony do sieci spełnia funkcję

wzmacniacza przekazywanych wiadomości.

Zalety

Topologia pierścieniowa posiada niewątpliwie kilka zalet.

Zbudowanie pierścienia jest nieco kosztowne, za to rozszerzenie

TOPOLOGIA PIERŚCIENIA

Rys. 0.6. Topologia

pierścieniowa

46

Windows NT 4 Server

struktury nie sprawia żadnych kłopotów. Poza tym stacje robocze

pracują niezależnie od stacji centralnej (aż do pojedynczych gniazd)

i wykluczone są jakiekolwiek kolizje w przesyłaniu danych. Struktura

ta, mimo małej ilości łączy, radzi sobie nieźle w momentach dużego

obciążenia.

Wady

Zasadniczą wadą tego założenia jest niebezpieczeństwo awarii.

Z chwilą uszkodzenia tylko jednego łącza lub jednej stacji roboczej

teoretycznie sieć przestaje funkcjonować, gdyż pierścień został

przerwany. Stosując MAU problemów takich można uniknąć,

ponieważ potrafią one rozpoznawać usterki. Kolejny mankament

wiąże się z dołączaniem nowego użytkownika - zmniejsza się

wydajność pierścienia.

Topologia magistralowa

W sieci magistralowej istnieje jedno wspólne łącze, którymi są

przesyłane dane i do którego podłączone są wszystkie komputery. To

wspólne łącze nosi nazwę magistrali lub szyny. Topologia tego typu

należy obecnie do najpopularniejszych i jest stosowana w Ethernecie.

Nadaje się ona przede wszystkim dla sieci wysokowydajnych, o dużej

przepustowości danych i niewielkiej ilości stacji roboczych.

Zalety

Istotną zaletą topologii magistralowej jest nieznaczna długość łącz,

prowadzących od magistrali do stacji roboczej. Ponieważ wszystkie

TOPOLOGIA MAGISTRALOWA

Rys. 0.7. Topologia

magistralowa

Wprowadzenie

47

komputery podłączone są do tego samego liniowego kanału

informacyjnego, zwiększa się efektywność systemu okablowania.

Koszty poniesione na okablowanie - w porównaniu z systemem

gwiaździstym czy topologią pierścieniową - są dość małe, ponieważ

kabel sieciowy musi być położony jedynie od jednej stacji do

następnej.

Wady

Wady takiego systemu ograniczają się do kwestii ewentualnych usterek. Jeśli

zdarzy się awaria kabla, bardzo ciężko jest ją zlokalizować. Ponadto

niebezpieczeństwo zaistnienia kolizji w przesyłaniu danych jest znacznie

wyższe, niż w strukturze pierścieniowej czy gwiaździstej.

Topologia gwiaździsta

W przypadku topologii gwiaździstej od wszystkich stacji roboczych

odchodzą łącza, które prowadzą do jednego, centralnego komputera,

spełniającego funkcję pośrednika. Sieć korzystającą z tego typu

topologii można przyrównać do sieci telefonicznej. Topologia

gwiaździsta jest właściwie rzadko spotykana i nadaje się jedynie do

małych sieci. Wydajność w przesyłaniu danych zależy tutaj w dużym

stopniu od stosowanych kabli i serwerów.

TOPOLOGIA GWIAZDY

Rys. 0.8. Topologia

gwiaździsta

48

Windows NT 4 Server

Zalety

Sieć gwiaździsta charakteryzuje się czytelną, łatwo rozszerzalną

strukturą. Także zarządzanie siecią fizyczną nie stanowi problemu,

ponieważ każda stacja robocza dysponuje własnym łączem, które

prowadzi bezpośrednio do komputera centralnego.

Wygodne okablowanie - z przypisaniem każdej stacji własnego kabla

sieciowego, łączącego komputer z „centralą”, umożliwia ponadto

sprawną wymianę danych.

Wady

Sporym mankamentem tego typu topologii jest jej mała elastyczność -

ograniczone możliwości dostosowania do struktury budynku.

Osieciowanie komputerów znajdujących się kilka pięter wyżej czy

niżej może przysporzyć wielu problemów, ponieważ wszystkie

maszyny muszą być podłączone do komputera centralnego. Przy stale

rosnącej liczbie użytkowników należy liczyć się także z dużymi

kosztami, związanymi z zakupem odpowiedniego serwera.

Inną wadą jest nieefektywna infrastruktura komunikacyjna,

wynikająca z

niedostatecznego wykorzystania pojedynczych

połączeń.

Zabezpieczenia na wypadek awarii

Niezwykle ważną kwestią jest tutaj zabezpieczenie sieci na wypadek

awarii. Co się stanie, gdy:

!

stacja robocza ulegnie awarii?

!

serwer ulegnie awarii?

!

kabel zostanie uszkodzony?

Gdy awarii ulegnie stacja robocza, konsekwencje - w przypadku

wszystkich trzech rodzajów topologii - są takie same, tzn. żadne,

pomijając oczywiście niewygody, jakie musi znosić jej użytkownik.

Jeśli chodzi o

topologię pierścieniową może zaistnieć pewien

problem. Z uwagi na fakt, iż łącze wędruje od komputera A do

komputera B a stąd do komputera C, dane - gdy uszkodzony będzie

komputer B - nie mogą być dalej przesyłane. Rozwiązaniem może być

przeprowadzenie w MAU bezpośredniego łącza z A do C, gdy B nie

działa. Wyłączony (lub uszkodzony) komputer zostaje następnie

usunięty z pierścienia.

Wprowadzenie

49

Gdy awarii ulegnie serwer problem i konsekwencje są poważne.

W sieciach o logicznej strukturze gwiazdy uszkodzenie centralnego

komputera całkowicie uniemożliwia jakąkolwiek komunikację.

Gdy uszkodzeniu ulega odcinek kabla, w sieciach pierścieniowych

i gwiaździstych nie stanowi to problemu, ponieważ awaria dotyczy

zawsze tylko jednej stacji. Pozwala to na szybkie ustalenie, którą jego

część należy wymienić. Natomiast uszkodzenie części okablowania

w

sieci magistralowej uniemożliwia jej dalsze funkcjonowanie.

Ponadto zlokalizowanie usterki jest dość skomplikowane i wymaga

specjalistycznych narzędzi testujących.

Układanie kabla

Inny problem powstaje w sieciach o fizycznej strukturze gwiazdy,

ponieważ do MAU (ewentualnie do komputera centralnego)

podłączane są wszystkie kable. Oznacza to, że należy położyć

ogromne ilości kabla, co oczywiście wiąże się z odpowiednimi

kosztami. Z kolei dalsza rozbudowa nie jest kłopotliwa, oczywiście

o ile istnieją wolne miejsca w MAU, ewentualnie na komputerze-

pośredniku.

Natomiast w sieciach o strukturze magistrali wszystkie komputery,

jeden po drugim, muszą łączyć się ze sobą - co stanowi szczególne

utrudnienie w strukturach rozłożonych na wielu piętrach. W każdym

razie położenie kabla w

topologii magistralowej jest znacznie

prostsze.

Komunikacja wewnątrz sieci

Aby sieć mogła dobrze funkcjonować, należy ustalić reguły

wewnętrznego komunikacji pomiędzy poszczególnymi

użytkownikami sieci. Trzeba określić, według jakich kryteriów będą

przyznawane prawa do transmisji - tzn. ustalić, która stacja, w jakim

czasie i na jak długo może uzyskać dostęp do sieci.

Dopóki stacje robocze przesyłają swoje dane po kolei, wszystko jest

w porządku. Ale co się stanie, jeśli kilka komputerów zechce

jednocześnie przesłać swoje dane przez sieć? Aby wyeliminować

kolizje muszą istnieć czytelne reguły, określające kto, kiedy i pod

jakim warunkiem może wysyłać dane. Wyróżnić możemy tutaj dwie

metody: Token-ring i Ethernet.

50

Windows NT 4 Server

Token-ring

Pomysł sieci typu Token-ring powstał w firmie IBM w oparciu

o topologię pierścieniową. Chodzi tutaj o metodę, polegającą na

zdeterminowanym dążeniu do uzyskania dostępu, w

której

komunikacja wewnątrz sieci i udzielanie pozwolenia na transmisję

regulowane są za pomocą przekazywania uprawnień. Token to

wiadomość, przetworzona na ustalony ciąg bitów krążących

bezustannie po sieci. Każdy komputer w sieci, jeden po drugim,

otrzymuje taką „przesyłkę”, którą może opisywać stan:

!

wolny

!

zajęty

Gdy jakaś stacja robocza chce przesłać przez sieć dane, musi czekać

tak długo, aż otrzyma token w stanie „wolnym”. Token to swego

rodzaju przepustka do sieci.

Przesyłając teraz dane uczestnik sieci zmienia znak „wolny” na

„zajęty”, dołącza adres stacji docelowej, komunikat i na końcu wysyła

cały pakiet. Adresat rozpoznaje (po adresie), że przesyłka

przeznaczona jest dla niego, odczepia ją z token’a i kwituje jej odbiór.

Nadawca z kolei otrzymuje pokwitowanie i zmienia z powrotem znak

„zajęty” na „wolny”.

Można byłoby teraz pomyśleć, że w takim trybie pracy jeden

uczestnik sieci blokuje wszystkich innych, gdyż korzysta bez przerwy

z przepustki token. Aby temu zaradzić, w sieciach typu Token-ring

obowiązuje limit czasowy. Po jego upływie stacja nadająca komunikat

musi zwolnić token dla innych użytkowników. Tylko w taki sposób

równouprawnienie wszystkich uczestników sieci może być

przestrzegane.

Metoda ta umożliwia bezkonfliktową komunikację wewnątrz sieci,

tzn. bezkolizyjną. Czas przyznawany na przesłanie danych może być

w związku z

tym wykorzystany zgodnie z

przeznaczeniem. Nie

odbywa się to jednak bez poniesienia pewnych ofiar, mianowicie

małą przepustowością danych (4/16 Mbit/s), zwłaszcza w porównaniu

z inną metodą - Ethernetem (10 Mbit/s).

Ethernet

Technologia sieci typu Ethernet opiera się na topologii

szynowej/magistralowej i polega na niezdeterminowanym (a przez to

i „konfliktowym”) postępowaniu przy określaniu reguł komunikacji

wewnątrz sieci. Dostęp do sieci uzyskiwany jest nie w sposób

Wprowadzenie

51

skoordynowany, lecz w warunkach konkurencji. Oznacza to, że

w Ethernecie możliwe jest jednoczesne przesyłanie informacji przez

dwóch uczestników sieci. Nieuchronnym skutkiem takiego

postępowania są kolizje w transmisji danych.

Aby komunikacja w sieci nie była ciągle zakłócana przez tego typu

kolizje, Ethernet stosuje technologię CSMA/CD. CSMA/CD (IEEE

802.3) to akronim od „Carrier Sens Multiple Access with Collision

Detection”. Jest to protokół dostępu do sieci, który w modelu OSI

należy przyporządkować warstwie bitowej transmisji danych

i warstwie zabezpieczania danych (więcej na ten temat nieco później).

Przy stosowaniu metody tego typu poszczególne stacje robocze

nieustannie „podsłuchują” sieć w celu sprawdzenia, czy transmisja

danych może odbyć się bez zakłóceń. Gdy tylko stacja gotowa do

nadania przesyłki zorientuje się, że „wszystko jest w porządku”,

natychmiast rozpoczyna transmisję. Jeśli jednak dojdzie do kolizji

(np. wskutek opóźnienia, wynikającego ze zwłoki pomiędzy

podsłuchaniem a nadaniem), zostaje to natychmiast zauważone przez

jednego z

„podsłuchujących”, który następnie emituje w

sieci

meldunek o kolizji. W ten sposób transmisja zostanie przerwana. Po

odczekaniu stacja gotowa do nadania rozpoczyna ją ponownie.

Metoda ta umożliwia naprawdę wysoką przepustowość (10 Mbit/s)

przy niewielkiej ilości użytkowników sieci. Wraz z rozrostem sieci

wzrasta także prawdopodobieństwo zaistnienia kolizji, co prowadzi

z kolei do nieuchronnego spadku wydajności.

Stąd też Ethernet zdaje egzamin w

niewielkich strukturach

sieciowych, a także w otoczeniu heterogennym.

FDDI

FDDI (Fibre Distributed Data Interchange) należy rozumieć jako

wymianę danych w sieciach z wykorzystaniem światłowodów o wiel-

kiej szybkości transmisji. FDDI powstał w oparciu o metodę token -

chodzi więc tutaj o metodę zdeterminowanego dostępu, bazującą na

topologii pierścieniowej.

W przeciwieństwie jednak do metody Token-ring, FDDI składa się

z podwójnego

pierścienia - podstawowego i

dodatkowego.

Przebiegają one w

odwrotnych kierunkach, celem uniknięcia

uszkodzeń łącz. Pierścień dodatkowy służy jedynie jako pierścień

zapasowy.

W metodzie FDDI token jest zwalniany bezpośrednio po zakończeniu

procesu nadawania, wtedy inna stacja może rozpocząć transmisję.

52

Windows NT 4 Server

W

ten sposób FDDI umożliwia równoczesne przesłanie kilku

pakietów danych. Jego niewątpliwą zaletą jest wysoka przepustowość

danych - 10 Mbit/s. Maksymalne rozpiętość sieci nie może

przekraczać 100 km.

Która topologia jest najlepsza?

Na pytanie to nie tak łatwo jest odpowiedzieć. Wybór rodzaju

topologii wiąże się z

podjęciem wstępnej decyzji, dotyczącej

komunikacji wewnątrz sieci i metody uzyskiwania dostępu:

!

Topologia pierścieniowa:

Token-ring, FDDI

!

Topologia magistralowa:

Ethernet

!

Topologia gwiaździsta:

ArcNet

Token-ring i Ethernet należą obecnie do najpopularniejszych typów

topologii. Obydwa typy sieci, oprócz niewątpliwych zalet, posiadają

także wady.

W zasadzie realizacja sieci Ethernet - w odniesieniu do typu Token-

ring - jest mniej kłopotliwa (ze względu na nieduży koszt kabla

i kart). Jednak nie cena, lecz nasze wymagania i oczekiwania powinny

decydować o wyborze rodzaju topologii. Podejmując decyzję powin-

niśmy uwzględnić następujące aspekty:

!

Strukturę użytkowników

!

Programy użytkowe wykorzystywane w sieci

!

Wymaganą przepustowość

!

Niezawodność

!

Możliwości rozszerzenia sieci

!

Uwarunkowania przestrzenne

!

Istniejącą infrastrukturę

Szczególnie ostatniemu punktowi powinniśmy poświęcić nieco więcej

uwagi, gdyż często elementy infrastruktury komputerowej wyznaczają

określoną topologię.

Zdecydowanie się na jedną z typologii nie musi wcale wykluczać

innego modelu. Możliwe jest np. połączenie ze sobą Ethernetu

i Token-ring. Raz podjęta decyzja nie oznacza „związku” na wieki.

Dzięki Windows NT Server i Workstation 4 możemy bez problemu

połączyć nasz komputer z różnymi strukturami sieci.

Wprowadzenie

53

Protokoły

Na najniższym poziomie w strukturze sieci komputerowej znajdują

się kable, wykorzystywane do wymiany informacji pomiędzy

pojedynczymi komputerami. Układ kabli może mieć formę pierścienia

lub jednego długiego przewodu, do którego przyłączane są wszystkie

komputery. Ich zadaniem jest przesyłanie informacji. W związku

z tym powstaje problem, w jaki sposób ustalić, kto i kiedy może

przesyłać dane. Ponadto potrzebny jest jeden wspólny język, którym

posługiwałyby się wszystkie komputery, wymieniające między sobą

informacje. Język taki nosi nazwę protokołu (komunikacyjnego).

W tekście powyżej poruszyliśmy kwestię różnych architektur i modeli

sieciowych, teraz natomiast skupimy się na logicznym połączeniu

pojedynczych komputerów w sieci. Aby poszczególne komputery

mogły się ze sobą komunikować, muszą mówić tym samym

„językiem”. Taki „język sieciowy” określa się mianem protokołu.

Protokół jest w zasadzie niezależny od rodzaju topologii sieciowej

i stosowanej metody uzyskiwania dostępu.

Metodę uzyskania dostępu dla Ethernetu IEEE 802.3 i sieci typu

Token-ring IEEE 802.5 określa się co prawda czasami, jako protokół

najniższego poziomu w modelu OSI (służącego do regulacji dostępu

w sieci). W naszych rozważaniach stosować będziemy termin

„protokół” - wyłącznie dla określenia „języka”, którym posługują się

użytkownicy sieci.

Warunkiem dla bezkonfliktowego komunikowania się ze sobą

różnych komputerów w sieci jest wspólnie wykorzystywany protokół.

Teraz omówimy dokładniej te typy protokołów, które mają duże

znaczenie w środowisku Windows NT.

NetBIOS

Pojęcie NetBIOS (Network Basic Input/Output System) należy

rozumieć, jako podstawowy sieciowy system wejścia/wyjścia. Gdy

w początkach lat osiemdziesiątych firma IBM opracowywała sieć

komputerową, było oczywiste, że najpierw potrzebny będzie protokół

do komunikowania się pojedynczych komputerów. Ponieważ

w owym czasie nikt nie mógł sobie nawet wyobrazić sieci, łączącej ze

sobą setki komputerów rozproszonych po całym swiecie, szczególną

uwagę skupiono zatem na małych wspólnotach sieciowych. W ten oto

sposób zrodził się NetBIOS. Obejmował on 17 poleceń, dzięki którym

połączenia pomiędzy komputerami w sieci mogły być nawiązywane,

54

Windows NT 4 Server

utrzymywane i

kończone. W

niedługim czasie IBM rozszerzył

NetBIOS o dalsze polecenia, tworząc NetBEUI.

Dzisiaj NetBIOS zyskał zupełnie inne znaczenie w środowisku

Windows NT. Wykorzystywany jest on jako interfejs programowy,

przy pomocy którego system może korzystać i sterować siecią.

Interfejs taki określa się także mianem interfejsu programów

użytkowych - API (Application Programming Interface).

NetBEUI

NetBEUI (NetBIOS Extended User Interface) jest dziełem firmy IBM.

Na rynek NetBEUI trafiło w roku 1985. W tym czasie nikt nawet nie

rozważał sieci LAN obejmującej kilkadziesiąt komputerów, bez

potrzeby korzystania z bram (gateways) - służących do połączeń

z innymi segmentami sieci LAN, czy z komputerem centralnym. Stąd

też protokół NetBEUI znajduje zastosowanie przede wszystkim

w małych sieciach LAN, w grupach roboczych lub na poziomie

jednego działu.

W dostarczanej z Windows NT wersji NetBEUI 3.0 usunięto niektóre

z ograniczeń jego wcześniejszych wersji. Protokół ten nie potrafi sam

wybierać trasy (rout), co limituje jego wykorzystanie do jednego

segmentu LAN. Z tego względu Windows NT dysponuje jeszcze

innymi protokołami, jak np. NWLink i TCP/IP.

W NetBEUI 3.0 ograniczenie liczby sesji do 225 należy już do

przeszłości, dzięki współpracy z warstwą TDI (omawianej w tej

książce w wielu miejscach). Poza tym NetBEUI 3.0 jest normalnym

protokołem typu plug and play (włącz i używaj), który (poza prostym

programem instalacyjnym) nie wymaga dodatkowej konfiguracji.

Konfiguracja następuje samoistnie - co sprawia, że NetBEUI może

być optymalnie wykorzystany na odpowiednim komputerze. Inną

cechą NetBEUI, kwalifikującą ten protokół jako „przyjazny dla

użytkownika”, jest stosowanie jasnych nazw komputerów - nazw

NetBIOS, co znacznie ułatwia administrowanie siecią i korzystanie

z jej zasobów.

NetBEUI w

Windows NT 3.1 był standardowym protokołem,

instalowanym wraz z systemem. Natomiast Windows NT 4 bazuje na

zdolnym do trasowania protokole TCP/IP oraz na NWLink,

kompatybilnym z IPX/SPX.

NetBEUI 3.0 nie jest właściwie typowym interfejsem NetBEUI, lecz

tzw. protokołem NetBIOS frame format (NBF). Starsze wersje

NetBEUI musiały wykorzystywać interfejs NetBIOS jako połączenie

Wprowadzenie

55

wyższe. Natomiast NetBEUI 3.0 dostosowany jest do interfejsu

sterownika transportu TDI (Tansport Driver Interface), którym

zajmiemy się szczegółowo w rozdziale 4. NetBEUI jest jednak

całkowicie zgodny ze swoimi poprzednimi wersjami i współpraca

między nimi przebiega bez zakłóceń.

IPX/SPX

Podstawowym protokołem systemu operacyjnego NetWare firmy

Novell jest IPX/SPX.

Tak naprawdę chodzi tutaj o dwa rodzaje protokołów, wywodzących

się od protokołu systemu sieciowego firmy Xerox - XNS (Xerox

Network System). Protokoły te odpowiedzialne są za bezkolizyjną

komunikację w

sieci. Protokół IPX/SPX może być stosowany

zarówno w otoczeniu Ethernetu jak i Token-ring, FDDI czy ArcNet;

nie jest on zależny od typu topologii.

Już nazwa - międzysieciowa wymiana pakietów - IPX (Internet

Packet Exchange), wyjaśnia bezpośrednio rolę tego protokołu. Jest

nią wymiana danych zarówno między różnymi sieciami, a także

wewnątrz jednej sieci. IPX „pakuje” w

pojedyncze pakiety

informację, która ma zostać przesłana przez sieć, i umieszcza na nich

nagłówek w celu ułatwienia identyfikacji przesyłki. Po stronie

odbiorcy natomiast pojedyncze segmenty łączone są powtórnie

w jedną całość.

SPX (Sequential Packet Exchange) oznacza sekwencyjną wymianę

pakietów. Chodzi tutaj o element oprogramowania komputera-klienta,

wykorzystywany do rozszerzenia protokołu IPX. SPX nadzoruje

i sprawdza przebieg transmisji danych a także określa, czy transmisja

została uwieńczona sukcesem. Jego zadaniem jest dopilnowanie, aby

komunikacja odbywała się bez zakłóceń. W tym celu żąda on od

odbiorcy potwierdzenia odbioru przesyłki. Pozwala to na ustalenie,

czy informacje dotarły do adresata oraz sprawdzenie (na podstawie

klucza), czy dane zostały poprawnie przesłane. Gdy program SPX

wykryje jakieś błędy, transmisja danych jest wznawiana. Po wielu

próbach zakończonych fiaskiem następuje przerwanie transmisji

(wyświetlany jest komunikat o błędzie).

NWLink i IPX/SPX

Windows NT dysponuje własną wersją protokołu IPX/SPX,

stosowanego w sieciowym systemie operacyjnym Netware firmy

Novell. Protokól ten określany jest mianem NWLink.

56

Windows NT 4 Server

NWLink jest kompatybilny ze wszystkimi interfejsami sieciowymi,

jak TDI, NetBIOS i Windows-sockets (omawianymi w dalszej części

tekstu). Windows-sockets są specjalną sieciową wersją interfejsów

sockets, które pierwotnie powstały z przeznaczeniem dla UNIX-a.

Windows NT posiada oprócz tego komponenty, ułatwiające korzysta-

nie z zasobów Netware w oparciu o protokół NWLink. Do grupy tej

należą: client-service dla NetWare i gateway-service dla Netware.

NWLink znajduje zastosowanie przede wszystkim w dużych sieciach,

ponieważ może on używać IPX-router. Nie ma przy tym znaczenia,

czy chodzi tutaj o router wewnątrz NetWare czy router IPX

(omawiamy na dalszych stronach). W

porównaniu z

NetBEUI

protokół NWLink w małych sieciach lokalnych LAN wydaje się być

nieco wolniejszy. NWLink należy do standardowych protokołów

systemu Windows NT, podobnie zresztą jak NetBEUI.

TCP/IP

TCP/IP (Transmission Control Protocol/Internet Protocol) jest to -

tłumacząc na język polski - protokół sterowania transmisją w sieci.

Opracowano go w latach siedemdziesiątych na zlecenie Ministerstwa

Obrony USA, które chciało połączyć ze sobą swoje wszystkie kompu-

tery, pochodzące od różnych producentów i

mające różną

architekturę. Defense Advenced Research Projects Agency (DARPA),

bo tak brzmi nazwa rządowej agencji, zleciło ogromnej grupie

przedsiębiorstw, instytucji i

organizacji (w tym Massachusetts

Institute of Technology) opracowanie odpowiedniego protokołu.

Naukowcy biorący udział w

pracach nad powstaniem TCP/IP,

stosowali go także we własnych sieciach, które łączyli z sieciami

położonymi w innych miastach. Tak powstał Internet (historia

przedstawiona w bardzo wielkim skrócie) - ogólnoświatowa sieć,

łącząca ze sobą najróżniejsze typy komputerów. Obecnie do Internetu

podłączonych jest kilka milionów komputerów i ich ilość zwiększa

się gwałtownie z każdym dniem. W ten sposób TCP/IP stał się

jednym z

najważniejszych protokołów (w Internecie nawet

najważniejszym). Fakt, że ogólnoświatowa sieć opiera się na

protokole TCP/IP i każdego dnia potwierdza jego skuteczność, może

być chyba znaczącym argumentem przemawiającym za jego

zastosowaniem w naszej własnej sieci.

Integracja - poprzez BSD (Berkley Software Distribution) - TCP/IP do

środowiska UNIX, ugruntowała pozycję tego protokołu także jako

standardu dla sieci opartych na tym systemie. Tymczasem wielu

liczących się producentów oprogramowania i sprzętu poleca TCP/IP

Wprowadzenie

57

dla swoich produktów, i na tym właśnie polega ogromna atrakcyjność

tego protokołu. Jest on najbardziej uniwersalnym i kompatybilnym

protokołem, umożliwiającym trasowanie/routing. TCP/IP jest

wykorzystywany do komunikacji pomiędzy komputerami

pracującymi pod nadzorem różnych systemów operacyjnych i

o najprzeróżniejszymi architekturach.

TCP/IP warunkuje ponadto korzystanie z protokołu SNMP (Simple

Network Managment Protocol), służącego do zarządzania siecią.

SNMP umożliwia przeprowadzenie zdalnej konserwacji, zdalnej

instalacji itd.

TCP/IP to właściwie zestaw pojedynczych protokołów:

!

TCP (Transmission Control Protocol) odpowiedzialny jest za

śledzenie przebiegu logicznego połączenia pomiędzy komputerem-

nadawcą a komputerem-odbiorcą. Poza tym jego zadaniem jest

detekcja błędów powstałych podczas transmisji i ich usuwanie.

!

IP (Internet Protocol) służy do wymiany danych w sieci. Każdy

komputer wyrażający chęć korzystania z TCP/IP potrzebuje adresu

IP, składającego się z czterech liczb (czterech bajtów). Adres taki

może mieć np. taką postać: 132.65.45.109. Adresy IP przydzielane

komputerom muszą być niepowtarzalne, w przeciwnym razie

w sieci mogłoby dojść do chaosu i totalnego zamieszania. IP musi

pomieścić jedynie w czterech bajtach adres sieciowy i adres węzła

(node). Ze względu na ciągle rozrastającą się wspólnotę

internetową nie jest to zadanie łatwe, gdyż pula dostępnych

adresów internetowych zaczyna się powoli wyczerpywać. Ipng (IP

next generation), uważany za protokół nowej generacji, ma temu

zapobiec, ale o wynikach będziemy mogli przekonać się dopiero

w przyszłości.

Protokołami wyższego rzędu są FTP (File Transfer Protocol) i Telnet

(Terminal Emulation/Network). FTP służy do wymiany danych

pomiędzy systemami i zawiera zestaw instrukcji pozwalający oglądać

i kopiować dane z „obcych” dysków twardych. Telnet, zgodnie ze

swoją długą nazwą, to emulacja terminala umożliwiająca dostęp do

dowolnego systemu, niezależnie od posiadanego sprzętu.

DLC

DLC (Data Link Control Protocol) nie jest właściwie protokołem

sieci komputerowej. Stosuje się go zasadniczo tylko w dwóch celach:

!

do nawiązania połączenia z dużymi komputerami kompatybilnymi

z IBM

58

Windows NT 4 Server

!

i do korzystania z drukarek sieciowych, dysponujących własnym

bezpośrednim połączeniem sieciowym (a więc nie podłączonych

za pomocą interfejsu szeregowego czy podstawowego komputera).

Aby uzyskać dostęp do komputera głównego, pracując na komputerze

z zainstalowanym systemem Windows NT, musimy dodać do naszego

komputera dodatkowy protokół DLC. Zainstalowanie tego protokołu

udostępni interfejs dla systemu DOS i 16- (ewentualnie 32-bitowych)

programów działających w środowisku Windows. Dzięki takim

interfejsom program emulacji terminala, jak np. Rumba, może

imitować w zupełności terminal IBM-3270.

Korzystanie - za pośrednictwem protokołu DLC - z bezpośrednio

podłączonych drukarek sieciowych możliwe jest obecnie tylko dzięki

drukarkom firmy Hewlett Packard, ponieważ jedynie dla nich istnieją

już odpowiednie sterowniki. Aby sterować pracą takiej drukarki,

stacja robocza, pełniąca funkcję serwera druku (print server) musi być

wyposażona w protokół DLC.

Protokół DLC nie przejmuje funkcji warstw modelu OSI, odpowie-

dzialnych za nawiązywanie połączeń i transport danych, jak czynią to

TCP/IP czy IPX/SPX. Pełni on natomiast rolę bezpośredniego inter-

fejsu do warstwy transmisji danych dla programów usytuowanych na

warstwach wyższych.

Apple Talk

Apple Talk jest specjalnym protokołem, wprowadzonym w 1984

roku, i przeznaczonym do wymiany danych pomiędzy komputerami

Macintosh. Maszyny te posiadają zintegrowaną kartę sieciową, tzw.

kartę LocalTalk, ktora umożliwia wymianę danych między

poszczególnymi użytkownikami Mac’ów, a także współużytkowanie

urządzeń peryferyjnych.

Karty sieciowe i okablowanie

W ostatnich akapitach wiele miejsca poświęciliśmy różnym modelom

sieci, a także protokołom. Teraz skupimy się na technicznej stronie

funkcjonowania sieci. Mówiąc nieco jaśniej - mamy tutaj na myśli

karty sieciowe i kabel.

Przed podjęciem decyzji o wyborze kabla i karty musimy przemyśleć,

jaki rodzaj topologii i jakiego typu metodę uzyskiwania dostępu

chcemy zastosować. Musimy zatem opowiedzieć się albo za

korzystaniem z Token-ring albo za Ethernetem.

Wprowadzenie

59

Karta sieciowa

Karta sieciowa jest to element wyposażenia komputera, umożliwiają-

cego podłączenie do sieci. Zawiera ona jedno lub więcej gniazd, do

których wpina się kabel sieciowy. Karta taka odpowiedzialna jest za

fizyczne przesyłanie i przyjmowanie danych pomiędzy komputerem

i kablem sieciowym.

Kryteria wyboru

Za metodą Token-ring i Ethernetem kryje się (obok topologii) coś

znacznie bardziej skomplikowanego - mianowicie logika. Token-ring

musi zostać wykonany i odpowiednio wykorzystany. Trzeba także

poradzić sobie z trudnościami powstającymi przy uzyskaniu dostępu

w sieci Ethernet. Dane muszą zostać rozłożone na małe segmenty.

Do tego potrzebne jest oprogramowanie instalowane na kartach

sieciowych - a dokładniej w ich pamięci stałej ROM.

Oznacza to, że stosując różne typy sieci potrzebne nam będą różne

rodzaje kart. Możemy zatem wbudować do naszego komputera karty

sieci Token-ring i Ethernetu. Przy wyborze karty należy kierować się

takimi oto kryteriami:

!

szerokość szyny

!

adaptacja / ustawienie

!

sterowniki

Ogromne znaczenie dla wyboru i oceny wydajności karty ma np.

szerokość magistrali danych. Istotne jest tutaj, czy karta pracuje

z szyną o szerokości 8, 16 czy nawet 32 bitów. Im szersza szyna, tym

większa przepustowość. Obecnie w większości komputerów stosuje

się karty o szynach 16-bitowych, co wydaje się w zupełności

wystarczać dla typowych aplikacji. W

wyniku rosnącego

zapotrzebowania, a także nieustającego postępu technicznego do

użytku wchodzą adaptery o magistrali 32-bitowej. Pociąga to za sobą

jednak stosowanie karty PCI, EISA czy micro-channel.

Na kartę 32-bitową powinniśmy zdecydować się także przy dużym

obciążeniu serwera, aby uniknąć na magistrali ewentualnego „korka”.

Konfiguracja

Gdy pracujemy na komputerze z zainstalowana kartą ISA o magistrali

16-bitowej istotne znaczenie ma kwestia przerwań (IRQs).

60

Windows NT 4 Server

Problem polega na tym, że komputery z szyną ISA posiadają tylko

ograniczoną ilość przerwań, a każda instalowana karta wymaga

przydzielenia przynajmniej jednego z nich.

Musielibyśmy zatem dopasować do siebie całą górę kart - czyli czeka-

łoby nas przedsięwzięcie żmudne i będące poważnym sprawdzianem

dla naszych nerwów.

Obecnie można spotkać karty sieciowe, konfigurowane za pośrednic-

twem dołączonego oprogramowania. Karty takie same wyszukują

wolne przerwanie i swoje miejsce w pamięci.

W innych typach kart sieciowych należy ustawić (na karcie) jumper

albo poeksperymentować z malutkimi mikroprzełącznikami (DIP

switch).

Karty samokonfigurujące się są oczywiście o wiele wygodniejsze.

Sterowniki

Do określonych typów kart sieciowych należy stosować zawsze

odpowiednie sterowniki. Chodzi tutaj o programowy sterownik, odpo-

wiedzialny za jej pracę.

Oprogramowanie sieciowe i protokoły muszą porozumiewać się

z kartą, a to oznacza, że przy wyborze karty musimy zwrócić uwagę,

czy jest ona przez nie akceptowana.

Szybkość

Prędkość transmisji danych w Ethernecie wynosi 10 Mbit/s. Dane,

które mają zostać przesłane, rejestrowane są wcześniej (na krótki

czas) przez kartę. Jeśli sieć sprawia wtedy wrażenie „przeciążonej” -

oznacza to, że problem leży po stronie serwera lub komputera

udzielającego swoich zasobów. Powodem takiego „spowolnienia”

może być sprzęt (dostęp do dysku twardego) lub - w sieci peer-to-peer

- zbyt rozbudowana struktura. W

sieci bazującej na serwerze

powodów może być więcej. Być może winę ponosi okablowanie,

które nie jest w stanie dostatecznie szybko przesyłać danych.

Wybór

Decydując się na jakąś kartę powinniśmy zwrócić uwagę na sposób

jej obsługi, która powinna być łatwa (bez konieczności ustawiania

jumperów ani mikroprzełączników). Najlepiej byłoby, gdybyśmy

postarali się o

kartę konfigurowaną za pośrednictwem

oprogramowania.

Wprowadzenie

61

Kabel

Podjęcie decyzji co do typu topologii nie oznacza jeszcze bynajmniej,

że dokonaliśmy wyboru rodzaju kabla sieciowego.

Karta sieciowa połączona jest z kablem. W sieci typu Token-ring

kabel wtykany jest po prostu do interfejsu (tak jak w drukarce).

W Ethernecie natomiast możemy skorzystać z dwóch wariantów.

Jeden z nich przewiduje, że bezpośrednio do karty podłączana jest

łączówka pomiędzy dwoma odcinkami kabla. Inna możliwość polega

na poprowadzeniu przewodu do magistrali.