Sformułować prawo Titiusa-Bodego.

Analizując wielkości orbit kolejnych planet Układu Słonecznego (US) w roku 1766 Jan Titius z Wittenbergii zauważył iż w miarę oddalania od Słońca długości średnic orbit kolejnych planet tworzą dosyć regularny ciąg liczb. Średnicą nazwano tu wielką oś orbity eliptycznej, połowa jej nazywana jest Średnią Odległością (ŚO) planety od Słońca. Spostrzeżenie Titiusa dotyczyło znanych wówczas planet: Merkurego, Wenus, Ziemi, Marsa, Jowisza i Saturna. Starając wyrazić to liczbowo Titius dopasował do zaobserwowanych wielkości zgrabny ciąg, którego pierwszymi dwoma wyrazami są: 0 i 3 a każdy następny powstaje przez podwojenie poprzedniego. Kiedy wyrazy tak powstałego ciągu: {0, 3, 6, 12, 24, 48, 96, 192,...} zwiększy się o 4 i podzieli przez 10, to otrzymane liczby: { 0.4, 0.7, 1.0, 1.6, 2.8, 5.2, 10.0, 19.6...} z niezłą dokładnością +5% określają w Jednostkach Astronomicznych średnie odległości planet od Słońca. Wyjątkiem był brak orbity planety odpowiadającej N=5-temu wyrazowi ciągu. Prawo Titiusa opublikował w roku 1772 (jako własne) berlińczyk Jan Bode. Przyjęło się nazywać je Prawem Titiusa-Bodego (T-B). Prawo T-B można zapisać: ![]()

gdzie "a"=pół wielkiej osi elipsy orbity wyrażone w Jednostkach Astronomicznych a "K" przyjmuje kolejno wielkości:

, 0, 1, 2, 3, ...

Podać zasadę działania absolutny grawimetr balistyczny (Grawimetr absolutny balistyczny FG-5)

Aparatura działa na zasadzie rejestracji czasu i drogi swobodnego pionowego spadku próbnika w wysokiej próżni. Posiada laserowy interferometr Michelsona. Osiągana precyzja to 2,5*10-8 m/s2, czyli 2,5 mikrogala. Jest to urządzenie przenośne. Urządzenie służy do bezwzględnych wyznaczeń natężenia siły ciężkości Ziemi. Rejestracja wskazań instrumentu pozwala na śledzenia zmian w czasie przyspieszenia ziemskiego i określania wartości tego parametru w miejscach badań geodynamicznych i na stanowiskach podstawowej sieci grawimetrycznej kraju oraz w międzynarodowych kampaniach kalibracyjnych, organizowanych przez Międzynarodowe Biuro Grawimetryczne International Association of Geodesy.

Sformułować izostatyczną koncepcję Airy'ego wraz z elementami antykorzeni.

Według niego wszystkie bloki skał na Ziemi mają mniej więcej taką samą gęstość (2,73 g/cm3). Ów bloki skorupy pływają po półpłynnej astenosferze, i są w niej zanurzone w te sposób, iż im wyższy blok tym głębiej jest on zanurzony (proporcjonalnie) W związku z tym pod kontynentami są tzw. korzenie skorupy, a pod morzami - antykorzenie skorupy. Airy założył także iż na pewnej głębokości musi występować wyrównanie ciśnień (poziom kompensacji). Naciski na tych głębokościach są jednakowe we wszystkich kierunkach, a stan materii jest lepko - plastyczny. Teorie Airy'ego zmodyfikowali: Heiskanen i Veining.

Podać zasadę działania i pomiar magnetometrem protonowym.

Służy do pomiaru całkowitego wektora indukcji magnet. Ziemi - T. Zbudowany jest pojemnika z cieczą, otoczonego solenoidem (cewką). Jeśli w cewce otaczającej pojemnik z cieczą popłynie wysokie napięcie, to spolaryzuje ono elektrony znajdujące się w ów cieczy zgodnie z kierunkiem przyłożonego pola, zaczną one krążyć i zarazem precesować. Zgodnie z warunkiem Larmara: natężenie pola magnet. jets wprost proporcjonalne do Hz precesji.

Jak, kiedy i w jakich warunkach można zmierzyć powierzchniową gęstość strumienia cieplnego. Podać wzór.

Strumień ciepła - jest to ilość ciepła przechodząca przez przekrój poprzeczny w jednostce czasu. Im skała starsza tym gorzej przewodzi ciepło. Dowód: najmniejsze wartości strumienia w pobliżu ryftu. Jak można wyznaczyć gęstość strumienia cieplnego:1. W warunkach ustalonej równowagi cieplnej (stacjonarnego strumienia ciepła lambda). 2 W warunkach nieustalonej równowagi cieplnej (niestacjonarny przepływ ciepła). 3 Halosymetryczna (wyznaczanie lambda).

Podać równanie wykładnicze rozpadu promieniotwórczego i podać, na jakiej podstawie można określić wiek minerału.Prawo rozpadu naturalnego - to zależność określająca szybkość ubywania pierwotnej masy substancji zbudowanej z jednego rodzaju cząstek, która ulega naturalnemu, spontanicznemu rozpadowi. Prawo ma zastosowanie w rozpadzie promieniotwórczym ciał, ale w ogólności dotyczy wielu procesów fizycznych. Prawo to głosi, że jeśli prawdopodobieństwo rozpadu cząstek tworzących substancję jest dla każdej z nich jednakowe i niezależne oraz nie zmienia się w czasie trwania procesu rozpadu, to ubytek masy substancji w niewielkim odcinku czasu można wyrazić wzorem: ![]()

Po scałkowaniu: ![]()

gdzie:m - masa substancji ulegającej rozpadowi,λ - stała rozpadu charakterystyczna dla danego izotopu lub substancji,t - czas,m0 - masa początkowa substancji w momencie t = 0m(t) - masa substancji w czasie t. W prawie rozpadu naturalnego w miejsce masy można używać inne wielkości mierzące ilość rozpadającego się czynnika, np. liczbę cząstek. Prawo rozpadu naturalnego ma zastosowanie do cząstek elementarnych, jąder atomowych i substratów reakcji chemicznych, które zachodzą zgodnie z kinetyką pierwszego rzędu. Prawo rozpadu naturalnego zastosowane do opisu zachowania izotopów promieniotwórczych znane jest jako prawo rozpadu promieniotwórczego lub prawo przemian promieniotwórczych a samo równanie jako równanie rozpadu promieniotwórczego. Prawo to jest matematycznie identyczne z prawami opisującymi wiele innych procesów w fizycznych np.: stygnięcie ciała opisuje wówczas zmianę temperatury (prawo stygnięcia), rozładowanie kondensatora - ładunek elektryczny q(t) na okładkach kondensatora.

Rozpisać równanie izochrony rubidowo-strontowej. Datowanie rubidowo-strontowe - metoda datowanie bezwzględnego ze względu na bardzo długi czas rozpadu izotopu rubidu (wynosi on około 48,6 mld lat) W tej metodzie Rb87 zamienia się w Sr87. Metoda ta jest użyteczna do datowania skał magmowych i osadowych o wieku ponad 100 mln lat. Metoda rubidowo-strontowa. Metoda ta została wprowadzona pod koniec lat 30 dwudziestego wieku i nadaje się do datowania minerałów zawierających rubid. Zawarty w minerale izotop Rb rozpada sie przez rozpady Beta w wyniku czego powstaje izotop strontu Sr. Wiek próbki można obliczyć na podstawie wzoru:

Na czym polega lokalizacja ogniska wstrzasu metoda fal P? istota metody, rownania stacyjne dla osrodka jednorodnego i izotropowego. Uzasadnij konieczna liczbe stacji (ktore zarejestrowały wstrzas), do zlokalizowania hipocentrum wstrzasu. Polega na rejestracji czasu wejścia fali podłużnej P na poszczególne stacje pomiarowe. Fala P zawsze przychodzi jako pierwsza. Jest to najdokładniejsza metoda wyznaczania epi i hipocentrum. X-stacje sejsmiczne; t- czas przyjścia fali pomiarowej do każdej stacji, to- czas w ognisku. Nalezy wyznaczyć współrzędne epicentrum xo,yo. Układamy to w układ równań, jeśli znamy prędkość- są 3 niewiadome w postaci płaskiej, a 4 w postaci przestrzennej. Aby rozwiązać układ równań należy mieć 4 równania w przypadku płaskim, a 5 w przestrzennym. Są to równania z kilkoma rozwiązaniami wiec musimy mieć wiekszą liczbe równań.

Czym jest intensywność-natężenie trzęsienia Ziemi, od czego zależą szkody? Jaki sens fizyczny ma pojęcie intensywności wstrząsu od czego zależą zniszczenia obiektów w wyniku dochodzących fal sejsmicznych

Energię wyzwalaną w trakcie trzęsienia ziemi wyraża się w stopniach magnitudy. Magnituda równa 0 lub ujemna (stosowana do oznaczania tzw. "mikrowstrząsów", rejestrowanych tylko przez bardzo czułe przyrządy) oznacza wibracje rejestrowane tylko przez aparaturę pomiarową, zaś magnituda równa 9,5 (wartość magnitudy najsilniejszego, udokumentowanego instrumentalnie trzęsienia ziemi) powoduje zmiany w otaczającym krajobrazie. Sejsmolodzy powątpiewają w istnienie trzęsień ziemi o magnitudzie większej niż 10, jednak teoretycznie wszystkie skale pomiarowe zjawisk sejsmicznych (np. logarytmiczna skala Richtera) to skale otwarte. Należy przy tym zaznaczyć, że każdy kolejny stopień magnitudy jest mierzony, jako dziesięciokrotnie większy od poprzedniego, ale faktycznie: każdy kolejny stopień niesie ze sobą w przybliżeniu 31-krotny wzrost energii.Do pomiaru intensywności drgań gruntu służy natomiast szereg skal - dawniej opierających się na sondażach, wykonywanych na grupie osób dotkniętych konkretnym trzęsieniem ziemi, obecnie zaś na wynikach pomiarów przyspieszenia gruntu zmierzonego w trakcie wstrząsów. Do najpopularniejszych skal należy zmodyfikowana skala Mercallego - Mercallego-Cancaniego-Sieberga (MCS). W skali tej stopień I oznacza wibracje rejestrowane wyłącznie przez aparaturę pomiarową, a stopień XII - wstrząsy powodujące zmiany w otaczającym krajobrazie.Fale sejsmiczne rozchodzące się z hipocentrum docierają najprędzej do powierzchni Ziemi w miejscu położonym bezpośrednio nad ogniskiem. Miejsce to zwiemy epicentrum. Im dalej od epicentrum, tym później dobiegają drgania i tym są one słabsze. Dlatego największe zniszczenia występują w najbliższym jego sąsiedztwie, tzw. Obszarze epicentralnym, w którym także najsilniej zaznacza się działania fal długich. Te ostatnie przedstawiają fale wtórne, wzbudzone na powierzchni ziemi przez fale podłużne i poprzeczne; powodują one największe wychylenia gruntu i tym samym - zniszczenia. Rozmiary obszaru epicentralnego zależą od wielkości trzęsienia ziemi i od głębokości ogniska. Skutki trzęsienia ziemi zalezą od siły wstrząsów, głębokości, na której powstają oraz od rodzaju skał na powierzchni ziemi. Grunt może pękać, unosić się i zapadać. W obszarach górzystych mogą powstać lawiny i osuwiska, nawet na łagodnych stokach gliniaste gleby mogą zacząć pełznąć na podobieństwo -płynnej lawy. Trzęsienie ziemi trwa na ogół nie dłużej niż kilka sekund, ale niektóre trwają minutę lub dłużej. Trzęsienie ziemi w San Francisco w 1906 roku trwało np.. 40 sekund, podczas gdy trzęsienie ziemi, które nawiedziło Alaskę 24 stycznia 1964 roku wstrząs sało ziemią ponad 7 minut, z tego przez 3 minuty ze szczególnie niszczącą siłą.

Często głównemu wstrząsowi towarzyszą tzw. Wstrząsy potomne, z których każdy kolejny jest słabszy od poprzedniego. Wstrząsy potomne powstają wskutek przemieszczania się mas skalnych, dopasowujących się do stanu nowej równowagi. Mogą one powodować katastrofalne zniszczenia nieobliczalne w skutkach. W 1985 roku zostało zniszczone centrum stolicy Meksyku w następnie trzęsienia ziemi ocenianego w skali Mercalliego na 11 stopni. Następnie wystąpił wstrząs potomny w sile 10 stopni, a obrócił on w ruinę jeszcze większą część miasta.

Wymień nieciągłości według Preliminary Reference Earth Model (Dziewoński, Anderson).Wstępne odniesienia Ziemia modelu: Region: Rdzeń wewnętrzny, Rdzeń zewnętrzna D '', Dolny płaszcz, Strefa przejściowa, Strefa niskiej prędkości, POKRYWA, skorupa, ocean. Wstępne odniesienia modelu Ziemi (PREM) jest jednowymiarowy model reprezentujące średnie właściwości Ziemi jako funkcję promienia planetarnego. To obejmuje tablicę właściwości Ziemi, w tym właściwości sprężyste, tłumienie, gęstość, ciśnienie i wagę, w funkcji promienia planetarnego. PREM jest powszechnie stosowany jako baza dla tomografii sejsmicznych i pokrewnych modelach globalnych geofizycznych. Zawiera on anelastic dyspersji i anizotropię, a zatem jest zależny od częstotliwości i poprzecznie izotropowe górnego płaszcza. PREM został opracowany przez Adama M. Dziewoński i Don L. Anderson, w odpowiedzi na wytyczne "standardowym modelu komisji Ziemi" Międzynarodowego Stowarzyszenia Geodezji (IAG) i Międzynarodowego Stowarzyszenia Sejsmologii i Fizyki Wnętrza Ziemi (IASPEI). [1] Inne modele referencyjne Ziemia to IASPE91.Streszczenie Duży zestaw danych składa się z około 1000 normalnych okresów trybie 500 podsumowanie podróży obserwacji czasowych, 100 normalnych wartości q Tryb, masy i momentu bezwładności zostały odwrócone, aby uzyskać promieniowy rozkład właściwościach elastycznych, wartości Q i gęstości wnętrza Ziemi.Zestaw danych został uzupełniony specjalnym badaniu 12 lat danych faz ISC, który dawał dodatkowe 1,75 × 106 obserwacji w czasie podróży do fal P i S. W celu uzyskania satysfakcjonującego porozumienia z całego zbioru danych zostaliśmy zobowiązani do uwzględnienia anelastic dyspersji.Wprowadzenie poprzecznej izotropii do 220 km zewnętrznych płaszcza było wymagane w celu zaspokojenia toroidalne krótszy okres podstawowy i tryby kuliste. Ten anizotropii również poprawić dopasowanie do większego zbioru danych. Prędkości poziome i pionowe w górnym płaszczu różnią się o 2-4%, zarówno dla fal P i S.Płaszcz poniżej 220 km nie musi być anizotropowe. Fale płaszcz Rayleigh są zaskakująco wrażliwe na kompresyjne prędkości w górnym płaszczu. Wysokie prędkości Sn, niskie prędkości PN i wyraźne strefy niskiej prędkości to cechy większości globalnych modeli inwersji, które są tłumione gdy anizotropii jest dozwolone w inwersji.

Co to pas kupiera i gdzie się znajduje?

Pas Kuipera, zwany też pasem Edgewortha-Kuipera - obszar Układu Słonecznego rozciągający się za orbitą Neptuna, od 30 do około 50 j.a. od Słońca. Jest podobny do pasa planetoid, ale o wiele większy: 20 razy szerszy i 20-200 razy bardziej masywny. Podobnie jak pas planetoid, zawiera wiele małych obiektów, będących pozostałościami po procesie formowania się Układu Słonecznego. Krążą w nim co najmniej trzy planety karłowate: Pluton, Haumea i Makemake. O ile pas planetoid składa się głównie z obiektów skalnych i metalowych, większość obiektów Pasa Kuipera jest zbudowanych z zestalonych prostych związków, takich jak metan, amoniak i woda.

Co to jest anomalia magnetyczna i od czego zależy kształt i wielkość anomalii?Anomalia magnetyczna - lokalne różnice między ziemskim polem magnetycznym w danym miejscu a jego wartością teoretyczną, wyliczonymi na podstawie położenia biegunów magnetycznych na Ziemi. Ze względu na wielkość obszarów dzieli się je na kontynentalne, regionalne i lokalne. Anomalie kontynentalne są obszarowo największe, najsilniejsza - wschodnioazjatycka - obejmuje obszar niemal całej Azji. Jej największa wartość sięga 30% natężenia pola średniego. Występowanie tych anomalii wiąże się z funkcjonowaniem głównego czynnika wytwarzającego ziemskie pole magnetyczne. Anomalie regionalne obejmują mniejsze obszary, ich występowanie wiąże się z pokładami skał i minerałów o mniejszym zasięgu i zalegających płycej.Za anomalie lokalne uznaje się te których obszar zawiera się w granicach od stu do kilku tysięcy km². Występujące w nich zmiany pola magnetycznego zazwyczaj nie przekraczają 10%. Anomalie te wiążą się z występowaniem dużych pokładów minerałów magnetycznych na znacznych (ponad 1km) głębokościach. W niektórych publikacjach występuje podział na anomalie kontynentalne i lokalne.Występowanie anomalii lokalnych związane jest najczęściej ze złożami minerałów magnetycznych, np. magnetytu (rudy żelaza). Tego typu anomalie występują między innymi w okolicach Kiruny (Szwecja) i Kurska (Rosja, tzw. kurska anomalia magnetyczna) oraz w Polsce w Krzemiance (okolice Suwałk). Mniejsze anomalie związane są z występowaniem skał zasadowych lub ultrazasadowych.

Co to są anomalie magnetyczne moduły wektora T? od czego zależy wartość anomalii magnetycznej ,,delta" T

Miarą anomalii w danym punkcie na pow. Ziemi jest różnica pomiędzy zmienioną wartością i kierunkiem mierzonego w tym punkcie wektora ziemskiego pola magnetycznego a wartością normalną wyliczoną na podstawie położenia biegunów magnetycznych. Obraz anomalii jest sumą wszystkich pól magnetycznych wytworzonych przez niejednorodne namagnesowanie skał górnych warstw skorupy ziemskiej. Dzielą się na: regionalne i lokalne Zależy od: *obecności minerałów ferromagnetycznych w kompleksach skał budujących skorupę w tym miejscu, *od obecności skał magmowych zawierających ferromagnetyki , *obecności osadowych kompleksów złóż rudnych, *od spękania, wzajemnego przesuwania części podłoża krystalicznego zbud ze skał metamorficznych lub intruzyjnych.

Co to anomalia grawimetryczna i od czego zależy kształt i wielkość anomalii? Anomalia grawimetryczna, różnica pomiędzy rzeczywistą, występującą na danym terenie siłą ciężkości a jej wartością teoretyczną. Wywołana jest nierównomiernym rozmieszczeniem mas skalnych we wnętrzu Ziemi i na jej powierzchni. W wysokich górach można zauważyć zwiększenie przyspieszenia ciała swobodnie spadającego. Analiza anomalii grawimetrycznej pozwala wykryć we wnętrzu Ziemi złoża lekkich lub ciężkich minerałów.

Na czym polega metoda fal S P (na zerówce) na czym polega metoda fali P (na I terminie) ???

Geofizyczna i geologiczna interpreatcja granicy MOHO Nieciągłość Mohorovičicia (nieciągłość Moho) - termin geologiczny, oznaczający granicę pomiędzy skorupą i płaszczem Ziemi. Jest to kilkusetmetrowej grubości warstwa przejściowa. Leży na różnych głębokościach, pod oceanami średnio na głębokości 5-8 km, natomiast pod kontynentami znacznie głębiej - około 35 km. Pod wysokimi górami (np. Himalajami) może leżeć nawet na głębokościach do 80 km.Odkryta została w 1909 roku przez Andriję Mohorovičicia, chorwackiego meteorologa i sejsmologa, który zauważył skokową zmianę prędkości fal sejsmicznych na tej właśnie głębokości od ok. 7 km/s do nieco powyżej 8 km/s.Warunki panujące w skałach w tej strefie są znane dzięki odsłonięciom sekwencji ofiolitowej - skał powstałych na dnie oceanu. Do tej pory żadne wiercenia nie dotarły do nieciągłości Moho. Najgłębszy odwiert na lądzie sięga ponad 12 km pod powierzchnię (SG-3 na Półwyspie Kolskim), a na oceanie - 2111 metrów (Statek JOIDES Resolution, odwiert 504B, wschodni Pacyfik) pod jego dnem. Na początku drugiej połowy XX wieku istniała propozycja wywiercenia otworu w dnie oceanu, który sięgałby do tej nieciągłości (tzw. Projekt MOHOLE), ale z powodu braku środków zaniechano jego realizacji w 1967 r.W ostatnich latach do strefy nieciągłości i do górnego płaszcza chcą się przewiercić Japończycy przy pomocy kosztującego 540 mln dolarów statku badawczego "Chikyu". Statek ten może wykonać odwierty do głębokości 10 km przy maksymalnej głębokości dna oceanu 2500 m. Dotarcie do strefy Moho jest dla japońskich naukowców sprawą kluczową, gdyż pozwala zweryfikować teorie na temat budowy płaszcza ziemskiego i w konsekwencji lepiej zrozumieć mechanizm powstawania trzęsień ziemi.

Zależność albo różnice między strumieniem cieplnym a gęstością strumienia cieplnego

Strumień ciepła - prędkość przepływu ciepła. Może być wyrażony przez stosunek elementarnej ilości ciepła dQ do czasu trwania wymiany tej ilości ciepła dt (czasu trwania przepływu elementarnej ilości ciepła), czyli jest to pochodna po czasie ilości ciepła przepływającego przez przekrój poprzeczny przegrody. Wyraża się wzorem. Jego jednostką jest wat. Jednostka jest taka sama, jak w przypadku mocy cieplnej. Jednak są to różne pojęcia, gdyż moc cieplna dotyczy źródła ciepła, podczas gdy strumień - jego przepływu. Strumień cieplny a jego gęstość. Strumień ciepła, tak jak ciepło, jest wielkością skalarną, jednak odniesienie strumienia ciepła do jednostki pola powierzchni S (ściśle zorientowanej w przestrzeni) wyraża wektor q zwany gęstością strumienia ciepła gdzie S jest wektorem powierzchni o zwrocie zgodnym z kierunkiem przepływu ciepła. Jednostką gęstości strumienia jest wat na metr kwadratowy. Gęstość strumienia ciepła q jest to wektor o module równym stosunkowi elementarnego strumienia ciepła dQi elementarnego pola powierzchni dA, prostopadłej do kierunku przepływu ciepła, przez którą ten strumień przepływa. Jest skierowany zgodnie ze spadkiem temperatury, prostopadle do powierzchni izotermicznej.

Co to jest izochrona ogólnie i bardziej szczegółowo izochrona Th-Pb (na zerówce) i Rb-Sr (na I terminie) napisać wzór i kiedy się stosuje te izochrony?Izochrona - linia na mapie łącząca punkty, w których występuje to samo zjawisko w tym samym czasie. Innymi słowy izochrony wyznaczają obszary o jednakowej osiągalności czasowej. Miarą stosowaną są same jednostki czasu, jak minuty, godziny, dni. Niższy gradient izochroniczny wskazuje na większą szybkość ruchu danego zjawiska, wyższy odwrotnie. Szybkość do obliczeń izochron może być: a) rzeczywista - spotykamy się z nią we wszystkich rodzajach komunikacji regularnej np. kolejowej, autobusowej. Środki lokomocji poruszają się zgodnie z rozkładem jazdy i można przewidzieć, w jakim czasie zostanie osiągnięty cel podróży. b) teoretyczna - pojęcie to pojawia się przy korzystaniu z indywidualnych środków lokomocji: pieszo, rowerów, samochodów.

Co to jest izochrona 87Rb-87Sr i jak można ja wyznaczyć

Metoda ta zakłada stały początkowy stosunek izotopów Sr dla różnych minerałów w skale, wiek można wyznaczyć bez jakichkolwiek założeń. Wartość wskazuje czy próbka pochodzi z przetopionej skały czy ze skał głębinowych. Problemy: Rb i Sr są mobilne, łatwo wymywane ze skały i nie występują we wszystkich rodzajach skał (wapieniach , skałach ultrazasadowych). Metody tej nie można stosować do skał młodych ze względu na duży błąd. Izochrona Sm - Nd.

Rozpad izotopów i co to systemie zamkniętym i kiedy jest szczególnie ważny albo stosowany Datowanie izotopowe (radiodatowanie) - metody datowania próbek, oparte na zjawisku rozpadu promieniotwórczego, stosowane głównie w naukach geologicznych i archeologicznych. Pierwszy raz opracowana przez Willarda Libby'ego. Metody oparte są na określeniu proporcji pomiędzy pierwotną zawartością danego izotopu promieniotwórczego a obecną zawartością tego izotopu w próbce. Proporcja ta zależna jest wyłącznie od czasu rozpadu. Warunkiem metodologicznym jest utrzymanie układu zamkniętego w czasie trwania rozpadu (z wyjątkiem metody radiowęglowej). Pierwotną zawartość izotopu oblicza się poprzez zsumowanie produktu jego rozpadu (stałego izotopu radiogenicznego) oraz reszty nierozpadniętego izotopu promieniotwórczego. Do metod datowania izotopowego zalicza się m.in.: datowanie radiowęglowe, datowanie uranowo-torowe, datowanie potasowo-argonowe (postas-40 i argon-40), datowanie rubidowo-strontowe (rubid-87 i stront-87), datowanie ołowiowe, datowanie renowo-osmowe (ren-187 i osm-187).

Kiedy i dlaczego w datowaniu bezwzglednym skal musimy przyjmowac zalozenie o "systemie zamkniety" (wyjasnic na podstawie prawa rozpadu)??? Prawo rozkładu-ilość izotopu macierzyrego maleje wraz z upływem czasu,

Prawo Willego: wzór i chyba od czego zależy? zależność z porowatością efektywną Porowatość efektywna (aktywna, czynna, odkryta) to zawartość porów, które łączą się z sobą i z zewnętrzną powierzchnią skały, pozwalająca na ruch cieczy poprzez ośrodek efektywną (aktywna, czynna, odkryta) to zawartość porów, które łączą się z sobą i z zewnętrzną powierzchnią skały (czyli porów otwartych), pozwalająca na ruch cieczy poprzez ośrodek.

Jakieś prawo Bricha albo Bircha ale nie pamiętam dokładnie PRAWO BIRCHA. Birch stwierdza przy wysokich ciśnieniach (do 1GPa), że prędkość zależy od: gęstości i średniej masy atomowej.

Różnice albo podobieństwa między magnitudą a energią sejsmiczną???Magnituda (łac. magnitudo "wielkość" od magnus) - parametr stosowany w pomiarach wielkości trzęsienia ziemi, wprowadzony w 1935 roku przez Charlesa Richtera wraz z opracowaniem przez niego „skali magnitud”, nazwanej później skalą Richtera. Obliczanie magnitudyWielkość ta była definiowana jako logarytm największej amplitudy drgań gruntu mierzonej w mikronach, zarejestrowanych przez sejsmograf Wooda-Andersona położony w odległości stu kilometrów od epicentrum trzęsienia. Tak dokładna definicja umożliwiała łatwe porównywanie wstrząsów sejsmicznych w różnych miejscach kuli ziemskiej.W 1970 r. japoński geofizyk, Hirō Kanamori, zmodyfikował sposób obliczania magnitudy, aby nadawała się ona do określania energii najsilniejszych wstrząsów i nie była zależna od przestarzałego sejsmografu.Obecnie magnituda obliczana jest na podstawie wartości momentu sejsmicznego, lecz w przedziale mierzonym przez skalę Richtera jest z nią porównywalna.

Co to magnituda i coś o skali wstrząsów było, chyba chodziło o jednostki o to jak wzrasta i kolejne stopnie o ile są większe od poprzednich Energię wyzwalaną w trakcie trzęsienia ziemi wyraża się w stopniach magnitudy. Magnituda równa 0 lub ujemna (stosowana do oznaczania tzw. "mikrowstrząsów", rejestrowanych tylko przez bardzo czułe przyrządy) oznacza wibracje rejestrowane tylko przez aparaturę pomiarową, zaś magnituda równa 9,5 (wartość magnitudy najsilniejszego, udokumentowanego instrumentalnie trzęsienia ziemi) powoduje zmiany w otaczającym krajobrazie. Sejsmolodzy powątpiewają w istnienie trzęsień ziemi o magnitudzie większej niż 10, jednak teoretycznie wszystkie skale pomiarowe zjawisk sejsmicznych (np. logarytmiczna skala Richtera) to skale otwarte. Należy przy tym zaznaczyć, że każdy kolejny stopień magnitudy jest mierzony, jako dziesięciokrotnie większy od poprzedniego, ale faktycznie: każdy kolejny stopień niesie ze sobą w przybliżeniu 31-krotny wzrost energii. Do pomiaru intensywności drgań gruntu służy natomiast szereg skal - dawniej opierających się na sondażach, wykonywanych na grupie osób dotkniętych konkretnym trzęsieniem ziemi, obecnie zaś na wynikach pomiarów przyspieszenia gruntu zmierzonego w trakcie wstrząsów. Do najpopularniejszych skal należy zmodyfikowana skala Mercallego - Mercallego-Cancaniego-Sieberga (MCS). W skali tej stopień I oznacza wibracje rejestrowane wyłącznie przez aparaturę pomiarową, a stopień XII - wstrząsy powodujące zmiany w otaczającym krajobrazie.

Magnituda- liczbowa miara wielkości trzęsienia ziemi, oparta na wielkości wydzielonej energii. Jest to miara wielkości trzęsienia ziemi, bazująca na danych instrumentalnych opracowana w 1935 r. przez Ch. F. Richtera do sklasyfikowania lokalnych wstrząsów kalifornijskich. Opracowana przez niego „skala magnitud” została później nazwana skalą Richtera. Oznaczanie siły trzęsień ziemi i intensywności drgań gruntu. Energię wyzwalaną w trakcie trzęsienia ziemi wyraża się w stopniach magnitudy. Magnituda równa 0 lub ujemna (stosowana do oznaczania tzw. "mikrowstrząsów", rejestrowanych tylko przez bardzo czułe przyrządy) oznacza wibracje rejestrowane tylko przez aparaturę pomiarową, zaś magnituda równa 9,5 (wartość magnitudy najsilniejszego, udokumentowanego instrumentalnie trzęsienia ziemi) powoduje zmiany w otaczającym krajobrazie. Sejsmolodzy powątpiewają w istnienie trzęsień ziemi o magnitudzie większej niż 10, jednak teoretycznie wszystkie skale pomiarowe zjawisk sejsmicznych (np. logarytmiczna skala Richtera) to skale otwarte. Należy przy tym zaznaczyć, że każdy kolejny stopień magnitudy jest mierzony, jako dziesięciokrotnie większy od poprzedniego, ale faktycznie: każdy kolejny stopień niesie ze sobą w przybliżeniu 31-krotny wzrost energii.Do pomiaru intensywności drgań gruntu służy natomiast szereg skal - dawniej opierających się na sondażach, wykonywanych na grupie osób dotkniętych konkretnym trzęsieniem ziemi, obecnie zaś na wynikach pomiarów przyspieszenia gruntu zmierzonego w trakcie wstrząsów. Do najpopularniejszych skal należy zmodyfikowana skala Mercallego - Mercallego-Cancaniego-Sieberga (MCS). W skali tej stopień I oznacza wibracje rejestrowane wyłącznie przez aparaturę pomiarową, a stopień XII - wstrząsy powodujące zmiany w otaczającym krajobrazie.

Skutki trzęsień ziemi i jak im zapobiegać albo obniżać ich skutki1. Jak możemy zapobiegać trzęsieniom ziemi?*przewidywanie potencjalnych skutków trzęsień ziemi w obszarach zurbanizowanych*zaprojektowanie, wybudowanie oraz utrzymanie konstrukcji w zgodzie z wymaganiami odnoszącymi się do oceny szkodliwości drgań przekazywanych przez podłoże na budynków*polega na odpowiednim projektowaniu konstrukcji obiektów budowlanych, tak aby były one zdolne przenieść siły powstałe podczas trzęsień ziemi.*zastosowanie technologii kontroli wibracji *w rejonach zagrożonych trzęsieniami ziemi istotną rolę odgrywa zagospodarowanie przestrzenne oraz określenie warunków technicznych dla obiektów zlokalizowanych w tych strefach;ogranicza się tam stawianie budowli, które mogłyby wywołać poważne wtórne skutki zagrożenia (zakłady chemiczne, elektrownie atomowe itp.).2. Skutki trzęsień ziemi. *ofiary śmiertelne wśród ludności*pozbawienie ludności dachu nad głową*szkody budowlane (pękające mury, rysy na budynkach)*szkody gospodarcze (pękają rurociągi, gną się szyny kolejowe)*zmiany w ukształtowaniu powierzchni ziemi wywołane przez trzęsienie ziemi obrywy, osuwiska mogą prowadzić do zmiany sieci hydrograficznej;powodują powstawanie fal tsunami.

Powstanie systemu sloecznego Powstanie i ewolucja Układu Słonecznego rozpoczęły się 4,6 miliarda lat temu, gdy na skutek grawitacyjnego zapadnięcia się jednej z części niestabilnego obłoku molekularnego rozpoczął się proces formowania Słońca i innych gwiazd. Większość zapadającej się masy z tej części obłoku zebrała się pośrodku, tworząc Słońce, podczas gdy reszta spłaszczyła się, formując dysk protoplanetarny, z którego następnie powstały planety, księżyce, planety karłowate i pozostałe małe ciała Układu Słonecznego.

Geoida - sens fizyczny i definicja Geoida- to powierzchnia ekwipotencjalna potencjału siły ciężkości, która pokrywa się ze średnim poziomem mórz i oceanów, Geoida - bryła, której powierzchnia w każdym miejscu jest prostopadła do pionu wyznaczonego przez siłę ciężkości. Geoida jest teoretyczną powierzchnią, na której potencjał siły ciężkości Ziemi jest stały, równy potencjałowi siły ciężkości na średnim poziomie mórz otwartych i przedłużoną umownie pod powierzchnią lądów. Ponieważ zawiera ona lustro wody w morzach i oceanach, dodatkowo określana jest jako Geoida Zerowa. Jako powierzchnia ekwipotencjalna, geoida w każdym swym punkcie jest prostopadła do kierunku siły ciężkości (lokalnego pionu). Pojęcie wprowadził w 1873 roku niemiecki matematyk Johann Benedict Listing.Ponieważ 71% powierzchni Ziemi stanowią oceany, najbardziej reprezentatywne przybliżenie figury Ziemi stanowi geoida. Jednak pod lądami przebieg geoidy jest skomplikowany ze względu na bardzo urozmaicony rozkład przestrzenny gęstości, głównie w przypowierzchniowych warstwach skorupy ziemskiej. Henri Poincaré wykazał, że jest niemożliwe wyrażenie w sposób ścisły równania geoidy na obszarze lądów i oceanów jedną funkcją analityczną.Przebieg geoidy jest efektem równowagi pewnych sił, jest ona zatem powierzchnią dynamiczną, stale ulegającą pewnym okresowym zmianom. W praktyce korzysta się z modelu geoidy, czyli zbioru liczb będących wartościami wysokości geoidy w węzłach siatki geograficznej.

Koncepcja rownowagi Airy'ego i Pratt'a Koncepcja równowagi izostatycznej Airy'ego. Według niego wszystkie bloki skał na Ziemi mają mniej więcej taką samą gęstość (2,73 g/cm3). Ów bloki skorupy pływają po półpłynnej astenosferze, i są w niej zanurzone w ten sposób, iż im wyższy blok tym głębiej jest on zanurzony (proporcjonalnie) W związku z tym pod kontynentami są tzw. korzenie skorupy, a pod morzami - antykorzenie skorupy. Airy założył także iż na pewnej głębokości musi występować wyrównanie ciśnień (poziom kompensacji). Naciski na tych głębokościach są jednakowe we wszystkich kierunkach, a stan materii jest lepko - plastyczny. Teorie Airy'ego zmodyfikowali: Heiskanen i Veining. Zarówno hipoteza Pratta, jak i hipoteza Airy'ego przyjmują istnienie głębokości, na której panuje równowaga hydrostatyczna. Poziom wyrównania izostatycznego, czyli poziom jednakowego ciśnienia działającego na jednostkę powierzchni, w koncepcji Pratta to linia, nad którą znajdują się bloki o różnej gęstości. Bloki o niskiej gęstości odpowiadają wzniesieniom na powierzchni.

Interpretacje ilosciowe i jakosciowe w grawimetrii Sondowanie oporu:Interpretacja:1. Interpretacja ilościowa- polega na analizie wydzielonej anomalii w powiązaniu z budową geologiczną rejonu badań. Zadaniem interpretacji ilościowej jest określenie kształtów, rozmiarów, głębokości i innych parametrów interesujących nas obiektów geologicznych.2. Interpretacja jakościowa- pozwala uzyskać dane co do lokalizacji struktur zaburzających, polega na opisie związków anomalii lokalnych i regionalnych z przyczynami wywołującymi je w świetle geologicznych warunków ich wystepowania.

Niejednoznacznosć interpretacji ilościowej w grawimetrii + możliwość jej ograniczenia Występuje w tej analizie zbyt dużo niewiadomych, dlatego aby ograniczyć ich ilość stosuje się zakres zmienności. Przyjmuje się za znane: kształt ciała zaburzającego (po dopasowaniu do wzorca), zasięg głębokościowy ciała, znana jest najcześciej różnica gęstości. W ten sposób można ograniczyć się do kilku alternatyw. Dla potwierdzenia stosuje się inne metody.

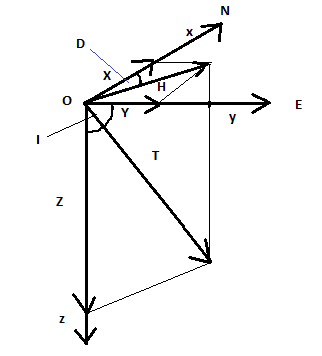

Rysunek i opis wektora ziemskiej indukcji magnetycznej

Ziemska indukcja magnetyczna (B) jest to podstawowa wielkość charakteryzująca pole magnetyczne Ziemii. Jednostką B jest tesla 1T=Wb∙m-2=104 Gs (gaus). Pole ziemskie jest na tyle słabe, że jego wartość i jej zmiany podaje się zwykle w nanoteslach 1 nT= 10-9 T.

Prostokątny, prawoskrętny układ współrzędnych( na półkuli północnej):

- wektor natężenia pola magnetycznego.

OX -składowa północna X, skierowana zgodnie z południkiem geograficznym ku północy (N).

OY- składowa wschodnia Y skierowana zgodnie z równoleżnikiem na wschód (E).

OZ - składowa pionowa Z skierowana pinowo w dół.

H - rzut poziomy wektora natęrzenia

.

D - deklinacja magnetyczna (pomiędzy H a X)

I - inklinacja magnetyczna (pomiędzy H a T)

Ziemskie pole magnetyczne - pole magnetyczne występujące naturalnie wewnątrz i wokół Ziemi. Odpowiada ono w przybliżeniu polu dipola magnetycznego z jednym biegunem geomagnetycznym w pobliżu geograficznego bieguna północnego i z drugim biegunem geomagnetycznym w pobliżu bieguna południowego. Linia łącząca bieguny geomagnetyczne tworzy z osią obrotu Ziemi kąt 9,98°[1]. Pole magnetyczne rozciąga się na kilkadziesiąt tysięcy kilometrów od Ziemi, a obszar w którym ono występuje nazywa się ziemską magnetosferą.

Podstawy fizyczne badan paleomagnetycznychPaleomagnetyzm - magnetyczne właściwości każdej skały ziemskiej zawierającej minerały ferromagnetyczne. W trakcie powstawania skał (wylewnych lub osadowych) utrwala się ziemskie pole magnetyczne istniejące w danym momencie - azymut (deklinacja) i inklinacja bieguna magnetycznego. Magnetyzacja szczątkowa zależy też od natężenia pola magnetycznego w momencie powstawania skały. Na podstawie badań paleomagnetycznych określa się miejsce i czas powstawania skał. W historii Ziemi wyróżnia się epoki paleomagnetyczne o normalnej i odwróconej polarności biegunów magnetycznych (patrz -Przebiegunowanie Ziemi). Dzięki paleomagnetyzmowi udowodniono różne rozmieszczenie w przeszłości geologicznej lądów i mórz - wędrówkę kontynentów i bieguna magnetycznego Ziemi (patrz Tektonika płyt). Paleomagnetyzm jest dziedziną geomagnetyzmu zajmującą się badaniem pola magnetycznego w przeszłości. Metoda paleomagnetyczna opiera się na fakcie, że powstające skały (zarówno wylewne, jak i osadowe) ulegają trwałemu namagnesowaniu w momencie zastygania lub sedymentacji w sposób zgodny z panującym w danym czasie polem magnetycznym; namagnesowanie to pozostaje pomimo zmian kierunku zewnętrznego pola magnetycznego. Badając skały w miejscu ich narastania, można określić kierunek pola magnetycznego w przeszłości.

Prawo rozpadu promieniotworczego (sens fizyczny i jak wykorzystuje sie je do okreslania wieku bezwzglednego) Prawo rozpadu promieniotwórczego.Rozpad promieniotwórczy, to zachodząca samorzutnie przemiana jądrowa: alfa, beta lub gamma w wyniku której następuje emisja odpowiednio cząstki alfa, elektronu bądź pozytonu lub promieniowania elektromagnetycznego (fotonu). Samorzutny charakter rozpadów promieniotwórczych oznacza, że rozpad danego jądra nie jest powodowany żadnymi czynnikami zewnętrznymi i nie zależy jego wcześniejszych losów. To, czy w danym momencie czasu nastąpi rozpad danego jądra możemy opisać jedynie z pomocą pojęć statystycznych określając prawdopodobieństwo takiego rozpadu. Rozpady poszczególnych jąder następują niezależnie od siebie. Liczba jąder, które ulegną rozpadowi w krótkim przedziale czasu proporcjonalna jest do liczby jąder N i do długości przedziału czasu, dt gdzie![]()

jest współczynnikiem proporcjonalności zwanym stałą rozpadu. Znak minus we wzorze oznacza, że liczba jąder ulegających rozpadowi dN, odejmuje się od liczby jąder N. Dzieląc obie strony tego wzoru przez N uzyskujemy równanie różniczkowe, które można łatwo scałkować gdzie C jest stałą całkowania. Oznaczając przez N0 liczbę jąder w chwili początkowej tj. dla t=0 możemy wyznaczyć stałą całkowania:![]()

Liczba jąder, które nie rozpadły się w czasie t wynosi więcWzór (14.3.6) wyraża prawo rozpadu promieniotwórczego - podstawowe prawo przemian jądrowych. Liczba jąder, które uległy rozpadowi w czasie t wynosi. Średni czas życia jądra promieniotwórczego ![]()

równy jest odwrotności stałej rozpadu: ![]()

Czas, w którym rozpadowi ulega połowa początkowej liczby jąder nazywany jest czasem połowicznego zaniku. Czas ten wyznaczyć można ze związku. Liczba rozpadów zachodzących w jednostce czasu w źródle promieniotwórczym nosi nazwę aktywności A. Aktywność źródła określona jest więc jako stosunek liczby rozpadów w danym przedziale czasu do wielkości tego przedziału, patrz wzór. Jednostką aktywności jest bekerel (Bq). Jeden bekerel, to aktywność źródła, w którym zachodzi jeden rozpad na sekundę. Zanik aktywności źródła określony jest przez prawo rozpadu promieniotwórczego.

Od czego zalezy opor skały Opór elektryczny skał zależy od następujących czynników:- skład mineralny skały,

- struktura i tekstura,- temperatura i ciśnienie,- stopień nasycenia por,- stosunki hydrogeologiczne i geochemiczne,

- wiek skał, ich geneza, rozwój i historia środowiska geologicznego.

Jaki sens fizyczny ma pojecie magnitudy wstrzasu? co oznacza ML= -3 ?

- pojęcie empiryczne, jest to skala względna, logarytmiczna, która polega na porównywaniu z wzorcem. Ml=log Am/Ao. Ludzie odczuwają magnitudy większe od 2,5 w tej skali a największe magnitudy nie przekraczają 9. obecnie def. Magnitudy jest uogólniona: M=log a/T + f(delta,h) + Cs +Cr

Jest kilka skal magnitud: - dla fal objętościowych, magnituda lokalna, dla fal powierzchniowych.

M=loga +c1log delta +c2, c1,c2- stała. Magnituda jest liniowo powiązana z energią sejsmiczną log epsylon=a+bMl

magnit wstrzasu -3=loga/ao, Qmax/Qo=10^-3

Na czym polega interpretacja sondowan oporu Sondowanie oporu:Interpretacja:1. Interpretacja ilościowa- polega na analizie wydzielonej anomalii w powiązaniu z budową geologiczną rejonu badań. Zadaniem interpretacji ilościowej jest określenie kształtów, rozmiarów, głębokości i innych parametrów interesujących nas obiektów geologicznych.2. Interpretacja jakościowa- pozwala uzyskać dane co do lokalizacji struktur zaburzających, polega na opisie związków anomalii lokalnych i regionalnych z przyczynami wywołującymi je w świetle geologicznych warunków ich wystepowania.Wygodną interpretację otrzymujemy, gdy spełnione są warunki:- quasi horyzontalne zaleganie warstw o stałej wartości oporu elektrycznego,- mała zmienność pionowa i pozioma przypowierzchniowych utworów geologicznych,- brak dużych i częstych niejednorodności opornościowych w osadach najwyżej położonych,- zachowanie na obszarze badań znacznej ciągłości warstw,- brak przewarstwień o bardzo dużym oporze, uniemożliwiającym badanie niżej ległego ośrodka skalnego.Sondowanie oporu:Zwane również pionowym sondowaniem oporu. Jest metodą rozpoznania następstwa warstw oraz ich miąższości w przekroju pionowym pod wybranym punktem na powierzchni ziemi wykorzystując zróżnicowanie oporów właściwych tych warstw. Wzrastająca w procesie sondowania rozpiętość obwodu zasilającego (elektrody AB) powoduje, że obejmuje on coraz głębsze warstwy. Zmiany oporu wskazują na następstwo warstw. Bezpośrednio mierzonymi wielkościami są: natężenie prądu I w obwodzie AB, spadek potencjału ![]()

w obwodzie pomiarowym MN oraz wymiary całego układu pomiarowego (K-współczynnik geometryczny układu pomiarowego). Na ich podstawie oblicza się tzw. opór pozorny (opór pozornie jednorodnego ośrodka skalnego).

Co musi zawierac prognoza trzesien ziemiPrognoza musi zawierać parametry:a) naukowe: ocena miejsca, czas, skalę (wielkość, energia, magnituda lub moment sejsmiczny) trzęsienia ziemi wraz z określonymi błędami [bez tego nie ma prognozy!]b) praktyczne: prognoza zagrożenia (hazardu) sejsmicznego - statystycznie realizowana i wykorzystywana, musi być z wyprzedzeniem!Z notatek Agnieszki Kochanowskiej:„Nie da się prognozować trzęsień ziemi. Nie ma zjawiska, które pozwoliłoby na skuteczne prognozowanie; nie ma prekursorów. Jak zmienimy definicję prognozy, to będziemy mogli prognozować trzęsienia ziemi”*widziałam jeszcze jeden rozdział w książce - jak doczytam to Wam podeślę, bo trochę tego było. Jednak w innych notatkach jest:Prognozowanie fizyczne opiera się na obserwacji i wyznaczaniu pewnych oznak poprzedzających trzęsienie ziemi:- tzw. for szoki - wstrząsy poprzedzające trzęsienie główne,- anomalie pola magnetycznego i siły ciężkości oraz zwiększona zawartość niektórych związków w wodach wgłębnych (m.in. radonu),- zmiany oporu, przewodności elektrycznej skały,- zmiany poziomu wód wgłębnych oraz wydatków w otworach naftowych. Właśnie nieznajomość warunków dostatecznych czyni prognozowanie zjawisk sejsmicznych zadaniem niezwykle trudnym. Niejasna są procesy fizyczne i mechanizmy samej inicjacji rozrywu mas skalnych związanych z powstawaniem trzęsienia ziemi. Przez długi e okresy w ogóle się go nie obserwuje. Siła tarcia utrzymuje płyty w bezruchu. Kiedy naprężenia stają się większe niż wytrzymałość skał następuje gwałtowne pęknięcie - trzęsienie ziemi uruchamiające płyty. Nikt nie potrafi przewidzieć dokładnie kiedy może nastąpić trzęsienie ziemi. Skrupulatne opracowywanie map i monitoring aktywności sejsmicznej umożliwiają naukowcom określenie stref zagrożenia i częstości występowania wstrząsów sejsmicznych. kilka wielkich trzęsień ziemi grzecznie zapowiedziało swoje nadejście w postaci serii drobnych wstrząsów.

Hodografy fal odbitych i zalamanych

a) Hodografem fali refleksyjnej jest hiperbola.b) Krzywizna hodografu jest funkcją prędkości i głębokości do granicy odbijającej. c) h↑hodograf jest bardziej płaski.V↑ hodograf jest bardziej płaski.

Zadania i cele glebokich sondowan POLONAISE'97 i CELEBRATION 2000

W 1997 i 2000 roku między innymi na obszarze Polski zostały przeprowadzone dwa

największe na świecie eksperymenty aktywne: POLONAISE'97 i CELEBRATION 2000.

Eksperyment POLONAISE'97 został przeprowadzony w maju 1997 roku, wykorzystano

około 600 sejsmometrów do zarejestrowania 63 strzałów wzdłuż pięciu profili. Łączna

długość profili wyniosła w przybliżeniu 2000 kilometrów, zaś najdłuższy profil (P4) miał

ponad 800 kilometrów. Prace polowe trwały dwa tygodnie. Do rozmieszczenia i detonacji

ładunków wybuchowych wynajęto piętnaście dwudziesto-osobowych grup, natomiast obsługą

sprzętu zajmowało się trzydzieści dwu, trój-osobowych grup. Dokładność rozmieszczenia

ładunków i stacji zapewniał system GPS, który synchronizował także czas detonacji.

Eksperyment CELEBRATION 2000 został przeprowadzony w czerwcu 2000 roku.

Całkowita długość profili wyniosła około 8900 kilometrów, a odległość pomiędzy stacjami

wzdłuż profili 2,8 lub 5,6 kilometra. Do zarejestrowania 147 strzałów użyto 1230

sejsmometrów. Średnia masa ładunków wynosiła około 500 kg, a najlżejsze ważyły 90 kg.

Najsilniejszy wybuch zafundowali Rosjanie odpalając około 15 ton. Prace polowe trwały trzy

tygodnie. W eksperymentach POLONAISE'97 i CELEBRATION 2000 wzięli udział naukowcy i

technicy z 15 krajów: Polski, USA, Kanady, Danii, Czech, Słowacji, Węgier, Austrii, Niemiec, Litwy, Białorusi, Rosji, Finlandii, Szwecji i Turcji.

Pętla Histerezy Histereza - w naukach przyrodniczych, zjawisko zależności aktualnego stanu układu od stanów w poprzedzających chwilach. Inaczej - opóźnienie w reakcji na czynnik zewnętrzny. Zjawisko odkrył i nazwał James Alfred Ewing w roku 1890. Termin ten zapożyczony został także przez nauki społeczne. Najbardziej znane przypadki histerezy występują w materiałach magnetycznych, głównie w ferromagnetycznych, gdzie namagnesowanie następuje dopiero po pewnym wzroście zewnętrznego pola magnetycznego. Histereza występuje także w układach mechanicznych (materiały elastyczne, mięśnie) oraz w procesie adsorpcji. Na wykresie dwóch zależnych od siebie wielkości, zjawisko histerezy ukazuje się najczęściej jako pętla. W przypadku braku histerezy wykres jest pojedynczym łukiem krzywej (w szczególności odcinkiem dla materiałów liniowych). Tzw. histereza kapilarna dotyczy izoterm adsorpcji na materiałach porowatych posiadających pory w kształcie otwartych obustronnie cylindrów lub butelek i oznacza inny przebieg adsorpcji (przy podwyższaniu ciśnienia adsorbatu) i desorpcji (przy obniżaniu ciśnienia). Zjawisko to jest wykorzystywane m.in. do badania struktury porowatych ciał stałych. W urządzeniach, w których następuje wielokrotne magnesowanie (np. rdzenie transformatorów), histereza postrzegana jest jako problem, ponieważ jej pole powierzchni jest proporcjonalne do strat energii podczas jednego cyklu przemagnesowania. W takich sytuacjach, poprzez odpowiedni skład chemiczny, obróbkę plastyczną i obróbkę termiczną dąży się do minimalizacji jej powierzchni. Najlepsze materiały magnetycznie miękkie mogą posiadać koercję nawet mniejszą niż 0,1 A/m (np. kobaltowa amorficzna taśma magnetyczna). Substancje wykazujące histerezę (materiały magnetycznie półtwarde) są wykorzystywane do zapisu informacji w twardych dyskach, dyskietkach, taśmach magnetycznych, kartach kredytowych itp. Po namagnesowaniu fragmentu materiału półtwardego i usunięciu pola magnesującego materiał taki pozostaje namagnesowany. Namagnesowanie to jest zależne (prawie proporcjonalnie) od natężenia pola magnesującego, co jest wykorzystywane w analogowych systemach zapisu dźwięku i obrazu. W systemach cyfrowych magnesuje się ferromagnetyk do nasycenia, zmiana stanu na przeciwny oznacza zmianę sygnału. Sygnał koduje się zazwyczaj czasem między kolejnymi przemagnesowaniami. W materiałach magnetycznie półtwardych powierzchnia pętli histerezy jest optymalizowana jako kompromis pomiędzy ilością energii zgromadzonej w magnetyku a łatwością jego przemagnesowania (łatwością odczytu/zapisu informacji). Wartości stosowanych koercji materiałów magnetycznie półtwardych są pośrednie pomiędzy materiałami miękkimi i twardymi (jednak bardziej w kierunku materiałów twardych - stąd też nazwa półtwarde). W materiałach magnetycznie twardych (czyli w magnesach trwałych) parametrem najważniejszym jest ilość zgromadzonej energii magnetycznej, toteż dąży się do osiągnięcia maksymalnej szerokość pętli histerezy. Parametrem charakterystycznym każdego magnesu jest wartość (B·H)max, którą wylicza się jako wartość maksymalną iloczynu BH z fragmentu histerezy leżącego w drugiej ćwiartce układu osi współrzędnych (tzw. krzywa odmagnesowania). W najnowszych materiałach magnetycznie twardych wartość koercji może osiągać nawet powyżej 20 MA/m. Histereza kąta zwilżania Kąt zwilżania cieczy postępującej wzdłuż powierzchni przekracza wartość kąta zwilżania cieczy cofającej się na tej powierzchni. Efekt ten można zauważyć poprzez obserwację kropel na szybie okiennej lub powierzchniach pochyłych. Różnica tych kątów nazywana jest histerezą kąta zwilżania, która potrafi być całkiem duża, aż do 50° dla wody na powierzchniach minerałów. Efekt ten ma duże znaczenie w procesach nakładania powłok. Histereza jest ogólnie przypisywana powierzchniom chropowatym, niejednorodnym, zanieczyszczeniom roztworu adsorbującymi się na powierzchni, pęcznieniu, reorganizacji lub zmianie powierzchni przez rozpuszczalnik. Miejscowe nachylenie chropowatej powierzchni lub miejscowe różnice w energiach międzyfazowych na powierzchniach niejednorodnych mogą powodować różnice kąta zwilżania. Nie jest do końca pewnym, jak w innych zjawiskach histeretycznych (jak w magnetyzmie), czy histereza kąta zwilżania może zostać opisana poprzez nieodwracalne przejścia lub „skoki” pomiędzy domenami stanów równowagowych. Histereza przemiany fazowej ciało stałe-cieczHistereza występuje w przemianach fazowych kiedy temperatury topnienia i krzepnięcia są różne. Na przykład, agar topi się w temperaturze ok 85 °C, a krzepnie w zakresie od 32 do 40 °C[2]. Oznacza to, że agar stopiony przy temperaturze 85 °C pozostaje w stanie ciekłym do temperatury 40 °C. Stąd też, od temperatury 40 do 85 °C, zależnie od stanu wyjściowego, agar może być w postaci ciekłej lub stałej. Histereza sprężysta Histereza sprężysta - wykres w kształcie pętli zależności odkształcenia ciała stałego od naprężenia; przejaw tarcia wewnętrznego i rozpraszania energii na skutek rozciągania i ściskania sprężystego ciała stałego w nie w pełni odwracalnym procesie. Alternatywne stany stabilne W ekologii efekt histerezy występuje przy przechodzeniu między dwoma stanami ekosystemu określanymi jako alternatywne stany stabilne. Przykładem jest stan ekologiczny żyznych jezior (mezotroficznych i eutroficznych), zwłaszcza płytkich. Przy umiarkowanej żyzności na roślinność takich jezior składają się głównie makrofity, utrudniając uwalnianie biogenów z osadów do toni wodnej, przez co biomasa fitoplanktonu jest umiarkowana, a woda przezroczysta. Przy wzroście żyzności albo zaburzeniu struktury zbiorowisk makrofitów, ilość biogenów w toni wodnej wzrasta, przez co zwiększa się udział fitoplanktonu i mętność wody, co - zacieniając dno - utrudnia rozwój makrofitów. Po przejściu ze stanu czystej wody (dominacja makrofitów) do stanu mętnej wody (dominacja fitoplanktonu) obniżenie żyzności nie powoduje automatycznego powrotu do stanu poprzedniego. Następuje to dopiero po znacznym obniżeniu żyzności, a proces przechodzenia między oboma stanami wyrażony jest krzywą histerezy. Histereza poza naukami przyrodniczymi. Termin histereza został z nauk przyrodniczych zapożyczony także do nauk społecznych. Stąd wziął się makroekonomiczny termin histerezy na rynku pracy - oznaczający wpływ zjawisk występujących w przeszłości na długookresową równowagę rynku pracy.

Hubbla Prawo Prawo Hubble'a jest podstawowym prawem kosmologii obserwacyjnej, wiążącym odległości galaktyk r z ich tzw. prędkościami ucieczki v (których miarą jest przesunięcie ku czerwieni z). Prawo to określa, iż te dwie wielkości są do siebie proporcjonalne, a stałą proporcjonalności jest stała Hubble'a H0: ![]()

Istnienie takiej proporcjonalności przewidział w 1927 roku Georges Lemaître (Annals of the Scientific Society of Brussels, 47, 49), a wykazał jako pierwszy Edwin Hubble w roku 1929. Dokonał on pomiaru odległości do sześciu galaktyk w Grupie Lokalnej przy użyciu cefeid jako świec standardowych, a następnie rozszerzył próbkę do 18 galaktyk, sięgając odległości gromady Virgo i wybierając jako świece najjaśniejsze gwiazdy w galaktykach. Zależność Hubble'a jest prawdziwa dla galaktyk (ściślej: gromad) odpowiednio nam bliskich, lecz na tyle dalekich, że nie są już powiązane grawitacyjnie z Drogą Mleczną i ogólniej z Grupą Lokalną.Prawo Hubble'a jest matematyczną interpretacją astronomicznego zjawiska, potocznie określanego jako „ucieczka galaktyk”, a objawiającego się tym, że światło niemal wszystkich galaktyk jest przesunięte ku czerwieni. Im większa odległość do danej galaktyki, tym przesunięcie jej widma ku dłuższym falom jest większe. Przez analogię z prawem Dopplera można stwierdzić oddalanie się dowolnej galaktyki względem pozostałych. Wnioskuje się na tej podstawie, że musiały dawniej znajdować się „w jednym miejscu” (bardzo blisko siebie), a ruch wszystkich został zapoczątkowany przez Wielki Wybuch. Prawo Hubble'a (obowiązujące lokalnie) można również wywnioskować na gruncie ogólnej teorii względności przy założeniu, iż Wszechświat jest jednorodny i izotropowy. Ekspansja jest wówczas opisana równaniem Friedmanna. Oprócz efektu związanego z ruchem galaktyk, zmiana długości fali elektromagnetycznej docierającej z odległości kosmologicznych jest powodowana również rozszerzaniem się samej przestrzeni.Odstępstwa od prawa Hubble'a są związane z tzw. prędkościami swoistymi galaktyk. W jednorodnie ekspandującym Wszechświecie prawo Hubble'a jest liniowe i interpretowane jako zależne od czasu kosmicznego. Relacja ta teoretycznie jest spełniona przez wszystkich obserwatorów fundamentalnych, ale w rzeczywistości zależy od wybranego kierunku w przestrzeni.

Anomalie sily ciezkosci Anomalie siły ciężkości przedstawia się na mapie w postaci izoanomalii. Anomalia siły ciężkości - w geofizyce różnica między zmierzoną (i zredukowaną do poziomu elipsoidy) w danym punkcie siłą ciężkości a normalną siłą ciężkości na danej szerokości geograficznej. Zwyczajowo mierzona jest w miligalach (mGal), rzadko stosuje się milimetry na sekundę do kwadratu (mm/s2).

W celu określenia anomalii, należy dla zmierzonej siły ciężkości zastosować szereg poprawek: poprawka wolnopowietrzna (Faye'a) - sprowadza punkt pomiarowy do poziomu elipsoidy, poprawka na płytę płaskorównoległą - uwzględnia masy leżące między punktem pomiaru a powierzchnią odniesienia, poprawka topograficzna - uwzględnia wpływ ukształtowania otaczającego terenu, poprawka lunisolarna - uwzględnia wpływ oddziaływania słońca i księżyca. Na podstawie anomalii siły ciężkości można określić położenie i kształt niektórych struktur geologicznych. Obiekty o gęstości wyższej, niż otoczenie (np. rudy) oddziałują dodatnio na siłę ciężkości, natomiast te o gęstości mniejszej (kawerny, wysady solne) - ujemnie. Należy przy tym zaznaczyć, że nad łańcuchami górskimi anomalie są ujemne, a nad morzami dodatnie - spowodowane jest to zjawiskiem izostazji. W centralnych Alpach typowa wartość anomalii wynosi -150 mGal (-1,5 mm/s2). Anomalie spowodowane dużymi i głęboko zalegającymi strukturami noszą nazwę anomalii regionalnych i rzadko stanowią obiekt badań - geofizyka stosowana wykorzystuje anomalie lokalne (należy je oddzielić od anomalii regionalnych na drodze interpretacji jakościowej).

Ogniska wstrzasu izochrony???

Wyszukiwarka

Podobne podstrony:

Sformułować prawo Titiusa Pyt poprz rok Ściąga

WYKLAD 7, Zarządzanie ZZL studia WAT, II SEMESTR, Prawo gospodarcze

ciaga nor, Zarządzanie ZZL studia WAT, II SEMESTR, Nauka o organizacji

K Pedagogika mi-dzykulturowa, Pedagogika ogólna APS 2013 - 2016, I ROK 2013 - 2014, II semestr, 2) K

Ekonomia zagadnienia 13 i 14, Notatki Europeistyka Studia dzienne, II semestr

ściaga z prezentacji, II rok II semestr, BWC, egzamin przyrodo

Wyklad I, Notatki Europeistyka Studia dzienne, II semestr

MIKROBIOLOGIA, Studia, WSIZ, II semestr, Mikrobiologia

Tabelka OP, Studia - Mechatronika, II semestr, Obróbka Plastyczna

PKB w cenach rynkowych, Notatki Europeistyka Studia dzienne, II semestr

Czasy miedzyzielone III-I, Studia Mgr, II semestr mgr, System sterowania ruchem

reszta zagadnień na egzamin, Notatki Europeistyka Studia dzienne, II semestr

program zajęć 2008, WNoŻ, Studia inżynierskie, II semestr, Chemia organiczna

Tomanek 11.05.2011, Studia Mgr, II semestr mgr, Zarządzanie Przedsięwzięciem Budowlanym

prawo gospodarcze nr 7 2, Zarządzanie WSB Poznań (licencjat), II semestr, Prawo gospodarcze - mgr Ro

PKM zerówka, studia SiMR, IV semestr, PKM egzamin+projekt

Hydromorfologia, II rok II semestr, BWC, egzamin przyrodo

więcej podobnych podstron