EGZAMIN PISEMNY

Z TECHNIK

FOTOGRAFICZNYCH

1. Dokonaj podziału aparatów fotograficznych.

przeznaczenie:

aparat amatorski

aparat popularny

aparat profesjonalny

technologia:

aparat analogowy

aparat cyfrowy

budowa:

aparat przeziernikowy

aparat skrzynkowy

aparat mieszkowy

aparat dalmierzowy

lustrzanka

lustrzanka jednoobiektywowa

lustrzanka dwuobiektywowa

aparat studyjny

lotniczy aparat fotograficzny

wielkość klatki filmu:

małoobrazkowe – 24 x 36 mm

aparat średnioformatowy – 4,5x6, 6x6, 6x9 (6x7, 6x8) cm

aparat wielkoformatowy – od 4x5 cala

sterowanie:

ręczne (manualne)

automatyczne

autofocus z automatycznym ustawianiem ostrości

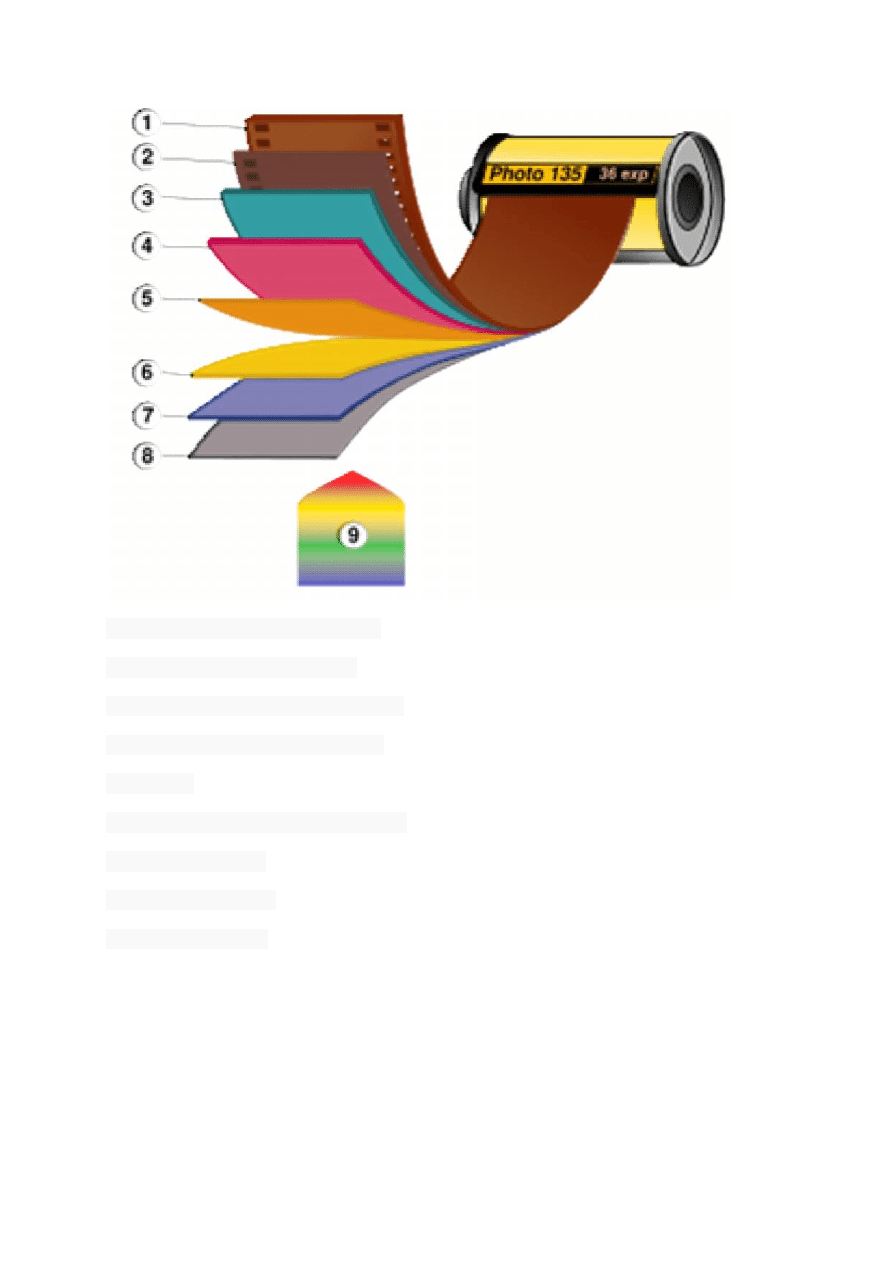

2. Dokonaj podziału materiałów światłoczułych.

Materiał światłoczuły – ogólne pojęcie oznaczające wszystkie wyroby wykazujące

wrażliwość na światło, które są wykorzystywane w różnorodnych procesach

fotograficznych. Należą do nich zarówno materiały wrażliwe na światło widzialne, jak

również na bliską podczerwień i ultrafiolet.

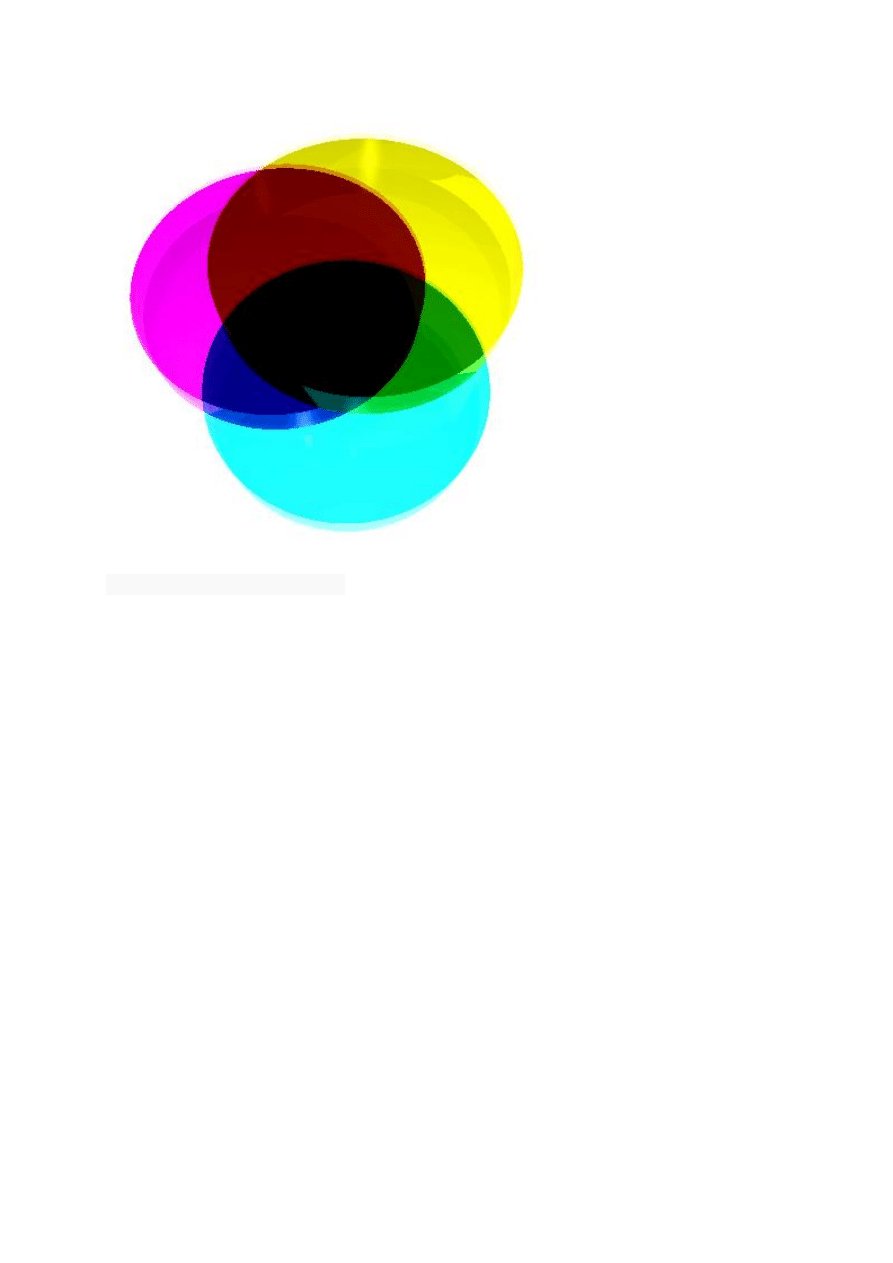

Podział materiałów światłoczułych

Zasadniczy podział materiałów fotograficznych, to materiały pozytywowe lub

negatywowe, oraz materiały monochromatyczne (najczęściej czarno-białe) lub

kolorowe, osobnym materiałem światłoczułym są matryce cyfrowe, mogące również

rejestrować światło widzialne i niewidzialne ludzkim okiem.

3. Jakie są sposoby wykonywania pomiaru światła.

Wstęp

Z technicznego punktu widzenia, jedną

z najważniejszych decyzji, które należy podjąć podczas fotografowania, jest

ustalenie, ile światła powinno dotrzeć do materiału światłoczułego (w przypadku cyfry

– przetwornika obrazowego, czyli matrycy). Za regulację ilości światła wpuszczanego

do środka aparatu odpowiadają dwie zmienne – czas otwarcia migawki i wielkość

otworu przysłony. Najpierw jednak musimy zmierzyć oświetlenie fotografowanej

sceny i odpowiednio zinterpretować wyniki, świa- domie wybierając rodzaj pomiaru.

Aparaty cyfrowe umożliwiają użytkownikowi korzystanie z trzech podstawowych

sposobów pomiaru światła: matrycowego, centralnie ważonego i pun- ktowego.

Każdy ma wady i zalety, i każdy sprawdza się w innych okolicznościach. To do

fotografa należy wybór trybu najlepszego dla danej sytuacji i to on bierze

odpowiedzialność za rezultaty. Dlatego poznanie możliwości różnych opcji i nauka

ich zastosowania jest tak ważna

Nazwy trybów pomiaru światła (zwanych też czasem nieprawidłowo trybami pomiaru

ekspozycji) to skrótowe opisy zasady ich działania. Dlatego, kiedy raz dowiemy się,

na czym polega dany tryb, nie będziemy mieli problemów z jego identyfikacją w

przyszłości.

Tryb matrycowy

Tryb matrycowy to naj- częściej używany spo- sób pomiaru oświetle- nia

wbudowanego w aparat. Nazywany jest także wielosegment- owym, ewaluacyjnym

lub wielopunktowym (choć ostatnie określenie tradycyjnie oznacza coś innego).

Podstawą matry- cowego pomiaru światła jest porównanie informacji o natężeniu

światła w różnych częściach kadru. Aparat mierzy jasność w wie- lu punktach,

porównuje rozkład jasności z wbudowaną bazą da- nych i za pomocą

skomplikowanych algorytmów oblicza, jaka kombinacja czasu i przysłony da

najlepsze rezultaty dla wybranej czułości. Aparat tak dobierze parametry ekspozycji,

żeby zdjęcie było równomiernie naświetlone – nie miało przepalonych świateł

i niedoświetlonych cieni. Dużym plusem takiego rozwiązania jest wygoda, ponieważ

w wielu typowych sytua-cjach system poradzi sobie bez problemu, umożliwiając

fotografującemu skupienie się na kadrowaniu i uchwyceniu chwili. Minusem jest jego

nieprzewidywalność oraz brak bezpośredniego wglądu w mechanizm działania.

Ponieważ aparat za każdym razem porównuje fotografowaną scenę ze swoją bazą

danych, nigdy nie możemy mieć pewności, jak się zachowa. A w świadomej fotografii

przewidywalność wyników to podstawa. Do tego nie zawsze (a właściwie – rzadko)

możliwe jest dobranie takich parametrów ekspozycji (czas i przysłona), żeby udało

się zachować szczegóły zarówno w światłach, jak i w głębokich cieniach. Wtedy

przydaje się tryb, którego działanie można przewidzieć, czyli pomiar centralnie

ważony i punktowy.

Tryb centralnie ważony

Znaczy to że przy dobieraniu parametrów ekspozycji jasność centrum ma wagę 60%,

a brzegów – 40% (w Nikonie D60 cent- rum ma wagę 75%). Zaletą pomiaru

centralnie ważonego jest przewidywalność rezultatów. Kiedy już się z nim

zaznajomimy,

z łatwością będziemy potrafili powiedzieć, jak się zachowa w da- nej sytuacji, i

ewentualnie skorygować odczyt za pomocą blokady lub kompensacji ekspozycji

(patrz ramka). Tryb centralnie ważony nie sprawdza się natomiast jako domyślne

ustawienie do łatwego i szybkiego „pstrykania”, chyba że wszystkie nasze zdjęcia

mają najważniejszy obiekt w centrum kadru. Oczywiście, nie zachęcamy do takiego

fotografowania.

Tryb punktowy

Tryb punktowy to wyższa szkoła jazdy. Po wybraniu tej opcji aparat mierzy natężenie

światła w jednym punkcie – zazwyczaj jest to pole centralne, ale w niektórych

modelach użytkownik może wybrać niemal dowolne położenie na powierzchni klatki

lub powiązać punkt pomiaru z punktem ostrości (to bardzo wygodne rozwiązanie).

Dzięki zawężeniu pomiaru do kilku procent kadru (w przywoływanym już wcześniej

jako przykład Nikonie D60 wartość ta wynosi ok. 2,5%) jesteśmy w stanie precyzyjnie

określić natężenie światła w najbardziej nas interesującym miejscu zdjęcia i dobrać

parametry ekspozycji tak, by osiągnąć pożądany efekt. Pomiarowi punktowemu

niestraszne jest ani kontrastowe oświetlenie (choćby podczas fotografowania pod

światło), ani silne źródła światła, które mogłyby zmylić tryb matrycowy czy centralnie

ważony. Dla wartości odczytu najważniejsze jest miejsce, na które skierujemy punkt

pomiarowy. Dzięki przeprowadzeniu pomiaru kolejno w kilku partiach obrazu

zaawansowani amatorzy fotografii mogą korzystać z pomiaru punktowego w celu

określenia rozpiętości tonalnej fotografowanej sceny, ale to temat na osobny artykuł.

Zalety punktowego pomiaru światła są jednocześnie jego wadami. Pomiar z

niewielkiego wycinka kadru nie bierze pod uwagę tego, co się dzieje w reszcie

zdjęcia, często nie mniej ważnej niż główny motyw. Łatwo wtedy o zdjęcie

niedoświetlone lub prześwietlone, ponieważ odczyt z głównego obiektu zdominuje

całe zdjęcie. Dlatego ten tryb jest zalecany osobom, które fotografują już w pełni

świadomie i mogą celowo dążyć do „nieprawidłowego” naświetlenia zdjęcia.

Trudność tego rozwiązania polega na tym, że to już nie aparat, a fotograf podejmuje

decyzję dotyczącą dobrania odpowiednich parametrów ekspozycji, wybierając punkt,

w którym mierzy światło. Dlatego do skutecznego stosowania trybu punktowego

pomiaru światła niezbędne jest zrozumienie zagadnienia średniej szarości (18%) i

sposobu działania światłomierza (patrz ramka).

Jak widać, każdy z rodzajów pomiaru światła ma swoje zastosowanie i sprawdza się

w innej sytuacji: matrycowy pozwala na łatwe i w miarę bezpieczne fotografowanie,

centralnie ważony daje większą kontrolę użytkownikowi, a punktowy jest

przeznaczony do zadań specjalnych. Pamiętajmy – jeśli nie jesteśmy zadowoleni z

rezultatów, to nie światłomierz się pomylił, lecz fotograf, który z niego korzystał.

Blokada ekspozycji

Warto pamiętać, że jeden z najpopularniejszych sposobów radzenia sobie z

ułomnością automatyki parametrów ekspozycji, czyli blokada ekspozycji (kiedy po

naciśnięciu spustu migawki do połowy następuje przekomponowanie kadru), nie

sprawdza się w pomiarze matrycowym. Całe założenie blokady ekspozycji opiera się

na tym, że użytkownik jest w stanie przewidzieć, jak zachowa się system pomiaru

światła. Tymczasem w przypadku trybu matrycowego nie możemy mieć pewności –

zapisujemy w pa- mięci aparatu zestaw ustawień, które zostały dobrane do

pierwotnego kadru i które mogą się nie nadawać do kadru ostatecznego (po

przekomponowaniu). Jeśli już korzystamy z pomiaru wielosegmentowego, zdajmy się

na niego w całości. Nie po to inżynierowie producenta aparatu męczyli się, by system

sprawdzał się w trudnych warunkach, żebyśmy potem nie korzystali z owoców ich

pracy. Należy pamiętać, że dzięki dobieraniu parametrów do każdej sceny z osobna

pomiar matrycowy ma szansę nas zaskoczyć i poradzić sobie z trudnym ujęciem.

Dajmy mu szansę lub skorzystajmy z trybu centralnie ważonego albo punktowego.

Średnia szarość (18%) i światłomierz

Światłomierz, czy to wbudowany w aparat, czy też zewnętrzny, nie widzi świata tak

jak my. Tak naprawdę nie mierzy też bezwzględnego natężenia światła. Odczyt

informuje użytkownika

o ilości światła odbitego od fotografowanego przedmiotu. Światłomierz jest

skalibrowany do pomiaru światła odbitego od obiektu o jasności na poziomie tzw.

średniej szarości (18%). Dlatego wszystko traktuje jakby było szare i podaje takie

wartości parametrów ekspozycji, które zapewnią oddanie tej osiemna-

stoprocentowej szarości na zdjęciu – nawet jeśli fotografujemy czarnego kota w

kopalni czy polarnego niedźwiedzia na śniegu. Wymusza to na użytkowniku

dokonywanie pomiaru (czy to w try- bie centralnie ważonym, czy też punktowym) na

obiektach o jasności zbliżonej do średniej szarości lub wprowadzanie korekty

ekspozycji. W trybie pomiaru punktowego, jeśli chcemy, by czarne ubranie wyszło na

zdjęciu w głębokiej czerni, należy albo wycelować punkt pomiarowy na główny obiekt

i wprowadzić ujemną korektę ekspozycji (ponieważ światłomierz będzie się starał

rozjaśnić czerń do szarości), albo zmierzyć światło w takim miejscu kadru, które jest

oświetlone podobnie jak model, ale jego poziom jasności jest zbliżony do szarości

18%.

Niektórzy polecają stosowanie tzw. szarej karty, która w każdej sytuacji zapewni nam

wzór dla światłomierza. Jednak w fotografii cyfrowej, dzięki możliwości

natychmiastowego obejrzenia zdjęcia po jego wykonaniu i funkcji histogramu, to

akcesorium stało się niepotrzebne.

Warto wiedzieć

W najprostszych aparatach kompaktowych pomiar światła jest zwykle powiązany z

punktem AF, dzięki czemu fotografowany obiekt (na który ustawiamy ostrość)

zostanie właściwie naświetlony. Modele bardziej zaawansowane pozwalają o

powiązaniu pomiaru światła z punktem ostrości użytkownikowi.

W aparatach cyfrowych marki Nikon tryb pomiaru światła wybiera się w Menu

fotografowania w polu Pomiar światła. Niektóre modele umożliwiają też dostęp do tej

opcji bezpośrednio z przycisku lub pokrętła na obudowie (jak w lu- strzance D300),

albo za pomocą nawigacji po wyświetlaczu LCD.

W trybie pomiaru matrycowego siatka punktów pomia- rowych - zwana też matrycą,

stąd nazwa - pokrywa większość powierzchni klatki. W amatorskiej lustrzance Nikon

D60 tych pól jest aż 420, ale zazwyczaj producenci ograniczają się do kilku,

kilkunastu a najwyżej kilkudziesięciu pól pomiarowych.

4. Jakie funkcje spełnia przysłona - wyjaśnij wyczerpująco.

Jednym z najważniejszych elementów każdego aparatu fotograficznego jest

przysłona. Pozwala ona ograniczyć ilość światła wpadającego przez obiektyw,

padającego następnie na materiał światłoczuły (matrycę), i dzięki temu pozwala (jako

drugi mechanizm obok migawki) wpływać na ekspozycję zdjęcia.

Przysłona, jako przyrząd służący ograniczaniu ilości światła rejestrowanego przez

aparat, jest na pozór jego zbędnym elementem. Właściwa ekspozycja zdjęcia zależy

od oświetlenia i czasu rejestracji zdjęcia, zatem do manipulowania nią powinno

wystarczyć samo regulowanie czasu naświetlania – a więc mechanizm migawki.

Niekiedy jednak zależy nam na określonym czasie ekspozycji. Długim, gdy chcemy

np. uzyskać rozmycie na zdjęciu obiektów znajdujących się w ruchu lub trwających

dłużej, np. fajerwerków. Krótkim, gdy wykonujemy zdjęcia przy bardzo długich

ogniskowych (dużym zoom-em), i chcemy uzyskać nieporuszone ujęcia. Z innym

ograniczeniem możemy się spotkać, gdy wykorzystujemy materiały światłoczułe

(ustawienia matrycy) o bardzo małej lub bardzo dużej czułości – wówczas konieczny

czas ekspozycji może wykraczać poza możliwości techniczne migawki.

W takiej sytuacji należałoby właściwą ekspozycję uzyskać, regulując oświetlenie

fotografowanego obiektu, jednak poza fotografią studyjną rzadko mamy taką

możliwość. I tu właśnie do akcji wkracza przysłona, pozwalając regulować ilość

światła wpadającego przez obiektyw, a więc wpływać na ekspozycję zdjęcia. Dzięki

temu taką samą ekspozycję możemy uzyskać za pomocą nieograniczonej

(teoretycznie, w praktyce ograniczeniem są zakresy działania migawki i przysłony)

liczby kombinacji wielkości otworu przysłony i czasu naświetlania.

Kolejną ważną funkcją przysłony jest regulowanie głębi ostrości, czyli strefy przed i

za ustawioną odległością fotografowania (przedmiotową), w której osiągamy jeszcze

zadowalająco ostre odwzorowanie. Im mniejszy jest otwór przysłony, tym większa

jest głębia ostrości – więcej na ten temat dowiecie się z artykułu Głębia ostrości w

teorii i w praktyce.

Od przysłony zależy jeszcze kilka innych aspektów obrazu. Jak już wspomnieliśmy,

kształt otworu przysłony wpływa na sposób odwzorowania nieostrych obszarów

zdjęcia, tzw. bokeh (czyt. boke). O ile zazwyczaj dąży się do uzyskania możliwie

kołowego kształtu otworu przysłony (przez odpowiednie kształt i liczbę jej listków),

niekiedy stosuje się przysłony o nietypowych, wymyślnych kształtach otworu –

pozwala to uzyskać interesujące, trikowe efekty plastyczne. Przykładem obiektywu

który umożliwia stosowanie takich przysłon (typu wsuwkowego) jest opisywany przez

nas niedawno Lensbaby.

Ponadto od otworu przysłony zależy zdolność rozdzielcza obiektywu – w pewnym

zakresie zwiększa się ona wraz ze zmniejszaniem otworu przysłony. Dzieje się tak

jednak tylko do pewnego momentu, poniżej pewnej średnicy otworu uwidacznia się

wpływ ugięcia światła (dyfrakcja) na krawędzi listków, i na wskutek tego zdolność

obiektywu do odwzorowania szczegółów zaczyna się pogarszać.

Przysłona – źrenica obiektywu

Sposób działania przysłony jest bardzo prosty – polega na wprowadzeniu w światło

obiektywu nieprzezroczystej płaszczyzny z wyciętym otworem, dzięki czemu do

wnętrza aparatu dostaje się tylko pewna część wpadającego do obiektywu światła. W

najstarszym historycznie wydaniu służyła do tego szczelina w obudowie obiektywu,

przez którą do jego wnętrza wsuwało się blaszki z otworami o różnych średnicach.

Oczywiście taka konstrukcja (wsuwkowa) była bardzo niewygodna w użyciu, dlatego

szybko poszukano rozwiązań, które pozwalałyby sprawniej zmieniać otwór przysłony.

Prostą przysłoną pozwalającą na płynną regulację otworu jest "kocie oko" –

konstrukcja składająca się z dwóch przeciwstawnie przesuwających się blaszek, z

których każda posiada wycięcie w kształcie litery V. Jej zasadniczą wadą jest

kwadratowy przekrój otworu, co powoduje nienaturalne odwzorowanie nieostrych

obszarów zdjęcia. W aparatach kompaktowych często spotykana jest przysłona

obrotowa (rewolwerowa), mająca postać okrągłej tarczy z koliście rozmieszczonymi

otworami o różnej wielkości. Jest on umieszczona tak, by przez jej obrót można było

owe otwory wprowadzać w światło obiektywu. Co prawda ograniczona jest liczba

otworów o różnej średnicy, jakie można dzięki niej uzyskać, jednak zaletą jest bardzo

prosta i zwarta budowa, pozwalająca stosować ją w również aparatach prostych,

tanich i o niewielkich gabarytach.

Niewątpliwie najdoskonalszą konstrukcją jest przysłona irysowa. Zbudowana z kilku

(zwykle 5 do 9) blaszek (tzw. listków) o sierpowatym kształcie pozwala płynnie

regulować otwór przysłony, zachowując przy tym jego okrągły (lub bardzo do niego

zbliżony) kształt. Listki przysłony są koliście rozmieszczone na obwodzie obiektywu i

zamocowane obrotowo, dzięki czemu mogą być płynnie wsuwane do wnętrza

obiektywu.

Przysłonę irysową stosuje się przede wszystkim w obiektywach wymiennych do

lustrzanek, zwykle jest ona również zintegrowana z migawką centralną przeznaczoną

do stosowania w aparatach dużego formatu. Wykorzystywana jest też w

zaawansowanych aparatach kompaktowych – tych, w których płynnie regulować

można otwór przysłony.

Nie sposób przeoczyć podobieństwo przysłony irysowej do źrenicy (tęczówki)

ludzkiego oka. Zupełnie jak w wypadku przysłony, reguluje ona ilość wpadającego do

oka światła. Z tego właśnie powodu po zmroku widzimy mniej wyraźnie – na skutek

zwiększenia otworu tęczówki zmniejsza się głębia ostrości obrazu, który

postrzegamy.

Ustawianie wartości przysłony

W starszych aparatach fotograficznych otwór przysłony ustalało się zwykle

pierścieniem umieszczonym na obudowie obiektywu. W wypadku obiektywów

wbudowanych na stałe niekiedy zamiast pierścienia służyła do tego celu

odpowiednia dźwignia. W obu wypadkach należało posługiwać się wygrawerowanymi

na obudowie obiektywu wartościami przysłony. Często przed wykonaniem zdjęcia

należało jeszcze dodatkowo przed samym wykonaniem zdjęcia przymknąć przysłonę

do pozycji roboczej, w bardziej zaawansowanych konstrukcjach przysłona domykana

była automatycznie.

W nowoczesnych aparatach, zarówno cyfrowych jak i analogowych korzystanie z

przysłony jest dużo prostsze, pod warunkiem jednak, że nasz aparat w ogóle na to

pozwala. Niestety, większość prostych aparatów kompaktowych pozbawionych jest

funkcji pozwalających użytkownikowi na regulowanie otworu przysłony. Jest to o tyle

usprawiedliwione, że zazwyczaj wyposażone są one w proste przysłony o jedynie

kilku wartościach, a ustalanie ekspozycji odbywa się przez dopasowanie czasu

naświetlania zdjęcia.

Jeśli zatem rozważamy wybór aparatu, a chcielibyśmy mieć w przyszłości wpływ na

takie elementy zdjęcia jak np. głębia ostrości, szukajmy modeli wyposażonych w tryb

manualny (Manual, M) lub priorytetu przysłony (Aperture Priority, A lub Av), a

najlepiej w oba.

Aby ustawić wartość przysłony w trybie A (Av), zwykle wystarczy kręcić kółkiem

nastawczym aparatu. W trybie M (manualnym) sprawa może być nieco bardziej

skomplikowana. Bardziej zaawansowane lustrzanki zwykle wyposażone są w dwa

pokrętła ustawień – w trybie manualnym jedno z nich służy do ustawienia czasu

ekspozycji, a drugie właśnie pozwala nam ustawić otwór przysłony. Większość

aparatów jednak wyposażona jest tylko w jedno pokrętło (lub jedynie w manipulator-

dżojstik), który służy do sterowania oboma parametrami, a wyboru konkretnego z

nich dokonujemy, wciskając dedykowany przycisk. Wartość ustawionej przysłony

widzimy na wyświetlaczu – w kompaktach i tanich lustrzankach głównym kolorowym,

lustrzanki zaawansowane zwykle wyposażone są w wyświetlacz pomocniczy,

pokazujący bieżące ustawienia aparatu.

Pokazywana na wyświetlaczu aparatu liczba to wartość przysłony. Jest ona tym

większa, im mniejszy jest otwór przysłony. Zatem F4 oznacza szeroko otwartą

przysłonę, F16 to wartość odpowiadająca przysłonie przymkniętej.

Przysłona a otwór względny

Jak widać, ten na pozór zbędny element aparatu ma ogromny wpływ na jego

funkcjonalność, możliwość wykonywania zdjęć w określonych warunkach a przede

wszystkim na plastykę rejestrowanego obrazu.

Na kształt otworu przysłony czy jej konstrukcję mechaniczną rzadko mamy wpływ,

zazwyczaj tylko w momencie wyboru konkretnego aparatu bądź obiektywu. Jednak w

zwykłej praktyce fotograficznej kwestie te nie są zbyt istotne, o ile nie mamy żyłki

eksperymentatora i majsterkowicza. Znacznie ważniejsze są: głębia ostrości i

ekspozycja zdjęcia – a tu znaczenia ma odpowiednia wielkość otworu przysłony.

Zasadniczą funkcją przysłony jest limitowanie ilości światła docierającego do

materiału światłoczułego, czyli filmu bądź matrycy. Natężenie to ściśle zależy od

odległości obrazowej – wynika to z prawa odległości Isaaca Newtona, które mówi że

natężenie oświetlenia jest odwrotnie proporcjonalne do kwadratu odległości

pomiędzy źródłem (obiektywem) a oświetlaną płaszczyzną (filmem, matrycą). Z tego

powodu wielkość otworu przysłony podaje się nie jako wartość bezwzględną, a jako

stosunek średnicy otworu do ogniskowej obiektywu (jest ona równa odległości

obrazowej przy ostrości ustawionej na nieskończoność) – wartość ta nosi nazwę

otworu względnego. Dzięki temu fotografując ten sam kadr dwoma obiektywami o

różnych ogniskowych, jednak o tym samym otworze względnym, uzyskamy tę samą

ekspozycję.

Wartość otworu względnego można podawać na kilka różnych sposobów: f/1, f:1

oraz f1 oznaczają otwór przysłony równy ogniskowej obiektywu. W wypadku

oznaczeń obiektywów często stosuje się oznaczenie, w którym ogniskowa podana

jest wprost, a więc 50/1 czy 50:2.

Otwór względny a czas ekspozycji

Jak już wspominaliśmy, stosując różne kombinacje otworu przysłony i czasu

naświetlania możemy uzyskać tę samą ekspozycję. Jeśli zatem zwiększamy

dwukrotnie czas ekspozycji, powinniśmy w odpowiednim stopniu zmniejszyć otwór

względny przysłony, tak by dwukrotnie zmniejszyć natężenie przechodzącego przez

obiektyw światłą. W odpowiedni – to znaczy właściwie w jaki?

Ilość światła przepuszczanego przez przysłonę zależy od powierzchni jej otworu,

zatem to ją należy zmniejszyć, w naszym wypadku dwukrotnie. Jak pamiętamy,

otwór przysłony ma najczęściej przekrój kołowy (lub ma kształt możliwie zbliżony),

zatem jego średnicę należy w tym celu podzielić przez pierwiastek kwadratowy z

dwóch. W ten sposób zmniejszymy jego powierzchnię o połowę, i w analogicznym

stopniu ilość przepuszczanego przez przysłonę światła.

Powtarzając tę operację, uzyskamy kolejno cztero-, ośmio- czy szesnastokrotne

ograniczenie ilości światła dochodzącego do materiału światłoczułego. Jak łatwo

zauważyć, jest to zmiana kolejno o 1, 2, 3 i 4 EV. Stosując wspomnianą wcześniej

nomenklaturę taki ciąg wartości otworu względnego miałby postać 1:1.414, 1:2,

1:2.828, 1:4 jednak w praktyce stosuje się wartości zaokrąglone 1:1.4, 1:2. 1:2.8, 1:4.

Często stosuje się dla uproszczenia również ich odwrotności, czyli tzw. liczbę

przysłony (wartość przysłony): 1, 1.4, 2, 2.8, 4, 5.6, 8, 11, 16, 22, 32, 45, 64.

Niezależnie od zapisu, im mniejsza jest liczba (lub podstawa ułamka, czyli liczba po

ukośniku lub dwukropku) reprezentująca otwór względny, tym większy jest otwór

przysłony. Podany powyżej szereg wartości przysłony nie jest zamknięty – można go

przedłużyć zarówno w stronę większych jak i mniejszych wartości, jednak zwykle ich

się nie spotyka (poza makrofotografią). Oprócz podanych wartości stosuje się

również wartości pośrednie, co 1/2 lub 1/3 EV, pozwalające precyzyjnie regulować

ekspozycję zdjęcia.

Ponieważ czasy otwarcia migawki również wyskalowane są tak, by zmiana o jeden

pełny stopień oznaczała dwukrotne (o 1 EV) wydłużenie lub skrócenie czasu

ekspozycji, równoczesne wydłużenie czasu i przymknięcie przysłony o jeden stopień

pozwala zachować tę samą ekspozycję. Poniżej przedstawiamy przykładowy ciąg

ustawień czasu ekspozycji i wartości przysłony zapewniających tę samą ekspozycję:

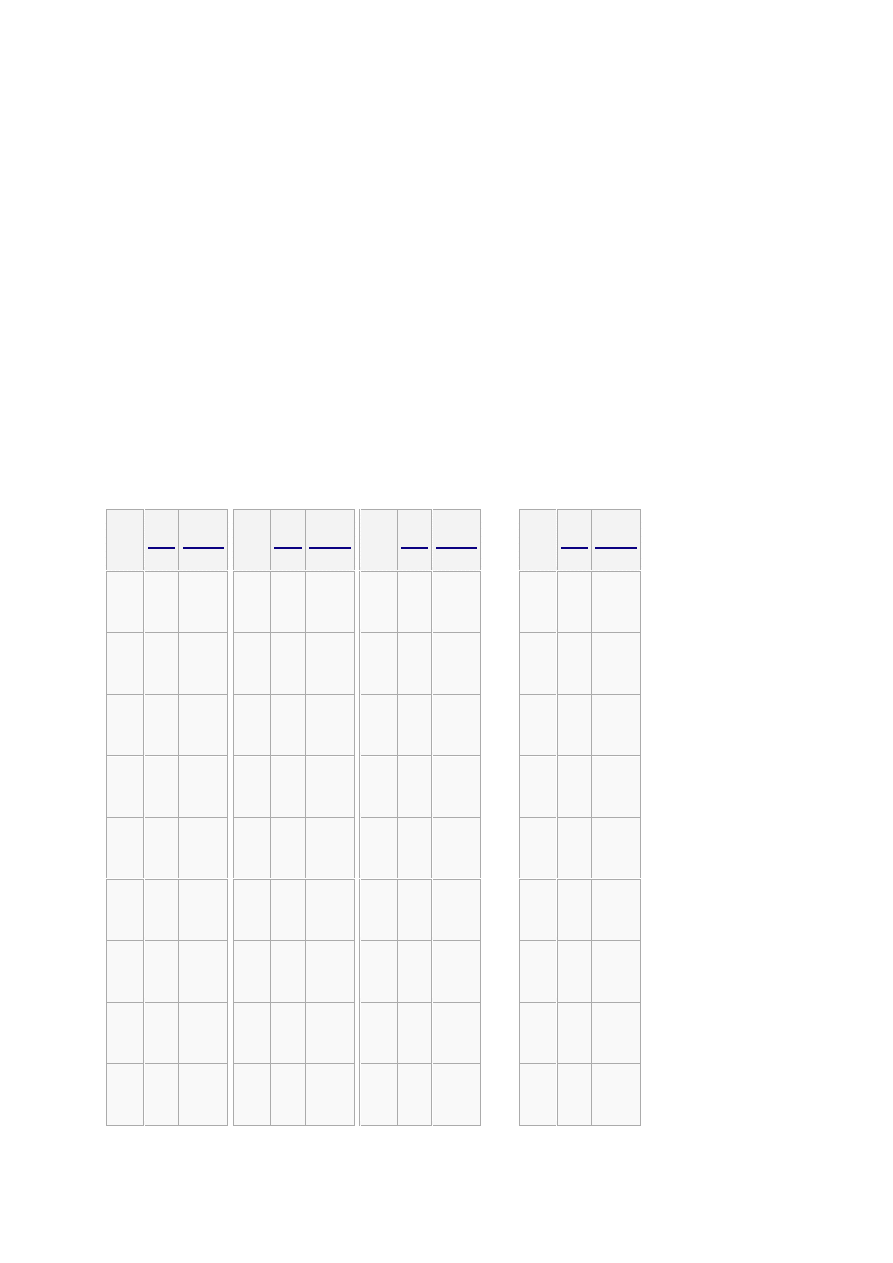

wartość przysłony 1,4 2 2,8 4 5,6 8 11 16

czas ekspozycji 1/250 s 1/125 s 1/60 s 1/30 s 1/15 s 1/8 s 1/4 s 1/2 s

Otwór względny a jasność obiektywu

Największy możliwy do ustawienia otwór względny (najmniejsza liczba przysłony)

nazywany jest jasnością obiektywu. Jest to dość niefortunne określenie, gdyż może

być mylone z fotometrycznym pojęciem natężenia światła, jednak powszechnie się

przyjęło w żargonie fotograficznym.

Obiektywy o dużej jasności (otworze względnym większym niż f:2) to zwykle

konstrukcje dość kosztowne, i przeznaczone do specyficznych zastosowań gdzie

przydatna jest niewielka głębia ostrości (np. fotografia portretowa) lub fotografowania

w warunkach niedostatecznego oświetlenia. Ponieważ przy pełnym otworze

przysłony najsilniej uwidacznia się większość wad optycznych obiektywu, ultrajasne

obiektywy są dla zwykłego fotoamatora mało przydatne, gdyż i tak większość zdjęć

będzie on wykonywał przy przysłonie przymkniętej do f:5.6 lub f:8.

Niestety, określenia wartość przysłony i otwór względny są często używane

zamiennie, co prowadzi do nieporozumień – należy pamiętać, że zwiększanie otworu

względnego oznacza zmniejszanie wartości (liczby przysłony).Innym częstym

nieporozumieniem jest twierdzenie, że największym możliwym otworem względnym

jest f:1. Tymczasem nic (poza względami technicznymi) nie stoi na przeszkodzie, by

konstruować obiektywy o większym otworze względnym. Najjaśniejszym chyba

obiektywem, jaki został wyprodukowany był 50 mm Planar f/0.7, wyprodukowany na

potrzeby misji kosmicznych NASA, stosowany również w kinematografii, m.in. przez

Stanleya Kubricka podczas kręcenia sceny przy świetle świec w filmie "Barry

Lyndon". Obiektywy o jasności większej niż f:1 produkowały również firmy takie jak

Canon, Rodenstock czy Schneider-Kreuznach.

Ponieważ jasność obiektywu (największy otwór względny) należy do jego

najważniejszych parametrów, jest on zawsze nanoszony na jego obudowę. Również

tutaj spotkać można wiele sposobów zapisu tej wartości, i tak dla obiektywu o

ogniskowej 50 mm i świetle f/2 może to być: 50/2, 50 F/2, 50 F2, 50 1:2… Za każdym

razem zapis ten znaczy to samo. Oczywiście, niektórzy producenci muszą

wprowadzać własną nomenklaturę – i tak Zeiss (a za nim Sony) odwracają kolejność

zapisu, mamy zatem również obiektywy takie jak Planar 1.4/50.

W amatorskich obiektywach zmiennoogniskowych (oraz znakomitej większości

obiektywów wbudowanych w aparaty kompaktowe) maksymalny otwór względny

zmniejsza się wraz z wydłużaniem ogniskowej, należało zatem ująć to w oznaczeniu

obiektywu. I tu również możemy spotkać się z wieloma wariantami: 28-210 3.5-5.6,

28-210mm 1:3.5-5.6 czy 28-210 F/3.5-5.6. Za każdym razem zapis ten oznacza, że

mamy do czynienia z obiektywem o zakresie ogniskowych od 28 do 210 mm, który

przy najkrótszej ogniskowej ma otwór względny f/3.5, a przy najdłuższej zwiększa się

on do f/5.6.

Otwór względny a odległość fotografowania

Powszechnie przyjmuje się, że otwór względny to stosunek średnicy otworu

przysłony do ogniskowej obiektywu. Jest to uproszczenie, które jest na tyle bliskie

rzeczywistym wartościom, że w normalnych warunkach fotograficznych sprawdza się

bardzo dobrze. Dlaczego jednak jest to tylko przybliżenie? Otóż tak naprawdę, w tej

definicji dla obu parametrów przyjęto niewłaściwe wartości…

W wypadku, gdy fotografowane obiekty znajdują się w dużej odległości od obiektywu

(nie musi to być nieskończoność, wystarczy mniej więcej dwudziestokrotność

ogniskowej obiektywu) można przyjąć, że płaszczyzna obrazowa znajduje się w

odległości równej ogniskowej od obiektywu (a dokładniej od tylnego, obrazowego

punktu węzłowego). W miarę jednak, jak zmniejsza się odległość od fotografowanego

przedmiotu (o. przedmiotowa) wydłuża się odległość obrazowa, stanowiąca

podstawę do wyznaczania otworu względnego. Oznacza to ni mniej ni więcej, że dla

niewielkich odległości fotografowania zmniejsza się otwór względny obiektywu w

stosunku do wartości nominalnej.

Nie musimy się tym przejmować, jeżeli używamy nowoczesnej lustrzanki AF z

dedykowanymi obiektywami bądź aparatu kompaktowego – wbudowany układ

kontroli ekspozycji uwzględni w obliczeniach odległość, na którą nastawiona została

ostrość, i wprowadzi do ustalonej ekspozycji odpowiednią korektę. Inaczej sytuacja

ma się, gdy chcemy posługiwać się manualnymi obiektywami (np. M42) lub

pierścieniami pośrednimi bez przeniesienia automatyki oraz zewnętrznym

światłomierzem. Tu już niezbędne będzie ręczne wprowadzenie korekty – jest to

szczególnie istotne w makrofotografii, gdyż w tym zastosowaniu najczęściej spotyka

się zarówno stare obiektywy manualne jak i niewielkie odległości fotografowania. O

ile w wypadku lustrzanki cyfrowej łatwo odpowiednią korektę ekspozycji ustalić

eksperymentalnie, posługując się histogramem, to w przypadku aparatu

analogowego nie mamy już tej możliwości, i musimy posłużyć się odpowiednimi

wzorami. Tu nie będziemy ich przytaczać, podamy jedynie orientacyjne tabele, o ile

należy wydłużyć ekspozycję dla różnych odległości fotografowania oraz skal

odwzorowania (za: Tadeusz Cyprian, "Fotografia, technika i technologia" 1960).

Odległość fotografowania f×17 f×9 f×5 f×3 f×2

Wydłużenie czasu ekspozycji ×1,12 ×1,25 ×1,56 ×2,25 ×4

Odległość fotografowania f:1 2:1 3:1 4:1 5:1

Wydłużenie czasu ekspozycji ×4 ×9 ×16 × 25 ×36

Jak łatwo zauważyć, "referencyjna" w makrofotografii skala odwzorowania 1:1

(osiągamy ją przy odległości fotografowania równej dwukrotności ogniskowej)

wymaga zwiększenia ekspozycji aż o 2 EV (np. przez czterokrotne wydłużenie czasu

ekspozycji). Z tego też powodu obiektywy do makrofotografii przy skali odwzorowania

1:1 zwykle oferują otwór względny f/64, a często nawet mniejszy.

Drugim parametrem w równaniu otworu względnego jest średnica otworu przysłony.

W rzeczywistości powinniśmy posługiwać się tzw. źrenicą wejściową, czyli

projekcyjną wielkością otworu przysłony… Na szczęście tą rozbieżnością w definicji

nie musimy się przejmować, dopóki nie zamierzamy samodzielnie budować

obiektywu. Wystarczy, jeśli będziemy polegać na wartościach podanych przez

producenta – jeśli zatem obiektyw o ogniskowej 50 mm ma otwór względny f/2, to

jego źrenica wejściowa (a nie fizyczna średnica otworu przysłony!) wynosi 25 mm.

Dla uproszczenia przyjmuje się jednak powszechnie, że oba pojęcia są tożsame.

5. Jakie funkcje spełnia czas naświetlania.

Czas ekspozycji to jeden z ważniejszych parametrów, które wybieramy ustalając

ekspozycję zdjęcia. Gdy już dokonamy wyboru, za jego realizację odpowiada

mechanizm zwany migawką.

Jednym ze sposobów wpływania na ekspozycję zdjęcia jest regulowanie czasu

naświetlania błony światłoczułej bądź matrycy aparatu cyfrowego. We wczesnym

okresie rozwoju fotografii wystarczało do tego proste nakrycie obiektywu, które

zdejmowało się ręcznie na czas niezbędny do uzyskania prawidłowej ekspozycji. Nie

było to problemem, gdy stosowane materiały światłoczułe były bardzo niskoczułe, a

czas ten mierzono w sekundach czy nawet minutach, dziś jednak tę metodę można

stosować wyłącznie w specyficznych sytuacjach (np. zdjęcia nocne), natomiast

typowy czas ekspozycji wynosi kilka dziesiątych, setnych a nawet tysięcznych części

sekundy. W tej sytuacji najbardziej nawet "szybkoręki" fotograf jest bez szans na

odsłonięcie obiektywu na potrzebny okres. Dlatego też we współczesnych aparatach

fotograficznych za regulowanie czasu ekspozycji odpowiada mechanizm zwany

migawką (ang. shutter).

Migawka to ruchoma mechaniczna przysłona, umieszczona na drodze światła

wpadającego do wnętrza aparatu przez obiektyw. Jest ona otwierana na czas

niezbędny do zapewnienia prawidłowej ekspozycji. W starszych aparatach czas ten

był regulowany za pomocą odpowiedniego układu mechanicznego, dziś migawki są z

reguły sterowane elektronicznie.

Pierwsza migawka pojawiła się dopiero w roku 1845, kiedy to dwóch francuskich

fizyków, Fizeau i Foucault opracowało urządzenie do kontrolowania czasu

ekspozycji, wykorzystywane do wykonywania zdjęć tarczy słonecznej. Aż do 1880

migawka traktowana była jak mniej lub bardziej użyteczny gadżet, jednak bynajmniej

nie niezbędny do wykonywania zdjęć. W późniejszym okresie szybki rozwój

materiałów światłoczułych (a zwłaszcza ogromny wzrost ich czułości) spowodował,

że migawka stała się obowiązkowym wyposażeniem każdego aparatu. W historii

fotografii przewinęło się wiele najróżniejszych rodzajów migawek, które różniły się

zarówno pod względem budowy, jak i miejsca umieszczenia w aparacie (lub poza

nim), jak np. migawki żaluzjowe, otworkowe czy miechowa Grundnera.

Dziś stosuje się niemal wyłącznie dwa typy migawek: szczelinowe i centralne.

Migawki szczelinowe to domena aparatów małego formatu, co dziś oznacza niemal

wyłącznie aparaty małoobrazkowe na błonę 35mm oraz lustrzanki cyfrowe będące

pochodną lustrzanek małoobrazkowych, można je też spotkać w aparatach

średniego formatu jak Hasselblad FC czy Pentacon Six. Migawkę centralną stosuje

się dziś w aparatach średniego i dużego formatu, przy czym różne może być jej

umieszczenie względem aparatu i obiektywu.

Czasy otwarcia migawki zostały usystematyzowane podobnie jak wartości otworu

przysłony. Dzięki temu w łatwy sposób można dostosować czas naświetlania do

wybranego otworu względnego, tak by otrzymać pożądaną ekspozycję zdjęcia.

Podstawowy szereg czasów otwarcia migawki wynosi:

1, 1/2,1/4, 1/8, 1/15, 1/30, 1/60, 1/125, 1/250, 1/500, 1/1000, 1/2000 s

Jak łatwo zauważyć, każdy kolejny czas otwarcia jest niemal dokładnie o połowę

krótszy, zatem różnica pomiędzy nimi wynosi 1 EV. Zwykle nowoczesne aparaty

pozwalają na dokładniejsze ustalanie czasu ekspozycji zdjęcia, zazwyczaj co 1/2 lub

1/3 EV.

Budowa migawki szczelinowej

Migawka szczelinowa we współczesnym wydaniu umieszczona jest możliwie blisko

płaszczyzny obrazowej aparatu (stąd jej angielska nazwa focal-plane shutter; w

zasadzie odnosiu się ona do wszystkich migawek tam umiejscowionych, ale dziś

umieszcza się w tym miejscu tylko migawki szczelinowe), a więc tuż przed błoną

światłoczułą lub matrycą. Składa się ona z dwóch przysłon rozdzielonych szczeliną,

przesuwających się przed płaszczyzną obrazową tak, że wpadające przez szczelinę

światło naświetla zdjęcie. Czas ekspozycji regulowany jest szerokością szczeliny –

im jest ona węższa, tym mniej światła dociera do filmu lub matrycy.

W starszych aparatach owe przysłony miały postać roletek z nieprzezroczystej

tkaniny, a szczelina przesuwała się wzdłuż dłuższego boku kadru. W nowoczesnych

konstrukcjach zbudowane są one z metalowych blaszek zwanych lamelkami, a

szczelina pomiędzy nimi przesuwa się w pionie, wzdłuż krótszego boku klatki.

Przy dłuższych czasach ekspozycji (w starszych aparatach jest to 1/30 do 1/60

sekundy, w nowszych z metalową migawką 1/125 do 1/250 sekundy) szerokość

szczeliny staje się równa szerokości klatki, dzięki czemu cała powierzchnia kadru

naświetlana jest równocześnie. Przy takim czasie (lub dłuższym) możliwe jest

skorzystanie z lampy błyskowej (jej błysk naświetli od razu całą klatkę), stąd też czas

taki nazywany jest minimalnym czasem synchronizacji z lampą błyskową.

Przy krótszym czasie ekspozycji błysk lampy naświetliłby jedynie wąski pasek kadru

znajdujący się w danym momencie naprzeciw szczeliny migawki. Z tego powodu

większość nowoczesnych aparatów po podłączeniu dedykowanej lampy błyskowej

(lub włączeniu wbudowanej) nie pozwoli ustawić krótszego czasu ekspozycji.

Niewątpliwą zaletą migawek szczelinowych jest duży zakres czasów ekspozycji – te

stosowane w profesjonalnych lustrzanka pozwalają uzyskać czas naświetlania

1/8000 s, w korpusach amatorskich normą jest najkrótszy czas ekspozycji rzędu

1/2000–1/4000 s.

Budowa migawki centralnej

Określenie migawka centralna odnosi się nie tyle do jej budowy, co do umieszczenia

wewnątrz aparatu, a w zasadzie obiektywu, gdyż migawka centralna powinna

znajdować się w płaszczyźnie głównej obiektywu, a zatem możliwie blisko przysłony.

Ponieważ tak umieszczone migawki mają wyłącznie budowę sektorową, mianem

migawki centralnej przyjęło się określać wszystkie migawki sektorowe, również te

umieszczone pomiędzy obiektywem a płaszczyzną obrazową.

Migawka sektorowa ma budowę bardzo podobną do klasycznej przysłony irysowej –

składa się z kilku (zwykle dwóch do siedmiu) półkolistych, metalowych blaszek

zawieszonych wahadłowo wokół otworu migawki. Za pomocą sprężyny utrzymywane

są one w takiej pozycji, by zasłonić otwór obiektywu. W trakcie naświetlania zdjęcia

są one rozsuwane na czas niezbędny do uzyskania prawidłowej ekspozycji, po czym

natychmiast wracają do pozycji zamkniętej.

Na efektywny czas otwarcia migawki sektorowej składa się zarówno okres pełnego

rozsunięcia listków, jak i proces ich otwierania oraz zamykania. Ruch migawki

odsłania najpierw środek obiektywu, i odwrotnie, zasłania go na samym końcu. Jest

to główna przyczyna umieszczania migawek sektorowych w pozycji centralnej, w

pobliżu przysłony – w tej pozycji migawka działa jak druga przysłona o zmiennej

średnicy i geometrii. Dzięki temu okres niepełnego otwarcia migawki wpływa jedynie

na zwiększenie głębi ostrości bądź zmianę charakteru przejścia pomiędzy obszarami

ostrymi i nieostrymi.

Inaczej rzecz będzie się miała gdy migawkę sektorową umieścimy poza obiektywem.

Im bliżej płaszczyzny obrazowej będzie się ona znajdowała, tym silniejsze będzie

zaciemnienie obrzeży kadru powodowane okresem niepełnego otwarcia migawki.

Efekt ten będzie tym silniejszy, im krótszy będzie czas ekspozycji. Dlatego tez w

sytuacji, gdy migawka znajduje się poza obiektywem, stosuje się odpowiednie filtry

korekcyjne z ciemniejszym centrum.

Wszystko to powoduje, że dziś migawki sektorowe występują wyłącznie jako migawki

centralne, a to ostatnie miano stało się w zasadzie ich synonimem. W tradycyjnym

wykonaniu, spotykanym również dziś w aparatach wielkoformatowych, migawka

centralna jest niezależnym modułem, zawierającym również układ przysłony, a

często również samowyzwalacza i synchronizacji z lampą błyskową. Często sama

migawka jest równocześnie przysłoną – po wyzwoleniu, otwiera się jedynie do

ustalonej uprzednio wartości. Do takiego modułu mocowane są dwie części

obiektywu – przednia i tylna. Takie rozwiązanie pozwala wykorzystywać jedną

migawkę z wieloma obiektywami.

Inne podejście od lat prezentuje Hasselblad, konsekwentnie wbudowując migawkę

centralną w obiektywy (z wyjątkiem tych przeznaczonych dla systemu FC). Z jednej

strony upraszcza to użytkowanie aparatu, pozwalając na szybką wymianę

obiektywów, z drugiej komplikuje budowę odpowiednich szkieł i podnosi ich koszty.

Chociaż migawka centralna jest bardzo prostym mechanizmem, na jej elementy

działają bardzo duże siły – wystarczy wspomnieć, że blaszki tworzące sektory

migawki w czasie jej otwierania i zamykania przyspieszają do prędkości 50 km/h w

czasie zaledwie 1/1000 sekundy! Powoduje to, że konieczna jest wysoka precyzja

wykonania i materiały wysokiej jakości. Co ciekawe, w wytwarzaniu migawek

centralnych wyspecjalizowało się kilka firm, które często nie produkowały ani

aparatów, ani obiektywów, zaś ich wyroby stosowane były powszechnie w większości

aparatów. Nazwy takie jak Prontor, Compur czy Copal trwale zapisały się w historii

fotografii, chociaż ich wytwórcy nie zawsze dotrwali dzisiejszych czasów. Firmy

Alfred Gauthier (producent Prontorów) oraz Deckel (wytwórca Compurów) zostały

wchłonięte przez Zeiss Foundation (holding będący właścicielem zakładów Zeissa

oraz wytwórcy szkła optycznego Schott), po czym połączone w 1984 roku. Produkcja

Compurów na rynek zewnętrzny była utrzymywana do 2002 roku, dziś można je

spotkać tylko wbudowane w obiektywy Zeissa (np. te przeznaczone dla systemu

Hasselblad 500). Dziś najbardziej znanym niezależnym wytwórcą jest Schneider, z

którego migawkami serii Copal współpracują obiektywy takich producentów jak

Nikon, Rodenstock (Linos)i Sinar (oraz oczywiście szkła Schneidera).

Migawki centralne (sektorowe) mają swoje wady i zalety. W porównaniu do migawek

szczelinowych, oferują one stosunkowo długie czasy naświetlania – najkrótszy czas

ekspozycji oferowany przez produkowaną obecnie zewnętrzna migawkę centralną

(Schneider Copal 0) to 1/500 sekundy. Nieco lepiej jest w wypadku migawek

wbudowanych w obiektywy średniego formatu w wypadku szkieł przeznaczonych dla

Hasselblada H3D jest to 1/800 sekundy. Trzeba przyznać, że w porównaniu do

możliwości migawek szczelinowych to niewiele. Wynika to z tego, że czas operacji

rozsuwania i zamykania sektorów migawki jest mniej więcej stały, zatem przy bardzo

krótkich czasach ekspozycji proporcje pomiędzy czasem pełnego a częściowego

otwarcia migawki byłyby już bardzo zachwiane. Z drugiej zaś strony, migawki

centralne pozwalają na synchronizację z lampą błyskową przy dowolnym czasie

otwarcia migawki, gdyż ta zawsze otwiera się na wystarczającą szerokość.

Migawki w aparatach cyfrowych

Cechą charakterystyczna migawek stosowanych w większości aparatów cyfrowych

jest to… że ich nie ma. To nie żart – matryce stosowane w aparatach cyfrowych

(przede wszystkim kompaktowych) pozwalają w dość dużym zakresie regulować

czas zbierania informacji o obrazie, a więc czas ekspozycji. Pozwala to nie tylko

uprościć konstrukcję takiego aparatu (a więc i obniżyć jego cenę), ale i zmniejszyć

rozmiary. To właśnie dzięki tej właściwości stosowanych sensorów zawdzięczamy

aparaty tak małe, że mieszczą się w telefonach komórkowych.jeśli zatem w

dokumentacji aparatu kompaktowego widzimy pozycję "migawka elektroniczna"

możemy być pewni, że aparat ten nie ma migawki z prawdziwego zdarzenia.

No dobrze, ale dlaczego w takim razie cyfrowe lustrzanki w dalszym ciągu

wyposażane są w mechaniczne migawki? Przecież to stosunkowo drogi element

aparatu, na dodatek podlegający zużyciu (migawka amatorskiej lustrzanki cyfrowej

wytrzymuje od 60 do 100 tysięcy cykli pracy, czyli wykonanych zdjęć). Aparaty

kompaktowe pozbawione są migawki niejako z konieczności – matryca musi przez

cały czas rejestrować obraz, by zapewnić możliwość kadrowania zdjęcia na

wyświetlaczu. Ponadto w cyfrowych kompaktach sensor światłoczuły jest

uniwersalnym elementem pomiarowym odpowiadającym za dostarczenie danych

układom kontroli ekspozycji oraz ustawienia ostrości (autofokusowi). Aby wszystko to

zapewnić, matryca aparatu musi pracować "na okrągło". Ma to jednak określone

konsekwencje. Część powierzchni matrycy musi zostać poświęcona na układy

kontrolujące czas zbierania danych – powoduje to, że zmniejszona zostaje jej

aktywna powierzchnia, a co za tym idzie, większe są elektroniczne szumy widoczne

na zdjęciach. Ponadto stale pracujący przetwornik wyraźnie się grzeje, co w

konsekwencji znów doprowadza do wzrostu zaszumienia (wraz z temperaturą rośnie

tzw. ciemny prąd matrycy).

Tymczasem w lustrzankach matryca nie musi pracować przez cały czas –

kadrowanie zdjęcia zapewnia nam lustrzany wizjer optyczny, zaś za pomiar

ekspozycji zdjęcia i ustawienie ostrości odpowiadają wyspecjalizowane układy

pomiarowe. Dzięki temu matryca mniej się grzeje, a zastosowanie migawki pozwala

dodatkowo uprościć budowę sensora światłoczułego i efektywniej wykorzystać jego

powierzchnię. Oczywiście od reguły bywają wyjątki – wśród lustrzanek jest nim Nikon

D70 (oraz aparaty wyposażone w analogiczną matrycę: D70s, D50 oraz D40). Otóż

aparat ten jest co prawda wyposażony w metalową migawkę lamelkową, jednak

reguluje ona czasy ekspozycji w zakresie od 30 sekund do 1/500 sekundy. Krótsze

czasy naświetlania zdjęcia są już uzyskiwane elektronicznie. Skutkuje to nieco

większym niż u konkurencji poziomem szumów (za wyjątkiem D40, ale jest to

zasługą bardzo dobrego układu redukcji szumów), ale ma też swoje zalety.

Mianowicie małoobrazkowe lustrzanki Nikona z hybrydową migawką jako jedyne

pozwalają wykonywać zdjęcia z lampą błyskową przy czasie synchronizacji 1/500 s

(pomijając wykonywanie zdjęć w trybie hi-speed, ale to już temat na odrębny artykuł).

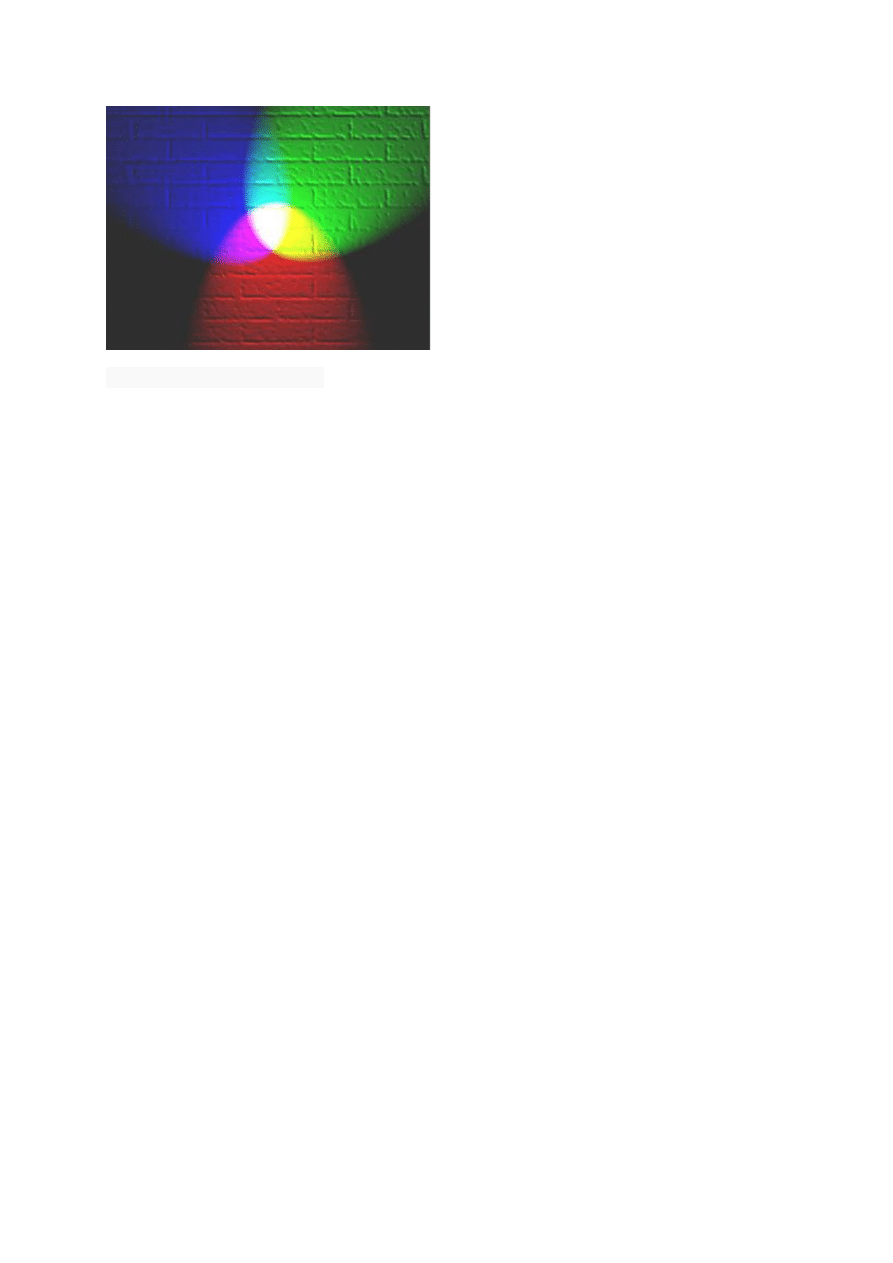

6. Po co jest balans bieli i co go łączy z temperatura barwową.

Często chwalimy fotografię cyfrową za to, że znacznie ułatwia robienie zdjęć.

Możliwości natychmiastowego obejrzenia rezultatów przyspiesza naukę, a obróbka

komputerowa daje praktycznie każdemu dostęp do efektów, które wcześniej były

zarezerwowane dla wtajemniczonych. Tymczasem jest jeden aspekt pracy fotografa

amatora, który cyfra skomplikowała, wprowadzając nowe zagadnienie. Mowa o

balansie bieli, czyli funkcji odpowiedzialnej za kolorystyczną neutralność zdjęcia.

Kiedyś można było znaleźć dwa rodzaje filmów kolorowych – przeznaczone do

użytku w świetle dziennym (znakomita większość) i przygotowane tak, że dawały

naturalne kolory w świetle sztucznym (rzadkie i drogie). Większość fotoamatorów

używała powszechnie dostępnych filmów do światła dziennego, godząc się z

dominantą kolorystyczną (czyli nienaturalnym zabarwieniem), jeśli część fotografii

została wykonana we wnętrzach oświetlonych sztucznym światłem, lub zdając się na

doświadczenia laboranta, który przygotowywał odbitki. Do równoważenia

temperatury światła stosowano też specjalne filtry optyczne, ale było to niewygodne i

uciążliwe. W cyfrze możliwości fotografa są ogromne. Możliwość dostosowania

ustawień aparatu do temperatury barwowej światła, w którym akurat fotografujemy

(choćby na jedno ujęcie!), to błogosławieństwo. Z drugiej jednak strony to kolejny

element fotograficznego abecadła, który musimy opanować, zanim będziemy mogli z

dumą stwierdzić, że fotografujemy w pełni świadomie i samodzielnie.

Oczywiście istnieje możliwość zdania się na kogoś innego – wprawnego laboranta

zastąpiła automatyka aparatu, ale nie w każdych warunkach takie rozwiązanie się

sprawdzi. Nie zaszkodzi więc poznać podstawy i nauczyć się korzystać przynajmniej

z ustawień predefiniowanych aparatu.

Zaczynamy jednak od skoku na głęboką wodę.

Im cieplej tym zimniej?

Określenie „balans bieli” to kalka językowa z angielskiego white balance. Termin ten

oznacza software’owy mechanizm równoważenia bieli, czyli interpretacji surowych

danych z matrycy (o czym później), żeby biel była na zdjęciu biała, w celu uniknięcia

niezgodnego z rzeczywistością zafarbu. Ludzkie oko ma ogromne zdolności

adaptacyjne i potrafi się przystosować do różnych warunków oświetleniowych, nie

tylko jasności (po chwili spędzonej w ciemności zaczynamy widzieć kontury

przedmiotów, a ostre słońce razi nas tylko przez chwilę), ale też różnych kolorów

światła. Nasz mózg to najskuteczniejszy system balansu bieli świata – on wie, co

powinno być białe, co czerwone, zielone itp., nawet w bardzo wymagających

sytuacjach widzimy prawidłowo (pomijając oczywiście sytuacje skrajne, np. podczas

koncertów). Aparat tak nie potrafi, trzeba mu pomóc w podjęciu decyzji, wybierając

odpowiednie ustawienie odpowiadające temperaturze barwowej najczęściej

spotykanych źródeł światła.

Temperaturę światła, mającą wpływ na jego kolor (widziany przez ludzkie oko),

mierzy się w Kelvinach (nie w „stopniach Kelvina”!). Wbrew intuicji, im wyższa

temperatura podawana w Kelvinach, tym „zimniejsze światło”. Za barwy ciepłe

przyjęło się uważać żółcie i czerwienie – gorące słońce ma przecież właśnie ten

zakres tonalny. Z kolei synonimem barwy zimnej jest niebieski. Są to oczywiście

skojarzenia czysto emocjonalne, ale na tyle powszechne, że trudno się od nich

uwolnić. Lecz kiedy chcemy zrozumieć temperaturę światła, jest to konieczne,

ponieważ tutaj jest odwrotnie.

Temperatura barwowa różnych rodzajów światła zazwyczaj ma wartość umowną, bo

nie ma przecież jednego, wzorcowego rodzaju światła słonecznego czy żarowego.

Poniższe wartości oscylują w powszechnie przyjętych granicach:

– światło żarowe: 3500 K,

– światło jarzeniowe: od 2700 K do 7200 K (białe 3700 K),

– światło słoneczne (powszechnie nazywane dziennym): 5200 K,

– światło lampy błyskowej: 5400 K,

– chmury: 6000 K,

– cień: 8000 K.

Do wyboru do koloru

W zależności od stopnia zaawansowania aparatu użytkownik ma do dyspozycji od

kilku do kilkunastu ustawień balansu bieli. Można je podzielić na trzy grupy:

- automatykę (aparat sam decyduje o ustawieniach),

- ustawienia predefiniowane (zapisane w pamięci aparatu, identyfikowane dzięki

obrazowym nazwom, np. światło dzienne, światło żarowe),

- ustawienia manualne (zarówno według wzoru, jak i możliwość wyboru temperatury

w Kelvinach).

Możliwość wyboru spośród dwóch pierwszych kategorii dają praktycznie wszystkie

aparaty cyfrowe – różnice mogą dotyczyć liczby ustawień predefiniowanych (np.

niektórzy producenci udostępniają użytkownikom nie jedną, lecz kilka opcji pracy w

świetle jarzeniówek, w zależności od ich rodzaju). Ustawienia manualne to domena

aparatów zaawansowanych, choć i wśród modeli z górnej półki widoczne są znaczne

różnice w stopniu szczegółowości i w łatwości dostępu do ustawień użytkownika.

Jedną z podstawowych zalet fotografii cyfrowej jest możliwość natychmiastowego

obejrzenia zdjęcia. A jeśli chodzi o balans bieli, najbardziej przydaje się możliwość

obserwacji obrazu na żywo na ekranie LCD, na którym użytkownik widzi wpływ

wybranych parametrów na zdjęcie – w tym również balansu bieli. Umożliwiają to

wszystkie kompakty i coraz więcej lustrzanek cyfrowych, wyposażanych zgodnie z

najnowszymi trendami w systemy podglądu na żywo. Dzięki tej funkcji łatwo

zrozumieć zależność między poszczególnymi ustawieniami predefiniowanymi a

wyglądem fotografii oraz zapamiętać, że im wyższa temperatura barwowa w

Kelvinach, tym „zimniejsze” światło.

Zaawansowane aparaty cyfrowe, zarówno kompakty z górnej półki, jak i lustrzanki,

oferują użytkownikowi możliwość zapisu zdjęć w surowym formacie RAW (każdy

producent stosuje inny sposób zapisu, stąd różne rozszerzenia plików). Zawierają

one wszystkie informacje zarejestrowane przez matrycę światłoczułą, dzięki czemu

pozwalają fotografowi przejąć rolę procesora aparatu i regulować wartość wielu

parametrów już po wykonaniu zdjęcia (w komputerze lub w aparacie), bez straty

jakości. Daje to ogromną swobodę, choćby przy równoważeniu bieli – możliwość

podjęcia decyzji w zaciszu domowym, przy komputerze, pozwala skupić się na

fotografowaniu ze świadomością, że niewłaściwie wybrane ustawienie nie zepsuje

zdjęcia.

W praktyce

W najczęściej spotykanych warunkach oświetleniowych (światło dzienne, chmury)

automatyka aparatu poradzi sobie znakomicie. Są jednak sytuacje, w których warto,

a nawet trzeba, sięgnąć przynajmniej do ustawień predefiniowanych. Tryb Auto ma

ograniczony zakres temperatur barwowych, który zazwyczaj nie obejmuje dolnych

wartości, przez co nie radzi sobie np. ze światłem żarowym. Automatyka ustawi

balans bieli tak, że zdjęcia będą miały mocną żółtą dominantę i o wiernym oddaniu

kolorów możemy zapomnieć.

Światło jest kapryśne i lubi czasem płatać figle. Nierzadko fotografujemy w

sytuacjach, w których źródeł światła jest kilka (np. dzienne, żarowe i jarzeniowe –

mówimy wtedy o świetle mieszanym), często o temperaturze barwowej z krańców

skali, przez co po prostu nie da się zrobić zdjęcia o neutralnych barwach. Czasami

można wyodrębnić główne, najmocniejsze źródło światła – wtedy ustawiamy balans

bieli z myślą o nim. Zdarza się jednak, że wszystkie źródła są tak samo silne i mają

taki sam wpływ na wygląd fotografowanej sceny. Nie ma wtedy rady – musimy

wybierać. Trzeba się zdecydować na któreś ustawienie i pogodzić z faktem, że część

zdjęcia będzie wyglądała nienaturalnie (ale czy to na pewno źle? – patrz ramka).

Ewentualnie możemy wykonać kilka zdjęć przy różnych ustawieniach i potem wybrać

to, które najbardziej przypadnie nam do gustu.

Tradycyjnie już w podsumowaniu ponownie zachęcę do brania spraw we własne ręce

i świadomego wyboru wszystkich parametrów zdjęciowych. Nie obrażajmy się na

cyfrę, że dała nam kolejne zagadnienie fotograficzne do poznania, bo wraz z nim

dostaliśmy większy wpływ na końcowy rezultat niż w czasach fotografii analogowej.

„Natychmiastowość” cyfry znacznie ułatwia naukę, więc balans bieli nie powinien

przysporzyć nam kłopotów. Wystarczy tylko chcieć.

Najwyższa precyzja

Zaawansowane modele cyfrówek pozwalają użytkownikowi dostroić ustawienia

predefiniowane do swoich upodobań. Dzięki temu nie jesteśmy ograniczeni do

założeń producenta, z którymi nie każdy musi się zgadzać. Jedne firmy umożliwiają

dokonanie zmian za pomocą narzędzi wizualnych na osiach żółty–niebieski i zielony–

purpura, inne podają po prostu wartość w Kelvinach, którą użytkownik może

zmieniać. Niektórzy producenci dają użytkownikowi do dyspozycji oba te narzędzia.

Warto pamiętać, że zasady są po to, żeby je łamać. Starając się o naturalne kolory

bez przekłamującej wygląd fotografowanej sceny dominanty barwnej, nie

zapominajmy, że fotografia to medium, które w dwóch wymiarach musi oddać całość:

nie tylko trójwymiarowość rzeczywistości, ale też nasze emocje i wrażenia związane

ze zmysłami innymi niż wzrok. Dlatego w wielu sytuacjach neutralne kolory się nie

sprawdzają. Oświetlona jarzeniówkami stacja metra będzie wyglądała znacznie

ciekawiej, jeśli sfotografujemy ją przy ustawieniu dla światła dziennego. To samo

dotyczy jednego z najczęstszych tematów fotograficznych – zachodu słońca. Nie

warto więc przesadzać z neutralnością.

Cała władza w ręce ludu

W wielu sytuacjach zdjęciowych automatyka balansu bieli nie radzi sobie, wybór

ustawienia predefiniowanego niewiele zmienia, a brakuje czasu na zabawę z

precyzyjnym dostrajaniem wartości zapisanych w pamięci aparatu. Najłatwiej i

najszybciej skorzystać wtedy z możliwości manualnego ustawienia równoważenia

bieli według wzorca. Polega to na tym, że wycelowujemy obiektyw w biały lub szary

przedmiot (ale koniecznie neutralny!, np. białą kartkę) znajdujący się w oświetleniu, w

którym fotografujemy. Po wybraniu odpowiedniej funkcji naciskamy spust migawki, a

aparat ustawia balans bieli tak, żeby przedmiot, w który wycelowaliśmy obiektyw, nie

miał dominanty barwnej. W niektórych aparatach „fotografowany” obiekt musi

wypełnić cały kadr, w innych wystarczy, że zajmie centralną część klatki. Modele z

górnej półki pozwalają zapamiętać kilka ustawień manualnych, dzięki czemu

użytkownik nie musi za każdym razem, kiedy zmienia sytuację zdjęciową, od nowa

ustawiać balansu bieli (np. kiedy fotografuje ślub i przechodzi z kościoła do domu

weselnego).

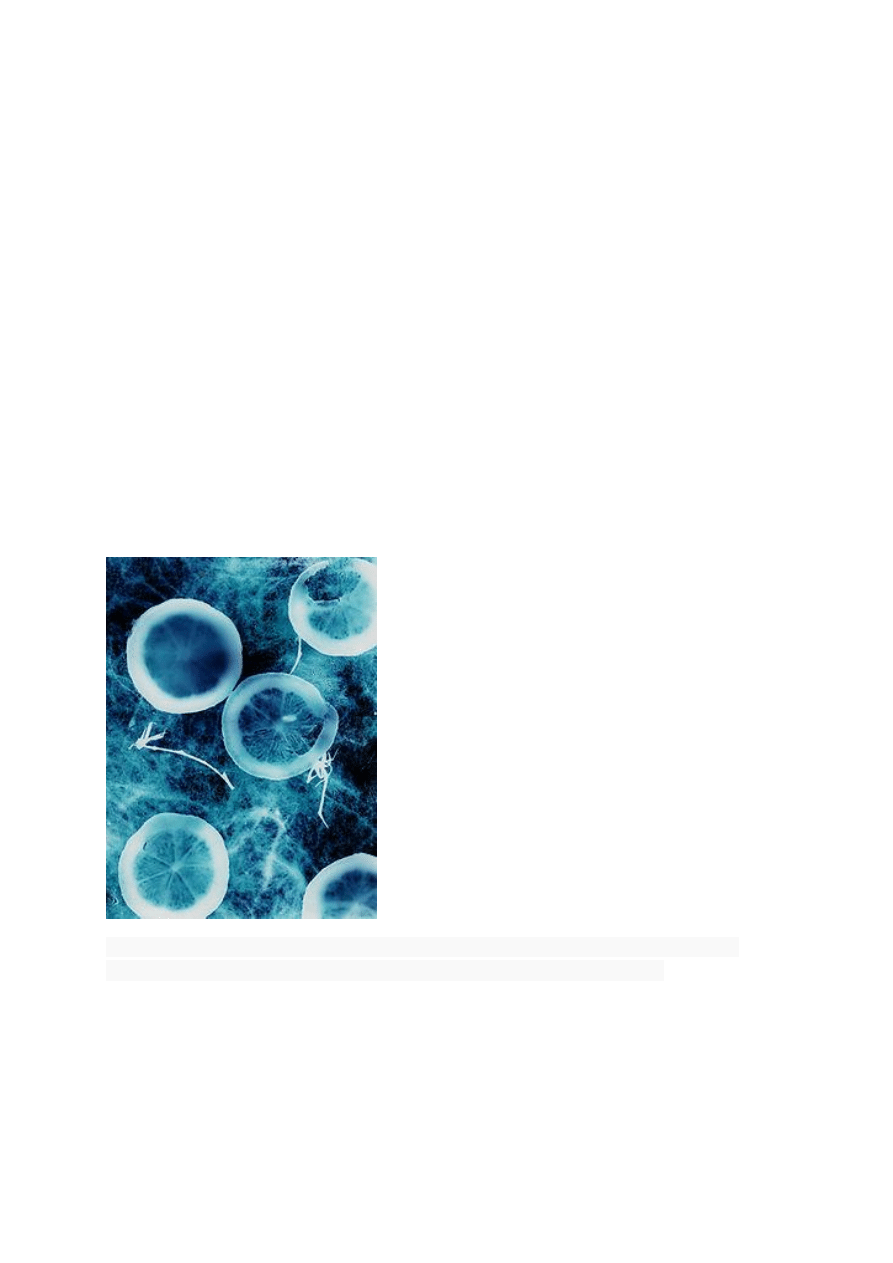

7. Co rozumiesz przez termin fotografia tradycyjna.

Fotografia tradycyjna (inaczej, chociaż nie do końca poprawnie: fotografia

analogowa, w odróżnieniu od cyfrowej) – fotografia w której nośnikiem obrazu są

chemiczne materiały światłoczułe (filmy, błony, płyty, papiery itp.). W fotografii

tradycyjnej dominuje fotografia srebrowa, czyli fotografia oparta na światłoczułych

halogenkach srebra. Do fotografii tradycyjnej zaliczają się też szlachetne techniki

fotograficzne wykorzystujące światłoczułe właściwości chromianów.

Fotografia tradycyjna ma wiele zalet w porównaniu z fotografią cyfrową. Na przykład

dla fotografii tradycyjnej na nośnikach srebrowych, wciąż zaletą pozostaje

rozdzielczość, nawet przy użyciu małego formatu. Dla przykładu, negatyw Fomapan

Creative 200 według danych producenta [1] osiąga zdolność rozdzielczą na poziomie

110 linii/mm. Oznaczałoby to przybliżony ekwiwalent 12 100 pkt obrazu na mm2

filmu. Przy rozmiarze klatki 36x24mm oznacza to w przybliżeniu 10 454 400 pkt

obrazu. Przewyższa to zdolność rozdzielczą większości współczesnych aparatów

cyfrowych, zwłaszcza że producenci tych ostatnich używają oznaczenia (w

Megapikselach) pomijając fakt, że aparaty te używają filtrów Bayera. Mamy także -

nawet w najtańszych modelach aparatów "tradycyjnych" - do czynienia z większym

obszarem światłoczułym (w aparatach cyfrowych odpowiednik to "sensor

pełnoklatkowy", dostępny tylko w profesjonalnych modelach). Dla filmu w średnim

formacie, moglibyśmy mówić o 43 560 000 pkt (43 MPix). Istnieją także materiały o

większej rozdzielczości, np. filmy Ilford.

Zalety fotografii cyfrowej

— natychmiastowy podgląd zdjęcia bez czekania na wywołanie filmu. Jeśli zdjęcie

jest nieudane, fotograf dowiaduje się o tym od razu i może spróbować ponownie,

— możliwość poprawienia bądź przekształcenia zdjęcia przed zrobieniem odbitek,

— płaci się jedynie za odbitki udanych zdjęć,

— małe koszty przechowywania dużej ilości zdjęć (jeśli pozostają w formacie

cyfrowym, a nie jako odbitki),

— zdjęcia mogą być kopiowane z jednego nośnika na drugi bez utraty jakości,

— nie ma potrzeby skanowania zdjęć przed użyciem ich w komputerze,

— możliwość wydruku własnych zdjęć na drukarce, czasami nawet bezpośrednio z

aparatu,

— aparaty cyfrowe mogą być o wiele mniejsze od aparatów tradycyjnych o

jednakowej jakości,

— możliwość dołączania do zdjęć dodatkowych danych (EXIF), takich jak data i czas

wykonania zdjęcia, model aparatu, czas naświetlania, użycie lampy błyskowej itp.

Ułatwia to przeglądanie i sortowanie zdjęć,

— profesjonalne aparaty oferują rozdzielczość porównywalną lub lepszą od aparatów

tradycyjnych,

Zalety fotografii tradycyjnej

— dłuższa żywotność baterii. Jednak niektóre współczesne aparaty cyfrowe używają

akumulatorów o bardzo dużej żywotności,

— manualne aparaty analogowe nie potrzebują baterii i są proste w konstrukcji,

przez co mogą pracować w warunkach ekstremalnych,

— filmy w aparatach tradycyjnych są ściśle ustandaryzowane i łatwe do kupienia,

podczas gdy karty pamięci mogą być niedostępne w mniej cywilizowanych rejonach,

w dodatku jest ich wiele rodzajów,

— aparaty tradycyjne nie wymagają umiejętności posługiwania się komputerem,

— w tańszych aparatach cyfrowych występuje długi czas pomiędzy naciśnięciem

spustu migawki a wyzwoleniem migawki, przez co można utracić ważny moment na

zdjęciu,

— lustrzanki cyfrowe są w tej chwili dużo droższe od ich tradycyjnych

odpowiedników, chociaż ceny szybko spadają,

— klisze filmowe oferują wciąż z reguły dużo większą rozdzielczość. Klatka 35 mm

odpowiada mniej więcej 19 megapikselom, średni format (56 mm x 56 mm) - 69

megapikselom, a duży format (8 x 10 cali) - 1135 megapikselom. Współczesne

profesjonalne lustrzanki cyfrowe mają matryce CCD o wielkości nawet 22

megapikseli.

8. Wymień przybory dodatkowe fotograficzne.

Dekielki na Obiektywy

Filtry Efektowe, Polaryzacyjne, typu Cokin, UV

Fotocele, Kostki Synchro

Karty Pamięci

Muszle Oczne

Obiektywy

Odwrotne Mocowania

Osłony LCD

Osłony Przeciwsłoneczne

Paski i Gripy

Pierścienie Pośrednie

Piloty na Podczerwień

Piloty Radiowe

Przewody

Redukcje Filtrowe

Tuleje Redukcyjne

Wężyki Spustowe

Zestawy Czyszczące

Zewnętrzne lampy błyskowe

Torby, Futerały, Plecaki

Statywy

Obudowy podwodne

Blendy

Parasolki

Dyfuzory

Gripy

9. Czym się różni ISO w analogowym aparacie od ISO w cyfrowym

aparacie.

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

…………………………………………………………………………………………………

10. Opisz kilka rodzajów perspektywy.

Rzadko zdarza się, abyśmy w każdej sytuacji patrzyli na świat wyłącznie w jeden

sposób. Zmiana perspektywy to doskonała metoda aby ujrzeć rzeczy w nowym

świetle. Podobnie ma się rzecz z fotografią – nietypowe uchwycenie rzeczywistości

pozwala wyodrębnić z niej na zdjęciach zupełnie nowe elementy. Umożliwiają to

między innymi różne rodzaje punktu widzenia, które opisujemy w niniejszym

poradniku.

Od kiedy w sztukach plastycznych człowiek zaczął poszukiwać sposobu na oddanie

przestrzeni na dwuwymiarowym dziele sztuki (w nowożytnej Europie moment ten

przypadł na schyłek średniowiecza), idealne odwzorowanie perspektywiczne stało się

"świętym Grallem" artystów malarzy. O jednym z wybitnych twórców tamtych czasów,

Paolo Uccello (1396-1475) krąży nawet anegdota, że w swoich (dziś

powiedzielibyśmy, że nieco naiwnych) studiach nad perspektywą posunął się tak

daleko, że zaniedbał własną żonę.

Fotografia nie stawia przed swoimi twórcami takich wymogów – prawa fizyki i

matematyczne reguły rzutowania przestrzennego obrazu na płaszczyznę wykonują

za nas "krecią robotę" w dziedzinie odwzorowywania na zdjęciu fotografowanej

rzeczywistości. Jednak znajomość pewnych reguł kompozycyjnych związanych z

perspektywą pozwala w prosty sposób bardzo urozmaicić wykonywane przez nas

zdjęcia.

Okiem człowieka, ptaka i żaby

W zależności od tego, jaką pozycję przyjmiemy wraz z aparatem w stosunku do

fotografowanego obiektu, możemy mówić o różnych rodzajach perspektywy. Jeżeli

nie zmieniając własnego położenia będziemy opuszczać, lub zadzierać obiektyw,

będziemy mieli do czynienia z trzema punktami widzenia: perspektywą ludzką

(normalną), ptasią oraz żabią.

Pierwszy typ perspektywy zazwyczaj nie jest nazywany w żaden sposób – na

potrzeby tego artykułu nazywać będziemy ją normalną lub ludzką. Jest to najczęstszy

sposób robienia zdjęć, który nie wymaga od fotografującego praktycznie niczego,

poza prostym trzymaniem aparatu. Sposób prezentacji przestrzeni na zdjęciu

wykonanym w perspektywie normalnej praktycznie nie różni się od naszego

codziennego sposobu postrzegania świata (o ile oczywiście fotografujący nie stosuje

żadnych innych zabiegów czyniących zdjęcie nietypowym – np. nie używa obiektywu

ultra szerokokątnego).

Perspektywa normalna jest więc fotograficznym narzędziem dokumentującym, gdyż

umożliwia zarejestrowanie obrazu pozbawionego zniekształceń, możliwości

różnorodnej interpretacji. Jednym słowem jest to narzędzie kronikarskie, a zarazem

dość bezpieczne w użyciu. Większość naszych zdjęć powstaje właśnie z tego punktu

widzenia i nie ma w tym nic dziwnego ani tym bardziej nagannego. Czasem jednak

możemy zechcieć przedstawić rzeczy nie takimi jakie są, lecz takimi jakimi chcemy,

aby się wydawały. Wówczas możemy sięgnąć po jeden z dwóch pozostałych

punktów widzenia.

Z perspektywą żabią mamy do czynienia wówczas, gdy zadzieramy aparat w górę i

fotografujemy obiekt lub osobę znacznie od nas wyższą lub wyżej umieszczoną. W

efekcie przedmiot lub żywa istota będąca tematem zdjęcia wydają się większe oraz

nabierają wrażenia siły i dostojeństwa – niezależnie od tego, jak duże są w

rzeczywistości.

Zabieg ukazywania ważnych miejsc i postaci od dołu w żabiej perspektywie

wykorzystywany jest bardzo często w kinie. Użyty na szeroką skalę po raz pierwszy

przez Orsona Wellesa w legendarnym już obrazie pt. "Obywatel Kane" z 1941 roku

stał się stałym elementem języka filmu.

Perspektywa ptasia daje – jak można się łatwo domyślić – zupełnie przeciwne do

żabiej efekty. Sfotografowane w ten sposób przedmioty oraz ludzie wydają się

mniejsi oraz "wciśnięci" w tło. Zabieg ten można wykorzystać wówczas, gdy zależy

nam na ukazaniu wielkości świata wobec fotografowanej osoby. W perspektywie

ptasiej doskonale można też przedstawić interakcję ludzi lub przedmiotów z

otoczeniem z uwagi na fakt, iż przy perspektywie tego typu tło jest bardzo istotne dla

kompozycji sceny.

Niestety, ptasi punkt widzenia jest bardzo często niewłaściwie stosowany przez

nieświadomych tego rodziców fotografujących swoje pociechy z wysokości swojego

wzroku. Małe dzieci uwiecznione w ten sposób są niejako "wyciągane" ze swojego

naturalnego środowiska, tego co je cieszy i interesuje. Aby oglądający fotografie

maluchów nie musieli "patrzeć na dzieci z góry", warto podczas robienia zdjęć

ustawić się z aparatem na wysokości wzroku małego modela – ten punkt widzenia,

nazywany czasem "psią perspektywą" opisujemy w dalszej części.

Praktyczne przykłady wykorzystania nietypowej perspektywy

Oczywiście punkty widzenia żaby i ptaka mogą pomysłowym fotografom posłużyć nie

tylko w celu pozornego powiększenia lub pomniejszenia głównego tematu zdjęcia. Po

osiągnięciu pewnej wprawy w stosowaniu tych technik możemy się pokusić o ich

twórcze wykorzystanie w celu uzyskania zupełnie niebanalnych kompozycji

fotograficznych. Poniżej przedstawiamy kilka takich przykładów wraz z ich krótkimi

omówieniami.

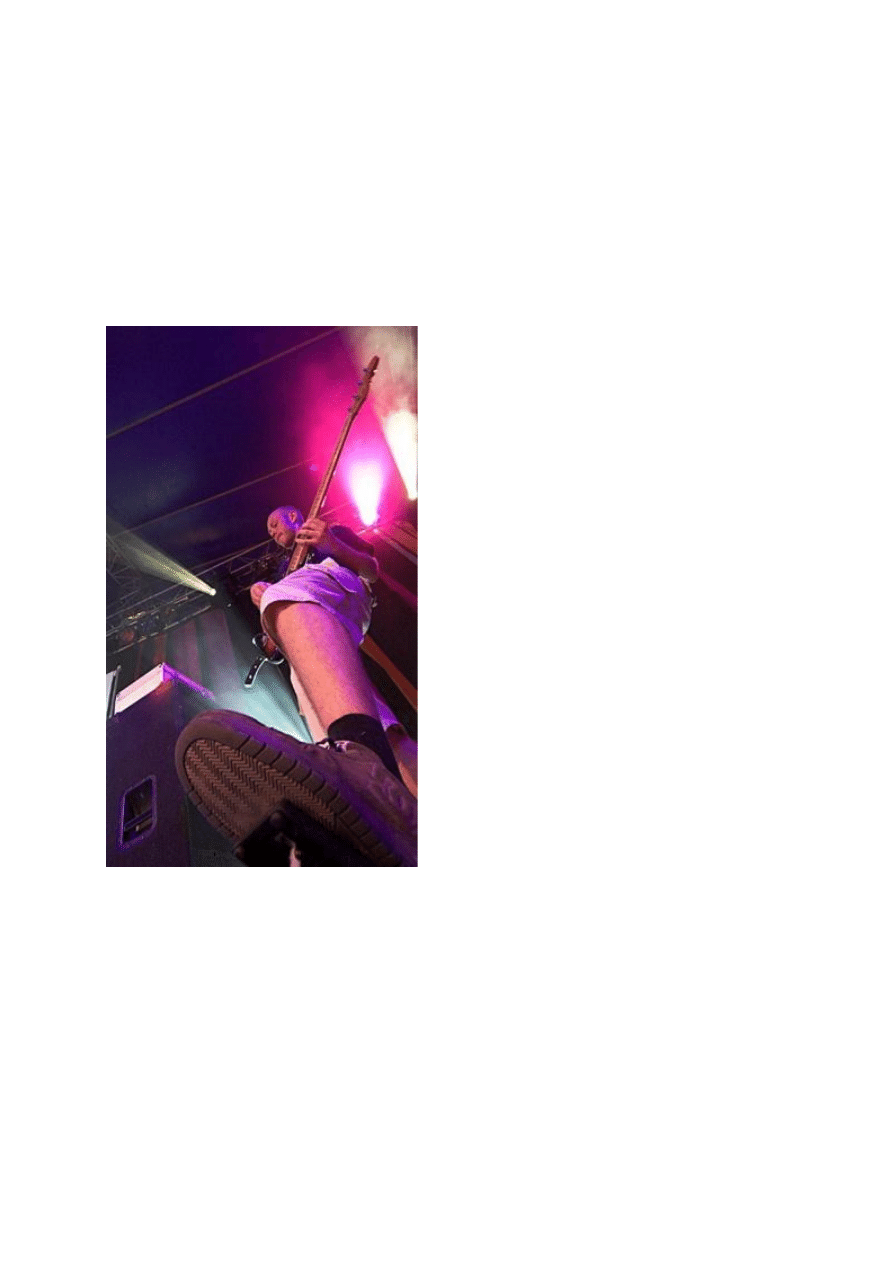

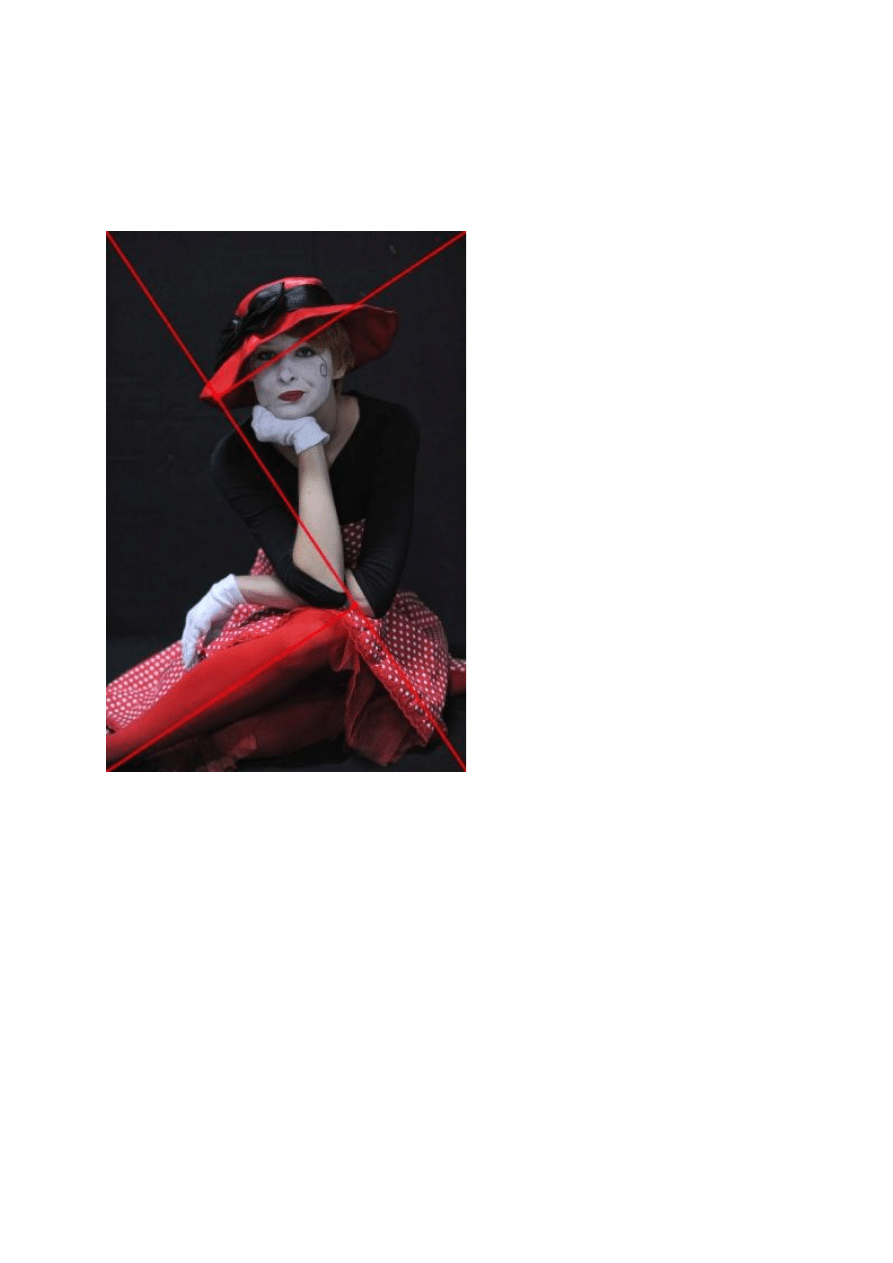

To zdjęcie, wykonane podczas koncertu zespołu Digit-All-Love w trakcie festiwalu

Wrocław Non Stop dnia 26 czerwca 2006 roku to przykład wykorzystania dość

szokującej kombinacji dwóch elementów – żabiej perspektywy oraz szerokiego kąta

widzenia (ogniskowa 19 mm w przeliczeniu na mały obrazek) – w celu zwiększenia

dynamiki zdjęcia reportażowego. Wykonanie samej fotografii z pewnością nie

należało do łatwych (wymagało wejścia na scenę w trakcie trwania koncertu), jednak

wysiłek i niecodzienny zabieg zaowocował uzyskaniem doskonałego ujęcia.

O efektach ubocznych zadzierania nosa

Za każdym razem, gdy odchylamy aparat w górę lub w dół, bądźmy świadomi

konsekwencji, jakie to ze sobą niesie. Jedną z nich jest zmiana linii zbiegu

perspektywy ujęcia. Ma to szczególne znaczenie podczas fotografowania

architektury – jeżeli bowiem nawet w niewielkim stopniu odchylimy aparat w górę (np.

aby zmieścić w kadrze całą fasadę budynku), wówczas okaże się, że fotografowany

obiekt na zdjęciu jest przechylony. Efekt ten będzie tym większy, im szerszy był kąt

widzenia aparatu w momencie wykonywania zdjęcia.

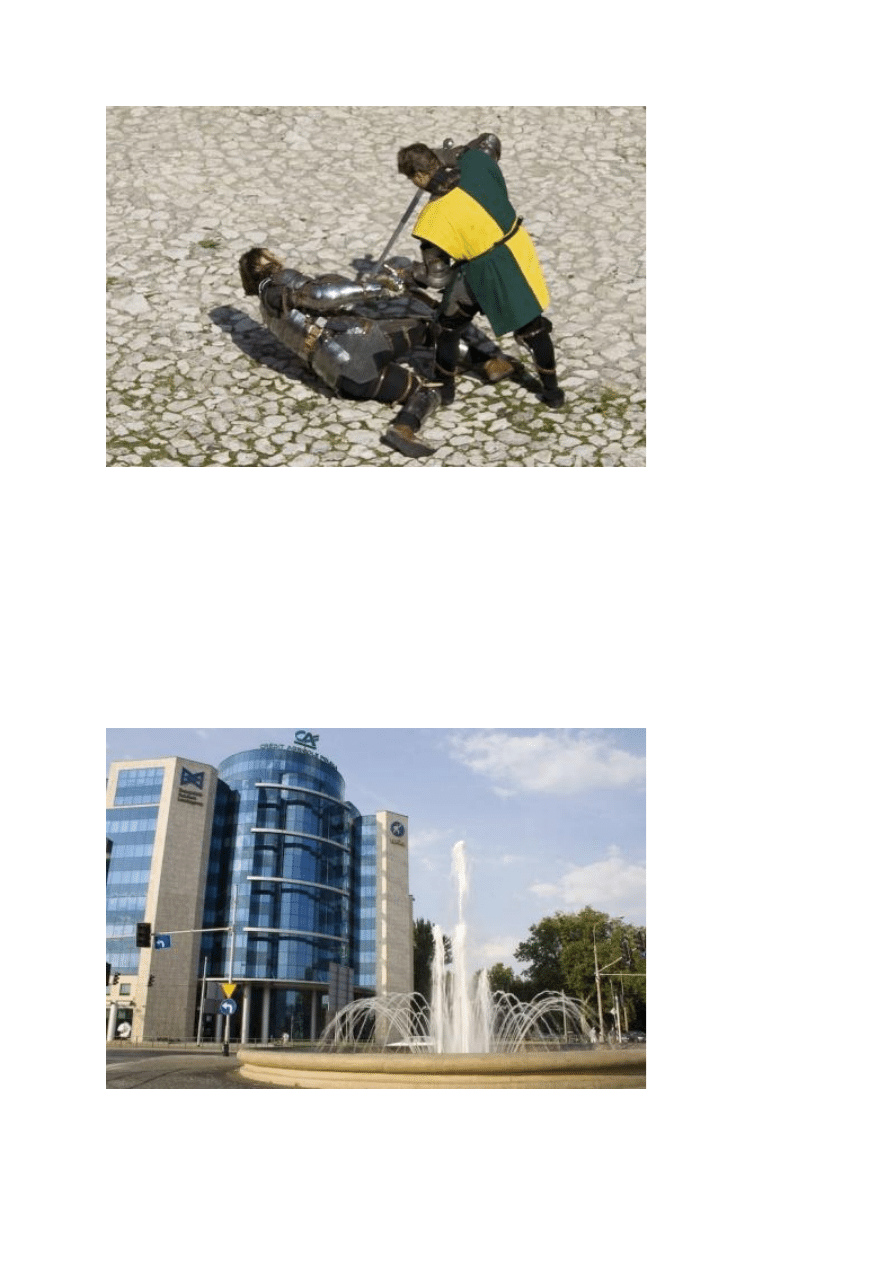

Aby zmieścić w kadrze cały biurowiec z widoczną na pierwszym planie fontanną

fotograf wykonał zdjęcie pod niewielkim kątem w górę. W efekcie uzyskał on zdjęcie

dziwacznie przechylonego budynku.

Jeżeli spotka nas taki problem, możemy spróbować go rozwiązać poprzez korektę

perspektywy w programie graficznym. Znacznie lepszym rozwiązaniem będzie

jednak wykonywanie zdjęć architektury zgodnie z zasadami sztuki – dbając o

prawidłowe położenie aparatu podczas kadrowania. A jeżeli mamy kłopoty z

ustawieniem właściwego kadru bez zadzierania obiektywu, najlepszym rozwiązaniem

jest… cofnięcie się o kilkanaście metrów lub (jeżeli jest to możliwe) wykonanie

zdjęcia z wyżej położonego punktu, np. balkonu lub dachu stojącego nieopodal

budynku.

Zniżyć się do poziomu modela

Jak wspomniałem już na początku tego artykułu, oprócz perspektywy normalnej,

żabiej i ptasiej istnieje jeszcze jeden punkt widzenia, który bywa szczególnie

przydatny podczas fotografowania dzieci i małych zwierząt. Bywa on czasem

nazywany "perspektywą psa". Najogólniej mówiąc fotografowanie z perspektywy psa

polega na silnym obniżeniu aparatu poprzez kucnięcie lub wręcz położenie się na

podłodze lub ziemi tak, aby znaleźć się na tej samej wysokości, co nasz model.

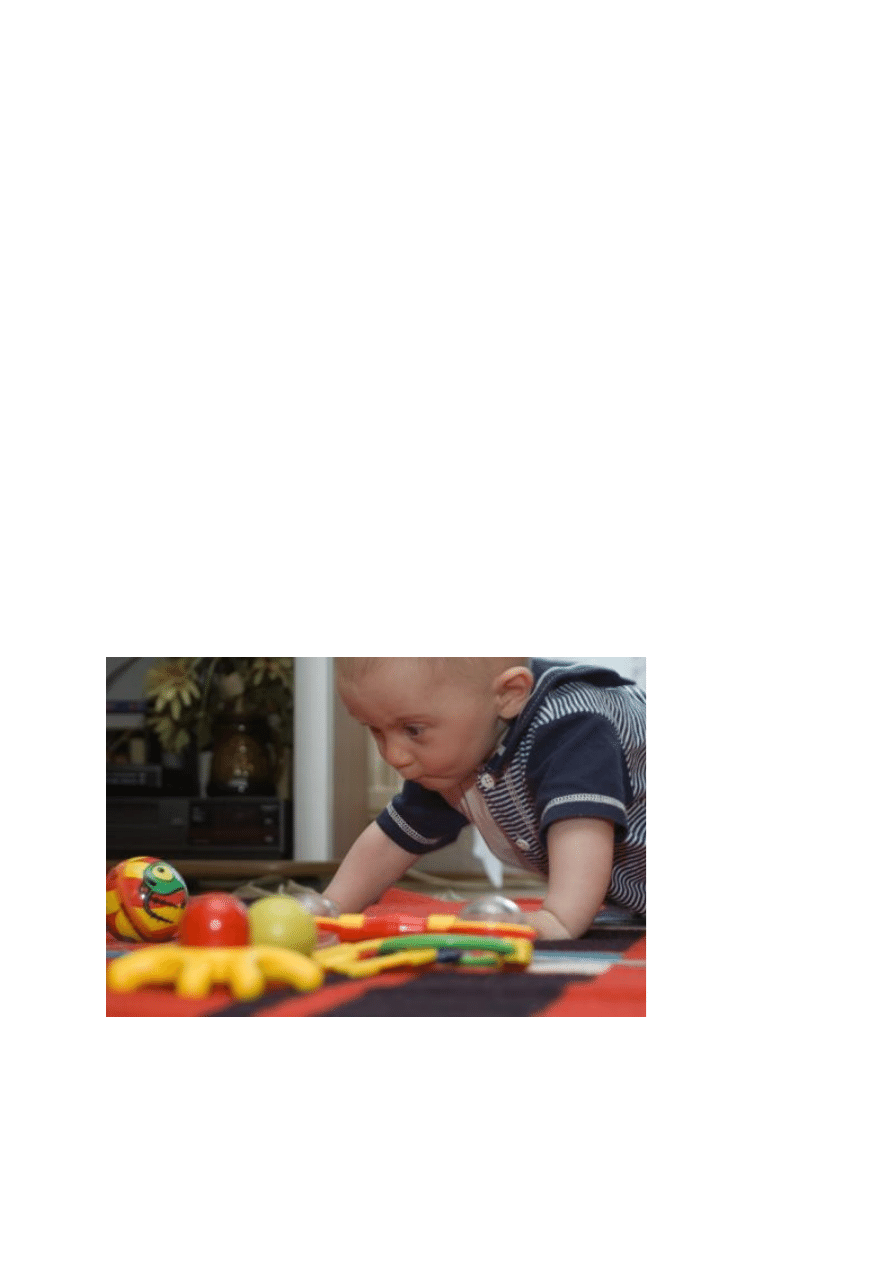

Fotografując dziecko z wysokości dla niego naturalnej uzyskano doskonałe ujęcie

przedstawiające malucha podczas zabawy.

Perspektywa "z oczu dziecka" jest jednym z najczęściej niedocenianych sposobów

na uwiecznienie malucha w jego naturalnym środowisku i ukazanie świata takim, jaki

może je on widzieć na co dzień. Stosujmy ją robiąc jak najwięcej zdjęć na wysokości

naszego małego modela, zamiast z góry. Jest to przy okazji doskonała okazja do

nawiązania jeszcze bliższego kontaktu z dzieckiem, z której warto korzystać zawsze

– nie tylko wówczas, gdy chcemy uzupełnić rodzinny album ze zdjęciami.

Na koniec

Perspektywa to jeden z wielu – obok kolorystyki, kompozycji, właściwie dobranego

tematu i innych – elementów w zasadniczy sposób wpływających na jakość naszych

fotografii. Z całą pewnością nie należy się ograniczać tylko do jednej, najprostszej i

najbardziej naturalnej. Jednak, jak wszystkie inne zabiegi fotograficzne, stosowanie

perspektywy powinno być uzasadnione treścią zdjęcia. Zanim więc postanowimy

zaszokować świat różnorodnością naszych prac, najpierw poćwiczmy i nabierzmy

wprawy w praktycznym stosowaniu świeżo nabytej wiedzy. Życzę powodzenia w

pierwszych i kolejnych próbach oraz setek udanych zdjęć wykonanych z wielu

punktów widzenia.

11. Podaj najważniejsze zasady poprawnej kompozycji obrazu.

Robienie zdjęć nie polega tylko na wycelowaniu obiektywu we właściwą stronę i

naciśnięciu spustu migawki. Udana fotografia powstaje w naszej głowie jeszcze

zanim podniesiemy aparat do oka. Jednym z najważniejszych elementów dobrego

zdjęcia jest jego kompozycja. Bardzo istotnym jej aspektem jest z kolei

rozmieszczenie w kadrze elementów istotnych dla fotografowanego tematu.

Jak to się dzieje, że pewne kompozycje fotograficzne wydają się nam harmonijne i

odpowiednie dla przedstawianego tematu (bardziej statyczne lub dynamiczne w

zależności od potrzeb), a inne przypadkowe i nieuporządkowane? Sposób, w jaki

odbieramy zdjęcia nie jest – jak się okazuje – kwestią przypadku. Choć może się to

wydawać niezwykłe jest on również w bardzo niewielkim stopniu regulowany naszymi

indywidualnymi cechami osobowymi. Za percepcję zdjęć, podobnie jak obrazów,

rzeźb i innych dzieł sztuk wizualnych, odpowiada u nas bowiem mechanizm, u

podstaw którego leżą bardzo proste prawa.

Przez wieki rozwoju wrażliwości estetycznej człowieka u podstaw tego procesu leżało

podpatrywanie natury. Ta ostatnia zaś pod tym względem okazała się być tak

konsekwentna, że już w starożytności podjęto udane próby opisania „przepisu natury

na piękno” za pomocą języka matematyki i geometrii. Stworzone wówczas reguły

odnaleźć można również u podstaw wszystkich udanych kompozycji fotograficznych.

Mocne punkty i linie kadru

Wykonując zdjęcie jakiegoś przedmiotu, zwierzęcia lub osoby, zazwyczaj

umieszczamy interesujący nas obiekt w centrum kadru. Robimy to odruchowo –

ponieważ tak jest wygodniej, ponieważ autofokus wielu aparatów zwykle działa

najlepiej w tym właśnie punkcie, a także ponieważ wydaje się to nam właściwe.

Tymczasem centrum kadru nie jest ani jedynym, ani najwłaściwszym punktem na

zdjęciu.

Czy kiedykolwiek, oglądając telewizję, zastanawialiście się, dlaczego logo stacji

umieszczone jest w narożniku (najczęściej jednym z górnych) ekranu? Wbrew

pozorom nie jest to bowiem spowodowane chęcią właścicieli stacji, aby statyczny

obrazek jak najmniej rzucał się w oczy. Wręcz przeciwnie! Narożniki te, to jedno z

miejsc, na które wzrok oglądającego pada w pierwszej kolejności po włączeniu

telewizora – tzw. mocny punkt.

W przypadku zdjęcia (podobnie jak w przypadku każdego innego dwuwymiarowego

obrazu) mocne punkty kadru to miejsca, w którym znajdujące się fotografowane

obiekty wywierają na oglądającego najsilniejszy wpływ. Odpowiednie wykorzystanie

dwóch lub więcej mocnych punktów pozwala uzyskać wyraziste zdjęcie o harmonijnej

kompozycji. Ignorując ich istnienie oraz nie dbając o równowagę w rozmieszczaniu

obiektów w kadrze nie osiągnie się udanej fotografii. Jak już zapewne zdążyliście się

domyślić, centrum fotografii niekoniecznie musi być mocnym punktem kadru.

Osobną, równie ważną sprawą są tzw. mocne linie kadru. Na większości zdjęć

można wyznaczyć ważne dla obrazu linie. Mogą być one rzeczywiste (np. fasada

budynku, linia horyzontu, pasy na jezdni), jak i wirtualne (takie jak linia wzroku

modelki, czy linie łączące uwiecznione osoby pozostające ze sobą w określonych

relacjach). W niemal każdym ujęciu, nad którym fotograf pomyślał dłużej niż

kilkanaście sekund, można wyznaczyć co najmniej kilka istotnych linii.

W wielu zdjęciach linie tworzące kadr są widoczne w sposób dosłowny – w tym

przypadku są to pobocza drogi, pasy na jezdni oraz horyzont. Nie jest to jednak

regułą, ponieważ bardzo często linie kadru nie są obecne na zdjęciu wprost.

Ważne jest, aby linie te pokrywały się z przebiegiem tzw. mocnych linii kadru, na

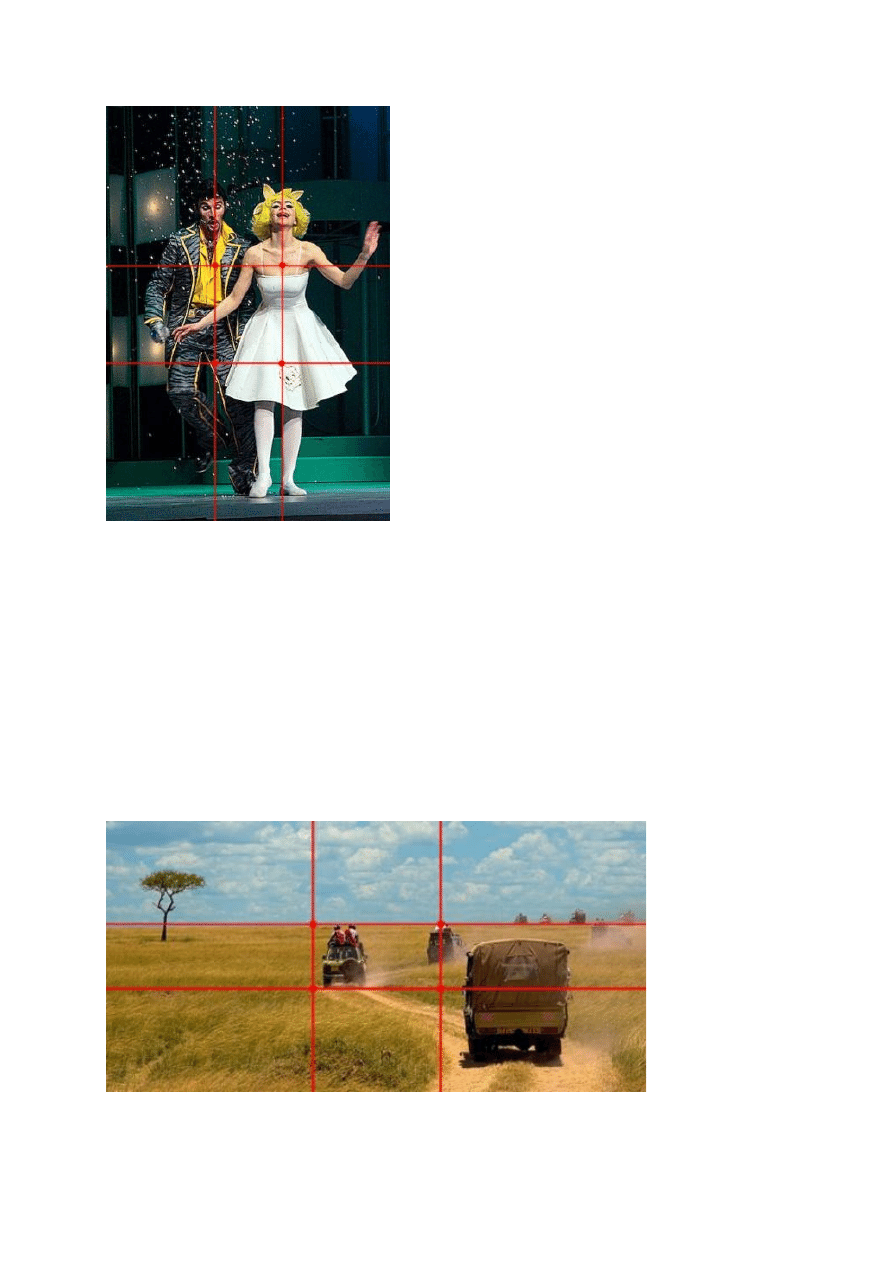

których przecięciu powstają mocne punkty. Linii takich jest bardzo wiele i mogą być

wyznaczane zgodnie z rozmaitymi regułami. Pewne układy mają charakter bardziej

dynamiczny, inne służą "uspokojeniu" obrazu, a jeszcze inne sprawiają, że kadr

"zapętla się" w sobie i w hipnotyzujący sposób przykuwa naszą uwagę. Jak łatwo

można się domyślić, nie każdy układ mocnych linii i mocnych punktów nadaje się do

skomponowania zdjęcia, o którym aktualnie myślimy.

Zarówno mocne linie jak i mocne punkty kadru nie istnieją przypadkowo. Ich

położenie wyznaczają prawa, które – jak wspominałem już wcześniej – nasi

przodkowie sformułowali po raz pierwszy ponad 2500 lat temu. A dokonali tego

obserwując piękno i harmonię natury.

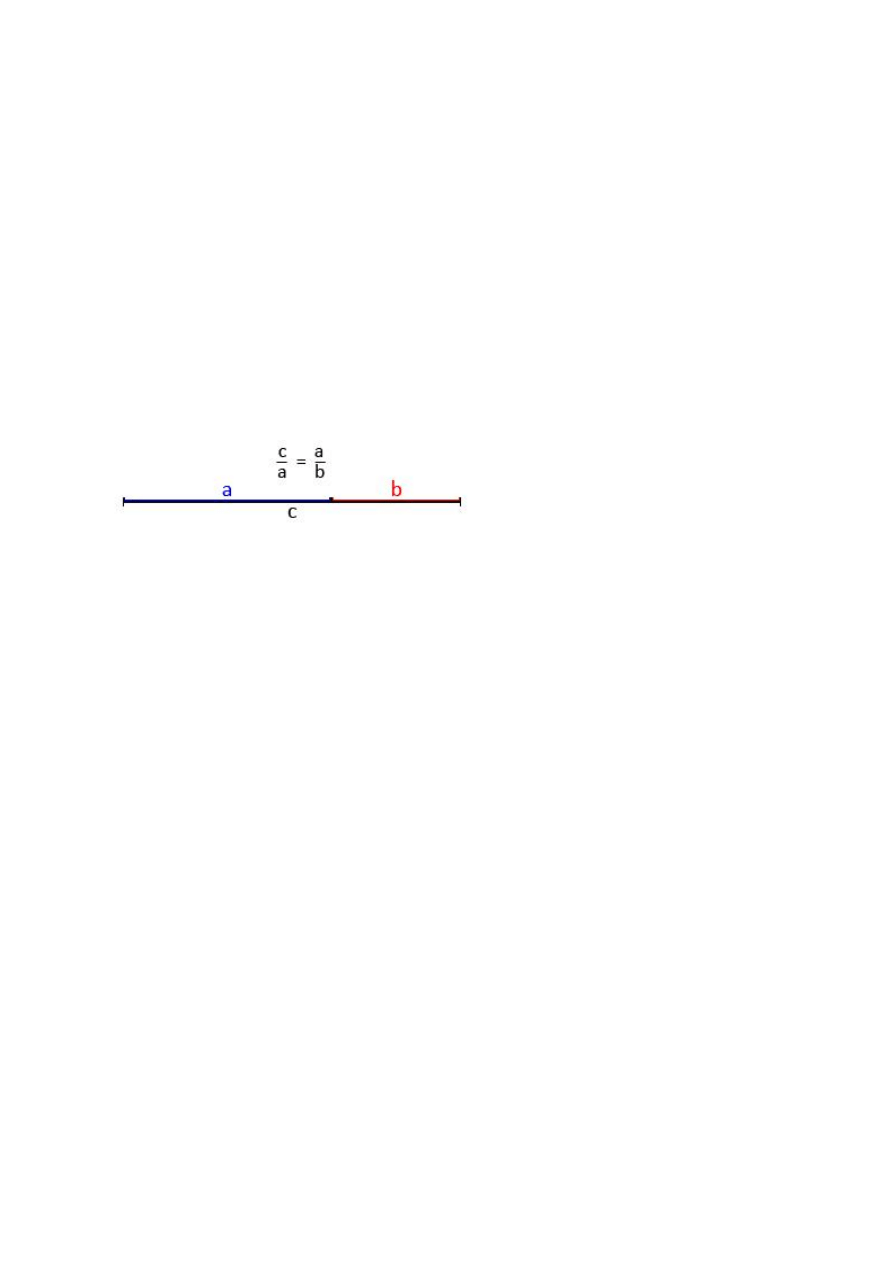

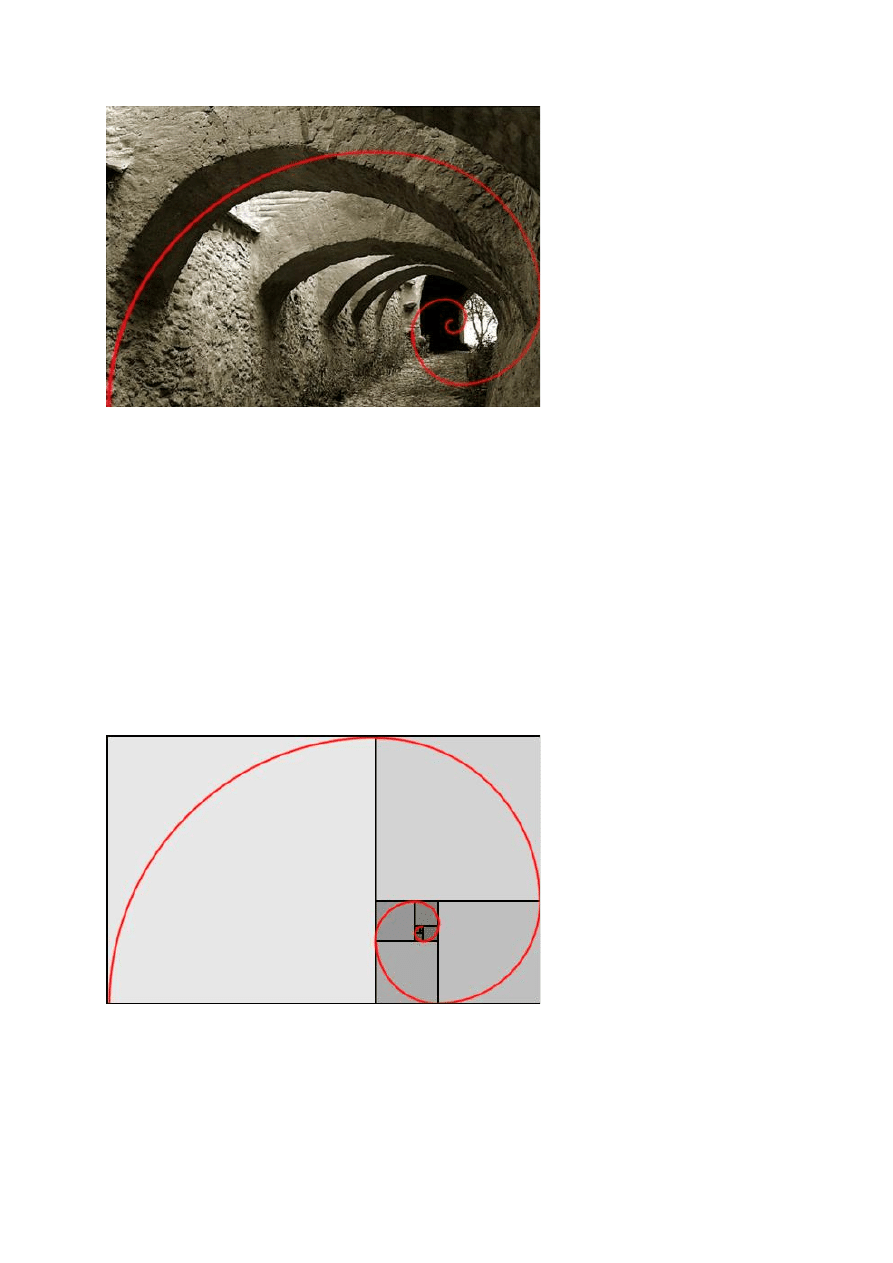

Złoty Podział

Pierwsza i najważniejsza reguła kompozycyjna nosi nazwę złotego podziału

(ang. Golden Sections) lub boskich proporcji (ang. Divine Proportions). Została

sformułowana po raz pierwszy w starożytnej Grecji a jej opracowanie przypisuje się

Pitagorasowi lub jego uczniom. Wiadomo jedynie, że Złota Reguła została

matematycznie opisana przez Euklidesa. Według tego opisu ze złotym podziałem

mamy do czynienia wówczas, gdy długość odcinka podzielonego na dwie nierówne

części pozostaje w stosunku do części dłuższej w takich samych proporcjach, jak

część dłuższa do krótszej. Ów złoty stosunek wynosi w przybliżeniu 1,618.

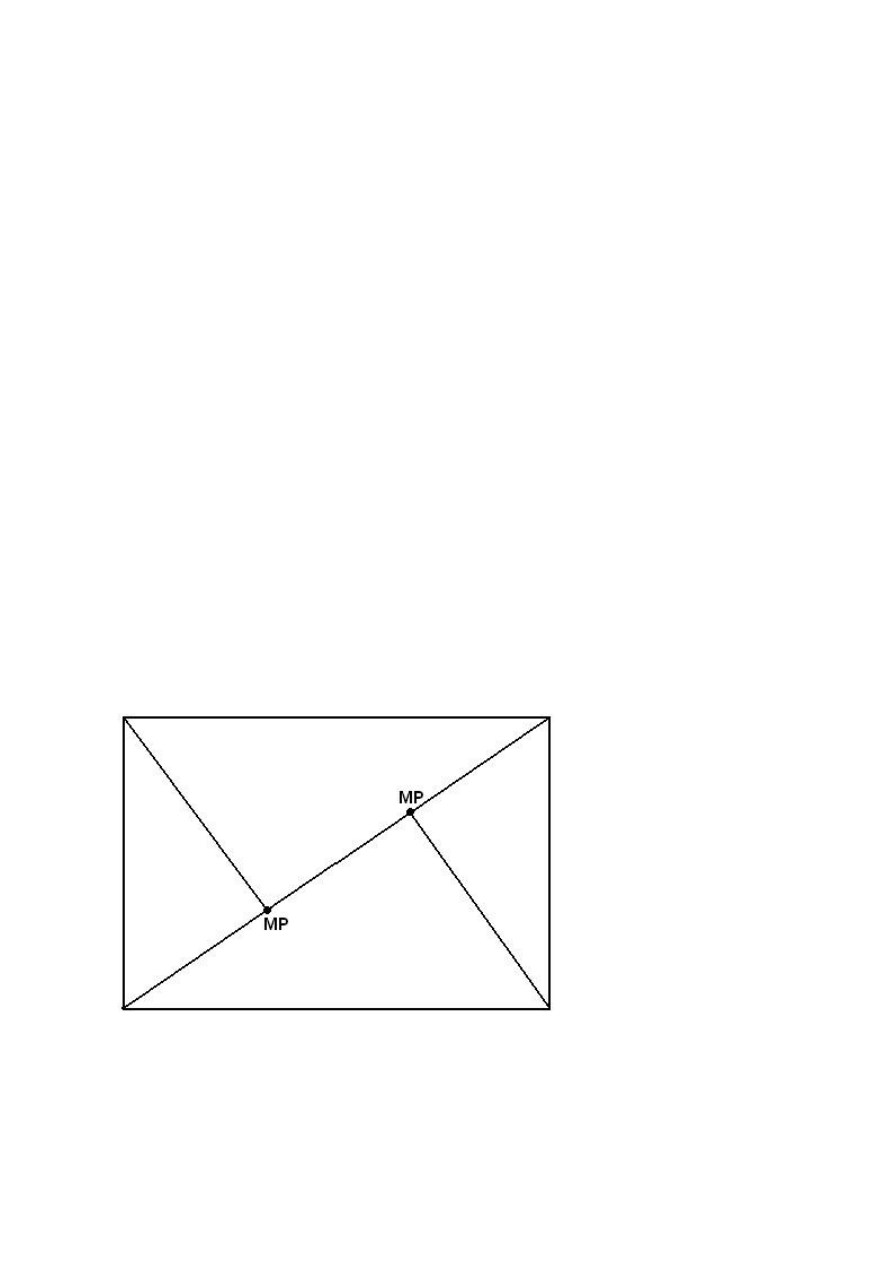

Jeżeli zgodnie z tą regułą podzielimy czterema liniami prostokąt wyznaczający kadr

zdjęcia, otrzymamy tzw. siatkę złotego podziału wyznaczającą cztery mocne punkty

kadru. Znajdują się one dość blisko centrum zdjęcia, jednak są też od niego wyraźnie

odsunięte. Takie ułożenie obiektów w kadrze pozwala silnie zaakcentować związek

między nimi, a jednocześnie czyni zdjęcie harmonijnym – jeżeli tylko zadbamy, aby

obiekty te wzajemnie się uzupełniały.

W grupowych zdjęciach skomponowanych z zastosowaniem reguły złotego podziału

fotografowane osoby zazwyczaj znajdują się bardzo blisko siebie.

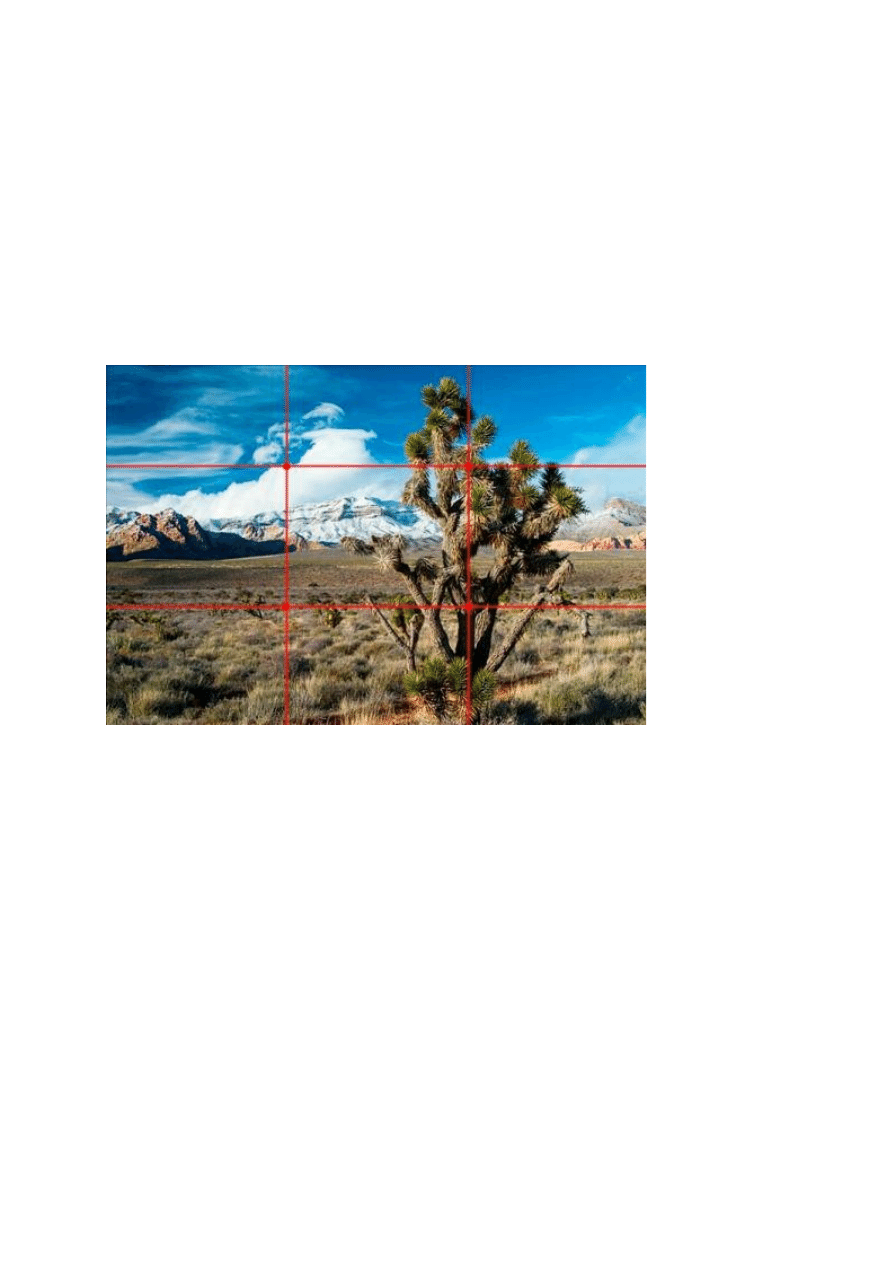

Poziome linie złotego podziału kadru to również dobra lokalizacja dla umiejscowienia

linii horyzontu. Efektem takiej kompozycji krajobrazu jest zdjęcie przypominające do

złudzenia klatkę z filmu – zwłaszcza, jeżeli obraz ma proporcje typowe dla filmu

kinowego (panoramiczne). Najlepsze efekty daje jednak wykorzystanie złotego

podziału w kadrach o proporcjach boków wyznaczonych przez tę samą regułę – czyli

zbliżonych do najczęściej spotykanego w cyfrowych lustrzankach standardu 3:2

(więcej na ten temat piszemy w dalszej części tekstu).

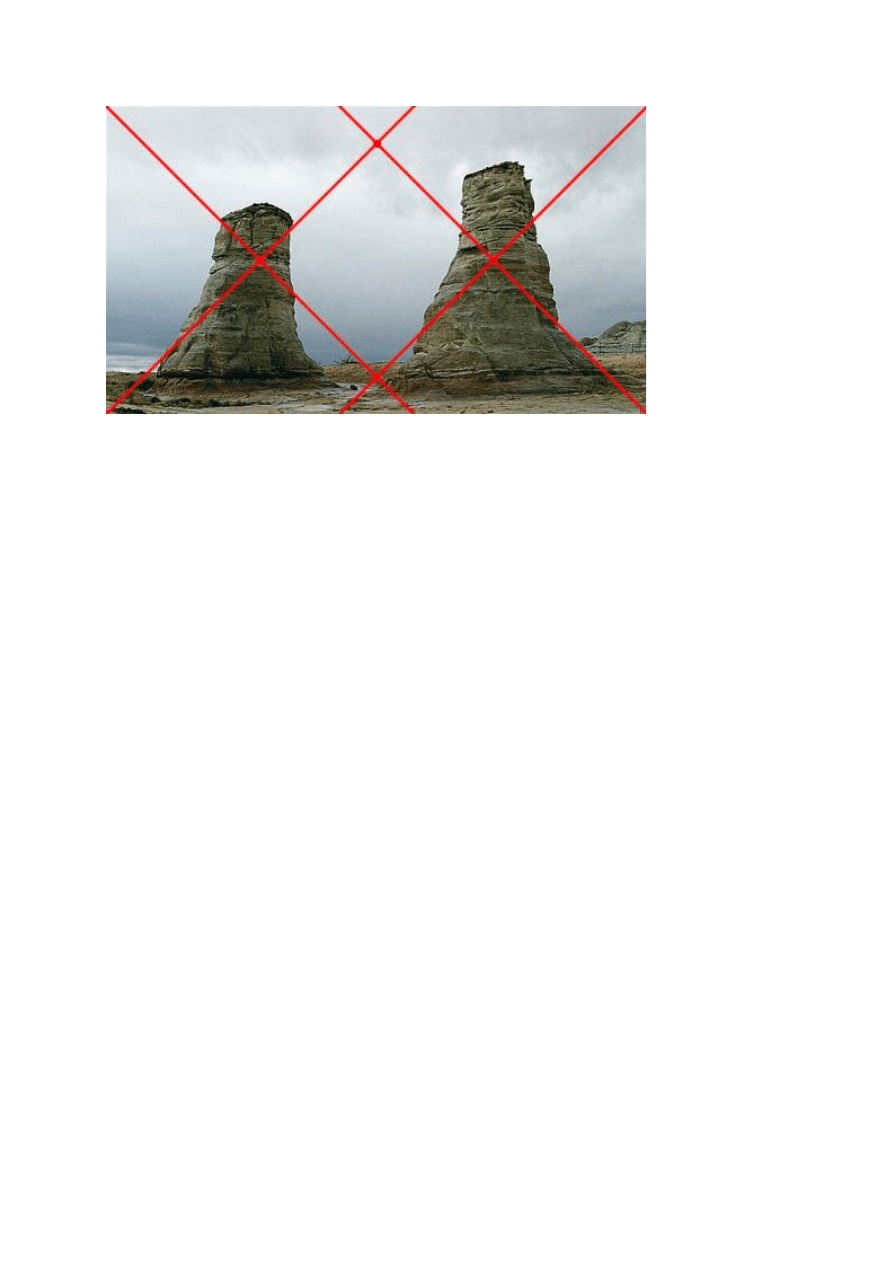

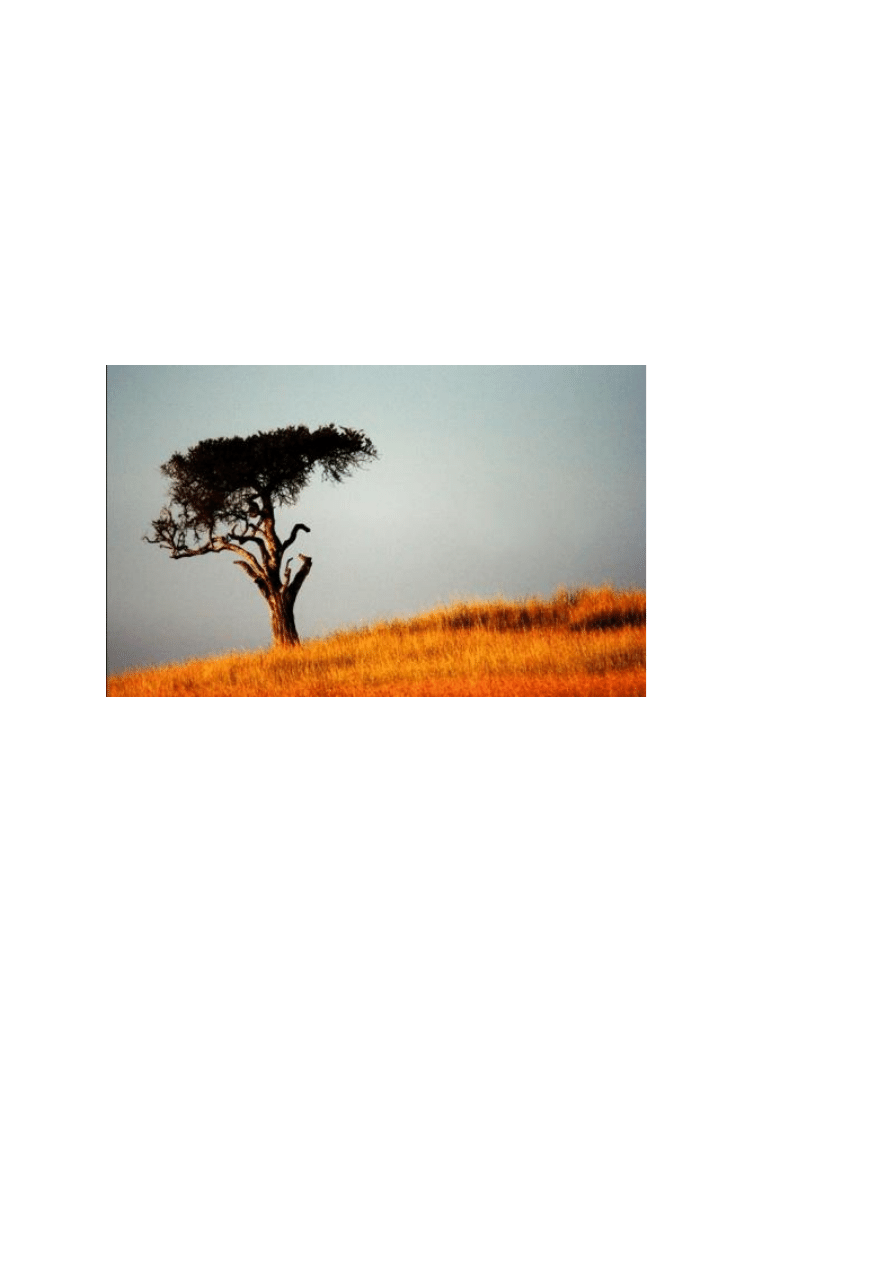

Ujęcie o bardzo filmowym charakterze. Położenie horyzontu wyznacza jedna z linii

złotego podziału.

Można nieco uprościć

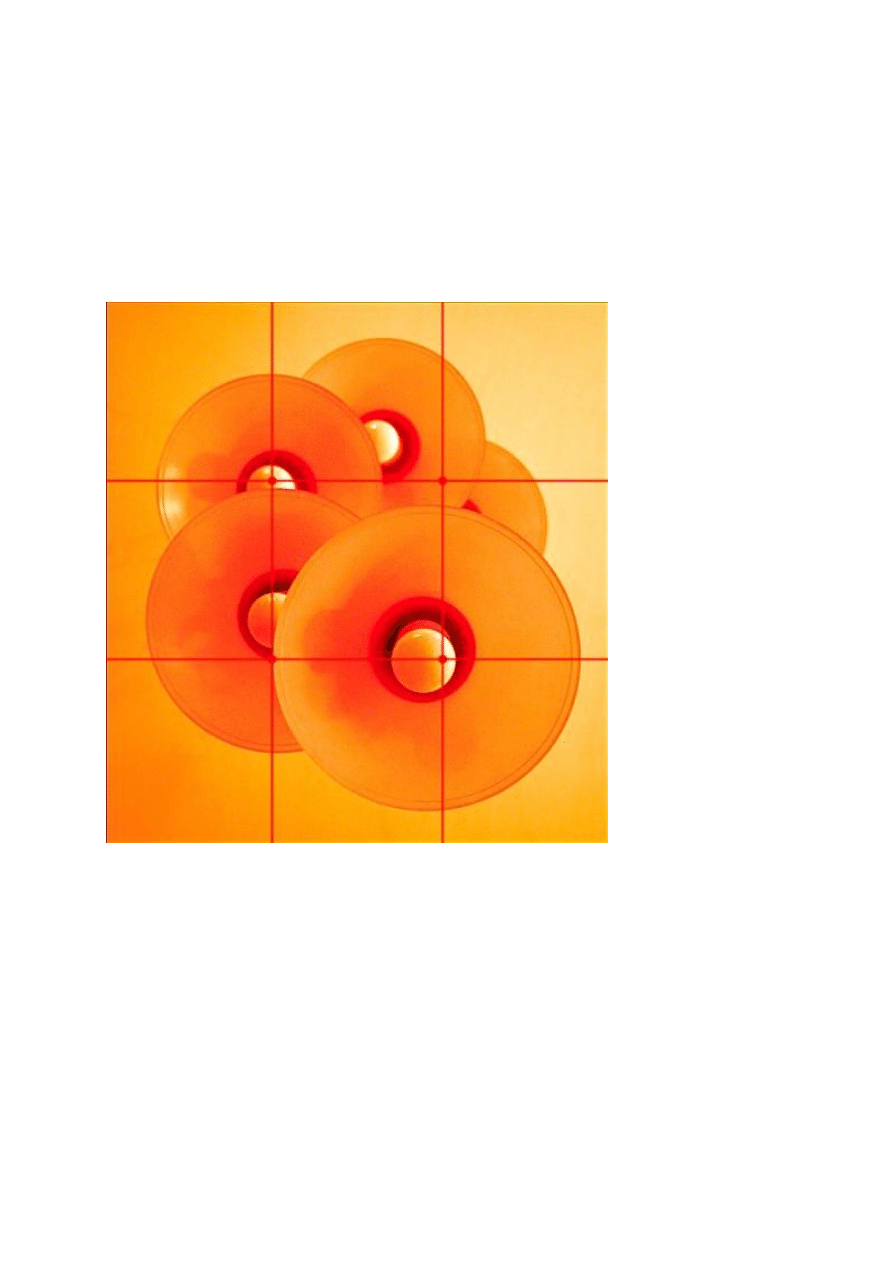

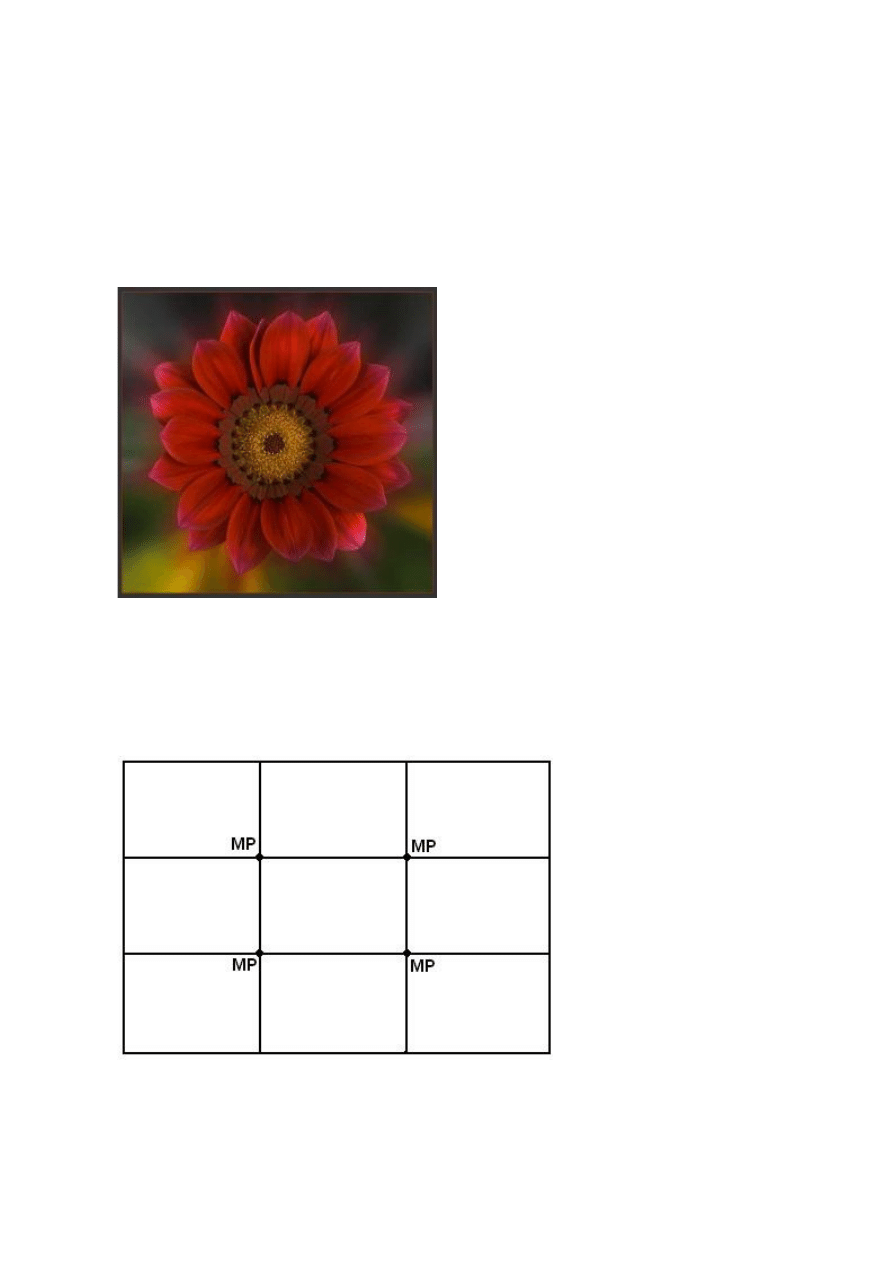

Pewnym przybliżeniem złotego podziału, łatwym do zastosowania praktycznie w

każdych warunkach, jest tzw. trójpodział. Polega on na prostym podzieleniu kadru

na trzy równe części pionowe i trzy poziome. W efekcie otrzymujemy układ dzielący

kadr na dziewięć części, z czterema mocnymi liniami i czterema mocnymi punktami.

Choć ich położenie odbiega od tego, co wynika z zasady złotego podziału, to reguła

ta sprawdza się znakomicie praktycznie w każdym rodzaju fotografii.

Trojpodział jest regułą kompozycji podobną do złotego podziału, ale prostszą w

użyciu.

Trójpodział jest najczęściej stosowaną z fotografii techniką kompozycyjną, zwłaszcza

przez początkujących fotografów. Wiele aparatów cyfrowych – zarówno prostych, jak

i zaawansowanych – umożliwia wyświetlenie pomocniczej siatki geometrycznej

jeszcze podczas wykonywania zdjęcia i najczęściej jest to właśnie siatka trójpodziału.

Wśród użytkowników lustrzanek cyfrowych popularne są z kolei wymienne matówki z

naniesionymi liniami wyznaczającymi tego typu mocne punkty kadru. Oczywiście

dotyczy to modeli, w których matówkę można wymienić w sposób w miarę

bezproblemowy, choć w Internecie można znaleźć firmy, które oferują wymianę

matówki również w modelach, w których nie przewidziano takiej możliwości (np. Katz

Eye Optics).