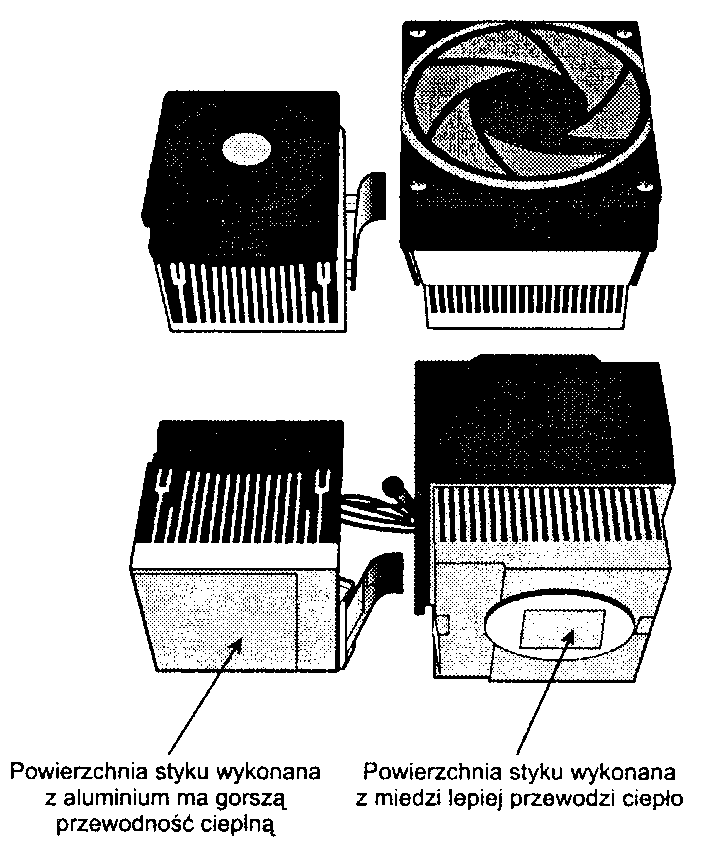

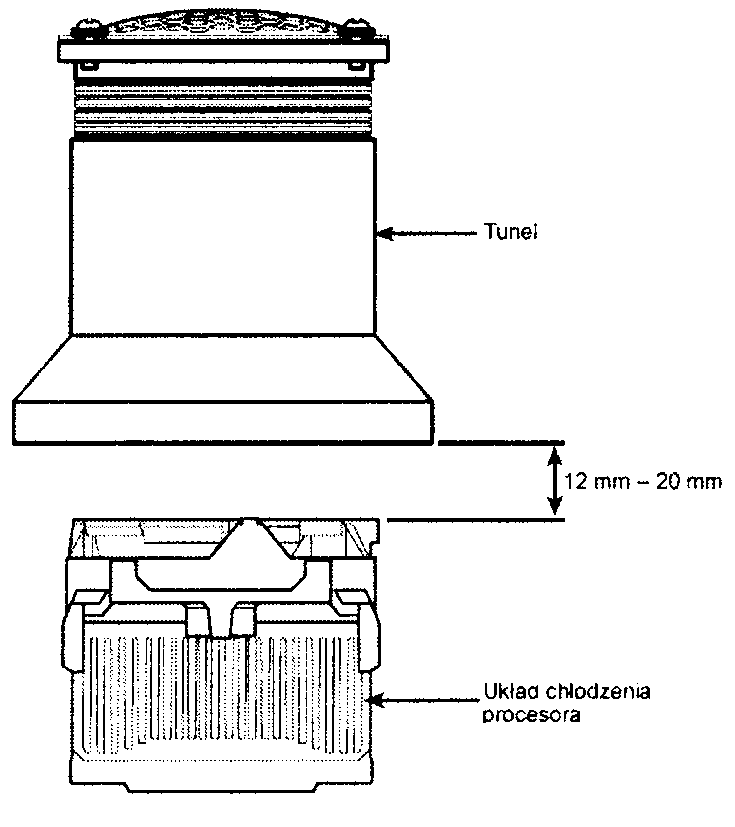

Rysunek 23.12.

Układ chłodzenia z radiatorem aluminiowym (lewa strona rysunku) przeznaczony jest dla wolniejszych procesorów, niż układ chłodzenia z radiatorem miedziano-aluminiowym (prawa strona rysunku)

wspomagane tunelowym wentylatorem znajdującym się w obudowie. W systemach tworzonych przez użytkowników lub przez niewielkie firmy nie dysponujące możliwościami zaprojektowania dedykowanego układu odprowadzającego ciepło opartego na radiatorze powinno się stosować układy chłodzenia aktywne wyposażone w wentylator. Systemy odprowadzania ciepła oparte na układach aktywnych niezależnie od innych charakterystyk związanych z przepływem powietrza należą do bardziej niezawodnych rozwiązań.

Procesory firmy AMD i Intel sprzedawane w wersji „pudełkowej" są wyposażone w wysokiej jakości aktywne układy chłodzenia zaprojektowane do pracy w najcięższych możliwych warunkach panujących w otoczeniu procesora (rysunek 23.13). Jednym z głównych powodów, dla których polecam kupowanie procesorów w wersji „pudełkowej", jest uzyskanie gwarancji zastosowania w nich wysokiej jakości układów chłodzenia przewidzianych do odprowadzania ciepła w najmniej sprzyjających warunkach pracy, a ponadto cechujących się trwałością pozwalającą na długie użytkowanie równe żywotności całego systemu.

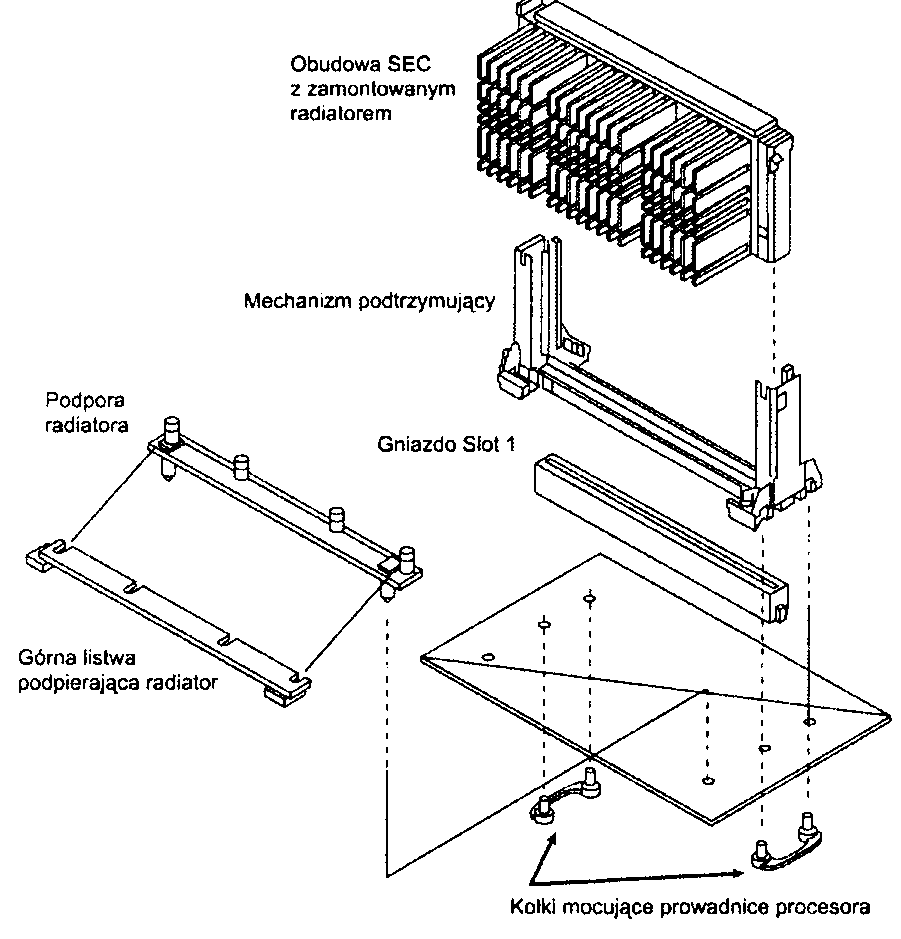

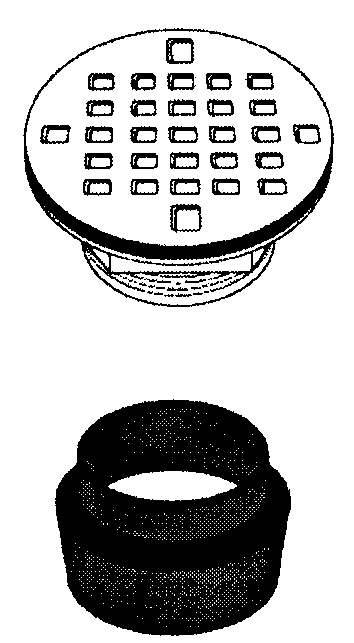

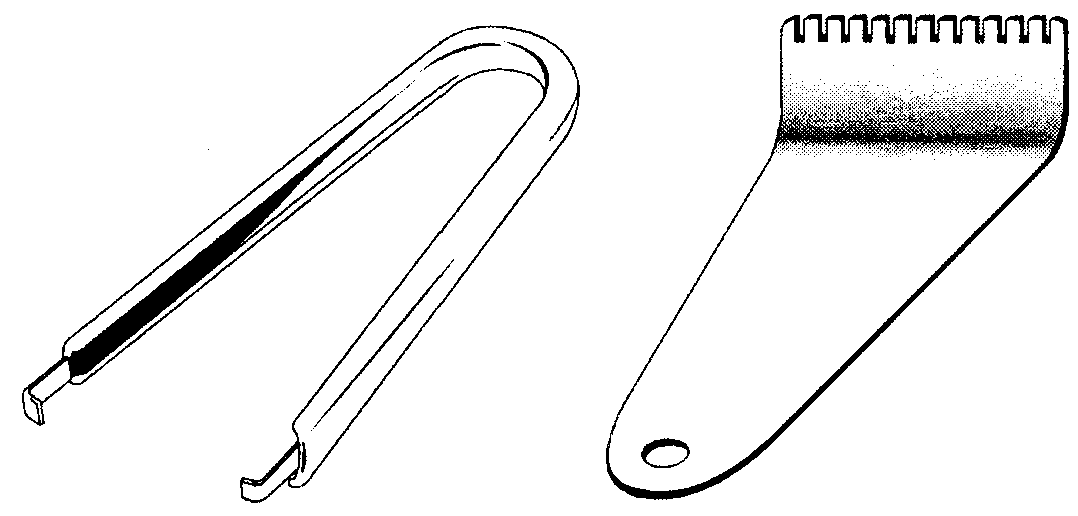

Rysunek 23.13.

Pasywny układ chłodzenia instalowany wraz z podporami na procesorach

Pentium II lub 1I1-SECC

Nacisk wywierany przez układ chłodzenia

Nazwa obudowy FC-PGA stosowanej w niektórych typach procesorów wzięła się stąd, że płytka procesora została umieszczona na jej górnej powierzchni spodem do góry. Umożliwiło to uzyskanie bezpośredniego styku radiatora z powierzchnią płytki procesora, dzięki czemu osiągnięto najlepsze warunki do odprowadzania ciepła. Niestety, pojawiły się dodatkowe komplikacje, które zmusiły producentów procesorów do modyfikacji tego rozwiązania.

Podstawowym problemem stał się zbyt duży i zmienny w czasie nacisk na płytkę procesora. Firma Intel dopuszcza średni statyczny nacisk radiatora na płytkę procesora wynoszący 10 kilogramów, natomiast firma AMD dopuszcza aż 14 kilogramów, wymaganych do utrzymania sprężynującego zacisku mocującego radiator procesorów Athlon. Duron i Athlon XP. Tak duże wartości nacisku spowodowały jednak w czasie instalacji radiatora wiele przypadków uszkodzenia procesora. Wyższa wartość nacisku występująca w przypadku układów chłodzenia dla procesorów firmy AMD wynika z konieczności uzyskania jak najlepszej przewodności cieplnej, która umożliwi lepsze chłodzenie procesorów firmy AMD z reguły wydzielających więcej ciepła niż produkty firmy Intel. Ze względu na to, że płytka procesora wystaje ponad powierzchnię obudowy, radiator utrzymuje kontakt tylko z płytką, natomiast w pozostałych miejscach unosi się nad obudową. Jeśli w trakcie instalacji układu chłodzenia do jednego z narożników lub krawędzi radiatora zostanie przyłożona zbyt duża siła. wtedy na płytkę procesora zadziała nierównomierny nacisk, który może doprowadzić do jej złamania, co objawi się wyraźnym trzaskiem. Po czymś takim procesor oczywiście ulegnie uszkodzeniu. Co więcej, tego typu przypadki zazwyczaj nie są objęte gwarancją producenta, który traktuje je jako przykład niewłaściwej eksploatacji, a nie błąd powstały z winy producenta. Chociaż problem z pękaniem płytki pojawił się zarówno w przypadku procesorów firmy AMD, jak i Intel, to jednak zdarzało się to znacznie częściej w układach pierwszej z nich. Wynikało to z konieczności użycia przy montażu zacisku układy chłodzenia większej siły. Tego typu problemy doprowadziły do tego, że wielu sprzedawców udzielało na procesor gwarancji tylko wtedy, gdy by! on sprzedawany łącznie z płytą główna, na której dokonano jego wcześniejszej instalacji.

W celu zapobieżenia występowania podobnych problemów zarówno firma AMD. jak i Intel opracowały różne rozwiązania. Firma AMD umieszczała w okolicy każdego z czterech narożników obudowy procesora gumowe podkładki, które podpierały radiator i zapobiegały występowaniu zmiennego nacisku powodującego pękanie płytki procesora. Niestety, nawet po zastosowaniu gumowych podkładek nadal, w przypadku gdy przed montażem radiator jest przekrzywiony lub przechylony, może dojść do złamania płytki. W procesorach Athlon 64 całkowicie zmieniono sposób montażu układu chłodzenia. W ich przypadku układ jest mocowany do płyty głównej za pomocą przykręconego do niej uchwytu.

Obecnie zarówno Intel, jak i AMD stosują metalową pokrywę przykrywającą płytkę procesorów, określaną skrótem 1HS (Integrated Heat Spreader). Zadaniem pokrywy IHS jest chronienie płytki procesora przed bezpośrednim naciskiem. Dodatkowo zwiększa ona powierzchnię przewodzącą pomiędzy procesorem a radiatorem. W przypadku większości procesorów wyposażonych w pokrywę IHS, maksymalna wartość statycznie działającej siły może wynosić do 45 kilogramów. Pokrywa IHS właściwie eliminuje problem związany z pękaniem płytek procesorów wynikający z nieprawidłowej instalacji radiatora. Wersja pokrywy IHS używana przez firmę Intel umożliwia stosowanie nacisku na obudowę procesora wynoszącego do 34 kilogramów. W pokrywę IHS wyposażone są wszystkie wersje procesora Pentium 4, Celeron 4, Pentium III/Celeron Tualatin (technologia 0.13 mikrona) oraz procesory firmy AMD Athlon 64 i 64 FX (rysunek 23.14). Przyjęto się obudowy FC-PGA wyposażone w pokrywę IHS nazywać FC-PGA2.

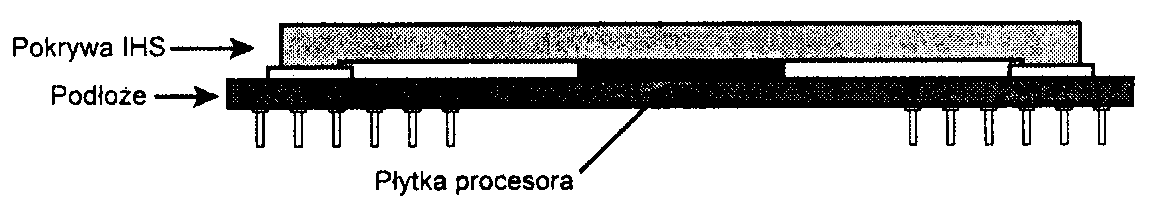

Rysunek 23.14.

Widok z boku procesora w obudowie FC-PGA2 ukazujący pokrywę IHS zamontowaną nad płytką procesora

Jeśli używany procesor firmy AMD lub Intel nie ma metalowej pokrywy IHS, należy zachować szczególną ostrożność i przed założeniem lub zdjęciem zacisku radiatora przytrzymać go tak, aby płasko przylegał do powierzchni płytki procesora.

Obliczanie parametrów układu chłodzenia

Układ chłodzenia odprowadza ciepło z procesora w powietrze. Zdolność układu do odprowadzania ciepła określa się rezystancją termiczną układu, wyrażoną w stopniach Celsjusza na wat (°C/W). Im mniejsza rezystancja termiczna, tym więcej ciepła układ chłodzenia może odprowadzić.

Jaką rezystancję termiczną R powinien mieć układ chłodzenia, można wyliczyć ze wzoru: R = (T0-T„)/Pr.

gdzie T0 jest maksymalną dopuszczalną temperaturą obudowy procesora, 7^ jest maksymalną dopuszczalną temperaturą powietrza wpływającego do układu chłodzenia, a Pp jest maksymalną mocą rozpraszaną przez procesor. Na przykład w przypadku procesora Pentium 4 3.4E (Prescott) maksymalna dopuszczalna temperatura obudowy procesora wynosi 73°C, maksymalna temperatura powietrza wpływającego do układu chłodzenia wynosi 38°C, a maksymalna rozpraszana moc termiczna wynosi 103 W. Łatwo z tego wyliczyć, że układ chłodzący, który ma ochłodzić ten procesor, musi mieć rezystancję termiczną nie większą niż (73°C - 38°C) / 103 W = 0,34 °C/W. Wartość ta obejmuje zarówno materiał termoprzewodzący łączący procesor z radiatorem, jak i układ chłodzenia. W przypadku pasty termoprzewodzącej o rezystancji 0,01 °C/W sam układ chłodzenia nie może mieć rezystancji większej niż 0,33 °C/W.

Maksymalną moc rozpraszaną przez procesor Pp można wyliczyć ze wzoru:

PV = C-V2F,

gdzie C jest pojemnością cieplną procesora. V— napięciem, a F— częstotliwością procesora. Jak widać we wzorze, dwukrotne zwiększenie częstotliwości procesora powoduje dwukrotny wzrost mocy rozpraszanej przez procesor, a dwukrotne zwiększenie napięcia zasilającego powoduje czterokrotne zwiększenie tej mocy. Analogicznie, zmniejszenie napięcia o połowę powoduje czterokrotne zmniejszenie mocy rozpraszanej. Warto pamiętać o tych zależnościach, przetaktowując procesor, gdyż niewielkie zwiększenie napięcia zasilania może mieć znacznie bardziej poważne skutki cieplne, niż zwiększenie prędkości procesora.

Zwiększenie prędkości procesora o 5% powoduje analogiczny wzrost mocy zużywanej przez procesor. W przypadku procesora z poprzedniego przykładu, jeżeli jego prędkość zostanie zwiększona o 5%, to 103-watowy procesor zacznie oddawać moc 108,15 W, a zatem rezystancja termiczna układu chłodzenia musi zmaleć z 0,34 °C/W do 0,32 °C/W. W większości przypadków, przy niewielkim przetaktowaniu procesora, dotychczasowy układ chłodzenia powinien wystarczyć. Można wówczas, w celu kompensacji nadmiaru ciepła, zmniejszyć w niewielkim stopniu napięcie zasilania procesora. Oczywiście może to spowodować, że procesor zacznie pracować niestabilnie, warto więc poddać go testom. Jak widać w przykładzie, dobranie odpowiednich wartości parametrów służące przyśpieszeniu procesora oraz przeprowadzenie koniecznych w takim przypadku testów może pochłonąć dużo czasu. Samemu należy zatem rozważyć, czy uzyskane efekty warte są ceny czasu przeznaczonego na konfigurowanie i testowanie.

Większość profesjonalnych producentów układów chłodzenia informuje o rezystancji termicznej swoich wyrobów, są jednak tacy, którzy takich danych nie podają. Wielu z nich kładzie nacisk w większym stopniu na wygląd swoich układów niż ich parametry.

Instalacja układu chłodzenia

Aby uzyskać jak najlepszą wymianę ciepła pomiędzy procesorem a radiatorem, większość producentów układów chłodzenia nakazuje umieszczać w przestrzeni między procesorem i radiatorem odpowiedni materiał termoprzewodzący. Zazwyczaj jest to pasta na bazie związków ceramicznych, tlenku glinu lub srebra, ale może to być również specjalna wkładka lub odpowiednia dwustronna taśma klejąca. Stosowane są też materiały zmiennofazowe, które powyżej pewnej temperatury zmieniają swoją lepkość (stają się rzadsze), dzięki czemu lepiej wypełniają wszystkie szczeliny między procesorem a radiatorem. Pasty termoprzewodzące mają na ogół lepszą skuteczność niż materiały zmiennofazowe, ale ponieważ są zawsze mniej lepkie, łatwiej się „rozpływają" i dlatego bardziej brudzą podczas nakładania. Ponadto nałożone w zbyt wielkiej ilości mogą spłynąć na gniazdo procesora lub nawet na płytę główną.

Zastosowana pasta termoprzewodząca lub materia! zmiennofazowy zwiększają zdecydowanie wydajność układu chłodzenia. Materiały te klasyfikuje się na podstawie ich przewodności termicznej (im wartość ta jest większa, tym lepiej) lub rezystancji termicznej (im mniejsza, tym lepiej). Niestety obecnie stosuje się kilka klasyfikacji, co utrudnia porównywanie różnych produktów. W niektórych klasyfikacjach podaje się przewodność termiczną, w innych rezystancję termiczną, a i używane skale różnią się od siebie. Najczęściej podawanym parametrem jest rezystancja termiczna wyrażona w stopniach Celsjusza na wat (°C/W) uzyskana dla próbki materiału o grubości 0,025 mm i o polu powierzchni 6,45 cm2. W przypadku każdego materiału, im cieńsza jest jego warstwa lub im większa jest jego powierzchnia, tym mniejsza jest jego rezystancja termiczna. Dodatkowo, z powodu innych zmiennych wpływających na wynik pomiaru, takich jak chropowatość powierzchni czy ciśnienie, często nie da się porównać ze sobą różnych materiałów, nawet korzystając z jednakowej klasyfikacji.

W celu przeprowadzenia porównań materiałów termoprzewodzących przyjrzyjmy się, jaki wpływ na temperaturę procesora ma użycie materiałów termoprzewodzących o różnej charakterystyce. W chwili, gdy powstawała ta książką, największą moc — 103 W — rozpraszał przez pokrywę IHS o polu powierzchni 9.68 cm2 procesor Pentium 4 3.4E. W tabeli 23.1 pokazano wpływ materiałów o różnej wartości rezystancji termicznej na wzrost temperatury procesora.

Tabela 23.1. Rezystancja termiczna materiałów termoprzewodzących a wzrost temperatury procesora Pentium 4 rozpraszającego moc 103 W

Rezystancja termiczna (°C/W) |

Wzrost temperatury (°C) |

Rezystancja termiczna (°C/W) |

Wzrost temperatury (°C) |

0,000 |

0,00 |

0,050 |

3,43 |

0,005 |

0,34 |

0,060 |

4,12 |

0,010 |

0,69 |

0,070 |

4,81 |

0,020 |

1.37 |

0,080 |

5,49 |

0,030 |

2,06 |

0,090 |

6.18 |

0,040 |

2,75 |

0,100 |

6,87 |

Większość lepszych past termoprzewodzących ma rezystancję termiczną wahającą się od 0.005 do 0,02 °C/W na 6.45 cm2 (cal kwadratowy), co powoduje wzrost temperatury procesora o od 0,34 do 1,37°C. Nawet gdyby istniała idealna pasta termoprzewodząca, zmniejszyłaby ona temperaturę procesora w porównaniu do dostępnych na rynku past. o zaledwie 2°C. Z dostępnych testów porównujących pasty termoprzewodzące różnych producentów wynika, że różnice między nimi są niewielkie, zatem nie warto wiele zastanawiać nad wyborem pasty — większość z nich jest dobrej jakości i ma bardzo zbliżoną wydajność.

Pastę termoprzewodząca można kupić w małej tubce przeznaczonej do jednokrotnego użycia lub w większym opakowaniu, zawierającym pastę dla większej liczby procesorów. Godne polecenia są pasty termoprzewodzące wykonane na bazie tlenku glinu lub srebra charakteryzujące się najmniejszą rezystancją termiczną. Pasty na bazie srebra są najlepsze, ale za to zdecydowanie droższe. Warto pamiętać, że z obliczeń oraz testów wynika, że w przypadku użycia w komputerze pracującym z pełną wydajnością różnych past termoprzewodzących różnice w temperaturze procesora są zaledwie kilkustopniowe. Ci, którzy potrzebują najbardziej skutecznego produktu, powinni sięgnąć po pasty tworzone na bazie srebra, pozostali mogą skorzystać z past na bazie tlenku glinu lub najtańszych (i trochę mniej skutecznych) past na bazie materiałów ceramicznych.

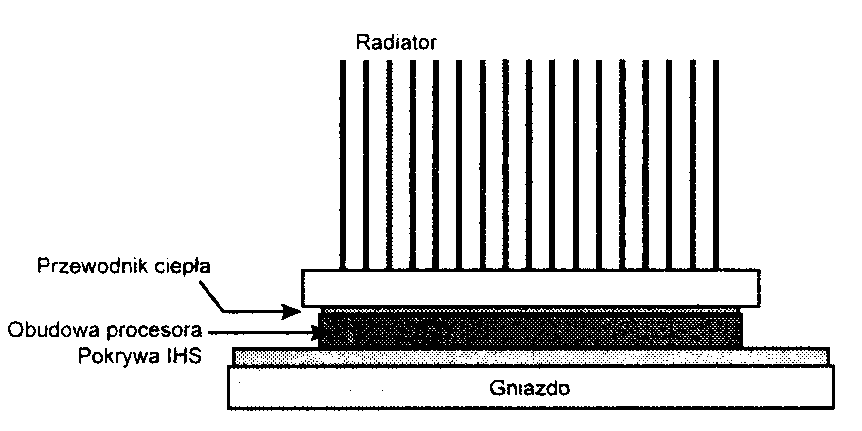

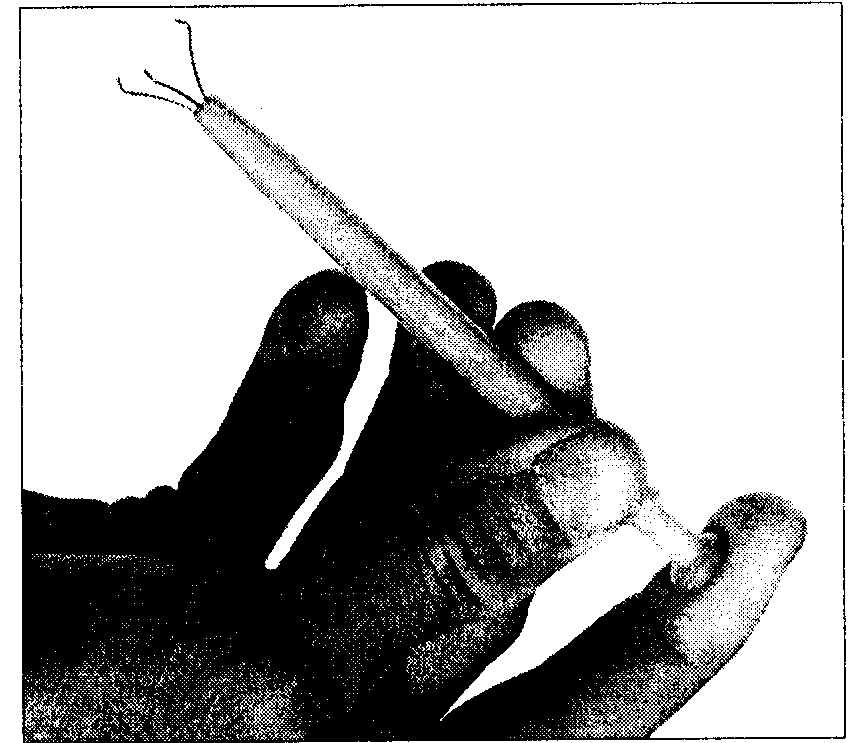

Na rysunku 23.15 pokazano wkładkę lub pastę termoprzewodząca umieszczoną pomiędzy procesorem a radiatorem.

W większości systemów dostępnych obecnie na rynku stosowane są płyty główne ATX lub BTX. Systemy, w których wykorzystano tego typu płyty główne i odpowiednią obudowę cechują się lepszym odprowadzaniem ciepła wydzielanego przez procesor. Wynika to z faktu zmiany lokalizacji gniazda procesora, co spowodowało powiększenie obszaru przestrzeni dostępnej dla wentylatora obudowy, a nawet pozwala na zastosowanie kanału z bezpośrednim nawiewem powietrza. Większość obecnie dostępnych obudów jest wyposażona w jeden albo dwa wentylatory, które dodatkowo wspomagają odprowadzanie ciepła. Wentylatory o większych rozmiarach, a zwłaszcza te wyposażone w tunele doprowadzone bezpośrednio do procesora, poprawiają wydatnie chłodzenie komputera.

Rysunek 23.15.

Przewodnik ciepła poprawia przekazywanie ciepła z procesora do radiatora

► Zajrzyj do punktu „Format ATX", znajdującego się na stronie 262.

► Zajrzyj do punktu „Format BTX", znajdującego się na stronie 277.

Chłodzenie cieczą

Jednym z najbardziej radykalnych sposobów chłodzenia komputerów PC jest chłodzenie cieczą. Ciecze mają znacznie większą pojemność cieplną niż powietrze, a w miarę, jak procesory robią się coraz to bardziej gorące, użycie chłodzenia cieczą do odprowadzenia bardzo wielkich ilości ciepła z małych przestrzeni może być bardzo korzystne lub wręcz nieodzowne.

Dostępnych jest kilka rozwiązań wykorzystujących chłodzenie cieczą:

rury cieplne (ang. heatpipes),

układy chłodzenia wodą,

chłodziarki.

W każdym z tych rozwiązań nadmiar ciepła z procesora czy innego elementu odbiera ciecz lub para. która przenosi je do wymiennika ciepła, gdzie ciepło musi zostać oddane powietrzu. Z tego względu we wszystkich układach chłodzenia cieczą wykorzystuje się również chłodzenie powietrzem — zastosowanie układu chłodzenia cieczą powoduje tylko zmianę miejsca, w którym ciepło oddawane jest powietrzu. W układach chłodzenia cieczą wymiennik ciepła (radiator) może być znacznie większy, gdyż nie musi już zmieścić się nad procesorem czy innymi układem. Jest to jeden z powodów, dla którego układy chłodzenia cieczą maja znacznie większą pojemność cieplną.

Spośród wszystkich dostępnych rodzajów układów chłodzenia cieczą jedynymi, które są praktyczne i na tyle ekonomiczne, aby można je było zastosować w komputerach PC, są rury cieplne. Układy wykorzystujące chłodzenie wodą, a w szczególności chłodziarki, polecane są tylko tym, którzy radykalnie przetak-towują swoje procesory i są w stanie ponieść bardzo duży koszt tych urządzeń oraz znieść związane z nimi niedogodności.

Rury cieplne

Pierwszą rurę cieplną skonstruował w 1963 roku w Los Alamos National Laboratory Georgie Grover. Opisując rurę cieplną jak najprościej, można powiedzieć, że jest to przewodnik termiczny, który skutecznie przenosi ciepło z jednego miejsca w drugie.

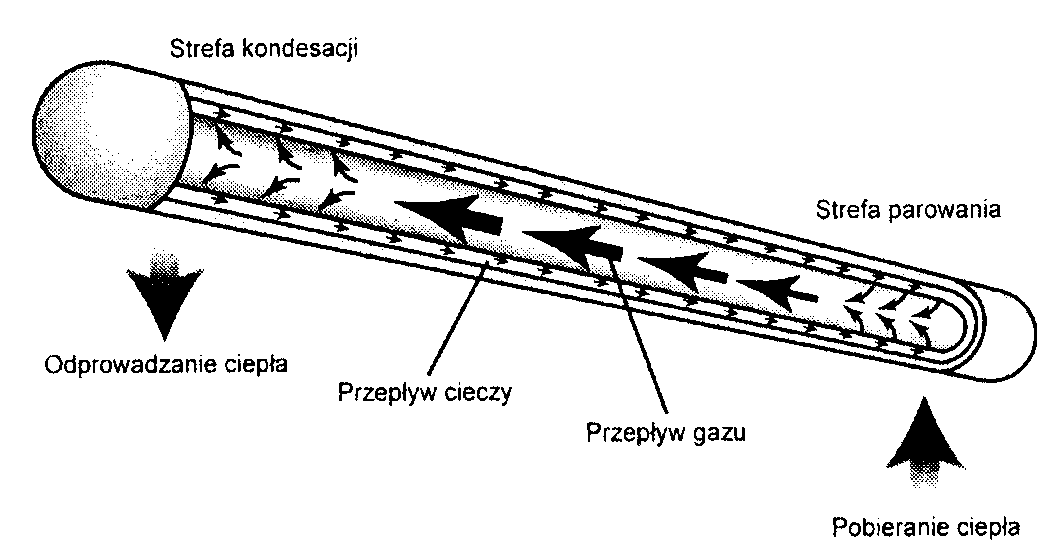

Typowa pompa cieplna składa się z wyposażonej w pusty w środku rdzeń hermetycznie zamkniętej rury, której wewnętrzna ścianka wyścielona jest drobną strukturą przenoszącą ciecz dzięki efektowi kapilarnemu. W czasie montażu z rury usuwa się powietrze, częściowo wypełnia się ją odpowiednią cieczą, a następnie szczelnie zamyka. Dzięki próżni w środku rury znajdująca się w niej ciecz wrze przy stosunkowo niskiej temperaturze. Gdy rurę cieplną podgrzeje się z jednego końca, ciecz zmienia swą postać z płynnej na gazową, absorbując przy tym duże ilości ciepła. Gaz ten przepływa pustym rdzeniem na drugi koniec rury, gdzie ulega kondensacji, zmieniając postać na ciekłą i uwalniając przy tym przenoszone ciepło. Ciecz powraca następnie na drugi koniec rury dzięki efektowi kapilarnemu (rysunek 23.16).

Rysunek 23.16.

Budowa i działanie rury cieplnej

W rurach cieplnych wykorzystywany jest efekt zmiany stanu cieczy z płynnego na gazowy podczas pobierania ciepła i zmiany z gazowego na płynny podczas oddawania ciepła. Energia potrzebna do zmiany stanu skupienia cieczy nazywana jest ciepłem parowania. Dla przykładu ciepło parowania wody wynosi około 540 cali/g. W większości rur cieplnych stosuje się wodę, amoniak lub metanol. Rodzaj użytej cieczy zależy od zakresu temperatur, przy których rura cieplna będzie pracować. Woda przy normalnym ciśnieniu wrze w temperaturze 100°C, jednak w rurze cieplnej ciśnienie jest znacznie mniejsze, co powoduje, że wrzenie następuje już w temperaturze pokojowej. Dzięki zjawisku parowania rura cieplna ma przewodność termiczną od 10 do 10 000 razy większą niż lity pręt miedziany o takiej samej średnicy i długości.

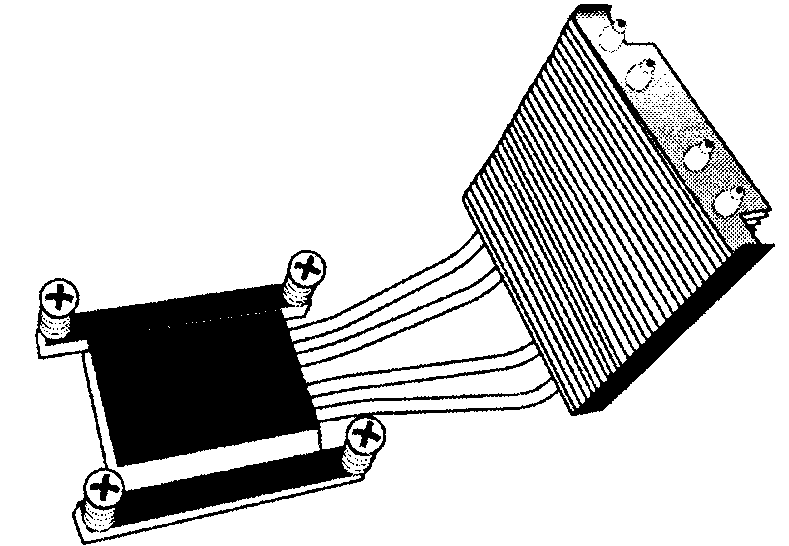

Same rury cieplne nie wystarczą do chłodzenia. Muszą być w jakiś sposób połączone z procesorem czy innym elementem wytwarzającym ciepło oraz wyposażone w jakiś element odbierający ciepło z drugiego ich końca. Zwykle jeden koniec rury cieplnej dołączony jest do konwencjonalnego układu chłodzenia, często wyposażonego jednocześnie w wentylator. Na rysunku 23.17 pokazano układ chłodzenia z rurami cieplnymi, stosowany w serii umieszczanych w małych obudowach komputerów Shuttle.

Rysunek 23.17.

Cztery rury cieplne

zastosowane

w układzie

chłodzenia

procesora

W pokazanym na rysunku rozwiązaniu wentylator montuje się tak, by strumień powietrza kierowany był na żeberka radiatora, do którego dołączone są końce rur cieplnych.

Rury cieplne mają wiele zalet. Hermetyczna budowa i brak ruchomych części powodują, że nie trzeba ich konserwować, a one same nie zużywają się. Odpowiednio zaprojektowane rury cieplne można nawet zamrażać, chociaż nie zaczną pracować, zanim obecna w nich ciecz nie rozmrozi się. Rury cieplne mają bardzo zwartą budowę i idealnie nadają się do stosowania w systemach mieszczących się w niewielkich obudowach. Z tego powodu w rury cieplne wyposaża się niemal wszystkie notebooki produkowane od wczesnych lat 90. ubiegłego stulecia.

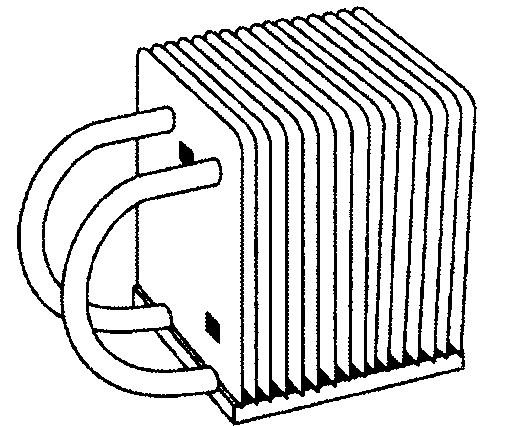

Rury cieplne wykorzystuje się również jako rozwiązanie wspomagające klasyczne układy chłodzenia. Umieszczając rury cieplne wewnątrz tradycyjnych układów chłodzenia, znacznie podnosi się ich możliwości odprowadzania ciepła. Na rysunku 23.18 pokazano radiator wyposażony w dwie rury cieplne, których zastosowanie ułatwia przenoszenie ciepła z dolnej do górnej części radiatora.

Rysunek 23.18.

Radiator z dwiema rurami cieplnymi poprawiającym i jego wydajność

Spośród wszystkich układów chłodzenia cieczą rury cieplne wydają się mieć w świecie komputerów stacjonarnych najbardziej obiecującą przyszłość.

Układy chłodzenia wodą

Idea chłodzenia wodą opiera się na prostym pomyśle, którego realizacja nie jest już jednak prosta. Pomysł polega na wymuszeniu obiegu wody nad procesorem czy innymi elementami elektronicznymi w celu odebrania od nich ciepła. Rzeczywistość jest jednak bardziej skomplikowana, co powoduje, że chłodzenie wodąjest drogie itrudne w realizacji, a zatem staje się przydatne tylko w wyjątkowych sytuacjach.

Układ chłodzenia wodą składa się z kilku podstawowych elementów:

Bloki wodne. Są to montowane na procesorze, czasem na karcie graficznej lub mostku północnym, metalowe bloki, przez które przepływa woda.

Wężyki i łączniki. Służą do łączenia wszystkich elementów układu.

Zbiornik. Zawiera odpowiednią do schłodzenia podzespołów ilość wody oraz układ jej schładzania.

Pompa. Służy do wywołania przepływu wody w układzie.

Chłodziwo. Ciecz, przeważnie woda, przepływająca w układzie.

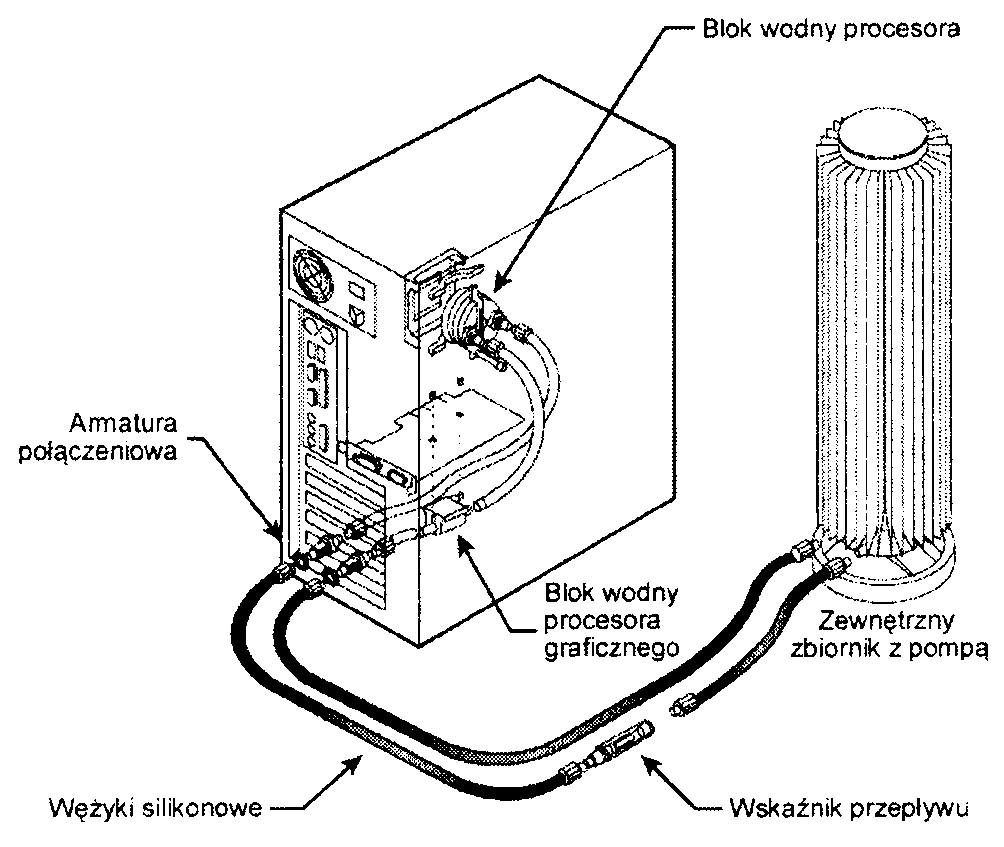

Na rysunku 23.19 pokazano układ chłodzenia wodą wyposażony w zewnętrzny zbiornik i pompę.

Rysunek 23.19.

Układ chłodzenia wodą firmy Zalman z zewnętrznym zbiornikiem i pompą

W niektórych układach chłodzenia wodą używane są zbiorniki wewnętrzne, montowane wewnątrz obudowy komputera, lub zewnętrzne — montowane na obudowie albo z jej boku lub tyłu. Zmieszczenie zbiornika i pompy wewnątrz obudowy komputera nie jest łatwe, gdyż zajmują one sporo miejsca.

Układy chłodzenia wodą mają znakomitą pojemność cieplną, są za to trudne w eksploatacji i konserwacji. Podstawową ich wadą jest fakt oparcia ich działania na pompie, której awaria powoduje przegrzanie się układów. Poza tym woda wywołuje korozję i zanieczyszczanie pompy, bloków wodnych i zbiorników, a dodatkowo może nawet zarosnąć glonami. Jakby tego było jeszcze mało, każde połączenie elementów układu chłodzenia wodą jest potencjalnym miejscem przecieku, a jeżeli woda dostanie się do układów elektronicznych, może spowodować zwarcie i uszkodzenie komputera. Układy chłodzenia wodą trzeba zatem regularnie przeglądać.

Największym problemem w przypadku układów chłodzenia wodą są zanieczyszczenia i korozja. W pierwszych konstrukcjach wykorzystywana była zwykła woda, a przecież każdy kierowca wie. że bardzo szybko wywoła to korozję i zanieczyszczenia. Najlepszym rozwiązaniem jest stosowanie, tak jak w samochodach, chłodziw opartych na glikolu, zawierających dodatki zapobiegające korozji i przedłużających żywotność układu. Nawet w takim przypadku chłodziwo musi być jednak od czasu do czasu wymieniane, a bloki wodne, pompę i zbiornik należy przeglądać w celu sprawdzenia, czy nie uległy korozji albo zanieczyszczeniu. Ponadto należy również systematycznie kontrolować, czy na łącznikach nie pojawiają się przecieki.

Dobry system chłodzenia wodą może kosztować tysiące złotych — dużo więcej niż najdroższy układ chłodzenia powietrzem czy nawet rury cieplne. Układy chłodzenia wodą uatrakcyjniają za to wygląd komputera — w wielu z nich używane są przezroczyste wężyki oraz barwione chłodziwo.

Z powodu swojej ceny, wymagań konserwacyjnych, możliwości uszkodzenia oraz rozmiarów składników układy chłodzenia wodą warto stosować jedynie w systemach przetaktowywanych w bardzo dużym stopniu lub w systemach eksperymentalnych. Dużo czasu jeszcze minie, zanim układy chłodzenia wodą osiągną taki stopień rozwoju, na którym będą mogły być stosowane w biurowych czy domowych komputerach PC.

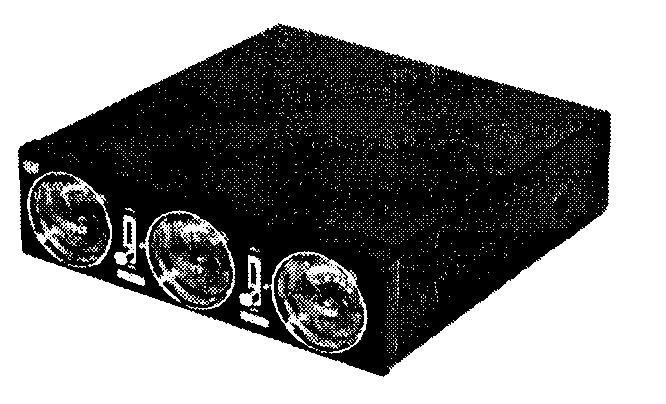

Chłodziarki

Zastosowanie najbardziej radykalnej formy chłodzenia, jaką są chłodziarki, umożliwia obniżenie temperatury procesora lub innych elementów dużo poniżej temperatury pokojowej, co pozwala na badanie granic prze-taktowywania i wydajności układów. Ochłodzony do temperatury -40°C procesor może pracować z prędkością od 33 do 100% większą od nominalnej. Wadą tego rozwiązania jest cena, jaką przychodzi za nie zapłacić — chłodziarki są bowiem bardzo drogie.

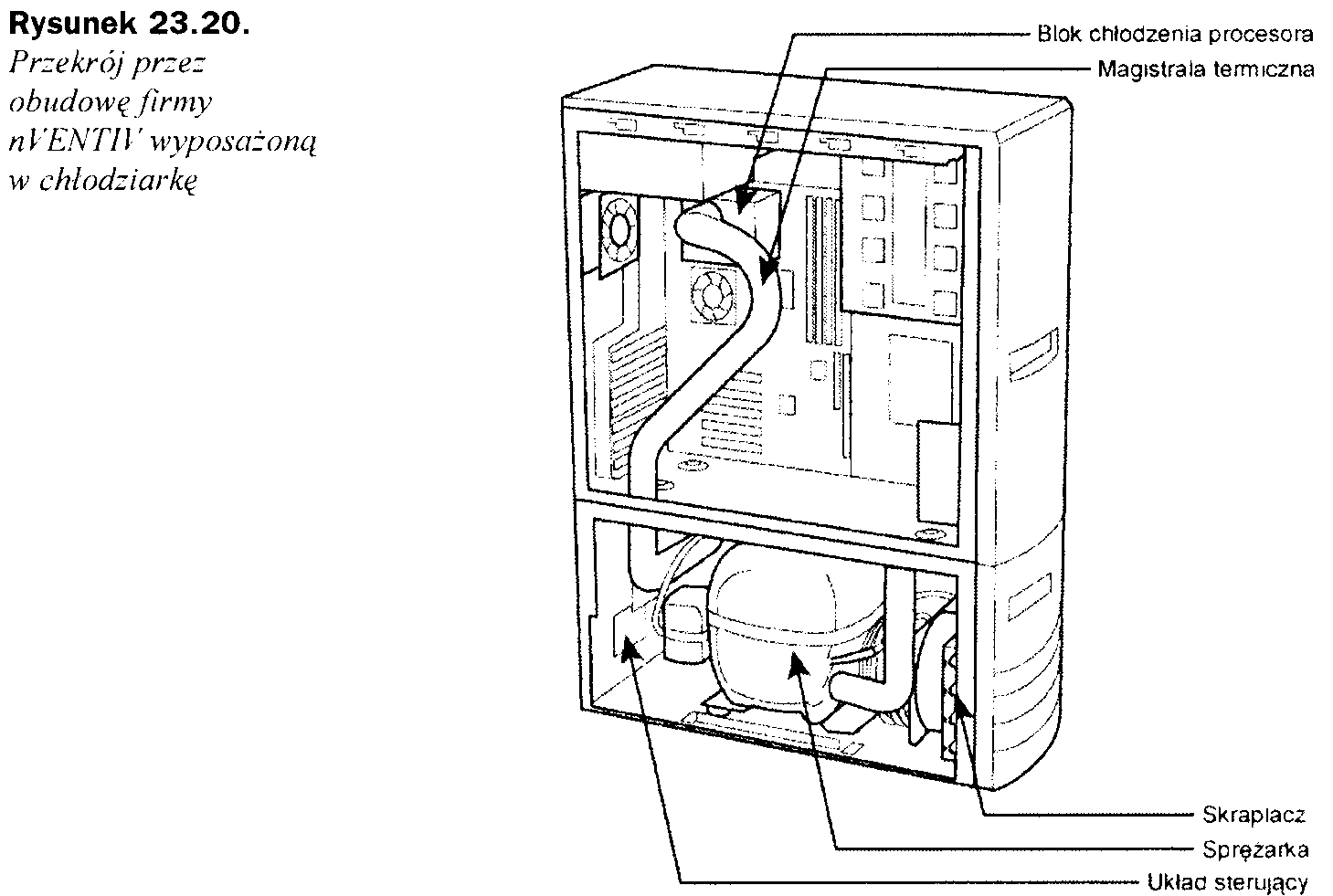

Z tego powodu niewielu producentów zaoferowało dotychczas obudowy wyposażone w chłodziarki — wymienić tu można firmy KryoTech oraz nVENTIV. Pierwszą komercyjną chłodziarkę dla komputerów PC zaoferowała w 1996 roku firma KryoTech (www.kryotech.com). Niestety z powodu problemów ze sprzedażą swego produktu firma zaprzestała produkcji takich obudów w 2002 roku. Powstała w 2000 roku pod nazwą Chip-con firma nVENTIV (www.nventiv.com) do dziś oferuje kilka modeli obudów wyposażonych w chłodziarki. Na rysunku 23.20 pokazano przekrój obudowy Mach II GT z widocznymi składnikami chłodziarki.

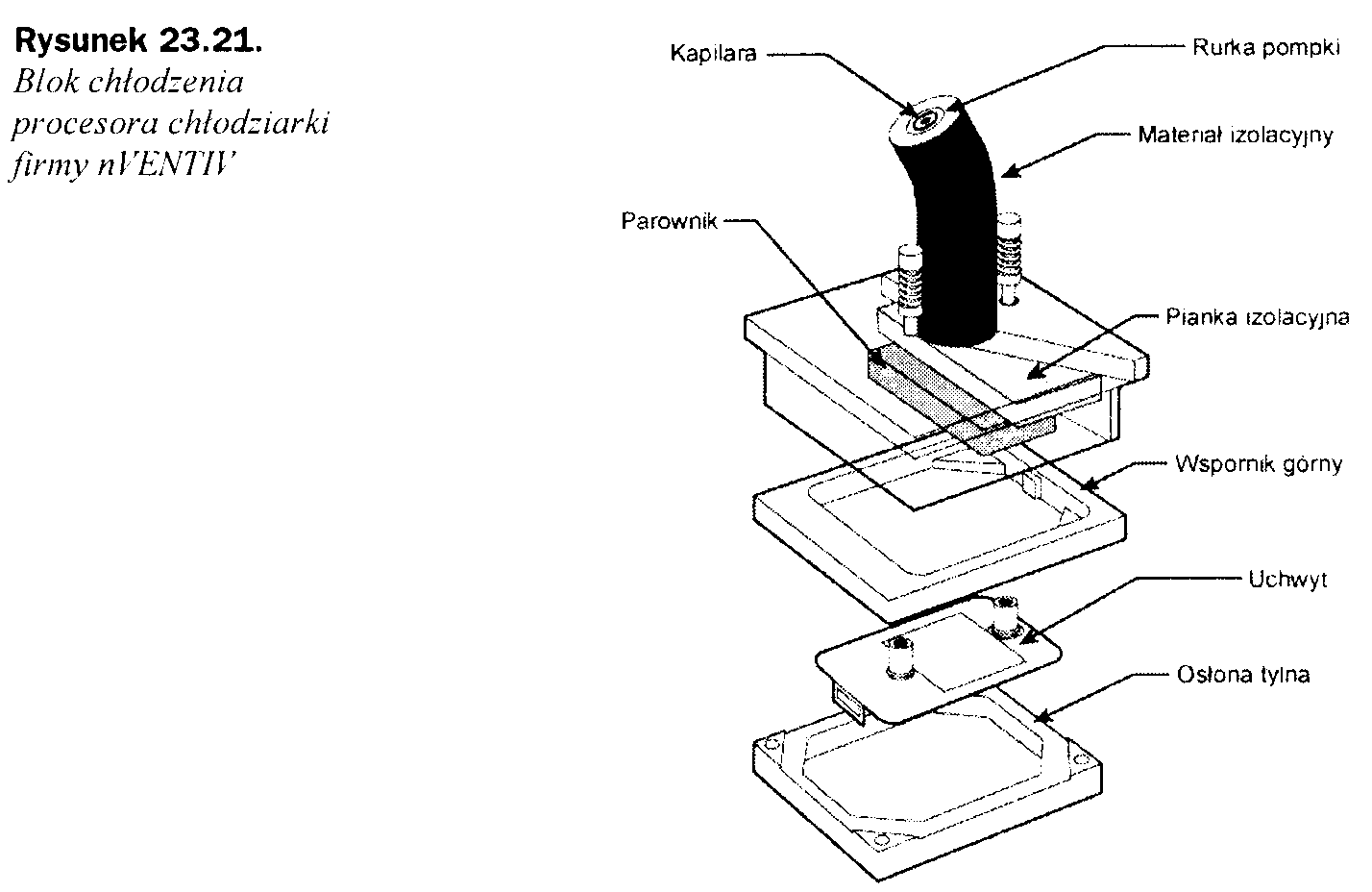

Schłodzenie procesora do temperatury -40°C powierza się blokowi procesora. Wykonany jest on ze specjalnych materiałów izolacyjnych, zapobiegających kondensowaniu się pary wodnej. Blok chłodzenia procesora pokazano na rysunku 23.21.

Kupić można obudowę wyposażoną w chłodziarkę lub tylko samą chłodziarkę, którą można zainstalować w każdej obudowie. Chłodziarki takie kosztują od 2 800 zł do 4 200 zł, zatem nie jest to urządzenie tanie. Są one za to jedynym rozwiązaniem, kiedy trzeba przetaktować procesor do granic jego możliwości.

Obudowy zoptymalizowane termicznie

Najnowsze rozwiązania projektowe i konstrukcyjne zastosowane w obudowach zapewniają poprawne chłodzenie coraz to szybszych procesorów bez potrzeby wydawania dużych pieniędzy na dodatkowe wentylatory czy drogie układy chłodzenia.

Wentylator w zasilaczach komputerów stosowano od zawsze. Jego zadaniem było nie tylko chłodzenie zasilacza, ale również wnętrza obudowy i samego procesora. Do czasów procesora 486 w ogóle nie stosowano układów chłodzenia, gdyż procesory wytwarzały ledwie kilka watów ciepła. Pierwsze pasywne układy chłodzenia w postaci radiatorów zamontowano dopiero w 1992 roku na zużywającym 5.7 W mocy procesorze 486DX2. Aktywne układy chłodzenia pojawiły się po raz pierwszy wraz z „pudełkowymi" wersjami procesora Pentium (tak zwanymi wersjami Overdrive), a od 1997 roku są standardowym wyposażeniem wszystkich „pudełkowych" procesorów Pentium II i Pentium III firmy Intel oraz Athlon firmy AMD. Aż do tamtej pory do chłodzenia układów elektronicznych nie stosowano wentylatorów, z wyjątkiem wentylatora umieszczonego w zasilaczu.

Pierwsze obudowy wyposażone w wentylatory pojawiły się w połowie lat 90. ubiegłego stulecia w komputerach OEM wyposażonych w procesory z tańszymi, pasywnymi układami chłodzenia. Tańsze było po prostu zastosowanie jednego wentylatora, chłodzącego zarówno wnętrze obudowy, jak i sam procesor. Od roku 2000 w wielu komputerach z procesorem Pentium 4 stosuje się aktywny układ chłodzenia procesora (zawierający wentylator) oraz dodatkowo wentylator wbudowany w obudowę. W większości nowoczesnych komputerów umieszcza się obecnie trzy wentylatory —jeden w zasilaczu, drugi w układzie chłodzenia procesora, a trzeci na tylnej ścianie obudowy. W niektórych komputerach instaluje się jeszcze dodatkowe tego rodzaju urządzenia, jednak najczęściej spotyka się rozwiązania z trzema wentylatorami.

Niestety w przypadku najnowszych procesorów, wydzielających ponad 100 W ciepła, standardowe obudowy nie dają sobie rady z odprowadzaniem nadmiaru ciepła. Trzeba je rozbudowywać o dodatkowe wentylatory lub bardziej egzotyczne (i drogie) układy chłodzenia. Na szczęście w ostatnich latach w konstrukcjach obudów zaznaczył się pewien postęp, umożliwiający poprawne chłodzenie procesorów o mocach przekraczających 100 W za pomocą standardowych trzech wentylatorów i to bez konieczności stosowania rozwiązań egzotycznych, a nawet bez instalowania wentylatorów dodatkowych.

Jak wiadomo z poprzednich punktów, moc zużywana przez procesor zależy od jego prędkości i kwadratu napięcia zasilania. Mimo stałego obniżania napięć zasilania procesorów wzrost ich prędkości jest na tyle duży, że moc pobierana przez układ zwykle przekracza 100 W. Do odprowadzania wytwarzanego przez procesor ciepła tworzono na przestrzeni ostatnich 10 - 15 lat coraz to bardziej skuteczne układy chłodzenia. Oferowane obecnie układy chłodzenia mają rezystancję termiczną wynoszącą 0,33 °C/W i mniej. Niestety współczesne rozwiązania oparte o chłodzenie powietrzem zbliżają się szybko do kresu swoich możliwości technologicznych.

Najbardziej ekonomiczną metodą zwiększenia wydajności układów chłodzenia jest zmniejszenie temperatury otaczającej procesor, a tym samym zmniejszenie temperatury powietrza dostającego się do układu chłodzenia procesora. Aby zapewnić poprawne chłodzenie procesorów „pudełkowych", zarówno Intel, jak i AMD podają maksymalną temperaturę, jaką może mieć powietrze wpływające do układu chłodzenia. Jeżeli powietrze ma większą temperaturę niż podana, układ chłodzenia nie będzie w stanie schłodzić procesora. Ponieważ układy chłodzenia muszą czasem działać w skrajnych warunkach, projektuje się je obecnie do pracy przy temperaturze otoczenia (poza obudową) wynoszącej 35°C. Oznacza to. że współczesne komputery PC mogą pracować w środowiskach o tak wysokiej temperaturze. Aby możliwe było wykorzystanie ich w środowiskach o wyższych temperaturach, konieczne jest zastosowanie specjalnej konstrukcji. W tabeli 23.2 przedstawiono maksymalne temperatury powietrza wchodzącego do układu chłodzenia dla różnych procesorów z zainstalowanymi fabrycznymi układami chłodzenia.

Tabela 23.2. Maksymalne dopuszczalne temperatury powietrza wpływającego do układów chłodzenia różnych procesorów

Temperatura na zewnątrz obudowy |

Maksymalna temperatura powietrza wpływającego |

Procesor |

35°C |

45°C |

AMD K6. Pentium 1, II. III |

35°C |

42°C |

AMD Athlon, XP, 64, 64 FX |

35°C |

40°C |

Pentium 4 Willamette, Northwood |

35°C |

38°C |

Pentium 4 Northwood 3 GHz i więcej, Prescott 2.4 GHz i więcej |

Jak widać, najnowsze, najbardziej nagrzewające się procesory stawiają większe wymagania dla układów chłodzenia. W przypadku najbardziej wymagającego procesora temperatura powietrza wpływającego do układu chłodzenia nie może przekraczać 38°C nawet przy temperaturze otoczenia wynoszącej 35°C. Za podwyższenie temperatury wewnątrz obudowy komputera odpowiadają układy płyty głównej, karta graficzna, pamięć, regulatory napięcia, dyski oraz oczywiście sam procesor. W specyfikacjach nowych procesorów określa się. że temperatura powietrza wewnątrz obudowy nie powinna być większa od temperatury panującej na zewnątrz obudowy o więcej niż 3°C. Oznacza to duże wymagania wobec systemu chłodzenia wnętrza obudowy.

Tradycyjne obudowy nie mogą zapewnić tak niewielkiej różnicy temperatur między wnętrzem a otoczeniem. Jedynym rozwiązaniem w ich przypadku jest zainstalowanie dodatkowych wentylatorów, co poza wzrostem ceny takiej obudowy powoduje również wzrost wytwarzanego przez nią hałasu. Mimo to nawet niektóre obudowy wyposażone w dodatkowe wentylatory, umieszczane na przednich, tylnych i bocznych ścianach, nie są w stanie zapewnić trzystopniowej różnicy temperatur. Na szczęście znaleziono rozwiązanie tego problemu, które nie tylko nie wymaga stosowania dodatkowych wentylatorów, ale również nie kosztuje zbyt wiele. Koszt nowego rozwiązania w przypadku najnowszych obudów nie przekracza kilkudziesięciu złotych, a jego zastosowanie nie nastręcza żadnych problemów.

Firmy Intel i AMD opublikowały dokumenty opisujące termiczne właściwości swoich procesorów oraz przedstawiające zalecenia co do sposobów chłodzenia i projektowania obudów zapewniających odpowiednie chłodzenie systemów. Obudowy zaprojektowane w celu zapewnienia wewnątrz temperatury nie większej niż 38°C nazywa się obudowami zoptymalizowanymi termicznie. Użycie tego typu obudów zapewnia nie tylko utrzymanie odpowiedniej temperatury procesora w najbardziej niekorzystnych warunkach, ale również przyczynia się do zmniejszenia hałasu. W większości nowych systemów stosuje się układy chłodzenia, które mogą zmieniać prędkość obrotów wentylatora. Jeżeli temperatury znajdują się poniżej pewnych wartości progowych, wentylatory obracają się wolniej, a tym samym mniej hałasują. W obudowach zoptymalizowanych termicznie prędkości obrotów wentylatorów są z reguły mniejsze, przez co obudowy są cichsze.

Obudowy zoptymalizowane termicznie powinny spełniać następujące zalecenia:

Muszą być używane standardowe płyty główne formatu ATX, MicroATX lub FlexATX.

Muszą być używane standardowe zasilacze ATX, SFX lub TFX, wyposażone w wentylator wyciągający.

Boczna pokrywa obudowy musi być wyposażona w regulowany tunel procesora oraz otwór wentylacyjny kart rozszerzeń.

Muszą być wyposażone w zamocowany na tylnej ścianie wentylator wyciągający o średnicy co najmniej 92 mm oraz w opcjonalny wentylator wyciągający o średnicy co najmniej 80 mm, zamontowany w przedniej ścianie obudowy.

Ponieważ przy bardzo niewielkim dodatkowym koszcie obudowa zoptymalizowana termicznie zapewnia znacznie lepsze chłodzenie, zalecane jest użycie takiej obudowy we wszystkich nowych komputerach.

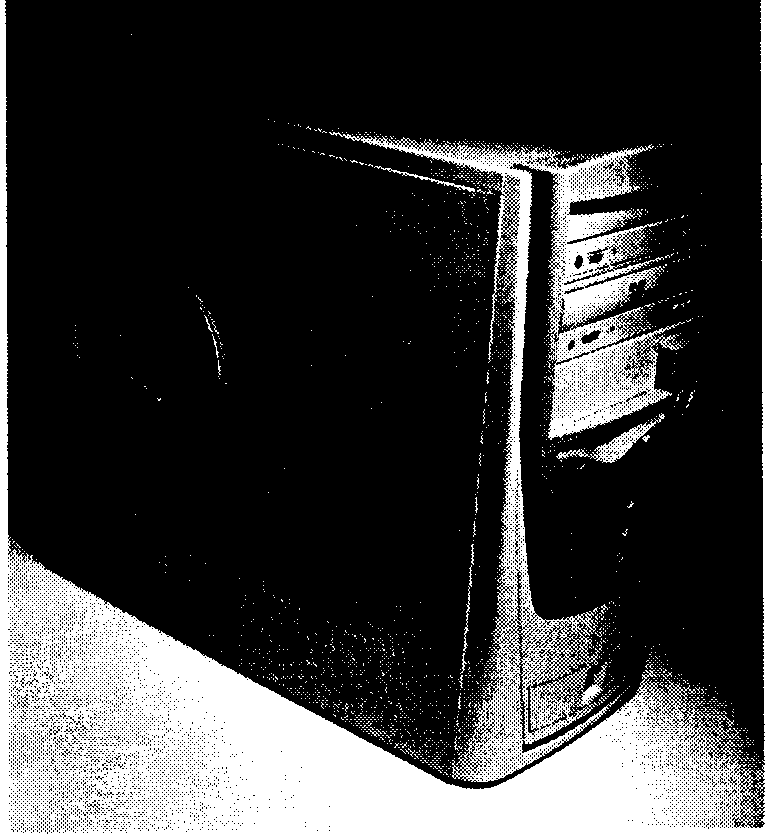

Tunel procesora

Najnowszym udoskonaleniem konstrukcji obudów jest tunel procesora, kierujący powietrze spoza obudowy bezpośrednio nad układ chłodzenia procesora. Rozwiązanie to zdecydowanie poprawia skuteczność układu chłodzenia procesora i z łatwością powoduje spełnienie wymogu, by powietrze dostarczane układowi chłodzenia procesora nie miało temperatury wyższej niż 38°C. Opis techniczny tunelu procesora oraz dodatkowego otworu wentylacyjnego wykonanego w osłonie bocznej obudowy w pobliżu kart rozszerzeń można znaleźć w standardzie Chassis Air Guide, opublikowanym w marcu 2002 roku i uaktualnionym we wrześniu 2003 r. W dokumencie tym opisano rozmiary i położenie tunelu procesora oraz inne jego cechy. Typową obudowę typu wieża wyposażoną w tunel procesora zainstalowany na bocznej ścianie pokazano na rysunku 23.22.

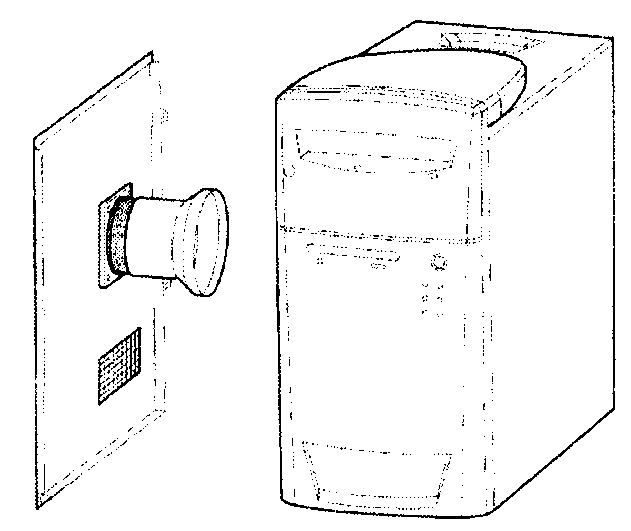

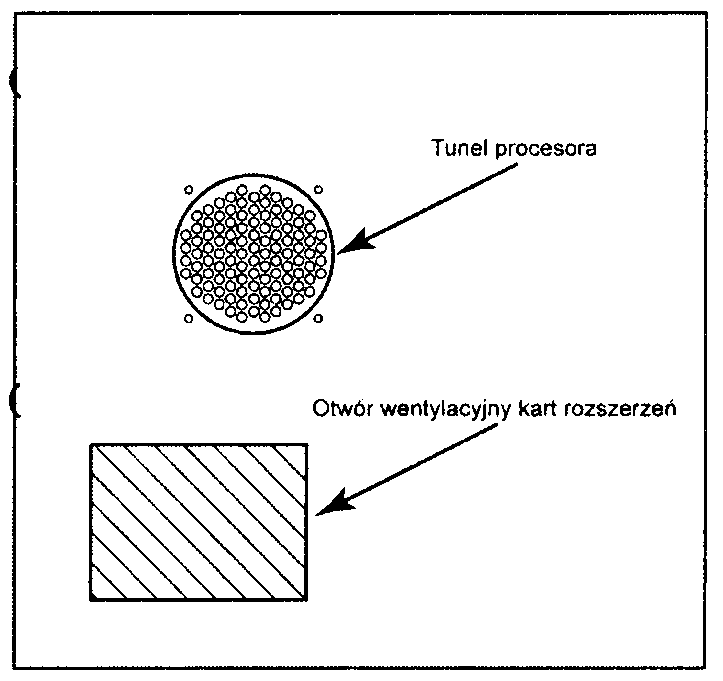

Tunel procesora to rura, której koniec kieruje się nad układ chłodzenia procesora, dzięki czemu pobiera on powietrze spoza obudowy. Drugi koniec tunelu przymocowany jest do bocznej ściany obudowy i osłonięty jest kratką. Na rysunku 23.23 pokazano otwór tunelu procesora oraz otwór wentylacyjny kart rozszerzeń, widziane z boku.

Rysunek 23.22.

Obudowa zoplymal izowana termicznie wyposażona w tunel procesora oraz otwór wentylacyjny kart rozszerzeń (oba elementy zainstalowane w bocznej ścianie obudowy)

Rysunek 23.23.

Tunel procesora

oraz otwór wentylacyjny

kart rozszerzeń obudowy

zoptymalizowanej

termicznie,

widziane z boku

Tunel procesora jest najważniejszym elementem obudowy zoptymalizowanej termicznie, a jego umiejscowienie jest niezwykle istotne. Tunel musi znajdować się nad środkiem układu chłodzenia procesora, a jego wylot musi być umieszczony w odległości 12 — 20 mm od układu. Tylko takie położenie zapewnia, że układ chłodzenia procesora pobiera wyłącznie powietrze spoza obudowy i umożliwia dodatkowo docieranie tego powietrza również do innych elementów komputera. Położenie końca tunelu względem układu chłodzenia procesora pokazano na rysunku 23.24.

Rysunek 23.24.

Umieszczenie wylotu tunelu procesora nad układem chłodzenia

Z powodu różnic między rozmiarami i kształtami obudów standard definiuje położenie tunelu procesora oraz otworu wentylacyjnego względem standardowej płyty głównej ATX.

Skutek zastosowania tunelu procesora jest wyraźny. Firma Intel przeprowadziła badania porównawcze, wykorzystując komputer z systemem Windows XP, procesorem Pentium 4 3 GHz. płytą główną D865PERL, kartą graficzną GeForce4. pamięcią DDR400, dyskiem twardym, stacją CD-ROM i kartą dźwiękową, umieszczonymi w obudowie wyposażonej w przedni i tylny wentylator o średnicy 80 mm. Komputer pracował w pomieszczeniu o temperaturze 25°C. Wyniki badań zestawiono w tabeli:

|

Komputer bez tunelu procesora |

" ■ — Komputer z tunelem procesora |

Temperatura powietrza wpływającego |

35°C |

28°C |

do układu chłodzenia procesora |

|

|

Prędkość obrotowa wentylatora |

4050 obr./min |

2810 obr./min |

układu chłodzenia procesora |

|

|

Natężenie hałasu |

39,8 dBA |

29.9 dBA |

Jak widać, dodanie tunelu obniżyło temperaturę procesora o 7°C. nawet przy wolniejszych obrotach wentylatora. Dzięki tunelowi procesor nagrzewa się mniej, a wentylator działa dłużej i mniej hałasuje. Nawet w przypadku dwóch wentylatorów wbudowanych w obudowę zastosowanie tunelu znacznie obniża temperaturę procesora.

Instalacja tunelu procesora

Wiemy już. że nasz nowy komputer powinien być wyposażony w tunel procesora, ale czy możemy zastosować go w już używanym komputerze? Na szczęście odpowiedź jest twierdząca, a instalacja tunelu procesora jest na dodatek bardzo prosta. W przeciwieństwie do wszystkich modyfikacji kosmetycznych, ta radykalnie zmienia warunki w jakich pracuje procesor i jest bardziej modyfikacją funkcjonalną niż estetyczną.

Po przestudiowaniu specyfikacji Chassis Air Guide postanowiłem poddać modyfikacji jeden ze swoich starszych komputerów. Korzyści z modyfikacji są oczywiste ■— chłodniejszy procesor to sprawniejszy procesor, a przy okazji i cała reszta systemu. Jeżeli ktoś chce przetaktować swój procesor, to ta przeróbka znacznie poprawi możliwości używanego układu chłodzenia, co może nawet spowodować, że nie trzeba będzie go wymieniać.

Zapoznając się z ofertą okolicznych sklepów z artykułami technicznymi, odkryłem zadowalające mnie rozwiązanie w dziale z materiałami hydraulicznymi! Przyglądając się i dopasowując do siebie różne elementy, tak by uzyskać najbardziej skuteczne, a zarazem jak najtańsze rozwiązanie, usłyszałem sakramentalne ..Może w czymś pomóc'?", wypowiedziane przez jednego ze sprzedawców. „I co ja mu teraz powiem?" — zastanawiałem się. Przecież nie powiem, że szukam części do komputera! „Ale mi się przytrafiło" — pomyślałem. „Chętnie!" — odpowiedziałem po chwili — „Szukam elementów, które mógłbym wykorzystać do budowy tunelu procesora, zgodnie ze specyfikacją Chassis Air Guide 1.1, dzięki czemu zoptymalizuję termicznie swoją obudowę!". „Nie szkodzi!" — odpowiedział sprzedawca i odszedł kręcąc głową.

Po sprawdzeniu wszystkich możliwości odkryłem, że mogę zbudować tunel procesora przy użyciu kosztującego 20 zł dwucalowego sitka wylewki prysznica (z osprzętem) oraz wartej 10 zł gumowej, czterocalowej złączki rury spustowej.

Elementy te można nabyć w praktycznie każdym sklepie z materiałami technicznymi. Moje zakupy przestawiłem na rysunku 23.25.

Zbudowany w ten sposób tunel procesora jest bardzo prosty i składa się jedynie z dwóch części. Gumową złączkę rury spustowej należy nałożyć na gwint sitka, a drugi jej koniec należy przyciąć tak. by znalazł się w odpowiedniej odległości od układu chłodzenia procesora.

Rysunek 23.25.

Dwucalowe sitko wylewki prysznica oraz czterocalowa złączka rury spustowej

Oto szczegółowa instrukcja montażu:

Zdejmujemy osłonę boczną obudowy. Zewnętrzną stronę osłony bocznej chronimy za pomocą taśmy maskującej przed zarysowaniami mogącymi powstać podczas wycinania otworu.

Przyglądamy się osłonie bocznej i stawiamy na niej znak w miejscu, które po założeniu osłony znajduje się dokładnie nad układem chłodzenia procesora.

Za pomocą piłki do metalu lub innego narzędzia wycinamy w osłonie otwór o średnicy 82,5 mm. Środkiem otworu jest zrobiony wcześniej znak. Krawędź otworu nie musi być wykończona idealnie, gdyż zasłoni ją na szerokości kilkunastu milimetrów kołnierz sitka wylewki.

Bierzemy sitko wylewki prysznica, wyjmujemy z niego dziurkowaną płytkę wykonaną ze stali nierdzewnej (powinna odskoczyć), odkręcamy wewnętrzną nakrętkę i wyjmujemy uszczelkę.

Odkręcamy zewnętrzną nakrętkę, wyjmujemy uszczelki papierową i gumową. Uszczelkę papierową wyrzucamy.

Resztę sitka wkładamy w wycięty otwór tak, by kołnierz znalazł się na zewnętrznej stronie osłony, a część gwintowana była skierowana do środka obudowy.

Na część gwintowaną nakładamy gumową uszczelkę, a następnie nakręcamy nakrętkę zewnętrzną. Całość skręcamy mocno.

Bierzemy gumową złączkę rury spustowej i naciągamy jej węższy koniec na gwintowaną część zamontowanego sitka.

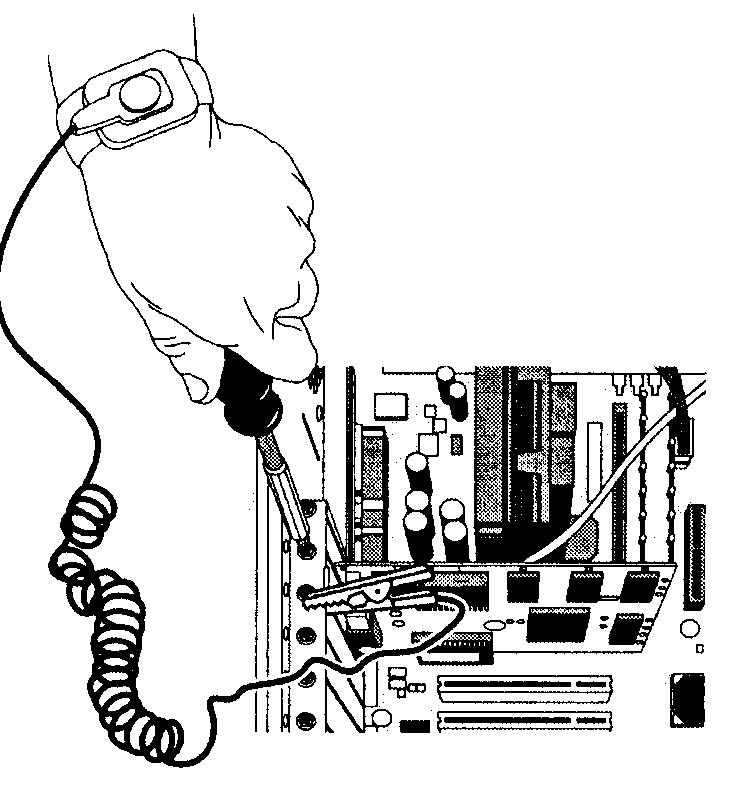

Zakładamy na chwilę osłonę obudowy komputera i poprzez otwór mierzymy odległość między końcem gumowej złączki a układem chłodzenia procesora (rysunek 23.26).

Rysunek 23.26.

Patrząc przez otwór, oceniamy odległość końca gumowej złączki od układu chłodzenia procesora

Zdejmujemy osłonę boczną, a następnie za pomocą noża lub żyletki skracamy gumową złączkę tak. by jej koniec znajdował się w odległości 12-20 mm od układu chłodzenia procesora. Być może trzeba będzie wykonać kilka przymiarek i kilka cięć.

Nakładamy dziurkowaną płytkę i mocujemy osłonę boczną obudowy (rysunek 23.27).

Rysunek 23.27.

Osłona boczna z zainstalowanym tunelem procesora

Jak widać, instalacja tunelu procesora jest bardzo łatwa. Najtrudniejszą czynnością jest wycięcie otworu w osłonie bocznej, ale i to nie jest specjalnie trudne, gdyż kołnierz sitka zasłoni ewentualne nierówności i zamaskuje brak idealnej kolistości otworu.

Końcowy efekt modyfikacji przedstawiono na rysunku 23.28.

Rysunek 23.28.

Tunel procesora i otwory wentylacyjne kart rozszerzeń w obudowie typuATX

Komputer, w którym dokonałem modyfikacji, miał już otwory wentylacyjne kart rozszerzeń oraz wyposażony był w 92-milimetrowy tylny wentylator. Zatem teraz po wyposażeniu go w tunel procesora stał się w pełni zgodny ze standardem Chassis Air Guide. Modyfikacja nie tylko rozszerzyła możliwości komputera, ale poprawiła również jego wygląd — nierdzewne sitko dodało mu nieco „przemysłowego" wyglądu.

Po włączeniu komputera od razu zauważyłem, że wentylator procesora zaczął pobierać powietrze z zewnątrz, dzięki czemu procesor osiągnął dużo niższą temperaturę. Całkiem nieźle jak na wydatek rzędu trzydziestu złotych i piętnaście minut pracy!

Panele czołowe z portami wejścia-wyjścia oraz innymi akcesoriami

W nowych obudowach spotyka się panele czołowe wyposażone w gniazda interfejsów USB, FireWire oraz gniazda mikrofonowe czy słuchawkowe, a nowe płyty główne zawierają złącza interfejsów USB, FireWire przeznaczonych do wykorzystania w tych panelach. W większości konstrukcji płyt głównych interfejsy te wyprowadzone są na tył obudowy, ale płyty te zawierają dodatkowo złącza szpilkowe, przeznaczone na włączenie kabli biegnących do gniazd paneli czołowych. Aby uaktywnić takie interfejsy, wystarczy w przypadku nowszych obudów umieścić wtyki ich kabli w odpowiednich złączach płyty głównej. Co jednak począć w przypadku, gdy nową płytę główną wyposażoną w zintegrowane porty USB i być może FireWire oraz porty audio umieszcza się w starej obudowie, a gniazda te trzeba wyprowadzić na przód obudowy?

Istnieje kilka rozwiązań tego problemu. Jednym z najciekawszych jest FrontX — system konfigurowalnych paneli instalowanych we wnęce 5,25" lub na dowolnej płaskiej powierzchni przedniej ściany obudowy.

Inne spotykane panele mają wysokość stacji dyskietek 3,5" i wykorzystują drugą wnękę 3,5". dostępną w większości obudów. Ponieważ wiele nowych systemów nie zawiera w ogóle stacji dyskietek, a w starszych systemach instalowana była tylko jedna stacja 3,5", bez wątpienia znajdzie się jedna wolna wnęka o tym rozmiarze.

System FrontX

Jednym z najbardziej interesujących, użytecznych, a co najważniejsze — konfigurowalnych akcesoriów przeznaczonych do montażu w obudowach jest panel czołowy firmy FrontX (www.frontx.com).

FrontX jest systemem opartym na specjalnej kasecie, przeznaczonej do montażu w zewnętrznej wnęce 5,25". Kaseta zawiera kilka przegród mogących pomieścić do ośmiu dowolnie wybranych gniazd. Jeżeli osiem gniazd nie wystarczy, można zastosować drugą kasetę, którą da się wyposażyć w kolejne osiem gniazd. Gniazda kupuje się osobno, a ich asortyment obejmuje praktycznie wszystkie rodzaje używanych złącz. Dodatkową cechą systemu jest dostępność wszystkich jego elementów w kolorach czarnym, szarym i kości słoniowej, dzięki czemu można je dopasować do koloru praktycznie każdej obudowy.

Kasetę systemu FrontX wyposażoną w gniazda szeregowe, mikrofonowe, głośnikowe, słuchawkowe, USB oraz portu gier pokazano na rysunku 23.29.

Rysunek 23.29.

Kaseta systemu FrontX wyposażona w kilka portów. Zdjęcie zamieszczone dzięki uprzejmości firmy FrontX. com

Jak widać na rysunku, w kasecie pozostaje miejsce na dodanie jeszcze jednego małego gniazda. Obecnie w systemie FrontX dostępne są następujące gniazda:

słuchawek,

wejścia audio,

mikrofonu,

portu gier-MIDI,

USB typu A,

podwójnego USB typu A.

IEEE 1394 (FireWire albo i.LINK),

S-Video,

RCA,

szeregowe.

PS2 (klawiatury lub myszy).

Wszystkie gniazda dostępne są w wersjach ze złączami wewnętrznymi lub zewnętrznymi. Jeżeli na przykład płyta główna wyposażona jest w złącze szpilkowe interfejsu USB, przeznaczone dla portów wyprowadzonych na panel czołowy, można użyć wersji wewnętrznej gniazda. Jeżeli jednak płyta główna nie ma złączy szpilkowych, lecz jedynie standardowe złącza USB wyprowadzone z tyłu obudowy, należy użyć zewnętrznego złącza systemu FrontX, dołączanego do zewnętrznego portu z tyłu komputera, którego kable za pomocą odpowiednich uchwytów wprowadzane są z powrotem do środka komputera, a następnie wyprowadzane na panel przedni.

Poza gniazdami w wersjach wewnętrznej i zewnętrznej system FrontX zawiera całą masę dodatkowych kabli, złączy, końcówek oraz wszelkich innych akcesoriów, które mogą się przydać podczas instalacji. W systemie znajdują się nawet prowadnice służące do instalacji gniazd systemu FrontX w zwykłych panelach czołowych, gdzie czasem przydają się znakomicie. Gorąco polecam to rozwiązanie wszędzie tam, gdzie trzeba umieścić na przedzie obudowy dowolne gniazda i to na dodatek w oprawie o dowolnym kolorze. Obecnie nie ma na rynku niczego lepszego.

Inne akcesoria przeznaczone do montażu w panelach czołowych

Jedno z najpopularniejszych urządzeń dających się zamontować we wnęce 3,5" wyposażone jest w gniazda USB. FireWire, mikrofonowe, słuchawkowe oraz w ośmioformatowy czytnik kart pamięci CompactFlash I/II, MicroDrive, Secure Digital/Multimedia Card, Memory Stick/Memory Stick Pro, SmartMedia oraz XD Picture Card, wykorzystywanych na przykład w cyfrowych aparatach fotograficznych. Urządzeniem tym jest pokazany na rysunku 23.30 panel In-Win CR-I530, dostępny w kolorach beżowym i czarnym.

Rysunek 23.30.

Mieszczący się we wnęce 3,5" panel In-Win CR-1530 z gniazdami USB, FireWire i audio, wyposażony w czytnik kart pamięci. Zdjęcie zamieszczone dzięki uprzejmości jirmy NewEgg. Com

Inne rozwiązania łączą w sobie stację dyskietek oraz czytnik kart pamięci. Produkują je firmy Mitsumi oraz Y.E. Data. W przypadku braku wolnych wnęk 3,5" można użyć panelu firmy Bytecc o rozmiarze 5,25", wyposażonego w gniazda USB, FireWire i audio oraz w siedmioformatowy czytnik kart pamięci.

Kolejnym podobnym urządzeniem jest 5,25" wielofunkcyjny panel Galaxy zawierający, tak jak podobne urządzenia, gniazda USB, FireWire i audio — z tym że zamiast czytnika kart pamięci wyposażony jest on w układ kontrolowania i wyświetlania temperatury oraz prędkości obrotowej czterech wentylatorów. Prędkość obrotowa wentylatorów jest ustalana na podstawie informacji uzyskiwanych z dwóch czujników zainstalowanych wewnątrz obudowy komputera.

Panel ten przydaje się, gdy komputer wyposażony jest w wentylatory przedni oraz tylny i należy kontrolować ich obroty po to. by modyfikować poziom hałasu lub by podczas używania gier lub innych intensywnie wykorzystujących procesor aplikacji wentylatory pracowały z największą wydajnością.

W systemach wykorzystujących wiele urządzeń USB często spotyka się jeden lub więcej koncentratorów USB udostępniających większą liczbę portów USB. Można je spotkać szczególnie w przypadku komputerów wyposażonych w starsze płyty główne, które — w przeciwieństwie do nowszych — wyposażone były jedynie w dwa lub cztery porty USB. Zamiast ustawiać koncentratory obok komputera, można zastosować koncentrator USB zamontowany w jednej z wnęk 3,5", na przykład czteroportowy koncentrator USB 2.0 firmy Heisei.

Jeżeli komuś zależy na poprawieniu wyglądu swojego komputera, czemu towarzyszyć będzie również rozszerżenie jego możliwości, powinien zwrócić uwagę na nostalgicznie wyglądający panel Cooler Master Musketeer. pokazany na rysunku 23.31

Na panelu pokazywane jest napięcie wentylatora, poziom dźwięku oraz temperatura czujnika, który można umieścić w dowolnym miejscu obudowy komputera. Szybkość obrotową wentylatorów oraz natężenie dźwięku można regulować za pomocą dwóch potencjometrów suwakowych. Na mnie, entuzjaście starych odbiorników radiowych, szczególne wrażenie robią zastosowane w panelu wskaźniki analogowe o surowym, przemysłowym wyglądzie.

Rysunek 23.31.

Panel 5,25" Cooler Master Musketeer. Zdjęcie zamieszczone dzięki uprzejmości firmy NewEgg.com

\

Rozdział 24.

Diagnostyka, testowanie i konserwacja komputera PC

Diagnostyka komputera PC

Niezależnie od tego, jak dobrej jakości jest Twój komputer oraz zainstalowane w nim oprogramowanie — prędzej czy później może stać się z nimi coś złego, a nie zawsze będziesz mógł w celu usunięcia usterki skorzystać z pomocy technicznej. Za każdym razem, gdy Twój komputer przestaje pracować lub gdy rozbudowujesz ważny jego składnik, a w szczególności w sytuacji, kiedy składasz nowe urządzenie od początku — bardzo przydatne może okazać się skorzystanie z oprogramowania diagnostycznego. Rozdział ten jest przeglądem rodzajów dostępnego oprogramowania diagnostycznego, a w szczególności tych narzędzi, które już posiadasz — gdyż dostarczane są one z systemami operacyjnymi i częściami komputerowymi.

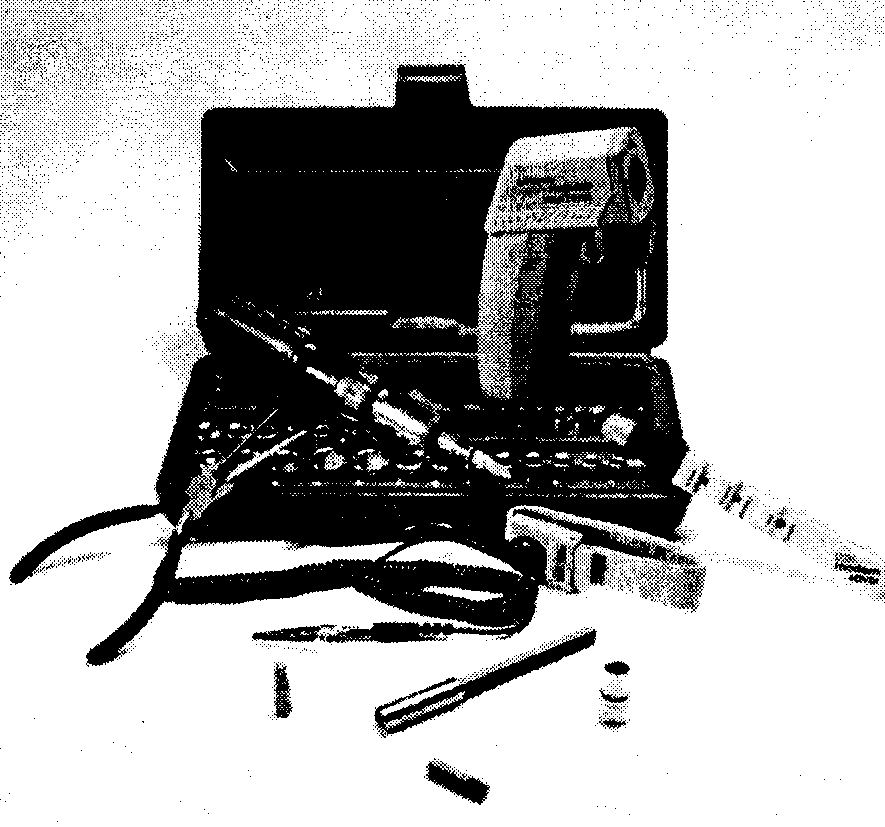

Możliwe, że problemy w działaniu komputera spowodowane zostaną przez niesprawność podzespołów, a w takim przypadku — żeby dokonać naprawy — będziesz musiał otworzyć jego obudowę. Rozdział ten omawia narzędzia i przyrządy — te najprostsze, które powinien mieć każdy użytkownik, oraz te bardziej zaawansowane — wykorzystywane przy rozbudowie i naprawie komputerów PC.

Oczywiście najlepszym sposobem radzenia sobie z problemami jest zapobieganie ich pojawianiu się. Cześć tego rozdziału traktująca o konserwacji komputera opisuje procedury, których regularne wykonywanie zapewni poprawną pracę całego systemu. Rozdział ten opisuje kilka rodzajów oprogramowania diagnostycznego, które włączone jest od razu do systemu operacyjnego lub też dostarczanego oddzielnie przez jego producenta, a także przez inne firmy. Z rozdziału tego dowiesz się, jak najlepiej wykorzystać te narzędzia. Opisane są w nim również szczegółowo różne sygnały dźwiękowe BIOS-u komputera oraz kody błędów, a także komercyjne i darmowe oprogramowanie diagnostyczne.

Oprogramowanie diagnostyczne

Dla komputerów PC dostępnych jest kilka rodzajów programów diagnostycznych. Pewne funkcje diagnostyczne posiadają podzespoły komputera PC lub jego urządzenia peryferyjne (takie jak na przykład karty rozszerzeń), a inne występują w formie narzędzi systemu operacyjnego lub też oddzielnych produktów. Programy te. wśród których część dostarczana jest z komputerem, pomagają użytkownikowi w rozwiązywaniu wielu problemów z poszczególnym podzespołami komputera. W wielu przypadkach programy te wystarczają do stwierdzenia, który element komputera PC jest uszkodzony lub całkowicie niesprawny. Oto przykłady tych programów:

POST (Power On SelfTest). Program ten uruchamiany jest przy każdym włączeniu komputera. Jego składniki znajdują się w pamięci ROM płyty głównej oraz kart rozszerzeń.

Programy diagnostyczne dostarczane przez producenta komputera. Wielu dużych producentów, a w szczególności tych najwyższej klasy, takich jak IBM. Hewlett-Packard. Dell czy też innych

— produkuje programy diagnostyczne ściśle dostosowane do ich zestawów komputerowych. Takie dostarczane przez producenta komputera oprogramowanie składa się zwykle z kilku testów, które dokładnie badają składniki komputera. Czasem programy te dostarczane są od razu z komputerem, a czasem trzeba je pobrać (bez żadnych opłat) z serwisu internetowego producenta lub też od niego kupić. Wielu producentów dołącza specjalnie dostosowane do ich komputerów okrojone wersje jednego z dostępnych na rynku pakietów diagnostycznych. W przypadku starszych komputerów firm IBM oraz Compaq oprogramowanie diagnostyczne było instalowane na dysku twardym (na specjalnej partycji) i mogło być uruchamiane w czasie startu komputera. Był to wygodny sposób na zapewnienie użytkownikom stałego dostępu do narzędzi diagnostycznych.

Oprogramowanie diagnostyczne urządzeń peryferyjnych. Wiele z urządzeń komputerowych dostarczanych jest wraz ze specjalnym oprogramowaniem przeznaczonym do testowania pracy tego urządzenia. Dla przykładu karty główne SCSI firmy Adaptec zawierają procedury diagnostyczne zapisane w BlOS-ie. które to procedury można wywołać w momencie uruchamiania komputera, korzystając kombinacji przycisków Ctrl +A. Karty dźwiękowe posiadają zwykle program diagnostyczny (dołączany na płycie CD-ROM lub dyskietce zawierającej sterowniki tej karty), służący do testowania i weryfikacji wszystkich jej funkcji. Również na płytce ze sterownikami dostarczane są zwykle programy diagnostyczne kart sieciowych. Także inne urządzenia czy karty rozszerzeń mogą mieć programy diagnostyczne przeważnie dołączane do sterowników tych urządzeń.

Oprogramowanie diagnostyczne systemu operacyjnego. Systemy operacyjne takie jak Windows 9x/Me oraz Windows NT/2000/XP zawierają duży zestaw programowych narzędzi diagnostycznych przeznaczonych do rozpoznawania i nadzorowania wydajności różnych podzespołów komputera.

Dostępne na lynku oprogramowanie diagnostyczne. Wielu producentów tworzy dla komputerów PC uniwersalne oprogramowanie diagnostyczne. Ten rodzaj oprogramowania jest często łączony z innymi narzędziami przeznaczonymi do konserwacji systemu oraz narzędziami naprawczymi — tworząc w ten sposób podstawowy zestaw narzędzi komputera PC.

Test startowy komputera (POST)

Kiedy w 1981 roku firma IBM rozpoczęła sprzedaż pierwszego komputera PC, włączyła do niego rozwiązania bezpieczeństwa nigdy wcześniej niespotykane w komputerach osobistych. Rozwiązaniami tymi były procedura testu startowego komputera (POST) oraz pamięć z kontrolą parzystości. Chociaż pamięci z kontrolą parzystości, a zwłaszcza pamięci z korekcją błędów (ECC), nie są już stosowane w większości chipsetów klasy podstawowej, wciąż każdy komputer PC wykonuje po włączeniu procedurę POST. W punkcie tym zostaną bliżej opisane zapisane w układzie ROM BIOS płyty głównej procedury testujące podzespoły komputera w momencie jego uruchamiania. Wykonywanie procedur POST odpowiedzialne jest za krótką zwlokę pomiędzy momentem włączenia komputera, a chwilą w której rozpoczyna się uruchamianie systemu operacyjnego.

Co jest testowane?

Za każdym razem, gdy uruchamiasz komputer, wykonuje on automatycznie serię testów, które sprawdzają podstawowe podzespoły komputera, takie jak procesor, ROM, układy obsługujące płytę główną, pamięć oraz ważne urządzenia peryferyjne. Testy te są krótkie, a zadaniem ich jest wykrycie tylko zasadniczych błędów. W przeciwieństwie do sprzedawanych programów diagnostycznych, procedury POST nie wykonują zbyt gruntownych testów. Procedura POST po wykryciu wadliwego podzespołu jedynie sygnalizuje błąd lub wyświetla komunikat o błędzie.

Chociaż testy diagnostyczne wykonywane przez POST nie są zbyt gruntowne, stanowią jednak pierwszą linię obrony, zwłaszcza w przypadku wykrycia poważnych problemów z płytą główną. Gdy procedura POST napotka problem na tyle poważny, by uniemożliwić poprawną pracę komputera — zatrzymuje proces jego uruchamiania i generuje komunikat błędu identyfikujący zwykle przyczynę problemu. Błędy wykryte przez POST są czasem nazywane błędami krytycznymi, ponieważ uniemożliwiają uruchomienie komputera.

Raportowanie błędów

Testy procedury POST generują trzy różne typy komunikatów: sygnały dźwiękowe, komunikaty tekstowe pokazywane na ekranie oraz kody w postaci liczb szesnastkowych wysyłane pod adres odpowiedniego portu wejścia-wyjścia.

Błędy wykryte przez testy POST przedstawiane są na trzy różne sposoby:

Sygnały dźwiękowe. Wydobywają się one z głośnika podłączonego do płyty głównej.

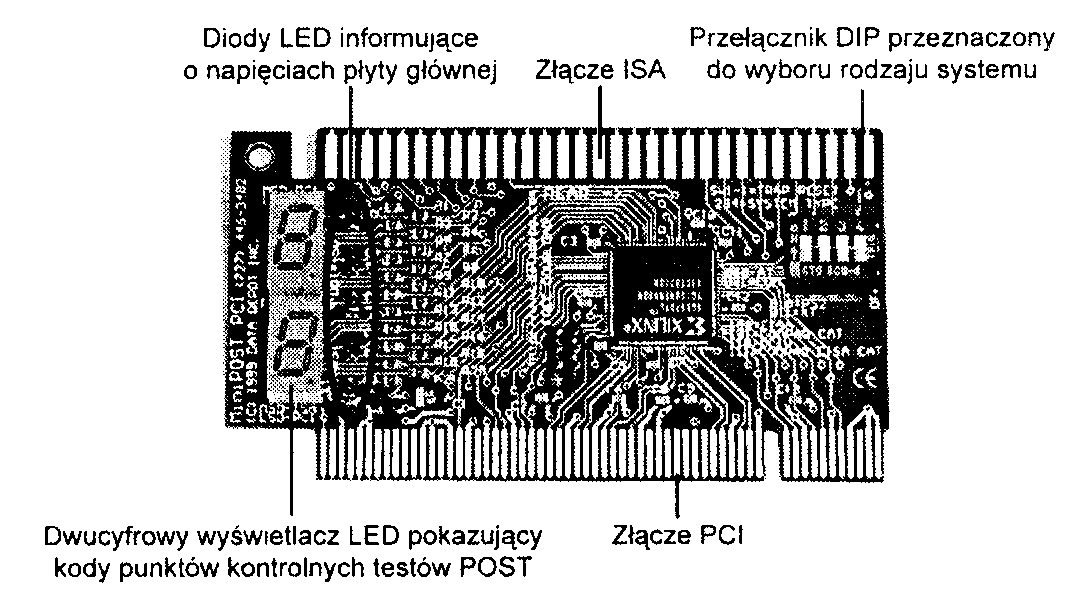

Punkty kontrolne POST. Szesnastkowe kody punktów kontrolnych wysyłane są pod adres odpowiedniego portu wejścia-wyjścia. Żeby odczytać te kody, wymagana jest specjalna karta włożona do gniazda ISA lub PCI.'

Komunikaty pokazywane na ekranie. Po zainicjalizowaniu karty graficznej komunikaty błędów pokazywane są na ekranie.

Sygnały dźwiękowe BIOS POST

Za pomocą sygnałów dźwiękowych sygnalizowane są tylko błędy krytyczne powstałe we wczesnej fazie testowania (przed uruchomieniem karty graficznej i innych urządzeń). Ponieważ kodów błędów nie można jeszcze pokazać na ekranie, przyjmują one postać serii dźwięków — identyfikujących wadliwy podzespół. Gdy komputer funkcjonuje poprawnie, podczas jego uruchamiania usłyszeć można jedynie krótki dźwięk informujący o zakończeniu procedury testującej. Niektóre komputery (takie jak na przykład produkowane przez firmę Compaq) generują po zakończeniu procedury POST dwa krótkie dźwięki. W przypadku, gdy wykryty zostanie jakiś problem, generowane są serie sygnałów dźwiękowych, a czasem też kombinacja dźwięków o różnym czasie trwania.

Punkty kontrolne BIOS POST

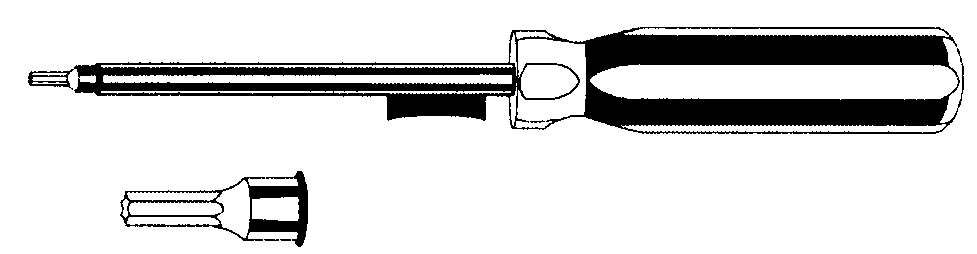

Punkty kontrolne POST są liczbami szesnastkowymi zapisywanymi przez procedurę POST na początku wykonywania każdego ważnego kroku procedury testowej — do portu wejścia-wyjścia o adresie 80h. Kody te często nazywane są po prostu kodami POST. Kody POST można odczytać jedynie przy wykorzystaniu specjalnej karty włożonej w jedno z gniazd rozszerzeń komputera. Karty takie były początkowo przeznaczone jedynie dla producentów komputerów w celu wykorzystywania ich na etapie testowania tworzonych przez nich płyt głównych. Obecnie kilka firm produkuje te karty z przeznaczeniem do wykorzystywania ich przez pracowników pomocy technicznej. Przykładami firm produkujących takie karty są Micro 2000, JDR Micro-devices. Data Depot. Ultra-X oraz Trinitech.

Kody punktów kontrolnych POST mogą służyć do śledzenia przebiegu procesu uruchamiania komputera, od chwili włączenia jego zasilania, aż do momentu, w którym uruchomi się program ładujący (i rozpocznie się procedura ładowania systemu operacyjnego). Gdy karta z czytnikiem kodów POST włożona jest w gniazdo rozszerzeń, w czasie trwania procedury POST pokazuje ona na swoim wyświetlaczu dwie liczby szesnastkowe punktu kontrolnego POST. Jeżeli uruchamianie komputera zostanie niespodziewanie zatrzymane lub zawieszone, odczytując dwucyfrowy kod pokazany na wyświetlaczu, można zidentyfikować test. który był wykonywany w momencie zawieszenia się komputera. W ten sposób da się zwykle wykryć niesprawny podzespół.

Większość starych kart czytników kodów POST wkłada się do 8-bitowego gniazda będącego elementem magistral ISA lub EISA. Wiele systemów, nawet tych z gniazdami PCI. wciąż wyposażonych jest w gniazda ISA i gniazda te można wykorzystać do tego celu. Jednak płyty główne montowane w większości nowych komputerów PC nie mają już w ogóle gniazd ISA, a więc karty POST ze złączami ISA oczywiście nie mogą być w nich wykorzystane. Praktycznie każda z firm, które produkują karty POST, wytwarza te karty również w wersji PCI. Firma Micro 2000 produkuje kartę o nazwie Post-Probe wyposażoną w oba złącza — ISA oraz PCI. Firma PCWiz produkuje podobną kartę o nazwie PCISA FlipPOST (rysunek 24.1). Obie te firmy oferują również karty dla magistrali MCA (MicroChannel Architecture). umożliwiające ich użycie w starszych komputerach IBM PS/2 wyposażonych w magistralę MCA.

Rysunek 24.1.

Karla diagnostyczna PCISA FlipPOST, przeznaczona do użycia w komputerach z magistralami PCI i ISA. Karta służy też do testowania napięć zasilania

Jeżeli pracujesz z nowoczesnymi komputerami PC postaraj się o kartę POST działającą w gnieździe rozszerzeń PCI. Większość nowych komputerów nie ma już gniazd ISA, a z gniazdem MicroChannel prawie zupełnie nie ma możliwości się zetknąć. Starsze komputery firmy Compaą lub wyposażone w magistralę EISA komputery innych firm mogą wysyłać kody punktów kontrolnych do innego portu niż 80h. Mniej zaawansowane karty monitorują tylko port 80h, inne (w tym pokazana na rysunku 24.1 karta PCISA FlipPOST) wyposażane są w przełączniki DIP lub zespoły zworek umożliwiających monitorowanie innych portów.

Więcej informacji na temat BIOS-u można znaleźć się w rozdziale 5.. „BIOS". Pamiętaj, ze kody T^i charakterystyczne dla Twojej wersji BIOS-u znajdziesz w jego dokumentacji technicznej. Również dokumentacja dołączana do różnych kart POST obejmuje zarówno najstarsze, jak i najnowsze wersje BIOS-ów.

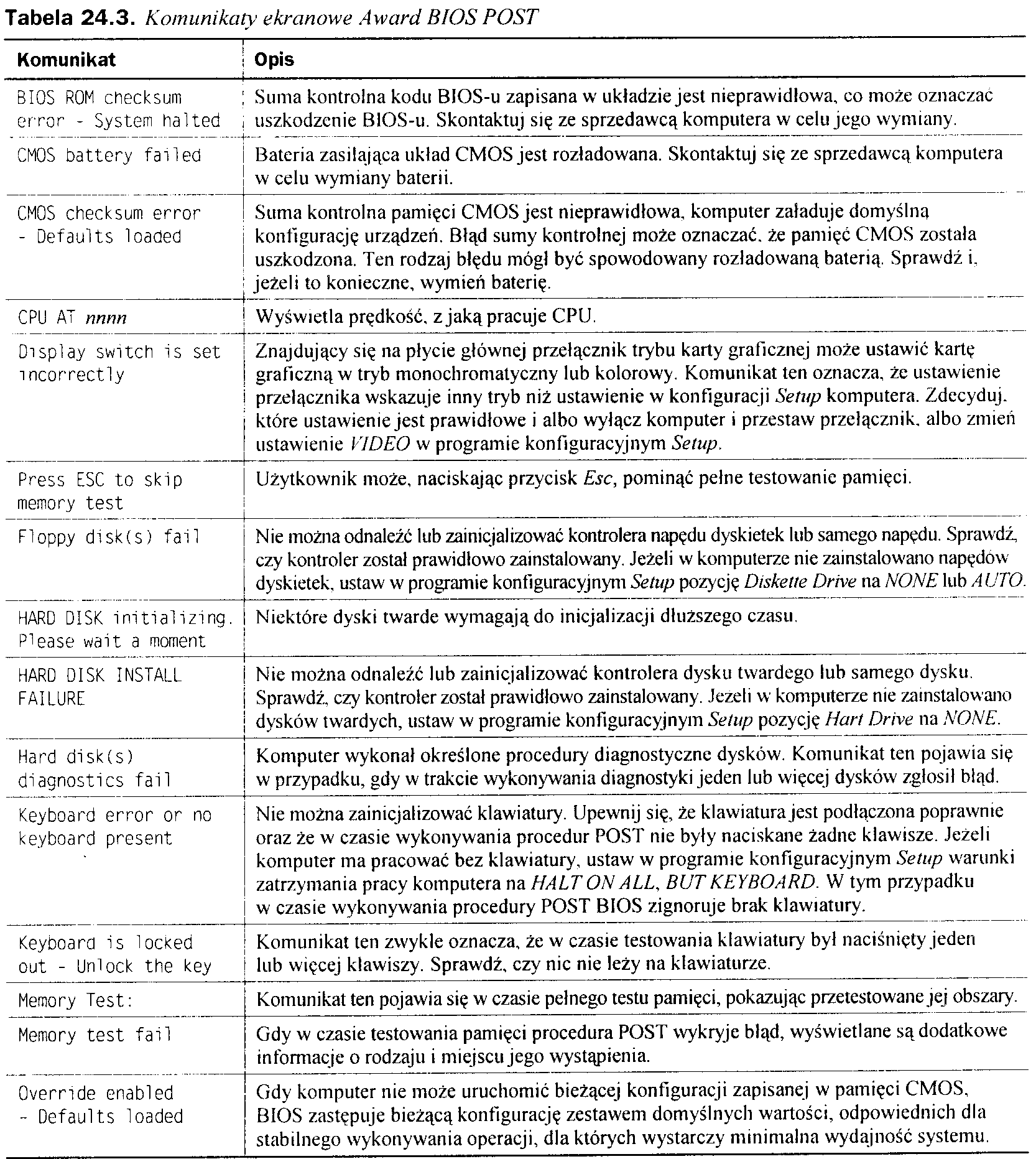

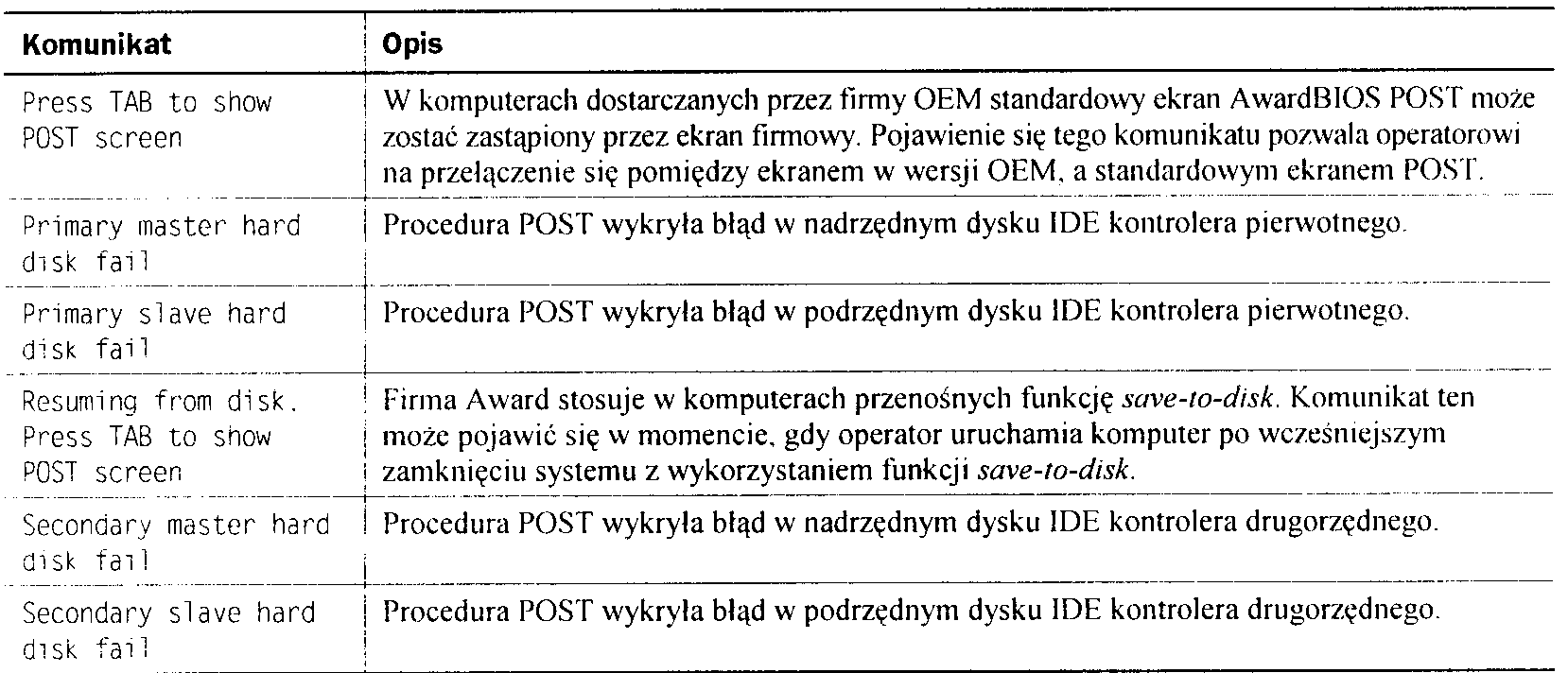

Komunikaty BIOS POST pokazywane na ekranie

Komunikaty pokazywane na ekranie są krótkimi informacjami mającymi zasygnalizować wystąpienie określonego uszkodzenia. Komunikaty te pokazywane są dopiero po zainicjalizowaniu karty graficznej.

Rodzaje komunikatów błędów zależą od konkretnego BIOS-u i różnią się u poszczególnych producentów, a czasem nawet różnice występują pomiędzy BlOS-ami tego samego producenta. W kolejnych podpunktach przedstawione zostaną kody stosowane w najpopularniejszych BIOS-ach (AMI. Award, Phoenix oraz IBM BIOS). Kody dla konkretnej płyty głównej i BIOS-u powinieneś otrzymać od producenta płyty głównej i BIOS-u.

Większość kart POST dostarczanych jest z dokumentacją zawierającą wykaz punktów kontrolnych POST dla różnych wersji BIOS-u. Jeżeli Twój BIOS nie jest wymieniony na zamieszczonej tu liście, zajrzyj do jego dokumentacji lub zapoznaj się z informacjami dostarczonymi z konkretną kartą POST.

Kody błędów A Ml BIOS POST

Tabela 24.1. Sygnały dźwiękowe |

4 MI BIOS POST |

|

Sygnały |

Komunikat błędu |

Podejmowane działania |

1 |

Błąd odświeżania pamięci. |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

2 |

Błąd parzystości pamięci. |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

3 |

Uszkodzenie pierwszych 64 KB pamięci podstawowej. |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

4 |

Uszkodzenie zegara systemowego. |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

5 |

Błąd procesora. |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Sprawdzamy poprawność instalacji procesora i układu chłodzenia, .leżeli trzeba, instalujemy je ponownie. Wymieniamy procesor. Wymieniamy płytę główną. |

6 |

Uszkodzenie linii A20 kontrolera klawiatury 8042. |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy klawiaturę, płytę główną, procesor. |

7 |

Błąd przerwania wyjątku w wirtualnym trybie pracy procesora. |

Sprawdzamy poprawność instalacji procesora i układu chłodzenia. Jeżeli trzeba, instalujemy je ponownie. Wymieniamy procesor. Wymieniamy płytę główną. |

8 |

Błąd odczylu-zapisu pamięci ekranu. |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

9 |

Błąd sumy kontrolnej pamięci ROM. |

Wyjmujemy i ponownie wkładamy układ ROM płyty głównej. Programujemy pamięć ROM ponownie. Wymieniamy płytę główną. |

10 |

Błąd odczytu-zapisu rejestru zamknięcia CMOS. |

Wymieniamy baterię układu CMOS. Wymieniamy płytę główną. |

11 |

Błąd pamięci podręcznej. _ |

Sprawdzamy prawidłowość ustawień programu konfiguracyjnego BIOS Setup. Wymieniamy procesor. Wymieniamy płytę główną. |

1 długi, 3 krótkie |

Uszkodzenie pamięci podstawowej lub rozszerzonej. |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

1 długi, 8 krótkich |

Test karty graficznej lub powrotu plamki nie powiódł się. |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

Kody AMI BIOS zostały zamieszczone za zgodą American Megatrends, Inc.

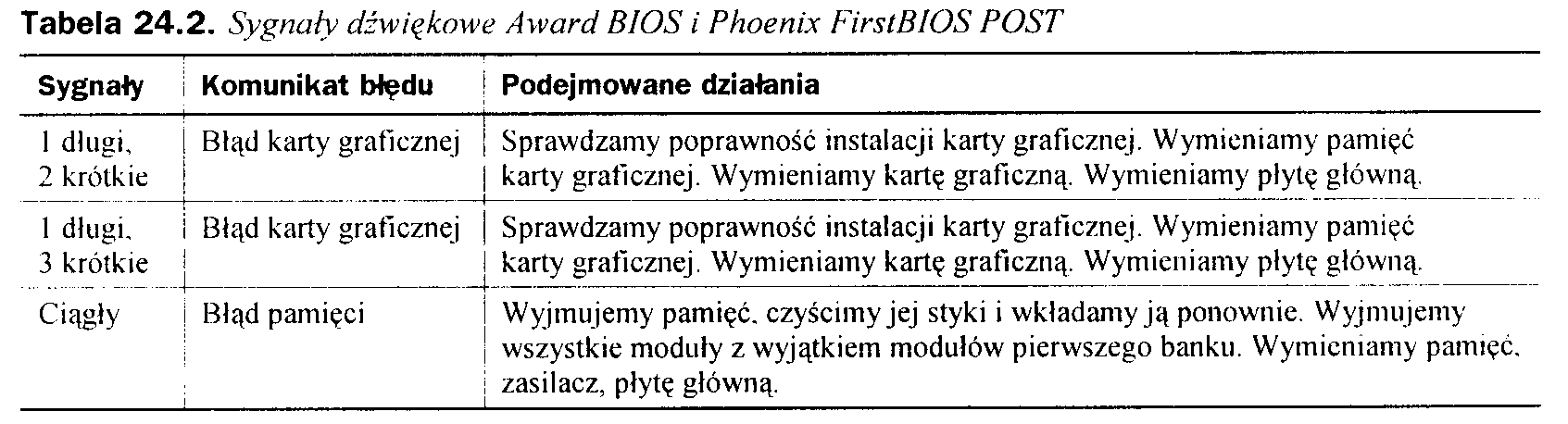

Kody błędów Award BIOS i Phoenix FirstBIOS POST

Obecnie BIOS firmy Award (znany też pod nazwą Phoenix FirstBIOS) używa tylko jednego standardowego sygnału dźwiękowego. Jest to pojedynczy długi sygnał, po którym następują dwa sygnały krótkie. Oznacza on. że BIOS nie może zainicjalizować karty graficznej w celu pokazania na ekranie dodatkowych informacji. Inne sygnały generowane przez BIOS firmy Award oznaczają zwykle problem z zasilaczem lub z pamięcią.

Kody błędów Phoenix BIOS POST

Wymienione niżej sygnały dźwiękowe obowiązują dla wersji 4. BIOS-u firmy Phoenix.

Tabela 24.4. Sygnały dźwiękowe |

' kody POST dla Phoenix BIOS w wersji 5.x i wcześniejszych |

||||

Sygnały |

\ Komunikat błędu |

Podejmowane działania |

|||

1-2 |

Błąd karty graficznej |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

|||

1-3 |

Błąd odczytu-zapisu pamięci CMOS RAM |

Wymieniamy baterię układu CMOS. Wymieniamy płytę główną. |

|||

1-1-4 |

Błąd sumy kontrolnej pamięci ROM |

Wyjmujemy i ponownie wkładamy układ ROM płyty głównej. Programujemy pamięć ROM ponownie. Wymieniamy płytę główną. |

|||

1-2-1 |

Błąd zegara systemowego |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

1-2-2 |

i Błąd inicjalizacji kanału ! DMA |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

1-2-3 |

Błąd odczytu-zapisu i rejestru strony układu DMA |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

1-3-1 |

Błąd weryfikacji odświeżania pamięci RAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

1-3-3 |

! Błąd linii danych w pierwszych 64 KB pamięci RAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

1-3-4 |

Błąd logiczny parzystości j (nieparzystości) j w pierwszych 64 KB | pamięci RAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

1-4-1 |

| Błąd linii adresowej ! w pierwszych 64 KB f pamięci RAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamyją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

1-4-2 |

Błąd parzystości w pierwszych 64 KB pamięci RAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

2-x-x' |

Błąd w pierwszych 64 KB pamięci RAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

3-1-1 |

Błąd podrzędnego rejestru DMA |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

3-1-2 |

Błąd nadrzędnego rejestru DMA |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

3-1-3 |

Błąd nadrzędnego rejestru maski przerwań |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

3-1-4 |

Błąd podrzędnego rejestru maski przerwań |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

3-2-4 |

Błąd kontrolera klawiatury |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy klawiaturę. Wymieniamy płytę główną. Wymieniamy procesor. |

|||

3-3-4 |

Błąd inicjalizacji ekranu |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

|||

3-4-1 |

Błąd powrotu plamki ekranu |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

|||

3-4-2 |

Błąd układu ROM karty graficznej |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

|||

4-2-1 |

Błąd przerwania zegara systemowego |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

4-2-2 |

Błąd zamknięcia |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy klawiaturę. Wymieniamy płytę główną. Wymieniamy procesor. |

|||

4-2-3 |

Błąd linii A20 |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy klawiaturę. Wymieniamy płytę główną. Wymieniamy procesor. |

|||

4-2-4 |

Nieoczekiwane przerwanie w trybie chronionym |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

|||

4-3-1 |

Błąd adresu pamięci RAM > FFFh |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

|||

4-3-3 |

Błąd kanału 2. zegara systemowego |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną |

|||

4-3-4 |

Błąd zegara czasu rzeczywistego |

Wymieniamy baterię układu CMOS. Wymieniamy płytę główną. |

|||

4-4-1 |

Błąd interfejsu szeregowego |

Ponownie konfigurujemy port w BIOS Setup. Wyłączamy port. |

|||

4-4-2 Bład interfejsu równoległego |

Ponownie konfigurujemy port w BIOS Setup. Wyłączamy port. |

||||

4-4-3 Błąd koprocesora matematycznego |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Sprawdzamy poprawność instalacji procesora i układu chłodzenia. Jeżeli trzeba, instalujemy je ponownie. Wymieniamy procesor. Wymieniamy płytę główną. |

||||

Nisko 1-1-2 |

Błąd wyboru płyty systemu |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Sprawdzamy poprawność instalacji procesora i układu chłodzenia. Jeżeli trzeba, instalujemy je ponownie. Wymieniamy procesor. Wymieniamy płytę główną. |

|||

Nisko 1-1-3 |

Błąd rozszerzonej pamięci CMOS RAM |

Wymieniamy baterię układu CMOS. Wymieniamy płytę główną. |

|||

Drugi i trzeci kod może składać się z od jednego do czterech sygnałów dźwiękowych, wskazujących uszkodzenie różnych bitów w pierwszych 64 KB pamięci RAM.

Tabela 24.5. Sygnały dźwiękowe kody POST dla Phoenix BIOS w wersji 6.x i późniejszych |

||

Sygnały |

Komunikat błędu |

Podejmowane działania |

1-2-2-3 |

Błąd sumy kontrolnej ROM BIOS |

Wyjmujemy i ponownie wkładamy układ ROM płyty głównej. Programujemy pamięć ROM ponownie. Wymieniamy płytę główną. |

1-3-1-1 |

Błąd odświeżania pamięci DRAM |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

1-3-1-3 |

Błąd kontrolera klawiatury 8742 |

Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy klawiaturę. Wymieniamy płytę główną. Wymieniamy procesor. |

1-3-4-1 |

Błąd linii adresowej pamięci |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

1-3-4-3 |

Błąd danych młodszego bajtu pamięci |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

1-4-1-1 |

Błąd danych starszego bajtu pamięci |

Wyjmujemy pamięć, czyścimy jej styki i wkładamy ją ponownie. Wyjmujemy wszystkie moduły z wyjątkiem modułów pierwszego banku. Wymieniamy pamięć, zasilacz, płytę główną. |

2-1-2-3 |

Błąd praw autorskich pamięci ROM |

Wyjmujemy i ponownie wkładamy układ ROM płyty głównej. Programujemy pamięć ROM ponownie. Wymieniamy płytę główną. |

2-2-3-1 |

Nieoczekiwane przerwania |

Szukamy nieprawidłowo funkcjonującej karty rozszerzeń. Sprawdzamy poprawność instalacji płyty głównej, szukamy zawieruszonych śrubek i innych elementów mogących spowodować zwarcie oraz zbyt mocno dokręconych śrub. Wymieniamy płytę główną. |

1-2 |

Błąd karty graficznej |

Sprawdzamy poprawność instalacji karty graficznej. Wymieniamy pamięć karty graficznej. Wymieniamy kartę graficzną. Wymieniamy płytę główną. |

Kody błędów IBM BIOS POST

Tabela 24.6. Sygnały dźwiękowe IBM BIOS POST

Sygnał dźwiękowy |

Opis |

|

1 krótki sygnał |

POST zakończony bez błędów — komputer sprawny. |

|

2 krótkie sygnały |

Błąd procedury POST — kod błędu pokazany na ekranie. |

|

Brak sygnału |

Zasilacz, płyta główna. |

|

Sygnał ciągły |

Zasilacz, płyta główna. |

|

Powtarzające się krótkie sygnały |

Zasilacz, płyta główna. |

|

1 długi, 1 krotki sygnał |

Płyta główna. |

|

1 długi. 2 krótkie sygnały |

Karta graficzna (MDA/CGA). |

|

1 długi, 3 krótkie sygnały |

Karta graficzna (MDA/CGA). |

|

3 długie sygnały |

Kontroler klawiatury 3270. |

|

Sygnały dźwiękowe oraz alfanumeryczne kody błędów zostały zamieszczone za zgodą firmy IBM.

Tabela 24.7. Ekranowe kody błędów diagnostycznych IBM BIOS POST

Kod |

Opis |

||||

1xx |

Błędy płyty głównej. |

||||

2xx |

Błędy pamięci RAM. |

||||

3xx |

Błędy klawiatury. |

||||

4xx |

Błędy karty graficznej MDA (ang. Monochrome Display Adapter). |

||||

4xx |

Błędy portu równoległego płyty głównej PS/2. |

||||

5xx |

Błędy karty CGA (ang. Color Graphics Adapter). |

||||

6xx |

Błędy kontrolera lub napędu dyskietek. |

||||

7xx |

Błędy koprocesora matematycznego. |

||||

9xx |

Błędy kontrolera równoległego portu drukarki. |

||||

10xx |

Błędy alternatywnego kontrolera portu drukarki równoległej. |

||||

11xx |

Błędy portu szeregowego COM1: (Primary Async Communications). |

||||

12xx |

Błędy alternatywnych portów szeregowych COM1:, COM2:, COM3: i COM4: (Primary Async Communications). |

||||

13xx |

Błędy kontrolera gier. |

||||

14xx |

Błędy drukarki mozaikowej. |

||||

15xx |

Błąd kontrolera SDLC (ang. Synchronous Data Link Control). |

||||

16xx |

Błędy urządzeń DSEA (ang. Display Station Emulation Adapter) 5520, 525x. |

||||

17xx |

Błędy kontrolera oraz dysku twardego ST-506/412. |

||||

18xx |

Błędy jednostki rozszerzenia portów wejścia-wyjścia. |

||||

19xx |

Błąd kontrolera połączeń 3270. |

||||

20xx |

Błędy kontrolera BSC (ang. Binary Synchronous Communications). |

||||

21xx |

Błędy alternatywnego kontrolera BSC (ang. Binary Synchronous Communications). |

||||

22xx |

Błędy kontrolera klasterów. |

||||

23xx |

Błędy adaptera monitora plazmowego. |

||||

24xx |

Błędy kart EGA (ang. Enhanced Graphics Adapter) lub VGA (ang. Video Graphics Array). |

||||

25xx |

Błędy alternatywnej karty EGA (ang. Enhanced Graphics Adapter). |

||||

26xx |

——-—• Błędy karty 370-M (pamięci) i karty 370-P (procesora) komputera XT lub AT/370. |

|

|||

27xx |

Błędy karty 3277-EM (emulatora) komputera XT lub AT/370. |

|

|||

28xx |

Błędy karty emulatora 3278/79 lub karty połączenia 3270. |

|

|||

29xx |

Błędy drukarki kolorowej lub graficznej. |

|

|||

30xx |

Btędy podstawowej karty sieciowej. |

|

|||

31xx |

Błędy drugorzędnej karty sieciowej. |

|

|||

32xx |

Błędy karty wyświetlacza i karty programowanych symboli w komputerach 3270 PC lub AT. |

|

|||

33xx |

Błędy drukarki kompaktowej. |

|

|||

35xx |