1

NADZĘDZIE SZTUCZNEJ INTELIGENCJI Lekcja 4: Uczenie sieci neuronowych

CEL: Znaleźć układ wag, aby zminimalizować funkcję błędu

I. Uczenie perceptronu

1. Reguła perceptronowa (dla dyskretnych neuronów)

Wnew = WM+rj(d-y)X

b„ew =boUi+ r] (d-y)

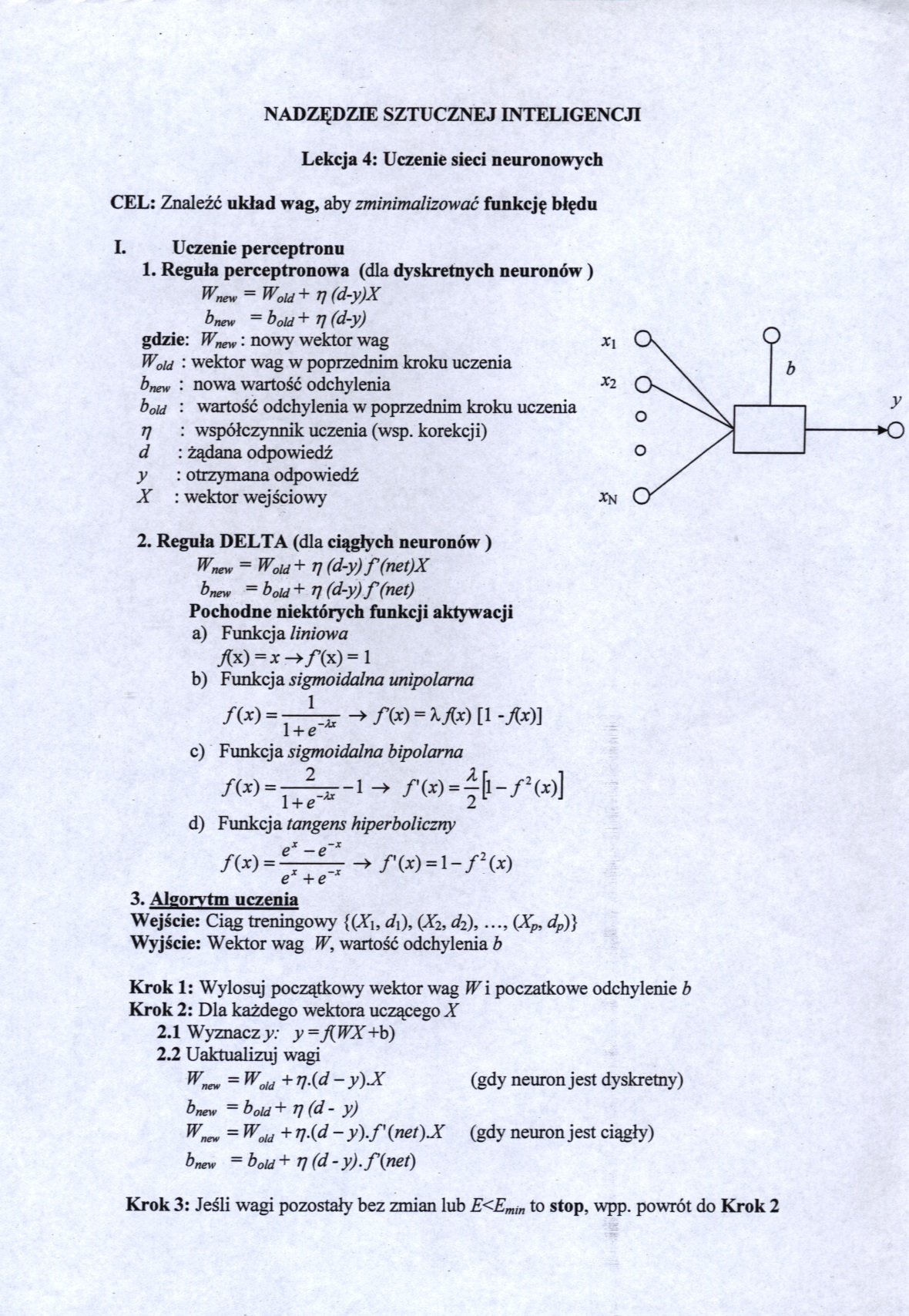

gdzie: Wnew: nowy wektor wag x\

W0id : wektor wag w poprzednim kroku uczenia

bmw : nowa wartość odchylenia Xl

b0id : wartość odchylenia w poprzednim kroku uczenia

ti : współczynnik uczenia (wsp. korekcji)

d : żądana odpowiedź

y : otrzymana odpowiedź

X : wektor wejściowy *n

2. Reguła DELTA (dla ciągłych neuronów )

Wnew = WoUi+ T] (d-y) f (net)X bnew =bM+Tj (d-y) f (net)

Pochodne niektórych funkcji aktywacji

a) Funkcja liniowa J(x) =x —>/’(x) = 1

b) Funkcja sigmoidalna unipolarna

/w -1—-z# -* m - M-t) [i -x*)i

l + e

c) Funkcja sigmoidalna bipolarna

/(i) = -^r-i -> XW=|[i-/!w]

d) Funkcja tangens hiperboliczny

m=4^ -»• r w -1 - P w

e+e

3. Algorytm uczenia

Wejście: Ciąg treningowy {(Xh d\), (X2, d2),(Xp, dp)} Wyjście: Wektor wag W, wartość odchylenia b

Krok 1: Wylosuj początkowy wektor wag W i początkowe odchylenie b Krok 2: Dla każdego wektora uczącego X

2.1 Wyznaczy: y=J[WX+ b)

2.2 Uaktualizuj wagi

Wnew = Wold +T].(d- y)X (gdy neuron jest dyskretny)

bneyy =boUJ+ TJ (d - y)

Wnew = WM + T].(d - y).f(net) X (gdy neuron jest ciągły) bnew = b0id + tj (d- y).f{net)

Krok 3: Jeśli wagi pozostały bez zmian lub E<Emm to stop, wpp. powrót do Krok 2

Wyszukiwarka

Podobne podstrony:

grupa II a Egzamin ze Sztucznej Inteligencji - Grupa IIZadl: Narysuj Neuron McCullocha-Pittsa z wejś

img117 117 Rozdział 9. Dynamika procesu uczenia sieci neuronowych Do tego samego wniosku można dojść

img143 (11) 8Formy uczenia sieci neuronowych8.1. Jak wykorzystać wielowarstwową sieć neuronową do

img146 (10) 140 Formy uczenia sieci neuronowych Możliwe też będą (w miarę komplikacji sieci - coraz

img160 (9) 154 Formy uczenia sieci neuronowych Dlatego kolejny eksperyment polegać będzie na zastoso

img166 (9) Formy uczenia sieci neuronowych doświadczenie podczas uczenia nie potwierdzało tych kateg

img112 Rozdział 9Dynamika procesu uczenia sieci neuronowych W poprzednich rozdziałach prezentowane b

img113 113 Rozdział 9. Dynamika procesu uczenia sieci neuronowych Rozwiązanie ma ogólną postać W(f)

img115 115 Rozdział 9. Dynamika procesu uczenia sieci neuronowych zjawisko jest znane w biologii pod

img117 117 Rozdział 9. Dynamika procesu uczenia sieci neuronowych Do tego samego wniosku można dojść

img119 119 Rozdział 9. Dynamika procesu uczenia sieci neuronowych albo — uwzględniając równanie opis

opis modelu w postaci „czarnej skrzynki”. Uczenie sieci neuronowej może być także realizowane w trak

więcej podobnych podstron