Sieci CP str030

:jo

3.3. Uczenie pojedynczego neuronu

ty*

|

,A.0) ...0) |

. w w |

(V | ||||

|

w, ws . . |

Wn |

wt Wg . . |

■ Wn |

. . . |

w; Wg. . |

T" T*

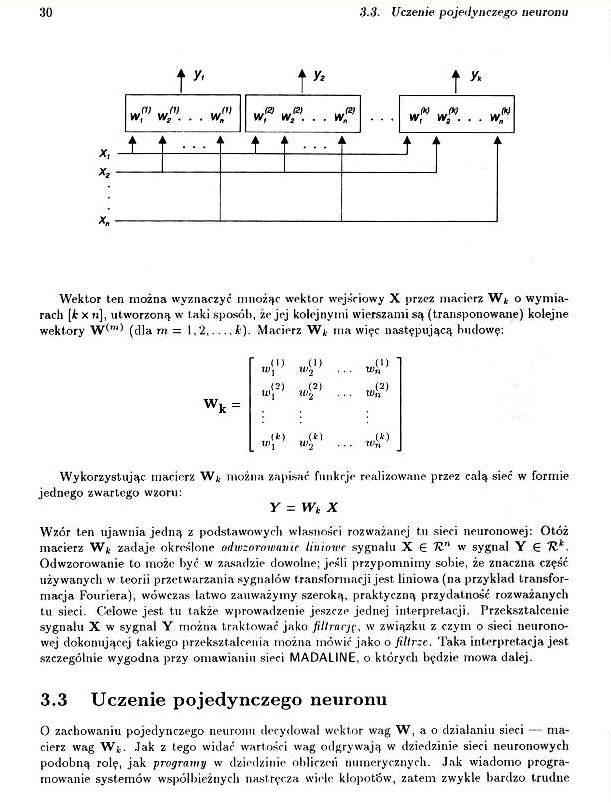

Wektor ten można wyznaczyć mnożąc wektor wejściowy X przez macierz W* o wymiarach [k x n], utworzoną w taki sposób, że jej kolejnymi wierszami są (transponowane) kolejne wektory (dla m = 1,2.....k). Macierz W* ma więc następującą budowę;

k =

|

„i" . | ||

|

-!!1 |

.. »?’ | |

|

-4*’ ■ |

W

Wykorzystując macierz W*, można zapisać funkcje realizowane przez całą sieć w formie jednego zwartego wzoru:

Y = Wk X

Wzór ten ujawnia jedną z podstawowych własności rozważanej tu sieci neuronowej: Otóż macierz W* zadaje określone odwzorowanie liniowe sygnału X 6 TZ'1 w sygnał Y € 7?.*. Odwzorowanie to może być w zasadzie dowolne; jeśli przypomnimy sobie, że znaczna część używany cli w teorii przetwarzania sygnałów transformacji jest liniowa (na przykład transformacja Fouriera), wówczas łatwo zauważymy szeroką, praktyczną przydatność rozważanych tu sieci. Celowe jest tu także wprowadzenie jeszcze jednej interpretacji. Przekształcenie sygnału X w sygnał Y można traktować jako fili rację, w związku z czym o sieci neuronowej dokonującej takiego przekształcenia można mówić jako o filtrze. Taka interpretacja jest szczególnie wygodna przy omawianiu sieci MADALINE. o których będzie mowa dalej.

3.3 Uczenie pojedynczego neuronu

0 zachowaniu pojedynczego neuronu decydował wektor wag W, a o działaniu sieci macierz wag Wfc. Jak z tego widać wartości wag odgrywają w dziedzinie sieci neuronowych podobną rolę, jak programy w dziedzinie obliczeń numerycznych. Jak wiadomo programowanie systemów współbieżnych nastręcza wiele kłopotów, zatem zwykle bardzo trudne

Wyszukiwarka

Podobne podstrony:

Sieci CP str032 32 3.3. Uczenie pojedynczego neuronu skorygowanie wektora wag W, by neuron lepiej re

Sieci CP str036 36 Uczenie sieci elementów liniowychty t* ty* ...IV ...(V ...W

img091 (20) oprowadzenie do techniki sieci uczenia - pojedynczego neuronu, albo i całej sieci (rys.

Sieci CP str060 60 4.6. Uczenie sieci nieliniowej,(i) _ XU) Jako ciekawostkę warto odnotować fakt, ż

img030 30 3.3. Uczenie pojedynczego neuronu ...m ...m (1) (2) (2) 00 00 00 w, w2 ... w„ W, W2

img032 32 3.3. Uczenie pojedynczego neuronu skorygowanie wektora wag W, by neuron lepiej realizował

Sieci CP str003 a 10.1.a Uczenie sieci .............................................................

Sieci CP str044 AA Uczenie forsowaniem do postaci macierzowej:w^+,) = wjJ) + >/zfj] [x0)]T Efekt

Sieci CP str056 56 4.4. Formy nieliniowości neuronu który można rozpisać jako y = exp (ffe) - exp (-

Sieci CP str106 106 8.4. Uczenie sieci BAM i przykład jej działania8.4 Uczenie sieci BAM i przykład

Sieci CP str056 56 4.4. Formy nieliniowości neuronu który można rozpisać jako y = exp (ffe) - exp (-

więcej podobnych podstron