PODSTAWY TELEKOMUNIKACJI

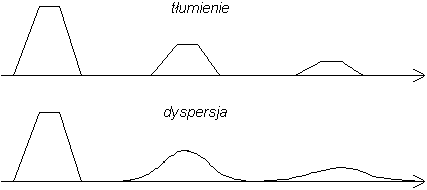

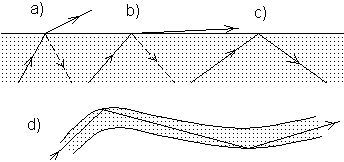

Około 1840 r. wynaleziono telegraf elektromagnetyczny, a wkrótce potem alfabet Morse'a. Pierwszy kabel transatlantycki położono w roku 1858. Miał on jednak bardzo małą przepustowość - mniejszą od 1 bita na sekundę (oczywiście, wtedy bit jako jednostka ilości informacji nie był stosowany). Przyczyną tego był znaczny opór tak długiego przewodu (ok. 10 kΩ) w połączeniu z jego dużą pojemnością elektryczną (ok. 20 F). Jak wynika z teorii przedstawionej we wstawce na stronie 6, stała czasowa takiego obwodu wynosi ok. 0,2 s, co oznacza, że narastanie sygnału, a potem jego spadek do zera w sumie zajmują czas rzędu sekundy. Przesyłanie impulsów w szybszym tempie oznaczałoby stratę informacji zarówno wskutek ich tłumienia (słabnięcia), a także wskutek dyspersji - „rozmywania się”. Różnicę między tymi dwoma zjawiskami ilustruje poniższy rysunek.

W 1876 r. wynaleziony został telefon (A.G.Bell, USA). Przekaz dźwięku za pośrednictwem sygnałów elektrycznych wymaga, oczywiście, ograniczenia wspomnianych powyżej niepożądanych efektów. Pierwsza rozmowa telefoniczna poprzez kabel położony na dnie Atlantyku miała miejsce w 1956 r., a zrealizowano ją instalując na kablu co pewien odcinek wzmacniacze pośrednie - tzw. repetory („powtarzacze”). W przypadku omawianego kabla było ich 51, co ok. 60 km, a ich zadaniem jest kształtowanie od nowa sygnałów, zanim zdążą ostatecznie zaniknąć. Ta zasada postępowania obowiązuje także i dzisiaj, np. w telekomunikacji światłowodowej.

ĆWICZENIE. Ile razy zwiększy się szybkość transmisji kabla o danej długości, jeśli podwoimy ilość repetorów, czyli dwukrotnie skrócimy odległość między nimi? Zakładamy, że na ograniczenie szybkości transmisji wpływa jedynie dyspersja, a decydującym czynnikiem jest stała czasowa obwodu RC.

Przeliczmy przepustowość kanału informacji (liczbę bitów na sekundę), jaka jest niezbędna przy różnych rodzajach przekazu. Dźwięk słyszalny dla człowieka obejmuje częstotliwości do 20 kHz - jeśli chcemy to przeliczyć na liczbę bitów na sekundę, należy powołać się na warunek Nyquista, zgodnie z którym częstotliwość próbkowania powinna być co najmniej 2 razy większa od najwyższej częstotliwości przekazywanego sygnału. Jest to zgodne z podaną wcześniej częstotliwością próbkowania dźwięku na płytach CD (44 kHz). Przemnożenie (16 bitów)·(44000 pomiarów/s)·(2 ścieżki stereofoniczne) daje wynik równy 1,4 Mb/s, a w rzeczywistości szybkość transmisji danych dla płyt CD jest - jak się zdaje - nieco mniejsza i wynosi ok. 1,1 Mb/s (przyczyną rozbieżności może być fakt, że część informacji opisującej obie ścieżki stereofoniczne jest wspólna). Podobny rachunek dla dźwięku w standardzie telefonii komórkowej GSM daje wynik (8 bitów)·(8 kHz) = 64 kb/s - jednak w rzeczywistości dzięki kompresji danych przesyła się tylko 14,4 kb/s. Obraz telewizyjny składa się z 625 linii, z których każda zawiera ok. 800 punktów (pikseli), a całość jest przekazywana 25 razy na sekundę, a jeśli przyjmiemy, że każdy pomiar jasności ma dokładność np. 3 bitów, to otrzymujemy 625·800·25·3 = 37,5 Mb/s - w rzeczywistości wystarcza ok. 30 Mb/s. Plany rozwoju telefonii komórkowej przewidują wprowadzenie w najbliższych latach nowego standardu UMTS o przepustowości około 2 Mb/s, co wystarcza do przesłania obrazu telewizyjnego niższej jakości (mniejsza liczba pikseli, niższa częstotliwość odświeżania).

Powyższe wartości wymagają porównania z przepustowością kabli różnego rodzaju. Do zwykłej linii telefonicznej opartej na parze skręconych ze sobą miedzianych drutów możemy podłączyć modem o szybkości 56 kb/s. Tę wartość można znacznie zwiększyć pod warunkiem zainstalowania na końcach kabla specjalnych urządzeń komutacyjnych - w tzw. technologii ADSL osiąga się 3-4 Mb/s w kierunku do abonenta i mniej niż 1 Mb/s z powrotem (przydatne w łączeniu się z Internetem). Od początku 2001 roku taką usługę pod nazwą Neostrada (o nieco gorszych parametrach - od 256 kb/s do 2 Mb/s „w dół” i 64 kb/s „w górę”) oferuje TP SA. Należy jednak stwierdzić, że standardowe linie telefoniczne nie były projektowane pod kątem przesyłania tak dużych ilości informacji, a instalowane w nich układy służące poprawie jakości dźwięku faktycznie tłumią wysokie częstotliwości, tak że linie ADSL można zakładać tylko przy odległości abonenta od centrali nie przekraczającej kilku kilometrów. Kablami koncentrycznymi (TV kablowa) można przesyłać kilkaset Mb/s, natomiast największą przepustowością charakteryzują się światłowody - wynosi ona kilkadziesiąt do kilkuset Gb/s, co odpowiada ok. 1-10 tysięcy kanałów TV (na jedno włókno światłowodu!).

Aby zrozumieć czynniki wpływające na przepustowość różnych kanałów informacji, musimy wprowadzić pojęcie modulacji, niesłychanie istotne przy przekazie informacji za pośrednictwem fal (radiowych lub świetlnych). Fala czysto sinusoidalna - harmoniczna - nie niesie, oczywiście, żadnej informacji. Dopiero gdy będziemy np. włączali i wyłączali sygnał kluczem telegraficznym (kreski i kropki alfabetu Morse'a), otrzymujemy falę zawierającą informację - falę zmodulowaną. Widać, że w obrębie każdego przekazywanego impulsu musi być przynajmniej kilka maksimów fali, dlatego częstotliwość fali musi być przynajmniej kilka razy wyższa od częstotliwości przekazywanych sygnałów.

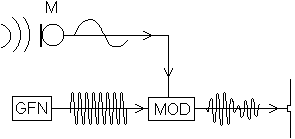

Przy okazji przypomnijmy kilka dat z historii rozwoju radia i telewizji. Pierwsze transmisje radiotelegraficzne miały miejsce w 1897 roku („telegraf bez drutu” Marconiego - przez kanał La Manche w 1899 r., przez Atlantyk w 1901 r.). Pierwszy przekaz radiofoniczny nastąpił w 1906 r., a publiczne stacje radiowe rozpoczęły działalność w latach 20-tych. Po raz pierwszy zademonstrowano publicznie telewizję w 1939 r., a w Polsce początki telewizji datują się na koniec lat 50-tych. Stosowany w radiofonii i telewizji system modulacji był jednak innego typu, niż w radiotelegrafii - nie była to modulacja impulsowa, lecz modulacja amplitudy lub modulacja częstotliwości (skróty AM i FM). Zasadę modulacji amplitudy przedstawia rysunek obok. Fala dźwiękowa pada na mikrofon M, z którego pochodzi wolnozmienny sygnał niosący informację. Skrótem GFN oznaczono generator fali nośnej o wysokiej częstotliwości, której amplituda zmieniana jest w modulatorze MOD według sygnału wolnozmiennego. Zmodulowana fala jest przekazywana na antenę, gdzie prąd elektryczny ulega przekształceniu w falę elektromagnetyczną. Aby fala zmodulowana wiernie oddawała przebieg sygnału, przyjmuje się, że częstotliwość fali nośnej powinna być od niego przynajmniej 10 razy wyższa. Zatem dla przekazu dźwięku o częstotliwości do 15 kHz częstotliwość fali nośnej powinna wynosić co najmniej 150 kHz, co odpowiada długości fali poniżej 2 km (por. następna strona, także wstawka na górze str. 2). Nieco dłuższe fale można wykorzystywać do nadawania dźwięku niskiej jakości, a znacznie dłuższe (10-100 km) już tylko do radiotelegrafii (są stosowane do łączności z okrętami podwodnymi pozostającymi w zanurzeniu). A oto analogiczny rachunek dla przekazu telewizyjnego: 625·800·25 = 12 mln sygnałów na sekundę, częstotliwość fali nośnej powinna więc wynosić co najmniej 120 MHz. Te obliczenia mają z natury rzeczy charakter raczej orientacyjny, encyklopedie podają, że minimalna częstotliwość fali radiowej dla potrzeb TV wynosi ok. 50 MHz, czyli maksymalna długość fali max = 6 m. Dla fal radiowych o wysokich częstotliwościach (np. UKF, telewizja) stosujemy zwykle modulację częstotliwości (rys. obok). Ten system modu

lacji jest bardziej odporny na typowe zakłócenia, które silniej wpływają na amplitudę (zaniki, pulsacje).

Odtworzenie informacji zawartej w fali zmodulowanej nosi nazwę demodulacji (albo detekcji). W odbiorniku radiowym demodulację poprzedza wybranie danej częstotliwości fali nośnej, czyli dostrojenie do danej stacji nadawczej. Funkcję tę zwykle pełni obwód rezonansowy składający się z cewki i kondensatora; jeśli częstotliwość odbieranej fali pokrywa się z częstotliwością własną takiego obwodu, to wzbudzone w nim drgania są szczególnie silne (zasada rezonansu). Na ogół zmianę częstotliwości rezonansowej osiąga się poprzez zmianę pojemności kondensatora, dlatego pokrętło strojenia w radioodbiornikach steruje położeniem ruchomych okładek kondensatora. Właściwą demodulację dla przypadku modulacji amplitudy można osiągnąć dzięki zastosowaniu diody, która prostując „obcina” ujemną połówkę sygnału, a następnie „wygładzeniu” części dodatniej. (Pierwsze prymitywne odbiorniki radiowe z lat 20-tych nazywano „kryształkowymi”, gdyż zawierały one kryształek półprzewodnika przyciskany stalowym ostrzem - taki styk ma własności prostujące, jak dioda.) Na rysunku powyżej przedstawiono kolejne etapy przekształcania sygnału w odbiorniku - od anteny do głośnika, z pominięciem wzmocnienia.

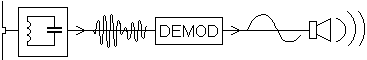

Następstwem modulacji jest zmiana widma fali. Pojęcie widma jest najbardziej znane w optyce, gdzie opisuje rozkład światła na barwy w pryzmacie lub siatce dyfrakcyjnej. Ponieważ każda barwa monochromatyczna odpowiada innej długości fali lub częstotliwości, więc widmo jest równoważne wykresowi przedstawiającemu na osi pionowej amplitudę barw monochromatycznych będących składowymi danego światła, a na osi poziomej - ich długość fali lub częstotliwość. W tym sensie pojęcie widma stosuje się w odniesieniu do fal dźwiękowych lub radiowych - np. fala harmoniczna (niezmodulowana fala nośna) ma widmo składające się z jednej linii pionowej. Wzór matematyczny opisujący takie drganie ma postać x(t) = Asin(2f0t), gdzie A - amplituda, f0 - częstotliwość, a t - czas. Jeśli rozpatrujemy modulację amplitudy, to stała A staje się funkcją A(t); niech ta funkcja również będzie falą harmoniczną A(t) = sin(2f1t) o znacznie niższej częstotliwości f1 (raczej „nieciekawy” sygnał, ale pozwalający łatwo przeprowadzić analizę matematyczną). Elementarny wzór trygonometryczny daje przekształcenie

sin(2f1t)sin(2f0t) =

= (1/2)(cos(2(f0-f1)t) - cos(2(f0+f1)t))

Otrzymaliśmy dwie składowe o częstotliwościach f0-f1 oraz f0+f1 (widmo (b) na rysunku). Gdy sygnał modulujący nie jest prostą sinusoidą, zamiast pojedynczych linii w widmie pojawiają się wstęgi boczne (rysunek c), których szerokość zależy od częstotliwości sygnału modulującego. Im szybciej modulujemy falę nośną (im więcej informacji przekazujemy), tym większą zatem szerokość zajmuje widmo fali. Fakt ten pozostaje w mocy również dla modulacji innych typów niż amplitudowa, a jego praktyczne znaczenie w telekomunikacji jest ogromne. Oznacza on bowiem, że stacje nadawcze nie mogą korzystać z częstotliwości nadmiernie do siebie zbliżonych - widma ich sygnałów muszą pozostawać rozdzielone. W przeciwnym wypadku nawet użycie bardzo selektywnego odbiornika niewiele by pomogło (ewentualnie mógłby odbierać tylko sygnał z jednej wybranej stacji, ale zubożony pod względem jakości). Szerokość pasma częstotliwości zajmowanego przez jednego nadawcę można w pewnym stopniu ograniczyć usuwając z widma jedną wstęgę boczną oraz falę nośną (modulacja jednowstęgowa) - okazuje się, że w ten sposób nie gubimy treści sygnału.

Dokonajmy przeglądu szerokości pasma niezbędnej do przekazu różnych rodzajów informacji. Górna granica częstotliwości dźwięku słyszanych przez ucho ludzkie wynosi ok. 20 kHz - zatem stacja nadająca muzykę wysokiej jakości wymaga co najmniej podobnej szerokości pasma. Standard przekazu dźwięku towarzyszącego obrazowi telewizyjnemu to pasmo szerokości 185 kHz (mamy tu modulację częstotliwości, która stawia wyższe wymagania). Międzynarodowy standard telefoniczny to jedynie 3100 Hz. Szerokość pasma kanału telewizyjnego wynosi 6-7 MHz (por. obliczenia na poprzedniej stronie), zbliżona do tej wartości jest też odległość sąsiednich kanałów telewizji kablowej (8 MHz).

Jak widać z powyższego, szerokość pasma (w Hz; oznaczmy ją symbolem B) jest miarą ilości informacji możliwej do przesłania drogą modulacji fali. Z drugiej strony, wcześniej wprowadziliśmy inną miarę, odpowiednią szczególnie dla przekazów cyfrowych - przepustowość kanału informacji w bitach na sekundę (symbol C). Te dwie wielkości wiąże ze sobą prawo Shannona-Hartleya

C = B·log2(S/N + 1)

gdzie S/N jest stosunkiem natężenia sygnału do natężenia szumu. Sens tego wzoru jest dość łatwy do zrozumienia, gdyż ilość przesyłanej informacji zależy nie tylko od częstotliwości sygnałów modulujących (szerokości pasma), ale także od dokładności, z jaką jesteśmy w stanie zmierzyć natężenie każdego z nich. Gdy stosunek S/N jest równy 1, jesteśmy w stanie jedynie stwierdzić, czy sygnał został przesłany, czy też nie (1 bit), ale nie zmierzyć jego wartości; gdy stosunek ten wynosi 3, możemy wybrać jedną z czterech ewentualności (brak sygnału lub jeden z trzech poziomów), a to odpowiada 2 bitom itd. Zwykle 1 Hz szerokości pasma odpowiada 3-5 bitom na sekundę.

ĆWICZENIE. Technologia Bluetooth ma umożliwić bezprzewodową łączność na falach radiowych o częstotliwości 2,4 GHz między różnymi urządzeniami elektronicznymi w jednym pomieszczeniu lub budynku. Ocenić orientacyjnie maksymalną szybkość transmisji (w rzeczywistości przewiduje się szybkość ok. 1 Mb/s).

Głównym czynnikiem decydującym o przepustowości łączy radiowych jest częstotliwość fali. Na przykład, w przedziale od długości fali 1 m do 0,5 m mamy częstotliwości od 300 do 600 MHz, co odpowiada ok. 40 kanałom telewizyjnym - ale w przedziale od 1 cm do 0,5 cm częstotliwości są 100 razy wyższe, czyli można tu zmieścić 4000 kanałów! Dlatego rozwój radiotelekomunikacji jest „wyścigiem” w stronę fal coraz krótszych. Ten sam powód zadecydował o karierze światłowodów - jeśli przesyłamy nimi promienie podczerwone o długości fali 1,55 m (obecny standard), to ich częstotliwość f = c/ = (3·108 m/s)/(1,55·10-6 m) ≈ 2·1014 Hz. Gdy - zgodnie z poprzednimi założeniami - przyjmiemy szerokość pasma równą 1/10 tej liczby, czyli 2·1013 Hz, to w tym przedziale zmieściłoby się 3 miliony kanałów TV! Jest to, oczywiście, tylko teoretyczne wyliczenie, gdyż istniejące systemy łączności światłowodowej nie pozwalają na tak szybką modulację (por. wcześniej podana granica kilkuset Gb/s). Widać, że mamy tu pewien margines na dalszy rozwój techniki światłowodowej, podczas gdy w przypadku kabli telefonicznych natrafiamy na ograniczenia o bardziej fundamentalnym charakterze.

Zasada działania światłowodów polega na wykorzystaniu zjawiska całkowitego wewnętrznego odbicia (zob. wstawka obok). Światłowód jest włóknem szklanym o średnicy poniżej 0,1 mm (giętkim dzięki tak małej grubości), wzdłuż którego promień światła biegnie nie wydostając się na zewnątrz. (Należy zdawać sobie sprawę, że ilustrujący tę zasadę rysunek jest pojęciowym uproszczeniem, nowoczesne światłowody dopuszczają bieg promienia jedynie wzdłuż osi światłowodu). Poza wielką przepustowością informacyjną zaletą światłowodów jest niewielkie tłumienie sygnałów - obecnie repetory (wzmacniacze pośrednie) można instalować na nich co 100 km, a przewiduje się 150 km i więcej. Są też odporne na zakłócenia elektromagnetyczne i podsłuch. Wadą światłowodów jest to, że przy instalacji i naprawach wymagają użycia techniki trudniejszej od kabli miedzianych, a szczególnie duże kłopoty sprawiają złącza przełączalne („zwrotnice”). Poza telekomunikacją światłowody znajdują zastosowanie m.in. w medycynie, gdzie służą do obserwacji wnętrza ciała ludzkiego, a także np. do oświetlania jamy ustnej.

Jednostką tłumienia sygnałów w kablach i światłowodach jest dB/km (decybel/km). Decybel jest jednostką stosunku dwóch wartości tej samej wielkości: W2 jest większa od W1 o N decybeli, jeśli N =10log(W2/W1). Taka definicja stosuje się do mocy sygnału elektrycznego, optycznego lub dźwięku, a ponieważ moc jest proporcjonalna do kwadratu amplitudy, więc dla amplitud A1 i A2 wzór ma postać N = 20 log(A2/A1). Przykładowo: jeśli jeden sygnał jest dwa razy silniejszy od drugiego (2 razy większa moc), różnica wynosi 10 log 2 ≈ 3 dB, gdy jest cztery razy silniejszy - 4 dB, a gdy dziesięć razy - 10 dB. Tłumienie we współczesnych światłowodach wynosi tylko ok. 0,2 dB/km.

ĆWICZENIE. Ile wynosi maksymalna długość światłowodu o tłumienności 0,2 dB/km, jeśli sygnał ma przejść przez niego osłabiony nie więcej niż trzykrotnie?

Rozwój telewizji doprowadzi prędzej czy później do wprowadzenia nowego standardu obrazu telewizyjnego, zawierającego więcej niż 625 linii, ewentualnie także z większą niż 25 razy na sekundę częstotliwością jego odświeżania. Już pod koniec lat 60-tych opracowano w Japonii analogowy system MUSE, w którym ilość przesyłanej informacji była 5-krotnie większa od zwykłej telewizji. Niestety, wymagało to pasma szerokości aż 30 MHz, czyli jeden kanał MUSE zajmował prawie 5 kanałów zwykłej TV - ze względu na „ciasnotę w eterze” system ten nie przyjął się poza Japonią. Rozwiązaniem tego problemu będzie zastosowanie cyfrowego przekazu sygnału telewizyjnego, pozwalającego zapewnić wyższą jakość mimo niezmienionej szerokości pasma. Jest to możliwe dzięki kompresji danych - praktycznie zawsze duża część danych jest „zbędna”, np. niektóre części obrazu zawierają niewielką liczbę szczegółów lub w kolejnych klatkach występują elementy powtarzające się. Algorytmy kompresji (MPEG 2) wykorzystują to, przesyłając tylko informacje o zmianach (jak programy archiwizujące dane komputerowe). Wprowadzana w Polsce telewizja cyfrowa nie zmienia na razie standardu obrazu, więc wyższa jakość polega tylko na eliminacji zakłóceń.

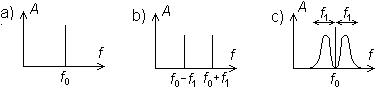

Przekaz danych w postaci cyfrowej wymaga odpowiedniej do tego zasady modulacji. Najważniejszą rolę pełni tu modulacja impulsowo-kodowa (pulse-code modulation - PCM), polegająca na przesyłaniu sygnału w postaci ciągu zer i jedynek, czyli czysto cyfrowej. Istnieją również systemy modulacji o charakterze pośrednim między analogową (FM lub AM) a cyfrową, np. modulacja impulsowo-amplitudowa (PAM), impulsowo-pozycyjna (PPM) lub pulse-duration modulation (PDM) [nie znam nazwy polskiej, chodzi o modulację opartą na długości impulsów]. Dwie spośród nich zostały zilustrowane na rysunku obok. Przesyłany tymi metodami sygnał jest próbkowany, ale nie kwantowany - nie zaokrąglany do całkowitej wielokrotności danej jednostki.

Aby przesłać jednym kablem np. kilka rozmów telefonicznych jednocześnie, stosujemy multipleksowanie. Multipleks. sygn. analogowych można zrealizować modulując nimi fale nośne o różnych częstotliwościach (zasada identyczna jak przy przesyłaniu fal radiowych). Sygnały poddane próbkowaniu (zob. np. wyżej) można przekazywać na przemian - nazywamy to podziałem czasu. Sygnały całkowicie cyfrowe możemy mieszać ze sobą na dowolne sposoby, albo tworzyć pakiety zaopatrzone w adres kierujący je do właściwego odbiorcy (np. Internet).

SIECI KOMÓRKOWE

Informacje na temat częstotliwości i szybkości transmisji w standardzie GSM zostały już podane wyżej, dlatego w tym ustępie ograniczymy się do samej struktury sieci. Obszar kraju został podzielony na sześciokątne komórki, przy czym każda ma swoją stację bazową, której przypisano pewną część kanałów radiowych. Stacja ta odbiera sygnały od telefonów znajdujących się w jej komórce i transmituje (na innym kanale) sygnały do nich. Co 15 minut stacja bazowa „wywołuje” wszystkie telefony włączone w obrębie komórki do zgłoszenia się - dzięki temu centralny komputer wie, dokąd należy skierować rozmowę z danym aparatem. Łączność między stacjami bazowymi jest oparta głównie na kablach światłowodowych. Grupa 8 sąsiednich komórek tworzy zespół, w którym kanały nie pokrywają się; ponieważ jednak zasięg nadawania jest niewielki, więc w bardziej odległych od siebie komórkach mogą być wykorzystywane te same częstotliwości. Aby obciążenie poszczególnych komórek było w przybliżeniu jednakowe, mają one różną wielkość: w centrach finansowych wielkich miast zaledwie 100 m średnicy, a na terenach o rzadkim zaludnieniu ok. ?? km.

Dość skomplikowany jest mechanizm zmiany częstotliwości uruchamiany wtedy, gdy abonent przekracza granicę komórki. Stacja bazowa, która początkowo obsługiwała rozmowę, stale ocenia siłę sygnału wysyłanego przez telefon. Jeśli spadnie ona poniżej pewnego poziomu, stacja bazowa wysyła komunikat do centrali głównej, która przekazuje sąsiednim stacjom bazowym polecenie śledzenia poziomu odbieranego przez nie sygnału. Jeśli któraś z nich odbiera sygnał silniejszy, do aparatu telefonicznego zostaje wysłane polecenie przestrojenia się na daną stację. Oczywiście, cała ta procedura przebiega w sposób niezauważalny dla użytkownika.

ŁĄCZNOŚĆ SATELITARNA

Pierwszy komercyjny satelita telekomunikacyjny został wystrzelony w 1965 r. i obsługiwał 240 kanałów telefonicznych. Dzisiaj przez satelity przechodzi 1/3 międzynarodowych rozmów telefonicznych (reszta głównie przez światłowody) i praktycznie wszystkie międzynarodowe transmisje telewizyjne.

Część satelitów telekomunikacyjnych okrąża Ziemię na takiej wysokości, że okres ich obiegu wokół Ziemi pokrywa się z okresem obrotu Ziemi wokół własnej osi (tzn. około 1 doby). Jeśli orbita takiego satelity leży w płaszczyźnie równika, to względem obserwatora ziemskiego „wisi” on w stałym punkcie na niebie. Taka orbita nazywa się geostacjonarną; jak można obliczyć na podstawie praw mechaniki (zob. wstawka), jej wysokość nad powierzchnią Ziemi wynosi ok. 36 tysięcy kilometrów. Zaletą satelity geostacjonarnego jest to, że skierowana w jego stronę antena pozostaje nieruchoma i niepotrzebny jest mechanizm jej obracania; ponadto duże jest pole widzenia i wystarczą 3 lub 4 satelity do pokrycia całej powierzchni Ziemi. Te plusy są szczególnie cenne w przypadku np. przekazu transmisji telewizyjnych, jednak w odniesieniu do bezpośredniej łączności z klientami telefonii komórkowej bardziej istotne okazują się wady tego rozwiązania. Przede wszystkim, do przekazu sygnałów na tak dużą odległość potrzebna jest albo duża moc nadawania (niewskazana ze względu na ryzyko negatywnego wpływu na zdrowie użytkownika telefonu; z tego powodu, a także dla oszczędności baterii przyjmuje się ograniczenie mocy do 1 W), albo antena wielkiej średnicy na satelicie. Po drugie, czas przejścia fali elektromagnetycznej tam i z powrotem jest wtedy równy ok. 1/4 s, co w rozmowie telefonicznej zaczyna być odczuwalne.

Dlatego coraz częściej planuje się systemy łączności oparte na satelitach krążących po orbitach niższych. Wykluczyć należy jedynie przedział wysokości od 2000 do 10000 km (tzw. pasy van Allena), w którym promieniowanie pochodzące od „schwytanych” przez pole magnetyczne Ziemi cząstek tzw. wiatru słonecznego może uszkadzać aparaturę. Ponieważ krótkie fale rozchodzą się praktycznie po liniach prostych, jak światło (nie ulegają ugięciu), więc satelita na niskiej orbicie może nawiązywać łączność tylko z niewielkim obszarem Ziemi. (Z tego samego powodu telewizja i „zwykła” telefonia komórkowa wymagają odpowiednio gęstej sieci przekaźników naziemnych). Potrzebna jest wtedy większa liczba satelitów - np. obejmujący całą Ziemię system Iridium składa się (a raczej składał, ostatnio zbankrutował) z 66 satelitów na wysokości 780 km, a system IPO to 10 satelitów na wysokości 9 tysięcy km. W sferze projektów pozostają bezzałogowe samoloty lub sterowce unoszące się na wysokości ok. 20 km nad największymi aglomeracjami. Dla telefonii komórkowej te satelity i samoloty (zbudowane i planowane) pełnią rolę podobną do naziemnych stacji bazowych, np. przełączenie z jednej stacji bazowej na inną i zmiana częstotliwości następuje automatycznie, w sposób niedostrzegalny dla użytkownika, gdy daje to zwiększenie natężenia odbieranego sygnału. Zaletą łączności satelitarnej jest mniejsze natężenie zakłóceń (np. odbić od budynków).

Bardzo ciekawa jest zasada działania anteny satelitów na niskich orbitach. Aby oszczędzić moc sygnału i nie „zaśmiecać eteru”, kierują one wiązkę w określone miejsce na powierzchni Ziemi (tam, gdzie znajduje się odbiorca). Ponieważ jednak satelita obsługuje jednocześnie setki lub tysiące połączeń, niemożliwe byłoby obracanie czaszy tradycyjnej anteny parabolicznej przy każdej zmianie kierunku. Rozwiązaniem tego problemu jest antena matrycowo-fazowa, pozwalająca błyskawicznie zmieniać kierunek wysyłanej wiązki bez zmiany położenia anteny i bez „przestawienia” jakichkolwiek części ruchomych. Anteny takie są produktem ubocznym „gwiezdnych wojen”, gdyż radary projektowane na wypadek masowego ataku nuklearnego również musiałyby jednocześnie śledzić tysiące nadlatujących pocisków. Przypomnijmy najpierw zasadę działania siatki dyfrakcyjnej: padająca fala świetlna ulega ugięciu na szczelinach (rysach) siatki, które w ten sposób stają się źródłami wtórnych fal kulistych. Interferencja tych fal powoduje ich wzmocnienie w tych kierunkach, w których ich fazy są ze sobą zgodne (grzbiet jednej fali pokrywa się z grzbietem innych, a dołek - z dołkiem), natomiast osłabienie w innych kierunkach. W antenie matrycowo-fazowej zamiast rys siatki mamy wiele nadajników tworzących pewien układ przestrzenny (matrycę), przy czym fazę wysyłanego przez nie sygnału można zmieniać - w efekcie mamy zmianę kierunku, w którym fala ulega wzmocnieniu. Takie zmiany mogą następować w czasie rzędu 1 s.

Żywiołowy rozwój telefonii komórkowej - naziemnej i satelitarnej - zmusza do przechodzenia na zakresy coraz krótszych fal elektromagn. Ostatnio obok standardowego dotychczas zakresu 900 MHz zaczęto wykorzystywać w Polsce także zakres 1800 MHz = 1,8 GHz, a na świecie intensywnie bada się możliwość wprowadzenia systemów łączności na częstotliwościach 20-50 GHz, co odpowiada długości fali od 6 do 15 mm. Podobne rozmiary mają zwykłe krople deszczu, co jest źródłem silnych zakłóceń. Konieczne jest więc podjęcie odpowiednich środków zaradczych: zwiększenie mocy nadajników, jednoczesne przesyłanie sygnału kilkoma różnymi drogami, użycie różnych metod korekty błędów, a także szybkie i częste zmienianie częstotliwości (tak że ewentualne zakłócenia dotykają tylko części przekazu). Ta ostatnia metoda - zwana techniką widma rozproszonego (ang. spread spectrum) jest też skuteczną ochroną przed podsłuchem. Metodę tę często stosuje się w połączeniu z kodowaniem bezpośrednim (ang. direct sequence), polegającym na zastępowaniu każdego bitu sekwencją bitów tak dobraną, aby były one jak najlepiej odróżnialne w razie wystąpienia przekłamań - np. 0 → 000100110101111, 1 → 111011001010000. Widoczna tu „nadmiarowość” informacji nazywana jest inaczej redundancją (powszechnie znanym przykładem zastosowania redundancji jest „literowanie” nazwisk, czyli zastępowanie każdej litery imieniem).

NAWIGACJA SATELITARNA

Najważniejszym systemem nawigacji satelitarnej jest obecnie GPS (Global Positioning System), składający się z 24 satelitów na wysokości nieco powyżej 20 tys. km (mniejszej niż geostacjonarna). Ustalenie położenia polega na pomiarze odległości do satelitów (w zasadzie wystarczyłyby 3 odległości do wyznaczenia trzech współrzędnych przestrzennych, w tym i wysokości nad ziemią). Pierwotnie stworzono GPS dla armii USA i z tego względu wykluczono wysyłanie przez użytkowników jakichkolwiek sygnałów (aby nie ujawniać swojej pozycji), tak więc jedynie odbierają oni sygnały wysyłane przez satelitę. Sygnały te są wysyłane bez przerwy i zawierają zakodowaną dokładną informację o czasie ich wysłania. Porównując go z czasem ich odebrania znajdujemy różnicę, która jest czasem przejścia drogi od satelity do odbiorcy, a mnożąc go przez prędkość światła wyznaczamy odległość.

Powyższy opis zawiera dwa uproszczenia. Po pierwsze, czas przejścia sygnału musi być znany z wielką dokładnością (w ciągu 1 s światło przebywa drogę 300 m), a tak dokładne zegary można zainstalować na satelicie, ale nie w każdym odbiorniku! Problem ten można rozwiązać, jeśli dokonamy pomiaru sygnałów wysyłanych przez 4 (a nie 3) satelity i stąd obliczymy 4 odległości, obarczone błędem wskutek niedokładności naszego zegara. Z powodu błędu te 4 wielkości będą ze sobą sprzeczne (4 sfery nie przecinają się na ogół w jednym punkcie), ale teraz możemy skorygować czas, zmieniając tym samym jednakowo wspomniane 4 odległości. Istnieje tylko jedna wartość takiej korekty, która sprawi, że te 4 odległości staną się zgodne, pozwalając obliczyć 3 współrzędne położenia odbiornika. Po drugie, twórcy systemu GPS pragnęli ograniczyć dokładność, z jaką może korzystać z niego „nieuprawniony” użytkownik (nieprzyjaciel?) i świadomie „popsuli” go przez wprowadzenie zakłóceń czasu emisji sygnałów. W rezultacie tego zmniejszono dokładność wyznaczenia położenia do 100 m (wartość, być może, nieaktualna - reklama odbiorników GPS w polskim czasopiśmie podaje dokładność 15 m), podczas gdy wojskowe odbiorniki osiągają dokładność 1 cm dzięki wyposażeniu ich w kody usuwające zakłócenia. Istnieje zresztą prosta technika pozwalająca każdemu odbiorcy w pewnym stopniu ominąć te ograniczenia - wystarczy dokonać pomiarów ze stacjonarnego punktu o dokładnie znanych współrzędnych i przesłać przez radio niezbędne korekty innym użytkownikom. W USA niektóre stacje radiowe standardowo transmitują te sygnały bez żadnych ograniczeń.

(w nocy z 1 na 2 maja 2000 nastąpiło wyłączenie zakłócania, dokładność cywilna wynosi 10 m, wojskowa lepsza dzięki dodatkowym częstotliwościom)

Najprostsze dostępne na rynku odbiorniki GPS są niewiele większe od telefonu komórkowego, a ich cena wynosi ok. 1000 zł.

LASERY I ICH ZASTOSOWANIA

Nazwa „laser” jest skrótem angielskich słów Light Amplification by Stimulated Emission of Radiation (wzmacnianie światła przez wymuszoną emisję promieniowania). Wymienione tu zjawisko emisji wymuszonej polega na tym, że kwant promieniowania pada na atom lub cząsteczkę w stanie wzbudzonym i powoduje jej przejście do stanu niższego, połączone z emisją dwóch kwantów identycznych z początkowym. Zjawisko to zostało przewidziane teoretycznie przez A. Einsteina w 1917 r. - jednak na wynalezienie lasera trzeba było czekać aż do 1960 roku (kilka lat wcześniej skonstruowano masery, działające w zakresie mikrofal). Przyczyną tak dużej zwłoki między odkryciem teoretycznym a jego praktycznym zastosowaniem był fakt, że w „normalnych” warunkach więcej atomów lub też cząsteczek znajduje się w stanie o niższej energii i z tego powodu padający kwant promieniowania z większym prawdopodobieństwem może zostać pochłonięty (zaabsorbowany), niż spowodować emisję wymuszoną. Aby emisja wymuszona zaczęła przeważać nad absorpcją, konieczne jest doprowadzenie do tzw. inwersji obsadzeń - nietypowej sytuacji, w której liczba atomów o wyższej energii jest większa. Wtedy kolejne przypadki emisji wymuszonej spowodują lawinowe „mnożenie się” jednakowych kwantów promieniowania. Ośrodek, w którym zachodzi akcja laserowa, umieszcza się między dwoma zwierciadłami, tak aby wiązka światła wielokrotne przechodziła przez niego tam i z powrotem, za każdym razem ulegając wzmocnieniu; wyprowadzenie promienia na zewnątrz można osiągnąć, jeśli jedno ze zwierciadeł będzie częściowo odbijające, a częściowo przezroczyste.

W pierwszych laserach opisywane zjawisko zachodziło w np. pręcie rubinowym albo w gazie zamkniętym w szklanej rurce. Przyrządy takie są stosunkowo drogie, trudne do miniaturyzacji i wymagają wysokiego napięcia zasilania. Dlatego szersze zastosowanie laserów w urządzeniach powszechnego użytku stało się możliwe dopiero po opanowaniu technologii produkcji laserów półprzewodnikowych, w których akcja laserowa następuje w złączu pn (por. o diodzie świecącej na s. 2).

Światło laserowe różni się od światła pochodzącego z innych źródeł następującymi cechami:

Jest w wysokim stopniu monochromatyczne (jednobarwne), czyli rozpatrywane jako fala jest falą prawie doskonale harmoniczną (por. s. 11).

Jest w wysokim stopniu spójne, co oznacza, że grzbiety fal są bardzo regularne, czyli w różnych punktach przestrzeni faza drgań jest skorelowana. Ta właściwość powoduje, że dla światła laserowego bardzo łatwo zaobserwować zjawisko interferencji.

Wiązka światła jest wąska i bardzo dokładnie równoległa.

Te cechy światła laserowego sprawiają, że można je bardzo dobrze zogniskować - w punkcie o rozmiarach rzędu długości fali (najlepsze zogniskowanie fali, jakie jest możliwe). Dzięki temu lasery znajdują zastosowanie jako czytniki płyt CD i DVD - ale z tego też powodu światło laserowe może być bardziej niebezpieczne dla oczu, gdyż zogniskowane światło łatwiej może uszkodzić siatkówkę (ponadto wiązka zwykłego światła zawsze jest częściowo rozproszona i wcześniej nas ostrzega, aby zamknąć oczy lub odsunąć się z drogi wiązki).

Wymieńmy pobieżnie niektóre inne zastosowania techniczne laserów: telekomunikacja (źródło światła do światłowodów), najbardziej precyzyjne pomiary odległości (definicja metra), pomiary odległości do satelitów i planet, pomiary geodezyjne (np. przewidywanie trzęsień ziemi), kierowanie maszynami na wielkich budowach (zwłaszcza podczas drążenia tuneli), chirurgia („skalpel laserowy”, przydatny zwłaszcza przy operacjach oka), precyzyjna obróbka powierzchni (wiercenie w twardych materiałach, odparowanie warstwy powierzchniowej), nagrzewanie plazmy do nadzwyczaj wysokich temperatur, niezbędnych do zainicjowania kontrolowanej reakcji termojądrowej (tu stosuje się lasery o wielkiej mocy)…

Na płytach CD (rozpoczęcie produkcji 1982) kolejne bity danych zapisuje się w postaci wgłębień na płycie z tworzywa poliwęglanowego, którą pokrywa się cienką warstwą aluminium, odbijającą światło lasera. Promień lasera jest kierowany na wirującą płytę od dołu, a zmiany natężenia światła odbitego są rejestrowane przez czujniki, które poza odczytywaniem zapisanych danych przekazują także informacje korygujące położenie punktu skupienia wiązki, co umożliwia śledzenie wybranej ścieżki danych. Pojemność typowych płyt CD o średnicy 12 cm wynosi do 640 MB (dużą literą B oznaczamy bajt równy 8 bitom), co odpowiada 75 minutom nagrania. W przypadku czytników CD-ROM (odczyt danych komputerowych) istotnym parametrem jest także szybkość odczytu, podawana zwykle w formie np. „szybkość 52×”, co oznacza wielokrotność 150 kB/s (w podanym przykładzie 52×150 kB/s = 7,8 MB/s).

ĆWICZENIE

Na podstawie podanych powyżej parametrów płyt CD obliczyć szybkość transmisji danych (w Mb/s) i porównać z wartością podaną na s. 10.

W 1995-1996 r. wprowadzono nowy format dysków optycznych DVD, osiągający znacznie większą pojemność przy niezmienionej średnicy dysku. Ten rezultat zawdzięczamy głównie dwuwarstwowemu zapisowi na każdej ze stron płyty (wiązkę można zogniskować głębiej lub płycej), a częściowo także większej gęstości zapisu, co z kolei stało się możliwe w wyniku zastosowania światła o mniejszej długości fali (por. informacje o dyfrakcji światła na górze tej strony, a także na s. 9). Poniższa tabelka jest zestawieniem niektórych parametrów czytników CD i DVD.

|

Rozmiar zagłębień |

Odległość ścieżek |

Długość fali światła |

Pojemność |

Podstawowa szybkość odczytu |

Osiągana obecnie szybkość odczytu |

CD |

0,83 μm |

1,6 μm |

0,78 μm (podczerwień) |

640 MB |

150 kB/s |

52× |

DVD |

0,4 μm |

0,74 μm |

0,635÷0,65 μm (widzialne) |

17 GB |

|

|

Każda warstwa zapisu na płytach DVD zawiera 4,7 GB danych. Przemnożenie tej liczby przez 4 (2 strony×2 warstwy) daje prawie 19 GB, czyli więcej od podanej pojemności 17 GB - ale zapis dwuwarstwowy zwiększa ilość błędów, tak więc niezbędne są specjalne systemy kontroli i korekcji błędów, a bity kontrolne pochłaniają pewną część pojemności płyty. Format ten jest przeznaczony głównie do zapisu filmów, z zastosowaniem kompresji danych (MPEG 2). Liczba bitów odpowiadających jednej sekundzie filmu może być różna, zależnie od ilości szczegółów i szybkości zmian obrazu.

Dalszy postęp techniki optycznego zapisu informacji mógłby nastąpić po wynalezieniu niebieskiego lasera, jeśli byłby on równie trwały, niezawodny i tani, jak istniejące lasery działające w zakresie czerwieni i podczerwieni. Jeszcze większe nadzieje wiąże się z wprowadzeniem pamięci holograficznych.

Holografia jest metodą rejestracji i odtwarzania fali świetlnej razem z jej przebiegiem w przestrzeni trójwymiarowej, tak że odtworzony obraz może być oglądany z różnych stron, a także można ogniskować wzrok na elementach bliższych lub dalszych (jak przy normalnym widzeniu). Zasady holografii zostały odkryte już w latach 1907-1920 (polski fizyk M. Wolfke), ale ich praktyczna realizacja stała się możliwa dopiero po wynalezieniu lasera. Podstawowy schemat zapisu holograficznego jest przedstawiony na rysunku obok: wiązka światła spójnego (w praktyce laserowego) przechodzi przez zwierciadło półprzepuszczalne Z i ulega podziałowi na dwie części. Jedna z tych wiązek oświetla fotografowany przedmiot, a po odbiciu pada na kliszę, gdzie ulega nałożeniu na drugą część (wiązkę odniesienia) dając obraz interferencyjny w postaci układu prążków. Tak otrzymana fotografia zupełnie nie przypomina zwykłego obrazu fotograficznego, gdyż jest bardzo gęstym (zbyt drobnym do obserwacji gołym okiem) i raczej nieregularnym deseniem. Gdy teraz oświetlimy hologram wiązką światła spójnego, w wyniku dyfrakcji na układzie prążków następuje odtworzenie wiązki przedmiotowej. Odnotujmy, że fragment powierzchni hologramu pozwala odtworzyć cały obraz, co się wiąże jednak z pogorszeniem jego jakości. Powszechnie znane hologramy na banknotach, niektórych dokumentach i towarach są wykonywane nieco bardziej skomplikowaną techniką, dzięki której można je oglądać w zwykłym świetle jako obrazy wielobarwne.

Wspomniane wyżej pamięci holograficzne są obecnie na etapie prób laboratoryjnych. Zapisywanie danych ma przebiegać w następujący sposób: pewna liczba bitów zostaje zobrazowana w postaci mozaiki jasnych i ciemnych pól na wyświetlaczu ciekłokrystalicznym. Oświetlenie tego wzoru światłem laserowym daje wiązkę, która interferuje z wiązką odniesienia, a trójwymiarowy obraz interferencyjny jest zapisywany w odpowiednim ośrodku poprzez zmiany jego współczynnika załamania. W ten sposób każdy bit jest zapisywany w całej objętości nośnika. Rekonstrukcja wiązki przedmiotowej (obrazu mozaiki) następuje po przepuszczeniu przez nośnik wiązki laserowej. Kolejne „strony” mogą być zapisywane i odczytywane w tym samym ośrodku, jeśli wiązka światła będzie padać pod innym kątem - ta technika nosi nazwę multipleksowania kątowego. Uważa się za możliwe, że pojemność pamięci holograficznych będzie rzędu setek GB, szybkość odczytu - rzędu 1 GB/s, a czas dostępu do dowolnego miejsca - rzędu 100 μs. Duża szybkość odczytu wynika stąd, że w jednym kroku odczytuje się całą stronę, zawierającą tysiące bitów - zamiast bit po bicie, jak w innych rodzajach pamięci.

WYŚWIETLACZE I MONITORY

„Zwykłe” monitory komputerowe działają na zasadzie bardzo podobnej do kineskopów telewizyjnych. Są to lampy próżniowe, w których wiązka elektronów zostaje rozpędzona wysokim napięciem (rzędu 10 kV) w stronę ekranu, a po drodze jest odchylana w pionie i w poziomie polem magnetycznym wytwarzanym przez prąd płynący w uzwojeniach. Ekran jest pokryty od tyłu luminoforem, czyli substancją świecącą pod wpływem padających na nią elektronów. Obraz barwny powstaje dzięki zastosowaniu trzech luminoforów, z których jeden emituje światło czerwone, drugi - zielone, a trzeci - niebieskie. Każdy z rodzajów luminoforów jest pobudzany do świecenia przez odrębną wiązkę elektronów, pochodzącą z odrębnej wyrzutni, a dzięki odpowiednim maskom elektrony trafiają tylko w te punkty ekranu, które pokryte są właściwym dla danej wiązki rodzajem luminoforu.

Opisana zasada uzyskiwania obrazu barwnego jest dostosowana do fizjologii widzenia u człowieka, który w swoich oczach ma 3 rodzaje receptorów (czopków), których maksima czułości przypadają na światło czerwone, zielone i niebieskie. Dzięki temu każdą barwę (w sensie wrażenia barwnego) można zbudować mieszając światło o 3 barwach podstawowych. Nazywa się to addytywnym mieszaniem barw, a chociaż istnieje pewna dowolność co do tego, jakie barwy uznamy za podstawowe, to w monitorach, kineskopach, skanerach, cyfrowych aparatach fotograficznych i na taśmie filmowej najczęściej obowiązuje zestaw RGB (ang. red, green, blue). Ponieważ jednakowa zmiana natężenia wszystkich 3 składników oznacza jedynie zmianę ogólnej jasności, ale nie barwy, więc po odrzuceniu tego wspólnego parametru pozostają nam dwie liczby (natężenia) określające samą barwę, które możemy skojarzyć ze współrzędnymi punktu na płaszczyźnie - zob. w encyklopediach tzw. „trójkąt barw”. Nie należy mylić tak określonej barwy z widmem światła, które niesie znacznie większą ilość informacji, nieodczuwalnych na ogół dla człowieka - np. monochromatyczne światło żółte jest nieodróżnialne dla oka od mieszaniny światła czerwonego i zielonego. Podobnie światło białe składające się z tylko dwóch barw monochromatycznych (tzw. barw dopełniających, np. niebieska i pomarańczowa) można odróżnić od światła słonecznego (zawierającego wszystkie długości fali od fioletu do czerwieni) tylko używając pryzmatu albo siatki dyfrakcyjnej.

Kineskopy próżniowe są produkowane już od ponad 60 lat, a związana z tym technologia jest „dojrzała” i ma liczne zalety (dość duża jasność ekranu, niewielki pobór energii). Dalszy rozwój techniki prawdopodobnie będzie jednak wymagał odejścia od niej. Na przykład, wprowadzenie telewizji wysokiej rozdzielczości (HDTV) przyniesie rzeczywistą poprawę jakości obrazu tylko wtedy, gdy ekran będzie miał odpowiednio duże rozmiary (przekątna powyżej 1 m). Tak wielki kineskop miałby też dużą objętość, a ważyłby tyle, że praktycznie taką konstrukcję należy wykluczyć. Dlatego bardzo intensywnie pracuje się nad udoskonaleniem wyświetlaczy o płaskim ekranie. Wymieńmy kilka technologii mających szanse na sukces:

W wyświetlaczach plazmowych impulsy napięcia powodują wyładowanie elektryczne w gazie wypełniającym poszczególne komórki ekranu. W rezultacie gaz emituje promieniowanie nadfioletowe, które padając na luminofor pokrywający powierzchnię komórki powoduje jego świecenie światłem widzialnym - czerwonym, zielonym lub niebieskim (zależnie od luminoforu). Elektrody, do których przykłada się napięcie, tworzą 2 zestawy równoległych linii w dwóch warstwach, przy czym linie w jednej warstwie są prostopadłe do linii w drugiej. Przyłożenie napięcia do odpowiedniej pary elektrod - jednej spośród elektrod poziomych i jednej spośród pionowych - powoduje emisję światła z wybranej komórki leżącej na przecięciu tych elektrod.

Wyświetlacze plazmowe pozostają - jak dotąd - zdecydowanie droższe od kineskopów (w 1998 r. monitor tego typu o przekątnej 1056 mm kosztował 11000$). Wynika to stąd, że napięcie sterujące wynosi ok. 100 V, co w mikroelektronice jest wartością nietypowo wysoką, a każda z elektrod wymaga odrębnego obwodu sterującego, którego funkcje są dość skomplikowane. (Nb. podobnie drogie są i inne wyświetlacze wymienione niżej.)

Elektroluminescencja cienkowarstwowa jest zjawiskiem podobnym do opisanego wyżej, jednak impulsy napięcia powodują tu świecenie luminoforu w ciałach stałych, a nie w gazach. Wyświetlacze tego typu znalazły już pewien zakres zastosowań, lecz ich koszt pozostaje wysoki, rozmiary - niewielkie, a paleta barw - niepełna.

Nowa, bardzo obiecująca odmiana tych wyświetlaczy zawiera półprzewodniki organiczne w roli luminoforu.

Matryce diod elektroluminescencyjnych LED (zob. s. 2) mogą osiągać bardzo duże rozmiary, a ich jasność pozwala na oglądanie obrazu nawet w pełnym słońcu. Bywają więc instalowane w miejscach publicznych (reklama, informacja w centrach handlowych). Są jednak drogie, a zbudowanie dużej matrycy w jednym chipie napotyka poważne trudności.

Wyświetlacze ciekłokrystaliczne (ang. LCD) są stosowane już od dawna w kalkulatorach. i zegarkach, czyli w komputerach przenośnych. Wciąż jednak tylko częściowo udaje się ograniczyć pewne ich słabe strony: niewielkie rozmiary, małą jasność, niewielki kąt widzenia obrazu, a zwłaszcza trudności z odtwarzaniem obrazów szybkozmiennych.

a

- - 13 -

Działanie wyświetlaczy ciekłokrystalicznych wynika ze zjawiska polaryzacji światła. Podobnie jak i inne rodzaje fal elektromagnetycznych, światło jest falą poprzeczną, tzn. kierunek drgania fali jest prostopadły do jej kierunku biegu. W zwykłym świetle kierunek drgań zmienia się chaotycznie, ale po przejściu przez polaryzator pozostaje tylko fala drgająca wzdłuż jednej wyróżnionej osi, gdyż druga składowa (drgająca wzdłuż osi prostopadłej) uległa pochłonięciu. Takie światło nazywamy spolaryzowanym. Jeśli dwa polaryzatory ustawimy jeden za drugim tak, że ich osie będą do siebie prostopadłe, światło przez nie przejdzie, gdyż jedna składowa ulegnie pochłonięciu w jednym polaryzatorze, a druga w drugim. Jakakolwiek zmiana stanu polaryzacji światła, która zajdzie w obszarze między polaryzatorami, spowoduje rozjaśnienie obrazu.

Każdy piksel ekranu ciekłokrystalicznego zawiera warstwę ciekłego kryształu umieszczoną między dwiema płytkami o wyróżnionej osi, mającymi właściwość porządkowania wzdłuż tej osi cząsteczek ciekłego kryształu w warstewce przylegającej do płytki. Gdy osie tych dwóch płytek są ustawione prostopadle do siebie nawzajem, efektem ich „rywalizującego” wpływu jest powstanie w ciekłym krysztale struktury śrubowej (rys. obok). Przechodzące przez cały układ światło podlega wtedy skręceniu płaszczyzny polaryzacji, czyli po umieszczeniu całości między skrzyżowanymi polaryzatorami obraz będzie jasny. Przyłożenie napięcia elektrycznego między płytkami zmienia tę sytuację: cząsteczki ustawiają się teraz wzdłuż pola i skręcenie płaszczyzny polaryzacji nie następuje, zatem obraz jest ciemny.

Ciekłe kryształy są stanem materii o cechach pośrednich między cieczą (w której cząsteczki mogą wykonywać dowolne ruchy) a ciałem stałym (w którym mogą tylko drgać wokół położeń równowagi). Ważnym przykładem jest struktura polegająca na tym, że podłużne cząsteczki ciekłego kryształu mają swobodę co do przemieszczeń, ale nie co do obrotu - ich kierunek pozostaje ustalony (zob. rysunek poniżej).

Plazmą nazywamy gaz, w którym duża część cząsteczek występuje w postaci jonów dodatnich i ujemnych. Jest to więc ośrodek przewodzący - w odróżnieniu od zwykłego gazu, w którym cząsteczki są elektrycznie obojętne. Plazma powstaje podczas wyładowań elektrycznych w gazach (np. jarzeniówki, neony).

Trzy podstawowe zjawiska zachodzące podczas oddziaływania promieniowania z materią

obwód rezon. demodulator głośnik

Modulacja częstotliwości: a) sygnał modulujący, b) fala zmodulowana

a) widmo fali harmonicznej, b) widmo fali z modulacją amplitudy wg wzoru podanego w tekście, c) typowe widmo fali z modulacją amplitudy. A - amplituda składowych

a) załamanie, słaby promień częściowo odbity zaznaczono linią przerywaną, b) sytuacja graniczna, c) przy dalszym zwiększeniu kąta padania promień załamany znika, a cała energia promienia padającego odnajduje się w promieniu odbitym, d) światłowód

Schemat analogowego multipleksera: GFN - generatory fali nośnej, OR - obwody rezonansowe. Grubszą linią zaznaczono kabel wspólny dla wszystkich sygnałów

Dla orbity kołowej siła dośrodkowa m(2/)2R równa się sile przyciągania Ziemi GMm/R2. Po podstawieniu okresu obiegu T równego 23 h 56 m, stałej grawitacji G i masy Ziemi M otrzymujemy R = 42170 km, a wysokość nad powierzchnią Ziemi wynosi h = R - r = 35 800 km (r - promień Ziemi).

Ugięcie dla długich fal (z lewej) i brak ugięcia dla fal krótkich (z prawej)

Lewa strona: nadajniki (oznaczone kropkami) wysyłają falę w jednakowej fazie, w kierunku poziomym (a) fala ulega wzmocnieniu, a w kierunku ukośnym (b) - osłabieniu. Prawa strona: fazy nadajników są przesunięte, w kierunku poziomym (c) mamy osłabienie, a w kierunku ukośnym (d) - wzmocnienie.

INTERFERENCJA I DYFRAKCJA FAL

Interferencja polega na nakładaniu się na siebie dwóch lub więcej fal, przy czym wynik tego nałożenia zależy od ich faz: jeśli fazy są zgodne (grzbiet jednej fali pokrywa się z grzbietem drugiej, a dołek z dołkiem), to następuje wzmocnienie (interferencja konstruktywna), natomiast gdy fazy są przeciwne (grzbiet jednej nakłada się na dołek drugiej), to następuje osłabienie (interferencja destruktywna).

Dyfrakcja fal jest to zmiana kierunku, jaka występuje po obejściu przeszkody lub przejściu przez szczelinę. Efekt ten jest wyraźny, gdy rozmiary przeszkody lub szerokość szczeliny są zbliżone do długości fali, natomiast słaby, gdy długość fali jest znacznie mniejsza.

Wyszukiwarka

Podobne podstrony:

Podstawy techniki 1, Fizyka

01 Podstawy i technika

PODSTAWY TECHNIK MIKROPROCESOROWYCH, Studia Pwr INF, Semestr IV, PTM

Lab 2 - Podstawowe techniki mikrobiologiczne, Laboratorium 2

cichosz,podstawy technik wytwarzania, Przepisy BHP przy spawaniu gazowym

Podstawy techniki mikroprocesor Nieznany

zadania egzaminacyjne dzienne (PTM), elektro, 1, Podstawy Techniki Mikroprocesorowej

80C51 pytania i odpowiedzi, elektro, 1, Podstawy Techniki Mikroprocesorowej

Podstawy Technik Prac Biurowych, moje prace semestralne, spp

ECDL Podstawy technik informatycznych

zadania egzaminacyjne zaoczne 2006 07 (PTM), elektro, 1, Podstawy Techniki Mikroprocesorowej

Egzamin z PTC podst kombinacyjne, elektro, 1, Podstawy Techniki Mikroprocesorowej

Podstawy Techniki Telwizyjnej Obraz anamorfotyczny

Laboratorium podstaw techniki światłowodowej Pomiar tłumienia włókna światłowodu

05 EW ZEW M pom nr5 Podstawowe techniki facylitacyjne

PODSTAWOWE TECHNIKI STOSOWANE W SOCJOTERAPII

Gronostajski,podstawy i techniki wytwarzania II,Metody walcowania

więcej podobnych podstron