1. Def inteligencji , zagrożenia i perspektywy rozwoju sztucznej inteligencji.

Inteligencja – uzdolnienie intelektualne , jest to zdolność do penetrowania informacji

na poziomie abstrakcyjnym, to zdolnośc do twórczego , a nie tylko mechanicznego

penetrowania info ,czyli tworzenia zupełnie nowych pojec i ich zastosowania

2. Budowa ludzkiego mózgu

V=1400cm

3

A=2000cm

2

M=1,5 kg

W korze mozgowej (3mm grubości) zawiera się 10

18

neuronów z czeko 10

11

połączonych i 10

15

połączeń

Długość połączeń :0,01 mm do kilku m

Cz. pracy od 1 do 100 Hz

Impulsy przychodzące od 1 do 2 ms

Napięcie 100 mV

Szybkość przesylu miedzy Komorkami nerwowymi 100 m/s

Budowa mózgu nie jest do konca rozpoznana, znane są tylko obrazy o różnych

zastosowaniach . Pamięć zalezy od połączeń między neuronoami

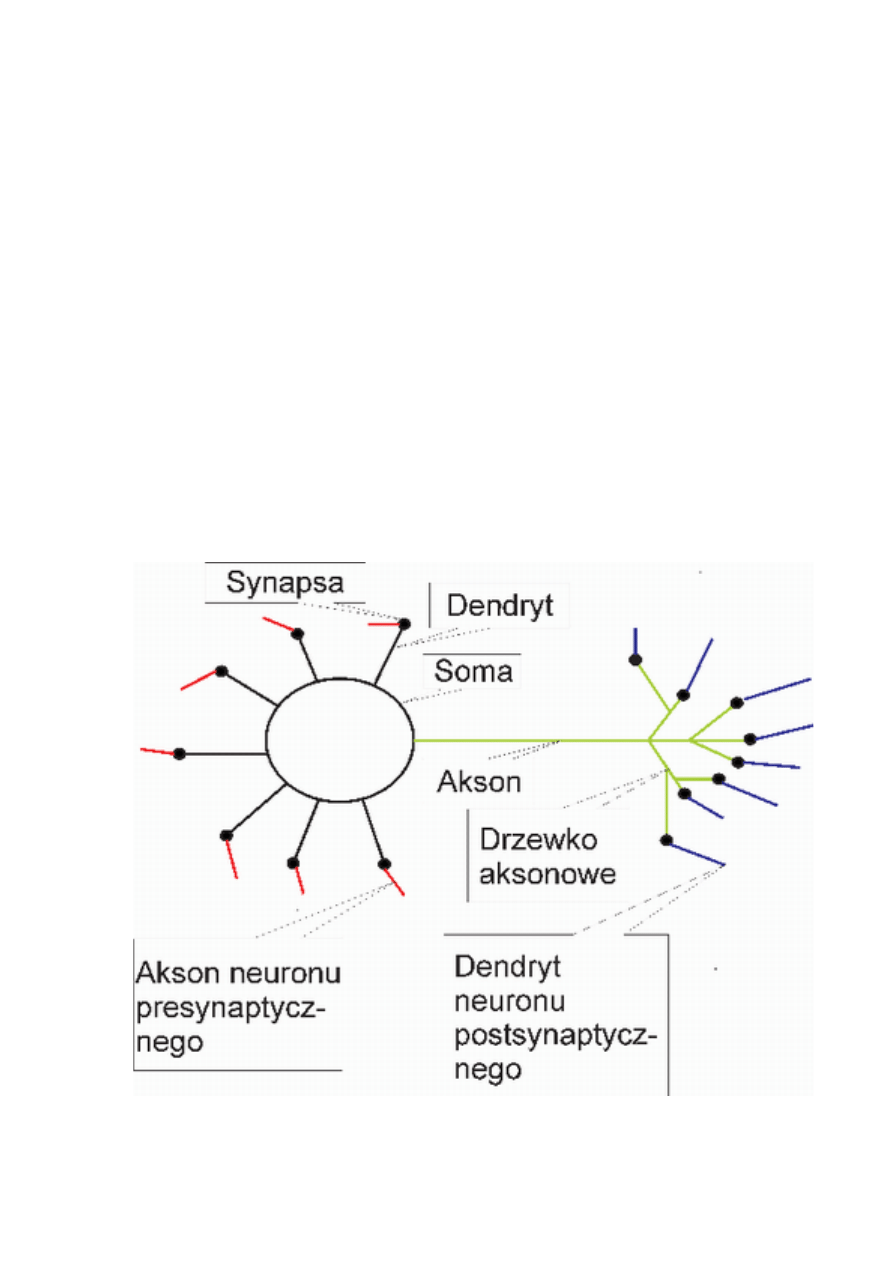

3. budowa ludzkiego neuronu

Soma-cialo komorki , dendryt – wejście , akson –wyjscie , dużo dendrytów , jeden akson

– z którego do wielu neuronów można wysłać inf. Pobudzenie przekazywane przez

złącze zwane synapsą

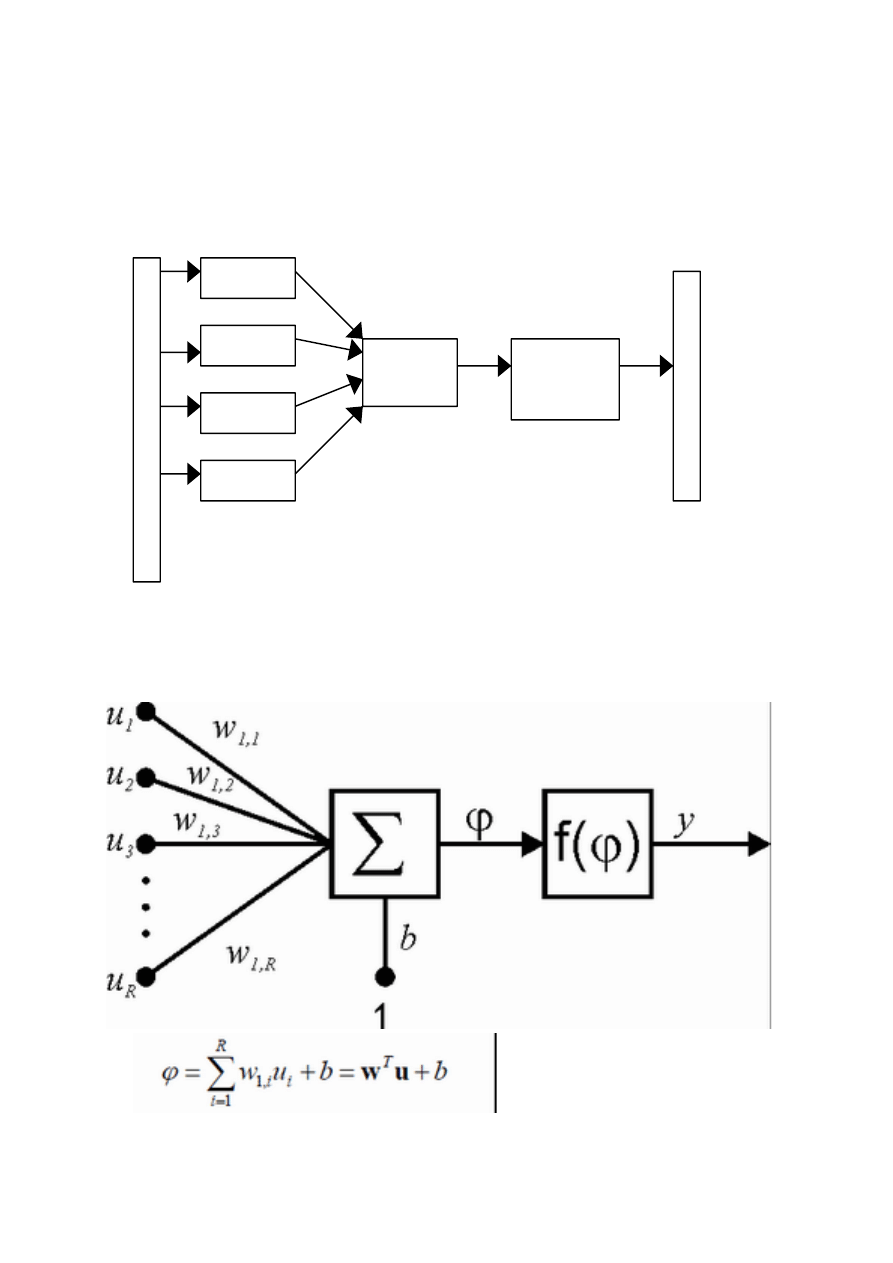

4. budowa i równanie sztucznego neuronu

Wagi pełnią rolę synaps, f. aktywacji określa wartość na wyjściu, podczas uczenia,

zmianą podlegają wartości wag.

W

e

j

ś

c

i

e

Waga 1

Waga 2

Waga 3

Waga n

Sumator

Funkcja

aktywacji

W

y

j

ś

c

i

e

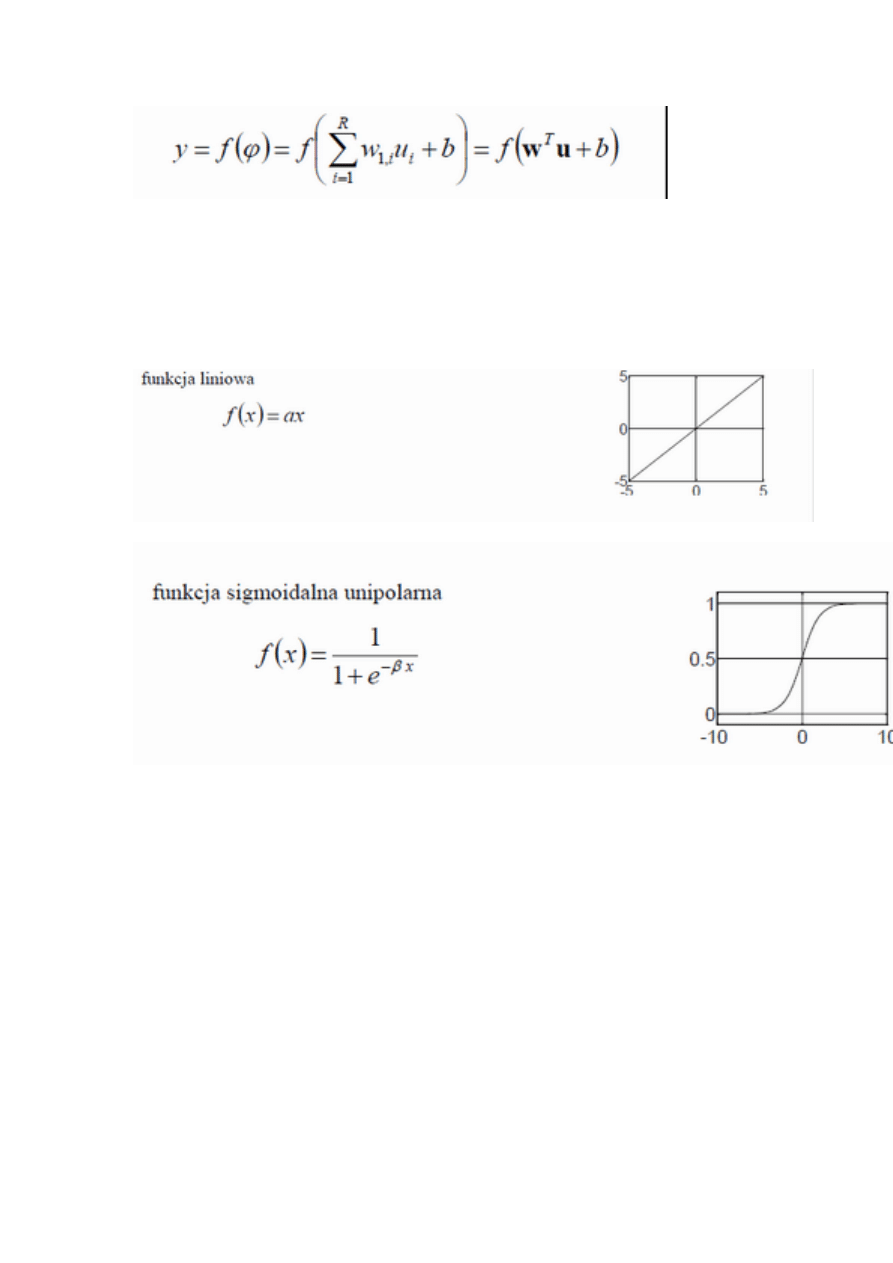

5. funkcje aktywacyjne neuronow

Funkcja aktywacji, w zależności od konkretnego celu, jakiemu służy neuron, może przyjmować różne

postacie.

-skokowa : od 0 do 1

od minus jeden do plus jeden

-

liniowa

-sigmoidalna (0d 0 do 1 v -1 do 1)

Gdy b-> nieskończoność – wtedy skokowa

Zaleta f. sigmoidalnej jest ciągłość funkcji.

-gaussa (neurony radialne)

-liniowa z ograniczeniem

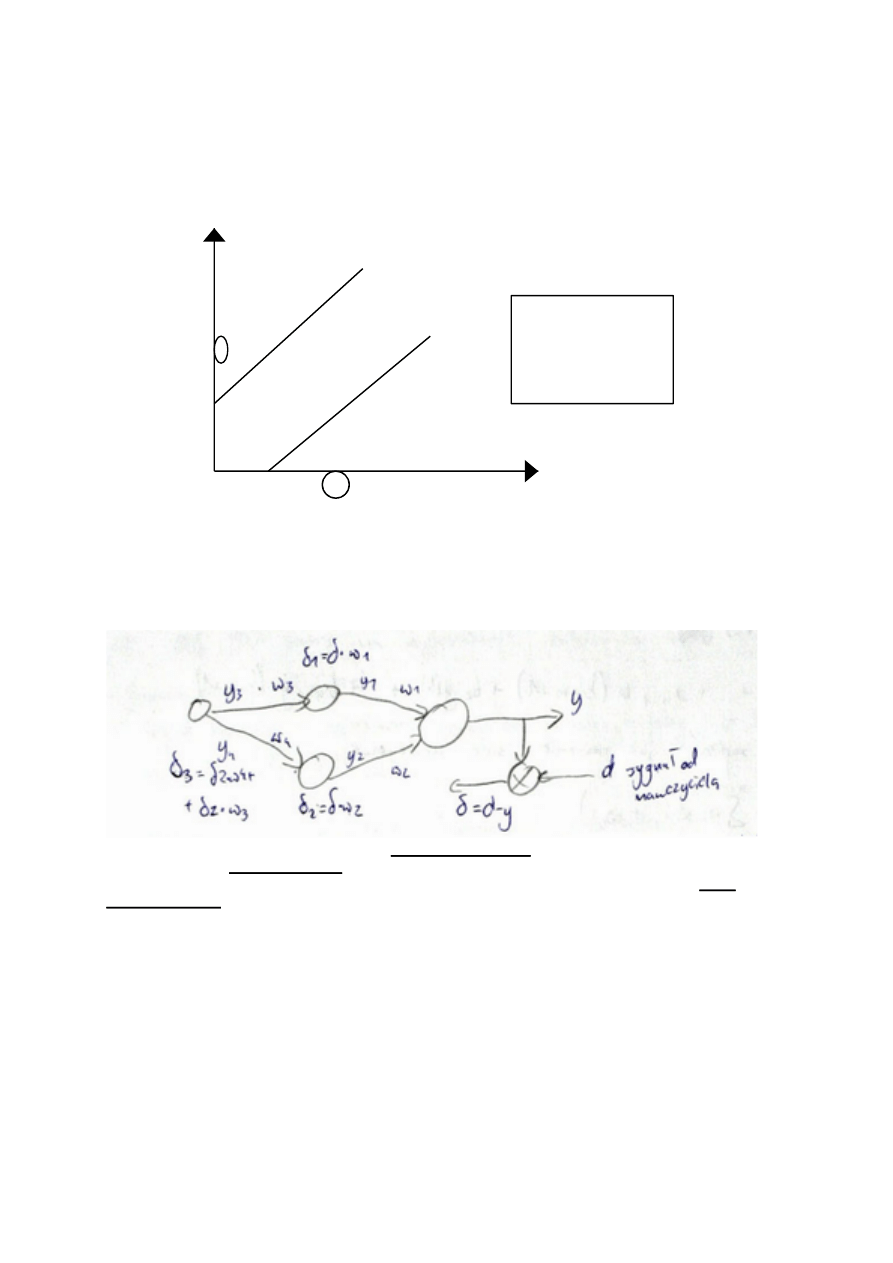

6. dzialanie neuronu dwuwejściowego. Granica decyzyjna

W przypadku neuronu 2-wejściowego granica decyzyjną wyznacza się dla fi=0.

7. metody uczenia neuronow. reguła delta

Metody uczenia :

-nadzorowana (z nauczycielem) – podanie na wejście sygnału przy znanej odpowiedzi,

jeśli generuje poprawny wynik to waga się nie zmienia

-nienadzorowana – mniej skuteczna z opracowaną funkcja określającą zmianę wag

Z nauczycielem – met. Widrowa-Hoffa : metoda delta

)

(

)

(

)

1

(

y

d

x

W

W

W

W

i

i

i

t

i

t

i

−

=

∆

∆

+

=

+

x

i

=u

i

- wekście , d-sygnał od nauczyciela

)

(

*

y

d

u

W

i

i

−

=

∆

η

η

-współczynnik uczenia się: (0:1)

Bez nauczyciela – met. Hebba

??????????

)

,

(

*

y

u

W

i

i

η

=

∆

η

- im wieksze tym szybciej się uczy neuron, ale czasem może się nigdy nie nauczyc

Reguła delta : Z regułą delta mamy do czynienia, gdy uaktualnianie wag następuje

każdorazowo po prezentacji jednej pary uczącej. Gdy uaktualnianie zachodzi po prezentacji

wszystkich par uczących mamy wtedy do czynienia z tzw. skumulowaną regułą delta.

Reguła delta przeznaczona jest dla neuronów z ciągłymi funkcjami aktywacji i stanowi

odpowiednik reguły perceptronowej. Nazywa jest ona również ciągłą regułą perceptronową.

Metoda ta łatwo daje się wprowadzić jako wynik minimalizacji kwadratowego kryterium

błędu. Jej uogólnioną wersję można wykorzystać w sieciach wielowarstwowych.

8. Uczenie nadzorowanie perceptronu , równanie uczenia

Równanie uczenia:

)

(

*

...)

(

*

)]

(

)

(

[

)

(

)

1

(

'

n

u

n

f

n

y

n

d

n

w

n

w

i

−

+

=

+

η

Uczenie : powstaje problem bo posiadamy tylko sygnał wyjściowy nie wiemy co jest w

warstwach ukrytych ( błąd się nawarstwia z warstwy na warstwe). Błąd neuronu mnoży się

razy wagę wyjścia

9. struktura programu modelującego neuron

- tworzenie wektorów uczących

- tworzenie sieci neuronowej przy użyciu funkcji net=newff()

- określanie liczby epok

- inicjacja wag sieci

- obliczanie odpowiedzi nie wytrenowanej sieci na wektor wyjściowy

- uczenie sieci

10. wpływ danych uczących (wejściowych) oraz współczynnika n na uczenie

perceptronu.

η

- im wieksze tym szybciej się uczy neuron, ale czasem może się nigdy nie nauczyc

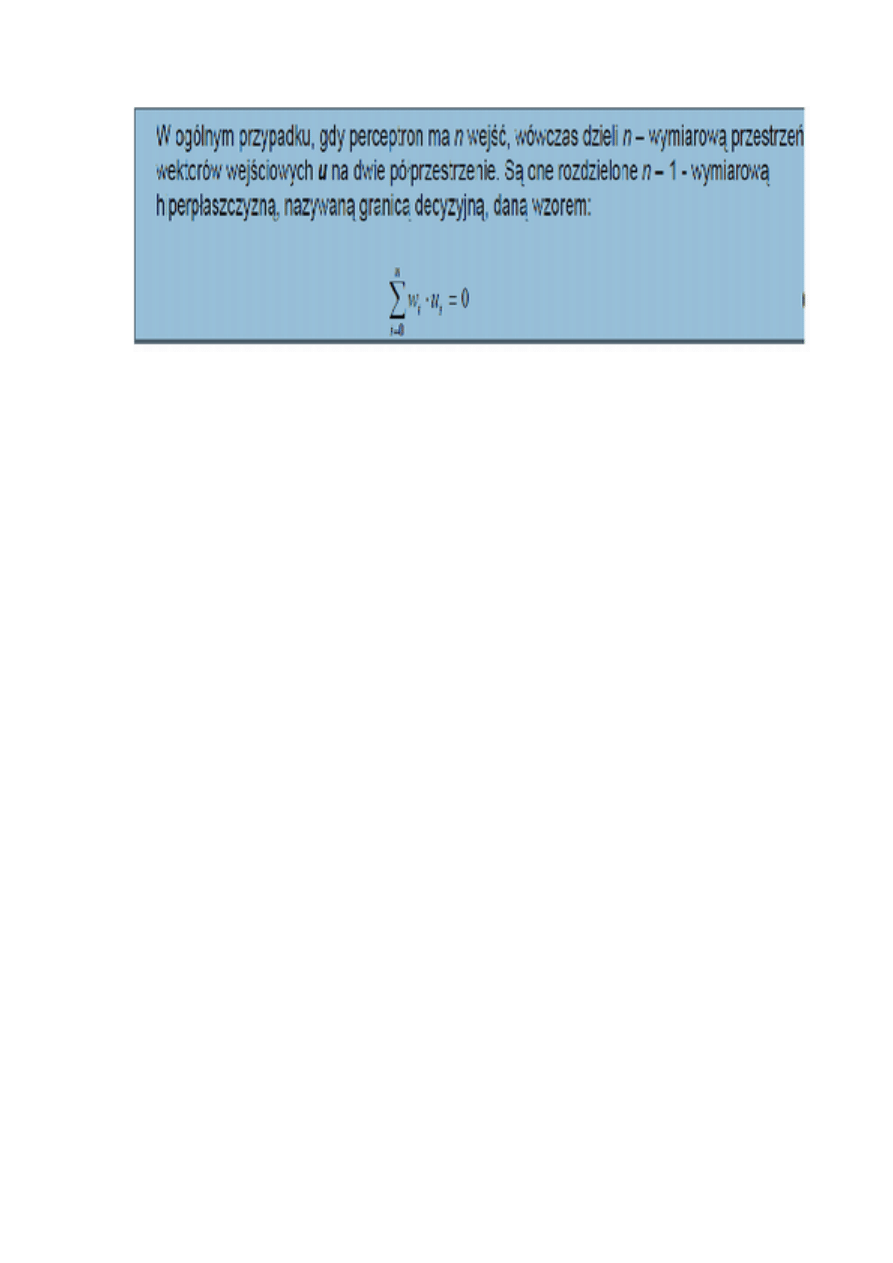

11. ograniczenia perceptronu

Perceptron dzieli płaszczyzny na 2 pół płaszczyzny. W ogólności perceptron jest wielowejściowy. Taki

perceptron dzieli przestrzeń n wymiarową na dwie powierzchnie

12. adaline, budowa , uczenie (algorytm LMS)

ADALINE-adaptive-linear-neuron/element

Błąd bierzemy sprzed funkcji aktywacji (w odróżnieniu od modelu McCullocha)

Budowa:

LMS- met. najmniejszych kwadratów

Uczenie : algorytm Widrowa-Hoffa

a) inicjalizacja wag i wartości progowych =w(0)

b) podanie na wejścia sieci neuronowej nowego obrazu (?)

2

2

1

)]

(

)........

(

)..

(

..

1

[

)

(

n

u

n

u

n

u

n

n

m

=

c) wyznaczenie y a następnie błędu

2

2

))

(

)

(

(

)

(

n

y

n

d

n

−

=

ε

d) zakończyć jeżeli

)

(

2

n

ε

większe od zadanej dokładności

e) adaptacja wektora wag

)

(

)

1

(

n

w

n

w

=

+

13. neuron sigmoidalny, budowa , uczenie -> równanie uczenia

Budowa:

Neuron typu sigmoidalnego ma strukturę podobną do modelu McCullocha-Pittsa, z tą

różnicą, że w przeciwieństwie do perceptronu funkcja aktywacji jest ciągła i przyjmuje

postać funkcji sigmoidalnej unipolarnej (0,1) lub bipolarnej (-1,1). Funkcja unipolarna

ma zwykle postać

, natomiast bipolarna

(inaczej

1

)

exp(

1

2

)

(

−

−

+

=

s

s

f

β

)

Parametr

jest dobierany przez użytkownika i jego wartość

wpływa na kształt funkcji aktywacji. Przy małych wartościach

funkcja ma mały kąt

nachylenia, w miarę wzrostu jej wartości przebieg staje się bardziej stromy. Przy

dążącym do nieskończoności funkcja sigmoidalna przechodzi w funkcję skokową,

identyczną z funkcją aktywacji perceptronu. W praktyce przyjmuje się najczęściej dla

uproszczenia współczynnik

=1

Uczenie neuronu sigmoidalnego odbywa się zwykle w trybie z nauczycielem, przez

minimalizację funkcji celu, podobnie jak w przypadku perceptronu.

Założenie ciągłej funkcji aktywacji umożliwia zastosowanie w uczeniu metody

gradientowej. Najprościej jest przyjąć metodę największego spadku, zgodnie z którą

aktualizacja wektora wag odbywa się w kierunku ujemnego gradientu funkcji celu

Równanie uczenia:

)

(

*

...)

(

*

)]

(

)

(

[

)

(

)

1

(

'

n

u

n

f

n

y

n

d

n

w

n

w

i

−

+

=

+

η

14. neuron hebba, budowa, uczenie -> metody uczenia , równania (z i bez

nauczyciela)

Siec hebba powinna odkryc bez dodatkowej pomocy wzajemne zależności, uczenie bez

nauczyciela jest skuteczne, gdy mamy nadmiarowe dane uczące. Cecha niekorzystna jest

niestabilność, brak …..?? , wynikiem uczenia jest wykładniczy wzrost wag.

Równanie modyfikacji wag:

i

i

u

y

w

*

*

η

=

∆

Zgodnie z regułą Hebba zamiana wagi w

ij

neuronu odbywa się proporcjonalnie do iloczynu

jego sygnału wejściowego oraz wyjściowego

15. neuron radialny , budowa ,uczenie

f.aktywacji to f. gaussowska -> łagodnie przechodzi z x na 0.

Dokonuje kołowy podział wokół punkutu.

y

x-t

1

1

f

r

n

...

f

r

n

x

t

n

1

t

1

x

Agregacja sygnałów wejściowych

w tym typie neuronu polega na obliczaniu odległości pomiędzy obecnym wektorem wejściowym X

a ustalonym podczas uczenia centroidem pewnego podzbioru T

16. typowe architektury sieci (jednokierunkowa + rekurencyjna)

-jednokierunkowe

-rekurencyjne

-jednowarstwowe

-wielowarstwowe

17. rozwiązanie problemu XOR (siec dwu i trój warstwowa perceptronowi)

Do rozwiązania problemu musimy zdefiniować architekturę sieci:

-liczba warstw

-liczba neuronow w każdej warstwie

-funkcje aktywacji neuronow

Zaproponować metode uczenia i jej parametry

Podobnej funkcji natomiast nie da się zrealizować dla funkcji XOR. Wynika to z tego, że nie da się jedną prostą

rozdzielić na dwa obszary płaszczyzny obrazującej funkcję XOR. Zostało to pokazane w aplecie 2. Widać, że

sieć nie może znaleźć optymalnego punktu pracy.S

Efekt ten jest znany jako „PROBLEM XOR”. Aby go rozwiązać wymagane są przynajmniej dwie proste, co

wiąże się z tym, że sieć musi mieć przynajmniej dwie warstwy. Taka struktura sieci została zaprezentowana na

rysunku 2.

Rysunek 2. Sieć składająca się z dwóch warstw.

Dla takiej struktury możliwe jest nauczenie funkcji XOR. Algorytm jaki został wybrany to algorytm ze wsteczną

propagacją błędów.

18. algorytm propagacji wstecznej

-jeden z najskuteczniejszych algorytmow uczenia sieci wielowarstwowych

-wyznacza się błąd neuronu wyjściowego (neuronow wyjściowych) i na podstawie tego zmienia się wagi

-błąd popełniony przez dany neuron to suma ważona błędu popełninego przez neurony warstwy wyższej

Propagacja wsteczna - podstawowy algorytm uczenia z nauczycielem wielowarstwowych

jednokierunkowych sieci neuronowych. Podaje on przepis na zmianę wag dowolnych połączeń elementów

przetwarzających rozmieszczonych w sąsiednich warstwach sieci. Oparty jest on na minimalizacji sumy

kwadratów błędów uczenia z wykorzystaniem optymalizacyjnej metody największego spadku. Dzięki

zastosowaniu specyficznego sposobu propagowania błędów uczenia sieci powstałych na jej wyjściu, tj.

przesyłania ich od warstwy wyjściowej do wejściowej, algorytm propagacji wstecznej stał się jednym z

najskuteczniejszych algorytmów uczenia sieci.

19. zast. Ssn do rozpoznawania liter, cech sygnałów

Najpopularniejsze obecnie zastosowanie sieci neuronowych

§

w programach do rozpoznawania pisma (OCR)

§

na lotniskach do sprawdzania, czy prześwietlony bagaż zawiera niebezpieczne ładunki

1

1

Tak należy

podzielic

płaszczyzne

§

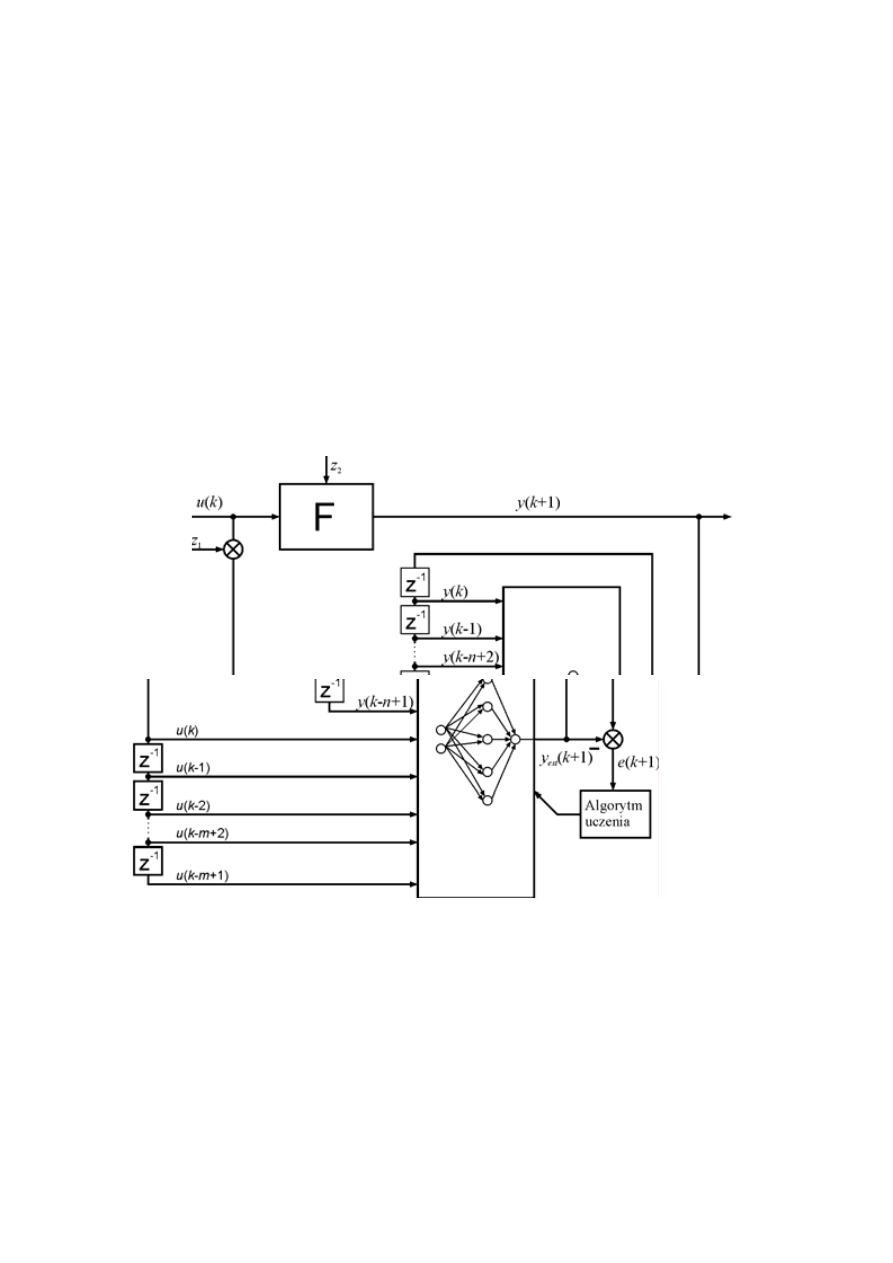

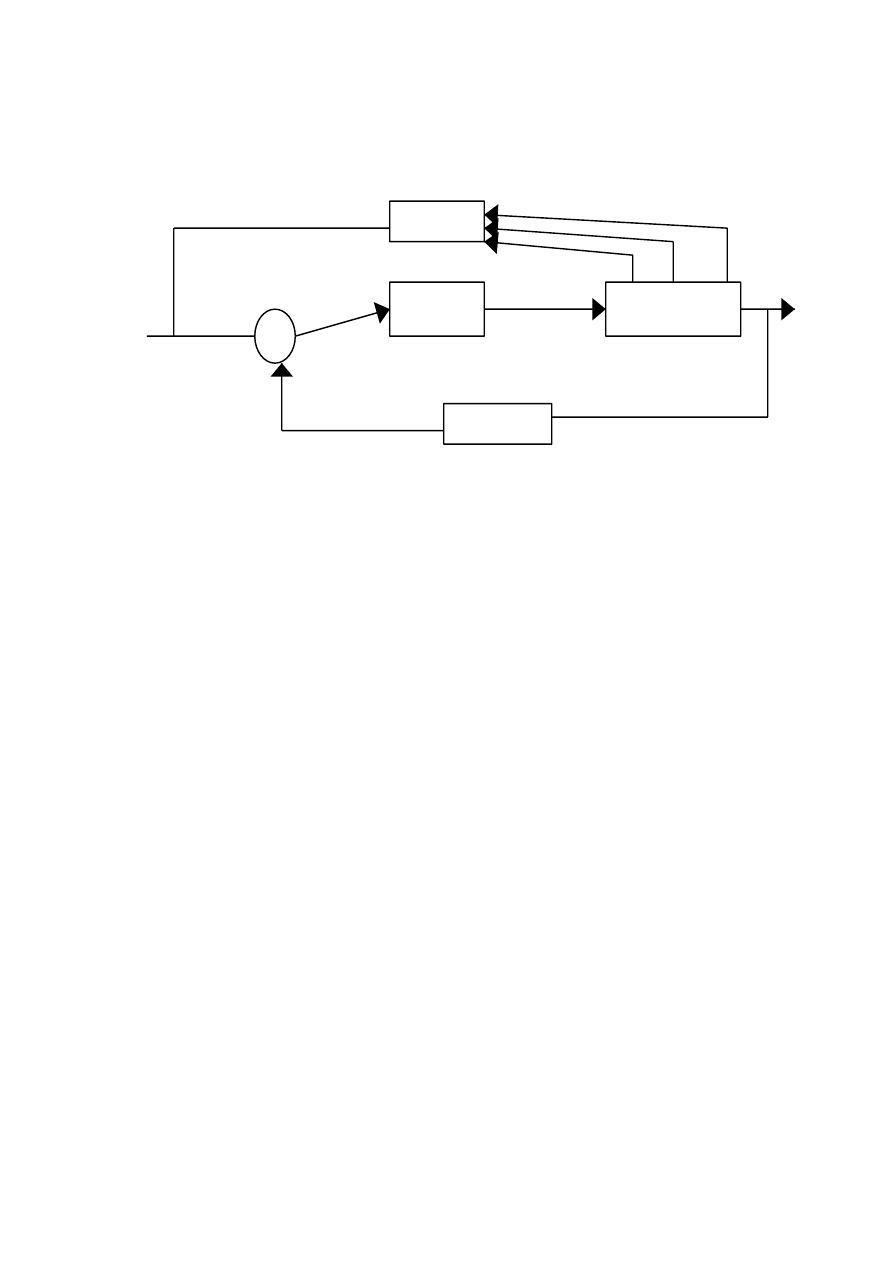

20. model identyfikacji równoległej

Struktura układu z równoległym modelem identyfikacji pokazana jest na rys. 3. W strukturze tej, jednym

z wejść modelu jest jego niezakłócone i niezaszumione wyjście

y

(

k +1

)

est

, co pozwala zwiększyć dokładność

identyfikacji. Sieć neuronowa będąca modelem obiektu F musi być siecią rekurencyjną.

W rozpatrywanej strukturze stabilność modelu identyfikacji z siecią neuronową, z uwagi na

ograniczoność sygnałów wejściowych oraz wyjściowych, nie jest zagwarantowana. W konsekwencji błąd

wyjścia e(k+1) może nie dążyć do zera.

21. def zbiorow klasycznych i rozmytych. Podstawy logiki rozmytej

Element należy do zbioru rozmytego z pewnym stopniem przynależności. Stwierdzenie może być częściowo

prawdziwe lub częściowo fałszywe. Przynależność jest liczba rzeczywista z przedziału 0 - 1. Stopień

przynależności stanowi informację, jak daleko element x jest oddalony od naszego podzbioru X. Określamy go

dzięki funkcji przynależności.

Zbior rozmyty (fuzzy set)

Niech X , dziedzina rozważań, będzie zbiorem pewnych elementow x.

Zbiorem rozmytym A dziedziny rozważań X , nazywamy zbior par:

Gdzie:

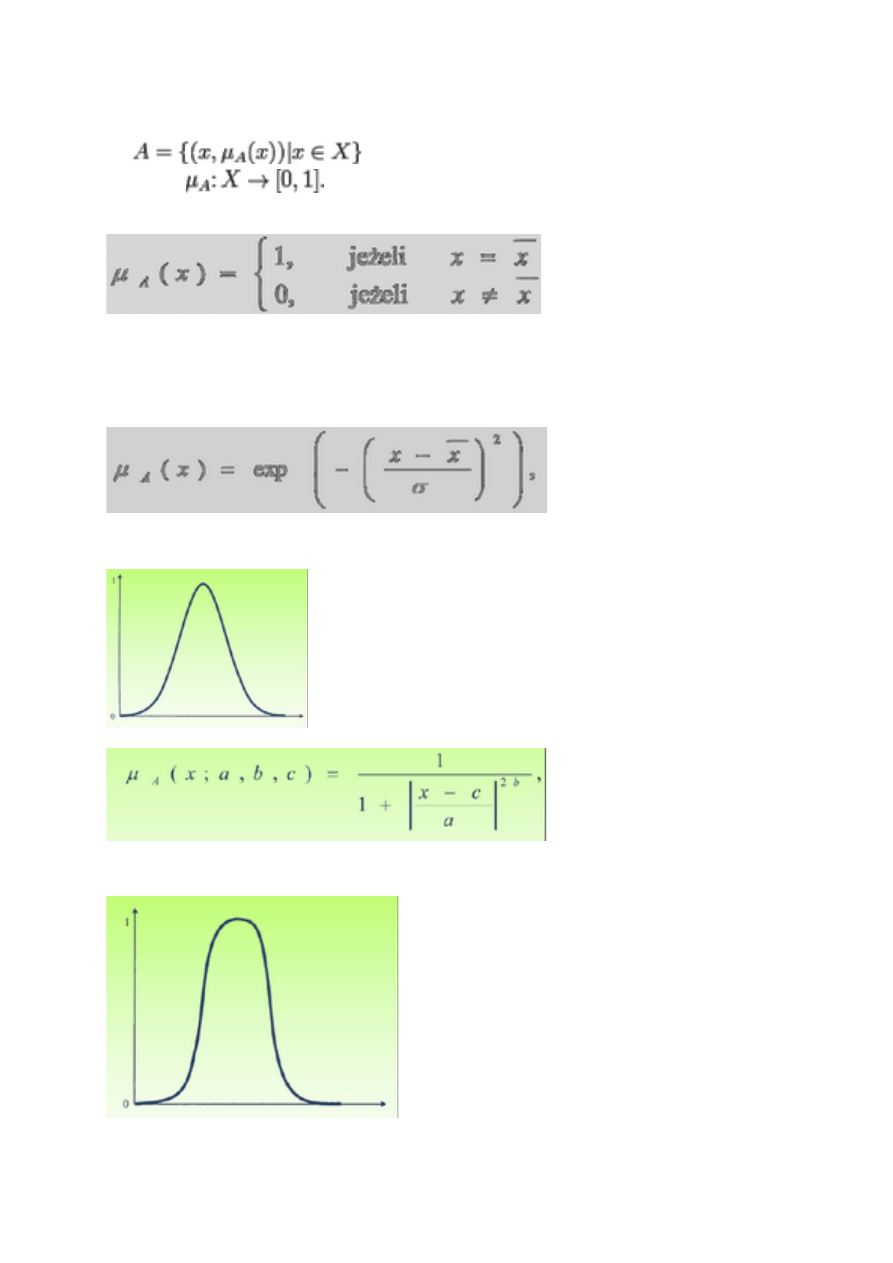

22. funkcje przynależności , rodzaje, kształty

1. Funkcję sigleton definiujemy następująco:

Singleton jest specyficzną funkcją przynależności, gdyż przyjmuje

wartośd 1 tylko w jednym punkcie przestrzeni rozważao,

należącym w pełni do zbioru rozmytego. W pozostałych punktach

przyjmuje wartośd 0.

2. Gaussowska funkcja przynależności:

w którym x jest środkiem, a a określa szerokośd krzywej

gaussowskiej. Jest to najczęściej spotykana funkcja

przynależności.

3. Funkcja przynależności typu dzwonowego

gdzie parametr a określa jej szerokośd, parametr b nachylenie,

natomiast parametr c środek.

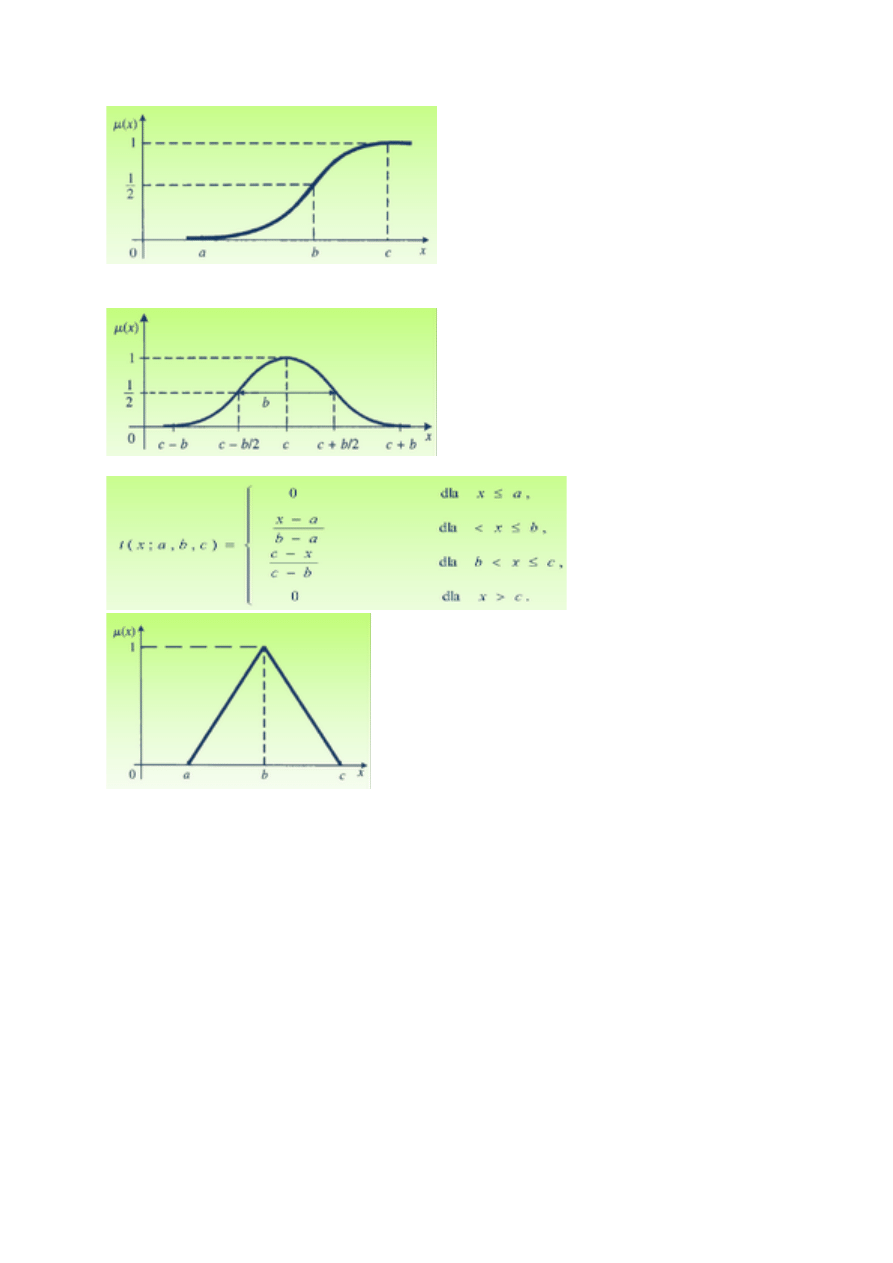

4. Funkcja przynależności klasy s

5. Funkcja przynależności klasy PI

7. Funkcja przynależności klasy t

23. na czym polega fuzzyfikacja ? jak się ja wykonuje i jakie SA zakresy

niewrażliwości zmian sygnalu wejściowego na dzialanie regulatora rozmytego

Pierwszym blokiem na jaki trafiają dane wejściowe, jest blok fuzyfikacji. W tym

miejscu ulegają one rozmyciu, czyli zostaje określony stopień przynależności

do poszczególnych zbiorów rozmytych.

Rozmywanie (fuzyfikacja) - operacja przekształcająca sygnały wejściowe z dziedziny

ilościowej na wielkości jakościowe reprezentowane przez zbiory rozmyte na

podstawie określających je funkcji przynależności.

Zmienne wejściowe jak i wyjściowe są wartościami rzeczywistymi, więc w praktyce

zakres ich zmienności jest skalowany w większości zastosowań do domkniętego

przedziału, np. [-1 ; 1]. Operacja taka nazywana jest normalizacją, a przekształcenie

odwrotne - denormalizacją przestrzeni zmiennych. Współczynniki takiej normalizacji

mogą zapewniać zarówno liniowe jak i nieliniowe odwzorowanie. Wartości rozmyte

są więc podzbiorami rozmytymi tych przedziałów.

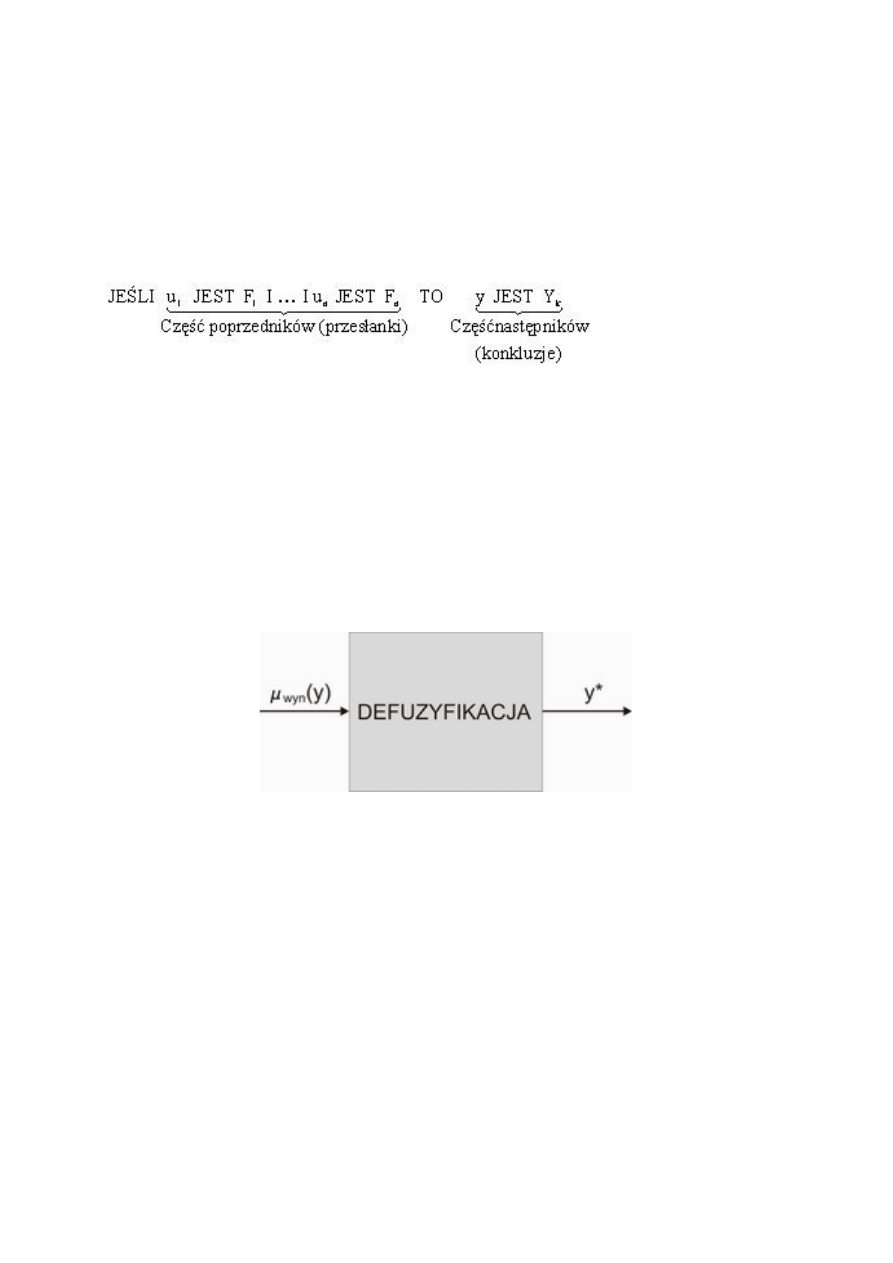

24. baza regul- budowa

Baza reguł - reprezentuje wiedzę jakościową o systemie w postaci zbioru reguł

rozmytych w postaci wyrażeń jeśli-to. W przypadku układu MISO mają one postać:

25. wyniki dzialania regul , poziom zaplonu, jak się go wyznacza, pokazac na

przykaldzie

26. metoda defuzzyfikacji, na czym polega metoda cyfrowa i analogowa

Jest to ostatni blok układu sterowania rozmytego[2]. Na jego wejście trafia wynikowa funkcja

przynależności. Jest to wynik działania regulatora przedstawiony w postaci rozmytej. Żeby móc go wyprowadzić

na obiekt sterowany, zamieniany jest na konkretną wartość liczbową. Działanie to, stanowiące istotę tego bloku,

nazywamy ostrzeniem (inaczej defuzyfikacją).

Ogólnie działanie bloku defuzyfikacja można przedstawić następująco:

Wyróżniamy kilka metod defuzyfikacji. Do najpopularniejszych należą:

1) metoda pierwszego maksimum

2) metoda ostatniego maksimum

3) metoda środka maksimum

4) metoda środka ciężkości

5) metoda wysokości

27. tabela regul , jak się ja zapisuje i jak ja rozumiec

28. podstawowe pojecia w algorytmie genetycznym (populacja ,

chromosomy ,funkcja przystosowania)

populacja-zbiór osobników o określonej liczebności (ustalona licba osobnikow) każdy

osobnik jest kodowany liczbami. Cechy za zakodowane w postaci liczb lub fragmentow bitow

chromosomy- cechy osobnikow zapisane za pomoca frag. Bitow. Najczescniej osobniki maja

tylko jeden chromosom

funkcja przystosowania – ustalamy f. podczas projektowania w jakim stopniu dany osobnik

jest przystosowany do zadania w środowisku. F ocenia osobnikow

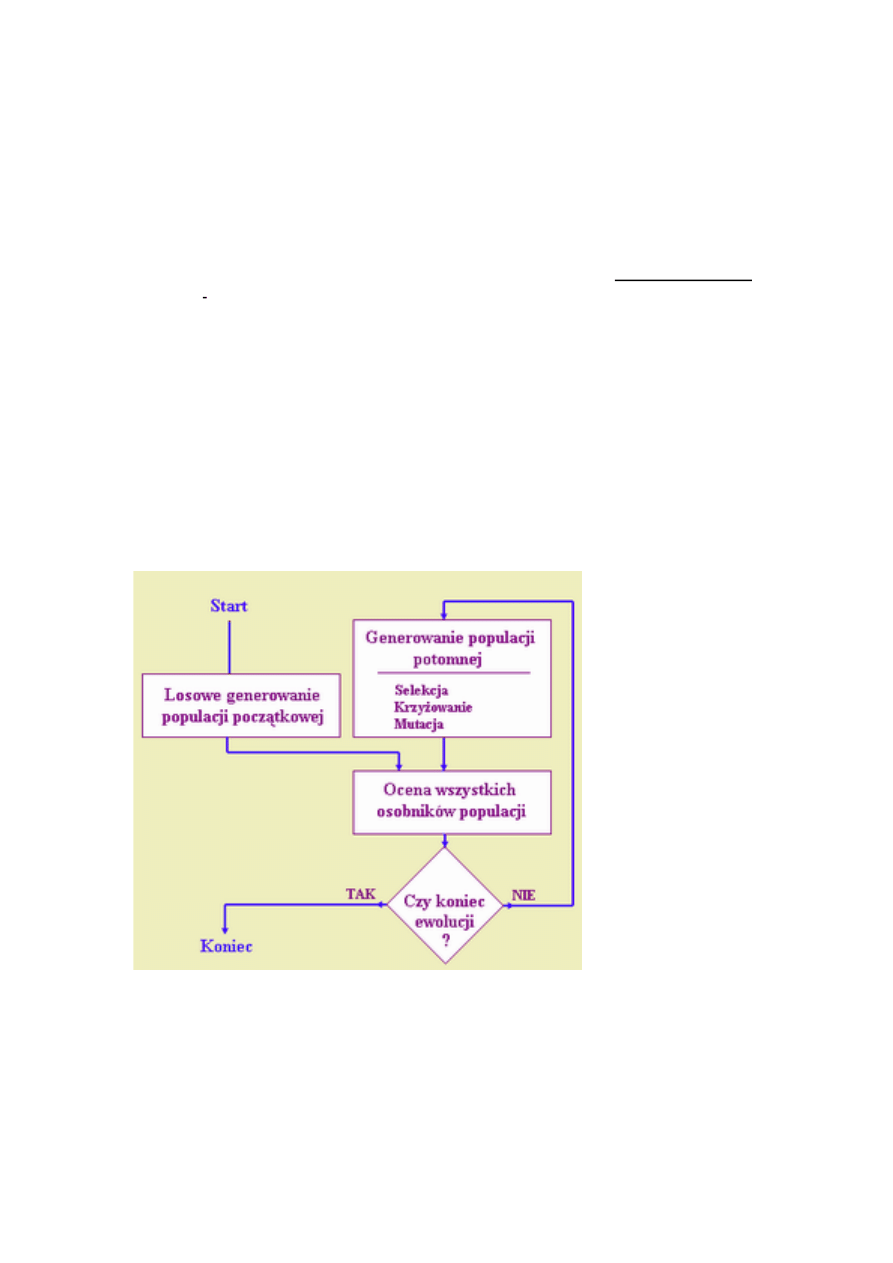

29. opisac dzialanie algorytmu genetycznego

Dzialanie algorytmu zaczyna się od stworzenia osobnikow (ilość bitow na osobnika), w programie bity

SA przydzielane losowo(bit tworzy liczbe), populacja powinna być liczba parzysta, pojedynczy bit to gen.

Wykorzystuje f. przystosowania dla każdego osobnika podawana zostaje wartość f.przystosowania. na podstawie

wartości dokonuj się losowanie nastepnej populacji (metoda kola ruletki).

Algorytm genetyczny operuje na chromosomach. Rolę tę pełni wektor o stałej długości, najczęściej składający

się z wartości binarnych. Każdy z bitów wektora pełni rolę genu. Zbiór chromosomów o określonej liczności

tworzy populację. Algorytm genetyczny potrzebuje zdefiniowania następujących operacji:

- generacji populacji początkowej,

- określenia jakości poszczególnych osobników,

- reprodukcji,

- mutacji,

- krzyżowania.

30. algorytm genetyczny do poszukiwania parametru optymalnego sterowania –

schemat wraz z komentarzem

sterownik

Obiekt

sterowania

Czujnik

+

Wyszukiwarka

Podobne podstrony:

MSI oprac, Mechatronika, Metody Sztucznej Inteligencji, msi materiały

dobre doc

dobre cv doc

Opadły mgły, wstaje nowy dzień Stare Dobre Małżeństwo doc

dobre wykresy dla Ohma doc

dobre fund doc

dobre cw1 DOC

Drewno i kamień dobre sąsiedztwo doc

28c Jan Andrzej Morsztyn, Wybór poezji, wyd (BN I 257) Lutnia s 110 135, oprac Paulina Surmacz do

europejski system energetyczny doc

więcej podobnych podstron