Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

Ewaluacja w epoce wskaźników

Wyzwania dla zarządzania sektorem publicznym

CAROL TAYLOR FITZ-GIBBON

i

University of Durham

Wstęp

Nieuchronny rozwój systemów wskaźników

wspomaganych komputerowo wpływa na zmianę zarówno

ewaluacji, jak i zarządzania sektorem publicznym. W

niniejszym artykule twierdzę, że – jako przedstawiciele

nauk społecznych – musimy przyjąć podejście naukowe,

za którym gorąco orędują Leeuw i inni:

Po pierwsze, analiza ewaluacyjna może

zostać scharakteryzowana jako

przestrzeganie metodologicznych

standardów solidności, zasadności oraz

wiarygodności, i wynikającą z tego

nieodpartą siłę prawdy... A po drugie, ten

rodzaj badania polityki społecznej może

być związany z potrzebą uzasadnienia

publicznego obowiązku ingerowania w

życie społeczne.

ii

Musimy opracować metodologicznie poprawne, złożone

systemy nadzoru i ewaluacji, szczególnie w sektorze

publicznym, który jest odpowiedzialny za „ingerowanie w

życie społeczne”. W poniższym omówieniu poszukuję

pewnych przydatnych zasad przewodnich, które mogą

pomóc w projektowaniu efektywnych systemów

zarządzania sektorem publicznym.

Analizuję również skutki stosowania systemów

wskaźników dla przeprowadzania ewaluacji.

Czego projektanci złożonych systemów nauczyli się z

doświadczenia?

Gene Glass, w przenikliwym artykule pt. „Paradoks

znakomitych szkół i ludzi do nich należących”, twierdził, że

występuje konflikt między naszym przekonaniem, że ludzie

działają najefektywniej w otoczeniu, które ich bardzo

wspiera i docenia, a koncepcją odpowiedzialności, oceny

skuteczności oraz wydawania opinii na jej temat, być może

ze szkodą dla osiąganych przez nich wyników.

iii

W innym

nowatorskim artykule pt. „Sposób na nieprzewidywalność”

zaproponował pewne ogólne zasady postępowania w

przypadku nieprzewidywalnych systemów.

Takie systemy muszą być starannie

nadzorowane; aktorzy w nich działający

muszą pozostawać uniwersalni i

elastyczni, a usługi muszą być w dużym

stopniu zdecentralizowane. Ludzie muszą

mieć możliwość wyboru, a nie wieczne

prawdy. W oświacie ten styl postępowania

byłby dokładnym przeciwieństwem

odgórnego planowania nakazowego i

polityki, którą my, badacze, w swoim

mniemaniu odkrywamy.

iv

Informacja zwrotna na temat rezultatów „starannego

nadzoru” musi być przekazywana jednostkom, które są w

stanie zinterpretować dane, a w razie potrzeby na ich

podstawie podjąć działania. Z tego względu zapewnienie

„informacji zwrotnej” (feedback) być może jest

zdecydowanie najważniejszą rolą systemów wskaźników.

Niektórzy twierdzą, że bezcelowe jest przekazywanie

informacji zwrotnej na temat wyników uczniów, którzy

zakończyli naukę; że jest to przestarzałe podejście.

Potrzebne są natomiast prognozy, przewidywania i cele do

osiągnięcia, ukierunkowane na przyszłość. Dotychczas nie

przeprowadzono jeszcze żadnych eksperymentów na

poparcie tych poglądów. Istnieją jednak argumenty

przemawiające przeciwko stosowaniu konkretnych celów

do osiągnięcia oraz skupianiu się na prognozach. Dobre

dane z przeszłości są przynajmniej wiarygodne; są one

dokładniejsze niż jakiekolwiek zakładane cele. Jak

twierdził znakomity amerykański metodolog, Donald T.

Campbell:

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

2

Tajemnicą racjonalnej innowacji jest

selekcja z perspektywy czasu, a nie

przewidywane zmiany.

v

Co więcej, Karl Popper twierdził, że w gruncie rzeczy

przyszłość jest nieprzewidywalna. Jego biograf, Magee,

napisał:

Wraz z upadkiem koncepcji, że przyszłość

można naukowo przewidzieć, załamuje się

również idea całkowicie zaplanowanego

społeczeństwa.

vi

„Naukowe” podejście Poppera, obejmujące systemy

oparte na współudziale i współdziałaniu, demokratyczne,

organiczne oraz uznanie, że przyszłość jest

nieprzewidywalna, możemy przeciwstawić „całkowicie

zaplanowanemu”, „menedżerskiemu” społeczeństwu, w

którym procedury są narzucone i określone przez systemy

hierarchiczne. Wydaje się prawdopodobne, że między tymi

podejściami istnieją dwie zasadnicze różnice: 1)

przekonanie, że przyszłość można kontrolować i

przewidywać, oraz 2) brak zaufania i szacunku dla

najbardziej zainteresowanych – dla „ludzi”. W Anglii

najlepszy przykład systemu opartego na autorytarnym

menedżeryzmie stanowi OFSTED, Urząd Standardów

Edukacji (Office for Standards in Education).

vii

W Tabeli 1 podaję przykładowe kontrasty między

podejściem naukowym, badawczym, a kontrolnym

menedżeryzmem, który wiąże się z ustalaniem

konkretnych celów do osiągnięcia i wskazywaniem

winnych niepowodzenia. Wskaźniki mogą pojawić się w

obu metodach.

Tabela 1. Dwa przeciwstawne podejścia do projektowania

systemów (np. zarządzania sektorem publicznym)

Etos Bierna

obserwacja

Czynna

ingerencja

Demokratyczny/profesjonaln

y

Naukowy

Informacja

zwrotna

Oparta na

wskaźnikac

h

Eksperyment

y

„Badania

rozproszone”

Rozwój

praktyki

„opartej na

dowodach”

Hierarchiczny/kontrolny

menedżerski

Opinie

Oparte na

władzy

Publikowane

wyniki

Z

zakładanymi

celami,

nagrodami i

karami

W odniesieniu do wartości i potrzeby „ingerowania w

społeczeństwo”, Popper reprezentował ciekawy punkt

widzenia. Twierdził, że podstawową wartością nie jest

umożliwianie ludziom poszukiwania szczęścia, lecz

„minimalizowanie cierpienia, którego można uniknąć”.

viii

Wynika z tego, że musimy wyszukiwać cierpienie (tj.

identyfikować problemy) i podejmować kroki mające na

celu poprawę systemu i usunięcie tych problemów.

Na opisanie tego podejścia Popper przewrotnie

wybrał trzy niepopularne słowa: „fragmentaryczna

inżynieria społeczna” (piecemeal social engineering).

Ostrzegał on, że próby planowania przyszłości – zamiast

rozwiązywania bieżących problemów – nie będą skuteczne

i doprowadzą do poszukiwania winnych, zrzucania

odpowiedzialności i stosowania przemocy.

Psycholog, ekonomista i informatyk, Herbert A.

Simon (laureat Nagrody Nobla za teorię

„satysfakcjonującego” wyboru w ekonomii) wyraził taki sam

pogląd.

ix

Utrzymywał, że nawet systemy komputerowe

wymagają „fragmentarycznej inżynierii społecznej”.

Systemy komputerowe są stosunkowo proste w

porównaniu z żywymi, wzajemnie na siebie oddziałującymi

systemami istot ludzkich, jednak Simon, pracując nad

rozwojem systemów podziału czasu w komputerach,

zauważył, że:

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

3

Były one tworzone, modyfikowane i

udoskonalane w kolejnych etapach. Być

może teoria mogła przewidzieć wyniki tych

eksperymentów i wyeliminować potrzebę

ich prowadzenia. W rzeczywistości tak się

nie stało i nie znam żadnego znawcy tych

niezmiernie złożonych systemów, który

umiałby konkretnie powiedzieć, jak można

było tego dokonać. Aby zrozumieć

działanie tych systemów, należało je

utworzyć i obserwować ich

funkcjonowanie.

x

Pracując z podobnie skomplikowanymi systemami w

produkcji i przemyśle maszynowym, statystyk, który został

głównym guru w dziedzinie kontroli jakości, W. Edwards

Deming, tak jak Popper podkreślał znaczenie identyfikacji

problemu, uznając ją za najważniejszy obowiązek

kierownictwa.

xi

Ponadto, zachęcał do „wypędzenia strachu”

i poszukiwania „radości w pracy”. Cenił zapewnianie

ludziom ważnych stanowisk pracy i uważał, że celem

prowadzenia przedsiębiorstwa powinno być utrzymywanie

miejsc pracy oraz dostarczanie dóbr i usług, a taki etos z

pewnością jest wskazany w zarządzaniu sektorem

publicznym. Jego przekonanie o potrzebie wypędzenia

strachu i poszukiwania radości w pracy opierało się na

realistycznej obserwacji sytuacji, w których wszystko

działało, a wręcz ulegało poprawie, w porównaniu z

efektami etosu strachu, który prowadził do podupadania

produkcji i pogarszania się jakości.

Inny przykład stanowią osoby dążące do

sprawowania kontroli nad gospodarką w Europie

Wschodniej za czasów komunizmu; z upodobaniem

ustalały one konkretne cele. Przeważnie cele te były

osiągane – według danych liczbowych – nawet jeśli nie

mały sensu. (Dla zilustrowania tej sytuacji Perrin przytoczył

przykład Polski, która miała najcięższe meble w Europie,

ponieważ produkcję mierzono na podstawie wagi.)

xii

Sprawozdania, dane, słowa lub opisy należą do

metod relacjonowania sytuacji. Lecz przed etapem

relacjonowania należy ustalić, wszelkimi możliwymi

sposobami, wykaz potrzeb i problemów stanowiących

nieodłączną część systemu, ponieważ zaspokajanie tych

potrzeb i rozwiązywanie tych problemów prowadzi do

udoskonalania systemu. Z tego względu, powszechnie

znany „Cykl ewaluacji” Alkina, który w latach 70. stanowił

podstawę prac Centrum Badań nad Ewaluacją (Center for

the Study of Evaluation) University of California w Los

Angeles (UCLA), rozpoczyna się od oceny potrzeb.

Następnie omawiane są planowanie programu, ewaluacja

kształtująca i ewaluacja sumująca.

xiii

Odpowiada to

podejściu Poppera w odniesieniu do identyfikacji

problemów, testowania rozwiązania, a następnie

sprawdzania, czy odniosło skutek –jego „fragmentarycznej

inżynierii społecznej”.

Glass przeciwstawiał również systemy „elastyczne i

zdecentralizowane” „odgórnemu planowaniu

nakazowemu”. Rozwijając tę dychotomię, przeciwstawne

systemy można określić jako

„demokratyczne/profesjonalne” w odróżnieniu od

„hierarchicznych/kontrolnych”, bądź „wychodzące z

ewaluacją do ludzi” w przeciwieństwie do „służących

ewaluacji ludzi”.

Czasami uważa się, że rozróżnienia przedstawione w

Tabeli 1 reprezentują samczą bezwzględność typową dla

dynamicznych przedsiębiorstw w odróżnieniu od

łagodnego, nastawionego na współpracę podejścia w

sektorze publicznym. Jednak zarówno w biznesie, jak i w

służbie publicznej można przyjąć dowolny z tych stylów.

Moglibyśmy przejść do pojęć bardzo ogólnych, i mówić o

„miękkim sercu” i „bezwzględności”, lecz byłoby to mylące.

Miękkie serce odnosi się do wartości – ceni się

bezpieczeństwo ludzi, posiadanie przez nich środków

utrzymania, ich zdrowie i szczęście. Jednak popieranie

wysokiej jakości życia nie ma większego sensu bez

„bezwzględnego” podejścia do kwestii sposobu jej

osiągnięcia i udostępnienia wszystkim; w tym zakresie

ważną rolę odgrywa nauka. Do skutecznej implementacji

miękkie serce wymaga bezwzględnej nauki. A dowody

naukowe dotyczące zarządzania złożonymi systemami nie

przemawiają za centralizacją i dirigisme (kierowaniem

gospodarką).

Deming bardzo mądrze zauważył, że „(...) tam, gdzie

jest strach, pojawią się błędne dane”.

xiv

Czternaście lat

później James Popham twierdził, że naciski na szkoły,

połączone z bodźcami finansowymi i sankcjami, prowadzą

do zafałszowania wyników egzaminów.

xv

Zawsze tak było.

Podobne obawy wyrażano w Anglii, szczególnie w

odniesieniu do sprawdzianów w szkołach podstawowych.

Znaną praktyką nauczycieli było otwieranie zestawów

egzaminacyjnych, aby przygotować do nich uczniów. Inne

zniekształcenia w zachowaniu wynikają z publikowania

surowych wyników egzaminacyjnych – tzw. „tabeli

ligowych” (League Tables) – kolejnego źródła strachu. Po

wprowadzeniu tabel liczba uczniów wydalonych ze szkół

wzrosła o 600%. Z tego względu dane przestały być

porównywalne, ponieważ niektóre szkoły usuwały uczniów

szybciej, a inne wolniej.

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

4

Projektowanie systemów wskaźników

Wskaźniki mają na celu kontrolę działania systemu za

pomocą regularnych pomiarów. Bez wątpienia wiążą się z

nimi zarówno wielkie możliwości, jak i poważne

niebezpieczeństwa.

xvi

Ile wskaźników powinno się stosować? W warunkach

efektywnej rejestracji i wymiany danych można

przetwarzać tysiące wskaźników. Lecz interpretacja

pomiaru wymaga czasu i wysiłku, więc może to nakładać

pewne ograniczenie na liczbę wskaźników, które powinno

się gromadzić. Jednak wskaźniki w formie informacji

zwrotnej należy przekazywać każdej osobie, na której

spoczywa pewna odpowiedzialność w systemie, więc

mogą być potrzebne setki wskaźników i rzeczywiście taka

ilość jest wykorzystywana w szkołach.

Jak odbywa się selekcja wskaźników? Należy:

1. zbadać, które wyniki mają znaczenie;

2. przejrzeć dane w celu zidentyfikowania

istotnych zmiennych, które wpływają na te

wyniki („współczynników losowych”), a

następnie

3. korygować te robocze zestawienia w ciągłej

dyskusji z osobami, których praca jest

nadzorowana - które najlepiej znają

system.

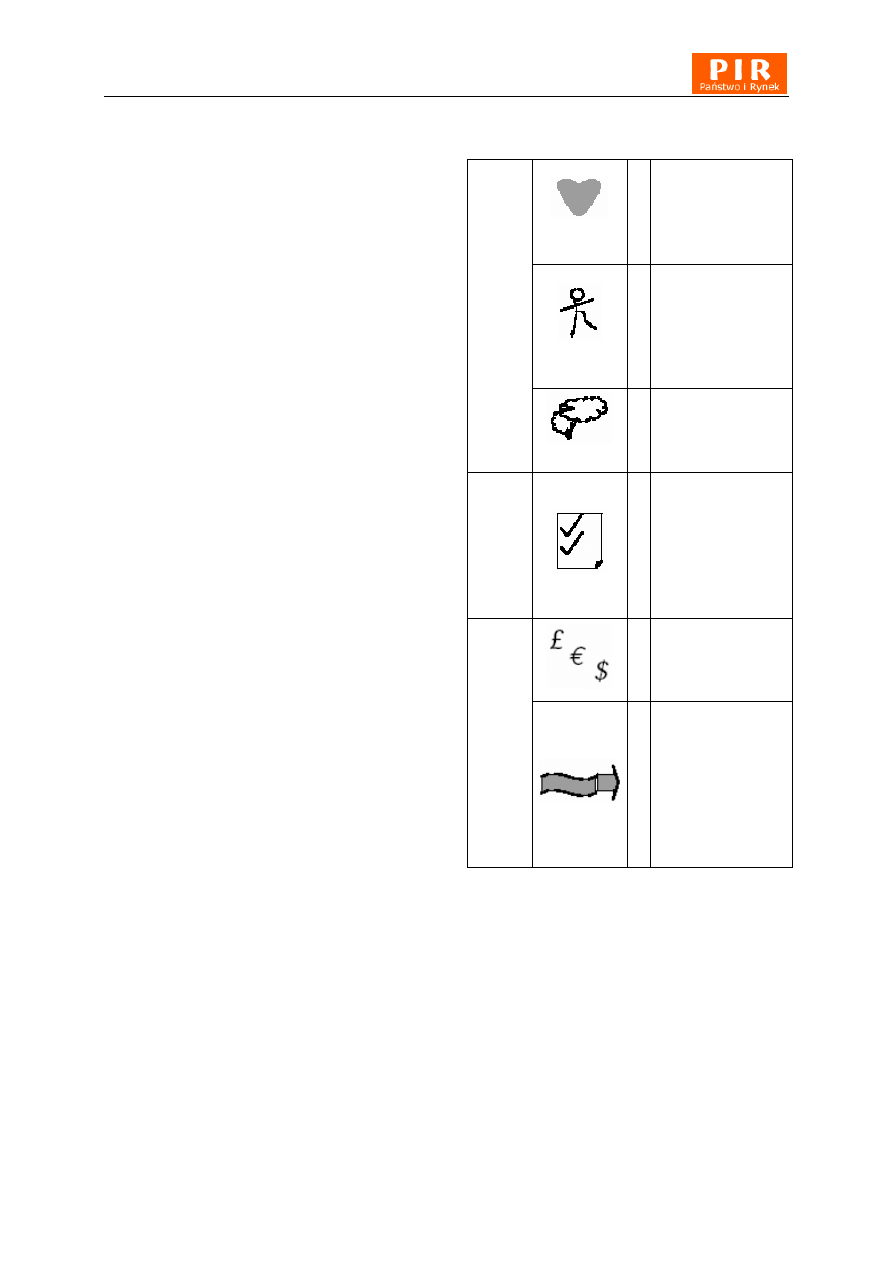

Tabela 2. Typologia

wskaźników w systemach

edukacyjnych

serce

A

Emocjonalne

(Affective)

np. postawy,

ambicje, jakość

życia

ciało

B

Behawioralne

(Behavioural)

np. umiejętności,

współpraca,

zachowania

zdrowotne

Cele

/Wyniki

umysł

C

Poznawcze

(Cognitive)

np. osiągnięcia,

przekonania

Grupy

D

Kategorie

demograficzne

(Demographic

descriptors)

np. płeć, wiek,

status społeczno-

ekonomiczny

E

Wydatki

(Expenditures)

np. zasoby, czas,

pieniądze

Strategie

F

Przepływ (Flow)

np. KTO CZEGO

jest uczony, JAK i

JAK DŁUGO?:

zrównoważony

program nauczania,

zapamiętywanie,

metody, czas

Uwaga: W każdej dziedzinie można opracować wskaźniki

dla zmiennych SEKWENCJI: zmiennych nakładów,

procesu, wyników pośrednich i długookresowych, a także

dla różnych JEDNOSTEK pomiaru: ucznia, klasy,

nauczyciela, wydziału, szkoły, kuratorium oświaty, kraju

itp.

Procesy te stanowiły podstawę opracowania

systemów wskaźników, które odniosły bezprecedensowy –

i jak dotychczas niedościgniony – sukces, a zastosowała je

dobrowolnie prawie jedna trzecia szkół w Anglii.

xvii

Tabela 2 może pomóc w wyborze wskaźników do

systemów kształcenia. Przedstawia typologię wskaźników,

którą łatwo zapamiętać mnemotechnicznie (ABCDEF) i

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

5

która ma na celu „pomiar rzeczy ważnych” w sposób dość

wyczerpujący.

Ze względu na słaby związek między procesami a

wynikami najważniejsze są wskaźniki wyników. W Tabeli 2

w wierszach dotyczących Celów/Wyników są one nazwane

podobnie jak w przypadku „Taksonomii celów

edukacyjnych” Blooma.

xviii

Do określenia wzajemnie na

siebie oddziałujących wskaźników dotyczących uczniów,

programu, sposobów i czasu nauczania, czyli trudnych do

opracowania wskaźników procesu, przyjęłam termin

OECD „przepływ”.

xix

Jednak, niestety, Tabela 2

przedstawia typologię idealną, która dotychczas nie

została zastosowana w żadnym systemie.

Wpływ systemów wskaźników na działania

ewaluacyjne

Wskaźniki stały się codziennością i szybko się rozwijają.

Zapewniają rodzaj nieustannej ewaluacji.

Czy ewaluatorzy mogą jeszcze odegrać jakąś rolę?

Tak, ale rola ta będzie się zmieniać w miarę wchodzenia w

erę ciągłej ewaluacji opartej na danych. Gdy ewaluator

pracuje z organizacją, w której funkcjonuje system

wskaźników, przestaje być potrzebne ustalenie kryteriów i

opracowanie systemów zbierania danych. W takiej sytuacji

ewaluatorzy mogą rozważyć następujące kwestie.

Podstawowe uzasadnienie (ewaluacja projektu) Należy

zadać poniższe pytania; niektóre mogą wydawać się

proste, lecz czasami odpowiedzi ujawniają naszą

niewiedzę. Czy mierzymy sprawy ważne, czy raczej

sprawdzamy, dla kogo są one ważne? Czy ten system

„nadzoru i informacji zwrotnej” wspiera nadrzędne cele

społeczeństwa obywatelskiego? Czy chcemy

zaproponować dodatkowe wskaźniki, czy zrezygnować z

niektórych istniejących? Czy pytania o rasizm są

korzystne, czy szkodliwe? Czy pytania o zażywanie

narkotyków zwiększają skalę tego zjawiska?

Jakość danych Czy procedury zbierania danych są

adekwatne? Czy np. zapewniają poufność, aby

respondenci mogli „wypowiadać się” bez obaw? (Prostym

sposobem na zwiększenie poufności mogą być plastikowe

koperty na kwestionariusze, ponieważ plastiku nie można

otworzyć, a następnie powtórnie zamknąć bez widocznego

uszkodzenia.) Czym można wyjaśnić brak danych? Czy

występują naciski na fałszowanie danych (np. czy w

szkołach niektórym dzieciom nakazuje się pozostać w

domu w dniu ważnych egzaminów oraz czy kadra ma

wcześniej dostęp do materiałów egzaminacyjnych)?

Wykorzystanie informacji zwrotnej Należy sprawdzić, w

jaki sposób wszystkie strony, np. osoby bezpośrednio

zainteresowane, kierownicy i personel, korzystają z

informacji zwrotnej. Czy występują zniekształcenia, np.

sugerowanie, że korelacje można interpretować jako

wskazanie przyczyn? Jeśli stosuje się standardy, to czy są

one sprawiedliwe (np. kryteria wartości dodanej na

jednego ucznia), czy rażąco niesprawiedliwe (np.

porównywanie szkół na podstawie jakiegoś prostego

wskaźnika statusu społeczno-ekonomicznego)? Czy

występują jakieś szczególne czynniki, które mogłyby

wyjaśniać pewne tendencje w danych dotyczących

konkretnej jednostki? Jest to niebezpieczne pytanie, lecz

bardzo interesujące (patrz „Hipotezy wysuwane na

podstawie danych” poniżej). Istotny problem w

interpretowaniu danych stanowią zmiany roczne

spowodowane nieodłącznym zróżnicowaniem różnych

prób ludzi. Zróżnicowanie jest nieuniknione. Ponadto, po

obliczeniu średniej mniej więcej połowa obserwacji

znajduje się poniżej średniej. Niestety, zwykle politycy

krytykują jednostki osiągające wyniki poniżej przeciętnej,

chociaż z konieczności w połowie z nich musi tak być.

Należy temu przeciwdziałać, aby chronić morale.

Identyfikacja problemu Ponieważ systemy udoskonala

się poprzez korygowanie błędów, należy identyfikować

problemy, aby dążyć do stałego ulepszania. Wymaga to

taktownej ewaluacji, opartej na współudziale badanych,

mającej na celu zajęcie się problemem, a nie

poszukiwanie winnych.

Hipotezy wysuwane na podstawie danych Czy można

wysuwać użyteczne hipotezy na podstawie rozwijających

się tendencji widocznej w danych oraz pojawiających się

prawidłowości w konkretnych instytucjach? Zbyt często

interpretacje prawidłowości w danych traktuje się jako

teorie, kiedy w rzeczywistości stanowią one jedynie

nieudowodnione hipotezy.

Sprawdzanie hipotez na podstawie kontrolowanych

eksperymentów na małą skalę Pojedyncza organizacja

może wprowadzić zmiany i obserwować wskaźniki, lecz

większość wskaźników wyników będzie się zmieniać z

roku na rok i jest to nieuniknione. Z tego względu

organizacja mogłaby potrzebować wielu lat na

sprawdzenie skuteczności nowej procedury. Jeśli jednak

pojedyncza organizacja połączy wysiłki z dwudziestoma

innymi organizacjami i systematyczne zmienią one swoje

postępowanie, aby zbadać wpływ na wskaźniki wyników,

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

6

wówczas w ciągu roku organizacja otrzyma rezultaty

równoważne zbieraniu danych z dwudziestu lat. W ten

sposób dobry projekt eksperymentów przyspiesza proces

zdobywania wiedzy o skutecznych metodach.

Często właśnie ostatni etap, sprawdzanie hipotez,

stanowi największy wkład ewaluatora. Przypomina

ewaluację kształtującą, działania mające na celu

doskonalenie programu, lecz w dużym stopniu jest

wspomagany przez nieprzerwany strumień danych

dotyczących wskaźników (zmodyfikowanych dla

konkretnych programów, patrz „Podstawowe uzasadnienie

(ewaluacja projektu)” powyżej) oraz na podstawie

szeregów czasowych danych z lat poprzednich.

Ewaluatorzy mogą uważać,

że nie warto

przeprowadzać sporadycznych eksperymentów na małą

skalę, mimo że są wykonalne, lecz w rzeczywistości każdy

kontrolowany eksperyment staje się istotny w czasach, gdy

metaanaliza odgrywa znaczącą rolę. Na przykład, Hedges

przedstawił niepowtarzalną syntezę trzech rodzajów

danych dotyczących skutków jednej zmiennej polityki –

zmniejszenia liczby uczniów w klasie.

xx

Były to następujące

rodzaje danych: wyniki badań ankietowych (tj. wskaźniki),

eksperymenty na małą skalę (np. podejmowane przez

profesjonalistów) oraz jeden duży eksperyment. Hedges

wykazał, że siła wpływu zmierza do wartości

współczynnika wynoszącego około 0.15 (the effect size)..

Eksperymenty na małą skalę warto przeprowadzać nie

tylko ze względu na wnioski z badania Hedgesa

sugerujące, że mogą one dać nam rezultaty zbliżone do

wyników, które można by otrzymać wskutek dużego

randomizowanego, kontrolowanego badania, lecz także

dlatego, że są one źródłem instytucjonalnej wiedzy o

wysokiej wiarygodności zewnętrznej dla danej instytucji.

Uczestnicy będą mieli poczucie, że jeśli eksperyment udał

się „na ich oczach”, wówczas w przyszłości również mogą

być pewni sukcesu. Boruch podaje przykłady roli

eksperymentowania w wielu dyscyplinach nauk

społecznych.

xxi

Oczywiście, z systemami wskaźników wiążą się

osobne problemy. Na przykład, kto powinien kontrolować

dostęp do danych (wskaźników) powstających w systemie

nadzorowania organizacji? Jeśli Ustawa o wolności

informacji, która niedługo ma nabrać mocy obowiązującej

w Anglii, wymaga pewnych danych, ile danych powinno się

publikować i w jakiej formie? Takie problemy nadal czekają

na rozwiązanie i, jak zawsze, „diabeł tkwi w szczegółach”.

Problem ten będzie przedmiotem rozważań (i sporów) w

każdej organizacji i w każdym systemie politycznym. Na

przykład, jako część dwuletniego kontraktu na

zaprojektowanie krajowego systemu wskaźników wartości

dodanej dla szkół, zalecano równowagę między

profesjonalną swobodą decyzji poszczególnych

nauczycieli a pragnieniem uzyskania informacji o

skuteczności szkół ze strony rodziców i państwa.

xxii

Rozwiązanie stanowił wybór wskaźników zagregowanych

na poziomie grupy przedmiotów nauczania (np.

„matematyka i nauki ścisłe”, „nauki humanistyczne” lub

„sztuka i projektowanie”). Zapewniał ogólnie akceptowalną

równowagę między prawem społeczeństwa do informacji a

prawem nauczycieli do profesjonalnego traktowania i

„uczciwego procesu”.

Zakończenie

Ewaluatorzy mogą z zadowoleniem przyjmować systemy

wskaźników i współpracować zarówno z osobami

zlecającymi ich opracowanie (najlepiej z profesjonalistami),

jak i z ich autorami. Jeśli nie istnieje system wskaźników,

ewaluatorzy mogą także rozważyć pomysł jego utworzenia

w ramach ewaluacji. Wówczas zostawią po sobie

możliwość ciągłej samooceny.

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

7

Bibliografia

Alkin, M. C. i C. T. Fitz-Gibbon (1975) ‘Methods and

Theories of Evaluating Programmes’, Journal of Research

and Development in Education 8(3): s. 2-15.

Bloom, B. E. (1956) Taxonomy of Educational Objectives.

Ann Arbor, MI: Longmans.

Boruch, R. (1997) Randomised Experiments for Planning

and Evaluation: A Practical Guide. Thousand Oaks, CA:

Sage.

Campbell, D. T. (1977) ‘Comment on Robert J. Richard’s

“The Natural Selection Model of Conceptual Evolution” ’,

Philosophy of Science 44: s. 502-507.

Deming, W. E. (1994) Out of Crisis: Quality, Productivity

and Competitive Position. Cambridge, MA: Cambridge

University Press.

Fitz-Gibbon, C. T. (1996a) Monitoring Education:

Indicators, Quality and Effectiveness. London and New

York: Cassell.

Fitz-Gibbon, C. T. (1996b) ‘Official Indicator Systems in the

UK: Examinations and Inspections’, International Journal

of Educational Research 25(3): s. 239-247.

Fitz-Gibbon, C. T. (1997) The Value Added National

Project: Final Report Feasibility Studies for a National

System of Value Added Indicators. London: School

Curriculum and Assessment Authority. (dokument w

formacie pdf dostępny na witrynie internetowej

www.cem.dur.ac.uk)

Glass, G. V. (1975) ‘A Paradox about Excellence of

Schools and the People in Them’, Educational Researcher

4(3): s. 9-13.

Glass, G. V. (1979) ‘Policy for the Unpredictable

(Uncertainty Research and Policy)’, Educational

Researcher 8(9): s. 12-14.

Hedges, L. V. (2000) ‘Using Converging Evidence in Policy

Formation: the Case of Class Size Research’, Evaluation

and Research in Education 14(3-4): s. 193-205.

Herman, J. L., L. L. Morris i C. T. Fitz-Gibbon (1987)

Evaluator’s Handbook. Newbury Park, CA: Sage.

Kogan, M. (1999) The Ofsted System of School Inspection:

an Independent Evaluation, A report of a study by The

Centre for the Evaluation of Public Policy and Practice and

Helix Consulting Group. London: CEPPP, Brunel

University.

Leeuw, F. L., R. C. Rist i R. Sonnichsen (red.) (1994) Can

Governments Learn? Comparative Perspectives on

Evaluation and Organizational Learning. New Brunswick,

NJ: Transaction Publishers.

Magee, B. (1976) Popper. Glasgow: Fontana/Collins.

OECD (1995) Education at a Glance: OECD Indicators.

Paris: Organization for Economic Co-operation and

Development.

OECD (1998) Education at a Glance: OECD Indicators.

Paris: Organization for Economic Co-operation and

Development.

Perrin, B. (2000) Personal Communication.

Popham, J. (2000) ‘The Coming Scandal in American

Education’, Paper presented at American Educational

Research Association annual meeting, New Orleans, April

s. 24-28.

Simon, H. A. (1988) The Sciences of the Artificial.

Cambridge, MA: The MIT Press.

Smith, P. (1995) ‘On the Unintended Consequences of

Publishing Performance Data in the Public Sector’,

International Journal of Public Administration 18(2-3): s.

277-310.

Tymms, P. (1999) Baseline Assessment and Monitoring in

Primary Schools: Achievements, Attitudes and Value-

added Indicators. London: David Fulton Publishers.

Tłumaczył: Dariusz Sielski.

i

Redakcja „Państwa i rynku“ dziękuje Autorce za zgodę na tłumaczenie tekstu na język polski.

ii

Leeuw, F. L., R. C. Rist i R. Sonnichsen (red.) (1994) Can Governments Learn? Comparative Perspectives on Evaluation and Organizational

Learning. New Brunswick, NJ: Transaction Publishers, s. 4-5.

iii

Glass, G. V. (1975) ‘A Paradox about Excellence of Schools and the People in Them’, Educational Researcher 4(3): s. 9–13.

iv

Glass, G. V. (1979) ‘Policy for the Unpredictable (Uncertainty Research and Policy)’, Educational Researcher 8(9): s. 14.

v

Campbell, D. T. (1977) ‘Comment on Robert J. Richard’s “The Natural Selection Model of Conceptual Evolution” ’, Philosophy of Science 44: s.

506.

vi

Magee, B. (1976) Popper. Glasgow: Fontana/Collins, s. 100.

vii

Patrz np. Kogan, M. (1999) The Ofsted System of School Inspection: an Independent Evaluation, A report of a study by The Centre for the

Evaluation of Public Policy and Practice and Helix Consulting Group. London: CEPPP, Brunel University; Fitz-Gibbon, C. T. (1996b) ‘Official

Indicator Systems in the UK: Examinations and Inspections’, International Journal of Educational Research 25(3): s. 239-247.

viii

Magee, B. (1976) Popper. Glasgow: Fontana/Collins, s. 84.

ix

Simon, H. A. (1988) The Sciences of the Artificial. Cambridge, MA: The MIT Press.

x

Simon, H. A. (1988) The Sciences of the Artificial. Cambridge, MA: The MIT Press, s. 25.

xi

Deming, W. E. (1994) Out of Crisis: Quality, Productivity and Competitive Position. Cambridge, MA: Cambridge University Press.

xii

Perrin, B. (2000) Personal Communication.

Państwo i Rynek – numer 2 / 2004

www.pir.org.pl

8

xiii

Np. Alkin, M. C. i C. T. Fitz-Gibbon (1975) ‘Methods and Theories of Evaluating Programmes’, Journal of Research and Development in

Education 8(3): s. 2-15; Herman, J. L., L. L. Morris i C. T. Fitz-Gibbon (1987) Evaluator’s Handbook. Newbury Park, CA: Sage.

xiv

Deming, W. E. (1994) Out of Crisis: Quality, Productivity and Competitive Position. Cambridge, MA: Cambridge University Press.

xv

Popham, J. (2000) ‘The Coming Scandal in American Education’, artykuł przedstawiony na dorocznym spotkaniu Amerykańskiego Towarzystwa

Badań Edukacyjnych w kwietniu w Nowym Orleanie, s. 24-28.

xvi

Smith, P. (1995) ‘On the Unintended Consequences of Publishing Performance Data in the Public Sector’, International Journal of Public

Administration 18(2–3): s. 277-310; Fitz-Gibbon, C. T. (1996a) Monitoring Education: Indicators, Quality and Effectiveness. London and New York:

Cassell; Tymms, P. (1999) Baseline Assessment and Monitoring in Primary Schools: Achievements, Attitudes and Value-added Indicators.

London: David Fulton Publishers.

xvii

Patrz www.cem.dur.ac.uk.

xviii

Bloom, B. E. (1956) Taxonomy of Educational Objectives. Ann Arbor, MI: Longmans.

xix

OECD (1995) Education at a Glance: OECD Indicators. Paris: Organization for Economic Co-operation and Development. OECD (1998)

Education at a Glance: OECD Indicators. Paris: Organization for Economic Co-operation and Development.

xx

Hedges, L. V. (2000) ‘Using Converging Evidence in Policy Formation: the Case of Class Size Research’, Evaluation and Research in Education

14 (3-4): s. 193-205.

xxi

Boruch, R. (1997) Randomised Experiments for Planning and Evaluation: A Practical Guide. Thousand Oaks, CA: Sage.

xxii

Fitz-Gibbon, C. T. (1997) The Value Added National Project: Final Report Feasibility Studies for a National System of Value Added Indicators.

London: School Curriculum and Assessment Authority. (na witrynie internetowej www.cem.dur.ac.uk)

Wyszukiwarka

Podobne podstrony:

Analiza finansowa wskazniki cd Nieznany (2)

8 Analiza wskaznikowa plynnosci Nieznany (2)

7 Analiza wskaznikowa aspektow Nieznany (2)

Fascia is able to contract a sm Nieznany

Analiza finansowa wskazniki cd Nieznany (2)

Podst wskazniki makro dla Polsk Nieznany

26 Prowadzenie analiz wskazniko Nieznany (2)

Lampki wskaznikowe zestawu wska Nieznany

Analiza wskaznikowa dochodow gm Nieznany (2)

Arkusz ewaluacji podrecznika i Nieznany

12 Wskazniki natezenia i wskazn Nieznany

grupa H klinimetria w sm id 705 Nieznany

badanie wskaznik tlenowy id 783 Nieznany (2)

do gieldy z neuro selmaj SM id Nieznany

2 Wskazniki pracyid 19723 Nieznany (2)

26 Wskazniki w C id 31425 Nieznany (2)

407 B1HG7PK1 Demontaz montaz Wskaznik poziomu paliwa Nieznany

więcej podobnych podstron