Część 1 Podstawy sieci .............................................................................................................................................................................8

Rozdział 1 ABC sieci...........................................................................................................................................................................8

Ewolucja sieci ...........................................................................................................................................................................8

Organizacje ustanawiające standardy ........................................................................................................................................9

ANSI.............................................................................................................................................................................10

IEEE .............................................................................................................................................................................10

ISO................................................................................................................................................................................10

IEC................................................................................................................................................................................10

IAB ...............................................................................................................................................................................10

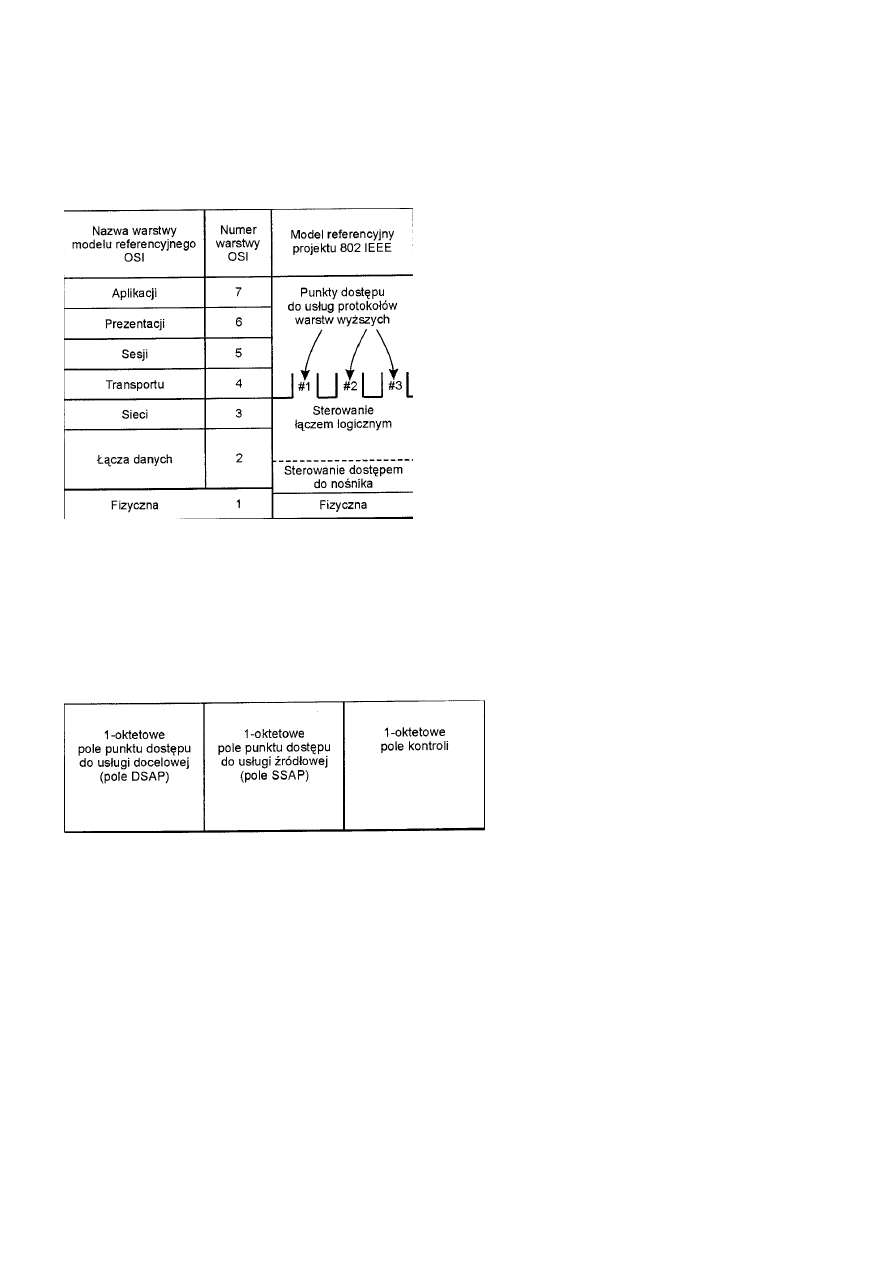

Model referencyjny OSI ..........................................................................................................................................................10

Warstwa 1: warstwa fizyczna .......................................................................................................................................11

Warstwa 2: warstwa łącza danych ................................................................................................................................12

Warstwa 3: warstwa sieci..............................................................................................................................................12

Warstwa 4: warstwa transportu.....................................................................................................................................12

Warstwa 5: warstwa sesji..............................................................................................................................................12

Warstwa 6: warstwa prezentacji ...................................................................................................................................12

Warstwa 7: warstwa aplikacji .......................................................................................................................................12

Zastosowania modelu ...................................................................................................................................................13

Podstawy sieci.........................................................................................................................................................................13

Sprzętowe elementy składowe ......................................................................................................................................14

Urządzenia dostępu..................................................................................................................................................14

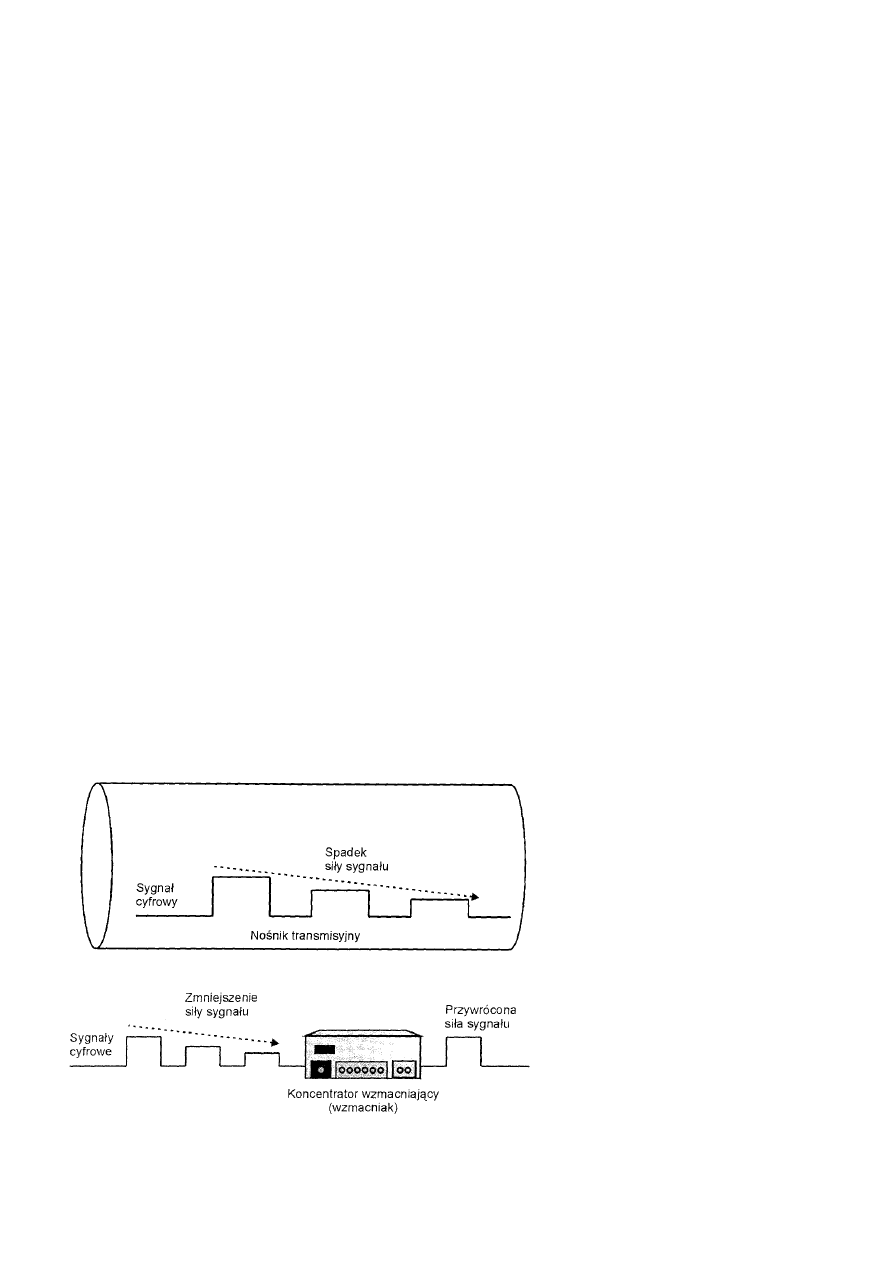

Wzmacniaki.............................................................................................................................................................14

Programowe elementy składowe ..................................................................................................................................15

Sterowniki urządzeń ................................................................................................................................................15

Oprogramowanie komunikacyjne............................................................................................................................15

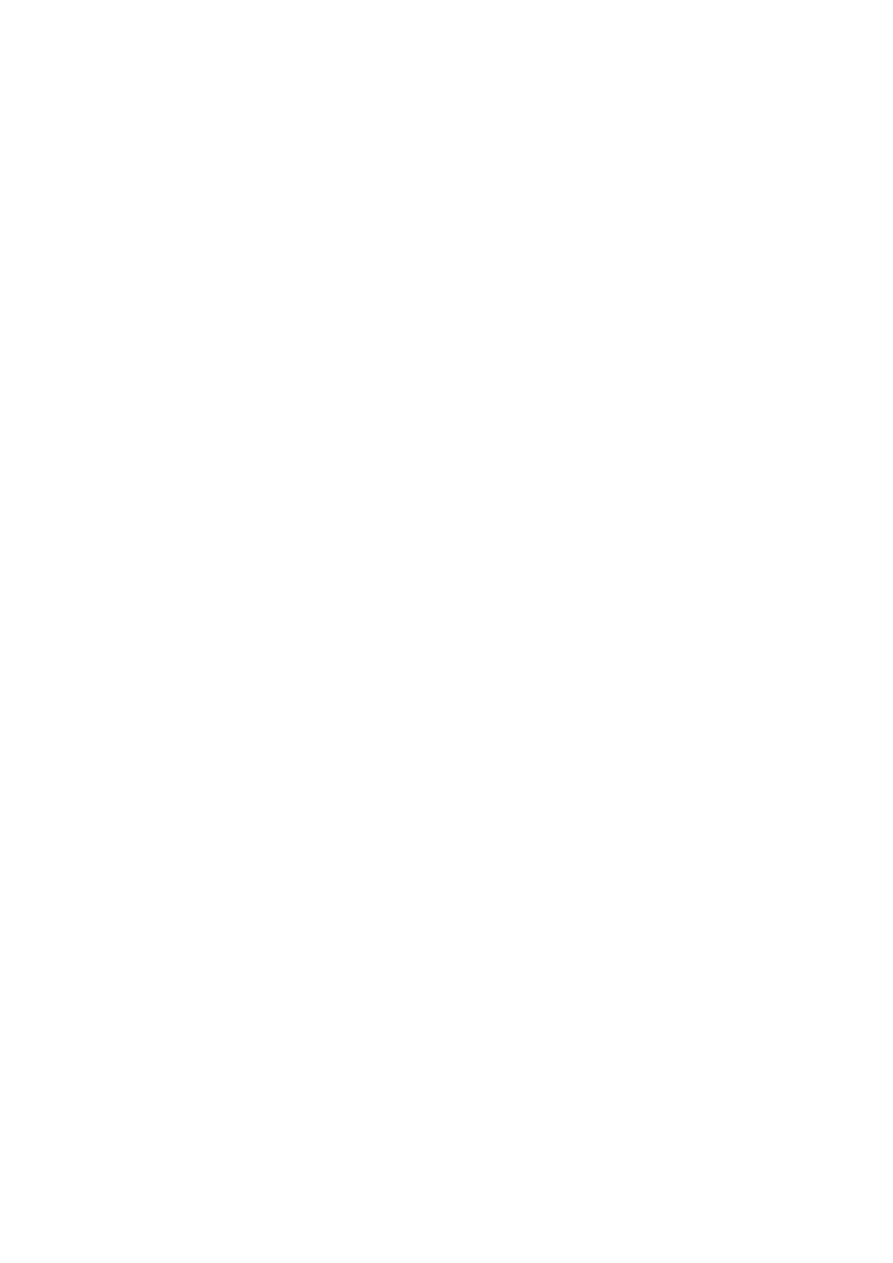

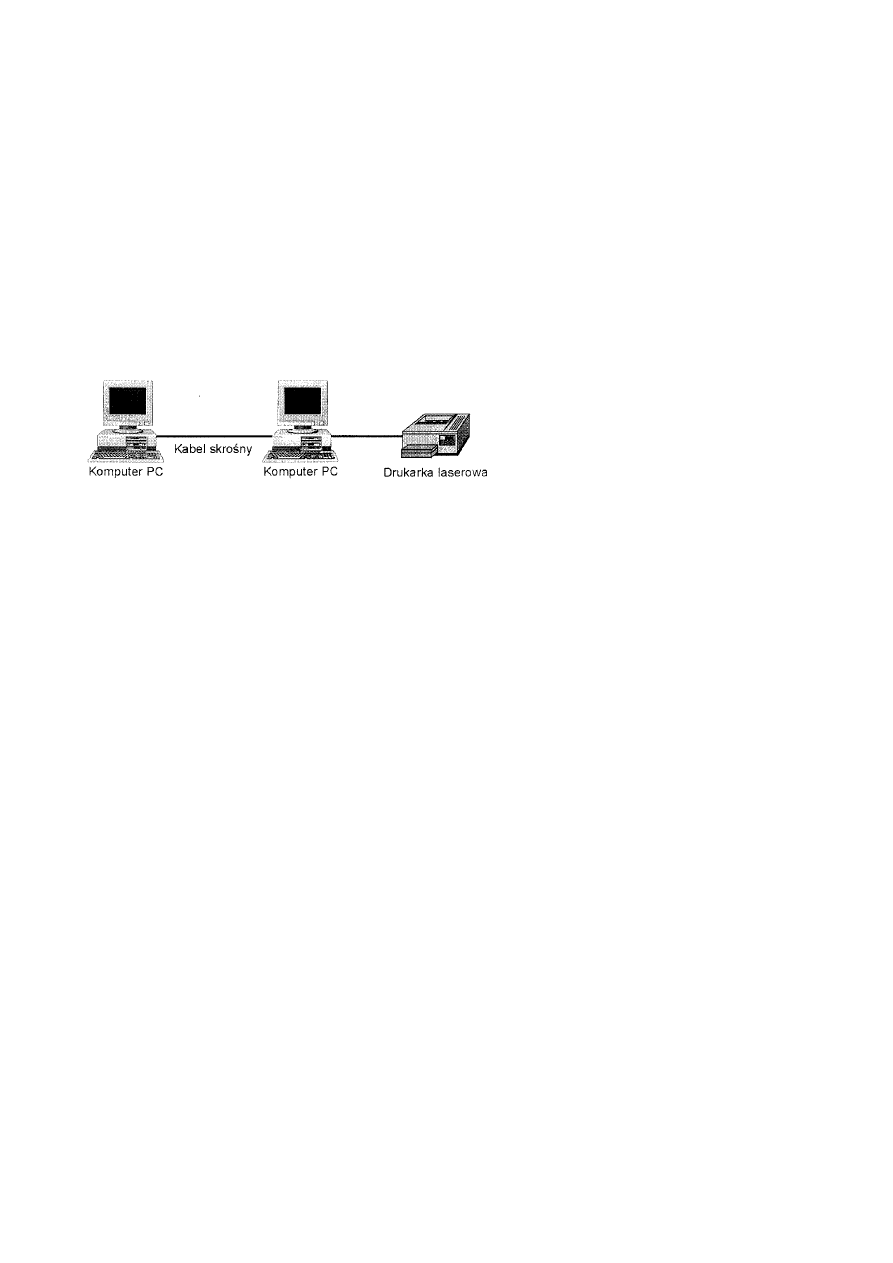

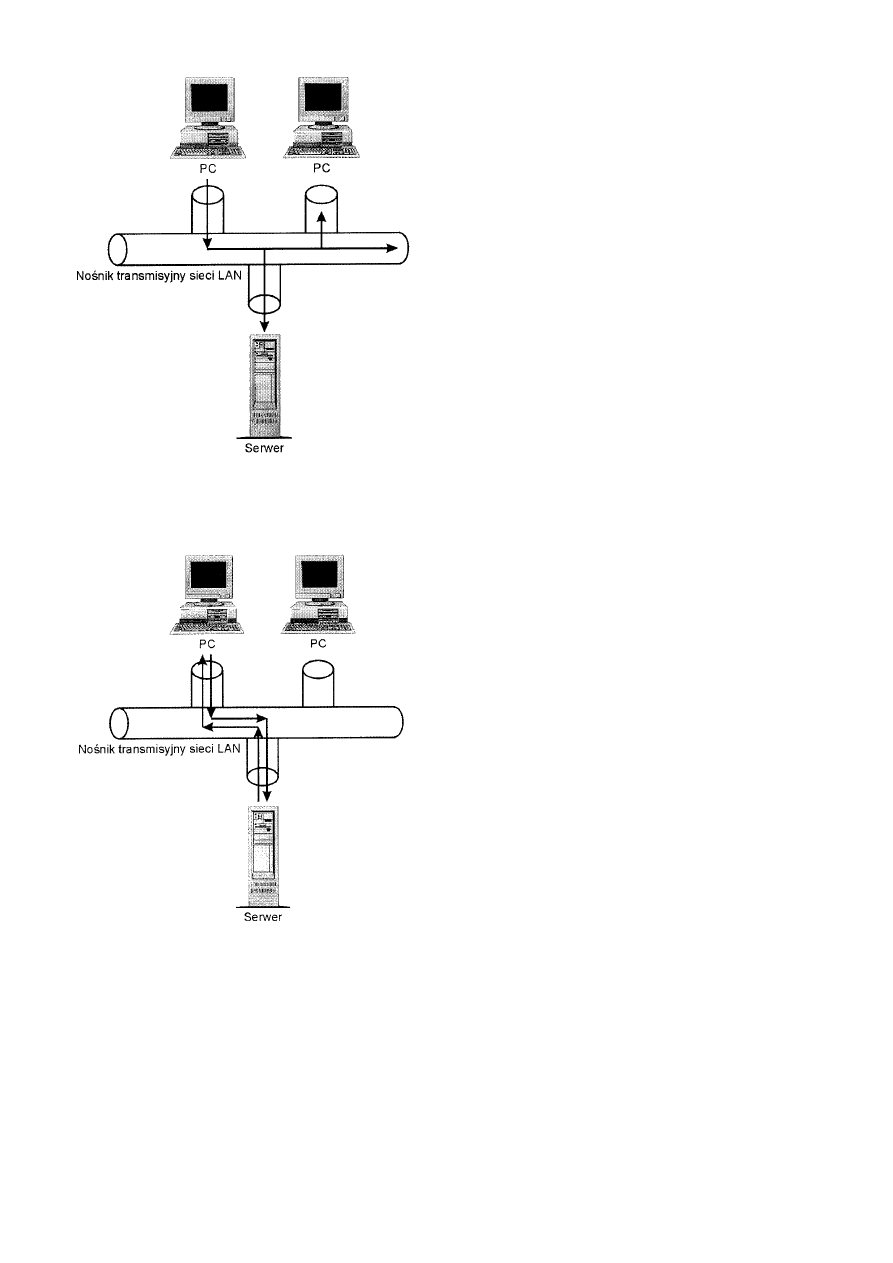

Składanie elementów w sieć....................................................................................................................................16

Sieci LAN bez wzmacniaków..................................................................................................................................16

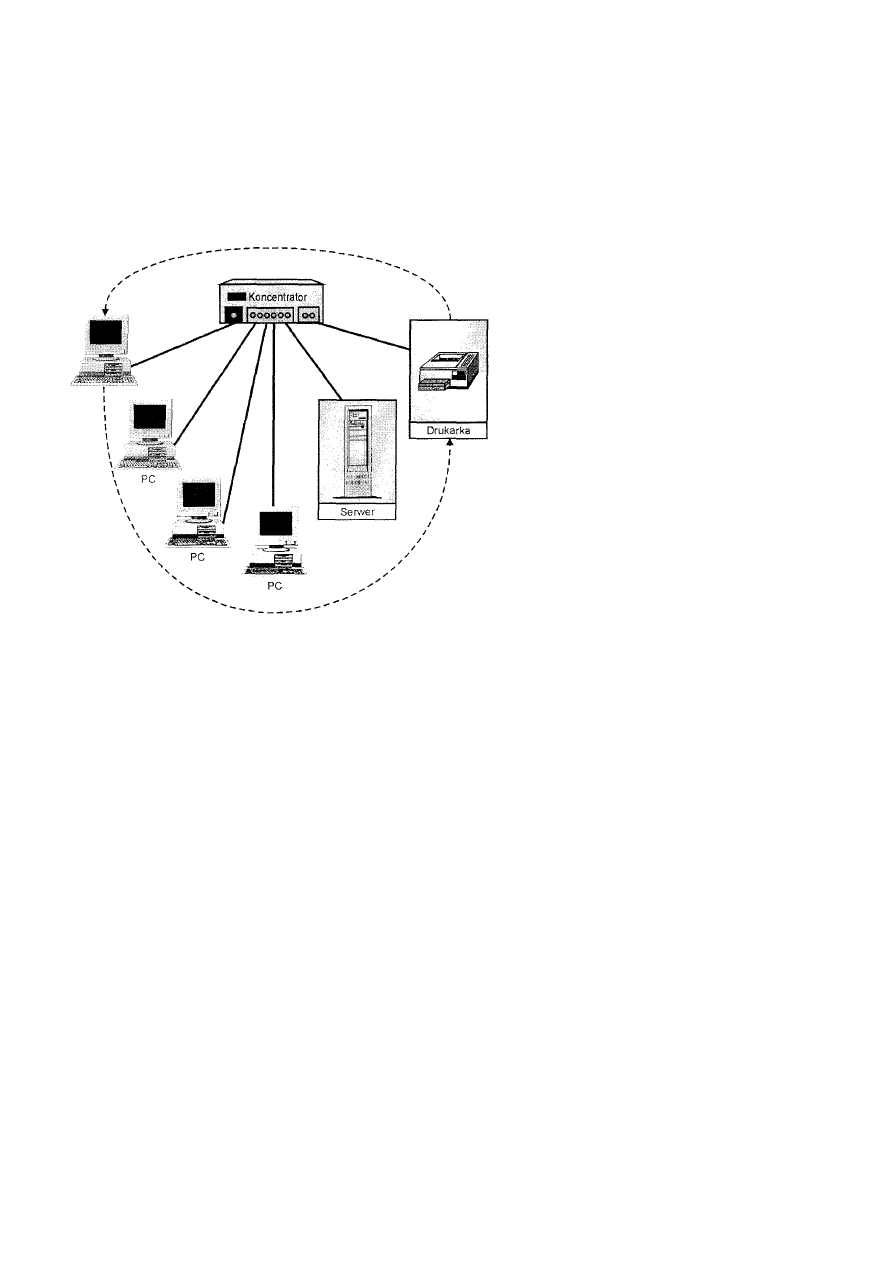

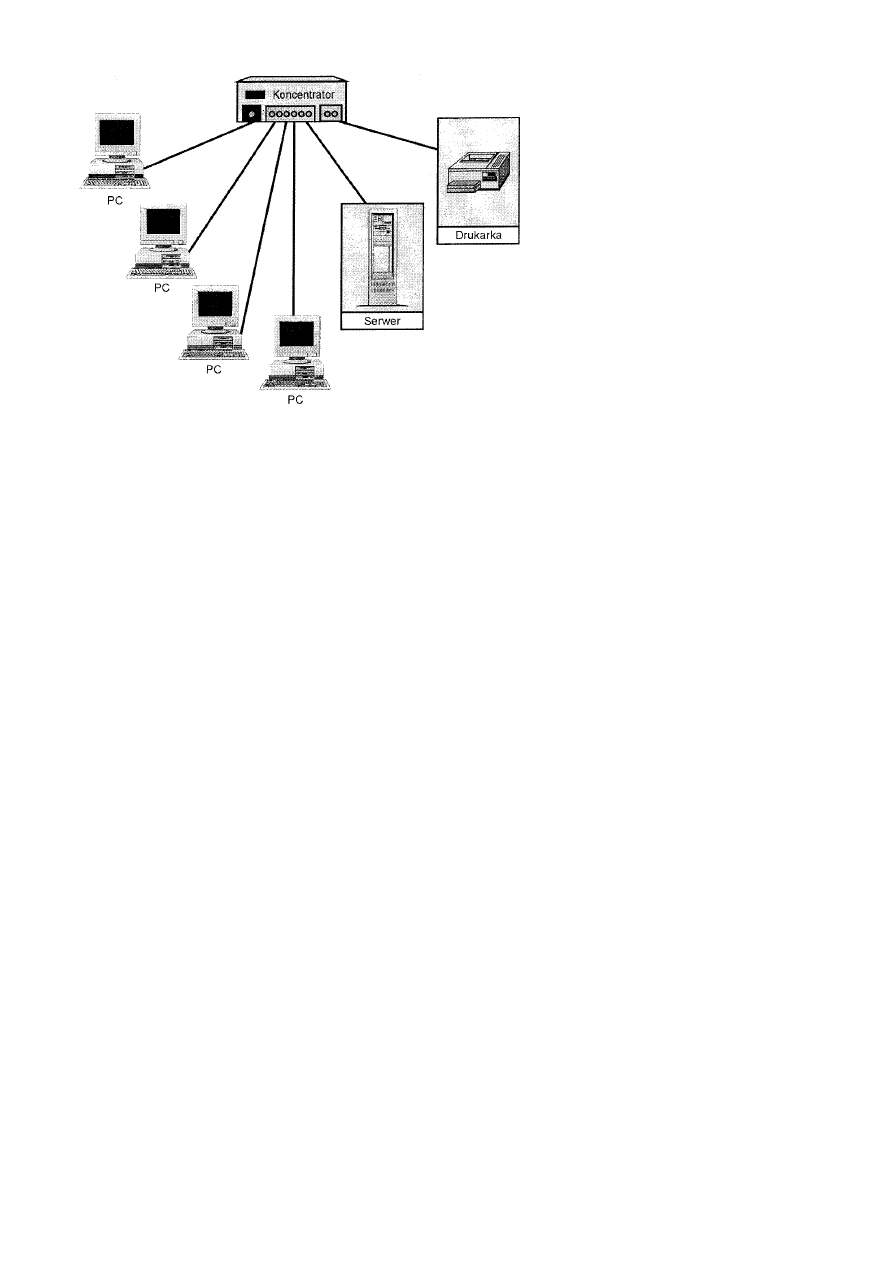

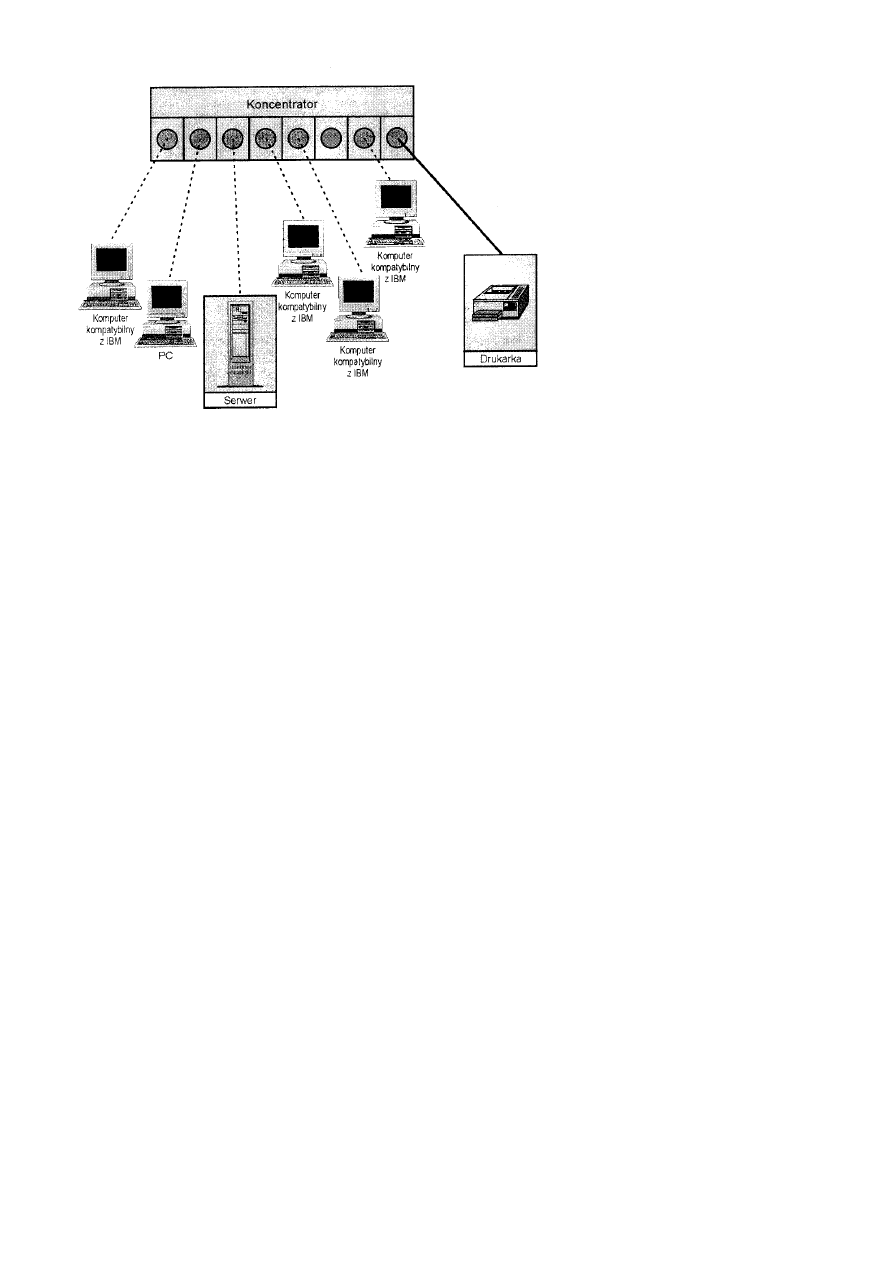

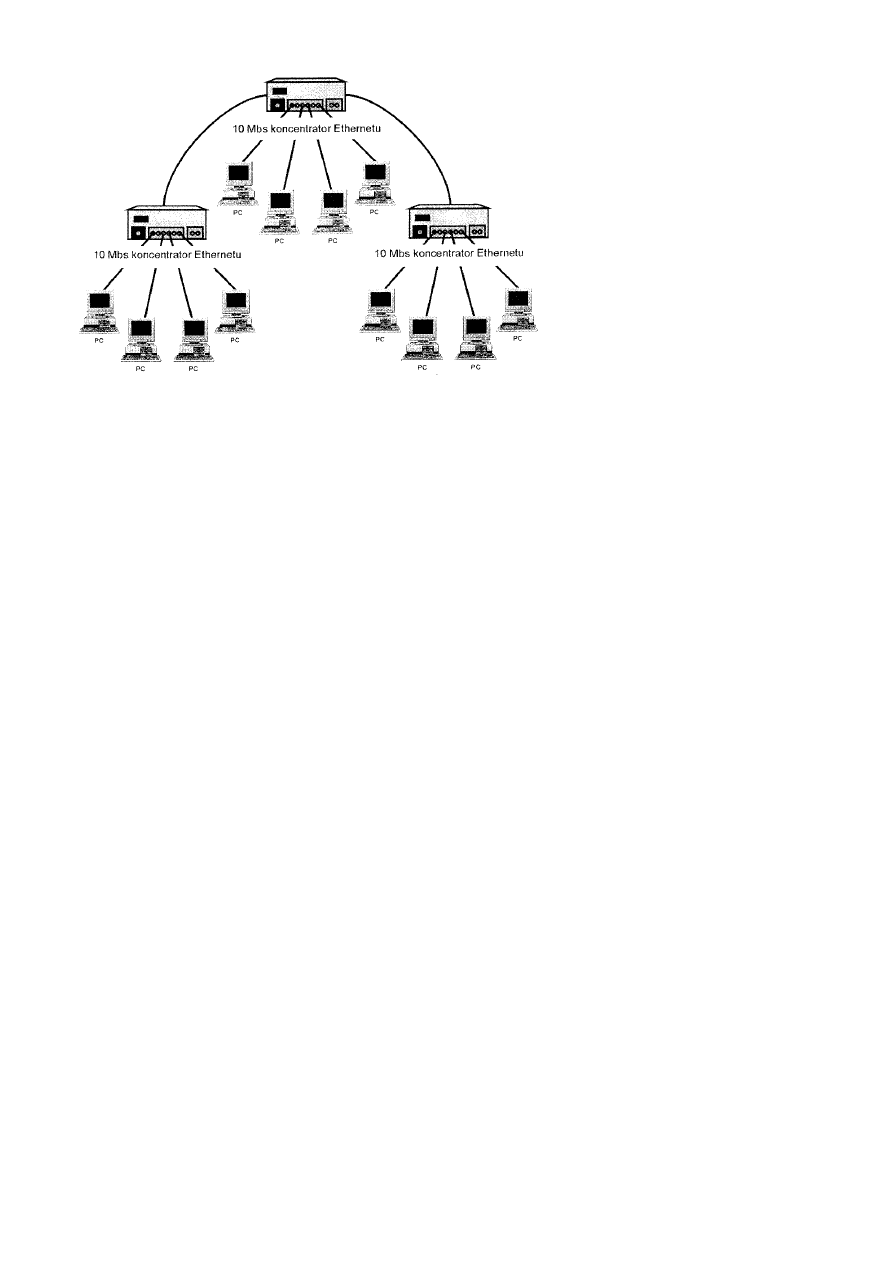

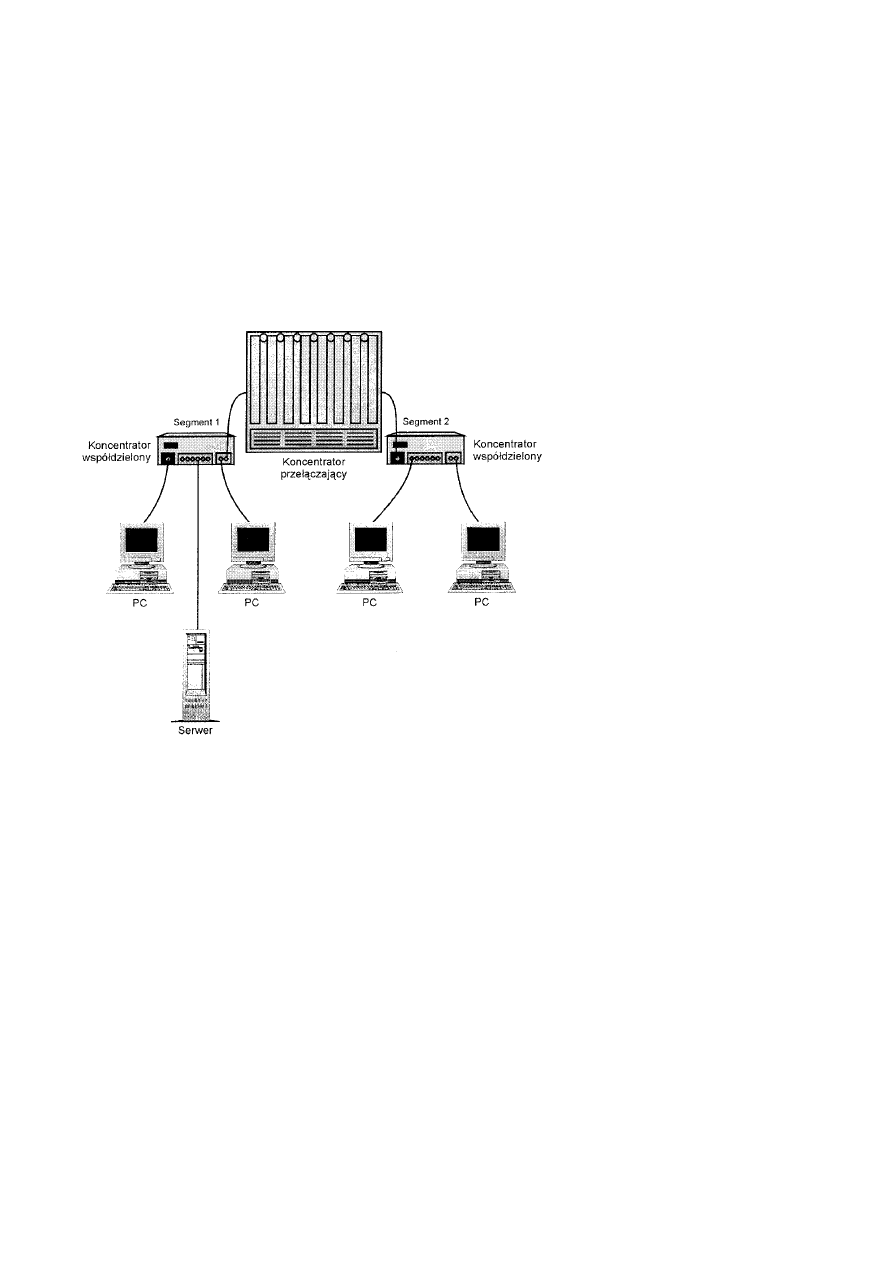

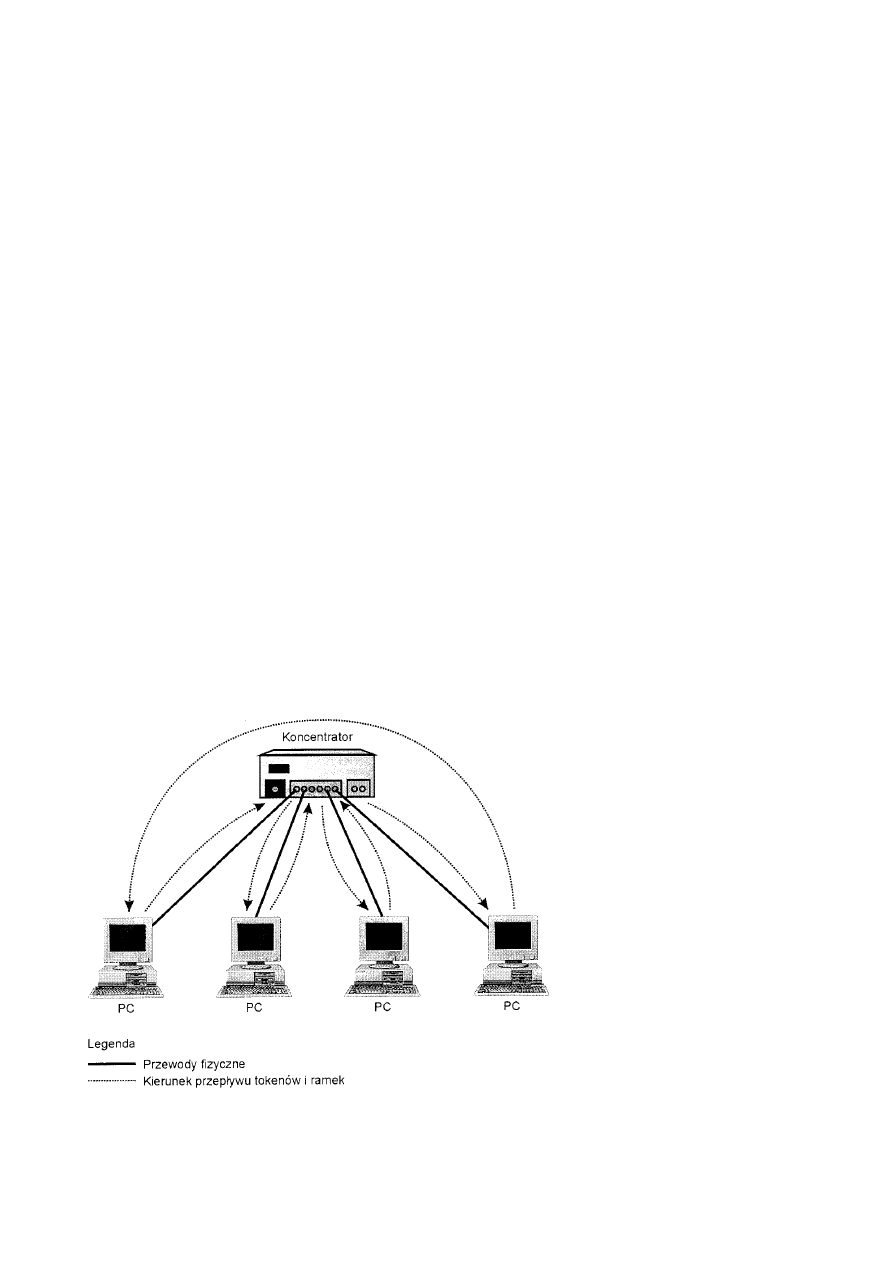

Sieci oparte na koncentratorze (koncentratorowe)...................................................................................................16

Podsumowanie ........................................................................................................................................................................18

Rozdział 2 Typy i topologie sieci LAN .............................................................................................................................................18

Urządzenia przyłączane do sieci LAN ....................................................................................................................................18

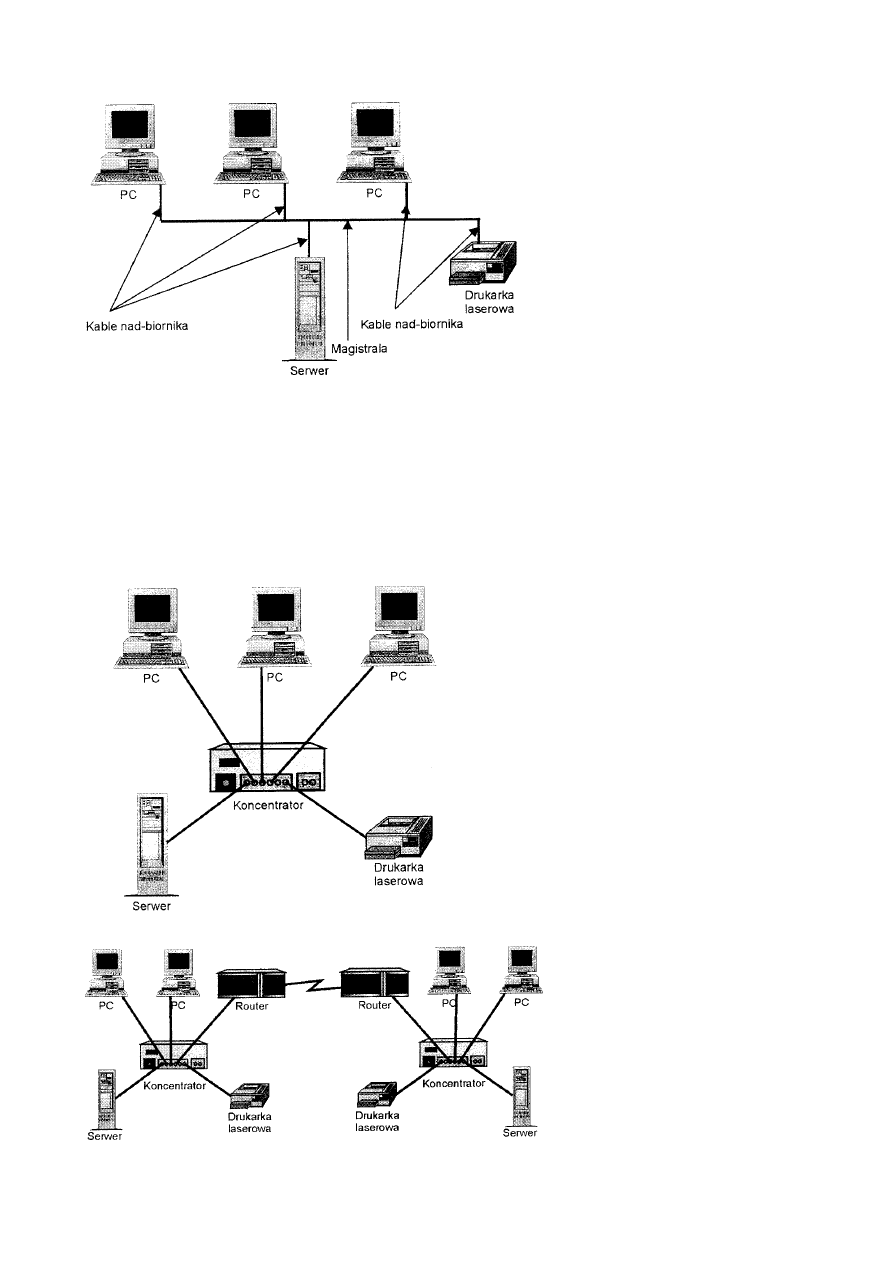

Typy serwerów........................................................................................................................................................................18

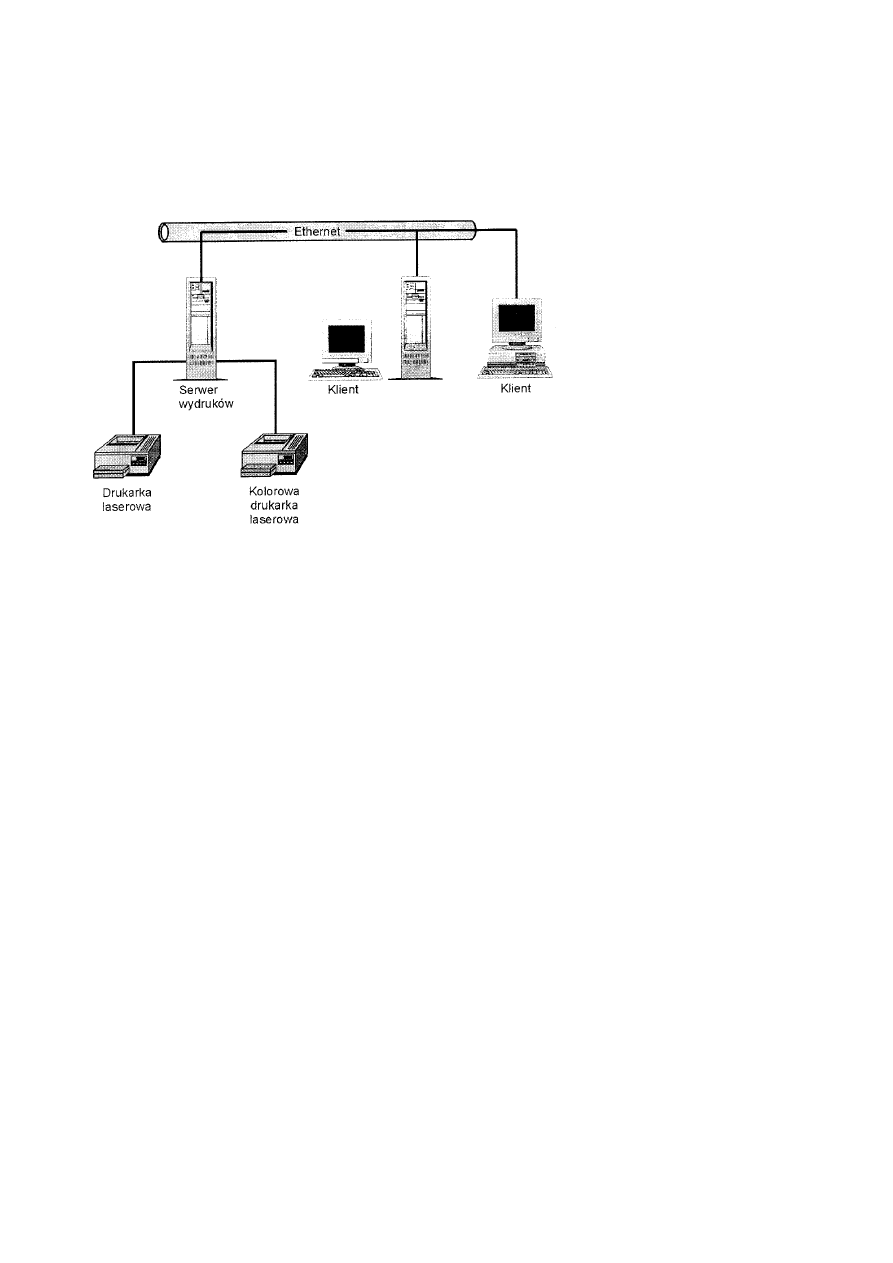

Serwery wydruków .......................................................................................................................................................19

Serwery aplikacji ..........................................................................................................................................................20

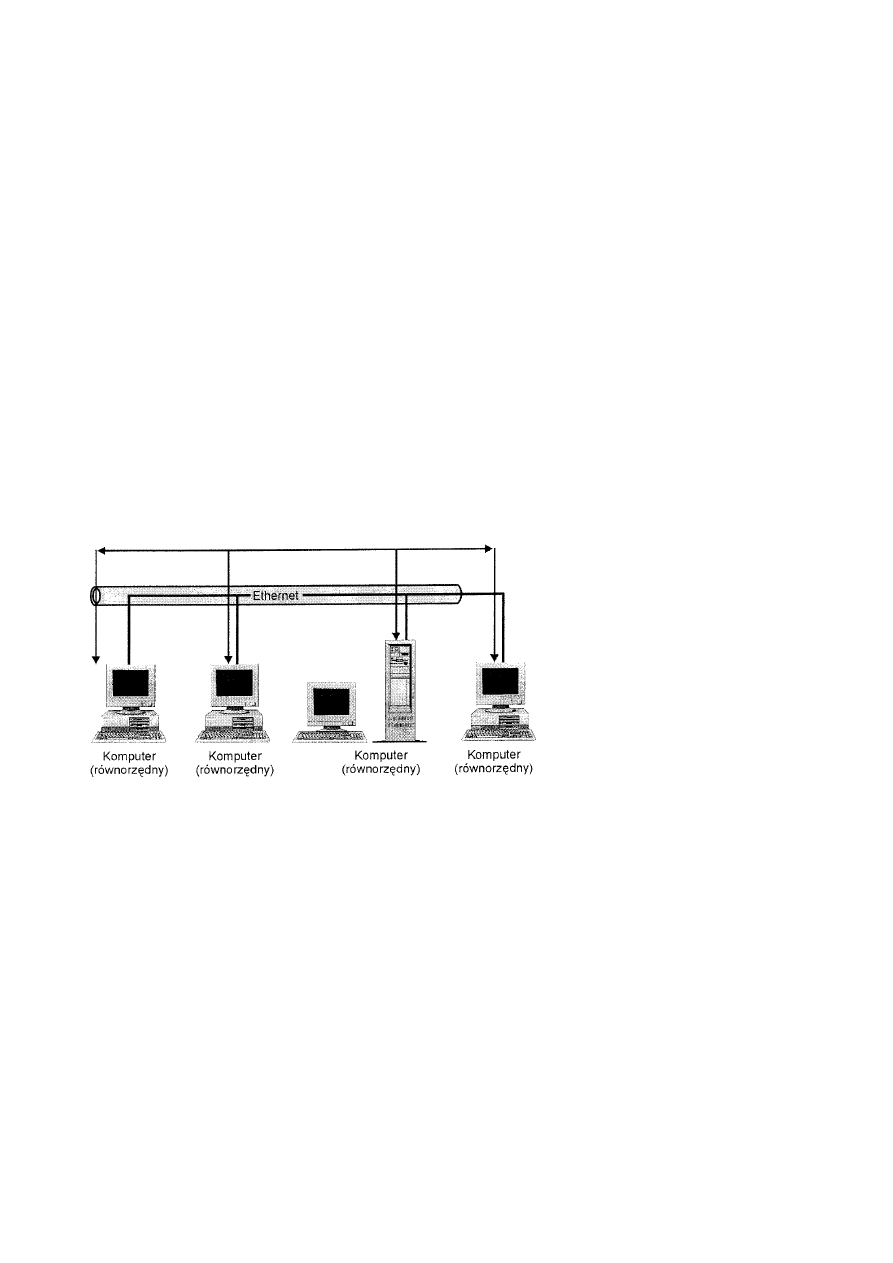

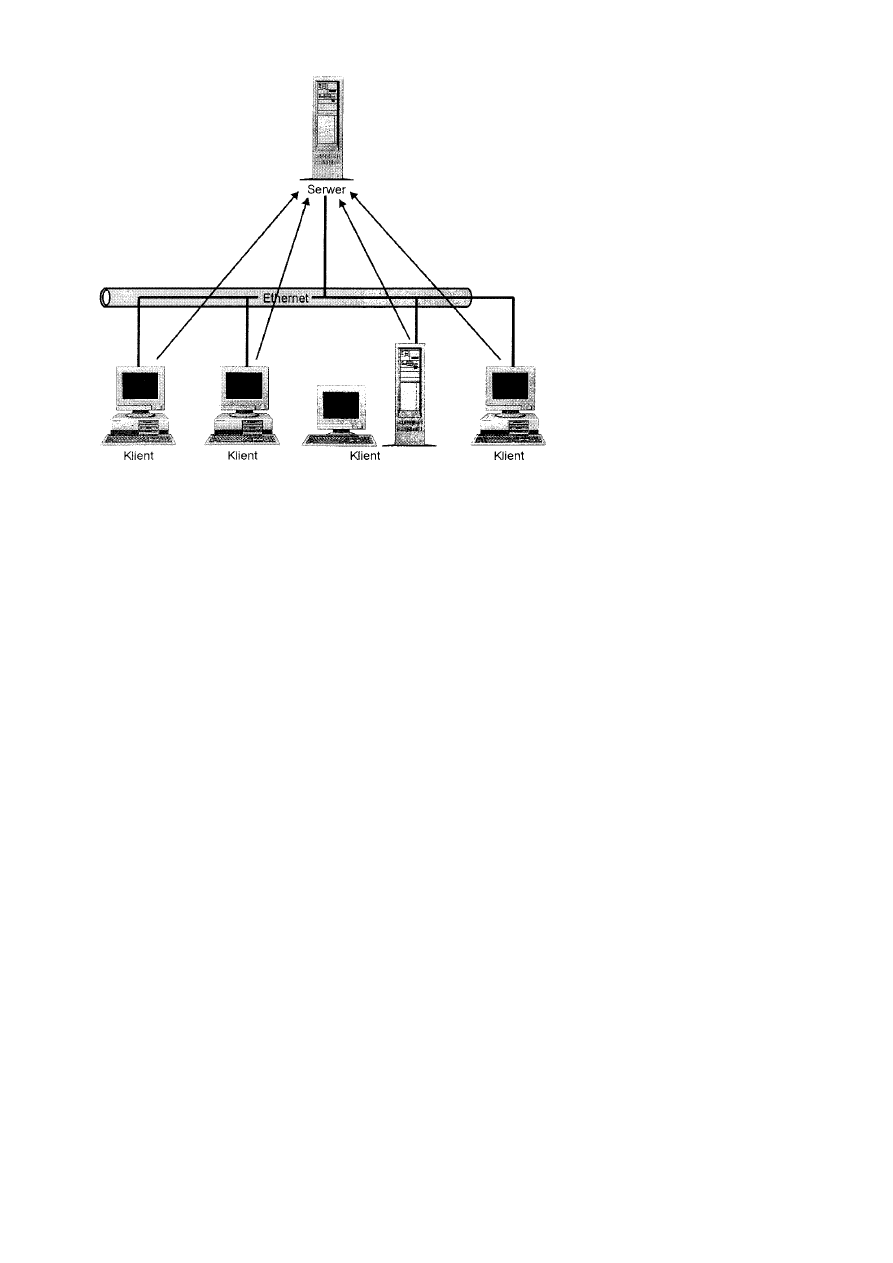

Typy sieci ................................................................................................................................................................................21

Sieci oparte na serwerach (klient-serwer) .....................................................................................................................22

Sieci mieszane ..............................................................................................................................................................24

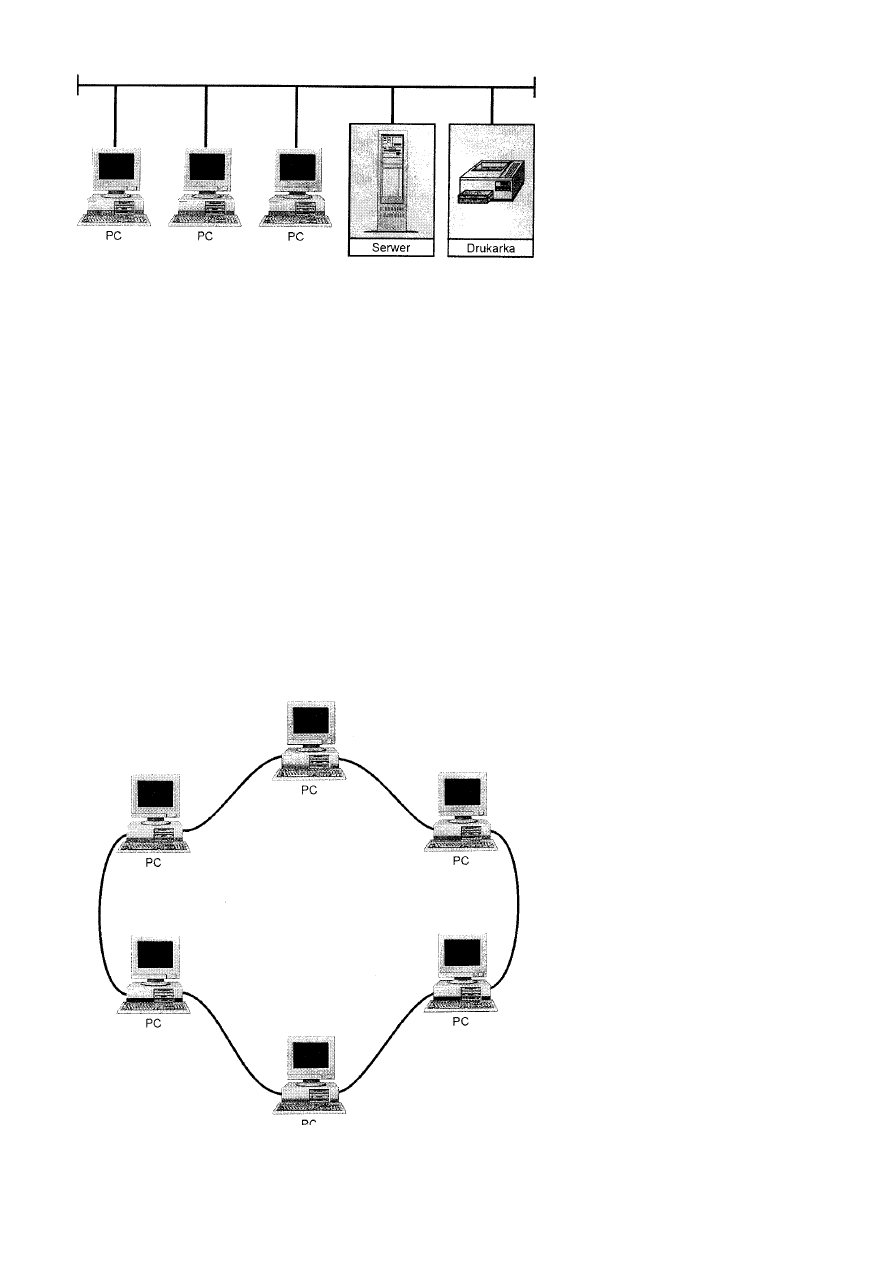

Topologie sieci lokalnych........................................................................................................................................................24

Topologia magistrali .....................................................................................................................................................24

Topologia pierścienia....................................................................................................................................................25

Topologia gwiazdy .......................................................................................................................................................26

Topologia przełączana ..................................................................................................................................................27

Topologie złożone.........................................................................................................................................................28

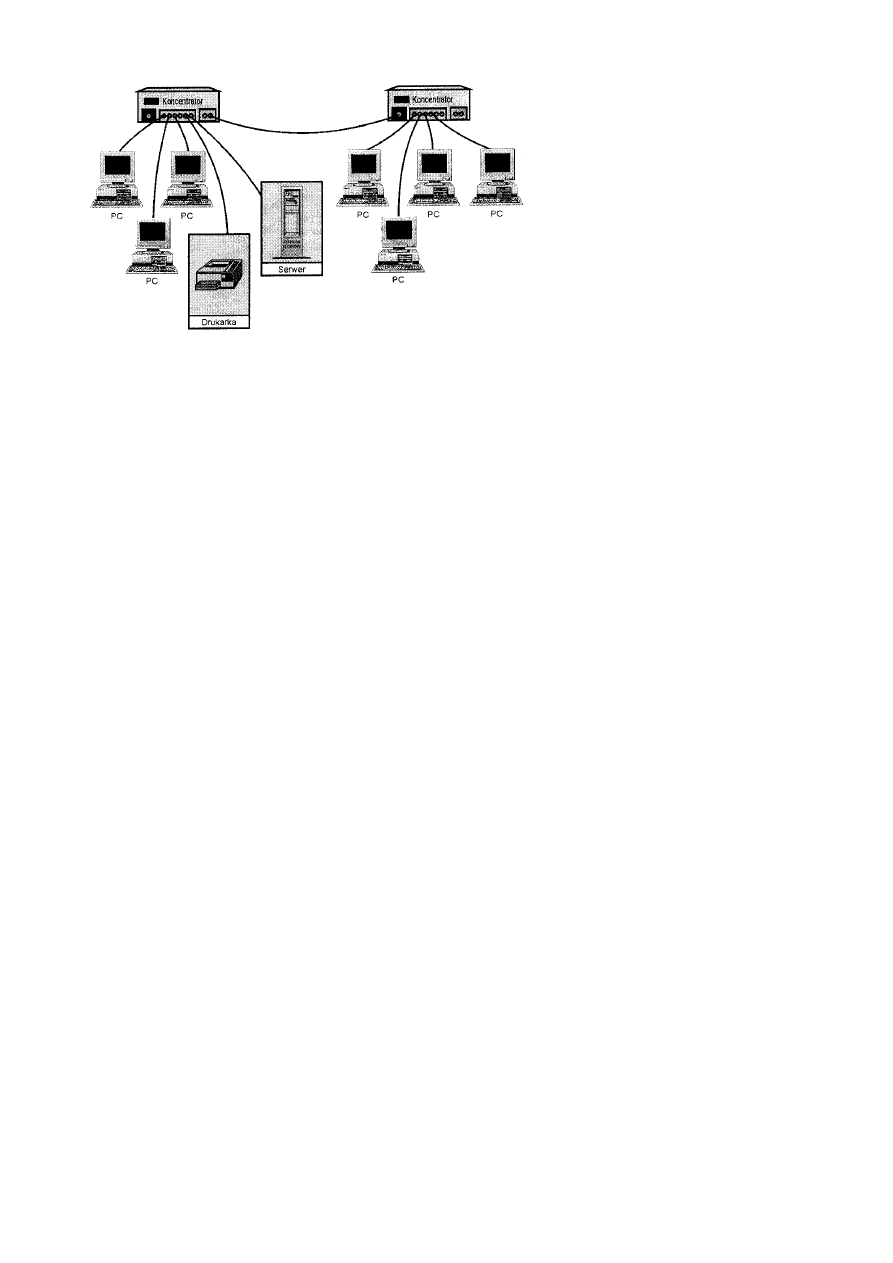

Łańcuchy .................................................................................................................................................................28

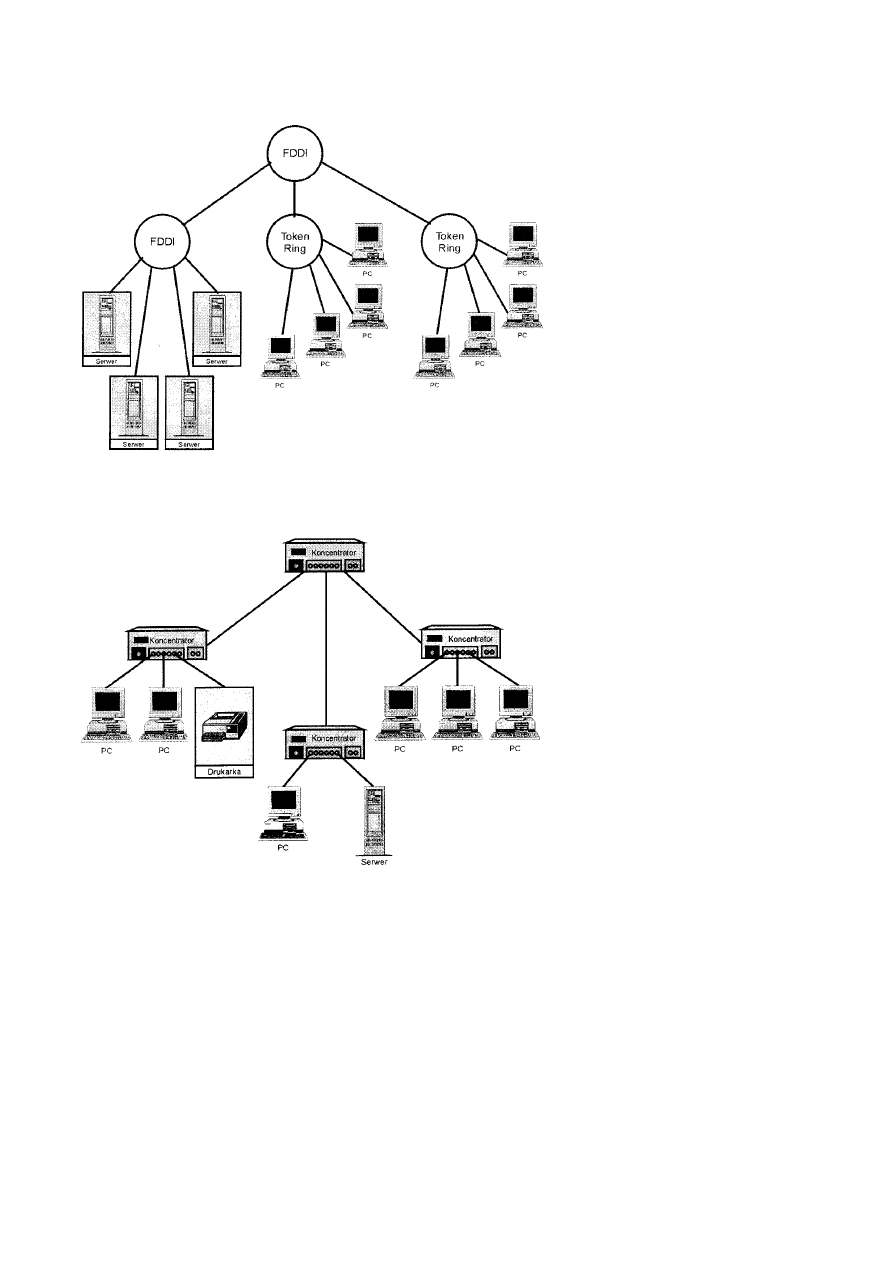

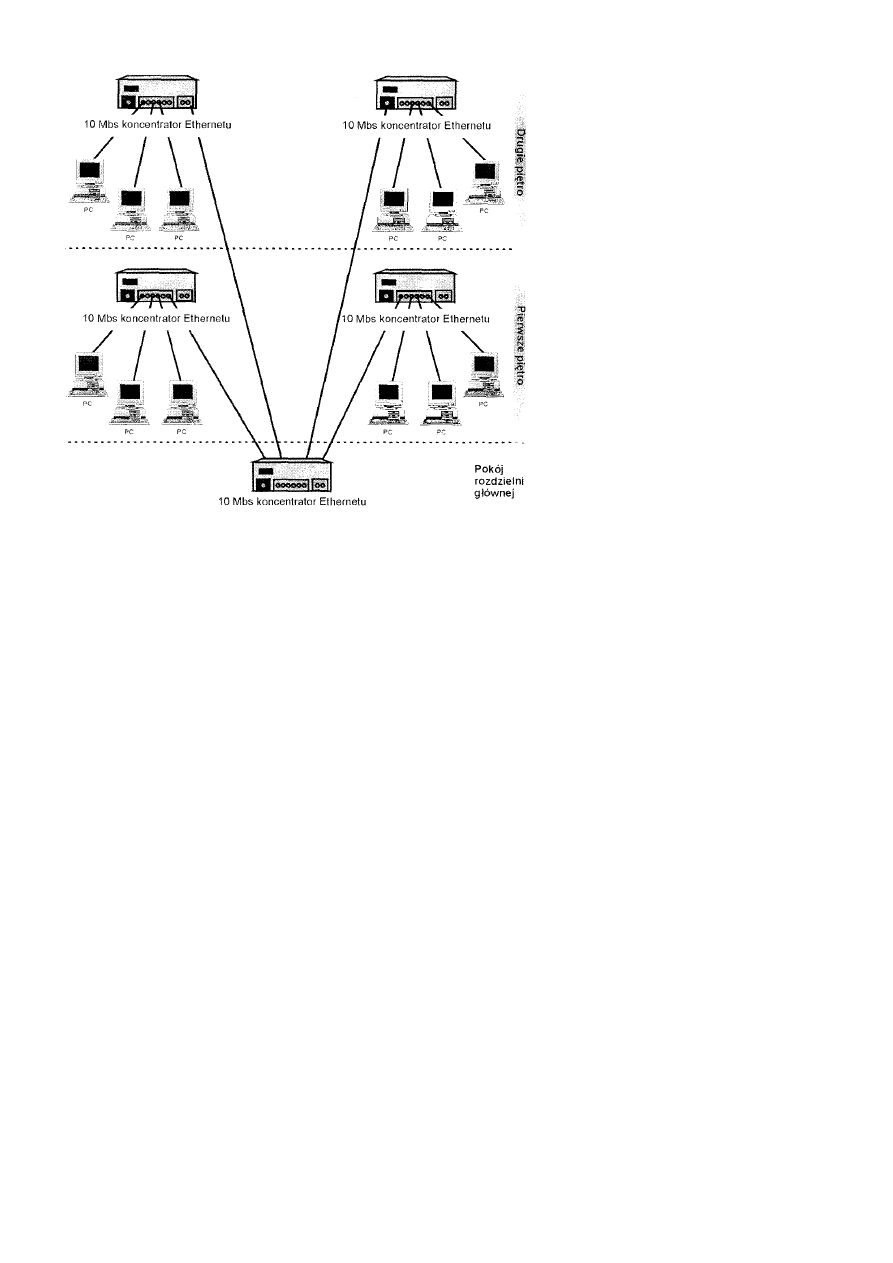

Hierarchie ................................................................................................................................................................29

Obwary funkcjonalne sieci LAN.............................................................................................................................................31

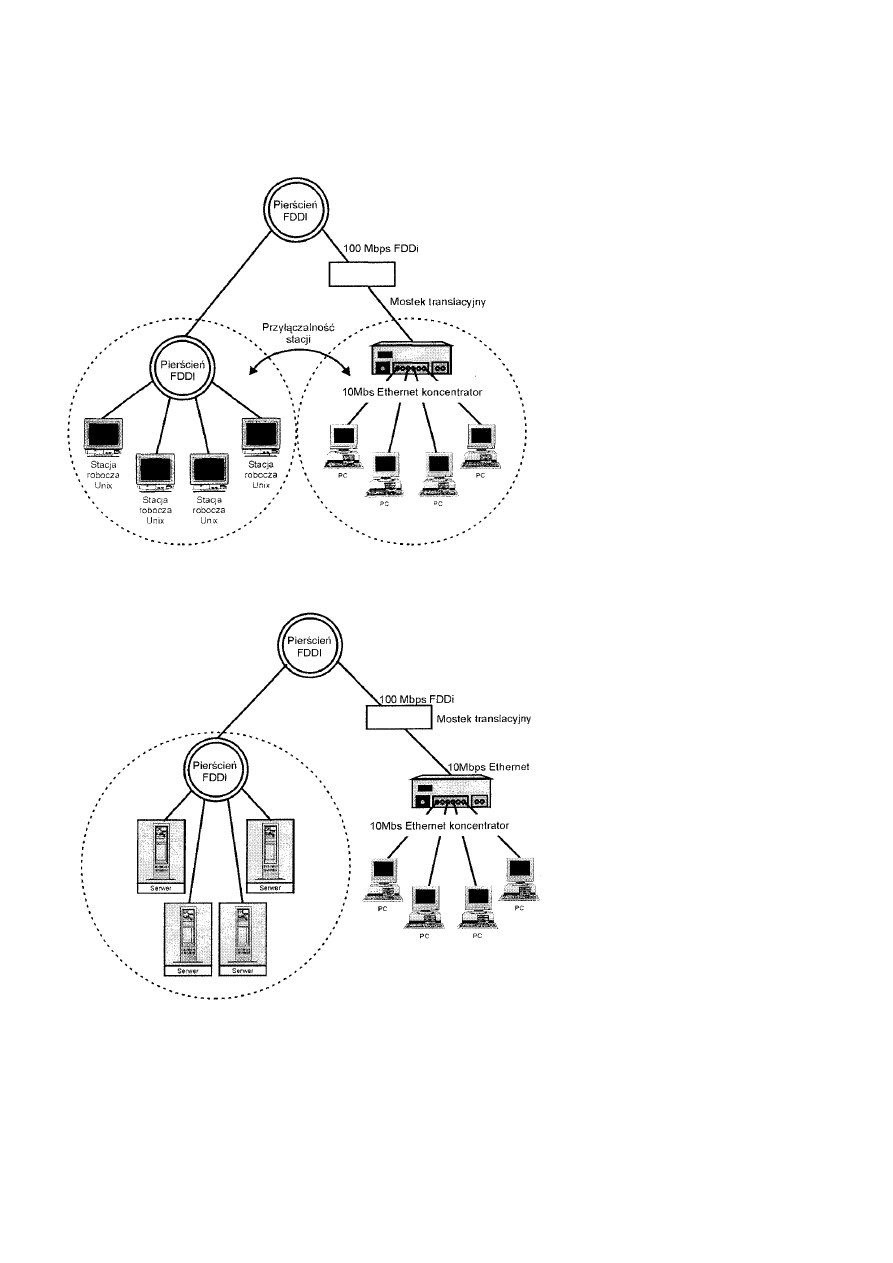

Przyłączanie stacji.........................................................................................................................................................31

Przyłączanie serwera.....................................................................................................................................................31

Przyłączanie do sieci WAN.....................................................................................................................................................31

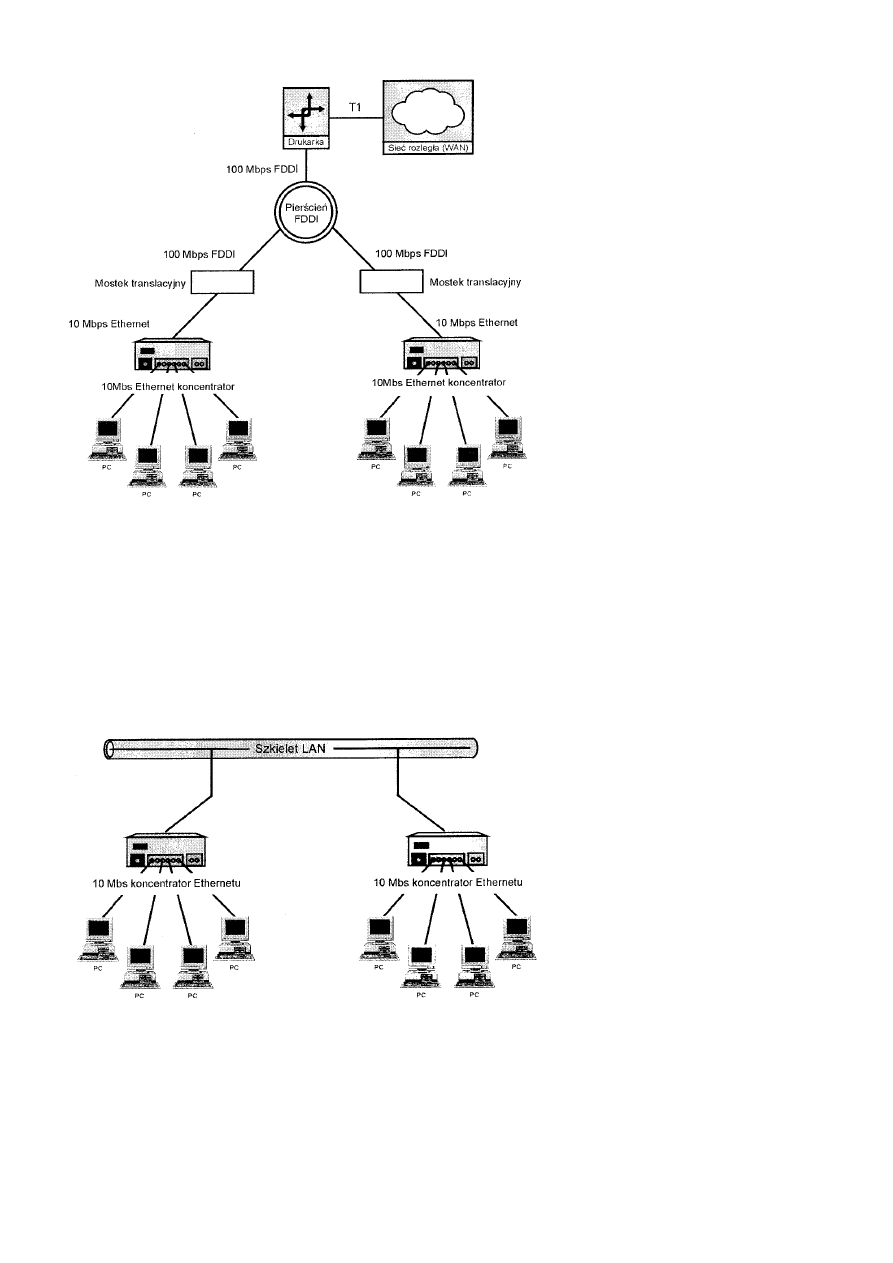

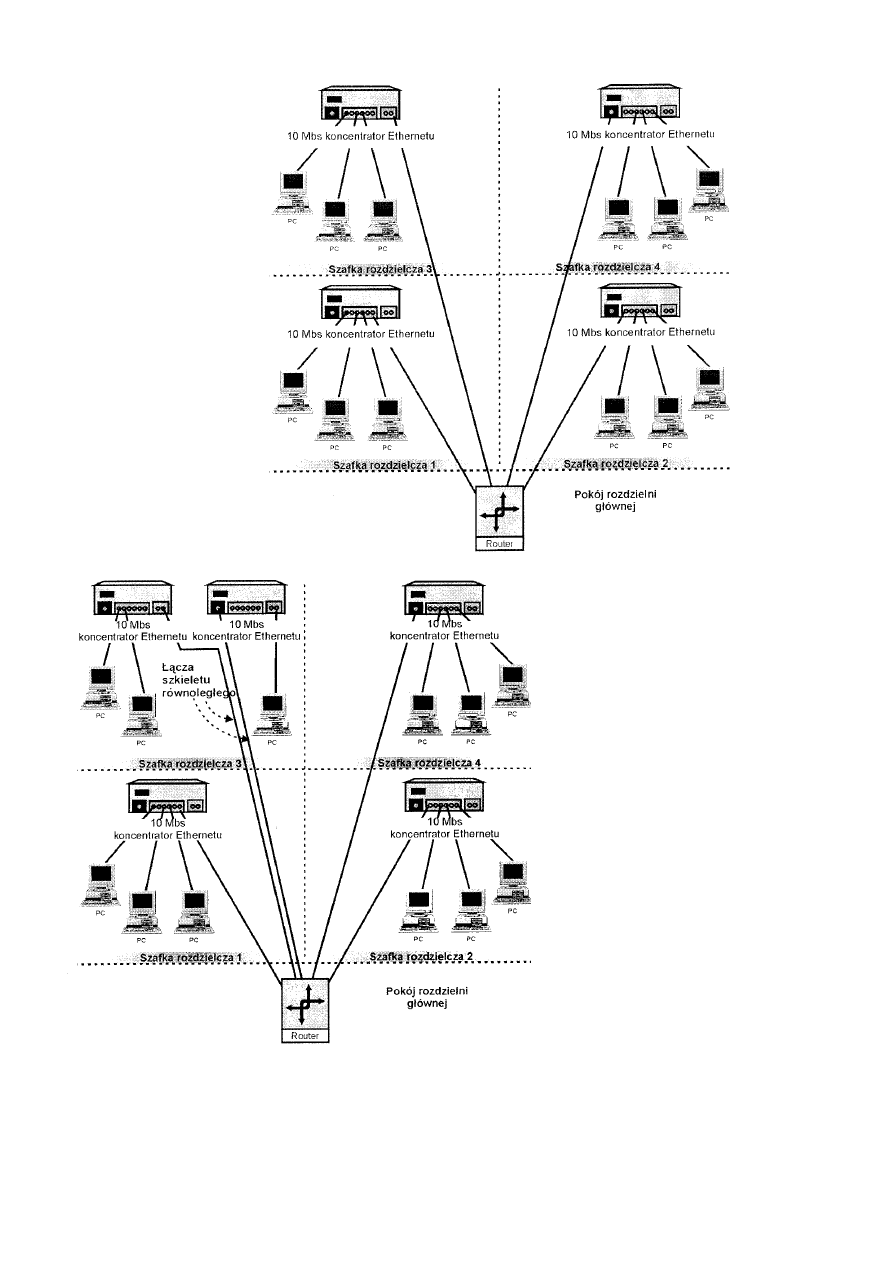

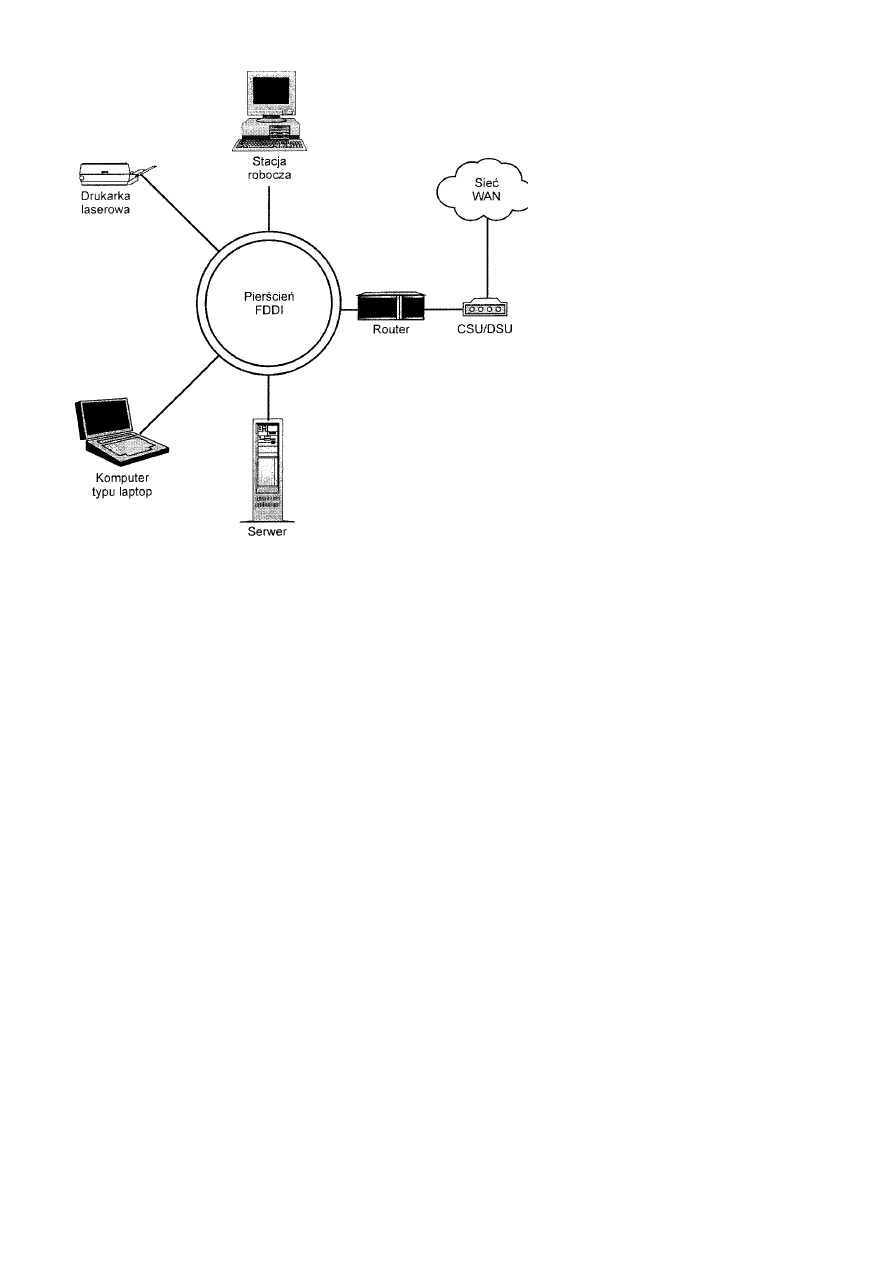

Przyłączanie do szkieletu ........................................................................................................................................................33

Szkielet segmentowy ....................................................................................................................................................34

Szkielet równoległy ......................................................................................................................................................35

Podsumowanie ........................................................................................................................................................................36

Rozdział 3 Warstwa fizyczna.............................................................................................................................................................37

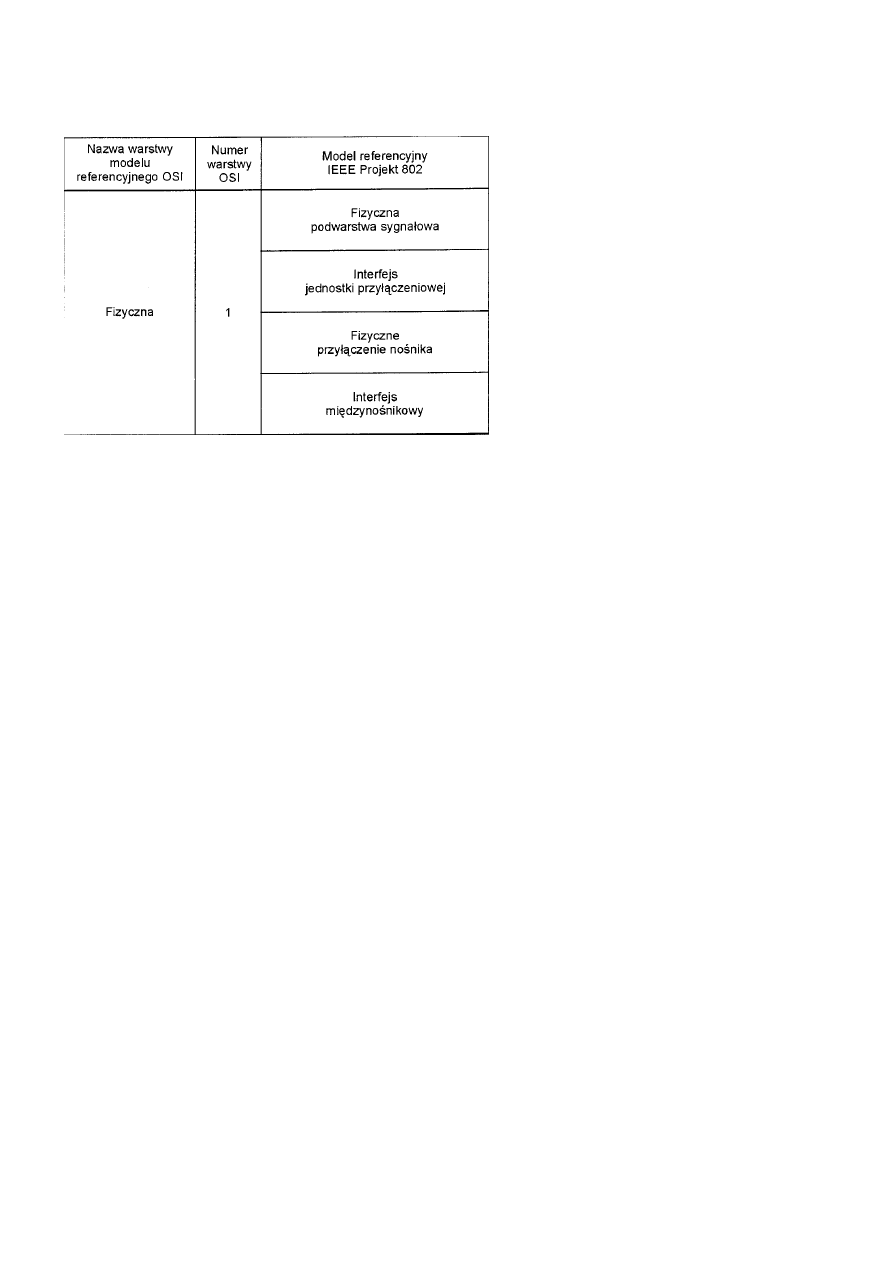

Warstwa 1: warstwa fizyczna..................................................................................................................................................37

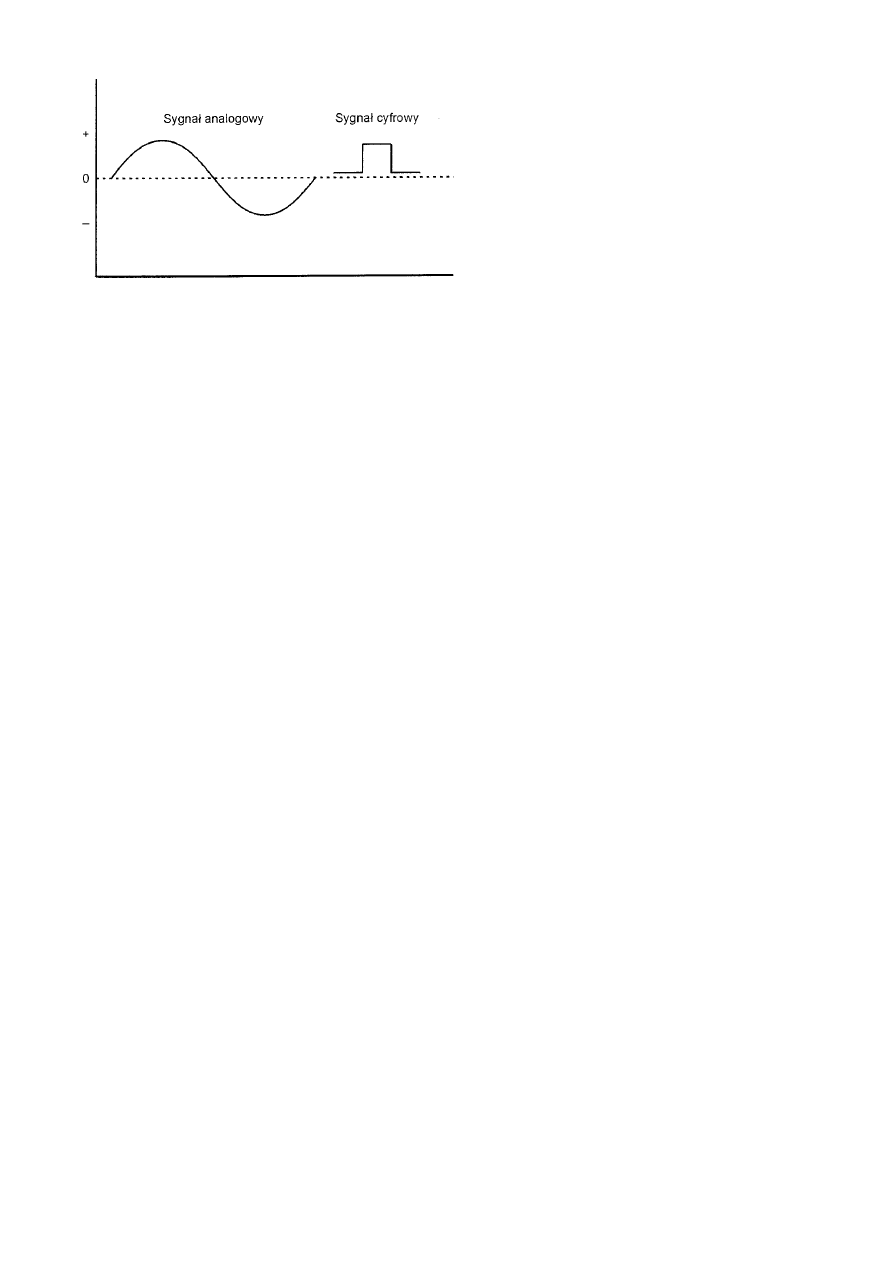

Funkcje warstwy fizycznej ...........................................................................................................................................37

Znaczenie odległości.....................................................................................................................................................39

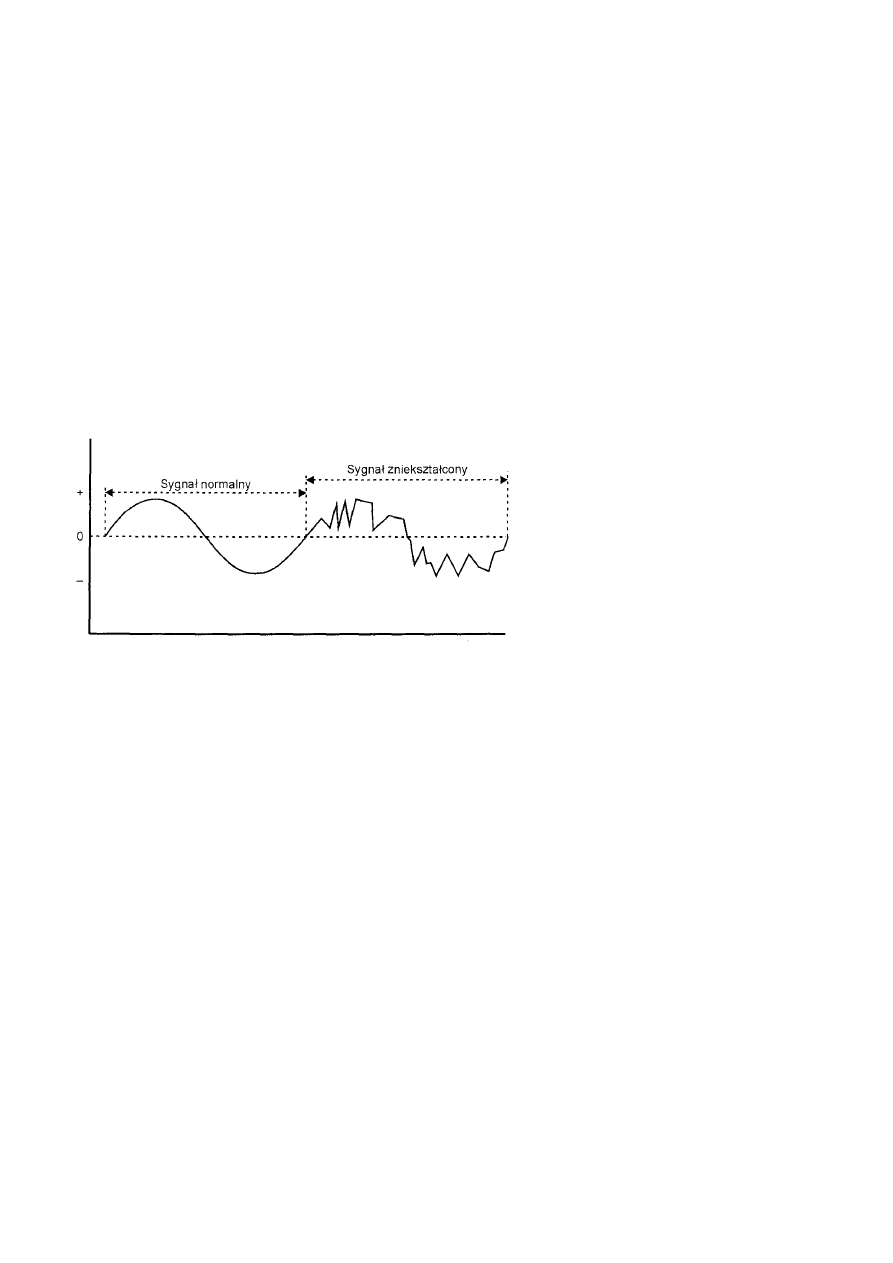

Tłumienie......................................................................................................................................................................40

Nośniki transmisji fizycznej ....................................................................................................................................................41

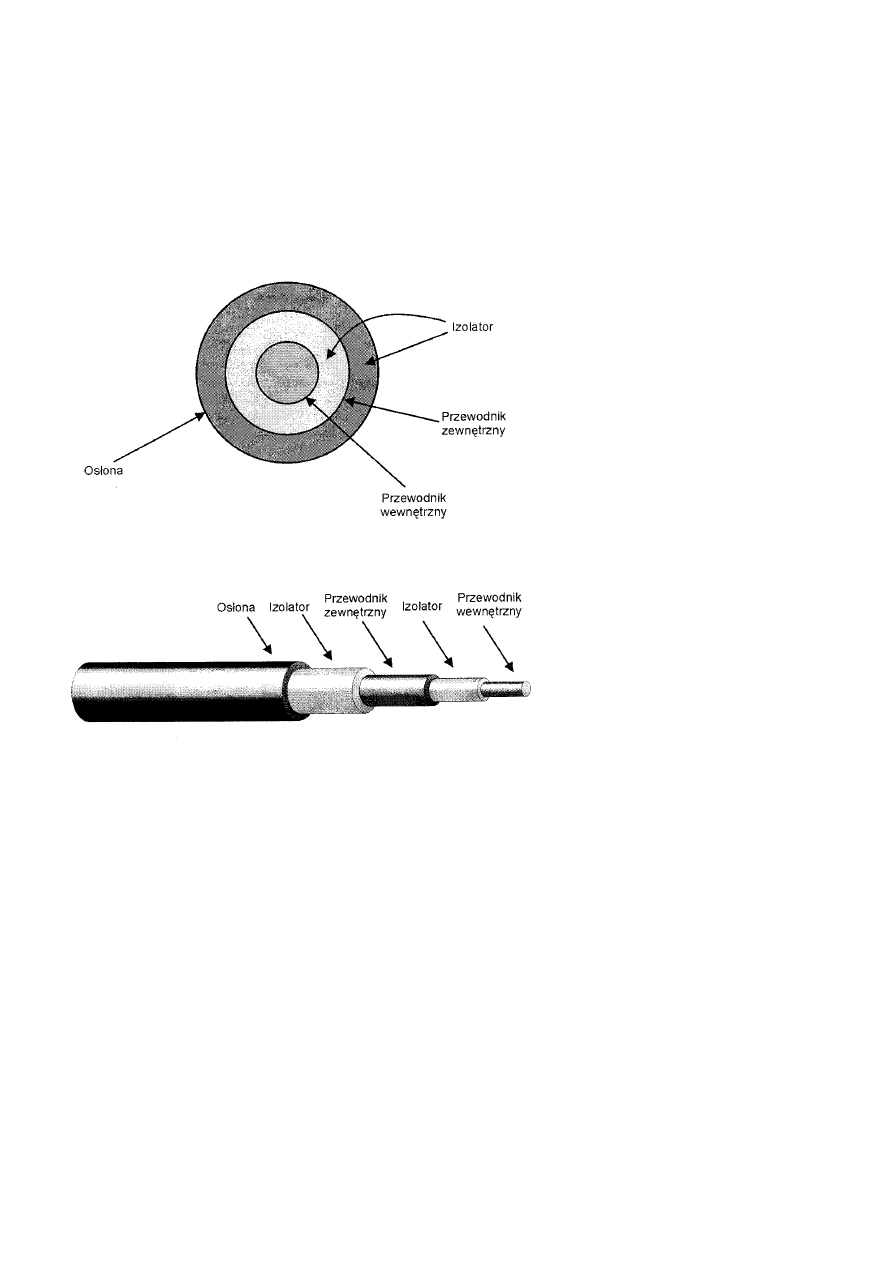

Kabel koncentryczny ....................................................................................................................................................41

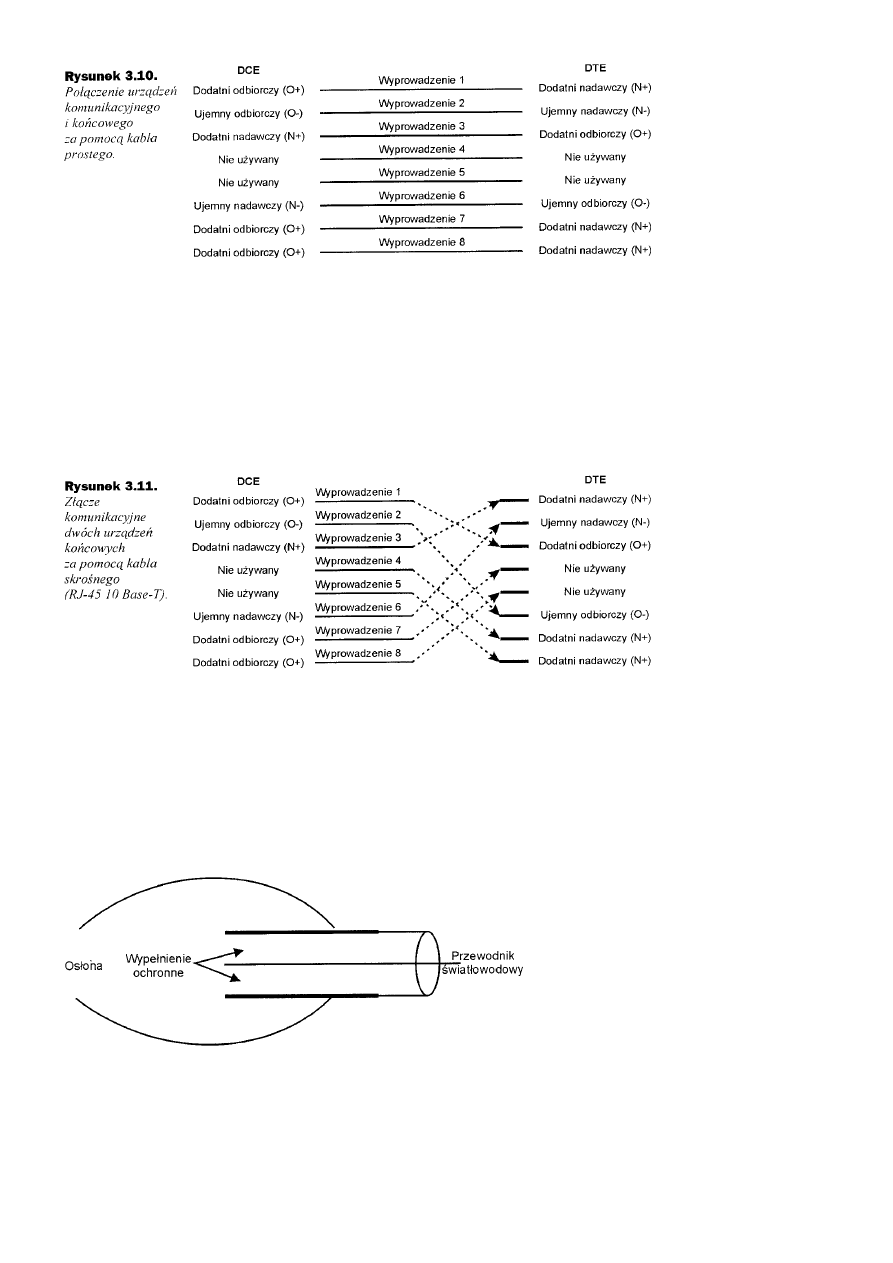

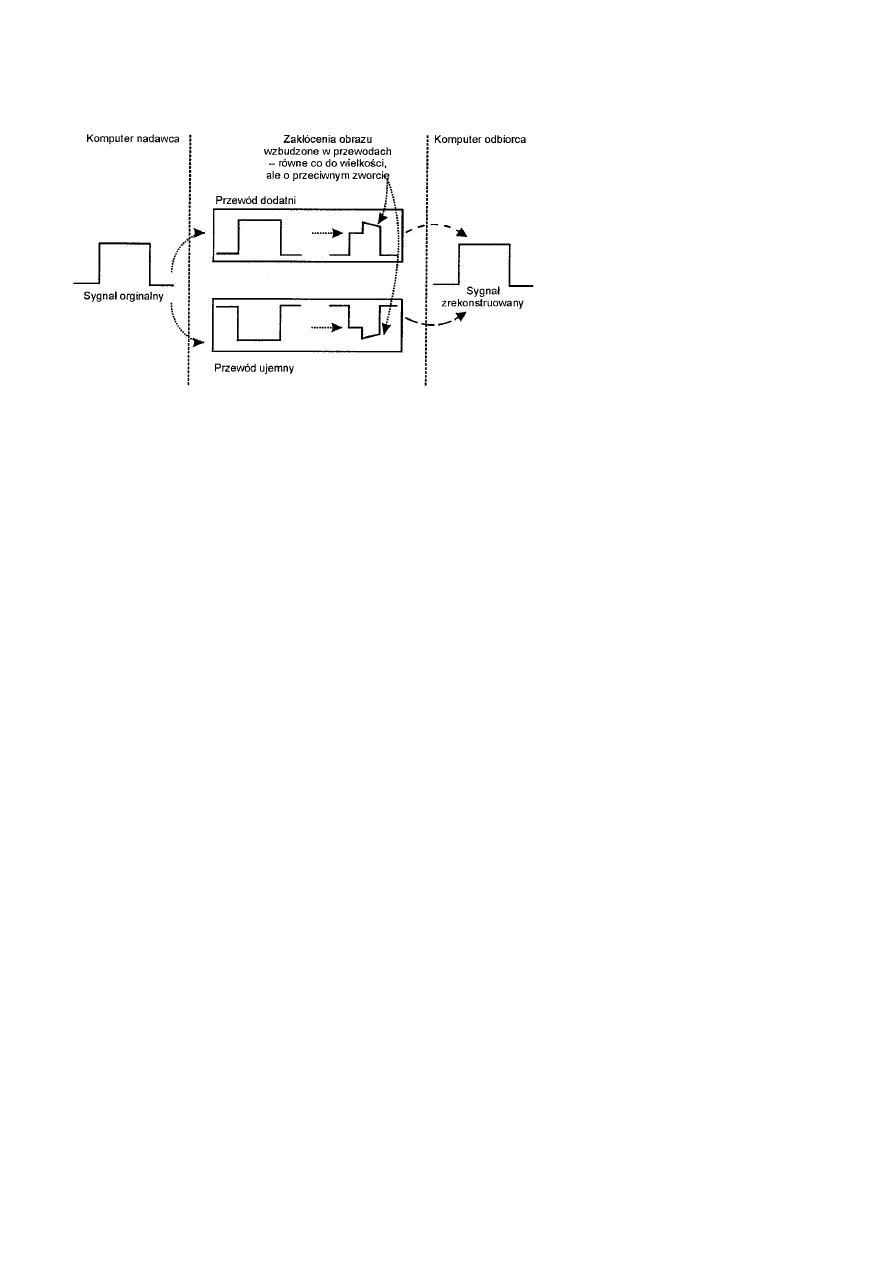

Skrętka dwużyłowa.......................................................................................................................................................42

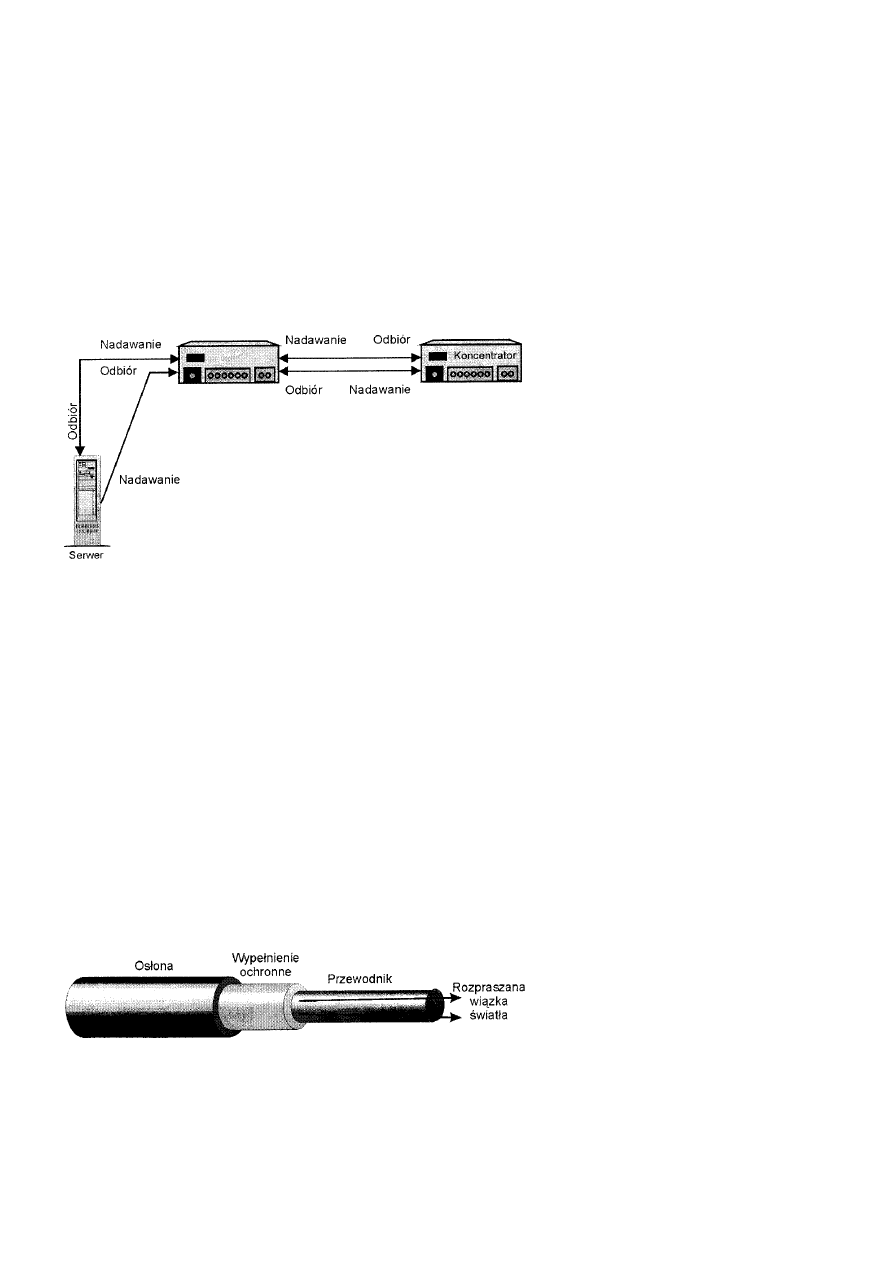

Kabel światłowodowy...................................................................................................................................................45

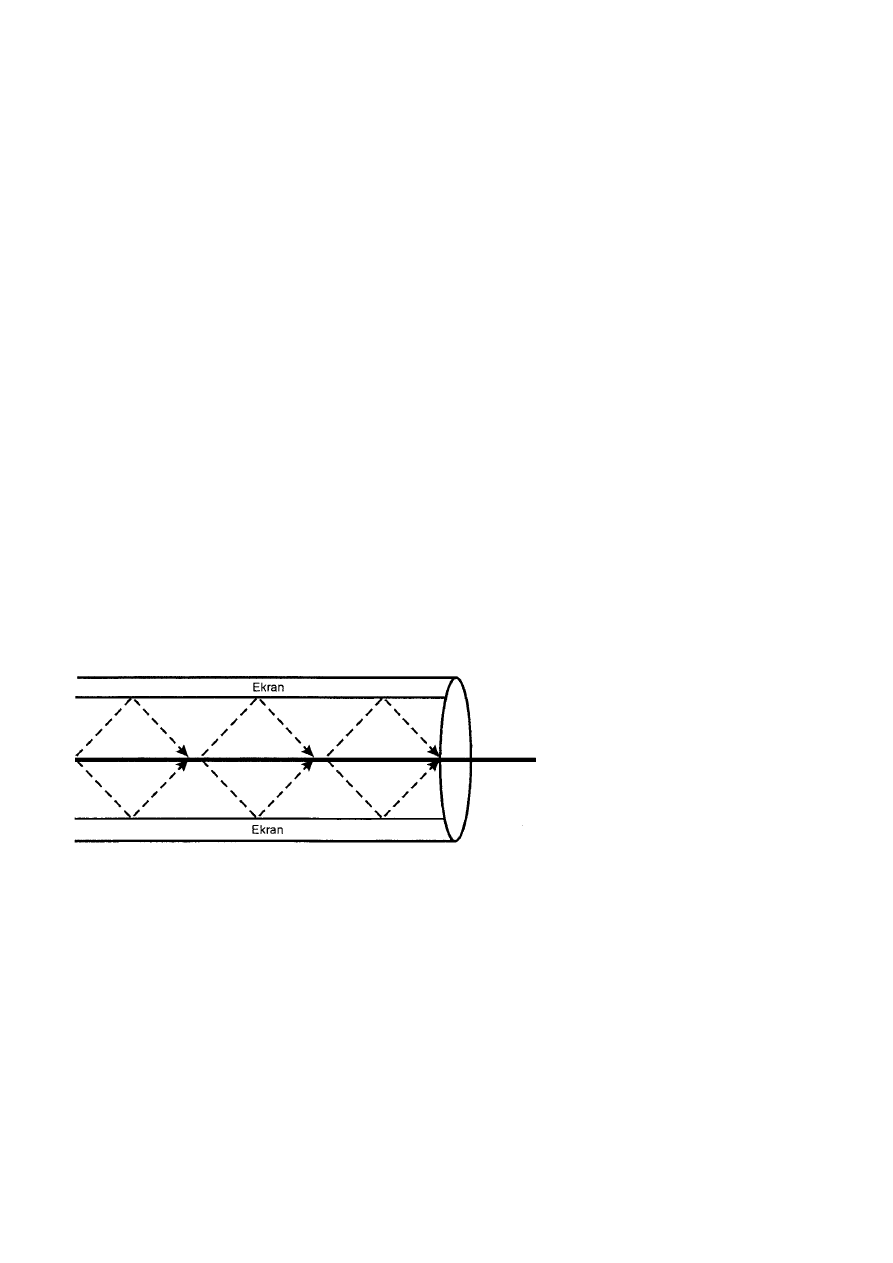

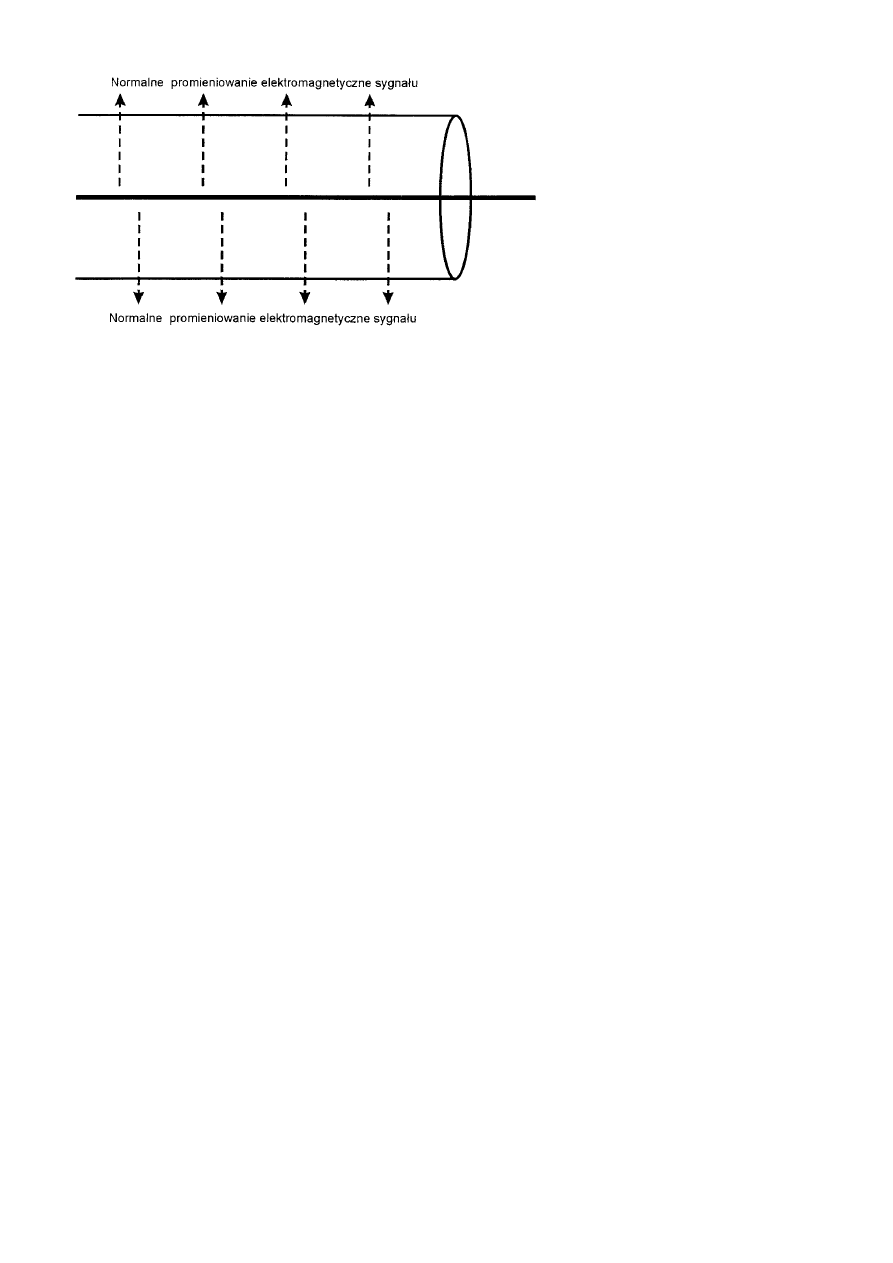

Transmisja wielomodowa........................................................................................................................................................46

Transmisja jednomodowa........................................................................................................................................................47

Podsumowanie ........................................................................................................................................................................47

Rozdział 4 Niezupełnie-fizyczna warstwa fizyczna...........................................................................................................................48

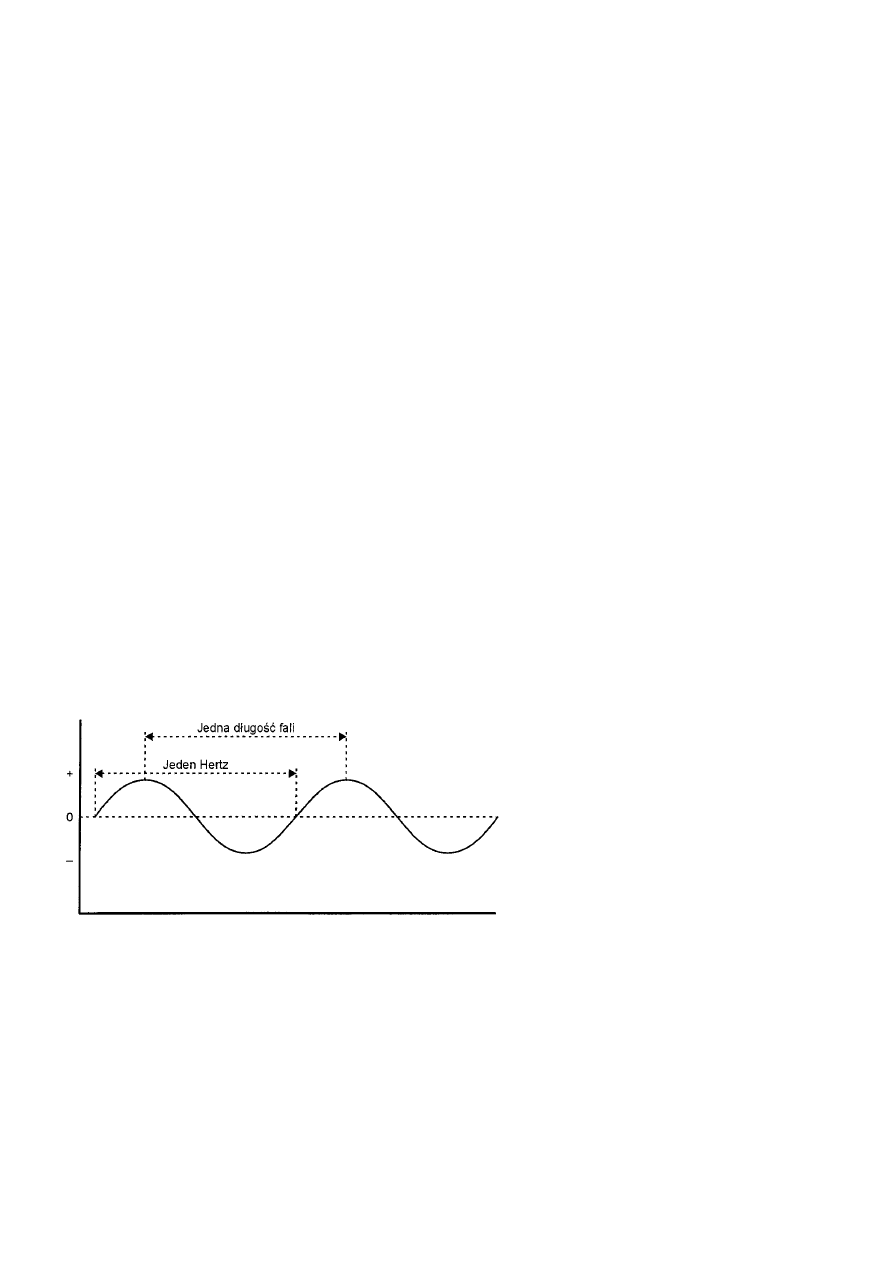

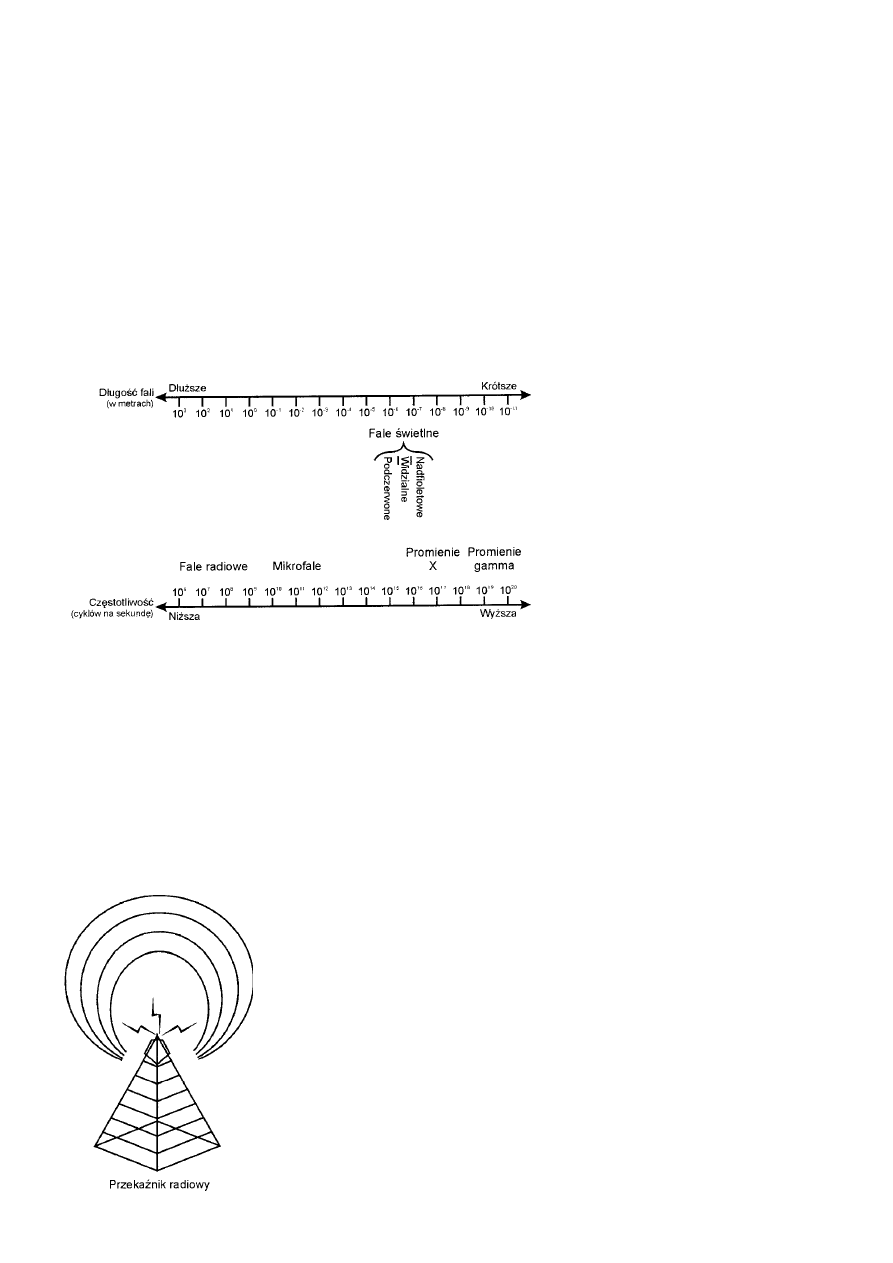

Spektrum elektromagnetyczne ................................................................................................................................................48

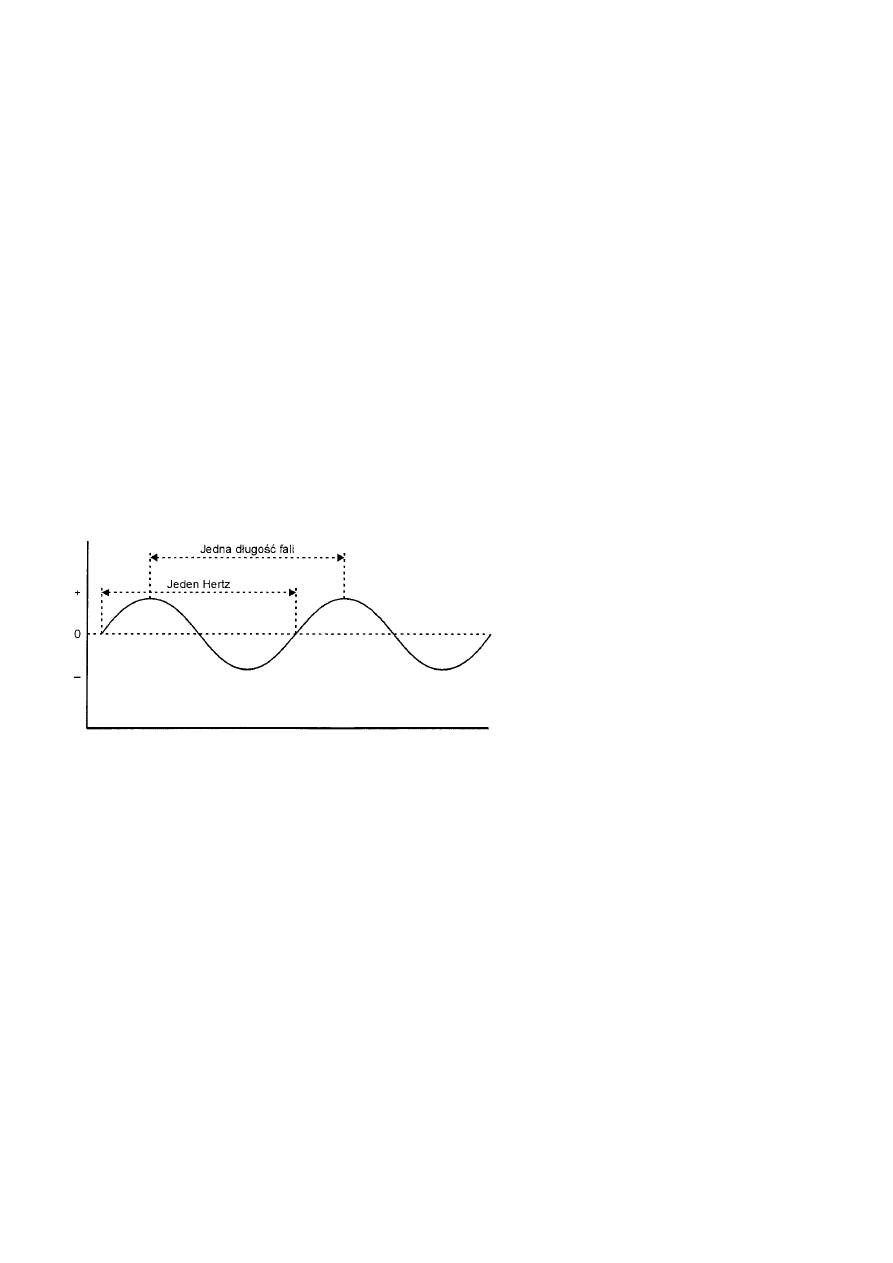

Charakterystyki spektrum .............................................................................................................................................49

Spektrum a szerokość pasma ........................................................................................................................................49

Co to oznacza? ........................................................................................................................................................................50

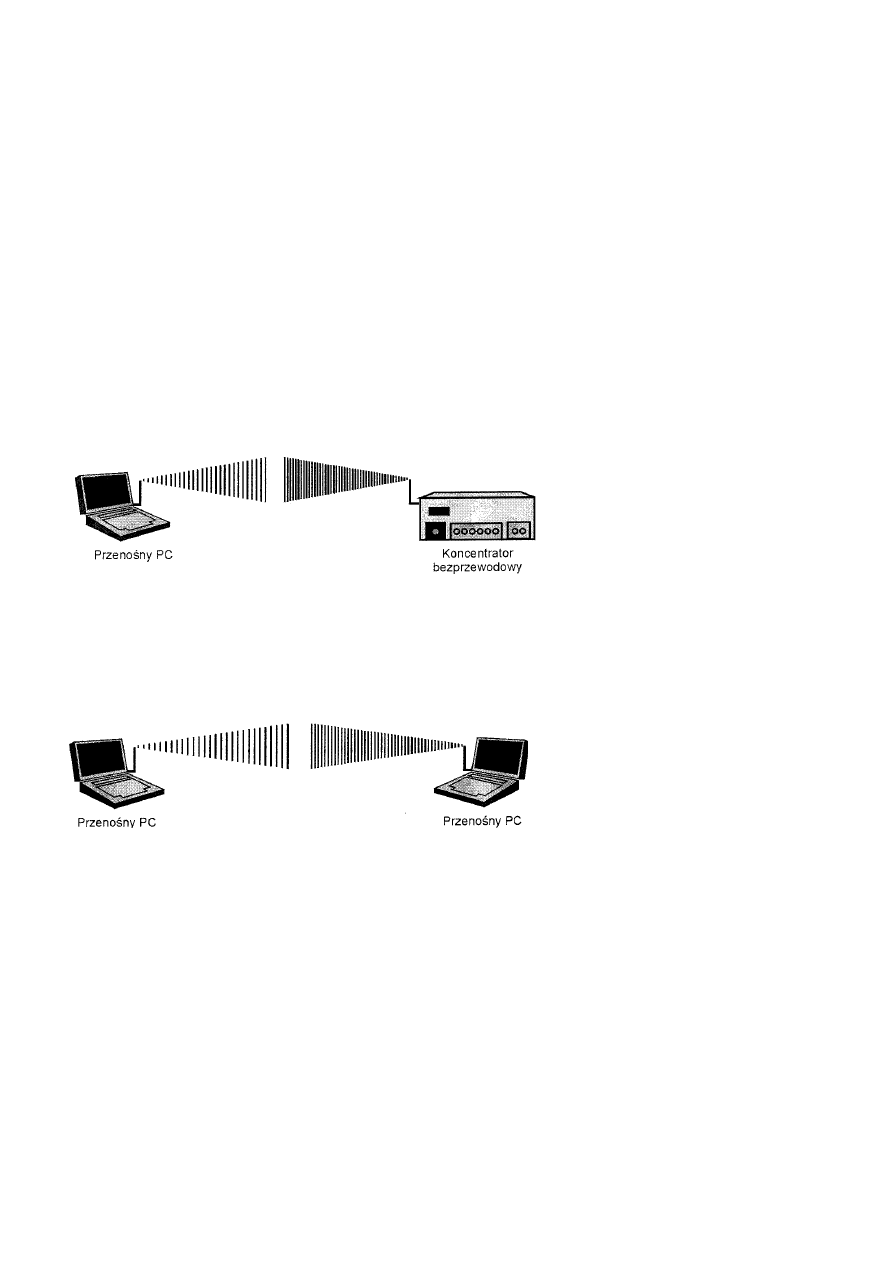

Bezprzewodowe sieci LAN.....................................................................................................................................................50

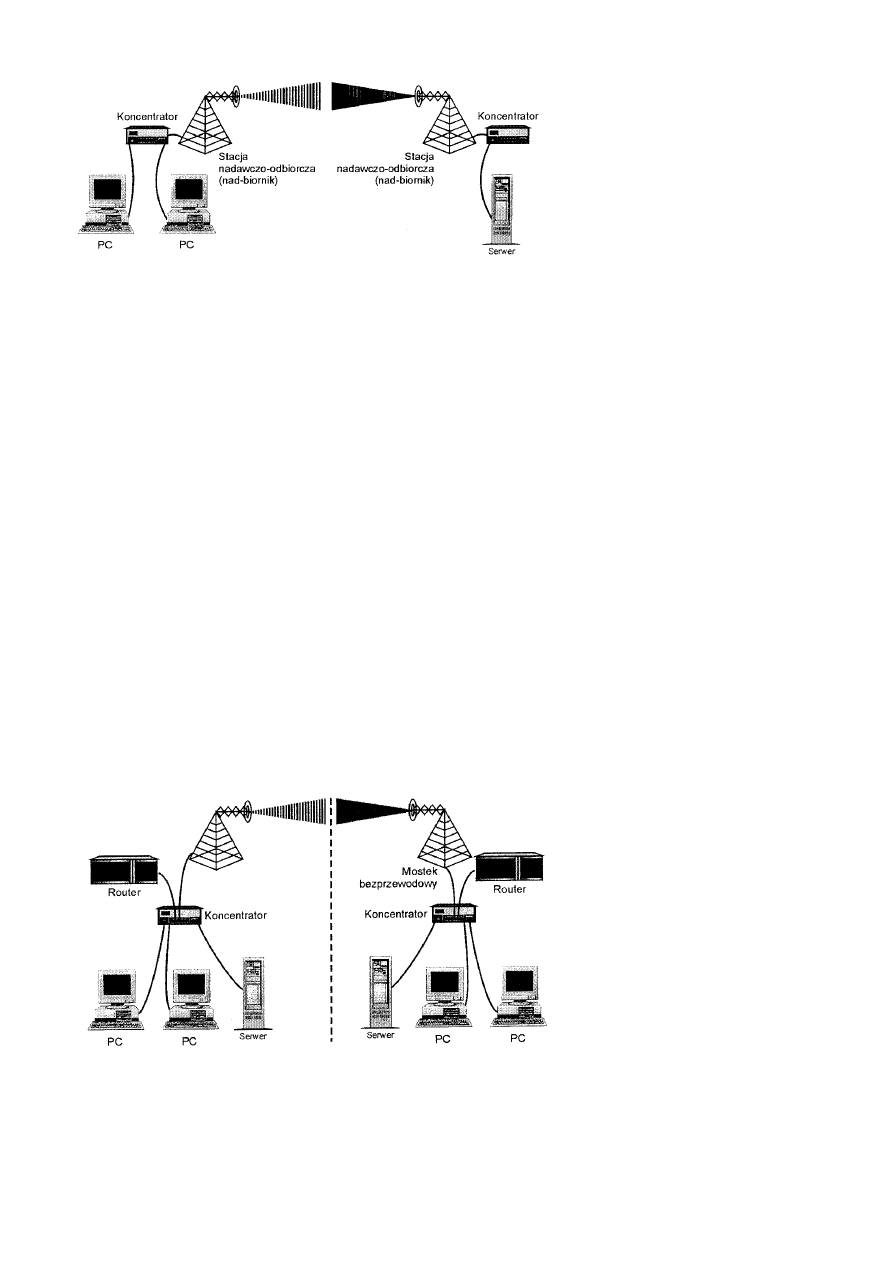

Bezprzewodowe łączenie stacji ....................................................................................................................................51

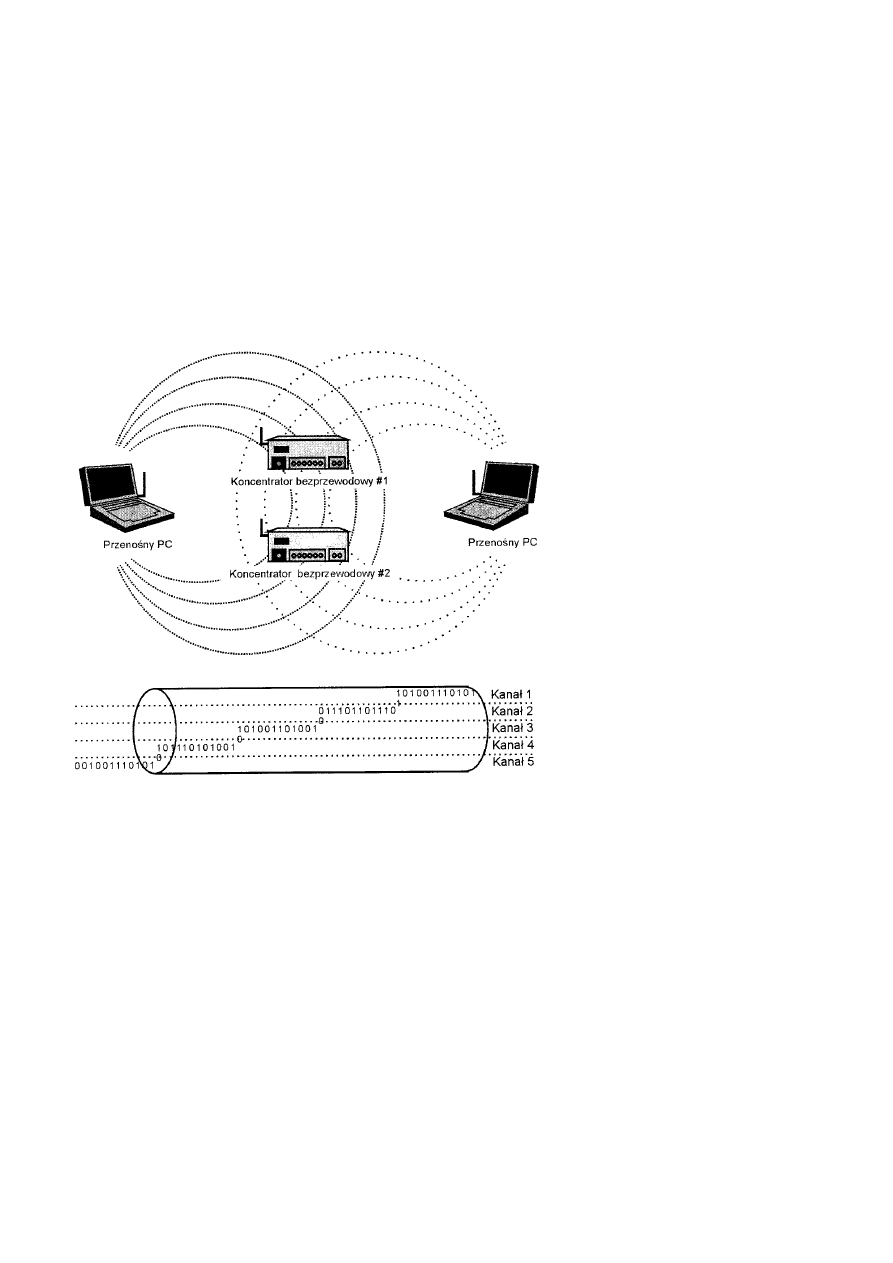

Bezprzewodowe łączenie koncentratorów ....................................................................................................................51

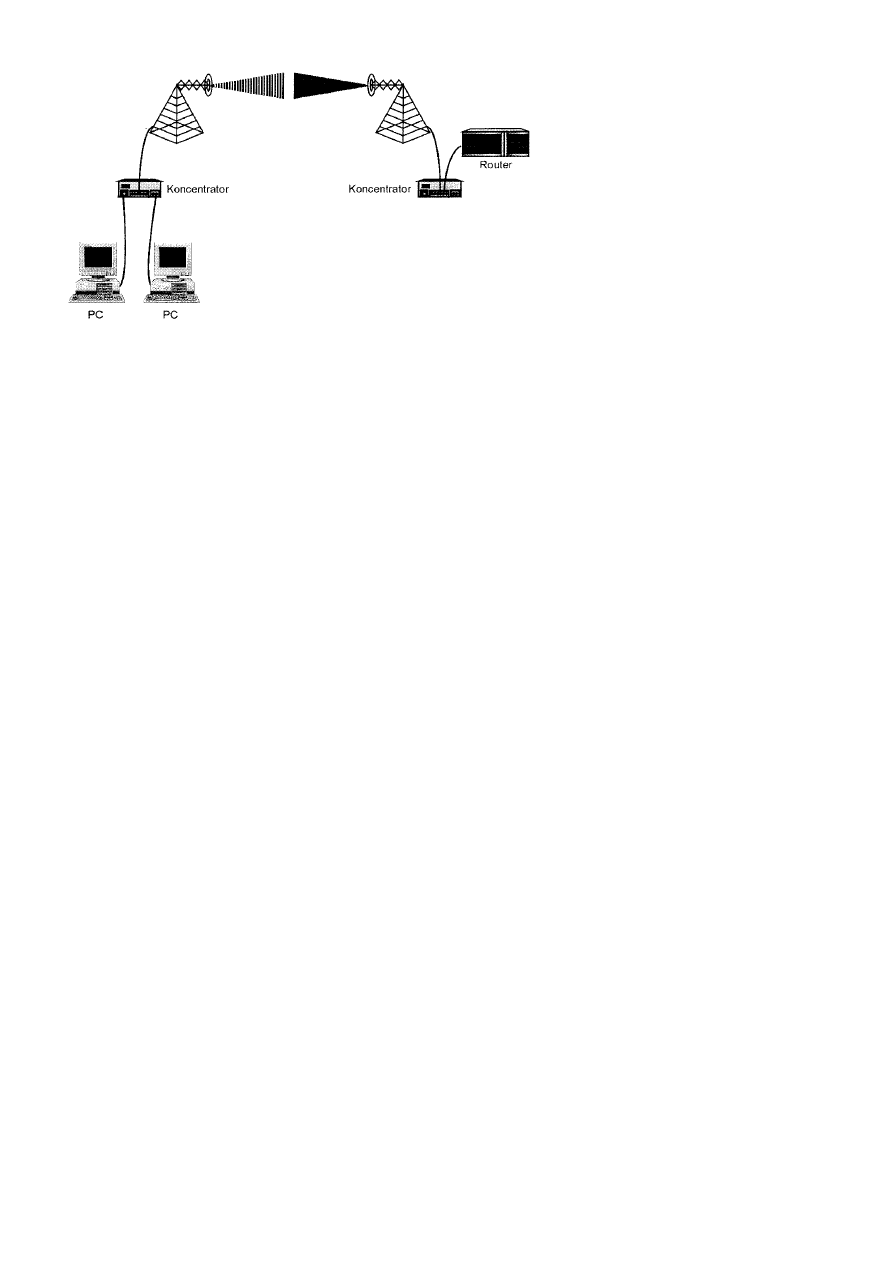

Bezprzewodowe mostkowanie......................................................................................................................................52

Technologie transmisji..................................................................................................................................................52

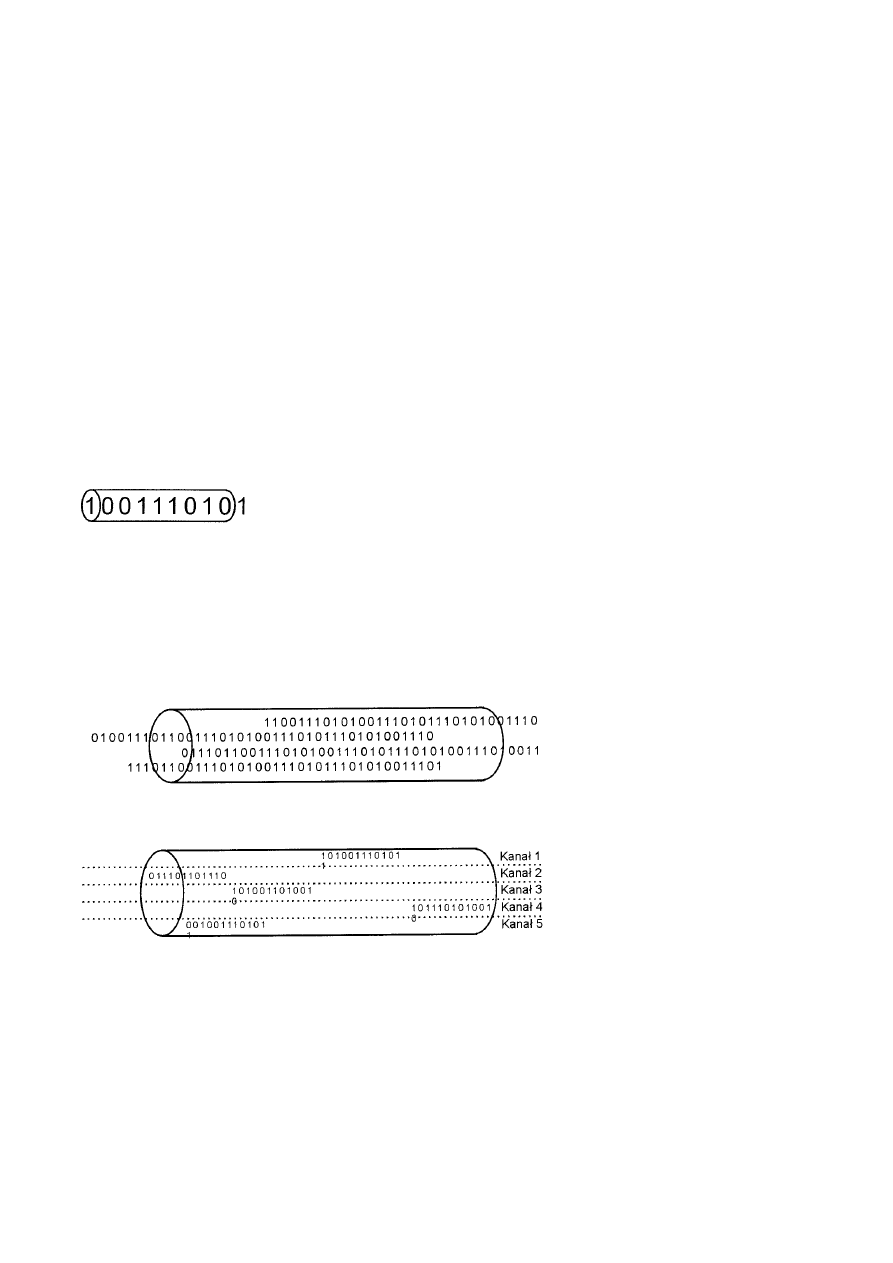

Częstotliwość radiowa szerokiego spektrum...........................................................................................................................52

Sekwencja bezpośrednia ...............................................................................................................................................54

Jednopasmowa częstotliwość radiowa ....................................................................................................................................55

Podczerwień ............................................................................................................................................................................55

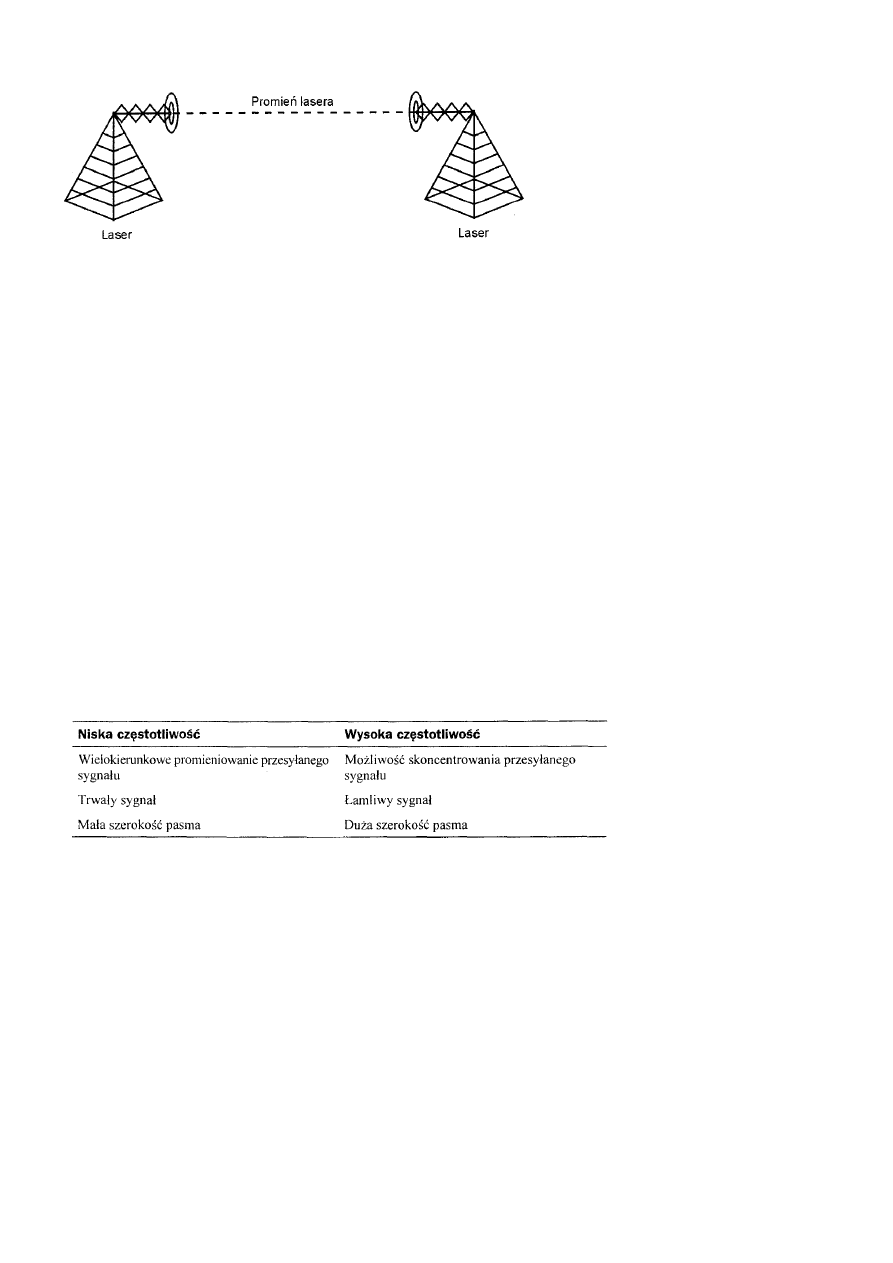

Laser........................................................................................................................................................................................56

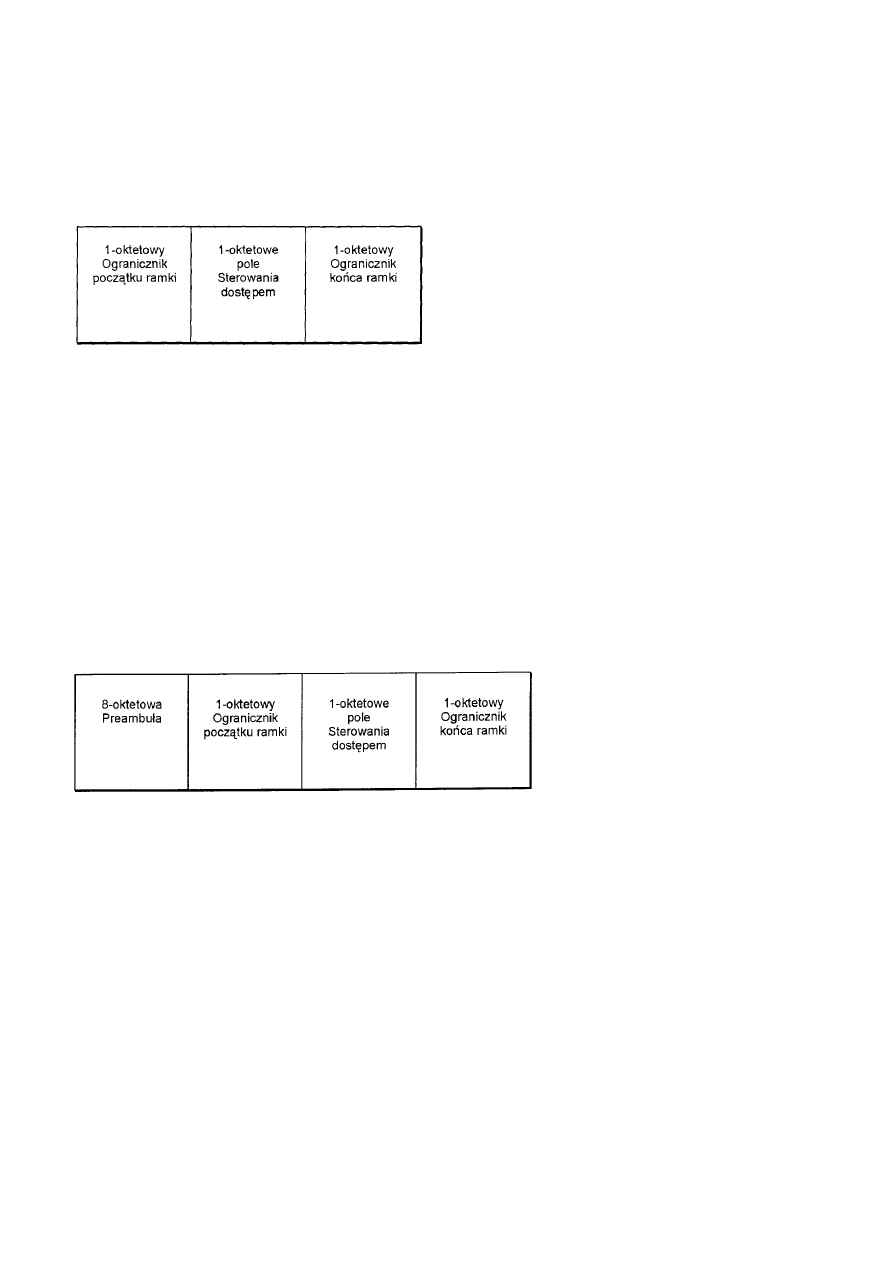

Standard IEEE 802.11 .............................................................................................................................................................57

Dostęp do nośnika.........................................................................................................................................................57

Warstwy fizyczne .........................................................................................................................................................57

Podsumowanie ........................................................................................................................................................................58

Rozdział 5 Warstwa łącza danych......................................................................................................................................................58

Warstwa 2 modelu OSI ...........................................................................................................................................................58

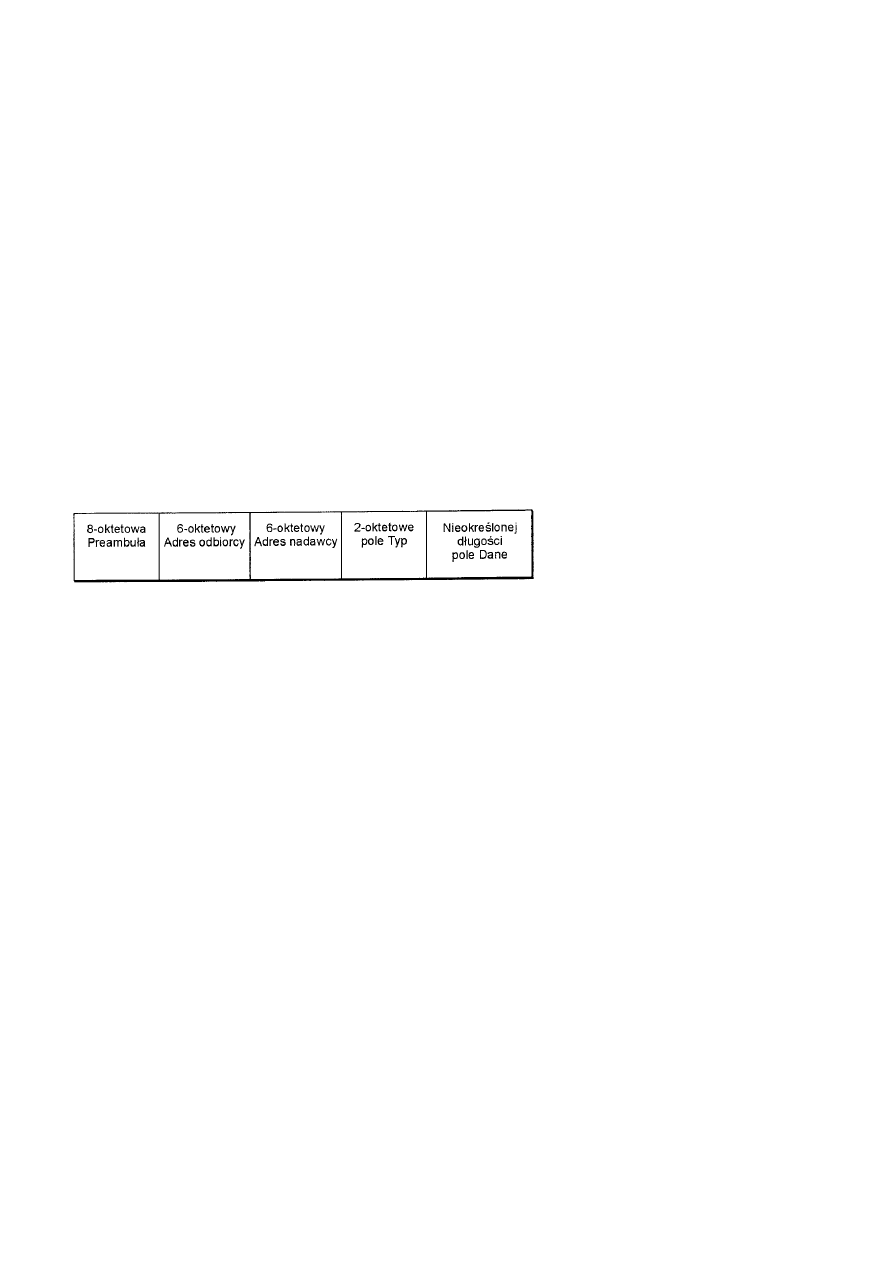

Ramki ......................................................................................................................................................................................59

Składniki typowej ramki ...............................................................................................................................................59

Definicja ramki........................................................................................................................................................59

Adres źródłowy i docelowy .....................................................................................................................................59

Ramki - podsumowanie ramowe .............................................................................................................................59

Ewolucja struktur ramek firmowych.............................................................................................................................60

Ramka sieci PARC Ethernet firmy Xerox ...............................................................................................................60

Ramka sieci DIX Ethernet .......................................................................................................................................60

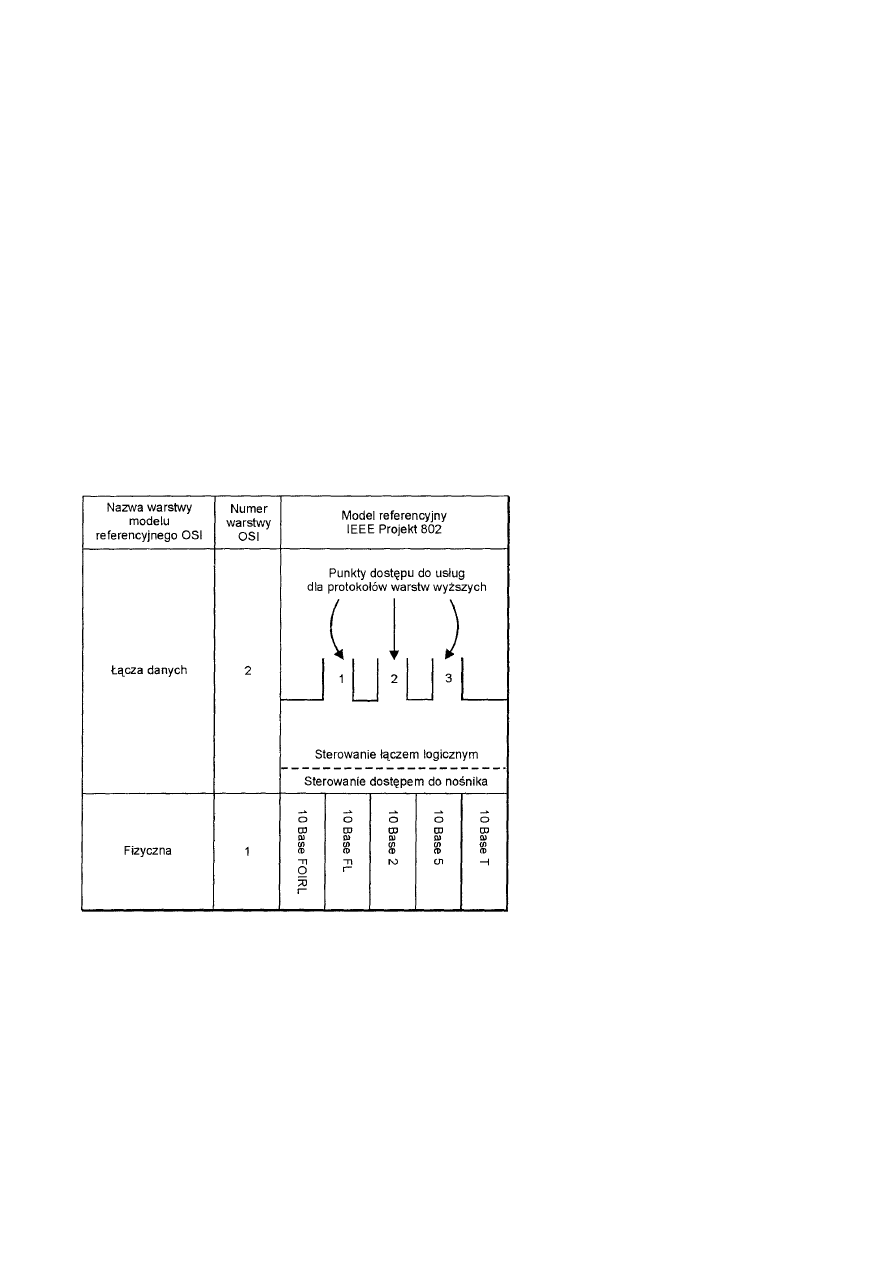

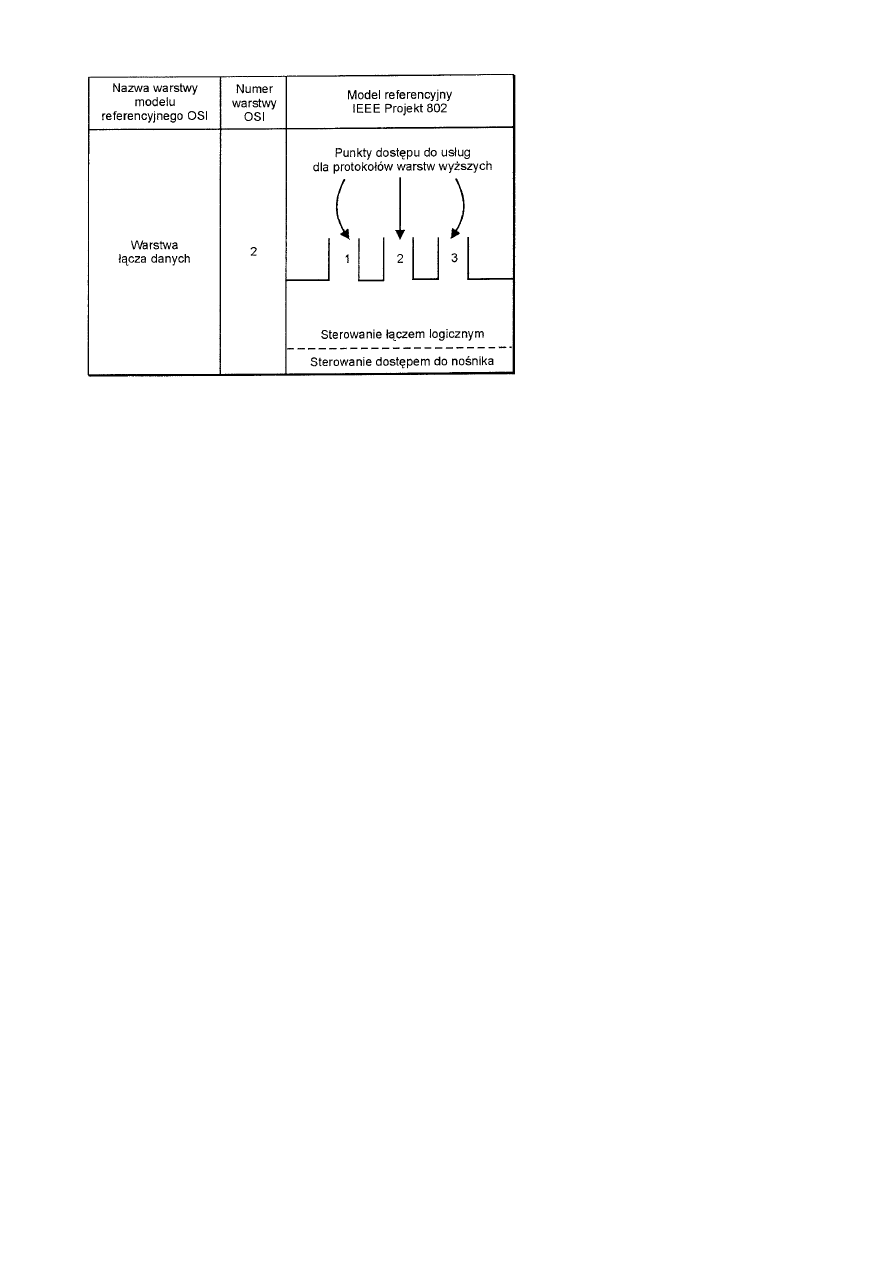

Projekt IEEE 802.....................................................................................................................................................................61

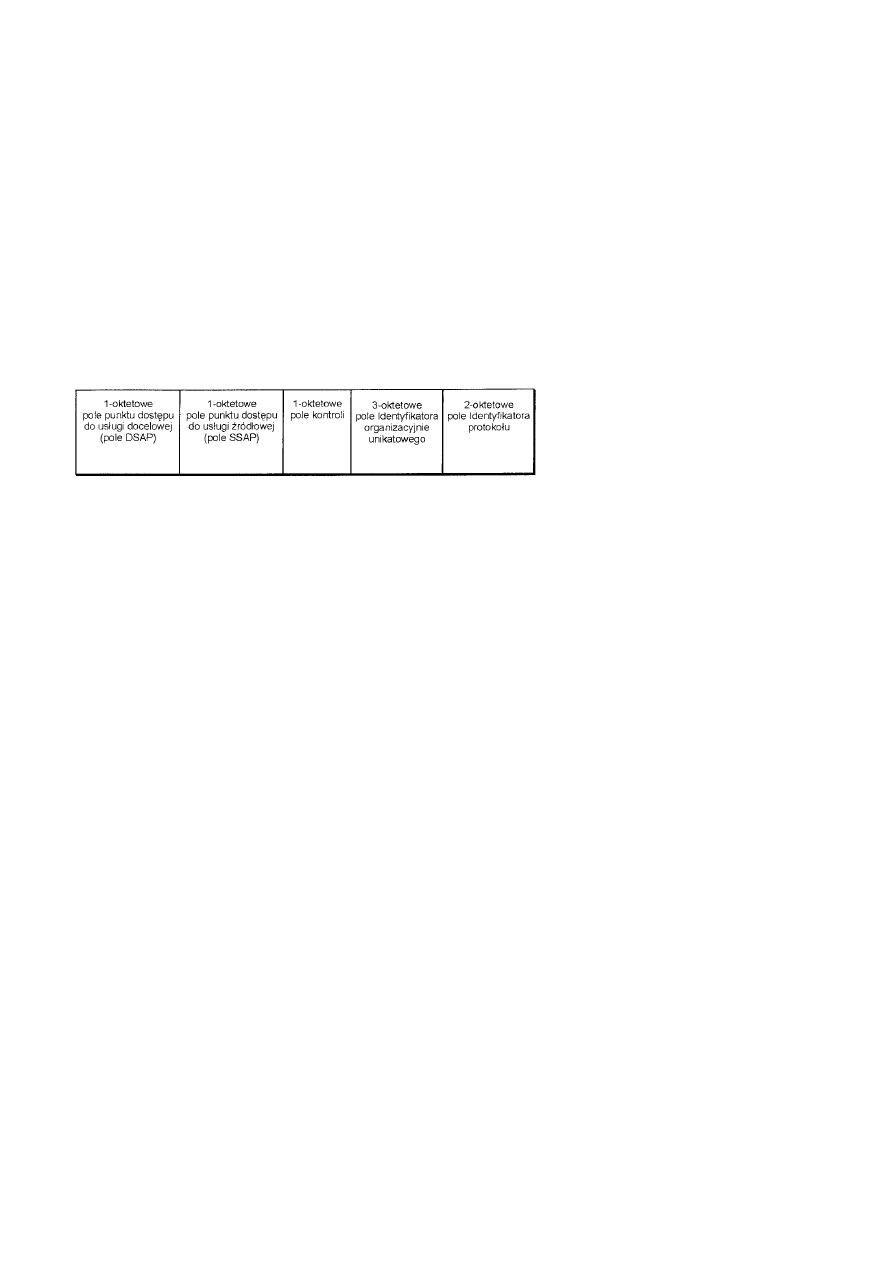

Sterowanie łączem logicznym w standardzie IEEE 802.2 ............................................................................................61

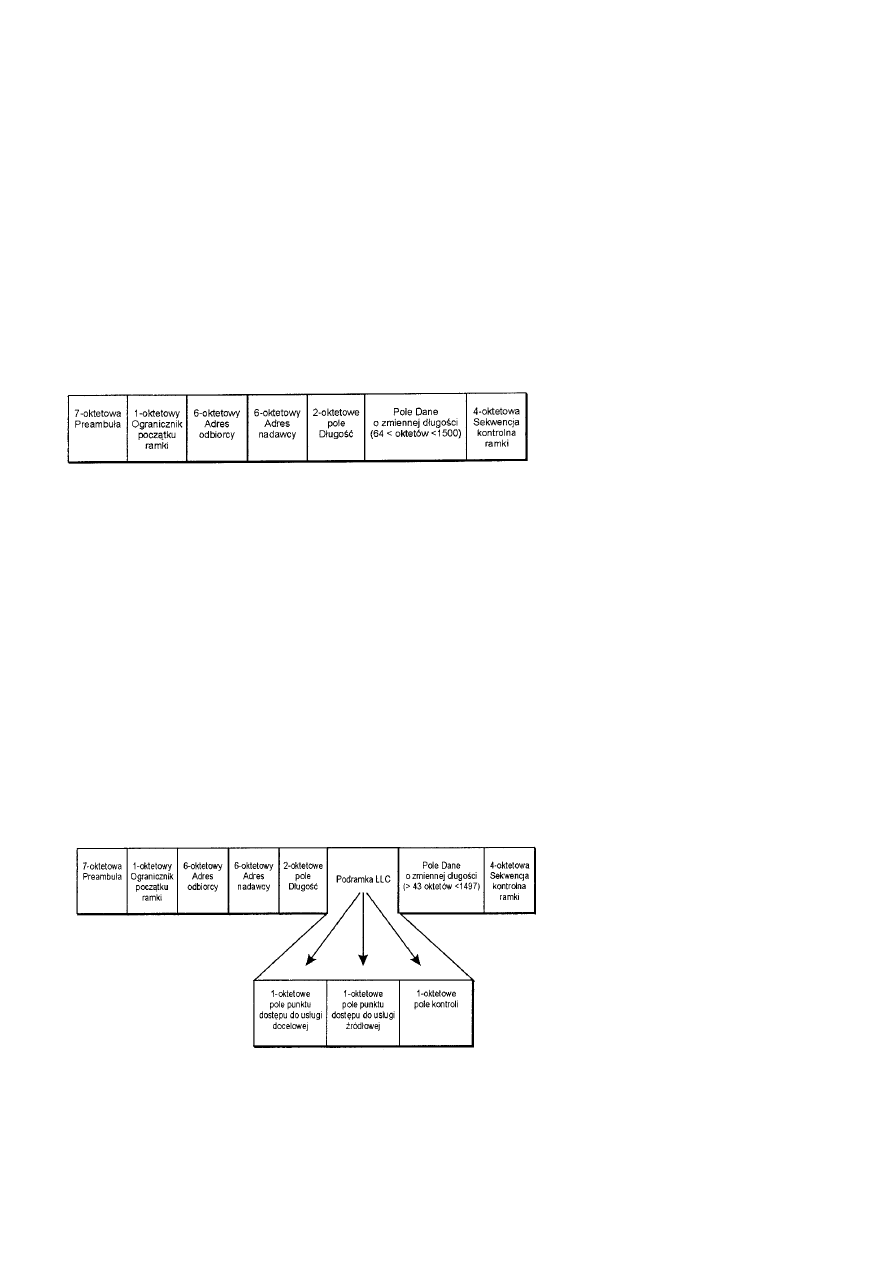

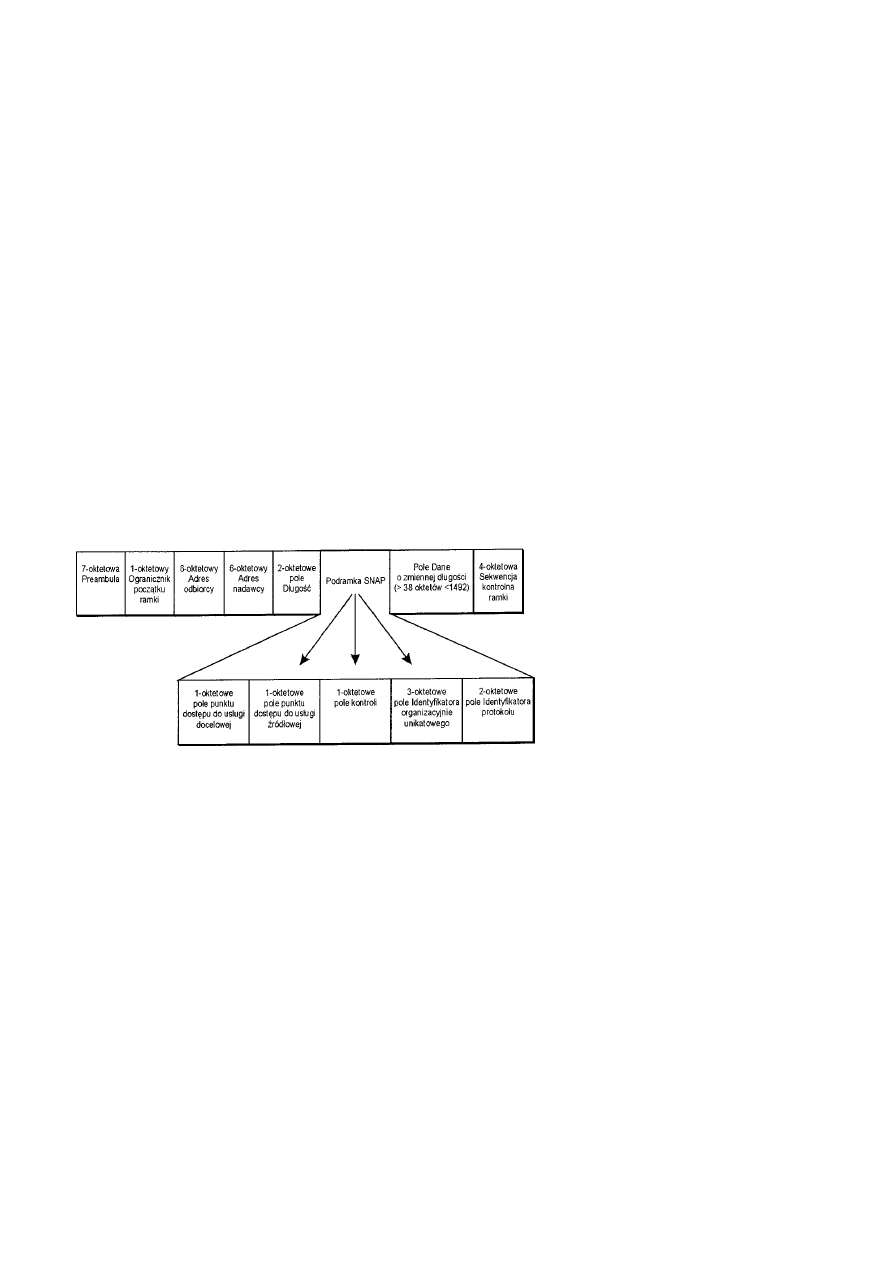

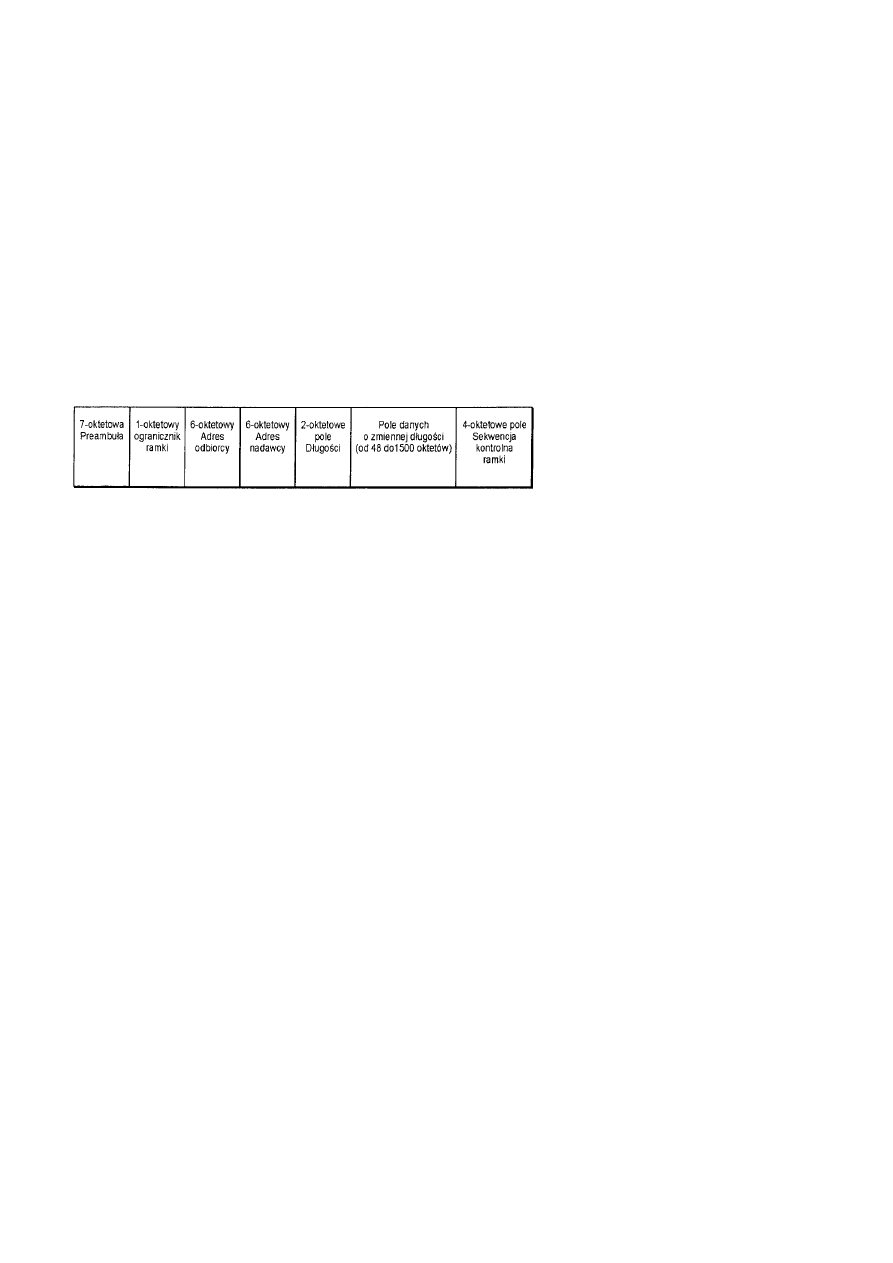

Ramka sieci Ethernet standardu IEEE 802.3.................................................................................................................63

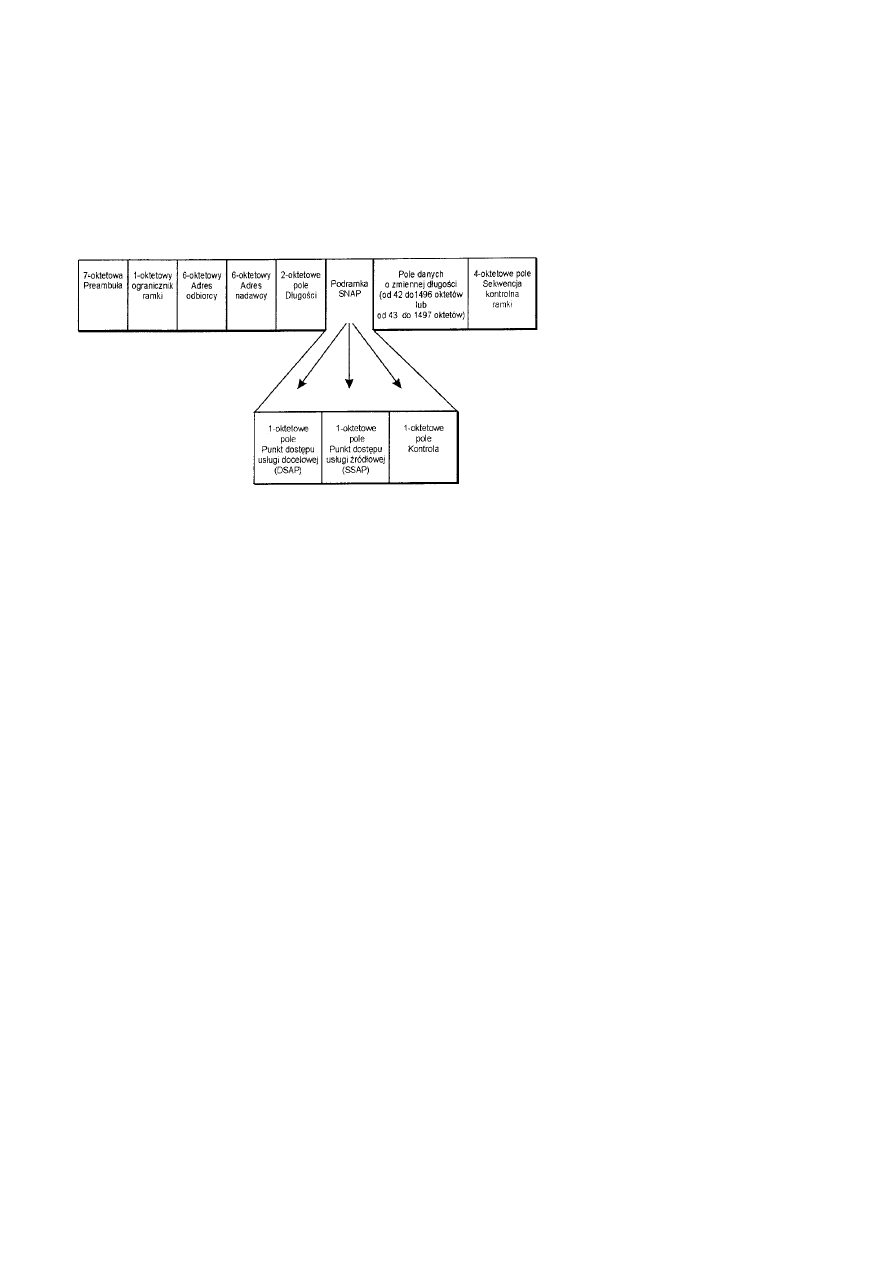

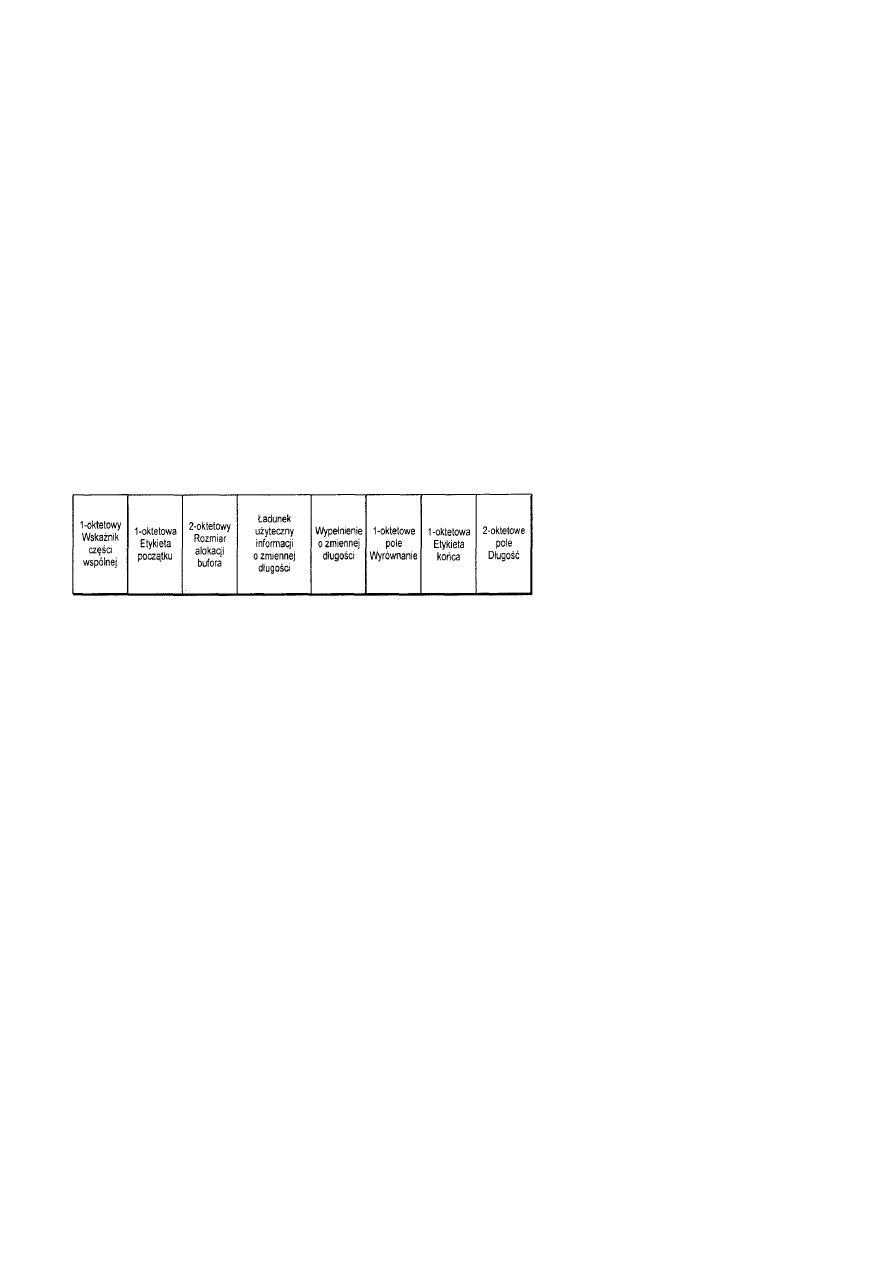

Struktura ramki LCC Ethernet.................................................................................................................................64

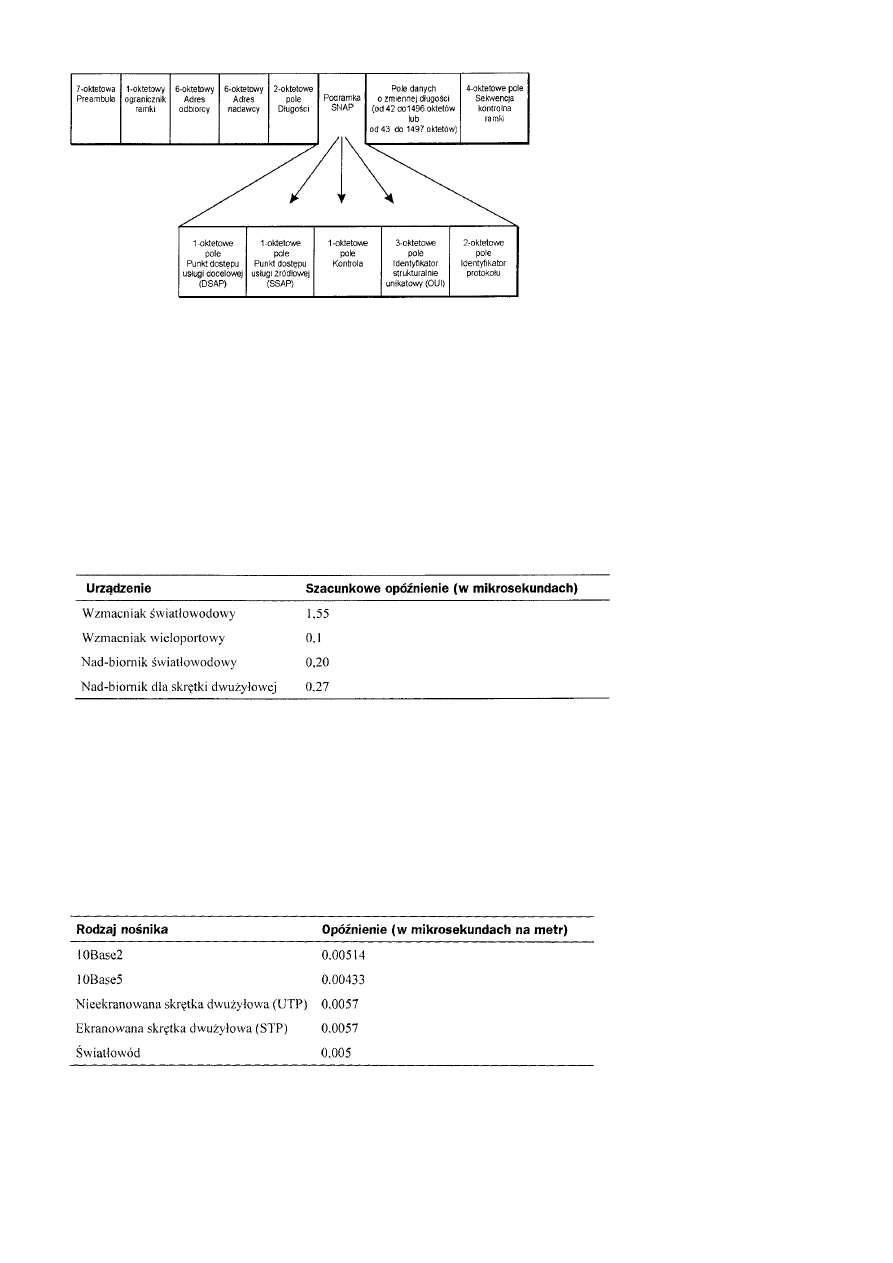

Struktura ramek Ethernet SNAP..............................................................................................................................65

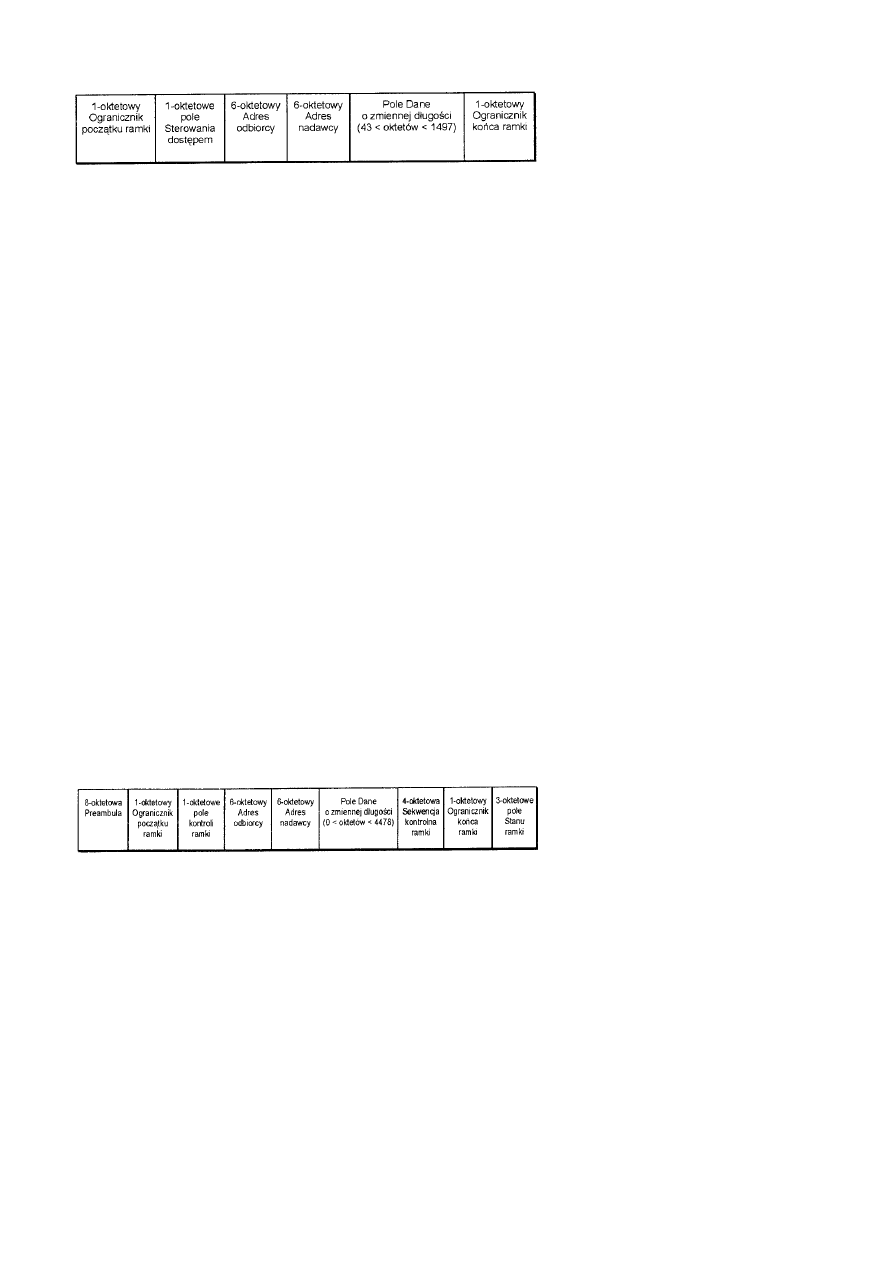

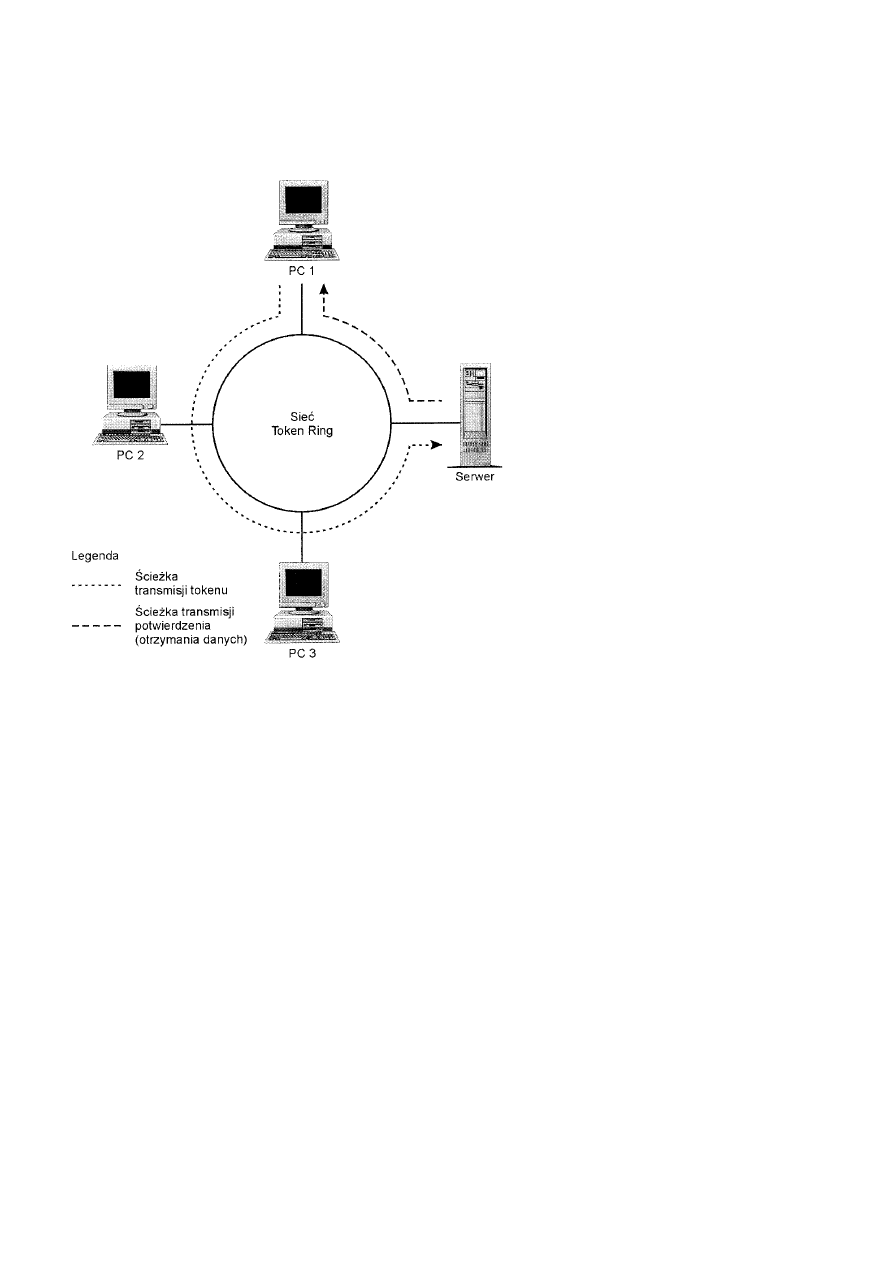

Sieci Token Ring standardu IEEE 802.5.......................................................................................................................65

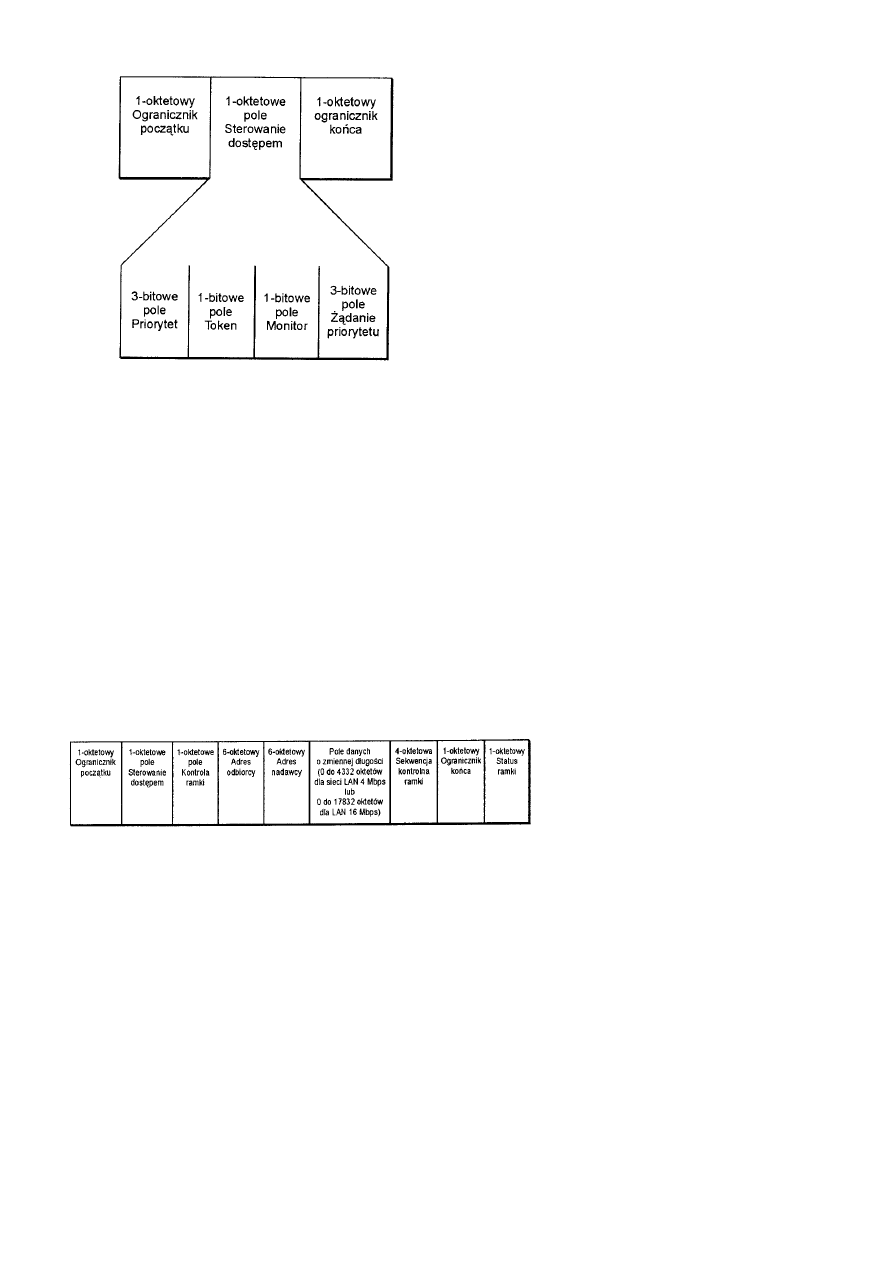

Struktura ramki IEEE 802.5 ....................................................................................................................................65

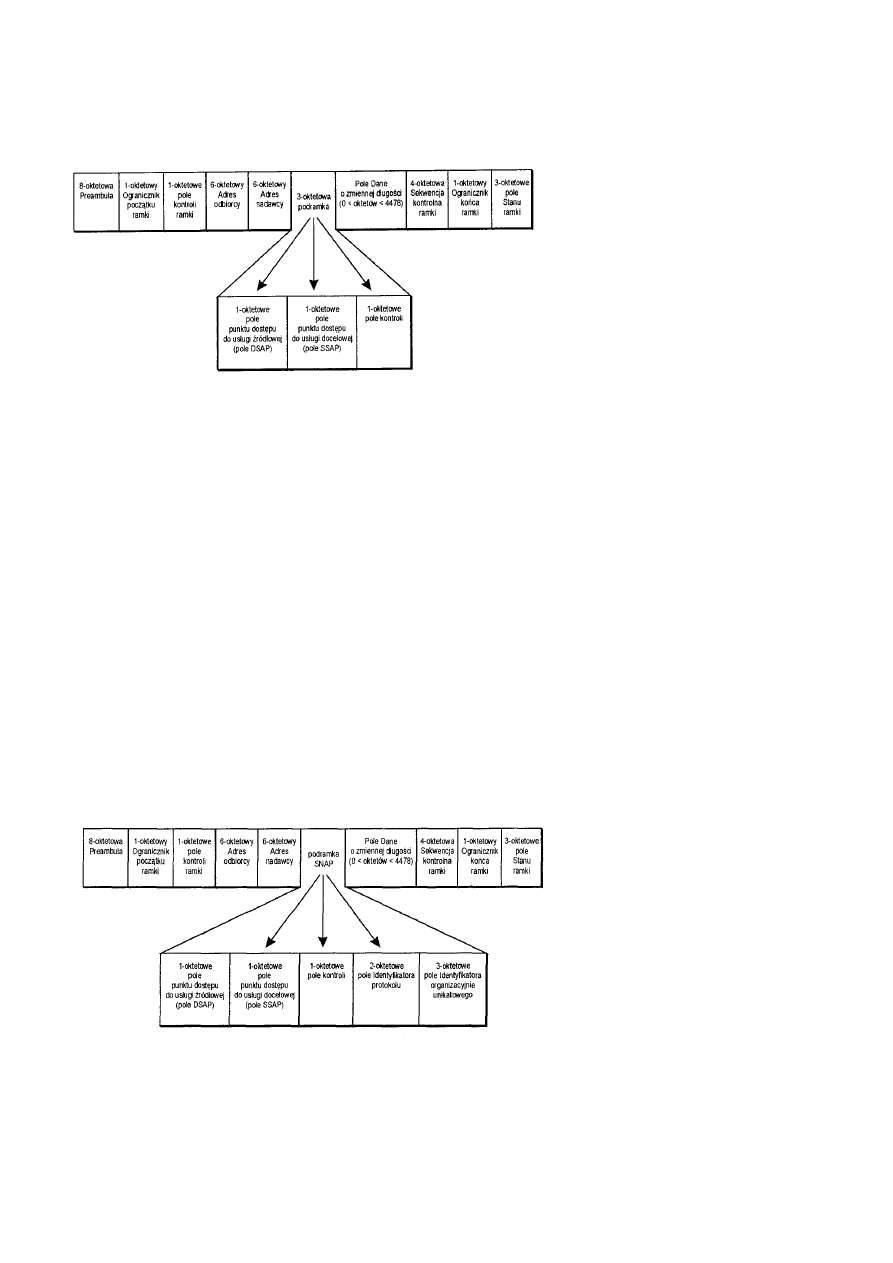

Architektura FDDI ..................................................................................................................................................................66

Struktura ramki FDDI LLC ..........................................................................................................................................66

Struktura ramki FDDI SNAP........................................................................................................................................67

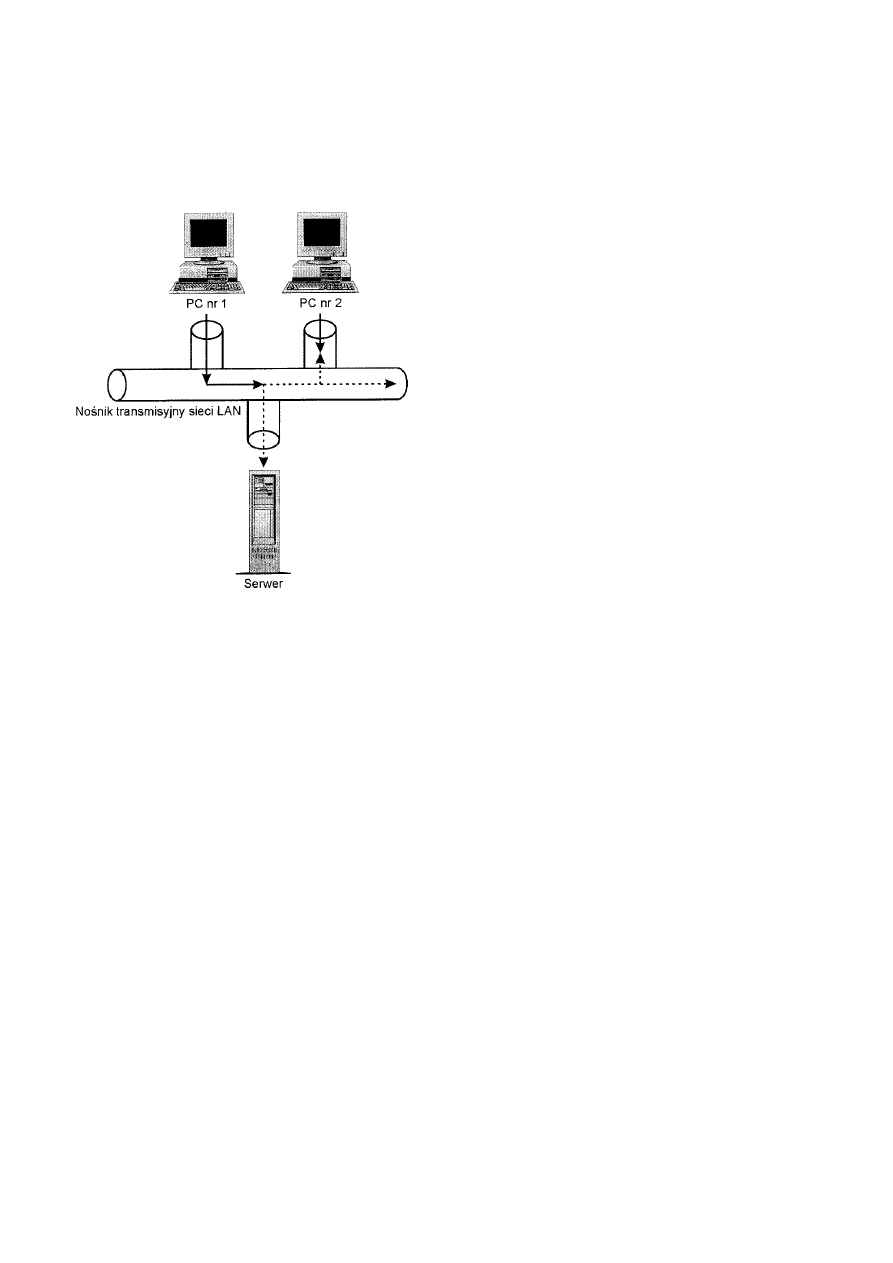

Zasady sterowania dostępem do nośnika.................................................................................................................................67

Dostęp do nośnika na zasadzie rywalizacji ...................................................................................................................68

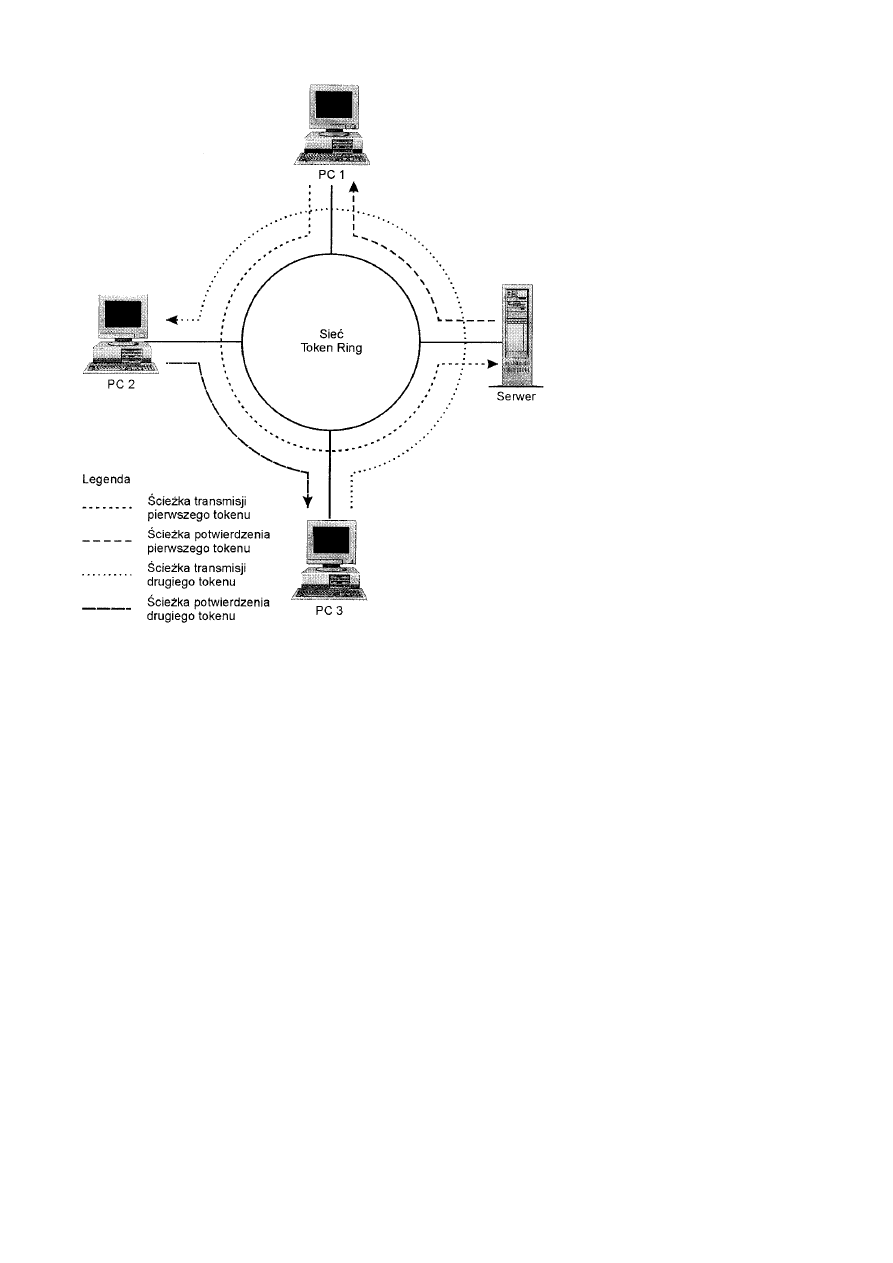

Dostęp do nośnika w sieci Token Ring 802.5..........................................................................................................69

Dostęp do nośnika w sieci FDDI .............................................................................................................................69

Wybór technologii LAN..........................................................................................................................................................69

Sieć Ethernet 802.8 .......................................................................................................................................................69

Sieć Token Ring 802.5..................................................................................................................................................70

Sieć FDDI .....................................................................................................................................................................70

Sieć VG-AnyLAN 802.12 ............................................................................................................................................70

Podsumowanie ........................................................................................................................................................................70

Rozdział 6 Mechanizmy dostępu do nośnika .....................................................................................................................................70

Dostęp do nośnika ...................................................................................................................................................................70

Dostęp do nośnika na zasadzie rywalizacji..............................................................................................................................71

Półdupleks a pełny dupleks...........................................................................................................................................71

Podstawa to timing ..................................................................................................................................................72

Kolizje .....................................................................................................................................................................73

Dostęp do nośnika na zasadzie pierścienia ..............................................................................................................................74

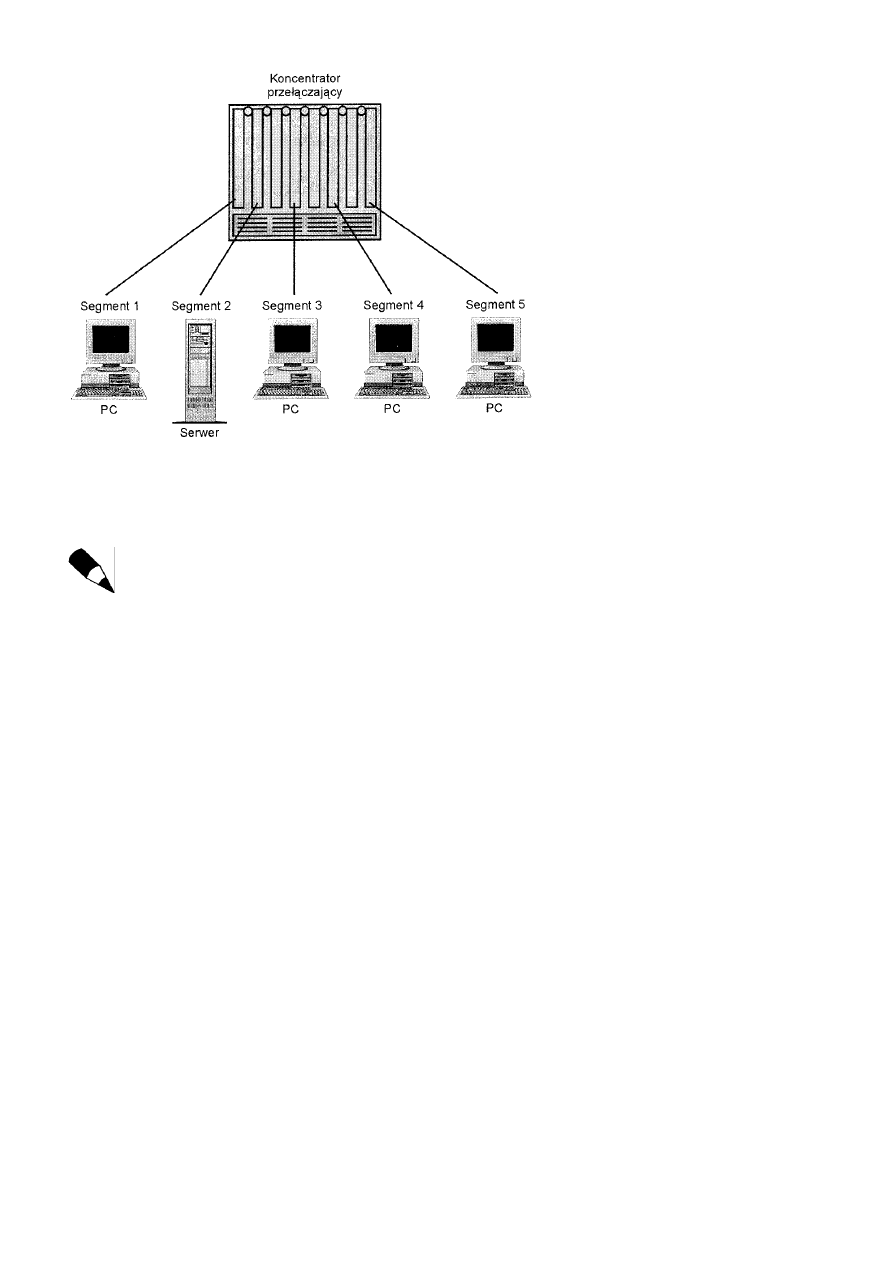

Dostęp do nośnika w komutowanych sieciach LAN ...............................................................................................................76

Podsumowanie ........................................................................................................................................................................78

Rozdział 7 Ethernet............................................................................................................................................................................78

Różne rodzaje sieci Ethernet ...................................................................................................................................................79

Obsługiwany sprzęt .................................................................................................................................................................80

Karty sieciowe ..............................................................................................................................................................80

Wzmacniaki ..................................................................................................................................................................80

Koncentratory nie wzmacniające ..................................................................................................................................80

Mosty ............................................................................................................................................................................80

Routery .........................................................................................................................................................................80

Funkcje warstwowe.................................................................................................................................................................81

Funkcje warstwy łącza danych .....................................................................................................................................81

Sterowanie łączem logicznym .................................................................................................................................82

Sterowanie dostępem do nośnika.............................................................................................................................82

Funkcje warstwy fizycznej ...........................................................................................................................................82

Interfejsy międzynośnikowe warstwy fizycznej ...........................................................................................................83

1OBase2 ..................................................................................................................................................................84

10Base5 ...................................................................................................................................................................84

1OBaseT..................................................................................................................................................................84

10BaseFL.................................................................................................................................................................85

10BaseFOIRL..........................................................................................................................................................86

Mieszanie typów nośników...........................................................................................................................................86

Ramka Ethernetu IEEE 802.3..................................................................................................................................................87

Struktura ramki Ethernet LLC.................................................................................................................................................87

Struktura ramki Ethernet SNAP ..............................................................................................................................................88

Prognozowanie opóźnień.........................................................................................................................................................89

Szacowanie opóźnień propagacji ..................................................................................................................................89

Prognozowanie opóźnień Ethernetu..............................................................................................................................89

Podsumowanie ........................................................................................................................................................................90

Rozdział 8 Szybsze sieci Ethernet......................................................................................................................................................90

Fast Ethernet............................................................................................................................................................................90

Nośniki Fast Ethernetu..................................................................................................................................................91

100BaseTX..............................................................................................................................................................91

100BaseFX ..............................................................................................................................................................91

100BaseT4...............................................................................................................................................................91

Schematy sygnalizacyjne ..............................................................................................................................................92

100Base4T+.............................................................................................................................................................92

100BaseX ................................................................................................................................................................92

Maksymalna średnica sieci ...........................................................................................................................................92

Podsumowanie sieci Fast Ethernet................................................................................................................................92

Gigabit Ethernet ......................................................................................................................................................................92

Interfejsy fizyczne.........................................................................................................................................................93

1000BaseSX ............................................................................................................................................................93

1000BaseLX............................................................................................................................................................93

1000BaseCX............................................................................................................................................................93

1OOOBaseT ............................................................................................................................................................94

Co jeszcze nowego?......................................................................................................................................................94

Odstęp między ramkami ..........................................................................................................................................94

Dostęp do nośnika na zasadzie rywalizacji..............................................................................................................95

Zbyt dobre, aby mogło być prawdziwe? .......................................................................................................................95

Podsumowanie ........................................................................................................................................................................95

Rozdział 9 Token Ring ......................................................................................................................................................................96

Przegląd...................................................................................................................................................................................96

Standaryzacja sieci Token Ring ..............................................................................................................................................96

Struktura ramki Token Ring....................................................................................................................................................97

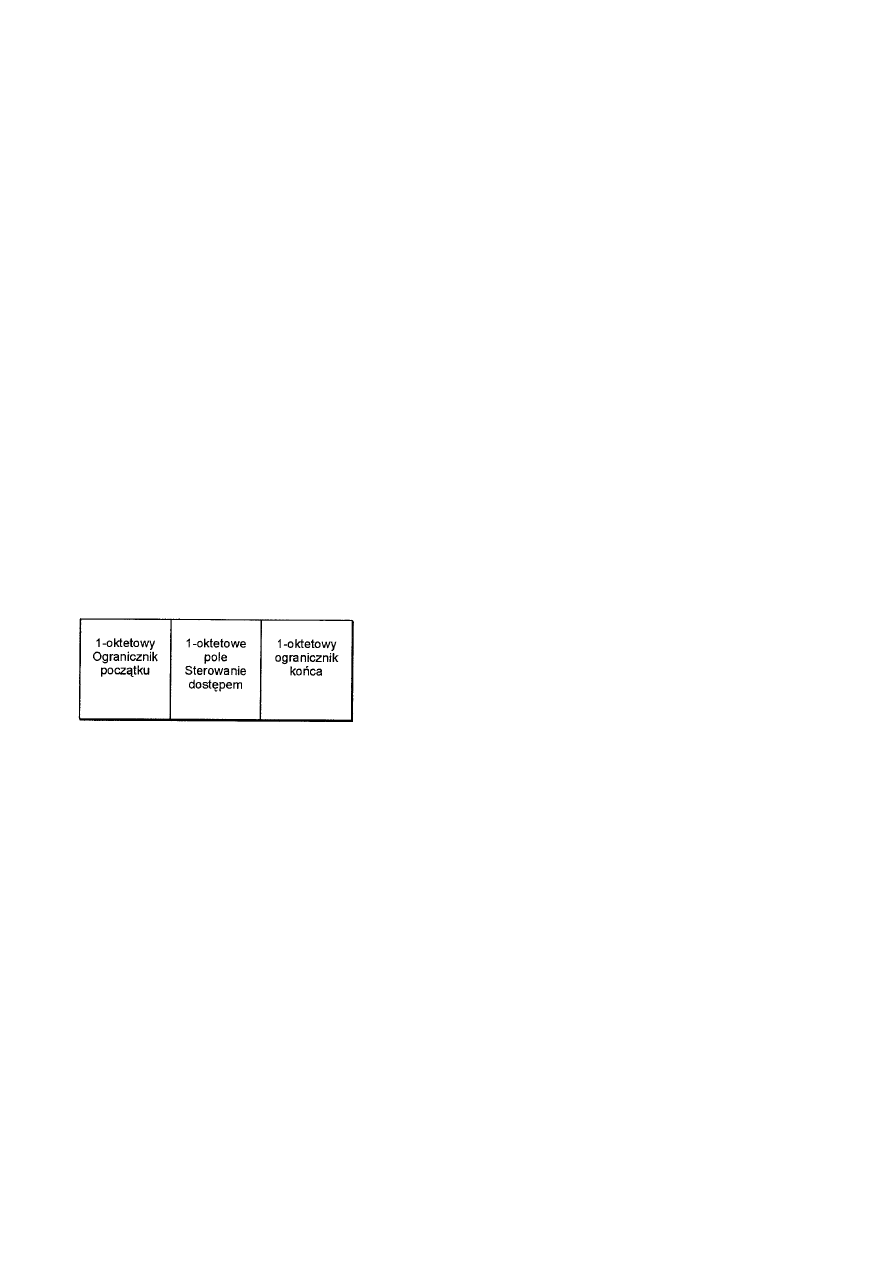

Ramka Token................................................................................................................................................................97

Ramka danych ..............................................................................................................................................................98

Ramki zarządzania MAC..............................................................................................................................................99

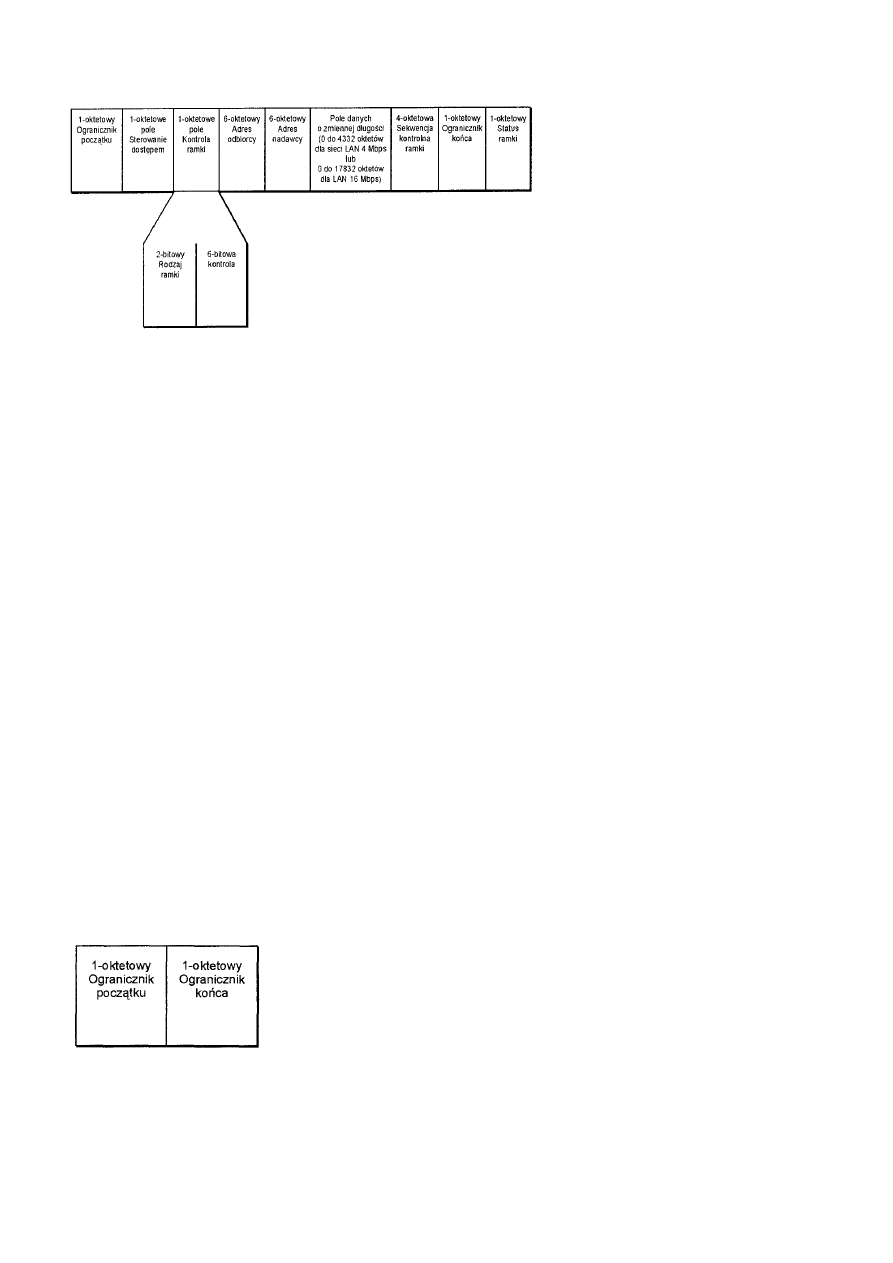

Ramka przerwania ........................................................................................................................................................99

Sekwencja wypełniania.................................................................................................................................................99

Funkcjonowanie sieci Token Ring ........................................................................................................................................100

Sprzęt..........................................................................................................................................................................100

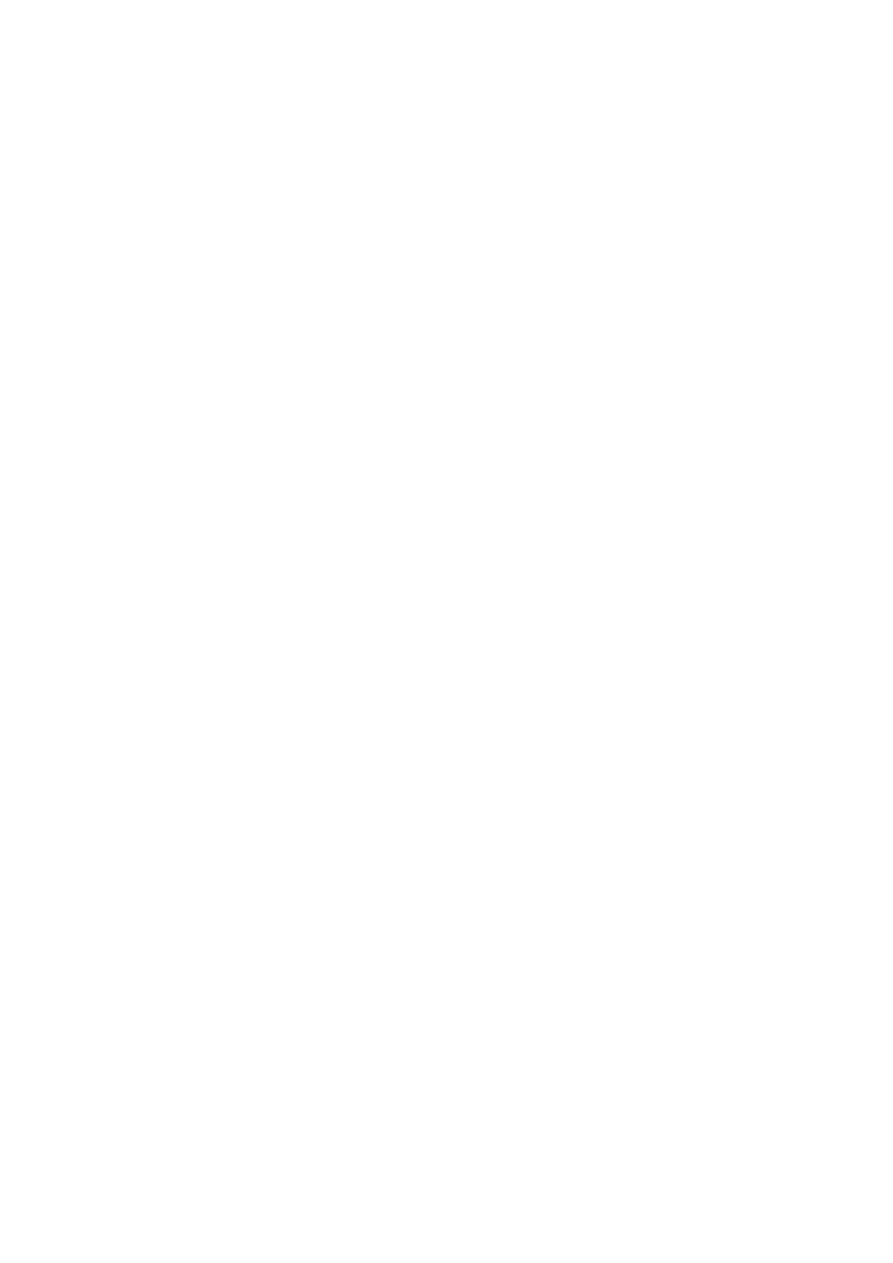

Kabel dalekosiężny................................................................................................................................................100

Kabel stacji końcowej............................................................................................................................................101

Jednostki dostępu do stacji wieloterminalowej......................................................................................................101

Topologia....................................................................................................................................................................101

Przyłączanie stacji.......................................................................................................................................................102

Awarie ........................................................................................................................................................................103

Monitor aktywny ........................................................................................................................................................103

Wybór nowego monitora aktywnego ..........................................................................................................................103

Co dalej z Token Ringiem? ...................................................................................................................................................104

Przełączanie a dedykowane sieci Token Ring ............................................................................................................104

Zwiększanie szybkości transmisji ...............................................................................................................................104

Będzie działać?......................................................................................................................................................105

Podsumowanie ......................................................................................................................................................................105

Zalety Token Ringu...............................................................................................................................................................105

Ograniczenia Token Ringu....................................................................................................................................................106

Rozdział 10 FDDI.......................................................................................................................................................................106

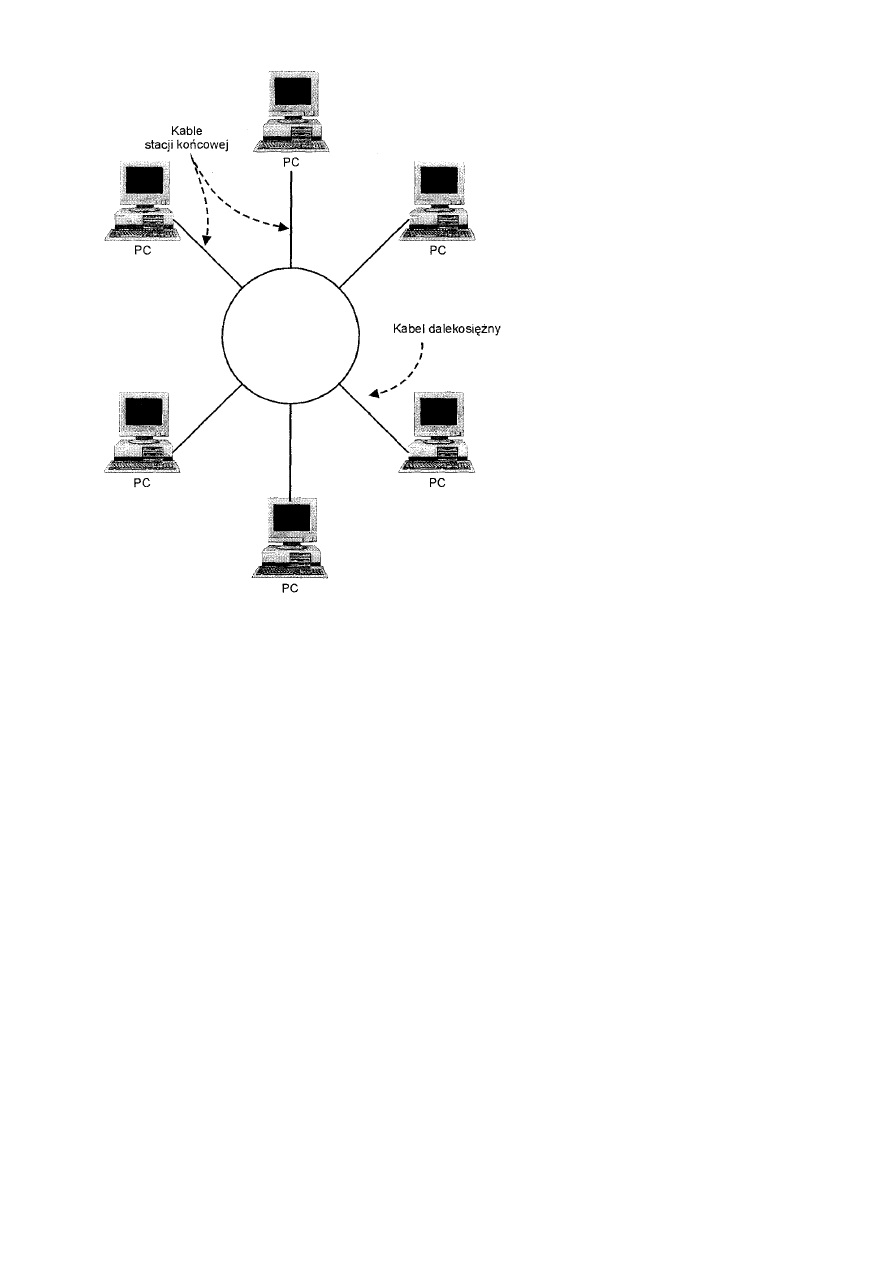

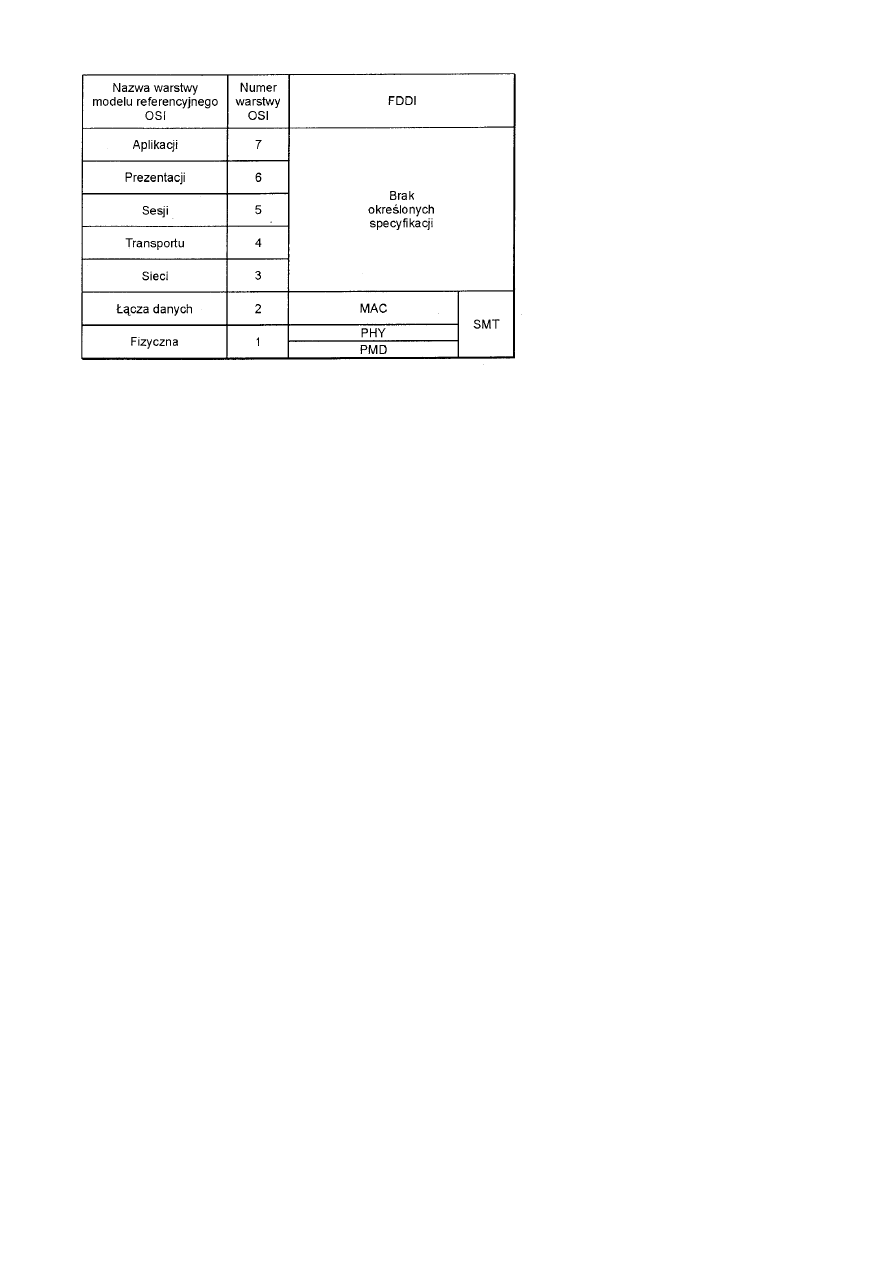

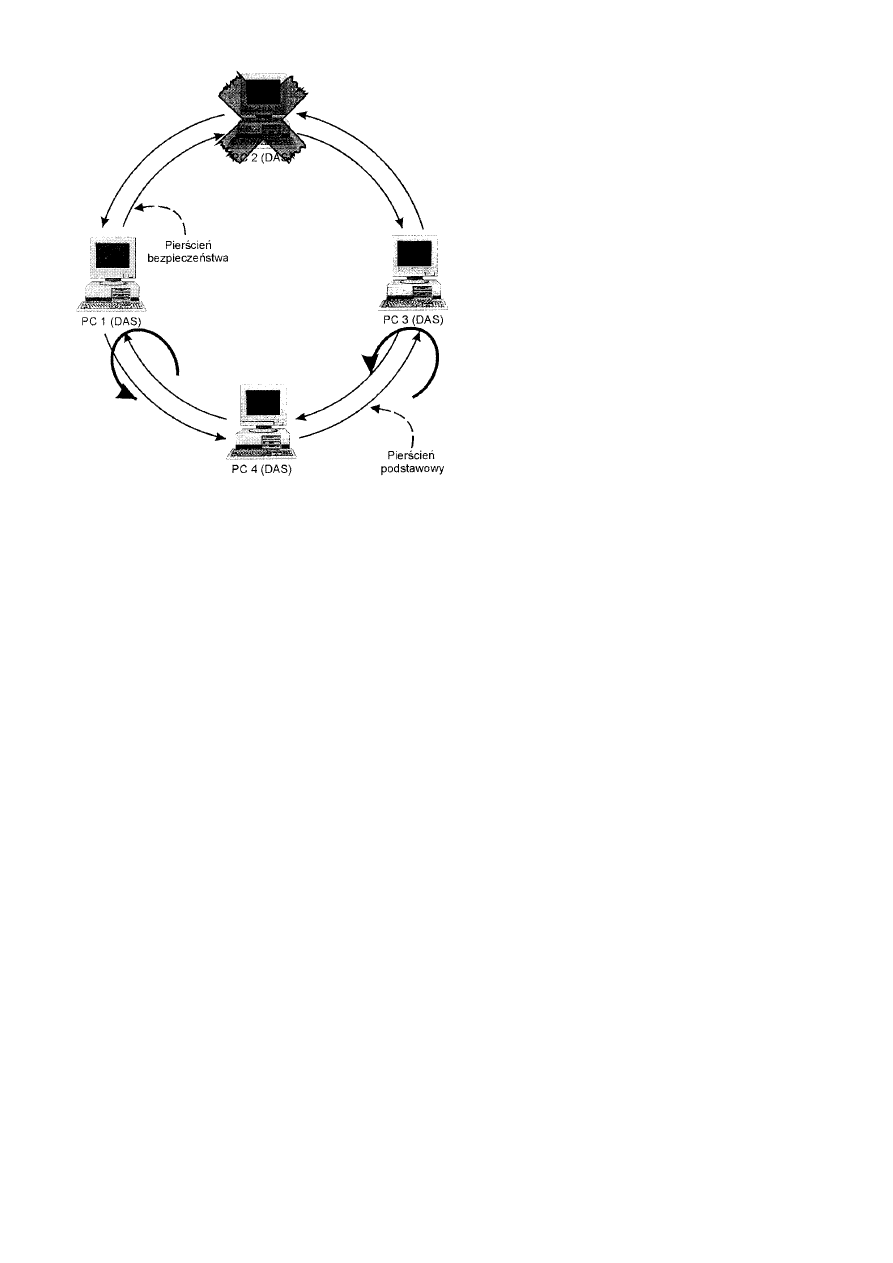

FDDI .....................................................................................................................................................................................106

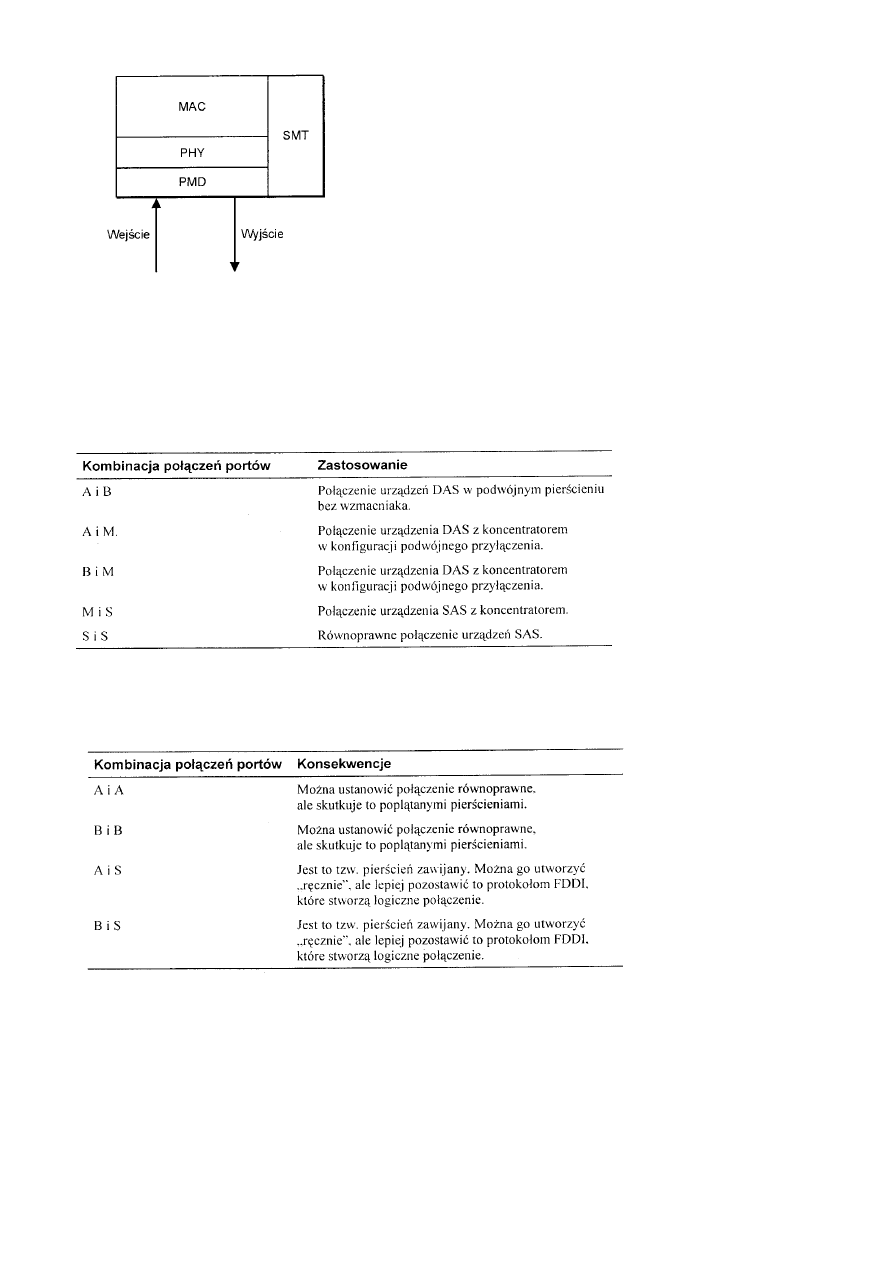

Składniki funkcjonalne ...............................................................................................................................................106

Protokół warstwy fizycznej ...................................................................................................................................106

Medium transmisyjne warstwy fizycznej ..............................................................................................................107

Zarządzanie stacją (SMT)......................................................................................................................................107

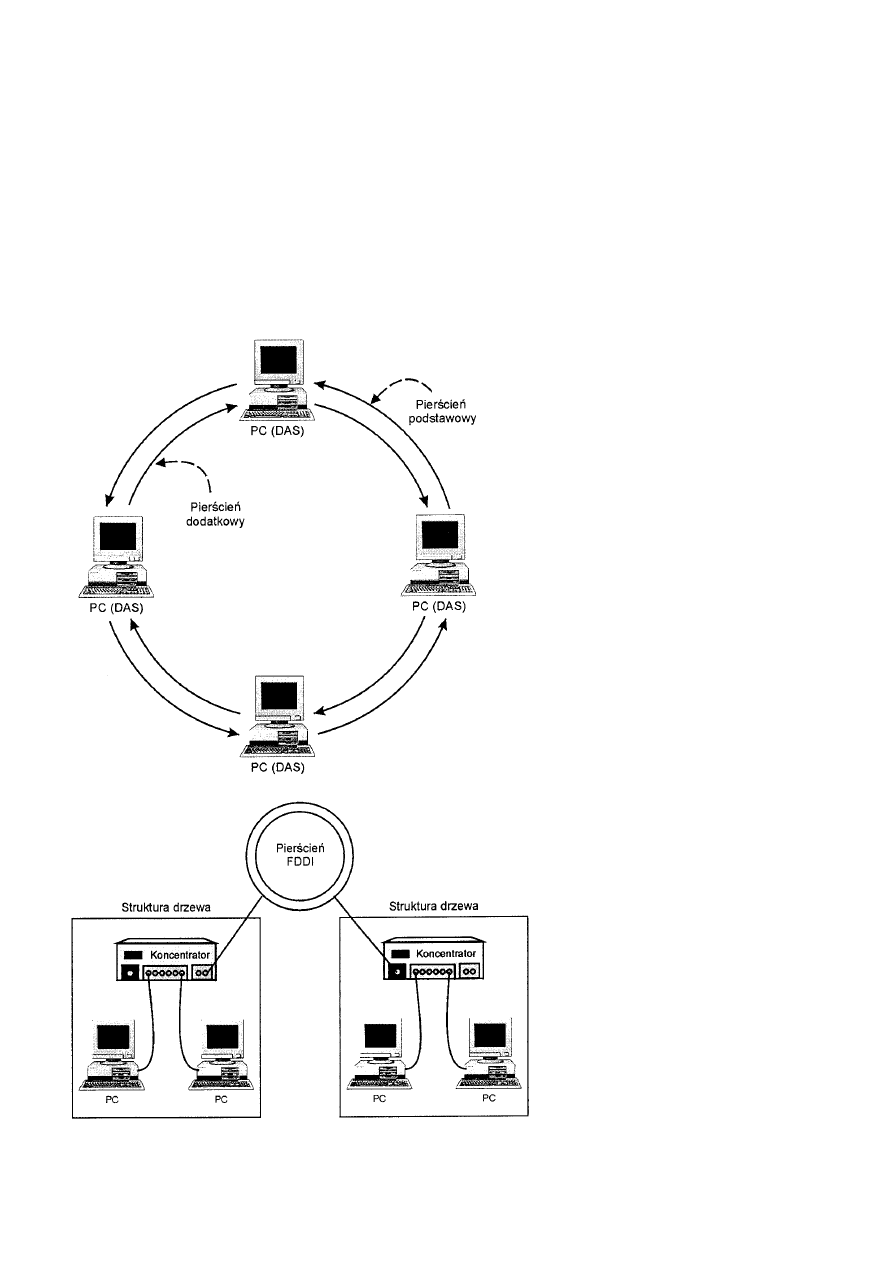

Tworzenie sieci FDDI ...........................................................................................................................................................107

Typy portów i metody przyłączania............................................................................................................................108

Stacje podwójnie przyłączane................................................................................................................................108

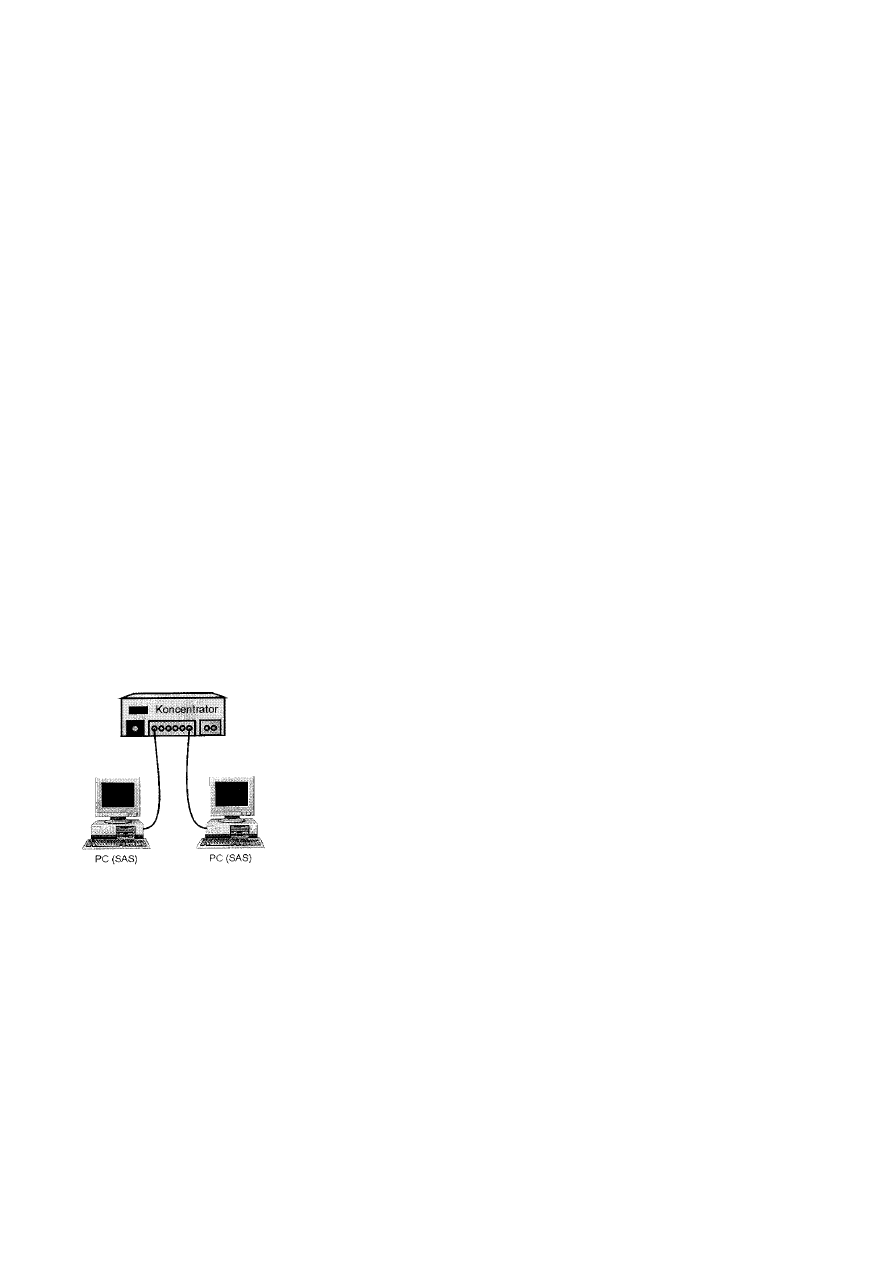

Stacje pojedynczo przyłączane ..............................................................................................................................108

Prawidłowe połączenia portów..............................................................................................................................109

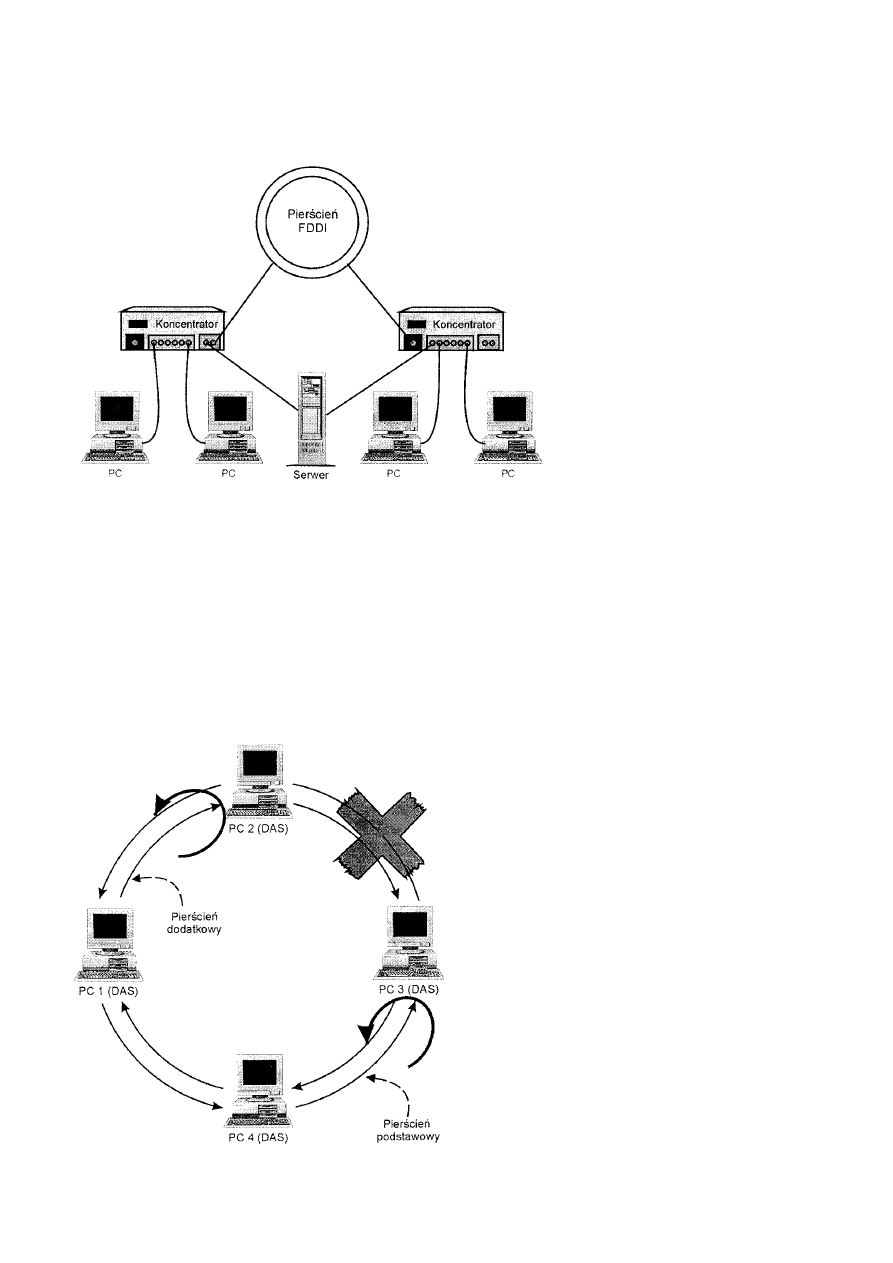

Topologie i implementacje .........................................................................................................................................109

Pojedyncze drzewo ................................................................................................................................................111

Podwójne kierowanie docelowe ............................................................................................................................111

Cykliczne zawijanie...............................................................................................................................................111

Rozmiar sieci.........................................................................................................................................................................113

Maksymalna liczba urządzeń ......................................................................................................................................113

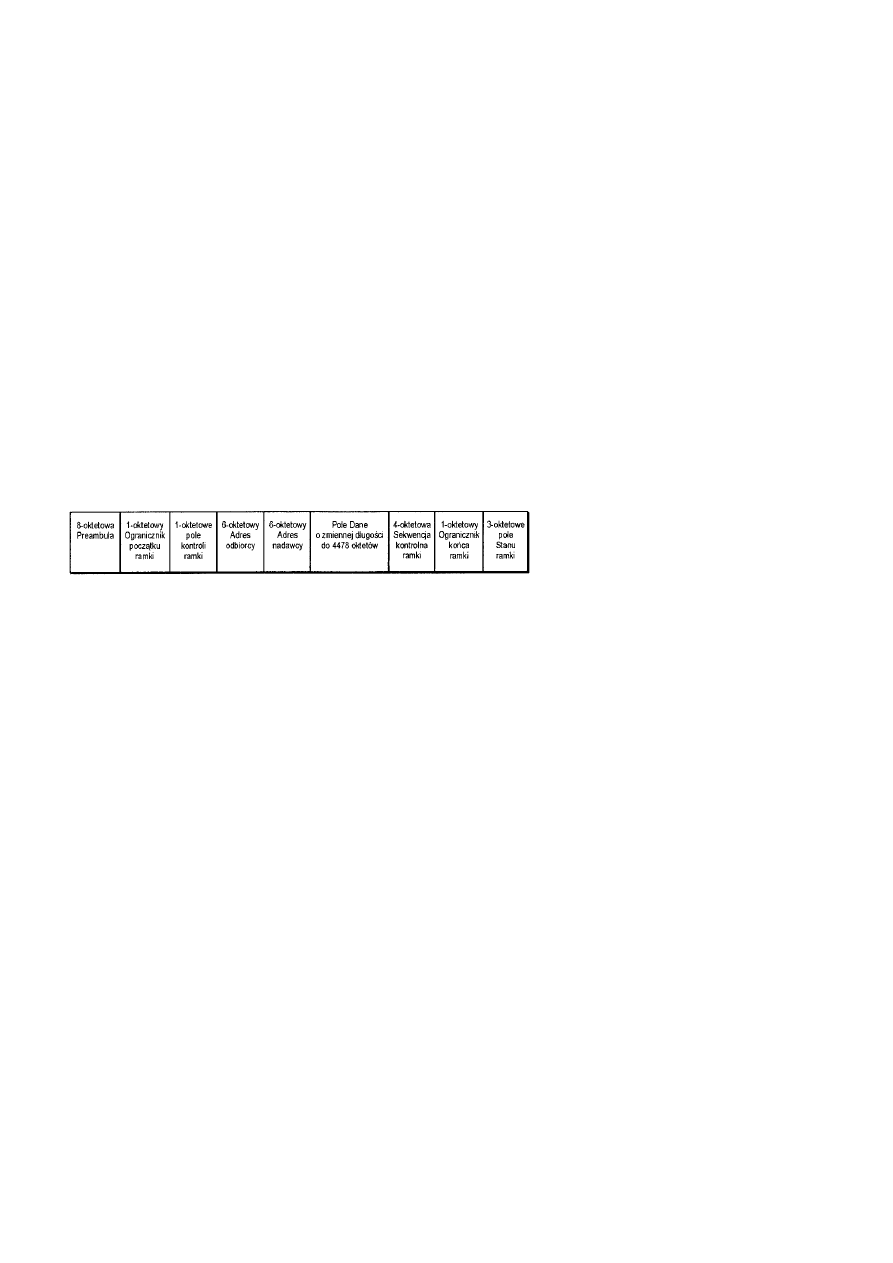

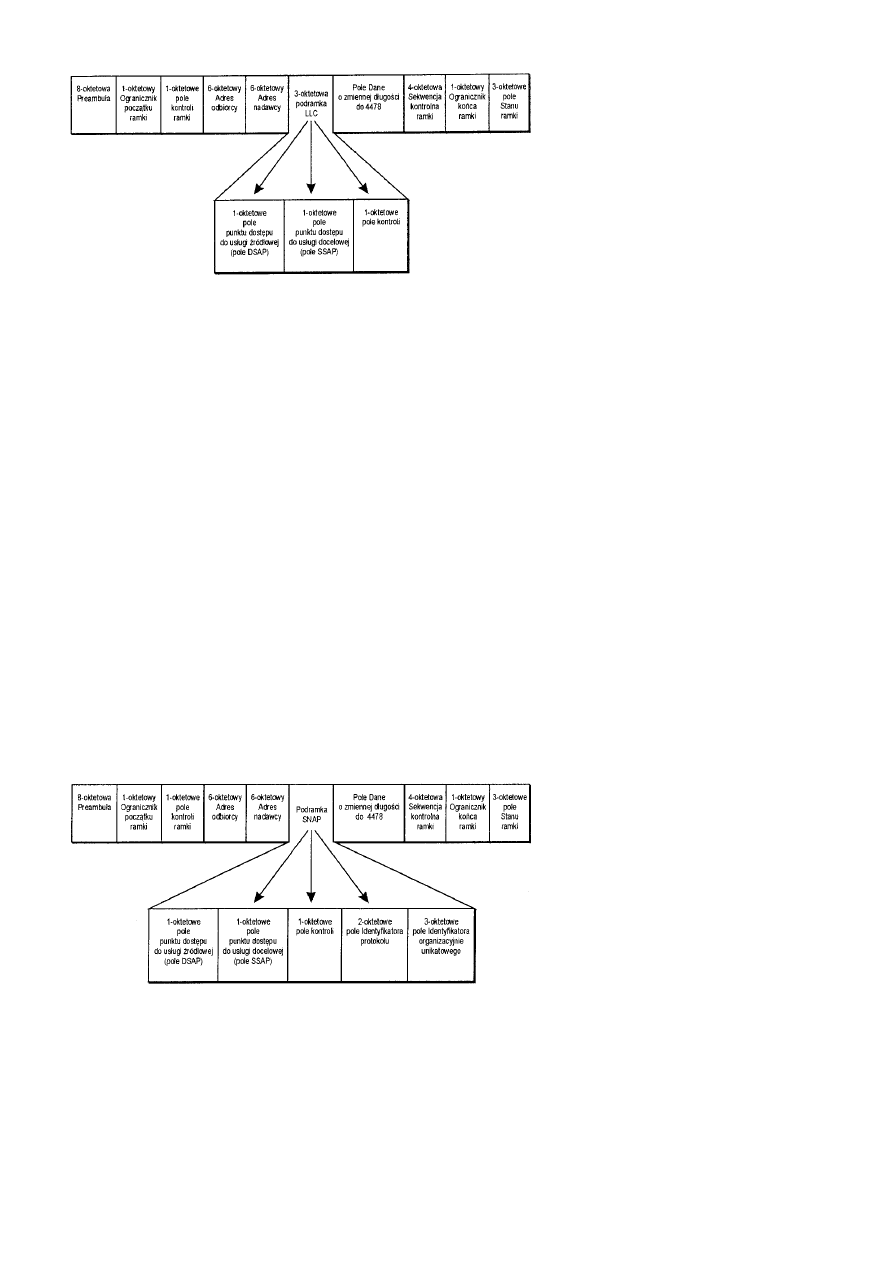

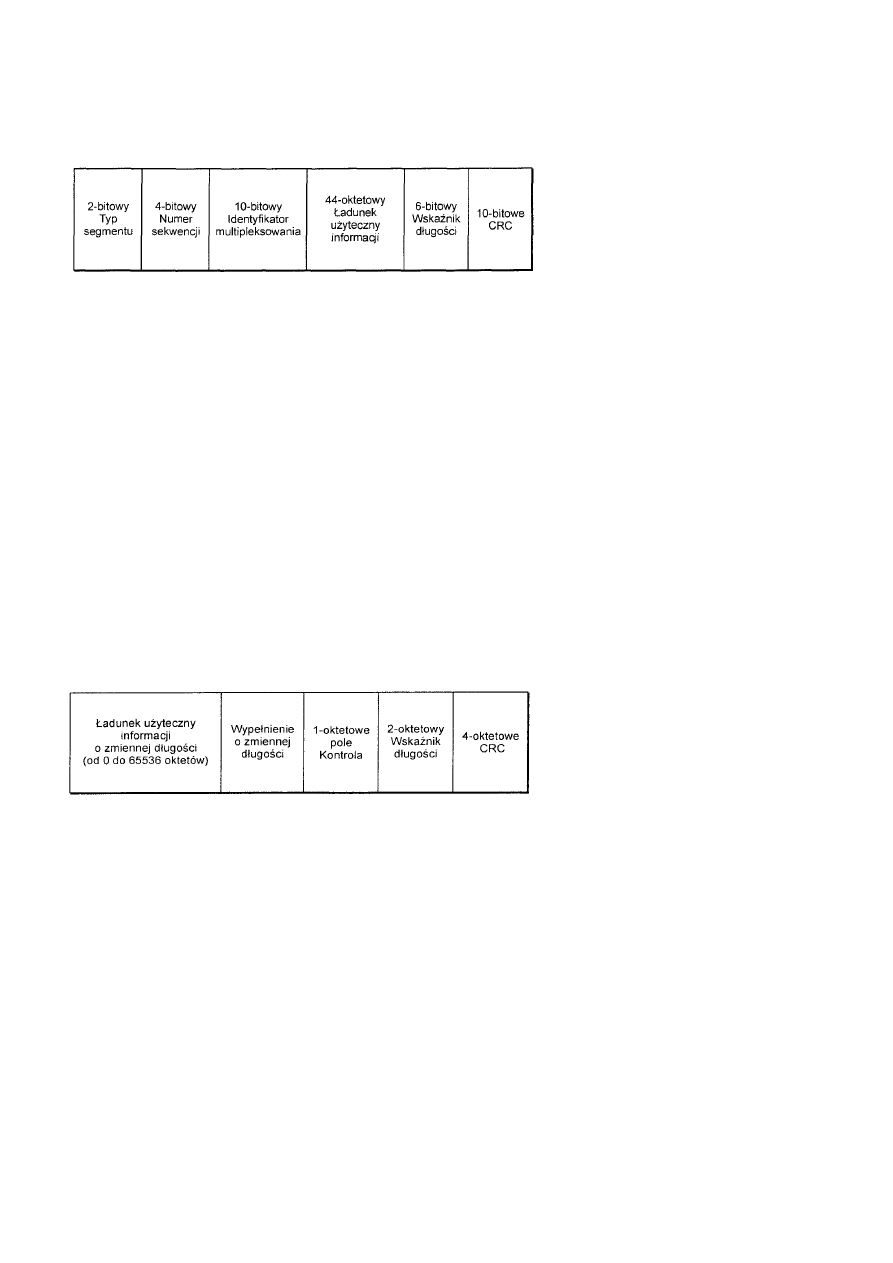

Ramki FDDI..........................................................................................................................................................................114

Ramka danych ............................................................................................................................................................114

Ramka danych LLC ....................................................................................................................................................114

Ramka danych LLC SNAP.........................................................................................................................................115

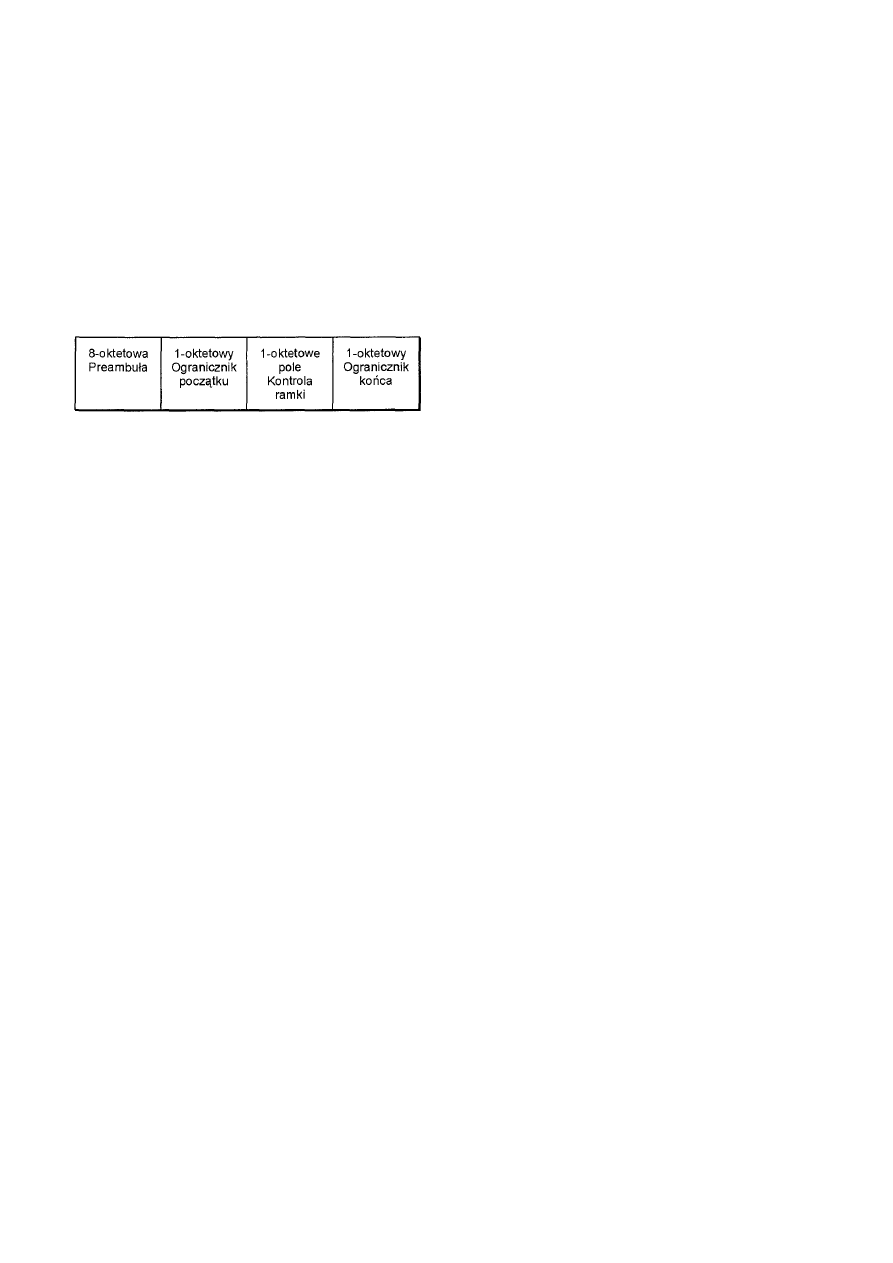

Ramka Token..............................................................................................................................................................116

Ramki SMT ................................................................................................................................................................116

Mechanika sieci FDDI...........................................................................................................................................................116

Inicjalizacja stacji .......................................................................................................................................................116

Inicjalizacja pierścienia...............................................................................................................................................117

Podsumowanie ......................................................................................................................................................................117

Rozdział 11.ATM .......................................................................................................................................................................117

Podstawy sieci ATM .............................................................................................................................................................118

Połączenia wirtualne..............................................................................................................................................................118

Typy połączeń .......................................................................................................................................................................118

Szybkości przesyłania danych...............................................................................................................................................119

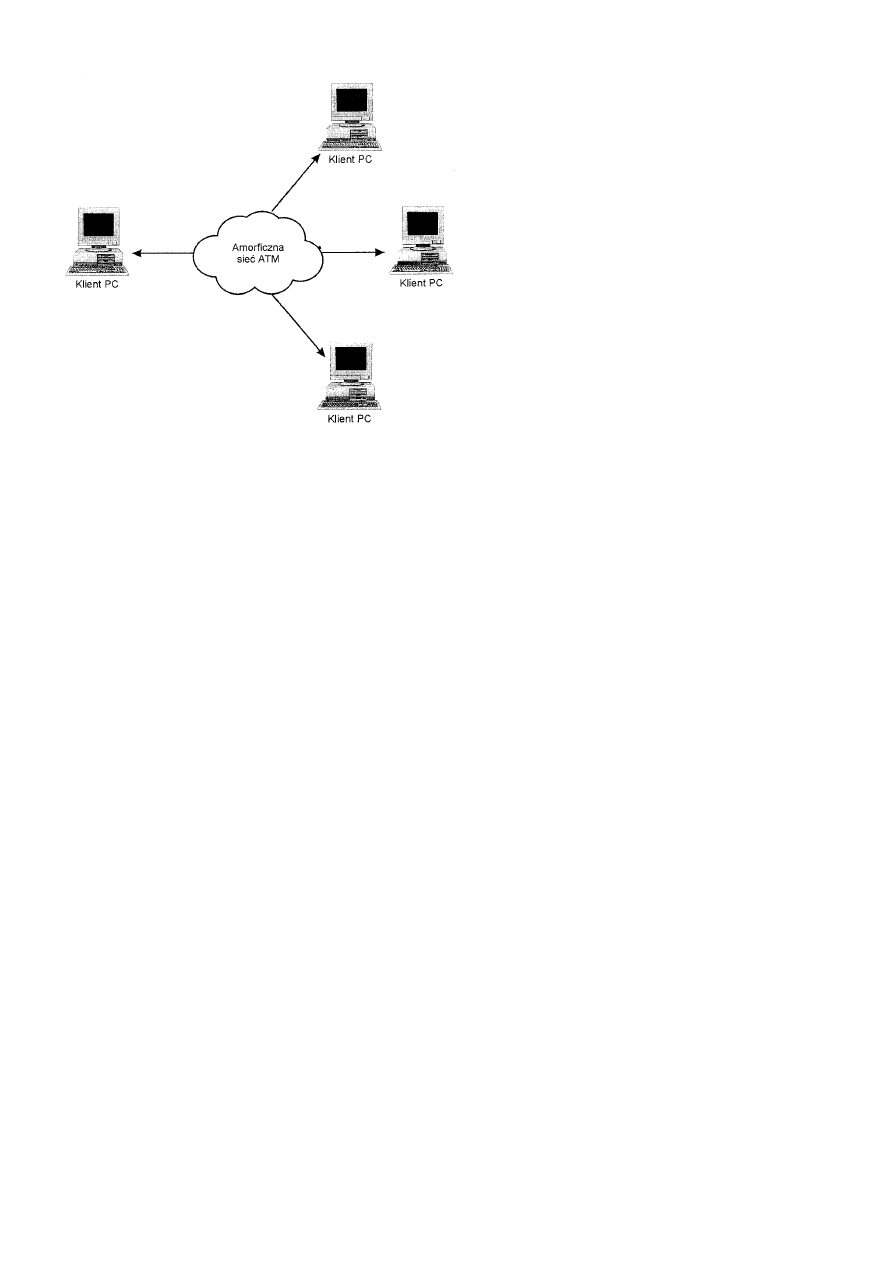

Topologia ..............................................................................................................................................................................119

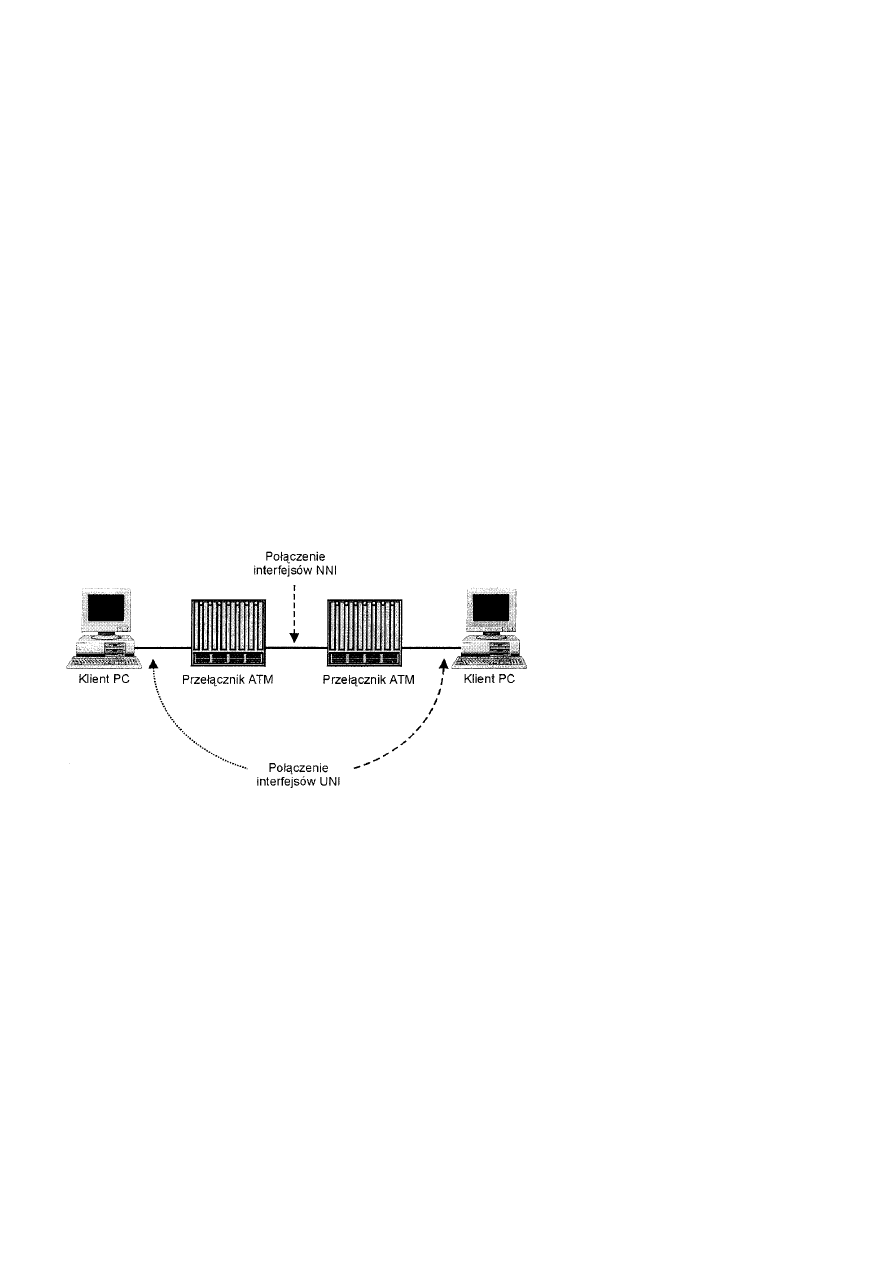

Interfejsy ATM......................................................................................................................................................................120

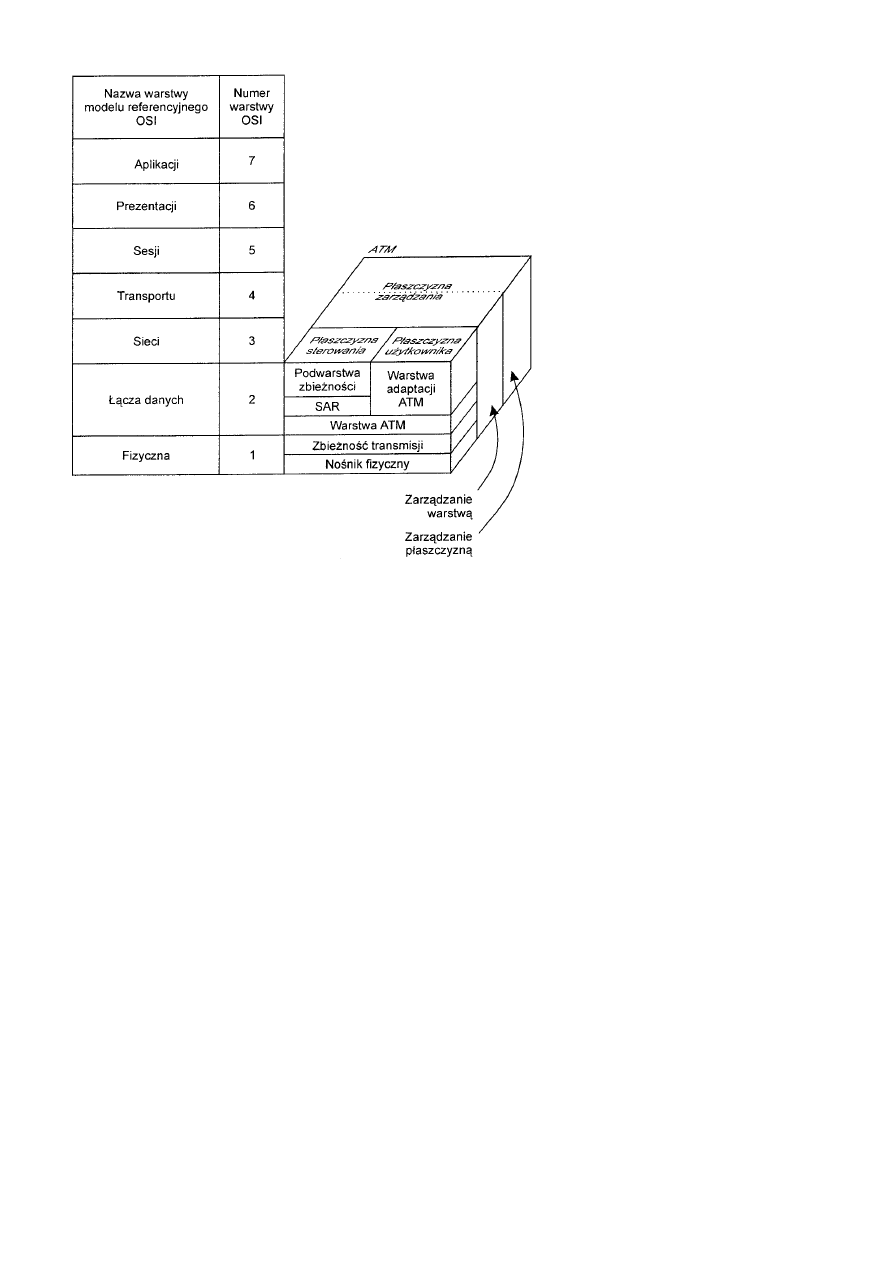

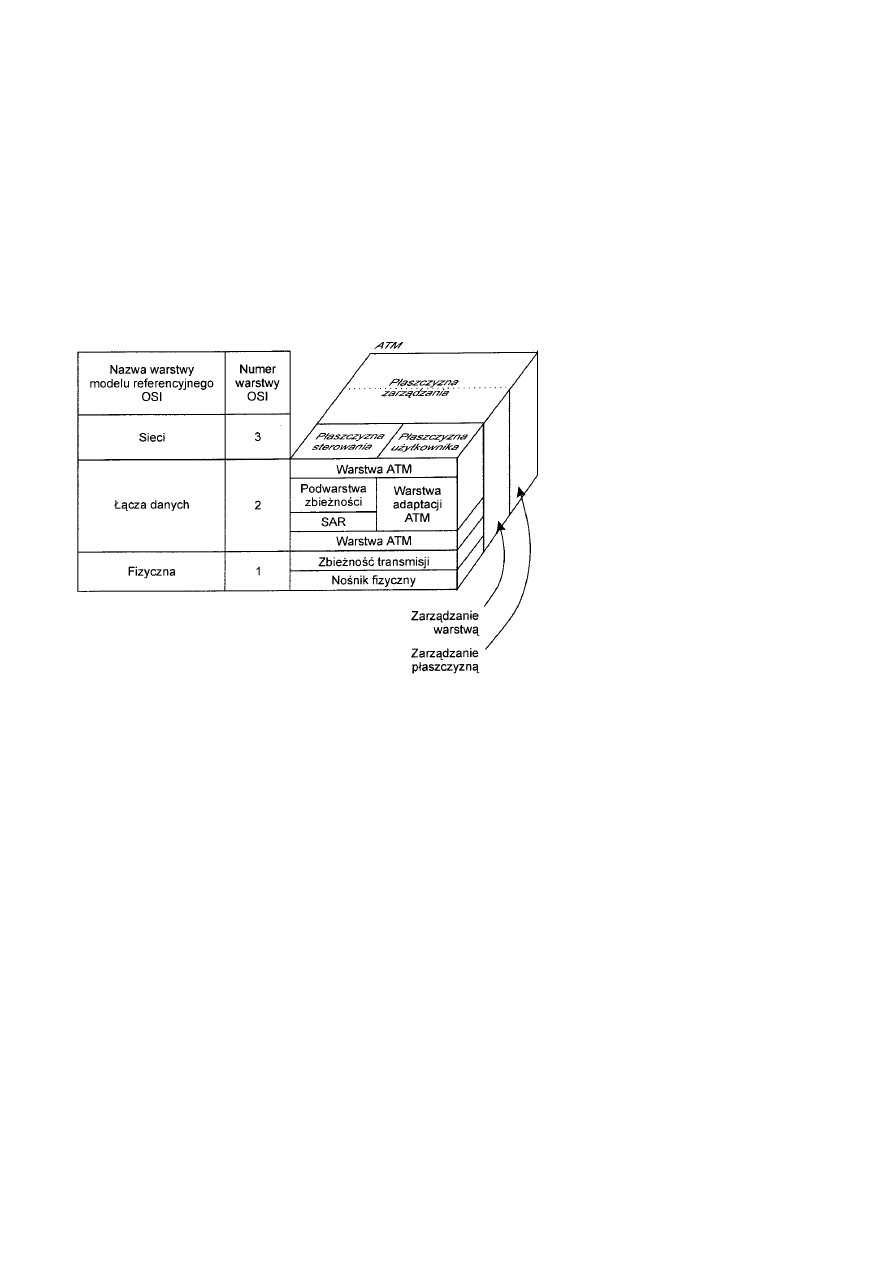

Model ATM ..........................................................................................................................................................................120

Warstwa fizyczna........................................................................................................................................................121

Warstwa adaptacji ATM .............................................................................................................................................122

Warstwa ATM.......................................................................................................................................................................124

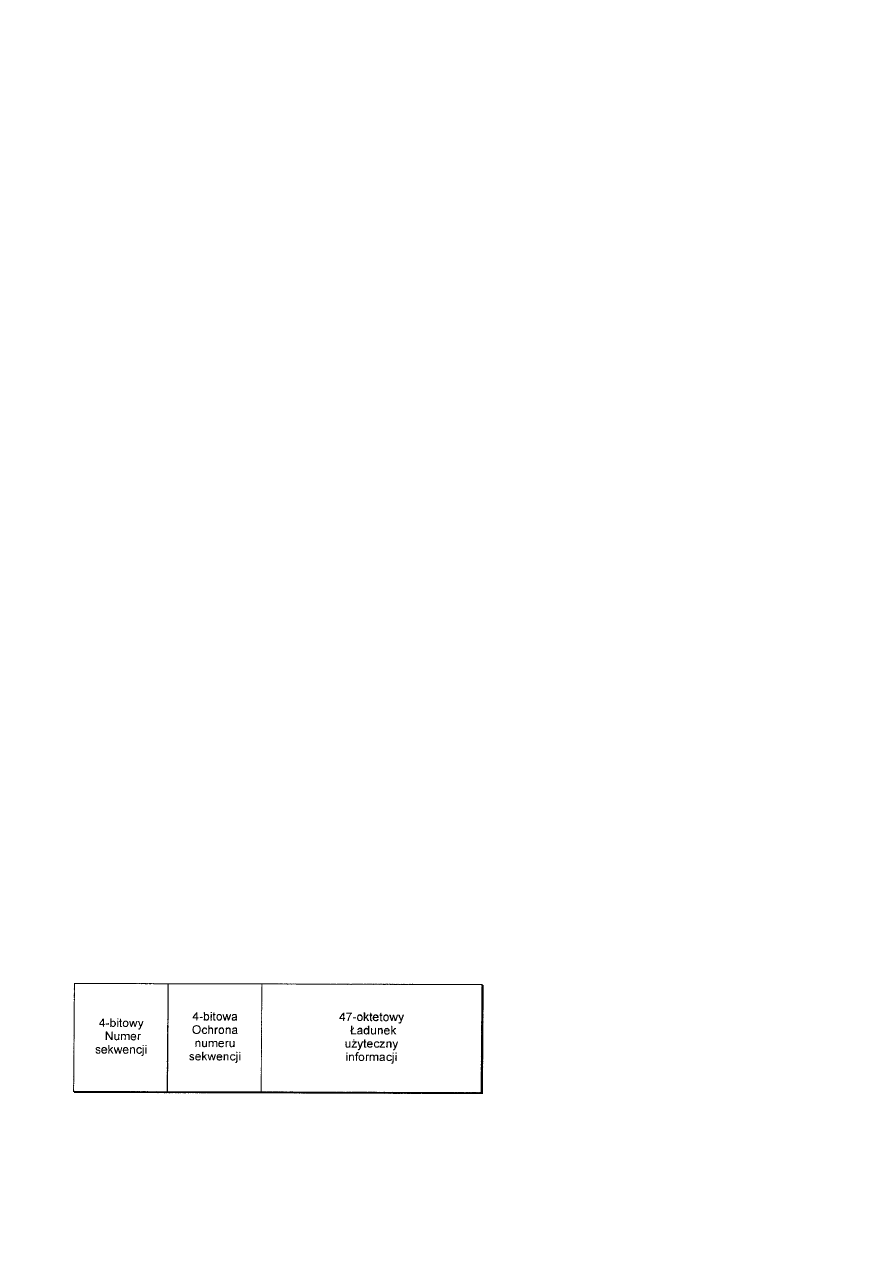

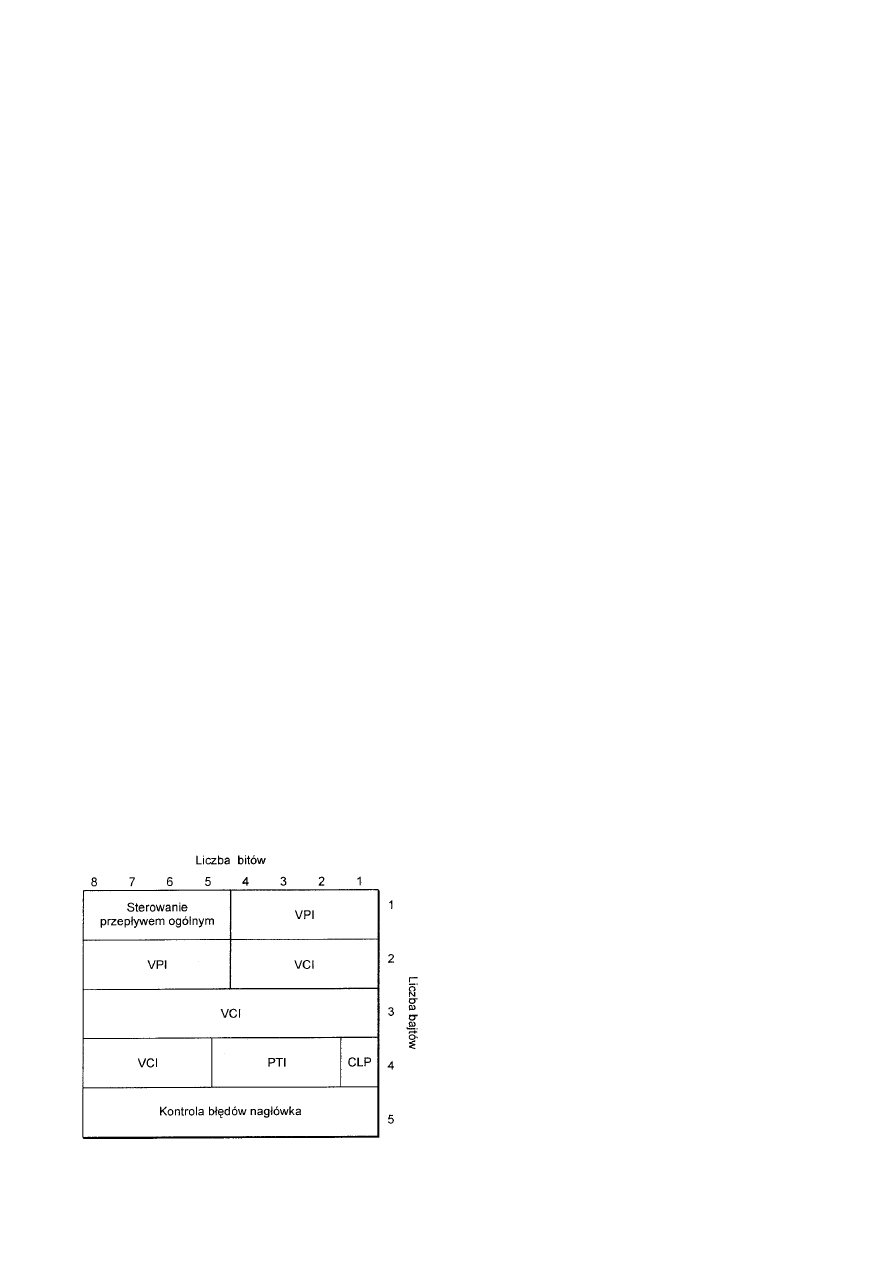

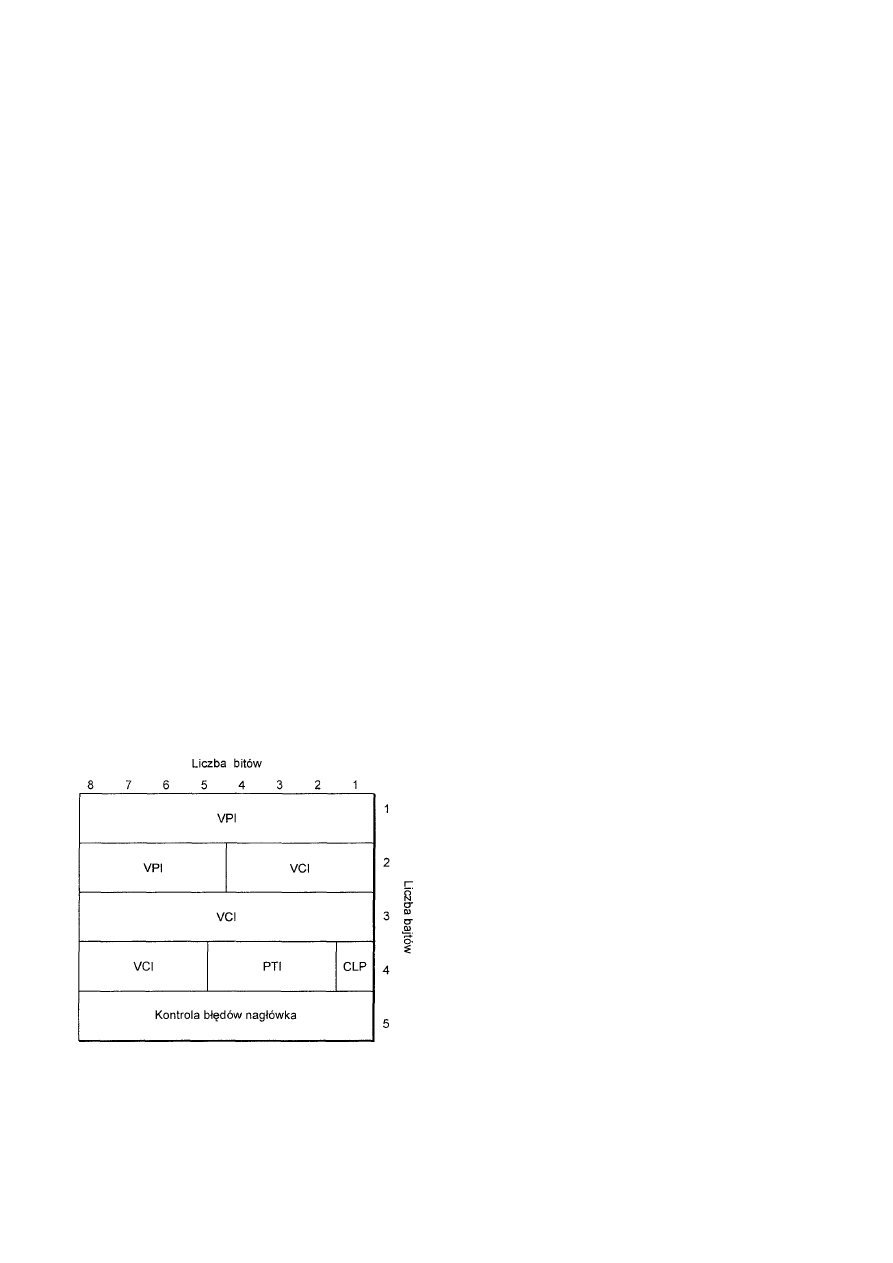

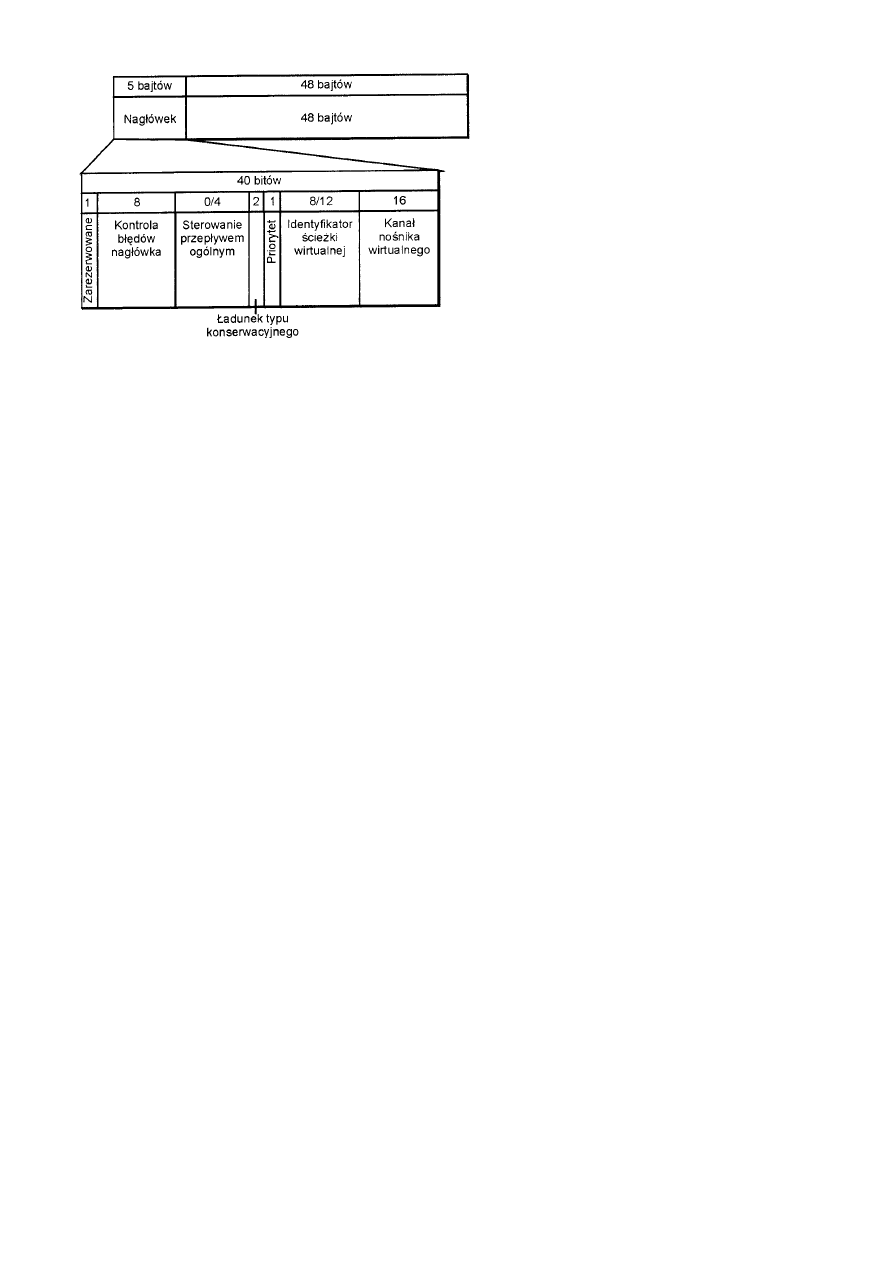

Komórka................................................................................................................................................................................125

Struktura komórki UNI ...............................................................................................................................................125

Struktura komórki NNI ...............................................................................................................................................126

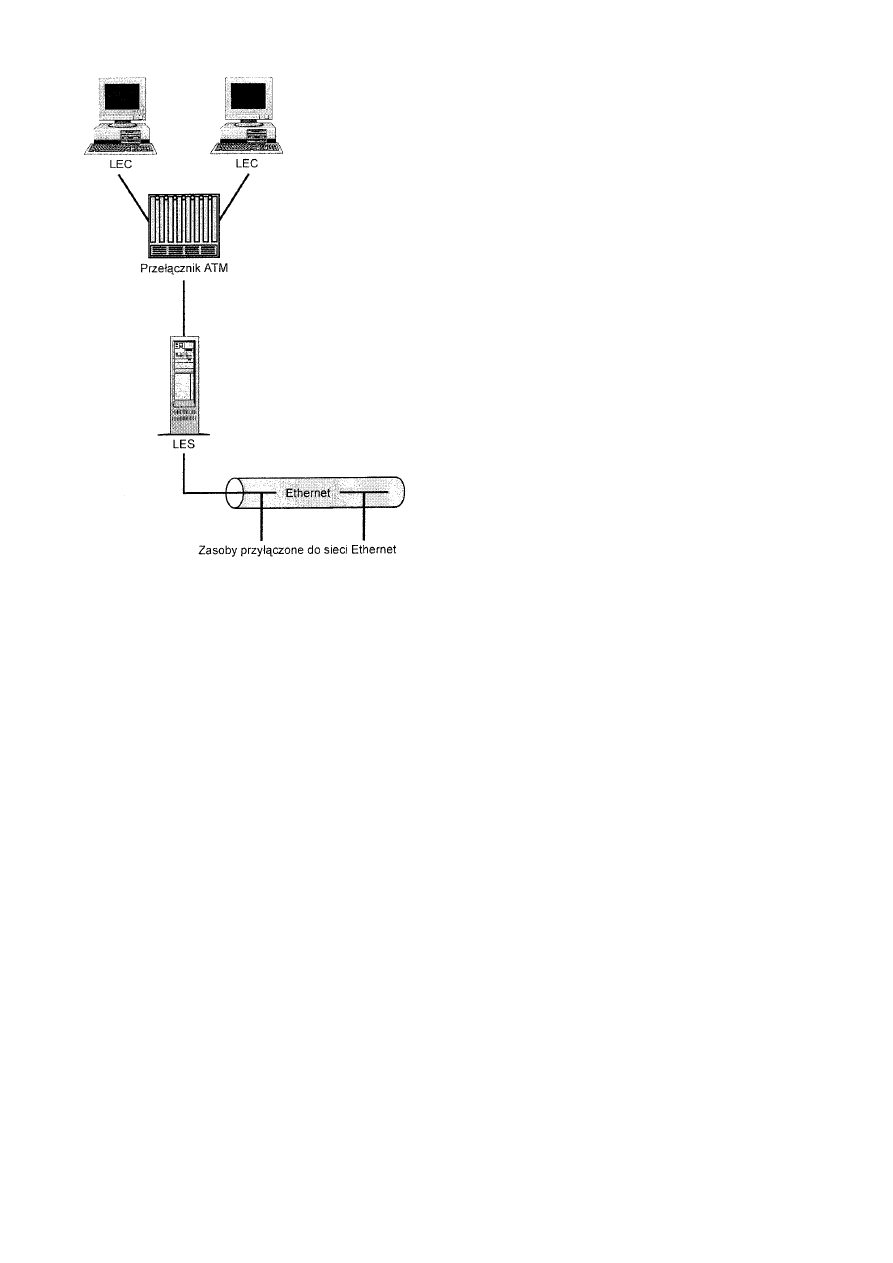

Emulacja sieci LAN .........................................................................................................................................................126

Podsumowanie .................................................................................................................................................................128

Rozdział 12 Protokoły sieciowe .................................................................................................................................................128

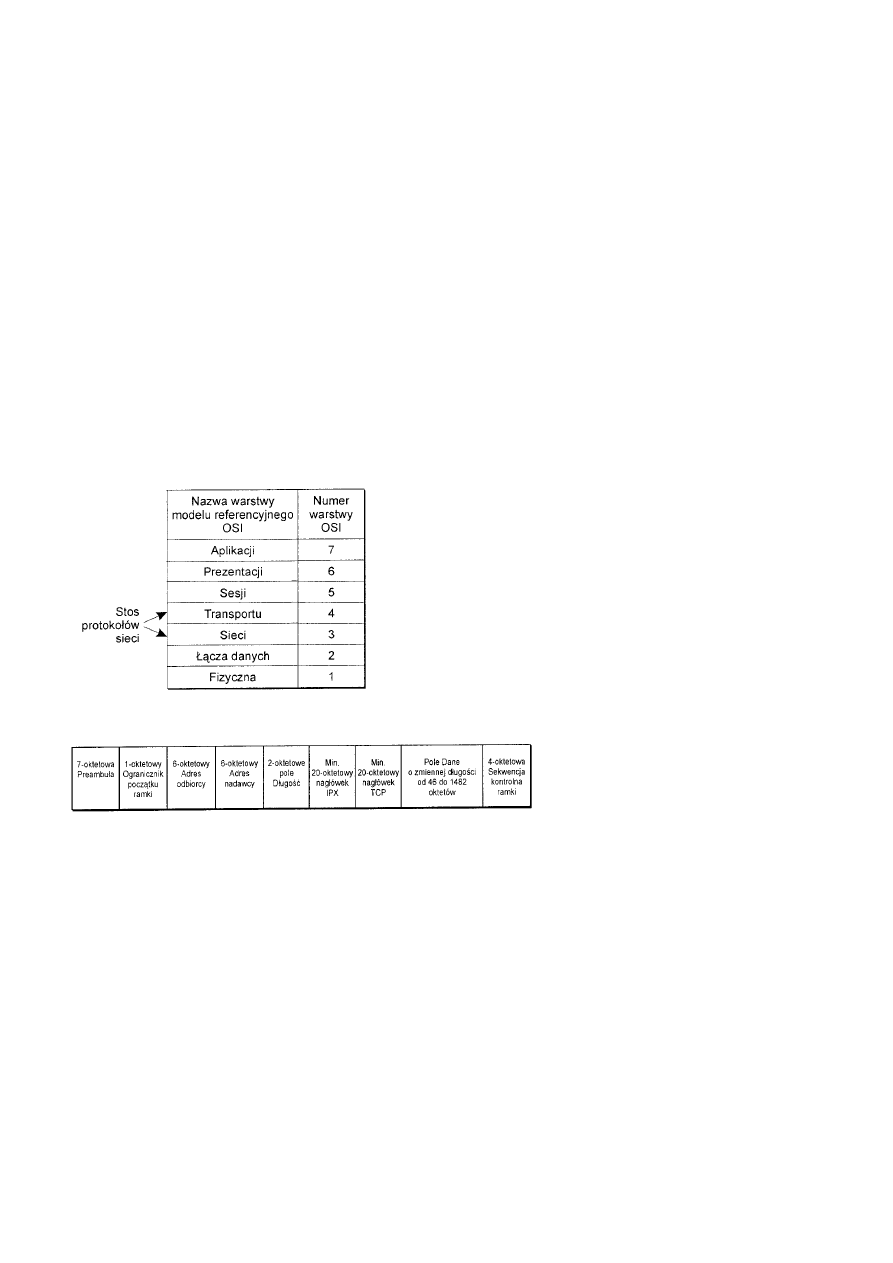

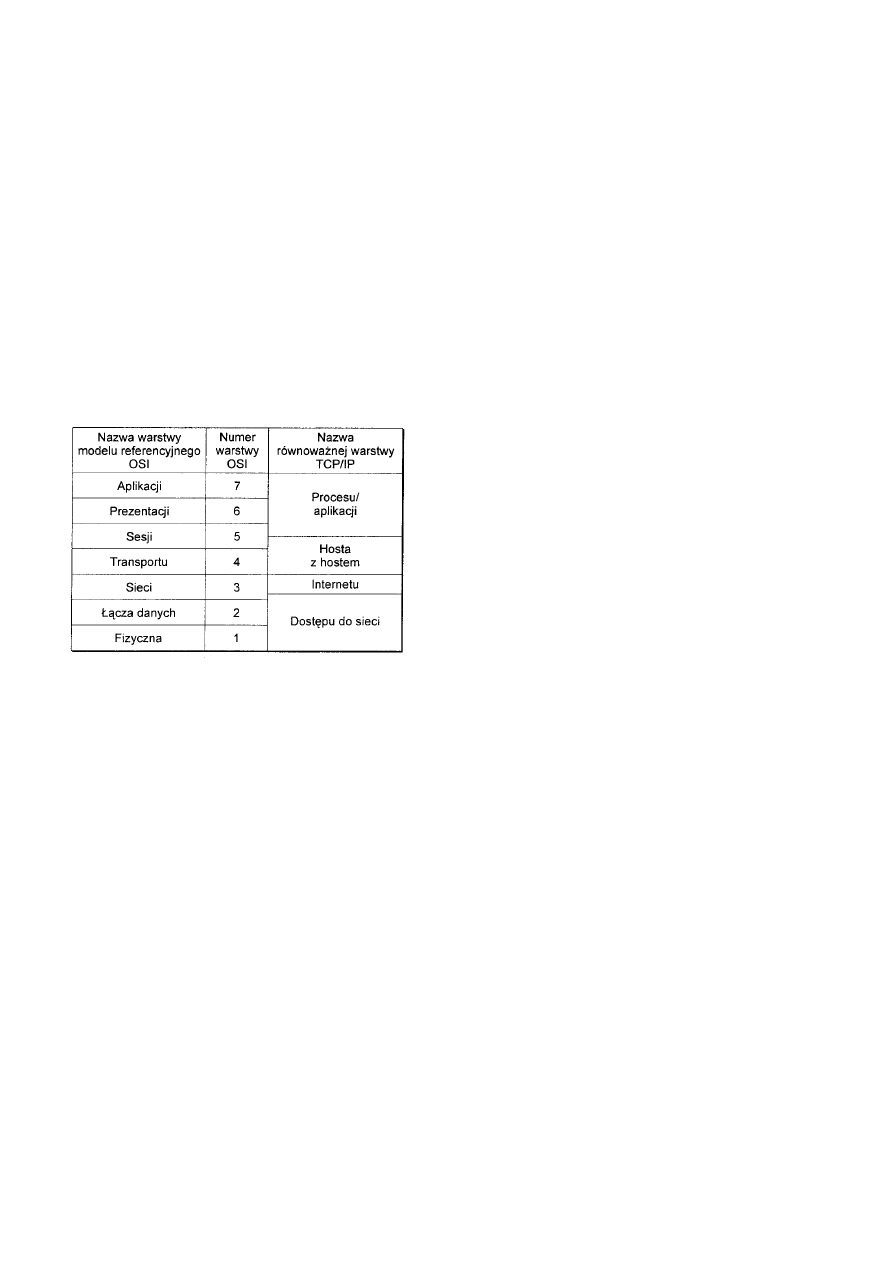

Stosy protokołów...................................................................................................................................................................128

Protokół Internetu, wersja 4 (Ipv4)........................................................................................................................................130

Analiza TCP/IP...........................................................................................................................................................130

Warstwa procesu/aplikacji ..........................................................................................................................................130

Typowe działanie protokołu IPv4 ...............................................................................................................................132

Schemat adresowania protokołu IP.............................................................................................................................132

Wnioski dotyczące IPv4 .............................................................................................................................................133

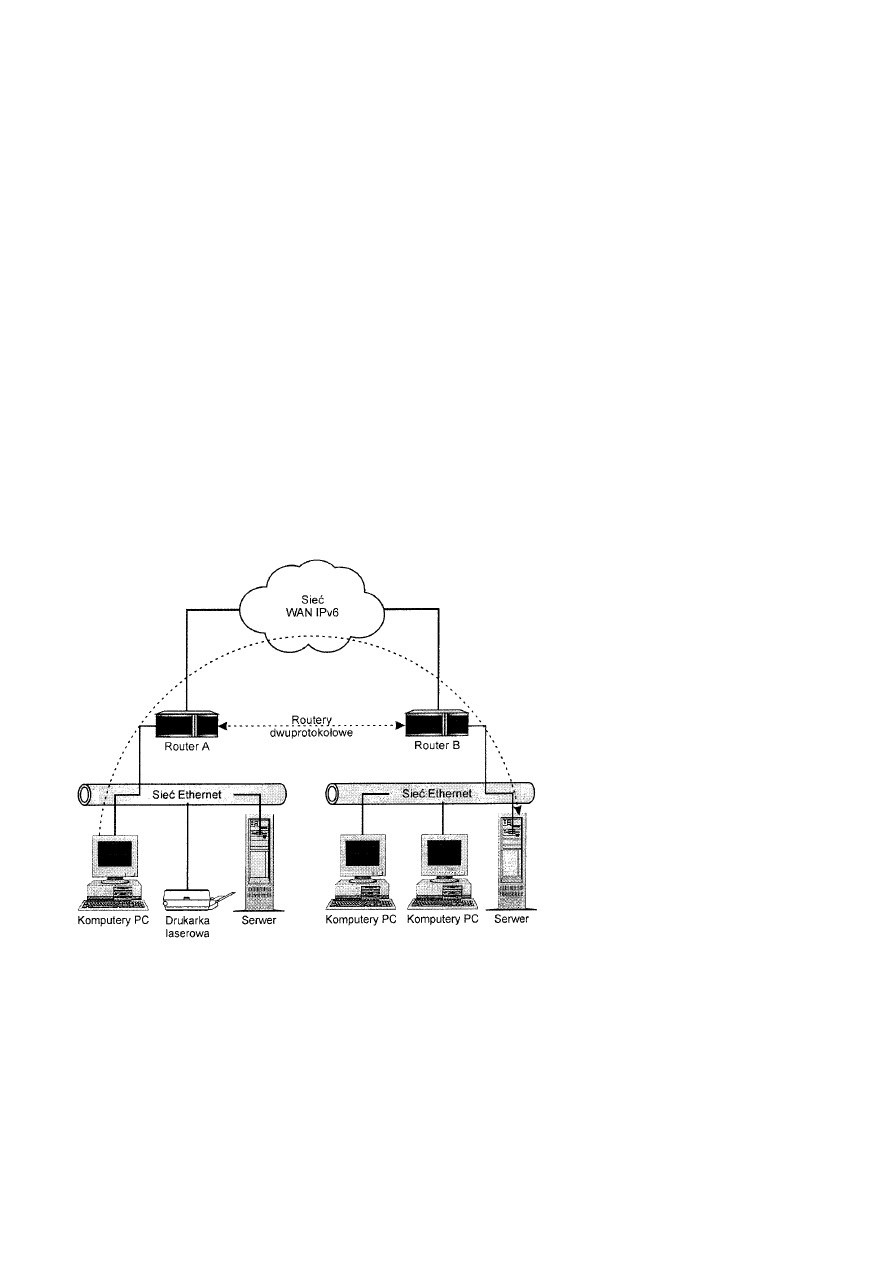

Protokół Internetu, wersja 6 (IPv6) .......................................................................................................................................133

Struktury adresów unicast IPv6 ..................................................................................................................................133

Adres dostawcy usług internetowych (ISP) ...........................................................................................................133

Adres użytku lokalnego dla miejsca ......................................................................................................................134

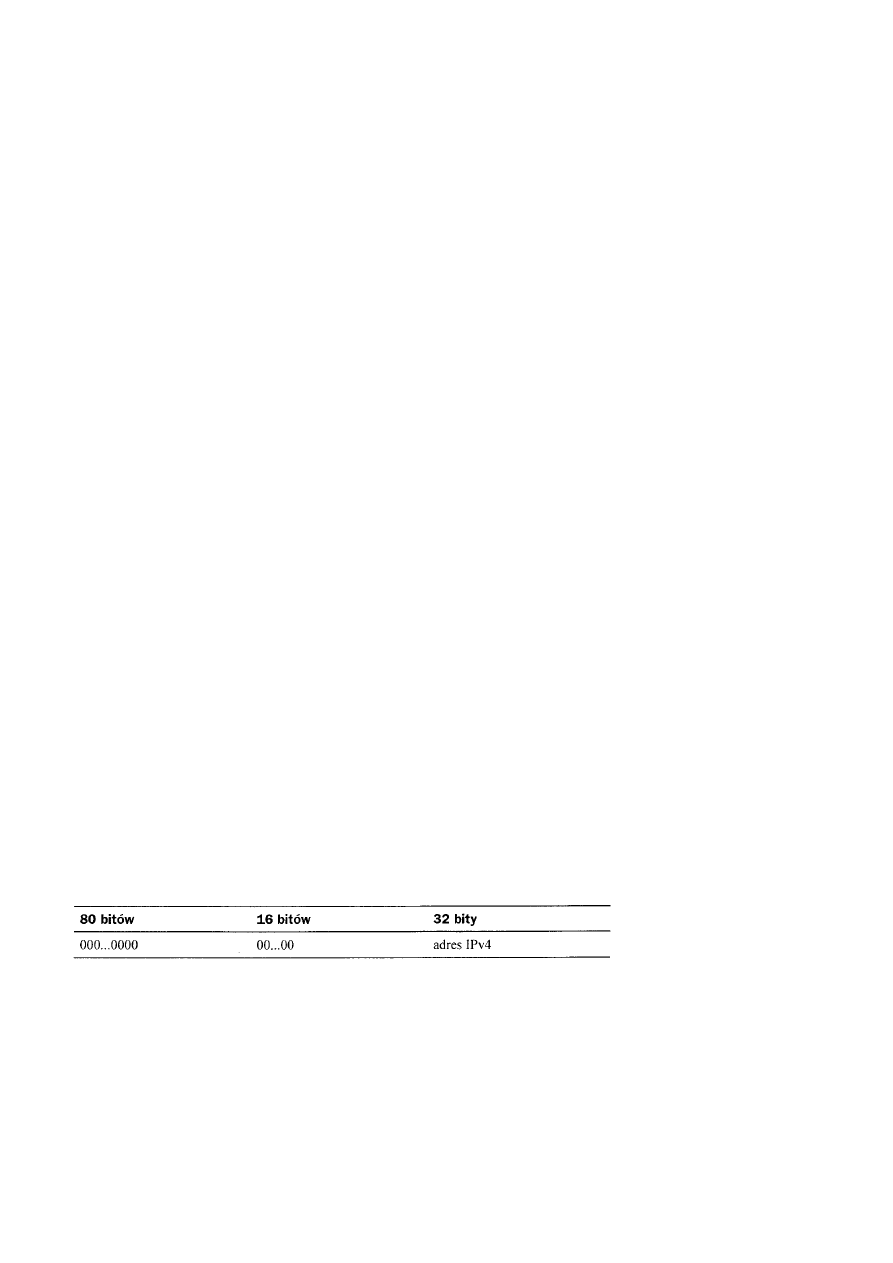

Adres unicast IPv6 zgodny z IPv4.........................................................................................................................134

Adres unicast IPv6 wzorowany na IPv4 ................................................................................................................134

Struktury adresów anycast IPv6 .................................................................................................................................135

Struktury adresów multicast IPv6 ...............................................................................................................................135

Wnioski dotyczące IPv6 .............................................................................................................................................135

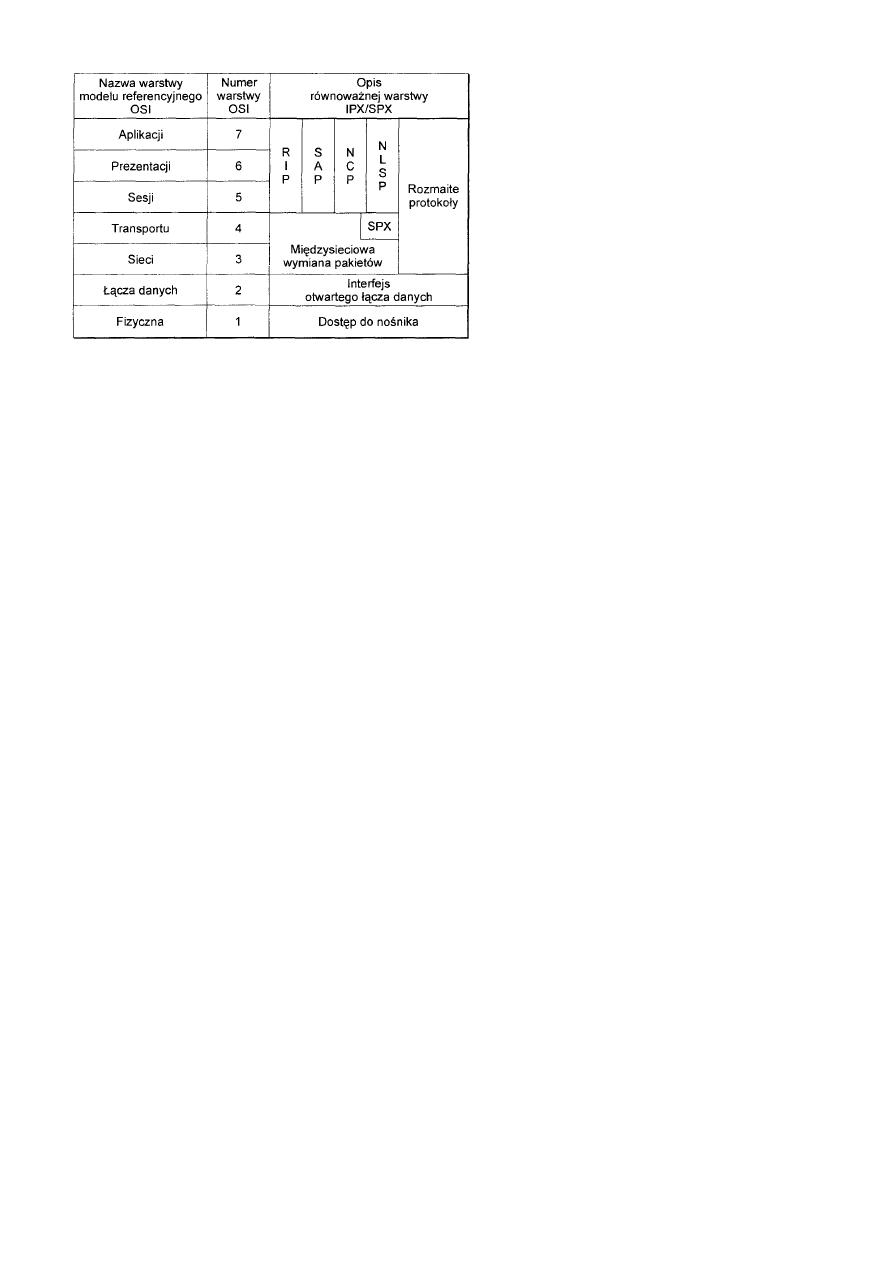

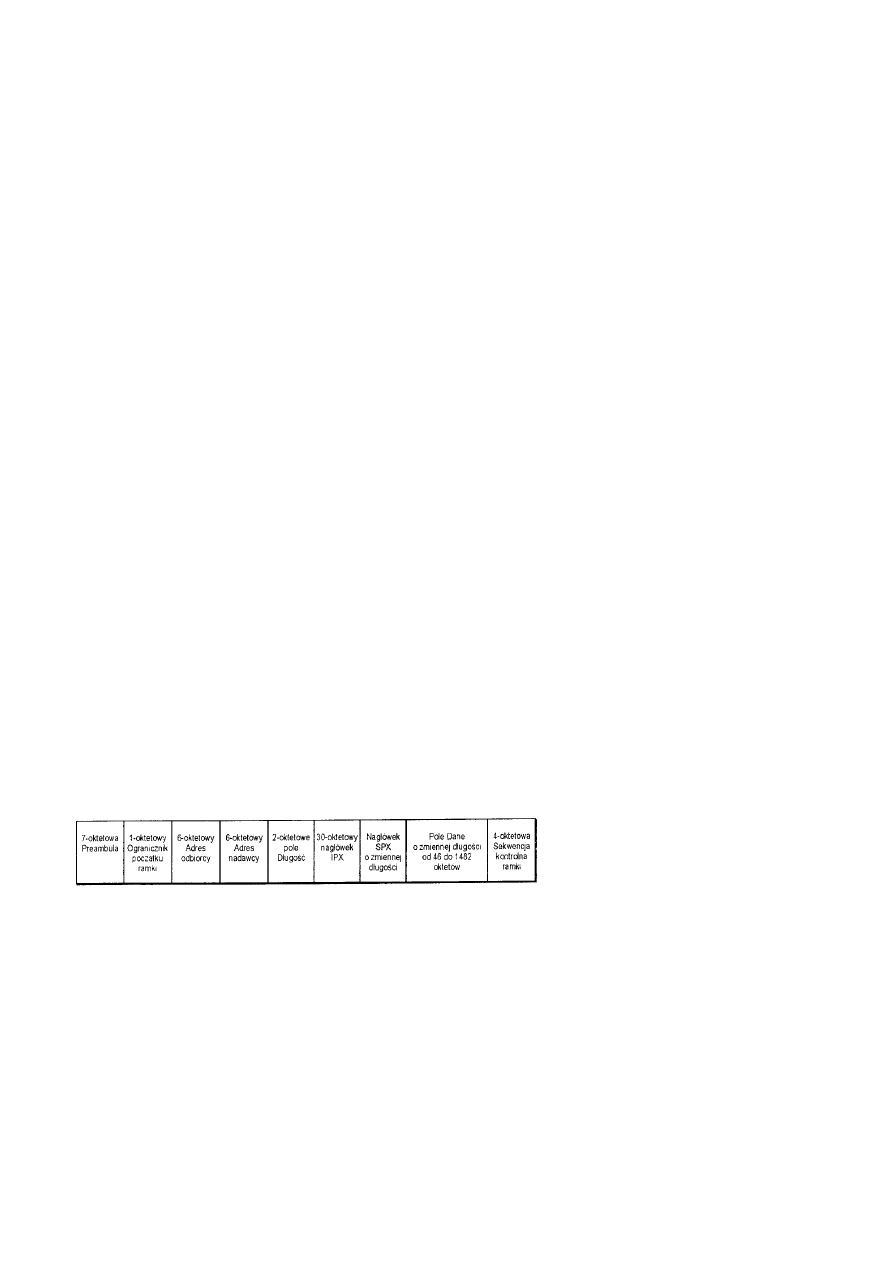

Wymiana IPX/SPX Novell....................................................................................................................................................135

Analiza IPX/SPX ........................................................................................................................................................135

Protokoły warstwy Internetu.......................................................................................................................................136

Adresowanie IPX........................................................................................................................................................137

Wnioski dotyczące IPX/SPX ......................................................................................................................................138

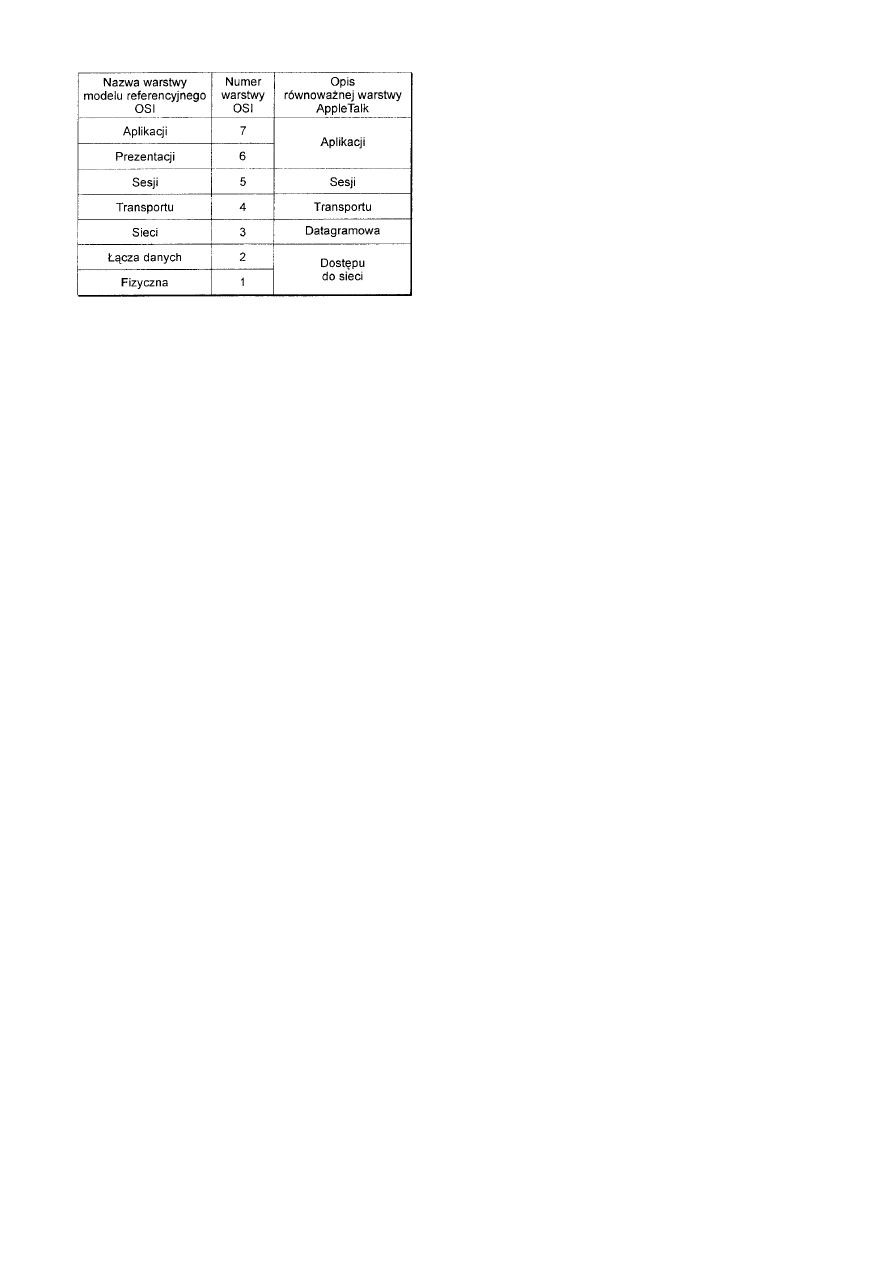

Pakiet protokołów AppleTalk firmy Apple ...........................................................................................................................138

Analiza AppleTalk......................................................................................................................................................138

Warstwa aplikacji sieci AppleTalk ........................................................................................................................138

Warstwa sesji sieci AppleTalk...............................................................................................................................139

Warstwa transportu sieci AppleTalk......................................................................................................................139

Warstwa datagramowa sieci AppleTalk ................................................................................................................140

Warstwa łącza danych sieci AppleTalk .................................................................................................................140

Schemat adresowania sieci AppleTalk........................................................................................................................140

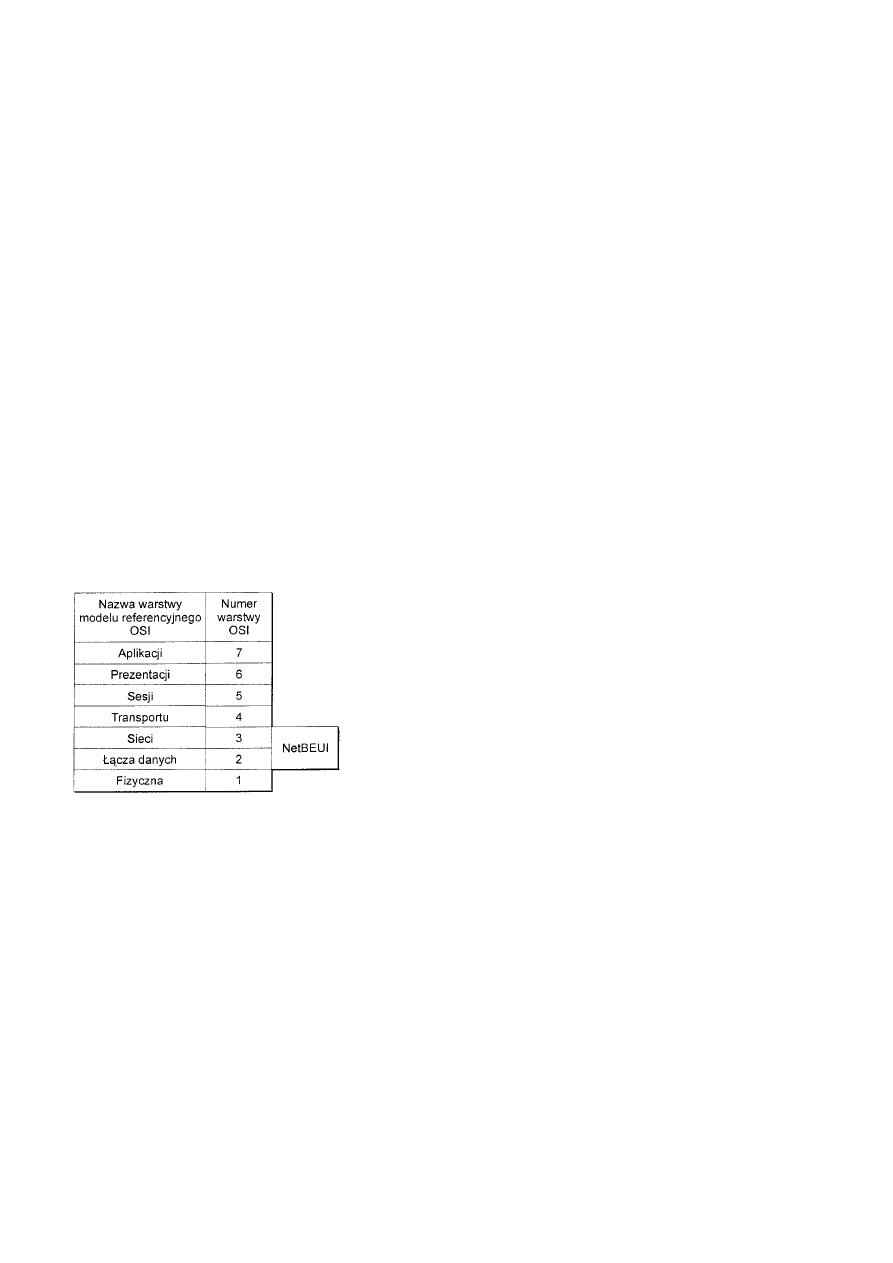

NetBEUI................................................................................................................................................................................141

Wnioski dotyczące NetBEUI ......................................................................................................................................141

Podsumowanie ......................................................................................................................................................................142

Rozdział 13 Sieci WAN..............................................................................................................................................................142

Funkcjonowanie technologii WAN .......................................................................................................................................142

Korzystanie z urządzeń transmisji ..............................................................................................................................142

Urządzenia komutowania obwodów ...........................................................................................................................142

Cyfrowa sieć usług zintegrowanych (ISDN)...............................................................................................................143

Urządzenia komutowania pakietów ............................................................................................................................143

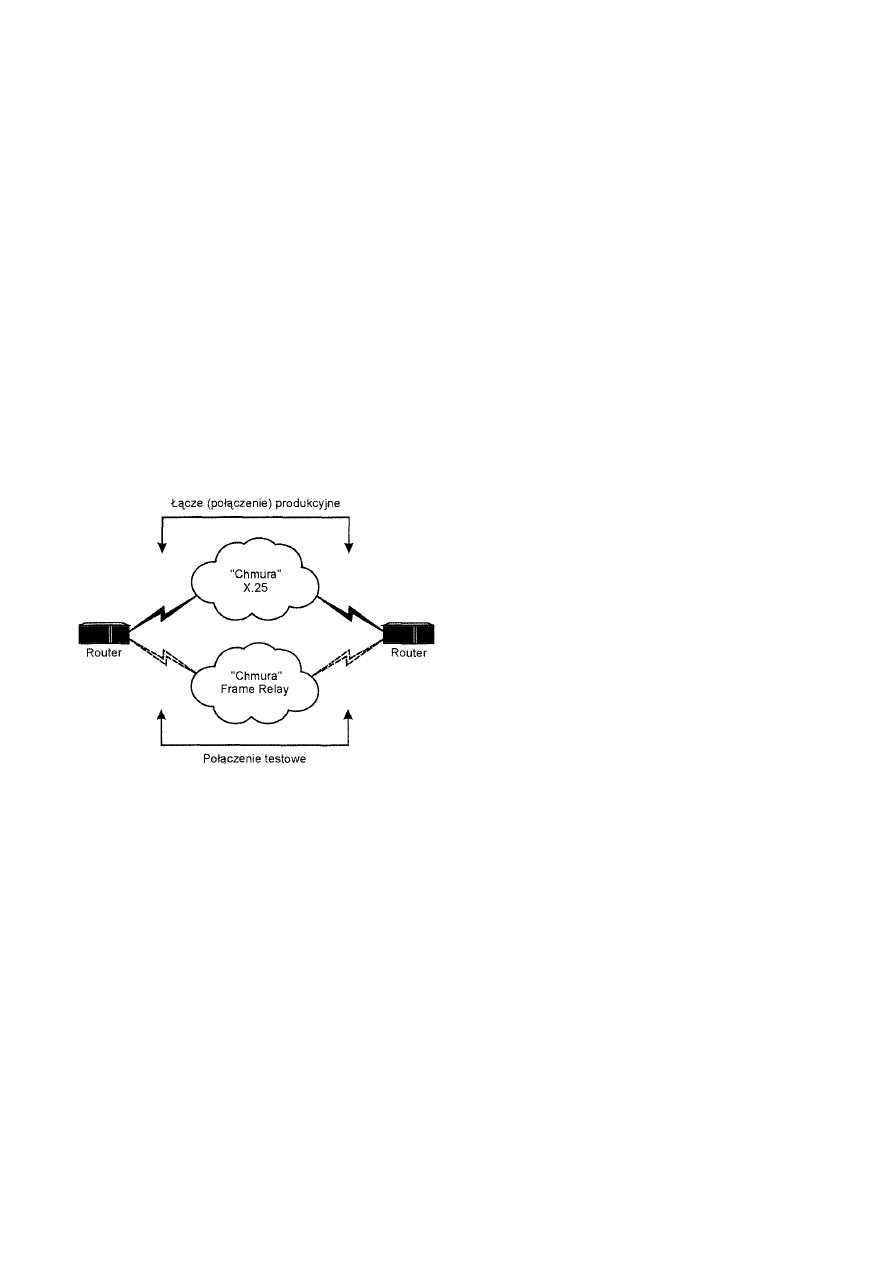

X.25 .......................................................................................................................................................................144

Frame Relay ..........................................................................................................................................................144

Urządzenia komutowania komórek.............................................................................................................................145

Tryb transferu asynchronicznego (ATM) ...................................................................................................................145

Wybór sprzętu komunikacyjnego ...............................................................................................................................146

Sprzęt własny klienta (CPE) .......................................................................................................................................146

Interfejs zestawiania i dekompozycji pakietów (PAD)..........................................................................................146

Adresowanie międzysieciowe ...............................................................................................................................................147

Zapewnianie adresowania unikatowego......................................................................................................................147

Tunele....................................................................................................................................................................148

Bramy ....................................................................................................................................................................148

Korzystanie z protokołów trasowania ...................................................................................................................................149

Trasowanie hybrydowe...............................................................................................................................................149

Trasowanie statyczne..................................................................................................................................................150

Wybór protokołu.........................................................................................................................................................150

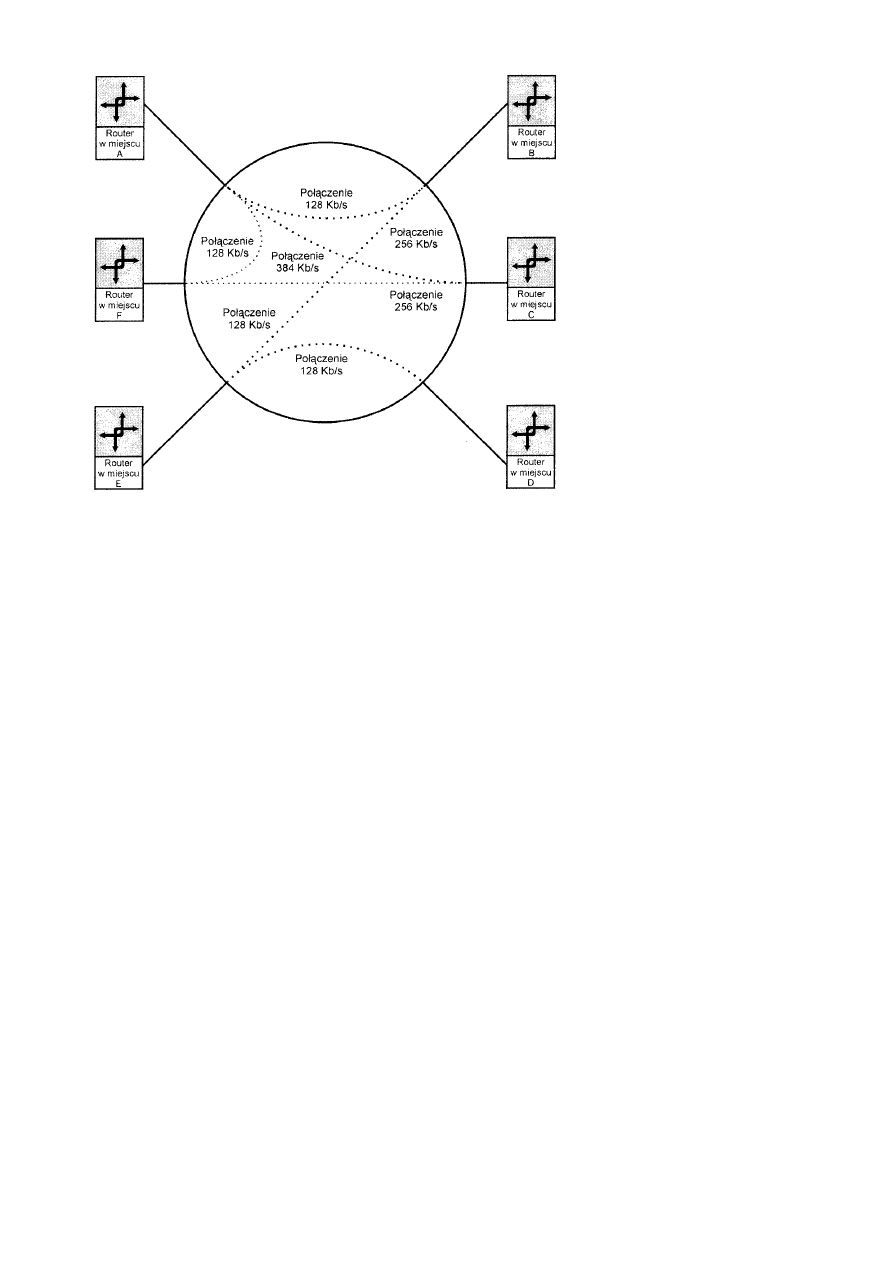

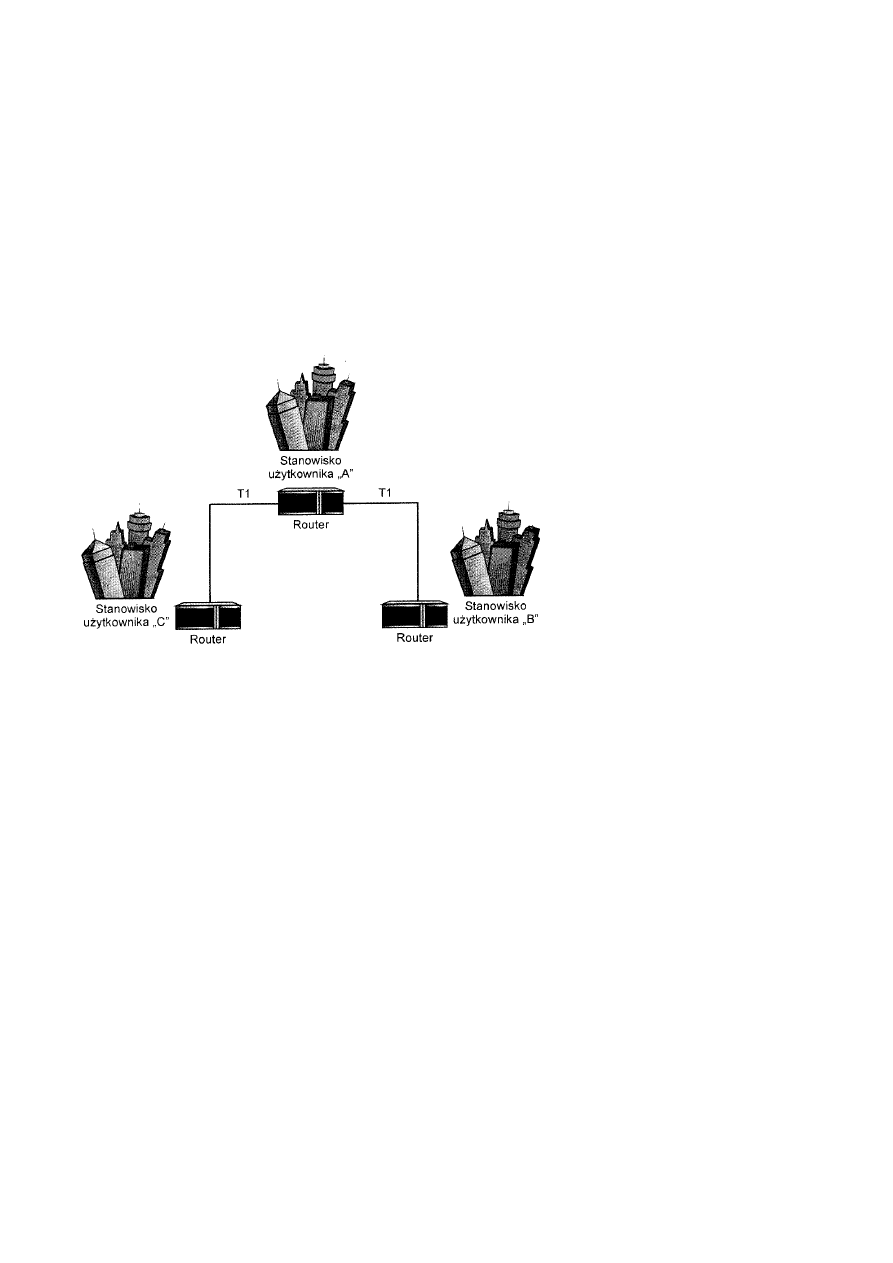

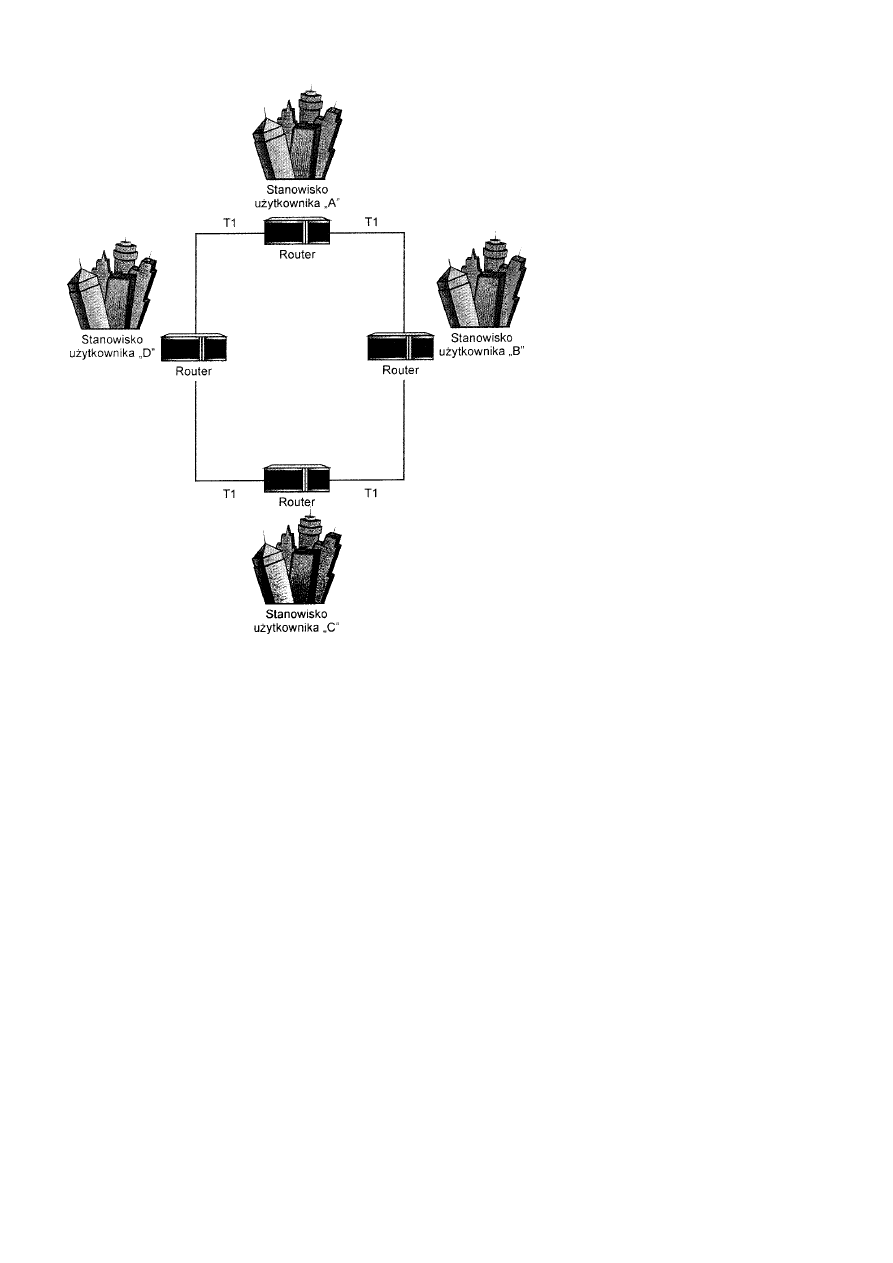

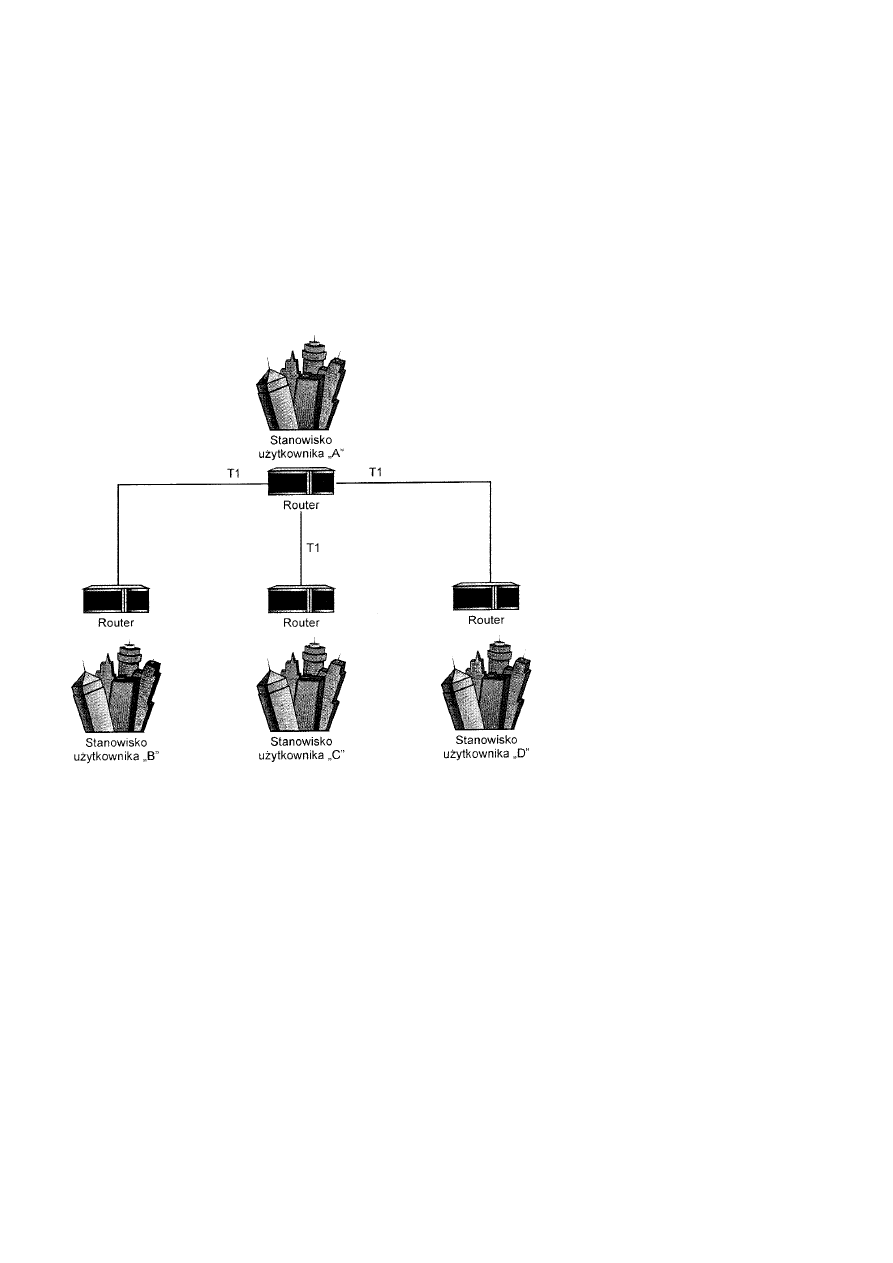

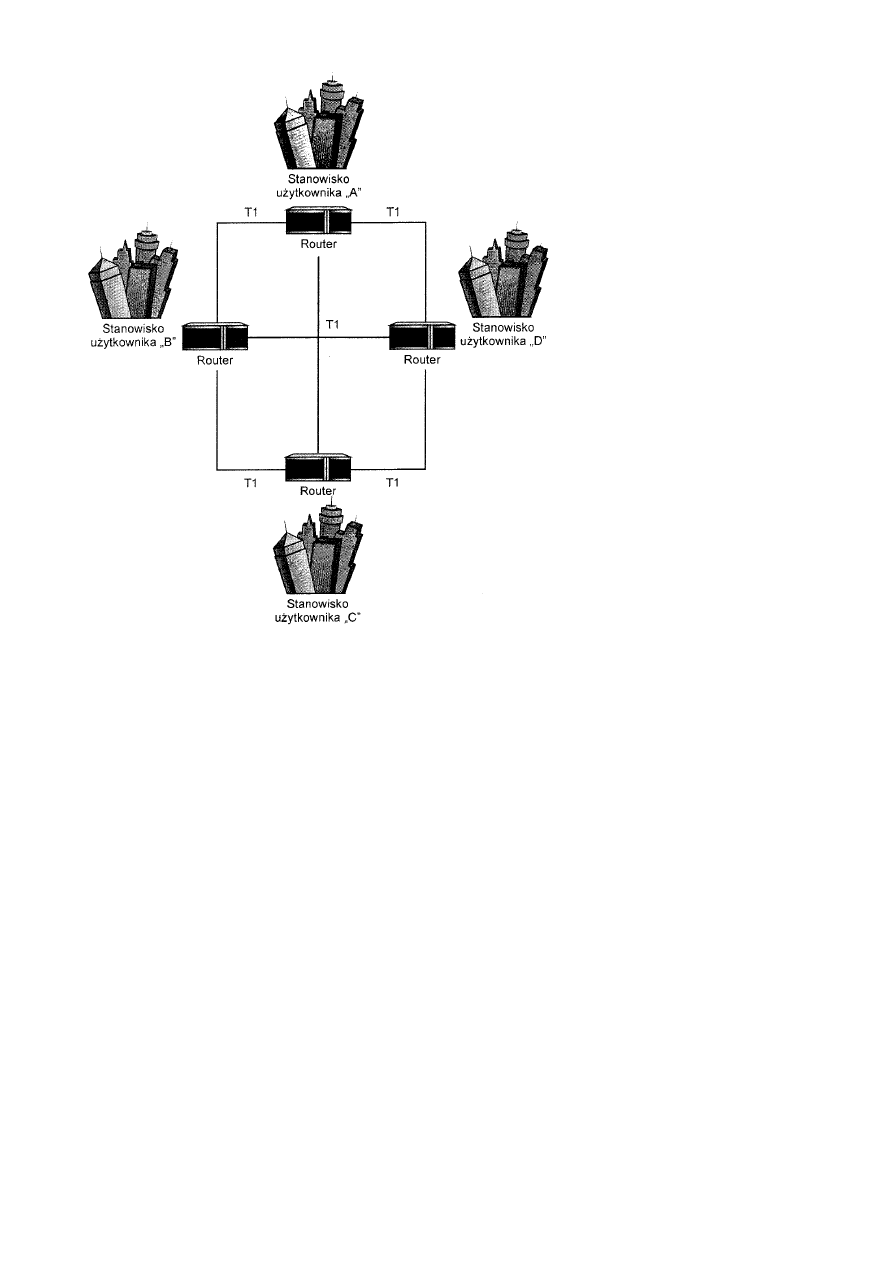

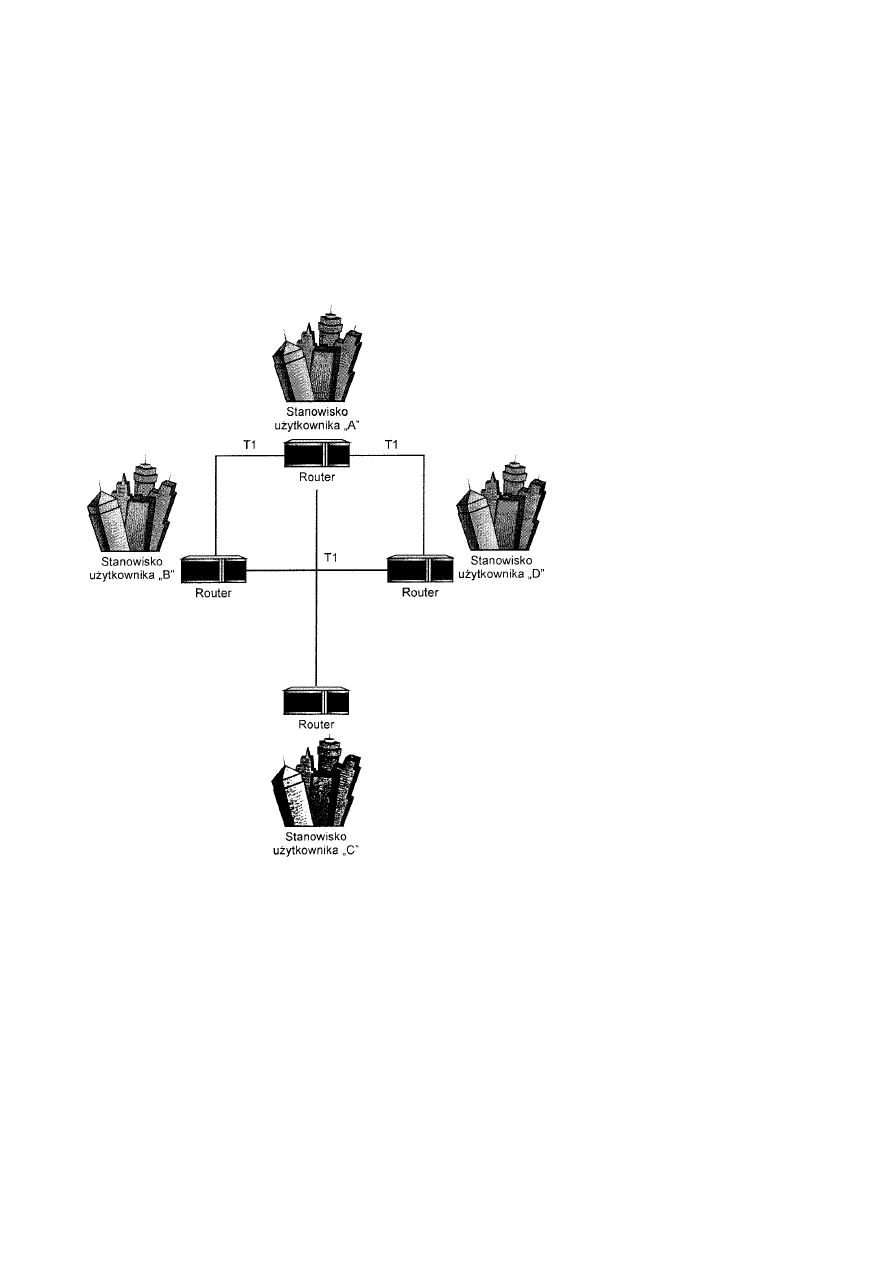

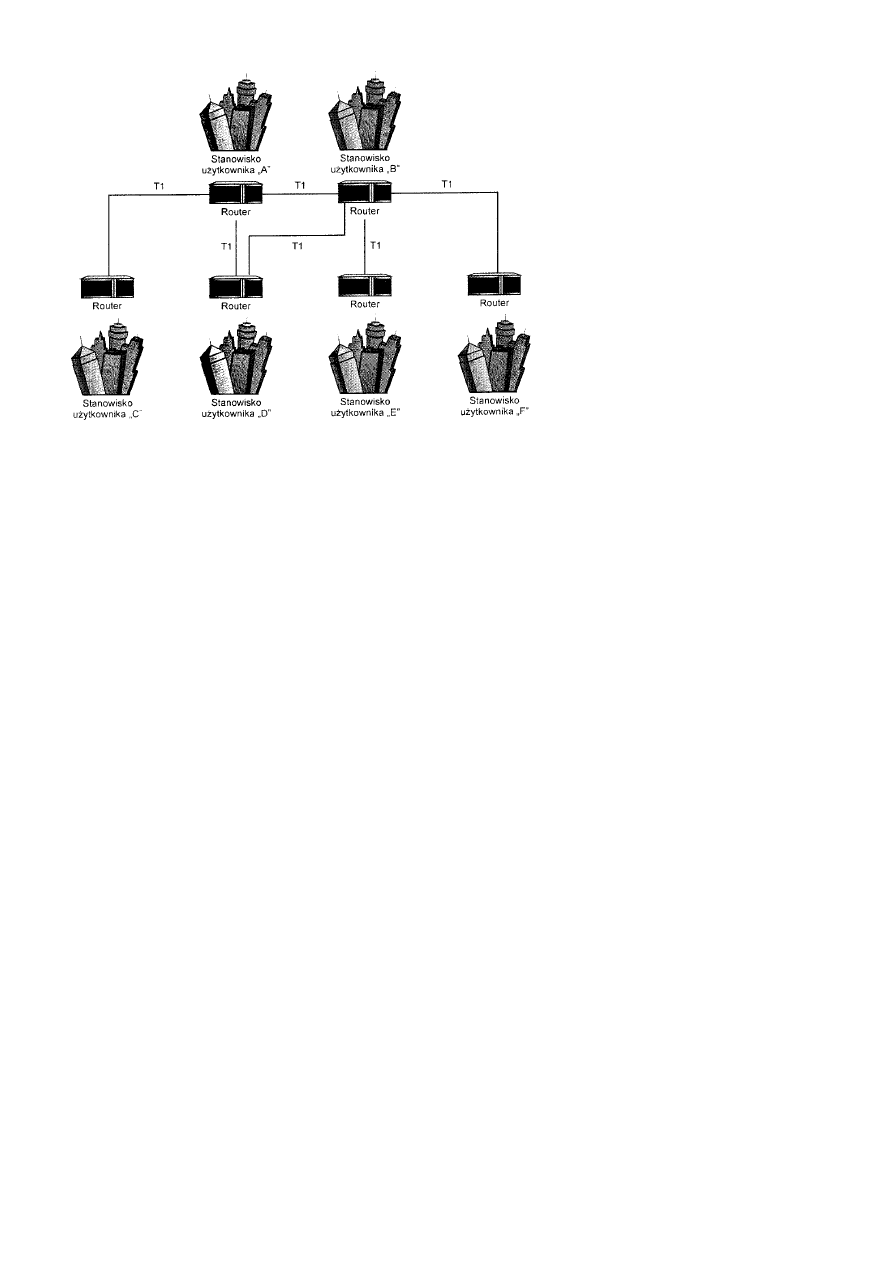

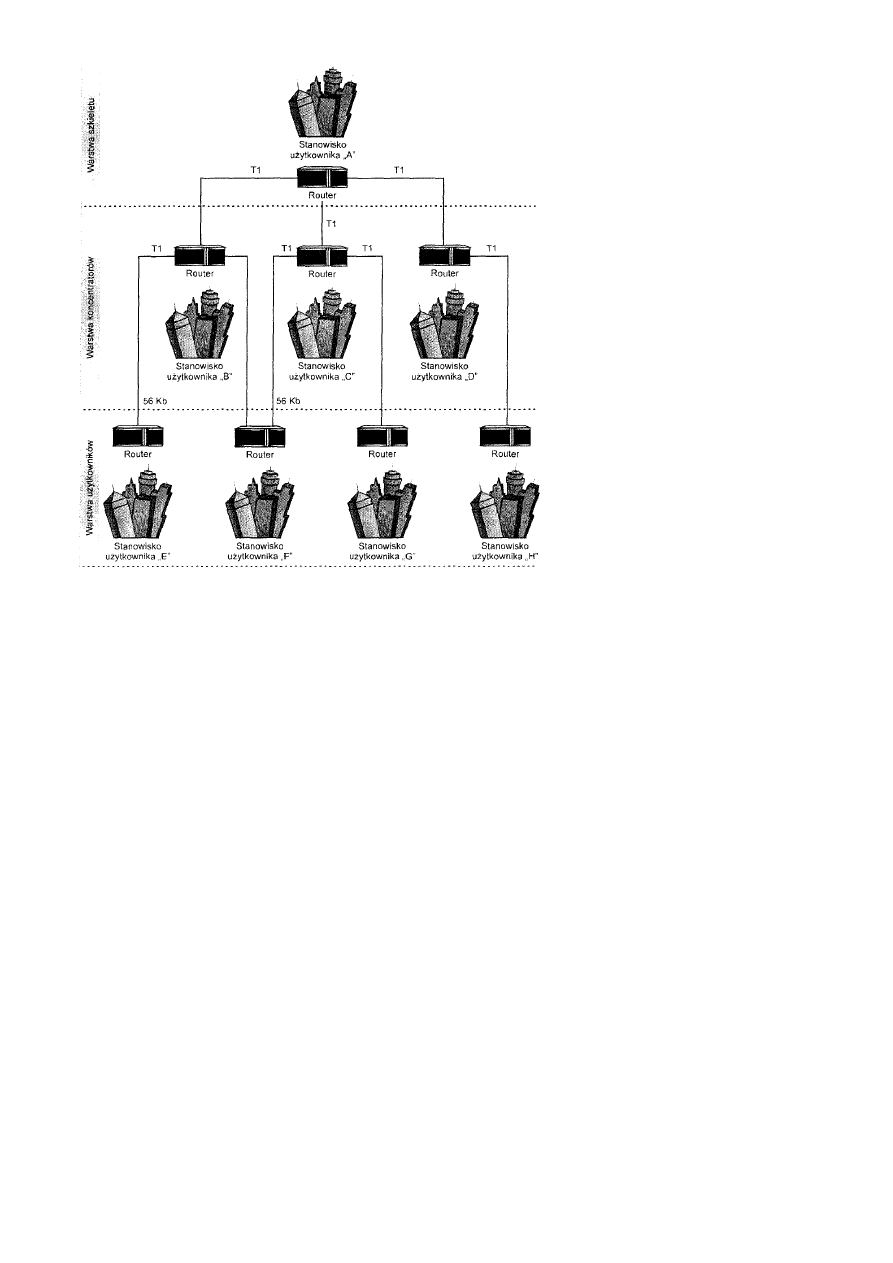

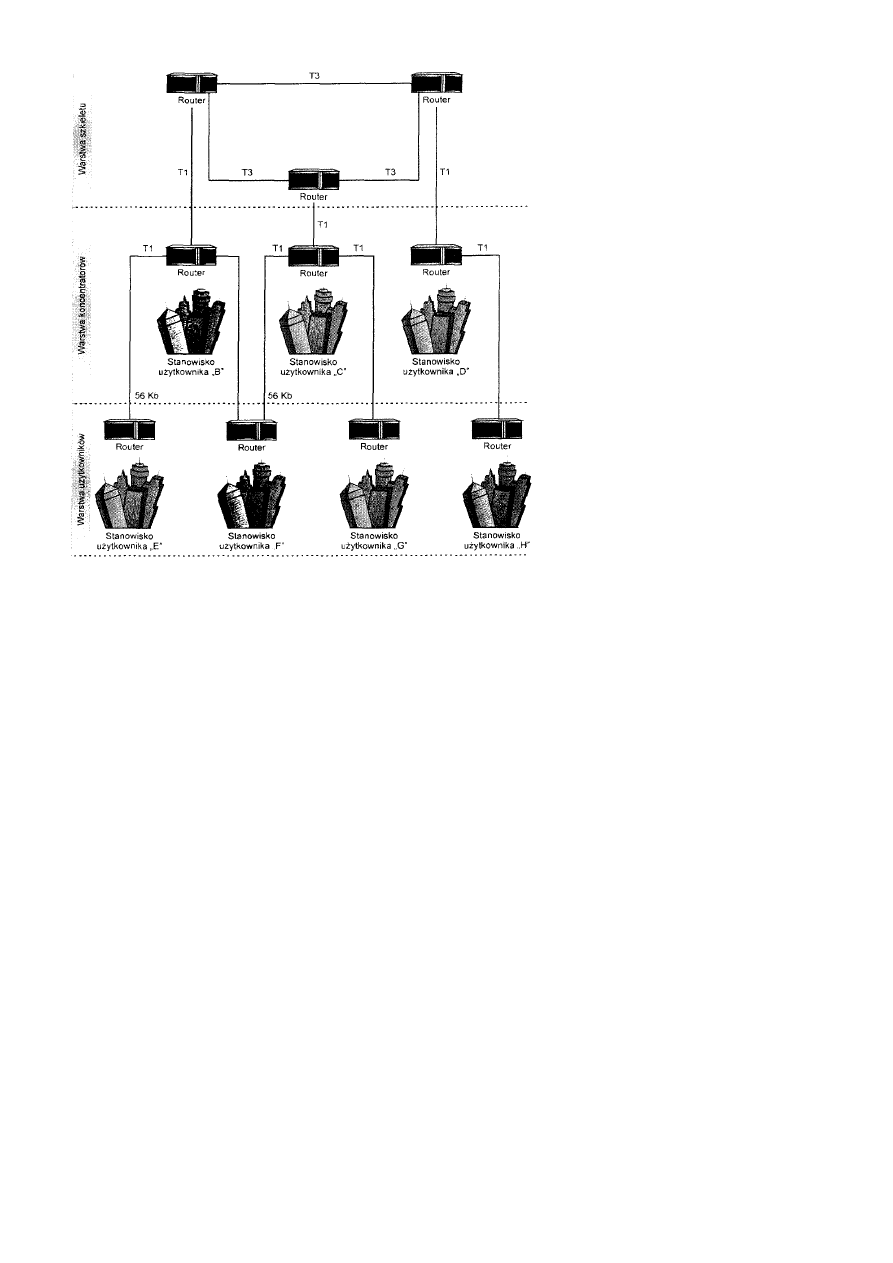

Topologie WAN....................................................................................................................................................................150

Topologia każdy-z-każdym.........................................................................................................................................150

Topologia pierścienia..................................................................................................................................................151

Topologia gwiazdy .....................................................................................................................................................152

Topologia oczek pełnych ............................................................................................................................................153

Topologia oczek częściowych ....................................................................................................................................154

Topologia dwuwarstwowa ..........................................................................................................................................154

Topologia trójwarstwowa ...........................................................................................................................................156

Topologie hybrydowe .................................................................................................................................................157

Projektowanie własnych sieci WAN .....................................................................................................................................158

Kryteria oceny wydajności sieci WAN.......................................................................................................................158

Czas przydatności elementu ..................................................................................................................................158

Natężenie ruchu .....................................................................................................................................................159

Zasoby routera.......................................................................................................................................................159

Koszt sieci WAN ........................................................................................................................................................160

Podsumowanie ......................................................................................................................................................................160

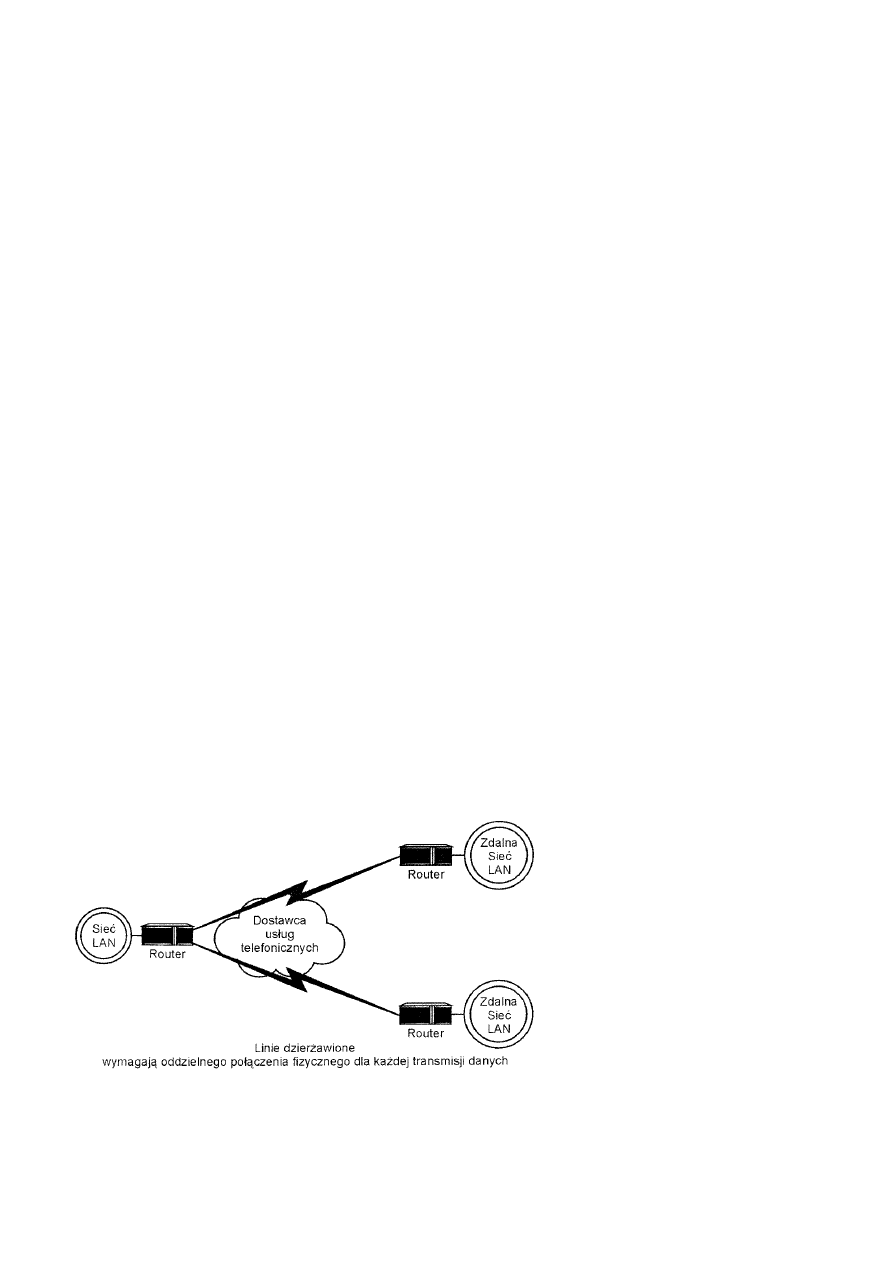

Rozdział 14 Linie dzierżawione .................................................................................................................................................161

Przegląd linii dzierżawionych ...............................................................................................................................................161

Techniki multipleksowania ...................................................................................................................................................161

Multipleksowanie czasowe .........................................................................................................................................161

Cienie i blaski linii dzierżawionych ......................................................................................................................................162

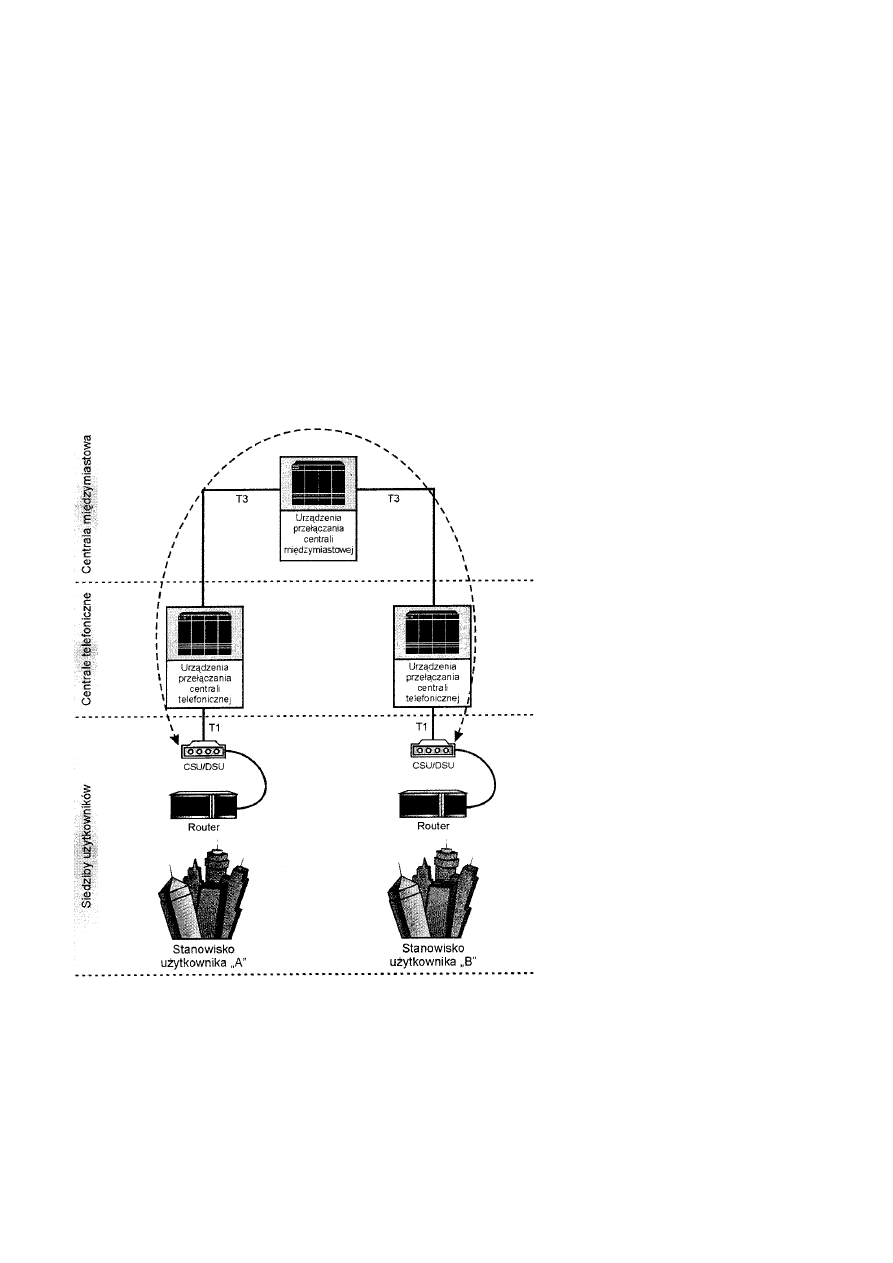

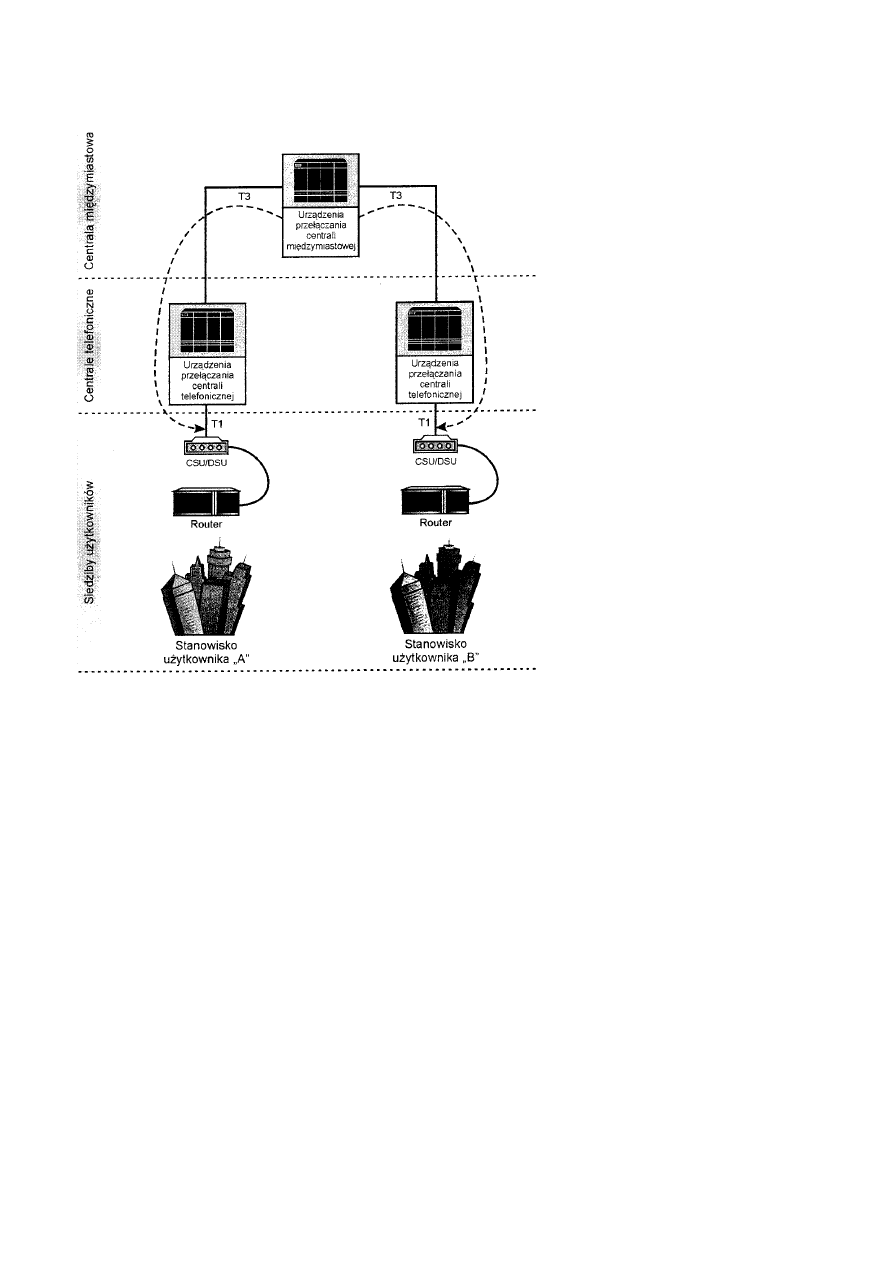

Topologia linii dzierżawionych .............................................................................................................................................163

Infrastruktura telefonii po podziale rynku...................................................................................................................164

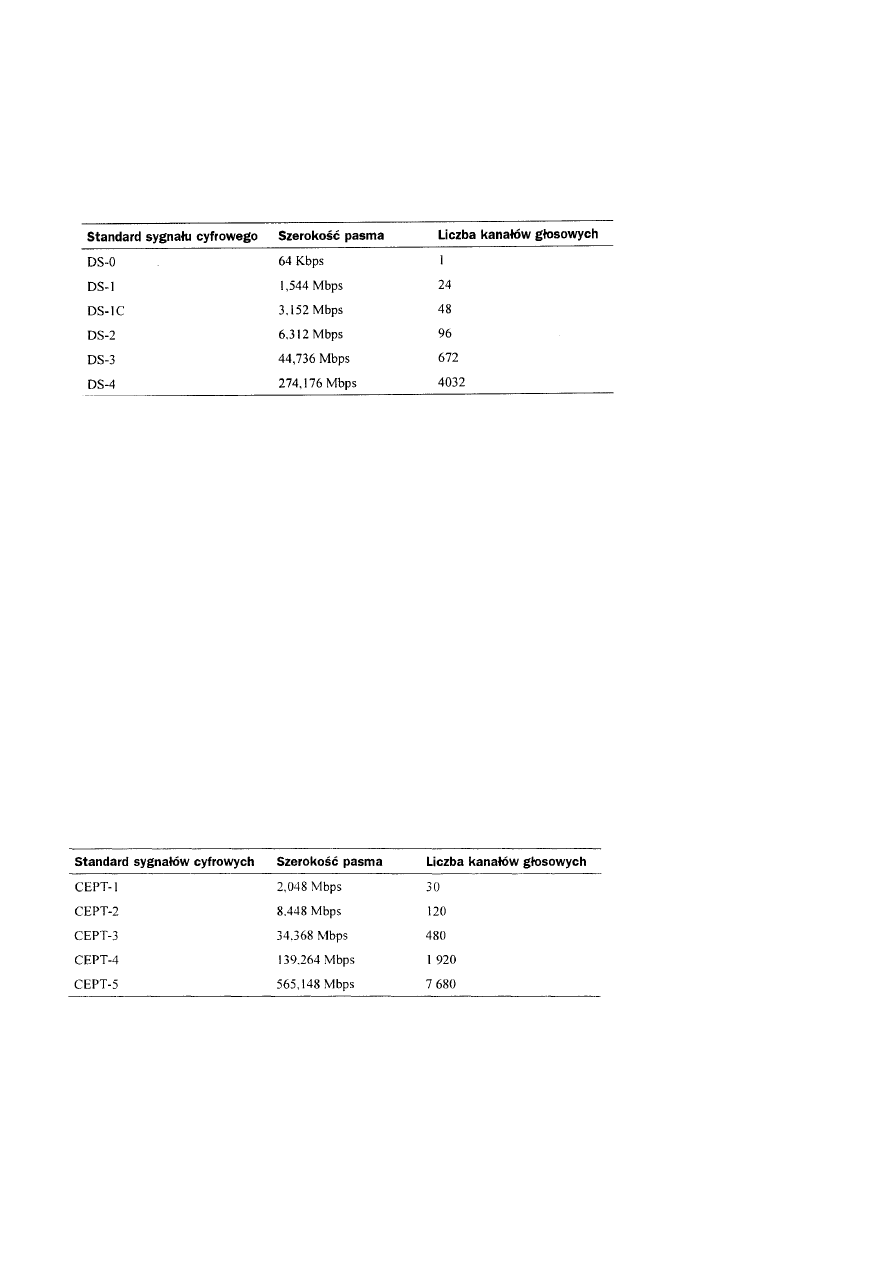

Standardy sygnałów cyfrowych.............................................................................................................................................164

Hierarchia ANSI sygnału cyfrowego ..........................................................................................................................164

Hierarchia ITU sygnału cyfrowego.............................................................................................................................165

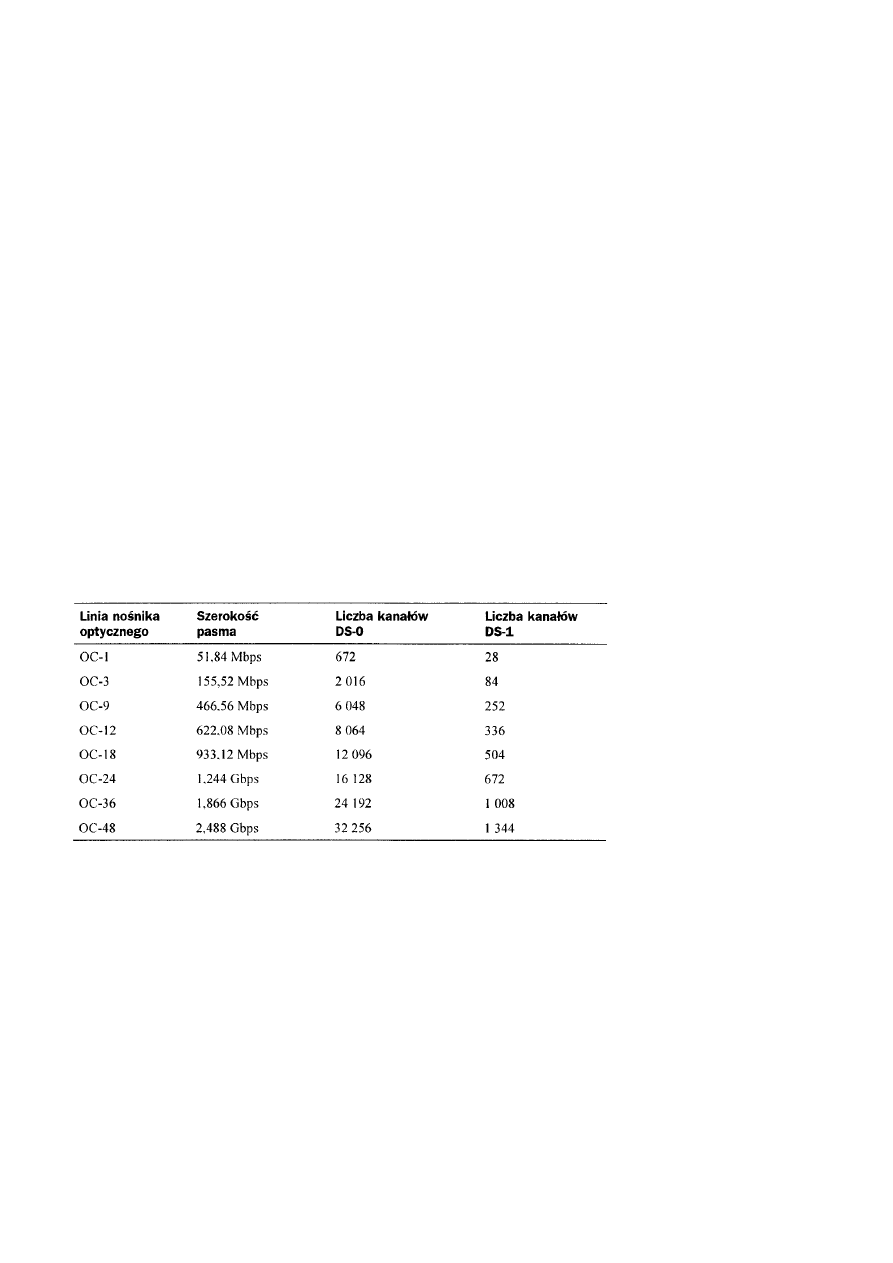

Systemy nośników SONET...................................................................................................................................................166

System nośników optycznych.....................................................................................................................................166

System T-Carrier ...................................................................................................................................................................166

Usługi T-Carrier..........................................................................................................................................................167

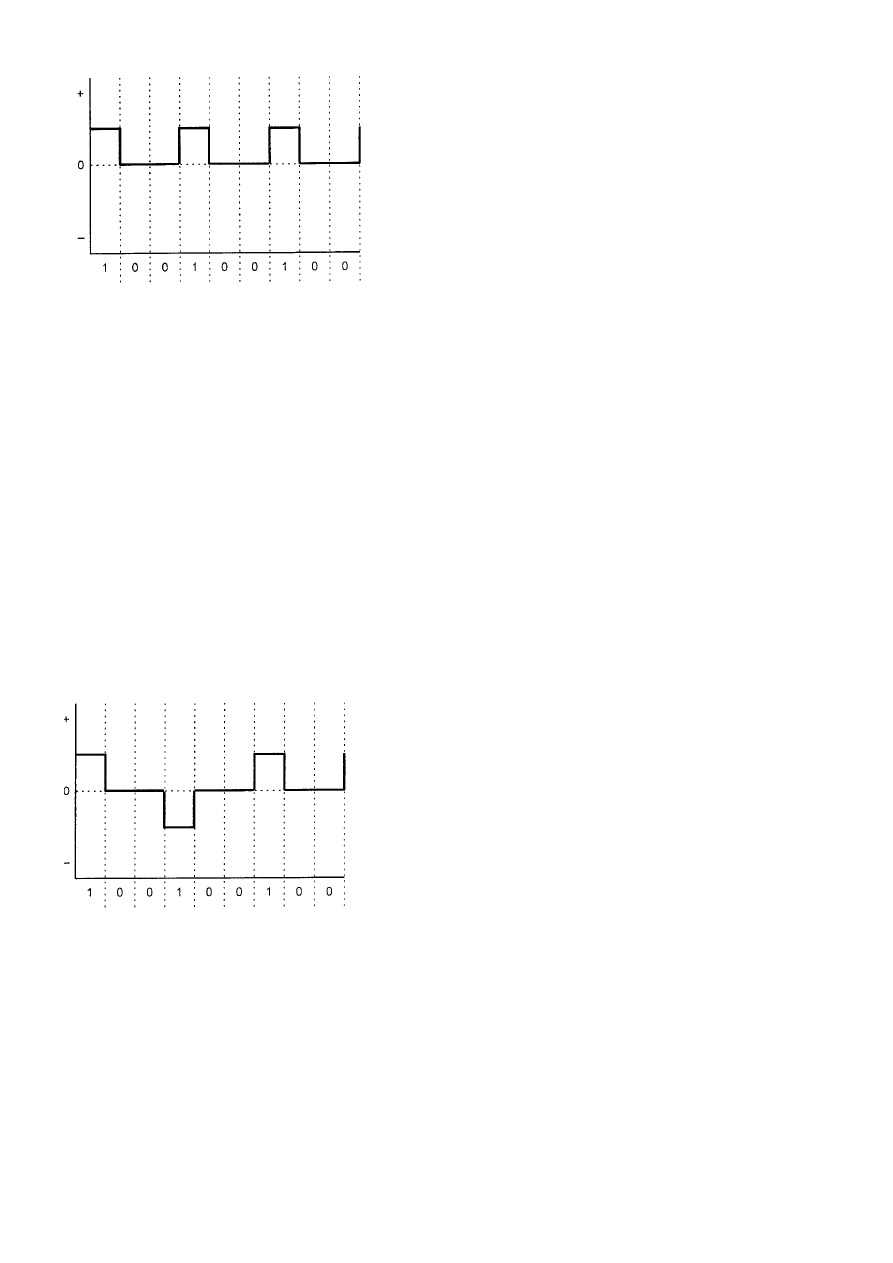

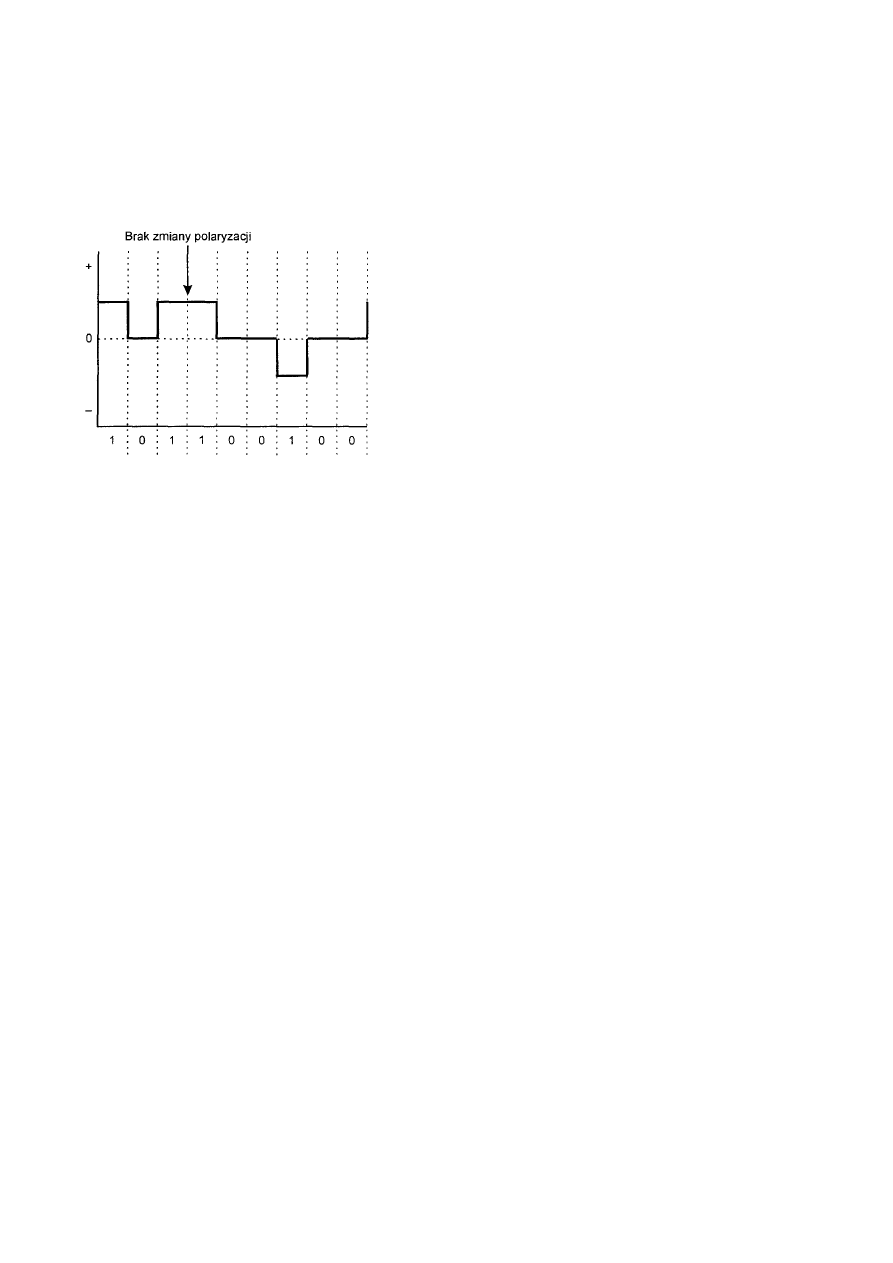

Kodowanie sygnału.....................................................................................................................................................167

Jednobiegunowe kodowanie binarne .....................................................................................................................167

Formaty ramek............................................................................................................................................................168

Format D-4 ............................................................................................................................................................168

Format ESF............................................................................................................................................................169

Format M1-3..........................................................................................................................................................169

Podsumowanie ......................................................................................................................................................................169

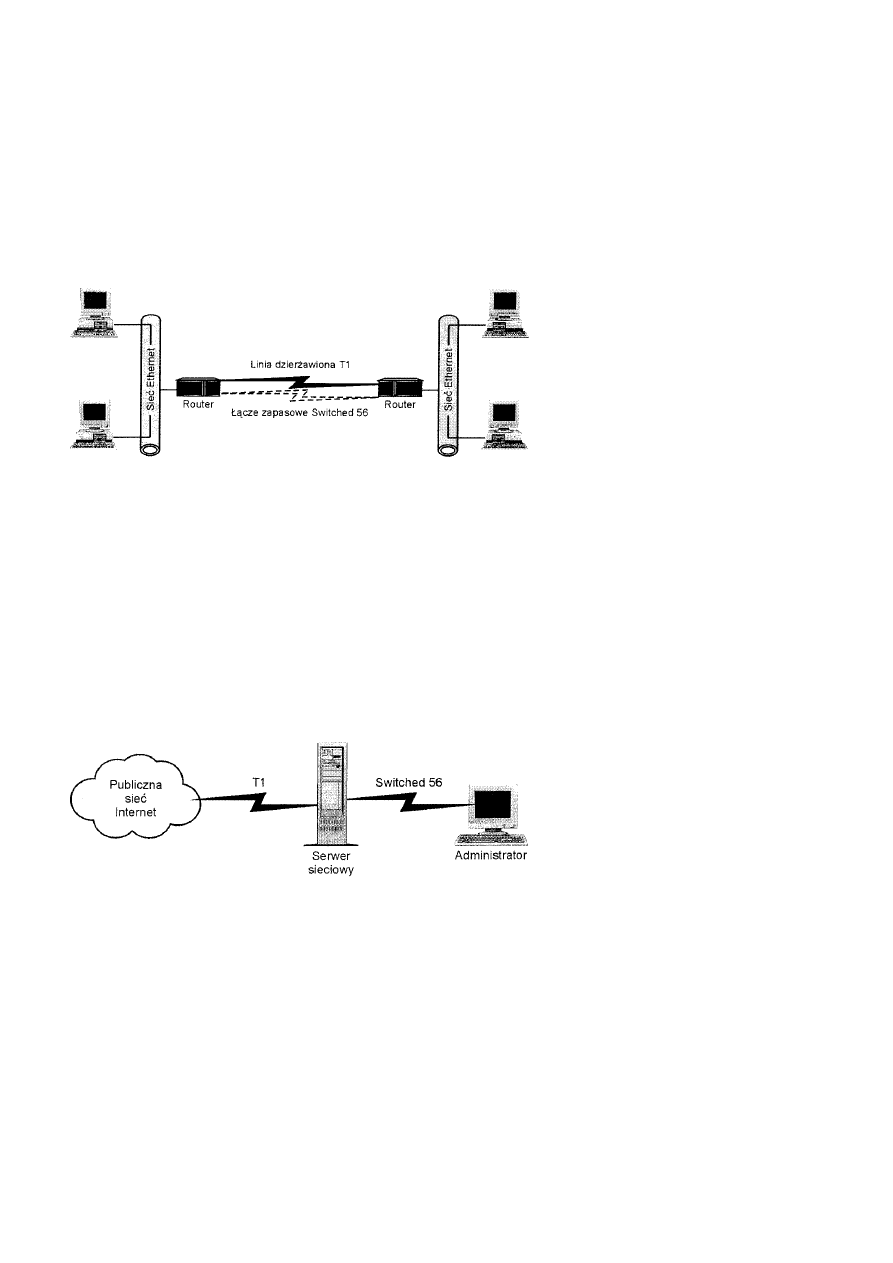

Sieci Switched 56 ..................................................................................................................................................................169

Najczęstsze zastosowania sieci Switched 56...............................................................................................................170

Technologie Switched 56............................................................................................................................................170

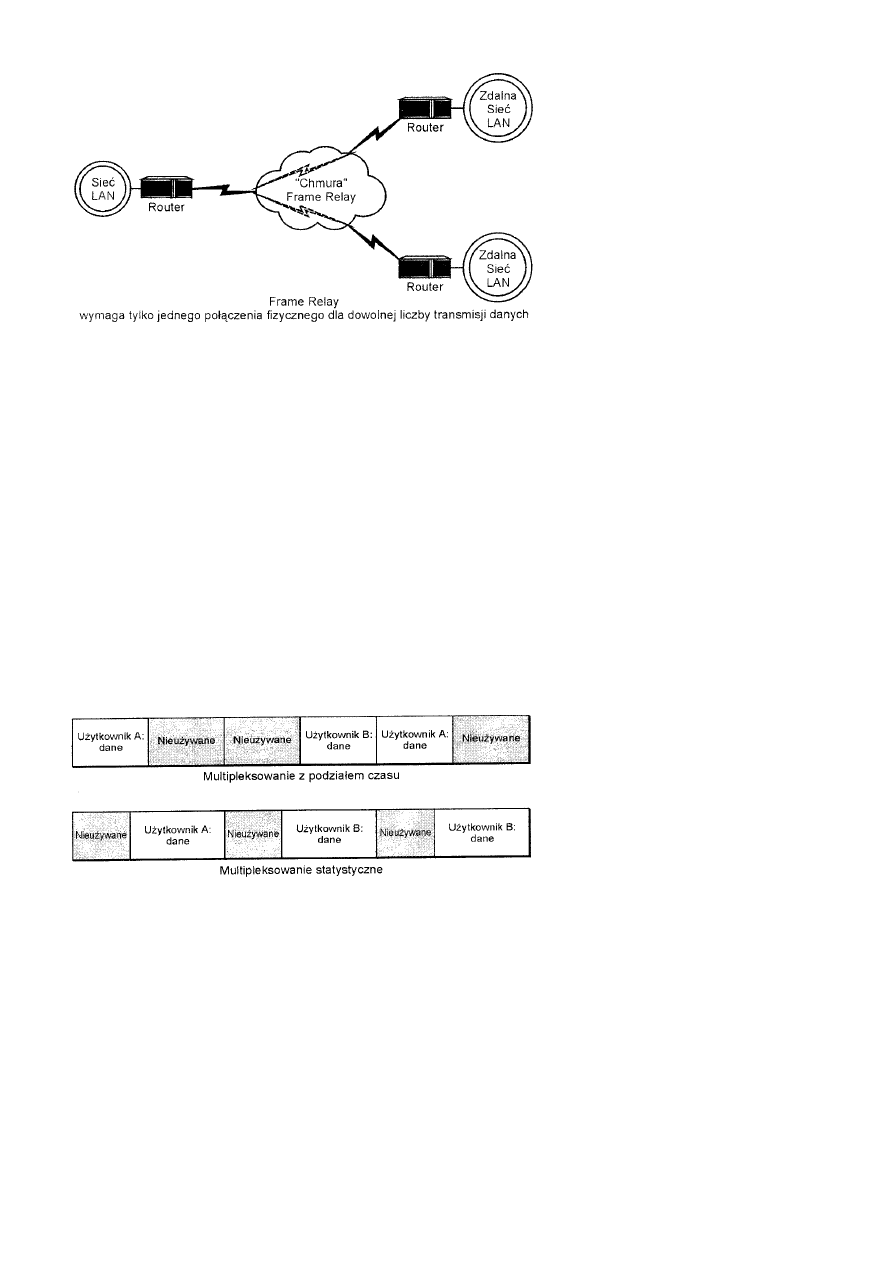

Sieci Frame Relay .................................................................................................................................................................170

Frame Relay a linie dzierżawione ...............................................................................................................................171

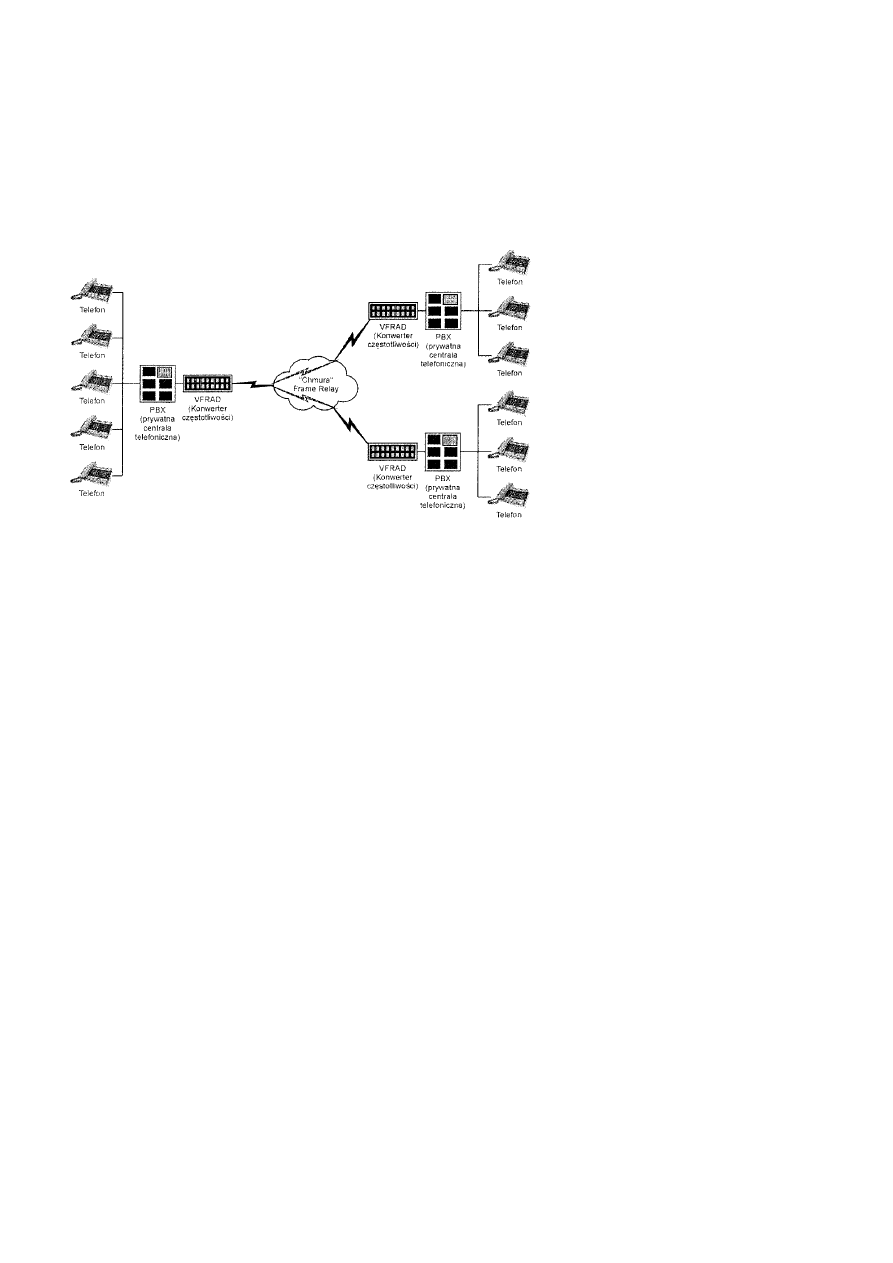

Rozszerzone Frame Relay...........................................................................................................................................172

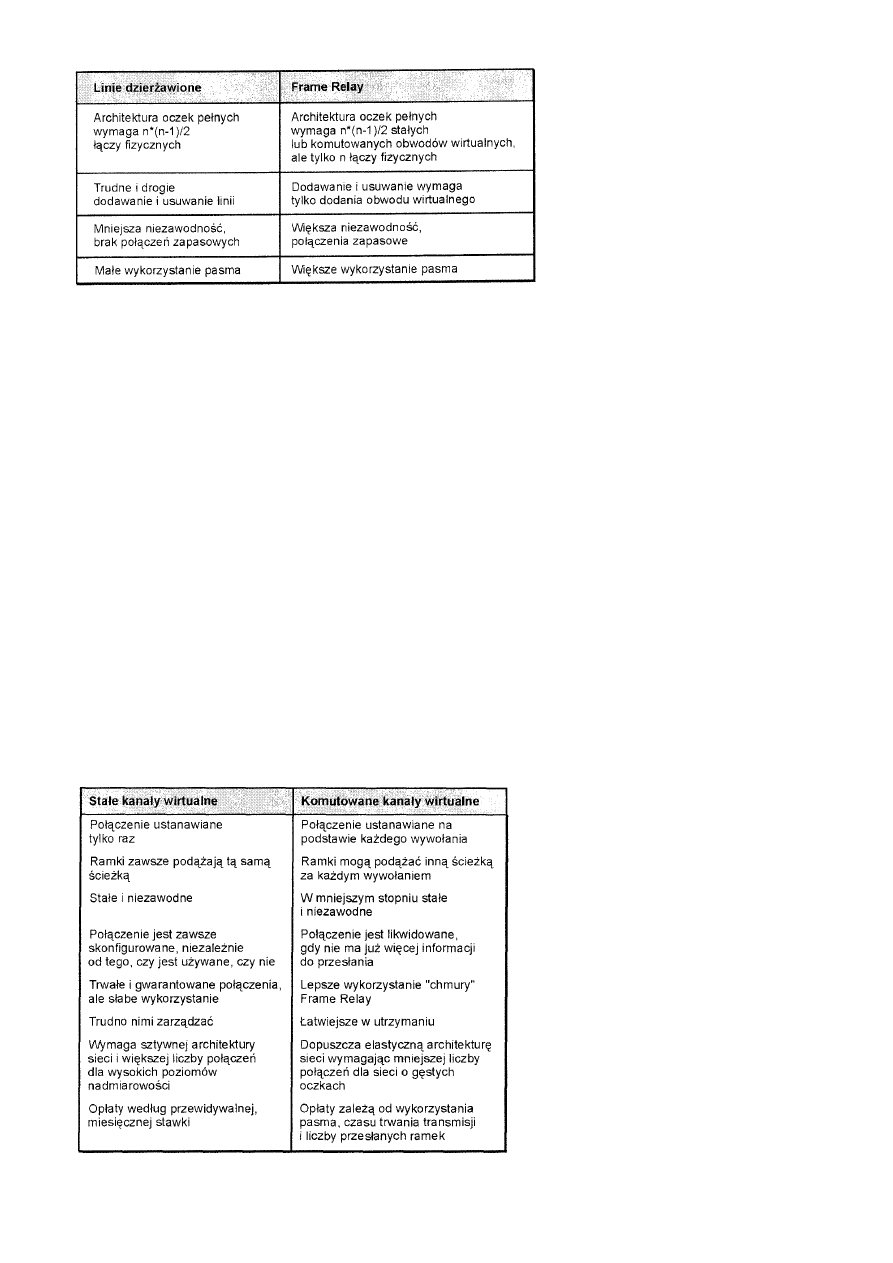

Stałe a komutowane kanały wirtualne.........................................................................................................................173

Format podstawowej ramki Frame Relay ...................................................................................................................173

Projektowanie sieci Frame Relay................................................................................................................................174

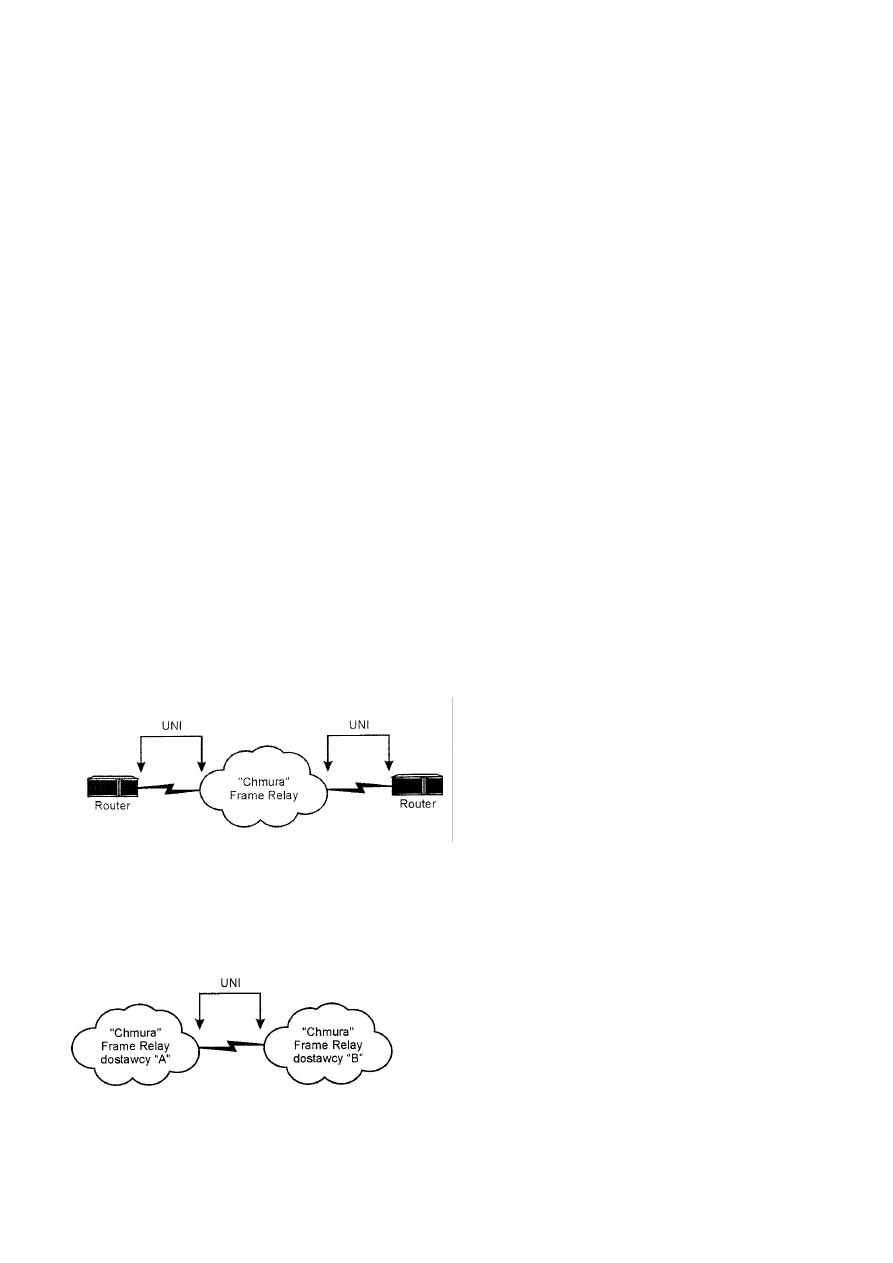

UNI a NNI ..................................................................................................................................................................174

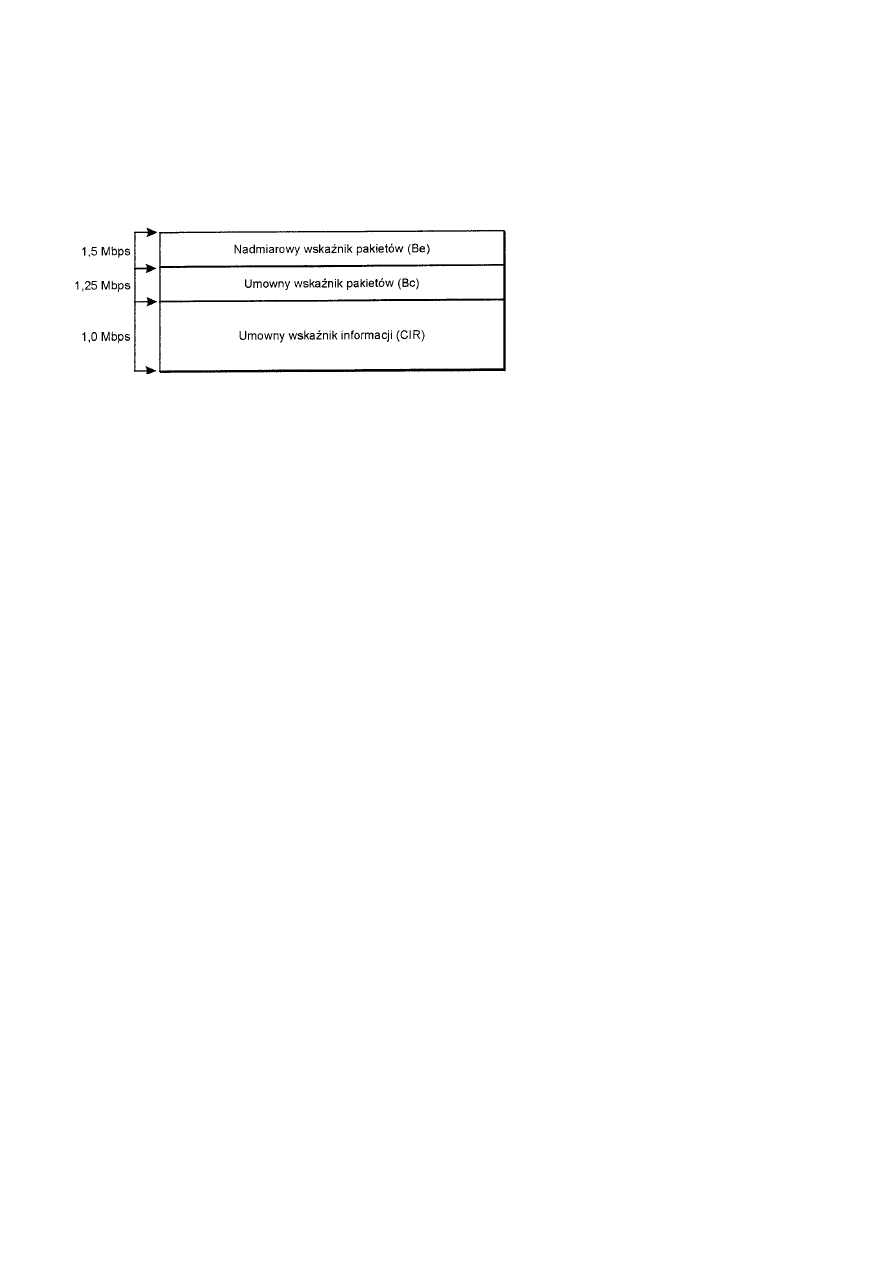

Sterowanie przepływem w sieci Frame Relay ............................................................................................................175

Sieci prywatne, publiczne i hybrydowe (mieszane)...............................................................................................................176

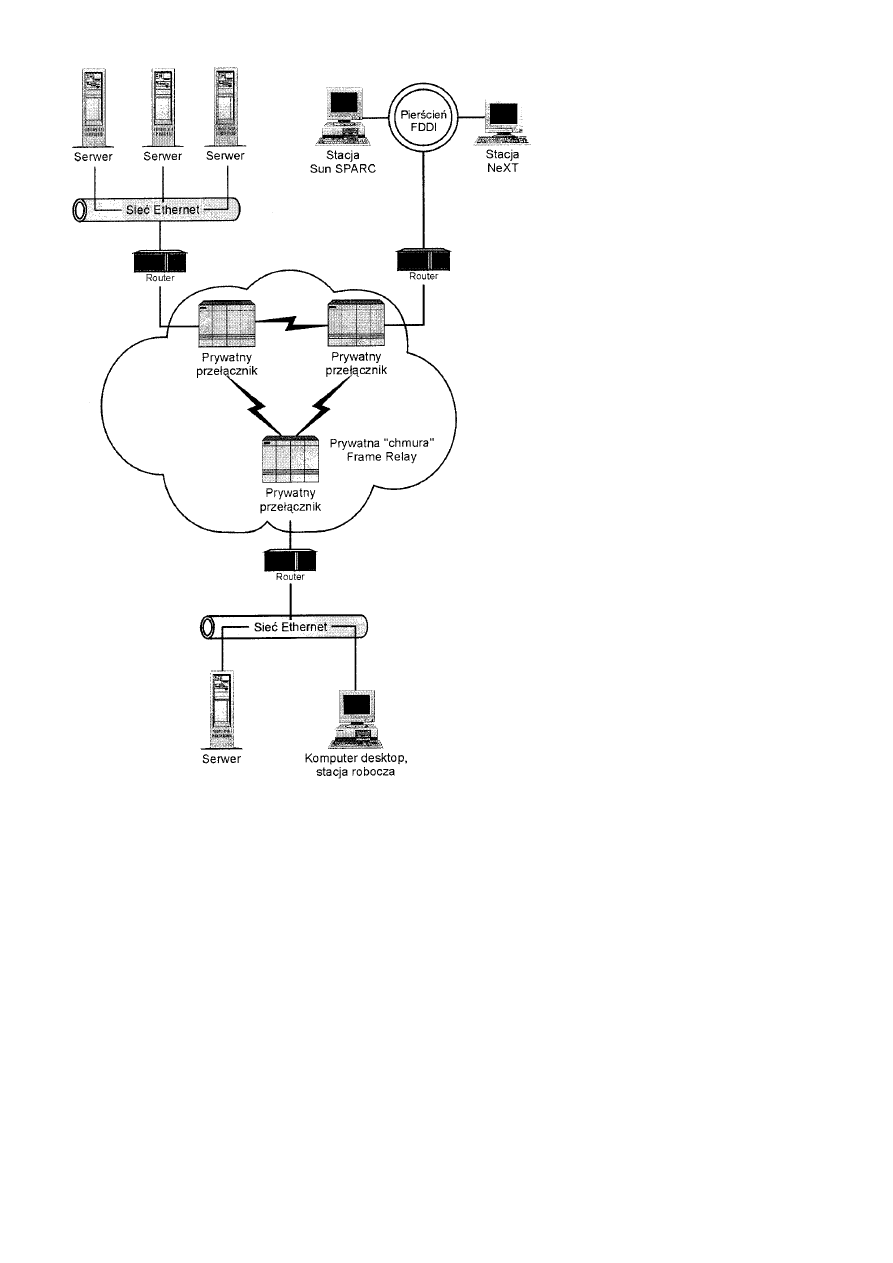

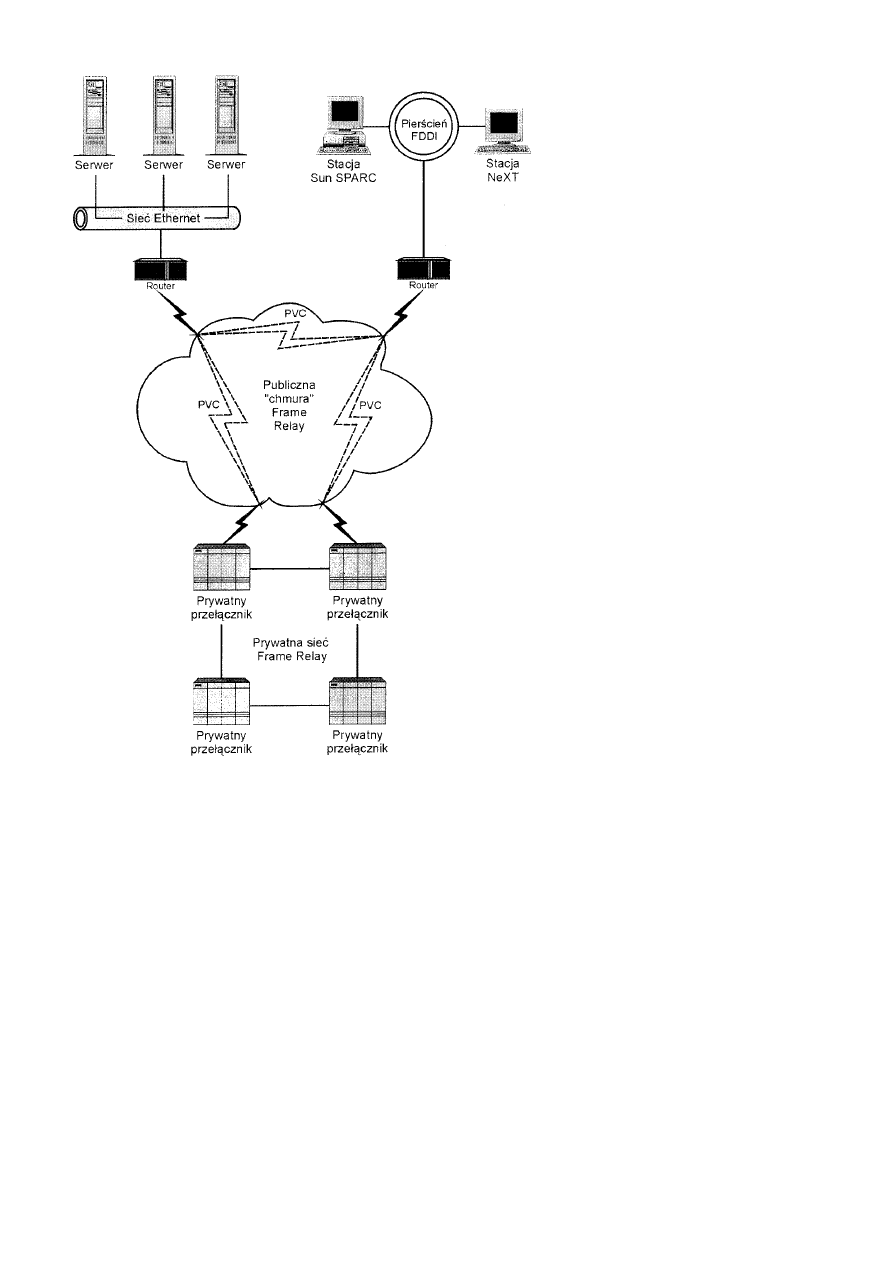

Prywatne sieci Frame Relay........................................................................................................................................176

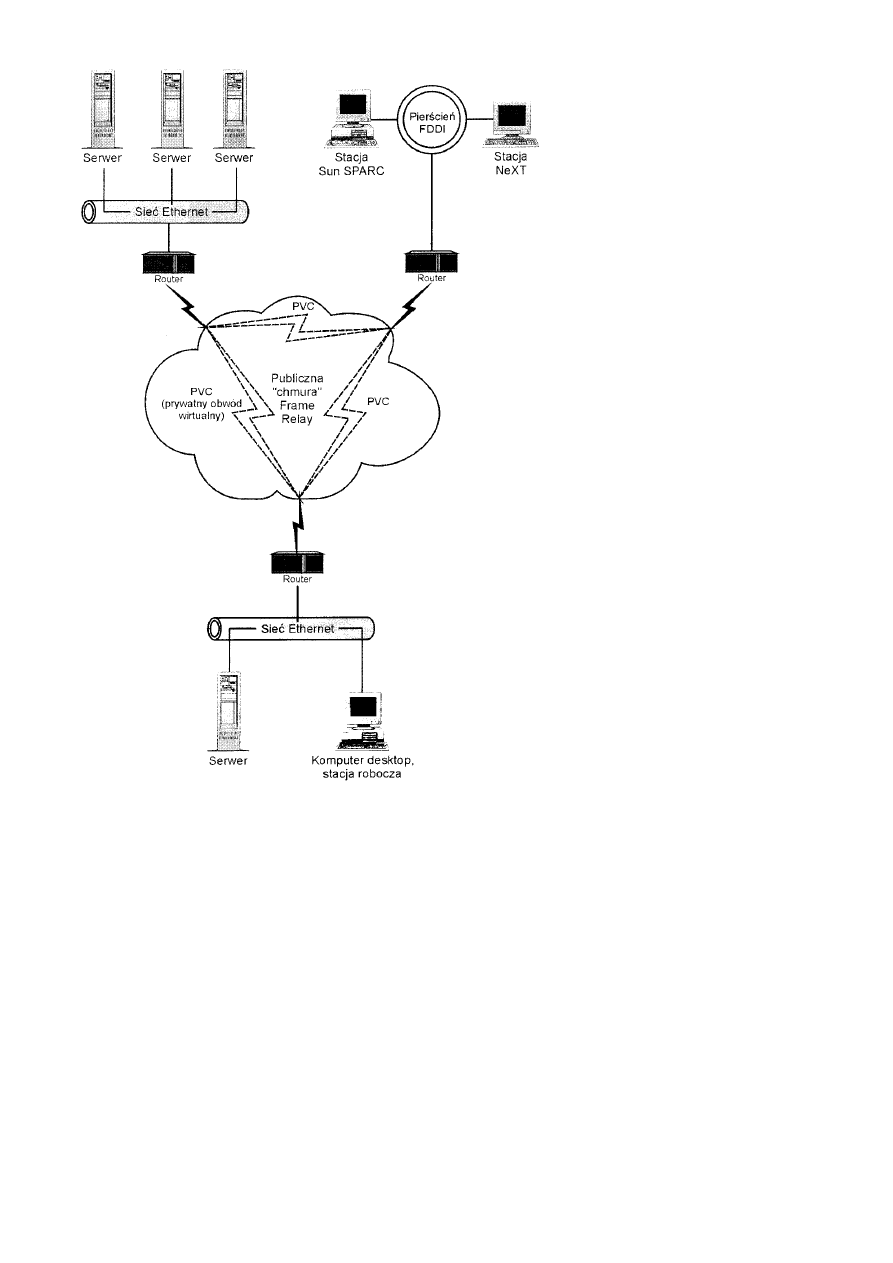

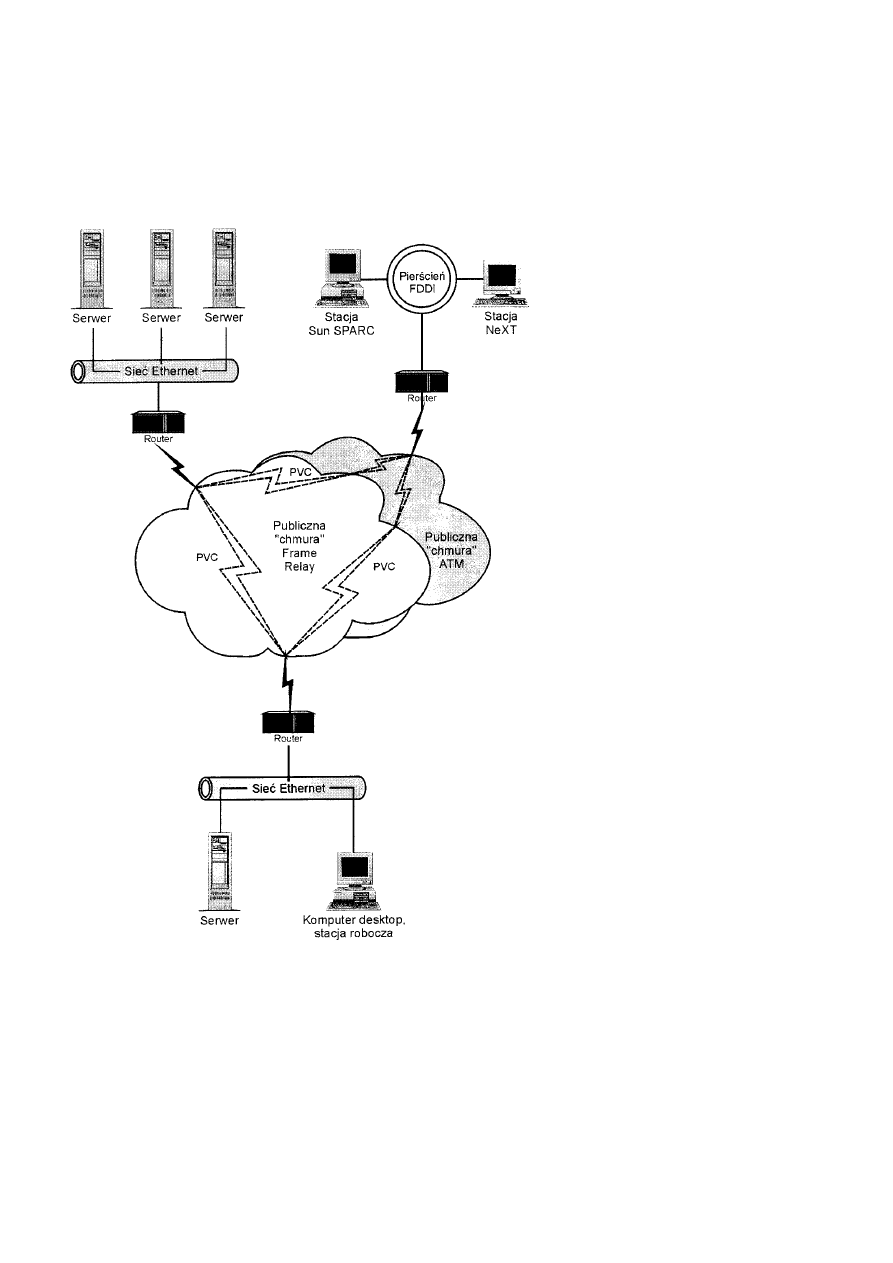

Publiczne sieci Frame Relay .......................................................................................................................................176

ATM......................................................................................................................................................................................179

Historia ATM..............................................................................................................................................................180

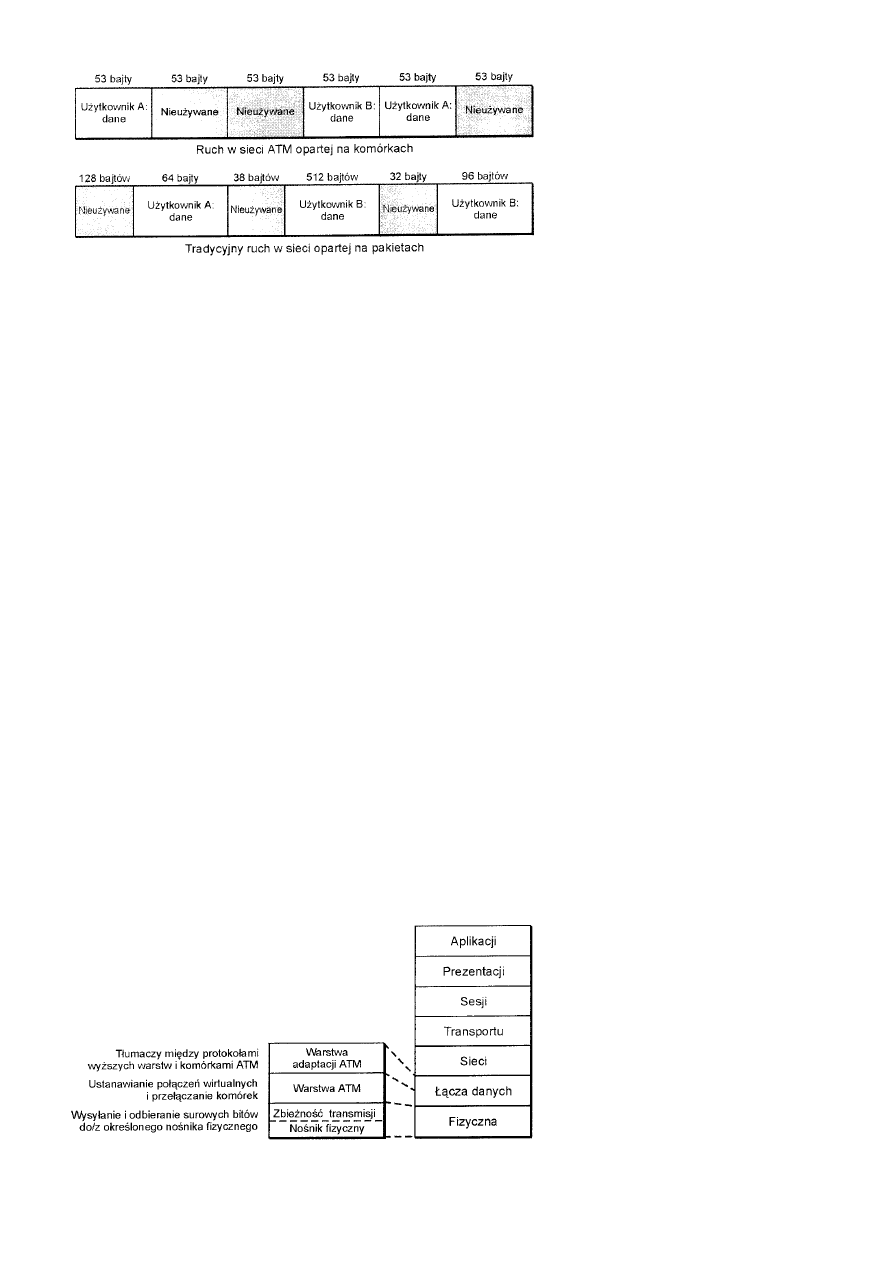

ATM - sedno sprawy ..................................................................................................................................................181

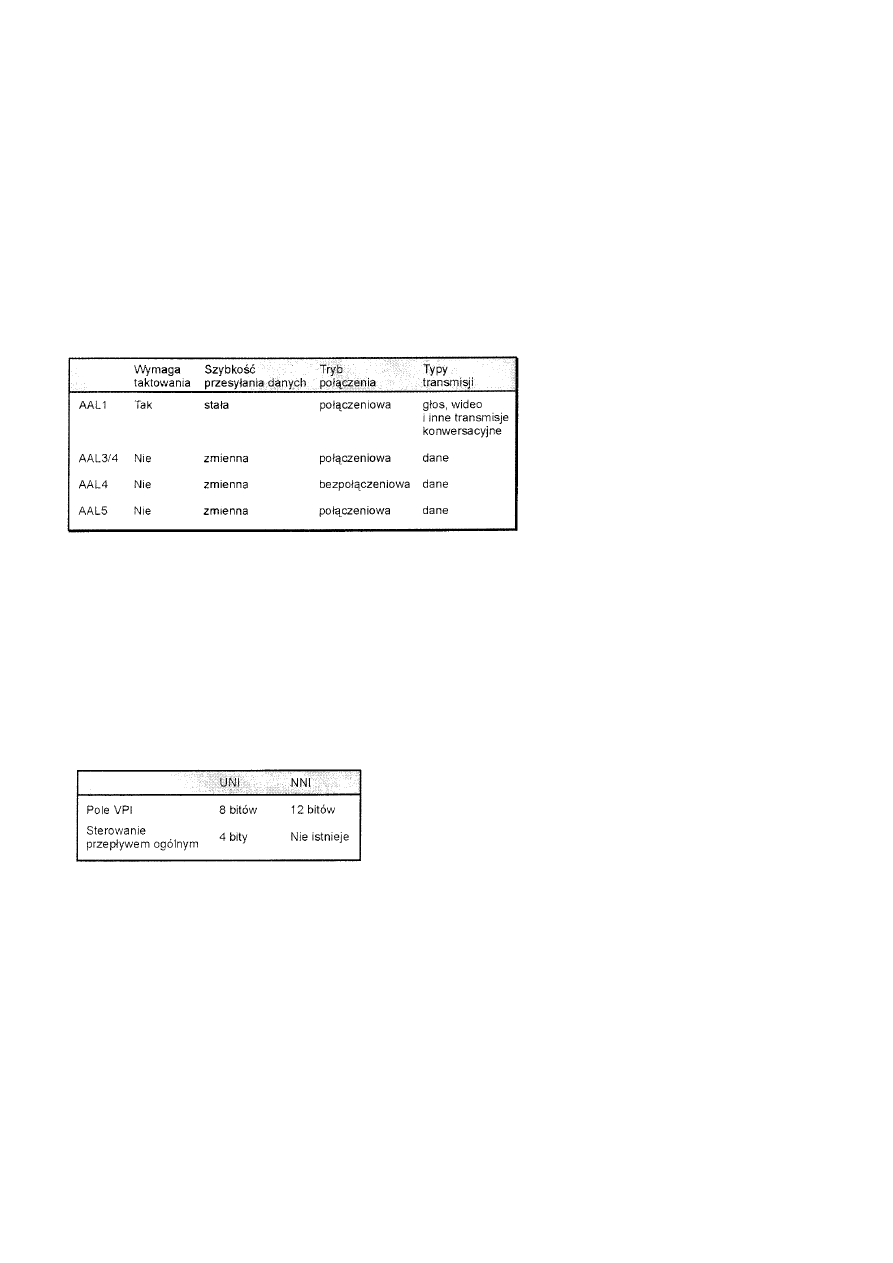

Warstwy ATM ............................................................................................................................................................181

Warstwa fizyczna ..................................................................................................................................................181

Format komórki ATM ................................................................................................................................................182

Ładunek typu konserwacyjnego (2 bity)................................................................................................................183

Wskaźnik typu priorytetu (PTI) (1 bit) ..................................................................................................................183

Połączenia ATM .........................................................................................................................................................184

Jakość usług...........................................................................................................................................................184

Sygnalizowanie......................................................................................................................................................184

Zamawianie obwodów ATM.................................................................................................................................184

Dostęp fizyczny.............................................................................................................................................184

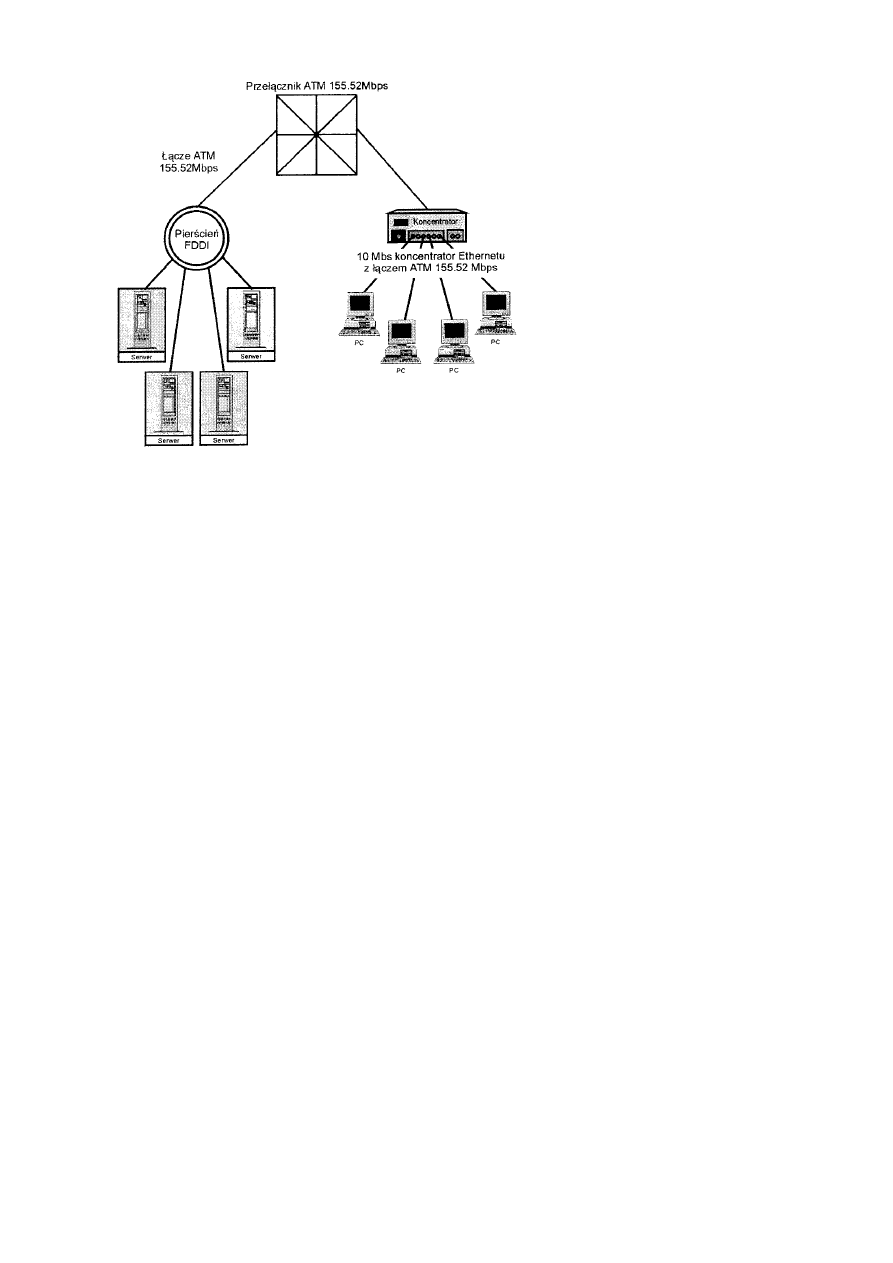

Współdziałanie przy użyciu emulacji LAN ................................................................................................................185

Migrowanie do sieci ATM..........................................................................................................................................185

Podsumowanie ......................................................................................................................................................................185

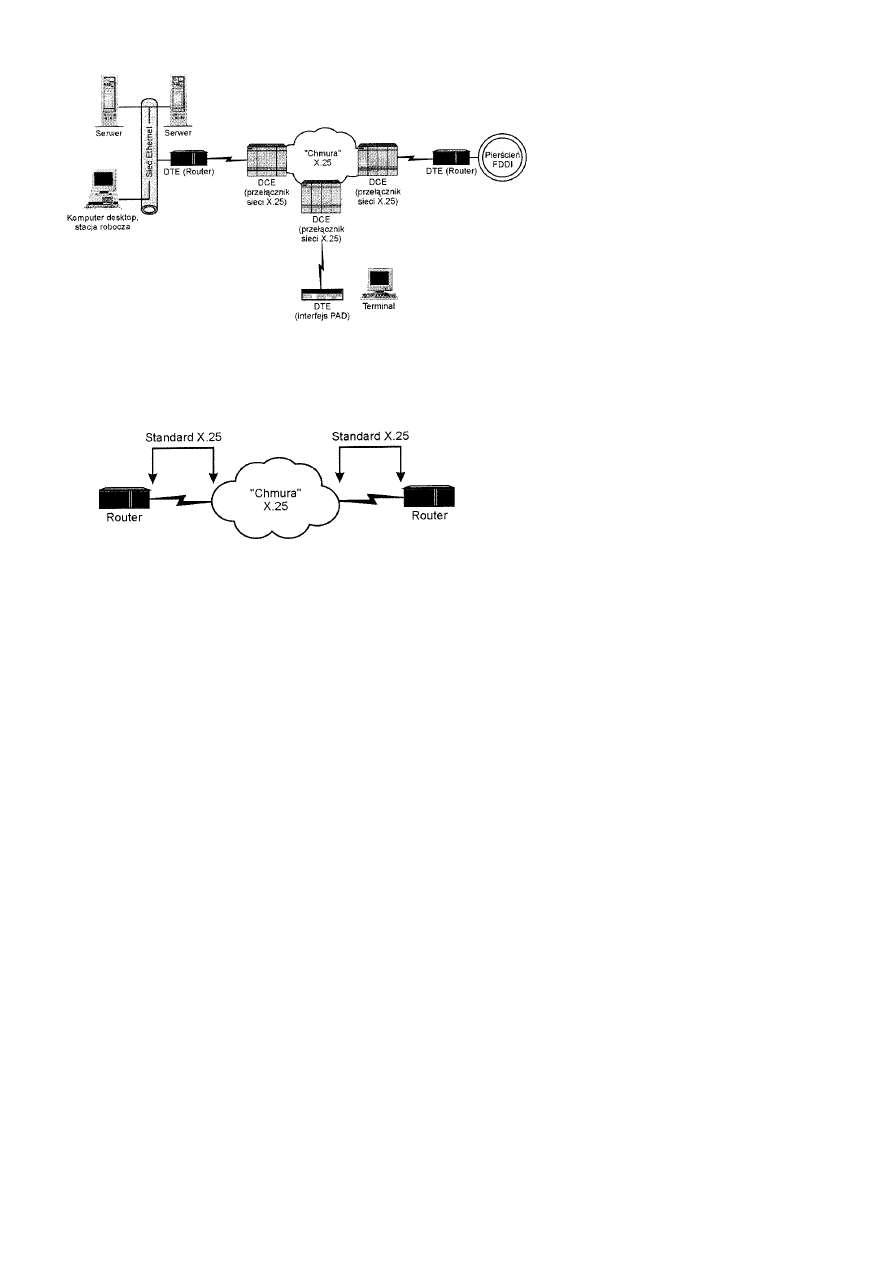

Sieci X.25..............................................................................................................................................................................185

Historia X.25...............................................................................................................................................................186

Zalety i wady sieci X.25 .............................................................................................................................................186

Najczęstsze zastosowania ...........................................................................................................................................186

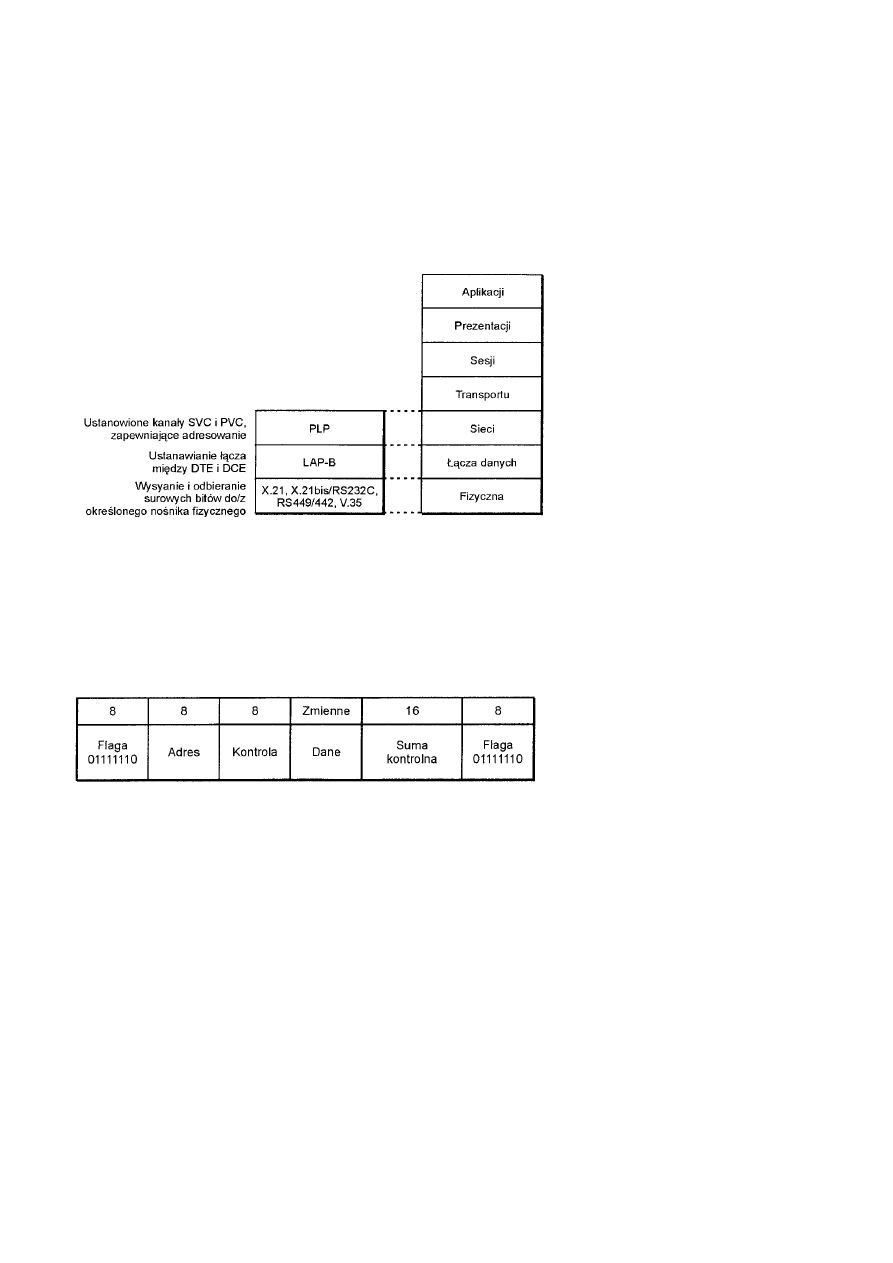

Porównanie z modelem OSI .......................................................................................................................................186

Warstwa fizyczna ..................................................................................................................................................187

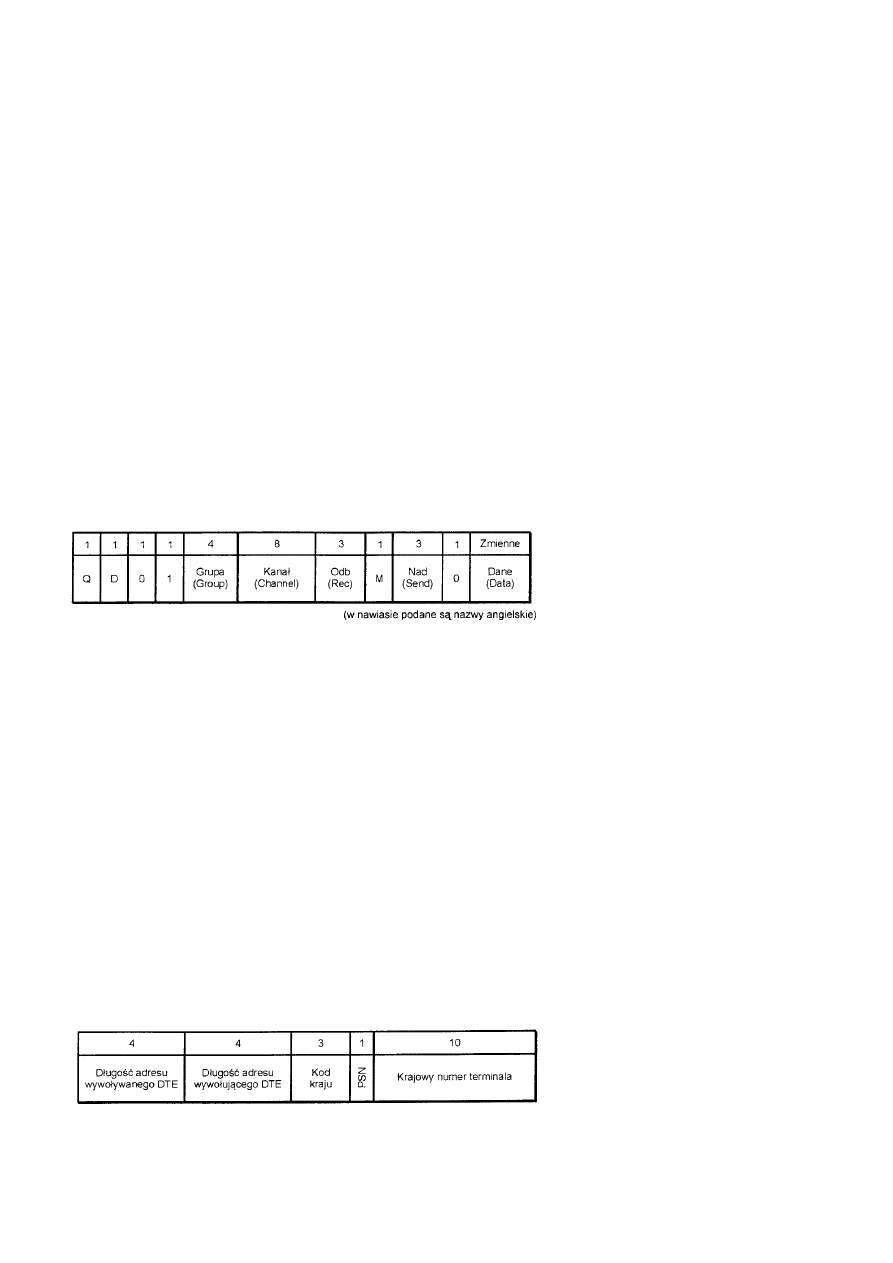

Poziom pakietu w warstwie sieci modelu OSI (X.25) ................................................................................................188

Różne typy sieci..........................................................................................................................................................189

Specyfikacje X.25 (RFC 1356)...................................................................................................................................189

ITU-T (dawniej CCITT)........................................................................................................................................189

IETF ......................................................................................................................................................................189

RFC 877, transmisja datagramów IP w publicznej sieci transmisji danych...........................................................189

RFC 1236, konwersja adresów IP na X.121 dla sieci DDN...................................................................................190

Migrowanie z sieci X.25 .............................................................................................................................................190

Podsumowanie ......................................................................................................................................................................190

Rozdział 17 Modemy i technologie Dial-Up ..............................................................................................................................190

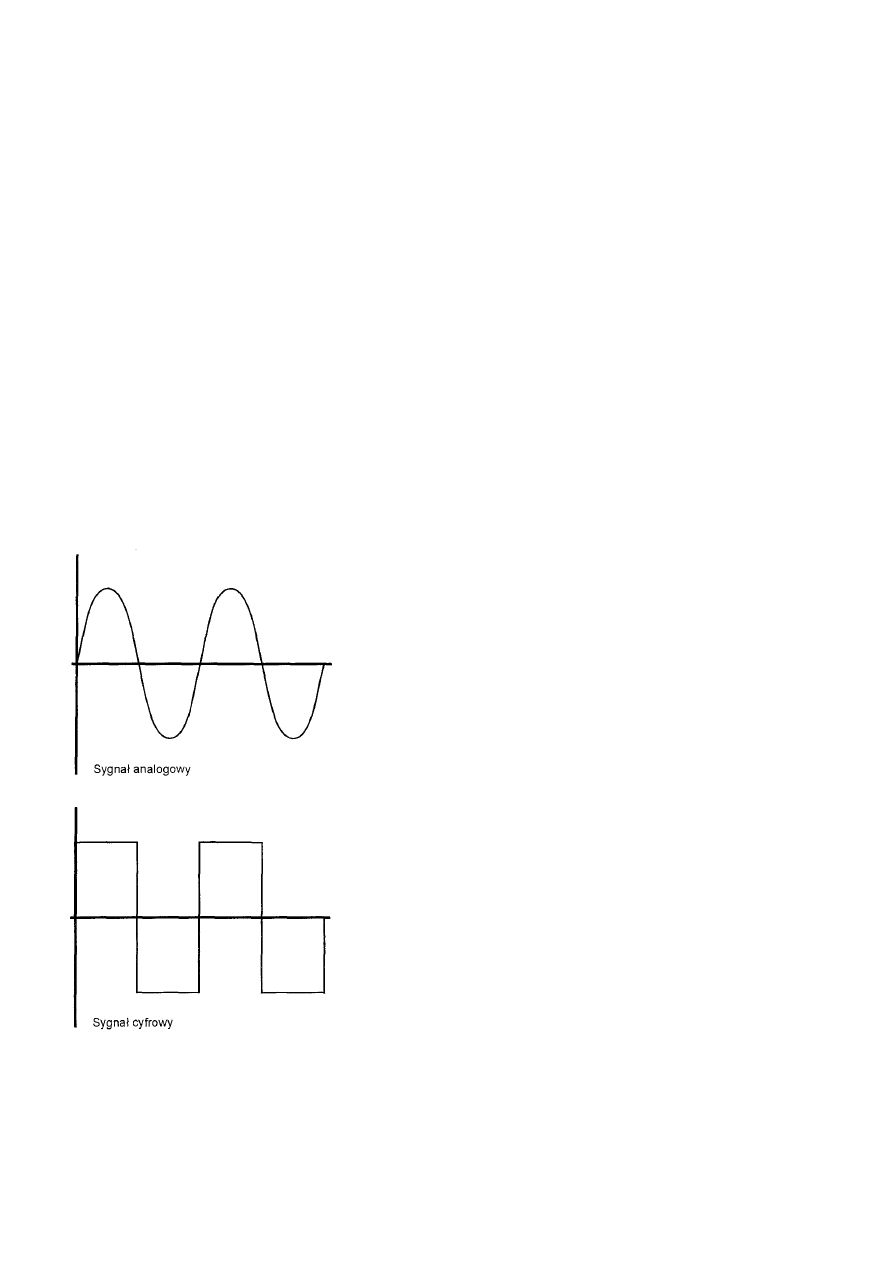

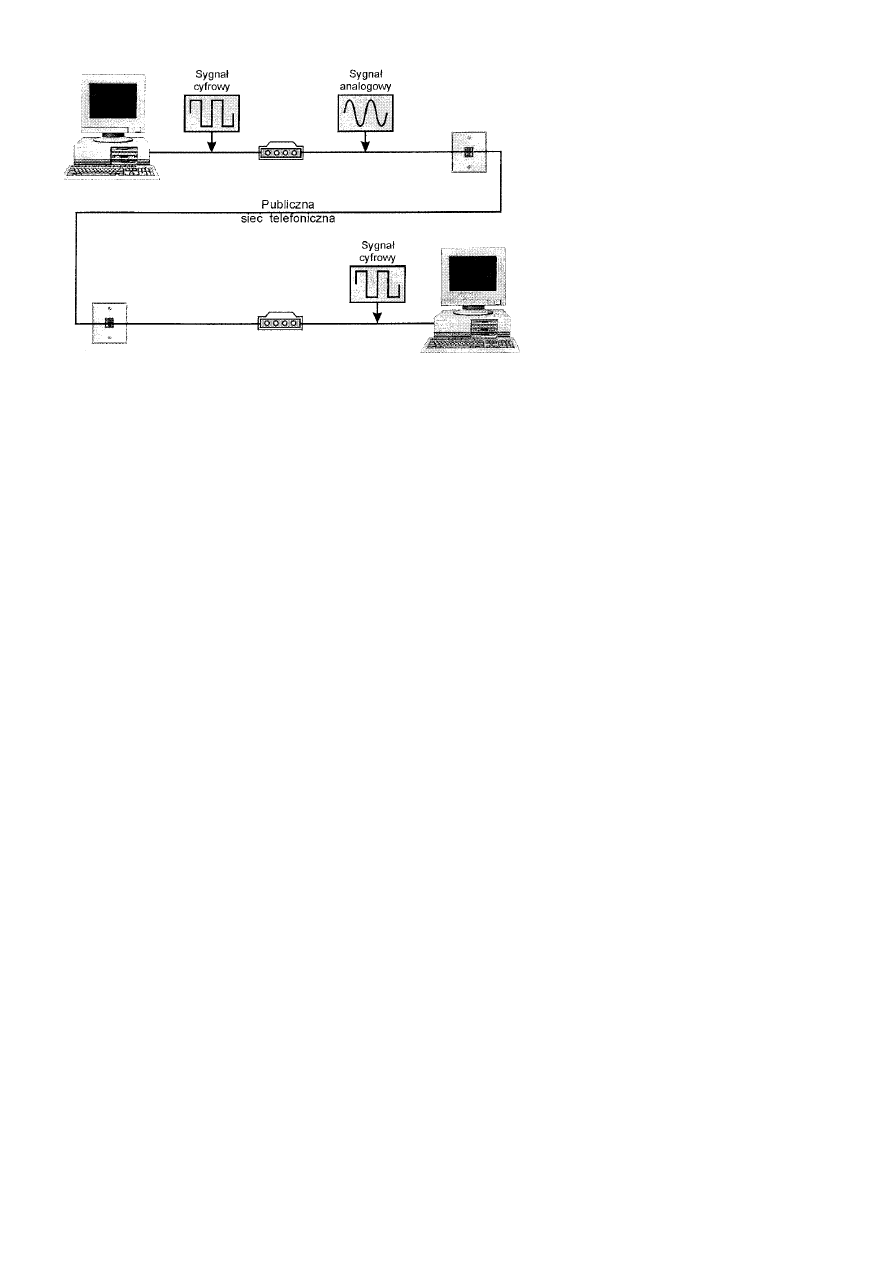

Sposób działania modemu.....................................................................................................................................................191

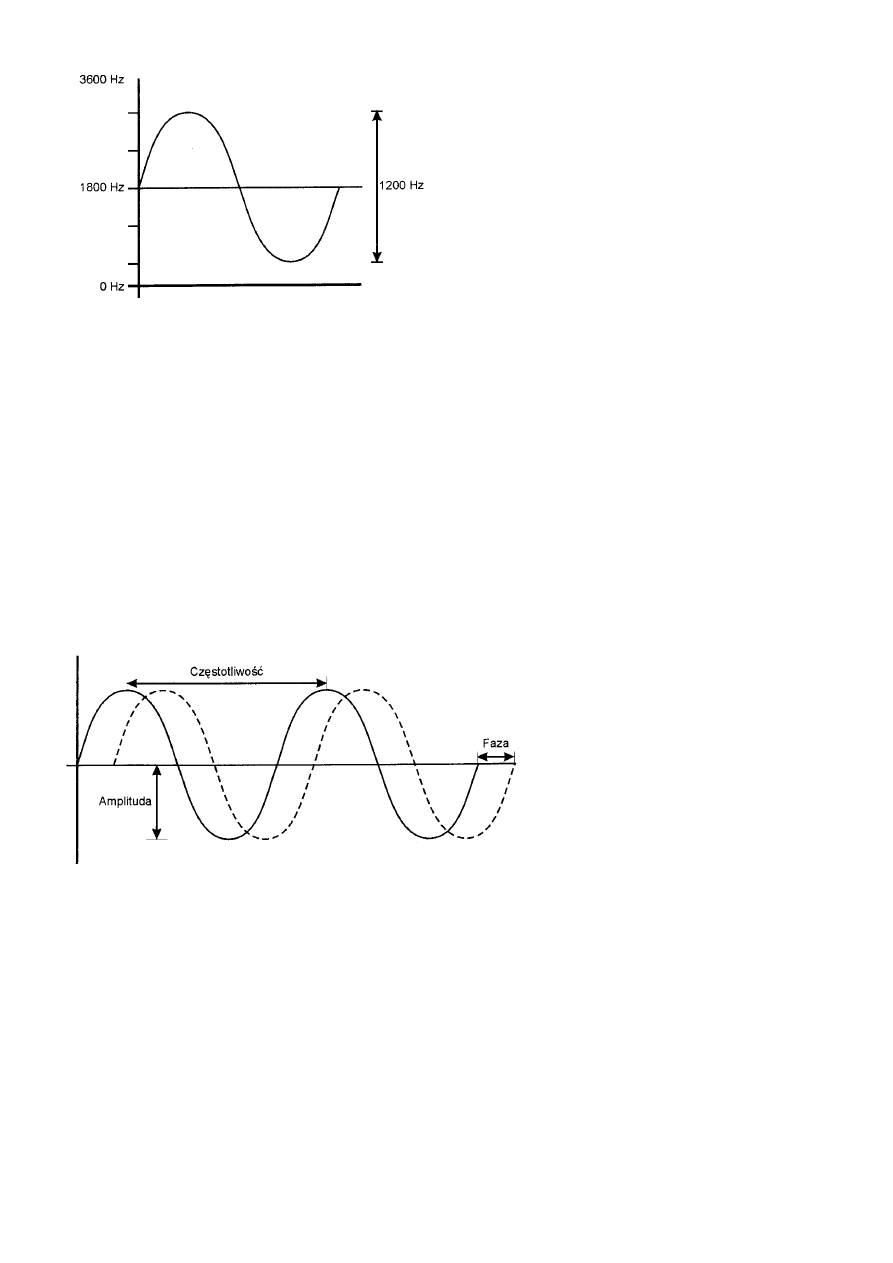

Bity i body.............................................................................................................................................................................192

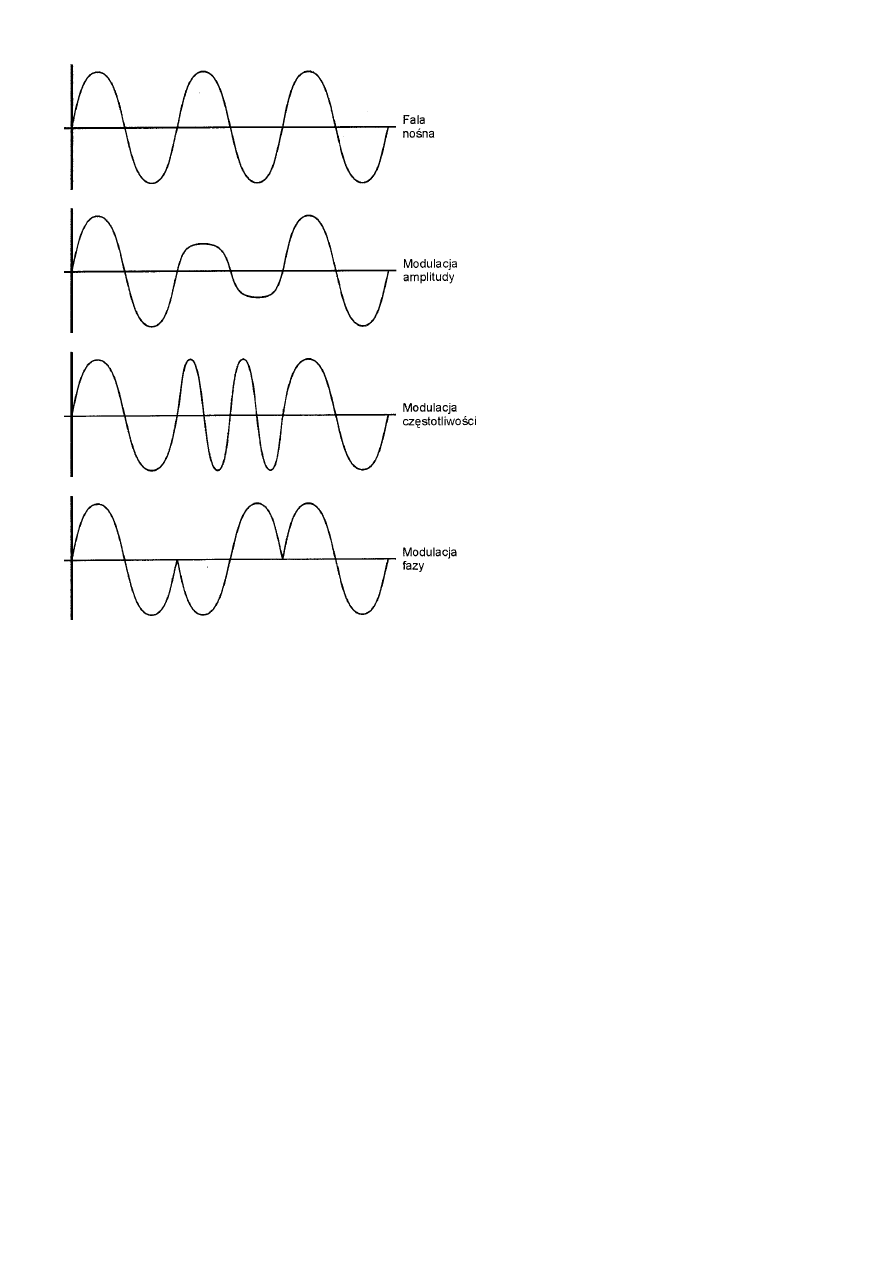

Typy modulacji modemów....................................................................................................................................................193

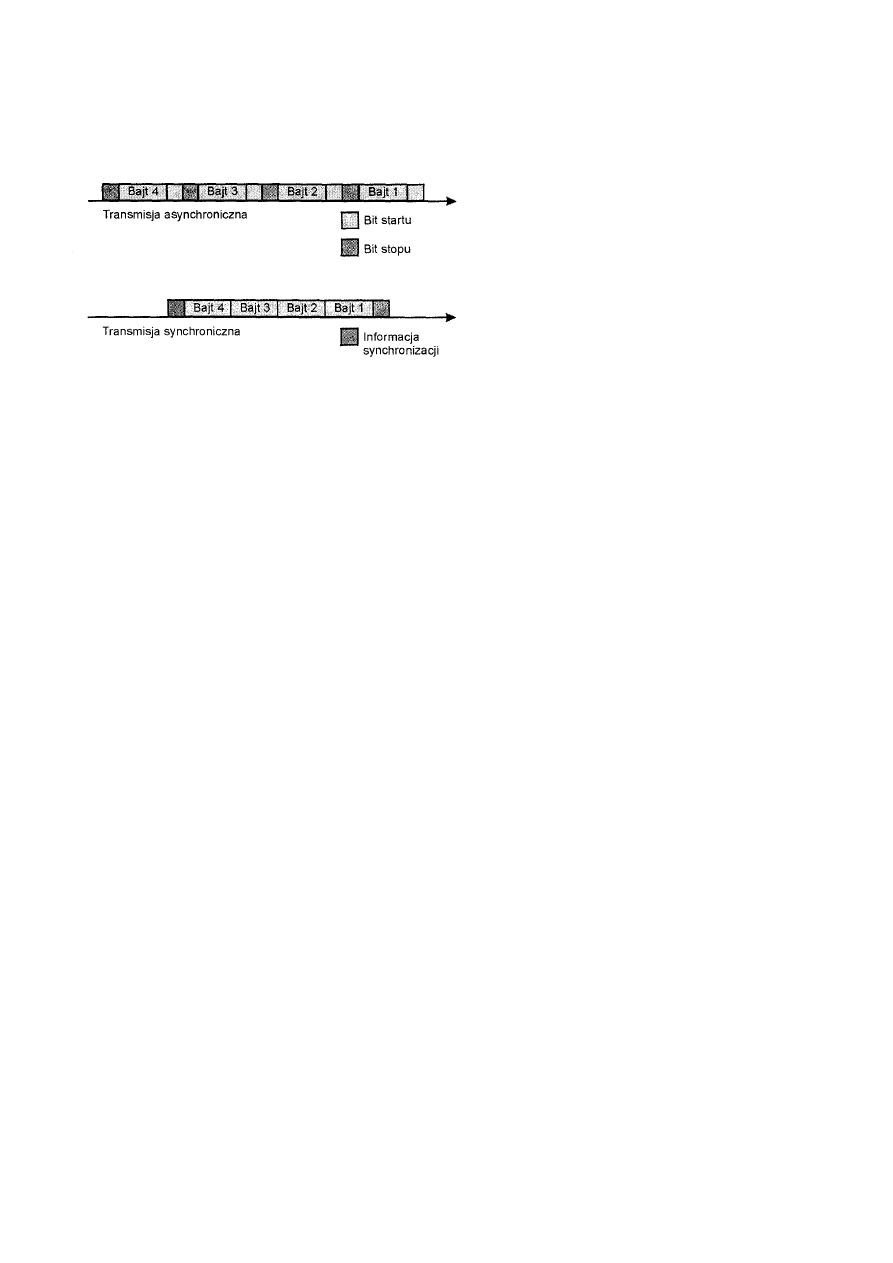

Asynchronicznie i synchronicznie ..............................................................................................................................194

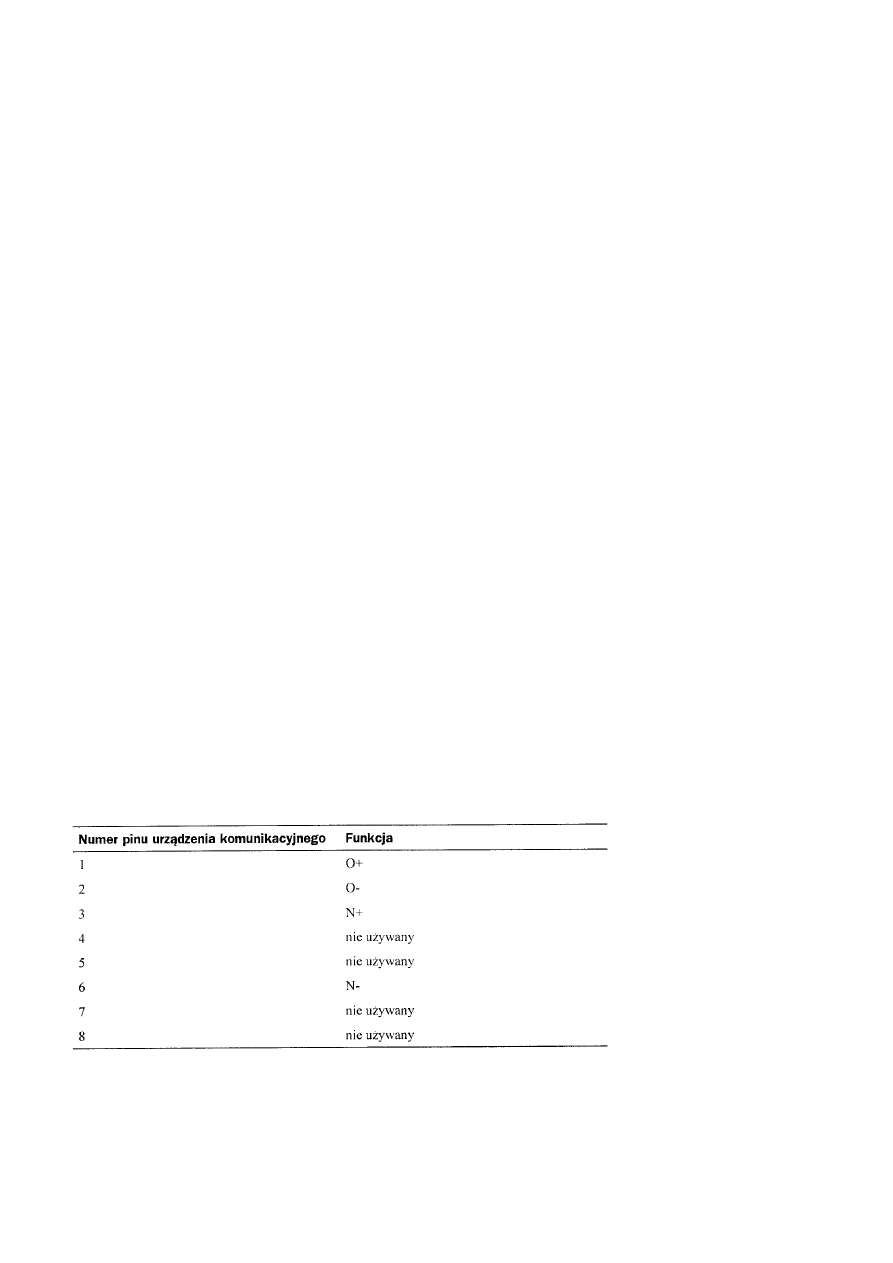

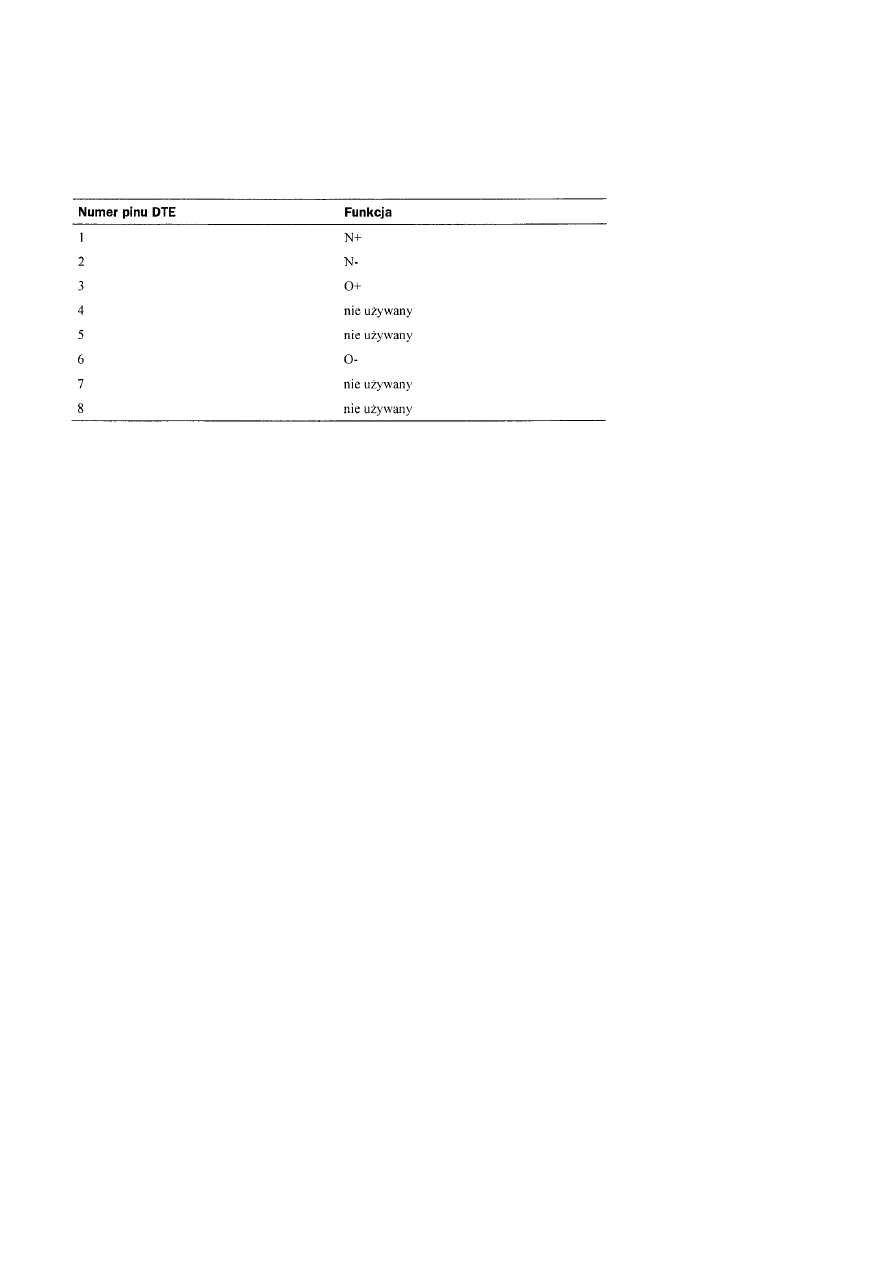

Standardowe interfejsy modemów ........................................................................................................................................195

Standardy ITU-T (CCITT) modemów...................................................................................................................................196

Modemy a Microsoft Networking .........................................................................................................................................197

Podsumowanie ......................................................................................................................................................................198

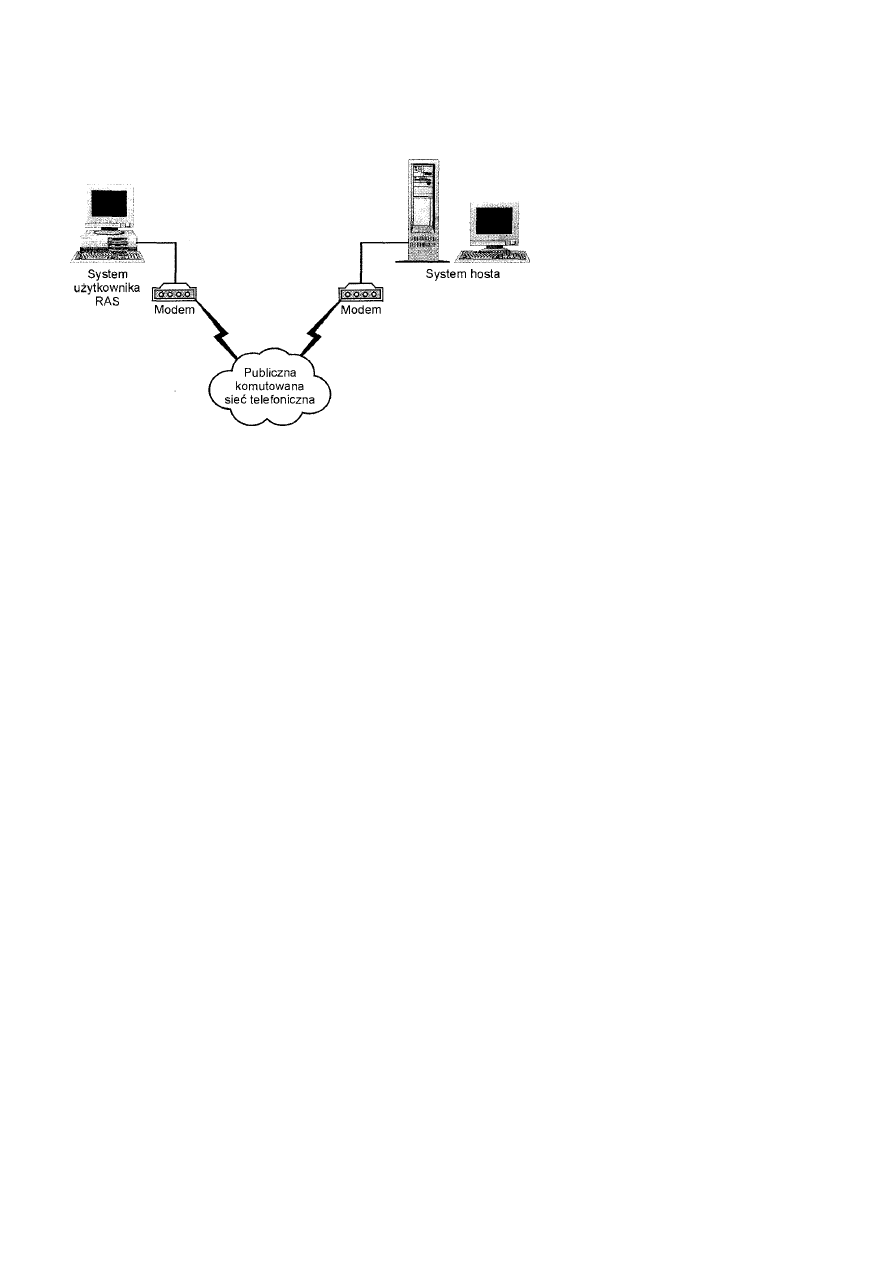

Rozdział 18 Usługi dostępu zdalnego (RAS)..............................................................................................................................198

Lata siedemdziesiąte ...................................................................................................................................................199

Lata osiemdziesiąte.....................................................................................................................................................199

Szaleństwo lat dziewięćdziesiątych ............................................................................................................................199

Ustanawianie połączeń zdalnych...........................................................................................................................................200

Ewolucja standardów protokołów...............................................................................................................................200

Zestaw poleceń AT .....................................................................................................................................................200

Protokoły połączeń zdalnych ......................................................................................................................................201

Ustanawianie sesji.......................................................................................................................................................201

Protokoły dostępu sieci TCP/IP ..................................................................................................................................201

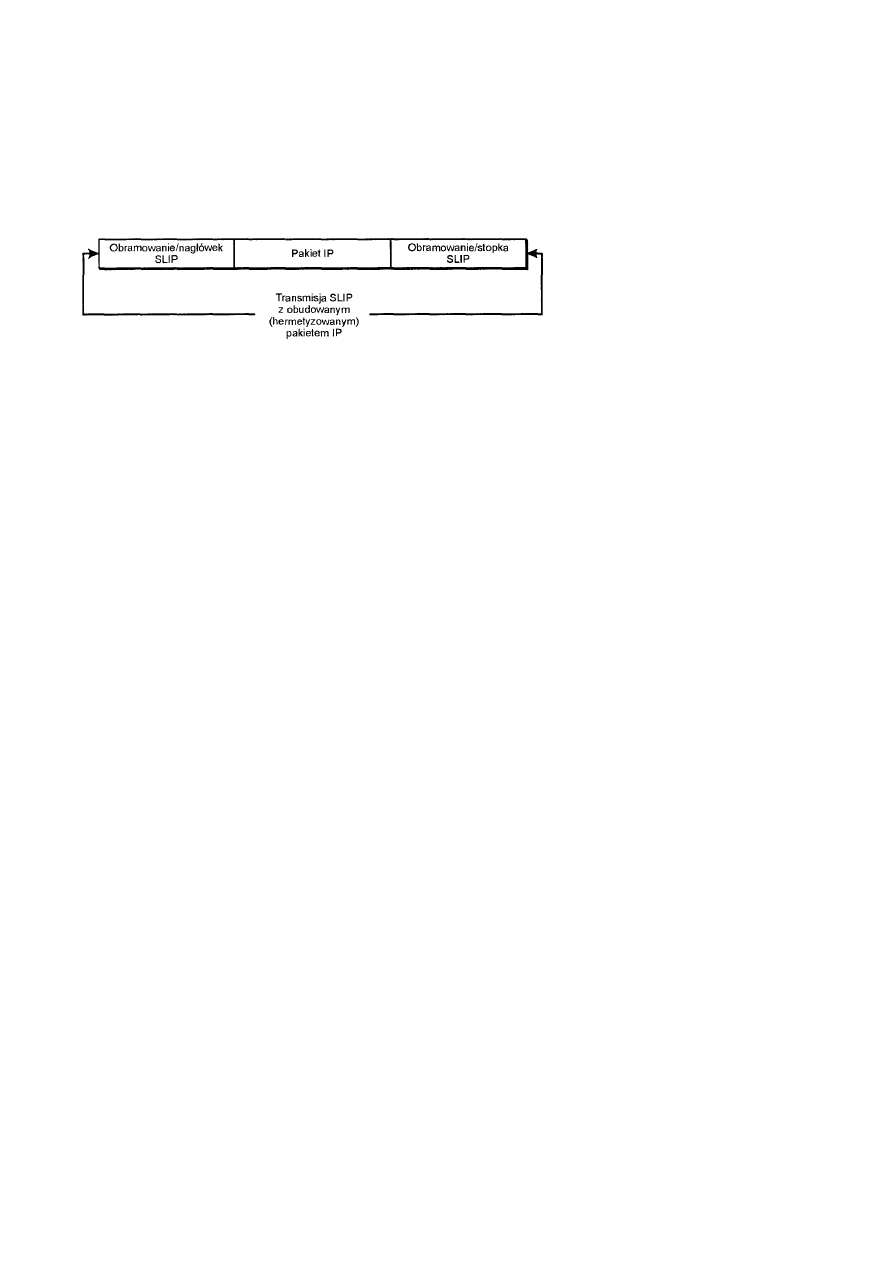

SLIP.......................................................................................................................................................................201

Protokół PPP..........................................................................................................................................................202

Trendy bieżące.......................................................................................................................................................203

Usługi transportu zdalnego....................................................................................................................................................203

1 Część 1 Podstawy sieci

1.1 Rozdział 1 ABC sieci

Mark A. Sportack

W miarę jak przetwarzanie danych na odległość staje się coraz to powszechniejsze, również coraz częstszym elementem praktycznie

wszystkich środowisk obliczeniowych stają się sieci komputerowe. Sieć komputerowa jest mechanizmem umożliwiającym komunikowanie

się komputerów znajdujących się w różnych miejscach; integralnym elementem owej komunikacji jest wzajemne udostępnianie sobie

zasobów. Pomimo wielorakich zastosowań, sieci komputerowe należą jednak do słabiej rozpoznanych obszarów technologii

informatycznych - czemu nierzadko towarzyszy swoista aura tajemniczości.

W niniejszym rozdziale przedstawione są różne typy sieci, zasady ich działania, a także omówiony jest sposób, w jaki ich ewolucja wpłynęła

na zmiany standardów informatycznych.

Standardy współdziałania sieciowego ustanawiane są przez różne organizacje. W rozdziale przedstawione są więc zarówno organizacje, ich

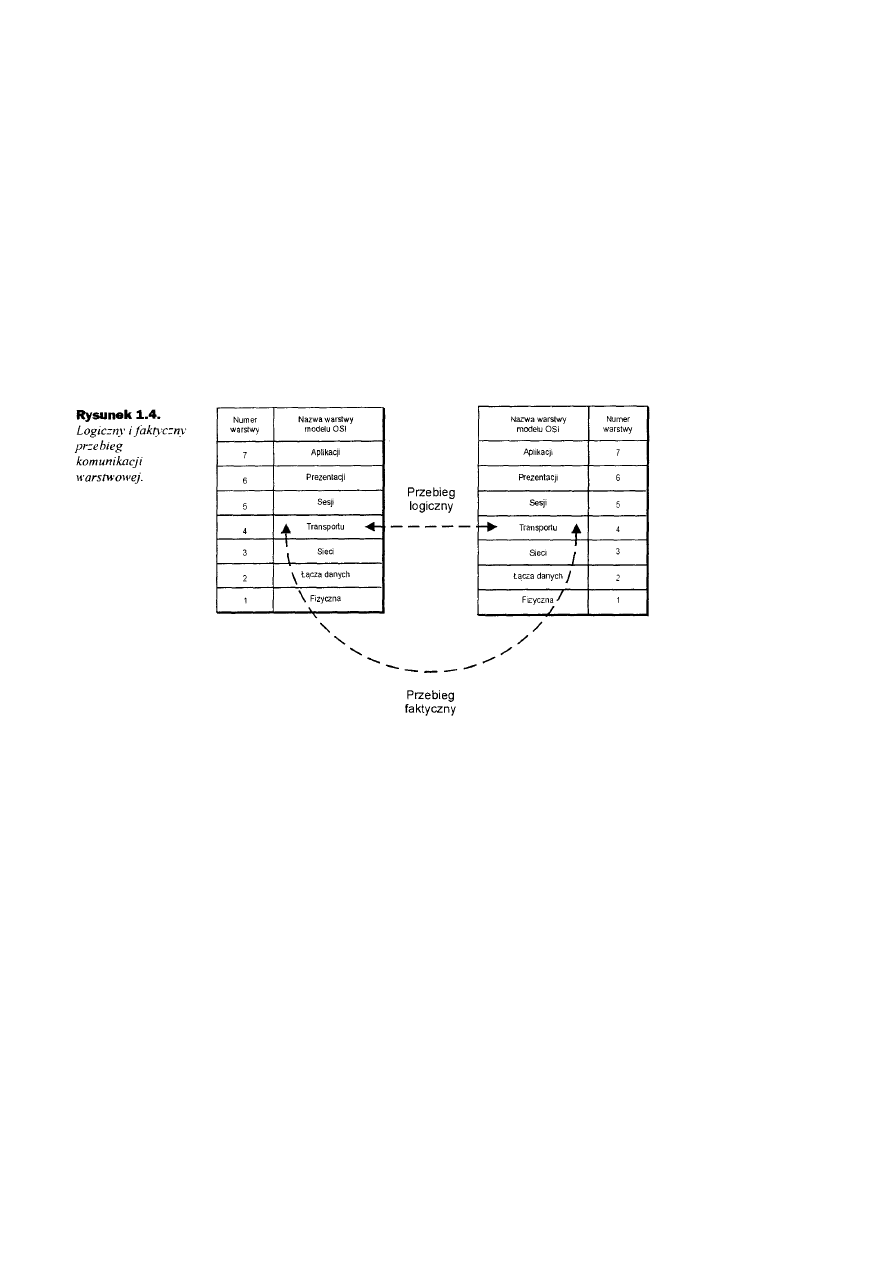

standardy, jak i związki pomiędzy nimi. .Jednym z ważniejszych standardów jest model połączonych systemów otwartych OSI). W modelu

tym każda warstwa obsługuje określony zbiór funkcji. Podział sieci na składniki funkcjonalne ułatwia zrozumienie zasad jej działania jako

całości. Grupy składników gromadzone są następnie w warstwy. A warstwowy model OSI jest dokładnie omówiony na dalszych stronach

niniejszego rozdziału.

1.1.1 Ewolucja sieci

U początków swego istnienia sieci komputerowe były zindywidualizowanymi formami połączeń, stanowiącymi integralną część równie

zindywidualizowanych rozwiązań obliczeniowych. Przedsiębiorstwa, które w owych przedpecetowych czasach zdecydowały się

zautomatyzować funkcje księgowości lub przetwarzania danych, wykonanie całego systemu musiały powierzyć jednemu wykonawcy.

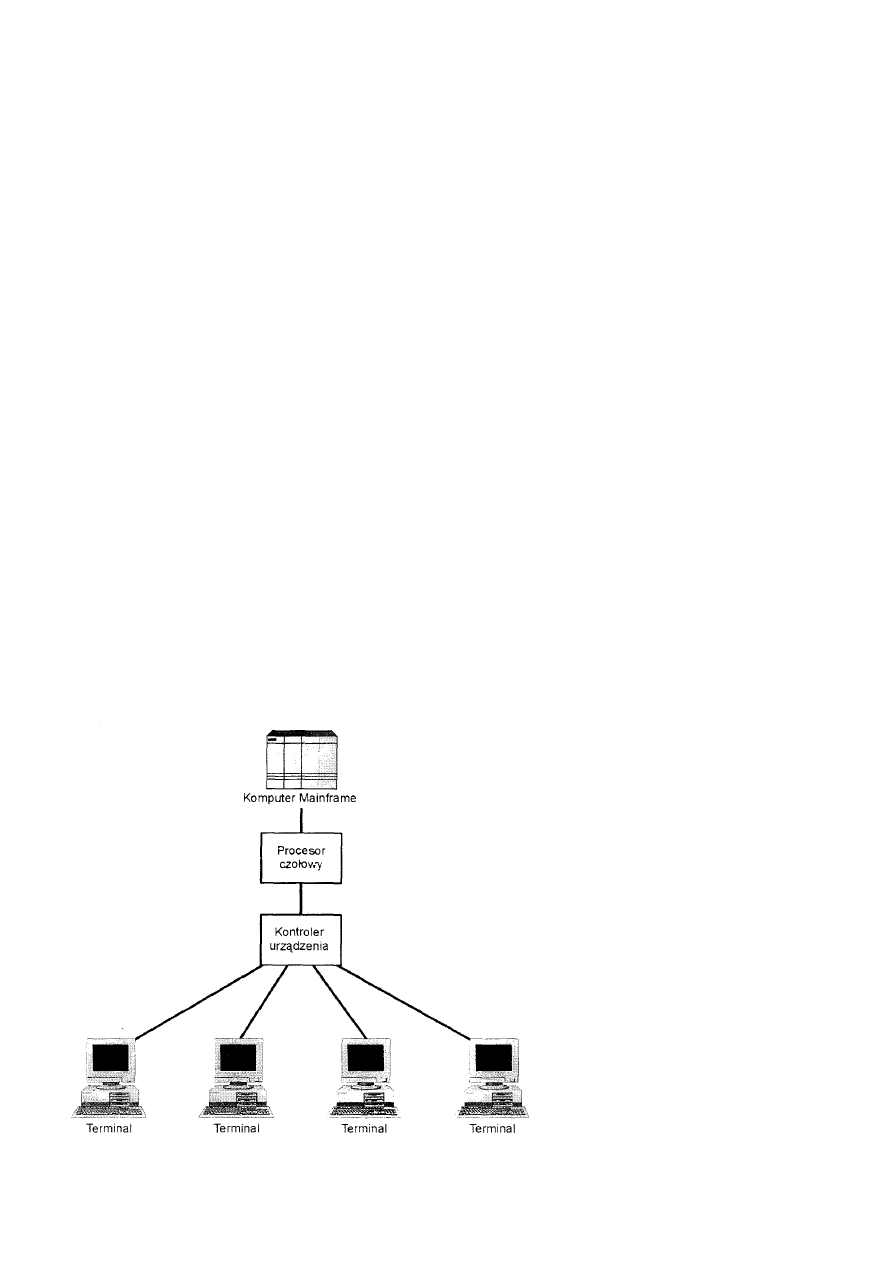

Standardowe konfiguracje składały się z terminali połączonych sprzętowo z kontrolerami urządzeń. Kontrolery te umożliwiały dostęp

multipleksowany (czyli wielodostęp) do urządzeń komunikacyjnych pozwalających na przyłączanie urządzeń do sieci głównej (mainframe).

Urządzenia komunikacyjne skupione były w procesorze czołowym sieci mainframe. Procesor czołowy umożliwiał wielu urządzeniom

komunikacyjnym współdzielenie pojedynczego kanału dostępu do sieci. Ze względu na różnicę w szybkości przetwarzania danych między

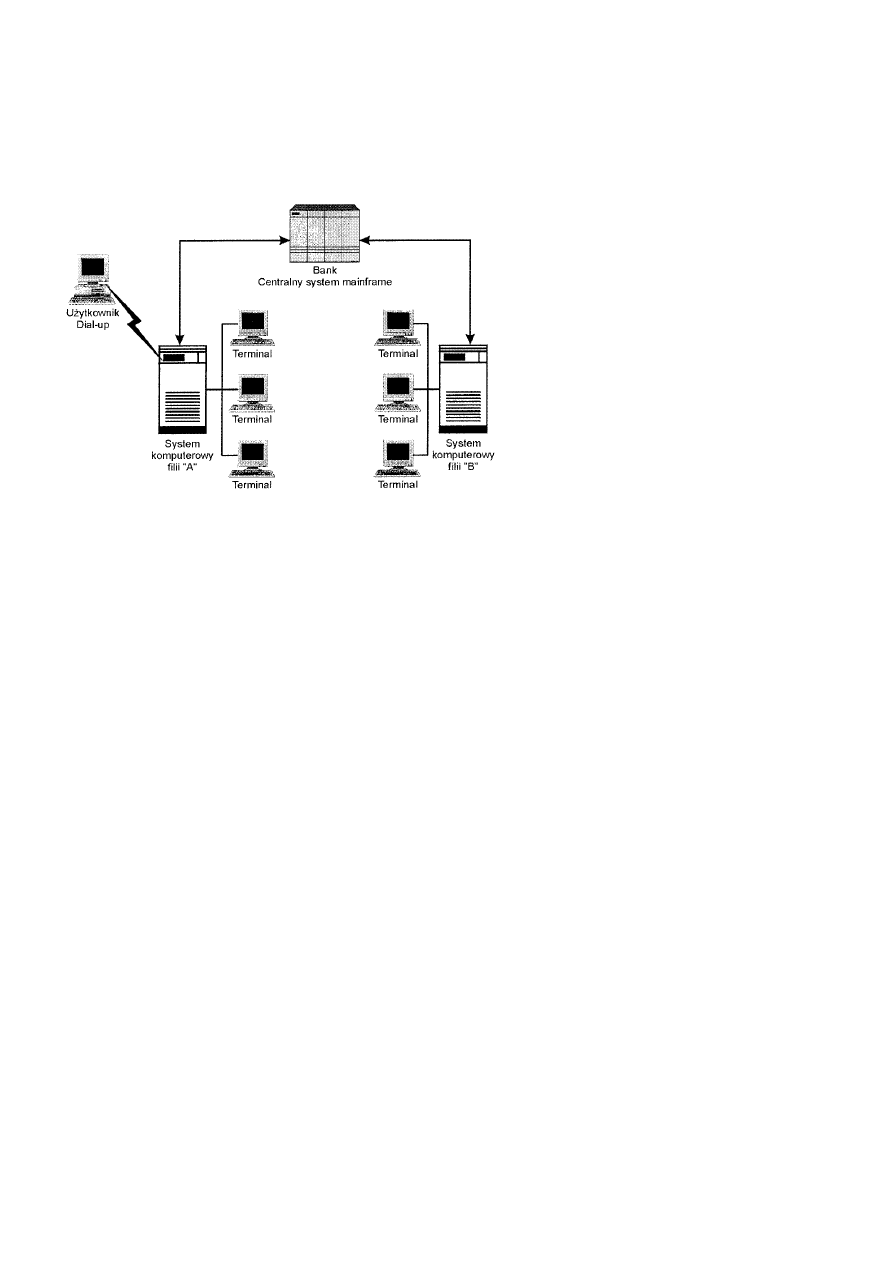

portami wejścia/wyjścia a procesorami sieci mainframe, rozwiązanie to było najbardziej efektywne ekonomicznie. Przedstawione jest ono na

rysunku 1.1.

Rysunek 1.1. Sprzętowy dostęp do sieci mainframe.

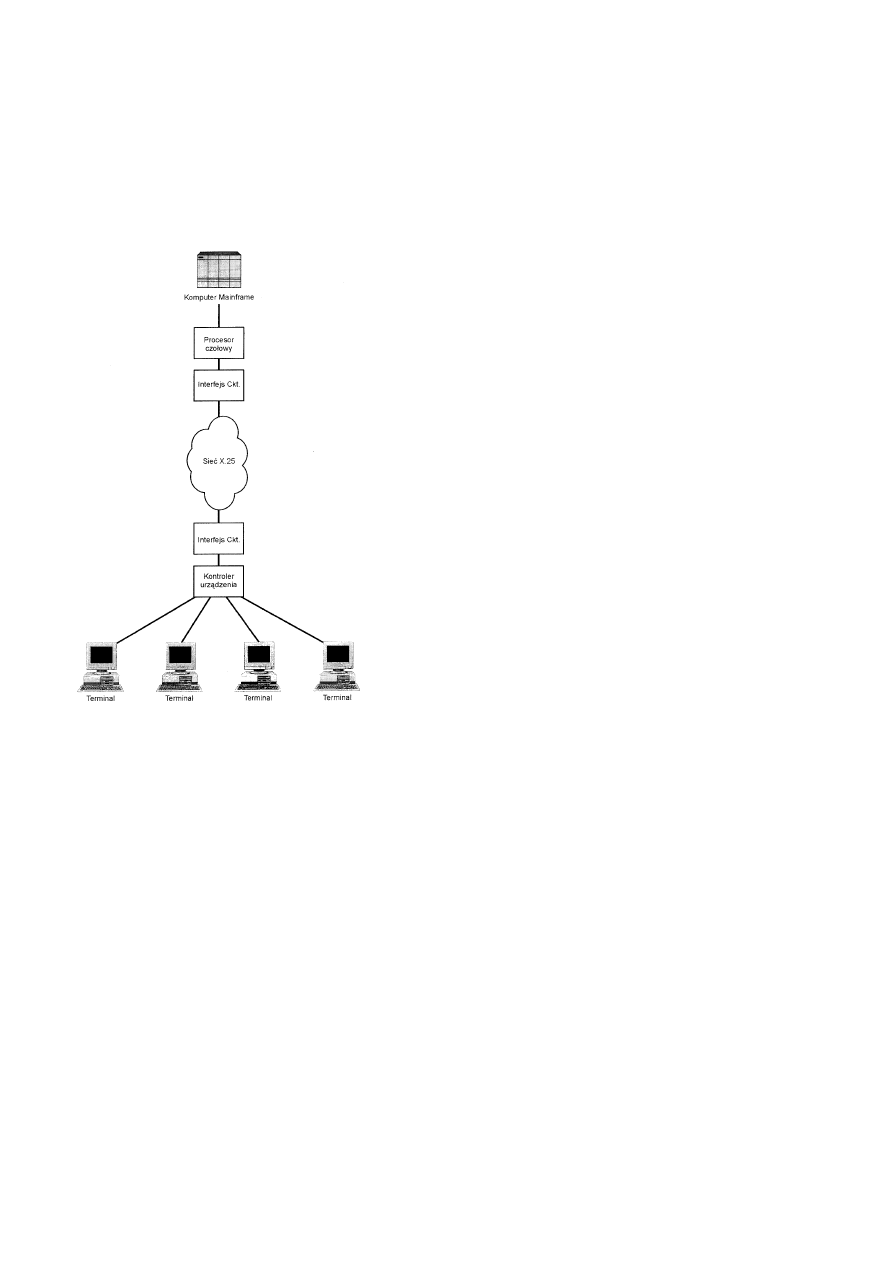

Do komunikacji z siecią mainframe na dużą odległość wykorzystywane były linie dzierżawione pasm o niskiej częstotliwości. Linia

dzierżawiona w takim przypadku łączona była z kanałem wejścia/wyjścia sieci mainframe Ilustruje to rysunek 1.2.

Programy działały jedynie w środowisku obsługiwanym przez pojedynczy system operacyjny. A system operacyjny mógł działać jedynie na

podstawie urządzenia jednego, określonego producenta. Nawet terminale użytkowników i urządzenia, za pomocą których były one

przyłączane do sieci, musiały być częścią zintegrowanego rozwiązania jednego producenta.

W czasach takich zintegrowanych rozwiązań systemowych nastąpiły dwie ewolucyjne zmiany technologiczne, które zmieniły kierunek

rozwoju informatyki. Pierwsza - to pojawienie się prymitywnych poprzedników dzisiejszych komputerów osobistych (czyli komputerów PC

lub inaczej pecetów). Innowacyjność tych urządzeń polegała na przeniesieniu miejsca wykonywania obliczeń - z osobnego pokoju,

mieszczącego (z trudnością) komputer główny, na biurka każdego z uczestników sieci.

Rysunek 1.2. Dostęp do sieci mainframe za pomocą linii dzierżawionych.

Druga zmiana wynikła z potrzeby poprawy wydajności pracy jaką odczuwali pracownicy centrum badawczego firmy Xerox w Palo Alto

(PARC). Dokładnie rzecz biorąc, próbowali oni usprawnić sposób współdzielenia plików i danych pomiędzy ich inteligentne stacje robocze -

praktykowane udostępnianie danych przy użyciu dyskietek było bowiem czasochłonne i nieporęczne, niezawodność zaś całego procesu -

wielce problematyczna.

Rozwiązanie opracowane w PARC polegało na utworzeniu pierwszej tzw.. sieci lokalnej LAN (ang. Local Area Network) - sieć ta nazwana

została Ethernet. Korzystała ona z protokołów współdziałania międzysieciowego wyższych warstw. Jej możliwości rynkowe zostały szybko

wykorzystane: pierwotny Ethernet, dziś znany jako Ethernet PARC lub Ethernet I, został zastąpiony przez nieco udoskonaloną wersję - DIX

Ethernet, zwaną również Ethernet II. Jej autorzy - firmy Xerox, Digital oraz Intel ustaliły wspólnie „standardy" sieciowe, do przestrzegania

których zobowiązały się przy produkcji jej elementów składowych.

Inteligentne urządzenia końcowe w połączeniu z sieciami LAN przyczyniły się do rozpowszechnienia nowego paradygmatu: otwartego,

rozproszonego przetwarzania danych.

1.1.2 Organizacje ustanawiające standardy

Sukces sieci Ethernet I oraz Ethernet II uwidacznia, że dawno już zmęczyliśmy się zindywidualizowanym podejściem do sieciowego

przetwarzania danych. Jako klienci wymagamy teraz bardziej otwartych środowisk. które umożliwiłyby nam tworzenie własnych rozwiązań

z różnych produktów wielu producentów. Współdziałanie międzysieciowe, jak widać na przykładzie Ethernetu, przyczynia się do

zwiększenia konkurencyjności i tempa wprowadzania innowacji technologicznych. Wzajemnie zależnymi celami otwartości są:

•

niższe koszty,

• większe możliwości,

• współdziałanie produktów różnych producentów.

Współdziałanie produktów różnych producentów wymaga, aby różne platformy rozpoznawały się wzajemnie oraz wiedziały, w jaki sposób

mogą się ze sobą komunikować i współdzielić dane. Wymogi te przyczyniły się do rozwoju uniwersalnych standardów dotyczących każdego

aspektu sieciowego przetwarzania danych.

Potrzeba standaryzacji zwiększyła wysiłki organizacji zajmujących się normalizowaniem. Dziś za określanie krajowych i

międzynarodowych standardów regulujących różne aspekty technologii informatycznych odpowiedzialnych jest wiele różnych organizacji.

Najczęściej współpracują one ze sobą w celu ustanowienia jak najbardziej uniwersalnego zbioru standardów. Może to, co prawda,

powodować pewne zamieszanie, które jednak -jest nieporównywalne z korzyściami płynącymi z owej standaryzacji.

Poniżej przedstawione są organizacje tworzące standardy i powiązania między nimi.

1.1.2.1 ANSI

Amerykański Narodowy Instytut Normalizacji lub - bardziej dosłownie: Amerykański Instytut Standardów Narodowych (ang. ANSI - The

American National Standards Institute) - jest prywatną organizacją niekomercyjną. Jej misją jest ułatwianie rozwoju,

koordynacja oraz publikowanie nieobligatoryjnych standardów. „Nieobligatoryjność" standardów ANSI polega na tym, że organizacja ta nie

wdraża aktywnie ani nie narzuca nikomu swoich standardów. Uczestniczy natomiast w pracach organizacji ustanawiających standardy

globalne, takich jak IOS, IEC itp., w związku z czym niezgodność z jej standardami powoduje niezgodność ze standardami globalnymi.

1.1.2.2 IEEE

Instytut Elektryków i Elektroników (ang. lEEE- The Institute of Electrical and Electronic Engineers) jest odpowiedzialny za definiowanie i

publikowanie standardów telekomunikacyjnych oraz przesyłania danych. Jego największym - jak dotąd - osiągnięciem jest zdefiniowanie

standardów sieci LAN oraz MAN. Standardy te tworzą wielki i skomplikowany zbiór norm technicznych, ogólnie określany jako „Project

802" lub jako seria standardów 802.

Celem IEEE jest tworzenie norm, które byłyby akceptowane przez instytut ANSI. Akceptacja taka zwiększyłaby ich forum dzięki

uczestnictwie ANSI w globalnych organizacjach określających standardy.

1.1.2.3 ISO

Międzynarodowa Organizacja Normalizacyjna (ang. ISO - lnternational Organization for Standardization) została utworzona w 1946 roku w

Szwajcarii, w Genewie-tam też znajduje się dziś jęj główna siedziba. Niektóre źródła organizację tę identyfikują za pomocą akronimu IOS.

Mimo iż to właśnie ten skrót jest formalnie poprawny, organizacja woli określać się za pomocą bardzięj mnemonicznego (łatwiejszego do

zapamiętania) skrótu: ISO. Skrót ten pochodzi od greckiego słowa i.sos, które jest odpowiednikiem polskiego „równy" lub „standardowy".

Dlatego ten właśnie skrót jest uznawany za skrót Międzynarodowej Organizacji Normalizacyjnej, która - przy okazji - jest niezależnym

podmiotem wynajętym przez Organizację Narodów Zjednoczonych (ONZ) do określania standardów międzynarodowych. Zakres jej

działania obejmuje praktycznie wszystkie dziedziny wiedzy ludzkiej, poza elektryką i elektroniką. Aktualnie ISO składa się z ponad 90

różnych organizacji standardo-dawczych z siedzibami na całym świecie. Najważniejszym prawdopodobnie standardem ustanowionym przez

ISO jest Model Referencyjny Połączonych Systemów Otwartych, czyli model OSI (ang. Open Systems Interconnection Reference Model).

Model ten jest szczegółowo omówiony w dalszej części niniejszego rozdziału- w podrozdziale „Model referencyjny OSI".

1.1.2.4 IEC