C

z´sto nazywa si´ Internet

Êwiatowà bibliotekà epoki cy-

frowej. To okreÊlenie nie wy-

trzymuje jednak nawet pobie˝nej ana-

lizy. Internet – a szczególnie jego

zbiór multimedialnych zasobów zna-

ny jako World Wide Web – nie zosta∏

stworzony z myÊlà o uporzàdkowa-

niu publikacji dajàcym mo˝liwoÊç

wyszukiwania ich tak jak w bibliotece.

Jego rozwój doprowadzi∏ do czegoÊ, co

da si´ porównaç do bez∏adnego zbioru

efektów pracy cyfrowych „maszyn dru-

karskich” na ca∏ym Êwiecie. Ten maga-

zyn informacji zawiera nie tylko ksià˝-

ki i dokumenty, ale równie˝ dane

naukowe, przepisy, reklamy, notatki ze

spotkaƒ, nagrania audio i wideo, zapi-

sy interaktywnych konwersacji. Rzeczy

efemeryczne przemieszane sà z pracami

o wartoÊci nieprzemijajàcej.

Mówiàc krótko, Internet nie jest cy-

frowà bibliotekà. Ale jeÊli jego rozwój

nie straci na tempie i doprowadzi do

uczynienia zeƒ nowego Êrodka komu-

nikacji, zajdzie potrzeba zorganizowania

czegoÊ bardzo podobnego do tradycyj-

nych us∏ug bibliotecznych. B´dzie si´ to

wiàza∏o z koniecznoÊcià uporzàdkowa-

nia, udost´pniania i archiwizowania in-

formacji zgromadzonych w Sieci. Na-

wet wtedy Internet nie musi jednak

przypominaç tradycyjnej biblioteki, po-

niewa˝ jego zawartoÊç jest znacznie bar-

dziej rozproszona. Umiej´tnoÊci klasy-

fikacji i selekcji, którymi dysponujà

bibliotekarze, trzeba b´dzie uzupe∏niç

umiej´tnoÊciami informatyka – auto-

matycznego indeksowania i przecho-

wywania informacji. Tylko synteza

obu profesji pozwoli nowemu me-

dium zachowaç ˝ywotnoÊç.

DziÊ prawie ca∏a odpowiedzialnoÊç

za uporzàdkowanie informacji w In-

ternecie spoczywa na technice kom-

puterowej. W teorii oprogramowa-

nie, które klasyfikuje i indeksuje zbiory

danych cyfrowych, powinno poradziç

sobie z zalewem informacji zgromadzo-

nej w Sieci, co przekracza mo˝liwoÊci

bibliotekarzy i archiwistów. Do auto-

matycznego przetwarzania informacji

b´dà s∏u˝yç coraz szybsze i coraz taƒ-

sze komputery; pozwoli to uniknàç wy-

sokich kosztów i opóênieƒ zwiàzanych

z indeksowaniem wykonywanym przez

cz∏owieka.

Ale jak wie ka˝dy, kto kiedykolwiek

przeszukiwa∏ Sieç, automaty kategory-

zujà informacje inaczej ni˝ ludzie. W

RAPORT SPECJALNY

PRZESZUKUJÑC INTERNET

Czy po∏àczenie umiej´tnoÊci bibliotekarza i komputerowego guru

pomo˝e w opanowaniu anarchii w Internecie?

Clifford Lynch

PRZESZUKIWARKA odwiedza („przeczesuje”) ró˝ne miejsca w World Wide Web, po-

kazane tu jako niebieskie kule. ˚ó∏te i niebieskie linie oznaczajà dane wejÊciowe i wyjÊcio-

we serwera przeszukiwarki (czerwona wie˝a), gdzie strony WWW sà wgrywane. Opro-

gramowanie serwera tworzy indeks (be˝owa kartka), do którego ma dost´p u˝ytkownik.

JEFF BRICE

BRYAN CHRISTIE

Â

WIAT

N

AUKI

Maj 1997 31

pewnym sensie praca wykonywana

przez rozmaite narz´dzia indeksujàce

i katalogujàce znane jako przeszukiwar-

ki jest wysoce demokratyczna. Maszyna

ujednolica podejÊcie do ka˝dej informa-

cji. W praktyce ten elektroniczny egali-

taryzm ma równie˝ z∏e strony. Internau-

ci, którzy formu∏ujà zapytanie, otrzy-

mujà cz´sto w odpowiedzi listy zawie-

rajàce tysiàce pozycji. Na listach tych

znajdujà cz´sto odnoÊniki do nie zwià-

zanych z tematem miejsc, brak na nich

natomiast innych, które kierujà do

materia∏ów istotnych.

Roboty sieci

Mechanizm elektronicznego indekso-

wania zrozumiemy, analizujàc, jak sie-

ciowe przeszukiwarki, takie jak Lycos

czy AltaVista, tworzà za pomocà progra-

mów indeksy i znajdujà informacje,

o które pyta u˝ytkownik. Co pewien czas

uruchamiajà one programy (b´dziemy

je nazywaç robotami indeksujàcymi –

crawlers, spiders, indexing robots) od-

wiedzajàce ka˝de miejsce w Sieci, które

potrafià znaleêç. Miejsce zawiera zbiór

dokumentów zwanych stronami inter-

netowymi. Robot indeksujàcy przeglà-

da strony i stara si´ uzyskaç informacje,

które mogà pos∏u˝yç do ich opisu. Proces

ten – nieco inny w szczegó∏ach w ró˝-

nych przeszukiwarkach – polega na zlo-

kalizowaniu wi´kszoÊci s∏ów pojawiajà-

cych si´ na stronach internetowych lub

przeprowadzeniu zaawansowanej anali-

zy w celu identyfikacji kluczowych s∏ów

czy fraz. Nast´pnie zostajà one umiesz-

czone w bazie danych przeszukiwarki

wraz z adresem dokumentu, z którego

pochodzà, zwanym URL (uniform re-

source locator). U˝ytkownik, korzysta-

jàc z przeglàdarki takiej jak popularny

Netscape, wysy∏a pytania do bazy prze-

szukiwarki. W odpowiedzi otrzymuje li-

st´ zasobów internetowych wraz z ich

adresami; klika na nie, gdy chce po∏à-

czyç si´ z danym miejscem.

Internetowe przeszukiwarki odpo-

wiadajà na miliony pytaƒ dziennie. Sta-

je si´ jasne, ˝e nie sà one idealnym na-

rz´dziem do przeszukiwania coraz

wi´kszych zasobów informacyjnych

zgromadzonych w Sieci. Inaczej ni˝ lu-

dzie trudniàcy si´ archiwizacjà automa-

tyczne programy miewajà trudnoÊci

z identyfikacjà charakteru dokumentu,

jego ogólnej tematyki lub rodzaju – na

przyk∏ad nie odró˝niajà powieÊci lub

poematu od reklamy.

Co wi´cej, w Internecie ciàgle braku-

je standardów, które by u∏atwia∏y auto-

matyczne indeksowa-

nie. Dokumenty w

Sieci nie majà struktu-

ry pozwalajàcej pro-

gramom wy∏uskaç w

sposób niezawodny

najprostszych infor-

macji, które cz∏owiek

uzyskuje, przeglàda-

jàc dokument na ekra-

nie – nazwisko autora,

dat´ publikacji, d∏u-

goÊç tekstu, jego te-

matyk´ (informacje ta-

kie nazywajà si´ me-

tadanymi). Interneto-

wy robot mo˝e zna-

leêç poszukiwany ar-

tyku∏ Jana Kowalskie-

go, ale równie˝ tysià-

ce innych dokumen-

tów, w których to po-

pularne imi´ i na-

zwisko pada w tekÊcie lub w przypisach

bibliograficznych.

Czasami ta nieselektywnoÊç automa-

tycznego indeksowania jest wykorzy-

stywana. KtoÊ mo˝e spowodowaç, by

dany dokument by∏ wybierany cz´Êciej,

powtarzajàc w nim kilkakrotnie s∏owo

wyst´pujàce w wielu zapytaniach, na

przyk∏ad „seks”. Przeszukiwarka poka-

zuje bowiem na poczàtku te dokumen-

ty, w których szukane s∏owo pojawia

si´ najcz´Êciej. Wykonujàcy t´ samà pra-

c´ ludzie nie daliby si´ nabraç na takie

naiwne sztuczki.

Dla profesjonalisty sporzàdzajàcego

indeks fakt, ˝e cz´Êci sk∏adowe doku-

mentu sà ró˝nego rodzaju (od tekstu po

film wideo) nie przedstawia trudnoÊci –

potrafi je przypisaç do okreÊlonych ka-

tegorii tematycznych. Fotografie z woj-

ny secesyjnej mogà na przyk∏ad stano-

wiç cz´Êç zbioru, który zawiera równie˝

muzyk´ z tamtego okresu czy wspo-

mnienia ˝o∏nierzy. Archiwista cz∏owiek

potrafi opisaç, jak zbiór zosta∏ zorgani-

zowany w miejscu, w którym magazy-

nuje si´ na przyk∏ad programy dla

komputerów Mackintosh. Historia da-

nego miejsca internetowego, cel jego po-

wstania oraz charakter jest natomiast

poza zasi´giem programu przeszuku-

jàcego Sieç.

Innà wadà automatycznego indekso-

wania jest to, ˝e wi´kszoÊç przeszukiwa-

rek rozpoznaje tylko tekst. Wielkie zain-

teresowanie Âwiatowà Paj´czynà wzi´∏o

si´ jednak stàd, ˝e pozwala ona równie˝

na wyÊwietlanie zdj´ç, rysunków czy wi-

deo. Badania nad rozpoznawaniem kolo-

rów i wzorów na ilustracjach przynios∏y

ju˝ pewne rezultaty. ˚aden program nie

potrafi jednak wydedukowaç ukrytych

znaczeƒ i konotacji kulturowych (nie od-

gadnie na przyk∏ad, ˝e obraz, na którym

grupa m´˝czyzn si´ posila, przedstawia

Ostatnià Wieczerz´).

JednoczeÊnie ciàgle zmienia si´ struk-

tura sieciowej informacji i cz´sto indek-

sujàcy robot nie umie tej informacji od-

czytaç. Wiele stron internetowych to ju˝

nie statyczne pliki, które dajà si´ anali-

zowaç i indeksowaç za pomocà obecnie

stosowanych programów. Coraz cz´Êciej

informacja wyÊwietlana w dokumencie

jest tworzona w czasie jej wyszukiwania

– modyfikowana zgodnie z ˝àdaniem

u˝ytkownika. Serwer potrafi przygoto-

waç map´, tabel´ czy tekst, wykorzystu-

jàc informacje z ró˝nych obszarów swo-

jej bazy danych. Wydawca gazety w

Internecie mo˝e pozwoliç czytelnikowi

na okreÊlenie osobistych preferencji; taka

wersja pisma b´dzie wyÊwietla∏a wy∏àcz-

nie artyku∏y o interesujàcej go tematyce,

na przyk∏ad dotyczàce przemys∏u nafto-

wego. Baza danych, z której pochodzà

te artyku∏y, nie jest dost´pna dla robota

indeksujàcego odwiedzajàcego t´ zindy-

widualizowanà gazet´.

Coraz cz´Êciej prowadzi si´ badania

zmierzajàce do eliminacji niektórych

problemów zwiàzanych z automatycz-

nymi metodami klasyfikacji. Jedno z

proponowanych podejÊç polega na do-

dawaniu metadanych do dokumentów,

tak aby systemy indeksujàce mog∏y te

informacje gromadziç. Najlepsze wyni-

ki w tej dziedzinie majà projekty specy-

fikacji Dublin Core Metadata i zwiàza-

ny z nim Warwick Framework – nazwa

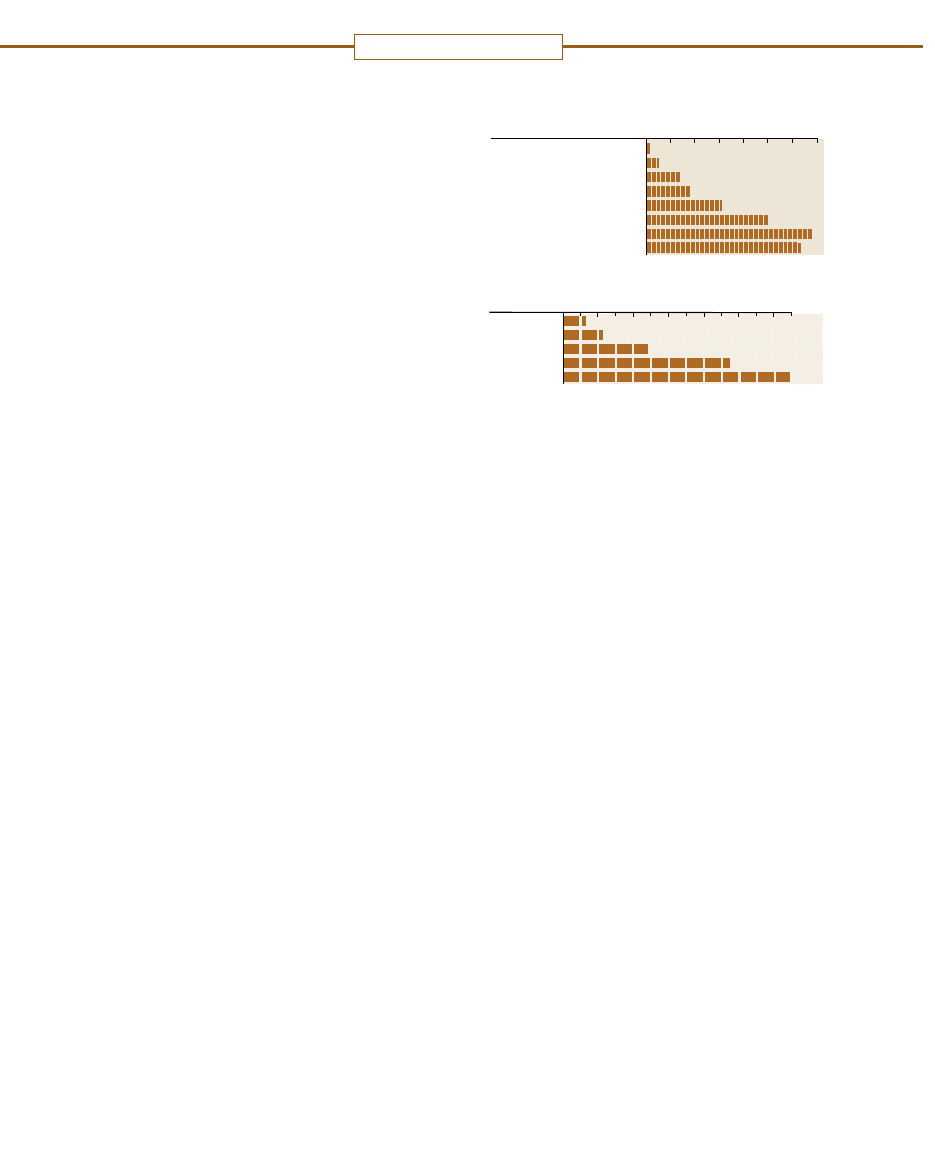

PRZYPUSZCZALNA

LICZBA

SERWERÓW WWW

SERWERY .com

(PROCENT WSZYSTKICH SERWERÓW)

CZERWIEC 1993

GRUDZIE¡ 1993

CZERWIEC 1994

GRUDZIE¡ 1994

CZERWIEC 1995

STYCZE¡ 1996

CZERWIEC 1996

STYCZE¡ 1997

130

620

2740

10 000

23 500

100 000

230 000

650 000

0

2

5

14

18

31

50

68

63

10

20

30

40

50

60

70

STYCZE¡ 1993

STYCZE¡ 1994

STYCZE¡ 1995

STYCZE¡ 1996

LIPIEC 1996

12.9

0

2

4

6

8

10

12

LICZBA KOMPUTERÓW BAZOWYCH

(MILIONY)

1.3

2.2

4.9

9.5

ROZWÓJ I ZMIANY w Internecie oddaje zwi´kszajàca si´ licz-

ba serwerów World Wide Web, komputerów bazowych i komer-

cyjnych serwerów, czyli tych, które znajdujà si´ w domenie .com

Na podstawie danych Mathew K. Graya: BRYAN CHRISTIE

RAPORT SPECJALNY

32 Â

WIAT

N

AUKI

Maj 1997

I

nternet wyszed∏ na swoje kilka lat temu, gdy pojawi∏a si´ World

Wide Web z szerokà paletà fotografii, animacji, rysunków, dêwi´-

ku i wideo, zawierajàcych wszystko – od wybitnych dzie∏ sztuki

po czystà pornografi´. Pomimo ogromnej liczby materia∏ów mul-

timedialnych znalezienie tych, które interesujà u˝ytkownika na

setkach tysi´cy serwerów internetowych, ciàgle jeszcze wyma-

ga wyszukiwania w indeksach s∏ów lub liczb.

KtoÊ, kto wpisze s∏owa „polska flaga” do popularnej przeszuki-

warki AltaVista, ma szans´ dotrzeç do obrazu polskiej flagi tylko

wtedy, gdy jest ona tymi s∏owami opisana. Ale co ma zrobiç ktoÊ,

kto pami´ta kolory flagi, ale nie wie, z jakiego kraju ona pochodzi?

Najlepiej by∏oby, gdyby przeszukiwarka pozwoli∏a u˝ytkowniko-

wi narysowaç lub zeskanowaç prostokàt, którego górna po∏owa by-

∏aby bia∏a, a dolna czerwona, i nast´pnie odnalaz∏a podobne ob-

razy wÊród milionów ilustracji umieszczonych na serwerach

internetowych. W ostatnich latach techniki ∏àczàce indeksowanie

s∏ów i analiz´ obrazu zaczynajà przecieraç szlak pierwszym ma-

szynom wyszukujàcym grafik´.

Dzi´ki tym prototypowym rozwiàzaniom mo˝na ju˝ dziÊ doceniç

mo˝liwoÊci indeksowania informacji wizualnej, przy okazji widaç

jednak równie˝, ˝e obecne narz´dzia sà jeszcze prymitywne i ˝e

szukajàc obrazów, ciàgle musimy polegaç na tekÊcie. Jeden z pro-

jektów – WebSEEk stworzony w Columbia University – pozwala

przeÊledziç, jak pracuje przeszukiwarka grafiki. WebSEEk zaczy-

na od Êciàgni´cia plików znalezionych w Sieci. Nast´pnie wyszu-

kuje wÊród nich te, które w nazwach majà rozszerzenia, takie jak

GIF czy MPEG, oznaczajàce, ˝e zawierajà grafik´ lub filmy wi-

deo. Ponadto szuka w nazwach plików s∏ów identyfikujàcych ich

treÊç. Gdy program znajdzie obraz, bada, jakie przewa˝ajà w nim

kolory i jakie jest ich roz∏o˝enie. Dzi´ki tym informacjom mo˝e

rozró˝niç fotografie, grafik´, ilustracje bia∏o-czarne lub w ró˝nych

odcieniach szaroÊci. Program równie˝ kompresuje ka˝dy obra-

zek i wyÊwietla go w postaci ikony, a w przypadku wideo – wybie-

ra kilka charakterystycznych klatek z ró˝nych scen.

U˝ytkownik zaczyna wyszukiwanie od wy-

brania z menu kategorii – na przyk∏ad „koty”.

WebSEEk pokazuje wybrane ikony nale˝àce

do tej kategorii. By ograniczyç zakres wyszu-

kiwania, u˝ytkownik klika na dowolnà ikon´

pokazujàcà czarnego kota. Wykorzystujàc prze-

prowadzonà uprzednio analiz´ kolorów, prze-

szukiwarka dobiera obrazki o podobnej cha-

rakterystyce kolorystycznej. Nast´pna grupa

ikon mo˝e pokazywaç czarne koty, ale rów-

nie˝ na przyk∏ad koty rude le˝àce na czarnych

poduszkach. GoÊç WebSEEka jeszcze bar-

dziej uÊciÊla wyszukiwanie, okreÊlajàc, jakie

kolory musi lub jakich nie powinien zawieraç

szukany obraz. Wy∏àczajàc na przyk∏ad kolor

czerwony i ˝ó∏ty, pozb´dzie si´ kotów rudych.

Mo˝e to uczyniç jeszcze proÊciej, wskazujàc te ikony, na których

nie ma czarnych kotów. Do tej pory WebSEEk skopiowa∏ i zain-

deksowa∏ ju˝ ponad 650 tys. obrazków z dziesiàtków tysi´cy ser-

werów internetowych.

Nad projektami wyszukiwania grafiki prowadzone sà równie˝

prace w University of Chicago, University of California w San Die-

go, Carnegie Mellon University, w Media Lab MIT i w University

of California w Berkeley. Liczne firmy komercyjne, w tym IBM i Vi-

rage, stworzy∏y oprogramowanie, które mo˝e byç u˝ywane do

przeszukiwania zbiorczych sieci czy baz danych. Dwie inne fir-

my – Excalibur Technologies i Interpix Software – po∏àczy∏y swo-

je wysi∏ki, by stworzyç oprogramowanie dla Yahoo i Infoseeka.

Jeden z najstarszych programów, Query by Image Content (QBIC)

powsta∏y w IBM, dysponuje bardziej wyszukanymi metodami dopa-

sowywania cech obrazu ni˝, powiedzmy, WebSEEk. Potrafi nie tyl-

ko odró˝niaç kolory, ale równie˝ kontrast (bia∏e i czarne paski zebry),

p∏ynnoÊç linii (od∏amki skalne i otoczaki) oraz ich kierunkowoÊç (s∏up-

ki ogrodzenia i roz∏o˝one na wszystkie strony p∏atki kwiatów). Zada-

Jak znaleêç obraz w Sieci

Gary Stix

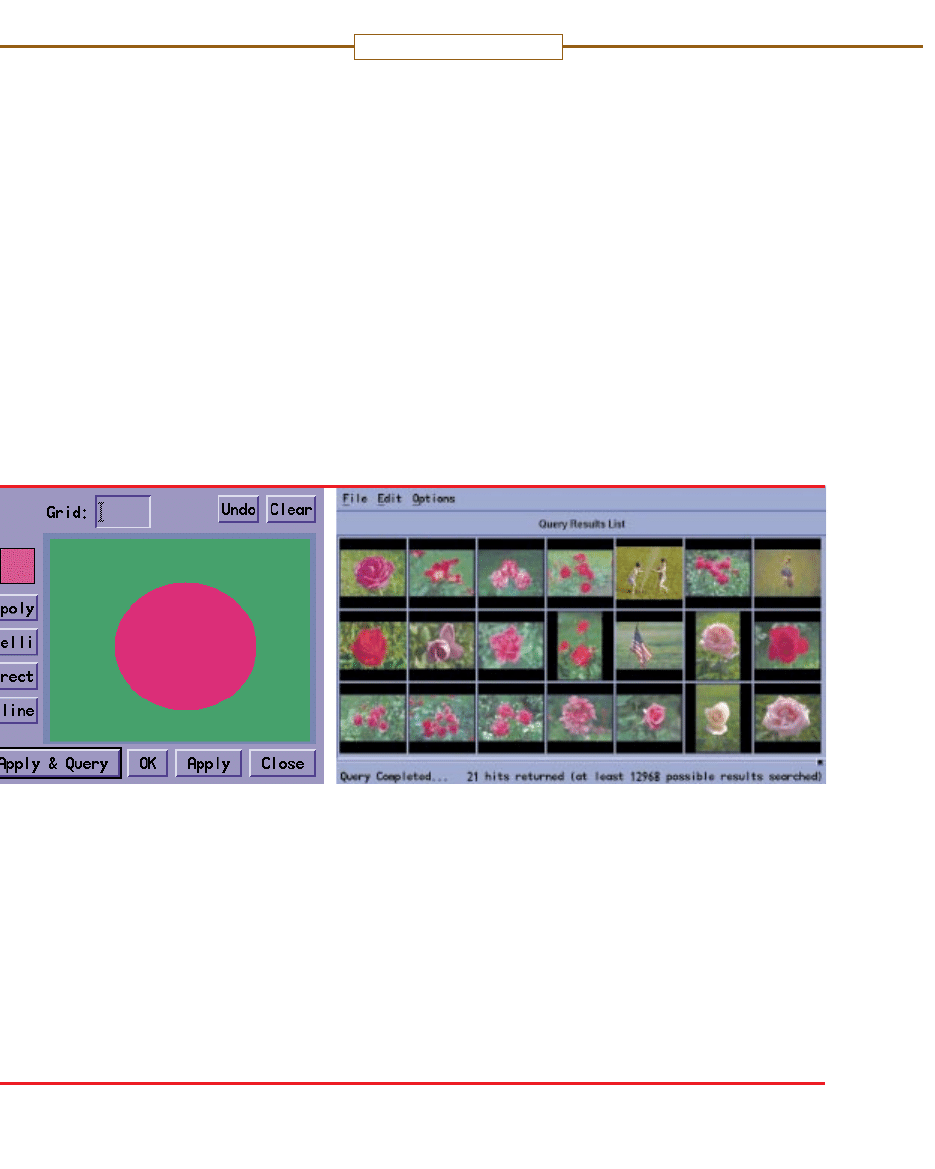

INDEKSOWANIE

AUTOMATYCZNE

INDEKSOWANIE

PRZEZ CZ¸OWIEKA

STRONA

AUTOMATYCZNE INDEKSOWANIE Sie-

ci przez robota analizuje stron´ (z lewej)

przez oznaczenie wi´kszoÊci s∏ów jako ter-

minów indeksujàcych (poÊrodku u góry) lub

grupowanie s∏ów w proste wyra˝enia (po-

Êrodku na dole). Indeksowanie wykonane

przez cz∏owieka (z prawej) dzi´ki dodatko-

wym informacjom pozwala poznaç kontekst

u˝ytych wyrazów.

BRYAN CHRISTIE

RAPORT SPECJALNY

pierwszego pochodzi od Dublina w sta-

nie Ohio, drugiego natomiast od War-

wick w Wielkiej Brytanii. Zatrudnione

przy nich zespo∏y zdefiniowa∏y zestaw

metadanych, które sà prostsze ni˝ w tra-

dycyjnych katalogach bibliotecznych,

oraz opracowa∏y sposoby ich w∏àczania

do stron internetowych.

Klasyfikacja metadanych mia∏aby obej-

mowaç ró˝ne kategorie: od tytu∏u i auto-

ra do typu dokumentu (np. tekst czy wi-

deo). Ich wyszukiwaniem mogliby si´

zajmowaç zarówno ludzie, jak i progra-

my indeksujàce. Tak zdobyte metadane

do∏àczane sà do strony internetowej, aby

automat przeszukujàcy potrafi∏ je odczy-

taç. Precyzyjne komentarze napisane

przez cz∏owieka pozwolà w przysz∏oÊci

na stworzenie bardziej szczegó∏owej cha-

rakterystyki strony ni˝ sporzàdzona

przez program indeksujàcy.

JeÊli wysokie koszty sà uzasadnione,

do tworzenia bibliografii niektórych

miejsc w Sieci anga˝uje si´ ludzi. Jest to

bardzo pracoch∏onne zaj´cie. Baza da-

nych Yahoo, przedsi´wzi´cie komercyj-

ne, grupuje internetowe miejsca w doÊç

rozleg∏e bloki tematyczne. Projekt ba-

dawczy prowadzony w University of

Michigan natomiast stanowi jednà z kil-

ku prób stworzenia bardziej formal-

nych opisów tych stron, które zawiera-

jà materia∏y interesujàce pod wzgl´dem

naukowym.

W jakim stopniu ludzkie umiej´tnoÊci

klasyfikacji czy strategie automatyczne-

go indeksowania i wyszukiwania stanà

si´ potrzebne, b´dzie zale˝a∏o od u˝yt-

kowników Internetu i oceny op∏acalno-

Êci przedsi´wzi´cia przez wydawców.

Dla wielu spo∏ecznoÊci naukowych mo-

del zorganizowanego zbioru danych –

cyfrowa biblioteka – ciàgle wydaje si´

odpowiedni. Dla innych pozbawione

kontroli, „demokratyczne” medium mo-

˝e byç najlepszym mechanizmem roz-

prowadzania informacji. Niektórym

u˝ytkownikom, od analityków finanso-

wych do szpiegów, potrzebny jest do-

st´p do baz zawierajàcych dane suro-

we, nie kontrolowane oraz nie reda-

gowane. Dla nich standardowe prze-

szukiwarki sà najlepszym narz´dziem

w∏aÊnie dlatego, ˝e nie selekcjonujà

informacji.

To nie tylko biblioteka

Ró˝norodnoÊç materia∏u w Sieci jest

znacznie wi´ksza ni˝ w tradycyjnej bi-

bliotece, w której nie klasyfikuje si´ zaso-

bów pod wzgl´dem wartoÊci. Poniewa˝

iloÊç informacji zgromadzonych w Sieci

jest ogromna, jej u˝ytkownicy potrzebu-

jà wskazówek, na co poÊwi´ciç ten ogra-

niczony czas, który przeznaczajà na okre-

Êlonà dziedzin´. Zainteresowani sà

poznaniem trzech „najlepszych” doku-

mentów dotyczàcych tematu i otrzyma-

niem tej informacji darmo, bez ponosze-

nia kosztów zatrudnienia ludzi do

analizy i oceny tysi´cy internetowych

miejsc. Jednym z rozwiàzaƒ, które jed-

nak znów wymaga udzia∏u cz∏owieka,

jest dzielenie si´ opiniami o tym, co jest

warte zachodu, a co nie. Systemy ocen

zaczynajà ju˝ opisywaç u˝ytkownikom

wartoÊç tych miejsc internetowych, któ-

re odwiedzajà [patrz: Paul Resnick, „Fil-

trowanie informacji”, strona 40].

Narz´dzia programistyczne przeszu-

kujà Internet oraz oddzielajà dobre ma-

teria∏y od z∏ych. Mogà byç jednak po-

Â

WIAT

N

AUKI

Maj 1997 33

nie: ró˝owa kropka na zielonym tle, powoduje znalezienie przez

program fotografii kwiatów i innych przedmiotów o podobnych kszta∏-

tach i kolorach [ilustracja powy˝ej]. Programy te umo˝liwià zarówno

wybór wzoru tapety, jak i znalezienie przez policj´ cz∏onków gangu

na podstawie sposobu ubierania si´ przez nich.

Wszystkie te programy po prostu porównujà tylko poszczegól-

ne cechy obrazu. W dalszym ciàgu potwierdzenie, czy znalezio-

ny obiekt jest kotem, czy poduszkà, wymaga oceny cz∏owieka

(lub do∏àczenia do ilustracji tekstu). Od ponad 10 lat badacze za-

jmujàcy si´ sztucznà inteligencjà próbujà, z ró˝nym skutkiem,

zmusiç komputery do bezpoÊredniej identyfikacji przedstawio-

nych na ilustracji obiektów, niezale˝nie od tego, czy sà to koty, czy

flagi. Metoda wprowadza korelacj´ mi´dzy kszta∏tami na ilustra-

cjach a geometrycznymi modelami obiektów realnego Êwiata.

Dzi´ki temu program mo˝e wydedukowaç, czy ró˝owy lub brà-

zowy walec to, powiedzmy, ludzkie rami´.

Przyk∏adem jest program szukajàcy nagich ludzi autorstwa Da-

vida A. Forsytha z Berkeley i Margaret M. Fleck z University of

Iowa. Program ten analizuje najpierw kolory i faktur´ fotografii.

Kiedy znajduje kolory odpowiadajàce kolorom cia∏a, w∏àcza algo-

rytm, który poszukuje fragmentów w kszta∏cie walca, mogàcych

oznaczaç rami´ czy nog´. Po ich znalezieniu szuka innych wal-

ców w kolorze cia∏a, u∏o˝onych pod odpowiednim kàtem, które

mogà byç potwierdzeniem obecnoÊci na obrazie koƒczyn. W ostat-

nio przeprowadzonym teÊcie pogram wybra∏ 43% zdj´ç ukazujà-

cych 565 nagich ludzi spoÊród 4854, co jest dobrym wynikiem jak

na ten rodzaj z∏o˝onej analizy obrazu. Ponadto w wypadku zbio-

ru zdj´ç nie pokazujàcych nagich cia∏ da∏ tylko 4% fa∏szywie po-

zytywnych odpowiedzi. Zdj´cia nagich ludzi pochodzi∏y z WWW,

inne fotografie natomiast g∏ównie z komercyjnych baz danych.

Próby stworzenia komputerowego wzroku najprawdopodobniej

b´dà trwa∏y jeszcze ca∏e dziesi´ciolecie albo d∏u˝ej. Przeszuki-

warki potrafiàce jednoznacznie rozró˝niç nagich ludzi, koty i fla-

gi narodowe sà ciàgle nie zrealizowanym marzeniem. Jednak

w miar´ up∏ywu czasu badacze na pewno zdo∏ajà wyposa˝yç pro-

gramy wyszukujàce w umiej´tnoÊç rozumienia tego, co widzà.

RAPORT SPECJALNY

IBM CORPORATION/ROMTECH/COREL

trzebne nowe programy, które zmniej-

szà obcià˝enia powodowane przez ro-

boty internetowe, skanujàce co pewien

czas ka˝de miejsce w Sieci. Niektórzy

administratorzy serwerów stwierdzajà,

˝e ich komputery tracà mnóstwo czasu,

dostarczajàc robotom informacji po-

trzebnej do indeksowania, zamiast po-

Êwi´ciç go na obs∏ug´ u˝ytkowników

∏àczàcych si´ z ich serwerem.

Próbujàc rozwiàzaç ten problem, Mi-

ke Schwartz i jego koledzy z University

of Colorado w Boulder stworzyli opro-

gramowanie o nazwie Harvest, które

pozwala serwerom WWW stworzyç in-

deks danych dla stron na nich umiesz-

czonych i wys∏aç go na ˝àdanie ró˝nym

przeszukiwarkom. Dzi´ki temu auto-

matycznie indeksujàcy robot Harvesta,

czyli robot zbierajàcy, zwalnia przeszu-

kiwarki z wysy∏ania siecià ca∏ej zawar-

toÊci serwera.

Roboty, tworzàc indeks, przenoszà na

swój serwer kopi´ ka˝dej strony, co

zmniejsza przepustowoÊç sieci (band-

width). Robot zbierajàcy informacje wy-

sy∏a natomiast tylko plik zawierajàcy da-

ne do indeksu. Co wi´cej, sà to informacje

tylko o tych stronach, które zosta∏y zmie-

nione po ostatniej „wizycie”, co równie˝

znacznie zmniejsza obcià˝enie sieci

i komputerów do niej pod∏àczonych.

Roboty takie jak robot zbierajàcy Har-

vesta mogà równie˝ pe∏niç inne funkcje.

Dzi´ki nim wydawcy zyskajà coÊ w ro-

dzaju ogranicznika zasobu informacji eks-

portowanych z serwerów. Kontrola taka

jest konieczna, poniewa˝ WWW staje si´

ju˝ czymÊ wi´cej ni˝ medium swobod-

nego przekazywania darmowych infor-

macji. Niejednokrotnie u∏atwia dost´p do

danych p∏atnych. Programy przeszuku-

jàce nie powinny penetrowaç takich ma-

teria∏ów. Roboty zbierajàce mog∏yby dys-

trybuowaç tylko te informacje, które chce

udost´pniç wydawca, na przyk∏ad odno-

Êniki do streszczeƒ lub przyk∏ady za-

mieszczonych materia∏ów.

Gdy Internet okrzepnie, decyzja co do

odpowiedniej metody zbierania informa-

cji b´dzie zale˝a∏a g∏ównie od u˝ytkowni-

ków. Dla kogo wi´c Internet stanie si´ ro-

dzajem biblioteki z jej formalnymi za-

sadami tworzenia zbiorów? Dla kogo na-

tomiast pozostanie anarchiczny, z auto-

matycznymi systemami dost´pu?

U˝ytkownicy, którzy zgodzà si´ op∏a-

caç autorów, wydawców, archiwistów

i recenzentów, mogà podtrzymaç trady-

cj´ biblioteki. Tam, gdzie informacja jest

udost´pniana bezp∏atnie lub finansowa-

na przez reklamodawców, dominowaç

b´dzie najprawdopodobniej tanie indek-

sowanie komputerowe – w rezultacie

otrzymamy to samo pozbawione upo-

rzàdkowanej struktury Êrodowisko, z któ-

rym mamy do czynienia obecnie. Wyni-

ka z tego, ˝e na metody uzyskiwania

informacji wp∏ynie nie technika, lecz ra-

czej czynniki spo∏eczne i ekonomiczne.

T∏umaczy∏

Jaros∏aw Zieliƒski

34 Â

WIAT

N

AUKI

Maj 1997

RAPORT SPECJALNY

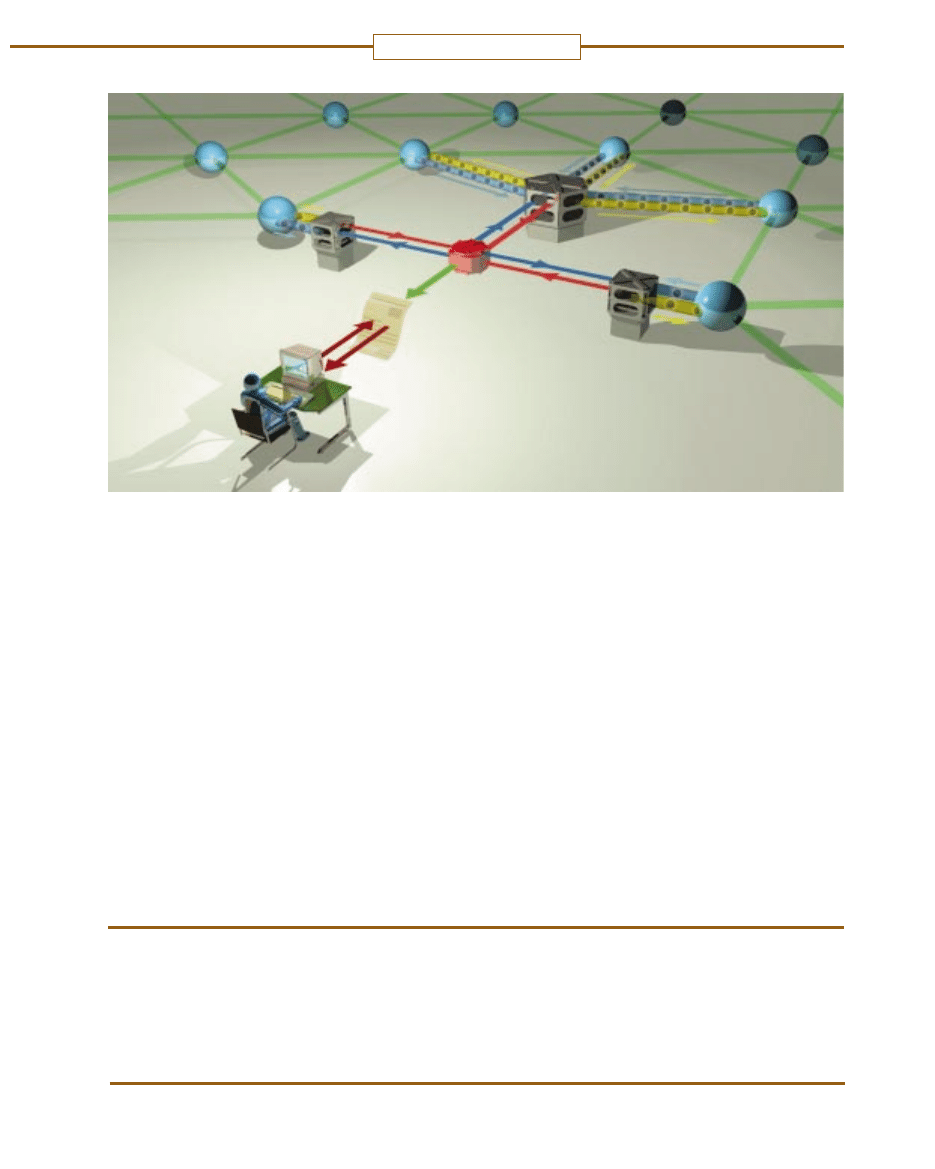

HARVEST, w którym zastosowano nowà architektur´ przeszukiwarki, mo˝e utwo-

rzyç indeks za pomocà programów „zbieraczy” (gatherers). Umieszczane sà one

w oÊrodkach Sieci (ciemne wie˝yczki obok niebieskich kul) lub w centralnym kom-

puterze (wi´ksza szeÊciokàtna wie˝a). Dzi´ki temu przeszukiwarka nie musi prze-

grywaç wszystkich dokumentów z danego miejsca WWW, co znacznie odcià˝a

Sieç. Serwer przeszukiwarki (czerwony obiekt w centrum) mo˝e po prostu popro-

siç roboty zbierajàce (fioletowe strza∏ki) o plik ze s∏owami kluczowymi (czerwo-

ne strza∏ki) i przetworzyç go w indeks (kartka), z którego skorzysta u˝ytkownik.

BRYAN CHRISTIE

Literatura uzupe∏niajàca

THE HARVEST INFORMATION DISCOVERY AND ACCESS SYSTEM

. C. M. Bowman i in.,

Computer Networks and ISDN Systems, vol. 28, nry 1-2, ss. 119-125, XII/1995.

„The Harvest Information Discovery and Access System” jest dost´pny

w World Wide Web: http://harvest.transarc.com/

THE WARWICK METADATA WORKSHOP: A FRAMEWORK FOR THE DEPLOYMENT OF RE-

SOURCE DESCRIPTION

. Lorcan Dempsey i Stuart L. Weibel, D-lib Magazine, VII-

VIII/1996. Dost´pny w World Wide Web: http://www.dlib.org/dlib/ju-

ly96/07contents.html

THE WARWICK FRAMEWORK: A CONTAINER ARCHITECTURE FOR DIVERSE SETS OF META-

DATA

. Carl Lagoze, ibid.

Informacje o autorze

CLIFFORD LYNCH jest dyrektorem dzia∏u automatyzacji bi-

bliotecznej rektoratu University of California i tam nadzoruje

MELVYL, jeden z najwi´kszych systemów publicznego udo-

st´pniania informacji. Lynch uzyska∏ doktorat z informatyki

w University of California w Berkeley. Obecnie wyk∏ada w tam-

tejszej School of Information Management and Systems. Jest

by∏ym prezesem American Society for Information Science

i cz∏onkiem American Association for the Advancement of

Science. Kieruje Architectures and Standards Working Group

z ramienia Coalition for Network Information.

Wyszukiwarka

Podobne podstrony:

Artykul (2015 International Jou Nieznany

Platnosci internetowe wypieraja Nieznany

Arkana radiowego internetu 2 id Nieznany (2)

PRZESZUKIWANIE TERENU I OBIEKTU Nieznany

Arkana radiowego internetu id 6 Nieznany

Oracle 8i a internet IGA2QB7WKB Nieznany

PERFEKT czas przeszL,y zL,oLzo Nieznany

17 12 2013 Sapa Internet[1]id 1 Nieznany (2)

12 11 2013 Sapa Internetid 1336 Nieznany (2)

klamm praca przez internet praw Nieznany

83 Przeszlosc 3 id 47426 Nieznany (2)

81 Przeszlosc 1 id 47341 Nieznany (2)

Marketing internetowy w malej f Nieznany

Bankowosc internetowa taniej i Nieznany (2)

Kamera internetowa w dydaktyce Nieznany

więcej podobnych podstron