POLSKO-JAPOŃSKA WYŻSZA SZKOŁA TECHNIK

KOMPUTEROWYCH

PRACA MAGISTERSKA

Nr ................

Pełnotekstowe wyszukiwanie informacji

dla polskich grup dyskusyjnych

Studenci

Borys Musielak

Jakub Wojciechowski

Nr albumu

s1846

s1549

Promotor

dr inż. Piotr Habela

Specjalność

Inżynieria Oprogramowania i Baz Danych

Katedra

Systemów Informacyjnych

Data zatwierdzenia tematu

24.10.03

Data zakończenia pracy

20.06.04

Podpis promotora pracy

Podpis kierownika katedry

....................................

.........................................

1

Streszczenie

Praca dotyczy problemu projektowania, implementacji i optymalizacji pełnotekstowych

wyszukiwarek internetowych. Rozważania poparte są działającym przykładem – aplikacją do

wyszukiwania informacji w zbiorze polskich grup dyskusyjnych. Przedstawione rozwiązanie opiera

się w pełni o podejście obiektowe, zarówno jeśli chodzi o projekt (zastosowanie notacji UML),

implementację (obiektowy język programowania Java), jak i sposób utrwalania danych

(wykorzystywanie mechanizmów obiektowej bazy danych Objectivity/DB). Rozwiązanie przyjęte w

pracy jest całkowicie autorskie. Wykorzystano własny mechanizm ściągania, indeksowania i

wyszukiwania informacji.. W tekście, oprócz opisu naszego rozwiązania, znaleźć można odwołania

do innych projektów tego typu, w szczególności do mechanizmów proponowanych przez popularną

wyszukiwarkę Google, obecnego lidera w tej branży. Oprócz szczegółowego opisu koncepcji i

implementacji prezentowanego systemu, przedstawione zostały również propozycje alternatywnych

rozwiązań poszczególnych poruszanych problemów, a także plany optymalizacji i rozwoju aplikacji w

przyszłości.

Podziękowania

Autorzy pracy chcieliby wyrazić podziękowania firmie Neurosoft Sp. z o.o., w szczególności

panu Cezaremu Dołędze, za bezpłatne udostępnienie komercyjnego programu Neurosoft Gram 2.0,

którego zastosowanie miało istotny wpływ na wyniki naszej pracy.

Osobne podziękowania należą się panu Robertowi Cheong z firmy Objectivity, za cierpliwość w

udzielaniu porad dotyczących różnych aspektów działania bazy Objectivity/DB.

2

Spis treści

1.WSTĘP..................................................................................................................................................................4

1.1.W

YSZUKIWANIE

PEŁNOTEKSTOWE

INFORMACJI

......................................................................................................... 4

1.2.C

EL

PRACY

........................................................................................................................................................4

1.3.R

OZWIĄZANIE

PRZYJĘTE

W

PRACY

..........................................................................................................................5

1.4.T

ECHNOLOGIA

I

NARZĘDZIA

ZASTOSOWANE

W

PRACY

................................................................................................5

1.5.R

EZULTATY

PRACY

..............................................................................................................................................7

1.6.O

RGANIZACJA

PRACY

...........................................................................................................................................7

2.WYSZUKIWANIE PEŁNOTEKSTOWE – RÓŻNE PODEJŚCIA...............................................................9

2.1.K

ONTEKST

PRACY

...............................................................................................................................................9

2.2.S

TAN

SZTUKI

....................................................................................................................................................10

2.3.N

ASZE

ROZWIĄZANIE

.........................................................................................................................................12

3.OPIS NARZĘDZI ZASTOSOWANYCH W PRACY....................................................................................15

3.1.O

BIEKTOWA

BAZA

DANYCH

O

BJECTIVITY

/DB.......................................................................................................15

3.2.J

AVA

...............................................................................................................................................................22

3.3.G

RAM

.............................................................................................................................................................23

3.4.P

YTHON

..........................................................................................................................................................23

3.5.P

OSTGRE

SQL..................................................................................................................................................24

3.6.L

EAFNODE

.......................................................................................................................................................25

3.7.B

IBLIOTEKI

.....................................................................................................................................................25

4.OBIEKTOWOŚĆ A WYSZUKIWANIE PEŁNOTEKSTOWE...................................................................27

4.1.O

BIEKTOWOŚĆ

A

WYSZUKIWANIE

INFORMACJI

.......................................................................................................27

4.2.O

MÓWIENIE

PRZYJĘTEGO

ROZWIĄZANIA

.................................................................................................................30

4.3.A

LGORYTM

INDEKSOWANIA

.................................................................................................................................33

4.4.A

LGORYTM

WYSZUKIWANIA

................................................................................................................................37

4.5.A

LTERNATYWNE

KONCEPCJE

...............................................................................................................................44

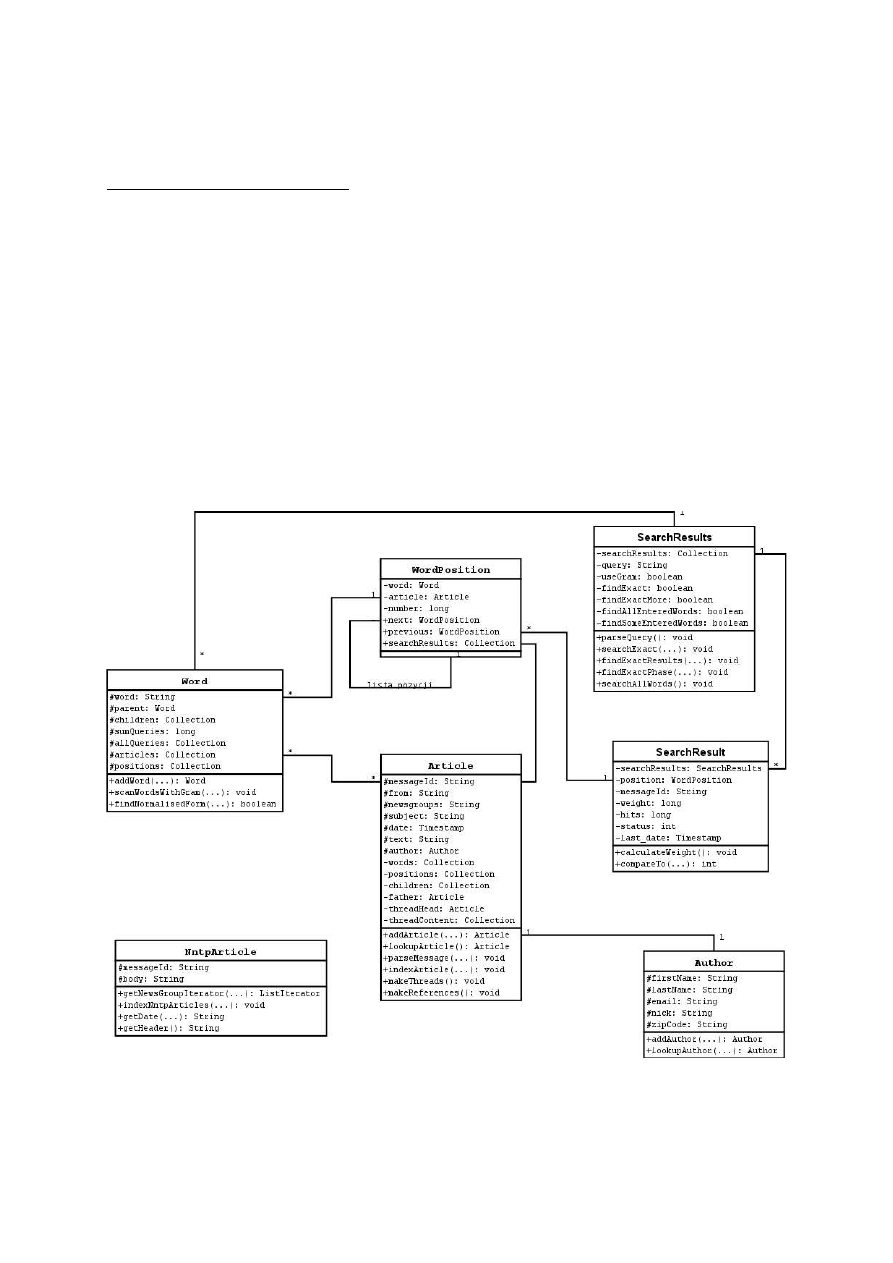

5.ROZWIĄZANIA IMPLEMENTACYJNE: SYSTEM ŚCIĄGANIA, INDEKSOWANIA I

WYSZUKIWANIA NEWSÓW............................................................................................................................50

5.1.O

PIS

NAJWAŻNIEJSZYCH

KLAS

..............................................................................................................................51

5.2.I

MPLEMENTACJA

FETCHERA

I

NARZĘDZIA

BACKUPUJĄCEGO

.......................................................................................56

5.3.I

MPLEMENTACJA

INDEKSOWANIA

..........................................................................................................................57

5.4.I

MPLEMENTACJA

WYSZUKIWANIA

............................................................. ............................................................ 62

5.5.F

RONTEND

.......................................................................................................................................................68

6.PROBLEMY ZWIĄZANE Z ZASTOSOWANYM ROZWIĄZANIEM......................................................70

6.1.P

ROBLEMY

NAPOTKANE

PODCZAS

IMPLEMENTACJI

...................................................................................................70

6.2.W

ADY

I

ZALETY

PRZYJĘTEGO

ROZWIĄZANIA

..........................................................................................................73

6.3.Z

ASTOSOWANIE

PRACY

......................................................................................................................................74

6.4.P

LANY

NA

PRZYSZŁOŚĆ

......................................................................................................................................74

7.PODSUMOWANIE...........................................................................................................................................79

PRACE CYTOWANE..........................................................................................................................................80

3

1. Wstęp

1.1.

Wyszukiwanie pełnotekstowe informacji

Internet to w tej chwili największe światowe repozytorium wiedzy ze wszystkich prawie

dziedzin naszego życia. Dziesiątki tysięcy artykułów na każdy możliwy temat dostępne są w, niestety

poważnie zaniedbanej, publicznej bibliotece. Większość całkowicie za darmo. Internet bywa nieraz

określany jako największy śmietnik świata. Wyszukanie pożądanej informacji wśród tysięcy ton „e-

makulatury” wydaje się więc być zadaniem godnym szaleńca. Zwłaszcza, jeśli informacja ma być

dokładna, a czas potrzebny na jej znalezienie akceptowalny. Informacja której poszukujemy

najprawdopodobniej jest jednak na wyciągnięcie ręki. Problem, z którym zmagają się nieustannie

tysiące internautów na całym świecie to: jak mądrze po nią sięgnąć. Podobnie, choć na nieco mniejszą

skalę, rzecz się ma z internetowymi grupami dyskusyjnymi. Tu również, a czasem tylko tu, możemy

znaleźć rozwiązanie dręczącego nas problemu. Tutaj także, niestety nazbyt często, mamy do czynienia

z niekompetencją, niewiedzą i całą masą informacji często zbędnych lub nieprawdziwych,

dostarczanych przez nadgorliwych użytkowników Usenetu. Odfiltrowanie śmieci od praktycznej

wiedzy wydaje się być w takiej sytuacji nieuniknionym zadaniem.

W obu tych przypadkach, z pomocą przychodzą nam aplikacje zwane wyszukiwarkami

pełnotekstowymi. To dzięki nim możemy bez obawy usiąść przed ekranem komputera i nie tracąc

czasu na żmudne poszukiwania, w kilka sekund otrzymać listę artykułów dotyczących interesującego

nas zagadnienia i spełniających podane przez nas kryteria. Tylko czy aby na pewno? Czy zawsze

jesteśmy w stanie znaleźć dzięki nim informację, której oczekujemy? A może często zdarza nam się

ślęczeć całymi godzinami przed komputerem, przeglądając kolejne, całkowicie nierelewantne

rezultaty wyszukiwania, z nadzieją że ten kolejny będzie w końcu właściwy? Zapewne zdarzają się

również i takie sytuacje. Powód jest prosty – uniwersalne produkty (a do takiego statusu dążą obecni

liderzy w branży wyszukiwarek internetowych) nigdy nie będą w stanie spełnić bardziej

specyficznych wymagań zaawansowanych użytkowników.

Zbudowanie idealnej wyszukiwarki, zawsze znajdującej adekwatne i interesujące nas dane jest

oczywiście (wbrew temu co próbują niekiedy wcisnąć nam specjaliści od reklamy) niemożliwą do

zrealizowania utopią. Dlatego też celem, który powinniśmy sobie stawiać nie może być jeden

uniwersalny i niezastąpiony program, lecz raczej stworzenie jak największej ilości bardzo

specyficznych rozwiązań, ułatwiających nam życie (czyli uzyskanie właściwej informacji) w

poszczególnych dziedzinach. Jedną z takich dziedzin, w których brakuje obecnie niestety dobrego,

dedykowanego mechanizmu wyszukiwania, jest światowe (a w szczególności polskie) archiwum

internetowych grup dyskusyjnych. Mimo, że dostępna jest w sieci całkiem spora ilość wyszukiwarek

indeksujących grupy, nie istnieje aplikacja, która koncentruje się wyłącznie na tym zagadnieniu i robi

to dobrze. A właśnie koncentracja i specyficzne podejście do konkretnego problemu jest warunkiem

(lecz oczywiście nie jedynym kryterium) sukcesu takiego projektu. Niniejsza praca jest jedną z prób

podjęcia się takiego właśnie wyzwania – stworzenie dedykowanej wyszukiwarki pełnotekstowej, dla

polskich grup dyskusyjnych.

1.2.

Cel pracy

Celem naszej pracy jest przedstawienie jednego z możliwych rozwiązań problemu

pełnotekstowego wyszukiwania informacji w dużych zbiorach danych. Nie jest naszym zadaniem

zaproponowanie uniwersalnego modelu, lecz raczej przedstawienie pewnej koncepcji budowy i

działania wyszukiwarki ukierunkowanej na wydobywanie specyficznego rodzaju informacji z

wcześniej zdefiniowanych zasobów. Jak wiadomo, trafność wyniku nie jest miarą obiektywną, lecz

zdefiniowaną li tylko przez wymagania konkretnego użytkownika. Przy tworzeniu wyszukiwarki

4

konieczne jest więc dokładne określenie sposobu pomiaru trafności wyników wyszukiwania. Na tej

podstawie możliwe będzie bowiem sprawdzenie czy i w jakim stopniu zakładana funkcjonalność

(rezultaty wyszukiwania) została osiągnięta.

W związku z tym, w naszej pracy postanowiliśmy skoncentrować się na kilku cechach, które

uważamy za ważne, a które często nie są uznawane za priorytetowe w istniejących produktach. Przede

wszystkich chcemy więc, aby zwracane wyniki zapytań były:

–

dokładne – chodzi o to, żeby użytkownik dostawał w wynikach wyszukiwania przede wszystkim

artykuły zawierające szukane przez niego całkowite ciągi słów, a dopiero z dalszym priorytetem

artykuły, które spełniają podane warunki tylko częściowo

–

niezależne od momentu w czasie – nieważne czy dany artykuł został napisany całkiem

niedawno, czy dziesięć lat temu, powinien się on pojawić w wynikach wyszukiwania z takim

samym priorytetem (o ile oczywiście nie została zaznaczona opcja wyboru przedziału

czasowego)

–

trwałe – jest to powiązane bezpośrednio z niezależnością w czasie i chodzi o to, żeby uniknąć

zjawiska “gubienia” artykułów – często występującego w popularnych wyszukiwarkach newsów

(również Google) – polegającego na marginalizacji a w końcu ignorowaniu wyników starszych w

czasie

Ponadto, ze względu na specyfikę języka polskiego, uznaliśmy, że istotne jest również, żeby

wyszukiwarka uwzględniała w swoim działaniu składnię języka polskiego, tj aby wyniki

prezentowane były niezależnie od formy fleksyjnej poszczególnych słów zapytania.

1.3.

Rozwiązanie przyjęte w pracy

Nasze rozwiązanie charakteryzuje się:

–

zastosowaniem podejścia obiektowego do projektowania i implementacji

–

odejściem od ograniczeń relacyjnych baz danych poprzez zastosowanie w projekcie bazy

obiektowej, bardziej adekwatnej dla omawianego problemu

–

wysokim stopniem modularyzacji systemu – zamiast tworzenia jednej aplikacji odpowiadającej

za całość mechanizmów niezbędnych do osiągnięcia zakładanych rezultatów, postawiono na

stworzenie wielu niezależnych aplikacji, ściśle ze sobą współpracujących

–

łatwością rozbudowy tworzonego systemu, optymalizacji czy dodania nowej funkcjonalności,

poprzez zastosowanie standardowych metod dokumentacji zarówno koncepcji projektowych

(UML) jak i samego kodu aplikacji (JavaDoc)

1.4.

Technologia i narzędzia zastosowane w pracy

Technologia, którą wybraliśmy do implementacji nie jest przypadkowa i ma bezpośredni

związek z założeniami przyjętego wcześniej rozwiązania.

Projekt został zrealizowany z użyciem następującego oprogramowania:

–

Obiektowa baza danych Objectivity/DB 8.0, obecnie jeden z liderów światowych w dziedzinie

zaawansowanych rozwiązań bazodanowych, oferujący między innymi: zarządzanie transakcjami,

wiązanie do Javy oraz wiele rodzajów zależności (relacji) między obiektami.

–

Obiektowy język programowania Java (połączenie wersji standardowej, J2SE, z wersją

enterprise, czyli J2EE – ta druga głównie do implementacji frontendu)

5

–

Obiektowy język skryptowy Python – wybrany do kilku specyficznych zastosowań, głównie w

celu optymalizacji (użycie Javy było niekiedy zbyt kosztowne ze względu na prędkość działania

lub niemożliwe ze względu na brak odpowiednich, niezawodnych bibliotek),

–

Program Gram 2.4.3 firmy Neurosoft – oparta na standardzie CORBA aplikacja, przeznaczona

do analizy językowej tekstu,

–

OmniORB – serwer CORBA, poprzez który aplikacja łączy się z programem Gram,

–

Serwer grup dyskusyjnych Leafnode odpowiedzialny za ściąganie wiadomości z archiwum

Usenetu na dysk

–

Serwer aplikacji Tomcat, oparty na Javie, który odpowiada za działanie frontendu aplikacji

–

CVS – program do kontroli wersji oprogramowania, przydatny przy równoległej pracy nad

kodem i dokumentacją

–

Dia – darmowa aplikacja (na licencji GPL) do rysowania diagramów (w tym UML),

–

OpenOffice.org – darmowy pakiet biurowy (licencja GPL) w którym powstała praca, składający

się m.in. z edytora tekstu Writer oraz narzędzia do tworzenia prezentacji Impress

–

Zintegrowana platforma programistyczna Eclipse IDE, szczególnie przystosowana do tworzenia

zaawansowanych projektów z użyciem technologii opartych o język Java

–

System operacyjny: Debian GNU/Linux.

Wybór Objectivity jako podstawowej bazy danych był ryzykowny. Po pierwsze ze względu na

małą popularność stosowania obiektowych baz danych do tego typu rozwiązań, po drugie ze względu

na nasze doświadczenia zawodowe, które opierają się głównie na znajomości baz relacyjnych. Już po

krótkim czasie pracy okazało się jednak że był to wybór prawidłowy. Baza danych nastawiona

bardziej na referencje, niż przeszukiwanie zawartości nadaje się idealnie do zastosowania w

projektach, w których ściśle określona jest struktura danych i dokładnie wiemy jakie informacje

chcemy z tych danych uzyskać (mówiąc ściślej – jakie zapytania będziemy chcieli zoptymalizować,

już na poziomie kodu programu). Idea relacyjnej bazy danych – czyli uniwersalny, deklaratywny

język zapytań, byłby w przypadku naszej aplikacji niepotrzebnym i – co zostanie udowodnione w

części dalszej pracy – bardzo kosztownym narzutem.

Java została wybrana natomiast z co najmniej dwóch względów. Po pierwsze, jest to

nowoczesny, spójny i prawdziwie obiektowy język programowania, doskonale nadający się do

zastosowania w aplikacji, w której większość funkcjonalności można rozpisać poprzez diagramy

UML, operujące na obiektach (de facto, wszystkie operacje, zarówno na poziomie aplikacji jak i bazy

danych reprezentowane są w naszej aplikacji z użyciem abstrakcji obiektowej). Po drugie – Java jest

(obok C++) najlepiej wspieranym przez Objectivity językiem programowania. W pakiecie dostępna

jest dokładna dokumentacja użytkowa, jak również biblioteki, zapewniające pełne wykorzystanie

standardowych, jak również bardziej zaawansowanych funkcji, oferowanych przez Objectivity.

Przykładem może być rozszerzenie języka Java o specyficzne dla Objectivity relacje (ang.

relationships) – czyli związki asocjacyjne pomiędzy klasami (również typu wiele-do-wiele),

reprezentacja wszystkich rodzajów kolekcji stosowanych w bazie jako obiekty Javy, jak również

operacje na federacji, znajdujących się w niej bazach danych, kontenerach oraz wszelkich innych

obiektach systemowych udostępnionych przez Objectivity/DB.

Przy wyborze pozostałych narzędzi, staraliśmy się zwracać uwagę na takie aspekty jak:

–

skalowalność, przystosowanie narzędzia do przetwarzania dużych ilości danych

–

uniwersalność (chodzi o to, żeby przy niewielkim nakładzie pracy możliwe byłoby przystosowanie

aplikacji i/lub środowiska programistycznego do pracy w innym środowisku, np. do działania w

systemie operacyjnym Microsoft Windows)

6

–

niezawodność, dojrzałość narzędzia – szczególnie korzystając z aplikacji typu open-source, na

licencji GPL lub podobnych, bardzo ważne jest zbadanie dojrzałości rozwiązania i przystosowania

do intensywnej eksploatacji

–

łatwość instalacji i obsługi – aby kwestie techniczne nie przesłoniły głównego, merytorycznego

aspektu pracy (m.in. dlatego postawiliśmy na system operacyjny Debian GNU/Linux, który

charakteryzuje się ogromną łatwością instalacji oprogramowania i ogólną dostępnością większości

potrzebnych nam aplikacji)

1.5.

Rezultaty pracy

Rezultatem naszej pracy jest działający i w pełni funkcjonalny system wyszukiwania

pełnotekstowego wiadomości z archiwum polskich grup dyskusyjnych. Składa się on z modułów, z

których każdy odpowiedzialny jest za oddzielne zadania związane z działaniem wyszukiwarki.

Krótka specyfikacja poszczególnych modułów:

•

fetcher – serwer ściągający nowe wiadomości z polskich grup dyskusyjnych i zapisujący je na

twardym dysku w postaci plików

•

backuper – narzędzie backupujące ściągane przez fetcher artykuły poprzez zapisywanie ich w nie

przetworzonej formie jednocześnie do dwóch baz danych: relacyjnej bazy PostgreSQL oraz

docelowej, obiektowej bazy Objectivity/DB

•

indekser – aplikacja przetwarzająca zapisane w prostej formie artykuły do postaci

usystematyzowanej, w celu takiej organizacji informacji w bazie, aby samo wyszukiwanie

sprowadziło się do prostych operacji na danych, a najlepiej ograniczyło się tylko do

przechodzenia po referencjach pomiędzy obiektami

•

wyszukiwarka – główna i jedyna widoczna dla końcowego użytkownika aplikacja, której

zadaniem jest zwrócenie odpowiednich wyników (artykułów) w zależności od podanego przez

użytkownika zapytania (zazwyczaj szukanego ciągu słów)

•

optymalizator – program działający w tle, którego zadaniem jest wykonywanie najczęściej

pojawiających się zapytań i zbieranie zaktualizowanych wyników takiego wyszukiwania; dzięki

niemu prezentacja wyników takich zapytań jest możliwa „od ręki” - bez potrzeby wyszukiwania,

gdyż są ode przetrzymywane bezpośrednio w bazie danych; przy czym optymalizator został

zaimplementowany tylko częściowo: w bazie przechowywane są zapytania wraz z ich wynikami,

nie ma jednak mechanizmu aktualizującego te zapytania

1.6.

Organizacja pracy

Pracę możemy podzielić na trzy zasadnicze najważniejsze części:

1. Omówienie problemu i możliwych rozwiązań

Pierwsza część pracy zawiera dokładne omówienie kontekstu pracy. Odwołuje się do

istniejących w chwili obecnej rozwiązań podobnego problemu wskazując ich najważniejsze

zalety i wady. Prezentuje też w sposób ogólny nasze podejście do problemu. W dalszej

części omówione zostają szczegółowo narzędzia, które wykorzystujemy w pracy, ze

szczególnym uwzględnieniem obiektowej bazy Objectivity/DB, odpowiedzialnej za

utrwalanie danych w prezentowanym systemie.

2. Omówienie naszego rozwiązania

7

To najważniejsza część pracy, zawierająca nasz wkład w rozwiązanie problemu jakim jest

pełnotekstowe wyszukiwanie informacji z dużych zbiorów danych. W rozdziale czwartym

przedstawiona została szczegółowo główna koncepcja proponowanego przez nas

rozwiązania, która doczekała się implementacji, jak również alternatywne podejścia, które

nie zostały zaimplementowane, jednak powinny być brane pod uwagę w przyszłej

rozbudowanie systemu.

Po omówieniu koncepcji następuje dokładne omówienie implementacji systemu, z opisem

struktury danych, poszczególnych modułów aplikacji oraz sposobu komunikowania się

między modułami.

3. Plany na przyszłość

Ostatni dział, opisuje różne koncepcje ulepszenia prezentowanego rozwiązania, zarówno

poprzez optymalizację jak i przez dodanie nowej funkcjonalności. Zajmuje się również

wskazaniem zalet i wad obecnego rozwiązania, opisuje problemy, które wynikły podczas

implementacji oraz wskazuje kierunek, w którym należy pójść w celu uniknięcia podobnych

kłopotów w przyszłości. W dziale tym przedstawiono również możliwe zastosowania

obecnego systemu, jak również możliwe przyszłe zastosowania, po wdrożeniu

proponowanych zmian.

Do pracy załączono również dodatki – są to informacje, które nie są wprawdzie niezbędne do

zrozumienia treści pracy, mogą być jednak przydatne do dokładniejszego zgłębieniu tajników

rozwiązania, oraz być może, do dalszego rozwoju systemu.

8

2. Wyszukiwanie pełnotekstowe – różne podejścia

W tym rozdziale opisany został kontekst pracy oraz obecny stan sztuki odnośnie problemu

pełnotekstowego wyszukiwania informacji. Na końcu rozdziału naszkicowane zostało proponowane

przez nas rozwiązanie problemu.

2.1.

Kontekst pracy

Dzięki Internetowi zyskujemy dostęp do niemal nieograniczonego zbioru danych. Sporo jest

zasobów bardzo wartościowych, jednak toną one w oceanie śmieci i bezużytecznego szumu

informacyjnego. Wyłuskanie wartościowych treści, nawet spośród zasobów danych powstających w

ciągu tylko jednego dnia, jest zadaniem bardzo czasochłonnym. A co, jeśli chcielibyśmy zebrać

informacje z zasobów zgromadzonych w ciągu kilku lat? Jedynym rozwiązaniem problemu dotarcia

do interesujących nas danych jest stworzenie mechanizmu pozwalającego na szybkie ograniczenie

zbioru dokumentów do odpowiadającego nam zakresu oraz ułożenia ich w odpowiedniej kolejności.

Narzędzia takie nazywamy pełnotekstowymi wyszukiwarkami internetowymi.

Wyszukiwarki internetowe są to aplikacje udostępniane najczęściej przez strony WWW. Ich

zadaniem jest wyszukiwanie i prezentowanie odnośników do dokumentów spełniających określone

przez użytkownika kryteria. Głównym kryterium wyszukiwania informacji są zapytania o

występowanie konkretnych słów lub zdań w treści artykułów. Osoba korzystająca z takiego narzędzia

podaje jedno lub więcej słów, które powinien zawierać wyszukany dokument. Aplikacja znajduje

wszystkie dokumenty dla podanego zapytania oraz ustawia je według szacowanej trafności.

Zasoby WWW można podzielić na dwie grupy: strony publikowane przez organizacje oraz

strony prywatne. W przypadku witryn firm i organizacji można się spodziewać, iż treści tam

prezentowane będą odpowiednio ustrukturalizowane oraz że będą one raczej dobrej jakości. W

przypadku stron prywatnych, a takich jest dużo więcej, struktury informacji są raczej luźne, a treści

często bezwartościowe. Większość dzisiejszych wyszukiwarek zoptymalizowana jest w ten sposób, iż

strony prywatne umieszczane są niżej w ocenach trafności od stron organizacji i firm.

Zupełnie inaczej wygląda sprawa w archiwum grup dyskusyjnych. Jak sama nazwa wskazuje, grupy

służą do wymiany informacji i poglądów przez użytkowników Usenetu. Nie można tutaj dokonać

podobnego podziału, jak w przypadku stron WWW. Wszystkie osoby i podmioty udzielające się w

dyskusjach traktowaną są jednakowo. Nie istnieje bowiem możliwość stworzenia uniwersalnego

mechanizmu oceniającego wiarygodność danego autora, a wszelkie próby takiej klasyfikacji skończyć

się mogą kompromitacją wyszukiwarki – nietrudno bowiem oszukać automat, choćby poprzez

podawanie fałszywego adresu zwrotnego e-mail, czy też wysyłanie wiadomości poprzez roboty z

różnych lokalizacji.

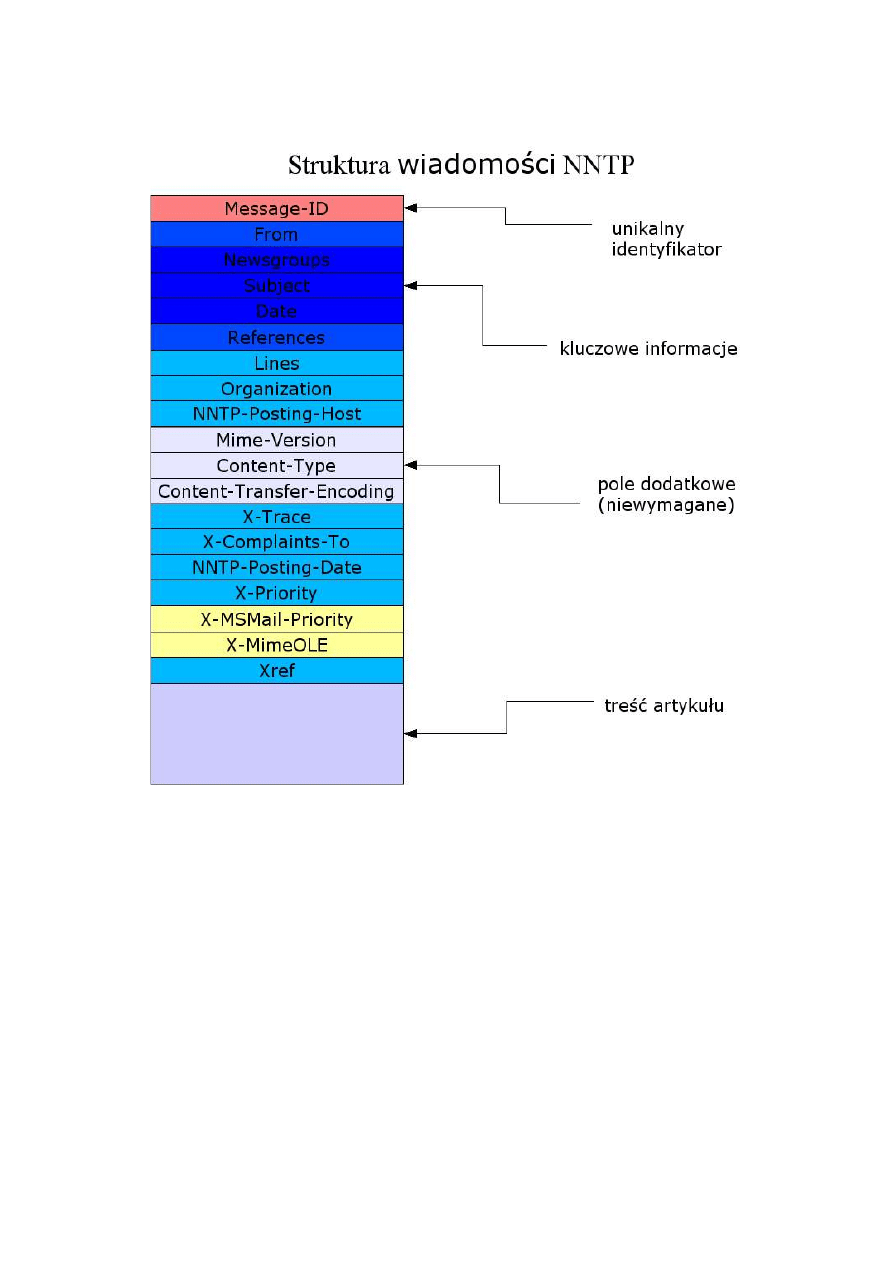

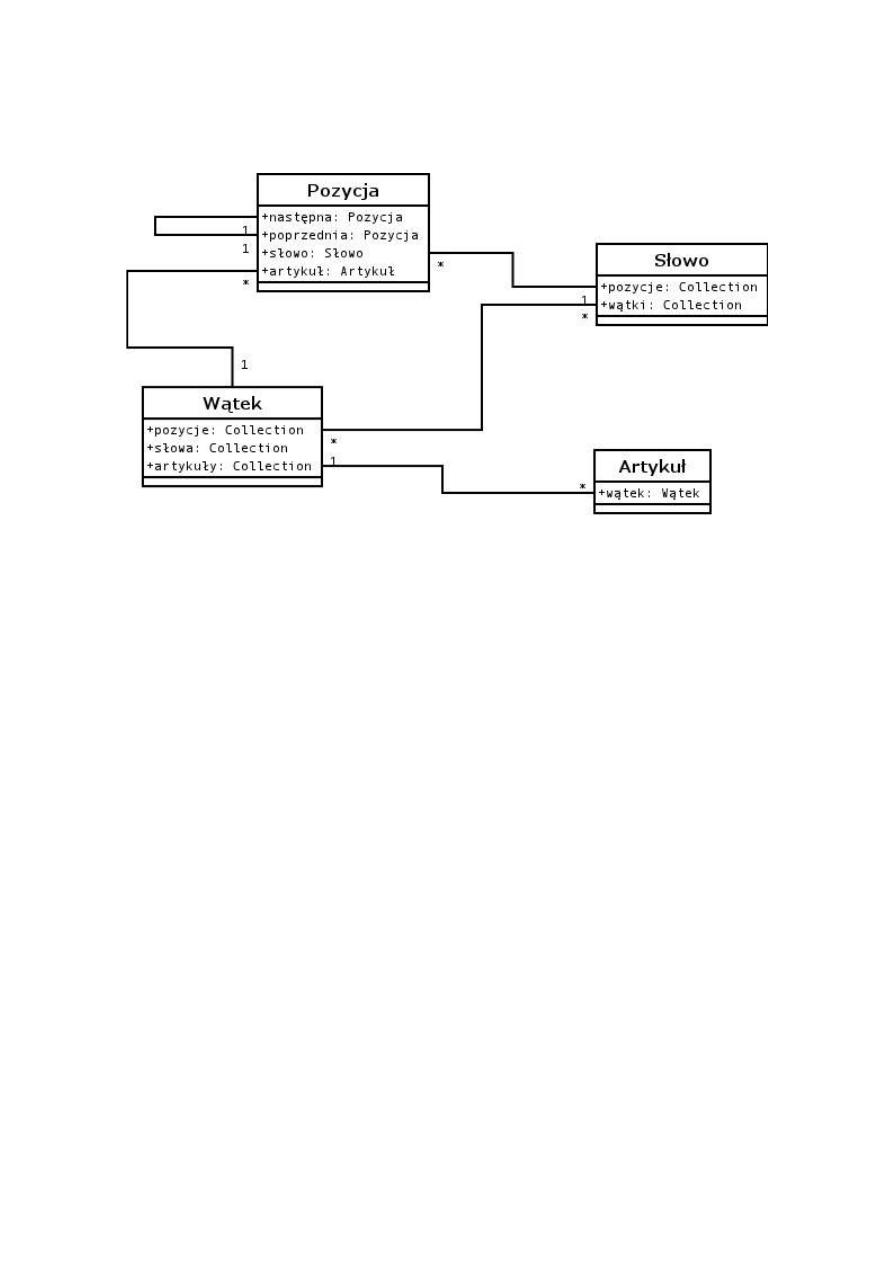

Budowa Usenetu, czyli grup dyskusyjnych, różni się diametralnie od struktury stron WWW.

World-Wide-Web stanowi rodzaj grafu skierowanego. Każda strona stanowi jego wierzchołek a

każdy link jest krawędzią. Istnieje prawie nieskończenie wiele możliwości połączeń pomiędzy

stronami. W przypadku grup dyskusyjnych mamy do czynienia bardziej z sekwencją drzew, niż z

grafem. Każda grupa dyskusyjna posiada swoją własną sekwencję postów głównych, nie

posiadających ojców, od których zaczynają się wszystkie wątki. Każdy wątek zorganizowany jest na

zasadzie drzewa. Dowolny post w wątku może posiadać tylko jednego ojca i jednocześnie może

posiadać dowolną liczbę odpowiedzi, które także mogą posiadać swoje odpowiedzi, itd. Posty nie są

w żaden sposób połączone między sobą poza relacją ojciec-dziecko (post-odpowiedź).

9

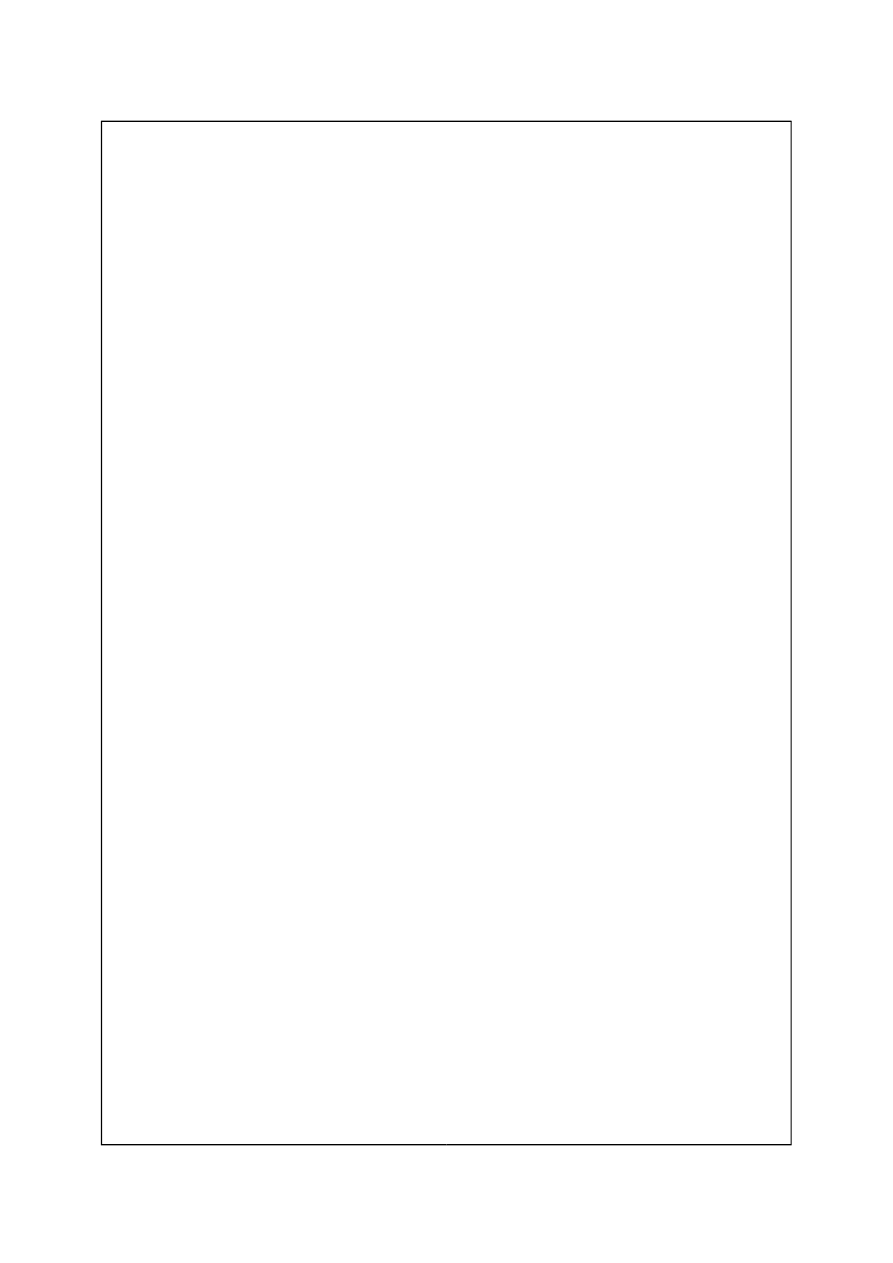

Rysunek 1. Struktura WWW

Rysunek 2. Struktura USENET-u

2.2.

Stan sztuki

Wszystkie poważne wyszukiwarki zbudowane są na zasadzie indeksu. Indeks jest to najprostsza

struktura danych jeżeli chodzi o znajdowanie informacji w tekście. Stanowi ona relacje wiele-do-

wielu pomiędzy dokumentem a słowem. Jak wiadomo każdy dokument składa się z wielu słów i

każde słowo może występować w wielu dokumentach. Rozwiązanie takie pozwala na bardzo szybkie

znalezienie odpowiednich dokumentów dla zadanego zapytania. Szukając tekstów, posiadających w

treści kilka podanych wyrazów należy pobrać część wspólną zbiorów dla każdego słowa oddzielnie.

Przecięcie to jest wynikiem wyszukiwania. W bardzo dużych indeksach (np. indeksy stron WWW)

samo znalezienie odpowiedniej listy dokumentów nie wystarcza. Potrzebne jest jeszcze przynajmniej

szacowane przypisanie każdemu znalezionemu dokumentowi jakiegoś rodzaju oceny trafności.

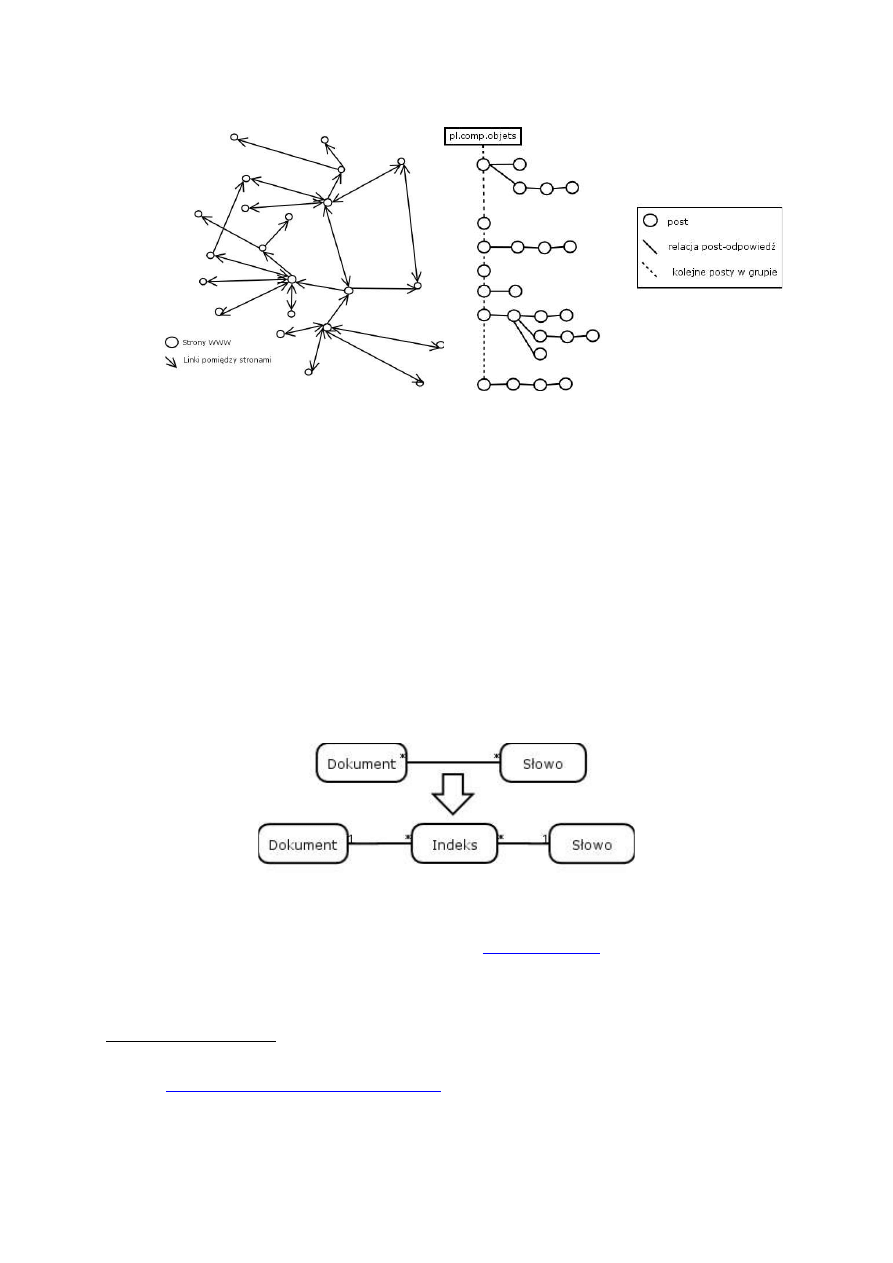

Rysunek 3. Indeks

Przykładowo, dla zapytania „prezydent polski”

www.google.com

zwraca około 180 tysięcy

dokumentów. Przejrzenie ich wszystkich w celu znalezienia tego, który nas interesuje jest nierealne

dla przeciętnego użytkownika. Jak widać, należy zastosować mechanizm oceniający dokumenty pod

względem ich ważności. W przypadku stron WWW najlepszym, stosowanym obecnie rozwiązaniem

jest algorytm PageRank

1

, stworzony przez twórców Google. Jego główną cechą jest prostota działania

1

The Anatomy of a Large-Scale Hypertextual Web Search Engine Sergey Brin and Lawrence Page. Computer

Science Department, Stanford University, Stanford, CA 94305.

(

http://www-db.stanford.edu/~backrub/google.html

)

10

i jak się wydaje to, że jest bardzo oczywisty. PageRank nadaje dokumentom WWW ocenę na

podstawie liczby odnośników wychodzących i wchodzących. Im jest ich więcej, tym wyższa jest

ocena. Założeniem tego algorytmu jest to, iż im więcej strona posiada linków do innych stron, tym

wydaje „ważniejsza” jest dla użytkownika, ponieważ trafiwszy na nią ma on większe szanse na

dotarcie do interesujących go danych. Na tej samej zasadzie, jeśli wiele miejsc w sieci posiada link do

danej strony, świadczy to o tym, iż jest ona interesująca dla większej grupy ludzi.

Algorytm ten jest kompletnie nieprzydatny w przypadku grup dyskusyjnych. Nie ma tutaj

bowiem rozbudowanej sieci linków. Każdy post posiada co najwyżej jednego posta-ojca i może

posiadać dowolną liczbę odpowiedzi, podczepionych pod niego, jednak nie świadczy to w żaden

sposób o jego ważności. W związku ze specyficzną budową Usenetu trudno tu o jakikolwiek algorytm

oceny trafności postów. Trudno jest też oceniać posty na podstawie ich autorów. Jedyną daną jaką

jesteśmy w stanie wydobyć na temat autorów to to, ile postów na danej grupie zamieścili do tej pory.

Nie jest to wskaźnik, który pokazuje nam stopień profesjonalizmu wypowiedzi. Element ten może być

tylko ciekawą informacją w statystyce natomiast nie nadaje się zbytnio do oceny trafności wyników.

Mechanizm działania wyszukiwarki można przedstawić jako trzy główne etapy. Są to:

1. Ściąganie – mechanizm oferowany przez fetcher, pobierający dane z różnych zasobów i zapisujący

je na dysk lub w bazie danych.

2. Indeksowanie – mechanizm budujący indeks na podstawie pobranych dokumentów.

3. Wyszukiwanie – mechanizm wyszukujący odpowiednie dokumenty według zapytania

użytkownika.

Budowa fetchera jest bardzo uzależniona od typu danych, jakie ma pobierać. Inaczej wygląda

dla stron WWW, inaczej dla grup dyskusyjnych, a jeszcze inaczej dla zasobów intranetowych. W

przypadku stron WWW fetchery buduje się na zasadzie pająków internetowych (ang. web spider lub

pełzaczy – ang. web crawler). Są to programy, które przechodzą od strony do strony, nawigując po

linkach, ściągając przy okazji całą zawartość stron na dysk lub do bazy danych. Proces pobierania

stron internetowych jest bardzo uzależniony od wydajności serwerów, na których znajdują się strony

oraz od przepustowości łącz na świecie. Przejście przez wszystkie strony na świecie jest procesem

pracochłonnym i w zależności od ilości uruchomionych pająków może trwać nawet kilkanaście dni.

Fetchery Usenetu mają ułatwione zadanie. W związku z rozproszeniem serwerów grup

dyskusyjnych po świecie i z faktem, iż każdy serwer posiada swoje archiwum prawie wszystkich grup

wystarczy połączyć się tylko z jednym z nich aby mieć dostęp do potrzebnych dokumentów. Posty

zamieszczane są na serwerach jako czysty tekst

2

, bez zbędnych dodatków. Dzięki temu operacja ich

pobierania jest bardzo szybka i mało obciążeniowa dla systemu. W ciągu kilku sekund klient Usenetu

jest w stanie pobrać kilka tysięcy postów.

Indekser jest to najbardziej obciążeniowa część wyszukiwarki. Jego zadaniem jest zbudowanie

struktury indeksu na podstawie pobranych wcześniej przez fetcher dokumentów, w formie surowej.

Operacja ta nie bardzo jest skomplikowana algorytmicznie, jednak w związku z ogromną ilością

danych do przetworzenia może być bardzo pracochłonna i długotrwała. Na ogół indekser pobiera

wcześniej zapisany, surowy dokument, parsuje go a następnie przechodzi przez niego słowo po

słowie. Parsowanie polega na wyodrębnieniu z dokumentu tekstu, z pominięciem wszystkich

zbędnych metainformacji, np.: formatowanie czcionki, tagi HTML-owe, itp. Przechodząc po treści

indekser analizuje każde słowo. Nowe słowa, wcześniej niezindeksowane, zapisywane są w bazie. Dla

2

Problemem mogą być jedynie grupy binarne, na których użytkownicy zamieszczają duże pliki graficzne,

wideo i audio. W postach binarnych bardzo rzadko spotyka się jakikolwiek tekst, więc z punktu

widzenie wyszukiwarki pełnotekstowej można je całkowicie pominąć, co też czynimy w naszej pracy.

11

słów już istniejących w strukturze tworzona jest tylko relacja z aktualnie przetwarzanym

dokumentem.

Przy okazji indeksowania zapisywane są wstępne informacje na temat ważności wystąpienia

danego słowa w tekście. Analizując dokument w formacie HTML można stwierdzić, czy dane słowo

występuje w tytule, nagłówku lub w treści. W zależności od położenia słowa w dokumencie oraz od

czcionki, jaką został napisany, można pokusić się o nadanie mu wagi. Im większą czcionka słowa –

tym większa waga wyniku. Największą ocenę otrzymują słowa zawarte w tytule strony. Taka wstępna

analiza artykułów ułatwia pracę kolejnemu mechanizmowi, czyli wyszukiwarce.

Wyszukiwanie jest to jedyny element całego mechanizmu dostępny dla użytkownika.

Najczęściej wyszukiwarki dostępne są jako aplikacje WWW. Jednak mogą to być równie dobrze

wszelkiego rodzaju aplikacje lub nawet dodatki do aplikacji lub systemów.

Proces wyszukiwania polega na odczytaniu indeksu słów i pobraniu odpowiedniego zbioru

dokumentów. Następnie zbiór ten jest sortowany według kryterium trafności każdego dokumentu.

Pobierając każdy dokument do wyników zapytania wyliczana jest jego waga w stosunku do podanego

zapytania. W prostszych rozwiązaniach jest to suma wag szukanych słów z danego dokumentu.

Szukając kilku słów, najwyżej w rezultatach pojawią się te dokumenty, w których słowa te występują

w tytule lub nagłówku, a najniżej te, w których szukane słowa pojawiają się w dalszej części treści.

2.3.

Nasze rozwiązanie

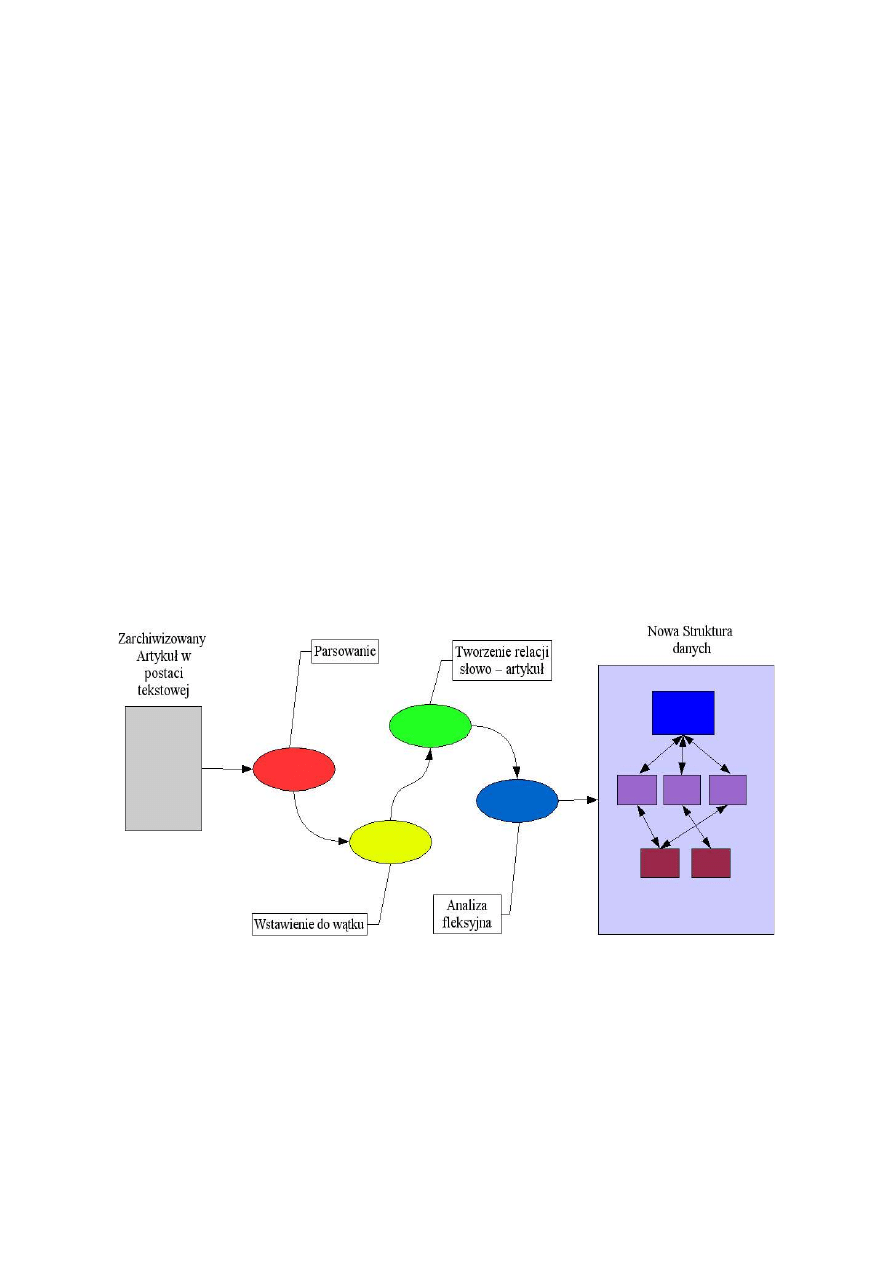

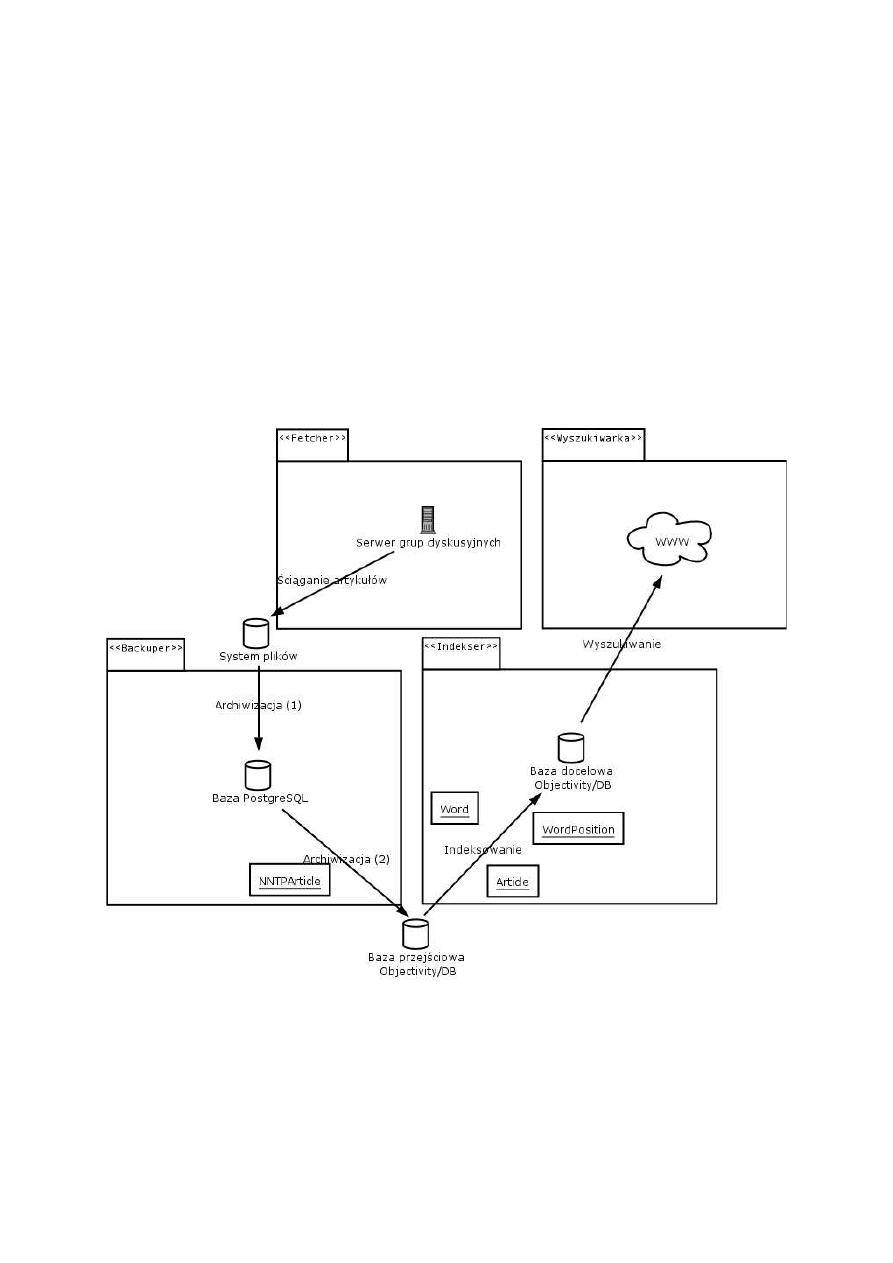

Prezentowane przez nas rozwiązanie, zgodnie z powszechnie przyjętą konstrukcją budowy

wyszukiwarek składa się z trzech głównych części: fetchera, indeksera i właściwej wyszukiwarki

informacji. Tym co wyróżnia je spośród innych tego typu projektów jest m.in. zastosowanie

obiektowego języka programowania z trwałością zapewnioną przez obiektową bazę danych

Objectivity/DB, a także specjalne podejście do indeksowanych danych, którymi są wiadomości

zamieszczane na polskich grupach dyskusyjnych.

Dzięki pełnemu zastosowaniu obiektowości, struktura danych i działanie aplikacji nie są

podporządkowane ciągłej potrzebie konwersji obiektów do relacyjnych krotek. Można się więc skupić

jedynie na wymaganej funkcjonalności systemu, co w znaczny sposób ułatwia zarówno modelowanie

jak i implementację. Dzięki specjalnemu podejściu do grup dyskusyjnych, mamy możliwość

uzyskania większej ilości informacji, niż przy zastosowaniu uogólnionego podejścia, traktując

jednakowo wszystkie elementy indeksowanego tekstu.

Inną ważną cechą naszego pomysłu jest modularyzacja rozwiązania. Każdy z modułów spełnia ściśle

określoną funkcję i przekazuje zdefiniowaną wcześniej informację innym modułom. Taka koncepcja

w tym konkretnym przypadku sprawdza się doskonale, gdyż każdy z elementów naszej aplikacji jest

w pewien sposób niezależny od pozostałych. Wykorzystanie innego fetchera nie zmieni sposobu

działania indeksera i wyszukiwarki. Zmiana koncepcji indeksowania nie powinna wpłynąć na

działanie analizy fleksyjnej czy mechanizmu wyszukiwania. Narzędzie do cache'owania wyników nie

polega w żaden sposób na mechanizmie indeksowania, etc.

Omówimy teraz pokrótce najważniejsze moduły naszej aplikacji. Bardziej szczegółowe

informacje, dotyczące poszczególnych rozwiązań znaleźć można w rozdziałach czwartym i piątym,

opisujących zarówno koncepcję rozwiązania jak i samą implementację. Tutaj skupimy się zatem

jedynie na przedstawieniu najważniejszych funkcji poszczególnych modułów.

Zadaniem naszego fetchera jest połączenie się z (lokalnym) serwerem grup dyskusyjnych i

pobranie wszystkich aktualnych postów z wybranych grup. Każdy post zapisywany jest następnie w

systemie baz danych Objectivity/DB, w bazie

NntpPostDB, jako obiekt klasy

pl.edu.pjwstk.NewsSearch.NntpArticle. Każda grupa zapisywana jest w oddzielnym

kontenerze (nazwą kontenera jest nazwa grupy).

12

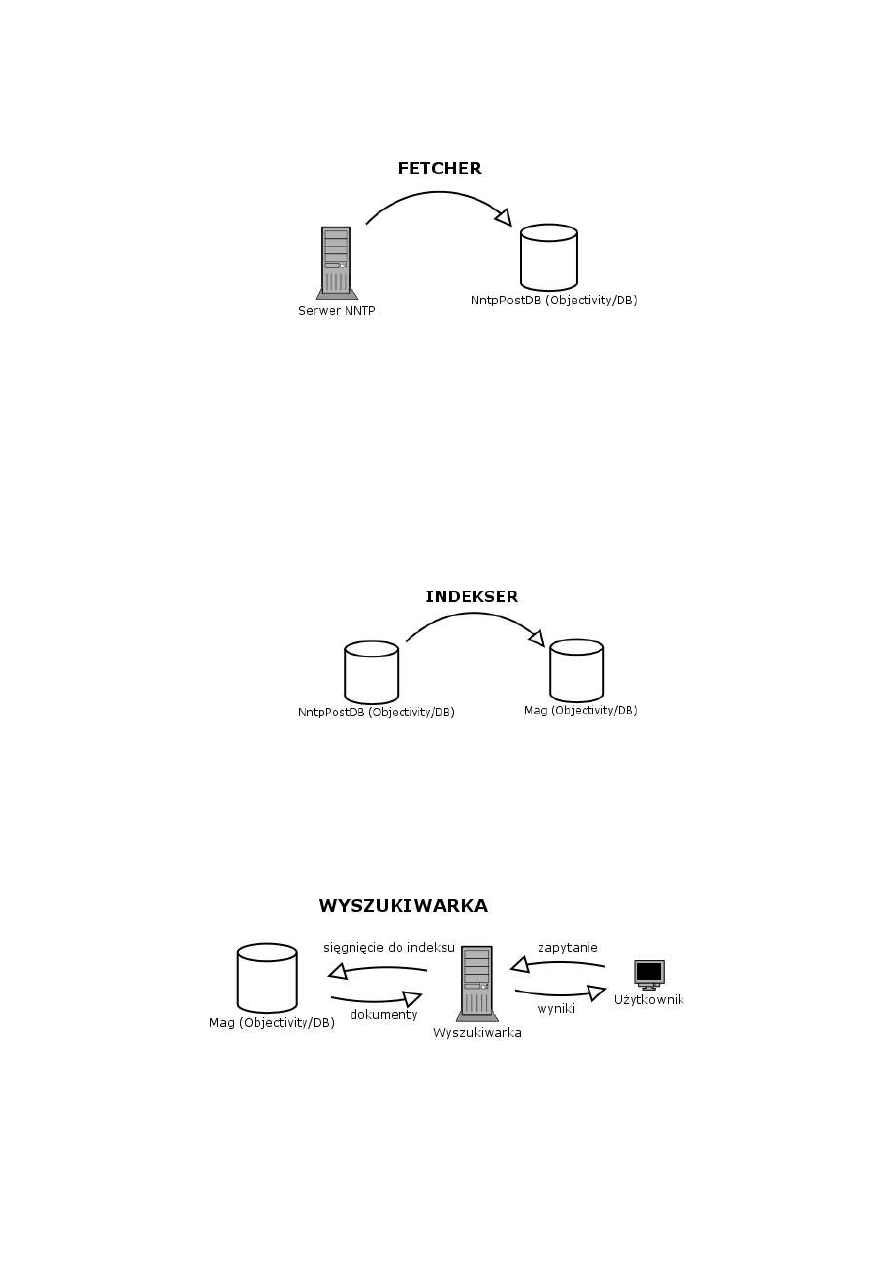

Rysunek 4. Rola fetchera

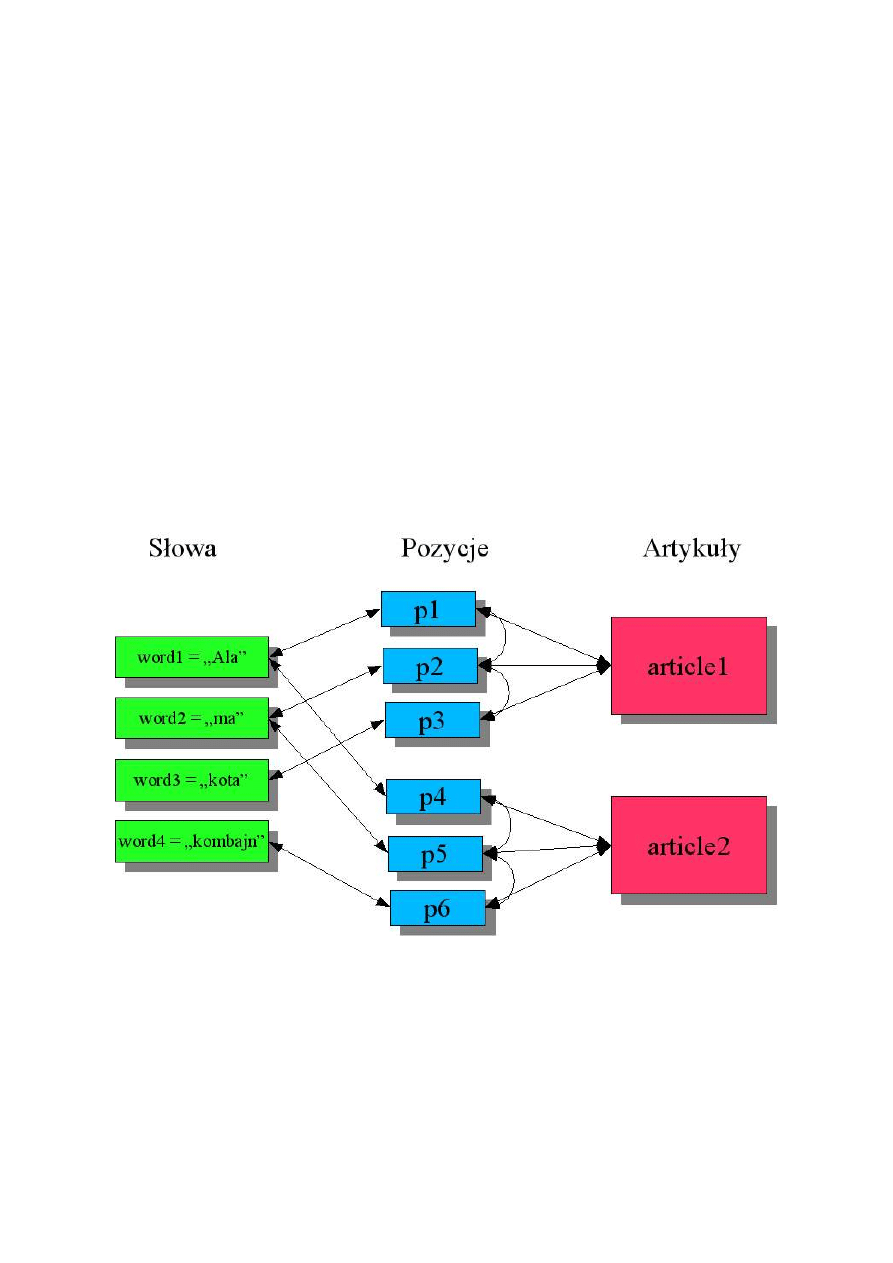

Indekser pobiera z bazy NntpPostDB dokumenty w postaci obiektów klasy NntpArticle, a

następnie parsuje je do obiektu klasy Article. Podczas parsowania, odczytywane są z nagłówków

posta dane, takie jak: data zamieszczenia na serwerze, tytuł, autor, odnośniki do poprzednich postów

(jeżeli post jest odpowiedzią) i inne. Następnie indekser przechodzi przez treść dokumentu tworząc

indeks występujących w nim słów. Dodatkowo dla każdego słowa zapisywana jest jego pozycja w

dokumencie. Będzie to wykorzystywane później, podczas wyszukiwania, do oceny trafności

prezentowanych wyników. Po przejściu przez wszystkie dokumenty uruchamiany jest proces

tworzenia struktury zależności między słowami, korzystając z oprogramowania GRAM, służącego do

analizy fleksyjnej i normalizacji tekstu. Słowa łączone są relacją z ich formami podstawowymi.

Rysunek 5. Rola Indeksera

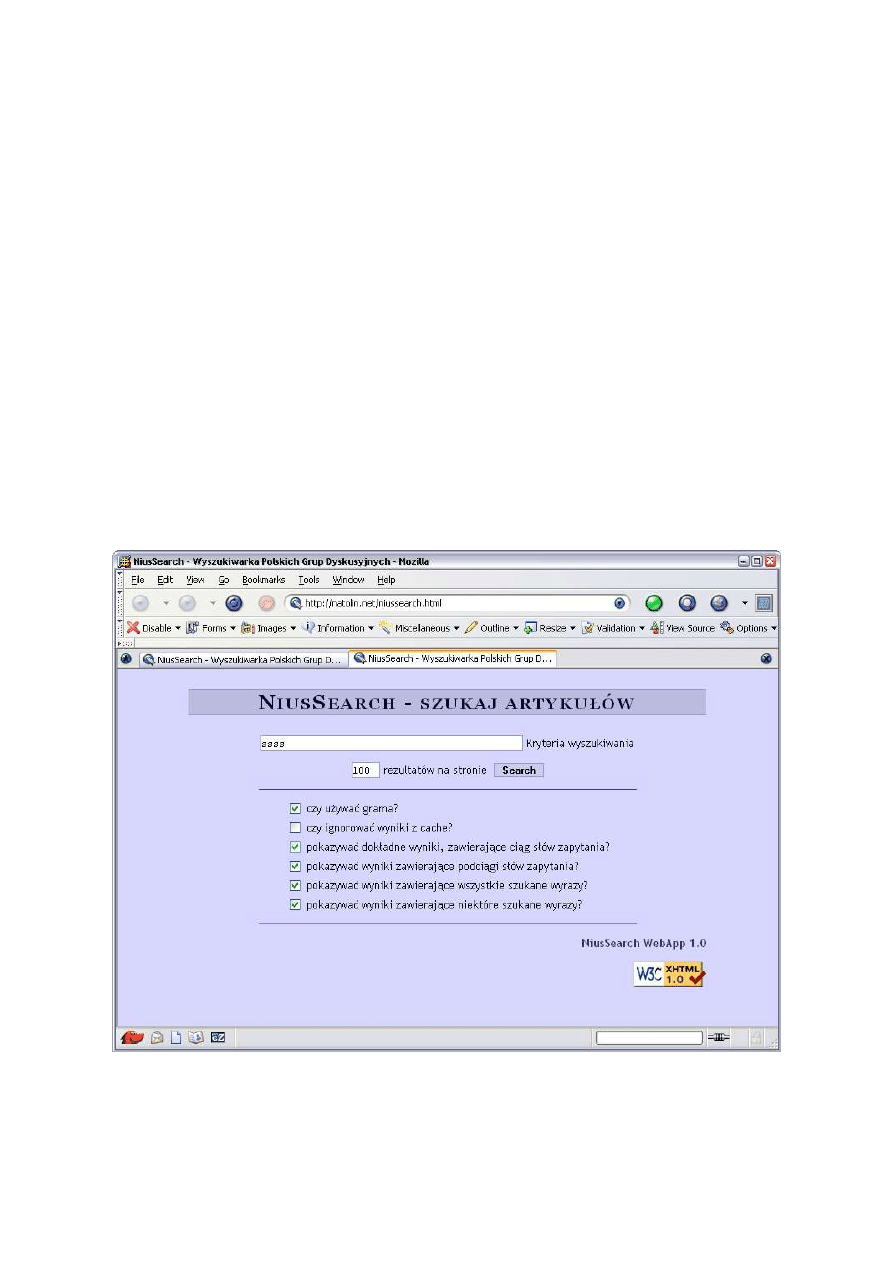

Wyszukiwarka działa standardowo – na podstawie podanego przez użytkownika zapytania

znajdowane są dokumenty, odpowiadające merytorycznie zadanemu zapytaniu. Zapytanie podawane

jest na przykład przez formularz znajdujący się na stronie internetowej. Dane z formularza

przetwarzane są w bazie danych i po przeładowaniu strony zwracany jest wynik – lista linków do

relewantnych artykułów, posortowanych według zdefiniowanej trafności.

Rysunek 6. Wyszukiwanie dokumentów

13

Nowym elementem jest tutaj możliwość wyboru typu wyszukiwania przez użytkownika. W

zależności od rodzaju informacji, jakie chce on znaleźć, może wybrać wyszukiwanie:

–

dokładnych ciągów podanych w zapytaniu

–

dokładnych ciągów wraz z podciągami, zawierającymi tylko niektóre ze słów zapytania, ale w

identycznej kolejności

–

części wspólnej wszystkich artykułów zawierających wszystkie słowa zapytania (bez sprawdzania

kolejności występowania poszczególnych słów)

–

standardowe wyszukiwanie, znajdujące zarówno artykuły zawierające wszystkie słowa zapytania,

jak również te, w których występuje tylko część podanych słów

–

wyszukiwanie z uwzględnieniem zależności fleksyjnych pomiędzy słowami

Domyślnie zaznaczone są wszystkie z tych opcji. Jeśli jednak użytkownik wie dobrze, jaki typ

informacji najbardziej go interesuje, wskazane jest wybranie konkretnych opcji wyszukiwania –

skraca to w znacznym stopniu czas oczekiwania na wyniki.

14

3. Opis narzędzi zastosowanych w pracy

Proponowane przez nas rozwiązanie opiera się na obiektowej bazie danych Objectivity/DB oraz

obiektowym języku programowania Java. W części indeksującej wykorzystany został produkt firmy

Neurosoft – Gram: oprogramowanie służące do analizy językowej tekstu. Indekser komunikuję się z

Gramem poprzez protokół zdefiniowany przez CORBA. Przy okazji tworzenia wyszukiwarki

powstało kilka niezbędnych dodatków, takich jak: oprogramowanie służące do archiwizacji zasobów

grup dyskusyjnych ściągające wszystkie posty z serwera i umieszczające je w relacyjnej bazie danych

PostgreSQL oraz mała biblioteka stworzona w Javie realizująca komunikację z serwerem grup

dyskusyjnych poprzez protokół NNTP zgodnie z RFC 977 (Network News Transfer Protocol) z 1986

roku..

3.1.

Obiektowa baza danych Objectivity/DB

Obiektowa baza danych Objectivity/DB zapewnia mechanizmy do trwałego przechowywania

oraz wyszukiwania obiektów stworzonych w trzech językach programowania: C++, Java, Smalltalk.

System zarządzania bazą danych ukrywa przed użytkownikiem wszystkie operacje niskopoziomowe

związane z trwałością danych.

Architektura

Wszystkie operacje bazodanowe odbywają się w tym samym procesie, w którym działa

aplikacja. Dzieję się tak dzięki dynamicznemu doładowywaniu potrzebnych bibliotek.

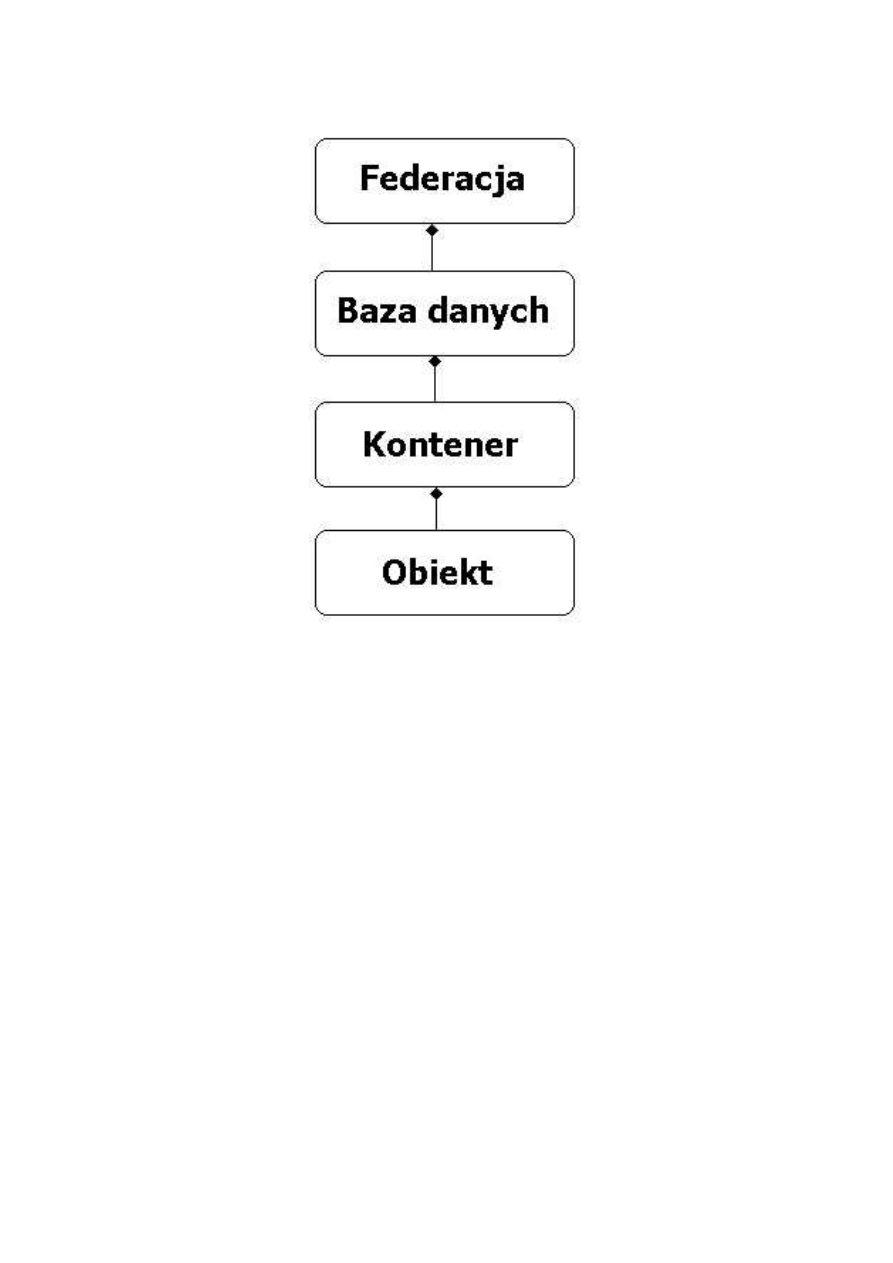

Objectivity/DB definiuje cztery rodzaje obiektów w bazie danych. Są to:

•

trwały obiekt

•

kontener

•

baza danych

•

federacja

Obiekt

Trwały obiekt, będący wystąpieniem „klasy zdolnej do trwałości” (ang. „persistence capable

class”) jest to najmniejszy byt programistyczny, który podlega zapisaniu lub odczytaniu z bazy. Jest to

typowy, zwyczajny obiekt z języków programowania, który dziedziczy z klasy dostarczanej przez

producenta bazy lub implementuje specjalny interfejs. Jedyną różnicą między obiektami trwałymi a

nietrwałymi jest to, że obiekty nietrwałe znikają wraz z zakończeniem działania aplikacji. Obiekty

trwałe potrafią przetrwać zamknięcie aplikacji i zostać przywrócone podczas kolejnego uruchomienia

tak jakby w ogóle nie zostały zniszczone. Baza Objectivity/DB przechowuje cały stan obiektu (za

wyjątkiem atrybutów zadeklarowanych jako ulotne („transient”)). Oznacza to, że dane z wszystkich

pól zostaną zachowane. Nie ważne czy są to pola prywatne, publiczne czy chronione. Wszystkie pola

nie będące wystąpieniami typów prostych powinny być także opisane klasami zdolnymi do trwałości.

System zarządzania bazą danych przechowuje także informacje o obiektach powiązanych

niezależnie czy jest to relacja jeden-do-jeden lub agregacja.

15

Rysunek 7. Struktura obiektów

w bazie Objectivity/DB

W przypadku Javy klasą, z której należy wyprowadzić trwałe obiekty jest ooObj. Jeżeli klasa

zaplanowana do bycia trwałą nie może z jakiś przyczyn dziedziczyć z ooObj istnieje możliwość

„ręcznego” programowania trwałość poprzez implementowanie interfejsu Persistent (lub jej

pochodnych: PersistnentEvents, IooObj).

Kontener

Kontener jest to obiekt służący do grupowania trwałych obiektów aplikacji. System zarządzania bazą

danych przechowuje obiekty należące do jednego kontenera blisko siebie w stronach w pamięci lub

na dysku, przez co uzyskuje się lepszą wydajność. Objectivity/DB zakłada zamki na całym

kontenerze. Oznacza to, że wszystkie obiekty w kontenerze zostaną zablokowane. Może to prowadzić

do pewnych problemów wydajnościowych, dlatego powinno się zwrócić szczególną uwagę

projektując strukturę i podejmując decyzję o tym jak trwałe obiekty będą rozmieszczone w bazie.

Kontener zorganizowany jest jako obiekt powoływany z poziomu aplikacji. Fizycznie zawiera się w

pliku bazy danych. Do zadań kontenera należą:

•

Zarządzanie mapą stron, która przechowuje fizyczne adresy stron na dysku. Pozwala to na

bardziej efektywne pobieranie stron z dysku

16

•

Zarządzanie przydzielaniem stron.

•

Zarządzanie mapą nazw, po których pobierane są obiekty.

•

Przechowywanie trwałych obiektów.

Wraz z utworzeniem nowej bazy danych tworzony jest jej podstawowy kontener o nazwie

„_ooDefaultContObj”, który jest instancją klasy ooDefaultContObj.

Żaden kontener nie może zawierać w sobie innych kontenerów. Istnieją dwa typy kontenerów:

„zwyczajne” i ze zbieraniem nieużytków (ang. garbage collector).

Kontenery ze zbieraniem nieużytków (tzw. również odśmiecaniem) działają na podobnej zasadzie

co analogiczny mechanizm w języku Java. Obiekty, które nie są osiągalne z nazwanego obiektu-

korzenia (ang. named root) są uznawane jako kandydaci do zniszczenia. W przeciwieństwie do Javy

odśmiecanie nie zachodzi automatycznie. Jest to proces uruchamiany poprzez narzędzie

administratorskie oogc.

Obiekt jest uznawany jako aktywny jeśli:

1

Jest nazwanym korzeniem

2

Można do niego dotrzeć z nazwanego korzenia. Obj1 jest osiągalny przez Obj2 jeśli:

2.1

Obj2 ma referencję do Obj1

2.2

Obj2 jest trwałą kolekcją posiadającą Obj1

2.3

Obj1 jest osiągalny z jakiegoś obiektu, do którego ma dostęp Obj2.

Zależności te nie dotyczą jedynie jednego kontenera. Relacje między obiektami mogą zachodzić

ponad kontenerami. W przypadku, kiedy obiekt osiągalny jest przez obiekt z innego kontenera nie jest

on uznawany jako kandydat do skasowania.

17

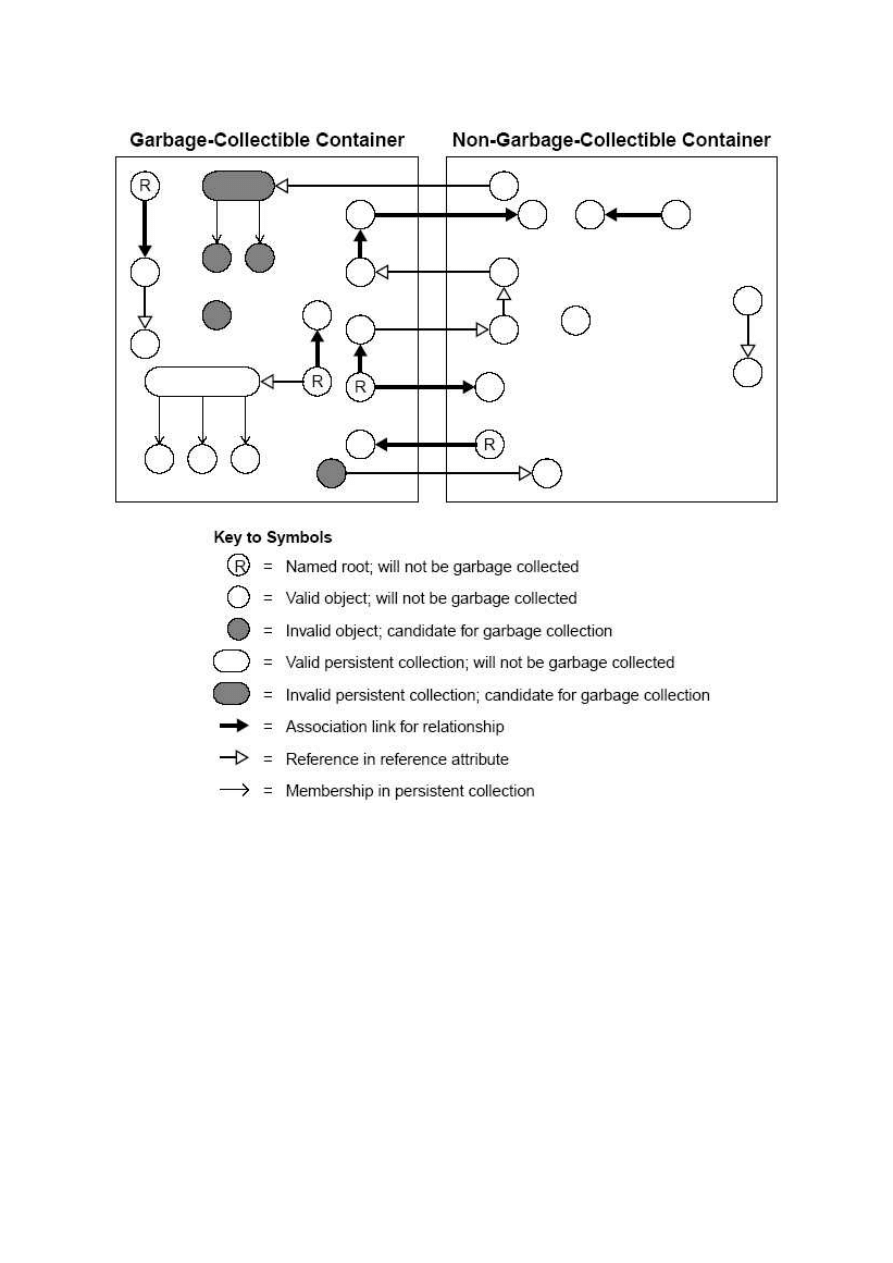

Rysunek 8„Objectivity for Java Programmer’s Guide” strona 181. Różnice

między kontenerem z odśmiecaczem a zwyczajnym.

Kontenery bez odśmiecacza uznają, że każdy trwały obiekt, który posiadają jest aktywny. Aplikacja

musi sama zadbać o usuwanie obiektów, które przestały należeć do struktury powiązań obiektów. Aby

skasować obiekt należy na nim wywołać metodę delete(). Obiekty z kontenera bez odśmiecacza nie

są kasowane podczas działania narzędzia oogc.

18

Dostęp do kontenerów odbywa się poprzez obiekt bazy danych. Metoda lookupContainer()

obiektu ooDBObj zwraca kontener o podanej nazwie lub null jeżeli taki nie istnieje. Istnieje też

możliwość przejścia iteratorem po wszystkich kontenerach bazy wywołując metodę contains().

Baza Danych jest to obiekt przechowujący kontenery. Każda baza danych posiada swój domyślny

kontener (ang. default container) oraz kontener nazwanych korzeni (ang. named roots). Dodatkowo

może posiadać kontenery utworzone przez aplikację.

Baza danych może być utworzona przez administratora poprzez odpowiednie narzędzia lub z poziomu

aplikacji. Każda baza danych należy tylko do jednej federacji i posiada unikalną nazwę w jej obrębie.

Fizycznie baza danych stanowi plik na dysku. Istnieje możliwość przenoszenia baz pomiędzy

federacjami za pomocą narzędzia ooattachdb. Taka operacja może powodować spore komplikacje

jeżeli okaże się, iż obiekty z pozoru tej samej klasy nagle okażą się niekompatybilne (błędy związane

z zarządzaniem schematem).

Federacja

Potocznie zwana „baza danych” w przypadku Objectivity/DB oznacza federację baz danych

(mogących znajdować się na różnych maszynach). Federacja jest to byt tworzony przez

administratora. Grupuje ona w sobie bazy danych korzystające ze wspólnego modelu obiektów

(schematu). Federacja może być stworzona tylko z poziomu narzędzi administratorskich.

Aplikacja łączy się z federacją baz danych poprzez BootFile, plik opisujący położenie pliku federacji.

Aplikacja może korzystać tylko z jednej federacji podczas swojego działania.

Wielowątkowość

Objectivity/DBDB zapewnia możliwość dostępu do bazy danych dla wielu klientów jednocześnie.

Obsługą wielowątkowości zajmuje się serwer zamków (ang. lock server) – oolockserver. Dba on

o zapewnienie zasad ACID w stosunku do transakcji operujących na bazie. Jest to mały proces, który

może być uruchomiony na dowolnej maszynie. W pliku bootFile każdej federacji zapisany jest adres

hosta, na którym uruchomiony jest serwer zamków. Aplikacja nie łączy się explicite z lock serverem.

Dzieje się to głębiej w bibliotekach obsługujących dostęp do bazy.

Aplikacja dokonuje wszystkich operacji bazodanowych w ramach sesji, która działa w ramach

konkretnego połączenia. Sesja jest instancją klasy Session dostarczanej przez producenta. Służy

ona do interakcji aplikacji z bazą danych oraz udostępnia dane i zasoby. Wszystkie transakcje

odbywają się w ramach sesji. Transakcja rozpoczyna się metodą begin() obiektu Session a

kończy commit(). Istnieje też możliwość zerwania transakcji – metoda abort(). Podczas

transakcji aplikacja zakłada dwa rodzaje zamków: do czytania (read lock) lub do modyfikacji

obiektów (write lock). W momencie, kiedy aplikacja pobiera obiekt do czytania baza danych, zakłada

na nim zamek „do czytania”. Jeżeli aplikacja będzie próbowała zapisać pobrany obiekt (np. po

zmianie zawartych w nim danych) zamek zostanie zaktualizowany do „do pisania” (write lock).

Baza Objectivity/DB zapewnia dwa rodzaje dostępu wielowątkowego:

•

Standardowa wielowątkowość

•

Tryb “Multiple Readers, One Writer (MROW)”

19

Standardowa wielowątkowość oznacza, że aplikacja może poprosić o zamek do odczytu tylko, jeżeli

na kontener nie został założony zamek do modyfikacji. Jeżeli na kontenerze założony został zamek do

pisania, nie można na nim zakładać innych zamków, nawet do czytania.

W trybie MROW baza dopuszcza możliwość czytania danych w momencie, kiedy na kontenerze

założony został zamek do pisania. Oznacza to, iż do momentu zatwierdzenia przez transakcję

modyfikującą wszystkie inne transakcje posiadające zamki do czytania będą widziały stan danych taki

jak w momencie zakładania zamków.

Wszystkie zamki założone przez transakcje zwalniane są w momencie jej zatwierdzenie lub zerwania.

Relacje między obiektami

Objectivity/DB pozwala na definiowanie relacji pomiędzy obiektami. Definicja taka zawarta jest w

kodzie źródłowym klasy i różni się od zwyczajnej definicji asocjacji z języka programowania.

Tworząc relację do innej klasy deklaruje się pole relacji i statyczną metodę określającą szczegóły

relacji. Pole relacji musi być jednym z dwóch typów dostarczanych przez producenta:

•

ToManyRelationship – jeżeli obiekt źródło będzie łączony z wieloma obiektami

docelowymi (agregacja)

•

ToOneRelationship – jeżeli obiekt źródło będzie łączony tylko z jednym obiektem

docelowym

Jeżeli obiekt dziedziczy z ooObj to Objectivity/DB wypełnia jego pola relacji odpowiednim

obiektem natychmiast po powołaniu go do życia.

Metoda statyczna relacji zwraca obiekt relacji, który jest typem jednym z:

•

OneToOne

•

OneToMany

•

ManyToOne

•

ManyToMany

Nazwa tej metody ma ściśle określoną formę. Musi to być [nazwa pola relacji]

_Relationship(). Zwracany obiekt przechowuje szczegóły dotyczące zachowania danej relacji.

Są to dane dotyczące:

20

public

class

Article

extends

ooObj {

...

// pole relacji

private

ToManyRelationship words;

...

}

Kod 1. Przykład definicji pola relacji.

•

Nazwa pola relacji w danej klasie

•

Pełna nazwa klasy na drugim końcu relacji (wraz z nazwą pakietu)

•

Nazwa pola relacji odwrotnej

•

Zachowanie podczas kopiowania obiektu. Może być jedno z:

➢

COPY_DELETE – po operacji skopiowania obiektu źródłowego, obiekt kopia nie będzie

posiadał relacji do obiektu docelowego

➢

COPY_MOVE – po operacji skopiowania obiektu źródłowego, relacja zostanie przeniesiona z

obiektu źródłowego do kopii. Po operacji obiekt źródło nie będzie posiadał relacji do obiektu

docelowego.

➢

COPY_COPY – wraz ze skopiowaniem obiektu źródłowego zostanie także skopiowana relacja.

Po operacji istnieć będą dwa obiekty z dwoma relacjami do tego samego obiektu docelowego.

•

Zachowanie podczas wersjonowania. Objectivity/DB w wersji dla języka Java nie obsługuje

wersjonowania. Mimo to należy zdefiniować sposób zachowania się relacji podczas

wersjonowania, aby można było korzystać z tej klasy łącząc się z bazą za pomocą innych

języków programowania.

•

Flaga (true/false) określająca, czy propagowane będzie usunięcie obiektu. Inaczej mówiąc, czy

jeżeli obiekt zostanie usunięty należy usunąć także obiekty z nim powiązane.

•

Flaga (true/false) określająca, czy propagować zamki na obiekty powiązane. Flaga ta ma

znaczenie tylko jeżeli zdecydujemy się wiązać relacjami obiekty ponad kontenerami. Jeżeli

wszystkie obiekty powiązane znajdują się w tym samym kontenerze to nie zauważymy różnicy

gdyż baza danych blokuje cały kontener a nie pojedyncze obiekty.

•

Tryb przechowywania relacji.

21

public

class

Article

extends

ooObj {

...

private

ToManyRelationship stats;

public

static

OneToMany stats_Relationship() {

return

new

OneToMany(

"stats"

,

// This relationship

"pl.edu.pjwstk.NewsSearch.WordStats"

,

// Destination class

"article"

,

// Inverse relationship

Relationship.COPY_MOVE,

// Move links to copy of object

Relationship.VERSION_MOVE,

// Move links to new version

false

,

// Don't propagate delete

false

,

// Don't propagate locks

Relationship.INLINE_NONE);

// Non-inline storage mode

}

// End stats_Relationship static method

...

}

Kod 2. Przykład definiowania relacji. Obiekt Article relacje „stats” do obiektów klasy

WordStats. Jest to relacje typu jeden-do-wielu.

Dodatki

Wraz z klasami niezbędnymi do budowania aplikacji opartych na bazie Objectivity/DB

producent rozpowszechnia zestaw dodatków. Chodzi tutaj głównie o trwałe kolekcje, które

przygotowane są do przechowywania w bazie. Spowodowane jest to główne tym, iż standardowe

kolekcje języka Java (listy, mapy i inne z pakietu java.util.*) nie są obiektami trwałymi i w

związku z tym nie mogą być przechowywane przez Objectivity/DB. W naszej pracy stosowaliśmy

ooTreeList i ooTreeMap. Obie te klasy dziedziczą z ooBTree, która zajmuje się zarządzaniem

kolekcją w środowisku Objectivity/DB. Struktura tej kolekcji oparta jest na zasadzie b-drzewa.

Przechowuje ona węzły i liście. Klasa ooBTree zajmuje się rozrzucaniem obiektów na węzły i liście.

Przy okazji sama tworzy strukturę kontenerów wiążąc je ze sobą.

Tworząc kolekcję użytkownik ma możliwość zdefiniowania maksymalnej liczby obiektów

przechowywanej w węźle b-drzewa. Przy małej liczbie spada liczba konfliktów przy zakładaniu

zamków w przypadku kiedy wiele aplikacji klienckich korzysta jednocześnie z tej samej kolekcji.

Podając dużą maksymalną liczbę obiektów minimalizujemy liczbę kontenerów obsługujących

kolekcję.

3.2.

Java

Obiektowy język programowanie stworzony przez firmę SUN (

http://

java.sun.com

). Główną

jego zaletą jest pełna obiektowość bez możliwości obejścia jej sztuczkami programistycznymi.

Dużym udogodnieniem Javy jest pełny zestaw kolekcji oraz gotowych klas pomocniczych, dzięki

którym tworząc aplikacje programuje się w zasadzie tylko jej logikę. Nie trzeba natomiast tworzyć od

zera swoich klas pomocniczych implementujących rożnego rodzaju struktury danych.

Wszystkie programy Javy uruchamiane są w maszynie wirtualnej (ang. Java Virtual Machine –

JVM). Kod źródłowy programu kompilowany jest do postaci bajtkodu (ang. byte code). Dzięki takiej

architekturze dowolna aplikacja stworzona przy pomocy standardowych klas Javy jest w pełni

przenośna pomiędzy dowolnymi systemami operacyjnymi, które posiadają implementacje maszyny

wirtualnej. Wszystkie operacje dostępu do zasobów (pliki, pamięć, zasoby sieciowe) odbywają się

poprzez JVM. Do zadań maszyny wirtualnej należy sprawne zarządzanie pamięcią aplikacji Javy oraz

umożliwianie dostępu do zasobów w danym systemie operacyjnym.

Java oferuje tzw. odśmiecacz (ang. Garbage Collector w skrócie GC). Jest to mechanizm

wbudowany w maszynę wirtualną Javy służący do usuwania z pamięci nieużywanych obiektów.

Programując w tym języku twórca aplikacji nie zajmuję się w ogóle kwestiami zarządzania pamięcią.

Obiekty są powoływane a ich niszczeniem zajmuje się GC.. W maszynie wirtualnej SUNa

znajdywanie kandydatów do usunięcia odbywa się wykorzystując algorytm „Mark and Sweep”.

Polega on na przejściu przez wszystkie obiekty zaczynając od najniższego na stosie. Przechodząc

przez każdy z nich odznaczana jest flaga „marked”. Po zakończeniu procesu wszystkie obiekty, które

nie mają ustawionej tej flagi zostają usunięte. Specyfikacja maszyny wirtualnej nie definiuje sposobu

znajdowania martwych obiektów. Kwestia ta pozostawiona jest do decyzji producenta danej

wirtualnej maszyny.

Obiekt jest aktywny jeśli istnieje jakaś ścieżka z aktualnie wykonywanego programu poprzez

obiekty powiązane, kolekcje itp. do danego obiektu. Jeżeli taka ścieżka nie istnieje, obiekt jest

kandydatem do skasowania. Usuwanie nieużywanych obiektów nie odbywa się natychmiastowo po

utracie dostępu do obiektu. Obiekty-śmieci istnieją przez jakiś czas w pamięci a proces odśmiecania

odbywa się raz na jakiś czas lub w razie konieczności uwolnienia pamięci (np. kończy się pamięć

programu a aplikacja próbuje powołać nowe obiekty).

22

3.3.

Gram

Dużym zagadnieniem w wyszukiwaniu pełnotekstowym jest analiza i przekształcanie tekstu. W

naszej pracy skupiliśmy się głównie na stworzeniu mechanizmu indeksującego i wyszukującego.

Analiza tekstu w języku polskim to temat na odrębną prace magisterską, dlatego też wykorzystaliśmy

gotowe oprogramowanie. Firma Neurosoft udostępniła nam swój główny produkt – GRAM

(

http://

gram.neurosoft.pl

/

). Jest to oprogramowanie służące do zaawansowanej analizy i

przekształcania tekstów w języku polskim. Jest ono wykorzystywane w profesjonalnych

zastosowaniach. Zostało wbudowane w mechanizm wyszukiwarki NetSprint.pl, który jest

wykorzystywany przez Wirtualną Polską oraz wiele innych wyszukiwarek dostępnych w polskim

Internecie.

Funkcjonalność oprogramowania Gram udostępniana jest poprzez interfejsy CORBA. Dzięki

temu analizy językowe stają się dostępne dla każdego języka programowania z obsługą standardu

CORBA.

Z oprogramowania GRAM korzystamy głównie w celu normalizacji tekstów. Normalizacja

polega na zamianie wszystkich słów na ich formy podstawowe. Dzięki temu wyszukiwanie informacji

staje się łatwiejsze i celniejsze. Wpisując tekst do znalezienia użytkownik nie musi się martwić czy

podał go w odpowiedniej formie. Mechanizm szukające odnajdzie wszystkie teksty, w których

występują dane słowa bez względu na to, w jakiej formie zostały użyte.

3.4.

Python

Język skryptowy, który aspiruje do miana „obiektowego”. Niestety po pierwszym momencie

fascynacji podsyconej dużym szumem w kręgach programistycznych wychwalającym ten język,

szybko doszliśmy do rozczarowania. Główną wadą tego języka jest to, że nie jest w stu procentach

obiektowy. Niestety, mimo dużych starań twórców przemknęły się do niego konstrukcje rodem z PHP

lub C. Najlepszym tego przykładem jest sposób pobierania długości listy. Mając obiekt lista, w

którym przechowujemy elementy naturalnym sposobem, z punktu widzenia obiektowości, wydaje się

wywołanie metody length() lub size() (lub podobnej) na naszym obiekcie. W Pythonie, z

niezrozumiałych względów, przyjęto rozwiązanie, w którym chcąc otrzymać rozmiar listy należy

wywołać funkcję globalną len(list) przekazując jako parametr referencję do obiektu lista.

Oczywiście, fakt iż jest to technologia skryptowa niesie ze sobą wszystkie wady (liczne) i

zalety (stosunkowo nieliczne) języków skryptowych. Są to:

•

Brak kompilacji: 90% błędów programisty jest do wychwycenia w procesie kompilacji. Błędy

popełnione w programie skryptowym ujawnią się dopiero w momencie wykonania wadliwego

kodu. W modułach bardzo rzadko uruchamianych taki błąd może ujawnić się bardzo późno

(nawet po miesiącach).

•

Brak mocnego typowania. Nie jest to cecha przywiązana do języków skryptowych, jednak

większość spotykanych języków skryptowych uznaje co najwyżej dwa typy: liczbowy i

tekstowy. Python nie odbiega od tego schematu

•

Brak deklaracji zmiennych. Zmienne powoływane są w momencie ich pierwszego użycia. Nie

jest to wielka wada, ale w dużych aplikacjach przy niskiej „higienie” kodu może wprowadzać

dodatkowe zamieszanie do i tak skomplikowanego kodu.

•

Metody i zmienne prywatne (zob. sekcja 9.6

dokumentacji

Pythona). Python nie oferuje

możliwości definiowania zmiennych i metod prywatnych. Pseudo-prywatność zmiennych i

metod można osiągnąć poprzez specjalne nazewnictwo: __metodaA(). Nazwy takie zamieniane

są podczas wykonania na [nazwaklasy]__metodaA(), co powoduje ukrycie takich pól przed

23

dostępem z zewnątrz. Mimo takich zabiegów istnieją sposoby obejścia zakresu widoczności

zmiennych tak, że pola i metody prywatne stają się dostępne z zewnątrz.

•

Bloki programu. Do definicji bloków programu nie stosuje się klamr (np. „{” i „}”). Zamiast

tego kod jest formatowany odpowiednio wcięciami. Wcięcie głębsze od aktualnego oznacza

wewnętrzny blok. W momencie przenoszenia plików na inne systemu operacyjne obsługujące

inne kodowania mogą powstawać błędy spowodowane przesunięciem się niektórych wcięć.

Oczywiście Python posiada również zalety:

•

Olbrzymi zasób bibliotek implementujących prawie wszystkie spotykane w Internecie

technologie (nntp, imap, pop3, http, ftp, wyrażenia regularne, kolekcje, CORBA, i inne).

•

Wyjątki. Podobnie do Javy wbudowany został mechanizm obsługi wyjątków. Wszelkie

nietypowe zachowanie sygnalizowane jest odpowiednimi wyjątkami zamiast zwracania kodów

błędów przez funkcje.

•

Szybkie tworzenie małych programów. Dzięki rozbudowanym zasobom biblioteki i możliwości

ściągnięcia dodatków z Internetu programowanie niewielkich aplikacji może okazać się bardzo

szybkie.

Ogólnie Python jest krokiem w dobrym kierunku jeżeli chodzi o języki skryptowe. Na pewno

jest on przyjemniejszy w programowaniu niż PHP. Jednak dla programisty Javy przejście na Pythona

może być źródłem sporej frustracji.

3.5.

PostgreSQL

Relacyjna baza danych rozpowszechniana na zasadzie Open Source. Zapewnia ona pełny

zestaw operacji bazodanowych – SQL, transakcje (pełna zgodność z ACID), procedury składowane

(ang. stored procedures), wyzwalacze (ang. triggers), indeksy, prawa dostępu, widoki (ang. views).

Postgres pozwala na prawie bezbolesne przenoszenie baz z/na Oracle, SQL Servera lub inne

obsługujące SQLa. Jest to w pełni profesjonalny system zarządzania bazą danych, który został

wykorzystany w wielu projektach komercyjnych.

Jedną z ciekawszych zalet tego SZBD stanowi konstrukcja „SELECT pole1, pole2

FROM tabela LIMIT x OFFSET y” ograniczająca zwracane rekordy tylko do określonego

wycinka. Jest to szczególnie istotne w aplikacjach internetowych gdzie zachodzi potrzeba

stronicowania danych, np. pokazywanie po 20 wątków na stronie. W innych SZBB (np. SQL Server)

24

„

początek petli

”

for

i

in

range(1,2):

"

i:

" + str(i)

„

kolejny krok pętli

”

„

koniec petli

”

Kod 3. Przykład deklaracji pętli w języku Python

trzeba niestety stosować obejścia poprzez implementowanie odpowiednich procedur składowanych

dla osiągnięcia podobnego efektu.

Niestety Postgres mimo swojego profesjonalnego podejścia i obsługi standardów SQL92 i

SQL99

(jak

chwalą

się

jego

twórcy

w

Internecie:

http://

www.postgresql.org

/ docs

/7.4/

interactive

/ preface.html

#INTRO-WHATIS

) nie oferuje żadnych

dodatkowych udogodnień:

•

Brak jest możliwości zaawansowanego tuningu bazy pod względem wydajności.

•

Brak zapamiętywania często wykonywanych niezmiennych zapytań.

Główną zaletą Postgresa jest fakt, iż jest dostępny za darmo i jednocześnie jest prawie w pełni

kompatybilny z SQL. W porównaniu z MySQL-em – innym darmowym system zarządzania bazą

danych Postgres wypada bardzo dobrze.

3.6.

Leafnode

Głównym i jedynym źródłem danych dla naszego mechanizmu wyszukiwarki jest domowy

serwer grup dyskusyjnych LeafNode (wersja leafnode-1.9.42.rel). Jest to proste

oprogramowanie obsługujące protokół NNTP, ściągające artykuły i grupy dyskusyjne z serwera

głównego (ang. feed). W naszym przypadku skorzystaliśmy z publicznego serwera

news://news.task.gda.pl oferującego większość grup światowych i prawie wszystkie grupy

polskie. Początkowo próbowaliśmy korzystać z serwera news://news.tpi.pl lecz jego

wydajność pozostawia sporo do życzenia. Server Leafnode udostępnia ściągnięte posty dalej

użytkownikom poprzez protokół NNTP. Można łączyć się z nim za pomocą każdego programu

czytnika grup dyskusyjnych.

Leafnode przechowuje ściągnięte artykuły na dysku jako pliki. Każdy artykuł to oddzielny plik,

a każda grupa to oddzielny katalog. Stwarza to pewne problemy gdyż tylko nieliczne systemy plików

potrafią sobie poradzić z ogromną ilością małych plików przechowywanych w jednym katalogu.

Początkowo dane zapisywane były w systemie Ext3 jednak szybko doszliśmy do fizycznego

ograniczenia liczby plików. Obecnie system działa na systemie plików ReiserFS, który nie posiada

limitu liczby plików.

Serwer LeafNode skonfigurowany jest tak, że nie kasuje starych postów. Dzięki temu jesteśmy

w posiadaniu pełnej historii polskich grup dyskusyjnych od połowy sierpnia roku 2003.

Co noc uruchamiany jest proces ściągania nowych artykułów z polskich grup dyskusyjnych

(pl.*, alt.pl.*, free.pl.*, ms-news.pl.*). Niestety, oprogramowanie to jest mało wydajne. Proces

ściągania przy rozmiarze archiwum ok. 10gb trwa ok. 22 godziny. Możliwe że jest to spowodowane

słabą wydajnością maszyny, na której działa (procesor 333MHz, 64mb RAMu). Przy przekroczeniu

24 godzin może dojść do dodatkowych komplikacji. Jeżeli zaś proces ściągania nowych postów

będzie uruchamiany co dwa dni może to doprowadzić do efektu „kuli śniegowej” – im rzadziej

ściągane posty tym ich więcej, więc dłużej to trwa itd.

3.7.

Biblioteki

Biblioteka NNTP

Implementacja fetchera (roz 5.2) korzysta z biblioteki, łączącej się z serwerem poprzez

protokół NNTP. Początkowo wykorzystywaliśmy bibliotekę gnu.inet.nntp projektu Savannah

(

http://

savannah.nongnu.org

/ projects

/nntp-

java

/

). Jest to rozbudowana biblioteka implementująca

większość komend protokołu NNTP. W czasie prac okazało się, że potrafi zawiesić się bez podania

25

błędu, przez co uniemożliwia dalszą prace. Jednym wyjściem okazało się zaprogramowanie własnego

modułu komunikacji z serwerem NNTP. Zadanie okazało się dosyć proste. W krótkim czasie powstała

skromna biblioteka obsługująca niezbędne elementy komunikacji z serwerem. Zaimplementowane

zostały tylko komendy przez nas wykorzystywane. Wiele możliwości protokołu NNTP zostało

pominięte, gdyż nie są one w jakimkolwiek stopniu nam przydatne.

26

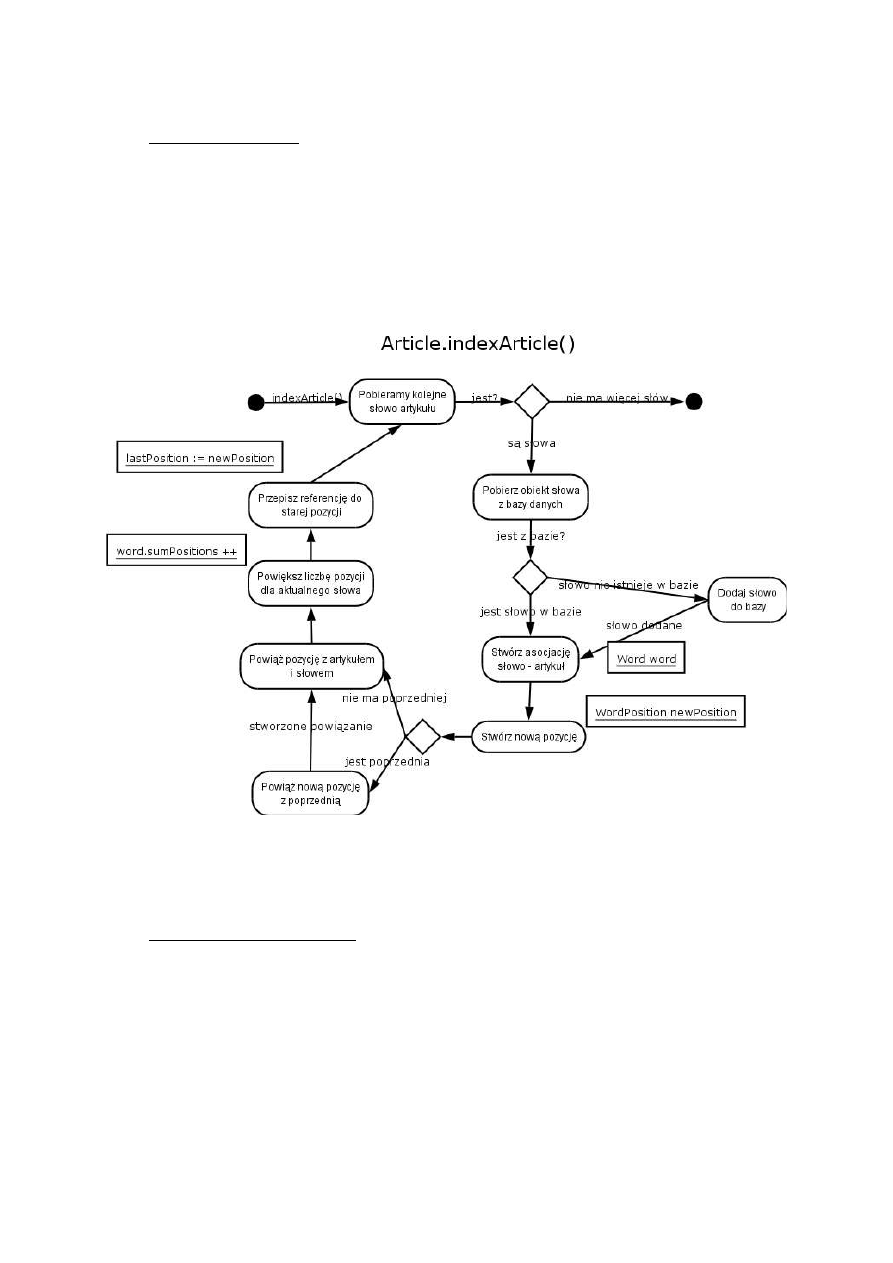

4. Obiektowość a wyszukiwanie pełnotekstowe

Rozdział czwarty pracy składa się głównie z dokładnego omówienia i uzasadnienie rozwiązania

zastosowanego w ramach pracy. Szczególny nacisk został położony na algorytmy stanowiące

zasadniczy rezultat pracy, czyli algorytm indeksowania i wyszukiwania informacji.

4.1.

Obiektowość a wyszukiwanie informacji

Od kilku dobrych dekad (to informatyczny odpowiednik tradycyjnego „od wieków”) trwa

nieustanna walka (niestety nie zawsze na rzeczowe argumenty) pomiędzy zwolennikami relacyjnych

(RDBMS) i obiektowych (ODBMS) systemów baz danych. Orędownicy obu koncepcji często nie

stronią od kategorycznych opinii na temat opiewanej przez siebie technologii, dyskwalifikując

jednocześnie wszystkie konkurencyjne rozwiązania („każde zadanie da się wykonać szybciej i

efektywniej stosując bazę relacyjną/obiektową”, „obiektowe/relacyjne bazy danych to relikt

przeszłości”, etc). Oczywiście, jak zwykle w takich przypadkach bywa, prawda leży pośrodku. Obie

koncepcje mają swoje dobre i słabe punkty, nie ma uniwersalnego rozwiązania, a zastosowanie

konkretnej technologii zależy przede wszystkim od specyfiki projektu. W tym miejscu należałoby

przybliżyć nieco konkretne „za i przeciw” obu rozwiązań, aby wyjaśnić powody, dla których w

omawianej aplikacji wybrane zostało konkretne rozwiązania, oparte o system obiektowy.

Ogromną zaletą baz relacyjnych jest powszechne użycie deklaratywnego języka zapytań SQL,

który mimo licznych wad i błędów koncepcyjnych, przyjął się i jest obecnie uznawany za standard.

Stosowanie SQL uwalnia programistę od ciągłego myślenia o niskopoziomowych szczegółach

implementacyjnych i pozwala spojrzeć na aplikację z wyższego poziomu abstrakcji, jedynie przez

pryzmat formalnych powiązań między danymi. Zaletą systemów relacyjnych jest więc przede

wszystkim znana i popularna technologia, a co za tym idzie, również bardzo dobre wsparcie dla

narzędzi wspomagających rozwijanie aplikacji opartych na relacyjnym silniku. Istotnym plusem jest

także istnienie standardów, takich jak ODBC i JDBC, dzięki którym, przynajmniej teoretycznie,

przejście do nowej wersji, czy zmiana stosowanego systemu baz danych nie powinna nieść za sobą

kłopotliwych zmian w kodzie aplikacji. Jednak trzeba tu poczynić pewne założenia. Po pierwsze

takie, że kod rozwijanej aplikacji zawiera jedynie standardowe komendy SQL i nie stosowane są

jakiekolwiek rozszerzenia standardu oferowane przez system. Po drugie, musimy przyjąć, że

stosowany system zarządzania bazą danych zapewnia całkowite wsparcie dla tego standardu. Niestety,

pierwsze założenie w znaczny sposób uszczupla możliwości programisty, szczególnie gdy powiązania

między danymi są skomplikowane i trudno je zamodelować jedynie przy użyciu standardowych

dostępnych w RDBMS metod. Wybiera się więc najczęściej rozwiązanie połowiczne – częściowe

odejście od standardu, wiążące się z utratą całkowitej przenaszalności kodu, na rzecz ułatwień

programistycznych i lepszej wydajności pracy. Wielu ważnych dostawców baz danych (w tym firma

Oracle) oferuje od pewnego czasu rozwiązania hybrydowe. Są to bazy oparte na filozofii relacyjnej,

jednak oferujące pewne elementy obiektowości, jak np. referencje między krotkami, dziedziczenie

encji, wołanie metod, itp. Rozwiązania te charakteryzują się całkowitą nieprzenaszalnością (brak jest

jakiegokolwiek standardu odnoszącego się do tego typu systemów), mogą być jednak dobrym

rozwiązaniem w przypadku gdy posiadamy już aplikację bazującą na systemie relacyjnym i występuje

potrzeba jej optymalizacji, czy reorganizacji struktury danych.

Rozwiązania hybrydowe nie eliminują jednak największej niedogodności, jaką stwarzają systemy

oparte na filozofii relacyjnej. Jak zauważa Steve McClure

3

z International Data Corporation, 25%

czasu jaki spędza programista przy tworzeniu aplikacji poświęcane jest na mapowanie struktury

danych w bazie na strukturę obiektową używaną w kodzie programu. Mapowanie takie może mieć

sens, jeśli ważnym wymaganiem aplikacji ma być jej przenaszalność na inne systemy baz danych. W

3

S.McClure, Object Database vs. Object-Relational Databases. IDC Bulletin #14821E - August 1997.

(

http://www.ca.com/products/jasmine/analyst/idc/14821E.htm#BKMTOC2

)

27

przypadku przywiązania firmy do konkretnego narzędzia bazodanowego jest to jednak zupełnie

niepotrzebny narzut, którego niestety nie sposób zniwelować, przy zastosowaniu standardowego

systemu RDBMS. Jedyną godną uwagi próbę pójścia w kierunku większej integracji języka

programowania z systemem RDBMS podjął Oracle, ze swoim PL/SQL. Język ten sprawdza się przy

systemach typowo bazodanowych, np. opartych na Oracle Forms, gdzie oprogramowanie aplikacji

sprowadza się do utworzenia pewnej ilości procedur i bloków programistycznych w PL/SQL,

zintegrowanych w sterowane zdarzeniowo środowisko formularzy. Rozwiązanie to nie ma jednak

zastosowania w bardziej zaawansowanych projektach, opartych na strukturze MVC (Model-View-

Controller), wymagających wielu aplikacji klienckich, pracujących na różnych platformach, a także

dostęp do danych przez aplikację internetową, czy Web Services.

Mimo wielu problemów, jakie narzuca sztywny model danych stosowany w RDBMS, rozwiązania

relacyjne (i obiektowo-relacyjne) nieustannie przewodzą na światowym rynku bazodanowym. Na

sukces RDBMS oraz SQL pracuje wszakże ogromne lobby producentów, przez co wiele osób

niesłusznie może odnieść wrażenie, że model relacyjny jest jedynym możliwym podejściem do baz

danych i nie istnieją żadne sensowne, alternatywne rozwiązania.

A rozwiązania takie istnieją. Wprawdzie lansowany przez grupę ODMG obiektowy język zapytań

OQL, ze względu na liczne niejasności i pomyłki koncepcyjne nie uzyskał aprobaty rynku i (z

nielicznymi wyjątkami) nie jest wykorzystywany komercyjnie, to jednak istnieją inne, równie dobre

jak SQL sposoby dostępu do danych, opierające się zazwyczaj na nieco innej koncepcji niż

deklaratywny język zapytań. Co więcej, w specyficznych przypadkach, sposoby te mogą okazać się o

wiele bardziej skuteczne. Zastosowaniu obiektowego modelu danych, zarówno na poziomie bazy jak i

kodu aplikacji ma wiele zalet. Takie rozwiązanie, już na starcie eliminuje wspomniane wyżej 25%

pracy programistycznej, polegającej na mapowaniu obiektów języka programowania na krotki w bazie

danych. Poza tym zyskujemy bardziej naturalną, intuicyjną strukturę danych opartą na obiektach.

Język SQL, wprawdzie wspierany przez niektórych dostawców ODBMS, nie jest najlepszą metodą

uzyskiwania dostępu do danych w systemach obiektowych. Obiektowe systemy baz danych

zapewniają bowiem wiele alternatywnych, najczęściej dużo bardziej wydajnych sposobów na

wykonanie identycznych czynności. Mogą to być na przykład:

●

dostęp do obiektów poprzez referencje i struktury (tablice, listy, drzewa) referencji

●

skanowanie obiektów w bazie danych (proste wyszukiwanie ze względu na jedno lub kilka

kryteriów)

●

bezpośrednie pobranie obiektu poprzez użycie struktury obiektów-korzeni

Pierwszym omawianym sposobem jest wykorzystanie w systemach obiektowych referencji i

kolekcji referencji jako naturalne zastąpienie relacji. Przy takim podejściu, aby uzyskać interesujące

nas dane, nie musimy zazwyczaj przeszukiwać całej bazy, zadając odpowiednie kryteria. Wystarczy

przeszukać dane bezpośrednio związane z aktualnie używanym obiektem, czyli przejść poprzez

referencję do powiązanego obiektu i wywołać odpowiednią metodę. Taka nawigacja po referencjach

między obiektami może w wielu sytuacjach zastąpić nam zupełnie operację przeszukiwania bazy.

Większość systemów opiera się bowiem na bardzo powiązanych ze sobą strukturach danych, więc

operując na konkretnym obiekcie prawdopodobne jest, że operacje jakie będziemy chcieli wykonać

dotyczą bezpośrednio tego właśnie obiektu, bądź obiektów z nim powiązanych.

Większość obiektowych systemów baz danych, w tym Objectivity/DB, oferuje również narzędzie do

skanowania – wyszukiwania obiektów w bazie w oparciu określone kryteria. Skanowania takiego

nie możemy równać z zapytaniem, gdyż dotyczy ono zazwyczaj jednej konkretnej klasy obiektów i

wyszukiwanie polega na przeszukaniu wszystkich obiektów w bazie pod kątem zadanego kryterium

Brak tutaj możliwości grupowania obiektów, agregacji w celu generowania raportów, czy zwykłego

złączenia (join) dwóch klas po określonym atrybucie. Skanowanie możemy traktować więc jedynie

jako wstępną segregację obiektów w bazie danych w celu pobrania ich do dalszego przetwarzania.

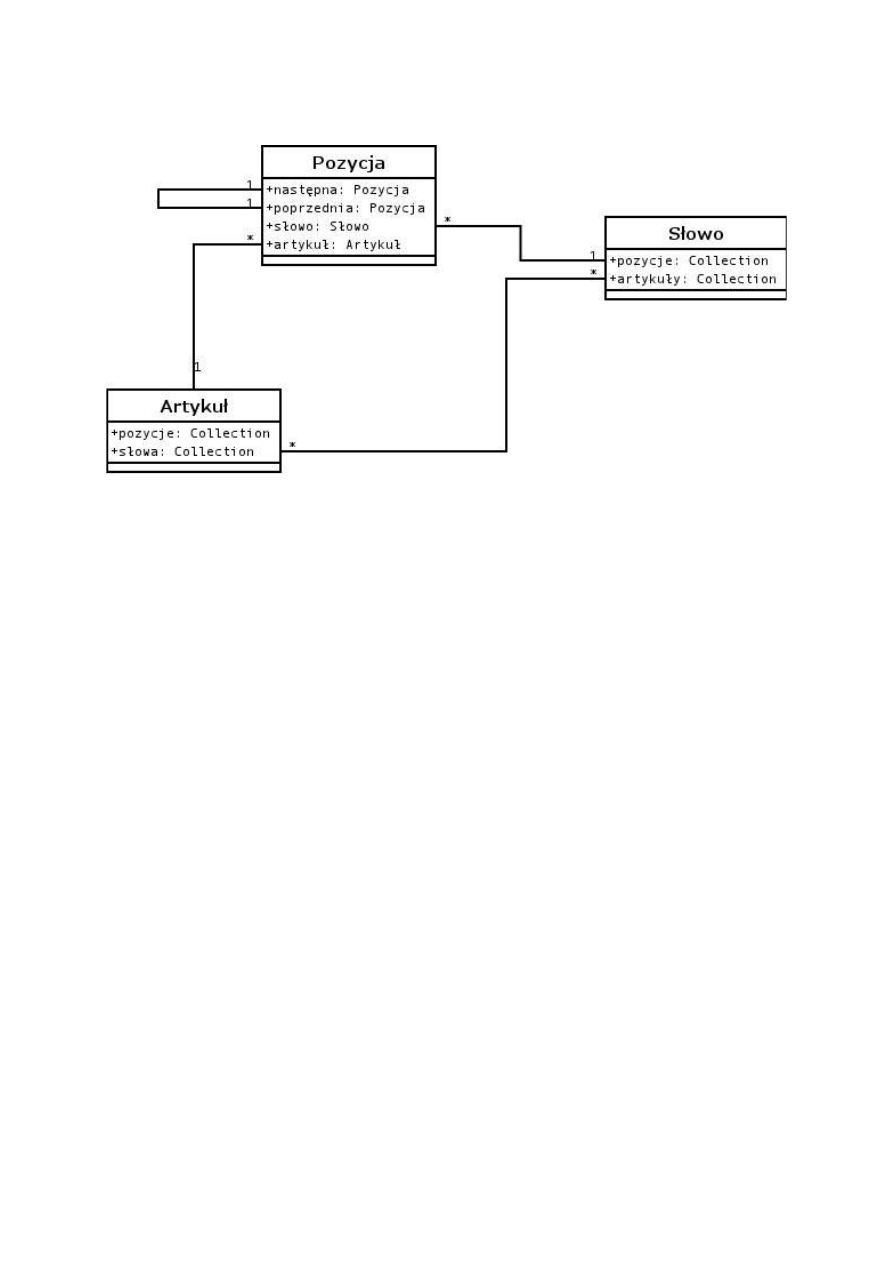

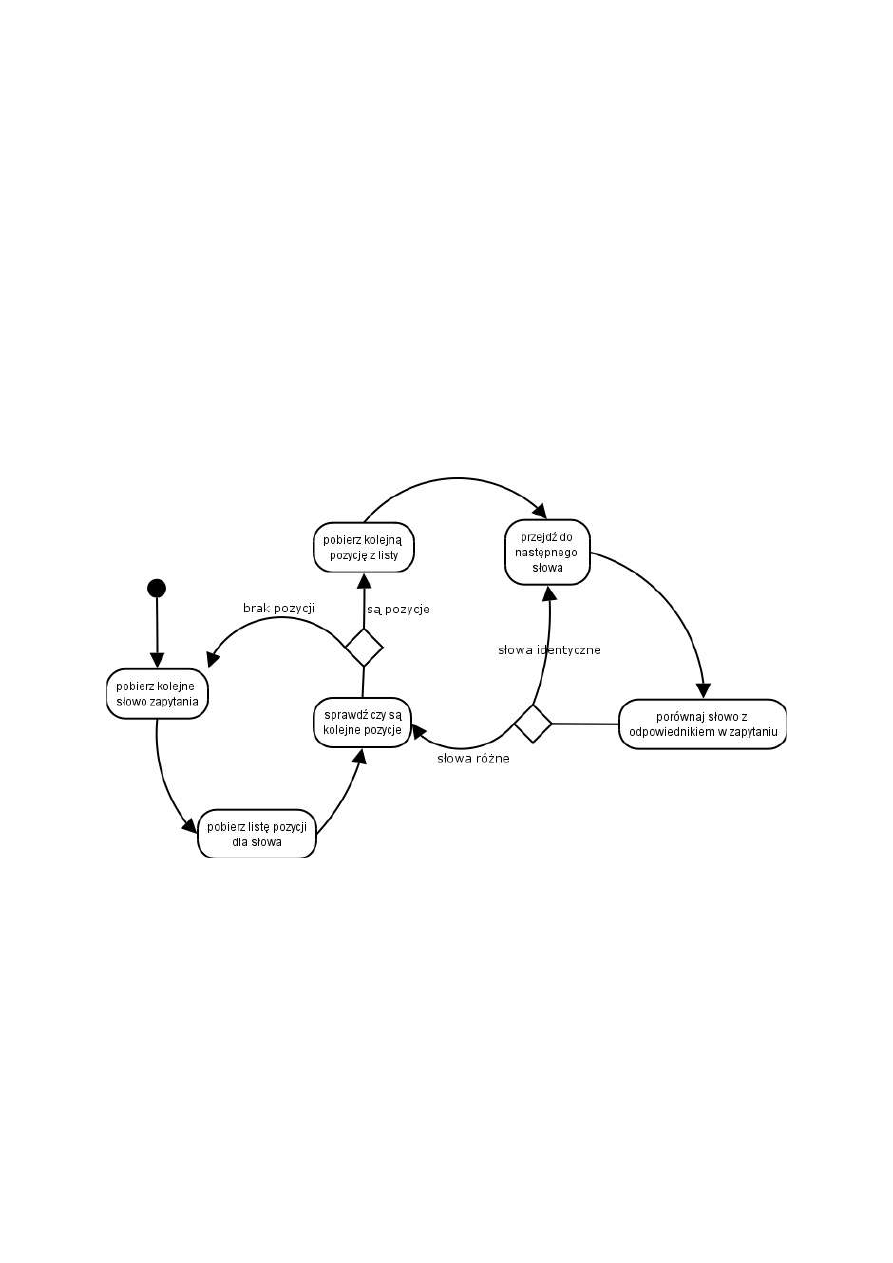

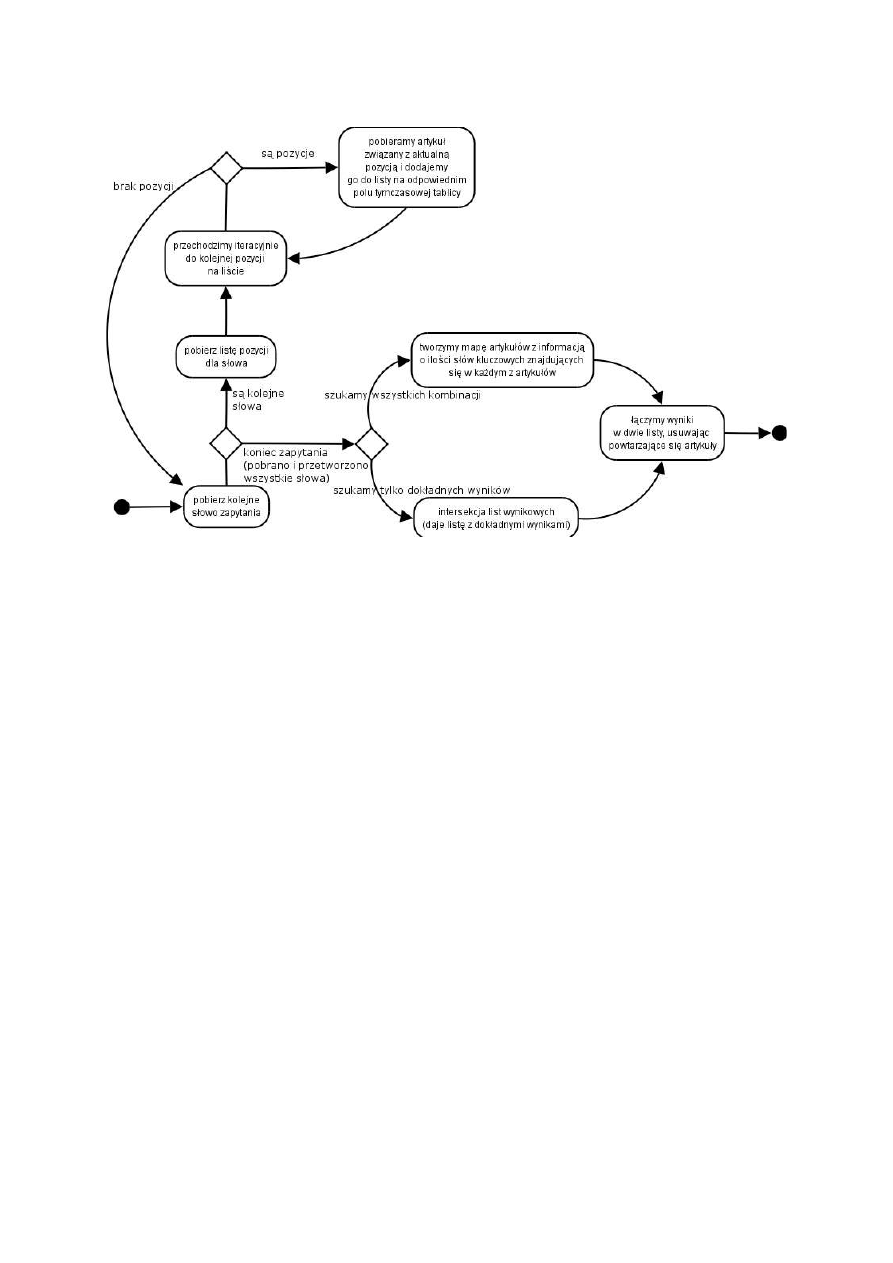

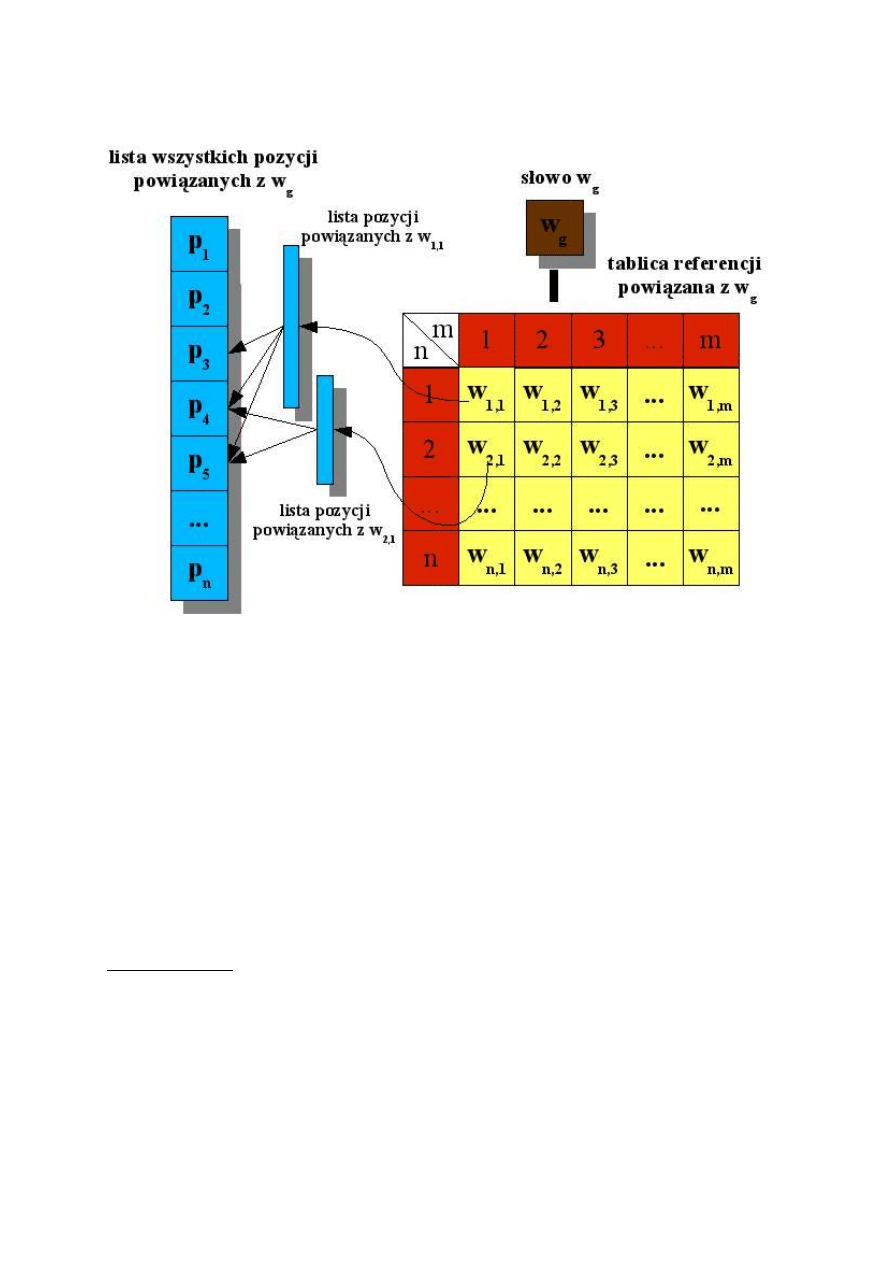

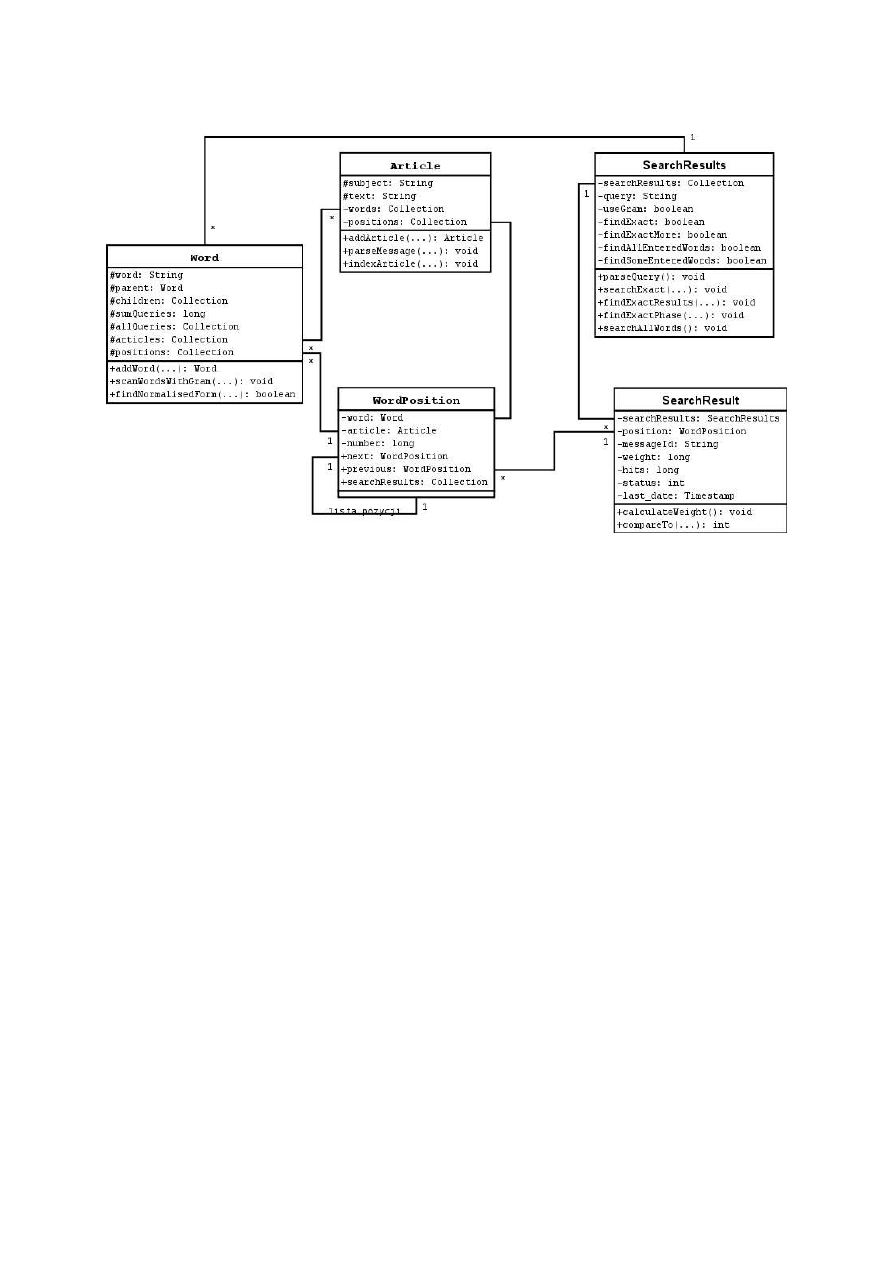

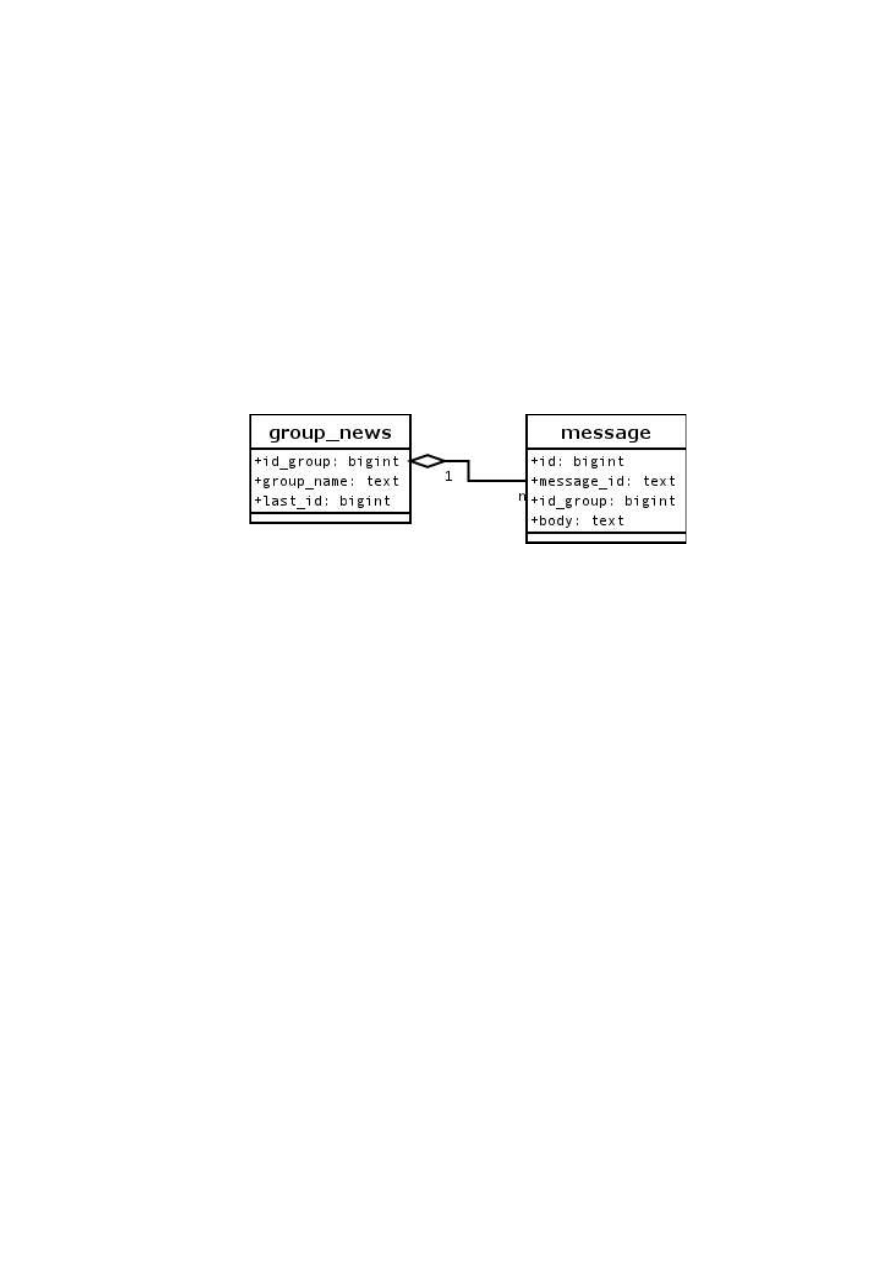

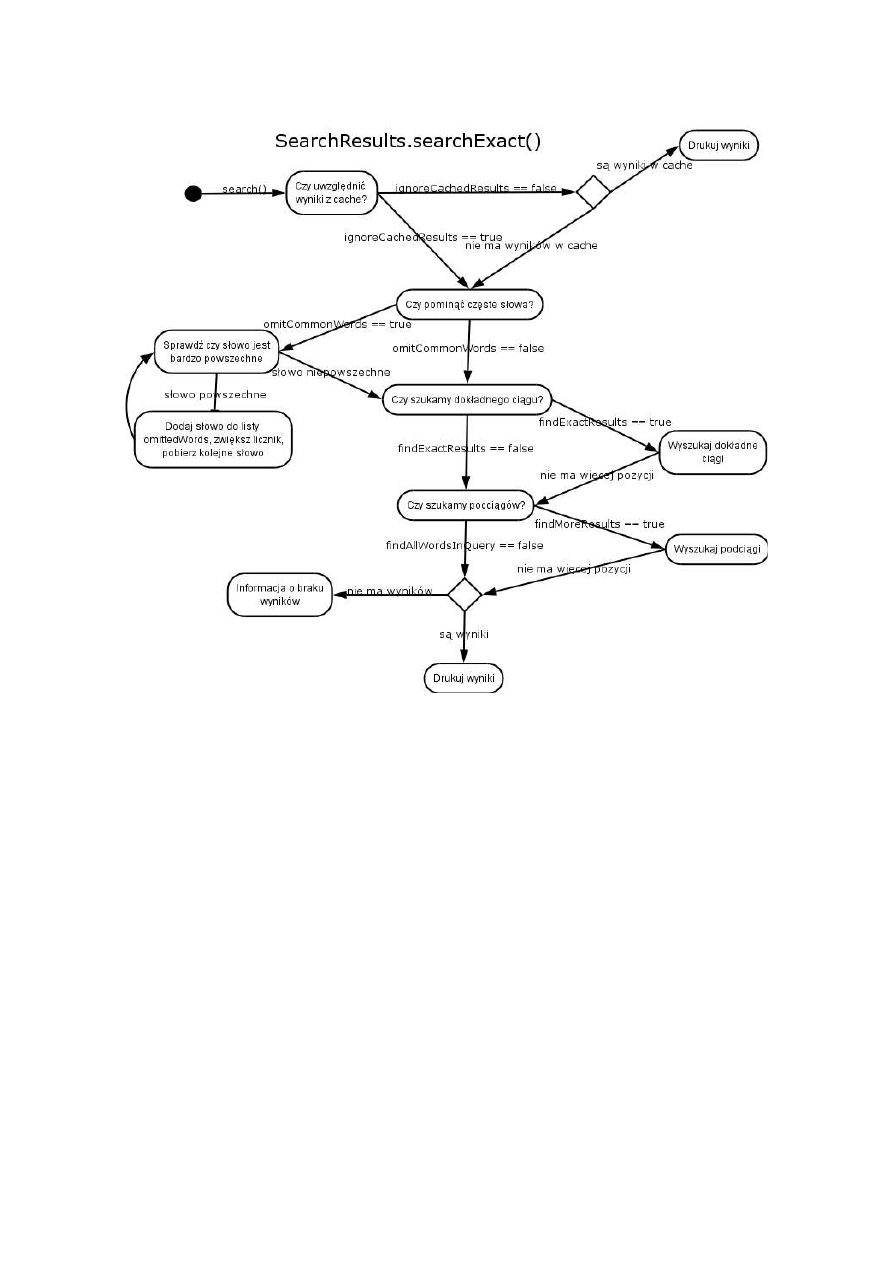

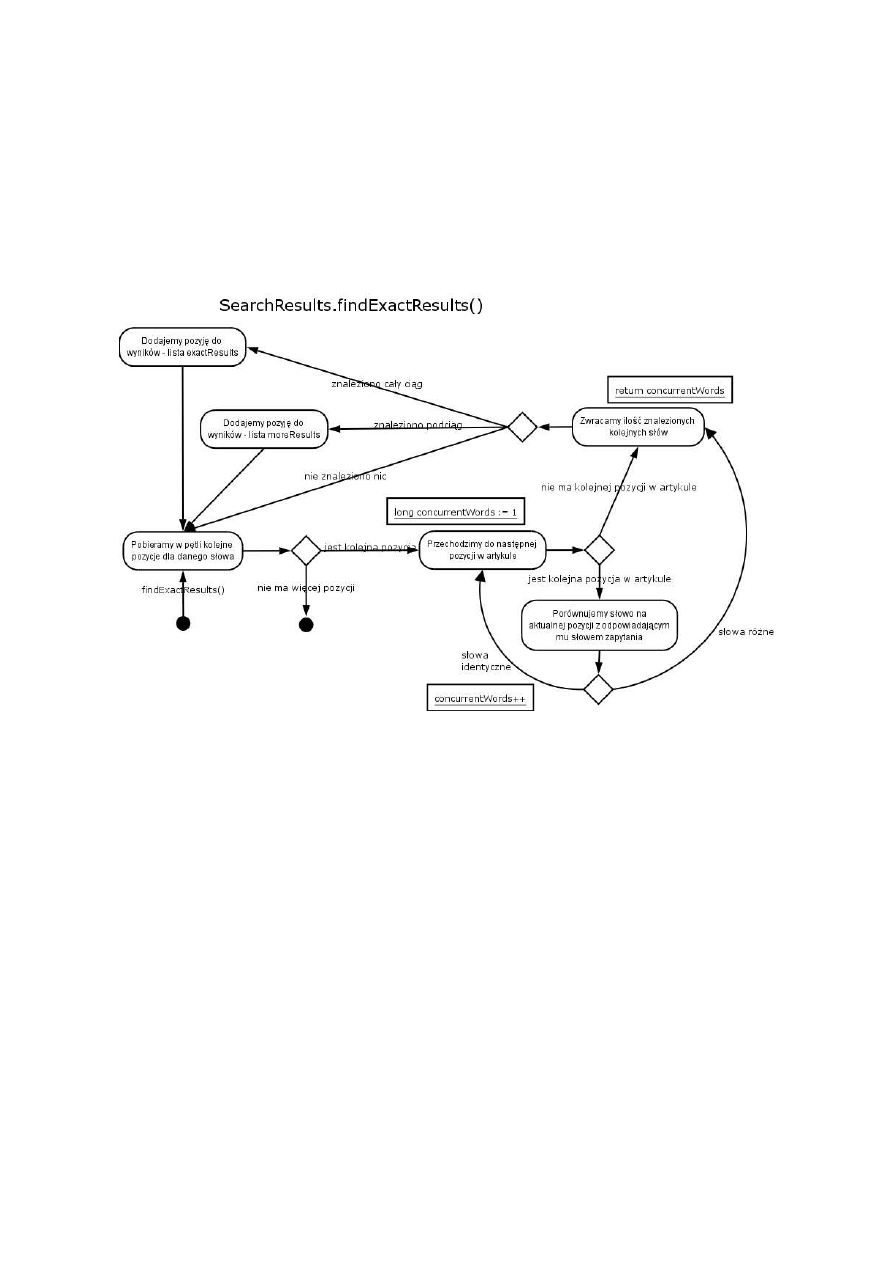

W specyficznych przypadkach stosowany może być również mechanizm bezpośredniego pobierania