Historia

Historia pamięci masowych sięga połowy dziewiętnastego wieku - już wtedy używano kart perforowanych do wprowadzania danych do mechanicznych maszyn liczących. Pierwsze elektroniczne komputery korzystały z pamięci zbudowanej z lamp elektronowych, potem zaczęły pojawiać się różnej maści pamięci magnetyczne - bąbelkowe, taśmowe, bębnowe.

Pierwszy w historii twardy dysk pojawił się w 1957 roku. Wtedy to IBM zaprezentował urządzenie o nazwie RAMAC 350 - złożony z pięćdziesięciu 24-calowych dysków zespół miał pojemność 5 MB, a koszt jego rocznej dzierżawy wynosił 35 tys. dolarów; jak nietrudno policzyć, oznaczało to 7 tys. dolarów za megabajt... W epoce maszyn mainframe budowano całe „farmy dysków” z zamkniętymi w klimatyzowanych pomieszczeniach zestawami talerzy o średnicach 14 czy 8 cali, wartymi grube dziesiątki tysięcy dolarów. Pojawienie się IBM PC w roku 1981 wcale nie zapowiadało rewolucji w dziedzinie pamięci masowych - system operacyjny „prapeceta” zawierał procedury obsługi pamięci w postaci magnetofonu kasetowego, choć oczywiście istniała także możliwość korzystania ze stacji dyskietek. Lista opcjonalnego wyposażenia IBM PC/XT z roku 1983 obejmuje już twardy dysk o pojemności 5 lub 10 MB - ówczesne napędy o znajomej średnicy 5,25" miały wysokość trzech cali (podobnie zresztą, jak wczesne stacje dyskietek) i stąd właśnie określenie „full height” (współczesny czytnik CD-ROM to „half height”).

W roku 1984 Western Digital skonstruował - dzierżący przez kilka lat godność „standardu przemysłowego”, zastosowany w IBM PC/AT interfejs ST506, zaś w 1986 - opracowany do spółki z firmą Compaq dobrze nam znany interfejs IDE (Integrated Drive Electronics). Mniej więcej rok później w komputerach stacjonarnych zaczęto instalować dyski 3,5" (o wysokości 1", czyli „low profile”) - dopiero potem znalazły one zastosowanie w przenośnych laptopach. Postęp technologii powodował ciągły wzrost pojemności i szybkości urządzeń, przy jednoczesnym spadku zapotrzebowania na energię, coraz mniejszej hałaśliwości i większej niezawodności. Wyniki tego wyścigu obserwujemy na co dzień. W dwudziestoletniej historii PC najbardziej eksponowany był zawsze postęp technologii półprzewodnikowej. Postęp w innych, bezpośrednio z nią związanych dziedzinach technologii był zawsze mniej eksponowany - w ciągu tego samego czasu, gdy stopniowo dokonywano 100-krotnego przyspieszania zegara procesora, pojemność typowego dysku stałego wzrosła 1000-krotnie. Dysk stały, dopóki działa i do momentu, gdy mieszczą się na nim bez kłopotów nasze dane i programy, rzadko bywa przedmiotem szczególnego zainteresowania. Tylko w momencie zakupu staramy się uzyskać możliwy kompromis pomiędzy pojemnościami - dysku i portfela, później dysk schodzi do swojej służebnej roli. Tymczasem od pojemności i szybkości dysku zależy wydajność komputera i wygoda jego użytkowania, a niezawodność dysku to w wielu przypadkach sprawa nie tylko bardzo ważna, ale wręcz kluczowa.

Przeciętny użytkownik komputera traktuje dysk jako „czarne pudełko” zdolne do zapamiętania pewnej ilości danych - im więcej, tym lepiej. Bardziej dociekliwi zwracają uwagę również na jego parametry wydajnościowe - średni czas dostępu do danych oraz szybkość odczytu i zapisu. Parametry eksploatacyjne każdego urządzenia wynikają z jego konstrukcji, dlatego najdociekliwsi użytkownicy lubią wiedzieć również, co jest wewnątrz „czarnego pudełka” i jak to działa.

Najważniejsze parametry techniczne dysków twardych, dostępnych obecnie na rynku:

pojemność (od kilkuset MB do kilkunastu GB),

liczba głowic odczytu/zapisu (od kilkunastu do kilkudziesięciu),

liczba cylindrów (od 615 do kilku tysięcy) - ścieżki o tych samych numerach na powierzchniach roboczych dysków nazywane są cylindrami,

średni czas dostępu (kilka milisekund) - na średni czas dostępu (ang. Average Access Time) składają się dwa elementy: średni czas poszukiwania potrzebny do umieszczenia głowicy w wybranym cylindrze (ang. Average Seek Time) oraz opóźnienie rotacyjne potrzebne do umieszczenia głowicy nad odpowiednim sektorem ang. Rotational Latency), które przy szybkości dysków równej 3600 obr/min wynosi ok. 8 milisekund,

prędkość obrotowa dysku (4500, 5400, 7200 obrotów na minutę),

szybkość transmisji danych (kilka tysięcy kilobajtów/sekundę),

zasilanie (+12 V, +5 V),

moc pobierana (od kilku do kilkunastu watów).

Budowa

Stosowana w dyskach twardych technika zapisu nie odbiega od tej, z jaką mamy do czynienia w magnetofonie czy w kartach telefonicznych, a także w dyskietkach. Wytwarzane przez elektromagnetyczną głowicę pole magnetyczne powoduje uporządkowanie domen magnetycznych w nośniku ferromagnetycznym o szerokiej pętli histerezy, a ruch tak zapisanego nośnika w pobliżu głowicy odczytującej powoduje w niej indukcję sygnału elektrycznego, odpowiadającego zapisanym danym. Współczesna technologia do odczytu danych używa, zamiast głowic indukcyjnych, półprzewodnikowych elementów magnetorezystywnych, umożliwiających zwiększenie zarówno odczytywalnej gęstości zapisu, jak i zwiększenie szybkości odczytu.

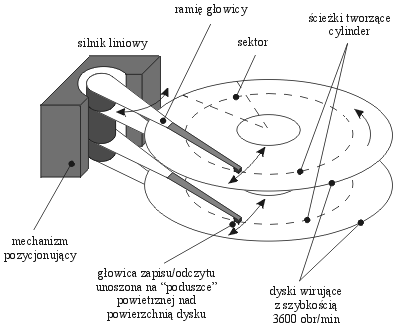

Dysk stały naszego PC to wirujący talerz lub zespół talerzy o powierzchni pokrytej nośnikiem magnetycznym, a odpowiednio ustawiane na tych powierzchniach głowice zapisują i odczytują dane. Głowice umieszczone są na przypominającym ramię gramofonu ramieniu pozycjonującym i dociskane do powierzchni dysku sprężynami, ale podczas obrotów dysku nie stykają się z nią - powstająca w wyniku szybkich obrotów talerzy „poduszka powietrzna” utrzymuje głowice nad powierzchnią. Rozwiązanie takie nazywane jest „pływającymi głowicami” i jak na razie jest bezkonkurencyjne i stosowane powszechnie, chociaż są już w toku prace nad innymi sposobami prowadzenia głowic.

Głowice dysku są zamontowane na konstrukcji obrotowej, budzącej skojarzenie z ramieniem gramofonu. Słuszne optycznie skojarzenie nie jest jednak prawdziwe. Podczas gdy ramię gramofonu było prowadzone przez ścieżkę zapisu na płycie, to z ramieniem głowic dysku jest zupełnie inaczej - musi ono być ustawione tak, by głowice znalazły się nad odczytywaną właśnie ścieżką (czy raczej - na odczytywanym „cylindrze”).

W pierwszych konstrukcjach dysków twardych pozycjonowanie głowic było realizowane przez mechanizm napędzany silnikiem krokowym (rozwiązanie takie jest do dziś stosowane w napędach dyskietek). W miarę wzrostu wymagań szybkościowych stosowano inne rozwiązania, spośród których optymalnym jak na razie okazało się voice coil, czyli układ magnetodynamiczny, wzorowany na stosowanym w głośnikach (stąd nazwa) - umieszczona w polu silnego magnesu stałego cewka porusza się zgodnie z przepływającym przez nią prądem, ustawiając w odpowiedniej pozycji związane z nią mechanicznie ramię głowic dysku. Technika ta pozwoliła na zmniejszenie czasu pozycjonowania głowic na zadanej ścieżce z kilkudziesięciu do kilku milisekund, a przy przejściach pomiędzy kolejnymi ścieżkami nawet poniżej jednej milisekundy.

Głowice:

Bardzo długo, bo aż do lat dziewięćdziesiątych, w twardych dyskach stosowano cienkowarstwowe głowice zapisująco-odczytujące, działające na zasadzie identycznej jak głowica magnetofonu. Przy odczycie zmienne pole magnetyczne indukowało w mikroskopijnym uzwojeniu napięcie, przekształcane następnie na ciąg zer i jedynek.

Przy zwiększeniu częstotliwości sygnału, wynikającym ze wzrostu gęstości zapisu danych, indukcyjność cewki stała się jednak przeszkodą - do odczytu zaprzęgnięto więc głowice magnetorezystywne, zawierające element ze stopu niklu i żelaza, który zmieniał oporność w zależności od natężenia pola magnetycznego. Głowice MR umożliwiły przekroczenie bariery jednego gigabajta pojemności dysków. Następnym krokiem były głowice GMR (Giant Magnetoresistive), wykorzystujące już zjawiska kwantowe, a konkretnie spin elektronów. Początkowo głowice MR i GMR używane były tylko przez firmę, w której je stworzono (IBM), dzisiaj to już standard.

Uzyskiwanie coraz większych gęstości upakowania danych, czyli tzw. gęstości powierzchniowej (areal density), wyrażonej w gigabitach na cal2, wymaga opracowywania coraz doskonalszych nośników magnetycznych pokrywających talerze dysków. Współcześnie sprzedawane napędy osiągają gęstość powierzchniową przekraczającą 30 gigabitów na cal kwadratowy, co pozwala pomieścić na jednym talerzu 3,5-calowego dysku 40 GB danych. Talerze o takiej pojemności mają np. napędy serii Maxtor 540DX czy uznawane za rekordzistę gęstości Seagate U Series 80020 (32,6 Gb/cal2).

Pozycjonowanie głowicy:

Kiedyś na potrzeby „nawigacji” zarezerwowana była cała jedna powierzchnia dysku, na której zapisane były znaczniki ścieżek i sektorów dla pozostałych głowic - system taki nazywał się „dedicated servo”. Dzisiejsze napędy wykorzystują technologię „embedded servo” - znaczniki umieszczone są na powierzchniach roboczych i przemieszane z obszarami danych. Wiąże się to co prawda z przydzieleniem elektronice dysku dodatkowych zajęć, pozwala jednak zwiększyć efektywną pojemność urządzenia.

W celu uniknięcia błędów odczytu głowica musi znajdować się dokładnie nad środkiem danej ścieżki. Nie jest to wcale łatwe zadanie, gdyż pod wpływem ciepła materiał, z którego wykonane są płyty dysku, może ulec odkształceniom. W odróżnieniu od tradycyjnej techniki Servo, przy której głowica musiała regularnie korzystać ze ścieżki sterującej, aby zoptymalizować swoją pozycję, mechanizm Embedded Servo wykorzystuje informacje sterujące zapisane na każdej ścieżce. Głowice zapisująco - odczytujące mogą więc korzystać z nich przez cały czas, co umożliwia dokładniejsze pozycjonowanie. Technika Embedded Servo działa na podobnej zasadzie, jak automatyczny pilot, który nieprzerwanie dba o utrzymanie właściwego toru lotu. Stosowana dawniej okresowa kalibracja głowicy dysku powodowała natomiast dodatkowe przerwy w transmisji danych.Inteligentne układy sterujące pozwoliły także zmienić sposób przesuwania głowicy nad szukaną ścieżkę - niegdyś służyły do tego stosunkowo powolne i zawodne silniczki krokowe (do dziś używane w stacjach dyskietek zdradzają swą obecność charakterystycznym burczeniem), teraz delikatne jak piórko kolibra ramię głowicy wychylane jest na podobieństwo wskazówki miernika elektrycznego za pomocą cewki, przez którą przepływa prąd o odpowiednio dobranym natężeniu (tzw. voice coil) - dzięki temu średni czas dostępu do danych to dziś 10 lub mniej milisekund. Niektóre firmy stosują technologię „Read on Arrival”, wykorzystującą mechanizm korekcji błędów - pierwsza próba odczytu podejmowana jest jeszcze zanim głowica ustabilizuje się nad żądaną ścieżką; albo próba się powiedzie, albo skutecznie zadziała mechanizm korekcji błędu odczytu, w najgorszym przypadku trzeba będzie ponowić odczyt - nic do stracenia, a można zyskać cenne milisekundy.

PRML (Partial Response Maximum Likelihood):

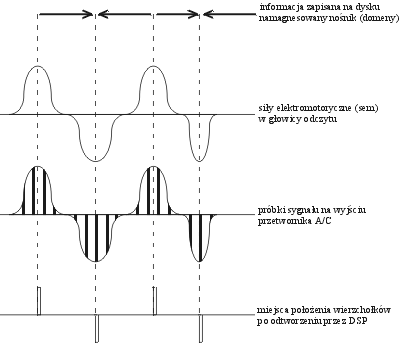

Większość napędów jeszcze do niedawna podczas odczytu danych używała techniki zwanej peak detection (wykrywanie wartości ekstremalnych - maksimum siły sygnału). W miarę wzrostu gęstości zapisu rozróżnienie sąsiednich wartości szczytowych sygnału od siebie nawzajem i od tzw. tła stawało się coraz trudniejsze. Problem ten rozwiązywano wstawiając pomiędzy sąsiadujące szczyty („jedynki”) rozdzielające chwile ciszy („zera”). Takie postępowanie sprowadzało się do kodowania zerojedynkowych ciągów za pomocą ciągów bardziej przejrzystych, czyli łatwiej identyfikowalnych, lecz z konieczności dłuższych. To oczywiście obniżało efektywną gęstość zapisu danych, a w konsekwencji także wydajność napędu.

Z pomocą przyszła opracowana na potrzeby długodystansowej komunikacji w przestrzeni kosmicznej technologia PRML (Partial Response Maximum Likelihood). Pochodzący z głowicy odczytującej analogowy sygnał jest próbkowany w wielu miejscach, a następnie cyfrowo filtrowany przez wbudowany w elektronikę dysku dedykowany procesor sygnałowy DSP. Uzyskaną w ten sposób próbkę analizuje się algorytmem Viterbi. Sprawdza on wszystkie kombinacje danych, które mogły wygenerować zbliżony ciąg i wybiera tę najbardziej prawdopodobną. Umożliwia to dodatkowe zwiększenie czułości kanału odczytu i istotne zmniejszenie prawdopodobieństwa wystąpienia błędów odczytu. Najlepsze efekty daje połączenie technologii PRML z magnetorezystywną głowicą odczytującą ze względu na dobrą jakość generowanego przez nią sygnału analogowego. Głowica magnetorezystywna (MRH) wykorzystuje inne zjawisko fizyczne niż głowice, zbliżone konstrukcją do stosowanych w zwykłych magnetofonach.

Element czytający MRH jest wykonany z substancji zmieniającej oporność w polu magnetycznym, więc namagnesowanie nośnika bezpośrednio rzutuje na natężenie płynącego przez głowicę MR prądu. Istotną zaletą technologii MR jest większa czułość, pozwalająca na radykalne zwiększenie gęstości zapisu, a co za tym idzie - wzrost pojemności napędu przy zachowaniu jego rozmiarów.

PRML oznacza także inną metodę kodowania danych na dysku: o ile przejście ze starej metody MFM (Multiple Frequency Modulation) na bardziej zaawansowaną RLL (Run Length Limited) oznaczało wzrost upakowania danych o około 50%, PRML daje tu kolejne 20-40% zysku (różne źródła podają różne wartości).

Rutenowy pył

Niestety, gęstości powierzchniowej nie da się zwiększać w nieskończoność - a w każdym razie nie przy użyciu konwencjonalnych nośników. Na przeszkodzie stoi bariera w postaci tzw. efektu superparamagnetycznego. Można wprawdzie poszukiwać nośników bardziej odpornych na zmiany namagnesowania, to jednak znacznie utrudnia zapisywanie danych. Co prawda wiosną 2000 roku Seagate przedstawił prototyp napędu osiągającego gęstość 45 Gb/cal2, ale o dalszych postępach na razie nie słychać.

Rozwiązanie problemu znaleźli badacze z laboratoriów IBM. Jest nim nośnik ze sprzężeniem antyferromagnetycznym (AFC - antiferromagnetically-coupled), składający się z trzech warstw. Dwie warstwy magnetyczne rozdzielone są warstewką rutenu o grubości trzech atomów (nazwaną przez twórców pyłkiem - pixie dust), której obecność wymusza przeciwną orientację domen w sąsiadujących z nią warstwach magnetycznych. Dzięki temu całość daje się zapisywać równie łatwo jak cienka warstwa tradycyjnego nośnika, jednak znaczna sumaryczna grubość zapewnia dużo lepsze utrzymanie zapisanej informacji. Co ciekawe, wynalazek został ujawniony jednocześnie z handlową premierą wykorzystujących go produktów - 2,5-calowych dysków Travelstar 48GH i 15/30GN, mieszczących do 48 GB. Napędy te osiągają co prawda gęstość powierzchniową "jedynie" 25,7 Gb/cal2, ale to dopiero początek - według IBM, AFC pozwoli przekroczyć barierę 100 Gb/cal2 już w roku 2003.

Gładkie jak szkło

Doskonałe parametry magnetycznego nośnika to jednak nie wszystko. Przy mikroskopijnych powierzchniach zajmowanych przez zapisane na powierzchni talerzy bity kluczową sprawą staje się gładkość powierzchni, którą pokrywa magnetyczna powłoka. Tradycyjnie talerze napędów wytwarzano z wysokiej jakości stopów aluminium i magnezu, pokrytych polerowaną warstewką fosforku niklu. Mimo olbrzymiej staranności wykonania, powierzchnia nigdy nie była doskonale gładka - nawet sam proces polerowania zostawiał nierówności.

Sięgnięto więc po materiał raczej w tym miejscu nieoczekiwany, a mianowicie... szkło. Cóż może być gładszego? Zastosowanie szklanych talerzy pozwoliło uzyskać znaczne obniżenie liczby defektów i ok. 20-procentową poprawę równomierności warstwy nośnika, a także większą niż w przypadku talerzy metalowych sztywność. Szkło, powszechnie uważane za symbol kruchości, okazało się znacznie odporniejsze od metalu na uszkodzenia wywołane wstrząsami. Dla przykładu, wspomniany już Travelstar 30GN wytrzymuje w stanie spoczynku przeciążenie 800 G trwające 1 ms, zaś w czasie pracy - dwumilisekundowe przeciążenie 180 G!

Odpornością na wstrząsy, pożądaną nie tylko w dyskach do zastosowań przenośnych, muszą odznaczać się nie tylko talerze. Z oczywistych względów źródłem uszkodzeń może być uderzenie głowicy o powierzchnię dysku - paradoksalnie, brutalne traktowanie lepiej znoszą nie grube i solidne zawieszenia głowic, a odpowiednio zaprojektowane lekkie ramiona z leciutkimi głowicami

Kulki w płynie

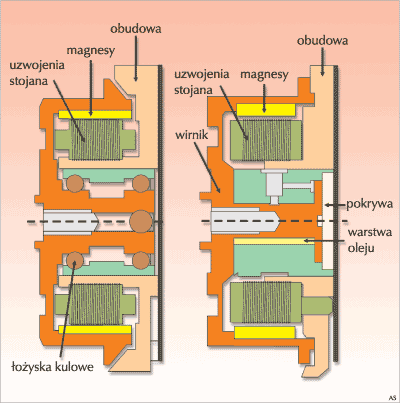

Przyczyną problemów spowodowanych uderzeniem mogą być też łożyska silnika napędzającego talerze wirujące z prędkością tysięcy obrotów na minutę. Kulki i bieżnie łożysk tocznych, stosowanych z powodzeniem w tradycyjnych napędach, choć wykonane z bardzo twardych stopów, pod obciążeniem ulegają jednak minimalnym trwałym odkształceniom. W wyniku tego (oraz nieuniknionych niedokładności wykonania) pojawiają się niepożądane wibracje, mogące utrudnić lub uniemożliwić prowadzenie głowicy po ścieżce, szczególnie przy bardzo wysokich gęstościach zapisu.

Seagate w 1996 roku po raz pierwszy zastosowało łożyska hydrodynamiczne (HDB lub FDB - Fluid Dynamic Bearing), w których rolę kulek spełnia odpowiednio dobrana ciecz. Zastosowanie FDB zmniejszyło wibracje o rząd wielkości w stosunku do wibracji towarzyszących wirowaniu (nieuszkodzonego) łożyska tocznego; dzięki mniejszemu obciążeniu powierzchni wzrasta też trwałość i odporność na przeciążenia. Uboczną, jednak jakże pożądaną korzyścią jest znacznie cichsza praca napędu. W łożyska FDB wyposażony jest najcichszy obecnie dysk świata - Seagate Barracuda IV (dwa talerze, 80 GB). Wirując z prędkością 7200 obr./min, wytwarza dźwięk o natężeniu 20 dB, hałas przy wyszukiwaniu danych nie przekracza 24 dB. Dla porównania, ludzkie ucho dźwięki o natężeniu poniżej 25 dB odbiera jako... ciszę.

W łożyska HDB/FDB wyposażone są też napędy Maxtor/Quantum Fireball Plus AS, Fujitsu serii MPF, wspomniane dyski IBM Travelstar. Bezszmerowy pecet na biurku oznacza większy komfort pracy, natomiast w pewnych zastosowaniach bezgłośne działanie dysku jest po prostu koniecznością - producenci urządzeń audio-wideo nowej generacji będą wkrótce jednym z największych nabywców napędów.

W stronę petabajtów

Pojemności współczesnych napędów liczy się już w dziesiątkach gigabajtów. Absolutnym rekordzistą jest wyposażony w interfejs Ultra160 SCSI Seagate Barracuda 180, jednak przeznaczone do komputerów klasy desktop dyski ATA nie pozostają daleko w tyle - najnowszy Maxtor 536DX 4W100H6 mieści 100 GB danych!

Zgodnie ze wspomnianą na wstępie dynamiką rozwoju, za rok na rynek powinien trafić model o pojemności 200 GB, wcześniej jednak należy pokonać kolejną barierę. Jest nią, narzucone przez obowiązującą specyfikację, ograniczenie pojemności dysków ATA do ok. 137,4 GB, co wynika z 28-bitowej długości adresu sektora mieszczącego 512 bajtów. Bądźmy jednak dobrej myśli - działający w ramach ANSI komitet ATA (ANSI NCITS T13 Technical Committee) przyjął zaproponowany przez Maxtora projekt standardu ATA/ATAPI-6. Projekt przewiduje m.in. zwiększenie długości słowa adresowego do 48 bitów, co umożliwia obsługę dysków o pojemności do 144 petabajtów (144 milionów GB) - na parę lat powinno to wystarczyć... W rzeczywistości zanim dojdziemy do petabajtów, trzeba będzie usunąć kolejne ograniczenie - większość współczesnych systemów operacyjnych operuje na 32 bitach, a więc na razie do wykorzystania dostaniemy "tylko" 2,2 terabajta.

IDE: Gdzie się to wszystko zaczęło

Pierwsze twarde dyski nie miały interfejsów takich, jakie popularne są dzisiaj. Zamiast tego instalowane były bezpośrednio na karcie kontrolera i wsuwane w gniazdo ISA. Z powodu tego dość niepraktycznego projektu, właściwy kontroler natychmiast przeniesiony został na spód twardego dysku, natomiast główna karta wciąż musiała być połączona z szyną ISA.

Dzisiaj karta ta zintegrowana jest z płytą główną, ale jest to w zasadzie tylko interfejs, ponieważ właściwa logika kontrolera umieszczona jest na dysku. Niezależnie od używanego protokołu, długość interfejsu IDE zawsze wynosiła 16 bitów. Współczesne płyty główne oferują dwa kanały interfejsu IDE, z których każdy zaadresować może dwa dyski.

W połowie lat osiemdziesiątych Imprimis używał własnego standardu interfejsu dla dysków 5.25" z serii Wren (dyski te były używane i sprzedawane głównie przez firmę Compaq). Gdy pojawiły się dyski 3.5", standard od razu został zaadoptowany. Nazwa interfejsu, a przez to i standardu, brzmieć miała "PC AT", ale skłoniono się ku terminowi, który nie będzie kolidował z żadnym znakiem handlowym: "Advanced Technology Attachment", w skrócie ATA - nazwa, która stosowana jest po dzień dzisiejszy.

Niemniej, nie tylko nazwa pozostawała miesiącami niejasna - niedostępna była również generalnie zaakceptowana specyfikacja. Właśnie z tego powodu twarde dyski jednego producenta często nie funkcjonowały z modelami pochodzącymi z innych źródeł. Szczególnie problematyczne było wykrywanie dysku w trybie "slave" (podrzędnym) jako drugiego dysku na kanale.

W tym samym czasie pewna liczba różnych producentów zebrała się, by stworzyć komitet CAM (Common Access Method - wspólna metoda dostępu), który koncentrował się przede wszystkim na standaryzowaniu specyfikacji SCSI. Ostatecznie organizacja ta zgodziła się zaadoptować najwcześniejszy standard ATA oparty na interfejsie Imprimis. Mimo to, dopiero w roku 1994 - po niezliczonych zmianach, adaptacjach i poprawkach - ANSI (American National Standard Institute - amerykański narodowy instytut standardów) zaakceptował propozycję i ogłosił ją standardem (X3.221).

W rzeczywistości termin IDE (Integrated Drive Electronics - zintegrowana elektronika napędu) stworzony został nieoficjalnie i nie stoi za nim żaden faktyczny standard. Jest to raczej ogólny termin zawierający w sobie wszystkie istniejące specyfikacje ATA. Tylko Western Digital używał terminu "IDE" z powodów marketingowych, rozszerzając go do "Enhanced IDE".

Aby obsługiwać napędy inne, niż twarde dyski (np. napędy ZIP lub CD-ROM), standard ATA musiał być rozszerzony i w takiej rozszerzonej postaci otrzymał nazwę ATAPI (ATA Packet Interface - interfejs pakietowy ATA). Było to spowodowane faktem, iż zestaw instrukcji ATA nigdy nie był projektowany z myślą o obsłudze funkcjonowania urządzeń pamięci masowej innych, niż twarde dyski.

Standard ST 506 - opracowany przez Seagate Technology Inc. narzucał producentom dysku twardych pewne ograniczenia: po pierwsze - jednoznacznie była zdefiniowana szybkość transmisji, tym samym - gęstość zapisu; po drugie - jednostka dysków twardych miała narzuconą metodę zapisu (MFM). Opracowano więc nowe standardy, które uwalniają producentów od tych ograniczeń. Jednym z nich jest: IDE - AT Bus Hard Disk Interface. W przypadku tego interfejsu producenci dysków twardych zintegrowali w swoich urządzeniach wszystkie układy związane ze sterowaniem transmisją danych (stąd nazwa interfejsu - IDE, Integrated Drive Electronics). Interfejs posiada 16-bitową szynę danych do transmisji informacji, nie mógł więc być stosowany w komputerach XT! Poszczególne linie tego interfejsu mają następujące znaczenie:

RESET - zerowanie - sygnał pojawia się w momencie włączenia zasilania

HD0..HD15 - 16-bitowa dwukierunkowa szyna danych; młodszy bajt używany jest do transmisji kodów sterujących do wewnętrznych rejestrów HDD. Cała szyna używana jest do transmisji danych

IOW - (I/O Write Strobe) impuls zapisu danych do HDD

IOR - (I/O Read Strobe) impuls umożliwiający przesyłanie danych z HDD do systemu

IOCHRDY - (I/O Channel Ready) utrzymywany w stanie niskim przez HDD w celu wydłużenia cyklu WE/WY

ALE - (Adres Latch Enable) sygnał informujący o ważnym adresie wystawionym przez system

IRQ - (Interrupt Request) zgłoszenie przerwania przez HDD

HIO16 - (Host 16Bit I/O) HDD powiadamia system, że aktualnie przesyłane dane są 16-bitowe

PDIAG - (Passed Diagnostic) - dysk podporządkowany (Slave) informuje dysk nadrzędny (Master) o zakończeniu wewnętrznego testu diagnostycznego

HA0, HA1, HA2 - (Host Address Bus) trzy bity adresowe wybierające jeden z rejestrów wewnętrznych HDD

CS0 - (Chip Select 0) sygnał umożliwiający dostęp do bloku rejestrów rozkazów w HDD. CS0 generowany jest przez dekoder adresów obszaru 1F0..1F7 przestrzeni I/O

CS1 - (Chip Select 1) sygnał umożliwiający dostęp do rejestrów kontrolnych HDD. CS1 generowany jest przez dekoder adresów: 3F6, 3F7 I/O

ACTIVE - (Drive Active) sygnał pochodzący z HDD, używany do sterowania diodą LED.

Dyski z interfejsem IDE funkcjonują od 1987 r. Systemy te osiągnęły granice swoich technicznych możliwości (pojemność max 528 MB). Opracowany w roku 1994 system Enhanced IDE (E-IDE) pokonał kilka ograniczeń standardu IDE:

zwiększenie szybkości przesyłanych danych,

pokonanie granicy 528 MB,

obsługa 4 dysków twardych,

obsługa innych urządzeń, np. CD-ROM lub jednostek pamięci taśmowej (streamery).

Standard E-IDE (zwany również ATA) może obsługiwać 4 dyski twarde za pomocą dwóch adapterów (dwóch kanałów IDE) o adresach 1F0-1F7H i poziomie przerwania IRQ 14 oraz adresach 170-177H i IRQ 15. Adaptery mogą znajdować się na wspólnej karcie, na kartach oddzielnych lub (i tak najczęściej obecnie bywa) bezpośrednio na płycie głównej.

Do każdego kanału można dołączyć dwa urządzenia IDE, które pracują w zwyczajnym systemie jako Master i Slave. Cztery twarde dyski, pracujące w systemie zachowają następującą kolejność:

Dysk Master - pierwotny adapter

Dysk Slave - pierwotny adapter

Dysk Master - wtórny adapter

Dysk Slave - wtórny adapter

Dyski E-IDE mogą posiadać pojemność przekraczającą 528 MB. Tę osławioną granicę narzucił pierwszy kontroler dysku z 1984 roku firmy Western Digital - WD1003 i bazujący na nim BIOS w komputerach IBM PC-AT. BIOS płyty głównej komputera AT wyposażony w procedury obsługujące ten sterownik wprowadził metodę adresowania dysku twardego, zwaną CHS - "Cylinder Head Sektor". Metoda ta pozwala obsługiwać dyski posiadające max 16 głowic, 63 sektory i 1024 cylindry.

Dla pokonania granicy 528 MB standard E-IDE wykorzystuje tzw. metodę LBA (Logical Block Address).

Rozszerzenia przerwania 13h i LBA

Zazwyczaj dostęp do danych na twardym dysku uzyskiwany jest przy pomocy trzech parametrów: cylindra, głowicy i sektora. Niemniej, jeśli dostęp jest uzyskiwany poprzez mocno siwiejące już przerwanie 19 (13h w notacji szesnastkowej), możliwe jest to tylko do pewnego momentu. Przerwanie to potrzebuje dokładnych danych pozycjonujących, aby uzyskać dostęp do danych.

Do dyspozycji ma 24 bity:

10 bitów na numer cylindra (do 1024);

8 bitów na numer głowicy (do 256);

6 bitów na numer sektora (63, ponieważ numeracja zaczyna się od 1, a nie od 0).

Jeśli przeliczyć to bazując na 512 bajtach na sektor, uzyskamy całkowitą liczbę 16.5 milionów sektorów, co jest odpowiednikiem 7.88 GB (8.46 GB jeśli oprzemy obliczenia na 1000 bajtów na KB).

Ponieważ nie jest to ilość, z którą można w dzisiejszych czasach wiele zrobić, przerwanie 13h musiało zostać rozszerzone. Prosta zmiana (na przykład z 24 na 32 bity) oznaczałaby, że żaden ze starych dysków nie mógłby być zaadresowany - była więc potrzeba stworzenia przezroczystego rozszerzenia zbioru instrukcji.

Z pomocą rozszerzenia przerwania 13h, adresowanie wzrosło do pełnych 64 bitów (co jest równoznaczne z możliwością zaadresowania 9.4 miliarda terabajtów); niemniej, nie tylko BIOS, ale również system operacyjny musi być w stanie poradzić sobie z tym nowym sposobem działania i adresować dysk poprawnie, jeśli przedstawi się on jako urządzenie korzystające z rozszerzenia przerwania 13h. Logiczne adresowanie blokowe (ang. Logical Block Addressing), znane jako tryb LBA, zajmuje się niezbędną konwersją geometrii napędu. Ostatecznie, dysk wciąż adresowany przy użyciu metody CHS (cylinder, głowica, sektor - ang. cylinder, head, sector), ale LBA pozwala na prostszy dostęp poprzez numerowane sektory.

Alternatywą dla metody LBA jest metoda Extendend CHS (XCHS), która zezwala na zwiększenie liczby głowic do 255. Z tego wynika iż BIOS może obsłużyć dyski posiadające 63 sektory, 255 głowic i 1024 cylindry, czyli o maksymalnej pojemności do 7.8 GB. Oczywiście w praktyce zakłada się iż liczba głowic nie może być większa niż 16. Jeśli więc BIOS natrafi na parametr określający liczbę głowic większą niż 16, wtedy przelicza wartości CHS w ten sposób, że dyskowi nie przydziela więcej niż 16 głowic, zwiększa natomiast liczbę sektorów lub cylindrów.

Współczesne dyski twarde E-IDE mogą być adresowane zarówno metodą LBA jak i XCHS - obie te metody są kompatybilne. BIOS-y współczesnych płyt głównych również zostały wyposażone w mechanizmy adresowania LBA/XCHS. Teoretyczna granica pojemności dysków twardych standardu E-IDE wynosi aż 127.5 GB (255 sektorów, 16 głowic i 65536 cylindrów).

Rzut oka na standardy ATA

ATA-1

Jest to matka wszystkich standardów IDE, istnieje od roku 1994. Specyfikacja ta zawiera jeden kanał, za pomocą którego obsługiwane mogą być dwa napędy (master i slave - odpowiednio: nadrzędny i podrzędny). Obsługuje tryby PIO 0, 1 i 2 (programmed I/O - programowe wejście/wyjście), jak również tryby DMA 0, 1, 2 (Direct Memory Access - bezpośredni dostęp do pamięci) i Multiword-DMA 0 (wielosłowowy DMA). Z powodu swojego wieku, ATA-1 nie jest w stanie obsługiwać napędów CD-ROM, gdyż są one oparte na ATAPI (poczynając od ATA-4). Nie pozwala również na tryb blokowy (ang. block mode) zwiększający wydajność, ani na logiczne adresowanie bloków - co skutkuje maksymalną użyteczną pojemnością twardego dysku ograniczoną do 528 MB.

ATA-2

Sprawy po prostu nie posuwały się wystarczająco szybko dla producentów twardych dysków. Właśnie dlatego Seagate (Fast-ATA) i Western Digital (Enhanced IDE) zdecydowali się wziąć je w swoje ręce. Do roku 1996 ANSI dała radę zaadoptować ATA-2 jako "ATA interface with extensions" (interfejs ATA z rozszerzeniami), który zawierał następujące udoskonalenia:

Dodane zostały tryby PIO 3 i 4 oraz Multiword-DMA 1 i 2. Ponadto, specyfikacja ATA-2 pozwała na transmisje blokowe i adresowanie twardych dysków przy użyciu logicznego adresowania bloków (ang. Logical Block Addressing - LBA). W standardzie zawarte zostały również różne rozszerzenia pozwalające na prostą identyfikację napędów co pozwoliło, aby BIOS po raz pierwszy niezależnie wykrywał twardy dysk i wszystkie jego parametry.

To co pozostało, to różne terminy tworzone przez wydziały marketingu.

ATA-3

Ten standard opublikowany został jako X3.298-1997 w roku 1997 i oferował stosunkowo mało udoskonaleń. Dotyczyły one głównie niezawodności szybkich trybów transmisji (Multiword DMA 2 i PIO 4), ponieważ konwencjonalne 40-żyłowe kable IDE często były źródłem błędów. Po raz pierwszy wprowadzona została funkcja aktywnego zwiększania niezawodności: od 1998 SMART (Self-Monitoring Analysis And Reporting Technology - technologia analizy i raportowania automonitoringu) wywołuje autosprawdzanie dysków, a następnie raportuje błędy do BIOS-u.

Standard został oficjalnie zaadoptowany w drodze wyjątku, ze względu na brak szybszych trybów transmisji. Tymczasem wielu producentów zdecydowało się na używanie funkcji takich jak SMART nie produkując jednocześnie sprzętu zgodnego ze specyfikacją ATA-3. Właśnie dlatego wciąż narastały problemy z kompatybilnością.

ATA/ATAPI-4

W 1998 ANSI włączyło standard ATAPI (NCITS 317, patrzcie niżej) do najnowszej wersji standardu ATA, co pozwoliło podłączać napędy CD-ROM i inne urządzenia pamięci masowej. Pozostałe zmiany zawierały w sobie wprowadzenie trybów UltraDMA 0, 1 i 2 oraz zalecenie korzystania z 80-żyłowego kabla IDE, który mógł powodować znaczne zwiększenie niezawodności. Niemniej, szybsze tryby (ATA-4) oznaczały konieczność używania takich kabli.

Aby zapewnić integralność danych protokół został rozszerzony o CRC (Cyclical Redundancy Checking - cykliczne sprawdzanie danych nadmiarowych (suma kontrolna)), zdefiniowane zostały również dodatkowe komendy - włączając w to tak zwane kolejkowanie komend (ang. Command Queuing) i możliwość nakładania komend na siebie. Ze względu na swój maksymalny poziom transmisji danych, UltraDMA 2 szybko przyjął nazwę UltraDMA/33. Z drugiej strony - tryby UltraDMA 0 i 1 nigdy nie zostały zaimplementowane przez producentów.

ATA/ATAPI-5

ATA-5 wprowadzony został pod nazwą NCITS 340 w roku 2000. Tryby UltraDMA 3 i 4 były najbardziej interesujące. Aby móc korzystać z maksymalnej przepustowości wynoszącej 44 lub 66 MB/s wymagane było użycie 80-żyłowego kabla IDE.

Wraz z wprowadzeniem ATA-5 część starych komend ATA zostało zarzuconych; inne zostały zmodyfikowane by odpowiadać nowym realiom wydajnościowym.

ATA/ATAPI-6

Obowiąząca obecnie wersja standardu ATA obejmuje jak na razie tryb UltraDMA 5 i rozszerzenie trybu LBA z 28 bitów (co pozwalało na obsłużenie maksymalnie 137 GB na napęd) do 48 bitów. Ponadto, w standardzie zawiera się również zarządzanie głośnością (ang. Acoustic Management). Pozwala to na zmniejszenie za pomocą oprogramowania szybkości dostępu nowoczesnych twardych dysków, co w znaczący sposób redukuje hałas towarzyszący pracy dysku. Po raz pierwszy jako istotny czynnik uznano ergonomię. Wysiłki mające na celu zintegrowanie komend służących do szybszej obsługo strumieni audio i wideo są aktualnie w toku.

ATA7?

Ten standard jeszcze nie istnieje, ponieważ lada moment wprowadzony zostanie Serial ATA, a nie jest jeszcze wspierany przez pewną liczbę czołowych producentów. Niemniej, jeżeli standard ATA7 zostanie później zatwierdzony, to na pewno będzie obejmował tryb UltraDMA 6.

|

ATA-1 |

ATA-2 |

ATA-3 |

ATA-4 |

ATA-5 |

ATA-6 |

Dodane tryby PIO |

0,1,2 |

3,4 |

- |

- |

- |

- |

Dodane tryby DMA |

0,1,2,Multiword 0 |

Multiword 1,2 |

- |

- |

- |

- |

Tryby UltraDMA |

- |

- |

- |

0,1,2 |

3,4 |

5 |

Maksymalna szybkość transferu danych |

11.1 MB/s |

16.6 MB/s |

16.6 MB/s |

33.3 MB/s |

66.6 MB/s |

100 MB/s |

Kable |

40-żyłowy |

40-żyłowy |

40-żyłowy |

40/80-żyłowy |

80-żyłowy |

80-żyłowy |

Standard ANSI, rok |

X3.221-1994 |

X3.279-1996 |

X3.298-1997 |

NCITS 317-1998 |

NCITS 340-2000 |

NCITS 347-2001 |

Dodane funkcje |

- |

Transmisja blokowa, LBA, identyfikacja napędu |

SMART, funkcje dotyczące niezawodności |

CRC, kabel 80-żyłowy |

- |

48-bitowe LBA |

Znany jako |

ATA/IDE |

ATA/IDE |

ATA/IDE |

UltraDMA/33 |

UltraDMA/66, ATA/66 |

UltraDMA/100, ATA/100 |

Przegląd: Wydajność trybów PIO

Przegląd PIO |

Czas cyklu |

Transfer danych |

Zaimplementowano |

tryb PIO 0 |

600 ns |

3.3 MB/s |

poczynając od ATA-1 |

tryb PIO 1 |

383 ns |

5.2 MB/s |

poczynając od ATA-1 |

tryb PIO 2 |

240 ns |

8.3 MB/s |

poczynając od ATA-1 |

tryb PIO 3 |

180 ns |

11.1 MB/s |

poczynając od ATA-2 |

tryb PIO 4 |

120 ns |

16.6 MB/s |

poczynając od ATA-2 |

Przegląd: Wydajność trybów DMA

Przegląd DMA |

Czas cyklu |

Transfer danych |

Zaimplementowano |

Single Word DMA 0 |

960 ns |

2.1 MB/s |

poczynając od ATA-1 |

Multi Word DMA 0 |

480 ns |

4.2 MB/s |

poczynając od ATA-1 |

Single Word DMA 1 |

480 ns |

4.2 MB/s |

poczynając od ATA-1 |

Multi Word DMA 1 |

150 ns |

13.3 MB/s |

poczynając od ATA-2 |

Single Word DMA 2 |

240 ns |

8.3 MB/s |

poczynając od ATA-1 |

Multi Word DMA 2 |

120 ns |

16.6 MB/s |

poczynając od ATA-2 |

Przegląd: Wydajność trybów UltraDMA

Przegląd UltraDMA |

Czas cyklu |

Transfer danych |

Zaimplementowano |

UltraDMA 0 |

240 ns |

16.6 MB/s |

poczynając od ATA-4 |

UltraDMA 1 |

160 ns |

25 MB/s |

poczynając od ATA-4 |

UltraDMA 2 |

120 ns |

33.3 MB/s |

poczynając od ATA-4 |

UltraDMA 3 |

90 ns |

44.4 MB/s |

poczynając od ATA-5 |

UltraDMA 4 |

60 ns |

66.6 MB/s |

poczynając od ATA-5 |

UltraDMA 5 |

40 ns |

100 MB/s |

poczynając od ATA-6 |

UltraDMA 6* |

30 ns |

133 MB/s |

Wraz z ATA-7* |

Dyski z interfejsem SCSI

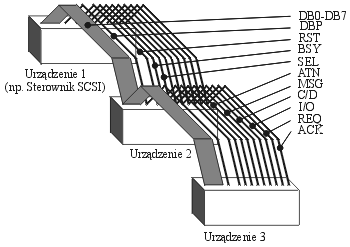

SCSI (Small Computer System Interface) wykorzystywany do sterowania napędów dysków twardych, stanowi raczej standard szyny niż standard interfejsu dysków twardych. Jeśli w komputerze PC zostanie zainstalowany sterownik SCSI, to otrzymamy nową magistralę do której będzie można podłączyć kilka urządzeń. Poprzez SCSI można połączyć ze sobą 8 inteligentnych jednostek w tzw. konfiguracji łańcuchowej (ang. Daisy Chain). W konfiguracji łańcuchowej wszystkie linie interfejsu są wspólne dla wszystkich urządzeń, a kabel łączy urządzenie pierwsze z drugim, drugie z trzecim, trzecie z czwartym, itd.

SCSI umożliwia każdej jednostce rozpoczynać transmisję danych. Jednak w praktyce najczęściej inicjatorem jest komputer (a dokładniej - sterownik SCSI), zaś adresatem - urządzenie zewnętrzne. Dostęp jednostek do magistrali rozstrzygany jest na drodze arbitrażu. Sygnały na liniach interfejsu SCSI mają następujące znaczenie:

RST - (Reset) zakończenie transmisji i sprowadzenie urządzeń w stan początkowy

DB0..DB7 - 8-bitowa szyna danych

DBP - parzystość przesyłanych danych

BSY - (Busy) magistrala zajęta

SEL - przesyłany bajt danych jest adresem urządzenia

ATN - (Attention) inicjator przesyła wiadomość do urządzenia

MSG - (Message) przesyłana informacja jest wiadomością

C/D - (Control/Data) C/D w stanie aktywnym - przesyłany bajt jest rozkazem lub statusem; C/D nieaktywne - przesyłana jest dana

I/O - kierunek transmisji

REQ - (Request) sygnał żądania transmisji

ACK - (Acknowledge) sygnał potwierdzenia przyjęcia danych

TERMPWR - (Terminator Power) linia zasilająca terminatory.

Połączenie między urządzeniami realizowane jest za pomocą 50-żyłowego kabla, w którym każdej linii interfejsu odpowiadają dwa przewody: przewód sygnałowy i przewód masy (w przypadku linii asymetrycznej) lub para skręconych przewodów (dla linii symetrycznej). Fizyczne zakończenia linii interfejsu muszą być obciążone rezystorami (ang. Terminator) o wartości równej impedancji falowej linii, w celu likwidacji odbić. Przykłady obciążeń linii asymetrycznej i symetrycznej pokazuje rysunek. Długość linii asymetrycznej może osiągnąć maksymalnie 6 metrów, natomiast symetrycznej, dzięki dużemu tłumieniu zakłóceń, do 25 metrów.

Standard SCSI może pracować w dwóch trybach: asynchronicznej transmisji danych i w trybie transmisji synchronicznej.

Tryb asynchroniczny polega na każdorazowym żądaniu transmisji sygnałem REQ i po przyjęciu bajtu danych potwierdzeniu wykonanej operacji impulsem ACK. Fakt, iż każdy przesłany bajt danych wymaga generowania pary impulsów REQ i ACK, powoduje spowolnienie szybkości transmisji.

W trybie synchronicznym transmisja może odbywać się bez każdorazowego potwierdzania pojedynczego bajtu danych za pomocą impulsu ACK - powoduje to przyspieszenie transmisji. Bajty danych przesyłane są w takt impulsów REQ o czasie powtarzania 200 nanosekund (czyli z częstotliwością 5 MHz), co pozwala na transmisję z szybkością 5 MB/s. Transmisja asynchroniczna jest nieco wolniejsza (ok. 3 - 4 MB/s).

Tryb FAST (szybki, zwany inaczej SCSI-2) jest odmianą trybu synchronicznego z czasem powtarzania impulsów REQ równym 100 nanosekund (z częstotliwością 10 MHz). Szybkość transmisji osiąga tu więc wartość 10 MB/s.

W trybie Ultra SCSI szyna danych taktowana jest zegarem o częstotliwości 20 MHz, a w trybie Ultra SCSI-2 z częstotliwością 40 MHz.

Interfejs SCSI posiada 8-bitową szynę danych DB0-7 oraz linię bitu parzystości DBP, za pomocą których następuje transmisja informacji pomiędzy sterownikiem a dołączonymi urządzeniami. Sygnały na wszystkich liniach interfejsu generowane są w logice ujemnej, tzn. aktywnym sygnałem na linii jest "zero" logiczne.

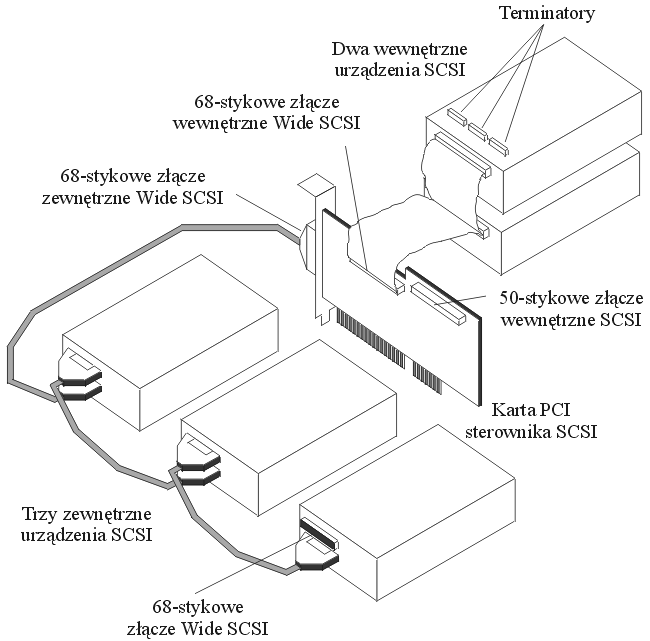

Nowy standard interfejsu zwany Wide SCSI posiada 16-bitową szynę danych DB0-15, co pozwala zwiększyć dwukrotnie szybkość transmisji. Kabel łączący urządzenia pracujące w tym standardzie posiada 68 linii.

Stosując SCSI, można tworzyć układy zbliżone do sieci lokalnych, pozwalające na wspólne korzystanie z droższych urządzeń peryferyjnych (np. drukarki laserowe, zewnętrzne stacje dysków twardych, skanery, CD-ROM).

Dysk twardy łączony jest kablem interfejsu SCSI ze sterownikiem umieszczonym w gnieździe płyty głównej. Karty sterowników SCSI posiadają własny BIOS; oznacza to, iż sterowniki te nie korzystają z procedur obsługi dysku, zawartych w BIOS-ie płyty głównej, dzięki temu parametry dysków SCSI nie są ograniczane przez ten BIOS (przede wszystkim pojemności dysków mogą znacznie przekraczać wartość 512 MB).

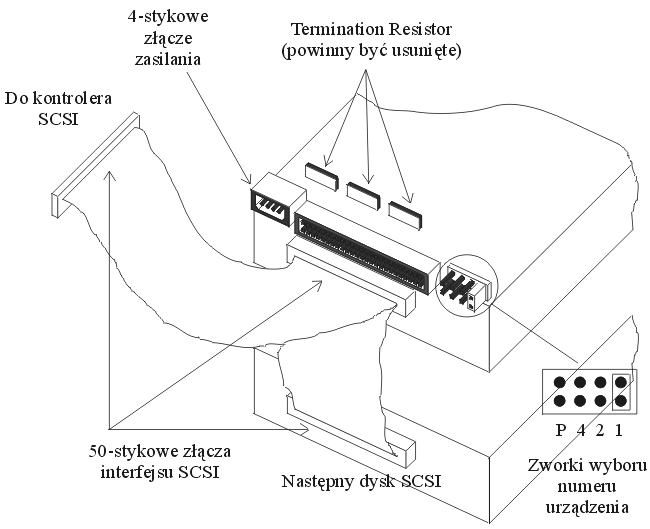

Dysk twardy również wymaga skonfigurowania: przede wszystkim ustawić należy numer dysku twardego (od 0 do 6, numer 7 zarezerwowany jest dla sterownika), który jest jednocześnie priorytetem urządzenia pracującego w systemie SCSI, ponadto za pomocą specjalnej zworki należy ustawić kontrolę parzystości lub zrezygnować z niej. Jeśli w komputerze będzie instalowanych więcej niż jeden dysk twardy, należy tylko na ostatnim ustawić terminatory (z pozostałych natomiast, terminatory należy usunąć lub wyłączyć).

Rysunek ilustruje fragment twardego dysku z interfejsem SCSI. Zworka "P" pozwala ustawić parzystość; zworki "4 2 1" służą do ustawienia numeru urządzenia (numer urządzenia ustawiany jest w kodzie dwójkowym). Kabel interfejsu nie powinien być dłuższy niż 6 m (lub 25 metrów przy łączu symetrycznym).

Współczesne karty sterowników SCSI mogą posiadać złącza dwóch standardów: 50-stykowe złącza 8-bitowego interfejsu SCSI i 68-stykowe złącza 16-bitowego Wide SCSI.

Poniższa tabela przedstawia szybkości transmisji przy różnych trybach pracy dla obu standardów.

|

Szybkość transmisji (teoretyczna) |

||

Częstotliwość |

Nazwa |

Szyna 8-bitowa |

Szyna 16-bitowa (Wide) |

5 MHz |

SCSI |

5 MB/s |

- |

10 MHz |

Fast SCSI |

10 MB/s |

20 MB/s |

20 MHz |

Ultra SCSI |

20 MB/s |

40 MB/s |

40 MHz |

Ultra SCSI-2 |

40 MB/s |

80 MB/s |

Podane tu szybkości transmisji są szybkościami teoretycznymi (przy wymienionych częstotliwościach taktowania szyny danych), tzn. szybkościami, które umożliwia elektronika; wąskim gardłem staje się (w uzyskaniu tych rezultatów) mechanizm dysków.

Przykład wykorzystania karty kontrolera SCSI pokazuje rysunek. Do zewnętrznego 68-stykowego złącza 16-bitowego można podłączyć 8 zewnętrznych urządzeń Wide SCSI (nadając im numery 15 - 8). Do wewnętrznego 68-stykowego złącza można podłączyć 7 urządzeń nadając im priorytety 6-0 (przyjęto następujący porządek priorytetów: 7, 6 - 0, 15 - 8). Sterownik SCSI powinien mieć ustawiony priorytet najwyższy - 7. Na końcu każdego "łańcucha" urządzeń dołączonych do sterownika muszą być zainstalowane terminatory (zwane również Resistor Networks). Oczywiście sterownik powinien mieć również zainstalowane rezystory dopasowujące.

Bezpieczeństwo : SMART

SMART, technologia analizy i raportowania automonitoringu (ang. Self-Monitoring Analysis and Reporting Technology) stale pobiera wartości z kilku czujników współczesnych twardych dysków.

Generalnie rozróżniamy dwa rodzaje awarii występujących podczas korzystania z dysku: błędy przewidywalne i nieprzewidywalne. Ten drugi rodzaj po prostu czasem się zdarza i nie możecie nic zrobić, aby mu zapobiec (na przykład nagłe uszkodzenie układu elektronicznego). Przykładem przewidywalnej awarii jest natomiast awaria silnika obracającego talerzami. Jeśli monitorujecie temperaturę łożyska silnika lub czas potrzebny na rozkręcenie silnika, będziecie w stanie wykryć nietypowe zachowanie na dni, czy nawet tygodnie przed awarią - w takim przypadku SMART podniesie alarm podczas uruchamiania komputera. W optymalnych warunkach użytkownik wciąż ma czas by zachować wszystkie ważne dane na innym urządzeniu pamięci masowej.

Zakres monitoringu może się różnić w zależności od konkretnego dysku. Niemniej, najbardziej popularny zawiera następujące elementy:

Liczba przemapowanych sektorów

Przemapowywanie ma miejsce, jeśli sektory na twardym dysku są bliskie uszkodzeniu. W takim przypadku dostępne są sektory zapasowe, aby zrekompensować stratę pojemności. Wady: nieznaczny spadek wydajności.Maksymalne miejsce dla głowicy

Jak daleko od powierzchni znajdują się głowice odczytu/zapisu? Jeżeli dystans jest mały, może to być zapowiedzią awarii głowicy.Zliczanie błędów ECC

Zapisuje liczbę napotkanych lub naprawionych błędnych bitów. Zwiększająca się liczba może oznaczać istniejący defekt.Temperatura

Zwiększenie temperatury dysku może oznaczać problemy z silnikiem obracającym talerzami.Przepustowość dla danych

Niewytłumaczalny spadek poziomu transferu również może być spowodowany awarią.

Nawet jeśli wasz BIOS nie obsługuje technologii SMART, przez większość czasu możecie określić status waszego napędu przy użyciu oprogramowania dostarczonego przez producenta dysku, lub narzędzi systemowych takich, jak Norton Utilities.

Uszkodzenia:

Niezawodność współczesnych dysków twardych wyraża się obecnie średnim czasem międzyuszkodzeniowym rzędu miliona godzin. Z pozoru wydaje się to bardzo wiele, ale, gdy się bliżej przyjrzeć, bezpieczeństwo danych na dysku twardym jest co najmniej iluzoryczne. Milion godzin to przeszło 114 lat. Współczynnik MTBF (Mean Time Between Failures) wynoszący milion godzin oznacza nie tylko, że dysk powinien pracować bezawaryjnie przez tyle czasu - w uproszczeniu oznacza to, że spośród 1000 dysków w ciągu bieżącego roku przeszło 8 ma prawo ulec awarii! A jeśli nawet założymy, że dyski pracują zaledwie po 8 godzin dziennie, to i tak wśród tysiąca dysków musimy się liczyć z blisko trzema awariami w ciągu roku.

Awarie dysku mają różny charakter. Może to być uszkodzenie układów zapisu i odczytu, w tym złożonej elektroniki dysku, awaria układu napędowego czy układu pozycjonowania głowic, a wreszcie, co jest najczęściej spotykane, mechaniczne uszkodzenie nośnika magnetycznego na powierzchni któregoś z talerzy. Wszystkie dzieła ludzkiego geniuszu mają ograniczoną niezawodność. Zastanawia jednak fakt - w jaki sposób powstają mechaniczne uszkodzenia powierzchni dysku, jeśli głowice nie dotykają bezpośrednio tych powierzchni?

Geneza powstawania uszkodzeń :

Mimo relatywnie dużych rozmiarów, dyski twarde stanowią arcydzieła mechaniki precyzyjnej. Przy typowej gęstości zapisu, szerokość pojedynczej ścieżki zapisu wynosi zaledwie ok. 0,01 mm. Szerokość głowicy odczytującej, wykonanej jako element magnetorezystywny, wynosi ok. 80% szerokości ścieżki - to odpowiada ostrzu nieco tylko stępionej żyletki! Każde dotknięcie powierzchni dysku przez głowicę odpowiada dotknięciu takim właśnie ostrzem. Warstwa nośnika magnetycznego na powierzchniach talerzy dysków pokryta jest bardzo cienką warstwą lakieru ochronnego. W normalnych warunkach eksploatacji twardość powierzchni ochronnej najzupełniej wystarcza - start i lądowanie głowic wiążą się co prawda z przesuwaniem ich po powierzchni talerza, ale występujące naciski są za małe, by zarysować powierzchnię ochronną. Podczas pracy dysku głowice przesuwają się nad powierzchnią talerzy na „poduszce powietrznej” o wysokości kilkunastu mikrometrów, wytwarzanej dzięki ruchowi talerzy, a dopuszczalne nierówności powierzchni nie przekraczają 10% wysokości „lotu” głowicy. W takich warunkach nośnik dysku nie ma prawa ulec uszkodzeniu.

Panuje powszechne przekonanie, że dysk nie działający jest odporny na wstrząsy i uderzenia. Tymczasem, co może być zaskakujące, źródłem większości uszkodzeń powierzchni roboczych dysku są właśnie wstrząsy i uderzenia, których napęd doznał w stanie spoczynku. W stanie spoczynku głowice leżą na wydzielonych obszarach powierzchni talerzy, zwanych strefą lądowania (landing zone), przyciśnięte do powierzchni przez odpowiedni układ sprężysty ramienia głowicy. Cóż się stanie, jeśli taki „zaparkowany” dysk dozna silnego, krótkotrwałego wstrząsu? Głowica oderwie się od powierzchni, wyginając sprężyste ramię, a następnie, w wyniku jego drgań, kilkakrotnie uderzy w powierzchnię, za każdym razem odbijając się od niej. Zwraca uwagę fakt, że głowica w takiej sytuacji nie uderza swoją powierzchnią, ale krawędzią! Twarda powierzchnia ochronna jest, niestety, zbyt krucha, by mogła to przy silniejszych wstrząsach wytrzymać - uderzająca głowica odłupuje drobne fragmenty ochronnego lakieru.

Wydawać by się mogło, że nawet ewentualne uszkodzenie powierzchni w strefie lądowania nie powinno spowodować obniżenia sprawności dysku - przecież w tym obszarze nie ma żadnych danych. Rzeczywiście, ale powstałe tam drobne okruchy materiału przemieszczają się, wraz z powietrzem, po całym wnętrzu napędu. Drobne, ale wielokrotnie większe od grubości poduszki powietrznej, unoszącej głowicę. A jeśli któryś z nich dostanie się pomiędzy głowicę a powierzchnię wirującego talerza, następują kolejne drgania głowicy i jej ramienia oraz kolejne uderzenia głowicy - tym razem już w roboczą powierzchnię dysku! Oprócz uszkodzeń powierzchni, na tyle drobnych, że układy korekcji błędów wbudowane w elektronikę dysku, poradzą sobie z powodowanymi przez nie błędami, powstają jeszcze nowe okruchy. Im jest ich więcej, tym częściej zdarza im się wpadnięcie pod głowicę i tym częściej powstają nowe uszkodzenia i nowe drobiny. Proces degradacji wartości użytkowej dysku postępuje lawinowo, tym bardziej, że przy uszkodzonej powierzchni strefy lądowania przy każdym starcie i lądowaniu głowicy mogą powstawać kolejne uszkodzenia.

Na jakiego rodzaju wstrząsy narażony jest dysk od momentu opuszczenia taśmy produkcyjnej, do chwili, kiedy trafi do komputera? Co mu grozi po drodze, a czym możemy mu zaszkodzić sami? Odpowiedzi na te pytania może w pewnym stopniu dostarczyć zamieszczony rysunek - wynika z niego, że dysk zamontowany w komputerze jest względnie bezpieczny, nawet upuszczenie komputera na twarde podłoże nie powinno spowodować poważniejszych szkód.

Dużym zagrożeniem dla dysku jest również sam proces montażu komputera. W tej fazie łatwo „nabawić się” kłopotów na przyszłość. O uderzenie metalowym narzędziem wcale nietrudno - wystarczy „obsunięcie” ręki, uderzenie dyskiem o konstrukcję obudowy też może się zdarzyć. A jeśli ktoś ma pecha, to i o upadek dysku na twarde podłoże wcale nietrudno. Wszystkie te „gwałtowne zdarzenia” dysk znosi pozornie bez szwanku - po zmontowaniu komputera działa poprawnie i nic nie wskazuje na to, by cokolwiek mu dolegało.

Ból głowy producentów

Uszkodzenia, których źródłem są wstrząsy, jakich doznał dysk w czasie między wyprodukowaniem a zamontowaniem w komputerze, stanowią według danych producentów przyczynę około 40% wszystkich awarii dysków twardych i przeszło 90% uszkodzeń powierzchni dysków. Lekarstwem na to stały się pewne zmiany w konstrukcji dysków, zmierzające do ograniczenia tego typu uszkodzeń. Zmiany te w większości przypadków sprowadzają się do odpowiednich rozwiązań konstrukcyjnych - najważniejsze jest tu wyeliminowanie drgań głowicy i jej wielokrotnego uderzania o powierzchnię po wstrząsie. Tego rodzaju rozwiązaniem jest, stosowany przez firmę Quantum, SPS (Shock Protection System). Również inni producenci od pewnego czasu zwracają uwagę na bezpieczeństwo dysku w czasie między opuszczeniem taśmy produkcyjnej a zainstalowaniem w komputerze, stosując własne rozwiązania, jak np. SeaShield Seagate.

Obecnie stosuje się narzędzia które sprawdzają stan dysku. Ważną ich cechą jest zdolność do wykorzystywania w celach diagnostycznych specjalnych procedur, wbudowanych w oprogramowanie napędów. Przy bardzo skutecznych mechanizmach korekcji błędów, jakie są stosowane w układach odczytu, drobniejsze uszkodzenia pozostawałyby niezauważone - dopiero uszkodzenie uniemożliwiające poprawny odczyt mogłoby zostać zarejestrowane. Należy zwrócić uwagę na fakt, że eliminowanie wadliwych sektorów nie usuwa przyczyn ich uszkodzenia - jeśli wewnątrz obudowy znalazły się luźne okruchy z uszkodzonych powierzchni, to proces niszczenia będzie postępował. Dlatego większość wspomnianych systemów stosuje statystyczną ocenę liczby wykrytych mikrodefektów, umożliwiającą, przy regularnym stosowaniu programu testującego, dość efektywną ocenę aktualnego stanu dysku i jego „perspektyw na przyszłość”.

Pamięci holograficzne i dyski "krzemowe" :

Ciągle jeszcze w każdym komputerze PC znaleźć można stację dyskietek. Ich „zawrotna” jak na dzisiejsze czasy pojemność (1,44 MB) jest już prawie całkowicie niewystarczająca. Mimo że producenci zasypują użytkowników coraz to nowszymi rozwiązaniami (ZIP, LS-120), to ciągle jesteśmy „skazani” na używanie owego „reliktu przeszłości” jakim jest poczciwa stacja dyskietek.

Wydawałoby się, że rozwiązaniem tych kłopotów są dyski twarde. Lecz prawda przedstawia się zgoła odmiennie. Producenci już dzisiaj niebezpiecznie szybko zbliżają się do fizycznej granicy pojemności. W miarę jej wzrostu przy niezmiennej w zasadzie powierzchni zapisu maleje trwałość zapisu magnetycznego. Powoduje to, że wyprodukowanie trwałego, i co ważniejsze, pojemnego nośnika danych staje się coraz droższe. Dlatego też poszukuje się alternatywnych metod przechowywania danych, jedną z nich są.

Pamięci holograficzne.

Uzyskanie olbrzymiej pojemności wymaga zastosowania zupełnie innej techniki - holografii. Pomysł ten zrodził się już w roku 1963, gdy jeden z pracowników firmy Polaroid - Pieter J. van Heerden zaproponował trójwymiarowy zapis danych. W chwili obecnej żadna z technologii oferujących pojemności rzędu setek GB i czas dostępu do dowolnego obszaru w granicach 100 (mikro)sekund nie jest tak bliska wejścia na rynek, jak właśnie holografia.

Zasada działania

Najistotniejszymi elementami układu zapisująco/odczytującego są dwie wiązki laserowe padające na nośnik pamięciowy, jakim jest kryształ niobianu litu (domieszkowany atomami żelaza). Jedna z nich - węższa - to tzw. wiązka sygnałowa. Zawiera ona dane, jakie mają być zachowane w krysztale. Wiązka druga - zwana referencyjną odpowiada za miejsce w krysztale, w którym dane przesyłane wiązką sygnałową mają być zachowane.

Warto wiedzieć, że w tego typu pamięciach nie istnieje pojęcie ścieżki danych. Pamięci holograficzne operują całymi stronami danych. Można sobie wyobrazić, że taki kryształek pokroimy na plasterki o grubości rzędu 100 (mikro)metrów każdy. Taki plasterek to właśnie strona danych przesyłanych przez wiązkę sygnałową. Zapis stronicowy daje olbrzymią korzyść - dużo szybszy czas dostępu do danych, które są odczytywane analogicznie do zapisu (całymi stronami) dzięki odpowiedniemu pozycjonowaniu wiązki referencyjnej.

Nośniki holograficzne

Najpopularniejszym, a raczej najpowszechniej stosowanym w laboratoriach nośnikiem danych był wspomniany już kryształ niobianu litu. Nie jest to jednak jedyna możliwa substancja pozwalająca na holograficzny zapis i odczyt danych. W 1994 firma DuPont wypuściła na rynek fotopolimer o obiecujących możliwościach. Najważniejszą innowacją jaką wnosił nowy materiał był fakt, że ów fotopolimer pod wpływem światła nie ulegał zmianom fotorefrakcyjnym (co ma miejsce w przypadku wzmiankowanego już kryształu) lecz przemianie chemicznej. Różnica polega na tym, że w przypadku fotorefrakcji, w krysztale dane są zapisywane poprzez odpowiednie rozdzielenie ładunków elektrycznych w strukturze kryształu, daje to możliwość ich późniejszej neutralizacji (co oznacza skasowanie zapisu). Natomiast naświetlanie (zapis danych) fotopolimeru wywoływało nieodwracalną reakcję fotochemiczną, co oznacza, że materiał ten nadaje się wyłącznie do tworzenia pamięci stałych (ROM).

Olbrzymie pojemności

Warto zapoznać się też z niektórymi wynikami osiągniętymi przez naukowców w dziedzinie pamięci holograficznych. Np. w 1995 roku niejaki Pu z California Institute of Technology uzyskał gęstość zapisu 10 bitów na 1 (mikro)m^2(kwadratowy) dla dysku o powierzchni zwykłego krążka CD, lecz o grubości zaledwie 100 (mikro)m. Jeżeli zwiększy się grubość materiału holograficznego np. do ok. 1 mm, to gęstość zapisu powinna osiągnąć wartość 100 bitów/mikrometr kwadratowy. Taki dysk holograficzny byłby identyczny rozmiarami z dzisiejszymi CD, lecz oferowałby pojemność rzędu 65 GB.

Kolejnym nie mniej spektakularnym osiągnięciem są rezultaty prac naukowców wydziału fizyki University of Oregon. Udało im się zaobserwować w krysztale o nazwie Tm^3+:YAG następujące wyniki: podczas zapisywania 1760-bitowej sekwencji z szybkością 20 Mbit/s osiągnięto gęstość około 8 Gbit/cal kwadratowy zaś transfer danych z zapisanego już nośnika określono na poziomie 1 Gbit/s. Tak olbrzymie wartości osiągnięto jednak w dalekich od domowych warunkach (niskie temperatury, specjalne soczewki itp.)

Zastosowania

Firma Holoplex skonstruowała szybki układ pamięciowy przechowujący wzory linii papilarnych, stosowany we wszelkiego rodzaju systemach wymagających selektywnego dostępu. Co prawda pojemność tego układu jest mniejsza o połowę od zwykłej płyty CD, lecz całą pamięć można odczytać w ciągu jednej sekundy. Warto też wiedzieć, że użycie układów holograficznych pozwoli na szersze wykorzystanie kojarzeniowej natury zapisu holograficznego. Czy będziemy więc świadkami rewolucji na wielką skalę? Raczej nie, z przyczyn ekonomicznych, lecz bez względu na sytuację można się pocieszyć, że pamięci nie zginą, ich przyszłość to holografia.

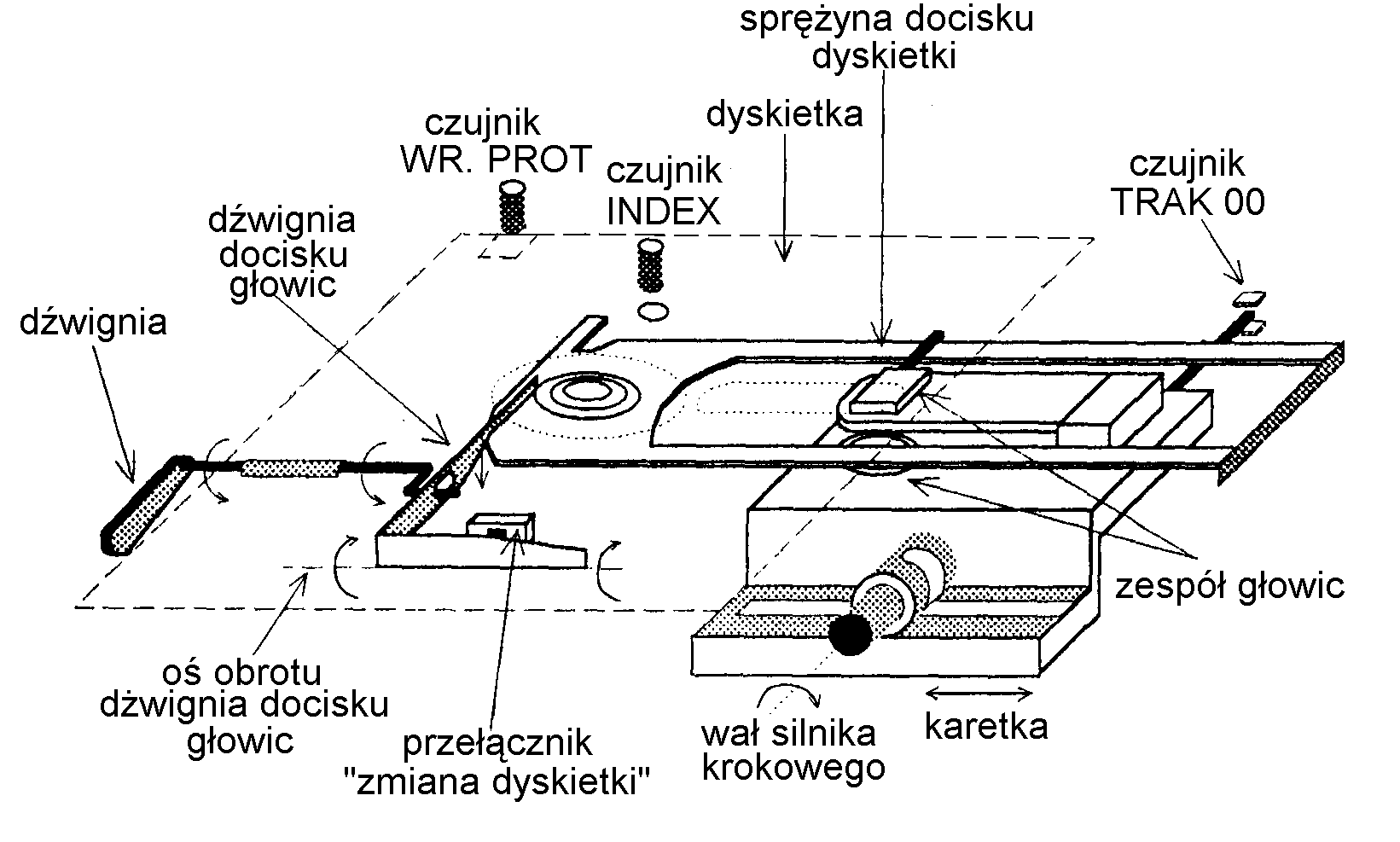

Budowa stacji dysków elastycznych.

Rozwiązania konstrukcyjne napędów dyskietek różnią się głównie sposobem przesuwu głowic. We wszystkich rozwiązaniach zastosowano optyczne wykrywanie otworu indeksowego (czujnik INDEX). Dodatkowy czujnik optyczny rozpoznaje, czy głowica osiągnęła ścieżkę 0 (czujnik TRACK 00). Istnieje też inny czujnik optyczny, badający stan wycięcia zabezpieczającego przed zapisem, umieszczonego na krawędzi obudowy dyskietki (czujnik WR PROT).

Wycięcie to możemy zakleić paskiem nieprzezroczystej folii, jeżeli na dyskietce nie chcemy zapisywać informacji

Najczęściej głowice przesuwane są za pomocą taśmy stalowej nawiniętej na wale silnika krokowego i końcami przymocowanej do karetki. W starszych typach stacji dyskowych linią Head Load uaktywniany był elektromagnes docisku głowicy (po włączeniu), który zapewniał kontakt fizyczny głowicy z dyskiem. Aby dokonać wymiany dyskietki, należy otworzyć kieszeń pamięci dyskowej, wyjąć dyskietkę i włożyć nową. Fakt ten jest rejestrowany sygnałem pojawiającym się na 34 lini interfejsu FDD o nazwie Changle Disk (pochodzący z mikroprzełącznika "zamiana dyskietki" Sterowanie układem zawiera układy: pozycjonowania głowic, zapis i odczytu danych, układu stabilizacji prędkości obrotowej silnika napędu dysku oraz układu formatowania impulsów z czujników fotoelektrycznych.

Budowa dysku elastycznego

Dysk elastyczny - dyskietka jest to krążek wykonany z giętkiego tworzywa sztucznego, pokryty warstwą materiału magnetycznego. Grubość krążka z folii jest mniejsza niż 1/10 mm, a grubość warstwy magnetycznej wynosi tylko 0,0025 mm. Zapis danych odbywa się na koncentrycznych ścieżkach, których liczba może być równa 35, 40 lub 80. Początek każdej ścieżki jest łatwo rozpoznawalny dzięki temu, że obudowa i dyskietka maja specjalne otwory, przez które przechodzi światło w momencie ich pokrywania się. Zwykle średnice dyskietek wynoszą; 5,25 lub 3,5 cala.

W najbardziej rozpowszechnionych komputerach używa się dyskietek o pojemnościach 360 KB, 720 KB, 1,2 MB lub 1,44 MB. Na początku każdej ścieżki zgodnie z formatem ISO-MFM, występuje przerwa nr1 (Gap1). Ścieżka podzielona jest na pewną liczbę sektorów, o jednakowej długości. Sektor składa się z pola indefikatora i pola danych. Pola: indefikatora i danych oddzielone są przerwą nr2 (Gap2).

Zawsze na końcu pola danych występuje przerwa nr3 (GAP3), która kończy się wraz z końcem sektora. Pomiędzy ostatnim sektorem a początkiem ścieżki znajduje się przerwa nr4 (Gap4). Na początku każdego pola znajduje się blok synchronizacji (SYNC) zawierający 12 bajtów zerowych. Formaty przerw zależą od metody i szybkości zapisu oraz typu stacji dysków. Dla standardu IS0-MFM są następujące: Gap 1zawiera 32 bajty 4e, gap 2 zawiera 22 bajty 4E, gap 3 jest przerwą programowaną, gap 4 zawiera tylko bajty jedynkowe. Pole indefikatora składa się z następujących bloków.

Informacja na dyskach może być zapisywana z pojedynczą gęstością (Single Density, SD), z podwójną gęstością (Double Density, DD) lub z wysoką gęstością (High Density, HD). Często gęstość zapisu podawana jest w bitach na cal.

Wszystkie typy pamięci na warstwach magnetycznych działają na tej samej zasadzie; na poruszającej się warstwie magnetycznej dokonywany jest zapis informacji polegający na odpowiednim przemagnesowaniu pól nośnika informacji.

Zapis i odczyt dokonywany jest za pomocą głowicy. Głowicę nazywamy rdzeń z nawiniętą na nią cewka i niewielką szczeliną miedzy biegunami. Zapis informacji sprowadza się do namagnesowania poruszającego się nośnika. Pole magnetyczne wytworzone w szczelinie magnesuje nośnik tak długo, jak długo płynie prąd w cewce głowicy. Namagnesowany odcinek nośnika zachowuje się jak zwykły magnes, wytwarzając własne pole magnetyczne. Istnieje wiele metod zapisu informacji cyfrowej na nośniku magnetycznym.

Metoda bez powrotu do zera

Polega na tym, że zmiana kierunku prądu w głowicy zapisu następuje w chwili zmiany wartości kolejnych bitów informacji. Zmiana kierunku prądu nie występuje podczas zapisywania ciągu zer lub jedynek. Metoda ta nie posiada możliwości samo synchronizacji, tzn z informacji odczytanej nie da się wydzielić impulsów określających położenie komórki bitowej.

Metoda modulacji częstotliwości (FM)

Polega na tym, że przy modulacji FM prąd w głowicy zapisu zmienia na początku każdej komórki bitowej, oraz w środku komórki, gdy zapisywany bit ma wartość "jedynki"

Metoda zmodyfikowanej modulacji częstotliwości (MFM)

Metoda MFM nazywana jest metodą z podwójną gęstością i dzięki niej jest podwojona jest pojemność dysku twardego, stosuje się tu regułę: bit o wartości "1" ustawia impuls zapisujący pośrodku komórki bitowej, bit o wartości "0", ustawia impuls na początku komórki bitowej lecz tylko wtedy, gdy poprzedni bit nie jest równy "1". W metodzie tej dla odtwarzania danych, w trakcie odczytu, stosowany jest układ z pętlą synchronizacji fazy PLL, na podstawie impulsów odczytanych z głowicy odczyt o nazwie READ DATA.

Metoda RRL

Redukuje o 35% ilości przemagnasowań nośnika - można zatem, przy niezmienionej maksymalnej częstotliwości pracy, półtorakrotnie zwiększyć gęstość zapisu danych.

Odczyt informacji polega na przemieszczeniu namagnesowanych odcinków nośnika pod szczeliną. Pole magnetyczne pochodzące od namagnesowanego odcinka nośnika, przenika rdzeń głowicy i indukuje w cewce siłę elektromotoryczną, która jest następnie wzmacniana i formowana w impuls cyfrowy, taktowany jako impuls zerowy lub jako bit danych, w zależności od metody zapisu informacji

Sterownik dysków elastycznych

Sterownik dysków elastycznych zapewnia współprace napędu dysków z systemem. Wykonany jest z reguły w formie karty, łączonej z płytą główną za pomocą złącza PC Sloyt, z napędem zaś poprzez Driver Intrerface. Karta FDC zawiera przeważnie specjalizowany układ scalony, realizujący wszystkie funkcji kontrolne i sterujące napędem dysków elastycznych, wiele firm światowych produkuje obecnie scalone kontrolery FDC. Jednym z takich kontrolerów jest kontroler blokowy karty FDC z układem UM 8388 UNITED MICROELEKTRONICS. Jest to układ scalony, programowo kompatybilny z układem8272A. Układ UM8388 może współpracować dwoma napędami dysków (360 Kb i 1,2 MB - dyski 5,25 cala oraz 720 KB i 1,444 MB -,35 cala)

Układ scalonego kontrolera UM8388 zawiera następujące elementy i układy:

Programowalny sterownik FDC, kompatybilny programowo z układem 8271A

Separator danych z pętlą PLL

Układ prekompresacji zapisu

Bufor danych

Dekoder adresów

Układy sterowania sygnałami zegarowymi

Dekoder wyboru napędu

Nadajniki i odbiorniki interfejsu

Detektor adresów służy do lokalizacji rejestrów wewnętrznych sterownika FDC w przestrzeni adresowej I/O, w której zarezerwowano dwa obszary (3F0...3F7 lub 370.. 377) przeznaczone dla sterowników dysków elastycznych. W niektórych kartach FDC można za pomocą zworek wybrać jeden z dwóch obszarów. Zadaniem separatora danych, jest wydzielenie impulsów zwanych "oknem danych odczytanych" z przebiegu Read Data, uzyskanego w trakcie odczytu danych z dysku. Separator działa w układzie pętli synchronicznej fazy. Zadaniem pętli PLL jest zrównanie częstotliwości generatora przestrajanego napięciem z częstotliwości generatora wzorcowego i to tak dokładnie, by nie zmieniało się przesuniecie fazowe obu przebiegów. Układ prekompresacji stosuje się w celu opóźnienia zapisu bitu o różne odcinki czasu, w zależności od kombinacji zapisywanych aktualnie bitów. Układem tym sterują wyjścia Preshift 0 i Preshift 1 (PS0, PS1).

5

Budowa dysku twardego i dyskietki.

Adam Brucki

Adam Szafarczyk

IIS, Studia Zaoczne, semestr 4.

Elbląg, 2003

Wyszukiwarka

Podobne podstrony:

Referat Inżynieria Produkcji Rolniczej

referat solidy

statystyka referat MPrzybyl

referat 4

Referat 3 v3

Referat 4

04 referat Pieprzyk szczelność powietrzna

Prywatne znaczy gorsze referat a krol 0

referat z biochemi, notatki

TEST NIEDOKOŃCZONYCH ZDAŃ, referaty

referat - adamek, resocjalizacja

referat bibliografia Fakultet, polityka społeczna fakultet

Twarde dyski, Informatyka -all, INFORMATYKA-all

Referat - Pedagogika społ. - Szkoła, Studia =), Resocjalizacja

referat - obrzęd świecki w 30 tezach, KULTUROZNAWSTWO, antropologia widowisk

Referat o Irlandii, Dokumenty( referaty, opisy, sprawdziany, itp.)

Wpływ różnego rodzaju pyłów na wzrost nadziemnej części roślin, referaty i materiały, biologia, dośw

więcej podobnych podstron