img028

28

3.1. Neurony

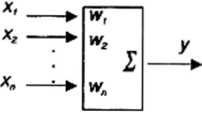

przy czyni współczynniki w,-, nazywane wagami synaptycznymi, mogą podlegać modyfikacjom w trakcie procesu uczenia, który stanowi jeden z zasadniczych wyróżników sieci neuronowych jako adaptacyjnych systemów przetwarzania informacji i o którym będzie dalej mowa w sposób znacznie bardziej szczegółowy. Element opisany przytoczonym wyżej równaniem liniowym jest między inymi zdolny do rozpoznawania wejściowych sygnałów.

Aby to wyjaśnić, wystarczy zastosować notację wektorową. Niech zestaw sygnałów wejściowych neuronu tworzy wektor

zapisywany przez nas jako kolumna o » składowych. Wektor ten interpretować można także jako punkt w ?*-wy miarowej przestrzeni X, nazywanej przestrzenią wejść. Wektor ten (i inne wektory) zapisywać niekiedy będziemy w wygodniejszej postaci

X =< *i,*2.....sf» >7

gdzie T jest symbolem transpozycji. Nawiasy < oraz > w powyższym zapisie (a także w innych kontekstach dalej) używane są do grupowania uporządkowanych elementów - na przykład składowych wektora. Zestaw n współczynników wagowych także można rozpatrywać jako wektor

W =< I0|,U>2,. ...Wn >T

wyznaczający punkt w n-wyniiarowej przestrzeni W, nazywanej przestrzenią wag. Przy tych założeniach równanie neuronu wyrazić można jako iloczyn skalarny wektora wejść i wektora wag:

y = W*X

Z formalnego punktu widzenia wygodniej będzie zastąpić iloczyn skalarny (zapisany wyżej z pomocą specjalnego operatora: gwiazdki *) zwykłym iloczynem transponowanego wektora W i wektora X

y = WT X

Z ogólnie znanych właściwości iloczynu skalarnego wynika, źe sygnał wyjściowy neuronu y będzie tym większy, im bardziej położenie wektora wejściowego X w przestrzeni X przypominać będzie położenie wektora wag W w przestrzeni W. W ten sposób można powiedzieć,

Wyszukiwarka

Podobne podstrony:

img028 28 3.1. Neurony przy czyni współczynniki w,-, nazywane wagami synaptycznymi, mogą podlegać mo

Sieci CP str028 28 3.1. Neurony przy czyni współczynniki w,-, nazywane wagami synaptycznymi, mogą po

img016 (63) współczynników ni,- nazywanych wagami. W rzeczywistym biologicznym neuronie odpowiedniki

img016 (63) współczynników ni,- nazywanych wagami. W rzeczywistym biologicznym neuronie odpowiedniki

img016 (63) współczynników ni,- nazywanych wagami. W rzeczywistym biologicznym neuronie odpowiedniki

DSCF6541 38 Współczynniki tij będziemy nazywać wagami pomiarowymi i oznaczać przez Wj, a średnią: =

img028 28 2. Zadanie rozpoznawania C*(x) i diametralnie różniące się techniki ich konstruowania. Trz

img028 28 1 c. 3 4 5 € 7 Siarka

img028 28 lim x » f{ lira mx*) m —*oc O —*• oo czyli a = f(a). Aby zakończyć dowód

img028 (28) The ADOBE TABLE RUNNER combines subtle, organie geometrie texture with linen’s shee

img093 (18) Elementarne wprowadzenie do techniki sieci neuronowych 87 wartości współczynnika określa

IMG028 28 - Klasa II obejmuje odbiorniki poBiadajace izolację podwójna lub wz

img028 28 2. Zadanie rozpoznawania C*(x) i diametralnie różniące się techniki ich konstruowania. Trz

img028 28 1 c. 3 4 5 € 7 Siarka

więcej podobnych podstron