INFORMATYKA

Komputer to „cudowne” narzędzie drugiej połowy XX wieku, dawno już przestał być genialnym rachmistrzem oddanym na usługi wyspecjalizowanych grup działania m.in. naukowców i inżynierów itp. grup. Rozpowszechniony jest on wśród szerokich rzesz ludzi różnych zawodów i stał się przede wszystkim uniwersalnym CENTRUM INFORMACYJNO - KOMUNIKACYJNYM - bez którego trudno sobie wyobrazić funkcjonowanie tętniącego życiem świata.

A skoro życie to wieczny ruch komputer „stara się” w nim uczestniczyć - zawsze towarzysząc swojemu użytkownikowi. Skoro nasz komputer to centrum INFORMACYJNO - KOMUNIKACYJNE to wyjątkową funkcjonalność tego systemu zapewnia sieciowa instalacja interaktywnego multimedialnego połączenia sprzętowego i programowego.

Wykorzystując komputery, a jak wiemy znajdują one zastosowanie w wielu różnych dziedzinach naszego życia m.in. technice, medycynie, naukach ekonomicznych, zarządzaniu, - zyskujemy „niebywałe” zasoby twórczości i innowacyjności jeśli uświadomimy sobie i otoczeniu, w którym funkcjonujemy, że można myśleć jak i robić taki biznes (wykorzystując tą technikę) - który nie liczy się z ograniczeniami wynikającymi z czasu i przypisania do aktualnego miejsca pobytu. Możemy powiedzieć więc, że komputer jest jednym z narzędzi - instrumentów wspomagających zarządzanie i podejmowanie decyzji. Należy jednak pamiętać, że spełnia on tylko funkcję wspomagającą i usprawniającą procesy zarządzania, a nie zastępuje menedżera w wypełnianiu jego funkcji. Dlatego też „wyzwaniem” dla współczesnego menedżera jest kreowanie jego działalności w oparciu o stosowanie zaawansowanych technik, metod i narzędzi informatycznych, gdzie poprzez wkomponowaną wielość różnorodnych modeli optymalizacyjnych, ekonometrycznych, algorytmów, funkcji finansowych, ekonomicznych, statystycznych m.in. w arkuszach analityczno planistycznych, relacyjnych bazach danych i innych aplikacjach pozwalają na powiązanie wiedzy technicznej użytkownika komputera z oczekiwaniami i możliwościami doświadczonego pracownika danej organizacji.

W warunkach gospodarki rynkowej każda decyzja gospodarcza, finansowa lub inwestycyjna zawiera w sobie elementy niepewności i ryzyka. Aby zmniejszyć ich wpływ na podejmowanie decyzji należy skorzystać z nowoczesnych narzędzi informatycznych pozwalających zarówno na nowoczesne sposoby zarządzania, kontrolowania, planowania, a więc najogólniej rzecz biorąc formułowania strategii taktyki działania obrębie organizacji gospodarczej.

Wykorzystanie narzędzi informatycznych, a więc (programów, pakietów, systemów) w szeroko rozumianym wspomaganiu zarządzania możemy umiejscowić w wielu obszarach. W szczególności analiza działalności organizacji gospodarczej może być prowadzona w następujących obszarach:

obszar finansowy firmy; - przyjmuje się, że poprzez pryzmat finansów najlepiej oraz najszerzej można prześwietlić każdy profil działania firmy, zarówno sukcesy jak i te aspekty, które firma najchętniej by ukryła. Główny wysiłek w tym obszarze skupia się na określeniu wartości rozmaitych funduszy w czasie. Po określeniu wielkości środków nominalnie na wybrane okresy działalności firmy oblicza się wartość tych funduszy w chwili obecnej oraz na potrzebne do dalszych analiz chwile czasu. W ramach tych narzędzi możliwe jest również oszacowanie wartości firmy, a więc jej wycena, określenie rentowności itp.

obszar działalności podstawowej, (produkcyjnej, usługowej) - w ramach tych analiz można określić koszty wielu wariantów realizacji produkcji, czy też optymalizacji sposobu wykonywania działań jak i usług. Dla każdej działalności określa się wartości progowe oraz oszacowuje dźwignię operacyjną (wynikającą ze skali produkcji) i finansową.

obszar zarządzania; - w tym rodzaju analiz wykorzystuje się narzędzia oceniające funkcjonowanie systemów przepływu zasobów organizacji gospodarczej,. Wykorzystując narzędzia takie jak Visio, Microsoft Project, Optima., znajduje się ścieżki i punkty krytyczne tych przepływów, określa optymalne struktury, znajdując i szacując różnice pomiędzy teoretycznie najlepszym wariantem a występującym w rzeczywistości.

Ostatnie lata przynoszą dynamiczny rozwój technologii informatycznych, które w dość istotny sposób mają wpływ na sposób prowadzenia działalności gospodarczej w organizacjach. Otwierając nowe możliwości stawiają coraz to nowe wyzwania dla organizacji jak i menedżerów. Aby wygrać w dynamicznie zmieniającym się otoczeniu organizacji, zdobyć przewagę na coraz to bardziej konkurencyjnym rynku, maksymalizować zysk firmy nie mogą zignorować postępu w rozwoju teleinformatyki.

Postęp w technologii informacyjnej ma swój wyraz zarówno w sprzęcie komputerowym, jak i oprogramowaniu. Więcej zadań, niż dotychczas, może być realizowanych przy udziale programów komputerowych. Do najbardziej znamiennych cech w trendach rozwoju współczesnej informatyki zaliczyć możemy więc następujące elementy:

multimedia, hipertekst,

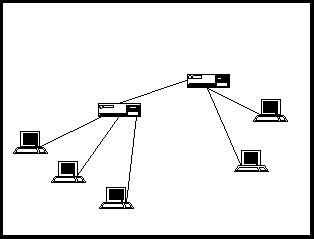

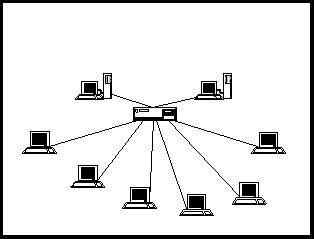

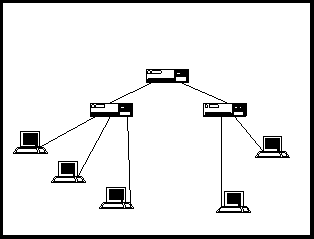

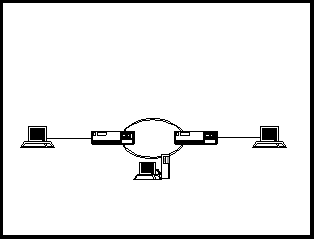

sieci komputerowe,

graficzny i przyjazny interfejs,

bazy danych o dostępie bezpośrednim oraz hurtownie danych,

integracja technologii,

optyczne skanowanie i elektroniczne publikacje,

wspólna praca z dokumentem.

Pozyskiwanie i integracja danych potrzebnych do tworzenia i realizacji systemów; konsolidacji oprogramowania oraz procedur niezbędnych do ich eksploatacji jak i znacznego rozwoju sprzętu komputerowego powoduje, że cały system informacyjny organizacji przesuwa się w kierunku zintegrowanego SIZ (Systemu Informacyjnego Zarządzania) - komputerowo zintegrowanej organizacji (Computer Integrated Organisation). W ramach tak przedstawionej koncepcji ujmującej w sposób kompleksowy wszystkie procesy zachodzące w organizacji, gdzie głównym elementem projektu jest zintegrowana baza danych, z której korzystają wszystkie komórki przedsiębiorstwa mamy możliwość sprawnego i efektywnego zarządzania i kierowania organizacją.

Systemy informacyjne wspomagające menedżera w jego działaniach służą dokonywaniu analiz decyzyjnych, kontroli funkcjonowania instytucji oraz koordynacji działań jej członków. Umożliwiają zatem rutynowe podejmowanie pewnej liczby decyzji o charakterze stałym i powtarzalnym, jak również wspomagają decydowanie i podejmowanie decyzji o pewnym stopniu ryzyka i niepewności (decyzje nie rutynowe).

Systemy informacyjne mają również możliwość przechowywania danych dotyczących przeszłości, co może być punktem odniesienia do kontroli bądź weryfikacji ewolucji organizacji, jak również identyfikacji niesprawności.

W ramach każdego procesu podejmowania decyzji można wyodrębnić specyficzny obieg informacji;

zbieranie informacji dotyczących sytuacji decyzyjnej,

przetwarzanie informacji w celu uzyskania większej użyteczności,

przekazywanie informacji o podjętej decyzji.

Informacja dla zarządzania jest szczególnym rodzajem informacji, gdyż związana jest z realizacją podstawowych funkcji zarządzania takich jak:

planowanie,

organizowanie,

przewodzenie,

kontrolowanie.

Efektywne zarządzanie jest możliwe tylko wtedy, kiedy posiadamy informacje o organizacji i jej otoczeniu.

Na ogół w działalności menedżerskiej odnosimy się do wielości informacji ekonomicznych, które dotyczą wszelkich zjawisk i procesów gospodarczych, które można wykorzystać w procesie zarządzania i w procesach podejmowania decyzji.

Wychodząc z ogólnego określenia systemu informacyjnego możemy stwierdzić, że elementami systemu informacyjnego dowolnej organizacji jest następujący zbiór elementów:

Si= {P, I, T, O, M, R}

gdzie:

Si - system informacyjny danej organizacji,

P - zbiór podmiotów, które są użytkownikami systemu,

I - zbiór informacji w sferze realnej, czyli o jej stanie i zachodzących w niej zmianach, a więc zasoby informacyjne,

T - zbiór narzędzi technicznych stosowanych w procesie pobierania, przesyłania, przetwarzania, przechowywania i wydawania informacji,

O - zbiór rozwiązań systemowych stosowanych w danej organizacji, a więc stosowana formuła zarządzania (scentralizowana, rynkowa).

M - zbiór metainformacji, czyli opis systemu informacyjnego i jego zasobów,

R - relacja między poszczególnymi zbiorami.

Jednak w literaturze polskiej używa się jeszcze pojęcia system informatyczny dla określenia takiego systemu informacyjnego, w którym zastosowany jest komputer.

System informatyczny jest to wyodrębniona część systemu informacyjnego, która jest, z punktu widzenia przyjętych celów skomputeryzowana.

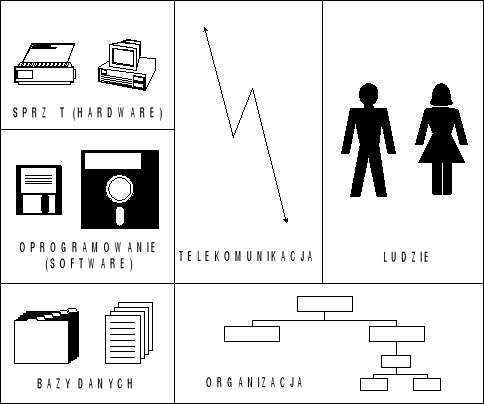

Na system informatyczny składa się więc: sprzęt (hardware), oprogramowanie (software), baza danych, telekomunikacja, ludzie, organizacja.

Przykładowe połączenie poszczególnych modułów systemu informatycznego ilustruje przytoczony graf.

Hardware jest to sprzęt techniczny, dzięki któremu informacje są nadawane, odbierane, przetwarzane i przesyłane. Jest to zbiór, który składa się z rozmaitych urządzeń technicznych takich jak: procesor, pamięć, urządzenia wejścia (klawiatura, czytniki), urządzenia wyjścia (monitory, drukarki).

Software po polsku oprogramowanie. Jest to zbiór programów i instrukcji napisanych w specjalnym języku, który jest zrozumiały dla komputera.

Baza danych jest to taka organizacja zintegrowanych i zaagregowanych zbiorów danych z pewnej dziedziny informacji, która pozwala na zaspokojenie potrzeb jednego lub wielu użytkowników bez uprzedniego sortowania w różne pożądane struktury potrzebne do przetwarzania lub bezpośredniego udzielania informacji. Dane są tak zorganizowane, że korzystanie z nich jest niezależne od oprogramowania, jak i od dysponowanego sprzętu. Powszechnie uważa się, że dopiero od czasu powstania bazy danych możemy mówić o pełnym zastosowaniu systemów informatycznych w zarządzaniu.

W literaturze przedmiotu spotkać się można też z określeniem bazy danych jako zbioru wzajemnie powiązanych danych pamiętanych bez zbędnej redundancji, służących jednej lub wielu zastosowaniom w sposób optymalny.

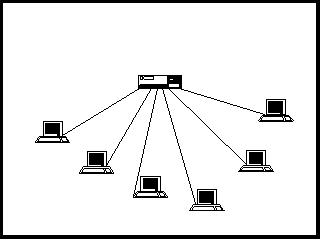

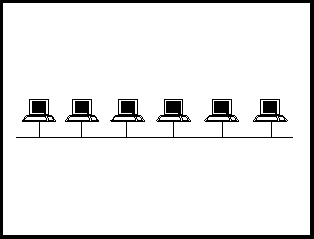

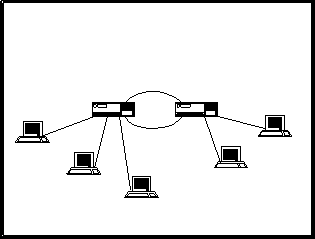

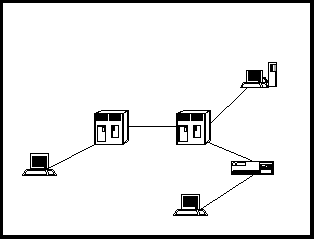

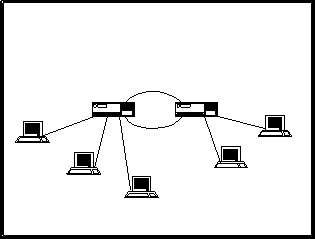

Telekomunikacja jest to organizacja, sprzęt oraz oprogramowanie umożliwiające wspólną pracę dwu lub wielu komputerów, a w pewnych sytuacjach pozwalająca na pracę jednego komputera z terminalami, czyli tzw. końcówkami (stacje robocze). Dzięki telekomunikacji możliwe jest połączenie komputerów w regionie, kraju lub na całym świecie (przykładem takiej globalnej sieci jest sieć rozległa typu INTERNET - INTRANET).

Ludzie to najważniejszy element całego systemu. Personel obsługujący informatyczne systemy zarządzania, kierowania, wspomagania decyzji jak również systemy doradcze to ludzie, którzy: zarządzają, projektują, programują, eksploatują, konserwują wymienione systemy. Oczywiście cały wymieniony personel jest również zaliczany do personelu systemu informatycznego. Przygotowanie ich wszystkich decyduje o tym, czy system będzie sprawny, efektywny i niezawodny. Na nic zda się zastosowanie najnowszego sprzętu informatycznego i oprogramowania, jeżeli personel go obsługujący i nadzorujący nie będzie na najwyższym profesjonalnym poziomie.

Organizacja sprawia, że poszczególne elementy systemu stanowią całość. Organizacja zawiera w sobie: strategie rozwoju, politykę, reguły i zasady postępowania.

W niedalekiej przyszłości nie będziemy używać pojęcia system informatyczny w stosunku do systemów informacyjnych zarządzania. Problem będzie dotyczyć tylko, jak wielkie powinno być w systemie informacyjnym nasycenie sprzętem komputerowym (komputery wraz z oprogramowaniem, sprzęt teleinformatyczny, reguły i modele zarządzania i decyzji).

W literaturze anglojęzycznej używa się w tym względzie szerszego pojęcia MIS czyli Management INFORMATION Systems. I tak:

R. M. Stair pisze, że system informacyjny zarządzania to, „zorganizowany zbiór ludzi, procedur przetwarzania baz danych oraz urządzeń używanych do dostarczania informacji dla menedżerów i decydentów".

Podobnie E. Turban stwierdza, że „System Informacyjny Zarządzania jest formalnym, komputerowym systemem stworzonym w celu dostarczenia, selekcjonowania i integracji dostarczonej z różnych źródeł informacji w celu zapewnienia aktualnych informacji niezbędnych dla podejmowania decyzji w zarządzaniu".

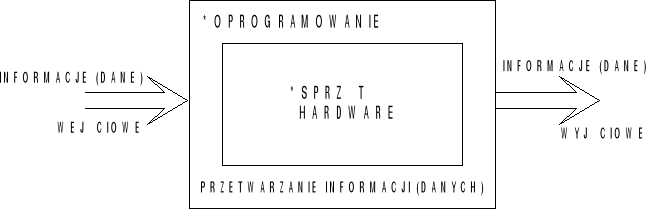

System informacyjny możemy określić zatem jako wielopoziomową strukturę, która pozwala użytkownikowi tego systemu na transformowanie określonych informacji wejścia na pożądane informacje wyjścia za pomocą odpowiednich procedur i modeli. W wyniku uzyskania tych informacji podejmowane są określone decyzje.

Dlatego też konkretny system informacyjny można analizować jako:

wielopoziomową strukturę,

element łańcucha decyzyjnego funkcjonujący w systemie zarządzania.

Analizując system informacyjny z punktu widzenia jego struktury rozpatruje się przede wszystkim samo jego zachowanie niezależne od zadań, dla których został on zbudowany.

Reasumując możemy powiedzieć, że system informacyjny organizacji to struktura, która pozwala użytkownikowi tego systemu na transformowanie określonych informacji wejścia na pożądane informacje wyjścia za pomocą odpowiednich procedur i modeli, w wyniku których usprawniamy funkcjonowanie organizacji i podejmowane są określone decyzje kierownicze.

Pojęcie informacji jest jednym z najtrudniej definiowanych pojęć naukowych. Mimo że każdy intuicyjnie zdaje sobie sprawę z tego, co to jest informacja, to jednak jej zdefiniowanie napotyka wiele problemów.

Podstawą funkcjonowania każdej organizacji jest posiadanie określonych informacji, które stanowią jej zasoby. Informacja we współczesnym świecie gospodarczym jest tym zasobem, którym dysponuje przedsiębiorstwo, wraz z ziemią, kapitałem i człowiekiem.

Stanowi więc jego główną siłę.

Nie istnieje jednak jedna uznana definicja informacji.

N. Winer wprowadzając pojęcie informacji stwierdza, że „... Jest ona jak gdyby nazwą treści pochodzącą ze świata zewnętrznego w miarę jak do niego przystosujemy swoje zmysły...”.

K. Krzakiewicz przez informację rozumie „...przekazywaną przez nadawcę do odbiorcy pewną treść będącą opisem, poleceniem, nakazem, zakazem lub poleceniem.”

R. Aschby uważa, że „...informacja to przekazywanie różnorodności”.

W. Głuszkow określa informację „...jako wszelkie wiadomości o procesach i stanach dowolnej natury, które mogą być odbierane przez organy zmysłowe człowieka lub przyrodę..”.

Definicja podana przez W. Flakiewicza określa „informację jako czynnik, który zwiększa naszą wiedzę o otaczającej nas rzeczywistości”.

Tsitchizris i Lochovsky definiują informację jako „przyrost wiedzy, który może być uzyskany na podstawie danych”

E. Niedzielska przytacza francuskie przysłowie, które głosi : „bez materii nie ma nic, bez energii wszystko nieruchome, bez informacji jest chaos”.

Uogólniając i odnosząc się raczej do intuicji w rozumieniu tego pojęcia możemy stwierdzić;

Informacja to więc taki rodzaj zasobów, który pozwala na zwiększenie naszej wiedzy o nas i otaczającym nas świecie.

Według B. Stefanowicza informacja wykorzystywana w organizacji przez menedżerów do procesów decyzyjnych powinna charakteryzować się następującymi własnościami:

Jest niezależna od obserwatora (obiektywna).

Przejawia cechę synergii.

Jest różnorodna.

Jest zasobem niewyczerpalnym.

Może być powielana i przenoszona w czasie i przestrzeni.

Można ją przetwarzać nie powodując jej zniszczenia (zużycia).

Ta sama informacja ma różne znaczenie dla różnych użytkowników (subiektywność ocen).

Każda jednostkowa informacja opisuje obiekt tylko ze względu na jego cechę.

W informatyce przyjmuje się, że informacją nazywamy wielkość abstrakcyjną, która może być przechowywana w pewnych obiektach (np. komputerach), przesyłana między pewnymi obiektami (np. komputerami), przetwarzana w pewnych obiektach (np. komputerach) i stosowana do zarządzania pewnymi obiektami. Obiekt może być komputerem, ale nie musi być nim. Informatyka zajmuje się wtedy informacją, jeżeli jeden z obiektów, biorących udział w: przechowywaniu, przetwarzaniu, przesyłaniu, zarządzaniu związany jest, jak stwierdziliśmy wcześniej, z komputerem.

Zamiennie z pojęciem informacja w literaturze bardzo często używa się pojęcia wiadomość i dana. Przyjmujemy więc, że informacja dla zarządzania ma charakter partykularny tzn. przedstawiona jest w postaci wiadomości wyrażonych w określonych językach, czy też systemach znakowych. Znakową postać informacji będziemy nazywali danymi.

Dane są taką postacią informacji , którą możemy przetworzyć z użyciem sprzętu komputerowego. W literaturze przyjmuje się, że Dane są to surowe nie poddane analizie fakty, a więc np. liczby i fakty dotyczące określonych zjawisk lub wydarzeń.

Informacja natomiast jest wynikiem uporządkowania danych lub ich przeanalizowania w jakiś znaczący sposób.

Użytkownik otrzymuje dane w formie wiadomości.

Wiadomości są to więc uporządkowane zbiory danych, które zawierają informacje dla zarządzania.

J. A. F. Stoner i C. Wankel przedstawiają następujący łańcuch w procesie podejmowania decyzji:

DANE (surowe fakty) mogą stać się - INFORMACJĄ (przeanalizowanymi danymi), które mogą stać się - INFORMACJĄ ZARZĄDCZĄ (wnioskami dotyczącymi działania), która może doprowadzić do - DECYZJI I DZIAŁANIA.

dane - informacja (informacja zarządcza) - decyzja (działanie) - zarządzanie

Rozwijając dalej tę myśl można stwierdzić, że dana jako jednostka jest to jeden lub kilka symboli użytych do reprezentowania „czegoś".

Natomiast informacja to zinterpretowane dane, umieszczone w znaczącym kontekście. Informacja wykorzystywana w organizacjach do zarządzania jak i użyta w procesie decyzyjnym powinna mieć charakter subiektywny i musi być zawsze rozpatrywana w kontekście odbiorcy. Te same dane mogą być różnie interpretowane bowiem przez różnych użytkowników w zależności od posiadanej wiedzy i przeznaczenia.

Informacja - może być więc interpretowana jako wynik uporządkowania danych lub ich określonego przeanalizowania w mniej lub bardziej znaczący sposób.

Uogólniając możemy więc przyjąć, że podstawowe cechy wyróżniające informację dla zarządzania w stosunku do innych typów informacji są takie, że:

zawsze są one związane z realizacją podstawowych funkcji zarządzania,

pozwalają na podjęcie decyzji na różnych szczeblach zarządzania.

Jako dziedzina naukowa INFORMATYKA - jest nauką o przetwarzaniu informacji za pomocą komputerów i przy użyciu odpowiedniego oprogramowania lub też możemy powiedzieć, że INFORMATYKA - jest to zespół dyscyplin naukowych i środków technicznych ukierunkowanych na przetwarzanie informacji przy użyciu środków technicznych.

PRZEDMIOTEM BADAŃ INFORMATYKI są zatem:

środki techniczne

oprogramowanie

organizacja związana z przetwarzaniem informacji

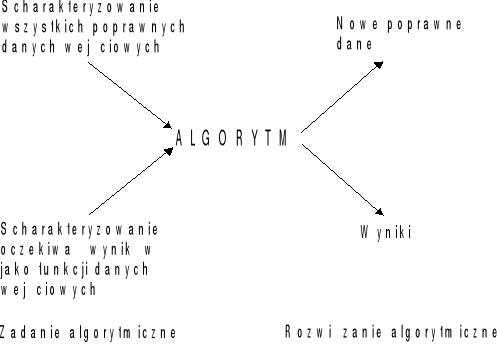

Algorytm przetwarzania - podaje pełny opis działania operatora przekształcenia danych i zawiera następujące elementy składowe:

- charakterystykę danych wejściowych,

- określenie reguł przetwarzania,

- charakterystyką danych wyjściowych.

Realizowane to jest więc w uporządkowanym ciągu działań i ustalonym czasie, ten uporządkowany ciąg działań w wyniku którego następuje przekształcenie danych wejściowych w dane wyjściowe nazywamy - PROCESEM PRZETWARZANIA DANYCH

Każdy taki proces przekształcenia danych w WE/WY zawiera co najmniej jeden algorytm przetwarzania

Elementami systemu przetwarzania danych są zatem:

- określone grupy ludzi,

- środki techniczne,

- ustalony zestaw metod i technik przetwarzania

Właściwy danemu systemowi zestaw metod i technik przetwarzania danych nazywamy więc SYSTEMEM PRZETWARZANIA DANYCH.

INFORMACJA W KOMPUTERZE.

Nośnikami informacji w komputerze są sygnały elektryczne. W odróżnieniu od stosowanego powszechnie systemu dziesiętnego, są one przedstawione w postaci dwójkowej (systemie binarnym).

Możemy więc przyjąć, że sygnały są dwustanowe, tzn. takie, że ich parametry mieszczą się w jednym z dwóch dopuszczalnych przedziałów. Cyfry 0 i 1 zwane są bitami. Jest to przyjęty skrót terminu angielskiego Binary Digit. Jest to elementarna jednostka informacji. Wszystkie informacje wewnątrz komputera trzeba przedstawić za pomocą wybranych ciągów zero jedynkowych. Przyporządkowanie wybranych ciągów zero jedynkowych obiektom, które mają reprezentować, nazywa się kodowaniem, natomiast ciągi zero jedynkowe, reprezentujące określone informacje, nazywa się kodami.

Bit jako element miary informacji jest jednostką małą i używa się w praktyce jej wielokrotność. Jednostką większą częściej używaną jest pojęcie bajtu, który równy jest 8 bitom. W większości współczesnych komputerów bajt stanowi podstawową jednostkę informacji. W praktyce mogą reprezentować np. liczbę, znak, rozkaz lub adres komórki.

Istotą poznania miar informacji stosowanych w komputerze jest to, że aby właściwie odczytać pewne istotne parametry funkcjonalne, takie jak:

wielkość pamięci operacyjnej,

wielkość pamięci masowych,

wielkość folderów,

wielkość dokumentu,

należy znać i prawidłowo interpretować miary informacji.

Większymi jednostkami są kilobajt skrót - kB, megabajt - skrót MB oraz gigabajt - skrót GB, terabajt - skrót TB.

1 kB = 210 bajtów = 1024 bajtów,

1 MB = 210 kB = 1024 kilobajtów = 1048576 bajtów,

1 GB = 210 MB = 1024 megabajtów,

1 TB = 210 GB = 1024 gigabajtów.

Praktycznie wielkości te zaokrągla się i przyjmuje w obliczeniach, że

1 MB równa się 1000 kB i 1000 000 bajtów. Jednak należy pamiętać, że jest to tylko pewne uproszczenie, natomiast faktyczne wielkości są nieco inne.

Człowiek komunikuje się z otoczeniem, w tym również z komputerem za pomocą technik wygodnych dla siebie, a więc za pomocą:

znaków określonego alfabetu,

cyfr dziesiętnych,

pewnych znaków dodatkowych, jak interpunkcja działań

arytmetycznych itp.

Te trzy grupy znaków określa się w informatyce wspólnym mianem znaków alfanumerycznych. A więc przy zapisie liczb korzysta się z:

pozycyjnego systemu dziesiętnego gdzie

1998 = 1 ⋅ 10 3 + 9 ⋅ 10 2 + 9 ⋅ 10 1 + 8 ⋅ 10 0

7,53 = 7 ⋅ 10 0 + 5 ⋅ 10 - 1 + 3 ⋅ 10 - 2

pozycyjnego systemu ósemkowego

8 = 10

10 = 12

15 = 17 itd.

pozycyjnego systemu binarnego /podobny do dziesiętnego z tym, że odpowiednie wagi stanowią tu potęgi o podstawie 2/

2 = 1 x 2 3 + 1 x 2 2 + 1 x 2 1 + 0 x 2 0 = 2 n dn

gdzie dn - wartość liczby przedstawionej na i-tej pozycji

zaś konwersja odwrotna z dziesiętnej na binarną

27 = 11011

27 / 2 13 reszta 1

13 6 1

6 3 0

3 2 1

1 0 1

pozycyjny system szesnastkowy (Hexagonalny)

AF 13 (16) = 3 + 16 1 x 1 + 16 2 x 15 + 16 3 x 10 = 3 + 16 + 3740 + 37560 = 41319 (10)

Do przetworzenia informacji przedstawionej w systemie dziesiętnym na inne stosuje się konwersję.

Konwersja polega na zmianie zapisu źródłowego na zapis pożądany - najczęściej realizowana jest w komputerach w ramach jego pracy (przetwarzania).

Przykład

HX DEC OTC BINARNY

8 8 10 1000

A 10 12 1010

F 15 17 1111

Ponieważ do zakodowania jednego znaku wykorzystujemy 1 bajt - przyjmujemy, że w ten sposób możemy zakodować 28 czyli 256 różnych znaków. Są to między innymi: małe i duże litery, cyfry, operatory matematyczne i logiczne, znaki specjalne.

Kody definiuje się za pomocą specjalnych tablic. Dla użytkowników istotne są kody rozkazów komputera i kody znaków stworzone do przekazania tekstów zrozumiałych dla człowieka. Kody znaków pisanych mają standaryzacje w skali międzynarodowej i są ujęte w normach wydawanych przez takie organizacje, jak ISO (International Standard Organization) czy ANST (American National Standard lnstitute). Dla wymiany informacji między różnymi komputerami opracowany został standardowy kod wymiany informacji ASCII (American Standard Code for lnformation Interchange), w którym każdemu znakowi podporządkowano odpowiedni kod (tab.1).

Do kodowania znaków alfanumerycznych (litery, cyfry, operatory matematyczne, znaki specjalne i inne) - stosowane są określone standardy.

Jednym z podstawowych standardów jest kod ASCII i American Standard Code for Information Interchange - Amerykański Standardowy Kod Wymiany Informacji.

Opiera się on na przyporządkowaniu wszystkim znakom z podstawowej klawiatury amerykańskiej oraz niektórym ważnym znakom specjalnym (np. powrót karetki, zmiana wiersza).

W wielu przypadkach ograniczenie się do kodu ASCII jest jednak niewystarczające - kwestie nacji językowych wykorzystano w tym celu kody od 128 do 255, bo mamy na to 1 bajt - jako elementarna jednostka informacji.

Przykłady znaczeń niektórych kodów ASCII

Kod ASCII |

Znaczenie |

Kod ASCII |

Znaczenie |

100 0001 100 0010 100 0011 100 0100 100 0101 100 0110 100 0111 100 1000 100 1001 100 1010 |

A B C D E F G H I J |

011 0000 011 0001 011 0010 011 0011 011 0100 011 0101 011 1011 011 0111 011 1000 011 1001 |

0 1 2 3 4 5 6 7 8 9 |

W tego typu kodach to:

kody od 0 do 31 to znaki specjalne, nie mające odpowiednika w alfabecie. Są to znaki sterujące ekranem i drukarką,

kody od 32 do l 27 to są między innymi; kody cyfr (od 48 (0) do 57 (9)), kody dużych liter alfabetu (od 65 (A) do 90 (Z), kody małych liter alfabetu (od 97 (a) do 122 (z).

Przy użyciu ASCII można przedstawić 128 znaków. Jest to kod 7-bitowy. Ze względu na fakt, że elementarną jednostką informacji jest 1 bajt, to dodatkowo można zakodować dalsze 128 znaków. Nazywa się on rozszerzonym kodem ASCII, który zawiera kody od 128 do 255. W tym zakresie można dodatkowe kody wykorzystać na polskie znaki. Jednak w Polsce nie ma w tym względzie ujednoliconego stanowiska i w praktyce spotykamy się z kilkoma różnymi standardami, z których najpopularniejszymi są: Mazovia oraz Latin II.

PRZETWARZANIE INFORMACJI LICZBOWYCH.

Komputer wykonuje obliczenia w układzie dwójkowym (binarnym). Istnieją różne metody zapisu liczb dziesiętnych na system dwójkowy lub odwrotnie. Jedną z najprostszych metod konwersji systemu dwójkowego na dziesiętny jest metoda pozycyjna. Wartość dziesiętną możemy wyliczyć ze wzoru:

W=do+21.d1+22.d2+...+2n.dn

gdzie d - wartość liczby przedstawionej na i-tej pozycji,

Dokonując podsumowania tej części materiału możemy stwierdzić, że informatyka jest nauką o przetwarzaniu informacji za pomocą komputera i przy użyciu odpowiedniego oprogramowania. System, który zajmuje się przetwarzaniem informacji, nazywamy systemem informacyjnym. System informatyczny jest pojęciem węższym i zawsze związane jest to z zastosowaniem techniki komputerowej. System komputerowy składa się z: hardware (sprzętu), software (oprogramowania), bazy danych często uzupełnionych o bazę modeli i bazę wiedzy, telekomunikacji, ludzi i organizacji.

Informacje przetwarzane są w komputerze przy pomocy dwustronnych sygnałów. Podstawową jednostką informacji jest bit. W praktyce używa się większych jednostek, takich jak: bajt, kilobajt, megabajt czy też gigabajt. Dla zapisania poszczególnych znaków, takich jak litery, cyfry, operatory matematyczne i inne, stosowane są określone standardy. Jednym z najbardziej popularnych standardów jest kod ASCII. Stosowany jest on dla wymiany znaków między różnymi komputerami.

Dla przetworzenia informacji przedstawionej w systemie dziesiętnym stosuje się konwersję. Konwersja polega na zmianie zapisu źródłowego na zapis pożądany. Najczęściej w przypadkach przetwarzania przez komputer polega na zmianie systemu dziesiętnego na system dwójkowy.

KOMPUTERY I ICH RODZAJE.

Postęp i rozwój techniki informatycznej dokonuje się w największym stopniu w zakresie technologii budowy komputerów. Konsekwencją jest pojawianie się wciąż nowych typów komputerów w dużej mierze chodzi o nowoczesne mikroprocesory, pamięci i urządzenia peryferyjne dostosowane do potrzeb współczesności. Podział na typy komputerów jest umowny. Problemem jest wybór kryterium rozróżnienia poszczególnych typów komputera. Najczęściej stosowanym kryterium jest przeznaczenie, budowa, funkcjonalność i cena, jaką płacimy za kupno komputera. Według tego handlowego kryterium komputery można podzielić na:

mikrokomputery,

minikomputery,

superkomputery,

Mikrokomputery są typem komputerów, które spowodowały największe zmiany i spowodowały rozpoczęcie ery informacyjnej. Mikrokomputery można podzielić na dwie podstawowe grupy, a mianowicie:

specjalizowane,

uniwersalne.

Uniwersalne z kolei można podzielić na:

domowe,

profesjonalne.

Komputery profesjonalne, zwane popularnie komputerami personalnymi, są grupą najliczniejszą w różnego typu zastosowaniach.

Komputery ze względu na sposób użytkowania można podzielić na:

biurowe (desk-top), które mogą pracować w zestawach, tzw. wieżach,

przenośne (portable), mieszczące się w jednej obudowie,

notatnikowe (notebook), przeznaczone do pracy w czasie podróży i które mogą być zasilane z akumulatorów o stosunkowo niewielkim ciężarze (2-3 kg),

podręczne (lap-top), również przeznaczone zwykle do pracy w podróży, jednak nieco cięższe niż notatnikowe.

Specjalną grupę stanowią dostępne od 1992 r. komputery sterowane pisakiem, tzw. pen-komputery, pen pad. Użytkownik może go bardzo łatwo przekształcić w normalny komputer. Dokonuje się tego przez dołączenie monitora o normalnych rozmiarach, stacji, dysków, klawiatury, myszy.

Minikomputery są to w zasadzie komputery, które w porównaniu z mikrokomputerami charakteryzują się większą pojemnością pamięci operacyjnej, dłuższym słowem maszynowym, możliwością równoczesnej pracy wielu użytkowników.

Podobnie jak produkcja personalnych komputerów zdominowana jest przez komputery firmy IBM i komputery z nimi kompatybilne. Głównie są to produkty firmy DEC (Digital Eguipment Corp.), przedstawicielem komputerów firmy DEC są komputery serii VAX. Popularnymi, również w Polsce są minikomputery firmy IBM serii AS/400 (Apllication System), oraz komputery firmy Hewlett - Packard, w tym popularny model P3000.

Do minikomputerów zalicza się często tzw, stacje robocze (work-stations). Stacje roboczą łączą cechy sprzętu mikro i mini. Współczesne stacje robocze można określić następująco według funkcjonalności parametrów techniczno eksploatacyjnych:

moc obliczeniowa, najczęściej kilkakrotnie przewyższająca komputery osobiste,

monitor, najczęściej 19-calowe o wysokiej rozdzielczości,

szybkie i pojemne pamięci zewnętrzne,

możliwość pracy w zestawach.

W grupie tej wyróżnić można stacje do: przetwarzania danych biurowych, obsługi procesów produkcyjnych, prac projektowo-inżynieryjnych, tzw. CAD/CAM, obsługi instytucji finansowych (szczególnie banków i giełd).

Main-frame, czyli komputery duże i średnie. W latach osiemdziesiątych rozpowszechniony był pogląd, że personalne komputery wyprą komputery innych typów. Okazało się jednak, iż mimo że komputery personalne przejęły szereg zadań i mogą je samodzielnie realizować to średnie i duże komputery będą odgrywały znaczną rolę, zwłaszcza w bankach, supermarketach, administracji, ubezpieczeniach, jak i wszędzie tam, gdzie niezbędne są niezawodność, działanie w sieci, jak też ochrona danych. Komputery typu mainframe są jedno- lub wieloprocesorowe o bardzo dużej wydajności. Pamięć zewnętrzna jest w praktyce nieograniczona. Ich ujemną cechą jest to, że wymagają specjalnych klimatyzowanych pomieszczeń, jak też profesjonalnej obsługi.

Superkomputery są obecnie komputerami o największej mocy obliczeniowej. Niekiedy o tego typie komputerów mówi się też: ultrakomputery, superserwery itp. Superkomputery produkuje niewiele firm, takich jak: Cray, NEC Hitachi, Fujitsu. Szybkość obliczeniowa superkomputerów mierzona jest w miliardach operacji na sekundę (gflops). Pamięci masowe w formie pakietów dysków są praktycznie nieograniczone, natomiast pamięć operacyjną cechuje pojemność rzędu miliardów bajtów. Wysoka cena superkomputerów jest tym czynnikiem, który powoduje ograniczenie ich zastosowań. Wielu nawet bardzo bogatych użytkowników dzierżawi tego typu komputery lub kupowane są przez wyspecjalizowane konsorcja. Także ich bardzo złożone konstrukcje wymagają specjalnych mediów chłodzących, np. ciekłego azotu, jak również innych wyspecjalizowanych mediów zabezpieczających ich funkcjonowanie.

W superkomputerach zastąpiono klasyczny system przetwarzania danych związanych z nazwiskiem Von Neumanna (przetwarza się jeden strumień danych w jednym procesie i jednej pamięci) na tzw. system współbieżny, gdzie zadania są realizowane równolegle na kilku procesorach (tzw. superskalary).

Człowiek ze zdrowym sercem i jasnym umysłem pozbawiony swoich zmysłów straciłby sens swojego istnienia, nie miałby żadnej możliwości komunikowania się z otaczającym go światem.

Podobnie komputer złożony jedynie z pamięci i procesora, byłby głuchym, ślepym i nieczułym na żadne bodźce, a więc nikomu nie potrzebnym urządzeniem.

Zasada działania naszych narządów zmysłów została już dawno poznana i umiemy budować urządzenia działające w podobny sposób.

Poszczególne zmysły mają dla nas różne znaczenie - najcenniejszy jest wzrok, potem słuch, następnie smak, węch, dotyk. Ta hierarchia nie jest przypadkowa, odpowiada ilości informacji, jaką nam te zmysły dostarczają, odpowiada też stopniowi skomplikowania urządzeń, które imitują narządy zmysłów:

zmysł dotyku - klawiatura, ekran dotykowy, mysz

zmysł słuchu - mikrofon

wzrok - ekran, skaner, digitizer itp.

Użytkowane, popularne programy w tym i systemy operacyjne np. typu Windows utrwalają obraz inteligencji maszyny. Ich zachowanie, prowadzenie „rozmowy” z użytkownikiem sprawia wrażenie, że komputer nie tylko wykonuje polecenia, ale potrafi także doradzić, którą drogę wybrać. Coraz częściej podczas instalacji systemu sam rozpoznaje typ sprzętu, ustawia właściwe przerwania optymalnie konfiguruje środowisko pracy. Takie - z pozoru inteligentne - działania maszyny w pewien sposób rozgrzeszają użytkowników z myślenia i odpowiedzialności. Powstaje zatem złudzenie, że tak zmyślny system potrafi sam o siebie ale również o użytkownika zadbać także w przyszłości. Samodzielność komputerów jest jednak „iluzją” wynikającą z nie dostrzeżenia roli człowieka w ich funkcjonowaniu.

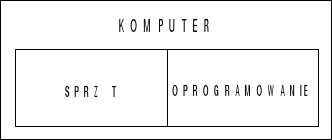

Komputer lub inaczej maszyna cyfrowa - jest to więc urządzenie służące do przetwarzania informacji, przy czym to przetwarzanie odbywa się automatycznie, według wprowadzonego uprzednio do jego pamięci programu.

Treść tej definicji można przedstawić obrazowo w sposób następujący;

Zaś graf obrazujący system komputerowy tj. zestaw komputerowy ujmujący zespolenie sprzętu i oprogramowania można przedstawić następująco:

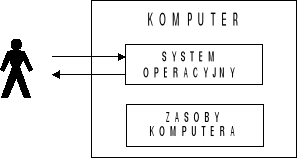

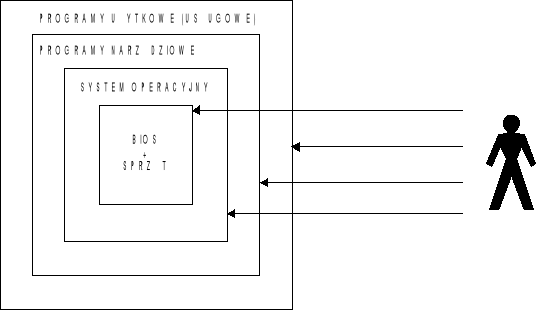

Przy czym komunikacja użytkownika z komputerem poprzez system operacyjny wyraża się wg załączonego rysunku.

Schemat funkcjonowania komputera.

Legenda:

1 - konsola operatorska,

2 - taśma magnetyczna,

3 - dysk twardy,

4 - dysk miękki (dyskietka),

5 - drukarka,

6 - monitor ekranowy.

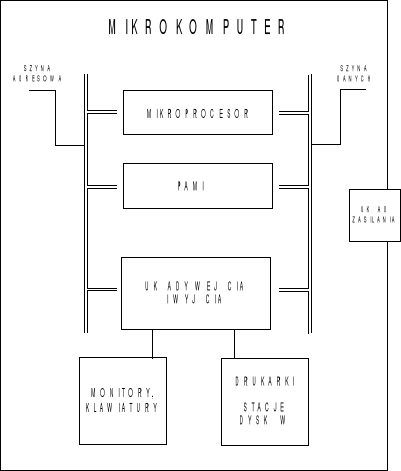

SYSTEM KOMPUTEROWY . Wszystkie elementy komputera wzajemnie ze sobą powiązane tworzą system komputerowy. W zależności od zastosowania i możliwości finansowych użytkownika struktura komputera może być bardziej lub mniej rozbudowana. Podstawowymi elementami komputera przedstawionymi na rysunku są:

1. Jednostka centralna, a w niej najbardziej istotnymi elementami są:

procesor,

pamięć wewnętrzna (operacyjna),

kanały wejścia i wyjścia.

2. Pamięci zewnętrzne.

3. Urządzenia wejścia i wyjścia.

Literatura przedmiotu określa również pojęcie komputera jako skomplikowane urządzenie, złożone z czterech podstawowych modułów:

- układu arytmetyczno-logicznego,

- układu sterowania,

- pamięci,

- układów wejścia i wyjścia.

Układ arytmetyczno-logiczny i sterowania umieszcza się razem i noszą one nazwę procesora. Procesor służy bezpośrednio do przetwarzania danych, wykonuje obliczenia i porównuje liczby. Dane i wyniki są przechowywane w pamięci. Tam też zapisany jest program, czyli zakodowany odpowiednio sposób przetwarzania informacji. Układy wejścia i wyjścia służą do komunikacji ze światem zewnętrznym. Za ich pośrednictwem dołącza się do komputera urządzenia do wprowadzania i wyprowadzania danych - urządzenia zewnętrzne. Komputery przetwarzają informacje zapisane binarnie, za pomocą wartości 0 i 1. Elementarną porcję informacji w postaci „0” i „1” nazwano bitem. Taki sposób reprezentowania informacji pozwala na uproszczenie budowy układów elektronicznych, z których zbudowany jest komputer oraz na zwiększenie niezawodności ich pracy.

Pojedynczy bit niesie małą porcję informacji, jednak za pomocą ciągu bitów można zapisać bardziej skomplikowane dane, liczby lub znaki alfabetu. W mikrokomputerach używa się na ogół porcji złożonych z ośmiu bitów, zwanych dalej bajtami.

Sposób połączenia ze sobą podstawowych modułów komputera nazywa się architekturą komputera. Uproszczony schemat połączenia czterech podstawowych modułów komputera przedstawiono na poniższym rysunku.

W schemacie zwracają uwagę moduły komputera oraz połączenia między nimi, tzw. szyny. Szyną adresową nazwano połączenie, które służy do przesyłania adresu z procesora do pamięci i układów wejścia i wyjścia. Szyna danych to połączenie, które przekazuje informacje odczytywane lub zapisywane przez procesor z pamięci lub układów wejścia lub wyjścia.

Liczba linii szyny danych, a tym samym liczba bitów, które mogą być jednocześnie przesyłane przez tę szynę, zależy od budowy procesora. Starsze mikrokomputery mają 16-bitowe szyny, nowsze 32-bitowe, a najnowsze 64-bitowe szyny. Zwiększona liczba bitów szyny pozwala na szybsze odczytywanie lub wpisywanie informacji do pamięci, a więc szybszą pracę komputera.

Jednostka centralna. Jak wcześniej stwierdzono elementem organizującym pracę całego systemu komputerowego jest procesor. Często też w przenośni nazywamy go sercem lub mózgiem. Nowoczesny komputer wyposażony jest zwykle w kilka procesorów, wyspecjalizowanych w wykonywaniu określonego rodzaju zadań. Każdy komputer zawiera jednak jeden główny mikroprocesor, określony często mianem CPU (Central Processing Unit). W najbardziej popularnych typach komputerów, a mianowicie w personalnych komputerach, takim „sercem" jest mikroprocesor umieszczony na płycie głównej o odpowiednich parametrach techniczno funkcjonalnych i otwartej architekturze. Przy zakupie procesora patrzymy na ogół na tzw. współczynnik wydajności - czyli porównanie do wydajności jakiegoś procesora Pentium. Ten współczynnik to: COMP - indeks wydajności komputera ustanowiony przez firmę INTEL do pomiaru wydajności procesorów. Mierzymy więc współczynnik szybkości COMP do ceny procesora.

Wydajność komputera zależy więc bezpośrednio od:

szybkości - tj. ilości instrukcji, którą może wykonać procesor w ciągu sekundy,

ilości danych - które może objąć procesor w ramach jednej operacji.

od technologii wykonania procesora (jego możliwości w zakresie operacji arytmetycznych, logicznych oraz sterowania.

Drugim z podstawowych elementów jednostki centralnej jest pamięć wewnętrzna. Jest to bardzo szybka pamięć, w której przechowywane są programy (w tym także system operacyjny), a także dane wejściowe oraz wyniki, uzyskane w trakcie przetwarzania. W tych sytuacjach, kiedy nie są one natychmiast potrzebne, przesłane są do tzw. pamięci zewnętrznych (o których będzie mowa w dalszej części poradnika).

Pamięć wewnętrzna, jest zorganizowana jako ciąg komórek. Każda komórka ma swój adres. Duża pamięć pozwala na wykonanie bardzo złożonych programów. Pamięć ta może być zbudowana z różnych elementów. Stosuje się: pamięć ferrytową, pamięć na cienkich warstwach magnetycznych, pamięć optyczną, pamięć półprzewodnikową oraz pamięć kriogeniczną, która wykorzystuje zjawiska nadprzewodnictwa w niskich temperaturach.

Dawniej najbardziej popularne były pamięci ferromagnetyczne, obecnie natomiast pamięci półprzewodnikowe. Wydaje się, że w niedalekiej przyszłości powszechnie będą stosowane pamięci optyczne, które mogą charakteryzować się dużą pojemnością i szybkością przekazywania danych. Największe możliwości w tym względzie powinna mieć pamięć holograficzna, która wykorzystuje zjawisko holografii i możliwości jakie daje światło laserowe. Obecną wadą takiej pamięci jest to, że zapisany hologram nie może być zmieniony, co utrudnia aktualizację zasobów informacyjnych. Obok wymienionych rodzajów pamięci istnieją również pamięci innego rodzaju, np. pamięć biologiczną, itp.

Postęp w zakresie budowy pamięci wewnętrznych polega na ilości gromadzonych danych jak również minimalizacji czasu dostępu do zgromadzonych tam danych. Przyspiesza to bowiem proces przetwarzania przez mikroprocesor ze względu na to, że wszelkie dane oraz programy pobiera on z pamięci operacyjnej.

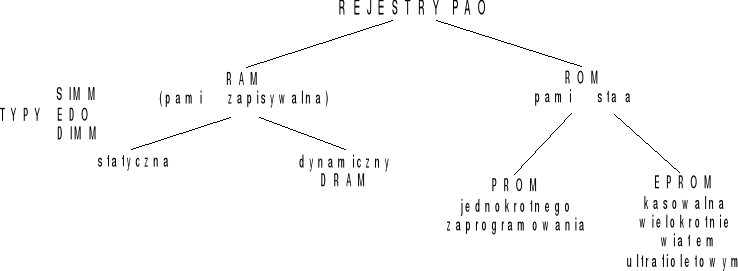

W pamięci wewnętrznej wyróżniamy dwa podstawowe rodzaje pamięci:

Pamięć RAM (Random Access Memory), inaczej zwana pamięcią o dostępie swobodnym - bezpośrednim, typu zapis/odczyt wymaga ona stałego odświeżania - podania źródła zasilania. Przechowuje program i dane dla programu aktualnie realizowanego. Po wyłączeniu komputera informacje te znikają. Jej głównymi elementami funkcjonalnymi jest więc pojemność i czas dostępu do informacji tam zgromadzonych (zapis-odczyt).

Pamięć ta jest zorganizowana jako ciąg elementarnych komórek związanych bitami pamięci z których każda jest zdolna do przechowywania jednego bitu informacji. Bity grupowane są w bajty pamięci. Każda komórka ma swój jednoznaczny numer i adres.

Na rynku informatycznym występują następujące rodzaje pamięci, które stosuje się w komputerach:

* pamięć ferrytową,

* pamięć na cienkich warstwach magnetycznych,

* pamięć optyczną,

* pamięć półprzewodnikową,

* pamięć kriogeniczną - która wykorzystuje zjawiska nadprzewodnictwa w niskich temperaturach.

Pamięci powinny charakteryzować się dwoma istotnymi parametrami:

* dużą pojemnością [GB]

* szybkością przekazywania danych [ns].

Optymalnie zatem w przyszłości powszechnie będą stosowane pamięci optyczne. W tym względzie największe możliwości powinna mieć pamięć holograficzna, która wykorzystuje zjawisko holografii i możliwości jakie daje światło lasera. Obecnie wadą tych pamięci jest to, że hologram może być zmieniony, co utrudnia aktualizację zasobów informacyjnych.

Postęp w zakresie budowy pamięci wewnętrznych dąży do koncentracji pamięci i układów logicznych związanych na bardzo małej powierzchni oraz przyspieszenia procesu przetwarzania.

PAO (pamięć operacyjna) służy do przechowywania danych i programów i składa się z następujących modułów:

Pamięć ROM (Read Only Memory), inaczej zwana pamięcią tylko do odczytu.

Pamięć ROM - jest to pamięć stała, nie ulotna - elementy programowalne typu EPROM. Zawarte są dane producenta tzn. ROM BIOS tj. informacje o systemie operacyjnym, do rozpoznania przez system, generator znaków, interpreter języka najczęściej języka BASIC.

Pamięć ROM występuje również między innymi w następujących postaciach:

PROM (Programmable ROM) programowalna jednokrotnie,

EPROM (Erasable PROM) pamięć stała kasowalna wielokrotnie światłem ultrafioletowym,

EAPROM (Electrically EPROM lub E2PROM) pamięć kasowalna.

Kanały wejścia-wyjścia.

Kanały te stanowią blok funkcjonalny pozwalający sterować przepływem danych pomiędzy pamięcią wewnętrzną a urządzeniami zewnętrznymi podłączonymi do procesora. Przez to umożliwiają procesorowi wykonywanie w tym samym czasie odczytu i zapisu informacji w pamięci operacyjnej i przetwarzanie danych. Kanały „kontaktują” się z urządzeniami zewnętrznymi poprzez łącze standardowe i jednostki sterujące urządzeń zewnętrznych. Stanowią funkcjonalny blok pozwalający na sterowanie przepływem danych pomiędzy pamięcią wewnętrzną, a urządzeniami zewnętrznymi podłączonymi do procesora. Umożliwiają przez to procesorowi w jego działaniu na wykonywanie w tym samym czasie odczytu i zapisu informacji w pamięci operacyjnej wraz z przetwarzaniem danych. Kanały kontaktują się z urządzeniami zewnętrznymi poprzez łącze standardowe i jednostki sterujące urządzeń zewnętrznych. Inaczej patrząc blok we/wy służy do komunikacji procesora z urządzeniami zewnętrznymi poprzez tzw. „porty” które są ogólnie rzecz biorąc programowalnymi układami logicznymi łącznie z liniami komunikacyjnymi (INTRFACE) przez które informacja przechodzi z i od urządzeń zewnętrznych. Realizowane jest to poprzez sterowniki i oprogramowanie.

Pamięć zewnętrzna. Pamięci te mają za zadanie przechowanie danych i programów nie będących w danej chwili przetwarzane. Do najpopularniejszych rodzajów pamięci zewnętrznych należą:

Pamięć taśmowa (pamięć sekwencyjna).

Pamięć na dyskach (pamięć o dostępie bezpośrednim).

Płyta kompaktowa (czytnik CD).

Pamięć ta składa się z dwóch następujących modułów funkcjonalnych: jednostki sterującej oraz z jednej lub kilku jednostek pamięci podłączonych do jednostki sterującej. Wymiana danych pomiędzy pamięcią wewnętrzną a jednostką pamięci zewnętrznej (zapisywanie danych) odbywa się na drodze: pamięć wewnętrzna - kanał (układ we/wy) - jednostka sterująca pamięcią - jednostka pamięci.

Odczytywanie danych z pamięci zewnętrznych odbywa się w kierunku przeciwnym. Podstawowymi parametrami decydującymi o przydatności i zastosowaniu danego rodzaju pamięci są:

pojemność pamięci,

szybkość pracy pamięci (zapis-odczyt),

koszt przechowywania informacji, liczona jako stosunek kosztu urządzenia do jego pojemności (ilości danych jaka może być przechowana w pamięci).

Pamięć na dyskach. Pamięć na dyskach, tzw. pamięć o dostępie bezpośrednim; można ją podzielić na następujące kategorie:

dyski twarde,

dyski elastyczne.

Pamięć dyskowa jest pamięcią o dostępie bezpośrednim. Wprowadzenie dysków magnetycznych przyczyniło się do szybkiego postępu w wykorzystywaniu komputerów.

Pojemności dysków są bardzo różne i wynoszą w pakietach od kilku megabąjtów do kilkudziesięciu gigabajtów i setek terabajtów. Najczęściej jest stosowany zestaw, w którym do jednostki sterującej można podłączyć do 8 jednostek dyskowych. Zestaw dysków zapewnia w praktyce nieograniczoną pojemność, ponieważ wymiana jednego pakietu jest niezwykle prosta. Pakiet dysków zawiera najczęściej 6 płyt, w których jest 10 powierzchni roboczych i 2 osłaniające. Przeciętnie czas dostępu do ścieżki sąsiedniej wynosi „~ 30 ms” (nowe tendencje zmieniają ten czas).

Prace dysku obsługują instrukcje:

sterujące, zawierające instrukcje wyszukiwania, powrotu oraz „nic nie rób”,

porównania, zawierające instrukcje porównania klucza i adresu (większy lub równy),

czytania, zawierające instrukcje czytania,

zapisu, zawierające instrukcje zapisu,

Dla zrozumienia organizacji zbiorów na dysku istotne jest „wyczucie” różnicy między zbiorem logicznym a zbiorem fizycznym. Zbiór logiczny jest to pewna grupa dokumentów jednorodnych tematycznie. Istnienie zbioru fizycznego wynika stąd, że każdy dokument jest magazynowany w pamięci w pewnym przeznaczonym dla siebie obszarze. Każdy taki obszar ma identyfikator zwany adresem.

W projektowaniu zbioru danych na dysku magnetycznym istotnymi parametrami są:

1. Liczba ścieżek na powierzchni dysku, która określa poprzeczną gęstość zapisu i ma decydujący wpływ na pojemność informacyjną dysku. Każda ścieżka na dysku jest podzielona na równe części, zwane blokami lub sektorami. Zapis i odczyt danych odbywa się całymi blokami. Blok stanowi najmniejszą „porcję” danych przesyłanych między dyskiem a pamięcią wewnętrzną systemu cyfrowego.

2. Czas dostępu do danych, który jest sumą czasu poszukiwania (czasu potrzebnego na przesunięcie głowicy magnetycznej na właściwą ścieżkę) i czasu oczekiwania (czas obrotu dysku niezbędnego do podejścia początku bloku pod głowicę magnetyczną).

Dysk magnetyczny jako nośnik ma określone zalety i wady.

a) Zalety:

duża pojemność informacyjna pakietu dysków,

nieograniczona możliwość zwiększenia pojemności przez wymianę dysków (pakietów),

stosunkowo krótki czas dostępu.

b) Wady:

wrażliwość nośnika na urządzenia mechaniczne,

trudności technologiczne przy wykonywaniu pakietu (jednorodna warstwa ferromagnetyku.

Dyski magnetyczne spełniają, podobnie jak taśmy magnetyczne, dwojaką rolę; po pierwsze nośnika, na którym są magazynowane dane, po drugie nośnika do wprowadzania danych do systemu cyfrowego. Postęp techniczny dotyczący pamięci dyskowych „idzie” zarówno w kierunku miniaturyzacji dysków, jak również zwiększenia pojemności i skracania czasu dostępu do danych.

Specyficznym nośnikiem pamięci dyskowej jest dyskietka, zwana też dyskiem elastycznym lub floppy - dyskiem. Jest ona zbudowana z plastikowego krążka, pokrytego materiałem magnetycznym. Krążek ten jest zamknięty w kopercie z elastycznego, ale odpornego tworzywa. Duży, umieszczony pośrodku, otwór służy do ustawienia dyskietki na wałku mechanizmu napędowego. Z boku znajduje się otwór indeksowy. Dzięki temu w momencie przesunięcia się otworu indeksowego pod wycięcie komputer może określić położenie obracającej się dyskietki względem głowicy zapisu-odczytu.

W ostatnim okresie coraz częściej stosowanym nośnikiem informacji jest płyta kompaktowa odczytywana przez czytnik CDD. Jest to dość trwały nośnik informacji charakteryzujący się dużą niezawodnością zarówno zapisu jak i odczytu ze względu, że w wymienionych procesach wykorzystano promień laserowy (monochromatyczne spójne światło o dużej energii gromadzonej w stosunkowo małym punkcie). Aby korzystać z zapisu na tego typu nośnikach, należy zestaw komputerowy rozszerzyć o „nagrywarkę”. Istotną zaletą tego nośnika jest kompatybilność odczytu danych przy różnych systemach operacyjnych instalowanych w systemach komputerowych (pomijana jest bowiem procedura formatu nośnika - tj. naniesienia struktury danego systemu operacyjnego).

URZĄDZENIA WEJŚCIA I WYJŚCIA. Istnieje wiele urządzeń komunikacji z komputerem. Grupa tych urządzeń określona jest wspólnym pojęciem urządzeń wejścia i wyjścia. Niektóre z nich są urządzeniami tylko wejścia inne zaś wyjścia, wiele zaś pełni obie funkcje. W prezentacji urządzeń przedstawione zostaną tylko najważniejsze i najbardziej popularne.

Monitor. Jak pisze P. Norton, jedyną - istotną z punktu widzenia użytkownika -częścią komputera jest monitor ekranowy. Monitor jest podstawowym urządzeniem do wyprowadzenia informacji z komputera. Traktowany jest często jako urządzenie we/wy, służące do wizualizacji danych. Może on pracować w tzw. trybie tekstowym - wyświetla znaki lub w trybie graficznym - obraz składa się z punktów.

Monitor ekranowy działa bardzo podobnie do telewizora. Zasada jego pracy znana jest pod nazwą wybierania liniowego i polega na ciągłym wykreślaniu obrazu przez poruszający się strumień (wiązkę) elektronów. Czytelność, ostrość i czystość obrazu przedstawionego na ekranie uzyskuje się dzięki zastosowaniu specjalnych kart graficznych zainstalowanych w komputerze i współpracujących z monitorem. Większość eksploatowanych monitorów pracuje z kartą Super VGA (Virtuall Graphic Array), pozwalającą pracować z rozdzielczością 800 x 600 pkt lub 1024 x 768 pkt (rozdzielczość określa się ilością linii i ilością punktów w każdej linii; skrót pkt pochodzi od słowa picture element, czyli element obrazu) i uzyskać 256 kolorów.

Często powód, że program działa na jednym komputerze, a nie działa na innym, związany jest w wyborem karty graficznej i współpracującego z nią monitora. Brak zgodności w tym zakresie uniemożliwia przenoszenie programów.

Nowe zastosowania monitora pozwalają nie tylko na wyprowadzenie danych, ale też na ich wprowadzanie. Istnieją tzw. ekrany dotykowe (touch screens), a ostatnio został opracowany specjalny ekran dotykowy, który reaguje też na siłę dotyku. W konsekwencji można otrzymać trójwymiarowy obraz. Niekiedy do monitora dołączone jest pióro świetlne, pozwalające na bezpośrednią komunikację z komputerem.

Klawiatura. Klawiatura wraz z monitorem stanowi podstawowe urządzenia komputera. Przy pomocy klawiatury możemy wprowadzić do komputera dowolne polecenia i teksty. Klawiatura zawiera w zależności od typu klawiatury 101 lub 102 i więcej klawiszy podzielonych na następujące bloki:

1. centralny, składający się z podstawowych symboli zgodnych z kodem ASCII. Jest to w zasadzie rozszerzona maszyna do pisania, najczęściej przedstawiona w systemie QWERTY (nazwa pochodzi od znaczenia kolejnych klawiszy w lewym górnym rogu),

2. pomocniczy, w którym istnieją powtórzone klawisze cyfrowe i operatory matematyczne,

3. funkcjonalny, w którym znajdują się klawisze oznaczone symbolami od F1 do F12, a ich znaczenie zależy od tego z jakim programem współpracują,

4. sterujący ruchem kursora, w obrębie napisanego tekstu,

5. specjalny, w którym umieszcza się klawisze o specjalistycznym przeznaczeniu np. Enter (naciśnięcie powoduje akceptacje wykonania polecenia), SHIFT (do pisania dużych liter oraz górnych znaków znajdujących się na niektórych klawiszach), ESC (rezygnacji z wykonania polecenia, często, jeśli nie wiemy, co należy dalej zrobić, naciskając klawisz ucieka się z takiej sytuacji).

„Mysz” - urządzenie sterujące. We współczesnych komputerach jest to urządzenie bardzo przydatne i pozwala na obsługę wielu programów bez użycia klawiatury. Informacją, że mysz funkcjonuje, jest na monitorze obraz strzałki, niekiedy prostokąta lub ręki. Jeśli przesuniemy myszką po stole lub po specjalnej podkładce (tzw. padzie), to odpowiedni ruch wykona strzałka na ekranie. Naciśnięcie klawisza myszki, tzw. kliknięcie, pozwala na akceptację realizacji polecenia. W niektórych komputerach wmontowana jest na stałe kulka i tu przez ruchy dłoni możemy realizować podobne funkcje jak przy pomocy myszki. Współczesne „myszki” mają do trzech wbudowanych klawiszy sterujących pozwalających na rozszerzenie możliwości stosowania użytkowego, a tym samym efektywniejszej i sprawniejszej obsługi wielu aplikacji wykorzystywanych przez użytkownika (np. menu podręczne, przesuw kursora itp.).

Drukarka. Urządzenie te służy do wyprowadzania wyników pracy komputera na trwałym nośniku informacji. Szybkość wykonywania przez komputer operacji nie przyniesie spodziewanych efektów, jeżeli nie zostanie sprzęgnięte z odpowiednio wydajnymi drukarkami. Ponieważ występuje dość często brak synchronizacji, dlatego dane z przetworzenia mogą być zapisywane na specjalistycznym dysku spełniającym rolę bufora, a następnie - w miarę możliwości i potrzeb drukowane. Istnieje wiele różnych rodzajów drukarek produkowanych przez różne firmy. W praktyce stosowane są drukarki: mozaikowe, strumieniowe, laserowe, termiczne i bezdotykowe.

Drukarka mozaikowa

- jest drukarką uderzeniową. Głowica drukarki zawiera cienkie igły (najczęściej 9 lub 24), które - dociskając taśmę barwiącą do papieru-tworzą znak. Im więcej igieł na jednostkę powierzchni, tym lepsza jakość druku, lecz czas druku się wydłuża. Znaki tworzone są w trybie draft (na brudno) i NQL (Near Letter Quality, czyli podwyższonej jakości). Drukarki te są stosunkowo tanie, a ich największą wadą jest niewielka szybkość i dość duża głośność pracy.

Drukarka strumieniowa

- zwana też drukarką atramentową (ink-.jet-printer), drukuje metodą strumienia tuszu wyrzucanego przez dyszę w uruchomionej głowicy. Są to więc podobnie jak drukarki igłowe drukarki uderzeniowe, lecz pracujące cicho i dające dobre jakościowo wydruki. Pewną ich wadą jest to, że nie można stosować w nich np. papieru kredowego (wydruk rozlewa się). Również z tego samego powodu nie są rekomendowane dla grafiki, natomiast zdają egzamin dla użytkowników pracujących w trybie tekstowym.

Drukarki laserowe są to obecnie najbardziej popularne typy drukarek. Są one droższe cenowo od atramentowych jednak coraz częściej instalowane ze względu na bezsporne zalety, jakimi są: wysoka jakość druku, cicha praca, większa szybkość realizacji. Zasada działania podobna jak w kserokopiarce. Różnica jest w tym, że obraz nie jest naświetlany światłem odbitym do oryginału, lecz przez laser, który jest w drukarce. W przeciwieństwie do drukarek atramentowych i mozaikowych drukowana jest cała strona (a nie linie po linii).

Drukarka bezdotykowa.

Jest to cała rodzina nowego typu drukarek o bardzo dużej wydajności. Drukarki te pracują z szybkością ponad 50% większą niż drukarki laserowe (drukują ponad 90 stron na minutę) i są odporne na wszelkiego rodzaju zakłócenia.

Skanery - pozwalające na cyfrowe przetwarzanie dowolnego obrazu. Skanery występują w postaci skanera ręcznego lub stacjonarnego. Działanie skanera polega na płynnym przesunięciu po skanowanym obrazie lampy fluorescencyjnej lub kilkunastu fotodiod umieszczonych w urządzeniu.

Skanery scharakteryzowane są przez następujące parametry:

rozdzielczość liczona w liczbie punktów na cal, tzw. dpi, większość skanerów ma około 600 dpi,

skala szarości decydująca o płynności przejścia od czerni do bieli,

szerokość skapowania określająca maksymalną szerokość oryginału przetwarzanego w pojedynczym cyklu pracy skanera,

szybkość skapowania.

Plotery - są to urządzenia wyjścia wykorzystywane między innymi w pracach projektowych. Przetwarzane w komputerze dane są wykreślane w postaci rysunku w układzie osi X i Y. Plotery należą do stosunkowo drogich urządzeń zewnętrznych.

Przedstawione urządzenia nie wyczerpują wszystkich urządzeń wejścia i wyjścia. Istnieją urządzenia, które pozwalają przetwarzać mowę i dźwięki. W dużych hurtowniach stosowane są czytniki kodów paskowych. Postęp techniczny idzie w kierunku wzbogacenia o odkrywania wciąż nowych urządzeń dla poprawienia komunikacji z komputerem.

PODSUMOWANIE. Komputer jest urządzeniem, które wykonuje automatycznie obliczenia, zgodne z zasadami jego funkcjonowania, określone przez zewnętrzną lub wewnętrzną informację, przekazywane w postaci danych i programów. Rozwój techniki komputerowej spowodował wydzielenie tzw. generacji komputerów. Generacja pierwsza oparta była na technice lampowej, druga zaś na tranzystorowej, trzecia - z kolei - na układach scalonych małej i średniej skali integracji. Obecnie funkcjonujące komputery zalicza się do czwartej generacji, opartej na układach scalonych o bardzo wysokiej skali integracji. Dalsze generacje oparte będą prawdopodobnie na jeszcze większej skali integracji mających inne niż dotychczas rozwiązania techniczne, jak przykładowo -neurokomputery, superskalary.

Komputery można podzielić według różnych kryteriów. Stosując kryterium handlowo-funkcjonalne oraz cenę możemy umownie wyróżnić mikrokomputery, minikomputery średnie i duże oraz super i ultrakomputery. Obecnie najbardziej popularne są mikrokomputery przeznaczone dla pojedynczych użytkowników, czyli tak zwane personalne komputery.

System komputerowy tworzony jest przez jednostkę centralną i gamę urządzeń peryferyjnych. Najbardziej istotnymi elementami jednostki centralnej są: procesor, pamięć wewnętrzna (operacyjna), kanały wejścia i wyjścia. Peryferia tworzą pamięć zewnętrzną oraz urządzenia wejścia i wyjścia. Elementem organizującym pracę całego systemu komputerowego jest procesor. Miniaturyzacja jest tak wielka, że przewiduje się iż mikroprocesor 786 firmy Intel, zawierający sto milionów tranzystorów, będzie to kostka krzemu o powierzchni około 6,5 cm. Istotnym elementem wpływającym na wydajność komputera są również urządzenia pamięci operacyjnej. Pamięć ta, nazywana jest często pamięcią RAM (pamięć dynamiczna o swobodnym, bezpośrednim dostępie wymagająca „stałego odświeżania”), pozwala na przechowywanie danych i programów, które są aktualnie przetwarzane - dostarczane do mikroprocesora. Pojemność zestawów dysków mierzona jest w gigabajtach (terabajtach) i charakteryzuje się bardzo krótkim czasem dostępu. Do urządzeń zewnętrznych, pozwalających na komunikację człowiek - komputer, należą: monitor. klawiatura, drukarka, skaner, mysz, ploter. Z punktu widzenia użytkownika najbardziej istotnym urządzeniem jest monitor. Monitor jest bowiem podstawowym urządzeniem do wizualizacji informacji wyprowadzanych i wyprowadzanych z komputera. Klawiatura natomiast podstawowym urządzeniem do wprowadzenia danych i rozkazów do komputera.

KOMUNIKACJA CZŁOWIEK - KOMPUTER. Komunikacja między człowiekiem - użytkownikiem a systemem komputerowym odbywa się bezpośrednio. Jest to osiągnięcie ostatnich lat, poprzednio bowiem łańcuch pośredników był dość duży. W konsekwencji w takim układzie występowało wiele przekłamań, zmian i uproszczeń, co powodowało, że różnica między zadaniami sformułowanymi przez użytkownika a wykonanym przez system komputerowy była dość duża.

Ujemnym zjawiskiem w tym względzie było to, że cała operacja trwała niekiedy bardzo długo. Wymagała bowiem opracowania dokumentacji systemu oraz wielu uzgodnień i zatwierdzeń. W rezultacie użytkownik otrzymywał rozwiązanie nie zawsze dotyczące problemu, który go interesował. Często rozwiązania były mu dostarczone wtedy, kiedy sytuacja zmieniła się i uzyskane informacje były nieaktualne. Aktualizacja wymagała znowu uzgodnień i zatwierdzeń. Obecnie w większości sytuacji użytkownik bezpośrednio „konsultuje się z komputerem”. Temu celowi służy zarówno sprzęt techniczny, jak też wygodne w użyciu oprogramowanie.

W układzie człowiek - komputer można wyróżnić dwa poziomy:

Pierwszy to bezpośredni układ człowiek - komputer, polegający na tym, że reakcja komputera i komunikat o efektach działania są natychmiastowe, a ewentualne opóźnienie wynika tylko z właściwości użytego sprzętu i rodzaju realizowanego zadania.

Drugi - kiedy dla zadania czas nie ma znaczenia, ewentualnie jest dopuszczone opóźnienie reakcji.

W pierwszym przypadku układy można przedstawić następująco:

K-KR-M.

K-KR-D,

M-KR-M,

M-KR-D.

gdzie:

K - konsola (klawiatura komputera),

KR - komputer - jednostka centralna,

M - monitor,

D - drukarka.

W drugim przypadku na wejściu lub wyjściu; ewentualnie i na wejściu i na wyjściu, pojawiają się maszynowe nośniki danych, takich ,jak dyski, dyskietki, taśmy magnetyczne. Można więc powiedzieć, że w tej drugiej sytuacji układ jest rozbudowany i wielostopniowy. W systemie tym szczególna rola przypada urządzeniom opisanym w poprzednim rozdziale, a więc klawiaturze i monitorom, wzbogaconym o zdalne manipulatory, np. mysz, pióro świetlne, ekran dotykowy.

Komunikacja człowiek - komputer realizowana jest przez działania, które określamy terminem zwanym programowanie.

Programowanie jest pewną sekwencją działań, składającą się z:

a. opracowania algorytmu rozwiązania problemu,

b. przetłumaczenia algorytmu na wybrany język komunikacji człowiek- komputer,

c. uruchomienia i zrealizowania programu.

ALGORYTM I FORMY JEGO PREZENTACJI.

Algorytm to sposób postępowania przedstawiający jednoznacznie skończoną ilość kroków (etapów) niezbędnych dla rozwiązania określonego zadania. Algorytm jest tak sformułowany, żeby, postępując według jego wskazań, komputer mógł rozwiązać określony problem. Algorytmy są rozwiązaniami takich zadań, które określamy jako zadania algorytmiczne albo obliczeniowe (rys).

Za podstawowe cechy algorytmu uznaje się (1):

uniwersalność, czyli zapewnienie rozwiązania każdego zadania należącego do określonego typu zadań, pod warunkiem konsekwentnego jego stosowania,

jednoznaczność, czyli prezentacji metody postępowania w postaci skończonej listy prostych j jednoznacznych rozkazów, dotyczących postępowania na kolejnych etapach wykonywania zadania.

zbieżność, czyli dla każdego dopuszczalnego zbioru danych początkowych liczba operacji prowadzących do poszukiwanego wyniku jest skończona,

powtarzalność, czyli każdy z użytkowników, stosując analogiczne dane i algorytm, uzyska analogiczne wyniki.

Zadanie algorytmiczne i jego rozwiązanie

Kolejność wykonywania działań, opisaną przy pomocy różnych instrukcji, nazywamy instrukcjami sterującymi. Do najważniejszych z nich należą następujące instrukcje:

następstwa, „wykonaj A, a następnie B",

warunku, tzw. instrukcja jeżeli („if” „jeżeli W to wykonaj A, a jeżeli nie. to wykonaj B",

skoku, „go to” „jeżeli W to skocz do A, jeżeli Q to skocz do B, jeżeli R to skocz do C", z tym że poszczególne wielkości A, B, C mogą być w różnych miejscach algorytmu.

Instrukcja skoku jest przez niektórych specjalistów krytykowana jako nieelegancka i ucząca złych nawyków w programowaniu. Instrukcja ta może też wprowadzać trudności techniczne, np. skok do pętli.

Tworzone algorytmy mogą być proste lub złożone. Złożone algorytmy są wtedy, kiedy zawierają podprogramy, które z kolei wywołują inne programy w celu pełnego opisu działania. Zazwyczaj algorytm rozwiązania danego zadania przedstawiony jest w formie:

opisu słownego,

notacji matematycznej,

graficznego schematu blokowego lub innej formy zapisu graficznego (tablica decyzyjna; tablica krzyżowa).

Opis słowny stosowany jest najczęściej i przykładami tego są:

Przepisy kulinarne.

Instrukcje składania mebli.

Instrukcje obsługi urządzenia, np. kamery wideo. - Wypełnienie zeznania podatkowego tzw. PIT.

Sporządzenie bilansu działalności firmy.

W notacji matematycznej dla prezentacji algorytmu korzysta się z typowych wzorów i reguł matematycznych. Prezentacja ta jest uzupełniania odpowiednimi komentarzami. Przykładami tego typu algorytmu są między innymi:

Rozwiązanie równań matematycznych.

Obliczanie pierwiastków równania.

Rozwiązanie modelu matematycznego programowania, np. metodą Simple.

Obliczenie ścieżki krytycznej w modelach graficznych typu PERT/CPM.

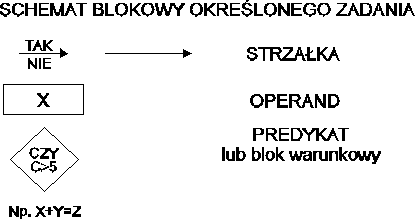

Schemat blokowy - jest najbardziej popularną metodą graficznej prezentacji algorytmu. Narzędzie to jest stosowane powszechnie dla rozwiązania złożonych problemów. Zasady budowania schematów blokowych są niezwykle proste. Cechują się małą liczbą elementów, co pozwala na łatwość kontroli. Schemat blokowy składa się z następujących elementów:

Strzałka, która wykazuje powiązania między poszczególnymi elementami schematu blokowego.

Operand -- prostokąt, w którym przedstawia się czynności arytmetyczne lub organizacyjne, dzięki którym otrzymuje się nową wartość, nowy format zapisu.

A=: B+C

Przy czym każdy operand ma powiązania z operandami poprzedzającymi co najmniej jednym i jednym operandem następującym.

Predykat lub też blok warunkowy, który przedstawiony jest w postaci rombu. Do predykatu wchodzi zawsze tylko jedna strzałka, wychodzą zaś zawsze dwie. W predykacie przedstawione są czynności logiczne, które służą do sprawdzenia, czy dany warunek został spełniony.

Objaśnienia, które służą do przedstawienia komentarza dla użytkownika, graficznie przedstawione są w postaci nie zamkniętego prostokąta.

Etykiety przedstawiające początek lub koniec schematu blokowego Etykieta ma tylko strzałki wyjściowe - start, lub strzałki wejściowe - koniec. Graficznie przedstawione są najczęściej w postaci okręgu, elipsy, niekiedy trójkąta.

Łącznik jest to specjalny typ etykiety, który ma za zadanie powiązanie poszczególnych części schematu blokowego, którego nie można przedstawić w jednej zwartej części. Wyróżnia się łączniki stronicowe, przedstawione w postaci koła, i łączniki międzystronicowe - przedstawione w formie pięciokąta.

Przykładowe elementy schematu blokowego przedstawia rysunek:

OPROGRAMOWANIE

Jak wcześniej stwierdziliśmy pojęcie system komputerowy obejmuje również oprogramowanie. System komputerowy stanowi bowiem spójny zestaw środków sprzętowych i programowych. Oprogramowaniem nazywamy ogół środków programowych dostępnych w systemie komputerowym. Oprogramowanie tworzone jest przy pomocy określonego języka programowania.

Podstawowym elementem oprogramowania jest program, realizowany przez komputer - bliżej przez mikroprocesor. Jest to zatem ciąg instrukcji jakie musi wykonać mikroprocesor w celu realizacji założonego algorytmu opisującego zadany problem.

Program jest więc opisem danego problemu przy pomocy określonego języka w ten sposób, że jest on akceptowany przez komputer (mikroprocesor).

Oprogramowanie z języka angielskiego zwane jest też softwarem.

Analizując relacje między ceną sprzętu (hardware) a oprogramowaniem (software) zauważyć można, że w poszczególnych latach uległa ona dużym zmianom. Początkowo cena sprzętu komputerowego była bardzo wysoka w stosunku do ceny oprogramowania. Obecnie możemy zaobserwować tendencje do coraz większego udziału ceny oprogramowania w całości wydatków na informatykę. Mimo że ceny systemów komputerowych w całości spadają, to ceny sprzętu ulegają o wiele większej obniżce niż ceny oprogramowania. Przedstawiona w tej części wykładu analiza oprogramowania została przeprowadzona w odniesieniu do komputerów personalnych. Większość zagadnień ma charakter uniwersalny, jednakże przedstawione przykłady dotyczą najbardziej popularnych komputerów, jakimi są komputery personalne (osobiste użytkownika). W większości zatem sytuacji spotkamy się w praktyce właśnie z tego typu oprogramowaniem. Podział oprogramowania związany jest z rodzajem komputerów, dla których to oprogramowanie zostało zaprojektowane.

Jak wiemy komputer jest urządzeniem działającym według ściśle określonych reguł. Aby go wykorzystać w swoich działaniach musi on posiadać określoną listę czynności do wykonania.

Programowanie jest więc pewną sekwencją działań składających się m.in. z:

opracowania algorytmu rozwiązania problemu,

przetłumaczenia algorytmu na wybrany język komunikacji człowiek - komputer,

uruchomienia i zrealizowania programu.

A zatem na udany nowoczesny i efektywny produkt informatyczny składają się trzy podstawowe moduły:

właściwy i dobrze zrealizowany produkt,

poprawne oprogramowanie,

odpowiedni sprzęt.

Oprogramowanie komputera decyduje w dużej mierze o:

jego możliwościach wykorzystania,

wykonywania określonych (założonych) zadań.

Dlatego też z punktu widzenia użytkownika sprzętu komputerowego „komputer jest tak dobry jak dobre jest jego oprogramowanie”, ono bowiem decyduje o rzeczywistej wartości komputera gdyż steruje pracą poszczególnych modułów sprzętu komputerowego, nadzoruje ich wykorzystanie i współdziałanie, sprawdza poprawność działania komputera a przede wszystkim współpracuje z użytkownikiem i realizuje jego zadania.

Na koszt zrealizowania prawidłowo funkcjonującego systemu komputerowego około 70% kosztów to koszt produkcji programów umożliwiających pracę systemu.

Reasumując można więc powiedzieć że od cech i jakości oprogramowania zależy łatwość posługiwania się komputerem jak i zakres wykonywanych przez niego zadań zadanych przez użytkownika.

Z punktu widzenia użytkownika obsługującego komputer oprogramowanie jest jakby otuliną okrywającą komputer przy czym ta otulina programowa złożona jest z kilku warstw, w efekcie tego użytkownik komunikuje się zwykle nie bezpośrednio ze sprzętem, lecz z określonym programem należącym do jego otoczenia.

Graficznie można to zilustrować w następujący sposób

Z punktu widzenia użytkownika systemu komputerowego oprogramowanie możemy podzielić na następujące moduły:

Dla decydentów nie są istotne problemy funkcjonowania oprogramowania systemowego zarządzającego systemem. Decydent jako użytkownik sprzętu komputerowego wykorzystuje tylko oprogramowanie narzędziowe oraz użytkowe. Granica pomiędzy nimi jest jednak trudna do ustalenia gdyż na dynamicznym rynku oprogramowania pojawiają się programy będące aplikacjami programów narzędziowych oraz programy narzędziowe umożliwiające przystosowanie ich do potrzeb programów użytkowych.

Oprogramowanie systemowe to zbiór programów, które są niezbędne w pracy komputerów niezależnie od ich zastosowania; są one opracowane najczęściej przez producentów sprzętu lub osoby zamawiające. Oprogramowanie systemowe, które będzie dalej przedstawione, nie jest pod kątem funkcjonalnym, jednoznaczne. Część oprogramowania czyli oprogramowanie, które możemy nazwać podstawowym (system operacyjny) jest tego typu, że bez ich udziału komputer nie byłby zdolny do pracy. Druga grupa ma mniejsze znaczenie, a ich zadaniem jest ułatwienie pracy użytkownika i pozwolenie na to aby ta praca była zgodna z przyjętymi standardami i wymaganiami. Podstawowe oprogramowanie systemowe jest dostarczane przez producenta wraz ze sprzętem, a jego cena jest zawarta w kontrakcie zakupu sprzętu.

Oprogramowanie użytkowe obejmuje zbiór programów, które są opracowane pod kątem realizacji konkretnych zadań i spełniających określone potrzeby użytkownika. I tak, jeśli oprogramowanie systemowe realizuje powtarzalne zadania wspólne dla różnych zastosowań, to oprogramowanie użytkowe służy do rozwiązania i realizacji konkretnych potrzeb użytkownika.

Podział na oprogramowanie systemowe i użytkowe nie zawsze jest ostry i jednoznaczny. Istnieje wiele pakietów oprogramowania, które realizują zadania systemowe jak i użytkowe. Odnosi się to zwłaszcza to współczesnego oprogramowania komputerów personalnych takiego jak przykładowo pakiet WlNDOWS.

Niezależnie od stosowanego stylu i typu programowania należy w konsekwencji dany algorytm napisać w takim języku, który będzie zrozumiały dla komputera. W tym sensie:

język programowania można określić jako zbiór znaków (słownik), oraz zbiór reguł posługiwania się nimi i ich interpretacji w procesie komunikowania się.

Komputer, aby mógł przetworzyć problem opisany w postaci algorytmu musi być opisany językiem programowania. Na ogół język programowania składa się z notacji i reguł, według których pisze się program.

B. Stefanowicz w podręczniku „Metody i techniki programowania komputerów” PWE, Warszawa 1987 - stawia językowi programowania - jako metodzie porozumiewania się człowieka z komputerem następujące wymagania:

Język musi być łatwy do opanowania przez człowieka i posługiwania się nim,

Sformalizowanie języka musi zapewnić jednoznaczność wszystkich jego elementów (znaków, wyrazów, zdań, zwrotów), co ułatwi opracowanie odpowiednich zasad wykonywania przez maszynę każdego polecenia, jakie w tym języku zostanie sformalizowane.

Język musi umożliwiać zakodowanie minimalnego zbioru operacji elementarnych, niezbędnych do wykonania określonych prac na komputerze,

Jest wskazane aby język umożliwiał także proste kodowanie operacji specyficznych dla danej klasy zastosowań.

Język powinien uwzględniać techniczne możliwości i wymagania dostępnego sprzętu oraz umożliwiać pisanie programów według znanych metod programowania.

Uogólniając te wymagania względem języka komunikacji człowiek - komputer można to sprowadzić do tezy wymagań:

łatwość posługiwania się

pełność realizacji żądań

A więc stan idealny to możliwość stosowania jako języka komunikacji człowiek - komputer JĘZYKA NATURALNEGO.

Języki programowania można przedstawić z dwóch punktów widzenia:

z punktu widzenia człowieka - a więc styl tworzenia programów,

z punktu widzenia komputera - a więc formalnie języki programowania.

Ad A.

Z punktu widzenia stylu tworzenia programów możemy wyróżnić:

programowanie proceduralne,

programowanie deklaratywne,

programowanie obiektowe,

programowanie strukturalne.

PROGRAMOWANIE PROCEDURALNE - charakteryzuje się tym, że program powinien zawierać pełny opis rozwiązania problemu opisanego danym algorytmem. Program składa się w tym przypadku z dwóch części:

deklaratywnej, w której opisuje się obiekty (dane), na których działa

proceduralnej, w której opisuje się czynności (instrukcje), które są wykonywane na tych danych.

PROGRAMOWANIE DEKLARATYWNE - polega na określeniu związków czyli relacji pomiędzy danymi a wynikami. Przy tego typu programowaniu nie kładzie się nacisku na „JAK PRZETWARZAĆ” (programowanie proceduralne) ale „CO MA BYĆ PRZETWARZANE”. Przykładowym językiem jest język PROLOG.

PROGRAMOWANIE OBIEKTOWE - jest próbą połączenia zarówno programowania proceduralnego i deklaratywnego. Jest to metoda programowania, w której program jest opisem działania zbioru wzajemnie powiązanych obiektów. Na opis obiektu składa się kilka następujących charakterystyk: metody, atrybuty, dziedziczenie, reguły, otoczenie. Przykładowe języki to: FRL, KEE, SMALLTALK do prezentacji wiedzy w bazach wiedzy.

PROGRAMOWANIE STRUKTURALNE - powstało na odpowiedź na niedostatki oprogramowania tradycyjnego - celem tego programowania jest rygorystyczna organizacja procesu projektowania i kodowania programu w dążeniu do zapobieżenia błędów logicznych i innych. Ma ono następujące cechy:

jest zastępujące,

modułowe.

Przykładowe języki to PASCAL i PL1

Ad B.

Języki programowania z punktu widzenia stopnia uzależnienia się od komputera możemy umownie podzielić na:

JĘZYK WEWNĘTRZNY MASZYNY (kod maszynowy) składa się z rozkazów mikroprocesora reprezentowanej w formie binarnej nr rozkazu adres kodu operacji, operandu

JĘZYKI SYMBOLICZNE - notacja w postaci skrótowych oznaczeń poszczególnych instrukcji oraz symbolicznych nazw danych i komórek pamięci, SAKO, MOST, MACRO PLAN,

JĘZYKI WYŻSZEGO RZĘDU zorientowane maszynowo - komputery ICL - PLAN, komputery IBM - Assembler

PROBLEMOWE m.in. do: przykładowe języki

obliczeń matematycznych Algol, Pascal, Fortran, Simula,

ekonomicznych Cobol, Pl1

konwersacyjne Basic, Jean, C

komunikacji z bazami danych Sqel, Query, Alpha

specjalistyczne - narzędziowe Psl/Psa, Portes

NATURALNE

OPROGRAMOWANIE SYSTEMOWE.

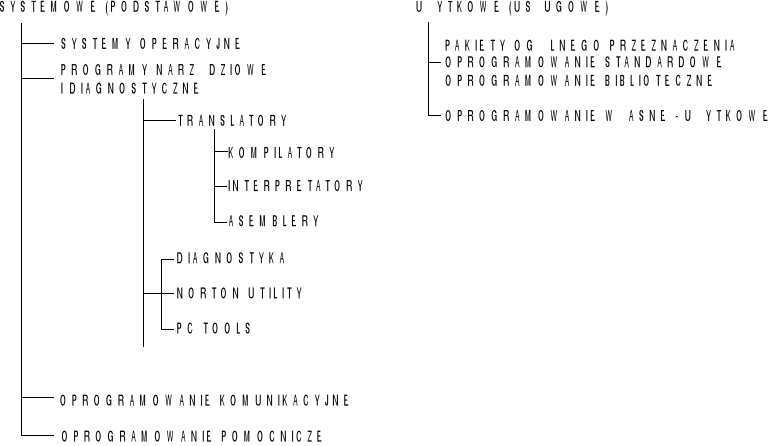

W oprogramowaniu systemowym zgodnie z przedstawioną uprzednio typologią, wyróżnić można następujące grupy:

systemy operacyjne,

translatory,

oprogramowanie dla testów i diagnostyki komputera,

oprogramowanie komunikacyjne,

oprogramowanie pomocnicze.

System operacyjny jest programem nadzorującym pracę wszystkich urządzeń systemu komputerowego, tworząc środowisko, w którym pracują inne programy. Jest więc zbiorem procedur zarządzających pracą całego systemu komputerowego. Podstawowe zadania systemu operacyjnego są następujące:

obsługa komunikacji człowiek - komputer,

przydział czasu pracy procesora dla poszczególnych użytkowników,

nadzór wymiany informacji między elementami systemu komputerowego,

zarządzanie pamięcią operacyjną,

uruchomienie innych programów w tym programów użytkowych,

sygnalizacja błędów i niesprawność urządzeń.

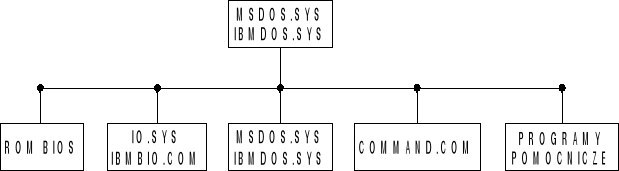

System operacyjny komputera - ogólna charakterystyka W systemie operacyjnym bardzo często spotykanym jakim jest MS DOS można wyróżnić wzajemnie z sobą współpracujące moduły:

ROM.BIOS

IO.SYS

MS.DOS.SYS

COMMAND.COM

Strukturę systemu operacyjnego na bazie DOS można przedstawić następująco.

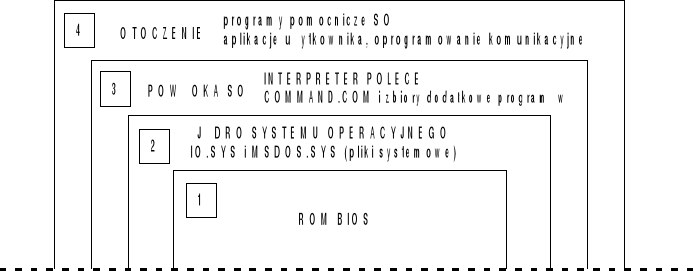

System operacyjny dzieli się więc na:

część stałą „zatopioną” w ROMie - PAO (pamięci operacyjnej),

część ruchomą przechowywaną w pamięci masowej.