SPIS MATERIAŁÓW POMOCNICZYCH:

mat-am-1

Podstawowe wiadomości na temat sygnału mowy i traktu głosowego

mat-am-2

Teoria wytwarzania dźwięków mowy. Formanty

mat-am-3

Modelowanie mechanizmów wytwarzania dźwięków mowy

mat-am-4

Perceptualne skale częstotliwości

mat-am-5

Metody analizy sygnału mowy

mat-am-6

Standardy

µµµµ

-law i A-law

mat-am-7

Parametryzacja sygnału mowy

mat-am-8

Kompresja sygnału mowy

mat-am-9

Podstawy automatycznego rozpoznawania mowy.

Podstawowe wiadomości na temat sygnału mowy

i traktu głosowego

Artykulacja - praca organów mowy (wiązadeł głosowych, języka, jamy ustnej, i nosowej)

potrzebna do wytworzenia dźwięków mowy.

Fonem - minimalny segment dźwiękowy mowy, który może odróżniać znaczenie, lub inaczej

klasa dźwięków mowy danego języka o różnicach wynikających wyłącznie z charakteru

indywidualnej wymowy lub kontekstu.

Alofon - wariant fonemu odróżniający się od innego alofonu cechami fonetycznymi a nie

funkcją.

Diafon - przejście międzyfonemowe (inaczej difon, tranzem)

Mikrofonem - jednostka sygnału mowy o stałej długości czasowej (ok. 20-40 ms).

Formant - obszar koncentracji energii w widmie danego dźwięku mowy

lub inaczej: taki zakres widma, którego obwiednia zawiera maksimum.

Cechy dystynktywne - cechy pozwalające na rozróżnienie.

Ekstrakcja parametrów - procedura wydzielania z sygnału cech reprezentowanych przez

wartości liczbowe (jest to element analizy sygnałów).

Redundancja - nadmiarowość w odniesieniu do informacji.

Logatomy - (ang. nonsense sylables) - sylaby służące do badania wyrazistości mowy w

testach odsłuchowych.

MFCC - (skrót od ang. Mel Function Cepstral Coeficients) wektor współczynników mel-

cepstralnych - cepstrum obliczone na podstawie melowej skali częstotliwości.

HMM - (skrót od ang. Hidden Markov Model) ukryty model Markowa używany w

algorytmach do rozpoznawania mowy.

ANN - (skrót od ang. Artificial Neural Network) sztuczne sieci neuronowe – stosowane jako

algorytmy konekcyjne do klasyfikacji.

GMM - (skrót od ang. Gaussian Mixture Model) modelowanie rozkładów

prawdopodobieństwa przy pomocy sumy rozkładów gaussowskich

SVM - (skrót od ang. Support Vector Machine) algorytm maszyny wektorów wsparcia do

klasyfikacji opartej na analizie regionu granicznego

Wokodery - urządzenia służące do ograniczania objętości informacyjnej sygnału mowy

metodą ekstrakcji parametrów i następnie po przesłaniu parametrów przez kanał

telekomunikacyjny dokonujące resyntezy tego sygnału.

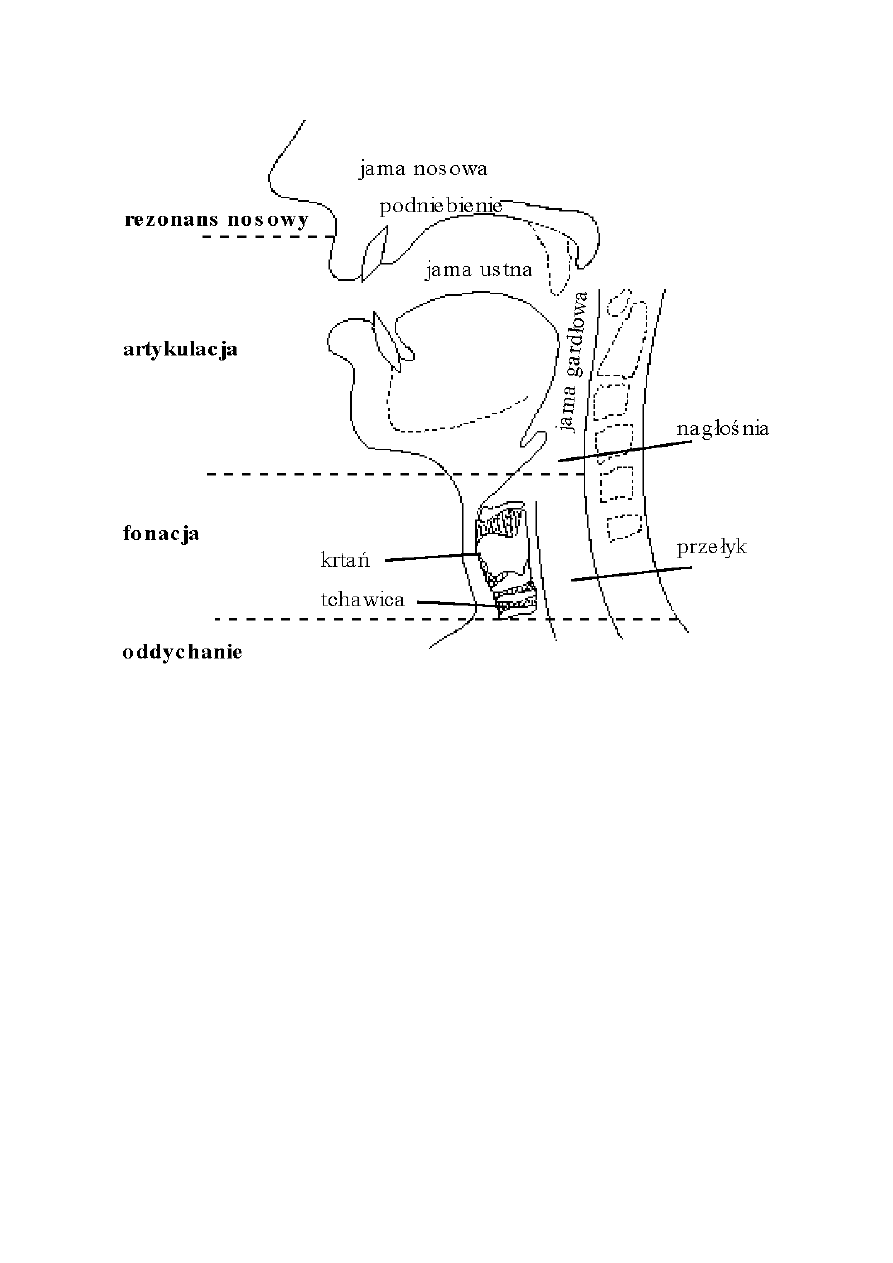

Narządy mowy w przekroju

Cechy mowy:

semantyczne - związane z treścią wypowiedzi

osobnicze - pozwalające rozpoznać osobę mówiącą

emocjonalne - pozwalające rozpoznać emocje osoby mówiącej; także stan zdrowia lub status

społeczny

prozodyczne - odnoszące się do akcentu, głośności, intonacji, długości dżwięków i pauz

Złożoność analizy sygnału mowy:

- zakres dynamiki

- rozdzielczość częstotliwościowa i czasowa

- uwzględnienie czułości narządu słuchu

- możliwość uczenia się i dostosowywania do zmiennych warunków (np. efekt "coctail

party")

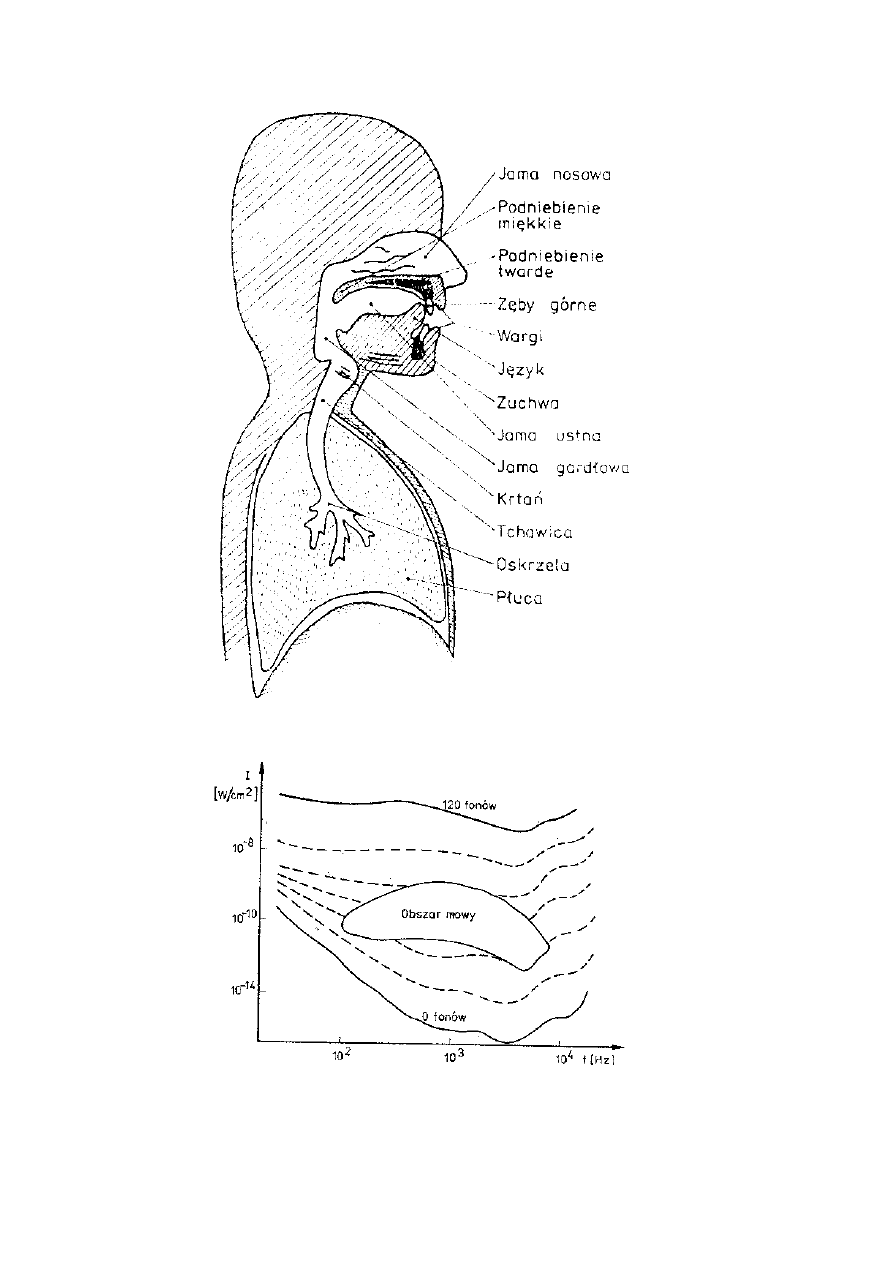

Zakresy częstotliwości podstawowej tonu krtaniowego dla głosek dźwięcznych:

bas 80-320 Hz

baryton 100-400 Hz

tenor 120-480 Hz

alt 160-640 Hz

mezzosopran 200-800 Hz

sopran 240-960 Hz

Analogie elektryczno-akustyczne:

prąd <-> prędkość objętościowa U:

U=v

.

A

v - prędkość liniowa drgań cząstek środowiska

A - pole powierzchni przekroju poprzecznego układu akustycznego

definicja ogólna:

impedancja akustyczna:

Z

a

=p/U

p - ciśnienie akustyczne

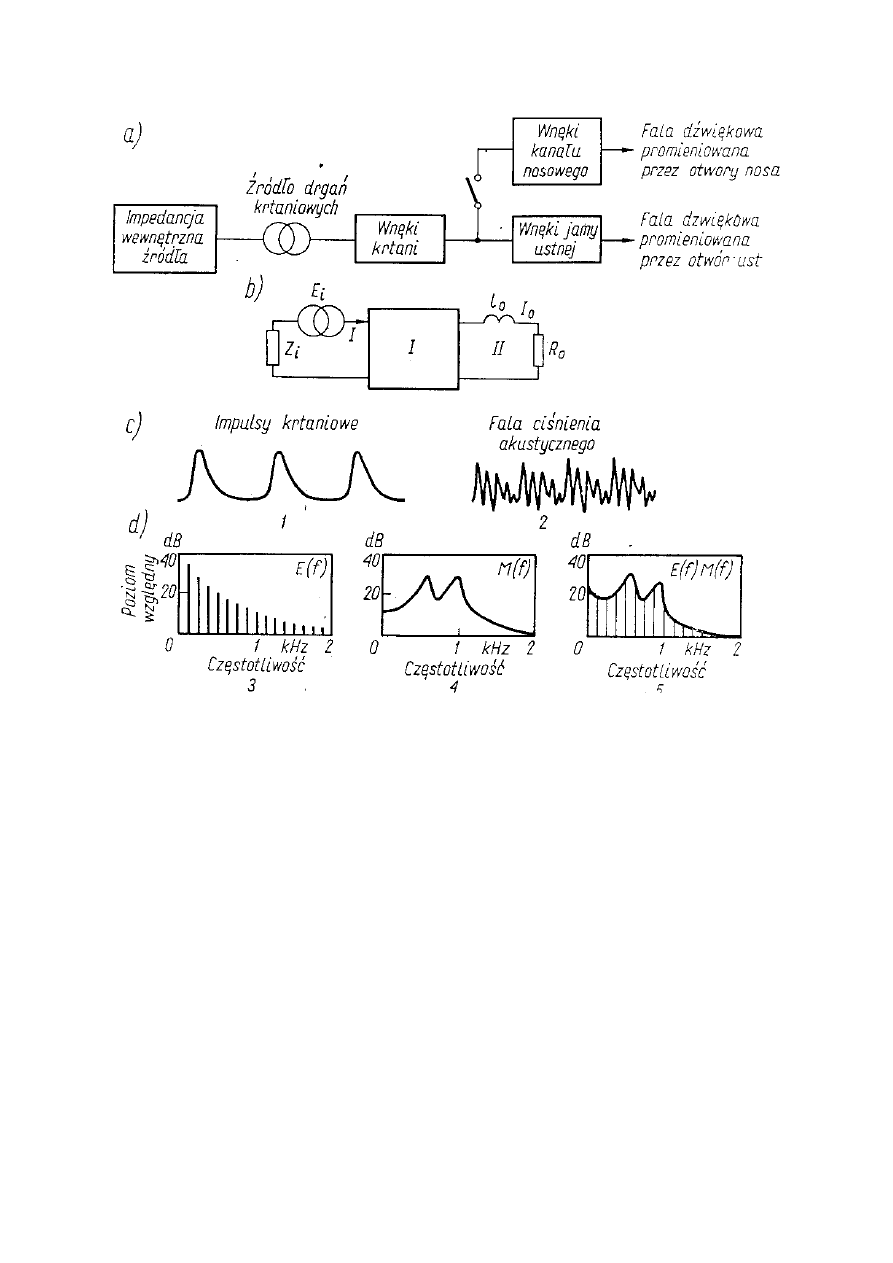

W dziedzinie czasu sygnał mowy można opisać jako splot:

p(t)=e(t)*m(t)

e(t) – sygnał pobudzenia

m(t) – odpowiedź impulsowa układu biernych efektorów artykulacyjnych (traktu

głosowego)

W dziedzinie zespolonej (transformacja Laplace'a) sygnał mowy można opisać:

p(s)=E(s)

.

M(s)

E(s) - pobudzenie

M(s) – transformata Laplace'a odpowiedzi impulsowej układu biernych efektorów

artykulacyjnych (traktu głosowego)

s=

σσσσ

+j

ω

ωω

ω

- częstotliwość zespolona

σσσσ

- tlumienie,

ω

ωω

ω

- pulsacja

na okręgu jednostkowym (transformacja Fouriera)

p(j

ω

ωω

ω

)=E(j

ω

ωω

ω

)

.

M(j

ω

ωω

ω

)

lub para równań:

|p(f)|=|E(f)|*|M(f)|

- amplitudowe

φ[

φ[

φ[

φ[

p(f)]=

φ[

φ[

φ[

φ[

E(f)]+

φ[

φ[

φ[

φ[

M(f)]

- fazowe

zalezności fazowe jednak nie mają wpływu na percepcję mowy

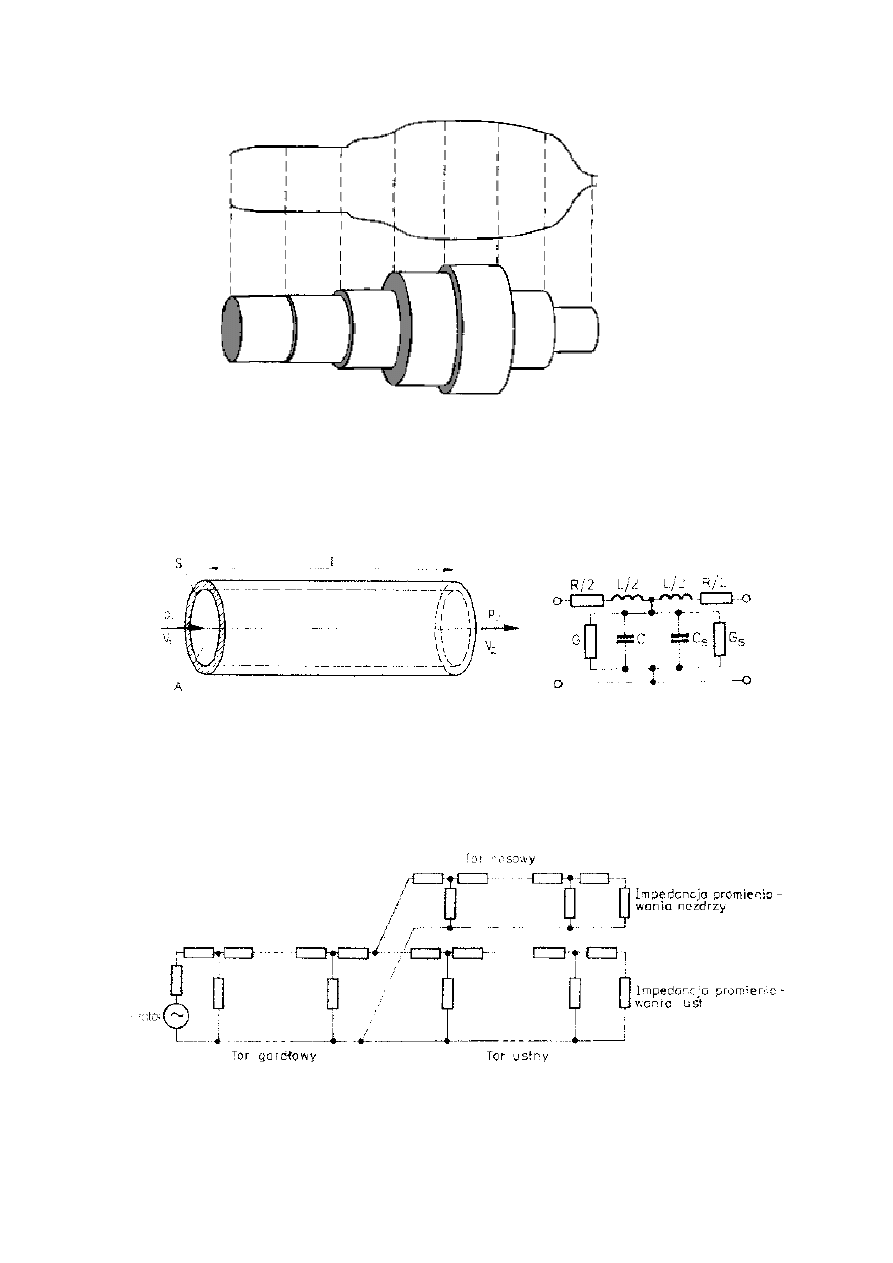

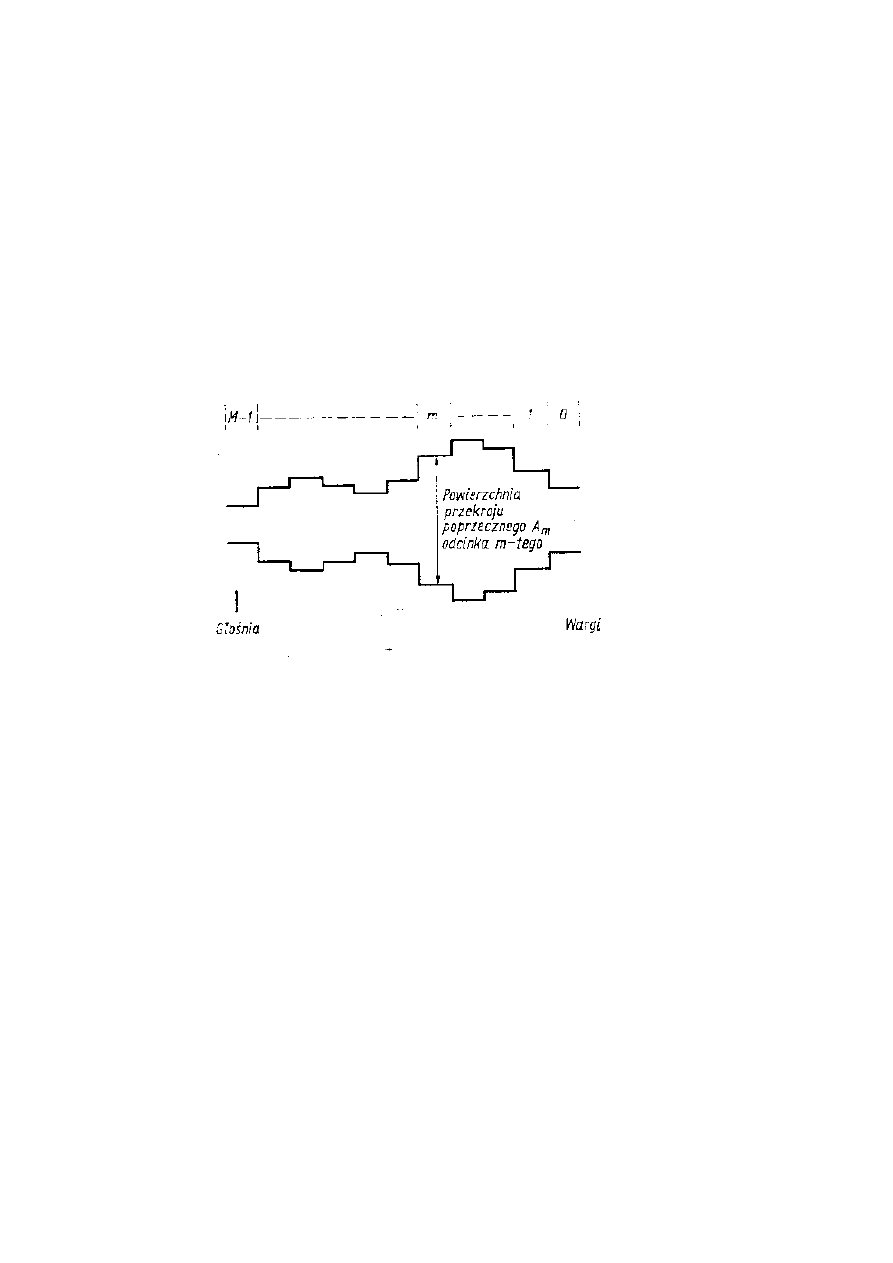

Uproszczony schemat traktu głosowego w przekroju

Wykres krzywych izofonicznych z zaznaczonym obszarem

zajmowanym przez naturalny sygnał mowy

Cztery podstawowe grupy polskich fonemów:

I. dźwięki o charakterze quasiperiodycznym:

1) samogłoski sylabiczne (a, e, i, o, u, y)

2) samogłoski niesylabiczne (j, ł)

3) spółgłoski nosowe (m, n, ń, ą, ę)

4) spółgłoski boczne (l)

II. dźwięki o charakterze przebiegów nieperiodycznych - szumowych:

1) spółgłoski bezdźwięczne trące (f, s, sz, ś, h)

2) spółgłoski bezdźwięczne zwarto-trące (c, ć, cz)

III. dźwięki o charakterze przebiegów nieperiodycznych - quasi-impulsowych:

1) spółgłoski zwarte dźwięczne (b, d, g)

2) spółgłoski zwarte bezdźwięczne (p, t, k)

IV. dźwięki o charakterze przebiegów będących superpozycją quasiperiodycznych i nieperiodycznych:

1) spółgłoski trące dźwięczne (w, z, ż, ź)

2) spółgłoski zwarto-trące dźwięczne dz, dż, dź)

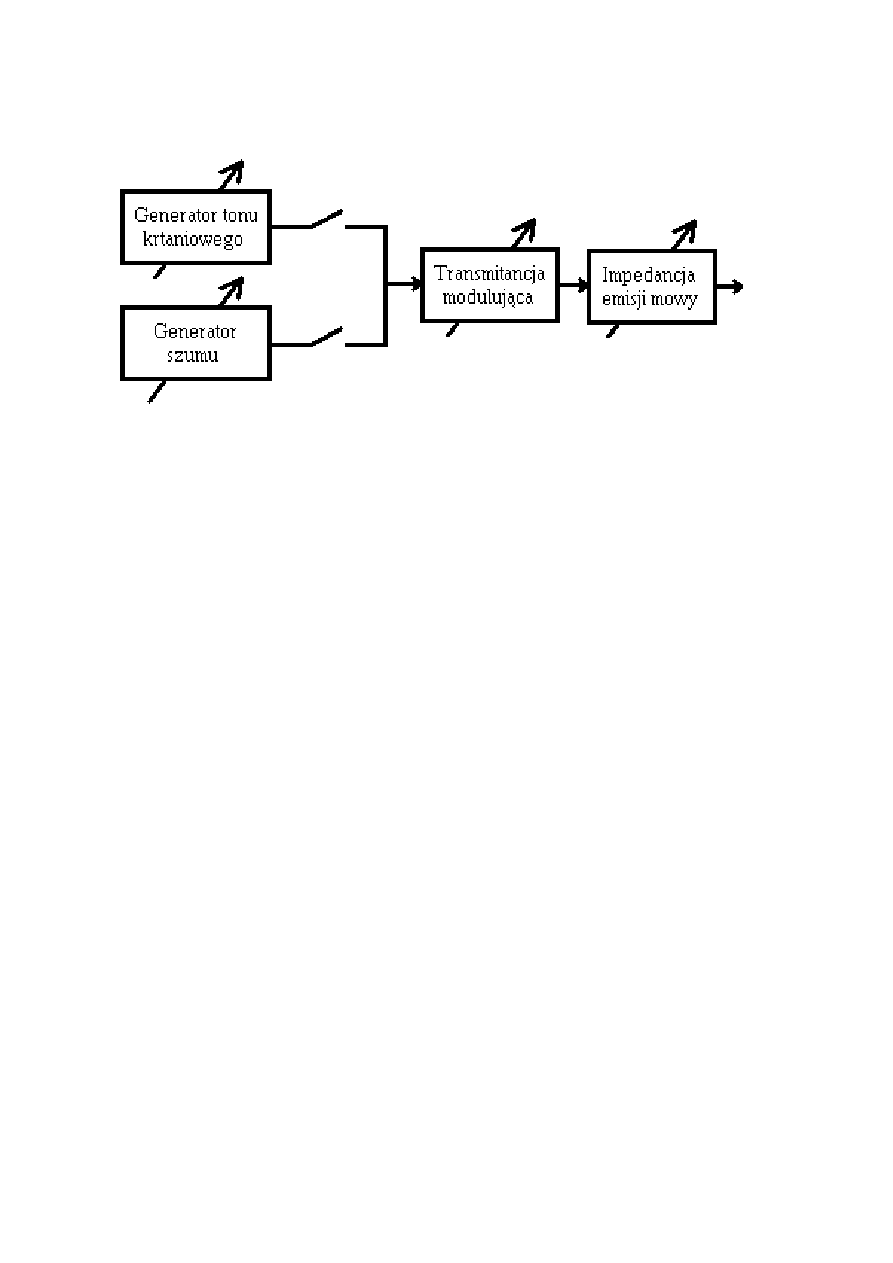

Teoria wytwarzania dźwięków mowy

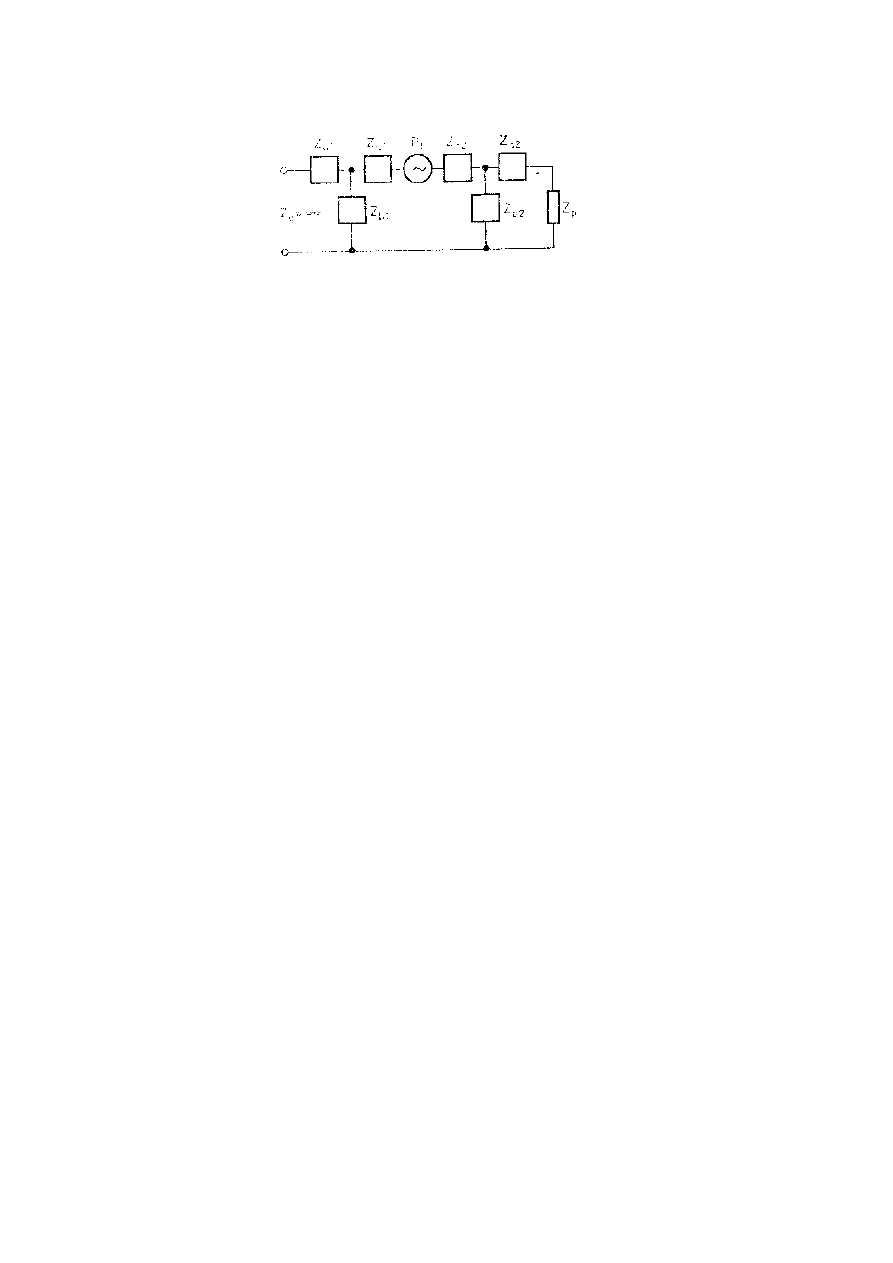

Schemat zastępczy układu wytwarzania dźwięków mowy

Formanty numeruje się: F1, F2, F3 itd., a odpowiadające im częstotliwości w Hz

oznacza się jako F

1

, F

2

, F

3

Największe znaczenie mają dwie wnęki jamy ustnej wynikające z obecności

języka (dwa formanty F1 i F2),

inne wnęki - jama gardłowa, ustna i nosowa.

Podstawowe założenie teorii wytwarzania dźwięków mowy:

Niezależność rezonansowych właściwości i charakterystyk efektorów

artykulacyjnych i źródła tonu krtaniowego

Parametry formantowe zależą zarówno od tonu krtaniowego jak i od

właściwości rezonansowych organu mowy - traktu głosowego

Wyznaczenie struktury formantowej widma sygnału mowy:

uśrednianie kształtu jego obwiedni w przedziałach częstotliwości o szerokości

250-300 Hz (w zakresie dolnym widma < 1500 Hz) oraz 500-700 Hz (w górnym

zakresie >2500 Hz) – ogólnie: powinno to być realizowane przy pomocy filtracji

zbliżonej do przypadku zastosowania filtrów o stałej dobroci.

struktura formantowa samogłosek w mowie ciągłej zależy także od fonemu

poprzedzającego

stała czasowa słuchu: narastanie 20-30 ms, zanikanie 100-200 ms

Mechanizm wytwarzania dźwięków mowy jako proces kształtowania

widma tonu krtaniowego (impulsów krtaniowych)

a) elektryczny układ zastępczy

b) czwórnikowy układ zastępczy dla głosek nienosowych

c) przebiegi czasowe

d) charakterystyki częstotliwościowe, kolejno: tonu krtaniowego,

traktu głosowego, sygnału wynikowego

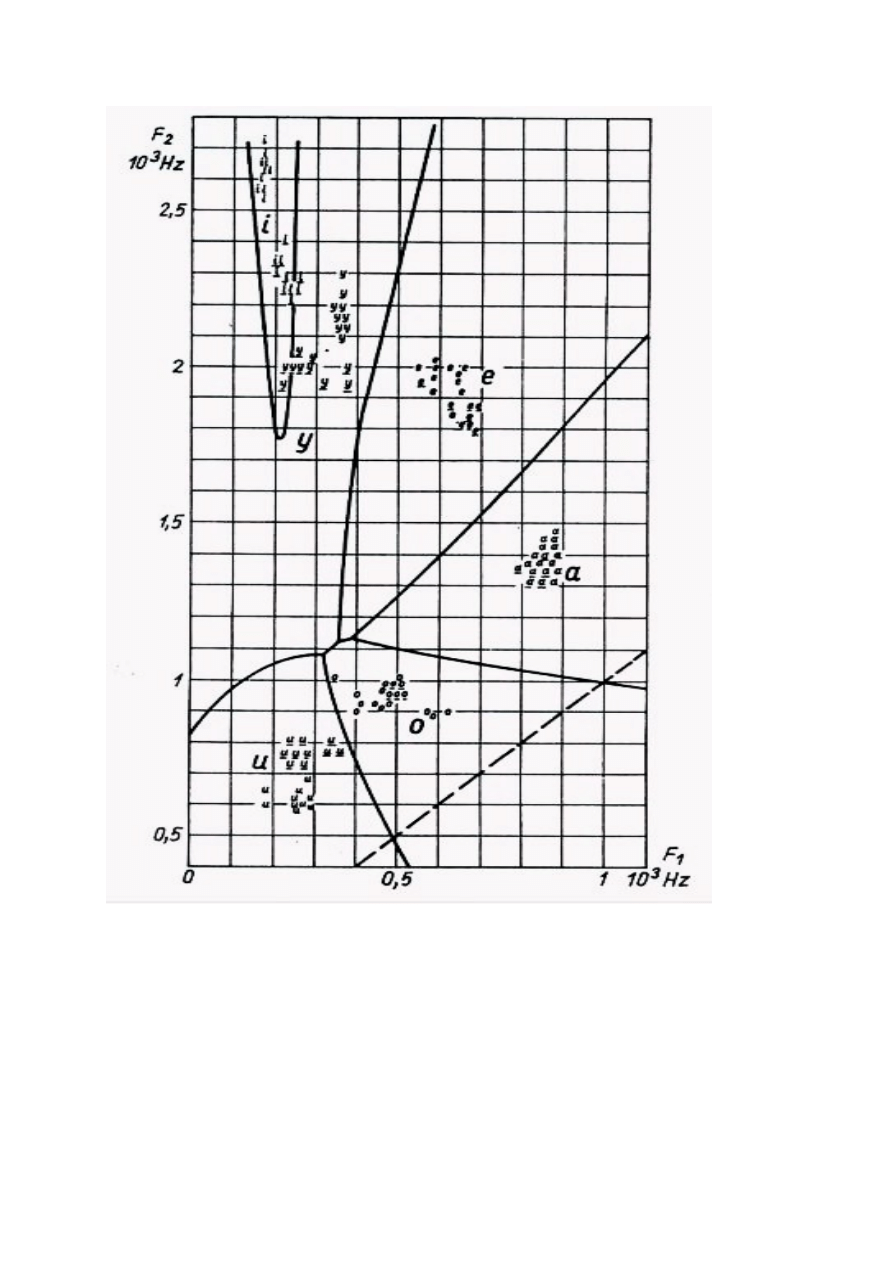

Płaszczyzna F

1

-F

2

dla polskich samogłosek (trójkąt samogłosek). Podane są

przykłady dla kilkunastu wypowiedzi oraz obliczone na ich podstawie obszary

klasyfikacji. Posłużono się tutaj metodyką reguły optymalnej: założenie o

gaussowskim charakterze rozkładów prawdopodobieństwa dla częstotliwości

formantowych F

1

i F

2

(rozkład dwuwymiarowy). Granice obszarów są

dyskryminantami

–

liniami,

w

których

wartości

funkcji

gęstości

prawdopodobieństwa sąsiadujących klas samogłosek są sobie równe. Jest to

jedna z metod identyfikacji nieznanej samogłoski (klasyfikator parametryczny).

Przykładowe parametry formantowe:

Fonem

cz

ę

stotliwo

ś

ci [Hz] poziomy wzgl

ę

dne [dB}

i

210 2750 3500 4200

0 -15 -15 -27

e

380 2640 3000 3600

0 -12 -16 -20

a

780 1150 2700 3500

0 -7 -25 -25

y

240 1550 2400 3300

0 -12 -20 -30

o

400 730 2300 3200

0 -3 -30 -35

u

270 615 2200 3150

0 -13 -40 -50

w

600 1700 2900 4100

-9 0 -2 -10

sz

- 2300 2900 3600

- -9 -8 0

h

500 1700 2500 4200

-12 0 -10 -17

z

- 1750 2950 4300

- -6 -10 0

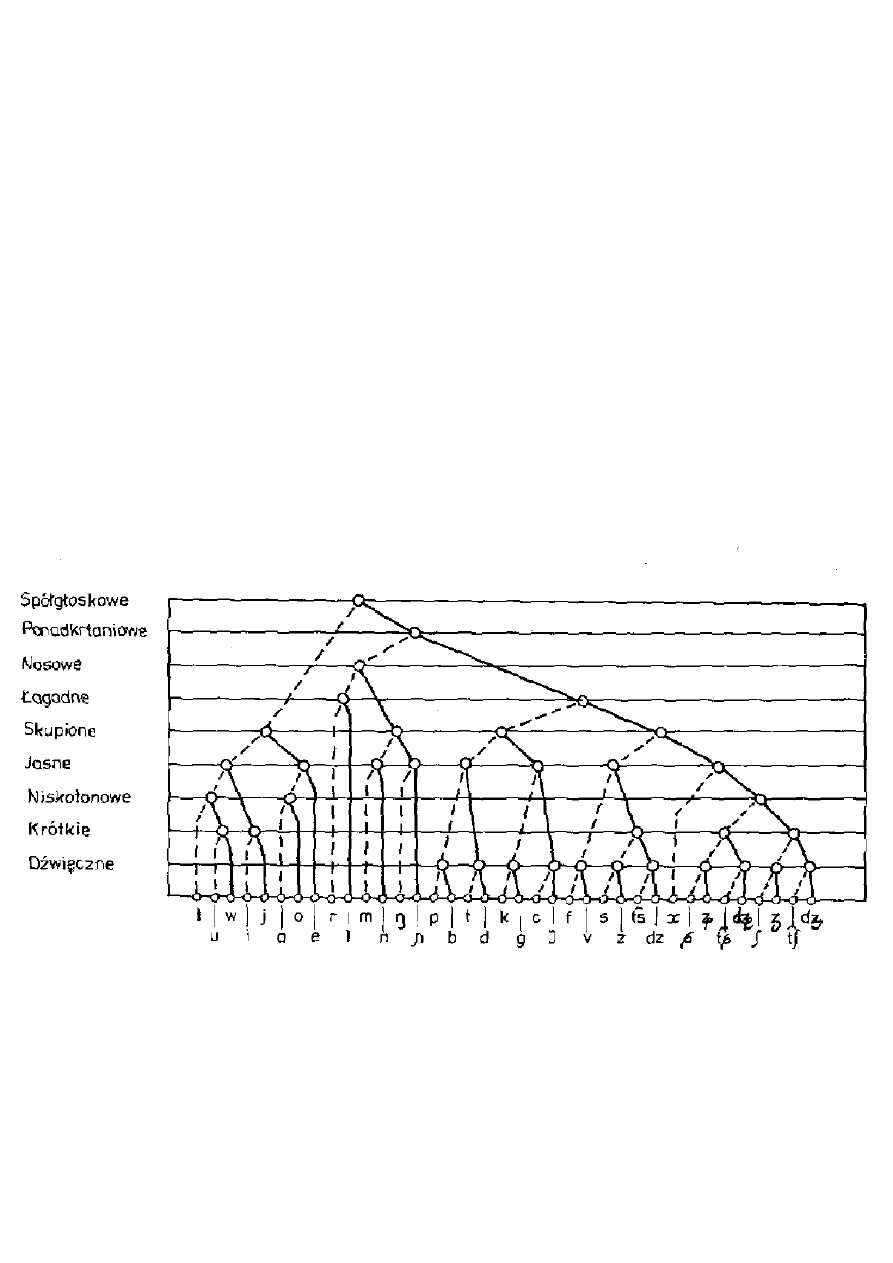

Dendryt binarnych cech dystynktywnych fonemów polskich. Linia ciągła

oznacza obecność cech podanej po lewej stronie rysunku, linia przerywana

brak tej cechy.

Modelowanie mechanizmów wytwarzania dźwięków mowy

TON KRTANIOWY (POBUDZENIE DLA GŁOSEK DŹWIĘCZNYCH)

Jest często nazywany formantem F0 – jego częstotliwość w konsekwencji to parametr F

0,

powstaje jako wynik modulacji strumienia powietrza wypływającego z płuc przez wiązadła

głosowe

- wyniki modelowania prowadzą do przybliżenia wartości nachylenia obwiedni

widma tonu krtaniowego jako –6...-12 dB/oktawę,

- jako przybliżenie przebiegu tonu krtaniowego często stosuje się przebieg

piłokształtny, którego obwiednia widma (wszystkie składowe harmoniczne) ma nachylenie -6

dB/oktawę/

Przyjmuje się, że ton krtaniowy to sygnał o częstotliwości podstawowej wynikającej z

charakteru głosu mówcy (np. tenor - 120-480 Hz) i o widmie składającym się z wszystkich

składowych harmonicznych z obwiednią o nachyleniu od –6 do –12 dB/oktawę

W praktyce widmo tonu krtaniowego nie jest idealnie monotoniczne

POBUDZENIE SZUMOWE

Szumy turbulencyjne - wtórny efekt działania strumienia powietrza

fala udarowa (przy nagłym otworzeniu drogi przepływu) sama staje się żródłem fal

(spółgłoski zwarte)

obwiednia widma - 6 dB/oktawę

TRAKT GŁOSOWY

Jest modelowany fizycznie jako układ fragmentów ściętych stożków lub układ walców. W

tym pierwszym przypadku powstaje model tubowy, zachowujący ciągłość przekroju, w

drugim model cylindryczny. Fakt, że ten drugi model jest łatwiejszy do analizy powoduje

jego rozpowszechnienie do różnych symulacji:

- rezonator Helmholtza (umożliwia modelowanie pojedynczego formantu)

- podwójny rezonator Helmholtza (umożliwia modelowanie dwóch formantów)

- modele złożone z kilku rur zakończonych płaską tarczą kołową (odgrodą) imitującą

charakterystykę promieniowania ust jako nadajnika dźwięku

- trójparametrowy model Fanta, uwzględniający rozkład biegunów i zer na płaszczyźnie

zespolonej i podstawowe trzy parametry: miejsce artykulacji (miejsce największego

przewężenia kanału), stopień tego przewężenia (powierzchnia przekroju) oraz kształt otworu

wylotowego ust

- model Markela-Graya

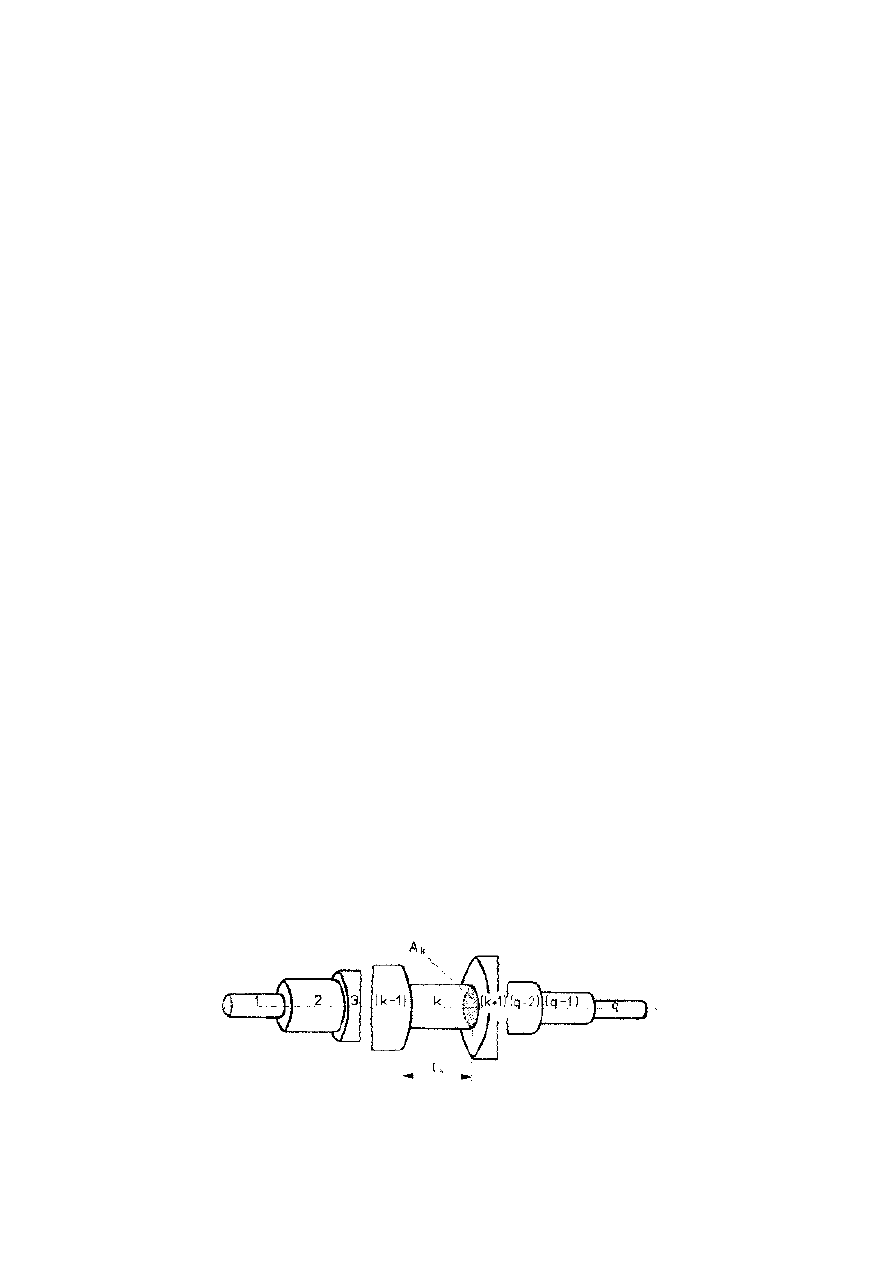

Uproszczony model traktu głosowego (w ogólnym przypadku poszczególne

elementy nie są równe)

Model traktu głosowego – fizyczny i cylindryczny

Elementarny fragment modelu traktu głosowego (z lewej strony) i czwórnik

elektryczny stosowany jako analogia elementarnego odcinka w

modelowaniu elektrycznym (z prawej)

Ogólna struktura modelu elektrycznego

Uproszczenia fizycznego modelu cylindrycznego:

1. niezgodność kształtu przekroju poprzecznego (nie jest kolisty)

2. brak płynności zmian przekroju

3, nieuwzględnienie elastyczności – sztywności ścianek

4, nieuwzględnienie strat propagacji dźwięku

Model Markela-Graya:

- kanał głosowy jest zamodelowany jako kaskadowe połączenie cylindrycznych rur o

jednakowej długości

- dźwięk rozchodzi się jako fala płaska, brak strat wewnętrznych i brak sprzężenia pomiędzy

kanałem głosowym i głośnią

Model konfiguracyjny kanału głosowego jako zbiór kaskadowo

połączonych odcinków cylindrycznych o jednakowych długościach i

zmieniającym się przekroju

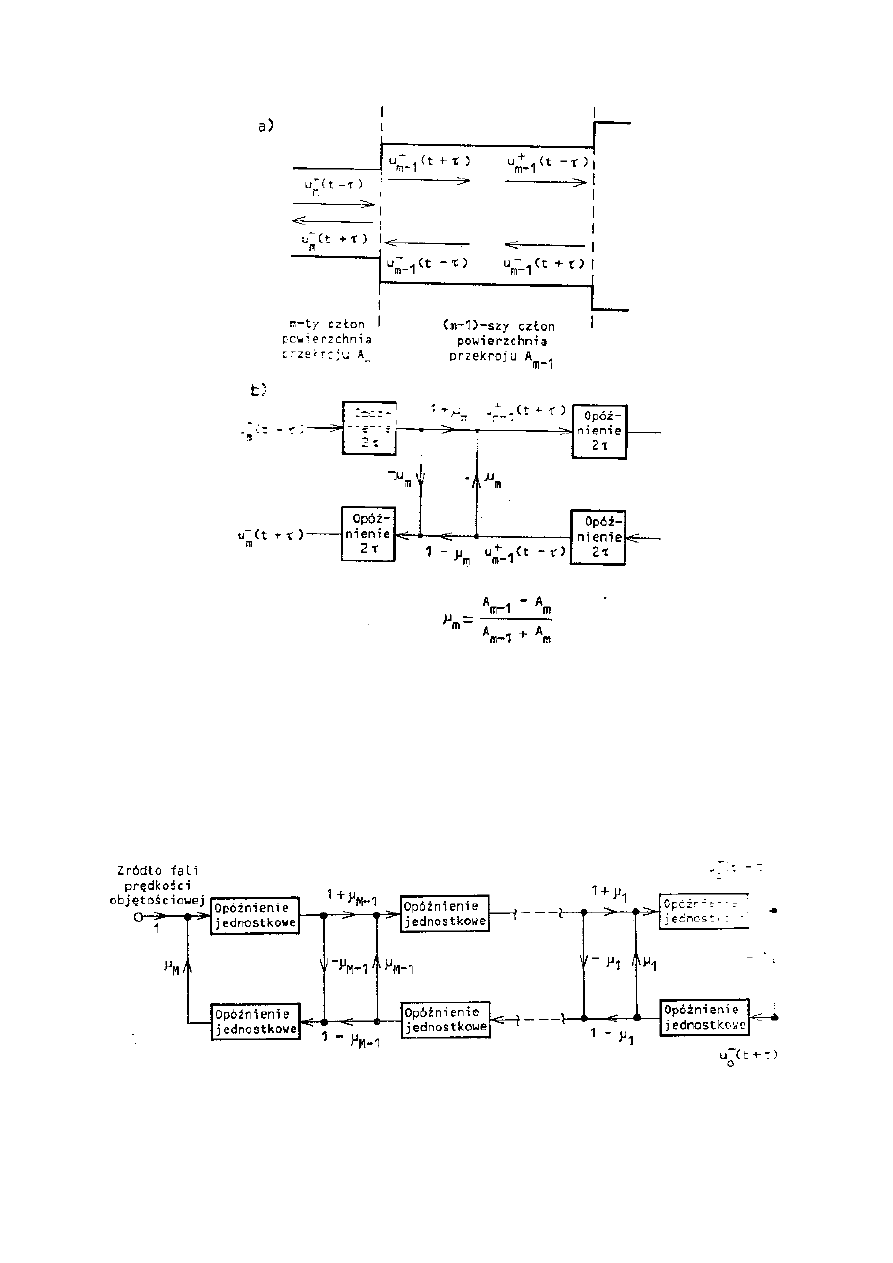

W tym modelu ciśnienie lub prędkość objętościową przedstawia się jako funkcję czasu i

położenia wzdłuż osi rury, zachowana jest ciągłość na granicy dwóch członów, co prowadzi

do odbicia fal w tym miejscu. Związki pomiędzy tymi falami można przedstawić w postaci

grafu przepływowego:

Dwa człony rury akustycznej z zaznaczeniem fal prędkości bieżącej i

powrotnej (a) i graf przepływu sygnału dla prędkości objętościowej (b),

µµµµ

m

– współczynnik odbicia

Liniowy graf przepływu sygnału opisujący zależności pomiędzy falami

prędkości bieżącej i powrotnej w całym modelu Markela-Graya

Uproszczony model procesu artykulacji głosek szumowych

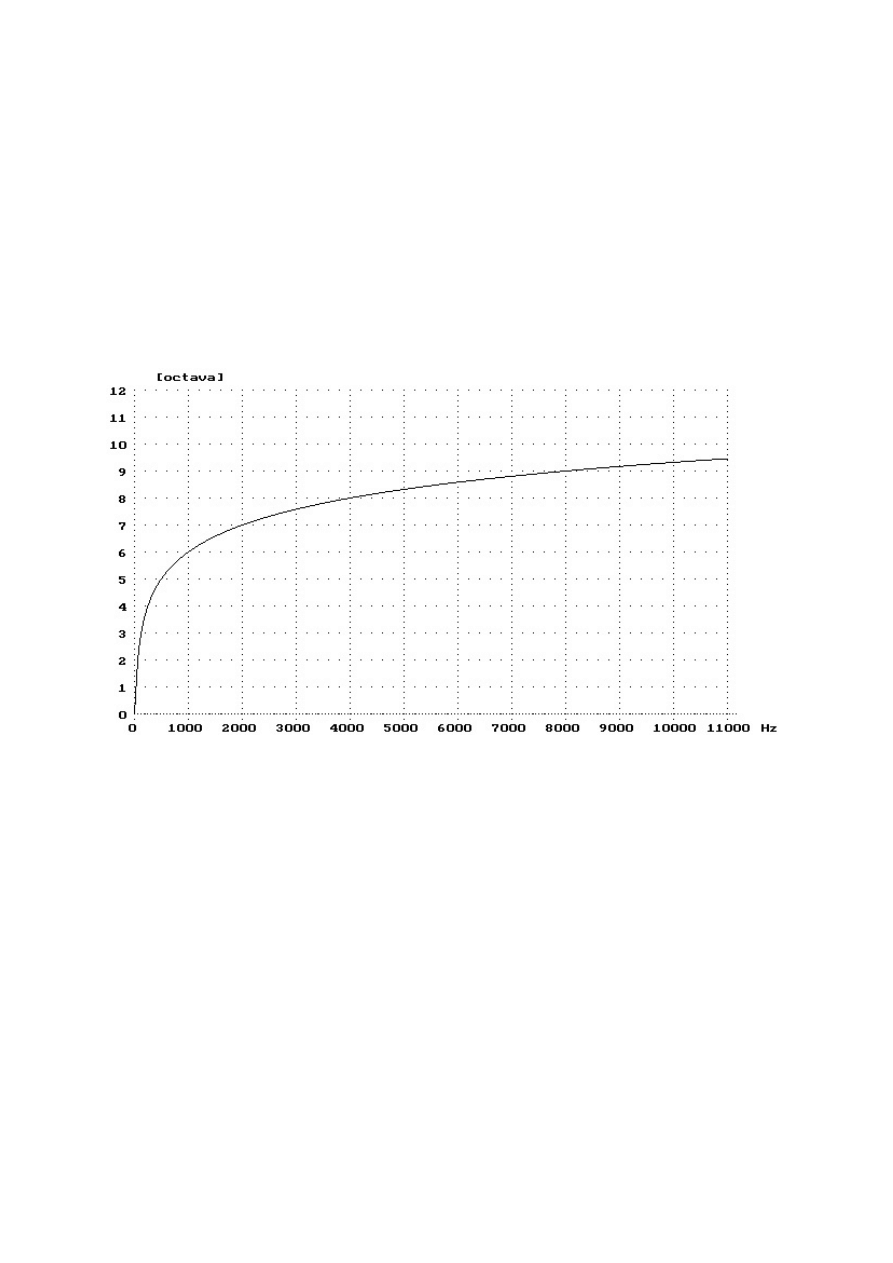

Perceptualne skale częstotliwości

We wszystkich podanych poniżej wzorach na nieliniowe skale częstotliwości

symbol f oznacza częstotliwość wyrażoną w kHz

Skala logarytmiczna (znana z akustyki muzycznej, odpowiada strojowi

równomiernie temperowanemu):

(

)

f

oktawa

⋅

=

64

log

2

Zależność pomiędzy liniową skalą częstotliwości a skalą oktawową

Cechy dźwięków obiektywne mają swoje odpowiedniki w subiektywnych, np.:

- natężenie [dB SPL - sound pressure level] odpowiada głośności w fonach,

- częstotliwość [Hz] ma swój odpowiednik jako wysokość w melach.

Zależności między nimi powstały w oparciu o wyniki tzw. pomiarów

subiektywnych

Skala melowa jest skalą dotyczącą wysokości tonu, czyli wrażenia słuchowego

pozwalającego na określenie położenia tonu na skali częstotliwości. Wrażenie to

zależy jednak także od natężenia dźwięku i dlatego w definicji przyjęto tę

wartość jako 40dB odpowiadające ciśnieniu 2

.

10

-5

Pa. Skala melowa powstała w

oparciu o tony proste - przebiegi sinusoidalne.

Skala melowa została wyznaczona w doświadczeniu, w którym badano słuch

ludzki. Osoba, której podawano dźwięk wzorcowy miała na jego podstawie

zestroić drugi dźwięk tak, aby był dwa razy wyższy od wzorcowego. Skala

melowa miała być zbliżona do charakterystyki "stroju" słuchu ludzkiego.

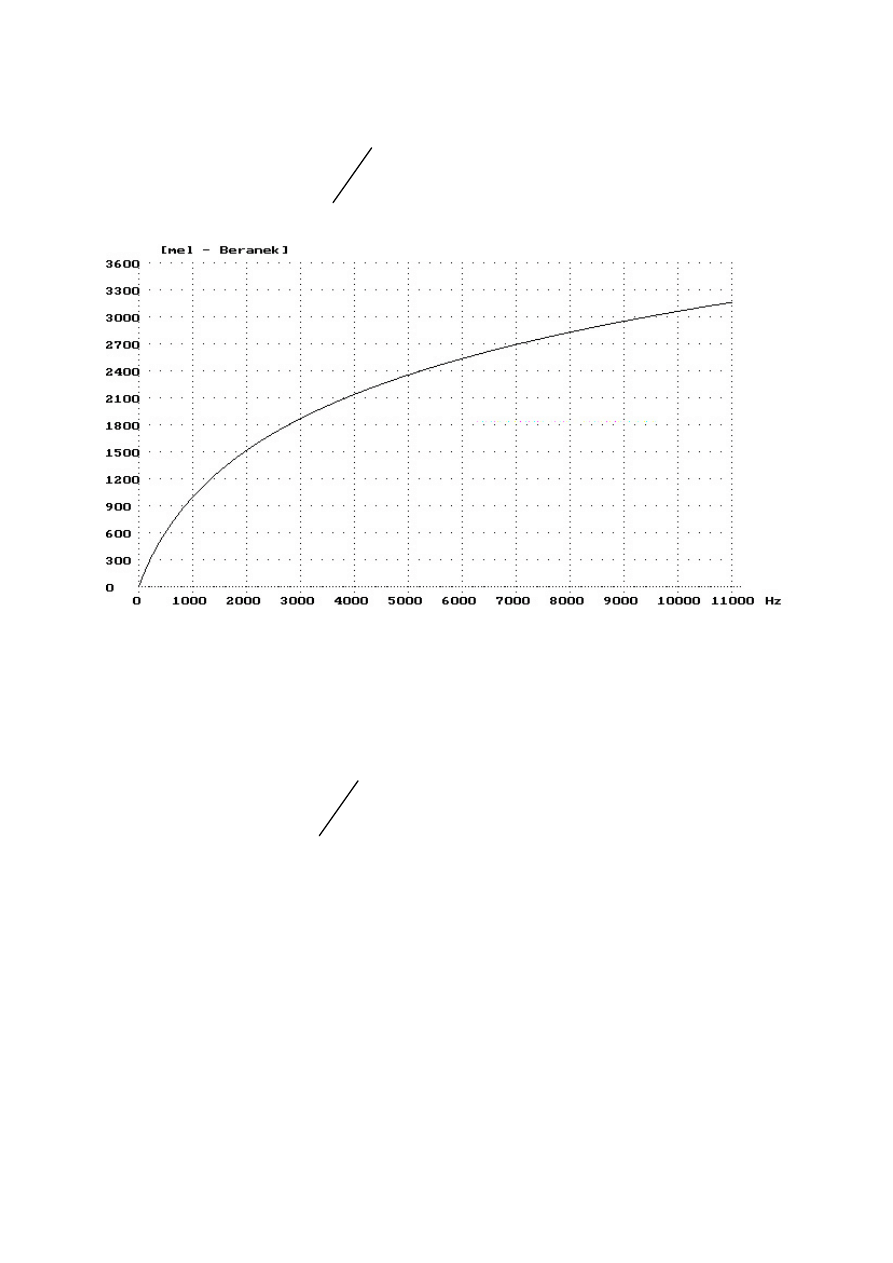

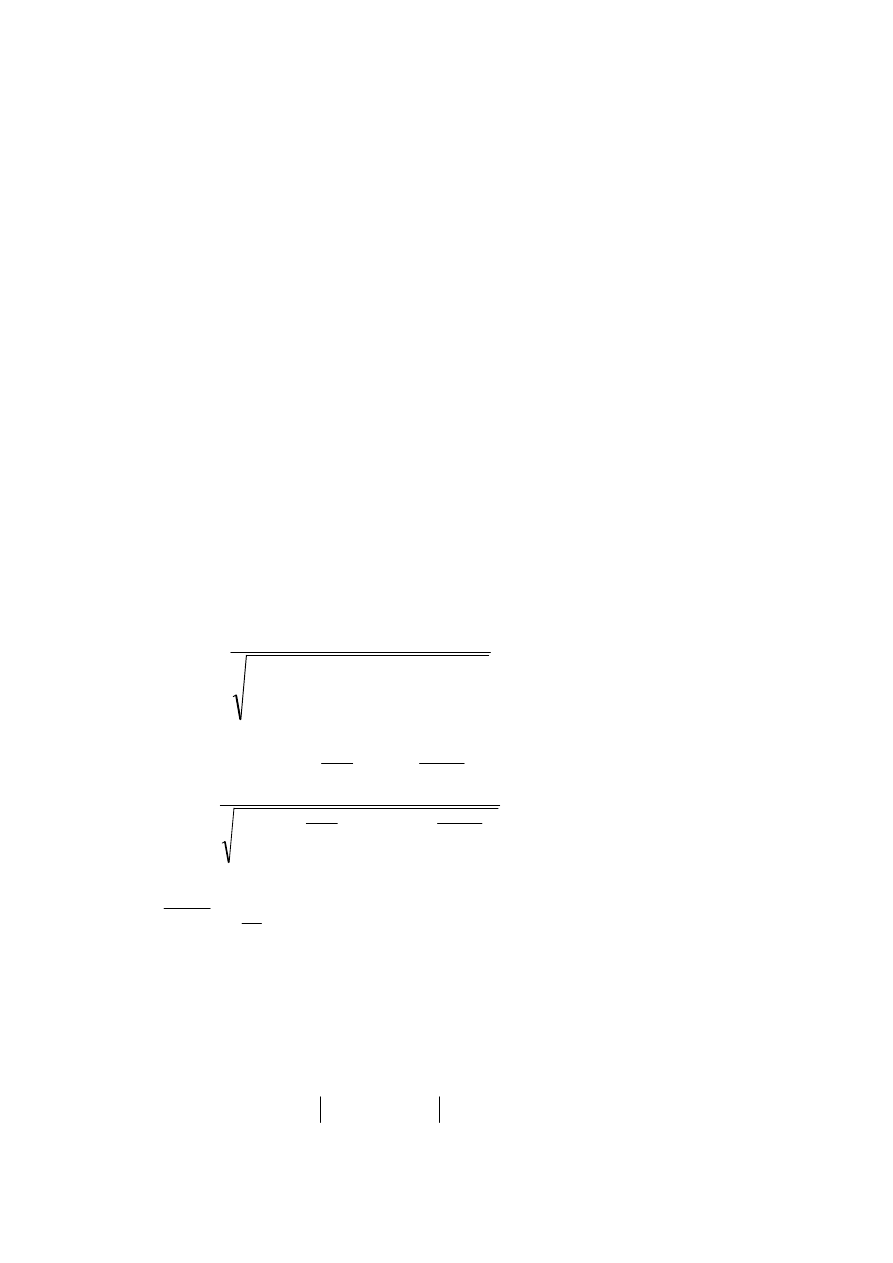

Skala melowa wg Beranka (1000 meli = 1000 Hz):

+

⋅

=

7

.

0

1

ln

1127

f

M

Zależność pomiędzy liniową skalą częstotliwości a skalą melową

Beranka

Skala melowa wg Boersmy & Weeninka:

+

⋅

=

55

.

0

1

ln

550

f

M

Skala barkowa jest związana z pojęciem pasma krytycznego, wynikającego z

badań nad percepcją głośności szumu wąskopasmowego (Zwicker) lub zjawisk

maskowania tonu prostego przez taki szum (Schröder).

Zwicker: badanie wąskopasmowego szumu białego o poziomie 60 dB i stałej

częstotliwości środkowej pasma (np. 1000 Hz). Poszerzanie pasma nie

powoduje zmian głośności dopóki jego szerokość nie osiągnie pewnej wartości

odpowiadającej pasmu krytycznemu (lub grupa częstotliwościowa - określenie

Zwickera)

Fletcher: badanie efektu maskowania tonu prostego przez wąskopasmowy biały

szum. Ton prosty znajduje się w środku tego pasma i ma ustalony taki poziom,

aby był na granicy słyszalności. Szerokość pasma krytycznego jest określana

jako ta, powyżej której nie obserwuje się efektu maskowania.

Definicja American Standard Association: elementarne pasmo częstostliwości

o szerokości

∆

f wydzielone z ciągłego widma szumu i zawierające w sobie moc

akustyczną równoważną mocy akustycznej tonu prostego o częstotliwości f

położonej w środku tego pasma, przy czym rozpatrywany ton prosty ma taką

intensywność, że zagłuszany przez szum o nieograniczonym widmie znajduje

się na granicy słyszalności.

Całe pasmo słyszenia zostało podzielone na 24 pasma krytyczne. Możliwe stało

się określenie zależności pomiędzy wysokością tonu w barkach a

częstotliwością w hercach.

Skala barkowa cechuje się większą nieliniowością od melowej. Można

podsumować, że obie skale są stworzone w celu odzwierciedlenia

charakterystycznej cechy słuchu ludzkiego, czyli jego nieliniowości.

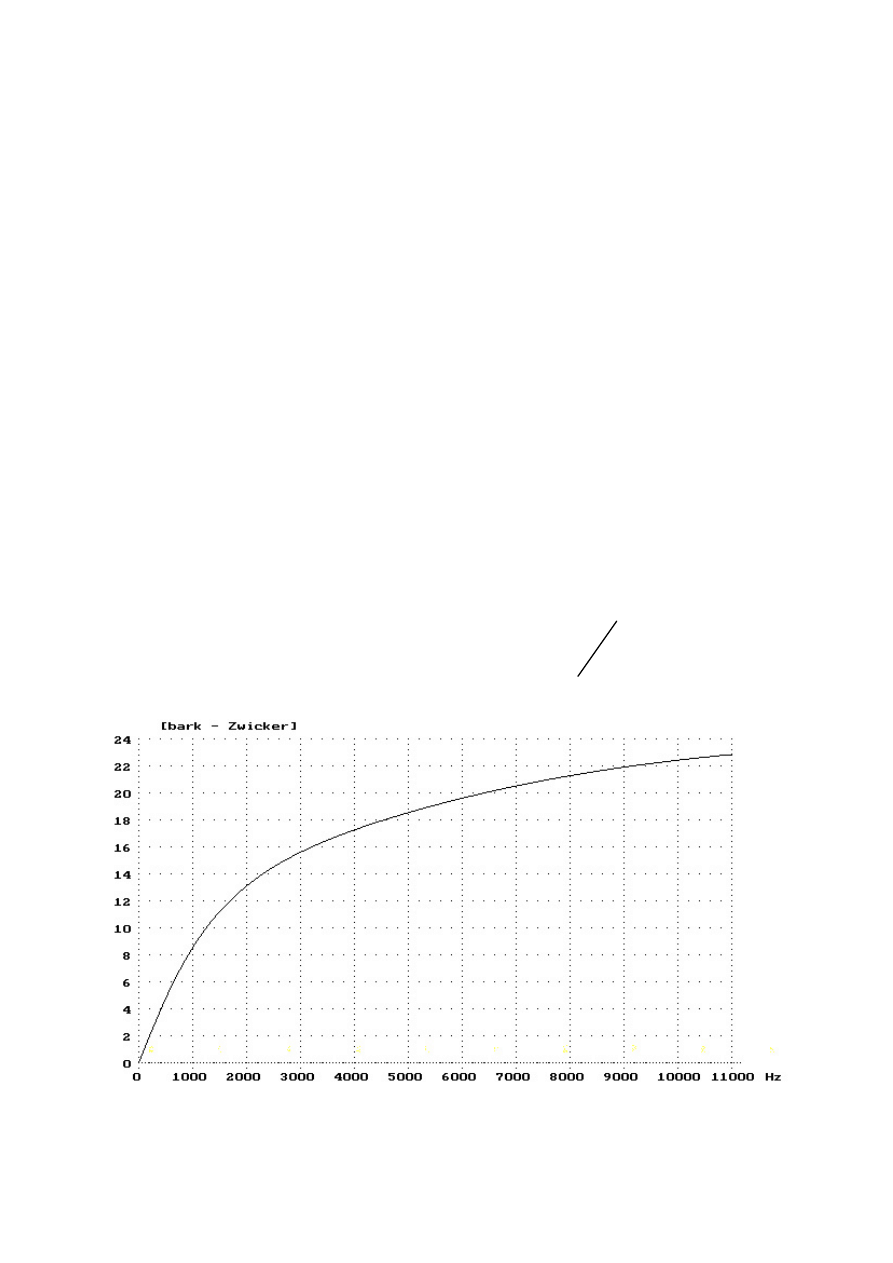

Skala barkowa wg Zwickera:

(

)

⋅

+

⋅

⋅

=

2

5

.

7

arctan

5

.

3

76

.

0

arctan

13

f

f

b

Zależność pomiędzy liniową skalą częstotliwości a skalą barkową Zwickera

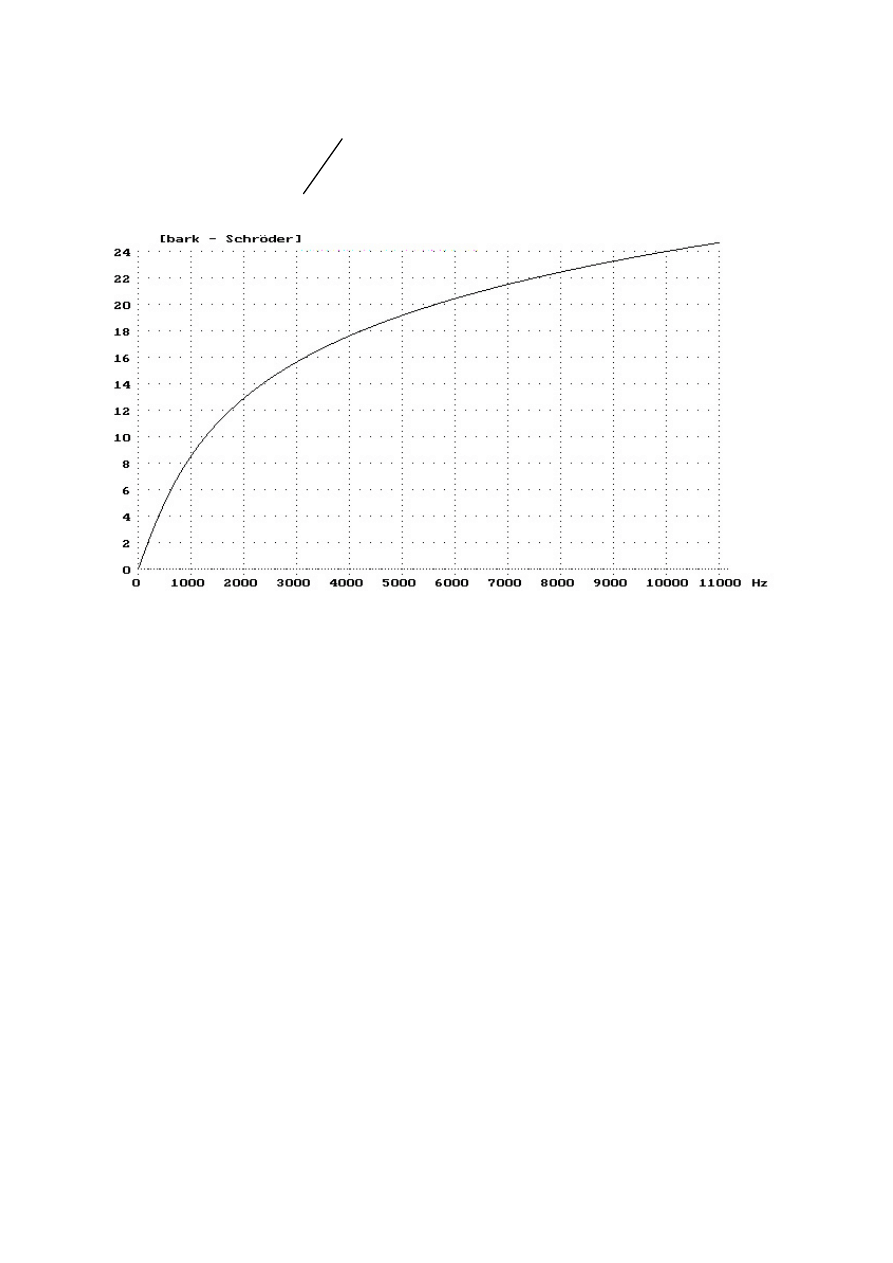

Skala barkowa wg Schrödera:

⋅

=

65

.

0

arcsin

7

f

h

b

Zależność pomiędzy liniową skalą częstotliwości a skalą barkową Schrödera

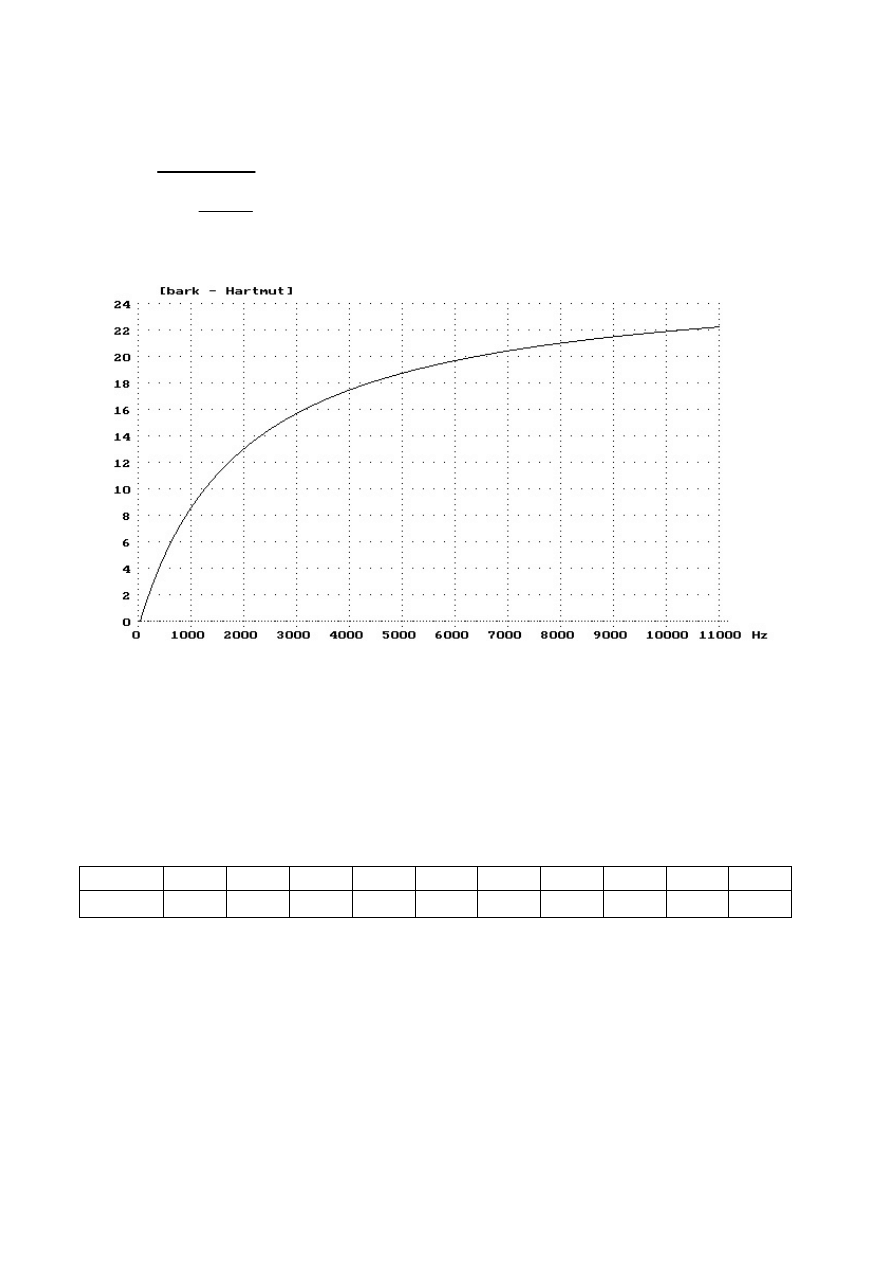

Skala barkowa wg Hartmuta:

53

.

0

96

.

1

1

81

.

26

−

+

=

f

b

Zależność pomiędzy liniową skalą częstotliwości a skalą barkową Hartmuta

Pasma krytyczne mowy: wąskie pasma częstotliwości sygnału mowy, które

pod względem wywoływanego wrażenia słuchowego mogą być traktowane jako

pewne sygnały elementarne równoważne tonowi prostemu.

f

0

[Hz]

200

300

500

800

1000 1500 2000 3000 5000 8000

∆

f [Hz]

60

60

60

70

80

100

130

200

300

600

Znaczenie każdego z pasm krytycznych jest jednakowe w przypadku

zrozumiałości mowy.

Skala Königa (zakres 0 – 4000Hz):

- 10 podpasm o stałej szerokości 100 Hz dla zakresu 0 – 1000Hz

- 10 podpasm o zmiennej szerokości (logarytmicznie) dla zakresu 1000Hz -

4000Hz (zmiana szerokości o czynnik 1.194)

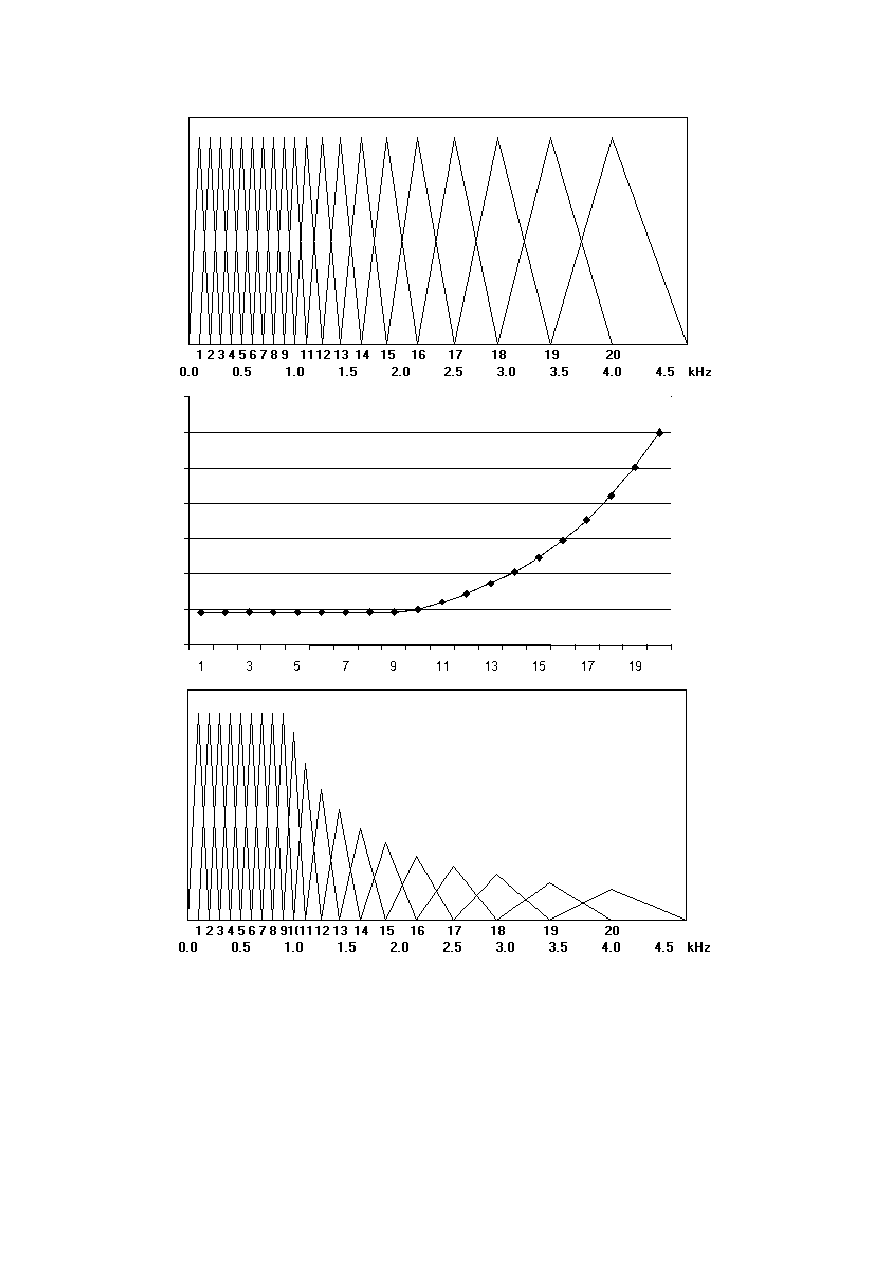

Wykres środkowy obrazuje zależność energii od numeru podpasma Königa.

Wykres dolny przedstawia taki układ wag, aby ilość energii w każdym

podpaśmie nie zależała od jego szerokości.

Metody analizy sygnału mowy

Poziomy analizy:

- akustyczny – związany z wprowadzaniem sygnału do systemu (dobór pasma,

zastosowanie preemfazy, system kodowania itp.),

- parametryczny – ekstrakcja (wydzielanie) parametrów i redukcja informacji,

co powinno prowadzić do równoważnego zapisu parametrycznego pod

względem identyfikacyjnym,

- strukturalny – podział sygnału na segmenty, które powinny podlegać

rozpoznawaniu,

- leksykalny – powinien prowadzić do syntezy rozpoznawanych elementów

fonetycznych w całościowe elementy rozpoznania - najczęściej wyrazy,

- syntaktyczny – analiza gramatyczna wypowiedzi,

- semantyczny – identyfikacja treści wypowiedzi i wydobycie jej „sensu”

DZIEDZINA CZASU

Funkcja autokorelacji r(i) sygnału x(i) może być przedstawiona przy pomocy

ogólnego równania:

( ) (

)

( )

[ ]

(

)

[

]

∑

∑

∑

−

+

=

−

+

=

−

+

=

+

⋅

+

=

1

2

1

2

1

)

(

N

q

q

i

N

q

q

i

N

q

q

i

m

i

x

i

x

m

i

x

i

x

m

r

lub inaczej funkcja autokorelacji to:

( )

(

)(

)

(

) (

)

∑

∑

∑

=

+

+

=

=

+

+

−

−

−

−

=

k

i

n

i

k

n

i

k

i

i

k

i

k

i

n

i

k

n

i

i

k

i

X

X

X

X

X

X

X

X

n

R

1

2

,

1

2

,

1

,

,

gdzie:

∑

+

=

=

i

k

i

j

j

i

k

X

k

X

1

,

Metoda AMDF (Average Magnitude Differential Function), nazywana

również metodą filtru grzebieniowego, stanowi modyfikację metody

autokorelacyjnej. Metoda ta polega na badaniu różnicy pomiędzy sygnałem, a

jego przesunięciem w dziedzinie czasu:

( ) (

)

∑

−

+

=

+

−

=

1

)

(

N

q

q

i

k

m

i

x

i

x

m

AMDF

Wykładnik k może przyjmować różne wartości, np. jeśli zostanie przyjęty jako 2

to wzór ten będzie przypominać podobny wzór służący do obliczenia błędu

ś

redniokwadratowego.

Obie te metody mogą służyć do badania okresowości sygnału, w przypadku

sygnału mowy do określenia dźwięczności danego fragmentu i ewentualnie

estymacji częstotliwości tonu krtaniowego.

Preemfaza 6 dB/oktawa jest równoważna operacji różniczkowania:

( )

( )

[ ]

t

x

dt

d

t

x

p

=

lub dla sygnału skwantowanego w dziedzinie czasu:

( ) (

) ( )

n

x

n

x

n

x

p

−

+

=

1

Preemfazę stosuje się w celu stłumienia niskich częstotliwości i

wyeliminowania składowej stałej (np. podczas analizy przejść przez zero lub

kodowania sygnału).

DZIEDZINA CZĘSTOTLIWOŚCI

Transformata Fouriera sygnału:

gdzie: f – częstotliwość,

t – czas,

y(t) – funkcja czasu (sygnał),

T – długość przedziału całkowania; interpretacja wyników zależy od charakteru

sygnału i od doboru wartości przedziału całkowania (tutaj przyjęto <0,T>)

lub w skrócie:

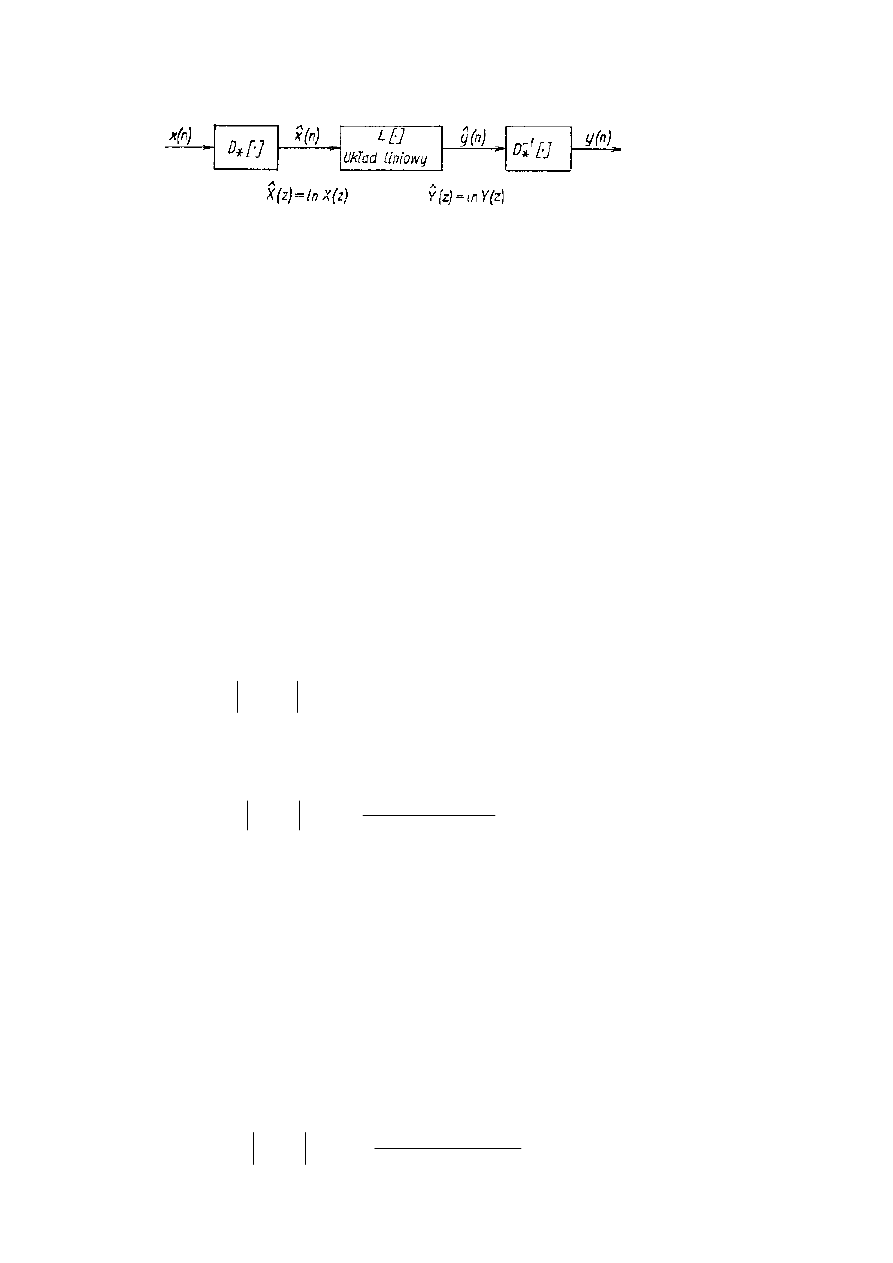

Analiza homomorficzna jest używana do tzw. rozplotu sygnału mowy

(operacja odwrotna do splotu). Sygnał mowy jest splotem funkcji pobudzenia i

odpowiedzi impulsowej kanału głosowego, stąd rozplot prowadzi do

rozdzielenia obu tych przebiegów.

( )

( )

dt

e

t

y

f

X

T

t

f

j

∫

⋅

⋅

⋅

−

⋅

=

0

2

π

( )

( )

[ ]

t

y

F

f

X

=

Postać kanoniczna systemu homomorficznego

Układ D

*

[

.

] przekształca splot sygnałów w sumę (sygnał na wyjściu tego układu

to cepstrum zespolone – cepstrum to anagram słowa spectrum), która w tym

wypadku dla małych n oznacza współczynniki cepstralne opisujące trakt

głosowy, a dla wyższych n wpółczynniki te opisują pobudzenie.

Układ L[

.

] poprzez zastosowanie odpowiedniego okna prostokątnego dokonuje

wyboru jednego lub drugiego składnika.

Końcowy układ poprzez operację pozwala uzyskać odpowiednie przebiegi

czasowe lub też wcześniej ich widma (np. transmitancja traktu głosowego –

widmo wygładzone cepstralnie.)

Cepstrum zespolone sygnału jest zdefiniowane jako:

gdzie: T – dziedzina czasu dla cepstrum,

Cepstrum mocy (transformacja Fouriera):

Cepstrum mocy sygnału (transformacja kosinusowa):

gdzie: X(n) – dyskretne widmo mocy

n –numer prążka widma

N–numer maksymalnego prążka widma analizowanego pasma

częstotliwości,

k–numer współczynnika cepstralnego

Mel-cepstrum (współczynniki mel-cepstralne) to cepstrum w skali melowej

(transformacja kosinusowa):

( )

( )

(

)

[

]

f

X

F

T

X

ln

ˆ

=

( )

( )

[

]

f

X

F

T

X

ln

ˆ

=

( )

( )

[

]

(

)

∑

−

=

⋅

⋅

−

⋅

=

1

0

5

.

0

cos

ln

ˆ

N

n

c

N

k

n

n

X

k

X

π

( )

( )

[

]

(

)

∑

=

⋅

⋅

−

⋅

=

N

n

N

k

n

n

E

k

M

1

5

.

0

cos

ln

π

Widmo wygładzone cepstralnie (transformacja kosinusowa):

gdzie: K – rząd wygładzania, oznacza to zastosowanie w stosunku do cepstrum

okna prostokątnego o wartościach: 1 dla k<=K i 0 dla k>K , odpowiedni dobór

K zapewnia wyeliminowanie sygnału pobudzenia, czyli tony krtaniowego.

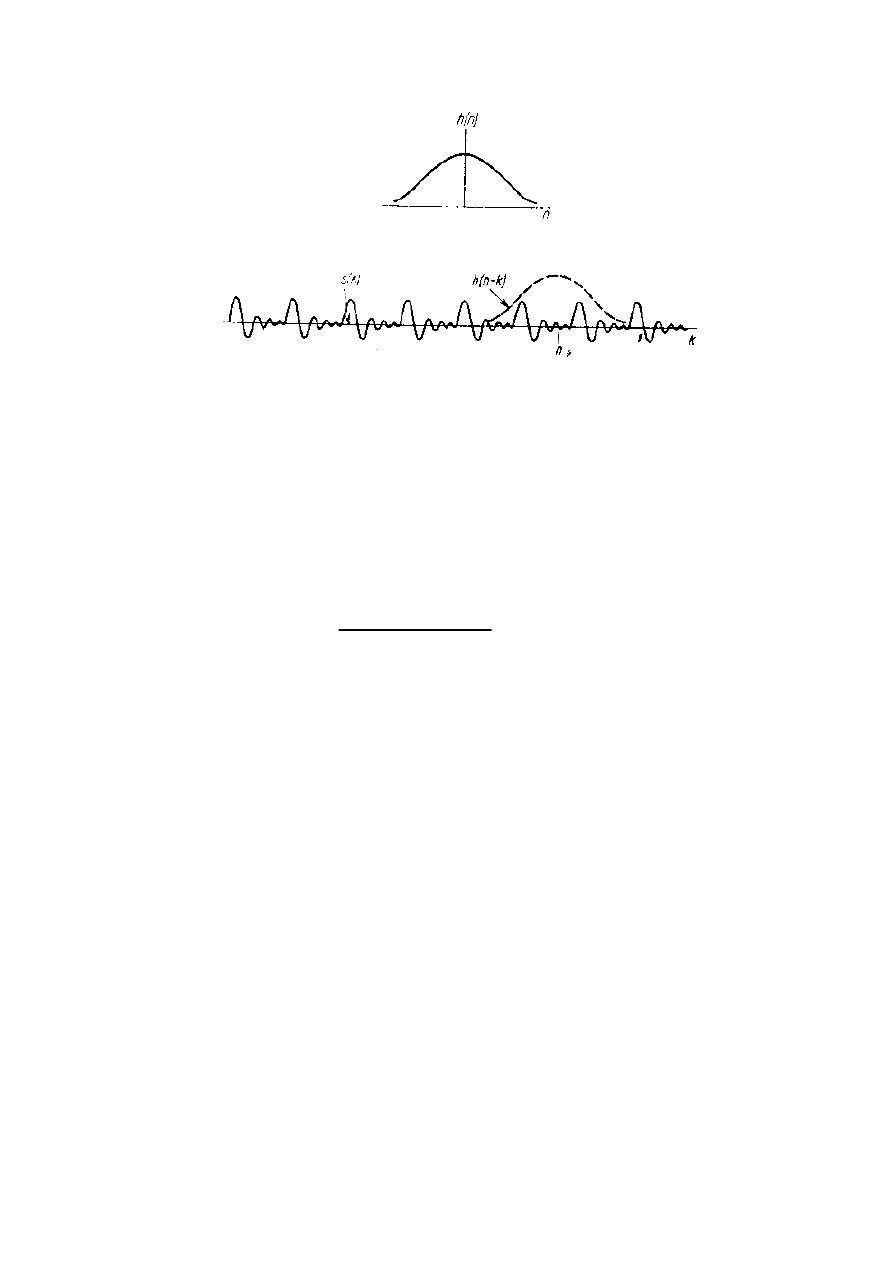

KRÓTKOOKRESOWA ANALIZA FOURIEROWSKA

Jest realizowana w oparciu o segmentację sygnału dając w wyniku serię widm i

w przypadku zastosowania kroku analizy o odpowiedniej długości możliwość

zaobserwowania ewolucji widma. Najczęściej taki wynik jest prezentowany

przy pomocy spektrogramu, czyli wykresu czasowo-częstotliwosciowego.

( )

( ) (

)

∑

+∞

−∞

=

−

⋅

−

⋅

=

k

k

j

e

k

n

h

k

s

n

S

ω

ω

,

gdzie: s(n) – spróbkowany sygnał mowy

h(n) – funkcja okna

( ) ( )

[

]

( )

n

h

e

n

s

n

S

n

j

*

,

ω

ω

−

⋅

=

jest to realizacja analizy poprzez zestaw filtrów

( )

( ) (

)

(

)

∑

+∞

−∞

=

−

−

⋅

−

⋅

⋅

=

k

k

n

j

n

j

e

k

n

h

k

s

e

n

S

ω

ω

ω

,

( )

( ) ( )

[

]

{

}

n

j

n

j

e

n

h

k

s

e

n

S

ω

ω

ω

⋅

⋅

=

−

*

,

gdzie:

( )

n

j

e

n

h

ω

−

⋅

- filtr środkowoprzepustowy o częstotliwości

ś

rodkowej

ω

( )

( )

∑

=

⋅

⋅

⋅

=

K

k

c

c

N

k

n

k

X

n

X

0

cos

ˆ

π

Przedstawienie krótkookresowej transformacji Fouriera

ANALIZA LPC (linear predictive code)

Ogólna postać transmitancji wymiernej opisującej kanał głosowy

przedstawia się następująco:

( )

∑

∑

=

−

=

−

⋅

−

⋅

+

⋅

=

p

k

k

k

q

l

l

l

z

a

z

b

G

z

H

1

1

1

1

gdzie:

G - wzmocnienie,

b

l

– współczynniki opisujące zera transmitancji,

a

k

– współczynniki opisujące bieguny transmitancji.

Odpowiedź

impulsowa

oraz

charakterystyka

częstotliwościowa

odpowiadające tej transmitancji są nieliniowymi funkcjami współczynników

licznika i mianownika, zatem obliczenie tych parametrów polega na rozwiązaniu

układu równań nieliniowych.

Podejście to jest ogólne w tym sensie, że zakłada jednoczesną obecność

zer i biegunów w rozpatrywanej transmitancji. Dla często przyjmuje się opis

transmitancji jako zawierającej wyłącznie zera (stopień mianownika p=0) lub

wyłącznie bieguny (stopień licznika q=0). W każdym z tych przypadków

rozwiązanie opiera się na układzie równań liniowych. Ten drugi przypadek

(wyłącznie bieguny) jest o tyle uzasadniony, że prowadzi do aproksymacji

charakterystyki kanału głosowego w postaci ukazującej częstotliwości

rezonansowe, czyli ujawniającej naturę formantową sygnału mowy.

Równanie to w przypadku pominięcia zer upraszcza się do postaci:

( )

∑

=

−

⋅

−

⋅

=

p

k

k

k

z

a

G

z

H

1

1

1

Odpowiedź impulsowa dla powyższej transmitancji jest opisana przez

równanie różnicowe:

( )

( )

(

)

∑

=

−

⋅

+

⋅

=

p

k

k

k

n

v

a

n

G

n

v

1

δ

Dla n>0 równanie upraszcza się do postaci:

( )

(

)

∑

=

−

⋅

=

p

k

k

k

n

v

a

n

v

1

Prawa strona powyższego równania to kombinacja liniowa p poprzednich

wartości odpowiedzi impulsowej, stąd pochodzi nazwa predykcja liniowa. Ze

względu na to, że model jest jedynie przybliżeniem rzeczywistej sytuacji, można

jedynie zminimalizować błąd e(n) pomiędzy wartościami obserwowanymi v(n)

a otrzymanymi z modelu

( )

n

vˆ

:

( ) ( ) ( ) ( )

(

)

∑

=

−

⋅

−

=

−

=

p

k

k

k

n

v

a

n

v

n

v

n

v

n

e

1

ˆ

Za kryterium służącym do obliczenia współczynników predykcji a

k

przyjmuje się minimum błędu średniokwadratowego:

( )

( )

(

)

∑

∑

∑

−

=

=

−

=

−

⋅

−

=

=

1

1

2

1

1

1

2

N

n

p

k

k

N

n

k

n

v

a

n

v

n

e

E

W powyższym wzorze górna granica sumowania N-1 oznacza liczbę

dostępnych próbek ciągu v(n). Obliczenie współczynników predykcji sprowadza

się więc do rozwiązania układu p równań:

0

=

i

a

E

ϑ

ϑ

gdzie i=1, 2 ...p.

Do rozwiązania powyższego układu równań stosowane są zazwyczaj dwie

metody: autokowariancji lub częściej zalecana metoda autokorelacji. Każda z

tych metod ma wady i zalety: pierwsza z nich jest dokładniejsza, ale może

prowadzić do niestabilnych rozwiązań. Druga natomiast zapewnia stabilność,

czyli lokalizację rozwiązań wewnątrz jednostkowego okręgu na płaszczyźnie

zespolonej. Ponadto współczynniki autokorelacji są elementami macierzy

Toeplitza, co umożliwia zastosowanie szybkiego algorytmu iteracyjnego

odwracania macierzy (algorytmy Levinsona, Robinsona i Durbina). Dodatkowo

przy zastosowaniu algorytmu Durbina uzyskuje się tablicę współczynników

odbicia, co stanowi nawiązanie do cylindrycznego modelu traktu głosowego

zaproponowanego przez Markela-Graya.

Metoda Durbina:

gdzie:

j=1…i-1

przy czym:

a

j

(i)

dla j=1,2…, i – współczynniki predykcji układu i-tego rzędu,

Zbiór równań rozwiązuje się rekurencyjnie dla i=1,2…, p, zaczynając

od E

0

=R(0)

Rozwiązanie końcowe:

a

j

= a

j

(p)

j=1,2…, p

k

j

– współczynniki odbicia

( )

(

) ( )

1

1

1

−

−

=

−

∑

−

−

=

i

i

j

j

i

j

i

E

i

R

j

i

R

k

α

( )

i

i

i

k

a

−

=

( )

( )

( )

1

1

−

−

−

⋅

+

=

i

j

i

i

i

j

i

j

a

k

a

a

(

)

1

2

1

−

⋅

−

=

i

i

i

E

k

E

Standardy

µµµµ

-law i A-law

Podstawą dla nieliniowej kwantyzacji jest

prawo Webera-Fechnera:

Minimalny dostrzegalny przyrost dowolnego bodźca

∆

p jest proporcjonalny do

wartości tego bodźca, względem którego dokonuje się tego porównania:

Występują jednak ograniczenia zakresu stosowalności prawa Webera-Fechnera -

dotyczą one skrajnych zakresów skali: dolnej - w pobliżu progu czułości i

górnej, gdzie występuje zjawisko nasycenia.

Z prawa Webera-Fechnera wynika celowość stosowania skali logarytmicznej w

celu dokonania kompresji amplitudy sygnalu przed jego transmisją lub

przetwarzaniem. Funkcję realizującą takie przekształcenie nazywa się funkcją

kompresji. Oczywiście dla odtworzenia pierwotnego sygnału należy zastosować

funkcję do niej odwrotną.

W praktyce stosowane skale są zmodyfikowane w sposób pozwalający na

uniknięcie obliczania logarytmu z zera.

Nieliniowa kwantyzacja

µµµµ

-law (amerykańska):

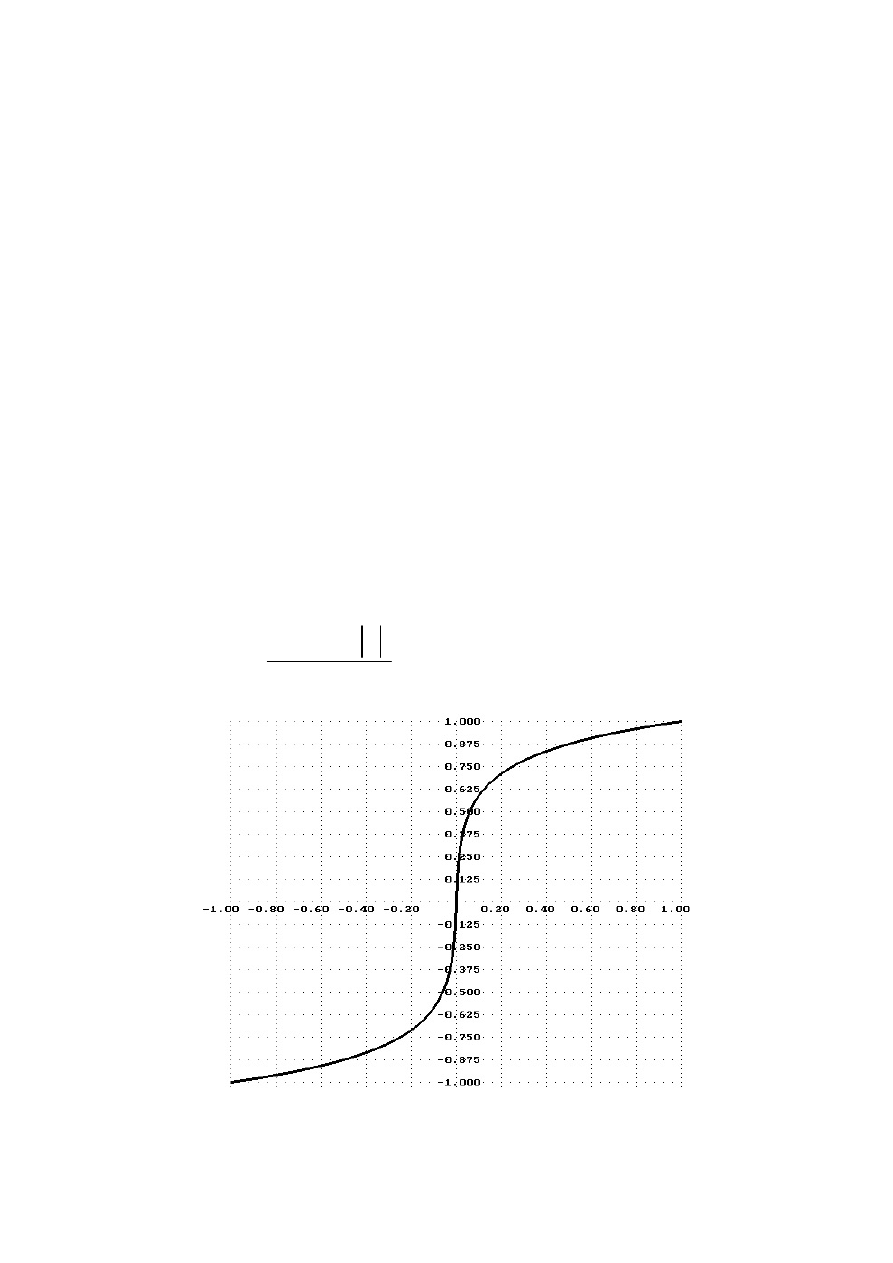

Wykres zależności pomiędzy skalą liniową a skalą

µµµµ

-law

( )

( )

(

)

(

)

1

1

1

ln

1

ln

sgn

≤

≤

−

+

⋅

+

⋅

=

x

dla

x

x

x

F

µ

µ

p

k

p

⋅

=

∆

Nieliniowa kwantyzacja A-law (europejska – Niemiecki Urząd Poczt):

Wartości funkcji kompresji dla wybranych punktów skali nieliniowych:

µµµµ

-law (

µµµµ

= 247):

x

0.5

0.25

0.125

0.0625

0.03125 0.015625

F(x)

0.87501 0.75074 0.62789 0.50777 0.39276 0.28674

A-law (A = 87.7):

x

0.5

0.25

0.125

0.0625

0.03125 0.015625

F(x)

0.87337 0.74675 0.62012 0.49349 0.36686 0.24024

skala logarytmiczna:

x

0.5

0.25

0.125

0.0625

0.03125 0.015625

F(x)

0.875

0.750

0.625

0.500

0.375

0.250

Zastosowanie powyższych standardów pozwala na zwiększenie dynamiki

sygnału o około 24dB, tzn. sygnał zakodowany na 8 bitach nieliniowu

odpowiada sygnałowi o kwantyzacji liniowej 12 bitów.

Standardy te są punktem odniesienia dla obliczeń stopnia kompresji sygnału

mowy w przypadku wokoderów (czyli: częstotliwość próbkowania = 8kHz,

liczba bitów na próbkę = 8, co oznacza szybkość transmisji 64 kilobity/sek.).

Przykładowo dla wartości kompresji dźwięku 1:10 szybkość transmisji wynosi

6,4 kb/sek.

( )

( )

(

)

( )

A

x

A

dla

A

x

A

x

x

F

1

1

ln

1

ln

1

sgn

≤

≤

−

+

⋅

+

⋅

=

( )

( )

( )

A

x

oraz

x

A

dla

A

x

A

x

x

F

1

1

1

1

ln

1

sgn

−

≤

≤

−

≤

≤

+

⋅

⋅

=

Parametryzacja sygnału mowy

DZIEDZINA CZASU:

Możliwe są dwa podejścia:

1. Oparte na tzw. makrostrukturze sygnału – obliczenia są wykonywane w odcinkach

czasowych po wstępnej segmentacji, uzyskane parametry to amplituda i szybkość zmian.

2. Oparte na tzw. mikrostrukturze sygnału, czyli przebiegu czasowym, analizującym

przejścia sygnału mowy przez zero. Prowadzi to uzyskania dwóch rodzajów parametrów:

gęstość przejść przez zero i rozkład interwałów czasowych. Analiza przejść przez zero

powstała w oparciu o spostrzeżenie, że sygnał mowy zachowuje zrozumiałość w

przypadku dokonania przekształcenia na falę prostokątną (mimo dużych zniekształceń i

utraty jakości). Zostaje wówczas zachowana jedynie informacja o momentach

czasowych, w których sygnał przechodzi przez zero. Odpowiada to kodowaniu

jednobitowemu.

Zaletą parametryzacji czasowej jest prostota i szybkość algorytmu.

W praktyce okazało się, że parametry czasowe nie są najlepsze pod względem

skuteczności rozpoznawania mowy, pomimo stosowania dodatkowych zabiegów na

sygnale: preemfaza 6dB/oktawę (różniczkowanie), preemfaza 12dB/oktawę (dwukrotne

różniczkowanie), deemfaza (całkowanie) i inne. Lepsze okazały się parametry

częstotliwościowe.

Gęstość przejść przez zero oznacza się parametrem

ρ

0

, po zastosowaniu preemfazy

6dB/oktawę

ρ

1

, zaś preemfazy 12dB/oktawę

ρ

2

. Odpowiednio dla deemfazy i podwójnej

deemfazy:

ρ

−1

i

ρ

−2

.

Preemfaza jest to proces mający na celu przeskalowanie mocy sygnału tak, by różne

częstotliwości miały podobny poziom, gdyż oryginalnie nie jest on równomierny dla

sygnału mowy.

Preemfaza jest skuteczna dla sygnału mowy, ponieważ podbija wysokie częstotliwości

(głoski szumowe mają małe amplitudy), wskutek tego staje się bardziej odporna na

zakłócenia.

DZIEDZINA CZĘSTOTLIWOŚCI:

Moment widmowy m-tego rzędu:

gdzie: G(k) – wartość widma mocy dla k-tego pasma częstotliwości

f

k

– częstotliwość środkowa k-tego pasma

( )

( )

[ ]

∑

∞

=

⋅

=

0

k

m

k

f

k

G

m

M

Moment unormowany m-tego rzędu:

Moment unormowany centralny m-tego rzędu:

Szczególne przypadki momentów widmowych:

Moment rzędu zerowego, mający zastosowanie normalizujące, oznacza moc sygnału:

Moment unormowany pierwszego rzędu jest używany we wzorach do obliczeń momentów

centralnych wyższych rzędów – ma interpretację środka ciężkości widma:

Moment unormowany centralny drugiego rzędu – ma interpretację kwadratu szerokości

widma:

Moment unormowany centralny trzeciego rzędu to niesymetria widma, inaczej skośność

(ang. skewness):

( )

( )

( )

0

M

m

M

m

M

u

=

( )

( )

( )

[

]

( )

∑

∞

=

−

⋅

=

0

0

1

k

m

u

k

uc

M

M

f

k

G

m

M

( )

( )

( )

∑

∞

=

⋅

=

0

0

1

k

k

u

M

f

k

G

M

( )

( )

( )

[

]

( )

∑

∞

=

−

⋅

=

0

2

0

1

2

k

u

k

uc

M

M

f

k

G

M

( )

( )

( )

[

]

( )

∑

∞

=

−

⋅

=

0

3

0

1

3

k

u

k

uc

M

M

f

k

G

M

( )

( )

∑

∞

=

=

0

0

k

k

G

M

Parametr będący miarą płaskości widma (ang. flatness):

inaczej:

gdzie: x

j

– j-ta obserwacja spośród N dostępnych obserwacji

x – średnia arytmetyczna dla wszystkich N obserwacji

σσσσ

x

– odchylenie standardowe liczone na podstawie obserwacji estymator

nieobciążony:

(

)

∑

=

−

⋅

−

=

N

j

j

x

x

x

N

1

2

1

1

σ

Inny parametr służący jako miara płaskości widma (ang. spectral flatness measure) do

stosunek średniej geometrycznej do średniej arytmetycznej widma mocy:

gdzie:

N

k

j

e

P

π

2

to widmowa gęstość mocy

obliczona za pomocą N-punktowej transformacji Fouriera.

Momenty widmowe mogą być także liczone dla fragmentów widma, zakresy sumowania w

powyższych wzorach muszą wówczas zostać zmienione z <0, ∞> na <f

d

, f

g

>, gdzie: f

d

i f

g

to punkty widma odpowiadające częstotliwości dolnej i górnej. Przykładowo pierwszy

moment znormalizowany (środek ciężkości widma) liczony w zakresie pomiędzy dwoma

kolejnymi minimami obwiedni widma może być interpretowany jako częstotliwość

formantu znajdującego się w tym paśmie częstotliwości.

( )

( )

[

]

2

2

4

uc

uc

M

M

kurtosis

=

(

)

∑

=

−

=

N

j

x

j

x

x

N

kurtosis

1

4

4

1

σ

⋅

⋅

=

∑

∏

=

=

2

/

1

2

2

/

1

2

/

1

2

2

/

1

log

10

N

k

N

k

j

N

N

k

N

k

j

e

P

N

e

P

SFM

π

π

Analiza cepstralna (homomorficzna)

Widmo wygładzone cepstralnie – jest to postać widma amplitudowego wygładzonego po

odfiltrowaniu z cepstrum części pobudzeniowej. Z fragmentu cepstrum (zawierającego

tylko część dotyczącą traktu głosowego) można wyekstrahować parametry niosące ważne

informacje o trakcie głosowym.

W oparciu o obliczone widmo mocy (lub jego fragment) można dokonać analizy

cepstralnej, która prowadzi do uzyskania współczynników cepstralnych, z których niskie

to parametry obwiedni widma, natomiast wyższe mogą nieść informację o tonie

krtaniowym o ile w wykresie cepstrum występuje wyraźne maksimum (to tylko dla

fonemów dżwięcznych). W tym przypadku parametry cepstralne to wektor składający się

z niskich współczynników opisujących obwiednię widma, natomiast wyższe

współczynniki mogą służyć jedynie do ekstracji tonu krtaniowego (tzn. określenia czy

istnieje oraz estymacji jego częstotliwości).

Na podstawie niskich współczynników cepstralnych można uzyskać widmo wygładzone

cepstralnie, przy czym liczba tych współczynników to rząd wygładzania cepstralnego.

Stosując wygładzanie cepstralne można uzyskać parametry formantowe (częstotliwości i

poziomy) jako współrzędne lokalnych maksimów widma wygładzonego cepstralnie.

Logarytm widma wygładzonego cepstralnie (transformacja kosinusowa):

Spośród innych metod prowadzących do parametrów formantowych to klasyczna analiza

przy pomocy filtrów o stałej dobroci oraz w dziedzinie cyfrowej analiza LPC, na

podstawie analizy maksimów, przy odpowiednim ustaleniu rzędu analizy.

( )

∑

=

⋅

⋅

⋅

=

K

k

k

N

k

n

C

n

Y

0

cos

π

Kompresja sygnału mowy

Wokodery - urządzenia służące do ograniczania objętości informacyjnej sygnału mowy

metodą ekstrakcji parametrów i następnie po przesłaniu parametrów przez kanał

telekomunikacyjny do odbiornika dokonujące resyntezy tego sygnału.

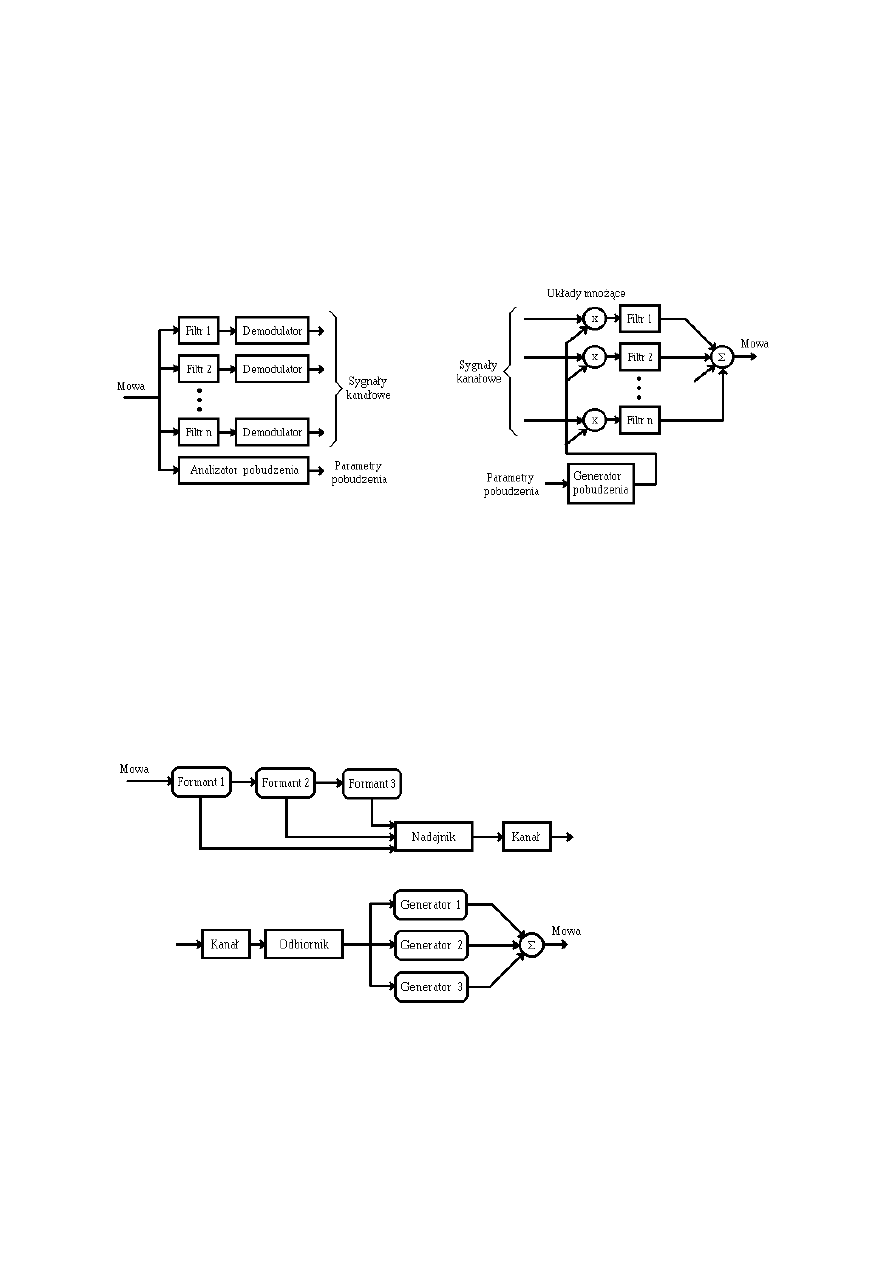

Struktura wokodera kanałowego (pasmowego)

Częstotliwość zmian sygnału w każdym kanale (po demodulacji) wynosi kilka Hz (rzadko dochodzi do 30

Hz), stąd wynika oszczędność na ilości informacji transmitowanej. Liczba kanałów wynosi przeciętnie 10

(minimalna dla zrozumiałości mowy w stopniu dostatecznym to 5). Podział całej skali częstotliwości jest

zazwyczaj nieliniowy: np. na pasma oktawowe, czasami stosuje się skalę Koniga. Parametry pobudzenia

to parametry tonu krtaniowego: głównie częstotliwość podstawowa (parametr F0), pozwalają one na

przekaz naturalnej intonacji, co poprawia zrozumiałość.

Struktura wokodera formantowego

Wokoder formantowy (parametryczny) - w praktyce operuje on na minimalnie trzech formantach.

Wyodrębnia parametry formantów: ich częstotliwości i poziomy. Odbiornik kształtuje obwiednie widma

sygnału na podstawie poziomów formantów poprzez odpowiednie sterowanie generatorami. Powyższy

schemat może być oczywiście uzupełniony i analizator i generator pobudzenia.

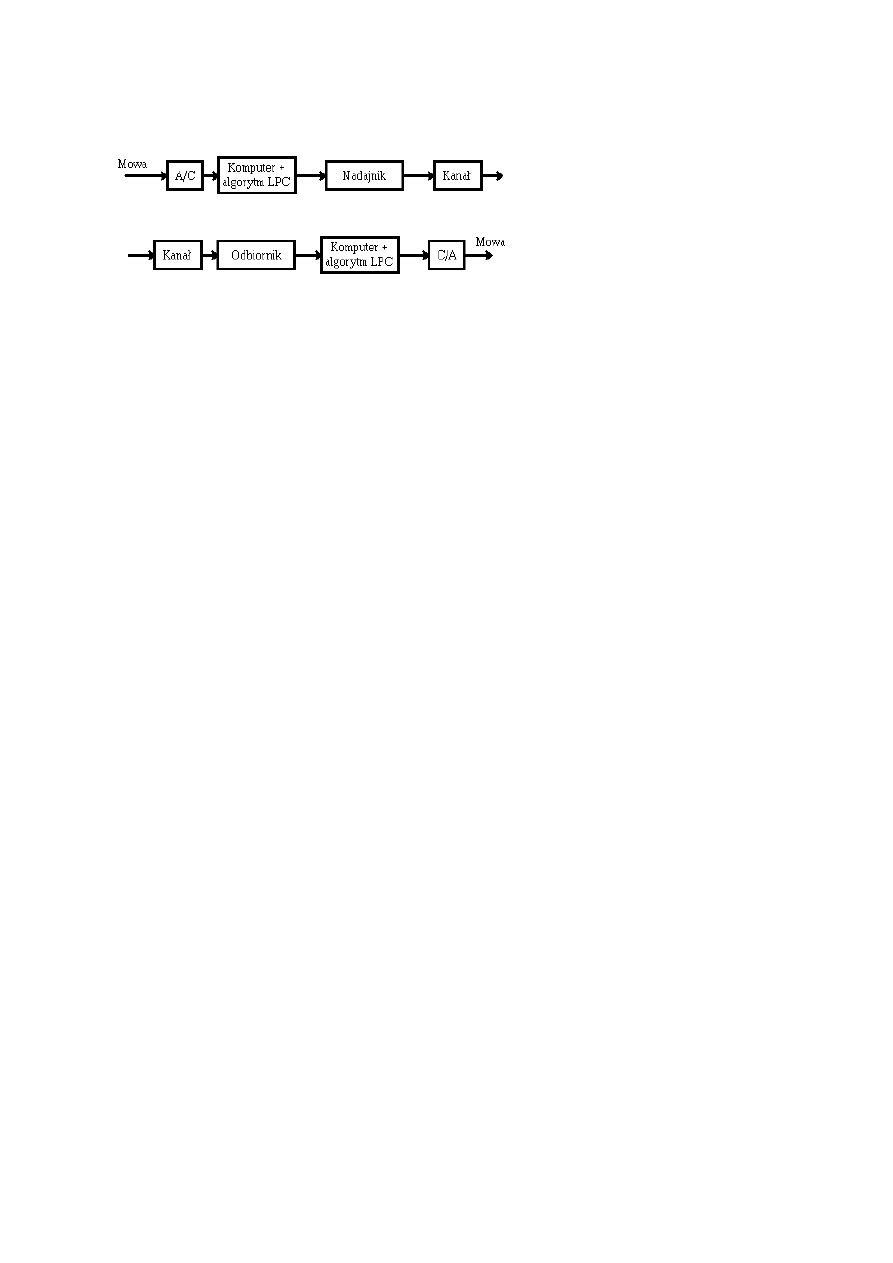

Struktura wokodera opartego na zasadzie predykcji liniowej

Ekstrakcja parametrów to obliczenie wektora LPC (np. algorytm Levinsona-Durbina). Na tej podstawie

jest kształtowana w odbiorniku obwiednia widma sygnału, a na podstawie analizy sygnału błędu predykcji

uzyskuje się parametry pobudzenia.

W podobny sposób można dokonać konstrukcji wokodera cepstralnego: niskie współczynniki cepstralne

opisują obwiednię widma, wyższe mogą posłużyć do detekcji tonu krtaniowego.

Podstawy automatycznego rozpoznawania mowy

Podstawy segmentacji sygnału mowy:

1. alfabet bazowy - dla mowy polskiej 37 fonemów

2. segmenty fonetyczne

- odcinki o jednorodnej strukturze fonetycznej decydującej o

przynależności do określonego fonemu

3. segmentacja stała

- odcinki o stałej długości - kwazistacjonarne

- "implicit segmentation" - mikrofonemy

4. segmentacja zmienna

- segmenty zdefiniowane przez transkrypcję fonetyczną

- "explicit segmentation" - dłuższe niż poprzednio

5. rodzaje segmentów dla sygnału mowy:

stacjonarne, transjentowe, krótkie, pauza.

6. granice segmentów:

dźwięcznych - płynne przejścia formantów

dźwięczny i bezdźwięczny - połączenie struktur formantowych i

szumowych

fonem i cisza - niepełna realizacja struktury widmowej

Wymagania:

- algorytm segmentacji powinien generować funkcję czasu, na podstawie której

można oznaczyć granice segmentów

- wybór metod parametryzacji

- kryteria podziału i wybór desygnatów znaczeniowych

Fonetyczna funkcja mowy :

Fonetyczna funkcja mowy jest funkcją czasu, na podstawie której można

wyznaczyć granice segmentów:

gdzie: R(t,p) – wektor parametrów w oknie czasowym (t, t+

∆

t),

∆

t – długość okna czasowego,

a

p

– waga p-tego parametru,

P – liczba parametrów,

τ

– przesunięcie czasowe, krok analizy .

( )

(

)

( )

∑

=

+

⋅

=

P

p

p

p

t

R

p

t

R

P

t

P

1

2

,

,

ln

1

τ

α

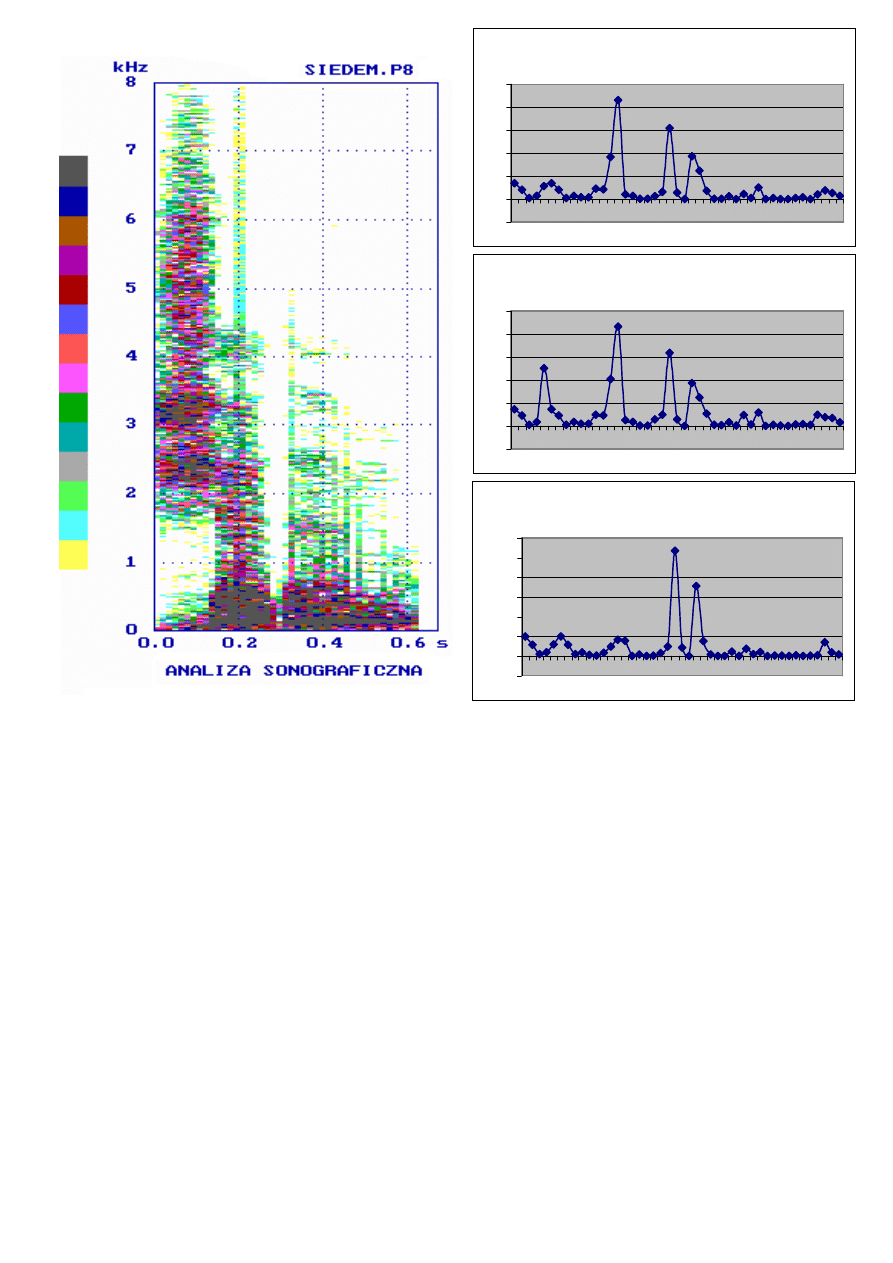

Porównanie wyników analizy sonograficznej z wynikami segmentacji

dla różnych długości P wektora parametrów

Analiza jest wykonywana na odcinku czasowym o długości około 40ms, czyli obejmuje

pojedyncze mikrofonemy. Odbywa się porównanie pomiędzy kolejnymi mikrofonemami w

oparciu o obrany system parametrów, małe różnice wskazują na to, że oba mikrofonemy

wchodzą w skład tego samego fonemu, duźe różnice wskazują na zmianę sygnału, czyli na

granicę między fonemami.

Funkcje bloku segmentacji fonematycznej:

- parametryzacja (dla mikrofonemów)

- obliczenie fonetycznej funkcji mowy

- detekcja granic segmentów (na podstawie maksimów ffm)

Problemy:

- nie każde lokalne maksimum jest granicą segmentu (stosuje się filtry

wygładzające, algorytmy eksperckie, itp.),

- dobór wag dla poszczególnych parametrów,

- dobór systemu parametryzacyjnego

Fonetyczna funkcja mowy dla P=1

-0,5

0

0,5

1

1,5

2

2,5

3

1

5

9

1

3

1

7

2

1

2

5

2

9

3

3

3

7

4

1

4

5

Fonetyczna funkcja mowy dla P=2

-1

0

1

2

3

4

5

1

5

9

1

3

1

7

2

1

2

5

2

9

3

3

3

7

4

1

4

5

Fonetyczna funkcja mowy dla P=3

-1

0

1

2

3

4

5

1

5

9

1

3

1

7

2

1

2

5

2

9

3

3

3

7

4

1

4

5

METRYKI STOSOWANE W PRZESTRZENI PARAMETRÓW:

Przestrzeń metryczna to zbiór z wprowadzonym uogólnieniem pojęcia odległości

dla jego elementów.

Euklidesa:

gdzie:

x

p

, y

p

– wartość p-tego parametru dla porównywanych obiektów,

P – liczba parametrów,

Hamminga (uliczna):

Charakteryzuje się prostotą obliczeń.

Minkowskiego:

Uwaga:

szczególne przypadki metryki Minkowskiego to: metryka Euklidesa dla r=2

i metryka Hamminga dla r=1

Euklidesa znormalizowana:

gdzie: S

P

– odchylenie standardowe parametru p populacji referencyjnej (X lub Y)

Potrzeba normalizacji metryk wynika z silnego wpływu różnic rzędów wartości poszczególnych

składowych wektora cech – różne typy mogą przyjmować wartości z różnych zakresów. Za

współczynnik normalizujący przyjmuje się zazwyczaj odwrotność wariancji (kwadrat

odchylenia standardowego). Ponadto różne parametry mogą reprezentować różne cechy

fizyczne opisywanych obiektów, obok siebie mogą występować parametry o różnych

wymiarach fizycznych, których dodawanie nie ma sensu. Normalizacja powoduje, że składniki

są bezwymiarowe.

( )

(

)

∑

=

−

=

P

p

p

p

y

x

y

x

D

1

2

,

( )

r

P

p

r

p

p

y

x

y

x

D

∑

=

−

=

1

,

( )

∑

=

−

=

P

p

p

p

y

x

y

x

D

1

,

( )

(

)

∑

=

−

⋅

=

P

p

p

p

p

y

x

S

y

x

D

1

2

2

1

,

Camberra:

Jest to metryka samonormalizująca

Czebyszewa:

Mahalanobisa:

gdzie:

C

– macierz kowariancji

Metryka Mahalanobisa jest związana tzw. regułą optymalną. Metryka Mahalanobisa

uwzględnia stopień skorelowania pomiędzy parametrami, jeśli zaś parametry są

nieskorelowane zamienia się w zwykłą ważoną metrykę Euklidesa (macierz

C

staje się

diagonalna). Przy obliczaniu odległości pomiędzy populacjami wymaga się, aby zachodziła

równość ich macierzy kowariancji (test statystyczny Boxa). Przypadek jednowymiarowy dla

tej metryki to w istocie rzeczy zmodyfikowana statystyka Behrensa-Fishera, z tym

wyjątkiem, że nie jest wymagana równość odchyleń standardowych.

FUNKCJE BLISKOŚCI:

Kosinus kierunkowy:

Tanimoto:

( )

∑

=

+

−

=

P

p

p

p

p

p

y

x

y

x

y

x

D

1

,

( )

p

p

p

y

x

y

x

D

−

=

max

,

( )

( )

( )

y

x

C

y

x

y

x

D

T

−

⋅

⋅

−

=

−

1

,

( )

y

x

y

x

y

x

B

T

⋅

=

,

( )

y

x

y

y

x

x

y

x

y

x

B

T

T

T

T

−

+

=

,

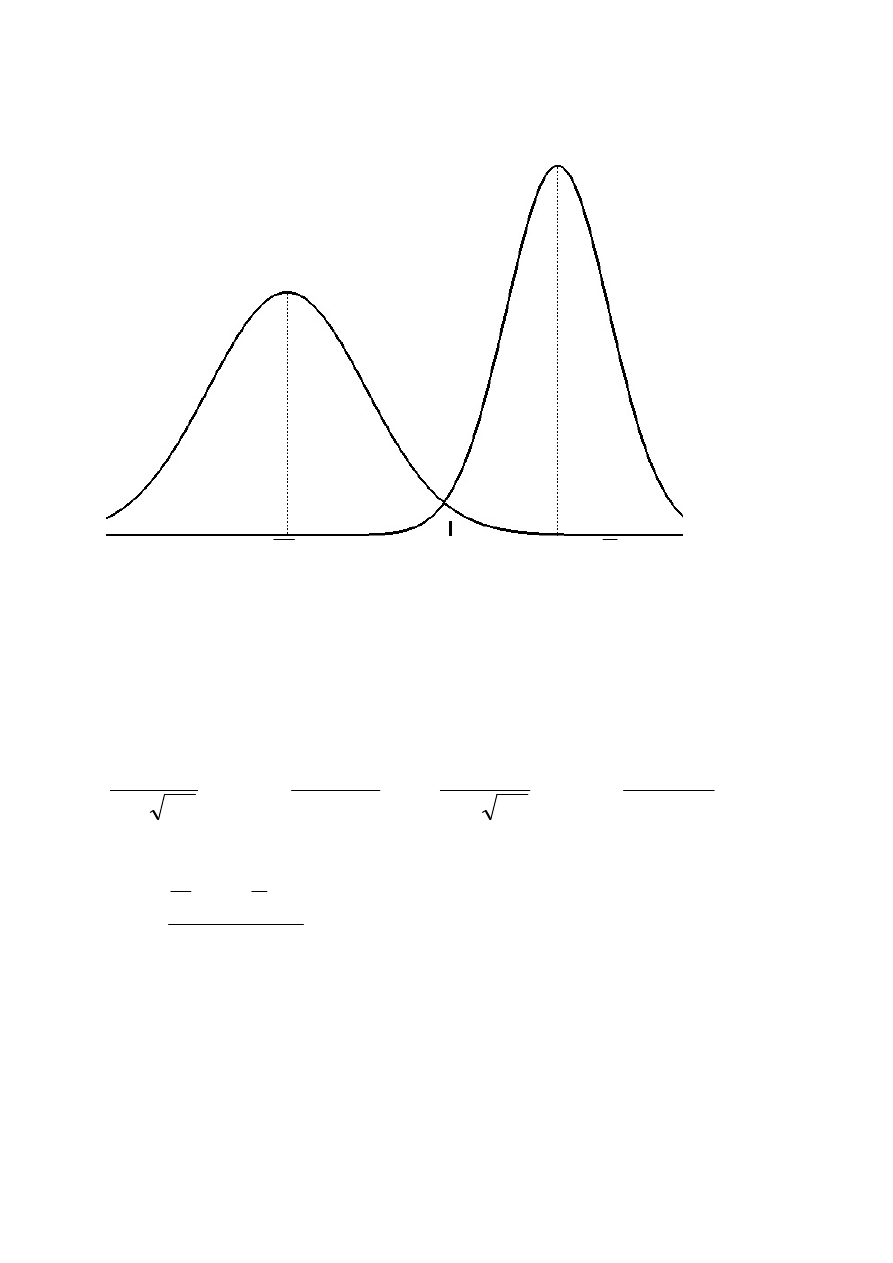

Przykład jednowymiarowego optymalnego systemu dyskryminacji

X

d

xy

Y

Przy

wyrównanym

prawdopodobieństwie

apriorycznym

wartość

dyskryminacyjna d

xy

powinna spełniać zależność:

(

) (

)

xy

xy

d

y

P

d

x

P

<

=

>

czyli:

(

)

(

)

∫

∫

∞

−

∞

+

−

−

⋅

=

−

−

⋅

xy

xy

d

d

dx

x

dx

x

2

2

2

2

2

2

1

2

1

1

2

exp

2

1

2

exp

2

1

σ

µ

π

σ

σ

µ

π

σ

zatem wartość dyskryminacyjna:

2

1

1

2

S

S

S

Y

S

X

d

xy

+

⋅

+

⋅

=

,

zapewniająca regułę o najmniejszym prawdopodobieństwie popełnienia błędu,

pod warunkiem, że założenie o kształtach funkcji gęstości prawdopodobieństwa

(gaussowskie) są spełnione

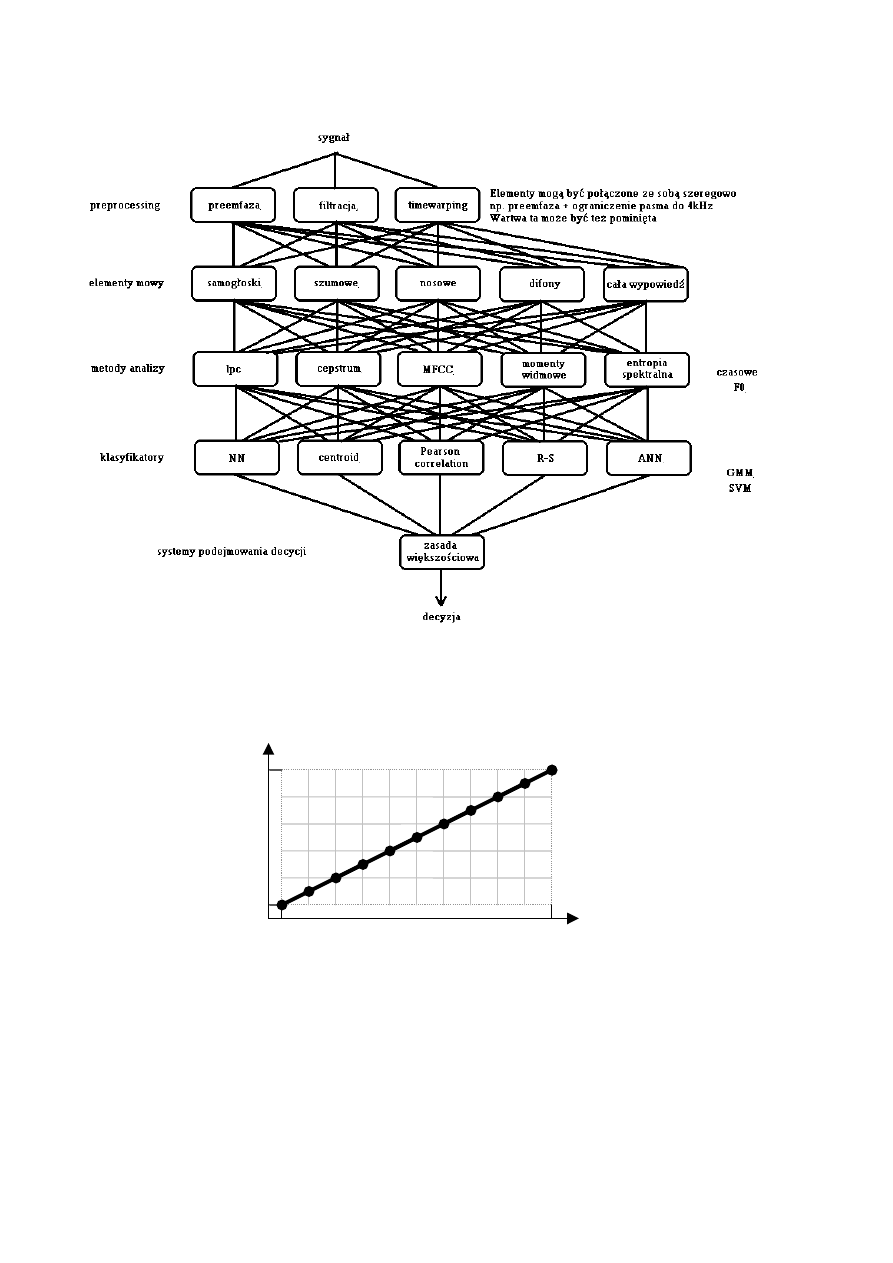

Schemat ogólny przetwarzania sygnału mowy w procesie rozpoznawania

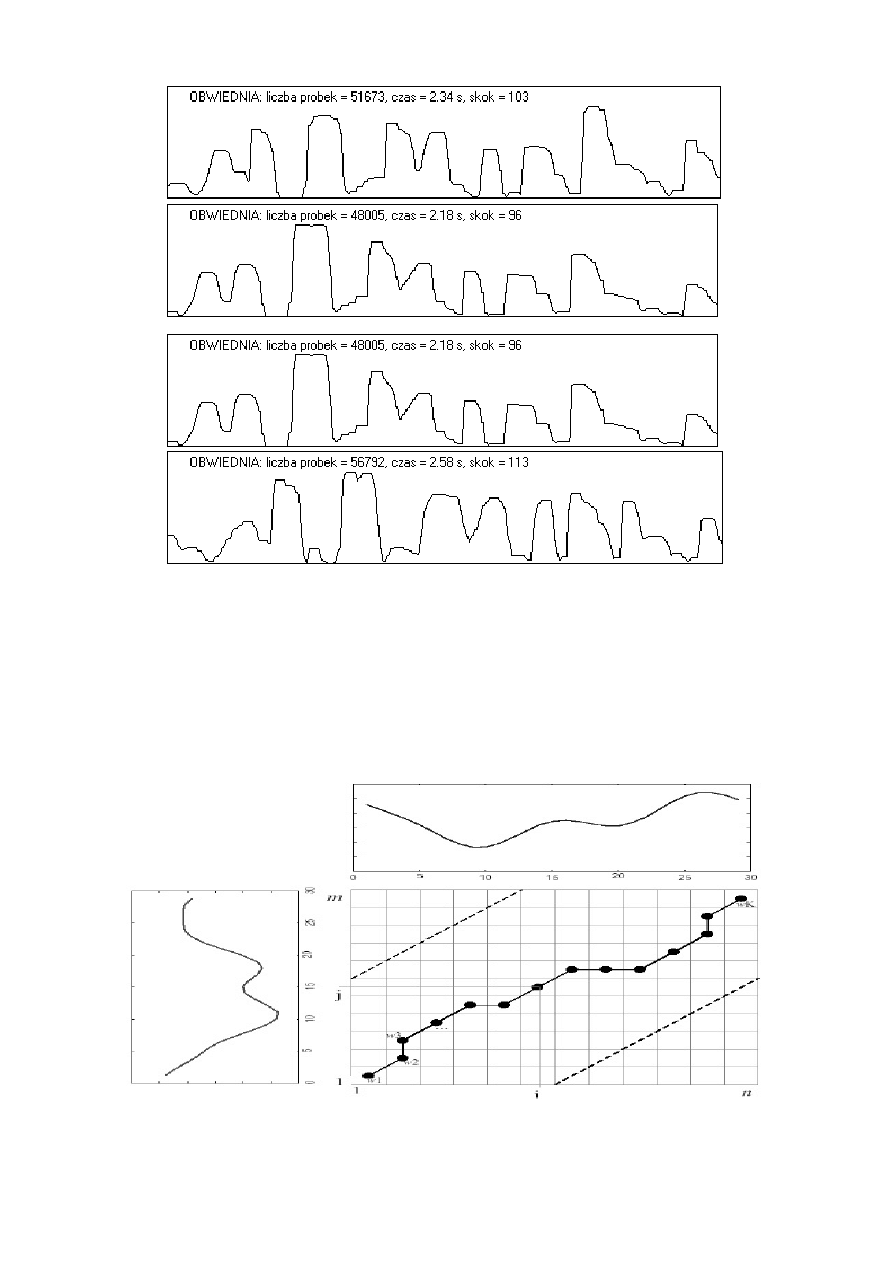

Ilustracja liniowej normalizacji czasowej

1

1

N

M

T(t

1

, t

2

,… t

N

)

R

(r

1

, r

2

,…

r

M

)

Porównanie obwiedni sygnału mowy dla czterech różnych wypowiedzi tego

samego zdania ("zdzisiek patrzy na świecące liście") przez dwóch mówców.

Pomimo zastosowania liniowej normalizacji czasowej widoczne są różnice

zależne od zmiennego tempa wypowiedzi.

Ilustracja nieliniowej normalizacji czasowej (dynamic time warping)

Procedura dynamicznego dopasowania czasowego polega na segmentacji stałej i

parametryzacji mikrofonematycznej. Umożliwia dopasowanie dwóch różnych

wypowiedzi różniących się czasem trwania i tempem poszczególnych

elementów. Parametry sygnału referencyjnego znajdują się w bazie danych (m

wektorów), zaś sygnału przeznaczonego do identyfikacji są obliczane na bieżąco

(n wektorów). Następnie obliczane są odległości pomiędzy wszystkimi

wektorami parametrów tworząc tablicę o wymiarach m

.

n. Kolejnym krokiem

jest znalezienie drogi łączącej przeciwległe narożniki tej tablicy zgodnie z

zasadą mającą na celu minimalizację sumy odległości z napotykanych komórek

tablicy. Tak obliczona suma nosi nazwę odległości skumulowanej. Warunkiem

uzyskania poprawnego wyniku jest właściwe zaznaczenie początku i końca

wypowiedzi. Po zastosowaniu procedury „time-warping” wobec wszystkich

danych z bazy można podjąć decyzję o klasyfikacji badanego sygnału.

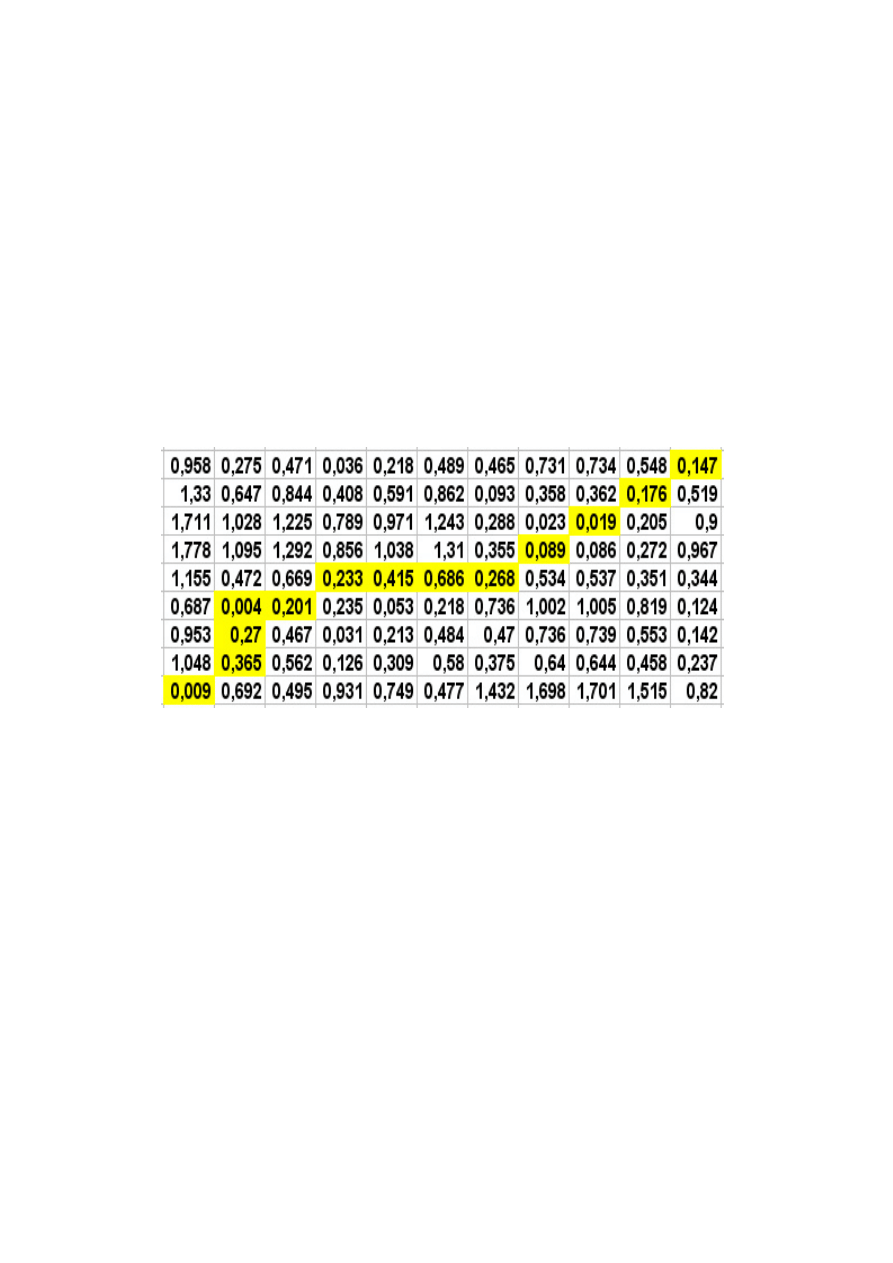

Tablica odległości pomiędzy wektorami parametrów dwóch wyrazów (oś y

– referencyjny, oś x - rozpoznawany) w procedurze nieliniowej normalizacji

czasowej (dynamic time warping). Liczby segmentów obu wyrazów nie są

sobie równe (m=9, n=11). Lewy dolny narożnik odpowiada początkom

wypowiedzi. Zaznaczona jest ścieżka ustalająca sposób obliczania odległości

skumulowanej.

Klasyfikatory parametryczne i nieparametryczne:

Wynikiem klasyfikacji jest prawdopodobieństwo przynależności do danej klasy (w

pierwszym przypadku) albo wskazanie klasy (w drugim przypadku).

W pierwszym przypadku potrzebna jest znajomość funkcji (parametrów statystycznych)

gęstości prawdopodobieństwa dla wartości parametrów obiektów wchodzących w skład

wszystkich klas, w drugim przypadku istnieje potrzeba stworzenia modelu (lub modeli) dla

każdej klasy na podstawie pewnej liczby przykładów (obiektów) tzw. ciągu uczącego

(treningowego).

Do klasyfikatory nieparametrycznych należą klasyfikatory minimalnoodległościowe, np.:

NN, k-NN, NM, VQ.

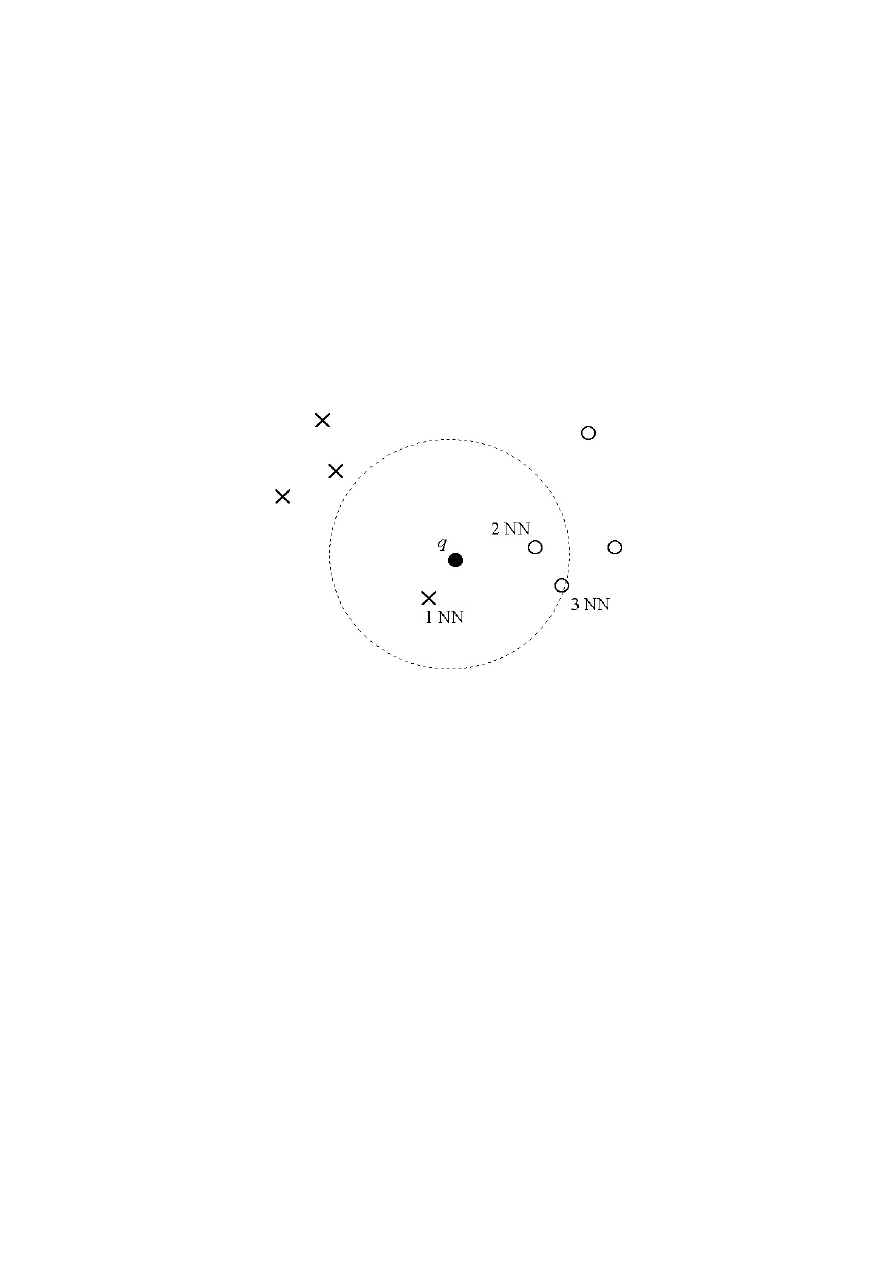

Algorytm „najbliższy sąsiad” (NN - ang. Nearest Neighbour)

Podczas procesu uczenia zapamiętywany jest cały ciąg uczący (zbiór odniesienia).

Procedura algorytmu NN oblicza funkcję podobieństwa (w sensie ustalonej miary

odległości) pomiędzy wszystkimi obiektami ciągu uczącego, a nieznanym obiektem. Po

obliczeniu wszystkich wartości odległości, wyszukiwana jest najmniejsza z nich.

Klasyfikator podejmuje decyzję o przydziale nazwy, kodu lub numeru klasy, do której

należał obiekt ciągu uczącego, który okazał się najbliższy do obiektu rozpoznawanego.

Zalety algorytmu NN to: skrajna prostota, brak fazy uczenia (o ile pominie się selekcję

cech), możliwość redukcji zbioru odniesienia w celu przyspieszenia klasyfikacji,

zazwyczaj dość wysoka jakość klasyfikacji.

Wady algorytmu NN: wolna klasyfikacja, konieczność przechowywania całego zbioru

odniesienia w pamięci, duża wrażliwość na zbędne cechy i na szum.

Algorytm „k - najbliższych sąsiadów” (k–NN)

Algorytm ten jest modyfikacją algorytmu NN. Pozwala on zmniejszyć wrażliwość systemu

rozpoznawania w stosunku do ciągu uczącego. Procedura algorytmu k-NN dokonuje

obliczeń odległości pomiędzy obrazem rozpoznawanym, a wszystkimi obrazami ciągu

uczącego i porządkuje te odległości w kolejności rosnącej. Następnie rozpatrywanych jest

k pierwszych wartości odległości, dla których określa się, ile z nich odpowiada

poszczególnym klasom. Klasyfikator wybiera tą klasę, która najczęściej pojawiała się

wśród k pierwszych odległości. Podkreślić należy, że kolejność k najbliższych sąsiadów (w

sensie ich odległości od próbki testowej) nie ma wpływu na wynik klasyfikacji.

Zalety algorytmu k-NN: prostota koncepcji/implementacji i łatwość wprowadzania

modyfikacji, możliwość estymacji błędu na etapie uczenia przy pomocy metody minus

jednego elementu (leave-one-out), w praktyce na ogół wysoka jakość klasyfikacji;

stosunkowo szybkie uczenie (wybór k) i selekcja cech;

Wady algorytmu k-NN: wolna klasyfikacja (nieco wolniejsza niż 1-NN), konieczność

przechowywania całego zbioru odniesienia w pamięci, duża, w porównaniu z wieloma

innych klasyfikatorami, wrażliwość na zbędne cechy.

Modyfikacje algorytmu k-NN:

- odmiana ważona (ang. weighted k-NN), w której waga sąsiada zadanej próbki q

uzależniona jest od jego odległości od q.

- wprowadzenie progu k’ oznaczającego minimalną liczbę sąsiadów z danej klasy

potrzebną do przypisania danej próbki do tej klasy.

- rozmyta reguła k-NN (ang. fuzzy k-NN) poszerza przestrzeń poszukiwań poprzez

zastąpienie „twardych” etykiet (ang. hard labels, crisp labels) próbek zbioru uczącego

etykietami rozmytymi o stopniach przynależności do poszczególnych klas, które w

pewnym sensie oddają charakter sąsiedztwa danej próbki.

- „k dyplomatycznych najbliższych sąsiadów” (k Diplomatic Nearest Neighbors, k-

DNN), reguła ta szuka k sąsiadów z każdej klasy osobno, a następnie wybiera tę klasę,

dla której średnia odległość opisanych sąsiadów do testowej próbki jest najmniejsza.

Przykład obrazujący działanie algorytmu k-NN dla k=3. Nieznany obiekt q

zostaje sklasyfikowany jako element klasy oznaczonej kółkami, gdyż

spośród trzech najbliższych obiektów danych treningowych dwa pochodzą z

tej klasy. Należy zauważyć, że dla k=1 decyzja będzie odmienna.

Algorytm „najbliższa średnia” (NM - ang. Nearest Mean)

W algorytmie NM wzorcem klasy rozpoznawanych obiektów jest wartość średnia lub

modalna (centroid). Podobnie też, jak w algorytmie NN, obliczane są odległości obiektu

rozpoznawanego od wszystkich obiektów wzorcowych (średnich) i wybierana jest

najmniejsza z nich.

Podstawowe zalety algorytmu NM w stosunku do k-NN to mniejsza ilość obliczeń oraz

brak konieczności pamiętania wszystkich obiektów ciągu uczącego. Do wad należy

zaliczyć niepoprawne działanie algorytmu w przypadku rozkładów wielomodalnych lub

opisanych funkcjami o kształtach odmiennych od gaussowskich. Wówczas obliczona

ś

rednia może leżeć z dala od obszaru zajmowanego przez obiekty treningowe.

Algorytm kwantyzacji wektorowej (VQ - ang. Vector Quantization)

W tej technice klasa jest reprezentowana przez zbiór kilku (lub więcej, zwykle < 100)

wektorów, zwanych kodowymi, które możliwie najdokładniej odzwierciedlają cechy całej

klasy (wielomodalność i rozmieszczenie w przestrzeni parametrów). Zbiór ten tworzy tzw.

książkę kodową. Podobnie jak dla metody NN, w trakcie rozpoznawania dla każdego

wektora testowego jest znajdowany jego najbliższy sąsiad z książki kodowej i jest

obliczana odległość pomiędzy nimi, która jest podstawą do podjęcia decyzji o rozpoznaniu.

Złożoność obliczeniowa rozpoznawania na podstawie kwantyzacji wektorowej jest

znacznie mniejsza w porównaniu z algorytmami NN i k-NN.

Problemem jest jednak algorytm tworzenia książki kodowej na podstawie sekwencji

treningowej. Jedną z dróg rozwiązania tego problemu jest zastosowanie standardowych

algorytmów k-średnich lub LBG. Idea polega na znalezieniu takich wektorów kodowych,

które minimalizują błąd kwantyzacji, czyli sumaryczną odległość pomiędzy sekwencją

treningową a danym modelem.

Inną metodą prowadzącą do stworzenia książki kodowej jest analiza skupień obiektów

danej klasy. Przy zastosowaniu metod klasteryzacji dla zbioru obiektów klasy wydzielane

są skupienia. Z każdego znalezionego skupienia wyznaczany jest wzorzec (centroid)

wpisywany następnie do książki kodowej. Algorytm ten nosi także nazwę: „najbliższe

skupienie” (NTuple - ang. Nearest Tuple).

Klasyfikator Support Vector Machine:

Jest możliwy do zastosowania w przypadku 2 klas (weryfikacja typu: „klasa- klasa” lub

„klasa-reszta”).

Składa się z 2 etapów:

1. nieliniowe przekształcenie hiperprzestrzeni

2. wyznaczenie hiperplaszczyzny dyskryminacyjnej (klasyfikacja metoda klasa-reszta lub

klasa-klasa)

Etap 1 ma na celu zapewnienie takiej konfiguracji parametrów, aby po etapie 2

wyznaczona hiperplaszczyzna była podstawa do optymalnego systemu decyzyjnego

(minimalne prawdopodobienstwo popełnienia bledu).

W etapie 1 stosuje sie różne funkcje nieliniowe (wielomianowa, gaussowska i inne)

dobierając odpowiednio ich współczynniki (zagadnienie Lagrange'a) - to jest etap treningu

systemu, bo opiera sie na zgromadzonych danych.

Zastosowana funkcja nazywa się kernel.

Do etapu 2 parametry dochodzą już przekształcone, dając możliwość wyznaczenia

hiperpłaszczyzny na podstawie wektora wspierającego (prostopadłego do tej

hiperpłaszczyzny, opartego na obiektach znajdujących się w sąsiedztwie regionu

granicznego).

Samo rozpoznawanie nieznanych obiektów to przekształcenie wg kernela i nastepnie

określenie po której stronie hiperplaszczyzny ten nieznany obiekt się znajduje.

Podział systemów rozpoznawania mówców

1. podział ze względu na cel rozpoznawania

- weryfikacja mówcy – potwierdzenie deklarowanej przez mówcę tożsamości

- identyfikacja mówcy – określenie, który z mówców się wypowiada, na podstawie

zbioru modeli odniesienia, przy założeniu, że mówca ma swój model głosu w bazie danych

- autentyzacja mówcy – określenie, czy głos mówcy należy do posiadanego zbioru

modeli

2. podział ze względu na zależność od tekstu

- niezależne od treści – skuteczne dla dowolnej wypowiedzi, wykorzystywane gdy nie

można liczyć na współpracę mówcy

- zależne od treści – skuteczne tylko dla niektórych wypowiedzi, wykorzystywane gdy

można się spodziewać, że mówca wymówi hasło, numer identyfikacyjny lub

podpowiedziany przez system tekst

3. podział identyfikacji mówcy ze względu na charakter zbioru modeli mówców

- z zamkniętym zbiorem – każdemu mówcy musi odpowiadać jakiś model

odniesienia, wybierany jest najbliższy spośród wszystkich modeli mówców

- z otwartym zbiorem – możliwe jest uznanie, że żaden z modeli odniesienia nie jest

wystarczająco podobny do danej wypowiedzi, wybierany jest najbliższy spośród

wszystkich modeli, pod warunkiem, że jego podobieństwo przekracza określony próg

Wyszukiwarka

Podobne podstrony:

mat am 9 id 282446 Nieznany

mat am 7

mat am 4 id 282444 Nieznany

mat-am-2

mat-am-1

mat am 3

mat-am-7

mat am 1

mat am 6

mat am 5

mat am 1

tul cyl montaz, AM mat, Remonty

Inne materiały, mat-potęgi, am*an=am+n

więcej podobnych podstron