ELEMENTY TEORII

INFORMACJI I

STEROWANIA

Warszawa, 7 grudnia 2007

INFORMATYTKA

• W świecie istnieją dwa główne obiegi:

• Energii

• Informacji

• Dziedziną, która łączy ze sobą w sieć

przyczynowo-skutkową elementy świata

przyrodniczego, jest biocybernetyka. Nauka

ta ukształtowała się w drugiej połowie XX

wieku i zajmuje się badaniem procesów

sterowania, regulacji i przetwarzania

informacji w maszynach i żywych

organizmach (Norbert Wiener, 1948)

Teoria informacji

• Teoria informacji zajmuje się analizą procesów

wytwarzania, przenoszenia, odbioru i przetwarzania

informacji. Nie uwzględnia się zazwyczaj struktury

obiektu ani postaci energii biorącej udział w

procesach.

• Przesyłanie informacji wymaga ustalenia

zrozumiałego zarówno przez nadajnik, jak i

odbiornik zasobu znaków (symboli), co do których są

one zgodne (kodowanie). Mogą to być słowa, litery

obrazy, kształty lub też dźwięki.

• Przesyłanie informacji przebiega kanałem

przesyłowym, którym może być powietrze, próżnia,

przewód sieci informatycznej, instalacja

pneumatyczna, hydrauliczna albo energetyczna

oraz wiele innych mediów przenoszących informacje

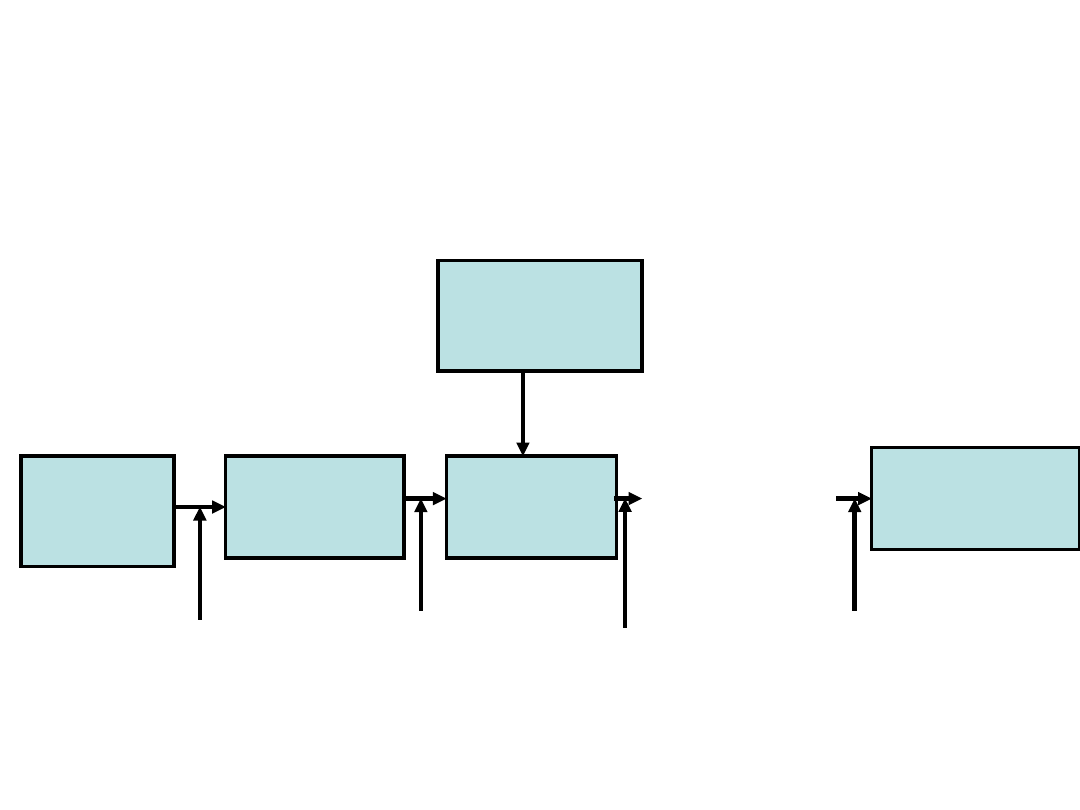

Łącze informacyjne

Źródł

o

Nadajnik

(kodowani

e)

Kanał

Odbiornik

(dekodowanie

)

Przeznaczenie

informacji

Informacja

Zakłóceni

a

Sygnał

y

Sygnał

y

Informacja

Informatyka

• Informatyka to dyscyplina nauk

technicznych zajmująca się zagadnieniami

pobierania, przechowywania, przesyłania,

przetwarzania i interpretacji informacji.

• W organizmach zwierząt i u człowieka

znane są dwa szczególnie ważne kanały

przesyłowe informacji: system nerwowy i

krwioobieg.

Łącza informacyjne w

organizmie

• Jako nadajnik mogą służyć na przykład mózg i

receptory oraz gruczoły wydzielania

wewnętrznego.

• Odbiornikami mogą być elementy wykonawcze,

mózg lub receptory.

• Na przykład:

• receptory - mózg

• mózg – mięśnie

• Gruczoły wydzielania wewnętrznego - narządy

Miara informacji

• Z punktu widzenia techniki najbardziej

odpornym na zakłócenia i prostym w

przetwarzaniu jest system binarny

(dwójkowy).

• Potwierdza to przyroda, stosując podobny

system w układzie nerwowym, zasada

wszystko albo nic.

• W systemie tym możliwe jest również

prowadzenie rachunku logicznego – algebry

Boole’a: prawda (tak) – 1, fałsz (nie) – 0.

Bit

• Informacja polegająca na wyborze

jednego ze stanów:

• 1 lub 0

• tak lub nie

• H lub L

• Ma ilość informacji równą 1 bitowi

• bit skrót od binary digit

Miara informacji

• Informacja w sensie potocznym

rozumiana jest jako znajomość

pewnego stanu otaczającego świata.

• Informację definiuje się jako zdarzenie

wybrania elementu ze zbioru

wszystkich możliwych elementów.

Negentropia

• Zdarzenie wybrania elementu ze zbioru wszystkich

możliwych elementów zachodzi z pewnym

prawdopodobieństwem.

• Biorąc pod uwagę to prawdopodobieństwo oraz

liczbę elementów zbioru n możliwych zdarzeń,

określa się miarę informacji I (zwaną negentropią):

• p

i

– prawdopodobieństwo wystąpienia i – tego

elementu zbioru

n

i

i

i

p

p

I

1

2

)

(

log

Negentropia

• Jednostką negentropii jest 1 bit

• 1 bit to wybór spośród dwóch

jednakowych zdarzeń czyli wybór

jednego z dwóch równie

prawdopodobnych zdarzeń jest

jednostką informacji.

Negentropia

• Wartość negentropii wzrasta wraz ze

zwiększeniem liczby stanów, które

mogą wystąpić oraz ze zwiększeniem

nieprzewidywalności stanu aktualnego.

• Negentropia wielu niezależnych

zbiorów stanów jest równa sumie ich

negentropii.

• Negentropia informacji niezmiennej

(występuje 1 stan) wynosi 0.

Negentropia

• Negentropia dla p

1

= p

2

= 0,5 wynosi I = 1

bit

• Negentropia,p

1

= 0,01 p

2

= 0.99, I = 0.0807

bita

• Dla równolicznych zbiorów negentropia

przyjmuje największą wartość gdy

prawdopodobieństwa wystąpienia każdego

z elementów są równe:

• I = log

2

(n)

Przepustowość informacji

• Przepustowość informacji to stosunek

przekazywanych ilości informacji do czasu:

]

1

/

[

bod

s

bit

t

I

L

bod – skrót nazwiska

Boudot

Gęstość informacji

(powierzchniowa)

• Gęstość informacji to stosunek ilości

informacji do powierzchni:

]

/

[

2

m

bit

S

I

B

Pojemność informacyjna łącza

informacyjnego

• Pojemność informacyjna łącza

informacyjnego to stosunek maksymalnej

ilości przekazywanych informacji do czasu:

]

/

[

max

s

bit

t

I

C

0<L≤C

Przepustowość informacji

żywych organizmów

• Ilość informacji odbieranych, wysyłanych

lub przetwarzanych przez żywe

organizmy może być tylko szacunkowa.

• Ilość informacji, które człowiek może

przyjąć wszystkimi zmysłami ocenia się

na około 10

9

bodów.

• Ilość informacji, które człowiek może

wysłać ocenia się na około 10

7

bodów.

Przepustowość informacji

•Świadomie przetworzyć

można co najwyżej 100

bodów na miliard

odbieranych, z czego 10

bodów można zapamiętać na

krótko, a tylko 1 bod trwale

.

Przepustowość informacyjna

receptorów [bod]

•Wzrok – 10

10

•Słuch - 5·10

4

•Ucisk – 10

5

•Temperatura – 10

3

•Węch – 10

2

•Smak - 10

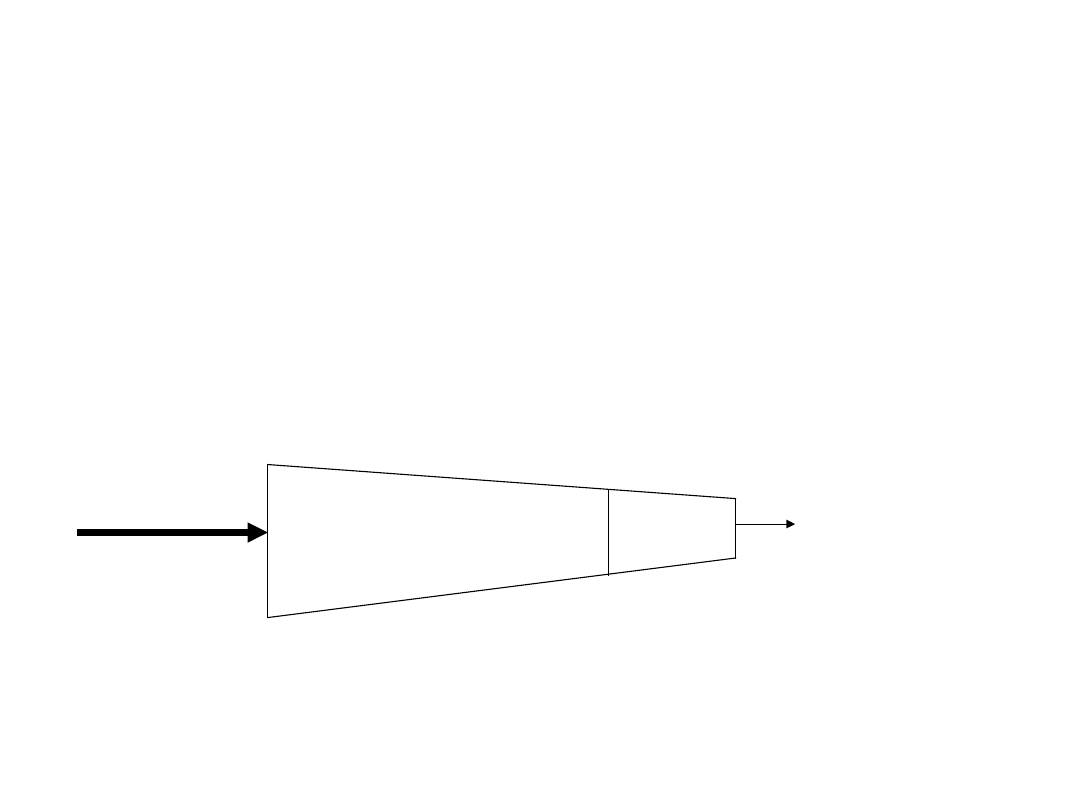

Lejek informacyjny

• Ograniczenia przepustowości

informacji mają miejsce we

wszystkich zmysłach.

• Ograniczenie przepustowości

nazywane jest lejkiem

informacyjnym.

Otoczeni

e 10

9

[bod]

Słuch

Wzrok

Węch

Smak

Dotyk

Selekcja 10

7

[bod]

10

2

[bod]

Świadomość

System dziesiętny

•C

1

10

n

+C

2

10

n-1

+C

3

10

n-2

+……

•1234=1·10

3

+2·10

2

+3·10

1

+4·10

0

System dwójkowy (binarny)

• bit – liczba binarna (binary digit)

• bajt – jednostka miary informacji

równa 8 bitom (ang. byte)

• bajt to 2

8

=256 informacji

• Zapis binarny:

• b·2

n

+b·2

n-1

+b·2

n-2

+……….

• b=0 lub b=1

Bajt

• Ośmiocyfrowa liczba binarna jest

podstawą zapisu różnych wielkości w

pamięci komputera.

• 00000000

0

• 00000001

1

• 00000010

2

• 11111111

256

• kilo – 10

3

2

10

= 1024

• Mega – 10

6

2

20

= 10487576

• Giga – 10

20

2

30

= 1073741824

Document Outline

- Slide 1

- Slide 2

- Slide 3

- Slide 4

- Slide 5

- Slide 6

- Slide 7

- Slide 8

- Slide 9

- Slide 10

- Slide 11

- Slide 12

- Slide 13

- Slide 14

- Slide 15

- Slide 16

- Slide 17

- Slide 18

- Slide 19

- Slide 20

- Slide 21

- Slide 22

- Slide 23

Wyszukiwarka

Podobne podstrony:

09 2007 pol 2 odp

pytania biofizyka 09

OLEJKI ETERYCZNE-wersja wysłana-Pisul 16-09-2007, Aromaterapia

Biofizyka, zaliczenie 2007

Biofizyka 08 2007

biofizyka 09 09 10

pytania z egz 11[1].09.2007 gr B, egzamin

09 2007 mat

Biofizyka zaliczenie 2007

zarzadzenie nr 1041 28.09.2007, WSPOL, I rok semestr II, Prawo policyjne

scenariusz 09 2007 Maj zieleni laki, Praca, Scenariusze

NEUROCHIRURGIA 19.09.2007, Neurologia i neurochirurgia

więcej podobnych podstron