Kilkanaście dni temu jeden z czytelników zwrócił się do mnie z pytaniem, w jaki sposób szybko i

bezboleśnie nabić duży site na jego stronie firmowej, jako argument przemawiający ZA podał, że

dzięki temu jego witryna tanim kosztem w krótkim okresie czasu zyska tysiące odwiedzin, ale nie

to pytanie jest istotne - ciekawszą kwestią jest jakiej metody użyć do generowania treści. Czy na

pewno przywołana metoda wciąż działa - mowa o nabijaniu site i czy są skuteczne metody w

generowaniu contentu?

Dawno dawno temu kiedy jeszcze można było wypozycjonować stronę na konkurencyjne frazy

samymi katalogami i preclami, faktycznie nabicie dużego site w Google przynosiło wymierne

korzyści. Seowcy masowo prześcigali się w coraz to nowszych metodach generowania treści na

strony, od scrapowania artykułów z Wikipedii, poprzez tłumaczenia tekstów z języka angielskiego

na polski, a kończąc na wyszukanych algorytmach analizy, przetwarzania i generowania. Wszystko

odbywało się w sposób w pełni zautomatyzowany lub w ostateczności półautomatyczny, tanim

kosztem można było osiągnąć to, na co wiele osób pracowało przez lata. Czy metody sprzed paru

lat wciąż działają? Zanim odpowiem na to pytanie przejdę do innego punktu.

By utrudnić działania, Google na przestrzeni kilku ostatnich lat wprowadziło liczne zabezpieczenia,

dzięki którym metoda nabijania site straciła na efektywności. Na podstawie

, które przeprowadziłem na przestrzeni ostatnich 2 lat można wyłowić

prawidłowości, które prowadziły do kar. Jedną z tych prawidłowości jest szybki przyrost site, czy to

poprzez umyślne generowanie nowych podstron w serwisie, czy też nieświadome powielanie

podstron w obrębie domeny i/lub subdomen.

Czy wygenerowanie dużej liczby podstron, których zawartość jest bardzo zbliżona do siebie

negatywnie wpływa na postrzeganie domeny i zwiększa ryzyko otrzymania kary od Google? Jasne

że TAK. Niestety wciąż wiele osób wychodzi z założenia - "czym więcej tym lepiej" lub "lepiej

byle jak niż wcale", jednak w dzisiejszych czasach takie podejście ma krótkie nogi i część osób,

których strony ugryzła Panda, przekonało się o tym na własnej skórze.

Jakiś czas temu pisałem o rel="canonical" zlecieli się wielcy "znawcy" tematu wypowiadając

słowa, jakoby canonical nie był żadnym zabezpieczeniem, owszem nie jest to panaceum na

wszystkie "choroby", ale jak pokazuje praktyka (

), poprawna implementacja canonical

mogła zmniejszyć duplikowanie i zapobiec późniejszym wydarzeniom. Na szczęście w tym

przypadku obyło się bez płaczu, szybka reakcja pozwoliła naprawić problem, jednak wielu

właścicieli sklepów wciąż bagatelizuje zagrożenie. Mam nadzieję, że w świadomości tych osób coś

drgnie, również za sprawą podobnych artykułów.

Nieco odbiegliśmy od tematu przewodniego, wracamy do pytania czytelnika. Czy sztucznie

generowany content może sprawić, że domena zyska tysiące odwiedzin? I tak i nie, wszystko zależy

od jakości generowanej treści tj. metody generowania. Najpopularniejsze to generowanie nowej

treści poprzez użycie synonimów. Niestety metoda aktualnie słabo sprawdza się chyba że...

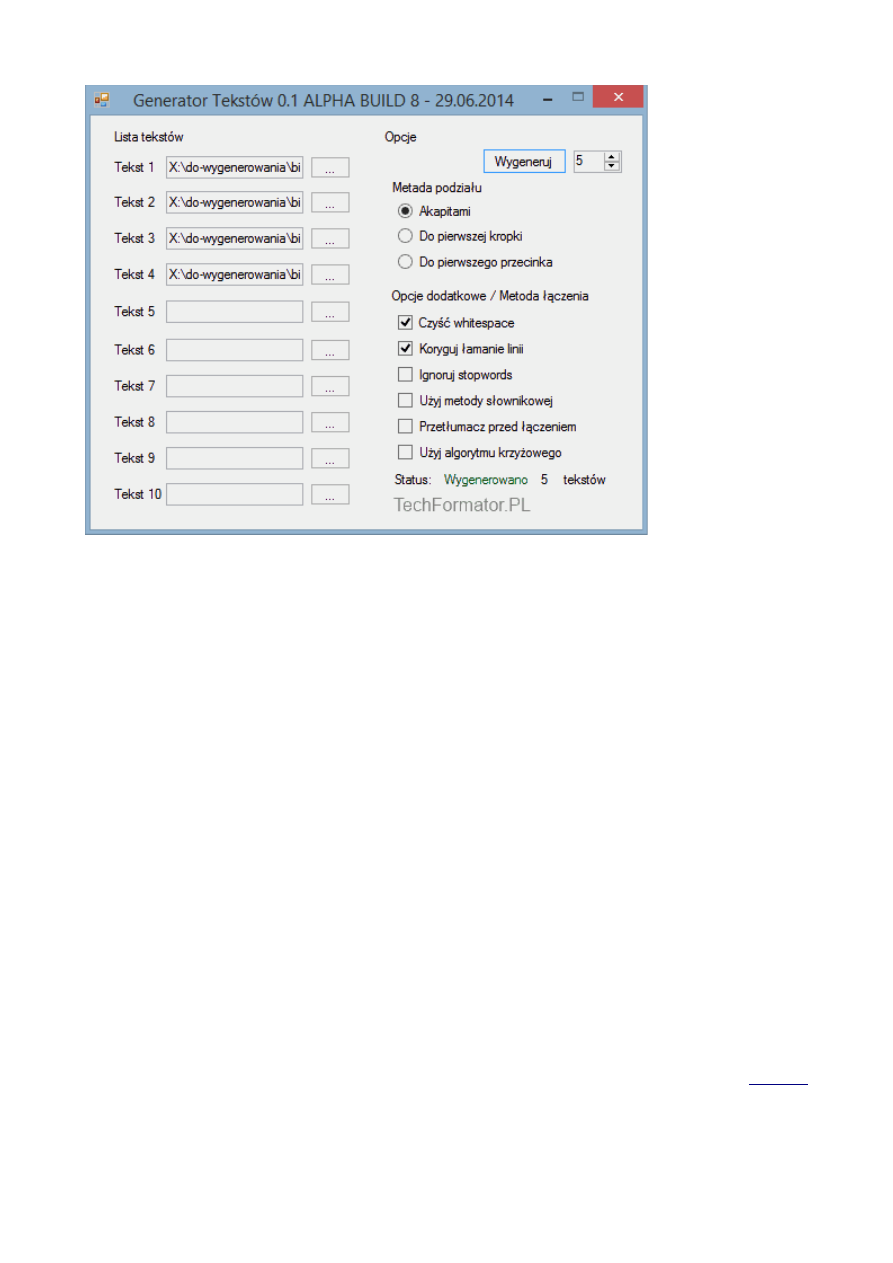

W zeszłym roku testowałem możliwości wykorzystania auto wygenerowanych tekstów w ściąganiu

ruchu na strony docelowe. Do tego celu między innymi stworzyłem prosty programik, który miał za

zadanie stworzyć nowe treści, które następnie mogły zostać umieszczone (zaimportowane) na

stronie.

Metoda okazała się połowicznie skuteczna albowiem nie miałem kiedy skończyć metody

słownikowej oraz wprowadzić udoskonalony algorytm krzyżowy (pochodzący z algorytmu

genetycznego). Udało się ściągnąć trochę ruchu na satelitę, ale to było poniżej moich oczekiwań -

inaczej mówiąc test powiedział, że gra nie jest warta świeczki. Google dobrze sobie radzi ze

sztucznie generowanymi tekstami ale uważam, że do ideału jeszcze daleka droga, z pewnością przy

użyciu odpowiednich aplikacji (algorytmów) da się stworzyć treści, które będą w pełni odporne na

algorytmy wykrywania sztucznej treści lub inaczej... będą zrozumiałe dla czytelnika na tyle, że

algorytm nie będzie potrafił nic wykryć. Jednak pamiętajmy, że analizując pełne spektrum tekstów

na stronie zawsze można wyłowić regularności, dotyczy to nawet treści pisanych przez ludzi, którzy

mają swoje nawyki w pisaniu.

W programie zastosowałem bardzo proste metody łączenia i podstawową podmianę wyrazów, co by

było gdyby oprzeć się na inteligentnych algorytmach zawartych choćby w zaawansowanych

synonimizatorach tekstów? Jeżeli tylko czas pozwoli na dokończenie programu, będę w tym roku

ponownie testował tę metodę.

Dla jasności, nikogo nie namawiam do wykonywania tego typu testów, a tym bardziej generowania

sztucznej treści na domenach firmowych - powiem wręcz, że sam nawet bałbym się zastosować

metody na lepszej jakości zapleczu nie mówiąc już o domenie firmowej. Test przeprowadzałem w

ramach corocznych eksperymentów, w celu sprawdzenia potencjału metody - wiemy doskonale ile

kasy przeznaczamy na napisanie przyzwoitej jakości treści na zaplecza, jeśli udałoby się

zaoszczędzić choćby 50% na tekstach zastępując je sztucznie generowanymi, sensownymi,

zrozumiałymi dla człowieka treściami i "uodpornionymi" na Google, byłaby to wielka oszczędność

czasu i przede wszystkim pieniędzy, co doprowadziłoby do wzrostu opłacalności projektów SEO

lub jak kto woli zwiększenia zysków.

Wyszukiwarka

Podobne podstrony:

Tworzenie nowych zmiennych

Nihongo gramatyka, 136, Tworzenie nowych czasowników - -GARU

Sposoby tworzenia nowych wyrazów, język polski konspekty

15 Metody tworzenia politykid 16261

Algorytmy wyklady, Metody tworzenia algorytmów

Mapa numeryczna metody tworzenia mapy

TWORZENIE NOWYCH PIERWIASTKÓW

prawoznawstwo metody tworzenia prawa, Prawo Administracyjne, Gospodarcze i ogólna wiedza prawnicza

Tworzenie nowych foloderów

METODY TWORZENIA PORTALI BIZNESOWYCH CO TO SĄ PORTALE KORPORACYJNE

3 Metody tworzenia algorytmu

Zapożyczenia i tworzenie nowych wyrazów

praca dyplomooww - Metodyka Tworzenia Stron WWW, komputery, sieci komputerowe

18(45) Metody tworzenia systemów informatycznychid 17860 ppt

Nihongo gramatyka, 137, Tworzenie nowych przymiotników - -YASUI, -NIKUI, -ZURAI

Metody tworzenia przeroczystych kanaw w systemach z podziaem czasowym

Metodyka tworzenie muzyki i improwizacja

Tworzenie nowych produktow i uslug jako podstawa procesow innowacyjnych, Katarzyna Ambroziak

Algorytmy wyklady, Metody tworzenia algorytmów

więcej podobnych podstron