Wpływ temperatury, energii aktywacji, szybkości ścinania, naprężenia ścinającego, stężenia substancji na lepkośc

Temperatura: Dla większości cieczy lepkość maleje ze wzrostem temperatury

--> η = A * e Wa/ kT

gdzie:

A - współczynnik proporcjonalności

Wa - energia aktywacji lepkosci

k - stała Boltzmanna

T - temperatura bezwzgledna cieczy

Krew - lepkosć zwiększa się z obniżeniem temp (0o C - 2,5 razy wieksza niż przy 37o C) - zmiany podobne do wody - lekosć względna nie zależy od temperatury.

2. Energia aktywacji:

Założenie teorii lepkości cieczy - kazda czesteczka zajmuje położenie równowagi --> przejście jej w kierunku przepływu możliwe - gdy uzyska energię aktywacji lepkości (Wa)

Względna liczba cząsteczek majacych w danej temp energię aktywacji

--> Δna/n = e -Wa/kT

Wzrost temp cieczy --> wzrost predkości --> wzrost energii bezładnego ruchu cząsteczek --> wzrost wzglednej liczby czasteczek majacych energię większą od en aktywacji.

Po zlogarytmowaniu poprzedniego równania:

--> ln η = ln A +Wa/k * 1/T

wykres - linia prosta - wyznaczenie en aktywacji i współczynnika A.

Prędkość scinania - lepkość pozorna krwi - funkcja malejąca predkosci ścinania.

( przy 37o C i hematokrycie 45% i szybkości ścinania 0,1 s-1 --> 100mPas, przy 230 s-1 --> spadek do 4mPas).

Powody:

agregacja krwinek czerwonych przy małych prędkościach ścinania

deformacja i ukierunkowanie erytrocytów przy dużych predkościach ścinania

Wzrost pedkości ścinania - maleje agregacja --> maleje lepkosć krwi

Przy prędkościach > 150- 200 s-1 - deformacja erytrocytów - zmniejszenie lepkości krwi - z powodu zmniejszenia oddziaływan hydrodynamicznych.

Stężenie (nie wiem czy to jest dobrze, bo to wynika tylko z mojej interpretacji wzoru, nie znalazlem tego gdzie indziej, jak to znajdziecie, dajcie mi koniecznie znać! )

Lepkość rośnie ze wzrostem stężenia, bo:

η/ηo = 1 + 2,5 Φ (wzór Einsteina na lepkosć wzgledną r-ru)

Φ = c * NA * v / M

gdzie:

Φ - objętościowy współczynnik r-ru

c - stężenie r-ru

M - masa molowa

NA - l. Avogadra

v - objętość 1 cząstki

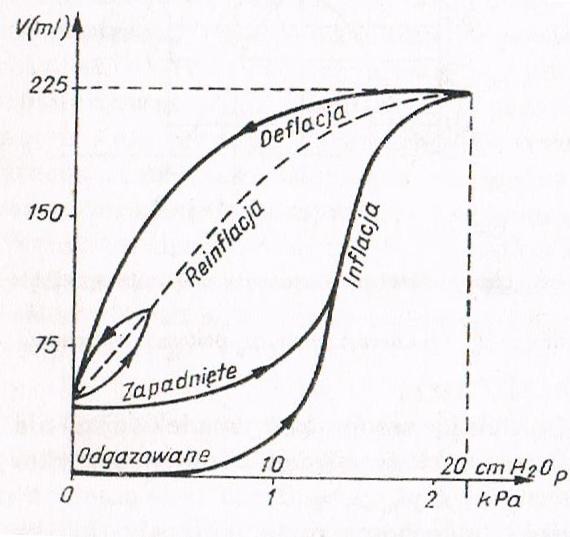

2.Właściwości reologiczne krwi

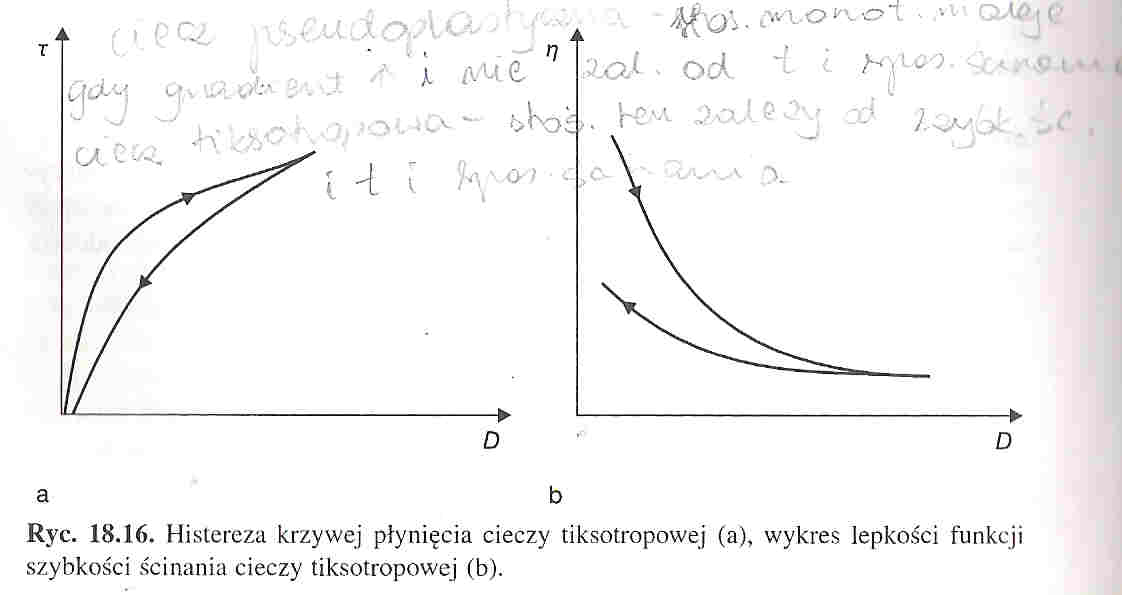

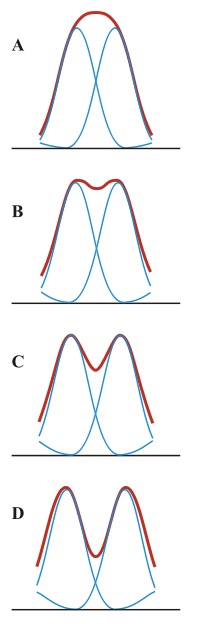

Krew jest cieczą nienewtonowską o charakterze pseudoplastycznym i tiksotropowym. Jej nienewtonowski charakter polega na tym, że stosunek naprężenia ścinającego do gradientu prędkości w danych warunkach ciśnienia i temperatury dla danej cieczy nie jest stały. Jeśli maleje on monotonicznie wraz ze wzrostem gradientu prędkości i nie zależy od czasu i sposobu ścinania, to mówimy o cieczy pseudoplastycznej. Jeśli stosunek ten zależy nie tylko od szybkości, ale też od czasu i sposobu ścinania, to ciecz nazywamy tiksotropową. Dla cieczy tiksotropowych krzywa płynięcia wykazuje histerezę.

Właściwości tiksotropowe krwi są związane z tworzeniem struktur w warunkach braku ścinania oraz ich rozpadaniem się w obecności naprężeń ścinających. Strukturami tymi są skupiska krwinek czerwonych; ich tworzenie się nazywamy agregacją.

Odtwarzanie struktur odbywa się w bardzo krótkim czasie, więc histereza krzywej płynięcia krwi jest prawie niezauważalna.

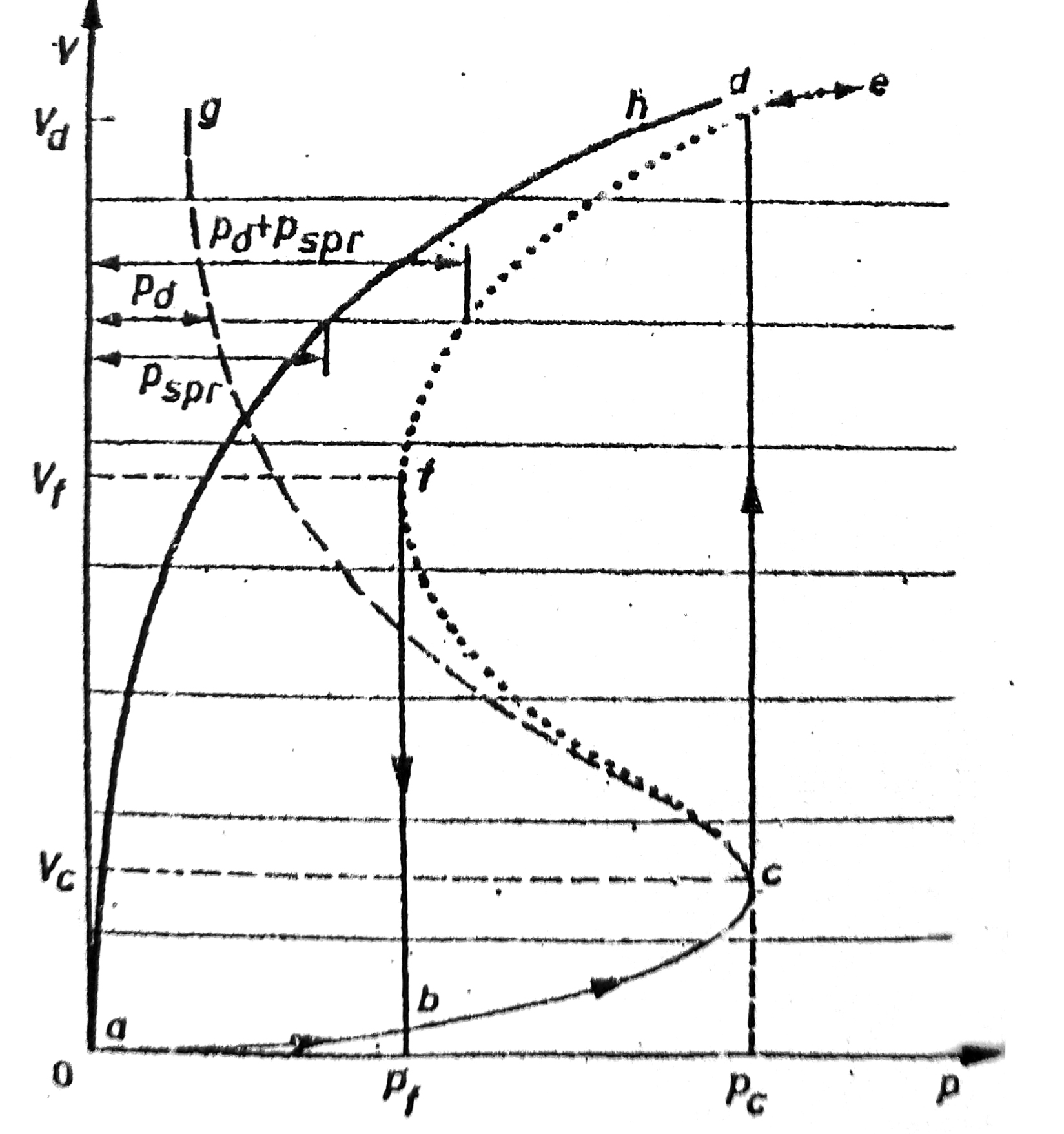

3.Krzywa płynięcia krwi

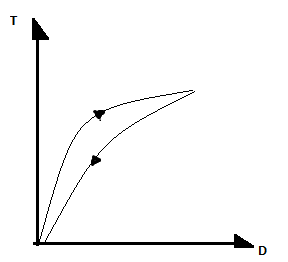

Przepływ cieczy lepkiej możemy traktować jako jeden ze specjalnych przypadków odkształcenia postaci materii. Oddziaływania występujące w przepływających płynach można scharakteryzować, podając naprężenia styczne (Τ=F/S) jako funkcję prędkości ścinania (u=dv/dx). Wykres zależności Τ=f(u) nazywamy krzywą płynięcia; na jej podstawie różnicujemy płyny na:

newtonowskie- wykresem jest linia prosta przechodząca przez początek układu współrzędnych

nienewtonowskie- wykresem jest linia prosta, która nie przechodzi przez początek układu współrzędnych.

Podział ten stosujemy dla ustalonych warunków ciśnienia i temperatury. Wartość ilorazu Τ/u nazywamy lepkością płynu. (η).

5. Krzywa pozornej lepkości krwi od prędkości ścinania, wartości przykładowe.

Lepkość pozorna krwi maleje wraz ze wzrostem prędkości ścinania. Przy temperaturze 37stopni C i hematokrycie 45% oraz prędkości ścinania 0,1 1/s wynosi 100mPas. Wzrost prędkości ścinania do 230 1/s powoduje spadek lepkości pozornej do około 4mPas.

Zależność ta wynika z dwóch zjawisk:

-agregacji erytrocytów(główny czynnik dla małych prędkości ścinania)

-deformacji i ukierunowaniu erytrocytów(główny czynnik dla dużych prędkości ścinania)

Wysoka prędkość ścinania prowadzi do zmniejszenia stopnia agregacji erytrocytów, a tym samym do spadku lepkości cieczy.

Przy prędkości ścinania około 150mPas-200mPas dochodzi do zjawiska deformacji erytrocytów i również spadku lepkosci w skutek zmniejszenia odzialywań hydrodynamicznych.

WYKRES- s.640 JAROSZYK 18.19

4.Prawo Ostwalda

Prawo dysocjacji Ostwalda nie pauje ni chuj do tematu! Skłaniam się ku temu, że chodzi tu o wyprowadzenie wzoru na lepkość względną w wiskozymetrze Ostwalda.

6. Równanie Cassona + Granica Płynięcia

Granica płynięcia - naprężenie powyżej którego krew dopiero zaczyna płynąć.

Krew - posiada granicę płynięcia - ale trudna do oznaczenia - przyczyny metodyczne.

Określenie granicy --> przy pomocy reologicznego modelu Cassona - wyraża w sposób analityczny krzywą płynięcia krwi

τ½ = τ0½ + kc * D½ <-- równanie Cassona

gdzie:

τ - naprężenie ścinające (styczne do powierzchni)

D - szybkość ścinania

τ0 - granica płynięcia

kc - współczynnik konsystencji

Według dotychczasowych badań - granica płyniecia krwi ~5mPa.

Wpływ na jej wartość maja:

hematokryt

-stężenie fibrynogenu i innych składników białkowych osocza

Wyznaczanie granicy płyniecia - ekstrapolacja krzywej płynięcia do prędkości równej 0.

Przykładowa krzywa płyniecia krwi w układzie pierwiastkowym dla krwi prawidłowej i krwi chorych na miażdżycę zarostową kończyn dolnych znajdziecie na stronie 600 Jaroszyka (rozdział 18.6.1 ryc 18.18)

8. Podatnosc erytrocytów na deformacje, rola w przepływie

Deformacje erytrocytów zachodzą przy prędkościach ścinania powyżej 150-200 1/s, które Są powodem zmniejszenia lepkości krwi (zmniejszenia oddziaływań hydrodynamicznych) i ich agregacji.

Przy prędkości ścinania 50/s krwinki mają kształt elipsoid, po zaniku ścinania powracają do pierwotnych kształtów. Agregacja może mieć znaczenia w miejscach o zwolnionym gradiencie prędkości (np. naczynia włosowate). (Pilawski str600)

10,Zależność lepkości od hematokrytu

Lepkość rośnie wraz ze wzrostem hematokrytu (przy 95% nadal jest zachowuje płynność)

Przy stałej prędkości ścinania porównuje się lepkośc skorygowaną (w odniesieniu do hematokrytu-45%).

η.krwi/η.osocza= exp{αH} gdzie α- współczynnik upakowania erytrocytów, H- hematokryt.

Lub η.krwiη.osocza45%=η.krwiη.osoczaH45H Lewa= lepkość wzgl. Przy H=45% ; Prawa= lepkość wzgl. Przy hematokrycie naturalnym podniesionym do potęgi (stosunku H standardowego do naturalnego)

7.

Elastyczność erytrocytów, która związana jest z ich zdolnością do odkształcania, powoduje większą lepkość krwi. Wysokie prędkości ścinania, które powodują zmniejszenie odkształcalności (ale zwiększenie odkształcenia…), są przyczyną spadku lepkości.

Zdolność erytrocytów do odkształcania wiąże się z:

Brakiem jądra

Małą lepkością cytoplazmy

Korzystnymi właściwościami lepko-sprężystymi błony

Dużą wartością stosunku powierzchni swobodnej do objętości

Zmniejszona odkształcalność krwi jest przyczyną wielu chorób.

9.

Największy wpływ na lepkość krwi przy stałym hematokrycie i małych prędkościach ścinania ma zjawisko agregacji krwinek czerwonych.

Im silniejsza agregacja tym większa lepkość krwi.

Im większa prędkość ścinania tym mniejsza agregacja

Przy prędkościach ścinania powyżej 150-200 s-1 występuje zjawisko deformacji krwinek czerwonych, co powoduje mniejszą lepkość wskutek zmniejszenia oddziaływań hydrodynamicznych.

11.Wiskozymetr Ubbelohde'a,

Pomiar lepkość względnej roztworów potrzebne do sporządzenia wykresu zależności lepkość właściwej od stężenia przeprowadzamy stosując wiskozymetr kapilarny Ubbelohde'a. Jego działanie jest oparte na prawie Poiseuila'e(strona 98 Kędzia).

Pomiar lepkości względnej cieczy polega na mierzeniu czasu t0 (zero) przepływy przez kapilarę wiskozymetru cieczy wzorcowej o objętości zawartej pomiędzy kreskami A i B oraz czasu t przepływu przez kapilarę cieczy badanej o tej samej objętości. Opierając na prawie Poiseuila'e oraz uwzgleniajac że objętości cieczy badanej i wzorcowej są równe, możemy zapisać:

(strona 105 Kędzia; wzór jest bez numeru),

następnie po przekształceniu powstania nam

(wzór 10.8; ta sama strona).

Dzięki swojej konstrukcji wiskozymetr zapewnia że na końcu kapilary podczas pomiarów tworzy się „wiszący poziom” dzięki czemu Δp powodujące przepływ cieczy nie zależy od ilości cieczy znajdującej się w wiskozymetrze, a także od napięcia powierzchniowego cieczy.

Δp jest to ciśnienie hydrostatyczne:

(Δp=ρ*g*h, Δp0(zero)=ρ0*g*h)

Ostateczny wzór na wyliczenie lepkości względnej przy pomiarach tym wiskozymetrem ma postać:

(wzór 10.9 strona ta sama)

jeśli gęstość cieczy badanej do wzorcowej są podobne można je nie umieszczać we

wzorze

(wzór 10.10)

Obu wzorów możemy wysnuć wniosek że do policzenia lepkości względnej potrzebny jest nam czas przepływu cieczy badanej i wzorcowej.

Wybaczcie brak wzorów ale nie posiadam ani skanera anie aparatu.

Na dole jest model wiskozymetru jaki znalazłam na necie.

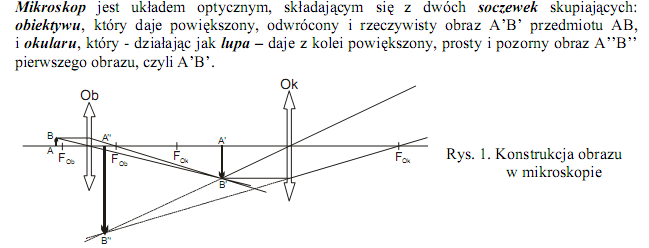

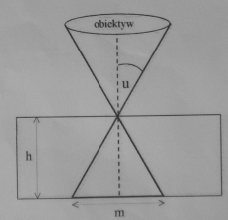

13.Wiskozymetr Ostwalda

Jest urządzeniem służącym do pomiaru lepkości względnej

Polega na mierzeniu czasu t zero przepływu przez kapilarę wiskozymetru cieczy wzorcowej o konkretnej objętości ( zawartej pomiędzy punktami A i B) oraz czasu przepływu przez kapilarę cieczy badanej o tej samej objętości

Możemy ją wyliczyć ze wzoru:

Można go otrzymać z zapisanego dwukrotnie Prawa Pouseulle'a dla cieczy wzorcowej i dla cieczy badanej oraz porównując strony tych równań.

12.Wiskozymetr rotacyjny

Jest urządzeniem służącym do badań cieczy nienewtonowskich i określania krzywej płynięcia czyli zależności naprężenia ścinającego od szybkości ścinania (D).

Wartość

obliczamy ze wzoru:

gdzie:

to lepkość pozorna dla badanej cieczy przy rosnących i malejących szybkościach ścinania.

D to szybkość ścinania

Wartości kolejnych naprężeń ścinajacych możemy obliczyc ze wzoru:

(Z odczytujemy z odpowiednich tabel dołączonych do wiskozymetru).

14. Wiskozymetryczny pomiar masy cząsteczkowej biopolimeru.

Ustaloną na podstawie doświadczeń zależność granicznej liczby lepkościowej roztworu polimeru od jego masy cząsteczkowej przedstawia wzór :

[η] = K × Mα

gdzie: K-stała zależna od rodzaju polimeru i rozpuszczalnika

α - współczynnik zależny od kształtu makrocząsteczki polimeru w roztworze

Wartość stałych K i są określane na podstawie pomiaru masy molowej polimeru metodą rozpraszania światła lub metodą sedymentacji.

Po zlogarytmowaniu wyżej wymienionego wzoru otrzymujemy:

Log M=1/α (log[η]-logK)

Wiskozymetryczny pomiar masy cząsteczkowej polega na wyznaczeniu granicznej liczby lepkościowej roztworu badanego polimeru ([η]=lim ηwł/c) i wyliczeniu masy cząsteczkowej z wyżej wymienionego wzoru.

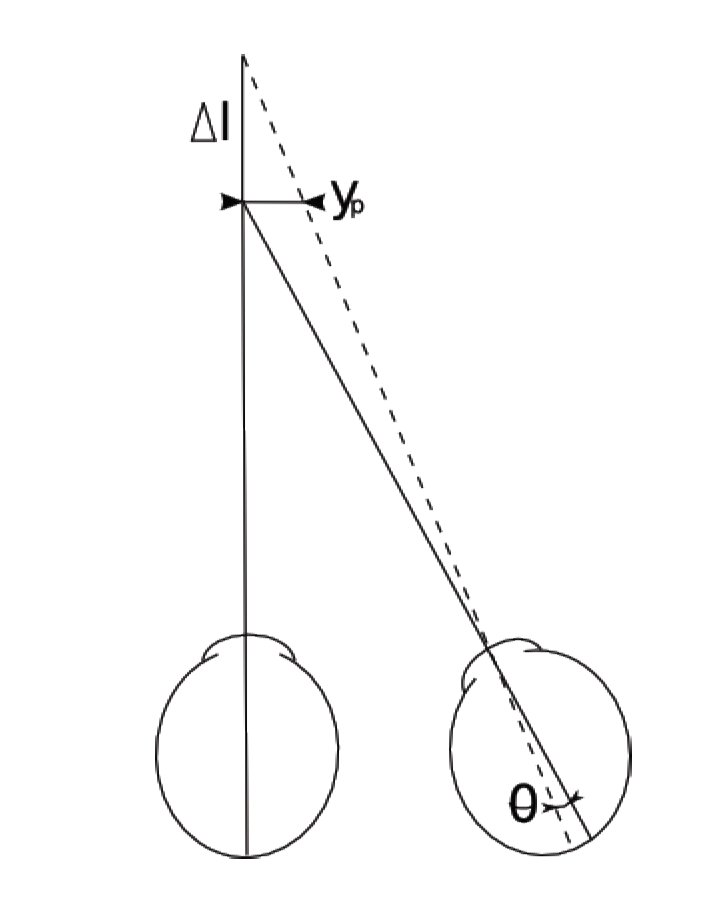

15. Metoda Stokesa

Metoda Stockesa polega na pomiarze prędkości opadania kulki w badanej cieczy. Na kulkę działają 3 siły:

siła ciężkości skierowana pionowo w dół, wyrażana wzorem

P = m*g = V*ρ*g = 4/3 πr3 *ρ *g

siła wyporu hydrostatycznego skierowana do góry, wyrażana prawem Archimedesa

Q = V* ρc*g = 4/3 πr3 * ρc*g

siła tarcia wewnętrznego ( oporu lepkości ), skierowana ku górze, wyrażana prawem Stockesa

R = 6πr*η*v

gdzie: Q R

m-masa kulki

V-objętośc kulki h

g-przyspieszenie ziemskie

ρc-gęstośc cieczy P

ρ-gęstośc kulki

r-promień kulki

η-lepkośc cieczy

v-prędkośc kulki

Początkowo kulka opada ruchem przyspieszonym, gdyż siła ciężkości kulki jest większa od sumy sił wyporu i lepkości. Zgodnie ze wzorem Stockesa, wzrost prędkości (v) kulki powoduje wzrost sily lepkości (R). Przy odpowiednio wysokiej prędkości zachodzi równośc:

P = Q + R

Od tej chwili kulka porusza się ruchem jednostajnym ze stałą prędkością. Podstawiając odpowiednie wartości sił do powyższego wzoru otrzymamy:

4/3 πr3 *ρ *g = 4/3 πr3 * ρc*g + 6πr*η*v

po przekształceniu otrzymamy:

η = 2r2 * g( ρ - ρc ) / 9v

Prędkośc opadania kulki otrzymujemy z czasu opadania kulki (t) i długości przedziału w którym ten czas mierzymy (h).

16. Rodzaje Lepkości

Lepkośc możemy wyliczyc z prawa Newtona ( patrz pytanie nr 17 ):

η = ( F*Δx)/(S*Δv)

Jest to siła niezbędna do utrzymania różnicy prędkości 1 m/s między dwiema warstwami cieczy o powierzchni 1 m2, przesuwającymi się względem siebie w odległości 1m. Jednostką lepkości jest N*s/ m2, używana jest też jednostka zwana puazem:

P = 0,1 N*s/ m2

Lepkośc względna to stosunek lepkości danej cieczy do lepkości cieczy wzorcowej w najczęstszym przypadku wody, a w przypadku roztworu jest do lepkości czystego rozpuszczalnika. Jest wielkością bezwymiarową.

[ η'] = η/ η0

Lepkośc właściwa także jest wielkością bezwymiarową definiowaną wzorem:

ηwł = η/ η0 - 1

Stosunek lepkości właściwej do stężenia (c) rozpuszczonego składnika przy tymże stężeniu dążącym do zera i prędkości ścinania (u) dążącej do zera, nazywamy lepkością graniczną:

[η] = limc-->0 u-->0 (ηwł/c)

Jednostką granicznej liczby lepkościowej jest cm3/g ( odwrotnośc stężenia ).

Wartości granicznej liczby lepkościowej odczytujemy z wykresu funkcji ηwł/c = f (c) poprzez ekstrapolację otrzymanej prostej do stężenia zerowego :)

ηwł/c

0 c

Posiadając wartośc granicznej liczby lepkościowej możemy wyliczyc masę dowolnych biopolimerów ( patrz pytanie 14 ).

17. Prawo Newtona, jednostki

Prawo newtona: Siła F wprowadzająca ciecz w ruch jest proporcjonalna do powierzchni S poruszających się względem siebie warstw cieczy oraz do spadku prędkości ∆V/∆x czyli:

F=Sη (∆V/∆x)

η - współczynnik lepkości (lepkość)

Jednostki lepkości: [η]=Ns/m²= kg/ms

Jednostka spoza układu Si: zwana Puazem ( P) 1P=10 ¹̄ Ns/m²

18. Reologia, wielkości, definicje

Reologia- obejmuje zagadnienia dotyczące odkształcenia i przepływu materii- czyli ruchu jednych elementów ośrodka względem innych. Przepływ cieczy lepkiej jest jednym ze specjalnych przypadków odkształcenia postaci materii.

Oddziaływania występujące w przepływających płynach można charakteryzować podając naprężenia styczne: τ = F/S , jako funkcję prędkości ścinania (u=dv/dx).

Wykres τ=f(u) nazywamy krzywą płynięcia. Różnicuje ona płyny na dwie kategorie: newtonowskie i nienewtonowskie. Dla pierwszej kategorii wykresem jest linia prosta przechodząca przez początek układu współrzędnych dla drugiej kategorii linia nie przechodzi przez początek.

Iloraz : τ/u jest lepkością płynu (η)

Rodzaje lepkości:

Lepkość względna i jej definicja: [η̕]=η/η₀

Lepkość właściwa Definicja: ηwł= (η/η₀)-1

Lepkość graniczna Definicja:

L. względna i właściwa- bezwymiarowe wielkości

L. graniczna- oznacza ηwł/c przy stężeniu c oraz u zmierzających do 0. Wyznaczamy ją z granicznej zależności: ηwł/c=[η] + k[η] gdzie k- stała Huggina

19. Ciecze newtonowskie i nienewtonowskie, podziały

Dla płynów newtonowskich lepkość nie zależy od szybkości ścinania, zależy natomiast od własności substancji tworzącej płyn i jego parametrów termodynamicznych takich jak temperatura i ciśnienie. Istnieją płyny, zwane płynami nienewtonowskimi, które nie spełniają powyższej zależności, dla nich naprężenia nie są proporcjonalne do gradientu prędkości, co jest równoznaczne z tym, że współczynnik lepkości nie jest stały lecz jest funkcją gradientu prędkości. Zależność naprężeń od gradientu prędkości przedstawiona na wykresie nosi nazwę krzywej płynięcia. Dla płynu newtonowskiego krzywa płynięcia jest prostą przechodzącą przez początku układu współrzędnych.

Krzywa płynięcia dla płynu newtonowskiego

Jeżeli krzywa płynięcia jakiegoś płynu nie jest prostą przechodzącą przez początek układu współrzędnych płyn taki jest płynem nienewtonowskim, lecz płynem z granicą płynięcia. Płyn newtonowski można też traktować jako specjalny przypadek płynu nienewtonowskiego.

20. Ciecze tiksotropowe

W cieczach tiksotropowych stosunek naprężenia ścinającego do gradientu prędkości zależy od szybkości, czasu i sposobu ścinania. Dla cieczy tiksotropowej krzywa płynięcia(wykres zależności naprężenia ścinającego od szybkości ścinania) wykazuje histerezę. Właściwości tiksotropowe krwi są związane z tworzeniem struktur w warunkach braku ścinania oraz i rozpadaniem się w obecności naprężeń ścinających. Dzięki temu badania krzywych płynięcia i ich analiza pozwalają wyciągnąć wnioski na temat rozmiarów struktur, łatwości ich tworzenia i warunków w jakich ulegają rozpadowi. Właściwości tiksotropowe krwi związane są z tworzeniem i rozpadaniem skupisk krwinek czerwonych. Zjawisko to nazywa się agregacją krwinek czerwonych. Odtwarzanie struktur odbywa się w bardzo krótkim czasie, w związku z tym histereza krzywej płynięcia jest prawie niezauważalna.

21. Ciecze pseudoplastyczne

Cieczami pseudoplastycznymi nazywa się ciecze w których stosunek naprężenia ścinającego do gradientu prędkości w określonych warunkach temperatury i ciśnienia nie jest stały. Może on także monotonicznie maleć wraz ze wzrostem gradientu prędkości lecz nie zależeć od czasu i sposobu ścinania. Taką ciecz jest między innymi krew.

22. Wzór Einsteina na lepkość

Wzór Einsteina określa lepkość względną roztworu, w Którym cząsteczki substancji rozpuszczonej mają kształt kulisty.

Gdzie:

Φ=

- współczynnik objętościowy roztworu; Vc-objętość cząsteczek substancji rozpuszczonej, Vr- objętość całkowita roztworu

η lepkość roztworu

η.-lepkość rozpuszczalnika

Objętość cząsteczek substancji rozpuszczonej jest równa iloczynowi liczby n moli tej substancji, liczby Avogadra NA i objętości V jednej cząsteczki:

Φ

Jeżeli uwzględnimy że M=

zaś c=

to powyższy wzór będzie wyglądał:

Φ

23. Akumulacja osiowa, efekt Magnusa

- Akumulacja osiowa polega na tym, że krwinki gromadzą się bliżej osi naczynia unikając jego ścian.

- Powstawanie akumulacji osiowej tłumaczy się efektem Magnusa (na ciało wykonujące ruch obrotowy i poruszające się ruchem postępowym działa siła prostopadła do tego ruchu powodująca odchylenie).

- Ruch obrotowy wywołujący efekt Magnusa (a co za tym idzie akumulację krwinek) powstaje w skutek wytworzonego gradientu prędkości (powstaję on ze względu na to, że bliżej ścianek naczynia warstwy płynu poruszają się wolniej). Ruch obrotowy pociąga za sobą ciecz nadając jej ruch cyrkulacyjny wokół krwinki, co jest powodem rozrzedzenia linii prądu przy odściennej stronie krwinki a zagęszczenie ich od strony odosiowej. W ten sposób wytwarza się różnica ciśnień, która znosi krwinkę do osi przewodu.

- Akumulacją osiową krwinek tłumaczy się zależność lepkości krwi od prędkości przepływu.

- W warunkach fizjologicznych krew zachowuje się jak ciecz newtonowska i lepkość prawię nie zależy od prędkości przepływu, jednakże akumulacja osiowa powoduje, że lepkość jest mniejsza (warstwa cieczy między ścianą a strumieniem krwinek zmniejsza tarcie)

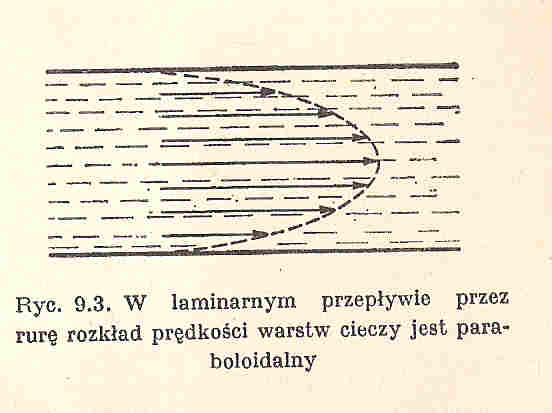

24. Przepływ laminarny

Przepływ laminarny (warstwowy) - jest to taki rodzaj przepływu płynu lepkiego, w którym największą prędkość ma ciecz poruszająca się wzdłuż osi przewodu, a ciecz przy ściance pozostaje nieruchoma (występuje gradient prędkości wywołany tarciem wewnętrznym <<lepkością>>). Zachodzi dla małych prędkości przepływu, gdy liczba Reynoldsa nie przekracza tzw. wartości krytycznej (powyżej której przepływ staje się turbulentny).

Objętość V cieczy przepływającej laminarnie w czasie t przez poprzeczny przekrój rurki włoskowatej o promieniu r i długości l, na końcach której panuje różnica ciśnień Δp jest określana prawem Poiseuille'a (które wykorzystujemy w pomiarze współczynnika lepkości).

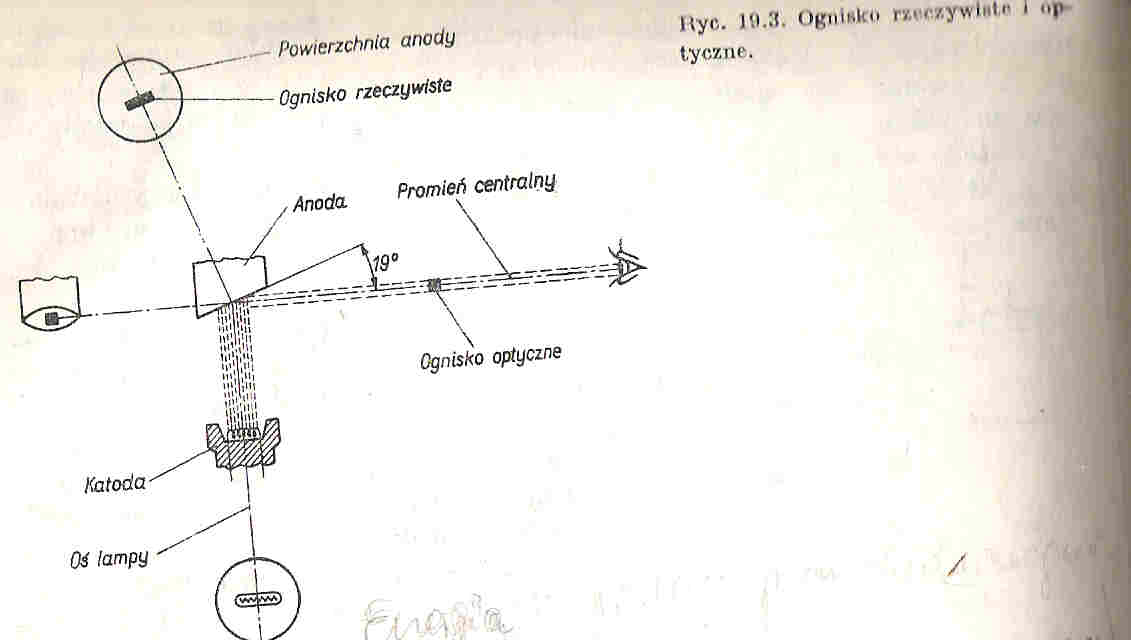

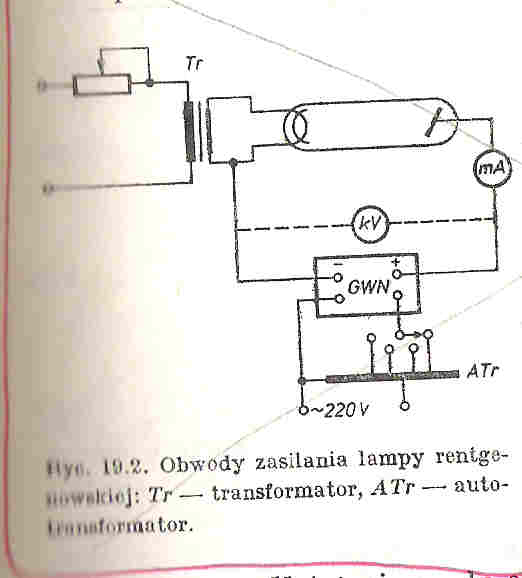

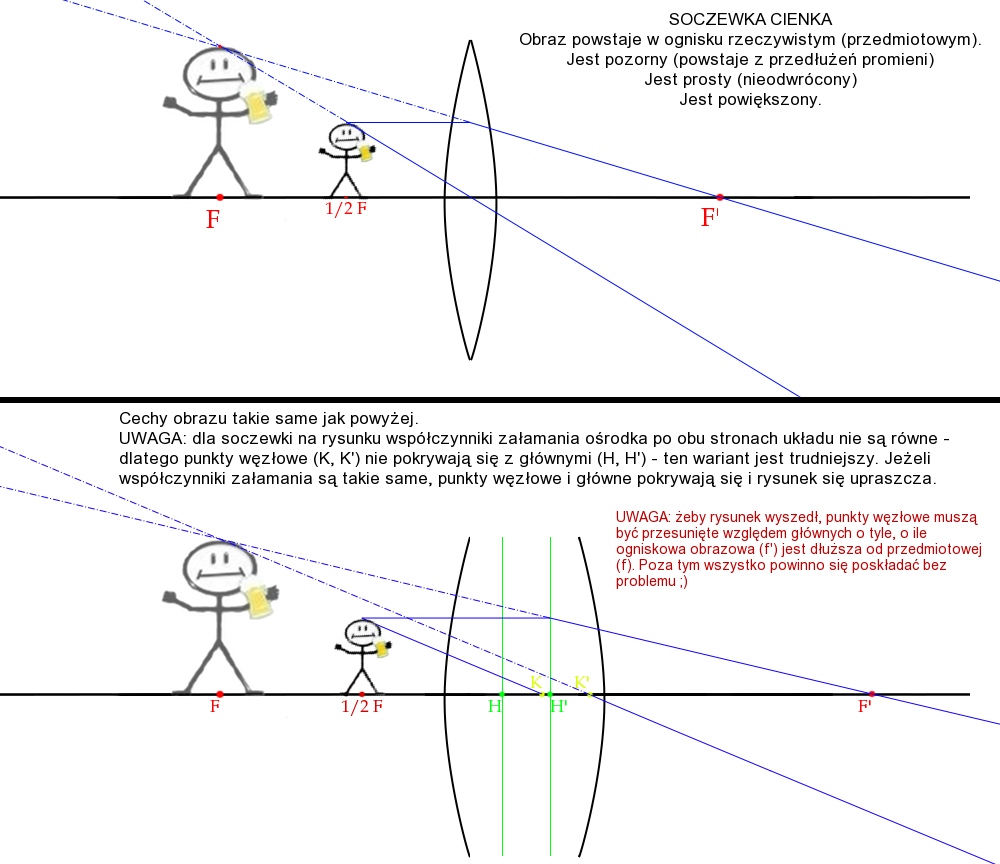

25. Budowa lampy rentgenowskiej i 26. Wytwarzanie promieni rentgenowskich

Działanie lampy rentgenowskiej opiera się na wykorzystaniu elektronów o wysokich energiach kinetycznych zaś uzyskanie promieniowania rentgenowskiego jest możliwe dzięki hamowaniu tych elektronów na anodzie lampy rentgenowskiej.

Lampa rentgenowska zbudowana jest z Katody (umieszczonej w czaszy ogniskującej) najczęściej wolframowej na, której na wskutek przyłożonego napięcia (ok. 10V) na drodze termoemisji wytwarzane są elektrony. Ilość emitowanych elektronów może być regulowana za pomocą umieszczonego w obwodzie katodowym opornika zmiennego, którym można regulować rozżarzenie katody.

Elektrony uzyskują wysoką energię kinetyczną w silnym polu elektrycznym, które powstaje dzięki przyłożonemu napięciu (od kilku do kilkuset tysięcy Volt), uzyskiwane dzięki generatorowi wysokich napięć (GWN), a następnie są ogniskowane za pomocą czaszy ogniskującej na anodzie w ognisku rzeczywistym.

Odbywa się tam zjawisko polegające na tym, że pola elektryczne jąder atomów anody działaj na wysokoenergetyczne elektrony co prowadzi do ich zahamowania. Podczas tego procesu 99% energii elektronów ulega rozproszeniu w postaci ciepła . Pozostała energia jest oddana w postaci promieniowania rentgenowskiego.

*Jeśli elektron ulegnie najpierw kilku zderzeniom niesprężystym to część energii traci podczas tych zderzeń.

*jeśli elektron straci całą energie podczas jednego gwałtownego hamowania to cała ta energia zostaje zamieniona na energie fotonu rentgenowskiego

Ognisko rzeczywiste - nazywamy miejsce na anodzie na które pada strumień elektronów.

Ognisko optyczne - nazywamy rzut ogniska rzeczywistego na płaszczyznę prostopadłą do przebiegu wiązki promieniowania elektromagnetycznego.

* rozmiary ogniska optycznego mają istotny wpływ na ostrość aparatu rentgenowskiego co jest ważne w lampach diagnostycznych

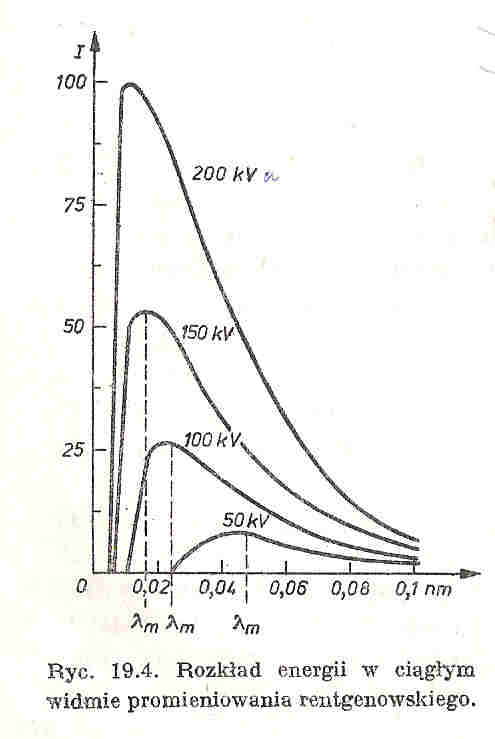

27. Powstawanie promieniowania rentgenowskiego, widmo ciągłe

Elektrony przyspieszone w silnym polu elektrycznym miedzy katoda, a anoda, przenikają w pobliże jader atomowych anody i pod działaniem pola elektrycznego atomu zostają zahamowane, uwalniając przy tym energie w postaci promieniowania elektromagnetycznego, o długości fali zależnej od wartości energii kinetycznej elektronu w okresie hamowania. Energia ta zależy od tego czy elektron straci od razu energie w procesie gwałtownego hamowania, czy najpierw dozna kilku zdarzeń niesprężystych z atomami anody, tracąc przy tym cześć energii, a po tym zostanie dopiero zahamowany. W tym pierwszym przypadku cala energia kinetyczna elektronów zostaje zamieniona na energie fotonu rentgenowskiego, dlatego promieniowanie emitowane przez lampę rentgenowska ma widmo ciągłe, czyli jest szerokim pasmem fal elektromagnetycznych o rożnych energiach i długościach fal. Rozkład energii widma jest na wykresie. Cechy charakterystyczne widma ciągłego:

1.istnienie ostrej granicy od strony fal krótkich. Związane z tym jest prawo Duane'a i Hanta,

U- napięcie anodowe

e- nabój elektronu

ν - częstość drgań krótkofalowej granicy widma

maksymalne ν otrzymamy gdy cala energie wypromieniowana zostanie w jednym fotonie. Max częstotliwość związana jest z minimalna w danym widmie długością fali, którą można otrzymać ze wzoru:

po podstawieniu h, c, i e otrzymuje się:

2. Gwałtowny wzrost natężenia promieniowania w miarę wzrostu napięcia anodowego, natężenie to jest proporcjonalne do kwadratu napięcia:

gdzie:

C - stała

Z - liczba atomowa materiału anody

i - natężenie prądu anodowego

U - Napięcie anodowe

28. Widmo charakterystyczne.

Na tle widma ciągłego występują wyraźne linie widmowe charakterystyczne dla pierwiastka, z jakiego jest zbudowana anoda. Powstaje wówczas, gdy energie elektronów przekroczy pewna konkretna wartość, która zależy od pierwiastka hamującego, wtedy spowoduje to przesuniecie sie elektronów orbitalnych atomów anody na wyższe poziomy energetyczne i powracając do stanu podstawowego emitują kwanty promieniowania rtg o energiach charakterystycznych dla danego pierwiastka. Są to głownie linie serii K i L, w przypadku cięższych pierwiastków M i N.

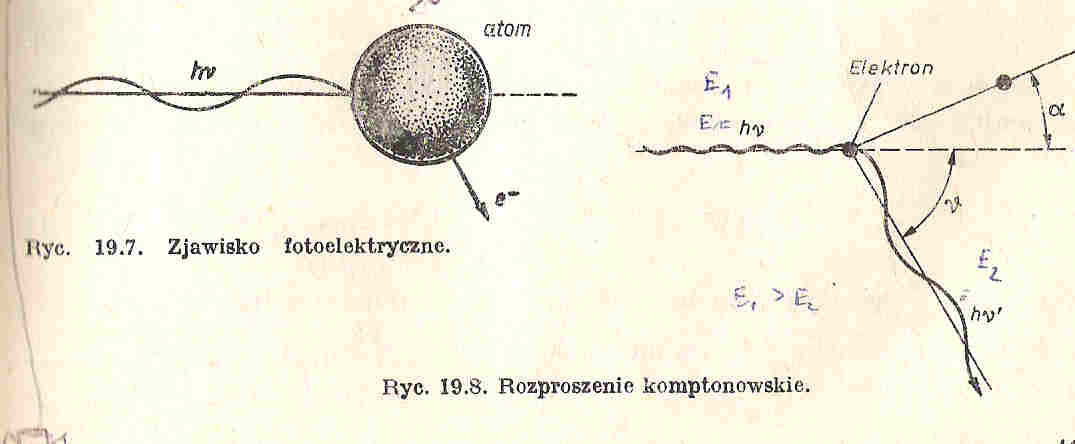

29. Zjawisko fotoelektryczne.

Zachodzi, gdy z atomu pod wpływem fali elektromagnetycznej zostaje wybity elektron, foton nadaje elektronowi energię kinetyczną 1/2mv2.

Energia fotonu hv zostaje zużyta na wykonanie pracy W potrzebnej do przezwyciężenia energii wiązania elektronu (praca wyjścia) oraz na nadanie elektronowi energii kinetycznej.

hv= W + 1/2mv2

Atom pozbawiony elektronu staje się jonem dodatnim. Wybity elektron to fotoelektron.

30 . Rozproszenie Comptonowskie.

Wynik sprężystego zderzenia fotonu z elektronem. Po zderzeniu foton zostaje odrzucony, a foton rozproszony. Elektron uzyskuje pęd p=mv, a foton rozproszony ma mniejszą częstotliwość od fotonu padającego. Związany jest z tym przyrost długości fali.

Ponieważ¿ zderzenie fotonu z elektronem jest sprężyste, podlega zasadzie zachowania pędu:

oraz zasadzie zachowania energii:

-długość fali Comptona

31. Tworzenie par elektron-pozyton

Zjawisko to zachodzi w polu jądra atomowego i polega na wyzwoleniu przez foton dwóch elektronów o przeciwnych ładunkach elektrycznych-negatonu i pozytonu, przy jednoczesnym jego unicestwieniu(fotonu).Proces ten jest możliwy jedynie wtedy, gdy energia fotonu przekracza energie równoważna masie spoczynkowej dwóch elektronów, czyli musi być większa niż. 1,022MeV (E jednego elektronu=0,511MeV). Przekaz energii i pędu zachodzi za pośrednictwem jądra atomowego lub elektronu.

hν=2 m0c2+Ek+ +Ek-

Ek- to energia kinetyczna elektronu Ek+ to energia kinetyczna pozytonu

Powstałe elektrony jonizują inne atomy kosztem swej energii kinetycznej. Pozyton po utracie energii łączy sie z negatonem, po czym oba elektrony ulęgają samounicestwieniu a na ich miejscu powstają 2 fotony.

32. Prawo osłabienia, współczynnik μ, warstwa połowiąca

Prawo osłabiania:

Mechanizmy oddziaływania promieniowania elektromagnetycznego z materia powodują, że wraz ze wnikaniem wiązki promieniowania w głąb środowiska, jej natężenie maleje w wyniku absorpcji i rozproszenia części fotonów. Spadek natężenia jest wyrażony prawem osłabiania, które głosi, że względne osłabianie natężenia promieniowania dI/I jest proporcjonalne do przyrostu grubości dx substancji pochłaniającej.

dI/I= - μdx

a po scałkowaniu:

I=I0 e-μx (I0- natężenie wiązki padającej; I- wiązki po przejściu warstwy o grubości x)

gdzie: μ -współczynnik osłabiania, jego wartość zależy od masy właściwej absorbentu i długości fali promieniowania

Warstwa połowiąca:

Warstwa połowiąca d - grubość warstwy danego materiału powodująca

zmniejszenie o połowę natężenia przechodzącej przez nią wiązki

promieniowania. Odgrywa ona wazna role przy ocenie przenikliwosci promieniowania w radioterapii.

0.5I0=I0e-μd

μd=lg2/lge=0.693

d=0.693/ μ

34. Działanie promieniowania jonizującego z materią

Oddziaływanie promieniowania jonizującego na materię sprowadza się głównie do jonizacji, będącej następstwem niesprężystych oddziaływań cząstek jonizujących z elektronami i jądrami atomów absorbentu. Jonizacja właściwa charakteryzuje zdolność jonizowania danego promieniowania. Jej miarą jest liczba par jon+elektron wytworzonych wzdłuż jednostki drogi cząstki jonizującej.

Cząstki jonizujące mogą powodować także wzbudzenie atomów lub cząsteczek (przeniesienie ich na wyższy poziom energetyczny, co jest związane z przesunięciem elektronów na orbitalach). Cząsteczki wzbudzone powstają bezpośrednio w wyniku zderzeń niesprężystych z cząstką jonizującą lub w wyniku jonizacji z natychmiastowym zobojętnieniem jonu: M M++ e- M*

Stany wzbudzone cząsteczek są nietrwałe, a powrót do stanu podstawowego może realizować się następującymi sposobami:

Nadmiar energii zostaje oddany w postaci promieniowania luminescencji,

Energia wzbudzenie zostaje zużyta na dysocjację cząsteczki,

Energia wzbudzenia jest przeniesiona na inną cząsteczkę poprzez bezpośrednie zderzenie lub rezonans.

Ciężkie cząstki naładowane (protony, deuterony, cząstki α) współdziałają z materią w następujących procesach:

Niesprężyste zderzenia z elektronami powłok atomów.

Reakcje jądrowe,

Sprężyste zderzenia z atomami lub jądrami atomów.

Rola każdego z tych procesów zmienia się w zależności od typu cząstki i jej energii. Nasilenie wywołanej jonizacji zależy od ładunku cząstki i jej masy. Gęstość jonizacji wzrasta w miarę zbliżania się cząstki do końca jej toru, gdzie następuje gwałtowny zanik jonizacji.

Elektrony działają na materię w odmienny sposób, co jest spowodowane ich małą masą. Mogą one bezpośrednio oddziaływać z polem elektrycznym jąder atomowych w sposób sprężysty lub niesprężysty. W pierwszym przypadku jądra absorbentu nie zyskują energii elektronów, natomiast w drugim ją pochłaniają.

Promieniowanie elektromagnetyczne (fotony): Oddziaływanie jonizacyjne fotonów z materią może być realizowane trzema mechanizmami: efektu fotoelektrycznego, zjawiska Comptona oraz zjawiska tworzenia się par elektron-pozyton. W ich wyniku powstają elektrony, zwane wtórnymi, które całkowicie lub częściowo przejmują energię fotonów. Są one właściwym czynnikiem jonizującym. Udział tych trzech procesów jest różny w zależności od energii fotonów, np. dla energii 10 keV zjawisko udział zjawiska fotoelektrycznego wynosi 99%, dla 2 MeV udział zjawiska Comptona wynosi 99%, a dla 20 MeV zjawisko Comptona i powstawanie par stanowią po 50% zachodzących procesów oddziaływania.

Neutrony mogą oddziaływać na materię na trzy sposoby:

Zderzenia sprężyste z jądrami atomów absorbentu. Suma energii kinetycznych rozproszonego neutronu i jądra absorbentu (jądro odskoku) po zderzeniu muszą być równe energii neutronu przed zderzeniem. W tkankach jądrami odskoku są zazwyczaj jądra tlenu, azotu, węgla i wodoru. Jądra wodoru w pewnych przypadkach mogą przejmować całkowitą energię neutronu. Neutrony nie jonizują więc materii bezpośrednio, lecz za pośrednictwem protonów.

Zderzenia niesprężyste. Część energii neutronu jest przekazana na wzbudzenie jąder absorbentu. Jądra te powracając do stanu podstawowego emitują kwanty γ.

Wychwyt neutronu przez jądra absorbentu. W procesie tym biorą udział głównie neutrony termiczne (znajdujące się w równowadze termicznej ze środowiskiem). W tkankach w procesie wychwytu biorą udział głownie jądra wodoru, fosforu i azotu. Dochodzi do przekształceń tych jąder np. 1H (n,p) 2H.

35: Dawki promieniowania jonizującego, jednostki, dawki graniczne, przykłady.

Wyróżniamy następujące dawki promieniowania jonizującego:

1. Dawka pochłonięta D określona wzorem D=E/m -jes to stosunek energii przekazywanej przez promienie jonizujące danemu elementowi masy m substancji przez masę m.

Jednostka: [1Gy]=1J/kg (Gy-grej)

W użyciu bywa też inna jednostka: 1rd (rad) 1rd=0,01J/kg

2. Dawka ekspozycyjna X określona wzorem X=Q/m -jest to suma ładunków elektrycznych jonów jednego znaku wytworzonych przez promieniowanie w jednostce masy powietrza m.

Jednostka: [X]=C/kg

W użyciu bywa też inna jednostka spoza układu SI 1R (rentgen) 1R=2,58*10^-4 C/kg

Ad 1,2 -stosujemy przyrosty dla m, E i Q dlatego iż pole promieniowania obszaru który nas interesuje (badany obiekt) jest niejednorodne.

3. Moc dawki pochłoniętej D jest to iloraz przyrostu dawki przez wartość czasu, w których przyrost następuje.

Określa ją wzór: D="delta"D/"delta"t

Jednostka: [D]=1Gy/s lub 1rd/s

Moc dawki ekspozycyjnej X="delta"X/"delta"t

Jednostka: [X]=1C/s lub 1R/s

4. Równoważnik dawki pochłoniętej H określa implikacje biologiczne spowodowane ekspozycją na promieniowanie przy małych wartościach dawek pochłoniętych.

Określony wzorem: H=D*Q*N

Jednostka: 1siwert 1Sv=PJ/kg używana jest także jednostka 1rem gdy D jest wyrażone w radach, czyli: 1Sv=1000rem

5. Efektywny równoważnik dawki Hef -ma zastosowanie w ocenie prawdopodobieństwa przypadku zgonu lub prawdopodobieństwa wystąpienia poważnych skutków dziedzicznych w dwóch pierwszych pokoleniach.

Określony jest wzorem:

36. Efektywny równoważnik dawki Hef

Wielkość ta jest wskaźnikiem pomocnym w ocenie prawdopodobieństwa przypadku zgonu(jako skutku somatycznego) lub prawdopodobieństwa wystąpienia poważnych skutków dziedzicznych w dwóch pierwszych pokoleniach.potrzeba wprowadzenia takiego wskaźnika wynika z tego że wra żliwość na promieniowanie różnych tkanek i organów dla takich samych równoważników dawek jest różna.

Hef=ΣT WTHT

gdzie:

HT-ŚREDNI równoważnik dawki w tkance lub organieT

WT-współczynnik wagi,wyrażający stosunek prawdopodobieństwa wystąpienia skutku somatyczno-stochastycznego wywołanego napromienieniem tkanki(organu) T do prawdopodobieństwa wystąpienia tego skutku przy równomiernym napromienieniu całego ciała

37. LET

LET (Linear Energy Transfer, liniowe przenoszenie energii) jest wielkością charakteryzującą zdolność jonizowania danej substancji, mierzona ilością energii oddanej przez cząstkę jonizującą na jednostkę drogi:

LET=E/x

Inna wielkością opisującą zdolność jonizowania jest jonizacja właściwa, której miarą jest liczba par jonów (jon + elektron) wyzwolonych wzdłuż jednostki drogi cząstki jonizującej

n/x.

LET lepiej obrazuje zjawisko wydatkowania energii gdyż cząstki jonizujące tracą swą energię nie równomiernie ale porcjami.

Między jonizacją właściwa i LET zachodzi związek:

E/xW = n/x

W- średnia energia, którą promieniowanie traci na wytworzenie jednej pary jonów (dla powietrza W= 34eV)

Wartość E/x zależy od wielu czynników

ładunku cząsteczki Ze (Z - liczba ładunków elementarnych, e - ładunek elementarny)

prędkości cząsteczki v

E/x (ZE)2/v2

LET jest wielkość odwrotnie proporcjonalną do kwadratu prędkości cząstki (cząstka dłużej przebywa w rejonie elektronu orbitalnego przez co prawdopodobieństwo oddziaływania z elektronem jest większe)

Polecam obejrzeć tę prezentację: http://www.biofizyka.amp.edu.pl/RADIOTERAPIA-MT-2009-studenci.pdf

38. Efekt biologiczny promieni jonizujących

z punktu widzenia biofizyki dwie właściwości wyróżniają promieniowanie jonizujące spośród czynników fizycznych

1. Niewspółmiernie intensywne działanie biologiczne stosunkowo bardzo małej ilości energii doprowadzonej do organizmu za pośrednictwem promieniowania jonizującego. Dawka śmiertelna dla człowieka w przypadku napromieniowania całego ciała wynosi ok. 600rad, co odpowiada 6 dżulom lub 1,4 kalorii. Ta mała energii jest biologicznie bardzo aktywna. Prawdopodobnie wiąże się to z tym, że pierwotne reakcje popromienne zachodzą w małych objętościach o rozmiarach cząsteczek i makrocząsteczek. Poza tym w warunkach żywego organizmu początkowe niewielkie uszkodzenie ulega zwielokrotnieniu (potencjalizacja uszkodzenia).

2. Każdy czynnik patogenny dowolnego pochodzenia (chemiczny, toksyczny, farmakologiczny, itp.) działa biologicznie dopiero po przekroczeniu charakterystycznej dlań wartości progowej. Powyżej tej wartości intensywność działania szybko wzrasta, aż do osiągnięcia wartości bezwzględnie śmiertelnej. W przeciwieństwie do tego promieniowanie jonizujące często cechuje się brakiem dawki progowej (np. dla uszkodzeń genetycznych), a oprócz tego różnica między nią a dawką śmiertelną może być bardzo duża. Fakt ten świadczy o istnieniu dużych różnic wrażliwości na promieniowanie między składnikami napromieniowanej populacji.

Efekt promieniowania ujawnia się w miejscu absorpcji tego promieniowania. Można je wtedy interpretować na podstawie tzw. Teorii trafień i teorii tarczy. Punktem wyjścia obu teorii jest stwierdzenie, że absorpcja promieniowania w materii nie jest procesem ciągłym, lecz kwantowym oraz podporządkowanym prawom statystyki.

Z matematyczny rozważań tego stwierdzenia wynika, że efekt biologiczny po napromieniowaniu jednorodnej populacji biologicznej (np.komórki w hodowli in vitro, kolonia drobnoustrojów, roztwór biocząsteczek, np. DNA itp.) ujawni się w statystycznym składniku tej populacji(komórka, bakteria cząsteczka DNA itp.) tylko wówczas,gdy w składniku tym znajdzie się określona minimalna ilość „trafień”, czyli pojedynczych aktów absorpcji promieniowania. Umiejscowienie trafień nie może być przy tym dowolne. W każdym żywym organizmie istnieje jedna lub kilka „wrażliwych objętości” lub „tarcz”, w których musi nastąpić określona ilość aktów absorpcji (trafień), aby efekt popromienny mógł się ujawnić.

Natura „tarcz” reprezentowanych przez liczbę ekstrapolacyjną nie jest dokładnie znana. Są dowody na to, że SA one zlokalizowane w jądrze komórkowym, przy czym cechom właściwym „tarczom” najbardziej odpowiada DNA. Liczba „tarcz” odpowiedzialnych za określoną funkcją komórki, np. reprodukcję, może być różna. Bakterie i komórki haploidalne mają jedną „tarczę” ( komórki diploidalne - więcej niż jedną. zniszczenie promieniowaniem jednej „tarczy” odpowiedzialnej za określoną funkcję powoduje wypadnięcie tej funkcji, np. komórka traci zdolność podziału.

W komórkach diploidalnych taki sam efekt można uzyskać po zniszczeniu wszystkich „Tarcz”. Jeśli pozostaje choćby jedna „tarcza”, odnośna funkcja zostaje zachowana. Uszkodzenie popromienne charakteryzujące się zniszczeniem części „Tarcz” nosi nazwę subletalnego. Po pewnym czasie „tarcze” unieczynione promieniowaniem ulegają odtworzeniu. Uważa się, że uszkodzenie subletalne dotyczy odpowiedniego odcinka tylko jednej nici DNA, a naprawa tego uszkodzenia jest realizowana na drodze syntezy sterowanej przez nie uszkodzoną komplementarną nić cząsteczki DNA. Natomiast uszkodzenie letalne dla komórki obejmuje obie nici cząsteczek DNA, co oczywiście uniemożliwia naprawę uszkodzenia.

W układach żywych nie zawsze zachodzi bezpośrednie działanie promieniowania: miejsce absorpcji energii nie musi być identyczne z miejscem ujawnienia się reakcji radiobiologicznej. w tym przypadku zachodzi pośrednie działanie promieniowania.

Za działanie pośrednio odpowiedzialne są przede wszystkim niektóre produkty radiolizy wody ustrojowej (rodniki H' , OH', HO2' oraz H2O2 i eaq). Ze względu na dużą zawartość wody działanie pośrednie odgrywa w organizmach żywych dużą rolę. Rodniki wodne mogą np. spowodować rozpad biocząsteczki na mniejsze fragmenty lub utleniając grupy SH, występujące prawie we wszystkich białkach, prowadzić do utraty lub zmiany aktywności biologicznej biocząsteczki. Rodniki wodne mogą działać biologicznie również pośrednio poprzez nadtlenki organiczne,np. rodnik OH', powstający podczas pośredniego działania promieniowania, reaguje ze związkami organicznymi według reakcji: RH+ OH' → ROO'. W obecności tlenu rodnik organiczny utlenia się: R' + O2 → ROO'.Nadtlenek organiczny staje się początkowym ogniwem reakcji radiobiologicznej.

Ważnym czynnikiem determinującym w dużym stopniu wrażliwość obiektów biologicznych na promieniowanie, a biorącym udział w pośrednim działaniu promieniowania, jest stężenie tlenu w obiekcie w chwili napromieniowania . od obecności tlenu zależy ukierunkowanie reakcji radiochemicznych w wodzie ustrojowej, np. rodnik HO2' powstaje tylko w obecności tlenu, przy czym ze względu na krótki czas trwania pierwotnych procesów radiolitycznych cząsteczek wody (rzędu 1018-1016s), istotne znaczenie ma tylko tlen obecny w czasie napromieniowania.

Eksponencjalne krzywe przeżycia przedstawiają skutki napromieniowania komórek białaczkowych myszy w warunkach beztlenowych (w atmosferze N2) i tlenowych. D37 wynosiła odpowiednio 3,6 i 1,6 Gy z czego wynika, że uwarunkowana obecnością O2 wrażliwość komórek za napromieniowanie jest około 2,3 - krotnie większa niż w warunkach beztlenowych.

Jest to fakt o dużym znaczeniu w radioterapii nowotworów. Większość guzów nowotworowych zawiera bowiem skupiska komórek niedotlenionych, czasem wręcz na pograniczu anoksji. Komórki te są względnie radioodporne, co w znacznym stopniu obniża wartość leczniczą radioterapii. Uważa się, ze właśnie od tych komórek zaczyna się ponowny rozwój nowotworu po napromieniowaniu . zapobieganie niepożądanemu oddziaływaniu hipoksji sprowadza się do :

poprawy natlenienia guza (reoksygenacja),

2) stosowania większych dawek promieniowania (nie zawsze jest to możliwe ze względuu na niebezpieczeństwo nieodwracalnego uszkodzenia tkanek zdrowych) i

3) stosowania promieniowania o wysokim LET. Im wyższy bowiem LET, tym mniejsze znaczenie ma „efekt tlenowy”. Równocześnie, ze wzrostem LET zwiększa się prawdopodobieństwo indukowania uszkodzeń letalnych w obrębie „tarcz”. Ogólnie, im większa dawka, moc dawki i LET tym większa skuteczność radioterapii. Tłumaczy to aktualne tendencje w radioterapii zmierzającej do wykorzystania strumieni cząstek o wysokich energiach i dużej zdolności jonizacyjnej (wysoki LET).

39. Efektywny okres połowicznego rozpadu izotopów promieniotwórczych podanych do wnętrza organizmu.

Radioaktywność zdeponowana w narządzie maleje w czasie dzięki dwóm procesom:

Rozpadowi radioaktywnemu z prędkością określoną stałą rozpadu λf zgodnie z równaniem:

Wydalaniu z organizmu na drodze normalnych procesów metabolicznych z prędkością określoną stałą wydalania λb zgodnie z równaniem

Oba te procesy sumują się, więc aktywność zdeponowana w tkance lub narządzie maleje z prędkością λef = λf+ λb. Korzystając z zależności λ= można zapisać:

Lub:

Tef - efektywny okres półtrwania substancji organicznej w organizmie jako funkcja rozpadu radioaktywnego i wydalania biologicznego

40. Zastosowanie izotopów promieniotwórczych do badania kinetyki przemian metabolicznych.

Badania kinetyki przemian metabolicznych są oparte na ocenie zmian aktywności źródła promieniotwórczości w czasie.

Badanie kinetyki jodu-123 w postaci 125I-:

Po dożylnym podaniu znacznika określa się jego aktywność w surowicy i w moczu, monitorując równocześnie od zewnątrz tarczycę licznikiem scyntylacyjnym. Badanie dotyczy układu trójprzedziałowego:

Powtarzane w odpowiednich odstępach czasu pomiary radioaktywności pozwalają na ocenę szybkości transferu k znacznika między składnikami układu

Badanie kinetyki technetu-99m w postaci 99mTcHO4-

Substancja wprowadzana jest dożylnie, skąd przechodzi do tkanek i narządów, wydalana jest z moczem.

Gdy za pomocą znakowanych związków jodu lub nadchlorku technetu zablokować wychwyt przez tkanki i narządy, układ ten redukuje się do składników 1 i 2, wtedy szybkość transferu k12 można obliczyć ze wzoru:

= k12*t

Znając k12 można obliczyć k13 ze wzoru

W podobny sposób bada się kinetykę związków żelaza lub bilirubiny w organiźmie

41. Metoda rozcieńczania izotopowego.

Metoda rozcieńczania izotopowego to jedna z metod analizy radiochemicznej. Opiera się na założeniu, że izotopy tego samego pierwiastka zachowują się pod względem chemicznym w identyczny sposób. Natomiast izotopy promieniotwórcze można łatwo wykryć poprzez emitowane przez nie promieniowanie.

Metoda pozwala wyznaczyć objętość lub stężenie składnika danej mieszaniny. Do wyznaczenia objętości V składnika S mieszaniny znakuje się odpowiednim izotopem objętość V₁ tej substancji. Gdy: Aktywność jednostki tej substancji wynosi A. Aktywność całkowita V₁ czyli A*V₁ musi być równa aktywności całkowitej objętości po w prowadzeniu V₁ do objętości V czyli ( V+ V₁)B (B- aktywność jednostki objętości V+V₁)

Czyli V₁*A = (V+V₁)*B

Po przekształceniu V = V₁ ( A/B - 1) gdzie A>B I V₁≥V

V = V₁ * A/B

Metoda rozcieńczania izotopowego ma zastosowanie gdy bezpośredni pomiar nieznanej objętości jest niemożliwy np. objętości krwi, chłonki, objętości krwinek czerwonych

42 - metody klirensowe

Są to badania izotopowe umożliwiające przede wszystkim pomiary przepływu krwi i

ukrwienia narządów.

Pomiar przepływu mózgowego:

Stosuje się tu Ksenon 133 - jest to radioaktywny gaz, który po wstrzyknięciu do tętnicy szyjnej dostaje się do naczyń włosowatych a następnie dyfunduje do ciał tłuszczowych. Miarą szybkości przejścia znacznika przez mózg jest krzywa oczyszczania ksenonu zmierzona nad mózgiem. W ten sposób możemy określić czy przepływ krwi przez badaną część OUN jest prawidłowy czy zaburzony.

Pomiar przepływu sercowego:

Do oceny przepływu sercowego znakuje się erytrocyty lub albuminy krwi nadtechnecjanem. Znacznik jest wstrzykiwany do żyły łokciowej po czym dokonuje się rejestracji przepływu krwi ze znacznikiem przez serce prawe, krążenie małe i serce lewe. Na podstawie uzyskanych informacjom można ustalić granice obszaru lewej komory, ruchliwość mięśnia sercowego, pojemność wyrzutową serca i czas przepływu krwi przez jamy serca.

Dzięki metodzie pefuzji mięśnia lewej komory serca talem 201 możliwe jest uwidocznienie miejsca przebytego zawału i określenie wielkości blizny pozawałowej.

Obecnie badania klirensowe przeprowadzane są za pomocą kamery scyntylacyjnej współpracującej z komputerem.

Inne przykłady badań klirenoswych:

- fitynian indu (In) - badanie wątroby, śledziony i płuc

43. Komora Wilsona i komora pęcherzykowa, działanie i zastosowanie

Komora Wilsona - W komorze Wilsona wykorzystuje się zdolność kondensacji pary wodnej na jonach wytworzonych przez cząstki naładowane. Komora ta składa się ze szklanego naczynia cylindrycznego, którego dno stanowi ruchomy tłok. Umożliwia on szybkie (adiabatyczne) rozprężenie znajdującego się w komorze powietrza z nasyconą parą wodną. W wyniku oziębienia pojawiają się kropelki rosy na jonach (ośrodkach kondensacji) tworzących się wzdłuż torów cząstek jonizujących przechodzących przez komorę. Zastosowanie bocznego oświetlenia powoduje rozproszenie światła na kropelkach rosy, dzięki czemu można obserwować ślady torów cząstek jonizujących i fotografować. Użycie pola magnetycznego w badaniach z komorą Wilsona umożliwia zakrzywianie toru cząstek. Pomiar promienia krzywizny dostarcza informacji o pędzie i masie cząstki, natomiast kierunek zakrzywienia toru pozwala określić znak ładunku cząstki. Wadą komory Wilsona jest mała zdolność hamowania cząstek, przez co duża część procesów oddziaływania cząstki z materią przebiega poza obrębem komory. Problem ten rozwiązało opracowanie komory pęcherzykowej.

Komora pęcherzykowa - w komorze tej zamieniono środowisko gazowe na ciekłe, co zwiększyło ilość oddziaływań cząstki z materią wzdłuż toru, a tym samym zdolność do hamowania cząstki. W komorze znajduje się ciecz (ciekły wodór, hel, etylen itp.) utrzymywana w stałej temperaturze. W wyniku działania urządzenia zwiększającego objętość komory, ciśnienie zmniejsza się do wartości mniejszej od ciśnienia pary nasyconej danej cieczy w panującej temperaturze. Ciecz staje się przegrzana. W wyniku przejścia cząstki jonizującej przez komorę, na powstałych jonach tworzą się pęcherzyki pary cieczy, co można zarejestrować aparatem fotograficznym. Tym samym fotografujemy podobnie jak w komorze Wilsona tory cząstek jonizujących.

Zastosowanie: Komora Wilsona i pęcherzykowa służą do obserwacji torów cząstek jonizujących. Pozwala to na badanie cząstek o wysokich energiach oraz procesów wzajemnego oddziaływania tych cząstek na siebie

44. Efekt Czerenkowa, MDD

Efekt Czerenkowa - zjawisko powstawania promieniowania widzialnego (świecenie) w przypadku, gdy naładowana cząstka porusza się w ośrodku, dla którego prędkość fazowa światła c/n (n- współczynnik załamania dla ośrodka) jest mniejsza od prędkości v poruszającej się cząstki. Promieniowanie (zwane promieniowaniem Czerenkowa) to można rejestrować za pomocą fotopowielaczy lub klisz fotograficznych. Urządzenie takie (nazwane licznikiem Czerenkowa) znajduje liczne zastosowania w badaniach fizyki jądrowej

MDD - Maksymalna dopuszczalna dawka - jest to graniczna (maksymalna) wartość mocy dawki promieniowania, którą można aplikować człowiekowi przez dowolnie długi czas bez obawy spowodowania uszkodzeń jego tkanek (moc dawki - wartość dawki promieniowania doprowadzonej do organizmu w określonym czasie np. 4Gy/min). Obecnie obowiązująca wartość MDD wynosi 2,58*10-5 C/kg na tydzień. Nie przekraczanie tej wartości chroni przed uszkodzeniami somatycznymi i ogranicza do minimum występowanie zmian o charakterze genetycznym. Zmiany te mogą dotyczyć aparatu genetycznego gamet i z tego względu ustalono dopuszczalną dawkę skumulowaną, w określonym czasie, która wynosi 1,29*10-3 C/kg/rok. Dopuszczalną dawkę skumulowaną przez organizm pracownika w dowolnym czasie można obliczyć ze wzoru Dskum.=1,29*10-3(N-18) C/kg, gdzie N- wiek pracownika w latach.

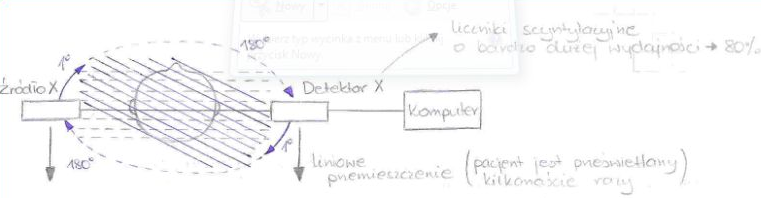

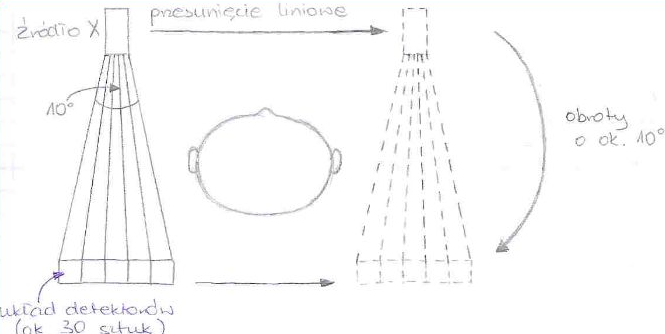

47. Scyntygraf, Scyntykamera - działanie, zastosowanie

Scyntygrafia jest metodą uzyskiwania obrazu narządów, a przede wszystkim oceny ich czynności, poprzez zastosowanie licznika scyntylacyjnego oraz niewielkiej dawki izotopu promieniotwórczego (radioznacznika). Detektor scyntylacyjny rejestruje promieniowanie, którego źródłem jest badana okolica ciała.

Scyntygrafy są aparatami, w których detektor przesuwa się nad badanym narządem ze stałą prędkością. Jego obraz drukowany jest na papierze dzięki odpowiednik pisakom. Zagęszczenie znaków jest proporcjonalne do liczny rejestrowanych impulsów. Scyntygrafia kolorowa pozwala zobrazować zmiany aktywności poprzez zastosowanie różnych barw.

Badanie scyntygraficzne trwa dość długo, dlatego służy do diagnostyki małych narządów (np. tarczycy).

Nowocześniejszych rozwiązaniem jest scyntykamera (gamma kamera). W scyntykamerze detektor jest nieruchomy. Duża głowica tego aparatu obejmuje swoim polem widzenia całość badanego narządu (wątroby, serca, mózgu, nerek), a badanie trwa znacznie krócej w porównaniu ze scyntygrafem. Wynik badania można otrzymać na błonie fotograficznej, chociaż obecnie utrwala się znacznie częściej w pamięci komputera. W obrazie komputerowym, zależnie od potrzeb, możliwa jest zmiana skal barwnych, filtrowanie, wygładzanie a przede wszystkim badanie czynności narządów. Gamma kamery ruchome (rotujące) umożliwiają uzyskanie obrazów warstwowych (tomograficznych), podobnie jak w tomografii komputerowej. Obrazy te uzyskuje się przez okrężny ruch głowicy aparatu wokół ciała pacjenta. Technika ta określana jest jako tomografia emisyjna pojedynczego fotonu (z angielskiego - SPECT).

48. Wyznaczanie dawki ekspozycyjnej metodą komory jonizacyjnej.

W celu wyznaczenia dawki ekspozycyjnej stosujemy komorę jonizacyjną. Stanowi ona pewien rodzaj kondensatora, pomiędzy którego okładki wprowadzana jest substancja promieniotwórcza. Pozwala on mierzyć natężenie promieniowania , poprzez pomiar zmiany różnicy potencjałów między elektrodami komory wywołanej działaniem promieniowania jonizującego.

W celu wyznaczenia dawki ekspozycyjnej na początku wyznaczamy wartość promieniowania tła odczytując wskazania, gdy nie jest wprowadzona ani źródło, ani absorbent, następnie wykonujemy pomiar natężenia promieniowania w układzie źródło-detektor). po wprowadzeniu do komory badanego obiektu lub jego fantomu w układzie źródło-absorbent-detektor (pomiarów dokonujemy wielokrotnie i wartości uśredniamy).

Otrzymujemy wartości średnie:

- szybkość zliczania związana z tłem

- szybkość zliczania związana z nieosłoniętym źródłem promieniowania

- szybkość zliczania związania ze źródłem przesłoniętym fantomem

Obliczamy pozorną aktywność źródła ze wzoru:

, gdzie A to aktywność źródła.

Następnie obliczamy dawkę ekspozycyjną związaną z pochłanianiem promieniowania przez absorbent:

Nr.49 Scholastyczne i niescholastyczne skutki napromieniowania

Działanie promieniowania jonizującego (rys.)

Biologiczne efekty oddziaływań promieniowania na żywy organizm dzielimy na:

Efekty somatyczne - dotyczą napromieniowanego organizmu i polegają na uszkodzeniu komórek utrzymujących procesy życiowe.

Efekty genetyczne- występują przy uszkodzeniu komórek rozrodczych odpowiedzialnych

Za przekazywanie cech dziedzicznych.

Ze względu na relacje między dawką promieniowania a efektem biologicznym skutki promieniowania dzielimy na:

Niescholastyczne (pewne)- kiedy możemy wykazać ścisły związek, zwykle liniowy, między wielkością dawki a natężeniem skutku.

Scholastyczne- jeśli możemy mówić o zależności prawdopodobieństwa wystąpienia

określonego skutku w funkcji pochłoniętej dawki promieniowania.

Efekty genetyczne promieniowania są zawsze scholastyczne, efekty somatyczne mogą być zarówno scholastyczne jak i niescholastyczne. Powstawanie jednych i drugich skutków tłumaczy się przy pomocy dwóch teorii oddziaływania promieniowania jonizującego:

Teoria „pocisku i tarczy” bezpośredniego oddziaływania.

Teoria oddziaływania pośredniego chemiczno-biologicznego.

50 Radioliza, znaczenie

Radioliza zachodzi pod wpływem działania promieniowania jonizującego. Prowadzi do zmian radiacyjnych związków biologicznie ważnych-białek, aminokwasów, enzymów, kwasów nukleinowych, polegających na inaktywacji cząsteczki. Istotne znaczenie mają zmiany radiochemiczne zachodzące w wodzie.

ETAP I

W wyniku jonizacji może zostać usunięty elektron:

- jeden z wiążących → cząsteczka rozpada się na H+ i OH lub H i OH-,

- niewiążący → powstaje jon H2O+.

Jon H2O+ z łatwością wychwytuje elektron, następuje przejściowa odbudowa cząsteczki, znajduje się ona w stanie wzbudzonym i ulega dalszemu rozpadowi na rodniki H˙ i OH˙.

H2O++e-->H2O*->H. .+OH.

Niezobojętnione jony H2O+ rozpadają się na H+ i OH-

Jony H+ reagując z elektronami dają atomy H.

ETAP II

Oprócz wolnych rodników powstają elektrony uwodnione e-(aq) → twory złożone z elektronu i grupy otaczających go cząsteczek wody. Powstają w ten sposób, że najpierw uwolnione elektrony podlegają terminalizacji ( ich energia ulega zmniejszeniu do poziomu właściwego ruchowi cieplnemu) a następnie hydratacji.

ETAP III

W końcowej fazie powstają cząsteczkowe produkty rozkładu wody w wyniku kombinacji atomów H

i rodników OH˙:

H + H→ H2

OH + OH → H2O2

W wyniku reakcji : H2O2 + OH˙ → HO2˙ + H2O. powstaje ważny w układach biologicznych rodnik HO2˙

51. Ochrona przed promieniowaniem jonizującym

W celu ochrony przed promieniowaniem jonizującym ustalono granicę bezpiecznego napromieniowania ludzi.

Jednym z parametrów charakteryzujących promieniowanie i decydującym o charakterze uszkodzenia jest moc dawki - stosunek dawki do czasu. Tą samą dawkę można doprowadzić do organizmu w różnym czasie. Im dłuższy jest czas promieniowania tym mniejsza jest moc dawki, a im mniejsza moc dawki tym mniejsze uszkodzenie żywej materii, mimo, że całkowita pochłonięta energia jest taka sama.

Ustalono również graniczną moc dawki czyli taką, którą można aplikować człowiekowi przez czas dowolnie długi bez obawy spowodowania uszkodzenia jego tkanek. Jest to maksymalna dopuszczalna moc dawki (MDD) i wynosi 2,58 × 10-5 C/kg × tydzień, przy 8-godzinnym dniu pracy. Dawka ta dotyczy osób zawodowo zatrudnionych przy źródłach promieniowania, dla ogółu ludności dawka ta ma wartość 10-krotnie niższą i wynosi 2,58 ×10-6 C/kg × rok. Utrzymywanie mocy ekspozycji na takim poziomie zapobiega powstawaniu uszkodzeń somatycznych i ogranicza możliwość wywołania zmian o charakterze genetycznym.

Wartość dopuszczalnej dawki skumulowanej w określonym czasie to 1,29 × 10-3 C/kg/rok.

Dopuszczalną dawkę skumulowaną, w dowolnie długim okresie oblicza się ze wzoru

Dskum. = 1,29 × 10-3 (N - 18) C/kg

Gdzie:

N - wiek pracownika w latach

18 - przy źródłach promieniowania można pracować dopiero po ukończeniu 18 roku życia

Promieniowanie jonizujące można również charakteryzować jako czynnik środowiskowy. Rozszerzający się zakres zastosowań promieni jonizujących sprawia, że na działanie tego promieniowania narażone są całe populacje ludzkie.

Wielkością odniesienia obciążenia populacji ze strony „cywilizacyjnych źródeł promieniowania” jest wartość tła - promieniowania jonizującego pochodzącego z przestrzeni pozaziemskiej oraz emitowanego przez naturalne radioaktywne skażenia biosfery.

Średnia wartość tła na półkuli północnej wynosi 100 - 120 mSv(milisiwertów)/rok.

Poza promieniowaniem tła istnieją źródła promieniowania stworzone przez człowieka, będące przyczyną dodatkowego promieniowania ludzi. Są to:

Źródła medyczne (promieniowanie rentgenowskie) stosowane w diagnostyce medycznej - 80-100% tła.

Opad promieniotwórczy pochodzący z doświadczalnych wybuchów jadrowych - 20-30% tła

Odpady radioaktywne w przemyśle atomowym i energetyce jądrowej - poziom nieustalony

Promieniowanie ze źródeł cywilizacyjnych obarcza populacje wartością równą wartości tla i stale rośnie. Może być to niebezpieczne ze względu na wzrost obciążenia genetycznego populacji.

Człowiek może być narażony na promieniowanie pochodzące z poza organizmu lub takie które znajduje się wewnątrz organizmu. To skąd pochodzi promieniowanie wpływa na ocenę stopnia zagrożenia i wybór sposobu ochrony.

Wewnętrzne skażenie organizmu substancją radioaktywna ma miejsce podczas stosowania otwartych źródeł promieniowania - substancji radioaktywnych w postaci płynów, gazów, aerozoli. W większości substancje te charakteryzują się wybiórczym powinowactwem tkankowym/ narządowym

35S - skóra

90Sr, 32P - kości

60Co - wątroba

131I - gruczoł tarczowy

59Fe - krwinki czerwone

Narządy te noszą nazwę krytycznych - zdeponowane w nich izotopy promieniotwórcze rozpadają się z właściwą im prędkością emitując przy tym promieniowanie. Promieniowanie γ dzięki dużej przenikalności opuszcza organizm, a β i α są pochłaniane w sąsiedztwie miejsca rozkładu, w takich warunkach narząd/tkanka mogą doznać znacznych uszkodzeń.

Możliwość usunięcia radioaktywności zdeponowanej w narządzie jest ograniczona - zachodzi dzięki procesom rozpadu radioaktywnego lub wydalania z organizmu na drodze normalnych procesów metabolicznych.

Analogicznie do MDD ustalono maksymalne dopuszczalne stężenia radioizotopów w wodzie i powietrzu (MDS). Są to aktywności, które po zdeponowaniu w narządzie krytycznym, rozpadając się całkowicie, nie obciążają go dawką, większą od dopuszczalnej.

52. Model anizotropowy kości.

Wielkości fizyczne dzielimy na skalary, wektory oraz tensory. Tensory są wielkościami bardziej złożonymi ni z tensory. Otrzymujemy je mnożąc każdy z trzech składowych jednego wektora przez trzy składowe drugiego. Przykładem tensorów są naprężenia mechaniczne oraz odkształcenia. Na rysunku poniżej zilustrowano schemat rozkładu sił działających na wycięty z materiału anizotropowego elementarny sześcian ułatwiający zrozumienie idei tensorów.

Na każdą ściankę sześcianu działają w trzech wzajemnie prostopadłych kierunkach siły, oznaczone odpowiednimi indeksami, przy czym pierwszy oznacza numer ścianki na którą działa siła, drugi - kierunek siły. Tak więc na każdą ze ścianek o powierzchni A działają po trzy siły o kierunkach wzajemnie prostopadłych. Ze względu na to, ze liczba ścianek wynosi 6, a liczba kierunków 3 otrzymujemy 3*6=18 tensorów naprężeń. Z kolei ze względu na warunek równowagi, w jakiej znajduje się rozważany element materiału, liczba naprężeń redukuje się do 9, a dalej - ze względu na symetrię - następuje dalsza redukcja liczby tensorów do 6, z których 3 mają kierunki normalne do danej powierzchni a pozostałem trzy równoległe.

Pierwsza cyfra oznacza numer ścianki, druga jej kierunek. W rezultacie otrzymujemy 6 tensorów naprężeń, przy czym i=1-6, podobnie otrzymujemy 6 tensorów względnych odkształceń sprężystych, przy czym j=1-6. Każda z sześciu składowych tensora naprężeń jest proporcjonalna do wszystkich sześciu składowych tensora odkształceń. Zatem dla materiałów anizotropowych prawo Hooke'a zapisujemy w postaci MACIERZY :

Macierz można zapisać również w postaci:

Macierz tensorów jest symetryczna względem przekątnej. tzn. cij=cji. W związku z czym dla ciał o całkowitej anizotropii liczba współczynników sprężystych redukuje się do 21, podczas gdy dla ciał izotropowych liczba ta wynosi 2; są to współczynniki związane ze sprężystością podłużną i poprzeczną. Współczynnikom tym odpowiadają odpowiednio: moduł sprężystości podłużnej E i moduł sprężystości poprzecznej G. Takie materiały jak kość, drewno itp. Są materiałami ortotropowymi. Dla tego typu materiałów liczba współczynników sprężystości cij=9. W przypadku izotropii poprzecznej liczba niezależnych współczynników sprężystości redukuje się do 5.

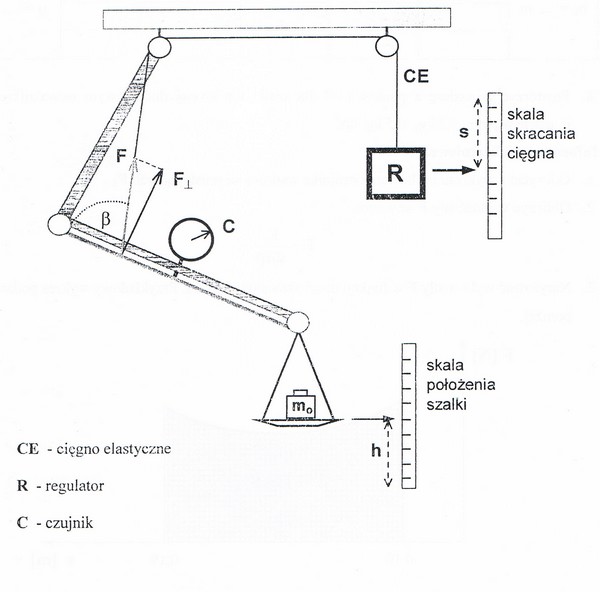

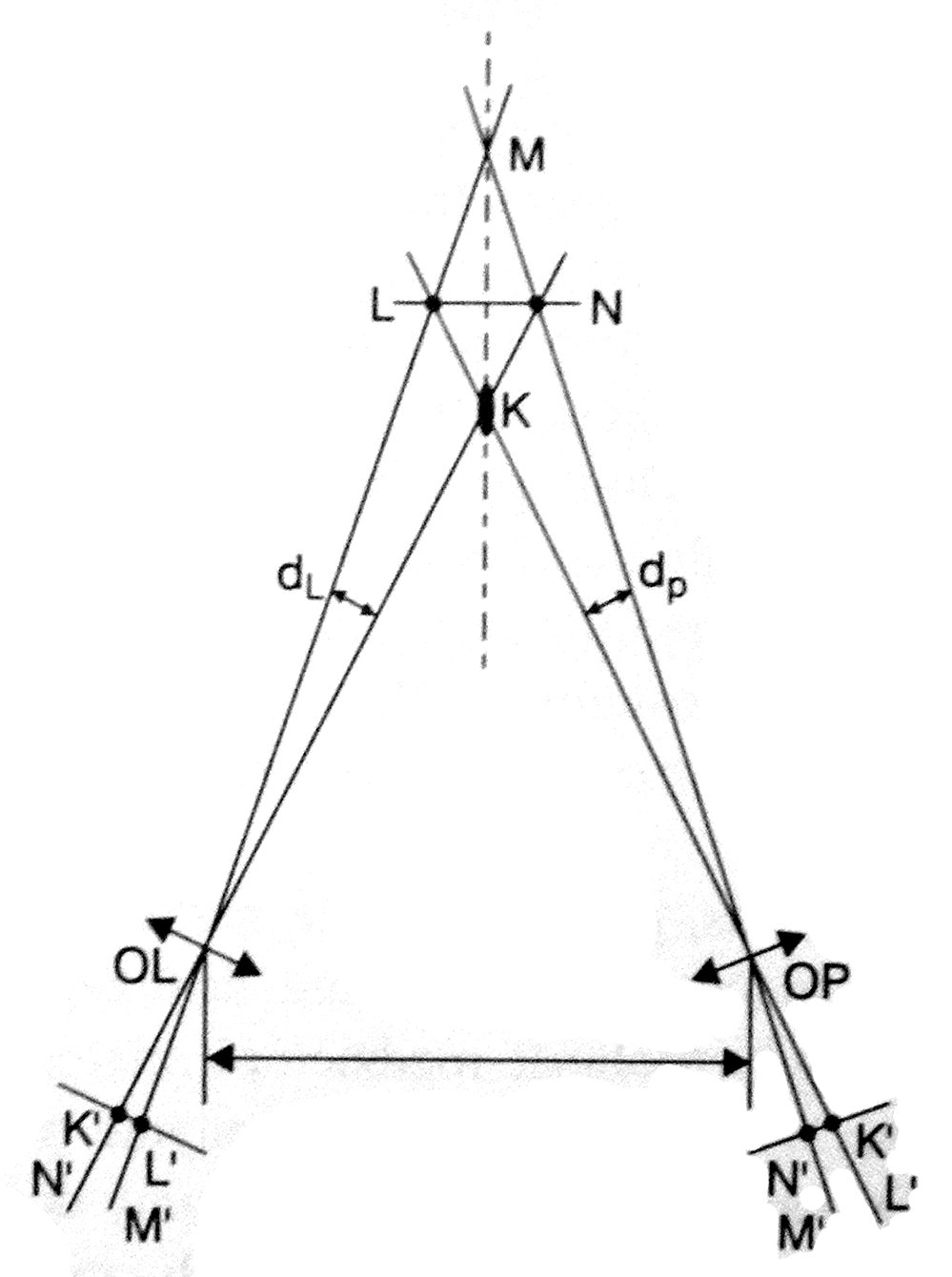

53. Model dźwignia - ramię.

Model zbudowany jest z dwóch dźwigni jednostronnych połączonych przegubowo oraz podwieszonych na statywie. Elastyczne cięgno C, symulując pracę włókien mięśniowych, łączy się poprzez zespół krążków z metalowym prętem, który odkształca się gdy układ jest obciążony ciężarem. Odkształcenie normalne pręta wyznaczane - w jednostkach arbitralnych au - przez czujnik C jest miarą składowej prostopadłej siły F napinającej cięgno (WAŻNY DOŁĄCZONY WYKRES CECHOWANIA z którego odczytujemy wartość siły prostopadłej w niutonach!!!) Związek trygonometryczny między siłami wyraża wzór: F= Fprostopadłe/sinβ, gdzie β jest kątem pomiędzy cięgnem a odkształcanym prętem. Śrubowym regulatorem R możemy zmieniać wartość siły F poprzez skracanie lub wydłużanie cięgna s, które odczytuje się z odpowiedniej skali.

Z doświadczenia takiego możemy odczytać z wykresu cechowania czujnika wartość sił prostopadłych F. Możemy także obliczyć wartość siły F ze wzoru

F=

Wykreślamy również wykres siły F w funkcji drogi skracania cięgna s i wyliczamy pole pod wykresem, które odpowiada wykonanej pracy W. Obliczamy jeszcze energię potencjalną szalki ze wzoru:

Ep=mg(hk-hp)

Gdzie m=ms + mo g=9.81

I na koniec wyznaczamy sprawność układu z zależności:

n=

OGÓLNIE ćwiczenie prowadziło do wyznaczenia pracy oraz sprawności modelu dźwigni szkieletowo - mięśniowych.

WYKRES CECHOWANIA:

54 Właściowości biomechaniczne mięśni

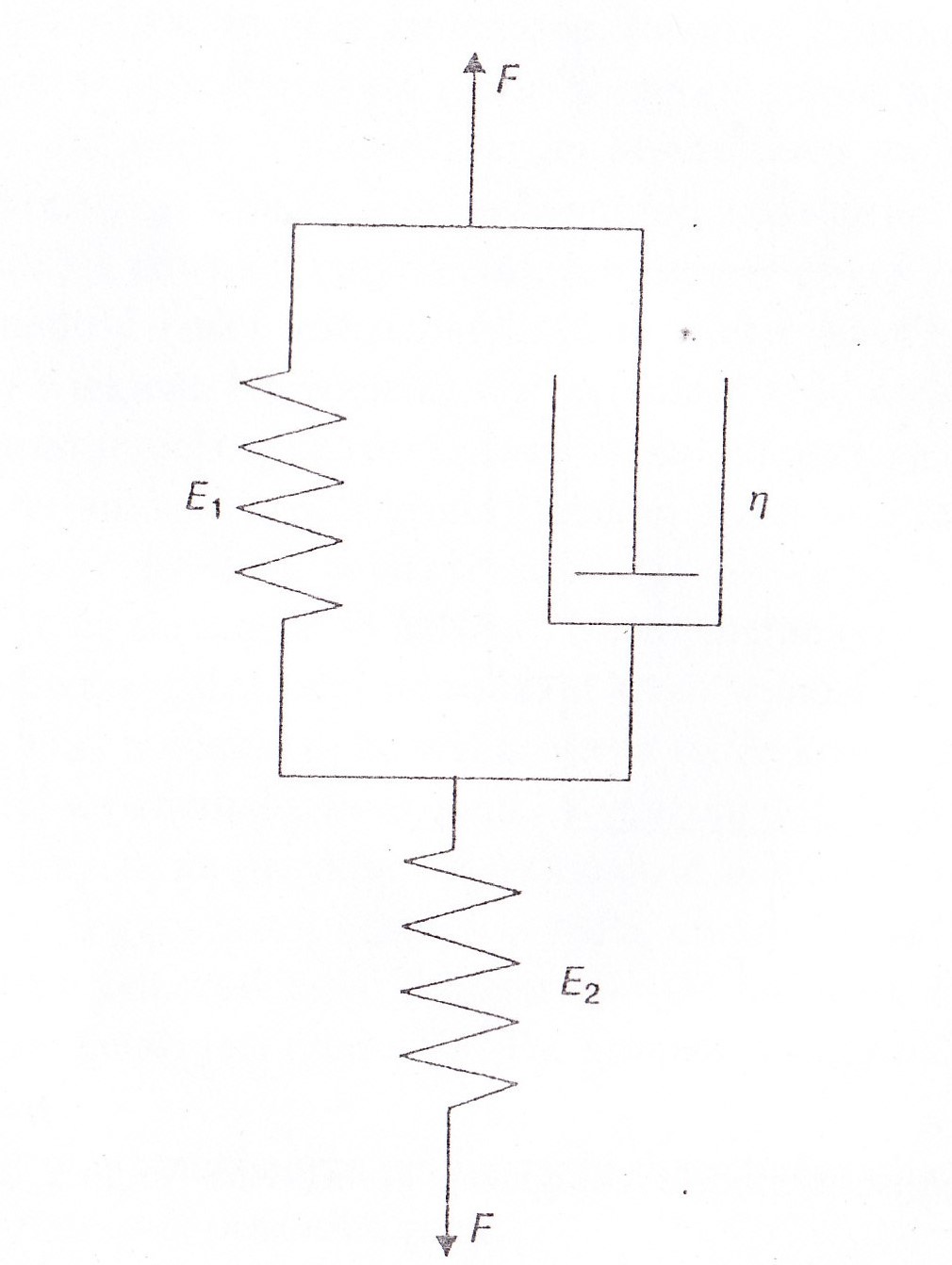

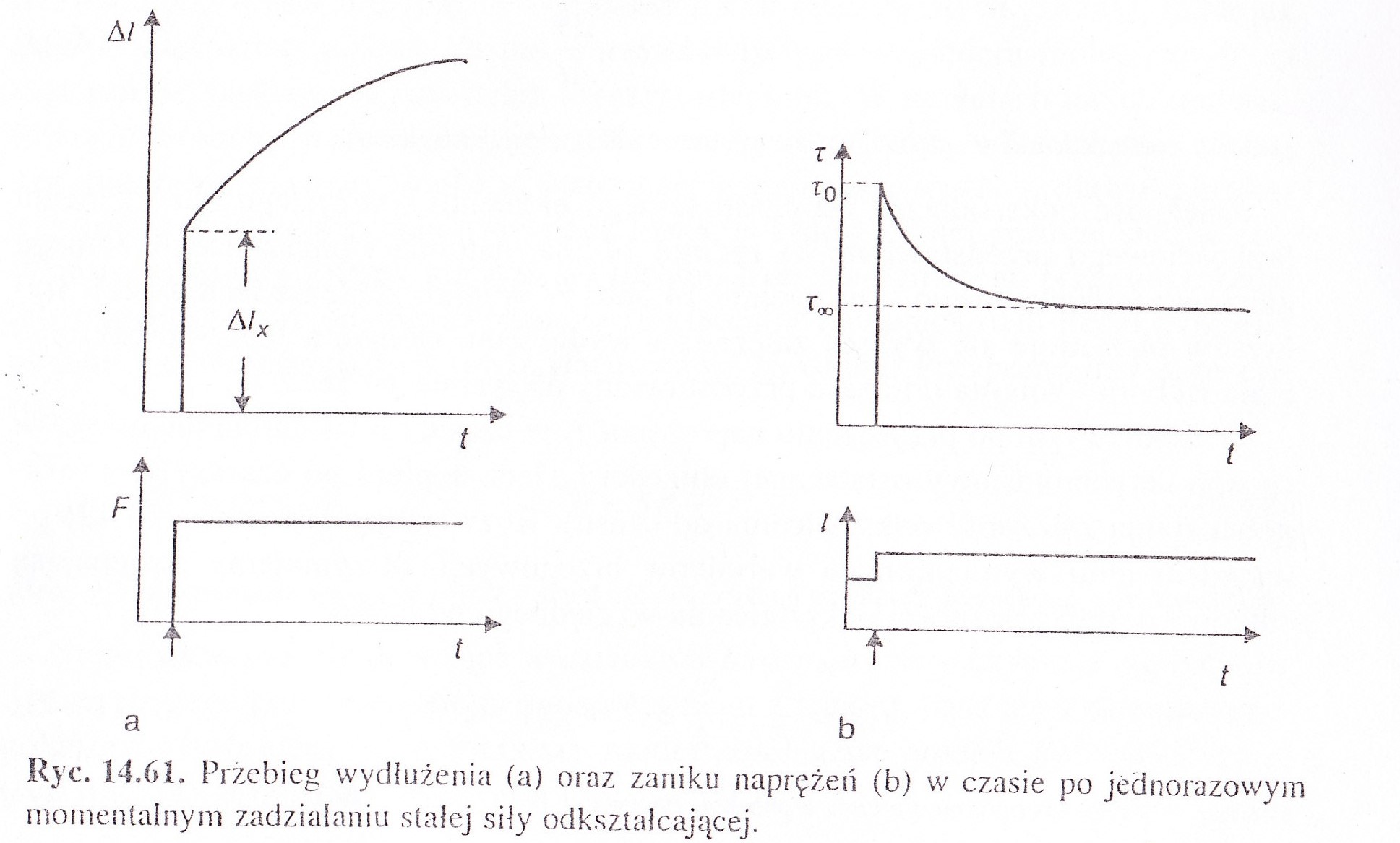

Mięśnie gładkie przy rozciąganiu zachowują się ja model reologiczny Maxwella.

Mięśnie poprzecznie prążkowane zachowują się ta jak ciała lepko-sprężyste(model przedstawiono na ryc.14.60,str.433)

Przebieg wydłużenia w zależności od czasu dla tego modelu na ryc.14.61a.

Przebieg zaniku naprężenia na ryc.14.61b

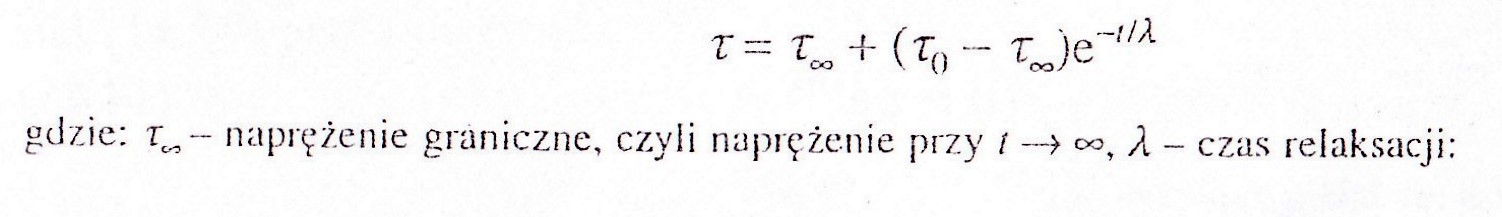

Naprężenie to znika zgodnie z równaniem:

τ =τ∞ +(τ0-τ∞ )e-t/λ

gdzie, τ∞ -naprężenie graniczne, czyli naprężenie t->∞, λ- czas relaksacji

λ= η/(E1+E2)

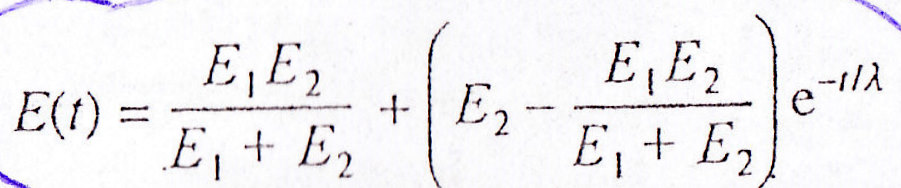

Moduł sprężystości w czasie zmienia się według wzoru:

E(t)=E1E2/E1+E2+ (E2-E1E2/E1+E2) e-t/λ

Podobnie zachowuje się model sprężystości mięśni i innych tkanek lepko-sprężystych. Wykazuje on silną zależność od szybkości odkształceń.

Naprężenie w mięśniach p.p:

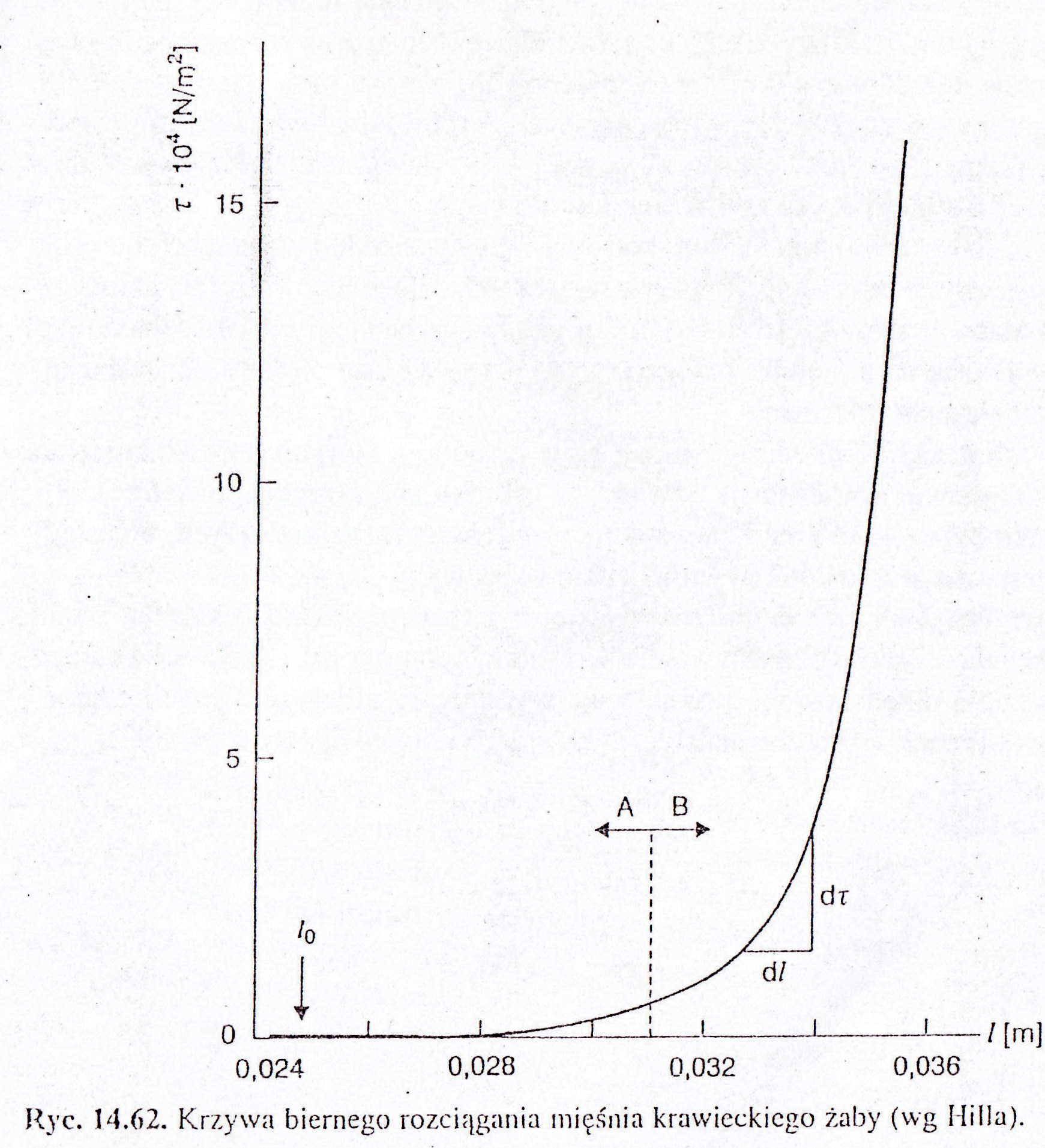

- mięsień znajdował się w stanie rozciągniętym, następuje jego skrócenie , podczas którego naprężenie szybko spada- nie do 0, do wartości napięcia fizjologicznego mięśnia = naprężenie spoczynkowe(wykres14.62)

Moduł sprężystości rośnie wraz ze wzrostem długości mięśnia( najpierw przy małych zakresach zmian długości nieznacznie, następnie znacznie szybszy). Krzywa naprężeniowo-odkształceniowa składa się z 2 części

A-naprężenie rośnie wolno

B- naprężenie rośnie szybko

Oba te zakresy odkształceń mają odmienne właściwości termodynamiczne( odmienna zależność naprężenia od temp.)

Podgrzewanie mięśnia przy odkształceniach odpowiednio zakresu A i B:

A.

Przy stałej długości mięśnia-wzrost naprężenia

Stałe naprężenie-skrócenie

B.

Przy stałej długości mięśnia-spadek naprężenia

Stałe naprężenie- wydłużenie

Odkształcenia tkanek powodują:

1.zmina energii wewnętrznej

2. zmiana entropii

Na podstawie 1 i 2 zasady termodynamik otrzymujemy: T-temp., U-energia wew., S-entropia, ε- odkształcenie względne.

τ =ρ(U/ε-T S/ε)r

Tak więc mamy źródła wzrostu naprężenia generowanego przez odkształcenie:

-wzrost energii wewnętrznej

- zmniejszenie entropii

Zgodnie z 1 i 2 zasadą termodynamiki: siła którą wydłużamy mięsień F

F=ΔU/Δl-TΔS/Δl

Dla zakresu A:

Zmniejsza się entropia towarzyszy temu wydzielanie ciepła. To zmniejszenie entropii wiąże się z porządkowaniem ogniw makrocząsteczek białkowych odpowiedzialnych za sprężyste właściwości mięśnia w kierunku działania siły-ta część siły sprężystości- termokinetyczna część siły sprężystości.

Dla zakresu B;

Przy dużym rozciągnięciu mięsień pochłania ciepło, następuje wzrost energii wew. Następuje wzrost siły sprężystości( powiększanie się odległości między drobinami białkowymi)

Właściwości elastyczne tkanek są związane z obecnością włókien kolagenu i elastyny. Są one ułożone w ten sposób że przy miernym rozciąganiu tkanki wydłużają się włókna elastylowe, przy większych obciążeniach kolagenowe.

55.Sarkomer, skurcz sarkomeru.

Sarkomer jest podstawową jednostką budowy komórki mięśniowej. Składa się z połówek miofilamentów cienkich - aktynowych (izotropowych) i (całych) miofilamentów grubych - miozynowych (izotropowego). Miofilamenty ograniczone są liniami Z (błonami podstawnymi), które jednocześnie oddzielają sarkomery od siebie. Pod mikroskopem obserwujemy w sarkomerach poprzeczne pasma, od których bierze się nazwa mięśnia poprzecznie prążkowanego szkieletowego.

Do skurczu sarkomeru dochodzi w wyniku zmiany polaryzacji błony komórkowej. Impuls nerwowy, dochodząc do sarkolemy depolaryzuje ją. Poprzez kanaliki T depolaryzacja dociera w okolice miofibryli. Zmiana spadku potencjału powoduje uwalnianie jonów wapniowych, które w fazie spoczynku związane są ze swoistymi białkami (zmiana potencjału wpływa na konformację białka, które zmienia swoje powinowactwo do jonów Ca2+). Jony dyfundują do wnętrza miofibryli i zapoczątkowują skurcz.

Mechanizm skurczu sarkomeru:

Cząsteczki aktyny i miozyny mogą się samorzutnie łączyć ze sobą w kompleks aktynomiozynę. Może on dysocjować na aktynę i miozynę poprzez dodanie ATP, które wiąże się z głową miozyny. Jeżeli dodamy do tego jony Ca2+ to aktywują one ATPazę miozyny i ATP ulega hydrolizie do ADP i Pi, a kompleks aktynomiozynowy ulega odnowieniu (ze względu na brak ATP, który go „blokuje”). Jeżeli ponownie dodamy ATP, znów dojdzie do dysocjacji na aktynę i miozynę. Te właściwości są podstawą skurczu mięśnia.

Wyróżniamy cztery jego fazy. W fazie 1 w głowowej części miozyny znajdują się związane cząsteczki ADP i Pi, a w cytoplazmie komórki nadmiar ATP. W fazie tej mięsień jest w spoczynku. Faza 2, w której głowa miozyny łączy się z aktyną (po aktywacji jonami Ca2+ troponiny C). W fazie 3 z powodu oddziaływania aktyny i miozyny zmienia się konformacja miozyny i głowa odchyla się o kąt 45', następnie zachodzi przesunięcie miofilamentów względem siebie. W fazie 4 cząsteczki ATP wiążą się z miozyną, wypierając cząsteczki ADP i Pi, wiązanie pomiędzy aktyną i miozyną zostaje rozerwane i układ wraca do fazy 1, czyli spoczynku. Przebieg procesu na wszystkich miofilamentach jednocześnie prowadzi do skurczu sarkomeru. W wyniku tego, że wszystkie sarkomery się kurczą, dochodzi do zmniejszenia długości komórki mięśniowej.

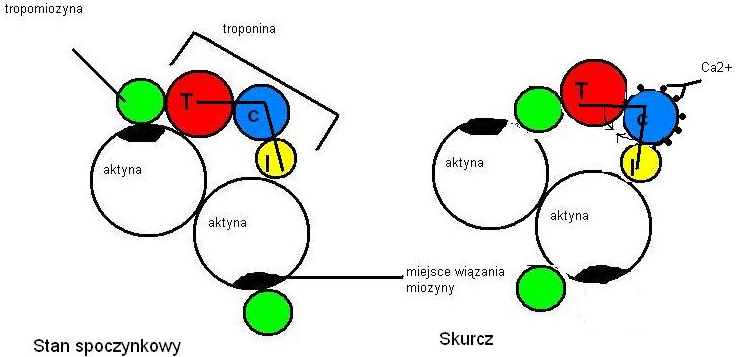

56.Miofilament. Skurcz

Aktyna. Cząsteczki aktyny mają kształt kulisty, łatwo polimeryzują, tworząc podwójne helisy. Są one głównym składnikiem miofilamentów cienkich. Oprócz aktyny w ich skład wchodzą cząsteczki tropomiozyny i troponiny. Troponina jest zbudowana z trzech podjednostek: troponiny I, troponiny C i troponiny T.

Miozyna. Cząsteczki miozyny są zbudowane z dwóch głównych łańcuchów polipeptydowych - tzw. łańcuchów ciężkich i czterech dodatkowych - łańcuchów lekkich. Większa część cząsteczki ma budowę podwójnej helisy, lecz głowa (są w niej zlokalizowane łańcuchy lekkie) jest aperiodyczna i to od niej zależy aktywność ATPazy miozyny. Cząsteczki miozyny agregują, tworząc miofilament gruby. Głowy miozyny tworzą wypustki do miofilamentów cienkich.

W stanie spoczynku cząsteczki tropomiozyny blokują miejsce wiązania miozyny na aktynie. Podczas skurczu jony Ca2+ łączą się z troponiną C, zmieniając konformację całego kompleksu troponinowego, co pociąga za sobą przesunięcie się tropomiozyny i odsłonięcie miejsc do związania miozyny - może dojść do połączenia miozyny i aktyny, co prowadzi do skurczu.

Pytanie 57 Jaroszyk strona 419 (zielone wydanie) Podstawowe zagadnienia i prawa związane z odkształceniami

Pytanie 58 Rodzaje odkształceń ciał stałych

1) Proste odkształcenie objętości- zostaje wywołane ciśnieniem działającym na ciało równomiernie ze wszystkich stron. Nosi ono nazwę naprężenia normalnego i wyraża się wzorem:

σ = F/Δ S [N/m2 = Pa]

F-wypadkowa sił działających prostopadle na element powierzchniowy ΔS

Miarą odkształcenia objętościowego jest zmiana objętości względnej ΔV/V, wtedy:

σ = K ΔV/V

K- moduł sprężystości objętościowej

2) Proste odkształcenie postaci- zostaje wywołane naprężeniem stycznym , zdefiniowanym zależnością:

τ = F/ ΔS

F-wypadkowa sił działających stycznie do elementu powierzchniowego ΔS

Miarą odkształcenia postaciowego jest kat γ skręcenia prostego, wówczas:

τ = G γ

G- moduł sprężystości postaciowej

59 i 60 Zginanie pręta i skręcanie pręta

Zginanie pręta

Czyste zginanie występuje, gdy siły zewnętrzne działające na belkę po jednej stronie od rozpatrywanego przekroju można sprowadzić do pary sił działających w osi belki lub równolegle do niej. Największe naprężenia występują w strefach skrajnych.

Strzałkę zgięcia S określającą wielkość odkształcenia dla belki w kształcie pręta:

S= 448π ∙ l3Er4 ∙F

r- promień belki

l- długość

Strzałkę zgięcia S, dla belki w kształcie rury zamocowanej na obu końcach i obciążonej w środku siła F, określającą wielkość odkształcenia wyraża wzór:

S= 448π∙ 1E ∙ l3Rz4- Rw4 ∙F

Rz- promień zewnętrzny

Rw- promień wewnętrzny

Ze wzoru wynika że strzałka zgięcia dla rury jest znacznie mniejsza od strzałki dla pręta o tej samej długości i wykonanego z tego samego materiału co rura. Stąd duża wytrzymałość kości przy jednoczesnej oszczędności materiału.

Skręcanie pręta

Skręcanie pręta o długości l zachodzi pod wpływem momentu skręcającego M wywołanego parą sił, przyłożonego w płaszczyźnie prostopadłej do jego osi w jednym końcu, drugi koniec przymocowany.

Kąt skręcenia w mierze łukowej przedstawia wzór:

φrad= 2π ∙ 1G ∙ lR4 ∙M

G- moduł sprężystości poprzecznej

M- moment pary sił

Pytanie 61 i 62

Prawo Hooke'a określa zależność miedzy siłą odkształcającą a odkształceniem dla ciał sprężystych.

τ= F/A = E ∆l/ll0 = E ε

τ- naprężenie

ε- wydłużenie względne

∆l- przyrost długości

l0- długość początkowa

A- pole powierzchni poprzecznego przekroju ciała

F- siła odkształcająca

E- moduł sprężystości podłużnej

Współczynnik Poissona- stosunek względnego wydłużenia poprzecznego εd do względnego wydłużenia podłużnego εp

µ= εd /εp

Pytanie 63 i 64. Energia skurczu mięśnia, wydajność energetyczna. Moc skurczu.

Rozkład ATP i łączenie się miozyny z aktyną są procesami samorzutnymi. Mięsień w fazie rozkurczu jest gotowy do skurczu, ale inhibitor (układ tropomiozyna-troponina) o odpowiedniej konformacji zapobiega skurczowi. Proces rozkurczu wymaga ATP. Ilość ATP w wypoczętym mięśniu wystarcza do kilkuset skurczów. Gdy poziom ATP spada do połowy zdolność do wykonania pracy zanika i mięsień pozostaje w fazie skurczu. Głównym procesem dostarczającym ATP jest oddychanie tlenowe w mitochondriach. W razie niedoboru tlenu zaczyna odgrywać rolę proces glikolizy. Mięsień posiada glikogen, który można rozłożyć do glukozy i z metabolizować. Część ATP mięsień uzyskuje z reakcji fosfokreatyny z ADP.

Miarą energii wyzwolonej w procesach chemicznych jest zmiana entalpii ΔH. Składa się na nią zmiana entalpii swobodnej ΔG oraz zmiana energii związanej TΔS. Procesy zachodzące w mięśniu są nieodwracalne. Entalpia swobodna równa ΔG'=ΔG-ΔQn jest zużyta na pracę, reszta ΔQn=TΔSi wyrażą ciepło nieskompresowane. Mięsień nie pobudzony wykonuje pracę wewnętrzną, która daje ciepło ( ΔWi=ΔGi=ΔG-ΔQni). Te ciepło nazywamy ciepłem spoczynkowym (ΔQsp=ΔHsp=ΔG'i + ΔQni+TΔS). Podczas skurczu izotonicznego, kiedy mięsień skracając się o długość x dźwiga ciężar F, zostaje wykonana praca ΔWe=Fx. Praca ta zostaje wykonana kosztem części zmiany entalpii swobodnej, której towarzyszy jednak wydzielanie dodatkowego ciepła ΔQsk w procesach wzmożonego metabolizmu. Mięsień wykonujący pracę zewnętrzną (ΔHsk=ΔWe+ ΔQsk+ ΔQsp. Na energię skurczu (E) wyraża się praca ΔWe i ciepło skurczu ΔQsk (E=ΔWe + ΔQsk). Na ciepło skurczu składa się ciepło (A)-ciepło aktywacji i ciepło skracania (ax). ΔQsk= A+ax. Ciepło aktywacji wytwarza się po pobudzeniu mięśnia i nie zależy od pracy. Ciepło skracania jest proporcjonalne do długości x skrócenia mięśnia. Współczynnik (a) nie zależy od wielkości naprężenia mięśnia. Po zakończeniu skurczu wydziela się ciepło odnowy.

Wydajność energetyczna η=ΔWe/E . E= A+(F +a)x. Po podstawieniu η=Fx/A+(F+a)x. Z całkowitej energii E można uzyskać moc skurczu. P=dE/dt (iloraz pochodnej energii do pochodnej czasu. Pochodna energii E= (F+a)dx/dt, bo dA=0 (pochodna wartości stałej zawsze jest 0). dx/dt=v (prędkość), więc P=(F+a)v.

65.Zależność siły od skracania mięśnia niepobudzonego

Zależność tą przedstawia ryc. 10.24 na stronie 229 w Pilawskim, można tu wywnioskować, że szybkość skurczu jest największa ,kiedy mięsień kurczy się bez obciążenia, czyli kiedy zwiększamy to obciążenie to szybkość skurczu maleje. Jest to jakby zobrazowanie równania Hilla i stąd wzór na tą szybkość maksymalną skurczu : Vmaks =Fmaks , więc gdy F=Fmaks to V=0.

Jak by spytał o zależność siły odkształcającej mięsień od wydłużenia to wtedy chodzi o zjawisko histerezy- ryc. 10.25 na tej samej stronie

66.Relaksacja- wiąże się z właściwościami lepko- sprężystymi ciał. Wyróżniamy:

Relaksację naprężenia- gdy przyłożymy do ciała naprężenie i spowoduje ono nagłe wydłużenie do pewnej długości ciała, która będzie następnie tak utrzymywana to naprężenie będzie malało z czasem- tą zależność przedstawia ryc. 14.59 b na str. 432 w Jaroszczyku . Relaksacja ta występuje w modelu Maxwella

Relaksację odkształcenia -jeśli utrzymuje stałą siłę, która odkształca ciało to długość ciała rośnie z czasem - jest to zjawisko zwane PŁYNIĘCIEM lub PEŁZANIEM, a zależność wydłużenia ciała w czasie przedstawia wykres 14.58 c na str. 431 w Jaroszczyku. Relaksacja odkształcenia występuje w modelu Kelvina- V oighta

67 i 68

Model Kelvina -Voighta służy do opisu właściwości lepko- sprężystych ciał o przewadze elementów sprężystych. Naprężenie jest sumą naprężeń wywołanych odkształceniem w elemencie sprężystym o module sprężystości E oraz w elemencie lepkim o lepkości η: τ = Eγ + η (dγ/dt)

Po przyłożeniu naprężenia w czasie t=0 ciało to nie osiąga w sposób natychmiastowy ostatecznej długości, lecz dopiero po czasie, po upływie którego odkształcenie= 0,63γo. Czas opóźnienia odkształceń odgrywa ważną role m.in. w układach regulacyjnych.

Model Maxwella służy do opisu właściwości materiałów o przewadze elementów lepkich(ciecze sprężysto- lepkie). Szybkość odkształceń jest sumą szybkości odkształceń zachodzących w elemencie sprężystym oraz lepkim.

W chwili t=0 naprężenie jest równe naprężeniu max., a następnie zanika do zera w czasie po upływie którego naprężenie spadnie do wartości 0,37 naprężenia początkowego. Czasy relaksacji odgrywają ważną rolę m.in. w zjawisku skracania i wydłużania mięśni, czy w zjawisku odkształcania erytrocytów i leukocytów. Zależności odkształceń-str.431 i 433M

69 model reologiczny mięśnia poprzecznie prążkowanego ( rysunek i wykresy powyzej) Mięśnie poprzecznie prążkowane zachowują się jak ciała lepko-spężyste.

Zanik naprężenia (rys. b) następuje zgodnie ze wzorem:

Efektywny moduł sprężystości mięśni

Wykazuje on silną zależność od szybkości odkształceń

Moduł sprężystości rośnie wraz ze wzrostem długości mięśnia.

W małych zakresach zmian długości wzrost ten jest powolny (A-naprężenie rośnie wolno wraz ze wzrostem odkształcenia).

W dużych zakresach - wzrost jest szybki (B).

Oba zakresy odkształceń charakteryzują się odmiennymi właściwościami termodynamicznymi (mają odmienną zależność naprężenia od temperatury).

W A - gdy stała jest długość mięśnia to podgrzewanie mięśnia powoduje wzrost naprężenia.

gdy stałę jest naprężenie mięśnia to podgrzewanie powoduje jego skrócenie.

W B - zachowanie odwrotne.

72. Prawo Fouriera

Każdy transport wymaga działania bodźców stanowiących „siły napędowe” przepływów. Transport energii (przewodzenie ciepła) opisuje prawo Fouriera:

S - powierzchnia

λ - przewodność cieplna właściwa

dT/dx - spadek temperatur

71.Równanie Hilla

Na ciepło skurczu mięśnia

składa się:

ciepło A - ciepło aktywacji

ciepło skracania q (q=ax) proporcjonalne do długości skrócenia mięśnia

Po zakończeniu skurczu wydziela się tak zwane ciepło odnowy.

Moc P jest proporcjonalna do różnicy między maksymalną siłą F, jaką może wywrzeć mięsień przy skurczu izomerycznym (x=0), a aktualnie przyłożoną siłą.

(F+a)*(v+b)=(Fmaks+a)*b=const

- a,b - współczynniki proporcjonalności

Równanie to nazywamy równaniem Hilla.

Powoduje ono ważną zależność pomiędzy siłą wywieraną przez mięsień a szybkością, z jaką się kurczy. Prędkość skurczu jest największa, gdy miesień kurczy się bez obciążenia. Prędkość maleje wraz ze wzrostem obciążenia i staje się zerem gdy F=Fmaks.

Pytanie 73 - ruch harmoniczny

Ruch harmoniczny zaliczamy do ruchów drgających. Jest to ruch okresowy opisywany sinusoidalna funkcja czasu y=Asin(ωt+ φ)

Gdzie:

y-wychylenie punktu drgającego

omega-czestotliwosc fazowa

phi- stala fazowa

ω=2π/T=2πV częstotliwość zwiazana z okresem drgan

W równaniu ruchu drgającego wychylenie w ruchu harmonicznym zmienia się w czasie sinusoidalnie. Tą zależność przedstawia wykres:

Prędkość w ruchu harmonicznym okresla się wzorem :

V=ωAcos(ωt+φ)

Energia punktu drgającego o masie m jest zawsze rowna sumie Ep+Ek.W chwili odpowiadającej położeniu równowagi Ep=0 wtedy Ek ma wartość maxymalna=całkowitej wartości punktu drgającego:

E=0,5mω2A2

Pytanie 74 Drgania harmoniczne proste

Drgania harmoniczne proste - rzadkie zjawisko-duzo czesciej występują drgania zlozone.

Najprostszy rodzaj drgan okresowych,w których wychylenie ciala zmienia się wedlug wzoru :

A = A0sin(ωt + φ0), gdzie A0 — amplituda, ω — częst. kątowa, t — czas, φ0 — faza początkowa.

75,76