P

OLITECHNIKA

W

ROCŁAWSKA

W

YDZIAŁOWY

Z

AKŁAD

I

NFORMATYKI

W

YDZIAŁ

I

NFORMATYKI I

Z

ARZ DZANIA

Wybrze e Wyspia skiego 27, 50-370 Wrocław

Praca Magisterska

METODY TESTOWANIA KODU OPROGRAMOWANIA.

BADANIE NIEZAWODNO CI OPROGRAMOWANIA.

Kamil Olszewski

Promotor:

dr hab. in . prof. nadzw. P.Wr. Ireneusz Jó wiak

Ocena:

Wrocław 2003

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

2

Temat pracy:

Metody testowania kodu oprogramowania.

Badanie niezawodno ci oprogramowania.

Streszczenie

Praca prezentuje aktualny stan wiedzy na temat testowania w procesie wytwarzania

oprogramowania, zarówno w nurcie metodyk ci kich jak i lekkich, kład c szczególny nacisk

na problem testowania kodu. Przedstawia równie zagadnienie jako ci i niezawodno ci

oprogramowania z punktu widzenia testowania kodu.

Celem pracy jest wytworzenie narz dzia wspomagaj cego modelowanie niezawodno ci

oprogramowania na podstawie danych testowych z wykorzystaniem metod sztucznej

inteligencji.

Title:

Software code testing methods.

Software reliability research.

Abstract

This paper shows the current level of knowledge on the subject of testing in software

development process both in heavy and agile methodologies. It emphasizes the code’s testing

problem and presents the issue of software quality and reliability as well, from the code’s

testing point of view.

The purpose of the work is to create an instrument to support software reliability

modeling on the ground of test data and with utilization of artificial intelligence methods.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

3

SPIS TRE CI

WST P

6

1. TESTOWANIE KODU W PROCESIE WYTWARZANIA OPROGRAMOWANIA 8

1.1. Wprowadzenie

8

1.2. Testowanie według metodyk ci kich

10

1.3. Testowanie według metodyk lekkich

13

1.4. Porównanie podej cia do testowania w metodykach ci kich i lekkich

15

2. METODY TESTOWANIA KODU

17

2.1. Wprowadzenie

17

2.2. Testowanie strukturalne i funkcjonalne

19

2.3. Testowanie jednostkowe

20

2.4. Testowanie integracyjne

21

2.5. Testowanie systemowe

21

2.6. Testowanie akceptacyjne

21

3. TESTOWANIE KODU DLA ZAPEWNIENIA NIEZAWODNO CI

OPROGRAMOWANIA

23

3.1. Wprowadzenie

23

3.2. Niezawodno sprz tu a niezawodno oprogramowania

25

3.3. Normy niezawodno ci

26

3.3.1. Podstawowe informacje o normach

26

3.3.2. Normy dotycz ce jako ci i niezawodno ci oprogramowania

28

3.4. Modele niezawodno ci oprogramowania

30

3.4.1. Przegl d modeli niezawodno ci oprogramowania

30

3.4.2. Wymagania modeli niezawodno ci oprogramowania

33

4. PROGNOZOWANIE NIEZAWODNO CI OPROGRAMOWANIA

35

4.1. Wprowadzenie

35

4.2. Metody sztucznej inteligencji w badaniu niezawodno ci

35

4.2.1. Zastosowania algorytmów genetycznych

35

4.2.2. Zastosowania sieci neuronowych

39

4.3. Prognozowanie niezawodno ci

41

4.4. Zastosowania

43

ZAKO CZENIE

48

LITERATURA

50

BIBLIOGRAFIA ELEKTRONICZNA

52

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

4

DODATEK A

53

DODATEK B

56

DODATEK C

60

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

5

SPIS RYSUNKÓW

Rys. 1.1. Fazy i etapy (przepływy) w metodyce RUP

12

Rys. 1.2. Fazy i etapy (przepływy) w metodyce USDP

12

Rys. 2.1. Testowanie w procesie wytwarzania oprogramowania – model „V”

18

Rys. 3.1. Zale no intensywno ci uszkodze od czasu w systemach technicznych

25

Rys. 3.2. Zale no intensywno ci uszkodze od czasu w oprogramowaniu

26

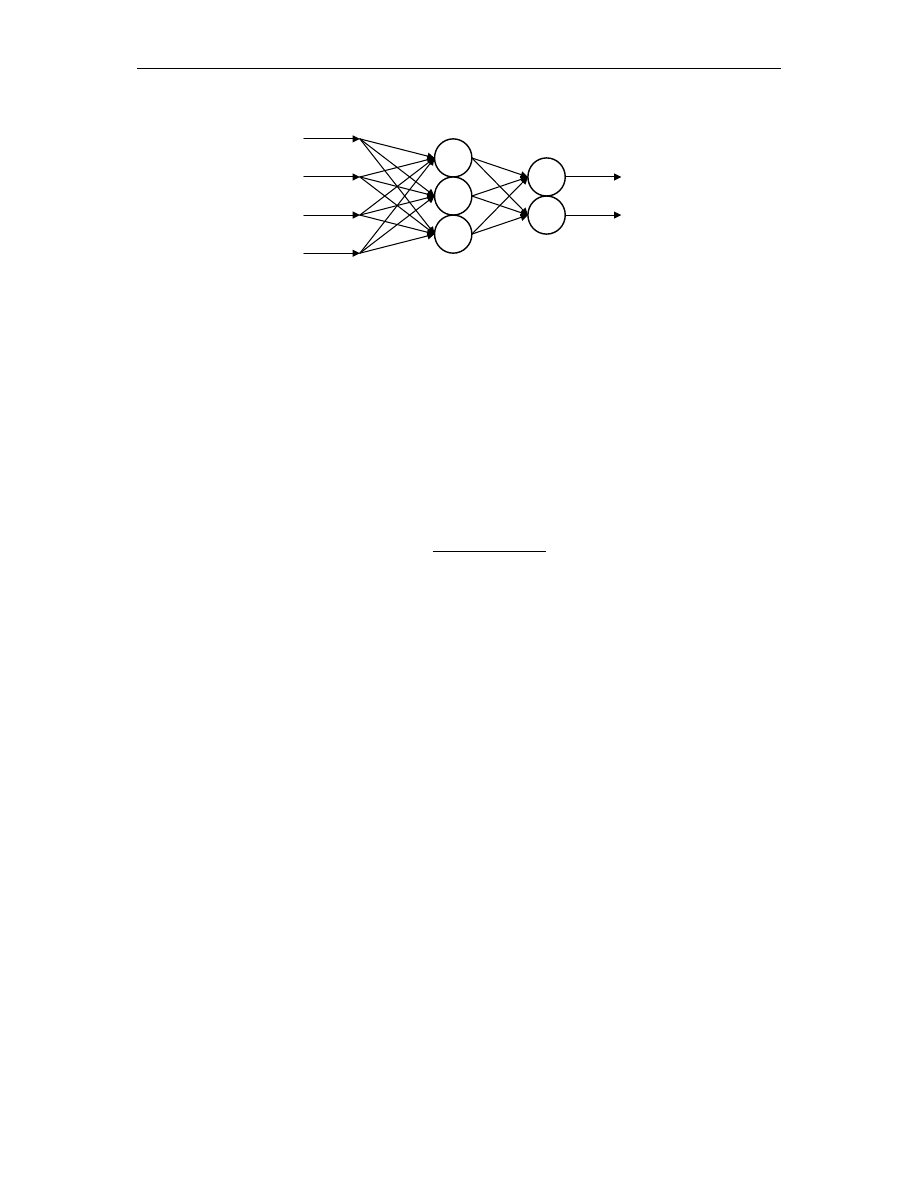

Rys. 4.1. Schemat dwuwarstwowej sieci jednokierunkowej

40

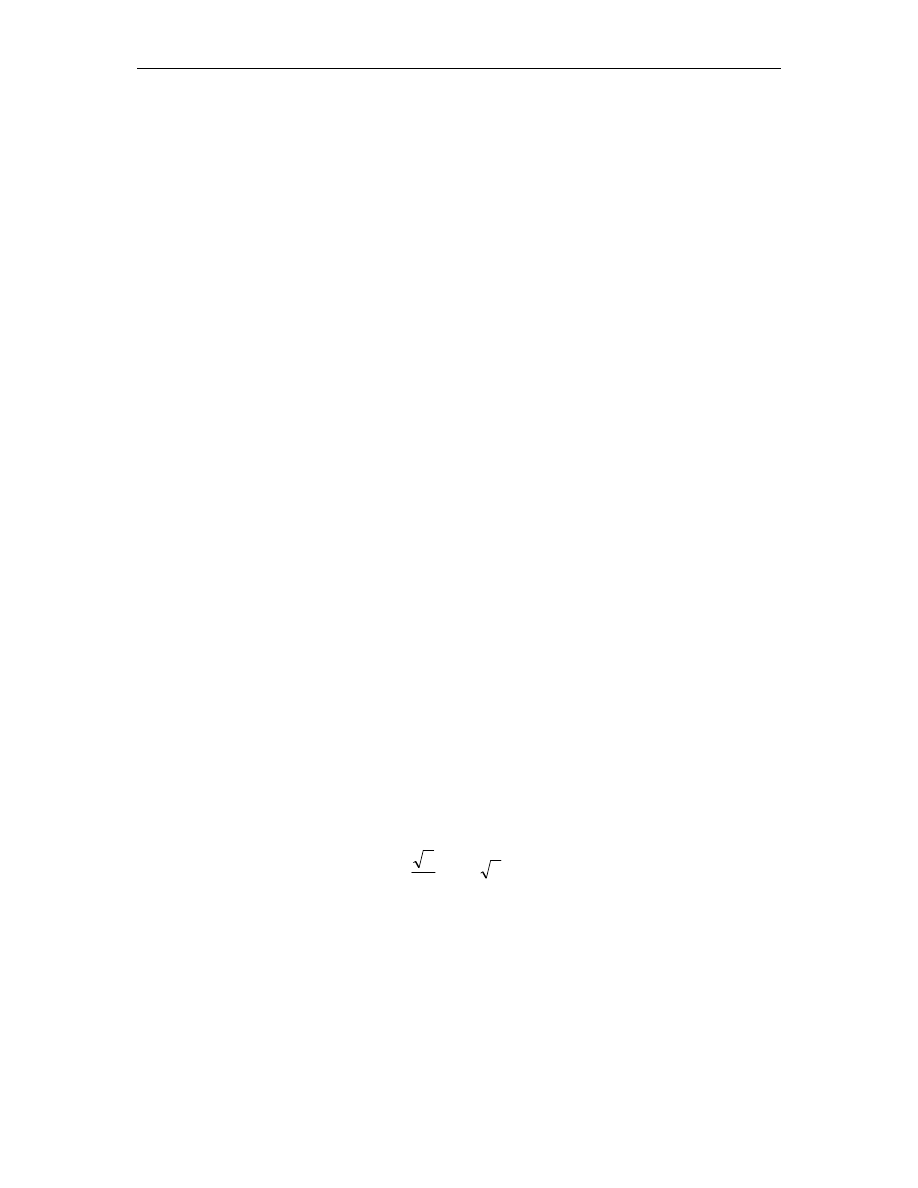

Rys. 4.2. Liczno klas przy podziale na 8

42

Rys. 4.3. Liczno klas przy podziale na 12

42

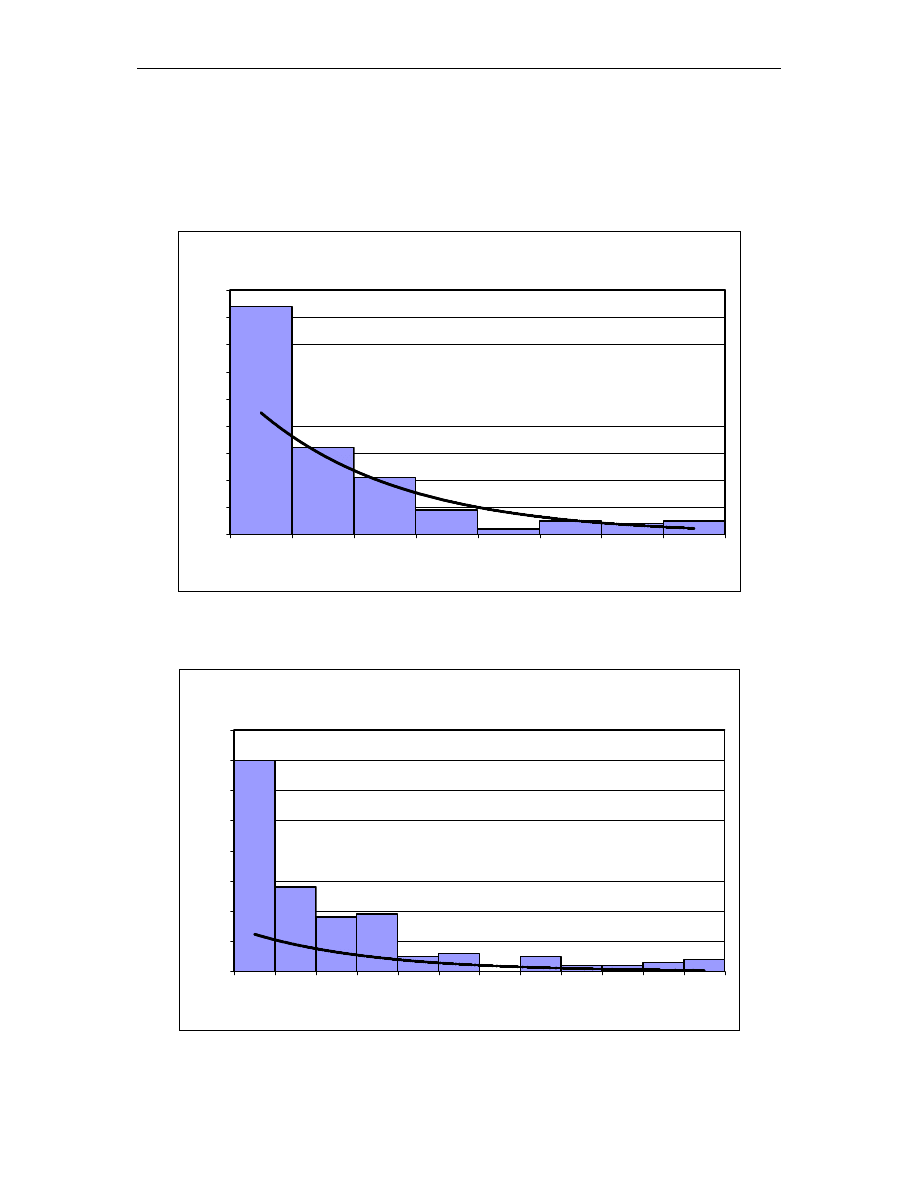

Rys. 4.4. Okno programu z wynikami testowania i prognozy sieci po wyuczeniu

44

Rys. 4.5. Ustalenie prognozy sieci dla warto ci granicznych

45

Rys. 4.6. Podział okresu badanego i okresu prognozy na 5 klas

46

Rys. 4.7. Podział okresu badanego i okresu prognozy na 8 klas

46

Rys. A.1. Graficzna reprezentacja zbioru 1

55

Rys. A.2. Graficzna reprezentacja zbioru 2

55

Rys. B.1. Pocz tkowy interfejs programu.

56

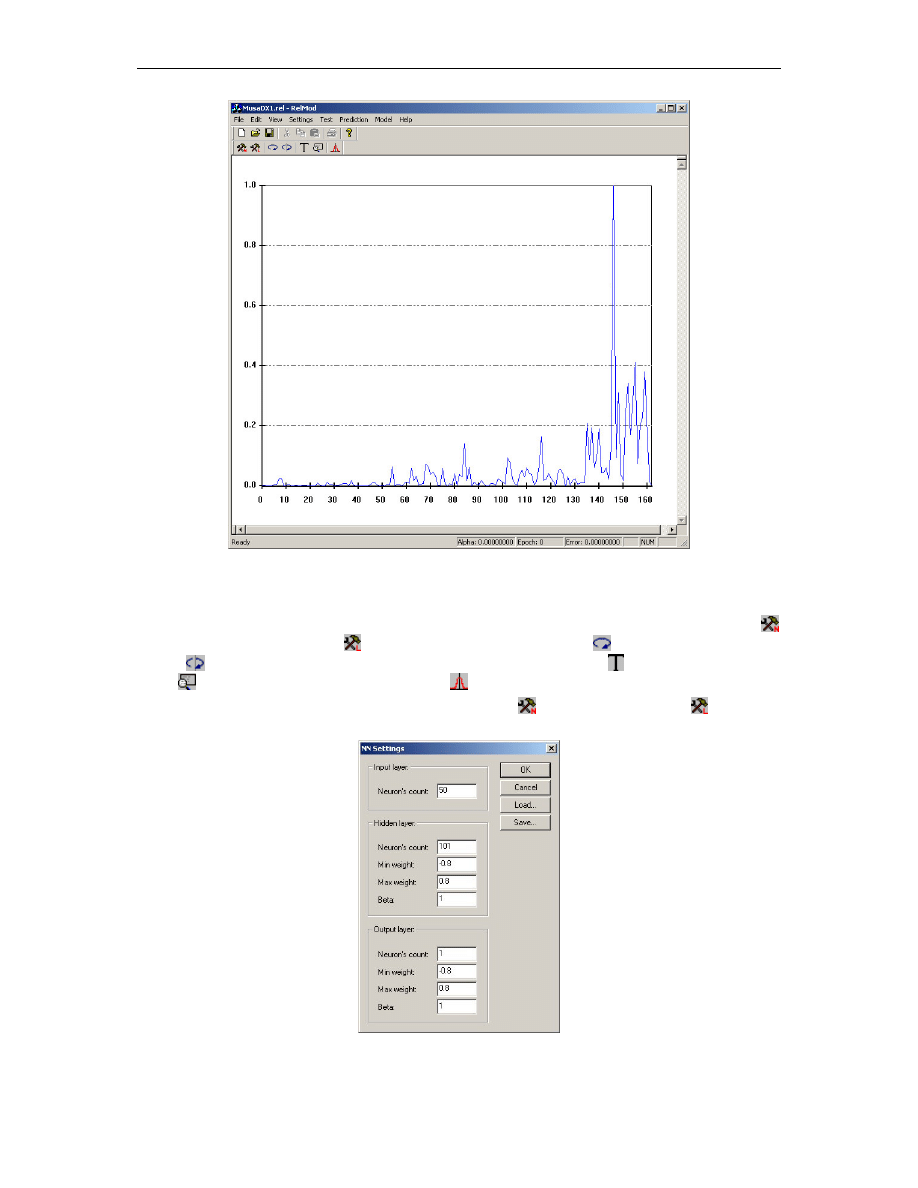

Rys. B.2. Interfejs programu po załadowaniu danych testowych.

57

Rys. B.3. Okno wprowadzania parametrów sieci neuronowej

57

Rys. B.4. Okno wprowadzania parametrów uczenia sieci neuronowej

58

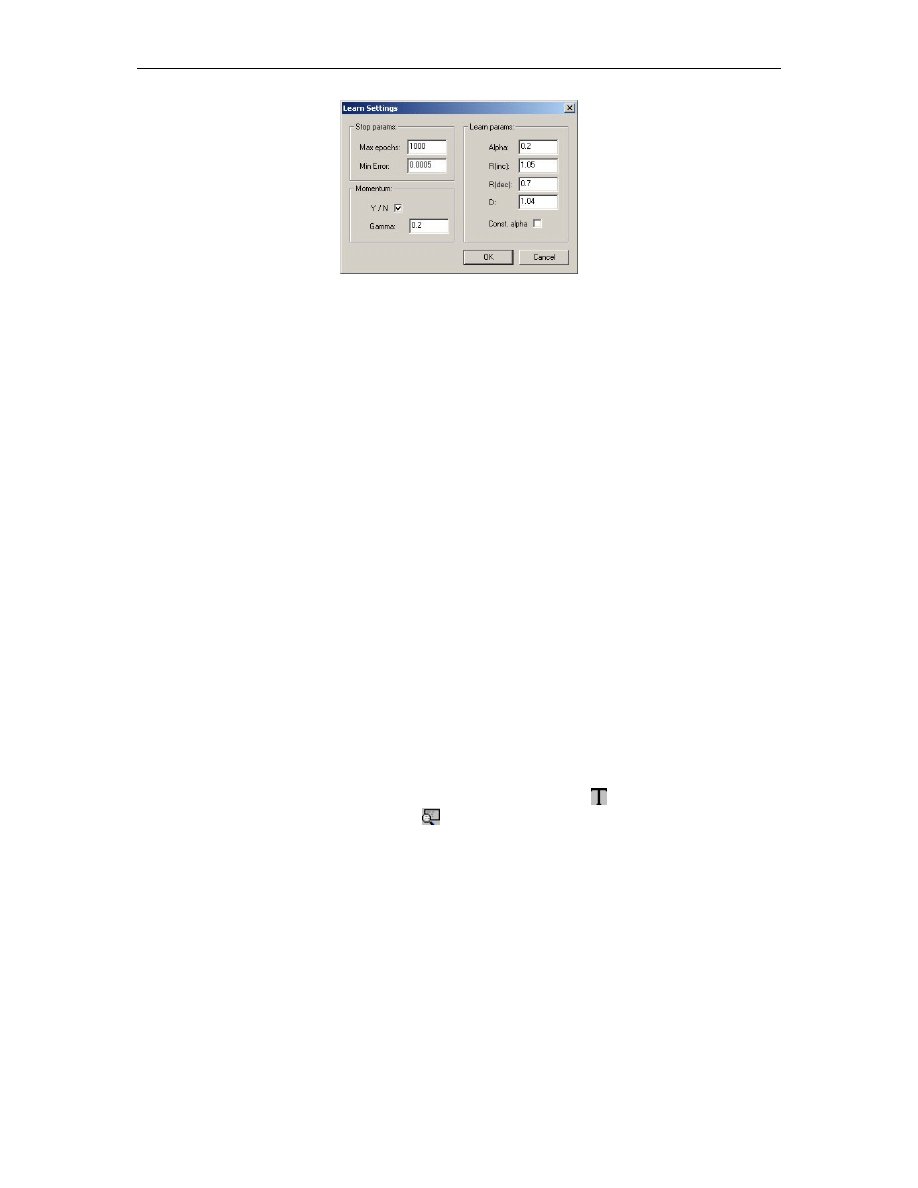

Rys. B.5. Okno wprowadzania liczby klas podziału danych

59

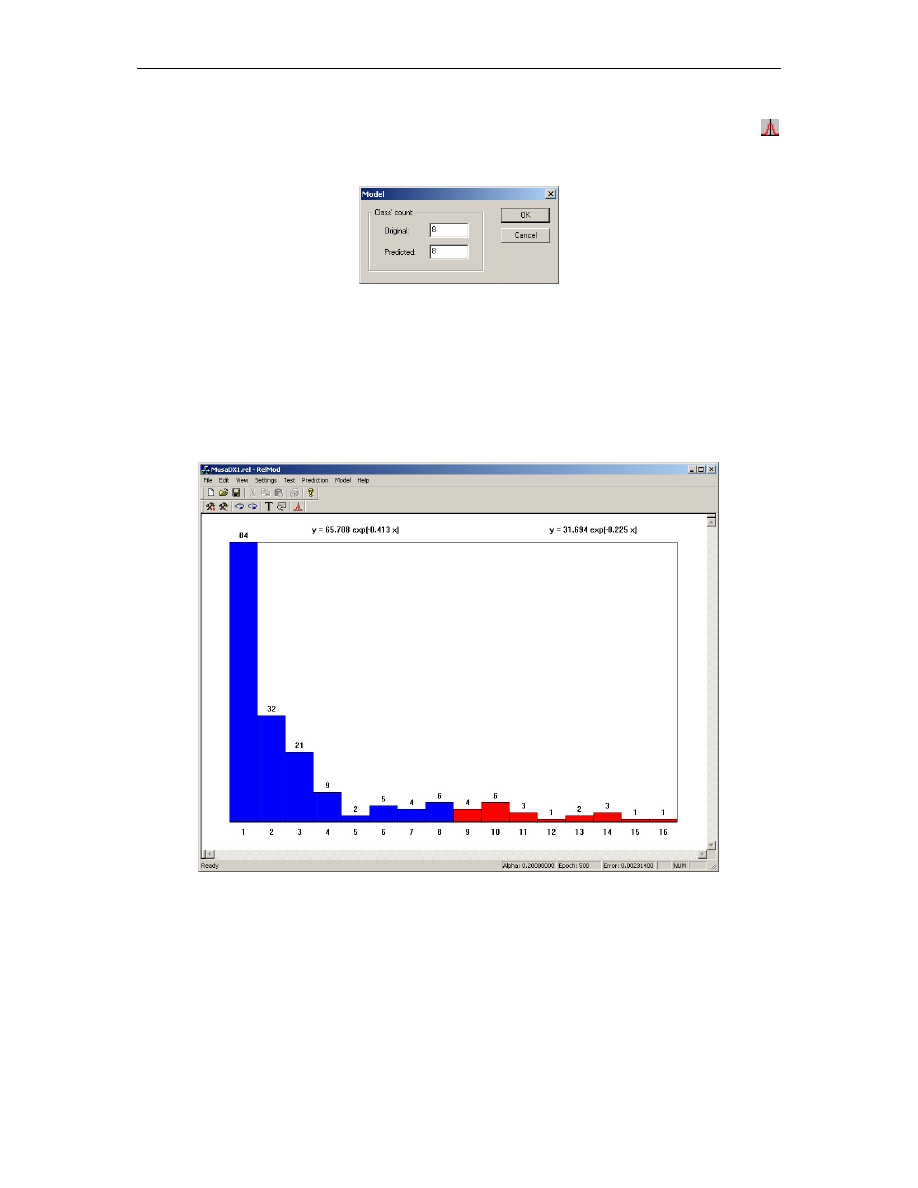

Rys. B.6. Wykres liczno ci klas i wzór krzywej trendu

59

SPIS TABEL

Tab. 1.1. Historia in ynierii oprogramowania

9

Tab. 1.2. Porównanie ról osób w zespole projektowym według metodyk XP i RUP

16

Tab. 1.2. Porównanie ról osób w zespole projektowym według metodyk XP i RUP (c.d.) 16

Tab. 3.1. Normy i standardy niezawodno ci oprogramowania

28

Tab. 3.2. Modele niezawodno ci oprogramowania uwzgl dniaj ce intensywno

uszkodze

31

Tab. 3.3. Modele niezawodno ci oprogramowania typu NHPP

32

Tab. 3.4. Zało enia modeli niezawodno ci oprogramowania

33

Tab. 3.5. Wymagania modeli niezawodno ci oprogramowania dotycz ce danych

wej ciowych

34

Tab. 4.1. Porównanie wyników rozwi za dla algorytmu numerycznego i genetycznego 38

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

6

WST P

Systemy informatyczne, z wyj tkiem najprostszych aplikacji, powstaj według przyj tej

metodyki, w procesie wytwarzania oprogramowania.

1

W in ynierii oprogramowania

2

[16]

w czasie kilkudziesi ciu lat jej istnienia wypracowano wiele ró nych procesów i metodyk.

Bardzo wa nym etapem ka dego procesu jest testowanie.

Zwłaszcza w USA zagadnienia jako ci, niezawodno ci i testowania oprogramowania s

przedmiotem bada wielu naukowców [2], [6], [7], [18], [19], [22], [26], [28], [29], [43],

[46]. Na szczególn uwag zasługuj prace [28], [29], [39], które powstały w Software

Assurance Technology Center przy NASA. Dostarczaj bowiem wielu informacji na temat

praktycznego wykorzystania modeli niezawodno ci w zastosowaniu do oprogramowania.

W Polsce natomiast istnieje tylko kilka o rodków naukowych zajmuj cych si tym tematem.

S to przede wszystkim: Politechnika Gda ska, Akademia Górniczo–Hutnicza, Akademia

Morska w Gdyni, Wydziałowy Zakład Informatyki Politechniki Wrocławskiej.

Je li za chodzi o literatur z zakresu testowania i niezawodno ci oprogramowania, to

pozycje polskoj zyczne stanowi nikły procent wszystkich prac obecnie dost pnych. Do tych

najwa niejszych mo na zaliczy podr cznik Górskiego [12], Jaszkiewicza [16], oraz

przetłumaczone z j zyka angielskiego i wydane przez Mikom ksi ki: Pattona [26], Becka [3]

oraz przez Helion: ksi ka Maguire’a [19]. Ksi ki Górskiego i Jaszkiewicza kompleksowo

traktuj o jednej z wa niejszych dziedzin informatyki, jak jest in ynieria oprogramowania.

Testowanie, jako element tej in ynierii, oczywi cie znajduje w nich swoje miejsce, jednak

z oczywistych powodów

3

nie jest omawiany zbyt dogł bnie. Natomiast inne jest podej cie

autorów Pattona i Maguire’a: ich ksi ki s pisane bezpo rednim j zykiem i na bazie wielu

przykładów poruszaj zagadnienia bardzo konkretne i praktyczne. Na uwag zasługuje

równie wydana ostatnio przez Mikom praca Szejki [31]. Jest to jedna z nielicznych ksi ek

z zakresu testowania i niezawodno ci oprogramowania napisanych w j zyku polskim. Nie ma

natomiast obecnie polskich ksi ek, które traktowałyby etap testowania jako pole do prac

badawczych.

Dlatego niniejsza praca powstała w du ej mierze dzi ki wykorzystaniu materiałów: prac

i dokumentów angielskoj zycznych pobranych z Internetu [2], [3], [6], [7], [8], [18], [22],

[41], [43], [45], [46], [48]. Szczególn warto maj prace poruszaj ce zagadnienia

nowatorskie, odpowiedniki polskich prac magisterskich i rozpraw doktorskich oraz

dokumenty publikowane w elektronicznej prasie bran owej, np. w katalogach Elsevier

i innych. Wszystkie te dokumenty s wyszczególnione w literaturze na ko cu pracy.

Przegl d dost pnych publikacji stał si powodem napisania tej pracy z dziedziny

testowania i badania niezawodno ci oprogramowania, poniewa małe liczby pozycji

polskoj zycznych stanowi powa ny brak w rodzimej literaturze informatycznej.

Niezwykle interesuj ca i godna uwagi okazała si praca po wi cona predykcji

czasowych szeregów wyst pie bł dów w fazie testowania [7], która stała si inspiracj tre ci

1

Ang. software development process.

2

Jako in ynieri oprogramowania nale y tu rozumie wiedz techniczn dotycz c faz cyklu ycia

oprogramowania, której celem jest wytworzenie wysokiej jako ci oprogramowania.

3

Prace dotycz ce cało ci in ynierii oprogramowania nie mog traktowa dokładnie o ka dym jej aspekcie

z powodu ograniczonej obj to ci publikacji.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

7

czwartego rozdziału. Ilustracj jego tre ci jest symulacja sieci neuronowej wzorowana na

do wiadczeniu opisanym w pracy [7].

Celem pracy jest wytworzenie narz dzia wspomagaj cego modelowanie niezawodno ci

oprogramowania na podstawie danych testowych z wykorzystaniem metod sztucznej

inteligencji.

Zakres pracy obejmuje teoretyczne opracowanie zagadnie zwi zanych z testowaniem,

niezawodno ci i jako ci produktu informatycznego, jakim jest oprogramowanie oraz

praktyczne przedstawienie mo liwo ci okre lania i modelowania niezawodno ci

oprogramowania za pomoc programu komputerowego.

Zawarto pracy przedstawia si nast puj co. Rozdział pierwszy jest wprowadzeniem

w zagadnienia zwi zane z miejscem etapu testowania w procesie wytwarzania

oprogramowania. Dokonany został przegl d najbardziej znanych metodyk z punktu widzenia

etapu testowania. Przegl d dotyczy zarówno metodyk ci kich, jak i, zyskuj cych ostatnio

coraz wi ksze zainteresowanie, metodyk lekkich,

4

tzw. agile methodologies.

Rozdział drugi pod tytułem: „Metody testowania kodu” stanowi studium obecnie

stosowanych metod testowania kodu oprogramowania – od testowania jednostkowego do

testowania akceptacyjnego, wł czaj c w to równie testowanie strukturalne i funkcjonalne.

Metody te b d omówione z punktu widzenia zarówno metodyk ci kich jak i lekkich.

Rozdział trzeci pod tytułem: „Testowanie kodu dla zapewnienia niezawodno ci

oprogramowania” jest merytoryczn kontynuacj rozdziału poprzedniego. Wprowadza

poj cie niezawodno ci, jako po redniego celu etapu testowania, którego celem ostatecznym

jest poprawa jako ci wytwarzanego oprogramowania. Na jego tre składa si równie

przegl d krajowych i mi dzynarodowych norm zwi zanych z jako ci i niezawodno ci

oprogramowania.

Rozdział czwarty pod tytułem: „Prognozowanie niezawodno ci oprogramowania” wraz

z rozdziałem trzecim stanowi najwa niejsz cz

pracy. Zawiera opis praktycznego

zastosowania wyników uzyskanych na etapie testowania do okre lania i prognozowania

niezawodno ci oprogramowania z u yciem metod statystycznych, jak równie

z powodzeniem znajduj cych tu zastosowanie metod sztucznej inteligencji i metod

hybrydowych. Ta cz

pracy zilustrowana jest programem symuluj cym działanie sieci

neuronowej zastosowanej do predykcji szeregu czasowego wyst pie bł dów

w oprogramowaniu, wspomagaj cej wyznaczanie jego niezawodno ci poprzez okre lenie

przyszłej liczby awarii w kolejnych jednostkach czasu. Badania te dotyczyły przede

wszystkim dokładno ci predykcji liczby awarii. Ponadto miały wykaza mo liwo estymacji

parametrów trendu wykładniczego dla tych samych danych testowych. Wyniki uzyskane

podczas przeprowadzonych bada oraz dyskusja uzyskanych wyników zostały umieszczone

w tre ci rozdziału czwartego.

Zako czenie jest podsumowaniem zawarto ci pracy. W tej cz ci zostały omówione

przyj te zało enia oraz została przedstawiona propozycja kierunków dalszych bada , jakie

pojawiły si w trakcie realizacji pracy.

Na samym ko cu pracy zostały zamieszczone dodatki. Zawieraj one kolejno: dodatek

A – wykaz danych testowych, które posłu yły do wykonania wymienionych powy ej bada ,

dodatek B – opis działania programu wykorzystanego w badaniach w rozdziale czwartym

oraz dodatek C – zawarto płyty CD doł czonej do pracy.

4

Zob. przypis 15.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

8

1. TESTOWANIE

KODU

W

PROCESIE

WYTWARZANIA

OPROGRAMOWANIA

1.1. Wprowadzenie

In ynieria Oprogramowania w czasie kilkudziesi ciu lat swojego istnienia od połowy

lat sze dziesi tych [16] wypracowała ró ne metodyki wytwarzania oprogramowania. Celem

ich było znalezienie i zdefiniowanie takiego zestawu czynno ci, których wykonanie

doprowadziłoby do wytworzenia oprogramowania jako produktu niezawodnego,

spełniaj cego wymagania klienta, zgodnego ze specyfikacj oraz mieszcz cego si

w planowanym harmonogramie i bud ecie [49]. W ten sposób powstało wiele ró nych

procesów wytwarzania oprogramowania. W [16] wyró nia si nast puj ce metodyki: model

kaskadowy,

5

realizacja kierowana dokumentami,

6

prototypowanie,

7

programowanie

odkrywcze,

8

realizacja przyrostowa,

9

model spiralny,

10

formalne transformacje.

11

The

Rational Unified Process

12

i Unified Software Development Process.

13

Wszystkie te procesy

nale do grupy tzw. metodyk ci kich.

14

Istnieje równie szereg tak zwanych metodyk

lekkich:

15

Extreme Programming,

16

Crystal,

17

Adaptive Software Development, Scrum

18

[30],

Feature Driven Development

19

oraz Dynamic System Development Method

20

[2], [3], [4], [6],

[8], [14], [30], [34], [40], [43], [46]. Metodyki lekkie zyskuj ostatnio coraz wi ksz

popularno w ród projektantów i programistów. Wybór metodyki dla konkretnego projektu

zale y od takich czynników, jak: przeznaczenie tworzonego systemu, jego wielko ,

umiej tno ci, do wiadczenie i zgranie członków zespołu projektowego, programistycznego,

itd.

Oprogramowanie powstaj ce w procesie wytwarzania nie jest wył cznie kodem

zapisanym w okre lonym j zyku programowania. W ka dej fazie i na ka dym etapie powstaje

fragment oprogramowania, który nale y przetestowa , aby wykaza , czy jest on zgodny ze

swoj specyfikacj . W zale no ci od tego, czy testuje si oprogramowanie istniej ce

w postaci wymaga u ytkowych, specyfikacji systemu, konstrukcji architektonicznej,

konstrukcji szczegółowej czy kodu [12], stosuje si odpowiednie rodzaje testów. Wi cej na

temat ró nych metod testowania b dzie mowa w rozdziale drugim.

In ynieria oprogramowania musiała stawia czoła bł dom w oprogramowaniu przez

cały czas swojego istnienia. Dzieje si tak równie dzisiaj. Tabela 1.1. przedstawia histori

5

Ang. waterfall.

6

Ang. document-driven.

7

Ang. prototyping.

8

Ang. exploratory programming.

9

Ang. incremental development.

10

Ang. spiral model.

11

Ang. formal transformations.

12

Produkt firmy Rational Software.

13

Pol. ujednolicony proces wytwarzania oprogramowania.

14

Poj cie „metodyki ci kie” pojawiło si w odpowiedzi na okre lenie „metodyki lekkie” (przyp. 15), jako ich

w pewnym sensie przeciwie stwo.

15

Ang. Agile Methodologies, agile – zwinny, sprawny; w angielskiej nomenklaturze zmieniono okre lenie light

na agile, w polskiej pozostało okre lenie: „metodyki lekkie”.

16

Pol. programowanie ekstremalne.

17

Według jej twórcy, Alistair’a Cockburn’a, Crystal jest raczej rodzin metodologii ni pojedyncz metodyk .

18

Pierwsza ksi ka o metodyce Scrum [30] ukazała si w pa dzierniku 2001.

19

Pol. wytwarzanie sterowane cechami; autorzy: Peter Coad (z TogetherSoft), Jeff de Luca.

20

Pol. dynamiczna metoda wytwarzania systemów, przygotowana przez konsorcjum przedsi biorstw Wielkiej

Brytanii.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

9

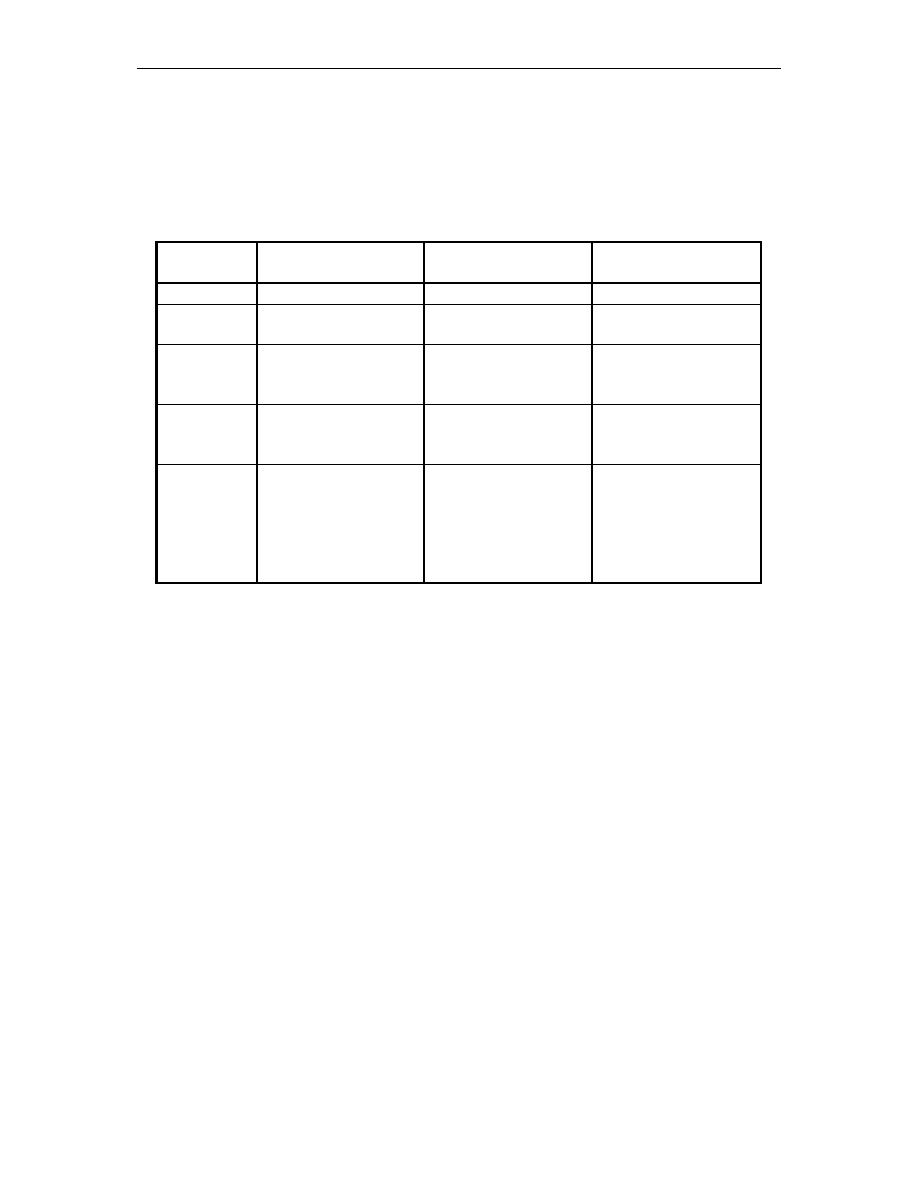

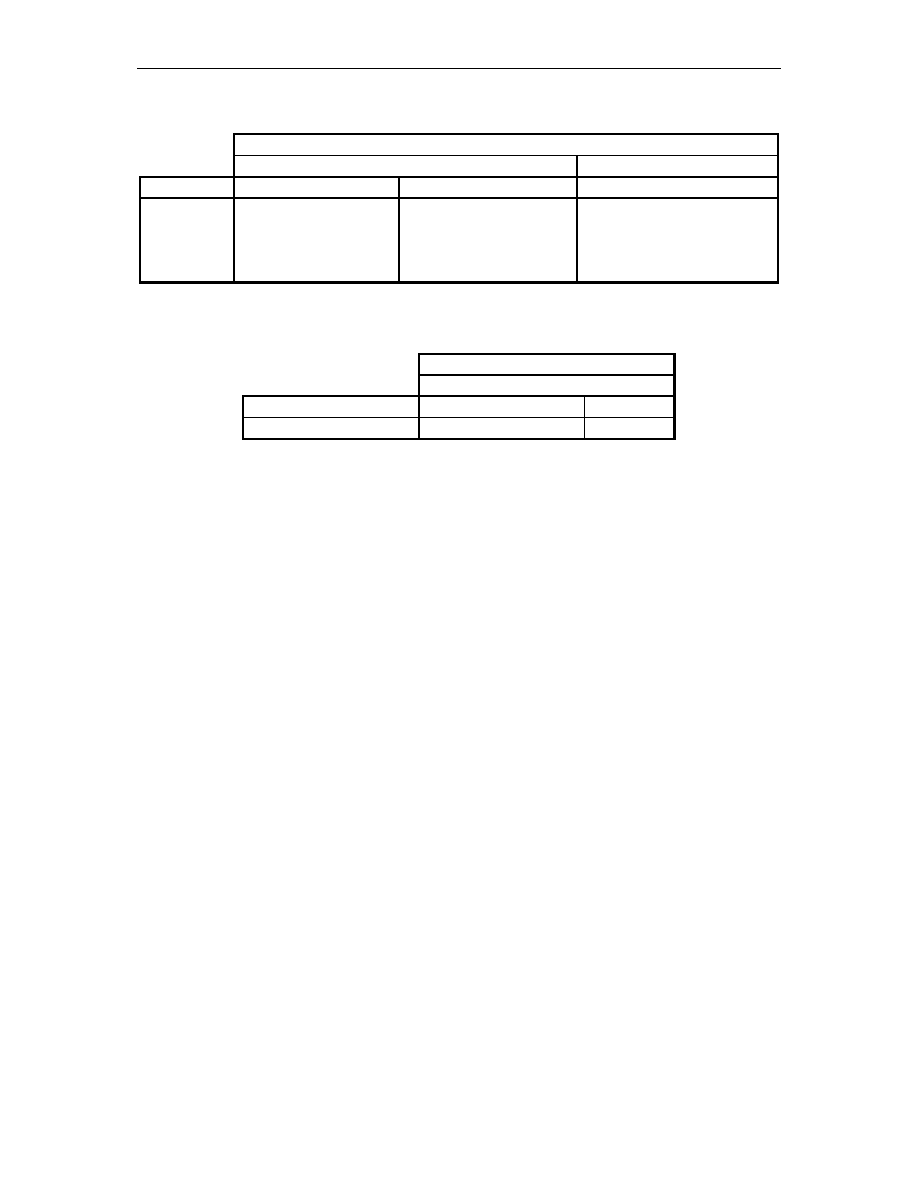

in ynierii oprogramowania [42]. Przykładowo, wiersz trzeci okre la, e w latach 1970–1990,

istniej cymi programami były w wi kszo ci olbrzymie systemy oraz komputery dla mas,

pojawiaj ce si bł dy były wyniszczaj ce i uznane zostały za rzecz zwykł , natomiast

in yniera oprogramowania była w tych latach w rozkwicie.

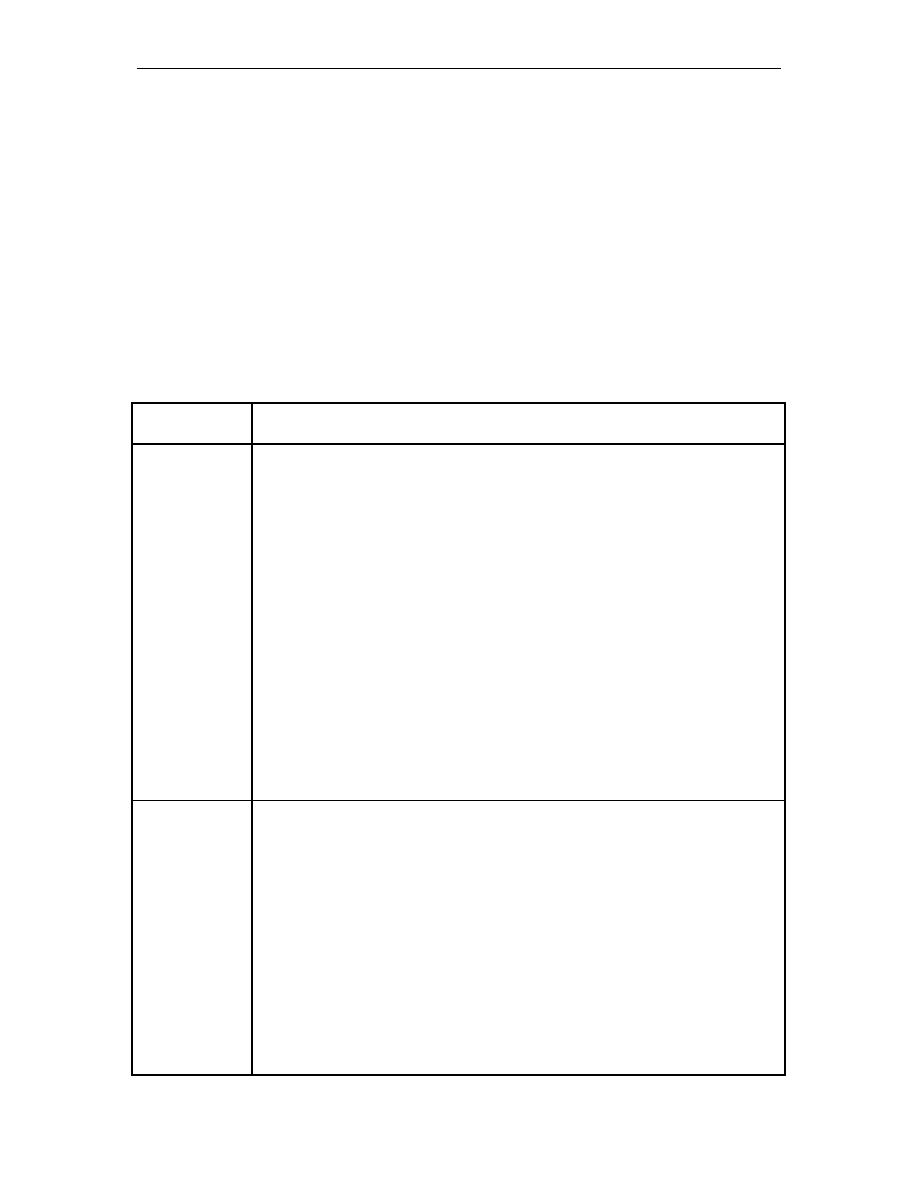

Lata

Programy

Bł dy

In ynieria

oprogramowania

1950 – 1960 programy dla siebie

niewielkie bł dy

nie istnieje

1960 – 1970

du e systemy

kosztowne bł dy,

pocz tki kryzysu

rodzi si

1970 – 1990

olbrzymie systemy

oraz komputery dla

mas

wyniszczaj ce bł dy,

uznanie bł dów za

rzecz zwykł

w rozkwicie

1990 – 2003

nic ju nie mo emy

bez komputerów

kryzys

oprogramowania

w rozkwicie

nadal kwitnie

przyszło

bł dnie

zaprogramowane

komputery

przeprogramowuj

ludzi do własnych

potrzeb

trudno ci z bł dami

w ludziach

powstaje in ynieria

oprogramowania

genetycznego ludzi

W pracy po wi conej metodykom RUP oraz XP [6] okre lono, e celem wprowadzenia

procesu wytwarzania oprogramowania jest obawa, e:

•

projekt doprowadzi do wytworzenia złego produktu, lub produktu gorszej

jako ci;

•

projekt b dzie miał opó nienia;

•

projekt b dzie wymagał 80 godzin pracy w tygodniu;

•

podczas realizacji projektu nie uda si wypełni zobowi za w nim

zawartych;

•

praca nad projektem nie dostarczy przyjemnych chwil i satysfakcji;

Obawy te motywuj do wytworzenia procesu, który ograniczy projektantom

i programistom pole działania i wymusi dokładnie okre lone wyniki. Ograniczenia i dane

wyniki okre la si na podstawie posiadanych do wiadcze , wybieraj c to, co poprzednio

udało si wykona , w nadziei, e uda si ponownie i zabierze obawy na przyszło . Gdy

przeanalizuje si udane projekty, mo na zauwa y , e chocia w szczegółach ró niły si

mi dzy sob , maj w istocie podobny kształt. Ten kształt jest dobrze opisany przez RUP.

Bjarne Stroustrup, twórca j zyka C++, stwierdził w 1991 roku: „Projektowanie

i programowanie s działalno ci (zaj ciem) człowieka; je li si o tym zapomni, wtedy

wszystko jest stracone” [6]. Je eli za jest to działalno człowieka, to nieuchronnie staje si

podatna na bł dy. Nie chc c o tym zapomnie , w ka dej metodyce stosuje si ró nego rodzaju

testy, których celem jest znalezienie i wyeliminowanie jak najwi kszej ilo ci bł dów. Nie

tylko sam etap testowania, ale wła ciwie cało podejmowanych aktywno ci w procesie słu y

Tab. 1.1.

Historia in ynierii oprogramowania

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

10

temu pierwszorz dnemu celowi: wytworzeniu niezawodnego oprogramowania, na ile to tylko

jest mo liwe.

Chc c mówi o testowaniu nie mo na tego czyni w oderwaniu od procesu

wytwarzania oprogramowania, w którym ma ono miejsce. Nie ma ani jednego przepływu

(w metodykach ci kich), jak równie nie ma wła ciwie adnej aktywno ci projektowej czy

programistycznej (w metodykach lekkich) bez testowania. Testowanie ma miejsce we

wszystkich procesach, ale idea, jak ka dy z nich realizuje powoduje, e nacisk kładziony na

ten etap mo e, i cz sto jest, zró nicowany. Zró nicowanie to wida szczególnie mi dzy

metodykami ci kimi i lekkimi.

Podział na metodyki lekkie i ci kie pojawił si w sposób naturalny po tym, jak

metodyki lekkie zacz to wprowadza i według nich wytwarza oprogramowanie. Poj cie

„lekko ci” i „ci ko ci” dotyczy technik w nich stosowanych. W metodykach ci kich du

wag przywi zuje si do wykonywania bie cej dokumentacji projektu, co zabiera jego

wykonawcom bardzo wiele czasu. Metodyki lekkie nie s całkowicie pozbawione obci enia

dokumentacji, ale zdecydowanie maj go mniej do uniesienia. Ró nica ta ma na pewno swoje

ródło mi dzy innymi w roli klienta w procesie wytwarzania. W metodykach ci kich

wył cznie pierwszy etap słu y pozyskaniu informacji o tym, jakiego systemu spodziewa si

klient i sporz dzeniu nieformalnego zapisu, z którego w dalszych etapach uzyskuje si coraz

to bardziej formaln posta , a do gotowego produktu. Natomiast w metodykach lekkich rol

klienta jest by obecnym podczas wszystkich etapów wytwarzania. Do niego nale y tak e

bie ca kontrola wyników testów jednostkowych i akceptacyjnych

21

oraz zgłaszanie

ewentualnych uwag, aby proces wytwarzania oprogramowania nieustannie posuwał si

w wyznaczonym kierunku, do celu.

Dokładniej ró nice i podobie stwa w podej ciu do testowania w metodykach ci kich

i lekkich opisane s w nast pnych podrozdziałach. Do porównania zostały wybrane

z metodyk ci kich: RUP, a z metodyk lekkich XP. S one bowiem kluczowymi

metodykami

22

ka da w swojej klasie, a porównanie ich stanowi przegl d tego, co dzieje si

obecnie w in ynierii oprogramowania.

1.2. Testowanie według metodyk ci kich

Spo ród wymienionych w podrozdziale 1.1 metodyk ci kich do dalszych rozwa a

zostały wybrane metodyki USDP i RUP. Obie te metodyki s metodykami generycznymi.

Oznacza to, e na ich podstawie mo na tworzy inne metodyki, które chocia podło e maj

wspólne, to jednak w konkretnej realizacji mog si ró ni . Tak wła nie powstała

licencjonowana metodyka RUP, wywodz ca si z darmowej USDP, która stanowi szkielet

23

dla metodyki RUP, znajduj cej si na ni szym poziomie abstrakcji.

USDP i inne wywodz ce si z niej metodyki, w tym RUP, stanowi klas procesów

iteracyjnych, rozszerzalnych i sterowanych przypadkami u ycia

24

[15], [16]. Iteracyjno tych

procesów polega na wykonywaniu w jednym kroku przej cia przez wszystkie fazy. Ka da

iteracja ko czy si wykonaniem odpowiednich testów.

25

Rozszerzalno polega na tym, e

ka da iteracja chocia przechodzi wci przez te same etapy, ko czy si wykonaniem

i przetestowaniem coraz to nowej funkcjonalno ci systemu. Teoretycznie istnieje mo liwo

wykonywania dowolnej ilo ci iteracji. Sterowanie przypadkami u ycia okre la sposób

21

Zob. rozdział drugi.

22

Mo na to stwierdzi np. na podstawie ilo ci publikacji na temat metodyk wytwarzania oprogramowania.

23

Ang. framework.

24

Ang. use-case driven, metoda wprowadzona przez Jacobsona w 1993.

25

W zale no ci od fazy, w jakiej miała miejsce iteracja, wykonuje si ró ne testy.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

11

podej cia do wytwarzania du ych systemów. Polega na tym, e w pierwszej kolejno ci

identyfikuje si klasy zewn trzne wzgl dem systemu. Klas zewn trzn mo e by

u ytkownik lub np. inny system. Nast pnie okre la si funkcje w systemie wykorzystywane

przez klasy zewn trzne. Tworzony jest wi c opis systemu z punktu widzenia poszczególnych

klas [16]. Ka dy przypadek u ycia zamyka w sobie odr bn funkcjonalno istotn dla klas

zewn trznych lub innych przypadków u ycia.

Przypadek testowy jest okre leniem analogicznym do poj cia przypadku u ycia.

Bowiem przypadki testowe tworzy si wła nie na podstawie przypadków u ycia. Celem

wykonywania przypadków testowych jest sprawdzenie, czy odpowiadaj cy mu przypadek

u ycia realizuje swoje funkcje zgodnie ze specyfikacj . Przypadki testowe wykonuje si na

etapie testowania w ramach testowania funkcjonalnego.

26

USDP zawiera pi przepływów (etapów): specyfikacja wymaga , analiza,

projektowanie, implementacja i testowanie. W metodyce RUP przepływów jest wi cej i s

one nieco inaczej podzielone

27

[6]. RUP ł czy ze sob etapy analizy i projektowania oraz

wprowadza pi dodatkowych etapów wzgl dem tego, co było w USDP: modelowanie

biznesowe,

28

zarz dzanie konfiguracj i zmianami

29

, zarz dzanie projektem

30

, zarz dzanie

rodowiskiem,

31

zarz dzanie rozmieszczeniem.

32

RUP mo e podlega dalszemu

uszczegóławianiu. Przepływy w procesie RUP stanowi jego realizacj [6], [49]. Przepływy

mog by ci sze, lub l ejsze. Zale y to od sposobu dostosowania RUP do potrzeb danego

procesu. Jednak w porównaniu z metodykami lekkimi pozostaj tak naprawd ci kie [49].

Etap testowania wyst puje podobnie w obu metodykach, dlatego b dzie omówiony wspólnie.

W metodykach USDP i RUP wyró nia si 4 fazy: zapocz tkowanie, opracowanie,

konstrukcja i przej cie

33

[6], [34]. Fazy dziel si na iteracje, a przej cie ka dej iteracji polega

na wykonaniu aktywno ci wszystkich etapów. Istotne jest to, aby podczas iteracji zespół

projektowy nie skupiał si na jednym fragmencie systemu, ale równocze nie wykonywał

wszystkie główne podsystemy. Na ka d iteracj składa si wysiłek wszystkich członków

zespołu, ka dy z nich buduje swoj cz

projektu. Na koniec iteracji wszystkie cz ci s

integrowane. Długo , tzn. czas trwania ka dej iteracji zale y od rodzaju projektu, jednak

bardziej zaleca si krótsze ni dłu sze iteracje. Dla wi kszo ci projektów 1 do 2 tygodni

zawsze powinno wystarczy [6].

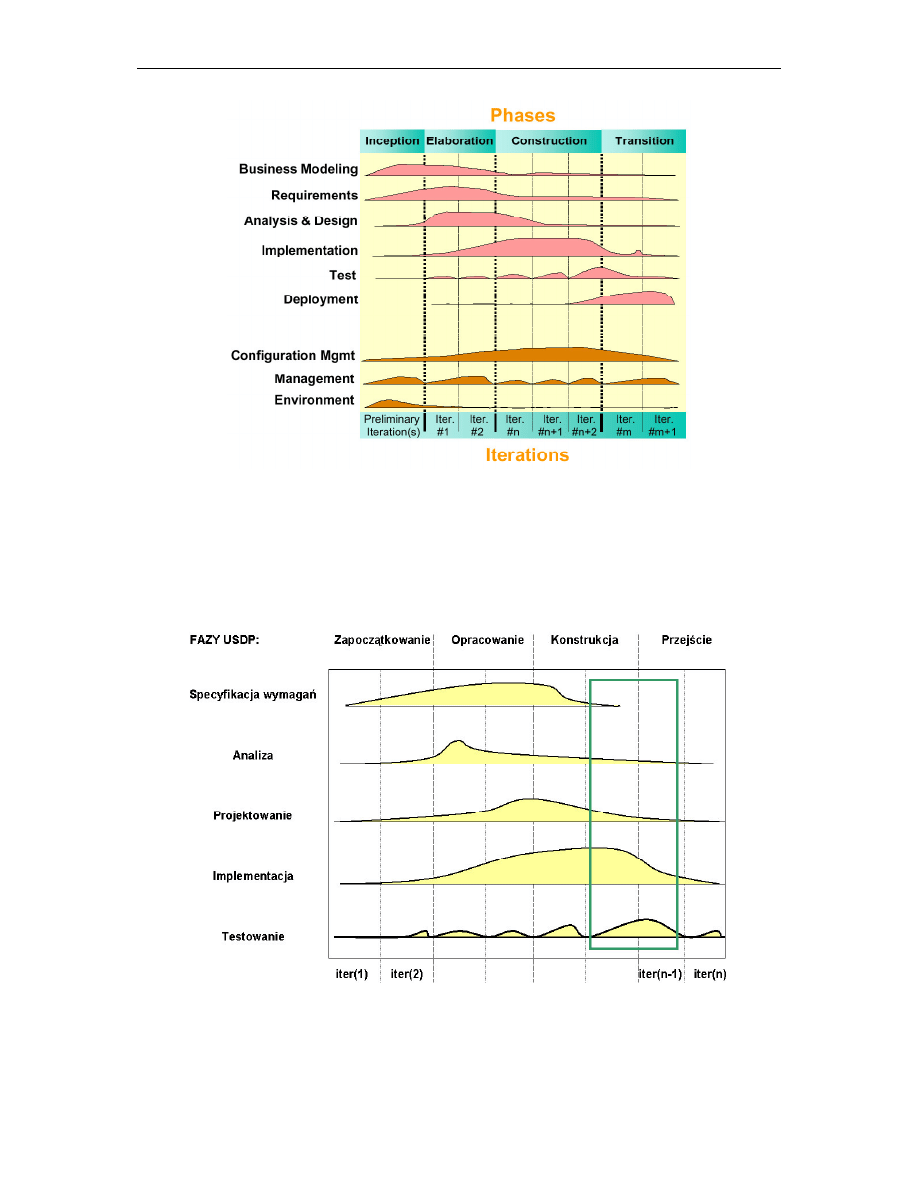

Rysunek 1.1 przedstawia fazy i etapy w metodyce RUP. Wida na nim, e etap

testowania ma szczególne nasilenie na granicy faz konstrukcji i przej cia, gdzie ilo

zaimplementowanego kodu jest ju znaczna. Etap implementacji ko czy si ju w połowie

fazy przej cia. Warto jednak zwróci uwag , e tak naprawd w ka dej fazie wykonuje si

testowanie, poniewa ka da iteracja ko czy si powstaniem tzw. buildu, który wymaga

sprawdzenia. Build jest działaj cym fragmentem systemu, który cz sto wykorzystuje si do

weryfikacji przez odbiorc systemu w celu okre lenia kierunku dalszej pracy nad rozwijaniem

systemu.

26

Zob. rozdział drugi.

27

Por. rysunki 1.1 i 1.2.

28

Zrozumienie i okre lenie potrzeb i wymaga informatyzowanego biznesu (przedsi biorstwa).

29

Zachowywanie cie ek wytwarzania wszystkich wersji systemu.

30

Zarz dzanie harmonogramem i zasobami.

31

Ustawianie i utrzymanie rodowiska projektowego.

32

Czynno ci zwi zane z wydaniem produktu.

33

Ang. inception phase, elaboration phase, construction phase, transition phase.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

12

Rys. 1.1.

Fazy i etapy (przepływy) w metodyce RUP

Dla porównania z metodyk RUP, rysunek 1.2 przedstawia fazy i przepływy

w metodyce USDP oraz miejsce (zaznaczone ramk ), w którym aktywno ci etapu testowania

s najwi ksze i najbardziej nasilone.

Rys. 1.2.

Fazy i etapy (przepływy) w metodyce USDP

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

13

Oprogramowanie podlega testowaniu w ka dej formie swojego istnienia: od

specyfikacji wymaga poprzez analiz i projektowanie, a po etap, w którym testuje si

gotowy produkt. Testowanie, jako etap rozło ony w czasie mo e dotyczy ró nych aspektów

oprogramowania.

34

W metodykach ci kich etap testowania traktuje si jako osobn aktywno

podejmowan przez testerów, tj. specjalnie wyznaczone do tego osoby z zespołu

projektowego. Po etapie kodowania, gdy programi ci wytworz kolejny fragment kodu

system lub jeszcze jego jest przekazywany testerom i poddawany testom. Celem testowania

jest wykrycie jak najwi kszej ilo ci bł dów.

1.3. Testowanie według metodyk lekkich

Pojawienie si metodyk lekkich wymagało od projektantów i programistów zmiany

dotychczasowej mentalno ci i sposobu podej cia do wytwarzania oprogramowania. Poprzez

specjalne techniki stosowane w tych metodykach testowanie, a zwłaszcza testowanie kodu

zyskało nowe znaczenie.

Najcz ciej wykorzystywan i najbardziej znan metodyk w ród metodyk lekkich

o wci wzrastaj cej popularno ci jest XP [38]. Twórca analizy strukturalnej, Tom de Marco

[20] okre la XP jako przełom w in ynierii oprogramowania [10]. Przełom ten mógł si

dokona dzi ki zastosowaniu w tej metodyce przedstawionych poni ej okre lonych praktyk

wytwarzania oprogramowania:

• Klient na miejscu

Klient ma pełn kontrol nad procesem rozwoju oprogramowania. Ci gła

obecno klienta stwarza programistom szans szybkiego rozwi zywania

napotykanych problemów i wyja niania w tpliwo ci dotycz cych cech

funkcjonalnych budowanego systemu. Klient aktywnie uczestniczy mi dzy

innymi w tworzeniu testów akceptacyjnych.

• Cz ste wydania

Kolejne wersje systemu buduje si na zasadzie przyrostów i dostarcza klientowi

w mo liwie krótkich cyklach (1-2 miesi ce). W ten sposób klient ma szans

lepszego poznania swoich potrzeb i wcze niej mo e skorygowa swoje

wymagania wobec systemu.

35

• Programowanie parami

Para programistów pracuje wspólnie przy jednym komputerze nad wykonaniem

okre lonego zadania. Taki sposób pracy oznacza de facto ci głe przegl dy kodu

(w XP zrezygnowano z formalnych przegl dów artefaktów).

• Ci gła integracja

Kod tworzony przez par programistów powinien by integrowany z cało ci

systemu tak cz sto, jak jest to tylko mo liwe. Przy ka dej integracji dodawana jest

nowa funkcjonalno do systemu.

• Refaktoryzacja

Oznacza ona przebudow kodu. Tworzony kod oraz struktura systemu ulegaj

iteracyjnemu poprawianiu i ulepszaniu przy zachowaniu zbudowanej

34

Ró ne metody testowania, zale ne od postaci, w jakiej wyst puje oprogramowania, s dokładniej omówione

w rozdziale drugim.

35

Patrz tak e p. 3.5 (testowanie akceptacyjne).

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

14

funkcjonalno ci. celem takiego działania jest uzyskanie przejrzystego,

komunikatywnego kodu, pozbywanie si powielonego kodu oraz zmniejszenie

ryzyka pojawienia si kolizji w trakcie procesu integracji [46].

• Testowanie

Proces kodowania zostaje zawsze poprzedzony przygotowaniem przypadków

testowych. Taki sposób pracy powoduje, e system jest w pełni zrozumiały dla

programistów, czego efektem jest wykonanie prostszej implementacji. XP kładzie

nacisk zarówno na testy jednostkowe, jak i akceptacyjne. Wa nym wymaganiem

jest automatyzacja wszystkich testów. Konieczno taka wynika z cz stych

integracji (ka da integracja systemu ko czy si wykonaniem wszystkich

istniej cych testów) oraz licznych refaktoryzacji. Dlatego metodyki te cz sto

okre la si mianem metodyk sterowanych testami.

Opisane podej cie pozwala utrzyma wysok jako wytwarzanego oprogramowania

przez cały okres prowadzonych nad nim prac.

W metodyce XP oraz innych metodykach lekkich mo na wyró ni takie praktyki,

w których znaczenie „sterowania testami” zostało posuni te jeszcze dalej. Ich nadrz dnym

celem jest wytwarzanie oprogramowania od pocz tku pozbawionego bł dów. Nie oznacza to

oczywi cie tego, e programi ci nie b d popełnia bł dów podczas pisania, ale stosowanie

testów jednostkowych na bie co nie pozwoli wytworzy du ej ilo ci niepoprawnego kodu,

którego testowanie i korekta okazałaby si niezmiernie czasochłonna, albo nawet niemo liwa.

Jedn z takich praktyk jest podej cie Test Driven Development

36

[47]. Jeden z twórców

podej cia sterowanego testami, Kent Beck [2], [3], [4], pionier na polu metodyk lekkich

przedstawia jego zało enia i praktyki.

Wytwarzanie sterowane testami jest praktyk efektywnego pisania i rozwijania

u ytecznego kodu. Chocia nazwa mo e sugerowa główny nacisk tej metodyki na

testowanie, jest ona jednak przede wszystkim projektowaniem: skupia uwag programistów

na wytwarzaniu kodu wył cznie zgodnego ze specyfikacj i unikaniu tworzenia kodu ponad

to, co jest konieczne i potrzebne.

37

U ywaj c tej techniki, programi ci rozpoczynaj tworzenie fragmentów kodu od

napisania dla nich testów. Nast pnie, gdy kod przejdzie testy pomy lnie, jest poddawany

refaktoryzacji i wszystko rozpoczyna si od nowa. TDD stwarza pewien rytm wytwarzania,

który upraszcza rozwijanie „szczupłego”, u ytecznego i w pełni przetestowanego kodu [41].

Na zako czenie mo na przytoczy słowa wiatowej sławy twórcy algorytmów, Dijkstry

[6]: „...jako człowiek powoli my l cy mam bardzo mał głow i lepiej b dzie je li naucz si

z tym y , respektowa moje ograniczenia i raczej ufa im, ni próbowa je ignorowa , aby

pó niej, mimo pró nego wysiłku, by ukaranym przez popełnienie bł du.”

Je li równocze nie próbuje si wykona wiele aktywno ci bez sprawdzania wyników, to

mo na przewidzie , e nie udadz si . Dlatego wybiera si i stawia małe kroki i ka dy z nich

testuje przed wykonaniem nast pnego. Dobry proces u ywa metod podobnych do metod

naukowych. Pierwszy krok jest niczym innym, jak hipotez . Ka d hipotez sprawdza si

empirycznie, za pomoc fizycznych eksperymentów. Dopiero gdy odpowiednia ilo testów

potwierdzi hipotez , mo na wybra nast pny krok. Jest to podstawowa motywacja dla

wszystkich metod iteracyjnych [6].

36

Pol. wytwarzanie sterowane testami.

37

Ang. over-engineering.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

15

1.4. Porównanie podej cia do testowania w metodykach ci kich

i lekkich

Podobie stwa i ró nice w podej ciu do testowania w metodykach ci kich i lekkich

mo na pokaza , jak to było ju w podrozdziałach 1.2 i 1.3 na przykładzie RUP oraz XP.

Warto w tym celu si gn do informacji ródłowych. Rational Software Corporation wraz

z Object Mentor Inc. [44] wydali elektroniczny przewodnik po RUP i XP [36]. Przewodnik

ten, który powstał we współpracy obu firm jest ródłem rzetelnych informacji na temat obu

sposobów podej cia do wytwarzania oprogramowania.

Wytwarzanie oprogramowania jest aktywno ci ludzk , która przekształca surow

intelektualn wizj w namacalny, wykonywalny kod. Z wyj tkiem najprostszych systemów,

wytwarzanie warto ciowego oprogramowania wymaga wysiłku grupy ludzi, z których cz

jest koderami, cz

testerami lub innymi członkami wnosz cymi swoje umiej tno ci

i perspektywy do wspólnego wysiłku. Ludzie wchodz cy w skład zespołu maj ró ne

przyzwyczajenia i sposoby pracy. Proces wytwarzania oprogramowania wprowadza

okre lenie i ujednolicenie wykonywanych aktywno ci, wdra a je i umo liwia porozumienie

mi dzy ró nymi członkami zespołu.

Rational Unified Process i Extreme Programming s wła nie takimi procesami.

W swojej istocie maj wiele podobie stw: oba uznaj wytwarzanie za aktywno ludzk i oba

d

do wytwarzania oprogramowania coraz lepiej i szybciej. Ponadto w swoim działaniu

wykazuj podobne aktywno ci:

•

Wytwarzanie koncentruje si na rozbudowie systemu poprzez małe iteracje

i jest procesem ci głym.

•

Iteracje zale od fazy, w której wyst puj ; ich ilo i dokładno zwi ksza

si przez cały cykl ycia projektu.

•

Wykonywalny kod jest przegl dany jako pierwotny produkt wraz ze

wszystkimi artefaktami. Artefakty s półproduktami procesu wytwarzania

oprogramowania, które pomagaj uzyska produkt finalny. Artefakty

pomagaj równie uzyska porozumienie pomi dzy członkami zespołu.

W rzeczywisto ci, patrz c z zewn trz na zespół pracuj cy według metodyki RUP,

mo na odnie wra enie, e post puj według XP i na odwrót.

Oczywi cie istnieje wiele ró nic mi dzy RUP a XP. Przede wszystkim RUP jest

metodyk generyczn , a nie konkretnym procesem, tak jak XP i mo e by dostosowywany do

aktualnych potrzeb projektantów. RUP i XP s całkiem podobne w swoich zasadach, ale

ró ne w zakresie działania. XP skupia si przede wszystkim na dynamikach mi dzyludzkich

(ang. social dynamics) wewn trz małych zespołów projektowo-programistycznych, podczas

gdy RUP równie mocno kładzie nacisk na kontekst otaczaj cy, wł czaj c w to zespoły

zarz dzaj ce zespołami projektowymi.

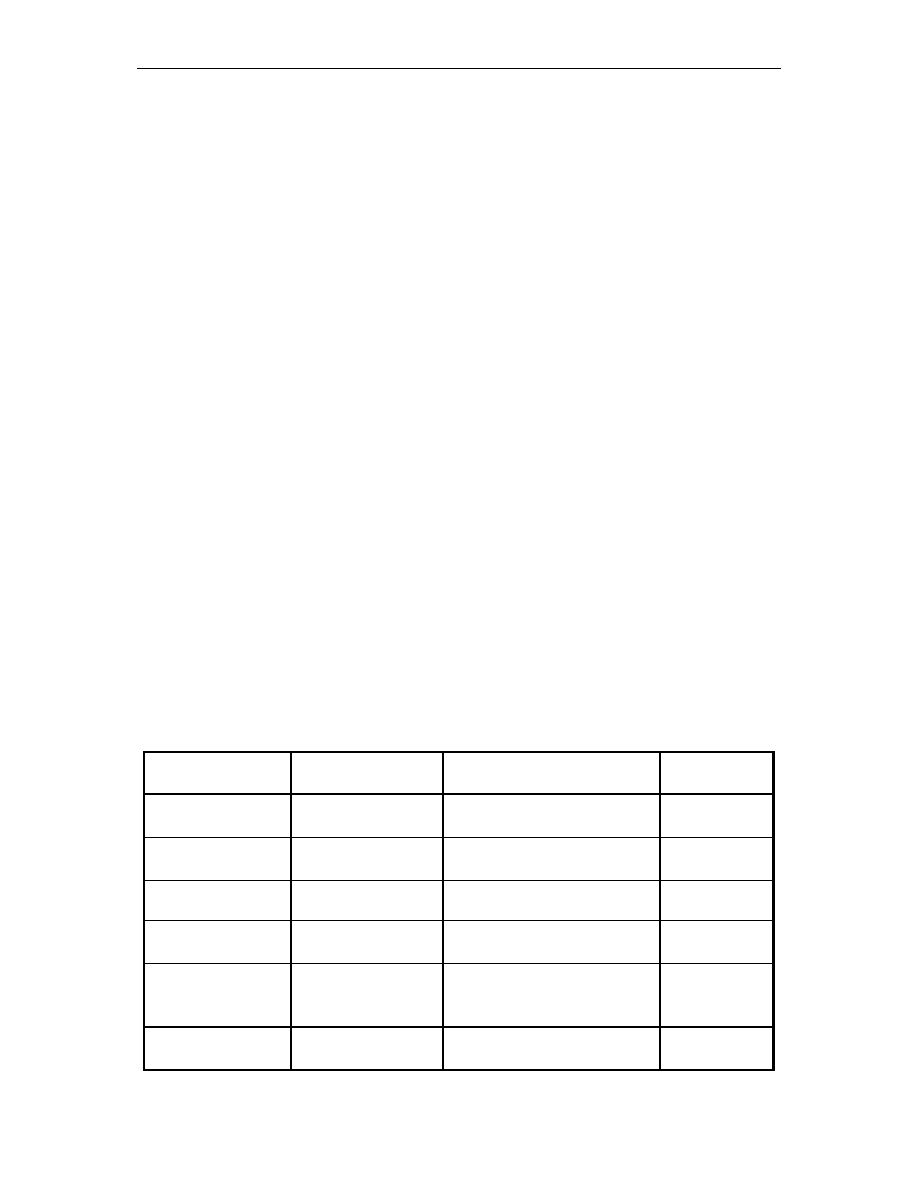

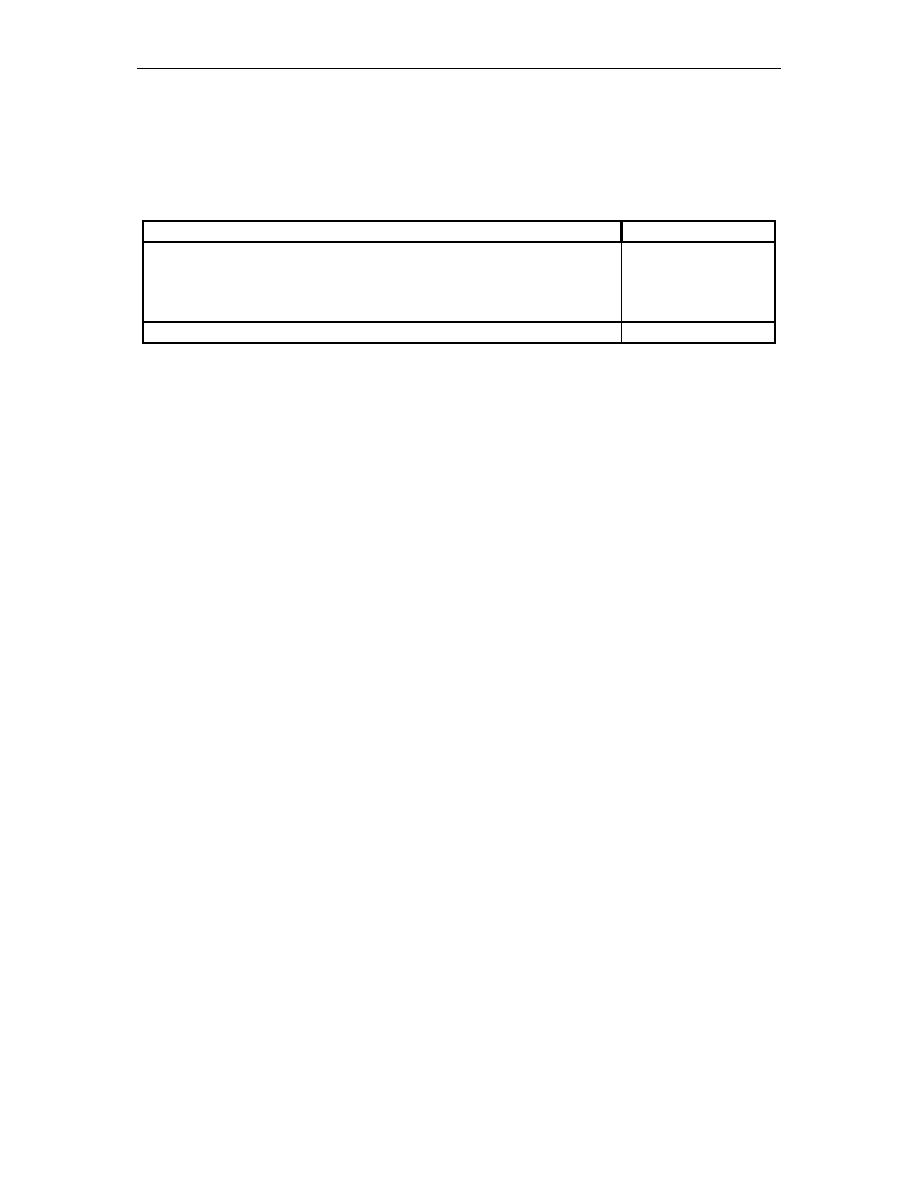

Tabele 1.2 i 1.3 przedstawiaj porównanie ról osób zwi zanych z wytwarzaniem

oprogramowania w metodykach RUP i XP. W wierszach wyszczególnione s role osób

wchodz cych w skład zespołów. Np. wiersz ostatni zawiera wykaz ról osób w metodyce

RUP: specyfikator wymaga (ang. Requirements Specifier), analityk systemowy (ang. System

Analyst) i mened er projektu (ang. Project Manager). Te trzy role odpowiadaj jednej roli

w metodyce XP: klientowi (ang. Customer).

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

16

Tab. 1.2.

Porównanie ról osób w zespole projektowym według metodyk XP i RUP

Whole Team

XP Customer Team

XP Developer Team

XP Roles

Customer

Tester

Programmer

RUP Roles

• Requirements

specifier

• System Analyst

• Project Manager

• Test Analyst

• Tester

• Test System

Administrator

• Implementer

• Designer

• Integrator

• System Administrator

Whole Team

XP Organization

XP Roles

Tracker

Coach

RUP Roles

Project Manager

–

RUP za USDP wprowadza cztery fazy: zapocz tkowanie, opracowanie, konstrukcja

i przej cie [6], [34]. W ka dej fazie wprowadza si i kładzie nacisk na ró ne aktywno ci:

okre lenie modelu biznesowego, okre lenie technicznego otoczenia, wytwarzanie systemu

oraz przej cie do w pełni funkcjonalnego u ytkowania. W XP fazy nie wyst puj w ogóle, ale

czynno ci projektowe mog by wykonywane w kolejno ci, jaka akurat wynika z potrzeb

projektu [37].

W XP identyfikuje si kilka praktyk, które kształtuj prac zespołu wytwórczego, ale za

to nie ingeruje si w sprawy otoczenia. Natomiast RUP nie okre la szczegółów pracy

i kształtu zespołu, ale wiele decyduje w kwestach otoczenia projektu. Pod tym wzgl dem XP

i RUP s procesami uzupełniaj cymi si wzajemnie.

Opisana w podrozdziale 1.2 metodyka RUP nale y do grupy metodyk ci kich. Jest

ponadto metodyk generyczn , czyli daje mo liwo dostosowania si do specyficznych

wymaga danego projektu.

W pracy [6] została opisana implementacja nowej metodyki na bazie RUP, któr

nazwano dX. Metodyka dX miała by minimaln , mo liwie lekk implementacj RUP.

Podstawy i zało enia nowej metodyki zostały zaczerpni te z prac m.in. Cunningham’a [47],

Beck’a [2], [3], [4], Jeffries’a [48], prekursorów metodyk lekkich oraz innych projektantów

i metodologów oprogramowania [39]. Udana próba adaptacji RUP do indywidualnych

potrzeb dały pocz tek nowej metodyce. Sukcesy projektów wytworzonych według tej

metodyki pokazały, e mo liwy jest kompromis mi dzy ci kim podej ciem, jakim wydaje

si by RUP a podej ciem lekkim, wzorowanym na XP.

Tab. 1.2.

Porównanie ról osób w zespole projektowym według metodyk XP i RUP (c.d.)

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

17

2. METODY TESTOWANIA KODU

2.1. Wprowadzenie

W rozdziale pierwszym wyja niona została ró nica pomi dzy oprogramowaniem

rozumianym jako kompletny produkt powstały w procesie wytwarzania oprogramowania

a kodem zapisanym w konkretnym j zyku programowania, b d cym jedynie cz ci

oprogramowania, chocia bardzo istotn .

W tym rozdziale na pocz tku wyja nione zostan podstawowe poj cia zwi zane

z dziedzin testowania oprogramowania. Nast pnie zostan dokładniej przedstawione metody

testowania samego kodu, problemy z nimi zwi zane oraz inne metody testowania na

wy szych poziomach wytwarzania oprogramowania.

38

Zagadnienia, które trudno pomin mówi c o testowaniu to poj cie bł du, awarii

i defektu. Bł d definiuje si jako zdarzenie zainicjowane przez człowieka lub rodowisko

programu, powoduj ce, e kod produkuje jaki nieoczekiwany rezultat; mówi c inaczej,

zachowuje si niezgodnie ze specyfikacj . Gdy program nie jest w stanie wykona co

najmniej jednej ze swoich funkcji, wówczas jest to awaria.

Defekt natomiast, to pomyłka

popełniona na dowolnym etapie cyklu ycia oprogramowania przez projektanta lub

programist . Podsumowuj c: bł d ujawnia si poprzez awari programu, a powstaje

w wyniku defektu w działaniu człowieka. Testowanie definiuje si jako eksperymentowanie

z programem lub poszczególnymi jego komponentami. Podczas tych eksperymentów

wykorzystuje si specjalnie dobrane dane testowe i porównuje uzyskane wyniki z wynikami

przewidywanymi. Testowanie ma na celu doprowadzenie do awarii systemu, by ujawni

ukryte w nim ewentualne bł dy [12].

Etap testowania uznawany jest za najtrudniejsze zadanie podejmowane w całym

procesie wytwarzania oprogramowania. Jest niezwykle istotne, aby czynno ci testowe były

podj te od samego pocz tku ycia projektu. Uwa a si , e 1$ zaoszcz dzony kosztem

testowania w pocz tkowych fazach poci ga za sob kwot 1000$ na wykrycie i usuni cie

bł du w fazach pó niejszych [45]. Mimo du ego wysiłku wkładanego w przygotowanie

i podejmowanie aktywno ci testowych, etap ten nie daje gwarancji, e przetestowane

oprogramowanie b dzie wolne od bł dów. W przypadku du ych systemów wiele bł dów

znajduje si ju po wydaniu produktu. Firmy o utwierdzonej renomie na rynku

oprogramowania zapewniaj w swoich produktach mo liwo zgłaszania przez klientów

znalezionych przez nich bł dów podczas u ytkowania systemu. Ta informacja zwrotna jest

wykorzystywana przy kolejnych wydaniach systemu do wyeliminowania znalezionych

bł dów. Przykładem mog by produkty firmy Microsoft: np. w Windows XP jest

wprowadzono mechanizm przesyłania informacji o bł dzie zaraz po jego wyst pieniu, je li

u ytkownik wyrazi zgod i posiada dost p do sieci Internet.

Mówi c o testowaniu, cz sto u ywa si takich poj jak przypadek testowy czy

kryterium zako czenia testu. Przypadek testowy to konkretne zachowanie si programu,

wybrane do testowania spo ród wielu mo liwych. Kryterium zako czenia testu umo liwia

podj cie decyzji, czy ilo wykonanych testów jest wystarczaj ca, tzn. czy udało si

zaobserwowa dostateczn ilo zachowa [12].

38

„Poziom wytwarzania oprogramowania” jest poj ciem nieformalnym. Jak wiadomo, na ró nych etapach

wytwarzania, oprogramowanie wyst puje w ró nej formie: od ogólnych i nieformalnych zapisów na etapie

specyfikacji wymaga (poziom najwy szy), poprzez modele analizy, projektu, a po kod (poziom najni szy).

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

18

Wykonywane testy mog podlega ocenie. Jedn z metod oceny jest technika

zasiewania bł dów [12]. Polega ona na celowym wprowadzeniu bł dów do kodu i mierzeniu,

w jakim stopniu dany test wykrywa te bł dy. Cz sto przy tej okazji wykrywane s bł dy

istniej ce w kodzie przed zasianiem.

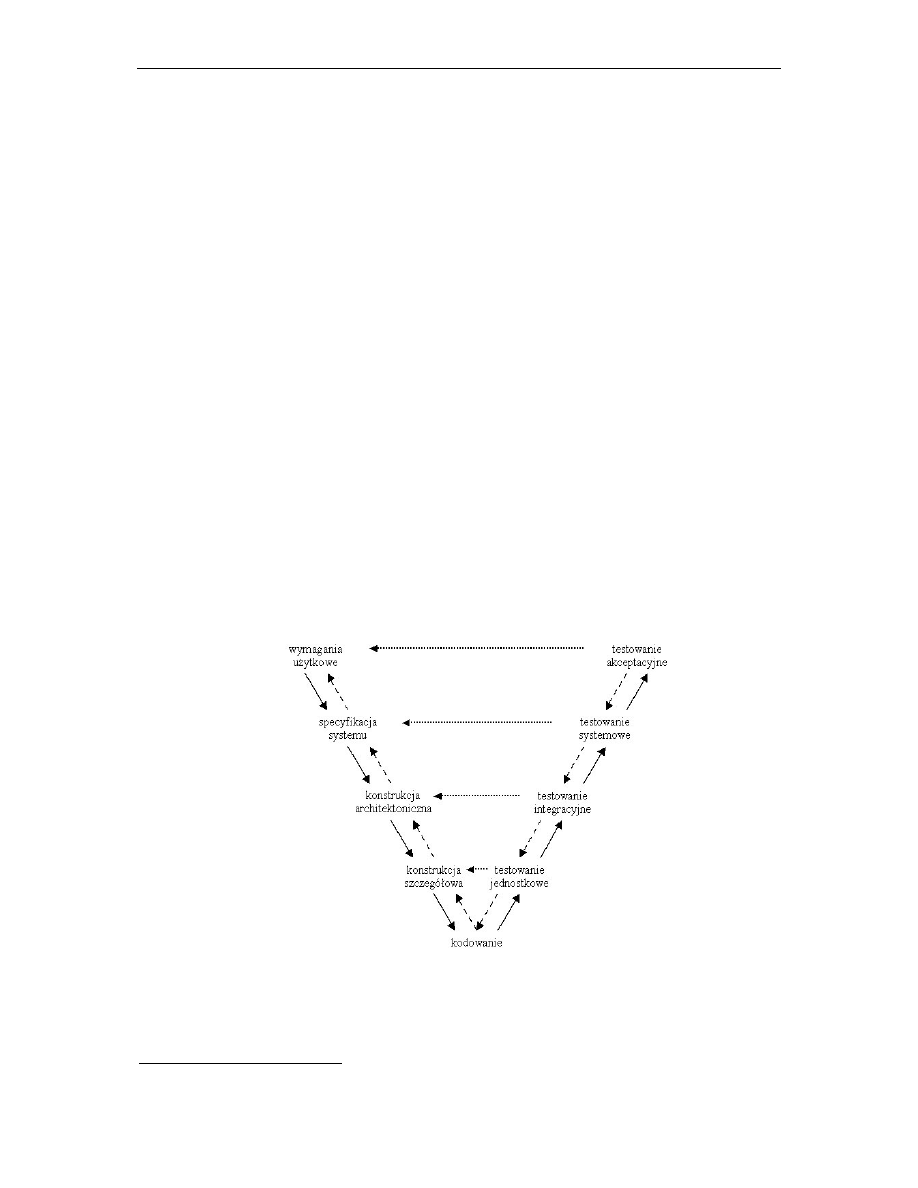

Prof. Wiszniewski [12] tak definiuje i wprowadza poj cia ró nych metod testowania:

najni szy poziom eksperymentowania z wykonywalnym kodem wytwarzanego produktu

(programu, systemu) nazywa si testowaniem jednostkowym. Testowanie jednostkowe polega

na wykonywaniu pojedynczych funkcji lub innych fragmentów kodu w oderwaniu od reszty

systemu. Powy ej tego poziomu realizowane jest testowanie integracyjne, gdzie

przetestowane jednostki kodu s stopniowo ł czone w wi ksz cało , a nast pnie ponownie

testowane ju jako grupa jednostek. Proces ł czenia i testowania jest powtarzany a do

powstania całego systemu. Eksperymenty s wówczas prowadzone w docelowym rodowisku

programu. Ten najwy szy poziom eksperymentowania nazywany jest testowaniem

systemowym [12]. Ponadto wyró ni mo na jeszcze inne rodzaje testowania: testowania

niezale ne i testowanie akceptacyjne [12]. Niezale ne polega na tym, e testowania kodu nie

wykonuje jego twórca (programista), ale inna osoba niekoniecznie nawet zwi zana z tym

konkretnym projektem. Je li ta sama osoba jest jednocze nie programist i testerem danego

fragmentu kodu, wówczas istnieje zagro enie tendencyjnego podej cia i niezamierzonego

pomini cia kontroli pewnych aspektów. Na samym ko cu, przed „oddaniem” systemu,

wykonuje si jeszcze testowanie akceptacyjne. Ilustruje to rysunek 2.1, który przedstawia

model „V”, miejsce testowania w procesie wytwarzania oprogramowania. Strzałki o liniach

ci głych oznaczaj kierunek wytwarzania, o liniach kreskowanych – lokalizacj bł du, a

o liniach kropkowanych – kierunek weryfikacji. Z rysunku mo na odczyta , e kodowanie

jest etapem wykonywanym na podstawie konstrukcji szczegółowej,

39

po czym wykonywane

jest testowanie jednostkowe, którego zadaniem jest weryfikacja kodu na podstawie

konstrukcji szczegółowej [12].

Rys. 2.1.

Testowanie w procesie wytwarzania oprogramowania – model „V”

39

Konstrukcja szczegółowa jest odpowiednikiem etapu projektowania w USDP i RUP.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

19

W podrozdziałach 2.2 i nast pnych zostały zamieszczone definicje i opisy

poszczególnych rodzajów testowania.

2.2. Testowanie strukturalne i funkcjonalne

Poj cia te ci le wi

si odpowiednio: funkcjonalne z metodami „czarnej skrzynki”

oraz strukturalne – „białej skrzynki” [16].

Dla metod realizowanych na zasadzie „czarnej skrzynki” ka dy przypadek testowy

40

opisany jest przez par <wej cie, wyj cie>. Dobór warto ci pary wykonuje si wył cznie na

podstawie specyfikacji systemu i wymaga analizy jego semantyki. Testowanie t metod

polega na porównaniu, czy dla danego wej cia otrzymane wyj cie jest prawidłowe. Przypadki

testowe tworzy si na podstawie przypadków u ycia okre lanych ju na etapie specyfikacji

wymaga systemu.

Testowanie metod białej skrzynki polega na przebadaniu elementów struktury

programu, np. pojedynczych instrukcji, czy cie ek z wybraniem odpowiednich danych

testowych.

Istnieje kilka kryteriów dostateczno ci

41

[18], które okre laj , na ile dany zbiór

przypadków testowych pokrywa kod programu. Kryteria te mog by sklasyfikowane ze

wzgl du na ródło informacji u ytej do sporz dzenia testów (specyfikacja systemu lub sam

program) lub ze wzgl du na sam rodzaj testowania. W pracy [18] u yto tzw. testów pokrycia

według strukturalnego kryterium pokrycia, a konkretnie pokrycia rozgał zie .

Definicja spełniania kryterium pokrycia: zbiór P cie ek wykonywania spełnia

kryterium pokrycia rozgał zie wtedy i tylko wtedy, gdy dla ka dej kraw dzi e w grafie

przepływu istnieje co najmniej jedna cie ka p w P, taka e P zawiera kraw d e.

Zaproponowano nast puj cy algorytm pokrycia rozgał zie :

1.

Wygeneruj wektor testowy według wybranego mechanizmu generacji;

2.

Je li jaka nowa gał została odkryta przez ten wektor, wówczas ilo prób

ustaw na 0, je li nie, ilo prób zwi ksz o 1;

3.

Je li ilo prób jest wi ksza od maksymalnej dozwolonej, wówczas

wykonaj rozszerzenie zakresu;

4.

Oblicz potencjał dla ka dej gał zi wektora testowego;

5.

Znajd gał ‘i’ o najwi kszej warto ci potencjału;

6.

Porównaj bie c najwi ksz warto potencjału z poprzedni . Je li bie ca

jest wi ksza, wówczas ilo prób ustaw na 0 i wykonaj redukcj zakresu ze

wzgl du na gał ‘i’;

7.

Je li dane pokrycie nie jest osi gni te, id do kroku 1;

Warto zwana potencjałem (pkt 5 algorytmu) jest miar dopasowania gał zi i została

wprowadzona w pracy [18]. Ponadto pomysłem autorów było, aby podczas testowania

wydoby u yteczne informacje o strukturze i w poł czeniu ze zmieniaj c si informacj

o stopniu pokrycia testów okre li warto bie cego potencjału gał zi. Warto ta posłu yła

do nakierowania testów typu „czarnej skrzynki” na gał zie mało b d w ogóle nie pokryte.

40

Zob. rozdział pierwszy.

41

Ang. adequacy criteria.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

20

Zaproponowano nowe podej cie zwane „wzmocnionymi gał ziami”,

42

które pomaga

ustawi w centrum uwagi gał zie trudniejsze do pokrycia. Porównano wyniki pokrycia testów

„czarnej skrzynki” (losowych) z u yciem i bez u ycia nowego podej cia. Wyniki pokazały, e

proste u ycie techniki nakierowania znacz co poprawiło pokrycie, szczególnie w przypadku

programów o zło onych strukturalnie własno ciach.

Graficzna reprezentacja tego algorytmu w postaci schematu blokowego dost pna jest

w pracy [18].

2.3. Testowanie jednostkowe

Norma definiuje testowanie jednostkowe jako testowanie pojedynczych jednostek

sprz tu czy oprogramowania lub powi zanych ze sob grup jednostek [32].

Testowanie jednostkowe stosuje si do weryfikacji konkretnych fragmentów kodu

w celu okre lenia zgodno ci strukturalnej i semantycznej ze specyfikacj , a zatem

z wykorzystaniem metod strukturalnych i funkcjonalnych. Tu odbywa si najbardziej

szczegółowa ocena pracy programisty odpowiedzialnego za kodowanie danego fragmentu

programu [12]. Poniewa programista posiada najlepsz wiedz na temat wytworzonego kodu

oraz istniej cych w nim niuansów

43

[12], wydaje si , e powinien uczestniczy

w wykonywaniu testów jednostkowych. Ze wzgl du jednak na opisywane ju wy ej

zagadnienie testowania niezale nego, konieczne jest zaanga owanie dodatkowo „osób

trzecich” do projektowania i wykonywania tego zadania.

Wida , jak istotne jest tutaj planowe i systematyczne podej cie oraz szczególne

zwrócenie uwagi na to, czy badana jednostka spełnia kryteria zako czenia testu oraz czy jest

gotowa do integracji. Je li podczas badania tej gotowo ci wyjd na jaw jakie bł dy, wówczas

wykonuje si tzw. testy regresywne, które polegaj na ponownym wykonaniu testowania

jednostkowego dla tych konkretnych jednostek [12].

W testowaniu jednostkowym cz sto wykorzystuje si techniki automatycznego

testowania. Daj one mo liwo przeprowadzania wielu testów z du ilo ci danych według

tego samego scenariusza [12]. Automatyczne testowanie wspomagane jest programami

narz dziowymi. Przykładowo, takim programem wspomagaj cym testowanie jest xUnit

44

[10], [33], dosy szeroko stosowany, zwłaszcza w metodykach lekkich.

Nacisk kładziony na testowanie jednostkowe mo e by zró nicowany w zale no ci od

przyj tego procesu wytwarzania oprogramowania. W metodykach lekkich jest to czynno

o kluczowym znaczeniu dla powodzenia przedsi wzi cia.

45

Najbardziej znanym przykładem metodyki lekkiej jest XP. W tej metodyce, przed

przyst pieniem do kodowania, przygotowuje si przypadki testowe. Dzi ki temu system jest

w pełni zrozumiały dla programistów, czego efektem jest wykonanie prostszej implementacji.

Dodatkowo wymaga si dokonywania automatyzacji wszystkich testów, co z kolei

podyktowane jest wykonywaniem cz stych integracji (ka da integracja systemu ko czy si

wykonaniem wszystkich istniej cych testów) oraz licznych refaktoryzacji.

46

Dzi ki takiemu

42

Ang. magnifying branches.

43

Dotyczy takich zagadnie , jak np. fizyczne rozmieszczenie elementów w pami ci, szczegóły organizacji

i konwersji ró nych typów danych, predykaty u yte w instrukcjach steruj cych itp.

44

Nazwa xUnit okre la rodzin aplikacji testowych dla ró nych rodowisk programistycznych: np. dla Javy jest

to JUnit, dla C++ – CppUnit, dla PHP – PhpUnit, dla Perla – PerlUnit, dla Smalltalk – SUnit, itd. Jej głównym

zastosowaniem jest tworzenie i wykonywanie powtarzalnych testów jednostkowych. Historycznie najwcze niej

powstał SUnit, napisany przez Kenta Becka.

45

Zob. rozdział drugi.

46

Zob. podrozdział 1.3, hasło: „Refaktoryzacja”.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

21

podej ciu udaje si utrzyma wysok jako wytwarzanego oprogramowania przez cały okres

prowadzonych nad nim prac [48].

2.4. Testowanie integracyjne

Testowanie integracyjne wykonuje si dla grupy co najmniej dwu jednostek

poł czonych ze sob i realizuj cych wspólnie jak bardziej zło on funkcj . Sprawdzaniu

podlegaj dwa aspekty tej grupy: interfejs ł cz cy jej elementy i wspólnie realizowana

funkcja. Dobór przypadków testowych i kryterium zako czenia testu s w zasadzie takie, jak

w testowaniu jednostkowym. Lokalizacja i eliminacja bł dów wymaga dobrej znajomo ci

struktury oraz do wiadcze zebranych w trakcie dotychczasowej integracji grupy, dlatego

znajduj tu zastosowanie metody „białej skrzynki”, metody strukturalne.

Ł czenie jednostek w wi ksz cało podlega pewnej strategii integracji. Mo na

wyró ni dwa typy strategii: przyrostowe i skokowe. Strategia przyrostowa polega na tym, e

do tworzonej cało ci doł cza si za ka dym razem tylko jedn przetestowan jednostk ;

strategia skokowa za polega na równoczesnym poł czeniu wszystkich lub wi kszej ilo ci

wybranych jednostek.

Wi cej na temat tych strategii oraz ró nych podej , jakie si w nich stosuje mo na

znale w literaturze [12].

2.5. Testowanie systemowe

Dzi ki czynno ciom testowania systemowego mo na okre li , czy wszystkie poł czone

komponenty systemu współpracuj ze sob tak, e działaj cy system jako cało jest zgodny

ze specyfikacj .

Testowaniu podlega funkcjonalno systemu z punktu widzenia interakcji

z u ytkownikiem i rodowiskiem. Testowanie systemowe nie mo e by zaliczone, je li oka e

si , e system nie realizuje w pełni swoich okre lonych funkcji. Przypadki testowe oraz

szczegóły wykonywania czynno ci testowych zale od wymaga u ytkowych, specyfikacji

systemu i jego konkretnych zastosowa .

W [12] wyró nia si kilka kategorii testowania systemowego, m.in.: testy u yteczno ci,

testy pami ci, testy instalacji, testy niezawodno ciowe i inne.

2.6. Testowanie akceptacyjne

Testowanie akceptacyjne po swoim zako czeniu powinno wykaza , e zostały

spełnione kryteria akceptacji, okre laj ce wszystkie funkcjonalne i pozafunkcjonalne

własno ci produktu. Istotnie ró ni si od testowania systemowego tym, e bardziej jest to

demonstracja systemu, a nie jego badanie. Mo na wyró ni dwa rodzaje testowania

akceptacyjnego: akceptacja fazowa i ostateczna [12].

Akceptacja fazowa ma na celu wykazanie cz ciowej realizacji wymaga , zakłada

cz sty kontakt z odbiorc systemu, aby móc na bie co kontrolowa , czy prace nad projektem

posuwaj si w kierunku zgodnym z jego oczekiwaniami.

Akceptacja ostateczna jest potwierdzeniem wywi zania si twórcy systemu z kontraktu

z klientem. Jest to czynno jednorazowa, zako czona formaln akceptacj produktu przez

klienta.

Podobnie, jak testowanie jednostkowe, testowanie akceptacyjne jest wa nym aspektem

metodyk lekkich, w tym programowania ekstremalnego. W metodyce XP wypracowano kilka

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

22

postulatów, których spełnienie umo liwia w bardzo szybki i efektywny sposób wykonywa

ten rodzaj testów [10].

Odbiorca systemu, dzi ki swojej aktywnej roli, mo e w pełni kontrolowa przebieg prac

projektowych. Mo e tak e uczestniczy w podejmowaniu decyzji podczas tworzenia

i wykonywania testów akceptacyjnych. Ponadto równie d y si do tego, aby nowe wydania

systemu pojawiały si na tyle cz sto (w odst pach 1–2 miesi cznych), aby klient miał szans

lepszego poznania własnych potrzeb i wcze niej mógł skorygowa swoje wymagania [10].

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

23

3. TESTOWANIE KODU DLA ZAPEWNIENIA NIEZAWODNO CI

OPROGRAMOWANIA

3.1. Wprowadzenie

W rozdziale drugim zostały wyja nione ró ne metody testowania oprogramowania,

których u ywa si w poszczególnych fazach procesu wytwarzania.

W tym rozdziale omówiony zostanie wpływ, jaki ma etap testowania na niezawodno

oprogramowania. Wpływ ten mo e by wi kszy lub mniejszy, a zale y przede wszystkim od

decyzji zespołu projektowego, który na podstawie wyników testowania oprogramowania

podejmuje okre lone kroki naprawcze w celu wyeliminowania znalezionych bł dów.

Wykonywanie aktywno ci testowych nie stanowi bowiem celu i warto ci samo dla siebie, ale

okazuje si bardzo istotne po odpowiednim wykorzystaniu.

Skoro za testowanie ma wpływ na niezawodno , to ma równie wpływ na jako

oprogramowania, poniewa niezawodno jest elementem jako ci produktu informatycznego

[28], [29].

Norma IEEE 610.12-1990 definiuje niezawodno oprogramowania jako zdolno

systemu lub komponentu do wykonywania okre lonych funkcji w okre lonych warunkach i

w okre lonym czasie.

Podstawow miar niezawodno ci obiektu w przedziale czasu

[ ]

t

,

0 jest

prawdopodobie stwo [5]:

)

(

)

(

t

T

P

t

R

≥

=

,

0

≥

t

(3.1)

nazywane krótko niezawodno ci obiektu. R jako funkcja czasu t bywa te nazywana

funkcj niezawodno ci.

Funkcja, która dla ka dego ustalonego

0

≥

t

przyjmuje warto prawdopodobie stwa,

e obiekt w chwili t jest uszkodzony:

( )

t

R

t

T

P

t

F

−

=

<

=

1

)

(

)

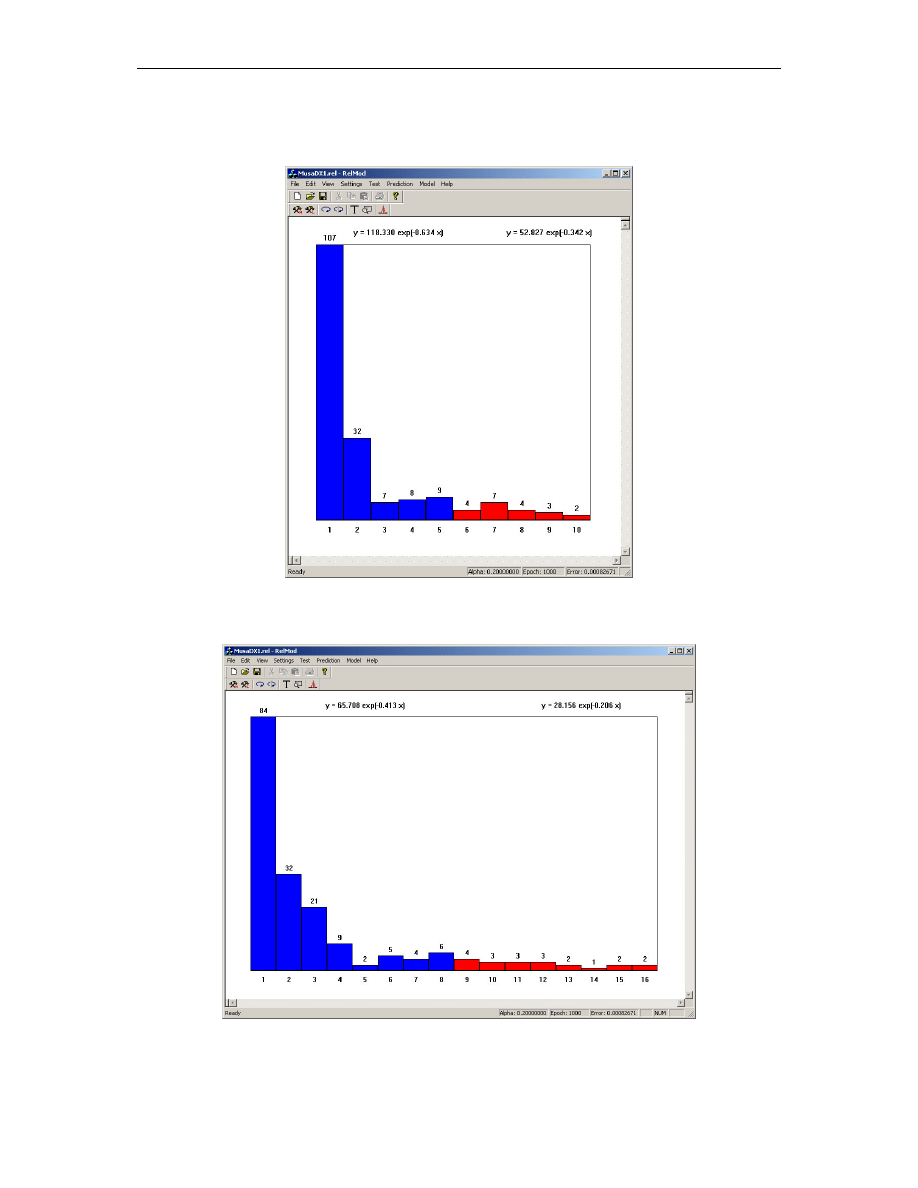

(

(3.2)

nosi nazw funkcji zawodno ci. Rozszerzenie funkcji zawodno ci na cał prost

(

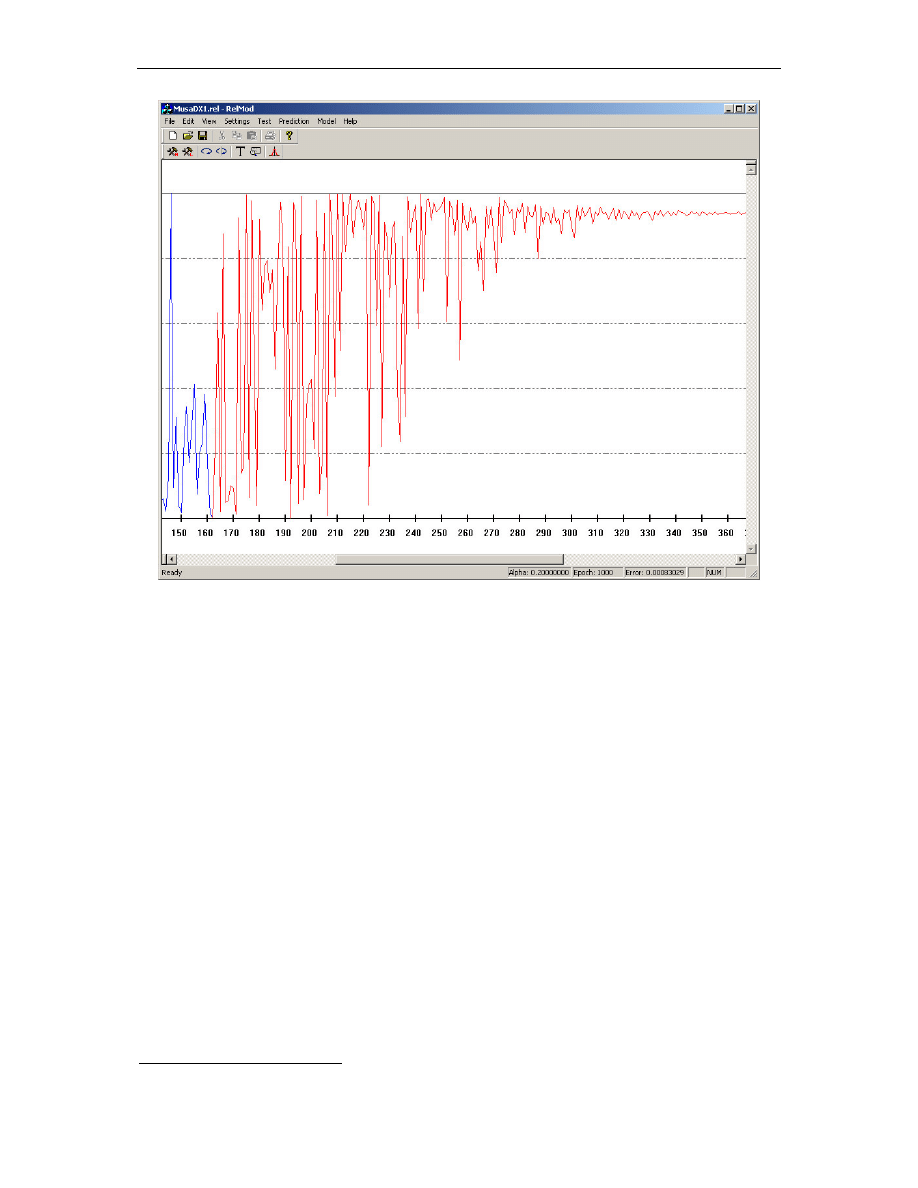

)

∞

∞

− , przez przyj cie

0

)

(

=

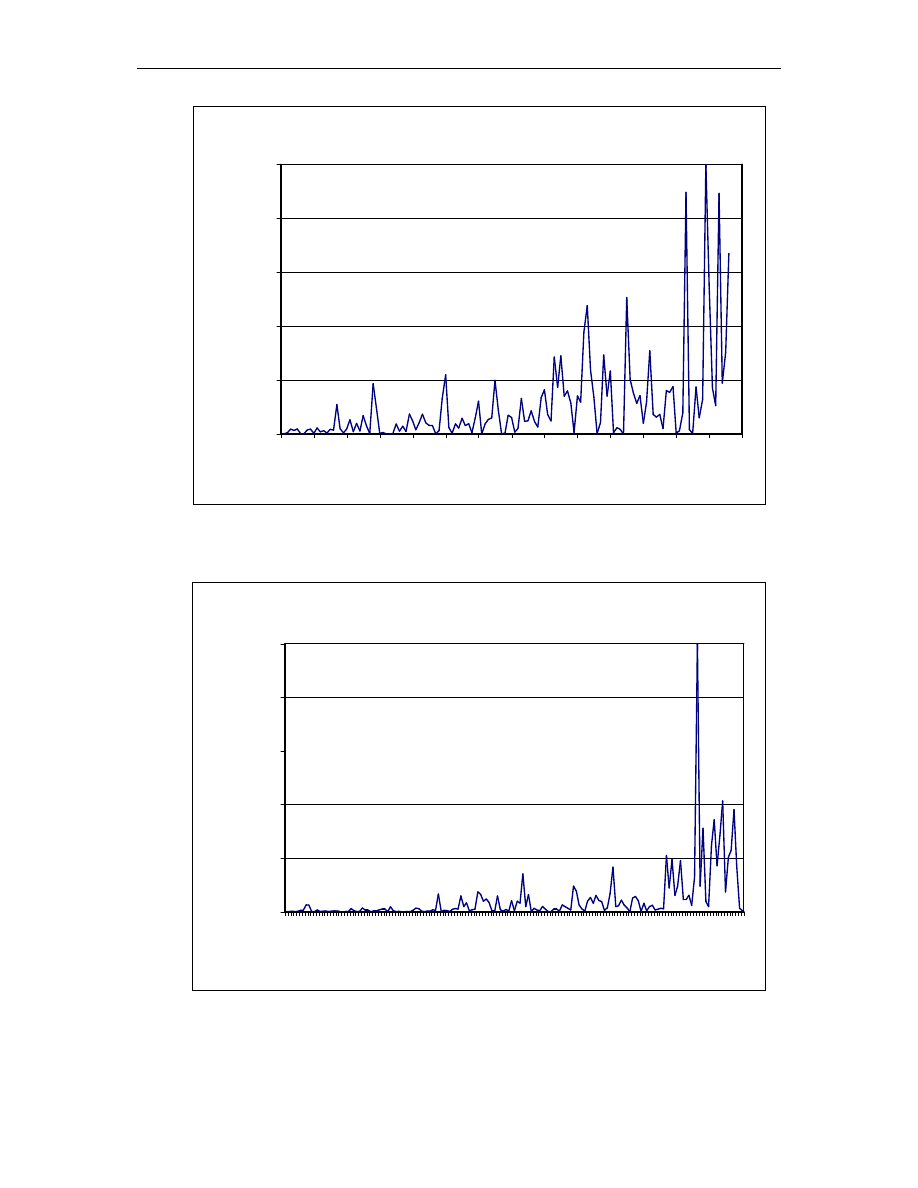

t

F

dla

0

<

t

jest dystrybuant zmiennej losowej T.

Je eli funkcja niezawodno ci jest absolutnie ci gła, to mo na j przedstawi w postaci:

( )

( )

du

u

f

t

R

t

∞

=

,

0

≥

t

(3.3)

Funkcja f spełniaj ca warunek (3.3.) nazywa si g sto ci prawdopodobie stwa. We

wszystkich punktach ci gło ci g sto prawdopodobie stwa mo e by wyra ona jako

pochodna:

( )

( )

[ ]

( )

[ ]

t

R

dt

d

t

F

dt

d

t

f

−

=

=

(3.4)

Je li istnieje g sto prawdopodobie stwa, to mo na okre li czwart kolejn

charakterystyk funkcyjn czasu zdatno ci, jak jest intensywno uszkodze :

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

24

( )

( )

[

]

( )

( )

t

R

t

f

t

R

dt

d

t

=

−

=

ln

λ

(3.5)

Korzystaj c ze wzoru Taylora otrzymuje si nast puj ce przybli enie:

( )

( ) (

)

t

t

t

R

t

R

t

f

∆

∆

+

−

≈

(3.6)

oraz:

( ) ( ) (

)

( )

t

t

R

t

t

R

t

R

t

∆

∆

+

−

≈

λ

(3.7)

Ze wzoru (3.6) wynika, e g sto prawdopodobie stwa mo na interpretowa jako

spadek niezawodno ci w małym przedziale czasowym o długo ci t, a z (3.7) wynika, e

intensywno uszkodze to wzgl dny spadek niezawodno ci w takim przedziale. W populacji

obiektów na tyle licznej, aby mo na zało y funkcjonowanie prawa wielkich liczb ze wzoru

(3.6) wynika, jaka cz

obiektów ulegnie uszkodzeniu w przedziale czasowym t gdy jako

podstaw przyjmie si liczb wszystkich zdatnych obiektów na pocz tku

(

)

0

=

t

, natomiast

z (3.7) mo na okre li t cz

w stosunku do obiektów zdatnych w chwili t. Typowy

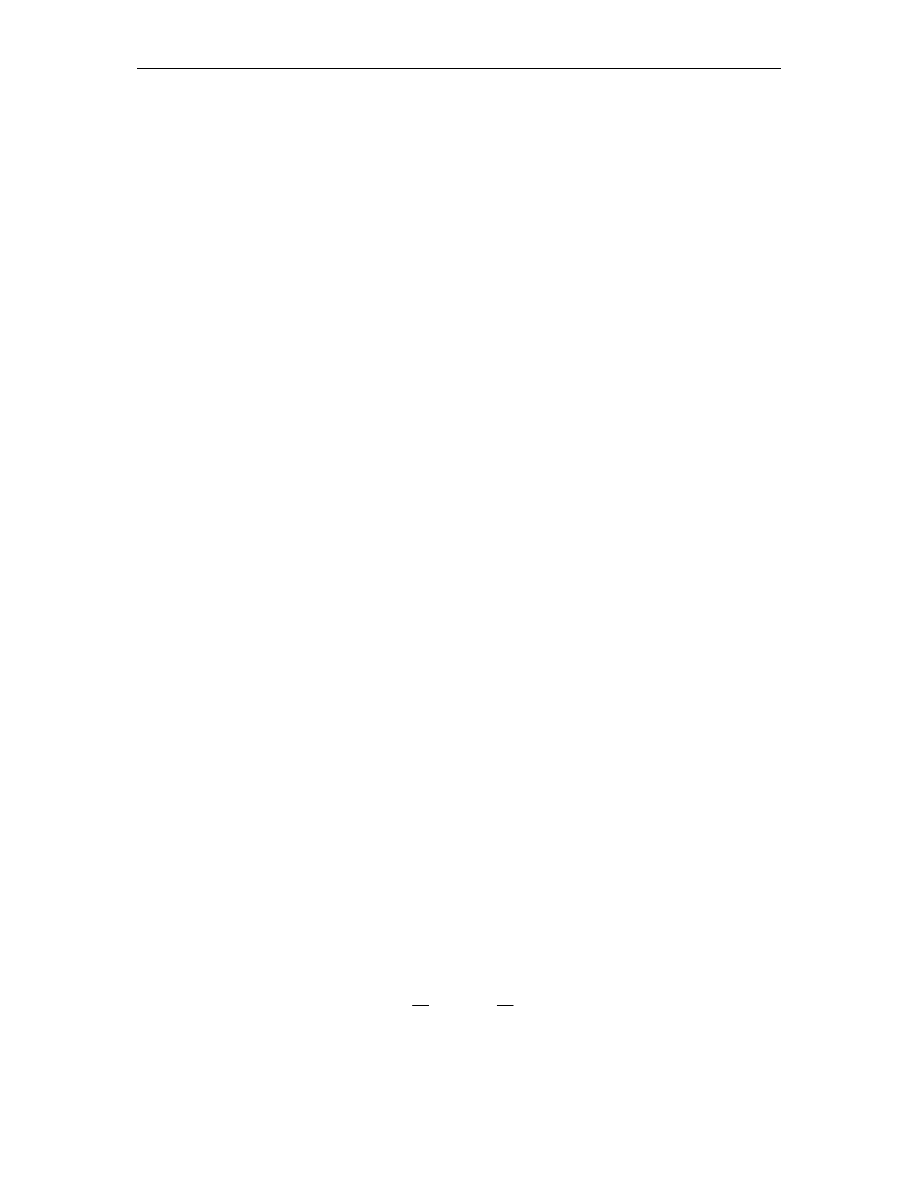

przebieg funkcji dla systemów technicznych i informatycznych przedstawiaj rysunki 3.1

i 3.2.

U ywa si równie tzw. funkcji wiod cej:

( )

( )

[ ]

( )

du

u

t

R

t

t

=

−

=

Λ

0

ln

λ

,

0

≥

t

(3.8)

któr mo na interpretowa jako informuj c o wyczerpywaniu si „zapasu

niezawodno ci” obiektu.

Ka d z wymienionych pi ciu funkcji charakteryzuj cych czas zdatno ci obiektu mo na

wyrazi przez dowoln inn spo ród nich. Uprzywilejowan rol w opisie niezawodno ci

obiektów odgrywaj : funkcja niezawodno ci i intensywno uszkodze . Zale no ci mi dzy

charakterystykami funkcyjnymi czasu zdatno ci pozwalaj na otrzymywanie ró norakich

informacji o czasie zdatno ci obiektów technicznych z danej populacji, w drodze

matematycznego przetworzenia informacji empirycznych posiadanych lub najłatwiejszych do

uzyskania [5].

Testowanie jest podstawow czynno ci dla wyznaczania niezawodno ci systemu.

Dostarcza bowiem danych na temat testowanego oprogramowania, lub jego fragmentu. Na

podstawie tych danych mo na okre la takie charakterystyki, jak: ilo wykrytych bł dów,

rednia ilo bł dów w jednostce czasu, redni czas mi dzy awariami itp. Nast pnie na

podstawie tych charakterystyk mo na podejmowa próby okre lania przyszłego zachowania

si badanego oprogramowania. Wi cej na temat prognozowania przyszłego zachowania si

systemu b dzie mowa w rozdziale 4.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

25

3.2. Niezawodno sprz tu a niezawodno oprogramowania

Ró nice mi dzy niezawodno ci sprz tu i oprogramowania wynikaj bezpo rednio

z ró nic mi dzy samym sprz tem i oprogramowaniem. Mog mie one wpływ na zasadno

stosowania modeli niezawodno ci sprz tu do oprogramowania.

ródłem awarii w oprogramowaniu jest bł d na etapie projektowania, podczas gdy

awarie sprz towe s skutkiem fizycznego zu ycia, defektu wytworzenia lub słabej jako ci

materiału. W sytuacjach awarii sprz tu, uszkodzony element jest usuwany i zast powany

nowym o tych samych parametrach technicznych. Bł dy projektowe elementów fizycznych s

zwykle usuwane przed wdro eniem systemu technicznego.

W przypadku oprogramowania poprawia si wył cznie wadliwy komponent

i podmienia uszkodzony moduł we wszystkich kopiach programu. Proces naprawy mo e by

niedoskonały i, usuwaj c pewne bł dy, wprowadzi nowe.

Czas poprawiania oprogramowania nieprawidłowo wlicza si do czasu

mi dzyawaryjnego, poniewa zało enia modeli uwzgl dniaj czas ci głej pracy.

W przypadku sprz tu czas kalendarzowy zwykle odpowiada czasowi pracy. Dla

oprogramowania natomiast, czas mi dzyawaryjny mie ci si w czasie kalendarzowym

i cz sto nie pokrywa si z czasem pracy.

S tak e inne problemy dotycz ce poprawy oprogramowania w procesie wytwarzania.

Je li na przykład nie b dzie wykonywana cisła kontrola konfiguracji, wówczas mo e si

zdarzy tak sytuacja, e po przetestowaniu i wykazaniu bł dów poprawiona zostanie

niewła ciwa, tj. która z poprzednich wersji programu. Poprawa nie uwzgl dni wtedy

wyst puj cych w tej wersji wcze niejszych bł dów. Je li równie nie wykona si testów

regresji, oprogramowanie mo e zawiera dodatkowe bł dy. Współczynniki modeli

niezawodno ci, ogólnie rzecz bior c, nie uwzgl dniaj takich i tego typu przypadków.

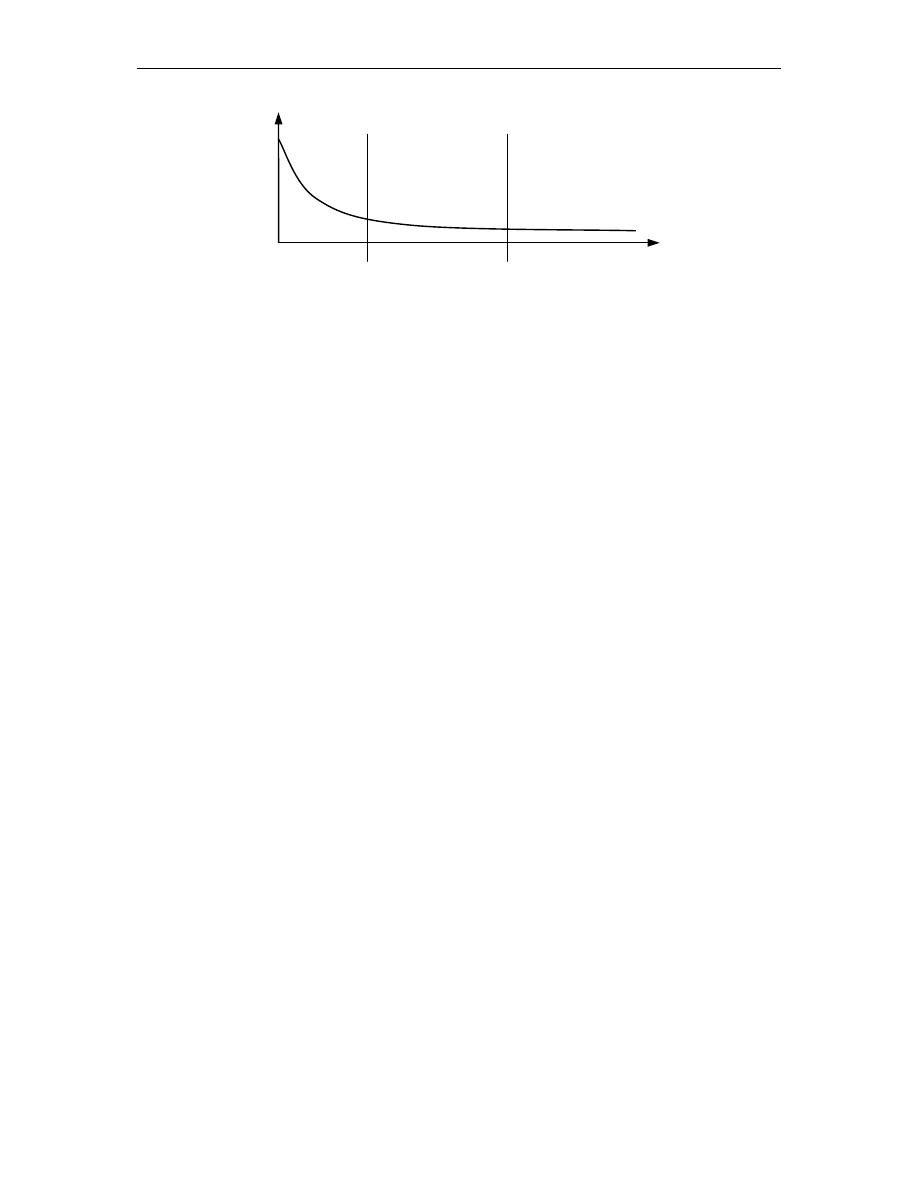

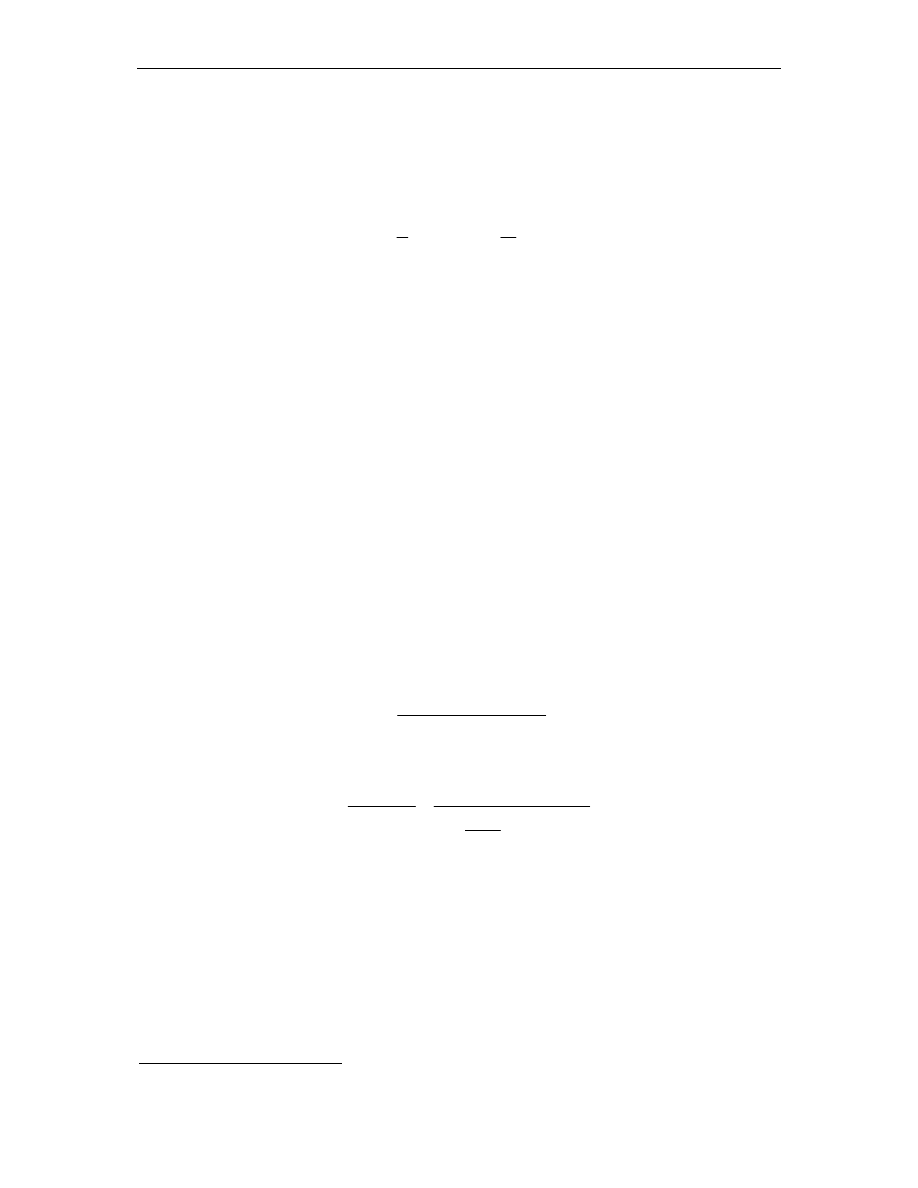

Rysunki 3.1 i 3.2 przedstawiaj zale no intensywno ci uszkodze od czasu

w systemach technicznych i oprogramowaniu.

λ

wytworzenie

u ywanie

zu ycie

t

Rys. 3.1.

Zale no intensywno ci uszkodze od czasu

w systemach technicznych

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

26

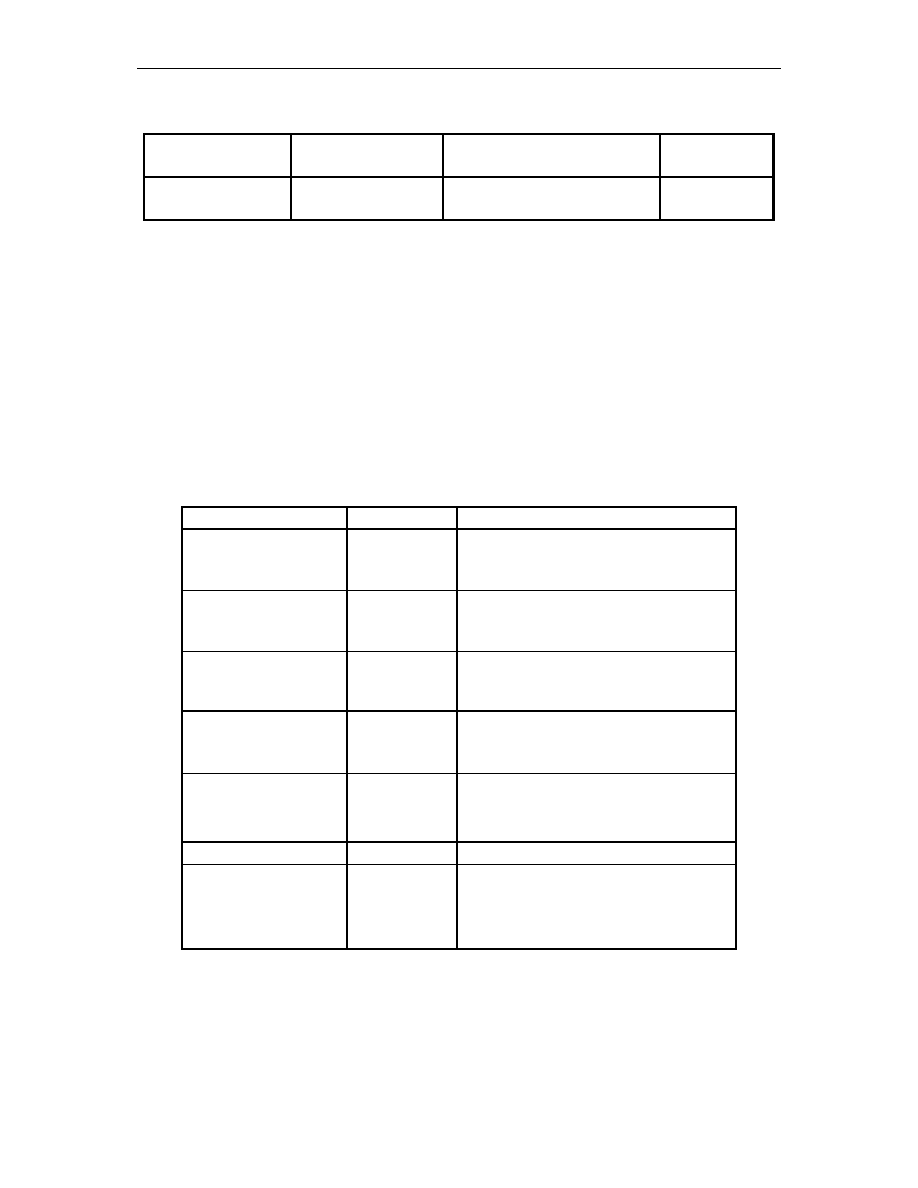

Niezawodno sprz tu mo e zmienia si w pocz tkowym i ko cowym okresie pracy

urz dzenia, ilustruje to rysunek 3.1. Niezawodno oprogramowania natomiast zmniejsza si

w całym okresie ycia programu – od powstania i przetestowania, poprzez wszystkie kolejne

wersje, a do porzucenia, gdy dalszy rozwój jest nieopłacalny. Oprogramowanie nie wykazuje

zu ycia i nie ma dodatkowych bł dów z tego powodu. Uszkodzenia prowadz ce do awarii

mog mie wiele przyczyn: nieprawidłowy model logiczny, bł dne zało enia, niezrozumiałe

lub niewła ciwie okre lone wymagania, nieprawidłowy opis danych wej ciowych lub inne

jeszcze bł dy popełnione podczas wytwarzania [28]. Przyjmuje si , e rozkład awarii

oprogramowania jest malej cy podczas testowania i w miar stabilny w czasie u ywania.

Rozkład uszkodze oprogramowania pokrywa si z rozkładem bł dów przy projektowaniu

sprz tu. W wielu przypadkach bł dy w projektowaniu sprz tu i oprogramowania s

systematyczne, poniewa powoduj , e system zachowuje si nieprawidłowo, gdy pojawiaj

si pewne dane wej ciowe lub okre lone warunki otoczenia. Podczas gdy zwykłe przyczyny

awarii sprz tu trac na wa no ci [28], a zło ono zintegrowanych układów ro nie, coraz

wi ksze znaczenie maj bł dy popełniane na etapie projektowania sprz tu. Niektórzy eksperci

z dziedziny niezawodno ci twierdz , e zagadnienia niezawodno ci sprz tu i oprogramowania

upodabniaj si do siebie [9].

3.3. Normy niezawodno ci

3.3.1. Podstawowe informacje o normach

Według [35] norma jest to wszelka wypowied dotycz ca tego, co „powinno by ”,

w szczególno ci za wyra aj ca wskazanie (zalecenie, dyrektyw ) okre lonego sposobu

post powania w okre lonej sytuacji. Ka da norma wyznacza obowi zek (powinno ) takiego,

a nie innego zachowania si w danych warunkach, zwłaszcza podj cia lub zaniechania

pewnych czynno ci, w celu spowodowania stanu rzeczy uznanego za pozytywny lub

po dany ze wzgl du na przyj te warto ci, np. dobro społeczne. Wypowiedzi zaliczane do

norm zawieraj zazwyczaj tzw. zwroty normatywne, np.: „trzeba”, „powinien”, „nale y”,

„musi”. Post powanie niezgodne z norm wi e si zwykle z okre lonymi sankcjami.

Zale nie od typu tych sankcji wyró nia si 4 główne grupy norm (systemów normatywnych):

relatywne, moralne, obyczajowe i prawne. Normy jako reguły zachowania si ludzi ró nicuje

si na 2 grupy: normy techniczne – kieruj ce post powaniem w procesie opanowywania

przyrody i wytwarzania dóbr materialnych, oraz normy społeczne – reguluj ce zachowanie

si jednostki w stosunku do innych jednostek, do zbiorowo ci społecznych, np. grupy, klasy

społecznej lub całego społecze stwa oraz do siebie samej. Całokształt norm uformowanych

i uwarunkowanych społecznie i historycznie, prawnie utrwalonych i zwyczajowo przyj tych

λ

integracja

u ywanie

porzucenie

t

i testowanie

Rys. 3.2.

Zale no intensywno ci uszkodze od czasu

w oprogramowaniu

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

27

stanowi podstaw społecznej kontroli zachowania si ludzi. Szczególne znaczenie społeczne

ma norma prawna.

W powy szej definicji warto zwróci uwag na nast puj ce zdanie: „normy jako reguły

zachowania si ludzi ró nicuje si na 2 grupy: normy techniczne – kieruj ce post powaniem

w procesie opanowywania przyrody i wytwarzania dóbr materialnych”.

Normy, którym podlega proces testowania i badania niezawodno ci oprogramowania,

s to w my l tej definicji – normy techniczne. Równie w [35] definiuje si techniczn norm

jako przepis pisemny, zazwyczaj powszechnie dost pny, b d cy wynikiem normalizacji.

Zwykle dokument techniczny (norma fakultatywna, tj. dobrowolna) lub techniczno-prawny

(norma obligatoryjna, tj. obowi zuj ca), przyj ty na zasadzie konsensu (porozumienia

polegaj cego na braku stałego sprzeciwu znacz cej cz ci zainteresowanych danym

zagadnieniem stron) i zatwierdzony przez odpowiedni jednostk administracyjn lub

prawn , ustala, do powszechnego i stałego u ytku, zasady post powania lub cechy

charakterystyczne wyrobów, procesów lub usług. Zastosowanie postanowie zawartych

w normie pozwala na uzyskanie optymalnego stopnia uporz dkowania w normalizowanej

dziedzinie. Normy powinny by oparte na trwałych osi gni ciach nauki, techniki i praktyki

oraz przyczynia si do uzyskania maksymalnych korzy ci społecznych. Normy dzieli si na:

znaczeniowe (np. normy terminologiczne, normy jednostek miar), przedmiotowe (normy

wyrobu, okre laj ce wymagania, których spełnienie przez wyrób stanowi o jego

funkcjonalno ci) i czynno ciowe (normy metod bada , normy procesu, normy usługi).

Normami powszechnie dost pnymi s normy mi dzynarodowe, przyj te i zatwierdzone przez

Mi dzynarodow Organizacj Normalizacyjn (normy ISO) lub Mi dzynarodow Komisj

Elektrotechniczn (normy IEC), zalecane przez GATT jako najbardziej skuteczny rodek

zapobiegania powstawaniu barier technicznych w handlu mi dzynarodowym i stosowane

szczególnie w krajach, których krajowe organizacje normalizacyjne s członkami

odpowiednich organizacji mi dzynarodowych. Normy regionalne, stosowane w danym

regionie geograficznym, ekonomicznym lub politycznym, przyj te i zatwierdzone przez

odpowiedni regionaln organizacj normalizacyjn , tj. przez CEN, CENELEC i ETSI

(norma europejska), ARSO (African Regional Organization for Standardization), ASMO

(Arab Organization for Standardization and Metrology), COPANT (Pan-American Technical

Standards Commission) i PASC (Pacific Area Standards Congress), normy krajowe,

stosowane na terenie danego kraju. Istniej równie normy nie spełniaj ce warunku

powszechnej dost pno ci, jak normy zakładowe (normy przedsi biorstw). Charakter norm

maj równie dokumenty normatywne opracowywane przez mi dzynarodowe, regionalne lub

krajowe organizacje naukowe, techniczne i inne, np. dokumenty Komisji Kodeksu

ywno ciowego FAO/WHO. W Polsce wyst puj obecnie Polskie Normy (PN), normy

bran owe (BN), stosowane w przedsi biorstwach danej bran y (obecnie stopniowo

zast powane normami PN), oraz normy zakładowe (ZN), stosowane w jednym lub kilku

przedsi biorstwach. W normalizacyjnych systemach mi dzynarodowych oraz w wi kszo ci

systemów regionalnych i krajowych normy s dobrowolne.

Polska Norma (PN), wymieniona wy ej i zdefiniowana równie w [35] jest to krajowa

norma techniczna ustanawiana przez Polski Komitet Normalizacyjny. Jest norm dobrowoln .

Polskie Normy okre laj wymagania stawiane wyrobom lub procesom, metody bada oraz

sposoby wykonywania ró nych czynno ci, głównie w zakresie: ochrony ycia i zdrowia,

bezpiecze stwa pracy i u ytkowania wyrobów oraz ochrony mienia i rodowiska;

podstawowych cech jako ciowych wspólnych dla asortymentowych grup wyrobów (w tym

wła ciwo ci techniczno-u ytkowych paliw, energii, materiałów i surowców powszechnie

stosowanych w produkcji i obrocie handlowym); głównie parametrów, typoszeregów,

wymiarów przył czeniowych i innych danych technicznych zwi zanych z klasyfikacj

rodzajow i jako ciow oraz zamienno ci wymiarow i funkcjonaln wyrobów;

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

28

projektowania obiektów budowlanych oraz warunków ich wykonania i odbioru; dokumentacji

technicznej. Polskie Normy okre laj ponadto powszechnie u ywane poj cia, nazwy,

oznaczenia i symbole w podanych wy ej dziedzinach, a tak e metody prowadzenia

działalno ci normalizacyjnej i certyfikacyjnej. Pierwsz Polsk Norm wydano w 1925; do

1939 PN nie miały mocy prawnej, a od 1953 były zatwierdzane kolejno przez Pa stw.

Komisj Planowania Gospodarczego, Polski Komitet Normalizacyjny (od 1961), Polski

Komitet Normalizacji i Miar (od 1972), Polski Komitet Normalizacji, Miar i Jako ci (od

1979), Polski Komitet Normalizacyjny (od 1994).

3.3.2. Normy dotycz ce jako ci i niezawodno ci oprogramowania

Istnieje wiele ró nych modeli jako ci oprogramowania, ale niemal we wszystkich

modelach niezawodno jest jednym z kryteriów jako ci, jej atrybutem. Norma ISO 9126

definiuje sze charakterystyk jako ci, z których jedn jest wła nie niezawodno . Wynika

z tego, e oprogramowanie o dobrej jako ci jest produktem o wysokiej niezawodno ci [29].

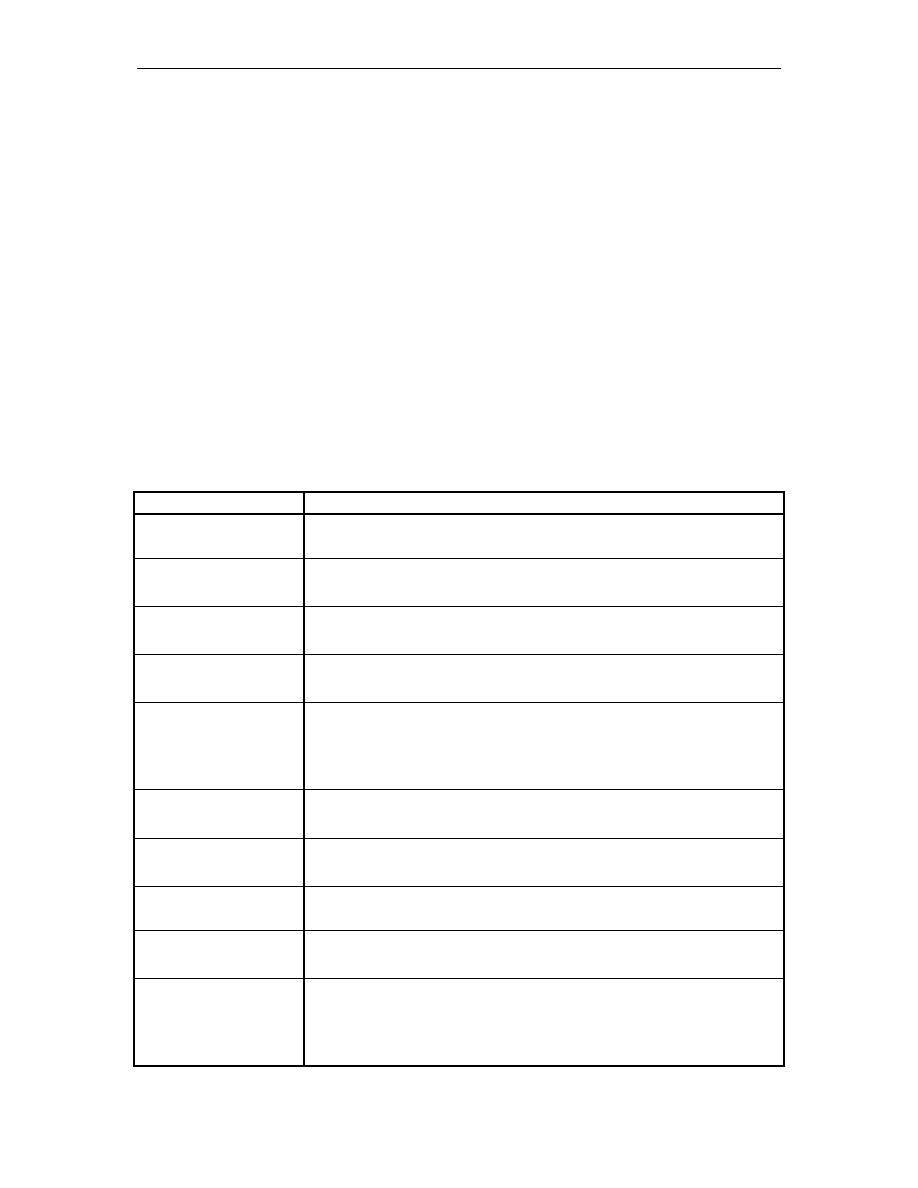

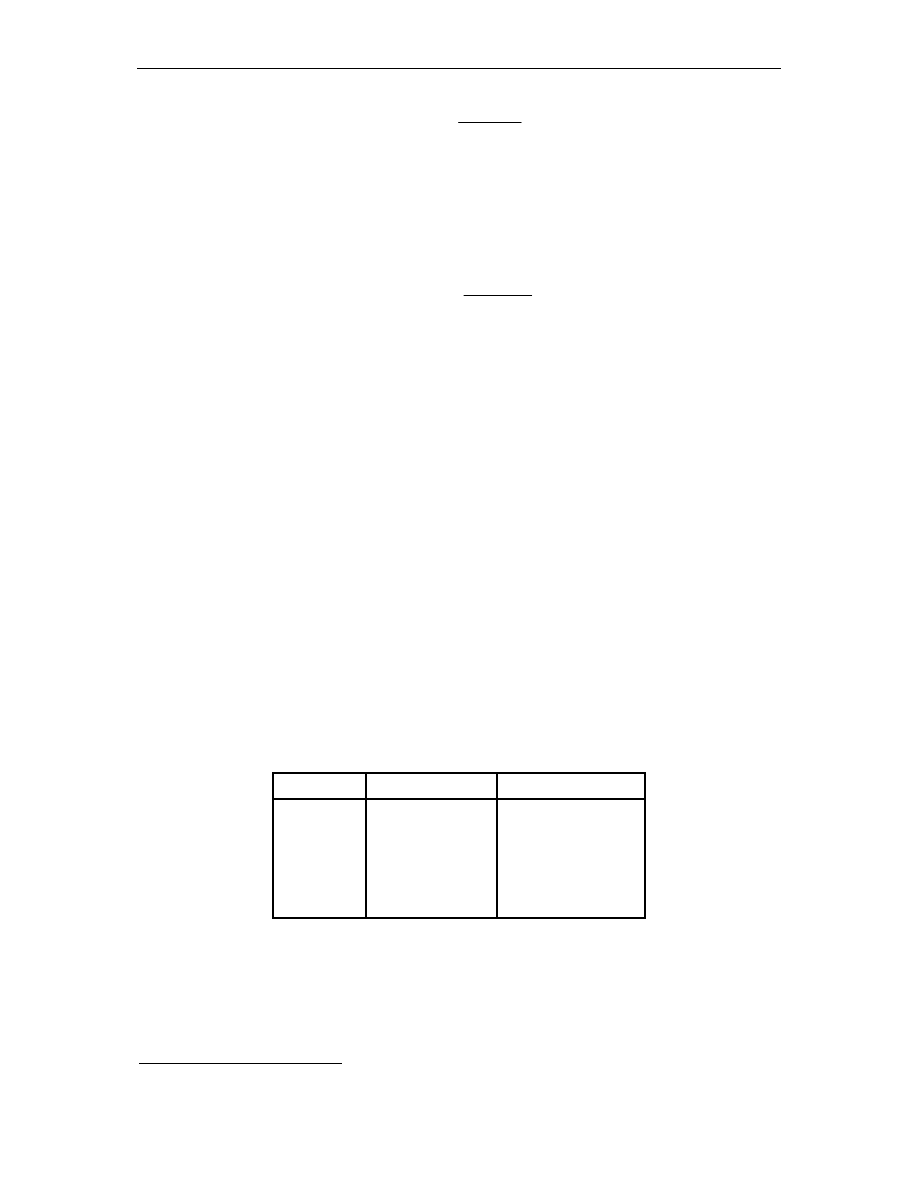

Tabela 3.1 zawiera wyszczególnienie najcz ciej stosowanych norm i standardów

w ka dej fazie cyklu ycia oprogramowania.

Tab. 3.1.

Normy i standardy niezawodno ci oprogramowania

Norma

Opis

IEEE Std982.2-1988

okre la odniesienie niezawodno ci do ró nych faz cyklu ycia

oprogramowania;

IEEE 730-1998

(ang.) Standard for Software Quality Assurance Plans;

(pol.) Standard dotycz cy planów zapewnienia jako ci;

IEEE 828-1998

(ang.) Standard for Software Configuration Management Plans;

(pol.) Standard dotycz cy planów konfiguracji zarz dzania;

IEEE 829-1998

(ang.) Standard for Software Test Documentation;

(pol.) Standard dotycz cy dokumentacji testowej;

IEEE 830-1998

(ang.) Recommended Practice for Software Requirements

Specifications;

(pol.) Zalecane czynno ci podczas specyfikacji wymaga

oprogramowania;

IEEE 1008-1987

(ang.) Standard for Software Unit Testing;

(pol.) Standard dotycz cy testowania jednostkowego;

IEEE 1012-1998

(ang.) Standard for Software Verification and Validation;

(pol.) Standard dotycz cy weryfikacji i walidacji oprogramowania;

IEEE 1016-1998

(ang.) Recommended Practice for Software Design Descriptions;

(pol.) Standard dotycz cy

IEEE 1219-1998

(ang.) Standard for Software Maintenance;

(pol.) Standard dotycz cy utrzymania i piel gnacji oprogramowania;

IEEE 12207.0-1996

(ang.) Standard for Information Technology: Software life cycle

processes;

(pol.) Standard dotycz cy technologii informatycznej: procesy

w cyklu ycia oprogramowania.

Metody testowania kodu oprogramowania. Badanie niezawodno ci oprogramowania.

29

Standardy, jako dokumenty wydawane przez instytucje zajmuj ce si standaryzacj , s

dokumentami płatnymi. Dlatego dost p do zatwierdzonych i obowi zuj cych norm jest

ograniczony. Ka da norma, zanim zostanie zatwierdzona w swoim ostatecznym brzmieniu

bywa kilkakrotnie wydawana w postaci tzw. draftu. Draft charakteryzuje si tym, e jest

bezpłatny, natomiast nie gwarantuje całkowitej zgodno ci z norm , która na jego podstawie

b dzie wydana.

Jako przykład jednej z norm wyszczególnionych w tabeli 3.1, zostanie poni ej

dokładniej przedstawiony standard IEEE 829-1998 dotycz cy dokumentacji testowej.

Celem standardu IEEE 829-1998 dotycz cego dokumentacji testowej jest opisanie

formy i zawarto ci zbioru dokumentów testowych oprogramowania. Ustandaryzowany

dokument testowy przynosi wiele, mi dzy innymi nast puj cych, korzy ci:

•

umo liwia łatwiejsz komunikacj wewn trz i poza zespołow poprzez

wprowadzenie wspólnej płaszczyzny odniesienia;

•

definiuje kompletn list czynno ci do wykonania przy wykonywaniu

i dokumentacji testowania;

•

umo liwia ocen wykonania dokumentacji testowej;

•

zwi ksza mo liwo ci zarz dzania całym etapem testowania.

Standard IEEE 829-1998 okre la form i zawarto nast puj cego zbioru dokumentów:

1.

Plan testu – opisuje zakres, podej cie, zasoby i harmonogram aktywno ci

testowych. Okre la elementy, które podlegaj testowaniu, cechy, które b d

i nie b d testowane, zadania testowe do wykonania, personel

odpowiedzialny za ka de zadanie, wymagane szkolenie, ryzyko i inne.

2.

Projekt specyfikacji testu – okre la cechy, które maj by przetestowane

przez wyznaczone do tego testy. Identyfikuje równie przypadki testowe,

procedury testowe i kryteria zako czenia testu.

3.

Specyfikacja przypadków testowych – opisuje aktualne warto ci u ywane

jako wej cie i warto ci

dane na wyj ciu w przypadku testowym.

Przypadek testowy okre la wszystkie ograniczenia wynikowe procedur

testowych dla u ycia tego konkretnego przypadku testowego. Przypadki

testowe s odseparowane od projektu testu, aby umo liwi ich ponowne

wykorzystanie.

4.

Specyfikacja procedur testowych – opisuje kroki wymagane przy

obsłudze systemu oraz aktywno ci przypadków testowych

eby

zaimplementowa zwi zany z nimi projekt testu. Procedury testowe s

oddzielone od projektu specyfikacji testów, poniewa s przeznaczone do

wykonywania krok po kroku.