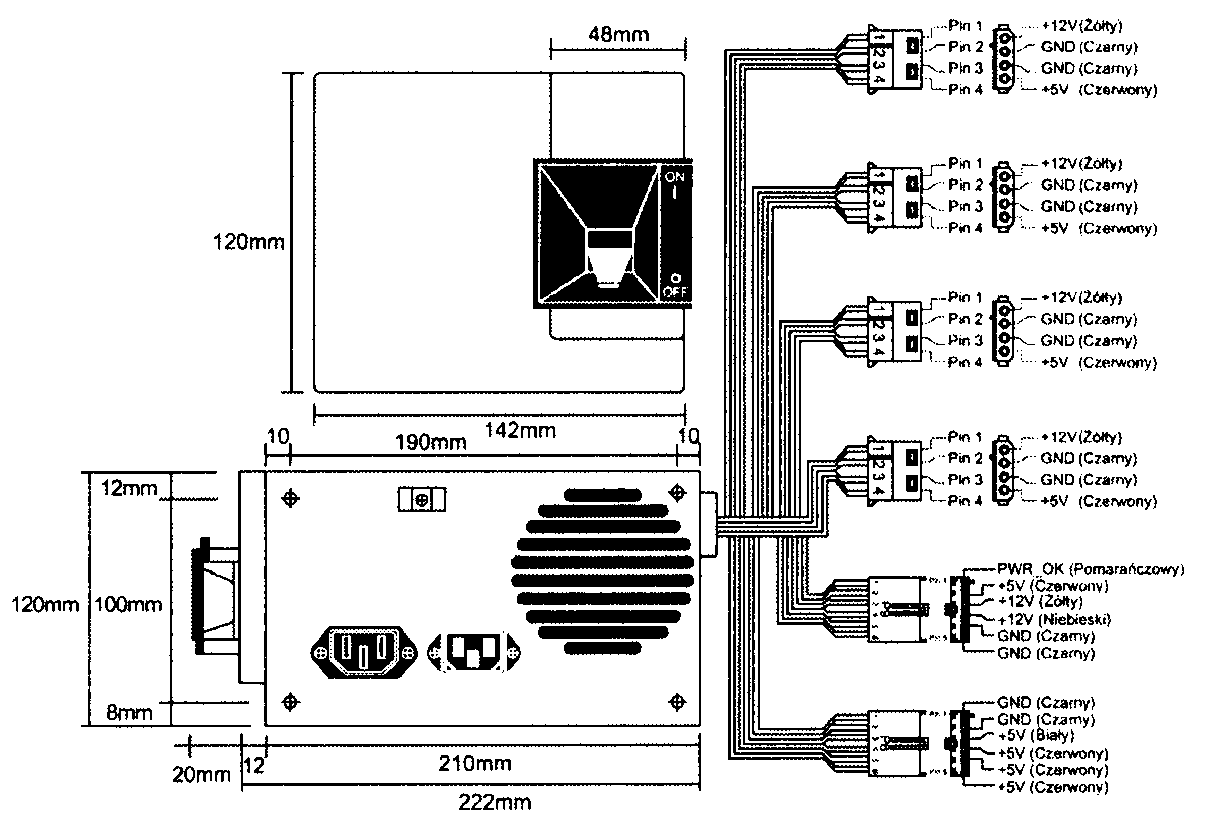

Rysunek 21.1.

Zasilacz PC/XT

AT/Desk

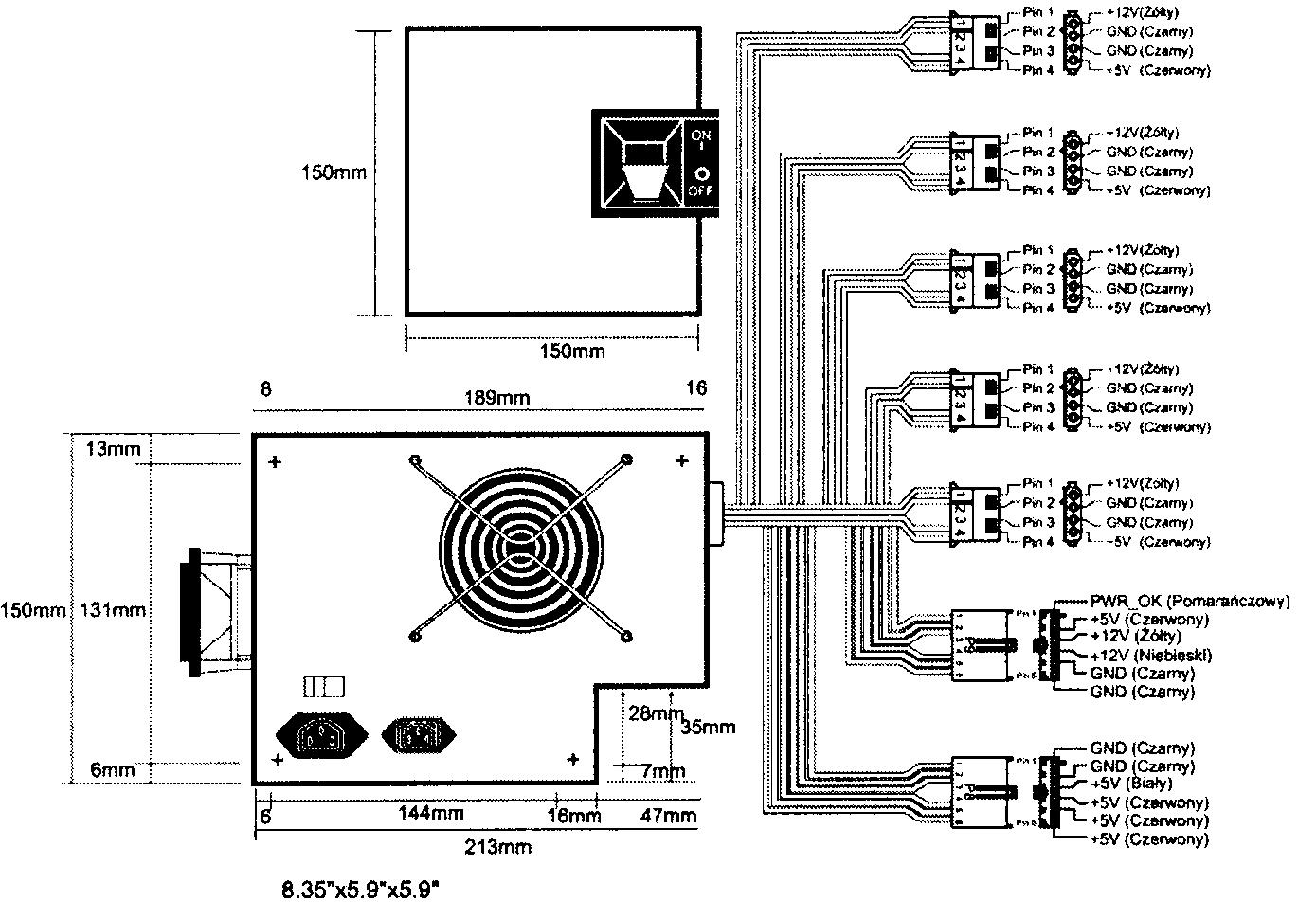

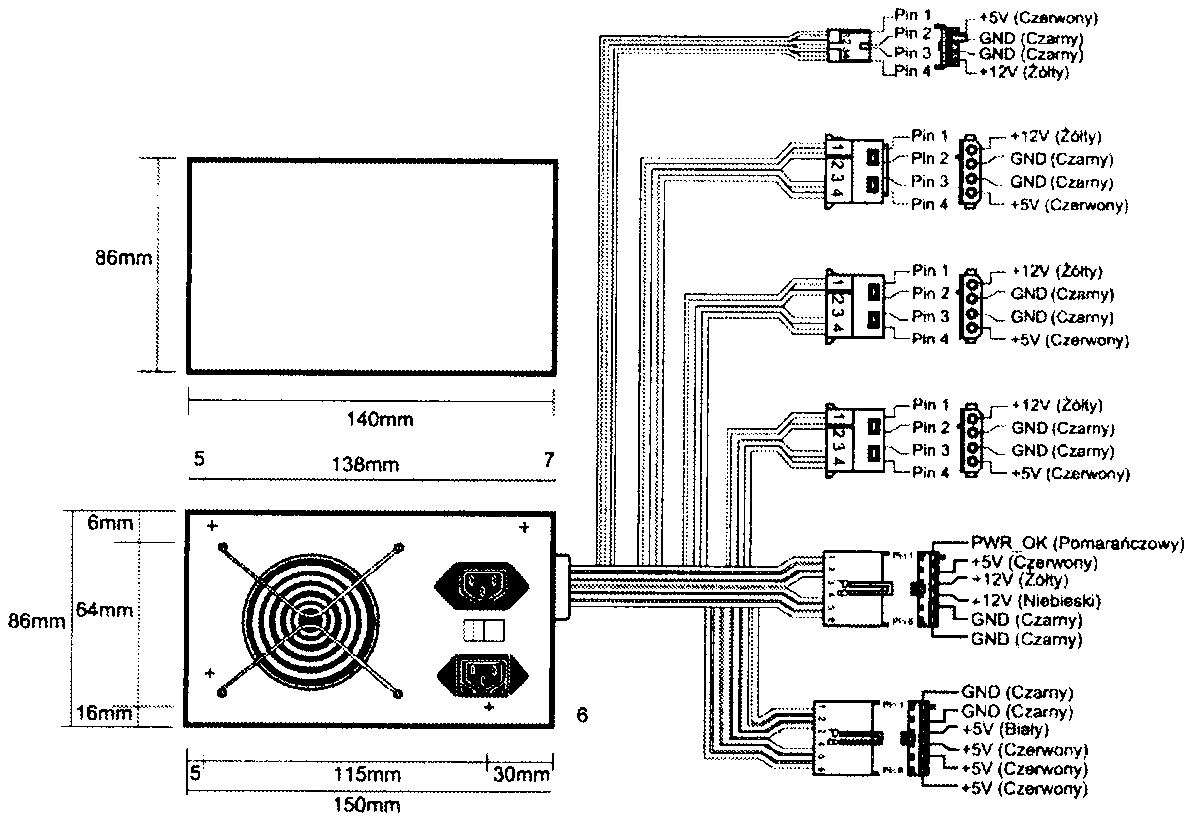

Systemy AT typu desktop zostały wprowadzone przez firmę IBM w sierpniu 1984 roku. Zostały wyposażone w większy zasilacz, o odmiennych rozmiarach niż stosowany w systemach PC/XT. Również i ten system uległ trendowi „klonowania" i stał się podstawą przyszłych modeli systemów „zgodnych z IBM". Zasilacz tego typu został nazwany AT/Desktop (rysunek 21.2). Setki producentów rozpoczęły produkcję płyt głównych, zasilaczy, obudów i innych elementów, które mogły być stosowane wymiennie z podzespołami oryginalnego komputera IBM AT. Również i ten typ zasilaczy nie jest już stosowany.

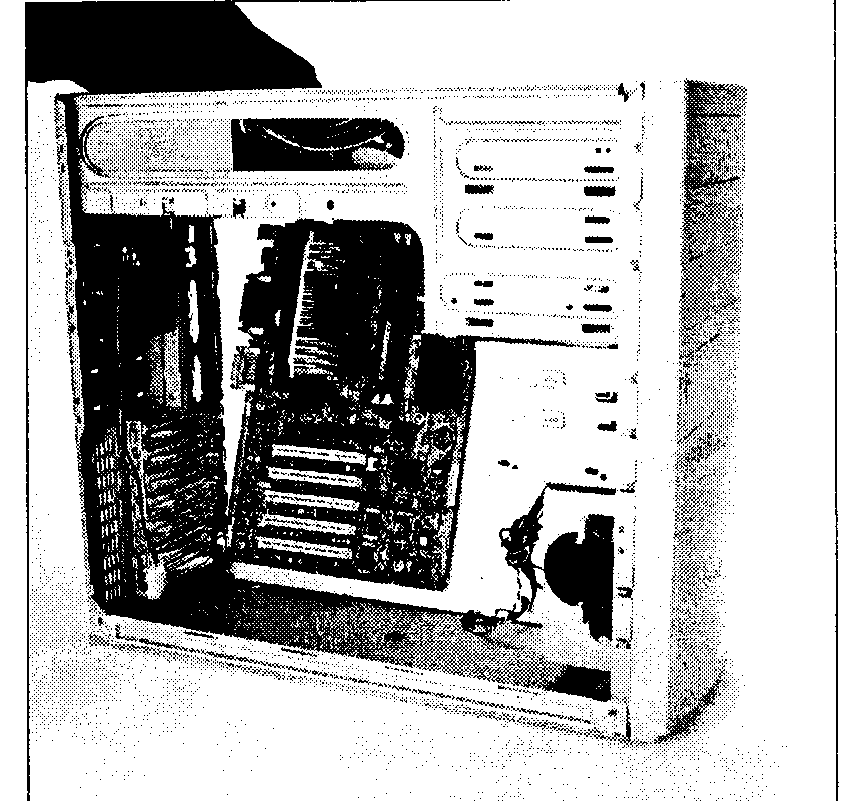

AT/Tower

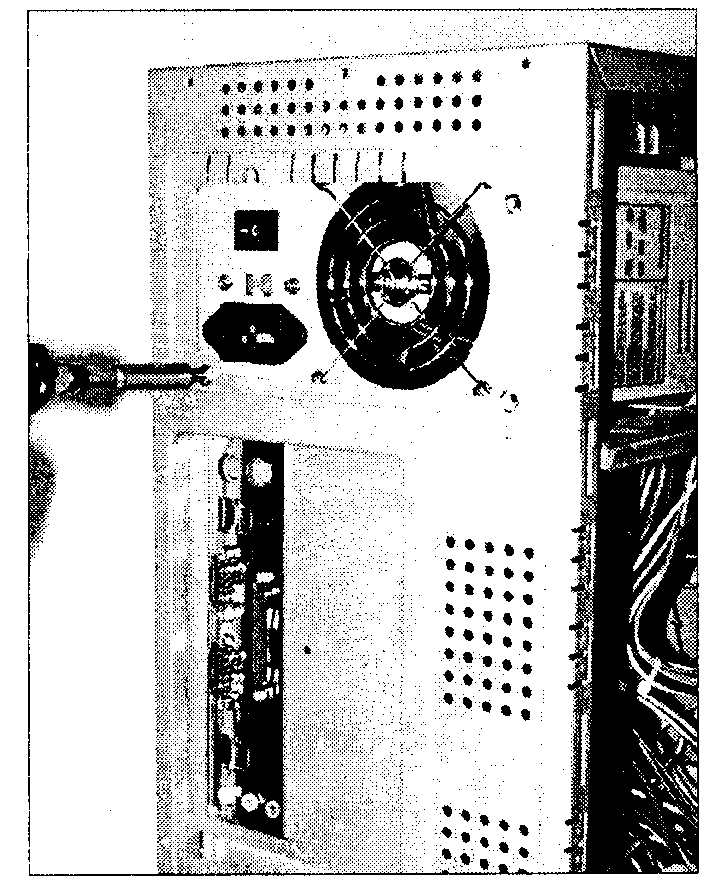

Konfiguracja AT/Tower to zasadniczo pełnowymiarowy system AT typu desktop, obrócony o 90 stopni. Układ tego rodzaju nie był nowością — już oryginalny system AT firmy IBM miał specjalnie zamontowane logo. które można było obrócić, gdy komputer stał na boku, pracując jako „tower" czyli „wieża".

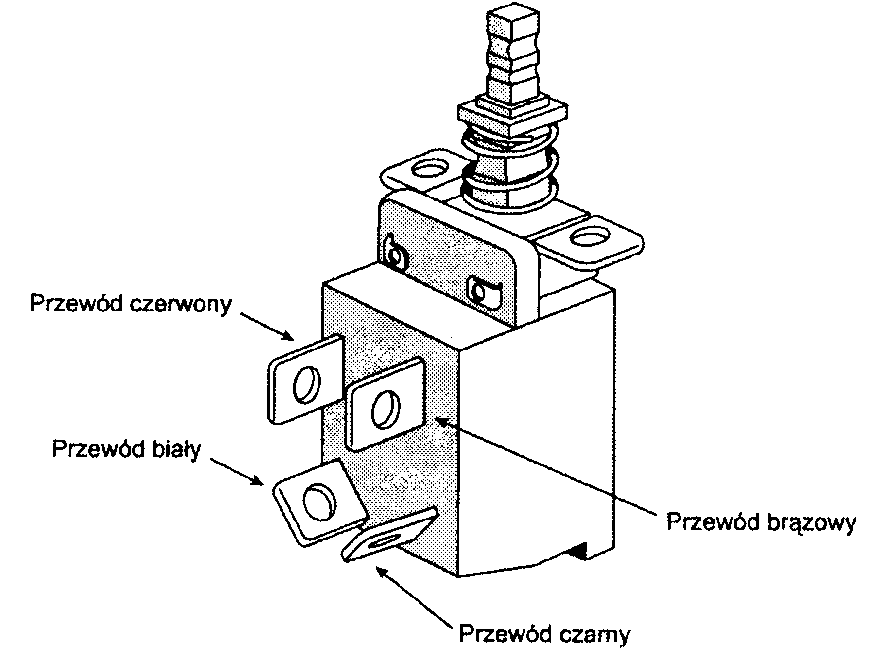

Zasilacz stosowany w większości systemów AT typu tower odróżnia od zasilacza typu desktop lokalizacją wyłącznika zasilania. W oryginalnych systemach AT/Desktop wyłącznik zasilacza znajdował się na ściance samego urządzenia. W systemach AT/Tower zastosowano wyłącznik zewnętrzny, połączony z zasilaczem czterożyłowym kablem. W konsekwencji, pełnowymiarowy zasilacz AT z wyłącznikiem zewnętrznym to zasilacz typu AT/Tower. Poza tą różnicą oba rodzaje urządzeń pozostają identyczne (rysunek 21.3). Z zasilaczami AT/Tower spotkać się można jeszcze w dużych obudowach serwerowych, w których pracują płyty główne typu AT.

Rysunek 21.3.

Zasilacz typu A T Tower

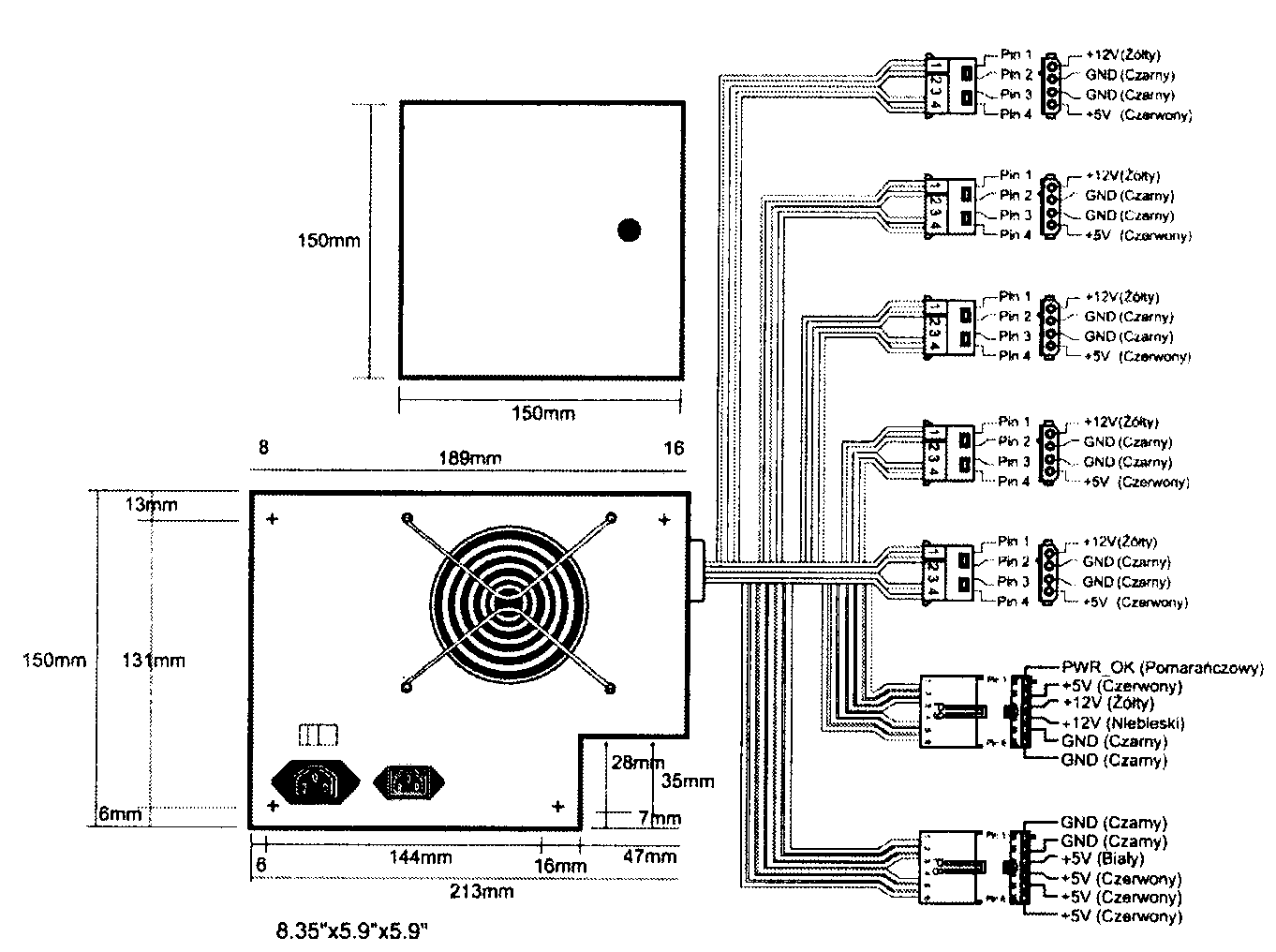

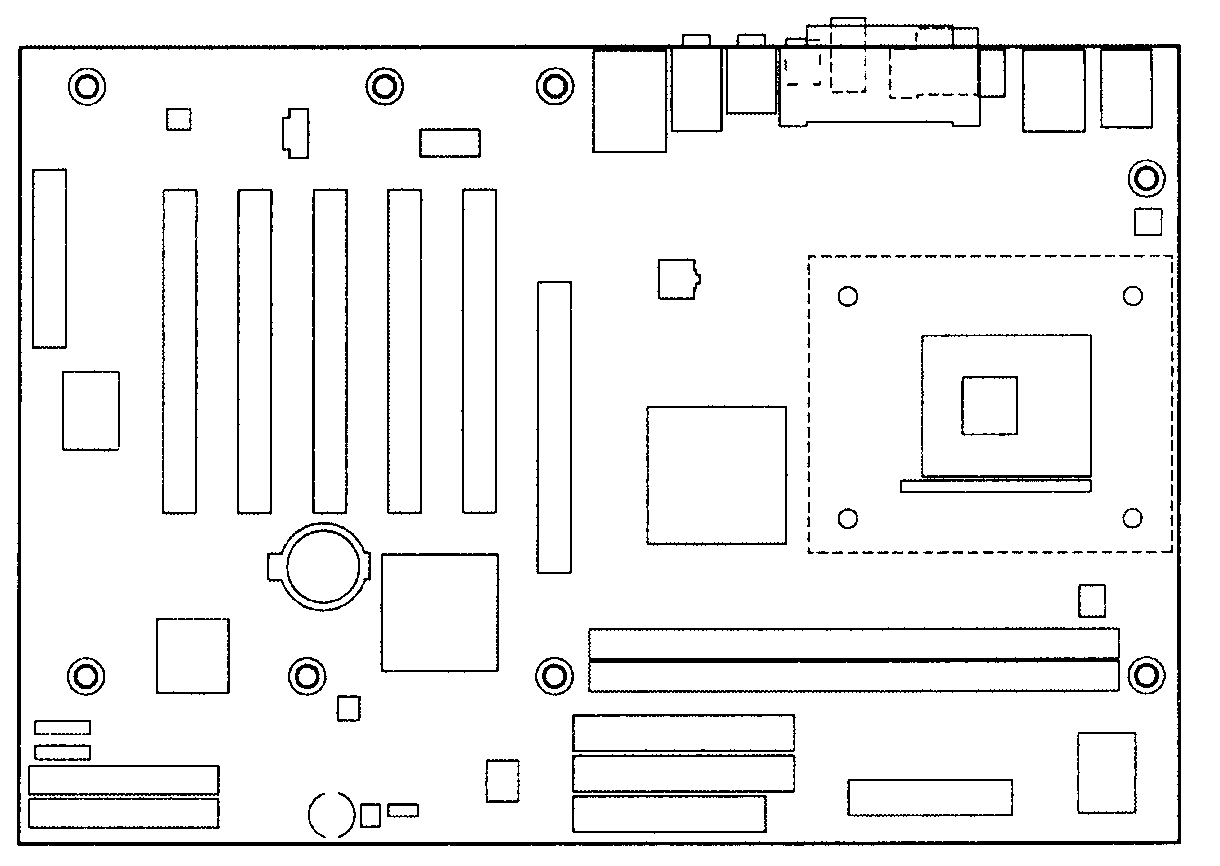

Baby-AT

Inną odmianą zasilaczy AT jest Baby-AT, charakteryzująca się zmniejszeniem jednego z wymiarów urządzenia. Mimo tej modyfikacji zasilacze Baby-AT zachowują pełną zgodność z pelnowymiarową konstrukcją AT.

Zasilacz Baby-AT może zastąpić zasilacz AT/Desktop. Zamiana odwrotna, czyli osadzenie zasilacza pełnowymiarowego (np. AT/Tower) w obudowie Baby-AT nie będzie możliwa (rysunek 21.4). Ponieważ modele Baby-AT mogą być stosowane wszędzie tam, gdzie zasilacze pełnowymiarowe, z czasem zyskały pozycję dominującą. Spotkamy je do dziś w wielu starszych komputerach.

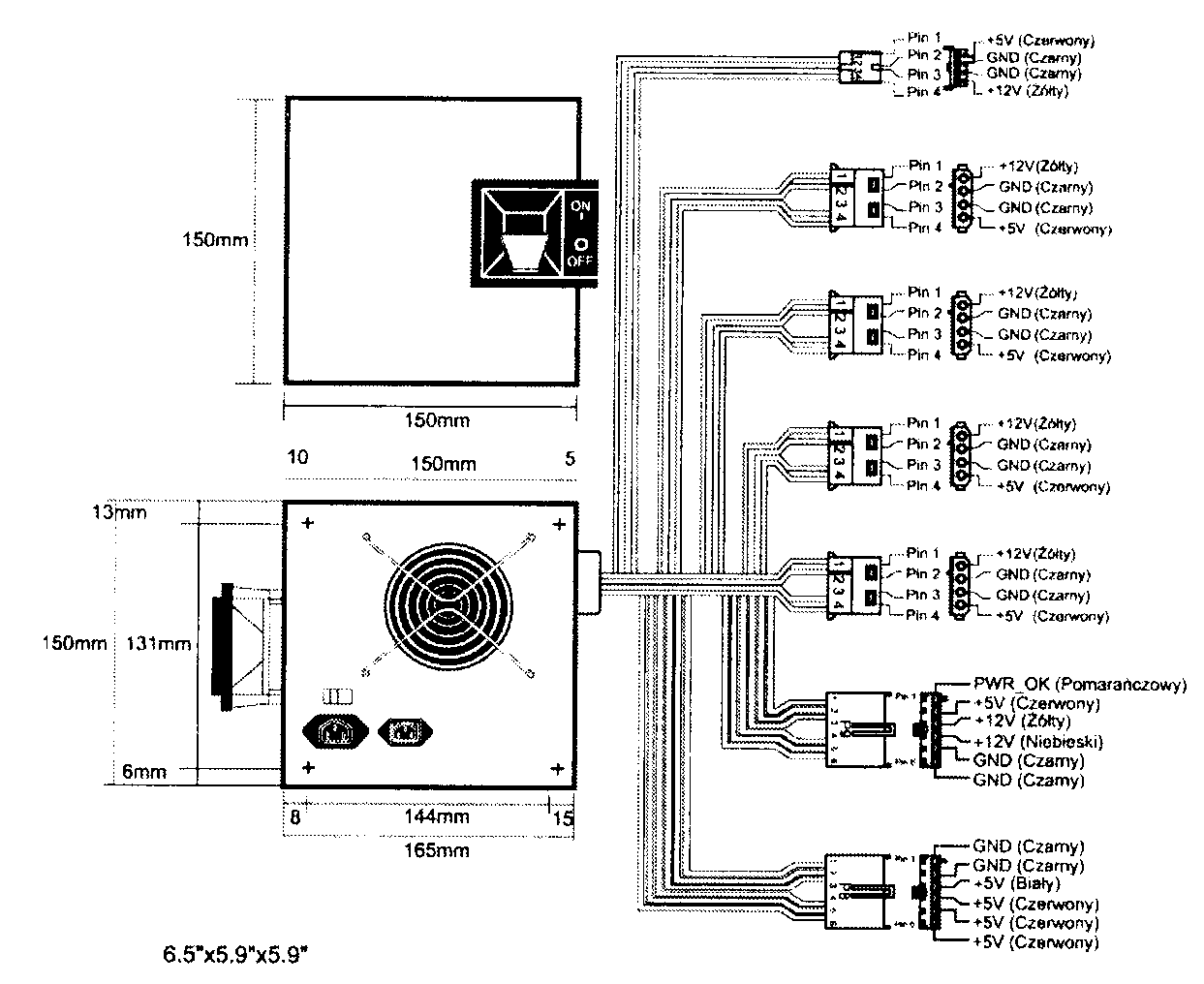

LPX

Kolejnym popularnym typem zasilacza stał się zasilacz typu LPX, nazywany również PS/2 lub Slimline (rysunek 21.5). Są w nim stosowane te same złącza co w odmianach wcześniejszych. Podstawową różnicą jest kształt. Systemy LPX miały zapewnić możliwość uzyskania mniejszych gabarytów komputera (we wszystkich trzech wymiarach) niż charakterystyczne dla systemów AT. Odmienny jest układ płyty głównej, gdzie złącza magistrali rozszerzeń są umieszczone na karcie typu riser, osadzanej w złączu płyty. Karty rozszerzeń są więc

Rysunek 21.5.

Zasilacz typu LPX

instalowane równolegle do płyty głównej. Mniejsza obudowa wymagała mniejszego zasilacza. Wszystkie wymiary zasilacza LPX są mniejsze od odpowiednich wymiarów zasilacza Baby-AT. Ogólnie, urządzenie zajmuje o połowę mniej miejsca.

Firma IBM zastosowała zasilacze LPX w niektórych modelach systemów PS/2, wprowadzonych pod koniec lat 80-tych. Stąd popularna nazwa „zasilacz PS/2".

Podobnie jak wcześniej Baby-AT, odmiana LPX zachowuje funkcje i możliwości poprzedników, zapewniając mniejsze rozmiary urządzenia. Zasilacz LPX szybko zyskał popularność i stal się kolejnym standardem. Przez wiele lat zasilacze LPX były instalowane we wszystkich odmianach systemów, zarówno w najtańszych komputerach z płytami głównymi LPX, jak i w pełnowymiarowych wieżach z płytami głównymi Baby-AT. a nawet z pełnowymiarowymi płytami AT. Zasilacze tego typu są jeszcze oferowane w niektórych nowych komputerach. Od 1996 roku wersja LPX jest stopniowo wypierana przez coraz popularniejszy standard ATX.

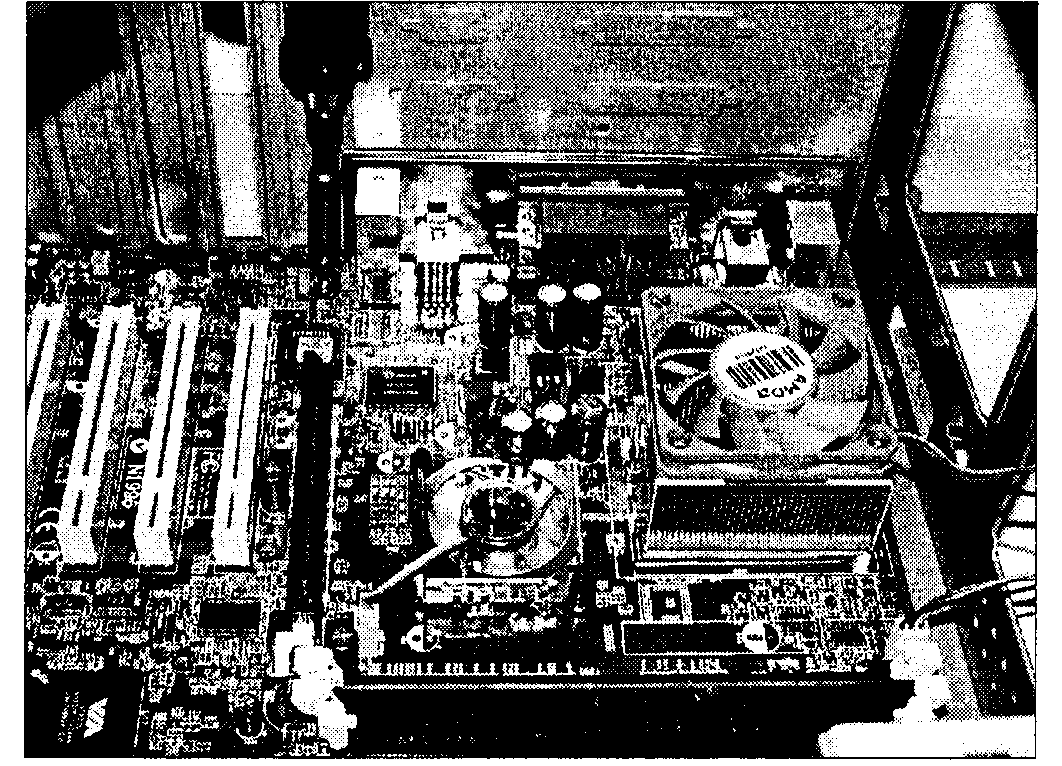

ATX

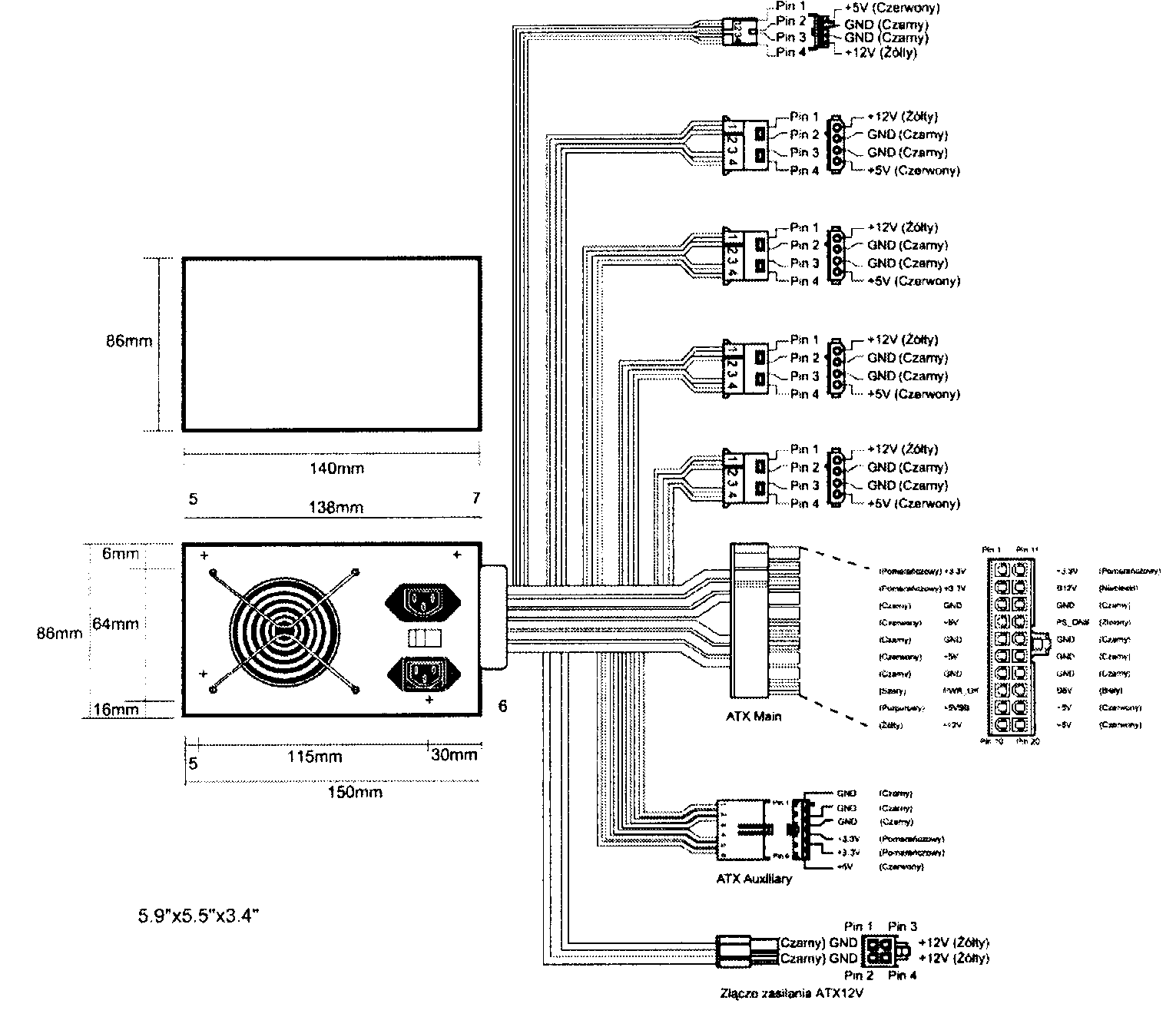

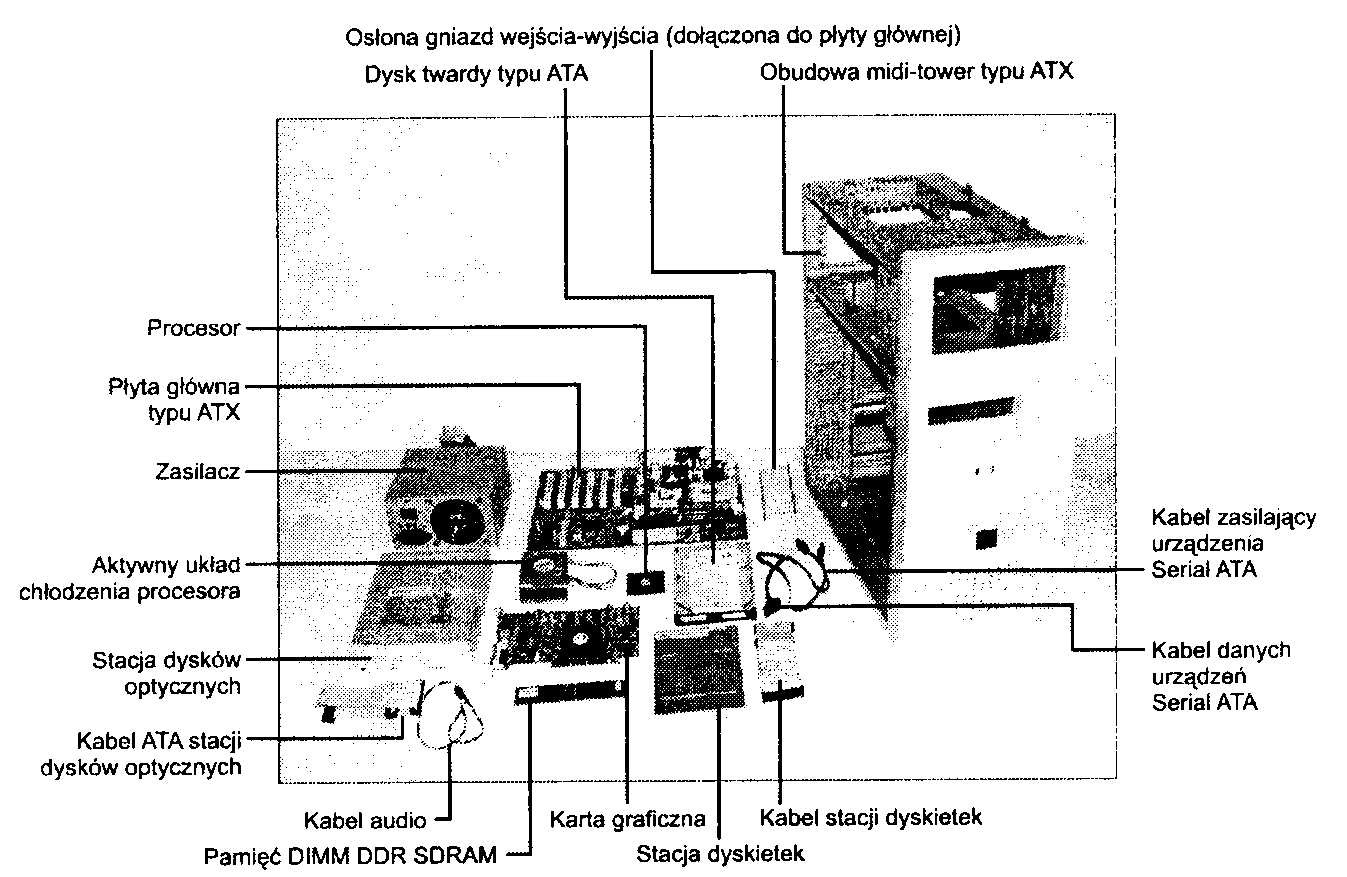

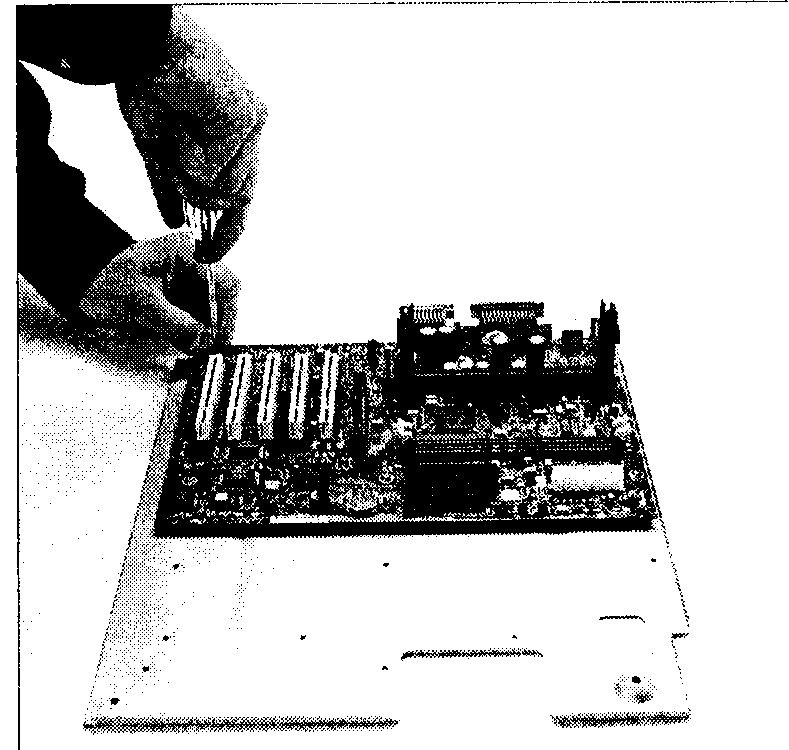

Obecnie najczęściej są wykorzystywane zasilacze zgodne ze standardem ATX (rysunek 21.6). Specyfikacja ATX, której bieżąca wersja to 2.03, definiuje zarówno wymiary zasilacza, jak i płyty głównej i obudowy.

Rysunek 21.6. Zasilacz typu ATXz opcjonalnymi złączami Auxilliary (pomocniczym) i ATX12V

Rozmiar, zasilacza ATX bazują na konstrukcji LPX. Różnice pomiędzy oba typami urządzeń są jednak dosyć znaczne.

Jedną z różnic jest wprowadzone w pierwszej wersji specyfikacji ATX założenie, że wentylator zasilacza będzie montowany po jego wewnętrznej stronie, a powietrze będzie zasysane przezeń z zewnątrz komputera i przekazywane do wewnątrz, wzdłuż płyty głównej. Jest to kierunek odwrotny do stosowanego wcześniej, gdzie powietrze było wypychane na zewnątrz, przez wentylator przymocowany do tylnej ścianki zasilacza. Nowe rozwiązanie miało zapewnić efektywniejsze chłodzenie komputera i możliwość wyeliminowania wentylatora CPU.

Innym efektem odwróconego kierunku przepływu powietrza jest oczyszczanie systemu z drobin pyłu i zanieczyszczeń. Wytworzone wewnątrz obudowy ciśnienia wypycha powietrze szczelinami w obudowie na zewnątrz. Rozwiązanie takie określa się często jako wentylacja z dodatnim ciśnieniem (postive pressure venti-lation). W systemie ATX z odwróconym kierunkiem cyrkulacji jedynym źródłem wciąganego do obudowy powietrza są otwory wentylatora zamontowanego wewnątrz zasilacza. Jeżeli komputer pracuje w środowisku szczególnie narażonym na zanieczyszczenia, otwór wlotowy powietrza może zostać osłonięty filtrem, który zapewni, że wnętrze obudowy będzie praktycznie wolne od kurzu.

Mimo że rozwiązanie takie prezentuje się bardzo zachęcająco, systemy wentylacji z odwróconym kierunkiem przepływu wymagają silniejszego wentylatora, niezbędnego do zassania odpowiedniej ilości powietrza i wytworzenia ciśnienia w obudowie. Jeżeli stosowany jest filtr ochronny, musi on być czyszczony lub wymieniany, czasem nawet raz w tygodniu. Dodatkowo, gdy moc zasilacza zostanie wykorzystana w pełni, wydzielane wewnątrz ciepło podwyższa temperaturę zasysanego powietrza. Chłodzenie procesora i płyty głównej podgrzanym powietrzem znacznie ogranicza możliwości rozwiązania.

Ewolucja procesorów w kierunku wydzielania coraz większych ilości ciepła nakłada coraz to większe wymagania na system chłodzenia komputera. Architektura z odwróconym obiegiem nie była w stanie ich spełnić. Późniejsze wersje specyfikacji ATX uwzględniają tak systemy wentylacji z ciśnieniem dodatnim, jak i systemy z ciśnieniem ujemnym. Rozwiązaniem podstawowym jest jednak układ tradycyjny, z ciśnieniem ujemnym, gdzie wentylator zasilacza wyciąga powietrze z obudowy, a jako uzupełnienie stosowany jest wysokiej jakości wentylator dmuchający powietrze bezpośrednio na procesor.

Ponieważ systemy z ciśnieniem ujemnym zapewniają dla każdego układu i szybkości wentylatora większą efektywność chłodzenia, praktycznie wszystkie nowe zasilacze ATX wypychają powietrze przez otwory w tylnej ściance ich obudowy.

Firma Intel po raz pierwszy opublikowała specyfikację ATX w 1995 roku. W 1996 roku zaczęła ona zyskiwać popularność w komputerach z procesorami Pentium i Pentium Pro. W ciągu pierwszego roku układ ATX zyskał 18% procentowy udział w rynku płyt głównych. W latach późniejszych płyty główne ATX zdominowały rynek, skutecznie wypierając zeń układ Baby-AT. Można oczekiwać, że układ ATX i jego odmiany będą powszechnie stosowane przez kilka kolejnych lat.

Wprowadzenie standardu ATX umożliwiło rozwiązanie kilku istotnych problemów związanych z zasilaczami AT i LPX. Jednym z nich jest stosowanie dwóch wtyków do gniazd płyty głównej. Zamiana ich kolejności lub odwrócenie powodują spalenie płyty. Na szczęście, większość producentów zabezpiecza obie strony połączenia w taki sposób, że niewłaściwe podłączenie nie jest możliwe. Nie jest to powszechną praktyką w przypadku systemów najtańszych. Wtyk i gniazdo ATX są od podstaw zaprojektowane w sposób uniemożliwiający niewłaściwe przyłączenie zasilania. Specyfikacja wymienia trzy odmiany złączy, z których każda jest zabezpieczona przed błędnym podłączeniem. Zasilacz doprowadza do płyty głównej napięcie +3,3 V, co pozwala uniknąć stosowania regulatorów napięcia do zasilania chipsetu, pamięci DIMM i innych obwodów +3.3 V.

Wyjście +3,3 V nie jest jedyną innowacją w zestawie połączeń zasilacza. O sygnałach Power On (PWR_OH) i 5V_Standby (5VSB), czyli tzw. Soft Power, wspominaliśmy już wcześniej. Umożliwiają one implementowanie funkcji takich jak Wake-on-Ring czy Wake-on-LAN, umożliwiających modemowi lub karcie sieciowej uruchomienie wyłączonego komputera. W wielu komputerach dostępna jest również opcja wprowadzenia daty i godziny uruchomienia automatycznego. Umożliwia to samoczynne uruchamianie komputera w celu wykonania czynności konserwacyjnych. Do „budzenia" wyłączonego komputera może również zostać użyta klawiatura (podobnie jak w komputerach Apple). Możliwości tego rodzaju zapewnia stała aktywność linii zasilania +5 V Standby, która zapewnia nawet wyłączonemu komputerowi minimalne źródło energii. Konfigurowanie takich funkcji umożliwia program konfiguracyjny BIOS-u komputera.

NLX

Specyfikacja NLX, opracowana również przez firmę Intel, definiuje niższą obudowę i płytę główną o atrybutach podobnych do ATX. Dla zapewnienia wymienności urządzeń, mimo odmiennych rozmiarów obudowy i płyty, komputery NLX zachowują możliwość korzystania z zasilaczy ATX.

Podobnie jak we wcześniejszym układzie LPX, płyta główna NLX jest wyposażona w kartę umieszczaną prostopadle do niej, na której umieszczone są karty rozszerzeń. NLX nie jest jednak standardem firmowym, ale specyfikacją przyjętą jako norma. O komputerach z urządzeniami o standardzie NLX piszemy szerzej w rozdziale 4.. „Płyty główne i magistrale".

Dla nas najistotniejsza będzie możliwość stosowania zasilacza ATX w komputerze NLX. Jedyną istotną róż-nicą jest podłączanie zasilacza nie do płyty głównej, ale do karty ze złączami. Ułatwia to wyjmowanie płyty z obudowy.

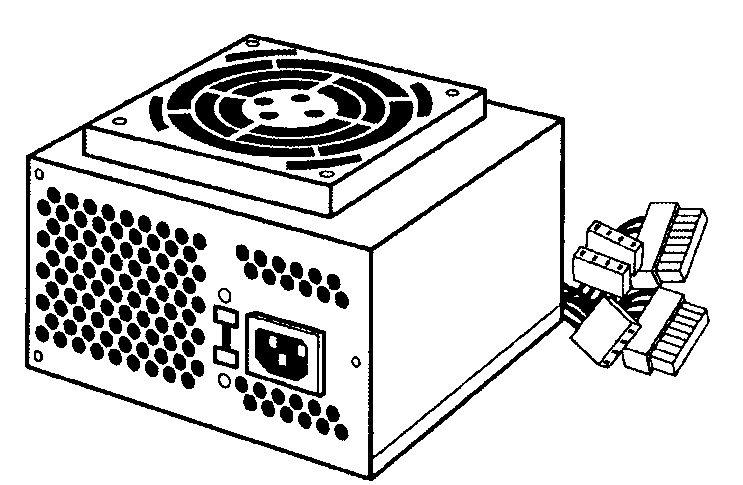

SFX

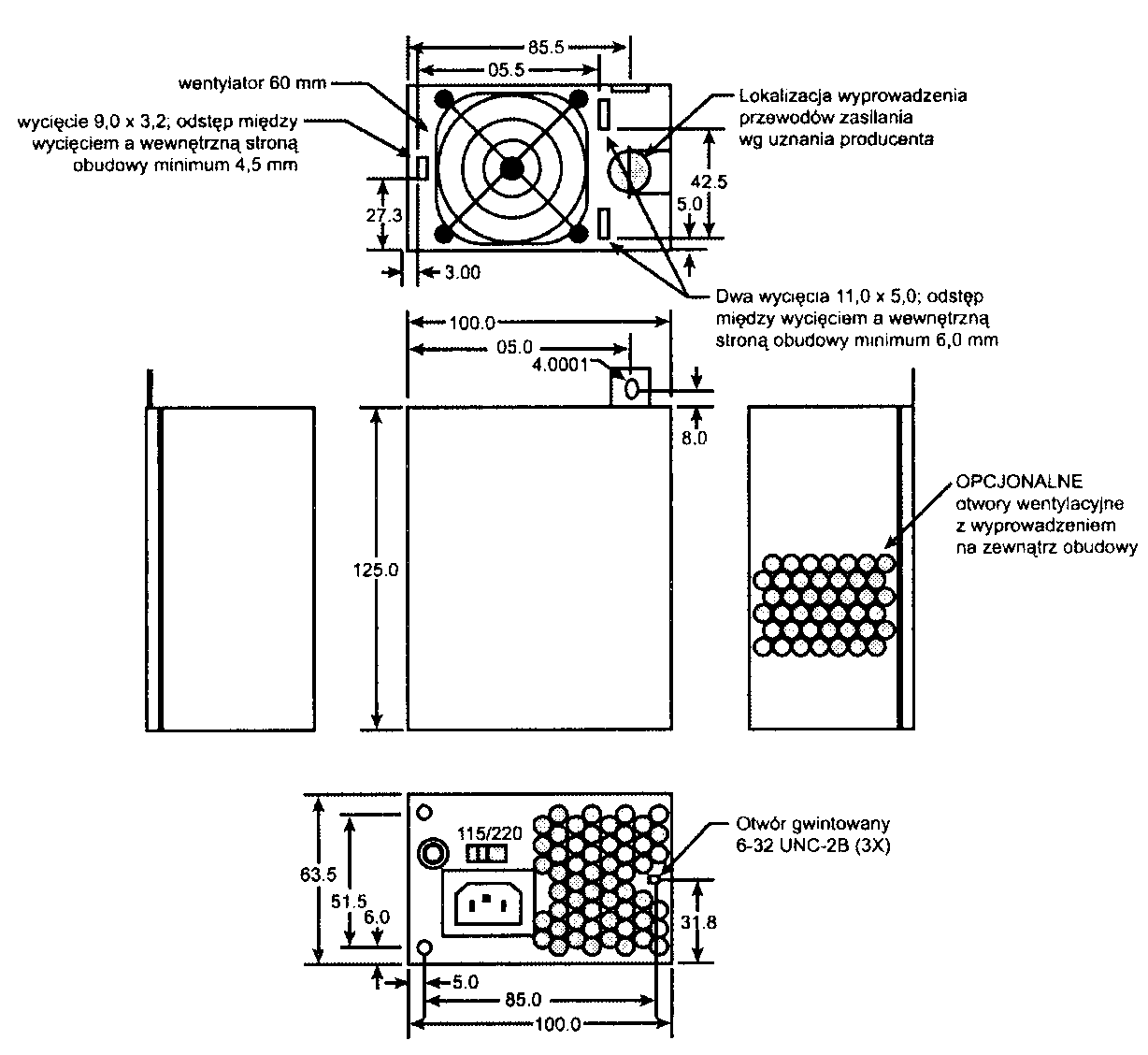

W grudniu 1997 roku firma Intel opublikowała specyfikację płyt głównych Micro-ATX. Towarzyszyła jej specyfikacja mniejszego zasilacza SFX (rysunek 21.7). W późniejszym czasie większość obudów Micro-ATX została wyposażona w standardowe zasilacze ATX. W reakcji na taki stan rzeczy firma Intel, w marcu 1999, opublikowała dodatek do specyfikacji Micro-ATX o nazwie Flex-ATX. Określa on jeszcze mniejszą płytę główną, zaprojektowaną pod kątem najtańszych komputerów PC i urządzeń budowanych w oparciu o architekturę komputera PC. Ostatecznie, zasilacze SFX zdobywają popularność w systemach komputerowych z obudową o rozmiarach mniejszych niż typowe.

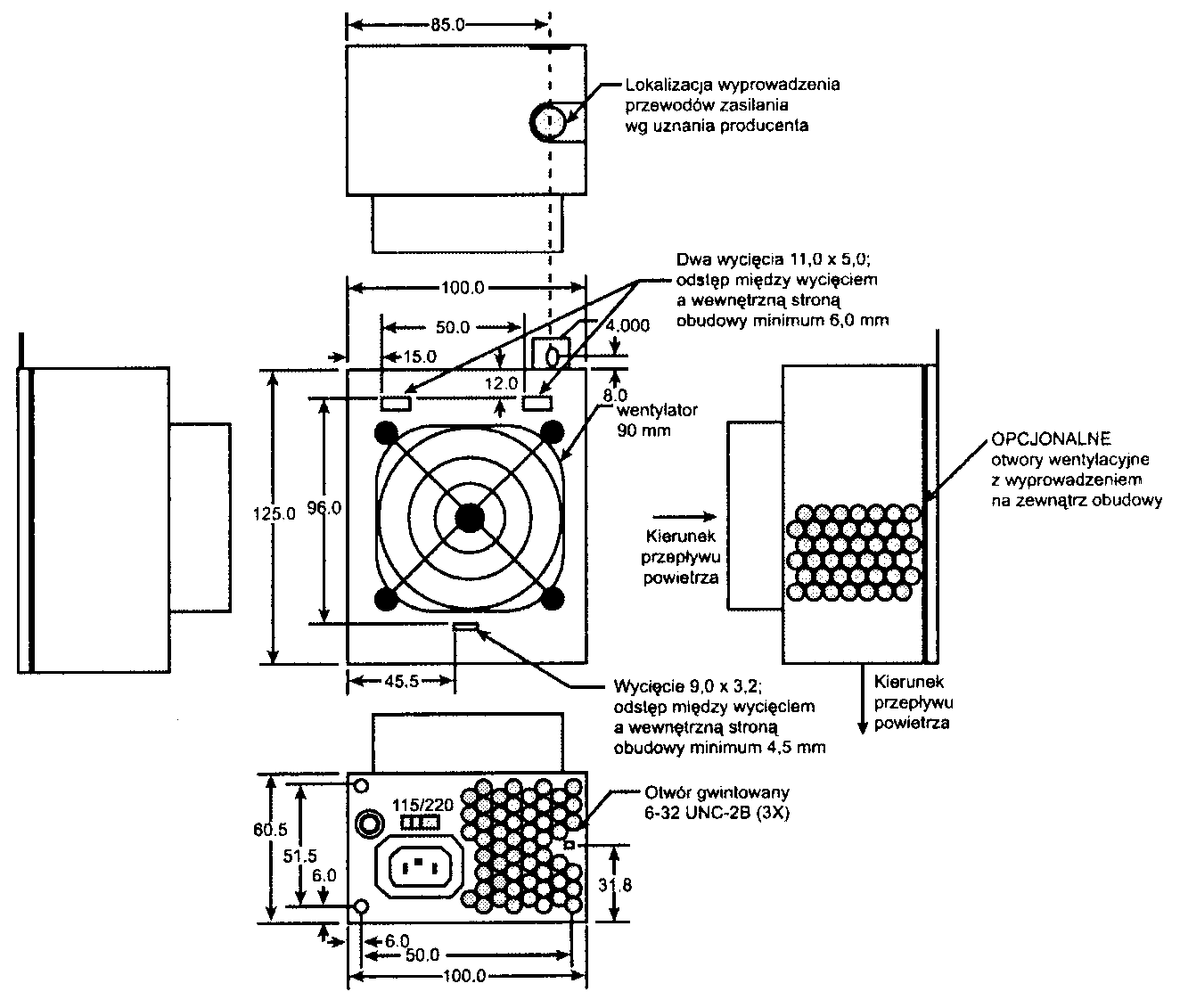

Rysunek 21.7.

Zasilacz typu SFX (na górnej ściance obudowy 80-milimetrowy wentylator)

Zasilacz SFX został zaprojektowany pod kątem małych komputerów, zawierających niewielką ilość elementów sprzętowych i mających ograniczone możliwości rozbudowy. Większość urządzeń zapewnia jedynie 90 W mocy zasilania ciągłego (graniczna wartość szczytowego poboru mocy wynosi 135 W). Wyprowadzone zostały cztery napięcia: +5 V, +12V, -12 V i +3,3 V. Jest to wystarczające dla prostego systemu z procesorem, interfejsem AGP, czterem kartami rozszerzeń i trzema urządzeniami peryferyjnymi, takimi jak dyski twarde lub stacje CD-ROM.

Mimo że firma Intel projektowała zasilacz SFX z myślą o płytach głównych Micro-ATX i Flex-ATX, SFX jest standardem niezależnym, zgodnym również z innymi płytami głównymi. Zasilacze SFX są wyposażone w standardowe, 20-stykowe złącze ATX płyty głównej i zapewniają sygnały Power_On i 5V Standby. O wyborze typu zasilacza decyduje nie płyta główna, ale obudowa komputera. Różnice między ATX a SFX nie mają natury elektrycznej, istotne jest jedynie dopasowanie wymiarów.

Zasilacze SFX nie dostarczają do płyty głównej napięcia-5 V, nie powinny więc być stosowane w połączeniu z płytami głównymi wyposażonymi w złącza ISA (większość płyt Micro-ATX i Flex-ATX nie ma Tkif-Ty ISA, podobnie jak płyty Mini-ITX). Większe znaczenie ma brak złączy Aiailliary (3,3 V i 5 V) i ATX12V, co uniemożliwia stosowanie zasilaczy SFX w pełnowymiarowych płytach ATX, które wymagają tych dodatkowych połączeń.

W standardowym zasilaczu SFX na powierzchni obudowy zamontowany jest 60-milimetrowy wentylator. Po zamontowaniu zasilacza pracuje on wewnątrz obudowy (rysunek 21.8), zasysając powietrze z wewnątrz i wypychając je przez otwory w tylnej ściance zasilacza. Jest to więc standardowy system z ciśnieniem ujemnym. Przeniesienie wentylatora głębiej do wnętrza komputera przyczynia się do redukcji słyszalnego szumu. Często stosuje się również dodatkowy wentylator, zapewniający chłodzenie procesora.

W systemach wymagających intensywniejszego chłodzenia można stosować odmianę z większym, 90-milime-trowym wentylatorem, mocowanym na górnej ściance obudowy zasilacza. Może on zapewnić silniejsze chłodzenie i szybszy przepływ powietrza (rysunek 21.9).

Rysunek 21.8.

Zasilacz typu SFX z 60-milimetrowym wentylatorem wewnętrznym

Rysunek 21.9.

Zasilacz typu SEX z 80-mil i metrowym wentylatorem wewnętrznym, mocowanym na górnej ściance

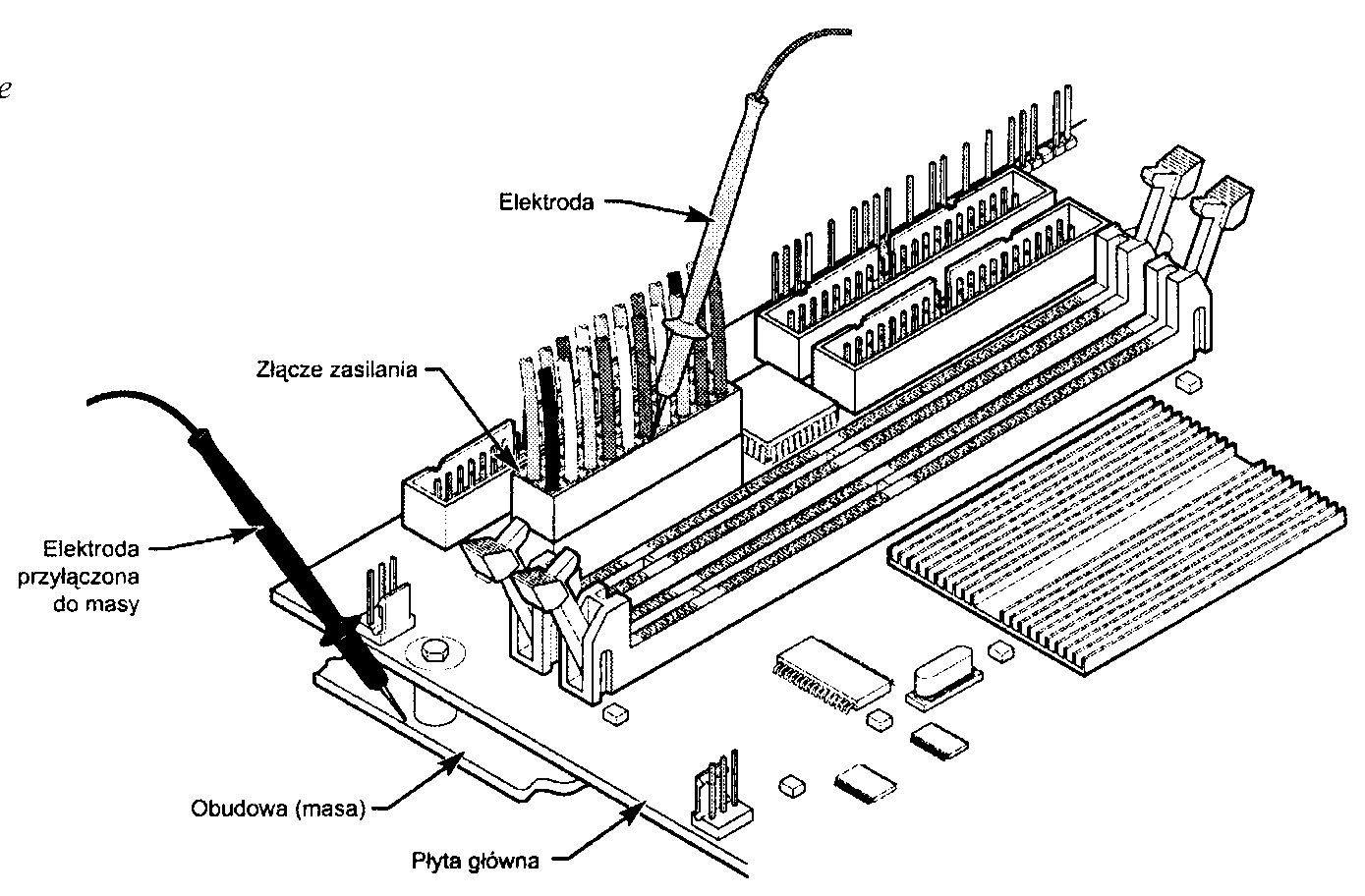

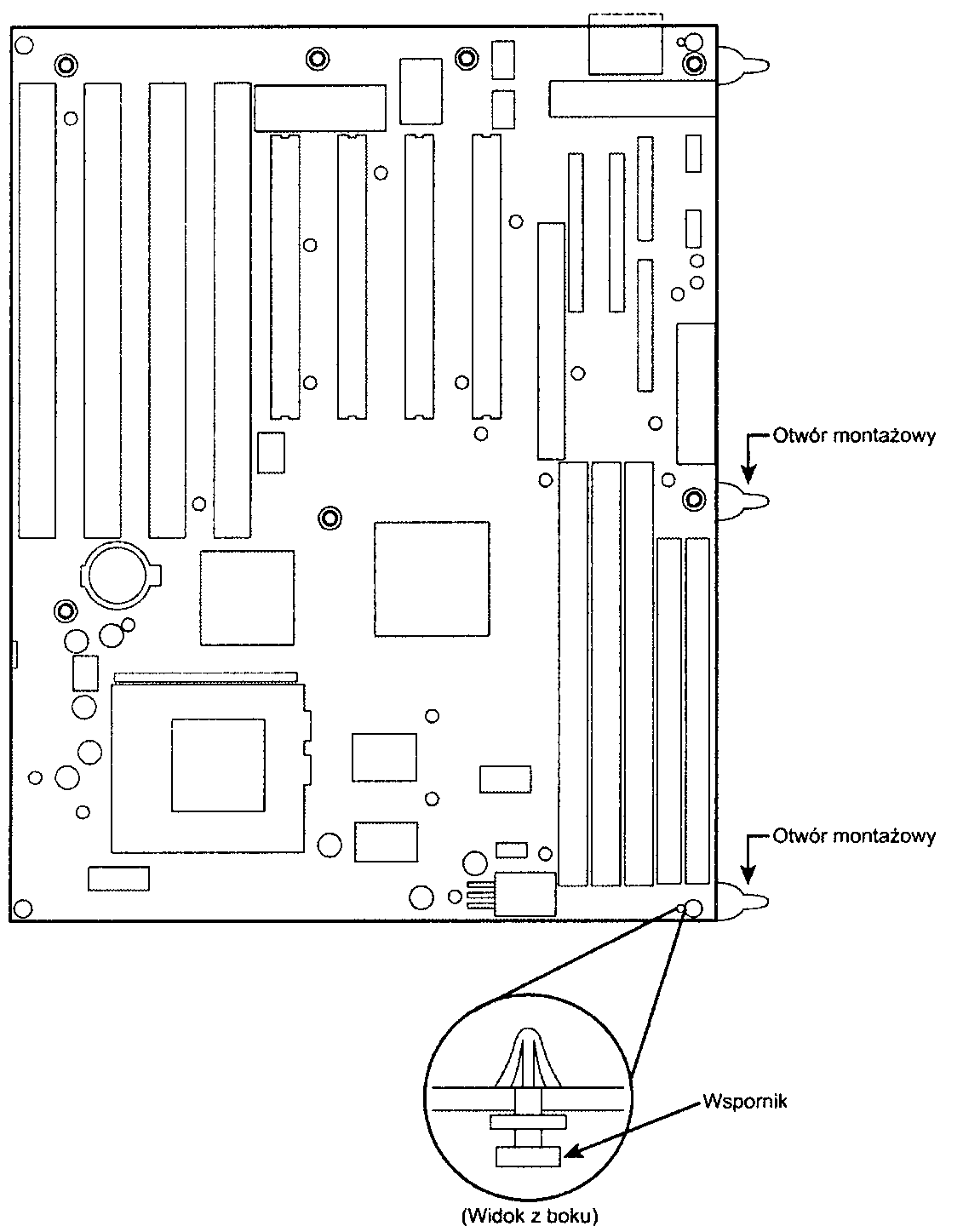

Złącza zasilania płyty głównej

Każdy zasilacz dla komputera PC wyposażony jest w wiązkę przewodów przyłączanych do płyty głównej. Zapewniają one zasilanie procesora, pamięci i kart rozszerzeń (ISA. PCI i AGP). Niewłaściwe połączenie zasilacza z płytą główną prowadzi do jej zniszczenia. Uszkodzeniu może ulec również zasilacz. Opiszemy teraz stosowane w różnych odmianach zasilaczy złącza płyty głównej.

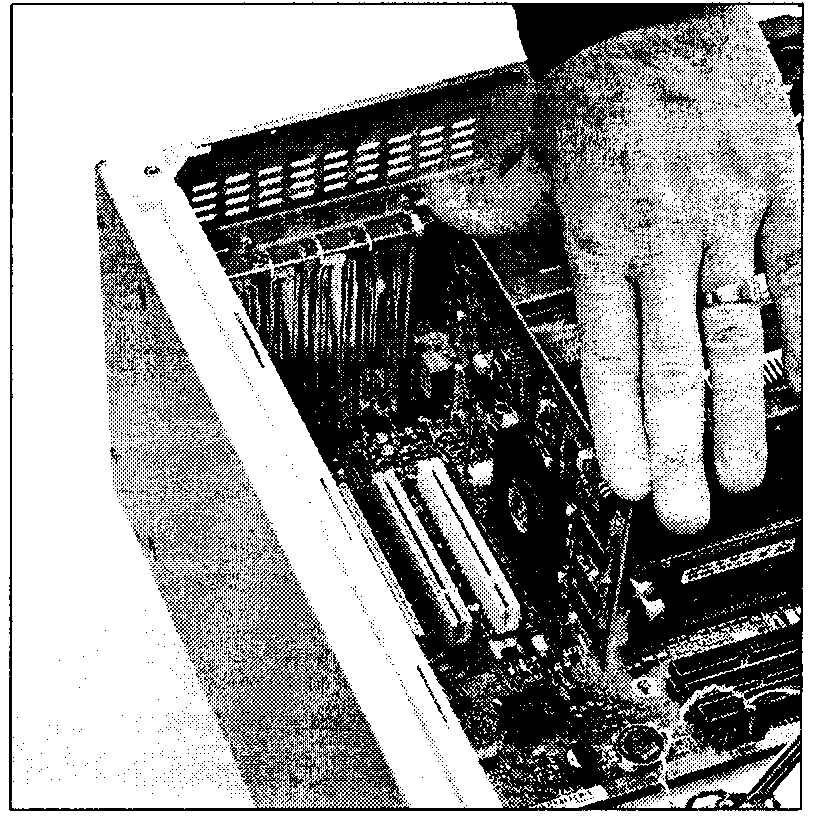

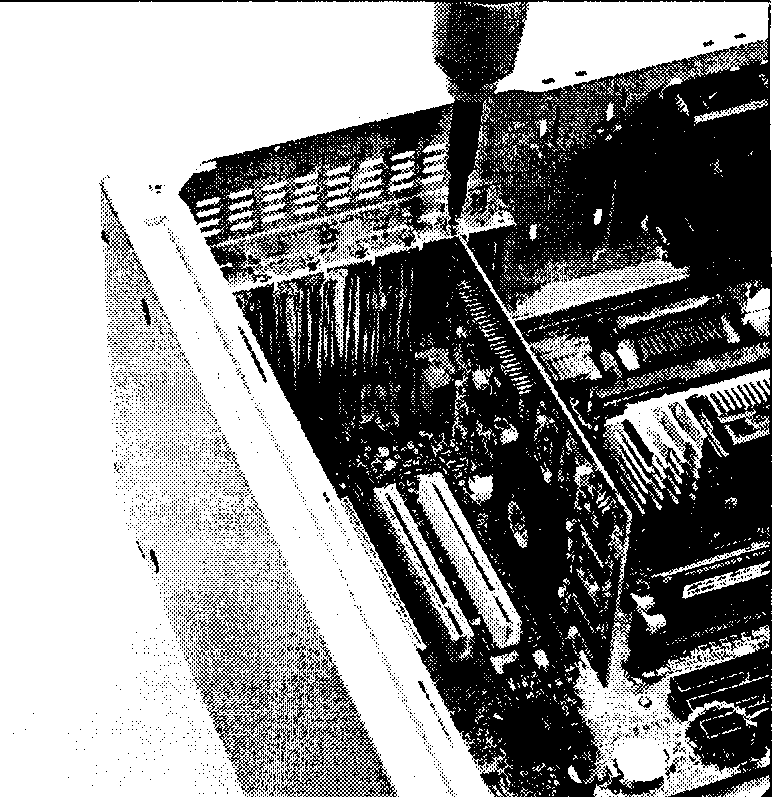

Złącza AT

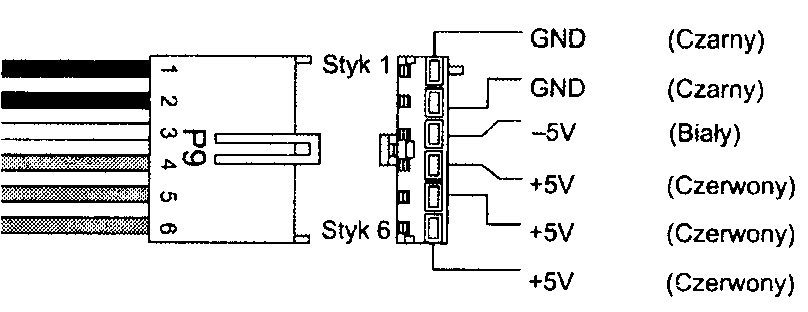

Wiązka przewodów zasilacza zakończona jest dwoma wtykami, P8 i P9 (rysunek 21.10). Każdy z nich ma sześć styków, które mogą przewodzić prąd o natężeniu do 5 amperów.

Rysunek 21.10.

Złącza zasilania P8/P9 (oznaczane też P1/P2) stosowane w zasilaczach AT/LPK

-

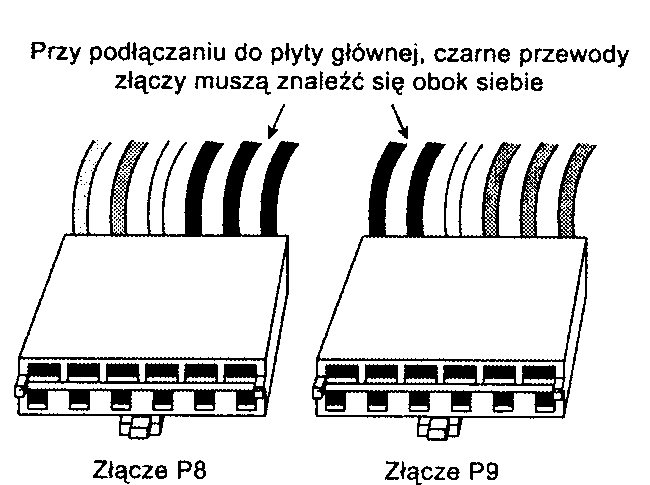

Złącza P8 i P9 umieszczane są zawsze w jednej linii. Wtyki powinny zostać osadzone w ten sposób, aby czarne przewody uziemienia znalazły się obok siebie. Oznaczenia P8 i P9 nie są w pełni standaryzowane, pozo-stająjednak w powszechnym użyciu, zgodnie z oznaczeniami stosowanymi przez firmę IBM. W niektórych zasilaczach wtyki oznaczane są symbolami PI i P2. Ponieważ wtyki tego rodzaju mają zazwyczaj wypustkę zabezpieczającą przed odwróceniem w gnieździe, problemem może być jedynie umieszczenie każdego z dwóch wtyków w gnieździe właściwym, z dbałością o to, aby nie pozostawić wolnego styku po żadnej ze stron. Przewody w kolorze czarnym zawsze powinny znaleźć się w środku, jeden przy drugim. Przesunięcie obu wtyków o jeden styk w lewo lub w prawo stanowi potencjalne zagrożenie — żaden ze styków płyty głównej nie powinien pozostawać po podłączeniu zasilania widoczny. Wynikiem pomyłki może być spalenie płyty głównej i wszystkich połączonych z nią urządzeń. Rysunek 21.11 przedstawia złącza P8\P9 {PI i P2) w układzie, w którym powinny zostać wpięte.

Rysunek 21.11.

Złącza zasilania P8/P9 (P1/P2). stosowane w zasilaczach AT/LPX, przed podłączeniem

W tabeli 21.3 przedstawiony jest rozkład styków złączy zasilania płyty głównej.

Tabela 21.3. Złącza płyty głównej zasilaczy AT/LPX

Złącze |

Styk |

Sygnał |

Kolor2 |

Złącze |

Styk |

Sygnał |

Kolor2 |

P8 (lub PI) |

1 |

Power Good (+5 v) |

Pomarańczowy |

P9 (lub P2) |

1 |

Ground |

Czarny |

|

2 |

+5 V |

Czerwony |

|

2 |

Ground |

Czarny |

|

3 |

+ 12 V |

Żółty |

|

3 |

-5 V |

Biały |

|

4 |

-12 V |

Niebieski |

|

4 |

+5 V |

Czerwony |

|

5 |

Ground |

Czarny |

|

5 |

+5 V |

Czerwony |

|

6 |

Ground |

Czarny |

|

6 |

+ 5 V |

Czerwony |

W pierwszej generacji płyt głównych i zasilaczy PC/X7' styk ten nie był wykorzystywany, może go więc brakować zarówno w gnieździe, jak i wiązce przewodów.

'Spotkać się można z zasilaczami, gdzie standard kolorów nie jest przestrzegany. Nie oznacza to jednak niezgodności

Mimo że starsze zasilacze PC/XT nie doprowadzają napięcia do styku numer 2 złącza P8, mogą być stosowane z płytami głównymi AT (i odwrotnie). Obecność napięcia +5 V na tym styku ma znaczenie niewielkie lub żadne, bo pozostałe przewody zapewniają odpowiednią moc zasilania.

Wszystkie zasilacze AT i LPX mają takie same złącza płyty głównej i rozkłady styków.

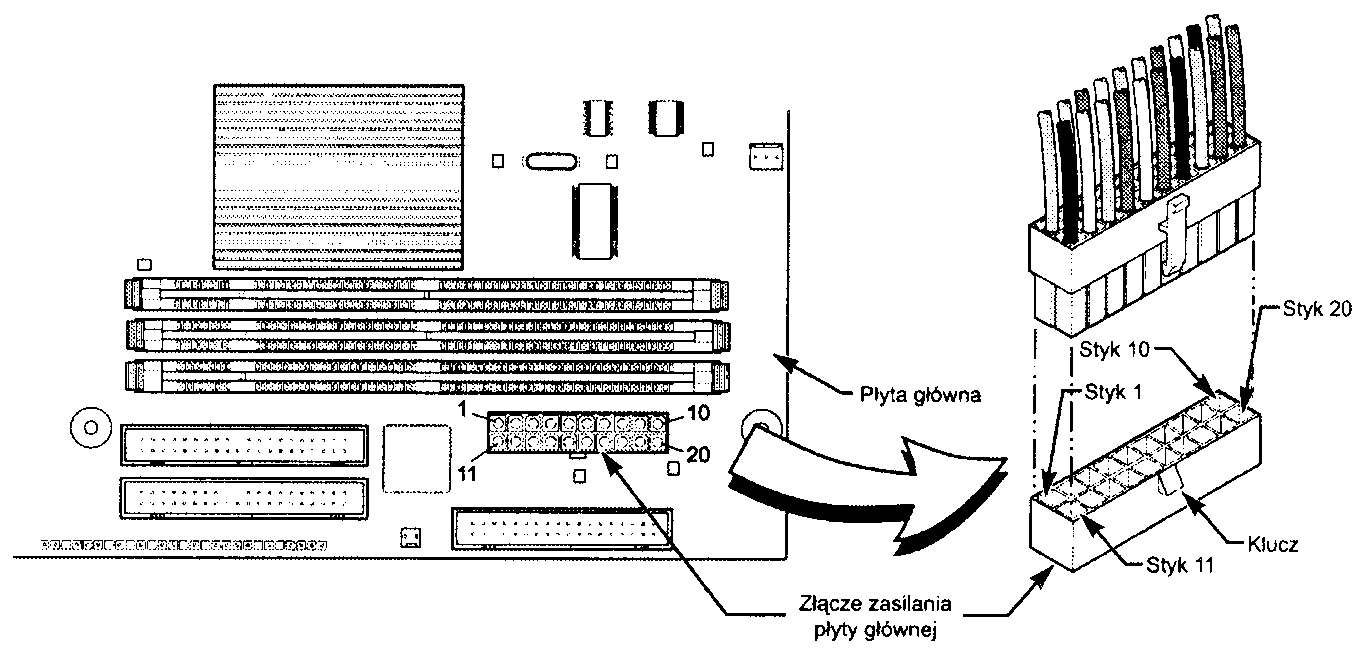

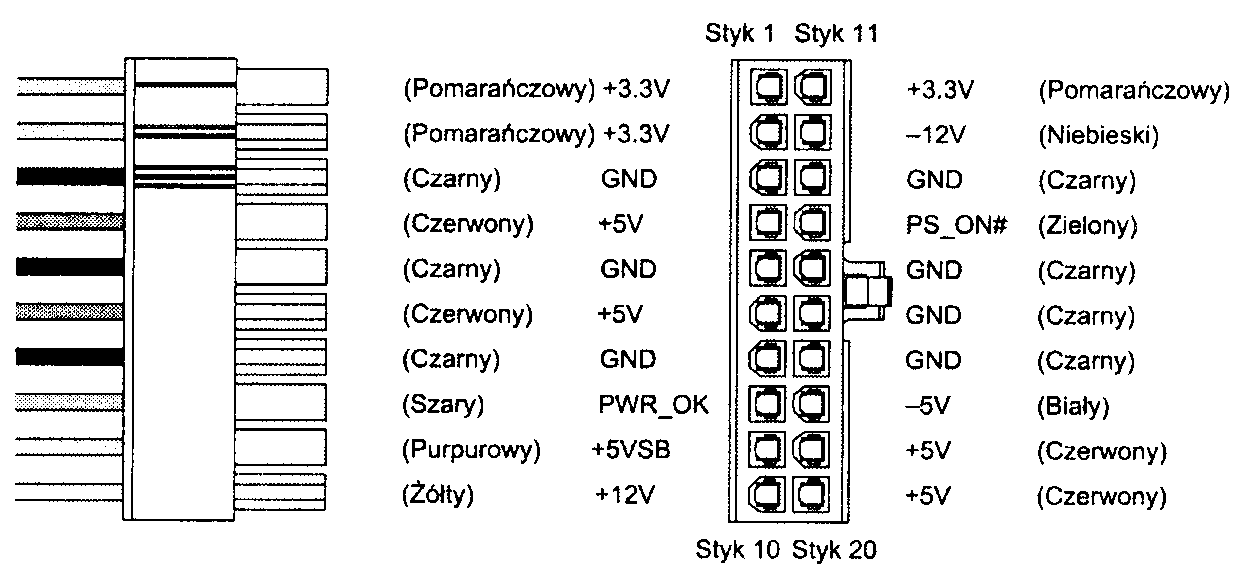

Złącze główne ATX (ATX Main)

Złącze zasilania płyty głównej standardu ATX to złącze Molex Mini-Fit, Jr. o numerze 39-29-9202 (lub jego odpowiednik). Najczęściej mówi się o nim jako o 20-stykowym złączu zasilania ATX (rysunek 21.12). Specyfikacja firmy Molex dopuszcza przepływ prądu o natężeniu do 6 amperów przez każdy ze styków (do 600 V). Złącze to stosowane jest również w konstrukcjach SFX i innych opartych na ATX. Opis układu styków zawiera tabela 21.4. Wymienione w niej kolory to zalecenia specyfikacji. Specyfikacja ATX nie wymaga jednak ich stosowania. Warto przyjrzeć się wtykowi od strony przewodów. Właśnie z tej strony widzimy go najczęściej, gdy sprawdzamy podłączenie zasilania do płyty głównej.

Tabela 21.4. Rozkład styków głównego złącza zasilania A TX (od strony przewodów)

Kolor |

Sygnał |

Styk |

Styk |

Sygnał |

Kolor |

Pomarańczowy1 |

+3,3 V |

11 |

1 |

+3,3 V |

Pomarańczowy |

Niebieski |

-12 V |

12 |

2 |

+3,3 V |

Pomarańczowy |

Czarny |

GND |

13 |

3 |

GND |

Czarny |

Zielony |

PSOn |

14 |

4 |

+5 V |

Czerwony |

Czarny |

GND |

15 |

5 |

GND |

Czarny |

Czarny |

GND |

16 |

6 |

+5 V |

Czerwony |

Czarny |

GND |

17 |

7 |

GND |

Czarny |

Biały |

-5 V- |

18 |

8 |

PowerGood |

Szary |

Czerwony |

+5 V |

19 |

9 |

+5VSB (Standby) |

Purpurowy |

Czerwony |

+5 V |

20 |

10 |

+ 12 V |

Żółty |

Może występować drugi przewód pomarańczowy lub brązowy, wykorzystywany do monitorowania regulacji napięcia 3,3 V 2 W nowszych modelach zasilaczy i płyt głównych może pozostawać nie podłączony. Zasilacze, w których styk 18 nie jest podłączony, nie powinny być stosowane z płytami głównymi z magistralą ISA.

Rysunek 21.12.

20-stykowe złącze zasilania płyty głównej typu ATX, perspektywa

Na rysunku 21.13 przedstawiony jest widok wtyku od strony gniazda.

Rysunek 21.13.

20-stykowe złącze zasilania płyty głównej typu A TX/NLX, widok od strony gniazda

Zasilacz ATX ma kilka napięć i sygnałów nie stosowanych w rozwiązaniach wcześniejszych +3,3 V, PS_On i +5V_Standby. Mimo zgodności kształtów urządzeń, zaadaptowanie zasilacza LPX do pracy z płytą główną ATX nie jest możliwe.

Ponieważ jednak ATX jest nadzbiorem standardu LPX, można użyć przejściówki, która umożliwi przyłączenie zasilacza ATX do starszej płyty głównej Baby-AT.

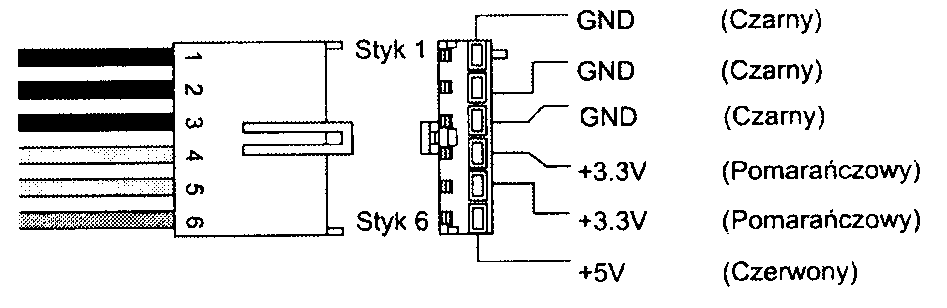

Złącze pomocnicze ATX (ATX Auxilliary)

Wraz z rozwojem płyt głównych i procesorów, rosną wymagania stawiane zasilaczowi. Konstrukcje chipsetów i pamięci DIMM o napięciu zasilania 3,3 V wymusiły wprowadzenie dodatkowych napięć zasilania płyty

głównej. Wciąż jednak stosowane są regulatory zamieniające napięcie +5 V na inne napięcia wymagane przez elementy płyty głównej. Duży pobór prądu o napięciu +3,3 V i +5 V okazuje się wykraczać poza możliwości stosowanych wtyków i gniazd zasilania. Każdy ze styków głównego złącza zasilania może przewodzić 6 am-perów prądu. Oznacza to, że płyta główna może korzystać co najwyżej z 18 amperów prądu +3,3 V i 24 ampe-rów prądu +5 V. Odpowiada to mniej więcej 250-watowemu zasilaczowi. Ponieważ płyty główne z szybkimi procesorami i wieloma kartami rozszerzeń mogą wymagać większej mocy, a producenci zasilaczy zaczęli oferować urządzenia o mocy 300 W i wyższej, problem stopionych wtyków stal się zagrożeniem jak najbardziej realnym. Tak duże obciążenie złącza płyty głównej prowadzi do jego przegrzania.

Aby umożliwić dostarczenie płycie głównej dodatkowej energii, firma Intel zmodyfikowała specyfikację ATX. wprowadzając złącze pomocnicze, przeznaczone dla płyt głównych o dużym poborze prądu i zasilaczy o mocy powyżej 250 W. Jak wynika z powyższych rozważań, wymóg stosowania złącza pomocniczego dotyczy sytuacji, gdy płyta główna pobiera ponad 18 amperów prądu o napięciu +3.3 V lub (i) ponad 24 ampery prądu o napięciu +5 V. Wówczas również stosuje się zasilacze o mocy 250 W, 300 W lub wyższej.

Złącza ATX Auxilliary to 6-stykowe złącze typu Molex, podobne do złączy zasilaczy AT/LPX (rysunek 21.14). Styki mają zapewniać pobór prądu o natężeniu 5 amperów każdy (do 250 V). Standardem jest zabezpieczanie wtyku „kluczem" uniemożliwiającym błędne osadzenie w gnieździe. Dodatkowy przewód o napięciu +5 V i dwa przewody o napięciu 3,3 V przekazują do płyty głównej w sumie prąd o natężeniu wynoszącym odpowiednio 29 i 28 A.

Rysunek 21.14.

Pomocnicze złącze zasilania płyty głównej A TX

Rozkład styków złącza jest opisany w tabeli 21.5.

Tabela 21.5. Rozkład styków złącza zasilania ATX Aiailliary

Styk |

Sygnał |

Kolor |

Styk |

Sygnał |

Kolor |

1 |

Gnd |

Czarny |

4 |

+3,3 V |

Pomarańczowy |

2 |

Gnd |

Czarny |

5 |

+3.3 V |

Pomarańczowy |

3 |

Gnd |

Czarny |

6 |

+5 V |

Czerwony |

Jeżeli płyta główna nie ma pomocniczego złącza zasilania, jest to sygnał, że nie została zaprojektowania do pracy przy tak dużym poborze prądu. W takim przypadku wtyk złącza pomocniczego zasilacza (o ile zasilacz jest weń wyposażony) może pozostawać nie podłączony. Jeżeli zasilacz ma zapewniać dostarczanie mocy 250 W lub wyższej, powinniśmy upewnić się, że został wyposażony w złącze pomocnicze. Podobnie, jeżeli płyta główna może pobierać więcej niż 18 A prądu +3,3 V lub 24 A prądu o napięciu 5 V. należy sprawdzić, czy jest wyposażona w pomocnicze gniazdo zasilania. Brak tego elementu grozi stopieniem złącza głównego.

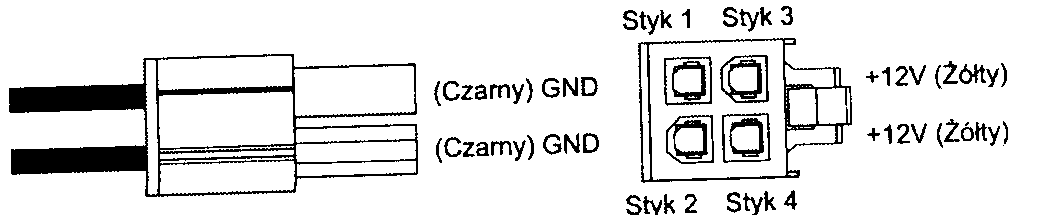

ATX12V

Procesor komputera jest zasilany przy użyciu specjalnego modułu regulacji napięcia (VRM, ang. voltage re-gulation module) stanowiącego integralny element większości nowoczesnych płyt głównych. Urządzenie to wykrywa wymagania procesora (zazwyczaj przy użyciu specjalnych styków złącza procesora) i dostosowuje dostarczane napięcia. Konstrukcja urządzenia może wymagać zasilania 5-woltowego lub 12-woltowego. Przez wiele lat standardem było 5 V. obecnie zauważalna jest tendencja do stosowania zasilania 12 V, ze względu na mniejsze natężenie prądu wymagane przy tym napięciu. Pozostałe podzespoły zadowalają się zazwyczaj zasilaniem 5-woltowym, wyjątkiem sąjedynie 12-woltowe silniki dysków. Zasilanie modułu VRM napięciem 5 V lub 12 V to zagadnienie związane z możliwościami regulatora i architekturą płyty głównej. Wiele nowoczesnych regulatorów może pracować przy dowolnym napięciu zasilania w zakresie od 4 V do 36 V. Zapewnia to dużą swobodę producentom płyt głównych.

Autor przyjrzał się bliżej komputerowi z płytą główną FIC (ang. First International Computer) SD-11, z regulatorem napięcia Semtech SCI I44ABCSW. Do wytwarzania niższych napięć procesora płyta wykorzystuje napięcie +5 V. Obwodami regulacji napięcia sterują zazwyczaj układy firmy Semtech (http://www.semtech.com) lub Linear Technology (http://www.linear.com). Na ich witrynach można znaleźć dokładne opisy układów.

Płyta główna SD-11 może pracować z procesorem Athlon 1 GHz Cartridge (Model 2). Zgodnie z danymi firmy AMD procesor ten pobiera do 65 watów mocy i wymaga napięcia nominalnego 1,8 V. 65 W prądu o napięciu 1.8 V wymaga natężenia wynoszącego 36,1 A (wolty x ampery = waty). 65 W odpowiada zarazem natężeniu 13 A prądu +5 V. Należy to skorygować o współczynnik sprawności regulatora. Jeżeli sprawność wynosi 80% (typowa wartość), faktyczny pobór prądu przez układ zasilania procesora będzie wynosi 16,25 A.

Gdy weźmiemy pod uwagę dalsze obwody płyty głównej, które również korzystają z napięcia +5 V, jak również karty rozszerzeń PCI i ISA, szybko zauważymy, jak łatwo doprowadzić do przeciążenia połączeń zasilacza z płytą główną.

Większość konstrukcji modułów regulacyjnych VRM płyt głównych, aż do wersji dla procesorów Pentium III i Athlon/Duron, korzysta z regulatorów 5-woltowych. Obecnie zyskują popularność regulatory 12-woltowe. Zastosowanie wyższego napięcia pozwala ograniczyć natężenie pobieranego prądu. Zależności między poborem mocy 65 W przykładowego procesora AMD Athlon 1 GHz a natężeniem prądu przy różnych napięciach przedstawione są w tabeli 21.6.

Tabela 21.6. Zależność natężenia prądu od napięcia przy tym samym poborze mocy

W (waty) |

V (wolty) |

A (ampery) |

A (ampery) przy sprawności 80% |

|

65 |

1,8 |

36,1 |

— |

|

65 |

3,3 |

19,7 |

24,6 |

|

65 |

5 |

13,0 |

16,3 |

|

65 |

12,0 |

5,4 |

6,8 |

|

Jak widać, przy napięciu 12 V wystarczy natężenie 5,4 A lub 6,8 A, jeżeli uwzględnimy 80-procentową sprawność regulatora.

Zmodyfikowanie obwodu VRM płyty głównej, tak aby korzystał z zasilania +12 V, może się wydawać dość proste. Niestety, standardowy zasilacz ATX 2.03 dysponuje tylko jednym wyprowadzeniem napięcia o tej wartości. Złącze pomocnicze nie poprawia sytuacji, jako że w ogóle nie ma w nim żadnego styku +12 V. Próba pobierania 8 amperów prądu o napięciu +12V ze standardowego kabla 18 AWG to prosta droga do stopienia złącza, którego każdy styk może przewodzić jedynie 6 amperów prądu.

Aby umożliwić dostarczenie do płyty głównej dodatkowego zasilania 12 V, firma Intel stworzyła nową specyfikację zasilacza, ATXI2V. Jest on wyposażony w trzecie złącze zasilania płyty głównej, nazwane ATX12V\ którego jedyną funkcjąjest dostarczanie napięcia 12 V. Złącze ma dwa styki +12 V. każdy o wytrzymałości 8 amperów. Zapewnia to płycie głównej możliwość korzystania z dodatkowych 16 A prądu o napięciu 12 V. W sumie uzyskuje się 22 A prądu o napięciu +12 V. Złącze przedstawiono na rysunku 21.15.

Rysunek 21.15.

Złącze zasilania ATX12V

W tabeli 21.7 opisany jest rozkład styków złącza +12 V.

Tabela 21.7. Rozkład styków złącza zasilania ATX +12 V (od strony przewodów)

Kolor |

Sygnał |

Styk |

Styk |

Sygnał |

Kolor |

Żółty |

+ 12 V |

3 |

1 |

Gnd |

Czarny |

Żółty |

+ 12 V |

4 |

2 |

Gnd |

Czarny |

Jeżeli zastępujemy płytę główną nowym modelem, który wymaga do obsługi regulatora napięcia CPU połączenia ATX12V, a starszy zasilacz nie ma takiego złącza, dostępne jest proste rozwiązanie. Jako złącze ATX12V można wykorzystać jedno z wyprowadzeń zasilania urządzeń peryferyjnych. Firma PC Power and Cooling oferuje prostą przejściówkę, którą można przyłączyć do jednego z takich wyprowadzeń. Rozwiązanie takie jest możliwe dzięki temu, że dostarczanie prądu o napięciu 12 V nie sprawia problemów zasilaczowi —jest ono zawsze udostępnianie przez złącza urządzeń peryferyjnych. Przedstawiona na rysunku 21.16 przejściów-ka rozwiązuje kwestię braku wtyku ATX12Vdość skutecznie.

Rysunek 21.16.

Przejściówka ATX12V firmy PC Power and Cooling

Architektura ATX firmy Dell

Poniższy opis dotyczy komputerów stacjonarnych firmy Dell wyprodukowanych pomiędzy 1998 a 2000 rokiem. Na nic nie spodziewającego się użytkownika czeka pułapka, dająca się we znaki, kiedy przychodzi czas na wymianę płyty głównej lub zasilacza komputera, która może doprowadzić do zniszczenia płyty głównej, zasilacza lub obu tych elementów!

Uczestnicy moich seminariów i Czytelnicy wcześniejszych wydań niniejszej książki zauważyli zapewne, że od długiego czasu jestem zdecydowanym zwolennikiem komputerów i podzespołów zgodnych ze standardami przemysłowymi i wykluczam zakup komputera, który nie jest wyposażony w płytę główną, zasilacz i obudowę o typowych rozmiarach (jak np. ATX). Wcześniej jednak korzystałem z systemów Packard Bell, Compaą. IBM i innych firm, gdzie stosowanych jest wiele podzespołów firmowych, specjalnych i wytwarzanych przez jednego producenta. Przykładem może być chwilowa utrata zdrowego rozsądku na początku lat 90-tych, kiedy zakupiłem komputer firmy Packard Bell. Jego możliwości szybko przestały być zadowalające, pojawiła się więc kwestia nowej płyty głównej i szybszego procesora. Wtedy odkryłem, że komponenty komputerów LPX nie mogą być stosowane zamiennie — różnice w kartach z gniazdami rozszerzeń skutecznie uniemożliwiały wymianę płyty głównej, samej karty, obudowy czy zasilacza. Był to więc „komputer jednorazowego użytku", którego nie można rozbudować, można jedynie wyrzucić. Zaoszczędzone początkowo pieniądze okazały się kwotą nieporównywalną z wydatkiem na wymianę całości komputera. Nie była to przyjemna lekcja.

Po kilku tego rodzaju doświadczeniach związanych z rozbudową lub naprawą komputera obiecałem sobie nigdy nie więcej nie wpadać w pułapkę posiadania komputera z niestandardowymi elementami. Stosowanie podzespołów typowych zapewnia szerokie możliwości ich niedrogiej wymiany, konserwacji lub naprawy, dostępne przez wiele kolejnych lat. Stąd właśnie bierze się powtarzana nie raz, w tej książce i na seminariach, zachęta do korzystania wyłącznie ze standardów przemysłowych.

Oczywiście składanie całego systemu od podstaw jest jednym z rozwiązań, które umożliwią uniknięcie składników określanych jako „firmowe" (proprietary), jest to jednak zazwyczaj znacznie bardziej czasochłonne i droższe niż zakup gotowego zestawu. Co więc można polecić tym, którzy pragną niedrogiego systemu, opartego na standardowych podzespołach, aby mieć możliwość przyszłej naprawy i rozbudowy? Spośród wielu producentów autor od lat wybiera! firmy Gateway, MPC (wcześniej MicronPC) i Dell. Jest to zarazem trzech największych producentów, którzy prowadzą sprzedaż bezpośrednią. Regułąjest stosowanie we wszystkich głównych liniach systemów stacjonarnych tych firm standardowych elementów typu ATX. Tak mogłoby się przynajmniej zdawać.

Wszystko wskazuje na to, że gdy w połowie 1998 roku firma Dell zaczęła stosować płyty główne ATX, odeszła nieco od nowego standardu, wyposażając intelowskie płyty ATX w nietypowo podłączone gniazda zasilania. Niezbędnym uzupełnieniem był oczywiście zasilacz o równie nietypowym układzie styków.

Jeszcze większą zbrodnią niż zastosowanie niestandardowego złącza zasilania płyty głównej jest użycie takiego samego złącza o zmienionym jedynie układzie połączeń. Wygląd i sposób zabezpieczania złącza pozostają identyczne z ATX. Nic więc nie zabezpiecza przez przyłączeniem niestandardowego zasilacza firmy Dell do nowej, standardowej płyty głównej ATX, zainstalowanej w starej obudowie. Równie łatwo można wpiąć do płyty głównej firmy Dell nowy zasilacz ATX.

Zadziwiające jest. jak niewiele mówiło się o tak znaczącej modyfikacji, powszechnej do niedawna w systemach jednego z wiodących producentów PC. Rozpowszechniając przedstawione tu informacje, można zapewne wciąż uratować wiele zasilaczy i płyt głównych.

Jeżeli Czytelnik miał już okazję spalić płytę główną może liczyć na zrozumienie autora. I on odkrył „cechę" dellowskiego rozwiązania w najgorszych z możliwych okolicznościach — doprowadzając do spalenia podzespołów komputera. Początkowo podejrzenie padło na zasilacz. Palił się żywym ogniem! Przed spaleniem kolejnego zasilacza uratowało mnie przejrzenie kolorów przewodów i zmierzenie napięć zasilania w drugim komputerze, również firmy Dell. Szczęściem w nieszczęściu płyta główna pozostała nie naruszona. Można jedynie podejrzewać, że uratowało ją szybkie spalenie zasilacza. Na taki przypadek nie należy jednak liczyć.

Można taki przypadek przypisywać głupocie, kto by jednak oczekiwał konieczności sprawdzania kolorów czy napięć wiązki przewodów zasilacza „ATX"! Sprzedawcy i producenci nie wymieniają tak uszkodzonych urządzeń w ramach naprawy gwarancyjnej — nietypowy układ kolorów przewodów jest uznawany za wystarczającą oznakę odmienności zasilacza.

Przedstawione przez firmę Dell oficjalne wyjaśnienie takiego braku zgodności ze standardem ATX mówi: „W połowie lat 90-tych przemysł IT zaczął szerzej stosować na płytach głównych zasilanie 3,3 V. Inżynierowie firmy Dell opracowali złącze, które wychodziło naprzeciw zwiększonemu zapotrzebowaniu na prąd o napięciu 3,3 V, uznane przez nas za znacznie lepsze od pozostałych". Wyjaśnienie to można uznać za dość niezwykłe, zważywszy, że główne złącze standardu ATX ma trzy styki 3.3 V. umożliwiające pobieranie 18 A. Uzupełnieniem jest złącze pomocnicze, z dwoma stykami, zapewniającymi razem 10 A. Dellowski „pseudo-ATX" ma tylko trzy styki 3,3 V w złączu pomocniczym, co umożliwia zasilanie prądem 15 A. Jest to mniej niż zapewnia samo złącze główne ATX!

Ponieważ techniczne wyjaśnienie rozbieżności raczej mija się z tematem, można podejrzewać, że prawdziwą przyczyną była chęć zmuszenia użytkowników do zakupywania części zamiennych i nowych płyt głównych w firmie Dell. Co bardziej bezczelne, firma ta wykorzystuje praktycznie wyłącznie płyty główne firmy Intel. Przykładem może być płyta Intel D815EEA, dokładnie taka sama jak stosowane przez innych producentów komputerów, takich jak Gateway czy Micron. Różni się wyłącznie złącze zasilania. Intel dostarcza wszystkim producentom standardowe płyty główne, modyfikując w dostawach dla firmy Dell złącza zasilania.

W tabelach 21.8 i 21.9 przedstawiamy opisy dellowskich złączy zasilania, głównego i pomocniczego. Złącza tego typu są stosowane w systemach pseudo-ATX firmy Dell.

Tabela 21.8. Firmowy układ głównego złącza zasilania ATXfirmy Dell

Kolor |

Sygnał |

Styk |

|

|

Styk |

Sygnał |

Kolor |

Szary |

PS_On |

11 |

|

|

1 |

+5 V |

Czerwony |

Czarny |

Gnd |

12 |

|

|

2 |

Gnd |

Czarny |

Czarny |

Gnd |

13 |

|

|

3 |

+5 V |

Czerwony |

Czarny |

Gnd |

14 |

|

|

4 |

Gnd |

Czarny |

Biały |

-5 V |

15 |

|

|

5 |

PowerGood |

Pomarańczowy |

Czerwony |

+5 V |

16 |

|

|

6 |

+5VSB (Standby) |

Purpurowy |

Czerwony |

+5 V |

17 |

|

|

7 |

+ 12 V |

Żółty |

Czerwony |

+5 V |

18 |

|

|

8 |

-12 V |

Niebieski |

Klucz (pusty) |

— |

19 |

|

|

9 |

Gnd |

Czarny |

Czerwony |

+5 V |

20 |

|

|

10 |

Gnd |

Czarny |

Tabela 21.9. Firmowy układ pomocniczego złącza zasilania A TXfirmy Dell |

|

||||||

Styk Sygnał |

Kolor |

|

|

Styk |

Sygnał |

Kolor |

|

1 Gnd |

Czarny |

|

|

4 |

|

+3,3 V |

Niebieski/biały |

2 Gnd |

Czarny |

|

|

5 |

|

+3,3 V |

Niebieski/biały |

3 Gnd |

Czarny |

|

|

6 |

|

+3.3 V |

Niebieski/biały |

Gdyby wszystkim, co zrobili inżynierowie firmy Dell, było przełożenie kilku przewodów w inne miejsca, możliwe byłoby wyjęcie połączeń z wtyku i zamocowanie ich we właściwych pozycjach. Pozwoliłoby to korzystać z zasilacza firmy Dell z nową płytą. Niestety, dokładniejsza analiza układów styków obu złączy firmy Dell prowadzi do konkluzji, że zmieniły się nie tylko pozycje napięć i sygnałów, ale i liczba przewodów uziemienia i różnych napięć. Choć więc operacja przerobienia zasilacza dellowskiego na „zwykły" lub odwrotnie, dostosowanie zasilacza ATX do pracy z płytą główną firmy Dell, jest możliwa, wymaga przycinania i rozdzielania przewodów. Efekt nie jest zazwyczaj warty poświęconego czasu i wysiłku.

Gdy decydujemy się na wymianę płyty głównej w jakimkolwiek systemie firmy Dell zakupionym pomiędzy 1998 a 2000 rokiem, możemy skorzystać z prostego rozwiązania—jednocześnie wymienić płytę główną i zasilacz na elementy standardowe. Istotną korzyścią jest wówczas powrót do rozwiązań opartych na normach branżowych. Możliwości wymiany samej tylko płyty głównej kończą się na płytach głównych firmy Dell. W przypadku wymiany samego zasilacza istnieje pewna alternatywa. Firma PC Power and Cooling oferuje wysoko wydajny zasilacz ATX 300 W ze złączem dellowskim w cenie około 90 dolarów. Ponownie, urządzenie nie różni się od standardowych zasilaczy 300 W standardu ATX poza zmienionymi połączeniami wtyku zasilania płyty głównej (i ceną niższą o 30%).

Poczynając od 2000 roku i systemów Dimension 4300, 4400 i 8200 firma Dell stosuje rozwiązania zgodne ze standardem ATX. Można więc liczyć na to, że będą one znacznie łatwiejsze w rozbudowie i pozwolą na wymianę samej płyty głównej lub zasilacza. Powrót do rozwiązań zgodnych ze standardami przywraca systemom tej firmy atrakcyjność jako platformy, która może być podstawą przyszłej rozbudowy i której naprawy nie sprawią trudności.

Wyłączniki zasilania

W komputerach PC stosuje się trzy rodzaje wyłączników zasilania:

przełącznik zintegrowany z zasilaczem.

przełącznik mocowany na panelu przednim,

przełącznik mocowany na panelu przednim ze sterowaniem przez płytę główną.

W najstarszych komputerach wyłącznik zasilania był elementem zasilacza służącym do prostego włączania i wyłączania dopływu prądu zmiennego. Było to rozwiązanie proste, jednak sięgnięcie ręką do umieszczonego na tylnej ściance obudowy przełącznika wymagało zazwyczaj uciążliwego pochylania się nad komputerem. Bezpośrednie wyłączanie zasilania z sieci elektrycznej uniemożliwiało zarazem uruchamiania komputera bez pomocy specjalnych urządzeń zewnętrznych.

Począwszy od końca lat 80. w komputerach PC zaczęto stosować wyłączniki mocowane na przedniej ściance obudowy komputera. Ich wprowadzenie nie wymagało istotnych zmian w konstrukcji zasilacza. Jedyną modyfikacją było zastąpienie wyłącznika wbudowanego w zasilacz modułem zewnętrznym, wyprowadzonym na przednią ściankę obudowy. Wyłącznik łączył z zasilaczem czterożyłowy kabel zakończony płaskimi wtykami widełkowymi, osadzanymi w gniazdach wyłącznika. Poszczególne żyły były oznaczone kolorami. Dodatkowo, niekiedy stosowana była piąta żyła uziemienia. Wyłącznik był zazwyczaj traktowany jako element nierozłączny z zasilaczem, a jego połączenie z kablem chroniła gruba, elastyczna warstwa izolacyjna, zabezpieczająca przed porażeniem prądem.

Przeniesienie wyłącznika sieciowego rozwiązało problem natury ergonomicznej, nic nie zmieniło jednak w kwestii zdalnego czy czasowego uruchamiania systemu. Co więcej, wewnątrz obudowy przebiegał dodatkowy kabel o niebezpiecznym napięciu 115 lub 230 V, prowadzący do umocowanego z przodu przełącznika. Dwie z jego żył pozostają pod napięciem zawsze, kiedy tylko komputer jest przyłączony do sieci (kiedy jest włączony, wszystkie są pod napięciem). Stwarza to zagrożenie dla osoby, która próbuje wykonać pewne czynności wewnątrz obudowy.

Co najmniej dwie z żyt kabla prowadzącego do wyłącznika zasilania AT/LPX stale pozostają pod napięciem 110 V lub 230 V prądu zmiennego. Jeżeli zasilacz jest podłączony do sieci elektrycznej, dotknięcie styków, do których są przyłączone, może spowodować porażenie prądem. Samo wyłączenie zasilacza nie jest wystarczające! Kiedykolwiek więc wykonujemy jakiekolwiek czynności związane z wyłącznikiem zasilania czy kablem połączeniowym, musimy całkowicie odłączyć zasilacz od sieci elektrycznej.

Kolory czterech lub pięciu przewodów wyłącznika są następujące:

Brązowy i niebieski. To dwa przewody prądu zmiennego 110 lub 230 V doprowadzające zasilanie z sieci elektrycznej do wyłącznika. Jeżeli tylko zasilacz jest połączony z gniazdkiem elektrycznym, przewody brązowy i niebieski są pod napięciem.

Czarny i biały. To dwa przewody doprowadzające prąd zmienny 110 lub 230 V od wyłącznika do zasilacza. Standardowo, są one pod napięciem tylko wtedy, gdy zasilacz jest włączony.

Zielony lub zielony z żółtym paskiem. Uziemienie. Powinno zostać połączone z obudową komputera. Zapewnia wyrównanie potencjałów zasilacza i obudowy.

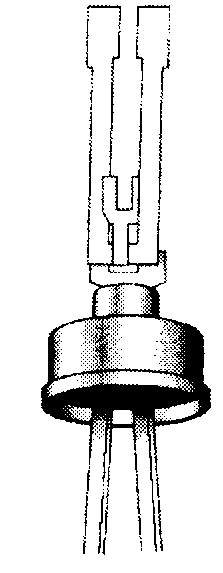

Również styki przełącznika są zazwyczaj oznaczane kolorami. Gdy tak nie jest, warto zwrócić uwagę na to, że dwa styki są ułożone równolegle, a dwa pod kątem. Przewody niebieski i brązowy powinny zostać połączone ze stykami równoległymi, a przewody czarny i biały — ze stykami ..pochylonymi". Jeżeli obie pary styków są równoległe, przewody niebieski i brązowy łączymy z pierwszą parą sąsiadujących styków, a przewody czarny i biały z drugą parą (rysunek 21.17).

Rysunek 21.17.

Zewnętrzny wyłącznik zasilacza

Mimo że wymieniane tu kolorowe oznaczenia i zasady mocowania styków odpowiadają większości zasilaczy, niektórzy producenci wprowadzają pewne odstępstwa. Jedna rzecz jest pewna: dwa przewody pozostają pod napięciem zawsze, kiedy wtyczka zasilacza znajduje się w gniazdu elektrycznym. Bez względu więc na sytuację, zanim cokolwiek zrobimy z wyłącznikiem, musimy sięgnąć do kabla zasilającego i w widoczny sposób przerwać połączenie z siecią energetyczna. Gdy wyłącznik zasilania zostanie ponownie zamontowany w obudowie nie możemy zapomnieć o założeniu koszulki termokurczliwej lub owinięciu styków taśmą izolacyjną. Należy liczyć się z tym, że każdy z elementów możemy któregoś dnia dotknąć przez czysty przypadek.

O ile tylko przewody niebieski i brązowy połączone zostały z jednym zestawem (parą) styków, a przewody czarny i biały z drugą (a nie „na krzyż"), wyłącznik i zasilacz będą pracować poprawnie. Inne połączenia doprowadzą najczęściej do spalenia bezpieczników sieci, spowodują bowiem zwarcie przewodów 110 lub 230 V.

Wszystkie zasilacze ATX i nowsze, w których stosowane jest 20-stykowe złącze płyty głównej, wymagają do uruchomienia komputera sygnału PSON. Wyłącznik nie zapewnia wówczas fizycznej kontroli nad dostępem zasilacza do zasilania sieciowego 110 lub 230 V. Włączenie lub wyłączenie zasilacza powoduje zmiana sygnału PSJDN, przekazywanego przez styk numer 14 złącza ATX.

Sygnał PS_ON może być generowany fizycznie przez wyłącznik zasilania lub elektronicznie, przez system operacyjny. Aktywność sygnalizowana jest niskim stanem sygnału, co oznacza, że gdy ma on napięcie wyższe lub równe 2.0 V, wyjścia zasilacza pozostają nieaktywne (komputer jest wyłączony). Wyjątkiem jest sygnał +5VSB (Standby), przekazywany przez styk numer 9 zawsze, gdy tylko zasilacz jest połączony z zewnętrznym źródłem energii. Faktyczny poziom aktywnego sygnału PS ON to 3,3 V lub 5 V. Sygnał jest przekazywany przez zasilacz do płyty głównej, a z niej — do wyłącznika zasilania. Wciśnięcie wyłącznika powoduje zwarcie sygnału z masą. Wykrycie przez zasilacz spadku napięcia do poziomu 0,8 V lub niższego powoduje włączenie komputera. Istotną korzyścią jest to. że w takim układzie (stosowanym również w systemach NLX i SFX) wyłącznik zasilania pracuje pod napięciem nie większym niż +5 V prądu stałego, w miejsce 120 - 240 V prądu zmiennego (jak w zasilaczach AT/LPX).

Stała obecność sygnału +5VSB na styku numer 9 złącza ATX oznacza, że gdy tylko zasilacz ma połączenie z zewnętrznym źródłem prądu zmiennego (nawet jeżeli komputer jest wyłączony), obwody płyty głównej mają dostęp do napięcia +5 V. Odłączanie zasilania ma więc w przypadku systemów ATX znacznie większą wagę niż w przypadku komputerów starszych.

Złącza zasilania urządzeń peryferyjnych

Poza złączami zasilania płyty głównej, zasilacze wyposażone są w zestaw złączy zasilania pozostałych elementów komputera, takich jak stacje dysków, dyski twarde i wentylatory. Złącza tego rodzaju występują w kilku odmianach.

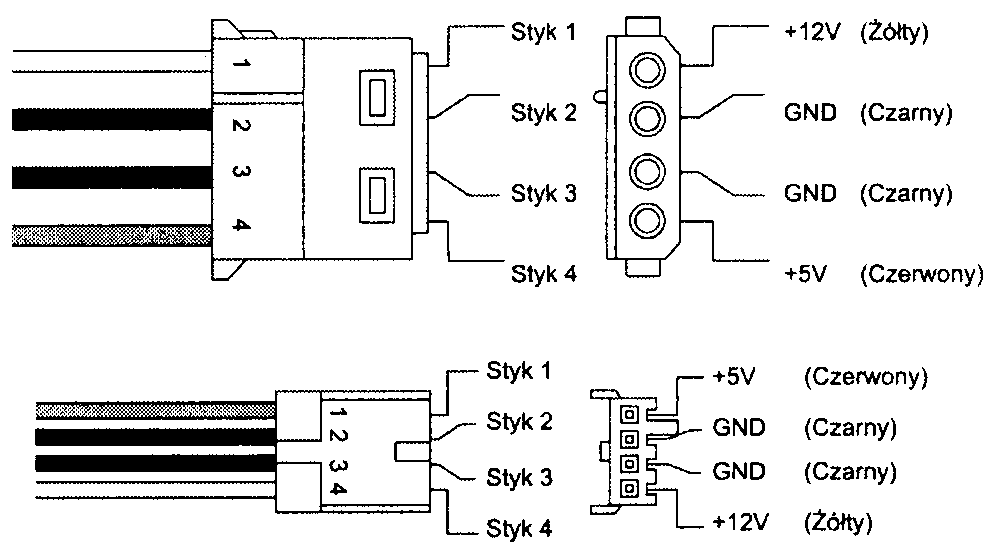

Złącza urządzeń peryferyjnych i stacji dyskietek

Złącza stacji dysków zasilaczy podlegają dość powszechnej konwencji układu styków i ich kolorów. Na rysunku 21.18 przedstawione są wtyki urządzeń peryferyjnych i stacji dyskietek.

Rysunek 21.18.

Złącza urządzeń peryferyjnych

i stacji dyskietek

W tabeli 21.10 przedstawione są opisy styków i kolory połączeń. Tabela 21.11 zawiera analogiczne dane dla złącza stacji dyskietek.

Tabela 21.10. Rozkład styków złącza zasilania urządzeń peryferyjnych (dużego złącza zasilania stacji dysków)

Styk Sygnał Kolor |

Styk Sygnał Kolor |

1 +12 V Żółty |

3 Gnd Czarny |

2 Gnd Czarny |

4 +5 V Czerwony |

Tabela 21.11. Rozkład styków złącza zasilania stacji dyskietek 3,5 cala (małego złącza zasilania stacji dysków) |

|

Styk Sygnał Kolor |

Styk Sygnał Kolor |

1 +5 V Czerwony |

3 Gnd Czarny |

2 Gnd Czarny |

4 +12 V Żółty |

Warto zwrócić uwagę na odwrócenie sposobu numerowania styków i napięć na obu złączach. Przy przerabianiu kabli należy zachować dużą ostrożność. Zamiana położenia przewodów czerwonego i żółtego prowadzi do spalenia urządzenia.

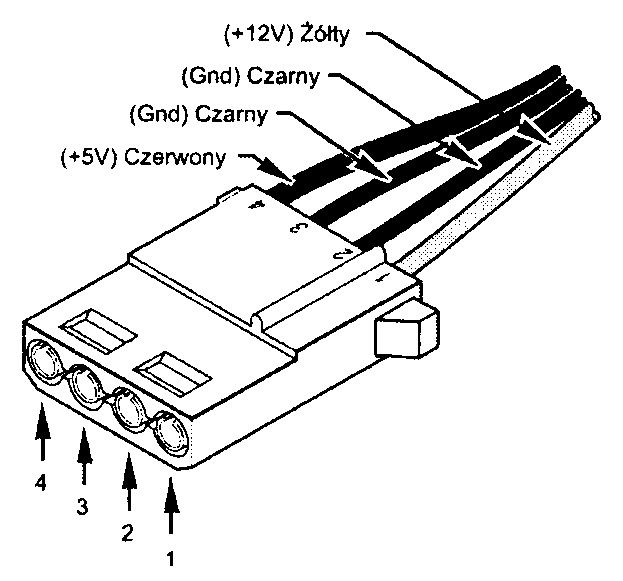

Numery styków są zazwyczaj wytłoczone na plastykowym wtyku. Jeżeli są małe i nieczytelne, położenie styku numer 1 można określić na podstawie układu zabezpieczeń przed niewłaściwym osadzeniem wtyku. Na rysunku 21.19 przedstawione są „klucze" wtyku oraz numery styków dużego złącza stacji dysków.

Rysunek 21.19.

Wtyk zasilania urządzeń peryferyjnych (żeński)

Niektóre złącza są wyposażone w dwa (a nie cztery) przewody: +5 V i masy (styki 3 i 4). Jest to konsekwencją faktu, że nowsze stacje dyskietek nie wykorzystują napięcia +12 V.

Wczesne odmiany zasilaczy były wyposażone w dwa duże złącza stacji dysków, nazywane dzisiaj najczęściej złączami urządzeń peryferyjnych. W późniejszych wersjach montowano cztery lub więcej złączy tego rodzaju oraz jedno lub dwa złącza stacji dyskietek 3,5 cala. W zależności od mocy zasilacza i jego przeznaczenia, liczba wyprowadzonych zeń wiązek zasilających może sięgać ośmiu.

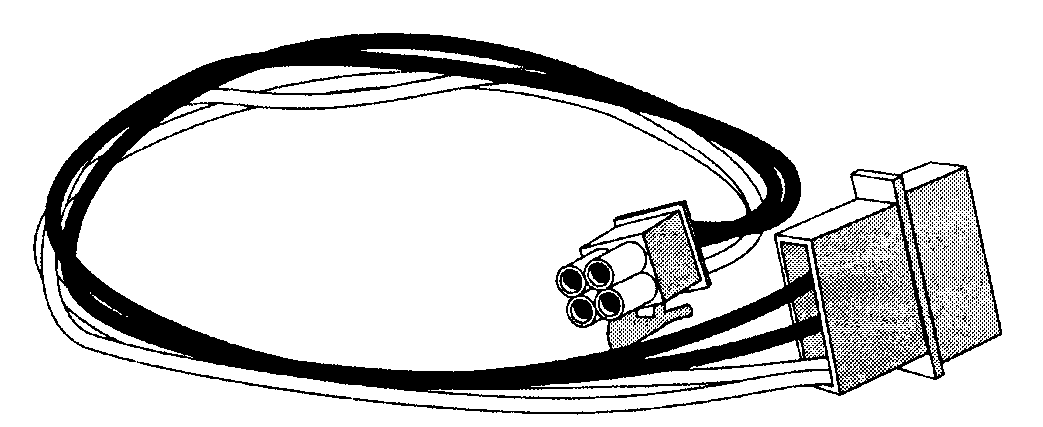

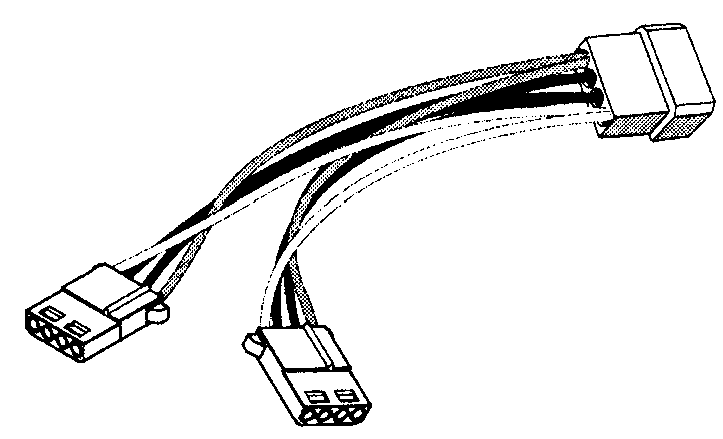

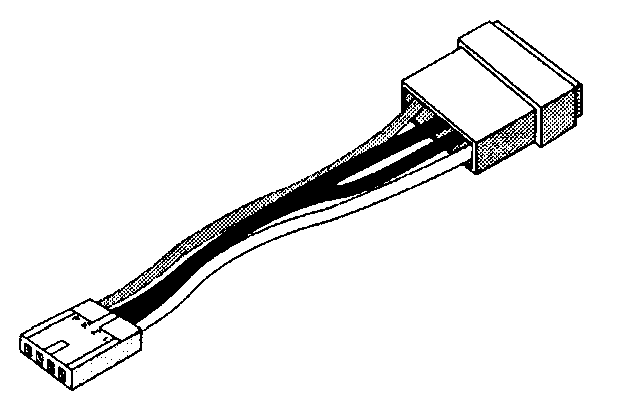

Jeżeli przyłączamy nowe stacje dysków i potrzebujemy dodatkowych złączy zasilania, możemy zastosować rozgałęźnik (rysunek 21.20) lub adapter pozwalający wykorzystać duże złącze do zasilania urządzenia z gniazdem stacji dyskietek (rysunek 21.21). Obie łączówki są powszechnie dostępne w sklepach z elementami elektronicznymi. Gdy stosujemy kilka rozgałęźników, warto upewnić się, czy zasilacz będzie w stanie dostarczyć prąd o odpowiedniej mocy.

Rysunek 21.20.

Typowy rozgałęźnik przewodów zasilania

Rysunek 21.21.

Typowa przejściówka złącze urządzeń peryferyjnych-złącze stacji dyskietek

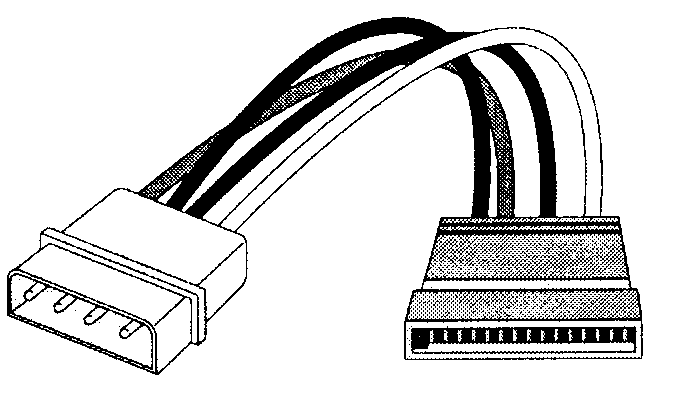

Aby do komputera podłączyć napędy Seria! ATA, potrzebna będzie przejściówka ze złącza Serial ATA do standardowego 4-końcówkowego złącza zasilania (jej przykład pokazano na rysunku 21.22). Przejściówka zamienia standardowe 4-końcówkowe złącze zasilające stosowane w tradycyjnych dyskach twardych na 15-końcówkowe złącze używane w napędach Serial ATA.

Rysunek 21.22.

Przejściówka 4-końcówkowe złącze zasilające-ztącze zasilające napędów Serial A TA

Numery części

Pierwszą specyfikację złączy fizycznych standardowych zasilaczy PC wprowadziła firma IBM, która zastosowała je w swoich komputerach PC, XT i AT. Wykorzystany został specyficzny typ złączy płyty głównej (PS i P9) i złączy stacji dysków. Było to rozwiązanie obowiązujące od 1981 roku (kiedy wprowadzono do sprzedaży komputery IBM PC) do 1995 roku (kiedy firma Intel opublikowała specyfikację ATX). W 1986 roku do zestawu złączy zostało dołączone mniejsze złącze stacji dyskietek 3,5 cala. W tabeli 21.12 przedstawione jest zestawienie standardowych złączy zasilania płyty głównej i stacji dysków.

Tabela 21.12. Złącza zasilania

Opis złącza |

Część żeńska (przyłączona do przewodów zasilania) |

Część męska (przyłączona do podzespołu) |

ATX/NLX/SFX (20-stykowe) |

Molex 39-01-2200 |

Molex 39-29-9202 |

ATX Auxilliary (opcjonalne, 6-stykowe) |

Molex 89931 |

Molex 86192 |

ATX12V (opcjonalne, 4-stykowe) |

Molex 39-01-2040 |

Molex 39-29-9042 |

PC/XT/AT/LPX P8/P9 |

Molex8993' |

Molex 86192 |

Urządzeń peryferyjnych (duże) |

AMP 1-480424-0 |

AMP 1-480426-0 |

Stacji dyskietek (małe) |

AMP 171822-4 |

AMP 171826-4 |

Serial ATA |

Molex 887515 |

Molex 87679-00014 |

Może być stosowane również GTC6P-1. 'Może być stosowane również GTC6RI.

3 Aby uzyskać oznaczenie wersji przejściówki z dwoma złączami (jednym z nich jest 4-końcówkowe złącze widoczne na rysunku 21.22), do numeru należy dodać -1310 lub -1311. W celu uzyskania oznaczenia wersji przejściówki z jednym złączem należy dodać -1410 lub -1411. ^Zawiera złącze danych SATA.

Najróżniejsze firmy oferują zarówno same złącza, jak i gotowe przejściówki, rozdzielacze i przedłużacze. Ich nabycie nie powinno sprawić kłopotu.

Przed zainstalowaniem nowych rozdzielaczy powinniśmy upewnić się, że zasilacz będzie w stanie zapewnić wystarczającą moc zasilania. Przeciążenie zasilacza może doprowadzić do uszkodzenia podzespołów elektronicznych i zniszczenia danych.

► ► Zajrzyj do punktu „Parametry zasilacza" znajdującego się na stronie 1230.

Parametry techniczne zasilaczy

Zasilacze charakteryzuje kilka parametrów opisujących ich możliwości w zakresie obsługi sygnałów wejściowych i wyjściowych oraz charakterystykę użytkową.

Obciążenie zasilacza

Zasilacze PC to zasilacze impulsowe (ang. switching), w odróżnieniu od zasilaczy liniowych (ang. linear). Zasilacz impulsowy wykorzystuje do konwersji wysokiego napięcia prądu zmiennego na niższe napięcie prądu stałego — niezbędne do zasilania podzespołów komputera — obwód oscylatora o dużej szybkości. Zasilacze impulsowe charakteryzują niewielkie rozmiary, waga i efektywność, przynajmniej w porównaniu z zasilaczami linowymi, gdzie stosowany jest duży transformator. Zasilacz liniowy ma trzy niekorzystne cechy. Przede wszystkim, napięcie wyjściowe transformatora jest liniowym odpowiednikiem napięcia wejściowego (stąd nazwa) — wszelkie fluktuacje poziomu zasilania sieciowego mogą powodować zakłócenia sygnałów wyjściowych. Drugą niekorzystną cechą jest wymóg stosowania dużej ilości grubego uzwojenia transformatora, niezbędnego do zapewnienia wymaganego przez komputer natężenia prądu. Trzecią trudnością jest filtrowanie 60- lub 50-hercowej częstotliwości prądu zmiennego, wymagające stosowania dużych i drogich kondensatorów i prostowników.

Zasilacz impulsowy wykorzystuje obwód przełączający, który dzieli pobierany prąd ze stosunkowo dużą częstotliwością. Umożliwia to stosowanie transformatorów wysokiej częstotliwości, znacznie mniejszych i lżejszych. Prąd o wyższej częstotliwości można też prościej i taniej filtrować, a tolerancja napięcia wejściowego jest znaczna. Poziom od 90 do 135 V umożliwia utrzymanie właściwych poziomów sygnałów wyjściowych, a wiele urządzeń zapewnia możliwość automatycznego dostosowywania swojej pracy do zasilania prądem 230 V.

Charakterystyczną cechą zasilaczy impulsowych jest to, że nie pracują one bez obciążenia (ang. load). Aby urządzenie rozpoczęło pracę, niezbędne jest przyłączenie doń na przykład płyty głównej lub dysku twardego. Próba włączenia samego zasilacza zakończy się albo jego spaleniem, albo wyłączeniem przez obwody zabezpieczające. Większość zasilaczy przy braku obciążenia zostanie natychmiast wyłączona. Niektóre z najtańszych modeli pozbawione są tego rodzaju zabezpieczeń i po kilku sekundach pracy bez obciążenia ulegają zniszczeniu. Wbudowane oporniki obciążające, umożliwiające pracę urządzenia bez obciążenia zewnętrznego, stosuje się sporadycznie.

Niektóre zasilacze mają określone obciążenie minimalne, określone osobno dla wyjścia o napięciu +5 V i wyjścia + 12 V. Zgodnie z IBM-owską specyfikacją zasilacza o mocy 192 watów, zastosowanego w oryginalnym komputerze AT, do poprawnej pracy urządzenia wymagany jest pobór prądu +5 V o natężeniu co najmniej 7,0 amperów i prądu +12V o natężeniu co najmniej 2,5 amperów. Przyłączenie samej płyty głównej zapewniało spełnienie warunku dotyczącego napięcia +5 V. Jednak napięcie +12 V jest zazwyczaj wykorzystywane jedynie przez silniki wentylatorów, dysków twardych, stacji dyskietek i stacji dysków CD/DVD. Ponieważ zarówno stacje dyskietek, jak i stacje dysków optycznych nie wykorzystują napięcia +12 V. jeżeli nie ma w nich obracającego się dysku, komputery bez dysku twardego mogą sprawiać problemy wynikające z braku wystarczającego obciążenia obwodów +12 V zasilacza.

Aby uniknąć związanych z tym problemów, firma IBM instalowała we wnęce dyskowej sprzedawanych bez dysku twardego komputerów AT duży, 5-omowy, 50-watowy opornik, do którego przyłączana była jedna z wiązek zasilania dysków twardych. W obudowie znajdowały się nawet specjalne otwory', umożliwiające zamocowanie opornika.

W latach 80-tych niektóre sklepy komputerowe zamawiały bezdyskowe stacje AT i instalowały w nich \\ 20- lub 30-megabajtowe dyski, kupowane u tańszych dostawców. Rezystory obciążeniowe zasilacza lądowały wówczas w koszu. Autorowi udało się wówczas zachować kilka takich elementów, dzięki czemu może teraz podać dokładny opis rozwiązania.

Opornik był przyłączany do styków numer 1 (+12 V) i 2 (masa) złącza zasilania dysku twardego. Zapewnia to 2,4-amperowe obciążenie wyjścia +12 V zasilacza i pobór 28.8 watów mocy (opornik się rozgrzewa!). Jest to wystarczające do zapewnienia normalnej pracy zasilacza. Warto zwrócić uwagę, że wentylator większości zasilaczy pobiera około 0,1 - 0,25 A ampera prądu, czyli ok. 2,5 W. Brak opornika obciążającego prowadziłby do nieregularnych problemów z uruchomieniem komputera.

Gros stosowanych dzisiaj zasilaczy nie wymaga tak dużego obciążenia. W większości wypadków obciążenie minimalne to 0 - 0.3 A prądu +3,3 V, 2,0 - 4,0 A prądu +5 V i 0,5 - 1,0 A prądu +12 V. Pobór niezbędnego prądu o napięciu +5 V zapewnia zazwyczaj sama płyta główna. Wentylator zasilacza pobiera 0,1 do 0,25 A, co wciąż nie pozwala uniknąć problemów z poborem prądu o napięciu +12 V przez stacje bezdyskowe. Ogólnie rzecz biorąc, im wyższa moc zasilacza, tym wyższe wymagane obciążenie minimalne. Istnieją jednak wyjątki, dane techniczne tego rodzaju musimy więc ustalić przy zakupie.

Niektóre z zasilaczy mają wbudowane oporniki, które umożliwiają ich uruchomienie bez obciążenia. Często można spotkać się z taką sytuacja, kiedy mimo braku oporników zasilacz wymaga jedynie minimalnego obciążenia linii +5 V. W innych przypadkach niezbędne będzie podłączenie odbiorników prądu +3.3 V, +5 V i +12 V —jedynym sposobem ustalenia takich wymagań jest zapoznanie się z dokumentacją zasilacza.

Bez względu na sytuację, poprawne i dokładne testowanie zasilacza wiąże się z dołączeniem obciążenia przynajmniej do jednego z wyjść napięcia dodatniego (a najlepiej do wszystkich trzech). Stąd też prosty wniosek, że najlepszym miejscem do testowania zasilacza jest obudowa kompletnego komputera. Do testów niezależnych niezbędna będzie zarówno płyta główna, jak i dysk twardy.

Parametry zasilacza

Producent komputera powinien dołączyć do niego dokumentację zastosowanego zasilacza. Informacje tego rodzaju mogą być ujęte w podręczniku dołączonym do komputera jako całości lub przyklejone do samego zasilacza. Jeżeli można zidentyfikować producenta zasilacza i odnaleźć jednego witrynę w WWW, jest to zazwyczaj najlepsze źródło danych.

Parametry wejściowe podawane są w woltach, parametry wyjściowe — w amperach, dla każdego z napięć niezależnie. Firma IBM określa moc wyjściowąjako nominalną moc wyjściową (ang. specified output wattage). Jeżeli producent nie podaje całkowitej mocy zasilacza, można ją obliczyć z prostego wzoru:

waty = wolty x ampery

Przykładowo, jeżeli płyta główna pobiera 6 amperów prądu o napięciu +5 V, oznacza to pobór 30 watów mocy.

Mnożąc napięcie przez dopuszczalny amperaż prądu każdego z wyjść i sumując wyniki, uzyskamy całkowitą moc wyjściową zasilacza. W obliczeniach bierzemy pod uwagę jedynie napięcia dodatnie. Napięcia ujemne, Standby, Power Good i inne specjalne nie powinny być uwzględniane w obliczeniach.

W tabeli 21.13 przedstawiona jest charakterystyka wyjść standardowych zasilaczy sprzed ery ATX. Większość producentów pozwala wybierać między urządzeniami o mocy od 100 do 450 i więcej watów. W tabeli 21.14 znajdziemy podobne dane dla zasilaczy ATX. Przedstawione liczby opierają się na specyfikacjach udostępnionych przez firmy Astec Power (aktualnie firma nie zajmuje się już produkcją zasilaczy komputerowych) i PC Power and Cooling. Można zauważyć, że sposób zaokrąglania mocy nominalnej zasilacza jest często niezwykle optymistyczny.

Wprowadzenie w zestawie wyjść zasilacza napięcia +3,3 V zmienia nieco sposób obliczania dopuszczalnego poboru mocy. Zwróćmy uwagę na dodatkowy wiersz w tabeli 21.14.

Obliczenie sumy mocy wyjściowej zasilaczy zgodnie z przedstawionym powyżej sposobem prowadzi do konkluzji, że zasilacze ATX mogą dostarczać mocy znacznie wyższej niż nominalna. Przykładowo, dla modelu 300 W uzyskujemy wartość 340 W. Ograniczeniem jest w tym wypadku dopuszczalny pobór mocy z wyjść +3.3 V i +5 V razem, który wynosi 150 W. Oznacza to, że nie można wykorzystać pełnych możliwości obwodów +5 V i +3,3 V jednocześnie — suma pobieranej z nich mocy nie może przekroczyć 150 watów. Całkowita moc wyjściowa zostaje w ten sposób sprowadzona do granicy 294 W.

Tabela 21.14. Moc zasilaczy A TX/A TX!2V oferowanych przez firmą PC Power and Cooling

Moc nominalna |

100 W |

150 W |

200 W |

250 W |

300 W |

375 W |

450 W |

|||||||||

Prąd wyjściowy (A): |

|

|

|

|

|

|

|

|||||||||

+5 V |

10,0 |

15,0 |

20,0 |

25,0 |

32,0 |

35,0 |

45,0 |

|||||||||

+ 12 V |

3,5 |

5,5 |

8,0 |

10,0 |

10,0 |

13,0 |

15,0 |

|||||||||

-5 V |

0,3 |

0,3 |

0,3 |

0,5 |

0,5 |

0,5 |

1.0 |

|||||||||

-12 V |

0,3 |

0,3 |

0,3 |

0,5 |

0,5 |

0,5 |

1,0 |

|||||||||

Obliczona moc wyjściowa |

92 W |

141 W |

196 W |

245 W |

280 W |

331 W |

405 W |

|||||||||

Moc nominalna |

235 W |

250 W |

275 W |

300 W |

350 W |

400 W |

425 W |

510 W |

||||||||

+3.3 V |

13 |

13 |

14 |

14 |

28 |

40 |

40 |

30 |

||||||||

+ 5V |

22 |

25 |

30 |

30 |

32 |

40 |

40 |

40 |

||||||||

+ 12V j 8 |

10 |

10 |

12 |

15 |

15 |

15 |

34 |

|||||||||

-5 V |

0,3 |

0,3 |

0,3 |

0,3 |

0,3 |

0,3 |

0,3 |

0,3 |

||||||||

-12 V j |

0,5 |

0,5 |

1,0 |

1,0 |

0,8 |

1,0 |

1,0 |

2,0 |

||||||||

+5VSB |

2,0 |

2,0 |

2,0 |

2,0 |

2,0 |

2.0 |

2,0 |

3,0 |

||||||||

Moc całkowita (3,3+5+12)' |

249 W |

288 W |

316W |

340 W |

432 W |

512 W |

512 W |

707 W |

||||||||

Dopuszczalny pobór I napięć +3,3 i +5 V ; |

125 W |

150 W |

150 W |

150 W |

215 W |

300 W |

300 W |

300 W |

||||||||

* Warto zwrócić uwagę, że podane w tym wierszu wartości maksymalne mają charakter czysto teoretyczny, ponieważ opierają się na pełnym wykorzystaniu napięć +3,3 V, +5 Vi +12 V. Praktycznie każdy zasilacz nakłada dodatkowe ograniczenia na sumę mocy pobieranej przez linie +3,3 Vi +5 V. Sprawia to. że faktyczna wielkość dopuszczalnego poboru mocy jest nieco niższa.

Wydaje się. że zasilacze o mocy 400 i 425 W podane w tabeli posiadają identyczne parametry, jednali pierwszy z nich korzysta ze specjalnego cichego wentylatora o niskiej prędkości obrotowej, oferującego nieco gorsze możliwości chłodzenia. W związku z tym w jego przypadku podano mniejszą dopuszczalną moc.

Większość zasilaczy zapewnia moc od 150 do 300 W. Moc mniejsza nie jest zwykle pożądana, dostępne są jednak zasilacze przeznaczone do pracy przy dużym obciążeniu, o mocy nominalnej 600 W lub wyższej.

Dla komputera stacjonarnego z pełnym wyposażeniem można zalecić zasilacz 300-watowy lub mocniejszy. Umożliwi to wykorzystywanie dowolnych płyt głównych i kart rozszerzeń, jak również dużej liczny stacji dysków i innych urządzeń peryferyjnych. W większości przypadków przeciążenie takich zasilaczy nie jest możliwe. Szybciej zabraknie miejsca do podłączania nowych elementów.

Większość zasilaczy może pracować na całym świecie. Nie sprawiają im problemów amerykańskie parametry zasilania 110 V i 60 Hz w sieci elektrycznej. Dostosowanie do nowego trybu zasilania może wymagać zmiany pozycji umieszczonego na zewnątrz obudowy przełącznika. Niektóre modele wykrywają napięcia i częstotliwość prądu zasilania automatycznie.

Jeżeli zasilacz nie zapewnia automatycznego przełączenia do korzystania z innego poziomu napięcia, musimy zadbać o właściwe ustawienie przełącznika. Przyłączenie zasilacza 230 V do gniazdka 110 V nie spowoduje jego uszkodzenia, ale uniemożliwi normalną pracę urządzenia. Skutki pomyłki odwrotnej mogą być tragiczne.

Inne parametry zasilaczy

Poza napięciem i prądem wyjściowym, pracę zasilacza opisują inne parametry, które pozwalają odróżnić zasilacz wysokiej jakości od innych. Autor korzystał przez lata z wielu różnych komputerów. Miał w tym czasie okazję zaobserwować, że w sytuacjach spadku napięcia w sieci elektrycznej, komputery o zasilaczach wysokiej jakości często utrzymywały ciągłość pracy, podczas gdy pozostałe ulegały nagłemu restartowi.

Zasilacz wysokiej jakości chroni komputer. Modele takich producentów jak Astec czy PC Power and Cooling nie ulegną uszkodzeniu w sytuacjach:

całkowitego braku zasilania przez dowolny okres czasu.

spadku napięcia w sieci elektrycznej.

krótkotrwałego impulsu o napięciu do 2500 V doprowadzonego do wejścia urządzenia (który może wywołać uderzenie pioruna lub urządzenie testujące).

Dobre zasilacze mają wyjątkowo niski upływ prądu do masy, nie przekraczający 500 mikroamperów. Jest to ważne, gdy uziemienie w miejscu pracy nie jest właściwie podłączone.

Są to wymagania dość ostre i zarazem wystarczające do rozpoznania urządzenia wysokiej klasy. Warto upewnić się. że spełnia je urządzenie, którego zakup planujemy.

Można również korzystać z wielu innych kryteriów oceny zasilacza. Jest element przez większość osób ignorowany przy zakupach, więc sprzedawcy nie starają się zanadto o dobór dobrej jednostki. Można oczekiwać, że o większej cenie komputera zdecyduje dodatkowa pamięć czy większy dysk twardy, ale nigdy lepszy zasilacz.

Przy kupowaniu komputera powinniśmy uzyskać jak najwięcej informacji o jego zasilaczu (podobnie przy kupowaniu samego zasilacza). Trzeba przyznać, że typowa specyfikacja zasilacza wydaje się większości nabywców mało czytelna. Poniżej przedstawiamy opis kilku podstawowych parametrów:

♦ Mean Time Between Failures (MTBF, ang. średnia długość okresu między awariami) lub Mean Time To Failure (MTTF, ang. średnia długość okresu przed wystąpieniem awarii). To obliczone przez producenta ilości godzin pracy zasilacza wyznaczające oczekiwaną długość okresu bezawaryjnej pracy. Wartość MTBF zasilaczy (sięgające 100 000 godzin i więcej) nie są wartościami wynikającymi z testów empirycznych. Producenci wykorzystują do ich wyliczania publikowane standardy.

w których wykorzystywane są miary awaryjności poszczególnych składników zasilacza. Wartości MTBF towarzyszy zazwyczaj obciążenie, z którym związana jest podana liczba (podane w procentach) i temperatura otoczenia.

Input Rangę lub Operating Rangę (zakres napięć wejściowych). Zakres napięć w sieci elektrycznej, przy których zasilacz może poprawnie pracować. Dla napięcia 120 V typowy zakres to 90 - 135 V, a dla napięcia 240V — 180 - 270 V.

Peak łnrush Current (szczytowy prąd rozruchowy). Największa ilość prądu pobieranego przez zasilacz bezpośrednio po włączeniu, wyrażona w amperach dla określonego napięcia zasilania. Im niższa jest ta wartość, tym mniejszy jest szok termiczny komputera.

Hold-Up Time (czas do wstrzymania). Podawana w milisekundach ilość czasu, przez który zasilacz może utrzymywać poprawny poziom napięć wyjściowych, kiedy nastąpi przerwa w dopływie prądu. Umożliwia to komputerowi kontynuowanie pracy mimo krótkiego zakłócenia w sieci elektrycznej. Typowe wartości to obecnie od 15 do 30 milisekund. Im dłuższy czas do wstrzymania, tym lepiej. Specyfikacja ATX12V zaleca wartość co najmniej 17 milisekund.

Transient Response (odpowiedź czasowa). Długość okresu (w mikrosekundach), przez który zasilacz przywraca poprawny poziom napięcia po nagłej zmianie w poborze prądu. Innymi słowy, jest to ilość czasu wymagana do stabilizacji napięć wyjściowych po włączeniu lub wyłączeniu zainstalowanego w komputerze elementu. W pewnych odstępach czasu zasilacz mierzy pobór prądu przez podłączone doń urządzenia. Jeżeli urządzenie zostanie włączone pomiędzy takimi sprawdzeniami (na przykład przestanie pracować silnik stacji dyskietek), przez krótki okres czasu dostarczane napięcie może być zbyt wysokie. Jest to tzw. chwilowe przeciążenie (overshoot). a odpowiedź czasowa to okres czasu, w ciągu którego napięcie powraca do standardowego poziomu. Dla komputera jest to krótkotrwały impuls wysokiego napięcia, który może spowodować zakłócenie funkcjonowania podzespołów lub zawieszenie systemu. Kwestia chwilowego przetężenia była niegdyś dużym, charakterystycznym

dla zasilaczy impulsowych, problemem. Przez lata sposoby jego rozwiązania zostały dopracowane. Wartości odpowiedzi czasowej są wyrażane jako okres czasu lub jako stwierdzenie „poziomy napięć wyjściowych zostają zachowane przy zmianach poboru mocy nie przekraczających 20%".

Overvoltage Protection (zabezpieczenie przed przepięciem). Definiuje wartości graniczne, których osiągnięcie powoduje wyłączenie zasilacza. Mogą być wyrażone w procentach (np. 120% dla +3,3 V i 5 V) lub bezpośrednio (np. +4,6 V dla napięcia +3,3 V i 7,0 V dla napięcia +5 V).

Maximum Load Current (największy dopuszczalny prąd obciążenia). Wyrażone w amperach maksimum poboru mocy dla danego wyjścia. Osobne wartości natężenia podawane są dla każdego napięcia wyjściowego. Umożliwia to nie tylko obliczenie całkowitej ilości dostarczanego przez zasilacz prądu, ale i określenie dopuszczalnej liczby urządzeń, które korzystają z tego samego napięcia zasilania.

Minimum Load Current (najmniejszy dopuszczalny prąd obciążenia). Wyrażone w amperach minimum poboru mocy dla danego wyjścia. Jeżeli pobór mocy jest mniejszy, zasilacz ulega uszkodzeniu lub samoczynnemu wyłączeniu.

Load Regulation lub Yoltage Load Regulation (regulacja obciążeniowa napięcia). Zmniejszanie i zwiększanie poboru prądu przez jedno z wyjść zasilacza powoduje niewielkie zmiany napięcia (ze wzrostem natężenia napięcie zazwyczaj rośnie). Regulacja obciążeniowa to zmiana napięcia dla danego wyjścia przy przechodzeniu od obciążenia minimalnego do obciążenia maksymalnego (lub odwrotnie). Wielkość zmiany wyraża się w procentach. Typowe wartości sięgają od ±1% do +5% dla każdego z napięć wyjściowych (+3,3 V, +5 V i +12 V).

Line Regulation (regulacja liniowa). Zmiana napięcia wyjściowego w zależności od napięcia wejściowego pomiędzy dolną a górną granicą dopuszczalnych napięć wejściowych. Nie powinna przekraczać 1%.

Efficiency (sprawność). Stosunek poboru mocy do mocy wyjściowej wyrażony w formie procentowej. Typowe wartości to obecnie 65 - 85%. Pozostałe 15 - 35% procent energii zostaje zamienione na ciepło w trakcie zamiany prądu zmiennego na prąd stały. Chociaż wyższa sprawność oznacza mniejszą ilość ciepła wewnątrz komputera (co zawsze jest dobrą rzeczą) i niższe rachunki za prąd, nie powinna być traktowana równie kategorycznie jak precyzja, stabilność i trwałość, mierzone przede wszystkim parametrami, takimi jak regulacja obciążeniowa i inne wcześniej wymieniane.

Ripple, Ripple and Noise, AC Ripple lub Periodic and Random Deviation (PARD, ang. okresowa i losowa dewiacja, tętnienie). Średnie napięcie prądu zmiennego wpływa na sygnały wyjściowe zasilacza, których odchylenie mierzy się jako procent napięcia nominalnego lub, bezpośrednio, jako liczbę miliwoltów między napięciami krańcowymi. Im mniejsza wartość, tym lepiej. Jednostki wysokiej jakości charakteryzuje tętnienie 1% lub mniejsze. Dla napięcia +5 V jeden procent to 0,05 V, czyli 50 mV (miliwoltów). Tętnienie może być wywoływane nieregularnościami pracy układu przetaczania wzbudzeniami na liniach prądu stałego i innymi zakłóceniami.

Korekcja współczynnika mocy

W ostatnich latach większą uwagę zwraca się na sprawność linii energetycznych i zniekształcenia harmoniczne generowane przez zasilacz. Zagadnienia tego rodzaju opisuje współczynnik mocy zasilacza. Współczynnik mocy to nie tylko miara sprawności zasilacza. Jest to parametr ściśle związany z redukcją zakłóceń harmonicznych wytwarzanych na liniach zasilających. W Unii Europejskiej zostały ostatnio wprowadzone nowe normy, wymagające redukcji zakłóceń harmonicznych do określonego poziomu. Obwód realizujący to zadanie określa się krótko jako korektor współczynnika mocy (PFC. ang. Power Factor Correction) lub regulator mocy biernej.

Współczynnik mocy (ang. power factor) to miara sprawności wykorzystania energii elektrycznej, wyrażana jako liczba z zakresu od 0 do 1. Duża wartość współczynnika oznacza dużą sprawność zasilacza, mała wartość odpowiada mało efektywnemu wykorzystaniu energii. Dokładniejsze omówienie znaczenia tej wartości wymaga podstawowej wiedzy o sposobach wykorzystania energii elektrycznej.

Ogólnie, linie zasilania prądem zmiennym obciążane są przez dwa typy źródeł:

Opornościowe — energia zamieniana na ciepło, światło, ruch i pracę.

Indukcyjne — utrzymują pole elektromagnetyczne, np. transformator lub silnik.

Obciążenie opornościowe określa się często mianem mocy czynnej. Moc czynna mierzona jest w kilowatach (kW). Z kolei obciążenie indukcyjne to moc bierna, mierzona w kilowarach (kvar). Suma mocy biernej i mocy czynnej to moc pozorna (apparent power), mierzona w kilowoltoamperach (kVA). Współczynnik mocy to stosunek mocy czynnej do mocy pozornej (kW/kVA). Wartością idealną jest 1, kiedy moc czynna jest równa mocy pozornej.

Koncepcja obciążenia opornościowego i mocy czynnej jest stosunkowo prosta. Przykładem może być żarówka 100-watowa, która zamienia 100 W energii elektrycznej na 100 W ciepła i światła. Jest to obciążenie czysto opornościowe. Nieco mniej oczywiste jest pojęcie obciążenia indukcyjnego. Wyobraźmy sobie transformator, którego zwoje generują pole elektromagnetyczne indukujące prąd w innych zwojach. Mimo że żadna praca nie jest wykonywana, nasycenie zwojów i utworzenie pola magnetycznego wymaga pewnej ilości energii. Przykładem obciążenia czysto indukcyjnego może być transformator, którego wyjście nie zostało podłączone. Żadna praca nie zostaje wykonana, więc nie występuje moc robocza, pewna ilość energii zostaje jednak związana.

Obciążony transformator wykorzystuje zarówno moc czynną jak i bierną. Energia czynna zostaje wykorzystana na wykonanie pracy (na przykład zasilania żarówki), a pozostała część pobranej energii służy do utworzenia pola elektromagnetycznego w zwojach transformatora. W obwodzie prądu zmiennego obciążenia różnego typu mogą ulec rozsynchronizowaniu lub przesunięciu w fazie, co oznacza, że ich szczyty nie są jednoczesne. Wynikiem może być odbierane i przekazywane przez linię elektryczną zniekształcenie harmoniczne. Jako przykład można podać silnik elektryczny, który zakłóca pracę podłączonego do tego samego obwodu telewizora.

Korekcja współczynnika mocy wymaga zazwyczaj zwiększenia pojemności w obwodzie, niezbędnej do utrzymania obciążenia indukcyjnego bez pobierania dodatkowej energii. Zapewnia to wyrównanie poziomu mocy czynnej i mocy pozornej i uzyskanie współczynnika mocy równego 1. Nie jest to, co prawda, proste włączenie paru kondensatorów do obwodu, jest jednak możliwe do uzyskania. Mamy wówczas do czynienia z pasywną korekcją współczynnika mocy. Aktywna korekcja współczynnika mocy wykorzystuje obwód zapewniający dopasowanie obciążenia opornościowego i indukcyjnego tak, że dla linii elektrycznej ich poziom pozostaje równy.

Zasilacz z aktywną korekcją współczynnika mocy pobiera niewielką ilość mocy biernej i ma współczynnik mocy 0,9 lub wyższy. Zasilacz bez korekcji współczynnika mocy pobiera prąd o dużych zniekształceniach i jest często określany jako obciążenie nieliniowe (nonlinear). Współczynnik mocy takiego zasilacza to zazwyczaj 0,6 - 0,8. Oznacza to wykorzystanie do wykonywania faktycznej pracy jedynie 60% pobieranej energii!

Zasilacz z aktywną korekcją współczynnika mocy może, choć nie musi, przyczynić się do zmniejszenia rachunku za energię (zależy to od sposobu mierzenia poboru mocy), ale w każdym przypadku zdecydowanie ograniczy obciążenie sieci elektrycznej budynku. Dzięki korekcji, cała moc pobierana przez zasilacz zostaje wykorzystana i poziom wykorzystania sieci elektrycznej spada. Przykładem takich korzyści może być sytuacja, gdy pewna liczba komputerów przyłączona jest do obwodu z bezpiecznikiem, który ciągle jest przeciążany. Zainstalowanie w nich zasilaczy z korekcją współczynnika mocy umożliwi zredukowanie obciążenia instalacji o 40% i, prawdopodobnie, rozwiązanie problemów z bezpiecznikiem.

Międzynarodowy Komitet ds. Elektryczności (IEC, ang. International Electrical Committee) opublikował normy dotyczące publicznych systemów zasilania niskiej częstotliwości. Początkowe wersje standardów miały numery 555.2 (zniekształcenia harmoniczne) i 555.3 (migotanie). Ich aktualne wersje to IEC 1000-3-2 i IEC 1000-3-3. Zgodnie z dyrektywami EMC, większość urządzeń elektrycznych sprzedawanych w krajach członkowskich Unii Europejskiej musi spełniać wymagania norm IEC. Nowe wersje wymienionych norm zostały wprowadzone w latach 1997 i 1998.

Nawet gdy mieszkamy poza granicami kraju, gdzie korekcja współczynnika mocy jest wymagana przez prawo, zdecydowanie warto wybrać zasilacz wyposażony w aktywną odmianę tej funkcji. Podstawowe korzyści to zmniejszenie obciążenia instalacji elektrycznej budynku i wprowadzanych do niej zniekształceń napięcia (co oznacza rzadsze występowanie zjawiska zakłócania pracy innych urządzeń).

Certyfikaty bezpieczeństwa zasilaczy

Wydawaniem certyfikatów bezpieczeństwa i jakości komponentów elektrycznych i elektronicznych zajmuje się wiele różnych agencji. W USA jedną z najbardziej znanych jest Underwriters Laboratories, Inc. (UL). Norma UL numer 60950 — Safety of Information Technology Eąuipment, Third Edition (norma bezpieczeństwa wyposażenia informatycznego, w tym elektrycznego wyposażenia biurowego, wydanie trzecie) — dotyczy zasilaczy i innych komponentów komputera PC. Czytelnikom z USA można zdecydowanie polecić kupowanie wyłącznie zasilaczy (i innych urządzeń), które posiadają certyfikat tej firmy. Mówi się często, że choć nie każdy produkt ma certyfikat UL, zle produkty go nie mają.

W Kanadzie urządzenia elektryczne i elektroniczne atestuje Canadian Standards Agency (CSA, Kanadyjska Agencja Normalizacyjna). Podobne organizacje w Niemczech to TUV Rheinland i VDE, a w Norwegii NEMKO. Wystawiają one certyfikaty urządzeń stosowanych w całej Europie. Producenci zasilaczy, którzy wchodzą na rynek międzynarodowy, dbają o uzyskanie certyfikatów co najmniej UL, CSA i TUV, a często nawet wszystkich wymienionych wyżej i innych.

Poza certyfikatami takimi jak UL. wielu producentów zasilaczy, nawet tych najbardziej poważanych, twierdzi, że ich produkty mają certyfikaty urządzeń klasy B komisji Federal Communications Commision (FCC. Federalna Komisja ds. Komunikacji), potwierdzające zgodność z normami FCC w zakresie interferencji elektromagnetycznej i częstotliwości radiowych (EM1/RFI). Jest to o tyle ciekawe, że komisja FCC nie wydaje certyfikatów zasilaczy jako niezależnych komponentów. Paragraf 47 Kodeksu Federalnego USA (CFR), część 15, rozdział 15.101 (c) mówi:

„FCC nie przyznaje obecnie atestów płyt głównych, obudów i wewnętrznych zasilaczy komputerowych. Wszelkie sformułowania typu obudowa z certyfikatem FCC, płyta główna z certyfikatem FCC lub zasilacz wewnętrzny z certyfikatem FCC są nieprawdziwe."

Certyfikaty FCC dotyczą w rzeczywistości całych komputerów. Tak więc, zasilacz określany jako certyfikowany przez FCC był w rzeczywistości testowany z pewną obudową i pewną płytą główną, jednak niekoniecznie z takimi, jakie znajdują się w kupowanym komputerze. Nie oznacza to oczywiście złej woli producenta czy niskiej jakości zasilacza. Jedynym wnioskiem może być przykładanie wagi nie tyle do certyfikatu FCC, ale do innych w rodzaju UL czy TUV.

Obliczanie poboru mocy

Przy rozbudowie komputera musimy dbać o to, aby wymagania montowanych w komputerze elementów nie przekroczyły możliwości zasilacza. Jednym ze sposobów prowadzących do ustalenia, czy komputer może być rozbudowywany, jest podsumowanie poboru mocy poszczególnych składników systemu i porównanie wyniku z parametrami zasilacza. Jest to podstawowe wyliczenie, niezbędne do rzetelnego ustalenia, czy posiadany zasilacz będzie wystarczający. Niestety, wielu producentów nie publikuje szczegółowych informacji o poborze energii przez oferowane urządzenia.

Uzyskanie informacji o poborze mocy przez urządzenia zasilane napięciem +5 V, przede wszystkim płyty główne i karty rozszerzeń, jest szczególnie trudne. Ilość pobieranej przez płytę główną energii zależy od wielu czynników. Wiele modeli pobiera mniej więcej 5 amperów prądu, nie jest to jednak regułą. Wykonanie przedstawionego poniżej wyliczenia wymaga również informacji o poborze mocy przez karty rozszerzeń. Gdy ich brak, dla pewności można posłużyć się limitem poboru mocy nakładanym przez magistralę rozszerzeń.

Rozważmy przykład oparty na wartościach typowych dla przeciętnego komputera PC typu desktop lub slim-line z 200-watowym zasilaczem dopuszczającym 20 amperów natężenia prądu o napięciu +5 V i 8 amperów natężenia prądu o napięciu +12 V. Specyfikacja ISA nie dopuszcza więcej niż 2,0 ampera prądu o napięciu +5 V i 0,175 ampera prądu o napięciu +12 V dla każdego ze złączy rozszerzeń. Większość komputerów ma osiem złączy; można oczekiwać, że cztery zostaną wykorzystane. W tabeli 21.15 dążymy do uzyskania wyniku operacji odejmowania całkowitej mocy pobieranej od mocy zasilacza.