1.Sztuczne sieci neuropodobne ogólna charakterystyka

informacje biologiczne:

Liczba neuronów w ludzkim mózgu: 1010-12, każdy posiada ok. 104 synaps(wejść) i jeden akson (wyjście). Komunikują się za pomocą impulsów elektrycznych generowanych w ciele neuronu, które docierają do końca aksonu połączonego z szeregiem synaps innych neuronów. Gdy suma wejść z synaps przekroczy wartość progową neuron odpala potencjał czynnościowy. Sieć neuronowa to układ z wyspecyfikowanymi obszarami o określonych specjalnościach (właściwościach). Nie jest to sieć połączeń każdy z każdym.

Impulsy w neuronie przyjmowane są przez drzewo dendrytowe (drzewo tworzone przez synapsy). Połączenia między neuronami nie są ,,równocenne''(??). Są sąsiedzi, którzy przeszkadzają neuronowi w pobudzeniu (połączenia hamujące) oraz którzy pomagają (pobudzające). Pobudzenia hamujące muszą występować gdyż inaczej układ nerwowy nie mógłby wchodzic w stabilne stany. Są niezbędne dla egzystencji. Cechy sieci neuronowej:

Odporność na zniekształcenia bodźców

Odporność na uszkodzenia fragmentów sieci

Zdolność do generalizacji zdobytej wiedzy

Uczenie przykładami zamiast programowania algorytmicznego

Równoległe przetwarzanie danych

To w jaki sposób modeluje się sieć neuronową zależy w głównej mierze od tego, do jakiego celu będzie służyć model, ostatnio rysuje się podział na:

Biologicznie realistyczne sieci neuropodobne , modelowanie i testowanie hipotez dotyczących biologicznych sieci neuronowych

Sztuczne sieci neuropodobne do zastosowań technicznych i praktycznych

2. Neuron jako element sieci i jego funkcje.

Neuron jest urządzeniem zbierającym, gromadzącym pobudzenia. Jest zawsze wbudowany w centralny układ. Skomplikowany mechanizm (jony Cl-, Ca++, Na+, K+, kanały jonowe.) Impuls- zaburzenie równowagi między jonami znajdującymi się na zewnątrz i wewnątrz komórki. Pobudzony przez synapsy neuron przechodzi do stanu aktywnego, co objawia się tym, że wysyła on poprzez swój akson wyjściowy sygnał elektrochemiczny o charakterystycznym kształcie, amplitudzie i czasie trwania. Ogólna forma sygnału pobudzonego neuronu jest identyczna dla wszystkich żywych organizmów, chociaż jego czas trwania jest różny dla różnych organizmów. Najkrótszy jest on u ssaków i dlatego mówi się często, że pobudzony neuron ssaka (w szczególności człowieka) wysyła impuls czynnościowy (iglicę, spike). Przejście od stanu bezczynności do stanu generacji impulsów zachodzi w typowych neuronach bardzo gwałtownie, dlatego mówi się często o "zapłonie" neuronu, który zaczyna generować na swoim wyjściu odpowiedni sygnał. Sygnał ten za pośrednictwem kolejnych synaps dociera do innych neuronów, które pod jego wpływem mogą również zostać postawione w stan zapłonu.

Neuron przechodzi w stan zapłonu tylko wówczas, gdy łączny sygnał, który dotarł do ciała komórki poprzez dendryty przekroczy pewien poziom progowy (poziom zapłonu). Siła otrzymanego przez neuron sygnału (i związana z tym szansa na zapłon) zależy w największym stopniu od efektywności (współczynnika wagi) synapsy do której dociera impuls. Ponieważ waga ta ma zasadnicze znaczenie z punktu widzenia objaśnienia działania sieci neuronowych - zarówno tych naturalnych (biologicznych) jak i ze względu na funkcjonowanie sztucznych sieci, przyjrzymy się odrobinkę dokładniej temu, co się dzieje w synapsach. Pobudzenia mogą być wzmacniające i hamujące.

3. Modele neuronu

Modelowanie neuronów:

modelowanie sprzętowe

modelowanie programowe

modele proste

modele złożone

Model złożony Huxleya-Hodgkina:

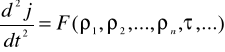

Nie ma możliwości opisu neuronu na poziomie biochemicznym. Neuron daje się opisać jako pewne urządzenie elektryczne . Fizycznie powiemy, że fragment neuronu możemy bardzo dobrze przez potencjał, oraz zastosować do niego prawa Kirchoffa, oraz opisać równaniem różniczkowym drugiego rzędu, które daje zależność:

, gdzie pierwszych n argumentów to oporności związane z przepływem jonów, ![]()

- czas relaksacji. Charakterystyki te uzyskuje się doświadczalnie. Zeby opisać cały układ trzeba takich równań napisać kilkaset- nazywane to jest sprzężonym układem równań Huxleya-Hodgkina. Moce obliczeniowe uniemożliwiają zbudowanie takiego modelu.

Model prosty McCulocha-Pitts'a:

Gdzie ![]()

N- liczba neuronów które pobudzają neuron. Po fakcie pobudzenia neuron zapomina (nie ma pamięci), wyjątkiem są np odruchy Pawłowa (bezwarunkowe) ale to charakterystyka sieci a nie neuronu. Model ten fałszuje rzeczywistość gdyż im większe pobudzeni tym większa aktywność a to nie występuje rzeczywiście.

Y= G(I) - funkcja zależna od pobudzenia neuronu, jest to funkcja fenomenologiczna, trzeba ją zadać,. Jest to symulowanie proste więc te funkcje muszą być bardzo proste - funkcje aktywności. Takie neurony nazywamy neuronami liniowymi - gdyż są opisane przez liniową funkcję aktywności. Wybierając funkcję ograniczamy się do funkcji spełniających warunki brzegowe, musi ona przedstawiać odzwierciedlać neuron (biologia), musi także mieć postać pierwszej pochodnej(aby latwo bylo znaleźć funkcję pierwotna), i musi byc łatwo różniczkowalna. Funkcje dość dobrze symulujące neuron, przy odejściu od jego prostoty to funkcje logistyczne np

. Pochodna funkcji wyraża się poprzez wartość funkcji: G'=f(G)

4. Mechanizm pobudzania neuronu i generowania odpowiedzi.

majy wektor wejściowy X = (x1; x2; :::; xn)T( transponowane)

zapamiętany we współczynnikach wagowych W = (w1;w2; :::;wn), liczona jest suma ważona wszystkich wejść czyli W*X i na podstawie funkcji aktywności zwracana jest aktywność neuronu czyli Y=G(W*X), gdzie G- funkcja aktywności., może być używana wartość progowa w funkcji aktywności nądź funkcja aktywności bedzie ciągła (przydatna w procesach uczenia się)

5. Ogólna struktura sieci.

Architekturę sieci możemy zadać poprzez tablicę połączeń: ![]()

={wkl}, przy czym

wkl >0(połączenia wzmacniające), wkl =0(nieaktywne), wkl<0(hamujące). Połączenia hamujące są potrzebne aby wytwarzane były stany stabilne czasowo a także energetycznie.

wkk<>0 - pobudzanie samego siebie, samopobudzający się neuron - wyjście z tego neuronu jest również wejściem do niego - połączenie zwrotne

(połączenie proste)wkl -> wlk (połączenie rekursywne)

Typy architektury sieci:

,,każdy z każdym''

wszystkie neurony w sieci są ze sobą połączone - liczba połączeń N^2, a gęstość

architektury ograniczające - takie gdzie z jakiejś zasady występuje ograniczenie połączeń:

poprzez zadanie

poprzez zadanie architektury

architektura warstwowa. Warstwa- wyróżniona grupa neuronów połączona z innymi neuronami, ale nie mają połączeń w grupie. Mogą być architektury wielowarstwowe

architektury warstwowe

neurony wejściowe - wprowadzają aktywność w sieć

neurony wyjściowe wyprowadzają aktywność poza sieć

neurony ukryte - pozostałe neurony znajdujące się w środku i przetwarzające

architektura warstwowa z propagacja wartości do przodu - nie ma w obrębie sieci połączenia zwrotnego wtedy Y=M(

,G,A)X, gdzie G -funkcja aktywności, A - architektura, X- wejscia, M- warstwy. Można tak zmodyfikować tą architekturę (poprzez dołączenie połączeń zwrotnych) że będziemy mowić o sieci rekurencyjnej i rekurencji sieciarchitektury modułowe

mamy różne sieci powiązane ze sobą, przy czym jedna sieć występuje w roli zarządzającej(kierujące j siecią). Elementami tej sieci są moduły będące sieciami o różnych architekturach (oddają one budowę mózgu).

6. Opis działania sieci.

Warstwa zawiera k neuronów,

Każdy neuron ma ten sam zestaw sygnałów wejściowych X=(x1,..,xn)T

Każdy neuron ma swoj wlasny wektor wag W(m)=(w1(m),,.., wn(m)), wyjście m-tego elementu mozna zapisac y(m)= W(m)*X, m - numer neuronu - jego identyfikator w sieci.

Działanie sieci neuronowej jest wypadkową działania poszczególnych neuronów oraz zachodzących pomiędzy nimi interakcji. Pojedynczy neuron w typowych przypadkach realizuje (z matematycznego punktu widzenia) operację iloczynu skalarnego wektora sygnałów wejściowych oraz wektora wag. W efekcie odpowiedź neuronu zależy od wzajemnych stosunków geometrycznych pomiędzy wektorami sygnałów i wektorami wag.

Właściwą geometrię położenia wektorów wag, gwarantującą poprawne działanie sieci, uzyskuje się w wyniku procesu uczenia, który może być interpretowany jako metoda automatycznego poszukiwania takiego zestawu współczynników wagowych występujących we wszystkich neuronach całej sieci, który gwarantuje najmniejszą wartość sumarycznego błędu popełnianego przez sieć (sumowanie odbywa się po zbiorze różnych zadań stawianych sieci).

W wyniku stosowania odpowiedniego algorytm uczenia (najbardziej znany jest tu algorytm wstecznej propagacji błędów) sieć może systematycznie zmniejszać błąd popełniany w trakcie procesu uczenia, w wyniku czego obserwujemy w czasie uczenia stopniową poprawę jej działania.

Wzięcie pod uwagę rodzajów funkcji nieliniowych (funkcji przejścia) występujących w sieci wielowarstwowej w modelach poszczególnych neuronów umożliwia przedstawienie - także w sposób intuicyjny i poglądowy pewnych kluczowych kwestii dotyczących sposobu działania i metod uczenia perceptronów wielowarstwowych. Należy przypomnieć, że poziom pobudzenia neuronów w perceptronach wielowarstwowych jest ważoną sumą wejść (plus wartość progowa dodawana jako tzw. bias). Taki sposób realizacji obliczeń powoduje, że poziom pobudzenia neuronu jest w rzeczywistości po prostu pewną liniową funkcją wartości wejściowych. Wyznaczona w ten sposób wartość łącznego pobudzenia przepuszczana jest przez funkcję sigmoidalną (S - kształtną) w celu wyznaczenia sygnału odpowiedzi neuronu.

Kombinacja wielowymiarowej funkcji liniowej i jednowymiarowej funkcji sigmoidalnej daje charakterystyczną odpowiedź sieci, typową dla neuronów wchodzących w skład pierwszej warstwy ukrytej perceptronu wielowarstwowego. Odpowiedź ta, tworząca tak zwane "urwisko sigmoidalne" sprzyja dychotomii liniowej wejściowego zbioru danych. Zmieniając wartości wag i parametrów progowych można modyfikować kształt odpowiedzi sieci. W szczególności może zostać zmieniona zarówno orientacja powierzchni, jej przesunięcie w stosunku do początku układu współrzędnych, jak również stromość zbocza. Kształtowanie funkcjonału opisującego zachowanie neuronów sieci odbywa się z reguły automatycznie, w trakcie procesu ucznia, jednak mimo to warto znać kilka ogólnych prawidłowości rządzących formowaniem tego funkcjonału, ponieważ ułatwia to takie świadome kształtowanie parametrów sieci, by z największym prawdopodobieństwem osiągać stawiane cele. Warto więc na przykład wiedzieć, że strome zbocza "urwiska" sigmoidalnego odpowiadają dużym wartościom wag. Oznacza to, że w wyniku proporcjonalnego (z takim samym mnożnikiem) zwiększenia wartości wszystkich wag uzyskuje się taka samą orientację tego "urwiska" - ale inne (stromsze) jego nachylenie.

Tak działa jeden neuron. Sieć wielowarstwowa działa (w uproszczeniu) w taki sposób, że łączy razem pewną liczbę takich powierzchni poprzez wielokrotne zastosowanie kombinacji liniowej sygnałów wyjściowych z kolejnych neuronów warstwy ukrytej i nieliniowej funkcji aktywacji w neuronach warstwy wyjściowej. Powstaje w ten sposób powierzchnia o dowolnie złożonym kształcie (stopień złożoności formy tej powierzchni zależy tylko od liczby zastosowanych warstw ukrytych i liczby neuronów w tych warstwach). Podczas uczenia sieci powierzchnia ta zmienia się w następujący sposób. W początkowej fazie uczenia sieci wagom oraz wartościom progowym nadaje się wartości będące niewielkimi liczbami losowymi. Powoduje to, że powierzchnia odpowiedzi neuronów ma kształt losowo zaburzonej, ale generalnie raczej płaskiej powierzchni, zawierającej jedynie bardzo niewielkie nachylenia. Powierzchnie tego typu z reguły nie są przydatne do rozwiązywania stawianych przed sieciami problemów, co zresztą doskonale odpowiada intuicyjnemu rozumieniu określenia "sieć nie nauczona". W trakcie trwania uczenia powierzchnie odpowiedzi dla poszczególnych neuronów ulegają obróceniu i przesunięciu w sposób, zapewniający docelowo przyjęcie przez nie prawidłowej pozycji, wynikającej z pożądanej (oczekiwanej) funkcji decyzyjnej. Towarzyszy temu wzrost wartości wag prowadzący do tego, że powierzchnie te stają się znacznie bardziej wydatne, chociaż ich kształt pozostaje charakterystycznie tarasowaty. Jednak w miarę uczenia jedne obszary płaskie (plateau) podnoszone są coraz wyżej, a inne plasują się zdecydowanie coraz niżej. Równocześnie zbocza pomiędzy nimi stają się coraz stromsze i mają coraz bardziej wyrazisty przebieg, który podlega zresztą licznym modyfikacjom (granice tarasów są oczywiście modyfikowane w trakcie uczenia, bo na tym właśnie owo uczenie polega). Takie silnie uformowane, wielowarstwowo piętrzące się tarasy są w stanie modelować poszczególne części zadanej powierzchni odpowiedzi, a ich odpowiednie złożenie stanowić może podstawę do tworzenia właściwej funkcji odpowiedzi sieci.

Z wykładu:

Aktywność sieci polega na tym, że sieć jest pobudzana przez neurony. Następnie jest przetwarzana na neuronach wewnętrznych i odpowiedź.

Pobudzenie(neurony wejściowe)-> przetwarzanie(neurony wewnętrzne) -> odpowiedź (neurony wyjściowe). Odpowiedź będzie dokładnym obrazem sieci gdy wszystkie wagi będą równe 1 oraz wystąpi tożsamość (funkcje tożsamościowe). Możemy manipulować:

wagami

funkcjami aktywności

architekturami

i wtedy przy tym samym pobudzeniu będziemy otrzymywać różne odpowiedzi.

7. Proces treningu sieci i jego rodzaje.

Proces uczenia to zdolność sieci do modyfikowania swojej wewnętrznej struktury pod wpływem pokazywania reprezentacji świata:

trening sieci zawsze odbywa się na pewnym skończonym zbiorze reprezentacji świata (skończony zbiór wektorów X) - zbiór uczący <- algorytm uczenia

następnie sieć wchodzi w stan nauczenia

Trening sieci może być prowadzony na dwa różne sposoby:

metoda nauczania nadzorowanego (z nauczycielem)- rola nauczyciela jest dwojaka:

nauczyciel ma możliwość oddziaływania na nauczany przedmiot poprzez ocene odpowiedzi(ingerencja w sieć)

wzorzec odpowiedzi

samonauczanie (uczenie nienadzorowane)

Czyli chodzi o takie przekształcanie wag,- liczby połączeń, - charakteru neuronu - zmiana funkcji aktywności lub jej parametrów aby dla każdego wektora ze zbioru uczącego generowana była poprawna odpowiedź

8. Trening perceptronu prostego.

Na podstawie perceptronu Rosenblatta (1958)

( xk ,ywzk )

xk - k-ty zestaw wartości wejściowych (wektor treningowy) (na rysunku wektor x1 … xn)

ywzk - wzorcowa odpowiedź do k-tego wektora treningowego (na rysunku y)

Algorytm uczenia polega na takim ustawieniu wag wejść perceptronu aby dla każdego wektora treningowego perceptron dawał poprawną odpowiedź.

w(t+1) = w(t) + deltaw(t)

dowolne wagi początkowe w(0), korekcja wag w przypadku błędnej klasyfikacji

deltaw = 0, jeżeli klasyfikacja była poprawna

delta = y*u, jeżeli klasyfikacja była błędna

czyli deltaw=u*sing(y*- y)

W jednym przebiegu pętli algorytmu „przechodzimy” po wszystkich elementach zbioru wektorów treningowych i dokonujemy modyfikacji wag. Powtarzamy ten proces aż do momentu, gdy nasz perceptron daje dla każdego elementu zbioru wektorów treningowych poprawną odpowiedź.

Wprowadza się także współczynnik u- szybkości uczenia, u >=0 i u<=1.

9.Układ ADALINE i reguła delta.

Jeżeli dla każdego wektora wejściowego X umiemy podać porządaną wartość

wyjścia neuronu z, to możemy obliczyć błąd jaki ten neuron popełnił: δ = z- y

Okazuje sie, że aby neuron lepiej realizował nasze odwzorowanie, należy

skorygować jego wagi w następujący sposób:

W' = W + ηδ X.

Dlaczego?

_ Dlaczego dodawa¢ fragment wejścia X do wektora wag W?

_ dlaczego η?

_ dlaczego δ?

z wykładu:

uproszczony perceptron, który praktycznie składa się praktycznie z jednego neuronu zaproponowali B. Hidow i T. Hoff. Na podstawie reguły delta możemy powiedzieć, że ucząc sieć uzależniamy zmiany przez generowane przez sieć odpowiedzi. Nauczyciel na podstawie jakości odpowiedzi ingeruje w sieć. Dokonuje zmian wag aż do czasu otrzymanie prawidłowych odpowiedzi.

Od Kawiaka:

Reguła DELTA zmienia wagi w sieci proporcjonalnie do błędu na wyjściu sieci (różnicy pomiędzy rzeczywistym sygnałem wyjściowym a sygnałem wzorcowym) i wielkości odpowiedniej sygnału wejściowego.

O zachowaniu pojedynczego neuronu decyduje wektor wag W, a o działaniu sieci - macierz wag W'. Aby zapewnić możliwość uczenia trzeba wprowadzić do modelu neuronu dwa dodatkowe elementy: procesor zmiany wag i detektor błędu. Taki neuron nazywa się ADALINE. Sygnał wyjściowy y jest związany z wygnałem wejściowym X zależnością.

y =f(X)

Funkcja f nie musi być zadana w sposób jawny, wystarczy że dla każdego wektora wejściowego potrafimy wskazać konkretną wartość

z = f(X)

stanowiącą nasze żądane odniesienie sygnału wyjściowego y.

Algorytm ten nazwany jest regułą DELTA, zakłada że w raz z każdym wektorem wejściowym X do neuronu podawany jest sygnał z. Neuron odpowiada na sygnał X sygnałem

y = W * X

Przy czym jeśli neuron nie jest nauczony, sygnał ten jest inny niż wymagany (y≠z). Wewnątrz neuronu istnieje blok oceniający wielkość błędu

δ = z - y

Blok ten składa się inwertora oraz sumatora. Na podstawie sygnału błedu oraz wektora wejściowego X możliwe jest takie skorygowanie wektora wag W, by neuron lepiej realizował zadaną funkcję y= f(X). Nowy wektor wag W' obliczany jest ze wzoru:

W' = W + ηδX

gdzie η jest współczynnikiem liczbowym, decydującym o szybkości nauki.

Zarzuty Mińskiego i Paperta: metodą Widrowa, Hoffa nie można uczyć sieci wielowarstwowych.

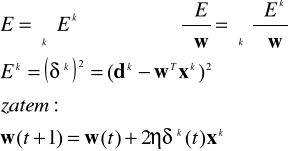

10.Uczenie z minimalizacją błędu (metoda gradientu).

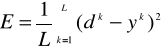

Przy wyższych założeniach błąd odpowiedzi sieci wynosi:

, gdzie L liczba wektorów w zbiorze uczącym

Estymacja gradientu gradE:

ALGORYTM UCZENIA SIECI:

Inicjalizuj wagi sieci jako niewielkie liczby losowe;

Oblicz wartość kwadratu błędu ၤk(t);

ၤk(t) = (dk-wTxk);

Oblicz zmianę wag ၄w:

၄w(t) = 2ၤၨk(t)xk;

Uaktualnij wektor wag w(t+1):

w(t+1)=w(t)+ ၄w(t);

Powtarzaj kroki 1-4 dopóki błąd nie osiągnie akceptowalnej wartości.

Bo z wykładów:

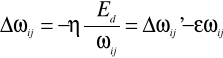

Reguła delta : ![]()

, gdzie ![]()

={wkl}, a E to błąd odpowiedzi sieci. W połowie lat 80 zaproponowano modyfikację reguły delta w prosty matematyczny sposób:

![]()

czyli wektor pochodnych. W oparciu o tę regułę można zbudować skutecznie algorytmy uczenia sieci wielowarstwowej.

11.Uczenie konkurencyjne (procesy samouczenia).

z wykładu: Gdy jakiś neuron jest pobudzany to chce być jeszcze bardziej pobudzany... dalej jakies krzaki;/

12.Metoda propagacji wstecznej błędu (BP).

13.Modyfikacje metody BP.

1.![]()

, gdzie ![]()

to człon bezwładności.

Dla ![]()

=0, ![]()

=1 występuje maksymalna bezwładność (sieć nieczuła na zmiany, zachowuje poprzedni kierunek), poprzez odpowiednia modyfikacje ![]()

i gamma mozemy uzyskac algorytm mnie czuly na minima

2. reprezentacja swiata z szumem

zeby nie dac sieci możliwości uczenia się na pamięć. Można to osiągnąć poprzez dodanie szumu do wzorca, zanim dostanie go sieć do uczenia. Zmiana ta nie powinna być duza ok 1%

3. Przypadkowe kolejności wzorców uczących(uczenie epokowe).

Przy uczeniu epokowym bedziemy pokazywać sieci wzorce w przypadkowej kolejności. Generujemy zbiorowy błąd sieci. W następnym akcie uczenia będą pokazane te same wzorce ale w innej kolejności.

4.Ingerencje w architekturę- optymalizacja archutektury

Proces uczenia i efekty uczenia zależą od BP. W środku uczenia zachowujemy architekturę sieci, zmieniamy tylko wagi.

Proces uczenia z ingerencją w strukturę sieci:

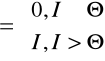

Funkcja kryterialna: ![]()

Reguła uczenia:

, gdzie ![]()

-stała uczenia natomiast ![]()

-stała rozpadu wag oraz ![]()

przy czym ![]()

- zmiana wag w standardowej metodzie wstecznej propagacji

15.Sieci Hebba.

Na przełomie lat 40 i 50 Hebb odkrywa mechanizm polegający na tym, że aktywność mózgu zależy od historii swoich wcześniejszych pobudzeń, zmienia się charakterystyka takiego neuronu. Próg neuronu zmienia się w zależności od tego czy był wcześniej pobudzany czy nie. Zjawisko Hebba jest źródłem pojawiania się odruchów warunkowych u zwierząt (połączenie bodźca nienaturalnego wraz z zachowaniem zwierzęcia). Odruch warunkowy jest związany z miechanizmem Hebba.

Sieci w których wprowadzany jest mechanizm oparty na mechanizmie Hebba są to sieci Hebbowskie. Zjawisko Hebba nie określa jakie zmiany zachodzą wraz z wykonywaniem odruchów warunkowych.

W latach 60 Grossben i Cohen- wprowadzili zmodyfikowany mechanizm Hebba i otrzymali stabilny układ sieci neuronowej(w stabilnych stanach się znajdującej) poprzez wprowadzenie zmodyfikowanego mechanizmu Hebba.

GENERALNIE U EWY W NOTATKACH TYLKO

Reszta też

16 zastosowanie

Rozpoznawanie obrazów;

Rozpoznawanie i synteza mowy;

Analiza sygnałów radarowych;

Kompresja obrazów;

Prognozowanie sprzedaży;

Prognozowanie giełdy;

Interpretacja badań biologicznych i medycznych;

Diagnostyka układów elektronicznych;

Typowania w wyścigach konnych;

Dobór pracowników;

Selekcja celów śledztwa w kryminalistyce;

Typowanie w wyścigach konnych.....

1. Fenomenologia jądra atomowego.

Reprezentacja świata. Na wejściu dostajemy zestaw danych (liczbę protonów i neutronów i pewien ułamek). Na wyjściu dostajemy średnią energię jądra. Jeżeli energia ta jest dodatnia to jądro takie może występować we wszechświecie, w przeciwnym razie nie.

2. Próba nauczenia czytania sztucznych sieci neuronowych

NETTALK (Sejnowski, Rosenberg, 1987). Sieć trenowana na tekście Szekspira zawierającym 1024 słowa. Po 50 epokach sieć "rozumiała" 95% tekstu. Tak nauczona sieć ma zdolność czytania owolnego angielskiego tekstu na poziomie 78%.

DECTALK- wprowadzamy tekst a sieć odczytuje. Skuteczność programu dla dowolnego tekstu- 92%. Program powstał w ciągu 10 lat przy współpracy 2000 specjalistów.

3. Analiza struktur biologicznych (analiza IIIrzędowa białek).

Na podstawie struktury Irzędowej trzeba przewidziec IIIrzędową. Skuteczność przewidywania- 62%, program Robsona rozwiązujący ten problem w oparciu o powiązania chemiczne miał skuteczność 53%.

4. Algorytmy dzielenia wyrazów na sylaby.

5. Rozpoznawanie celów sonarowych.

6. Automatyczne kierowanie samochodem .

7. Gry.

8. Projektowanie obwodów elektrycznych. (z wiki)

9. Rozwiązywanie problemów NP. (z wiki)

10. Przeszukiwanie. (z wiki)

![]()

![]()

![]()

Wyszukiwarka

Podobne podstrony:

Mię¶niaki macicy w ci±ży[2]

Projekt dom opis tech 01, UCZELNIA ARCHIWUM, UCZELNIA ARCHIWUM WIMiIP, Budownictwo, stare

StacjonarneBAT pytania egzamin2013-KW, Uczelnia PWR Technologia Chemiczna, Semestr 6, BAT-y egzamin

CHEMIA FIZYCZNA- spektrografia sc, Ochrona Środowiska pliki uczelniane, Chemia

poprawa druk, Uczelnia, sem I, fiza, LABORATORIUM, Nowe laborki, Ciecz

Natura 2000 a autostrada A1, Ochrona Środowiska pliki uczelniane, Natura 2000

Badania makroskopowe, uczelnia, materialoznastwo

Psychologia społeczna 07.03.2009, Uczelnia, Psychologia społeczna

178 i 179, Uczelnia, Administracja publiczna, Jan Boć 'Administracja publiczna'

278 i 279, Uczelnia, Administracja publiczna, Jan Boć 'Administracja publiczna'

58 i 59, Uczelnia, Administracja publiczna, Jan Boć 'Administracja publiczna'

PROCESY NIESTACJONARNEJ WYMIANA CIEPŁA, Uczelnia, Metalurgia

Finanse przedsiębiorstw(1), Uczelnia, Finanse przedsiębiorstw

Test 1, uczelnia - pielegniarstwo, II ROK, Geriatria i piel geriatryczne, Geriatria i pielęgniarstwo

MSI sciaga z konspekow, Studia, Studia sem IV, Uczelnia Sem IV, MSI

więcej podobnych podstron