65253 statystyka skrypt�61

wać hcsjan funkcji kryterium i rozpatrywać metodę Manjuardta jako wariant metody Newiona-Raphsona. Należy podkreślić, że metoda Marquardta pozwala wyznaczyć minimum funkcji kryterium w przypadkach, gdy wcześniej opisane metody zawodzą, np. przy niezbyt dobrze określonych wartościach początkowych.

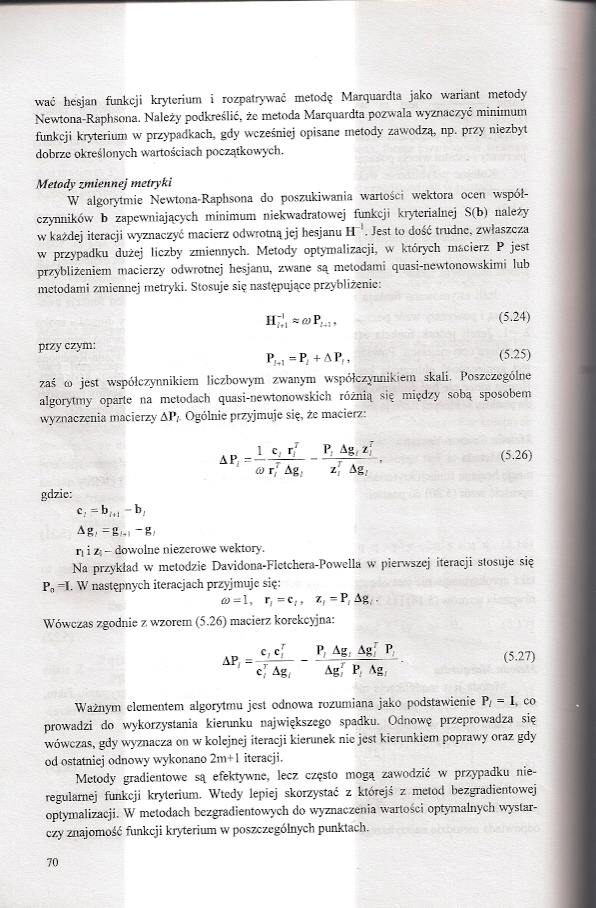

Metody imiennej metryki

W algorytmie Newtona-Raphsoru do poszukiwania wartości wektora ocen współczynników b zapewniających minimum niekwadratowej funkcji krytcrialncj S(b) należy w każdej iteracji wyznaczyć macierz odwrotną jej besjanu ii Jest to dość trudne, zwłaszcza w przypadku dużej liczby zmiennych. Metody optymalizacji, w których macierz P jest przybliżeniem macierzy odwrotnej besjanu. zwane są metodami qaasi-oewtooowskimi lub metodami zmiennej metry ki Stosuje się następujące przybliżenie:

- >*■ (5.24)

przy czym:

P,., -F, +AP,, (5.25)

zaś o> jest współczynnikiem liczbowym zwanym współczynnikiem skali. Poszczególne algorytmy oparte na metodach quasi-newtonowskich różnią się między sobą sposobem wyznaczenia macierzy AP< Ogólnie przyjmuje się. że macierz:

(5.26)

o i f Ag, *; Ag,

gdzie:

ar, =r,„ -g,

i) i zt - dowolne niezerowe wektory.

Na przykład w metodzie Davidona-Ficłchcra-Powclla w pierwszej iteracji stosuje się Po “I- W następnych iteracjach przyjmuje się:

»=1. r,-«„ «,-P,Ag;.

Wówczas zgodnie z wzorem (5.26) macierz korekcyjna:

(5.27)

AP . P> **>

ł"c,rAg, Agf P, Ag,

Ważnym elementem algorytmu jest odnowa rozumiana jako podstawienie P, ■ I. co prowadzi do wykorzystania kierunku największego spadku. Odnowę przeprowadza się wówczas, gdy wyznacza on w kolejnej iteracji kierunek nic jest kierunkiem poprawy oraz gdy od ostatniej odnowy wykonano 2m+l iteracji.

Metody gradientowe są efektywne, lecz często mogą zawodzić w przypadku nieregularnej funkcji kryterium. Wtedy lepiej skorzystać z którejś z metod bezgradientowej optymalizacji. W metodach hrz gradientowych do wyznaczenia wartości optymalnych wystarczy znajomość funkcji kryterium w poszczególnych punktach.

70

Wyszukiwarka

Podobne podstrony:

statystyka skrypt�61 wać hcsjan funkcji kryterium i rozpatrywać metodę Manjuardta jako wariant metod

40926 statystyka skrypt�73 Weryfikację hipotezy Ho: P - 0 można też przeprowadzić w oparciu o analiz

statystyka skrypt�53 Do równania regresji dołącza się funkcję fk(x) dla której wartość F,* jest najw

statystyka skrypt�72 funkcji straty (np. 1K* 37), wskazuje to na rozbieżność procesu estymacji i wów

statystyka skrypt�53 Do równania regresji dołącza się funkcję fk(x) dla której wartość F,* jest najw

19567 statystyka skrypt�60 gdzie Y jest m wymiarowym wektorem pochodnych cząstkowych funkcji d2V dbp

84288 statystyka skrypt�52 Procedura eliminacji zmiennych ma tę niedogodność, że po odrzuceniu kolej

22934 statystyka skrypt�66 Proces hcracyjny optymalizacji można zakończyć, gdy wystąpi: 1) ustabiliz

skanuj0397 (3) Rozdział 15. ♦ Generowanie statystyk 413 Modyfikacji uległa funkcja checkPass. Przede

statystyka skrypt�02 SPIS

statystyka skrypt�06 - Kody użytkownika - tabele liczebności i histogramy tworzone

więcej podobnych podstron