40926 statystyka skrypt�73

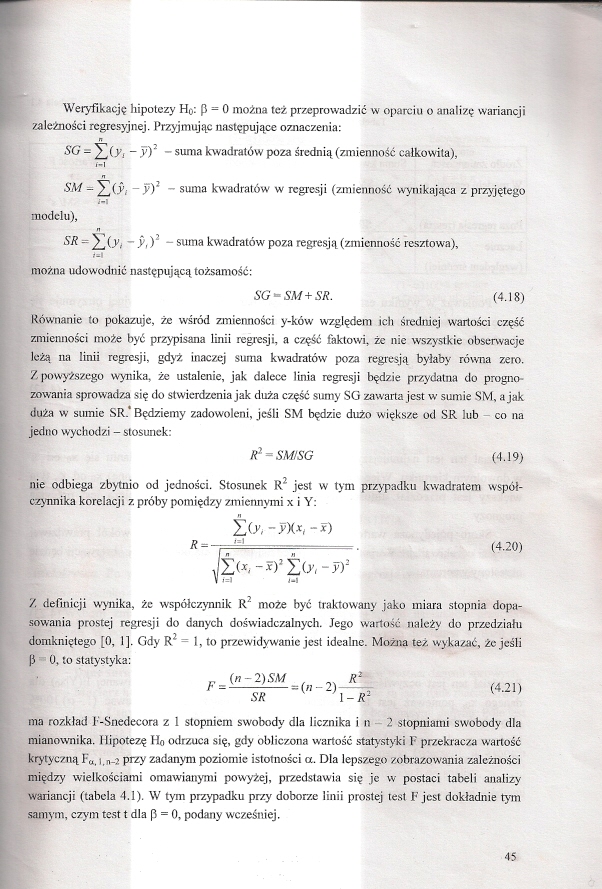

Weryfikację hipotezy Ho: P - 0 można też przeprowadzić w oparciu o analizę wariancji zależności represyjnej. Przyjmując następujące oznaczenia:

SG * y*.(y, - y)3 - suma kwadratów poza średnią (zmienność całkowita),

SM = y](v,- - y)2 - suma kwadratów w regresji (zmienność wynikająca z przyjętego modelu),

SR=J)(yJ ~y,y - suma kwadratów poza regresją (zmienność rcszłowa).

#■|

można udowodnić następującą tożsamość:

SG-SM+SR. (4.18)

Równanie to pokazuje, że wśród zmienności y-ków względem ich średniej wartości część zmienności może być przypisana linii regresji, a część faktowi, że nic wszystkie obserwacje leżą na linii regresji, gdyż inaczej suma kwadratów poza regresją byłaby równa zero. Z powyższego wynika, że ustalenie, jak dalece linia regresji będzie przydatna do prognozowania sprowadza się do stwierdzenia jak duża część sumy SG zawarta jest w sumie SM. a jak duża w sumie SR. Będziemy zadowoleni, jeśli SM będzie dużo większe od SR lub co na jedno wychodzi -stoswek:

&-SM/SG (4.19)

nie odbiega zbytnio od jedności. Stosunek R2 jest w tym przypadku kwadratem współczynnika korelacji z próby pomiędzy zmiennymi x i Y:

icrt-w*,-*)

R= **ł . (4.20)

V i-i j-i

Z definicji wynika, żc współczynnik R2 może być traktowany jako miara stopnia dopasowania prostej regresji do danych doświadczalnych. Jego wartość należy do przedziału domkniętego [0, 1]. Gdy R2 = I, to przewidywanie jest idealne. Można też wykazać, żc jeśli P ■ 0, to statystyka:

1

ma rozkład F-Snedecora z 1 stopniem swobody dla licznika i n - 2 stopniami swobody dla mianownika. Hipotezę Ho odrzuca się, gdy obliczona wartość statystyki F przekracza wartość krytyczną F«. j.n_2 przy zadanym poziomic istotności a. Dla lepszego /obrazowania zależności między wielkościami omawianymi powyżej, przedstawia się je w postaci tabeli analizy wariancji (tabela 4.1). W tym przypadku przy doborze linii prostej test F jest dokładnie tym samym, czym test t dla p = 0, podany wcześniej.

Wyszukiwarka

Podobne podstrony:

statystyka skrypt�17 2. WERYFIKACJA HIPOTEZ STATYSTYCZNYCH2.1. Cci ćwiczenia Celem ćwiczenia jest za

statystyka skrypt�32 Pizy hipotezie alternatywnej I I3 obszar krytyczny jest prawostronny (rys. 2.3)

26501 statystyka skrypt�45 W polu Wykresy prawdopodobieństwa można wybrać: (Normalnego reszt (Mil -

22934 statystyka skrypt�66 Proces hcracyjny optymalizacji można zakończyć, gdy wystąpi: 1) ustabiliz

Rozdział 5. WNIOSKOWANIE STATYSTYCZNE. ESTYMACJA I WERYFIKACJA HIPOTEZ

statystyka skrypt�44 fcapisz reszty i przewidywane (fil - umożliwia zapisanie wyników analizy res/t

statystyka skrypt�61 wać hcsjan funkcji kryterium i rozpatrywać metodę Manjuardta jako wariant metod

Xerox Phaser200MFP 081126114251 128 Janusz Buga, Helena Kassyk-Rokicka gowanie można też przeprowadz

65253 statystyka skrypt�61 wać hcsjan funkcji kryterium i rozpatrywać metodę Manjuardta jako wariant

więcej podobnych podstron