Zadania eksploracji danych

•

opis

•

grupowanie

•

klasyfikacja

•

przewidywanie

(predykcja)

•

szacowanie

(estymacja)

•

odkrywanie reguł

I EKSPLORACJA

DANYCH

Zadania eksploracji danych: przewidywanie

Przewidywanie jest podobne do klasyfikacji i

szacowania, z wyjątkiem faktu, że w

przewidywaniu wynik dotyczy przyszłości.

XI EKSPLORACJA DANYCH

Typowe zadania przewidywania to:

•

przewidywanie ceny akcji na giełdzie

•

przewidywanie rozwoju sektora

gospodarki

•

przewidywanie własności nowego

tworzywa

Zadania eksploracji danych: przewidywanie

Wszystkie metody i techniki wykorzystywane

do klasyfikacji i szacowania mogą być również

użyte, pod odpowiednimi warunkami, do

przewidywania.

XI EKSPLORACJA DANYCH

Metody wykorzystywane do przewidywania

obejmują:

•

tradycyjne metody szacowania wartości

punktu

i przedziału ufności

•

metody eksploracji danych, takie jak sieci

neuronowe, drzewa decyzyjne i inne

•

regresję liniową i korelację oraz regresję

wielokrotną

XI EKSPLORACJA DANYCH

Zadania eksploracji danych: klasyfikacja

Algorytm klasyfikacji: algorytm k - najbliższych sąsiadów

• wybieramy nowy obiekt o wejściowym wektorze Y

• analizujemy k najbliższych punktowi Y punktów ze

zbioru

danych treningowych (uczących)

• przydzielamy ten obiekt do klasy, w której jest

większość spośród tych k punktów

XI EKSPLORACJA DANYCH

Zadania eksploracji danych: klasyfikacja

Algorytm klasyfikacji: algorytm k - najbliższych sąsiadów

Algorytm k – najbliższych sąsiadów może być również

stosowany do szacowania i przewidywania.

Uśrednianie lokalnie ważone – metoda szacuje

zmienną celu jako średnią ważoną dla k najbliższych

sąsiadów wg. wzoru:

Σ

i

w

i

y

i

Σ

i

w

i

y

nowy

=

gdzie w

i

= 1/

odległość

2

XI EKSPLORACJA DANYCH

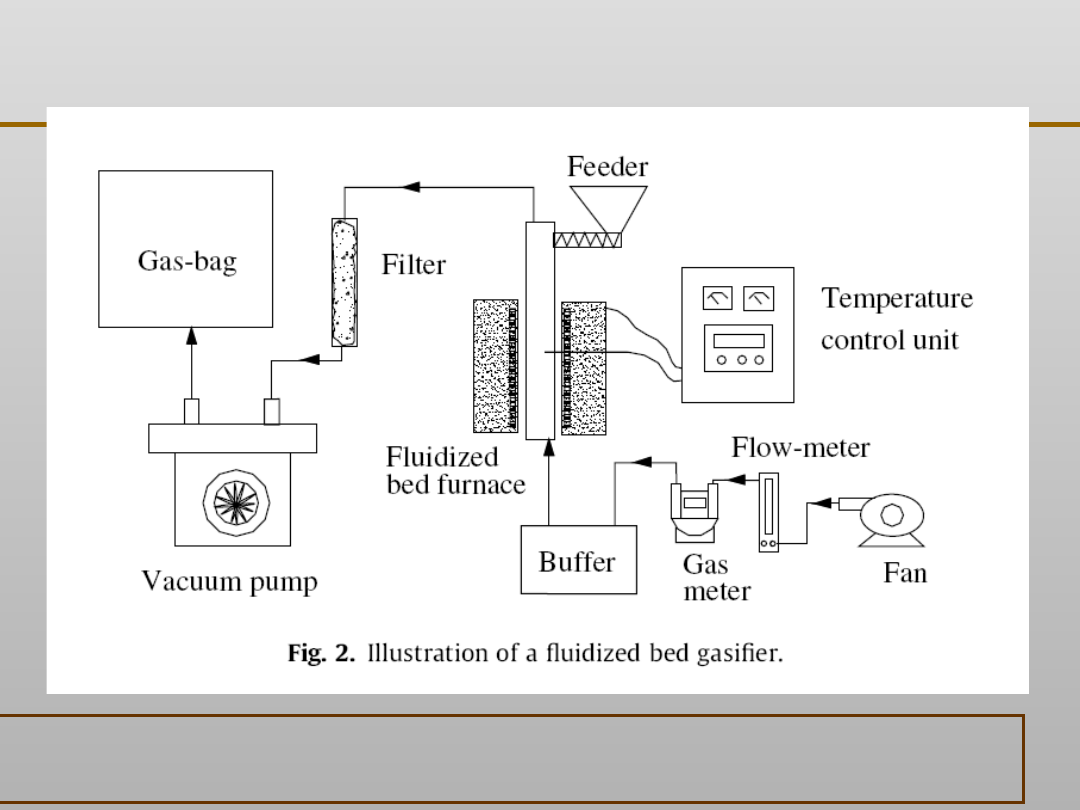

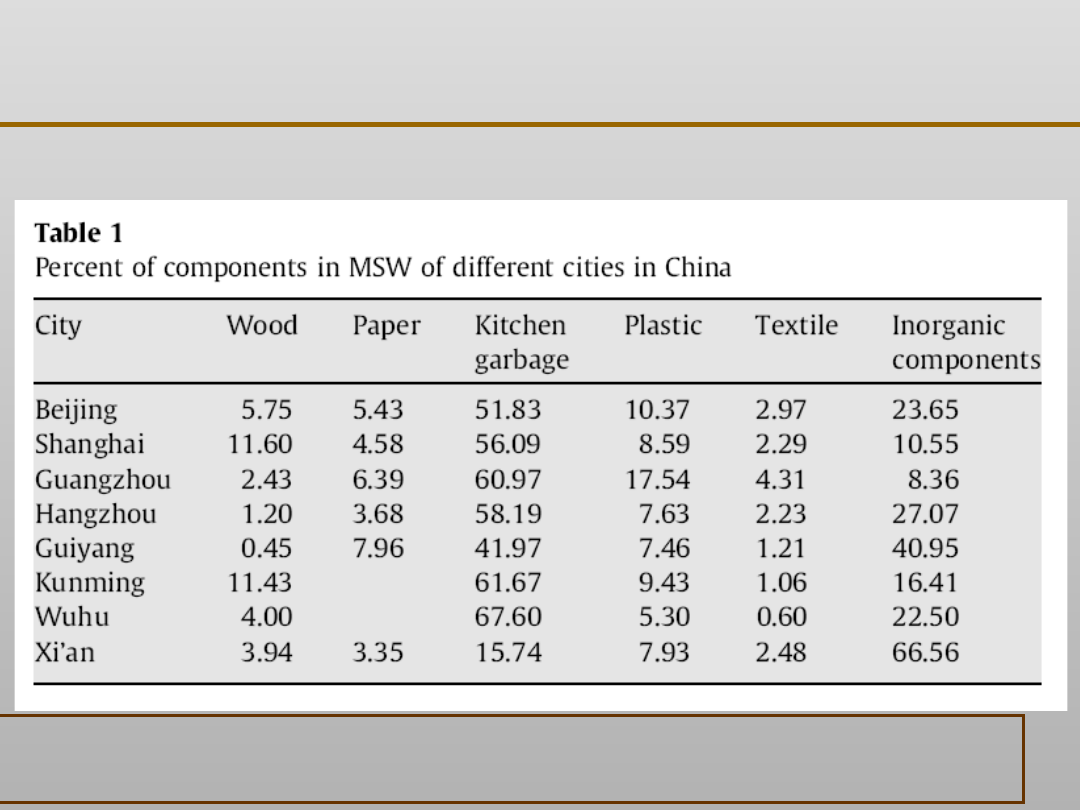

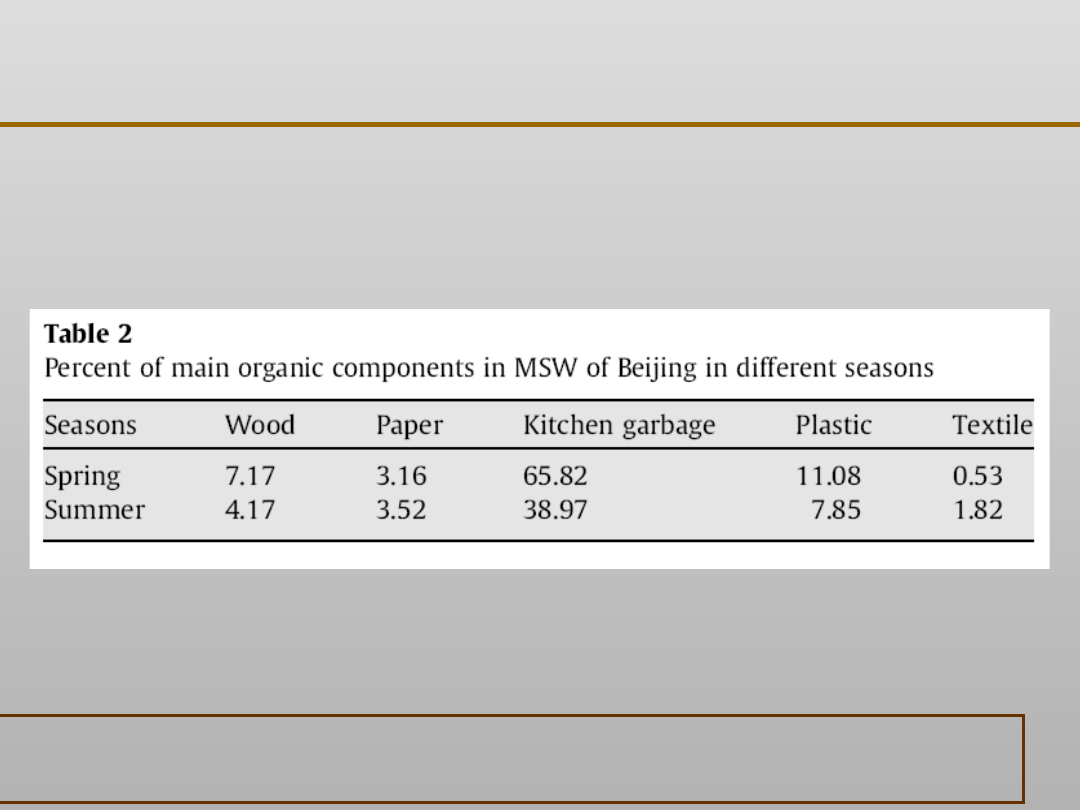

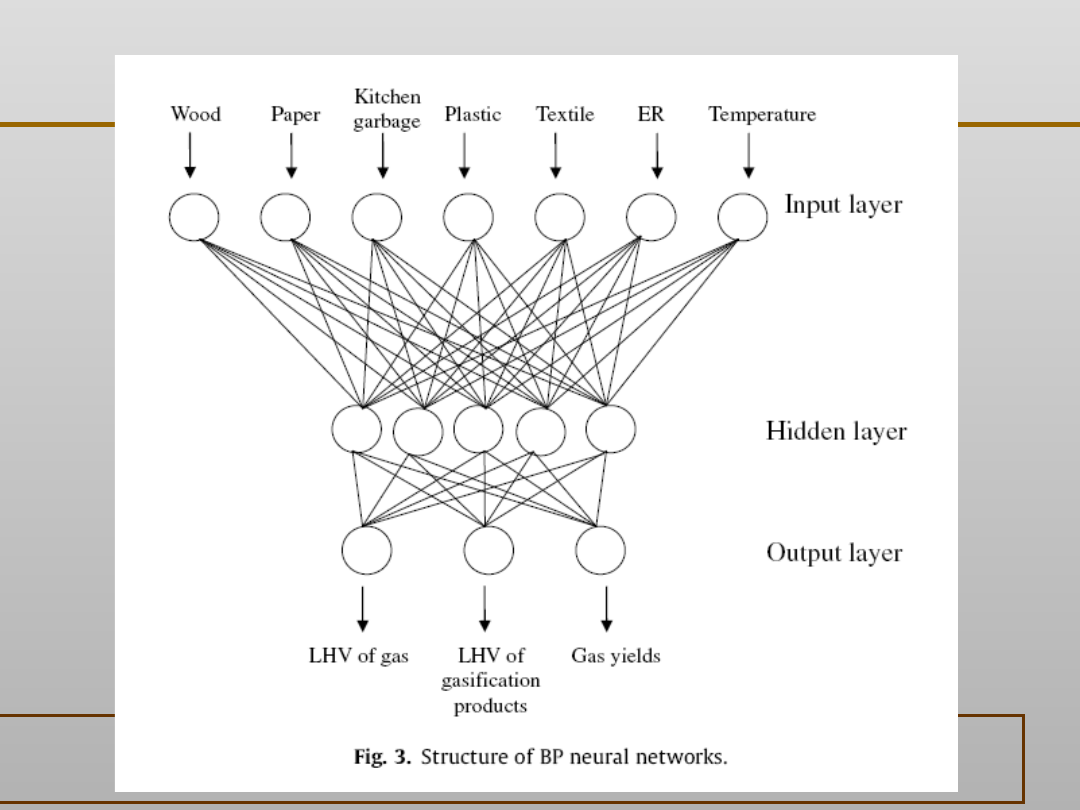

Gasification characteristics of MSW and an ANN prediction model

Gang Xiao, Ming-jiang Ni, Yong Chi, Bao-sheng Jin, Rui Xiao, Zhao-ping Zhong, Ya-ji Huang

Waste Management 29 (2009) 240–244

XI EKSPLORACJA DANYCH

Gasification characteristics of MSW and an ANN prediction model

Gang Xiao, Ming-jiang Ni, Yong Chi, Bao-sheng Jin, Rui Xiao, Zhao-ping Zhong, Ya-ji Huang

Waste Management 29 (2009) 240–244

XI EKSPLORACJA DANYCH

Gasification characteristics of MSW and an ANN prediction model

Gang Xiao, Ming-jiang Ni, Yong Chi, Bao-sheng Jin, Rui Xiao, Zhao-ping Zhong, Ya-ji Huang

Waste Management 29 (2009) 240–244

XI EKSPLORACJA DANYCH

Gasification characteristics of MSW and an ANN prediction model

Gang Xiao, Ming-jiang Ni, Yong Chi, Bao-sheng Jin, Rui Xiao, Zhao-ping Zhong, Ya-ji Huang

Waste Management 29 (2009) 240–244

XI EKSPLORACJA DANYCH

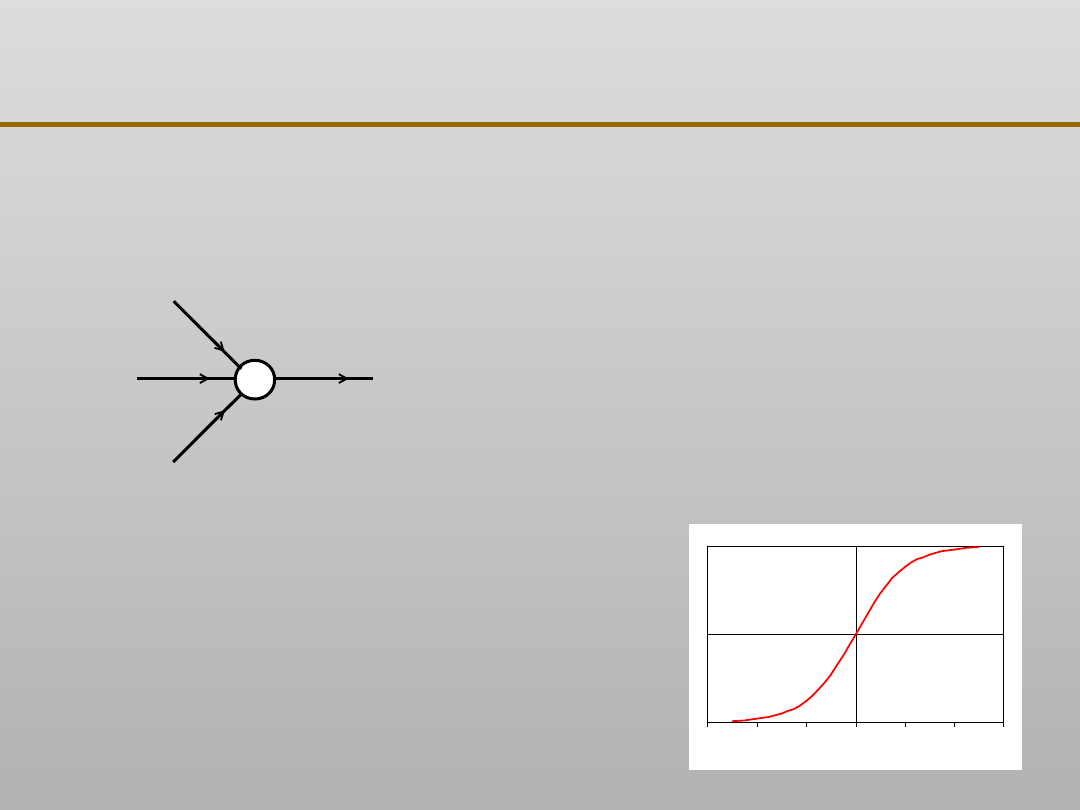

XI EKSPLORACJA DANYCH

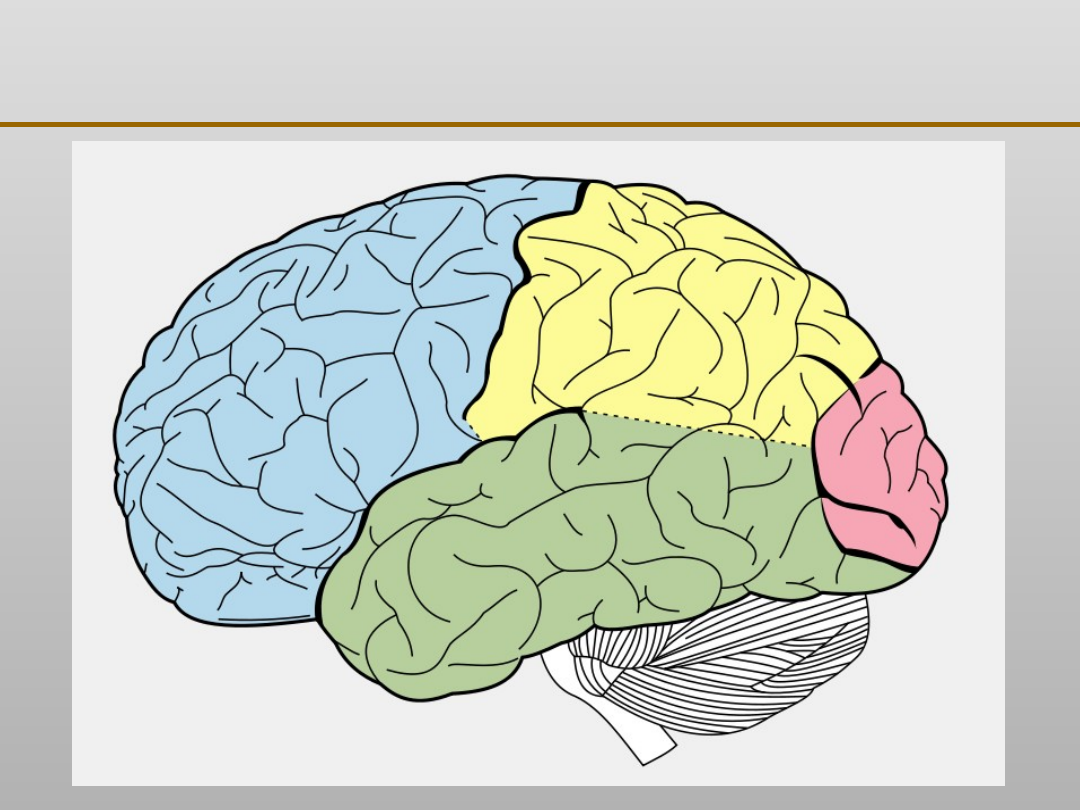

Sztuczna sieć neuronowa jest to złożona zależność

matematyczna, której struktura naśladuje strukturę i

przetwarzanie sygnałów, jakie mają miejsce w korze

mózgowej ssaków, w tym ludzi

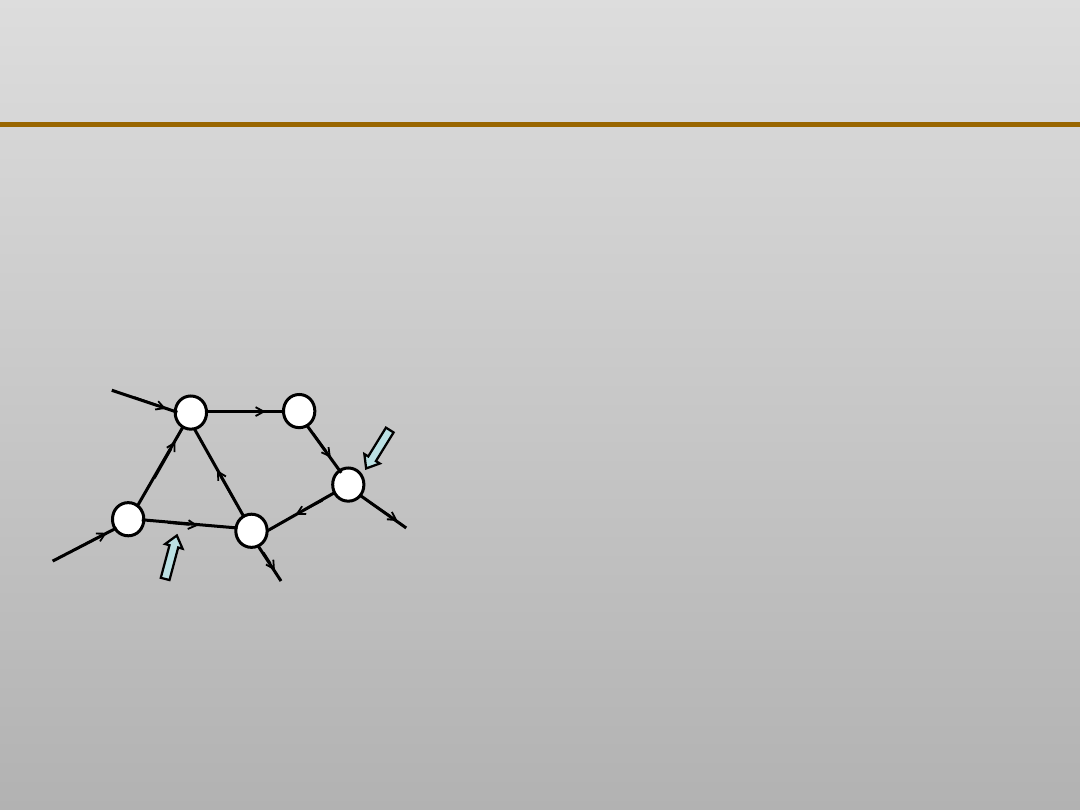

Neuron (węzeł sieci)

Synapsa

(połączenie węzłów,

także wejście i wyjście

sieci)

Synapsy zawierają (przekazują)

wartości zmiennych – sygnały

oraz stałe modelu - wagi

synaps.

Neurony wykonują operacje

(działania) matematyczne na

tych wielkościach.

Sztuczne sieci neuronowe: informacje ogólne

XI EKSPLORACJA DANYCH

Zdolność do uczenia się i uogólniania nabytej wiedzy.

Sztuczne sieci neuronowe pozwalają na znalezienie

prawidłowości w warunkach dużej liczby zmiennych

o różnym charakterze. Prawidłowości takie są

często niewykrywalne przez zmysły naukowców i

inne metody matematyczne.

Sieć jest odporna na błędy w danych (zaszumienia)

oraz błędy pojawiające się w niektórych wagach,

czyli błędnie wyznaczonych niektórych stałych

modelu.

Szybkie przetwarzanie informacji, często możliwe w

czasie rzeczywistym.

Sztuczne sieci neuronowe: informacje ogólne

XI EKSPLORACJA DANYCH

Sieci neuronowe należą do systemów uczących się. Wartości

stałych (wag sieci) wyznaczane są na podstawie wyników

doświadczeń (przykładów uczących) drogą kolejnych poprawek

(korekt) tak, aby wyjścia (odpowiedzi sieci) zbliżały się do

wartości rzeczywistych. Jest to tzw. uczenie nadzorowane (inaczej

z nauczycielem), spotykane najczęściej.

Przykład zależności opisywanej przez sieć:

Y1 = f

1

(X1, X2, X3, ...)

Y2 = f

2

(X1, X2, X3, ...)

Współczynniki tych równań W (wagi synaps) są znajdowane

(korygowane) w procesie uczenia na podstawie różnic

pomiędzy wartościami przewidywanymi przez sieć Y, a

uczącymi Z (znanymi, zaobserwowanymi):

W’ = F {W, (Y – Z)}

X – sygnały wejściowe (zmienne

niezależne),

Y – sygnały wyjściowe (zmienne

zależne)

Sztuczne sieci neuronowe: informacje ogólne

XI EKSPLORACJA DANYCH

Regresja inaczej aproksymacja nieznanej funkcji wielu

zmiennych (najczęściej), na podstawie znanych obserwacji

doświadczalnych

Predykcja, czyli przewidywanie przyszłych zachowań się

systemu na podstawie ciągu wartości z przeszłości z ciągłą

adaptacją wag sieci (rzadziej)

Wykrywanie wzorców, umożliwiające grupowanie

sygnałów wykazujących podobne cechy (sieci typu

Kohonena, stosowane rzadko). Jest to uczenie

nienadzorowane, nie wymagające zbioru uczącego typu:

wejście – zaobserwowane wyjście

Sieci neuronowe mogą realizować kilka rodzajów zadań.

W modelowaniu procesów technologicznych

(produkcyjnych), w tym metalurgicznych i odlewniczych

wykorzystywane są:

Sztuczne sieci neuronowe: informacje ogólne

XI EKSPLORACJA DANYCH

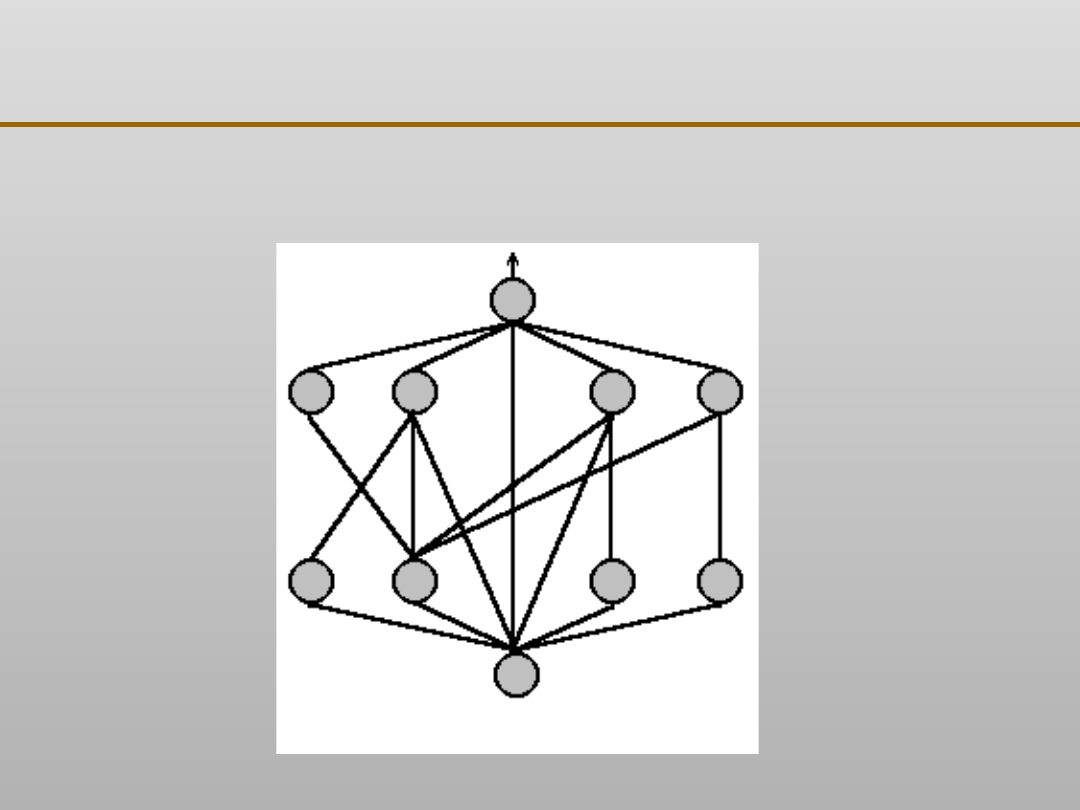

Sieć jednokierunkowa wielowarstwowa, zwana

siecią MLP (od skrótu angielskiego), najczęściej

wykorzystywana w realizacji zadań związanych z

modelowaniem procesów technologicznych.

Sieć rekurencyjna, charakteryzująca się

występowaniem sprzężeń zwrotnych między

elementami wejściowymi a wyjściowymi.

Sieci neuronowe mogą posiadać różne

architektury, czyli typy struktury oraz ich

konkretne realizacje w ramach danego typu. Do

najważniejszych należą:

Sztuczne sieci neuronowe: informacje ogólne

XI EKSPLORACJA DANYCH

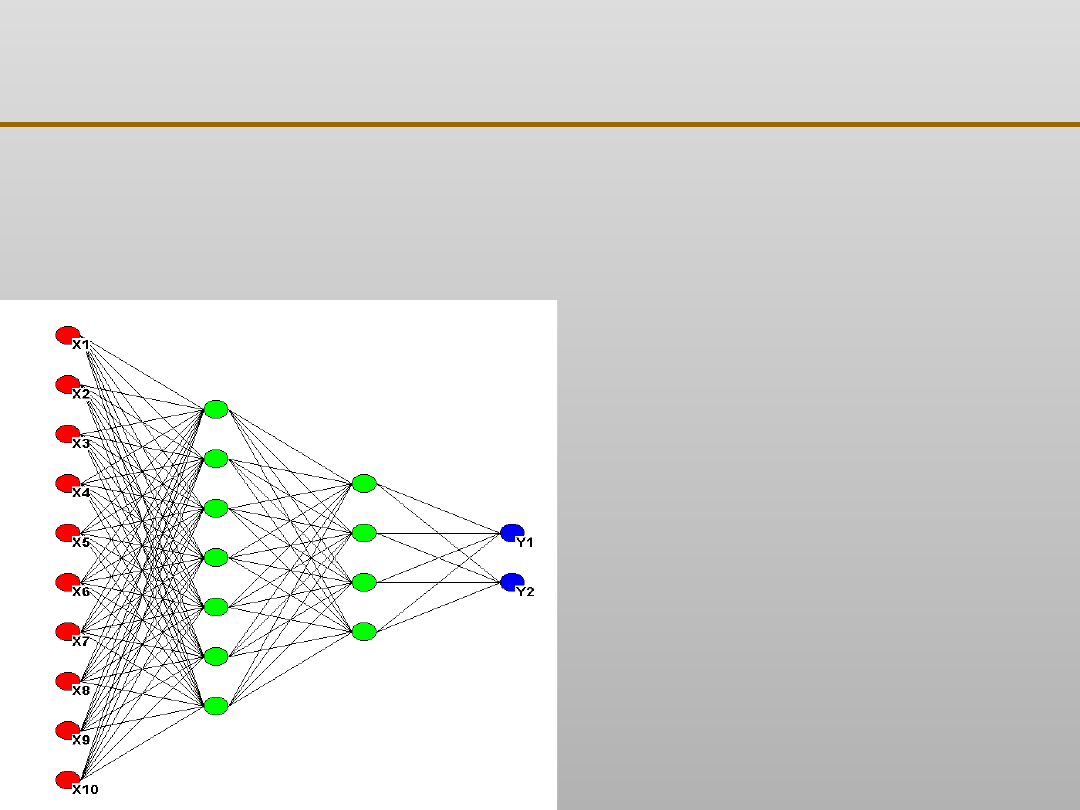

Sztuczne sieci neuronowe: sieć typu MLP

Sieć jednokierunkowa czterowarstwowa

realizująca aproksymację funkcji typu:

Y1 = f

1

(X1, X2, X3, ..., X10)

Y2 = f

2

(X1, X2, X3, ..., X10)

Kolorem

zielonym

oznaczono

warstwy ukryte sieci (w tym

przypadku występują dwie)

Kolorem

niebieskim

oznaczono warstwę

wyjściową

Kolor

czerwony

oznacza

warstwę wejściową, w której

neurony nie wykonują

żadnych operacji

matematycznych

XI EKSPLORACJA DANYCH

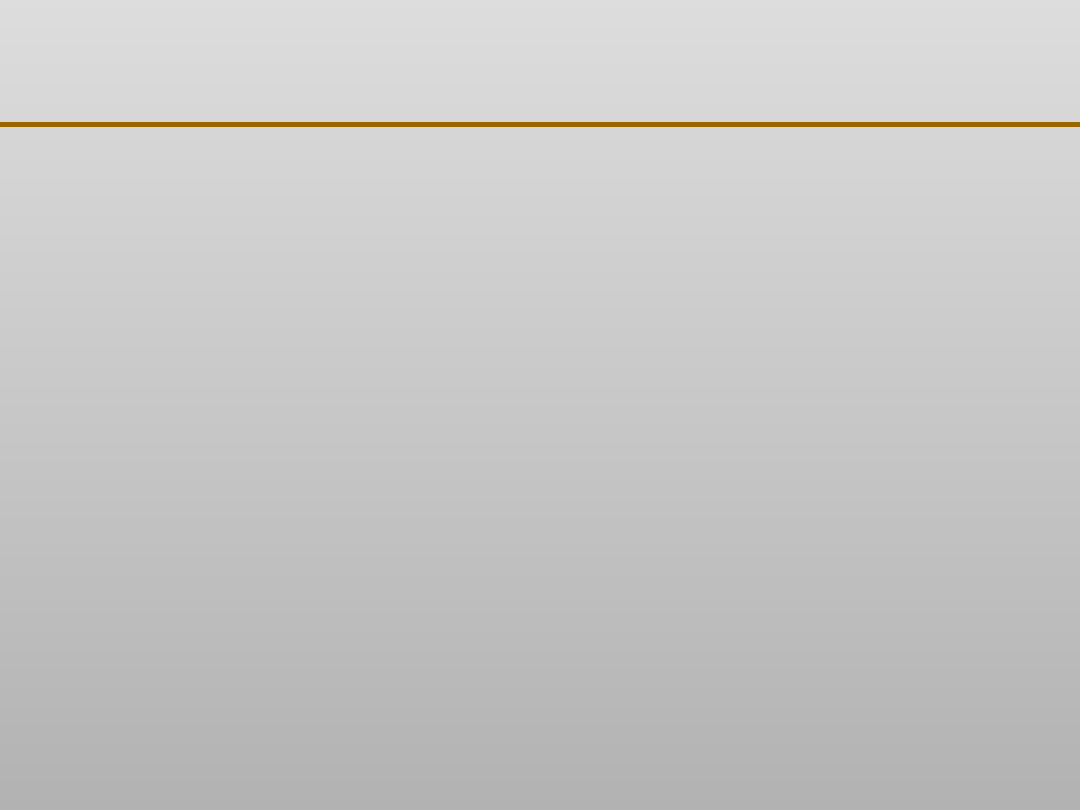

Sztuczne sieci neuronowe: informacje ogólne

x

1

, w

1

x

2

, w

2

x

n

, w

n

y, (w)

Neuron

liniowy:

Neuron

nieliniowy:

0

n

1

i

i

i

w

w

x

y

0

n

1

i

i

i

w

w

x

f

y

f

oznacza tzw. funkcję aktywacji,

najczęściej mającą kształt

sigmoidalny, np. dany wzorem:

1

s

exp

1

s

f

0

0,5

1

-6

-4

-2

0

2

4

6

XI EKSPLORACJA DANYCH

Uczenie sieci polega na rozwiązaniu zagadnienia

optymalizacyjnego funkcji wielu zmiennych (równej liczbie

wszystkich wag synaps plus wyrazów wolnych występujących w

całej sieci).

Dążymy do znalezienia takich wartości wag, aby wartość błędu

średniokwadratowego E wszystkich odpowiedzi sieci, w stosunku

do obserwacji doświadczalnych, była najmniejsza.

p

1

k

m

1

j

2

kj

kj

Y

d

m

1

p

1

E

m - liczba wyjść sieci,

p – liczba prezentacji, czyli rekordów obserwacji

doświadczalnych

d – wartości doświadczalne

Y – wartości otrzymywane z sieci

Uczenie sieci neuronowych: istota problemu

XI EKSPLORACJA DANYCH

Zbiór uczący, podstawowy, wykorzystywany do korygowania

wag sieci

Zbiór weryfikujący (na ogół mniejszy) służący do bieżącego

obliczania błędu dla innych danych w celu sprawdzenia

zdolności sieci do uogólnienia.

Korekty wag sieci przeprowadza się wielokrotnie, dla całego

zbioru uczącego. Jeden cykl: obliczenie błędu – modyfikacja wag

nazywamy epoką.

Koniec uczenia następuje najczęściej wówczas, gdy zaczyna

rosnąć błąd dla danych weryfikujących. Ma to na celu

niedopuszczenie do przeuczenia się sieci, czyli do nadmiernego

dopasowania się do danych uczących bez zdolności do

generalizacji przewidywań dla innych danych.

Uczenie sieci neuronowych: zasady i praktyka

XI EKSPLORACJA DANYCH

Metody gradientowe (stosowane najczęściej)

Losowo ustala się początkowy zbiór wartości wag, a

następnie koryguje się ich wartości tak, aby błąd

sieci stale ulegał zmniejszeniu. Prowadzi to często

do znajdowania minimum lokalnego tego błędu.

Metody poszukujące minimum globalnego błędu

(stosowane rzadko)

Obejmują metodę symulowanego wyżarzania

Znanych jest wiele metod znajdowania minimum

błędu sieci, które można podzielić na dwie grupy:

Sztuczne sieci neuronowe: metody uczenia

XI EKSPLORACJA DANYCH

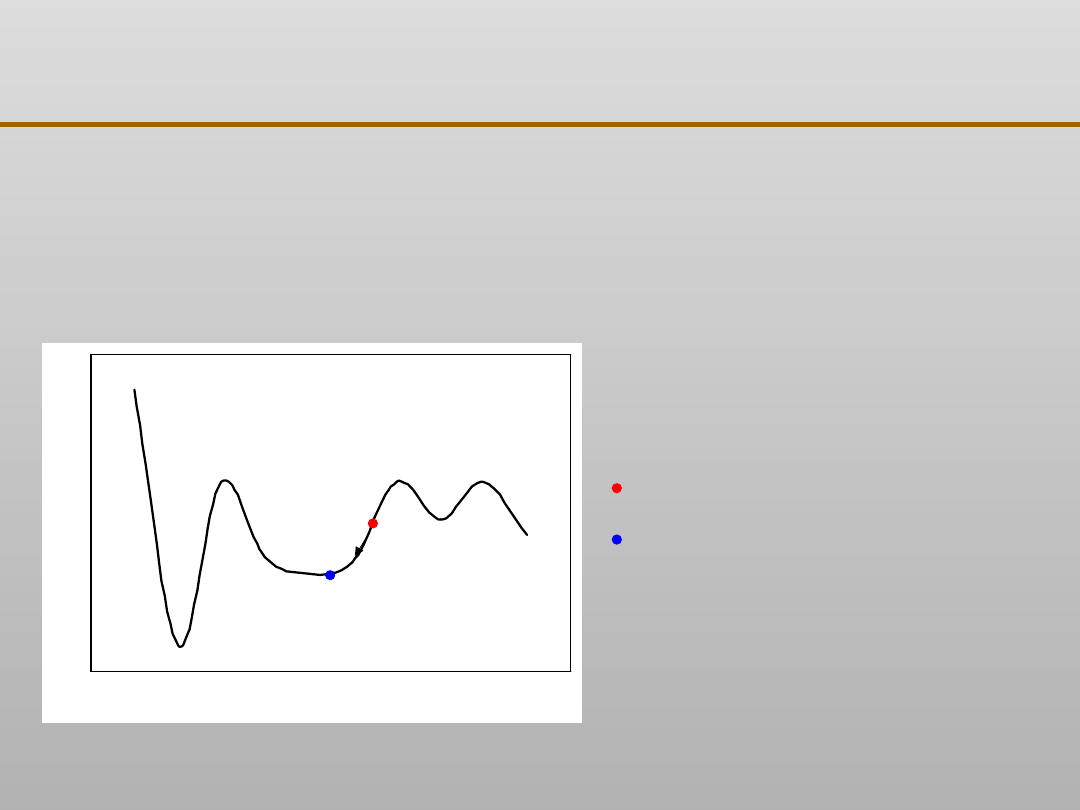

Wartości wag sieci

B

łą

d

si

ec

i

Wylosowany punk

startowy

Osiągnięte najbliższe

minimum błędu

Uczenie nadzorowane sieci: metoda gradientowa

XI EKSPLORACJA DANYCH

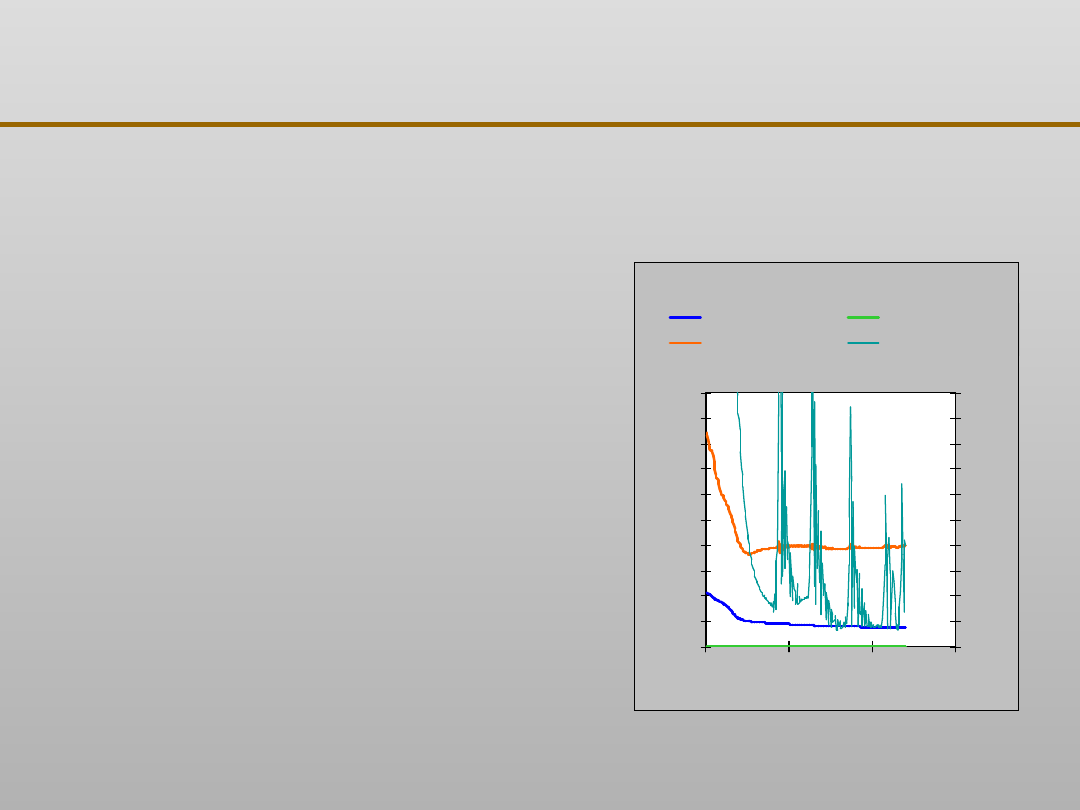

Metoda propagacji wstecznej błędu

0

0,1

0,2

0,3

0,4

0,5

0,6

0,7

0,8

0,9

1

0

100

200

300

Nr epoki

B

łą

d

0

0,1

0,2

0,3

0,4

0,5

0,6

0,7

0,8

0,9

1

M

ax

. g

ra

di

e

n

t b

łę

d

u

Błąd średni

Błąd minimalny

Błąd maksymalny

Max. gradient błędu

Znanych jest wiele metod

gradientowych, z których metodą

klasyczną i najczęściej stosowaną

jest metoda propagacji wstecznej

błędu.

Rysunek przedstawia przykładowy

przebieg korekt błędu sieci w

kolejnych iteracjach. Dla tych

samych danych wylosowanie

innego punktu startowego może

dać zupełnie inny kształt

krzywych.

Uczenie nadzorowane sieci: metoda gradientowa

XI EKSPLORACJA DANYCH

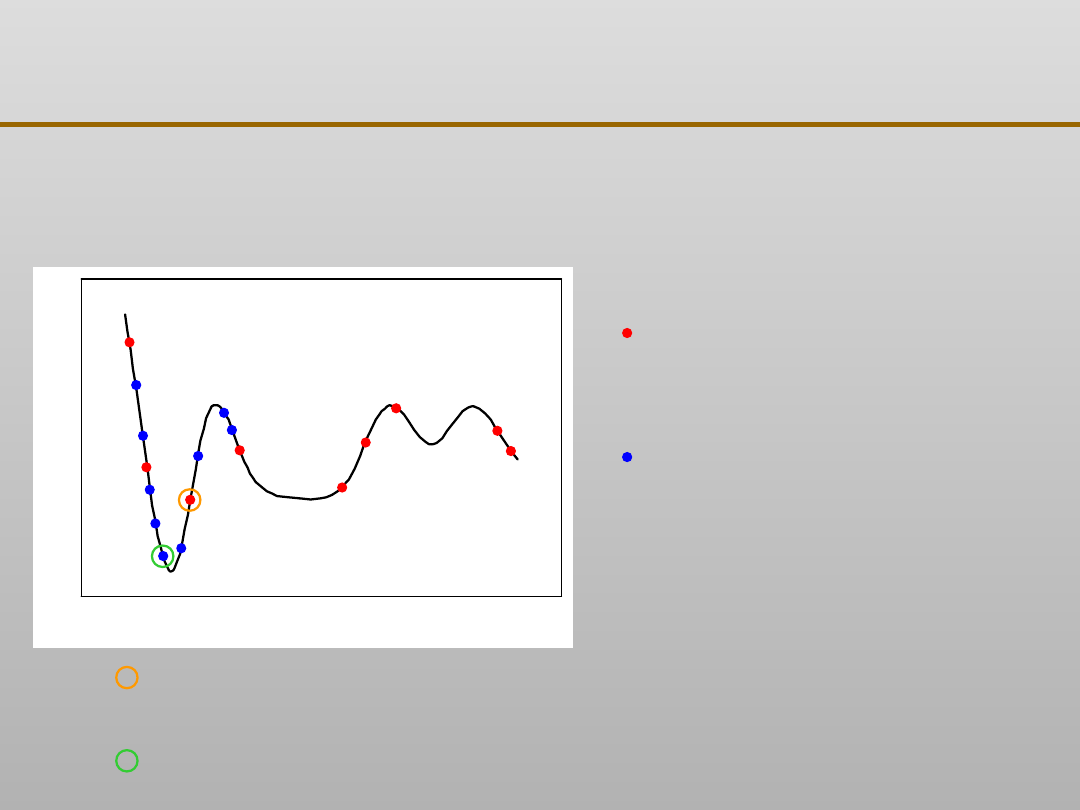

Wartości wag sieci

B

łą

d

si

ec

i

Najlepszy wynik z pierwszych losowań (środek przedziału

następnego losowania)

Najlepszy wynik z następnych losowań

Losowania w pierwszym

(szerszym) zakresie

(wyższa temperatura)

Losowania w następnym

(węższym) zakresie

(niższa temperatura)

Uczenie nadzorowane sieci: metoda symulowanego

wyżarzania

XI EKSPLORACJA DANYCH

Rysunek przedstawia przykładowy

przebieg korekt błędu sieci w

kolejnych losowaniach wartości

wag, dla trzech kolejno

zawężanych zakresów

(temperatur).

Metoda symulowanego wyżarzania

może być stosowana jako

samoistna, albo jako wstępna, dla

ustalenia najlepszego punktu

startowego do metody

gradientowej.

Metoda symulowanego wyżarzania

0

0,1

0,2

0,3

0,4

0,5

0,6

0,7

0,8

0,9

0

200

400

Nr iteracji wstrząsania wag

B

łą

d

ś

re

d

n

io

kw

a

d

ra

to

w

y

0

1

2

3

4

5

6

T

e

m

p

e

ra

tu

ra

Błąd

Temperatura

Nr epoki (losowania

wag)

Uczenie nadzorowane sieci:

metoda symulowanego

wyżarzania

XI EKSPLORACJA DANYCH

Należy wytypować zmienne wejściowe i wyjściowe

modelu, kierując się następującymi zasadami:

Wytypowanie zmiennych wejściowych (niezależnych)

należy poprzedzić analizą istotności ich znaczenia dla

zmiennych wyjściowych (zależnych), z wykorzystaniem np.

metod statystycznych z grupy analizy wariancji. Należy

odrzucić te najmniej znaczące, co ułatwi uczenie sieci i

analizę wyników.

Ustalając liczbę wyjść (równą liczbie wielkości wynikowych

modelu) należy zawsze rozważyć konstruowanie kilku sieci z

pojedynczymi wyjściami, co daje zmniejszenie liczby

poszukiwanych wag.

Dla uzyskania wiarygodnych rezultatów liczebność zbioru

uczącego powinna istotnie przewyższać liczbę

poszukiwanych wag.

Sztuczne sieci neuronowe: wstępna analiza danych

XI EKSPLORACJA DANYCH

Liczba warstw ukrytych najczęściej wynosi 1, rzadziej 2,

bardzo rzadko 3.

Liczba neuronów w warstwie wyjściowej (równa liczbie

wielkości wynikowych modelu) może być dowolna.

Większe liczby neuronów w warstwach ukrytych,

związane z większą liczbą poszukiwanych wag, dają

dokładniejsze, bardziej elastyczne przewidywania

modelu. Wymagają jednak większych zbiorów uczących

lub mogą prowadzić do przeuczenia sieci (nadmiernego

dopasowania do danych) oraz powodują wydłużenie

czasu obliczeń.

Sztuczne sieci neuronowe: zasady budowania MLP

Dobrą praktyką jest wstępne ustalenie liczby neuronów w

poszczególnych warstwach wg zasady postępu geometrycznego

pomiędzy liczbą wejść a wyjść sieci.

XI EKSPLORACJA DANYCH

Różne architektury sieci i poszczególne uczenia

tych samych sieci mogą prowadzić do różnych

wyników. Należy zatem:

– przeprowadzić próby z różnymi wariantami sieci

(liczbami warstw ukrytych – poczynając od jednej

– spróbować stosować różne liczby neuronów w

tych warstwach

– dla każdej konfiguracji wykonać po kilka lub

kilkanaście uczeń.

Sztuczne sieci neuronowe: proces uczenia

W procesie uczenia wykorzystuje się programy

komputerowe, których wiele jest dostępnych

na

zasadzie shareware.

XI EKSPLORACJA DANYCH

Jakość nauczonej sieci można ocenić wyliczając błąd

średniokwadratowy dla zbioru testowego, nie

wykorzystywanego w procesie uczenia, tj.

niezależnego od zbioru uczącego i weryfikującego

(służącego do ustalenia zakończenia procesu

uczenia).

Jeżeli stosowano różne architektury sieci i/lub

wielokrotne uczenie, to w przypadku rozwiązywania

zadań typu regresji:

stosuje się uśrednianie przewidywanych przez sieci

rezultatów, albo

korzysta się z sieci o najmniejszym błędzie

przewidywania.

Sztuczne sieci neuronowe: wykorzystanie i analiza

XI EKSPLORACJA DANYCH

Najprostszym sposobem wykorzystania nauczonej

sieci jest jej odpytywanie, tj. obliczanie wartości

wyjść (odpowiedzi) dla zadanych wejść.

Ważnym rezultatem nauczonej sieci mogą być także

wartości tzw. współczynników istotności wielkości

wejściowych, pozwalające na wykrycie znaczenia

poszczególnych parametrów dla modelowanego

procesu.

Są różne sposoby obliczania współczynników

istotności.

Sztuczne sieci neuronowe: wykorzystanie i analiza

XI EKSPLORACJA DANYCH

Przewidywanie własności wyrobów na podstawie

parametrów procesu technologicznego

Zastąpienie symulacji numerycznej procesów

fizycznych uogólnionymi przez sieć neuronową

wynikami 'eksperymentów numerycznych'

Opis własności materiałów (równania empiryczne)

Projektowanie oparte na doświadczeniach zebranych

w przemyśle, uogólnionych przez sieć neuronową

Przewidywanie awarii urządzeń na podstawie

sygnałów typu obciążenie siłowe, temperatura itp.

Stosowanie sieci jako sterowników w automatyce

Sztuczne sieci neuronowe: ogólne zastosowania

przemysłowe

XI EKSPLORACJA DANYCH

Przewidywanie różnego typu awarii, zwłaszcza przy

odlewaniu ciągłym

Sterowanie procesami wytopu w żeliwiaku i piecu

łukowym

Gospodarka energetyczna w odlewni

Projektowanie odlewów i układów zasilających dla

odlewów

Projektowanie odpowietrzeń w rdzennicach

Sterowanie procesem przerobu masy formierskiej

Przewidywanie własności odlewanych stopów

Dobór parametrów odlewania ciśnieniowego

Sztuczne sieci neuronowe: zastosowanie w

odlewnictwie

XI EKSPLORACJA DANYCH

Porównanie własności i sposobu działania sztucznej sieci neuronowej i komputera von Neumanna

Sieć neuronowa

Komputer von Neumanna

trenowana (uczona prezentowanymi

przykładami) przez zmiany wartości wag

synaps, progów i ilości połączeń między

neuronami

programowany, działa według

napisanych instrukcji wykorzystujących

operacje "jeśli - to"

elementy pamięci i obliczeniowe są tymi

samymi elementami

elementy pamięci i jednostka

obliczeniowa są rozdzielone

obliczenia prowadzone są równolegle

(zarówno dla sygnałów ciągłych jak i

dyskretnych) i asynchronicznie

obliczenia prowadzone są

synchronicznie (taktowane zegarem),

seriami lub w sekwencjach, w postaci

cyfrowej

odporna na pojawiające się uszkodzenia

(lub fałszywe dane) ze względu na dużą

liczbę poprawnych sygnałów

podawanych w czasie uczenia

nie toleruje błędów

samoorganizująca się w trakcie uczenia

zależny od oprogramowania

informacje przechowywane są w

synapsach, a sieć ma zdolność do zmian

(korekty) pod wpływem nowych danych

informacje przechowywane są w

określonych miejscach (adresowanych

komórkach pamięci) i można je tylko

zastąpić nowymi danymi

przetwarzanie jest anarchiczne

przetwarzanie jest autokratyczne

czas jednego cyklu, od którego zależy

prędkości przetwarzania, jest rzędu 10

-3

czas jednego cyklu, odpowiadający

jednemu krokowi w programie

przetworzonemu przez jednostkę

centralną, jest rzędu 10

-9

XI EKSPLORACJA DANYCH

W jednej z odlewni polskich zebrano wyniki blisko 800 wytopów,

dla których określano zawartość 9 pierwiastków w kąpieli

metalowej oraz mierzono wytrzymałość na rozciąganie, twardość

Brinella i wydłużenie otrzymanego żeliwa.

Sieć neuronową typu MLP uczono wielokrotnie kombinowaną

metodą symulowanego wyżarzania (dla ustalenia startowych

wartości wag) oraz propagacji wstecznej błędu.

Wykonano następujące porównania z innymi modelami:

Przewidywania sieci z przewidywaniami modelu typu

wielomianu, zastosowanego w jednej z odlewni w

Finlandii.

Jakość dopasowania do danych uczących i weryfikujących

dla sieci i dla naiwnego klasyfikatora Bayesa

Sztuczne sieci neuronowe: prognozowanie

własności

żeliwa

XI EKSPLORACJA DANYCH

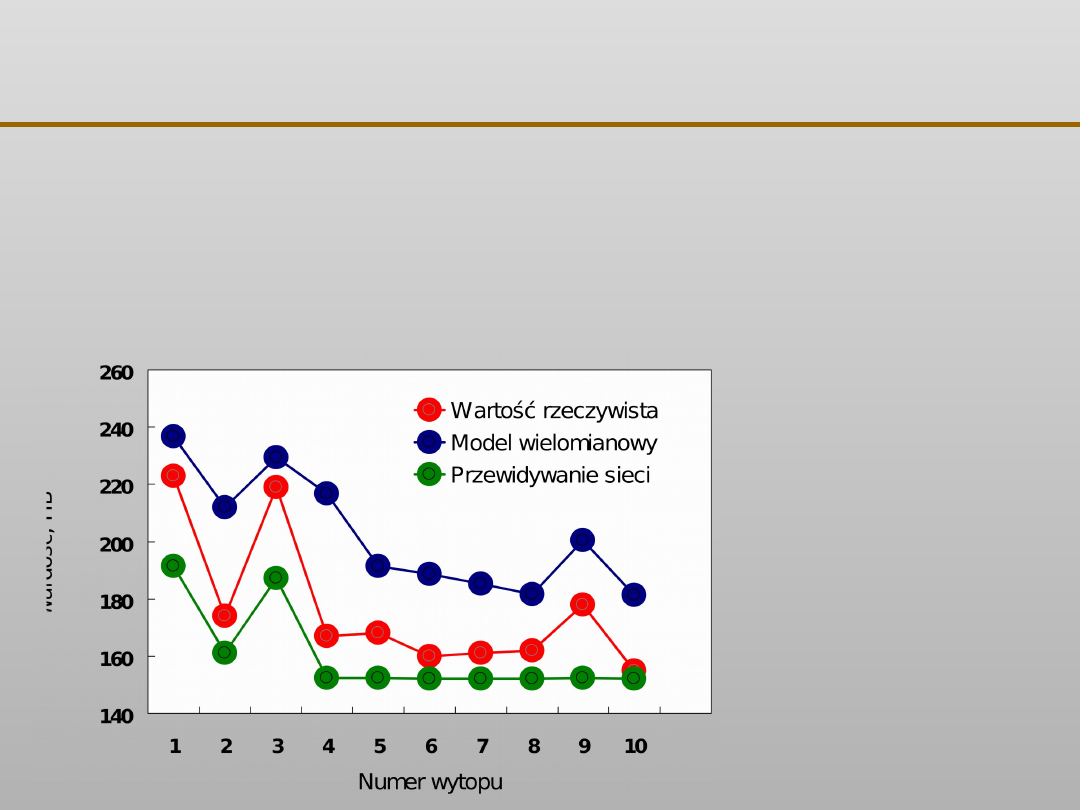

Porównanie prognozowania twardości żeliwa na podstawie

jego składu chemicznego metodą wielomianową,

zastosowaną w odlewni fińskiej, z uzyskanym z odpytywania

sieci neuronowej

Żeliwo

otrzymane w

jednej z odlewni

fińskich.

Sieć neuronowa

nauczona na

podstawie

wyników

zebranych w

jednej z odlewni

polskich.

Prognozowanie własności żeliwa: cd

XI EKSPLORACJA DANYCH

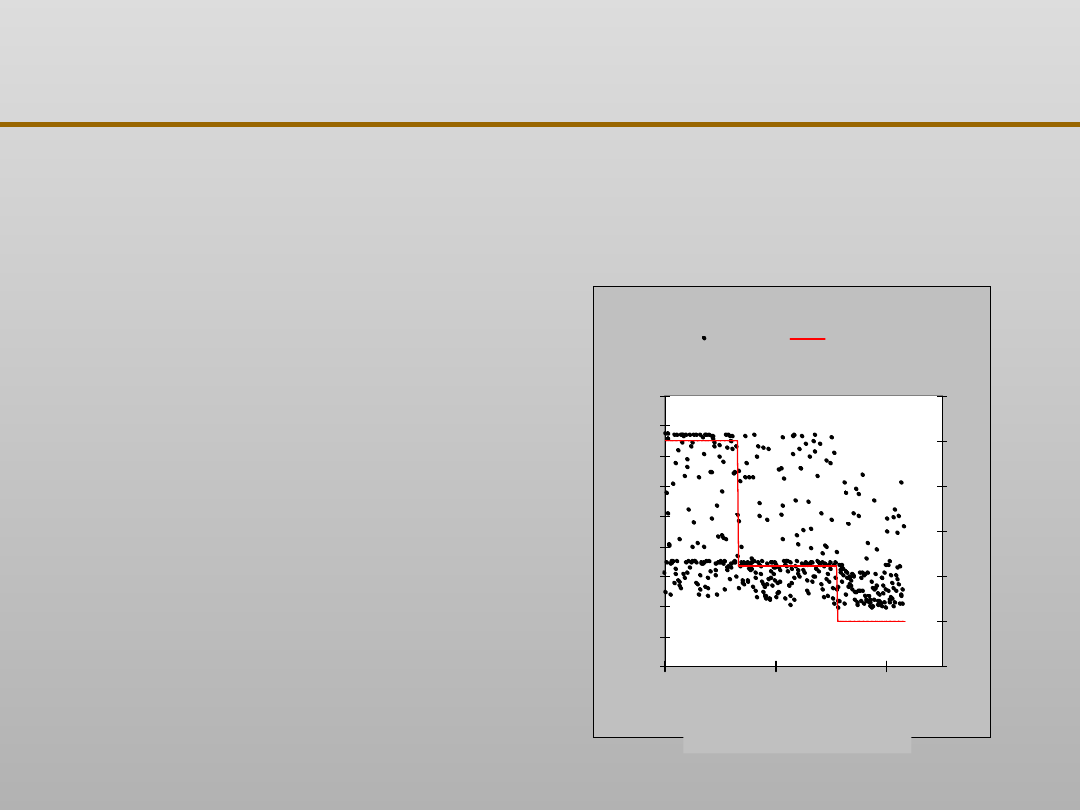

0

0,2

0,4

0,6

0

d

o

5

5

d

o

1

0

1

0

d

o

1

5

1

5

d

o

2

0

>

2

0

Błędy względne, %

U

d

zi

a

ł w

yn

ik

ó

w

z

d

a

n

ym

b

łę

d

e

m

.

NKB, dane uczące

NKB, dane weryfikujące

SSN, dane uczące

SSN, dane weryfikujące

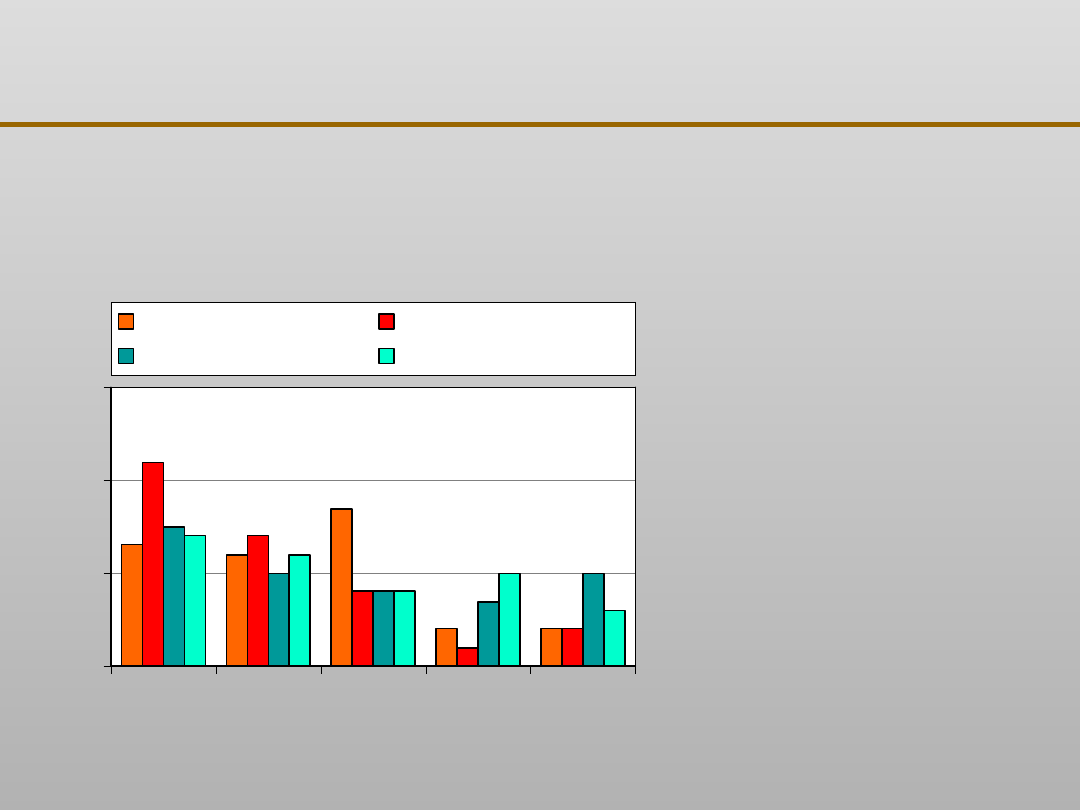

Porównanie błędów

średniokwadratowych

wytrzymałości żeliwa

dla odpowiedzi sieci i

klasyfikatora Bayesa.

Otrzymane rozkłady są

typowe dla

zaszumionych danych

przemysłowych

Oznaczenia:

NKB – naiwny

klasyfikator Bayesa,

SSN – sieć neuronowa

Prognozowanie własności żeliwa: cd

XI EKSPLORACJA DANYCH

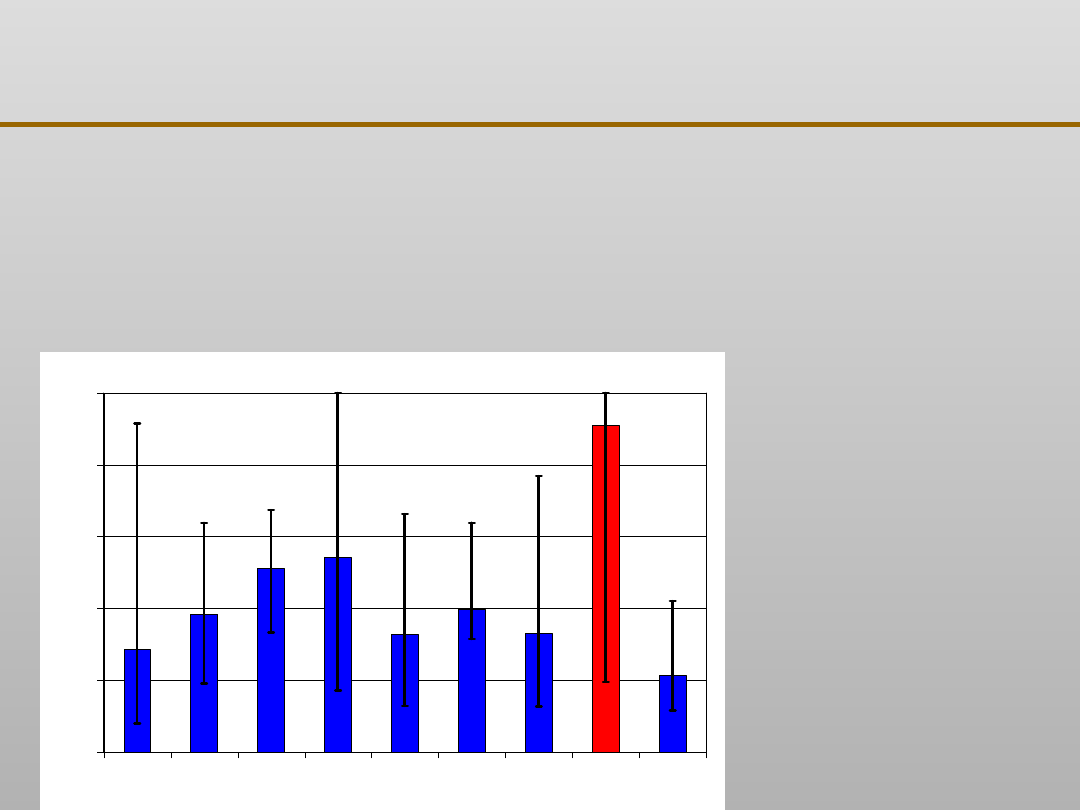

0

0,2

0,4

0,6

0,8

1

C

Mn

Si

P

S

Cr

Ni

Cu

Mg

Istotności względne pierwiastków z punktu widzenia

wytrzymałości żeliwa sferoidalnego, otrzymane z nauczonej sieci

neuronowej. Decydujące znaczenie miedzi jest zgodne z wiedzą

metalurgiczną.

Wysokości słupków

odpowiadają

wartościom

uśrednionym z 10

uczeń tej samej sieci,

zaś czarne linie

oznaczają rozstępy w

tej próbie.

Prognozowanie własności żeliwa: cd

XI EKSPLORACJA DANYCH

XI EKSPLORACJA DANYCH

XI EKSPLORACJA DANYCH

Gasification characteristics of MSW and an ANN prediction model

Gang Xiao, Ming-jiang Ni, Yong Chi, Bao-sheng Jin, Rui Xiao, Zhao-ping Zhong, Ya-ji Huang

Waste Management 29 (2009) 240–244

Document Outline

- Slide 1

- Slide 2

- Slide 3

- Slide 4

- Slide 5

- Slide 6

- Slide 7

- Slide 8

- Slide 9

- Slide 10

- Slide 11

- Slide 12

- Slide 13

- Slide 14

- Slide 15

- Slide 16

- Slide 17

- Slide 18

- Slide 19

- Slide 20

- Slide 21

- Slide 22

- Slide 23

- Slide 24

- Slide 25

- Slide 26

- Slide 27

- Slide 28

- Slide 29

- Slide 30

- Slide 31

- Slide 32

- Slide 33

- Slide 34

- Slide 35

- Slide 36

- Slide 37

- Slide 38

- Slide 39

Wyszukiwarka

Podobne podstrony:

EKSPLORACJA DANYCH 9

EKSPLORACJA DANYCH zagadnienia

EKSPLORACJA DANYCH, zagadnienia

EKSPLORACJA DANYCH 10

D Hand, H Mannila, P Smyth Eksploracja danych

Bazy danych 11

Modul 9(Eksploracja danych)

instrukcja bhp przy eksploatacj Nieznany (11)

EKSPLORACJA DANYCH 12

Istota i struktury hurtowni danych Zasady eksploracji danych

EKSPLORACJA DANYCH 7

EKSPLORACJA DANYCH 8

EKSPLORACJA DANYCH 9

Microsoft SQL Server Modelowanie i eksploracja danych sqlsme

Microsoft SQL Server Modelowanie i eksploracja danych

informatyka microsoft sql server modelowanie i eksploracja danych danuta mendrala ebook

Serwer SQL 2008 Uslugi biznesowe Analiza i eksploracja danych ss28ub

więcej podobnych podstron