Rachunek prawdopodobieństwa i statystyka matematyczna

1. Definicja prawdopodobieństwa (aksjomatyczna).

2. Własności dystrybuanty.

3. Sprawdzić, czy funkcja

)

2

1

)

(

(

1

)

(

x

arctg

x

F

może być dystrybuantą rozkładu

prawdopodobieństwa.

4. Definicja prawdopodobieństwa warunkowego.

5. Udowodnić, że

0

)

(

P

.

6. Udowodnić, że

)

(

1

)

(

A

P

A

P

7. Udowodnić, że dla dowolnych dwóch zdarzeń

)

(

)

(

)

(

)

(

B

A

P

B

P

A

P

B

A

P

.

8. Udowodnić, że: jeśli

,

B

A

to

)

(

)

(

B

P

A

P

.

9. Sformułować i udowodnić twierdzenie o prawdopodobieństwie zupełnym.

10. Sformułować i udowodnić twierdzenie Bayesa.

11. Definicja zmiennej losowej .

12. Udowodnić, że

)

(

)

(

)

(

a

X

P

b

X

P

b

X

a

P

.

13. Rozkład Bernoulliego

14. Rozkład Poissona

15. Rozkład normalny

16.Napisać funkcję gęstości zmiennej losowej o rozkładzie normalnym z wartością oczekiwaną 5 i

odchyleniem standardowym 7.

17. Podać wartość oczekiwaną, wariancję, wartość modalną i medianę zmiennej losowej, której

funkcja gęstości wyraża się wzorem

8

2

5

2

2

1

)

x

(

e

)

x

(

f

18. Parametry zmiennych losowych (średnia, wariancja, odchylenie standardowe, mediana i

wartość modalna).

19. Udowodnić, że jeśli zmienna losowa X ma wartość oczekiwaną m i odchylenie standardowe

, to

zmienna losowa

m

X

Y

ma wartość oczekiwaną zero i odchylenie standardowe 1.

20. Udowodnić, że jeśli zmienna losowa X ma wartość oczekiwaną 7 i odchylenie standardowe 2, to

zmienna losowa

2

7

X

Y

ma wartość oczekiwaną zero i odchylenie standardowe 1.

21. Twierdzenie Poissona (dowód)

22. Zmienne losowe typu skokowego. Rozkład zmiennej losowej typu skokowego.

23. Zmienne losowe typu ciągłego. Rozkład zmiennej losowej typu ciągłego.

24. Twierdzenie Linderberga-Levy’ego

25. Określenie populacji i próby

26. Definicja i własności estymatorów punktowych.

27. Wyprowadzić wzór na estymator wartości oczekiwanej.

28. Udowodnić, że średnia arytmetyczna jest nieobciążonym estymatorem wartości oczekiwanej.

29. Udowodnić, że

n

)

x

(

D

2

2

30. Wyprowadzić wzór na przedział ufności dla wartości oczekiwanej na podstawie próby z populacji o

rozkładzie normalnym ze znanym odchyleniem standardowym.

1. Definicja prawdopodobieństwa (aksjomatyczna)

Prawdopodobieństwem nazywamy funkcję, która każdemu zdarzeniu A ⊂ Ω przyporządkowuje liczbę

P(A) tak, aby spełnione były warunki:

1. P(A) ≥ 0 dla każdego A∈K

2. P(Ω) = 1

3. Jeśli A ∩ B = ϕ, to P(A∪B) = P(A) + P(B)

zdarzenie elementarne - najprostszy wynik doświadczenia losowego, tzn. zdarzenie losowe, którego nie

da się rozłożyć na zdarzenia prostsze.

Ω - zbiór zdarzeń elementarnych

K – zbiór zdarzeń: σ- ciało na zbiorze Ω

σ- ciało - Przestrzeń mierzalna – zbiór z określoną rodziną jego do której należy zbiór

pusty oraz dopełnienia wszystkich jej elementów, a ponadto należy do niej suma dowolnej przeliczalnej

rodziny jej elementów.

2. Własności dystrybuanty

Dystrybuantą nazywany funkcję F która spełnia 3 warunki:

1. F jest funkcją niemalejącą

2. lim

x→−∞

F(x) = 0 lim

x→∞

F(x) = 1

3. F jest funkcją lewostronnie ciągłą (granica funkcji w punkcie = punktowi: lim

x→x

0

F(x) = F(x

0

) )

Dystrybuanta – w rachunku prawdopodobieństwa, statystyce i dziedzinach pokrewnych, funkcja

rzeczywista jednoznacznie wyznaczająca rozkład prawdopodobieństwa.

3. Sprawdzić, czy funkcja

)

2

1

)

(

(

1

)

(

x

arctg

x

F

może być dystrybuantą rozkładu

prawdopodobieństwa.

)

2

1

)

(

(

1

)

(

x

arctg

x

F

1

:

F’(x) =

1

π

∗

1

1+x

2

- dla każdego xϵR F’(x)>0, więc funkcja jest rosnąca.

2: lim

x→−∞

)

2

1

)

(

(

1

x

arctg

=

1

π

(−

π

2

+

π

2

) = 𝟎

(przy tym pytaniu trzeba wiedzieć skąd się wzięło

π

/2 i –

π

/2 w limesie)

lim

x→∞

)

2

1

)

(

(

1

x

arctg

=

1

π

(

π

2

+

π

2

) = 𝟏

3: z analizy funkcja arctg jest ciągła, więc jest też lewostronnie ciągła

4. Definicja prawdopodobieństwa warunkowego.

Jeśli P(B)>0, to P(A/B) =

P(A∩B)

P(B)

1. P(A ∩ B) ≥ 0, P(B) > 0 → P(A B

⁄ ) ≥ 0

2. P(Ω B

⁄ ) =

P(Ω∩B)

P(B)

=

P(B)

P(B)

= 1

3. A

1

,A

2

,… A

i

∩A

j

= ∅

i ≠ j

P((A

1

, A

2

, … ) B

⁄ ) =

P((A

1

∪ A

2

∪ … ) ∩ B)

P(B)

=

P(A

1

∩ B) ∪ P(A

2

∩ B) ∪ …

P(B)

=

P(A

1

∩ B)

P(B)

+

P(A

2

∩ B)

P(B)

+ ⋯ = P(A

1

B

⁄ ) + P(A

2

B

⁄ ) + ⋯

Jeżeli P(A/B) = P(A) to o zdarzeniach A i B mówimy, że są niezależne.

5. Udowodnić, że P(ϕ) = 0.

P(ϕ) = 0

ϕ = ϕ ∪ ϕ ∪ ϕ ∪ ϕ ∪ ϕ ∪ …

P(ϕ) = P(ϕ ∪ ϕ ∪ … ) , ponieważ zdarzenia niemożliwe ϕ są rozłączne (wzajemnie się wykluczają):

P(ϕ) = P(ϕ) + P(ϕ) + P(ϕ) + ⋯

P(ϕ) = 0

6.Udowodnić, że

)

(

1

)

(

A

P

A

P

)

(

1

)

(

A

P

A

P

A ∪ A

̅ = Ω

P(A ∪ A

̅ ) = Ω A ∩ A̅ = ∅

P(A

̅ ) + P(A) = 1

)

(

1

)

(

A

P

A

P

c.n.d.

7.Udowodnić, że dla dowolnych dwóch zdarzeń

)

(

)

(

)

(

)

(

B

A

P

B

P

A

P

B

A

P

P(A ∪ B) = P(A) + P(B) − P(A ∩ B)

A ∪ B = B ∪ (A − B) = B ∪ (A ∩ B

′

)

A = (A ∩ B) ∪ (A − B) = (A ∩ B) ∪ (A ∩ B

′

)

P(A ∪ B) = P(B ∪ (A ∩ B

′

))

P(A) = P((A ∩ B) ∪ (A ∩ B

′

))

B i A∩B’ oraz (A ∩ B) i (A ∩ B

′

) wzajemnie się wykluczają, więc:

P(A ∪ B) = P(B) + P(A ∩ B

′

)

P(A) = P(A ∩ B) + P(A ∩ B

′

)

P(A ∩ B

′

) = P(A) − P(A ∩ B)

P(A ∪ B) = P(A) + P(B) − P(A ∩ B) c.n.d.

8.Udowodnić, że: jeśli

,

B

A

to

)

(

)

(

B

P

A

P

Tw.

B

A

→

)

(

)

(

B

P

A

P

B = A ∪ (B − A) = A ∪ (B ∪ A

′

)

P(B) = P(A ∪ (B ∩ A

′

)) = P(A) + P(B ∩ A

′

) ≥ P(A) c.n.d.

9.Sformułować i udowodnić twierdzenie o prawdopodobieństwie zupełnym

Tw. Jeśli zdarzenia A

1

, A

2

,… tworzą układ zupełny zdarzeń, oraz P(Ai)>0 (i=1,2,3…),

to dla dowolnego zdarzenia B zachodzi równość:

P(B) = P(A

1

)P(B A

1

⁄ ) + P(A

2

)P(B A

2

⁄ ) + ⋯

Wyjaśnienie – tworzą układ zupełny zdarzeń, tzn.

A

1

∪ A

2

∪ A

3

∪ … = Ω A

i

∩ A

j

= ∅ dla i ≠ j

Dowód:

A

1

, A

2,

A

3

– układ zupełny zdarzeń, P(Ai)>0

P(B) = P(B ∩ Ω) = P(B) ∩ (A

1

∪ A

2

∪ A

3

∪ … ) = P((B ∩ A

1

) ∪ (B ∩ A

2

) ∪ (B ∩ A

3

))

= P(B ∩ A

1

) + P(B ∩ A

2

) + ⋯ = P(A

1

)P(B A

1

⁄ ) + P(A

1

)P(B A

1

⁄ ) + ⋯

Ostatnie przejście na mocy definicji prawdopodobieństwa warunkowego:

P(A/B) =

P(A∩B)

P(B)

, więc P(A ∩ B) = P(B)P(A B

⁄ )

10. Sformułować i udowodnić twierdzenie Bayesa

Jeśli zdarzenia A

1

, A

2

, A

3

… tworzą układ zupełny zdarzeń (A

1

∪ A

2

∪ A

3

∪ … = Ω ; A

i

∩ A

j

= ∅ dla i ≠ j)

oraz P(A

i

)>0 (i=1,2,3…), i mamy zdarzenie B, takie że P(B)>0, to dla każdego zdarzenia A

j

(j=1,2,3…)

zachodzi równość zwana wzorem Bayesa:

P(A

j

B

⁄ ) =

P(A

j

)P(B A

j

⁄ )

P(B)

Dowód:

P(B ∩ A

j

) = P(A

j

) P(B /A

j

) z tw. o prawdopodobieństwie warunkowym

P(B ∩ A

j

) = P(B) P(A

j

/ B)

P(A

j

) P(B /A

j

) = P(B) P(A

j

/ B)

P(A

j

/ B) =

P(A

j

)P(B A

j

⁄ )

P(B)

c.n.d.

11.Definicja zmiennej losowej

Niech (Ω, K, P) będzie przestrzenia probabilistyczną.

Zmienną losową nazywamy każda funkcje

ξ

określoną na przestrzeni zdarzeń elementarnych, przyjmująca

wartości rzeczywiste, taka, ze dla każdej liczby rzeczywistej x zbiór zdarzeń elementarnych ω

spełniających warunek ξ (ω) < x jest zdarzeniem losowym, tzn. należy do rodziny K.

Tzn.

ξ: Ω → ℝ

nazywamy zmienną losowa, jeżeli:

⋀{ω ∈ Ω: ξ(ω) < x} ∈ K

x∈R

K – zbiór zdarzeń: σ- ciało na zbiorze Ω

σ- ciało - Przestrzeń mierzalna – zbiór z określoną rodziną jego do której należy zbiór

pusty oraz dopełnienia wszystkich jej elementów, a ponadto należy do niej suma dowolnej przeliczalnej

rodziny jej elementów.

12.Udowodnić, że

)

(

)

(

)

(

a

X

P

b

X

P

b

X

a

P

Przyjmijmy, że A: X<a B: a ≤ X < b C: X<b

(A∪B) = C

P(A∪B) = P(C)

A∩B = ∅, więc P(A) + P(B) = P(C)

P(B) = P(C) - P(A) c.n.d.

13.Rozkład Bernoulliego

Rozkład Bernoulliego (dwumianowy) to dyskretny (ze zbioru przeliczalnego) rozkład prawdopodobieństwa

opisujący liczbę sukcesów k w ciągu n niezależnych prób, z których każda ma stałe prawdopodobieństwo

sukcesu równe p. Pojedynczy eksperyment nosi nazwę próby Bernoulliego.

ξ

k=0,1,2,3,…,n

Jeżeli:

P(ξ = k) = (

n

k

) p

k

(1 − p)

n−k

To mówimy, że zmienna losowa ξ ma rozkład Bernoulliego.

m=n*p σ

2

=np-(1-p)

14.Rozkład Poissona

Rozkład Poissona jest dyskretnym rozkładem prawdopodobieństwa, wyrażającym prawdopodobieństwo

szeregu wydarzeń mających miejsce w określonym czasie, gdy te wydarzenia występują ze znaną średnią

częstotliwością i w sposób niezależny od czasu jaki upłynął od ostatniego zajścia takiego zdarzenia.

Zmienna losowa ma rozkład Poissona jeśli zmienna ξ przyjmuje wartości k=0,1,2,3,... i ich

prawdopodobieństwo wynosi

P(ξ = k) =

λ

k

k!

e

−λ

m=

λ

λ ≡ const. > 0; λ – oczekiwana liczba zdarzeń w danym przedziale czasu;

15.Rozkład normalny

O zmiennej losowej ciągłej powiemy, że posiada rozkład normalny, jeżeli funkcja gęstości f(x) tego

rozkładu ma postać:

f(x) =

1

σ√2π

e

−(x−m)

2

2σ

2

Fakt, że zmienna losowa ξ ma rozkład normalny z wartością oczekiwaną m i wariancją σ

2

zapisuje się

często ξ ~ N(m, σ).

Jeśli m = 0 i σ = 1, to rozkład ten nazywa się standardowym rozkładem normalnym.

Dystrybuanta:

F(x) =

1

σ√2π

∫ e

−(x−m)

2

2σ

2

x

−∞

16.Napisać funkcję gęstości zmiennej losowej o rozkładzie normalnym z wartością oczekiwaną 5 i

odchyleniem standardowym 7

N(5,7) -> m=5, σ = 7

f(x) =

1

σ√2π

e

−(x−m)

2

2σ

2

f(x) =

1

7√2π

e

−(x−5)2

2∗72

=

1

7√2π

e

−(x−5)2

98

17.Podać wartość oczekiwaną, wariancję, wartość modalną i medianę zmiennej losowej, której funkcja

gęstości wyraża się wzorem

8

2

5

2

2

1

)

x

(

e

)

x

(

f

m=5, σ = 2 -> N(5,2)

Wartość oczekiwana: 5

Mediana: 5

Wartość modalna: 5

Wariancja: 2

2

=4

18.Parametry zmiennych losowych (średnia, wariancja, odch. standardowe, mediana i wartość

modalna)

Wariancja: Niech (Ω, K, P) będzie przestrzenią probabilistyczną, zaś

- zmienną losową,

posiadającą skończoną wartość oczekiwaną m = E(X). Wariancją zmiennej losowej X nazywamy liczbę:

Mediana: P(ξ ≤ x) ≤

1

2

< P(ξ ≥ x)

Dla zmiennej typu ciągłego:

Średnia (wartość oczekiwana)

m = ∫ xf(x)dx

∞

−∞

Wariancja

σ

2

= ∫(x − m)

2

f(x)dx

∞

−∞

Odchylenie standardowe

σ = √ ∫(x − m)

2

f(x)dx

∞

−∞

Mediana

Funkcja gęstości przyjmuje wartość

1

2

Wartość modalna

Max dla funkcji gęstości.

Dla zmiennej losowej typu skokowego

Średnia (wartość oczekiwana)

m = ∑ x

i

p

i

i

Wariancja

σ

2

= ∑(x − m)

2

p

i

i

Odchylenie standardowe

σ = √∑(x − m)

2

p

i

i

Mediana

Środkowy element, w posortowanym ciągu x.

Wartość modalna

Taki x, dla którego prawdopodobieństwo p jest największe.

19.Udowodnić, że jeśli zmienna losowa X ma wartość oczekiwaną m i odchylenie standardowe

, to

zmienna losowa

m

X

Y

ma wartość oczekiwaną zero i odchylenie standardowe 1.

Y =

X−m

σ

E(x)=m D

2

(x)=

σ

2

E(Y) = E (

X−m

σ

) =

1

σ

E(X − m) =

1

σ

(E(x) − m) =

1

σ

(m − m) = 0

D

2

(Y) = D

2

(

X−m

σ

) =

1

σ

2

D

2

(X − m) =

1

σ

2

D

2

(X) =

1

σ

2

σ

2

= 1

20.Udowodnić, że jeśli zmienna losowa X ma wartość oczekiwaną 7 i odchylenie standardowe 2, to

zmienna losowa

2

7

X

Y

ma wartość oczekiwaną zero i odchylenie standardowe 1.

Y =

X−7

2

E(x)=7 D

2

(x)=

4

E(Y) = E (

X−7

2

) =

1

2

E(X − 7) =

1

2

(E(x) − 7) =

1

2

(7 − 7) = 0

D

2

(Y) = D

2

(

X−7

2

) =

1

2

2

D

2

(X − 7) =

1

2

2

D

2

(X) =

1

4

∗ 4 = 1

21. Twierdzenie Poissona (dowód)

Niech zmienna losowa X

n

ma rozkład Bernoulliego określony wzorem:

P(X

n

= k) = (

n

k

)p

n

k

(1 − p

n

)

n−k

k=0,1,2,3,…,n

p

n

- prawdopodobieństwo sukcesu dla określonej zmiennej losowej X

n

Jeśli prawdopodobieństwo p

n

maleje do 0 w ten sposób, że poczynając od pewnego n

0

:

⋀

np

n

= σ

n>n

0

,

gdzie σ ≡ const. > 0, to:

lim

n→∞

P(X

n

= k) =

σ

k

k!

e

−σ

Jeśli wykonujemy dużą liczbę doświadczeń zgodnych ze schematem Bernoulliego, a prawdopodobieństwo

sukcesu jest bliskie 0, to zamiast liczyć z rozkładu Bernoulliego liczymy z rozkładu Poissona.

Dowód: niech λ = np

n

lim

n→∞

P(X

n

= k) = lim

n→∞

(

n

k

)p

n

k

(1 − p

n

)

n−k

) = lim

n→∞

n!

k!(n−k)!

p

n

k 1−p

n

n

1−p

n

k

=

1

k!

lim

n→∞

(n − k + 1)(n − k +

2) ∗ … ∗ (n − 1) ∗ n ∗

λ

k

n

k

∗

(1−

λ

n

)

n

(1−

λ

n

)

k

=

λ

k

k!

lim

n→∞

(

n−k+1

n

) ∗ (

n−k+2

n

) ∗ … ∗ (

n−1

n

) ∗

n

n

∗

(1−

λ

n

)

n

(1−

λ

n

)

k

=

λ

k

k!

lim

n→∞

(1 −

k−1

n

)(1 −

k−2

n

) … (1 −

1

n

) ∗

[(1+

1

−n

λ

)

−n

λ

]

−λ

(1−

λ

n

)

k

=

λ

k

k!

e

−λ

c.n.d.

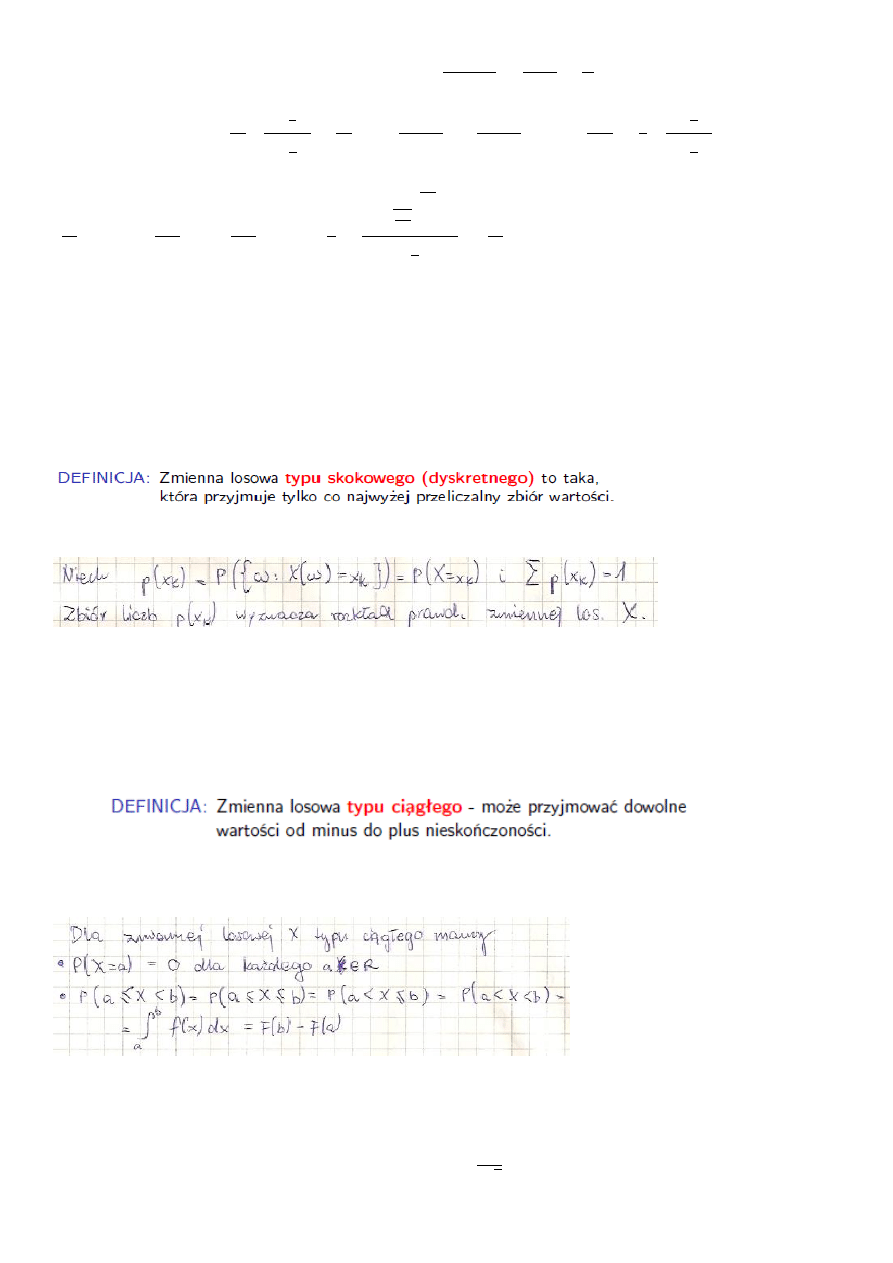

22. Zmienne losowe typu skokowego. Rozkład zmiennej losowej typu skokowego.

Skokowy (dyskretny) rozkład prawdopodobieństwa to w probabilistyce rozkład prawdopodobieństwa

zmiennej losowej dający się opisać przez podanie wszystkich przyjmowanych przez nią wartości, wraz z

prawdopodobieństwem przyjęcia każdej z nich. Przykład: rzut monetą lub rzut kostką.

+ wzory ze pkt 18

Zmienne losowe typu skokowego , np.: rzut kostką, zbiór wartości jest przeliczalny. Oznaczenie

prawdopodobieństwa to określenie prawdopodobieństw dla każdego ze zdarzeń.

23.Zmienne losowe typu ciągłego. Rozkład zmiennej losowej typu ciągłego.

Ciągły rozkład prawdopodobieństwa - rozkład prawdopodobieństwa dla którego dystrybuanta jest funkcją

ciągłą. Przykład: rozkład normalny.

+ wzory ze pkt 18

Zmienne losowe typu ciągłego, (zbiorem wartości jest zbiór liczb rzeczywistych). Są one

charakteryzowane przez funkcję gęstości .

24.Twierdzenie Linderberga-Levy’ego

Jeżeli X

n

jest ciągiem losowym niezależnych zmiennych o jednakowych rozkładach mających wartość

oczekiwaną m i wariancję σ

2

> 0, to ciąg losowy {U

n

}: U

n

=

1

σ√n

(∑

X

k

− nm)

n

k=0

jest zbieżny według

dystrybuant do zmiennej losowej o rozkładzie N(0,1). Czyli dla każdego U zachodzi relacja:

lim

n→∞

F

n

(U) =

1

√2π

∫ e

−

x

2

2

dx

U

−∞

= Φ(U)

E (∑ X

k

n

k=0

) = ∑ E(X

k

) =

n

k=0

∑ m =

n

k=0

nm

D

2

(∑ X

k

n

k=0

) = ∑ D

2

(X

k

) =

n

k=0

∑ σ

2

=

n

k=0

nσ

2

U

n

=

∑

x

k

− mn

n

k=0

σ√n

25.Określenie populacji i próby

Populacja - zbiór elementów podlegających badaniu statystycznemu.

Próbą jest część populacji spełniająca następujące warunki: musi być reprezentatywna i losowa .

Struktura próby musi być taka jak struktura badanej populacji.

26.Definicja i własności estymatorów punktowych.

Estymator – statystyka z próby obliczona celem uzyskania informacji o parametrach populacji generalnej.

Q – parametr populacji generalnej

Q

n

– jego estymator obliczony z próby n-elementowej

Q

n

= f(x

1

,x

2

,…) jest zmienną losową, Q NIE.

Inaczej: Wzory podające oszacowania (oceny) parametrów rozkładów teoretycznych (x,𝜎

2

, 𝜎 i innych)

nazywamy estymatorami.

Własności estymatorów:

Nieobciążoność – wartość średnia estymatora jest równa wartości parametru populacyjnego.

Zgodność – wraz ze wzrostem liczebności próby wartość estymatora zbliża się do parametru

Efektywność – miarą efektywności estymatora jest rozrzut otrzymywanych wartości, czyli wariancja;

najefektywniejszy estymator ma najmniejszą wariancję.

Dostateczność – estymator jest dostateczny, jeśli wykorzystuje całą informację o parametrze, jaka

zawarta jest w próbie.

parametr

estymator

średnia

m

𝑥̅

wariancja

σ

2

s

2

odchylenie standardowe

σ

s

modalna

m

o

𝑚𝑜

̂

mediana

m

e

𝑚𝑒

̂

27.Wyprowadzić wzór na estymator wartości oczekiwanej.

x

i

= m + ε

i

ε

i

− błąd losowy

∑

ε

i

2

→ min

n

i=1

– metoda najmniejszych kwadratów

Q(m) = ∑(x

i

− m)

2

n

i=1

→ min

Q

′

(m) = 2 ∑(x

i

− m) ∗ (−1) =

n

i=1

− 2 ∑(x

i

− m) = 0 | ∶ −2

n

i=1

∑(x

i

− m) = 0

n

i=1

∑(x

i

) −

n

i=1

∑(m) = 0

n

i=1

∑ (x

i

) − n ∗ m = 0

n

i=1

m =

1

n

∑ x

i

n

i=1

x̅ =

1

n

∑ x

i

n

i=1

28.Udowodnić, że średnia arytmetyczna jest nieobciążonym estymatorem wartości oczekiwanej.

E(x̅) = E (

1

n

∑

x

i

n

i=1

) =

1

n

E(∑

x

i

n

i=1

) =

1

n

∑

E(x

i

)

n

i=1

=

1

n

∑

m =

n

i=1

1

n

nm = m

c.n.d.

29.Udowodnić, że

n

)

x

(

D

2

2

D

2

(x

i

) = σ

2

D

2

(x̅) = D

2

(

1

n

∑

x

i

n

i=1

) =

1

n

2

D

2

(∑

x

i

n

i=1

) =

1

n

2

∑

D

2

(x

i

)

n

i=1

=

1

n

2

∑

σ

2

=

n

i=1

1

n

2

nσ

2

=

σ

2

n

c.n.d.

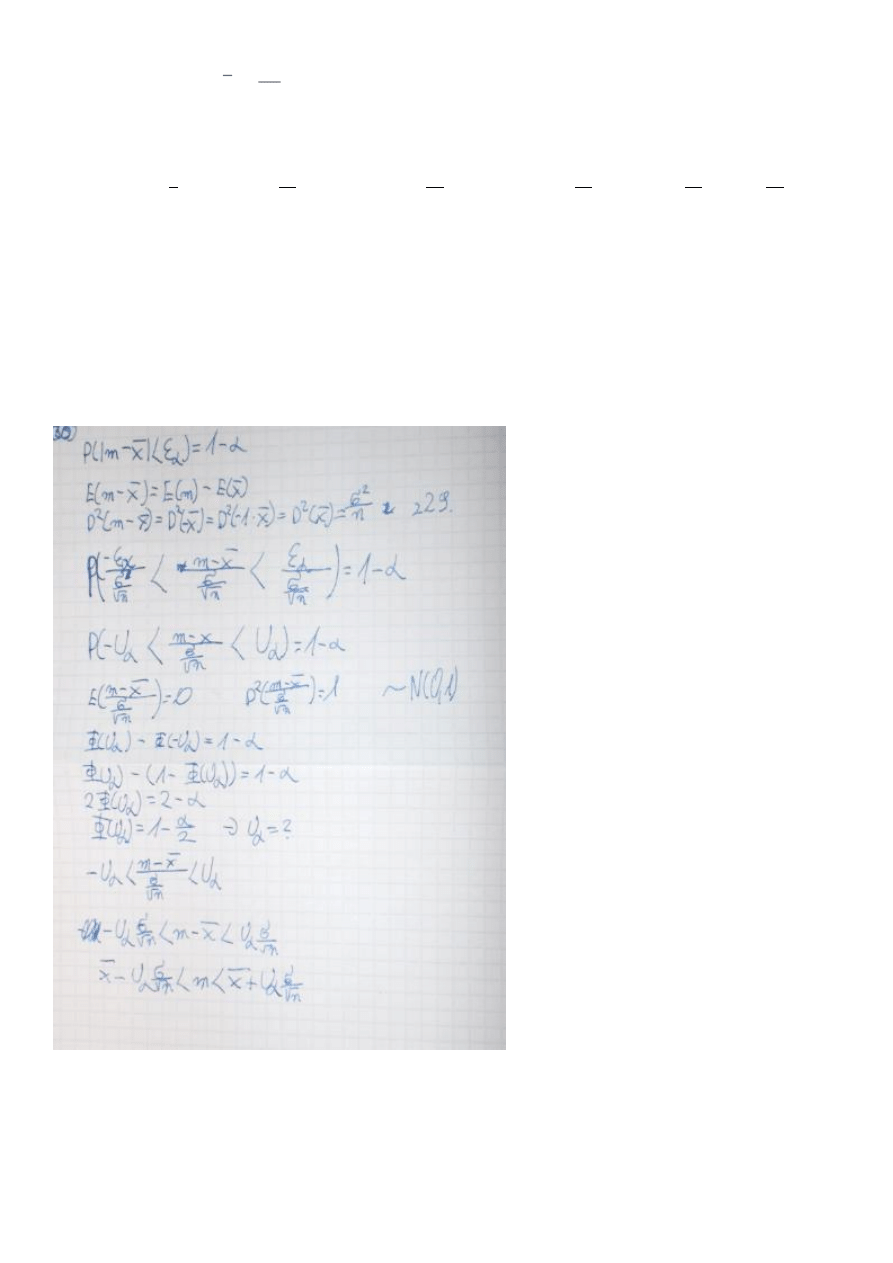

30.Wyprowadzić wzór na przedział ufności dla wartości oczekiwanej na podstawie próby z populacji o

rozkładzie normalnym ze znanym odchyleniem standardowym.

Wyszukiwarka

Podobne podstrony:

Statystyka - opracowane pyt 3(1), Nauka, statystyka

Metrologia statystyczne opracowanie wyników

ChMB kolokwium I opracowane zagadnienia by Owca

Probabilistic slope stability analysis by finite elements

Opracowanie TiME by?i

Analiza błędów Statystyczne opracowanie wyników pomiarów

02 opracowanie OŻE by BJ 11

PAiR Opracowanie Egzamin by Yanoo

Opracowanie z Elektrotechniki by MartaM(1), nauka, fizyka, FIZYKA-ZBIÓR MATERIAŁÓW

Opracowanie pytan (by GR)

Statystyka - opracowane pyt 5, Statystyka

laboratorium 9 i 10, Metody probabilistyczne i statystyka

pytania 27-30, ZUT, III Semestr, Metody probabilistyczne i statystyka

Statystyka-opracowane, Studia, Psychologia, SWPS, 2 rok, Semestr 04 (lato), Metodologia ze statystyk

opracowanie 2013, Studia, Informatyka, Semestr IV, Wstęp do sztucznej inteligencji

ZPI Egamin Opracowanie 2013

Opracowanie pytań by bartez3do druku

więcej podobnych podstron