CCF20121215�28

44

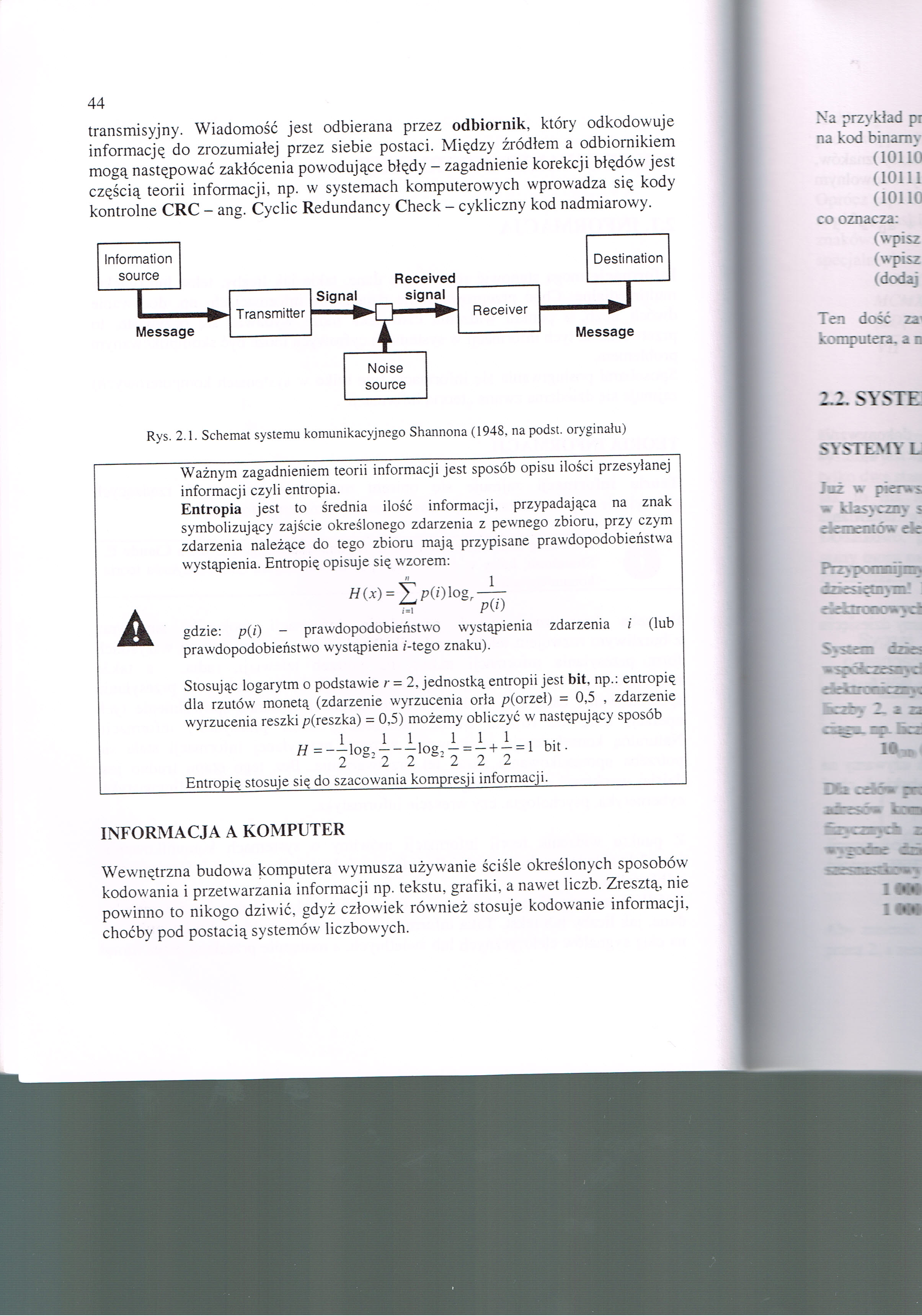

transmisyjny. Wiadomość jest odbierana przez odbiornik, który odkodowuje informację do zrozumiałej przez siebie postaci. Między źródłem a odbiornikiem mogą następować zakłócenia powodujące błędy - zagadnienie korekcji błędów jest częścią teorii informacji, np. w systemach komputerowych wprowadza się kody kontrolne CRC - ang. Cyclic Redundancy Check - cykliczny kod nadmiarowy.

44

Information

source

Destination

I

Message

Received

Signal signal

►j Transmitter

Receiver

Message

Noise

source

Rys. 2.1. Schemat systemu komunikacyjnego Shannona (1948, na podst. oryginału)

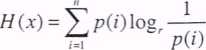

Ważnym zagadnieniem teorii informacji jest sposób opisu ilości przesyłanej informacji czyli entropia.

Entropia jest to średnia ilość informacji, przypadająca na znak symbolizujący zajście określonego zdarzenia z pewnego zbioru, przy czym zdarzenia należące do tego zbioru mają przypisane prawdopodobieństwa wystąpienia. Entropię opisuje się wzorem:

gdzie: p(i) - prawdopodobieństwo wystąpienia zdarzenia i (lub prawdopodobieństwo wystąpienia i-tego znaku).

Stosując logarytm o podstawie r = 2, jednostką entropii jest bit, np.: entropię dla rzutów monetą (zdarzenie wyrzucenia orła p(orzeł) = 0,5 , zdarzenie wyrzucenia reszki p(reszka) = 0,5) możemy obliczyć w następujący sposób

Entropię stosuje się do szacowania kompresji informacji.

INFORMACJA A KOMPUTER

Wewnętrzna budowa komputera wymusza używanie ściśle określonych sposobów kodowania i przetwarzania informacji np. tekstu, grafiki, a nawet liczb. Zresztą, nie powinno to nikogo dziwić, gdyż człowiek również stosuje kodowanie informacji, choćby pod postacią systemów liczbowych.

Wyszukiwarka

Podobne podstrony:

9,10 (2) Przykład 3. W dowolnych chwilach przedziału czasu o długości T możliwe jest odebranie przez

hormony (2) S.Wazopresyna wydzielana jest: i^aj przez część nerwową przysadki wprosi do krwi; b)

DSC00051 (7) Tempo humifikacji • Jest determinowane przez stosunek substancji łatwo dostępnych do tr

1. Tryb powoływania Rady Ministrów. Rada Ministrów jest powoływana przez Prezydenta, który zawsze mu

DSC04159 (5) il PARABOLA IRONU NA il PARABOLA IRONU NA tego drugiego jest zadaniem pozostawionym odb

DSC00346 (20) Informacja o otoczeniu jest odbierana za pomocą sensorów wizyjnych i przekazywana do k

img040 (44) 40 Pryzmat: jest osadzony w oprawie zaopatrzonej w uchwyt z u szklą ta do zawieszania pl

63 2 ■Ti U N ITR R =1 DIORAEWA 2 jest nowoczesnym, przenośnym, odbiornikiem radiowym prze* znaczon

• Jawny - jest uświadomiony przez strony, ukryty bywa wyparty do nieświadomoś

Rejestracja zdarzeń jest prowadzona przez stacyjne punkty sterowania. Informacje o zdarzeniach przec

Podstawą tworzenia budżetu jest ustawa przyjmowana przez parlament, który upoważnia rząd do realizac

przestępstwo przed Trybunałem Stanu jest podjęcie przez Sejm uchwały o pociągnięciu go do tej

11 41 Hasło Prowizja.xls jest zastrzeżony przez Wydawnictwo HELION Wprowadź hasło do zapisu&n

11 41 Hasło -U-*! Prowizja.xls jest zastrzeżony przez Wydawnictwo HELION Wprowadź hasło do

więcej podobnych podstron