img077

77

Rozdział 6. Sieci rezonansowe

neuronie) podali w kilku swoich oryginalnych pracach Gaił Carpenter i Stephen Grossberg [Carp87], [Gros89]. W tej książce konsekwentnie stosowany jest opis polegający na prezentacji uczenia jako iteracyjnego procesu, w którym wartości wag w fc-tyin kroku procesu uczenia zmieniają się według pewnej reguły w zależności od wartości wag uprzednio zdefiniowanych oraz od sygnałów pojawiających się w sieci w ż-tym kroku. Taki sposób pozwala na pokazanie istoty uczenia w formie uproszczonej, chociaż nie pozbawionej praktycznej przydatności (każdy program symulujący sieć będzie zawsze obliczał zmiany wag w formie iteracji, a nie w formie procesu ciągłego, opisanego równaniem różniczkowym). W tym uproszczonym, prezentowanym tu modelu wagi wfj zmieniają się w sposób następujący:

1 gdy (nf*) = i)A(i£(*, = i) = ' 11 «<iy «j(k) = o

.0 gdy (»?“' = 0) A (yf‘> = l) gdzie indeks k pojawiający się przy poszczególnych tu i y jest numerem kroku w procesie uczenia.

Warto zauważyć, że podana reguła uczenia nie jest regułą typu Hebba ze względu na czynnik zapominania, wyrażony ostatnim wierszem przytoczonego wzoru. Warto także zauważyć, że z powodu rywalizacji w warstwie wyjściowej w rzeczywistości jedynie nieliczne współczynniki wagowe podlegają uczeuiu, gdyż dla wszystkich j z wyjątkiem j = c zachodzi Vj — 0. Wartości początkowe nadawane przed procesem uczenia połączeniom ,,z góry na dół" są jednakowe i wynoszą tu^-1^ = 1. Warto zauważyć, że w tym przypadku wartości początkowe nie są losowe.

Reguła uczenie wag połączeń wiodących w górę jest podobna do wyżej opisanej, ale bardziej subtelna (to znaczy zmiany wartości wag nie są tak gwałtowne i radykalne). Regułę tę można zapisać w następującej postaci:

+ gdy (.vf*) = l)A(y't‘)=l) = • »?/“> . gdy = 0

. «#*>-«, gdy (!/?“’ = 0) A (yfł) = I)

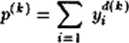

Przyrosty i 62 nadawane wspólczynikom wagowym w trakcie procesu uczenia mogą być przyjmowane jako stale, ale lepsze wyniki uczenia i dokładniejsze dopasowanie do rozpoznawanych klas uzyskuje się przyjmując te wartości jako zależne od liczby pobudzonych neuronów w pierwszej warstwie. Liczbę tę można wyznaczyć jako

n

ponieważ wszystkie yf^ są binarne. Mając wyznaczoną liczbę można ustalać tfi i 62 z dokładnych wzorów wyprowadzonych przez Oarpentera

Wyszukiwarka

Podobne podstrony:

Sieci CP str077 77 Rozdział 0. Sieci rezonansowe neuronie) podali w kilku swoich oryginalnych pracac

img081 Rozdział 6. Sieci rezonansowe81 W podobny sposób działa drugi neuron, badający aktywność Y9 d

Sieci CP str081 Rozdział 6. Sieci rezonansowe 81 W podobny sposób działa drugi neuron, badający akty

img075 75 Rozdział 6. Sieci rezonansowe alfabetu łacińskiego (których jest 26) trzeba mieć około czt

img079 79 Rozdział 6. Sieci rezonansowe Wówczas obszar, w którym spotykają się sygnały wyjściowe Y*

img083 83 Rozdział 6. Sieci rezonansowe Opisany mechanizm ma dwie istotne zalety. Z jednej strony po

img085 85 Rozdział 6. Sieci rezonansowe Trudno nie przyznać, że zakłócenie ma charakter drobny i nie

Sieci CP str079 79 Rozdział 6. Sieci rezonansowe Y9 = □ imHBB55 Wówczas obszar, w którym spotykają s

Sieci CP str085 85 Rozdział 6. Sieci rezonansowe TYudno nie przyznać, żc zakłócenie ma charakter dro

więcej podobnych podstron