427 2

427

10.5. Nieliniowe zadania optymalizacji

f-yeflberg (1944) sugerował, aby G(xv) zastąpić macierzą p-tdao jednak wybrać odpowiednie u. W tych algorytmac

prosię

dodatnio określoną C(xv) -fil. Igorytmach unika się poszukiwania wzdłuż W pierwszym z przypadków wyróżnionych w (10.5.9) wybiera się 2 = 1, jeśli jednak ^ ^xv), lo ^ się połowi; robi się to aż do osiągnięcia nierówności ę(xr—Xdj\ < <vKrv). Ostatnie X uznaje się za 2V. W drugim przypadku próbuje się najpierw wartości ?^gTgigTGg, jeśli gTGg>0. W przeciwnym razie przyj tuje się, że ;.= max 2,,|l</,l||/||rfr||

^ V5*0 j X= 1 dla v=0.1 tym razem X połowi się wielokrotnie, aż do otrzymania nierówności ?(*v-M)<?(-0.

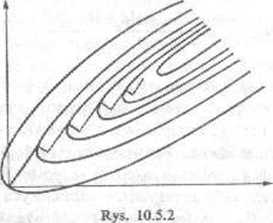

Zauważmy, że kierunek w metodzie Newtona nie jest kierunkiem najszybszego spadku, jeśli g'G~lg^0. Taka sytuacja nie jest prawdopodobna w pobliżu x zc względu na dodatnią (lub przynajmniej nieujemną) określoność macierzy G (x). Natomiast zdała od x może się tak zdarzyć, a to przemawia za dopuszczeniem gradientu jako alternatywnego wyboru kierunku — szczególnie ze względu na niebezpieczeństwo dojścia w kierunku newtonowskim do punktu siodłowego.

Spowolniona metoda Newtona nie jest zbyt efektywna dla dużych n, np. dla n>5, wobec konieczności obliczania hefjanu.

Istnieje klasa metod, zwanych metodami aktualizacji macierzy, w których hesjanu w ogóle się nie oblicza, natomiast przybliżony hesjan tworzy się w procesie iteracyjnym przez stopniowe sumowanie macierzy' niskiego rzędu. Jedną z najbardziej znanych jest metoda Dauidona-Fletchera-Po+rella (1959, 1963). N.ech będzie

<5=xv-xr_lf 7 = *(*,)“0(*v-i).

Wtedy

(Xv określa się przez poszukiwanie wzdłuż prostej).

j'

y(g>-i7)t «v-i y

VVzory wydają się skomplikowane, ale oprócz obliczania gradientu w każdej iteracji wy-jeszcze wykonać tylko około 2/i2 mnożeń. Natomiast klasyczna metoda Newtona mnożeń, obliczania gradientu i hesjanu. Zauważmy, że macierz

Wyszukiwarka

Podobne podstrony:

429 2 429 10.5. Nieliniowe zadania optymalizacji pominęliśmy wskaźnik v. Zgrabniej — i ogólniej —

431 2 431 10.5. Nieliniowe zadania optymalizacji (getodS Newtona i wzór (6.9.11) dla funkcji kary 7p

425 2 425 10.5. Nieliniowe zadania. opłymaliza^i Wymaga się dobrego przybliżenia początkowego (nic j

423 2 423 10.4. Zadanie transportowe i inne zadania optymalizacyjne Pożądani a transportowego sprowa

427 (10) Mięśnie uda 427 Mięśnie uda 427 Przebieg mięśni przywodzicieli (rys. schematyczny). Mięśnie

430 2 430 10. Optymalizacja W zasadzie te metody można by uogólnić na zadania optymalizacji z dowoln

Programowanie nieliniowe Programowaniem nieliniowym nazywamy zadanie optymalizacyjne postaci: I min

D. 198.15.10.112 Zadanie 25. Sieć o adresie IP 192.168.2.0/24 podzielono na cztery podsieci. Jaką ma

IMG166 166 W tak^a razie P2 • U2;) I~ coe 6 m 240 . 10 . 1 - 2400W Zadania 13.6*6, Trójfazowy odbior

IMG!10 5. Pytania 1 zadania do realizacji ■ Jaka będzie wartość napięcia na wyjści

więcej podobnych podstron