9965379430

EtaUkl, EtaUk2, EtaWy - bieżące wartości parametrów eta dla każdej warstwy (zmienia się dynamicznie; zależy od liczby błędów w ostatniej epoce)

Po poprawnym nauczeniu SSN program zapisuje do pliku ParametryNaukiSSN.txt wszystkie parametry SSN i wiele innych informacji o nauce.

Uwaga. Jeśli SSN nie chce się nauczyć i często występuje błąd dla wzorca nr Nrp (wyświetlany w kolejnych liniach pola tekstowego programu do nauki), to być może warto taki wzorzec usunąć z bazy znaków.

Program 4- RozpoznawanieObrazow.exe

Ostateczny program do rozpoznawania znaków z podanego obrazu z pliku BMP.

Program przy uruchamianiu od razu tworzy na podstawie pliku parametry.ssn odpowiednich rozmiarów SSN i wczytuje, tam zapisane, parametry nauczonej wcześniej SSN. Plik ten musi być w katalogu z programem.

Program:

- Wczytuje plik BMP z obrazem znaków [Wczytaj BMP)

- Wyszukuje w obrazie z podanego pliku BMP obrazy znaków (tzw. ramki znaków) [Szukaj ramekl

- Obrazy znaków transformuje (skalowanie, kontrast, normalizacja itp.) do standardowej postaci gotowej dla wejścia SSN

-Umożliwia dopisanie obrazu znaku wraz z podaną etykietą i informacjami o jego ramce do wskazanego pliku (BazaObrazowZnakow.boz) [Dopisz do bazvl

DZIAŁANIE SZTUCZNEJ SIECI NEURONOWEJ

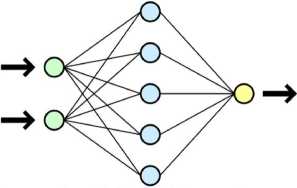

Uproszczony schemat jednokierunkowej sieci neuronowej

Sieci jednokierunkowe to sieci neuronowe, w których nie występuje sprzężenie zwrotne, czyli pojedynczy wzorzec lub sygnał przechodzi przez każdy neuron dokładnie raz w swoim cyklu. Najprostszą siecią neuronową jest pojedynczy perceptron progowy, opracowany przez McCullocha i Pittsa w roku 1943.

W programie uczącym SSN zaimplementowano czterowarstwową nieliniową sztuczną sieć neuronową jednokierunkową (wielowarstwowa sieć perceptronowa (ang. Multi-Layered Perceptron MLP)).

Zgodnie z teorią sieć o dwóch lub trzech warstwach perceptronowych może być użyta do aproksymacji większości funkcji.

Kolejne warstwy sieci, to: warstwa danych wejściowych, dwie warstwy ukryte (wewnętrzne) i warstwa danych wyjściowych. Użycie dwóch warstw ukrytych zamiast tylko jednej znacząco poprawia uczenie się SSN i jej możliwości generalizacji. Trzy warstwy to już przesada, a dwie w zupełności wystarczają do poprawnej nauki.

Połączenia neuronów między warstwami - każdy z każdym.

Wektorem uczącym są następujące dwa ciągi danych: uczący (wejściowy) i weryfikujący (wyjściowy).

Wyszukiwarka

Podobne podstrony:

13. Dla jakich wartości parametru a różnica pierwiastków równania ax2+x-2 = 0 równa się trzy? R

206 Jan Jaremski, Grzegorz Straż Zestawienie wartości parametrów wytrzymałościowych dla wybranych

Zadanie 7. Wyznaczyć wszystkie wartości parametru c € C dla których formy her-mitowskie wyznaczone p

img289 otrzymano dla C wartość 1498,3. Szacując C dla każdej z czaszek oddzielnie i obliczając średn

Wartości te zostają zunifikowane, to znaczy dla każdej przesłanki wyznacza się (różnymi metodami)

67851 IMG 89 (3) filcować subiektywne systemy o „ostatecznym” znaczeniu dla dorosłych członków zmien

68 W STRONĘ POROZUMIENIA rizenia sformułowane w języku właściwym dla każdej nauki mogą się w jakiś

Reakcje w roztworach wodnych wartość iloczynu stężeń jonów w tych układach zmieniła się i wynosiła:

skanuj0255 (3) 268 PHP i MySQL dla każdego Tabela 9.1. Wartości parametru prawa polecenia GRANT Nazw

Radosław Grzymkowski MATEMATYKA Zadania I Odpowiedzi Strona 4 Pochodna Funkcji 94 8. Pochodna

więcej podobnych podstron