8. Wyjaśnij pojęcie testu post-hoc i wymień przykłady takich testów.

Odrzucamy H

0

w analizie wariancji -> czyli nie wszystkie średnie dla poziomów czynnika są

identyczne.

Pojawia się problem: które średnie nie są równe.

Testy POST HOC (testy „po fakcie”, znane również pod nazwą porównań wielokrotnych) wykonuje

się jako kolejny krok analizy wariancji, pozwalają one znaleźć pary średnich istotnie się różniące.

Wyjaśnienie z neta jeśli któraś z Was by potrzebowała: Sama analiza wariancji mówi nam tylko o tym

czy różnice w porównywanych średnich występują czy nie. Nie wiemy jednak między którymi grupami

zachodzą te różnice. Istotny współczynnik F wskazuje jedynie na słuszność (lub brak słuszności)

odrzucenia hipotezy zerowej. Jeśli ją odrzucimy musimy dowiedzieć się czy wszystkie średnie różnią

się między sobą czy tylko niektóre. Stąd też nazwa “po fakcie” – wykonujemy je dopiero po

sprawdzeniu czy wynik F jest istotny statystycznie. Jeśli nie jest, nie musimy wykonywać testów POST

HOC.

Ogólnie testy te powinny być tak konstruowane, żeby przy wykonywaniu porównań między parami

średnich utrzymywać na ustalonym z góry poziomie prawdopodobieństwo popełnienia błędu I-

rodzaju, który polega na odrzuceniu prawdziwej hipotezy zerowej.

Istnieje wiele testów dla porównań post hoc. Przykłady – trzeba koniecznie podać Tukeya:

Rozwiązanie I (częściowo poprawne)

Test t-studenta w parach z korektą Bonferroniego

Taki test bierze poprawkę na ilość wykonywanych porównań. Dotychczasowy poziom istotności α =

0,05 dzielimy przez liczbę zaplanowanych do przeprowadzenia testów t-studenta w parach –

otrzymując nowy poziom istotności α* (α*< α). Odrzucamy H

0

w danym teście t-studenta, gdy p-

wartość < α*.

Bardzo dobrze spisuje się w przypadku małej liczby porównań (stosujemy gdy ich liczba nie

przekracza 5).

Przy tej metodzie nadmiernie wzrasta prawdopodobieństwo popełnienia błędu II rodzaju – zbyt

rzadko pozwala na odrzucenie fałszywej H

0

.

Rozwiązanie z poprawką Bonferroniego jest jednak uważane za lepsze niż stosowanie zwykłych

testów t-studenta w parach, ponieważ w statystyce na ogół bardziej zależy nam na kontrolowaniu

błędu I-rodzaju niż II rodzaju. Za groźniejsze uważamy odrzucenie prawdziwej H

0

(błąd I-rodzaju) niż

przyjęcie fałszywej H

0

(błąd II-rodzaju).

Rozwiązanie II (częściowo poprawne)

Test Najmniejszej Istotnej Różnicy NIR – metoda Fishera

Jest to najstarszy test wielokrotnych porównań.

Pomysł Fishera polegał na tym żeby przyjąć wspólne dla wszystkich porównań oszacowanie dla

wariancji równicy średnich jako MSW.

Zaleta: metoda Fishera może być stosowana w przypadku nierównych liczebności grup.

Wada: metoda nie zapobiega w wystarczającym stopniu wzrostowi prawdopodobieństwa błędu I-

rodzaju.

Metoda NIR jest niewiele lepsza od zwykłych testów t-studenta w parach. Nie bierze poprawki na

ilość porównań. Najczęściej używa się jej do potwierdzenia innych wyników testów POST HOC

Rozwiązanie III (najlepsze) !!! – koniecznie trzeba je znać

Test Tukeya HSD (HonestySignificantDifference - uczciwie istotnej różnicy )– Jest to test najbardziej

polecany do porównywania par średnich. Możliwy do stosowania tylko dla równej liczebności grup.

Metoda HSD Tukeya jest najbardziej godna polecenia do dokonywania porównań w parach,

ponieważ utrzymuje w ryzach prawdopodobieństwo popełnienia błędu I-rodzaju. Nie dopuszcza do

jego nadmiernego wzrostu co skutkowałoby wskazywaniem statystycznie istotnych różnic w parach,

tam gdzie ich nie ma.

Metoda ta nie prowadzi także do nadmiernego wzrostu prawdopodobieństwa błędu II-rodzaju, tzn.

nie będzie nadmiernie często sytuacji, kiedy H

0

będzie fałszywa, a my jej nie odrzucimy.

Minus HSD Tukeya: należy spełnić założenie o równości liczebności porównywanych grup. W

pakietach statystycznych istnieją modyfikację metody HSD Tukeya dla nierównych liczebności, ale nie

ma ona aż tak dobrych własności jak HSD Tuckeya.

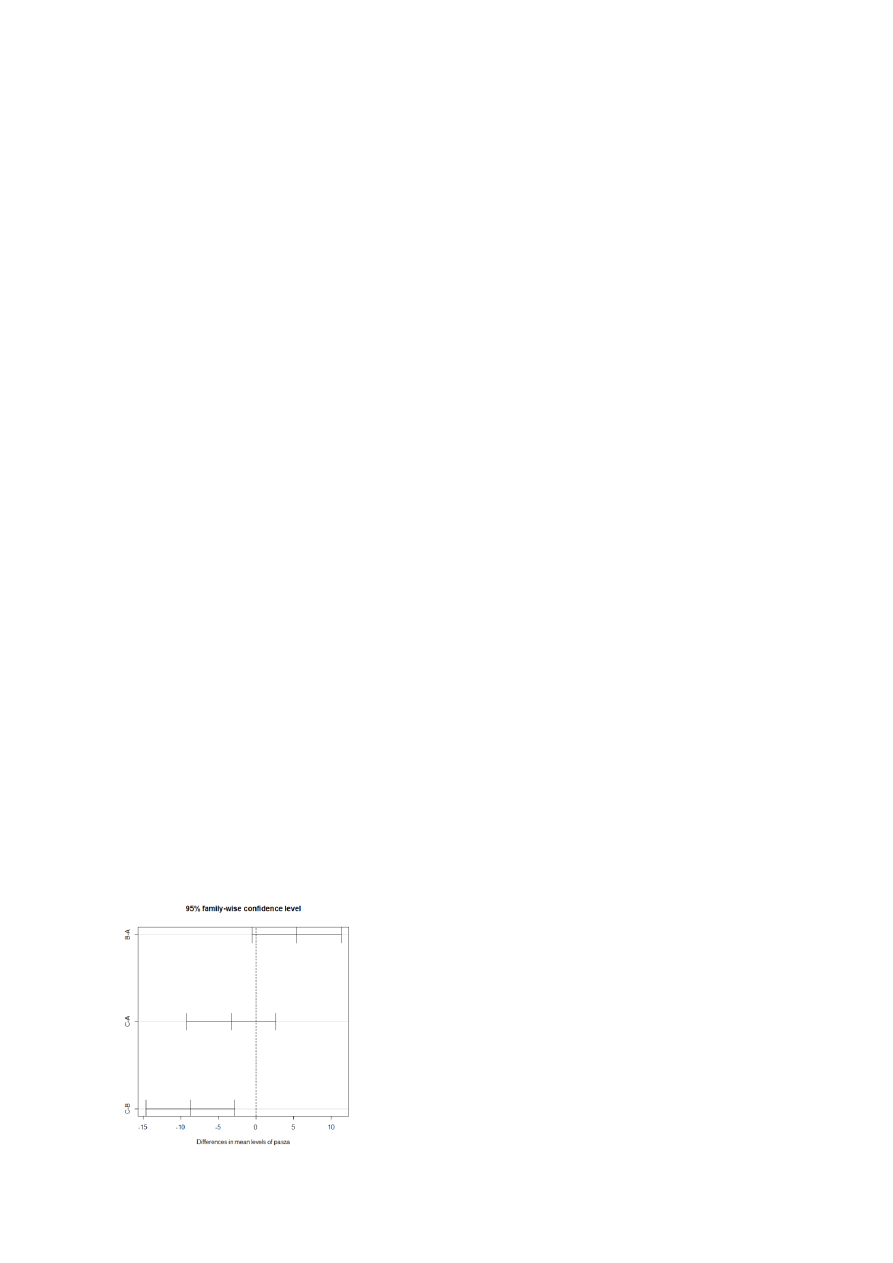

Przykład testu Tukeya:

Mamy 3 rodzaje paszy: A, B, C – badamy różnice w przyroście masy ciała w zależności od rodzaju

paszy, którą są karmione kurczaki.

Wniosek do analizy wariancji: ponieważ p-wartość < od alfa=0,05, to należy odrzucić hipotezę

zerową o tym, że średnie przyrosty dla każdej z pasz są takie same. Pasze różnicują wartości przyrostu

wagi.

Ze względu na to, możemy zastosować test Tukey'a – szukamy par owsa statystycznie się różniących.

>TukeyHSD(aov(przyrost~pasza))

W teście TukeyHSD otrzymujemy wartości p-adj (p-wartość dopadowana) oraz dolny i górny

zakres ufności.

Jeżeli p-adj> α=0,05 – para różni się w sposób statystycznie istotny

Jeżeli p-adj< α=0,05 – para nie różni się w sposób statystycznie istotny

Wniosek do testu Tukey’a: Dla par A -B oraz A-C otrzymałyśmy wartości p-adj> α = 0,05, czyli między

nimi nie ma istotnej statystycznie różnicy. Natomiast dla pary B-C wartość p-adj była mniejsza od α =

0.05, dlatego między tymi paszami występuje istotna statystycznie różnica w przyroście masy.

> plot(TukeyHSD(aov(przyrost~pasza))) – wykres dla naszych pasz

Wyszukiwarka

Podobne podstrony:

8 test post hock

Test W.Post i Wielkanoc, konspekty scenariusze, testy

05 READING POST TEST Student

TEST WIADOMOŚCI-Wielki Post, TEST WIADOMOŚCI:

Pre post test

TEST NR 5

test dobry

test poprawkowy grupa 1

TEST zalicz mikroskopia czescETI z odpowiedz

Wyklad 9 Post HF

Zajecia 6 7 Test Niedokonczonych Zdan

etyka test

Test osobowości Dalajlamy

dependent t test

TEST ZE ZDROWIA ŚRODOWISKOWEGO – STACJONARNE 2008 2

więcej podobnych podstron