Wydział Badań i Ewaluacji CKE

Warszawa, listopad 2007

Wydanie 2., uzupełnione

A

A

A

N

N

N

A

A

A

L

L

L

I

I

I

Z

Z

Z

A

A

A

I

I

I

I

I

I

N

N

N

T

T

T

E

E

E

R

R

R

P

P

P

R

R

R

E

E

E

T

T

T

A

A

A

C

C

C

J

J

J

A

A

A

W

W

W

Y

Y

Y

N

N

N

I

I

I

K

K

K

Ó

Ó

Ó

W

W

W

O

O

O

C

C

C

E

E

E

N

N

N

I

I

I

A

A

A

N

N

N

I

I

I

A

A

A

I

I

I

E

E

E

G

G

G

Z

Z

Z

A

A

A

M

M

M

I

I

I

N

N

N

O

O

O

W

W

W

A

A

A

N

N

N

I

I

I

A

A

A

Opracowanie:

Jolanta Czarnotta-Mączyńska, Marta Firsiuk,

Małgorzata Lipska, Zofia Lisiecka

Redaktor cyklu:

Zofia Lisiecka

Wydawca: Wydział Badań i Ewaluacji CKE

00-842 Warszawa, ul. Łucka 11

tel. 022 656 37 41

e-mail: badania@cke.edu.pl

Wydanie 2., uzupełnione

Warszawa, listopad 2007

A

A

A

N

N

N

A

A

A

L

L

L

I

I

I

Z

Z

Z

A

A

A

I

I

I

I

I

I

N

N

N

T

T

T

E

E

E

R

R

R

P

P

P

R

R

R

E

E

E

T

T

T

A

A

A

C

C

C

J

J

J

A

A

A

W

W

W

Y

Y

Y

N

N

N

I

I

I

K

K

K

Ó

Ó

Ó

W

W

W

O

O

O

C

C

C

E

E

E

N

N

N

I

I

I

A

A

A

N

N

N

I

I

I

A

A

A

I

I

I

E

E

E

G

G

G

Z

Z

Z

A

A

A

M

M

M

I

I

I

N

N

N

O

O

O

W

W

W

A

A

A

N

N

N

I

I

I

A

A

A

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

3

Cykl broszur Teoria i praktyka egzaminowania powstał w odpowiedzi na zapotrzebowanie

uczestników procesu egzaminowania na syntetyczne, popularyzatorskie ujęcie trudnej

problematyki związanej z diagnostyką edukacyjną, w szczególności zaś z ocenianiem

wewnątrzszkolnym i egzaminowaniem zewnętrznym. W kolejnych publikacjach przybliżo-

ne zostaną kwestie związane z planowaniem badań osiągnięć uczniów, jakością

materiałów egzaminacyjnych, metodą pomiaru dydaktycznego, organizacją i przepro-

wadzaniem egzaminów, analizą i interpretacją wyników egzaminu, wykorzystaniem

wyników egzaminów w podnoszeniu jakości pracy szkoły, etc.

Cykl przeznaczony jest przede wszystkim dla nauczycieli i dyrektorów szkół, ale może też

stanowić pomoc dla tych, którym nieobojętna jest jakość polskiej edukacji – wizytatorów,

opiekujących się szkołami pracowników jednostek samorządów terytorialnych, rodziców,

dziennikarzy.

Mamy nadzieję, że niniejsza broszura, w swojej strukturze przypominająca ilustrowany

słownik tematyczny, przybliży Państwu podstawy statystyki, dostarczając licznych

przykładów, jak można wyniki prowadzonych analiz wykorzystać w praktyce. Liczymy też,

iż ilustrujące pojęcia statystyczne cytaty z publikacji przygotowanych przez Centralną

Komisję Egzaminacyjną dopomogą w niełatwej drodze od teorii do praktyki oceniania i

egzaminowania.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

4

SPIS TREŚCI

Podstawowe parametry statystyczne pomocne w analizie ilościowej wyników................s. 5

Miary położenia............................................................................................................s. 7

Miary tendencji centralnej.......................................................................................s. 7

Modalna....................................................................................................…..........s. 8

Mediana...................................................................................................................s.8

Średnia arytmetyczna.............................................................................................s. 8

Średnia ważona......................................................................................................s. 9

Kwantyle.................................................................................................................s. 9

Kwartyle..................................................................................................................s. 9

Zastosowanie podstawowych miar tendencji centralnej..................s. 12

Miary rozproszenia (zróżnicowania) ....................................................................s. 14

Rozstęp................................................................................................................s. 14

Wariancja..............................................................................................................s. 14

Odchylenie standardowe.......................................................................................s.15

Miary współzmienności..............................................................................................s. 16

Korelacja...............................................................................................................s. 16

Przykładowe zestawienie wyników egzaminu zewnętrznego....................................s. 17

Podstawowe parametry statystyczne pomocne w analizie ilościowej wyników zadań

egzaminacyjnych i testu..................................................................................................s. 18

Rozkład liczebności..............................................................................................s. 18

Łatwość zadania/testu..........................................................................................s. 19

Trudność zadania/testu........................................................................................s. 22

Frakcja

opuszczeń................................................................................................s. 22

Moc

różnicująca zadania......................................................................................s. 23

Rzetelność pomiaru..............................................................................................s. 23

Efekt

standardowy................................................................................................s. 25

Wynik

standardowy..............................................................................................s. 26

Skale znormalizowane....................................................................................................s. 28

Pojęcie normy............................................................................................................s. 28

Normalizacja

wyników

testowania........................................................................s. 29

Obszar wyników typowych.........................................................................s. 29

Definicje wybranych skal znormalizowanych.............................................................s. 32

Skala

staninowa...................................................................................................s. 32

Standardowa

„piątka”...........................................................................................s. 34

Skala

centylowa....................................................................................................s. 36

Skala akademicka CEEB.....................................................................................s. 37

Przykłady analiz wyników egzaminów zewnętrznych.....................................................s. 42

Analiza i interpretacja wyników staninowych uczniów i szkół....................................s. 42

Analizy porównawcze i korelacyjne...........................................................................s. 57

Zastosowanie wybranych skal znormalizowanych w analizie wyników matury podczas

rekrutacji na wyższe uczelnie....................................................................................s. 59

Źródła danych.................................................................................................................s. 62

Polecana literatura..........................................................................................................s. 62

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

5

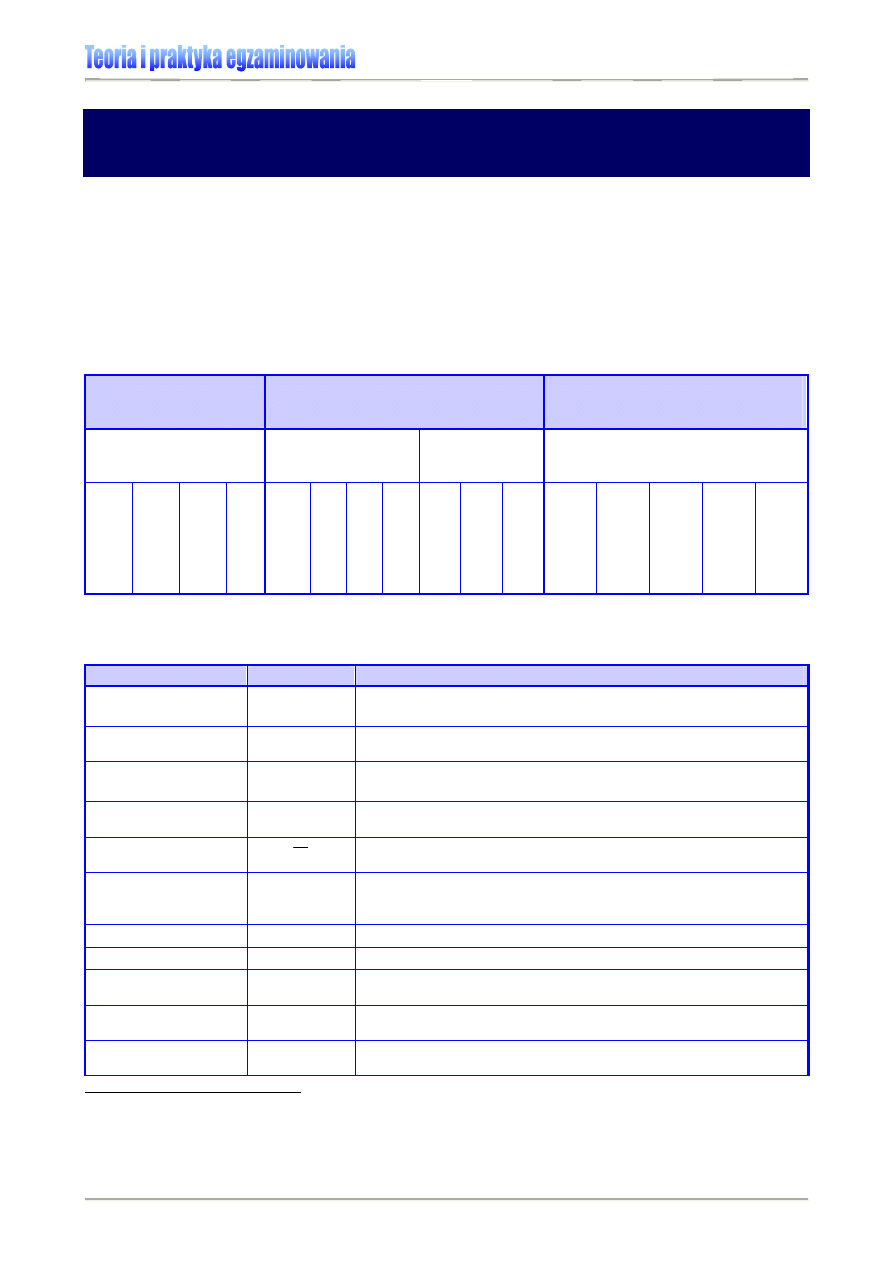

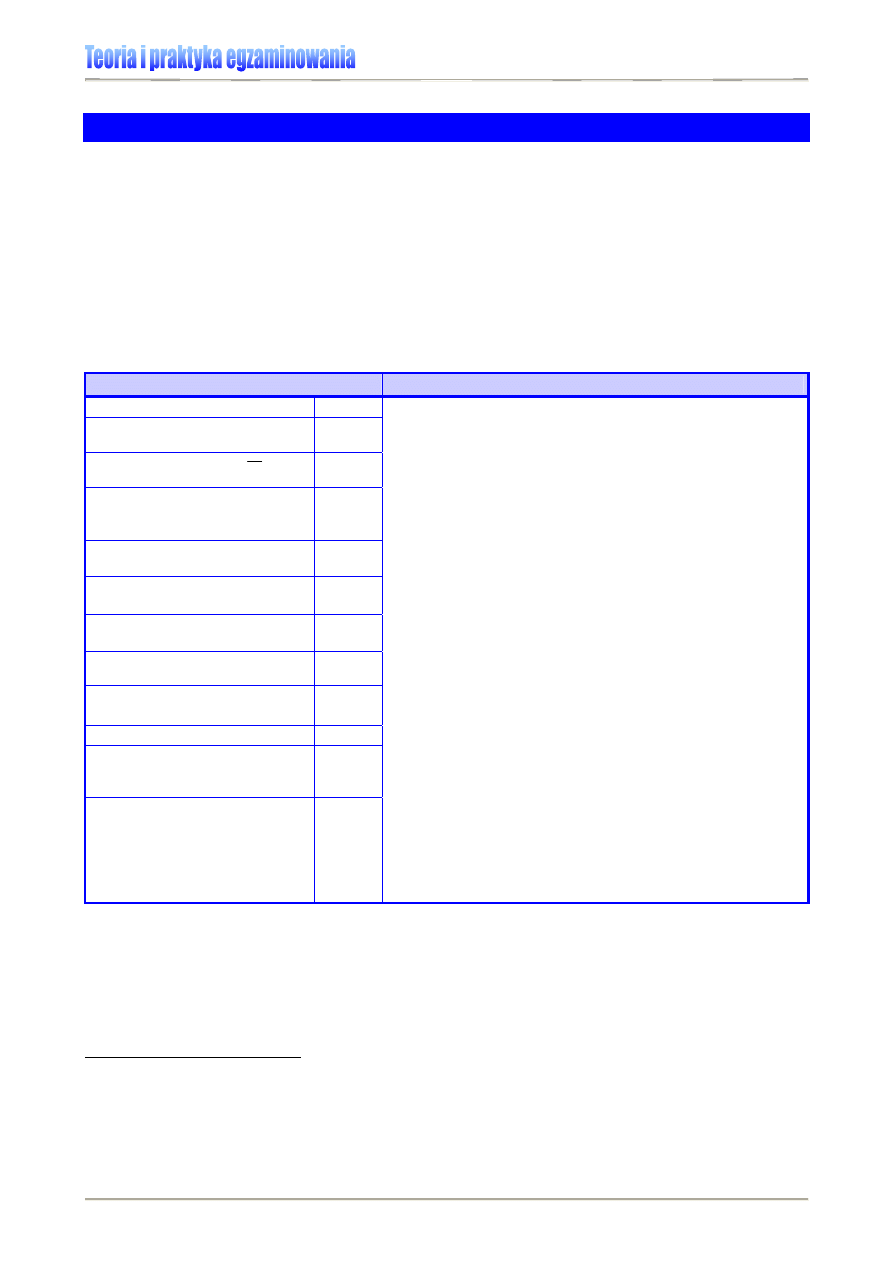

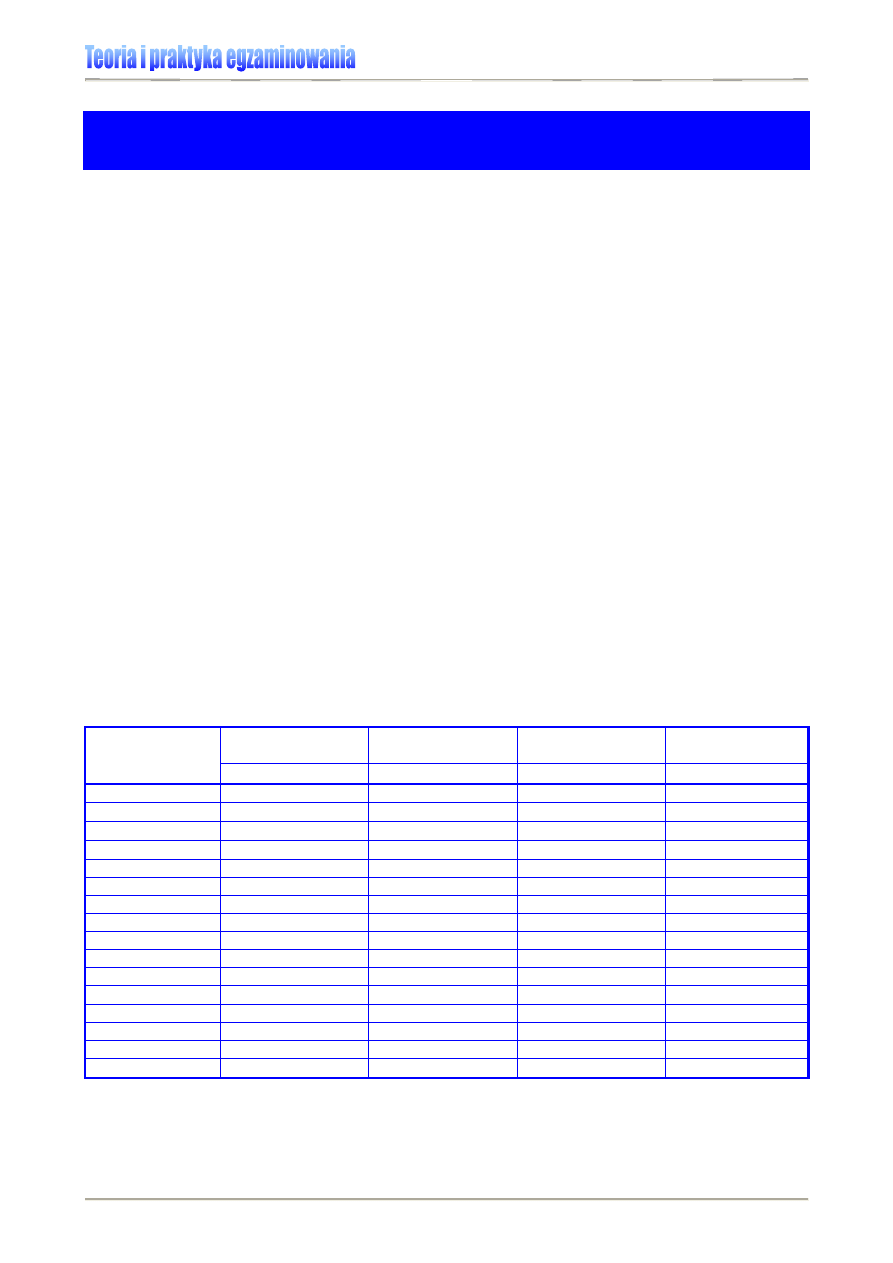

PODSTAWOWE PARAMETRY STATYSTYCZNE

POMOCNE W ANALIZIE ILOŚCIOWEJ WYNIKÓW

Analiza ilościowa wyników polega na zebraniu, zestawieniu, statystycznym opracowaniu

i interpretacji danych uzyskanych podczas badań edukacyjnych, psychologicznych, spo-

łecznych, itp. Opiera się na analizie statystycznej, dzięki czemu uzyskujemy możliwość

dokładniejszego porównania i opisu badanych grup lub zjawisk

0F0F0F0F

1

. Tabela 1. zawiera cha-

rakterystykę podstawowych wskaźników pomocnych w prowadzeniu analiz i interpretowa-

niu wyników oceniania osiągnięć uczniów.

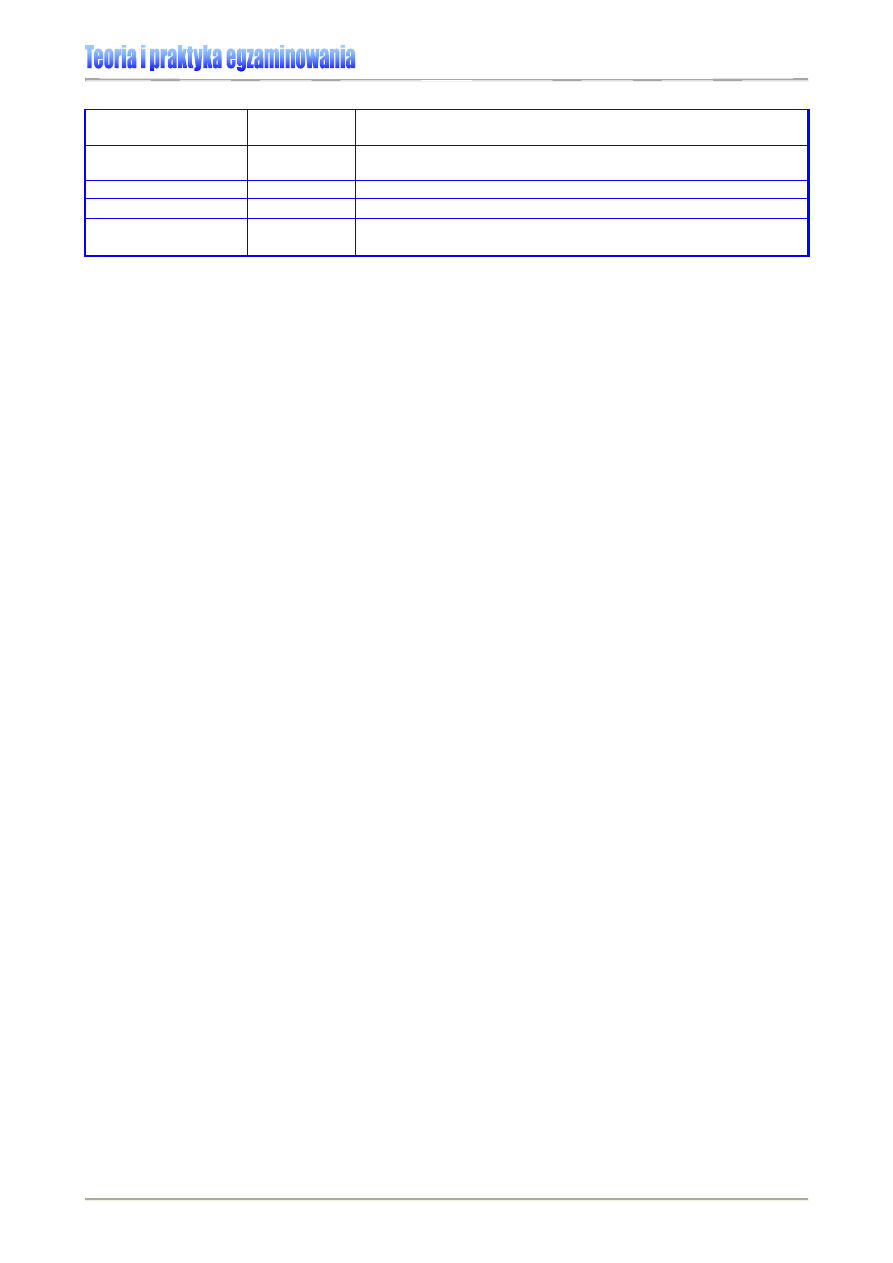

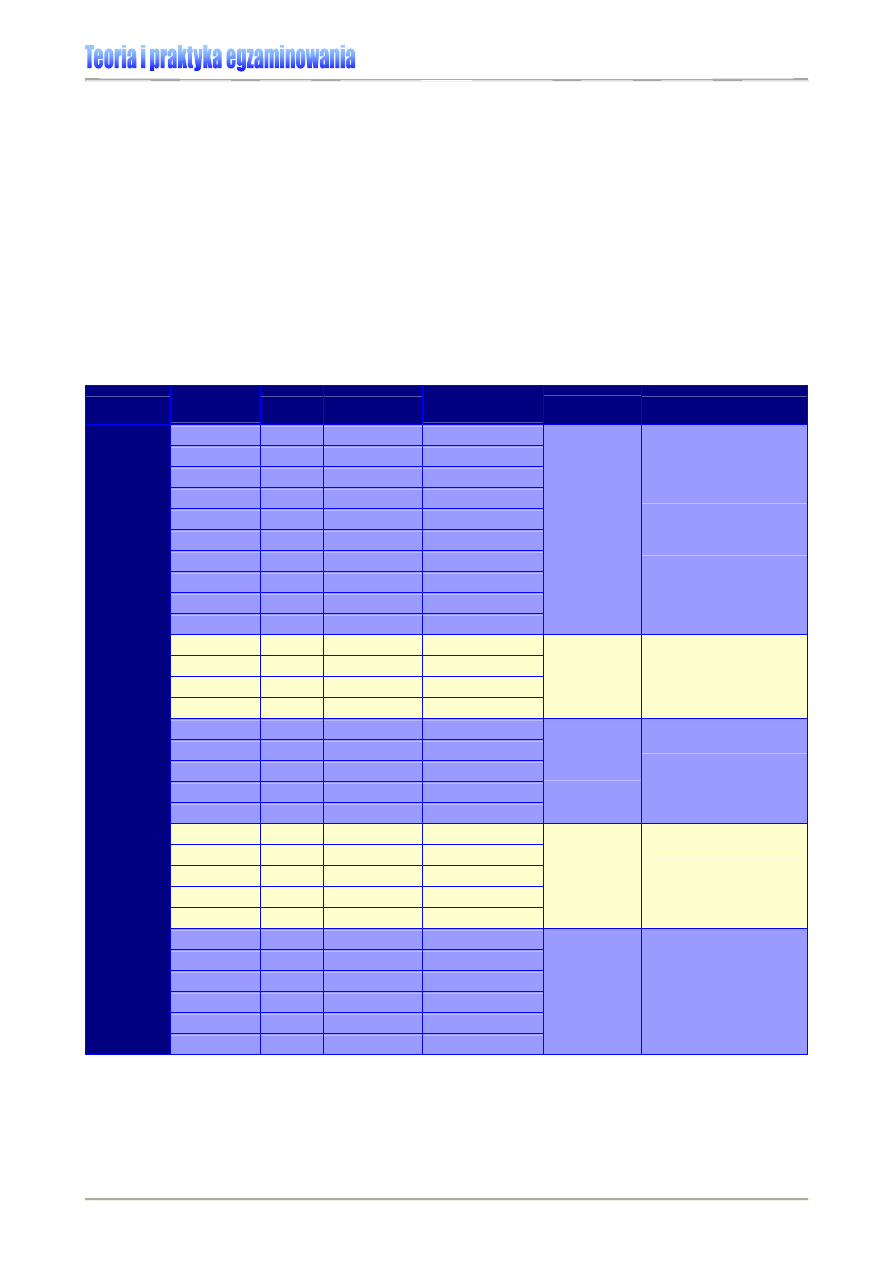

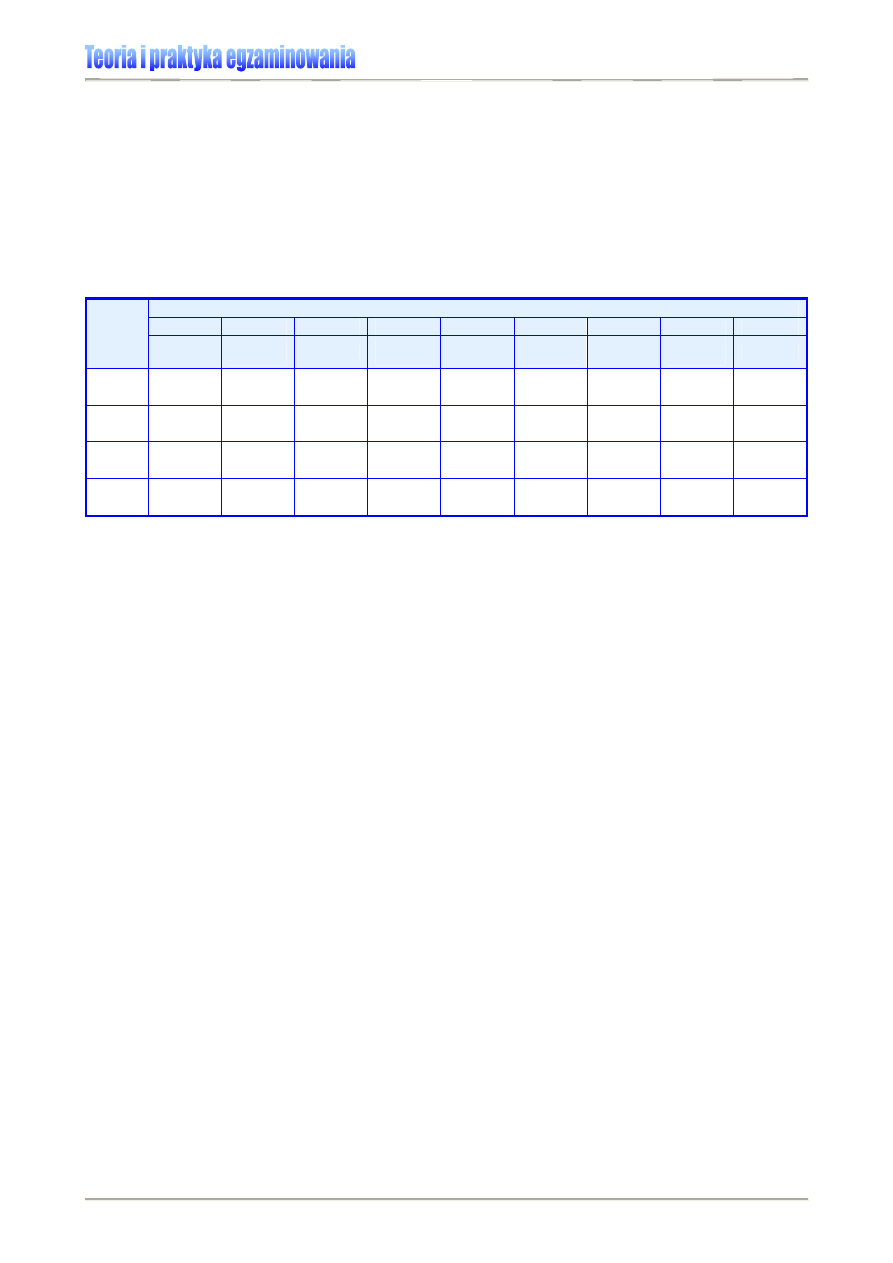

Tabela 1. Podstawowe parametry statystyczne wykorzystywane w analizie i prezentacji wyników osiągnięć

edukacyjnych [6]

1F1F1F1F

2

Parametry statystyczne

służące do analizy

zadań i testu

Parametry statystyczne

służące do analizy

wyników testowania

Sposoby porządkowania

i grupowania

wyników testowania

Analiza zadania/testu

Ustalenie miar

położenia

Ustalenie miar

rozproszenia

Porządkowanie i grupowanie zaob-

serwowanych wartości zmiennej

(tu: wyników testowania uczniów)

Łatwo

ść

Trud

no

ść

Wa

rian

cja

zad

ania

Moc

ró

żnicuj

ąca

śre

dnia

aryt

m

et

ycz

na

Modaln

a

Median

a

Kwantyl

e

Ro

zst

ęp

Wa

rian

cja

tes

tu

Odchyl

enie

stand

ard

owe

Ro

zk

ład

pun

ktowy

Ro

zk

ład

liczebno

ści

Ro

zk

ład

stanin

owy

Ro

zk

ład

cent

ylo

w

y

Sk

ala CEEB

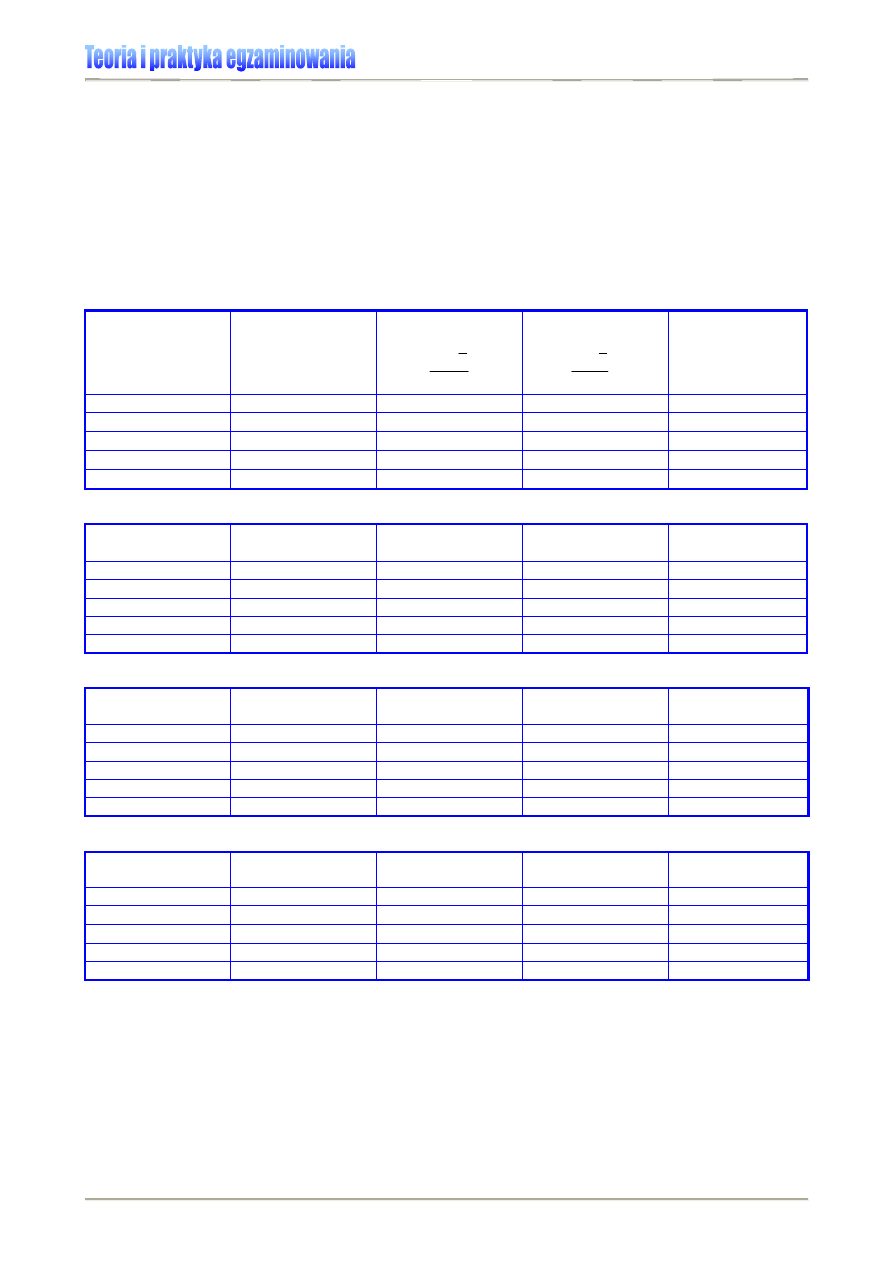

Tabela 2. Podstawowe parametry statystyczne wykorzystywane w analizie i prezentacji wyników osiągnięć

edukacyjnych – charakterystyka [6]

Nazwa parametru Oznaczenie

Objaśnienie

frakcja opuszczeń

zadania

f

o

stosunek liczby uczniów, którzy nie podjęli się rozwiązania danego

zadania (opuścili je) w teście do liczby egzaminowanych uczniów

łatwość zadania/testu

p

stosunek liczby punktów uzyskanych przez ucznia/ów do maksy-

malnej liczby punktów możliwych do zdobycia za zadanie lub test

trudność zadania

q

stosunek liczby uczniów, którzy nieprawidłowo rozwiązali zadanie

w teście do liczby egzaminowanych uczniów

moc różnicująca

zadania

np. D

50,

R

pb

zdolność zadania (zadań testowych) do odróżniania uczniów o

wyższych i niższych osiągnięciach egzaminacyjnych

średnia arytmetyczna

wyników

X

średni wynik uzyskany przez badaną grupę uczniów (np. klasę

szkolną)

mediana

Me

wynik środkowy zbioru wyników egzaminowania określonej popu-

lacji (np. klasy szkolnej), uporządkowanych w kolejności malejącej

lub rosnącej

kwartyle

Q

układ wyników w procentowych przedziałach 25, 50 i 75

modalna (dominanta)

Mo

wynik najczęściej występujący w badanej grupie

rozstęp

(obszar zmienności)

R

różnica pomiędzy najwyższym a najniższym wynikiem uzyskanym

przez daną grupę uczniów podczas badania

wariancja

s

2

x

średnia arytmetyczna kwadratów odchylenia wyników uzyskanych

przez uczniów od ich średniej wartości

odchylenie

standardowe

s

x

miara rozrzutu wyników, pozwalająca na ustalenie przedziału wy-

ników typowych

1

Por. W.P. Zaczyński, Statystyka w pracy badawczej nauczyciela, Warszawa 1997, Wydawnictwo „Żak”, s.

3-5.

2

Cyfry w nawiasach kwadratowych wskazują źródło danych, których wykaz zamieszczono na końcu

opracowania.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

6

obszar wyników

typowych

OWT

przedział wyników na skali mieszczący się pomiędzy sumą

a różnicą średniej arytmetycznej i odchylenia standardowego

rzetelność

np. alfa

Cronbacha

wskaźnik powtarzalności wyników testowania; dokładność

pomiaru

skala staninowa

-

dziewięciostopniowa skala znormalizowanego rozkładu wyników

„standardowa piątka”

-

pięciostopniowa skala znormalizowanego rozkładu wyników

skala centylowa

-

dziewięćdziesięciodziewięciostopniowa skala znormalizowanego

rozkładu wyników

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

7

MIARY POŁOŻENIA

Miary położenia wskazują miejsce, w którym leży wartość (liczba) najlepiej reprezentująca

wszystkie wielkości wchodzące w skład danego zbioru wyników.

Miary tendencji centralnej

Terminem tendencja centralna określa się wartość, która położona jest najbliżej najwięk-

szego skupienia wartości i dlatego można ją uznać za typową dla całego zbioru badanych.

Do najczęściej stosowanych miar należą: średnia arytmetyczna, wartość modalna i

mediana

2F2F2F2F

3

.

Przykład:

Prezentowane przez system egzaminacyjny

3F3F3F3F

4

doroczne wyniki szkół zawierają informa-

cje o tych miarach:

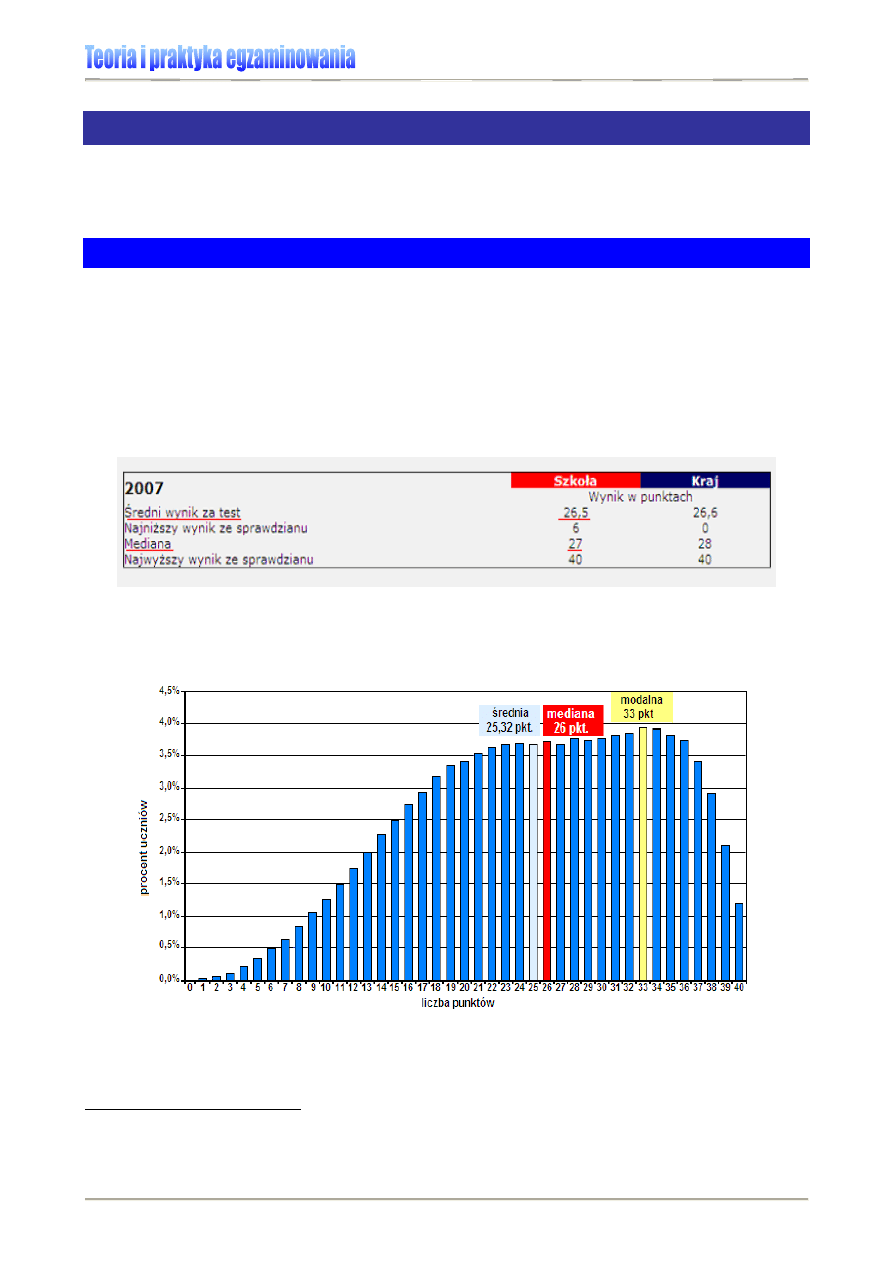

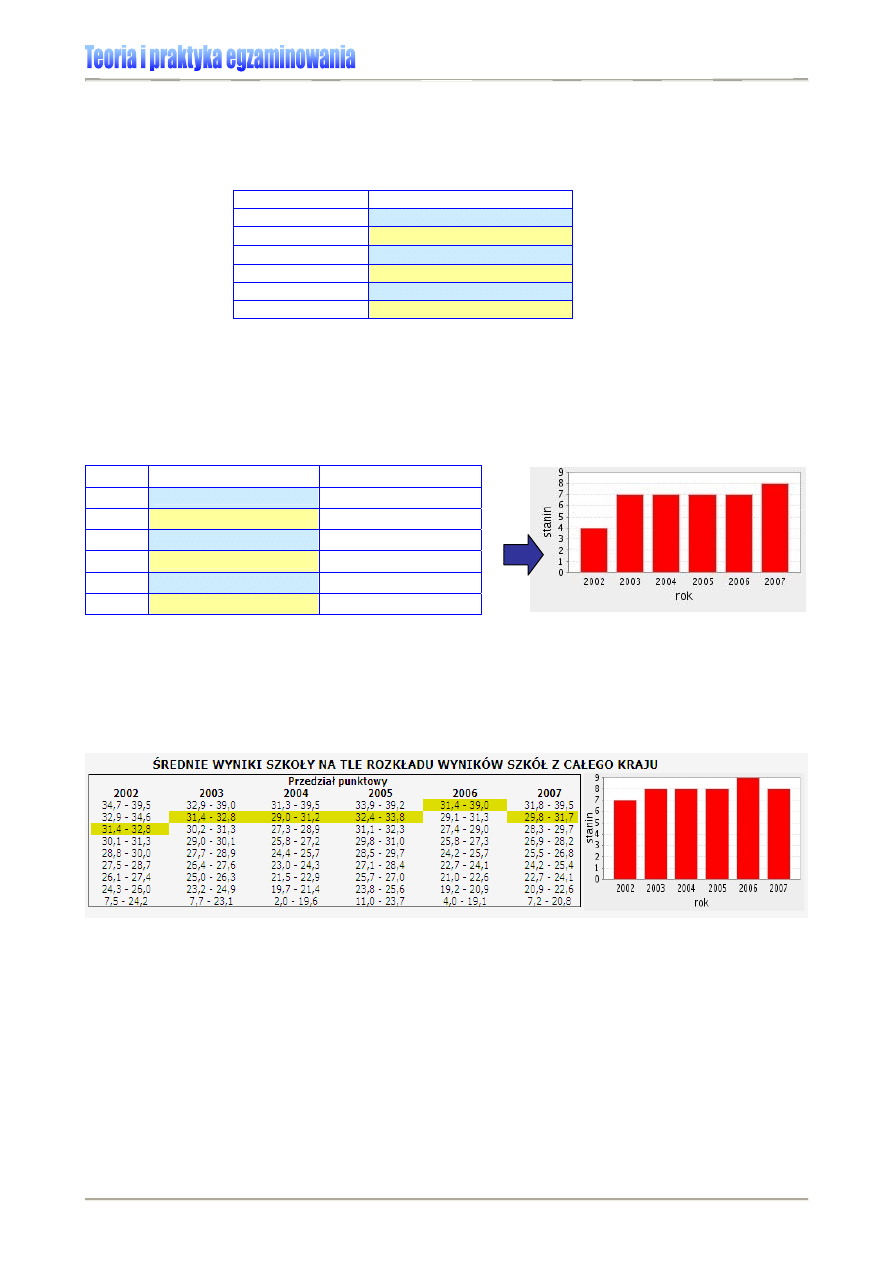

Tabela 3. Miary tendencji centralnej dla wyników sprawdzianu 2007 Szkoły Podstawowej w M. [7]

Miary tendencji centralnej służą do wyznaczenia wartości, wokół której grupują się dane

4F4F4F4F

5

.

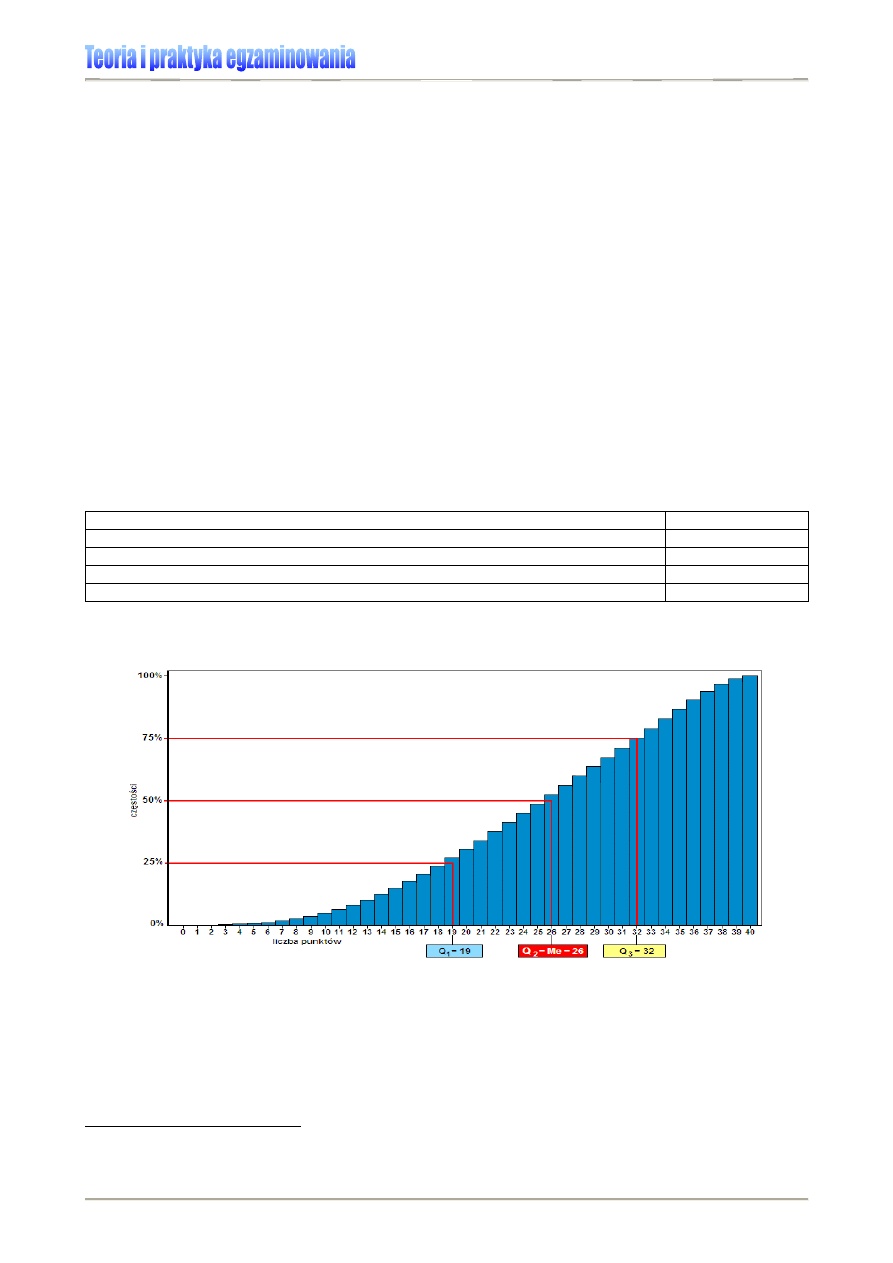

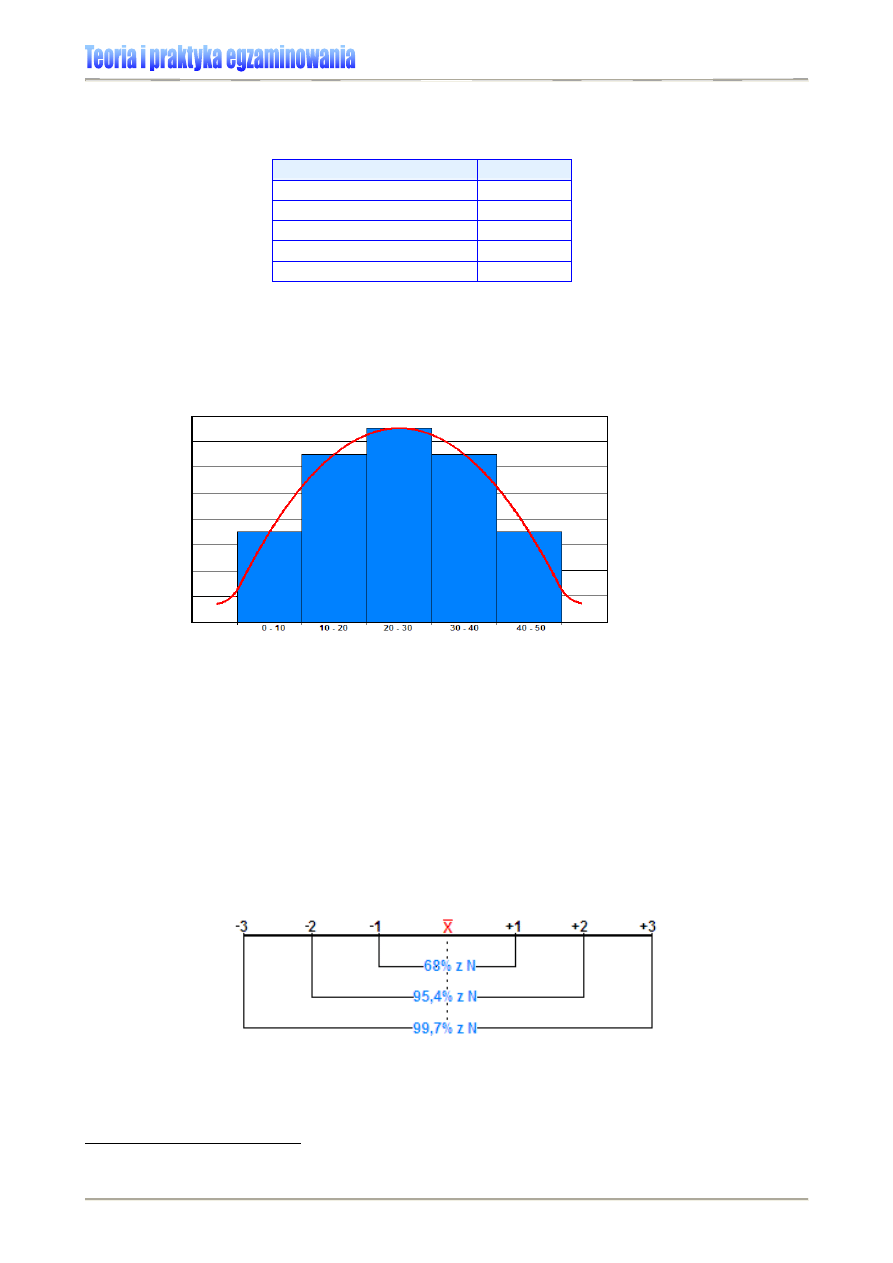

Wykres 1. pozwoli nam wskazać te parametry dla sprawdzianu 2006.

Wykres 1. Rozkład wyników krajowych sprawdzianu 2006 [2]

3

G.A. Ferguson, Y. Takane, Analiza statystyczna w psychologii i pedagogice, PWN, Warszawa 2004, s.69.

4

Zob.: www.cke.edu.pl – tu: Wyniki szkół.

5

W. Starzyńska, Statystyka praktyczna, PWN, Warszawa 2002, s.47.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

8

N

Xi

X

∑

=

Modalna (dominanta, moda)

Modalna (oznaczana często symbolem D lub M

o

) jest wynikiem, który w badanej populacji

występuje najczęściej, tzn. jest np. najczęściej uzyskaną liczbą punktów, najczęściej wy-

bieraną odpowiedzią.

Na sprawdzianie w 2006 roku modalna przyjęła wartość 33, co oznacza, że taką liczbę

punktów uzyskało najwięcej uczniów piszących ten sprawdzian.

Mediana

Mediana (Me, M) jest wartością dzielącą wyniki pomiaru uporządkowane od najwyższego

do najniższego (lub odwrotnie) dokładnie na połowy. Aby ją wyznaczyć, porządkujemy

wszystkie wyniki określonej populacji (np. klasy szkolnej, szkoły, uczniów szkół w woje-

wództwie, czy też wszystkich uczniów w kraju, którzy np. przystąpili do egzaminu) w kolej-

ności malejącej lub rosnącej. Następnie otrzymany zbiór dzielimy na pół. W przypadku

nieparzystej liczby badanych (wyników), medianę stanowi wartość środkowa.

Przykład:

Testowaniu zostało poddanych trzynastu uczniów.

Ich wyniki zostały uporządkowane od

najniższego do najwyższego: 2, 3, 4, 4, 6, 8,

9

, 11, 12, 15, 16, 16, 18. Zatem medianą będzie wy-

nik siódmy, czyli 9 punktów.

Jeżeli liczba badanych (wyników) jest parzysta, medianę wyznaczamy, obliczając średnią

dwóch środkowych wyników

5F5F5F5F

6

.

Przykład:

. Testowaniu zostało poddanych dwunastu uczniów.

Ich wyniki zostały uporządkowane

od najniższego do najwyższego: 2, 3, 4, 4, 6,

8

,

9

, 11, 12, 15, 16, 16. Zatem medianą będzie wynik

szósty i siódmy, czyli 8,5 punktu [8 + 9 = 8,5].

Podczas sprawdzianu przeprowadzonego w 2006 roku, mediana przyjęła wartość 26

punktów (patrz: Wykres 1.) i była nieznacznie wyższa niż średnia, co oznacza, że dla du-

żej części uczniów sprawdzian ten okazał się dość łatwy. Dowodzi tego też „najpopular-

niejszy” wynik, czyli modalna – 33 punkty.

Średnia arytmetyczna

Średnia arytmetyczna informuje o tym, ile punktów teoretycznie otrzymałby każdy uczeń

za rozwiązanie testu, gdyby wszystkie uzyskane przez badanych punkty rozdzielić między

nich po równo. Zatem statystyczny uczeń, który przystąpił do sprawdzianu 2006 (patrz:

Wykres 1.) średnio uzyskał 25,32 pkt. Średnią arytmetyczną oznacza się najczęściej sym-

bolem X i oblicza według wzoru

6F6F6F6F

7

:

6

B. Niemierko, Testy osiągnięć szkolnych. Podstawowe pojęcia i techniki obliczeniowe. WSiP, Warszawa

1975, s. 56-57.

7

Por. G.A. Ferguson, Y. Takane, op.cit., s.69-70.

gdzie:

Xi

∑

oznacza sumę wszystkich mierzonych wartości (punktów), a N liczbę pomiarów

(uczniów).

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

9

∑

∑

=

N

X

ni

X

Przykład:

Mamy liczby: 1, 2, 3, 2, 2, 6. Średnią z tych liczb otrzymamy, sumując je i dzieląc przez

liczbę ich wystąpień:

67

,

2

6

16

6

6

2

2

3

2

1

=

=

+

+

+

+

+

=

X

W powszechnym użyciu średnia arytmetyczna zastępowana jest słowem przeciętna, jak

np. przeciętna ocen.

Uwaga: Należy pamiętać o tym, że średnia arytmetyczna jest miarą bardzo wrażliwą na

wyniki skrajne (tj. najniższe i najwyższe). Jeżeli mamy pojedynczy wynik znacząco niższy

lub wyższy od pozostałych, to wpłynie on na wartość średniej

7F7F7F7F

8

, zwłaszcza w przypadku

niewielkiej grupy badanych. Na przykład w zespole klasowym, w którym przeważa grupa

uczniów o bardzo wysokich wynikach kształcenia, niski wynik pojedynczego ucznia zna-

cząco wpłynie na obniżenie średniej, a wynik żadnego ucznia nie będzie zbliżony do śred-

niej.

Średnia ważona

Średnią ważoną liczymy wówczas, gdy poszczególne wartości mają różne wagi (rangi), tj.

wyższe znaczenie, nierównorzędną ważność. Obliczamy ją według wzoru:

Przykład:

Uczeń uzyskał następujące oceny szkolne: ze sprawdzianu – 5, z pracy domowej – 3, z

odpowiedzi – 4 i 3 (średnia 3,5). Załóżmy, że większą wartość informacyjną dla nauczyciela o

osiągnięciach edukacyjnych ucznia mają stopnie uzyskane ze sprawdzianu niż z odpowiedzi ust-

nej, dlatego poszczególnym aktywnościom ucznia podlegającym ocenie nadajemy odpowiednią

rangę (w statystyce – wagę). Dajmy na to, że sprawdzianowi nadajemy wagę 3, pracy domowej 1,

odpowiedziom ustnym 2. Sumę tych wartości - 6 wpisujemy w mianowniku.

Średnią ważoną obliczamy w następujący sposób:

17

,

4

6

25

2

1

3

2

5

,

3

1

3

3

5

=

=

+

+

⋅

+

⋅

+

⋅

=

X

Gdybyśmy obliczali tylko średnią arytmetyczną, uzyskalibyśmy wynik niższy:

X

=3,75.

Kwantyle

Kwantyle to wartości, które dzielą badaną zbiorowość na części pozostające ze sobą w

odpowiednim stosunku. Do najczęściej stosowanych należą kwartyle, dzielące zbioro-

wość na 4 części, decyle (na 10 części) i percentyle (na 100 części).

Kwartyle

Definiuje się je jako wartości cechy badanej zbiorowości, przedstawionej w postaci szere-

gu statystycznego (czyli uporządkowanego według określonego kryterium, np. od naj-

mniejszego do najwyższego wyniku), które dzielą zbiorowość na cztery części pod wzglę-

dem liczby jednostek. Części te pozostają do siebie w określonych proporcjach. Kwartyle

są wartościami granicznymi w szeregu wyników wyznaczających te części.

8

B. Niemierko, op.cit., s.52.

gdzie:

X

ni

to iloczyn średniej i rangi (wagi), a

∑

X

ni

oznacza sumę tych iloczynów;

∑

N

to su-

ma wag poszczególnych wartości.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

10

Kwartyl zerowy to wartość minimalna uzyskana przez badanych (patrz: rozstęp wyników).

Kwartyl pierwszy „odcina” dolną ćwiartkę uporządkowanego zbioru wyników, czyli 25%

wyników ma od niego mniejszą wartość, a 75% większą. Z kolei kwartyl drugi dzieli zbiór

na połowę i stanowi medianę. Trzeci kwartyl wyznacza górną ćwiartkę wyników, czyli 75%

wyników ma od niego mniejszą wartość, a 25% wyższą. Natomiast kwartyl czwarty to war-

tość maksymalna wyników.

Podanie kwartyli wzbogaca informację o łatwości danego arkusza. Im trudniejszy test dla

uczniów, tym niższe będą wartości poszczególnych kwartyli.

8F8F8F8F

9

Rozstęp ćwiartkowy jest różnicą wyniku pomiędzy trzecim i pierwszym kwartylem. Mierzy

on poziom zróżnicowania tylko części jednostek, pozostałych po odrzuceniu 25%

jednostek o wartościach najmniejszych (Q1) i 25% jednostek o wartościach największych

(Q3). Ponieważ między pierwszym i trzecim kwartylem znajduje się z definicji 50%

wyników, dlatego im większy jest rozstęp, tym większe zróżnicowanie badanej cechy.

Przykład:

Tabela 4. przedstawia podział na kwartyle obliczony dla sprawdzianu 2006 (por. też

Rysunek 1.). Rozstęp ćwiartkowy wynosi 13, bo kwartyl trzeci przyjął wartość liczbową 32, a

kwartyl pierwszy – 19 [32 – 19 = 13].

Tabela 4. Podział kwartylowy i rozstęp ćwiartkowy wyników sprawdzianu 2006 [6]

1. kwartyl – najwyższy wynik uczniów z pierwszej ćwiartki (25%) wyników

19

2. kwartyl (mediana) – wynik środkowy w zbiorze wyników sprawdzianu

26

3. kwartyl – najwyższy wynik uczniów z trzeciej ćwiartki (75%) wyników

32

4. kwartyl – najwyższy wynik ze sprawdzianu

40

rozstęp ćwiartkowy (3. kwartyl minus 1. kwartyl)

13

Kwartyle możemy wyznaczyć graficznie, tak jak to pokazano na Rysunku 1.

Rysunek 1. Wyznaczanie kwartyli dla wyników sprawdzianu 2006 [6]

Dla przykładu przeanalizujmy i zinterpretujmy wyniki sprawdzianu 2006 uczniów pewnej

szkoły podstawowej.

Przykład:

W Szkole Podstawowej w Iksowie sprawdzian pisało stu uczniów. Informacji o rozkła-

dzie ich wyników dostarczą nam: Tabela 5., Wykres 2. oraz Rysunek 1. Rozstęp wyników (40 pkt.

– 3 pkt. = 37 pkt.) dowodzi, że w tej szkole sprawdzian pisała dość zróżnicowana populacja

uczniów, gdyż znalazł się wśród nich i taki, którego wynik to zaledwie 3 pkt., ale jest też dwóch

9

H. Szaleniec, M.K. Szmigel, Doskonalenie kompetencji nauczycieli w zakresie oceniania zewnętrznego,

Wydawnictwo Zamiast korepetycji, Kraków 2001, s.62-63

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

11

uczniów o wyniku maksymalnym. Widać jednak wyraźnie, że grupa 25% dzieci o najsłabszych

wynikach z testu, to uczniowie o bardzo zróżnicowanych osiągnięciach, bo należą do niej zarówno

ci, którzy zdobyli zaledwie 3 czy 4 punkty, jak i ci, którzy uzyskali ich 17, 18 czy 19. Bardziej jedno-

rodną grupę stanowią uczniowie o wynikach najwyższych, bo ich wyniki zawierają się w przedziale

od 33 do 40 punktów. Przeciętny wynik ucznia w tej szkole to 26 punktów (tyle wynosi mediana).

Rozstęp ćwiartkowy pokazuje nam wynik grupy 50% uczniów, którzy napisali test średnio (pamię-

tajmy – w porównaniu z wynikami innych uczniów tej szkoły, a nie „w ogóle”). Zróżnicowanie ich

wyników jest mniejsze (13 punktów) niż w grupie uczniów o najniższych osiągnięciach (17 punk-

tów). W tej szkole największa liczba uczniów (siedmiu) uzyskała 27 punktów (to modalna).

Tabela 5. Rozkład wyników sprawdzianu 2006 w SP w Iksowie (N=100) [6]

Wynik

0. kwartyl – najniższy wynik ze sprawdzianu

3 pkt.

1. kwartyl – najwyższy wynik uczniów z pierwszej ćwiartki (25%) wyników

19 pkt.

2. kwartyl (mediana) – wynik środkowy w zbiorze wyników sprawdzianu

26 pkt.

3. kwartyl – najwyższy wynik uczniów z trzeciej ćwiartki (75%) wyników

32 pkt.

4. kwartyl – najwyższy wynik ze sprawdzianu

40 pkt.

rozstęp (wynik najwyższy minus wynik najniższy) 37

pkt.

rozstęp ćwiartkowy (3. kwartyl minus 1. kwartyl)

13 pkt.

Wykres 2. Rozkład wyników sprawdzianu 2006 w SP w Iksowie (N=100) [6]

liczba egzaminowanych:

N=100

0

1

2

3

4

5

6

7

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40

liczba punktów uzyskanych przez uczniów za test

cz

ę

sto

ść

(liczba uczniów, którzy uzyskali

dany wynik)

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

12

Zastosowanie podstawowych miar tendencji centralnej

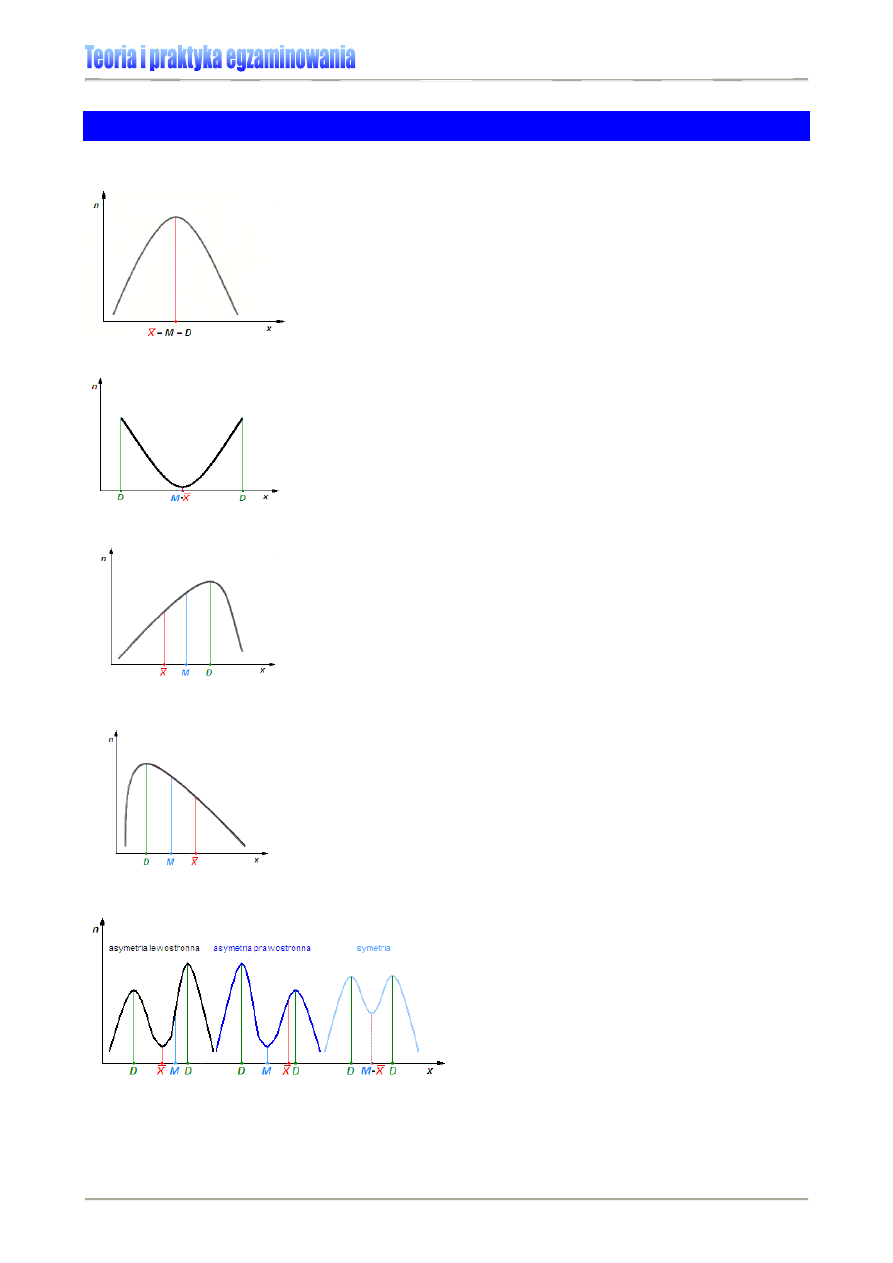

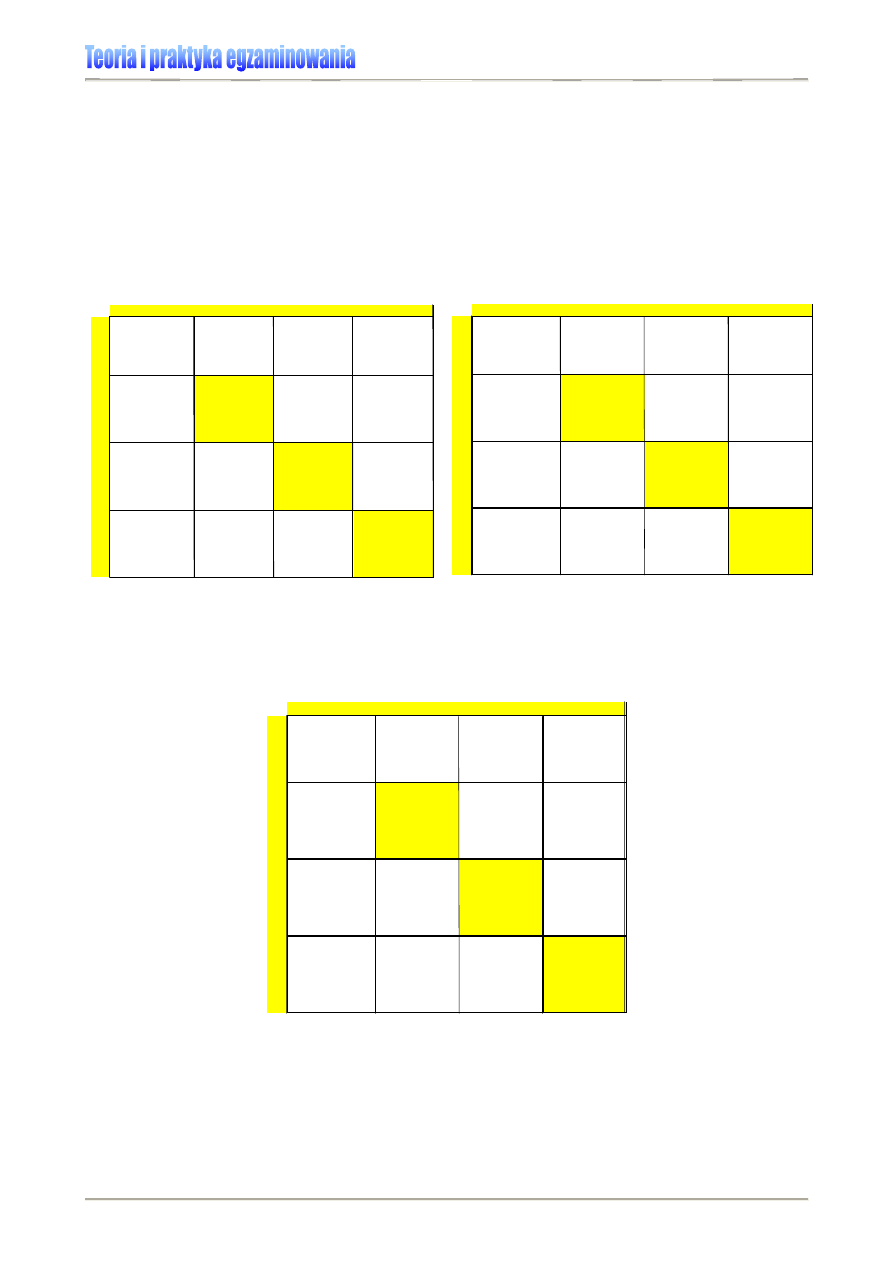

Rysunek 2. Rozkład symetryczny

Rysunek 3. Rozkład u-kształtny

Rysunek 4. Rozkład asymetryczny lewostronnie

Rysunek 5. Rozkład asymetryczny prawostronnie

Rysunek 6. Rozkład dwumodalny

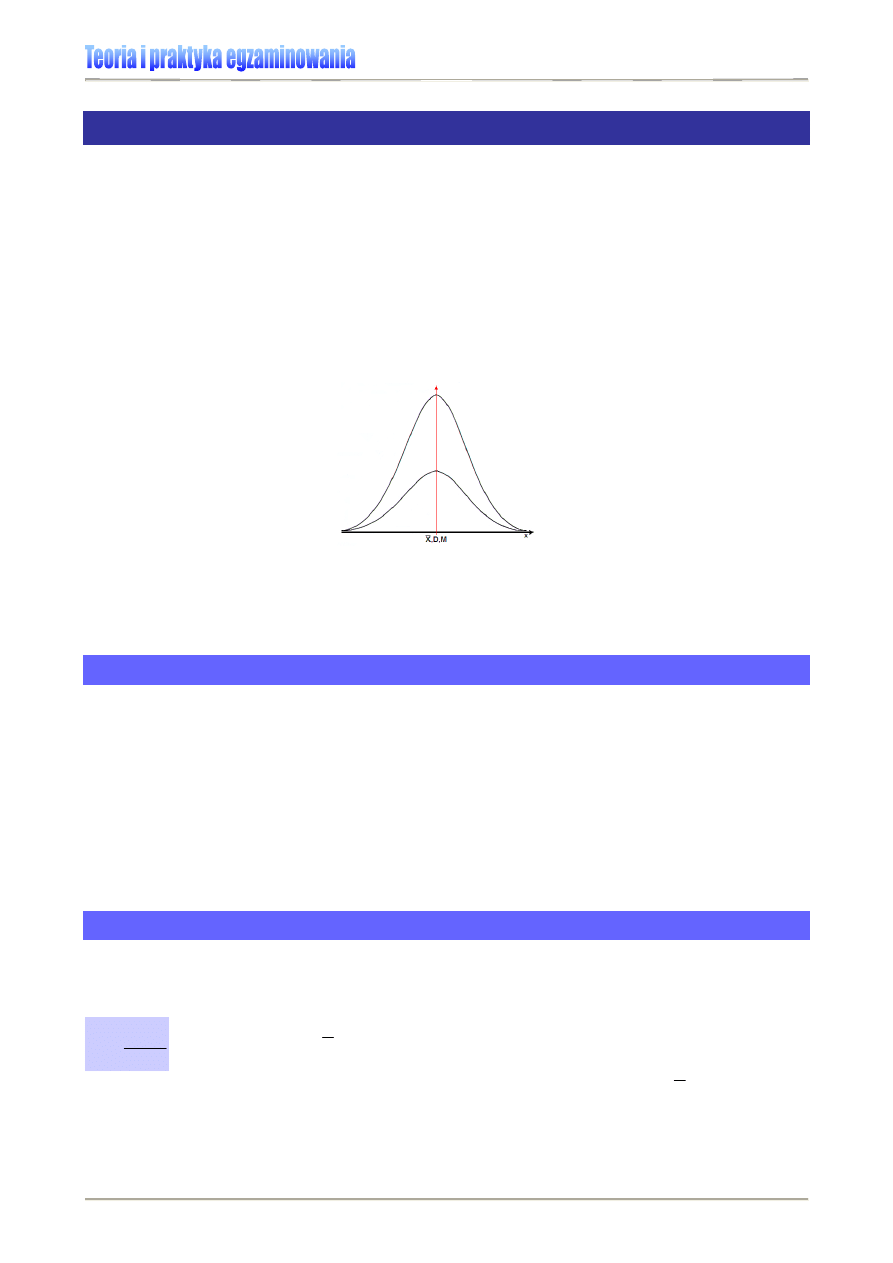

Na Rysunku 2. przedstawiony jest rozkład wyników, gdzie

średnia, mediana i modalna (dominanta) przyjęły tę samą

wartość, tj. znajdują się w tym samym miejscu. Rozkład wy-

ników w związku z tym jest symetryczny. Rozkłady syme-

tryczne rzadko występują w praktyce szkolnej związanej z

badaniem osiągnięć uczniów. Najczęściej mamy do czynienia

z wykresami asymetrycznymi.

Jeżeli średnia jest niższa od modalnej i mediany, uzyskuje-

my rozkład wyników asymetryczny ujemnie (patrz: Rysunek

4.). Rozkład zwany ujemnieskośnym lub lewoskośnym,

oznacza że uczniowie w większości uzyskali wysokie wyniki

w teście lub na egzaminie.

Rozkład, w którym modalna jest niższa od mediany, a me-

diana niższa od średniej, nazywany jest dodatnioskośnym

lub prawoskośnym (Rysunek 5.). Taki rozkład wyników

oznacza, że większość uczniów uzyskała niskie wyniki w te-

ście lub na egzaminie, bo rozwiązywane zadania okazały się

dla nich trudne.

Rozkład, w którym wystąpiły dwie dominanty

(modalne) nazywamy dwumodalnym. Taki

rozkład wyników oznacza, że w badaniu ma-

my do czynienia z dwiema grupami uczniów o

różnych osiągnięciach. Rysunek 6. przedsta-

wia przykłady trzech typowych, symetrycz-

nych układów dwumodalnych.

Rozkład stanowiący lustrzane odbicie rozkładu zaprezento-

wanego na Rysunku 2., w którym dominują wyniki skrajne –

najwyższe i najniższe, nazywamy u-kształtnym (Rysunek

3.). W wypadku rozkładu normalnego u-kształtnego media-

na i średnia mają wartości najniższe i pokrywają się ze so-

bą. Taki układ wyników często wynika z użycia niezbyt traf-

nego narzędzia pomiarowego (testu).

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

13

Przykład:

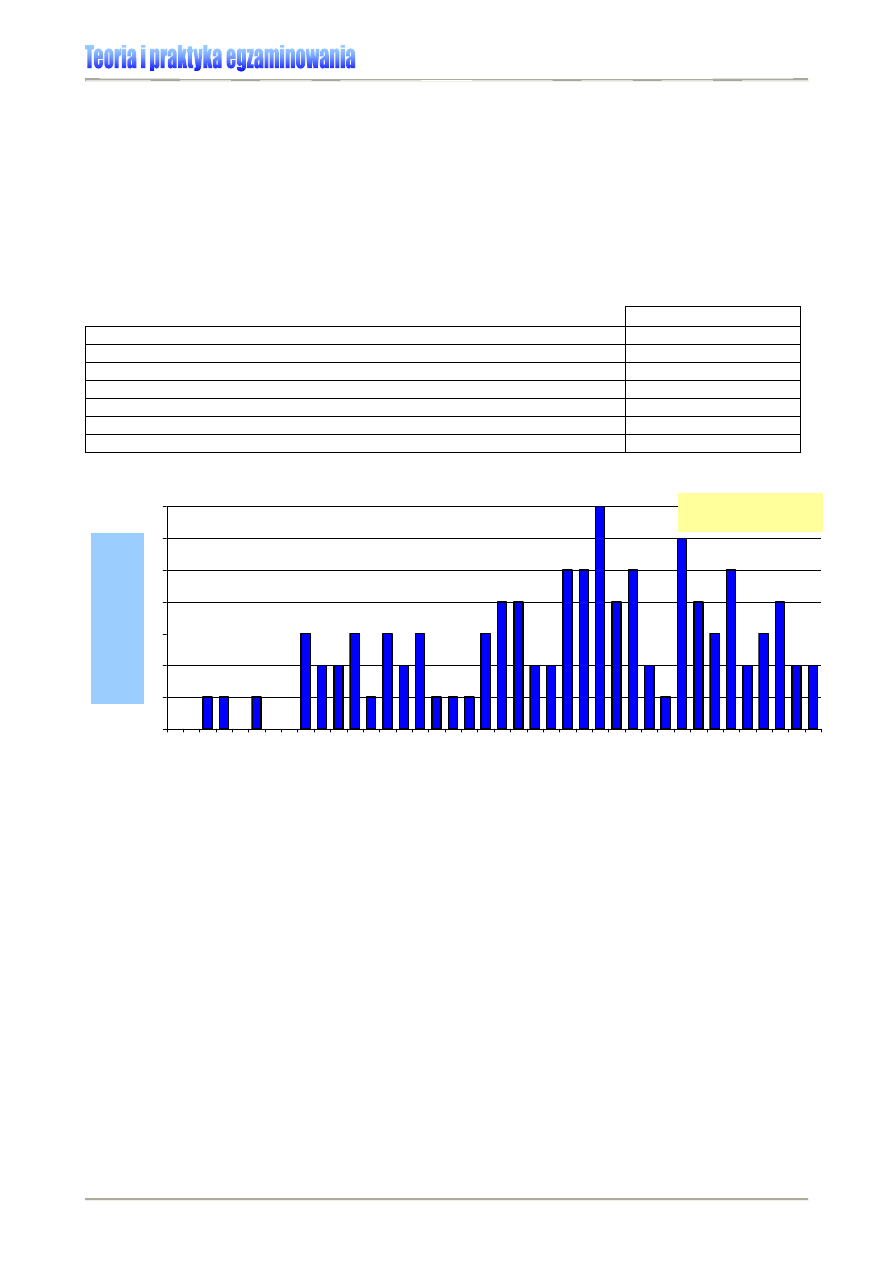

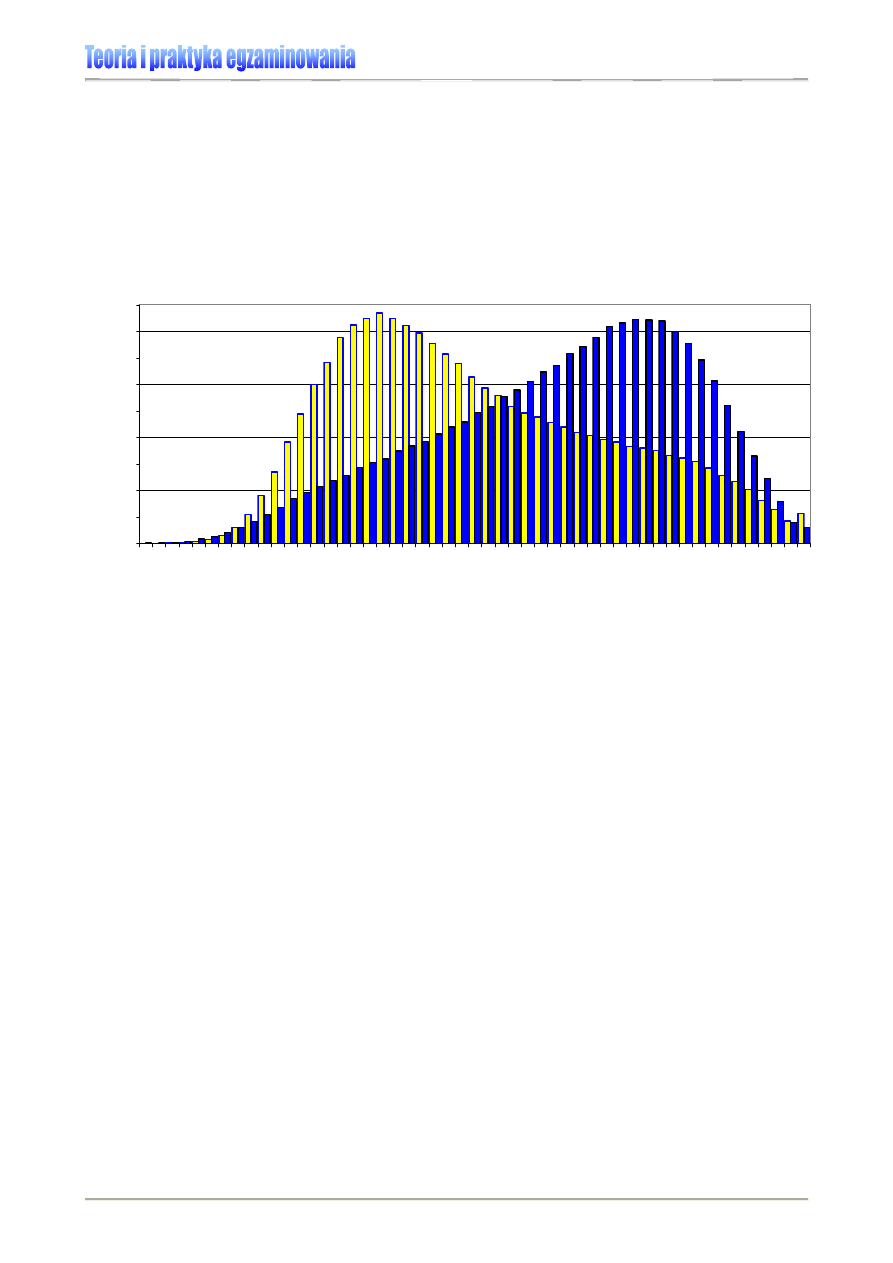

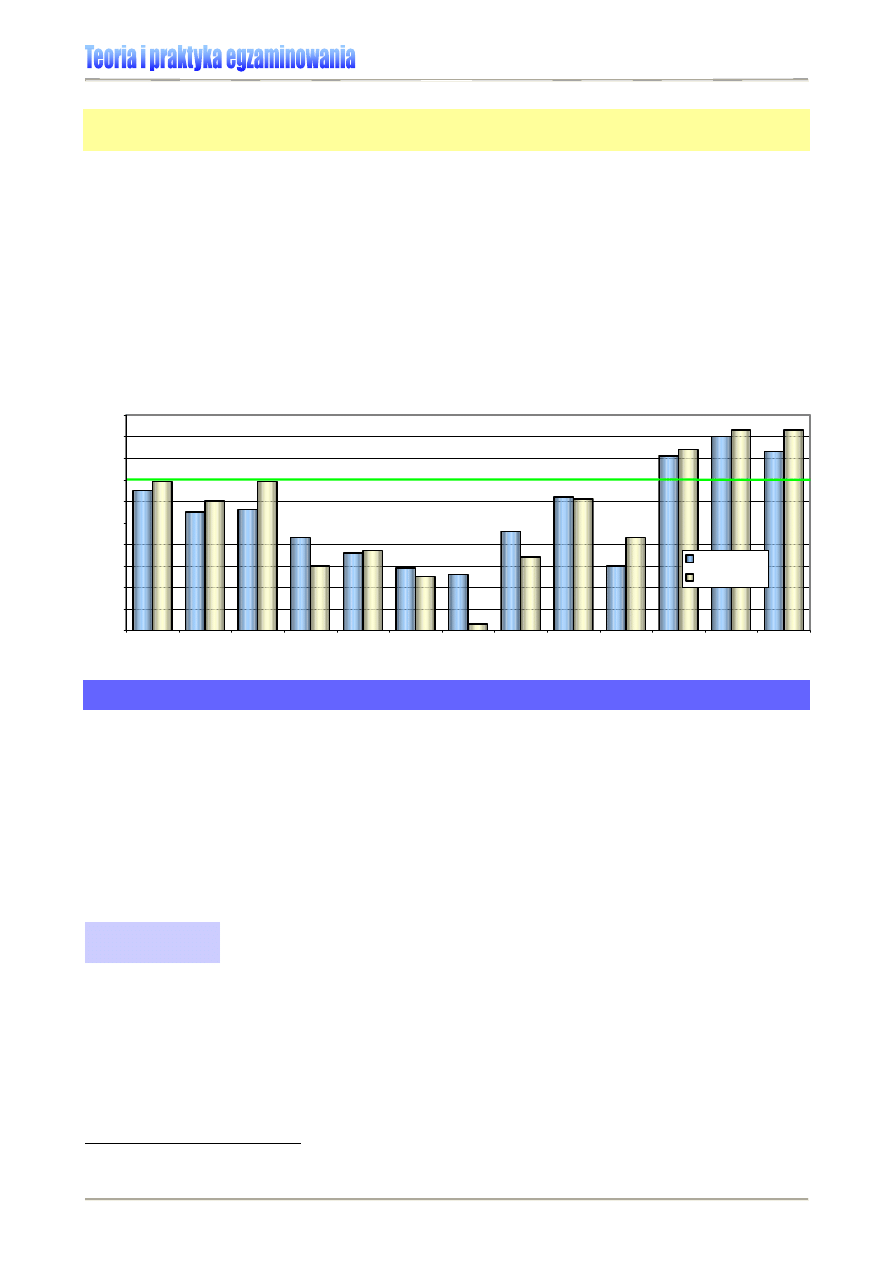

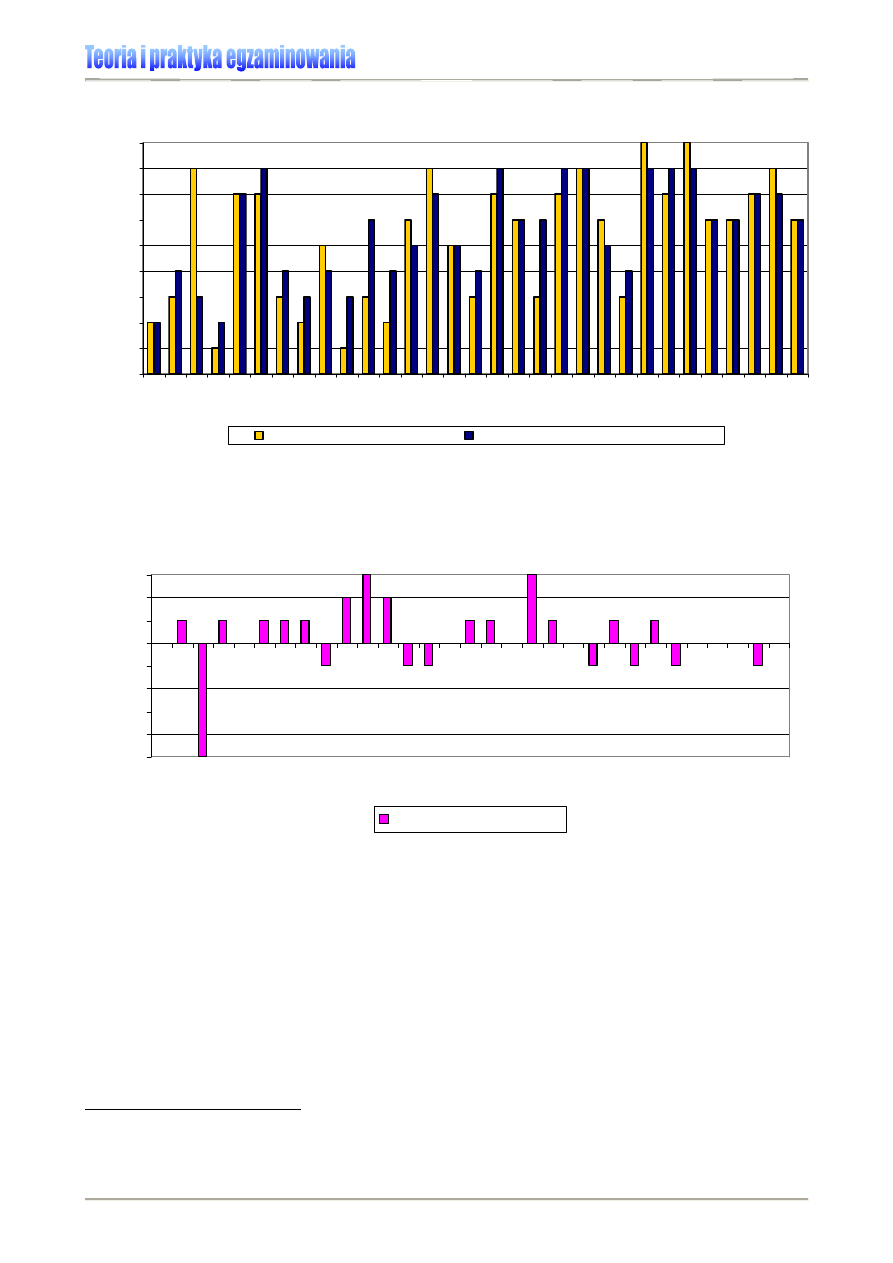

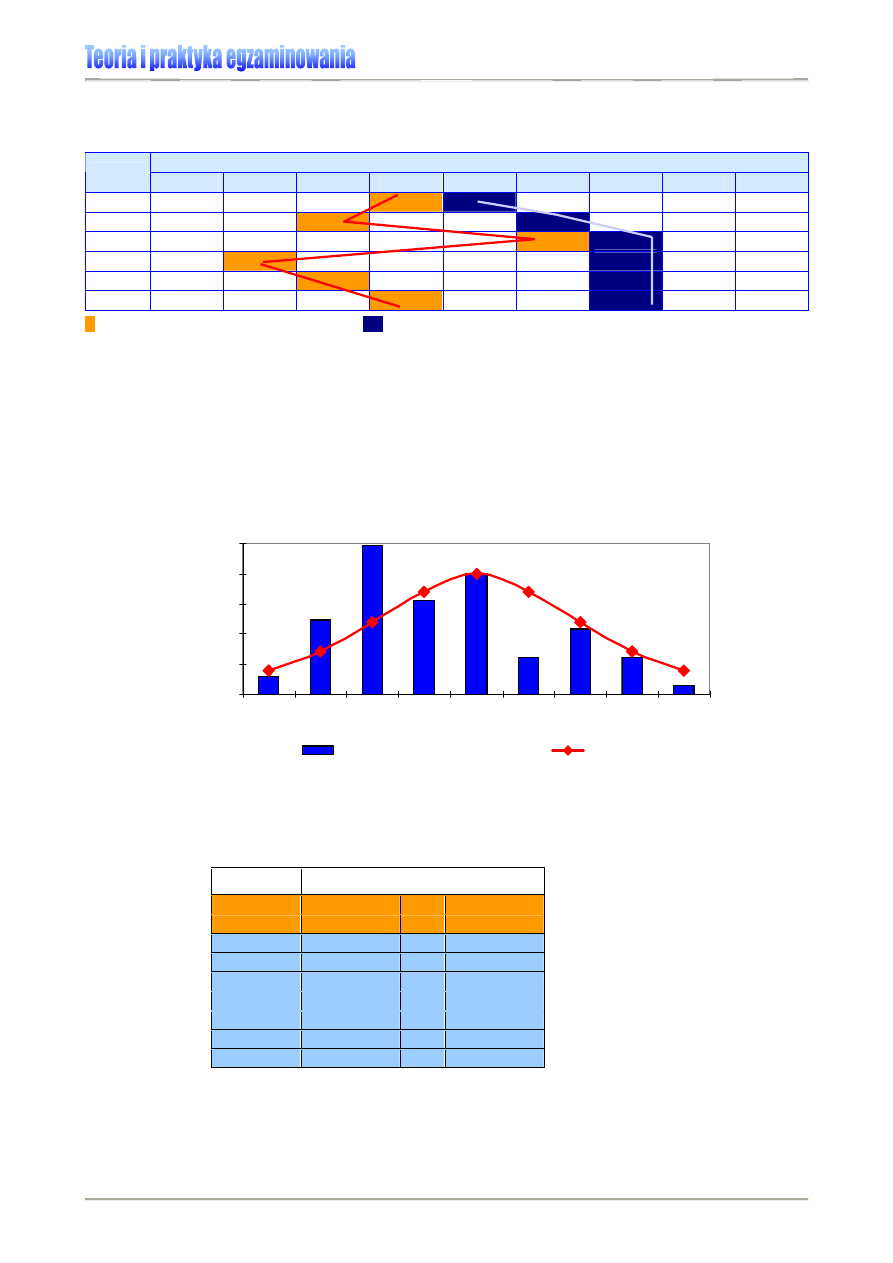

Wykres 3. prezentuje rozkłady wyników przeprowadzonych w 2007 r. dwóch części eg-

zaminu gimnazjalnego. Ich odmienne ukształtowanie zwraca uwagę na różnicę w rozkładzie wyni-

ków z części humanistycznej i matematyczno-przyrodniczej egzaminu – lewoskośny rozkład wyni-

ków z części humanistycznej (kolor niebieski) świadczy o większej liczbie w populacji wyników

wysokich, prawoskośność rozkładu wyników z części matematyczno-przyrodniczej (kolor żółty)

wskazuje zaś na dominację wyników niskich i średnich. Tak więc, mimo że oba testy pisali ci sami

uczniowie, sprawiły im one różną trudność.

Wykres 3. Egzamin gimnazjalny 2007 – rozkład wyników krajowych w części humanistycznej (kolor

niebieski) i matematyczno-przyrodniczej (kolor żółty) [4]

0,0%

0,5%

1,0%

1,5%

2,0%

2,5%

3,0%

3,5%

4,0%

4,5%

0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50

punkty

% l

iczebno

ści

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

14

MIARY ROZPROSZENIA (ZRÓŻNICOWANIA)

Miary tendencji centralnej nie wystarczają, aby w pełni scharakteryzować i porównać ba-

dane cechy populacji. Może się bowiem zdarzyć, że w kolejnych pomiarach, mimo iż śred-

nia, mediana i modalna przyjmą identyczną wartość, wyniki będą różnić się w istotny spo-

sób (zob. Rysunek 7.). Stąd, by dokładniejszej scharakteryzować badane grupy, oblicza

się miary rozproszenia (rozrzutu), które opisują, jak bardzo wyniki te odchylają się od war-

tości centralnej, jak bardzo są zróżnicowane. Są to wskaźniki dyspersji. Należą do nich:

rozstęp wyników pomiaru, wariancja i odchylenie standardowe. Im mniejszą wartość

liczbową przyjmuje współczynnik dyspersji, tym większe jest skupienie wyników pomiarów

wokół średniej i tym mniej są one zróżnicowane.

Rysunek 7. Przykład różnic rozkładów przy identycznej wartości centralnej

Jeśli wariancja jest mała, wówczas wyniki poszczególnych pomiarów leżą w pobliżu war-

tości średniej (rozkład w kształcie wąskiego dzwonu). Jeżeli jest ona duża, to wyniki są

bardziej rozproszone (rozkład przyjmuje kształt szerokiego dzwonu).

Rozstęp

Rozstęp jest różnicą między najwyższym i najniższym wynikiem. Pokazuje, jak różne wy-

niki uzyskali badani uczniowie.

Przykład:

Mamy kolejne liczby: 4, 8, 9, 45, 32, 13. Rozstęp liczymy, odejmując od najwyższej licz-

by liczbę najniższą w szeregu: 45 – 4 = 41.

W przypadku wyników sprawdzianu 2006 (Wykres 1.), wynikiem najniższym był wynik mi-

nimalny – 0 punktów (uzyskało go 23 uczniów na 473 924 zdających), zaś wynik maksy-

malny to 40 punktów – ten wynik uzyskało 5498 osób (1,2%). Zatem rozstęp wynosi 40.

Wariancja

Wariancja jest kwadratem odchylenia standardowego, gdzie

∑

oznacza sumę obserwacji

(wyników).

N

x

s

∑

=

2

2

gdy

(

)

2

2

∑

∑

−

=

X

X

x

gdzie:

∑

2

x

to suma kwadratów odchyleń, N – liczebność populacji, X – wynik ucznia,

X

– średnia arytme-

tyczna z testu (egzaminu).

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

15

W celu uzyskania

∑

2

x

, należy:

obliczyć odchylenie od średniej dla każdego ucznia

(

)

X

X

−

,

sprawdzić, czy suma odchyleń od średniej równa się zero,

podnieść do kwadratu każde odchylenie od średniej, żeby zlikwidować wartości

ujemne,

zsumować wszystkie odchylenia od średniej.

9F9F9F9F

10

Wariancja opisuje wielkość błędu, jaki popełniamy wtedy, kiedy średni wynik traktujemy

jako dobre odzwierciedlenie wszystkich wyników indywidualnych. Mała wariancja (niewiel-

kie zróżnicowanie wyników wokół wartości średniej) wskazuje, że średni wynik dobrze od-

zwierciedla wyniki indywidualne. Duża wariancja informuje, że wartości średniej nie można

traktować jako rzetelnej miary wyników indywidualnych.

10F10F10F10F

11

Odchylenie standardowe

Odchylenie standardowe, które jest kwadratowym pierwiastkiem z wariancji, określa

zmienność wyników w obrębie średniej. Służy m.in. do opisu zróżnicowania wyników.

Obliczamy je następująco:

N

x

s

∑

=

2

Gdy zmienność wyników rośnie, zwiększa się odległość pomiaru od średniej, czyli im

większe odchylenie standardowe, tym rozproszenie wyników większe. Im mniejsze jest

odchylenie standardowe, tym większe jest skupienie wartości zmiennej wokół średniej. Im

większe odchylenie standardowe, tym mniej precyzyjna informacja wynika z porównania

analizowanego wyniku do średniej (patrz: Rysunek 7.)

Najlepiej odchylenie standardowe można opisać na rozkładzie normalnym, o którym

w dalszej części materiałów.

Przykład:

Odchylenie standardowe wyników sprawdzianu 2006 (patrz: Wykres 1.) wynosi 8,6 pkt.

10

D. Sołtys, M.K. Szmigel, Doskonalenie kompetencji nauczycieli w zakresie diagnozy edukacyjnej,

Wydawnictwo „Zamiast korepetycji”, Kraków 1997, s. 55

11

Elżbieta Hornowska, Testy psychologiczne. Teoria i praktyka, Wydawnictwo Naukowe SCHOLAR,

Warszawa 2003, s. 70.

gdy

(

)

2

2

∑

∑

−

=

X

X

x

gdzie:

∑

2

x

to suma kwadratów odchyleń, a N – liczebność populacji.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

16

MIARY WSPÓŁZMIENNOŚCI

Miary współzmienności opisują stopień, w jakim są ze sobą związane dwie zmienne.

Korelacja

Korelacja (łac. wzajemny związek) to współzależność jakichś zjawisk lub obiektów. Anali-

zy korelacyjne prowadzimy wówczas, gdy chcemy zbadać związki między niejednorodny-

mi zmiennymi. W systemie egzaminacyjnym coraz częściej szuka się powiązań między

wynikami różnych egzaminów.

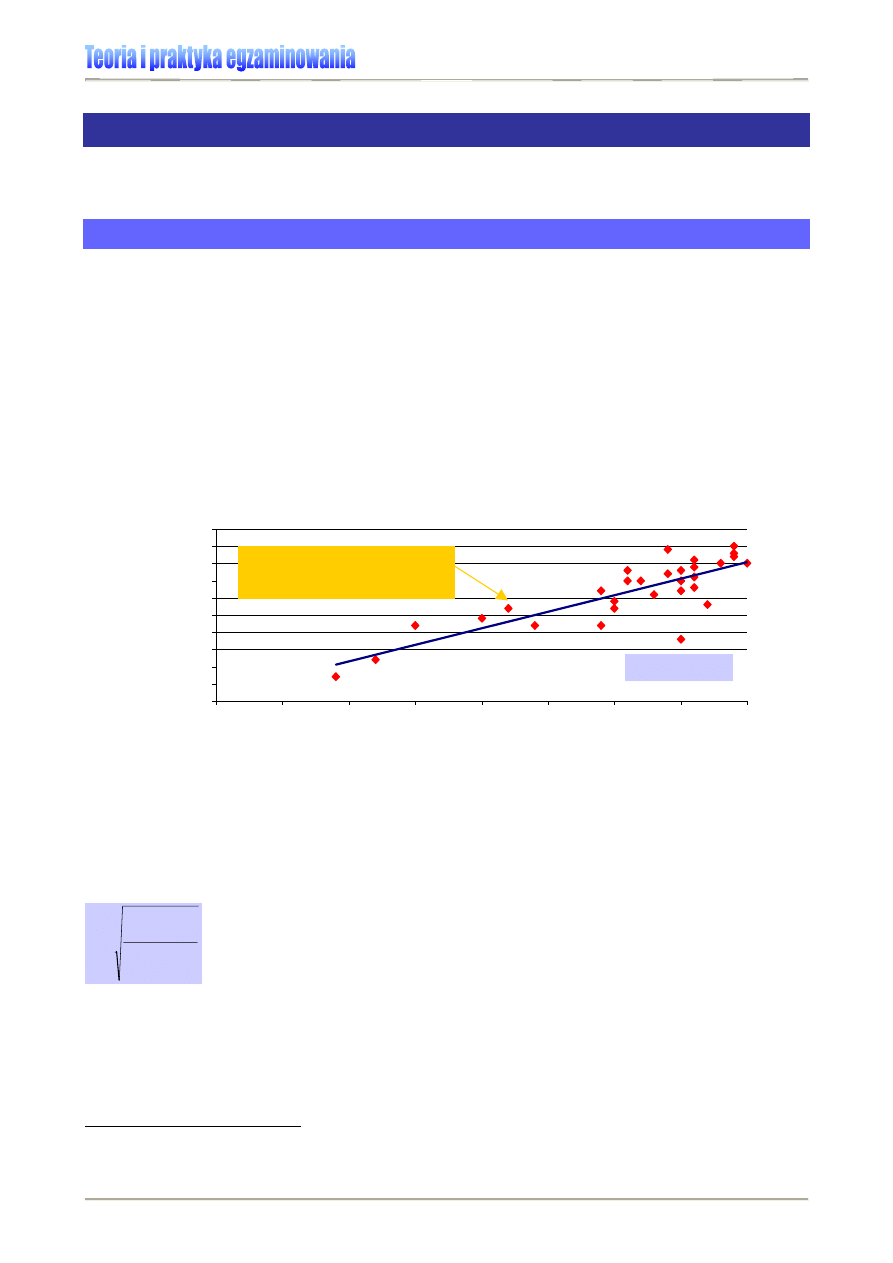

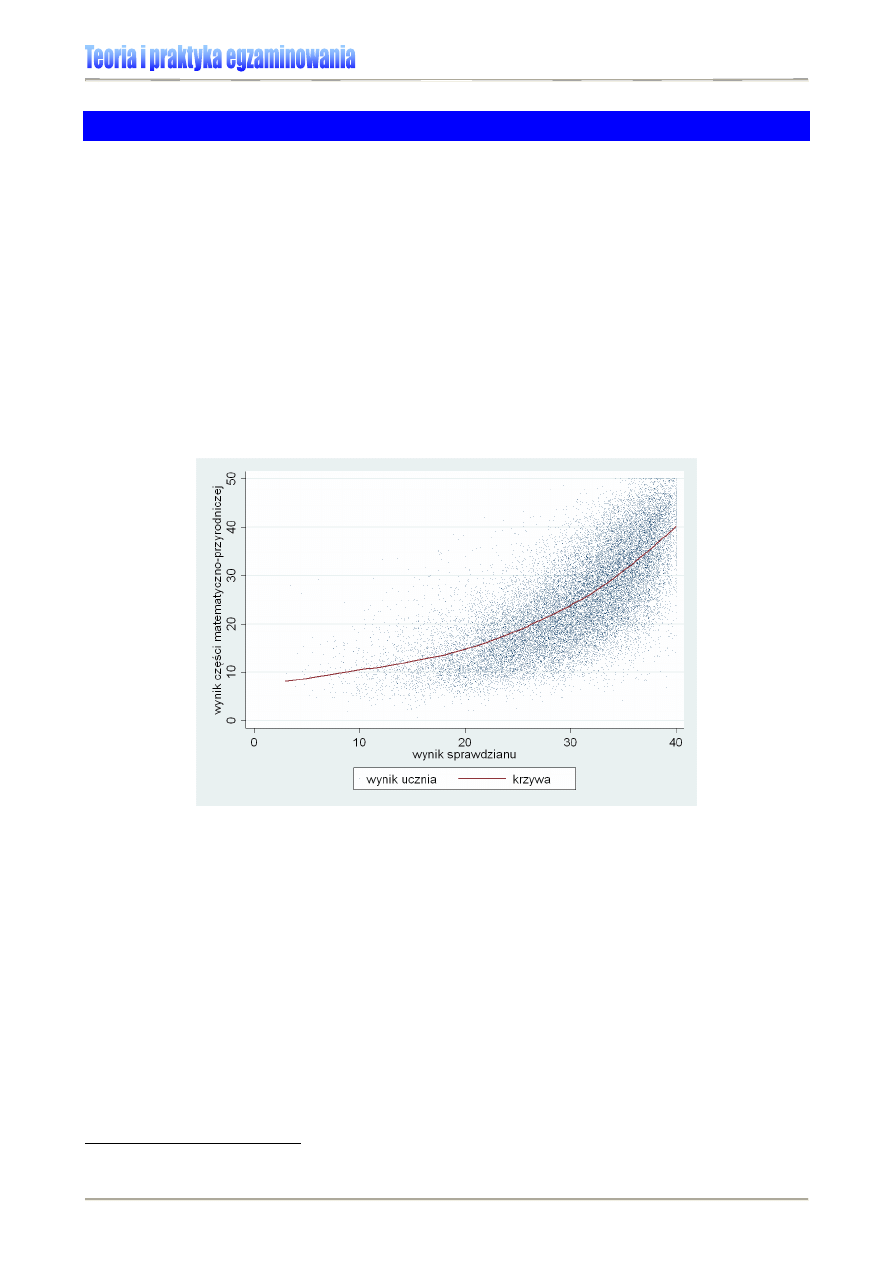

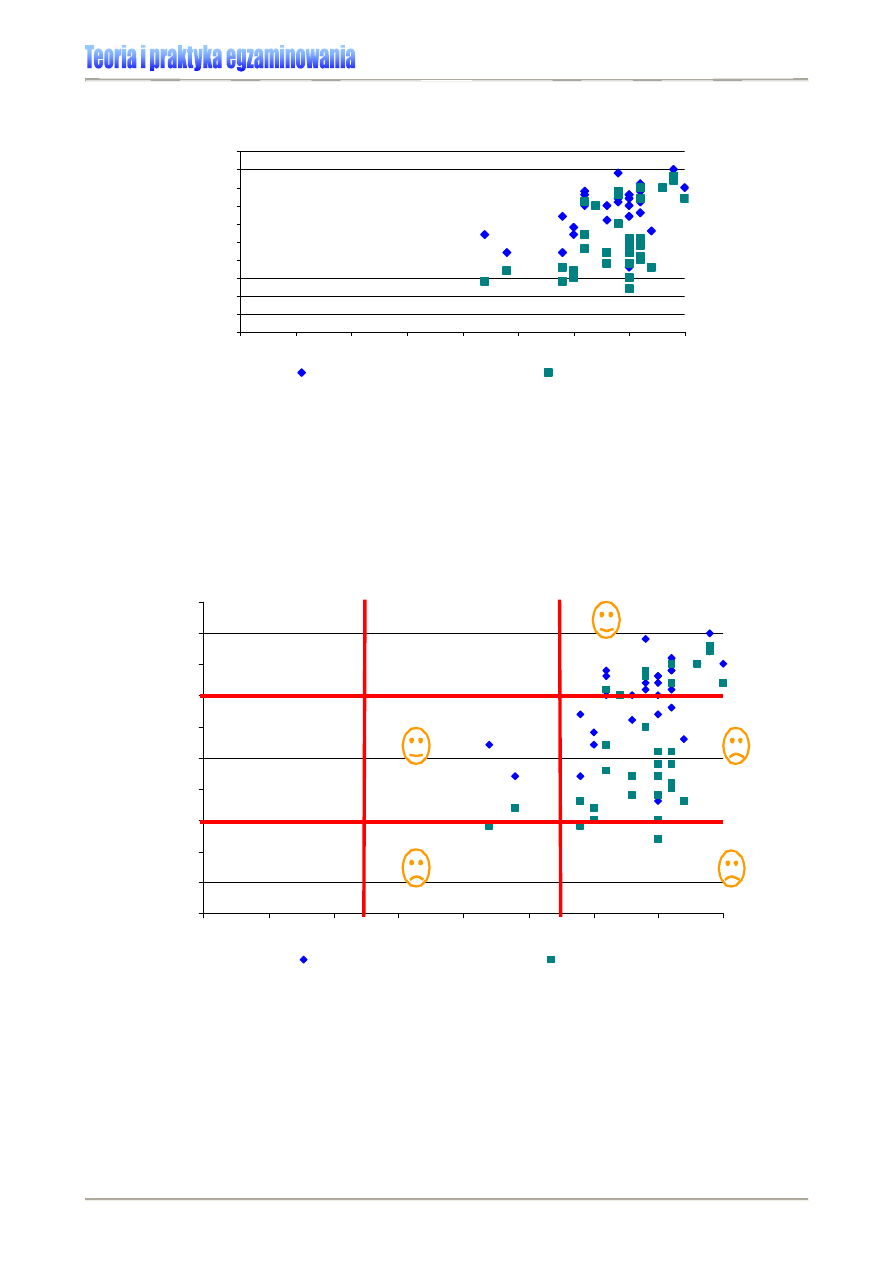

Oto

przykład

analizy wyników 30 uczniów jednego z oddziałów szkolnych Gimnazjum

w L., uzyskanych na sprawdzianie 2004 i egzaminie gimnazjalnym 2007. Każdy z punktów

obrazuje pozycję na skali wyników jednego ucznia, opisaną dwiema zmiennymi: wynikiem

sprawdzianu (maks. 40 pkt.) oraz jednej z części egzaminu gimnazjalnego (maks. 50 pkt.).

By uchwycić ogólną prawidłowość, możemy wykreślić linię trendu, zwaną linią regresji,

która powinna być jak najlepiej dopasowana do wszystkich 30 punktów.

Wykres 4. Korelacja wyników sprawdzianu i egzaminu gimnazjalnego klasy IIId Gimnazjum w L. [6]

0

5

10

15

20

25

30

35

40

45

50

0

5

10

15

20

25

30

35

40

wynik sprawdzianu

wynik cz

ęś

ci humanistyczn

egzaminu gimnazjalnego

Najczęściej używanym wskaźnikiem korelacji jest współczynnik r korelacji liniowej Pe-

arsona. Odzwierciedla on stopień liniowej zależności pomiędzy dwoma zbiorami danych,

dając możliwość porównania zróżnicowania wartości zmiennej wokół linii regresji z całym

zróżnicowaniem wartości tej zmiennej.

11F11F11F11F

12

Jego wartość mieści się w zakresie od -1,0 do

1,0 włącznie i informuje o sile związku pomiędzy zmiennymi (1 – całkowita korelacja, 0 –

jej brak). Liczymy go wg wzoru (może nas w tym zastąpić komputer):

∑

∑

=

−

=

⎟

⎠

⎞

⎜

⎝

⎛

−

⎟

⎠

⎞

⎜

⎝

⎛

−

±

=

n

i

i

n

i

i

Y

y

y

y

r

1

2

1

2

'

Znak przy współczynniku zależy od nachylenia linii regresji. Gdy jest rosnąca (jak na Wy-

kresie 4.), znak jest dodatni. Mówimy wtedy, że korelacja jest dodatnia (im większa war-

tość X, tym większa wartość Y). Gdy linia regresji jest malejąca, mamy do czynienia z ko-

relacją ujemną (im większa wartość X, tym mniejsza Y).

12

Zob. K. Konarzewski, Jak uprawiać badania oświatowe. Metodologia praktyczna, WSiP, Warszawa 2002,

s. 186-189.

r = 0,82488

Wynik Kamila J.:

22 pkt. na sprawdzianie,

27 pkt na egzaminie gimnazjalnym.

gdzie r to pierwiastek z ułamka, w którego liczniku mamy sumę kwadratów odległości

poszczególnych przypadków od linii regresji, a w mianowniku – sumę kwadratów odle-

głości od średniej; y’ to punkt na linii regresji odpowiadający wartości x

i

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

17

Przykładowe zestawienia wyników egzaminu zewnętrznego

Po zebraniu wszystkich wyników pomiaru (testowania, egzaminowania), otrzymujemy „su-

rowy” materiał statystyczny

12F12F12F12F

13

, który, aby móc go właściwie zinterpretować w odniesieniu

do badanej populacji, powinien być usystematyzowany i odpowiednio opisany. Analiza

wartości parametrów statystycznych umożliwi scharakteryzowanie badanych zbiorowo-

ści w sposób systematyczny.

Przykład:

Aby trafnie wnioskować o osiągnięciach edukacyjnych uczniów przystępujących do eg-

zaminów zewnętrznych, oblicza się – biorąc pod uwagę liczbę zdających – następujące parametry

statystyczne:

Tabela 6. Podstawowe dane i parametry statystyczne sprawdzianu 2006 [2] [6]

Parametry

Komentarz

Liczba egzaminowanych (N)

473 924

►

Sprawdzian 2006 pisało prawie pół miliona uczniów.

Łatwość testu egzaminacyjnego

(p)

0,62

►

Łatwość testu na poziomie 0,62 wskazuje na fakt, iż był on

umiarkowanie trudny dla uczniów.

Średnia arytmetyczna (

X

)

25 pkt.

►

Statystyczny uczeń zdający ten egzamin uzyskał 25 na 40

punktów możliwych do uzyskania.

Mediana (Me, M)

26 pkt.

►

Uczeń, który uzyskał wynik plasujący się w środku wyników

rozkładu uporządkowanego rosnąco otrzymał 26 punktów,

czyli 65% punktów możliwych do uzyskania.

Modalna (dominanta) (Mo, D)

33 pkt.

►

Na sprawdzianie 2006 uczniowie uzyskiwali najczęściej 33

punkty.

Maksymalny wynik (x

max

) 40

pkt.

►

Maksymalna liczba punktów możliwa do uzyskania w

sprawdzianie to 40 punktów.

Najwyższy wynik

40 pkt.

►

W 2006 roku 5498 uczniów w kraju uzyskało ze spraw-

dzianu wynik maksymalny.

13F13F13F13F

14

Najniższy wynik

0 pkt.

►

Najniższy wynik 0 pkt. na sprawdzianie miało tylko 23

uczniów.

Rozstęp (R)

40 pkt.

►

W r. 2006 rozstęp wyników wyniósł 40 pkt., przybierając

wielkość maksymalną.

Wariancja (s

2

x

) 73,3

Odchylenie standardowe (s

x

)

8,6 pkt.

►

68% uczniów osiągnęło wynik w przedziale wyników typo-

wych (stanowiącym 2/3 wszystkich wyników), uzyskując od

17 do 34 punktów.

Kwartyle

1. – 25%

2. – 50%

3. – 75%

18 pkt.

26 pkt.

32 pkt

.

►

Rozkład wyników egzaminu zbliżony jest do normalnego,

z wyraźnym przesunięciem w stronę wyższych wyników.

25% uczniów uzyskało wynik równy lub niższy od 19 punk-

tów; 50% uczniów uzyskało wynik równy lub niższy od 26

punktów; 75% uczniów uzyskało wynik równy lub niższy od

32 punktów.

13

„Surowy” wynik testowania to suma punktów uzyskanych przez badanego za rozwiązanie testu. Por. B.

Niemierko, Testy osiągnięć szkolnych. Podstawowe pojęcia i techniki obliczeniowe, Warszawa 1975, WSiP,

s. 116.

14

Najwyższy wynik z testu nie zawsze oznacza wynik maksymalny (liczba punktów możliwa do uzyskania za

rozwiązanie całego testu). Może się np. zdarzyć, że żaden z piszących sprawdzian uczniów w szkole nie

uzyska 40 punktów.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

18

PODSTAWOWE PARAMETRY STATYSTYCZNE

POMOCNE W ANALIZIE ILOŚCIOWEJ WYNIKÓW

ZADAŃ EGZAMINACYJNYCH I TESTU

Rozkład liczebności

Rozkład liczebności to najprostsza forma przedstawiania wyników testowania. Polega na

uporządkowaniu danych od wyniku najwyższego do najniższego (lub odwrotnie) w formie

tabeli bądź wykresu, z uwzględnieniem liczebności zaobserwowanych wartości zmiennej

(wyników).

14F14F14F14F

15

Przykład:

Klasa szkolna liczy 25 uczniów. W wyniku klasyfikacji śródrocznej z matematyki jeden

uczeń uzyskał ocenę celującą, trzech ocenę bardzo dobrą, sześciu ocenę dobrą, dziesięciu ocenę

dostateczną, trzech dopuszczającą i dwóch niedostateczną. Rozkład liczebności przedstawia się

więc następująco:

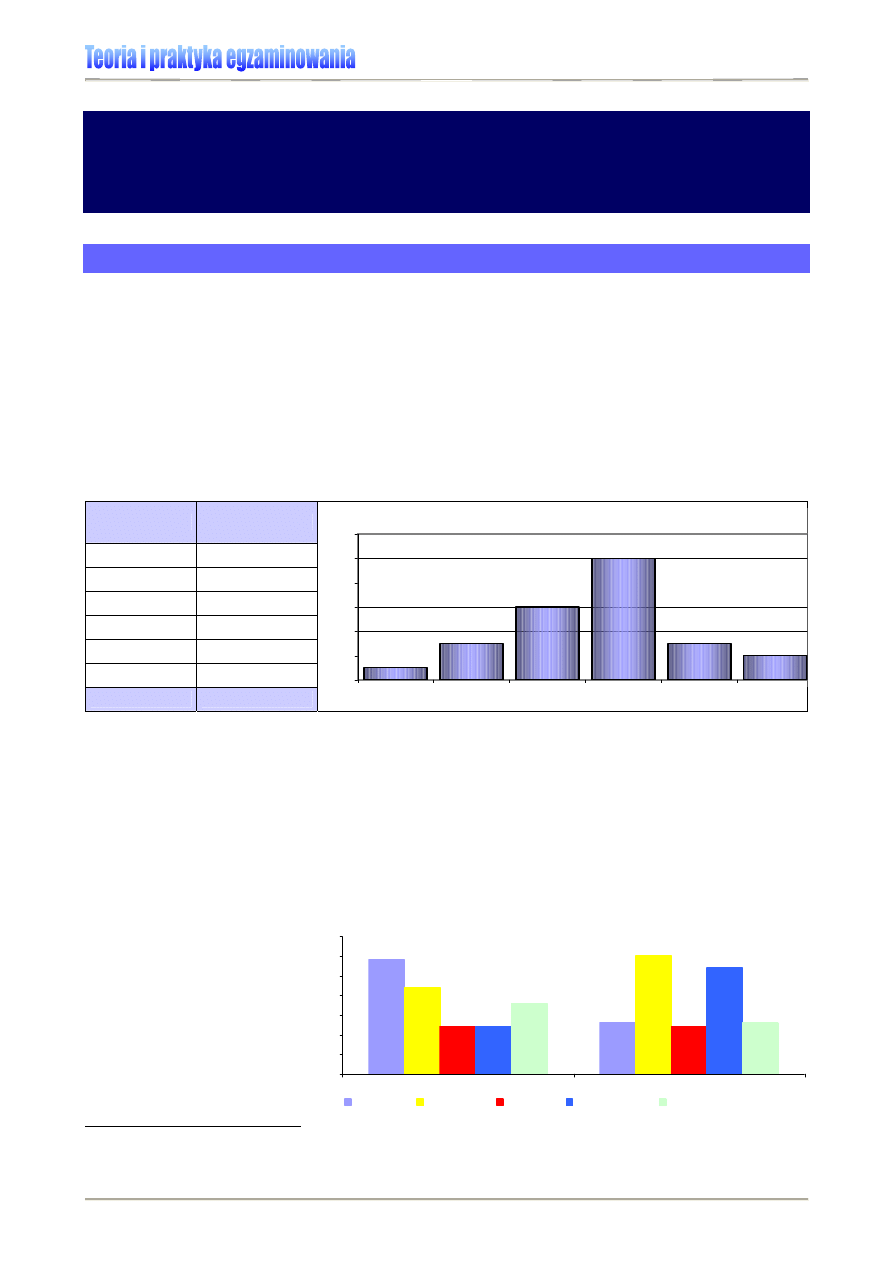

Tabela 7., Wykres 5

.

Rozkład wyników oceniania wewnątrzszkolnego za I okres w klasie Ib SP w B. [6]

Ocena

Liczba uczniów

celująca 1

bardzo dobra

3

dobra 6

dostateczna 10

dopuszczająca 3

niedostateczna 2

razem

25

Rozkład liczebności ocen w klasie VI b

1

3

6

10

3

2

0

2

4

6

8

10

12

celująca

bardzo dobra

dobra

dostateczna

dopuszczająca

niedostateczna

liczba uczniów

W pomiarze dydaktycznym rozkład liczebności wykorzystywany jest do graficznej prezen-

tacji wyników, najczęściej w postaci wykresu słupkowego, gdzie na osi poziomej umiesz-

czona jest liczba punktów, a na pionowej podana jest liczba albo procent uczniów, którzy

dany wynik uzyskali. Wyniki mogą być prezentowane co 1 punkt lub pogrupowane w klasy.

Przykład:

Rozkład liczebności wykorzystywany jest w raportach CKE do prezentacji wyników eg-

zaminów (zobacz np. Rozkład wyników krajowych sprawdzianu 2006 przedstawiony na Wykresie

1.) lub charakterystyki zróżnicowania populacji, czego przykładem może być Wykres 6., ukazujący

zależność między płcią maturzysty 2007 a wyborem przedmiotu zdawanego na maturze.

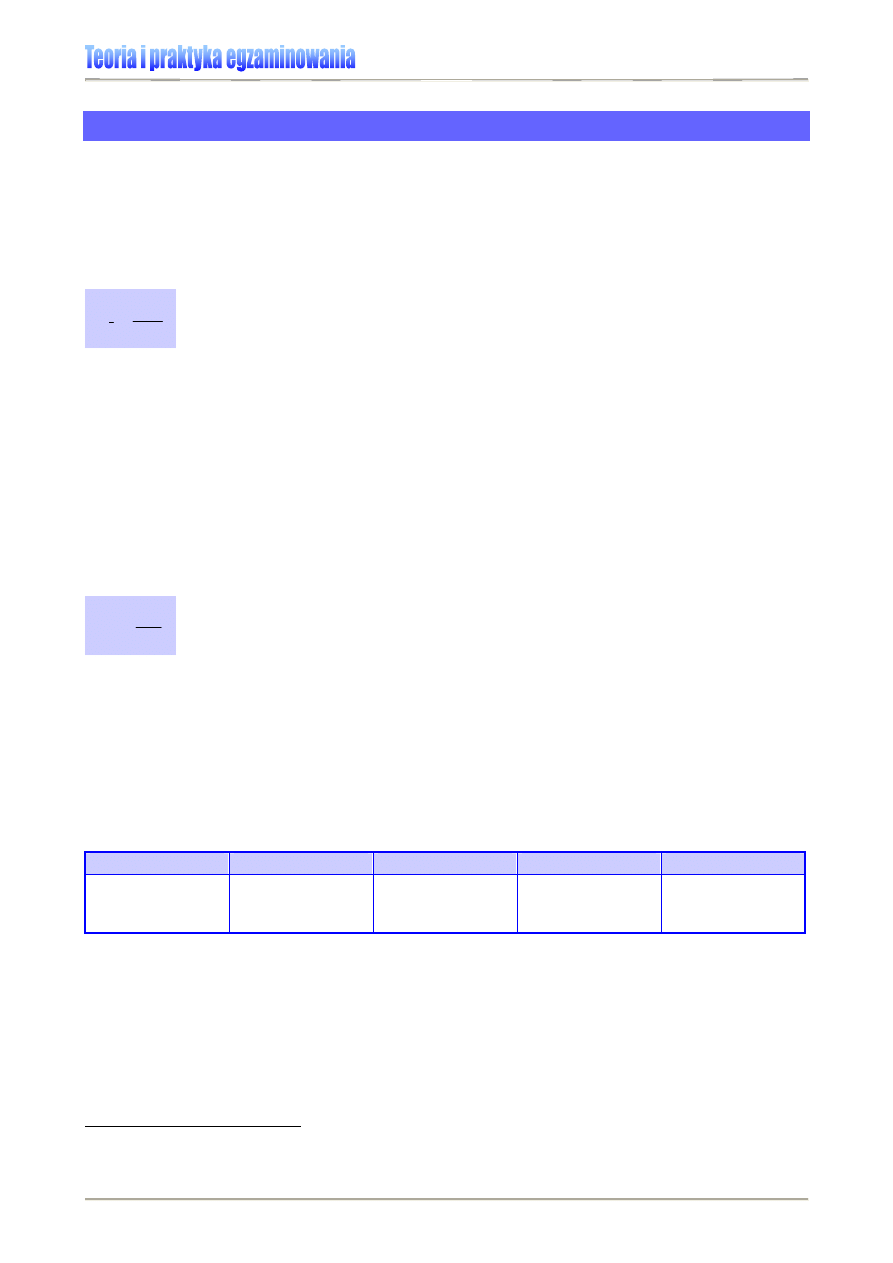

Wykres 6. Wybór przedmiotów

obowiązkowych a płeć

maturzysty 2007 – histogram.

[5]

15

B. Niemierko, Testy osiągnięć..., s. 50. Sposób grupowania wyników testowania został również opisany w

części Normalizacja wyników testowania.

29%

13%

22%

30%

12%

12%

12%

27%

18%

13%

0%

5%

10%

15%

20%

25%

30%

35%

kobiety

mężczyźni

biologia

geografia

historia

matematyka

wiedza o społeczeństwie

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

19

Łatwość zadania / testu

Łatwość zadania (bądź całego testu) jest wskaźnikiem używanym zarówno podczas ana-

lizy wyników egzaminów zewnętrznych, jak i wyników testowania wewnątrzszkolnego. Jest

to wskaźnik pozytywny, tzn. taki, którego wartość rośnie wraz ze wzrostem osiągnięć.

15F15F15F15F

16

Łatwość zadania (testu), rozumiana jako stosunek sumy punktów uzyskanych przez zda-

jących za zadanie lub test do iloczynu liczby egzaminowanych uczniów i maksymalnej

liczby punktów możliwych do uzyskania za zadanie lub test, liczona jest według wzoru:

Przykład:

30 uczniów rozwiązywało zadanie punktowane w skali 0-3. Maksymalną liczbę punktów

(3 pkt.) uzyskało dziewięciu uczniów, 2 punkty – trzech, 1 punkt – piętnastu, a pozostałych trzech –

0 p. Zatem suma punktów uzyskanych za rozwiązanie zadania wynosi: 9 x 3 + 3 x 2 +15 x 1 = 48.

Natomiast za poprawne rozwiązanie tego zadania wszyscy uczniowie mogli uzyskać 90 punktów:

30 x 3 = 90. Współczynnik łatwości zadania wynosi więc 0,53 [48 : 90 = 0,53].

W przypadku zadań punktowanych 0-1, łatwość zadania jest stosunkiem liczby uczniów,

którzy prawidłowo rozwiązali to zadanie, do liczby uczniów biorących udział w testowaniu.

Wyraża to wzór:

Przykład:

30 uczniów rozwiązywało zadanie punktowane w skali 0-1. Prawidłowej odpowiedzi

udzieliło 14. Zatem współczynnik łatwości zadania wynosi 0,47 [14 : 30 = 0,47].

Wskaźnik łatwości zadania/testu pozwala określić stopień trudności zadania dla ucznia lub

grupy uczniów, pokazując poziom opanowania badanej czynności. Jego wartości gra-

niczne to 0 (nikt nie sprostał zadaniu) i 1 (wszyscy piszący rozwiązali je prawidłowo). In-

terpretację współczynnika łatwości przedstawia Tabela 8.

Tabela 8. Interpretacja współczynnika łatwości

16F16F16F16F

17

0 – 0,19

0,20 – 0,49

0,50 – 0,69

0,70 – 0,89

0,90 – 1,00

zadanie

bardzo trudne

zadanie

trudne

zadanie

umiarkowanie

trudne

zadanie

łatwe

zadanie

bardzo łatwe

Łatwość zadania wyrażamy ułamkiem dziesiętnym (0,7) lub w procentach (70%).

16

B. Niemierko, Pomiar wyników kształcenia, WSiP, Warszawa 1999, s. 152-154.

17

Jw.

nk

x

p

x

∑

=

gdzie:

∑

x

– suma punktów uzyskanych za rozwiązanie zadania lub testu

n – liczba egzaminowanych uczniów

k – maksymalna liczba punktów możliwych do uzyskania przez ucznia za rozwiązanie

danego zadania lub całego testu

gdzie:

p – oznacza łatwość zadania punktowanego 0-1

n

p

– liczba uczniów, którzy rozwiązali zadanie

n – liczba uczniów testowanych

n

n

p

p

=

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

20

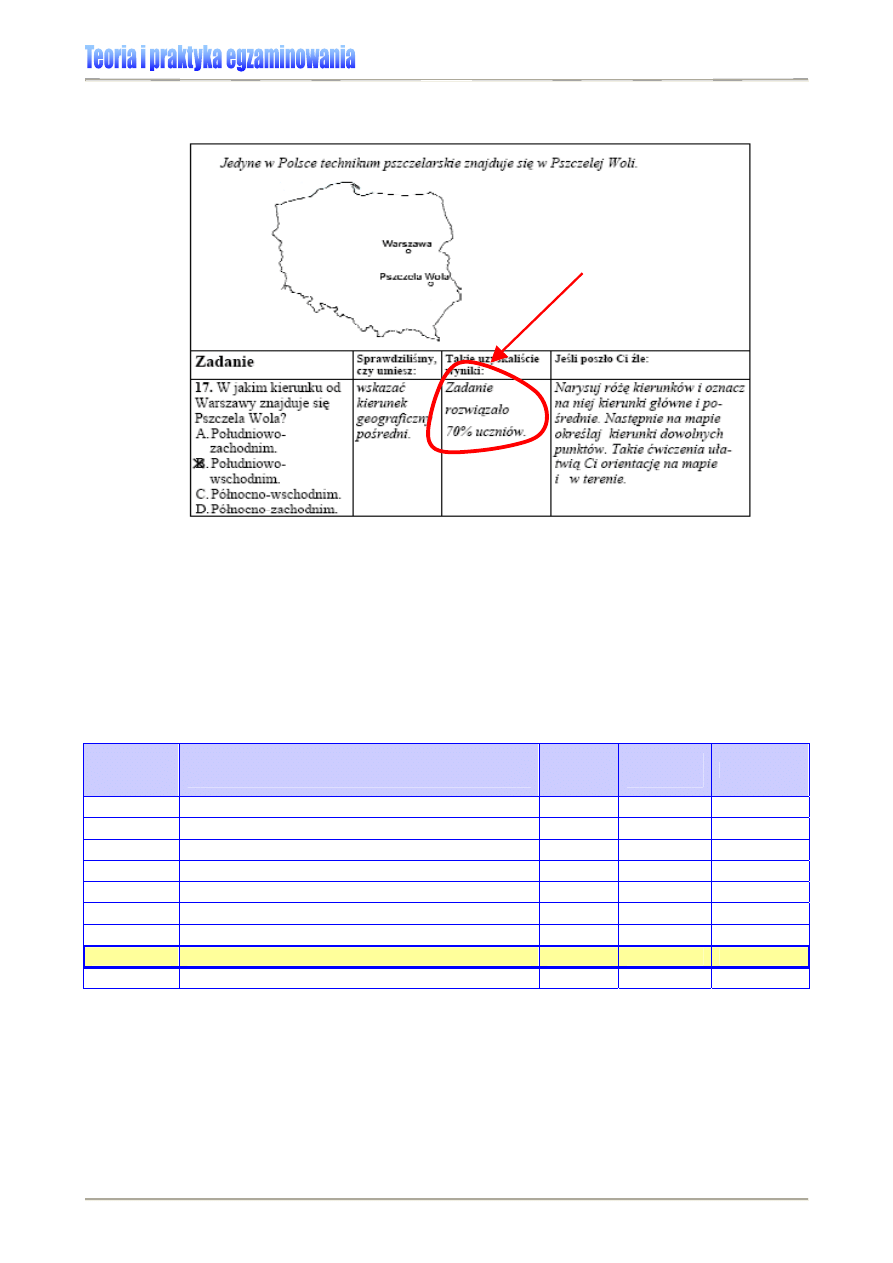

Rysunek 8. Przykładowa prezentacja wyniku uzyskanego za rozwiązanie zadania ze sprawdzianu 2006 [2]

Interpretując wskaźnik łatwości, trzeba zawsze pamiętać o tym, że jego wartość odnosi się

do stopnia opanowania czynności badanej danym zadaniem (zgodnie z zapisem w karto-

tece testu) i w ten sposób powinna być rozumiana.

Przykład:

W 2006 roku 70% uczniów klas VI opanowało umiejętność odczytywania danych

z mapy (potrafiło wskazać kierunek geograficzny pośredni) badaną zadaniem 17. – patrz: Rysunek

8. i Tabela 9. Oznacza to równocześnie, że współczynnik łatwości tego zadania przyjął wartość 0,7

i mieści się w obszarze zadań łatwych.

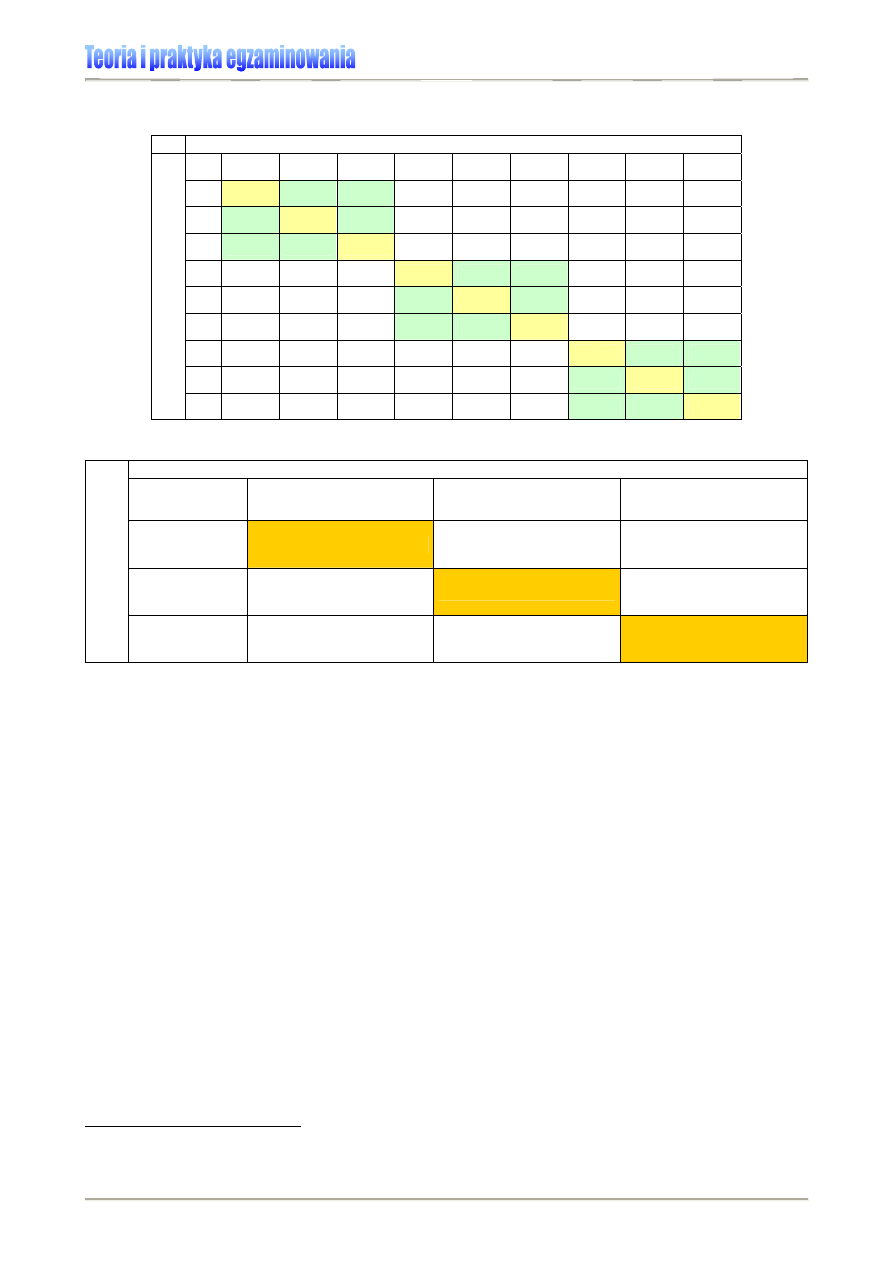

Tabela 9. Fragment kartoteki (planu) testu S-A1 sprawdzianu 2006 ze wskaźnikami łatwości

zadań/czynności [2]

Nr zadania

Sprawdzana czynność ucznia

Uczeń:

Maks.

liczba

pkt.

Nr

standardu

Łatwość

1

odczytuje tekst popularnonaukowy

1

1.1

0,90

2

odczytuje tekst popularnonaukowy

1

1.1

0,85

3

odczytuje tekst popularnonaukowy

1

1.1

0,78

4

wykonuje obliczenia dotyczące temperatury

1

5.3

0,48

... ....

15

wykorzystuje w sytuacji praktycznej własności liczb

1

5.5

0,62

16

sprawdza wyniki z warunkami zadania

1

3.9

0,52

17

odczytuje dane z mapy

1

1.4

0,70

18

wykonuje obliczenia dotyczące długości 1

5.3

0,55

Wskaźnik łatwości obliczany jest również np. dla obszarów standardów egzaminacyjnych.

W tym przypadku interpretujemy go w odniesieniu do stopnia opanowania umiejętności

badanych danym standardem. Tak przedstawiane bywają wyniki uczniów i szkół w

raportach OKE i CKE (Rysunek 8.), tak prezentowane są zainteresowanym w Internecie

(Tabela 10. i Rysunek 9.).

łatwość

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

21

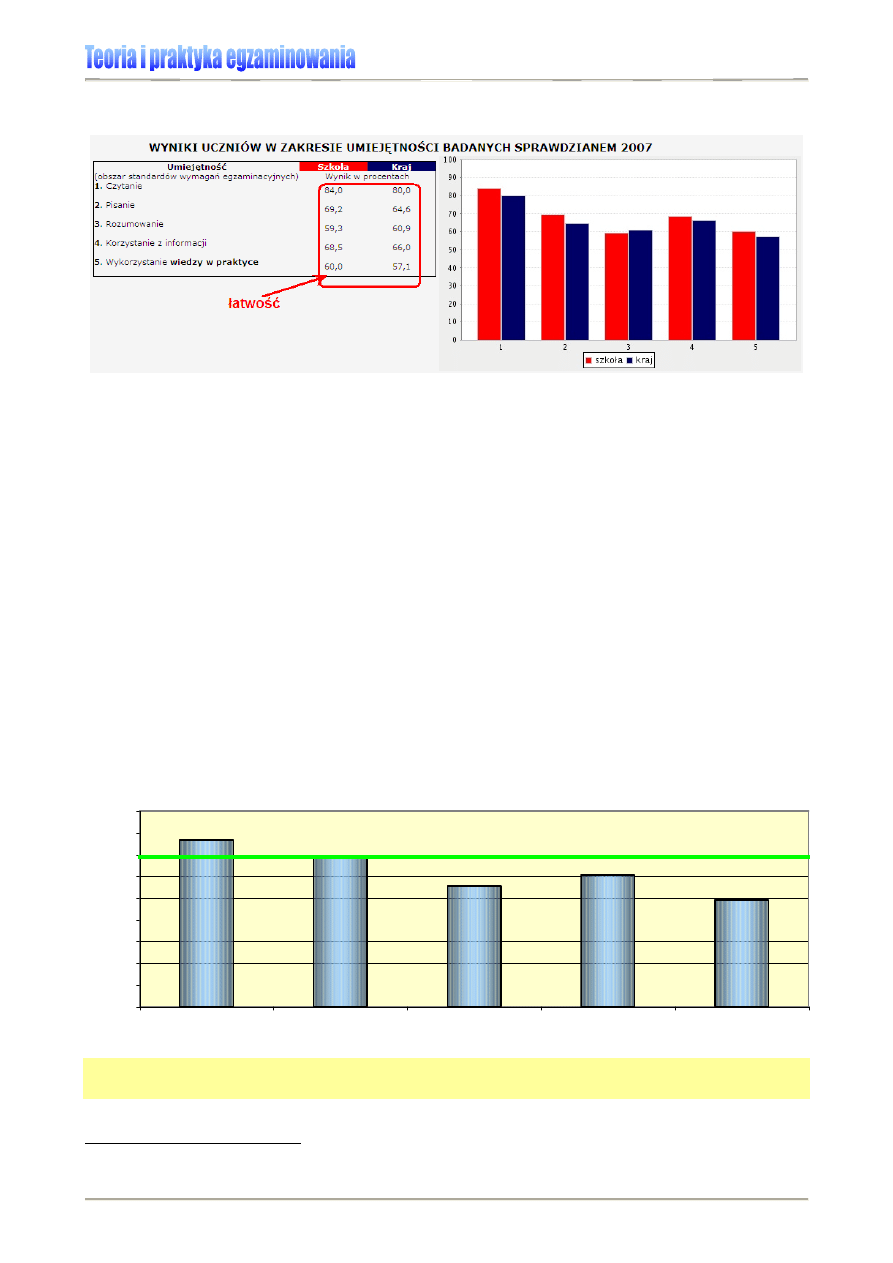

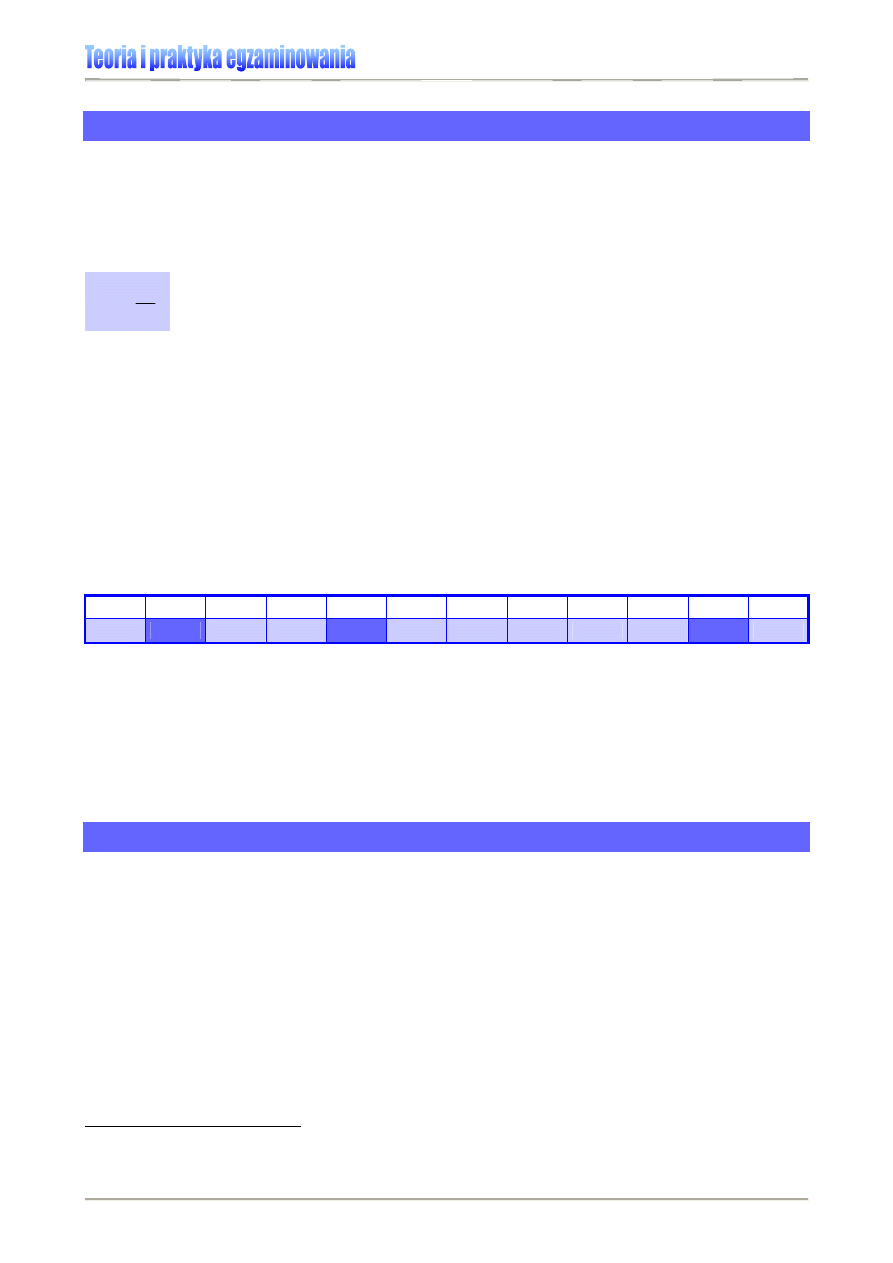

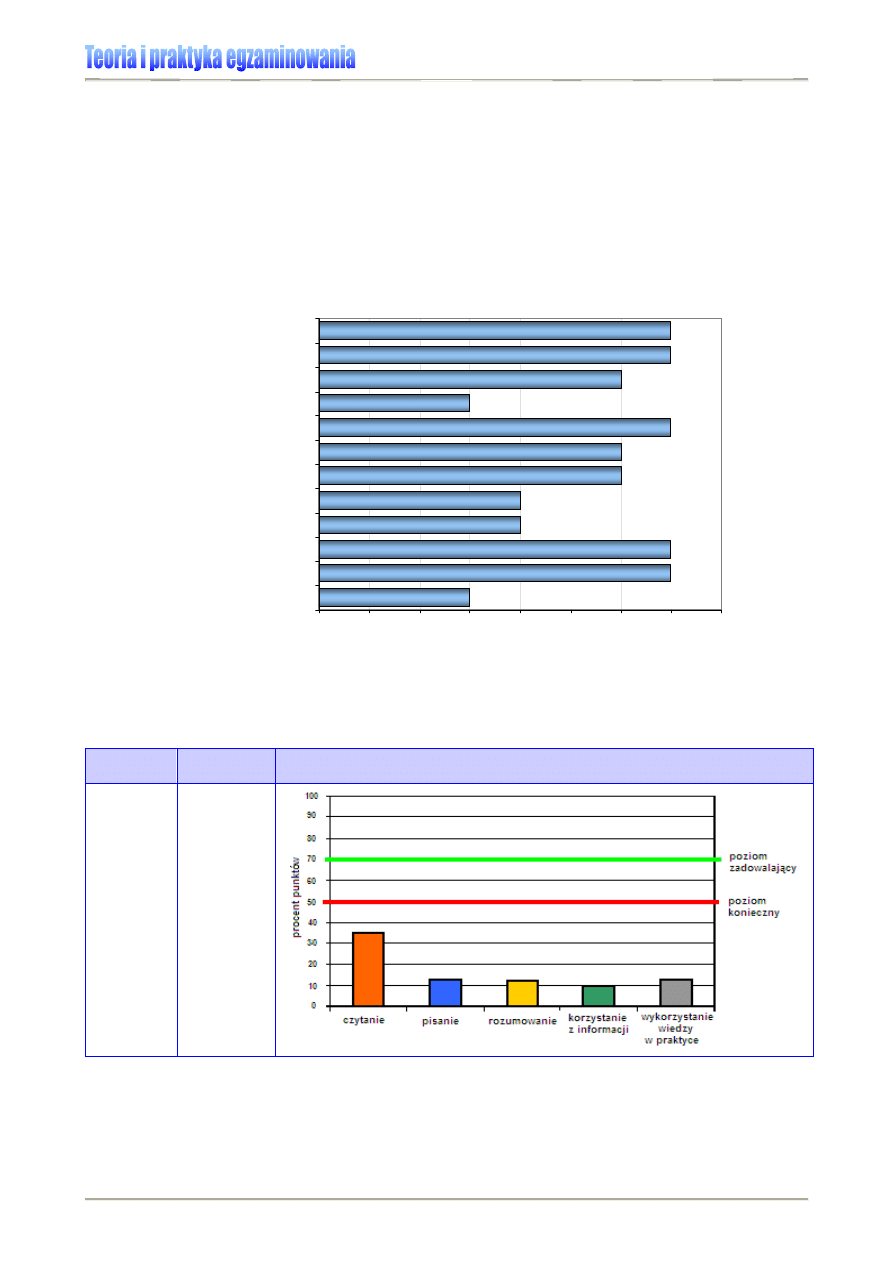

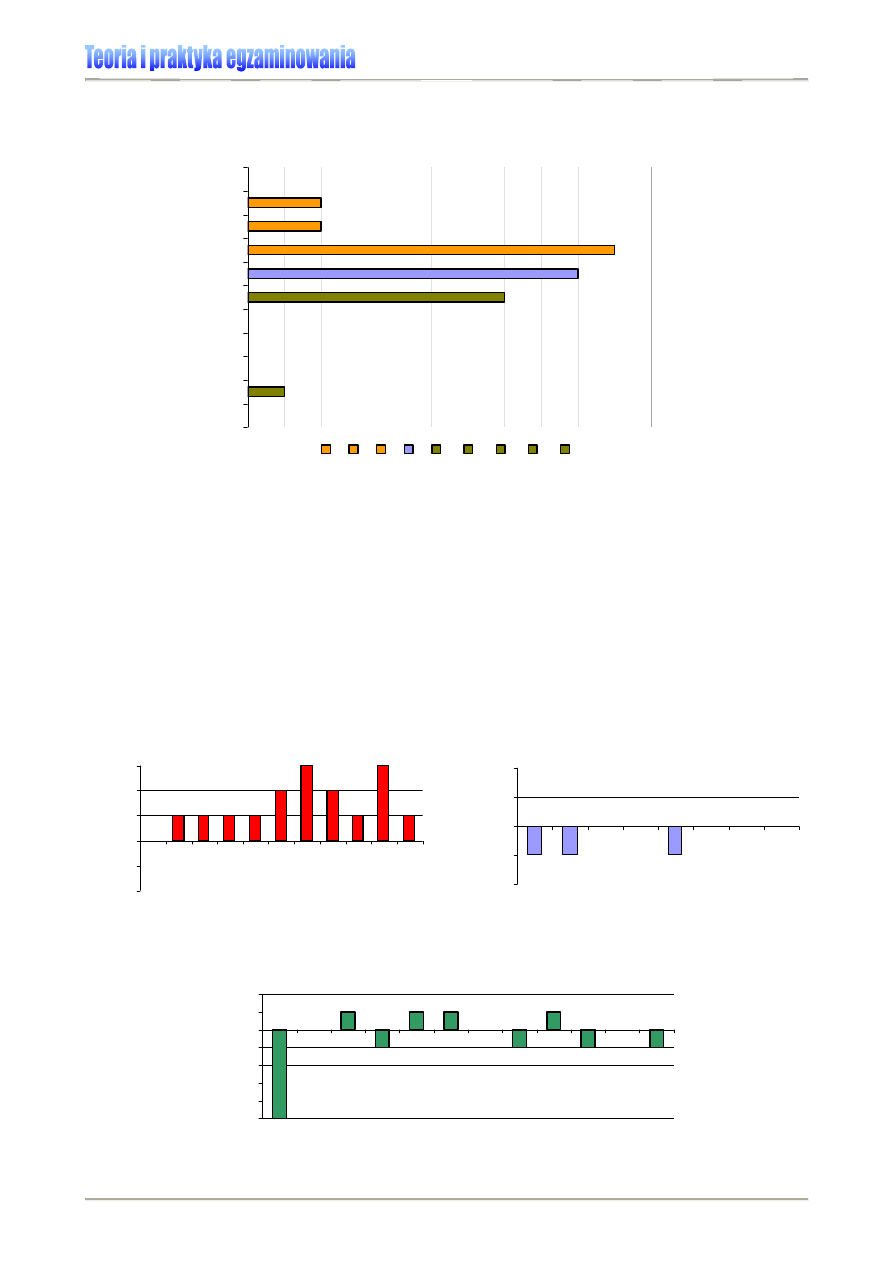

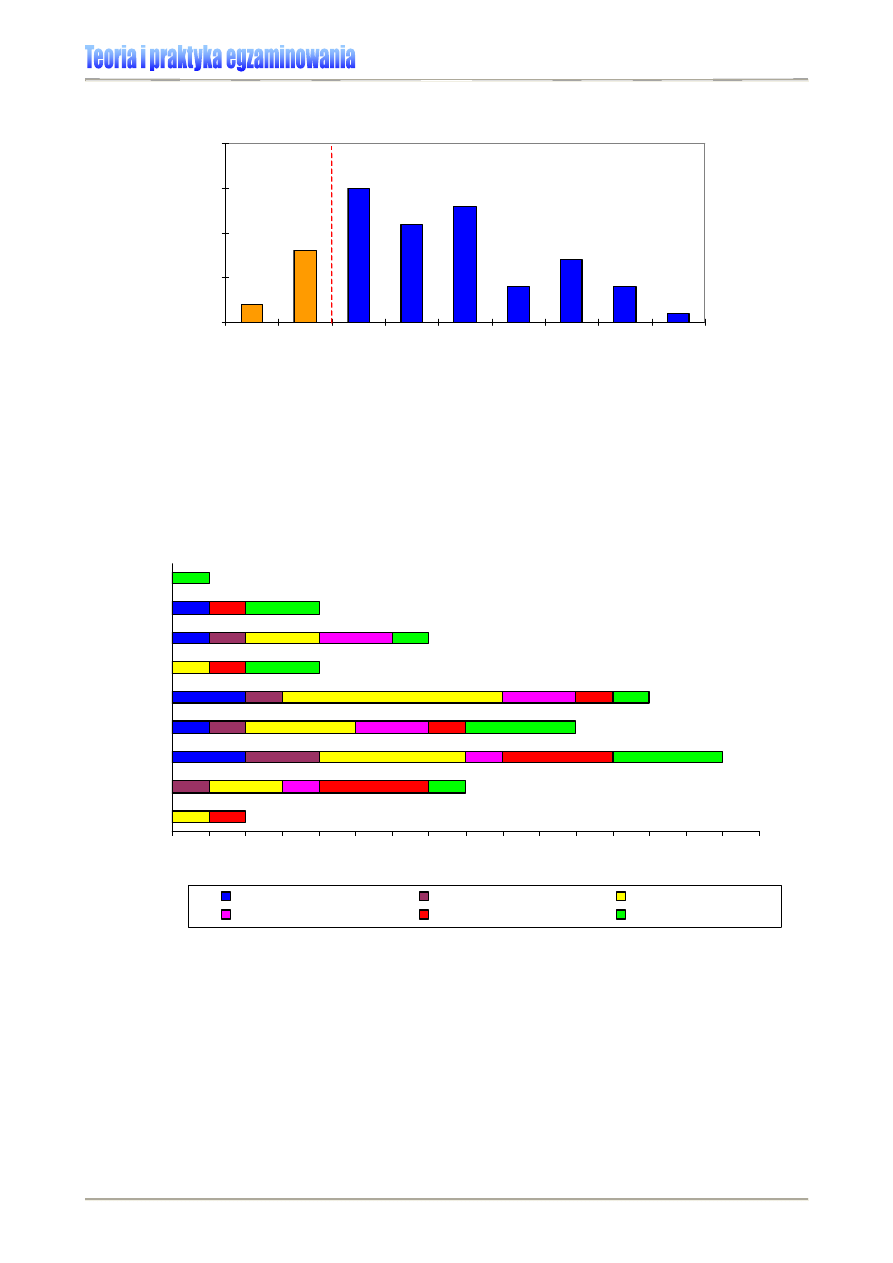

Tabela 10., Rysunek 9. Przykład prezentacji osiągnięć uczniów szkoły w R. na sprawdzianie 2007 [7]

Aby zinterpretować wyniki uczniów wyrażone wskaźnikiem łatwości, konieczne jest ustale-

nie umownego progu, którego osiągnięcie pozwoli uznać, że dana umiejętność jest opa-

nowana zadowalająco. Określenie progu „zaliczenia” umożliwi tym samym zidentyfikowa-

nie najważniejszych potrzeb edukacyjnych (braków) uczniów i podjęcie decyzji dotyczą-

cych zmian/modyfikacji w procesie kształcenia. Zgodnie z propozycją prof. Bolesława

Niemierki można przyjąć, że normę biegłości stanowić będzie 70% punktów możliwych do

uzyskania za rozwiązanie zadań/testu

17F17F17F17F

18

, nie znaczy to jednak, że wewnątrzszkolny sys-

tem oceniania szkoły nie może stanowić inaczej.

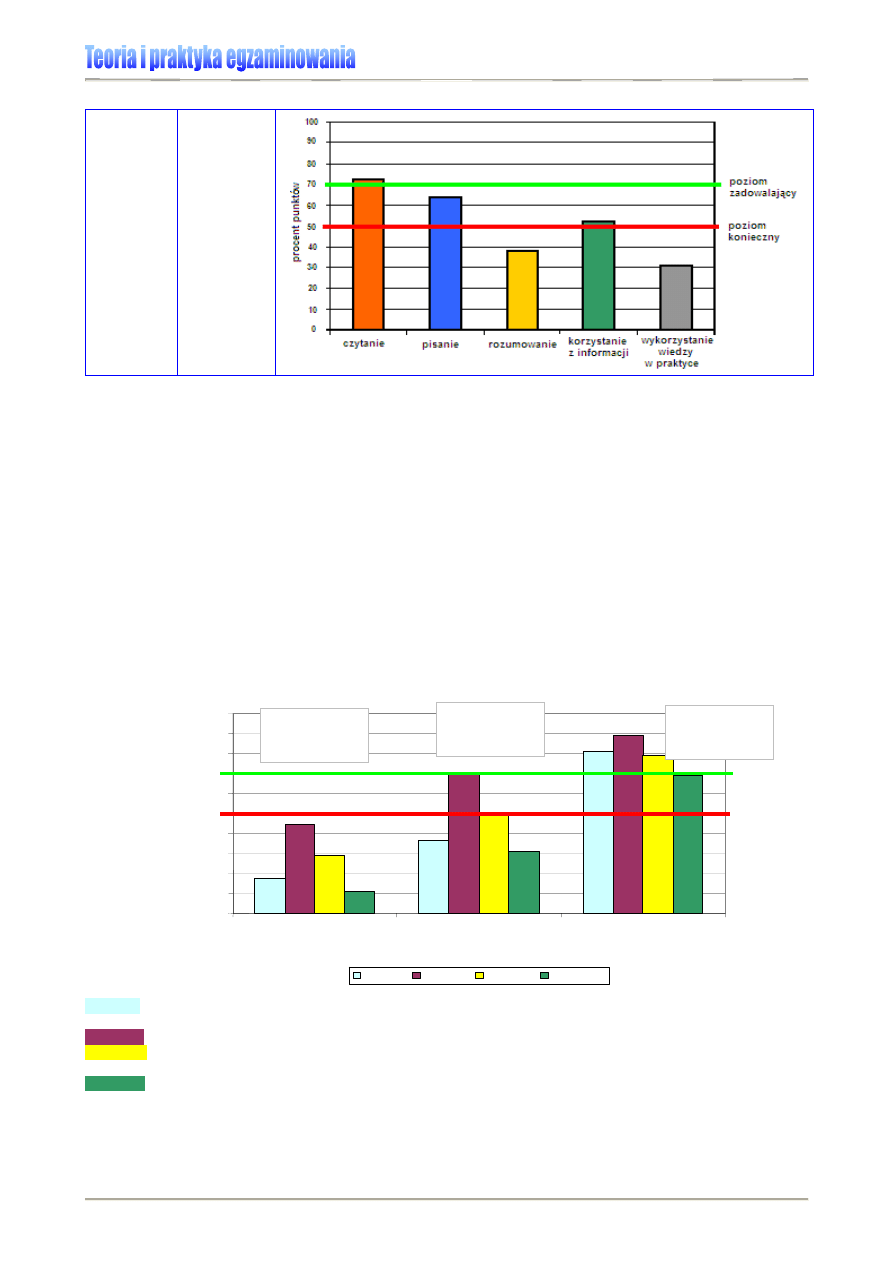

Przykład:

W 2006 roku uczniowie przystępujący do sprawdzianu uzyskali 63,3% punktów

możliwych do uzyskania. Zatem test zastosowany na egzaminie okazał się dla zdających

umiarkowanie trudny, bo łatwość testu przyjęła wartość 0,63. W stopniu zadowalającym uczniowie

opanowali umiejętności z obszaru standardów „Czytanie” (patrz: Wykres 7.). W pozostałych nie

osiągnęli progu 70%. Wobec tego wszelkie zmiany lub modyfikacje procesu dydaktycznego w

szkole powinny przede wszystkim dotyczyć kształcenia umiejętności opisanych w pozostałych

obszarach standardów wymagań egzaminacyjnych, szczególnie w obszarze „Wykorzystanie

wiedzy w praktyce”.

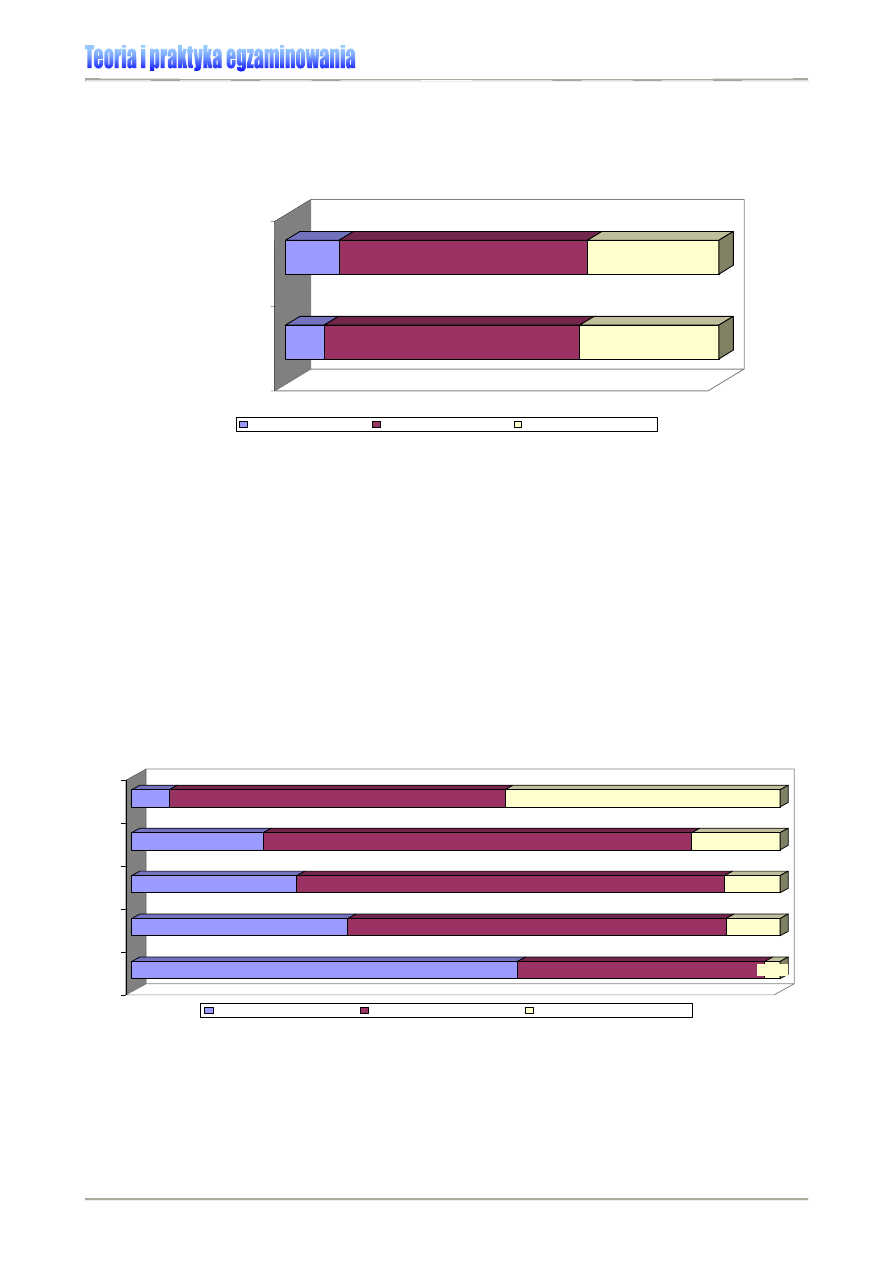

Wykres 7. Wyniki sprawdzianu 2006 w obszarach umiejętności (dla uczniów rozwiązujących arkusz

standardowy) [2]

Co potrafi statystyczny szóstoklasista 2006?

76,6%

68,5%

55,6%

49,1%

60,5%

0%

10%

20%

30%

40%

50%

60%

70%

80%

90%

czytanie

pisanie

rozumowanie

korzystanie z informacji wykorzystanie wiedzy w

praktyce

procent punktów

☺

Uwaga: Analizując wyniki egzaminów, należy pamiętać, że co roku stosuje się testy, które

mogą obejmować inne treści i mieć różny stopień trudności. Nie należy zatem wprost po-

18

Por. B. Niemierko, Pomiar sprawdzający w dydaktyce, Warszawa 1990, s. 357.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

22

q = 1 - p

równywać surowych (punktowych lub procentowych) wyników z kolejnych lat, w zamian

posługując się skalą znormalizowaną.

Wskaźnik łatwości jest użyteczny również w różnorodnych analizach porównawczych pro-

wadzonych w ramach wewnątrzszkolnych badań osiągnięć edukacyjnych uczniów.

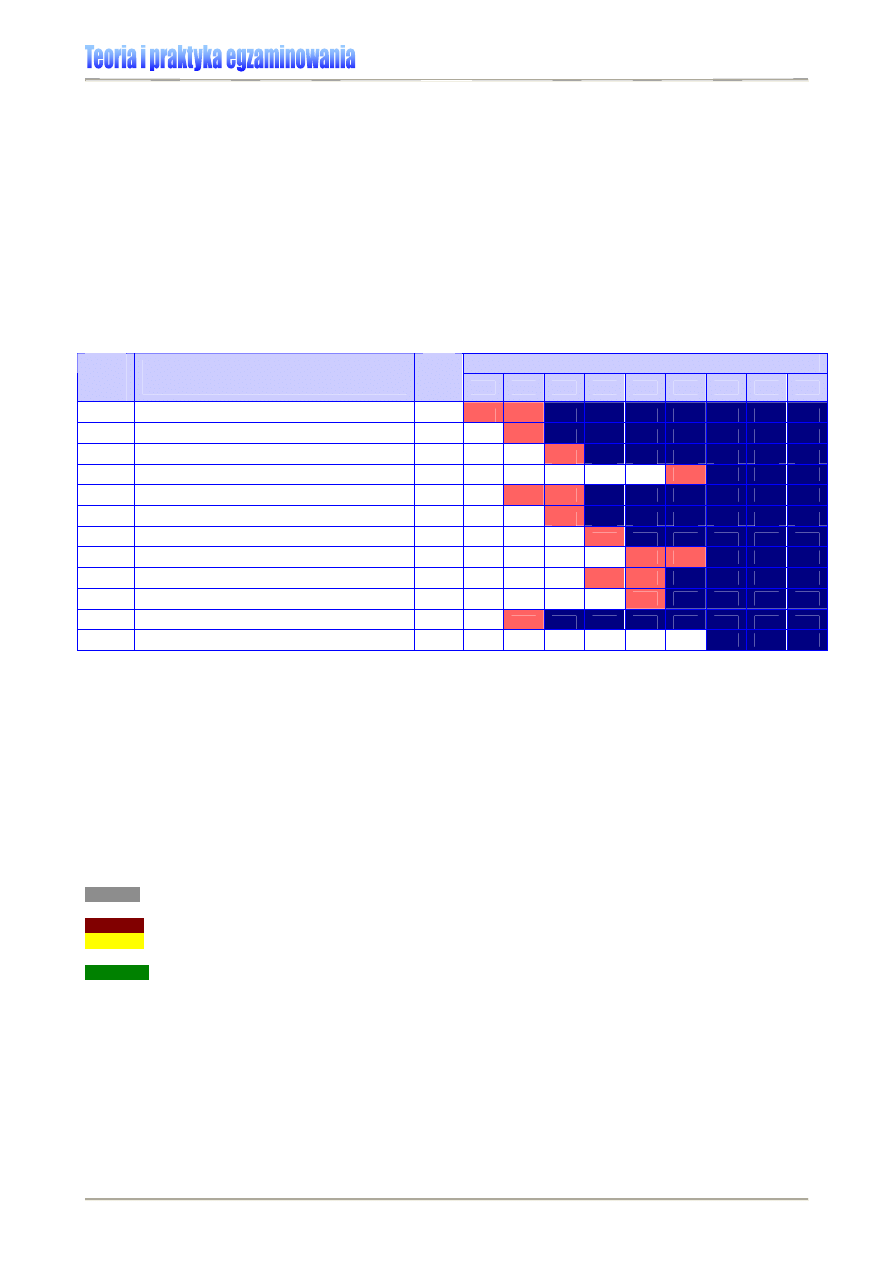

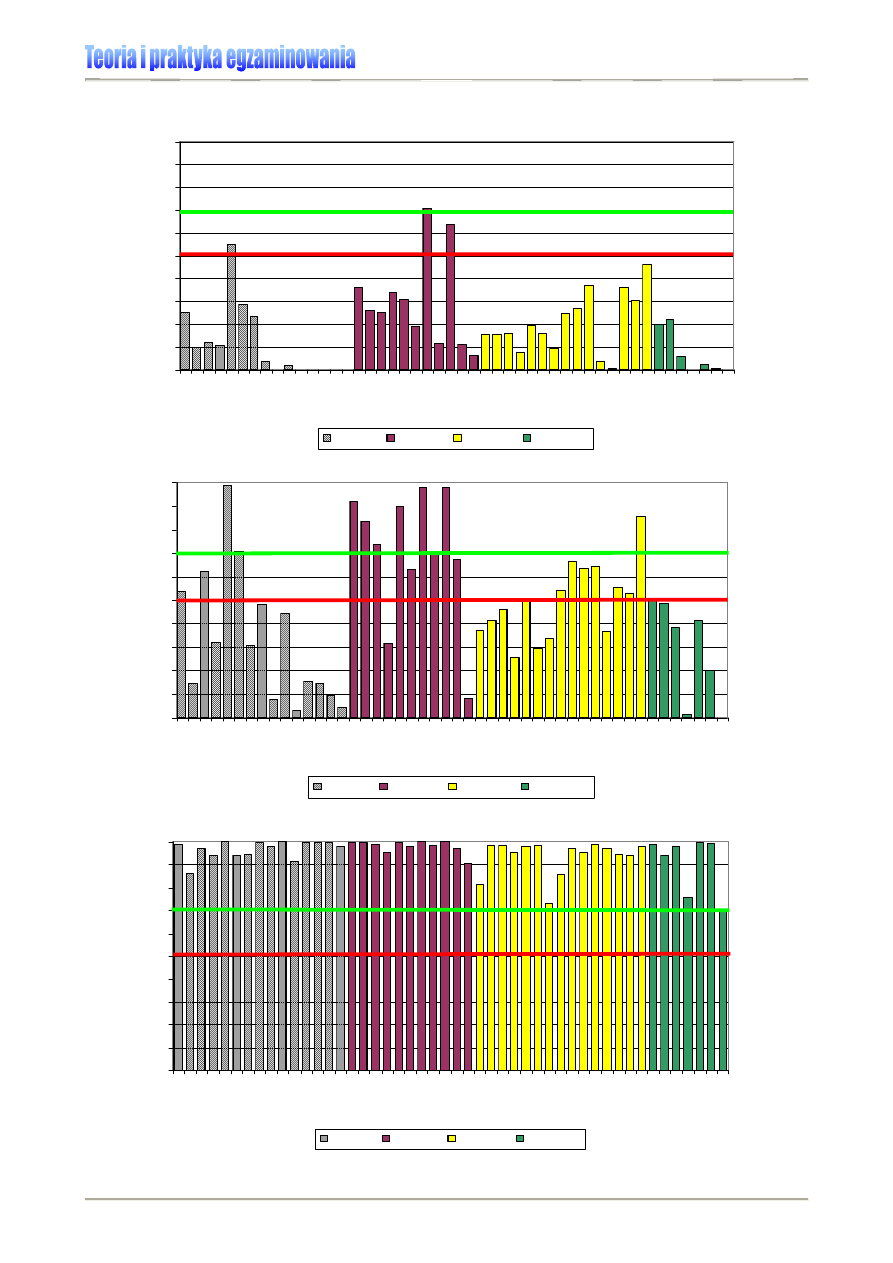

Przykład:

Analizując zestawienie wyników wewnątrzszkolnych badań osiągnięć edukacyjnych

uczniów klasy VIa Szkoły Podstawowej w C. – Wykres 8.), łatwo możemy wskazać zadania, które

sprawiły uczniom szczególne kłopoty (np. zad. 4-8, 10), i te, które pokazały, że czynności nimi ba-

dane opanowane zostały w stopniu zadowalającym (zad. 11-13). Jakie to czynności – wskaże kar-

toteka, czyli zestawienie czynności sprawdzanych testem. Bez sięgnięcia do niej, nauczyciel nie

jest w stanie ocenić efektywności swej pracy z uczniem.

Wykres 8. Fragment wewnątrzszkolnej analizy wyników badań osiągnięć edukacyjnych uczniów klasy VIa na

tle wyników Szkoły Podstawowej w C. [6]

Trudność zadania / testu

W analizach wyników testu złożonego z zadań punktowanych 0-1, wartości liczbowe

wskaźnika łatwości zadania wykorzystuje się do obliczania wskaźnika trudności tegoż za-

dania. Dostarcza on jakościowej informacji o stopniu trudności zadania testowego, bo im

niższy jest wskaźnik łatwości zadania, tym jest ono trudniejsze (tzn. rozwiązuje go mniej

uczniów). Inaczej mówiąc, parametr trudność zadania jest odwrotnością łatwości, bo

wskazuje, jaki odsetek uczniów nie rozwiązał danego zadania. Test, w którym dominują

zadania o takich wartościach, prowadzi do skośności dodatniej rozkładu wyników testo-

wych.

Trudność zadania punktowanego 0-1 jest to stosunek liczby uczniów,

którzy nie rozwiązali prawidłowo tego zadania, do liczby uczniów

biorących udział w testowaniu

18F18F18F18F

19

.

Przykład:

Trudność zadania, które ma współczynnik łatwości 0,73, wynosi 0,27, bo 1 – 0,73=0,27.

Jest to wskaźnik rzadziej stosowany w analizach wyników testowania niż łatwość zadania,

stąd jego mniejsza popularność w szkolnych analizach statystycznych.

19

B. Niemierko, Pomiar wyników ..., op. cit., s. 153.

Stopień opanowania czynności badanych testem przez uczniów klasy VI a

0,65

0,55

0,56

0,43

0,36

0,29

0,26

0,46

0,62

0,30

0,81

0,90

0,83

0,69

0,60

0,69

0,30

0,37

0,25

0,03

0,34

0,61

0,43

0,84

0,93

0,93

0

0,1

0,2

0,3

0,4

0,5

0,6

0,7

0,8

0,9

1

1

2

3

4

5

6

7

8

9

10

11

12

13

numer zadania

łatwo

ść

zadania

wynik szkoły

wynik klasy

gdzie: p – łatwość zadania/testu, q – trudność zadania/testu.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

23

n

n

f

o

o

=

Frakcja opuszczeń

W analizie poprawności dydaktycznej i stosowności zadań testowych uwzględnia się rów-

nież zadania, które uczniowie pominęli, czyli pozostawili bez odpowiedzi z powodu braku

czasu, utraty motywacji lub zbyt wysokiej trudności zadania.

Frakcja opuszczeń zadania wyrażona jest stosunkiem liczby uczniów, którzy opuścili za-

danie, do liczby egzaminowanych uczniów.

Frakcja opuszczeń zadania nie powinna przekraczać 0,15. Jeżeli jest większa, zadanie

może nie być poprawne dydaktycznie (merytorycznie, redakcyjnie lub pod względem trud-

ności)

19F19F19F19F

20

, należy mu się ponownie przyjrzeć przed następnym zastosowaniem, zwracając

uwagę również na jego kategorię taksonomiczną (np. zadania sprawdzające czynności z

kategorii A, badającej zapamiętywanie wiadomości, mogą być opuszczane częściej, po-

nieważ uczniowie nie zapamiętali szczegółowych informacji) oraz na ich miejsce w teście

(zadania opuszczane w końcowej części mogą świadczyć o braku czasu na ich rozwiąza-

nie). Frakcja opuszczeń to informacja ważna przede wszystkim dla konstruktorów testów

(także nauczycielskich).

Przykład:

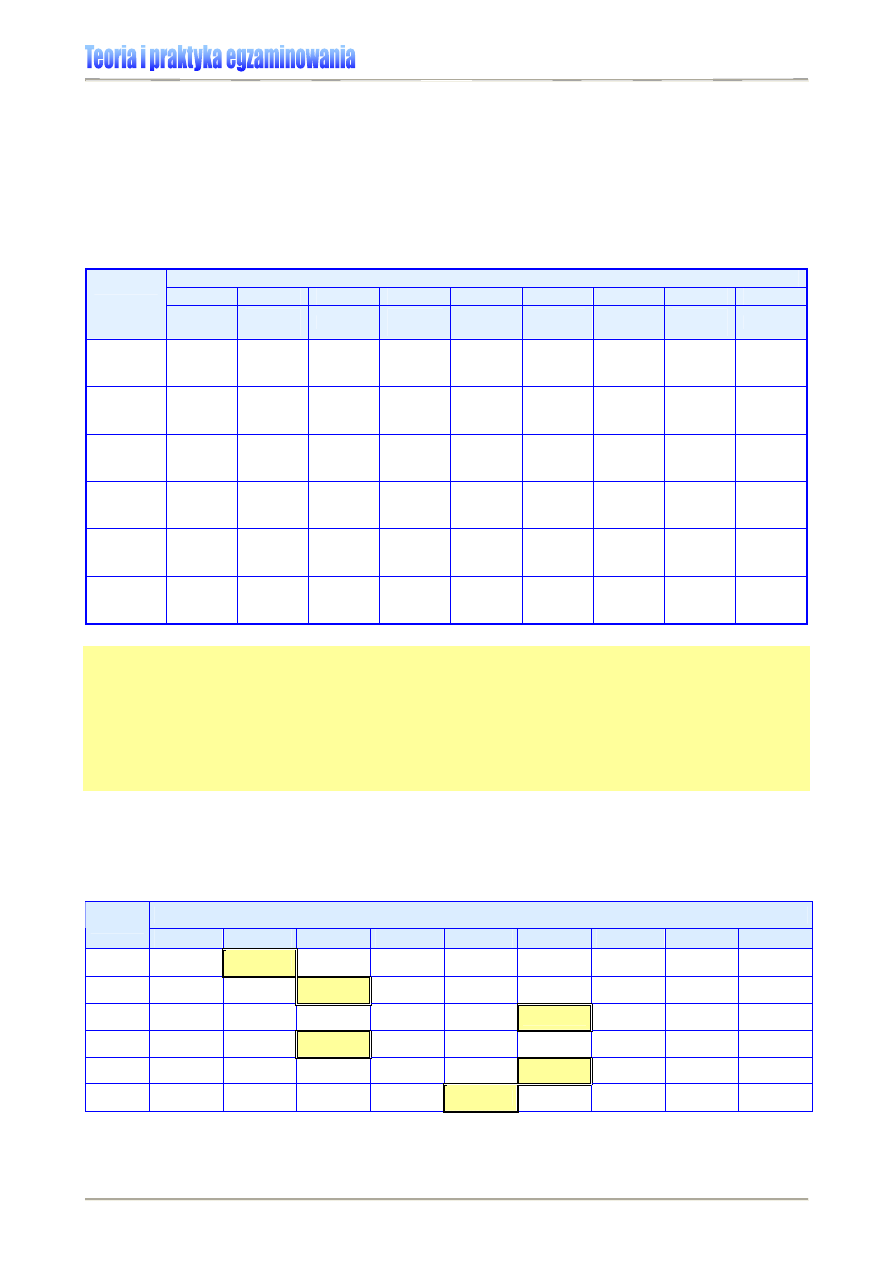

Do potrzeb analizy wyników testowania sporządzono zbiorczą tabelę (Tabela 11.).

Tabela 11. Fragment analizy zbiorczej wyników testowania [6]

Nr

1 2 3 4 5 ... .... 17 18 19

20

f

0

0,19

0,05

0,05

0,17

0,00

...

...

0,02

0,11

0,18

0,03

Z prezentowanego zestawienia wynika, że frakcja opuszczeń zadań nr 1, 4, 19 przyjęła wartość

powyżej 0,15. Zatem zadania 1 i 4 wymagają pogłębionych analiz konstrukcyjnych, ponieważ są to

zadania umieszczone na początku testu, w związku z tym powód ich opuszczenia jest inny niż

brak czasu na rozwiązanie zadania przez ucznia. Również zadanie 19. należy poddać dodatko-

wym analizom jakościowym, ponieważ to nie jego umieszczenie pod koniec testu spowodowało

brak rozwiązania. Uczniowie podejmowali próbę zmierzenia się z ostatnim zadaniem (frakcja

opuszczeń 0,03), a więc można przypuszczać, że na pracę mieli wystarczająco dużo czasu.

Moc różnicująca zadania

Moc różnicująca zadania jest informacją o związku wyniku tego zadania z wynikami in-

nych zadań danego testu. Jest mierzona korelacją wyników zadania z wynikami testu, któ-

rego jest częścią. Miara ta posiada zdolność do odróżniania uczniów o wyższych i niż-

szych osiągnięciach. Przyjmuje wartość od -1 do +1

20F20F20F20F

21

. Jest wskaźnikiem wykorzystywa-

nym w procesie konstruowania testu po pierwszym zastosowaniu narzędzia (po testowa-

niu próbnym lub na etapie standaryzacji). Informuje o zdolności zadania do rozróżniania

uczniów na podstawie ich osiągnięć, czyli odpowiada na pytanie, jak zadanie rozróżnia

egzaminowanych uczniów. Im wyższy wskaźnik mocy różnicującej, tym zadanie jest kon-

strukcyjnie lepsze. Zadanie o wysokiej mocy różnicującej rozwiązują uczniowie lepsi, na-

tomiast słabsi nie. Natomiast ujemny wskaźnik oznacza, że zadanie jest prawdopodobnie

niepoprawnie skonstruowane i wymaga pogłębionej analizy jakościowej.

20

Ibidem, s. 152.

21

Ibidem, s.154-155.

gdzie:

f

o

– frakcja opuszczeń, n

o

– liczba opuszczeń, n – liczba uczniów.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

24

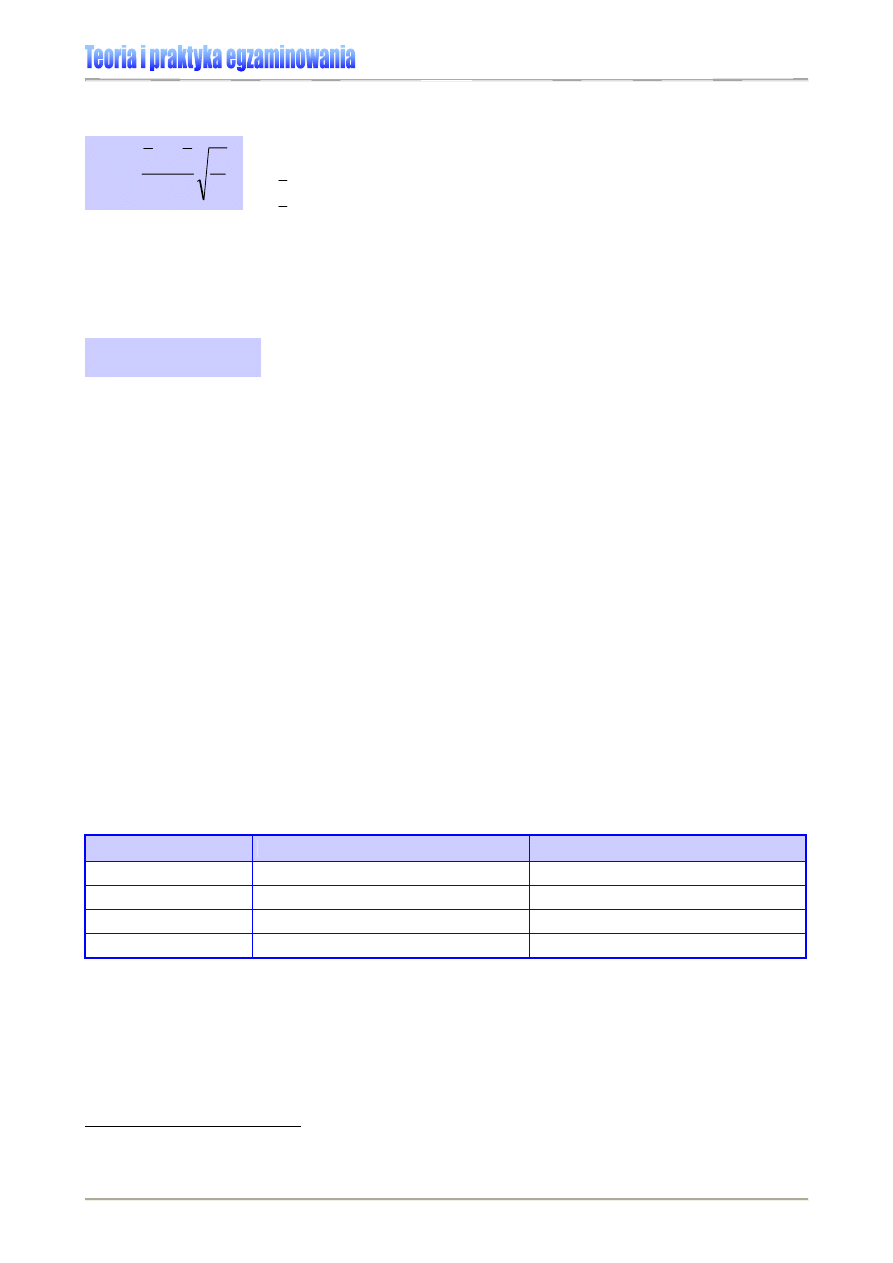

Moc różnicująca zadania punktowanego 0-1 obliczana jest według wzoru:

W praktyce często stosowany jest prostszy, ale mniej doskonały wskaźnik zastępczy mocy

różnicującej zadania punktowanego 0-1, oznaczany D

50

i

obliczany według wzoru:

Przykład:

Aby obliczyć wskaźnik mocy różnicującej D

50

, należy uszeregować wyniki od najwyż-

szego do najniższego. Otrzymany zbiór dzielimy na połowy i obliczamy wskaźnik łatwości dla wyż-

szej (lepszej) i dla niższej (słabszej) połówki rozwiązań, a następnie znajdujemy różnicę.

Załóżmy, że współczynnik łatwości dla uczniów w „lepszej” połowie (tych, którzy uzyskali lepszy

wynik w teście) rozwiązujących dane zadanie wyniósł 0,75, a dla radzących sobie słabiej – 0,31.

Moc różnicująca zadania wyrażona wskaźnikiem D

50

wyniesie więc 0,44. Jeżeli test składał się z co

najmniej 25 zadań, to przykładowe zadanie dobrze różnicuje osiągnięcia uczniów. Gdyby wartość

wskaźnika mocy różnicującej wyniosła 0, znaczyłoby to, iż liczba poprawnych odpowiedzi w obu

grupach uczniów jest jednakowa.

Interpretacja wskaźnika mocy różnicującej jest skomplikowana

21F21F21F21F

22

. Najczęściej rozważane

są trzy zależności wyznaczające wartość tego wskaźnika:

1. zależność od łatwości zadania (np. zadania najtrudniejsze i najłatwiejsze nie różni-

cują osiągnięć uczniów),

2. zależność od rodzaju kryterium,

3. zależność od długości danego testu.

Przybliżone progi zadowalających wartości wskaźnika mocy różnicującej przedstawia Ta-

bela 12.

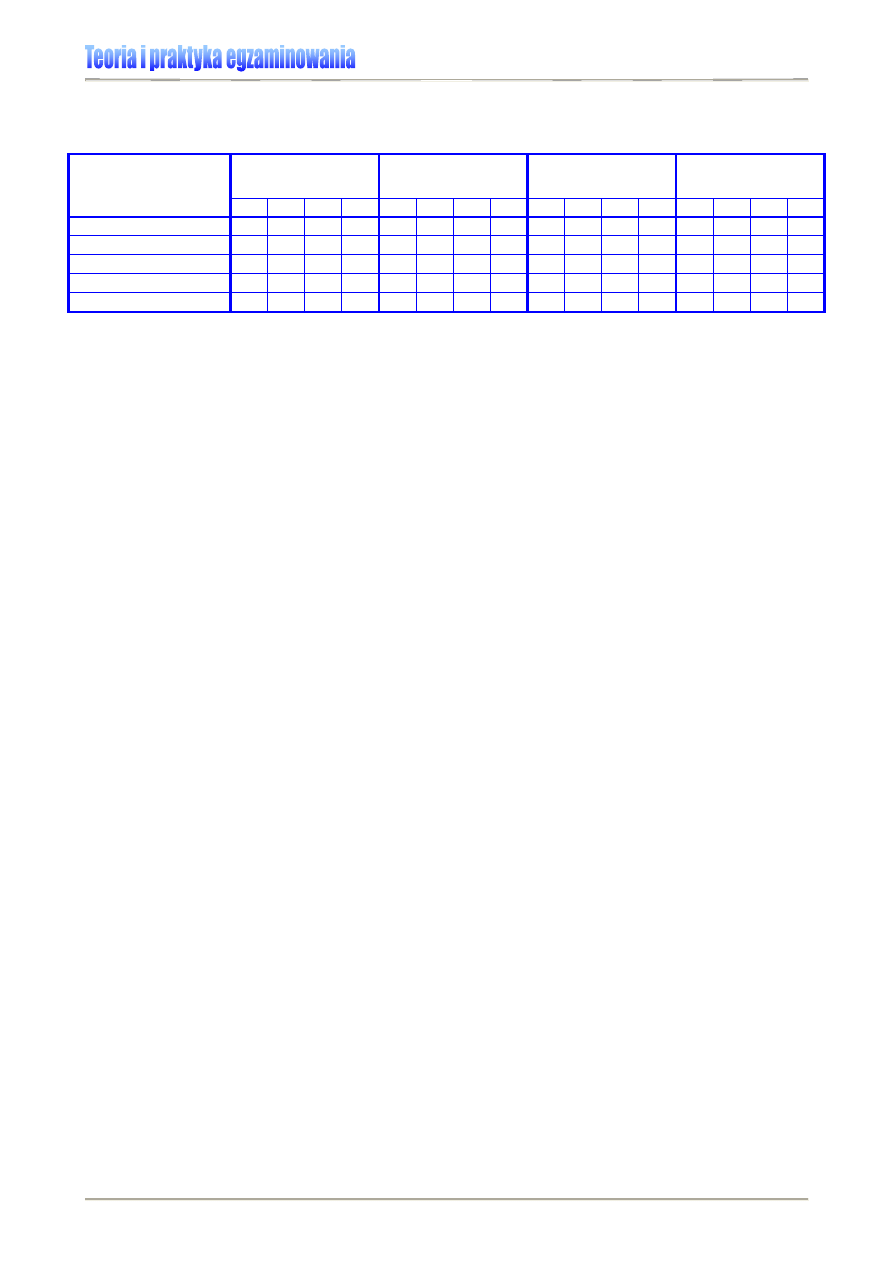

Tabela 12. Interpretacja wskaźnika mocy różnicująca zdań w testach o różnej długości

22F22F22F22F

23

Liczba zadań w teście

Minimalna moc różnicująca zadań

Zadowalająca moc różnicująca zadań

100 0,10

0,22

25 0,20

0,42

10 0,32

0,60

5 0,45

0,75

22

Więcej na ten temat można przeczytać w: Pomiar wyników..., s. 156-158.

23

Za: B. Niemierko, ibidem, s. 158.

q

p

s

x

x

r

t

p

pb

−

=

D

50

= p

L

-p

S

gdzie:

r

pb

– wskaźnik mocy różnicującej, tzw. punktowo-dwuseryjny, korelacyjny

x

p

– średnia arytmetyczna wyników uczniów, którzy wykonali zadanie

x

– średnia arytmetyczna wyników testu

s

t

– odchylenie standardowe wyników egzaminowania

p – łatwość zadania

q – trudność zadania

gdzie:

D

50

– wskaźnik mocy różnicującej, tzw. połówkowy

p

L

– łatwość zadania w lepszej połowie wyników egzaminu

p

S

– łatwość zadania w słabszej połowie wyników egzaminu

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

25

Rzetelność pomiaru

Rzetelność jest miarą dokładności pomiaru dokonywanego za pomocą testu. Najogólniej

rozumiana jest jako powtarzalność (stałość) wyników pomiaru w określonych warunkach.

Oznacza to, że uczniowie badani ponownie po jakimś czasie w porównywalnych warun-

kach tym samym testem uzyskują podobne wyniki

23F23F23F23F

24

.

Jednym ze sposobów szacowania rzetelności jest obliczenie alfy Cronbacha wg wzoru:

W przypadku wewnętrznej zgodności testu k jest liczbą zadań w teście,

2

i

α

wariancją wy-

ników i-tego zadania, zaś

2

x

α

wariancją wyników testowania.

W przypadku zadań punktowanych 0-1, rzetelność szacuje się z wykorzystaniem wzoru

KR20 (Kudera i Richardson nr 20):

Współczynnik rzetelności może przybierać wartości w przedziale 0-1. Wartość 0 oznacza,

że cała zmienność wyników pochodzi z błędów pomiaru, zatem różnice między osiągnię-

ciami uczniów są wyłącznie losowe, a test niewiele mierzy. Natomiast wartość 1 oznacza,

że wyniki testowania są wolne od błędów pomiaru

24F24F24F24F

25

. Ponieważ nie ma idealnego testu,

należy wiedzieć, jak duży popełniamy błąd, stosując konkretne narzędzie badawcze i

określić granice interpretacji otrzymanego wyniku testowego. Innymi słowy, rzetelność

pomiaru jest to wielkość błędu, jaki możemy popełnić, interpretując wyniki danego testu

25F25F25F25F

26

.

Efekt standardowy

26F26F26F26F

27

Do zmierzenia wpływu określonego czynnika na wynik całej badanej populacji wykorzystu-

je się wskaźnik zwany efektem standardowym, który obliczany jest według wzoru:

24

Ibidem, s.192.

25

Ibidem, s.196.

26

Więcej na ten temat można przeczytać w: B. Niemierko, Pomiar wyników..., s. 192-219.

27

Przykłady w: Ewa Stożek, O czym mówi efekt standardowy?, [w:] Holistyczne i analityczne metody dia-

gnostyki edukacyjnej, Perspektywy informatyczne egzaminów szkolnych, red. B. Niemierko, G. Szyling, Fun-

dacja Rozwoju UG, Gdańsk 2005, s.520-525; także: www.ptde.org.pl

⎟

⎟

⎠

⎞

⎜

⎜

⎝

⎛

−

−

=

∑

2

2

1

1

x

i

k

k

α

α

α

⎟

⎟

⎠

⎞

⎜

⎜

⎝

⎛

−

−

=

∑

2

1

1

x

i

i

tt

q

p

m

m

r

α

s

x

x

d

2

1

−

=

gdzie:

α – współczynnik rzetelności (alfa Cronbacha)

k – liczba pomiarów cząstkowych składających się na zmienną x

∑

2

i

α

– suma wariancji wyników k pomiarów cząstkowych

2

x

α

– wariancja zmiennej x

gdzie:

r

tt

– współczynnik rzetelności KR20

m – liczba zadań w teście (długość testu)

p

i

– łatwość i-tego zadania

2

x

α

– wariancja wyników testowania

q

i

– trudność i-tego zadania

gdzie:

d – efekt standardowy

1

x

– średnia grupy pierwszej (eksperymentalnej, którą będziemy porównywać)

2

x

– średnia grupy drugiej (kontrolnej, bazowej, do której będziemy porównywać)

s – odchylenie standardowe

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

26

Odchylenie obliczane jest wg wzoru:

Efekt standardowy pozwala m. in. na porównywanie uzyskanej przewagi bez względu na

właściwości skali i rozkładu wyników.

Pozwala na porównywanie wyników różnych grup (np. równoległych oddziałów klasowych)

pod względem określonej cechy, umiejętności. Proponuje się następującą skalę siły efek-

tu:

Tabela 13. Skala siły efektu według Cohena

27F27F27F27F

28

d = 0,2

d = 0,5

d = 0,8

mały efekt (wpływ)

średni efekt (wpływ) duży efekt (wpływ)

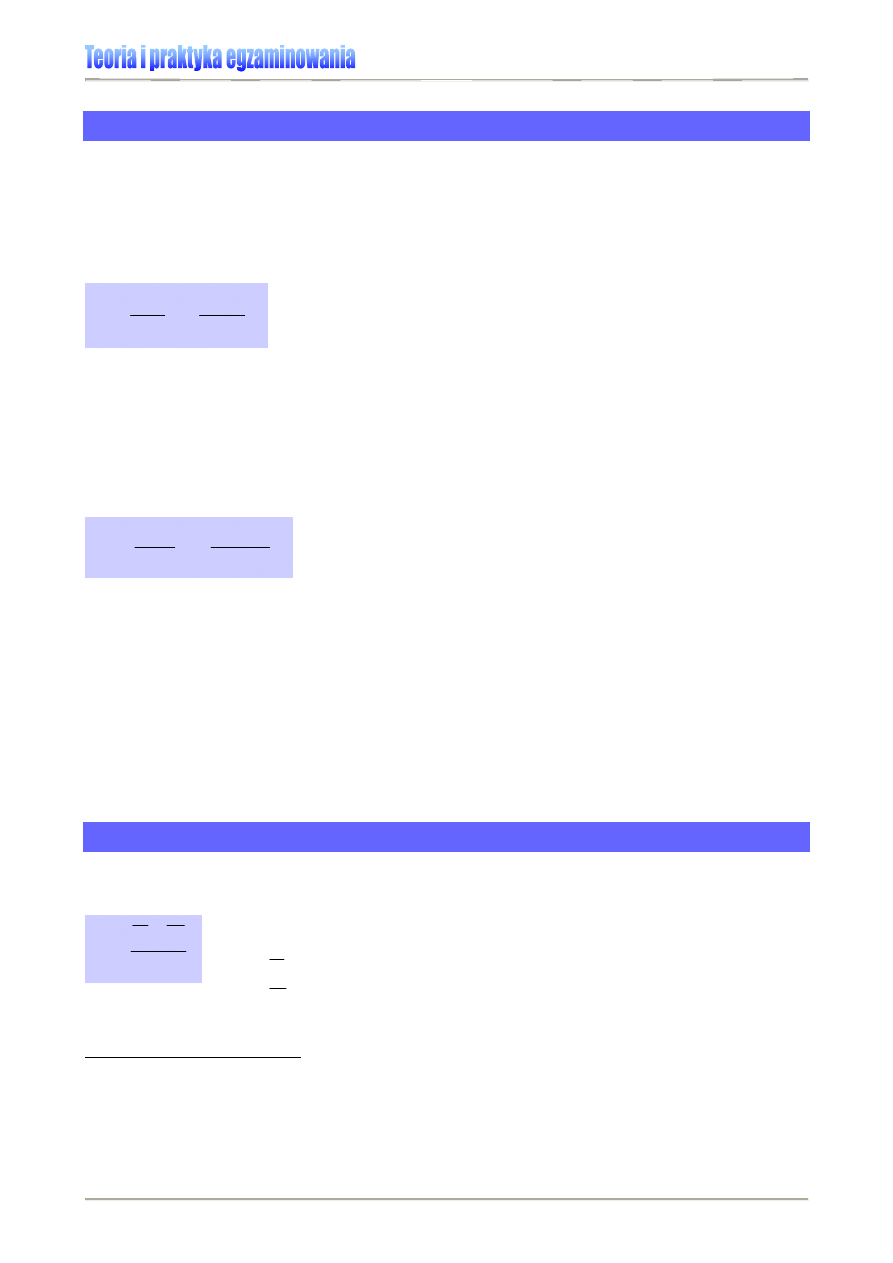

Efekt standardowy jest corocznie wykorzystywany w prezentacji wyników sprawdzianu. Z

jego pomocą analizowany jest między innymi wpływ na wynik egzaminu płci czy też wiel-

kości miejscowości.

Dla przykładu,

fragment sprawozdania ze sprawdzianu 2007, dotyczący wpływu płci na wynik

egzaminu: „Analiza efektu standardowego płci w latach 2002-2007 wykazuje, że do roku 2004

przewaga dziewcząt rosła, w kolejnych dwóch latach nieznacznie zmalała, a w bieżącym roku po-

nownie wzrosła.”

28F28F28F28F

29

.

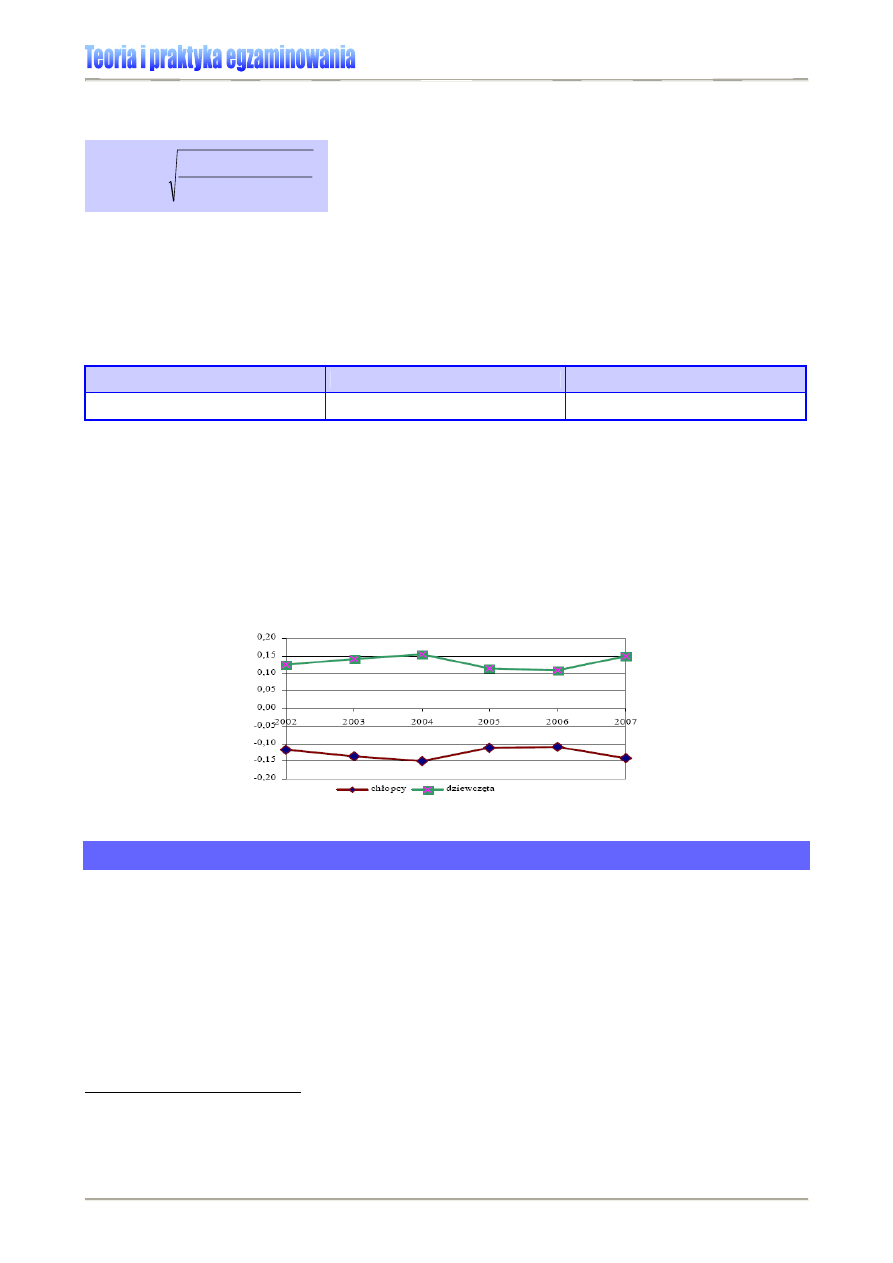

Wykres 9. Efekt standardowy na sprawdzianie 2002-2007 [3]

Wynik standardowy

Wynik standardowy jest wskaźnikiem zbliżonym do efektu standardowego. Pozwala na

umieszczenie wyniku pojedynczego ucznia na skali, niezależnie od wielkości średniej i

odchylenia standardowego. Jest informacją o tym, w jakiej odległości od średniej mierzo-

nej w odchyleniach standardowych znajduje się wynik ucznia. Wyniki standardowe mają

średnią 0 i odchylenie standardowe 1. O ile efekt standardowy służy do porównywania

grup, wynik standardowy umożliwia porównywanie wyników ucznia w obrębie badanej

grupy.

29F29F29F29F

30

Wyniki standardowe stosuje się w celu porównania wyników uzyskanych przy

użyciu różnych narzędzi pomiaru, np. wyniku ucznia uzyskanego w części humanistycznej

28

Za: E. Stożek, ibidem.

29

Osiągnięcia uczniów kończących szkołę podstawową w roku 2007. Sprawozdanie ze sprawdzianu 2007,

Centralna Komisja Egzaminacyjna, Warszawa, maj 2007, s. 15.

30

E. Stożek, op.cit., s. 523-524.

2

)

1

(

)

1

(

2

1

2

2

2

2

1

1

−

+

−

+

−

=

=

N

N

s

N

s

N

s

s

pooled

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

27

i matematyczno-przyrodniczej egzaminu gimnazjalnego. Wynik standardowy jest obliczany

według wzoru

30F30F30F30F

31

:

s

x

x

z

−

=

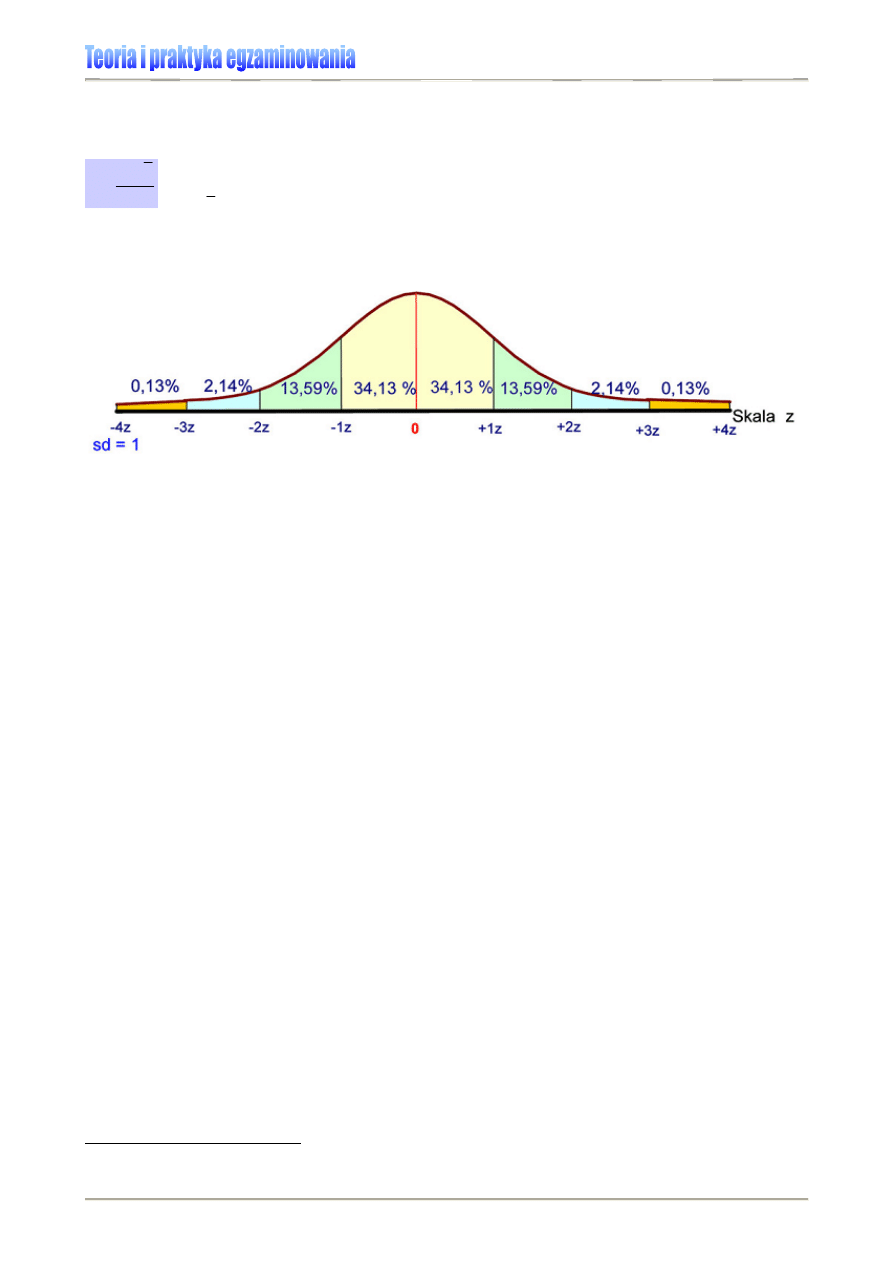

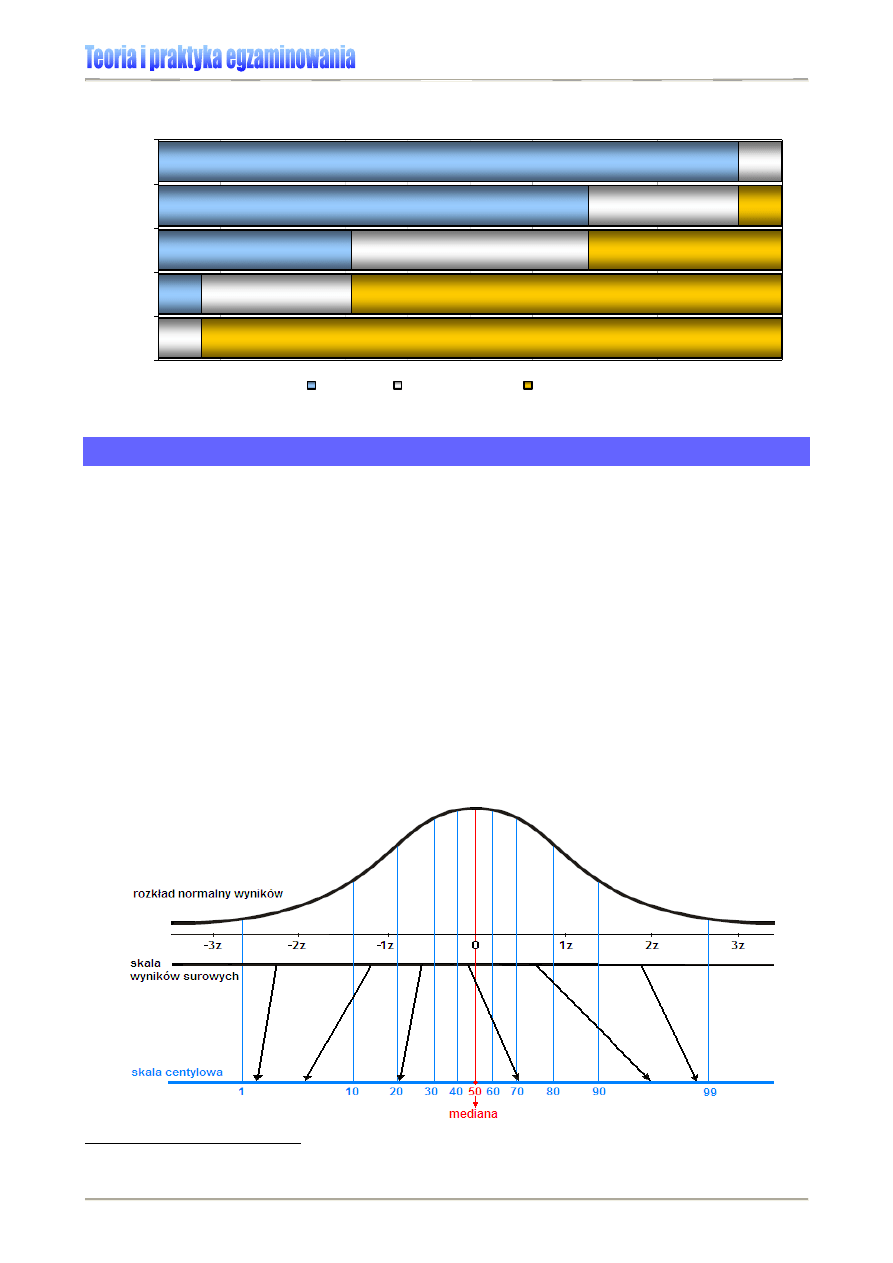

Rysunek 10. Rozkład normalny wyników standardowych

31

G.A. Ferguson, Y. Takane, op. cit., s.92-93.

gdzie:

x – wynik pojedynczego ucznia

x

– średni wynik z testu

s – odchylenie standardowe w teście

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

28

SKALE ZNORMALIZOWANE

Skale znormalizowane są stosowane w statystycznych analizach danych uzyskiwanych w

badaniach, które obejmują duże próby. W związku z tym nie normalizuje się wyników

egzaminów zewnętrznych ani na poziomie szkoły, ani tym bardziej na poziomie kla-

sy szkolnej, wykorzystuje się je natomiast w analizach np. na poziomie kraju.

Pojęcie normy

W powszechnym rozumieniu termin norma oznacza ustaloną, przyjętą zasadę, wzór, regu-

łę, kanon lub ilość, miarę, granicę przewidzianą jako wymaganą lub obowiązującą w ja-

kimś zakresie. Z pojęciem tym nierozerwalnie łączą się takie właściwości, jak powszech-

ność, masowość, częstość występowania określonej cechy lub zachowania w badanej

populacji (por. Hornowska, 2003). Natomiast z punktu widzenia statystyki normą jest to, co

opisywane jest jako zachowanie większości, czy też jako zachowanie średnie lub przecięt-

ne. Inaczej mówiąc, normą jest typowy wynik w teście otrzymany przez określoną grupę

badanych osób. Dzięki niemu można ustalić np. rzeczywistą wartość surowego wyniku

testowego, uzyskanego przez ucznia w stosunku do wyników otrzymanych przez pozosta-

łe badane osoby, bowiem norma nie oznacza, że test został dobrze rozwiązany, ale opisu-

je poziom typowego wykonania tegoż testu.

Przystąpiwszy do egzaminów zewnętrznych, uczeń otrzymuje wynik punktowy (spraw-

dzian i egzamin gimnazjalny) lub procentowy (matura). Jest to tzw. wynik surowy, które-

go bez określonego punktu odniesienia nie można interpretować, zatem oceniać, czy to

wynik wysoki, czy też niski. Dopiero przeniesienie wyników surowych na wspólną skalę

pozwoli na ustalenie norm, dokonywanie porównań i nadanie wynikom znaczenia treścio-

wego, tj. określenie, jaka jest np. pozycja wyniku pojedynczego ucznia (szkoły) względem

wyników innych zdających (szkół).

W badaniach używa się różnych sposobów przedstawiania norm. Punktem wyjścia w ich

ustalaniu jest rozkład normalny wyników, tzw. krzywa Gaussa-Laplace’a. Do najczęściej

spotykanych należą normy standardowe, rangowe lub równoważnikowe

31F31F31F31F

32

.

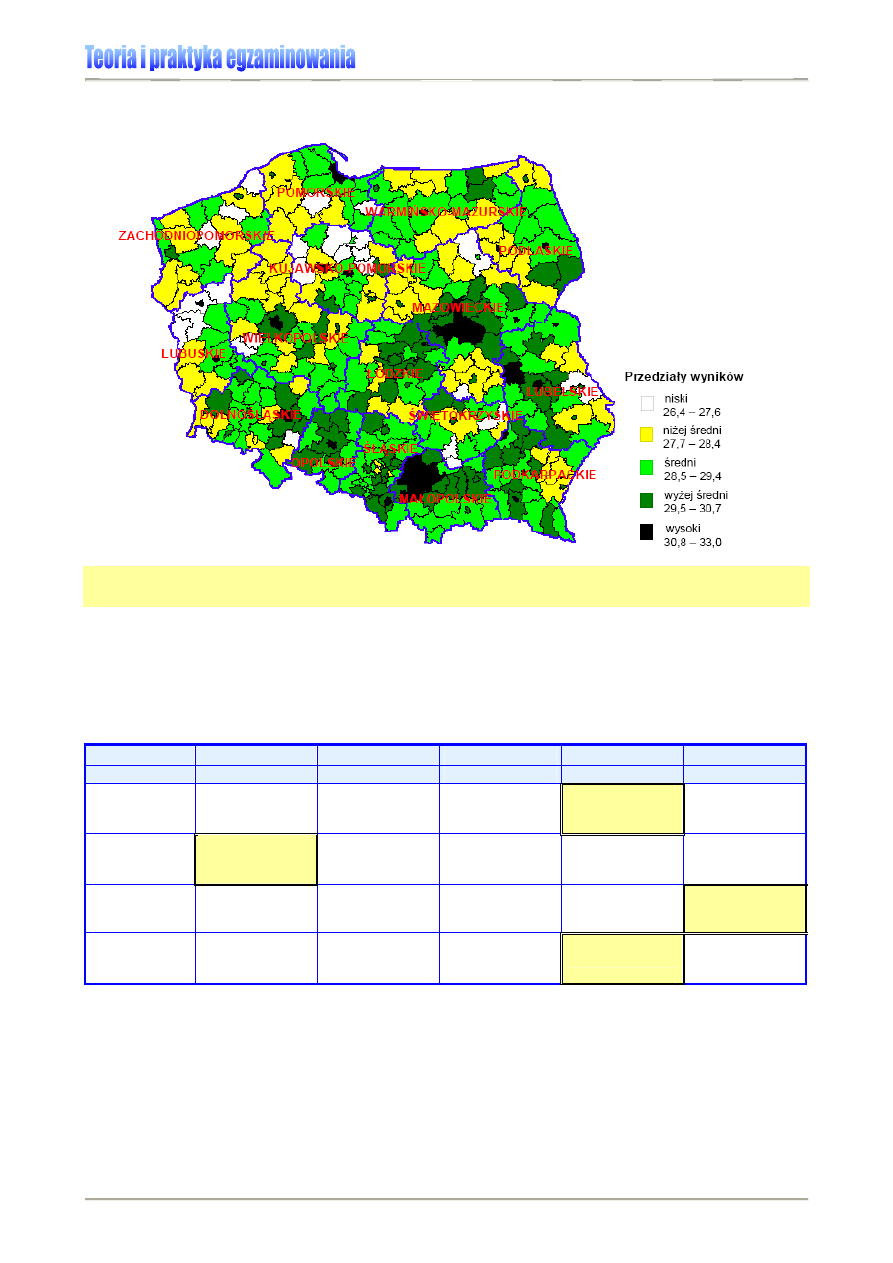

Dla przykładu: w Polsce do interpretacji wyników egzaminów zewnętrznych stosuje się

standardową skalę staninową, zaś skala centylowa służy do analizy wskaźnika eduka-

cyjnej wartości dodanej (EWD). Natomiast do interpretacji wyników uzyskanych w Pro-

gramie Międzynarodowej Oceny Umiejętności Uczniów OECD (PISA) wykorzystuje się

skalę równoważnikową CEEB. Trwają prace nad zastosowaniem tej skali w komuniko-

waniu wyników matury 2008.

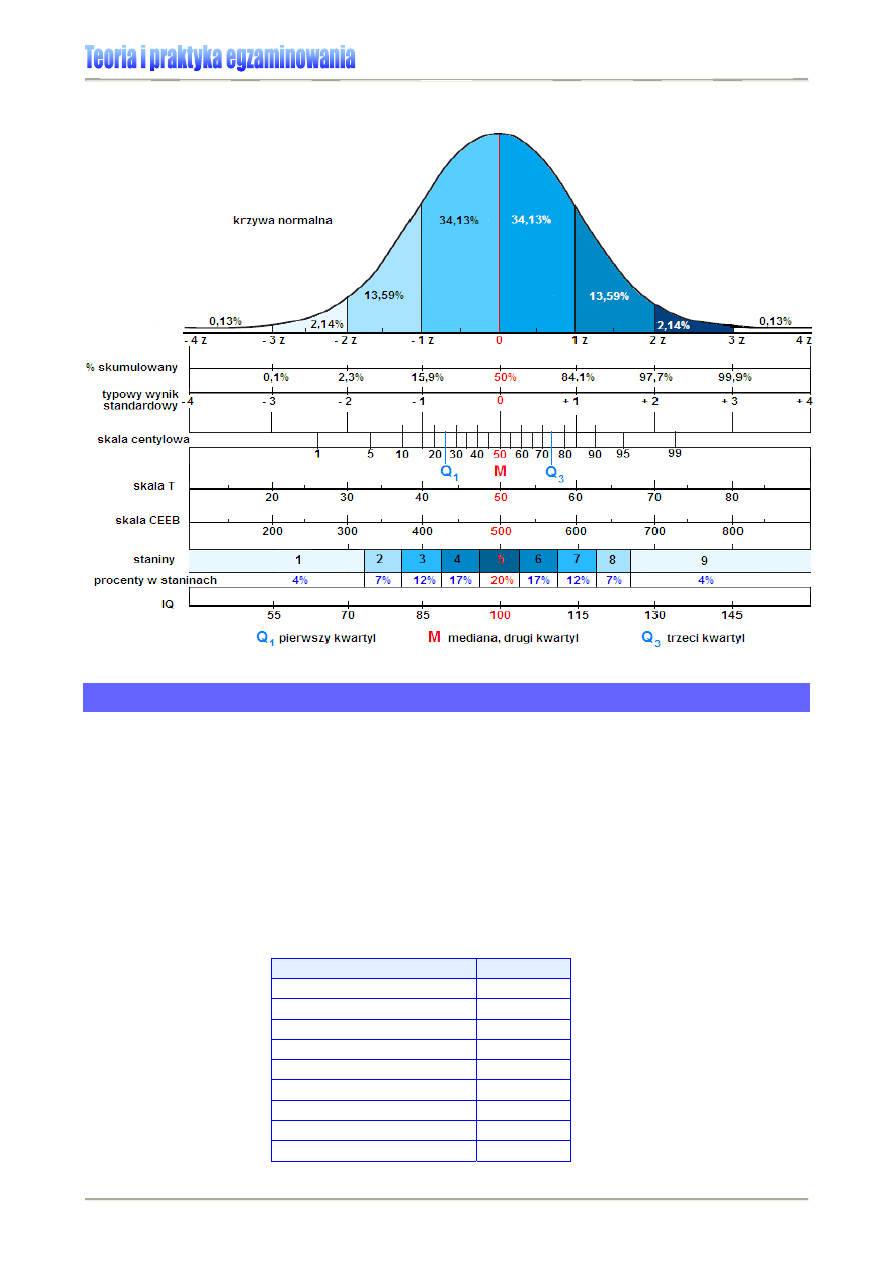

Rysunek 11. przedstawia wybrane skale wykorzystywane w badaniach psychologicznych

i pedagogicznych.

32

Elżbieta Hornowska, op. cit., s.134

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

29

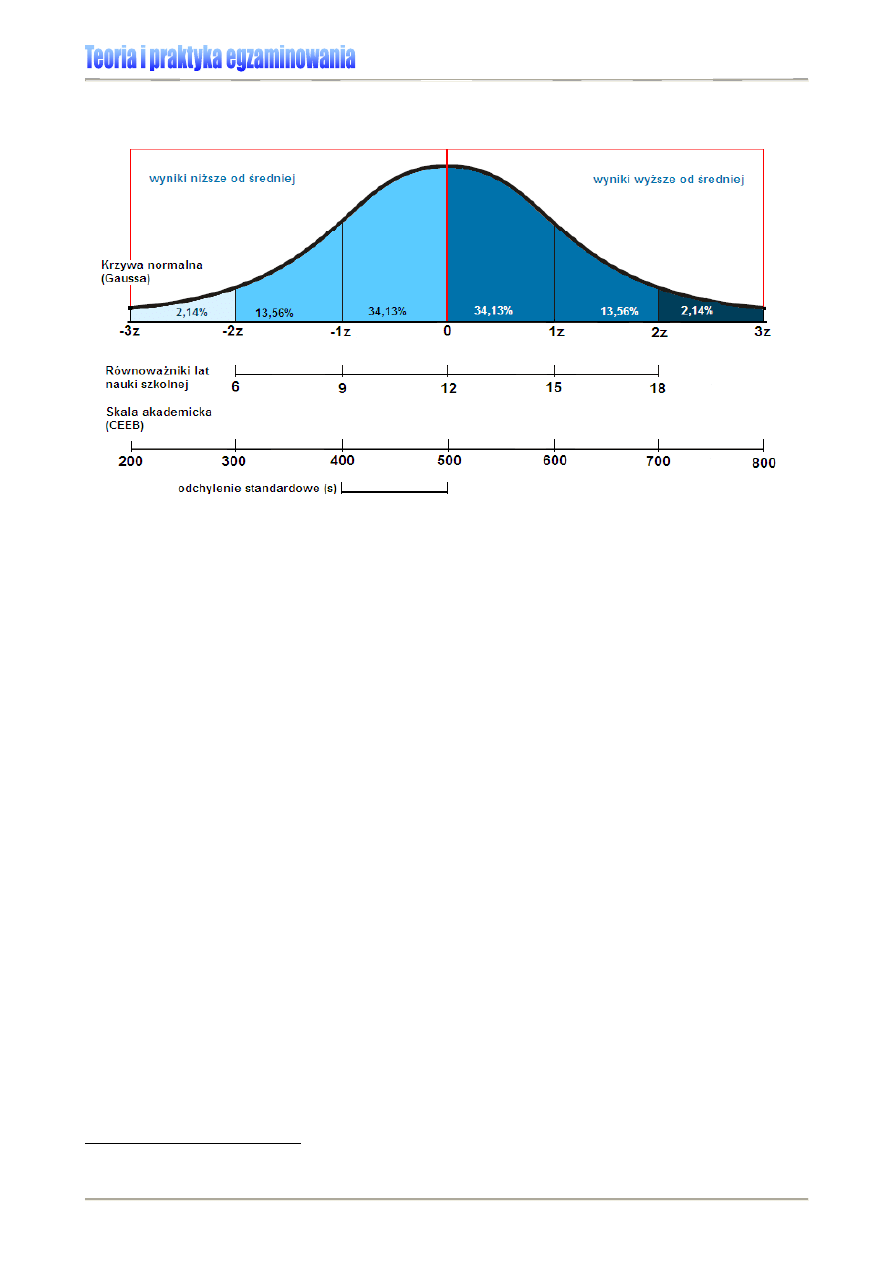

Rysunek 11. Wybrane normy typu standardowego

Normalizacja wyników testowania

Rozkład normalny, stanowiący podstawę do tworzenia skal znormalizowanych, uzyskuje

się przez dopasowanie krzywej do wyników testowania ujętych w przedziały, graficznie

przedstawione za pomocą histogramu. Zatem wynik w skali standardowej jest przekształ-

ceniem (przy użyciu odpowiedniej funkcji) wyniku surowego w zmienną, której kształt roz-

kładu z góry ustalamy. Należy pamiętać, że rozkład normalny jest rozkładem idealnym,

teoretycznym.

„Przepis” na wyznaczenie rozkładu normalnego:

1. Uporządkuj wartości zmiennej (rosnąco) – oblicz częstości wartości zmiennej przypa-

dające na każdą z kategorii:

Tabela 14.

Wartości zmiennej

Częstość

0 2

1 3

2 2

11 13

28 15

32 2

39 10

40 2

45 5

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

30

2. Umieść wyniki w przedziałach (podziel wartości zmiennej na przedziały, pamiętając, że

liczba przedziałów nie powinna być mniejsza od 5 i większa od 20).

Wartości zmiennej

Częstość

0 - 10

7

10 - 20

13

20 - 30

15

30 - 40

12

Tabela 15.

40 - 50

7

3. Na tej podstawie narysuj histogram, który przedstawia rozkład zmiennej.

Przedziały, które wcześniej zostały ustalone, zaznacza się na osi współrzędnych. Często-

ści wyznaczają wysokość (w obrębie określonego przedziału – oś y). Na osi x zaznaczone

są wyniki.

Rysunek 12. Histogram

Histogram umożliwia poznanie typu rozkładu zbiorowości statystycznych wg badanej ce-

chy

.

4. Przez środek przedziałów wyznaczonych w punkcie 2. przeprowadź krzywą, która nigdy

nie łączy się z zerem, ale dąży do nieskończoności.

5. Wyznaczona krzywa to krzywa normalna. Obszar pod krzywą posiada określone wła-

ściwości: od +1 do -1 odchylenia standardowego rozciąga się obszar wyników typowych

obejmujących ok. 68% wszystkich przypadków; od +2 do -2 odchyleń standardowych za-

wiera się ok. 95% wszystkich wyników, od +3 do -3 odchyleń zawiera się ok. 99% wszyst-

kich przypadków. Innymi słowy, w przypadku rozkładu normalnego procent wartości wyni-

ków między obliczonymi współczynnikami odchylenia standardowego jest stały

32F32F32F32F

33

.

Rysunek 13. Procent wartości wyników między współczynnikami odchylenia standardowego w rozkładzie

normalnym.

33

W.P. Zaczyński, Statystyka w pracy badawczej nauczyciela, Warszawa 1997, s. 19.

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

31

Obszar wyników typowych

Obszar wyników typowych (OWT) przy rozkładzie normalnym obejmuje 2/3 wszystkich

wyników (ok. 68%). Jego granice stanowią wartości, które obliczamy z jednej strony

odejmując od średniej arytmetycznej wartość odchylenia standardowego, z drugiej –

dodając te dwa współczynniki do siebie.

Rysunek 14. Wyznaczanie obszaru wyników typowych

Przykład:

Obszar wyników typowych sprawdzianu 2006 (patrz: Wykres 1.) mieści się w przedziale

od 16,7 do 33,9 punktów. Wyznaczyliśmy go, odejmując i dodając od/do średniej (25,3 pkt.)

wartość odchylenia standardowego (8,6 pkt.). [25,3 – 8,6 = 16,7; 25,3 + 8,6 = 33,9]

Ponieważ wyniki egzaminu są wyrażane liczbą całkowitą, po zaokrągleniu wyników, rezultaty

typowe dla uczniów piszących sprawdzian 2006 zawrą się w przedziale <17; 34>.

_

x - s

x

_

x

_

x + s

x

OWT

A n a l i z a i in te r p r e t a cj a w y n i k ó w o c e n i a ni a i egz a m i n o w a nia

W y d z i a ł B a d a ń i E w a l u a c ji C K E

32

Definicje wybranych skal znormalizowanych

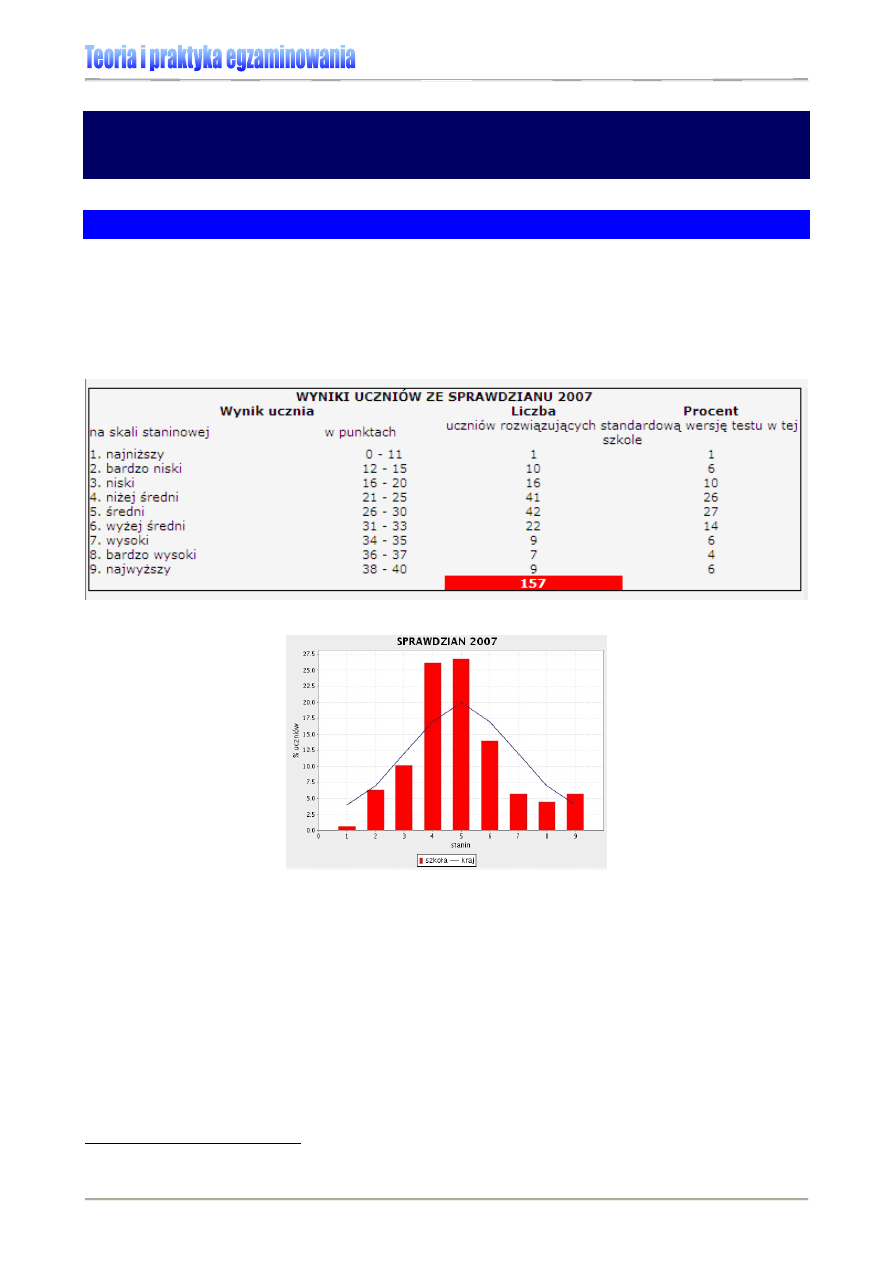

Skala staninowa

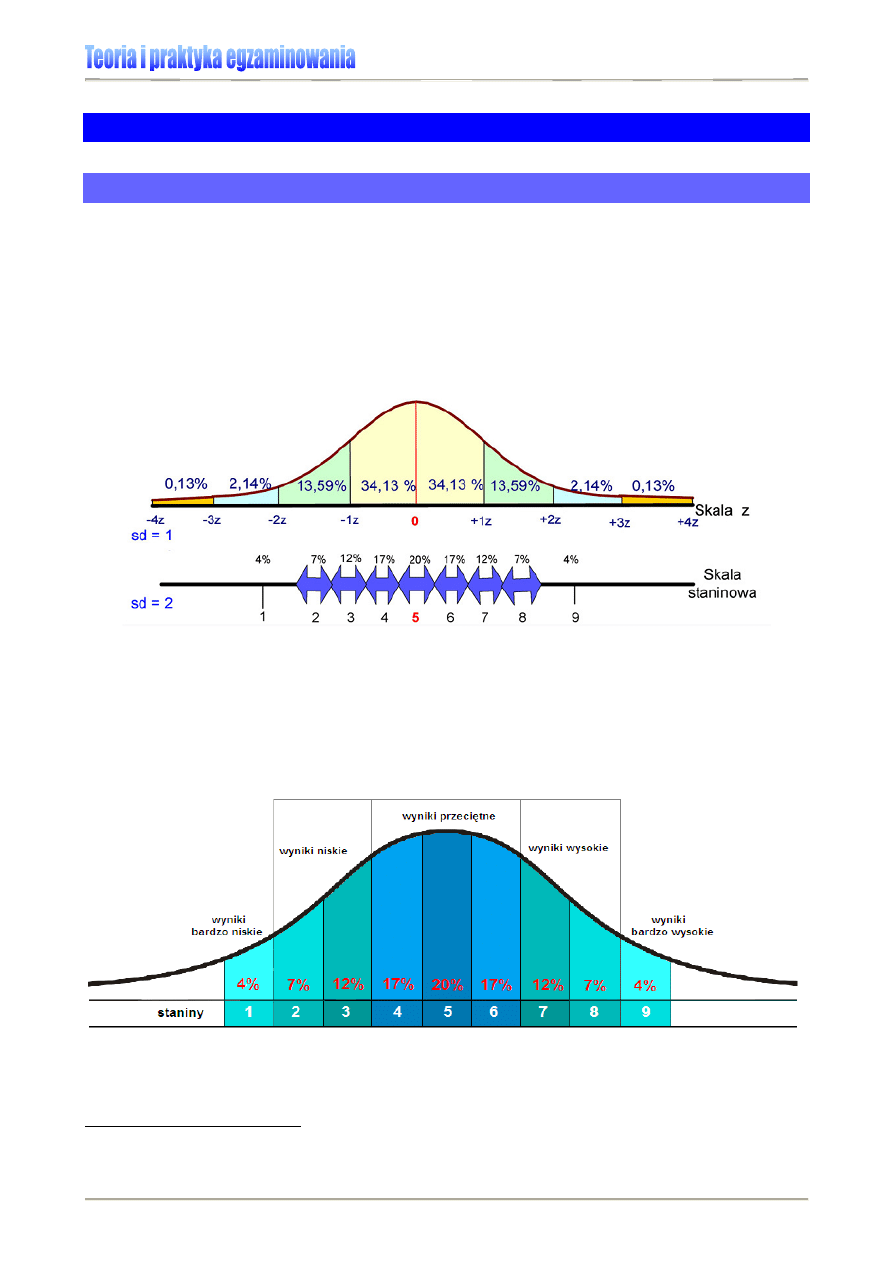

Skala staninowa (od ang. standard nine), zwana także standardową dziewiątką, jest ska-

lą dziewięciostopniową, zaproponowaną w 1942 r. przez Guilforda. Średnia arytmetycz-

na staninów wynosi 5, a odchylenie standardowe 2 (dokładnie 1,96). Staniny wewnętrzne,

od drugiego do ósmego, mają jednakową długość, wynoszącą połowę odchylenia stan-

dardowego, i rozciągają się od -1,75 do +1,75 odchylenia standardowego wyników

w rozkładzie normalnym. Staniny zewnętrzne, pierwszy i dziewiąty, nie mogą być unor-

mowane co do długości, bo muszą zawierać minimalny i maksymalny wynik na tej skali.

33F33F33F33F

34

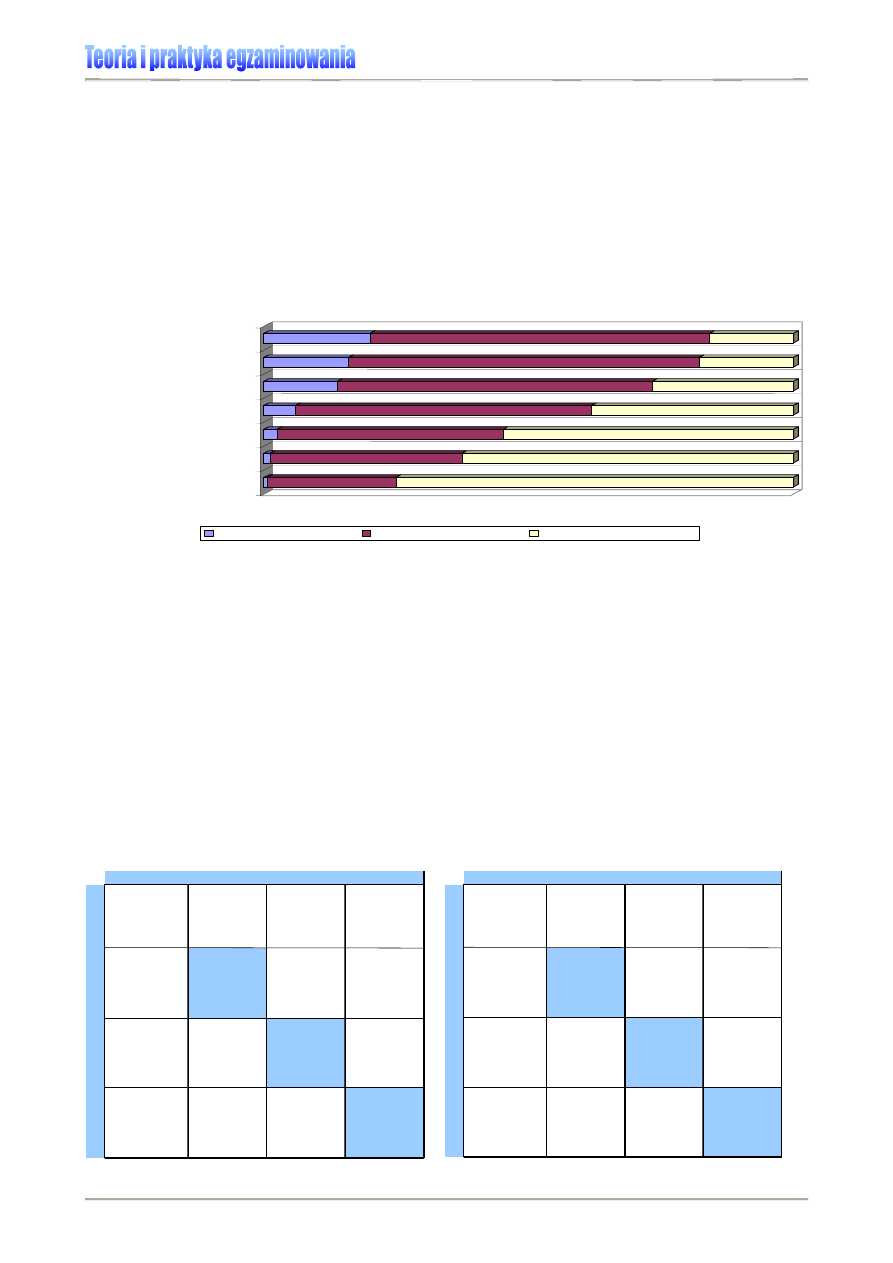

Rysunek 15. Skala staninowa

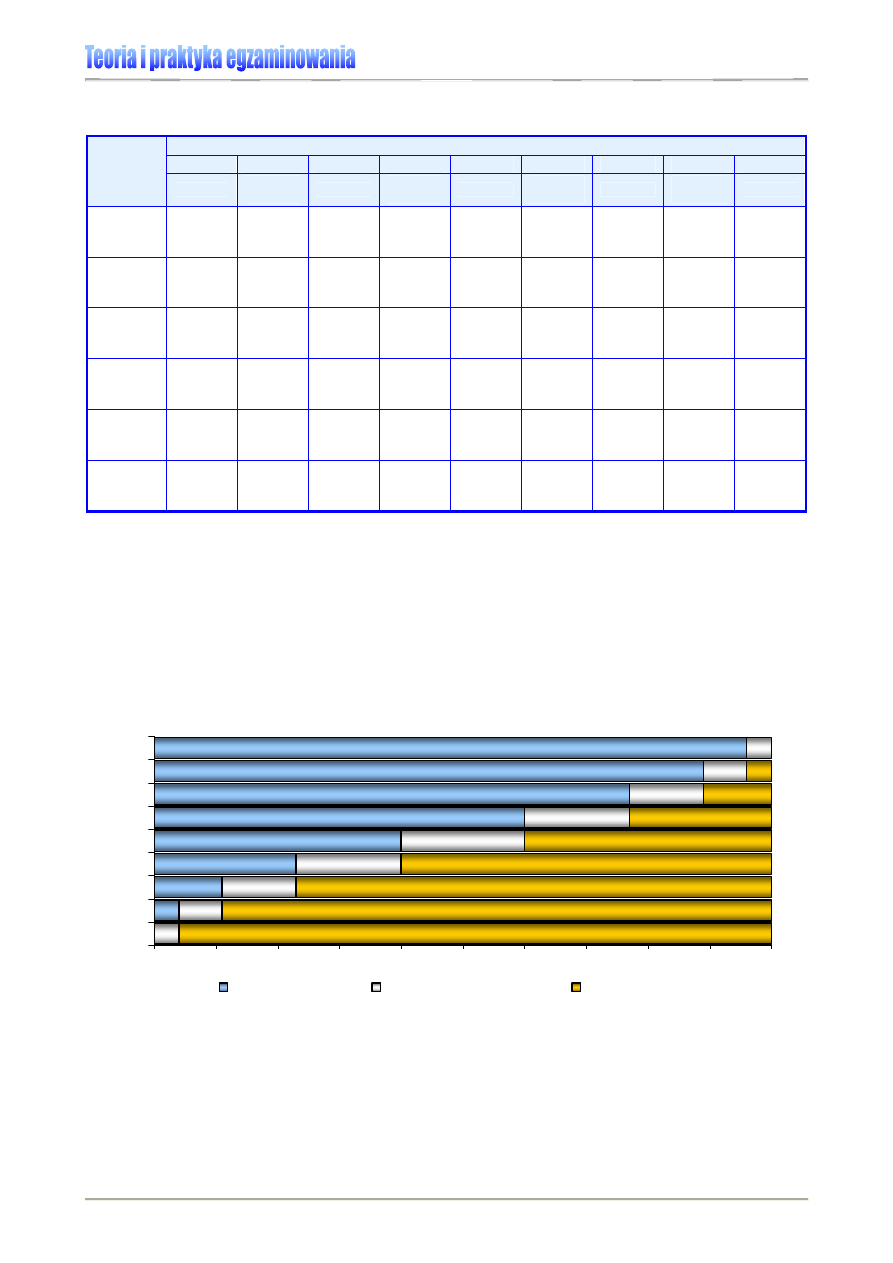

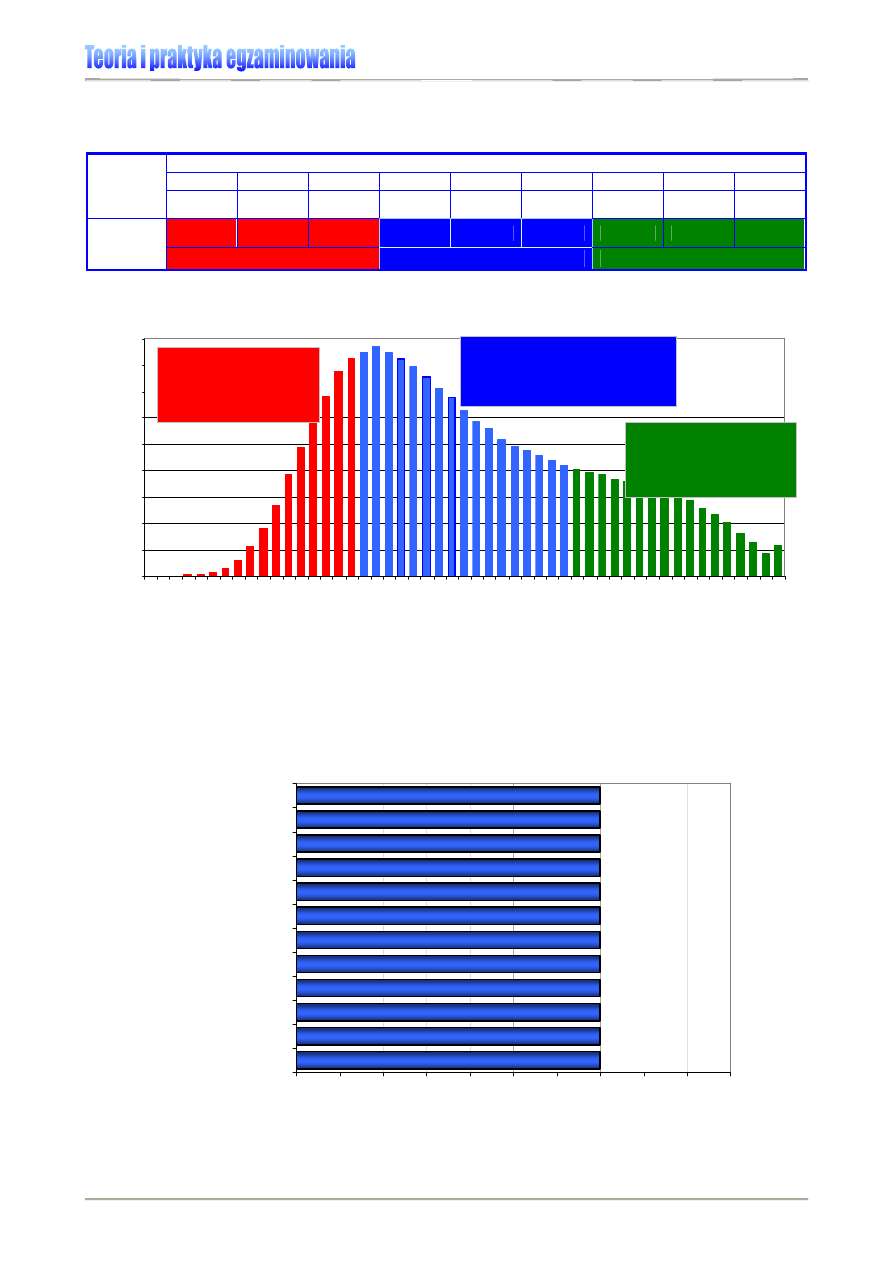

Skalę staninową wyników budujemy poprzez uporządkowanie wyników surowych od wyni-

ku najniższego do najwyższego i podzielenie ich na 9 przedziałów, które kolejno zawiera-

ją: 4% wyników najniższych, 7% wyników bardzo niskich, 12% wyników niskich, 17% wy-

ników niżej średnich, 20% wyników średnich oraz analogicznie w górę 17% wyników wyżej

średnich, 12% wyników wysokich, 7% wyników bardzo wysokich i 4% wyników najwyż-

szych.

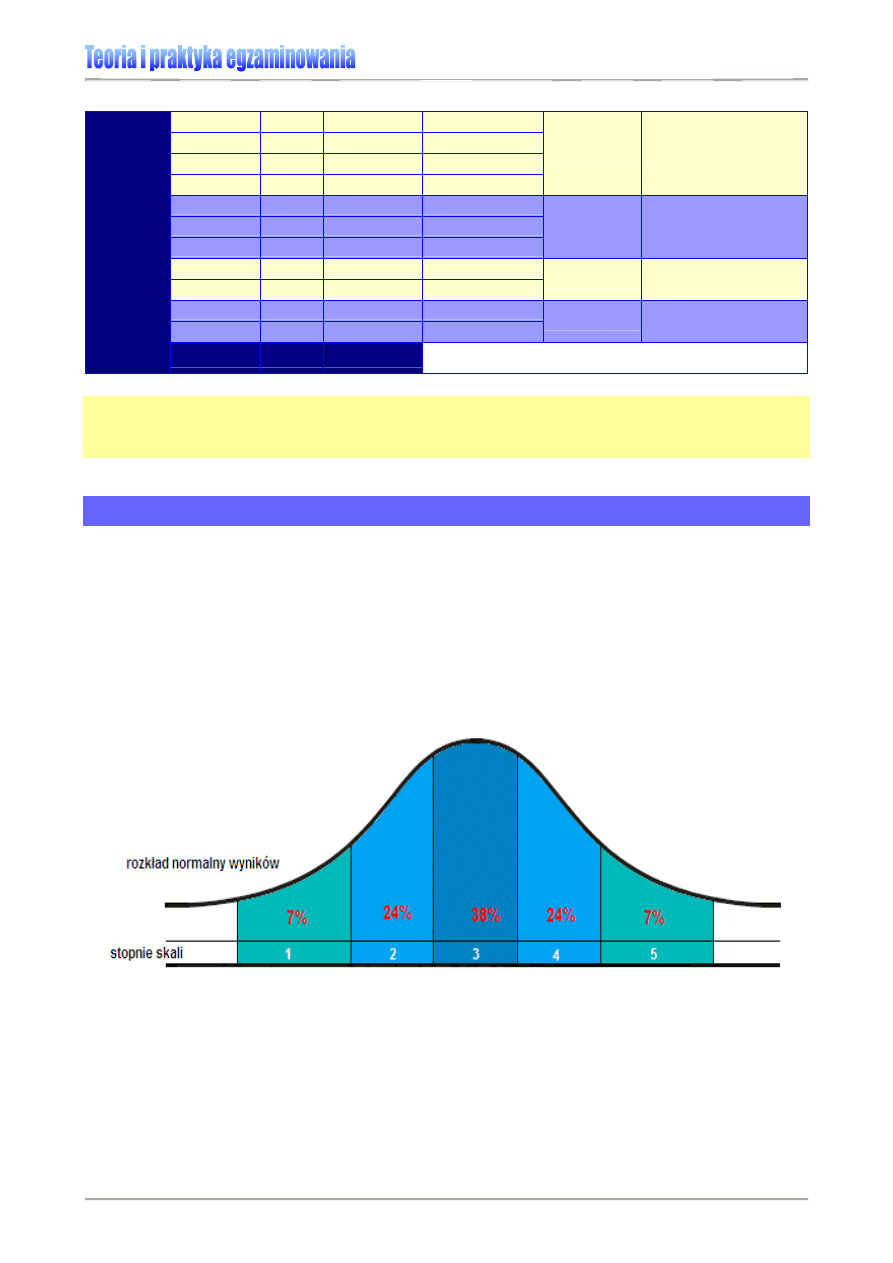

Rysunek 16. Rozkład normalny a skala staninowa wyników egzaminu

34F34F34F34F

35

Następnie dla kolejnych staninów wyznacza się przedziały punktowe. Polega to na ustale-

niu liczby punktów uzyskanych przez uczniów zdających egzamin w danym roku, którzy