To, co wydaje się być najważniejsze...

Utrwala się podział na tych, którzy potrafią i którzy nie potrafią korzystać z komputera jako narzędzia pracy (ang. Digital divide)

knowledge workers, czyli osoby, których zadaniem będzie wyszukiwanie, udostępnianie i dostarczanie wiedzy innym

optymalizacja warunków współpracy człowieka z komputerem

Dwa główne filary definiują informatykę: algorytm (myślenie algorytmiczne) oraz komputer

USA używamy nazwy computer science, czyli nauki komputerowe, w Kanadzie computational science

Information sciences to zastosowania komputerów do zarządzania informacją

Wyróżnia się w niej dwa działy, dotyczące sprzętu i oprogramowania

„Informatyka to systematyczne badanie procesów algorytmicznych, które charakteryzują i przetwarzają informację, teoria, analiza, projektowanie, badanie efektywności, implementacja i zastosowania procesów algorytmicznych. Podstawowe pytanie informatyki to: co można (efektywnie) zalgorytmizować”

Obecnie do podstawowych działów informatyki zalicza się:

algorytmy, czyli przepisy postępowania prowadzące do rozwiązania określonego zadania i struktury danych

języki programowania, czyli języki opisu algorytmów przeznaczonych do wykonywania na komputerze.

architekturę komputera, czyli jak połączyć sprzęt i oprogramowanie

obliczenia numeryczne i symboliczne

systemy operacyjne, czyli zespół programów przeznaczony do zarządzania zasobami komputera

inżynierię oprogramowania, czyli jak produkować bezpieczne oprogramowanie

zbiory danych i systemy wyszukiwania informacji

sztuczną inteligencja, czyli metody wnioskowania, wspomagania decyzji i maszynowego uczenia

relacje człowiek-komputer, czyli jak efektywnie wymieniać informacje pomiędzy człowiekiem i komputerem.

Trzy elementarne czynności będzie zawierał każdy algorytm:

określenie czynności (operacji)

wskazanie przedmiotów (obiektów), których operacja dotyczy

określenie miejsca, w którym umieszcza się wynik operacji.

algorytmy numeryczne, operujące na liczbach

algorytmy nienumeryczne, operujące na obiektach nieliczbowych (np. algorytm wyszukiwania dokumentów w dużych zbiorach)

Algorytm może być sekwencyjny, gdy kolejność czynności jest określona jednoznacznie lub niesekwencyjny (równoległy, współbieżny), gdy porządek ten nie jest ściśle określony

możliwość wyrażania w różnych językach, np. języku naturalnym lub w językach programowania — algorytm zapisany w języku programowania nazywa się programem;

możliwość wyrażania za pomocą skończonej liczby symboli, bez używania zwrotów odwołujących się do analogii, jak itd., itp.;

realizowalność czyli fizyczna. możliwość wykonania poleceń;

możliwość wielokrotnego wykonywania (na ogół z różnymi danymi); pojedyncze wykonanie algorytmu nazywa się procesem.

poprawność - Algorytm może być poprawny (gdy to, co realizuje, jest zgodne z intencjami jego konstruktorów, użytkowników) oraz powinien posiadać własność STOPu (tzn. zakończenia swojego wykonywania)

Złożoność czasowa algorytm - od liczby tych czynności zależy ściśle czas wykonania algorytmu

Złożoność pamięciowa algorytmu - z rozmiarem danych wiąże ilość miejsca w pamięci, niezbędną do wykonania algorytmu

Język programowania to język opisu algorytmów

język niskiego poziomu - programowania maszynowo ukierunkowane, które odzwierciedlają listę rozkazów komputera

język wysokiego poziomu (Pascal, C) - języki programowania maszynowo niezależne, gdy nie jest związany z określonym typem komputera

języki niekonwersacyjne - których cały program wprowadza się do komputera przed rozpoczęciem jego wykonywania

języki konwersacyjne (np. Basic), w których wprowadza się określony zwrot językowy (np. instrukcję) i w zależności od reakcji komputera wykonuje się kolejny krok

Tak więc liczba 10110110 w notacji binarnej oznacza liczbę:

1*27 + 0*26 + 1*25 + 1*24 + 0*23 + 1*22 + 1*21 + 0*20 = 128 + 32 + 16 + 4 + 2 = 182

Każda z wartości 0 lub 1 w zapisie binarnym to bit = binary unit, czyli jednostka binarna (0/1, tak/nie)

8 bitów pozwala odróżnić 28 = 16 x 16 = 256 znaków

Bramki logiczne!!!

hardware czyli sprzęt, software czyli oprogramowanie, dane, ludzie i procedury. Wydajny system informatyczny to właściwy dobór wszystkich elementów systemu!

Reprezentacji informacji należy nadać postać danych - liczb, symboli czy faktów. To definiuje podstawowe typy danych - numeryczne, alfanumeryczne, logiczne, graficzne, muzyczne

Wyróżnia się dwa rodzaje sygnałów - analogowe i dyskretne (cyfrowe). Większość sygnałów w przyrodzie ma naturę analogową

prawo Moore'a oznacza, że co 18 miesięcy moc obliczeniowa komputerów podwaja się

częściami składowymi komputera są: procesor, pamięć operacyjna oraz układy wejścia-wyjścia

możliwość zupełnej zmiany realizowanych przez niego funkcji jedynie przez zmianę programu w jego pamięci

Architektura otwarta komputera oznacza, że poszczególne jego elementy można kupić u wielu producentów

Wydajny system komputerowy to właściwego dobór wszystkich elementów systemu

Płyta główna - Za jej pośrednictwem odbywa się wzajemna komunikacja pomiędzy poszczególnymi podzespołami, Z płyty głównej odchodzą złącza do modułów pamięci, gniazd CPU, napędów dysków. Znajdują się również gniazda PCI, ISA i AGP pozwalające podłączyć karty rozszerzeń,

->Parametry charakterystyczne płyty głównej:

- określenie gamy możliwych procesorów, z którymi może współpracować

- parametry wynikające z zastosowanego chipsetu: wielkość obsługiwanej pamięci RAM; pojemność i parametry pamięci cache; dostępny zakres częstotliwości zegara FSB i sposoby współpracy szyny FSB z szynami peryferyjnymi.

- parametry stanowiące wybór producenta: liczba gniazd ISA i PCI, BIOS (producent i wersja) oraz Setup

->Architektura współczesnej płyty głównej zawiera:

- BIOS czyli “wokółsprzętowa” warstwa systemu operacyjnego

- podsystem zasilania procesora i pamięci cache

- blok pamięci RAM wraz z jego obsługą

- interfejsy szyn ISA, PCI oraz AGP

- interfejsy peryferyjne

- zegar czasu rzeczywistego, podtrzymywana bateryjnie pamięć konfiguracji,

sterownik klawiatury itp.

Chipsem - wyznacznikiem całej konstrukcji płyty! Odpowiada za całość komunikacji w obrębie płyty głównej, integralna część całej płyty jest z nią nierozerwalnie związany, dlatego niemożliwa jest jego wymiana tak ja to ma miejsce z innymi elementami komputera, North Bridge (mostek północny) i South Bridge (mostek południowy).

Wymiana informacji pomiędzy poszczególnymi komponentami komputera dokonuje się z kolei za pomocą tzw. magistrali, którą podzielić możemy na dwa rodzaje: zewnętrzną odpowiadającą za komunikację systemu z urządzeniami zewnętrznymi, oraz wewnętrzną sprawującą kontrolę nad urządzeniami wewnętrznymi

Procesor (processor) to urządzenie wykonujące elementarne rozkazy zapisane we właściwym kodzie (kodzie maszynowym)

Podstawowe rodziny procesorów to:

Intel x86 (komputery PC):

16 bitowe: 8086/88, 80286

32 bitowe: i386, i486, Pentium, Pentium Pro, Pentium II, Celeron, Pentium III, Celeron II, Pentium IV, Xeon

64 bitowe: Itanium (architektura EPIC)

AMD (zgodne z x86):

32 bitowe: AMD486, 5x86, K5, K6, Athlon, Duron

Motorola 68k (komputery Apple):

68000, 68020 (16-bit), 68030, 68040, 68060 (32-bit).

Mikroprocesor (CPU, Central Processing Unit) to więc najważniejsza jednostka każdego komputera, będąca najczęściej pojedynczym mikroprocesorem, połączonym z płytą główną za pomocą specjalnego gniazda typu ZIF lub Slot

Procesor ma za zadanie przetwarzać i wykonywać typowe operacje arytmetyczno logiczne, jakie dochodzą do niego poprzez pamięć operacyjną, a ilość takich operacji waha się w granicach od kilkuset do milionów na sekundę. Podstawowymi parametrami technicznymi procesora są: liczba bitów przetwarzanego słowa np. 8, 16, 32, 64 bity, szerokość szyny adresowej, lista rozkazów i częstotliwość zegara taktującego mierzona w MHz.

Mikroprocesor zawiera trzy główne części: jednostkę arytmetyczno-logiczną (arithmetic and logic unit, ALU), w której są wykonywane wszystkie obliczenia i operacje logiczne, jednostkę sterującą (control unit), która dekoduje, synchronizuje i wykonuje rozkazy programu i pamięć o dostępie bezpośrednim (immediate access memory), w której przechowuje się aktualnie wykonywane rozkazy i dane

Chłodzenie - procesor w trakcie pracy wydziela dużo ciepła (ponad 70 W!). Nadmierny wzrost temperatury może powodować awaryjna pracę komputera, a w skrajnym przypadku nawet uszkodzenie CPU. Warto więc zadbać, aby oprócz solidnego radiatora, "przyklejonego" za pomocą pasty przewodzącej ciepło, zamontować na procesorze łożyskowany wentylator chłodzący

Nie ulega wątpliwości, że głównym celem rozwoju procesorów jest zwiększanie ich mocy obliczeniowej (przetwarzania informacji). Już w roku 1965 współzałożyciel firmy INTEL, Gordon Moore przewidywał, że z technologivznego punktu widzenia gęstość upakowania tranzystorów w mikroprocesorze może się podwajać co dwa lata (twierdzenie to nazywa się prawem Moore'a)

Przez pamięć w informatyce rozumiemy urządzenia używane przez komputer do przechowywania danych. Komórka pamięci to elementarny rejestr pamięci służący do zapamiętania jednego bajtu lub jednego słowa danych

Hierarchia pamięci (ang. memory hierarchy) to usystematyzowanie typów pamięci według ich szybkości, pojemności oraz ceny (najszybsze rodzaje pamięci są najdroższe). W systemie komputerowym można wyróżnić nawet siedmiopoziomową hierarchię pamięci:

1) rejestry - pamięć najszybsza, lecz najskromniej reprezentowana. W zasadzie liczba rejestrów ogranicza się do kilku lub kilkunastu, na uwagę zasługują tu rejestry asocjacyjne, stosowane w pamięciach stronicowanych;

2)sprzętowa pamięć podręczna (cache) - jej rozmiar określa się w dziesiątkach i setkach KB, jest szybsza niż pamięć główna;

3) pamięć główna, czyli operacyjna współczesnych komputerów - to już setki MB;

4) dysk elektroniczny (RAM-dysk) - zachowujący się jak “zwykła” pamięć dyskowa, lecz działający wielokrotnie szybciej;

5) pamięci dyskowe (magnetyczne) - o pojemnościach setek i tysięcy MB (czyli gigabajtów);

6) dyski optyczne - o pojemnościach porównywalnych z dyskami magnetycznymi;

7) pamięć taśmowa - powolna, lecz tania, praktycznie o nieograniczonej pojemności

Pamięć główna komputera to pamięć półprzewodnikowa. Dzieli się ja na pamięć o dostępie swobodnym (RAM) a pamięć przeznaczoną tylko do odczytu ROM (stałą). Pamięci RAM można podzielić dalej na pamięci statyczne (SRAM) i dynamiczne (DRAM), natomiast pamięci ROM mają kilka odmian programowalnych (PROM, EPROM, EEPROM, FLASH). Pamięci półprzewodnikowe są powszechnie stosowane jako pamięci operacyjne i podręczne

DRAM (Dynamic RAM), komputer co kilka milisekund musi odświeżać zawartość pamieci bo inaczej grozi skasowaniu danych. W czasie odświeżania zawartość pamięci DRAM nie może być odczytywana przez procesor, co spowalnia działanie komputera. DRAM wolny ale tani.

SRAM (Static RAM) - nie wymaga ciągłego dopływu prądu w celu odświeżania danych. dużo szybsza niż DRAM, ale jednocześnie znacznie droższa.

Pamięć SRAM stosuje się w produkcji pamięci cache.

SDRAM (Synchronous DRAM) - rodzaj szybkiej, synchronicznej pamięci RAM,; stosowanej -> jako pamięć RAM, i pamięć do kart graficznych. Taktowanie 100mhz i 133.

DDR-SDRAM (Double Data Rate RAM) - nowy rodzaj pamięci SDRAM cechujący się dwukrotnie większą szybkością działania niż tradycyjne moduły. Pamięć typu DDR-RAM wykonuje dwa cykle pracy w ciągu jednego impulsu zegara podczas gdy SDRAM tylko jeden.

PROM (ang. Programmable ROM), pamięć półprzewodnikowa,

Raz określona zawartość pamięci PROM może być później tylko czytana.

EPROM (ang. Erasable PROM), półprzewodnikowa, programowalna pamięć stała, o pojemności od 16 KB do kilku MB.

zawartość można usuwać za pomocą naświetlania promieniami ultrafioletowymi.

drozsze z okienkami -> można zmieniac dane

tansze bez okienek ->nie można zmieniać.

Programowania pamięci EPROM w programatorach.

EEPROM, E2PROM (ang. Electrically Erasable PROM), pamięć półprzewodnikowa zapisywanie i odczyt za pomocą zmiany sygnałów elektrycznych (bez programatorów).

Czas zapisywania wielokrotnie dłuższy od czasu czytania,

Ograniczona liczba przeprogramowań .

Cache, podręczna pamięć procesora.

krótkim czasem dostępu.

Przechowuje dane, które będą w niedługim czasie przetwarzane.

rodzaje pamięci cache:

L1 (zintegrowana z procesorem)

L2 i L3 (umieszczone na płycie głównej komputera).

Jej obecność powoduje ogromny wzrost wydajności komputera

Czas dostępu do pamięci (ang. access time) to czas upływający między zamówieniem jednostki informacji a jej uzyskaniem; podstawowy parametr określający szybkość działania pamięci lub łącza komunikacyjnego

Pamięć dyskowa (ang. disk memory) to odmiana pamięci masowej (zewnętrznej)

Istnieje wiele rodzajów pamięci dyskowej, z których najważniejsze to dysk magnetyczny, dysk optyczny i dysk magnetooptyczny.

Niezawodność dysków twardych wyraża tzw. średni czas międzyuszkodzeniowy (ang. MTBF, Mean Time Between Failures), który wynosi obecnie około miliona godzin

Dyski magnetyczne - Na rynku istnieje wiele odmian dysków magnetycznych, głównie jako stacjonarne wielokrążkowe twarde dyski (hard disk) na stałe wbudowane do napędów dyskowych (disk drive)

Rozróżnia się dyski pozwalające tylko na odczyt (ROM — read only memory), dyski pozwalające na jednorazowy zapis (WORM — write once read many). Wśród dysków ROM najprostsze są dyski CD ROM (compact disc ROM)

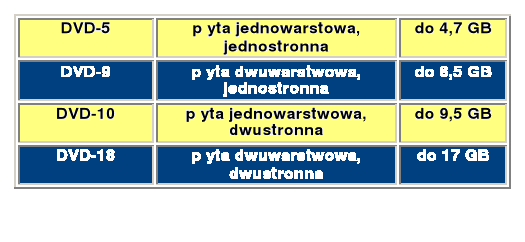

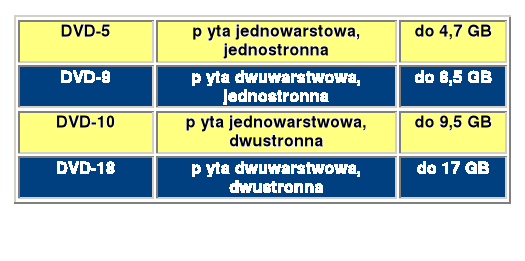

DVD - Digital Versatile Disk

Jeżeli komputer nie jest wyposażony w akcelerator 3D wszystkie obliczenia mające związek z grafiką wykonywane są przez procesor (istotnie to spowalnia prace komputera)

podstawowym kryterium doboru karty jest standard szyny karty: PCI lub AGP. PCI

Rodzaje grafiki komputerowej

Grafika rastrowa (bitmapowa) - obraz jest reprezentowany poprzez zbiór punktów (pikseli) o indywidualnie określonych parametrach barwnych

Cechy grafiki rozdzielczej - Umożliwia zachowanie dużego realizmu kolorystycznego poprzez indywidualne określanie barwy każdego elementu obrazu. Nie pozwala na dokonywanie transformacji geometrycznych na elementach składowych (a nie fragmentach) obrazu. Wielkość plików szybko rośnie wraz rozdzielczością (ilością pikseli) obrazu.

Grafika wektorowa - poszczególne elementy obrazu są reprezentowane za pomocą wyrażeń matematycznych, opisujących położenie punktów te elementy tworzących.

Cechy grafiki wektorowej - Doskonale nadaje się do reprezentacji obrazów zawierających elementy strukturalne

Umożliwia dokonywanie płynnych transformacji elementów obrazu jak i jego całości bez utraty jakości prezentacji

Wielkość plików słabo zależy od rozdzielczości obrazu, jest tylko funkcją ilości i złożoności opisu jego elementów składowych.

Tryb graficzny

Rozmiar pamięci potrzebnej do opisania wyglądu ekranu jest zależny od:

- rozdzielczości obrazu - determinuje ona ilość pikseli tworzących obraz,

- palety barw - determinuje ona ilość informacji potrzebnej do opisania wyglądu pojedynczego piksela,

- opcjonalnego buforowania obrazu - możliwe jest budowanie następnego kadru w czasie wyświetlania poprzedniego, komponowanie kilku obrazów np. wzajemnie przesłaniających się (bufor Z)

Model barw addytywnych oparty o teorię trój-stymulacji,

stosowany w monitorach ekranowych CRT. Trzy barwy podstawowe: czerwona (Red), zielona (Green) i niebieska (Blue) dają w sumie barwę białą

Pozostałe odcienie otrzymywane są poprzez dodawanie udziałów barw podstawowych (np. żółty = czerwony + niebieski).

Model barw subtraktywnych (pochłaniających), stosowany w drukarkach, ploterach, poligrafii. Trzy barwy podstawowe: seledynowa (Cyan), purpurowa (Magenta) i żółta

(Yellow) pochłaniają selektywnie światło białe. Pozostałe odcienie otrzymywane są poprzez odejmowanie udziałów barw podstawowych od światła białego.

XGA |

1024 |

768 |

monitor 17" |

4/3 - rozdzielczość

Wielkość pikseli ekranu wynosi 0.25-0.42 mm. Im mniejsze tym ostrzejszy obraz na ekranie.

Pionowa częstotliwość odchylania: pionowa, czyli częstotliwość powtarzania obrazu, 50-120 obrazów/sek. W kinie 24 obrazy/s, TV 25-30 obrazów/s, dobre monitory komputerowe > 70 obrazów/s.

Pozioma częstotliwość odchylania: liczba linii kreślonych przez strumień elektronów w ciągu sekundy, 15-64kHz.

Np. przy 70 obrazach/sekundę i 480 linii częstość 70x480=33600 Hz, ok. 35 kHz.

Typy monitorów:

Katodowe, działają podobnie do kineskopów TV. - Trinitron (siatka szczelinowa) - patent Sony, płaskie kineskopy, świetny obraz.

LCD - mniejsza masa, cienkie, miniejszy pobór mocy, brak migotania, niezła jakość

Plazmowe - ciągle droższe od pozostałych

Klawiatury

Podział ze względu na technologię „wciskania klawiszy”

*mechaniczne, *foliowe, *pojemnościowe, *hallotronowe i kontaktronowe

Mysz - to rodzaj lokalizatora, który powoduje wyświetlenie na ekranie znaku,

znaku śledzenia (zwanego znacznikiem) i zmienianie jego położenia odpowiedniego

do ruchów lokalizatora

Drukarka (ang. printer) to podstawowe urządzenie zewnętrzne komputera służące do wykonywania “twardych kopii” (wydruków) danych, w różnorodnej postaci. Podstawowe parametry drukarki to jakość i technika druku, rozdzielczość, szybkość pracy i koszt eksploatacji.

Ze względu na technikę druku można wyróżnić:

*drukarki uderzeniowe, *drukarki bezuderzeniowe.

Druk monochromatyczny i kolorowy

Wydruki zawierające odcienie szarości uzyskuje się przez zastosowanie rastrowania, czyli rozmieszczania na drukowanej powierzchni drobnych czarnych punktów. Sterując wielkością lub gęstością rozmieszczenia tych punktów, można otrzymywać różne odcienie szarości.

Wydruk kolorowy otrzymuje się przez nanoszenie kolejno barw podstawowych na papier w odpowiednich proporcjach. Intensywność barw podstawowych wydruku reguluje się identycznie jak poziom szarości - stosując rastrowanie. Kolory pośrednie są uzyskiwane przez rozsiewanie (ang. dithering), czyli mieszanie sąsiednich punktów o innych kolorach.

Podstawowe rodzaje drukarek

Drukarki igłowe - Drukarka igłowa jest wyposażona w głowicę drukującą zawierającą od 9 do 48 (najczęściej 9 lub 24) stalowych igieł umieszczonych w jednym lub dwóch rzędach.

Drukarki atramentowe - W drukarkach atramentowych (ang. inkjet printer) punkty druku są tworzone przez kropelki atramentu wystrzeliwane z głowicy zawierającej dysze o średnicy kilkudziesięciu mikrometrów, Bubble-Jet,

Technika piezoelektryczna - przekształca bezpośrednio napięcie elektryczne na ruch mechaniczny,

Drukarki termosublimacyjne - polega na termicznym uwalnianiu odpowiedniej ilości jednego z trzech kolorów daje precyzyjne wydruki o płynnych przejściach tonalnych, W drukarce termosublimacyjnej barwnik zmagazynowany jest na specjalnej taśmie termotransferowej

Drukarki laserowe - Za pomocą specjalnej rolki toner rozkładany jest w tych miejscach powierzchni światłoczułego bębna, które wcześniej oświetlonego zostały promieniem lasera.

Druk laserowy w kolorze - wykorzystuje paletę barw CMYK (kolory: niebieskozielony, purpurowy, żółty i czarny)

Rozróżnia się dwie grupy papierów :

papiery bezdrzewne (nie zawierające ścieru drzewnego),

papiery drzewne (zawierające ścier drzewny).

Gramatura papieru jest to ciężar w gramach jednego metra kwadratowego papieru. Podawana jest w gramach na metr kwadratowy, jednostce, która pozwala na łatwe porównywanie dwóch arkuszy, nawet gdy są to dwa różne typy papieru.

W zależności od gramatury papiery dzieli się na:

bibułkę (do 25 g/m2),

papier właściwy (25-160 g/m2),

karton (160-315 g/m2,),

tekturę (powyżej 315 g/m2).

Pracując przy komputerze, jesteśmy przede wszystkim narażeni na oddziaływanie różnych pól i promieniowania. Są to:

- zmienne pola elektromagnetyczne (EM) o różnych częstotliwościach, pochodzące od zasilacza oraz cewek odchylania poziomego i pionowego monitora.

- pole elektrostatyczne (ES) wywołane silnym, dodatnim naładowaniem ekranu monitora, powstające między monitorem a siedzącą przed nim osobą.

- słabe, lecz wykrywalne promieniowanie Roentgena.

- ultradźwięki towarzyszące działaniu transformatora zwrotnego w monitorze katodowym.

Syndrom Sicca

Zauważalne zmniejszenie częstotliwości mrugania oczyma spowodowane długotrwałym kontaktem z monitorem. Objawy: wysychanie i wykrzywienie rogówki oraz stopniowa utrata wzroku

Zespół cieśni nadgarstka

Następstwo nieprawidłowego ułożenia rąk podczas korzystania z klawiatury (przeguby uniesione ku górze!) W najwęższym miejscu przeguby dłoni, tzw. kanale nadgarstka nerwy są zbyt mocno ściśnięte. Objawy: nadwrażliwość, drętwienie, mrowienie oraz ból kciuka i trzech kolejnych palców oraz całych dłoni i nadgarstków.

Repetitive Strain-Injury Syndrom (RSI)

Zespół urazów wywołanych jednostronnym, chronicznym przeciążaniem kończyn górnych na odcinku dłoń-bark. Objawy: dotkliwy, piekący ból przedramienia, ramienia, szyi i łopatki; obrzęk, usztywnienie, bezwład, niezdolność do pracy.

Pod względem sposobu komunikacji z użytkownikiem rozróżniamy:

- systemy tekstowe - komunikujące się za pomocą wydawanych z linii poleceń komend (CP/M, DOS)

- systemy graficzne - komunikujące się za pomocą graficznych okienek i symboli (ikon)

Pod względem architektury, systemy operacyjne dzielimy na:

- monolityczne - o najprostszej strukturze i jednozadaniowe, czyli gdy system może jednocześnie wykonywać tylko jedno zadanie

- warstwowe - o hierarchicznej strukturze poleceń systemowych, system może już wykonywać w tym samym czasie kilka poleceń (np. nadzorować proces drukowania w czasie edycji tekstu w programie)

Najważniejsze systemy operacyjne to:

CP/M

UNIX/LINUX

DOS

WINDOWS

CP/M Control Program for Microprocessors, zaprojektowany przez Kanadyjczyka Garry Kildalla dla systemów 8-bitowych (Intel 8080)

WINDOWS - 32-bitowy system operacyjny - wersje WINDOWS zawierają obsługę mechanizmów Plug & Play (automatyczne rozpoznawanie i instalowanie przez tzw. Hardware Assistanta kart PCI, i częściowo ISA oraz urządzeń SCSI i USB), funkcje zarządzania energią dla komputerów przenośnych, obsługę systemu plików FAT32, wsparcie DirectX, usługę Active Directory Services (ADS) umożliwiającą gromadzenie informacji o wszystkich obiektach w sieci komputerowej, dynamiczną konfigurację (po zmianie konfiguracji systemu lub przeinstalowaniu sterowników nie jest wymagany ponowny restart systemu jak w poprzednich wersjach), oraz szereg użytecznych narzędzi systemowych.

Najpopularniejsze dystrybucje Linuxa to:

RedHat,

Debian,

S.u.S.E. Linux,

SlackWare,

Mandera,

Caldera OpenLinux,

Corel Linux.

Licencja jednostanowiskowa one-site licence, jeden komputer, kopia zapasowa, nie dla sieci

Licencja grupowa site licence, rodzaj licencji zezwalającej na użytkowanie oprogramowania w sieci lub w zestawie komputerów, np. w szkole lub w pracowni, określającej maksymalną liczbę stanowisk, na których wolno zainstalowac objęte nią oprogramowanie. Odmianą licencji grupowej jest licencja sieciowa (network licence).

Licencje edukacyjne mogą użytkować Instytucje Ministerstwa Edukacji Narodowej, przedszkola, szkoły publiczne i niepubliczne, wyższe uczelnie, biblioteki publiczne, muzea finansowane ze środków publicznych, szpitale, które prowadzą zajęcia dydaktyczne.

Oprogramowanie towarzyszące „OEM” - jest to oprogramowanie, które dostępne jest wyłącznie z towarzyszącym mu sprzętem, a prawo użytkowania programu OEM obejmuje tylko i wyłącznie sprzęt, z którym został zakupiony. Na jednym sprzęcie, bez kopii. Licencje OEM są zbywalne, jeśli jest przekazane lub odsprzedane łącznie z zestawem komputerowym.

Freeware - to określenie programu który można używać bezpłatnie i bez żadnych ograniczeń, jego autor nie jest zainteresowany komercyjnym rozprowadzaniem swoich produktów, jednak jego prawa autorskie pozostają nadal w mocy, dlatego nikt nie może np. wprowadzać żadnych zmian w tych programach.Bez rejestracji, rozpowszechniane w niezmienionej firmie, ale licencje dla firm, płatna rozbudowana wersja.

Shareware - dzieła bezpłatnie do testów, dzięki czemu każdy przed podjęciem decyzji o zakupie może gruntownie przetestować, ograniczenia,

Na przykład:

Trialware - program po zainstalowaniu jest w pełni sprawny i działają wszystkie jego komponenty, ale tylko przez określoną ilość czasu od dnia jego zainstalowania w systemie (przeciętnie 30 do 90 dni)

Demo - część jego funkcji jest niedostępna (nieaktywna), co pomniejsza jego wartość dla użytkownika, ale daje ogólny pogląd na jego możliwości

Adware to programy, za których użytkowanie nie płaci się ani grosza. Developerzy czerpią zyski z tytułu tych programów poprzez umieszczanie w nich reklam. Większość autorów adware proponuje także wersję bez reklam za niewielką opłatę.

Powszechna Licencja Publiczna GNU - bezpłatnie dostępnych pakietów. Proponujemy zapoznanie się z warunkami licencji, jakiej właściciele oprogramowania GNU udzielają użytkownikom. Na tych właśnie zasadach udostępniane jest jądro systemu Linux, jak również większość dostarczanego wraz z nim oprogramowania.

Inne użyteczne pojęcia:

Aplikacja - to rodzaj programu komputerowego. Termin ten oznacza program, który ma bezpośredni kontakt z użytkownikiem i nie jest częścią większego programu. Z technicznego punktu widzenia jest to oprogramowania korzystające z usług systemu operacyjnego.

Sterownik to program kontrolujący pracę przyłączonego do komputera urządzenia. Każdy system operacyjny wymaga stosowania odpowiednich sterowników.

Upgrade - (ang. upgrade) to uaktualnianie czyli typ programowania, które jest nowszą wersją oprogramowania sprzedawanego użytkownikom korzystającym z wcześniejszych wersji programu po preferencyjnych cenach.

Firmware to oprogramowanie wbudowane w jakieś urządzenie, zapewniające podstawowe procedury obsługi tego urządzenia.

Wirusy komputerowe to najczęściej proste programy komputerowe, które w sposób celowy powielają się bez zgody użytkownika. Niektóre wirusy mają też inne skutki, np. dokonują celowych zniszczeń w oprogramowaniu. Wirusy wykorzystują słabość zabezpieczeń systemów komputerowych lub właściwości systemów oraz niedoświadczenie i beztroskę użytkowników.

Największe zalety elektronicznych baz danych to szybkość wyszukiwania informacji i zdalny dostęp do danych. Zdalny oznacza obecnie - z dowolnego miejsca na świecie.

Prosta baza danych obejmuje jedną lub kilka tabel, natomiast bardziej rozbudowane bazy posiadają dziesiątki, setki a nawet tysiące tabel zawierających mnóstwo rekordów. Dane w bazie są przechowywane w postaci pól i rekordów. Pole w bazie odpowiada pojedynczemu elementowi pola ( Imię, nazwisko, adres). Komplet pól tworzy rekord.

Najprostsze bazy danych, które w całości znajdują się na jednym komputerze to bazy lokalne. Dobrym ich przykładem są Access, Paradox, dBase.

Rekord to typ danych złożony ze skończonej liczby danych innych typów. Elementy rekordu przyjęto nazywać polami. Pole to więc element rekordu opatrzony nazwą.

Użyteczne pojęcia:

DBMS - (ang. Data Base Management System) systemy oprogramowania do zarządzania bazami danych

PIM - (ang. Personal Information Manager) programy do zarządzania podręczną informacją.

Rozproszona baza danych (ang. distributed database) to system bazy danych obejmujące komputery znajdujące się w różnych miejscach - może to dotyczyć jednego biura, budynku, a także obszarów rozległych geograficznie, np. krajowy system oddziałów banku.

Uwypuklenie fragmentów tekstu za pomocą wyróżnień (atrybutów) takich jak pogrubienie, kursywa i podkreślenie.

Wielkość czcionek (fontów) to rozmiar lub stopień pisma. Podaje się go zazwyczaj w punktach typograficznych (didit). Jeden punkt (1 p) wynosi 0.375 mm wg standardu europejskiego lub 0.351 mm w standardzie amerykańskim. Podstawowa wielkość czcionki to Cycero =12 pt, garmont=10 pt. Zwykłe teksty piszemy stopniem 10-13.

Gęstość druku - liczba znaków na cal (cpi, character per inch), zwykle 12 cpi, druk ściśnięty 15-20 cpi, rozrzedzony (rozspacjowany) 10 lub mniej cpi.

wyrównanie jednocześnie do lewego i prawego marginesu (wyjustowanie)

Odstęp między wierszami (interlinia) - Zbyt mała interlinia zmniejsza szybkość czytania tekstu

Wyrównanie - wyrównanie do lewego marginesu, do prawego marginesu, wyśrodkowanie i wyrównanie jednocześnie do lewego i prawego marginesu (wyjustowanie).

Tryby pisania tekstu - wstawianie tekstu (insert mode), oraz zastępowanie tekstu (nadpisywanie, overwrite mode).

UWAGA! Przyjmuje się, że standardowa strona tekstu zawiera około 1800 - 2000 znaków. Arkusz to 22 strony tekstu. Strona o formacie A4 ma rozmiary 210 mm x 297 mm.

Komputery (serwery DNS - ang. Domain Name System) tłumaczą nazwy domenowe na odpowiadające im adresy IP

Wszystkie komputery połączone do Internetu (bez względu na zastosowane komponenty i wykorzystywane systemy operacyjne) mogą wymieniać ze sobą dane dzięki tzw. protokołom wymiany danych (np. TCP/IP - ang. Transfer Control Protocol/Internet Protocol).

Ponieważ Internet składa się z wielu sieci opartych wykorzystujących różne technologie sieciowe, koniecznym jest umieszczenie w węzłach sieci specjalizowanych komputerów (Router), których zadaniem jest odczytywanie adresów i kierowanie przesyłanego pakietu danych do odbiorcy. W sieciach rozległych dane przesyłane są pomiędzy dwoma konkretnymi węzami a nie do wszystkich węzłów. Po drodze napotykają na wiele węzłów pośredniczących, mogą też być transmitowane wieloma różnymi trasami. Router jest jednym z tych węzłów, który ma za zadanie przesłać dane najlepszą (tzn. W danej chwili najszybszą) trasą. Do kierowania ruchem danych routery używają tzw. tablicy routingu, która zawiera informacje o sąsiadujących routerach i sieciach lokalnych. Pozwala to wyszukać optymalną drogę od obecnego położenia pakietu do docelowego miejsca sieci.

- Portal jest witryną WWW, w której w jednym miejscu zgromadzono wiele usług i treści.

- WWW (ang. World Wide Web)

- e-mail, czyli poczta elektroniczna, to szybka wymiana informacji przez sieć komputerową,

- Wyszukiwarka internetowa to baza danych zawierająca skatalogowane adresy internetowe

- FTP - udostępnianie plików przez Internet (np. cenników, dokumentacji)

- Inne (IRC, RealAudio, NetMeeting ...)

Wirusy mogą realizować określone zadania, np. generowanie komunikatów tekstowych, graficznych, dźwiękowych), oraz fałszować i niszczyć pliki, a także ingerować w sposób działania sprzętu. Mówiąc ściślej wirus komputerowy jest to samoreplikujący się segment wykonywalnego kodu, umieszczony w innym programie lub w inny sposób sprzężony z nim. Wykonanie kodu programu powoduje uaktywnienie kodu wirusa. Na ogół kod wirusa wykonuje się jako pierwszy przekazując następnie sterowanie do właściwego programu.

Koń trojański to ukryty w programie kod, który sprawia, że program ten po uruchomieniu realizuje oprócz swoich funkcji także różne przykre dla użytkownika działania jak np. zawieszanie systemu operacyjnego, usuwanie plików bądź też wyświetlanie na ekranie różnych komunikatów. Trojany, w przeciwieństwie do wirusów, nie powielają się samodzielnie - "złapać" trojana można jedynie poprzez zainstalowanie na dysku komputera programu będącego nosicielem.

Robaki - wysyłają swoje kopie przez połączenia sieciowe do innych systemów komputerowych. W odróżnieniu od wirusa, robak nie potrzebuje programu nosiciela, a jest samodzielnym programem wykonywalnym. W przypadku zarażenia robakiem internetowym rozsyłanym przez pocztę elektroniczną, należy przede wszystkim odłączyć się od sieci komputerowej (wyłączyć kartę sieciową w systemie, wyjąć przewód łączący komputer z siecią komputerową), co przerwie rozsyłanie wirusa dalej.

Sztuczna inteligencja (ang. Artificial Intelligence - AI)

INTELIGENCJA [łac.], to czynność intelektu, polegająca na aktualnym rozumieniu poznawanej rzeczy; INTELEKT - umysł, rozum; całokształt wiedzy, doświadczenia i zdolności umysłowych człowieka; utożsamiany niekiedy z inteligencją.

Formy inteligencji

Praktyczna - umiejętność rozwiązywania konkretnych zadań

Abstrakcyjna - zdolność operowania symbolami i pojęciami

Społeczna - zdolność zachowania się w grupie.

Cechy inteligencji

Dopasowanie działania do okoliczności - wybieranie najlepszego wariantu rozwiązania danego zadania,

Świadomość działania - droga od sformułowania problemu do jego rozwiązania jest zawsze określona,

Znajomość własnych ograniczeń - nie odpowiada na pytania, na które nie zna odpowiedzi.

Współczesne definicje inteligencji - trzy aspekty:

zdolność uczenia się,

zdolność przystosowania się,

zdolność metapoznawczą (rozeznanie we własnych procesach poznawczych i zdolnościach ich kontrolowania; osoba inteligentna używa umysłu bardziej refleksyjnie i jest w stanie sterować własnymi procesami poznawczymi).

Uczenie się systemu to każda autonomiczna zmiana w systemie zachodząca na podstawie doświadczeń, która prowadzi do poprawy jakości jego działania.

W metodach sztucznej inteligencji następuje przejście od przetwarzania danych do przetwarzania wiedzy.

Podstawowe pojęcia:

Poszukiwanie - sprawdzanie dużej ilości możliwości w celu znalezienia rozwiązania (gry - puzzle, szachy, planowanie).

Reprezentacja wiedzy - poszukiwanie języka, w którym można zakodować wiedzę, by maszyna mogła jej używać (logika pierwszego rzędu, logika rozmyta, systemy podtrzymywania spójności).

Planowanie - odnajdowanie sekwencji akcji, które poprowadzą od stanu początkowego do założonego celu.

Optymalizacja - poszukiwanie optymalnego zbioru parametrów (funkcji, ...).

Data mining (drążenie danych) - proces wyekstraktowania użytecznych reguł z bardzo dużej liczby danych. Obserwowanie trendów, odnajdowanie ich przyczyn.

Istnieją dwa różne podejścia do pracy nad AI.

Pierwsze - tworzenie całościowych modeli matematycznych analizowanych problemów i implementowanie ich w formie programów komputerowych, mających realizować konkretne cele.

Drugie - próby tworzenia struktur i programów "samouczących się", takich jak modele sieci neuronowych oraz opracowywania procedur rozwiązywania problemów poprzez "uczenie" takich programów, a następnie uzyskiwanie od nich odpowiedzi na "pytania".

Koncepcje sztucznej inteligencji

„Mocna” sztuczna inteligencja - system inteligentny, to taki, który jest bezpośrednim odzwierciedleniem inteligencji człowieka.

„Słaba” sztuczna inteligencja - system inteligentny, to taki, który działa racjonalnie (koncepcja systemowa).

System funkcjonuje racjonalnie, jeśli wykonuje właściwe działania, tzn. działa tak, aby osiągnąć cel, przy aktualnie dostępnych danych.

UWAGA! Racjonalne działanie/zachowanie to „coś więcej” niż racjonalne myślenie/wnioskowanie. Racjonalne myślenie warunkiem wystarczającym a nie koniecznym racjonalnego działania/zachowania.

Współczesne zastosowania AI

Technologie oparte na logice rozmytej - powszechnie stosowane do np. sterowania przebiegiem procesów technologicznych w fabrykach w warunkach "braku wszystkich danych".

Systemy ekspertowe - czyli rozbudowane bazy danych z wszczepioną "sztuczną inteligencją" umożliwiającą zadawanie im pytań w języku naturalnym i uzyskiwanie w tym samym języku odpowiedzi. Systemy takie stosowane są już w farmacji i medycynie.

Sieci neuronowe - stosowane z powodzeniem w wielu zastosowaniach łącznie z programowaniem "inteligentnych przeciwników" w grach komputerowych.

Rozpoznawanie optyczne - programy rozpoznające osoby na podstawie zdjęcia twarzy lub rozpoznające automatycznie zadane obiekty na zdjęciach satelitarnych.

Rozpoznawanie mowy - stosowane już powszechnie na skalę komercyjną

Rozpoznawanie ręcznego pisma - stosowane już masowo np. do automatycznego sortowania listów, oraz w elektronicznych notatnikach.

Maszynowe tłumaczenie tekstów - systemy takie jak SYSTRANS, jakkolwiek wciąż bardzo ułomne, robią szybkie postępy i zaczynają się nadawać do tłumaczenia tekstów technicznych.

Deep Blue - program, który wygrał z Gary Kasparowem w szachy

Sztuczna twórczość - istnieją programy automatycznie generujące krótkie formy poetyckie, komponujące, aranżujące i interpretujące utwory muzyczne, które są w stanie skutecznie "zmylić" nawet profesjonalnych artystów, którzy nie rozpoznają tych utworów jako sztucznie wygenerowanych.

2

Wyszukiwarka

Podobne podstrony:

Informacja czysta a zbeletryzowana, studia, dziennikarstwo i komunikacja społeczna, różne

help i workshop do AI, dziennikarstwo i komunikacja społeczna, technologie informacyjne

Analiza serwisu informacyjnego - Panorama 20.02.2012, dziennikarstwo i komunikacja społeczna, telew

Wykład 8 - Społeczeństwo informacyjne, Notatki, Dziennikarstwo i komunikacja społeczna, Nauka o komu

REKLAMA WE WSPÓŁCZESNYM SPOŁECZEŃSTWIE INFORMACYJNYM, studia, dziennikarstwo i komunikacja społeczna

ZSM - agencje informacyjne, Dziennikarstwo i komunikacja społeczna, Zagraniczne systemy medialne

Era informacji, komunikacja społeczna

Manipulacja informacyjna, studia, dziennikarstwo i komunikacja społeczna, różne

Zarządzanie i komunikowanie społeczne

01 Prezentacja Komunikacja spoleczna

Grupa B, Studia dziennikarstwo i komunikacja społeczna, Ekonomika mediów - pytania i notatki

detrywializacja, Dziennikarstwo i komunikacja społeczna UŁ, NoK + PiM

Prawo 06.12.11 - prawo cywilne, Dziennikarstwo i komunikacja społeczna (KUL) I stopień, Rok 1, semes

komunikacja społeczna ćwiczenia 1, pliki zamawiane, edukacja

6 wykład komunikacja społeczna, pliki zamawiane, edukacja

KODY I SYSTEMY ZNAKOWE, inż. BHP, I Semestr, Komunikacja społeczna

więcej podobnych podstron