Metody probabilistyczne i statystyka

Laboratorium 9 i laboratorium 10

EF DI2

rok akademicki 2012/13

Korelacja i regresja

Materiały opracowane z wykorzystaniem między innymi następujących źródeł:

[1] Ostasiewicz S., Rusnak Z., Siedlecka U.: Statystyka. Elementy teorii i zadania. Wydawn. Akademii Ekonomicznej we Wrocławiu, Wrocław 2006.

[2] M. Sobczyk: Statystyka, PWN, Warszawa, 2007.

[3] W. Krysicki, J. Bartos, W. Dyczka, K. Królikowska, M. Wasilewski: Rachunek prawdopodobieństwa i statystyka matematyczna w zadaniach, cz. I, Rachunek prawdopodobieństwa, PWN, Warszawa 2002.

[4] W. Krysicki, J. Bartos, W. Dyczka, K. Królikowska, M. Wasilewski: Rachunek prawdopodobieństwa i statystyka matematyczna w zadaniach, cz. II, Statystyka matematyczna, PWN, Warszawa 2002.

[5] J. Kisielińska, U. Skórnik - Pokrowska: Podstawy statystyki, Wydawnictwo SGGW, Warszawa 2005.

[6] M. Piłatowska: Repetytorium ze statystyki, Wydawnictwo Naukowe PWN , Warszawa 2009

[7] Z. Hellwig, Elementy rachunku prawdopodobieństwa i statystyki matematycznej, Wydawnictwo Naukowe PWN, Warszawa 1995

Metody analizy współzależności zjawisk masowych

W dotychczasowej tematyce uwaga skupiona była na wydobyciu pewnej prawidłowości występującej w zbiorowości statystycznej badanej ze względu na jedną cechę oraz na jej uogólnieniu na całą populację generalną jednowymiarową. Prawidłowości statystyczne mają swoje przyczyny. W związku z tym dla poznania całokształtu badanego zjawiska konieczna jest jednoczesna analiza z punktu widzenia dwóch lub kilku cech, które pozostają we wzajemnym związku.

Badaniem zależności między kilkoma cechami zajmuje się analiza współzależności (lub analiza korelacji regresji), a uogólnieniem zależności na populację dwuwymiarową lub wielowymiarową - wnioskowanie statystyczne w zakresie korelacji i regresji.

Synteza tych zagadnień przedstawiona jest na tzw. mapie „mentalnej” .

Mapa mentalna „Analiza zależności zjawisk” [6]

Prezentowane dotychczas metody statystyczne dotyczyły analizy struktury zbiorowości i opierały się na obserwacjach jednej zmiennej (cechy). Tymczasem jednostki tworzące zbiorowość charakteryzowane są zazwyczaj za pomocą więcej niż jednej cechy. Cechy te nie są od siebie odizolowane, ale wzajemnie się warunkują. Zachodzi zatem potrzeba ich łącznego badania. Celem tego rodzaju analizy jest stwierdzenie, czy między badanymi zmiennymi zachodzą jakieś zależności, jaka jest ich siła, jaki jest ich kształt i kierunek.

Współzależność między zmiennymi może być:

- funkcyjna

- stochastyczna.

Istota zależności funkcyjnej polega na tym, że zmiana wartości jednej zmiennej (zmiennej niezależnej inaczej objaśniającej) powoduje ściśle określoną zmianę drugiej zmiennej (zmiennej zależnej inaczej objaśnianej).

Zależność stochastyczna występuje wtedy, gdy wraz ze zmianą jednej zmiennej zmienia się rozkład prawdopodobieństwa drugiej zmiennej. Szczególnym przypadkiem zależności stochastycznej jest zależność korelacyjna (statystyczna) [2]. Polega ona na tym, że określonym wartościom jednej zmiennej odpowiadają ściśle określone średnie wartości drugiej zmiennej.

Badanie związków korelacyjnych ma sens jedynie wtedy, gdy między zmiennymi istnieje więź przyczynowo-skutkowa, dająca się logicznie wytłumaczyć. Analiza związków między zjawiskami powinna zawsze być dwukierunkowa: jakościowa i ilościowa. Najpierw na podstawie analizy merytorycznej należy uzasadnić logiczne wystąpienie związku, a dopiero potem można przystąpić do określenia siły i kierunku zależności.

O badaniu związku korelacyjnego można mówić tylko wtedy, gdy przynajmniej jedna zmienna jest mierzalna. W celu określenia stopnia zależności między badanymi zmiennymi można posłużyć się współczynnikiem korelacji lub funkcją regresji.

Współczynnik korelacji jest miernikiem siły zależności między badanymi zmiennymi.

W wyniku analizy regresji można odpowiedzieć na pytanie, jakiej zmiany średniej wartości zmiennej zależnej należy oczekiwać, przy zmianie o jednostkę wartości zmiennej niezależnej.

Proste sposoby stwierdzania zależności korelacyjnej

Diagram korelacyjny (wykres rozrzutu) sporządzamy w prostokątnym układzie współrzędnych, odkładając na osiach wartości badanych zmiennych. Na osi odciętych zaznaczamy wartości tej zmiennej, którą przyjmujemy za niezależną (objaśniającą), wyrażającą ilościowo zjawisko traktowane jako przyczyna, natomiast na osi rzędnych wartości tej zmiennej, którą przyjmujemy jako zależną (objaśnianą), wyrażającą ilościowo zjawisko uznane za skutek.

Przez obserwacje wykresów rozrzutu można wydedukować z jakim rodzajem zależności mamy do czynienia. Na wykresie o numerze 1 przedstawiono zależność dodatnią (o dosyć mocnej sile). Dodatni związek oznacza, że wzrostowi wyników na jednej zmiennej towarzyszy WZROST wyników na drugiej zmiennej. Jest to diagram korelacji liniowej dodatniej

Na wykresie 2 przedstawiono zależność ujemną (również o dosyć mocnej sile). Ujemny związek oznacza, że wzrostowi wyników na jednej zmiennej towarzyszy SPADEK wyników na drugiej zmiennej. Jest to diagram korelacji liniowej ujemnej.

Diagram korelacyjny może przedstawiać też korelację krzywoliniową (wykres nr 4) lub wskazywać na brak korelacji (wykres nr 3).

Wykres rozrzutu służy jedynie oszacowaniu istnienia pewnej zależności, ale dla stwierdzenia istotnej zależności należy przeprowadzić obliczenia statystyczne.

Tablice korelacyjne sporządzamy w przypadku gdy próba jest liczna. Na skrzyżowaniu kolumn z wierszami wpisywane są liczebności jednostek zbiorowości statystycznej, dla których zaobserwowano jednoczesne występowanie określonej wartości xi i yj.

|

y1 |

y2 |

… |

yj |

… |

yr |

|

x1 |

n11 |

n12 |

… |

n1j |

… |

n1r |

n1• |

x2 |

n21 |

n22 |

… |

n2j |

… |

n2r |

n2• |

… |

… |

… |

… |

… |

… |

… |

… |

xi |

ni1 |

ni2 |

… |

nij |

… |

… |

ni• |

… |

… |

… |

… |

… |

… |

… |

… |

xk |

nk1 |

nk2 |

… |

nkj |

… |

nkr |

nk• |

|

n•1 |

n•2 |

… |

n•j |

… |

n•r |

n |

Zmienna losowa X przyjmuje k wariantów (i= 1,2 …k), zmienna losowa Y zaś r wariantów (r= 1, 2, …r). Symbol n•j oznacza liczbę jednostek, które maja wariant yj zmiennej Y, natomiast symbol ni• - liczbę jednostek, które mają wariant xi zmiennej X. Symbole nij oznaczają liczbę jednostek, które posiadają jednocześnie wariant xi zmiennej X i wariant yj zmiennej Y. Symbol n oznacza liczebność próby.

![]()

Zamiast liczebności absolutnej można podawać liczebności względne: ![]()

. Jeżeli zmienne X i Y są zmiennymi ciągłymi, to wartości xi i yj w tablicy korelacyjnej są środkami przedziałów klasowych [6].

W tablicy korelacyjnej są dwa rodzaje rozkładów: brzegowe i warunkowe. Rozkład brzegowy prezentuje strukturę wartości jednej zmiennej (X lub Y) bez względu na kształtowanie się wartości drugiej zmiennej. Rozkład brzegowy zmiennej X tworzy pierwsza i ostatnia kolumna tablicy, a rozkład brzegowy zmiennej Y - pierwszy i ostatni wiersz. Rozkład warunkowy prezentuje strukturę wartości jednej zmiennej (X lub Y), pod warunkiem, że druga zmienna przyjęła określoną wartość.

Miary rozkładów w tablicy korelacyjnej

Średnie arytmetyczne rozkładów brzegowych:

![]()

, ![]()

Średnie arytmetyczne rozkładów warunkowych:

![]()

, ![]()

Wariancje rozkładów warunkowych zmiennej X:

![]()

Wariancja ogólna zmiennej X:

![]()

Wariancje rozkładów warunkowych zmiennej Y:

![]()

![]()

Wariancja ogólna zmiennej Y:

![]()

Ocena korelacji za pomocą tablicy korelacyjnej

Cecha X jest stochastycznie niezależna od cechy Y, jeżeli spełnione są jednocześnie następujące warunki:

![]()

![]()

i ![]()

Cecha Y jest stochastycznie niezależna od cechy X, jeżeli spełnione są jednocześnie następujące warunki:

![]()

i ![]()

Cechy stochastycznie niezależne są również niezależne korelacyjnie, ale nie na odwrót.

Liniowość związku można ocenić na podstawie różnicy między średnimi warunkowymi danej zmiennej, obliczonymi dla konkretnych wariantów drugiej zmiennej. Związek jest liniowy, jeżeli różnice między średnimi są takie same, tzn:

![]()

,

![]()

Siłę, kierunek i kształt związku korelacyjnego można również stwierdzić wstępnie na podstawie oceny stopnia skupienia lub rozproszenia liczebności nij w tablicy korelacyjnej. Gdy warianty zmiennych X i Y ułożone są w tablicy rosnąco, to skupienie liczebności wzdłuż przekątnej od lewego górnego rogu do prawego dolnego rogu świadczy o istnieniu dodatniej korelacji prostoliniowej. Odwrotny układ liczebności (od prawego górnego do lewego dolnego rogu tablicy) sugeruje istnienie ujemnej korelacji prostoliniowej.

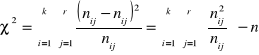

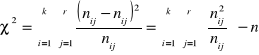

Test niezależności χ2 (chi-kwadrat)

Badanie współzależności ma sens jedynie wówczas, gdy pomiędzy zmiennymi występują powiązania typu stochastycznego lub co najmniej korelacyjnego.

Badanie niezależności stochastycznej oparte na równości średnich warunkowych i wariancji warunkowych jest możliwe tylko w przypadku cech mierzalnych.

W praktyce badań statystycznych spotykamy się również z koniecznością oceny niezależności stochastycznej cech niemierzalnych.

W takich przypadkach weryfikację hipotezy o niezależności zmiennych umożliwia test niezależności chi-kwadrat.

Test chi-kwadrat jest stosowany w przypadku konieczności oceny niezależności statystycznej cech niemierzalnych.

Gdy przedmiotem badania jest populacja generalna scharakteryzowana za pomocą dwóch cech jakościowych, to z populacji tej należy wylosować dużą próbę o liczebności n elementów i wyniki tej próby sklasyfikować w tzw. tablicę niezależności o r wierszach i k kolumnach (tablica korelacyjna). Tablica niezależności jest podstawą weryfikacji nieparametrycznej hipotezy zerowej, głoszącej, że n-elementowa próba losowa pochodzi z takiej zbiorowości generalnej, w której występuje stochastyczna niezależność zmiennych losowych X i Y.

Hipoteza zerowa:

H0: ![]()

lub H0: cechy X i Y są niezależne

Hipoteza alternatywna:

H1: ![]()

lub H1: cechy X i Y nie są niezależne,

Gdzie symbol E jest operatorem nadziei matematycznej (wartości oczekiwanej), a ![]()

są liczebnościami teoretycznymi z tablicy niezależności, spełniającymi warunek stochastycznej niezależności zmiennych losowych X i Y.

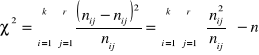

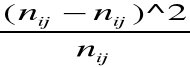

Do weryfikacji hipotezy zerowej stosuje się statystykę:

gdzie liczebność teoretyczna oblicza się z zależności:

![]()

Prawostronny obszar krytyczny w tym teście określa nierówność: ![]()

, gdzie ![]()

jest wartością krytyczną odczytaną z tablicy rozkładu ![]()

dla ustalonego z góry poziomu istotności α i dla ![]()

stopni swobody w taki sposób, aby zachodziła relacja: ![]()

. W przypadku gdy ![]()

, hipotezę zerową o stochastycznej niezależności zmiennych losowych X i Y odrzucamy, czyli badanie związków korelacyjnych jest istotne.

Natomiast jeśli ![]()

, to nie ma podstaw do odrzucenia hipotezy zerowej o stochastycznej niezależności zmiennych losowych X i Y, czyli badanie związków korelacyjnych jest nieistotne.

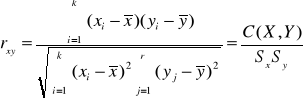

Współczynnik korelacji liniowej Pearsona

Najważniejszym miernikiem siły związku prostoliniowego między dwiema cechami mierzalnymi jest współczynnik korelacji liniowej Pearsona lub krócej współczynnik korelacji. Współczynnik korelacji Pearsona wyliczamy wówczas, gdy obie zmienne są mierzalne i mają rozkład zbliżony do normalnego, a zależność jest prostoliniowa (stąd nazwa). Przy interpretacji współczynnika korelacji liniowej Pearsona należy pamiętać, że wartość współczynnika bliska zeru nie zawsze oznacza brak zależności, a jedynie brak zależności liniowej.

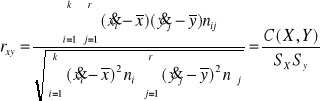

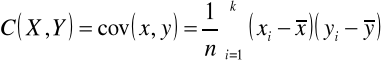

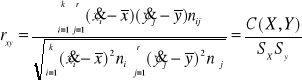

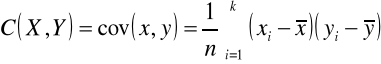

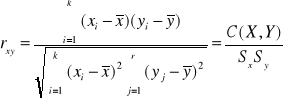

Dla szeregu szczegółowego współczynnik korelacji liniowej Pearsona obliczany jest według wzoru:

gdzie: ![]()

Kowariancja cov(x,y) jest średnią arytmetyczną iloczynu odchyleń wartości zmiennych X i Y od ich średnich arytmetycznych. Znak współczynnika korelacji informuje nas o kierunku korelacji, natomiast jego bezwzględna wartość - o sile związku. Oczywiście rxy jest równe ryx. Jeśli rxy = 0, oznacza to zupełny brak związku korelacyjnego między badanymi zmiennymi X i Y (wykres 3. na rysunku). Im wartość bezwzględna współczynnika korelacji jest bliższa jedności, tym zależność korelacyjna między zmiennymi jest silniejsza. Gdy rxy=1, to zależność korelacyjna przechodzi w zależność funkcyjną (funkcja liniowa).

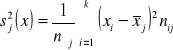

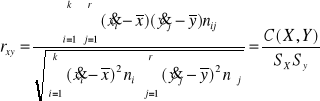

Dla szeregu rozdzielczego z przedziałami klasowymi:

gdzie: ![]()

W analizie statystycznej zwykle przyjmuje się następującą skalę:

rXY = 0 zmienne nie są skorelowane

0 < rxy < 0,1 korelacja nikła

0,1 ≤ rxy < 0,3 korelacja słaba

0,3 ≤ rxy < 0,5 korelacja przeciętna

0,5 ≤ rxy < 0,7 korelacja wysoka

0,7 ≤ rxy < 0,9 korelacja bardzo wysoka

0,9 ≤ rxy < 1 korelacja prawie pełna.

Przedstawiona skala jest oczywiście umowna; w literaturze można spotkać również inne określenia (zamiast 0,7 jest 0,6 , a zamiast 0,9 jest 0,8).

Współczynnik korelacji jest określonym wskaźnikiem, a nie pomiarem na skali liniowej o jednakowych jednostkach.

Kwadrat współczynnika korelacji nazywamy współczynnikiem determinacji (określoności). Współczynnik determinacji informuje o tym, jaka część zmian zmiennej objaśnianej (skutek) jest wyjaśniana przez zmiany zmiennej objaśniającej (przyczyna). Jeżeli np. rxy = 0,5, to ![]()

. Oznacza to, że tylko 25% zmian wartości zmiennej objaśnianej zostało wyjaśnionych przez zmiany przyjętej zmiennej objaśniającej. Można zatem stwierdzić, że na daną zmienną objaśnianą oddziałują jeszcze inne zmienne objaśniające (przyczyny).

Statystyczna ocena istotności otrzymanej wartości rxy

Tak jak wartość innych parametrów populacji, współczynnik korelacji (w populacji) nie jest znany i musimy go oszacować na podstawie znajomości losowej próby par wyników obserwacji zmiennych X i Y. Tak wyliczony z próby współczynnik rxy jest estymatorem współczynnika korelacji w populacji generalnej, a jego wartość liczbowa stanowi ocenę punktową siły powiązania w całej populacji. Stąd konieczność testowania istotności współczynnika korelacji wyliczonego w oparciu o próbę losową. Najpowszechniej stosowany test polega na sprawdzeniu, czy zmienne X i Y są w ogóle skorelowane. Weryfikujemy więc następujący układ hipotez:

Hipoteza zerowa:

H0: ρxy = 0 (ρxy - współczynnik korelacji w populacji generalnej)

hipoteza alternatywna:

H1: ρxy ≠ 0 lub ρxy < 0 lub ρxy > 0

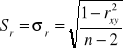

Do weryfikacji hipotezy H0 stosujemy test istotności, którym zazwyczaj jest statystyka

t-Studenta:

![]()

, gdzie:

W celu przyjęcia lub odrzucenia hipotezy H0 trzeba określić przedział krytyczny przy zadanym współczynniku α. Określenie przedziału krytycznego jest uzależnione od sformułowanej hipotezy H1 i tak :

H1: ρxy ≠ 0 to przedział krytyczny ![]()

H1: ρxy < 0 to przedział krytyczny ![]()

H1: ρxy > 0 to przedział krytyczny ![]()

Analiza regresji

Narzędziem badania mechanizmu powiązań między zmiennymi jest funkcja regresji.

Funkcja regresji to analityczny wyraz przyporządkowania średnich wartości zmiennej objaśnianej (zależnej) do konkretnych wartości zmiennych objaśniających (niezależnych). Dokładny obraz takiego przyporządkowania daje funkcja regresji I rodzaju, która realizacjom zmiennych objaśniających przypisuje średnie warunkowe zmiennej objaśnianej.

Funkcją regresji I rodzaju zmiennej losowej Y względem zmiennej losowej X nazywamy:

![]()

Analogicznie, funkcją regresji I rodzaju zmiennej losowej X względem zmiennej losowej Y nazywamy średnią warunkową zmiennej X, która jest funkcją ustalonych wartości zmiennej Y, tzn.:

![]()

Empiryczna linia regresji zmiennej X względem zmiennej Y jest linią łamaną powstała przez połączenie punktów o współrzędnych: ![]()

dla j = 1, 2, …, r. Empiryczna linia regresji zmiennej Y względem zmiennej X jest linią łamaną powstała przez połączenie punktów o współrzędnych: ![]()

dla i = 1, 2, …, k.

Funkcja regresji II rodzaju jest aproksymantą (przybliżeniem) funkcji regresji I rodzaju, opisującą zależność korelacyjną zmiennych w próbie losowej.

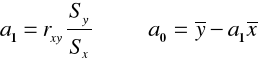

Liniowa funkcja regresji

Funkcję regresji zmiennej zależnej (objaśnianej) Y przy danej zmiennej niezależnej (objaśniającej) X określa się jako:

![]()

oraz funkcję regresji zmiennej X względem Y:

![]()

gdzie:

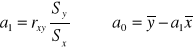

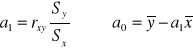

![]()

Oceny a1 i b1 noszą nazwę współczynników regresji liniowej. Odpowiadają one na pytanie, jaki jest przeciętny przyrost wartości zmiennej zależnej na jednostkę przyrostu wartości zmiennej niezależnej.

Wykorzystując metodę najmniejszych kwadratów współczynniki można także obliczyć z następujących zależności:

![]()

![]()

![]()

Natomiast współczynnik korelacji liniowej jest równy:

![]()

Współczynniki regresji mają zawsze jednakowe znaki. Współczynnik korelacji ma taki sam znak jak współczynniki regresji.

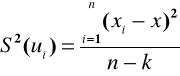

Metody badania dokładności oszacowania funkcji regresji

Do oceny dopasowania prostej regresji do punktów empirycznych wykorzystuje się tzw. reszty, które są określone następująco:

-

dla zmiennej Y względem zmiennej X ![]()

- dla zmiennej X względem zmiennej Y ![]()

gdzie i = 1, …, n

Wartości yi i xi są realizacjami zmiennych Y i X zaobserwowanymi w próbie losowej, a ![]()

i ![]()

są wartościami teoretycznymi (wynikającymi z oszacowanych funkcji regresji II rodzaju) zmiennych Y i X.

Średni błąd szacunku oblicza się wykorzystując wzór na wariancję składnika resztowego:

- dla zmiennej Y względem zmiennej X

dla zmiennej X względem zmiennej Y

Pierwiastek kwadratowy z wariancji resztowej, czyli odchylenie standardowe składnika resztowego jest nazywane średnim błędem szacunku. Średni błąd szacunku informuje o tym, jakie jest przeciętne odchylenie empirycznych wartości zmiennej objaśnianej od wartości teoretycznych otrzymanych z funkcji regresji.

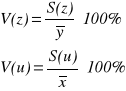

Celem "relatywnego" spojrzenia na rolę reszt w obu funkcjach regresji należy określić wartość współczynnika zmienności resztowej wg wzorów:

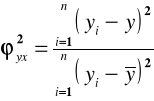

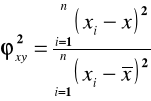

Współczynnik zbieżności ϕ2 i współczynnik determinacji R2

W analizie regresji do oceny dopasowania funkcji regresji najczęściej stosowaną miarą jest współczynnik zbieżności ![]()

.

Współczynnik zbieżności jest określony następująco:

,

Współczynnik zbieżności przyjmuje wartości z przedziału [0,1]. Współczynnik zbieżności określa jaka część zmian wartości zmiennej objaśnianej nie została wyjaśniona zmianami zmiennych objaśniających przyjętych w funkcji regresji. Im wartość współczynnika zbieżności jest bliższa zeru, tym oszacowana funkcja regresji jest lepiej dopasowana do wartości empirycznych zmiennej objaśnianej [1].

Współczynnik determinacji:

![]()

Współczynnik determinacji informuje o tym, jaka część zmian wartości zmiennej objaśnianej została wyjaśniona przez oszacowaną funkcję regresji. Im wartość współczynnika determinacji jest bliższa jedności, tym „dobroć” dopasowania zastosowanej funkcji regresji do danych empirycznych jest lepsza [1].

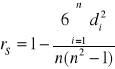

KORELACJA RANGOWA

Przy badaniu cech niemierzalnych nie można, z oczywistych powodów wykorzystać współczynnika korelacji. W przypadku jednak, gdy badane cechy niemierzalne mają charakter porządkowy, możliwe jest nadanie wariantom tych odpowiednich rang, tzn. umownych wartości, którymi są numery miejsc zajmowanych przez obserwacje

w uporządkowanym ciągu. Badanie zależności między cechami niemierzalnymi może polegać wtedy na badaniu korelacji między rangami przyporządkowanymi wariantom tych cech, tzn. na badaniu stopnia odpowiedniości między rangami.

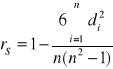

Odpowiednie postępowanie, prowadzące do określenia tzw. współczynnika korelacji rang zaproponował w 1906 roku C. Spearman. Oznaczmy przez xi rangę przyporządkowaną i-tej obserwacji z pierwszego ciągu, przez yi rangę przyporządkowaną tej jednostce w drugim ciągu oraz przez di różnicę między rangami przyporządkowanymi i-tej jednostce w obu ciągach (di = xi - yi ). Współczynnik korelacji rang Spearmana jest zdefiniowany wtedy jako zwykły współczynnik korelacji Pearsona dla rang xi i yi. Jeśli w zbiorze danych nie ma obserwacji powiązanych, tzn. nie ma podzbioru obserwacji, których nie można uporządkować, wzór na współczynnik korelacji rang Spearmana można przedstawić w postaci:

gdzie:

i - numer obserwacji

n - liczba obserwacji

di = xi - yi

xi - ranga przyporządkowana i-tej realizacji zmiennej X

yi - ranga przyporządkowana i-tej realizacji zmiennej Y

Współczynnik rS przyjmuje wartości z przedziału [-1,+1]. Wartość współczynnika nie powinna być interpretowana bez powiązania z liczbą obserwacji n.

KORELACJA RANG KENDALLA

Współczynnik korelacji rang Kendalla służy do pomiaru siły związku między dwiema zmiennymi opisanymi ca najmniej na skali porządkowej, jeśli dysponujemy większą liczbą obserwacji i występuje duża liczba rang.

Rozważmy dwie cechy. Rangujemy dwie cechy - cechę X i cechę Y zgodnie z przyjętymi zasadami. Następnie rozpoczynamy od ustawienia par obserwacji w taki sposób, aby kolejność ocen (rang) ze względu na jedną zmienną była rosnąca i przypisujemy odpowiadającą ocenę (rangę) drugiej zmiennej. W kolejnym kroku ustalamy, ile par pomiarów zmiennej nieuporządkowanej odzwierciedla porządek rosnący, a ile malejący. Parom, które są uporządkowane rosnąco, przypisujemy wartość "+1", a parom, które są uporządkowane malejąco "-1".

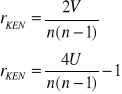

Współczynnik korelacji rang Kendalla obliczamy z następujących zależności:

![]()

gdzie:

V - suma wszystkich not

U - suma not dodatnich,

n - liczba rangowanych elementów.

Współczynnik korelacji rang Kendalla przyjmuje wartości z przedziału [-1;+1].

Etap 1

|

|

|

|

opinia o samochodzie nie zalezy od płci |

|

|

|

|

|

zależy od płci |

|

Etap 2

![]()

n i1 |

n i2 |

n i3 |

ogółem |

n^ i1 |

n^ i2 |

n^ i3 |

|

|

|

20 |

8 |

58 |

86 |

22,63158 |

8,147368 |

55,22105 |

0,305998 |

0,002666 |

0,139848 |

30 |

10 |

64 |

104 |

27,36842 |

9,852632 |

66,77895 |

0,253036 |

0,002204 |

0,115643 |

50 |

|

122 |

190 |

50 |

18 |

122 |

|

|

|

te żółte pola to suma n^11 = 86*50 / 190, n^22 = 104*18 / 190, itp.

chi^2 =suma(

Etap 3

alfa = 0,05

Etap 4

chi^2 alfa =5,99 =ROZKŁAD.CHI.ODW(alfa;2)

Obszar krytyczny |

[5,99; +inf) |

Etap 5

Przyjmujemy hipotezę zerową

Wykres punktowy

|

xi |

yi |

xi - x śr |

yi - y śr |

(xi - x śr) ^2 |

(yi - y śr )^2 |

(xi - x śr)*(yi - y śr ) |

1 |

6 |

4,2 |

-16,3077 |

-2,39231 |

265,94083 |

5,72313609 |

39,01301775 |

2 |

8 |

3,3 |

-14,3077 |

-3,29231 |

204,71006 |

10,8392899 |

47,10532544 |

|

|

|

|

Suma = |

1910,7692 |

52,2292308 |

294,8307692 |

Sx^2 = suma((xi - x śr) ^2)/n Sx = pierwiastek(Sx^2)

Sy^2 = suma((yi - y śr )^2)/n Sy = pierwiastek(Sy)

C(X,Y)=

rxy=

współczynnik determinacji = r xy^2

lp |

|

Dane |

|

|

|

|

|

|

Województwo |

xi |

yi |

rang xi |

rang yi |

di=rang xi -rang yi |

di^2 |

1 |

Mazowieckie |

2,63 |

22,9 |

1 |

2 |

-1 |

1 |

2 |

Kujawsko-Pomorskie |

2,42 |

21 |

2 |

6 |

-4 |

16 |

3 |

Zachodniopomorskie |

1,65 |

19,7 |

3 |

11 |

-8 |

64 |

4 |

Pomorskie |

1,51 |

20,4 |

4 |

8 |

-4 |

16 |

5 |

Wielkopolskie |

1,26 |

26 |

5 |

1 |

4 |

16 |

6 |

Opolskie |

1,22 |

22,1 |

6 |

3,5 |

2,5 |

6,25 |

7 |

Śląskie |

0,85 |

22,1 |

7 |

3,5 |

3,5 |

12,25 |

8 |

Łódzkie |

0,78 |

21,5 |

9 |

5 |

4 |

16 |

9 |

Małopolskie |

0,78 |

20 |

9 |

10 |

-1 |

1 |

10 |

Lubelskie |

0,78 |

19 |

9 |

12 |

-3 |

9 |

11 |

Warmińsko-Mazurskie |

0,63 |

17,4 |

11 |

14,5 |

-3,5 |

12,25 |

12 |

Dolnośląskie |

0,62 |

20,1 |

12 |

9 |

3 |

9 |

13 |

Lubuskie |

0,6 |

20,8 |

13 |

7 |

6 |

36 |

14 |

Świętokrzyskie |

0,48 |

17,4 |

14 |

14,5 |

-0,5 |

0,25 |

15 |

Podlaskie |

0,38 |

16,8 |

15 |

16 |

-1 |

1 |

16 |

Podkarpackie |

0,35 |

18,3 |

16 |

13 |

3 |

9 |

|

|

|

|

|

|

suma= |

225 |

rs= 0,669117647

r krytyczne = 0,507 z tablic dla alfa 0,05 i 16 stoi swobody

odp. Moduł obliczonej wartości współczynnika (0,669) jest większy od wartości krytycznej (0,507) zatem stwierdzamy, ze istotna zależność statystyczna między zmienną X a Y

|

Liczba punktów |

|

|

|

Nazwa uczelni |

Warunki mieszkaniowe |

Selektywność |

rang xi |

rang yi |

SGH |

84 |

67 |

1 |

1 |

UE - Poznań |

66 |

62 |

3 |

2 |

UE - Kraków |

76 |

58 |

2 |

4 |

UE - Wrocław |

61 |

61 |

4 |

3 |

UE - Katowice |

55 |

48 |

5 |

5 |

Każdej parze przypisujemy -1(+1) gdy różnica yi - xi jest

para x, y |

1,2 |

1,4 |

1,3 |

1,5 |

3,5 |

2,4 |

2,3 |

2,5 |

4,3 |

4,5 |

|

nota |

1 |

1 |

1 |

1 |

1 |

1 |

1 |

1 |

-1 |

1 |

|

|

|||||||||||

u = suma dodatnich not |

|||||||||||

odp.

Otrzymany wynik świadczy o silnym skorelowaniu uporządkowania uczelni wg warunków mieszkaniowych z uporządkowaniem wg selektywności

Numer studenta |

Średni czas dojazdu xi |

Liczba spóźnień yi |

xi - x śr |

yi - y śr |

(xi - x śr)^2 |

(yi - y śr)^2 |

(xi - x śr)*(yi - y śr) |

1 |

10 |

1 |

-6,77778 |

-1,55556 |

45,938272 |

2,4197531 |

10,54320988 |

2 |

15 |

2 |

-1,77778 |

-0,55556 |

3,1604938 |

0,308642 |

0,987654321 |

3 |

15 |

3 |

-1,77778 |

0,444444 |

3,1604938 |

0,1975309 |

-0,790123457 |

4 |

20 |

4 |

3,222222 |

1,444444 |

10,382716 |

2,0864198 |

4,654320988 |

5 |

23 |

5 |

6,222222 |

2,444444 |

38,716049 |

5,9753086 |

15,20987654 |

6 |

22 |

4 |

5,222222 |

1,444444 |

27,271605 |

2,0864198 |

7,543209877 |

7 |

17 |

1 |

0,222222 |

-1,55556 |

0,0493827 |

2,4197531 |

-0,345679012 |

8 |

15 |

2 |

-1,77778 |

-0,55556 |

3,1604938 |

0,308642 |

0,987654321 |

9 |

14 |

1 |

-2,77778 |

-1,55556 |

7,7160494 |

2,4197531 |

4,320987654 |

|

|

|

|

Suma = |

139,55556 |

18,222222 |

43,11111111 |

cov xy |

4,790123457 |

sx2 |

15,50617284 |

sy2 |

2,024691358 |

sx |

3,93778781 |

sy |

|

r xy |

0,85489934 |

a1 |

0,308917197 |

a0 |

-2,627388535 |

wsp. Det. |

0,730852882 |

y=0,309x-2,63 |

|

y^ |

e = yi - y^ |

|

0,46 |

0,54 |

0,2916 |

2,005 |

-0,005 |

2,5E-05 |

2,005 |

0,995 |

0,990025 |

3,55 |

0,45 |

0,2025 |

4,477 |

0,523 |

0,273529 |

4,168 |

-0,168 |

0,028224 |

2,623 |

-1,623 |

2,634129 |

2,005 |

-0,005 |

2,5E-05 |

1,696 |

-0,696 |

0,484416 |

|

Suma = |

4,904473 |

k - ilość estymowanych parametrów (czyli2 bo jest X i Y)

S=0,837042

y=0,309x-2,63 +- 0,84

|

Uczelnia (i) |

Y |

X |

xi - xsr |

yi - y sr |

(xi - x sr)^2 |

(yi - y sr)^2 |

(xi - x śr)*(yi - y śr) |

1 |

ASP |

1000 |

1800 |

-4600 |

-7000 |

21160000 |

49000000 |

32200000 |

2 |

AWF |

3000 |

2500 |

-3900 |

-5000 |

15210000 |

25000000 |

19500000 |

3 |

UR |

4000 |

4500 |

-1900 |

-4000 |

3610000 |

16000000 |

7600000 |

4 |

AP |

6000 |

4200 |

-2200 |

-2000 |

4840000 |

4000000 |

4400000 |

5 |

PK |

9000 |

6000 |

-400 |

1000 |

160000 |

1000000 |

-400000 |

6 |

UE |

12000 |

8800 |

2400 |

4000 |

5760000 |

16000000 |

9600000 |

7 |

UJ |

21000 |

17000 |

10600 |

13000 |

112360000 |

169000000 |

137800000 |

|

|

|

|

|

Suma = |

163100000 |

280000000 |

210700000 |

a1 |

|

|

a0 |

-267,81116 |

|

b1 |

0,7525 |

|

b0 |

380 |

|

a)y^=1,29x-267,8 |

||

b)x^=0,75y+380 |

||

c)r xy= |

0,98595828 |

|

ui = xi - x^ zi = yi - y^

x^ |

y^ |

ui |

ui^2 |

zi |

zi^2 |

1132,5 |

2057,511 |

667,5 |

445556,3 |

-1057,51 |

1118329 |

2637,5 |

2961,803 |

-137,5 |

18906,25 |

38,19742 |

1459,043 |

3390 |

5545,494 |

1110 |

1232100 |

-1545,49 |

2388550 |

4895 |

5157,94 |

-695 |

483025 |

842,0601 |

709065,2 |

7152,5 |

7483,262 |

-1152,5 |

1328256 |

1516,738 |

2300495 |

9410 |

11100,43 |

-610 |

372100 |

899,5708 |

809227,7 |

16182,5 |

21693,56 |

817,5 |

668306,3 |

-693,562 |

481028,6 |

|

|

Suma = |

4548250 |

|

7808155 |

wariancja składnika resztowego

średni błąd szacunku S(zi) = pierwiastek(S^2(zi)), S(ui) = pierwiastek(S^2(ui))

![]()

wartość współczynnika zmienności resztowej

Współczynnik zbieżności ϕ2

![]()

współczynnik determinacji R2

20

Y

X

![]()

![]()

![]()

3,5 = (3+4)/2

![]()

![]()

![]()

Wyszukiwarka

Podobne podstrony:

laboratorium 7 i 8, Metody probabilistyczne i statystyka

pytania 27-30, ZUT, III Semestr, Metody probabilistyczne i statystyka

Statystyka wykład 7n, Studia INF 1F, Metody probabilistyczne i statystyka

GrupaA, ZUT, III Semestr, Metody probabilistyczne i statystyka

Zmienna losowa typu ciaglego, ZUT, III Semestr, Metody probabilistyczne i statystyka

Probabilistyka - teoria v.0.1, Archiwum, Metody probabilistyczne i statystyka

MPiS wzory, WI ZUT studia, Metody probabilistyczne i statystyka, od kolesia

Metody probabilistyczne i statystyka program

05 Metody Probabilistyczno Statystyczne 25 06 2007id 5752 ppt

GrupaB, ZUT, III Semestr, Metody probabilistyczne i statystyka

Test z odp, ZUT, III Semestr, Metody probabilistyczne i statystyka

Metody probabilistyczne i statystyka

Metody Statystyczne - Laboratorium, Instrukcja, Metody analizy współzależności zjawisk masowych

10 Metody otrzymywania zwierzat transgenicznychid 10950 ppt

10 Metody otrzymywania sztywnych pianek poliuretanowych

10 Metody molekularne cz 2 Repa

Metody probabilistyczne

metody probablistyczne definicje TVQHLC5TC7JG4EOHQ2LLLL4EDLRIVLTY3DTA2II

więcej podobnych podstron