.

1

Modelowanie Procesów Dyskretnych

SKRYPT

Lech Jamroż, Jerzy Raszka

Wydział Fizyki, Matematyki i Informatyki

Politechniki Krakowskiej

Kraków 2011

Materiały dydaktyczne zostały przygotowane w ramach Projektu

„Politechnika XXI wieku - Program rozwojowy Politechniki Krakowskiej – najwyższej

jakości dydaktyka dla przyszłych polskich inżynierów”

współfinansowanego ze środków Unii Europejskiej w ramach Europejskiego Funduszu

Społecznego. Umowa o dofinansowanie nr UDA-POKL.04.01.01-00-029/10-00

Niniejsza publikacja jest rozpowszechniana bezpłatnie

1. ZAGADNIENIE SZEREGOWANIA ZADAŃ........................................................... 4

1.1. Wprowadzenie ....................................................................................................... 4

1.2. Struktury systemów wykonawczych ........................................................................ 6

1.3. Czasowe parametry zadań ................................................................................... 10

1.4. Kryteria optymalizacji ......................................................................................... 12

1.5. Specyfikacja problemów szeregowania................................................................. 14

1.6. Algorytmy szeregowania ...................................................................................... 16

1.7. Szeregowanie zadań z dodatkowymi zasobami...................................................... 27

1.8. Szeregowanie zadań cyklicznych .......................................................................... 31

2. METODY OPTYMALIZACJI DYSKRETNEJ ...................................................... 36

2.1. Metoda podziału i ograniczeń .............................................................................. 38

2.2. Algorytm zachłanny ............................................................................................. 43

2.3. Algorytmy metaheurystyczne................................................................................ 47

3. MODELE SIECIOWE PROCESÓW DYSKRETNYCH ........................................ 54

3.1. Wprowadzenie ..................................................................................................... 54

3.2 Podstawowe pojęcia i definicje ............................................................................. 55

3.3. Sieci znakowane .................................................................................................. 57

3.4. Własności dynamiczne sieci ................................................................................. 58

3.5 Czasowe sieci Petriego ......................................................................................... 61

3.6. Przykłady sieciowego modelowania procesów dyskretnych.................................. 62

3.7. Konstrukcja drzew i grafów pokrycia znakowań .................................................. 68

3.8 Oprogramowanie narzędziowe ND. ..................................................................... 72

3.9. Edytor i symulator PIPE ..................................................................................... 78

4. JĘZYKI SYMULACYJNE SYSTEMÓW DYSKRETNYCH ............................. 83

4.1 Zastosowanie........................................................................................................ 83

4.2 Język GPSS .......................................................................................................... 85

4.3 Przykłady do ćwiczeń i tematy zadań................................................................... 103

4.4 Obsługa pakietu GPSS World ............................................................................ 106

4.5 Inne wersje pakietów GPSS ............................................................................... 112

.

3

5. PROGRAMOWANIE SYSTEMÓW DYSKRETNYCH ....................................... 115

5.1 Wprowadzenie.................................................................................................... 115

5.2 Proces projektowania symulacji.......................................................................... 116

5.3. Elementy modelu symulacyjnego....................................................................... 120

5.4 Metody symulacji dyskretnej ............................................................................... 122

5.5. Sterowanie i monitoring procesów dyskretno-ciągłych ....................................... 133

5.6 Systemy SCADA/HMI ......................................................................................... 144

.

4

1. ZAGADNIENIE SZEREGOWANIA ZADAŃ

1.1. Wprowadzenie

Dziedzinę wiedzy zajmującą się szeregowaniem zadań nazywamy teorią

szeregowania (scheduling theory, sequencing theory).

Ogólne zagadnienia szeregowania zadań, nazywane również zagadnieniami

kolejnościowymi lub sekwencyjnymi można umiejscowić w obszarze badań

operacyjnych, programowania dyskretnego lub optymalizacji kombinatorycznej.

Zagadnienia szeregowania modelują funkcjonowanie rzeczywistych systemów.

Przykładem takich systemów są systemy komputerowe ogólnego przeznaczenia,

systemy uwarunkowane czasowo RTS (Real Time Systems), Elastyczne systemy

produkcyjne FMS (Flexible Manufacturing Systems), Systemy wytwarzania na

czas JIT (Just-in-Time).

Zdecydowana większość stawianych zagadnień praktycznych, charakteryzuje

się NP-trudnością odpowiednich problemów optymalizacyjnych. Implikuje ona

wykładniczy czas obliczeń algorytmów komputerowych wyznaczających

optymalne rozwiązanie, co podważa zasadność ich stosowania.

Zagadnienie rozdziału zasobów systemowych, w szczególności szeregowanie

zadań, pojawia się niemal w sposób oczywisty przy ustalania wszelkich

harmonogramów. W ogólności, wyróżnione są dwa podejścia do jego

rozwiązywania:

1.

dynamiczne szeregowanie (dynamic scheduling, on-line scheduling),

2.

statyczne szeregowanie (static scheduling, off-line scheduling).

W zależności od typu systemu, poszczególne strategie szeregowania są

implementowane na różne sposoby.

Szeregowanie dynamiczne odbywa się w trakcie pracy systemu. Na podstawie

aktualnego stanu systemu podejmowane są decyzje, które zadanie będą

wykonywane następnie. Podstawową cechą szeregowania dynamicznego jest

nieznajomość, na etapie projektowania systemu, kolejności wykonywania zadań

(kolejność ta zależy od kolejności zdarzeń zachodzących w otoczeniu systemu). W

pewnych okolicznościach cecha ta może być zaletą, jednakże w systemach

krytycznych MCS (Mission Critical Systems) ze względu na bezpieczeństwo jest

ona wadą. Trudno jest także realnie oszacować czas odpowiedzi (response time)

dla obsługi konkretnego zdarzenia.

W przypadku szeregowania dynamicznego wymagane jest zastosowanie prostych

algorytmów np. EDD (Earliest Due Date), gdyż w przeciwnym razie czas

przeznaczony na budowaniu uszeregowania może być zbyt długi, co z kolei

doprowadziłoby do naruszenia linii krytycznej konkretnego zadania. Szeregowanie

dynamiczne składa się z tylko etapu wykonawczego (run-time).

.

5

Alternatywą dla szeregowania dynamicznego jest statyczne szeregowanie.

Wymagana jest znajomość czasów ich wykonywania, albo też okresów

powtarzania na etapie kompilacji oprogramowania (przed uruchomieniem systemu).

Szeregowanie statyczne składa się z dwóch etapów: przygotowawczego (pre-run

time) oraz wykonawczego (run-time). Podstawową zaletą szeregowania

statycznego w stosunku do dynamicznego jest większa skuteczność wynikająca z

przeniesienia większości obliczeń do etapu przygotowawczego. Analiza i

uruchamianie systemu ze statycznym szeregowaniem jest znacznie prostsze. W

systemach krytycznych, ze względu na bezpieczeństwo należy wyłącznie stosować

szeregowanie statyczne, gdyż tylko wówczas mamy pewność, że wszystkie

ograniczenia czasowe zostaną spełnione. Przykładem statycznego szeregowania są

algorytmy RMS (Rate Monotonic Scheduling), DMPO (Deadline Monotonic

Priority Ordering) oraz CES (Cyclic Executive Scheduling).

Przyjmijmy następujące oznaczenia:

1. Zadania (jobs, tasks),

Z={Z

1

, Z

2

, ..., Z

n

}

2. Procesory, maszyny (processors, machines),

P={P

1

, P

2

, ..., P

m

}

3. Zasoby (resources),

R={R

1

, R

2

, ..., R

s

}.

Przykładowe interpretacje zadania:

-

program komputerowy, proces obliczeniowy (w systemie komputerowym),

-

proces obróbki detalu (w przemyśle maszynowym),

-

proces montażu (w przemyśle samochodowym),

-

zlecenie inwestycyjne (w budownictwie),

-

prace naukowe (w projekcie badawczym).

Zasobami mogą być: procesory, maszyny, stanowiska montażu, personel, surowce

energetyczne, kapitał itp. Zarówno zadania jak i zasoby posiadają swoje cechy

charakterystyczne np. termin gotowości do wykonania, żądany termin zakończenia,

przerywalność wykonywania itp. W przypadku zasobów mogą to być następujące

kategorie:

-

odnawialne (procesor, maszyna, robot),

-

nieodnawialne (surowce, materiały podlegające zużyciu),

-

podwójnie ograniczone (energia, kapitał).

Zasoby odnawialne charakteryzuje ograniczona dostępność, nieodnawialne –

ograniczenie globalnej ilości, zaś podwójnie ograniczone oba rodzaje ograniczeń.

.

6

1.2. Struktury systemów wykonawczych

Rozważane są przepływowe systemy obsługi zadań. Systemy przepływowe są

jednymi z prostszych i często analizowanych modeli systemów, w szczególności

produkcyjnych (przemysłowych). Mają bardzo dobre aplikacje praktyczne,

głównie

w

procesach

chemicznych,

niektórych

procesach

przemysłu

elektronicznego czy samochodowego.

Tworzą podstawy do analizy bardziej złożonych struktur szeregowo-równoległych

(potokowe linie automatyczne), dominujących we współczesnych systemach

wytwarzania. Traktowane są także, jako wskaźniki praktycznych możliwości

rozwiązywania trudnych numerycznie problemów, przy użyciu narzędzi i metod

teorii szeregowania zadań.

Do podstawowych systemów obsługi zadań należą:

1.

Przepływowy F (Flow-shop system).

2.

Permutacyjny przepływowy PF (Permutation flow-shop system).

3.

Otwarty O (Open-shop system).

4.

Gniazdowy J (Job-shop system).

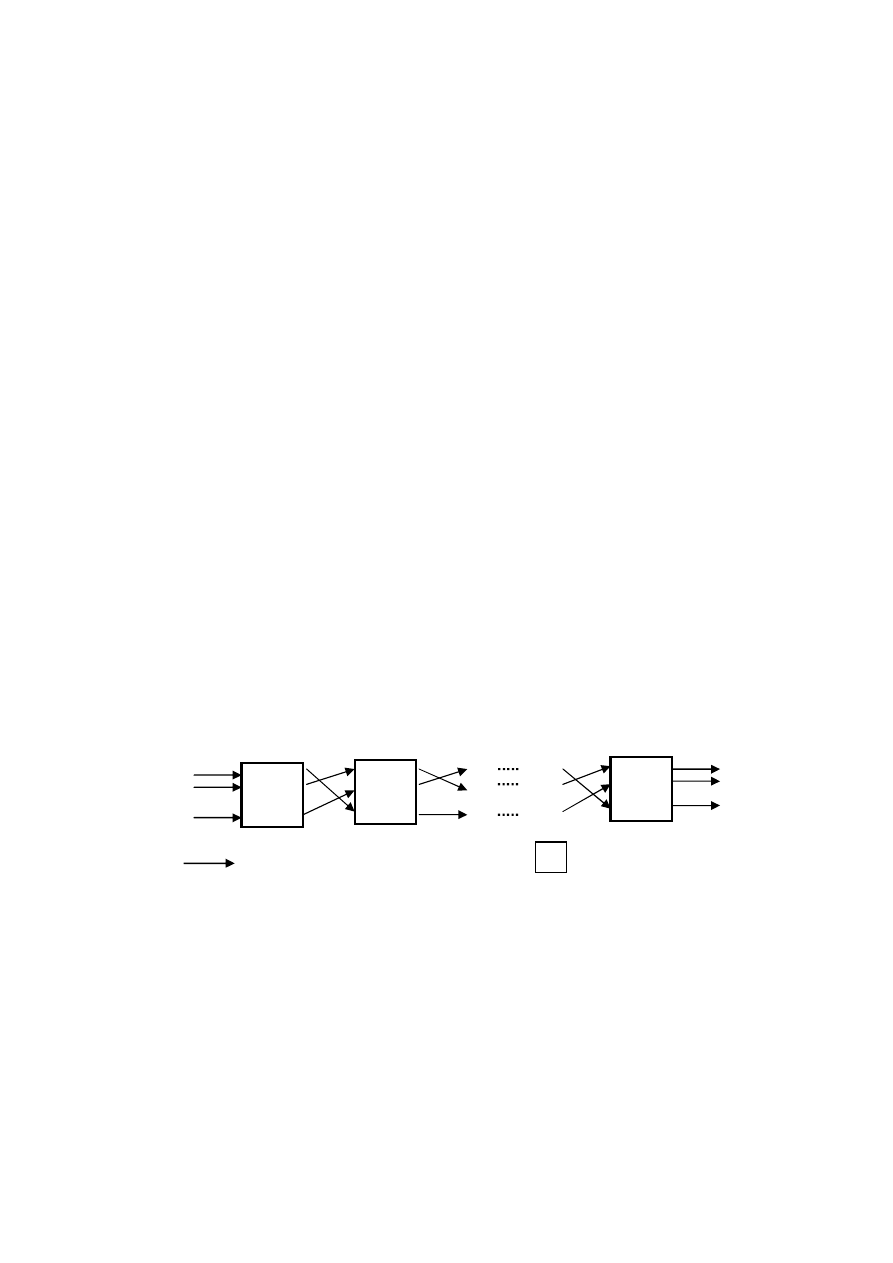

1.2.1. System przepływowy

W przepływowym systemie obsługi wszystkie zadania (sekwencja operacji,

potoki operacji) posiadają jednakową marszrutę technologiczną, wykonywane są

na wszystkich maszynach (procesorach, stanowiskach), a każda z maszyn wymaga

określenia odpowiedniej kolejności wprowadzania zadań.

1

2

m

Przepływ zadań

Maszyna (procesor)

.

7

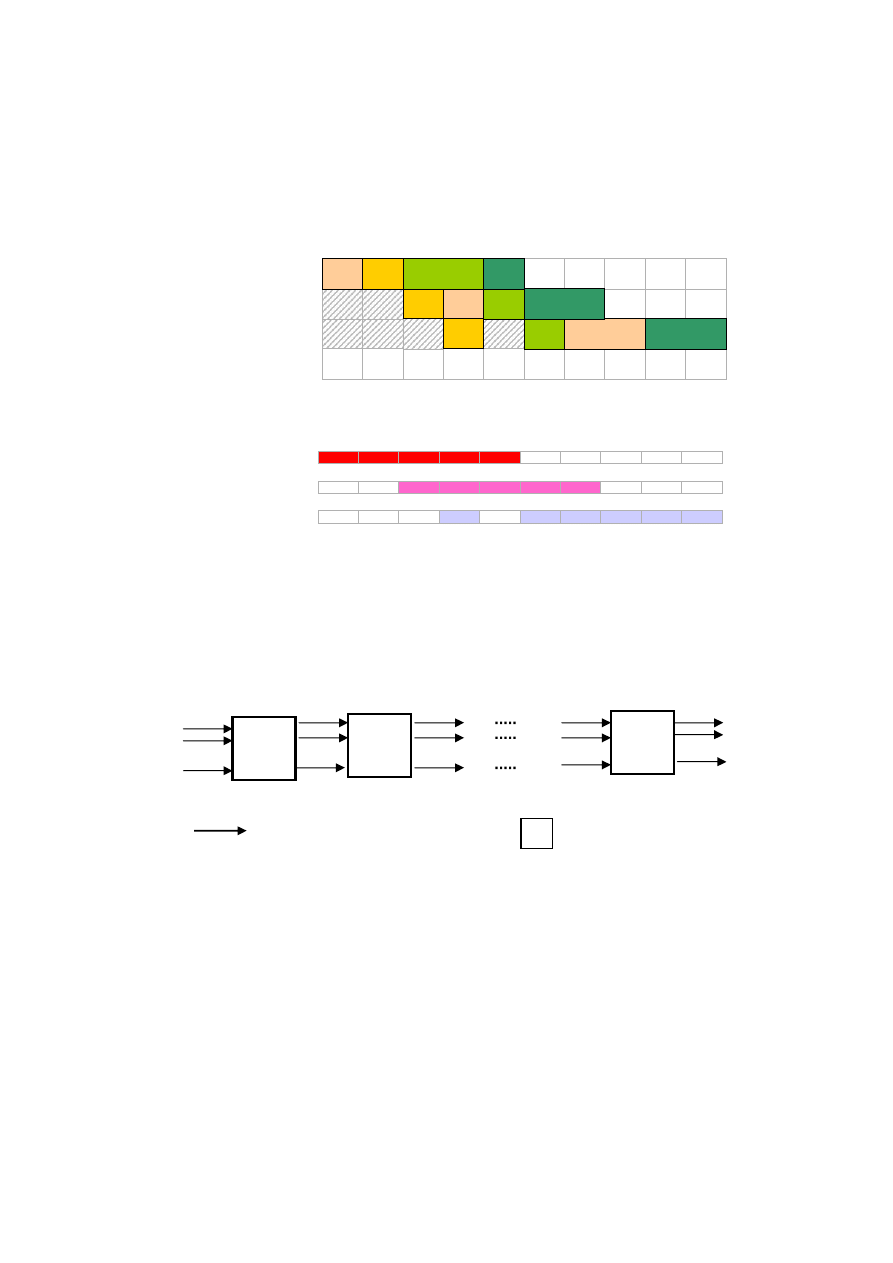

1.2.2. Permutacyjny system przepływowy

W permutacyjnym systemie przepływowym obsługi zadań złożenia są takie

same jak dla systemu typu F z dodatkowym wymaganiem, aby kolejność

(permutacja) wykonywania zadań była taka sama, zgodna z kolejnością

wprowadzania zadań do systemu.

Ciągłość pracy P

1

P

3

1

2

3

4

5

6

7

8

9

10

P

2

P

1

Z

1

Z

1

Z

1

Z

3

Z

2

Z

3

Z

2

Z

4

Z

4

Z

4

Z

2

Z

3

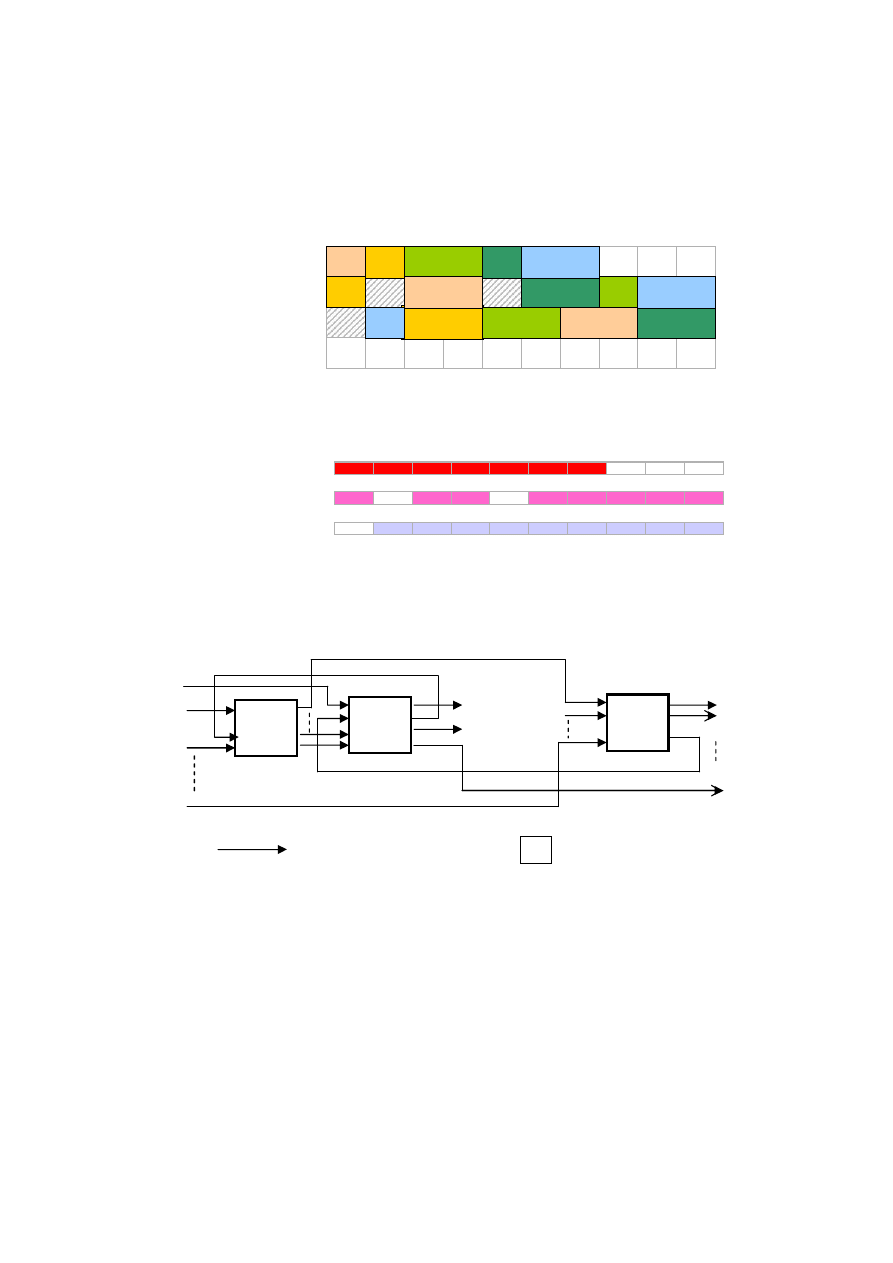

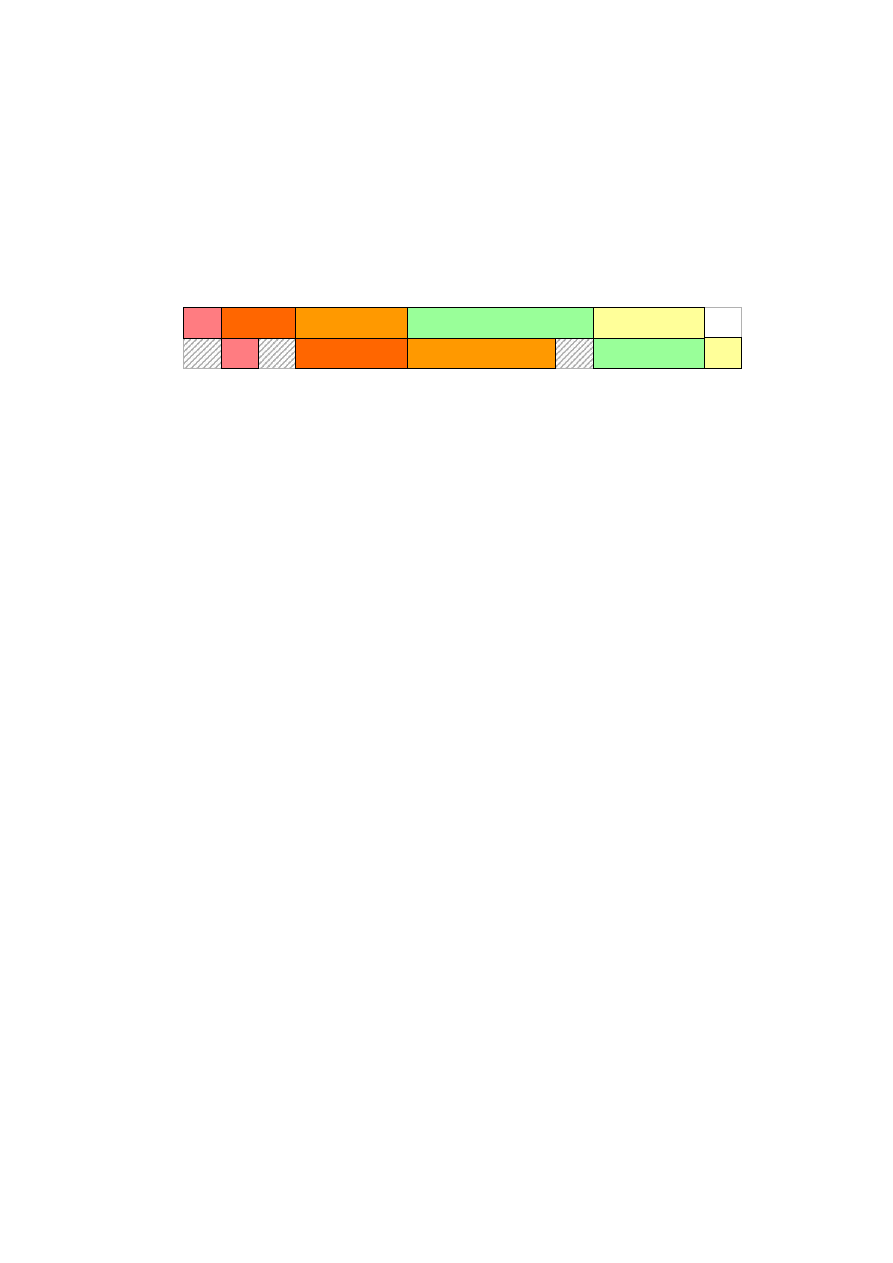

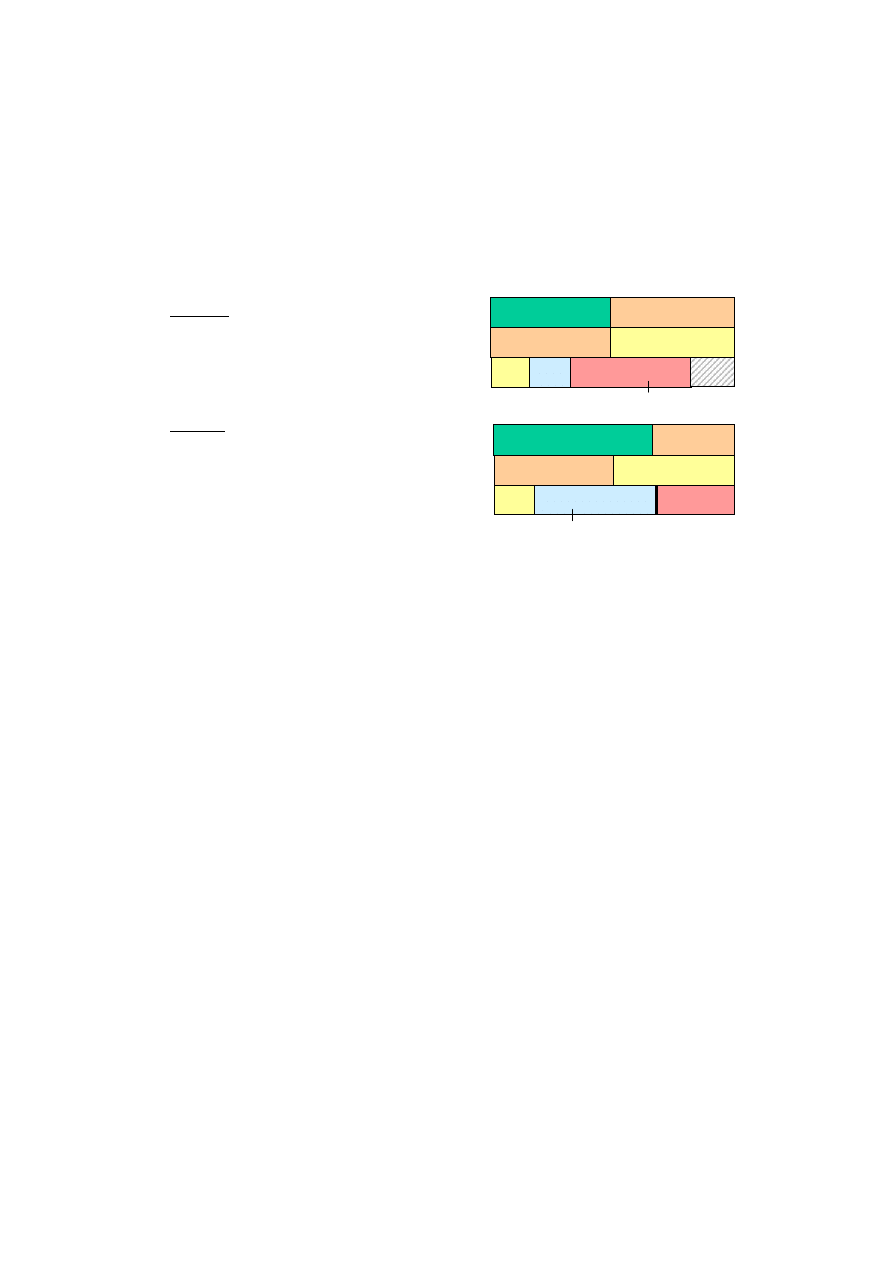

Rys. 1.1. Przykładowy diagram Gantta uszeregowania dla systemu F

Ciągłość pracy P

2

Ciągłość pracy P

3

1

2

m

Przepływ zadań

Maszyna (procesor)

.

8

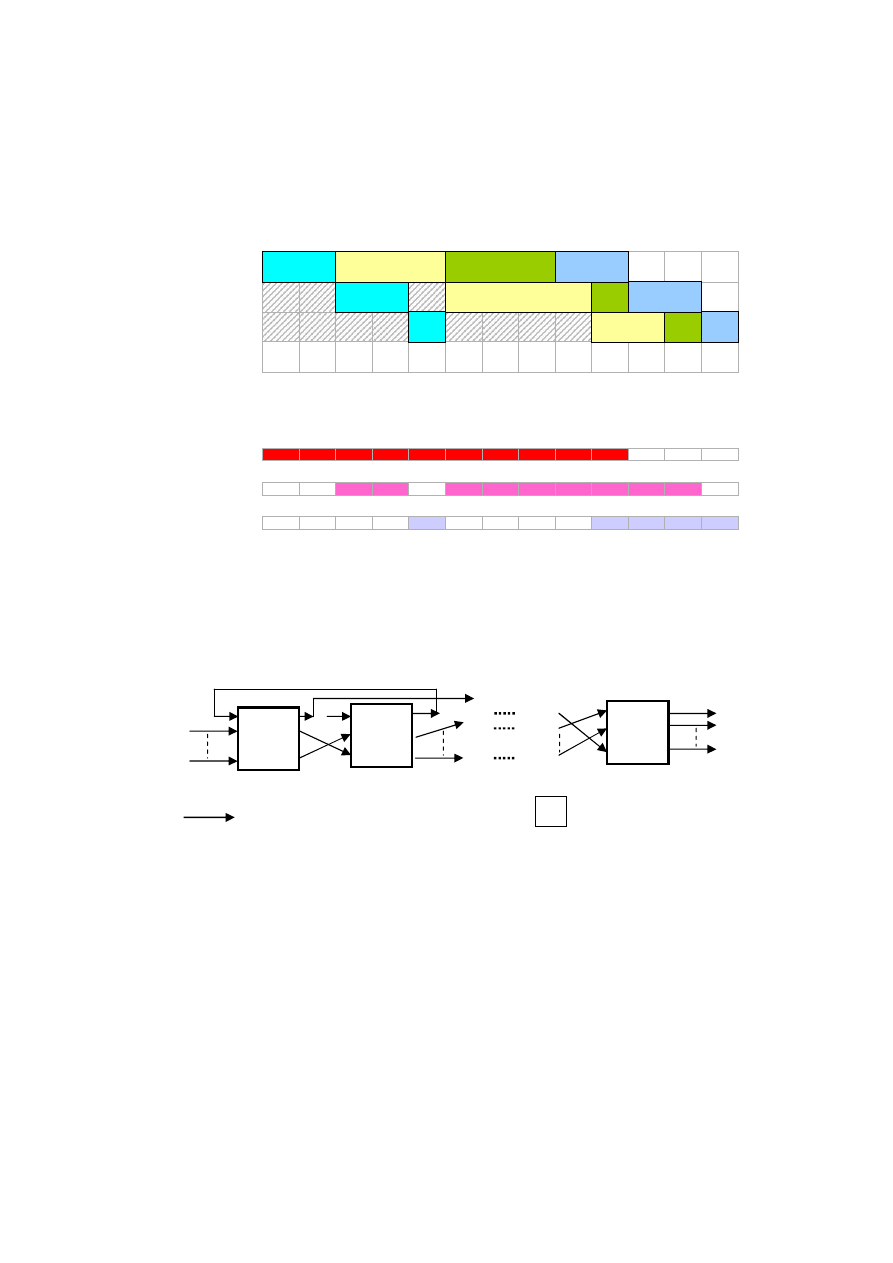

1.2.3. System przepływowy otwarty

W systemie obsługi otwartym, każde zadanie wykonane jest na wszystkich

maszynach, lecz kolejność wykonywania operacji w obrębie zadań może być

dowolna, nie jest ustalona.

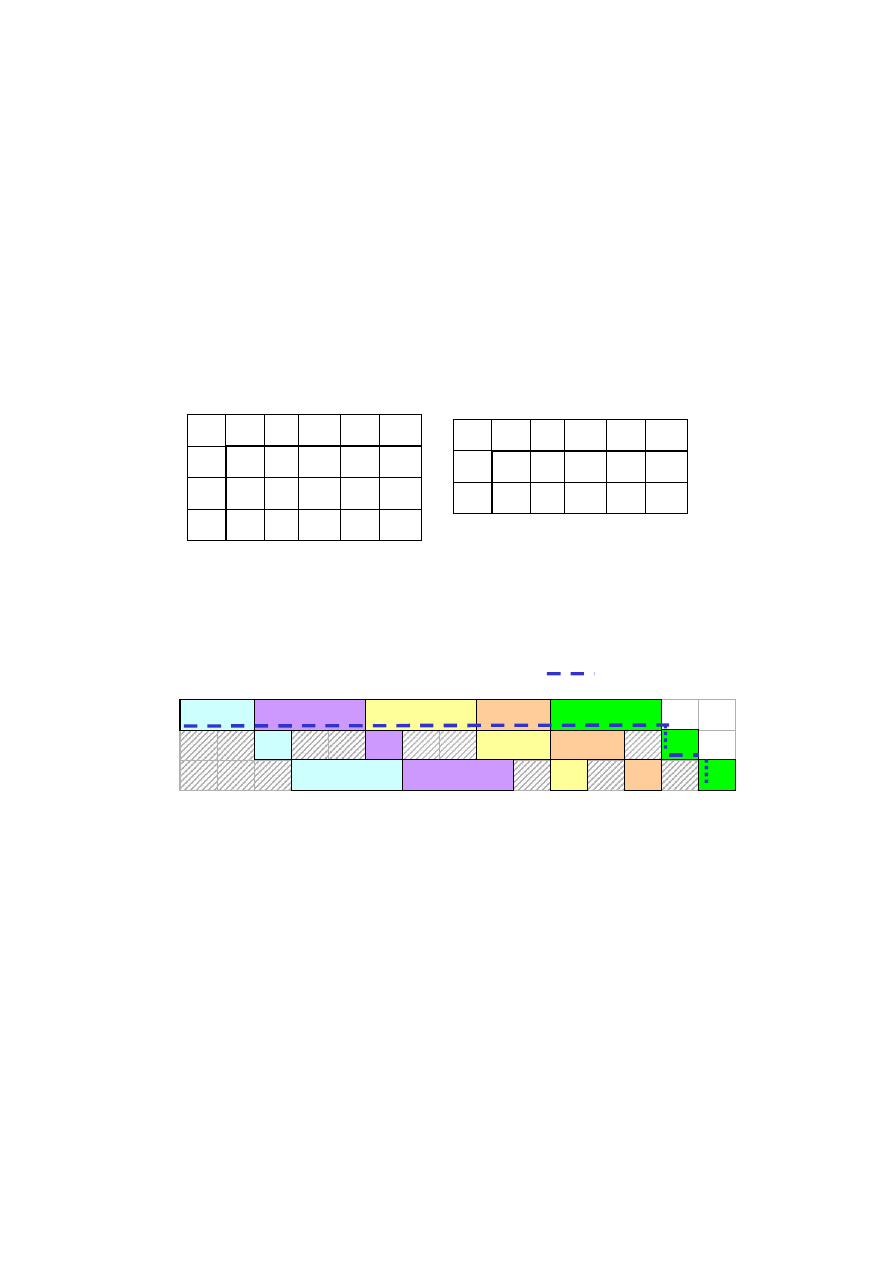

Rys. 1.2. Przykładowy diagram Gantta uszeregowania dla systemu PF

P

3

1

2

3

4

5

6

7

8

9

1

0

1

1

1

2

P

2

P

1

Z

2

Z

2

Z

2

Z

3

Z

Z

1

Z

3

Z

3

1

3

Z

4

Z

4

Z

1

Z

4

Ciągłość pracy

P

Ciągłość pracy

P

Ciągłość pracy

P

Przepływ zadań

Maszyna (procesor)

m

1

2

.

9

1.2.4. System gniazdowy

W systemie gniazdowym założenia dla F i FP nie są zachowane. Zadania mogą

posiadać różne (co do liczby jak i kolejności) marszruty technologiczne.

Ciągłość pracy P

1

Ciągłość pracy P

2

Ciągłość pracy P

3

P

3

1

2

3

4

5

6

7

8

9

1

0

P

2

P

1

Z

1

Z

3

Z

2

Z

4

Z

4

Z

4

Z

2

Z

3

Z

2

Z

1

Z

3

Z

1

Z

5

Z

5

Z

5

Rys. 1.3. Przykładowy diagram Gantta uszeregowania dla

systemu otwartego

Maszyna (procesor)

Przepływ zadań

1

2

m

.

10

1.3. Czasowe parametry zadań

Do najważniejszych czasowych (timingowych) parametrów zadań należą:

r

i

(release time, arrival time) – najwcześniejszy możliwy termin rozpoczęcia

wykonywania zadania, termin uwolnienia jest chwilą, gdy zadanie dołącza do

kolejki zadań gotowych do wykonania. Czas, w którym zadanie uzyskuje

uprawnienia do wykonania. Zdanie może być wykonane w każdej chwili po

uwolnieniu, jeśli tylko spełnione będą specyficzne warunki zewnętrzne, (np.

obecność danych wejściowych, dostępność zasobu itp.).

p

i

(execution time, processing time, computation time) - czas wykonania,

maksymalny czas trwania wykonania zadania, czas trwania obliczeń.

s

i

(start time, inception) - rzeczywisty (aktualny) moment rozpoczęcia

wykonywania zadania. Chwila, w której zadanie rozpoczyna wykonywanie.

c

i

(completion time, finishing time) – rzeczywisty (aktualny) termin zakończenia

wykonywania zadania. Chwila, w której zadanie kończy wykonywanie.

d

i

(deadline, due date) - żądany termin zakończenia wykonywania zadania, termin

ostateczny, maksymalny dopuszczalny czas odpowiedzi. Opcjonalny parametr.

Występuje w dwóch wariantach. Może oznaczać czas, od którego nalicza się

spóźnienie (due date), lub termin, którego przekroczyć nie wolno (deadline).

Parametr ten może być zastąpiony przez okno czasowe [d

j

, D

j

].

L

i

= c

i

– d

i

- nieterminowość (Lateness), opóźnienie w wykonywaniu zadania.

Ciągłość pracy P

1

Ciągłość pracy P

2

Ciągłość pracy P

3

P

3

1

2

3

4

5

6

7

8

9

10

P

2

P

1

Z

3

Z

4

Z

3

Z

6

Z

4

Z

2

Z

5

Z

6

Z

5

Z

3

Z

2

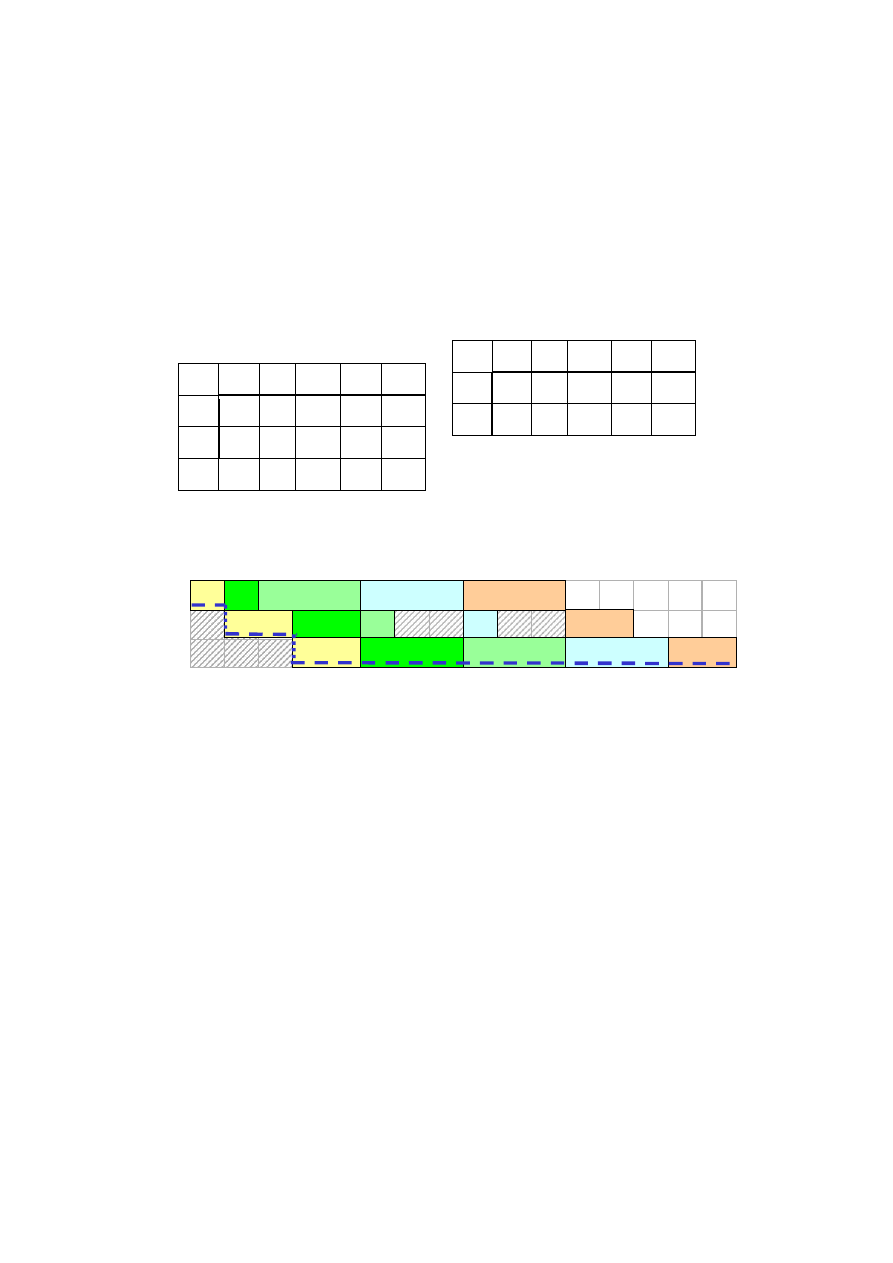

Rys. 1.4. Przykładowy diagram Gantta uszeregowania dla systemu

gniazdowego

.

11

T

i

= max[0, c

i

– d

i

] – spóźnienie (Tardiness) w wykonywaniu zadania.

U

i

= w(C

i

> d

i

) - znacznik spóźnienia (0/1 Nie/Tak).

E

i

= max[0, r

i

– s

i

] - przyspieszenie w wykonywaniu zadania (Earliness).

V

i

- priorytet zadania (ważność zadania).

F

i

= (c

i

– r

i

) - czas reakcji, czas odpowiedzi zadania (response time), czas od chwili

uwolnienia zadania do chwili zakończenia jego wykonania.

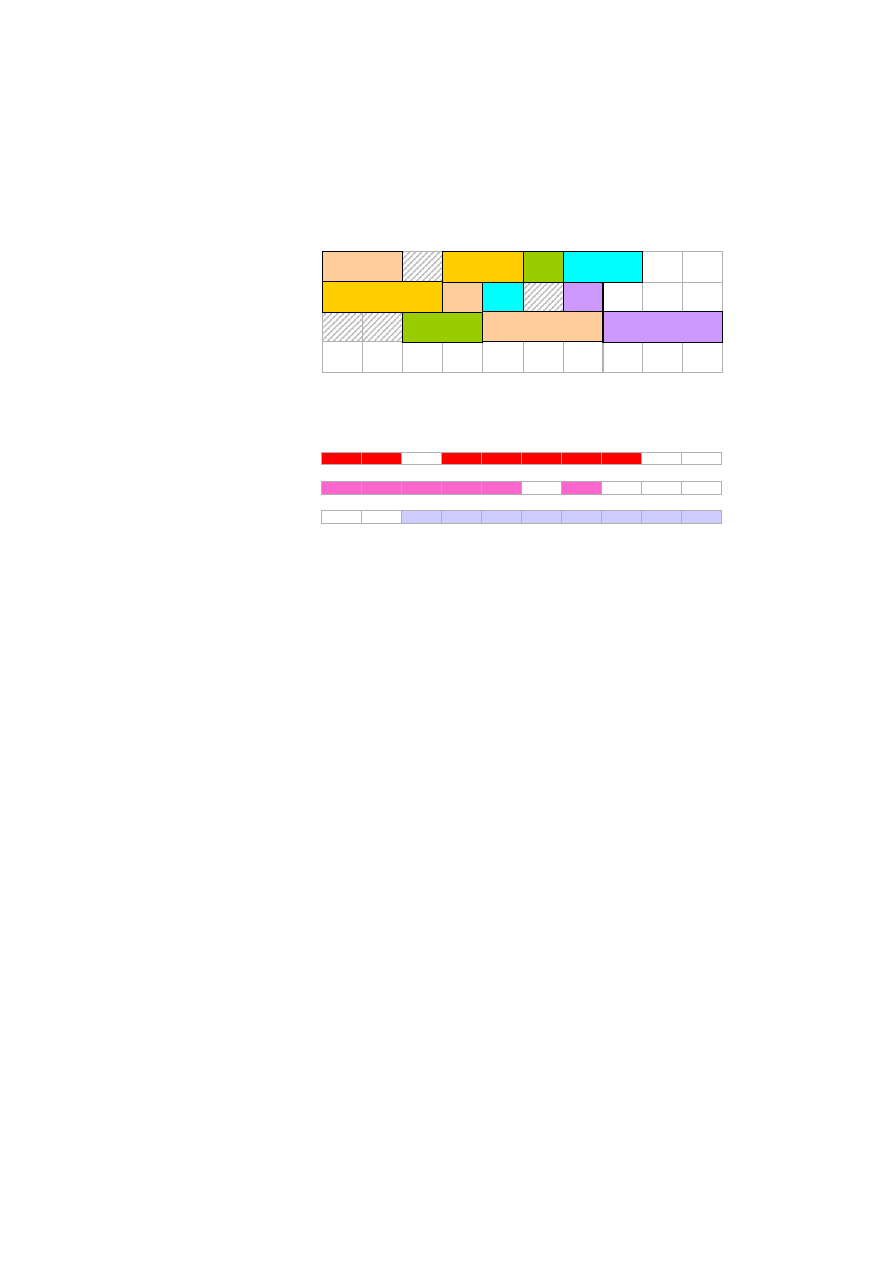

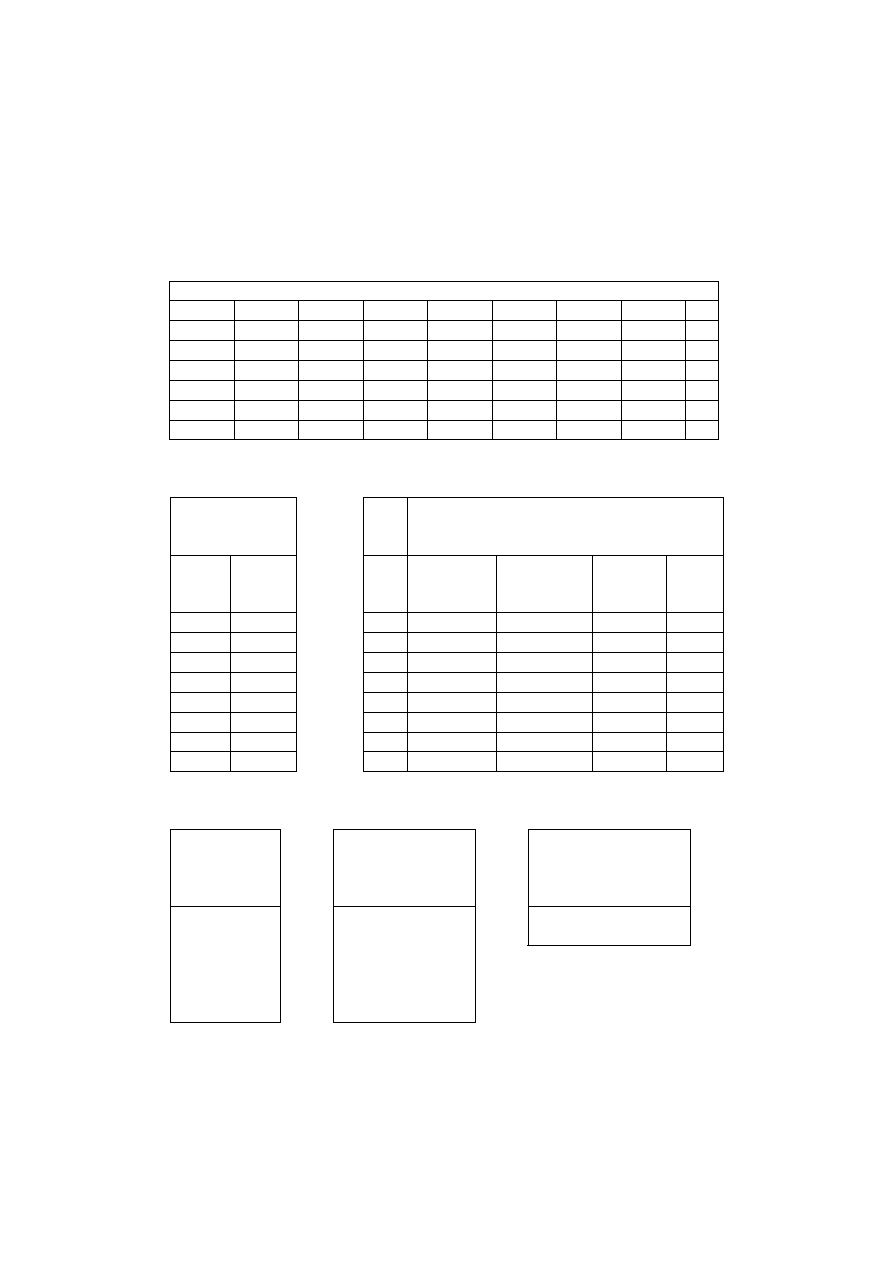

Rys. 1.4. Interpretacja parametrów timimingowych zadania

Z

i

t

s

i

c

i

d

i

r

i

p

i

Z

3

Z

5

Z

1

Z

2

Z

4

P

1

P

2

P

3

0

2

4

6

d

i

5

3

2

7

4

r

i

0

1

0

2

1

s

i

0

1

0

3

2

c

i

4

3

2

6

5

L

i

-1

0

0

-1

1

T

i

0

0

0

0

1

Z

1

Z

2

Z

3

Z

4

Z

5

.

12

W zbiorze zadań można wprowadzić ograniczenia kolejnościowe w postaci

dowolnej relacji częściowego porządku. Wówczas Z

i

Z

j

oznacza, że zadanie Z

j

może być wykonywane dopiero po zakończeniu zadania Z

i

. Jeżeli ograniczenia te

nie występują, mówimy o zadaniach niezależnych (domyślnie).

Dla zadań niepodzielnych przerwy w ich wykonywaniu są niedopuszczalne.

Zadania podzielne mogą być wywłaszczane i wznawiane ponownie.

Uszeregowaniem nazywamy przyporządkowanie w czasie maszyn i dodatkowych

zasobów do zadań, dla którego spełnione są następujące warunki:

-

w każdej chwili każdy maszyna wykonuje co najwyżej jedno zadanie,

-

zadanie wykonywane jest w przedziale czasowym [r

j

, ),

-

dla każdych dwóch zadań Z

i

, Z

k

Z takich, że Z

i

Z

k

, wykonywanie

zadania Z

k

rozpoczyna się po zakończeniu zadania Z

i

,

-

w przypadku zadań niepodzielnych żadne zadanie nie jest przerywane, dla

zadań podzielnych liczba przerw w wykonywaniu każdego zadania jest

skończona,

-

wszystkie zadania zostaną wykonane.

Zarządzanie (sterowanie) wykonywaniem zadań ma na celu efektywne

wykorzystanie dostępne zasoby.

1.4. Kryteria optymalizacji

Wyróżniamy dwie kategorie kryteriów optymalizacji: czasowe oraz kosztowe.

I. Przykładowe kryteria czasowe:

1. Długość uszeregowania (czas wykonania zbioru zadań) (maximum completion

time, makespan)

gdzie c

i

jest momentem zakończenia wykonywania zdania Z

i

w danym

uszeregowaniu. N – zbiór liczb naturalnych.

2. Suma terminów zakończenia zadań.

3. Średni czas przepływu zdań.

gdzie F

i

= c

i

– r

i

jest łącznym czasem wykonywania i oczekiwania na obsługę

zadania Z

i

.

C

max

= max

i=1,...,n

{c

i

}

(1.0)

C =

i=1,...,n

c

i

,

(1.1)

F = 1/n

i=1,...,n

F

i

(1.2)

.

13

4. Maksymalne opóźnienie zadania.

5.

Maksymalne spóźnienie.

6.

Całkowite spóźnienie.

7. Ważone spóźnienie (wprowadzenie wag dla zadań).

8.

Liczba spóźnionych zadań.

II. Kryteria kosztowe.

fi(t), gi(t) – niemalejące funkcje względem swoich argumentów.

L

max

= m a x

i=1,...,n

{L

i

}

(1.3)

T

max

=max

i=1,...,n

{T

i

}

(1.4)

T =

j=1,...,n

T

j

(1.5)

wT =

j=1,...,n

w

j

T

j

(1.6)

U=

j=1,...,n

U

j

(1.7)

H

max

= max[m a x

[f(T

j

)], m a x [g(E

j

)]]

(1.8)

h = 1/n

j=1,...,n

[ f(T

j

) + g(E

j

)]

(1.9)

.

14

1.5. Specyfikacja problemów szeregowania

Problematyka szeregowania zadań i rozdziału zasobów systemowych doczekała

się standardu specyfikacji. Standardem tym jest trójpolowa notacja Grahama:

Interpretacja parametrów.

1. Parametr =

1

2

opisuje typ systemu i środowisko wykonawcze.

Parametr

1

:

a)

Gdy

1

{ PF, F, O, J }:

1

= F – system przepływowy,

1

= PF – system przepływowy permutacyjny,

1

= O – system otwarty,

1

= J – system gniazdowy (ogólny).

Parametr

2

oznacza liczbę maszyn. Gdy

2

= , to liczbę maszyn dowolna,

jest zmienną w problemie, (oczywiście

1

= wtedy i tylko wtedy, gdy

2

= 1).

2.

Parametr charakteryzuje zadania, dodatkowe zasoby i ograniczenia.

{, prm} określa dopuszczalność przerywania wykonywania zadań,

- = - zadania niepodzielne (nonpreemptive),

- = prm – zadania podzielne (preemptive),

- {

, prec, tree, chain, seq-par} - określa wymaganą kolejność

wykonywania zadań precedence) oznacza odpowiednio: brak ograniczeń

kolejnościowych (zadania niezależne), dowolny graf, drzewo, łańcuch,

graf szeregowo-równoległy.

{r

i

, } określa chwile dostępności zadań.

- = - chwile dostępności są równe tj. r

i

= 0, i=1, 2, ..., n.

- = r

i

– chwile dostępności dowolne,

{p

i

= 1, p

d

p

i

p

g

, } - określa czasy wykonywania zadań.

- p

i

= 1 – czasy wykonywania zadań (operacji) są równe,.

- p

d

p

i

p

g

– czasy wykonywania zadań (operacji) są ograniczone od

dołu i od góry,

- - czasy wykonywania zadań są dowolne.

no-idle - maszyny muszą pracować w sposób ciągły,

no-wait – oznacza, że czas rozpoczęcia operacji następnych (w sensie

porządku technologicznego) jest równy czasowi zakończenia operacji

poprzednich.

.

15

{, res } opisuje ograniczenia i żądania zasobowe: (discretely-

additional resources).

-

- brak dodatkowych zasobów,

-

= res - istnieją dodatkowe zasoby:

{, k} – oznaczają odpowiednio: liczbę rodzajów dodatkowych

zasobów, ograniczenia zasobowe, żądania zasobowe zadań.

= k – oznaczają odpowiednio: k rodzajów dodatkowych zasobów, k

jednostek każdego rodzaju, żądania zasobowe każdego zadania nie

przekraczają k jednostek każdego zasobu.

= - liczba rodzajów dodatkowych zasobów, ograniczenia oraz

żądania zasobowe są dowolne.

Domyślnie, jeżeli pole jest puste, przyjmujemy, że: zadania są niepodzielne,

niezależne, r

j

= 0, czasy wykonania i ewentualne wymagane terminy zakończenia

d

j

są dowolne.

Interpretacja 3 (precedence) - szczególne postaci relacji zależności

kolejnościowych.

Przykłady specyfikacji wybranych problemów szeregowania w notacji

trójpolowej:

F2 C

max

P r

j

, p

j

=1L

max

1 prm, prec L

max

P res 11, r

j

, p

j

=1C

max

in–tree

out–tree

.

16

1.6. Algorytmy szeregowania

1.6.1. Permutacyjny system przepływowy

Specyfikacja zagadnienia szeregowania n zadań w dwumaszynowym

systemie permutacyjnym przepływowym w zapisie notacji trójpolowej ma

postać: PF2C

max

. Kryterium optymalizacji jest czasem zakończenia

wykonania wszystkich zadań C

max

.

Założenia:

- każda maszyna wykonuje jednocześnie co najwyżej jedno zadanie,

- w każdej chwili zadanie może być obsługiwane przez co najwyżej jedną

maszynę,

- każde zadanie wykonuje się nieprzerwanie w pewnym domkniętym

przedziale czasowym,

- przydział każdego zadania jest dosunięty w harmonogramie maksymalnie w

lewo,

- optymalność uszeregowania wyprowadzamy jako wniosek z nieprzerwanej

pracy maszyny P

1

w horyzoncie szeregowania.

Algorytm Johnsona.

Algorytm Johnsona wyznacza optymalne uszeregowanie. Rząd złożoności

algorytmu O(n logn). Idea algorytmu:

1. Utworzyć dwa rozłączne podzbiory zadań: A={Z

i

: p

i1

p

i2

, i=1,2,...,n} oraz

B={Z

i

: p

i1

> p

i2

, i=1,2,...,n}. Zadania ze zbioru A uszeregowane wg

niemalejących wartości p

i1

tworzą permutację

A

. Analogicznie, zadania ze

zbioru B uszeregowane wg nierosnących wartości p

i2

tworzą permutację

B

.

2.

Permutacja * będąca konkatenacją <

A

B

> jest optymalnym

uszeregowaniem zadań.

3.

Wyznaczyć C

max

(*) = c

*(n),2

Interpretacja algorytmu.

p

ik

Z

1

Z

2

Z

3

Z

4

Z

5

P

1

3

3

1

5

2

P

2

4

1

1

3

3

C

max

(*) = m i n

C

max

()

(1.10)

.

17

P

2

1

2

3

4

5

6

7

8

9

1

0

1

1

1

2

1

3

1

4

1

5

P

1

Z

3

Z

3

Z

5

Z

5

Z

1

Z

1

Z

4

Z

4

Z

2

Z

2

Rys. 1.7. Diagram Gantta uszeregowania.

Optymalne uszeregowanie zadań:

< Z

3

Z

5

Z

1

Z

4

Z

2

>

Wartość funkcji kryterialnej C

max

= c

*(n),2

=

15.

Istnieje optymalna kolejność wykonywania zadań dla zagadnienia: PF2 | | C

max

taka, że dla każdej pary i oraz k, (1 i < k n) spełniony jest warunek Johnsona:

Jeżeli założymy, że optymalną permutacją jest = (1, 2, …, n) oraz, że k=i+1, to

warunek Johnsona przyjmie postać:

Rozszerzenie algorytmu Johnsona

na przypadek trzech maszyn.

Istnieje optymalna kolejność wykonywania zadań dla problemu:

PF3|P

2

, no-bottl.|C

max

z czasami p

i1

, p

i2

, p

i3

wykonywania zadań Z

i

Z, taka jak optymalna kolejność dla

problemu PF2C

max

z czasami p

'

i1

= p

i1

+ p

i2

, p

'

i2

= p

i2

+ p

i3

przy założeniu, że:

W takim przypadku, czas wykonywania zadań na drugiej maszynie nie odgrywa

roli, a optymalne uszeregowanie można otrzymać stosując algorytm Johnsona dla

problemu pomocniczego. Warunek pierwszy reprezentuje dominację P

1

nad P

2

,

zaś

drugi dominację P

3

nad P

2

.

Problem pomocniczy dostarcza tylko permutacji , zaś odpowiednie terminy

zakończenia wykonywania zadań dla problemu: PF3|P

2

, no-bottl.|C

max

należy

wyznaczyć posługując się danymi p

ij

, przy czym dla maszyn P

1

, P

3

należy

skorzystać z rekurencyjnej zależności:

c

(i),j

= max { c

(i-1),j

, c

(i),j-1

} + p

(i),j

t 0

1

2

3

4

5

6

7

8

9 10 11 12

13 14 15

P

2

P

1

Z

3

Z

3

Z

5

Z

5

Z

1

Z

1

Z

4

Z

4

Z

2

Z

2

Rys. 1.7. Diagram Gantta uszeregowania.

min ( p

(i),1

, p

(k),2

) min ( p

(k),1

, p

(i),2

)

min ( p

(i),1

, p

(i+1),2

) min (p

(i+1),1

, p

(i),2

)

min {p

i1

} max {p

i2

}

i i

lub

min {p

i3

} max {p

i2

}

i i

.

18

zaś dla maszyny P

2

z zależności:

c

(i),j

= c

(i),j-1

+ p

(i),j

Dla przypadku dominacji P

1

nad P

2

spełniony jest warunek:

min {p

i1

} max {p

i2

}

i i

(

P

2

zdominowany przez P

1

)

p

ik

Z

1

Z

2

Z

3

Z

4

Z

5

P

1

3

3

2

2

3

P

2

1

2

2

1

1

P

3

3

1

1

3

1

p

’

ik

Z

1

Z

2

Z

3

Z

4

Z

5

P

1

4

5

4

3

4

P

2

4

3

3

4

2

A

: < Z

4

, Z

1

>

B

: < Z

2

, Z

3

, Z

5

>

Optymalne uszeregowanie zadań: < Z

4

Z

1

Z

2

Z

3

Z

5

>

P

3

P

2

P

1

Z

4

Z

4

Z

1

Z

2

Z

1

Z

2

Z

3

Z

3

Z

5

Z

5

Z

4

Z

1

Z

2

Z

3

Z

5

Ścieżka krytyczna

Rys. 1.8. Diagram Gantta uszeregowania. Wartość funkcji kryterialnej C

max

(*)

= c

*(n),3

= 15

t 0

1

2

3

4

5

6

7

8

9 10 11 12

13 14 15

.

19

W przypadku dominacji P

3

nad P

2

spełniony jest warunek:

1.6.2. Jednomaszynowe problemy szeregowania

Stopień złożoności problemów szeregowania zależy od liczby maszyn,

struktury zadań oraz od charakteru i liczby dodatkowych ograniczeń. Z tego punktu

widzenia, problemy jedno-maszynowe zalicza się do najprostszych, pomimo iż

wiele z nich należy już do klasy problemów NP-trudnych

.

Zasadność badań problemów jednomaszynowych można uzasadnić kilkoma

względami:

-

problemy te są przydatne jako problemy pomocnicze przy rozwiązywaniu

bardziej złożonych zagadnień szeregowania,

-

wykazane dla nich własności szczególne mogą być przeniesione przez

analogię na bardziej złożone zagadnienia,

-

stanowią podstawę metodologii rozwiązywania wielu problemów NP-

trudnych.

P

3

p

ik

Z

1

Z

2

Z

3

Z

4

Z

5

P

1

3

1

3

3

1

P

2

1

2

2

1

2

3

2

2

3

3

(

P

2

zdominowany przez P

3

)

p

’

ik

Z

1

Z

2

Z

3

Z

4

Z

5

P

1

4

3

5

4

3

P

2

4

4

4

4

5

A

: < Z

2

, Z

5

, Z

1

, Z

4

>

B

: < Z

3

>

Optymalne uszeregowanie zadań: < Z

2

Z

5

Z

1

Z

4

Z

3

>

min {p

i3

} max {p

i2

}

(1.11)

i i

Diagram Gantta uszeregowania:

P

3

P

2

P

1

Z

2

Z

2

Z

1

Z

4

Z

5

Z

4

Z

3

Z

3

Z

2

Z

5

Z

1

Z

5

Z

1

Z

4

Z

3

Rys. 1.9. Wartość funkcji kryterialnej C

max

(*) = c

*(n),3

= 16

t 0

1

2

3

4

5

6

7

8

9 10 11 12 13 14 15 16

.

20

Rozważane zostaną jednomaszynowe problemy z kryteriami optymalizacji C

max

,

oraz L

max

. Zbiór indeksów zadań oznaczmy przez N = {l, 2, ... , n}. Każde

zadanie ma ustalony, znany czas wykonywania p

i

>0, iN. Rozwiązaniem

problemu jest harmonogram wykonania zadań, reprezentowany przez wektory

terminów ich rozpoczęcia s = (s

1

... , s

n

) oraz zakończenia c=(c

1

, ... , c

n

).

W praktyce rozwiązanie jest charakteryzowane przez jeden z tych wektorów,

ponieważ istnieje wzajemnie jednoznaczna zależność c

i

= s

i

+ p

i

.

Jeśli funkcja celu jest regularna, np. C

max

, L

max

, to harmonogram optymalny

jest dosunięty w lewo na osi czasu, co oznacza, że zadania rozpoczynają się

w najwcześniejszym dopuszczalnym momencie. Rozwiązania optymalnego

poszukuje się tylko w zbiorze takich harmonogramów.

W przypadku jednej maszyny, każdy taki harmonogram może być

jednoznacznie reprezentowany kolejnością wykonywania zadań, ta zaś z

kolei jest reprezentowana permutacją = ((1), (2), …, (n)) na zbiorze N.

Dla danej permutacji , terminy zakończenia wykonywania określone są

wzorem rekurencyjnym

gdzie: (0) = 0, c

0

= 0.

Dla kryterium C

max()

=c

(n)

każda permutacja jest optymalna, bowiem wartość

sumy (1.13) nie zależy od permutacji .

1. Zagadnienie: 1r

j

C

max

Rozważane jest zagadnienie uwzględniające terminy gotowości zadań r

j

, dla

których zachodzi r

j

s

j

, i=1,2,..,n. Zagadnienie to opisywane jest symbolem

klasyfikacyjnym 1r

j

C

max

, rozwiązywane jest przez wielomianowy algorytm

o złożoności O( n log n). W celu wyznaczenia rozwiązania generujemy permutację

, odpowiadającą uporządkowaniu zadań według niemalejących wartości r

j

, a

następnie wyznaczamy odpowiednie terminy zakończenia wykonywania zadań,

wykorzystując wzór rekurencyjny:

c

(j)

= max{r

(j)

, c

(j-1)

} +p

(j)

, j = l, ... , n,

(1.14)

wówczas wartość funkcji kryterialnej wynosi C

rnax

()=c

(n)

.

c

(i)

= c

(i-1)

+ p

(i)

i=1,2,...,n

(1.12)

c

(j)

=

j

i=1

p

(i)

j=1,…, n

(1.13)

.

21

Rozwinięcie wzoru rekurencyjnego (1.14) prowadzi do wyrażenia na terminy c

j

c

(j)

= max

1ij

(r

(i)

+

j

k=i

p

(k)

),

j=1,2,…,n

(1.15)

implikującego wzór określający C

max

() postaci:

C

max

() = max

1in

(r

(i)

+

j

k=i

p

(k)

),

j=1,2,…,n

(1.16)

Innym praktycznym uogólnieniem problemu jest wprowadzenie czasów q

j

,

mających sens niekrytycznych czynności zakończeniowych (wymagających tylko

upływu czasu, lecz nie angażujących maszyny), wykonywanych po zasadniczej

obsłudze zadania na maszynie.

2. Zagadnienie: 1q

j

C

max

Problem 1q

j

C

max

, jest symetryczny do problemu 1r

j

C

max

. Symetria ta

oznacza, że podstawiając r

j

= q

j

, optymalne wartości funkcji kryterialnej obu

problemów są sobie równe, zaś permutacje optymalne są wzajemnie odwrotne.

Rozwiązanie problemu 1q

j

C

max

można wyznaczyć poprzez zastosowanie

własności wynikającej z symetrii. Istnieje rozwiązanie optymalne, w którym

zadania są wykonywane w kolejności nierosnących wartości q

j

.

Generujemy zatem permutację odpowiadającą uporządkowaniu zadań według

nierosnących wartości q

j

(złożoność obliczeniowa O(n log n)), wyznaczamy

terminy ich zakończenia ze wzoru (1.12), następnie obliczamy wartość funkcji celu

z zależności:

C

max

() = max

1in

(c

(i)

+ q

(i)

)

(1.17)

Wykorzystując zależność

(1.13)

otrzymujemy:

C

max

() = max

1in

(

i

k=1

p

(k)

+ q

(i)

)

(1.18)

3. Zagadnienie: 1L

max

Istnieje rozwiązanie optymalne problemu szeregowania 1L

max

, w którym

zadania są wykonywane w kolejności niemalejących wartości żądanego terminu

zakończenia d

j

.

Generowana jest permutacja odpowiadającą uporządkowaniu zadań według

niemalejących wartości d

j

, a następnie wyznaczane są odpowiednie terminy

rozpoczęcia i zakończenia wykonywania zadań ze wzoru (1.12). Wartość funkcji

celu obliczamy z zależności:

.

22

L

max

()=max

jN

L

j

=max

jN

(c

j

- d

j

)= max

1jn

(

j

i=1

p

(i)

+d

(j)

) (1.19)

Złożoność obliczeniowa algorytmu O(nlgn).

1.6.3. Zadania podzielne

Dążenie do konstruowania algorytmów szeregowania o jak najmniejszej

złożoności obliczeniowej jest szczególnie istotne w przypadku systemów

komputerowych, gdyż algorytmy te często wchodzą w skład procedury

szeregującej systemu operacyjnego. W związku z tym stosuje się algorytmy,

których funkcja złożoności obliczeniowej jest ograniczona od góry przez

wielomian od rozmiaru rozwiązywanego zagadnienia.

1. Zagadnienie: P| prm |C

max

Z punktu widzenia rozważanego kryterium C

max

możliwość przerywania

wykonywania zadań jest korzystna. W tym przypadku czas wykonania zadań nie

może być mniejszy niż większa z dwóch wartości: najdłuższy z czasów

wykonywania poszczególnych zadań i średni czas wykonywania wszystkich zadań

przez maszyny. Powyższy algorytm zawsze dostarcza uszeregowania, a jego

optymalność wynika z faktu, że długość tego uszeregowania jest zawsze określona

wzorem C*

max

a zatem jest minimalna.

Algorytm McNaughtona R.

1.

Wyznaczyć wartość:

C*

max

= max {max

i=1,...,n

{ p

i

},

i=1,..n

p

i

/ m}, Rozpocząć wykonywanie

dowolnego zadania na dowolnym procesorze w chwili t = 0.

2.

Wybrać dowolne nieuszeregowane jeszcze zadanie i rozpocząć jego

wykonywanie na tej samej maszynie w chwili zakończenia wykonywania

poprzedniego zadania. Powtarzać ten krok do chwili, gdy wszystkie

zadania zostaną uszeregowane lub t = C*

max

.

3.

Część zadania pozostającą do wykonania po osiągnięciu t = C*

max

przydzielić do innej wolnej maszyny, rozpoczynając jej wykonanie od

chwili t=0. Wykonać krok 2.

Złożoność algorytmu jest O(n), ponieważ każde zadanie jest rozpatrywane tylko

raz, natomiast czas z tym związany jest stały i niezależny od zadań.

.

23

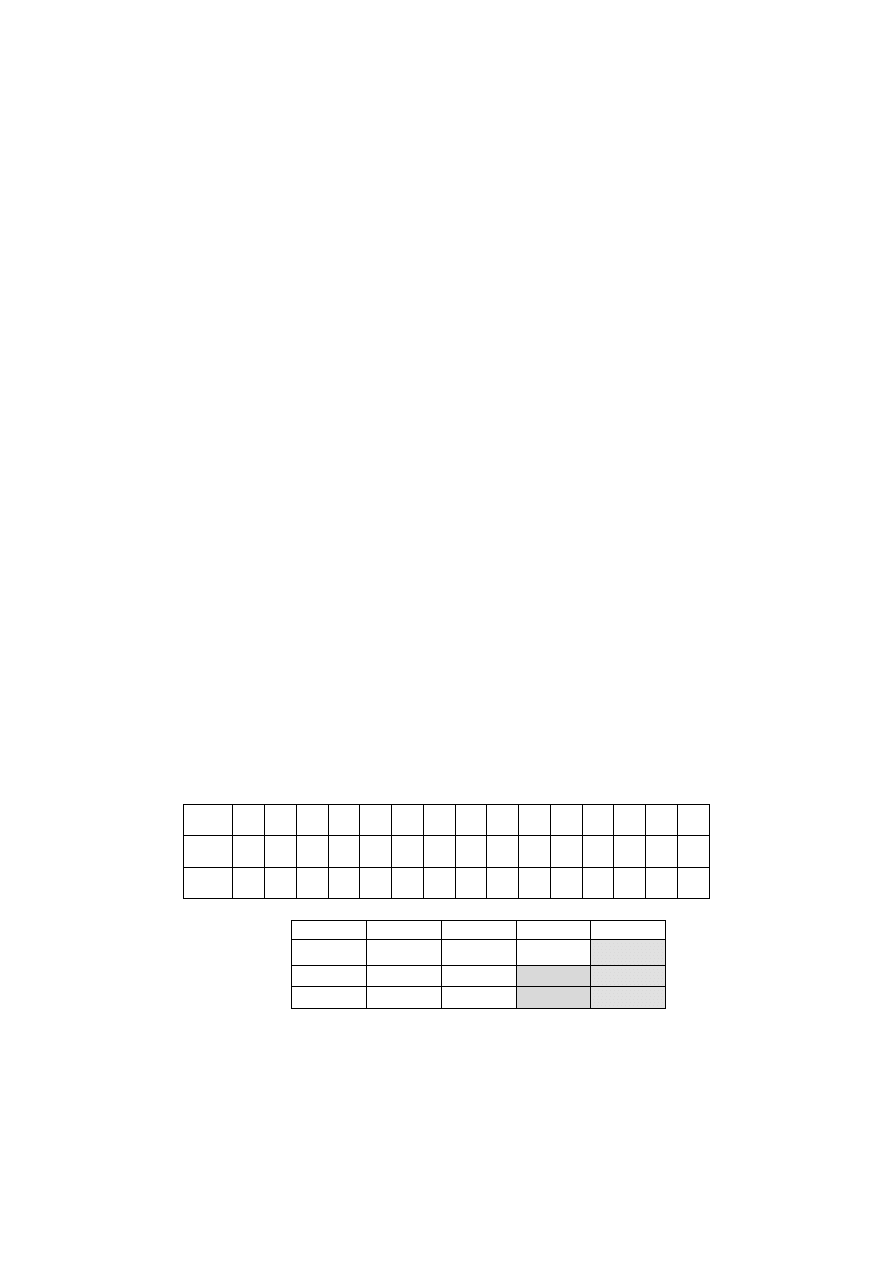

Przykład.

n=5, m=3,

Wersja1.

{p

j

}={3, 6, 4, 1, 3}

i=1,...,5

p

i

=17, max {p

i

} =6,

C

max

*=max{17/3, 6}=6

Wersja2.

{p

j

}={4, 5, 4, 3, 2}

i=1,...,5

p

i

=18, max {p

i

} =5,

C

max

*=max{18/3, 5}=6

W przypadku zadań niepodzielnych problem minimalizacji długości

uszeregowania jest NP-zupełny.

2.

Zagadnienie: P| p

i

=1, in–tree|C

max

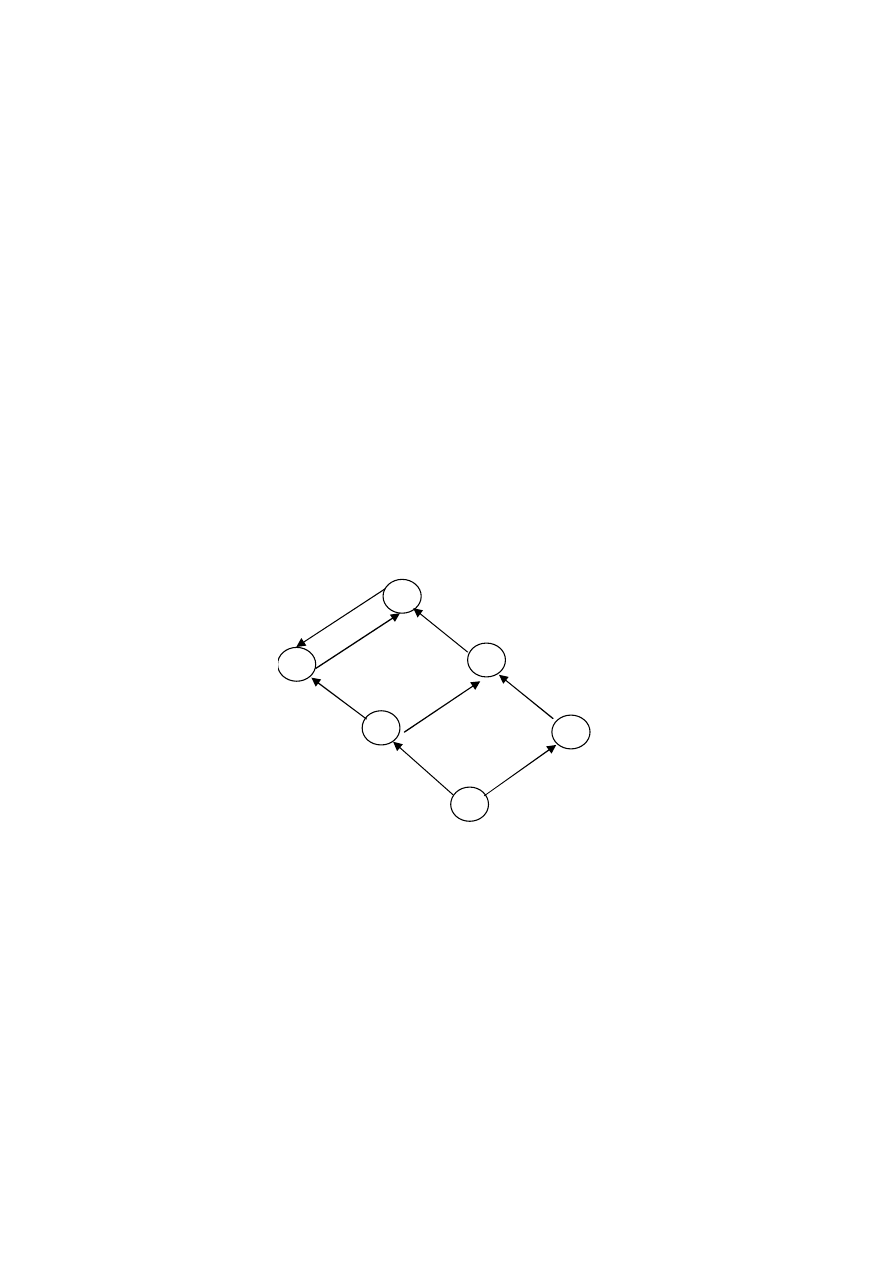

Ze specyfikacji zagadnienia wynika założenie o jednostkowych czasach

wykonania zadań, a ponadto zbiór zadań tworzy digraf typu drzewo. Poziom

zadania określa się jako liczba węzłów na drodze od węzła reprezentującego

zadanie do korzenia drzewa. Zadanie jest gotowe do wykonania jeżeli wcześniej

wykonane zostały wszystkie zadania poprzedzające.

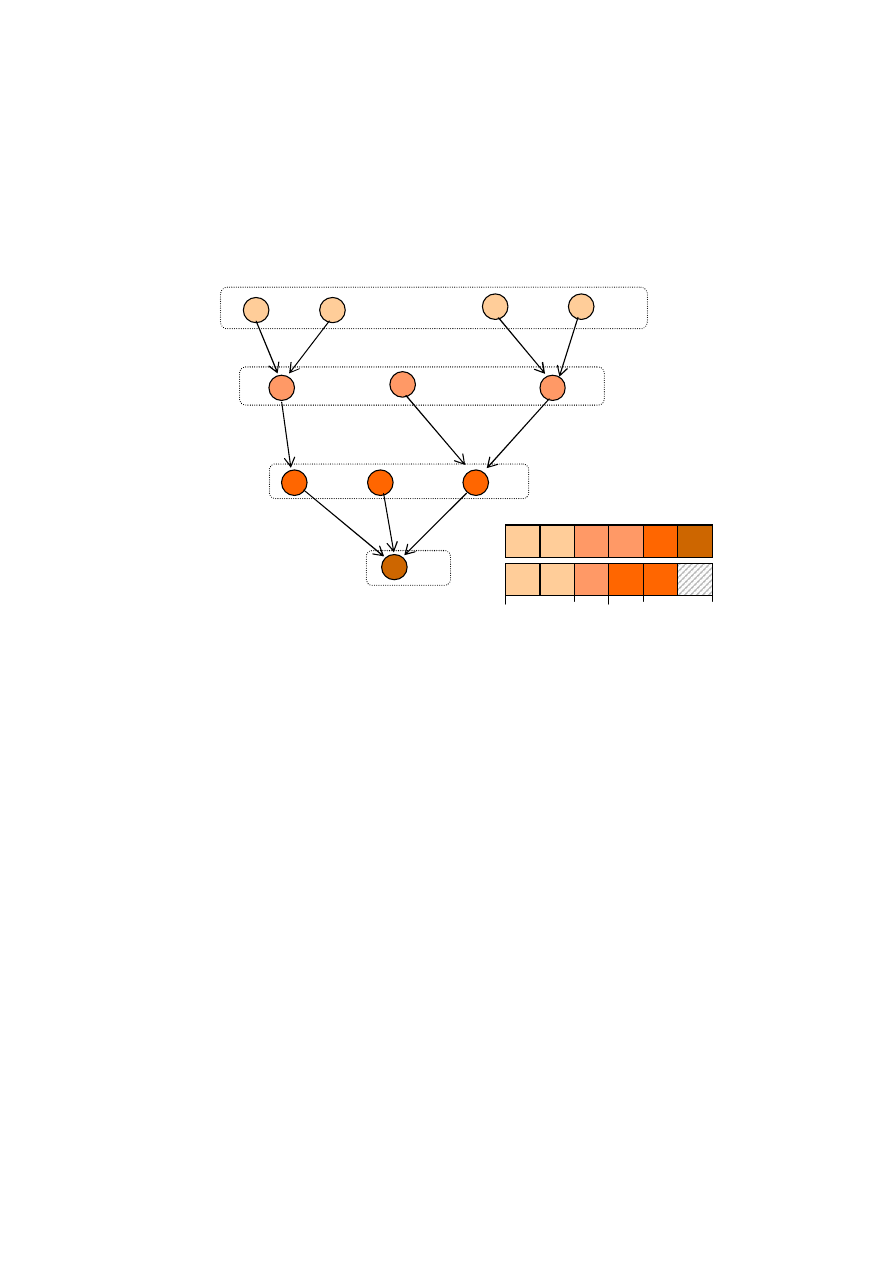

Algorytm polega na szeregowaniu listowym, według nierosnącego poziomu zadań

z uwzględnieniem ograniczeń kolejnościowych.

Algorytm szeregowania listowego.

1. Określić poziomy zadań.

2. Jeśli liczba zadań bez poprzedników jest mniejsza lub równa m, to

przydzielić tym zadaniom maszyny, wykonać p.3. W przeciwnym

przypadku wybrać spośród nich m zadań o najwyższych poziomach i

przydzielić im maszyny.

3. Usunąć wybrane zadania z grafu. Powtarzać p. 2 dopóki wszystkie zadania

nie zostaną wykonane.

Złożoność obliczeniowa algorytmu O(n).

2

6

4

0

P

1

P

2

Z

5

Z

3

P

3

Z

3

Z

4

Z

2

Z

1

Z

2

2

6

4

0

P

1

P

2

Z

4

Z

3

P

3

Z

3

Z

2

Z

1

Z

2

Z

5

.

24

Przykład: n=11, m=2

Złożoność algorytmu wynika z liczby łuków w digrafie typu in-tree.

1.6.4. Minimalizacja opóźnienia

Kryterium L

max

jest uogólnieniem kryterium C

max

, zagadnienia NP–trudne dla

C

max

pozostaną też NP–trudne w przypadku L

max

. Intuicyjnie, szeregując zadania z

różnymi wymaganymi terminami zakończenia deadline spóźnimy się „najmniej”

zaczynając zawsze od „najpilniejszego” zadania. Reguła EDD bazuje na

uszeregowaniu zadań w kolejności niemalejących wymaganych terminów

zakończenia.

1. Zagadnienie: 1|r

j

, prm, prec|L

max

Dla zadań podzielnych, szeregowanych na jednym procesorze można podać

algorytm wielomianowy optymalny dla dowolnych ograniczeń kolejnościowych i

różnych momentów uwolnienia zadań. Polega on na określeniu wartości

zmodyfikowanych terminów zakończenia i szeregowaniu zadań w kolejności

niemalejących ich wartości.

1

2

3

4

Z

1

Z

2

Z

3

Z

4

Z

5

Z

6

Z

7

Z

8

Z

10

Z

11

Z

9

2

6

4

0

P

2

Z

2

Z

4

Z

6

Z

8

Z

10

P

1

Z

1

Z

3

Z

5

Z

7

Z

9

Z

11

.

25

Algorytm Liu C.L.

1. Określić dla każdego zadania Z

j

(j=1,2,…,n) zmodyfikowane terminy

zakończenia:

d

j

*

=min{d

j

, min{d

i

:Z

j

Z

i

}}

2. Przydzielić procesor dostępnemu zadaniu Z

j

, które ma najmniejszą wartość

d

j

*

. Zadanie wykonywane jest tak długo, dopóki nie zakończy się, albo nie

będzie dostępne zadanie Z

k

, dla którego d

k

*

< d

j

*

, wtedy wykonywanie

zadanie Z

j

będzie przerwane.

3. Powtarzać p. 2 dopóty, dopóki wszystkie zadania nie zostaną wykonane.

Złożoność obliczeniowa algorytmu O(n

2

).

Z

1

Z

2

Z

3

Z

4

Z

5

Z

6

Z

7

p

j

3

2

2

1

4

1

2

r

j

0

4

2

5

6

15

15

d

j

4

6

8

15

10

20

25

Z

7

Z

6

Z

5

Z

1

Z

3

Z

2

Z

4

2

6

4

0

Z

1

Z

3

Z

5

Z

4

Z

3

Z

2

8

10

12

Z

6

Z

7

14

18

16

1.10. Uszeregowanie optymalne L

*

max

= 2

d

j

*

4

6

8

10

10

20

25

.

26

Złożoność obliczeniowa algorytmu.

Graf o n wierzchołkach zawiera co najwyżej n(n-1)/2 łuków, wyznaczenie d

*

j

,

j=1, 2, ..., n, może być przeprowadzona w O(n

2

) krokach.

Rozpatrzmy punkty 2 i 3 oraz niekorzystny przypadek zadań niezależnych.

Uszeregowanie zadań dostępnych w chwili t=0 według rosnących wartości

zmodyfikowanych terminów zakończenia wykonywania ma złożoność równą

O(n log n). W chwili przybycia nowego zadania średnia liczba obsługiwanych i

oczekujących (łącznie) zadań wynosi bn, gdzie 0 b 1. Umieszczenie nowego

zadania w odpowiednim miejscu ciągu zadań, uszeregowanych zgodnie z

rosnącymi zmodyfikowanymi terminami zakończenia wykonywania, wymaga co

najwyżej O(n) kroków. Ponieważ przybyć może co najwyżej n zadań, zatem

złożoność obliczeniowa punktów 2 i 3 wynosi O(n

2

). Rząd złożoności algorytmu

jest również O(n

2

).

Możliwość przerywania zadań w przypadku problemu 1| prm, prec |L

max

nie

wpływa na wartość opóźnienia L

max.

. Wystarczy wykazać, że jeśli istnieje

uszeregowanie optymalne dla zadań podzielnych, to istnieje także uszeregowanie

dla zadań niepodzielnych o nie większej wartości L

max

. Implikacja odwrotna jest

słuszna, gdyż każde uszeregowanie dla zadań niepodzielnych jest jednocześnie

uszeregowaniem dla zadań podzielnych

2. Zagadnienie: P|p

j

=1, in–tree|L

max

Algorytm Bruckera P.,

Oznaczmy przez next(j) - bezpośredni następnik zadania Z

j

.

1. Podstawić d

root

*=1 – d

root

2.

Dla zadania Z

j

, j=2,3,..,n wyznaczyć zmodyfikowane terminy zakończenia:

d

j

* = max{1+ d

next(k)

*, 1– d

j

}

3. Uszeregować zadania w kolejności nie rosnących wartości ich zmody-

fikowanych terminów zakończenia, zgodnie z ograniczeniami kolejnoś-

ciowymi.

.

27

Złożoność obliczeniowa algorytmu O(n log n).

1.7. Szeregowanie zadań z dodatkowymi zasobami

Oznaczmy przez R zbiór dodatkowych zasobów (discretely-divisible resources):

R={R

1

, R

2

, ..., R

s

}.

W ogólności, zadanie Z

j

Z jest scharakteryzowane przez wektor żądań zasobo-

wych

R(Z

j

) = [R

1

(Z

j

), R

2

(Z

j

), ..., R

s

(Z

j

)]

gdzie: 0 R

v

(Z

j

) |R

v

|, v=1, 2, ..,s, oznacza liczbę jednostek zasobu R

v

potrzebną do wykonania zadania Z

j

.

Dla każdego 0 t,

j

R

k

(Z

j

) |R

v

|,

k=1, 2, ...,s, Z

j

A(t),

gdzie: A(t) - zbiór zdań wykonywanych w chwili t.

(-4

*

, 5)

(-1

*

, 2)

(-1

*

, 3)

(-2

*

, 3)

(0

*

, 4)

Z

1

Z

2

Z

3

Z

5

Z

6

Z

7

Z

8

Z

10

Z

9

Z

4

(-6

*

, 7)

(-5

*

, 6)

(0

*

, 2)

(0

*

, 2)

(-1

*

, 4)

(d

j

*

, d

j

)

L

*

max

= 0

2

4

0

P

2

P

3

Z

3

Z

2

Z

6

Z

5

Z

7

Z

9

Z

1

P

1

Z

4

Z

8

Z

10

5

2

.

28

Pole w notacji trójpolowej specyfikuje zadania i dodatkowe

zasoby jest postaci:

res

{ , k} - oznaczają odpowiednio: liczbę rodzajów dodatkowych zasobów,

ograniczenia zasobowe, żądania zasobowe zadań.

= k - oznaczają odpowiednio: k rodzajów dodatkowych zasobów, k jednostek

każdego rodzaju, żądania zasobowe każdego zadania nie przekraczają k

jednostek każdego zasobu.

= - liczba rodzajów dodatkowych zasobów, ograniczenia oraz żądania

zasobowe są dowolne.

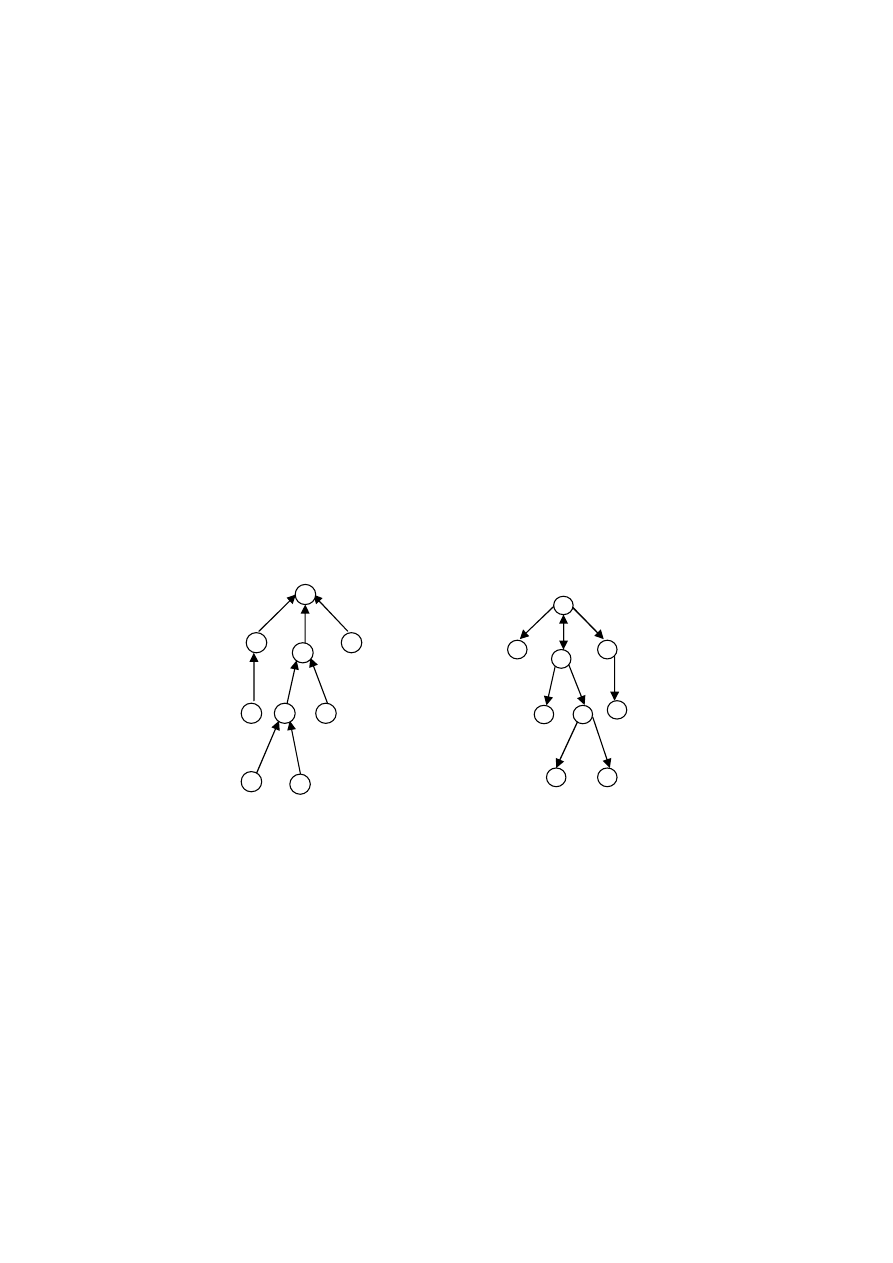

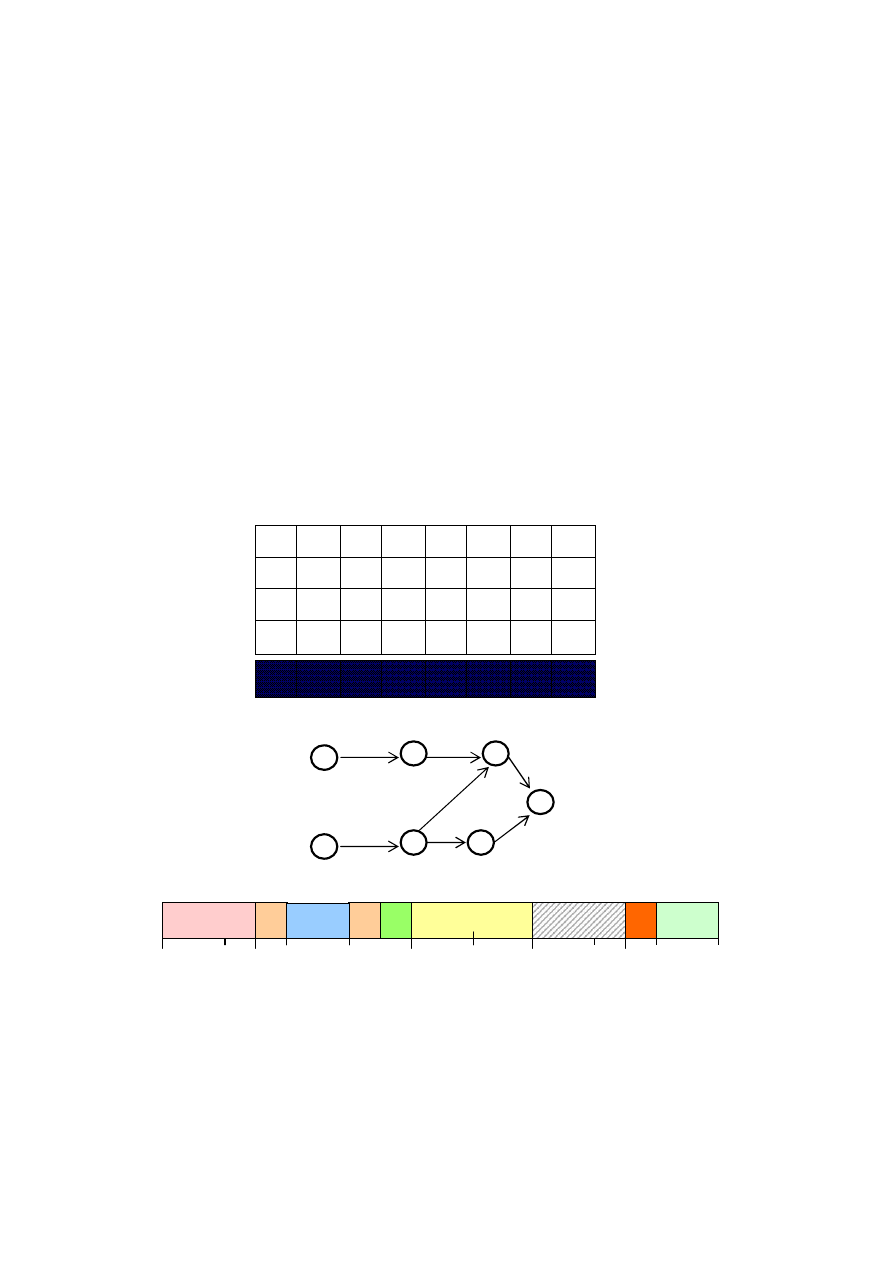

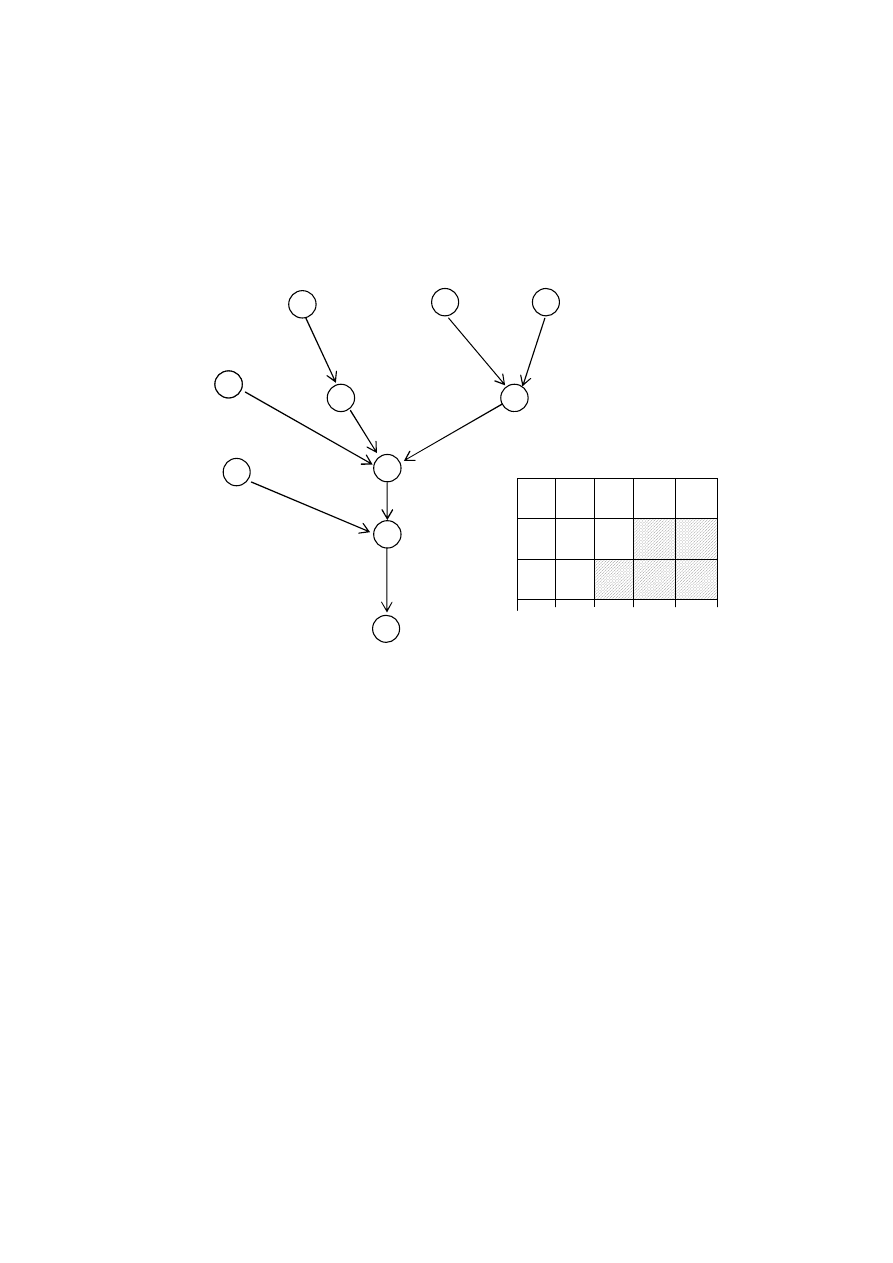

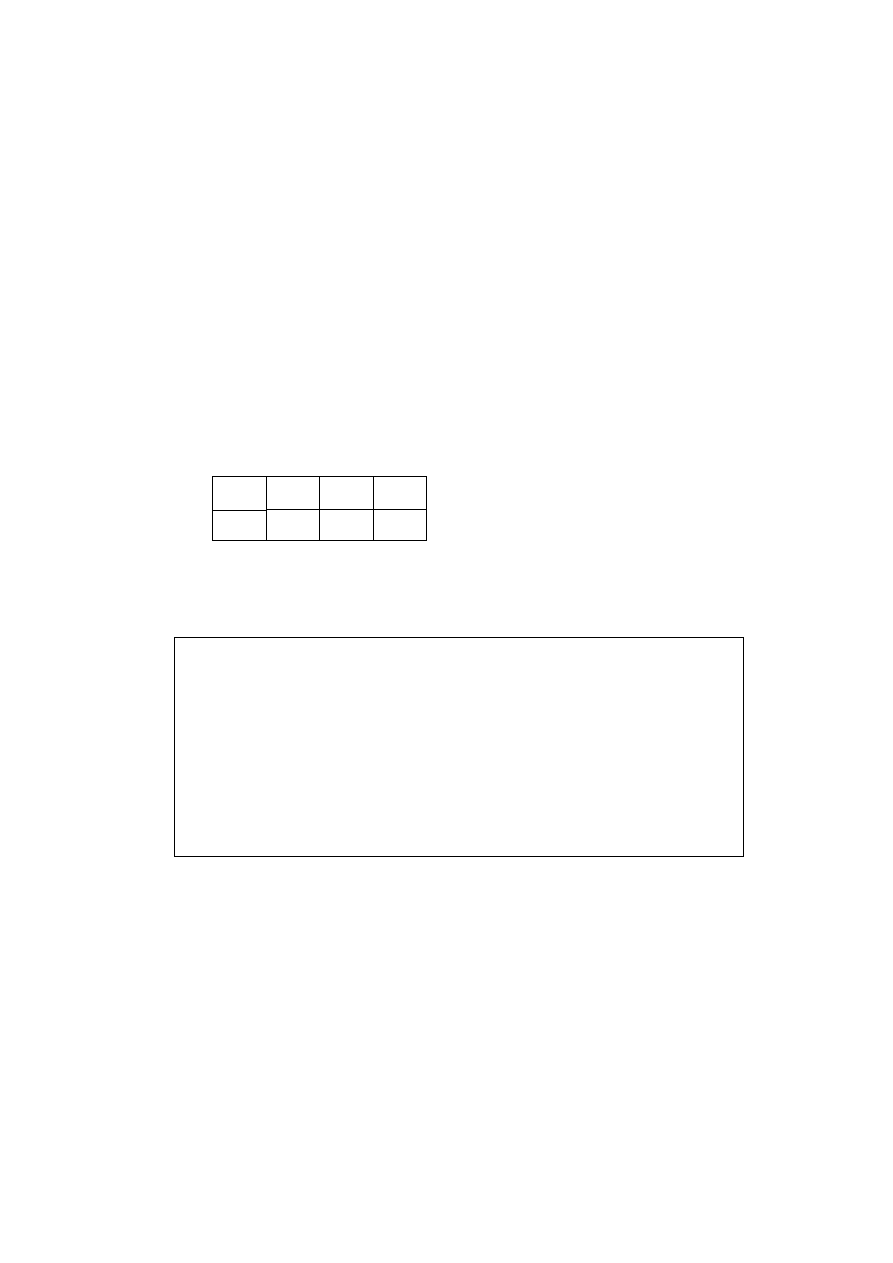

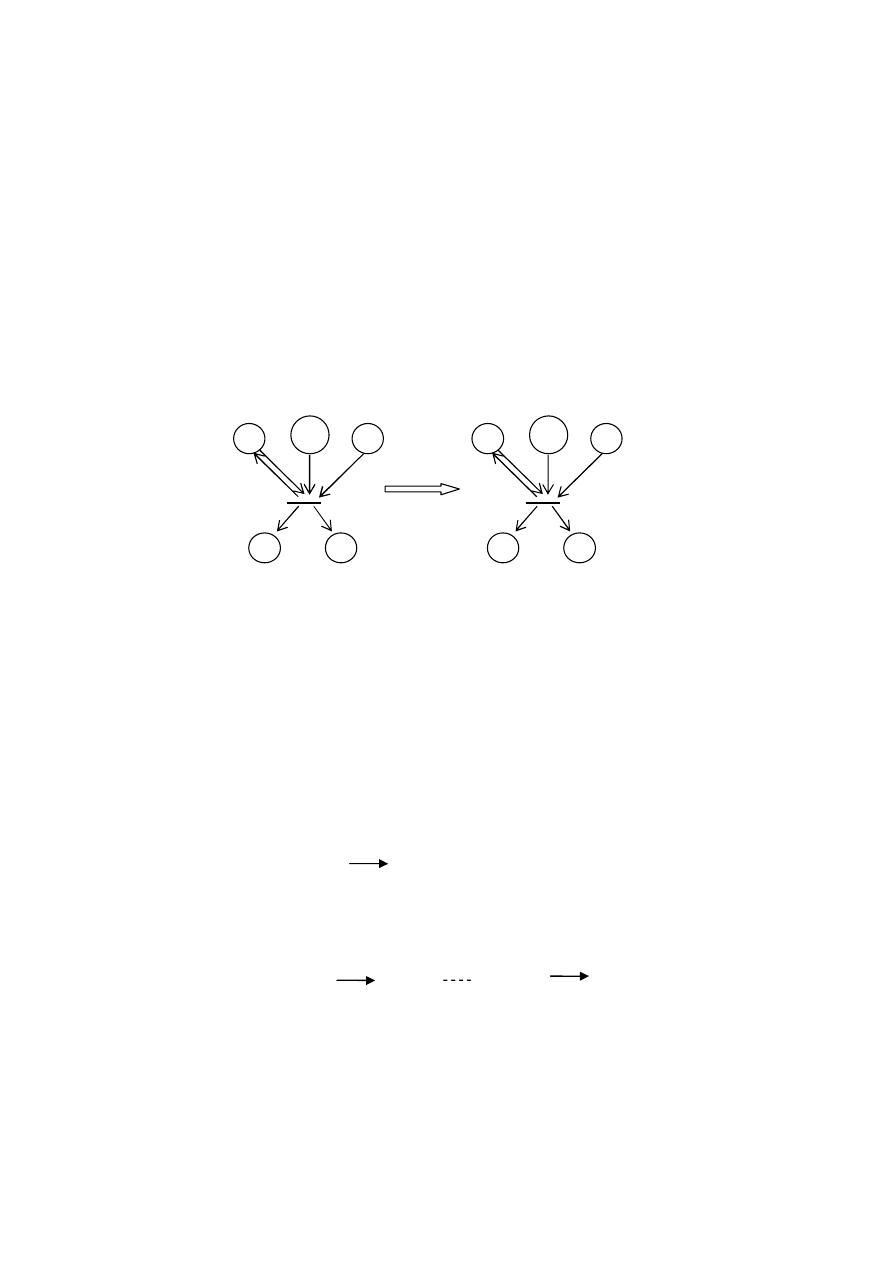

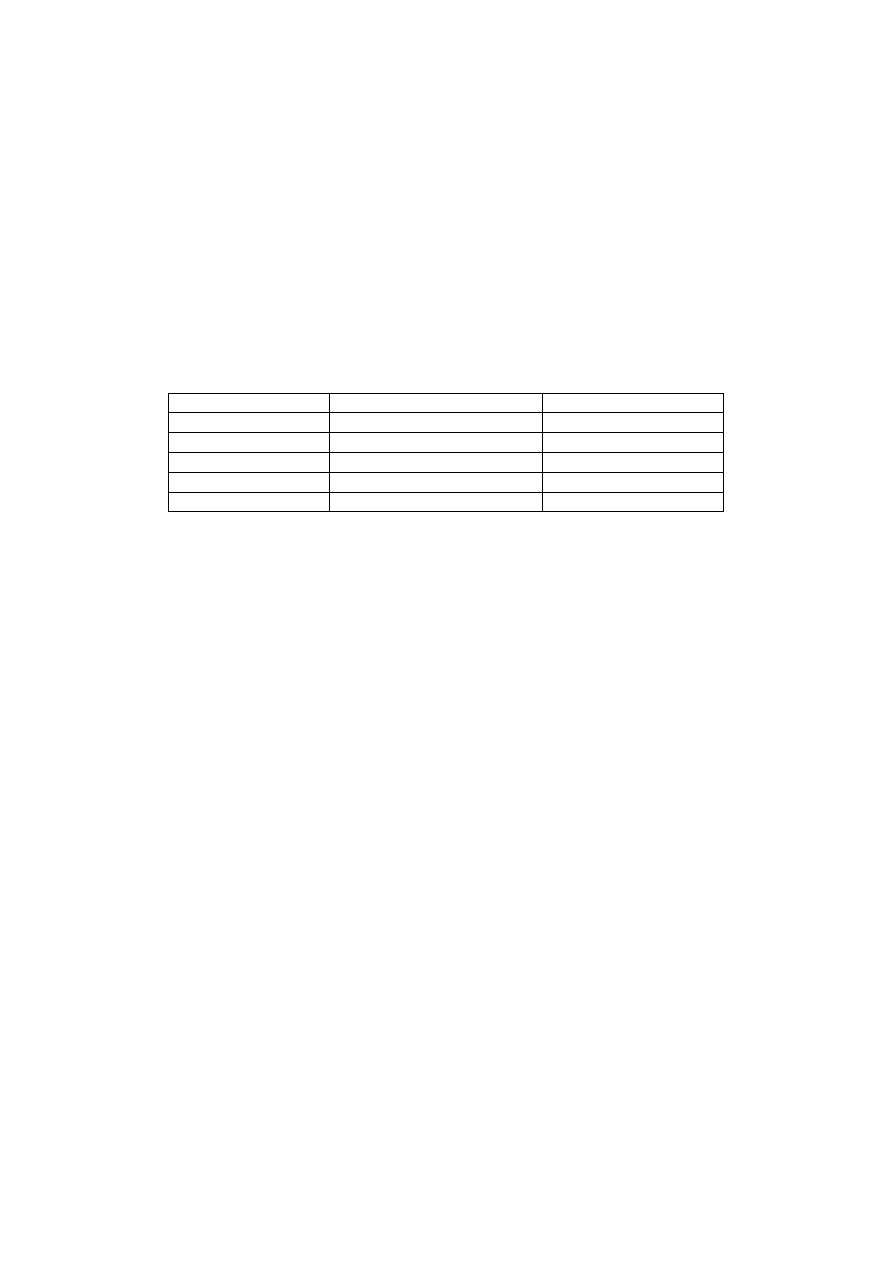

Poniższy diagram jest schematem uogólnień pomiędzy problemami

szeregowania z ograniczonymi zasobami

Wierzchołki grafu reprezentują problemy szeregowania różniące się jedynie

liczbą rodzajów dodatkowych zasobów, ograniczeniami lub żądaniami

zasobowymi zadań. Łuki wskazują kierunek uogólnienia problemów.

Udowodnienie NP-zupełności wybranego problemu implikuje NP-zupełność tych

problemów, do których prowadzi skierowana ścieżka od danego problemu NP-

res ...

res 1..

res 1.1

res 111

res .11

res ..1

Rys. 1.11. Wielomianowa transformowalność pomiędzy problemami

szeregowania z ograniczeniami zasobowymi.

.

29

zupełnego. Podobnie jeśli dany problem należy do klasy P, to wszystkie problemy

leżące na ścieżkach prowadzących do niego także należą do klasy P.

Wykazanie np NP-zupełności problemu scharakteryzowanego żądaniami

zasobowymi res111, implikuje NP-zupełność wszystkich pozostałych problemów o

identycznych parametrach i jakichkolwiek założeniach dotyczących dodatkowych

zasobów.

1.7.1. Minimalizacja długości uszeregowania.

Specyfikacja rozwiązywanego problemu: Pr

j

, p

j

=1, res11C

max

Algorytm (złożoność obliczeniowa O(n)).

1.

t=0, k=0.

2. Przydzielić w chwili t do wolnej maszyny dostępne zadanie Z

j

, dla którego

R

1

(Z

j

)=1, podstawić k=k+1.

Powtarzać ten punkt dopóty, dopóki albo k=|R

1

|, albo nie będzie zadania o

powyższych własnościach.

3. Przydzielić do pozostałych wolnych maszyn w chwili t, dostępne zadania,

dla których R

1

(Z

i

)=0. Podstawić t=t+1 oraz k=0 i powtórzyć p.2 jeśli są

jeszcze nie przydzielone zadania.

Optymalność algorytmu wynika z faktu, że w każdej chwili zapewnia on

maksymalne wykorzystanie maszyn i dodatkowego zasobu, minimalizując długość

uszeregowania a tym samym średni czas przepływu przez system zadań.

Algorytm sprawdza każde zadanie jednokrotnie. Ponieważ czas związany z takim

sprawdzeniem jest stały O(1), niezależnie od zadania, więc złożoność algorytmu

jest T(n)=n O(1) = O(n).

Z

1

2

3

4

5

6

7

8

9 10 11 12 13 14 15

R

1

(Z

i

)

1

0

0

1

1

1

0

0

0

1

1

0

1

0

1

r

i

3

2

0

1

0

2

2

1

0

0

1

2

0

1

4

P

1

Z

5

Z

13

Z

11

Z

1

Z

15

P

2

Z

10

Z

4

Z

6

Z

12

P

3

Z

3

Z

8

Z

2

P

4

Z

9

Z

14

Z

7

Rys. 1.12. Uszeregowanie wg. algorytmu dla |R

v

| = 2

0 1 2 3 4 5

.

30

Szeregowanie zadań podzielnych z ograniczonymi zasobami. Specyfikacja

rozwiązywanego problemu: Pprm, res11C

max

.

Algorytm (złożoność obliczeniowa O(n)).

1. Wyznaczyć minimalną długość uszeregowania

C*

max

= max { max

j

{p

j

},

j=1,n

t

j

/m,

ZjZR

p

j

/|R

1

|}

(ZR - zbiór zadań, dla których R

1

(Z

j

) = 1, m-liczba procesorów).

Podstawić t = 0.

2. Jeżeli są nie przydzielone zadania należące do zbioru ZR, rozpatrzyć dowolne

z nich, (założymy Z

j

)

, w przeciwnym przypadku wykonaj p. 3.

Jeśli t+p

j

C*

max

, przydzielić Z

j

do pierwszego wolnego procesora w

przedziale czasu [t, t+p

j

], podstawić t = t + p

j

.

W przeciwnym przypadku przydzielić Z

j

do tego procesora w przedziale

[t, C*

max

] i do następnego wolnego procesora w przedziale [0, p

j

– (C*

max

– t)]

oraz podstaw t = p

j

– (C*

max

- t). Powtórz p. 2.

3. Jeżeli są jeszcze nieprzydzielone zadania, przydzielić je w ten sam sposób jak

zadania ze zbioru ZR w p. 2. W przeciwnym przypadku STOP.

Wartość C*

max

jest minimalną długością uszeregowania, nie może być krótsze niż

maksymalna spośród trzech wartości:

1.

najdłuższego czasu wykonywania zadania,

2.

wartości średniej czasu wykonywania zadania przez jedną maszynę,

3. czasu wykonywania zadań o żądaniu zasobowym równym jednej jednostce

zasobu przypadającego na jednostkę tego zasobu.

Szeregując zadania według powyższego algorytmu nie przekroczymy wartości

C

*

max

. Analizując złożoność obliczeniową powyższego algorytmu należy

zauważyć, że każde zadanie rozpatrywane jest jednokrotnie a ponieważ liczba

kroków związana z tym jest stała zatem złożoność algorytmu jest T(n)=O(n).

.

31

1.8. Szeregowanie zadań cyklicznych

W celu uporządkowania zbioru współbieżnych zadań cyklicznych nadaje się im

priorytety. Strategia doboru priorytetów oraz zasada posługiwania się nimi

określona jest algorytmem szeregowania. Ze względu na przyczynę podejmowania

decyzji szeregujących wyróżniamy:

- szeregowanie wymuszane czasem (clock driven scheduling),

-

szeregowanie wymuszane zdarzeniami (event driven scheduling).

W szeregowaniu wymuszanego czasem decyzje szeregujące podejmowane są w

specyficznych, często ustalonych z góry chwilach czasu. Gdy parametry zadań są

znane apriori, plan szeregowania można ułożyć w postaci tabeli (szeregowanie

cykliczne).

W przypadku szeregowania wymuszanego zdarzeniami decyzje podejmowane

są gdy zachodzą określone zdarzenia np.: zadanie staje się gotowe do wykonania,

procesor jest zwalniany przez bieżące zadanie lub zmienia się priorytet zadania.

Procedura szeregująca może być uaktywniona gdy wystąpiło przerwanie sprzętowe

lub wewnętrzne (wyjątek), albo też proces bieżący wykonał wywołanie systemowe.

Algorytmy szeregowania zadań cyklicznych, w szczególności dotyczących

systemów czasu rzeczywistego (real time systems) opierają się na podstawowym

modelu zadnia, w którym czas dyskretny biegnie od chwili początkowej t=0.

Zadanie (task) Z

i

=(p

i

, T

i

, d

i

) jest charakteryzowane przez następujące parametry:

p

i

- czas wykonania zadania (processing time),

T

i

- okres (period) występowania zadania,

d

i

- względne ograniczenie czasowe zadania (relative deadline), odniesione do

chwili wystąpienia żądania wykonania zadania.

Względne ograniczenie czasowe zadania oznacza limit czasu, przed upływem

którego procesor powinien zakończyć jego wykonanie. Zwykle takie ograniczenie

czasowe jest mniejsze lub równe okresowi występowania zadania. Okres

występowania zadania T

i

, czas jego wykonania p

i

oraz ograniczenie czasowe d

i

powinny spełniać warunek:

i

i

i

T

d

p

.

.

32

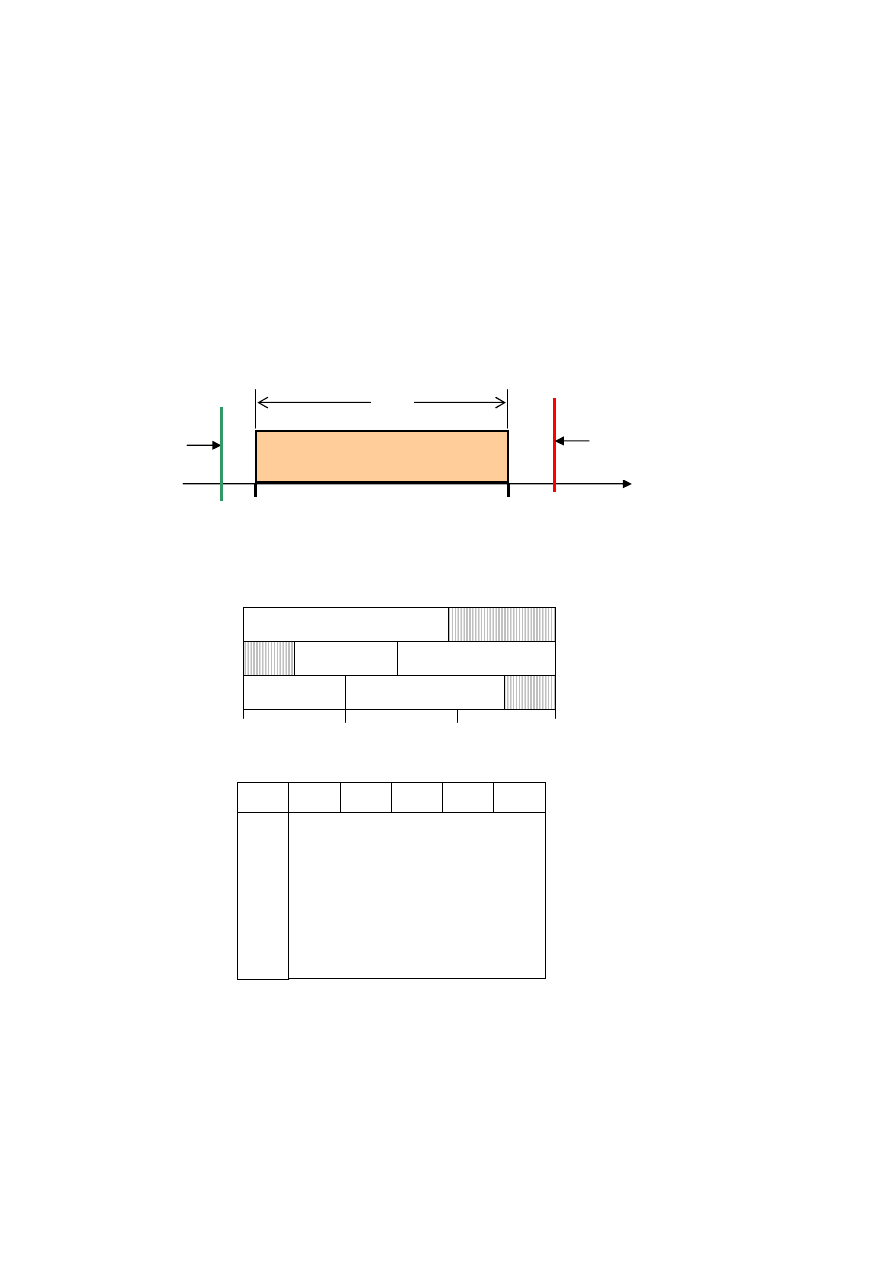

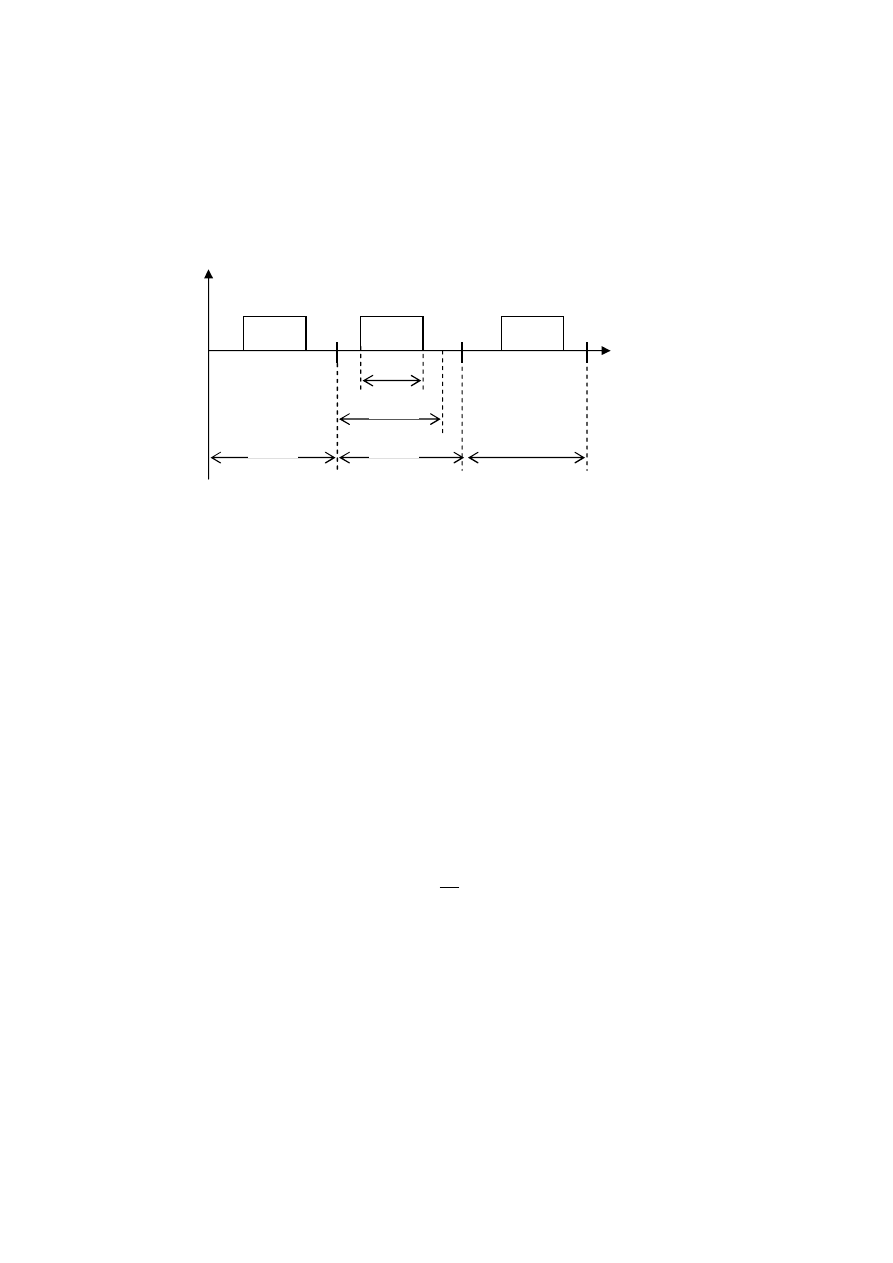

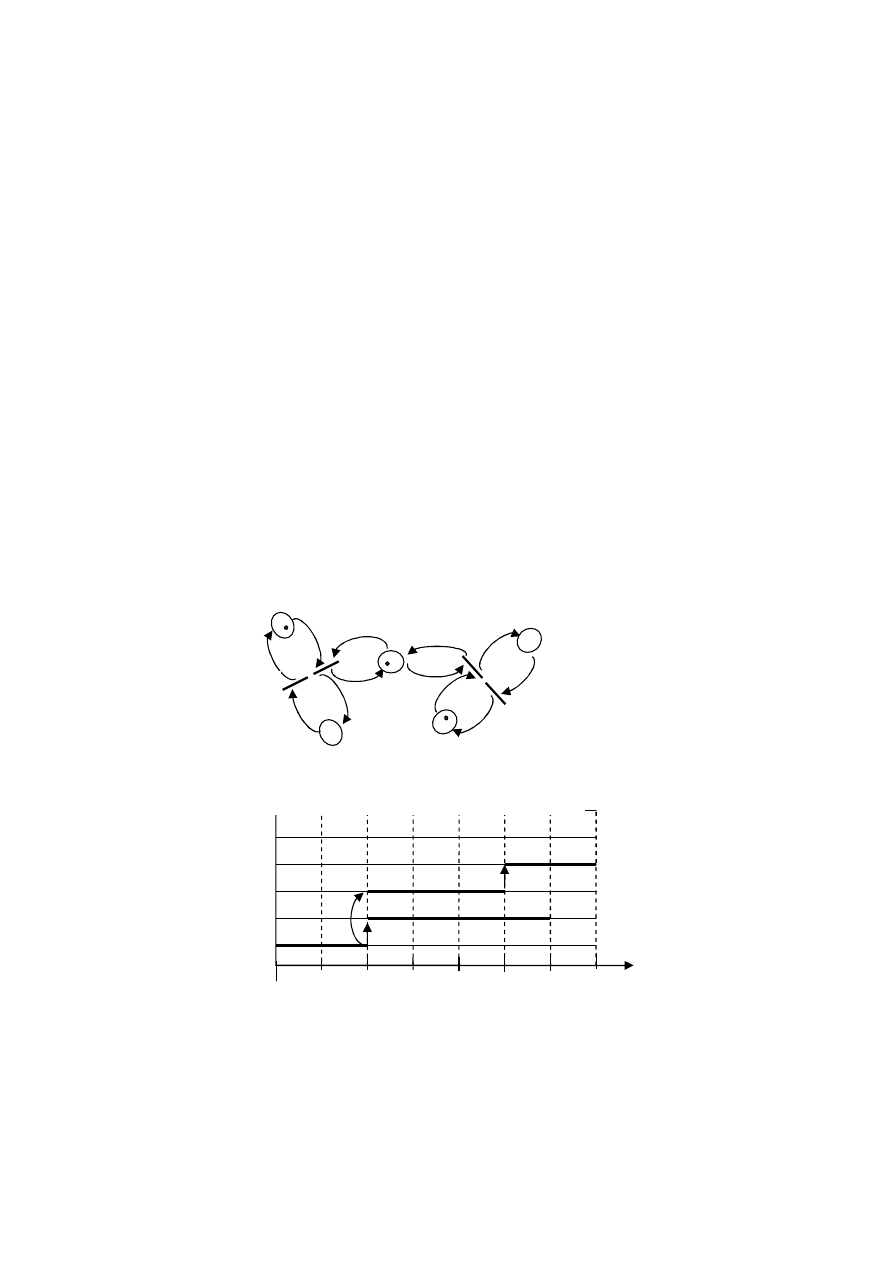

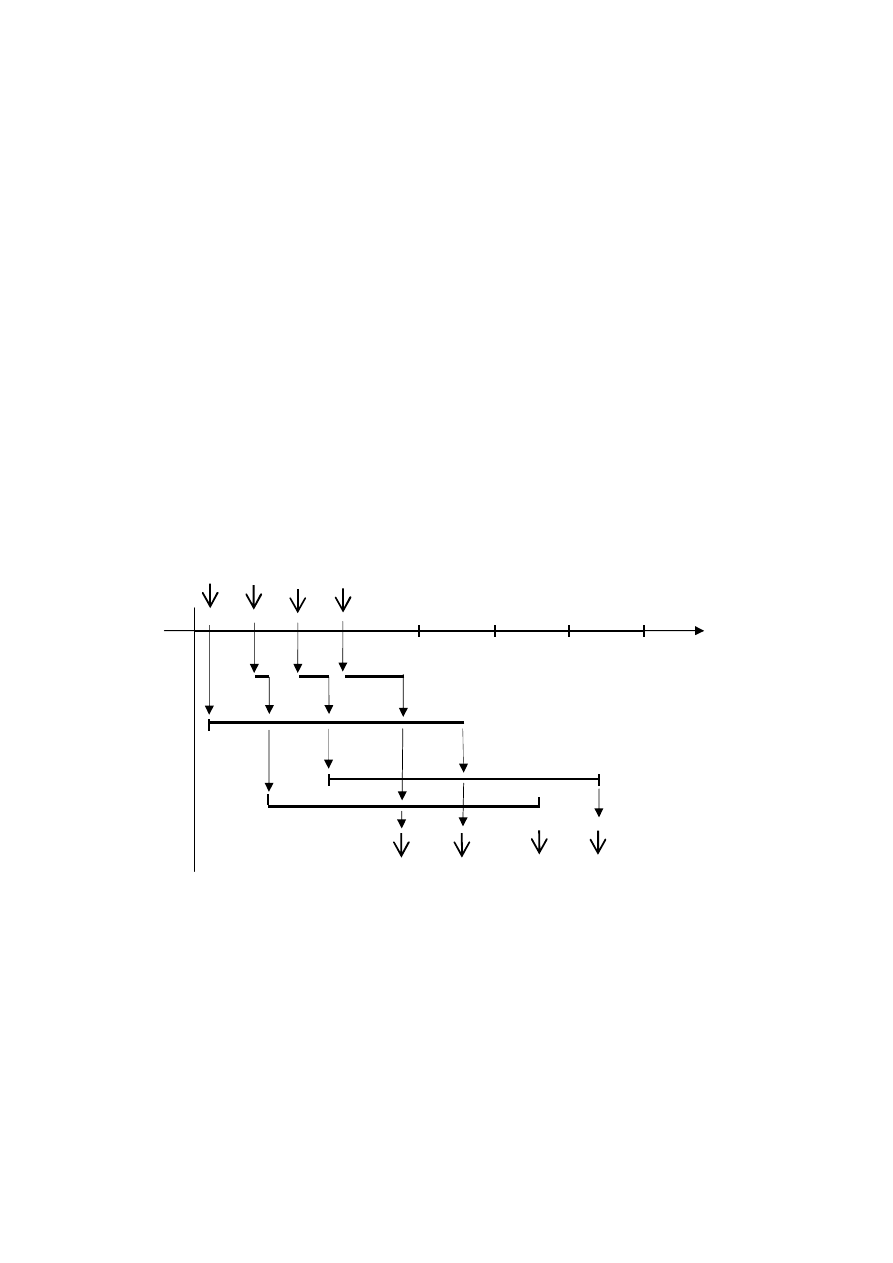

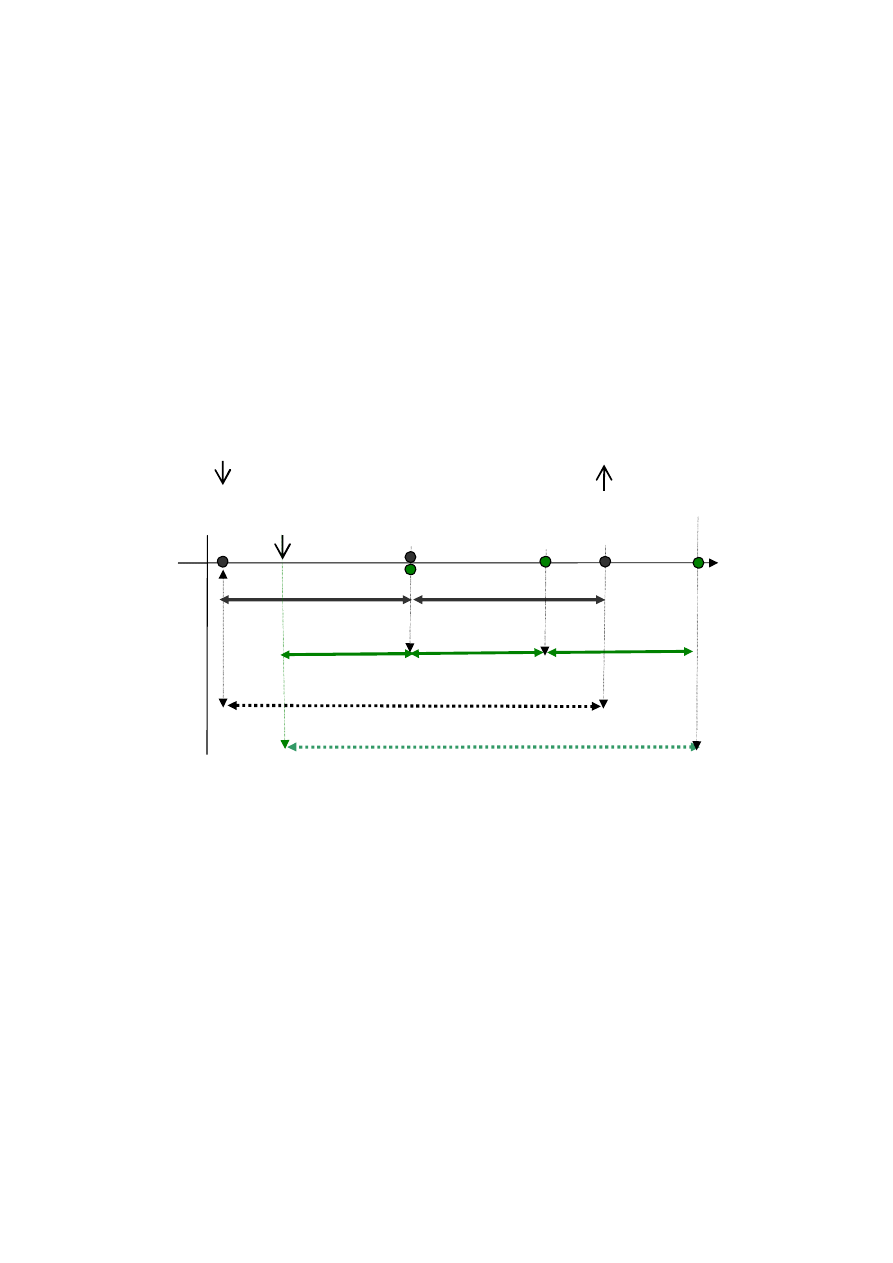

Parametry czasowe zadania cyklicznego przedstawia poniższy rysunek.

Własności zadań cyklicznych:

-

wszystkie zadania są cykliczne ze znanym okresem T

i

pomiędzy kolejnymi

wystąpieniami,

-

wszystkie instancje zadania mają niezmienny czas wykonania p

i

,

-

zadania są od siebie niezależne, dopuszcza się ich wywłaszczanie,

-

zadania wykonywane są cyklicznie z założoną częstotliwością określoną na

podstawie wymagań danej aplikacji (np. wolna, szybka pętla obliczeń).

Implementacją zadania jest sekwencyjny program uruchamiany w

dyskretnych chwilach t

i

takich, że t

i+1

=t

i

+T

i

. Instancje (kolejne wystąpienia)

zadania periodycznego są regularnie aktywowane ze stałą częstotliwością i

mają ten sam najdłuższy czas wykonywania WCET (Worst Case Execution

Time). Wszystkie instancje zadania mają tą samą wartość względnego

ostatecznego terminu zakończenia. Współczynnik wykorzystania procesora

definiowany jest następująco:

n

i

i

i

T

p

U

1

(1.20)

Współczynnik ten opisuje obciążenie procesora podczas wykonywania zbioru

zadań cyklicznych.

Dla różnych algorytmów szeregowania i różnych zbiorów zadań współczynnik U

może przyjmować różne graniczne wartości, dla których dany zbiór zadań jest

szeregowalny tzn. może wykonać wszystkie swoje obliczenia w zadanych

ograniczeniach czasowych.

t

p

i

Z

i

Z

i

Z

i

d

i

T

i

T

i

T

i

Rys. 1. 13. Parametry czasowe zadania cyklicznego

.

33

Celem algorytmu szeregowania zadań cyklicznych jest takie ustalenie kolejności

ich wykonywania, aby żadne zadanie nie przekroczyło swojego żądanego terminu

zakończenia. Jeżeli istnieje taka kolejność mówimy, że zbiór zadań jest

szeregowalny. Ewentualne włączanie nowego zadania do systemu odbywa się

według ściśle określonej procedury (mode change protocol). Zadania sporadyczne

są uwzględniane poprzez traktowanie ich jako zadania cykliczne, o okresie

równym minimalnemu czasowi pomiędzy kolejnymi wystąpieniami tego typu

zadań.

Wiele aplikacji w szczególności aplikacji czasu rzeczywistego składa się ze

zbioru zadań wykonywanych cyklicznie (odczyt danych sensorycznych, pętle

sterowania, monitorowanie). Często stosowaną metodą szeregowania takich zadań

jest przydzielanie priorytetu, wówczas w danej chwili jest uruchamiane zadanie o

najwyższym priorytecie. Podstawowe algorytmy priorytetowe do szeregowania

zadań cyklicznych:

1. RMS (Rate Monotonic Scheduling) – algorytm monotoniczny w częstotliwości.

2. EDD (Earliest Due Date) – pierwszy z najmniejszą wartością względnego

ograniczenia czasowego („najwcześniejsza linia krytyczna najpierw”).

3. CE (Cyclic Executive) - wykonywanie cykliczne.

1.8.1. Algorytmy priorytetowe

I. Algorytm RMS.

Algorytm RMS jest algorytmem statycznym. Działanie algorytmu oparte jest na

systemie priorytetów przydzielanych do poszczególnych zadań w ten sposób, że im

krótszy okres, tym wyższy priorytet. Stosowanie tej zasady wynika z faktu, że

zadania występujące częściej zazwyczaj są ważniejsze od zadań występujących

rzadziej.

System niezależnych, wywłaszczanych zadań cyklicznych ze względnymi

ograniczeniami czasowymi równymi ich okresom tj. d

i

= T

i

, może mieć poprawny

harmonogram na jednym procesorze utworzony przez algorytm RMS, jeśli

współczynnik wykorzystania procesora spełnia warunek konieczny:

1

1

n

i

i

i

T

p

(1.21)

Powyższy warunek na szeregowalność zadań wynika z faktu, że łączny stopień

wykorzystania czasu pracy procesora przez wszystkie zadania nie może być

większy niż 100%. Warunek wystarczający pozwalający na weryfikację spełnienia

warunków czasowych i gwarantujący, że n zadań zostanie wykonanych przed

.

34

upływem ich ograniczenia czasowego został podany przez Liu i Laylanda i wyraża

się wzorem:

)

1

2

(

/

1

1

n

n

i

i

i

gr

n

T

p

U

(1.22)

Dla dużych wartości n , U

gr

= ln2 0.69 co oznacza, że każdy zbiór zadań,

dla którego współczynnik wykorzystania procesora jest 0.69 zawsze będzie

szeregowalny. Jeśli dla danego zbioru zadań współczynnik wykorzystania

procesora U mieści się w przedziale U

gr

U 1 to zbiór ten może nie być

szeregowalny. Wówczas dla rozstrzygnięcia należy rozważyć przypadek najgorszy

(worst case), dla którego wszystkie zadania podlegające szeregowaniu wchodzą

jednocześnie w stan gotowości. Jeżeli każde z rozważanych zadań zostanie

zakończone przed upływem swego ograniczenia czasowego, to dany zbiór zadań

jest szeregowalny.

Algorytm RMS, spośród priorytetowych algorytmów statycznych, wyznacza

uszeregowanie optymalne, w tym sensie że jeżeli nie są utrzymywane ograniczenia

czasowe, to żaden inny algorytm z tej klasy również ich nie dotrzymuje.

II. Algorytm EDD.

Systemy, w których podczas pracy priorytet przydzielany zadaniu, może zostać

zmieniony nazywamy systemami z dynamicznym przydziałem priorytetu.

Przykładem

dynamicznego

przydziału

priorytetu

jest

algorytm

EDD

wykorzystujący zasadę zgodnie, z którą najwyższy priorytet przydzielany jest

zadaniu, któremu najwcześniej kończy się ograniczenie czasowe. Algorytm EDD

jest ogólnym algorytmem szeregującym zbiory zadań w oparciu o jeden procesor,

przy czym żądany termin wykonania każdego z zadań jest równy jego okresowi,

ponadto zadania są niewywłaszczalne.

Podstawą działania algorytmu EDD jest regularne aktualizowanie żądanych

terminów zakończenia zadań. Czynność ta wykonywana jest po wystąpieniu

każdego przerwania obsługiwanego przez moduł szeregujący tj. przerwania

zegarowego, pojawienia się nowego zadania czy też zakończenia wykonywania

aktualnego.

Zaletą metody dynamicznego przydziału priorytetu EDD, w porównaniu do

metod statycznego przydziału priorytetu RMS, jest lepsze wykorzystanie procesora.

Jej wadą jest większe obciążenie procesora czynnościami szeregowania podczas

pracy. Pojawiające się w systemie nieokresowe zadania traktowane są przez

algorytm analogicznie do zadań okresowych. Jedyną różnicą jest brak cyklicznego

ich wykonywania.

.

35

II. Algorytm CE.

Zastosowanie wykonywania cyklicznego CE to jedno z pierwszych i

popularnych podejść do szeregowania zadań cyklicznych. Procedura szeregująca

wywoływana jest w cyklu minimalnym (minor cycle). Cyklem głównym jest

najmniejsza wspólna wielokrotność z cykli poszczególnych zadań (T

1

, T

2

, ..., T

n

).

Plan szeregowania sporządzany jest dla cyklu głównego, w którym wszystkie

zadania przyporządkowane do procesora powinny zostać wykonane tak, aby

ograniczenia czasowe zadań nie zostały przekroczone.

Główny cykl określa maksymalny cykl w systemie.

Przyjmuję się, że względny

termin d

i

jest równy okresowi T

i

.

Cechami charakterystycznymi algorytmu CE są determinizm i brak wywłaszczeń.

Opracowanie tabeli wykonywania cyklicznego jest w ogólności trudne trudna

aktualizacja, powstaje problem z włączeniem zadań o długim okresie a także z

włączeniem zadań sporadycznych.

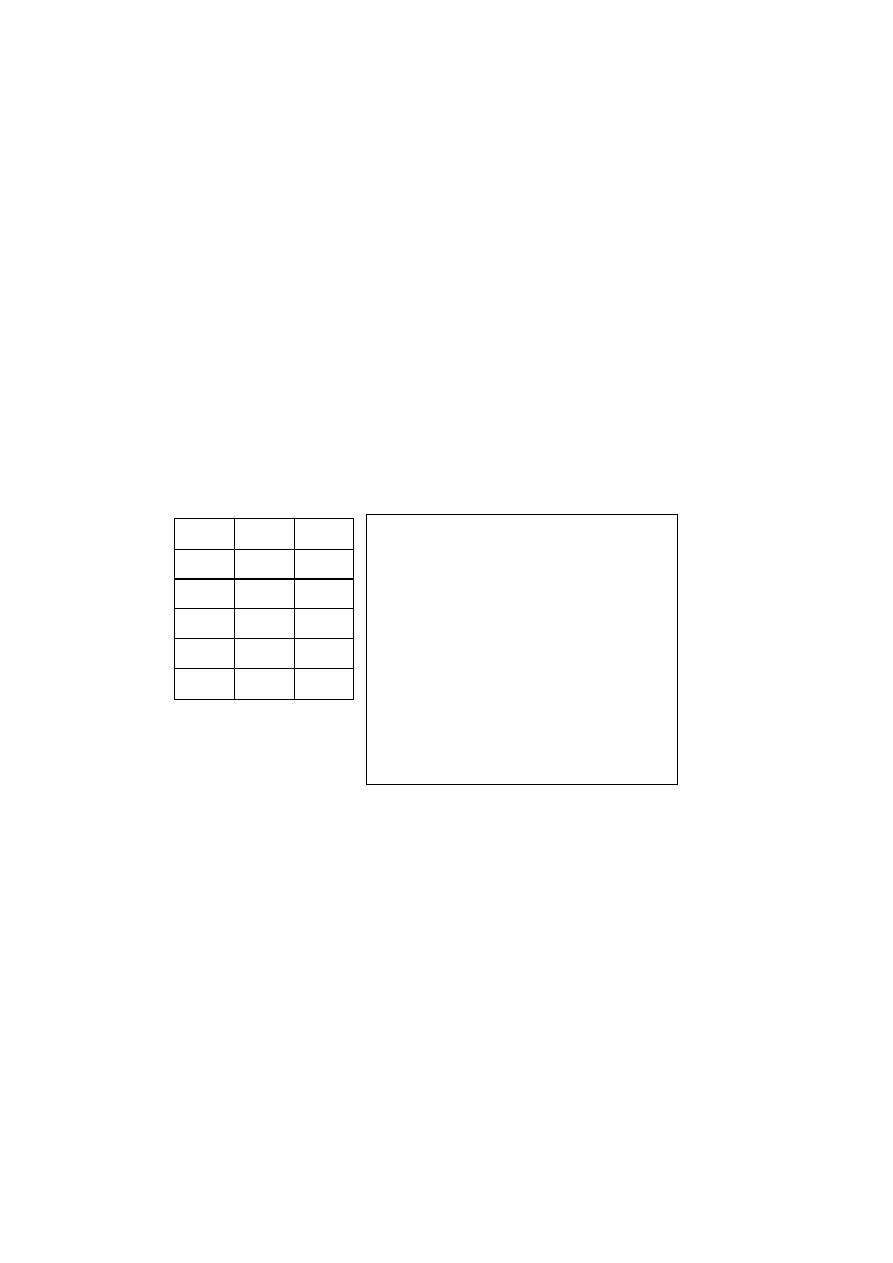

Z

i

T

i

p

i

Z

1

25

10

Z

2

25

8

Z

3

50

6

Z

4

50

4

Z

5

100

2

// Ustawić przerwania na 25 jedn.

DO {

wait_for_interrupt;

procedure Z

1

; procedure Z

2

;

procedure Z

3

;

wait_for_interrupt;

procedure Z

1

; procedure Z

2

;

procedure Z

4

; procedure Z

5

;

wait_for_interrupt;

procedure Z

1

; procedure Z

2

;

procedure Z

3

;

wait_for_interrupt;

procedure Z

1

; procedure Z

2

;

procedure Z

4

;

}

WHILE (1);

.

36

2. METODY OPTYMALIZACJI DYSKRETNEJ

Problemy szeregowania zadań najczęściej formułowane są w terminach

optymalizacji dyskretnej, w której zmienne decyzyjne przyjmują wartości,

całkowitoliczbowe lub binarne. Problemy te należą do klasy problemów

wyjątkowo trudnych z obliczeniowego punktu widzenia. Głównymi powodami

tych trudności jest częsty brak analitycznych własności oraz wieloekstremalność ze

znaczną liczbą ekstremów lokalnych. Istnienie wielu ekstremów, kłopotliwe już dla

przypadku optymalizacji ciągłej, nabiera dla problemów dyskretnych szczególnego

znaczenia. Bezpośrednią konsekwencją NP-trudności jest to, że czas obliczeń

odpowiedniego algorytmu komputerowego jest funkcją wykładniczą od rozmiaru

rozwiązywanego problemu.

W celu uniknięcia kłopotów, próbuje się zamiast rozwiązywać problem

dokładnie, wyznaczać jego rozwiązanie przybliżone. Z tego też powodu, dziedzina

deterministycznego szeregowania zadań charakteryzuje się znaczną rozmaitością

zarówno modeli jak i metod rozwiązywania, zwykle dedykowanych dla wąskich

klas zagadnień. Ograniczenie ogólności modeli ma na celu wykrycie tych

szczególnych własności problemu, których umiejętne wykorzystanie w algorytmie

zdecydowanie poprawia jego cechy numeryczne, takie jak czas obliczeń, czy

zbieżność do rozwiązania optymalnego. Często dla tego samego problemu NP-

trudnego występuje wiele różnych algorytmów o istotnie różnych cechach

numerycznych. Znajomość dziedziny zastosowań oraz metod rozwiązywania,

pozwala na właściwy dobór dla każdego nowo postawionego problemu

odpowiedniego algorytmu.

Rozważany problem optymalizacji dyskretnej zapisujemy jako zadanie

minimalizacji:

gdzie: K() - funkcja celu (kryterium optymalizacji), - dyskretny zbiór

rozwiązań dopuszczalnych, określonych przez zestaw warunków ograniczających.

Tak zdefiniowane problemy, w kontekście szeregowania są od wielu lat

przedmiotem intensywnych badań. W związku z tym istnieje duża ilość

różnorodnych podejść do rozwiązywania takich zagadnień.

Najogólniej, metody optymalizacji dyskretnej można podzielić na dokładne i

przybliżone. Do metod dokładnych można zaliczyć metody oparte na schemacie

podziału i ograniczeń (B&B), metody subgradientowe, metody programowania

całkowitoliczbowego czy też pewne algorytmy dedykowane do poszczególnych

zagadnień.

K*=

def

K(

*

) = min

K()

(2.1)

.

37

Współczesne wymagania dotyczące optymalizacji dyskretnej wymuszają

osiąganie rozwiązań bardzo szybko. Z tego względu trudna do zastosowania staje

się kosztowna metoda bezpośredniego przeglądu całej przestrzeni rozwiązań

dopuszczalnych. W takiej sytuacji pojawia się konieczność wypracowania zupełnie

nowych podejść do optymalizacji i sięgnięcie po prostsze, gorsze jakościowo , ale

za to szybsze metody przybliżone. Słuszność takiego przejścia jest tym bardziej

uzasadniona, że przy pomocy takich metod, wiele problemów uznawanych

dotychczas za trudne z obliczeniowego punktu widzenia, doczekało opracowania

szybkich technik rozwiązywania.

Metody przybliżone wyznaczają pewne rozwiązanie

A

takie, że:

Metody przybliżone są z reguły problemowo zorientowane. Podstawową ich cechą,

odróżniającą je od metod dokładnych, jest najczęściej brak formalnych dowodów

na ich zbieżność do rozwiązania optymalnego.

Z drugiej strony, rozwiązania znajdowane przez algorytmy przybliżone nie

tylko okazują się dobre w sensie oceny ich optymalności, ale także uzyskiwane są

w zdecydowanie krótszym czasie. Kolejną cechą algorytmów przybliżonych są

parametry sterujące. O ile w algorytmach dokładnych nie mają wpływu na

końcowe rozwiązanie, o tyle w przypadku technik heurystycznych ich znaczenie

jest duże. Wśród algorytmów przybliżonych wyróżnia się kilka klas, które

wzajemnie się przenikają. Najczęściej wyróżnia się algorytmy konstrukcyjne oraz

algorytmy typu ”popraw rozwiązanie”. Pierwsze z nich są metodami szybkimi,

łatwo implementowanymi, jednak generują rozwiązania obarczone względnie

dużym błędem przybliżenia. Do drugiej grupy należą algorytmy, które są

wolniejsze wymagają rozwiązania początkowego poprawianego następnie krokowo,

ale dostarczają rozwiązań o bardzo dobrej jakości. Algorytmy konstrukcyjne służą

do generowania rozwiązań początkowych dla metod bardziej ogólnych. Ważną

grupę metod stanowią algorytmy metaheurystyczne.

Optymalizacja dyskretna ma znaczenie w rozwiązywaniu praktycznych zagadnień

takich jak:

•

Szeregowanie zadań (Sequencing , Scheduling Problem)

•

Zagadnienie komiwojażera (Traveling Salesman Problem)

•

Problem osiągalności w grafie (Reachability problem)

•

Zagadnienie przepływu (Max-flow Problem)

•

Problem plecakowy (Knapsack Problem)

•

Problem przydziału (Assignment problem )

Zagadnienia te mają charakter kombinatoryczny i należą do optymalizacji

dyskretnej.

K(

A

) K(

*

)

(2.2)

.

38

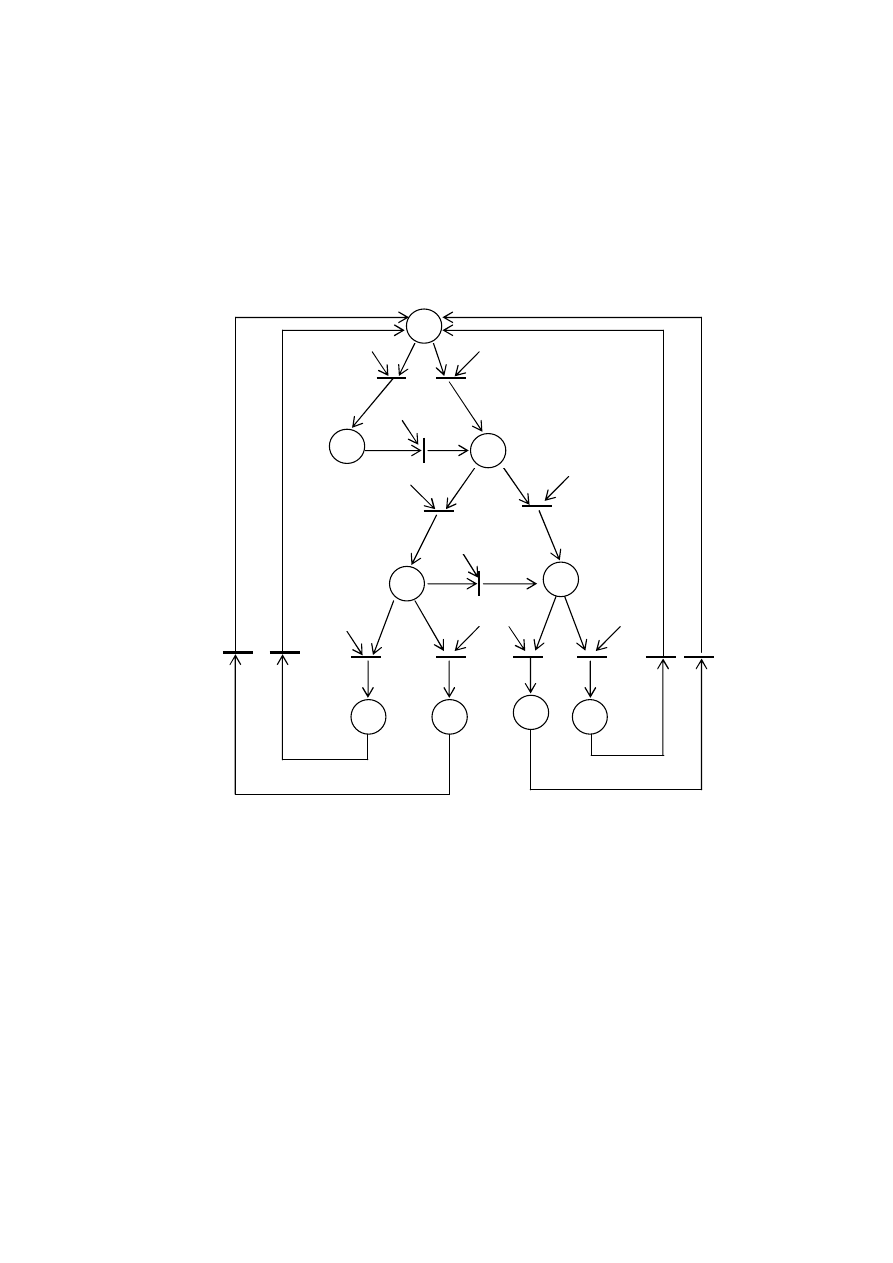

2.1. Metoda podziału i ograniczeń

Metoda podziału i ograniczeń B&B (Branch and Bound method) należy do

podstawowych metod wyznaczania optymalnych rozwiązań dla dyskretnych

problemów optymalizacyjnych. Dekompozycja zbioru rozwiązań dokonywana jest

tak długo aż dalszy podział jest niemożliwy, czego rezultatem jest drzewo podziału

(branching tree). W węzłach drzewa znajdują się częściowe rozwiązania,

natomiast w liściach odnajdziemy potencjalne rozwiązanie optymalne. Istotą

algorytmu B&B jest znalezienie dokładnego optymalnego rozwiązania bez

konieczności przeglądania całego drzewa rozwiązań cząstkowych.

Ogólna idea metody podziału i ograniczeń polega na uporządkowanym

przeszukiwaniu skończonego zbioru rozwiązań. Przegląd zupełny (pełny przegląd)

zbioru rozwiązań zastępujemy przeglądem ukierunkowanym. Pozwala to ocenić

pośrednio pewne podzbiory rozwiązań i ewentualnie je odrzucić lub czasowo

pominąć, bez utraty rozwiązania optymalnego, co znacznie przyspiesza uzyskanie

rozwiązania. Zbiór wszystkich rozwiązań dzieli się (branch), sukcesywnie na

coraz mniejsze podzbiory, a dla każdego podzbioru oblicza się dolną granicę ( w

przypadku minimalizacji) LB (Lower Bound) wartości funkcji celu.

Algorytm podziału i ograniczeń w każdym węźle drzewa podziału wylicza

wartość LB, które pozwala stwierdzić, czy węzeł ten jest „potencjalnie obiecujący”

do dalszego uwzględniania. Wartość ta jest granicą wartości rozwiązania, jakie

można uzyskać dzięki rozwinięciu tego węzła. Jeżeli wartość ta nie jest lepsza niż

wartość dotychczas znalezionego rozwiązania, węzeł jest oznaczany jako

„nieobiecujący”, w przeciwnym razie potencjalnie zawiera rozwiązanie optymalne.

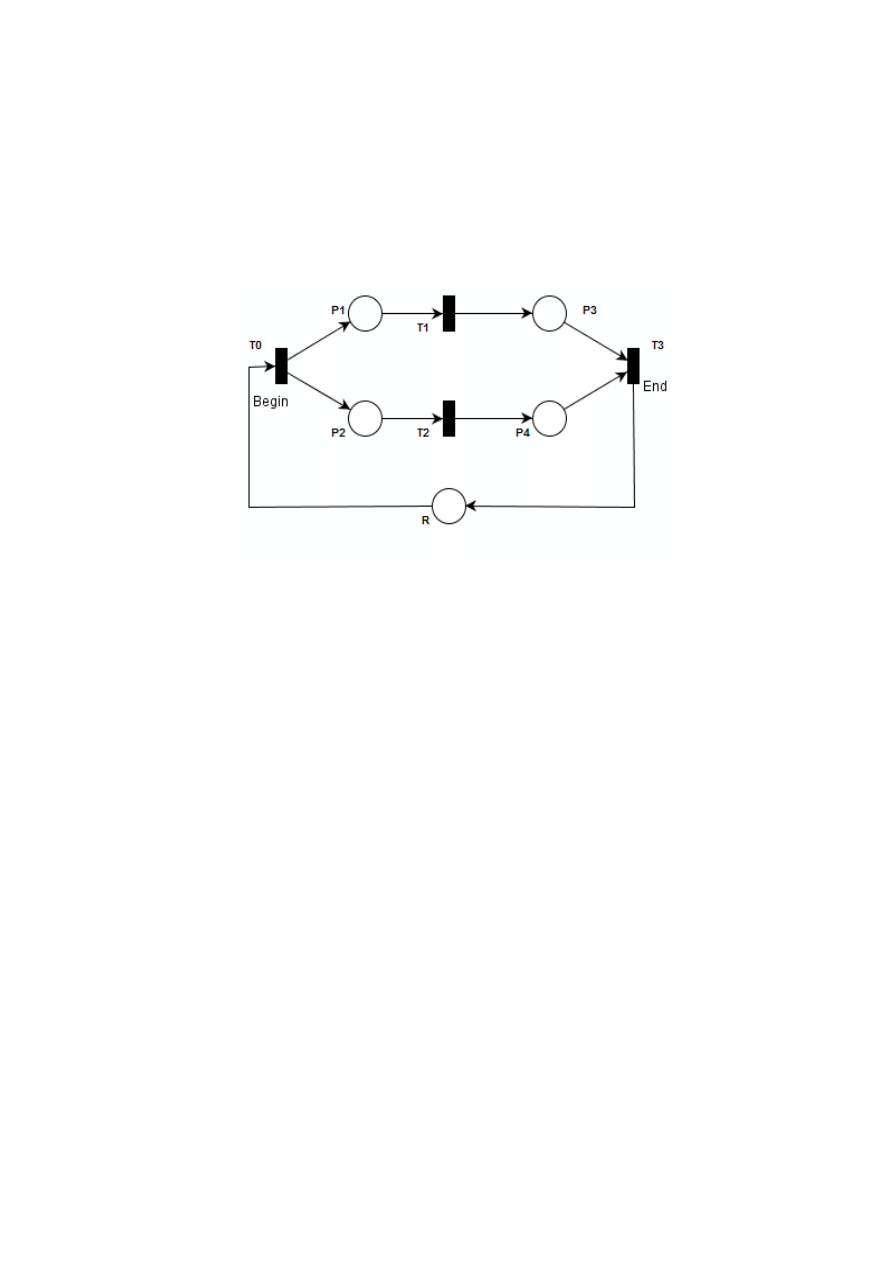

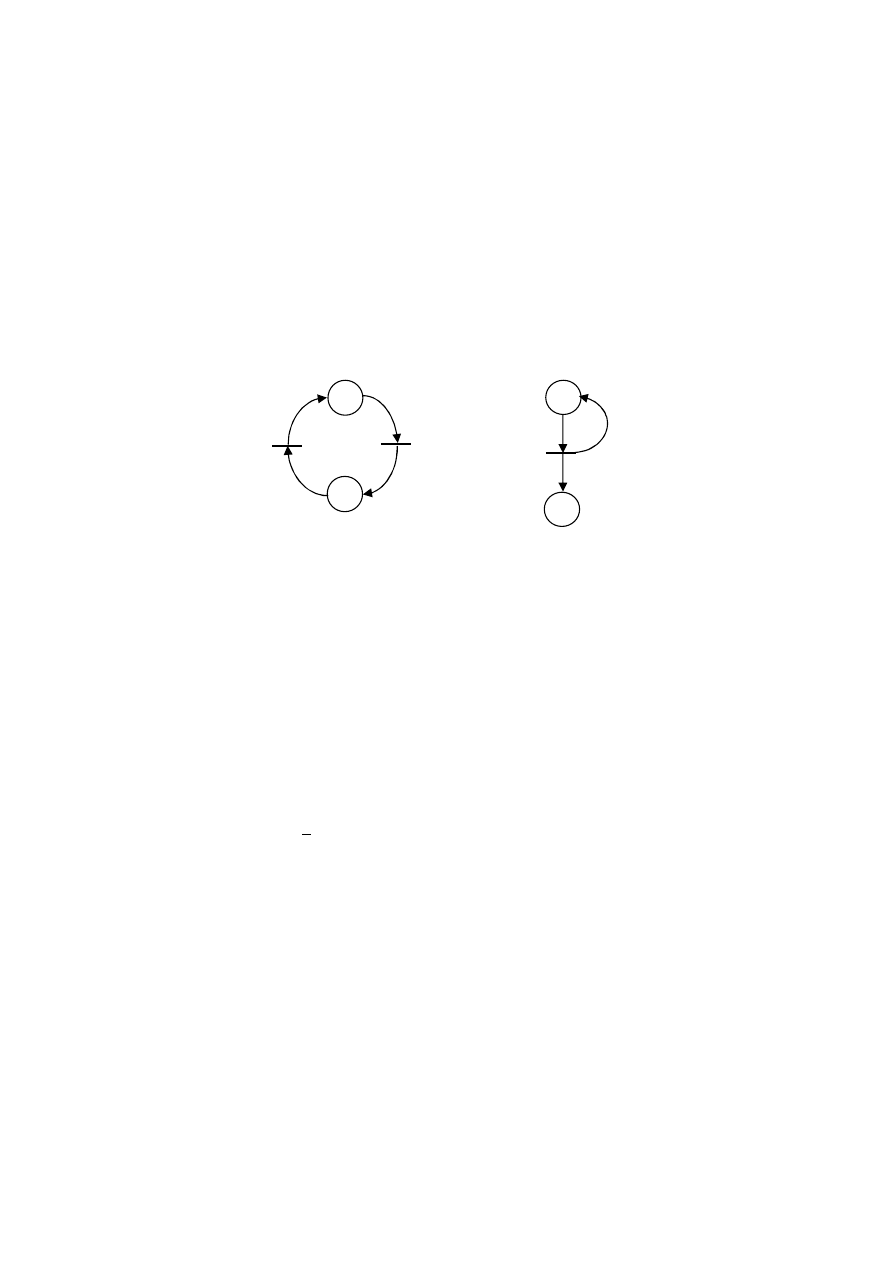

Po każdym podziale, podzbiory, dla których dolne ograniczenie jest większe od

wartości funkcji celu dla najlepszego, znanego dotychczas rozwiązania są

eliminowane z dalszego podziału. Dzięki temu unika się bezpośredniego

sprawdzania rozwiązań należących do eliminowanych podzbiorów. Podział

postępuje do chwili znalezienia rozwiązania dopuszczalnego, dla którego wartość

funkcji celu jest nie większa niż najmniejsze dolne ograniczenie wszystkich

niepodzielonych podzbiorów. W najgorszym razie trzeba sprawdzić wszystkie

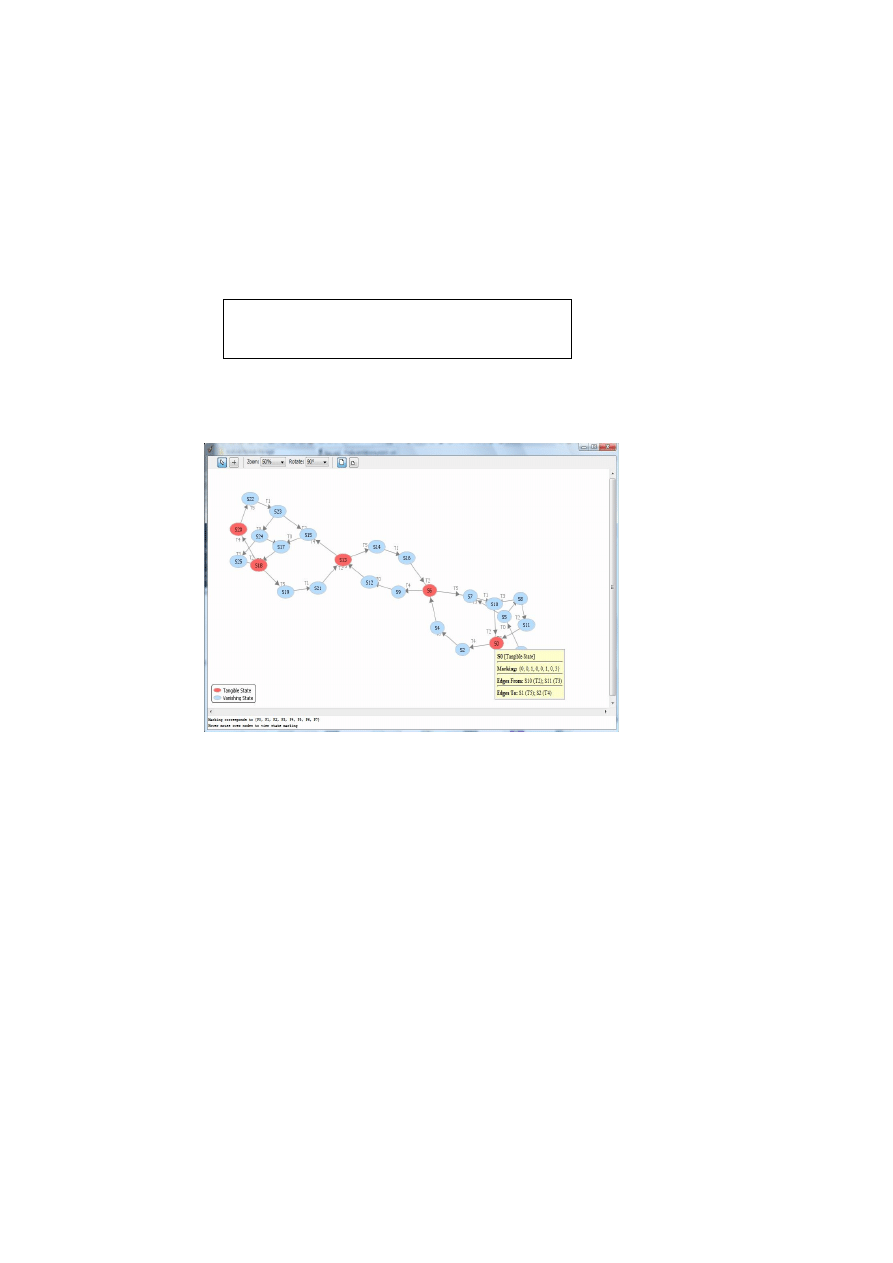

rozwiązania, co przesądza o wykładniczej złożoności obliczeniowej metody

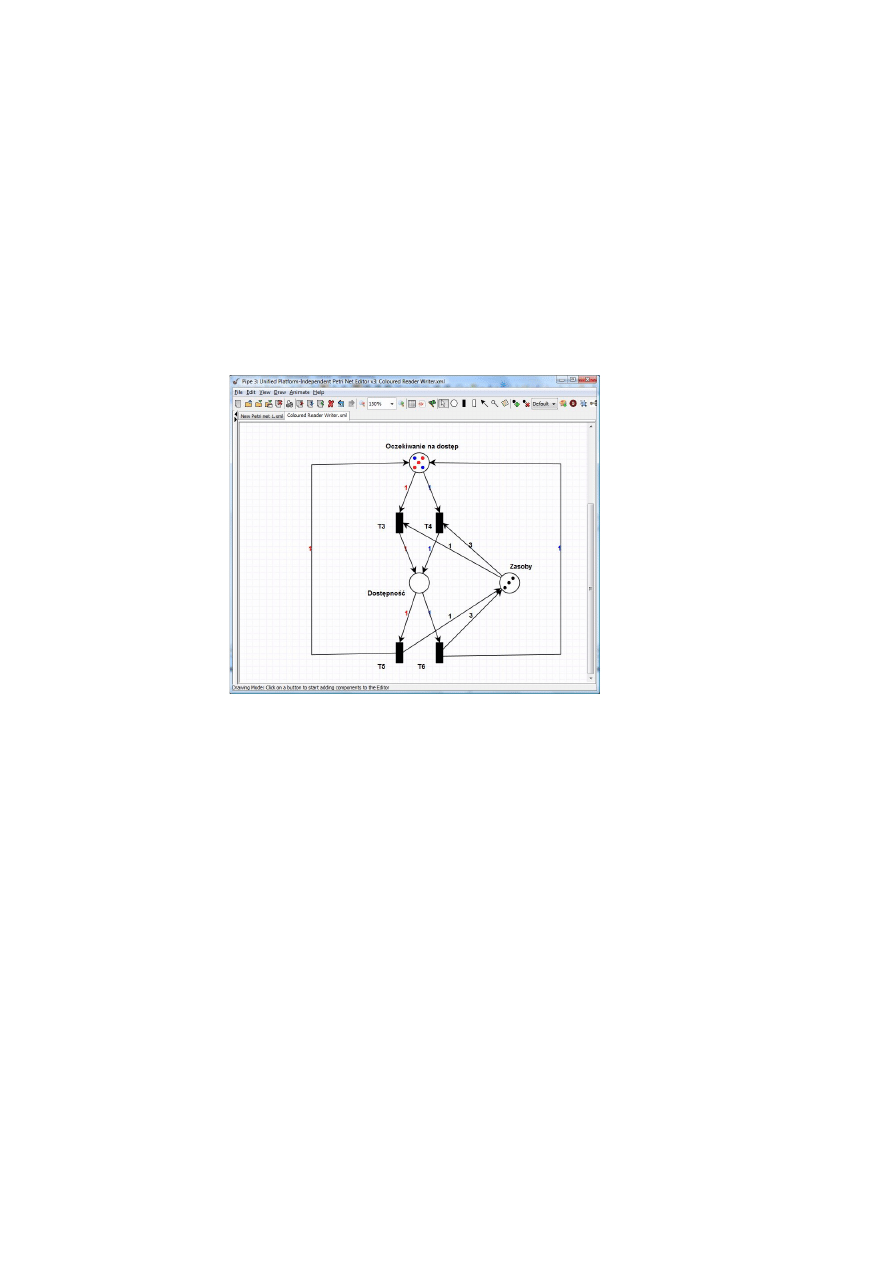

podziału i ograniczeń (worst-case complexity). Na ogół liczba rozwiązań

sprawdzanych przed znalezieniem rozwiązania optymalnego jest znacznie mniejsza,

co świadczy o efektywności metody.

Schemat B&B określa tylko ogólne podejście, oparte na dekompozycji i

„inteligentnym” przeszukiwaniu zbioru rozwiązań dopuszczalnych problemu

optymalizacyjnego. Istnieje wiele algorytmów opartych na tym schemacie. Jego

zastosowanie jest uzasadnione tylko wtedy gdy rozwiązywany problem jest NP-

zupełny.

.

39

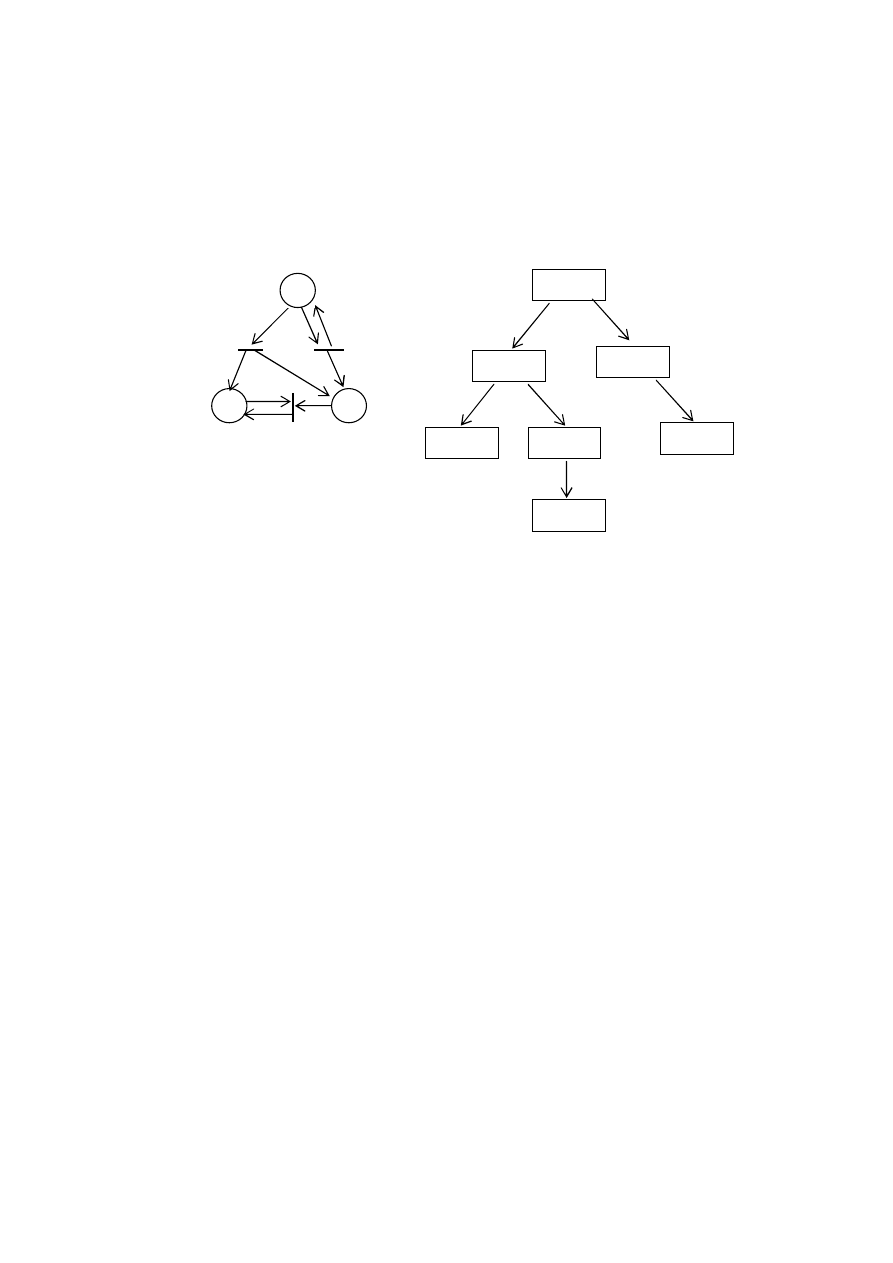

2.1.1. Ogólny schemat B&B

Metoda wyznacza rozwiązanie globalnie optymalne * takie, że

Dla dowolnego zadania optymalizacji zachodzi

gdzie

j

, jS jest rozbiciem zbioru na podzbiory parami rozłączne i

wyczerpujące tzn.

Zatem rozwiązanie problemu można otrzymać rozwiązując wpierw zbiór

podproblemów postaci:

dla jS, a następnie stosując zależność (2.4).

Pełny zbiór podproblemów jest scharakteryzowany poprzez:

•

funkcję kryterialną (funkcję celu) K()

•

rozbicie P = {

j

: jS}.

Odpowiednie podproblemy mogą być rozwiązywane szeregowo (system

jednoprocesorowy) lub równolegle (system wieloprocesorowy).

Dekompozycja problemu jest uzasadniona jeśli uzyskanie rozwiązania dla

problemu (2.7) jest istotnie łatwiejsze niż dla problemu (2.1).

Problem (2.7) dla wybranego ustalonego jS można rozwiązać stosując przegląd

niejawny (implicite search) oraz rekaksację ograniczeń lub funkcji kryterium.

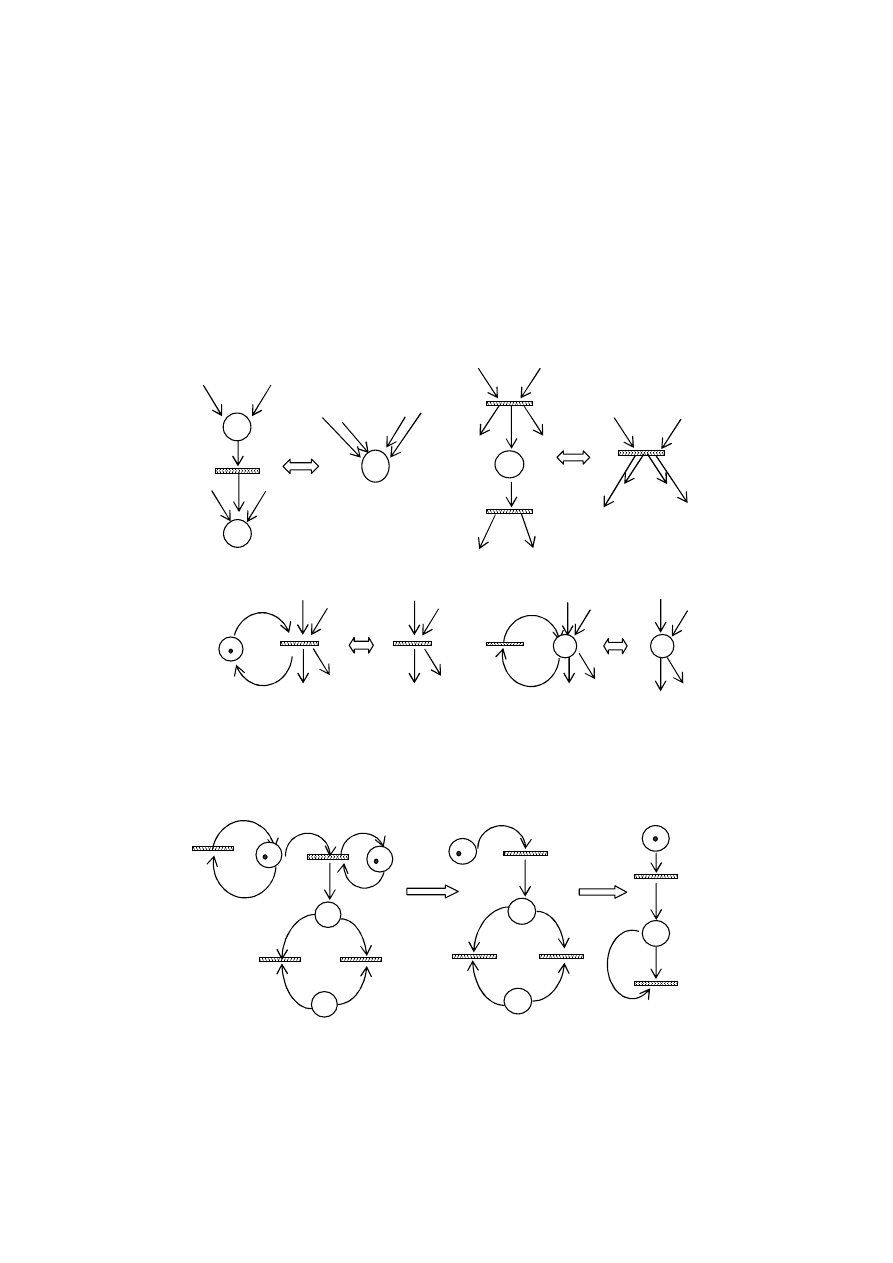

2.1.2. Metoda relaksacji

1.

Relaksacja ograniczeń.

Relaksacja ograniczeń to usunięcie lub złagodzenie części (lub całości)

ograniczeń wyznaczających zbiór rozwiązań dopuszczalnych

j

. Zachodzi bowiem

j

j

R

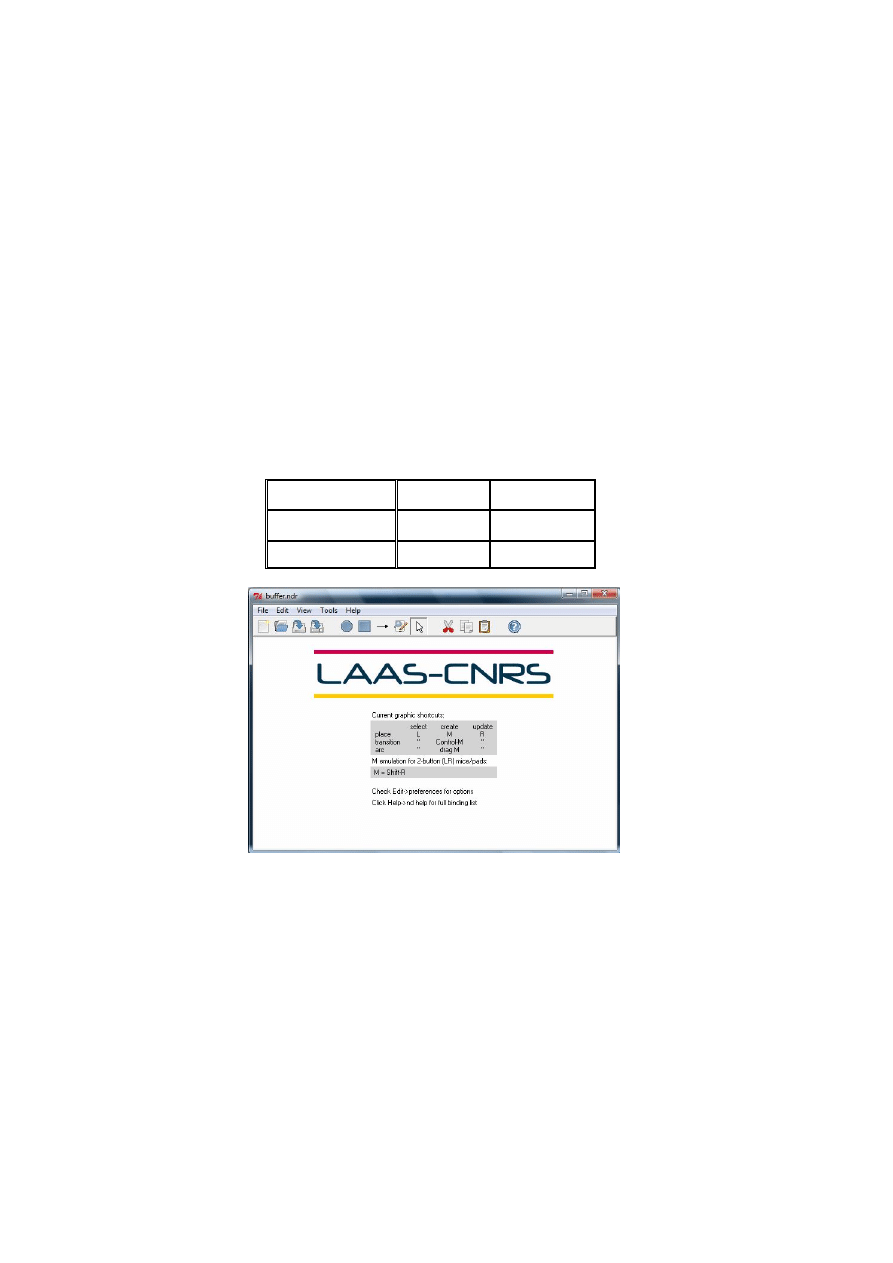

, gdzie

j

R

jest zbiorem rozwiązań dopuszczalnych problemu, w stosunku

do którego zastosowano relaksację. Spełniona jest również zależność:

K(

*

) = m i n

K()

(2.3)

m i n

K() = min {m i n

1

K(),..., m i n

s

K()}}

(2.4)

j

i

S

j

i

i

j

,

,

0

(2.5)

j

S

j

(2.6)

m i n

j

K()

(2.7)

m i n

j

K() m i n

j

R

K() = K(

* R

) =

def

LB(

j

)

(2.8)

.

40

Jeżeli dla wyznaczonego rozwiązania optymalnego *

R

problemu zrelaksowanego

zachodzi *

R

j

, to otrzymane rozwiązanie jest również rozwiązaniem

optymalnym problemu postaci (2.7). W przeciwnym przypadku K(*

R

) stanowi

dolne ograniczenie LB(

j

) wartości funkcji kryterialnej dla wszystkich rozwiązań

problemu (2.7).

2. Relaksacja funkcji kryterium.

Relaksacja funkcji kryterium to zastąpienie funkcji K() funkcją K’() taką, że

K’() K() dla wszystkich .

W ten sposób zachodzi:

Jeżeli dla wyznaczonego rozwiązania optymalnego ` problemu zrelaksowanego

m i n

j

K`() zachodzi K(`) = K`(`) to otrzymane rozwiązanie ’ jest także

rozwiązaniem optymalnym problemu bez relaksacji. W przeciwnym przypadku

wielkość K(

*R

) stanowi dolne ograniczenie LB’(

j

) wartości funkcji kryterialnej

dla wszystkich rozwiązań problemu (2.7).

Postać relaksacji jest w zasadzie dowolna, chociaż zakłada się domyślnie, że

rozwiązanie problemu zrelaksowanego powinno być istotnie łatwiejsze niż

problemu (2.7), np. problem zrelaksowany należy do P-klasy.

W praktyce relaksacja jest silnie specyficzna dla każdego rozważanego problemu.

Pośrednio rozwiązany został również problem (2.7) dla którego stwierdzono

zachodzenie warunku

gdzie: UB (Upper Bound) jest pewnym górnym ograniczeniem wartości funkcji

celu dla wszystkich rozwiązań problemu (2.1).

Problem taki faktycznie nie jest rozwiązywany lecz eliminowany z rozwiązań

bowiem nie zawiera rozwiązania o wartości funkcji celu mniejszej niż podana

wartość progowa UB. Dla szeregu problemów szczególnych możliwe jest

uzyskanie specyficznych reguł eliminacji, które mimo iż nie zawsze są

przedstawiane w formie warunku (2.10) mogą być do niego sprowadzone.

Problem (2.7) odpowiadający wybranemu

j

jest usuwany ze zbioru , zaś na

jego miejsce dodawane są podproblemy otrzymane przez podział

j

na pewną

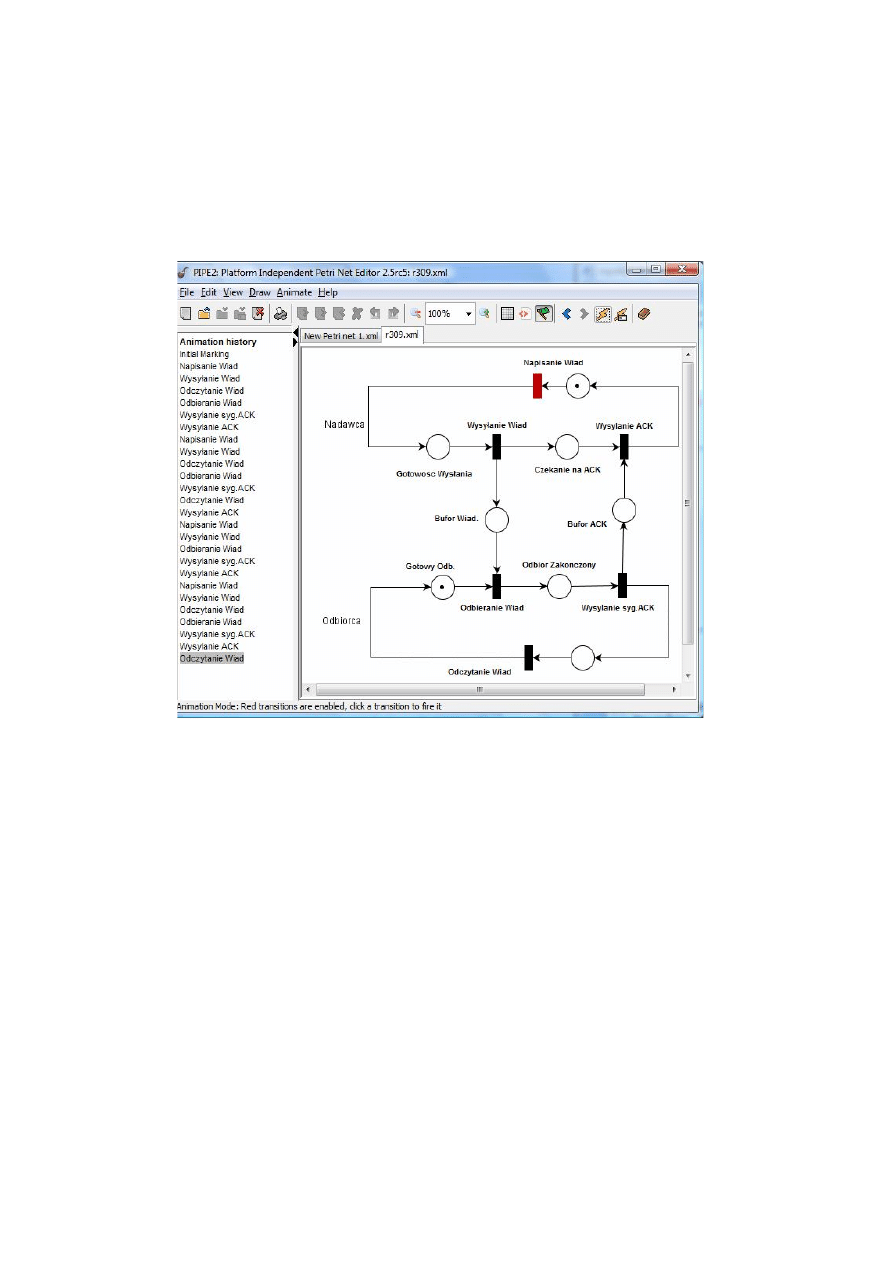

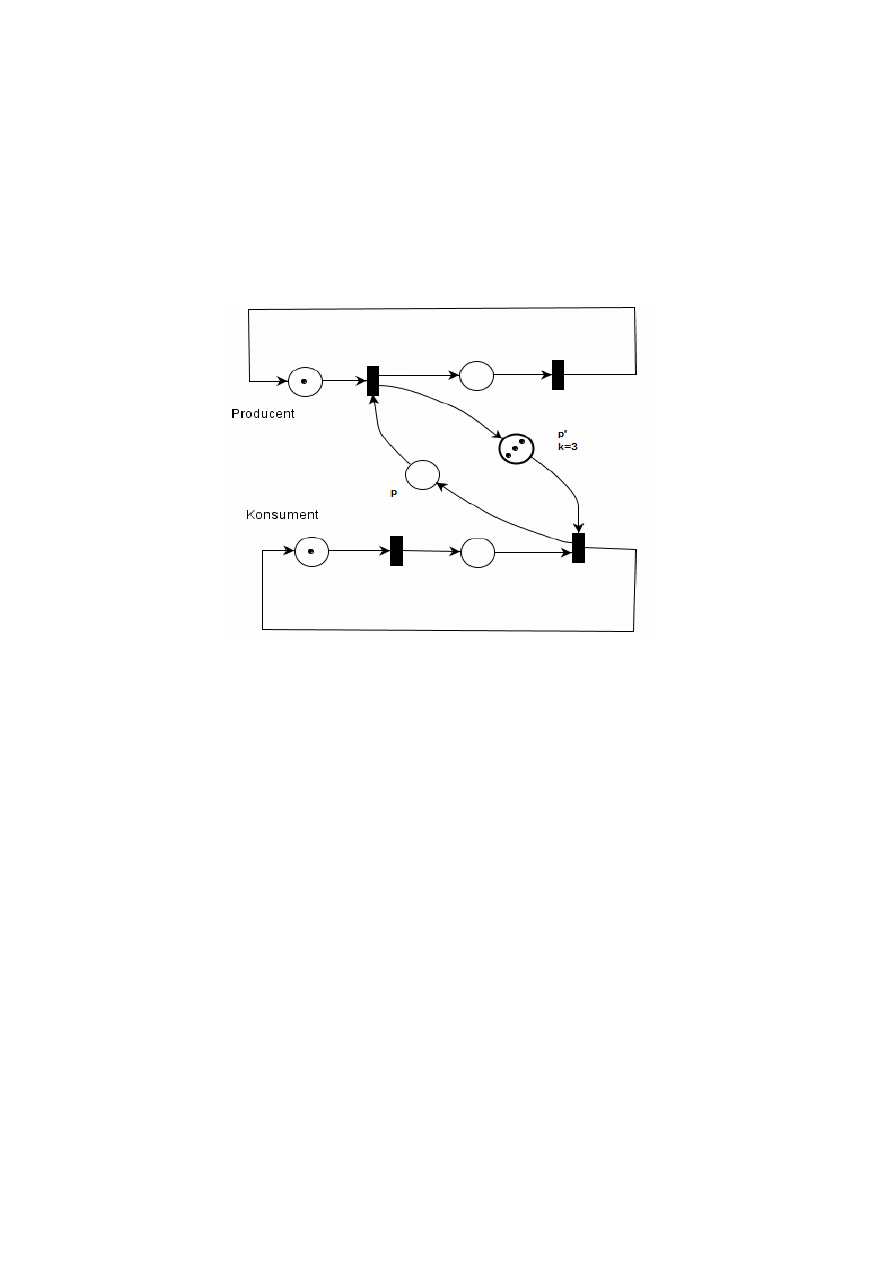

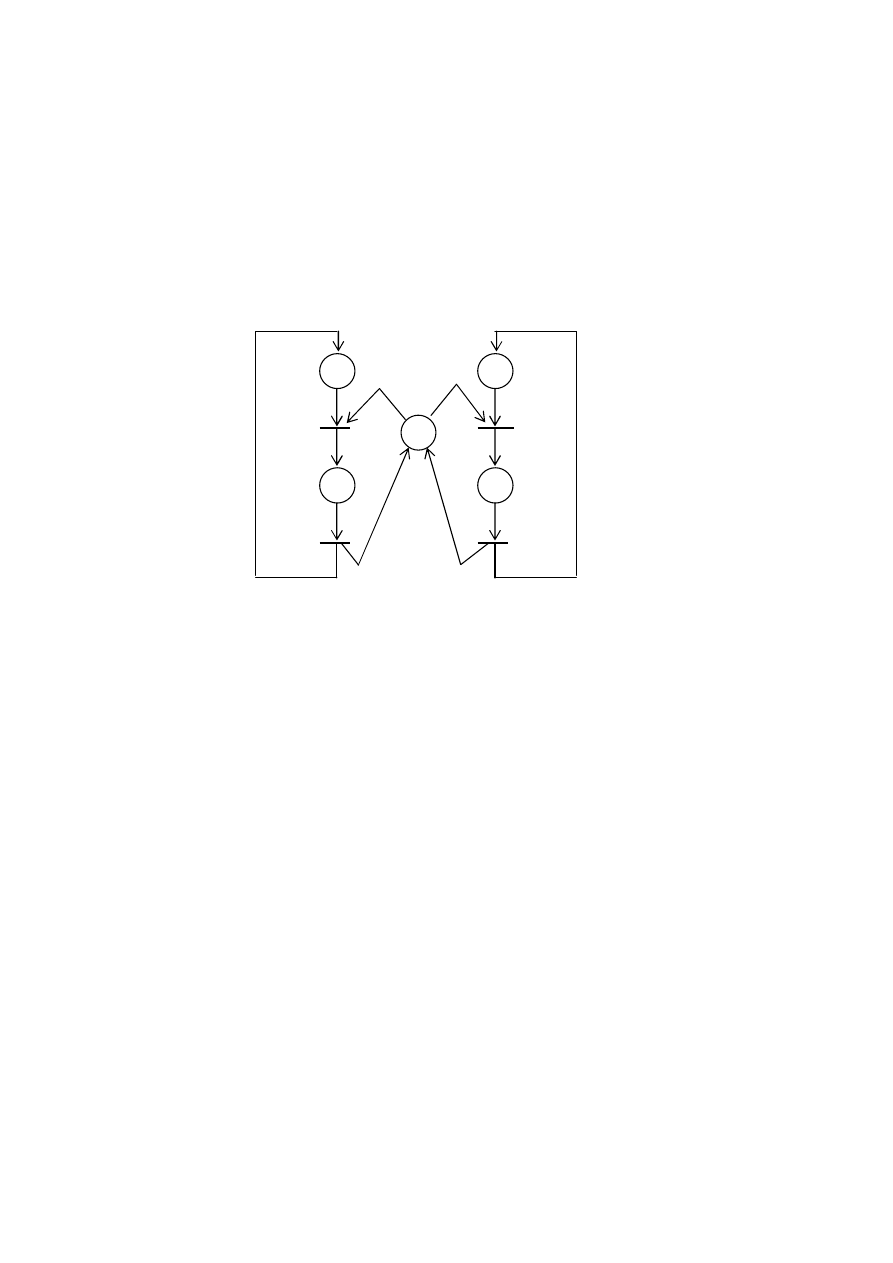

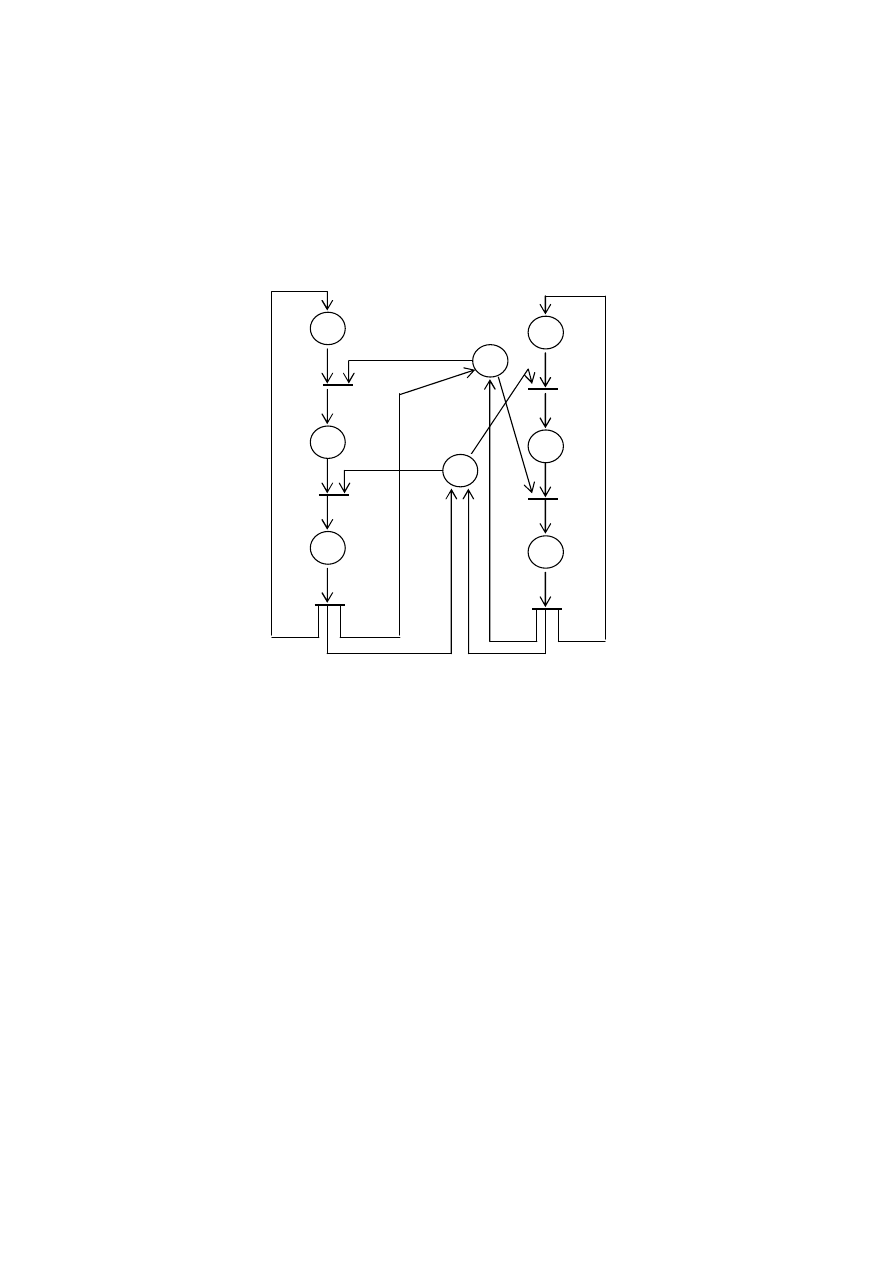

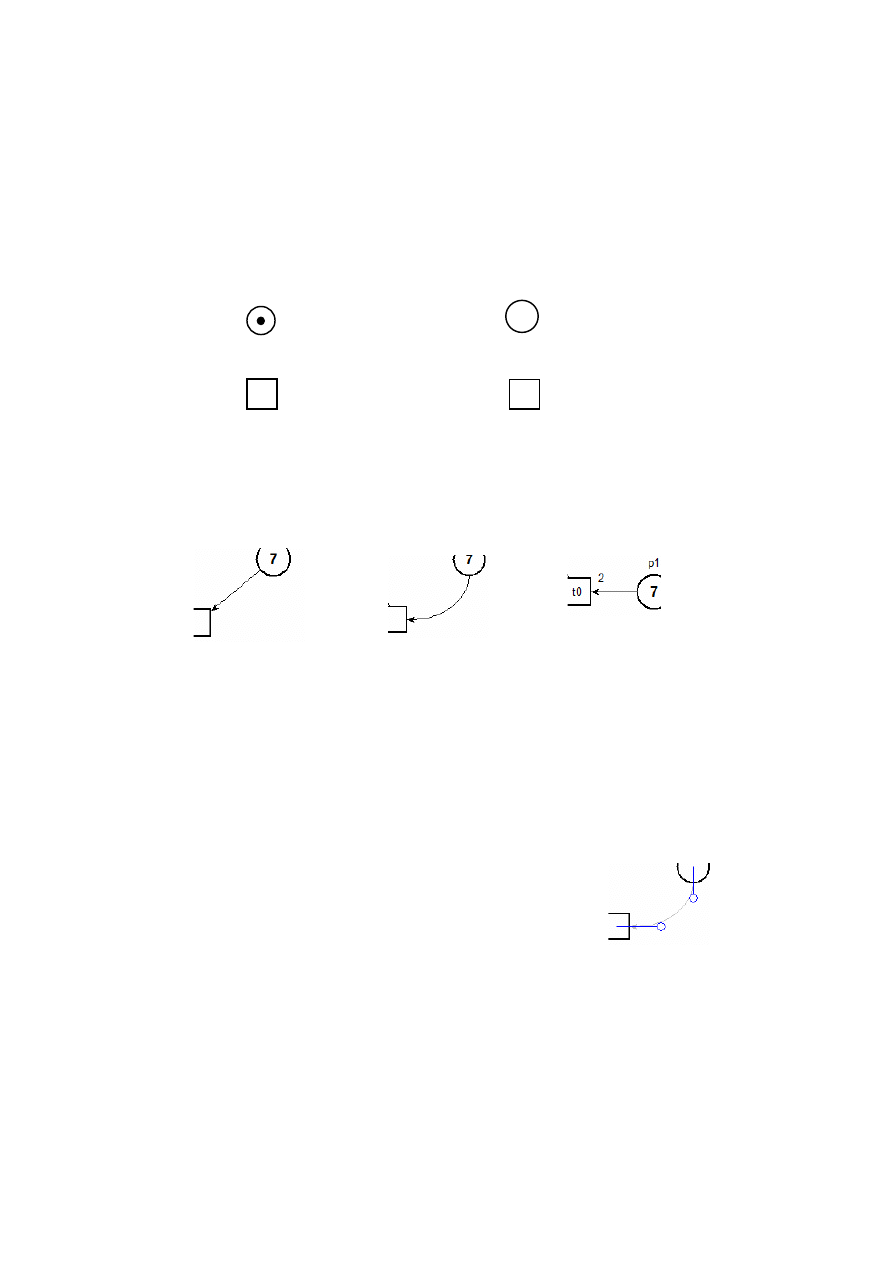

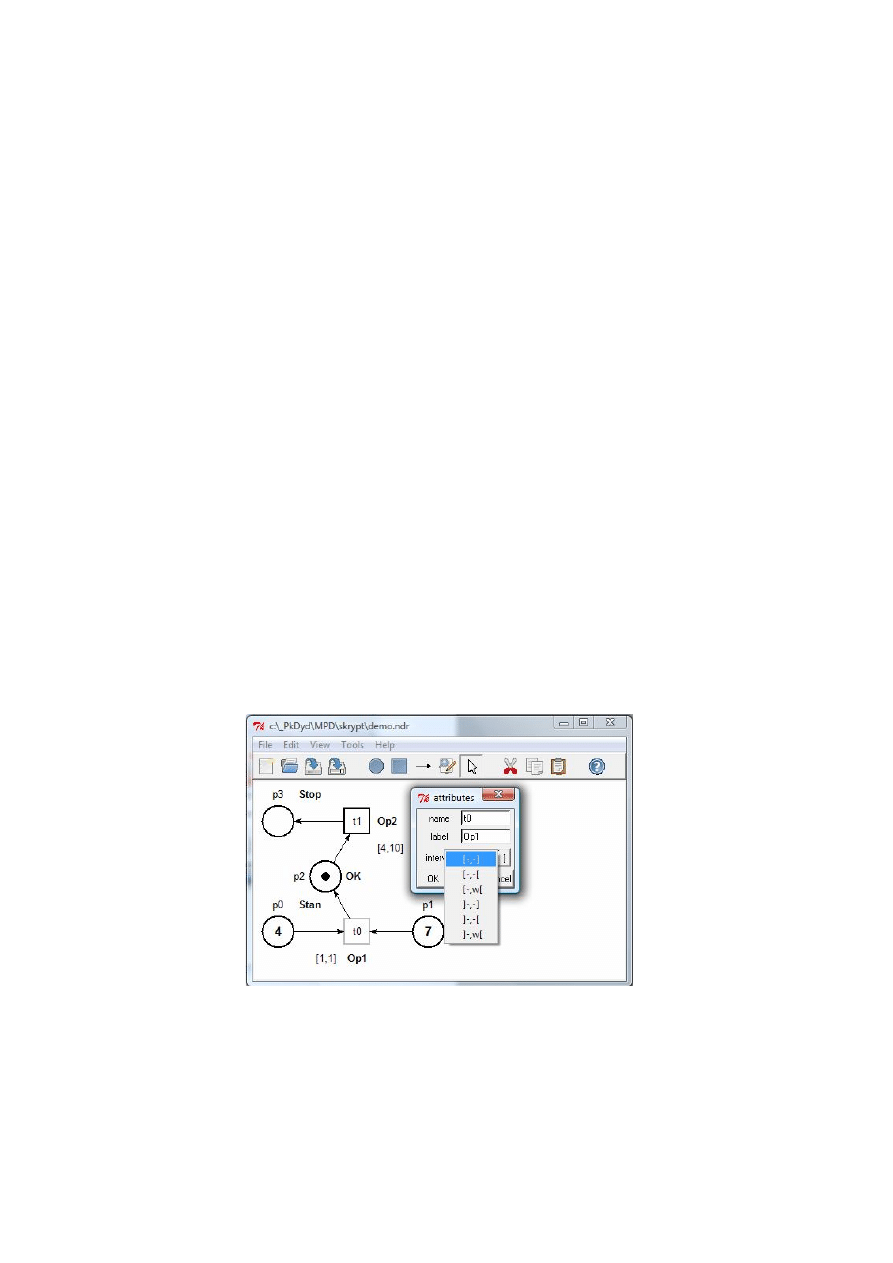

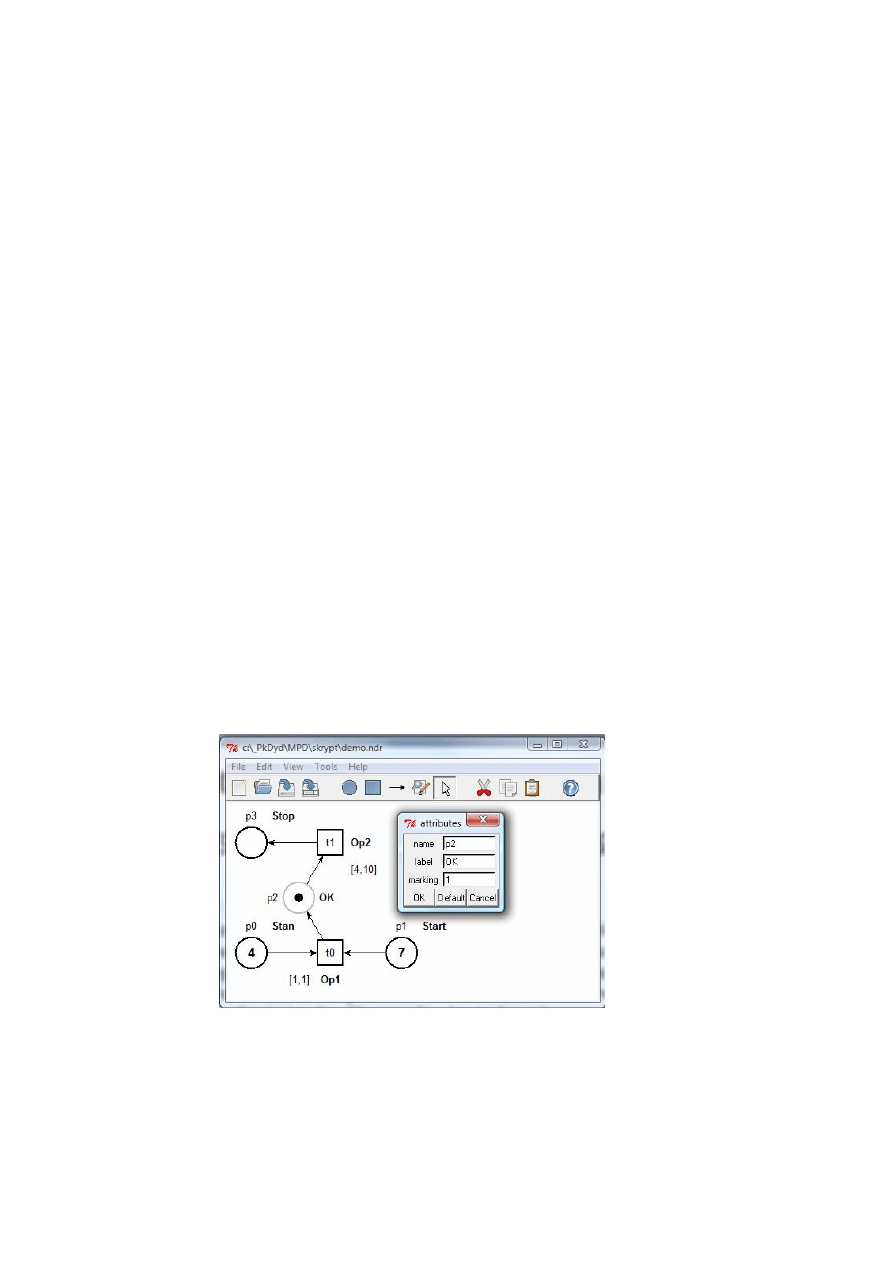

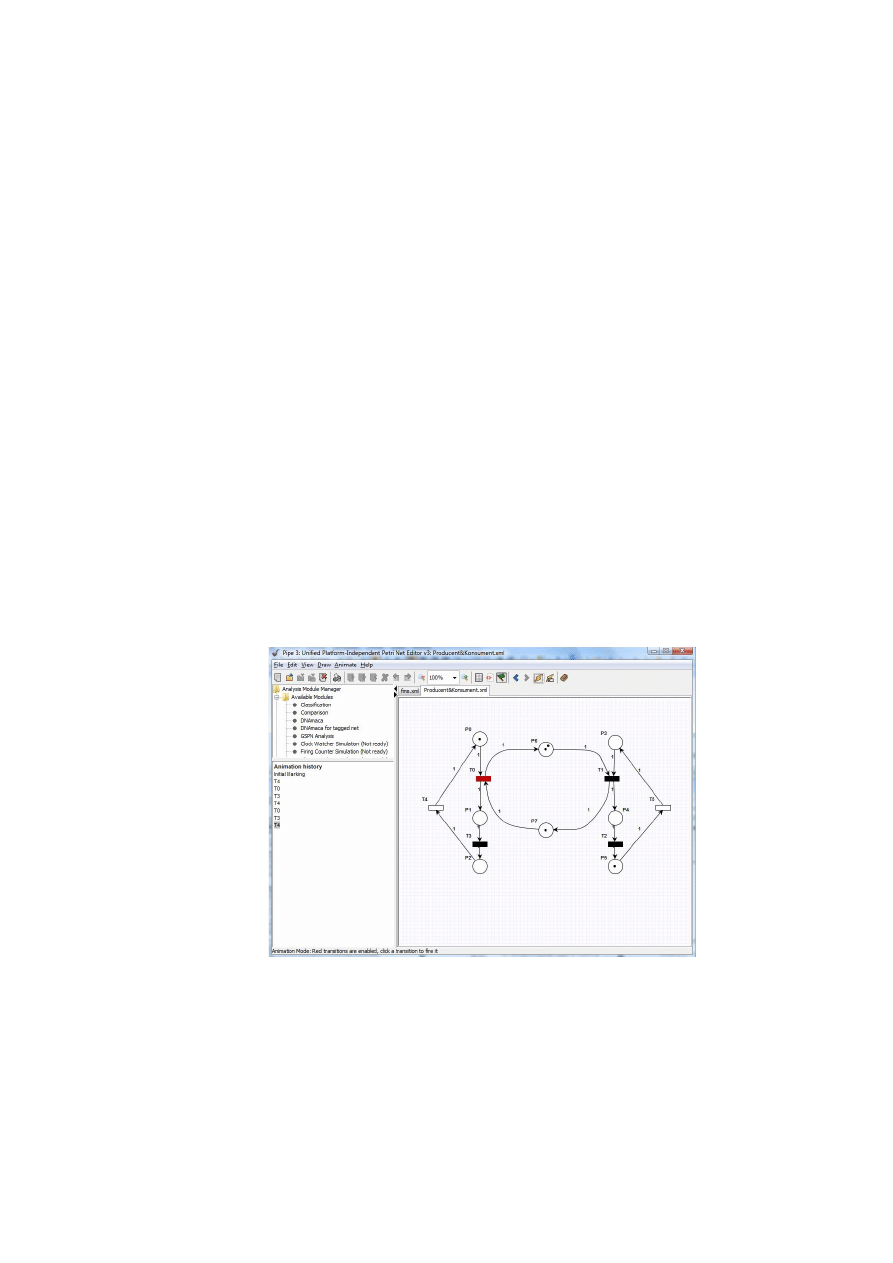

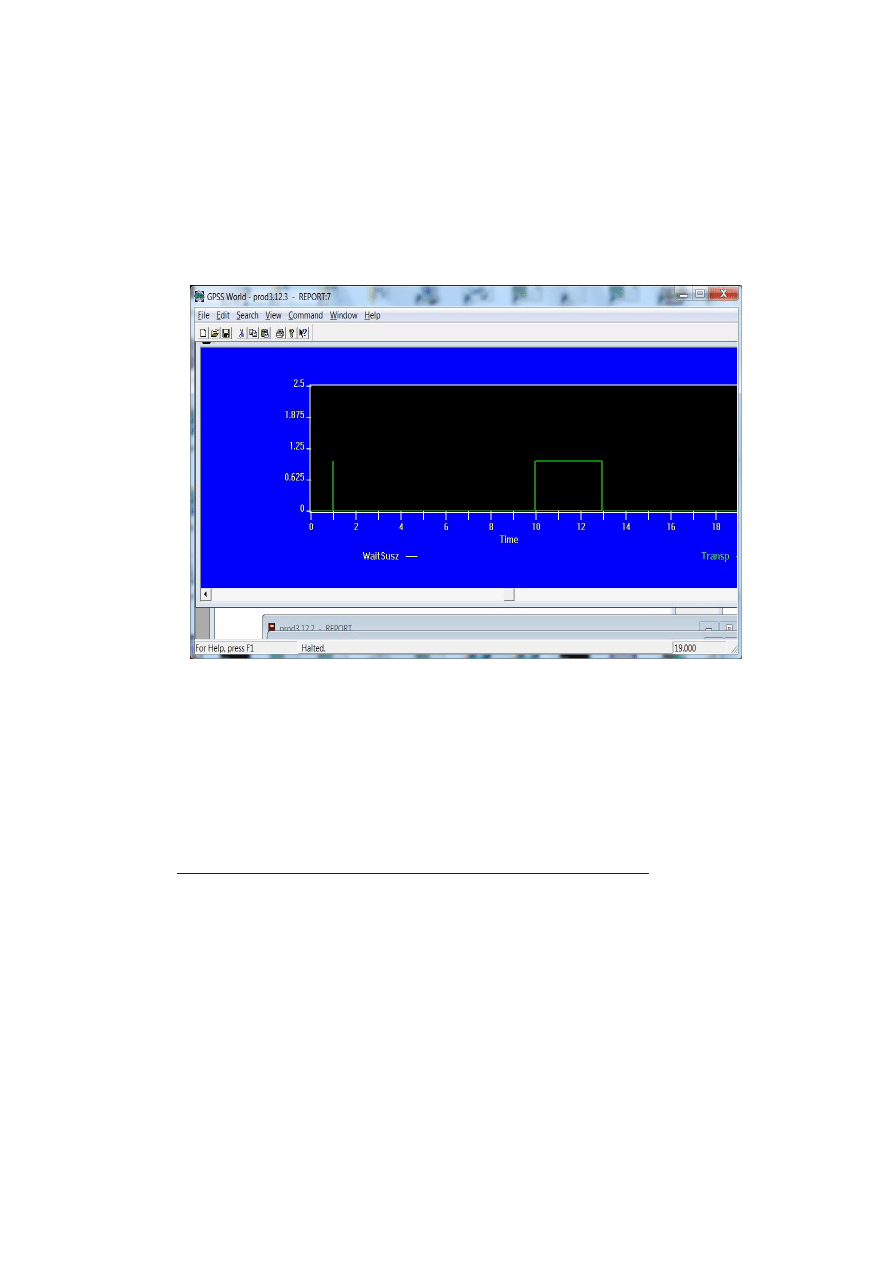

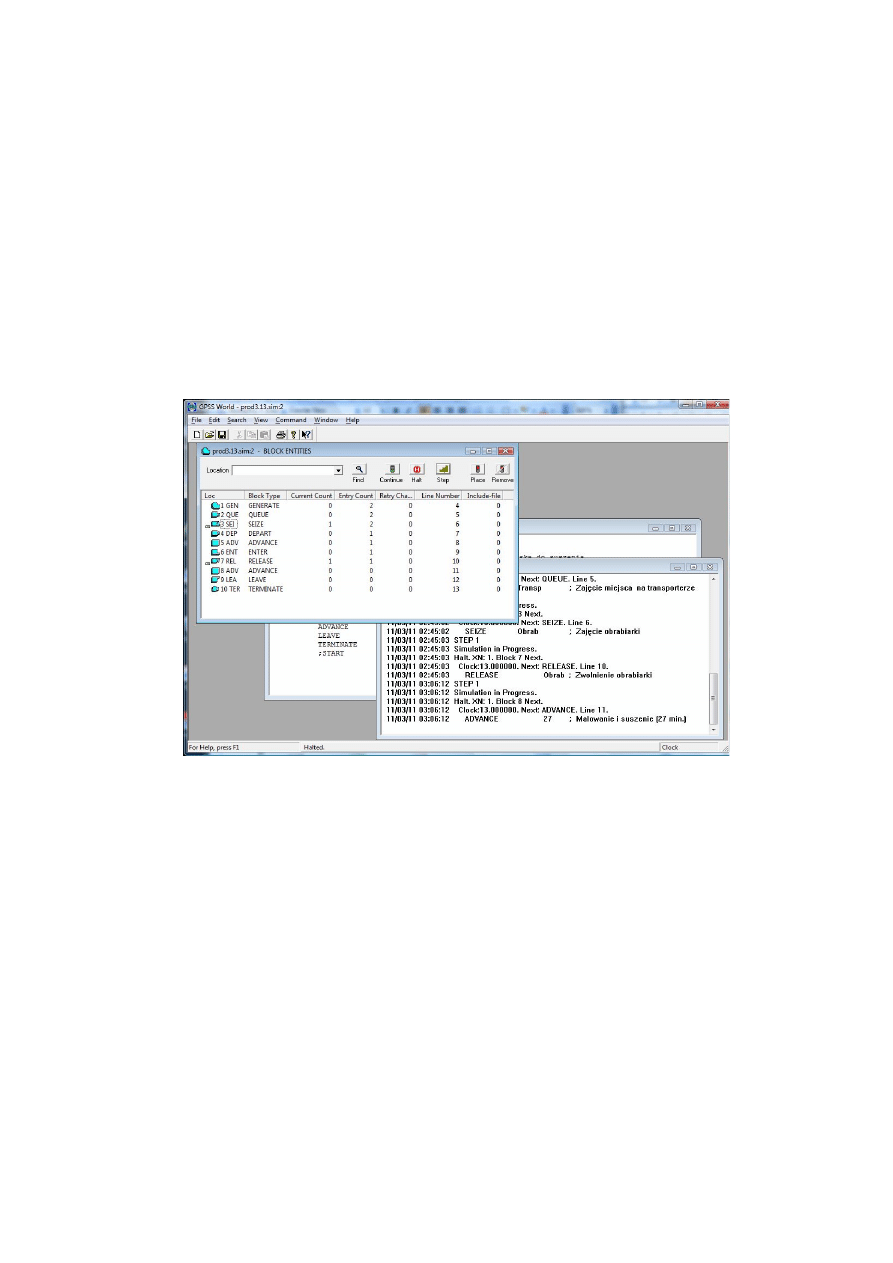

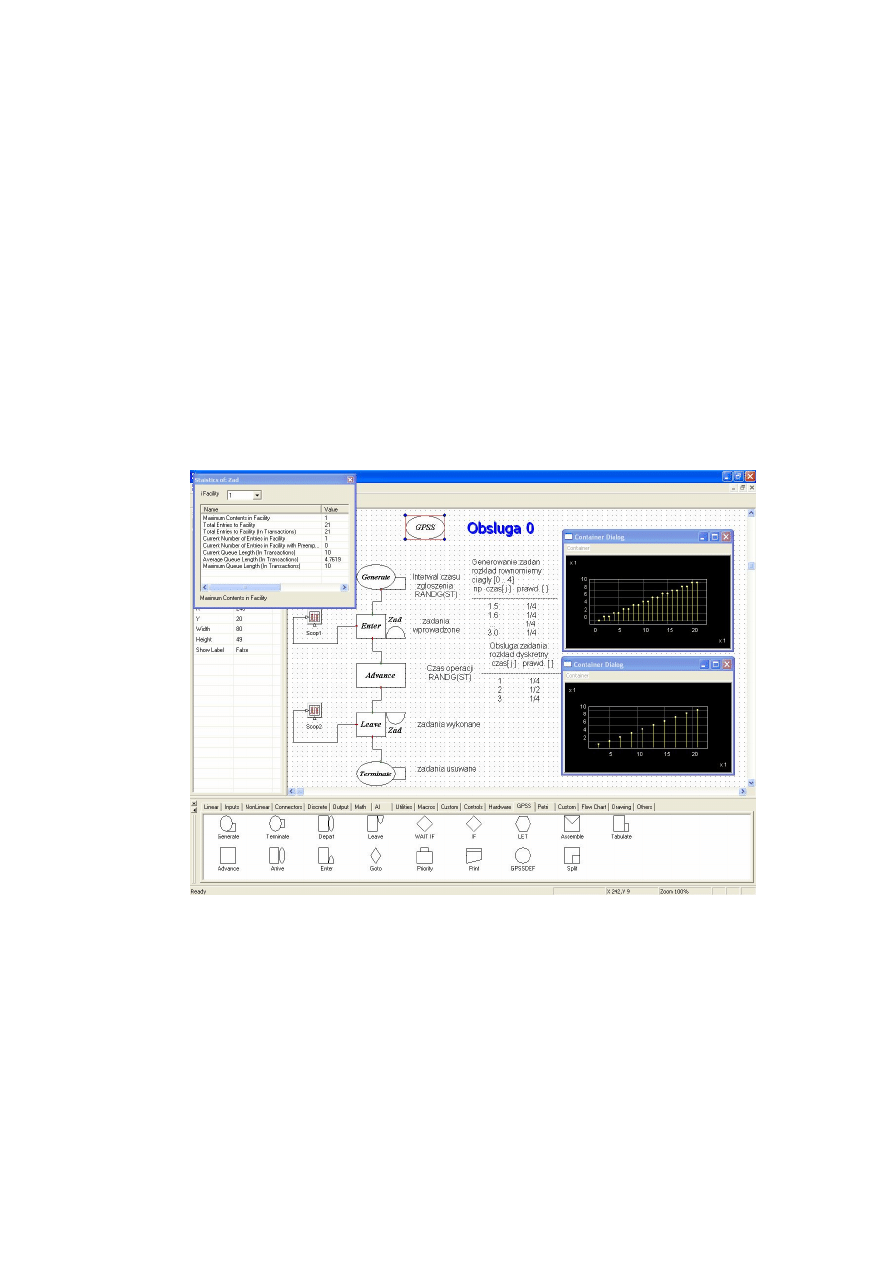

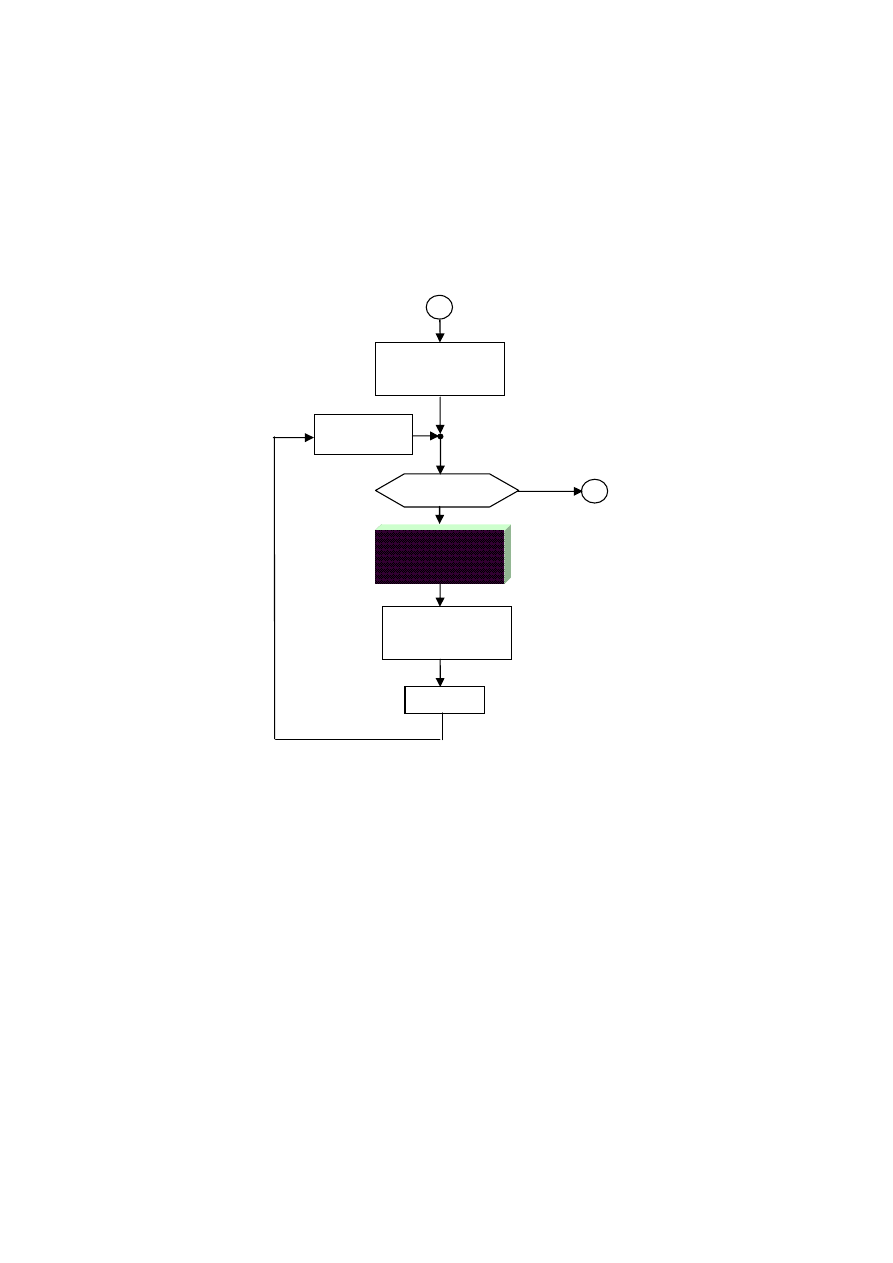

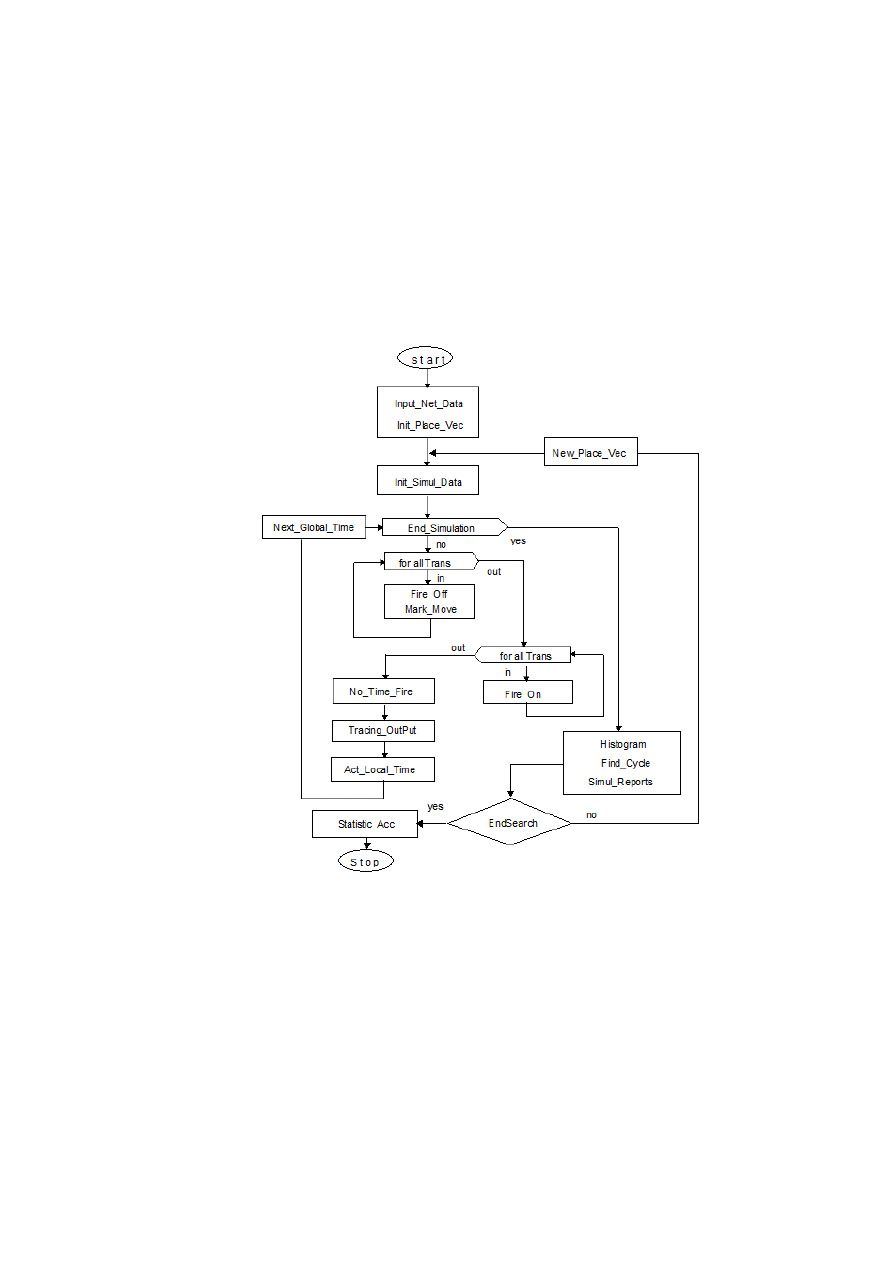

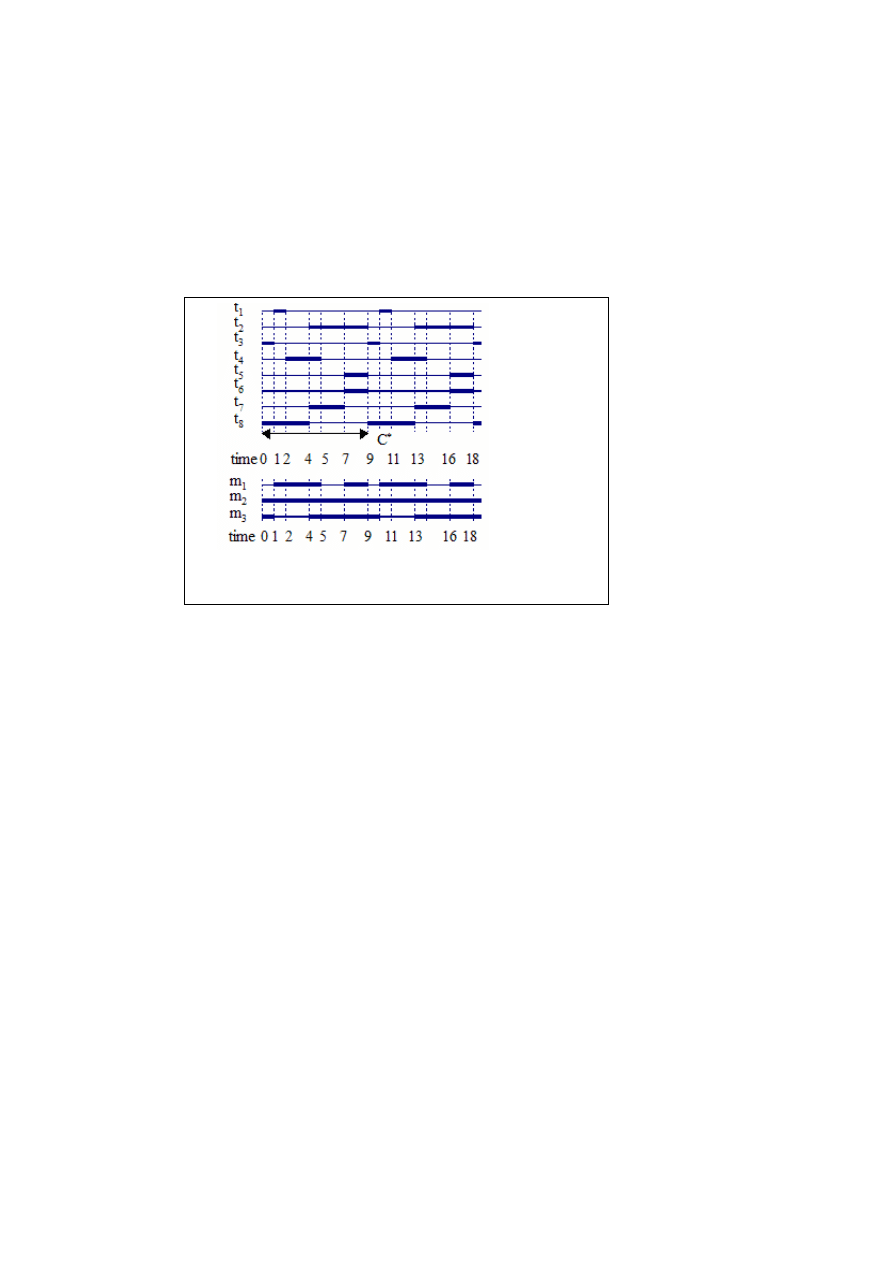

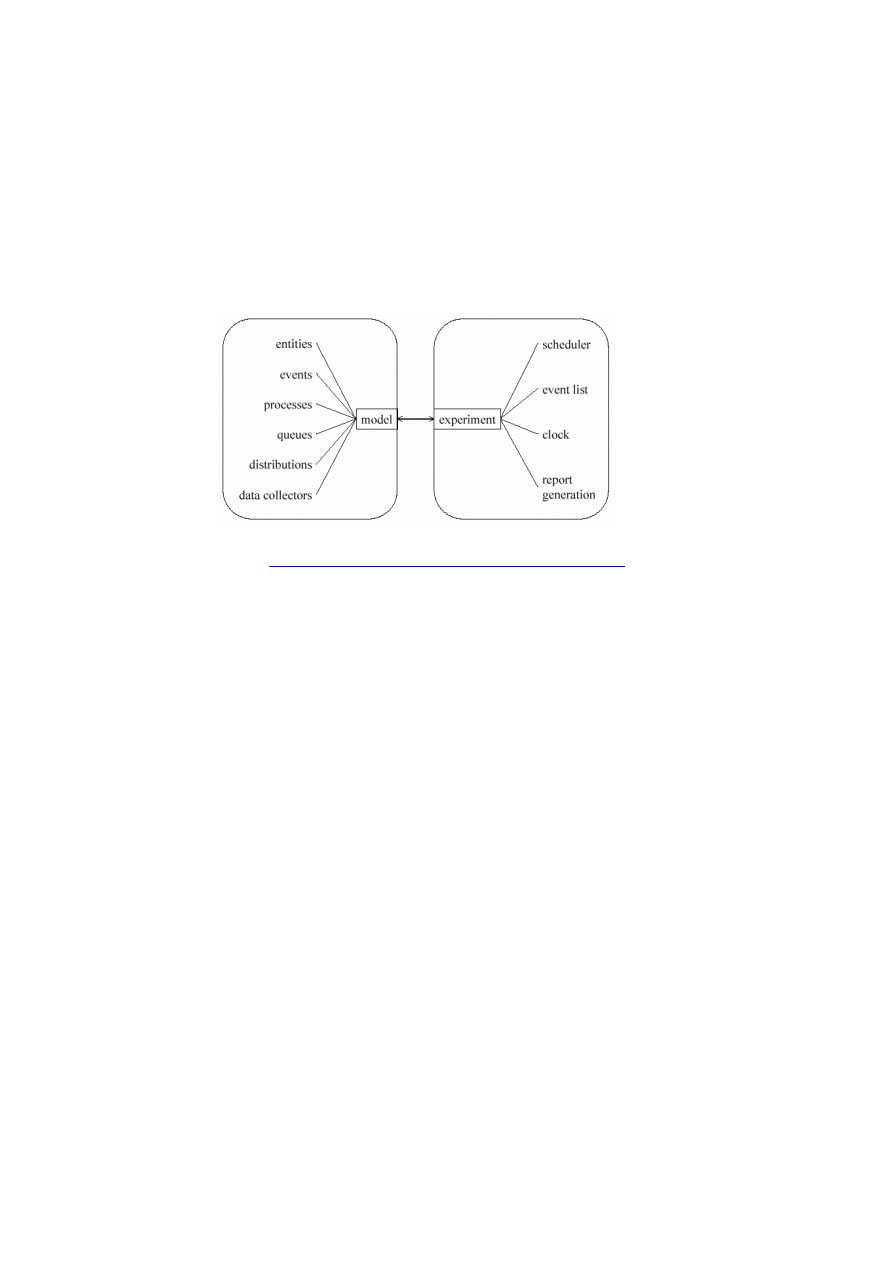

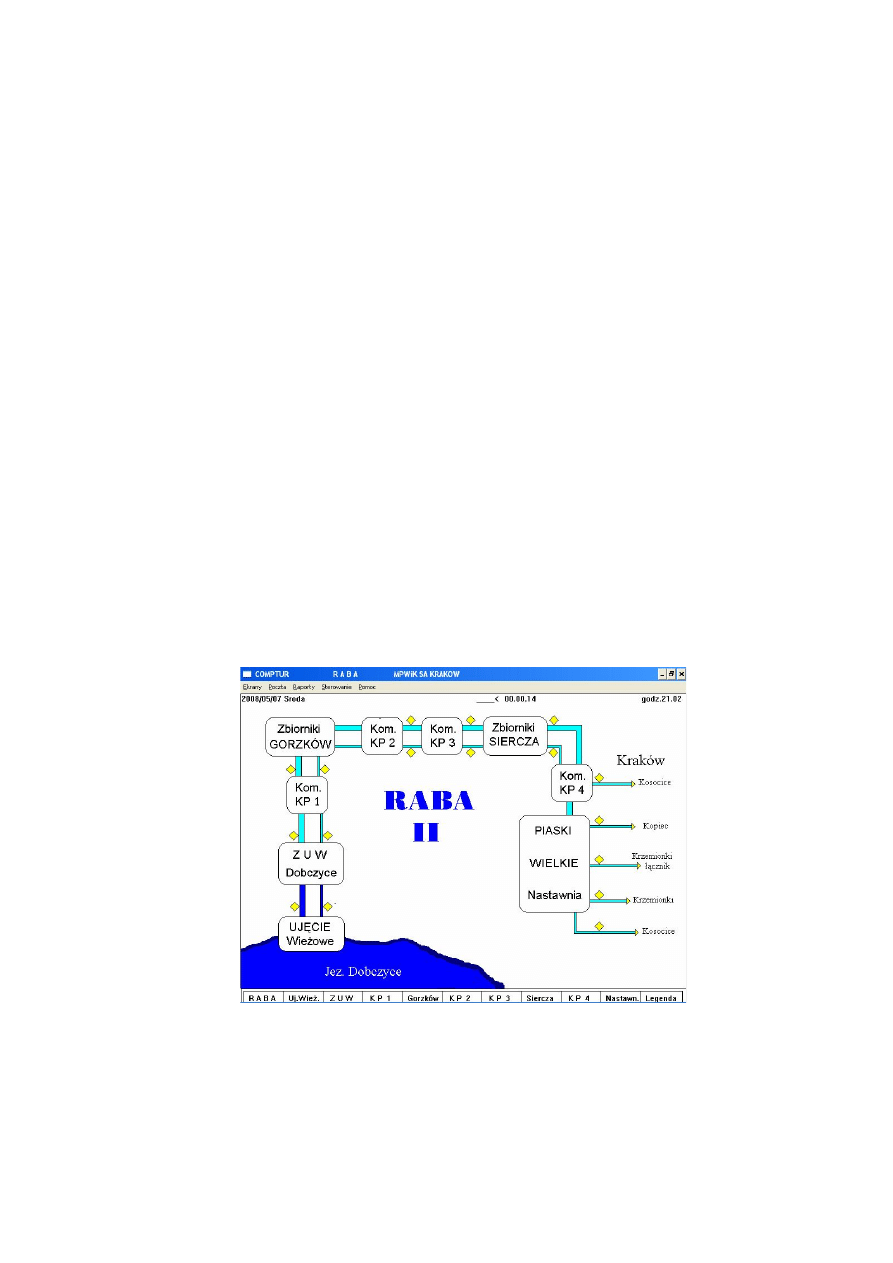

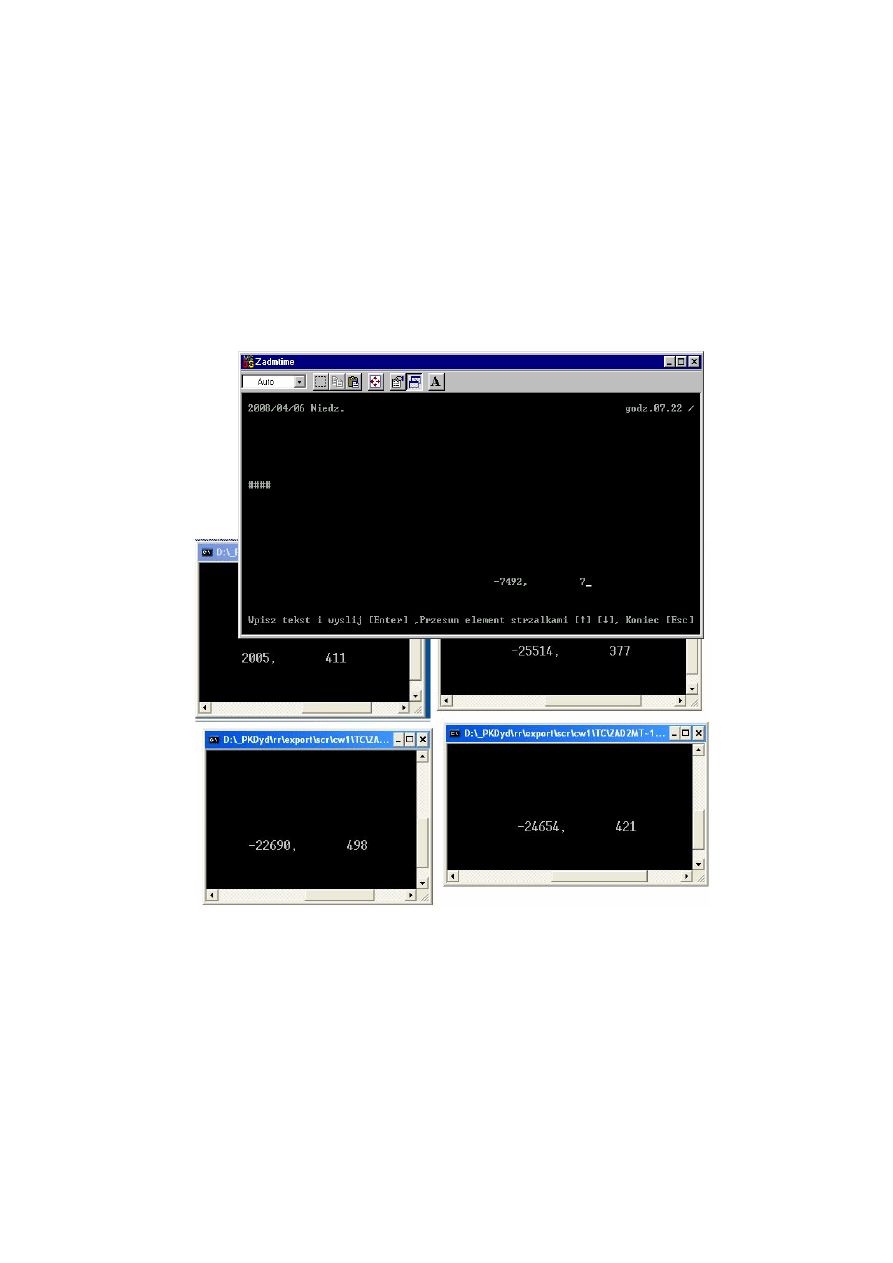

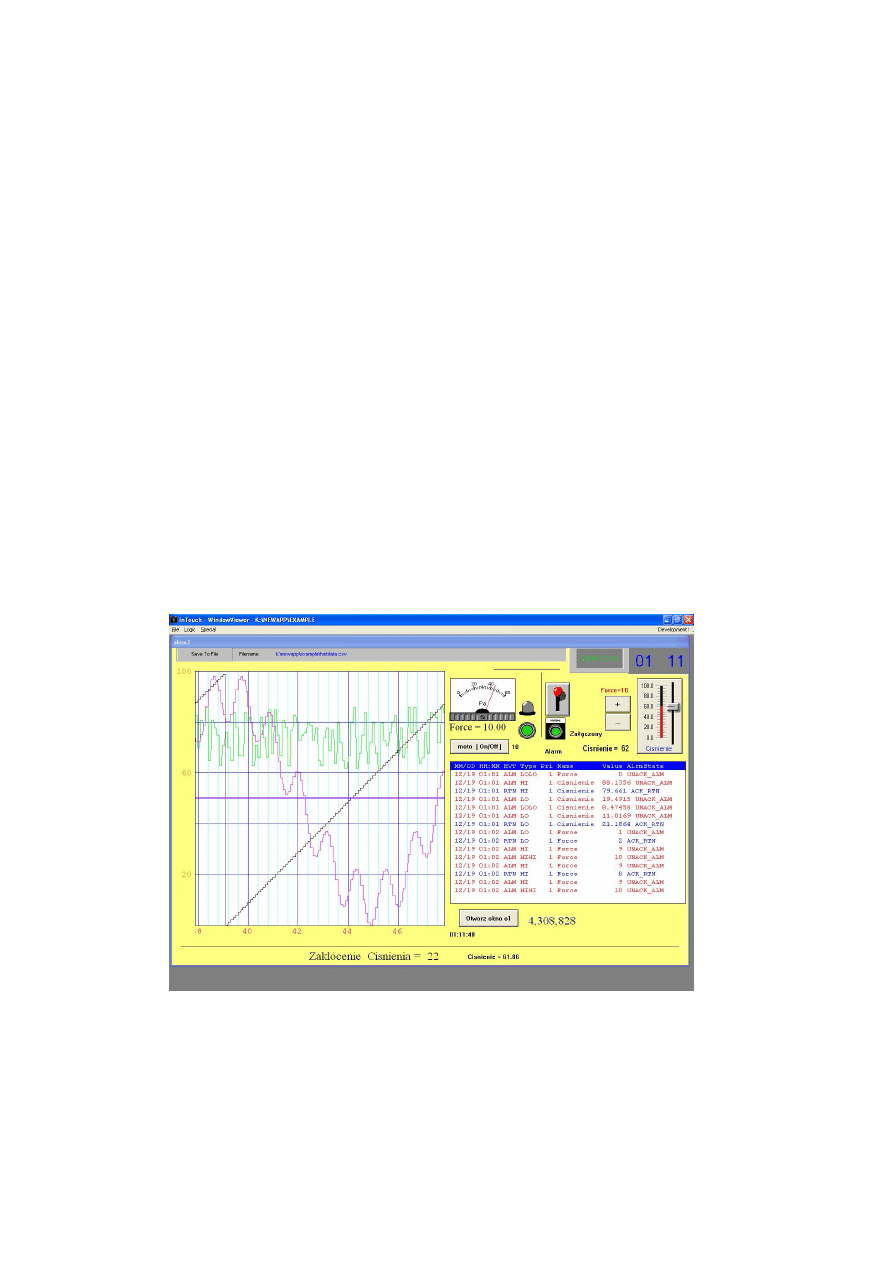

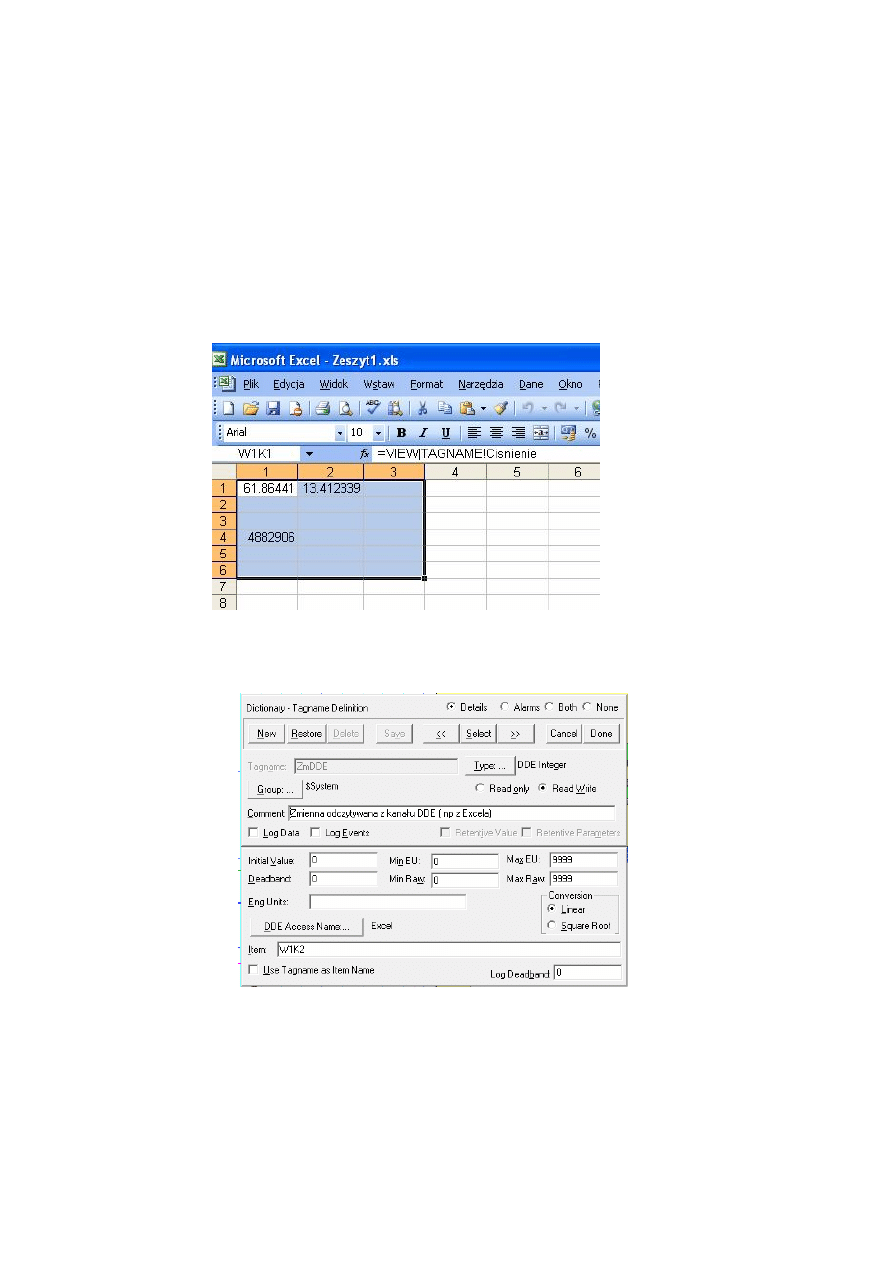

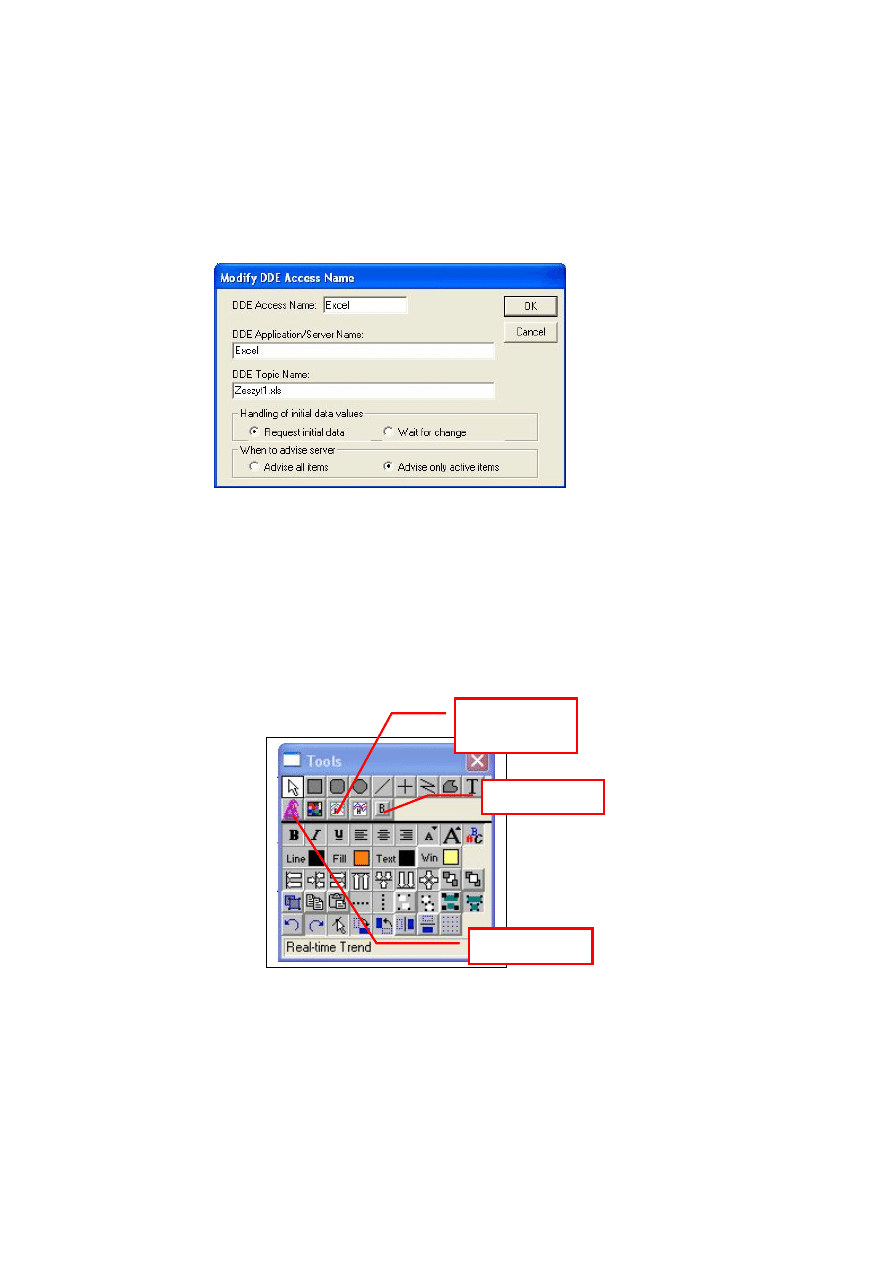

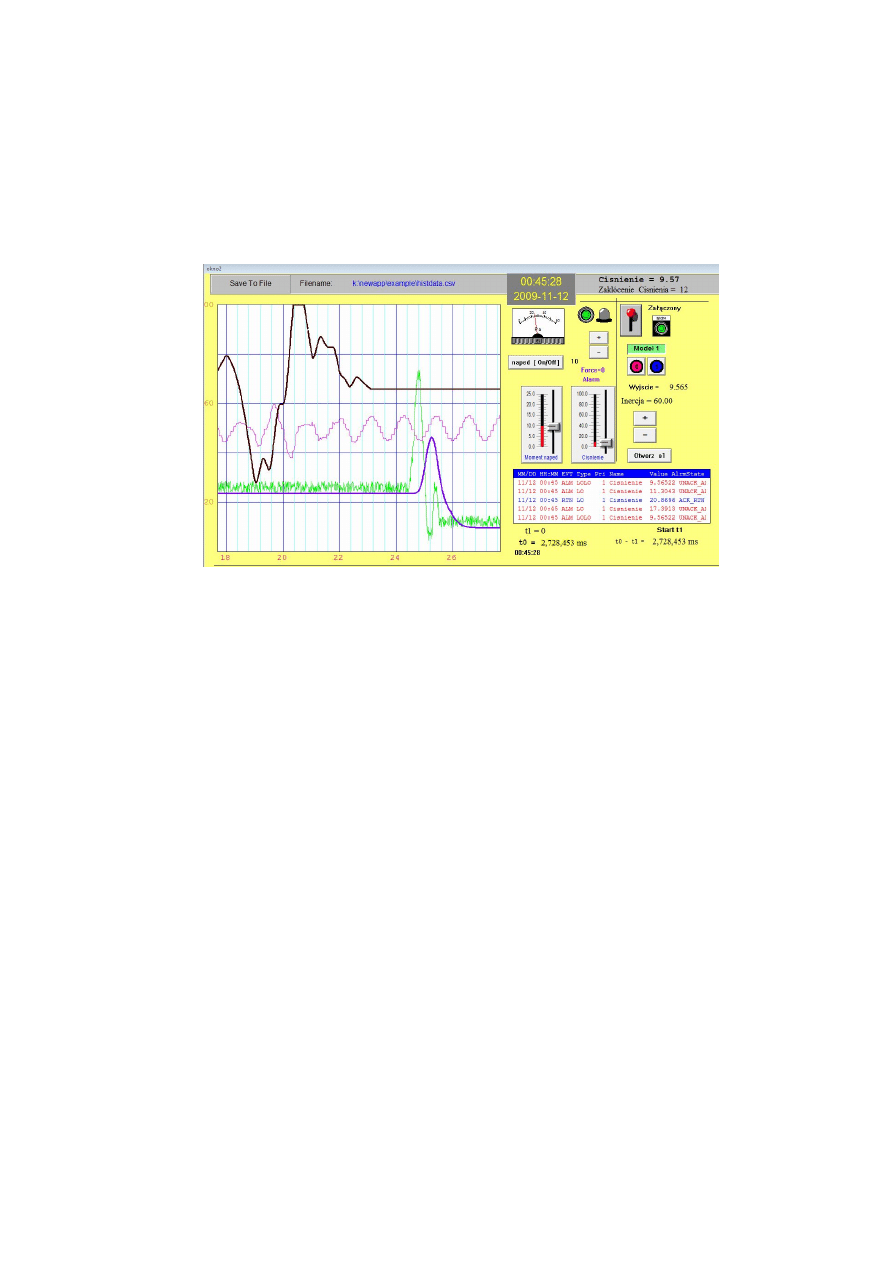

liczbę podproblemów potomnych, skojarzonych ze zbiorem rozwiązań Y