Metody numeryczne dla fizyk ´

ow

Krzysztof Golec–Biernat

(December 4, 2006)

Wersja robocza nie do dystrybucji

Krak ´ow

2005/06

2

Spis tre´sci

1

Liczby

6

1.1

Systemy liczbowe . . . . . . . . . . . . . . . . . . . . . . . . . .

6

1.2

Zapis liczb w komputerze . . . . . . . . . . . . . . . . . . . . . .

8

1.2.1

Liczby całkowite . . . . . . . . . . . . . . . . . . . . . .

8

1.2.2

Liczby rzeczywiste . . . . . . . . . . . . . . . . . . . . .

9

2

Błe¸dy

11

2.1

Dokładno´s´c zapisu . . . . . . . . . . . . . . . . . . . . . . . . .

11

2.2

Bła¸d wzgle¸dny zapisu . . . . . . . . . . . . . . . . . . . . . . . .

12

2.3

´

Zr´odła błe¸d´ow . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13

2.4

Stabilno´s´c numeryczna . . . . . . . . . . . . . . . . . . . . . . .

16

3

Interpolacja

18

3.1

Wielomian interpolacyjny Lagrange’a . . . . . . . . . . . . . . .

18

3.2

Interpolacja Lagrange’a znanej funkcji . . . . . . . . . . . . . . .

20

3.3

Wielomiany Czebyszewa . . . . . . . . . . . . . . . . . . . . . .

21

3.4

Optymalny wyb´or we¸zł´ow interpolacji . . . . . . . . . . . . . . .

23

3.5

Interpolacja przy pomocy funkcji sklejanych . . . . . . . . . . . .

24

3

4

Aproksymacja

25

4.1

Regresja liniowa . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

4.2

Aproksymacja ´sredniokwadratowa . . . . . . . . . . . . . . . . .

26

4.3

Aproksymacja Czebyszewa . . . . . . . . . . . . . . . . . . . . .

28

4.3.1

Aproksymacja Czebyszewa w dowolnym przedziale . . .

30

4.4

Aproksymacja trygonometryczna . . . . . . . . . . . . . . . . . .

31

4.4.1

Wzory dla dowolnego okresu

. . . . . . . . . . . . . . .

32

5

R´o˙zniczkowanie

33

5.1

Metody z aproksymacja¸ . . . . . . . . . . . . . . . . . . . . . . .

33

5.2

Metody z rozwinie¸ciem Taylora

. . . . . . . . . . . . . . . . . .

33

5.3

Wy˙zsze pochodne . . . . . . . . . . . . . . . . . . . . . . . . . .

34

6

Całkowanie

36

6.1

Podstawowe metody

. . . . . . . . . . . . . . . . . . . . . . . .

36

6.1.1

Metoda prostokat´ow . . . . . . . . . . . . . . . . . . . .

36

6.1.2

Metoda trapez´ow . . . . . . . . . . . . . . . . . . . . . .

37

6.1.3

Metoda parabol Simpsona . . . . . . . . . . . . . . . . .

37

6.1.4

Bła¸d przybli˙zenia . . . . . . . . . . . . . . . . . . . . . .

38

6.2

Kwadratura i jej rza¸d . . . . . . . . . . . . . . . . . . . . . . . .

39

6.3

Wielomiany ortogonalne . . . . . . . . . . . . . . . . . . . . . .

41

6.4

Kwadratura Gaussa . . . . . . . . . . . . . . . . . . . . . . . . .

43

6.4.1

Popularne kwadratury Gaussa . . . . . . . . . . . . . . .

44

7

Zera funkcji

48

7.1

Metoda połowienia . . . . . . . . . . . . . . . . . . . . . . . . .

48

7.2

Metoda Newtona . . . . . . . . . . . . . . . . . . . . . . . . . .

50

7.3

Metoda siecznych i metoda falsi . . . . . . . . . . . . . . . . . .

52

4

8

Macierze

54

8.1

Układ r´owna´n liniowych . . . . . . . . . . . . . . . . . . . . . .

54

8.2

Metoda eliminacji Gaussa . . . . . . . . . . . . . . . . . . . . . .

56

8.3

Rozkład LU macierzy . . . . . . . . . . . . . . . . . . . . . . . .

58

8.3.1

Wyznacznik . . . . . . . . . . . . . . . . . . . . . . . . .

61

9

R´ownania r´o˙zniczkowe zwyczajne

62

9.1

Metody Eulera

. . . . . . . . . . . . . . . . . . . . . . . . . . .

64

9.2

Stabilno´s´c numeryczna rozwia¸za´n . . . . . . . . . . . . . . . . .

66

9.3

Metoda Rungego-Kutty . . . . . . . . . . . . . . . . . . . . . . .

67

10 Metody Monte Carlo

70

10.1 Zmienna losowa i jej rozkład . . . . . . . . . . . . . . . . . . . .

70

10.1.1 Rozkład wielu zmiennych losowych . . . . . . . . . . . .

73

10.1.2 Niezale˙zno´s´c zmiennych losowych

. . . . . . . . . . . .

74

10.2 Generowanie liczb losowych . . . . . . . . . . . . . . . . . . . .

75

10.2.1 Metoda transformacji . . . . . . . . . . . . . . . . . . . .

75

10.2.2 Metoda odwracania dystrybunaty . . . . . . . . . . . . .

77

10.2.3 Metoda odrzucania . . . . . . . . . . . . . . . . . . . . .

78

10.3 Centralne twierdzenie graniczne . . . . . . . . . . . . . . . . . .

80

10.4 Całkowanie metoda¸ Monte Carlo . . . . . . . . . . . . . . . . . .

81

10.4.1 Metoda importance sampling . . . . . . . . . . . . . . . .

83

5

Rozdział 1

Liczby

1.1

Systemy liczbowe

Przypomnijmy zapis liczby całkowitej w systemie dziesie

‘

tnym, na przykład

1234

= 4 · 10

0

+ 3 · 10

1

+ 2 · 10

3

+ 1 · 10

4

.

(1.1)

Do zapisu u˙zywamy dziesie

‘

´c cyfr

{0,1,2,...,9}, a 10 to podstawa systemu licz-

bowego. Warto´s´c cyfry zale˙zy od pozycji w liczbie.

W og´olno´sci, dowolna

‘

liczbe

‘

całkowita

‘

mo˙zna zapisa´c w systemie pozycyjnym

o podstawie p przy pomocy cyfr c

i

∈ {0,1,..., p − 1}:

(c

k

. . . c

1

c

0

)

p

= c

0

· p

0

+ c

1

· p + ... + c

k

· p

k

(1.2)

Szczeg´olnie wa˙zna

‘

role

‘

odgrywa system dw´ojkowy o podstawie p

= 2 i cyfrach

c

i

∈ {0,1}. Przykładowo

(11010)

2

= 0 · 2

0

+ 1 · 2

1

+ 0 · 2

2

+ 1 · 2

3

+ 1 · 2

4

= 2 + 8 + 16 = 26

(1.3)

Znaczenie tego systemu dla maszyn cyfrowych wynika z faktu, ˙ze podstawowa

‘

jednostka

‘

informacji jest bit przyjmuja

‘

cy jedna

‘

z dw´och mo˙zliwych warto´sci: 0

lub 1. Maja

‘

c n bit´ow mo˙zemy zapisa´c wszystkie liczby całkowite dodatnie od 0 do

2

n

− 1.

6

Przykładowo, dysponuja

‘

c 1 bajtem

= 8 bit´ow, najwie

‘

ksza

‘

liczba

‘

jest

(11111111)

2

= 1 · 2

0

+ . . . + 1 · 2

7

= 2

8

− 1 = 255.

(1.4)

Podobnie dowolna

‘

liczbe

‘

ułamkowa

‘

z przedziału

(0, 1) mo˙zemy zapisa´c w sys-

temie dw´ojkowych przy pomocy (na og´oł niesko´nczonego) rozwinie

‘

cia

(0. c

−1

c

−2

. . . c

−n

)

2

= c

−1

· 2

−1

+ c

−2

· 2

−2

+ . . . + c

−n

· 2

−n

(1.5)

Przykładowo

(0.1101)

2

= 1 ·

1

2

+ 1 ·

1

4

+ 0 ·

1

8

+ 1 ·

1

16

=

13

16

.

(1.6)

Wygodnie jest zapamie

‘

ta´c naste

‘

puja

‘

ca tabelke

‘

ułatwiaja

‘

ca

‘

zamiane

‘

liczby z

systemu dw´ojkowego na dziesie

‘

tny.

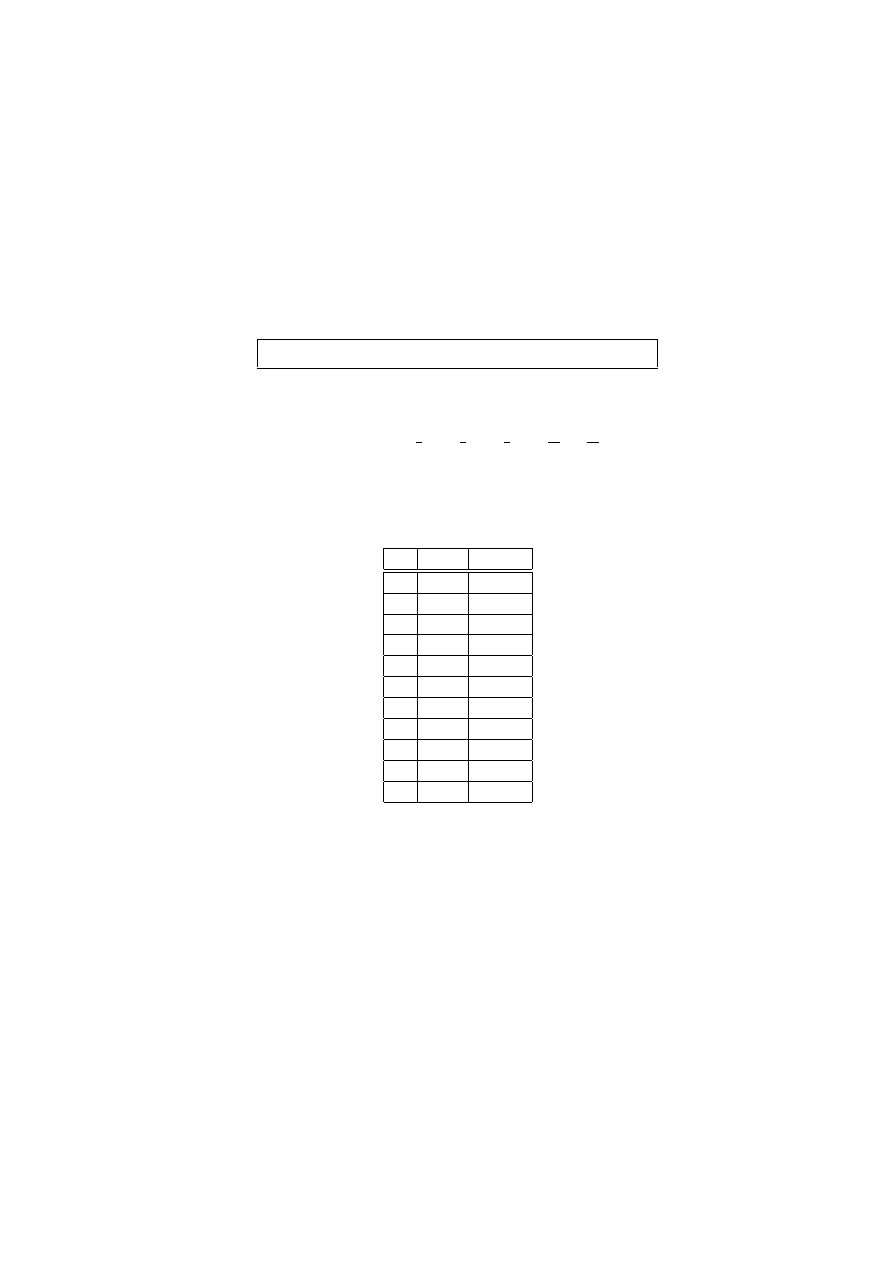

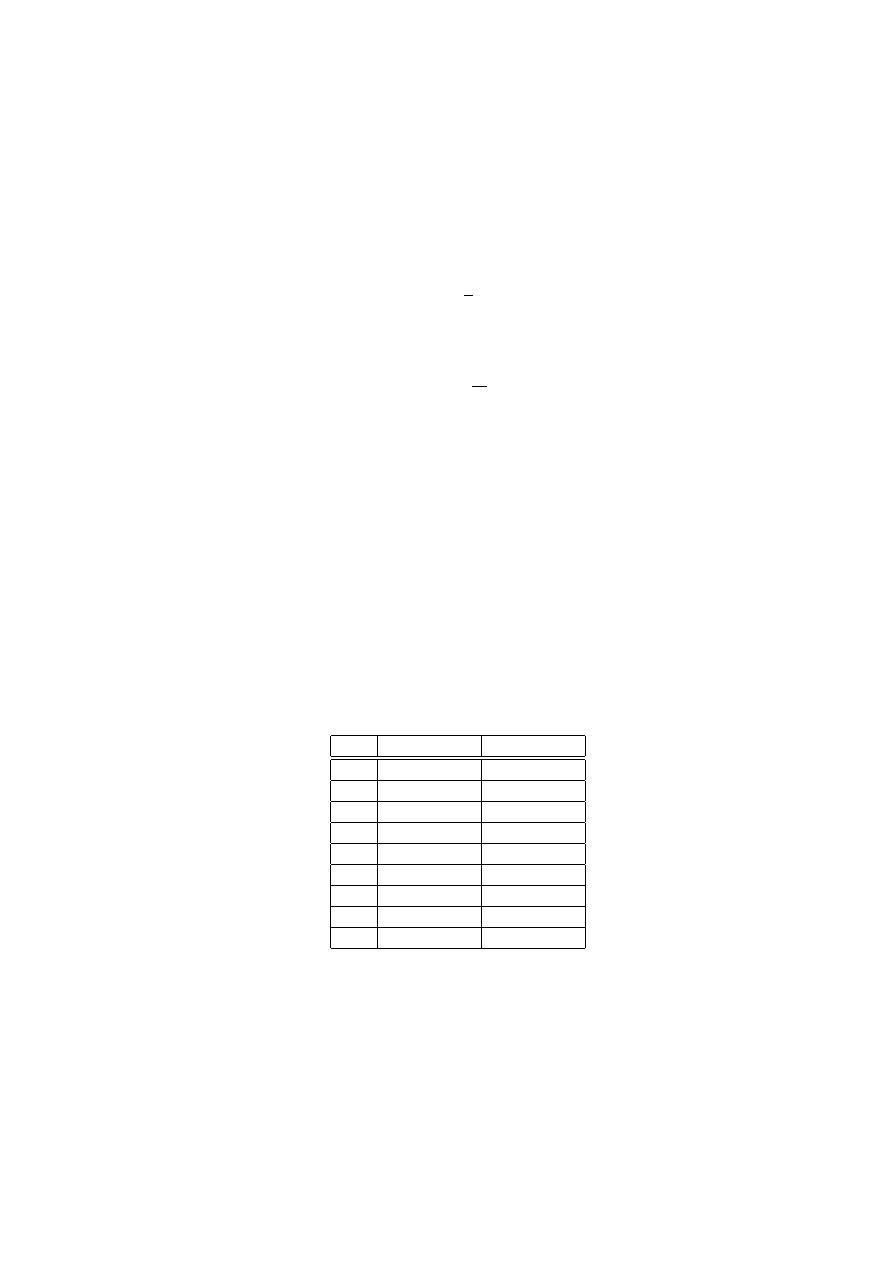

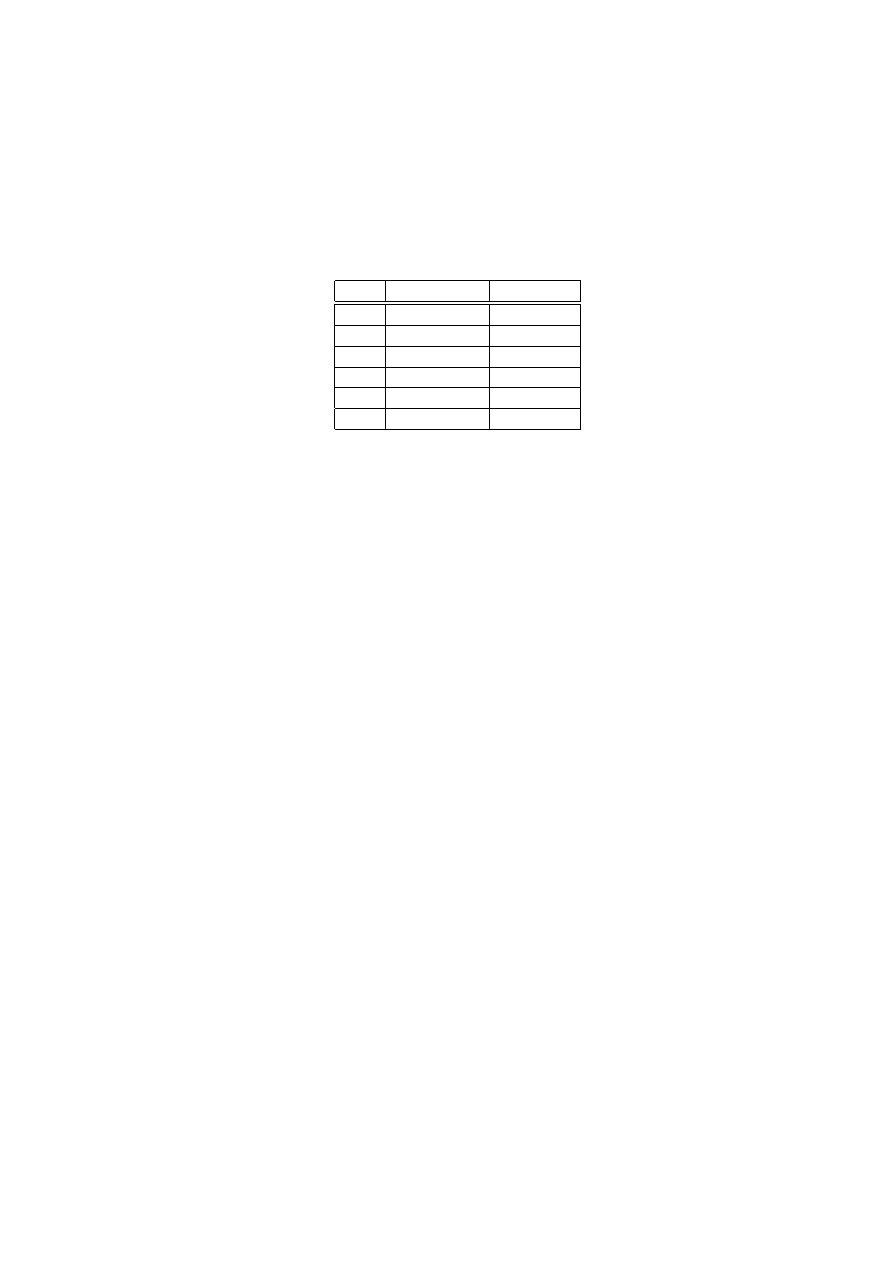

n

2

n

2

−n

0

1

1

1

2

1/2

2

4

1/4

3

8

1/8

4

16

1/16

5

32

1/32

6

64

1/64

7

128

1/128

8

256

1/256

9

512

1/512

10

1024

1/1024

Konwersje

‘

odwrotna

‘

(10

→ 2) dla liczb całkowitych realizuje sie

‘

zauwa˙zaja

‘

c,

˙ze

x

= c

0

+ c

1

· 2

1

+ . . . + c

k

· 2

k

= c

0

+ 2 · (c

1

+ . . . + c

k

· 2

k

−1

)

(1.7)

Tak wie

‘

c c

0

to reszta z dzielenia x przez 2. Podobnie c

1

jest reszta

‘

z dzielenia

(c

1

+ . . . + c

k

· 2

k

−1

) przez 2, itd.

Przykładowo, konwertuja

‘

c 31 otrzymamy

7

31

2

· 15 + 0

15

2

· 7 + 1

7

2

· 3 + 1

3

2

· 1 + 1

1

2

· 0 + 1

Odczytuja

‘

c reszty od dołu do g´ory otrzymujemy: 31

= (11110)

2

.

Podobnie, dla liczb ułamkowych x

∈ (0,1), po pomno˙zeniu przez dwa otrzy-

mamy

2x

= c

−1

+ (c

−2

· 2

−1

+ . . . + c

−n

· 2

−n+1

)

|

{z

}

r

(1.8)

Jak łatwo zauwa˙zy´c c

−1

jest cze

‘

´scia

‘

całkowita

‘

liczby 2x (r´owna

‘

0 lub 1) natomiast

r

< 1 jest cze

‘

´scia

‘

ułamkowa

‘

. Mno˙zymy wtedy r przez dwa by wydoby´c c

−2

, itd.

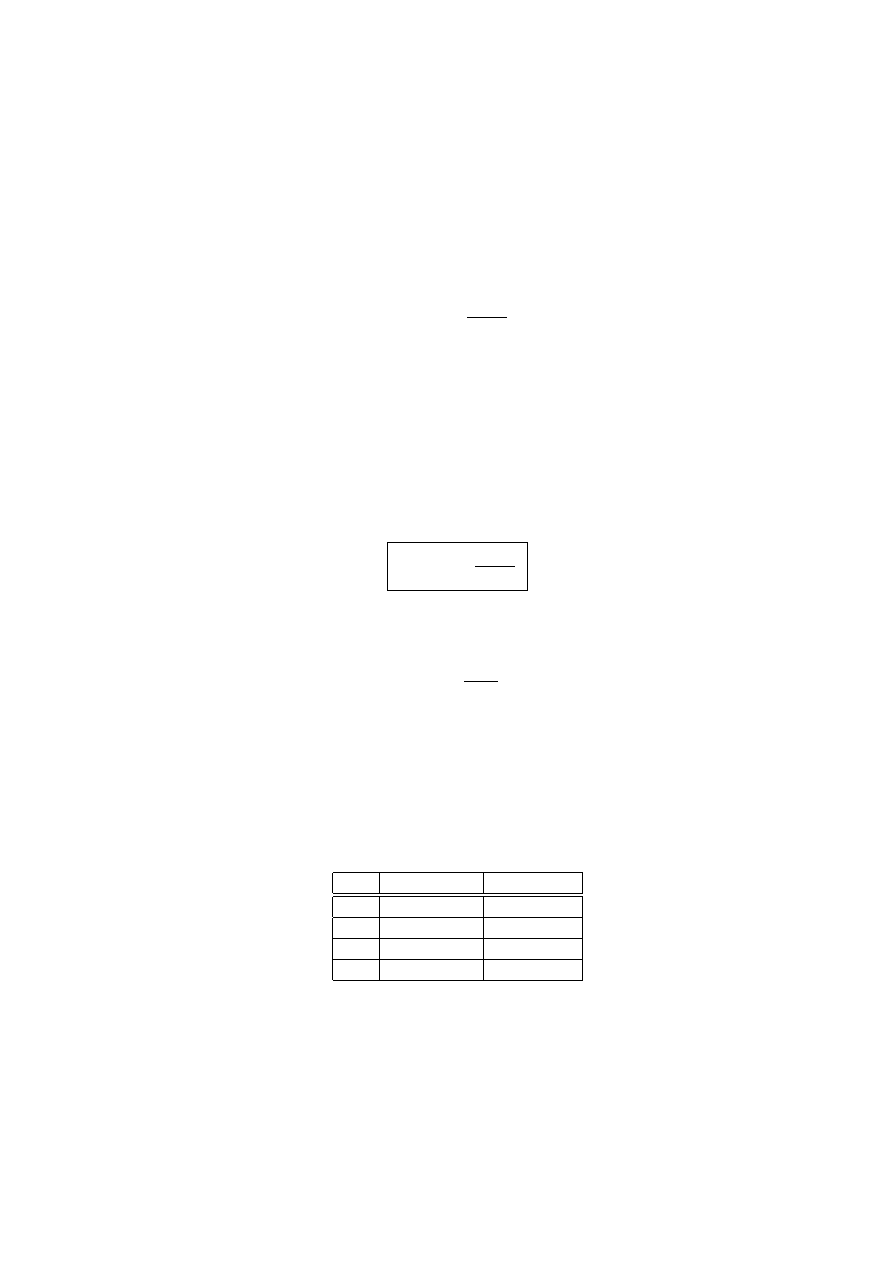

Przykładowo, dla 0

.375 otrzymujemy

0

.375

×2 = 0.750

0

.750

×2 = 1.500

0

.500

×2 = 1.000

Odczytuja

‘

c cze

‘

´sci całkowite liczb po prawej stronie r´owno´sci od g´ory do dołu,

dostajemy 0

.375 = (0.011)

2

La

‘

cza

‘

c dwie przedstawione metody konwersji 10

→ 2, mo˙zemy znale´z´c repre-

zentacje

‘

dw´ojkowa

‘

dowolnej liczby rzeczywistej, na przykład:

31

.375 = 31 + 0.375 = (11110.011)

2

(1.9)

1.2

Zapis liczb w komputerze

1.2.1

Liczby całkowite

Zał´o˙zmy, ˙ze mamy do dyspozycji n bit´ow. Pierwszy z nich przeznaczamy na znak

liczby:

(0) dla znaku dodatniego i (1) dla znaku ujemnego. Pozostałe (n−1) bit´ow

słu˙zy do zapisu liczb całkowitych z przedziału:

(−2

n

−1

+ 1 , 2

n

−1

− 1)

(1.10)

8

Przykładowo, dysponuja

‘

c 4 bajtami czyli 32 bitami (zapis w pojedynczej precyzji),

mo˙zemy zapisa´c wszystkie liczby całkowite pomie

‘

dzy:

±(2

31

− 1) = ±2147483647.

Operacje arytmetyczne na tych liczbach moga

‘

prowadzi´c do przekroczenia za-

kresu. Chwilowym wyj´sciem z problemu jest zwie

‘

kszenie liczby bajt´ow przezna-

czonych do zapisu jednej liczby całkowitej, np. do 8 bajt´ow czyli 64 bit´ow (zapis

w podw´ojnej precyzji). Wtedy zakres wynosi:

±(2

63

− 1).

1.2.2

Liczby rzeczywiste

Najbardziej efektywny zapis liczb rzeczywistych wykorzystuje reprezentacje

‘

zmie-

nnoprzecinkowa

‘

. W reprezentacji tej nie ustala sie

‘

maksymalnej liczby cyfr po

przecinku przy zapisie liczby.

Przykładowo, rozwa˙zmy liczbe

‘

x

= 0.00045. Mo˙zemy ja zapisa´c w naste

‘

puja

‘

cy

spos´ob

x

= 45 · 10

−5

= 4.5 · 10

−4

= 0.45 · 10

−3

.

Liczba stoja

‘

ca przez pote

‘

ga

‘

dziesia

‘

tki to mantysa M, natomiast wykładnik pote

‘

gi

to cecha C. Dowolna

‘

liczbe

‘

rzeczywista

‘

mo˙zna wie

‘

c zapisa´c w postaci

x

= M · 10

C

.

(1.11)

Przyjmujemy konwencje

‘

, ˙ze mantysa zawiera sie

‘

w przedziale:

1

≤ |M| < 10.

(1.12)

Dla przykładowej liczby: M

= 4.5 i C = −4.

Przyjmuja

‘

c za podstawe

‘

p

= 2 dostajemy analogiczny zapis w systemie dw´oj-

kowym

x

= M · 2

C

,

(1.13)

gdzie tym razem dla mantysy zachodzi:

1

≤ |M| < 2.

(1.14)

Reprezentacja (1.13) jest podstawa

‘

zapisu liczb rzeczywistych w komputerze.

Dzielimy n bit´ow przeznaczonych do zapisu liczby rzeczywistej na n

M

bit´ow słu-

˙za

‘

cych do zapisu mantysy i n

C

bit´ow dla zapisu cechy, łacznie ze znakiem,

n

= n

M

+ n

C

.

(1.15)

9

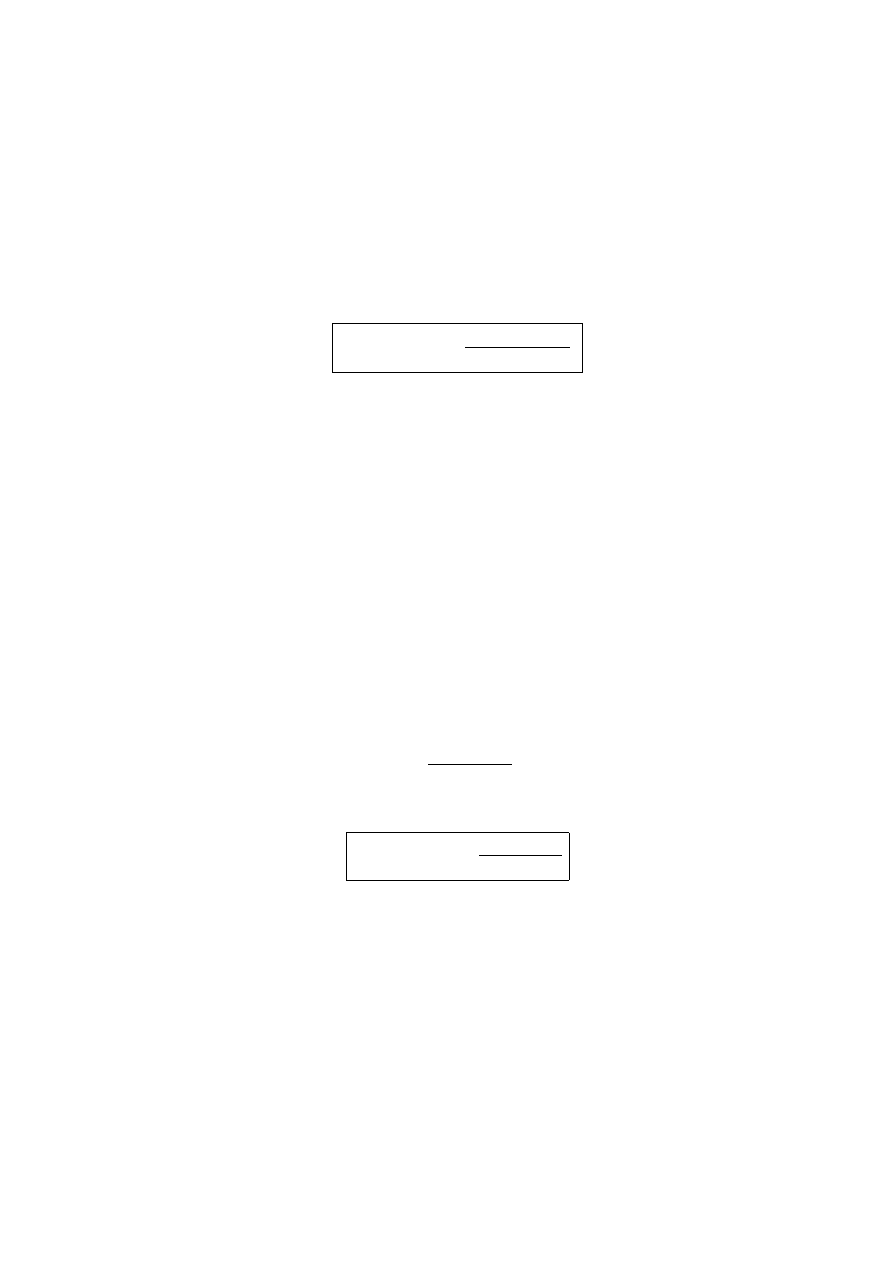

Przykładowo, dla podziału 8

= 4 + 4 najmniejsza liczba dodatnia to

(0)100

| {z }

M

(1)111

| {z }

C

= (1 · 2

0

+ 0 · 2

−1

+ 0 · 2

−2

) · 2

−(1·2

0

+1·2

1

+1·2

2

)

= 1 · 2

−7

=

1

128

.

gdzie liczby odczytujemy od lewa do prawa. Pierwsze bity mantysy i cechy (w

nawiasie) sa

‘

zarezerwowane na znak:

(0) = (+) oraz (1) = (−). Zauwa˙zmy, ˙ze

ze wzgle

‘

du na warunek M

≥ 1 nie musieliby´smy rezerwowa´c jednego bitu dla

zapisu mantysy, zachowamy go jednak ze wzgle

‘

du jednak na klarowno´s´c dyskusji.

Najwie

‘

ksza liczba to

(0)111(0)111 = (1 · 2

0

+ 1 · 2

−1

+ 1 · 2

−2

) · 2

(1·2

0

+1·2

1

+1·2

2

)

=

7

4

· 2

7

= 224 .

Liczba 1 jest reprezentowana przez

(0)100(0)000 = 1 · 2

0

= 1 ,

natomiast liczba 0 nie jest reprezentowana i na jej zapis musi by´c przeznaczone

dodatkowe osiem bit´ow.

Podsumowuja

‘

c, przy ustalonym podziale o´smiu bit´ow mo˙zemy zapisa´c 2

8

=

256 liczb rzeczywistych z przedziału

−224, −

1

128

∪

1

128

, 224

.

Oczywistym jest, ˙ze prawie wszystkie liczby rzeczywiste sa

‘

reprezentowane z

pewnym przybli˙zeniem.

10

Rozdział 2

Błe¸dy

2.1

Dokładno´s´c zapisu

Miara

‘

przybli˙zonego zapisu liczby rzeczywistej jest epsilon maszynowy, zdefinio-

wany w naste

‘

puja

‘

cy spos´ob. Rozwa˙zmy najmniejsza liczbe

‘

mo˙zliwa

‘

do zapisu w

komputerze wie

‘

ksza od 1 i oznaczny ja

‘

przez x. Epsilon maszynowy to r´o˙znica:

ε

m

= x − 1.

(2.1)

W naszym przykładzie z podziałem 8

= 4 + 4 bit´ow najmniejsza

‘

zapisana

‘

liczba

‘

wie

‘

ksza

‘

od 1 to

(0)101(0)000 = (1 · 2

0

+ 0 · 2

−1

+ 1 · 2

−2

) · 2

0

= 1 +

1

4

(2.2)

i sta

‘

d

ε

m

= 2

−2

= 0.25. W og´olno´sci, przeznaczaja

‘

c n

M

bit´ow do zapisu mantysy

(z czego jeden bit jest po´swie

‘

cony na znak), mamy

ε

m

=

1

2

(n

M

−2)

(2.3)

Zdefiniujmy tak˙ze precyzje

‘

p zmiennoprzecinkowego systemu liczbowego.

Jest to liczba bit´ow u˙zyta do zapisu mantysy (bez znaku)

p

= n

M

− 1.

(2.4)

Tak wie

‘

c

ε

m

= 1/2

p

−1

. Zwie

‘

kszaja

‘

c liczbe

‘

bit´ow mantysy n

M

zwie

‘

kszamy pre-

cyzje

‘

. Odbywa sie

‘

to kosztem zmniejszenia maksymalnej liczby mo˙zliwej do za-

pisania, gdy˙z przy ustalonej całkowitej liczbie bit´ow n, mniej bit´ow mo˙zna przez-

naczy´c do zapisu cechy: n

C

= n − n

M

. Jest to ilustracja wymienno´sci pomie

‘

dzy

dokładno´scia

‘

a zakresem reprezentowanych liczb zmiennoprzecinkowych w kom-

puterze.

11

2.2

Bła¸d wzgle¸dny zapisu

Na og´oł dowolona liczba zmiennoprzecinkowa x nie mo˙ze by´c reprezentowana w

komputerze dokładnie. Je˙zeli najbli˙zsza

‘

liczba

‘

zapisana

‘

dokładnie jest x

′

, to bła

‘

d

bezwgle

‘

dny jest zdefiniowany jako r´o˙znica

δ

x

= x

′

− x ,

(2.5)

natomiast bła

‘

d wzgle

‘

dny to stosunek błe

‘

du bezwzgle

‘

dnego do warto´sci dokładnej

liczby

ε

=

x

′

− x

x

(2.6)

Z ostatniego wzoru wynika

x

′

= x (1 +

ε

).

(2.7)

Mo˙zna pokaz´c, ˙ze moduł błe

‘

du wzgle

‘

dnego jest mniejszy od epsilona maszyno-

wego

|

ε

| ≤

ε

m

.

(2.8)

Przyklad

Chcemy zapisa´c liczbe

‘

0

.48 = 12/25 przy pomocy 8 = 4 + 4 bit´ow. Zapiszmy

ja

‘

w reprezentacji cecha-mantysa, przyjmuja

‘

c podstawe

‘

p

= 2:

0

.48 = 1.92/4 = (1.92) · 2

−2

.

Mantysa zapisana w systemie dw´ojkowym to

1

.92 = (1.111010 . . .)

2

.

(2.9)

W reprezentacji 8

= 4 + 4 pozostawiamy pierwsze trzy bity w rozwinie

‘

ciu dw´oj-

kowym mantysy. Sta

‘

d

0

.48 ≈ (0)111(1)010 = (1 · 2

0

+ 2

−1

+ 2

−2

) · 2

−2

=

7

16

= 0.4375 .

Jest to ilustracja zaokra

‘

glania, polegaja

‘

cego na odrzuceniu cyfr w rozwinie

‘

ciu

dw´ojkowym mantysy wykraczaja

‘

cych poza przyje

‘

ta

‘

liczbe

‘

bit´ow (w tym przy-

padku trzech). Powstały w ten spos´ob bła

‘

d wzgle

‘

dny to

|

ε

| =

7

16

−

12

25

12

25

=

17

192

.

Jak wida´c

|

ε

| < 1/4 =

ε

m

, zgodnie z warunkiem (2.8).

12

2.3

´

Zr´odła błe¸d´ow

Przy obliczeniach komputerowych mamy do czynienia z trzema rodzajami błe

‘

d´ow.

Błe

‘

dy wej´sciowe.

Sa

‘

one spowodowane tym, ˙ze dane wej´sciowe (punkty eksperymentalne, liczby

niewymierne) ju˙z sa

‘

obarczone błe

‘

dem niezale˙znym od komputera lub u˙zytej pro-

cedury numerycznej.

Błe

‘

dy obcie

‘

cia.

Powstaja

‘

na skutek niemo˙zno´sci wykonania w obliczeniach numerycznych nie-

sko´nczonych sumowa´n lub ´scisłych przej´s´c granicznych. Dla przykładu, obliczaja

‘

c

warto´s´c funkcji przy pomocy rozwinie

‘

cia Taylora,

f

(x + h) = f (x) +

f

′

(x)

1!

h

+

f

′′

(x)

2!

h

2

+ . . . +

f

(N)

(x)

N!

h

N

+ R

N

(x, h)

popełniamy bła

‘

d zadany przez odrzucana

‘

reszte

‘

R

N

(x, h). W szczeg´olno´sci, dla

kilku podstawowych funkcji u˙zywamy naste

‘

puja

‘

cych przybli˙zonych rozwinie

‘

´c:

exp x

≈ 1 + x +

x

2

2!

+ . . . +

x

N

N!

sin x

≈ x −

x

3

3!

+

x

5

5!

+ . . . + (−1)

N

x

2N

+1

(2N + 1)!

(2.10)

cos x

≈ 1 −

x

2

2!

+

x

4

4!

+ . . . + (−1)

N

x

2N

(2N)!

ln

1

+ x

1

− x

≈ 2

x

+

x

3

3!

+

x

5

5!

+ . . . +

x

2N

+1

(2N + 1)!

|x| < 1.

Z ostatniego wzoru korzystamy obliczaja

‘

c logarytm dowolnej liczby dodatniej w

=

(1 + x)/(1 − x), odwracaja

‘

c najpierw te

‘

relacje

‘

:

x

=

(w − 1)

(w + 1)

,

13

a naste

‘

pnie podstawiaja

‘

c po prawej stronie.

Błe

‘

dy zaokra

‘

gle´n.

To błe

‘

dy wynikaja

‘

ce z niedokładno´sci zapisu liczb rzeczywistych, propagu-

ja

‘

cych sie

‘

przy wykonywaniu wielokrotnych działa´n arytmetycznych. Je´sli przez

fl

(x) oznaczymy wynik oblicze´n numerycznych r´o˙znia

‘

cy sie

‘

od dokładnej warto´sci

x na skutek błe

‘

d´ow zaokra

‘

gle´n, to zgodnie z (2.6) dla pojedynczej liczby mamy:

fl

(x) = x (1 +

ε

) .

(2.11)

W przypadku wykonywania działa´n arytmetycznych obowia

‘

zuje:

Lemat Wilkinsona

Błe

‘

dy zaokra

‘

gle´n powstaja

‘

ce przy wykonywaniu działa´n zmiennoprzecinko-

wych sa

‘

r´ownowa˙zne zaste

‘

pczemu zaburzaniu liczb, na kt´orych wykonujemy dzia-

łania. W przypadku pojedynczych działa´n zachodzi

fl

(x

1

± x

2

) = x

1

(1 +

ε

1

) ± x

2

(1 +

ε

2

)

fl

(x

1

· x

2

) = x

1

(1 +

ε

3

) · x

2

= x

1

· x

2

(1 +

ε

3

)

(2.12)

fl

(x

1

/x

2

) = x

1

(1 +

ε

4

)/x

2

= x

1

/(x

2

(1 +

ε

5

)) ,

gdzie mo˙zna tak dobra´c zaburzenia, ˙ze wszystkie liczby

|

ε

i

| <

ε

m

.

(2.13)

Przyklad

Zilustrujmy lemat Wilkinsona dodaja

‘

c do siebie dwie liczby w reprezentacji

8

= 4 + 4 bit´ow:

0

.48 + 0.24 =

12

25

+

12

50

.

Na podstawie przykładu z poprzedniego rozdziału:

0

.48 = 1.92 · 2

−2

≈ (0)111(1)010 = (1 · 2

0

+ 2

−1

+ 2

−2

) · 2

−2

=

7

16

0

.24 = 1.92 · 2

−3

≈ (0)111(1)110 = (1 · 2

0

+ 2

−1

+ 2

−2

) · 2

−3

=

7

32

.

Po dodaniu

fl

(0.48 + 0.24) =

7

16

+

7

32

=

21

32

= 1.625 · 2

−1

≈ (0)110(1)100 =

3

4

14

gdy˙z 1

.625 = (1.101)

2

. Ten sam wynik mo˙zna otrzyma´c zaburzaja

‘

c dodawane do

siebie liczby

12

25

(1 +

ε

1

) +

12

50

(1 +

ε

2

) =

3

4

,

ska

‘

d wynika relacja

2

ε

1

+

ε

2

=

1

8

.

Wyb´or liczb

ε

i

nie jest jednoznaczny, np.

ε

1

=

ε

2

= 1/24. Mo˙zna wie

‘

c tak dobra´c

te parametry, ˙ze oba

|

ε

i

| ≤

ε

m

= 1/4, zgodnie z lematem Wilkinsona.

Obliczmy bła

‘

d wzgle

‘

dny r´o˙znicy dw´och liczb. Zgodnie z lematem Wilkinsona

|

ε

| =

fl

(x

1

− x

2

) − (x

1

− x

2

)

x

1

− x

2

=

x

1

·

ε

1

− x

2

·

ε

2

x

1

− x

2

.

(2.14)

Bła

‘

d wzgle

‘

dny mo˙ze by´c dowolnie du˙zy w sytuacji gdy odejmowane liczby niewiele

sie

‘

od siebie r´o˙znia

‘

. Na przkład dla x

1

= x

2

(1 +

δ

) otrzymujemy

|

ε

| ≃

|

ε

1

−

ε

2

|

|

δ

|

→

∞

dla

δ

→ 0.

(2.15)

Nale˙zy wie

‘

c unika´c odejmowania mało r´o˙znia

‘

cych sie

‘

od siebie liczb.

Nieograniczony wzrost (2.15) nie jest sprzeczny z warunkiem (2.13) w lemacie

Wilkinsona, gdy˙z epsilony w tym lemacie to zaburzenia indywidualnych liczb, a

nie bła

‘

d wzgle

‘

dny (2.14) wyniku działa´n arytmetycznych.

Przyklad

Obliczaja

‘

c jeden z pierwiastk´ow r´ownania kwadratowego dla b

2

≫ 4ac,

x

=

−b +

√

b

2

− 4ac

2a

,

(2.16)

nale˙zy wykorzysta´c r´ownowa˙zna

‘

posta´c

x

=

−b +

√

b

2

− 4ac

2a

·

(−b −

√

b

2

− 4ac)

(−b −

√

b

2

− 4ac)

=

−2c

b

+

√

b

2

− 4ac

.

(2.17)

Dodajemy wtedy dwie wielko´sci tego samego rze

‘

du w mianowniku, zamiast odej-

mowa´c dwie bliskie liczby w liczniku.

15

2.4

Stabilno´s´c numeryczna

Zagadnienie to dotyczy wpływu błe

‘

d´ow zaokra

‘

gle´n lub błe

‘

d´ow obcie

‘

´c na sta-

bilno´s´c algorytm´ow numerycznych. Wynikaja

‘

ce sta

‘

d niebezpiecze´nstwa przed-

stawimy analizuja

‘

c przykład zaczerpnie

‘

ty z Numerical Recipes [2].

Rozwa˙zmy liczbe

‘

φ

=

√

5

− 1

2

≈ 0.618033989.

(2.18)

Chcemy obliczy´c kolejne pote

‘

gi

φ

n

. Poniewa˙z

φ

2

= 1−

φ

, wydaje sie

‘

, ˙ze najprostsza

‘

metoda

‘

jest skorzystanie z relacji rekurencyjnej

φ

n

+2

=

φ

n

−

φ

n

+1

.

(2.19)

Okazuje sie

‘

, ˙ze numeryczna realizacja tej relacji prowadzi do szybko rosna

‘

cych

kolejnych warto´sci

φ

n

, co jest sprzeczne z warunkiem

lim

n

→

∞

φ

n

= 0 .

(2.20)

Jest to spowodowane nieuniknionym błedem zaokra

‘

glenia niewymiernej liczby

(2.18). Aby to zrozumie´c, rozwa˙zmy og´olna

‘

relacje

‘

rekurencyjna

‘

F

n

+2

= F

n

− F

n

+1

(2.21)

z warunkami F

0

= 1 oraz F

1

=

φ

. Rozwia

‘

˙zemy te

‘

relacje

‘

posługuja

‘

c sie

‘

funkcja

‘

tworza

‘

ca

‘

F

(z) =

∞

∑

n

=0

F

n

z

n

+1

.

(2.22)

Otrzymujemy

F

(z) = z +

φ

z

2

+

∞

∑

n

=2

F

n

z

n

+1

= z +

φ

z

2

+

∞

∑

n

=0

F

n

+2

z

n

+3

(2.23)

= z +

φ

z

2

+

∞

∑

n

=0

(F

n

− F

n

+1

) z

n

+3

= z +

φ

z

2

+ z

2

F

(z) − z

∞

∑

n

=0

F

n

+1

z

n

+2

= z +

φ

z

2

+ z

2

F

(z) − z

∞

∑

n

=1

F

n

z

n

+1

= z +

φ

z

2

+ z

2

F

(z) − z(F(z) − z)

(2.24)

16

Sta

‘

d znajdujemy

F

(z) =

(1 + z (1 +

φ

)) z

1

+ z − z

2

.

(2.25)

Wyra˙zenie to mo˙zemy zapisa´c w naste

‘

puja

‘

cy spos´ob

F

(z) =

1

+ z (1 +

φ

)

(a − b)

1

1

− az

−

1

1

− bz

,

(2.26)

gdzie a

+ b = −1 oraz ab = −1, co prowadzi do rozwia

‘

zania

a

=

√

5

− 1

2

b

= −

√

5

+ 1

2

.

(2.27)

Tak wie

‘

c

F

(z) =

1

+ z (1 +

φ

)

√

5

∞

∑

n

=0

(a

n

− b

n

) z

n

=

1

√

5

(

∞

∑

n

=1

(a

n

− b

n

) z

n

+ (1 +

φ

)

∞

∑

n

=0

(a

n

− b

n

) z

n

+1

)

=

1

√

5

(

∞

∑

n

=0

(a

n

+1

− b

n

+1

) z

n

+1

+ (1 +

φ

)

∞

∑

n

=0

(a

n

− b

n

) z

n

+1

)

=

1

√

5

∞

∑

n

=0

(a

n

+1

− b

n

+1

) + (1 +

φ

)(a

n

− b

n

)

z

n

+1

=

∞

∑

n

=0

F

n

z

n

+1

.

Sta

‘

d rozwia

‘

zanie rekurencji (2.21) z zadanymi warunkami pocza

‘

tkowym

F

n

=

1

√

5

{a

n

(1 + a +

φ

) − b

n

(1 + b +

φ

)}

(2.28)

Je˙zeli

φ

= a to po podstawieniu do (2.28) otrzymujemy zgodnie z oczekiwa-

niami:

F

n

= a

n

.

(2.29)

Jednak w obliczeniach numerycznych liczba niewymierna

φ

jest zawsze zadana z

przybli˙zeniem, tak wie

‘

c

φ

= a +

ε

(2.30)

i po podstawieniu do (2.28), otrzymujemy

F

n

= a

n

1

+

ε

√

5

− b

n

ε

√

5

.

(2.31)

Poniewa˙z a

< 1 oraz |b| > 1, drugie wyra˙zenie dominuje dla du˙zych warto´sci n,

prowadza

‘

c do niestabilnej rekurencji spowodowanej błe

‘

dem zaokra

‘

glenia liczby

φ

.

17

Rozdział 3

Interpolacja

3.1

Wielomian interpolacyjny Lagrange’a

Poszukujemy og´olnej zale˙zno´sci funkcyjnej w sytuacji gdy znamy te

‘

zale˙zno´s´c w

(n + 1) punktach:

x

0

x

1

... x

n

y

0

y

1

... y

n

.

(3.1)

Punkty x

i

nazywamy we

‘

złami interpolacji, przy czym x

i

< x

j

dla i

< j. Problem ten

ma jednoznaczne rozwia

‘

zanie je´sli poszukiwana

‘

funkcja

‘

jest wielomian stopnia n

W

n

(x) = a

0

+ a

1

x

+ ... + a

n

x

n

.

(3.2)

Wsp´ołczynniki wielomianu a

i

musza

‘

by´c tak dobrane by wielomian W

n

przechodził

przez ka˙zdy punkt

(x

i

, y

i

):

y

i

= W

n

(x

i

)

i

= 0, 1, . . ., n .

(3.3)

Warunek ten prowadzi do układu liniowego

(n + 1) r´owna´n na (n + 1) niewia-

domych wsp´ołczynnik´ow wielomianu a

i

:

a

0

+ a

1

x

0

+ ... + a

n

x

n

0

= y

0

a

0

+ a

1

x

1

+ ... + a

n

x

n

1

= y

1

...

a

0

+ a

1

x

n

+ ... + a

n

x

n

n

= y

n

,

(3.4)

18

lub zapisuja

‘

c w postaci macierzowej

1

x

0

x

2

0

. . . x

n

0

1

x

1

x

2

1

. . . x

n

1

..

.

..

.

..

.

..

.

1

x

n

x

2

n

. . . x

n

n

a

0

a

1

..

.

a

n

=

y

0

y

1

..

.

y

n

.

(3.5)

Rozwia

‘

znie powy˙zszego układu r´owna´n istnieje i jest ono jednoznaczne gdy˙z wyz-

nacznik macierzy gł´ownej, be

‘

da

‘

cy wyznacznikiem Vandermonde’a, jest r´o˙zny od

zera

det

=

∏

(i, j) i> j

(x

i

− x

j

) 6= 0.

(3.6)

Istnieje wie

‘

c dokładnie jeden wielomian interpoluja

‘

cy (3.2) przechodza

‘

cy przez

punkty (3.1). Wielomian ten nazywamy wielomianem Lagrange’a.

Aby znale´z´c jawna

‘

posta´c wielomianu Lagrange’a nale˙zy rozwia

‘

za´c układ r´ow-

na´n (3.5). Dzie

‘

ki warunkowi jednoznaczno´sci alternatywna

‘

metoda

‘

jest poszuki-

wanie wielomianu w postaci

W

n

(x) = y

0

L

0

(x) + y

1

L

1

(x) + ... + y

n

L

n

(x)

(3.7)

gdzie L

i

(x) sa

‘

wielomianami stopnia n, dla kt´orych zachodzi

L

i

(x

j

) =

δ

i j

.

(3.8)

Spełniony jest wtedy warunek (3.3) nało˙zony na wielomian Lagrange’a:

W

n

(x

j

) =

n

∑

i

=0

y

i

L

i

(x

j

) =

n

∑

i

=0

y

i

δ

i j

= y

j

.

(3.9)

Zgodnie z warunkiem (3.8) wielomian L

i

(x) zeruje sie

‘

we wszystkich we

‘

złach

z wyja

‘

tkiem x

= x

i

. Tak wie

‘

c jest on proporcjonalny do iloczynu wszystkich jed-

nomian´ow

(x − x

j

) z wyła

‘

czeniem czynnika

(x − x

i

):

L

i

(x) = a (x − x

0

) ... (x − x

i

−1

) (x − x

i

+1

) ... (x − x

n

) .

(3.10)

Wsp´ołczynnik a wyznaczamy z warunku L

i

(x

i

) = 1, co prowadzi do wzoru

L

i

(x) =

(x − x

0

) ... (x − x

i

−1

) (x − x

i

+1

) ... (x − x

n

)

(x

i

− x

0

) ... (x

i

− x

i

−1

) (x

i

− x

i

+1

) ... (x

i

− x

n

)

.

(3.11)

19

Przyklad

Rozwa˙zmy interpolacje

‘

zale˙zno´sci funkcyjnej okre´slonej w trzech we

‘

złach

x

0

, x

1

, x

2

. Wielomian Lagrange’a przyjmuje posta´c

W

2

(x) = y

0

(x − x

1

)(x − x

2

)

(x

0

− x

1

)(x

0

− x

2

)

+ y

1

(x − x

0

)(x − x

2

)

(x

1

− x

0

)(x

1

− x

2

)

+ y

2

(x − x

0

)(x − x

1

)

(x

2

− x

0

)(x

2

− x

1

)

Podsumowuja

‘

c, interpolacja Lagrange’a pozwala jednoznacznie rozwia

‘

za´c pro-

blem znalezienia funkcji, przechodza

‘

cej przez

(n + 1) zadanych punkt´ow. Ta

‘

funkcja

‘

jest wielomian Lagrange’a stopnia n. Poniewa˙z prawdziwa zale˙zno´s´c fun-

kcyjna nie jest znana, nie mo˙zna okre´sli´c błe

‘

du tej metody.

3.2

Interpolacja Lagrange’a znanej funkcji

Cze

‘

sto w zastosowaniach numerycznych mamy do czynienia z problemem przy-

bli˙zenia znanej funkcji y

= f (x) w przedziale [a, b] przy pomocy wyra˙zenia wyko-

rzystuja

‘

cego znajomo´s´c tej funkcji w sko´nczonej liczbie punkt´ow z tego przedziału.

Wybierzmy w tym celu

(n + 1) we

‘

zł´ow i znajd´zmy odpowiadaja

‘

ce im warto´sci

funkcji

x

0

,

x

1

...

x

n

f

(x

0

)

f

(x

1

)

...

f

(x

n

) .

(3.12)

Przybli˙zmy naste

‘

pnie znana

‘

funkcje

‘

przy pomocy wielomianu interpolacyjnego

(3.7):

W

n

(x) =

n

∑

i

=0

f

(x

i

) L

i

(x) .

(3.13)

Zakładaja

‘

c, ˙ze istnieje

(n + 1) pochodna f mo˙zna pokaza´c (dow´od w podre

‘

czniku

[1]), ˙ze

f

(x) −W

n

(x) =

f

(n+1)

(

ξ

)

(n + 1)!

ω

n

+1

(x)

(3.14)

gdzie

ξ

∈ [a,b], natomiast

ω

n

+1

to wielomian:

ω

n

+1

(x) = (x − x

0

)(x − x

1

) . . . (x − x

n

) .

(3.15)

20

Ze wzoru tego wynika, ˙ze maksymalny bła

‘

d interpolacji Lagrange’a jest ograni-

czony przez

| f (x) −W

n

(x)| ≤

M

n

+1

(n + 1)!

|

ω

n

+1

(x)|

(3.16)

gdzie M

n

+1

jest kresem g´ornym:

M

n

+1

= sup

x

∈[a,b]

| f

(n+1)

(x)|.

(3.17)

Zauwa˙zmy, ˙ze dla wielomian´ow stopnia

≤ n pochodna f

(n+1)

znika. Sta

‘

d M

n

+1

= 0

i bła

‘

d interpolacji Lagrange’a wynosi zero. Tak wie

‘

c prawdziwe jest:

Twierdzenie

Interpolacja Lagrange’a z

(n + 1) we

‘

złami jest dokładna dla ka˙zdego wielomianu

stopnia

≤ n.

3.3

Wielomiany Czebyszewa

Powstaje pytanie, jak dobra´c we

‘

zły interpolacji by prawa strona wyra˙zenia (3.16)

była jak najmniejsza. Nale˙zy w tym celu znale´z´c najmniejsze oszacowanie maksy-

malnej warto´sci

|

ω

n

+1

(x)| w przedziale [a,b]. Odpowied´z na to pytanie otrzymuje

sie

‘

rozwa˙zaja

‘

c wielomiany Czebyszewa.

Wielomian Czebyszewa stopnia n jest zdefiniowany przy pomocy wzoru

T

n

(x) = cos(n arccos x)

n

= 0, 1, 2, . . .

(3.18)

gdzie x

∈ [−1,1]. Z definicji tej wynika relacja

|T

n

(x)| ≤ 1.

(3.19)

Dwa pierwsze wielomiany Czebyszewa to

T

0

(x) = 1

T

1

(x) = x .

(3.20)

Kolejne wielomiany mo˙zna wyliczy´c korzystaja

‘

c z relacji rekurencyjnej.

T

n

+1

(x) = 2x T

n

(x) − T

n

−1

(x) ,

n

≥ 1.

(3.21)

Dow´od:

21

Podstawiaja

‘

c

φ

= arccos x, rozwa˙zmy

T

n

+1

(x) = cos(n + 1)

φ

= cos(n

φ

) cos

φ

− sin(n

φ

) sin

φ

= x T

n

(x) − sin(n

φ

) sin

φ

.

Wykorzystuja

‘

c naste

‘

pnie to˙zsamo´s´c trygonometryczna

‘

sin

α

sin

β

=

1

2

{cos(

α

−

β

) − cos(

α

+

β

)}

otrzymamy

T

n

+1

= x T

n

−

1

2

{cos((n − 1)

φ

) − cos((n + 1)

φ

)} = x T

n

−

1

2

(T

n

−1

− T

n

+1

) .

Sta

‘

d wynika ju˙z relacja (3.21).

Tak wie

‘

c naste

‘

pne wielomiany Czebyszewa to

T

2

(x) = 2x

2

− 1

T

3

(x) = 4x

3

− 3x

T

4

(x) = 8x

4

− 8x

2

+ 1 .

(3.21)

Wida´c sta

‘

d, ˙ze wielomian T

n

jest funkcja

‘

o okre´slonej parzysto´sci, dodatniej dla

parzystych n i ujemna

‘

dla nieparzystych warto´sci stopnia wielomianu. Ponadto,

rozwa˙zaja

‘

c wsp´ołczynnik przy najwy˙zszej pote

‘

dze zauwa˙zamy, ˙ze

T

n

(x) = 2

n

−1

x

n

+ ··· .

(3.22)

Ka˙zdy wielomian Czebyszewa stopnia n ma dokładnie n pierwiastk´ow rzeczy-

wistch. Aby je znale´z´c rozwia

‘

zujemy r´ownanie

T

n

(x) = cos(n arccos x) = 0 ,

(3.23)

otrzymuja

‘

c naste

‘

puja

‘

ce pierwiastki

x

k

= cos

π

(k + 1/2)

n

,

k

= 0, 1, . . . , n − 1

(3.24)

Dowolny wielomian Czebyszewa mo˙zna wie

‘

c zapisa´c w postaci

T

n

(x) = 2

n

−1

(x − x

0

)(x − x

1

) . . . (x − x

n

−1

)

= 2

n

−1

ω

n

(x) ,

(3.25)

gdzie wsp´ołczynnik 2

n

−1

wynika z uwagi (3.22).

22

3.4

Optymalny wyb´or we¸zł´ow interpolacji

Powracaja

‘

c do problemu optymalnego wyboru we

‘

zł´ow interpolacji dla dowolnej

funkcji f

(x), rozpatrzymy najpierw funkcje zadane na przedziale [−1,1].

Wybierzmy

(n + 1) we

‘

zł´ow interpolacji

{x

0

, x

1

, . . . , x

n

} jako zera wielomianu

Czebyszewa T

n

+1

, wz´or (3.24):

x

k

= cos

π

(k + 1/2)

(n + 1)

,

k

= 0, 1, . . . n .

(3.26)

Na podstawie relacji (3.25) oraz własno´sci (3.19) otrzymujemy dla tak wybranych

we

‘

zł´ow

|

ω

n

+1

(x)| =

1

2

n

|T

n

+1

(x)| ≤

1

2

n

.

(3.27)

Relacja (3.16) przyjmuje wie

‘

c teraz posta´c

| f (x) −W

n

(x)| ≤

M

n

+1

2

n

(n + 1)!

(3.28)

gdzie M

n

+1

to kres g´orny

| f

(n+1)

(x)| w przedziale [−1,1]. Otrzymali´smy najm-

niejsze oszacowanie maksymalnego błedu interpolacji Lagrange’a.

Dla funkcji f

(y) okre´slonej na przedziale [a, b], optymalnie wybranymi we

‘

złami

sa

‘

obrazy zer (3.26) poprzez transformacje

‘

liniowa

‘

y

=

1

2

{(b − a)x + (a + b)},

x

∈ [−1,1].

(3.29)

Wtedy

ω

n

+1

(y) =

n

∏

k

=0

(y − y

k

) =

(b − a)

n

+1

2

n

+1

n

∏

k

=0

(x − x

k

) =

(b − a)

n

+1

2

n

+1

ω

n

+1

(x) .

Wykorzystuja

‘

c naste

‘

pnie relacje

‘

(3.27) otrzymujemy

|

ω

n

+1

(y)| ≤

(b − a)

n

+1

2

n

+1

1

2

n

.

(3.30)

Sta

‘

d najmniejsze oszacowanie błe

‘

du maksymalnego interpolacji Lagrange’a

| f (y) −W

n

(y)| ≤

M

n

+1

2

n

(n + 1)!

b

− a

2

n

+1

,

(3.31)

gdzie M

n

+1

to kres g´orny warto´sci

| f

n

+1

(y)| w przedziale [a,b].

23

3.5

Interpolacja przy pomocy funkcji sklejanych

Dla ka˙zdego układu

(n + 1) we

‘

zł´ow w przedziale

[a, b] istnieje funkcja cia

‘

gła w

przedziale, dla kt´orej metoda interpolacyjna nie jest zbie˙zna. Dla takiej funkcji

zwie

‘

kszenie liczby we

‘

zł´ow pogarsza jako´s´c interpolacji (zwłaszcza bli˙zej ko´nc´ow

przedziału), zwie

‘

kszaja

‘

c r´o˙znice

‘

| f (x) −W

n

(x)|. Przykładem jest funkcja f (x) =

|x| interpolowana w przedziale [−1,1] przy pomocy r´ownoodległych we

‘

zł´ow.

W takich przypadkach stosuje sie

‘

interpolacje

‘

, w kt´orej nie zwie

‘

ksza sie

‘

liczby

we

‘

zł´ow. Dla

(n + 1) we

‘

zł´ow

{x

0

, x

1

, . . . , x

n

} otrzymujemy n przedział´ow numero-

wanych indeksem lewego ko´nca:

[x

0

, x

1

] ∪ [x

1

, x

2

] ∪ ... ∪ [x

n

−1

, x

n

] .

(3.32)

W ka˙zdym takim przedziale funkcja f

(x) jest interpolowana przy pomocy wielo-

mianu trzeciego stopnia:

P

i

(x) = a

0 i

+ a

1 i

x

+ a

2 i

x

2

+ a

3 i

x

3

.

(3.33)

gdzie i

= 0, 1, . . . , (n − 1). Otrzymujemy n wielomian´ow o 4n wsp´ołczynnikach do

wyznaczenia. Nakładamy na nie 4n warunk´ow prowadza

‘

cych do jednoznacznego

rozwia

‘

zania.

1. Na brzegach ka˙zdego przedziału spełnione jest 2n warunk´ow interpolacji:

P

i

(x

i

) = f (x

i

)

P

i

(x

i

+1

) = f (x

i

+1

) .

(3.34)

2. W punktach wewne

‘

trznych

{x

1

, . . . , x

n

−1

} spełnione jest 2(n − 1) warunk´ow

cia

‘

gło´sci dla pierwszych i drugich pochodnych:

P

′

i

(x

i

+1

) = P

′

i

+1

(x

i

+1

)

P

′′

i

(x

i

+1

) = P

′′

i

+1

(x

i

+1

) ,

(3.35)

gdzie i

= 0, 1, . . . , (n − 2).

3. W punktach zewne

‘

trznych

{x

0

, x

n

} ˙za

‘

damy dla drugich pochodnych:

P

′′

0

(x

0

) = f

′′

(x

0

)

P

′′

n

−1

(x

n

) = f

′′

(x

n

) .

(3.36)

W sumie otrzymujemy wie

‘

c 2n

+ 2(n − 1) + 2 = 4n warunk´ow.

24

Rozdział 4

Aproksymacja

W wielu przypadkach przybli˙zanie zale˙zno´sci funkcyjnej poprzez wielomian prze-

chodza

‘

cy przez wszystkie znane punkty nie jest dobra

‘

metoda

‘

, w szczeg´olno´sci,

gdy punkty sa

‘

obarczone błe

‘

dem lub gdy jest ich bardzo du˙zo. W tym ostat-

nim przypadku stopie´n wielomianu Lagrange’a byłby bardzo wysoki co prowadzi´c

mo˙ze do niestabilno´sci numerycznych. Znacznie lepsza

‘

metoda

‘

jest wtedy aproksy-

macja przy pomocy wzgle

‘

dnie prostej funkcji, tak by była ona jak najmniej “od-

legła” od aproksymowanej funkcji. Metode

‘

te

‘

zilustrujemy na pocza

‘

tek w najprost-

szym przypadku, gdy dobrym przybli˙zeniem jest zało˙zenie o liniowej zale˙zno´sci

funkcyjnej.

4.1

Regresja liniowa

W metodzie tej mamy do czynienia z

(N + 1) we

‘

złami x

k

i odpowiadaja

‘

cymi im

warto´sciami y

k

. Zał´o˙zmy, ˙ze dobra

‘

poszukiwana

‘

zale˙zno´scia

‘

jest funkcja liniowa

y

= ax + b ,

(4.1)

gdzie parametry a i b pozostaja

‘

do wyznaczenia. Utw´orzmy w tym celu funkcje

‘

S

(a, b) =

N

∑

k

=0

(y

k

− (ax

k

+ b))

2

(4.2)

be

‘

da

‘

ca

‘

suma

‘

kwadrat´ow odległo´sci punkt´ow

(x

k

, y

k

) od prostej (4.1), mierzonych

wzdłu˙z osi y. Dobierzmy naste

‘

pnie parametry a i b tak, by warto´s´c tej funkcji była

25

jak najmniejsza. R´o˙zniczkuja

‘

c, otrzymamy

∂

S

∂

a

=

N

∑

k

=0

(−2x

k

)(y

k

− ax

k

− b) = 0

∂

S

∂

b

=

N

∑

k

=0

(−2)(y

k

− ax

k

− b) = 0,

(4.3)

ska

‘

d dostajemy układ r´owna´n na wsp´ołczynniki a i b:

a

(

∑

k

x

2

k

) + b (

∑

k

x

k

) =

∑

k

x

k

y

k

a

(

∑

k

x

k

) + b (

∑

k

1

) =

∑

k

y

k

.

(4.4)

Rozwia

‘

zanie zadane jest poprzez wzory Cramera

a

=

(N + 1)(

∑

x

k

y

k

) − (

∑

x

k

)(

∑

y

k

)

(N + 1)(

∑

x

2

k

) − (

∑

x

k

)

2

b

=

(

∑

x

2

k

)(

∑

y

k

) − (

∑

x

k

y

k

)(

∑

x

k

)

(N + 1)(

∑

x

2

k

) − (

∑

x

k

)

2

.

(4.5)

Uog´olnienie tej metody polega na rozwa˙zeniu zale˙zno´sci wielomianowej

y

= a

0

+ a

1

x

+ . . . + a

n

x

n

(4.6)

i minimalizacje

‘

ze wzgle

‘

du na wsp´ołczynniki tego wielomianu naste

‘

puja

‘

cej r´o˙znicy

S

(a

i

) =

N

∑

k

=0

{y

k

− (a

0

+ a

1

x

+ . . . + a

n

x

n

)}

2

.

(4.7)

Zwr´o´cmy uwage

‘

, ˙ze na og´oł liczba punkt´ow

(N + 1), w kt´orych znamy aproksy-

mowana

‘

funkcje

‘

, jest du˙zo wieksza od stopnia wielomianu aproksymuja

‘

cego n.

4.2

Aproksymacja ´sredniokwadratowa

Przedstawiona w poprzednim rozdziale metoda jest przykładem aproksymacji ´sre-

dniokwadratowej. W og´olno´sci, znaja

‘

c

(N + 1) we

‘

zł´ow x

k

i warto´sci f

(x

k

) niez-

nanej na og´oł funkcji f , chcemy ja

‘

aproksymowa´c przy pomocy wyra˙zenia

F

(x) = c

0

φ

0

(x) + c

1

φ

1

(x) + . . . + c

M

φ

M

(x) ,

(4.8)

26

gdzie

{

φ

0

,

φ

1

. . .

φ

M

} jest układem dogodnie wybranych funkcji bazowych. W

przykładzie (4.7) funkcjami bazowymi sa

‘

jednomiany

φ

i

(x) = x

i

. Zauwa˙zmy, ˙ze

liczba we

‘

zł´ow

(N + 1) jest niezale˙zna od liczby funkcji bazowych (M + 1).

Wsp´ołczynniki c

i

sa

‘

tak dobrane by zminimalizowa´c odległo´s´c pomie

‘

dzy funk-

cja

‘

dokładna

‘

f

(x) i przybli˙zona

‘

F

(x):

S

(c

i

) =

N

∑

k

=0

{ f (x

k

) − (c

0

φ

0

(x

k

) + c

1

φ

1

(x

k

) + . . . + c

M

φ

M

(x

k

))}

2

.

(4.9)

R´o˙zniczkuja

‘

c po parametrach,

∂

S

/

∂

c

i

= 0, otrzymujemy naste

‘

puja

‘

cy układ r´owna´n

(

φ

0

,

φ

0

) c

0

+ (

φ

0

,

φ

1

) c

1

+ ··· + (

φ

0

,

φ

M

) c

M

= (

φ

0

, f )

(

φ

1

,

φ

0

) c

0

+ (

φ

1

,

φ

1

) c

1

+ ··· + (

φ

1

,

φ

M

) c

M

= (

φ

1

, f )

...

(

φ

n

,

φ

0

) c

0

+ (

φ

n

,

φ

1

) c

1

+ ··· + (

φ

n

,

φ

M

) c

M

= (

φ

n

, f ) ,

(4.10)

gdzie

(·, ·) to iloczyn skalarny w przestrzeni funkcji bazowych, zdefiniowany przy

pomocy dyskretnego zbioru we

‘

zł´ow

{x

k

}:

(

φ

i

,

φ

j

) =

N

∑

k

=0

φ

i

(x

k

)

φ

j

(x

k

)

(4.11)

Rozwia

‘

zanie układu (4.10) jest szczeg´olnie proste, gdy układ funkcji bazowych

jest ortogonalny:

(

φ

i

,

φ

j

) ∼

δ

i j

.

(4.12)

W r´ownaniach (4.10) pozostaja

‘

tylko składowe diagonalne i sta

‘

d

c

i

=

(

φ

i

, f )

(

φ

i

,

φ

i

)

,

i

= 0, 1, . . ., M .

(4.13)

Ostatecznie funkcja aproksymuja

‘

ca to

F

(x) =

M

∑

i

=0

(

φ

i

, f )

(

φ

i

,

φ

i

)

φ

i

(x)

(4.14)

W naste

‘

pnych rozdziałach przedstawimy przykłady dw´och szczeg´olnie wa˙znych

realizacji powy˙zszego rozwia

‘

zania. Rozwa˙zymy aproksymacje

‘

przy pomocy wielo-

mian´ow Czebyszewa oraz funkcji trygonometrycznych.

27

4.3

Aproksymacja Czebyszewa

Aproksymacja wielomianami Czebyszewa jest szczeg´olnie efektywna

‘

metoda

‘

przy-

bli˙zania funkcji przy pomocy wielomian´ow ortogonalnych w sensie iloczynu ska-

larnego (4.11).

Wybierzmy

(N + 1) we

‘

zł´ow x

k

be

‘

da

‘

cych zerami wielomianu Czebyszewa

T

N

+1

(x

k

) = 0

(4.15)

Zgodnie ze wzorem (3.24) we

‘

zły

x

k

= cos

π

(2k + 1)

2

(N + 1)

,

k

= 0, 1, . . . N .

(4.16)

Wielomiany Chebyszewa

{T

0

, T

1

, . . . , T

N

} sa

‘

ortogonalne wzgle

‘

dem iloczynu ska-

larnego (4.11) z powy˙zszymi we

‘

złami.

(T

m

, T

n

) =

N

∑

k

=0

T

m

(x

k

) T

n

(x

k

) =

N

+ 1

dla

m

= n = 0

(N + 1)/2

dla

m

= n 6= 0

0

dla

m

6= n

(4.17)

Dow´od

Policzmy iloczyn skalarny dla 0

≤ n,m ≤ N:

N

∑

k

=0

T

m

(x

k

) T

n

(x

k

) =

N

∑

k

=0

cos

m

π

(2k + 1)

2

(N + 1)

cos

n

π

(2k + 1)

2

(N + 1)

.

Dla m

= n = 0 otrzymujemy sume

‘

r´owna

‘

(N + 1). Rozwa˙zmy naste

‘

pnie

przypadek m

6= n. Korzystaja

‘

c ze wzoru

cos

α

cos

β

=

1

2

{cos(

α

+

β

) + cos(

α

−

β

)}

otrzymujemy

(T

m

, T

n

) =

1

2

N

∑

k

=0

cos

(2k + 1)

π

(m + n)

2

(N + 1)

+ cos

(2k + 1)

π

(m − n)

2

(N + 1)

.

(4.18)

28

Policzmy naste

‘

pnie dla dowolnego ka

‘

ta

φ

6= 0:

N

∑

k

=0

cos

(2k + 1)

φ

= Re

N

∑

k

=0

e

i

(2k+1)

φ

(4.19)

= Re

e

i

φ

(1 + e

2i

φ

+ . . . + e

2Ni

φ

)

= Re

(

e

i

φ

1

− e

2i

φ

(N+1)

1

− e

2i

φ

)

=

sin

(2(N + 1)

φ

)

2 sin

φ

.

Podstawiaja

‘

c

φ

±

=

π

(m ± n)/2(N + 1) 6= 0, otrzymujemy dla wzoru (4.18)

(T

m

, T

n

) =

sin

(

π

(m + n))

4 sin

φ

+

+

sin

(

π

(m − n))

4 sin

φ

−

.

Wyra˙zenie to znika dla m

6= n. Sta

‘

d warunek ortogonalno´sci dla wielo-

mian´ow Czebyszewa. Dla m

= n 6= 0 r´ownanie (4.18) przyjmuje posta´c

(T

m

, T

m

) =

1

2

N

∑

k

=0

{cos(2k + 1)

φ

+ 1}

=

1

2

N

∑

k

=0

cos

(2k + 1)

φ

+

N

+ 1

2

,

gdzie

φ

=

π

m

/(N + 1). Z (4.19) suma cosinus´ow daje zero i sta

‘

d warto´s´c

(N + 1)/2 iloczynu skalarnego.

Mo˙zemy wie

‘

c aproksymowa´c przy pomocy wielomian´ow Czebyszewa funkcje

okre´slone w przedziale

[−1,1]:

f

(x) ≃

1

2

c

0

+

N

∑

j

=1

c

j

T

j

(x)

(4.20)

gdzie wsp´ołczynniki c

j

sa

‘

wyliczone ze wzoru (4.13):

c

j

=

2

N

+ 1

N

∑

k

=0

T

j

(x

k

) f (x

k

) ,

j

= 0, 1, . . . , N .

(4.21)

Wsp´olczynnik 1

/2 we wzorze (4.20) wynika z dwukrotnie wie

‘

kszej warto´sci ilo-

czynu sklaranego

(T

0

, T

0

) w stosunku do (T

m

, T

m

) dla m ≥ 1.

29

Zaleta

‘

aproksymacji Czebyszewa jest fakt, ˙ze w sumie (4.20) mo˙zna zachowa´c

jedynie M

< N składnik´ow przy niezmienionych wsp´ołczynnikach c

j

. W wie

‘

kszo-

´sci przypadk´ow staja

‘

sie

‘

one coraz mniejsze dla rosna

‘

cych warto´sci wska´znika,

natomiast ka˙zdy wielomian Czebyszewa jest ograniczony warunkiem (3.19). Nie

popełniamy w ten spos´ob du˙zego błe

‘

du odrzucaja

‘

c wyrazy z j

> M.

Podsumowuja

‘

c, kluczowym punktem w aproksymacji Czebyszewa jest zna-

jomo´s´c funkcji f w we

‘

złach Chebyszewa. Na tej podstawie konstruuje sie

‘

wsp´oł-

czynniki (4.21), a naste

‘

pnie przybli˙zenie (4.20).

4.3.1

Aproksymacja Czebyszewa w dowolnym przedziale

Rozwa˙zmy aproksymacje

‘

funkcji f

(y) okre´slonej na dowolnym przedziale [a, b].

Niech

y

= y(x) ,

x

∈ [−1,1]

(4.22)

be

‘

dzie dowolna

‘

transformacja

‘

bijektywna

‘

odwzorowuja

‘

ca

‘

[−1,1] → [a,b]. Istnieje

wie

‘

c funkcja odwrotna odwzorowuja

‘

ca

[a, b] → [−1,1]

x

= y

−1

(y) ,

y

∈ [a,b].

(4.23)

Zdefiniujmy przy pomocy transformacji y

= y(x) nowa

‘

funkcje

‘

okre´slona

‘

na

przedziale

[−1,1]:

˜

f

(x) = f (y) ,

(4.24)

a naste

‘

pnie zastosujmy do niej wz´or aproksymacyjny (4.20):

˜

f

(x) ≈

1

2

c

0

+

N

∑

j

=1

c

j

T

j

(x) .

(4.25)

Podstawiaja

‘

c po prawej stronie relacje

‘

odwrotna

‘

x

= y

−1

(y), otrzymujemy apro-

ksymacje

‘

funkcji f

(y):

f

(y) ≈

1

2

c

0

+

M

<N

∑

j

=1

c

j

T

j

(y

−1

(y)) .

(4.26)

Wsp´ołczynniki c

j

sa

‘

zadane przez

c

j

=

2

N

+ 1

N

∑

k

=0

T

j

(x

k

) f (y

k

) .

(4.27)

W powy˙zszym wzorze y

k

= y(x

k

) sa

‘

obrazami we

‘

zł´ow Czebyszewa (4.16) poprzez

transformacje

‘

(4.22).

30

4.4

Aproksymacja trygonometryczna

Aproksymacje

‘

te

‘

stosujemy, gdy mamy do czynienia z funkcja

‘

okresowa

‘

f

(x) o

okresie 2

π

. Wła´sciwym układem funkcji bazowych dla aproksymacji (4.8) sa

‘

wte-

dy funkcje trygonometryczne

{1, sinx , cosx , sin2x , cos2x ... sinkx , coskx ...}

(4.28)

Zał´o˙zmy, ˙ze znamy funkcje

‘

f

(x) w parzystej liczbie 2N r´ownoodległych punkt´ow

z przedziału

[0, 2

π

):

x

k

= k

π

N

,

k

= 0, 1, . . . , (2N − 1)

(4.29)

Zbi´or funkcji (4.28) z maksymalna

‘

warto´scia

‘

k

= (N − 1) jest ortogonalny na tym

zbiorze punkt´ow. Zachodzi bowiem dla 1

≤ m,n ≤ (N − 1):

2N

−1

∑

k

=0

sin

(mx

k

) · sin(nx

k

) =

2N

−1

∑

k

=0

cos

(mx

k

) · cos(nx

k

) = N

δ

mn

2N

−1

∑

k

=0

cos

(mx

k

) · sin(nx

k

) = 0 .

(4.30)

Ponadto

2N

−1

∑

k

=0

sin

(mx

k

) · 1 =

2N

−1

∑

k

=0

cos

(mx

k

) · 1 = 0,

2N

−1

∑

k

=0

1

· 1 = 2N .

(4.31)

Sta

‘

d, aproksymuja

‘

c funkcje

‘

f

(x) przy pomocy funkcji trygonometrycznych,

otrzymujemy

f

(x) ≈

1

2

a

0

+

M

<N

∑

j

=1

a

j

cos

( jx) + b

j

sin

( jx)

.

(4.32)

Wsp´ołczynniki a

j

i b

j

dla j

= 0, 1, . . ., (N − 1) mo˙zna wyliczy´c ze wzoru (4.13):

a

j

=

1

N

2N

−1

∑

k

=0

f

(x

k

) cos( jx

k

)

b

j

=

1

N

2N

−1

∑

k

=0

f

(x

k

) sin( jx

k

) .

(4.33)

31

4.4.1

Wzory dla dowolnego okresu

Zastosujmy powy˙zsza

‘

aproksymacje

‘

do funkcji czasu o okresie T

f

(t) = f (t + T ) .

(4.34)

Zdefiniujmy nowa

‘

funkcje

‘

˜

f

(x) o okresie 2

π

:

˜

f

(x) = f (t)

(4.35)

przy pomocy transformacji:

t

= x

T

2

π

.

(4.36)

Naste

‘

pnie aproksymujemy funkcje

‘

˜

f

(x) za pomoca

‘

wzoru (4.32):

˜

f

(x) ≈

1

2

a

0

+

N

−1

∑

j

=1

a

j

cos

( j x) + b

j

sin

( j x)

(4.37)

Podstawiaja

‘

c po prawej stronie transformacje

‘

odwrotna

‘

x

= 2

π

t

/T , otrzymamy

aproksymacje

‘

funkcji f

(t):

f

(t) ≈

1

2

a

0

+

M

<N

∑

j

=1

a

j

cos

2

π

j

T

t

+ b

j

sin

2

π

j

T

t

.

(4.38)

Wsp´ołczynniki a

j

i b

j

dla j

= 0, 1, . . ., (N − 1) sa

‘

teraz zadane wzorami:

a

j

=

1

N

2N

−1

∑

k

=0

f

(t

k

) cos( j x

k

)

b

j

=

1

N

2N

−1

∑

k

=0

f

(t

k

) sin( j x

k

) ,

(4.39)

w kt´orych t

k

sa

‘

obrazami we

‘

zł´ow (4.29) poprzez transformacje

‘

(4.36):

t

k

= x

k

T

2

π

=

k

2N

T

,

k

= 0, 1, . . ., (2N − 1).

(4.40)

32

Rozdział 5

R´o˙zniczkowanie

5.1

Metody z aproksymacja¸

W metodzie tej najpierw aproksymujemy funkcje

‘

, kt´orej pochodna

‘

chcemy znale´z´c

przy pomocy jednej z metod opisanych w poprzednim rozdziale:

f

(x) ≃

N

∑

i

=0

c

i

φ

i

(x) ,

(5.1)

gdzie

φ

i

to znane i r´o˙zniczkowalne funkcje bazowe, np. jednomiany x

i

lub wielo-

miany Czebyszewa T

i

(x). Przyjmujemy, ˙ze pochodna tej funkcji to

f

′

(x) ≃

N

∑

i

=0

c

i

φ

′

i

(x)

(5.2)

Podobnie poste

‘

pujemy przy obliczniu wy˙zszych pochodnych.

5.2

Metody z rozwinie¸ciem Taylora

Ta metoda r´o˙zniczkowania wykorzystuja

‘

rozwinie

‘

cie Taylora funkcji. Zakladaja

‘

c,

˙ze rozwinie

‘

cie takie istnieje w otoczeniu punktu x, mamy

f

(x + h) = f (x) + f

′

(x) h + f

′′

(x)

h

2

2!

+ f

′′′

(x)

h

3

3!

+

O

(h

4

)

(5.3)

33

gdzie symbol

O

(h

4

) oznacza reszte

‘

rze

‘

du h

4

, tzn

lim

h

→0

O

(h

4

)

h

4

= const .

(5.4)

Aby obliczy´c pierwsza

‘

pochodna

‘

wykorzystujemy wz´or

f

(x + h) = f (x) + f

′

(x) h +

O

(h

2

) ,

ska

‘

d wynika

f

′

(x) =

f

(x + h) − f (x)

h

+

O

(h) .

(5.5)

Aby poprawi´c dokładno´s´c oblicznej w ten spos´ob pochodnej wykorzystujemy dwa

rozwinie

‘

cia Taylora

f

(x + h) = f (x) + f

′

(x) h + f

′′

(x)

h

2

2!

+

O

(h

3

)

f

(x − h) = f (x) − f

′

(x) h + f

′′

(x)

h

2

2!

+

O

(h

3

) .

(5.6)

Po odje

‘

ciu stronami wyra˙zenia z parzystymi potegami h upraszczaja

‘

sie

‘

i sta

‘

d

dostajemy

f

′

(x) =

f

(x + h) − f (x − h)

2h

+

O

(h

2

)

(5.7)

Znaja

‘

c wie

‘

c warto´sc funkcji w punktach sa

‘

siednich

(x − h) oraz (x + h), poprawia-

my dokładno´s´c obliczonej pochodnej.

5.3

Wy˙zsze pochodne

Dodaja

‘

c stronami wyra˙zenia (5.6) otrzymujemy wz´or na druga

‘

pochodna

‘

f

′′

(x) =

f

(x + h) − 2 f (x) + f (x − h)

h

2

+

O

(h

2

)

(5.8)

Rza

‘

d reszty wynika z faktu kasowanie sie

‘

wyra˙ze´n z nieparzystymi pote

‘

gami h

przy dodawaniu stronami.

Lepsza

‘

dokładno´s´c obliczanych pochodnych mo˙zna uzyska´c rozwa˙zaja

‘

c roz-

winie

‘

cia Taylora zapisane z dokładno´scia do pia

‘

tej pote

‘

gi h dla warto´sci funkcji

34

w czterech punktach: f

(x − 2h), f (x − h), f (x + h), f (x + 2h). Jako po˙zyteczne

´cwiczenie nale˙zy udowodni´c, ˙ze w takim przypadku dla pierwszej pochodnej otrzy-

mujemy

f

′

(x) =

f

(x − 2h) − 8 f (x − h) + 8 f (x + h) − f (x + 2h)

12h

+

O

(h

4

) ,

(5.9)

natomiast druga pochodna to

f

′′

(x) =

− f (x − 2h) + 16 f (x − h) − 30 f (x) + 16 f (x + h) − f (x + 2h)

12h

2

+

O

(h

4

) .

(5.10)

W podobny spos´ob mo˙zna wyprowadzi´c wzory na wy˙zsze pochodne, korzys-

taja

‘

c z wyprowadzonych wcze´sniej formuł dla ni˙zszych pochodnych. Na przykład,

aby obliczy´c trzecia

‘

pochodna

‘

odejmujemy od siebie dwa rozwinie

‘

cia

f

(x + h) = f (x) + f

′

(x) h + f

′′

(x)

h

2

2!

+ f

′′′

(x)

h

3

3!

+

O

(h

4

)

f

(x − h) = f (x) − f

′

(x) h + f

′′

(x)

h

2

2!

− f

′′′

(x)

h

3

3!

+

O

(h

4

) ,

(5.11)

otrzymuja

‘

c

f

′′′

(x) = 3

f

(x + h) − f (x − h)

h

3

− 6

f

′

(x)

h

2

+

O

(h

2

) .

(5.12)

Zwr´o´cmy uwage

‘

, ˙ze podstawienie wzoru (5.7) w miejsce pierwszej pochodnej w

powy˙zszym wzorze daje reszte

‘

O

(1), niezale˙zna

‘

od odchylenia h. Jeste´smy wie

‘

c

zmuszeni do u˙zycia dokładniejszego wzoru (5.9), prowadza

‘

cego do

f

′′′

(x) =

− f (x − 2h) + 2 f (x − h) − 2 f (x + h) + f (x + 2h)

2h

3

+

O

(h

2

)

35

Rozdział 6

Całkowanie

6.1

Podstawowe metody

Rozwa˙zmy jednowymiarowa

‘

całke

‘

na przedziale

[a, b ]

I

( f ) =

Z

b

a

f

(x) dx

(6.1)

Podzielmy przedział całkowania na N r´ownych odcink´ow o długo´sci h

= (b−a)/N

i wyznaczonych przez kolejne punkty

x

k

= x

0

+ kh

k

= 0, 1, . . ., N .

(6.2)

Zauwa˙zmy, ˙ze x

0

= a oraz x

N

= b sa

‘

ko´ncami przedziałow. Wtedy

I

( f ) =

N

−1

∑

i

=0

Z

x

i

+1

x

i

f

(x) dx

(6.3)

Nale˙zy wie

‘

c policzy´c całke

‘

w ka˙zdym z przedział´ow

[x

i

, x

i

+1

].

6.1.1

Metoda prostokat´ow

W metodzie prostoka

‘

t´ow

Z

x

i

+1

x

i

f

(x) dx ≃ h f (x

i

)

(6.4)

36

i wtedy, wprowadza

‘

c oznacznie f

i

≡ f (x

i

),

Z

b

a

f

(x) dx ≃ h( f

0

+ f

1

+ . . . + f

N

−1

)

(6.5)

Otrzymany wynik odpowiada przybli˙zeniu funkcji f w ka˙zdym z podprzedziałow

poprzez funkcje

‘

stała

‘

f

(x) = f

i

. Warto´sci funkcji f

i

moga

‘

by´c r´ownie˙z wzie

‘

te w

´srodkach podprzedział´ow

f

i

= f

x

i

+ x

i

+1

2

.

(6.6)

6.1.2

Metoda trapez´ow

W metodzie trapez´ow otrzymujemy

Z

x

i

+1

x

i

f

(x) dx ≃

h

2

{ f

i

+ f

i

+1

}

(6.7)

i wtedy

Z

b

a

f

(x) dx ≃

h

2

{ f

0

+ 2( f

1

+ . . . + f

N

−1

) + f

N

}

(6.8)

W tym przypadku wynik otrzyma´c mo˙zna korzystaja

‘

c z liniowej interpolacji

Lagrange’a w ka˙zdym z podprzedziałow:

f

(x) ≃ f

i

x

− x

i

+1

x

i

− x

i

+1

+ f

i

+1

x

− x

i

x

i

+1

− x

i

.

(6.9)

Całkuja

‘

c bowiem (6.9) i pamie

‘

taja

‘

c, ˙ze x

i

+1

− x

i

= h, otrzymujemy wz´or (6.7):

1

h

Z

x

i

+1

x

i

{ f

i

+1

(x − x

i

) − f

i

(x − x

i

+1

)} dx =

h

2

{ f

i

+ f

i

+1

}.

Łatwo uog´olni´c te

‘

metode

‘

, przybli˙zaja

‘

c funkcje

‘

podcałkowa

‘

przy pomocy wie

‘

kszej

liczby punkt´ow. Przykładem jest metoda Simpsona.

6.1.3

Metoda parabol Simpsona

W metodzie tej dzielimy

[a, b ] na parzysta

‘

liczbe

‘

przedziałow o r´ownej długo´sci:

h

=

(b − a)

2N

.

(6.10)

W ka˙zdej sa

‘

siedniej parze przedział´ow wyznaczonych przez

(x

i

, x

i

+1

, x

i

+2

) stosu-

jemy interpolacje

‘