LAWRENCE M. KRAUSS

FIZYKA PODRÓŻY

MIĘDZYGWIEZDNYCH

( Przełożyli: Ewa L. Łokas; Bogumił Bieniok)

PRZEDMOWA

Było ml bardzo miło, że Data zdecydował się zaprosić Newtona, Einsteina i

mnie na partyjkę pokera na pokładzie kosmicznego statku Enterprise. Miałem okazję

zdobyć przewagę nad dwoma wielkimi ludźmi grawitacji, zwłaszcza nad Einsteinem,

który nie wierzył w przypadek, czyli w to, że Bóg gra w kości. Niestety, nie udało mi

się zabrać ze sobą wygranej, ponieważ musieliśmy porzucić grę z powodu alarmu.

Kontaktowałem się później ze studiem Paramount, aby zamienić żetony na gotówkę,

ale jego przedstawiciele nie znali kursu wymiany.

Fantastyka naukowa, do której należy Star Trek, służy nie tylko dobrej

zabawie, ale także poważniejszym celom, takim jak rozszerzanie ludzkiej wyobraźni.

Być może nie potrafimy dotrzeć tam, gdzie nie stanęła dotąd ludzka stopa, ale

możemy spróbować dokonać tego przynajmniej w wyobraźni. Możemy przewidywać

reakcje ludzkości na przyszły postęp w nauce i spekulować na temat charakteru tego

postępu. Wymiana myśli między fantastyką naukową a nauką zachodzi w obie strony.

Fantastyka dostarcza pomysłów, które naukowcy włączają do swoich teorii, ale

czasami to właśnie nauka stwarza pojęcia, które nie przyszłyby do głowy żadnemu

autorowi science fiction. Przykładem są czarne dziury, do których rozgłosu walnie

przyczyniła się trafna nazwa nadana im przez Johna Archibalda Wheelera. O

„zamarzniętych gwiazdach” lub „obiektach całkowicie zapadniętych grawitacyjnie”,

jak początkowo nazywano czarne dziury, nie napisano by zapewne nawet połowy

tego, co mieliśmy okazję przeczytać.

Zarówno Stor Trek, jak i inne utwory fantastycznonaukowe, poświęcają

szczególnie dużo uwagi podróżom z prędkościami ponadświetlnymi. Rzeczywiście,

trudno wyobrazić sobie bez nich fabułę Star Trek. Gdyby Enterprise mógł

przemieszczać się jedynie z prędkościami choćby niewiele mniejszymi od prędkości

światła, podróż do środka Galaktyki i z powrotem trwałaby dla załogi tylko kilka lat,

ale na Ziemi upłynęłoby w tym czasie 80 tysięcy lat. Nie byłoby mowy o ponownym

spotkaniu z rodziną!

Na szczęście ogólna teoria względności Einsteina stwarza możliwość obejścia

tej trudności: można zakrzywić czasoprzestrzeń i stworzyć drogę na skróty między

miejscami, które chce się odwiedzić. Mimo pojawiających się wtedy problemów z

ujemną energią, takie zakrzywianie czasoprzestrzeni może być dla nas w przyszłości

wykonalne. Jak dotąd nie prowadzono w tej dziedzinie zbyt wielu poważnych badań,

po części, jak sądzę, dlatego, że za bardzo przypomina to fantastykę naukową. Jedną

z konsekwencji szybkich podróży międzygwiezdnych byłaby możliwość podróży

wstecz w czasie. Można sobie jednak wyobrazić krzyk, jaki podniosłaby opinia

publiczna w obronie pieniędzy podatników, gdyby ogłoszono, że rządowe agendy

wspierają finansowo badania nad podróżami w czasie. Naukowcy pracujący w tej

dziedzinie muszą zatem ukrywać swoje prawdziwe zainteresowania, używając

technicznych terminów, takich jak „zamknięte krzywe czasowe”, które oznaczają po

prostu podróże w czasie. Jednakże dzisiejsza fantastyka naukowa staje się często

naukowym faktem jutra. Fizyka leżąca u podstaw Star Trek jest niewątpliwie warta

zbadania. Ograniczenie poszukiwań do spraw czysto ziemskich byłoby równoznaczne

z narzucaniem ograniczeń ludzkiemu duchowi.

STEPHEN HAWKING

WSTĘP

Dlaczego zajmując się fizyką podróży międzygwiezdnych, zagłębimy się w

świat Stor Trek? Dzieło Gene'a Rodden-berry'ego jest przecież fantastyką i nie

przedstawia faktów naukowych. Wiele cudów techniki w tym serialu odwołuje się

więc z konieczności do pojęć, które mogą być niewłaściwie zdefiniowane lub w inny

sposób pozostają w sprzeczności z naszą obecną wiedzą o Wszechświecie. Nie

chciałem napisać książki poświęconej tylko wyliczeniu kwestii, w których twórcy

Star Trek nie mieli racji.

Nie mogłem jednak uwolnić się od myśli o tej książce. Przyznam się, że tak

naprawdę oczarował mnie transporter. Myślenie o tym, jakim wyzwaniom należałoby

sprostać tworząc taką fantastyczną technologię, zmusza do rozważenia szerokiego

wachlarza tematów: od komputerów i przekazu informacji po zagadnienia fizyki

cząstek elementarnych, mechaniki kwantowej, fizyki jądrowej, budowy teleskopów,

zawiłości biologii, a nawet problem istnienia ludzkiej duszy! Do tego doszły jeszcze

takie pojęcia, jak zakrzywiona czasoprzestrzeń i podróże w czasie, i tak temat ten

wciągnął mnie bez reszty.

Wkrótce zdałem sobie sprawę, że to, co było dla mnie tak fascynujące, bliskie

jest temu, co niezmiennie pociąga dzisiejszych wielbicieli Star Trek, prawie

trzydzieści lat po wyemitowaniu pierwszego odcinka serialu. Tym czymś, jak to ujął

Q, wszechmocny żartowniś ze Star Trek, jest „badanie nieznanych możliwości

istnienia”. Q zapewne zgodziłby się ze mną, że samo wyobrażanie sobie tych

możliwości to już dobra zabawa.

W przedmowie do tej książki Stephen Hawking stwierdza, że fantastyka

naukowa pomaga rozwijać ludzką wyobraźnię. Rzeczywiście, badanie

nieskończonych możliwości, jakie niesie przyszłość - łącznie ze światem, w którym,

przezwyciężywszy napięcia międzynarodowe i uprzedzenia rasowe, ludzkość

wyrusza, by w pokoju badać Wszechświat -jest częścią nie słabnącego powodzenia

Stor Trek. Ponieważ wydaje mi się to istotną cechą cudu współczesnej fizyki, na tych

właśnie możliwościach postanowiłem się skoncentrować w niniejszej książce.

Jak wynika z przeprowadzonych przeze mnie pewnego dnia nieformalnych

badań w trakcie spaceru po miasteczku uniwersyteckim, liczba ludzi w Stanach

Zjednoczonych, którzy nie znają wyrażenia „prześlij mnie, Scotty”, jest w zasadzie

porównywalna z liczbą ludzi, którzy nigdy nie słyszeli o ketchupie. Jeśli weźmiemy

pod uwagę, że wystawa na temat statku Enterprise, zorganizowana przez Smithsonian

Institution w Waszyngtonie, cieszyła się największym powodzeniem w całej historii

tamtejszego Muzeum Lotnictwa i Lotów Kosmicznych -większym nawet, niż

pokazywany tam prawdziwy statek kosmiczny - staje się oczywiste, iż Star Trek jest

dla wielu ludzi symbolem zaciekawienia Wszechświatem. Czy istnieje lepszy

kontekst, w którym można by przedstawić jedne z najciekawszych teorii fizyki dnia

dzisiejszego i wskazać, w jakim kierunku podąży fizyka jutra? Mam nadzieję, że ta

podróż będzie dla czytelników tej książki równie fascynująca, jak dla mnie.

Szerokiej drogi!

CZĘŚĆ I

KOSMICZNY POKER

W części tej fizyka amortyzatorów bezwładności

i wiązek holowniczych przeciera szlak dla podróży w czasie,

napędu czasoprzestrzennego, deflektorów,

tuneli czasoprzestrzennych i innych osobliwości czasoprzestrzeni.

ROZDZIAŁ I

OTWARCIE NEWTONA

Gdziekolwiek pójdziesz, tam będziesz.

Z tablicy na statku Exctlsior.

Star Trek VI: Nieznany kraj

(prawdopodobnie zapożyczenie z Przygód Buckaroo Banzai)

Znajdujesz się za sterem statku kosmicznego Defiant (NCC-1764), krążącego

właśnie po orbicie wokół planety Iconia, w pobliżu strefy neutralnej. Masz spotkać

się na drugim końcu tego układu słonecznego ze statkiem będącym składem części

zamiennych, by zdobyć części potrzebne do zreperowania głównych cewek

zasilających transporter. Nie musisz rozwijać prędkości czasoprzestrzennych;

ustawiasz tylko na pełną moc silnik pulsacyjny, aby spokojnie podróżować z

prędkością równą połowie prędkości światła. Powinno to wystarczyć do osiągnięcia

celu w ciągu kilku godzin; w tym czasie będziesz mógł zaktualizować dziennik

pokładowy. W miarę oddalania się od orbity zaczynasz jednak odczuwać silny ucisk

w klatce piersiowej. Ręce ci ciążą i przyklejasz się do fotela. Twoje usta zamierają w

grymasie, masz wrażenie, że za chwilę oczy wyskoczą ci z orbit, a płynąca w twoim

ciele krew nie chce dochodzić do głowy. Powoli tracisz świadomość... i w ciągu kilku

minut umierasz.

Co się stało? Nie są to pierwsze oznaki międzyfazowego znoszenia

przestrzennego, które później obejmie cały statek, ani atak ukrytego dotąd statku

romulańskiego. Padłeś ofiarą czegoś znacznie potężniejszego. Pomysłowi twórcy

serialu Star Trek, od których jesteś uzależniony, nie wynaleźli jeszcze amortyzatorów

bezwładności; urządzenia te dopiero później zostaną wprowadzone do serialu.

Zostałeś pokonany przez coś tak zwykłego, jak prawa ruchu Izaaka Newtona, o

których uczymy się w szkole, lecz zazwyczaj szybko zapominamy.

Już słyszę głosy trekkerów: „Ale beznadzieja! Nie częstuj mnie Newtonem.

Opowiedz mi o czymś naprawdę interesującym, na przykład jak działa napęd

czasoprzestrzenny lub co to za błysk pojawia się przy osiąganiu prędkości

czasoprzestrzennych (czy przypomina uderzenie dźwiękowe przy przekraczaniu

prędkości dźwięku?), albo co to takiego ten kryształ dwulitu?” W tej chwili mogę

jedynie powiedzieć, że dojdziemy i do tego. Podróżowanie po świecie Stor Trek

wiąże się z najbardziej niezwykłymi pojęciami w fizyce. Zetkniemy się z wieloma

różnymi problemami, zanim będziemy mogli zadać najbardziej fundamentalne

pytanie związane ze Star Trek: czy coś z tego może zdarzyć się naprawdę, a jeśli tak,

to w jaki sposób?

Zanim udamy się tam, gdzie nikt jeszcze nie dotarł - zanim nawet wyjdziemy

z Kwatery Głównej Gwiezdnej Floty - musimy stawić czoło tym samym

zagadnieniom, z którymi ponad trzysta lat temu zmagali się Galileusz i Newton. W

przeciwnym razie nigdy nie uda nam się rozstrzygnąć kosmicznego pytania,

tkwiącego u źródeł wizji Gene'a Roddenberry'ego, twórcy Star Trek: co, na podstawie

współczesnej nauki, możemy powiedzieć na temat przyszłości naszej cywilizacji?

Pytanie to leży u podstaw tej książki.

Każdy, kto kiedykolwiek znajdował się w samolocie lub szybkim

samochodzie, zna uczucie wgniatania w fotel, gdy pojazd rusza z dużym

przyspieszeniem. Zjawisko to jeszcze silniej daje się odczuć na pokładzie statku

kosmicznego. Reakcje syntezy w silniku pulsacyjnym wytwarzają olbrzymie

ciśnienia, które wypychają z dużymi prędkościami gazy i promieniowanie ze statku.

To właśnie siła reakcji wywierana na silniki przez uciekający gaz i promieniowanie

powoduje „odrzut” w przód. Ponieważ statek jest połączony z silnikami, również

zostaje „odrzucony”. Także osoba siedząca przy sterach jest popychana do przodu za

sprawą siły wywieranej przez fotel na ciało, które z kolei działa taką samą siłą na

fotel.

I tu właśnie tkwi sedno sprawy. Młotek uderzający z dużą prędkością w

Twoją czaszkę działa z siłą, która może okazać się śmiertelna. Na podobnej zasadzie

może Cię zabić fotel, na którym siedzisz, jeśli siła, którą zadziała on na Twoje ciało,

będzie zbyt wielka. Piloci samolotów odrzutowych i statków kosmicznych nazywają

siły, jakim poddawane są ich ciała w trakcie dużych przyspieszeń (w samolocie lub

podczas wystrzeliwania statku kosmicznego) siłami G. Mogę je opisać posługując się

przykładem swoich bolących pleców. Kiedy pracuję na komputerze, zawsze czuję

nacisk krzesła na pośladki - presję, z którą nauczyłem się żyć (choć, mógłbym dodać,

moje pośladki reagują na to w bardzo niehigieniczny sposób). Siła działająca na moje

pośladki ma swoje źródło w grawitacji, która, gdyby nic jej nie przeciwdziałało,

spowodowałaby mój ruch w kierunku Ziemi. Powstrzymuje mnie przed tym - czyli

przed upadkiem na podłogę - Ziemia, wywierając skierowaną przeciwnie siłę na

żelbetonową konstrukcję mojego domu, która działa siłą skierowaną ku górze na

drewnianą podłogę mojego gabinetu na pierwszym piętrze; z kolei podłoga działa na

krzesło, wywierające siłę na tę część mojego ciała, która znajduje się z nim w

kontakcie... Gdyby Ziemia miała dwa razy większą masę, ale taką samą średnicę,

nacisk wywierany na moje pośladki byłby dwa razy większy. Siły skierowane ku

górze musiałyby być dwukrotnie większe, aby zrównoważyć siłę grawitacji.

Te same czynniki należy wziąć pod uwagę w przypadku podróży

kosmicznych. Jeśli siedzisz w fotelu kapitana i wydajesz polecenie przyspieszenia

statku, musisz wziąć pod uwagę siłę, z jaką będzie na Ciebie oddziaływał fotel. Gdy

zwiększysz przyspieszenie dwukrotnie, działająca na Ciebie siła również wzrośnie

dwa razy. Im większe przyspieszenie, tym większa siła. Jedyny problem polega na

tym, że żaden materiał - a już na pewno nie Twoje ciało - nie wytrzyma działania siły

potrzebnej do przyspieszenia statku do prędkości pulsacyjnych.

Ten sam problem pojawia się wielokrotnie w serialu Stor Trek, nawet

wówczas, gdy akcja filmu dzieje się na Ziemi. Na początku Star Trek V: Ostateczna

granica James Kirk, bawiący na wakacjach w Parku Narodowym Yosemite, wspina

się bez asekuracji. Nagle potyka się i spada. Spock, który ma na sobie buty rakietowe,

pędzi na ratunek i chwyta kapitana, gdy ten znajduje się już metr czy dwa nad ziemią.

Niestety, jest to jeden z tych przypadków, kiedy rozwiązanie może być tak samo

fatalne w skutkach, jak sam problem. To właśnie proces hamowania na dystansie

kilku centymetrów może być śmiercionośny, niezależnie od tego, czy spada się na

Ziemię czy w objęcia Spocka Vulcana.

Zanim jeszcze pojawią się siły reakcji, które rozerwą lub połamią Twoje ciało,

na scenę wkroczą inne poważne fizjologiczne problemy. Co najważniejsze, Twoje

serce nie będzie już mogło pompować krwi wystarczająco silnie, aby docierała ona do

głowy. Dlatego właśnie piloci wojskowi czasami tracą świadomość w trakcie

wykonywania manewrów wymagających dużych przyspieszeń. Aby temu zapobiec,

wynaleziono nawet specjalne skafandry wymuszające przepływ krwi z nóg pilotów.

Te zaburzenia fizjologiczne są jednym z czynników, które należy wziąć pod uwagę

przy określaniu, jak wielkie może być przyspieszenie współczesnego statku

kosmicznego. Dlatego też NASA nigdy nie wystrzeliła na orbitę ludzi z wielkiej

armaty, jak proponował Juliusz Verne w powieści Podróż na Księżyc.

Jeśli chcę przyspieszyć rakietę od stanu spoczynku do, powiedzmy, 150 tyś.

Km/s, czyli do połowy prędkości światła, muszę to robić stopniowo - tak, by moje

ciało nie uległo rozerwaniu. Abym uniknął wgniatania w fotel z siłą większą niż 3G,

moje przyspieszenie nie może przekroczyć trzykrotnej wartości przyspieszenia, z

jakim przedmioty spadają na ziemię. W tym tempie osiągnięcie połowy prędkości

światła zajęłoby około 5 milionów sekund, czyli blisko 2,5 miesiąca! Nie byłoby to

ekscytujące wydarzenie.

Wkrótce po wyprodukowaniu pierwszego statku kosmicznego klasy

konstytucyjnej - Enterprise (NCC-1701) - autorzy Star Trek musieli odpowiedzieć na

krytykę dotyczącą tego, że olbrzymie przyspieszenia na pokładzie statku

kosmicznego powinny zmieniać jego załogę w marmoladę. Aby rozwiązać ten

problem, wynaleźli „amortyzatory bezwładności”, rodzaj kosmicznych pochłaniaczy

uderzenia, bardzo przemyślne urządzenie, zaprojektowane w celu rozwiązania tego

dokuczliwego problemu.

Amortyzatory bezwładności najłatwiej zauważyć, gdy ich nie ma. Na przykład

statek Enterprise ledwie uniknął zniszczenia po utracie kontroli nad swoimi

amortyzatorami bezwładności, kiedy elektroniczne formy życia, znane jako Nanici,

zaczęły, w ramach swojego procesu ewolucyjnego, chrupać pamięć centralnego

komputera statku. Łatwo zauważyć, że prawie każdą katastrofę Enterprise (która

zdarza się zwykle w najmniej odpowiedniej chwili) poprzedza awaria amortyzatorów

bezwładności. Skutki podobnej utraty kontroli na romulan-skim statku Wdrbird

umożliwiły nam przekonanie się, że krew Romulan jest zielona.

Niestety, podobnie jak w przypadku większości technologii we wszechświecie

Stor Trek, o wiele łatwiej jest opisać problem, który rozwiązują amortyzatory

bezwładności, niż dokładnie wyjaśnić, jak mogłyby one działać. Pierwsze Prawo

Fizyki Star Trek musi więc brzmieć: im bardziej podstawowy jest problem, który

chce się rozwiązać, tym bardziej niezwykłe musi być rozwiązanie. Przyczyną, dla

której doszliśmy tak daleko i dla której możemy w ogóle spodziewać się przyszłości

takiej, jaką pokazano w Star Trek, jest specyfika fizyki, która rozwija się odwołując

się do własnych podstaw. Przyszłość będzie więc musiała poradzić sobie nie tylko z

danym problemem w fizyce, ale także z każdym fragmentem wiedzy fizycznej, który

wiąże się z tym właśnie problemem. Postęp w fizyce dokonuje się nie dzięki

rewolucjom, które znoszą wszystko, co było przedtem, ale drogą ewolucji, która

wykorzystuje to, co najlepsze w dotychczasowym rozumieniu świata. Prawa Newtona

będą tak samo prawdziwe za milion lat jak obecnie, bez względu na to, jak dalece

rozszerzymy granice nauki. Upuszczona piłka zawsze spadnie na ziemię. Jeśli będę

siedział przy biurku i pisał przez całą wieczność, moje pośladki zawsze będą tak samo

cierpiały.

Czego by nie powiedzieć, nie byłoby w porządku, gdybyśmy zostawili

amortyzatory bezwładności bez jakiegokolwiek dokładniejszego opisu ich działania.

Jak już wcześniej stwierdziłem, muszą one tworzyć wewnątrz statku kosmicznego

sztuczny świat, w którym znika siła reakcji na siłę przyspieszającą. Przedmioty

znajdujące się wewnątrz statku zostają „oszukane”; mają zachowywać się tak, jak

gdyby nie było przyspieszenia. Opisywałem już, w jaki sposób przyspieszenie imituje

grawitację. Związek ten, który stał się podstawą ogólnej teorii względności Einsteina,

jest o wiele głębszy, niż mogłoby się wydawać na pierwszy rzut oka. Amortyzatory

bezwładności mogą więc działać tylko na jednej zasadzie: muszą wytwarzać

wewnątrz statku sztuczne pole grawitacyjne, które znosi siły reakcji.

Nawet, jeśli przyjmiemy tę możliwość, pozostają jeszcze inne praktyczne

sprawy, jak choćby to, że włączenie się amortyzatorów bezwładności po pojawieniu

się nieoczekiwanego impulsu wymaga czasu. Kiedy na przykład Enterprise został

uwięziony w pętli przyczynowej przez Bozemana, gdy ten ostatni wynurzał się z

zakrzywienia czasowego, załoga została rozrzucona po całym obszarze mostka

(zanim jeszcze nastąpiła awaria napędu czasoprzestrzennego i amortyzatorów). W

opisie technicznym Enterprise wyczytałem, że czas reakcji amortyzatorów

bezwładności wynosi około 60 milisekund. Wydaje się on krótki, ale takie opóźnienie

podczas zaprogramowanych okresów przyspieszania wystarczyłoby, żeby Cię zabić.

Aby się o tym przekonać, pomyśl, ile czasu potrzebuje spadający z wysoka młotek,

by rozbić ci głowę, lub ziemia, by zabić człowieka spadającego ze stromego urwiska

w Parku Narodowym Yosemite? Wystarczy pamiętać, że zderzenie z prędkością 20

km/h jest równoważne kolizji biegacza z murem z cegieł! Lepiej więc, żeby

amortyzatory bezwładności miały krótki czas reakcji. Kilku znajomych trekkerów

zauważyło, że kiedy statek zostaje uderzony, nikogo z załogi nie odrzuca na odległość

większą niż parę metrów.

Zanim opuścimy znany świat fizyki klasycznej, chciałbym wspomnieć o

innym cudzie technologii, który, aby działać, musi brać pod uwagę prawa Newtona, a

mianowicie o wiązce holowniczej na Enterprise. Odegrała ona pewną rolę w czasie

ratowania kolonii Genomów na Moabie IV, odchylając zbliżający się fragment jądra

gwiazdy, a także w podobnej próbie, (choć zakończonej niepowodzeniem) uratowania

Bre'ela IV przez skierowanie planetoidalnego księżyca z powrotem na orbitę. Na

pierwszy rzut oka wiązka holownicza wygląda prosto - mniej więcej tak jak

niewidzialna lina lub wędka - nawet jeśli wywierana przez nią siła jest niezwykła.

Podobnie jak mocna lina, wiązka holownicza świetnie sobie radzi z wciąganiem

wahadłowca, holowaniem innego pojazdu lub zapobieganiem ucieczce wrogiego

statku kosmicznego. Jedyny problem polega na tym, że kiedy ciągniemy coś na linie,

musimy się uczepić Ziemi lub innego ciężkiego przedmiotu. Każdy, kto kiedykolwiek

jeździł na łyżwach, wie, co się dzieje, gdy znajdujemy się na lodzie i próbujemy

odepchnąć kogoś od siebie. Udaje nam się rozdzielić, ale bez punktu zaczepienia

stajemy się bezradną ofiarą własnej bezwładności.

Ta właśnie zasada skłoniła kapitana Jeana-Luca Picarda w odcinku pod

tytułem Bitwa do wydania polecenia porucznikowi Rikerowi, aby wyłączył wiązkę

holowniczą; Picard zauważył, że holowany statek będzie przemieszczał się obok nich

dzięki swojemu własnemu pędowi - własnej bezwładności. Na tej samej zasadzie,

gdyby Enterprise spróbował użyć wiązki holowniczej do oddalenia od siebie

Stargazera, powstała siła popchnęłaby Enterprise do tyłu tak samo, jak Stargazera do

przodu.

To zjawisko ma duży wpływ na sposób, w jaki obecnie pracuje się w

przestrzeni kosmicznej. Załóżmy na przykład, że jesteś astronautą, który ma dokręcić

śrubę w Kosmicznym Teleskopie Hubble'a. Jeśli zabierzesz ze sobą w tym celu

śrubokręt elektryczny, po dotarciu na miejsce może Cię czekać niemiła

niespodzianka. To, że uda Ci się dokręcić śrubę, jest tak samo prawdopodobne jak to,

że Ty sam zaczniesz się wtedy obracać.

Dzieje się tak dlatego, że teleskop Hubble'a jest o wiele cięższy od Ciebie.

Kiedy śrubokręt działa pewną silą na śrubę, silą reakcji, jaką odczuwasz, obróci

raczej Ciebie niż śrubę, zwłaszcza Jeśli śruba trzyma się dość mocno. Jeśli jednak -

podobnie jak zabójcy Kanclerza Gorkona - jesteś szczęśliwym posiadaczem butów

grawitacyjnych, które utrzymują Cię pewnie na każdym podłożu, możesz się

przemieszczać tak samo skutecznie jak na Ziemi.

Można też zobaczyć, co się stanie, gdy Enterprise spróbuje przyciągnąć do

siebie inny statek kosmiczny. O ile Enterprise nie jest znacznie cięższy od tego statku,

po włączeniu się wiązki holowniczej to on będzie się przysuwał do drugiego obiektu,

a nie odwrotnie. W przestrzeni kosmicznej to rozróżnienie nie ma wielkiego

znaczenia. Bez znajdującego się w pobliżu układu odniesienia skąd możemy

wiedzieć, kto kogo ciągnie? Jeżeli znajdujesz się jednak na planecie tak pechowej, jak

Moab IV, na drodze zagubionej gwiazdy, to nie jest bez znaczenia., czy Enterprise

odsuwa na bok gwiazdę, czy gwiazda statek.

Jeden z moich znajomych trekkerów utrzymuje, że sposób obejścia tego

problemu został już pośrednio zasugerowany przynajmniej w jednym odcinku: gdyby

Enterprise użył swoich silników pulsacyjnych, kiedy włączona jest wiązka

holownicza, działając w przeciwnym kierunku siłą swoich silników mógłby

skompensować wywieraną nart siłę, gdy jest ciągnięty lub na coś pchany. Jak twierdzi

ów trekker, powiedziano gdzieś, że aby wiązka holownicza mogła działać, musi być

uruchomiony napęd pulsacyjny. Nigdy jednak nie zauważyłem, by Kirk lub Picard

wydawali polecenie włączenia silników pulsacyjnych w trakcie używania wiązki

holowniczej. Poza tym nie sądzę, aby społeczeństwo, które potrafi zaprojektować i

zbudować amortyzatory bezwładności, potrzebowało takich siłowych rozwiązań.

Pamiętając o tym, że Geordi LaForge musiał zakrzywić czasoprzestrzeń, aby

spróbować cofnąć księżyc Bre'ela IV, sądzę, że ostrożna - choć na razie nieosiągalna -

manipulacja przestrzenią i czasem równie skutecznie pomogłaby wykonać to zadanie.

Aby lepiej to zrozumieć, musimy użyć amortyzatorów bezwładności i przeskoczyć

jak najszybciej do współczesnego świata zakrzywionej przestrzeni i czasu.

ROZDZIAŁ 2

EINSTEIN PODNOSI STAWKĘ

Pewna młoda dama imieniem Aurora

Gdy nie pędziła szybciej od światła, była chora.

Kiedy razu pewnego w podróż wyjechała,

Na relatywny sposób się zdecydowała

i powróciła poprzedniego wieczora.

ANONIM

„Czas, ostateczna granica” - tak lub podobnie powinien zaczynać się każdy

odcinek serialu Star Trek. Trzydzieści lat temu, w klasycznym odcinku Jutro będzie

wczoraj, Enterprise rozpoczął podróże w czasie. (Właściwie już pod koniec

wcześniejszego odcinka Nagi czas statek zostaje przerzucony w czasie o trzy dni

wstecz - jest to jednak podróż tylko w jedną stronę). W wyniku bliskiego spotkania z

„czarną gwiazdą” (termin „czarna dziura” nie funkcjonował jeszcze wtedy w kulturze

masowej) statek przenosi się na Ziemię XX wieku. Dziś pojęcia tak niezwykłe, jak

„tunele czasoprzestrzenne” i „osobliwości kwantowe”, pojawiają się regularnie w

odcinkach najnowszej serii Star Trek: Voyager. Dzięki Albertowi Einsteinowi i tym,

którzy poszli jego śladem, tkanina czasoprzestrzeni utkana jest z dramatów.

Chociaż każdy z nas jest podróżnikiem w czasie, przekonanie, iż jesteśmy

skazani na podróż tylko w jednym kierunku -w przyszłość - podnosi historię

ludzkości do rangi tragedii. Czego byśmy nie dali za możliwość podróży w

przeszłość, ponownego przeżycia chwil chwały, naprawienia błędów, spotkania

historycznych bohaterów, a może nawet uniknięcia katastrof lub po prostu

powtórnego przeżycia młodości, korzystając z nabytej z wiekiem mądrości? Podróże

w czasie przychodzą nam na myśl za każdym razem, gdy spoglądamy w gwiazdy, ale

wydaje się, że jesteśmy na stałe uwięzieni w teraźniejszości. Pytanie, które inspiruje

nie tylko twórczość dramatyczną, ale i zadziwiająco dużą część badań we

współczesnej fizyce teoretycznej, można sformułować następująco: Jesteśmy czy nie

Jesteśmy więźniami w kosmicznym pociągu czasu, który nie może zmieniać toru?

Początki nowoczesnego gatunku literackiego, który nazywamy fantastyką

naukową, są ściśle związane z motywem podróży w czasie. Wczesny utwór Marka

Twaina Jankes na dworze króla Artura jest bardziej beletrystyką niż fantastyką

naukową, mimo że treść książki obraca się wokół przygód wynikających z

przeniesienia nieszczęsnego Amerykanina do średniowiecznej Anglii. (Być może

Twain nie zastanawiał się szczególnie nad naukowymi aspektami podróży w czasie,

gdyż obiecał Picardowi na pokładzie Enterprise, że nie opisze swojego spojrzenia w

przyszłość, kiedy już powróci do dziewiętnastego stulecia, przeskakując przez

szczelinę czasową na Devidii II, w odcinku Strzałka czasu). Dopiero niezwykłe dzieło

H. G. Wellsa Wehikuł czasu stworzyło paradygmat, na którym oparł się Stor Trek,

Wells był absolwentem Imperiał College of Science and Technology w Londynie i

rozmowy jego bohaterów, podobnie jak wypowiedzi załogi Enterprise, przesiąknięte

są językiem naukowym.

Te odcinki serialu Star Trek, które opowiadają o podróżach w czasie, są

niewątpliwie najbardziej twórcze i zmuszają do myślenia. W pierwszych dwóch

seriach doliczyłem się ponad dwudziestu dwóch odcinków zajmujących się tym

tematem. Podobnie jest w trzech pełnometrażowych filmach Star Trek oraz w

odcinkach z serii Voyager i Stacja kosmiczna, które wyemitowano do chwili obecnej.

Jeśli chodzi o Stor Trek, prawdopodobnie najbardziej fascynującym aspektem

podróży w czasie jest niechęć do łamania Najwyższego Zakazu. Załogi Gwiezdnej

Flory przestrzegane są przed ingerencją w normalny historyczny rozwój obcych

cywilizacji, które odwiedzają. Cofnięcie się w czasie umożliwia jednak całkowitą

likwidację teraźniejszości. Może nawet całkowicie zniweczyć historię!

Zarówno w literaturze fantastycznonaukowej, jak i w fizyce, pojawia się ten

sam słynny paradoks: co się stanie, jeśli cofniesz się w czasie i zabijesz swoją matkę

przed własnymi narodzinami? Niewątpliwie przestaniesz wtedy istnieć. Ale jeśli

przestaniesz istnieć, nie będziesz mógł wrócić i zabić swojej matki. Skoro zaś nie

zabiłeś swojej matki, nie przestałeś istnieć. Innymi słowy, jeśli istniejesz, to nie

możesz istnieć, a jeśli nie istniejesz, to musisz istnieć.

Są jeszcze inne, mniej oczywiste, ale równie dramatyczne i zdumiewające

pytania, które piętrzą się, gdy zaczynamy myśleć o podróżach w czasie. Na przykład

w zakończeniu Strzałki czasu Picard pomysłowo wysyła wiadomość z XIX do XXIV

wieku - wprowadza kod binarny do głowy Daty, wiedząc, że zostanie ona

odnaleziona i połączona z jego ciałem prawie pięć wieków później. Patrzymy, jak

wpisuje wiadomość, a następnie widzimy LaForge'a, który w XXIV stuleciu

przytwierdza Dacie głowę. Widzowi te wydarzenia wydają się jednoczesne, ale takie

nie są; po tym, jak Picard wprowadza wiadomość do głowy Daty, leży ona jeszcze

przez pół tysiąclecia. Ale jeśli badam głowę Daty w XXIV wieku, a Picard nie odbył

jeszcze podróży w przeszłość, aby zmienić przyszłość, czy mógłbym taką wiadomość

odczytać? Można by się spodziewać, że jeśli Picard nie odbył jeszcze podróży, nie

mogła ona mieć wpływu na głowę Daty. Jednak działania zmieniające

oprogramowanie Daty zostały podjęte w XIX wieku, bez względu na to, kiedy Picard

wyruszył w podróż w czasie, aby je wykonać. A więc to już się stało, nawet jeśli

Picard jeszcze nie wyruszył! W ten sposób przyczyna w XIX wieku (wprowadzanie

kodu przez Picarda) może wywołać efekt w dwudziestym czwartym stuleciu (zmiana

obwodów elektrycznych Daty), zanim przyczyna w XXIV wieku (wyprawa Picarda)

wywoła skutek w dziewiętnastym stuleciu (przybycie Picarda do jaskini, gdzie

znajduje się głowa Daty), który pozwoli, aby początkowa przyczyna (wprowadzenie

kodu przez Picarda) w ogóle miała miejsce.

Jeśli powyższe rozumowanie jest niejasne, to co powiedzieć o największym ze

wszystkich paradoksów czasowych, który pojawia się w ostatnim odcinku serii Stor

Trek: Następne pokolenie.

Picard zapoczątkowuje w nim łańcuch wydarzeń, które cofną się w czasie i

unicestwią nie tylko jego przodków, ale i całe życie na Ziemi. Dokładniej,

„podprzestrzenne zakrzywienie czasu” związane z „antyczasem” narasta wstecz w

czasie, pochłaniając w końcu zbudowaną z aminokwasów protoplazmę na młodej

Ziemi, zanim jeszcze powstaną pierwsze proteiny - cegiełki, z których zbudowane są

żywe organizmy. Jest to jaskrawy przykład skutku powodującego przyczynę.

Zakrzywienie czasu powstaje w przyszłości. Gdyby w odległej przeszłości

podprzestrzenne zakrzywienie czasu zniszczyło pierwsze żywe organizmy na Ziemi,

życie nigdy nie mogłoby się rozwinąć i zbudować cywilizacji zdolnej do wytwarzania

takich zakrzywień w przyszłości!

Popularnym wśród wielu fizyków typowym rozwiązaniem takich paradoksów

jest przyjęcie a priori, że w racjonalnym wszechświecie, podobnym do tego, w

którym żyjemy, takie wydarzenia są niemożliwe. Problem polega na tym, że równania

ogólnej teorii względności Einsteina nie tylko nie wykluczają takich możliwości, lecz

wręcz je przewidują.

W ciągu trzydziestu lat badań nad równaniami ogólnej teorii względności

znaleziono rozwiązanie, w którym wyraźnie pojawia się możliwość podróży w czasie.

Jego autorem jest słynny matematyk Kurt Godel, który pracował razem z Einsteinem

w Institute for Advanced Study w Princeton. Mówiąc językiem Star Trek,

rozwiązanie to pozwala na stworzenie „czasowej pętli przyczynowej”, analogicznej

do tej, w jaką został złapany Enterprise po ataku Bozemana. Bardziej sucha

terminologia współczesnej fizyki określa to zjawisko jako „zamkniętą krzywą

czasową”. Jakkolwiek je nazwiemy, wynika z niego możliwość podróżowania w

czasie w obie strony i powracania do punktu wyjścia zarówno w przestrzeni, jak i w

czasie! Rozwiązanie Godła dotyczy wszechświata, który, w przeciwieństwie do

znanego nam, nie rozszerza się, ale jednostajnie obraca. Okazuje się, że w takim

wszechświecie w zasadzie można cofnąć się w czasie, zataczając jedynie duże koło w

przestrzeni. Choć ten hipotetyczny wszechświat dramatycznie różni się od naszego,

sam fakt, że takie rozwiązanie w ogóle istnieje, wskazuje jasno, że ogólna teoria

względności dopuszcza podróże w czasie.

Istnieje pewna maksyma o Wszechświecie, którą zawsze przekazuję moim

studentom: To, co nie jest jawnie zakazane, na pewno się zdarzy, lub, jak powiedział

Data w odcinku Wszechświaty równolegle, mając na myśli prawa mechaniki

kwantowej: „wszystkie zjawiska, które mogą zajść, zachodzą”. Sądzę, że w tym

duchu należy podchodzić do praw fizyki rządzących światem Star Trek. Powinniśmy

rozróżniać nie miedzy tym, co praktyczne, a tym, co niepraktyczne, lecz między tym,

co możliwe, a tym, co niemożliwe.

Fakt ten oczywiście nie pozostał nie zauważony przez samego Einsteina, który

napisał: „Problem [rozwiązania] Kurta Godła [dopuszczającego podróże w czasie]

niepokoił mnie już podczas tworzenia ogólnej teorii względności i nie udało mi się go

wyjaśnić. [...] Interesujące będzie rozważenie, czy rozwiązań tych nie należy

wykluczyć ze względów fizycznych”.

Od tej pory wyzwaniem dla fizyków stało się określenie konsekwencji

istnienia takich „fizycznych powodów”, które wykluczałyby możliwość podróży w

czasie, przewidywanych przez równania ogólnej teorii względności. Aby

przedyskutować te problemy, będziemy musieli wyjść poza klasyczny świat teorii

względności i wkroczyć w mroczny obszar, gdzie mechanika kwantowa decyduje o

naturze przestrzeni i czasu. Po drodze, podobnie jak Enterprise, napotkamy czarne

dziury i tunele czasoprzestrzenne. Najpierw jednak musimy przenieść się w czasie do

drugiej połowy XIX wieku.

Mariaż przestrzeni i czasu, który ogłosił nadejście ery nowoczesności,

rozpoczął się wraz z połączeniem zjawisk elektryczności i magnetyzmu w 1864 roku.

To niezwykłe osiągnięcie intelektualne, u podstaw którego legł wspólny wysiłek

takich wielkich fizyków, jak Andre-Marie Ampere, Charles-Augustin de Coulomb i

Michael Faraday, zostało uwieńczone przez błyskotliwego fizyka brytyjskiego

Jamesa Gierka Maxwella. Odkrył on nie tylko, że prawa elektryczności i magnetyzmu

są ze sobą ściśle związane, ale że wynika z nich istnienie fal elektromagnetycznych,

które powinny poruszać się w przestrzeni z określoną prędkością, wynikającą ze

znanych własności elektryczności i magnetyzmu. Prędkość ta okazała się równa

prędkości światła, którą zmierzono już wcześniej.

Od czasów Newtona spierano się o to, czy światło jest falą - to znaczy

przemieszczającym się w pewnym ośrodku zaburzeniem - czy też cząstką, która

podróżuje niezależnie od obecności ośrodka. Odkrycie fal elektromagnetycznych i

tego, że poruszają się one z prędkością światła, zakończyło tę debatę: światło okazało

się falą elektromagnetyczną.

Każda fala jest po prostu przemieszczającym się zaburzeniem. Jeśli światło to

zaburzenie elektromagnetyczne, czym w takim razie jest ośrodek, który ulega

zaburzeniu, gdy rozchodzi się w nim fala? Pod koniec XIX wieku wiele uwagi

poświęcono temu problemowi. Ośrodek ów miał już swoją nazwę od czasów

Arystotelesa. Nazywano go eterem, ale wszystkie próby jego bezpośredniego

wykrycia kończyły się niepowodzeniem. W roku 1887 Albert A. Michelson i Edward

Morley (pracujący w instytucjach, które połączyły się w 1967 roku, tworząc Case

Western Reserve University - obecne miejsce mojej pracy) przeprowadzili

eksperyment, gwarantujący wykrycie nie tyle samego eteru, co efektów jego istnienia.

Ponieważ przypuszczano, że eter wypełnia całą przestrzeń, Ziemia musiała się

poruszać względem niego. Światło podróżujące w różnych kierunkach względem

kierunku ruchu Ziemi w eterze powinno zatem wykazywać różnice w prędkości.

Eksperyment ten uważa się obecnie za jeden z najważniejszych w ubiegłym stuleciu,

mimo że Michelson i Morley nigdy nie zaobserwowali efektu, którego poszukiwali.

Właśnie dlatego, że nie udało im się zaobserwować efektu ruchu Ziemi względem

eteru, pamiętamy dziś ich nazwiska (A. A. Michelson został pierwszym

amerykańskim laureatem Nagrody Nobla z fizyki za swoje badania eksperymentalne

nad prędkością światła, a ja czuję się zaszczycony, zajmując obecnie pozycję, którą

on piastował ponad sto lat temu. Edward Morley zasłynął jako chemik między innymi

dzięki wyznaczeniu masy atomowej helu).

Negatywny wynik eksperymentu wywołał pewien niepokój wśród fizyków,

ale, jak w przypadku wielu przełomowych odkryć, z jego implikacji zdawało sobie w

pełni sprawę bardzo niewielu uczonych, którzy zaczynali już zauważać paradoksy

związane z teorią elektromagnetyzmu. Mniej więcej w tym czasie pewien uczeń

szkoły średniej, który miał osiem lat w chwili, gdy Michelson i Morley

przeprowadzali swój eksperyment, spróbował niezależnie stawić czoło tym

paradoksom. W 1905 roku, zanim skończył 26 lat, Albert Einstein - bo o nim tu

mowa - rozwiązał ten problem. Ale jak to zwykle bywa, kiedy fizyka stawia wielkie

kroki naprzód, wyniki Einsteina stworzyły więcej problemów niż rozwiązały.

Rozwiązanie Einsteina, które stanowi jądro szczególnej teorii względności,

wynikało z prostego, choć pozornie absurdalnego założenia: jedynym sposobem na

to, by teoria elektromagnetyzmu Maxwella pozostała spójna, było przyjęcie, że

obserwowana prędkość światła jest niezależna od prędkości obserwatora względem

światła. Problem polega na tym, że stwierdzenie to całkowicie przeczy zdrowemu

rozsądkowi. Jeśli z poruszającego się z prędkością pulsacyjną statku Enterprise

wypuszczona zostanie sonda, obserwator na pobliskiej planecie zobaczy, jak

przelatuje ona z prędkością dużo większą niż ta, którą zmierzyłby członek załogi

Enterprise patrzący przez okno statku. Einstein uświadomił sobie jednak, że teoria

Maxwella może być nie-sprzeczna tylko wtedy, gdy fale światła zachowują się

inaczej: jeśli ich prędkość mierzona przez obydwu obserwatorów jest taka sama,

niezależnie od ich względnego ruchu. Jeśli więc wystrzelę wiązkę fazera z dziobu

Enterprise i będzie się ona poruszała z prędkością światła w kierunku mostka

romulanskiego statku Warbird, który sam zbliża się do Enterprise z prędkością

pulsacyjną równą 3/4 prędkości światła, obserwatorzy na wrogim statku zauważą, że

wiązka zbliża się do nich dokładnie z prędkością światła, a nie z prędkością l i 3/4

rażą większą. Tego rodzaju problemy sprawiają trudności wielu trekkerom, którzy

wyobrażają sobie, że jeżeli Enterprise porusza się z prędkością bliską prędkości

światła, a inny statek leci w przeciwnym kierunku z podobną prędkością, światło

wysłane z Enterprise nigdy nie dotrze do drugiego statku (a zatem Enterprise

pozostanie dla niego niewidoczny). Sprawa wygląda Jednak inaczej; obserwatorzy na

drugim statku powinni dostrzec, że światło z Enterprise zbliża się do nich z

prędkością światła.

Nie to odkrycie jednak przyniosło Einsteinowi sławę. Znacznie ważniejsze

było to, że chciał on badać wynikające z tego spostrzeżenia wnioski, które na

pierwszy rzut oka wydawały się absurdalne. W naszym codziennym doświadczeniu to

czas i przestrzeń sprawiają wrażenie absolutnych, natomiast prędkość jest czymś

względnym: obserwowana prędkość poruszającego się obiektu zależy od tego, jak

szybko się poruszamy. Kiedy jednak zbliżamy się do prędkości światła, to prędkość

staje się wielkością absolutną, a więc przestrzeń i czas muszą stać się względne!

Dzieje się tak dlatego, że prędkość definiuje się ściśle jako odległość

pokonaną w pewnym określonym czasie. Tak więc jedynym sposobem, aby

poruszający się względem siebie obserwatorzy mogli stwierdzić, że pojedynczy

promień światła przebywa względem nich w ciągu jednej sekundy tę samą odległość -

powiedzmy 300 milionów metrów - konieczne jest, aby ich „sekundy” lub ich

„metry” różniły się między sobą! Okazuje się, że szczególna teoria względności

wybiera rozwiązanie najgorsze, to znaczy zarówno sekundy, jak i metry stają się

wielkościami względnymi.

Wychodząc od prostego założenia, że prędkość światła mierzona przez

różnych obserwatorów jest zawsze taka sama, niezależnie od ich względnego ruchu,

Einstein wyciągnął następujące wnioski na temat przestrzeni, czasu i materii:

(a) Zdarzenia, które dla danego obserwatora zachodzą w tym samym czasie i

w dwóch różnych miejscach, nie muszą być równoczesne dla innego obserwatora,

poruszającego się względem pierwszego. Dla każdego z nich „teraz” znaczy co

innego. Pojęcia „przed” i „po” są względne dla odległych zdarzeń.

(b) Wszystkie zegary na statkach kosmicznych, które poruszają się względem

mnie, chodzą wolniej niż mój zegar. Czas zwalnia dla obiektów w ruchu.

(c) Linijki znajdujące się na statkach, które poruszają się względem nas,

wydają się krótsze, niż gdyby spoczywały w naszym układzie odniesienia. Obiekty,

ze statkami kosmicznymi włącznie, ulegają skróceniu podczas ruchu.

(d) Wszystkie obiekty mające masę stają się tym cięższe, im szybciej się

poruszają. Gdy ich prędkość zbliża się do prędkości światła, ich masa staje się

nieskończona. Innymi słowy, tylko obiekty pozbawione masy, takie jak światło, mogą

poruszać się z prędkością światła.

Nie będę tu opowiadał o wszystkich wspaniałych pozornych paradoksach,

jakie pojawiają się w teorii względności. Niech nam wystarczy to, że - czy nam się to

podoba, czy nie - wszystkie cztery wnioski są prawdziwe, zostały bowiem

sprawdzone. Na pokład poruszających się z wielkimi prędkościami samolotów

zabrano zegary atomowe i zaobserwowano, że spóźniają się one po powrocie w

stosunku do swoich ziemskich odpowiedników. Na całym świecie w laboratoriach

fizyki cząstek elementarnych konsekwencje szczególnej teorii względności są

chlebem powszednim eksperymentatorów. Niestabilne cząstki przyspiesza się do

prędkości bliskich prędkości światła, a ich mierzone czasy życia zwiększają się

wielokrotnie. Kiedy elektrony, które w spoczynku mają masę 2000 razy mniejszą niż

protony, przyspieszy się do prędkości bliskich prędkości światła, niosą one pęd

równoważny pędom ich cięższych kuzynów. Elektron przyspieszony do prędkości

równej

0,9999999999999999999999999999999999999999999999999999999999999999

prędkości światła uderzyłby Cię z taką samą siłą, jak jadąca z przeciętną prędkością

ciężarówka.

Oczywiście przyczyną, dla której tak trudno jest nam wziąć za dobrą monetę

wnioski dotyczące względności przestrzeni i czasu, jest to, że żyjemy i poruszamy się

z prędkościami znacznie mniejszymi niż prędkość światła. Każdy z wymienionych

efektów staje się zauważalny dopiero wtedy, gdy wchodzą w grę prędkości

relatywistyczne. Nawet przy prędkości równej połowie prędkości światła zegary

zwalniają, a linijki kurczą się tylko o około 15%. Na wahadłowcu NASA, który

okrąża Ziemię z prędkością 8 km/s, zegary chodzą tylko o jedną dziesięciomilionową

procenta wolniej, niż ich odpowiedniki na powierzchni Ziemi.

W świecie Enterprise lub innego statku kosmicznego, gdzie powszechne są

duże prędkości, z względnością mielibyśmy jednak do czynienia na co dzień. Można

sobie wyobrazić trudności w zarządzaniu Federacją, gdy konieczne byłoby

zsynchronizowanie zegarów na dużym obszarze Galaktyki, zwłaszcza że znaczna

część tych zegarów poruszałaby się z prędkością bliską prędkości światła. W wyniku

tego w gwiezdnej flocie przyjęto jako regułę, że normalne manewry, wykonywane

przy użyciu napędu pulsacyjnego, będą ograniczone do prędkości 0,25c, czyli 1/4

prędkości światła: marnych 75 tysięcy km/s.

Nawet przy zastosowaniu tej zasady zegary na statkach podróżujących z taką

prędkością będą zwalniały o około 3% w stosunku do zegarów w Centrum

Dowodzenia. Oznacza to, że po miesiącu podróży zegary będą opóźnione o prawie

jeden dzień. Gdyby po takiej podróży Enterprise wrócił do Centrum Dowodzenia, na

statku byłby piątek, a w bazie sobota. Przypuszczam, że ta niedogodność nie

sprawiałaby większego problemu niż przestawianie zegarków przy przekraczaniu

międzynarodowej granicy daty podczas podróży na wschód, choć w tym przypadku

załoga powróciłaby o jeden dzień młodsza, natomiast w trakcie podróży na wschód i

z powrotem zyskuje się jeden dzień jadąc w jednym kierunku, a traci się go wracając.

Możemy się teraz przekonać, jak istotny dla Enterprise jest napęd

czasoprzestrzenny. Pozwala on nie tylko obejść zasadę nieprzekraczalności prędkości

światła i w ten sposób efektywnie podróżować przez Galaktykę, lecz także uniknąć

problemów związanych z dylatacją czasu, pojawiającą się, gdy statek porusza się z

prędkością bliską prędkości światła.

Nie można przecenić tych faktów. Wielu autorów fantastyki naukowej (a tak

naprawdę wszyscy, którzy marzą o podróżach międzygwiezdnych) traktuje zjawisko

zwalniania chodu zegarów w miarę zbliżania się do prędkości światła jako otwarcie

możliwości pokonywania olbrzymich odległości między gwiazdami w czasie życia

ludzkiego - przynajmniej za życia osób znajdujących się na pokładzie statku

kosmicznego.

Podróż z prędkością bliską prędkości światła do, powiedzmy, centrum naszej

Galaktyki zajęłaby ponad 25 tysięcy lat czasu ziemskiego. Dla osób znajdujących się

na pokładzie statku, gdyby poruszał się on z prędkością dostatecznie bliską prędkości

światła, podróż ta mogłaby trwać krócej niż 10 lat -czas długi, ale do przyjęcia.

Jednak nawet gdyby umożliwiło to odbywanie pojedynczych podróży, z pewnością

nie pozwoliłoby na sprawne zarządzanie federacją cywilizacji rozproszonych po całej

Galaktyce. Jak słusznie przypuszczali twórcy Star Trek, fakt, że dziesięcioletnia

podróż Enterprise odpowiadałaby okresowi 25 tysięcy lat w Centrum Dowodzenia,

zniweczyłby szansę jakiegokolwiek działania mającego na celu zorganizowanie i

kontrolowanie ruchu wielu takich statków kosmicznych. Jest więc niezwykle istotne,

aby: po pierwsze, uniknąć ograniczenia związanego z prędkością światła i nie

powodować dezorganizacji Federacji; po drugie, zastosować prędkości

ponadświetlne, by swobodnie przemieszczać się po Galaktyce.

Szkopuł w tym, że w ramach samej szczególnej teorii względności tej

ostatniej możliwości nie można zrealizować. Jeśli dopuści się prędkości

ponadświetlne, fizyka staje się pełna sprzeczności. Nie bez znaczenia jest tu między

innymi to, że ponieważ w miarę zbliżania się do prędkości światła wzrasta masa

obiektów, potrzeba stopniowo coraz więcej energii, aby przyspieszyć je o coraz

mniejszą wartość. Jak w greckim micie o Syzyfie, który skazany był na wtaczanie

głazu pod górę przez całą wieczność po to tylko, aby za każdym razem, gdy docierał

do szczytu, ponosić klęskę, cała energia we Wszechświecie nie wystarczyłaby na to,

aby przyspieszyć ziarnko piasku, nie mówiąc już o statku kosmicznym, do prędkości

ponadśwłetlnej.

Na tej samej zasadzie nie tylko światło, ale każde bezmasowe promieniowanie

musi przemieszczać się z prędkością światła. Oznacza to, że wiele rodzajów istot

zbudowanych z „czystej energii”, jakie napotyka Enterprise, a później Voyager, nie

mogłoby istnieć w pokazanej postaci. Po pierwsze, nie mogłyby one pozostawać w

bezruchu. Światło nie może zwolnić, nie mówiąc już o zatrzymaniu. Po drugie,

zegary każdej inteligentnej, zbudowanej z energii istoty - na przykład fotonowi

osobnicy w serii Voyager, zbudowani z energii mieszkańcy obłoku Beta Renna w

serii Następne pokolenie, Zetarianie w pierwszej serii, czy Dal’Rok w serii Stacja

kosmiczna - która zmuszona jest poruszać się z prędkością światła, miałyby

nieskończenie duże opóźnienie w stosunku do naszych zegarów. Cała historia

Wszechświata przebiegałaby dla niej w ciągu krótkiej chwili. Gdyby zbudowane z

energii istoty mogły czegokolwiek doświadczać, doświadczałyby wszystkiego narazi

Nie trzeba dodawać, że zanim skontaktowałyby się z istotami cielesnymi, te ostatnie

już dawno byłyby martwe.

Skoro mówimy o czasie, myślę, że nadeszła już pora, by zapoznać się z

manewrem Picarda. Jean-Luc zdobył sławę, wprowadzając tę taktykę, gdy przebywał

na pokładzie Stargazera. Chociaż dotyczy ona podróży z prędkościami

czasoprzestrzennymi, czyli ponadświetlnymi, które - jak dowodziłem - są niemożliwe

w ramach samej szczególnej teorii względności, wymaga zastosowania takich

prędkości tylko przez moment, tak że nie przeczy temu, co do tej pory

powiedzieliśmy. W trakcie manewru Picarda, mającego na celu pomieszanie szyków

atakującemu statkowi wroga, przyspiesza się własny statek na krótką chwilę do

prędkości czasoprzestrzennej. Jest on wtedy widoczny w dwóch miejscach naraz.

Dzieje się tak dlatego, że poruszając się przez moment szybciej niż światło

wyprzedza on promienie świetlne, które opuściły go tuż przed uruchomieniem napędu

czasoprzestrzennego. Chociaż jest to błyskotliwa strategia - i wydaje się na razie

całkiem sensowna (jeśli zapomnimy na chwilę o tym, że nie wiemy, czy możliwe jest

osiąganie prędkości czasoprzestrzennych) - widać od razu, iż otwiera ona prawdziwą

puszkę Pandory. Po pierwsze, zaniedbuje kwestię podnoszoną przez wielu trekkerów

przez lata: w jaki sposób załoga Enterprise może „widzieć” obiekty zbliżające się do

niej z prędkością czasoprzestrzenną? Podobnie jak Stargazera wyprzedził swój

własny obraz, to samo uczynią wszystkie obiekty podróżujące z prędkością

czasoprzestrzenną; obiekt poruszający się z taką prędkością można zobaczyć dopiero

długo po tym, jak przybędzie na miejsce. Możemy tylko przypuszczać, że kiedy Kirk,

Picard czy Janeway chcą obejrzeć obraz na ekranie, pojawia się tam obraz uzyskany

za pomocą czujników „podprzestrzennych” dalekiego zasięgu (to znaczy komunikacji

ponadświetlnej). Nawet jeśli przymkniemy oko na to wyraźne przeoczenie, pokazany

w Star Trek wszechświat, choć niewątpliwie ciekawy, byłby trudny do zarządzania -

pełen pozornych obrazów obiektów, które dawno temu dotarły do celu, podróżując z

prędkością czasoprzestrzenną.

Powróćmy do świata prędkości mniejszych niż prędkość światła; nie

uporaliśmy się bowiem do końca z Einsteinem. Jego słynny związek między masą a

energią, E = mc

2

, będący konsekwencją szczególnej teorii względności, stanowi

kolejne wyzwanie dla podróży międzygwiezdnych z prędkościami pulsacyjnymi.

Rakieta, jak opisałem to w rozdziale pierwszym, wyrzuca materię w tył, aby poruszać

się do przodu. Łatwo sobie wyobrazić, że im szybciej materia jest odrzucana w tył,

tym większe będzie pchnięcie w przód. Spaliny nie mogą jednak wydostawać się z

prędkością większą niż prędkość światła. Nawet nadawanie im prędkości światła nie

jest łatwe: jedynym na to sposobem jest użycie paliwa spreparowanego z materii i

antymaterii, które (o czym przekonamy się w jednym z kolejnych rozdziałów) może

zupełnie anihilować i wytwarzać czyste promieniowanie poruszające się z prędkością

światła.

Chociaż napęd czasoprzestrzenny w Enterprise wykorzystuje takie właśnie

paliwo, napęd pulsacyjny działa na innej zasadzie. Jest on zasilany za pomocą syntezy

jądrowej - tych samych reakcji Jądrowych, dzięki którym wodór przemienia się w hel

we wnętrzu Słońca. W reakcjach jądrowych w energię zamienia się około 1%

dostępnej masy. Przy takiej energii wytwarzane atomy helu wydostają się z tyłu

rakiety z prędkością około 1/8 prędkości światła. Znając prędkość wypływu helu,

możemy obliczyć ilość paliwa, jakiej potrzebuje Enterprise, aby przyspieszyć,

powiedzmy, do połowy prędkości światła. Obliczenie to nie jest trudne, ale ograniczę

się do podania odpowiedzi. Może ona być zaskakująca. Za każdym razem, kiedy

Enterprise przyspiesza do połowy prędkości światła, musi spalić 81 razy więcej

paliwa wodorowego niż sam waży. Statek klasy galaktycznej, taki jak Enterprise-D

Picarda, ważyłby ponad 4 miliony ton, a zatem, aby przyspieszyć ten statek do

połowy prędkości światła za pomocą napędu pulsacyjnego, za każdym razem trzeba

by było zużyć ponad 300 milionów ton paliwa! Gdyby w silniku pulsacyjnym

zastosować układ napędowy wykorzystujący materię i antymaterię, sytuacja

wyglądałaby nieco lepiej. W tym przypadku wystarczyłoby spalić w trakcie

przyspieszania tylko dwa razy więcej paliwa niż wynosiłaby waga statku.

Ale to nie wszystko. Obliczenie, które przedstawiłem powyżej, jest poprawne

dla pojedynczego przyspieszenia. Aby zatrzymać się po osiągnięciu celu, statek

potrzebowałby drugie tyle paliwa. Oznacza to, że aby udać się gdzieś z prędkością

równą połowie prędkości światła, a następnie zatrzymać się, potrzebne byłoby paliwo

w ilości 81x81= 6561 razy całkowita masa statku! Co więcej, przypuśćmy, że ktoś

chciałby przyspieszyć do połowy prędkości światła w ciągu kilku godzin (zakładamy

oczywiście, że amortyzatory bezwładności są włączone, osłaniając załogę oraz statek

przed skutkami działania olbrzymich sił G). Moc wypromieniowana przez silniki w

postaci spalin wyniosłaby wtedy około l O

22

watów, czyli niemal miliard razy więcej

niż całkowita średnia moc wytwarzana obecnie i zużywana przez ludzkość na Ziemi!

Prawdopodobnie powiesz teraz (jak to zrobił pewien mój bystry kolega, gdy

pewnego dnia przedstawiłem mu tę argumentację), że jest tutaj pewna furtka.

Rozumowanie to zakłada, że paliwo podróżuje razem z rakietą. Co by się jednak

stało, gdyby paliwo można było zbierać w trakcie podróży? W końcu wodór jest

najbardziej rozpowszechnionym pierwiastkiem we Wszechświecie. Czy nie można by

go gromadzić, podróżując przez Galaktykę? Cóż, średnia gęstość materii w naszej.

Galaktyce wynosi około 1 atom wodoru na centymetr sześcienny.

Aby uzbierać tylko 1 gram wodoru w ciągu sekundy, poruszając się nawet z

prędkością będącą sporym ułamkiem prędkości światła, trzeba by było rozwinąć

powierzchnie zbierające o średnicy ponad 40 kilometrów. Nawet gdyby udało się całą

tę materię zamienić na energię, wystarczyłoby to tylko na około jedną stumilionową

potrzebnej do napędu mocy!

Można tu przytoczyć słowa fizyka, laureata Nagrody Nobla, Edwarda

Purcella, którego argumenty przedstawiłem i rozszerzyłem: „Jeśli wydaje Ci się to

niedorzeczne, masz rację”. Ta absurdalność bierze się z podstawowych praw

mechaniki klasycznej i szczególnej teorii względności. Argumenty przedstawione

tutaj są tak pewne, jak to, że piłka spadnie, kiedy upuści się ją na ziemię. Podróże

międzygwiezdne przez Galaktykę w statkach z napędem rakietowym z prędkością

bliską prędkości światła nie są i nigdy nie będą praktycznie wykonalne!

Czy należy więc w tym miejscu zakończyć książkę? Czy powinniśmy odesłać

gadżety związane ze Star Trek i poprosić o zwrot pieniędzy? Otóż nie, gdyż wciąż

jeszcze nie skończyliśmy z Einsteinem. Jego ostatnie i chyba największe odkrycie

daje nam iskierkę nadziei.

Cofnijmy się do roku 1908: odkrycie przez Einsteina względności przestrzeni

i czasu zwiastuje jedno z tych doświadczeń ludzkości, które co jakiś czas

nieodwołalnie zmieniają nasz obraz Wszechświata. Jesienią 1908 roku fizyk i

matematyk Her-mann Minkowski napisał słynne zdanie: „Odtąd przestrzeń sama w

sobie i czas sam w sobie są skazane na odejście w cień, a tylko rodzaj związku tych

dwóch wielkości zachowa niezależne istnienie”.

Minkowski zdał sobie sprawę z tego, że chociaż przestrzeń i czas są względne

dla obserwatorów poruszających się względem siebie - Twój zegar może tykać

wolniej niż mój, a mierzone przeze mnie odległości będą inne niż mierzone w Twoim

układzie odniesienia - to gdy zostają one połączone w jedną cztero-wymiarową całość

(trzy wymiary przestrzenne i jeden czasowy), pojawia się nagle znowu pewna

„absolutna”, obiektywna rzeczywistość.

Przebłysk zrozumienia, który stał się udziałem Minkowskie-go, można

wyjaśnić uciekając się do analogii ze światem jednookich istot, które nie dostrzegają

głębi. Przypuśćmy, że zamknąłeś jedno oko, ograniczając w ten sposób swoją

percepcję głębi, a ja trzymam linijkę, tak abyś mógł ją widzieć. Następnie proszę

kogoś innego, patrzącego pod innym kątem, by również zamknął jedno oko.

Wówczas trzymana przeze mnie linijka wyda mu się krótsza niż Tobie; poniższy

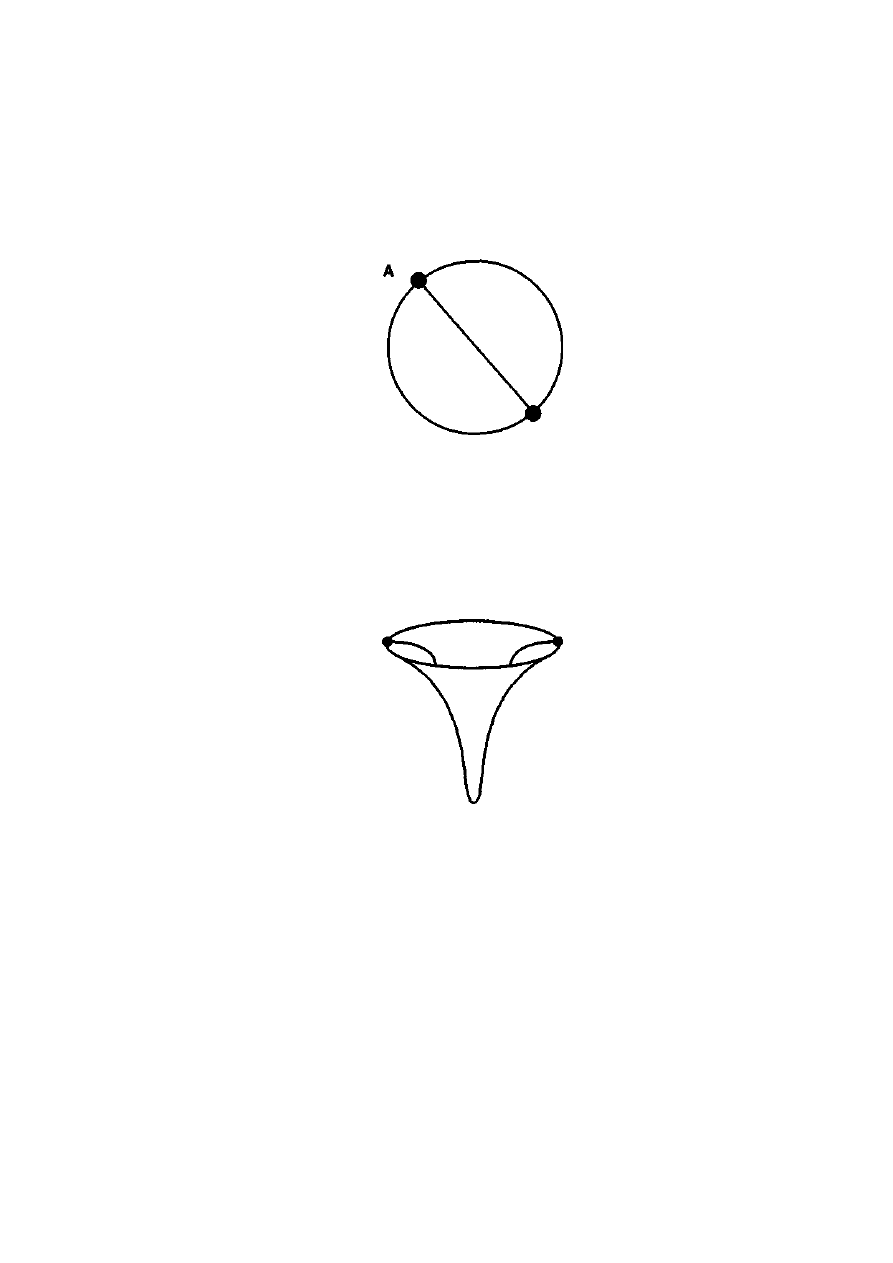

rysunek pokazuje opisaną sytuację z lotu ptaka:

Każdy obserwator pozbawiony możliwości bezpośredniej oceny głębi określi

„długość” linijki (L lub L’) jako dwuwymiarowy rzut rzeczywistej, trójwymiarowej

długości linijki na własną płaszczyznę widzenia. Ponieważ wiemy, że przestrzeń ma

trzy wymiary, taka sztuczka nas nie oszuka. Wiemy, że patrzenie na coś pod innym

kątem nie zmienia rzeczywistej długości przedmiotu, nawet jeśli zmienia ją pozornie.

Minkowski wykazał, że w podobny sposób można wyjaśnić różne paradoksy teorii

względności. Trzeba tylko przyjąć, że nasze widzenie przestrzeni to trójwymiarowy

przekrój czegoś, co w rzeczywistości jest czterowymiarowym obiektem, w którym

przestrzeń i czas są połączone. Dwaj różni obserwatorzy, poruszający się względem

siebie, postrzegają różne trójwymiarowe przekroje ukrytej czterowymiarowej

przestrzeni w bardzo podobny sposób, jak obróceni względem siebie obserwatorzy na

rysunku widzą różne dwuwymiarowe przekroje przestrzeni trójwymiarowej.

Minkowski wyobraził sobie, że odległość przestrzenna mierzona przez dwóch

poruszających się względem siebie obserwatorów jest projekcją ukrytej

czterowymiarowej odległości na trójwymiarową przestrzeń, którą mogą postrzegać; i

podobnie, że czasowa „odległość” między dwoma zdarzeniami jest rzutem odległości

w czterowymiarowej czasoprzestrzeni na ich własny wymiar czasowy. Podobnie jak

obrót przedmiotów w trzech wymiarach może wymieszać szerokość i głębokość, tak

względny ruch w czterowymiarowej przestrzeni może pomieszać pojęcia

„przestrzeni” i „czasu” różnych obserwatorów. Podobnie jednak jak długość

przedmiotu nie zmienia się, gdy obracamy go w przestrzeni, tak samo odległość

między dwoma zdarzeniami w czterowymiarowej czasoprzestrzeni jest stała -

niezależnie od tego, w jaki sposób różni, poruszający się względem siebie

obserwatorzy przypisują odległościom „przestrzenność” i „czasowość”.

I tak zadziwiająca niezmienność prędkości światła dla wszystkich

obserwatorów stała się kluczem do odsłonięcia prawdziwej, czterowymiarowej natury

Wszechświata, w którym żyjemy. Światło ukazuje ukryty związek między

przestrzenią a czasem. W rzeczywistości prędkość światła definiuje ów związek.

To właśnie w tym miejscu Einstein powrócił, aby uratować Stor Trek. Kiedy

już Minkowski wykazał, że czasoprzestrzeń szczególnej teorii względności jest jak

czterowymiarowa kartka papieru, Einstein spędził większą część następnego

dziesięciolecia napinając swoje matematyczne mięśnie, aż udało mu się zgiąć tę

kartkę, co z kolei pozwala nam nagiąć reguły gry. Jak się zapewne domyślasz,

kluczem do tego okazało się znowu światło.

ROZDZIAŁ 3

HAWKING WYKŁADA KARTY

Jakże słabo wy, śmiertelnicy, rozumiecie czas. Czy musisz być taki liniowy,

Jean-Luc?

Q do Picarda w odcinku Wszystko, co dobre...

Planeta Wulkan, z której pochodzi Spock, jest bardzo zasłużona dla fizyki XX

wieku. Na początku naszego stulecia wielką zagadkę astronomii stanowiło to, że

peryhelium Merkurego - czyli punkt orbity, w którym planeta znajduje się najbliżej

Słońca - w trakcie każdego jego obiegu wokół Słońca ulega niewielkiej precesji w

sposób niezgodny z teorią grawitacji Newtona. Aby rozwiązać ten problem,

wysunięto hipotezę, że jeszcze bliżej Słońca niż Merkury krąży inna planeta, która

zaburza jego ruch. (Co ciekawe, podobne wyjaśnienie anomalii w ruchu orbitalnym

Urana zaowocowało wcześniej odkryciem Neptuna). Ową hipotetyczną planetę

nazwano Wulkanem.

Niestety, tajemnicza planeta Wulkan nie istnieje. Natomiast Einstein

zaproponował, aby zastąpić płaską przestrzeń Newtona i Minkowskiego zakrzywioną

czasoprzestrzenią ogólnej teorii względności. W tej zakrzywionej przestrzeni orbita

Merkurego odchylałaby się nieco od toru, jaki przewidywała teoria Newtona, co

wyjaśniałoby obserwowaną niezgodność.

Chociaż w ten sposób znikła potrzeba istnienia planety Wulkan, pojawiły się o

wiele bardziej ekscytujące możliwości: z zakrzywioną przestrzenią związane są

czarne dziury, tunele czasoprzestrzenne, a być może realne stają się nawet podróże w

czasie.

Rzeczywiście, jeszcze zanim twórcy Star Trek wymyślili pole zakrzywiające

czasoprzestrzeń, Einstein zakrzywiał ją podobnie jak oni, uzbrojony jedynie w swoją

wyobraźnię. Zamiast jednak wyobrażać sobie technologię podróży

międzygwiezdnych w XXII wieku, uczony przeprowadzał eksperymenty myślowe z

windami. Einstein był niewątpliwie wielkim fizykiem, ale pewnie nigdy nie

sprzedałby scenariusza.

Jego argumenty można jednak w nienaruszonej postaci przenieść na pokład

Enterprise. Ponieważ światło jest nitką splatającą przestrzeń i czas, tory promieni

świetlnych tworzą mapę czasoprzestrzeni tak samo, jak osnowa i wątek ukazują

wzory gobelinu. Zazwyczaj światło podróżuje po liniach prostych. Co by się jednak

stało, gdyby romulański dowódca na pokładzie znajdującego się w pobliżu statku

Warbird wystrzelił promień fazera w kierunku Picarda, siedzącego na mostku

swojego kapitańskiego jachtu Calypso, którego silnik pulsacyjny został właśnie

uruchomiony (w tym przykładzie przyjmujemy, że amortyzatory bezwładności

zostały wyłączone)? Picard ruszyłby gwałtownie naprzód, ledwo unikając promienia

fazera. Z punktu widzenia układu odniesienia Picarda sytuacja wyglądałaby tak jak na

rysunku na następnej stronie.

Dla Picarda tor promienia fazera byłby więc zakrzywiony. Co jeszcze mógłby

on zauważyć? Jeśli przypomnimy sobie argumentację z rozdziału pierwszego, bez

trudu stwierdzimy, że gdy amortyzatory bezwładności są wyłączone, Picard zostanie

wgnieciony w fotel. Zwróciłem tam również uwagę na to, że gdyby Picard poruszał

się naprzód z takim samym przyspieszeniem, z jakim spadają na Ziemię ciała pod

wpływem siły grawitacji, odczułby, iż siła, która wgniata go w fotel, jest taka sama

jak siła, która ciągnie go w dół, kiedy stoi na Ziemi. Einstein dowodził, że Picard (lub

na przykład ktoś znajdujący się w jadącej w górę windzie) nie mógłby nigdy

przeprowadzić eksperymentu, który wskazałby różnicę między siłą reakcji wywołaną

przyspieszeniem a działaniem grawitacji jakiegoś ciężkiego obiektu znajdującego się

w pobliżu statku. W ten sposób Einstein wszedł śmiało na teren nie znany dotąd

fizykom i dowodził, że wszelkie zjawiska zaobserwowane przez przyspieszającego

obserwatora wyglądałyby tak, jakby przebiegały w polu grawitacyjnym.

Z tego przykładu wynika co następuje: ponieważ Picard obserwuje

zakrzywianie się promienia fazera, gdy oddala się od niego z pewnym

przyspieszeniem, promień taki musi się również zakrzywiać w polu grawitacyjnym.

Ale promienie świetlne wytyczają mapę czasoprzestrzeni; a zatem zakrzywieniu w

takim polu ulega sama czasoprzestrzeń. Skoro zaś materia wytwarza pole

grawitacyjne, to ona właśnie musi zakrzywiać czasoprzestrzeń!

Można jednak argumentować, że ponieważ światło ma energię, masa zaś i

energia są związane ze sobą słynnym równaniem Einsteina, zakrzywianie się

promienia świetlnego w polu grawitacyjnym nie jest wielkim zaskoczeniem - a już na

pewno nie wynika z tego, że musimy przyjąć, iż to sama czasoprzestrzeń się

zakrzywia. W końcu tory, po jakich porusza się materia, również ulegają

zakrzywieniu (wystarczy chociażby podrzucić piłkę). Nawet Galileusz mógłby

wykazać - gdyby znał takie obiekty - że tory piłek baseballowych i rakiet Pathfinder

ulegają zakrzywieniu i wcale nie musiałby przy tym wspominać o zakrzywionej

przestrzeni.

Można jednak obliczyć, o ile powinien zakrzywić się promień świetlny, gdyby

zachowywał się tak samo, jak piłka baseballowa, a następnie zmierzyć rzeczywiste

zakrzywienie. Zrobił to

w 1919 roku sir Arthur Stanley Eddington, który kierował ekspedycją mającą

określić pozycje gwiazd na niebie w pobliżu Słońca w czasie jego zaćmienia.

Eddington zmierzył ten efekt i okazało się, że światło zakrzywia się dokładnie dwa

razy bardziej, niż mógłby przewidzieć Galileusz, zakładając, iż światło zachowuje się

jak piłka baseballowa w płaskiej przestrzeni. Jak łatwo się domyślić, ta dwukrotnie

większa wartość jest dokładnie zgodna z przewidywaniami Einsteina, przy założeniu,

że czasoprzestrzeń zakrzywia się w pobliżu Słońca i światło (lub na przykład

Merkury) porusza się w tym miejscu po „prostej” w zakrzywionej przestrzeni! Nagle

nazwisko Einsteina stało się powszechnie znane.

Zakrzywiona przestrzeń otwiera cały wszechświat możliwości, jeśli mogę

posłużyć się takim kalamburem. Podobnie jak Enterprise, uwalniamy się z okowów

swego rodzaju liniowego myślenia - narzuconego nam przez szczególną teorię

względności - tak znienawidzonego przez Q. W zakrzywionej przestrzeni możliwych

jest wiele rzeczy, które nie mają racji bytu w przestrzeni płaskiej. Można na przykład

wędrować ciągle w tym samym kierunku, a mimo to wrócić do punktu wyjścia -

ludzie podróżujący dookoła świata robią to przez cały czas.

Centralne założenie ogólnej teorii względności Einsteina przedstawia się

bardzo prosto i brzmi następująco: zakrzywienie czasoprzestrzeni jest określone przez

rozkład zawartej w niej materii i energii. Równania Einsteina ustanawiają ścisły

matematyczny związek między zakrzywieniem z jednej strony, a. materią i energią z

drugiej:

lewa strona równania =

prawa strona równania

ZAKRZYWIENIE

=

MATERIA I ENERGIA

Tym, co czyni tę teorię tak piekielnie trudną w zastosowaniach, jest właśnie

owo proste sprzężenie zwrotne: zakrzywienie czasoprzestrzeni jest określone przez

rozkład materii i energii we Wszechświecie, z kolei rozkład ten jest uzależniony od

zakrzywienia czasoprzestrzeni. Można to porównać do problemu, co było pierwsze -

jajko czy kura? Materia jest źródłem zakrzywienia czasoprzestrzeni, które z kolei

określa ewolucję materii, co wpływa na zakrzywienie i tak dalej.

Dla zagadnienia podróży międzygwiezdnych jest to zapewne najważniejszy

aspekt ogólnej teorii względności. Złożoność tej teorii oznacza, że ciągle jeszcze nie

rozumiemy w pełni wszystkich jej konsekwencji, a zatem nie możemy wykluczyć

różnych niezwykłych możliwości. Te właśnie możliwości są wodą na młyn Star Trek.

Jak się przekonamy, u ich podstaw leży wielka niewiadoma, która przenika wszystko:

od tuneli czasoprzestrzennych i czarnych dziur po wehikuły czasu.

Pierwszym ważnym dla przygód statku Enterprise wnioskiem wynikającym z

tego, że czasoprzestrzeń nie musi być płaska, jest to, że sam czas staje się wielkością

jeszcze bardziej dynamiczną niż w szczególnej teorii względności. Czas może płynąć

w różnym tempie dla różnych obserwatorów, nawet jeśli nie poruszają się oni

względem siebie. Wyobraźmy sobie, że podziałka na tarczy zegara zachowuje się jak

podziałka na linijce zrobionej z gumy. Jeżeli rozciągniemy lub zegniemy linijkę,

odległości między kreskami podziałki będą się zmieniać od punktu do punktu. Gdyby

odległości te odpowiadały tyknięciom zegara, zegary umieszczone w różnych

miejscach chodziłyby w różnym tempie. W ogólnej teorii względności Einsteina

„zgiąć” linijkę może pole grawitacyjne, które z kolei wymaga obecności materii.

Ujmując to bardziej praktycznie: jeśli umieścimy w pobliżu zegara ciężką kulę

żelazną, tempo jego tykania powinno ulec zmianie. Mówiąc jeszcze bardziej

poglądowo: jeśli podczas mego snu budzik znajduje się bardzo blisko mojego ciała,

zostanę obudzony nieco później, niż gdyby był daleko, przynajmniej w stosunku do

reszty świata.

Słynny eksperyment, przeprowadzony w laboratoriach Uniwersytetu Harvarda

w roku 1960, zademonstrował, że upływ czasu może zależeć od tego, gdzie się

znajdujesz. Robert Pound oraz George Rebka wykazali, że częstość promieniowania y

mierzonego przy źródle w piwnicy budynku różniła się od częstości tego

promieniowania, gdy docierało ono na dach budynku, 22 metry wyżej (detektory,

oczywiście, dokładnie wykalibrowano, tak by same nie powodowały żadnej różnicy).

Przesunięcie było niezwykle małe - sięgało jednej milionowomiliardowej. Jeśli każdy

okres fali promieniowania y porównać z ryknięciem zegara atomowego, z

eksperymentu tego wynika, że zegar w piwnicy będzie chodził wolniej niż jego

odpowiednik na dachu. Na niższym piętrze czas zwalnia, ponieważ znajduje się ono

bliżej Ziemi niż dach, a więc pole grawitacyjne -a co za tym idzie również

zakrzywienie czasoprzestrzeni - jest tam większe. Chociaż efekt ten był bardzo mały,

jego wielkość dokładnie odpowiadała wartości przewidywanej przez ogólną teorię

względności, przy założeniu, że w pobliżu Ziemi czasoprzestrzeń ulega zakrzywieniu.

Drugi wniosek z tego, że przestrzeń się zakrzywia, jest, jeśli chodzi o podróże

międzygwiezdne, może jeszcze bardziej ekscytujący. Gdy przestrzeń jest

zakrzywiona, linia prosta nie musi być najkrótszą drogą między dwoma punktami.

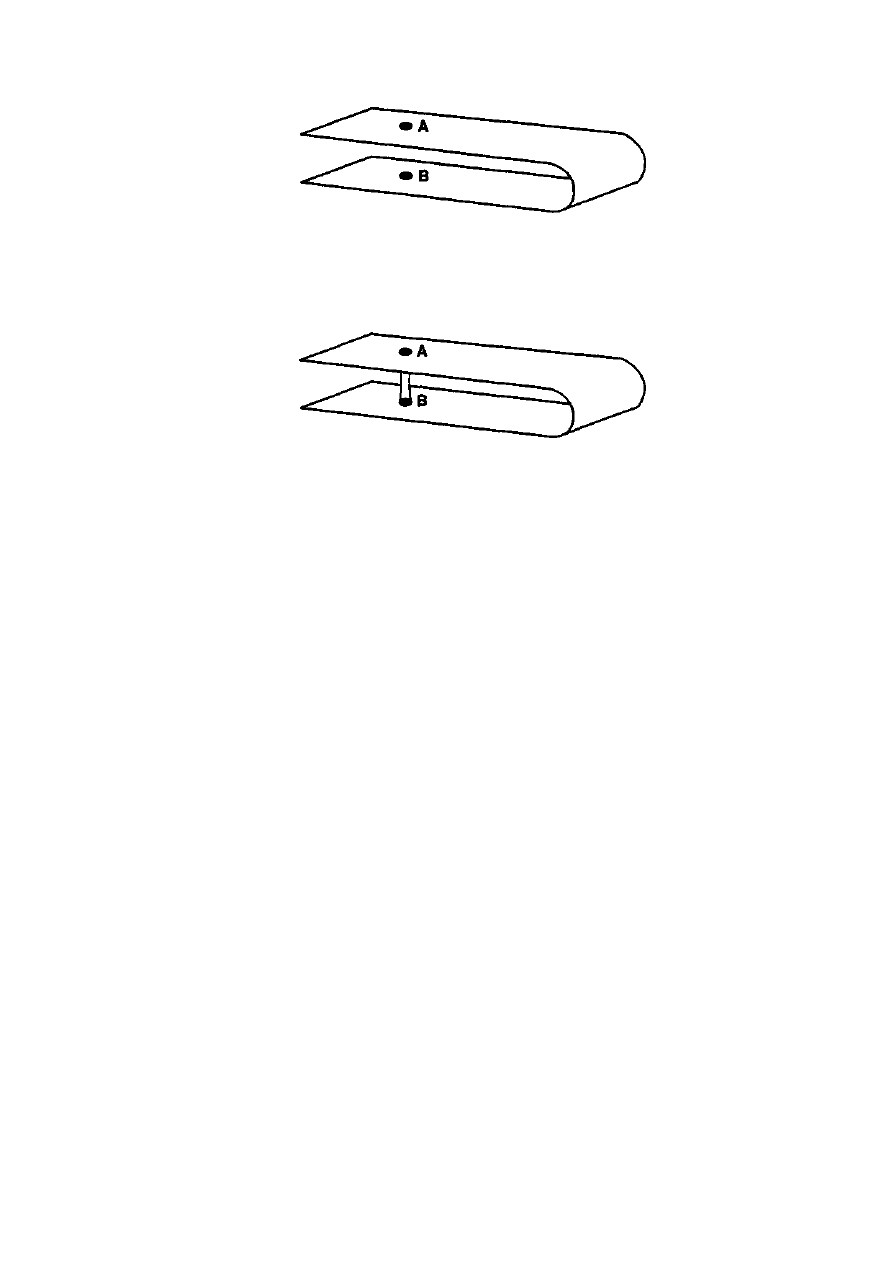

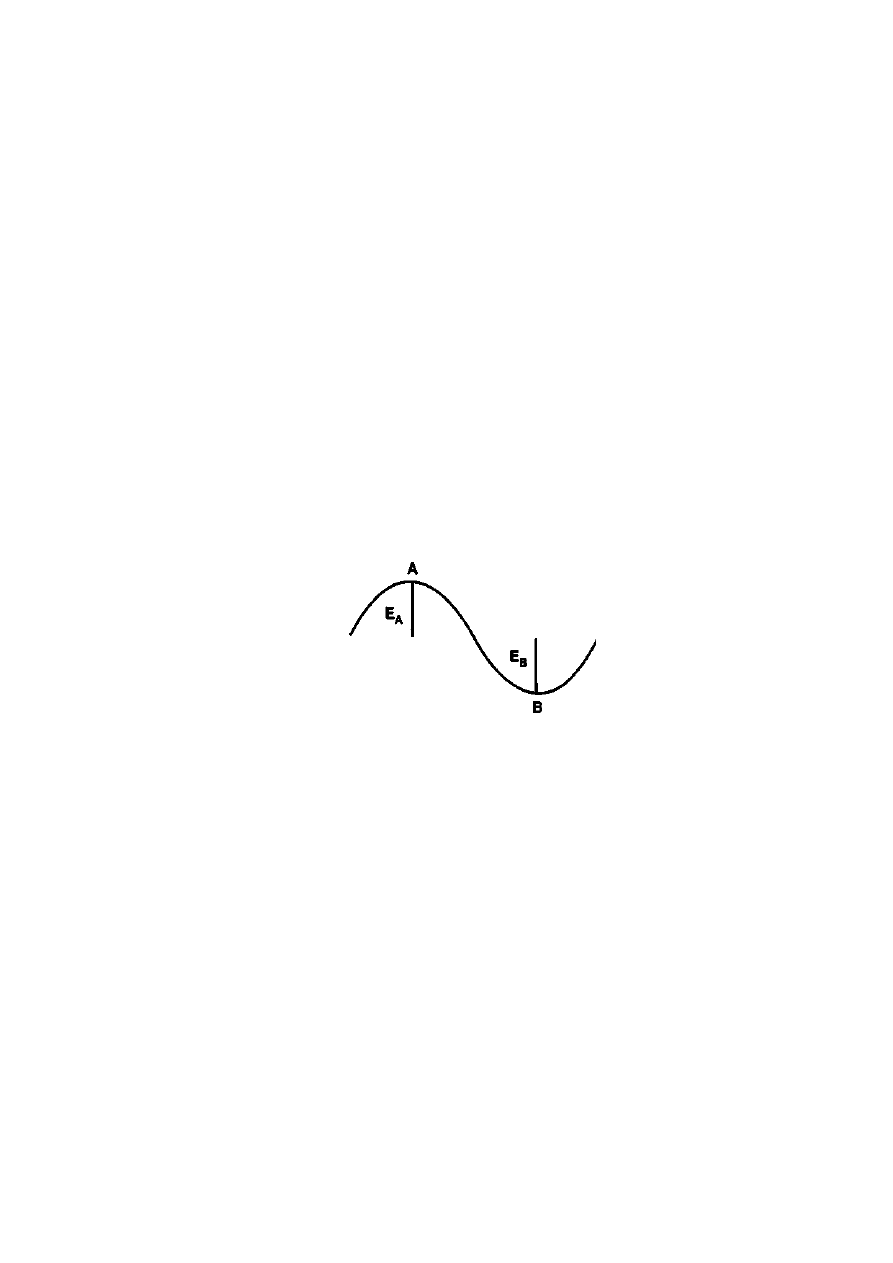

Oto przykład. Przyjrzyjmy się okręgowi na kartce papieru. Zazwyczaj najkrótszą

odległość między dwoma punktami A i B, umieszczonymi po przeciwnych stronach

okręgu, stanowi łączący je odcinek, który przechodzi przez środek okręgu:

Gdybyśmy natomiast musieli przemieścić się z A do B po okręgu, podróż

byłaby około 1,5 rażą dłuższa. Teraz narysujmy ten okrąg na kawałku gumy i

odkształćmy środkowy obszar w następujący sposób:

Jeśli popatrzymy z naszej trójwymiarowej perspektywy, stanie się jasne, że

podróż z -A do B przez środek tego obszaru będzie znacznie dłuższa niż po okręgu.

Gdybyśmy jednak sfotografowali ten układ z góry, tak że powstałby obraz

dwuwymiarowy, linia łącząca punkty A oraz B przez środek wyglądałaby jak linia

prosta. Co ważniejsze, gdyby niewielki robaczek (lub jedna z dwuwymiarowych istot,

jakie napotkał Enterprise) miał przejść po torze łączącym A i B przez środek,

posuwając się po powierzchni, tor ten wydałby mu się prosty. Byłby zdziwiony, że

linia prosta biegnąca przez środek i łącząca A z B nie jest już najkrótszą drogą

między tymi dwoma punktami. Gdyby był inteligentny, musiałby dojść do wniosku,

że dwuwymiarowa przestrzeń, w której żyje, jest zakrzywiona. Tylko obserwując, jak

powierzchnia ta zanurzona jest w trójwymiarowej przestrzeni, możemy bezpośrednio

zauważyć krzywiznę.

Należy pamiętać, że żyjemy w czterowymiarowej czasoprzestrzeni, która

może być zakrzywiona, i nasze możliwości postrzegania jej krzywizny są tak samo

ograniczone, jak możliwości robaczka idącego po powierzchni kartki. Nietrudno

zgadnąć, do czego zmierzam: jeśli w zakrzywionej przestrzeni najkrótsza odległość

między dwoma punktami nie musi być linią prostą, nie można wykluczyć, że dzięki

znalezieniu krótszej drogi przez zakrzywioną czasoprzestrzeń uda się przebyć

odległość, która wzdłuż linii widzenia wydaje się duża.

Opisane własności czasoprzestrzeni pozwalają snuć marzenia o podróżach

międzygwiezdnych. Pozostaje oczywiście pytanie: ile z tych marzeń może się

pewnego dnia urzeczywistnić?

TUNELE CZASOPRZESTRZENNE: FAKTY I MITY. Tunel bajorański w

serii Stacja kosmiczna jest chyba najsłynniejszym tunelem czasoprzestrzennym w

Star Trek, choć było też wiele innych, na przykład niebezpieczny tunel, który Scotty

stworzył powodując zachwianie równowagi między materią i antymaterią w napędzie

czasoprzestrzennym Enterprise, a także niestabilny tunel barzański, w którym zgubił

się statek Ferengów w odcinku Cena serii Następne pokolenie, czy tunel czasowy,

który napotkał Voyager, próbując powrócić do domu z krańca Galaktyki.

Idea tuneli czasoprzestrzennych ma swoje źródło w hipotezach, o których

pisałem wcześniej. Jeśli czasoprzestrzeń jest zakrzywiona, mogą istnieć różne drogi

łączące dwa punkty, między innymi takie, wzdłuż których odległość między

punktami jest o wiele krótsza, niż gdybyśmy zmierzyli ją podróżując przez

zakrzywioną przestrzeń wzdłuż „linii prostej”. Ponieważ nie potrafimy sobie

wyobrazić zjawisk w zakrzywionej cztero-wymiarowej czasoprzestrzeni, jeszcze raz

posłużymy się dwuwymiarowym kawałkiem gumy, którego zakrzywienie możemy

obserwować w przestrzeni trójwymiarowej.

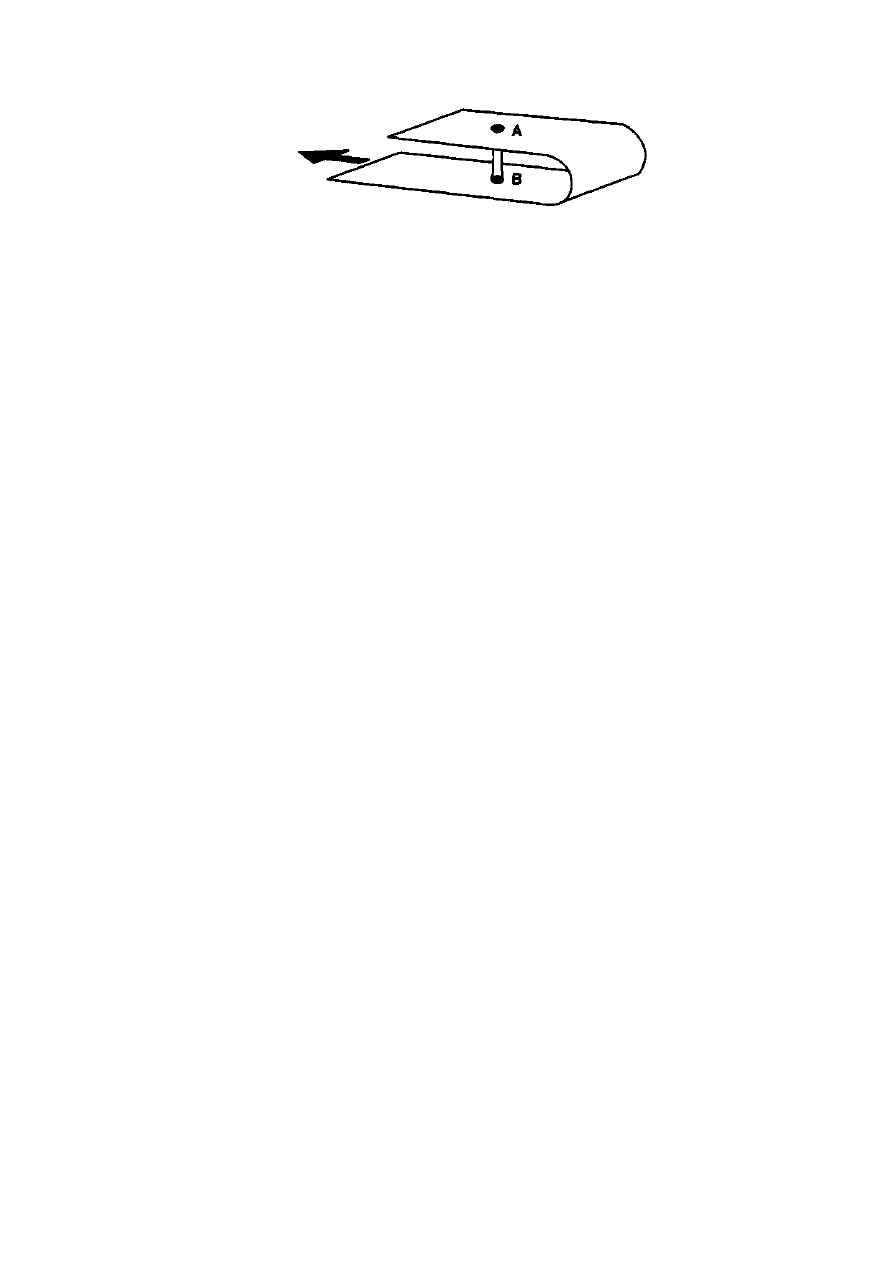

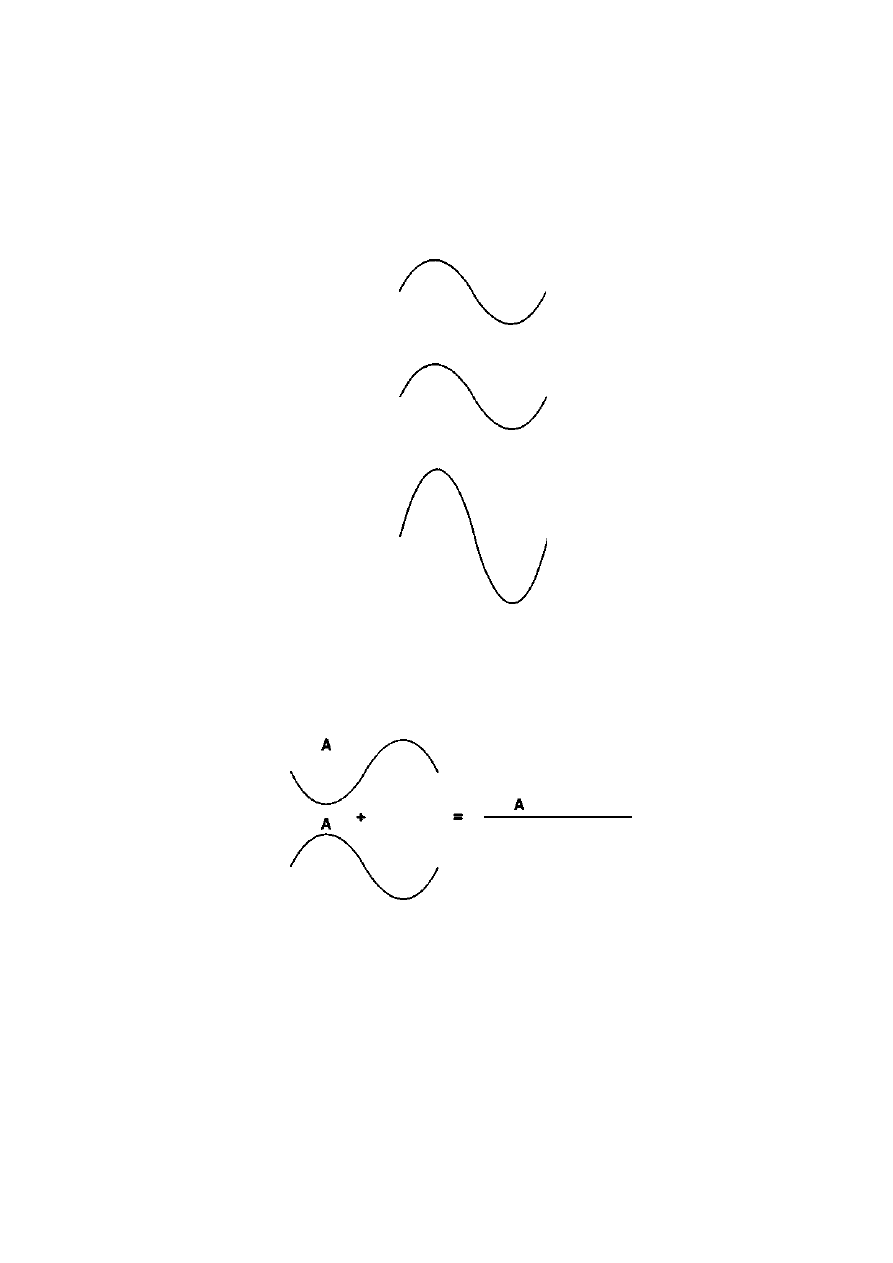

Jeśli kawałek gumy zakrzywiony jest w dużej skali, można go sobie

wyobrazić następująco:

Gdybyśmy wbili ołówek w punkcie A i naciągnęli gumową powierzchnię aż

do punktu B, a następnie zszyli obie części w ten sposób:

utworzylibyśmy znacznie krótszą drogę z A do B niż droga biegnąca między

tymi punktami po powierzchni. Zauważmy, że w pobliżu A i B powierzchnia wydaje

się płaska. Zakrzywienie, które powoduje, że te dwa punkty znajdują się

wystarczająco blisko siebie, aby można je było połączyć tunelem, związane jest z

globalnym zagięciem powierzchni na dużych odległościach. Robaczek (nawet

inteligentny), znajdujący się w punkcie A i zmuszony do podróży po powierzchni, nie

miałby pojęcia, że punkt B leży tak „blisko”, nawet gdyby potrafił przeprowadzać w

okolicy A eksperymenty mające określić krzywiznę powierzchni.

Jak łatwo zgadnąć, tunel łączący na tym rysunku punkty A i B jest

dwuwymiarowym odpowiednikiem trójwymiarowego tunelu, który mógłby biec

między odległymi obszarami czasoprzestrzeni. Chociaż jest to fascynująca

możliwość, należy zwrócić uwagę na kilka jej zwodniczych aspektów. Po pierwsze,

nawet jeśli gumowa powierzchnia jest zanurzona w trójwymiarowej przestrzeni tak,

abyśmy mogli „zobaczyć” jej zakrzywienie, ten powyginany kawałek gumy może

istnieć również bez otaczającej go trójwymiarowej przestrzeni. A zatem, chociaż

tunel między A i B mógłby się pojawić, stwierdzenie, że A i B są „blisko siebie”, nie

ma sensu, jeśli nie ma tunelu. Nie można opuścić gumowej powierzchni i przemieścić

się z A do B w trójwymiarowej przestrzeni, w której jest ona osadzona. Bez

trójwymiarowej przestrzeni gumowa powierzchnia jest całym wszechświatem.

Wyobraź teraz sobie, że jesteś członkiem nieskończenie zaawansowanej w

rozwoju cywilizacji (ale nie aż tak zaawansowanej, jak wszechmocne istoty Q, które

właściwie nie liczą się

z prawami fizyki), potrafiącej budować tunele w przestrzeni. Urządzenie do

budowy tuneli działałoby w zasadzie tak, jak ołówek w podanym przeze mnie

przykładzie. Gdybyś posiadał moc wystarczającą, by wytwarzać olbrzymie,

miejscowe zakrzywienia przestrzeni, musiałbyś potem przekłuwać przestrzeń wokół

na chybił trafił w nadziei, że uda Ci się jakoś połączyć dwa obszary przestrzeni, które

do momentu powstania tunelu znajdowały się bardzo daleko od siebie. Aż do chwili,

gdy tunel utworzy most między tymi obszarami, w żaden sposób nie są one blisko

siebie. To sam proces budowania tego mostu zmienia globalną naturę

czasoprzestrzeni.

Z tego powodu tworzenia tuneli nie należy lekceważyć. Kiedy barzańska

premier Bhavani odwiedziła Enterprise, aby odsprzedać prawa do barzańskiego

tunelu, wykrzyknęła: „Przed wami rozciąga się pierwszy i jedyny znany stabilny tunel

czasoprzestrzenny!” Niestety, nie był on stabilny: wszystkie tunele, których

matematyczne istnienie zostało udowodnione w ramach ogólnej teorii względności, są

w istocie krótkotrwałe. Powstają, gdy dwie mikroskopijne „osobliwości” - obszary

czasoprzestrzeni, w których krzywizna staje się nieskończenie duża - odnajdują się i

na chwilę łączą. Tunel zamyka się jednak szybko, pozostawiając znowu dwie

rozłączne osobliwości. Trwa to tak krótko, że przez tunel nie zdążyłby się przedostać

żaden amator podróży międzygwiezdnych. Nieszczęsny podróżnik rozpadłby się na

kawałki w jednej lub drugiej osobliwości jeszcze przed końcem podróży.

Problem polegający na tym, jak wejście do tunelu utrzymać otwarte, jest

niezwykle trudno sformułować w ścisły, matematyczny sposób, ale w sensie

fizycznym można go łatwo wyrazić: grawitacja wciąga! Każdy rodzaj zwyczajnej

materii lub energii zapada się pod wpływem własnego przyciągania grawitacyjnego,

chyba że proces ten zostanie zatrzymany przez coś innego. Podobnie, w normalnych

warunkach wejście do tunelu zostanie rozerwane w mgnieniu oka.

Sztuka polega więc na tym, aby pozbyć się owych normalnych warunków. W

ostatnich latach m.in. Kip Thorne, fizyk z Caltech, dowodził, że jedynym sposobem

na utrzymanie otwartych tuneli jest przymocowanie ich za pomocą „egzotycznej

materii” o niezwykłych własnościach: przynajmniej dla niektórych obserwatorów

miałaby ona „ujemną” energię. Można by oczekiwać (choć naiwne pomysły rzadko

się sprawdzają w teorii względności), że taka materia „rozdmuchiwałaby”, a nie

„wciągała”, przynajmniej jeśli chodzi o grawitację.

Nie trzeba być zagorzałym trekkerem, aby przystać na pomysł materii o