WARUNKOWANIE

INSTRUMENTALN

E

Autorki:

Natalia Kawalec

Monika Kostyra

EDWARD THORNDIKE I PRAWO

EFEKTU:

Mówi ono o tym, że gdy w sytuacji

bodźcowej, wystąpią pozytywne

konsekwencje reakcji, reakcja ta będzie

powtarzana - jeśli jednak konsekwencje

będą negatywne wystąpi tendencja do

zaniechania reakcji.

Innym znanym badaczem metod

instrumentalnych był Edward Tolman.

Thorndike badał ten

rodzaj zachowania w

następujący sposób za

pomocą „skrzynki

zadaniowej”. Była to

klatka, którą można

było otworzyć tylko od

wewnątrz przez

pociągniecie pętli.

Do klatki tej wkładano kota, który usiłował się

uwolnić, by dostać pokarm. Kot wykonując

szereg prób chcąc się wyjść stamtąd,

przypadkowo pociągał za pętlę i wydostawał się

przez otwarte drzwi na zewnątrz klatki.

Cała sytuację powtarzano wiele razy.

Początkowo zwierzęta potrzebowały dużo czasu

by wydostać się z klatki, jednak po kilku

udanych próbach czas potrzebny na

wydostanie się uległ znacznemu skróceniu.

Okres czasu jaki potrzebował kot na znalezienie

rozwiązania nazwano wskaźnikiem uczenia

się.

Thordike uważał, że warunkowanie

instrumentalne jest w zasadzie

metodą

uczenia się, metodą prób i błędów.

Istotnym elementem jaki jest potrzebny do

warunkowania i uczenia się jest

zapamiętywanie reakcji za pomocą

nagrody

lub wygaszenia jej za pomocą

kary.

W

przypadku kota była to nagroda- wolność.

Im większe zadowolenie, tym silniejszy związek

sytuacji z wyuczonym zachowaniem.

Metoda instrumentalna powinna być stosowana

indywidualnie i konsekwentnie.

Warunkowanie instrumentalne dotyczy całego życia

człowieka. Badania Reinholda (1959) i Blooma (1979)

wykazały, że zachowanie niemowlęcia może być

kształtowane za pomocą warunkowania

instrumentalnego i tak wykazano, że liczba dźwięków

wydawanych przez trzy miesięczne niemowlęta może

się

zwiększyć jeśli dorosły reagując werbalnie wzmacnia

wypowiedzi niemowlęcia.

Warunkowania instrumentalnego

używa się również do modyfikowania

zachowań niepożądanych u ludzi, czyli

ignorowało się zachowania

niepożądane np. u dzieci a wzmacniało

poprzez nagrodę zachowania pożądane

(trening czystości u dziecka).

Innym przykładem warunkowania

instrumentalnego jest sala, a w niej

studenci piszący egzamin.

SKINNER

Zasadniczy wkład do

badań nad

warunkowaniem

instrumentalnym wniósł

Burrhus F. Skinner.

Odkryte przez niego w

latach trzydziestych

dwudziestego wieku

prawa uczenia się

uznawane są w

psychologii do dziś.

Skinner odkrył, że organizm uczy się wykonywania lub

powstrzymywania się od wykonania danej reakcji w

zależności od tego, jakie pojawiają się wraz z wykonaniem

reakcji konsekwencje. Konsekwencje mogą być atrakcyjne,

nazywane nagrodami lub awersyjne czyli kary.

Warunkowanie instrumentalne tworzy ścisły związek

pomiędzy zachowaniem i jego skutkami. Skinner

wyróżnił cztery podstawowe rodzaje relacji:

1. wzmacnianie pozytywne

, czyli każda konsekwencja

zachowania, która powoduje zwiększenie się

prawdopodobieństwa powtórzenia się tego zachowania w

przyszłości.

np. pies dostaje nagrodę w chwili, gdy usiądzie - zwiększa

to szansę na ponowne siadanie psa.

2. pozytywne wygaszanie

nazywane potocznie karą, czyli

każda konsekwencja zachowania, która zmniejsza

prawdopodobieństwo pojawienia się tego zachowania w

podobnych warunkach w przyszłości.

np. uderzenie psa w chwili, kiedy położy się na boku

zmniejsza szansę jego ponownego położenia się na boku w

podobnych warunkach.

3. negatywne wzmacniania

, czyli takie wykonanie reakcji,

które pozwala uniknąć przykrych, awersyjnych konsekwencji,

co powoduje zwiększenie się prawdopodobieństwa

powtórzenia tej reakcji w przyszłości.

np. szarpanie psa na smyczy, gdy stoi, co powoduje jego

siadanie w celu uniknięcia szarpania.

4. wygaszanie ujemne

nazywane także

pomijaniem, jeśli po wystąpieniu zachowania

nie pojawiają się konsekwencje, które

wystąpiłyby gdyby ta reakcja nie powstała. Z

otoczenia zastaje usunięty czynnik, którego

brak zmniejszy prawdopodobieństwo

powtórzenia danego zachowania,

np. odwrócenie się i odejście od psa gdy ten

skacze na właściciela, co zmniejsza

prawdopodobieństwo ponownego skakania.

BODŹCE KONTROLUJĄCE

Jak już wiadomo, jeżeli wytwarzana jest pewna

reakcja sprawcza i następuje po niej bodziec

wzmacniający, prawdopodobieństwo ponownego

wystąpienia tej reakcji wzrasta.

Bodziec, który kontroluje zachowanie, czyli tak

zwany bodziec kontrolujący, zmienia

prawdopodobieństwo wystąpienia reakcji

instrumentalnej. Bodźce kontrolujące pełnią role

adaptacyjną dzięki możliwości przewidywania przez

organizm konsekwencji jego działania w

określonych warunkach. W obecności bodźca

kontrolującego częstość występowania reakcji

sprawczej może być większa lub mniejsza niż w

przypadku braku tego bodźca.

Wyróżnia się dwa typy bodźców kontrolujących:

bodźce

dyskryminacyjne

oraz

wygaszeniowe.

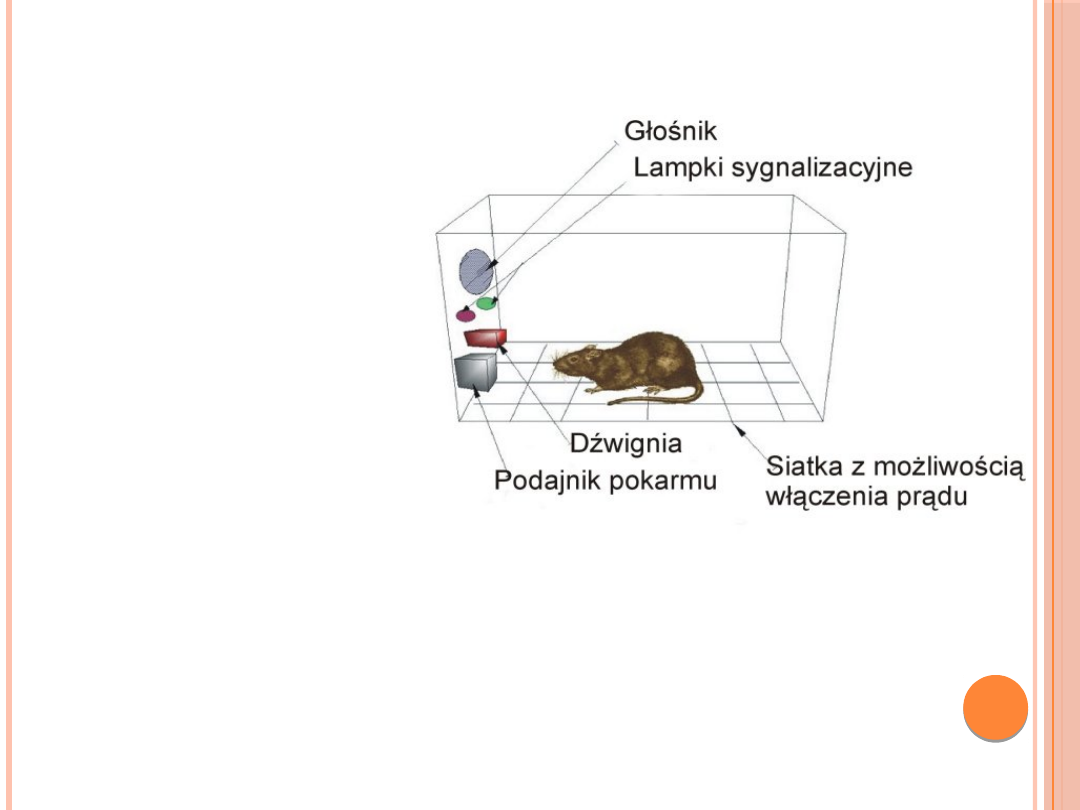

Bodźce dyskryminacyjne informują dany organizm, że po

wykonaniu reakcji pojawi się wzmocnienie czyli nagroda lub

kara.

Bodziec dyskryminacyjny sygnalizuje, kiedy wykonać daną

reakcję, aby uzyskać wzmocnienie. Na przykład w klatce

szczura wyposażonej w dźwignię, której naciśnięcie powoduje

podanie pokarmu, ale tylko w obecności zapalonej lampki,

bodźcem dyskryminacyjnym jest paląca się lampka.

Początkowo szczur naciska dźwignię przez cały czas, kojarząc

naciskanie z otrzymaniem pokarmu. Z czasem jednak uczy się,

że pokarm pojawia się tylko gdy jest zapalona lampka, inaczej

naciskanie dźwigni nie powoduje pojawienia się pokarmu.

Szczur uczy się dyskryminować te bodźce, które są sygnałami

czynników wzmacniających. W obecności bodźca

dyskryminacyjnego po reakcji sprawczej następuje bodziec

wzmacniający.

Bodźce wygaszeniowe

informują, że po

wykonanej reakcji nie

pojawi się

wzmocnienie.

Prawdopodobieństwo

wystąpienia danego

zachowania spada. Na

przykład, jeżeli zmieni

się znaczenie palącej

się lampki tzn. w

obecności zapalonej

lampki pokarm nie

będzie się pojawiał to

stanie się ona bodźcem

wygaszeniowym.

Szczur przestanie

naciskać dźwignie, gdy

będzie zapalona

lampka.

GENERALIZACJA I RÓŻNICOWANIE BODŹCÓW

W warunkowaniu instrumentalnym, następuje generalizacja

bodźca. Jest to zjawisko uogólnienia reakcji na bodźce,

które nie wystąpiły podczas pierwotnej sytuacji uczenia się.

Bodźce te muszą być podobne do bodźców pierwotnych.

Np. gołąb, który nauczył się uderzać dziobem w

narysowane kółko, może reagować także na narysowany

owal. Jeżeli nie reaguje na owalną figurę znaczy, że

wzmocnione zostało dziobanie koła czyli nastąpiło

różnicowanie bodźców. Gołąb dostawał tylko pokarm za

dziobanie w koło, nauczył się, że dziobanie w inne

elementy nie przynosi korzyści.

Document Outline

- Slide 1

- Slide 2

- Slide 3

- Slide 4

- Slide 5

- Slide 6

- Slide 7

- Skinner

- Slide 9

- Slide 10

- Slide 11

- BODŹCE KONTROLUJĄCE

- Slide 13

- Slide 14

- Slide 15

Wyszukiwarka

Podobne podstrony:

WARUNKOWANIE INSTRUMENTALNE, Studia, Fizjoterapia, Studia - fizjoterapia, Psychologia, wykłady

odruchy warunkowe instrumentalne referat

WARUNKOWANIE INSTRUMENTALNE(1)

inne, Pamięć2, WARUNKOWANIE INSTRUMENTALNE (sprawcze): proces, w którym reakcja staje się mniej lub

inne, 1,2,3. Warunkowanie instrumentalne (Zajęcia 3, Agusia), Zajęcia 3 : Warunkowanie instrumentaln

Warunkowanie instrumentalne, Psychologia Ogólna B Złożone Procesy Poznawcze

Warunkowanie instrumentalne, autyzm

METODA WARUNKOWANIA INSTRUMENTALNEGO

Warunkowanie instrumentalne, Warunkowanie instrumentalne

WARUNKOWANIE INSTRUMENTALNE, Studia, Fizjoterapia, Studia - fizjoterapia, Psychologia, wykłady

05 Instrukcje warunkoweid 5533 ppt

Instrumenty zabezpieczajace przed ryzykiem w warunkach kryzysu ryzyko kursowe i opcje walutowe

[lekcja 13] Instrukcja warunkowa if else Kurs C++ » Poziom 1

Konspekt - Warunki dopuszczenia pojazdu do ruchu, Materiały dla instruktora nauki jazdy, Prezentacja

instrukcje warunkowe

więcej podobnych podstron