W

ojciech

Ko

rdecki

Rachunek prawdopodobie«stwa

i statystyka matematyczna

W

ro

cª

a

w

1998

Spis tre±ci

Wst¦p

1

1. Prawdopodobie«stwo

2

1.1. Aksjomaty prawdopodobie«stwa

2

1.1.1. Przestrze« zdarze«

2

1.1.2. Aksjomaty Koªmogorowa

3

1.1.3. Geometryczna i klasyczna denicja prawdopodobie«stwa 5

1.1.4. Zadania

6

1.2. Prawa wielkich liczb i symulacja

8

1.2.1. Mocne i sªabe prawo wielkich liczb

8

1.2.2. Pierwsze przykªady symulacji

9

1.2.3. Zadania

11

1.3. Prawdopodobie«stwo warunkowe

12

1.3.1. Denicja i podstawowe wªasno±ci

12

1.3.2. Wzór Bayesa

13

1.3.3. Zadania

14

2. Zmienne losowe

15

2.1. Rozkªady zmiennych losowych

15

2.1.1. Denicja zmiennej losowej

15

2.1.2. Dystrybuanta zmiennej losowej

16

2.1.3. G¦sto±¢

18

2.1.4. Zadania

19

2.2. Momenty zmiennych losowych

20

2.2.1. Caªka Stieltjesa

20

2.2.2. Warto±¢ oczekiwana

20

2.2.3. Momenty wy»szych rz¦dów

22

2.2.4. Zadania

24

2.3. Rozkªady dyskretne

25

2.3.1. Rozkªad dwupunktowy i dwumianowy

25

2.3.2. Rozkªad Poissona

26

2.3.3. Zadania

28

2.4. Rozkªady ci¡gªe

29

2.4.1. Rozkªad jednostajny

29

2.4.2. Rozkªad wykªadniczy

29

2.4.3. Rozkªad normalny

31

2.4.4. Zadania

34

3. Twierdzenia graniczne

35

3.1. Nierówno±¢ Czebyszewa i prawa wielkich liczb

35

3.1.1. Nierówno±ci Markowa i Czebyszewa

35

3.1.2. Prawa wielkich liczb

36

3.1.3. Zadania

37

3.2. Funkcje charakterystyczne

38

3.2.1. Denicje i wªasno±ci

38

3.2.2. Rozkªad gamma

39

i

3.2.3. Zadania

40

3.3. Centralne twierdzenie graniczne

41

3.3.1. Twierdzenie Lindeberga-Levy'ego

41

3.3.2. Rozkªady chi-kwadrat i t-Studenta

42

3.3.3. Zadania

43

4. Podstawowe poj¦cia statystyki

44

4.1. Denicje

44

4.1.1. Sªownik poj¦¢ statycznych

44

4.1.2. Najwa»niejsze statystyki

44

4.1.3. Zadania

46

4.2. Dystrybuanta empiryczna i histogramy

47

4.2.1. Dystrybuanta empiryczna

47

4.2.2. Histogramy

47

4.2.3. Zadania

47

5. Estymacja

48

5.1. Estymacja punktowa

48

5.1.1. Metoda momentów

48

5.1.2. Metoda najwi¦kszej wiarogodno±ci

48

5.1.3. Zadania

50

5.2. Estymacja przedziaªowa

51

5.2.1. Przedziaªy ufno±ci

51

5.2.2. Przedziaªy ufno±ci dla ±redniej

51

5.2.3. Przedziaªy ufno±ci dla wariancji

53

5.2.4. Zadania

54

6. Testowanie hipotez

55

6.1. Testy parametryczne

55

6.1.1. Testy dla ±redniej

56

6.1.2. Testy dla wariancji

57

6.1.3. Testy dla dwóch ±rednich

58

6.1.4. Zadania

58

6.2. Testy nieparametryczne

59

6.2.1. Testy zgodno±ci

59

6.2.2. Testy niezale»no±ci

60

6.2.3. Zadania

61

Literatura

62

ii

1

Wst¦p

Materiaª zawarty w konspekcie wykªadu jest podzielony na dwie zasadnicze

cz¦±ci { rachunek prawdopodobie«stwa i statystyk¦ matematyczn¡. Przezna-

czony on jest na jednosemestralny wykªad w wymiarze 4 godzin tygodniowo.

Caªy wykªad rachunku prawdopodobie«stwa jest oparty na aksjomatyce Koª-

mogorowa, w tym na ±cisªym zdeniowaniu zdarze« jako podzbiorów prze-

strzeni zdarze« elementarnych , tworz¡cych

-algebr¦ zdarze«. Z tego po-

wodu eksponowana jest raczej ÿgeometryczna denicja prawdopodobie«stwa"

zamiast ÿkombinatorycznej denicji prawdopodobie«stwa". Z drugiej strony,

na samym pocz¡tku wykªadu podaje si¦ prawo wielkich liczb w najprostszej

postaci, aby mo»na byªo wprowadzi¢ intuicje cz¦sto±ciowe, (autor ±wiadomie

unika terminu ÿcz¦sto±ciowa denicja prawdopodobie«stwa", obawiaj¡c si¦

jego nieco baªamutnego wyd¹wi¦ku), co pozwala na ilustracj¦ wykªadu symula-

cjami komputerowymi. Z tego wzgl¦du, nieco na marginesie wykªadu pojawia

si¦ te» metoda Monte Carlo i generatory liczb losowych.

Druga poªowa semestru po±wi¦cona jest na statystyk¦ matematyczn¡. Nacisk

jest poªo»ony przede wszystkim na podanie ogólnych metod i ich zrozumienie,

a nie na podanie szczegóªowych rozwi¡za«, które mo»na znale¹¢ w licznych,

a cz¦stokro¢ bardzo dobrych podr¦cznikach i poradnikach. Ta cz¦±¢ wykªadu

jest uzupeªniona o procedury uªatwiaj¡ce obliczanie warto±ci niektórych staty-

styk. Procedury te, napisane gªównie w Pascalu, tylko cz¦±ciowo umieszczone

s¡ w tym konspekcie. Wszystkie procedury s¡ dost¦pne w internecie pod ad-

Adres

internetowy

resem

http://neyman.im.pwr.wroc.pl/~kordecki

.

Przy opracowaniu tego konspektu, autor korzystaª z wielu podr¦czników.

Przede wszystkim z nieco przestarzaªego ju», ale dobrego podr¦cznika M. Fi-

sza [2] oraz z ksi¡»ek W. Fellera [5] i [6]. S¡ to jednak ksi¡»ki trudne, prze-

znaczone raczej dla matematyków i studentów matematyki, ni» dla studentów

politechnik. Zbiory zada«, to przede wszystkim skrypt T. Inglota, T. Ledwiny

i Z. awniczak [4] oraz podr¦cznik J. Grenia [3].

Obecnie na rynku ksi¦garskim i bibliotekach mo»na spotka¢ wielk¡ liczb¦ ty-

tuªów, po±wi¦conych zagadnieniom rachunku prawdopodobie«stwa i statystyki

matematycznej.Ich przegl¡dowi b¦dzie po±wi¦cony ostatni rozdziaª konspektu.

2

1. Prawdopodobie«stwo

1.1. Aksjomaty prawdopodobie«stwa

1.1.1. Przestrze« zdarze«

Niech b¦dzie dowolnym zbiorem, zwanym przestrzeni¡ zdarze« elementar-

Zdarzenia

elementarne

nych. Elementy tej przestrzeni

!

2

nazywamy zdarzeniami elementarnymi.

Przykªad.

Rzut monet¡: =

fO

;

Rg

, gdzie

O

jest stron¡ monety z orªem,

a

R

jest stron¡ monety z reszk¡.

Rzut kostk¡ do gry: =

f

[1]

;[2];[3];[4];[5];[6]

g

, gdzie [

i] jest t¡ ±ciank¡ kostki,

na której jest

i oczek.

Strzelanie do tarczy: jest ±cian¡, na której wyznaczono koªo o danej ±rednicy.

Traenie jest punktemz tej ±ciany { zakªadamy tu, »e zawsze w ±cian¦ traamy,

cho¢ niekoniecznie w tarcz¦.

Zdarzeniami b¦dziemy nazywa¢ podzbiory przestrzeni zdarze« elementarnych

. Jednak»e nie wszystkie takie podzbiory musz¡ by¢ zdarzeniami. Musz¡

one jednak speªnia¢ pewne warunki. Aby na przykªad okre±li¢ zdarzenie

A

jako ÿwyrzucono co najmniej 5 oczek lub co najwy»ej 2 oczka" warto mie¢

sum¦ zdarze«

A = A

2,

[

A

5+

, gdzie

A

2,

oznacza wyrzucenie co najwy»ej

2 oczek, a

A

5+

oznacza wyrzucenie co najmniej 5 oczek. Podobnie, je±li

A

b¦dzie zdarzeniem polegaj¡cym na traeniu w tarcz¦, warto okre±li¢ zdarzenie

przeciwne

A

0

=

n

A polegaj¡ce na nietraeniu w tarcz¦. Rozwa»ania te

prowadz¡ nas do nast¦puj¡cej denicji.

Denicja.

Niech b¦dzie ustalon¡ przestrzeni¡ zdarze« elementarnych.Zda-

rzeniami nazywamy podzbiory przestrzeni , które tworz¡ rodzin¦ (czyli zbiór

-algebra

zdarze«

zbiorów)

S

tak¡, »e

(i)

;

2

S

,

(ii) je»eli

A

2

S

to

A

0

2

S

,

(iii) je»eli dla dowolnego ci¡gu

A

i

2

S

, to

A

1

[

A

2

[

[

A

n

2

S

;

gdzie

A =

;

nazywamy zdarzeniem niemo»liwym, a

A

0

=

n

A nazywamy

zdarzeniem przeciwnym do

A. Rodzin¦

S

nazywamy

-algebr¡ zdarze«.

Wyst¦puj¡ca w denicji suma mo»e by¢ sko«czona lub niesko«czona. Stosuje

si¦ cz¦sto skrótowy zapis, podobny do zapisu sumy liczb:

n

[

i

=1

A

i

=

A

1

[

A

2

[

[

A

n

;

1

[

i

=1

A

i

=

A

1

[

A

2

[

[

A

n

[

::: :

Bezpo±rednio z denicji wynikaj¡ dalsze wªasno±ci

-algebry zdarze«.

1.1 Aksjomaty prawdopodobie«stwa

3

Fakt 1.1.1.

Je»eli jest przestrzeni¡ zdarze« elementarnych, a

S

jest

-al-

gebr¡ zdarze«, to

2

S

:

(1.1.1)

Dowód.

Poniewa»

;

2

S

oraz =

;

0

, to z (i) i (ii) wynika, »e

2

S

.

Zdarzenie

A = nazywamy zdarzeniem pewnym. Podobnie jak dla sumy,

stosuje si¦ dla iloczynu zbiorów zapis, podobny do zapisu iloczynu liczb:

n

\

i

=1

A

i

=

A

1

\

A

2

\

\

A

n

;

1

\

i

=1

A

i

=

A

1

\

A

2

\

\

A

n

\

::: :

Fakt 1.1.2.

Je»eli dla dowolnego ci¡gu

A

i

2

S

, to

\

i

A

i

2

S

:

Dowód.

Powy»sz¡ równo±¢ otrzymuje si¦ z prawa de Morgana oraz z wªasno±ci

(ii) i (iii). Poniewa»

A =

\

i

A

i

!

0

=

[

i

A

0

i

;

oraz

A

0

i

2

S

. to równie»

A = (A

0

)

0

2

S

.

Wyst¦puj¡ca w powy»szym wzorze suma mo»e by¢ sko«czona lub niesko«-

czona.

1.1.2. Aksjomaty Koªmogorowa

Podana ni»ej denicja prawdopodobie«stwa zwana aksjomatyczn¡ denicj¡

prawdopodobie«stwa, pochodzi od A. N. Koªmogorowa. Byªa opublikowana

w roku 1933 roku

1

i staªa si¦ podstaw¡ wspóªczesnej teorii prawdopodobie«-

stwa.

Denicja. Aksjomaty Koªmogorowa.

Je»eli jest przestrzeni¡ zdarze«

elementarnych, a

S

jest

-algebr¡ zdarze«, to prawdopodobie«stwem nazy-

wamy funkcj¦ Pr :

S

!

R

, czyli funkcj¦ przypisuj¡c¡ liczby zdarzeniom tak¡,

»e

Denicja

prawdopodo-

bie«stwa

0

¬

Pr(

A)

¬

1

;

(1.1.2)

Pr() = 1

;

(1.1.3)

1

A. N. Koªmogorow (1903 { 1987), miaª wtedy zaledwie 30 lat!

1.1 Aksjomaty prawdopodobie«stwa

4

je»eli dla dowolnych

i

6

=

j jest A

i

\

A

j

=

;

, to

Pr

[

i

A

i

!

=

X

i

Pr(

A

i

)

:

(1.1.4)

Je»eli

A

\

B =

;

to mówimy, »e

A i B s¡ wykluczaj¡ce si¦. Warunek 1.1.4

oznacza, »e dla ci¡gu parami wykluczaj¡cych si¦ zdarze«, prawdopodobie«stwo

sumy jest równe sumie prawdopodobie«stw.

Uwaga.

Dla iloczynów zdarze« nie ma podobnej wªasno±ci.

Z aksjomatów Koªmogorowa wynikaj¡ dalsze wªasno±ci.

Twierdzenie 1.1.1.

Je»eli

A

2

S

to Pr(

A

0

) = 1

,

Pr(

A).

Dowód.

Poniewa»

A

\

A

0

=

;

, to z równo±ci (1.1.3) i (1.1.4) wynika, »e Pr(

A)+

Pr(

A

0

) = 1.

Podobnie dowodzi si¦ nast¦puj¡cego wyniku.

Twierdzenie 1.1.2.

Je»eli

B

A, to Pr(A

n

B) = Pr(A)

,

Pr(

B).

Kilka nast¦pnych u»ytecznych wzorów, pozostawimy do samodzielnego udo-

wodnienia jako zadania.

Trójk¦ (

;

S

;Pr) nazywa si¦ przestrzeni¡ probabilistyczn¡. W nast¦pnym

Przestrze«

probabili-

styczna

punkcie rozpatrzymy dwa specjalne przypadki przestrzeni probabilistycznych.

Teraz tylko jeden bardzo prosty (najprostszy nietrywialny) przykªad.

Przykªad.

Rzucamy jeden raz monet¡. Wtedy =

fO

;

Rg

,

S

=

f;

;

fO g

;

fRg

;

g

oraz Pr(

O

) = Pr(

R

) = 1

=2. Wten sposób zostaªa okre±lona caªa przestrze«

probabilistyczna (

;

S

;Pr).

Niezale»no±¢ zdarze« jest wªasno±ci¡ nie tylko samych zdarze« jako zbiorów,

Niezale»no±¢

zdarze«

ale zale»y od okre±lonego na nich prawdopodobie«stwa.

Denicja.

Ci¡g zdarze«

A

1

;A

2

;::: (sko«czony lub niesko«czony) jest nieza-

le»ny, gdy dla dowolnego jego sko«czonego podci¡gu

A

i

1

;A

i

2

;:::A

i

k

zachodzi

równo±¢

Pr(

A

i

1

\

A

i

2

\

\

A

i

k

) = Pr(

A

i

1

)Pr(

A

i

2

)

Pr(

A

i

k

)

:

(1.1.5)

Je»eli o pewnych zdarzeniach wiemy, »e s¡ niezale»ne, to znaj¡c ich prawdo-

podobie«stwa mo»emy obliczy¢ prawdopodobie«stwa ich iloczynów.

Przykªad.

Rzucamy dwoma monetami. Je»eli wiemy, »e rzuty s¡ niezale»ne

i prawdopodobie«stwa wyrzucenia zarówno orªa jak i reszki s¡ równe, to praw-

dopodobie«stwo wyrzucenia dwóch orªów jest (jak dobrze zreszt¡ wiadomo)

równe Pr(

O

)

Pr(

O

) = (1

=2)(1=2) = 1=4.

1.1 Aksjomaty prawdopodobie«stwa

5

1.1.3. Geometryczna i klasyczna denicja prawdopodobie«stwa

Rozpatrzymy teraz dwa szczególne przypadki. Jako pierwszy okre±limy tzw.

geometryczn¡ denicj¦ prawdopodobie«stwa. Nazwa denicja jest tu myl¡ca,

bo tak naprawd¦, jest to tylko szczególny przypadek ogólnej, aksjomatycznej

denicji prawdopodobie«stwa.

Niech b¦dzie pewnym podzbiorem

R

k

, gdzie

k = 1;2;3, tzn. jest podzbio-

Geometryczna

denicja

prawdopodo-

bie«stwa

rem prostej, (najcz¦±ciej odcinkiem), pªaszczyzny lub przestrzeni trójwymia-

rowej. Zdarzeniami z

S

b¦d¡ podzbiory z maj¡ce miar¦

2

m(A) { dªugo±¢,

powierzchni¦ lub obj¦to±¢. Prawdopodobie«stwo zdarzenia

A okre±limy wzo-

rem

Pr(

A) = m(A)

m() :

(1.1.6)

Tak okre±lone prawdopodobie«stwo nazywamy geometrycznym.

Przykªad.

Na odcinku [0

;1] umieszczamy losowo, tzn. zgodnie z prawdopo-

dobie«stwem geometrycznym oraz niezale»nie, dwa punkty

x i y. Przestrze«

mo»emy wobec tego okre±li¢ jako kwadrat o wierzchoªkach w punktach (0

;0),

(0

;1), (1;0) oraz (1;1). Teraz zdarzeniami elementarnymi s¡ punkty z tego

kwadratu:

! = (x;y)

2

. Dla jednego punktu

x zgodnie ze wzorem (1.1.6)

mamy Pr(

f

! : x

2

[

a;b]; b > a

g

) =

b

,

a. To samo mamy dla punktu y. Po-

niewa» punkty s¡ umieszczane niezale»nie, to

Pr(

f

! : !

2

[

a;b]

[

c;d]; b > a; d > c

g

) = (

b

,

a)(d

,

c):

Iloczyn kartezja«ski odcinków [

a;b]

[

c;d] jest oczywi±cie prostok¡tem we-

wn¡trz kwadratu .

-

6

1

0

1

d

d

1

,

d

1

,

d

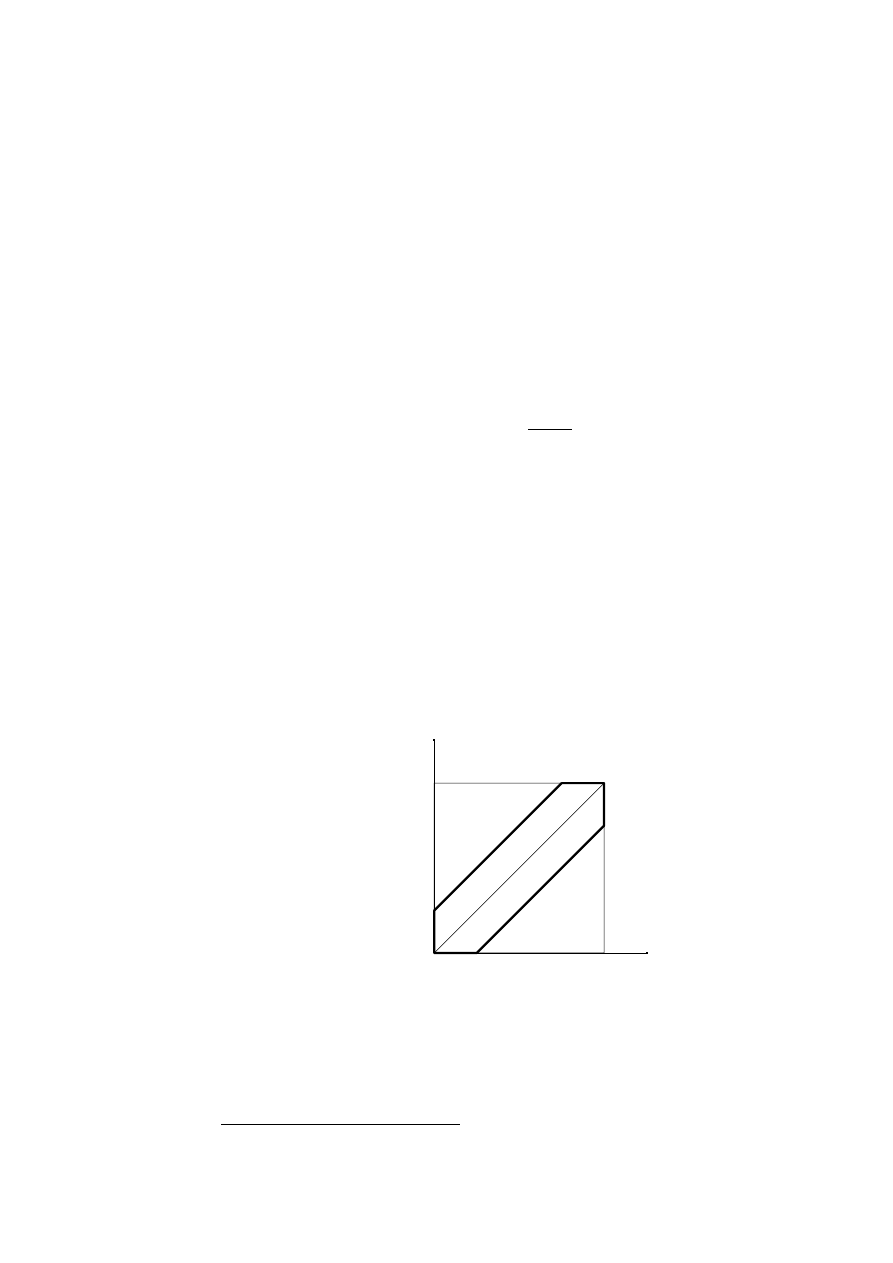

Rysunek 1: Prawdopodobie«stwo, »e

j

x

,

y

j

< d.

Niech

A

d

b¦dzie zdarzeniem polegaj¡cy na tym, »e

j

x

,

y

j

< d, tzn.

A

d

=

f

! :

j

x

,

y

j

< d

g

:

2

Nie na wszystkich zbiorach z

R

k

da si¦ okre±li¢ miar¦, ale tym zagadnieniem nie b¦dziemy

si¦ zajmowa¢

1.1 Aksjomaty prawdopodobie«stwa

6

Zbiór punktów le»y wewn¡trz obszaru obwiedzionego grubsz¡ lini¡ na rysun-

ku 1. Pole tego obszaru jest równe

Pr(

A

d

) = 1

,

(1

,

d)

2

:

Zaªó»my teraz, »e =

A

1

[

A

2

[

[

A

n

,

A

i

2

S

oraz wszystkie

A

i

,

i =

Klasyczna

denicja

prawdopodo-

bie«stwa

1

;2;:::;n s¡ wykluczaj¡ce si¦ i maj¡ to samo prawdopodobie«stwo, a wi¦c

Pr(

A

i

) = 1

=n. Wtedy dla dowolnego zdarzenie A b¦d¡cego sum¡ k zdarze«

postaci

A

i

, czyli dla

A = A

i

1

[

[

A

i

k

ma pradopodobie«stwo Pr(

A) = k=n.

Zdarzenia

A

i

A nazywa si¦ wtedy zdarzeniami sprzyjaj¡cymi zdarzeniu A, a

jego prawdopodobie«stwo jest równe stosunkowi liczby zdarze« sprzyjaj¡cych

do wszystkich

n zdarze«. Tak okre±lone prawdopodobie«stwo nosi tradycyjn¡

nazw¦ ÿklasycznej denicji prawdopodobie«stwa", cho¢ nie jest denicj¡, ale

pewnym bardzo szczególnym przypadkiem.

Zauwa»my, »e w tym wªa±nie przypadku

-algebr¦

S

wystarczy ograniczy¢ do

zdarze«

A

i

i ich wszystkich sum. Taka

-algebra jest rodzin¡ 2

n

zdarze«.

Przykªad.

Rzucamy

n razy monet¡. Niech A b¦dzie zdarzeniem polegaj¡cym

na wyrzuceniu

m orªów. Przestrzeni¡ zdarze« elementarnych mo»e tu by¢

zbiór wszystkich ci¡gów zero-jedynkowych dªugo±ci

n, gdzie jedynka to wyrzu-

cenie orªa, a zero to wyrzucenie reszki. Zdarzenia

A

i

=

f

!

i

g

= (

x

1

x

2

:::x

n

),

gdzie

i = (x

1

x

2

x

n

)

2

jest liczb¡ w postaci binarnej odpowiadaj¡cej takiemu

ci¡gowi, s¡ wzajemnie wykluczaj¡ce si¦ i maj¡ te same prawdopodobie«stwa.

Jest ich 2

n

. Zdarze« sprzyjaj¡cych zdarzeniu

A jest

,

m

n

. St¡d

Pr(

A) =

,

m

n

2

n

:

1.1.4. Zadania

1.

Do±wiadczenie polega na rzucaniu kostk¡ do gry, a» do wyrzucenia po raz

pierwszy sze±ciu oczek. Okre±li¢ przestrze« probabilistyczn¡.

2.

Uogólni¢ zadanie 1 na przypadek rzucania

n kostkami, a» do wyrzucenia po

raz pierwszy co najmniej

k szóstek w jednym rzucie, k

¬

n.

3.

W zadaniach 1 i 2 obliczy¢ prawdopodobie«stwo, »e liczba rzutów b¦dzie

równa

m, m = 1;2;::: .

4.

Drut o dªugo±ci

l zgi¦to w dwóch niezale»nie wybranych punktach. Obliczy¢

prawdopodobie«stwo, »e mo»na w ten sposób utworzy¢ trójk¡t.

5.

Z odcinka [0

;1] wybieramy losowo dwie liczby p i q. Jakie jest prawdo-

podobie«stwo tego, »e równanie

x

2

+

px + q = 0 b¦dzie miaªo dwa sprz¦»one

pierwiastki zespolone? Jakie jest prawdopodobie«stwo tego, »e b¦dzie miaªo

dwa ró»ne pierwiastki rzeczywiste?

6.

Dla jakich zdarze«

A i B zachodzi wzór

Pr(

A

[

B) = Pr(A) + Pr(B)

,

Pr(

A)

Pr(

B)?

1.1 Aksjomaty prawdopodobie«stwa

7

7.

Udowodni¢, »e Pr(

A

[

B) = Pr(A) + Pr(B)

,

Pr(

A

\

B).

8.

Wzoruj¡c si¦ na zadaniu 7, sformuªowa¢ wzór na Pr(

A

[

B

[

C) i spróbowa¢

go uogólni¢ na przypadek sumy

n zdarze«, tzn. znale¹¢ wzór na obliczenie

Pr

n

[

i

=1

A

i

!

:

9.

Udowodni¢, »e

n

k

=

n

,

1

k

,

1

+

n

,

1

k

;

nie wykonuj¡c rachunków.

10.

W urnie jest

m

3 biaªych i

n

3 czarnych kul. Obliczy¢ prawdopodo-

bie«stwo wylosowania trzech czarnych kul, gdy kule losujemy

a) bez zwracania,

b) ze zwracaniem.

1.2 Prawa wielkich liczb i symulacja

8

1.2. Prawa wielkich liczb i symulacja

1.2.1. Mocne i sªabe prawo wielkich liczb

Wedªug potocznych opinii, je»eli przeprowadzaj¡c

n obserwacji, zaobserwu-

jemy interesuj¡ce nas zjawisko

k razy, to prawdopodobie«stwo zaj±cia tego

zjawiska powinno wynosi¢

k=n. Iloraz ten jest cz¦sto przyjmowany za tzw.

ÿstatystyczn¡ denicj¦ prawdopodobie«stwa". Okre±lenie to nie jest caªkiem

poprawne, ale intuicyjnieuzasadnione, a poni»sze twierdzenia nadaj¡ mu ±cisªy

matematycznie charakter.

Twierdzenie 1.2.1.

Niech (

;

S

;Pr) b¦dzie przestrzeni¡ probabilistyczn¡, a

Mocne prawo

wielkich liczb

f

A

i

2

S

g

b¦dzie niesko«czonym ci¡giem zdarze« niezale»nych o tym samym

prawdopodobie«stwie Pr(

A

i

) =

p. Niech !

2

b¦dzie dowolnym, ale ustalo-

nym zdarzeniem elementarnym. Oznaczmy przez

N(n;!) liczb¦ tych zdarze«

A

i

, dla których

!

2

A

i

, gdy

i = 1;2;:::;n. Wtedy

Pr

! : lim

n

!1

N(n;!)

n = p

= 1

:

(1.2.1)

Twierdzenie 1.2.2.

Przy oznaczeniach z twierdzenia 1.2.1 dla ka»dego

" > 0

Sªabe prawo

wielkich liczb

zachodzi równo±¢

lim

n

!1

Pr

! :

N(n;!)

n

,

p

> "

= 0

:

(1.2.2)

Twierdzenie 1.2.1 nosi nazw¦ mocnego prawa wielkich liczb, a twierdzenie 1.2.2

{ sªabego prawa wielkich liczb. Tak te» jest. Z mocnego prawa wielkich liczb

ªatwo jest wyprowadzi¢ sªabe prawo wielkichliczb. Dowodów tych nie b¦dziemy

tu przeprowadza¢, a sªabe prawo wielkich liczb udowodnimy po¹niej, w innej,

ªatwiejszej i ogólniejszej postaci. W tym momencie zajmiemy si¦ interpretacj¡

tych twierdze«.

W twierdzeniu 1.2.1 zdarzenie elementarne

! jest ustalonym do±wiadczeniem,

polegaj¡cym na niesko«czonymci¡gu obserwacji. W ka»dej obserwacji badamy,

czy zaszªo interesuj¡ce nas zjawisko, tzn. czy w

i-tej obserwacji byªo !

2

A

i

.

Tak wi¦c

N(n;!) jest liczb¡ zaobserwowanych zjawisk w pierwszych n obser-

wacjach, w ustalonym do±wiadczeniu

!. Równo±¢ (1.2.1) mówi, »e stosunek

liczby zjawisk zaobserwowanych w

n obserwacjach do liczby obserwacji równej

n, d¡»y do prawdopodobie«stwa zaobserwowania zjawiska przy jednej obser-

wacji dla prawie wszystkich do±wiadcze«, tzn. mog¡ si¦ zdarzy¢ do±wiadczenia,

w których nie zajdzie równo±¢ (1.2.1), ale stanie si¦ to z zerowym prawdopo-

dobie«stwem.

Podobny charakter ma twierdzenie 1.2.2. Mówi ono, »e stosunek liczby zjawisk

zaobserwowanych w

n obserwacjach do liczby obserwacji ró»ni si¦ niewiele

od prawdopodobie«stwa zaobserwowania zjawiska przy jednej obserwacji, tzn.

prawdopodobie«stwo, »e ró»ni si¦ wi¦cej ni» dowolnie maªa liczba

", d¡»y do

zera, a wi¦c jest dowolnie maªe, je±li tylko we¹miemy dostatecznie du»e

n.

1.2 Prawa wielkich liczb i symulacja

9

Przykªad.

Rzucamy

n razy kostk¡ do gry, a n jest ÿbardzo du»e". Je»eli liczba

wyrzuconych szóstek

N(n) daje nam N(n)=n znacznie ró»ni¡ce si¦ od 1/6, to

w my±l twiedzenia 1.2.2 albo zabserwowali±my zjawisko rzadkie, które powinno

zdarzy¢ si¦ z maªym prawdopodobie«stwem (dokªadniej, z prawdopodobie«-

stwem d¡»¡cym do zera) albo kostka jest faªszywa, tzn. prawdopodobie«stwo

wyrzucenia szóstki jest ró»ne od 1/6. Twierdzenie 1.2.1 mówi za± wi¦cej { za-

obserwowali±my zjawisko, które zdarzy¢ si¦ w ogóle nie powinno, bo mo»e zaj±¢

z prawdopodobie«stwem zero, cho¢ oczywi±cie tylko w granicy, przy

n

!

1

.

1.2.2. Pierwsze przykªady symulacji

Przedstawimy tu dwa przykªady wykorzystania praw wielkich liczb do symu-

lacji, zwanej metod¡ Monte-Carlo.

Przykªad.

Na pªaszczyzn¦ poliniowan¡ liniami równolegªymi, odlegªymi od

Igªa Buona

siebie o 1, rzucamy losowo igª¦ o dªugo±ci 1. Jakie jest prawdopodobie«stwo,

»e igªa przetnie lini¦?

Aby rozwi¡za¢ ten przykªad, musimy sprecyzowa¢, co rozumiemy przez okre-

±lenie ÿna poliniowan¡ pªaszczyzn¦ rzucamy losowo igª¦ o danej dªugo±ci". W

tym celu zaªó»my, »e linie na pªaszczyznie s¡ uªo»one poziomo oraz wpro-

wad¹my oznaczenia:

x { odlegªo±¢ dolnego ko«ca igªy od najbli»szej linii pod

igª¡,

{ k¡t mi¦dzy ligª¡ a lini¡, 0

¬

< . Poªo»enie igªy jest teraz okre-

±lone przez par¦ liczb (

x;). Losowo±¢ rzutu na pªaszczyzn¦ rozumiemy w tym

przykªadzie jako umieszczenie punktu (

x;) w prostok¡cie [0;1]

[0

;], zgod-

nie z geometryczn¡ denicj¡ prawdopodobie«stwa. Niech

A b¦dzie zdarzeniem

polegaj¡cym na tym, »e igªa przetnie lini¦.

Igªa przecina lini¦ wtedy, gdy sin

> 1

,

x. Poniewa» pole obszaru speªniaj¡-

cego ten warunek jest równe

Z

0

sin

d = 2;

a pole prostok¡ta jest równe

, to Pr(A) = 2=. Je»eli teraz r

1

;r

2

;::: b¦-

dzie niezale»nym ci¡giem punktów, ka»dy z odcinka [0

;1] wybranym zgodnie z

geometryczn¡ denicj¡ prawdopodobie«stwa, to ci¡g (

r

1

;r

2

)

;(r

3

;r

4

)

;::: b¦-

dzie niezale»nym ci¡giem punktów, ka»dy z prostok¡ta [0

;1]

[0

;] wybranym

zgodnie z geometryczn¡ denicj¡ prawdopodobie«stwa. Niech teraz

A

i

b¦dzie

zdarzeniem polegaj¡cym na tym, »e w

i-tym rzucie igªa przetnie lini¦. Zgodnie

z twierdzeniem 1.2.1 i przyj¦tymi w nim oznaczeniami, ze wzoru (1.2.1) wy-

nika, »e dokonuj¡c coraz to wi¦kszej liczby rzutów, stosunek ich liczby

n do

liczby tych rzutów

k w których igªa przeci¦ªa lini¦, n=k, b¦dzie d¡»yª prawie

zawsze do

=2. Dla n sko«czonego, n=k b¦dzie tylko przybl»eniem liczby , o

losowym bª¦dzie. Oszacowaniem tego bª¦du zajmiemy si¦ po¹niej.

Symulacja polega na dokonaniu takiego eksperymentu i obliczeniu

n=k. Gdy

punkty

r

i

s¡ otrzymywane nie z zycznego eksperymentu, a generowane s¡ na

1.2 Prawa wielkich liczb i symulacja

10

drodze programowej, to taki komputerowy eksperyment daje wygodn¡ i ta-

ni¡ metod¦ otrzymywania przybli»e« { w wielu przypadkach wygodniejsz¡ od

czysto numerycznych oblicze«.

Pzykªad ten nie ma praktycznego znaczenia. Warto±¢ liczby

jest znana z wy-

starczaj¡c¡ dokªadno±ci¡, lepsz¡ od mo»liwej do otrzymania metod¡ symulacji.

Nast¦pny przykªad mo»e mie¢ ju» znaczenie nieco bardziej praktyczne.

Przykªad.

Obliczy¢ caªk¦

Caªka

obliczona

metod¡ Monte

Carlo

1

Z

0

e

sin

2

x

1 +

x

2

dx;

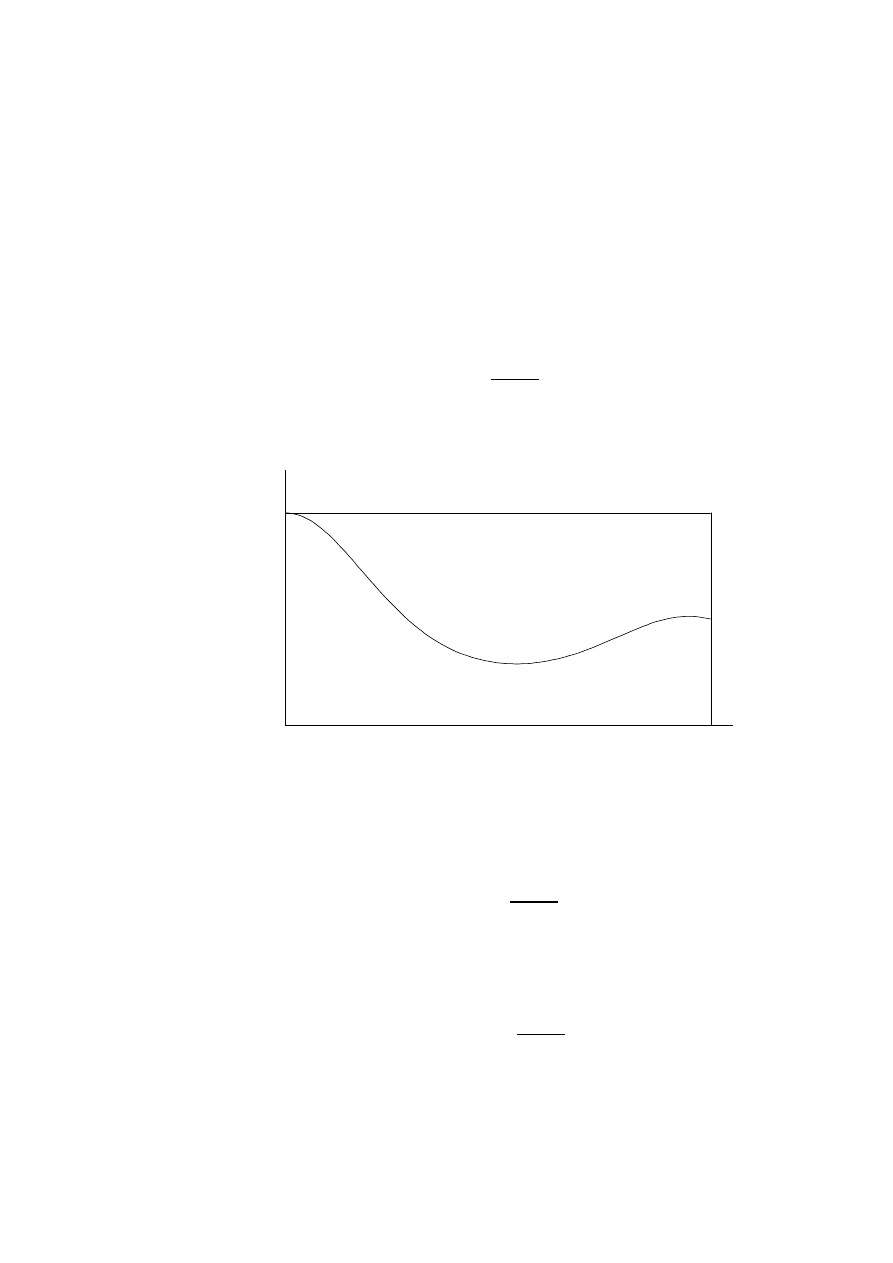

(wykres funkcji podcaªkowej na rysunku 2).

6

-

y

x

Rysunek 2: Wykres funkcji z przykªadu

Caªki tej nie da si¦ obliczy¢ analitycznie. Metoda Monte Carlo polega na otrzy-

maniu ci¡gu

n niezale»nych punktów (x

i

;y

i

) z prostok¡ta [0

;1]

[0

;1], a na-

st¦pnie obliczeniu liczby

k tych punktów, które speªniaj¡ nierówno±¢

y

i

< e

sin

2

x

i

1 +

x

2

i

:

Wtedy na podstawie prawa wielkich liczb (twierdzenia 1.2.1 i 1.2.2) mo»na

przyj¡¢, »e

k=n

1

Z

0

e

sin

2

x

1 +

x

2

dx;

gdy» maksimum funkcji podcaªkowej wynosi 1.

1.2 Prawa wielkich liczb i symulacja

11

Procedura

Symulacja

w Turbo

Pascalu

const n=1000;

var i,k:integer;

x,y:double;

begin

randomize;

k:=0;

for i:=1 to n do

begin

x:=random;

y:=random;

if y<exp(-sqr(sin(pi*x)))/(1+sqr(x)) then inc(k);

end;

writeln('Caªka=',k/n:0:4);

end;

daªa dla 5 kolejnych przebiegów

3

liczby:

0.5320, 0.4870 0.5340 0.4610 0.5160,

a ta sama procedura, ale dla

n = 10000 daªa

0.5045, 0.5011, 0.5046, 0.5006, 0.5045,

podczas gdy prawdziwa warto±¢ caªki (obliczona numerycznie przy pomocy

programu

Mathematica

) jest równa 0.503498.

1.2.3. Zadania

1*.

Niech b¦dzie kwadratem o boku 2

R oraz A b¦dzie koªem wpisanym w

ten kwadrat. Poda¢ metod¦ obliczania liczby

metod¡ Monte Carlo i napisa¢

odpowiedni¡ procedur¦ obliczaj¡c¡.

2*.

Obliczy¢ caªk¦

1

Z

0

arctg(

x

2

sin

x)

ln

2

(1 + (

e

,

1)

x) dx

metod¡ Monte Carlo.

3*.

Hipocykloida jest krzyw¡ zakre±lon¡ przez punkt okr¦gu koªa o promieniu

r tocz¡cego si¦ bez po±lizgu po wewn¦trznej stronie okr¦gu staªego koªa o

promieniu

R. Je»eli m = R=r > 2 jest liczb¡ caªkowit¡, to krzywa ta nie

przecina si¦ i ogranicza obszar wewn¡trz koªa. Dla

m = 4 krzywa taka jest

znana jako

asteroida

.

Napisa¢ procedury obliczaj¡ce metod¡ Monte Carlo pole ograniczone takimi

krzywymi dla

m > 2. Porówna¢ te wyniki z wynikami dokªadnymi. Dla m = 3

pole wynosi

S = 2r

2

, a dla

m = 4 pole wynosi S =

3

8

A

2

.

3

Dla nast¦pnych 5 przebiegów dostanie si¦ zapewne inne liczby

1.3 Prawdopodobie«stwo warunkowe

12

1.3. Prawdopodobie«stwo warunkowe

1.3.1. Denicja i podstawowe wªasno±ci

Prawdopodobie«stwem warunkowym zdarzenia

A jest prawdopodobie«stwo

tego samego zdarzenia

zwanego skutkiem, ale maj¡ce inn¡ warto±¢, zmody-

kowan¡ na podstawie informacji o innym zdarzeniu, zwanym przyczyn¡ lub

warunkiem. Nie ma natomiast poj¦cia zdarzenia warunkowego.

Denicja.

Prawdopodobie«stwo warunkowe zdarzenia

A pod warunkiem zda-

rzenia

B okre±lonwe jest wzorem

Pr(

A

j

B) = Pr(A

\

B)

Pr(

B) ;

(1.3.1)

przy zaªo»eniu Pr(

B) > 0.

Bezpo±rednio z denicji otrzymuje si¦ nast¦puj¡cy

Fakt 1.3.1.

Pr(

A

\

B) = Pr(A

j

B)Pr(B);

(1.3.2)

dla Pr(

B) > 0.

Wªasno±¢ wyra»ona wzorem (1.3.2) jest bardzo u»yteczna w sytuacji, gdy

prawdopobie«stwa warunkowe s¡ znane w sposób naturalny, a nieznane s¡

prawdopodobie«stw iloczynów.

Przykªad.

W ciemnym pokoju mamy dwie urny: du»¡, do której traamy z

pradopodobie«stwem 3/4 i maª¡ do której traamy z prawdopodobie«stwem

1/4. W maªej urnie mamy 2 czarne i 1 biaª¡ kul¦, a du»ej 2 biaªe i 1 czarn¡

kul¦. Jakie jest prawdopobie«stwo, »e tramy na du»¡ urn¦ i równocze±nie

wyci¡gni¦ta z urny kula b¦dzie biaªa.

Rozwi¡zanie. Niech

A b¦dzie zdarzeniem polegaj¡cym na traeniu do du-

»ej urny,

B zdarzenie polegaj¡ce na wylosowaniu kuli biaªej. Jest jasne, »e

Pr(

B

j

A) = 2=3, a poniewa» Pr(A) = 3=4, to zgodnie ze wzorem (1.3.2) otrzy-

mujemy

Pr(

A

\

B) = 23

3

4 =

1

2 :

Prawdopodobie«stwo warunkowe ma wszystkie wªasno±ci ÿzwykªego" prawdo-

podobie«stwa, tzn. zachodzi nast¦puj¡ce twierdzenie.

Twierdzenie 1.3.1.

Dla dowolnej przestrzeni probabilistycznej (

;

S

;Pr)

i ustalonego

B

2

S

takiego, »e Pr(

B) > 0, prawdopodobie«stwo warun-

kowe Pr

B

(

) = Pr(

j

B) speªnia postulaty Koªmogorowa (1.1.2) { (1.1.4), tzn.

(

;

S

;Pr

B

) jest przestrzeni¡ probabilistyczn¡.

Intuicje dotycz¡ce prawdopodobie«stwa warunkowego zgodne s¡ z nast¦puj¡-

cym rezultatem.

Twierdzenie 1.3.2.

Je»eli zdarzenia

A i B s¡ niezale»ne i Pr(B) > 0, to

Pr(

A

j

B) = Pr(A):

1.3 Prawdopodobie«stwo warunkowe

13

1.3.2. Wzór Bayesa

Twierdzenia przedstawione w tym punkcie znane s¡ pod tradycyjn¡ nazw¡

wzorów. Trzeba jednak zwróci¢ uwag¦, »e wzory te s¡ prawdziwe tylko przy

speªnionych zaªo»eniach, wspólnych dla obydwóch twierdze«.

Twierdzenie 1.3.3.

(prawdopodobie«stwo caªkowite). Niech

A

i

b¦dzie ci¡-

Wzór na

prawdopodo-

bie«stwo

caªkowite

giem zdarze« takim, »e

A

i

\

A

j

=

;

dla

i

6

=

j oraz

X

i

Pr(

A

i

) = 1. Wtedy

Pr(

B) =

X

i

Pr(

B

j

A

i

)

P(A

i

)

:

(1.3.3)

Dowód.

Twierdzenie udowodnimy w szczególnym przypadku, gdy zaªo»enie

X

i

Pr(

A

i

) = 1 zast¡pimy mocniejszym:

S

i

A

i

= . Ze wzoru (1.3.2) otrzy-

mujemy zale»no±¢ Pr(

B

j

A

i

)

P(A

i

) = Pr(

A

i

\

B). Poniewa» A

i

s¡ rozª¡czne, to

równie» rozª¡czne s¡

B

\

A

i

oraz

B = B

\

S

i

A

i

. St¡d

Pr(

B) = Pr

B

\

[

i

A

i

!

= Pr

[

i

(

B

\

A

i

)

!

=

X

i

Pr(

B

j

A

i

)

P(A

i

)

:

Bezpo±rednio ze wzorów (1.3.1) i (1.3.2) otrzymuje si¦ nast¦puj¡ce

Twierdzenie 1.3.4.

(Bayesa

4

). Przy zaªo»eniach z twierdzenia 1.3.3 oraz

Wzór Bayesa

dla Pr(

B) > 0:

Pr(

A

i

j

B) = Pr(B

j

A

i

)Pr(

A

i

)

Pr(

B)

;

(1.3.4)

gdzie Pr(

B) wyznaczone jest ze wzoru (1.3.3).

Przykªad.

Dwóch strzelców strzela do tarczy. Strzelec 1 traa z prawdopo-

dobie«stwem 2/3, a strzelec 2 z prawdopodobie«stwem 1/2. Po oddaniu po

jednym strzale okazaªo si¦, »e tarcza zostaªa traona dokªadnie raz. Jakie jest

prawdopodobie«stwo, »e traª strzelec 1?

Oznaczmy przez

A

11

fakt traenia w tarcz¦ przez obydwóch strzeleców,

A

10

{

przez pierwszego,

A

01

{ przez drugiego, a przez

A

00

przez »adnego. Poniewa»

strzelcy strzelaj¡ niezale»nie (to trzeba zaªo»y¢), to Pr(

A

11

) = 1

=3, Pr(A

10

) =

1

=3, Pr(A

01

) = 1

=6, Pr(A

00

) = 1

=6. Wszystkie te zdarzenia s¡ rozª¡czne, wi¦c

s¡ speªnione zaªo»enia twierdzenia 1.3.4. Przez

B oznaczmy fakt traenia w

tarcz¦ dokªadnie raz. Szukanym prawdopodobie«stwem jest

Pr(

A

10

[

A

11

j

B) = Pr(A

10

j

B);

gdy» Pr(

A

11

j

B) = 0. Wiadomo te», »e Pr(B

j

A

10

)Pr(

A

10

) = 1

=3 oraz

Pr(

B

j

A

01

)Pr(

A

10

) = 1

=6, pozostaªe prawdopodobie«stwa warunkowe s¡ równe

4

Thomas Bayes

y

1763

1.3 Prawdopodobie«stwo warunkowe

14

zeru. Tak wi¦c ze wzoru (1.3.3) otrzymujemy Pr(

B) = 1=2. Ze wzoru Bayesa

(1.3.4) wynika, »e

Pr(

A

10

j

B) = 1=3

1

=2 ;

co jest szukanym prawdopodobie«stwem.

Wyst¦puj¡ce w nast¦pnym punkcie zadania 1 i 2 równie» s¡ typowymi zasto-

sowaniami wzoru na prawdopodobie«stwo caªkowite i wzoru Bayesa.

1.3.3. Zadania

1.

W ka»dej z trzech urn s¡ po cztery kule { w urnie

i-tej jest i kul biaªych,

a reszta czarnych. Z urny pierwszej losujemy jedn¡ kul¦ i przekªadamy do

drugiej, z drugiej losujemy jedn¡ kul¦ i przekªadamy do trzeciej, a w ko«cu z

trzeciej urny losujemy jedn¡ kul¦. Jakie jest prawdopodobie«stwo, »e b¦dzie

to kula biaªa?

2.

W urnie pierwszej s¡ 2 dwie biaªe i dwie czarne kule, a w drugiej jedna

biaªa i trzy czarne kule. Z ka»dej urny losujemy po jednej kuli i nast¦pnie

losujemy z nich jedn¡ kul¦. Okazaªo si¦, »e wylosowali±my kul¦ biaª¡. Jakie

jest prawdopodobie«stwo, »e kula ta pochodziªa z pierwszej urny.

3.

Udowodni¢, »e je±li Pr(

A

j

B) = Pr(A

j

B

0

), to zdarzenia

A i B s¡ niezale»ne.

4.

Przy szeregowej transmisji danych do ka»dego bajtu dodawany jest jeden bit

tak, aby liczba jedynek byªa parzysta. Prawdopodobie«stwo przekªamania dla

ka»dego bitu wynosi

p. Obliczy¢ prawdopodobie«stwo niewykrycia przekªama-

nia { dokªadne dla dowolnego

p oraz przybli»one, gdy p jest bardzo maªe.

15

2. Zmienne losowe

2.1. Rozkªady zmiennych losowych

2.1.1. Denicja zmiennej losowej

Formuªowanie problemów wyª¡cznie w terminach przestrzeni zdarze« elemen-

tarnych,

-algebry zdarze« i prawdopodobie«stwa okre±lanego bezpo±rednio

na zdarzeniach, nie jest zbyt wygodne. Cz¦sto bowiem zamiast okre±lenia ca-

ªej przestrzeni probabilistycznej (

;

S

;Pr), wystarczy okre±li¢ charakterystyki

liczbowe zdarze« elementarnych, bez opisywania samych zdarze«. Na przykªad

je±li przy rzutach monet¡ interesuje nas tylko liczba wyrzuconych orªów, to

zamiast opisywa¢ rzut monet¡ w terminach orªów i reszek, mo»na zast¡pi¢

je zerami i jedynkami i dodawa¢ tylko te ÿlosowe" liczby. Co to wi¦c s¡ te

ÿlosowe" liczby? Potrzebna jest tutaj nast¦puj¡ca denicja.

Denicja.

Zmienn¡ losow¡ nazywamy funkcj¦ okre±lon¡ na przestrzeni zda-

Zmienna

losowa

rze« elementarnych i przyjmuj¡c¡ warto±ci rzeczywiste:

X :

!

R

;

tak¡, »e

f

! : X(!) < x

g

2

S

;

(2.1.1)

dla ka»dego

x

2

R

.

Zamiast pisa¢

A =

f

! : X(!) < x

g

b¦dzie pisa¢ w skrócie

A =

f

X < x

g

.

Denicja powy»sza zapewnia nam, »e mo»na powiedzie¢: ÿzdarzenie polegaj¡ce

na tym, »e

X < x".

Bezpo±redno z denicji wynika równie», »e zdarzeniami s¡ równie» zbiory:

f

! : X(!)

¬

x

g

;

f

! : X(!) > x

g

;

f

! : X(!)

x

g

;

f

! : X(!) = x

g

;

f

! : X(!)

2

[

a;b]

g

;

f

! : X(!)

2

[

a;b)

g

;

f

! : X(!)

2

(

a;b]

g

;

f

! : X(!)

2

(

a;b)

g

:

Równie» w tych przypadkach najcz¦±ciej stosowa¢ b¦dziemy skrótowy zapis,

np.

f

X

2

[0

;1]

g

zamiast peªnego

f

! : X(!)

2

[0

;1]

g

, pami¦taj¡c jednak

zawsze, »e

X = X(!), czyli »e zmienna losowa jest funkcj¡ zdarze« elementar-

nych.

B¦dziemy równie» równie» pisa¢ Pr(

X < x) zamiast

f

! : X(!) < x

g

. Podob-

nie we wszystkich dalszych przypadkach.

2.1 Rozkªady zmiennych losowych

16

Na zmiennych losowych mo»na dokonywa¢ rozmaitych operacji, co precyzuje

nast¦puj¡ce twierdzenie.

Twierdzenie 2.1.1.

Je»eli

X(!) jest zmienn¡ losow¡, a h(x) jest funkcj¡ prze-

dziaªami ci¡gª¡, której dziedzina zawiera zbiór warto±ci

X, to Y (!) = h(X(!))

jest te» zmienn¡ losow¡ okre±lon¡ na tej samej przestrzeni probabilistycznej co

X.

2.1.2. Dystrybuanta zmiennej losowej

Denicja zmiennej losowej zapewnia nam poprawno±¢ denicji podanej ni»ej.

Denicja.

Dystrybuant¡ nazywamy funkcj¦ rzeczywist¡ zmiennej rzeczywi-

Dystrybuanta

stej, okre±lon¡ wzorem

F(x) = Pr(

f

! : X(!) < x

g

) = Pr(

X < x):

(2.1.2)

Twierdzenie 2.1.2.

Funkcja

F jest dystrybuant¡ pewnej zmiennej losowej

Warunki

konieczne

i dostateczne

wtedy i tylko wtedy, gdy

(a) jest niemalej¡ca,

(b) lim

x

!,1

= 0, lim

x

!1

= 1,

(c) jest lewostronnie ci¡gªa.

Przykªad.

Nale»y dobra¢ staªe

A, B, C, D, E i F tak, aby funkcja

F(x) =

8

>

>

>

<

>

>

>

:

A

dla

x <

,

1,

Bx

2

+

C dla

,

1

¬

x

¬

0,

Dx + E dla 0 < x

¬

1,

F

dla

x > 1

byªa dystrybuant¡ pewnej zmiennej losowej. Trzeba wi¦c staªe dobra¢ tak, aby

byªy speªnione warunki (a) { (c) w twierdzeniu 2.1.2. Najpierw sprawdzimy

warunek (b). Wynika z niego, »e musi by¢

A = 0 oraz F = 1. Na to, aby dla

x =

,

1 byª speªniony warunek (c),

F(x) musi by¢ lewostronnie ci¡gªa w tym

punkcie, a wi¦c musiby¢ równie» ci¡gªa, (bo inaczej byªaby tylko prawostronnie

ci¡gªa) co oznacza, »e

B +C = 0. Dla speªnienia warunku (a) na odcinku [0;1]

trzeba przyj¡¢, »e

B

¬

0, a wi¦c równie»

C

0. Dalej, w punktach

x = 0

i

x = 1 funkcja F(x) jest zawsze lewostronnie ci¡gªa, wystarczy wi¦c sprawdzi¢

warunek (a). Oznacza to, »e

C

¬

E

¬

1,

D

0 oraz

D

¬

1

,

E. Tak wi¦c tylko

dwa parametry s¡ wyznaczone jednoznacznie, (

A = 0 i F = 1), a pozostaªe s¡

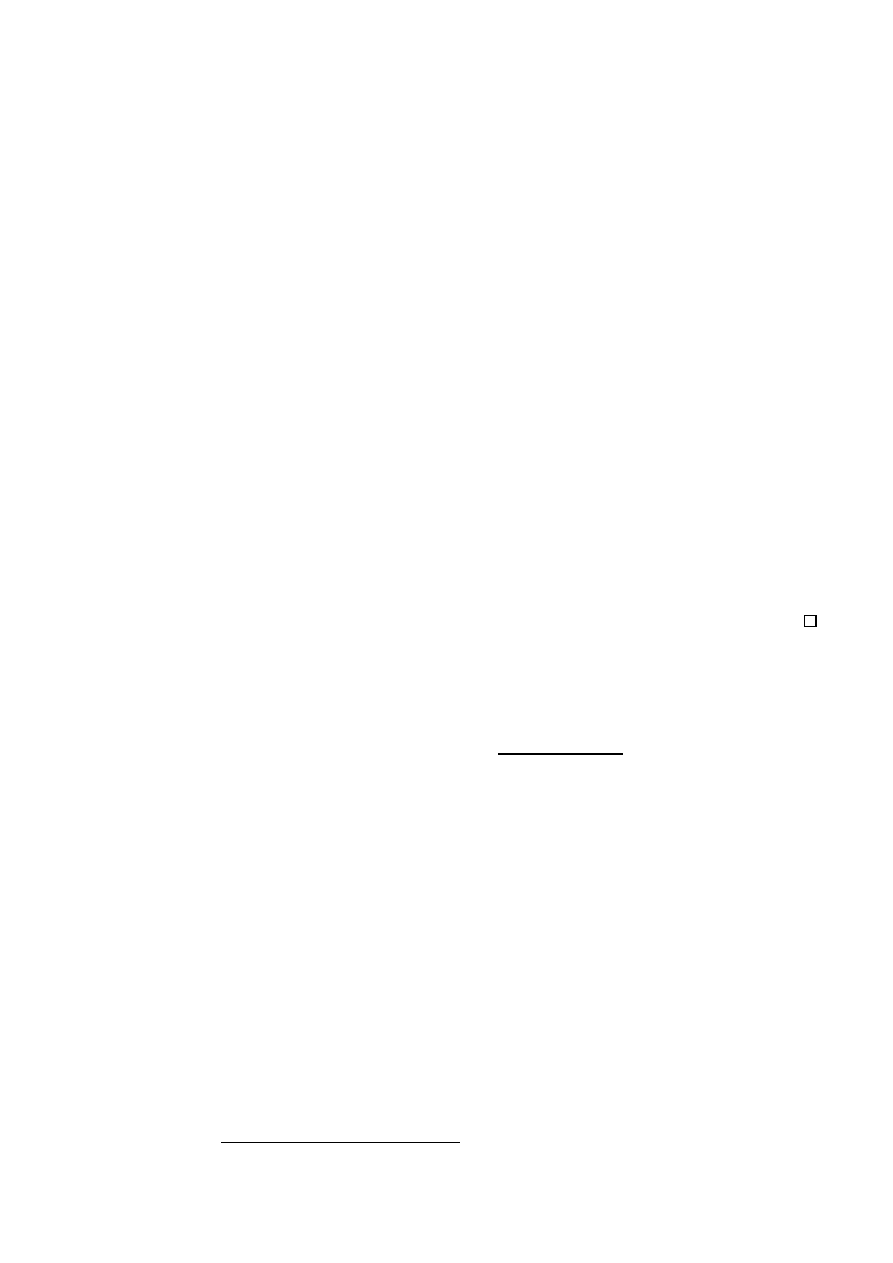

okre±lone przy pomocy ukªadu nierówno±ci i równo±ci. Na rysunku 3 pokazany

jest wykres takiej dystrybuanty dla

B =

,

0

:25, C =

,

B = 0:25, D = 0:25,

E = 0:5.

Przy pomocy dystrybuanty mo»na okre±li¢ prawdopodobie«stwa zdarze«, o

2.1 Rozkªady zmiennych losowych

17

-1

0

1

0.25

0.5

0.75

1

6

-

y

x

u

u

e

u

e

Rysunek 3: Wykres dystrybuanty z przykªadu

których byªa mowa punkcie 2.1.1.

Pr(

X

¬

x) = lim

t

!

x

+

F(t) = F(x

+

)

;

Pr(

x

1

¬

X < x

2

) =

F(x

2

)

,

F(x

1

)

;

Pr(

X = x) = F(x

+

)

,

F(x);

Pr(

X > x) = 1

,

F(x

+

)

i tak dalej.

W±ród zmiennych losowych mo»na, ze wzgl¦du na posta¢ dystrybuanty, wy-

ró»ni¢ dwa typy:

zmiennelosowe typu skokowego (zmiennelosowe dyskretne),których dys-

trybuanta jest przedziaªami staªa, a ponadto ma tylko skoki w punktach

x

i

{ taka zmienna losowa mo»e przyjmowa¢ (z prawdopodobie«stwem 1)

tylko warto±ci

x

i

,

zmienne losowe typu ci¡gªego, których dystrybuant¦

F(x) mo»na przed-

stawi¢ w postaci

F(x) =

x

Z

,1

f(t)dt:

(2.1.3)

Funkcj¦

f(x) okre±lon¡ wzorem (2.1.3) nazywa si¦ g¦sto±ci¡.

Uwaga.

Nie ma zmiennych losowych ci¡gªych, bo nie s¡ one funkcjami zmien-

nej rzeczywistej, a mog¡ by¢ okre±lone na zbiorach dowolnej natury. S¡ tylko

zmienne losowe

typu ci¡gªego

, tzn. takie, które maj¡ g¦sto±¢.

Wªasno±ci g¦sto±ci omówimy dokªadniej w nast¦pnym punkcie.

Rozkªadem zmiennej losowej okre±lamy jej dystrybuant¦ lub inne funkcje w

peªni j¡ chakteryzuj¡ce, np. g¦sto±¢ dla zmiennej losowej typu ci¡gªego lub

prawdopodobie«stwa

p

i

= Pr(

X = x

i

) dla zmiennej losowej dyskretnej.

2.1 Rozkªady zmiennych losowych

18

W dwóch nast¦pnych punktach omówimy najwa»niejsze rozkªady dyskretne

i rozkªady typu ci¡gªego.

Niezale»no±¢ zmiennych losowych deniuje si¦ przy pomocy niezale»no±ci zda-

Niezale»no±¢

X

i

Y

rze« lub przy pomocy dystrybuant. Tutaj podamy tylko denicj¦ niezale»no±ci

dwóch zmiennych losowych, cz¦±ciowo w terminach dystrybuant. Ogólna de-

nicja zostanie podana pó¹niej, przy okazji rozpatrywania wektorów losowych

i ich dystrybuant.

Denicja.

Zmienne losowe

X i Y s¡ niezale»ne, gdy

Pr(

X < x;Y < y) = F(x)G(y);

gdzie

F jest dystrybuant¡ zmiennej losowej X, a G { zmiennej losowej Y .

2.1.3. G¦sto±¢

Wzór (2.1.3) deniuje g¦sto±¢ rozkªadu. Mówi si¦ te» w przypadku, gdy

F(x)

jest dystrybuant¡ zmiennej losowej

X, »e f(x) jest g¦sto±ci¡ zmiennej losowej

X mimo, »e X nie wyst¦puje jawnie w denicji g¦sto±ci.

Podobnie jak twierdzenie 2.1.2 podaje warunki konieczne i dostateczne na

Warunki

konieczne

i dostateczne

to, aby dana funkcja byªa dystrybuant¡, poni»sze twierdzenie podaje warunki

konieczne i dostateczne na to, aby funkcja byªa g¦sto±ci¡.

Twierdzenie 2.1.3.

Funkcja

f(x) jest g¦sto±ci¡ pewnej zmiennej losowej

wtedy i tylko wtedy, gdy

(A)

f(x)

0,

(B)

1

Z

,1

f(x)dx = 1.

Nale»y zwróci¢ uwag¦, »e g¦sto±¢ nie musi by¢ okre±lona jednoznacznie, ponie-

wa» mo»na w dowolny sposób ustali¢ jej warto±¢ w sko«czonej liczbie punktów.

Dzieje si¦ tak, gdy» zarówno we wzorze (2.1.3) deniuj¡cym g¦sto±¢ jak i w wa-

runku (B) w twierdzeniu 2.1.3, warto±ci caªek nie zmieniaj¡ si¦ przy zmianie

warto±ci funkcji podcaªkowej w sko«czonej liczbie punktów. Przyjmuje si¦ jed-

nak zawsze, »e speªniony jest warunek (A) w twierdzeniu 2.1.3.

Bezpo±rednim wnioskiem ze wzoru (2.1.3) jest

Wzór na

g¦sto±¢

2.1 Rozkªady zmiennych losowych

19

byªa g¦sto±ci¡ pewnej zmiennej losowej. Trzeba wi¦c dobra¢ staªe tak, aby byª

speªniony warunek (A) w twierdzeniu 2.1.3, sk¡d wynika

a

0 oraz

b

¬

=2.

Dla speªnienia warunku (B) w tym twierdzeniu, musi by¢ speªniona równo±¢

b

Z

0

cos

xdx = 1:

St¡d po obliczeniu caªki otrzymujemy warunek

asinb = 1, przy czym a > 0.

Za pomoc¡ g¦sto±ci mo»na ªatwo wyznaczy¢ prawdopodobie«stwo nale»enia

warto±ci zmiennej losowej do zbioru.

Twierdzenie 2.1.4.

Je»eli zmienna losowa

X ma g¦sto±¢ f(x), to

Pr(

X

2

[

a;b]) = Pr(X

2

[

a;b))

= Pr(

X

2

(

a;b]) = Pr(X

2

(

a;b)) =

b

Z

a

f(x)dx:

(2.1.5)

2.1.4. Zadania

1.

Dla jakich parametrów

a i b funkcja F(x) = aarctgx+b jest dystrybuant¡

pewnej zmiennej losowej?

2.

Niech

F(x) =

(

1

,

e

,

x

2

; dla x

0,

0

;

dla

x < 0,

b¦dzie dystrybuant¡ zmiennej losowej

X, (sprawdzi¢, »e jest to dystrybuanta).

Wyznaczy¢ Pr(

X > 1), Pr(1 < X

¬

2), Pr(

X = 3).

3.

Dla jakich warto±ci

a i b funkcja f(x) =

a

1 + (

bx)

2

jest g¦sto±ci¡ pewnej

zmiennej losowej? Wyznaczy¢ dystrybuant¦.

4.

Niech dystrybuanta

F(x) zmiennej losowej X b¦dzie funkcj¡ ±ci±le rosn¡c¡ i

ci¡gª¡, a funkcja

h(x) b¦dzie ró»nowarto±ciowa. Znale¹¢ dystrybuant¦ zmiennej

losowej

h(X).

5.

Niech

f(x) =

(

a dla x

2

[0

;],

0 dla

x =

2

[0

;]

b¦dzie g¦sto±ci¡ zmiennej losowej

X. Wyznaczy¢ a, znale¹¢ dystrybuant¦

zmiennej losowej

X oraz korzystaj¡c z zadania 4 znale¹¢ dystrybuant¦ i g¦sto±¢

zmiennej losowej

Y = sinX.

2.2 Momenty zmiennych losowych

20

2.2. Momenty zmiennych losowych

2.2.1. Caªka Stieltjesa

Podana w tym punkcie denicja caªki Stieltjesa

5

jest uogólnieniem zwykªej

caªki. Jej u»ycie umo»liwia podanie jednolitej denicji momentów zmiennych

losowych, zarówno dla typu ci¡gªego, jak i skokowego.

Denicja.

Zaªó»my, »e dystrybuanta

F(x) jest przedziaªami ci¡gªa i ró»nicz-

kowalna. Caªk¡ Stieltjesa z funkcji

g(x) wzgl¦dem dystrybuanty F(x) nazy-

wamy liczb¦, okre±lon¡ wzorem

Caªka

Stieltjesa

b

Z

a

g(x)dF(x) =

b

Z

a

g(x)dF(x)

dx dx +

X

i

g(x

i

)

,

F(x

+

i

)

,

F(x

i

)

; (2.2.1)

gdzie

x

i

s¡ punktami skoków dystrybuanty

F(x), pomi¦dzy którymi jest ona

ci¡gªa i ró»niczkowalna.

Je»eli dystrybuanta

F(x) ma g¦sto±¢, to we wzorze (2.2.1) znika suma, (bo

Przypadki

szczególne

caªki Stieltjesa

dystrybuanta jest ci¡gªa, wi¦c skoki s¡ równe zeru), a caªka Stieltjesa sprowa-

dza si¦ do zwykªej caªki Riemanna. Je±li natomiast zmienna losowa jest typu

skokowego, to pochodna pomi¦dzy skokami jest równa zeru, (bo dystrybuanta

jest tam staªa), a caªka Stieltjesa redukuje si¦ we wzorze (2.2.1) do sumy.

Przykªad.

Okre±lmy dystrybuant¦

F(x) wzorem

F(x) =

(

0

dla

x

¬

0,

1

,

e

,

x

=2 dla x > 0.

Wtedy skok w zerze

F(0

+

)

,

F(0) = 1=2, caªka w przedziale (

,1

;0) jest

równa zeru, a wi¦c

1

Z

,1

(

x + 1)dF(x) = 12

1

Z

0

(

x + 1)e

,

x

dx + 12 =

3

2 :

2.2.2. Warto±¢ oczekiwana

Warto±¢ oczekiwana zmiennej losowej, zwana te» nadziej¡ matematyczn¡, war-

to±ci¡ ±redni¡ lub przeci¦tn¡, nale»y do podstawowych poj¦¢ rachunku praw-

dopodobie«stwa.

Denicja.

Warto±ci¡ oczekiwan¡ zmiennej losowej

g(X) o dystrybuancie

F(x) = Pr(X < x) jest liczba oznaczana jako Eg(X) i okre±lona wzorem

E

g(X) =

1

Z

,1

g(x)dF(x);

(2.2.2)

5

Thomas Stieltjes, (1856-1895), matematyk holenderski.

2.2 Momenty zmiennych losowych

21

o ile caªka we wzorze (2.2.2) jest bezwzgl¦dnie zbie»na, to znaczy je»eli istnieje

caªka

1

Z

,1

j

g(x)

j

dF(x):

(2.2.3)

Je»eli zmienna losowa jest typu ci¡gªego o g¦sto±ci

f(x), to warto±¢ oczekiwana

Warto±¢

oczekiwana {

przypadki

szczególne

zamiast wzorem (2.2.2), wyra»a si¦ wzorem

E

g(X) =

1

Z

,1

g(x)f(x)dx;

a je±li jest dyskretna, to wzorem

E

g(X) =

X

i

g(x

i

)

p

i

;

gdzie

p

i

= Pr(

X = x

i

). Oczywi±cie w obydwóch tych przypadkach, suma lub

caªka musi by¢ bezwzgl¦dnie zbie»na.

Je»eli caªka (2.2.2) nie istnieje lub je±li istnieje, ale nie jest bezwzgl¦dnie

zbie»na, a wi¦c nie istnieje caªka (2.2.3), to mówimy, »e warto±¢ oczekiwana

nie istnieje. W przypadku, gdy

g(x)

0 i nie istnieje warto±¢ oczekiwana, to

mówi si¦ te», warto±¢ oczekiwana jest niesko«czona.

W pewnych przypadkach mo»na ªatwo stwierdzi¢, »e warto±¢ oczekiwana ist-

nieje. Przykªadem s¡ tu dwa, ªatwe do udowodnienia fakty.

Fakt 2.2.1.

Je±li zmienna losowa

X ma g¦sto±¢ f(x), która jest równa zeru

poza pewnym ograniczonym zbiorem na prostej rzeczywistej, (tzn. istnieje od-

cinek (

a;b) taki, »e je±li x =

2

(

a;b), to f(x) = 0) oraz je±li g(x) jest ograniczona

na tym zbiorze, to istnieje E

g(X).

Fakt 2.2.2.

Je±li zmiennalosowa dyskretna

X przybiera tylkosko«czon¡ liczb¦

warto±ci

x

i

, to warto±¢ oczekiwana E

g(X) istnieje.

Poni»ej przedstawione zostan¡ dwa najprostsze, ale bardzo wa»ne przykªady.

Przykªad.

Rozkªad zero-jedynkowy: Pr(

X = 1) = p, Pr(X = 0) = q = 1

,

p,

a wi¦c zmienna losowa

X nie przyjmuje innych warto±ci ni» 0 i 1.

E

X = 0

q + 1

p = p:

Przykªad.

Rozkªad jednostajny na odcinku [0

;1]:

f(x) =

(

1 dla

x

2

[0

;1],

0 dla

x =

2

[0

;1].

Warto±¢ oczekiwana istnieje (patrz fakt 2.2.2) i wyra»a si¦ wzorem

E

X =

1

Z

0

xdx = 12 :

2.2 Momenty zmiennych losowych

22

Dla warto±ci oczekiwanych prawdziwa jest wªasno±¢ taka jak dla caªek, któr¡

mo»na sªownie sformuªowa¢ nast¦puj¡co:

warto±¢ oczekiwana sumy jest równa sumie warto±ci oczekiwanych, (o ile

warto±ci oczekiwane istniej¡),

staª¡ mo»na wyci¡gn¡¢ przed znak warto±ci oczekiwanej.

Formalnie sformuªujemy to w postaci twierdzenia.

Operator

liniowy

Twierdzenie 2.2.1.

Je»eli istniej¡ E

X i EY , to istnieje E(aX + bY ) oraz

E(

aX + bY ) = aEX + bEY ;

(2.2.4)

czyli warto±¢ oczekiwana jest

operatorem liniowym

.

Podobnie jak dla caªek, nie ma ogólnej reguªy, jak oblicza¢ warto±¢ oczeki-

Warto±¢

oczekiwana

iloczynu

wan¡ iloczynu zmiennych losowych. Reguªa taka istnieje tylko dla niezale»nych

zmiennych losowych.

Twierdzenie 2.2.2.

Je»eli zmienne losowe

X i Y s¡ niezale»ne, to

E(

XY ) = (EX)(EY ):

(2.2.5)

Warto±¢ oczekiwana zmiennej losowej

X, nazywa si¦ momentem rz¦du pierw-

szego i oznaczana jest bardzo cz¦sto symbolem

m = m

1

= E

X.

2.2.3. Momenty wy»szych rz¦dów

Momentem rz¦du

k, czyli momentem k-tego rz¦du lub krótko, k-tym momen-

Moment

zwykªy

tem zmiennej losowej

X jest warto±¢ oczekiwana jej k-tej pot¦gi, czyli EX

k

.

Moment rz¦du

k jest cz¦sto oznaczany symbolem m

k

. Moment ten nazywany

jest momentem zwykªym, dla odró»nienia od innego rodzaju momentów oma-

wianych dalej.

Przykªad.

Dla zmiennej losowej zero-jedynkowej

m

k

= E

X

k

= 0

k

p + 1

k

q = p:

Przykªad.

Dla zmiennej losowej rozkªadzie jednostajnym na [0

;1]

m

k

= E

X

k

=

1

Z

0

x

k

dx = 1

k + 1 :

Dalej deniuje si¦ moment centralny rz¦du

k, (k-ty moment centralny), wzo-

Wariancja

rem

c

k

= E(

X

,

E

X)

k

. Przypadek

k = 2 ma szczególn¡ rol¦ w rachunku

prawdopodobie«stwa. Moment centralny drugiego rz¦du nazywa si¦ wariancj¡

i jest oznaczany symbolem D

2

X,

2.2 Momenty zmiennych losowych

23

D

2

X = E(X

,

E

X)

2

:

(2.2.6)

Ze denicji wariancji wynika w szczególno±ci, »e D

2

X

0. Na oznaczenie

Wariancja jest

nieujemna!

wariancji u»ywany jest te» symbol Var

X. Z wariancj¡ zwi¡zana jest wa»na

charakterystyka, zwana ±rednim odchyleniem standardowym lub dyspersj¡,

oznaczona symbolem

i okre±lana jako pierwiastek z wariancji: =

p

D

2

X.

Z istnienia momentów wy»szych rz¦dów wynika istnienie momentów ni»szych

rz¦dów.

Twierdzenie 2.2.3.

Je»eli istnieje E

X

k

oraz

l < k, to istnieje EX

l

.

Dla wariancji nie jest prawdziwy bez dodatkowych zaªo»e« odpowiednik twier-

dzenia 2.2.1. Mo»na jednak sformuªowa¢ twierdzenie nast¦puj¡ce.

Twierdzenie 2.2.4.

D

2

(

aX) = a

2

D

2

X ;

(2.2.7)

a je»eli zmienne losowe

X i Y s¡ niezale»ne, to

D

2

(

X + Y ) = D

2

X + D

2

Y

(2.2.8)

lub oznaczaj¡c

X

=

p

D

2

X i

Y

=

p

D

2

Y ,

X

+

Y

=

q

2

X

+

2

Y

:

Wariancja zmienne losowej

X, a zwªaszcza jej dyspersja, jest miar¡ odchylenia

si¦ zmiennej od jej ±redniej warto±ci, czyli miar¡ rozrzutu. Interpretacja taka

wynika bezpo±rednio ze wzoru (2.2.6). Wariancj¦ ªatwiej ni» ze wzoru (2.2.6),

mo»na obliczy¢ korzystaj¡c z nast¦puj¡cej wªasno±ci.

Fakt 2.2.3.

D

2

X = EX

2

,

(E

X)

2

(2.2.9)

albo równowa»nie

2

=

m

2

,

m

2

1

:

Dowód.

Ze wzoru (2.2.6) wynika, »e

D

2

X = E

,

X

2

,

2

XEX + (EX)

2

= E

,

X

2

,

2

m

1

X + m

2

1

:

Nast¦pnie z twierdzenia 2.2.1 wynika, »e

D

2

X = EX

2

,

2

m

1

E

X + m

2

1

=

m

2

,

2

m

2

1

+

m

2

1

=

m

2

,

m

2

1

2.2 Momenty zmiennych losowych

24

Ponadto mamy nast¦puj¡cy

Fakt 2.2.4.

D

2

X = 0 wtedy i tylko wtedy, gdy zmienna losowa X przyjmuje

warto±¢ staª¡ z prawdopodobie«swem 1, to znaczy, gdy Pr(

X = x

0

) = 1 dla

pewnej warto±ci

x

0

.

Dowód.

Je»eli Pr(

X = x

0

) = 1, to

m

1

=

x

0

oraz

m

2

=

x

0

, a wi¦c D

2

X = 0.

Z drugiej strony, je±li D

2

X

6

= 0, to oczywi±cie D

2

X > 0. Przypu±¢my, »e

D

2

X = 0, a równocze±nie Pr(X = x

0

)

< 1. Ze wzoru (2.2.6) otrzymujemy

2

= D

2

X =

1

Z

,1

(

x

,

m)

2

dF(x)

0

;

gdy» (

x

,

m)

2

0, przy czym

2

= 0 tylko wtedy, gdy funkcja podcaªkowa jest

to»samo±ciowo równa zeru, (co nie jest prawd¡) albo gdy w dokªadnie jednym

punkcie

x

0

=

m dystrybuanta F(x) ma skok równy 1, czyli F(x

+

0

)

,

F(x

0

) =

1.

2.2.4. Zadania

1.

Niech

R b¦dzie zmienn¡ losow¡ o rozkªadzie jednostajnym na odcinku [0;1].

Obliczy¢ momenty zwykªe i centralne

k-tego rz¦du.

2.

Zmienna losowa

X ma rozkªad dany tabel¡:

x

k

0 1 2 3 4

p

k

0

:2 0:1 0:1 0:3 A

Znale¹¢ staª¡

A, a nast¦pnie warto±¢ oczekiwan¡ oraz wariancj¦ zmiennych X

i

Y = sin(X=2).

3.

Rzucamy trzy razy monet¡. Niech

X b¦dzie liczb¡ wyrzuconych orªów.

Obliczy¢ E

X i D

2

X.

4.

Zmiennalosowa

X przyjmujetylko warto±ci 2

k

dla

k = 1;2;::: oraz Pr(X =

2

k

) = 4

5

,

k

. Znale¹¢ E

X oraz D

2

X. Czy istnieje trzeci moment zmiennej X?

5.

Zmienna losowa

X przyjmuje tylko warto±ci 3

k

,1

dla

k = 1;2;::: oraz

Pr(

X = 3

k

,1

) = 2

3

,

k

. Czy istnieje E

X? Obliczy¢ E

p

X.

6.

Rzucamy dwoma kostkami. Obliczy¢ warto±¢ oczekiwan¡ i wariancj¦ sumy

oczek.

2.3 Rozkªady dyskretne

25

2.3. Rozkªady dyskretne

2.3.1. Rozkªad dwupunktowy i dwumianowy

Zmienna losowa

X ma rozkªad dwupunktowy, gdy z prawdopodobie«stwem 1

przyjmuje tylko dwie warto±ci, tzn. je±li Pr(

X = x

1

) =

p i Pr(X = x

2

) =

q,

to

p + q = 1. atwo policzy¢ momenty: EX = x

1

p + x

2

q, co w przypadku

p = q = 1=2 daje m = x

1

+

x

2

2 , czyli ±redni¡ arytmetyczn¡. Moment zwykªy

rz¦du

k wynosi m

k

=

x

k

1

p + x

k

2

q.

Szczególnym przypadkiem rozkªadu dwupunktowego jest rozkªad zero-jedyn-

kowy, rozwa»any ju» w punkcie 2.2.2. Zajmiemy si¦ tym przypadkiem dokªad-

niej, bo mimo swej prostoty, (a mo»e wªa±nie dzi¦ki swej prostocie), jest on

podstaw¡ wielu dalszych rozwa»a«.

Niech

X

i

,

i = 1;2:::;n b¦dzie ci¡giemniezale»nychzmiennychlosowych o tym

Rozkªad zero-

jedynkowy

samym rozkªadzie zero-jedynkowym, Pr(

X

i

= 1) =

p, Pr(X

i

= 0) =

q = 1

,

p.

Oznaczmy przez

X sum¦ n takich zmiennych losowych:

X = X

1

+

X

2

+

+

X

n

:

(2.3.1)

Z twierdze« 2.2.1 i 2.2.4 otrzymujemy równo±ci: E

X = np i D

2

X = npq, sk¡d

te»

=

X

=

p

npq.

Zbadajmy rozkªad zmiennej losowej

X, to znaczy obliczmy prawdopodobie«-

stwa Pr(

X = k) = p

k

. Przede wszystkim zauwa»my, »e

k mo»e zmienia¢ si¦

tylko od 0 do

n. Poniewa» zdarzenie

f

X = k

g

zachodzi wtedy i tylko wtedy,

gdy na dokªadnie

k pozycjach w sumie pojawi si¦ jedynka { prawdopodo-

bie«stwo tego wynosi

p

k

q

n

,

k

, a mo»liwych takich ukªadów

k jedynek w ci¡gu

n-elementowym jest

,

n

k

, to

Rozkªad

dwumianowy

Pr(

X = k) =

n

k

p

k

q

n

,

k

:

(2.3.2)

Wzór (2.3.2) okre±la rozkªad, znany jako rozkªad dwumianowy (gªównie w lite-

raturze anglosaskiej) lub rozkªad Bernoulliego

6

. Zmienn¡ losow¡

X okre±lon¡

wzorem (2.3.1) mo»na interpretowa¢ jako liczb¦ sukcesów (jedynek) w ci¡gu

niezale»nych do±wiadcze«, zwanych próbami Bernoulliego, gdzie prawdopodo-

bie«stwo sukcesu wynosi

p, a pora»ki (zera) wynosi q = 1

,

p.

Przykªad.

Wykonujemy ci¡g

n = 10 do±wiadcze« Bernoulliego. W ka»dym

z nich odnosimy sukces z prawdopodobie«stwem

p = 0:9. Jakie jest prawdo-

podobie«stwo, »e w w dokªadnie jednej próbie lub w nie wi¦cej ni» 10% prób

odniesiemy sukces. W tym przypadku rozwi¡zanie jest proste. Zarówno w jed-

nym jak i w drugim przypadku obliczamy

Pr(

X = 1) =

10

1

0

:9

1

0

:1

9

= 9

10

,9

:

6

Jakub Bernoulli (1654 { 1705), matematyk szwajcarski, jeden z licznej rodziny Berno-

ullich, autor

A

rs

c

onje

ctandi

, pierwszego dzieªa po±wi¦conego rachunkowi prawdopodobie«-

stwa.

2.3 Rozkªady dyskretne

26

Co jednak b¦dzie, gdy przy tym samym

n b¦dzie p = 0:09? Obliczenie liczby

0

:09

0

:91

9

jest ju» kªopotliwe, a obliczenie prawdopodobie«stwa, »e uda si¦ nie

wi¦cej ni» 10% do±wiadcze« z 1000 prób jest ju» praktycznie bardzo trudne.

Spróbujmy bowiem bezpo±rednio i dokªadnie obliczy¢

Pr(

X

¬

100) =

100

X

k

=0

1000

k

p

k

q

1000,

k

:

Napisanie procedur (np. w Pascalu lub C) wykorzystuj¡cych wprost wzory

(2.3.2) i obliczaj¡cy wspóªczynniki Newtona ze wzoru rekurencyjnego

n

k

=

n

,

1

k

,

1

+

n

,

1

k

nie daje zadowalaj¡cych efektów dla wi¦kszych

n i k.

Dla wygody przyjmiemy oznaczenie

Wzór

rekurencyjny

b(n;k;p) =

n

k

p

k

q

n

,

k

:

Wtedy ªatwo jest udowodni¢ wzór rekurencyjny

b(n;0;p) = q

k

;

(2.3.3)

b(n;k + 1;p) = n

,

k

k + 1

p

q b(n;k;p):

(2.3.4)

Wzór ten do bezpo±redniego zaprogramowania nadaje si¦ w równie maªym

stopniu jak i wzór (2.3.2), ale stanowi¢ b¦dzie podstaw¦ dla efektywnych przy-

bli»e« rozpatrywanych w nast¦pnym punkcie.

2.3.2. Rozkªad Poissona

Zmienna losowa

X przyjmuj¡ca tylko waro±ci caªkowite nieujemne ma rozkªad

Poissona

7

z parametrem

, gdy

Pr(

X = k) = e

,

k

k! :

(2.3.5)

Denicja tego rozkªadu jest poprawna, to znaczy wszystkie prawdopodobie«-

stwa s¡ nieujemne i sumuj¡ si¦ do jedynki, gdy» jak wiadomo z rozwini¦cia

funkcji

e

x

w szereg Maclaurina,

1

X

k

=0

e

,

k

k! = e

,

1

X

k

=0

k

k! = e

,

e

= 1

:

Podobnie jak dla rozkªadu dwumianowego, równie» dla rozkªadu Poissona

przyjmiemy oznaczenie

p(k;) = e

,

k

k! :

2.3 Rozkªady dyskretne

27

Twierdzenie 2.3.1.

(Poissona) Je»eli

np = np

n

!

dla n

!

1

, to dla

Przybli»enie

rozkªadem

Poissona

ka»dego

k,

lim

n

!1

b(n;k;p) = p(;k):

(2.3.6)

Dowód.

Dla uproszczenia przyjmiemy

np = , zamiast granicy np

!

. Dowód

przeprowadzimy przez indukcj¦.

1

b

n;0; n

=

n

0

1

,

n

n

!

e

,

;

2

b

,

n;k + 1;

n

b

,

n;k;

n

=

,

n

k

+1

,

n

k

p

q =

n

,

k

k + 1

n

1

,

n

!

k + 1 =

p(k + 1;)

p(k;) ;

co daje wzór (2.3.5)

Uwaga.

Twierdzenie 2.3.1 daje dobre przybli»enie rozkªadu dwumianowego

Przybli»enie

dla ±rednich

rozkªadem Poissona, gdy

n jest du»e, (n

100),

p jest maªe, a ±rednie.

Wtedy zamiast (2.3.6) mo»na przyj¡¢

b(n;k;p)

p(;k):

(2.3.7)

Przykªad.

W

n = 100 próbach Bernoulliego prawdopodobie«stwo sukcesu

wynosi

p = 0:98. Niech X b¦dzie liczb¡ pora»ek. Prawdopodobie«stwo pora»ki

wynosi

q = 0:02. Szukamy prawdopodobie«stwa, »e poniesiemy co najwy»ej

jedn¡ pora»k¦. Poniewa»

= nq = 2, to mo»na zastosowa¢ przybli»enie wzo-

rem (2.3.7):

Pr(

X

¬

1) = Pr(

X = 0) + Pr(X = 1)

e

,2

2

0

0! +

2

1

1!

= 3

e

,2

:

Przykªad.

Prawdopodobie«stwo przesªania bª¦dnego bitu wynosi 2

:5

10

,9

niezale»nie od pozostaªych. Przesyªamy 10

8

bitów i na ko«cu dodajemy bit pa-

rzysto±ci. Bª¦dny ci¡g odbierzemy jako prawdziwy, gdy przekªamaniu ulegnie

parzysta liczba bitów. Prawdopodobie«stwo odebrania bª¦dnego ci¡gu jako

prawdziwego, wynosi w przybli»eniu

2

e

,

=2, gdzie = 0:25, gdy» prawdo-

podobie«stwo przekªamania czterech bitów wynosi

4

e

,

=24 i mo»e by¢ po-

mini¦te, tak jak i dalsze parzyste liczby przekªama«. Tak wi¦c prawdopodo-

bie«stwo odebrania bª¦dnego ci¡gu jako prawdziwego wynosi w przybli»eniu

2

e

,

=2! = 2:5

2

e

,0

:

25

=2 = 0:2565.

Na koniec obliczmy parametry w rozkªadzie Poissona { warto±¢ oczekiwan¡

i wariancj¦.

Twierdzenie 2.3.2.

Je»eli zmienna losowa

X ma rozkªad Poissona z parame-

trem

, to EX = i D

2

X = .

7

Simeon Denis Poisson (1781 { 1840), francuski mechanik, zyk i matematyk

2.3 Rozkªady dyskretne

28

Dowód.

Korzystaj¡c z twierdzenia 2.3.1 mo»na zauwa»y¢, »e przyjmuj¡c

!

np otrzymujemy

E

X = lim

n

!1

np =

oraz

D

2

X = lim

n

!1

np(1

,

p) = lim

n

!1

1

,

n

:

2.3.3. Zadania

1.

Prawdopobie«stwo sukcesu w jednej próbie wynosi 0

:01. Niech X

n

b¦dzie

liczb¡ sukcesów w

n niezale»nych próbach. Znale¹¢ Pr(X

¬

1), gdy a)

n = 3,

b)

n = 100.

2.

Ksi¡»ka o 500 stronicach zawiera 50 bª¦dów drukarskich. Obliczy¢ prawdo-

podobie«stwo tego, »e na przypadkowo wybranej stronicy znajd¡ si¦ co naj-

mniej 3 bª¦dy.

3*.

Pokaza¢, »e je±li

X ma rozkªad dwumianowy przy ustalonym n i p, to

b(n;k;p) ma tylko jedn¡ lub dwie równe warto±ci najwi¦ksze. Znale¹¢ takie k

przy których te warto±ci s¡ przyjmowane.

4*.

Pokaza¢, »e analogiczn¡ wªasno±¢ maj¡ prawdopodobie«stwa w rozkªadzie

Poissona.

5.

Bity przekazywane szeregowo s¡ przekªamywane niezale»nie od siebie, ka»dy

z prawdopodobie«stwem

p = 10

6

. Na ko«cu ka»dego bloku bitów dodajemy bit

parzysto±ci. Jaka jest najwi¦ksza dªugo±¢ bloku, przy której prawdopodobie«-

stwo niewykrycia bª¦du jest mniejsze od 0.001?

2.4 Rozkªady ci¡gªe

29

2.4. Rozkªady ci¡gªe

2.4.1. Rozkªad jednostajny

Rozkªad jednostajny na odcinku [

a;b] ma g¦sto±¢ okre±lon¡ wzorem

f(x) =

8

<

:

1

b

,

a dla x

2

[

a;b],

0

dla

x =

2

[

a;b].

Momenty zwykªe

m

k

= 1

b

,

a

b

Z

a

x

k

dx = 1

b

,

a

x

k

+1

k + 1

b

a

= b

k

+1

,

a

k

+1

(

b

,

a)(k + 1)

maj¡ dla

a = 0 i b = 1 szczególnie prost¡ posta¢ (patrz zadanie 1 do roz-

dziaªu 2.2):

m

k

= 1

=(k + 1). St¡d obliczamy wariancj¦

2

=

m

2

,

m

2

1

= a

2

+

ab + b

2

3

,

a

2

+ 2

ab + b

2

4

= (b

,

a)

2

12 :

Dla rozkªadu jednostajnego momenty centralne nieparzystego rz¦du s¡ równe

zeru. atwo jest te» obliczy¢ momenty rz¦du parzystego, co jednak pozosta-

wimy jako zadania 6 i 7 do tego rozdziaªu. Zauwa»my tu jednak, (co b¦dzie

pomocne przy rozwi¡zywaniu tych zada«), »e je±li zmienna losowa

X ma roz-

kªad jednostajny na odcinku [0

;1], to zmienna losowa Y = (b

,

a)X + a ma

rozkªad jednostajny na odcinku [

a;b].

2.4.2. Rozkªad wykªadniczy

Rozkªad wykªadniczy z parametrem

> 0 ma g¦sto±¢ okre±lon¡ wzorem

f(x) =

(

e

,

x

dla

x

0,

0

dla

x < 0,

(2.4.1)

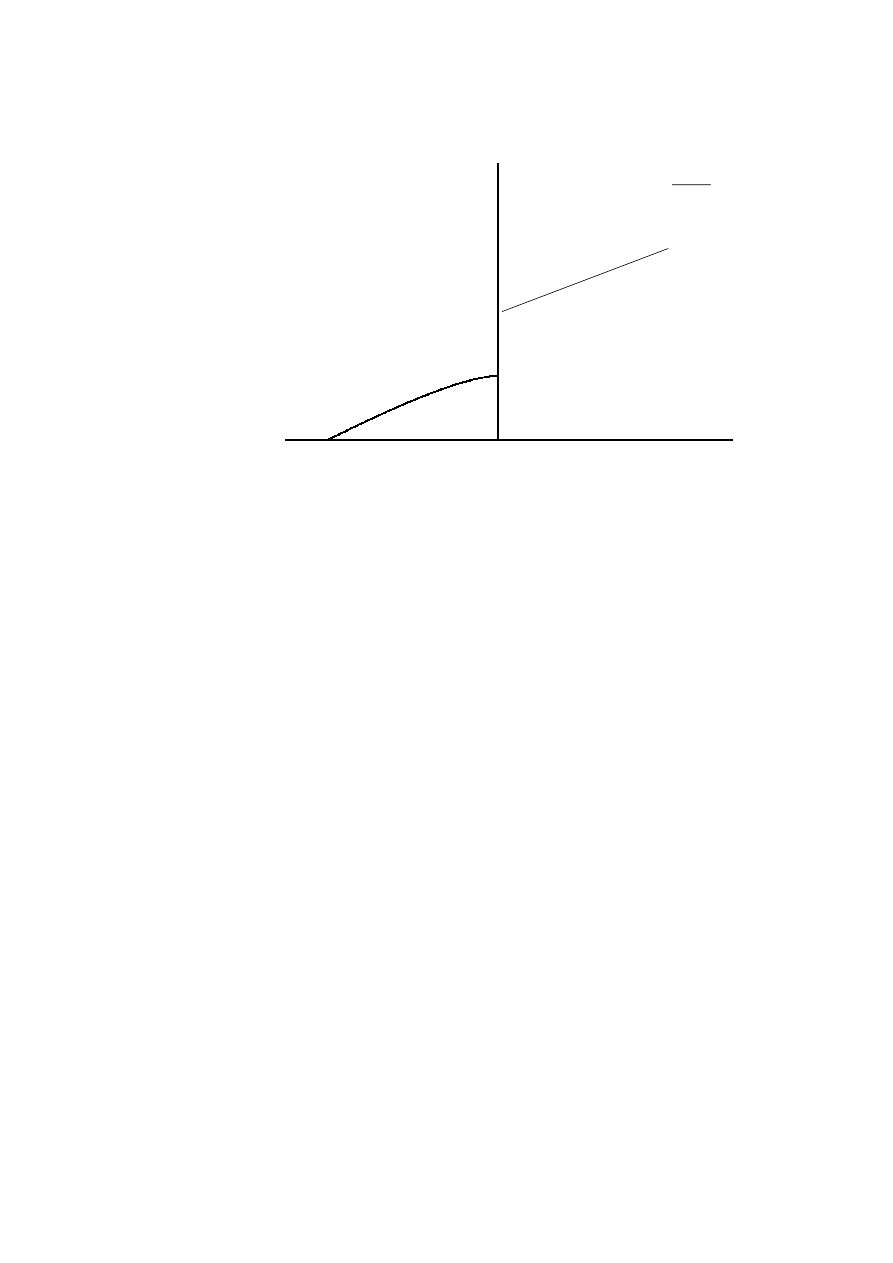

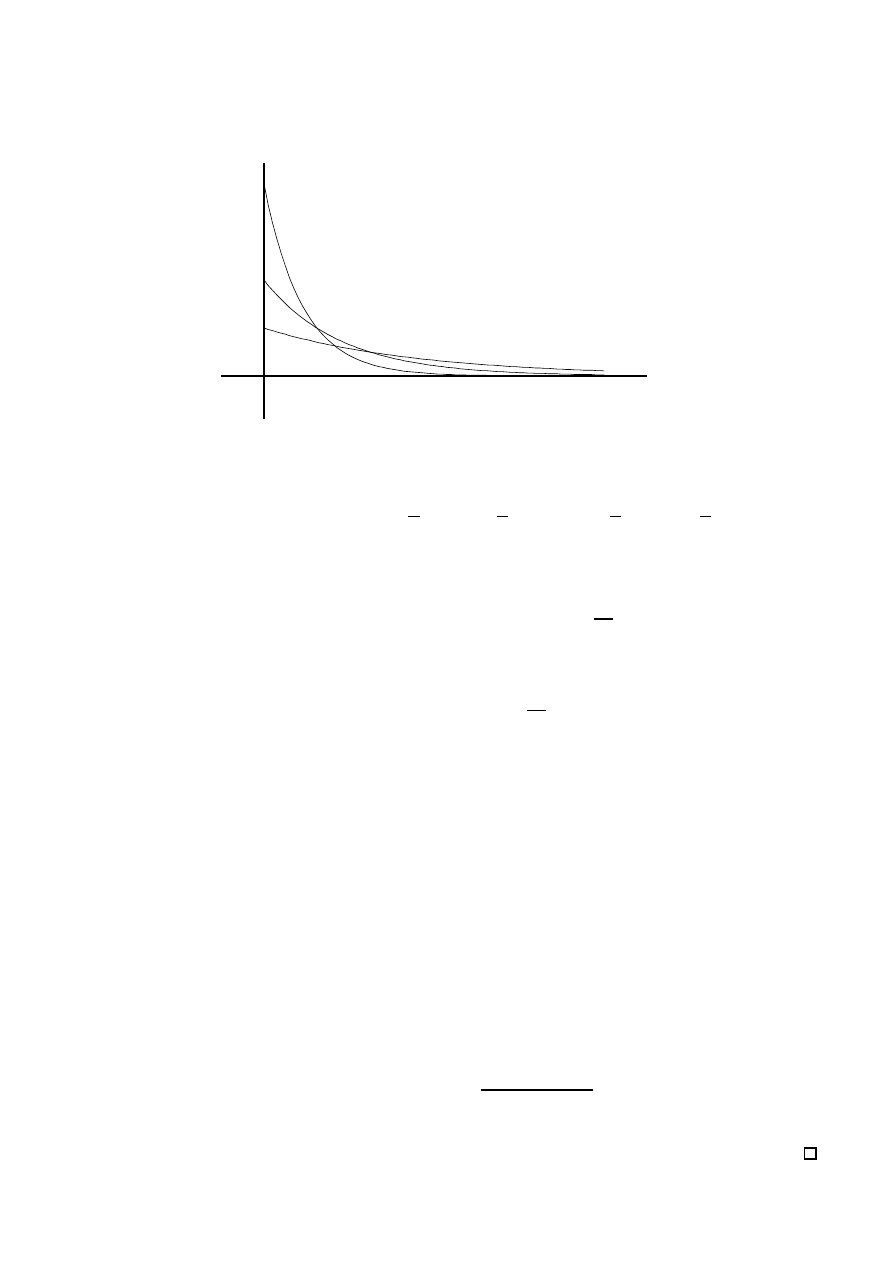

której wykres jest przedstawiony na rysunku 4. Ze wzoru (2.4.1) otrzymujemy

wzór na dystrybuant¦

F(x) =

(

1

,

e

,

x

dla

x

0,

0

dla

x < 0.

(2.4.2)

Obliczmy dwa pierwsze momenty i wariancj¦.

m

1

=

1

Z

0

xe

,

x

dx;

sk¡d obliczaj¡c caªk¦ przez cz¦±ci, (

e

x

=

,

,

e

,

x

0

), otrzymujemy

Warto±¢

oczekiwana

2.4 Rozkªady ci¡gªe

30

6

-

x

f(x)

= 1

= 0:5

= 2

Rysunek 4: Wykres g¦sto±ci rozkªadu wykªadniczego

m

1

=

0

@

,

x

e

,

x

1

0

+ 1

1

Z

0

dx

1

A

=

,

1

e

,

x

1

0

= 1 :

Podobnie, ale dwukrotnie caªkuj¡c przez cz¦±ci, obliczamy

m

2

=

1

Z

0

x

2

e

,

x

dx = 2

2

;

sk¡d

Wariancja

2

= 1

2

:

Rozkªad wykªadniczy jest cz¦sto u»ywany w teorii niezawodno±ci, gdzie dobrze

opisuje czas pracy elementów niestarzej¡cych si¦. Je»eli zmienna losowa

T jest

czasem pracy elementu, to

= 1= jest ±rednim czasem pracy, a parametr

= 1= jest nazywany intensywno±ci¡ uszkodze«. Niestarzenie si¦ elementu

oznacza, »e prawdopodobie«stwo uszkodzenia si¦ elementu w czasie

t od chwili

obecnej, nie zale»y od dotychczas przepracowanego czasu

t

0

. Wªasno±¢ ta nazy-

wana jest brakiem pami¦ci rokªadu wykªadniczego. Sformuªujemy j¡ w postaci

twierdzenia.

Twierdzenie 2.4.1.

Je»eli

T jest zmienn¡ losow¡ o rozkªadzie wykªadniczym,

to

Pr(

T > t + t

0

j

T > t

0

) = Pr(

T > t):

(2.4.3)

Dowód.

Poniewa»

f

T > t+t

0

g

f

T > t

g

oraz Pr(

T > t) = 1

,

F(x) = e

,

t=

,

to

Pr(

T > t + t

0

j

T > t

0

) = Pr(T > t + t

0

)

Pr(

T > t

0

)

=

e

(

t

+

t

0

)

=

e

,

t

0

=

=

e

,

t=

= Pr(

T > t):

2.4 Rozkªady ci¡gªe

31

Mo»na te» pokaza¢, czego jednak nie b¦dziemy robi¢, »e tylko rozkªad wykªad-

niczy ma wªasno±¢ braku pami¦ci, to znaczy speªnia równanie (2.4.3).

Uogólnieniem rozkªadu wykªadniczego jest rozkªad Weibulla, którego dystry-

Rozkªad

Weibulla

buanta jest modykacj¡ dystrybuanty danej równaniem (2.4.2)

F(x) =

(

1

,

e

,

x

dla

x

0,

0

dla

x < 0.

(2.4.4)

G¦sto±¢ tego rozkªadu wyra»a si¦ wzorem

f(x) =

(

x

,1

e

,

x

dla

x

0,

0

dla

x < 0,

(2.4.5)

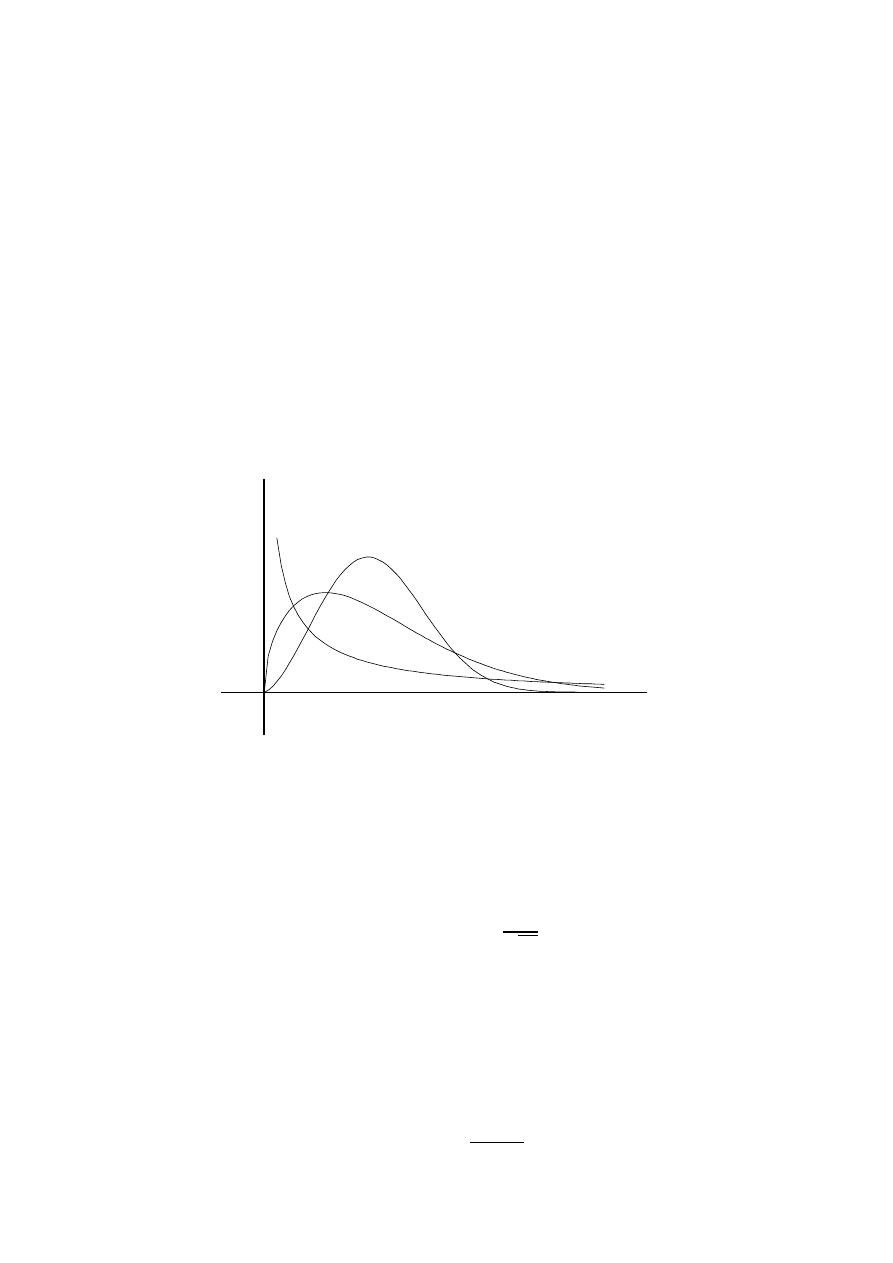

której wykres dla

= 1 i = 0:5, = 1:5, = 2:5 jest przedstawiony na

rysunku 5. Przypadek

= 1 daje rozkªad wykªadniczy. Rozkªad Weibulla jest

6

-

x

f(x)

= 0:5

= 1:5

= 2:5

Rysunek 5: Wykres g¦sto±ci rozkªadu Weibulla

stosowany w teorii niezawodno±ci.

2.4.3. Rozkªad normalny

Rozkªad normalny N(0

;1) ma g¦sto±¢ dan¡ wzorem

f(x) = 1

p

2

e

,

x

2

=

2

;

(2.4.6)

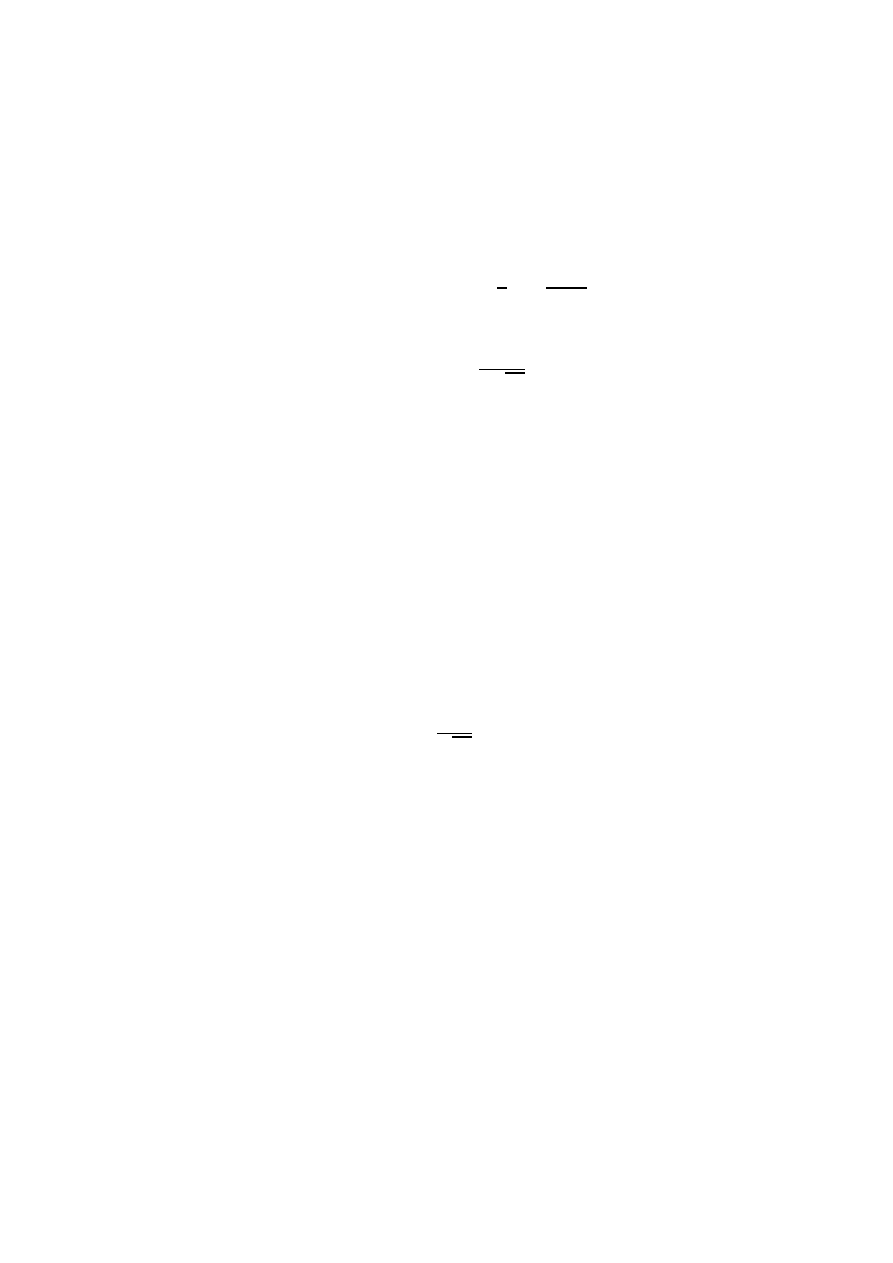

której wykres jest przedstawiony na rysunku 6. Je±li zmienna losowa

Y ma

rozkªad normalny N(0

;1), to zmienna losowa

Rozkªad

normalny

N(

m;

)

X = Y + m

(2.4.7)

ma rozkªad normalny N(

m;). W ten sposób deniuje si¦ rozkªad normalny o

parametrach

m i . Z drugiej strony, je±li X ma rozkªad normalny N(m;), co

oznaczamy symbolicznie jako

X

N(

m;), to jak ªatwo sprawdzi¢

e

X = X

,

m

N(0

;1):

(2.4.8)

2.4 Rozkªady ci¡gªe

32